Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как я написал книгу почти по социнжинирингу |

Как я написал книгу почти по социнжинирингу

Когда от издательства пришло письмо про готовность, я старался не дышать. Кенгуру валлаби с детёнышем в сумке уже подошла на три метра и шевелила носом. Боялась и что-то подозревала, но морковки ей хотелось больше. Потом было ещё много австралийских приключений вдали от цивилизации, поэтому про поступление книги в магазины я узнал уже из писем читателей. Оказалось, нужно не только владельцам бизнеса. Это удивляло.

Если коротко – она о том, как рассказывать истории. Точнее даже так: как в работающем бизнесе (или другом проекте) выбрать самые интересные истории, правильно их подать, в полной мере собрать факты и не облажаться потом. Методология построена именно на «не облажаться потом», то есть на проверке фактов и очень спокойной работе без истерических криков. Это продаёт, и этот канал рассказов о своих проектах называется контент-маркетингом (термин появился позже, чем тот же Фёдор из Сыктывкара начал рассказывать про свой книжный бизнес, но раньше, чем он начал печь пиццу). Ещё Евгений Чичваркин с Евросетью живо чувствовал, что нужно что-то такое – но он хотел снимать шоу про работу магазина, чтобы с отжимом поставщиков, собеседованиями, злыми клиентами, инвентаризациями и другими взлётами и падениями.

Я собрал в кучу всё то, что хотел рассказать про то, как писать посты, собирать информацию для них, как убеждать на сайте и прочее-прочее-прочее. Но всё равно много где – психология влияния.

О чём книга

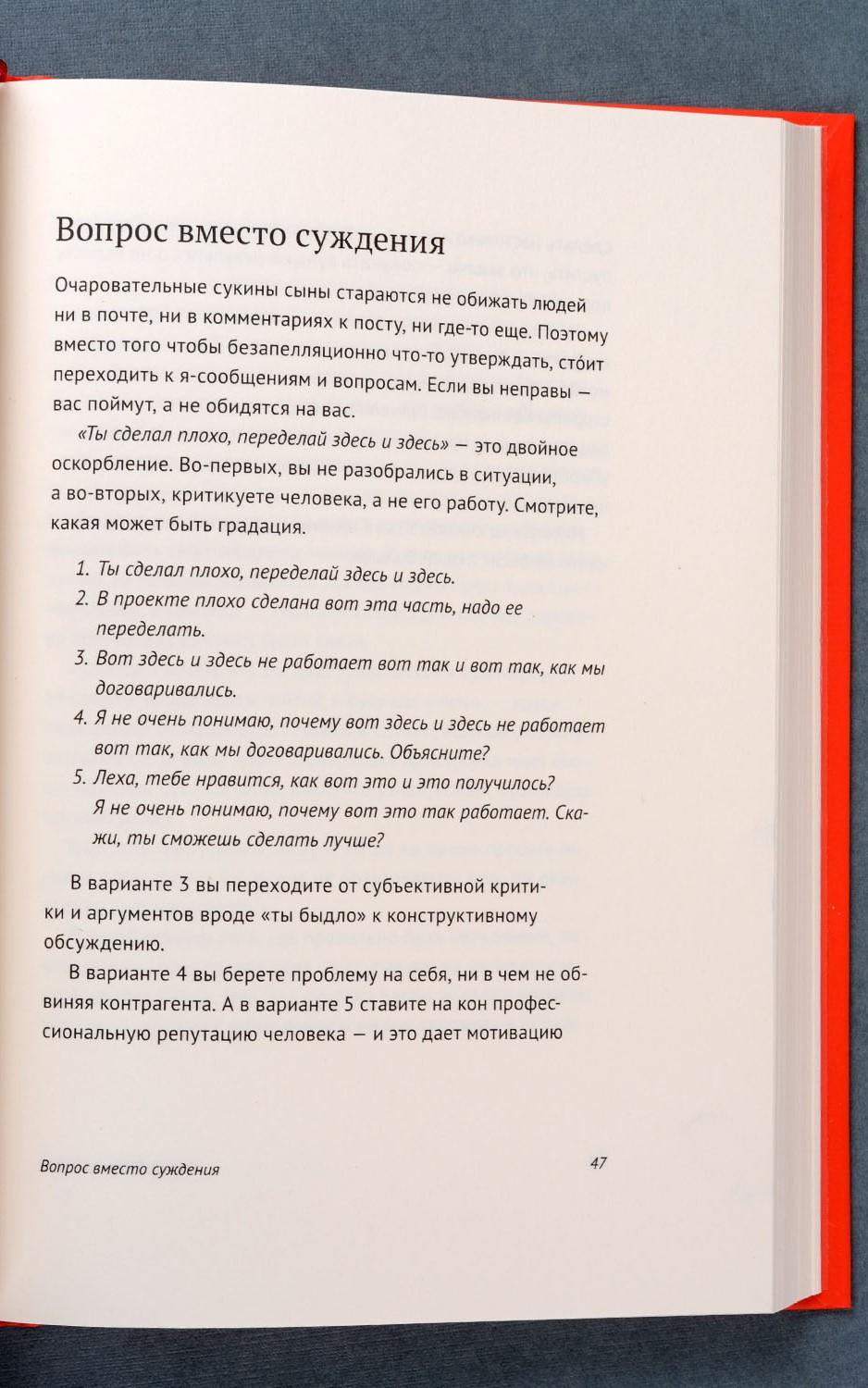

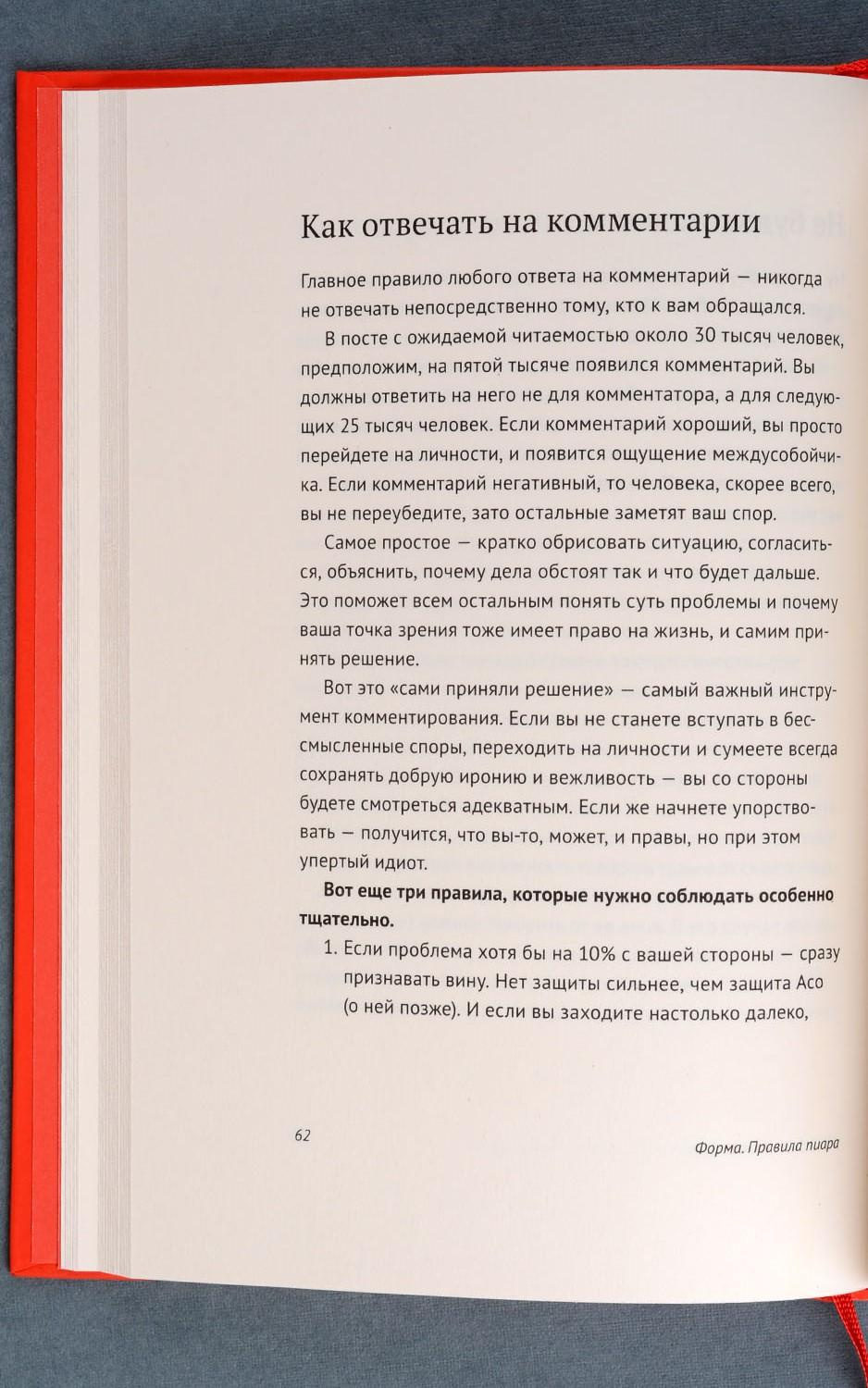

Первая здоровенная часть – о том, как и что рассказывать. Логика выстроения системы такая: если принять за аксиому желаемый результат (о вас знают как о позитивной компании далеко за пределами рынка), то дальше можно начать доказывать всё в обратную сторону – к тому что рассказывать и как рассказывать. И в этой системе доказательств произойдут достаточно неожиданные отсечки. Например, в ответе на комментарий не имеет смысла отвечать тому, кто задал вопрос (точнее, как – не имеет смысла его переубеждать, ответ предназначается для одного него и ещё 5-10 тысяч других людей). В письменной форме никогда не должно быть негатива – его только устно. Потому что можно не так понять, можно перечитать, можно вернуться через год, можно процитировать и т.п. Долгий анализ реакции на разные ответы в обсуждениях породил механики ответов неадекватам и конкурентам (частая задача на просторах Рунета) — там, где не помогает обычная логика, лёгкое изменение формы ответа резко меняет эффект. Помните, как в анекдоте про связистов, мол, вышку построили, теперь голова болит у всей деревни и тараканы мрут? Это ещё фигня, через неделю питание подадим. Плюс форма – почему надо коротко, понятно и предельно конкретно.

Вторая часть – уже про работу журналиста внутри компании. Я когда-то был редактором астраханской детской газеты, и ещё помню хардкор от опытных журналистов. Нас гоняли за поиск объективной информации и оценку разных точек зрения как не в себе. Мою хрупкую детскую психику раз и навсегда травмировал дядька Кара-Мурза, который читал лекцию про манипуляции сознанием (я передал его эстафету в одном детском робототехническом лагере с похожей лекцией, — вожатые ещё не в полной мере понимали, что при выборе тем «размножение человека» и «социальная инженерия» первое безопаснее). В общем, там практические наработки, что и как делать внутри компании.

Третья часть – для тех, кто вообще не умеет писать. Там короткие ликбезы. Часть вы могли видеть на Мегамозге (когда он ещё был жив).

В общем, я надеюсь, что получилась полезная штука для тех, кто не знает, что писать и о чём писать про своё дело. Ну и как это всё правильно начать и продолжить.

Как шло издание

У меня снова подло похитили букву «ё» со всей книги. Потом, правда, часть вернули, где по смыслу было не обойтись.

Корректор зачем-то расставил ударения в словах (но при этом пропустил минимум две опечатки). Меня это тоже немного расстраивает, потому что каждый раз, когда я вижу слово со знаком ударения, мне хочется прочитать его наоборот — мозг решает, что это нестандартная версия, и надо углубиться в распознавание. Вот пример в начале страницы:

Снова адские переносы, но я уже знаю, что книгу через несколько недель похитят пираты и всё поправят в fb2-формате. Я скачаю и успокоюсь. Вот пример — вроде это «ся» грамотное, но контринтуитивное. Возможно, конечно, я как-то не так читаю:

Сам рабочий процесс шёл куда быстрее. Когда уже понятно, что и как делать, всё очень просто. Долго бодались с названием. Я всегда смеялся, когда слышал «Евангелист Яндекса» (это Бобук, например), но тут пришлось перестать. Потому что, оказалось, что ничего более сжатого по смыслу нет. Итог вот такой:

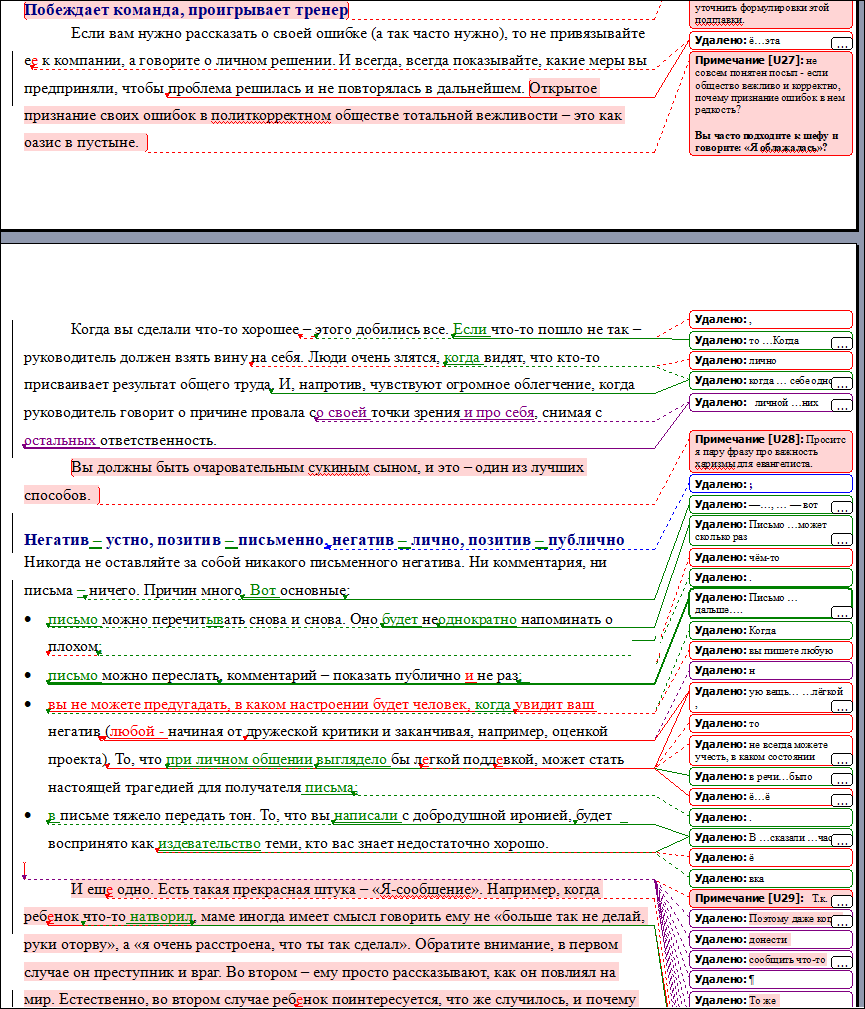

Литредактор у МИФа прекрасный. Эта милая девушка набрасывалась на текст с яростью дракона, присылая кровавое месиво из правок. Ниже одна страница. Так вот, вся книга по всей длине была именно такой:

Я примерно так же работаю с новыми райтерами, вызывая у них леденящий душу набор впечатлений. Она чистила мой ужасный разговорный язык, а я отстаивал важные конструкции. В этот раз удалось сохранить русские написания многих англицизмов, ура.

Вот как-то так. Вот тут лежит оглавление и ещё пара страничек.

Теперь немного статистики. По первой книге «Бизнес как игра» статистика такая: 17 тысяч продано в бумаге, чуть меньше 3 тысяч раз книга куплена в электронном виде и примерно 30 тысяч раз она закачана пиратами, похоже, в основном через сервис Мейл.ру Вконтакте (оценки примерные, про пиратов так вообще пальцем к носу). Критерий успешности — 3 тысячи копий в год на бумаге. Критерий прямо-огонь-бестселлера — около 20 тысяч копий в год. Говорят, с книгами, не привязанными к конкретным историческим моментам типа «Эффективная работа в Windows 98» тиражи с годами обычно растут.

МИФ, кстати, оказывается, яростно борется с пиратами, и там можно писать целые приключенческие романы про это. Подозреваю, что их контрагент умеет раскладывать сайты-обманки, где в поиске предлагается скачать книгу бесплатно, а вместо файла — короткая демо на 33 страницы или просто реферальная ссылка на Озон или ещё куда. Но это не точно, что они. Надо было ещё что-то подписать про удаление с обменников, но я не стал. Сюрприз в том, что в обмен хотелось обновить файл на Флибусте (там опечатки). Мне кажется, только природная вежливость книжных людей спасла меня от фразы: «Флибуста? Ты что, в конец охренел?».

Следующий момент. Книга пришла в Озон ниже, чем рекомендованная розничная цена, то есть чем цена у нас, например. Или ещё где в книжном. Там вообще волшебная история — похоже, что они автоматически упали, когда повысилась доля поиска в категории: это отличная механика же. Издатель анонсирует, а весь эффект ловят именно они. У нас, правда, слово «Хабрахабр» при заказе даёт скидку, уравнивающую шансы.

Ну и ещё от хабралюдей было много вопросов, как показывать книгу издателю. Всё просто: примерное оглавление (потом можно будет менять) и 10-15 страниц (или одну-две главы, если они большие). Уже по этому редактор говорит, ок или нет, и если ок — ждёт финальный текст. Это сильно проще, чем написать цикл постов на Хабр — так что если у вас есть что-то вневременное без привязки к текущему ПО — возможно, стоит немного подготовиться и спросить.

|

Метки: author Milfgard управление проектами управление медиа блог компании мосигра книга социнжиниринг истории |

Хакатон от ABBYY |

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

Хакатон от ABBYY

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

А подробности ниже.

Хакатон mABBYYlity – это 24-часовой конкурс по разработке сервисов для мобильных платформ с применением технологий интеллектуальной обработки информации. Мы хотим дать возможность разработать уникальный продукт вместе с отличными разработчиками и менторами, шанс зарекомендовать себя перед представителями крупных IT-компаний и получить приятные подарки.

За 24 часа в команде из 2-5 человек или самостоятельно участникам mABBYYlity предстоит придумать или развить бизнес-идею и создать прототип приложения или сервиса для мобильных устройств в сфере обработки текста, изображений, документов и форм. Это могут быть решения в следующих областях:

• боты, сервисы в социальных сетях и мессенджерах;

• дополненная реальность в мобильных устройствах;

• обработка текстов, классификация документов, поиск;

• распознавание и обработка изображений и видео;

• улучшение, дополнение, фильтрация фотографий;

• распознавание и обработка изображений в браузере;

• распознавание в камерах различных устройств;

• цифровое предприятие, повышение продуктивности;

• технологии повышения безопасности;

• облачные технологии и сервисы;

• технологии обмена информацией.

ABBYY предоставит всем участникам доступ к собственным продуктам для разработчиков. Кроме того, команды смогут использовать любые общедоступные инструменты для разработки.

Лучшие мобильные продукты по итогам хакатона выберет экспертное жюри. В него вошли:

• директор по продуктам группы компаний ABBYY Андрей Исаев;

• руководитель департамента мобильных продуктов ABBYY Игорь Акимов;

• руководитель отдела образовательных проектов ABBYY Андрей Очеретный;

• руководитель проектного офиса ZeptoLab Пётр Савельев;

• CEO Maps.Me Евгений Лисовский;

• менеджер по работе с разработчиками Google Звиад Кардава;

• исполнительный директор по экосистеме цифровых ресурсов Сбербанка Анатолий Стояновский;

• руководитель команды машинного обучения Яндекс.Такси Виктор Кантор;

• руководитель направления развития мобильных сервисов Бинбанк Диджитал Анастасия Бельченко.

Эксперты оценят результаты команд по следующим критериям: рыночный потенциал идеи и актуальность решаемой проблемы, техническая реализация продукта и прогресс команды за время хакатона, соответствие идеи продукта направлению мероприятия, а также степень новизны и оригинальности идеи.

Узнать больше и подать заявку можно на сайте mobility.abbyy.com/hack.

Добавляйтесь в соцсети, там много интересного пишу про новые технологии в рамках направлений конкурса: Telegram, Facebook, VK

Ну и ещё раз напомню про конкурс идей. Он отдельный от хакатона и продлится до 30 сентября. Результаты конкурса будут объявлены на открытии хакатона mABBYYlity. Победители получат новейшие модели устройств на платформах iOS и Android, в том числе iPhone X. Подать заявку на конкурс идей можно на сайте mobility.abbyy.com/ideas.

|

|

Как построить самоуправляемый бизнес: формулируем «законы робототехники» Hamster Marketplace |

- Управление сообществом,

- Развитие стартапа,

- Венчурные инвестиции,

- Бизнес-модели,

- Блог компании Hamster Marketplace

Как построить самоуправляемый бизнес: формулируем «законы робототехники» Hamster Marketplace

- Управление сообществом,

- Развитие стартапа,

- Венчурные инвестиции,

- Бизнес-модели,

- Блог компании Hamster Marketplace

Контракты с ритейлерами держат в ежовых рукавицах?

— Тогда сделаем маркетплейс только нишевой электроники и гаджетов

Невозможно вынырнуть из-под потоков хлама с Али настолько дешёвого, что и не важно, что это хлам?

— Пусть у нас будут только уникальные товары, а не sort of, зато в 20 раз дешевле

Комиссия «Амазона» обходится дороже, чем ты можешь себе позволить?

— Значит, надо делать маркетплейс некоммерческим, чтобы его услуги стоили ровно столько, сколько стоит их оказать

Но кто им тогда будет управлять?

— Да мы сами, вендоры, управлять и будем

Кстати, если вы тоже вендор и узнали свою головную боль в вопросах выше — пожалуйста, ответьте на несколько вопросов в этой гугл-форме.

К счастью, эта идея ему пришла в голову в 2017 году, а не в 1997 — то есть когда уже не нужно разрабатывать инструмент организации распределённого управления предприятием тысячами незнакомых друг с другом акторов, гарантирующий прозрачность и надёжность этого процесса. Да, блокчейн уже изобретён. Но восхищаться уникальными свойствами сетевой технологии, хорошо справляющейся с передачами небольших пакетов данных — это одно. Заставить многоуровневый глобальный бизнес, сочетающий несколько мощных направлений работы (логистика, поддержка, платежи), оперировать на том же уровне эффективности внутри двухмерной структуры — уже немного другое. Так ли уютно будет жить вместо дома на его чертеже в натуральную величину?

Айзек Азимов

И причём здесь Айзек Азимов?

Ну во-первых, он один из наших самых любимых фантастов.

А во-вторых, когда мы сели записывать принципы, по которым должна действовать подлинно децентрализованная распределённая система управления бизнесом, то очень быстро стало ясно, что мы пишем свои законы робототехники. Только в нашем случае, хочется верить, есть не просто все шансы дожить до применения теории наяву, а прямо этому поспособствовать.

Кстати, Айзек был абсолютным детерминистом, если вы помните его цикл «Основание»: вот уж что-то, а идею самоуправляемой без вмешательства извне системы он бы точно одобрил.

Начинаем копать

Автоматизация и децентрализация процесса управления бизнесом может внедряться на самых разных уровнях: от поверхностного до глубинного, создающего принципиально новую форму управления компанией.

Самое простое, что себе можно представить — это управление компанией по принципу акционерного общества, где держатели акций — производители, представленные на маркетплейсе — раз в год выбирают руководство компании, а уже оно управляет ей как обычным бизнесом, за зарплату и бонусы. Блокчейн в данном случае выполняет роль защиты от корпоративных махинаций с голосованием.

На следующем уровне погружения в архитектуру бизнеса, блокчейн может предоставить надёжную инфраструктуру для отчётности. Согласно новейшим директивам Евросоюза, записи в блокчейне могут приниматься проверяющими органами как валидные официальные документы. Тем более их должно быть достаточно акционерам компании, желающим быть уверенным в достоверности приводимых в отчётности менеджментом данных.

Если два перечисленных выше пункта в той или иной степени уже не новы, то управление бюджетированием компании, распределением средств непосредственно через блокчейн ещё ни один бизнес в мире не занимался. Блокчейн здесь даже нужен не столько как механизм транзакций (легальный бизнес всё равно ещё не скоро сможет функционировать полностью за счёт криптовалюты), а как механизм передачи и учёта распоряжений в обычный банк. Распоряжения в виде смарт-контрактов позволяют дополнительно автоматизировать, ускорить процесс с одной стороны, и гарантировать новый уровень надёжности — с другой.

Четвёртый, глубокий, как лимб в фильме «Начало», уровень — это прямое управление через блокчейн. Менеджмент маркетплейса в этом случае сводится к своего рода секретариату/мозговому тресту, сопровождающему процесс оформления предложений. А предложения принимаются, становясь решениями, или не принимаются и остаются в этом лимбе навсегда прямым блокчейн-голосованием. Этот уровень наиболее интересен, поэтому рассмотрим некоторые его принципы подробнее.

Как принимаются решения

Решение — это главный строительный материал любого процесса, любого дела, любой системы, любого бизнеса. По сути, любая организационная структура из одних решений и состоит.

При этом, решение в смысле «распоряжение», «указ», «приказание» — это всего лишь одна из стадий процесса, который на самом деле начинается вовсе не с принятия решения.

Стадии решения:

- Определение проблемы. Решение — это ответ, но ответу нужен вопрос. А вопросу — основания его задать. Решение несуществующей проблемы подобно умножению на ноль. Тем не менее, в любых видах человеческой активности всегда находятся любители и даже профессионалы паразитировать на лакунах коммуникации, создавая видимость бурной деятельности там, где делать вообще нечего. Поставить проблему может любой участник системы децентрализованного управления или даже аутсайдер, если кто-то из участников одобрит входящее сообщение.

- Валидация проблемы. В любой системе прямой демократии будет какой-то процент «неуверенных» запросов: «Идя по коридору офиса, я увидел, что стены выкрашены в два разных цвета. Это баг или фича?» Автоматизация процесса управления сужает пространство для подобного «творчества», потому что автомату нужен алгоритм. А алгоритм требует чёткого взгляда на проблему, включающего критерии её наличия и оценку факторов вытекающих рисков. Если этого не сделал тот, кто проблему обозначил, это ложится на плечи сообщества. Разумеется, множеству тысяч участников не нужно всем вместе проврять «ящик жалоб и предложений». Система может рандомно распределять её по некой части — например, 1% участников, которые в кадждом конкретном случае являются валидационной комиссией, решающей, дать или нет ход проблеме. Таким образом, каждый конкретный участник системы видит не более 1% входящих запросов.

- Формирование запроса. Хорошо, проблема есть: валидационная комиссия подтвердила, что вам не померещилось. Вы проанализировали её, оценили риски. Самое время определиться, что дальше: что нам с этой проблемой делать и зачем? По идее, пожелание формируется уже на этапе постановки задач. Но это не обязательно — потому что это отдельный этап процесса принятия решения, а значит, в децентрализованной системе, он всё тоже неизбежно проходит через коллегиальный процесс. Проблема попадает уже в общий доступ, когда любой участник механизма может:

— уточнить принадлежность проблемы (какой департамент её должен решать);

— предложить желаемый результат уровня: «А давайте перекрасим! А давайте переедем! А давайте потребуем снизить арендную плату!».

В последнем случае кворум, необходимый для принятия решения, может быть уже значительнее: до 5% участников системы, в зависимости от того, какие департаменты были предложены в качестве ответственных за решение. К примеру, вряд ли для постановки задач отделу контента об исправлении опечатки на странице сайта требует акцепта более, чем 1% участников системы или 2-3 голосов в абсолютном выражении. - Назначенный на эту проблему департамент в большинстве случаев должен иметь право акцепта проблемы — или отправки её на доработку в виде захода на нужный уровень — например, второй, если требуется ре-валидация самого факта наличия проблемы, либо на шаг 3, если требуется доработка постановки цели, добавив свои комментарии.

— Одним из департаментов децентрализованной системы должен быть департамент арбитража, который, например, решал бы ситуации, когда назначенный департамент бесконечно отфутболивает проблему обратно.

— Функции арбитража должны включать в себя как возможность принудительного назначения проблемы, так и вынос вопроса доверия команде конкретного департамента на общее голосование.

При этом, поскольку мы говорим о распределённой децентрализованной системе, арбитраж как механизм не обязан даже иметь постоянный состав. В него могут, скажем, рандомно приглашаться каждый раз наиболее доверенные участники системы, отметившие согласие выполнять свои «функции жюри» время от времени (и даже периодичность, с которой они на это согласны). - Анализ вариантов. Любая проблема имеет как минимум два варианта решения, один из которых — её не решать. А если решать — то количество способов этого может множиться до бесконечности. Когда проблема определена и цель обозначена, назначенный департамент приступает к анализу способов её решения. Скажем, если проблема — «купить компьютер конкретной модели», в обязанности департамента входит выбор подходящих предложений и, вполне возможно, даже процесс торга.

Многоуровневые проблемы, как, например, найм сотрудника, могут разбиваться департаментов (в данном случае — по кадровым вопросам, либо депараментом, в который нужен сотрудник) на промежуточные этапы с голосованием. Например, сперва определение круга обязанностей. Затем — согласование с коммьюнити условий оплаты.

- Принятие решения. Финальный элемент решения проблемы. Стол выбран, сотрудник найден — коммьюнити должно сказать «да» или «нет», «нанять» или «отказать». От промежуточных этапов принятия проблемы финальное решение отличает опция «закрыть задачу». Если голосующий участник системы считает, что решение, за которое он голосует, решает проблему, обозначенную на этапе 1, то он отмечает «закрыть задачу». Если более 50% голосовавших так же, как он, отметили тот же чекбокс, то, в случае принятия их решения, проблема так же автоматически закрывается.

Звучит сложно? А ведь это только основная ветвь развития ситуации. На самом деле, побочных сценариев может быть множество. Но именно так, если разложить ситуацию на составляющие, выглядит принятие решение человеком в принципе. Просто свои собственные решения люди принимают через централизованный механизм (если, конечно, речь не идёт о герое фильма «Сплит»), поэтому многие этапы принятия решения проходятся сразу и неощутимо.

В децентрализованном же механизме принятия решений, все проблемы должны разбиваться на максимально простые, дискретные составляющие. Если вопрос разбивается на два: покрасить Кремль в зелёный цвет и сослать в лагеря ещё 10 тысяч человек, то его нужно разбивать на два — иначе невозможно будет понять, как бы ни проголосовало сообщество, за какой вариант на самом деле были отданы голоса.

Поэтому полная децентрализация подразумевает не референдум раз в четыре, а тысячи и миллионы микроголосований, из которых складывается принятие решений компании.

Впрочем, это не должно сводить деятельность участников системы к бесконечному потоку микроменеджмента. Есть несколько мер, совокупность которых снижает управленческую нагрузку на каждого участника системы до уровня не просто приемлемого, а желаемого.

- Разные уровни решения задач требуют разной степени вовлечённости участников. Самые мелкие задачи могут требовать одобрения любых двух участников. Если в системе, скажем, 10 000 участников с правом голоса, то это означает, что каждому её участнику будет попадаться не более, чем одна пятитысячная подобных мелких вопросов.

- Разные типа решения задач не требуют работы постоянных команд. Различные направления работы — тот же арбитраж — могут закрываться разово отобранной командой.

- Задачи, которые могут решаться алгоритмами — должны решаться алгоритмами. Принцип дробления любой проблемы на минимально возможные шаги позволяет очень чётко категоризировать любой вопрос. И если он по 100% критериев попадает в тот, для которого существует уже одобренный протокол решения, то он решается системой автоматически, без привлечения участников.

- Системы рейтингов, оценки и самоопределения участников позволят сделать распределение вопросов на голосование ещё более эффективным.

- А система определения уровня желаемого участия в управлении гарантирует, что децентрализованный механизм управления никогда не пригласит участника голосовать в принятии решения, которое ему не интересно. Всегда должна быть возможность определения категории или уровня важности задачи, голосование по которым участник не желает пропускать. А абсолютно индифферентные участники могут вообще полностью отключить запросы на участие в голосовании, отдав судьбу проекта на откуп другим участникам.

- Посадить решать ИИ. Не стоит забывать, что блокчейн — не самое впечатляющее изобретение последнего десятилетия. Самообучающиеся нейронные сети — прорыв куда более масштабный и значимый. Должны ли его игнорировать разработчики системы децентрализации Hamster Marketplace? Конечно, нет. У каждого участника системы управления будет доступ к нейросети, которой он сможет делегировать решение определённых категорий вопросов, настроив, например, принятие решений на основе анализа своих собственных решений или на основе анализа результатов общих голосований.

Совокупность этих пяти факторов: детализации проблем, продуманности системы сдержек и противовесов, кастомизируемости степени индивидуального участия в решении проблем, бесповоротности записей в блокчейне и использования ИИ — позволяют сформировать механизм самоуправления максимально эффективный, демократичный, ненавязчивый и при этом по-настоящему децентрализованный. В каком-то смысле, речь идёт о создании коллективного разума, где каждый участник системы — это нейрон, а каждый дискретный запрос — это электрический импульс.

Тестирование, тестирование и ещё раз тестирование

Продумать принципы работы децентрализованного управляющего механизма, на деле, не так сложно. Сложно — это его настроить, создать идеально уравновешенную со всех сторон систему, у которой не было бы ни одной торчащей нитки — ни одной цепочки действий, которая бы обрывалась незавершённой. Для этого нужно:

- построить прототип системы;

- прогнать через миллиарды комбинаций возможных сценариев развития.

Причём генерировать сценарии проблем должна одна нейросетка, а помогать закрывать обнаруженные дыры и уязвимости — другая. При этом идеально сбалансированная система будет защищена не только от внутренних сбоев, основанных на случайной или намеренной эксплуатации пропущенных уязвимостей — она так же должна до определённой степени быть устойчивой к извне. От ядерной войны или массовых расстрелов, возможно, никакие алгоритмы не защитят, но, как минимум, система должна быть достаточно устойчивой, чтобы сохранять управляемость и независимость в случае локальных отключений света, интернета или попыток враждебного поглощения другими компаниями.

Потому что в тот момент, когда система децентрализованного управления маркетплейсом Hamster будет полностью настроена, запущена и площадка перейдёт под управление ей, пути назад уже не будет. Фарш невозможно провернуть назад — и запись из блокчейна не сотрёшь просто так.

Но зато, в случае успеха проекта, его результат — система децентрализованного управления на блокчейне и с элементами ИИ — будет намного больше и значимее, чем сам маркетплейс. Потому что вариантов применения подобному механизму будет едва ли не больше, чем самому блокчейну — от любых объединений людей до управления целыми государствами. Фантасты, футуристы, криптоэнтузиасты и просто анархисты всегда мечтали о работающих механизмах прямой демократии, например. Но подобный никогда не будет создан государством или для государства — у «стационарного бандита» нет никакой мотивации полностью отказываться от власти.

А вот из бизнеса, тем более торговли — такое решение вполне может придти. И команда Hamster Marketplace имеет все шансы быть среди первых — если вы нас в этом поддержите.

Краудфандинг для маркетплейса

- Чтобы профинансировать создание и маркетплейса как работающего бизнеса, решающего проблемы малых и средних производителей нишевых гаджетов и электроники;

- равно как и обеспечить возможность проработки и тестирования механизмов децентрализованного самоуправления платформы самими производителями представленных на ней товаров,

Hamster Marketplace запускает краудфандинговую кампанию осенью этого года.

Распродажа токенов позволит профинансировать как маркетинговые расходы на продвижение маркетплейса и раскрутку продаж на нём, так и все необходимые исследования и разработки для создания автономно и надёжно работающего механизма децентрализованного самоуправления.

Токены, в свою очередь, будут являться частью архитектуры площадки, которыми можно будет оплачивать использование собственных ресурсов Hamster Marketplace:

- вендоры смогут использовать их, чтобы оплачивать внутренние инструменты промо и продвижения, экономя фиатные деньги;

- покупатели будут иметь доступ к ограниченным акциям, предложениям и раннему доступу как к товарам, так и самой платформе перед её выходом в открытую бету.

Прямо сейчас, впрочем, делать ничего не надо. Просто оставьте вашу почту на сайте ICO Hamster Marketplace, чтобы не пропустить даты регистрации на участие в ICO. Ещё можно подписаться на наш канал в «Телеграме» или зайти к нам в телеграмовскую же группу, чтобы получать информацию из первых рук.

P.S. Если вы вендор — примите, пожалуйста, участие в нашем небольшом исследовании.

|

|

Как работает Android, часть 3 |

Как работает Android, часть 3

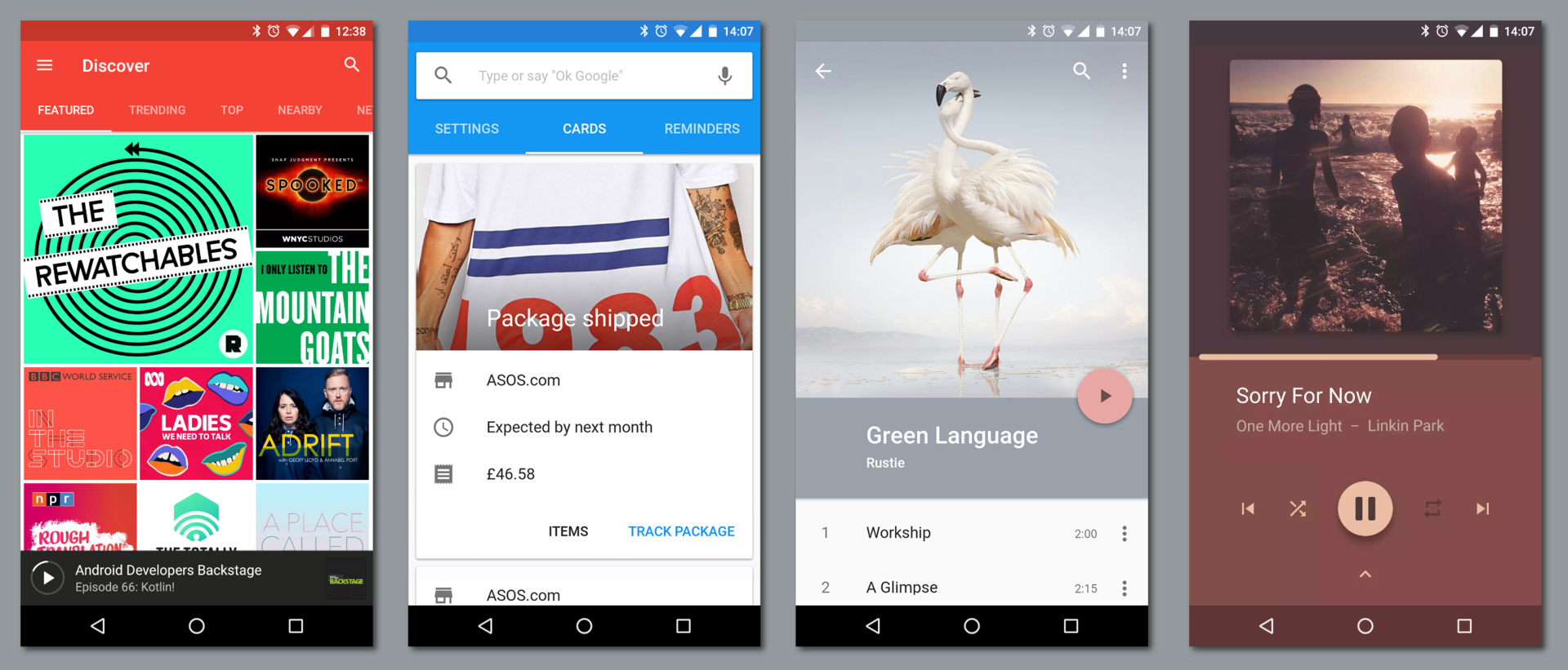

В этой статье я расскажу о компонентах, из которых состоят приложения под Android, и об идеях, которые стоят за этой архитектурой.

Статьи серии:

- Как работает Android, часть 1

- Как работает Android, часть 2

- Как работает Android, часть 3

- ...

Web vs desktop

Если задуматься об отличиях современных веб-приложений от «обычных» десктопных приложений, можно — среди недостатков — выделить несколько преимуществ веба:

- Веб-приложения переносимы между архитектурами и платформами, как и Java.

- Веб-приложения не требуют установки и всегда обновлены, как и Android Instant Apps.

Кроме того, веб-приложения существуют в виде страниц, которые могут ссылаться друг на друга — как в рамках одного сайта, так и между сайтами. При этом страница на одном сайте не обязана ограничиваться ссылкой только на главную страницу другого, она может ссылаться на конкретную страницу внутри другого сайта (это называется deep linking). Ссылаясь друг на друга, отдельные сайты объединяются в общую сеть, веб.

Несколько копий одной страницы — например, несколько профилей в социальной сети — могут быть одновременно открыты в нескольких вкладках браузера. Интерфейс браузера рассчитан на переключение между одновременными сессиями (вкладками), а не между отдельными сайтами — в рамках одной вкладки вы можете перемещаться по ссылкам (и вперёд-назад по истории) между разными страницами разных сайтов.

Всё это противопоставляется «десктопу», где каждое приложение работает отдельно и часто независимо от других — и в этом плане то, как устроены приложения в Android, гораздо ближе к вебу, чем к «традиционным» приложениям.

Activities & intents

Основной вид компонентов приложений под Android — это activity. Activity — это один «экран» приложения. Activity можно сравнить со страницей в вебе и с окном приложения в традиционном оконном интерфейсе.

Собственно окна в Android тоже есть на более низком уровне — уровне window manager. Каждой activity обычно соответствует своё окно. Чаще всего окна activity развёрнуты на весь доступный экран, но:

- Во-первых, Android поддерживает мультиоконный режим — split-screen, picture-in-picture и даже freeform.

- Во-вторых, Android поддерживает подключение нескольких дисплеев.

- В-третьих, activity может намеренно занимать небольшую часть экрана (

Theme_Dialog).

Например, в приложении для электронной почты (email client) могут быть такие activity, как Inbox Activity (список входящих писем), Email Activity (чтение одного письма), Compose Activity (написание письма) и Settings Activity (настройки).

Как и страницы одного сайта, activity одного приложения могут запускаться как друг из друга, так и независимо друг от друга (другими приложениями). Если в вебе на другую страницу обращаются по URL (ссылке), то в Android activity запускаются через intent’ы.

Intent — это сообщение, которое указывает системе, что нужно «сделать» (например, открыть данный URL, написать письмо на данный адрес, позвонить на данный номер телефона или сделать фотографию).

Приложение может создать такой intent и передать его системе, а система решает, какая activity (или другой компонент) будет его выполнять (handle). Эта activity запускается системой (в существующем процессе приложения или в новом, если он ещё не запущен), ей передаётся этот intent, и она его выполняет.

Стандартный способ создавать intent’ы — через соответствующий класс в Android Framework. Для работы с activity и intent’ами из командной строки в Android есть команда am — обёртка над стандартным классом Activity Manager:

# передаём -a ACTION -d DATA

# открыть сайт

$ am start -a android.intent.action.VIEW -d http://example.com

# позвонить по телефону

$ am start -a android.intent.action.CALL -d tel:+7-916-271-05-83Intent’ы могут быть явными (explicit) и неявными (implicit). Явный intent указывает идентификатор конкретного компонента, который нужно запустить — чаще всего это используется, чтобы запустить из одной activity другую внутри одного приложения (при этом intent может даже не содержать другой полезной информации).

Неявный intent обязательно должен указывать действие, которое нужно сделать. Каждая activity (и другие компоненты) указывают в манифесте приложения, какие intent’ы они готовы обрабатывать (например, ACTION_VIEW для ссылок с доменом https://example.com). Система выбирает подходящий компонент среди установленных и запускает его.

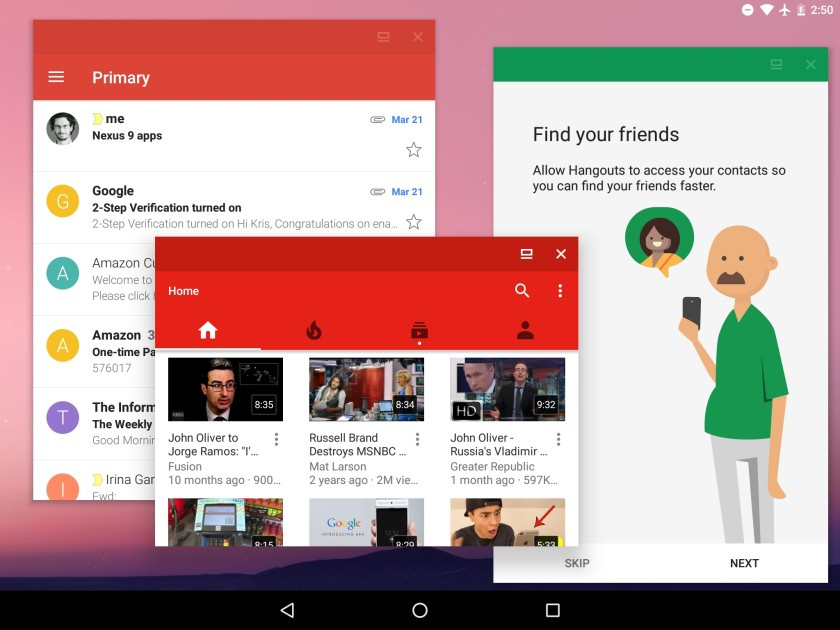

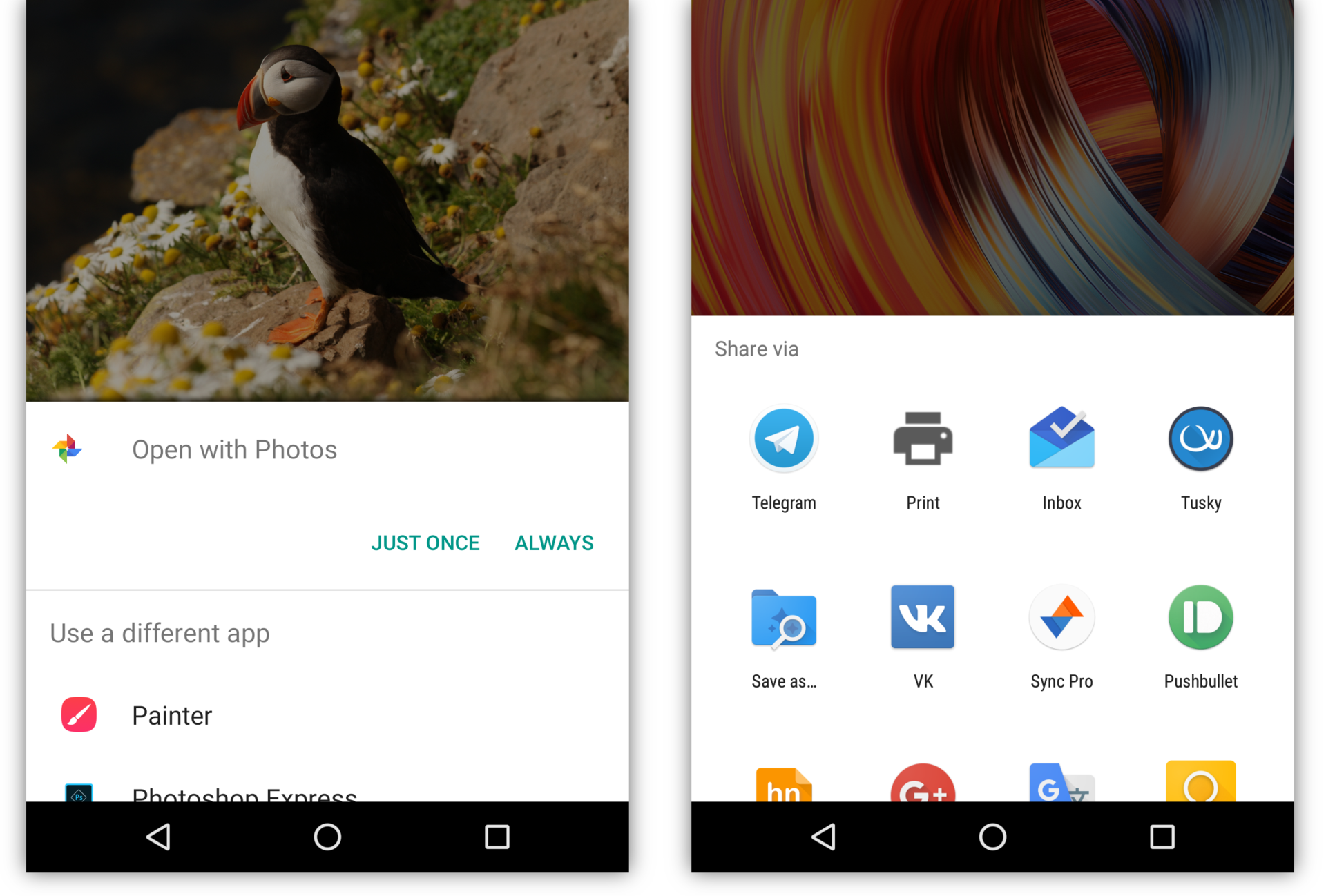

Если в системе есть несколько activity, которые готовы обработать intent, пользователю будет предоставлен выбор. Обычно это случается, когда установлено несколько аналогичных приложений, например несколько браузеров или фоторедакторов. Кроме того, приложение может явно попросить систему показать диалог выбора (на самом деле при этом переданный intent оборачивается в новый intent с ACTION_CHOOSER) — это обычно используется для создания красивого диалога Share:

Кроме того, activity может вернуть результат в вызвавшую её activity. Например, activity в приложении-камере, которая умеет обрабатывать intent «сделать фотографию» (ACTION_IMAGE_CAPTURE) возвращает сделанную фотографию в ту activity, которая создала этот intent.

При этом приложению, содержащему исходную activity, не нужно разрешение на доступ к камере.

Таким образом, правильный способ приложению под Android сделать фотографию — это не потребовать разрешения на доступ к камере и использовать Camera API, а создать нужный intent и позволить системному приложению-камере сделать фото. Аналогично, вместо использования разрешения READ_EXTERNAL_STORAGE и прямого доступа к файлам пользователя стоит дать пользователю возможность выбрать файл в системном файловом менеджере (тогда исходному приложению будет разрешён доступ именно к этому файлу).

A unique aspect of the Android system design is that any app can start another app’s component. For example, if you want the user to capture a photo with the device camera, there’s probably another app that does that and your app can use it instead of developing an activity to capture a photo yourself. You don’t need to incorporate or even link to the code from the camera app. Instead, you can simply start the activity in the camera app that captures a photo. When complete, the photo is even returned to your app so you can use it. To the user, it seems as if the camera is actually a part of your app.

При этом «системное» приложение — не обязательно то, которое было предустановлено производителем (или автором сборки Android). Все установленные приложения, которые умеют обрабатывать данный intent, в этом смысле равны между собой. Пользователь может выбрать любое из них в качестве приложения по умолчанию для таких intent’ов, а может выбирать нужное каждый раз. Выбранное приложение становится «системным» в том смысле, что пользователь выбрал, чтобы именно оно выполняло все задачи (то есть intent’ы) такого типа, возникающие в системе.

Само разрешение на доступ к камере нужно только тем приложениям, которые реализуют свой интерфейс камеры — например, собственно приложения-камеры, приложения для видеозвонков или дополненной реальности. Наоборот, обыкновенному мессенджеру доступ к камере «чтобы можно было фото отправлять» не нужен, как не нужен и доступ к совершению звонков приложению крупного банка.

Этой логике подчиняются даже такие «части системы», как, например, домашний экран (лончер, launcher). Лончер — это специальное приложение со своими activity (которые используют специальные флаги вроде excludeFromRecents и launchMode="singleTask").

Нажатие кнопки «домой» создаёт intent категории HOME, который дальше проходит через обычный механизм обработки intent’ов — в том числе, если в системе установлено несколько лончеров и ни один не выбран в качестве лончера по умолчанию, система отобразит диалог выбора.

«Запуск» приложения из лончера тоже происходит через intent. Лончер создаёт явный intent категории LAUNCHER, который «обрабатывается» запуском основной activity приложения.

Приложение может иметь несколько activity, которые поддерживают такой intent, и отображаться в лончере несколько раз (при этом может понадобиться указать им разную taskAffinity). Или не иметь ни одной и не отображаться в лончере вообще (но по-прежнему отображаться в полном списке установленных приложений в настройках). «Обычные» приложения так делают довольно редко; самый известный пример такого поведения — Google Play Services.

Многие операционные системы делятся на собственно операционную систему и приложения, установленные поверх, ничего друг о друге не знающие и не умеющие взаимодействовать. Система компонентов и intent’ов Android позволяет приложениям, по-прежнему абсолютно ничего друг о друге не зная, составлять для пользователя один интегрированный системный user experience — установленные приложения реализуют части одной большой системы, они составляют из себя систему. И это, с одной стороны, происходит прозрачно для пользователя, с другой — представляет неограниченные возможности для кастомизации.

По-моему, это очень красиво.

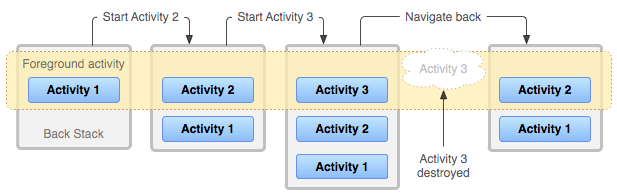

Tasks & back stack

Как я уже говорил, в браузере пользователь может переключаться не между сайтами, а между вкладками, история каждой из которых может содержать много страниц разных сайтов. Аналогично, в Android пользователь может переключаться между задачами (tasks), которые отображаются в виде карточек на recents screen. Каждая задача представляет собой back stack — несколько activity, «наложенных» друг на друга.

Когда одна activity запускает другую, новая activity помещается в стек поверх старой. Когда верхняя activity в стеке завершается — например, когда пользователь нажимает системную кнопку «назад» — предыдущая activity в стеке снова отображается на экране.

Каждый стек может включать в себя activity из разных приложений, и несколько копий одной activity могут быть одновременно открыты в рамках разных задач или даже внутри одного стека.

При запуске новой activity могут быть указаны специальные флаги, такие как singleTop, singleTask, singleInstance и CLEAR_TOP, которые модифицируют этот механизм. Например, приложения-браузеры обычно разрешают запуск только одной копии своей основной activity, и для переключения между открытыми страницами реализуют собственную систему вкладок. С другой стороны, Custom Tabs — пример activity в браузере (чаще всего Chrome), которая ведёт себя почти «как обычно», то есть показывает только одну страницу, но позволяет одновременно открывать несколько своих копий.

App lifecycle

Одно из основных ограничений встраиваемых и мобильных устройств — небольшое количество оперативной памяти (RAM). Если современные флагманские устройства уже оснащаются несколькими гигабайтами оперативной памяти, то в первом смартфоне на Android, HTC Dream (он же T-Mobile G1), вышедшем в сентябре 2008 года, её было всего 192 мегабайта.

Проблема ограниченной памяти дополнительно осложняется тем, что в мобильных устройствах, в отличие от «обычных» компьютеров, не используются swap-разделы (и swap-файлы) — в том числе и из-за низкой (по сравнению с SSD и HDD) скорости доступа к SD-картам и встроенной флеш-памяти, где они могли бы размещаться. Начиная с версии 4.4 KitKat, Android использует zRAM swap, то есть эффективно сжимает малоиспользуемые участки памяти. Тем не менее, проблема ограниченной памяти остаётся.

Если все процессы представляют собой для системы чёрный ящик, лучшая из возможных стратегия поведения в случае нехватки свободной памяти — принудительно завершать («убивать») какие-то процессы, что и делает Linux Out Of Memory (OOM) Killer. Но Android знает, что происходит в системе, ему известно, какие приложения и какие их компоненты запущены, что позволяет реализовать гораздо более «умную» схему освобождения памяти.

Во-первых, когда свободная память заканчивается, Android явно просит приложения освободить ненужную память (например, сбросить кэш), вызывая методы onTrimMemory/onLowMemory. Во-вторых, Android может эффективно проводить сборку мусора в фоновых приложениях, освобождая память, которую они больше не используют (на уровне Java), при этом не замедляя работу текущего приложения.

Но основной механизм освобождения памяти в Android — это завершение наименее используемых компонентов приложений (в основном activity). Подчеркну, что Android может завершать приложения не полностью, а покомпонентно, оставляя более используемые части запущенными — например, из двух копий одной activity одна может быть завершена, а другая остаться запущенной.

Система автоматически выбирает компоненты, наименее важные для пользователя (например, activity, из которых пользователь давно ушёл), даёт им шанс дополнительно освободить ресурсы, вызывая такие методы, как onDestroy, и завершает их, полностью освобождая используемую ими память и ресурсы (в том числе view hierarchy в случае activity). После этого, если в процессе приложения не осталось запущенных компонент, процесс может быть завершён.

Если пользователь возвращается в activity, завершённую системой из-за нехватки памяти, эта activity запускается снова. При этом перезапуск происходит прозрачно для пользователя, поскольку activity сохраняет своё состояние при завершении (onSaveInstanceState) и восстанавливает его при последующем запуске. Реализованные в Android Framework виджеты используют этот механизм, чтобы автоматически сохранить состояние интерфейса (UI) при перезапуске — с точностью до введённого в EditText текста, положения курсора, позиции прокрутки (scroll) и т.д. Разработчик приложения может дополнительно реализовать сохранение и восстановление каких-то ещё данных, специфичных для этого приложения.

С точки зрения пользователя этот механизм похож на использование swap: в обоих случаях при возвращении в выгруженную часть приложения приходится немного подождать, пока она загружается снова — в одном случае, с диска, в другом — пересоздаётся по сохранённому состоянию.

Именно этот механизм автоматического перезапуска и восстановления состояния создаёт у пользователя ощущение, что приложения «запущены всегда», избавляя его от необходимости явно запускать и закрывать приложения и сохранять введённые в них данные.

Services

Приложениям может потребоваться выполнять действия, не связанные напрямую ни с какой activity, в том числе, продолжать делать их в фоне, когда все activity этого приложения завершены. Например, приложение может скачивать из сети большой файл, обрабатывать фотографии, воспроизводить музыку, синхронизировать данные или просто поддерживать TCP-соединение с сервером для получения уведомлений.

Такую функциональность нельзя реализовывать, просто запуская отдельный поток — это было бы для системы чёрным ящиком; в том числе, процесс был бы завершён при завершении всех activity, независимо от состояния таких фоновых операций. Вместо этого Android предлагает использовать ещё один вид компонентов — сервис.

Сервис нужен, чтобы сообщить системе, что в процессе приложения выполняются действия, которые не являются частью activity этого приложения. Сам по себе сервис не означает создание отдельного потока или процесса — его точки входа (entry points) запускаются в основном потоке приложения. Обычно реализация сервиса запускает дополнительные потоки и управляет ими самостоятельно.

Сервисы во многом похожи на activity: они тоже запускаются с помощью intent’ов и могут быть завершены системой при нехватке памяти.

Запущенные сервисы могут быть в трёх состояниях:

- Foreground service — сервис, выполняющий действие, состояние которого важно для пользователя, например, загрузка файла или воспроизведение музыки. Такой сервис обязан отображать уведомление в системной шторке уведомлений (примеры: состояние загрузки, название текущей песни и управление воспроизведением). Система считает такой сервис примерно настолько же важным для пользователя, как и текущая activity, и завершит его только в крайнем случае.

Background service — сервис, выполняющий фоновое действие, состояние которого не интересует пользователя (чаще всего, синхронизацию). Такие сервисы могут быть завершены при нехватке памяти с гораздо большей вероятностью. В старых версиях Android большое количество одновременно запущенных фоновых сервисов часто становилось причиной «тормозов»; начиная с версии 8.0 Oreo, Android серьёзно ограничивает использование фоновых сервисов, принудительно завершая их через несколько минут после того, как пользователь выходит из приложения.

- Bound service — сервис, обрабатывающий входящее Binder-подключение. Такие сервисы предоставляют какую-то функциональность для других приложений или системы (например,

WallpaperServiceи Google Play Services). В этом случае система может автоматически запускать сервис при подключении к нему клиентов и останавливать его при их отключении.

Рекомендуемый способ выполнять фоновые действия — использование JobScheduler, системного механизма планирования фоновой работы. JobScheduler позволяет приложению указать критерии запуска сервиса, такие как:

- Доступность сети. Здесь приложение может указать, требуется ли этому сервису наличие сетевого подключения, и если да, то возможна ли работа в роуминге или при использовании лимитного (metered) подключения.

- Подключение к источнику питания, что позволяет сервисам выполняться, не «сажая батарею».

- Бездействие (idle), что позволяет сервисам выполняться, пока устройство не используется, не замедляя работу во время активного использования.

- Обновления контента — например, появление новой фотографии.

- Период и крайний срок запуска — например, очистка кэша может производиться ежедневно, а синхронизация событий в календаре — каждый час.

JobScheduler планирует выполнение (реализованное как вызов через Binder) зарегистрированных в нём сервисов в соответствии с указанными критериями. Поскольку JobScheduler — общесистемный механизм, он учитывает при планировке критерии зарегистрированных сервисов всех установленных приложений. Например, он может запускать сервисы по очереди, а не одновременно, чтобы предотвратить резкую нагрузку на устройство во время использования, и планировать периодическое выполнение нескольких сервисов небольшими группами (batch), чтобы предотвратить постоянное энергозатратное включение-выключение радиооборудования.

Как можно заметить, использование JobScheduler не может заменить собой одного из вариантов использования фоновых сервисов — поддержания TCP-соединения с сервером для получения push-уведомлений. Если бы Android предоставлял приложениям такую возможность, устройству пришлось бы держать все приложения, соединяющиеся со своими серверами, запущенными всё время, а это, конечно, невозможно.

Решение этой проблемы — специальные push-сервисы, самый известный из которых — Firebase Cloud Messaging от Google (бывший Google Cloud Messaging).

Клиентская часть FCM реализована в приложении Google Play Services. Это приложение, которое специальным образом исключается из обычных ограничений на фоновые сервисы, поддерживает одно соединение с серверами Google. Разработчик, желающий отправить своему приложению push-уведомление, пересылает его через серверную часть FCM, после чего приложение Play Services, получив сообщение, передаёт его приложению, которому оно предназначено.

Такая схема позволяет, с одной стороны, мгновенно доставлять push-уведомления всем приложениям (не дожидаясь следующего периода синхронизации), с другой стороны, не держать множество приложений одновременно запущенными.

Broadcast receivers & content providers

Кроме activity и сервисов, у приложений под Android есть два других вида компонентов, менее интересных для обсуждения — это broadcast receiver’ы и content provider’ы.

Broadcast receiver — компонент, позволяющий приложению принимать broadcast’ы, специальный вид сообщений от системы или других приложений. Исходно broadcast’ы, как следует из названия, в основном использовались для рассылки широковещательных сообщений всем подписавшимся приложениям — например, система посылает сообщение AIRPLANE_MODE_CHANGED при включении или отключении самолётного режима.

Сейчас вместо подписки на такие broadcast’ы, как NEW_PICTURE и NEW_VIDEO, приложения должны использовать JobScheduler. Broadcast’ы используются либо для более редких событий (таких как BOOT_COMPLETED), либо с явными intent’ами, то есть именно в качестве сообщения от одного приложения к другому.

Content provider — компонент, позволяющий приложению предоставлять другим приложениям доступ к данным, которыми оно управляет. Пример данных, доступ к которым можно получить таким образом — список контактов пользователя.

При этом приложение может хранить сами данные каким угодно образом, в том числе на устройстве в виде файлов, в настоящей базе данных (SQLite) или запрашивать их с сервера по сети. В этом смысле content provider — это унифицированный интерфейс для доступа к данным, независимо от формы их хранения.

Взаимодействие с content provider’ом во многом похоже на доступ к удалённой базе данных через REST API. Приложение-клиент запрашивает данные по URI (например, content://com.example.Dictionary.provider/words/42) через ContentResolver. Приложение-сервер определяет, к какому именно набору данных был сделан запрос, используя UriMatcher, и выполняет запрошенное действие (query, insert, update, delete).

Именно поверх content provider’ов реализован Storage Access Framework, позволяющий приложениям, хранящим файлы в облаке (например, Dropbox и Google Photos) предоставлять доступ к ним остальным приложениям, не занимая место на устройстве полной копией всех хранящихся в облаке файлов.

В следующей статье я расскажу о процессе загрузки Android, о содержимом файловой системы, о том, как хранятся данные пользователя и приложений, и о root-доступе.

|

Метки: author bugaevc разработка под android блог компании solar security android internals android lifecycle activity intent jobscheduler |

Что увидело НЛО, прилетев на РИТ++ 2017 |

Что увидело НЛО, прилетев на РИТ++ 2017

Жизнь – скучная штука, и надо использовать любую возможность, чтобы заставить людей улыбаться (Э. Кустурица)

ИТ-шный Вавилон

Теоретически мы предполагали, что летний РИТ++ будет отличаться от осеннего HighLoad++, но совершенно ошиблись с вектором своих догадок. Казалось, что фестиваль Интернет-технологий будет более лайтовым, с меньшим количеством хардкорных докладов и с большим количеством участников, мало связанных с ИТ. Всё оказалось с точностью до наоборот — РИТ++ оказался фестивалем очень серьёзных, хардкорных технологий. Но от HighLoad его отличали люди — они были гораздо более включёнными, контактными и готовыми к диалогу. Хайлоад более интровертен, и это действительно заметно. Было 1800 участников, 14 параллельных потоков, 23 митапа, 16 стендов компаний.

Организаторы постарались формировать коммуникации внутри фестиваля: так, были организованы каналы в Slack и Telegram. В них активно шли обсуждения, происходила переписка, каждый участник мог спросить, попросить, оставить важное объявление, уточнить какие-то детали. Более того, каналы живы и активны до сих пор — в них задают вопросы, общаются, устраивают мини-бунты и флешмобы. В целом, это коммуникации, от которых не хочется отключаться даже спустя три месяца.

Немного отличались и стенды компаний — лето и публика внесли свои коррективы. Так, можно было насладиться крутыми граффити на стенде Avito, пообниматься с йети компании Vscale, угоститься мороженым с шоколадной крошкой и выпить прохладный лимонад.

Сложный, яркий стенд Avito — граффити и адрес компании на Хабре

Шаман нашаманил подарков и призов

Йети пользовался огромной популярностью. Как видите, кто-то даже умудрился напоить приветливое существо

Хабр тоже не остался в стороне — оба дня у нас проходил сложный экзамен, на котором мы давали решать задачи, собранные заранее у разных компаний. Некоторые добровольцы стояли у стенда по несколько часов и исчёркивали ручками лист за листом — вокруг нас царил азарт. И всё неспроста — кроме крутых наклеек и наклеек марафона, мы раздавали инвайты. Строго один в руки! А в конце второго дня у нас на стенде было пиво. Но о нём мы ещё расскажем, это отдельная эпопея.

1. Что такое VT-x, для чего нужно, как работает (в общих словах)?

2. Что такое RVI, для чего нужно, как работает (в общих словах)?

Вопрос от компании «Аладдин Р.Д.»

Windows: Почему перед захватом spin-lock система повышает IRQL до DPC?

Windows: Предположим, у вас есть стек устройства, в котором есть фильтр, сжимающий данные. Как прочитать данные в сжатом виде?

Вопрос от компании Badoo

Ваш коллега, единственный, пишущий на Go, летит в командировку и в данный момент находится над Атлантическим океаном. Админы разбудили вас посреди ночи и говорят, что программа коллеги выдает единственную ошибку «access denied» без каких-либо подробностей. Миллионы долларов летят в трубу. Какие действия вы предпримете этой ночью, чтобы поправить косяк вашего теперь уже бывшего коллеги?

Задача от компании Mail.ru Group

Мальчик Онуфрий живет в восьмибитном (беззнаковом) мире. Онуфрий отложил в копилку 181 рубль. На День рождения родители подарили ему ещё 75 рублей. Сколько теперь всего денег у Онуфрия?

Задача от компании Иннополис Университет

Очень талантливый двухметровый баскетболист демонстрирует свою крутизну и кидает мяч от головы в оооочень высоко подвешенную корзину — на высоте 15 метров. Мяч взмывает в воздух с вертикальной скоростью 16 м/c. Есть ли шанс у очень талантливого баскетболиста, если (в стиле всех физических задач) предположить, что из спортивного зала откачан воздух,

а ускорение свободного падения хитрыми манипуляциями доведено до 10 м/с2?

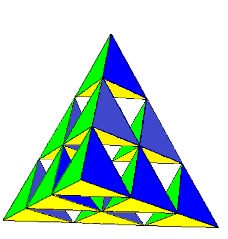

Дети, живущие в 4-мерном пространстве, не строят карточные домики — это очень скучно. Вместо этого они строят вот такие пирамидки: опирают тетраэдр очередного слоя на три вершины предыдущего. Каждый маленький тетраэдр весит 1 грамм и имеет высоту 1 см. Сколько весит пирамидка высотой в метр?

Вам от предыдущего разработчика достался вот такой код.

#include

#include

int x, i = 0, r = 0;

void* busy_worker(void* arg) {

int shift = *((int*)arg);

for (x = shift; x < shift + 500; x++) r += x;

i++;

return NULL;

}

int main() {

pthread_t t1, t2;

int s1 = 0, s2 = 500;

pthread_create( &t1, NULL, busy_worker, &s1 );

pthread_create( &t2, NULL, busy_worker, &s2 );

while(i < 2);

printf("result = %d\n", r);

}Что этот код делает? Что с ним (с кодом, не с разработчиком) не так? Перечислите как можно больше проблем.

Вопрос от компании М.Видео

У Vmware есть интересная технология VMware Fault Tolerance которая позволяет защитить виртуальные машины с помощью кластеров непрерывной доступности, позволяющих в случае отказа хоста с основной виртуальной машиной мгновенно переключиться на ее «теневую» работающую копию на другом сервере ESX. Однако эта технология не имеет широкого распространения. Почему?

Участники решают хабразадачи от компаний

Напротив нас был один из самых притягательных во всех смыслах этого слова стенд издательства Альпина Паблишер с сотнями книг по разработке, дизайну, презентациям и даже умных и полезных книг для детей. Мы нет-нет, да и подходили полистать очередное издание. Они все были прекрасны.

И вот среди этого Вавилона внезапно грянул разухабистый оркестр с прекрасными бодрящими мелодиями — так мог сделать только Кустурица. Верите-нет, но именно это событие задало задорный тон и энергичный темп всему мероприятию. Это было стопроцентное попадание.

Настроение на РИТ++ было замечательным: за окном тёплый дождик-туман, в Сколково — весело, умно, креативно

Но и на этом режиссёрская часть не закончилась — оба дня по Сколково ходил потрясающий шаман, лихо пританцовывая с симпатичными участницами под тогда ещё нетленку «Грибов» «Между нами тает лёд». Ещё бы этот шаман стабильное Интернет-соединение нашаманил, цены бы ему не было. Увы, перебои со скоростью интернета — технологическое проклятье инновационного центра Сколково. Это было, пожалуй, единственное, что иногда портило настроение.

Шаман никого не оставил равнодушным. Лиса тоже доставила

Кстати, оказался большим любителем российской попсы. А пока вы можете изучить устройство бубна

Кстати, оказался большим любителем российской попсы. А пока вы можете изучить устройство бубна

Даже шаман не смог пройти мимо наклеек с НЛО — так он усилил свои способности

Территория Интернета

Однако внешний блеск ничего не значит, если нет содержания. Содержание РИТ++ было настолько насыщенным, что наши два текстовых транслятора непрерывно ругались и разрывались между теми секциями, на которые хотели попасть. Любая аудитория могла найти доклады на свой вкус или поучаствовать в многочисленных событиях внутри РИТ++.

Секции с докладами

Весь РИТ++ был разделён на несколько тематических конференций. Причём выступления всех докладчиков секций были глубоко-тематическими. Что всегда радует на фестивалях Олега Бунина, так это время доклада — за один час можно успеть и отлично развернуть тему, и ответить на вопросы. Отсутствие технических накладок с презентациями и микрофонами превращает каждую секцию в непрерывный поток отборной и нужной информации.

- Whaile Rider — конференция по управлению и предпринимательству. Доклады этого потока отражали все направления управления компанией, от стратегических вопросов до детального разбора подготовки инфографики (совершенно потрясающий доклад) и поиска секретов эффективности работы техподдержки.

На некоторых докладах не хватало мест

На некоторых докладах не хватало мест- Aletheia Business — конференция по применению психологии в управлении и бизнесе. Если коротко — учились лучше разбираться в себе и в людях, говорили о карьере, лояльности и о том, почему русские люди не улыбаются. Вообще, в ходе РИТ++ было много обсуждений именно HR-аспектов IT-сферы и вопросов психологии. Хедлайнерами этого обсуждения стали Петр Людвиг со своим докладом «Конец прокрастинации» и Максим Дорофеев с идеей экономии мыслетоплива и потрясающими слайдами. Эти ребята в прямом смысле слова собрали зал, точнее, самый большой зал — конгресс-холл.

Пётр Людвиг пытался победить непобедимое. Или нет?

- Web-scale IT Conference — конференция на стыке enterprise и web-культур. Эта, на первый взгляд, расплывчатая по тематикам конференция, собрала в себе нестандартные обсуждения: государство + бизнес, микросервисы, омниканальность и т.д. Из того, что мы слышали в этом потоке, особенно нам понравился доклад Александра Тараторина из Райффайзенбанка о реальном DevOps в Enterprise — больше всего удивила структурированность и прозрачность того, как это сделано в банке. Казалось бы, косная функциональная оргструктура, а насколько современно всё решено.

- Frontend Conf — конференция фронтенд-разработчиков. Фронтенд есть фронтенд — говорили буквально обо всём.

- App’s Conf — конференция по разработке мобильных приложений занимала аж два зала. Вопросы интерфейсов, логики работы приложений, тестирования и дизайна обсуждали представители компаний, знающих толк в мобильной разработке как никто: Avito, Lamoda, 2ГИС, Mail.ru Group, Одноклассники, Яндекс, Сбербанк-Технологии и т.д.

- Root Conf — конференция по эксплуатации и DevOps. Всё ожидаемо: много о DevOps, немного о Docker, мониторинге и других вопросах администрирования.

- High Load Junior — обучающая конференция разработчиков высоконагруженных систем. Это не подборка «лайтовых» докладов, как кто-то мог подумать, а глубокие обучающие доклады для начинающих, но уже секущих тему джуниоров. Некоторые доклады были хардкорнее, чем на осеннем Хайлоаде. Но главное — это чёткие и понятные инструкции, которые можно взять и перенести в свою повседневную работу. Кстати, в этот раз было много про DDoS-атаки и привычно много — про базы данных. Тон всему High Load Junior задал мужественный и умный доклад о MySQL от женственных и креативных Светы Смирновой и Насти Распопиной из Percona. Ну а докладом потока, заслуживающим гран-при по скромному мнению наших трансляторов, стал доклад Сергея Спорышева из компании ITSumma — он поведал полную историю создания Проект1917. Ума не приложим, почему этого захватывающего рассказа до сих пор нет в блоге ребят на Хабре!

Хайлоад-девушки Percona Света и Настя

Хайлоад-девушки Percona Света и Настя

Ребятам из ITSumma даже на конференции приходилось работать. Ещё бы, когда у них такие проекты! Юля строго следила за процессом

- Backend Conf— конференция бэкенд-разработчиков. Бэкенд есть бэкенд — крутые профильные обсуждения.

Митапы

Ещё одна форма работы экспертов на РИТ++ — многочисленные митапы. В небольших и больших залах собирались люди, которые обсуждали вопросы в острой дискуссионной форме. Впрочем, форма была заранее гарантирована содержанием. Вот только некоторые темы, на которые мы успели зайти на несколько минут и погреть уши:

- управление интеллектуальными активами

- DevOps

- релокация в Европу

- правовые вопросы

- создание фреймворка с чистого листа

- Tarantool

- TDD

- производительность и проч.

Судя по обсуждениям, особый интерес для участников представлял митап, а точнее, мастер-класс по микросервисам и Kubernetes. А ещё мы заметили, что в свободных мини-переговорных Сколково создавались стихийные митапы и мастер-классы — ещё одна хорошая традиция конференций Олега Бунина.

Да нормально всё было :) Главное, что конференция не портится, на ней по-прежнему много возможностей послушать самых-самых разных специалистов, расширить свой кругозор и углубить знания. Это было и остаётся самым главным. Всё остальное — мелочи. Впрочем, мне нравится что вы все время что-то меняете и добавляете. Само по себе это пользы может и не приносить, но есть ощущение динамики и стремления развиваться. Это воодушевляет.

Выделенные события

В рамках РИТ++ проходили отдельные потоки «под крылом» компаний — серии докладов, объединённые в одну конференцию. В этом году это были:

- Разработка и машинное обучение от SuperJob, Tarantool и Digital Security

- Микросервисы от Avito

- День PGDAY’17 Russia — много всего о базах данных и о PostgreSQL в частности.

PostgreSQL — родина слонов

Подобные секции позволяют общаться внутри узкой группы по интересам и уделить больше внимания практическим вопросам. Ну и конечно, это возможность продемонстрировать компаниям свой опыт, а участникам — свой. Иногда они друг друга находят.

Участники продолжают решать задачи на стенде Хабра

Кроме официальных мероприятий от организаторов, общение происходило непрерывно — в кулуарах, столовых, на диванах по периметру Сколково, на кофе-брейках и стендах компаний. Ради интереса мы подходили к небольшим группам, прислушивались — все разговоры касались опыта, лучших практик, работы. Собственно, тем и хороши подобные фестивали — ты возвращаешься на работу с идеями, а иногда и с готовыми решениями.

Наклейки Хабра разлетелись в мгновение ока

НЛО прилетело и оставило надписи там

Хабр давно нашёл свой уголок в Сколково, причём весьма нескромный — ещё бы, кроме стойки, нам нужно разместить целую студию, где мы брали интервью у самых интересных, ярких, узнаваемых спикеров. В этом году мы пошли на эксперимент и попросили одних профессионалов взять интервью у других профессионалов. Наша задумка была идеальной — разговоры легко клеились, это были целые обсуждения, выходящие за формат «вопрос-ответ».

Коварная паутина нашей студии заманивала самых лучших спикеров

Они грелись в лучах

Мы отсняли более 10 часов видео и вот только-только стали выходить цельные ролики. Кстати, 47% участников отметили стенд Хабрахабра как наиболее полезный.

Наш продюсер нативных проектов Катя и Олег Бунин. «Вооот столько народу на РИТ++. Воооот такие планы на будущее».

Денис пришёл и оставил НЛО там

Угадайте, кто сидит спиной

Это Денис Крючков, основатель Хабра. И НЛО всегда с ним (в смысле в верхнем правом углу)

Интересный разговор состоялся у основателя Хабра Дениса Крючкова с советником Президента по Интернету Германом Клименко. Вот это версус-баттл, а не то, что вы там на Youtube на 20 млн. просмотров насмотрели.

Хардкорное интервью с Иваном Васильевым, дизайн-директором Альфа-Банка:

Самое честное интервью с Петром Людвигом (английский):

Прекрасный Максим Дорофеев, «доктор-прокрастинолог». В интервью вы в том числе узнаете, какие слова нельзя говорить в студии:

В интервью была наша фишка — все собеседники общались не только с хабрарепортёрами, но и с самим НЛО, которое задавало резкие, короткие и провокационные вопросы. Некоторые даже терялись.

Хабрахабр традиционно не ограничился студией, а провёл круглый стол по вопросам HR и технологического евангелизма при участии евангелиста Александра Белоцерковского из Microsoft, devrel Avito Михаила Клюева, Александра Сербула из 1С-Битрикс и Ольги Белой из «Моего Круга». По ощущениям слушателей и ведущего, один час круглого стола пролетел как 10 минут. Местами было горячо!

Со спикерами было настолько интересно, что Марика была вынуждена прерывать ИТ-беседы с помощью суровых табличек:

Параллельно наши репортёры веди текстовый онлайн обоих дней конференции, накручивая по Сколково по 27 000 шагов в день.

Редкое фото — онлайн изнутри. А заодно и ноутбук одного из модераторов Хабра. Палится любитель сразу трёх браузеров! (на самом деле, там ещё и Firefox был)

НЛО иногда нуждается в техобслуживании

Коламбия не представляет, какой был хардкор

Однако сессиями конференций и докладами хардкор не ограничивался. В первый день в шатре мы отмечали день рождения Хабра и всем наливали изысканные сорта пива.

Помните Чёрного Властелина? Он был и там

Вдарим рок в этом инновационном центре!

А пока все потягивали хабрапиво, со сцены играли коллективы, состоящие из айтишников. Влажная тёплая погода немного разморила участников, и они неспеша общались во дворе.

Дождя не было, был приятный туман. Общались в тёплой во всех смыслах атмосфере

Настольные игры увлекли многих

В то же самое время чуть ли не до глубокой ночи на территории Сколково происходили горячие соревнования по киберспорту и неспешные турниры по настольным играм. Словами не передать степень азарта и эмоциональной напряжённости с площадки. Все буквально выгорали.

Ни одна фотография не передаст атмосферу соревнований по киберспорту. Это был накал

Ну ничего, утренняя спецзарядка это исправила.

Мастерами кунг-фу — не рождаются

Мастерами кунг-фу — становятся

Опасностей — не пугаются

Приемы точны — все сбудется...

We will rock you

А пока вы читаете этот пост, вовсю идёт подготовка к HighLoad++ — осень уже здесь, самое время поднять вопросы высоконагруженных проектов. Кстати, в этом году будут IoT и блокчейн. Готовьтесь!

Шаману просто сказали, что до HighLoad++ осталось совсем немного

|

Метки: author TM_content конференции рит++ конференции олега бунина интернет-фестиваль рит++ 2017 |

Перформанс: что в имени тебе моём? — Алексей Шипилёв об оптимизации в крупных проектах |

Перформанс: что в имени тебе моём? — Алексей Шипилёв об оптимизации в крупных проектах

Под катом — расшифровка его доклада.

А вот тут можно найти саму презентацию: jpoint-April2017-perf-keynote.pdf

О спикере

Алексей Шипилёв — в проблематике производительности Java более 10 лет. Сейчас работает в Red Hat, где разрабатывает OpenJDK и занимается его производительностью. Разрабатывает и поддерживает несколько подпроектов в OpenJDK, в том числе JMH, JOL и JCStress. До Red Hat работал над Apache Harmony в Intel, а затем перешел в Sun Microsystems, которая была поглощена Oracle. Активно участвует в экспертных группах и сообществах, работающих над вопросами производительности и многопоточности.

Я работаю в компании Red Hat. Раньше, когда я работал в Oracle, мы вставляли «Safe Harbor»-слайды, которые говорили, что всё, что мы будем вам рассказывать, на самом деле может быть неправдой, поэтому нужно думать своей головой. Если вы пытаетесь внедрить какие-нибудь решения в свои продукты, неплохо было бы нанять профессионалов, которые вам скажут, что там правда, а что — нет.

Крупно: каковы критерии успеха в разработке

Предположим, вы разрабатываете продукт. Что для вас успешный продукт? Мы тут все — коммерческие программисты. Мы можем обманывать себя тем, что нам платят зарплату за то, что мы кодим. Но на самом деле нам платят зарплату для того, чтобы продавались либо сервисы, которые продукты обслуживают, либо продукты целиком.

Но какие существуют чисто разработческие критерии успешности продукта (без учета бизнес-цели)?

- Когда ты общаешься с программистами, они обычно говорят, что хороший (успешный) продукт — тот, у которого корректная реализация.

- Потом приходят безопасники и говорят: «Вы там, конечно, накодили, но неплохо было бы сделать так, чтобы там не было дырок. Потому что иначе мы-то продадим, но потом нас в суд потащат». Однако это тоже не главное.

- Главный критерий успешности проекта — это соответствие того, что получилось, желаниям пользователя. Конечно, если у нас есть хороший маркетинговый департамент, он может объяснить клиенту, что результат — это именно то, что он хочет. Но в большинстве случаев хочется, чтобы клиент сам это понял. Очень много программистов как бы на подкорке это имеют в виду, но очень мало людей это прямо вербализируют.

- Где-то на четвёртом месте — быстрота и удобство разработки. Это удобство и не сумасшествие программистов. Когда вы во время найма разговариваете с HR-ами, они будут обещать всякие плюшки, массаж и тому подобное, но на самом деле бизнесу всё равно, как вам там живётся, при условии, что вы всё ещё работаете и не собираетесь уходить. И что код написан условно хорошо, а не так, что вы хотите выброситься из окна или пойти работать в другую компанию.

- Производительность обычно стоит ещё ниже в списке приоритетов. Часто её даже нет в критериях успеха. Продукт хоть как-то шевелится, да и слава Богу.

Поэтому я удивляюсь, когда читаю на Хабре посты про производительность Java и вижу там подобные комментарии:

Эксперты говорят: «Ну а что говорить по производительность Java? Она работает нормально. Нас устраивает, всё хорошо». Но приходят комментаторы и отвечают: «Очень показательно, что никто из четырех экспертов не оценил Java, как быструю. Скорее, как достаточную и удовлетворяющую».

Вы говорите так, будто это плохо. Если с точки зрения бизнеса технология удовлетворяет бизнес-критериям, то и слава Богу! У меня нет идеалистических представлений о том, что всё должно быть вылизано, гладко, идеально. Так не бывает — обычно продукты содержат ошибки.

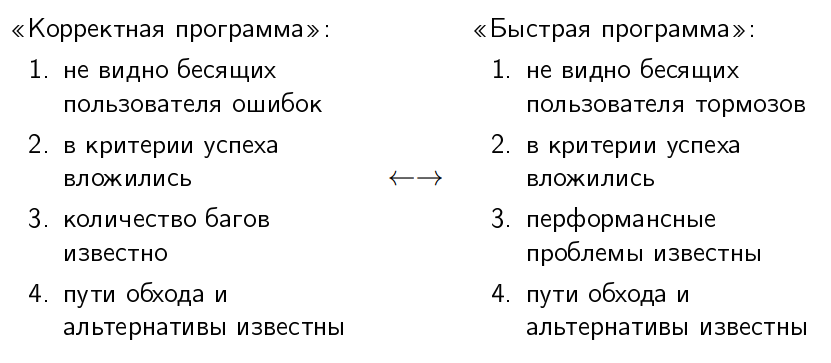

Корректная vs быстрая программа

Люди давно научились некоторому двойному мышлению по поводу корректности программ. (спрашивает в зал) Кто может честно сказать, что в его программах есть баги? (в зале много рук) Подавляющее большинство. Но все же считают, что их программы более-менее корректны. Понятие корректной программы обладает симметрией с понятием быстрой программы.

«Корректная программа» — это программа, в которой не видно бесящих пользователя ошибок. То есть ошибки там вообще-то есть, но они не заставляют пользователя отказаться от покупки продукта. С «быстрой программой» симметричная ситуация — в ней не то, чтобы нет перформансных проблем, просто эти проблемы не бьют пользователя по темечку каждый раз, когда он пытается что-то сделать.

«В критерии успеха вложились». Критерии успеха есть как функциональные, так и перформансные: хорошо, если программа отвечает за 100 миллисекунд. Отвечает? Отлично, едем дальше.

«Количество багов в корректной программе обычно известно». Это как раз одна из показательных метрик взрослости проекта, поскольку ноль багов в программе означает, что никто толком не заботится о том, чтобы их в багтрекере регистрировать (потому что у вас и пользователей нет, ха-ха!). С перформансными проблемами такая же история. Перформансные проблемы известны, и тогда мы говорим, что это «быстрая» программа. (делает воздушные кавычки)

Как в корректной, так и в быстрой программе пути обхода этих перформансных и функциональных багов известны. У вас есть FAQ, который говорит: «Если вы сделаете так, то будет больно; ну дак и не делайте так».

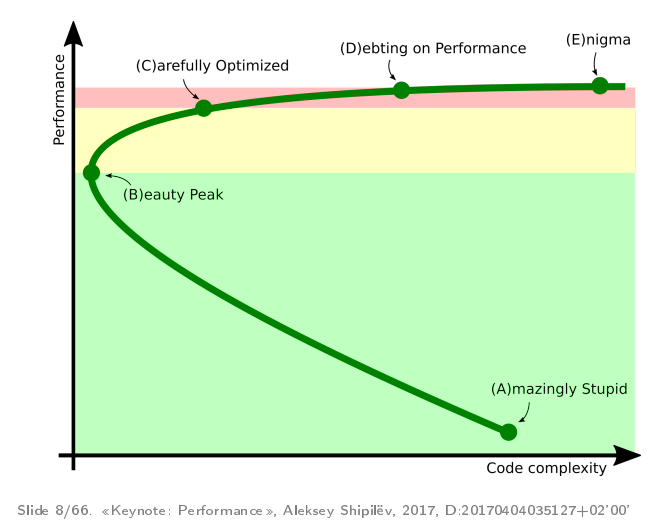

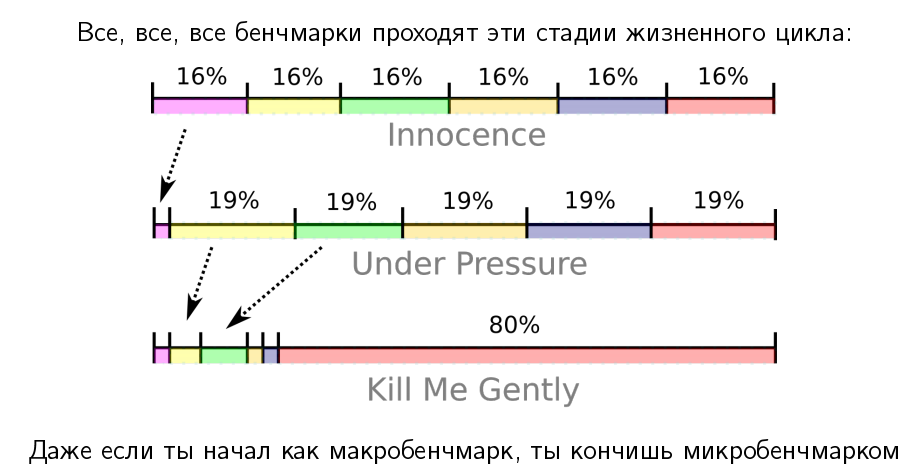

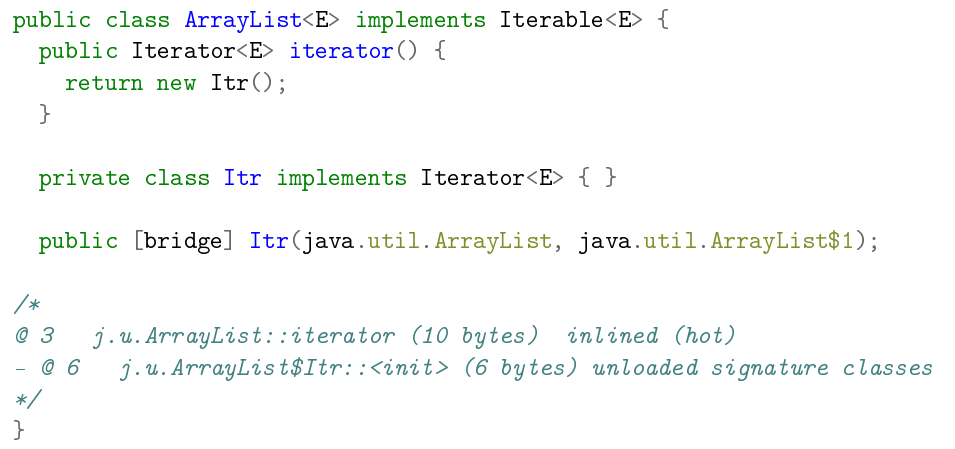

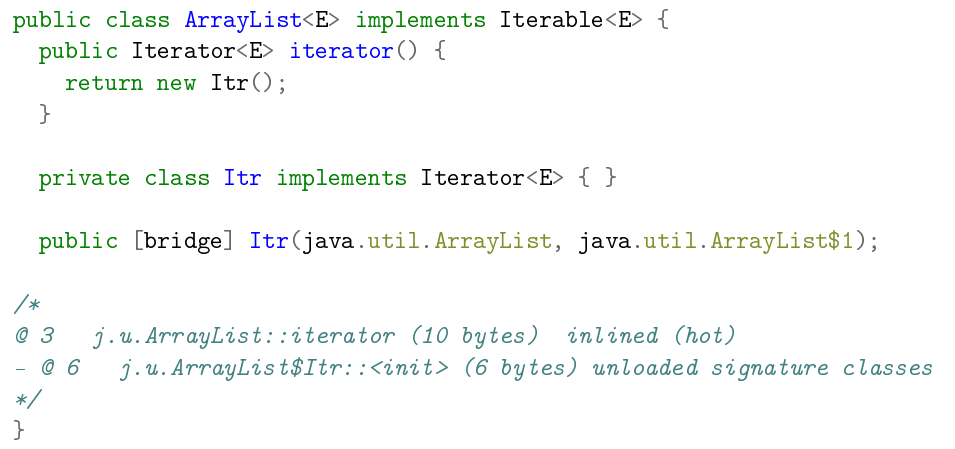

Стадии развития проектов — кривая им. Ш

Практически все проекты, где я участвовал в перформансной работе, проходят некоторые стандартные фазы развития. Когда-то я сформулировал, что эти фазы выглядят примерно так:

Это параметрический график: время тут течет от точки «A» до точки «B», «C», «D», «E». По оси ординат у нас производительность, по оси абсцисс — некоторая абстрактная сложность кода.

Обычно всё начинается с того, что люди велосипедят прототип, который медленно, но работает. Он достаточно сложен, потому что мы навелосипедили просто так, чтобы он не разваливался под собственным весом.

После того как начинается оптимизация — потихонечку начинается переписывание разных частей. Находясь в этой зелёной зоне, разработчики обычно берут профайлеры и переписывают куски кода, которые написаны очевидно ужасно. Это одновременно снижает сложность кода (потому что вы выпиливаете плохие куски) и улучшает производительность.

В точке «B» проект достигает некоторого субъективного пика «красоты», когда у нас вроде и перформанс хороший, и в продукте всё неплохо.

Далее, если разработчикам хочется ещё производительности, они переходят в жёлтую зону, когда берут более точный профайлер, пишут хорошие рабочие нагрузки и аккуратненько закручивают гайки. В этом процессе они там делают вещи, которые они бы не делали, если бы не производительность.

Если хочется ещё дальше, то проект приходит в некоторую красную зону, когда разработчики начинают корежить свой продукт, чтобы получить последние проценты производительности. Что делать в этой зоне — не очень понятно. Есть рецепт, по крайней мере, для этой конференции — идёте на JPoint/JokerConf/JBreak и пытаете разработчиков продуктов, как писать код, повторяющий кривизну нижних слоёв. Потому что, как правило, в красной зоне возникают штуки, которые повторяют проблемы, возникающие на нижних слоях.

Остальная часть доклада подробно рассказывает про то, что обычно происходит в этих зонах.

Зелёная зона

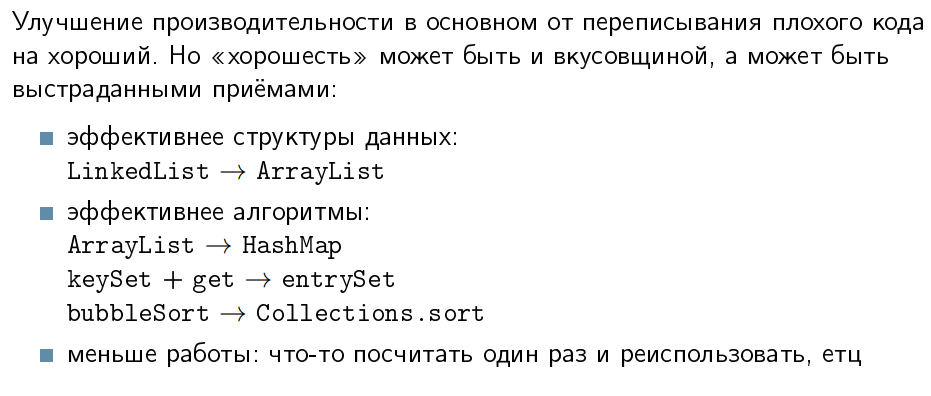

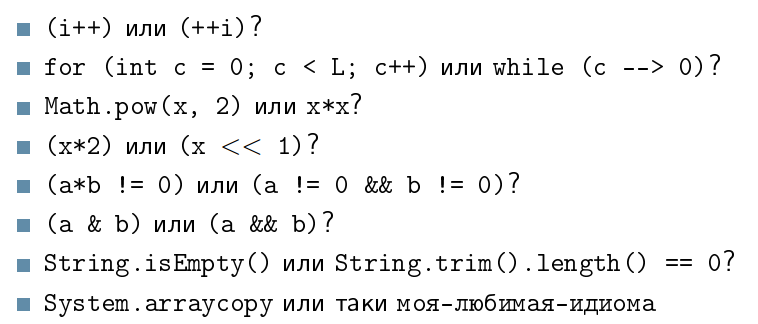

Мотивационная карточка зелёной зоны — это борьба с заусенцами в коде грубой силой:

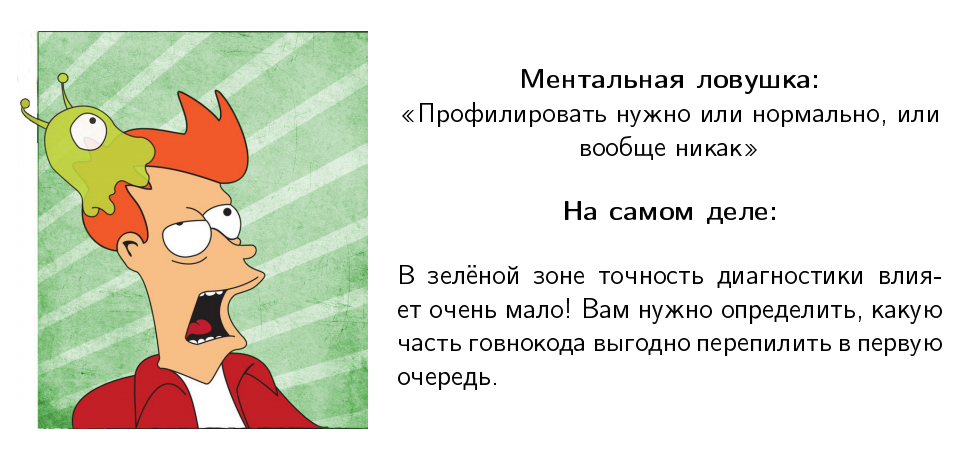

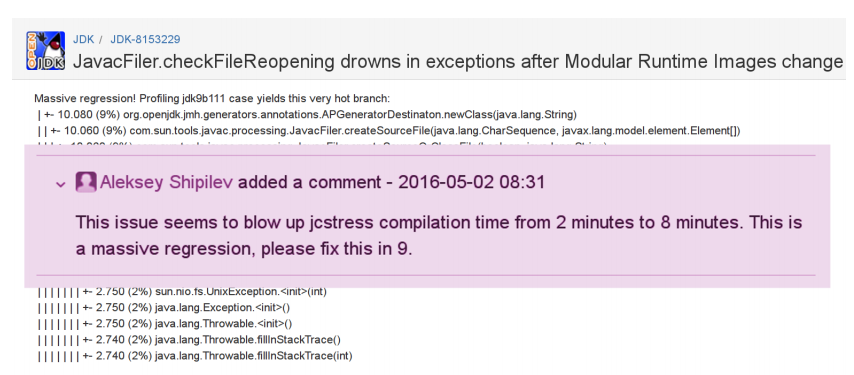

Грубая сила означает, что не надо точных инструментов — просто берём и делаем. В зелёной зоне есть некоторые ментальные ловушки.

Моя любимая звучит так: «Профилировать нормально или никак»:

Я постоянно слышу: «Послушайте доклады Шипилёва, он вам скажет, что профилировать нужно нормально или никак». Я ни разу этого не говорил. Когда вы в зелёной зоне, точность диагностики влияет очень мало. И, вообще говоря, профилировка вам нужна, чтобы понять, какую часть из того «микросервисного монолита», который вы умудрились написать, вам нужно переписать в первую очередь.

Профилирование и диагностика

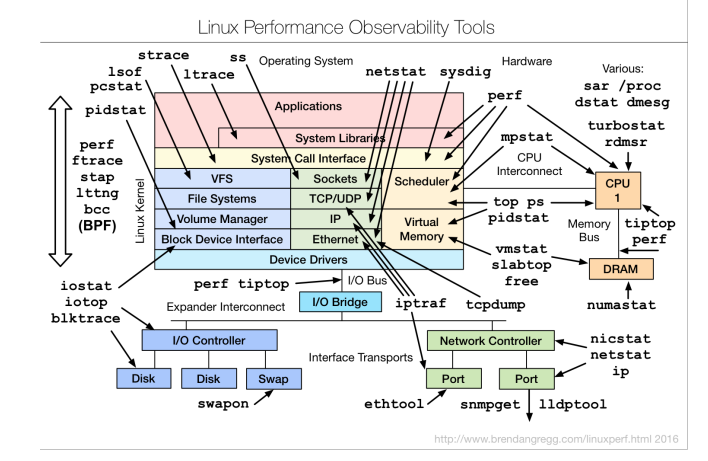

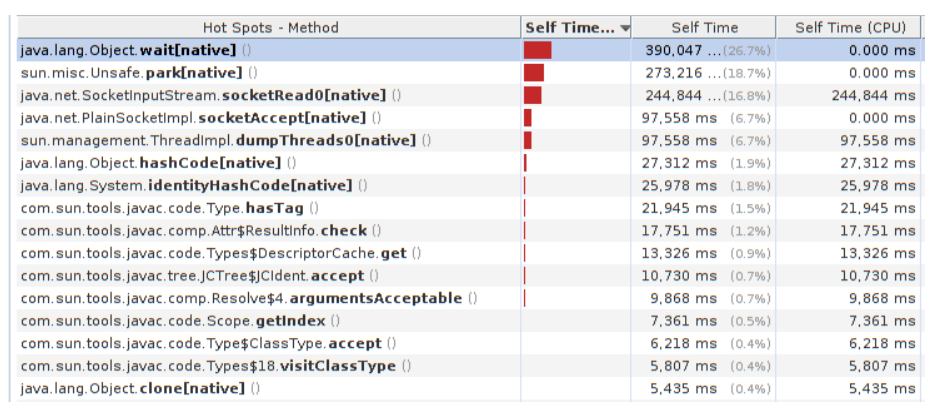

Если вы посмотрите на блоги разных классных перформансных чуваков, например, Брендана Грегга, он будет показывать такие страшные диаграммы, говорить, что вот такими инструментами можно посмотреть туда-сюда:

Многие говорят, когда смотрят на эти диаграммы: «Перформанс — это очень сложно, и мы не будем этим заниматься». Хотя на самом деле мысль Брендана не об этом. Она о том, что существуют достаточно простые способы быстро оценить, что в приложении происходит. Когда у нас есть хотя бы крупноклеточное понимание, нам гораздо лучше.

Поэтому диагностика в зелёной зоне опирается на очень простую мысль: мы не должны бояться смотреть на наше приложение. Даже крупноклеточное понимание, чего нам из ресурсов не хватает в нашем стеке, уже даст нам некоторую идею о том, на что стоит обращать внимание, а на что — нет. Даже если какую-нибудь полносистемную профилировку сделать, уже будет примерно понятно, где у вас bottleneck.

Профилирование

Наша цель в зелёной зоне — примерно понять, где мы проводим время.

Даже наивный профайлер, который вы можете собрать из палок и желудей, даст вам достаточно информации, чтобы совершать осознанные действия в зелёной зоне.

Если у вас есть продакшн, на который злые админы не дают устанавливать профайлер, можно просто через ssh взять jstack и сделать «while true; do jstack; sleep 1; done». Собрать тысячу этих jstack, агрегировать их. Это и будет «наколеночный» профайлер, который уже даст достаточно понимания, что в вашем продукте плохо.

Даже если вы руками расставите stopwatch-и в продукте и оцените, что в этой части продукта вы проводите 80% времени, а в этой — 20%, — это уже будет лучше, чем просто гадать на кофейной гуще о том, что будет, если мы в случайно попавшемся классе, написанном Васей в 2005 году, что-то поправим.

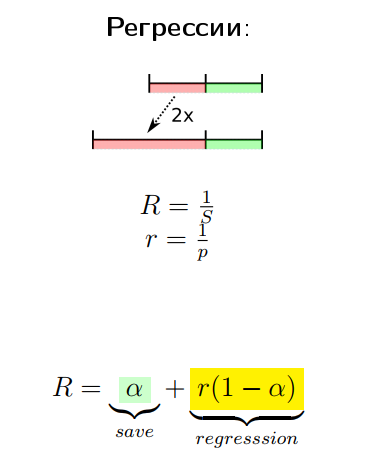

Измерение производительности

Следующая ментальная ловушка, связанная с профилированием, говорит, что производительность нужно измерять или нормально, или вообще никак.

Я про это постоянно слышу. Но в зелёной зоне улучшения «плюс-минус километр» обычно можно и глазками увидеть. Обычно это говорят в контексте «у вас плохой бенчмарк, он ничего не показывает, потому что он написан плохо, а нужно правильно мерить производительность», а в то же время у вас там грабля, которую видно практически на любом ворклоаде.

Мораль

Мораль очень простая: в зелёной зоне даже тривиальные нагрузочные тесты покажут вам крупные огрехи.

Я видел случаи, когда люди тратят недели на то, чтобы написать нагрузочные тесты на JMeter, вместо того, чтобы положить публичную ссылку в какой-нибудь Twitter и получить кучу народа, который придёт на бета-тестирование и повалит ваше приложение (а вам останется только сидеть с профайлером и смотреть, где же там упало). Даже обычный Apache Bench достаточно хорошо показывает крупные огрехи.

Чем раньше вы в разработке получите эти перформансные данные о крупных огрехах, тем быстрее вы сможете их исправить. Это вам тем более поможет планировать работы по производительности.

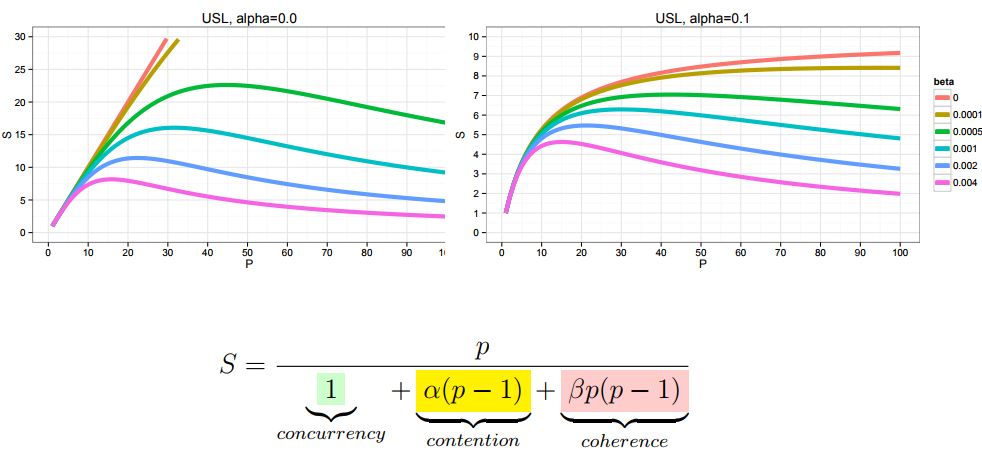

Пример-сюрприз