Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как разочароваться и НЕ перейти на Linux |

Как разочароваться и НЕ перейти на Linux

Недавний конфуз Джима Землина (Jim Zemlin) на Open Source Summit с презентацией, запущенной на Mac OS, не отменяет того факта, что и на десктопном направлении есть крупные успехи в последнее время. О некоторых я уже рассказывал: Ускорение WiFi, Графика без швов, Новый лучший I/O планировщик.

Вместе с тем, не все еще гладко и пока есть немало тех, кто пытался перейти на Linux и затем разочаровавшись вернулся к прежней ОС, чаще всего — Windows. Раньше для этого было довольно много поводов, но уже ясно, что их будет все меньше и меньше. Если вы желаете попробовать перейти на Linux и разочароваться, сделайте это сегодня, так как завтра может быть уже поздно. Итак, мои рецепты, для тех кто желает узнать, как провалить позможность подружиться с пингвинами и уйти ни с чем.

Подставить плечо или дать подножку?

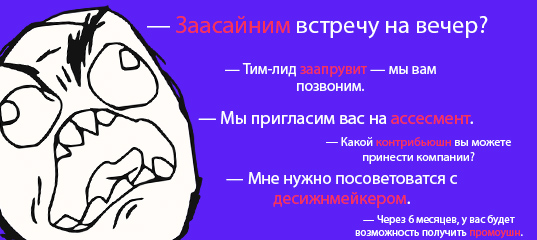

Мантра, которая быстрее всего приведет вас к краху цели звучит так: НЭВЛнР (ни%%% этот ваш Линукс не работает). Тут самым важным является местоимение «ваш», именно оно задает нужную дистанцию и точку зрения. Пользователь, который выдает этот комментарий, подсознательно имеет следующую картину перед глазами.

- Если программа с открытыми исходниками не работает как надо, это забота разработчиков и мейнтейнеров. Они обязаны отыскать все баги и починить их.

- Пользователь программы с открытым исходным кодом никому ничем не обязан, он и так потратил кучу времени. Не хватало еще, чтобы он сам чинил свой софт и портил глаза, ковыряясь в текстовых файлах и скриптах запуска службы.

- В конце-концов какая разница, открытое ПО или платное? Главное чтобы работало — вам шашечки или ехать?

Конечно же это совсем не так, и в этом успех программ с открытым кодом. Наряду со свободой пользоваться программой, изучать и изменять ее во благо, в нагрузки идет некий свод не очень обременительных обязанностей, суть которых — вносить посильную лепту в общую копилку. Кто умеет программировать, тот присылает патчи, другой открывает заявку на исправление дефекта, присылает необходимые данные, воспроизводит ошибку по несколько раз и служит подопытным промежуточных исправлений.

Помимо этого можно делать еще много чего, для помощи проекту с открытым кодом: создавать базу знаний, локализацию, отвечать на вопросы новичков. Было бы желание, а повод всегда найдется.

Use case: не смог открыть флешку

Комментарий пользователя немного облагорожен.

Пробовал эту вашу убунту. Она даже флешку не могла адекватно открыть. Причем то открыла, то нет. Снес через 10 минут к черту.

Скорее всего dark не сумел присоединить диск, возможно не хватало прав. Смонтировать флешку можно с помощью графического интерфейса в KDE, Gnome и всех более-менее полноценных DE. Можно и с командной строки, это можно найти в поиске за 5 минут. Однако, если бы действительно это было ошибкой драйвера, все равно можно было найти иной выход.

Остерегайтесь командной строки

Это верный путь к поставленной цели, то есть к провалу. Не раз и не два я видел коллег, которые лезут в Приложения, чтобы найти управление пакетами вместо того, чтобы освоить apt-get / aptitude и управление репозитариями. Это довольно быстро кончалось сносом, перестановкой ОС, так как скачать пакеты, обновления не получалось — для этого надо прописать внутренние ftp сервера, чтобы обойти межсетевой экран, GUI часто не имеет этих настроек.

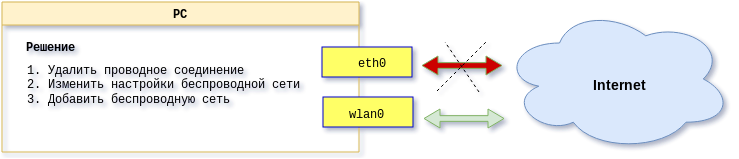

Use case: поменять устройство маршрута по умолчанию

В одном знакомом офисе как-то случилось неожиданное событие — отключилась проводная сеть и надо было поменять маршрутизацию, используя беспроводную сеть, которая по прежнему была в норме. Что тут началось...

Нужно было всего лишь удалить проводное соединение, изменить настройки беспроводной сети, которой долгое время не пользовались, и подключиться к беспроводной сети. Эта задача оказалась никому не под силам, из-за того, что они заложниками беспорядочного графического интерфейса сетевых настроек Windows. Причем против Windows играли боролись специалисты ИТ, которые умеют решать технические проблемы, в том числе и сетевые.

Повозившись, я осознал, что Windows не имеет полноценного end-to-end точки настроек сетевых соединений. В частности штатными средствами невозможно поменять настройки беспроводной сети после того, как она разведана и соединение установлено. На своем Gentoo Linux, все это завелось после трех команд NetworkManager.

(5:31)$ nmcli delete id

(5:32)$ nmcli connection edit

(5:33)$ nmcli connection up id Но можно конечно и из графического интерфейса, он позволяет полноценно управлять сетевыми соединениями.

!_rtfm

Не вникайте, не учите матчасть, сохраните естественный цвет глаз и шелковистые волосы. Центр настройки KDE, gedit и Центр приложений Ubuntu наше все! Кто и вправду так считает, очень скоро столкнется с обстоятельствами непреодолимой силы и вернется на Windows, или Mac OS, повторяя мантру: НЭВЛнР.

Не копайтесь в инит-скриптах, xml файлах, даже не открывайте grub.conf, и тем более xorg.conf. В противном случае разочароваться у вас не получится, потому что вы поймете, что практически все проблемы, с которыми вы столкнетесь, имеют разумное решение за приемлемый срок, при условии, что вы вникаете в детали и постигаете принципы.

И еще, если вы умеете пользоваться поиском в интернете, то документация вам не нужна.

man word,man -K wordinfo word#это и вправду фейлapropos word- лог файлы

- Howto

/usr/src/linux/уже ясно, что- Руководства пользователя

/usr/share/your_app/docs/

Греется ноут? Не мешкай, сноси Linux. GRUB не поднялся на UEFI? Хабр не читай, ОС удаляй.

Вам шашки или ехать?

Для меня шашки имеют значение, если подразумевать под этим программы с открытым исходным кодом, их социальное значение.

Если же важнее двигаться, не важно на чем, то тогда и вправду нет смысла оставаться на ОС, в которой нет привычных программ: 1С, Civilization, AutoCAD, SQL Server, Unreal Tournament. Но что вы будете делать, когда очередной анонс года свершений для Linux на рабочей станции, Линуса Торвальдса или Джима Землина, наконец-то сбудется?

|

Метки: author temujin системное администрирование настройка linux *nix linux windows desktop |

[Перевод] PowerShell для ИТ-безопасности. Часть IV: платформа безопасности с использованием скриптов |

PowerShell для ИТ-безопасности. Часть IV: платформа безопасности с использованием скриптов

- Перевод

В предыдущей заметке этой серии я предложил возможность объединения моих отдельных скриптов — один для обработки событий, другой для классификации — в одну систему. Не замахнуться ли на платформу безопасности на основе одного кода PowerShell?

Проработав некоторые детали, в основном относящиеся к зубодробительным событиям PowerShell, я смог заявить о своей победе и зарегистрировал патент на платформу безопасности на базе скриптов — SSP (Security Scripting Platform ).

Соединенные штаты PowerShell

Пока я получал незабываемый опыт работы с PowerShell, я понял, что некоторые из вас могут не вспомнить мои результаты работы со скриптами.

Давайте вспомним их вместе.

В первой заметке я представил удивительную строку кода PowerShell, которая следит за событиями доступа к файлам и запускает блок скрипта, аналогичный PS, — то есть код скрипта, который выполняется в собственной области памяти.

1. Register-WmiEvent -Query "SELECT * FROM __InstanceModificationEvent WITHIN 5 WHERE TargetInstance ISA 'CIM_DataFile' and TargetInstance.Path = '\\Users\\bob\' and targetInstance.Drive = 'C:' and (targetInstance.Extension = 'doc' or targetInstance.Extension = 'txt)' and targetInstance.LastAccessed > '$($cur)' " -sourceIdentifier "Accessor" -Action $actionДобавив некоторые элементы скрипта, я получил код, который назвал приложением анализа доступа к файлам. Фактически оно подсчитывает события доступа и отображает некоторые основные статистические данные, а также определяет всплески доступа, которые могут указывать на попытки взлома.

Это упрощенная версия технологии анализа поведения пользователей, которая широко применяется нами здесь в компании Varonis.

Пока все идет хорошо.

Затем в третьей заметке я показал, как с помощью PowerShell можно относительно просто просканировать и классифицировать файлы в папке. Поскольку это действие связано с интенсивным использованием диска, для ускорения классификации имеет смысл использовать функцию многозадачности PowerShell, известную как Runspaces.

В существующих решениях по обработке событий файлов и классификации данных, скажем Data Classification Framework компании Varonis, используется более оптимизированный подход к распределению файлов по категориям путем передачи операций с файлами в модуль классификации.

Почему?

Потому что им не требуется повторно классифицировать содержимое файлов заново: рассматриваются только файлы, которые изменены. Поэтому мой скрипт-классификатор сильно выиграет, если будет получать некоторую информацию о событиях изменения файлов.

Этот подход я реализовал с помощью платформы безопасности с использованием скриптов.

Собственные агенты Varonis, которые перехватывают события файлов Linux или Windows, — это узко специализированный код низкого уровня. Для работы такого типа требуется код, который будет коротким, простым и полностью сфокусированным на сборе сведений о событиях и быстрой передаче этих данных в другие приложения, которые уже будут выполнять обработку более высокого уровня.

Поэтому я взял свой исходный скрипт обработки событий, оптимизировал его и удалил весь код для отображения статистических данных. Затем я переработал классификатор, чтобы он проверял только измененные файлы.

В основном это классическая комбинация внутреннего модуля и внешнего интерфейса.

Вопрос состоит в том, как соединить два скрипта: как сообщить классификатору о произошедшей операции с файлом?

Сообщения и события

После того, как я провел несколько долгих дней за изучением форумов разработчиков, я наконец наткнулся на функцию PowerShell под именем Register-EngineEvent.

Что представляет собой этот командлет PowerShell?

Мне представляется, что это способ передачи сообщений с помощью именованного события, которое можно совместно использовать в двух скриптах. Он работает несколько иначе, чем традиционные системные сообщения и очереди, поскольку получаемое сообщение асинхронно запускает блок скрипта PowerShell. Далее это станет более понятным.

Дело в том, что у register-EngineEvent есть два варианта работы. С параметром -forward этот командлет работает как издатель событий. Без параметра -forward он выполняет роль получателя.

Понятно?

Я использовал событие с именем Delta — которое технически выполняет роль значения идентификатора SourceIdentifer — для координации работы моего скрипта обработки событий, который выдает сообщения о событиях, и моего скрипта-классификатора, который получает эти сообщения.

В первом из этих двух скриптов, отрывок из которого представлен далее, я показываю, как я регистрировал публичное имя события Delta с помощью строки -Register-EngineEvent -forward, а затем ожидал внутренних событий доступа к файлам. Когда такое событие происходило, я отправлял сообщение о внутреннем событии файла — говоря на языке PowerShell, пересылал его — соответствующему командлету Register-EngineEvent в скрипте-классификаторе во втором отрывке кода.

1. Register-EngineEvent -SourceIdentifier Delta -Forward

2. While ($true) {

3. $args=Wait-Event -SourceIdentifier Access # wait on internal file event

4. Remove-Event -SourceIdentifier Access

5. if ($args.MessageData -eq "Access") {

6. #do some plain access processing

7. New-Event -SourceIdentifier Delta -EventArguments $args.SourceArgs -MessageData $args.MessageData #send event to classifier via forwarding

8. }

9. elseif ($args.MessageData -eq "Burst") {

10. #do some burst processing

11. New-Event -SourceIdentifier Delta -EventArguments $args.SourceArgs -MessageData $args.MessageData #send event to classifier via forwarding

12. }

13. }На стороне получателя я не использовал параметр -forward и вместо этого переходил в блок скрипта PowerShell, который асинхронно обрабатывал событие. Результат вы можете увидеть ниже.

1. Register-EngineEvent -SourceIdentifier Delta -Action {

2.

3. Remove-Event -SourceIdentifier Delta

4. if($event.MessageData -eq "Access") {

5. $filename = $args[0] #got file!

6. Lock-Object $deltafile.SyncRoot{ $deltafile[$filename]=1} #lock&load

7. }

8. elseif ($event.Messagedata -eq "Burst") {

9. #do something

10. }

11.

12. }Запутались? А я говорил недавно, что обработка событий файлов — это непросто, и что мои учебные скрипты не справятся с обработкой реальных производственных нагрузок?

Путаница возникает, поскольку командлеты New-Event и Wait-Event для внутреннего обмена сообщениями о событиях отличаются от функций внешнего обмена сообщениями о событиях, предоставленных в Register-EngineEvent.

Еще больше путаницы

Полный скрипт классификации представлен далее. Я подробнее расскажу о нем в следующей и последней заметке из этой серии. А пока посмотрите на этот скрипт и обратите внимание на обработку событий и многозадачность.

1. Import-Module -Name .\pslock.psm1 -Verbose

2. function updatecnts {

3. Param (

4. [parameter(position=1)]

5. $match,

6. [parameter(position=2)]

7. $obj

8. )

9.

10. for($j=0; $j -lt $match.Count;$j=$j+2) {

11. switch -wildcard ($match[$j]) {

12. 'Top*' { $obj| Add-Member -Force -type NoteProperty -Name Secret -Value $match[$j+1] }

13. 'Sens*' { $obj| Add-Member -Force -type NoteProperty -Name Sensitive -Value $match[$j+1] }

14. 'Numb*' { $obj| Add-Member -Force -type NoteProperty -Name Numbers -Value $match[$j+1] }

15. }

16.

17. }

18.

19. return $obj

20. }

21.

22. $scan = {

23. $name=$args[0]

24. function scan {

25. Param (

26. [parameter(position=1)]

27. [string] $Name

28. )

29. $classify =@{"Top Secret"=[regex]'[tT]op [sS]ecret'; "Sensitive"=[regex]'([Cc]onfidential)|([sS]nowflake)'; "Numbers"=[regex]'[0-9]{3}-[0-9]{2}-[0-9]{3}' }

30.

31. $data = Get-Content $Name

32.

33. $cnts= @()

34.

35. if($data.Length -eq 0) { return $cnts}

36.

37. foreach ($key in $classify.Keys) {

38.

39. $m=$classify[$key].matches($data)

40.

41. if($m.Count -gt 0) {

42. $cnts+= @($key,$m.Count)

43. }

44. }

45. $cnts

46. }

47. scan $name

48. }

49.

50.

51. $outarray = @() #where I keep classification stats

52. $deltafile = [hashtable]::Synchronized(@{}) #hold file events for master loop

53.

54. $list=Get-WmiObject -Query "SELECT * From CIM_DataFile where Path = '\\Users\\bob\' and Drive = 'C:' and (Extension = 'txt' or Extension = 'doc' or Extension = 'rtf')"

55.

56.

57. #long list --let's multithread

58.

59. #runspace

60. $RunspacePool = [RunspaceFactory]::CreateRunspacePool(1,5)

61. $RunspacePool.Open()

62. $Tasks = @()

63.

64.

65. foreach ($item in $list) {

66.

67. $Task = [powershell]::Create().AddScript($scan).AddArgument($item.Name)

68. $Task.RunspacePool = $RunspacePool

69.

70. $status= $Task.BeginInvoke()

71. $Tasks += @($status,$Task,$item.Name)

72. }

73.

74.

75. Register-EngineEvent -SourceIdentifier Delta -Action {

76.

77. Remove-Event -SourceIdentifier Delta

78. if($event.MessageData -eq "Access") {

79. $filename = $args[0] #got file

80. Lock-Object $deltafile.SyncRoot{ $deltafile[$filename]=1} #lock& load

81. }

82. elseif ($event.Messagedata -eq "Burst") {

83. #do something

84. }

85. }

86.

87. while ($Tasks.isCompleted -contains $false){

88.

89. }

90.

91. #check results of tasks

92. for ($i=0; $i -lt $Tasks.Count; $i=$i+3){

93. $match=$Tasks[$i+1].EndInvoke($Tasks[$i])

94.

95.

96. if ($match.Count -gt 0) { # update clasafication array

97. $obj = New-Object System.Object

98. $obj | Add-Member -type NoteProperty -Name File -Value $Tasks[$i+2]

99. #defaults

100. $obj| Add-Member -type NoteProperty -Name Secret -Value 0

101. $obj| Add-Member -type NoteProperty -Name Sensitive -Value 0

102. $obj| Add-Member -type NoteProperty -Name Numbers -Value 0

103.

104. $obj=updatecnts $match $obj

105. $outarray += $obj

106. }

107. $Tasks[$i+1].Dispose()

108.

109. }

110.

111. $outarray | Out-GridView -Title "Content Classification" #display

112.

113. #run event handler as a separate job

114. Start-Job -Name EventHandler -ScriptBlock({C:\Users\bob\Documents\evhandler.ps1}) #run event handler in background

115.

116.

117. while ($true) { #the master executive loop

118.

119.

120. Start-Sleep -seconds 10

121. Lock-Object $deltafile.SyncRoot { #lock and iterate through synchronized list

122. foreach ($key in $deltafile.Keys) {

123.

124. $filename=$key

125.

126. if($deltafile[$key] -eq 0) { continue} #nothing new

127.

128. $deltafile[$key]=0

129. $match = & $scan $filename #run scriptblock

130. #incremental part

131.

132. $found=$false

133. $class=$false

134. if($match.Count -gt 0)

135. {$class =$true} #found sensitive data

136. if($outarray.File -contains $filename)

137. {$found = $true} #already in the array

138. if (!$found -and !$class){continue}

139.

140. #let's add/update

141. if (!$found) {

142.

143. $obj = New-Object System.Object

144. $obj | Add-Member -type NoteProperty -Name File -Value $Tasks[$i+2]

145. #defaults

146. $obj| Add-Member -type NoteProperty -Name Secret -Value 0

147. $obj| Add-Member -type NoteProperty -Name Sensitive -Value 0

148. $obj| Add-Member -type NoteProperty -Name Numbers -Value 0

149.

150. $obj=updatecnts $match $obj

151.

152. }

153. else {

154. $outarray|? {$_.File -eq $filename} | % { updatecnts $match $_}

155. }

156. $outarray | Out-GridView -Title "Content Classification ( $(get-date -format M/d/yy:HH:MM) )"

157.

158. } #foreach

159.

160. } #lock

161. }#while

162.

163. Write-Host "Done!"Вкратце, этот классификатор выполняет первоначальное сканирование файлов в папке, сохраняет результаты классификации в $outarray, затем, когда возникает событие изменения файла, он обновляет $outarray, занося в него новые данные классификации. Другими словами, реализуется система добавления данных.

Есть небольшая побочная проблема в необходимости работы с обновлениями в $outarray, которая возникает каждый раз, когда в другой части скрипта классификации выполняется поиск того, что было изменено в этой переменной хеш-таблицы.

Это классическая ситуация состязания. И для обработки этой ситуации я решил использовать синхронизированныепеременные PowerShell.

Более подробно об этой загадочной функции PowerShell я расскажу в своей следующей заметке, и в заключении скажу несколько слов о том, как мастерить собственные решения.

|

Метки: author Alexandra_Varonis информационная безопасность big data блог компании varonis systems varonis powershell хранение данных |

Числа — расшифровка доклада Дагласа Крокфорда с HolyJS 2017 Piter |

Числа — расшифровка доклада Дагласа Крокфорда с HolyJS 2017 Piter

Давайте посмотрим, откуда пришли цифры, куда они могут привести и как они работают.

В основе статьи — доклад Дугласа Крокфорда (Douglas Crockford) с июньской конференции HolyJS 2017 в Санкт-Петербурге (презентацию доклада можно найти тут)

Пальцы

Начнем с пальцев. Пальцы намного старше чисел. Человек развил пальцы, чтобы лучше лазить по деревьям и собирать фрукты. И он был действительно счастлив, занимаясь этим на протяжении миллионов лет.

Инструменты

Но климат изменился, деревья начали исчезать. Человеку пришлось спуститься на землю, пойти по траве и искать другие источники пищи. И пальцы понадобились для манипулирования инструментами, например, палкой. С ее помощью можно было копать землю, чтобы найти клубни. Еще один пример инструмента — камень, позволяющий колотить клубни, чтобы сделать их достаточно мягкими для еды (наши маленькие обезьяньи зубы не позволяют есть всё подряд; чтобы выжить, мы были вынуждены учиться готовить).

Со временем человек набирался опыта в обращении с инструментами. И инструменты влияли на нашу эволюцию, поэтому мы продолжали их обновлять. Вскоре мы узнали, как делать ножи из вулканического стекла, и в итоге научились управлять огнем. Теперь человек знал, как посадить семена в землю и вырастить свою собственную еду. С новыми знаниями люди начали собираться в более крупные сообщества. Мы перешли от семей и кланов к городам и нациям.

Общество росло, и появилась проблема отслеживания всей человеческой деятельности. Чтобы решить ее, человеку пришлось придумать счет.

Счет

Как оказалось, наш мозг не очень хорошо запоминает много цифр. Но чем сложнее становилось общество, тем больше всего нужно было запоминать. Поэтому человек научился делать зарубки на древесине и надписи на стенах. Появились идеи нанизывать орехи на струны. Но мы все равно забывали, что именно представляют собой эти числа. Поэтому пришлось придумать письменность.

Письменность

Сегодня мы используем письменность для решения множества задач: для писем, для законов, для литературы. Но сначала это были рукописи. Я считаю изобретение письменности самым важным открытием из когда-либо совершенных человеком, и произошло оно трижды.

Первые следы письменности были найдены на Ближнем Востоке. Многие умные люди считают, что это случилось в Месопотамии. Я же думаю, что это произошло в Египте. Кроме того, письменность была изобретена в Китае и в Америке. К сожалению, последняя из упомянутых цивилизаций не пережила испанское вторжение.

Давайте рассмотрим подробнее некоторые исторические системы счисления.

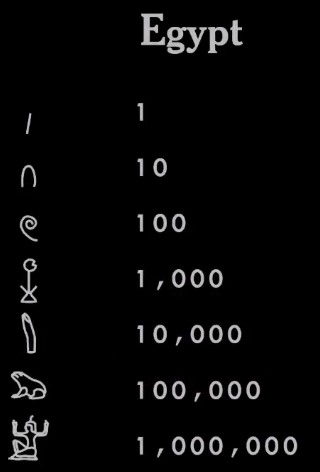

Египет

Так выглядели числа в Египте.

У египтян была десятичная система. Для каждой степени 10 у них был предусмотрен свой иероглиф. Палка представляла единицу, кусок верёвки — 100, палец — 10000, а парень с поднятыми руками — миллион (это демонстрирует некоторую математическую изощренность, т.к. у них был символ, обозначающий не абстрактное понятие «много», а точно «миллион» — ни больше, ни меньше).

Египтяне придумали много других вещей: треугольник 3 на 4 на 5 с прямым углом (они знали, зачем этот угол нужен), действительно умную систему для работы с дробями. У них было приближение для числа Пи и много чего еще.

Финикия

Египтяне научили своей системе финикийцев, которые жили на территории современного Ливана. Они были очень хорошими мореплавателями и торговцами — плавали по всему Средиземному морю и части Атлантики. Приняв от египтян довольно сложную систему счисления, они упростили ее. Используя письменность, состоящую только из согласных букв, они уменьшили набор символов с тысяч, которые были у египтян, до пары десятков, что было намного проще в использовании. И они научили своей системе людей, с которыми торговали, в частности, греков.

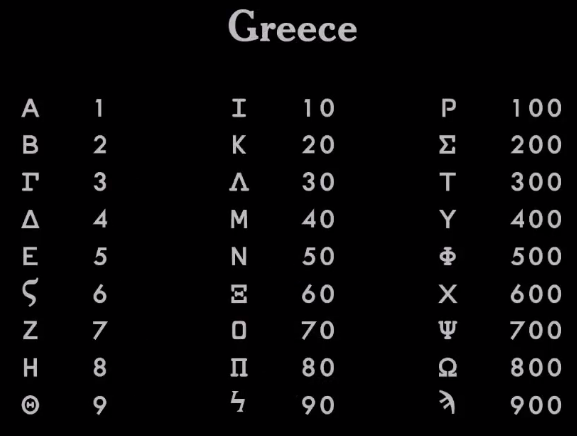

Греция

Греки взяли финикийскую систему и улучшили ее, добавив гласные. Поэтому теперь они могли корректно записывать все слова. С того времени греческий алфавит содержит 27 букв.

Греки использовали тот же набор символов для записи чисел. Они взяли первые 9 букв алфавита для обозначения цифр с 1 по 9, следующие 9 букв — для десятков от 10 до 90, и еще 9 букв для сотен — от 100 до 900. Свою систему они передали римлянам.

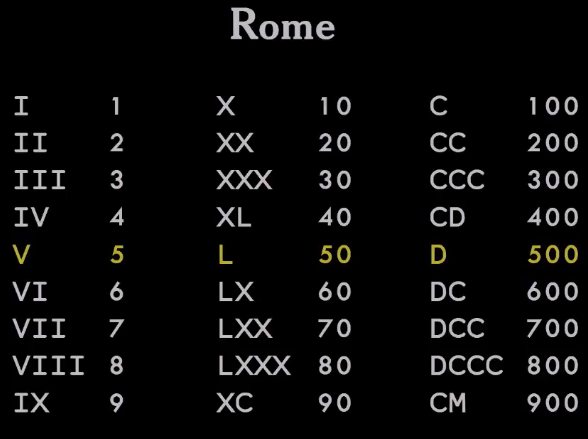

Рим

Но римляне по-прежнему использовали в основе своей системы счисления египетскую систему. Хотя они переняли греческий подход — использование букв вместо иероглифов. Также они добавили некоторые инновации, чтобы сделать цифры немного компактнее.

Одна из проблем египетской системы заключалась в том, что для записи числа 99 требовалась последовательность из 18 символов. Римляне хотели сократить запись. Для этого они придумали символы, представляющие половину десяти или половину сотни (тысячи). Один у них был представлен символом I (или палкой), 10 — X (пучок палок, соединенных вместе), а 5 — V, что есть всего лишь X пополам.

Другая инновация заключалась в добавлении вычитания в систему счисления. До сих пор системы были аддитивными. Число представлялось суммой всех символов. Но у римлян была реализована идея, что определенные символы (на определенных позициях) могут уменьшать число.

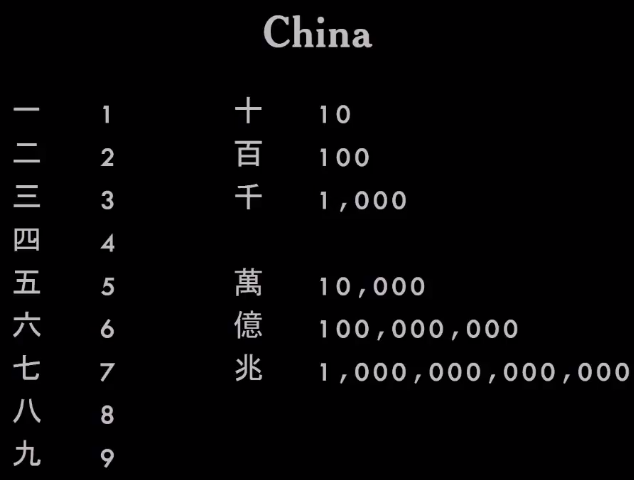

Китай

Между тем в Китае творились действительно интересные вещи.

У них была другая система, в которой использовались символы от 1 до 9 и набор множителей или модификаторов. Так можно было записывать числа любого размера и сложности, просто составляя иероглифы вместе. Очень элегантная система.

Индия

Больший скачок произошел в Индии.

Математики в Индии пришли к идее нуля — числа, которое ничего не представляло. И они догадались использовать его на позиционной основе. Для отображения чисел применялись всего 10 символов, но они могли быть объединены для создания любого числа. Это было действительно важной идеей.

Тиражирование идеи

Индийцы передали свою систему персам. Те назвали её индийскими цифрами. А от персов идея попала к арабам. В свою очередь арабы передали ее европейцам, которые и называли такой способ записи арабскими цифрами. Это основная система счисления, которую сегодня использует большая часть мира.

Действительно замечательно то, что вне зависимости от того, на каком языке вы говорите, вы можете понять эти цифры. Запись числа так же универсальна, как и человеческое общение.

Запись чисел и математика

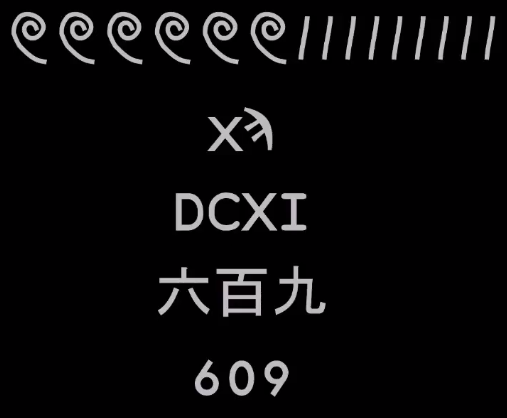

Вот одно и то же число, записанное во всех упомянутых системах.

И все эти системы работали. Они использовались ключевыми нациями и империями на протяжении веков. Поэтому трудно утверждать, что одна из этих систем лучше, чем другая.

Единственное преимущество, которое имела индийская система над всеми остальными, заключалось в том, что можно было взять столбец чисел и сложить их вместе, не используя счеты — с помощью только лишь ручки, бумаги и слегка тренированного мозга. Это нелегко было сделать в любой другой системе.

Сегодня это неважно, поскольку у нас есть компьютеры. Поэтому нет ясного ответа на то, почему мы все еще используем эту систему. Возможно, есть некоторые преимущества ее использования, которые я не могу себе представить, например, в наборе номера телефона. Кажется, что с использованием римских цифр это будет сделать довольно сложно. Но я не помню, когда последний раз набирал номер телефона. Так что, возможно, это уже не имеет значения.

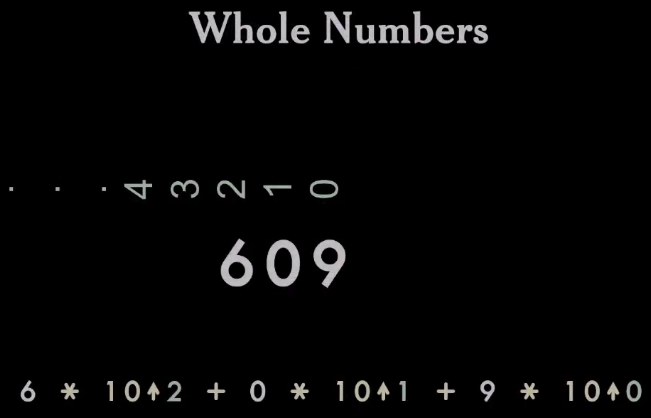

Важная идея заключается в том, что индийские числа научили нас математике.

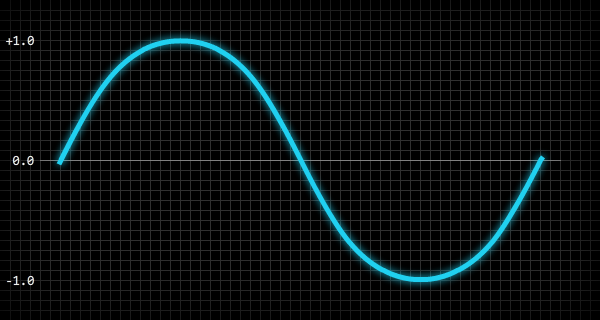

Это позиционная система. Вы можете взять цифры и поместить их на числовую линию, а дальше просуммировать, цифры в каждой позиции, умножая их на 10 в степени, соответствующей номеру этой позиции. Получается, что индийские числа являются сокращением для полиномов. А полином — действительно важное понятие в математике. Мы получили способ записи чисел. Этого не было в других системах.

Целые числа

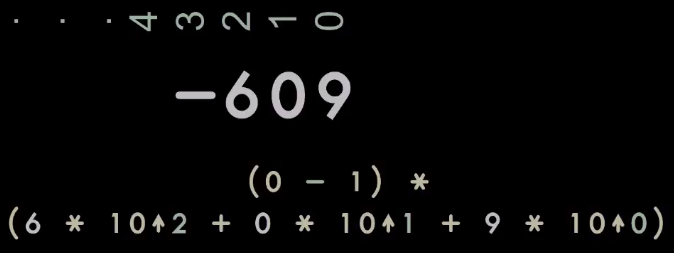

Данная система также допускала отрицательные числа.

Мы могли записать число со знаком минус, представив негативные вещи. Эта концепция была бессмысленной в других системах счисления. Мы не могли говорить о негативном в Египте, в этом не было смысла. Но мы можем делать это в индийской системе. И оказывается, есть много интересных вещей, происходящих с отрицательными числами.

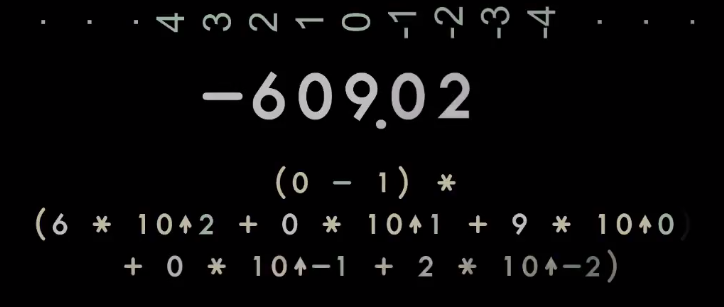

Вещественные числа

Мы можем взять числовой ряд и продолжить его в обратном направлении до бесконечности. Используя такую запись, мы получим действительные числа.

Другие системы счисления также могли работать с дробями. Но это всегда были особые случаи. С индийской системой мы можем записывать дроби точно так же, как целые числа — нужна лишь небольшая дисциплина в управлении десятичными знаками.

В оригинальной индийской записи указывалась позиция разделителя с помощью линии сверху.

Но с годами разделительный символ менялся.

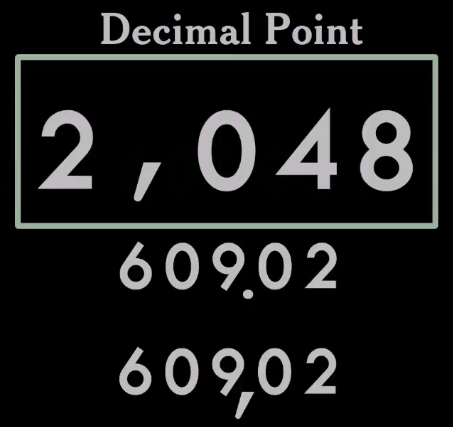

В разных странах существуют свои соглашения о том, как следует писать. В одних культурах используется десятичная точка, в других — запятая. И это долго не имело значения. Вы были в своей стране и могли писать числа правильно или неправильно. Но это становится проблемой, когда у вас есть интернет, потому что теперь числа повсюду. Записанное вами число могут увидеть где угодно. И все будут видеть разные вещи — может возникнуть путаница.

Например, в зависимости от того, где вы находитесь и как обучались, первое число на картинке вы можете прочитать как 2048 или 2 и 48 тысячных. И это может оказаться действительно серьезной ошибкой, особенно если речь идет о финансах.

Поэтому я предсказываю, что мир рано или поздно найдет способ выбрать один из вариантов записи. Потому что нет никакой ценности в этой путанице. Однако сложность в выборе одного из вариантов заключается в том, что ни один из них не является явно лучшим. Как мир будет выбирать?

Я предсказываю, что это решите вы. И выберите вы десятичную точку, потому что ее используется ваш язык программирования. А все цифры в мире в конечном счете проходят через компьютерные программы. В конце концов вы просто решите упростить это.

Основание

Все рассмотренные выше системы имеют основание 10. Так записывали числа на Ближнем Востоке и в Китае. Они не общались между собой, но взяли основание 10.

Как это произошло? Они просто посчитали пальцы на обеих руках. И это сработало.

Но есть и другие культуры, которые записывали числа по-другому. Например, в Америке была система счисления с основанием 20. Знаете, как они до нее додумались? Полагаю, это очевидно: они посчитали пальцы не только на руках, но и на ногах. И это тоже сработало. У них была развитая цивилизация. Они выполняли достаточно много вычислений, но использовали основание 20.

Некоторые культуры использовали основание 12. И мы все еще можем видеть их следы в нашем мире. Например, у наших часов основание 12. У нас все ещё 12 дюймов в футах. Мы выучились этому у британцев и до сих пор не можем отказаться от использования подобных усложнений.

Компромиссы: 60

Шумеры использовали основание 60. Да и мы все еще придерживаемся основания 60, верно? Мы так считаем наше время и делаем географические измерения. Географическим приложениям приходится использовать систему координат на базе системы счисления с основанием 60. Это добавляет ненужную сложность.

Как появилось основание 60? Я думаю, когда города росли, они поглощали много мелких поселений, объединяя их в большие. В какой-то момент они попытались объединить сообщество, которое использовало основание 10, с сообществом, которое взяло в качестве основания 12. Наверняка был какой-то король или комитет — кто-то должен был решить, как объединить их. Правильный вариант был — использовать основание 10. Второй вариант — развиваться с основанием 12. Но вместо этого они выбрали худший вариант из возможных — использовали основание, являющееся наименьшим общим кратным. Причина, по которой было принято такое решение, состоит в том, что комитет не мог решить, какой из вариантов лучше. Они пришли к компромиссу, который, по их мнению, похож на то, что все хотели. Но дело же не в том, кто и что хочет.

Надо отметить, что комитеты все ещё принимают такие решения каждый раз, когда выпускают стандарты.

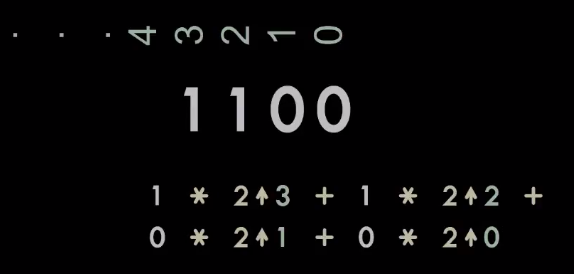

Двоичная система

Действительно интересная вещь, связанная с основанием, — появление двоичной системы. Мы можем взять индийскую систему и просто заменить 10 на 2.

Так мы можем представлять все при помощи бит. И это был действительно важный шаг вперед, потому что позволил изобрести компьютер.

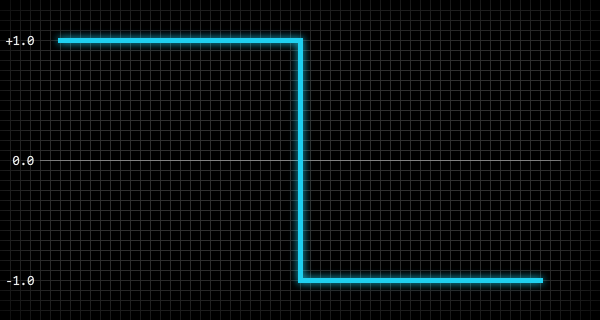

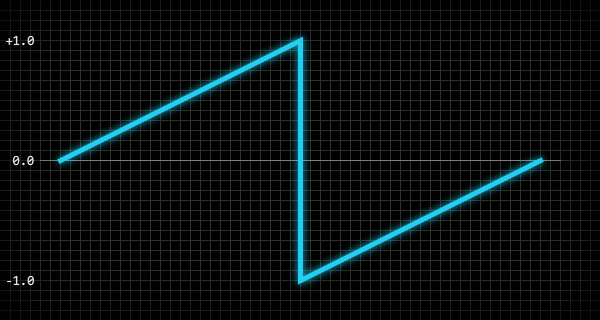

Если мы начинаем говорить о компьютерах, использующих двоичный формат, необходимо вспомнить о знаке числа. Записывать и отображать знак можно тремя способами:

- Знаковая величина (Signed magnitude representation). В этом случае мы просто добавляем дополнительный двоичный бит к числу и решаем, в каком из состояний этот бит соответствует положительному числу, а в каком — отрицательному. И неважно, поставим ли мы этот бит спереди или сзади (это всего лишь вопрос конвенции). Недостатком этого способа является присутствие двух нулей: положительного и отрицательного, что не имеет смысла, поскольку ноль не имеет знака.

- Первое дополнение (One’s complement), в котором мы выполняем операцию побитового нет для числа, чтобы сделать его отрицательным. Помимо двух нулей (положительного и отрицательного — как в предыдущем варианте) у этого представления присутствует проблема переноса: при обычном сложении двух чисел, представленных таким образом, для получения корректного результата необходимо в конце добавлять 1 бит. Но в остальном это работает.

- Второе дополнение (Two's complement), в котором удалось обойти проблему переноса. Отрицательное N представляется не побитовым отрицанием положительного N, а им же + 1. Помимо отсутствия проблемы переноса мы получаем только один нуль, что очень хорошо. Но при этом мы получаем дополнительное отрицательное число. И это проблема, потому что вы не можете получить абсолютное значение этого числа — вместо этого вы получите то же отрицательное число. Это потенциальный источник ошибок.

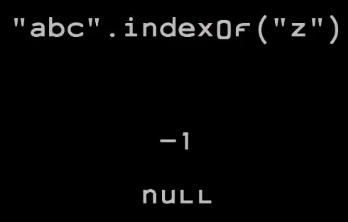

Каждый из вариантов имеет свои недостатки, в частности, какие-то дополнительные числа. Я думаю, что мы должны взять это дополнительное число (отрицательный 0 или дополнительное отрицательное число из второго дополнения), и превратить его в сигнал о том, что это не число вовсе. Таким образом это позволит нам избежать проблемы, которая проявляется в Java: если мы используем метод indexOf, чтобы найти строку в другой строке, и если она ее не находит, Java не может сигнализировать об этом. Потому что это дурацкая система может возвращать только int, а int может представлять только целые числа.

Чтобы обойти эту проблему, придумали сомнительный компромисс: возврат минус единицы. Но, к сожалению, если вы просто возьмете возвращаемое значение и поместите его в другую формулу, можете получить неверный результат. Если бы метод возвращал нулевое значение, это можно было бы обнаружить в downstream, и мы с меньшей вероятностью получали бы плохой результат вычислений.

Types

Давайте немного подробнее рассмотрим типы, использующиеся в наших языках.

int

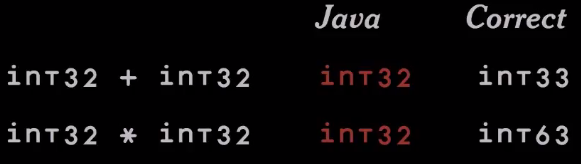

У нас есть много языков, где под разными именами есть int32. Если мы сложим два числа int32, к какому типу будет относиться результат? Ответ — int33, потому что в результате сложения вы можете получить число, которое немного больше int32.

Здесь Java ошибается. Java говорит, что это int32.

Еще один пример — умножение int32 на int32. Что мы получим в результате? Похоже, int63.

Когда в результате обычного вычисления получается результат, который выходит за рамки типа, мы получаем переполнение. И наши CPU знают об этом. Например, в архитектуре Intel в ЦП есть флаг переноса, который содержит этот 33-й бит. Также на архитектуре Intel, если вы делаете умножение 32-битных чисел, вы получаете 64-битный результат. Т.е. предусмотрен регистр, который содержит необходимые вам «дополнительные» 32 бита. И есть флаг переполнения, который устанавливается, если требуется игнорировать высокий порядок умножения. Он сообщает, что произошла ошибка. К сожалению, Java не позволяет вам получать эту информацию. Она просто отбрасывает все, что является проблемой.

Что вообще должно происходить, при переполнении? Здесь есть несколько вариантов действий:

- мы можем хранить значение null, что, я думаю, очень разумно;

- или максимально возможную часть (насыщение — saturation). Это может быть разумно при обработке сигналов и в компьютерной графике. Однако вы не захотите так делать в финансовых приложениях;

- можно выдавать ошибку — машина должна вызвать исключение или что-то должно произойти. Софт должен понять, что в вычислениях произошла путаница и нужно исправить ситуацию;

- некоторые говорят, что программа должна остановиться. Это довольно резкая реакция, но такой вариант работал бы, если бы машина не просто останавливалась, а как-то сообщала, что что-то не так.

Если же вы намерены максимизировать количество возможных ошибок, вы просто отбрасываете самые важные биты без уведомления. Именно так поступает Java и большинство наших языков программирования. Т.е. они предназначены для повышения количества ошибок.

Разбиение чисел на значения из разных регистров

Первые вычислительные машины работали с целыми числами. Но машины были построены и запрограммированы математиками, а они хотели работать с вещественными числами. Поэтому была разработана арифметика, где вещественное число представляется целым числом, умноженным на некоторый масштабный коэффициент.

Если у вас есть два числа с одинаковыми коэффициентами масштабирования, вы можете их просто складывать, а если они имеют разные масштабные коэффициенты, для выполнения простейших операций придется изменить хотя бы один из них. Поэтому перед выполнением каких-либо операций необходимо сопоставлять масштабный коэффициент. И запись стала немного сложнее, потому что в конце вы должны были поставить избыточный масштабный коэффициент. И деление усложнилось, потому что вам приходится учитывать коэффициент масштабирования. В результате люди стали жаловаться, что это сделало программирование действительно трудным, очень подверженным ошибкам. Кроме того, было сложно найти оптимальный масштабный коэффициент для любого приложения.

В качестве решения этих проблем кто-то предложил сделать числа с плавающей запятой, которые могли бы отображать аппроксимированные действительные числа при помощи двух компонент: самого числа и записи того, где находится внутри него десятичный разделитель.

Используя такую запись, можно сравнительно легко делать сложение и умножение. Так вы получаете наилучшие результаты, которые машина может предоставить, используя гораздо меньше программирования. Это был большим достижением.

Первая форма записи числа с плавающей запятой выглядит примерно так: у нас есть некоторое число, значение которого увеличено на 10 в степени логарифма масштабного коэффициента.

Этот подход был реализован в программном обеспечении первых машин. Он работал, но крайне медленно. Сами по себе машины были очень медленными, а все эти преобразования только ухудшали ситуацию. Неудивительно, что появилась потребность интегрировать это в железо. Следующие поколения машин уже на аппаратном уровне понимали вычисления с плавающей запятой, правда, для двоичных чисел. Переход от десятичной к двоичной системе был вызван потерей производительности из-за деления на 10 (которое необходимо иногда выполнять, чтобы нормализовать числа). В двоичной системе вместо деления достаточно было просто сдвинуть разделитель — это практически «бесплатно».

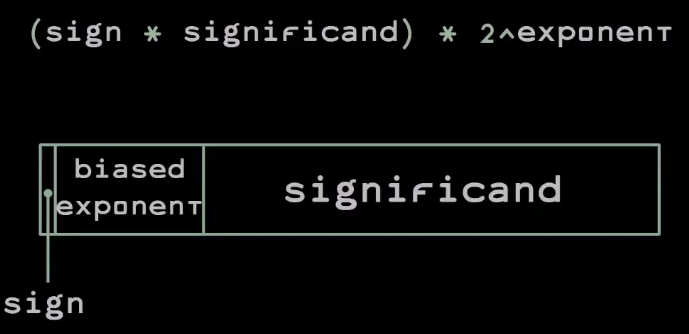

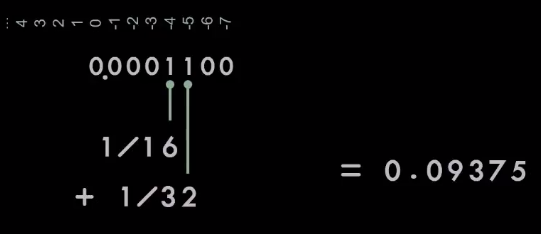

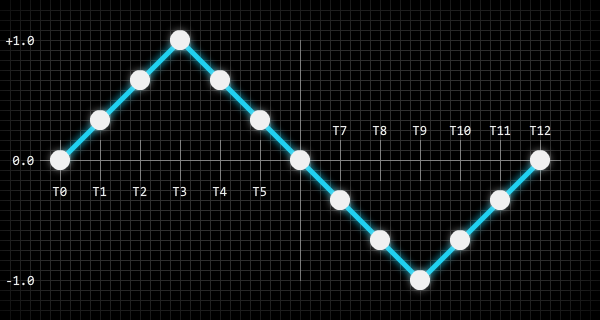

Вот как выглядит стандарт вычислений с плавающей запятой в двоичной системе:

Число записывается при помощи бита знака мантиссы, который равен 0, если число положительное, и 1, если отрицательное, самой мантиссы, а также смещённой экспоненты (biased exponent). Смещение в данном случае играет роль небольшой оптимизации — за счет нее вы можете выполнить целочисленное сравнение двух значений с плавающей точкой, чтобы увидеть, которое из них больше.

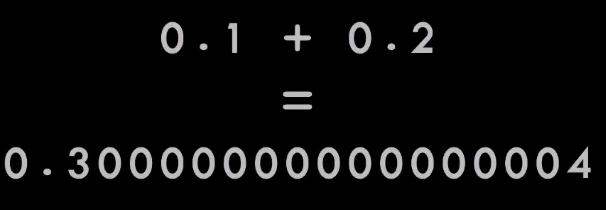

Однако с этой записью есть проблема: в ней 0,1 + 0,2 не равно 0,3.

Результат близок, но он неправильный.

Давайте посмотрим, что происходит.

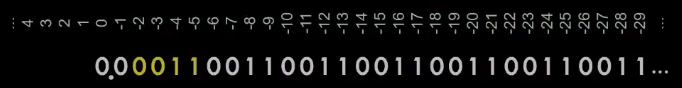

Представим числовой ряд. 0,1 — это приблизительно 1/16 + 1/32, но немного больше, поэтому нам понадобятся ещё несколько бит. По мере движения по числовому ряду мы получим бесконечно повторяющуюся серию 0011, похожую на то, что происходит с 1/3 в десятичной дроби.

Это прекрасно, если у вас в запасе бесконечное количество бит. Если вы продолжите эту последовательность до бесконечности, получите именно то, что нужно. Но у нас нет бесконечного количества бит. В какой-то момент мы должны отрезать этот хвост. И от того, где вы отрезаете, будет зависеть итоговая ошибка.

Если вы отрезаете перед 0, вы потеряете все последующие биты. Поэтому ваш результат окажется чуть меньше, чем нужно. Если вы отрезаете перед 1, по правилам округления необходимо перенести единицу, тогда результат будет чуть больше.

И вы можете надеяться, что в ходе вычислений вы будете немного ошибаться в одну и в другую сторону, а в результате ошибки будут сбалансированы. Но этого не происходит. Вместо этого ошибка накапливается — чем больше вычислений мы делаем, тем хуже результат.

Всякий раз, когда мы представляем константу в написанной на каком-то языке программе или в данных в виде десятичной дроби, мы не получаем именно это число. Мы получаем приближение этого числа, потому что мы работаем с числовой системой, которая не может точно представлять десятичные дроби. И это нарушает ассоциативный закон.

Ассоциативный закон действительно важен в ходе алгебраической манипуляции с выражениями в программах. Но он не соблюдается, если вводы / выводы и промежуточные результаты вычислений не могут быть точно представлены.

А поскольку ни одно из наших чисел не представлено точно, все вычисления ошибочны! Это означает, что (A + B) + C не то же самое, что A + (B + C), что порядок, в котором вы выполняете вычисления, может изменить результат.

Эта проблема не нова. Она была известна еще тогда, когда развивались вычисления с плавающей точкой в двоичной системе — разработчики таким образом шли на компромисс.

В то время были две школы вычислений:

- те, кто занимались научным трудом, писали на Фортране с использованием чисел с плавающей точкой в двоичной системе;

- те, кто занимались бизнесом, писали на Cobol, используя двоично-десятичный код (binary coded decimal, BCD). Двоично-десятичный код выделяет 4 бита для каждой цифры и ведет обычный подсчет в десятичной системе (используя обычную арифметику).

Компьютеры становятся все дешевле, и теперь уже решают практически любые задачи, но мы все ещё застряли в этом шаблоне с двумя разными мирами.

Еще одна проблема представления числа в двоичном формате с плавающей точкой — сложность с преобразованием текста. Берем фрагмент текста и превращаем его в число; затем берём число и преобразуем обратно в кусок текста. Это нужно сделать правильно, эффективно и без сюрпризов, используя как можно меньше цифр. Оказывается, в такой записи это очень сложная проблема, дорогая с точки зрения производительности.

Проблема с типами

В большинстве современных языков программирования присутствует путаница из-за ошибочных типов данных. Например, если вы пишите на Java, каждый раз создавая переменную, свойство или параметр, вам нужно правильно выбрать тип из Bite, Char, Short, Int, Long, Float, Double. И если вы выберете неправильно, программа может не заработать. Причем ошибка проявится не сразу, и в тестах её не будет видно. Она покажет себя в будущем, когда произойдёт переполнение и связанные с этим плохие вещи.

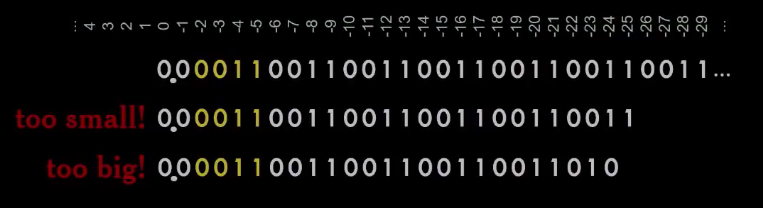

Что может случиться? Одним из самых впечатляющих примеров был отказ Aryan 5. Это ракета, отправленная Европейским космическим агентством. Она сильно отклонилась от курса, а затем взорвалась через несколько секунд после старта. Причиной тому была ошибка в программном обеспечении, написанном на Ада. Здесь я перевел ошибку на Java:

У них была переменная, определяющая горизонтальное смещение. И ее перевели в Short, который переполнился. Результат, попавший в Short, был неправильный. Но он был отправлен в систему наведения и полностью ее спутал, так что курс уже не удалось восстановить. Эта ошибка оценивается примерно в полмиллиарда долларов.

Я полагаю, что вы еще не делали ошибок, которые бы стоили полмиллиарда долларов. Но могли бы (технически это все ещё возможно). Поэтому мы должны попытаться создать системы записи и языки, которые позволяют избежать таких проблем.

DEC64

С точки зрения выбор типа данных при объявлении переменных JavaScript намного лучше — этот язык имеет только один численный тип. Это означает, что целого класса ошибок можно автоматически избежать. Единственная проблема — этот тип неправильный, поскольку это двоичные числа с плавающей точкой. А нам нужны десятичные числа с плавающей точкой, т.к. иногда мы складываем деньги и хотим, чтобы результат имел смысл.

Я предлагаю исправить этот тип. Мое исправление носит название DEC64, это современная запись десятичных чисел с плавающей точкой. Я рекомендую DEC64 в качестве единственного численного типа в прикладных языках программирования в будущем. Потому что если у вас будет только один численный тип, вы не сможете сделать ошибку, выбрав неправильный тип (я думаю, это обеспечит гораздо большую ценность, чем-то, что мы можем получить, имея несколько типов).

Аппаратная реализация DEC64 позволяет складывать числа за один цикл, что снижает значимость производительности при использовании старых типов. Преимущество DEC64 заключается в том, что в этой записи основные операции над числами работают так, как привыкли люди. А устранение числовой путаницы уменьшает ошибки. Кроме того, преобразование чисел DEC64 в текст и обратно — просто, эффективно и не содержит сюрпризов. На самом деле это немного сложнее, чем преобразование целых чисел в текст и обратно — вам просто нужно следить за тем, где находится десятичная точка, и вы можете удалить избыток нулей с обоих концов, а не только с одного.

DEC64 может точно представлять десятичные дроби, содержащие до 16 цифр, чего вполне достаточно для большинства наших приложений. Вы можете представлять числа от 1*10-27 до 3 с 143 нулями.

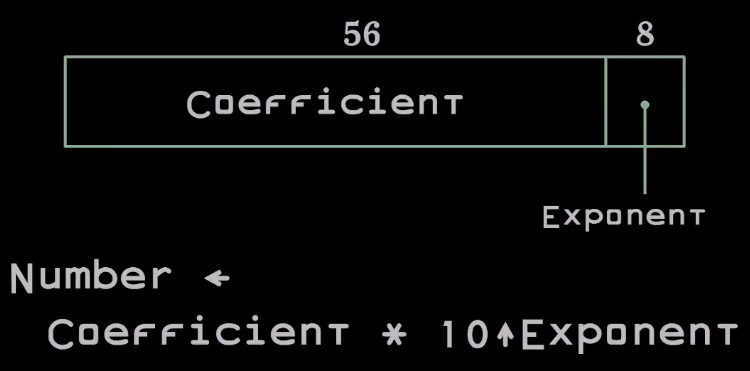

DEC64 очень похож на исходные числа с плавающей точкой, разработанные в 40-х годах. Число представлено в виде двух чисел, которые упакованы в 64-битное слово. Коэффициент представлен 56 битами, а показатель — 8 битами.

Причина, по которой экспонент находится в конце, заключается в том, что в архитектуре Intel мы можем распаковать такое число практически бесплатно. Это помогает в реализации программного обеспечения.

Если вы хотите посмотреть на программную реализацию DEC64, ее можно найти на GitHub. И если вы думаете о разработке следующего языка программирования, я очень рекомендую вам рассмотреть DEC64 в качестве единственного численного типа.

С форматом DEC64 я не надеюсь попасть в следующий JavaScript, поскольку это фундаментальное изменение. Зная как работает комитет, я не думаю, что это возможно. DEC64 поможет создателю следующего языка программирования (я надеюсь, что JavaScript не станет последним языком программирования — мы не можем оставить его детям; мы должны предложить им что-то другое).

Неопределенности и нули

=Давайте вернемся к числам.

Что такое 0/0?

- Большинство математиков скажут, что это значение не определено, подразумевая, что глупо так делать — такое выражение не имеет смысла (JavaScript определяет это как Undefined). Такая позиция хороша для математики, потому что там все происходит в теоретическом пространстве. Но это не работает для вычислений, потому что если кто-то может подать эти данные на вход машины, та должна как-то отреагировать (вы не можете сказать, что дизайн машины не определён — что-то должно произойти).

- Еще одна теория говорит, что машина должна загореться, потому что никто не будет в здравом уме пытаться делить 0 на 0, так что этого никогда не должно произойти. Но мы знаем, что это неправда. Потому что если что-то может произойти, это произойдет.

- Другая версия — это должно быть null или какое-то иное понятие, которое говорит, что это не значение. И это разумно.

- Еще одна школа считает, что результат должен быть нулевым. Есть математики, которые уверены в этом, но для большинства бизнес-задач такой результат не имеет смысла. Если в прошлом месяце мы продали 0 единиц товара, и общая прибыль по этим единицам составляла 0, какова была средняя прибыль за товар? 0?

- Некоторые люди говорят, что это 1, потому что N / N = 1.

- Когда-то я работал на мэйнфрейме, где результат был 2. Это была машина, которую создал Сеймур Крей — величайший компьютерный дизайнер в истории. Я ввел 0/0 и получил 2. Могу представить себе диалог в Control Data Corporation. Кто-то сказал: «Сеймур, есть проблема с вашей схемой деления!». «В чем проблема?». «Если кто-то разделит 0 на 0, получит 2!». И Сеймур говорит: «Послушай… Такой операции не должно быть. Ни один разумный человек никогда не должен этого делать. И если я включу дополнительную логику для этого случая, чтобы определить поведение машины, т.е. добавлю ещё одну проверку, она ухудшит производительность для всех, в том числе, для умных людей, которые не выполняют таких операций. И это сделает машину дороже. Я не собираюсь этого делать только из-за того, что какой-то идиот хочет разделить 0 на 0».

Также меня интересует, чему равно 0 * n для любого значения n.

Я думаю, что это 0. Но были компиляторы, которые, если встречали в умножении 0, не делали умножение вовсе. Это было большим плюсом к скорости. К сожалению, когда был создан стандарт записи чисел с плавающей точкой, такой подход был объявлен ошибочным, потому что если n является NaN, то результат 0 x NaN не равен нулю.

Почему мы вообще должны заботиться об этом?

Такой код пишут немногие люди, а также многие машины: генераторы кода, макропроцессоры, средства автоматизации — все они будут писать код, вполне может умножить что-то на ноль.

Современные процессоры имеют очень длинные протоколы декодирования команд, которые занимают много циклов. Но они могут быстро перерабатывать множество инструкций, пока нет никаких условных переходов. Если же есть условный переход, все останавливается, пока не будет ясно, в какую сторону двигаться дальше. И это действительно замедляет работу. Есть способ написания кода, когда вы вместо выбора между двумя значениями (условия), выполняется дополнительное действие — умножение на 0 или 1, являющиеся результатом логической операции (того самого условия). Хотя это дополнительная работа, ее исполнение может быть быстрее, чем выполнение кода с условными переходами. Поэтому я рекомендую все операции с 0 (деление, умножение, деление с остатком) приравнивать к нулю.

Как и DEC64, эта идея предложена для следующего поколения прикладных языков программирования.

Вместо заключения

Есть люди, которых я действительно хочу поблагодарить.

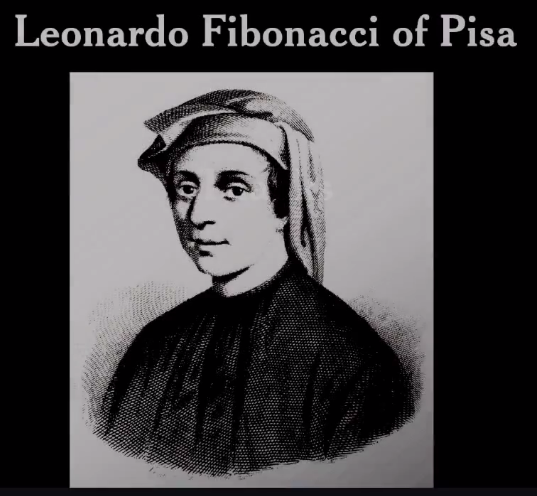

Я хочу начать с Леонардо Фибоначчи из Пизы. В конце XII века Леонардо посетил Аравию и узнал удивительные вещи, которые арабские математики воплотили через свою систему счисления — алгебру, геометрию, алгоритмы. Он привез их в Европу и написал книгу, которую опубликовал в 1202 году. В течение следующего столетия эта книга преобразовала Европу. Он создал базу для новых форм банковского дела, что привело к увеличению капитала, подпитывающего Ренессанс.

Я хочу поблагодарить Готфрида Вильгельма Лейбница за отличные вычисления, а также за двоичную систему. Он был первым, кто понял, что можно поставить основание 2 в индийскую позиционную систему счисления. Он думал, что это замечательно. И он был прав.

Я хочу поблагодарить Джорджа Була — английского логика, который разработал алгебру, основанную только на двух значениях — true и false. Булевский тип данных назван в честь него.

Я хочу поблагодарить Клода Шеннона — американского исследователя. Он сделал две потрясающие вещи: во-первых, нашёл соответствие между электроникой и булевой алгеброй, чтобы мы могли преобразовать булеву алгебру в схемы. Именно так создаются компьютеры. Во-вторых, он создал теорию информации, которая гласит, что любой аналоговый сигнал можно превратить в цифровой и обратно с любой желаемой степенью точности. Это утверждение лежит в основе Интернета и всех цифровых медиа: видеороликов, аудио и т.п. Все они возможны благодаря работам Шеннона.

И, наконец, я хочу поблагодарить Техути. Я не смог найти его фотографию, у меня есть только это изображение, которое было вырезано на камне.

Техути изобрёл письмо. Он жил в Египте и понял принцип Ребуса — что вы можете взять изображение чего-либо, поставить в соответствие этому изображению некий звук и дальше использовать эти изображения, чтобы записать созвучия, которые не могли быть представлены картинками. Этот принцип дал начало письму.

Техути был бухгалтером, изобретателем и учителем. Он обучал своей системе письма и создал профессию писцов. Когда писалась мифология Египта, её составители вставили Техути в историю. Они возвели его в ранг бога письма и магии. Он стал очень важной фигурой истории.

Почему они это сделали? Я думаю, по двум причинам. Во-первых, они хотели показать, насколько важна позиция писца. Они поставили главного писца на уровень бога, а другие боги приходили к нему за помощью. А во-вторых, хотели поблагодарить его за то, что он дал им лучшие рабочие места в Египте. Они не занимались сельским хозяйством и не вытаскивали камни, не выполняли другие тяжёлые работы.

Мы — дети Техути. Используем язык программирования для перевода чисел в магию.

Если вам понравился этот доклад Дугласа Крокфорда, приглашаем вас на два его новых выступления в рамках грядущей конференции HolyJS 2017 Moscow, которая пройдет в Москве 10 и 11 декабря.

- The Post JavaScript Apocalypse — это его первый доклад, где он расскажет о том, каким мог бы быть язык следующего за JS поколения, а также о новых полезных фишках в ES6.

- Managing Asynchronicity with RQ — второй доклад, рассказывающий о решении, которое призвано повысить простоту использования благодаря минимализму.

|

Метки: author ARG89 программирование математика javascript it- стандарты блог компании jug.ru group системы счисления |

[Перевод] Как быстрее DOM построить: парсинг, async, defer и preload |

Как быстрее DOM построить: парсинг, async, defer и preload

- Перевод

На сегодняшний день, джентльменский набор по ускорению сайта включает в себя всё от минификации и оптимизации файлов до кеширования, CDN, разделения кода и так называемого tree shaking. Но даже если вы не знакомы с этой терминологией, значительного ускорения можно добиться и парой ключевых слов с продуманной структурой кода.

В Firefox скоро появится новый веб стандарт

Самое важное для веб разработчика — это понимание того, что происходит под капотом браузера. В статье, мы рассмотрим как браузер интерпретирует код страницы и как он помогает загружать их быстрее при помощи спекулятивного парсинга, а дальше разберёмся с

defer, async и как можно использовать новый стандарт preload.По кирпичикам

HTML описывает структуру страницы. Для того, чтобы браузер смог извлечь из HTML хоть какую то пользу, его надо конвертировать в понятный браузерам формат — Document Object Model или попросту DOM. У браузера есть специальная функция парсер, позволяющая конвертировать из одного формата в другой. HTML парсер конвертирует HTML в DOM.

Связи различных элементов в HTML определяются вложенностью тегов. В DOM, эти же связи образуют древовидную структуру данных. У каждого тега HTML в DOM есть своя вершина (вершина DOM).

Шаг за шагом браузер строит DOM. Как только первые строки кода становятся доступными, браузер начинает парсить HTML, добавляя вершины в дерево.

У DOM две роли: объектная репрезентация HTML документа и в то же время DOM служит интерфейсом, связывая страницу с внешним миром, например с JavaScript. Если, например, вызвать

document.getElementById() то функция вернёт вершину DOM. Для манипуляции с вершиной и тем как её видит пользователь у вершины есть множество функций.

CSS стили на странице отображаются в модель CSSOM — CSS Object Model. Очень похож на DOM, но для CSS, а не HTML. В отличии от DOM, CSSOM нельзя построить пошагово, т.к. стили в CSS могут переопределять друг друга. Браузеру приходится значительно потрудится чтобы применить CSS к DOM.

История тега

|

Метки: author A3a разработка веб-сайтов клиентская оптимизация браузеры html firefox preload async defer dom optimization browser |

Отправка запроса на все базы данных всех указанных серверов на примере MS SQL Server и C#.NET |

Отправка запроса на все базы данных всех указанных серверов на примере MS SQL Server и C#.NET

- Tutorial

Предисловие

Нередко необходимо послать запрос всем БД (базам данных) всем указанным серверам.

Многие DML-запросы можно сделать встроенными средствами.

Например, так

Но как быть с DDL-запросами?

В данной статье будет разобран пример реализации приложения, которое отправляет запрос всем базам данных всех указанных серверов, используя MS SQL Server и C#.NET.

Решение

Например, необходимо создать или изменить представление (для примера возьмем создание представления из задачи):

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

CREATE view [inf].[vTableSize] as

with pagesizeKB as (

SELECT low / 1024 as PageSizeKB

FROM master.dbo.spt_values

WHERE number = 1 AND type = 'E'

)

,f_size as (

select p.[object_id],

sum([total_pages]) as TotalPageSize,

sum([used_pages]) as UsedPageSize,

sum([data_pages]) as DataPageSize

from sys.partitions p join sys.allocation_units a on p.partition_id = a.container_id

left join sys.internal_tables it on p.object_id = it.object_id

WHERE OBJECTPROPERTY(p.[object_id], N'IsUserTable') = 1

group by p.[object_id]

)

,tbl as (

SELECT

t.[schema_id],

t.[object_id],

i1.rowcnt as CountRows,

(COALESCE(SUM(i1.reserved), 0) + COALESCE(SUM(i2.reserved), 0)) * (select top(1) PageSizeKB from pagesizeKB) as ReservedKB,

(COALESCE(SUM(i1.dpages), 0) + COALESCE(SUM(i2.used), 0)) * (select top(1) PageSizeKB from pagesizeKB) as DataKB,

((COALESCE(SUM(i1.used), 0) + COALESCE(SUM(i2.used), 0))

- (COALESCE(SUM(i1.dpages), 0) + COALESCE(SUM(i2.used), 0))) * (select top(1) PageSizeKB from pagesizeKB) as IndexSizeKB,

((COALESCE(SUM(i1.reserved), 0) + COALESCE(SUM(i2.reserved), 0))

- (COALESCE(SUM(i1.used), 0) + COALESCE(SUM(i2.used), 0))) * (select top(1) PageSizeKB from pagesizeKB) as UnusedKB

FROM sys.tables as t

LEFT OUTER JOIN sysindexes as i1 ON i1.id = t.[object_id] AND i1.indid < 2

LEFT OUTER JOIN sysindexes as i2 ON i2.id = t.[object_id] AND i2.indid = 255

WHERE OBJECTPROPERTY(t.[object_id], N'IsUserTable') = 1

OR (OBJECTPROPERTY(t.[object_id], N'IsView') = 1 AND OBJECTPROPERTY(t.[object_id], N'IsIndexed') = 1)

GROUP BY t.[schema_id], t.[object_id], i1.rowcnt

)

SELECT

@@Servername AS Server,

DB_NAME() AS DBName,

SCHEMA_NAME(t.[schema_id]) as SchemaName,

OBJECT_NAME(t.[object_id]) as TableName,

t.CountRows,

t.ReservedKB,

t.DataKB,

t.IndexSizeKB,

t.UnusedKB,

f.TotalPageSize*(select top(1) PageSizeKB from pagesizeKB) as TotalPageSizeKB,

f.UsedPageSize*(select top(1) PageSizeKB from pagesizeKB) as UsedPageSizeKB,

f.DataPageSize*(select top(1) PageSizeKB from pagesizeKB) as DataPageSizeKB

FROM f_size as f

inner join tbl as t on t.[object_id]=f.[object_id]

GO

Это представление показывает размеры всех таблиц для каждой БД (базы данных).

Создадим файл FileQuery.sql и запишем туда указанный выше запрос.

Теперь определим функцию, которая отправляет запрос из файла всем БД всем указанным серверам:

///

/// Отправка запроса ко всем БД указанного сервера

///

/// имя указанного сервера (экземпляра MS SQL Server)

/// T-SQL-запрос

/// Поток для логирования

void RunQueryInAllDBServer(string server, string sql, TextWriter tw_log)

{

SqlConnectionStringBuilder scsb = null;

//список имен всех баз данных на сервере

List ldbs = new List();

//настройка строки подключения

scsb = new SqlConnectionStringBuilder();

scsb.ApplicationName = "НАЗВАНИЕ_ПРИЛОЖЕНИЯ";

scsb.InitialCatalog = "master";

scsb.IntegratedSecurity = true;

scsb.DataSource = server;

//вывод в лог текущего времени и названия экземпляра сервера MS SQL Server

tw_log.WriteLine($"{DateTime.Now} ServerName: {server}:");

//создание подключения с запросом для получения имен всех БД на сервере

using (SqlConnection conn = new SqlConnection())

{

conn.ConnectionString = scsb.ConnectionString;

SqlCommand comm = new SqlCommand("select [name] from sys.databases");

comm.CommandType = System.Data.CommandType.Text;

comm.Connection = conn;

conn.Open();

var result = comm.ExecuteReader();

while (result.Read())

{

ldbs.Add(result.GetString(0).ToString());

}

}

//выполнение запроса sql на каждой БД сервера

for (int i = 0; i < ldbs.Count; i++)

{

using (SqlConnection conn = new SqlConnection())

{

scsb.InitialCatalog = ldbs[i];

conn.ConnectionString = scsb.ConnectionString;

SqlCommand comm = new SqlCommand(sql);

comm.CommandType = System.Data.CommandType.Text;

comm.Connection = conn;

conn.Open();

try

{

comm.ExecuteNonQuery();

tw_log.WriteLine($"{DateTime.Now} DBName: {ldbs[i]} успешно выполнен запрос");

}

catch(Exception exp)

{

tw_log.WriteLine($"{DateTime.Now} DBName: {ldbs[i]} Exception: {exp.Message}");

}

}

}

}

Данная функция получает название экземпляра MS SQL Server, запрос T-SQL и поток для логирования. Внутри заполняется список имен всех БД сервера. Далее к каждой БД производится запрос. В целях безопасности выставлена авторизация Windows: scsb.IntegratedSecurity = true;

Также стоит быть осторожным с данной функцией, т к она выполняет любой запрос на всех БД сервера.

Теперь создадим код вызова описанной выше функции:

string sql = null;

using (Stream st_log = new FileStream("НАЗВАНИЕ_ФАЙЛА_ДЛЯ_ЛОГИРОВАНИЯ", FileMode.Create, FileAccess.Write))

{

using (TextWriter tw_log = new StreamWriter(st_log, Encoding.Default))

{

using (Stream st = new FileStream("FileQuery.sql", FileMode.Open, FileAccess.Read))

{

using (TextReader tr = new StreamReader(st, Encoding.Default))

{

sql = tr.ReadToEnd();

}

}

//здесь servers-массив имен экземпляров MS SQL Server, на которые необходимо отправить запрос T-SQL

for (int i = 0; i < servers.Length; i++)

{

RunQueryInAllDBServer(servers[i], sql, tw_log);

}

tw_log.WriteLine($"Конец {DateTime.Now}");

}

}

Все. Приложение готово.

Естественно, список серверов, а также путь к файлу запроса лучше вынести в настройки.

Результат

В данной статье был рассмотрен пример отправки запроса, который записан в файле, всем базам данных всех указанных серверов. Это позволяет посылать DDL-запросы ко всем БД, что нельзя сделать недокументированной хранимой процедурой sp_MSForEachDB.

А какими инструментами Вы пользуетесь для данной или подобной ей задачи?

Источники:

» MSDN

» Автоматизация по сбору данных о росте таблиц и файлов всех баз данных MS SQL Server

» Как применить операцию сразу ко всем таблицам или ко всем базам данных

|

Метки: author jobgemws администрирование баз данных ms sql server c#.net |

Веб-сервер — ваша первая сетевая программа Arduino |

Веб-сервер — ваша первая сетевая программа Arduino

- Tutorial

Введение

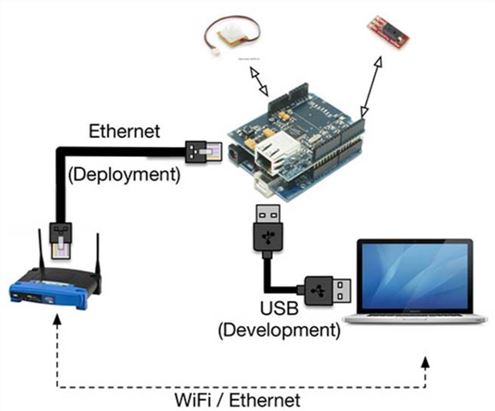

В моих публикациях [1,2,3] подробно описана цепочка датчик – Arduino-интерфейс Python. В реальных условиях промышленного производства датчики находиться на значительном удалении не только друг от друга но и от места где осуществляется централизованная обработка измерительной информации. Логично передавать информацию от датчиков по компьютерной локальной сети используя хорошо разработанные сетевые технологии. Данная публикация написана в стили упражнения по сборке и настройке сетевого приложения с Arduino в домашних условиях.

Постановка задачи

- Использовать библиотеку Arduino Ethernet с расширением Arduino Ethernet Shield для создания веб-сервера.

- Создать удаленный доступ к Arduino с использованием сети вашего домашнего компьютера.

- Использовать стандартный пример Arduino для обеспечения значений влажности и датчика движения с помощью веб-сервера.

- Разработать веб-приложений с использованием Python.

Этапы решения поставленной задачи

- Проектирование и создание аппаратных средств для использования Arduino и Ethernet Shield.

- Запуск примера по умолчанию из среды разработки Arduino как начальную точку создания сервера.

- Изменение примера для размещения вашего оборудования и повторного развертывания кода.

- Разработка веб-приложений с использованием Python.

Подключение Ethernet Shield поверх Arduino Uno

Arduino Ethernet Shield — официально поддерживаемое сетевое расширение с открытым исходным кодом, предназначенное для работы с Arduino Uno. Ethernet Shield оснащен разъемом RJ45 для подключения к сети Ethernet. Ethernet Shield предназначен для установки на Arduino Uno, и он расширяет выводы(пины) от Arduino Uno в верхней части платы. Ethernet Shield также оснащен гнездом для карт памяти microSD для хранения важных файлов по сети. Как и большинство расширений, Ethernet Shield питается от платы Arduino, к которой он присоединен.

Каждая плата Ethernet Shield оснащена уникальным аппаратным (MAC) адресом. Вы можете видеть это на обратной стороне платы. Вы можете записать этот аппаратный адрес, поскольку он будет часто требоваться в предстоящих упражнениях. Также убедитесь, что вы знакомы с установкой Arduino Ethernet Shield для выполнения последующих упражнений.

Ниже приведена диаграмма Fritzing схемы, требуемой для этого упражнения. Первое, что вам нужно сделать, это подключить Ethernet Shield поверх вашего Arduino Uno.

Arduino Uno

При развертывании аппаратного обеспечения Arduino для удаленного подключения без USB вам необходимо будет обеспечить внешнее питание платы, поскольку у вас больше нет подключения USB для питания платы.

Теперь подключите Arduino Uno к компьютеру с помощью USB-кабеля. Вам также необходимо подключить Arduino к локальной домашней сети с помощью кабеля Ethernet. Для этого используйте прямой кабель CAT5 или CAT6 и подключите один конец кабеля к домашнему маршрутизатору.

Этот маршрутизатор должен быть тем же устройством, которое обеспечивает сетевой доступ к компьютеру, который вы используете. Подключите другой конец кабеля Ethernet к порту Ethernet платы Arduino Ethernet Shield. Если соединение физического уровня установлено правильно, вы должны увидеть зеленый свет на порту.

Теперь пришло время начать кодирование вашего первого примера Ethernet.В коде вам нужно будет изменить MAC и IP-адреса, чтобы он работал для вашей конфигурации. Хотя вы можете получить MAC-адрес Ethernet Shield с задней стороны платы, вам придется выбрать IP-адрес в соответствии с конфигурацией вашей домашней сети.

Когда вы уже получили IP-адрес компьютера, с которым работаете, выберите другой адрес в диапазоне. Убедитесь, что ни один другой сетевой узел не использует этот IP-адрес. Используйте эти MAC и IP-адреса для обновления следующих значений в коде.

byte mac [] = {0x00, 0xAA, 0xBB, 0xCC, 0xDE, 0x02};

IPAddress ip (192, 168, 0, 102); // автоматически присвоен в домашней сети с помощью File --> Examples --> Ethernet --> DhcpAddressPrinter

В IP-сети видимый диапазон IP-адресов для вашей сети является функцией другого адреса, называемого subnetwork или subnet. Subnet вашей сети LAN IP может помочь вам выбрать соответствующий IP-адрес для Ethernet Shield в диапазоне IP-адресов вашего компьютера. Вы можете узнать об основах подсети по адресу [4].

Прежде чем углубляться в код, скомпилируйте код с этими изменениями и загрузите его в Arduino. После успешного завершения процесса загрузки откройте веб-браузер и введите IP-адрес, указанный в скетче Arduino. Если все будет хорошо, вы должны увидеть текст, отображающий значения аналоговых контактов.

Чтобы лучше понять, что здесь произошло, вернемся к коду. Как вы можете видеть, в начале кода мы инициализируем библиотеку Ethernet-сервера на порту 80, используя метод EthernetServer из библиотеки Ethernet:

EthernetServer server(80);Во время выполнения setup () программа инициализирует Ethernet-соединение через Ethernet Shield с помощью метода Ethernet.being () с переменными mac и ip, которые вы определили ранее. Метод server.begin () запустит сервер отсюда. Оба этих шага являются обязательными для запуска сервера, если вы используете библиотеку Ethernet для кода сервера:

Ethernet.begin (mac, ip);

server.begin ();

В функции loop () мы инициализируем client объект для прослушивания входящих клиентских запросов с использованием метода EthernetClient. Этот объект будет отвечать на любой запрос, поступающий от подключенных клиентов, которые пытаются получить доступ к серверу Ethernet через порт 80:

EthernetClient client = server.available ();После получения запроса программа будет ожидать окончания загрузки запроса. Затем он будет отвечать клиенту с форматированными данными HTML, используя метод:

client.print ():

while (client.connected()) {

if (client.available()) {

char c = client.read();

Serial.write(c);

# Response code }

Если вы попытаетесь получить доступ к серверу Arduino из браузера, вы увидите, что веб-сервер отвечает клиентам с помощью данных на аналоговых контактах. Теперь, чтобы получить правильные значения датчиков влажности и PIR, которые мы соединили в аппаратном дизайне, вам придется выполнить следующую модификацию кода.

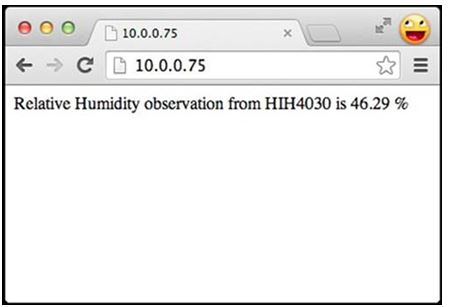

Здесь вы заметите, что мы отвечаем клиентам с вычисленными значениями относительной влажности вместо необработанных показаний со всех аналоговых выводов. Мы также изменили текст, который будет напечатан в веб-браузере, чтобы соответствовать правильному названию датчика:

if (c == '\n' && currentLineIsBlank) {

// send a standard http response header

client.println("HTTP/1.1 200 OK");

client.println("Content-Type: text/html");

client.println("Connection: close");

client.println("Refresh: 5");

client.println();

client.println("");

client.println("");

float sensorReading = getHumidity(analogChannel, temperature);

client.print("Relative Humidity from HIH4030 is ");

client.print(sensorReading);

client.println(" %

");

client.println("");

break; }

В этом процессе мы также добавили функцию Arduino, getHumidity (), которая будет вычислять относительную влажность по значениям, наблюдаемым с аналоговых выводов.

float getHumidity(int analogChannel, float temperature){

float supplyVolt = 5.0;

int HIH4030_Value = analogRead(analogChannel);

float analogReading = HIH4030_Value/1023.0 * supplyVolt;

float sensorReading = 161.0 * analogReading / supplyVolt - 25.8;

float humidityReading = sensorReading / (1.0546 - 0.0026 * temperature);

return humidityReading; }

Эти изменения можно применить к примеру, WebServer Arduino для фазы тестирования или просто открыть скетч WebServer_Custom.ino из папки Exercise 1 — Web Server в каталоге вашего кода. Как вы можете видеть в открытом файле скетча, мы уже модифицировали код, чтобы отразить изменения, но вам все равно придется изменить MAC и IP-адреса на соответствующие адреса.

После того как вы закончите с этими незначительными изменениями, скомпилируйте и загрузите скетч в Arduino. Если все пойдет по плану, вы должны иметь доступ к веб-серверу с помощью веб-браузера. Откройте IP-адрес недавно подготовленного Arduino в веб-браузере.

Вы должны получить такой же ответ, как показано на следующем скриншоте. Хотя мы показываем значения влажности только через этот скетч, вы можете легко прикрепить значения датчика движения, используя дополнительные методы client.print ().

Подобно механизму, который мы реализовали в этом упражнении, веб-сервер отвечает на запрос, сделанный веб-браузером, и предоставляет веб-страницы, которые вы ищете. Хотя этот метод очень популярен и универсален для доставки веб-страниц, полезная нагрузка содержит много дополнительных метаданных (данные о данных) по сравнению с фактическим размером информации датчика.

Кроме того, реализация сервера с использованием библиотеки серверов Ethernet занимает много ресурсов Arduino. Arduino, будучи устройством с ограниченными ресурсами, не подходит для запуска серверного приложения, поскольку ресурсы Arduino должны быть приоритетными для обработки датчиков, а не связи.

Веб-сервер, созданный с использованием библиотеки Ethernet, поддерживает очень ограниченное количество подключений, что делает его непригодным для крупномасштабных приложений и многопользовательских систем.

Лучшим подходом к решению этой проблемы является использование Arduino в качестве клиентского устройства или использование легких коммуникационных протоколов, предназначенных для работы с аппаратными устройствами с ограниченными ресурсами. В следующих нескольких разделах вы узнаете и реализуете эти подходы для коммуникации Arduino на Ethernet.

Разработка веб-приложений с использованием Python

Внедрив предыдущую программу, вы включили работу в сети на Arduino. В предыдущем примере мы создали веб-сервер HTTP, используя методы, доступные из библиотеки Ethernet. Создав веб-сервер Arduino, мы сделали доступными ресурсы Arduino в сети. Аналогично, Python также обеспечивает расширяемость посредством различных библиотек для создания интерфейсов веб-сервера.

Запустив веб-сервер на базе Python на вашем компьютере или других устройствах, таких как Raspberry Pi, вы можете избежать использования Arduino для размещения веб-сервера. Веб-приложения, созданные с использованием языков высокого уровня, таких как Python, также могут предоставить дополнительные возможности и расширяемость по сравнению с Arduino.

Будем использовать библиотеку Python, web.py, для создания веб-сервера Python. Мы также будем использовать эту библиотеку для создания интерактивных веб-приложений, которые позволят передавать данные между клиентом Arduino и веб-браузером.

После того, как вы изучите основы web.py, мы будем взаимодействовать с Arduino с web.py, используя последовательные порты, чтобы сделать Arduino доступным через веб-сервер Python. Затем мы обновим коммуникационный метод Arduino от последовательного интерфейса до обмена сообщениями на основе HTTP.

Веб-фреймворк Python — web.py

Веб-сервер может быть разработан в Python с использованием различных веб-фреймворков, таких как Django, bottle, Pylon и web.py. Мы выбрали web.py как предпочтительную веб-структуру благодаря своим простым, но мощным функциям.

Библиотека web.py была первоначально разработана покойным Aaron Swartz с целью разработки простого подхода для создания веб-приложений с использованием Python. Эта библиотека предоставляет два основных метода, GET и POST, для поддержки архитектуры HTTP Representation State Transfer (REST).

Эта архитектура предназначена для поддержки протокола HTTP путем отправки и получения данных между клиентами и сервером. Сегодня архитектура REST реализуется огромным количеством веб-сайтов для передачи данных по HTTP.

Установка web.py

Чтобы начать работу с web.py, вам нужно установить библиотеку web.py с помощью Setuptools. В Linux и Mac OS X выполните одну из этих команд на терминале, чтобы установить web.py:

$ sudo easy_install web.py

$ sudo pip install web.py

В Windows откройте командную строку и выполните следующую команду:

> easy_install.exe web.pyДля pythn 3.61 надо набрать в командной строке:

> easy_install-3.61.exe web.pyЕсли Setuptools настроен правильно, вы можете установить библиотеку без каких-либо трудностей. Чтобы проверить установку библиотеки, откройте интерактивную подсказку Python и запустите эту команду, чтобы убедиться, что вы импортировали библиотеку без каких-либо ошибок:

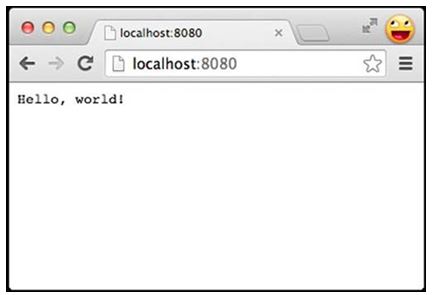

>>> import webПервое веб-приложение Python

Реализация веб-сервера с помощью web.py — очень простой и понятный процесс. Для библиотеки web.py требуется объявление обязательного метода GET для успешного запуска веб-сервера.

Когда клиент пытается получить доступ к серверу с помощью веб-браузера или другого клиента, web.py получает запрос GET и возвращает данные, указанные в этом методе. Для создания простого веб-приложения с использованием библиотеки web.py создайте файл Python, используя следующие строки кода и выполните файл с помощью Python.

import web

urls = ( '/', 'index')

class index:

def GET(self):

return "Hello, world!"

if __name__ == "__main__":

app = web.application(urls, globals())

app.run()

При выполнении вы увидите, что сервер теперь запущен и доступен через адрес 0.0.0.0:8080. Поскольку серверная программа запущена на IP-адресе 0.0.0.0, вы можете получить к ней доступ с помощью того же компьютера, локального хоста или любого другого компьютера из той же сети.

Чтобы проверить сервер, откройте веб-браузер и перейдите по адресу 0.0.0.0:8080. Когда вы пытаетесь получить доступ к серверу с того же компьютера, вы также можете использовать 127.0.0.1:8080 или localhost:8080. 127.0.0.1 IP-адрес фактически означает localhost, то есть сетевой адрес того же компьютера, на котором запущена программа. Вы сможете увидеть ответ сервера, отображаемого в браузере, как показано на следующем снимке экрана:

Чтобы понять, как работает этот простой код, ознакомьтесь с методом GET в предыдущем фрагменте кода. Как вы можете видеть, когда веб-браузер запрашивает URL-адрес, метод GET возвращает Hello, world! в браузер.

Тем временем вы также можете наблюдать еще два обязательных компонента web.py в вашем коде: методы urls и web.application (). Библиотека web.py требует инициализации местоположения ответа в объявлении переменной urls.