Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] MVP системы рекомендаций для GitHub за неделю |

|

Метки: author yurtaev машинное обучение mongodb github data mining big data python react machine learning recommendation systems django data science |

[Перевод] Укрощение Змейки с помощью реактивных потоков |

Укрощение Змейки с помощью реактивных потоков

- Перевод

- Tutorial

Веб в наши дни двигается очень быстро и мы все это знаем. Сегодня Реактивное Программирование является одной из самых горячих тем в веб-разработке и с такими фреймворками, как Angular или React, она стала гораздо более популярной, особенно в современном мире JavaScript. В сообществе произошел массовый переход от императивных парадигм программирования к функциональным реактивным парадигмам. Тем не менее, многие разработчики пытаются с этим бороться и часто перегружены его сложностью (большой API), фундаментальным сдвигом в мышлении (от императивного к декларативному) и множеством понятий.

Хотя это не самая простая тема, но как только мы сумеем ее понять, мы спросим себя, как мы могли без нее жить?

Эта статья не предназначена для введения в реактивное программирование, и если вы совершенный новичок в ней, мы рекомендуем следующие ресурсы:

- Введение в Реактивное Программирование (Introduction to Reactive Programming) от Andr'e Staltz

- RxJS 5 Мыслить Реактивно (RxJS 5 Thinking Reactively) от Ben Lesh

- RxJS 5 Окончательный (RxJS 5 Ultimate) от Chris Noring

- Изучение RxJS (Learn RxJS) от Brian Troncone

- RxJS 5 Операторы на примерах (RxJS 5 Operators By Example) от Brian Troncone

Цель этой публикации — научиться мыслить реактивно, построив классическую видеоигру, которую все мы знаем и любим — Змейка. Правильно, видеоигра! Это забавная, но сложная система, которая содержит в себе много внешнего состояния, например: счет, таймеры или координаты игрока. Для нашей версии мы будем широко использовать Observables (наблюдаемые) и использовать несколько разных операторов, чтобы полностью избежать сторонних влияний на внешнее состояние. В какой-то момент может возникнуть соблазн сохранить состояние за пределами потока Observable, но помните, что мы хотим использовать реактивное программирование и не полагаться на отдельную внешнюю переменную, которая сохраняет состояние.

Примечание. Мы будем использовать HTML5 и JavaScript исключительно с RxJS, чтобы преобразовать программный цикл событий в приложение, основанное на реактивном событии.

Код доступен на Github, и здесь можно найти демо-версию. Я призываю Вас клонировать проект, немного повозиться с ним и реализовать интересные новые игровые функции. Если вы это сделаете, напишите мне в Twitter.

Содержание

- Игра

- Настройка сцены

- Идентификация исходных потоков

- Управление змейкой

- Поток направления (direction$)

- Отслеживание длины

- BehaviorSubject как спасение

- Реализация счета (score$)

- Укрощение змейки (snake$)

- Создание яблок

- Вещание событий

- Собирая всё вместе

- Поддержание производительности

- Отображение сцены

- Будущая работа

- Особая благодарность

Игра

Как упоминалось ранее, мы собираемся воссоздать Змейку, классическую видеоигру с конца 1970-х годов. Но вместо простого копирования игры мы добавим немного вариации к ней. Вот как работает игра.

Как игрок Вы контролируете линию, похожую на голодную змею. Цель состоит в том, чтобы съесть столько яблок, сколько сможете, чтобы вырасти как можно длиннее. Яблоки можно найти в случайных позициях на экране. Каждый раз, когда змея ест яблоко, её хвост становится длиннее. Стены не остановят вас! Но послушайте, Вы должны стараться избегать попадания в своё собственное тело любой ценой. Если Вы этого не сделаете, игра окончена. Как долго Вы сможете выжить?

Вот предварительный пример того, что мы собираемся сделать:

Для этой конкретной реализации змея представлена в виде линии синих квадратов, где ее голова окрашена в черный цвет. Можете ли Вы сказать, как выглядят фрукты? Точно, красные квадраты. Все сущности это квадрат, и это не потому, что так они выглядят красивее, а потому что это очень простые геометрические фигуры и они легко рисуются. Графика не очень блестящая, но эй, речь ведь идет о переходе от императивного программирования к реактивному программированию, а не об игровом искусстве.

Настройка сцены

Прежде чем мы начнем работать с функциональностью игры, нам нужно создать элемент canvas (холст), который дает нам мощные API-интерфейсы рисования из JavaScript. Мы будем использовать холст для рисования нашей графики, включая игровое поле, змею, яблоки и в основном все, что нам нужно для нашей игры. Другими словами, игра будет полностью отображаться в элементе canvas.

Если это совершенно ново для Вас, ознакомьтесь с этим курсом на egghead от Keith Peters.

Файл index.html довольно прост, потому что большая часть магии происходит в JavaScript.

Сценарий (script), который мы добавляем к телу (body), по сути является результатом процесса сборки и содержит весь наш код. Однако вам может быть интересно, почему в body нет такого элемента как canvas. Это потому, что мы создадим этот элемент с помощью JavaScript. Кроме того, мы добавляем несколько констант, которые определяют количество строк и столбцов, а также ширину и высоту холста.

export const COLS = 30;

export const ROWS = 30;

export const GAP_SIZE = 1;

export const CELL_SIZE = 10;

export const CANVAS_WIDTH = COLS * (CELL_SIZE + GAP_SIZE);

export const CANVAS_HEIGHT = ROWS * (CELL_SIZE + GAP_SIZE);

export function createCanvasElement() {

const canvas = document.createElement('canvas');

canvas.width = CANVAS_WIDTH;

canvas.height = CANVAS_HEIGHT;

return canvas;

}

С помощью этого мы можем вызвать эту функцию, создать элемент canvas на лету и добавить его в body нашей страницы:

let canvas = createCanvasElement();

let ctx = canvas.getContext('2d');

document.body.appendChild(canvas);

Обратите внимание, что мы также получаем ссылку на CanvasRenderingContext2D, вызывая getContext ('2d') на элементе canvas. Этот контекст 2D-рендеринга для холста позволяет нам рисовать, например, прямоугольники, текст, линии, пути и многое другое.

Мы готовы двигаться! Давайте начнем работу над основной механикой игры.

Идентификация исходных потоков

Исходя из примера и описания игры мы знаем, что нам нужны следующие функции:

- Управление змеей с помощью клавиш со стрелками

- Слежение за счетом игрока

- Слежение за змеей (включая еду и перемещение)

- Слежение за яблоками на поле (включая создание новых яблок)

В реактивном программировании речь идет о программировании на основе потоков данных, потоков входных данных. Концептуально, когда выполняется реактивная программа, она устанавливает наблюдение за источником информации, и реагирует на изменения, такие как например, взаимодействие пользователя с приложением, при нажатии клавиши на клавиатуре или просто следующий этап интервала. Так что все дело в том, чтобы понять, что может измениться. Эти изменения часто определяют исходные потоки. Главная задача определиться с исходными потоками, а затем составить их вместе, чтобы рассчитать все, что Вам нужно, например, состояние игры.

Попробуем найти наши исходные потоки, посмотрев на вышеприведенные функции.

Прежде всего, вводимые пользователем данные определенно будут меняться со временем. Игрок перемещает голодную змею с помощью клавиш со стрелками. Это означает, что наш первый исходный поток — keydown$, который будет инициировать изменение значения всякий раз, когда нажата клавиша.

Затем нам нужно следить за счетом игрока. Счет в основном зависит от того, сколько яблок съела змея. Можно сказать, что счет зависит от длины змеи, потому что всякий раз, когда змея растет, мы хотим увеличить счет на 1. Поэтому наш следующий исходный поток — snakeLength$.

Опять же, важно определить основные потоки, из которых мы можем вычислить все, что Вам нужно, например, счет. В большинстве случаев исходные потоки объединяются и преобразуются в более конкретные потоки данных. Через минуту мы увидим это в действии. На данный момент давайте продолжим определение наших основных потоков.

На данный момент мы получили события пользовательского ввода и счет. Нам остались более игровые или интерактивные потоки, такие как змея или яблоки.

Давайте начнём со змеи. Основной механизм змеи прост: она движется со временем, и чем больше яблок она съедает, тем больше она растет. Но что именно является потоком змеи? На данный момент мы можем забыть о том, что она ест и растет, потому что в первую очередь важно то, что она зависит от фактора времени, когда она движется со временем, например, 5 пикселей каждые 200 ms. Таким образом, наш исходный поток — это интервал, который отправляет значение после каждого периода времени, и мы называем это ticks$. Этот поток также определяет скорость нашей змеи.

И последнее, но не менее важное: яблоки. Расположить яблоки на поле учитывая всё — довольно просто. Этот поток в основном зависит от змеи. Каждый раз, когда змея движется, мы проверяем, сталкивается ли голова змеи с яблоком или нет. Если это так, мы удаляем это яблоко и генерируем новое в произвольной позиции на поле. Как упоминалось, нам не нужно вводить новый поток данных для яблок.

Отлично, это всё, что касается основных потоков. Вот краткий обзор всех потоков, которые нам нужны для нашей игры:

- keydown$: события нажатия клавиши (KeyboardEvent)

- snakeLength$: представляет длину змеи (Number)

- ticks$: интервал, который представляет движение змеи (Number)

Эти исходные потоки создают основу для нашей игры, из которой мы можем рассчитать все другие значения, которые нам необходимы, включая счет, состояние змеи и яблоки.

В следующих разделах мы более подробно рассмотрим, как реализовать каждый из этих исходных потоков и применить их для генерации необходимых нам данных.

Управление змейкой

Давайте погрузимся прямо в код и внедрим механизм управления для нашей змеи. Как упоминалось в предыдущем разделе, управление зависит от ввода с клавиатуры. Оказывается, это ужасно просто, и первым шагом является создание наблюдаемой (observable) последовательности из событий клавиатуры. Для этого мы можем использовать оператор fromEvent():

let keydown$ = Observable.fromEvent(document, 'keydown');Это наш самый первый исходный поток, и он будет инициировать KeyboardEvent каждый раз, когда пользователь нажимает клавишу. Обратите внимание, что буквально каждый keydown инициирует событие. Поэтому мы также получаем события для клавиш, которые нас абсолютно не интересуют, и это в основном все остальные клавиши, кроме клавиш со стрелками. Но прежде чем решать эту конкретную проблему, мы определяем постоянную карту направлений:

export interface Point2D {

x: number;

y: number;

}

export interface Directions {

[key: number]: Point2D;

}

export const DIRECTIONS: Directions = {

37: { x: -1, y: 0 }, // Left Arrow

39: { x: 1, y: 0 }, // Right Arrow

38: { x: 0, y: -1 }, // Up Arrow

40: { x: 0, y: 1 } // Down Arrow

};

Посмотрев на объект KeyboardEvent, можно предположить, что каждый ключ имеет уникальный keyCode. Чтобы получить коды для клавиш со стрелками, мы можем использовать эту таблицу.

Каждое направление имеет тип Point2D, который является просто объектом с x и y свойствами. Значение для каждого свойства может быть равно 1, -1 или 0, указывая, где должна быть змея. Позже мы будем использовать направление для получения новой позиции сетки для головы и хвоста змеи.

Поток направления (direction$)

Итак, у нас уже есть поток для событий keydown, и каждый раз, когда игрок нажимает клавишу, нам нужно сопоставить значение, которое являет собой KeyboardEvent, одному из векторов направления выше. Для этого мы можем использовать оператор map() для проецирования каждого события клавиатуры на вектор направления.

let direction$ = keydown$

.map((event: KeyboardEvent) => DIRECTIONS[event.keyCode])

Как упоминалось ранее, мы будем получать каждое событие нажатия клавиши, потому что мы не отфильтровываем те, которые нас не интересуют, например, клавиши символов. Однако можно утверждать, что мы уже фильтруем события, просматривая их на карте направлений. Для каждого keyCode, который не определен на этой карте, он будет возвращен как undefined. Тем не менее, на самом деле это не фильтрует значения в потоке, поэтому мы можем использовать оператор filter(), чтобы обрабатывать только нужные значения.

let direction$ = keydown$

.map((event: KeyboardEvent) => DIRECTIONS[event.keyCode])

.filter(direction => !!direction)

Хорошо, это было легко. Код выше отлично работает и работает так, как ожидалось. Тем не менее, есть еще кое-что для улучшения. Вы догадались что именно?

Ну, одна идея состоит в том, что мы хотим помешать змее идти в противоположную сторону, например. справа налево или сверху вниз. На самом деле не имеет смысла допускать такое поведение, потому что правило номер один заключается в том, чтобы избежать попадания в собственный хвост, помните?

Решение довольно просто. Мы кэшируем предыдущее направление и когда вызывается новое событие, мы проверяем, не отличается ли новое направление от противоположного. Вот функция, которая вычисляет next (следующее) направление:

export function nextDirection(previous, next) {

let isOpposite = (previous: Point2D, next: Point2D) => {

return next.x === previous.x * -1 || next.y === previous.y * -1;

};

if (isOpposite(previous, next)) {

return previous;

}

return next;

}

Это первый случай, когда у нас возникает соблазн сохранить состояние за пределами Observable (наблюдаемого) источника информации, потому что нам как-то нужно правильно отслеживать предыдущее направление… Легким решением является просто сохранить предыдущее направление во внешней переменной состояния. Но постойте! Ведь мы хотели избежать этого, не так ли?

Чтобы избежать внешней переменной, нам нужен способ сортировки совокупных бесконечных Observables. RxJS имеет очень удобный оператор, который мы можем использовать для решения нашей проблемы — scan().

Оператор scan() очень похож на Array.reduce(), но вместо того, чтобы только возвращать последнее значение, он инициирует отправку каждого промежуточного результата. С помощью scan() мы можем в основном накапливать значения и бесконечно сокращать поток входящих событий до одного значения. Таким образом, мы можем отслеживать предыдущее направление, не полагаясь на внешнее состояние.

Давайте применим это и посмотрим на наш окончательный direction$ поток:

let direction$ = keydown$

.map((event: KeyboardEvent) => DIRECTIONS[event.keyCode])

.filter(direction => !!direction)

.scan(nextDirection)

.startWith(INITIAL_DIRECTION)

.distinctUntilChanged();

Обратите внимание, что мы используем startWith(), чтобы инициировать начальное значение, прежде чем начинать отправлять значения из источника Observable (keydown$). Без этого оператора наш Observable начнет отправлять значения только тогда, когда игрок нажимает клавишу.

Второе улучшение заключается в том, чтобы инициировать отправку значений только тогда, когда новое направление отличается от предыдущего. Другими словами, нам нужны только отличающиеся значения. Возможно, вы заметили в приведенном выше фрагменте distinctUntilChanged(). Этот оператор делает грязную работу за нас и подавляет повторяющиеся элементы. Обратите внимание, что distinctUntilChanged() только отфильтровывает одинаковые значения, если между ними не выбрано другое.

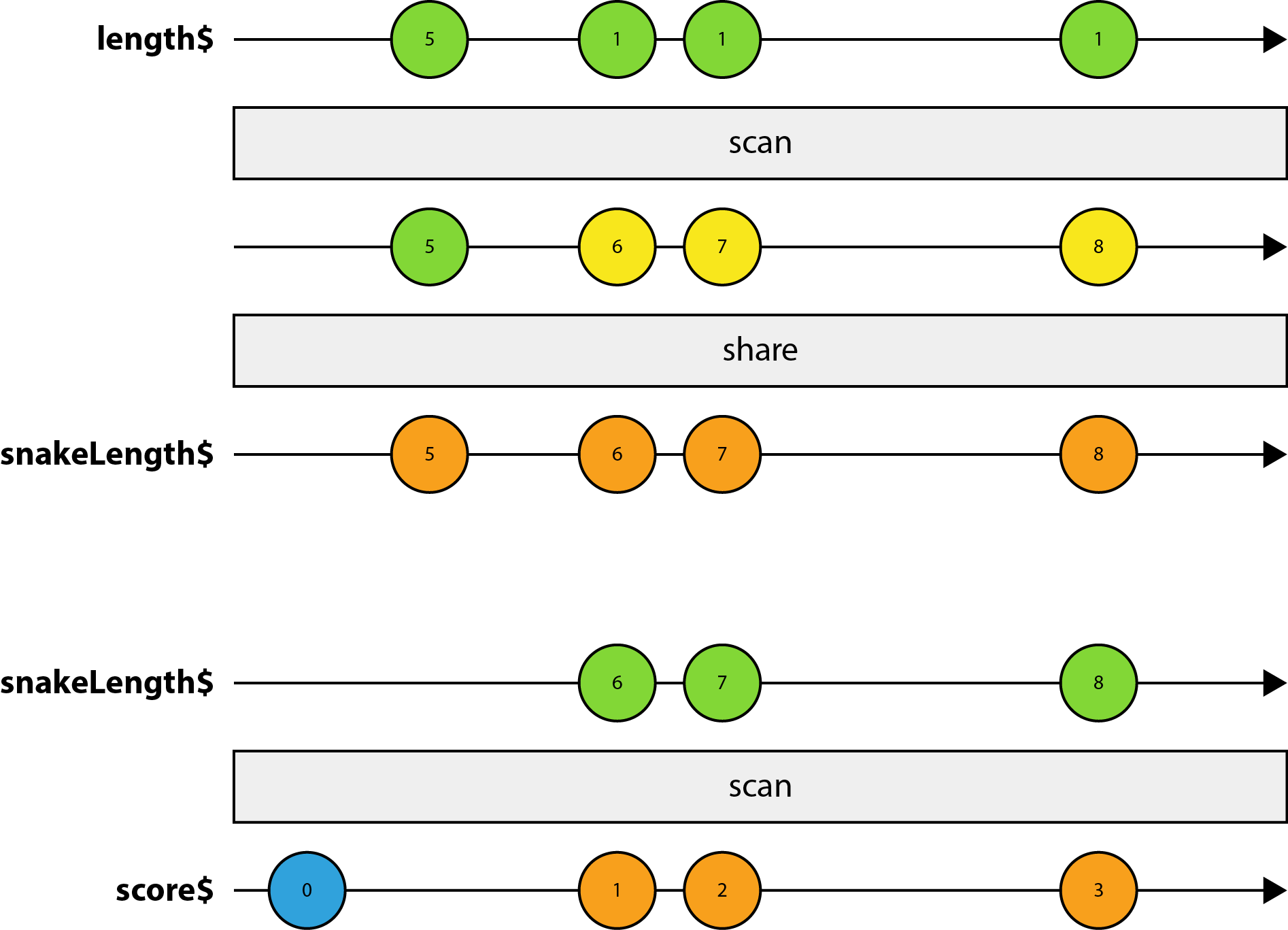

Следующая схема визуализирует наш поток direction$ и то, как он работает. Значения, окрашенные в синий цвет, представляют начальные значения, желтый означает, что значение было изменено на потоке Observable, а значения, отправленные в потоке результатов, окрашены в оранжевый цвет.

Отслеживание длины

Прежде чем мы реализуем саму змею, давайте придумаем как отслеживать ее длину. Почему нам нужна длина в первую очередь? Ну, мы используем эту информацию для моделирования счета. Правильно будет сказать, что в императивном мире мы просто проверяем, было ли столкновение всякий раз, когда змея движется, и если это так, мы увеличиваем счет. Таким образом, на самом деле нет необходимости отслеживать длину. Тем не менее, такой подход представил бы еще одну переменную внешнего состояния, которой мы хотим избежать любой ценой.

В реактивном мире решение немного отличается. Один из простых подходов может заключаться в использовании потока snake$, и каждый раз, когда он отправляет значение, мы знаем, что змея увеличилась в длину. Хотя это действительно зависит от реализации snake$, пока мы не будем реализовывать этот поток. С самого начала мы знаем, что змея зависит от ticks$, поскольку она перемещается на определенное расстояние с течением времени. Таким образом, snake$ будет накапливать массив сегментов тела, и поскольку она основана на ticks$, она будет генерировать значение каждые x миллисекунд. Тем не менее, даже если змея не сталкивается ни с чем, snake$ будет по-прежнему отправлять значения. Это потому, что змея постоянно движется по полю, и поэтому массив всегда будет другим.

Это может быть немного сложно понять, потому что между различными потоками есть определенные зависимости. Например, apples$ будут зависеть от snake$. Причина этого в том, что каждый раз, когда движется змея, нам нужен массив сегментов её тела, чтобы проверить, не сталкивается ли какая-либо из этих частей с яблоком. В то время как поток apples$ будет накапливать массив яблок, нам нужен механизм моделирования коллизий, который в то же время избегает круговых зависимостей.

BehaviorSubject как спасение

Решение этой задачи заключается в том, что мы будем внедрять механизм вещания, используя BehaviorSubject. RxJS предлагает различные типы Subjects (предметов) с различными функциональными возможностями. Таким образом, класс Subject предоставляет базу для создания более специализированных Subjects. В двух словах, Subject является типом, который реализует одновременно типы Observer (наблюдатель) и Observable (наблюдаемый). Observables определяют поток данных и создают данные, в то время как Observers могут подписаться на Observables и получать данные.

BehaviorSubject — это более специализированный Subject, предоставляющий значение, которое изменяется со временем. Теперь, когда Observer подписывается на BehaviorSubject, он получит последнее отправленное значение, а затем все последующие значения. Его уникальность заключается в том, что он включает в себя начальное значение, так что все Observers получат как минимум одно значение при подписке.

Давайте продолжим и создадим новый BehaviorSubject с начальным значением SNAKE_LENGTH:

// SNAKE_LENGTH specifies the initial length of our snake

let length$ = new BehaviorSubject(SNAKE_LENGTH);

С этого места остался лишь небольшой шаг для реализации snakeLength$:

let snakeLength$ = length$

.scan((step, snakeLength) => snakeLength + step)

.share();

В приведенном выше коде мы видим, что snakeLength$ основана на length$, которая является нашим BehaviorSubject. Это означает, что всякий раз, когда мы передаем новое значение для Subject, используя next(), он будет отправлять значение на snakeLength$. Кроме того, мы используем scan() для накопления длины с течением времени. Круто, но вам может быть интересно, что это за share(), не так ли?

Как уже упоминалось, snakeLength$ будет позже использоваться как входящие данные для snake$, но в то же время действует как исходный поток для счёта игрока. Как результат мы в конечном итоге воссоздаем этот исходный поток со второй подпиской на тот же Observable. Это происходит потому, что length$ является cold Observable (холодным Наблюдаемым).

Если вы совершенно не знакомы с hot and cold Observables (горячими и холодными наблюдателями), мы написали статью о Cold vs Hot Observables.

Дело в том, что мы используем share(), чтобы разрешить мульти подписки к Observable, которые в противном случае повторно создавали бы его источник при каждой подписке. Этот оператор автоматически создает Subject между исходным источником и всеми будущими подписчиками. Как только количество подписчиков перейдет от нуля к одному, он подключит Subject к базовому источнику Observable и инициирует отправку всех своих уведомлений. Все будущие подписчики будут подключены к этому промежуточному Subject, так что это эффективно, что есть только одна подписка на лежащий ниже холодный Observable. Это называется многоадресной рассылкой (мультикастинг) и поможет Вам выделиться.

Потрясающие! Теперь, когда у нас есть механизм, который мы можем использовать для передачи значений нескольким подписчикам, мы можем пойти дальше и реализовать score$.

Реализация счета (score$)

Реализация счета игрока настолько проста, насколько это возможно. Вооружившись snakeLength$, мы теперь можем создать поток score$, который просто накапливает счет игрока с помощью scan():

let score$ = snakeLength$

.startWith(0)

.scan((score, _) => score + POINTS_PER_APPLE);

По сути мы используем snakeLength$ или, скорее, length$, чтобы уведомлять подписчиков о том, что произошло столкновение, и если это действительно было так, мы просто увеличиваем счет на POINTS_PER_APPLE, постоянное количество очков за яблоко. Обратите внимание, что startWith(0) необходимо добавить перед scan(), чтобы избежать указания начального значения.

Давайте посмотрим на более наглядное представление того, что мы только что реализовали:

Посмотрев на приведенную выше схему, вы можете задаться вопросом, почему начальное значение BehaviorSubject появляется только на snakeLength$ и отсутствует в score$. Это связано с тем, что первый подписчик заставит share() подписаться на базовый источник данных и, поскольку исходный источник данных сразу же отправляет значение, это значение уже будет отправлено к тому времени, когда произошли последующие подписки.

Чудно. Начиная с этого места, давайте реализуем поток для нашей змеи. Разве это не захватывающе?

Укрощение змейки (snake$)

К этому моменту мы уже выучили много операторов и теперь можем использовать их для реализации нашего потока snake$. Как обсуждалось в начале этой статьи, нам нужен какой-то тикер, который удерживает нашу голодную змею двигающейся. Оказывается, есть удобный оператор для этого interval(x), который отправляет значения каждые x миллисекунд. Давайте будем называть каждое значение тиком.

let ticks$ = Observable.interval(SPEED);

С этого момента до реализации финального потока snake$ совсем немного. Для каждого тика, в зависимости от того, съела ли змея яблоко или нет, мы хотим либо переместить её вперёд, либо добавить новый сегмент. Поэтому мы можем использовать уже знакомую нам функцию scan() для накопления массива сегментов тела. Но, как вы, возможно, догадались, перед нами возникает вопрос. Где вступают в игру потоки direction$ или snakeLength$?

Абсолютно законный вопрос. Направление, как и длина змеи легко доступны внутри нашего потока snake$, если мы сохраним эту информацию в переменной за пределами наблюдаемого потока. Но опять же, мы нарушаем наше правило не изменять внешнее состояние.

К счастью, RxJS предлагает еще один очень удобный оператор с именем withLatestFrom(). Это оператор, используемый для объединения потоков, и это именно то, что мы ищем. Этот оператор применяется к первичному потоку, который контролирует, когда данные будут отправляться в результирующий поток. Другими словами, вы можете думать о withLatestFrom() как о способе регулирования отправки данных вторичного потока.

Учитывая вышесказанное у нас есть инструменты, необходимые для окончательного внедрения голодной snake$:

let snake$ = ticks$

.withLatestFrom(direction$, snakeLength$, (_, direction, snakeLength) => [direction, snakeLength])

.scan(move, generateSnake())

.share();

Наш основной источник — это ticks$, и всякий раз, когда новое значение проходит вниз по своему пути, мы берем последние значения как с direction$, так и с snakeLength$. Обратите внимание, что даже если вторичные потоки часто отправляют значения, например, если игрок разбивает себе голову на клавиатуре, мы будем обрабатывать данные только для каждого тика.

Кроме того, мы передаем селекторную функцию (функцию для настройки) в withLatestFrom, которая вызывается, когда первичный поток инициирует отправку значения. Эта функция является необязательной, и если ее убрать, то появляется список со всеми элементами.

Мы не будем объяснять функцию move(), поскольку основной целью этого поста является содействие изменению фундаментального мышления. Тем не менее, вы можете найти её исходный код на GitHub.

Вот схема, которая наглядно демонстрирует код выше:

Видите как мы регулируем поток direction$? Дело в том, что использование withLatestFrom() очень практично, когда вы хотите объединить несколько потоков, и Вы не заинтересованы в создании значений в блоке Observable (наблюдаемом), когда любой из потоков отправляет данные.

Создание яблок

Вы можете заметить, что внедрение наших основных строительных блоков для игры становится всё проще, поскольку мы узнаем все больше и больше операторов. Если Вы дошли до этой точки, то оставшиеся шаги будут легкими.

На данный момент мы реализовали несколько потоков, таких как direction$, snakeLength$, score$ и snake$. Если мы объединим их вместе, мы сможем перемещаться по этому зверю змею. Но что это за игра, если нечего есть. Довольно скучно.

Давайте создадим несколько яблок, чтобы удовлетворить аппетит нашей змеи. Во-первых, давайте проясним, какое состояние нам нужно сохранить. Ну, это может быть либо один объект, либо массив объектов. Для нашей реализации мы выберем массив яблок. Вы слышите звон колоколов?

Правильно, мы снова можем использовать scan() для накопления массива яблок. Мы начинаем с начального значения, и каждый раз, когда змея движется, мы проверяем, произошло ли столкновение. Если это так, мы создаем новое яблоко и возвращаем новый массив. Таким образом мы можем использовать distinctUntilChanged() для фильтрации одинаковых значений.

let apples$ = snake$

.scan(eat, generateApples())

.distinctUntilChanged()

.share();

Круто! Это означает, что всякий раз, когда apples$ отправляет новое значение, мы можем предположить, что наша змея съела один из этих вкусных фруктов. Осталось увеличить счет, а также сообщить другим потокам об этом событии, таким как snake$, которая берет последнее значение от snakeLength$, чтобы определить, добавить ли новый сегмент тела.

Вещание событий

Немного ранее мы реализовали механизм вещания, помните? Давайте использовать его для запуска желаемых действий. Вот наш код для eat():

export function eat(apples: Array, snake) {

let head = snake[0];

for (let i = 0; i < apples.length; i++) {

if (checkCollision(apples[i], head)) {

apples.splice(i, 1);

// length$.next(POINTS_PER_APPLE);

return [...apples, getRandomPosition(snake)];

}

}

return apples;

}

Простым решением является вызов length$.next(POINTS_PER_APPLE) прямо внутри блока условия. Но тогда мы столкнемся с проблемой, потому что мы не сможешь извлечь этот метод в свой собственный модуль утилит (модуль ES2015). В ES2015 модули хранятся в файлах, и для каждого файла существует ровно один модуль. Наша цель состоит в том, чтобы организовать наш код таким образом, чтобы его было легко поддерживать и расширять.

Более утонченным решением является введение еще одного потока, называемого applesEaten$. Этот поток основан на apples$ и каждый раз, когда в потоке отправляется новое значение, мы хотели бы выполнить какое-то действие, вызывая length$.next(). Для этого мы можем использовать оператор do(), который будет выполнять часть кода для каждого события.

Звучит выполнимо. Но нам как-то нужно пропустить первое (начальное) значение, испускаемое apples$. В противном случае мы в конечном итоге увеличиваем счет сразу, что не имеет большого смысла, поскольку игра только началась. Оказывается, у RxJS есть оператор для этого, а именно skip().

Тот факт, что applesEaten$ действует только как распространитель уведомлений для других потоков, означает что у нас не будет наблюдателя подписанного на этот поток. Поэтому мы должны подписаться на поток самостоятельно.

let appleEaten$ = apples$

.skip(1)

.do(() => length$.next(POINTS_PER_APPLE))

.subscribe();

Собирая всё вместе

На этом этапе мы реализовали все основные строительные блоки нашей игры, и мы готовы, наконец, объединить все в один поток результата — scene$. Для этого мы будем использовать combineLatest. Этот оператор очень похож на withLatestFrom, но отличается в деталях. Во-первых, давайте посмотрим на код:

let scene$ = Observable.combineLatest(snake$, apples$, score$, (snake, apples, score) => ({ snake, apples, score }));

Вместо того, чтобы регулировать частоту вторичных потоков, нас интересует событие каждый раз, когда любой из входных Observables (наблюдаемых) потоков генерирует новое значение. Последний аргумент снова является функцией настройкой, и мы просто берем все значения и возвращаем объект, который представляет собой наше состояние игры. Состояние игры содержит все, что нужно отображать на холсте.

Поддержание производительности

Не только в игре, но и в веб-приложениях мы стремимся поддерживать производительность. Понятие производительности может означать много, но с точки зрения нашей игры мы хотели бы перерисовать всю сцену 60 раз в секунду.

Мы можем сделать это, представив другой поток, похожий на ticks$, но для рендеринга. В основном это лишь другой интервал:

// Interval expects the period to be in milliseconds which is why we devide FPS by 1000

Observable.interval(1000 / FPS)

Проблема в том, что JavaScript является однопоточным. В худшем случае мы не позволяем браузеру ничего делать, и блокируем его. Другими словами, браузер не сможет обработать все эти обновления достаточно быстро. Причина этого заключается в том, что браузер пытается отобразить кадр, а затем сразу же запрашивает возможность рендерить следующий. В результате он бросает текущую задачу и начинает следующую, чтобы поддерживать скорость. Вот тогда анимации начинают выглядеть неряшливо.

К счастью, мы можем использовать requestAnimationFrame, позволяя браузеру работать и выполнять наш скрипт в самое подходящее время. Но как мы используем его для нашего блока Observable? Хорошей новостью является то, что многие операторы, включая interval(), принимают в качестве последнего аргумента Scheduler (планировщик). В двух словах, Scheduler — это механизм, позволяющий запланировать выполнение какой-либо задачи в будущем.

Хотя RxJS предлагает множество планировщиков, тот, который нас интересует, называется animationFrame. Этот планировщик выполняет задачу при запуске window.requestAnimationFrame.

Отлично! Давайте применим это к нашему интервалу, и назовем результирующий Observable game$:

// Note the last parameter

const game$ = Observable.interval(1000 / FPS, animationFrame)

Этот интервал теперь будет отправлять значения примерно каждые 16 мс, поддерживающие 60 FPS.

Отображение сцены

Нам осталось объединить нашу game$ с scene$. Можете ли вы догадаться, какой оператор мы используем для этого? Помните, что оба потока отправляются с разными интервалами, и теперь цель состоит в том, чтобы отобразить нашу сцену на холсте 60 раз в секунду. Мы будем использовать game$ в качестве основного потока, и каждый раз, когда он отправляет значение, мы объединяем его с последним значением из scene$. Звучит знакомо? Да, мы снова можем использовать withLatestFrom.

// Note the last parameter

const game$ = Observable.interval(1000 / FPS, animationFrame)

.withLatestFrom(scene$, (_, scene) => scene)

.takeWhile(scene => !isGameOver(scene))

.subscribe({

next: (scene) => renderScene(ctx, scene),

complete: () => renderGameOver(ctx)

});

Возможно, вы заметили takeWhile() в приведенном выше коде. Это еще один очень полезный оператор, который мы можем вызвать на существующем Observable. Он будет возвращать значения из game$ до тех пор, пока isGameOver() не вернет true.

Вот живое демо для вас с которым можно поиграться:

Будущая работа

Игра очень простая, и в следующих записях мы будем расширять ее различными функциями, одна из которых перезапускает всю игру. Кроме того, мы рассмотрим, как мы можем реализовать паузу и возобновление игры, а также различные уровни сложности.

Будьте на связи!

Особая благодарность

Особая благодарность James Henry и Brecht Billiet за их помощь с кодом.

|

Метки: author Poccomaxa_zt разработка игр javascript html canvas блог компании инфопульс украина реактивное программирование rxjs gamedev snake |

Как мы учим ИИ помогать находить сотрудников |

Как мы учим ИИ помогать находить сотрудников

Статья подготовлена по материалам доклада на РИТ 2017 «Ранжирование откликов соискателей с помощью машинного обучения».

Почему рекрутерам не хватает ИИ?

Есть два базовых способа работы рекрутера с SuperJob. Можно, используя внутренний поиск сервиса, отсматривать резюме и приглашать подходящих специалистов на собеседования. А можно разместить вакансию и работать с откликами специалистов.

15% вакансий на SuperJob получают более 100 откликов в сутки. Соискатели не всегда отправляют резюме, соответствующее должности. Поэтому эйчарам приходится тратить лишнее время, чтобы отобрать нужных кандидатов.

Например, вакансия «Ведущий PHP-разработчик» обязательно соберет отклики программиста «1С», технического писателя и даже директора по маркетингу. Это осложняет и замедляет подбор даже на одну позицию. А в работе у рекрутера одновременно бывает несколько десятков вакансий.

Мы разработали алгоритм скоринга резюме, который автоматически выделяет резюме, совсем не подходящие к вакансии. С помощью него мы определяем нерелевантные отклики и пессимизируем их в списке откликов в личном кабинете работодателя. Получаем задачу классификации на два класса:

+ подходящий

— неподходящий отклик

И даем возможность рекрутеру возможность фильтровать отклики по данному признаку в личном кабинете.

Готовь данные летом, зимой, осенью и весной. И еще — летом

Подготовка данных для обучения — это один из важнейших этапов. От того, насколько тщательно подготовлен этот этап, зависит ваш успех. Мы обучаемся на событиях из личного кабинета рекрутера. Выборка включает в себя примерно 10—12 миллионов событий за последние 3 месяца.

В качестве меток классов используем события отклонения резюме и приглашения на собеседование. Если рекрутер сразу отклоняет резюме, без приглашения на собеседование, то скорее всего оно является нерелевантным. Соответственно, если рекрутер приглашает на собеседование (даже если впоследствии отклоняет), то отклик релевантен вакансии.

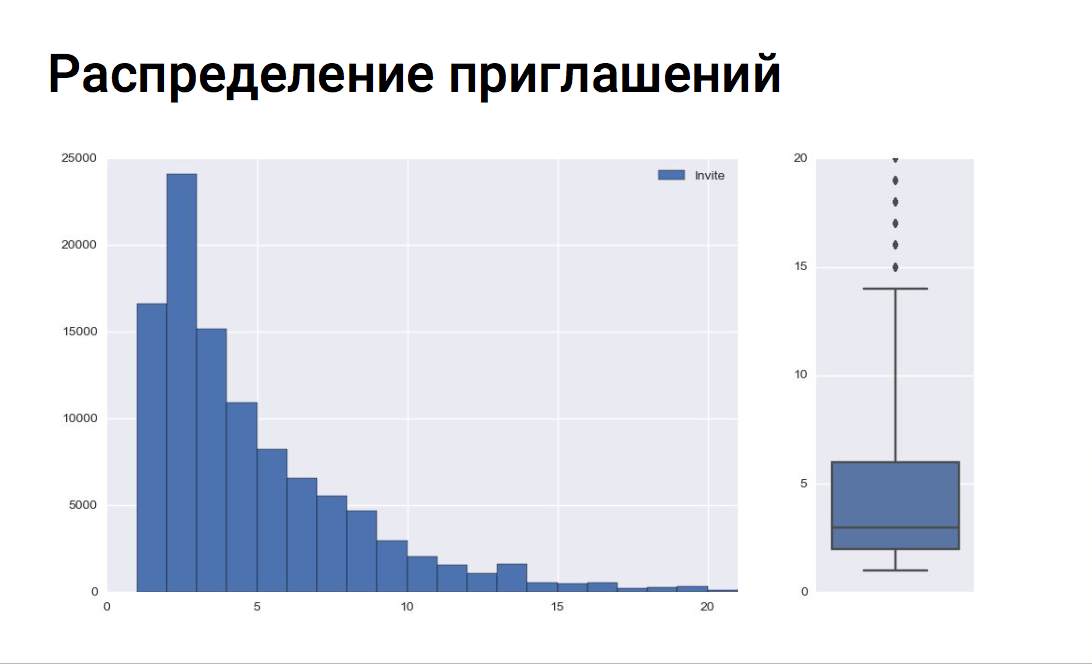

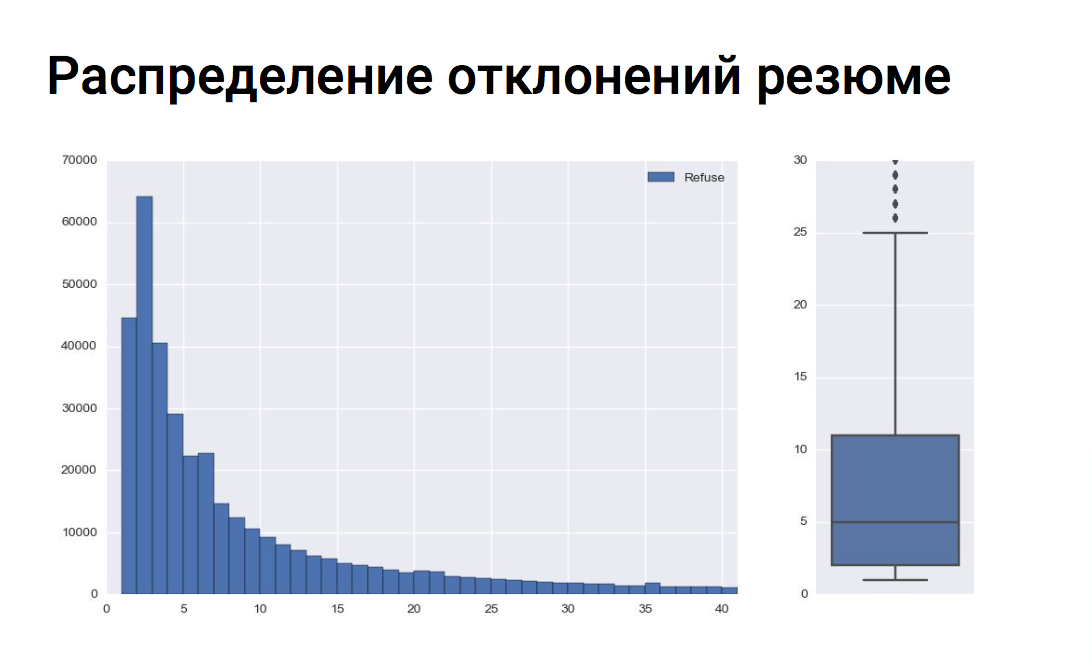

Для каждой вакансии проверяем распределение приглашений на собеседование и отклонений без рассмотрения и соответственно не обучаем модель на событиях вакансий, в которых количество отклонений существенно превышает количество приглашений. Или наоборот: там, где рекрутер приглашает всех подряд (или отклоняет всех подряд), такие вакансии мы также считаем выбросами.

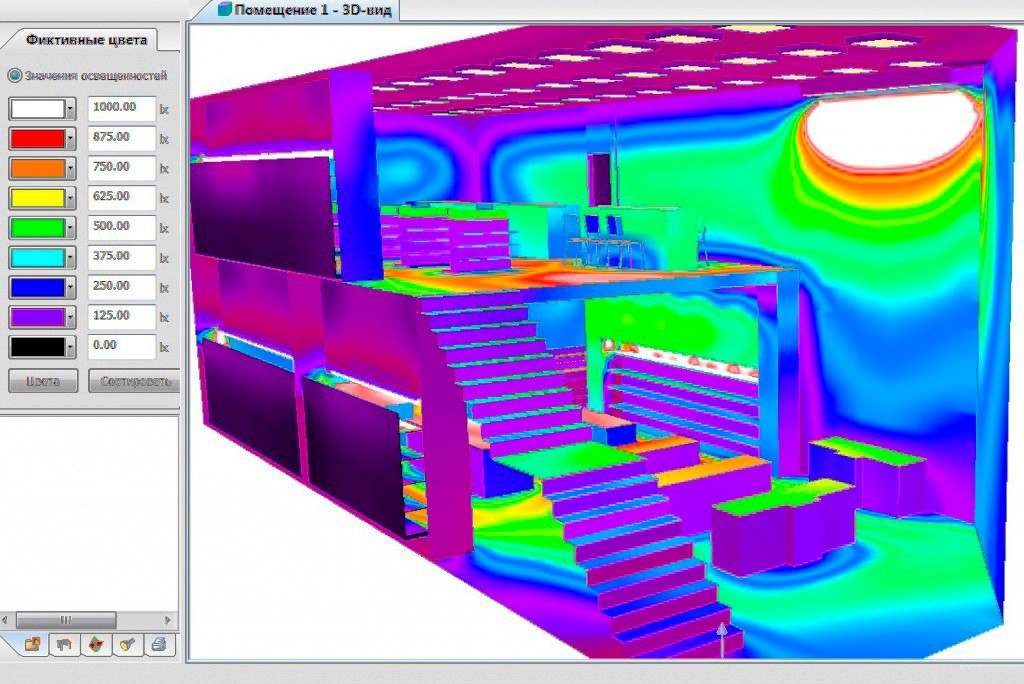

Ось Х — количество приглашений на собеседование

Ось Y — количество вакансий

На графике видно, что рекрутеры в основном приглашают 5—6 соискателей на одну вакансию. По боксплоту можно оценить медиану приглашений, верхний и нижний квартиль и выявить выбросы. В нашем примере все вакансии с более чем 14 приглашениями на собеседование являются выбросами.

Ось Х — количество отклонений резюме

Ось Y — количество вакансий

В среднем для одной вакансии рекрутер отклоняет 8—9 соискателей. И все вакансии с количеством отклонений более 25 являются выбросами, что видно на боксплоте.

Кто не хочет работать головой — работает руками

После обучения модели для каждого рекрутера мы построили свою матрицу ошибок и обнаружили кластер работодателей, с которыми наша модель плохо справлялась. После анализа лога действий данных рекрутеров стало понятно, почему модель пессимизировала отклики соискателей, которых потом приглашали на собеседование. Данные рекрутеры массово приглашали на собеседование соискателей с резюме вообще из другой профессиональной области, не соответствующей вакансии, то есть приглашали всех подряд. То есть вакансия расходилась с резюме приглашенного кандидата практически полностью. Как ни странно, в основном это были клиенты с безлимитным тарифом. Они получают полный доступ к базе и берут количеством, а не качеством. Данных рекрутеров мы включили в черный список и не обучались на их действиях, т.к. паттерн поведения расходился с поставленной задачей.

Самый запоминающийся пример был с вакансией полицейского московского метрополитена. Рекрутер приглашал на собеседование кого угодно: продавцов, торговых представителей, актеров — и отклонял сотрудников национальной гвардии и полицейских. Возможно, он перепутал кнопки «отклонить» и «пригласить» в интерфейсе личного кабинета.

Генерация признаков

Наша модель использует более 170 признаков. Все признаки основаны на свойствах вакансии, резюме и их сочетаниях. В качестве примера можно привести зарплатную вилку вакансии, желаемую зарплату резюме и попадание зарплаты резюме в зарплатную вилку вакансии как сочетание признаков резюме и вакансии.

К категориальным признакам применяем бинарное кодирование (One-Hot Encoding). Требование вакансии о наличии определенного типа образования, категории водительских прав или знания одного из иностранных языков раскрывается в несколько бинарных фич для модели.

Работа с текстовыми признаками:

Текст очищаем от стоп-слов, пунктуации, лемматизируем.

Из тестовых признаков формируем тематические группы:

- профессия вакансии и профессии из резюме;

- требования вакансии и ключевые навыки резюме;

- обязанности вакансии и обязанности с предыдущих мест работы соискателя.

Для каждой группы обучаем свой TF-IDF Vectorizer. Получаем векторайзеры, обученные на всем списке профессий, на всех требованиях вакансий совместно с навыками резюме и т.д. Например, у нас есть такая фича, как сходство профессии из вакансии с профессиями из опыта работы соискателя. Для каждой фразы получаем tf-idf вектор и вычисляем cosine similarity (косинус угла между векторами) c вектором другой фразы путем скалярного умножения векторов. Таким образом получаем меру сходства двух фраз.

В процессе генерации признаков мы консультировались с исследовательским центром SuperJob. Для рекрутеров был запущен опрос с целью выявить наиболее значимые признаки, по которым они принимают решение, пригласить кандидата или отклонить.

Результаты ожидаемы: рекрутеры смотрят на опыт работы, продолжительность работы на последнем месте, на среднюю продолжительность работы во всех компаниях. На то, является ли желаемая должность из резюме новой для кандидата, т.е. работал ли он по данной профессии раньше или нет. Мы учли данные опроса при составлении признаков для модели.

Примеры признаков:

- средняя продолжительность работы на одном месте, в месяцах;

- количество месяцев работы на последнем месте;

- разница между требуемым опытом вакансии и опытом из резюме;

- попадание желаемой зарплаты резюме в зарплатную вилку вакансии;

- мера сходства между желаемой должностью и предыдущим местом работы;

- мера сходства между специальностью образования и требованиями вакансии;

- рейтинг (заполненнность) резюме.

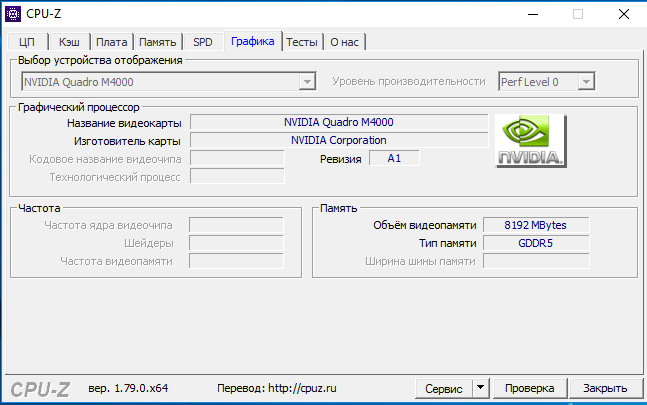

When it doubt, use xgboost

Для решения задачи классификации мы используем реализацию градиентного бустинга xgboost.

После обучения модели мы смогли собрать статистику по значимым признакам. Среди значимых признаков ожидаемо оказались опыт работы, зарплатные фичи, попадание желаемой зарплаты из резюме в зарплатную вилку вакансии, мера сходства профессии вакансии и опыта работы соискателя, сходство требований вакансии и ключевых навыков резюме.

Также в топе признаков оказался возраст соискателя. Мы решили провести эксперимент и убрали данный признак, так как не хотели дискриминировать наших соискателей. В итоге в топ попала фича «количество лет с момента получения высшего образования», которая, очевидно, коррелирует с возрастом. Мы убрали и этот признак и заново обучили модель. После всех манипуляций с возрастом мы увидели, что метрики качества модели немного просели. В итоге решили вернуть возраст, т.к. в массовом подборе он действительно важен рекрутеру, на него обращают внимание. Но компенсируем соискателям в возрасте очки скоринга, если их отклик немного не дотягивает до релевантного, т.к. считаем, что именно возраст соискателя пессимизировал его резюме.

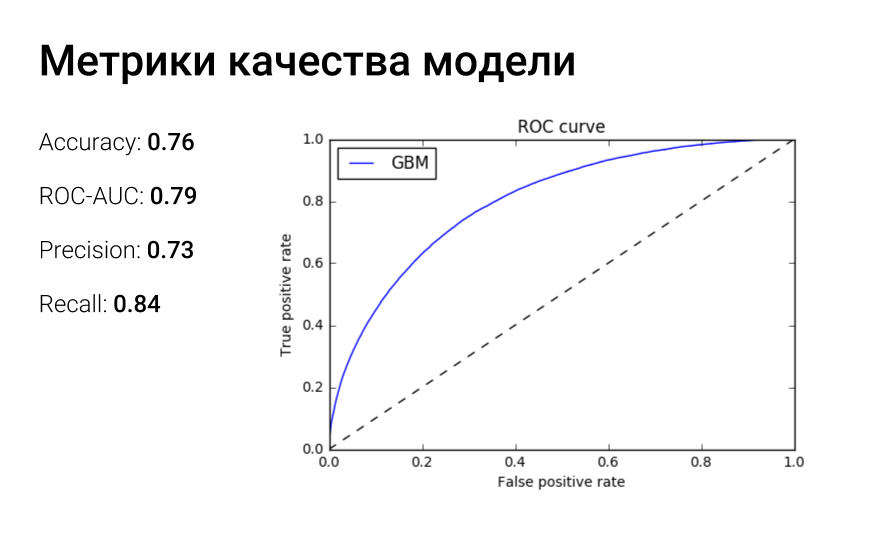

После нескольких итераций по обучению модели, подготовке фич мы получили модель с неплохими метриками качества.

ROC-кривая отражает зависимость доли верных положительный классификаций от доли ложных положительных классификаций. А площадь под roc-кривой можно интерпретировать следующим образом: auc-roc равен вероятности того, что случайно взятый объект 1 класса получит оценку выше, чем случайно взятый объект класса 0.

Мы не останавливаемся на данной модели и проводим новые эксперименты. Сейчас работаем над наполнением списка синонимов профессий, используя doc2vec, чтобы точнее определять факт того, что профессия из резюме соответствует профессии вакансии, и чтобы ведущий php-разработчик и senior php developer не были разными профессиями для модели. Также идут работы над тематическим моделированием с использованием библиотеки BigARTM для получения ключевых тем вакансии и резюме.

Также нам было необходимо, чтобы как можно меньше подходящих резюме оказалось в нерелевантных, т.е. мы должны минимизировать количество ошибок второго рода или ложно-отрицательных срабатываний. Для этого мы немного снизили значение threshold-вероятности принадлежности к релевантному классу. Таким образом снизили количество FN-ошибок. Но это имело и обратный эффект: возросло количество FP-ошибок.

На фреймворке Flask реализовали небольшой микросервис с REST API скоринга, упаковали его в docker контейнер и развернули на выделенном под эту задачу сервере. В контейнере запущен uWSGI веб сервер с мастер-процессом и 24 процессами-воркерами, по одному на ядро.

После того как пользователь откликается на сайте на вакансию, сообщение об этом факте попадает в очередь rabbitmq. Обработчик очереди получает сообщение, подготавливает данные, объект вакансии, объект резюме и вызывает endpoint api скоринга. Далее значение скоринга сохраняется в базу данных для последующей фильтрации откликов рекрутером в своем личном кабинете.

Сначала мы хотели реализовать онлайн-скоринг непосредственно при обращении к личному кабинету, но, оценив количество откликов на некоторые вакансии и итоговое время работы модели над одной парой резюме-вакансия, реализовали скоринг в асинхронном режиме.

Сам процесс скоринга занимает примерно 0,04—0,05 секунды. Таким образом, чтобы пересчитать значение скоринга для всех активных откликов на текущем железе, понадобится примерно 18—20 часов. С одной стороны, это большая цифра, с другой — мы пересчитываем скоринг достаточно редко, только при внедрении в продакшн новой модели. И с этой проблемой на данный момент можно как-то жить.

Самую большую нагрузку на сервис скоринга генерируют не соискатели, откликающиеся на вакансии, а наш сервис почтовых рассылок «подписки на резюме». Данный сервис срабатывает раз в сутки и рекомендует соискателей на вакансии рекрутеров. Естественно, результат работы сервиса мы также должны проскорить, чтобы советовать рекрутеру только релевантные отклики.

В итоге в пике работы мы обрабатываем 1000—1200 запросов в секунду. Если количество откликов, которые нужно проскорить, возрастет, то мы поставим рядом еще один сервер и горизонтально отмасштабируем сервис скоринга.

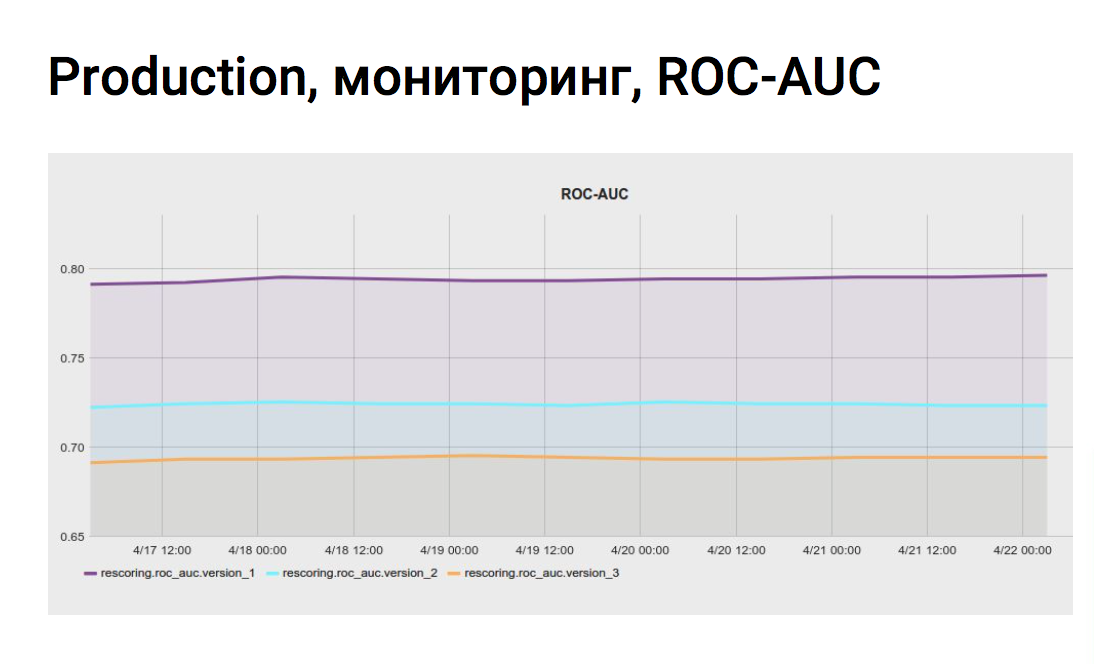

Мониторинг

Для того чтобы непрерывно оценивать метрики качества модели на актуальных данных личного кабинета, мы настроили задание мониторинга в jenkins. Скрипт несколько раз в сутки собирает данные из vertica по приглашениям и отклонениям, смотрит, как отработала модель на данных событиях, считает метрики и отправляет в систему мониторинга.

Также мы можем сравнивать метрики разных моделей скоринга на одних данных из личного кабинета. Мы не сразу внедряем новые модели, сначала скорим все отклики экспериментальной моделью, сохраняем значения скоринга в базу, а потом на графиках смотрим, лучше отрабатывают экспериментальные модели или хуже.

Графики делают нашу жизнь спокойнее, мы уверены, что качество скоринга не изменилось и все этапы работают в штатном режиме.

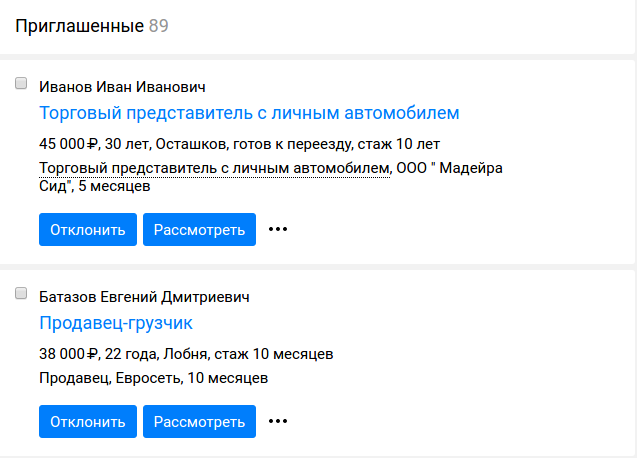

Реализация в личном кабинете

В списке откликов на определенную вакансию появились два таба, подходящие и неподходящие отклики. В качестве примера все та же вакансия ведущего программиста php в SuperJob. Резюме php-программиста, пусть и не ведущего или senior и резюме fullstack-разработчика со знанием php попало в подходящие отклики, а резюме программиста .net и руководителя it-отдела ожидаемо ушли в неподходящие.

АБ-тестирование

После реализации функционала скоринга мы провели ab-тест на рекрутерах.

Для теста мы выбрали следующие метрики:

- Конверсия присланных резюме в приглашенные — impact 8.3%

- Число приглашенных резюме — impact 6.7%

- Конверсия открытых вакансий в закрытые — impact 6.0%

- Число закрытых вакансий — impact 5.4%

- Количество дней до закрытия вакансий — impact 7.7%

Данный тест мы проводили с уровнем значимости в 5%, это означает, что существует 5% вероятность допустить ошибку первого рода или ложноположительное срабатывание.

После ab-тестирования собрали обратную связь от рекрутеров, которые попали в вариант с функционалом скоринга. Обратная связь также была положительной. Они пользуются функционалом, тратят меньше времени на массовый подбор.

Выводы

Самое главное — обучающая выборка.

Мониторим метрики качества модели.

Фиксируем random_state.

|

Метки: author matvey_travkin программирование машинное обучение блог компании superjob.ru superjob machine learning xgboost |

Краткий FAQ о Федеральном законе N 242-ФЗ |

Краткий FAQ о Федеральном законе N 242-ФЗ

Не далее, как 1-го сентября Роскомнадзор опубликовал итоги реализации федерального закона о локализации баз персональных данных российских граждан на территории России. Полная версия статьи находится по адресу: https://rkn.gov.ru/news/rsoc/news49466.htm

С момента реализации Федерального закона №242-ФЗ сотрудниками Роскомнадзора проведено 2256 плановых проверок, 192 внеплановые проверки и более 3000 мероприятий систематического наблюдения, по итогам которых выявлено 56 нарушений требований, связанных с локализацией персональных данных, что составляет около 1 % от общего числа выявленных нарушений.

Итак, о чем пойдет речь? Да, про приславутый ФЗ №242. Попытаемся ответить на наиболее типичные вопросы, и попытаемся ответить на вопрос: "А что делать, чтоб не попасть в эти проценты?"

Для тех, кто не в курсе, небольшой ликбез.

C 1 сентября 2015 года в Российской Федерации начало действовать положение о локализации хранения и отдельных процессов обработки персональных данных, определенное в Федеральном законе №242 от 21 июля 2014 года «О внесении изменений в отдельные законодательные акты Российской Федерации в части уточнения порядка обработки персональных данных в информационно-телекоммуникационных сетях».

242-м законом были внесены, в том числе, и изменения по интересующим нас вопросам. ФЗ №242 в статье 1 дополнил Федеральный закон от 27 июля 2006 г. №149 «Об информации, информационных технологиях и о защите информации» новой статьёй 15.5 «Порядок ограничения доступа к информации, обрабатываемой с нарушением законодательства Российской Федерации в области персональных данных».

В соответствии с частью 1 статьи 1 была создана автоматизированная информационная система «Реестр нарушителей прав субъектов персональных данных», целью которой является ограничение доступа к информации в «Интернет», обрабатываемой с нарушением законодательства Российской Федерации в области персональных данных. Основанием для внесения в "Реестр нарушителей" доменного имени, URL-адреса интернет-страницы, законодателем установлено вступившее в законную силу решение суда о признании деятельности по распространению информации, содержащей персональные данные, нарушающей требования ФЗ №152, а также права субъекта персональных данных на неприкосновенность частной жизни, личную и семейную тайну.

Как мы знаем, вся эта система уже работает. Как пример, приведем одно из множества подобных судебных решений.

Решением Симоновского районного суда г. Москвы от 02.06.2016 по делу № 2-5818/16 деятельность Интернет-ресурса http://zvonki.octo.net, предоставлявшего доступ неограниченного круга лиц к персональным данным граждан в объеме: ФИО, телефон, адрес, паспортные данные, без соответствующего согласия, признана незаконной. Также суд обязал Роскомнадзор принять меры по ограничению доступа к информации в сети Интернет, обрабатываемой с нарушением законодательства Российской Федерации в области персональных данных, путем внесения указанного сайта в Реестр нарушителей.

Той же статьей, частью 3, Роскомнадзор определен в качестве органа, уполномоченного на создание, формирование и ведение Реестра нарушителей.

Статистика ведения "Реестра нарушителей" показывает, что 50% владельцев сайтов, включенных в "Реестр нарушителей", в добровольном порядке устраняют нарушения законодательства Российской Федерации в области персональных данных.

Второй же статьей вносятся изменения в две статьи (ст. 18, 22) главы 4 «Обязанности оператора» и одну статью (ст. 23) главы 5 «Контроль и надзор за обработкой персональных данных. Ответственность за нарушение требований настоящего федерального закона» (ФЗ № 152).

Так же, частью 1 второй статьи законодателем внесены изменения в статью 18 «Обязанности оператора при сборе персональных данных» ФЗ № 152, согласно которым для оператора установлевается обязанность осуществлять при сборе персональных данных определенные виды обработки персональных данных в базах данных, которые находятся на территории России. Определенные виды обработки это: запись, систематизация, накопление, хранение, уточнение (обновление, изменение), извлечение персональных данных граждан Российской Федерации. Т.е. фактически любые действия с ПД, оператор обязан осуществлять с использованием баз данных, находящихся на территории Российской Федерации.

Вот об этом требовании и пойдет далее речь.

Кого касается данная мера?

Ответим комментарием Минкомсвязи: "… обязанности по локализации отдельных процессов обработки персональных данных распространяются на иностранных операторов при условии осуществления ими направленной деятельности на территорию Российской Федерации и отсутствии исключений, прямо указанных в ч. 5 ст. 18 ФЗ «О персональных данных» (например, международного договора, для достижения целей которого осуществляется обработка)."

Да, в общем всех, кто работает с нашими согражданами, т.е. и наших и ваших.

А что же делать, если мы данные уже собрали и храним за рубежом?

Можете их там и хранить, но если у вас появится необходимость поработать с этими данными, то базу вместе с результатами обработки придется уже разместить в России. Так это сейчас трактуется.

Что если данные физически хранятся в России, но обработка осуществляется за рубежом?

Закон, с определенными оговорками, это позволяет (трансграничная передача и все такое). Но, главное при этом помнить, что результаты этой обработки так же должны сначала попасть в базу на нашей территории. Т.е., грубо говоря, база на нашей территории всегда должна быть "полнее, выше, сильнее"!

А как определят, что иностранный сайт работает с Россией?

На данном этапе определяют работу с Россией так:

1) использование делегированного доменного имени, связанного с Российской Федерацией (.ru,.рф., .su) и/или

2) наличие русскоязычной версии Интернет-сайта, созданной владельцем такого сайта или по его поручению иным лицом (использование на сайте или самим пользователем плагинов, предоставляющих функционал автоматизированных переводчиков с различных языков, не должно приниматься во внимание);

3) возможности исполнения заключенного на таком Интернет-сайте договора на территории Российской Федерации (доставки товара, оказания услуги или пользования цифровым контентом на территории России).

А вообще пока этот вопрос прорабатывается и ждите следующих версий! Как это похоже на наших законотворцев!)

Мы уже подавали уведомление в Роскомнадзор как оператор ПД, нам нужно что-то еще сделать?

Давно пора!

… Операторы, сведения о которых уже внесены в Реестр операторов, в соответствии с частью 7 статьи 22 Федерального закона № 152-ФЗ должны направить Информационное письмо о внесении изменений в сведения об Операторе в Реестре операторов с указанием сведений о месте нахождения базы данных информации, содержащей персональные данные граждан Российской Федерации…

Так что же делать?

Если у вас базы хранятся в России, то в первую очередь, подать уведомление в Роскомнадзор и внести в дополнительные поля адреса нахождения этих баз. Только будьте внимательны. Множество ошибок из-за того, что наименование страны вводят, а подробный адрес забывают.

Ниже ссылка на электронную форму уведомления, чтоб долго не искали.

«Информационное письмо о внесении изменений в сведения в реестре операторов, осуществляющих обработку персональных данных»: https://rkn.gov.ru/personal-data/forms/p333/

Если же базы пока зарубежом, то пора как минимум задуматься об их локализации, например, в облаке. Многие гиганты индустрии (Microsoft, Samsung, Lenovo, Aliexpress, Ebay, PayPal, Uber, Booking.com), как мы знаем из СМИ, это уже давно сделали. Не думаю, что пользователям приятно видеть эту надпись при доступе к любимому сайту.

Однако, не все зарубежные компании торопятся с этим. Ранее глава Роскомнадзора Александр Жаров сообщил журналистам, что Facebook прекратит работу в России по аналогии с социальной сетью Linkedin, если не исполнит закон о персональных данных, это может произойти в 2018 году. Позднее представитель ведомства Вадим Ампелонский добавил, что в 2017 году никаких контрольных мероприятий в отношении деятельности Facebook в России не запланировано.

«Facebook располагает в России значительной аудиторией, но при этом не является уникальным ресурсом. Роскомнадзор учитывает это при взаимодействии с компанией, оставляя приоритетом собственной деятельности неукоснительное соблюдение российского законодательства всеми без исключения участниками рынка» — отметил он в общении с ТАСС.

Также стоит помнить, что если персональные данные передаются за границу под конкретную задачу, то принимающая данные сторона (если она не находится в стране-участнице Конвенции Совета Европы №108 о защите персональных данных, принятой большинством европейских стран, включая Россию, и в частности, не ратифицированной со стороны США) должна предоставить письменное подтверждение, которое гарантирует безопасность и корректное использование получаемой информации. Причем в соответствии с комментарием директора правового департамента Минкомсвязи Романа Кузнецова, условия подтверждения безопасности полностью совпадают с условиями Конвенции.

Многие вопросы, возникающие у организаций по поводу 242-ФЗ. тесно связаны с конкретными условиями её дейтельности и осветить их в рамках статьи затруднительно. Задавайте интересующие вас вопросы в комментариях, мы постараемся ответить на них максимально подробно.

|

Метки: author Cloud4Y терминология it локализация продуктов законодательство и it-бизнес блог компании cloud4y 242- фз персональные данные пдн трансграничная передача |

Графический интерфейс или чат бот в управлении проектами: что эффективнее?.. Практический эксперимент |

Графический интерфейс или чат бот в управлении проектами: что эффективнее?.. Практический эксперимент

Маленькое отступление:

Меня всегда ставит в тупик то, что на Хабре с некоторых пор разделено «Управление» и «Разработка». А если статья о разработке системы управления? Честно говоря, в раздел «Управление» я никогда ничего еще не писал, но логика подсказывает, что нынешний материал скорее подходит сюда — он все-таки больше не про программирование, а про опыт в сфере управления проектами.

Но, простите за отклонение от темы повествования, вернемся.

Этап 1. Начало

Началось все с малого. В нашей компании традиционно были проблемы с распределением задач и контролем результата… Точнее, пока работало 1.5 человека их не было. А когда штат резко вырос до 8, они начались — блокнот и мессенджер резко стали неэффективным средством организации работы. Тогда мы попробовали использовать Trello и Asana, и, до определенной степени, это решило проблему. Но в один прекрасный день нас посетила “великая” идея приделать голосовой интерфейс и посмотреть, что получится. Дело казалось небольшим — “всего навсего” нужно ведь чтобы голосом или через чат можно было создать задачу и узнать какие задачи надо делать.

На момент начала воплощения этой идеи в жизнь аналогов не было (Cortana в Microsoft Dynamics понимала только английские команды).

На сборку прототипа ушло пару недель. Изначально машинным обучением решили не заморачиваться и сделать распознавание смысла команд по шаблонам. Исходя из того, что шаблонами можно сделать очень много, и полагая, что основной набор команд будет небольшой, и все очень быстро их запомнят. Для распознавания голоса просто подключили API от Google (опыт показал, что он работает лучше всего).

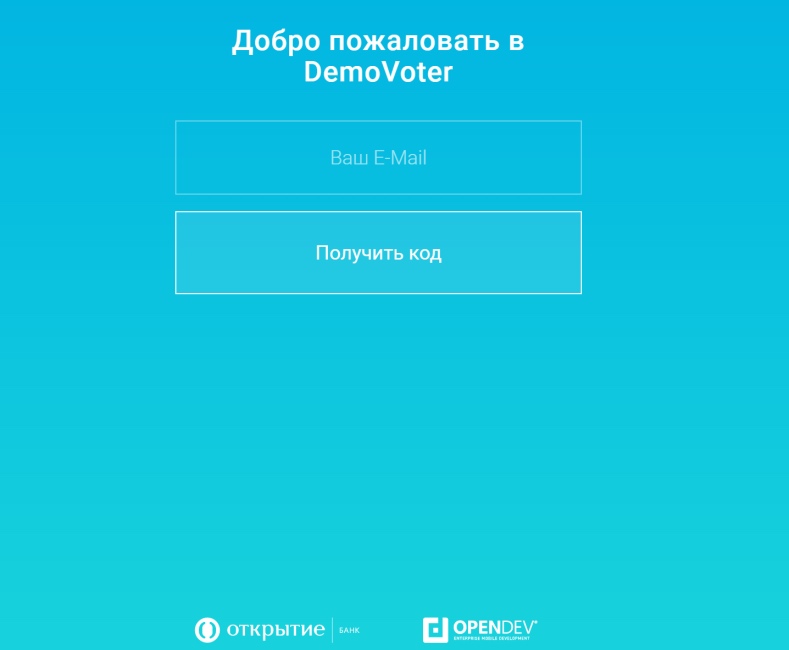

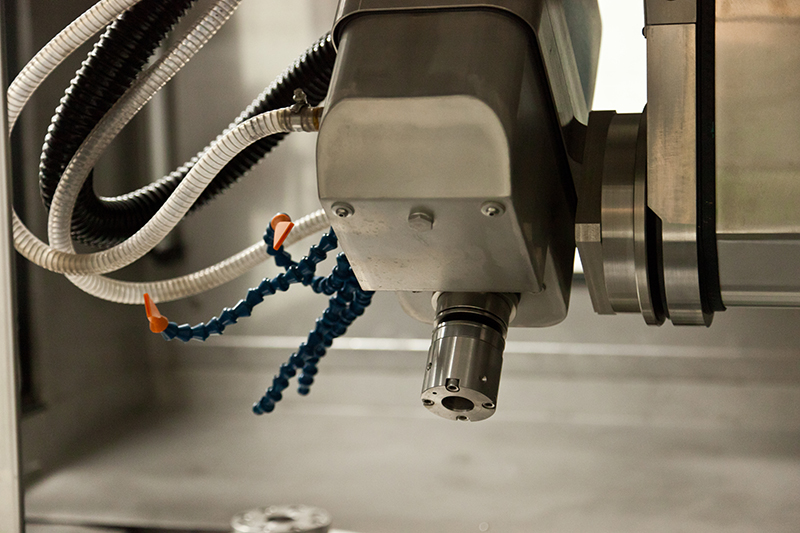

Выглядел первый результат примерно так, как на картинке сверху. Окно, строка ввода, и чат.

Поскольку только практика — критерий истины, указанный результат решили внедрить для половины сотрудников, чтобы иметь возможность сравнить, что удобней.

Этап 2. Этим пользоваться невозможно!

Эту фразу сказали абсолютно все, вовлеченные в тестирование. Измерив же время, нужное для выполнения типовых операций, мы обнаружили, что оно замедлилось. Например, для создания задачи теперь требовалось более минуты (в “контрольной группе” 27 — 40 сек). Для замера времени поначалу использовали секундомер.

Причин оказалось много. Во-первых, распознавание речи работает “лучше чем человеческое” только в теории (и, вероятно, только для английского языка). Даже простое “выполняет Дмитрий Иванович” легко превращается в “воняет Дмитрий Иван ВИЧ”. А сказать сколько-нибудь длинную фразу без ошибок и вовсе сложно. Поэтому все поголовно писали команды текстом. Ругаясь при этом нецензурно, что еще более осложняло работу программы.

Запомнить команды оказалось тоже делом не простым. Кто-то запомнил, а кто-то продолжал писать как приходит в голову. Обнаружилось, что тонкая разница между “какие есть задачи” и “какие у меня есть задачи” не всегда улавливается человеком. А если при создании задачи вся нужная информация не поместилась в одну, то дальше нужно долго колебаться: “задаче поместить кнопку на сайт назначить срок выполнения до 15 сентября”

Наконец, то, что в графическом интерфейсе решается перетаскиванием за пять секунд, у чат-бота превращается в “задачу исправить ошибку в программе, которая не работает перенести из раздела разное в раздел исправление ошибок”. Короче, командная строка с голосовым управлением никак не заменяет GUI

Этап 3. Работа над ошибками

По хорошему, на этапе 2, возможно, стоило бы остановится. Но

- Люди опираются на контекст и понимание задачи собеседником. Т.е. “Возьми эту хрень там и приделай к ней такую фигню” — гораздо короче.

- Люди пользуются бумагой и ручкой, чтобы объяснить что-то

- Люди понимают недосказанные инструкции. Смысл одной и той же фразы меняется исходя из контекста

- Люди пользуются короткими именами и иногда кличками

Исходя из этого были реализовали новые функции:

- Возможность использования в командах контекста — одной или нескольких последних созданных или упомянутых задач.

- Возможность упоминать обрывки названия задачи, похожие названия и т.п.

- Список сотрудников и поиск наиболее похожих имен в списке.

- Минимальный графический интерфейс для отображения задач

- Расширили список вариантов в шаблонах и добавили несколько десятоков новых команд.

- Функция регистрации жалоб на систему

Кроме того, усовершенствовали методику замера времени. Время теперь измерялось по набору из 4 типовых случаев использования (поставить новую задачу, узнать что делать, отметить что задача сделана, посмотреть результаты работы). В каждый случай добавили 5 примеров и вычисляли среднее время. Новые тесты показали примерное равенство эффективности чат-бота и обычной системы. Количество жалоб субъективно несколько сократилось (люди привыкли?), но все же недовольства осталось много.

Также удалось найти небольшие (субъективные) плюсы чат-бота:

- Некоторые люди утверждали, что окно чата меньше “нагружает мозг”, потому что в нем меньше кнопок и надписей

- При работе с телефона, набор команд текстом (а мы помним, что большинство все еще не пользуется голосовым вводом) стал гораздо проще, после того как клавиатура выучила типичные команды. Утверждалось, что это быстрее, чем нажимать кнопки интерфейса.

Как видим, плюсы пока очень шаткие. Анализ же жалоб показал, что:

- На стационарных компьютерах все же очень не хватает кнопок для выполнения частых задач

- Команд стало очень много, запомнить их тяжело, писать долго

- Не хватает привычного функционала

Этап 4. Функционал, интеллект, интерфейс

В реальности, человек-программист никогда не спросит начальника “какие у меня есть задачи”, не будет ждать перечисления всех задач, чтобы потом сказать “сейчас я буду делать задачу такую-то” (да, смешно. А многие на чат-боты так и работают в реальности).

Подумав над проблемой, мы сократили набор команд исполнителя до “дай задачу”, “задача готова”, “есть проблема”, “дай другую”.

Хотя, это легко сказать. На практике, “дай задачу” стало сложной интеллектуальной командой, которая анализирует приоритеты задач, сроки, сложность, загруженность исполнителей, и выбирает следующую задачу автоматически.

Для исполнителей в этот момент наступило счастье. Думать не надо! Нажимать ничего не надо! Берешь задачу, делаешь, затем берешь следующую. Все дружно сказали — новая система — самая крутая! Другую не хотим.

А мы поняли важный момент смысл интерфейса на естественном языке — не в том, чтобы понимать длинные сложно завернутые предложения. На самом деле чат-бот эффективен только если за ним стоит интеллект, понимающий предметную область. Когда человек обращается к программе, понимающей его речь, он подсознательно ждет, что система будет умной и сможет решать какие-то его проблемы. Объяснит что ему делать, как минимум. А может быть еще сама назначит исполнителя, распределит задачи заболевшего сотрудника. А в реальности чат-бот обладает в лучшем случае интеллектом собаки — «стоять, лежать, сидеть». Поэтому, попробовав вариант, когда у программы «больше прав решать, что делать», мы получили интересный результат.

На самом деле не все так просто. Было много опасений, что такая система с автовыбором не справится с реальными ситуациями. Плюс, создается большая нагрузка на руководителя, который должен снабдить систему нужной информацией и правильно расставить приоритеты ( в нашем варианте система все-таки сама не решает, что и как, а скорее старается выполнить поставленный план). Практика действительно внесла определенные коррективы, но в целом, на удивление, новая методика оказалась проще и эффективнее.

Правда, с точки зрения исполнителя чат-бот в основном стал не нужен. Достаточно четырех кнопок с указанными выше названиями.

Вторым важным нововведением стал модуль самообучения для понимания команд. Мы оставили пока опознавание команд по шаблону, но добавили возможность автоматического создания новых шаблонов на основе анализа обращений. В результате быстро создалось много шаблонов, учлись все варианты произношения (вроде “воняет”), и голосовые команды стало возможно нормально использовать (и адаптировать под конкретного человека).

Наконец, появился выигрыш в производительности — работа с системой стала быстрее (по тестовому набору типовых задач) в среднем на 45% по сравнению с “контролем”.

Кроме того, я заметил некоторые субъективные плюсы:

- Можно получать информацию, ставить задачи и при этом ходить туда-сюда рядом с компьютером (иногда так проще думать)

- Вечером и в дороге, с телефона гораздо быстрее и проще создать задачу. Поэтому меньше задач стало теряться и забываться

- Можно разговаривать с программой как с человеком по телефону

Желания вернуться к «традиционным» системам у меня не возникает. Наоборот, идея о том, что придется вводить задачи клавиатурой и мышкой вызывает ужас. Хотя, в офисе, где много народу, диктовать что-то программе бывает психологически некомфортно.

Программе мы еще дорастили и интерфейс. Вот так он стал выглядеть:

Функционал приблизился к тому, что есть во всякой другой системе управления проектами. Сроки, зависимости между задачами, разделы и подразделы, уведомления, отчеты.

Заключение

В итоге, мы добились повышения эффективности. Хотя получилась в каком-то смысле, каша из топора — к “топору” (чат-боту) пришлось добавить много функционала, без которого он был бесполезен. Имея уже достаточно значительный опыт в создании систем обработки языка, мы наступили на грабли много раз и потратили более 6 месяцев до момента когда система стала приносить нам реальную пользу.

Ну и, конечно, то, что удалось рассказать в статье, это только верхушка айсберга — самые основные моменты с которыми мы столкнулись.

PS

|

|

Как мы за неделю создали чат-бота и подружили его с веб-приложением |

Как мы за неделю создали чат-бота и подружили его с веб-приложением

Фото chatbotsmagazine.com

Первое поручение для банковского чат-бота

Итак, искусственный интеллект пришел в банковский сектор и явно намерен здесь обосноваться. Технологии далеки от совершенства, чат-боты пока не способны полностью заменить человека. Но уже сегодня им можно смело доверить большинство рутинных задач по взаимодействию с клиентами. По крайней мере, здесь у них куда больше перспектив, чем у традиционных веб-приложений: 75% банковских сотрудников, опрошенных консалтинговым агентством Accenture, назвали основным вектором развития для данного направления именно искусственный интеллект.

Если технология Bot Framework от Microsoft действительно способна улучшить клиентский сервис – наш банк просто не имеет морального права оставаться в стороне. При помощи своего чат-бота с использованием решения Bot Framework мы решили оптимизировать процесс голосования. Дело в том, что у нас регулярно проводятся презентации и прочие мероприятия, на которых мы знакомим людей с нашими последними достижениями и новшествами. Аудитория может голосовать за те сессии, которые им понравились, оставлять комментарии и вносить предложения.

До сих пор мы предлагали участникам после мероприятия заполнить некое подобие анкеты на нашем сайте. Однако очевидно, что такая форма взаимодействия не является активной: достаточно часто пользователь просто закрывал веб-страницу. Другое дело – добавление ChatBot в список контактов. Наш робот не только вовлекает клиента в процесс обсуждения, но и остается с ним на связи после мероприятия. Впоследствии через чат-бот можно рассылать объявления, анонсы и прочую информацию.

Фото nonworkplace.com

Созданный нами при поддержке Microsoft и OpenDev чат-бот способен поддерживать множество каналов – различных устройств и платформ, которые пользователи привносят на мероприятие. В отличие от веб-формы наш виртуальный помощник остается активным на протяжение всего мероприятия. Он следит за вопросами участников о сессиях и ораторах, может провести опрос или голосование.

Принципиальные вопросы и первичная архитектура

Оценка границ и объемов проекта проходила в несколько этапов. Задача кажется простой только на первый взгляд. Копнув чуть глубже, наша команда столкнулась с целым рядом вопросов, потребовавших серьезного мозгового штурма.

- Должны ли все пользователи, подключенные к чат-боту через один канал – например Telegram, – состоять в одной группе? Или лучше организовать приватное взаимодействие для каждого клиента, чтобы сохранить тайну коммуникаций с ChatBot? Может быть, следует использовать оба варианта?

- Для организации группового общения (первый и третий варианты из предыдущего абзаца) нужно управлять контекстом и сеансами. Но есть ли в Bot Framework и Telegram достаточно эффективные средства для решения этой задачи?

- Можем ли мы использовать внутренние механизмы хранения, которые поддерживаются в Bot Framework?

- Как быть с веб-формой для голосования? Если мы продолжаем ее поддерживать – что делать в случаях, когда клиент одновременно пользуется и Web Form, и ChatBot?

Фото chatbotsmagazine.com

Отметим, что от идеи организации групповой связи мы в конечном итоге отказались. Bot Framework для Node.js – платформы, на которой мы разрабатывали чат-бота, – не позволяет эффективно управлять множественным контекстом. Поэтому поддержка связи была реализована через частный канал.

В необходимости использования веб-формы в качестве дополнительного инструмента для голосования мы не сомневались: было бы неправильно оставить Telegram единственным каналом связи. Но для корректного взаимодействия нужно добиться максимальной идентичности обоих каналов. Разумеется, динамика процесса отличается: чат-бот моделирует разговор, предлагая начать процесс голосования. Кроме того, он знакомит пользователя с новым отчетом и снабжает его дополнительной информацией.

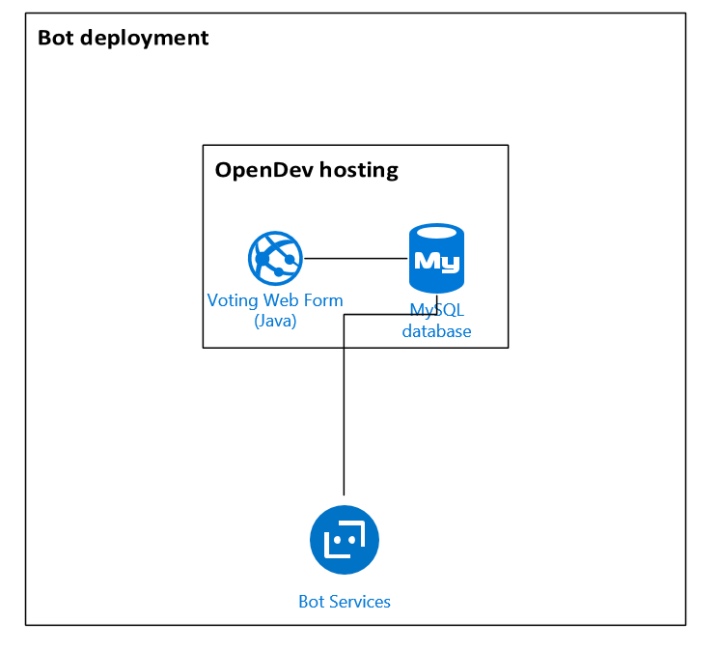

Как уже сказано выше, чат-бот разрабатывался в Node.js. Что касается веб-формы, то она представляет собой сайт, написанный на Java. Оба компонента используют базу данных MySQL, расположенную в инфраструктуре OpenDev. Выбор системы базы данных основывался на ее простоте и низких требованиях к ресурсам сервера. Изначально архитектура была реализована на одном MySQL сервере. Первая версия, показанная на рисунке ниже, выглядит чрезвычайно просто. Осталось усовершенствовать эту модель, добавив масштабируемости и надежности.

Чат-бот, устойчивый к стрессам

Для начала – немного терминологии. Под масштабируемостью мы понимаем стрессоустойчивость программного обеспечения, его способность справляться с повышенной нагрузкой. Таким образом в любых ситуациях все одновременные пользователи должны иметь одинаковый опыт – с точки зрения латентности, времени загрузки и пр.

Надежность определяется временем, в течение которого система работает без сбоев. Кроме того, для обмена сообщениями необходимо обеспечить приложению высокую доступность. Иными словами, пользователи должны отправлять и получать сообщения в течение соответствующих временных интервалов.

Создать надежную и легко масштабируемую архитектуру помогло использование некоторых передовых методов.

- Loose coupling (https://en.wikipedia.org/wiki/Loose_coupling) – метод компоновки системы из максимально независимых друг от друга элементов. Каждый из компонентов архитектурного решения может быть легко и безболезненно заменен, обновлен или удален. То есть система остается работоспособной при отказе одного или нескольких компонентов.

Отметим, что большинство архитектурных решений уже было принято в Bot Framework и командой Azure. Нам осталось только протестировать методику в процессе.

- Separation of concerns (https://en.wikipedia.org/wiki/Separation_of_concerns) – передовая практика, идеально подходящая для разработки систем обмена сообщениями. В нашей ситуации «разделение интересов» выглядит следующим образом: хранение данных – внешнее, логика – внутри ChatBot, все остальное обрабатывается в Bot Framework.

- Disaster recovery architecture (архитектура восстановление после сбоев) была реализована при помощи части Azure Web Apps в сочетании с Bot Dashboard (https://github.com/CatalystCode/ibex-dashboar). В качестве средства мониторинга мы использовали Application Insights.

Вторая и окончательная версия архитектуры показана на рисунке ниже.

Аутентификация с вариантами и другие особенности системы

Взаимодействие чат-бота и веб-формы требуется с самого первого шага – аутентификации. Рассмотрим для начала классическую авторизацию через сайт. Мы постарались максимально упростить процесс: пользователь вводит в веб-форму свою электронную почту – и получает письмо с двумя вариантами входа в систему:

- по специальной ссылке;

- при помощи кода.

Второй способ универсален: код вводится либо в веб-форме, либо в чате. Синхронизация контента чат-бота и веб-формы происходит при любом из методов аутентификации. Правда, пользователь, авторизованный в веб-форме, все равно должен ввести код в чате. В этом случае чат-бот приветствует пользователя по имени, под которым он зарегистрировался на сайте.

Для чего нужна повторная аутентификация по коду? Для дополнительной безопасности: фактически после авторизации пользователя код служит в качестве токена.

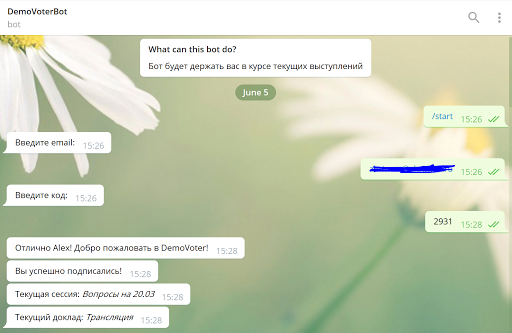

Теперь рассмотрим «чистую» аутентификацию в чат-боте. Последовательность выглядит следующим образом:

- Type / start.

- Enter Email.

- Get the code and enter it.

Аутентификация с использованием источника данных в базе MySQL позволила сделать процесс простым и удобным, дав при этом возможность частично синхронизировать контекст. Полная синхронизация контекста потребовала бы введения многофакторной аутентификации. А это – неоправданное усложнение логики плюс увеличение нагрузки на бэкэнд. В нашем случае, когда жизненный цикл взаимодействия пользователя с приложениями ограничивается несколькими днями, такой подход не имеет практического смысла.

Ниже приведен код, при помощи которого реализована процедура подтверждения. Как вы можете видеть, сначала код проверяется регулярным выражением, подтвержденным на бэкэнд. Затем он заменяет набор констант на пользовательские данные и завершает процесс, приветствуя пользователя по имени.

``js

promptCode() {

return [

(session, args) => {

if (!_.isEmpty(args) && args.code) {

return session.replaceDialog('/promptName', session.userData);

}

if (!_.isEmpty(args) && args.reprompt) {

return Prompts.text(session, 'Введите код из **4-х** цифр:');

}

return Prompts.text(session, 'Введите код, присланный вам по email: ');

},

(session, result) => {

if (/^[0-9]{4}$/.test(result.response)) {

return auth.makeUnauthRequest({

url: '/login',

method: 'POST',

body: {

password: result.response,

login: session.userData.email

}

}, (err, res, body) => {

if (err) {

console.error(err);

return session.replaceDialog('/error');

}

if (body.status >= 300 || res.statusCode >= 300) {

console.error(body);

return session.replaceDialog('/promptName', session.userData);

}

session.userData.code = result.response;

session.userData.id = body.id;

session.userData.permissions = body.permissions;

session.userData.authToken = body.authToken;

session.userData.allowToVote = !_.isEmpty(body.permissions)

&& (body.permissions.indexOf("PERM_VOTE") !== -1

|| body.permissions.indexOf("PERM_ALL") !== -1);

return auth.makeAuthRequest({

url: '/login',

method: 'GET',

authToken: body.authToken

}, (err, res, body) => {

if (err) {

console.error(err);

return session.beginDialog('/error');

}

if (!_.isEmpty(body) && !_.isEmpty(body.name)) {

session.userData.name = body.name;

return session.endDialogWithResult(session.userData);

}

return session.replaceDialog('/promptName', session.userData);

});

});

}

return session.replaceDialog('/promptCode', {reprompt: true});

}

];

}

``При взаимодействии с чатом или веб-формой можно получить информацию об отчетах без авторизации в системе. Чат-бот предлагает оценить отчет и написать комментарий всем клиентам. Но сделать это смогут лишь пользователи, прошедшие проверку подлинности. В противном случае бот высылает запрос на аутентификацию, как показано в следующем фрагменте кода.

``js

rate() {

return [

(session) => {

if (_.isEmpty(session.userData.authToken) && !_.isEmpty(this.socket.actualPoll)) {

session.send('Чтобы оценить выступление, вам следует войти в свой аккаунт.\n\n' +

'Просто напишите `/start` и начнём! ');

return session.endDialog();

}

if (!session.userData.allowToVote) {

session.send('У вас не хватает привилегий для оценивания выступлений');

return session.endDialog();

}

Prompts.choice(session, ' Оцените выступление', RATES);

},

(session, res) => {

if (res.response) {

let result = parseInt(res.response.entity, 10) || res.response.entity;

if (!_.isNumber(result)) {

result = RATES[result.toLowerCase()];

}

return auth.makeAuthRequest({

url: `/polls/${this.socket.actualPoll.id}/vote`,

method: 'POST',

body: {

myRating: result

},

authToken: session.userData.authToken

}, (err, response, body) => {

if (err) {

console.log(err);

return session.beginDialog('/error');

} else if (body.status === 403) {

session.send('У вас недостаточно прав на выполнение данной операции, простите ');

} else {

console.log(body);

session.send('Выступление успешно оценено ');

}

return session.endDialog();

})

}

session.endDialog();

}

];

}

``Помимо прочего, чат-бот может подсказать вам следующие шаги. Это особенно важно для клиентов, использующих бота в качестве основного способа общения с системой.

``js

help() {

return [

(session) => {

const keys = _.keys(commands);

const result = _.map(keys, (v) => (`**/${v}** - ${commands

session.send(result.join('\n\n'));

session.endDialog();

}

];

}