Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Мультиформатные баннеры в Tinkoff.ru и подход к верстке адаптивных баннеров в Google AdWords |

Мультиформатные баннеры в Tinkoff.ru и подход к верстке адаптивных баннеров в Google AdWords

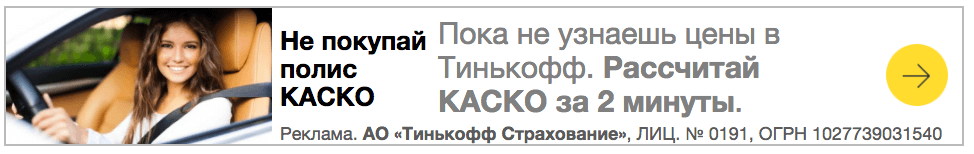

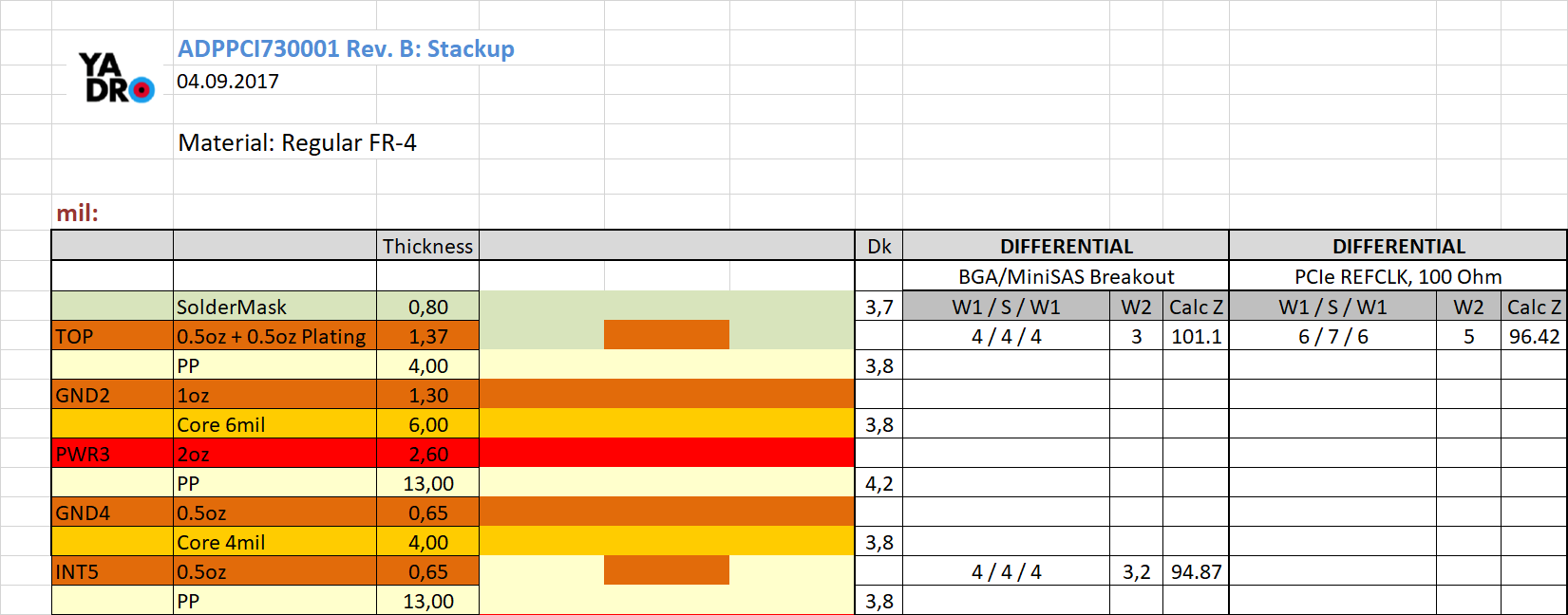

Реализация мультиформатного баннера, шаблон Leaderboard 1.

Мы обратили внимание, что проблема адаптивного баннера уже решена для медийных баннеров в AdWords, и детально исследовали эту технологию. Обнаружили много интересного, подробности — под катом.

Тот, кто хоть раз имел дело с запуском медийных рекламных кампаний по технологии RTB (англ. Real Time Bidding), сталкивался с проблемой: клиент предоставил для размещения баннер формата 240x400 и на этом всё. Однако стандарты IAB предусматривают как минимум 15 разных форматов: Leaderboard (728x90), Inline rectangle (300x250), Mobile leaderboard (320x50), Half-page (300x600), Banner, Large rectangle и другие.

Получается, когда мы заказываем у дизайнера несколько форматов, мы априори сужаем не только свою аудиторию и потенциальный список площадок, но и повышаем конкуренцию на аукционе среди этих форматов. Поэтому стоимость тысячи показов для рекламной кампании с одним форматом баннера оказывается гораздо выше, чем для кампании с несколькими форматами. Чтобы снизить стоимость рекламной кампании, нужно попросить дизайнера нарисовать целую кучу баннеров, но это скучно и для нас, и для дизайнера.

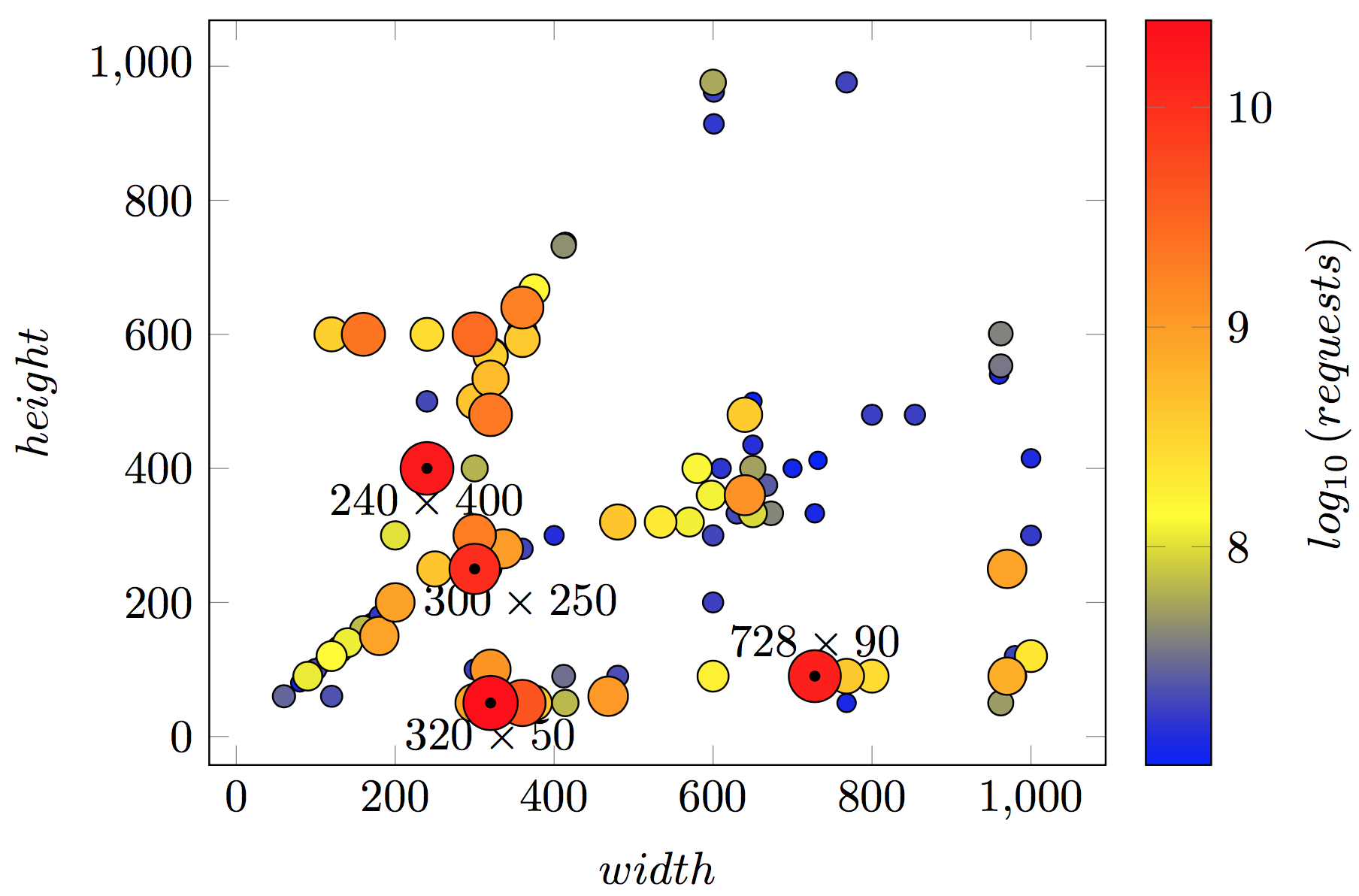

Сколько форматов баннеров в RTB-трафике

Их очень много: по данным рекламной платформы DataMind, на конец 2016 года — около 1700 форматов, количество потенциальных показов по которым превышает 100 тысяч в месяц.

Ниже представлена диаграмма распределения трафика между размерами рекламных блоков. Чем больше точка, тем больше трафика на нее приходится. В топ выходят всем известные форматы: 320x50, 240x400, 728x90, 300x250. Но для проведения масштабной рекламной кампании этих форматов оказывается недостаточно.

Диаграмма распределения трафика между размерами рекламных блоков

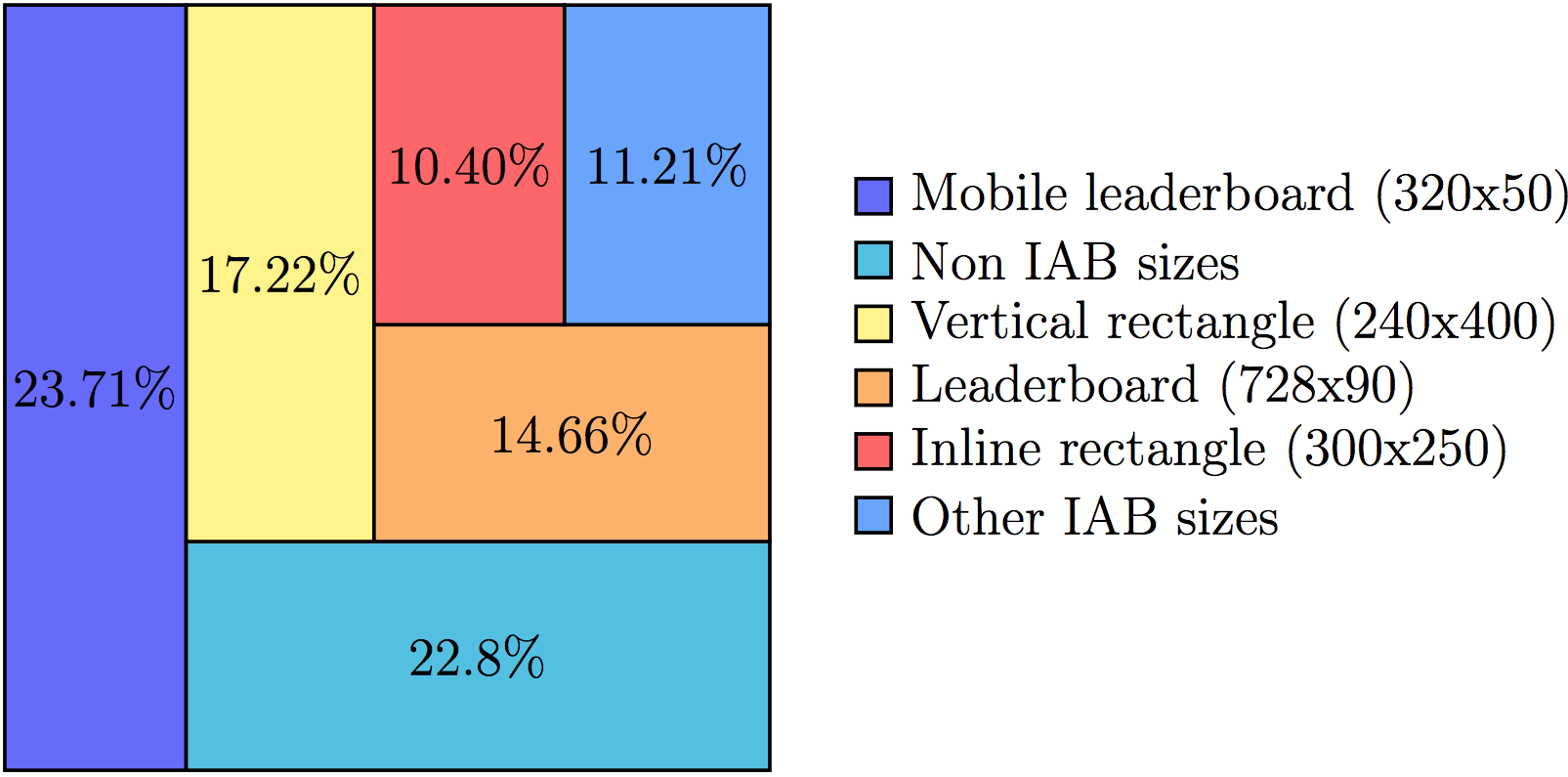

Если рекламная кампания запускается только с одним баннером формата 240x400, рекламодатель охватывает только 17,22% от всего доступного трафика. А если подготовить рекламные материалы для всех IAB-форматов, охват увеличится до 77,2%.

Распределение рекламного трафика по форматам баннеров. 22,8% рекламных показов возможны для форматов, которые не включены в стандарт IAB

Но что делать, если хочется получить все 100% и еще сэкономить? Не каждый рекламодатель будет делать баннер формата, например, 800x90, поэтому и аукцион для этого формата будет менее «горячим» по сравнению с аукционом для формата 240x400.

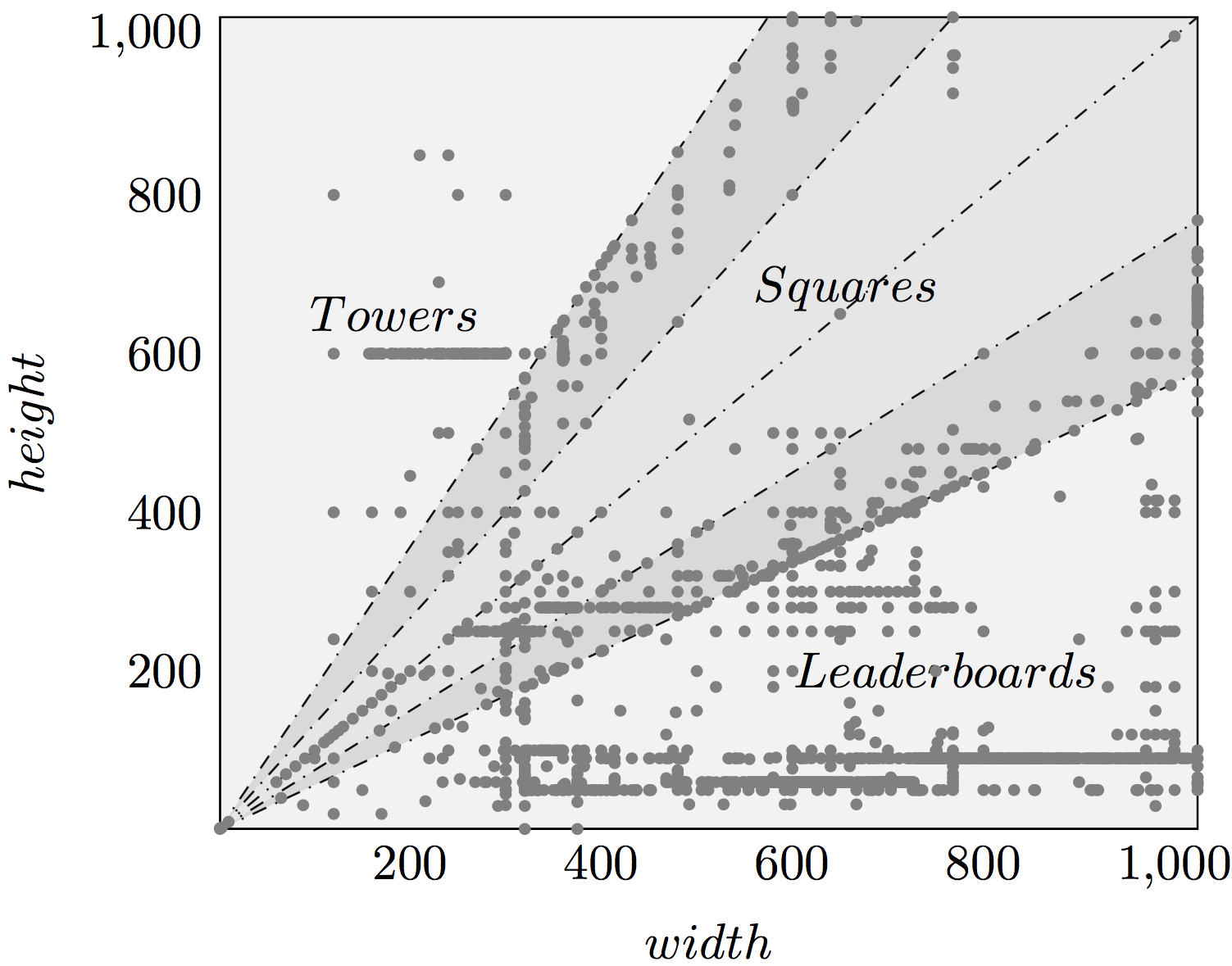

Универсальная классификация рекламных форматов баннеров

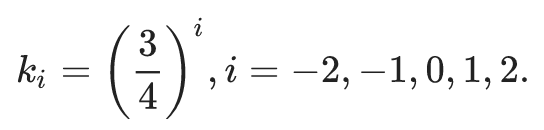

На диаграмме ниже каждой точке соответствует конкретный формат, а по осям абсцисс и ординат откладываются ширина и высота баннера соответственно.

Точечная диаграмма для форматов баннеров с потенциальными показами свыше 100 тысяч в месяц в RTB-трафике для территории России. Классифицированы форматы Towers, Squares, Leaderboards

Здесь вся плоскость разбита на три больших области:

- баннеры-башни (Towers);

- баннеры-квадраты (Squares);

- баннеры-перетяжки (Leaderboards).

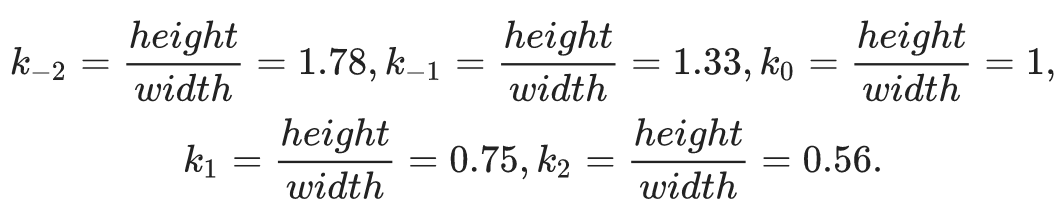

Обратите внимание как ведут себя точки диаграммы: они выстраиваются вдоль четырех линий с коэффициентами наклона:

Можно обнаружить интересную степенную зависимость, которая, кажется, как-то связана с историческим развитием форматов экранов (См. Соотношение сторон экрана):

Если у вас есть идеи на этот счет, пожалуйста, расскажите о них в комментариях.

Классификация форматов баннеров на Towers, Squares, Leaderboars интуитивно понятна. Кажется, что достаточно сверстать три HTML-шаблона для каждого формата, и мы сможем отобразить рекламные материалы в рекламном блоке любого размера. Отчасти это так.

Как устроены адаптивные баннеры AdWords

Разрабатывая собственную технологию мультиформатных баннеров, мы в Tinkoff.ru решили исследовать технологию, которую использует Google. Оказалось, что она не применяет резиновую верстку в комбинации с media-запросами. Для каждого рекламного блока удаленный и очень хитрый сервис отдает позицию каждого элемента HTML-баннера, по которой элемент жестко фиксируется в рекламном блоке. Нам стало интересно, какой алгоритм используется для адаптации рекламных материалов к рекламному блоку заданного размера.

Для исследования был «пойман» реальный рекламный мультиформатный баннер с рекламой одного из продуктов Tinkoff.ru. Он был принудительно отображен в блоках разного размера, при этом ширина блока изменялась от 216 до 1 200 px, а высота — от 36 до 1 200 px с шагом в 1 пиксель. Мы провели около 1,145 миллиона наблюдений за поведением верстки мультиформатного баннера при разных значениях ширины и высоты рекламного места. И выявили девять типичных HTML-шаблонов, которые использует Google при отображении баннера. Мы разбили их на три класса и дали им названия:

- для класса Tower: Tower 1 и Tower 2 (визуально различаются только используемыми шрифтами, поэтому далее не будем выделять Tower 2 отдельно);

- для класса Square: Square 1, Square 2, Square 3, Square 4;

- для класса Leaderboard: Leaderboard 1 (пример — на первом рисунке в статье), Leaderboard 2, Leaderboard 3.

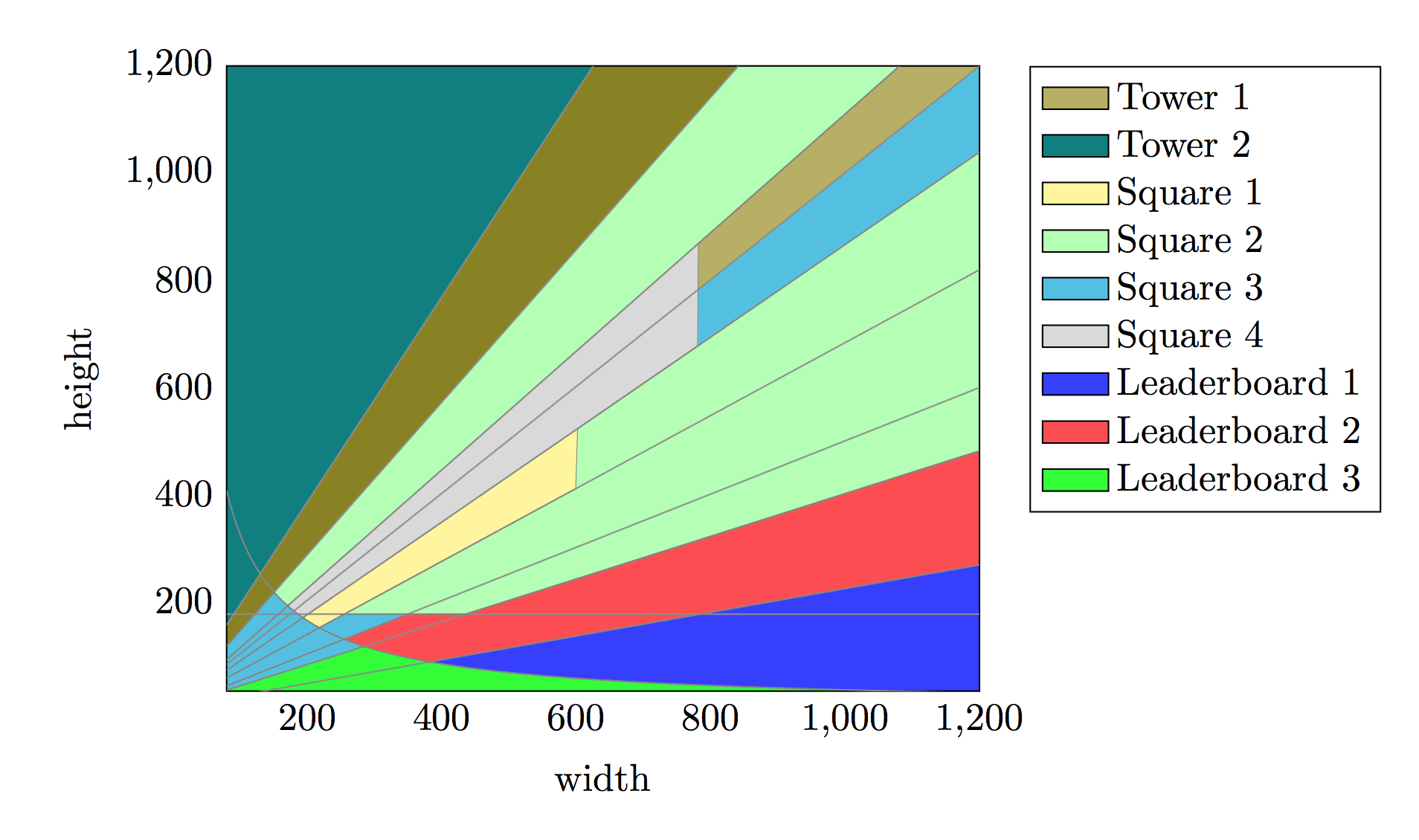

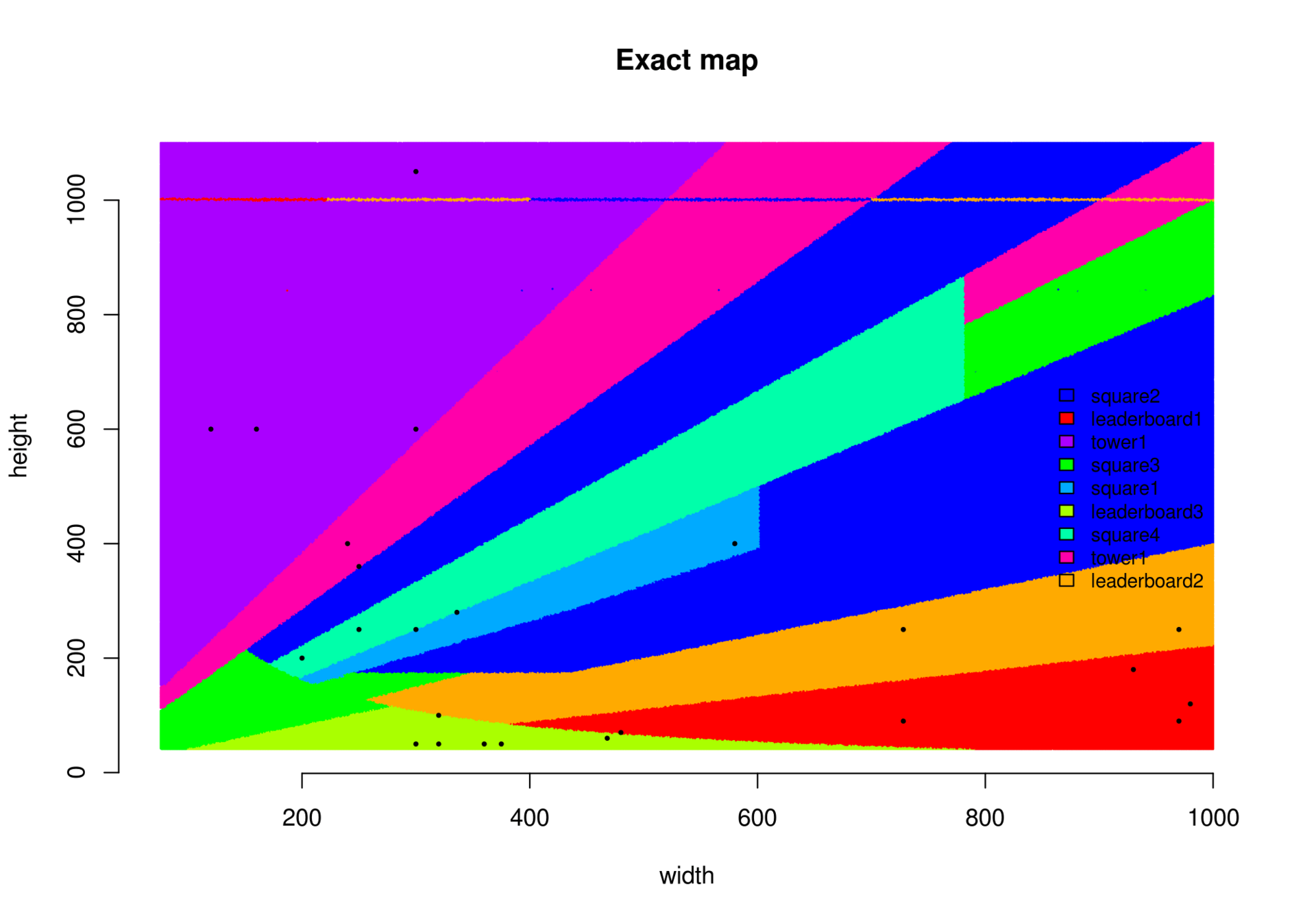

Области использования каждого HTML-шаблона изображены на рисунке ниже. Мы обнаружили существенно нелинейную область, граница которой описывается гиперболой (для форматов Leaderboard 3 и др.).

Области использования девяти HTML-шаблонов в зависимости от ширины и высоты рекламного места. Каждая точка плоскости классифицирована именем используемого шаблона

То, что область помечена нашим классификатором как Tower 1, не означает, что в этой области корректно отображается только этот шаблон. Шаблон Tower 1 может с успехом заменять некоторые области из Square 2. Поэтому разметка плоскости этого рисунка может быть адаптивной и меняться в процессе рекламной кампании в зависимости от показателей.

Обработка результатов наблюдений

Алгоритм выбора шаблона в зависимости от размера рекламного блока устанавливается просто, если использовать деревья решений. Мы использовали Recursive Partitioning and Regression Trees из R-пакета rpart со следующим набором фич:

- Площадь рекламного блока ;

- Угол наклона ;

- Ширина ;

- Высота .

Полученное дерево решений абсолютно точно объяснило результаты измерений и оказалось не таким сложным, как казалось. Здесь можно ознакомиться с реализацией полученных правил:

template_names = ['leaderboard1', 'leaderboard2', 'leaderboard3', 'square1', 'square2', 'square3', 'square4', 'tower1'];

function getTemplate(w, h) {

var wdh = w/h,

wh = w*h;

if (wdh >= 0.7000456) {

if (wdh >= 2.499373) {

if (wh >= 32399) {

if (wdh >= 4.501131) {

return template_names[0]; //leaderboard1 - bannerA

} else {

return template_names[1]; //leaderboard2 - bannerB

}

};

return template_names[2]; //leaderboard3 - smallBanner

} else {

if (wdh < 1.200121) {

if (wdh >= 0.8999545) {

if (w < 781.5) {

if (wh < 32399.5) {

return template_names[5];// "square3"; //smallSquare

} else {

return template_names[6];//"square4"; //square191

}

} else {

if (wdh >= 0.9995005) {

return template_names[5];//"square3"; //smallSquare

} else {

return template_names[7];//"tower1"; //towerB

}

}

} else {

if (wh < 32399) {

return template_names[5]; //"square3"; //smallSquare

} else {

return template_names[4]; //"square2"; //squareC

}

}

} else {

if (h< 174.5) {

if (wdh >= 2.002874 && wh >= 32392.5) {

return template_names[1];//"leaderboard2"; //bannerB

}

return template_names[5];//"square3"; //smallSquare

} else {

if (w < 601.5 && wdh < 1.531339) {

return template_names[3];//"square1"; //squareA

}

return template_names[4];//"square2"; //squareC

}

}

}

} else {

return template_names[7];//"tower1"; //towerA + towerB

}

}

Визуализация сырых результатов измерений

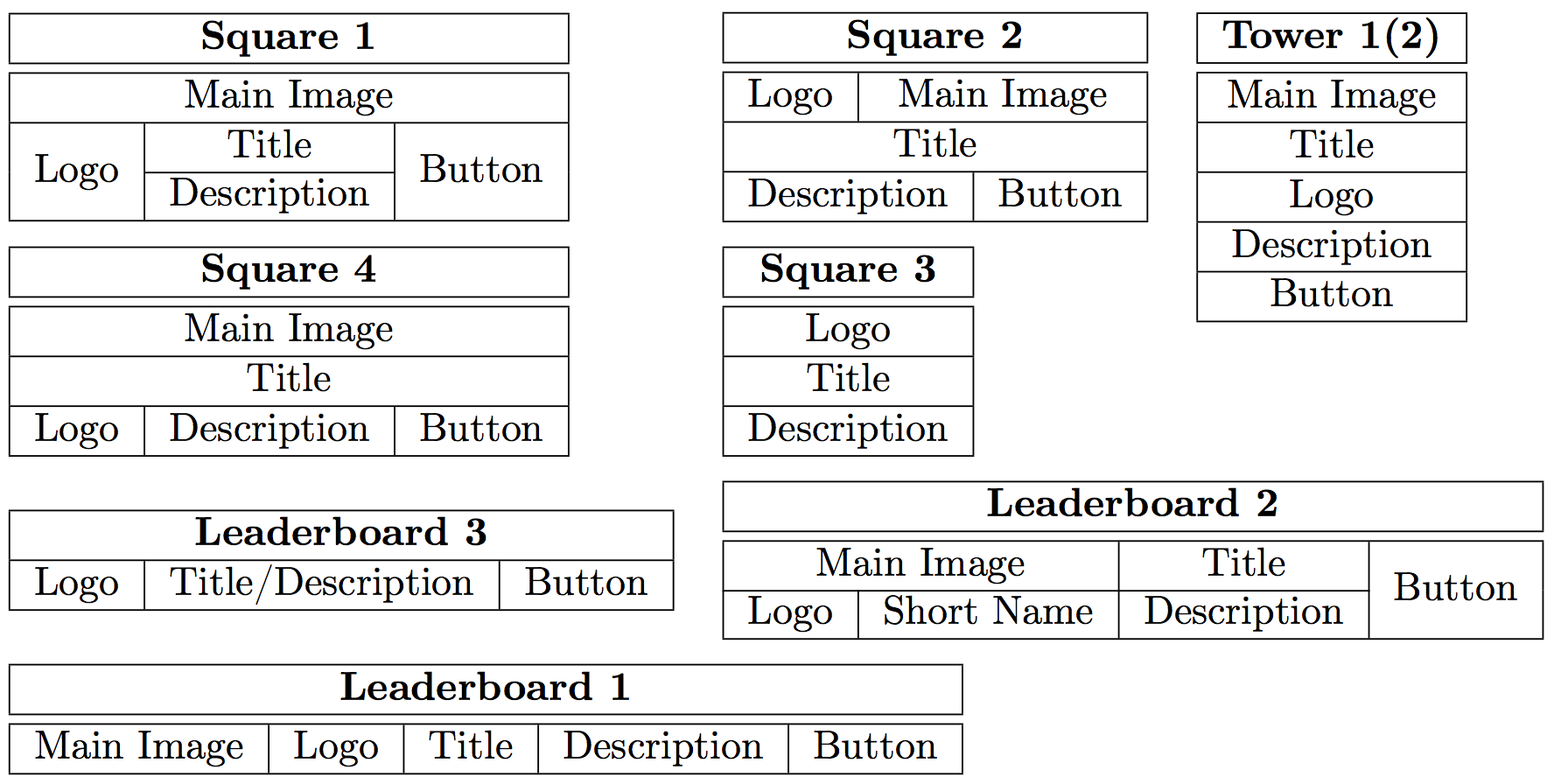

Схематичное представление шаблонов

Как же выглядят эти шаблоны для отображения рекламных материалов? Мы представили их в виде схем-таблиц.

Схематичное представление девяти HTML-шаблонов, используемых в AdWords

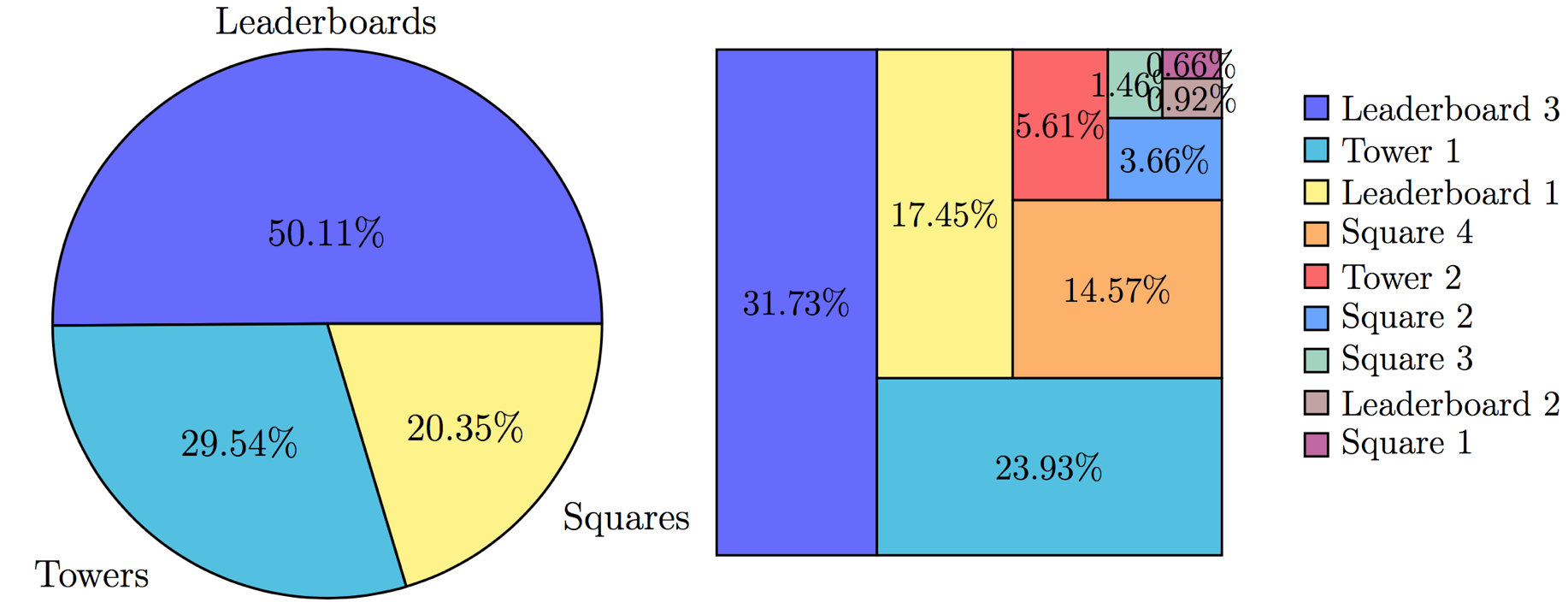

Рассматривая 1700 наиболее популярных размеров, о которых я писал в начале статьи, мы можем указать, какие из шаблонов используются чаще всего. Выяснилось, что большая часть трафика состоит из баннеров-перетяжек.

Частота присутствия рассмотренных девяти шаблонов в RTB-трафике

Шаблоны из класса Leaderboard

Leaderboard 1 — один из самых простых шаблонов. Ассеты — главная картинка, логотип, заголовок, описание, кнопка — располагаются последовательно. Leaderboard 2 — более сложный шаблон, который отображает дополнительную информацию о компании — дополнительный ассет Short Name в схеме-таблице выше. Шаблон Leaderboard 3 часто используется в рекламных блоках на мобильных устройствах. Из-за ограниченного места он анимирует смену заголовка и описания. Сравните реализацию этих шаблонов:

|

Leaderboard 1 для рекламного блока 480x70 |

|

Leaderboard 2 для рекламного блока 400x125 |

|

Leaderboard 3 для рекламного блока 400x100. Показан второй кадр с описанием |

Шаблоны из класса Square

Квадратные шаблоны востребованы меньше всего, но они занимают свою большую долю в 20,35%. Различия между шаблонами Square 1 и Square 4 визуально практически отсутствуют, однако согласно полученному классификатору, на шаблон Square 1 приходится около 0,66% трафика. Почему так происходит, остается загадкой. Возможно, гипербола, которую мы наблюдали выше, — результат работы какого-то адаптивного алгоритма, специфичного для нашего экспериментального баннера.

|

|

|

|

| Square 1 для рекламного блока 300x300 |

Square 2 для рекламного блока 150x215 |

Square 3 для рекламного блока 215x250 |

Square 4 для рекламного блока 250x250 |

Шаблоны из класса Tower

Мы не нашли существенных различий между шаблонами Tower 1 и Tower 2, поэтому реализовали только первый из них.

|

|

|

| Реализации шаблона Tower |

||

Использование мультиформатного баннера в RTB

После проведенного исследования мы можем приступать к созданию универсального баннера, который может корректно отображаться в рекламных блоках любого размера. Мы раскрыли информацию только о самих видах шаблонов, хотя верстка каждого из них достаточно проста и успешно реализуется с помощью ламповой табличной верстки.

Отдельная проблема сервинга мультиформатных баннеров — создание так называемых заглушек. Часто каждый HTML-баннер должен сопровождаться заглушкой в виде картинки. Она является компаньоном к HTML-баннеру и отображается, если рендеринг HTML5 по каким-то причинам невозможен. Поэтому для каждого формата рекламного блока нужно уметь создавать не только HTML-код, но и соответствующее изображение. Для этого мы используем

CasperJs. С помощью этого модуля организовано и скриншот-тестирование представленных в статье шаблонов.

Заключение

Что дает технология мультиформатных баннеров? В первую очередь она позволяет проводить масштабные A/B-тестирования рекламных слоганов и других ассетов на 100% рекламных блоков разного размера без привлечения дизайнеров. Разнообразную механику многоруких бандитов можно применить для тестирования конкретных вариаций ассетов и самих шаблонов баннеров.

К сожалению, в AdWords недоступна статистика показов в разрезе рассмотренных шаблонов. Система AdWords выбирает шаблон автоматически, и в этой статье мы попытались разобраться, как она это делает. Нам не удалось определить используемый в AdWords алгоритм выбора размера шрифтов — для каждого шаблона он особенный. Идентифицировать методику фиксации высоты/ширины каждого ассета в шаблоне тоже оказалось крайне сложно. Для этого мы придумали собственное решение, но это уже совсем другая история.

|

Метки: author AndreyIvanoff медийная реклама интернет-маркетинг веб-аналитика блог компании tinkoff.ru баннеры реклама в интернете дизайн rtb- реклама rtb |

[Из песочницы] Продажа электронных подписей и сопутствующих услуг |

Продажа электронных подписей и сопутствующих услуг

Введение

Вообще я юрист. Живу в небольшом городке Ставропольского края на юге России. По роду деятельности постоянно сталкиваюсь с информационными технологиями. Неожиданно для себя увлеклась web-программированием, пока делала сайт для своей фирмы. Тогда зачем то выбрала Битрикс, о чем ни раз пожалела, но как говорится — это совсем другая история.

Расширение бизнеса

Сначала хотели открывать удостоверяющий центр, но после долгих подсчетов стало понятно, что финансово не окупится. Решено было стать партнером удостоверяющего центра, ведь продавать электронную подпись очень хотелось. «Спрос рождает предложение» — у нас постоянно спрашивают не занимаемся ли мы электронными ключами. Видимо такие выводы делает клиент, который приходит к нам допустим, зарегистрировать свой бизнес. Ведь, что ему нужно, что бы бизнес начал свое существование? Допустим:

- Документация для регистрации в налоговой;

- Документация для открытия расчетного счета (обязательно, если это ООО);

- Круглая печать;

- Электронная подпись для сдачи отчетности;

Это самый минимальный список, для нормальной работы нужно гораздо больше. Конечно можно сдавать отчеты почтой (только не НДС), некоторым ИП можно работать без печати, даже счета не открывая, но мы все же о бизнесе, а не о выживании).

Три первые пункта мы предоставляем клиентам, осталось как то организовать работу с ЭП.

«Начать может и один человек, без лицензии»

Таким был ответ одного из удостоверяющих центров. Сразу как то не очень поверилось, пришлось проверять.

Партнерский договор был напичкан всякими терминами и сокращениями, читался сложно, но из смысла было понятно, что нами будут обрабатываться персональные данные. Соответственно нужно подать уведомление в Роскомнадзор. Перед тем как это делать — нужно все привести в соответствии с законом о защите персональных данных. А это финансовые затраты. Допустим:

- Покупка межсетевого экрана и его настройка;

- Покупка антивируса;

- Покупка охранного оборудования;

- Ежемесячные затраты на охрану;

Отлично, все сделано. Идем дальше — лицензия. Региональный менеджер удостоверяющего центра настаивал, что мы можем работать и без нее, но как говориться чувствовался подвох. «Она потом понадобиться» — звучала как то странно с юридической точки зрения. Бизнес должен быть законным с самого начала, иначе его существование будет не долгим, это я поняла из практики.

Из обзора судебной практики стало понятно, что никакого единого мнения нет. От штрафа в 2 000.00 рублей до тюремного заключения. Предусмотрена как административная, так и гражданская с уголовной ответственность.

Осуществление предпринимательской деятельности без специального разрешения (лицензии), если такое разрешение (такая лицензия) обязательно (обязательна), — влечет наложение административного штрафа:

- на граждан в размере от двух тысяч до двух тысяч пятисот рублей с конфискацией изготовленной продукции, орудий производства и сырья или без таковой;

- на должностных лиц — от четырех тысяч до пяти тысяч рублей с конфискацией изготовленной продукции, орудий производства и сырья или без таковой;

- на юридических лиц — от четырехсот до пятисот минимальных размеров оплаты труда с конфискацией изготовленной продукции, орудий производства и сырья или без таковой.

Уголовная ответственность возникает в случае особо крупных размеров или причинения вреда. С точки зрения гражданского кодекса — все сделки не действительны, а значит и ключи эп, а это грозит судами и компенсациями.

Мы будем просто передавать документы

Региональный менеджер продолжал настаивать что наши действия законны, и мы можем начать работу без лицензии. Для себя то мы уже однозначно решили что делать, но настойчивый молодой человек все же до меня дозвонился и счастливым и жизнерадостным голосом стал уговаривать начать работу с клиентами до получения лицензии.

«Ну чего вы боитесь, вы же не будете выпускать электронную подпись, вы просто передаете документы и консультируете клиентов по вопросам нашего программного обеспечения!»- звучит неплохо, жаль только все равно попадает под лицензирование.

Постановление Правительства РФ от 16.04.2012 N 313 (ред. от 18.05.2017)

21. Передача шифровальных (криптографических) средств, за исключением шифровальных (криптографических) средств защиты фискальных данных, разработанных для применения в составе контрольно-кассовой техники, сертифицированных Федеральной службой безопасности Российской Федерации.

(п. 21 в ред. Постановления Правительства РФ от 18.05.2017 N 596)

(см. текст в предыдущей редакции)

22. Передача защищенных с использованием шифровальных (криптографических) средств информационных систем.

23. Передача защищенных с использованием шифровальных (криптографических) средств телекоммуникационных систем.

24. Передача средств изготовления ключевых документов.

С Вами говорит ФСБ

Звонок в Федеральную службу безопасности снял все сомнения и расставил все на свои места. В отделе лицензирования трубку взяла доброжелательная женщина, ответившая на мои вопросы:

- Да, лицензия нужна;

- Для ее получения нам необходимо обучить всего одного человека;

- Необходимые виды деятельности для работы с УЦ "*******" в качестве партнера — 21, 22, 23, 24;

Этот вопрос кстати, уже не раз поднимался на обучении по информационной безопасности. Например озвучивалось, что фирма оказывает платные услуги по сопровождению регистрации на портале, а ЭП выдается клиенту в подарок. Наивно полагать, что работники контролируемых органов примут такие объяснения. Просто составят протокол о правонарушении, а вы потом бегайте по судам. Еще и компьютеры изымут и доказывайте потом что хотите.

Предпринимателям

Будьте бдительны. Особенно когда дело касается информационных технологий — все что с ними связано, сейчас основной вектор развития нашей страны. Эта сфера активно развивается, «дырок в законодательстве» много, можно легко попасть под штрафы и суды. Суды дело муторное, дорогое и рискованное — в эту систему лучше не попадать, плюс практики еще очень мало и надеяться на то, что судья станет разбираться во всех тонкостях и отменит протокол правонарушения ФСБ не стоит.

Ваш бизнес должен быть законным с самого начала, иначе это перечеркнет возможность заниматься им в будущем серьезно.

Не доверяйте слепо партнерам, у них уже устойчивый бизнес, от ваших проблем им не жарко не холодно.

|

Метки: author ninadinastiia управление проектами законодательство и it-бизнес организация бизнеса информационная безопасность защита информации лицензирование |

Пишем для UEFI BIOS в Visual Studio. Часть 2 – создаем свой первый драйвер и ускоряем отладку |

Введение

В этой статье будут рассмотрены базовые вещи, касающиеся программирования текстового ввода-вывода. В программе, которую на этот раз создадим сами с нуля, вначале введем с клавиатуры, а потом выведем на экран текстовую строку, коснувшись по пути некоторых неочевидных особенностей программирования под UEFI.

Вторая половина статьи будет про ускорение загрузки драйвера при запуске на отладку, поскольку две минуты, что тратятся на это сейчас, при многократном запуске в процессе отладки своего драйвера будут сильно раздражать.

Те, кто заинтересовался — добро пожаловать под кат.

Читать дальше ->

|

Метки: author DarkTiger системное программирование bios uefi |

Внедрение Help Desk. 9 типичных заблуждений на этапе выбора. Развеиваем мифы |

Внедрение Help Desk. 9 типичных заблуждений на этапе выбора. Развеиваем мифы

- ит аутсорсинг;

- обслуживание ККТ и другого специализированного оборудования;

- digital агентства и веб студии;

- вендоры и разработчики сервисов.

Оказывается, неудачный выбор и внедрения, вызванные неправильным подходом к проектам автоматизации в некоторых компаниях, порождают на рынке мифы относительно бесперспективности внедрений в определенных ситуациях. По итогам общения с более чем 1000 представителями среднего и малого бизнеса, мы отобрали наиболее распространенные заблуждения, из-за которых компании отказываются от внедрения систем службы поддержки (Help Desk). Многие из этих заблуждений являются причинами отказа от внедрения и других систем автоматизации. Нам захотелось поделиться этими заблуждениями с читателями и развеять эти мифы.

«Мы — слишком маленькие. У нас мало клиентов / заявок»

Действительно, небольшим компаниям, особенно в начале развития, удобнее не тратить время на внедрение Help Desk систем, не приносящих на данной стадии заметной пользы. Однако при масштабировании важно не упустить тот момент, когда отсутствие системы службы поддержки будет якорем, т.е. когда заявки начнут теряться из-за того, что существующая система учета (будь то бумажный журнал, канал в viber или цепочки писем в ящике электронной почты) перестанет справляться с нагрузкой. По нашей статистике “средняя температура по больнице”, при которой заявки начинают “теряться”, составляет 10-12 обращений в день.

«Мы стали терять заявки клиентов. В разгар сезона только в течение месяца это привело к потере двух клиентов на абонентском обслуживании в год приносящих нам около 100 тыс. рублей»

Александр Мишин, директор ООО «Бизнес Технологии»

В идеале поддержка пользователей, наряду с CRM системами в части продаж то, с чего нужно начинать выстраивание процессов и автоматизацию с самого старта работы любого, особенно, B2B бизнеса. Кстати, на западе делают именно так.

Отметим также, что, зачастую, кажущиеся малые объемы возникают как раз по причине того, что заявки от клиентов нигде не учитываются или учитываются в разных местах. В итоге руководитель компании попросту не имеет представления о реальных масштабах бедствия.

«Система поддержки пользователей не будет поддерживать текущий рабочий процесс»

Налаженные рабочие процессы действительно важны, а боязнь того, что с трудом отлаженную систему придется менять, вполне обоснована. Но, во-первых, систем автоматизации существует много, и большинство из них — весьма гибкие с точки зрения адаптации к принятым на рынке методикам работы. Во-вторых, не нашедшие отражения в системах автоматизации уникальные и сложные бизнес-процессы — повод серьезно задуматься и Вашей компании. Иногда это конкурентное преимущество, но чаще — просто неумение выстроить процессы в соответствии с лучшими практиками (и соответствии с процессами, заложенными в системы автоматизации тех.поддержки).

В любом случае организационных сложностей при внедрении любой системы не избежать: никто не любит меняться и работать по новым правилам. Очень часто придется столкнуться и с саботажем. Если Вы руководитель компании, для Вас такое поведение сотрудников, наоборот, должно послужить сигналом к необходимости проведения изменений.

Постоянная нехватка времени или рабочих рук для внедрения нового

Подавляющее большинство компаний среднего и малого бизнеса постоянно «тушат пожары», т.е. время и силы вкладываются туда, где в данный момент «уже горит». При сохранении существующей схемы работы возможностей даже на небольшие преобразования, как организационные, так и ИТ-ландшафта, такой бизнес не найдет никогда. Но именно для них и существуют простые системы службы поддержки. Важно лишь правильно распределить усилия — немного отклониться от принципа “постоянного затыкания дыр” и подумать о перспективах. Зачастую вопрос решается административно: выделяется время и люди на внедрение тех самых простых инструментов, вне зависимости от статуса остальных задач. Важным аргументом в пользу выбора Help Desk решения для таких компаний, несомненно, будет удобный и простой интерфейс, а также отсутствие необходимости серьезных и длительных настроек для старта работы. Например, Okdesk компании запускают в эксплуатацию за 1-2 дня.

«Долгое время использовали в работе Intraservice, но функционально он перестал отвечать нашим требованиям. Переход на новую систему, как и в случае любой миграции, вызывал опасения: новый интерфейс, новые правила работы, недовольство сотрудников. На Okdesk переход прошел незаметно и был встречен всеми исключительно положительно. Система действительно очень удобная и интуитивно понятная»

Алексей Теплоухов, директор ООО «Частные решения»

Нехватка денег на внедрение Help Desk системы

Во многом, эта проблема аналогична предыдущей: имеющиеся средства постоянно вкладываются туда, где есть прямое сокращение затрат, т.е. на какие-то улучшения “на перспективу” (ради косвенных аспектов: экономии времени, повышения удовлетворенности клиентов) средств нет.

На старте действительно сложно оценить, будет ли экономический эффект от вложения в автоматизацию, тем более, если речь идет про системы клиентской поддержки. Чтобы оценить эффект, необходимо собрать статистику и сравнить ее с текущими данными, но при этом текущие данные почти никто не собирает (так что и сравнить не с чем).

В данном случае поможет опыт коллег по рынку. Например, опыт внедрения системы службы поддержки в ИТ-аутсорсинговой компании или в компании по автоматизации общепита и HoReCa. А чтобы снизить “порог входа” для таких компаний существуют облачные сервисы с пробными периодами, позволяющие протестировать инструмент с минимальными затратами.

Негативный опыт внедрения в прошлом или боязнь выбора неподходящего “партнера”

Дать гарантии, что компания-разработчик нового решения просуществует так же долго, как и компания-клиент, не может никто. К сожалению, на рынке действительно очень много стартапов, которые активно «пиарятся», а уже через год закрываются или полностью сворачивают развитие. Рынок Help Desk систем — не исключение.

Внимательно изучайте число активных пользователей и их отзывы, масштабы бизнеса разработчика выбранного ПО, команду основателей сервиса (тщательно изучите этот аспект по предыдущим достижениям на предыдущих местах работы), а также по тому, как они работают на этапе продаж. Все это поможет сделать выводы о «жизнеспособности» решения и значительно уменьшить риски выбора «решений — однодневок».

Непреодолимые организационные барьеры

Люди по своей природе консервативны. Коллектив может и будет сопротивляться нововведениям, причем делать это довольно успешно. Проблема решается грамотным подходом к мотивации сотрудников, которых заставляют менять привычки.

Грубо говоря, систему службы поддержки нужно сначала “купить” самому, а уже потом продать своим сотрудникам, пояснив, что все — во благо (ну или навязать в приказном порядке, если по-другому не получается).

Снизить негатив со стороны коллектива позволяет простота внедряемого инструмента. Чем меньше придется изучать нового и ломать свой привычный стиль работы рядовым сотрудникам — тем охотнее они пойдут на внедрение.

«Наши сотрудники довольно гладко приняли внедрение Okdesk, за исключением того, что появилось требование документирования решения заявок. Вот тут мы получили возмущение и недовольство типа “мы же работаем”. Но объяснение причин помогает. В частности, в нашем случае, документирование используется не с целью постоянного контроля за работой, а с целью помочь избежать конфликтов или разобраться в них, то есть оно защищает самих сотрудников»

Игорь Зверев, директор «Кейсистемс-Иваново»

«Отсутствие опыта подобных внедрений обязательно приведет к неудаче»

Компания, работающая на перспективу, не оставит своих клиентов наедине с нерешаемыми задачами. Проблемы, вызванные отсутствием опыта, вполне решаются при поддержке разработчиков и менеджеров самого сервиса, которые видели на своей практике не одно внедрение.

Однако один из важных моментов в основе успеха — четко сформулированная цель внедрения и требования к выбираемому решению. Каких показателей стремиться достичь компания? Какие проблемы решить? Какие функции обязательно нужны, а какие скорее являются идеализированными «хотелками» без реального применения? К сожалению, зачастую, многие не понимают чего действительно хотят и даже не могут сформулировать четких требований. Еще одна проблема кроется в желании получить гибкий, заточенный под очень специфичные «хотелки» за небольшие деньги. Такие компании проводят в поисках подходящего варианты годы, не получая никакого результата.

«У нас и так все хорошо!»

Так бывает, когда руководство спускает задачу выбора и внедрения Help Desk системы на линейных руководителей. Однако и сами собственники в малом бизнесе зачастую отмахиваются от систем автоматизации с таким же обоснованием. Важный (можно сказать даже “философский”) вопрос: ценности у какого-то конкретного инструмента в данном случае действительно нет или ее просто не хотят видеть? По нашему опыту подобная причина отказа возникает тогда, когда серьезно не хватает мотивации на повышение качества и прозрачности работы (а отсюда и саботаж)? Мало ли что выявит новая система?!

Для объективной оценки нужны метрики. У бизнеса их нет? Это уже повод задуматься о том, не пора ли взяться за эффективность.

В целом рыночные условия становятся все более жесткими. Конкуренция и так высока, а в дополнение постоянно повышается налоговая нагрузка, да и от инфляции никуда не деться. Единственный способ остаться на плаву в этих условиях — постоянно двигаться вперед, изыскивая новые источники ресурсов. И один из таких источников — оптимизация производительности труда как раз за счет автоматизации.

«Честно говоря, я искренне желаю, чтобы мои конкуренты и дальше работали с заявками в Excel. Но это желание не реализуемо. Все развивается, в любом случае нужно будет внедрять что-либо, если они хотят дальше находиться на рынке. Количество денег все меньше. В следующем году нам предложат более полно платить налоги (у государства появится возможность детальнее контролировать налогооблагаемую базу). Затраты на налогообложение вырастут, а значит где-то нужно найти резервы. По моим представлениям они есть только в производительности труда»

Владимир Бачурин, директор «ИННИКО»

«Уже есть другая система»

Уже есть какая-то автоматизация. Однако инструмент инструменту рознь. Зачастую для автоматизации того же Help Desk используется электронная почта или Excel, совершенно для этого не предназначенные. Такой инструментарий работает неэффективно. Причем, чем больше масштабы бизнеса, тем серьезнее на результате сказываются недостатки инструмента. И тут мы возвращаемся к предыдущему пункту: а есть ли мотивация работать эффективнее? Если есть, необходимо реформировать набор используемых инструментов, ведь дальше без необходимого функционала будет все сложнее и сложнее. Мы писали об этом в заметке о недостатках Excel как инструмента учета.

В одной из ближайших статей мы разберем вопросы миграции со специализированной системы.

Вместо выводов

Если в вашей организации развитие инструментов «производства» застопорилось по одной из перечисленных причин, задумайтесь, о том, насколько Вы управляете ситуацией в компании и как Вы будете преодолевать эти барьеры в будущем. Ну и, конечно, всегда будьте готовы к сложностям и необходимости их преодоления!

|

|

RAIF-Challenge 2017: онлайн-чемпионат по искусственному интеллекту. Применяем ML/AI на практике |

|

|

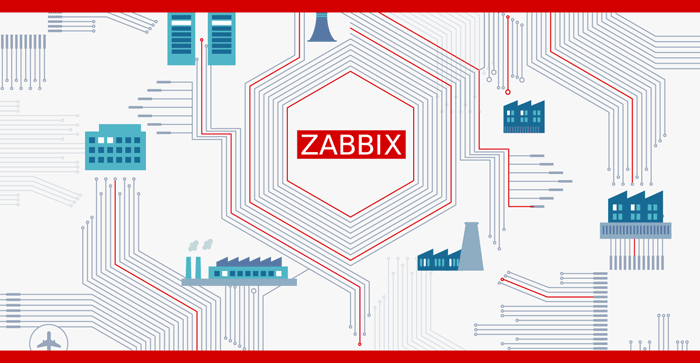

Zabbix 3.4: Массовый сбор данных на примерах счетчика Меркурий и smartmontools |

Zabbix 3.4: Массовый сбор данных на примерах счетчика Меркурий и smartmontools

- Tutorial

Всем привет, ранее мы уже упоминали о возможностях по массовому сбору данных в новой версии опенсорс системы мониторинга Zabbix 3.4. Теперь остановимся на этом функционале поподробнее, и чтобы было нагляднее, расскажем о нем на двух примерах:

- сбор всех данных за раз, полученных в JSON от консольной утилиты счетчика электроэнергии Меркурий 236

- сбор показателей S.M.A.R.T. жестких дисков и SSD, полученных в табличном виде от smartmontools.

А в чем была собственно проблема?

Собирать данные через консольные утилиты или вызовы API данные можно было и ранее, но существовали сложности:

- медленные запуски утилит каждый раз, на каждый нужный элемент данных

- обращение к ресурсу (диск, порт, счетчик, API приложения) на каждый элемент данных

- парсинг результата нужно было делать внешними скриптами/утилитами

- а если потом нужно было поправить парсинг – приходилось опять обновлять UserParameters или скрипты

- кроме всего прочего, одновременные запросы от нескольких Zabbix pollers приводили к ошибке при обращении, например, к последовательному порту.

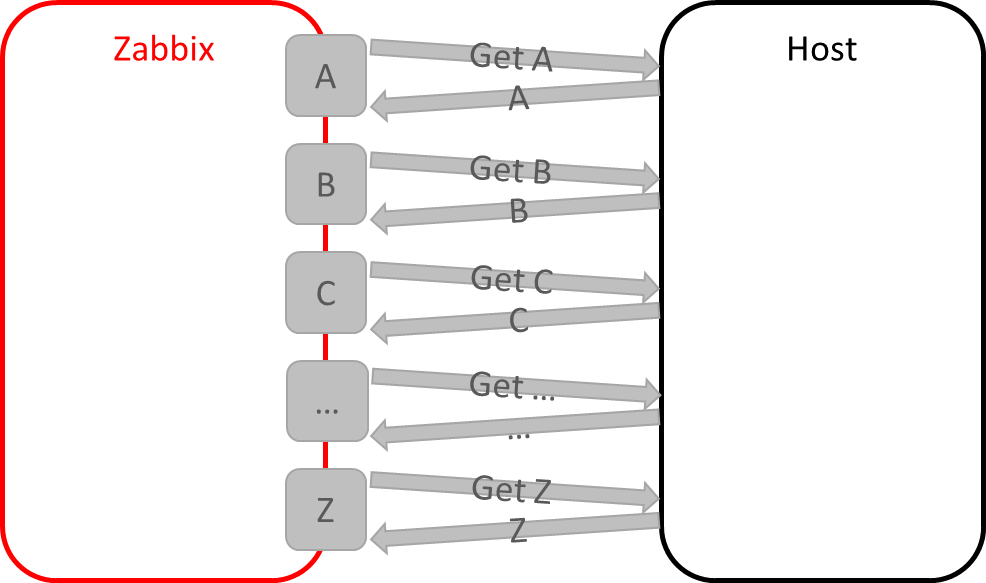

В общем, дело было так:

А с появлением зависимых элементов данных, стало возможно так:

Как это работает?

- В Zabbix 3.4 источником данных может выступать другой элемент данных, который называется родительским или мастер-элементом. Такой элемент может, например, содержать массив данных в формате JSON, XML или фривольном текстовом формате.

- В момент поступления новых данных в родительский элемент, остальные элементы данных, которые называются зависимыми, обращаются к родительскому элементу и при помощи таких функций препроцессинга как JSON path, XPath или Regex выделяют из текста нужную метрику.

Кстати, препроцессинг – тоже нововведение 3.4, он реализован добавлением новых процессов preprocessing_manager и preprocessing_worker на Zabbix-сервере. Поэтому, если вы обновляетесь с 3.2 – не забудьте обновить шаблон для сервера, чтобы мониторить их работу.

Переходим к примерам.

Меркурий 236

Представим, что на нашем проекте, кроме контейнеров, виртуальных машин, приложений, сетевых устройств, баз данных, бизнес показателей и всего прочего требующего контроля, присутствует необходимость мониторить показатели электросети и другой «инженерки», как, например, климатическое оборудование. Используются стандартные для нашей средней полосы устройства: трехфазный счетчик электроэнергии Меркурий 236 АRT-01 PQRS с интерфейсом RS-485, поверх которого общение происходит через проприетарный протокол производителя.

Задача ответственная – сразу собирать показатели напряжения, мощности, тока, потребления, частоты. Подключить такой прибор к серверу с Zabbix агентом – задача посильная – достаточно будет серийного порта с RS-485, например, в форме USB адаптера. Но как прочитать данные? Если бы не github и добрые люди, поделившиеся своим решением для умного дома, писать бы нам модуль к Zabbix, который бы мы учили разговаривать на протоколе счетчика и опрашивать показатели.

Утилита простая и удобная (за что автору большое человеческое спасибо) подключается к счетчику на указанный порт, считывает данные и отдает нам в виде текста, CSV или JSON.

Давайте попробуем установить и запустить:

git clone https://github.com/Shden/mercury236.git

cd mercury236

make

./mercury236 /dev/ttyS0 --help

Usage: mercury236 RS485 [OPTIONS] ...

RS485 address of RS485 dongle (e.g. /dev/ttyUSB0), required

--debug to print extra debug info

--testRun dry run to see output sample, no hardware required

Output formatting:

....

--help prints this screen

Запускается! Отлично, подключаем счетчик, опрашиваем, получаем JSON:

./mercury236 /dev/ttyS0 --json

{

"U": {

"p1": 0.35,

"p2": 0.35,

"p3": 226.86

},

"I": {

"p1": 0.00,

"p2": 0.00,

"p3": 0.39

},

"CosF": {

"p1": 0.00,

"p2": 0.00,

"p3": 0.60,

"sum": 0.60

},

"F": 50.00,

"A": {

"p1": 41943.03,

"p2": 41943.03,

"p3": 41943.03

},

"P": {

"p1": 0.00,

"p2": 0.00,

"p3": 53.45,

"sum": 53.45

},

"S": {

"p1": 0.00,

"p2": 0.00,

"p3": 89.83,

"sum": 89.83

},

"PR": {

"ap": 120.51

},

"PR-day": {

"ap": 86.00

},

"PR-night": {

"ap": 34.51

},

"PY": {

"ap": 0.00

},

"PT": {

"ap": 0.04

}

}В итоге утилита уже сделала всю сложную работу за нас, реализовав протокол общения с счетчиком, вытащив данные, да еще и предложила нам это в виде удобного JSON объекта. Вот только раньше просто так мы ей не смогли бы воспользоваться — пришлось бы писать обвязку в виде скриптов, а самое главное – реализовывать механизм контроля доступа к среде последовательного порта. Ведь если два поллера Zabbix одновременно обратятся к нему – один за током третьей фазы 3, а другой — за током фазы 2, у нас не вернулось бы ничего.

В 3.4 все становится гораздо проще, и мы теперь быстро и легко можем передавать данные сторонних консольных утилит в Zabbix, не прибегая к оберточным скриптам, и не запуская по 10 раз одно и тоже на каждый элемент данных отдельно. Итак,

Настроим запуск утилиты mercury236 из Zabbix

sudo cp mercury236 /etc/zabbix/scripts

cd /etc/zabbix/scripts

chmod +x mercury236

sudo usermod -G dialout zabbix

Для запуска скрипта, создадим в конфиге Zabbix-агента новый UserParameter:

UserParameter=mercury236[],/etc/zabbix/scripts/mercury236 $1 $2Сохраняем файл, не забываем перезапустить наш Zabbix-агент.

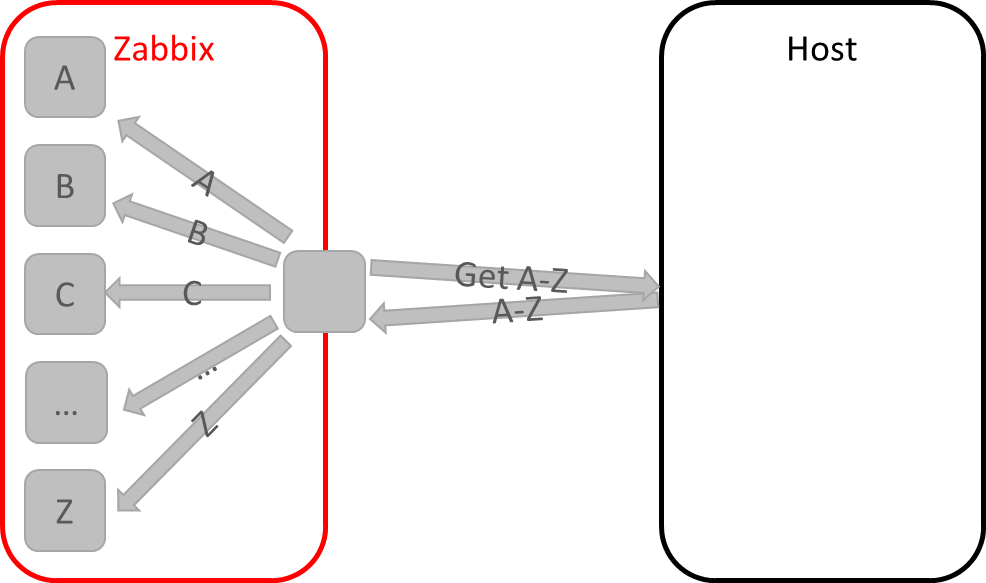

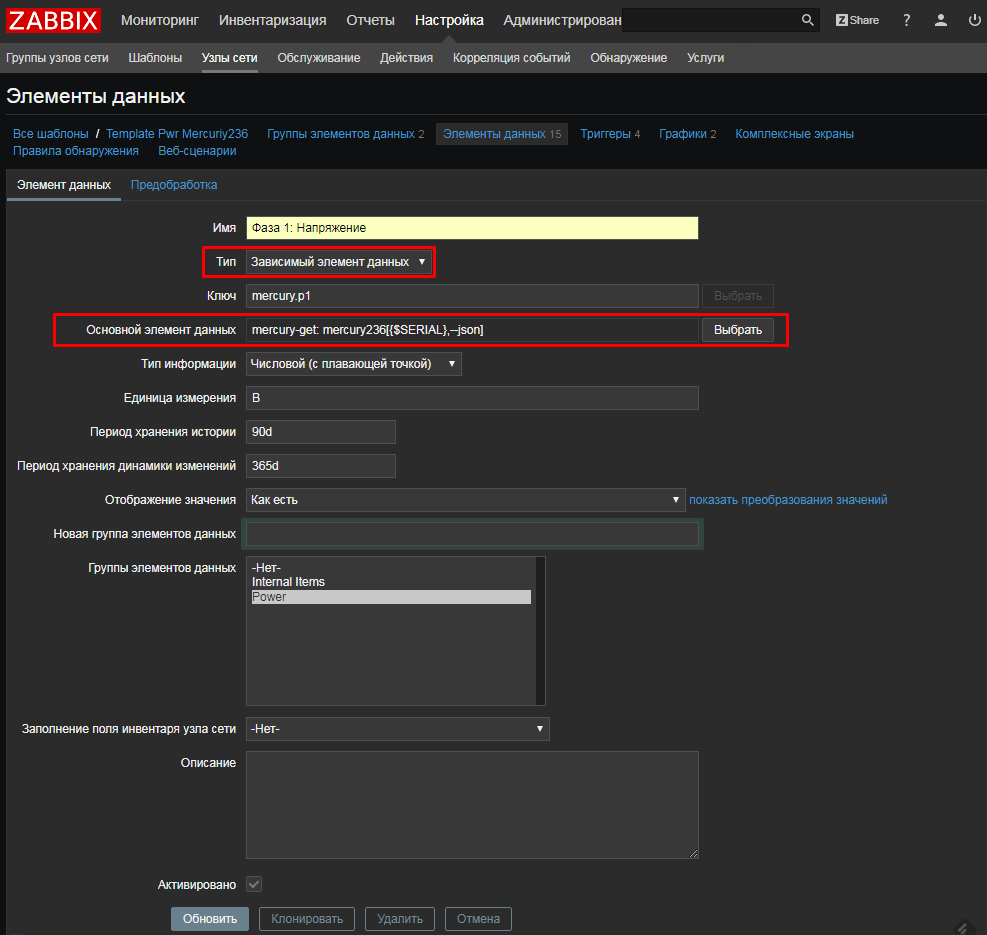

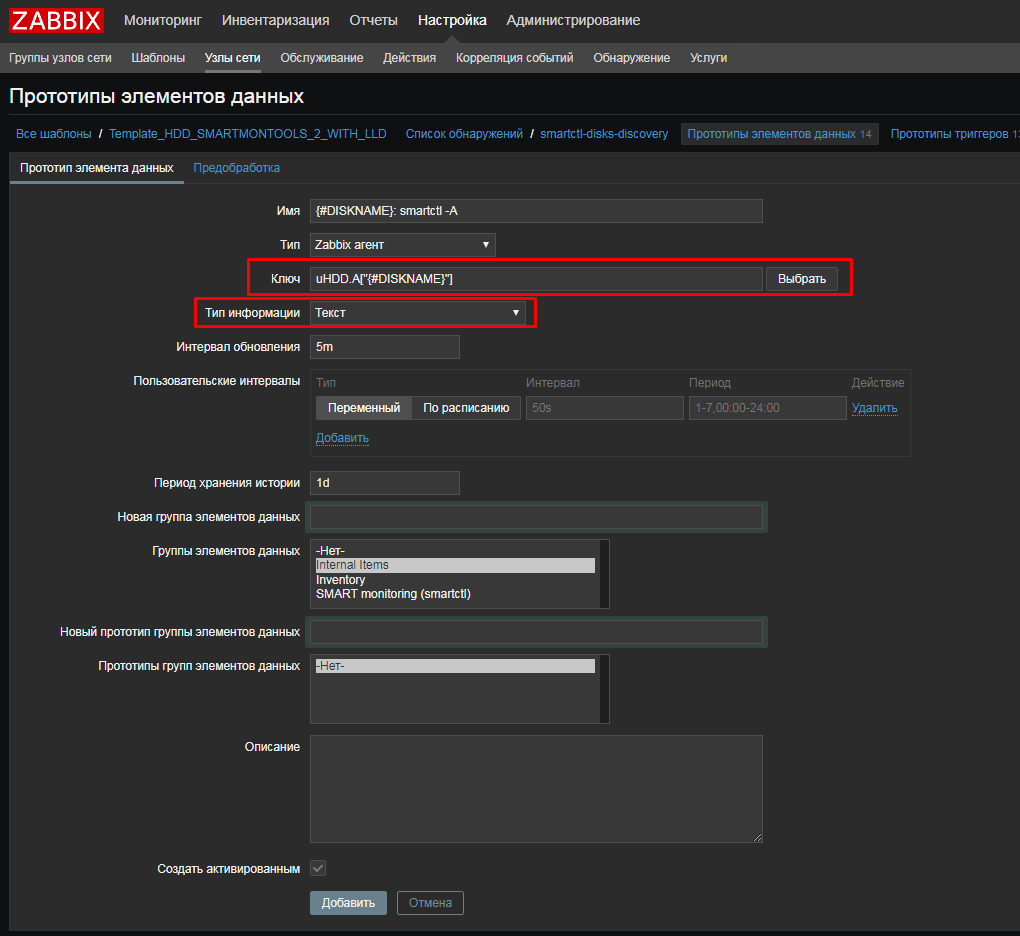

Теперь создадим в новом шаблоне родительский элемент данных:

Как видите, в родительском элементе данных нет ничего особенного – просто проверка через UserParameter Zabbix-агента. А это значит, что и нет никаких ограничений на то, какой тип проверки может выступать в роли родительского элемента – здесь могут быть и данные полученные через Zabbix trapper или через Внешние проверки. Единственное, мы выбрали Тип информации – Text и срок хранения истории в 1 день – хранить дольше мы собираемся метрики отдельно в зависимых элементах (можно не хранить данные вообще в родительском элементе, выставив срок хранения 0). Обратите внимание, что препроцессинг в этом элементе данных мы не трогаем.

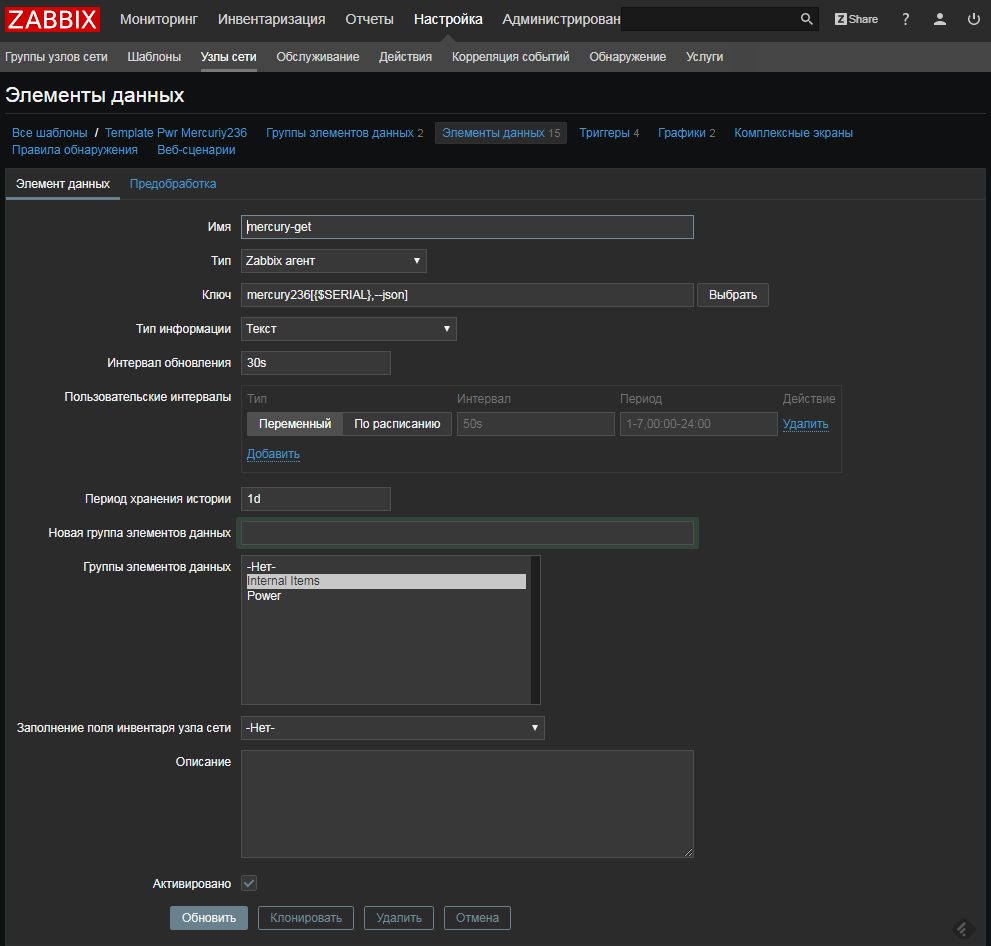

Настроим получение наших метрик счетчика

Для того чтобы начать создавать зависимые элементы данных, можно воспользоваться новым помощником. Ну или просто нажать «Создать элемент данных»:

Создадим элемент данных для напряжения первой фазы, выберем:

- Тип: Зависимый элемент данных

- Основной элемент данных: mercury-get

Затем во вкладке «Предобработка» добавим наше выражение JSON Path:

Путь JSON: $.U.p1

Кстати, маленький совет. Чтобы не тратить много времени на отладку и ловлю ошибок, перед тем как заполнять JSON Path можно быстро проверить правильность выражения онлайн, например здесь: jsonpath.com, скопировав туда JSON, полученный от утилиты.

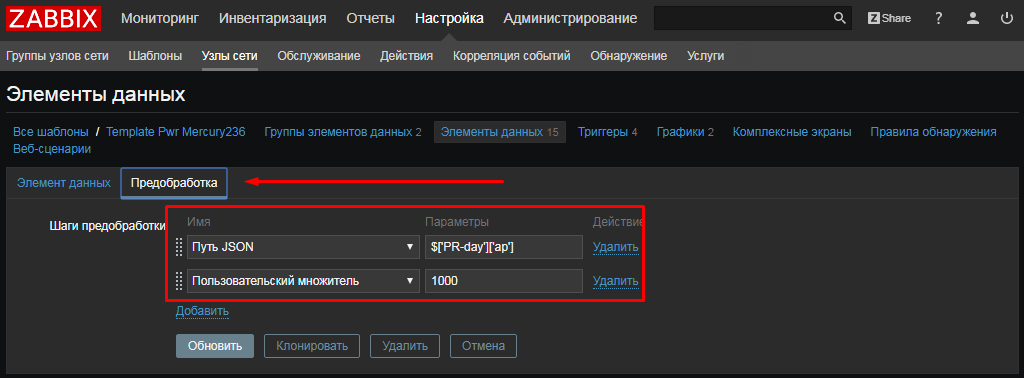

Аналогичным образом создаем другие интересующие нас метрики. В том числе — для накопленной энергии по дневному тарифу.

Для этого создадим новый элемент данных и выберем:

- Тип: Зависимый элемент данных

- Основной элемент данных: mercury-get

А вот во вкладке «Предобработка» обратите внимания на два нюанса:

- будем использовать нотацию с квадратными скобками, так как в пути JSON есть дефис

- препроцессинг может быть многошаговым, например здесь результата первого шага умножим на 1000, чтобы получить Вт*ч из кВт*ч

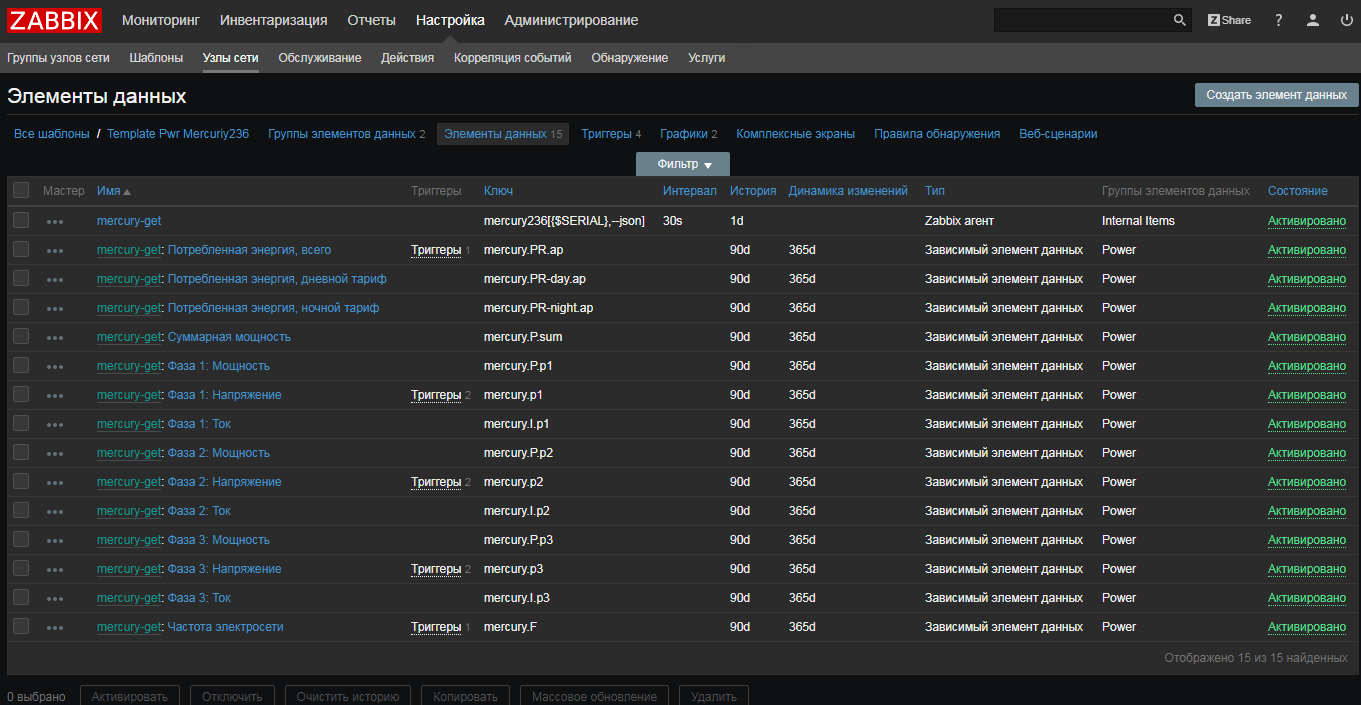

Проделаем аналогично для остальных ключевых метрик счетчика, в итоге получим вот такой список:

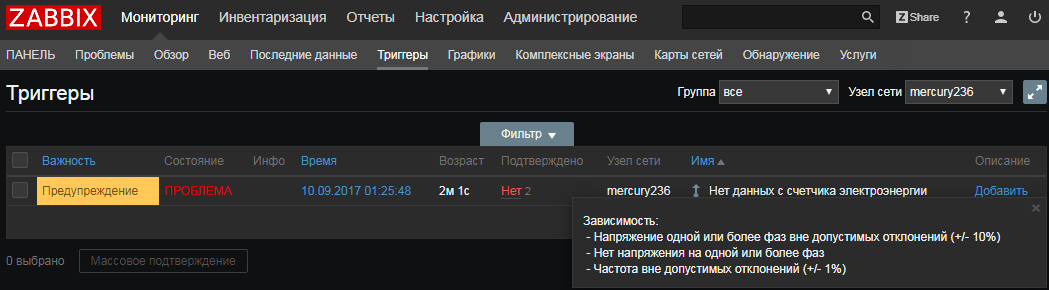

Доведем наш шаблон до ума

Чтобы шаблон был законченным, добавим триггеры, используя макросы, делая его максимально гибким. Не забываем про зависимости триггеров.

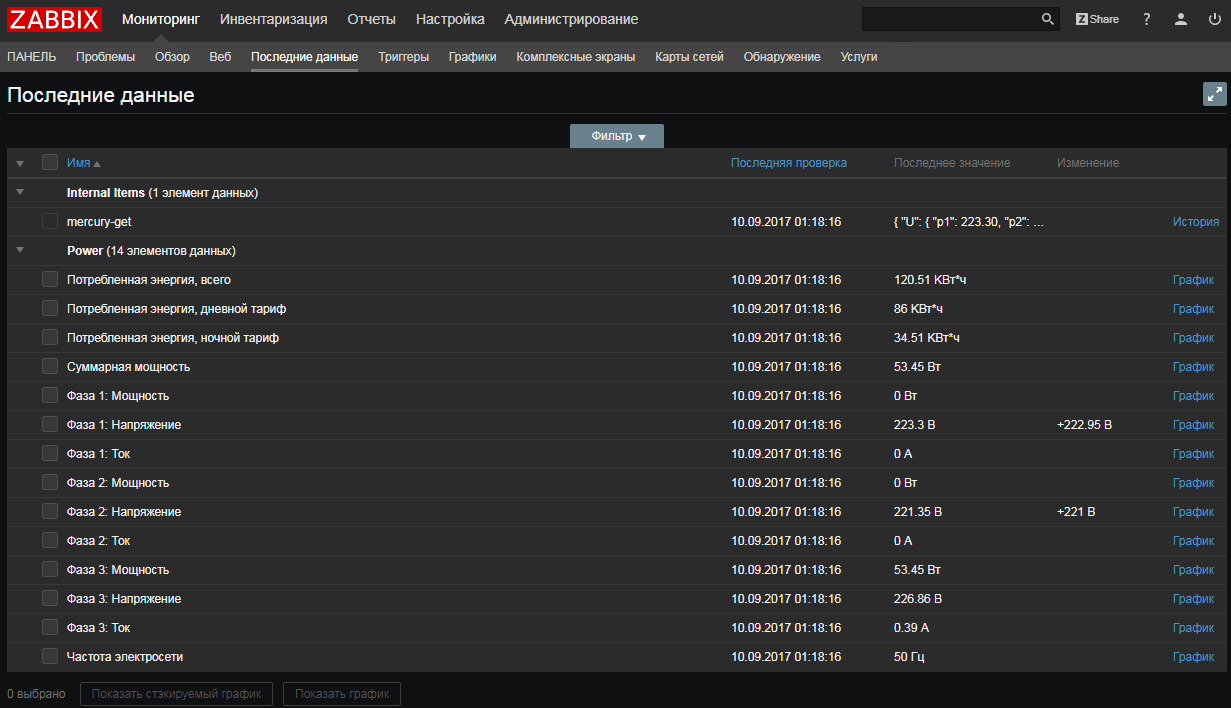

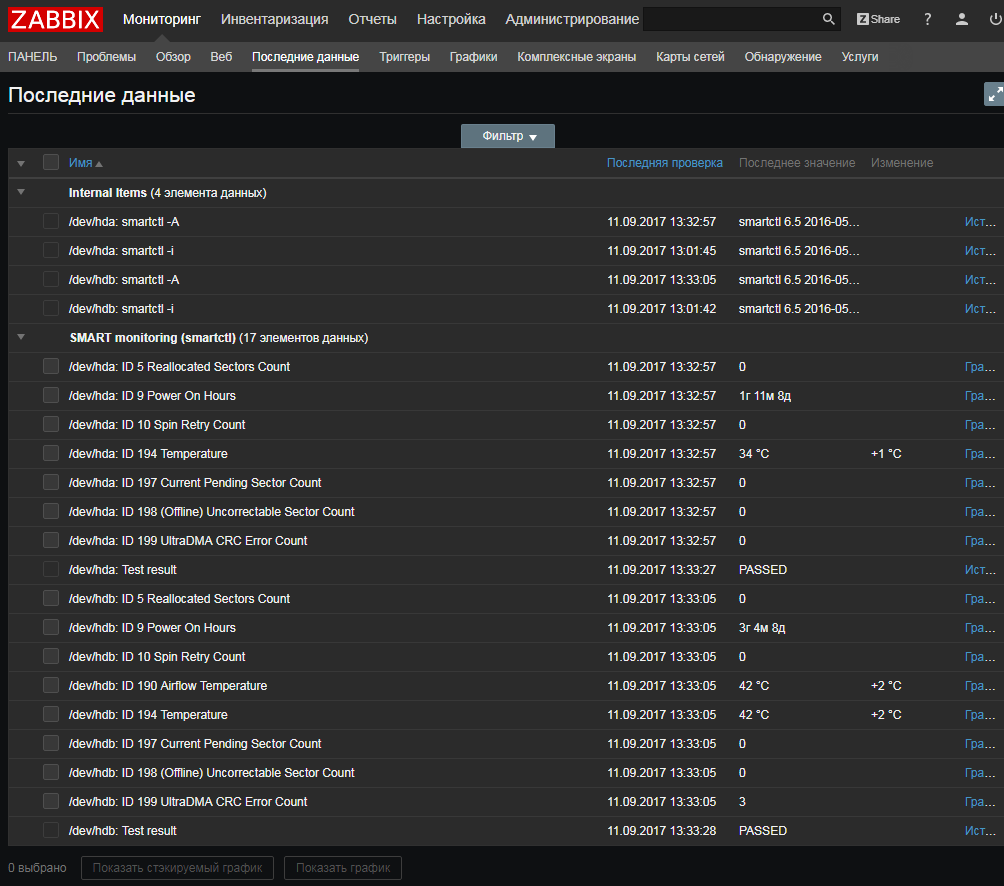

Что получилось

Шаблон готов, данные побежали, посмотрим, что у нас получилось:

Все последние данные, собранные за одно обращение:

Обратите внимание, что время сбора всех метрик абсолютно идентично.

Итоговый шаблон для счетчика доступен на репозитории решений на share.zabbix.com здесь.

Подведем итоги:

- переиспользовали хорошую программку и не тратили время на написание своей реализации сбора данных по протоколу Меркурий

- UserParameter остался, но схлопнулся до простого вызова. По сути можно даже system.run[] использовать

- cкрипты-обертки тоже не писали. Всё распарсили через JSON path в шаблоне

- cчетчик не мучали сильно, один запрос – все нужные нам данные разом.

Smartctl и smartmontools

Давно мы уже писали на хабре, как можно контролировать S.M.A.R.T. жестких дисков, чтобы успеть их вовремя поменять, через использование UserParameters. Такой подход работает, но он не был лишен недостатков:

- избыточные запуски утилиты smartctl, а она в свою очередь каждый раз обращалась к контроллеру жесткого диска

- пришлось делать отдельный парсинг для Linux и Windows. Особенно больно с этим сейчас работать в Win: (for /F… так… экранируем двойные кавычки еще кавычками…. Аааа!!!!)

Постараемся в 3.4 от всего этого избавится.

Случай с smartmontools имеет два отличия от примера со счетчиком выше:

- smartctl нам JSON не возвращает

- дисков в сервере может быть различное количество, поэтому нам нужно использовать низкоуровневое обнаружение(LLD).

Но ничего страшного! Во-первых, зависимые элементы данных работают и для LLD, а во-вторых у нас среди preprocessing-фильтров есть и PCRE regex. Воспользуемся им, чтобы вытащить нужные показатели из не супер сильно структурированного ответа утилиты. Примерно такого:

Приступим.

Упрощаем UserParameters

Было:

UserParameter=uHDD[], sudo smartctl -A $1| grep -i "$2"| tail -1| cut -c 88-|cut -f1 -d' '

UserParameter=uHDD.model.[],sudo smartctl -i $1 |grep -i "Device Model"| cut -f2 -d: |tr -d " "

UserParameter=uHDD.sn.[],sudo smartctl -i $1 |grep -i "Serial Number"| cut -f2 -d: |tr -d " "

UserParameter=uHDD.health.[],sudo smartctl -H $1 |grep -i "test"| cut -f2 -d: |tr -d " "

UserParameter=uHDD.errorlog.[],sudo smartctl -l error $1 |grep -i "ATA Error Count"| cut -f2 -d: |tr -d " "

UserParameter=uHDD.discovery,sudo /etc/zabbix/scripts/smartctl-disks-discovery.pl

Стало:

UserParameter=uHDD.A[],sudo smartctl -A $1

UserParameter=uHDD.i[],sudo smartctl -i $1

UserParameter=uHDD.health[],sudo smartctl -H $1

UserParameter=uHDD.discovery,sudo /etc/zabbix/scripts/smartctl-disks-discovery.pl

Аналогично делаем и для Windows, попутно избавляясь от CMD магии с использование for /F и find. Посмотреть можно тут.

Создаем новые родительские элементы данных

Для сбора всех атрибутов S.M.A.R.T. создадим прототип мастер-элемента данных:

Как и в предыдущем примере, ничего особенного настраивать не надо. Только Тип информации – Text, а Период хранения — 1 день.

Для сбора результатов тестов и инвентарных данных нам потребуется запускать smartctl с другими ключами. Поэтому аналогично создадим еще два элемента данных:

- uHDD.i["{#DISKNAME}"]

- uHDD.health["{#DISKNAME}"]

Настроим получение наших атрибутов S.M.A.R.T. диска

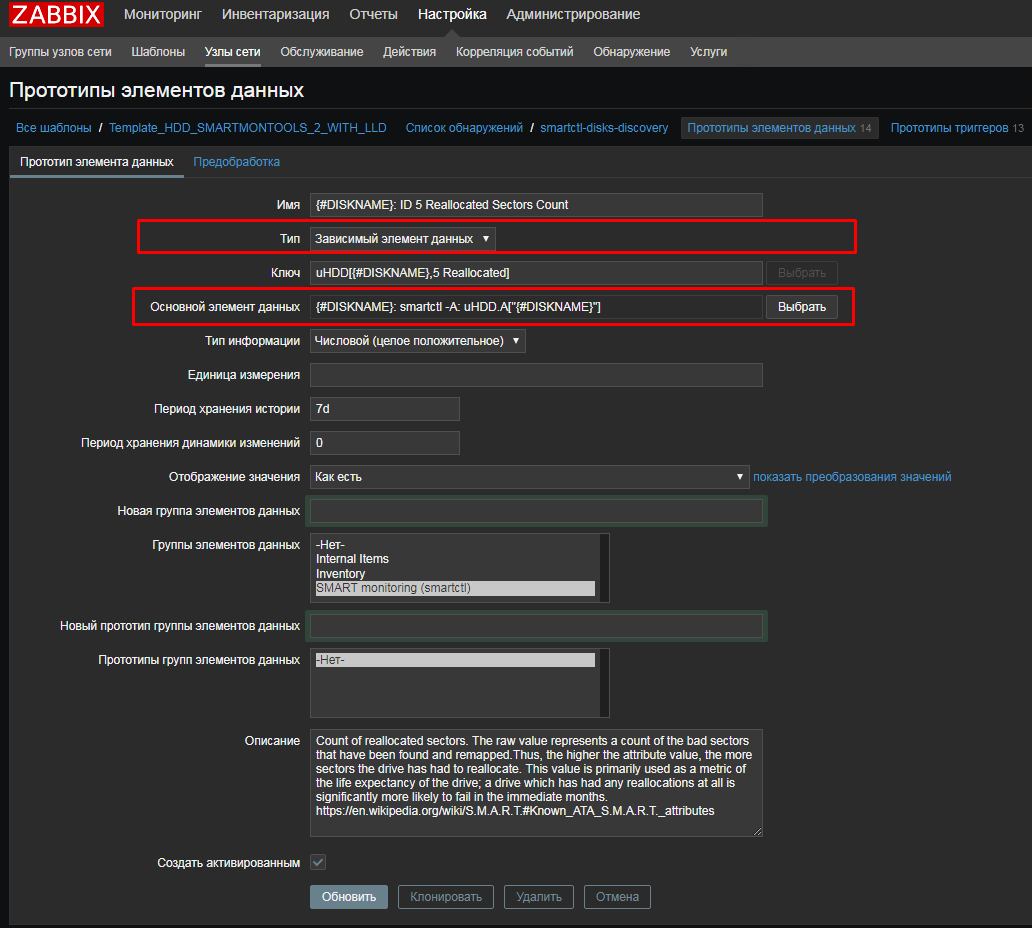

Создадим зависимый элемент данных для атрибута 5, Reallocated:

И во вкладке «Предобработка» используем регулярное выражение:

И так же как и с JSON Path, чтобы не тратить много времени на отладку и ловлю ошибок, перед тем как заполнять regex, удобно быстро проверить правильность выражения онлайн, например здесь: regex101.com скопировав туда наш вывод smartctl.

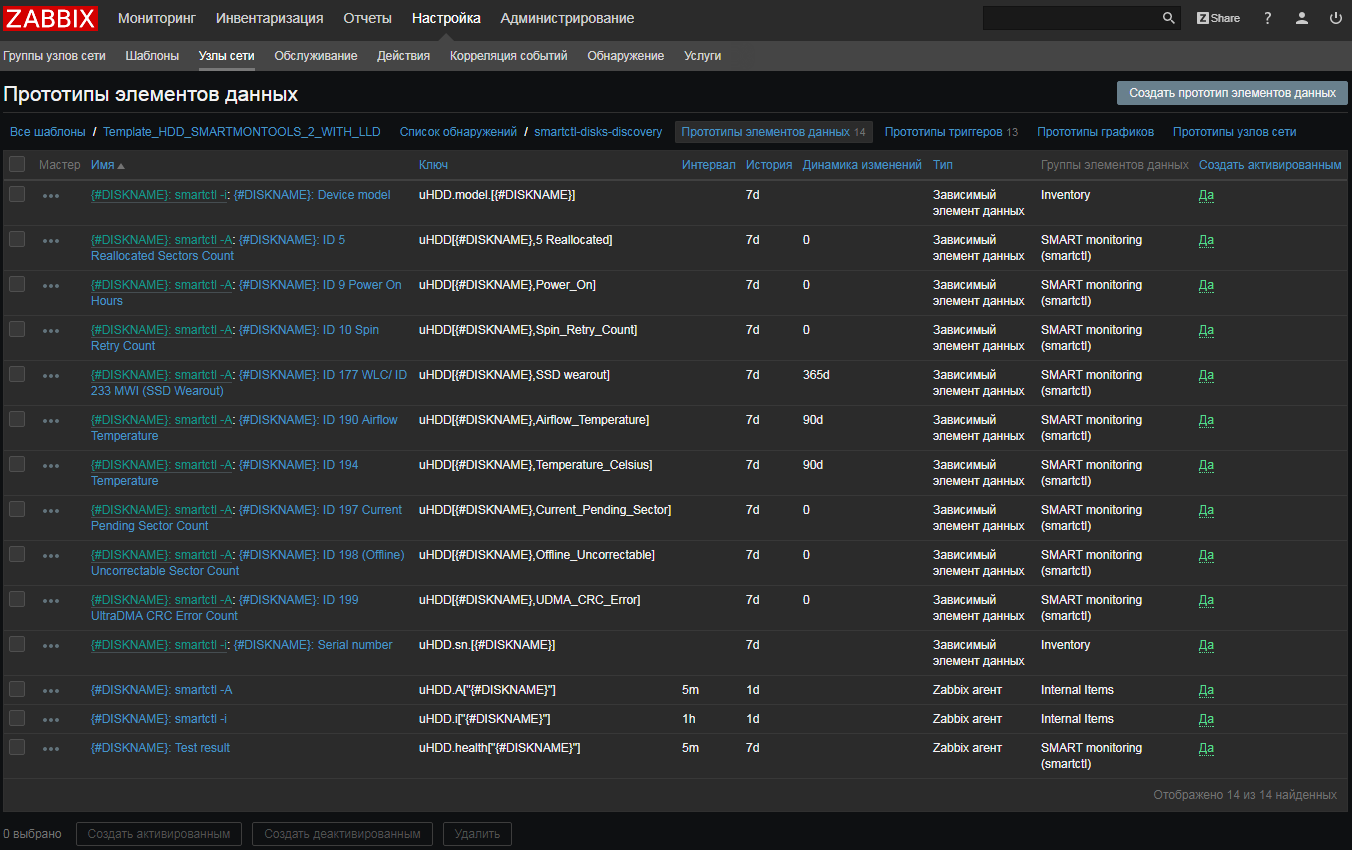

В итоге получим такой вот список прототипов:

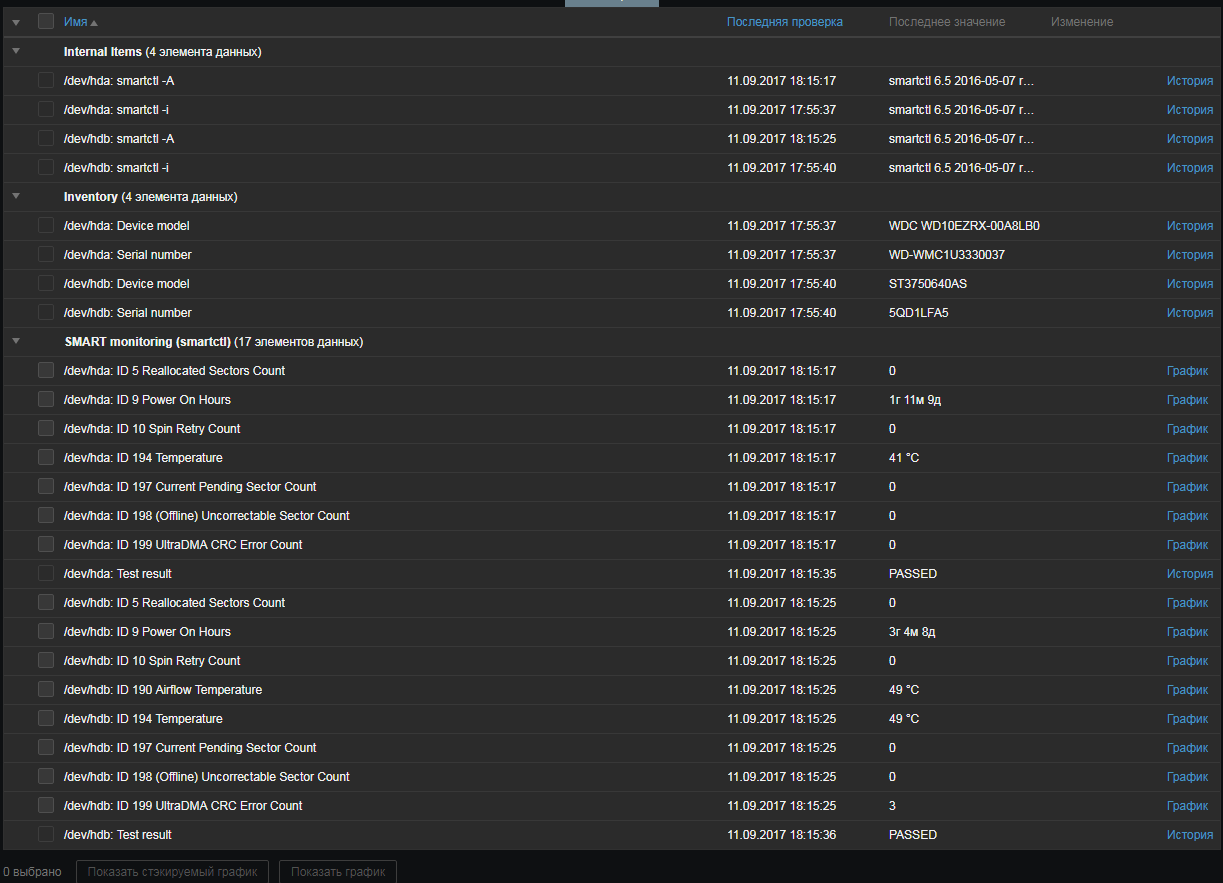

Тестируем, смотрим что получилось

Для двух HDD:

Для SSD под Windows:

Подведем итоги примера с smartmontools:

- мы убрали весь парсинг из UserParameters

- нет внешних скриптов (кроме LLD), нет внешних зависимостей, весь парсинг происходит на Zabbix-сервере, там его легко посмотреть и подправить, если нужно

- когда утилита или API не возвращает XML/JSON – не беда, всегда можно попробовать использовать регулярные выражения

- жесткие диски больше не мучаем – сначала достаем весь список параметров S.M.A.R.T., а затем уже на Zabbix-сервере раскладываем его по метрикам.

Обновленный шаблон (заодно обновили триггеры, добавили элементы данных для SSD) доступен на репозитории решений на share.zabbix.com здесь.

В завершении

Массовой сбор метрик – простой и легкий способ уменьшить нагрузку на сеть и на ресурсы наблюдаемых систем, а также снизить потребность во внешних скриптах. Уверены, что многим пользователям Zabbix он придется по душе.

|

Метки: author wabbit системное администрирование сетевые технологии серверное администрирование блог компании zabbix monitoring мониторинг меркурий230 smartmontools opensource |

LibGDX. Практические вопросы и ответы |

LibGDX. Практические вопросы и ответы

- Tutorial

Привет хабр!

Привет хабр!Закончился конкурс от ВКонтакте vk.com/wall-104669514_37 и мой 2-х недельный марафон в интернете по поиску нужной информации

Хочу поделится небольшим опытом работы с графическим движком LibGDX. В интернете полно примеров, но большинство далеки от практики (нарисованный спрайт это далеко еще не игра) или уже устарели.

Честно, мне он понравился, потому что легко интегрируется с android studio, написан на удобном мне языке, отлично выполняет свою графическую задачу.

Вопросы, которые мне приходилось решать:

import com.badlogic.gdx.Gdx;

public class GdxLog {

public static boolean DEBUG;

@SuppressWarnings("all")

public static void print(String tag, String message) {

if (DEBUG) {

Gdx.app.log(tag, message);

}

}

@SuppressWarnings("all")

public static void d(String tag, String message, Integer...values) {

if (DEBUG) {

Gdx.app.log(tag, String.format(message, values));

}

}

@SuppressWarnings("all")

public static void f(String tag, String message, Float...values) {

if (DEBUG) {

Gdx.app.log(tag, String.format(message.replaceAll("%f", "%.0f"), values));

}

}

}

//... вызов

GdxLog.d(TAG, "worldWidth: %d", worldWidth);

Плюс для удобства различные float значения 1.23456789 округляются

Gdx.app.postRunnable(new Runnable() {

@Override

public void run() {

// Здесь выполняется в самом потоке

}

});

Впринципе аналогично, как и в случае, view.postInvalidate()

Я не любитель анонимных классов, поэтому написал такой простой метод для сокращения кода (иначе он просто становился не читаемым). Хотя с java 8 это уже не такая проблема, но из дополнительных плюсов то, что обрабатываются InvocationTargetException, когда, например, файл не найден, приложение уже не упадет по такой незначительной ошибке.

// null may be only String params

public void postRunnable(final String name, final Object...params) {

Gdx.app.postRunnable(new Runnable() {

@Override

public void run() {

Method method = null;

Class[] classes = new Class[params.length];

for (int i = 0; i < params.length; i++) {

classes[i] = params[i] == null ? String.class : params[i].getClass();

}

try {

method = World.class.getMethod(name, classes);

} catch (SecurityException e) {

GdxLog.print(TAG, e.toString());

} catch (NoSuchMethodException e) {

GdxLog.print(TAG, e.toString());

}

if (method == null) {

return;

}

try {

method.invoke(WorldAdapter.this, params);

} catch (IllegalArgumentException e) {

GdxLog.print(TAG, e.toString());

} catch (IllegalAccessException e) {

GdxLog.print(TAG, e.toString());

} catch (InvocationTargetException e) {

GdxLog.print(TAG, e.toString());

}

}

});

}

Важно, чтобы параметры не были примитивами, а наследовали Object. И плюс здесь упрощение с null параметром (только от класса String)

Пример:

public class ActivityMain extends AppCompatActivity

implements AndroidFragmentApplication.Callbacks {

protected FragmentWorld fragmentWorld;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

// ...

getSupportFragmentManager()

.beginTransaction()

.add(R.id.world, fragmentWorld, FragmentWorld.class.getSimpleName())

.commitAllowingStateLoss();

}

@Override

public void exit() {}

И сам фрагмент:

public class FragmentWorld extends AndroidFragmentApplication {

public World world;

@Override

public View onCreateView(LayoutInflater inflater, ViewGroup container,

Bundle savedInstanceState) {

int worldWidth = getResources().getDimensionPixelSize(R.dimen.world_width);

int worldHeight = getResources().getDimensionPixelSize(R.dimen.world_height);

world = new World(BuildConfig.DEBUG, worldWidth, worldHeight);

return initializeForView(world);

}

}

Поэтому придумал такой лайфхак с OutputStream классом. Работает прекрасно и не требует медленных r/w операций

final Pixmap pixmap = getScreenshot();

Observable.fromCallable(new Callable () {

@Override

public Boolean call() throws Exception {

PixmapIO.PNG writer = new PixmapIO.PNG((int)(pixmap.getWidth() * pixmap.getHeight() * 1.5 f));

writer.setFlipY(false);

ByteArrayOutputStream output = new ByteArrayOutputStream();

try {

writer.write(output, pixmap);

} finally {

StreamUtils.closeQuietly(output);

writer.dispose();

pixmap.dispose();

}

byte[] bytes = output.toByteArray();

Bitmap bitmap = BitmapFactory.decodeByteArray(bytes, 0, bytes.length);

return true;

}

}).subscribeOn(Schedulers.io()).subscribe();

Соотвественно понадобился парсер:

protected Color parseColor(String hex) {

String s1 = hex.substring(0, 2);

int v1 = Integer.parseInt(s1, 16);

float f1 = 1 f * v1 / 255 f;

String s2 = hex.substring(2, 4);

int v2 = Integer.parseInt(s2, 16);

float f2 = 1 f * v2 / 255 f;

String s3 = hex.substring(4, 6);

int v3 = Integer.parseInt(s3, 16);

float f3 = 1 f * v3 / 255 f;

return new Color(f1, f2, f3, 1 f);

}

Пример параметра «ffffff»

Sticker sticker = (Sticker) stickersStage.hit(coordinates.x, coordinates.y, false);

@Override

public boolean pinch(Vector2 initialPointer1, Vector2 initialPointer2, Vector2 pointer1,

Vector2 pointer2) {

// initialPointer doesn't change

// all vectors contains device coordinates

Sticker sticker = getCurrentSticker();

if (sticker == null) {

return false;

}

Vector2 startVector = new Vector2(initialPointer1).sub(initialPointer2);

Vector2 currentVector = new Vector2(pointer1).sub(pointer2);

sticker.setScale(sticker.startScale * currentVector.len() / startVector.len());

float startAngle = (float) Math.toDegrees(Math.atan2(startVector.x, startVector.y));

float endAngle = (float) Math.toDegrees(Math.atan2(currentVector.x, currentVector.y));

sticker.setRotation(sticker.startRotation + endAngle - startAngle);

return false;

}

Единственно необходимо перед этим событием запоминать текущий зум и поворот

@Override

public boolean touchDown(float x, float y, int pointer, int button) {

if (pointer == FIRST_FINGER) {

Vector2 coordinates = stickersStage.screenToStageCoordinates(new Vector2(x, y));

Sticker sticker = (Sticker) stickersStage.hit(coordinates.x, coordinates.y, false);

if (sticker != null) {

// здесь

sticker.setPinchStarts();

currentSticker = sticker.index;

}

}

return false;

}

@Override

public void pinchStop() {

Sticker sticker = getCurrentSticker();

if (sticker != null) {

// здесь

sticker.setPinchStarts();

}

}

И на время события pinch актер неподвижен в этом случае

spriteBatch.begin();

stickersStage.act();

stickersStage.getRoot().draw(spriteBatch, 1);

spriteBatch.end();

gradientTopLeftColor = parseColor(topLeftColor);

gradientBottomRightColor = parseColor(bottomRightColor);

gradientBlendedColor = new Color(gradientTopLeftColor).add(gradientBottomRightColor);

@Override

public boolean pan(float x, float y, float deltaX, float deltaY) {

if (currentSticker != Sticker.INDEX_NONE) {

Sticker sticker = getCurrentSticker();

if (sticker != null) {

sticker.moveBy(deltaX * worldDensity, -deltaY * worldDensity);

}

}

return false;

}

worldDensity это разница между перемещением пальца в экранных координатах и актера в игровых. Без этого параметра актер будет отрываться от пальца

@Override

public void resize(int width, int height) {

if (height > width) {

worldDensity = 1f * worldWidth / width;

} else {

worldDensity = 1f * worldHeight / height;

}

viewport.update(width, height, true);

}

И если сделать привязку touch input через sticker.addListener, то поступающие координаты будут относительного самого актера к текущему положению пальца. Лучше так не делать, потому что при малом размере актера (зум) он задергается и вылетит из сцены (как было у меня)

public void onAppear() {

ScaleToAction scaleToAction = scaleToPool.obtain();

scaleToAction.setPool(scaleToPool);

scaleToAction.setScale(startScale);

scaleToAction.setDuration(ANIMATION_TIME_APPEAR);

addAction(scaleToAction);

}

Наверное все, что из интересного. Сам не нашел решение проблемы увеличения viewport. Камера zoom помогает только с приближением сцены, и получается, что сцена сокращается больше чем надо (область видимости неизменная).

Другой вопрос это сохранение рендера мира. На выходе он соотвествует размеру экрана, но мне нужен определенный размер. Пробовал с framebuffer, но не получилось вытащить с него pixmap (присутствуют какие-то баги с инициализацией класса Texture)

Еще недостаток в движке, что не позволяет, например, полностью отключить ввод с клавиатуры. Получалось так, что он перехватывал фокус с другого виджета (но он на это и не рассчитан собственно, хотя было бы неплохо. Go pull request, одним словом)

Но в целом, все очень даже хорошо. Развивайся дальше LibGDX)

Ссылка на проект: github.com/androidovshchik/VKAdvancedPosting

|

Метки: author mr-cpp разработка под android разработка игр libgdx android |

Первый суперкомпьютер DGX-1 на базе Tesla V100 применят в медицине |

Первый суперкомпьютер DGX-1 на базе Tesla V100 применят в медицине

/ Flickr / Fritzchens Fritz / PD

Платформу для дата-центров Tesla V100 представили в мае 2017 года. Она содержит 21,1 млрд транзисторов, построена по 12-нанометровому техпроцессу FinFET, а отдельные 640 ядер Tensor используются для обеспечения работы нейронных сетей, выдавая 120 терафлопс при глубоком обучении.

Nvidia провела апгрейд своей шины NVLink — теперь она «развивает» 300 Гбит/с, что почти в два раза больше по сравнению с предыдущей реализацией. Это стало возможно благодаря увеличению числа контактов с четырех до шести и расширению пропускной способности до 25 Гбит/с. Модуль 3D-памяти HBM2 также получил улучшения — пропускная способность выросла до 900 Гбит/с.

Центр клинических научных исследований занимается автоматизацией и машинным обучением в области здравоохранения. Они работают над нейронной сетью, которая анализирует данные об исследованиях заболеваний пациентов и в дальнейшем помогает быстрее ставить диагнозы.

«Врачи вынуждены иметь дело с огромным количеством информации: лабораторные исследования, МРТ, томография, данные о здоровье членов семьи и многое другое. Из-за этого принимать решения невероятно сложно. Технология, которая поможет врачам в диагностике, способна оптимизировать их работу», — рассказал исполнительный директор CCDS Марк Михалски (Mark Michalski).

Ожидается, что в будущем у рентгенологов появится ассистент с искусственным интеллектом, который будет помогать с диагнозами. Сейчас врачи изучают снимки в том порядке, в каком они были сделаны. А искусственный интеллект сможет сразу определить, какие из них наиболее проблемные, чтобы направить специалиста. Также, благодаря нейросетям, ассистенты смогут анализировать снимки буквально по пикселям, а затем сопоставлять их с другой информацией о пациентах и быстро ставить диагноз.

Еще на старом оборудовании исследователи разработали алгоритмы для кардиологической, офтальмологической, дерматологической и психиатрической диагностики. С использованием DGX-1 на базе видеопроцессоров Volta эти алгоритмы станут точнее и обретут более широкое применение.

Кто еще использует GPU

Все больше приложений поддерживают работу с GPU-вычислениями, включая фреймворки для разработки искусственного интеллекта. Поэтому многие дата-центры, которые имеют дело с глубоким обучением, работают одновременно с GPU и CPU — формат называется гетерогенными вычислениями. Таким образом, удается взять лучшее от обоих типов ядер: GPU справляется с ресурсоемкими математическими вычислениями, а CPU «берет» на себя работу операционной системы и многочисленные простые операции.

Согласно исследованию ученых Калифорнийского университета, по сравнению с дата-центрами с вычислительными ядрами одного типа, у гетерогенных на 21% выше производительность и на 23% — энергоэффективность.

Использует мощности GPU в своих системах искусственного интеллекта и машинного обучения компания Facebook. Соответствующая лаборатория внутри компании разрабатывает нейронные сети для решения специфических задач.

По словам экспертов области, объемы данных, которые собирают компании, увеличиваются. Поэтому GPU начинают применяться не только для работы с ресурсоемкими вычислениями для обучения нейросетей. Но и для работы с базами данных.

Например, Nike использует серверы с GPU и ПО MapD для анализа истории продаж и предсказания спроса в отдельных регионах. Еще один клиент MapD — Verizon — использует системы с GPU для анализа логов серверов, отслеживающих мобильные телефоны.

Предлагают работу с серверами с GPU-ускорением и облачные провайдеры. В том числе и компания «ИТ-ГРАД». Решение позволяет экспериментировать с аналитическими или требующими визуальной поддержки проектами. GPU-системы дают организациям возможность быстро анализировать большие своды данных и в некоторых частных ситуациях способны заменить целые кластеры серверов.

P.S. Несколько материалов по теме из нашего блога:

|

Метки: author it_man высокая производительность блог компании ит-град ит-град dgx-1 nvidia нейросети |

Есть ли OpenVPN GUI для Linux? |

Есть ли OpenVPN GUI для Linux?

После запуска утилиты VpnGUI в трее появится иконка (квадрат разбитый на четыре сине-красных квадратика) утилиты:

Трей имеет меню, которое появляется при нажатии правой клавиши мышки, когда курсор мышки находится на трее утилиты VPNGui. Меню имеет два пункта – Restore (развернуть окна) и Stop (завершить работу ). После выбора пункта меню «Restore» на экране появится главное окно утилиты VPNGui:

Разработка велась на python с использованием графического пакета Tkinter и дизайнера Page.

Напомним, что для использования «великого, могучего, правдивого и свободного русского языка!» (И.С. Тургенев), необходимо добавить в файл файл gui_pyton_gen.tcl дизайнера Page после 418 строки следующий код:

# -*- coding: utf-8 -*- Аналогичный код необходимо дабавить также в файл support_python_gen.tcl (после 458 строки).

Для программирования трея был установлен пакет Pystray.

Работа утилиты начинается с выбора пользователем выполняемого файла openvpn или его форков. Утилита проверяет наличие выполняемого файла и заполняет списки перечнем поддерживаемых mac (алгоритмя контроля целостности), ciphers (алгоритмы шифрования) и перечнем поддерживаемых шифрсьютов:

# openvpn –show-digests

…

#openvpn –show-ciphers

…

#openvpn –show-tls

…

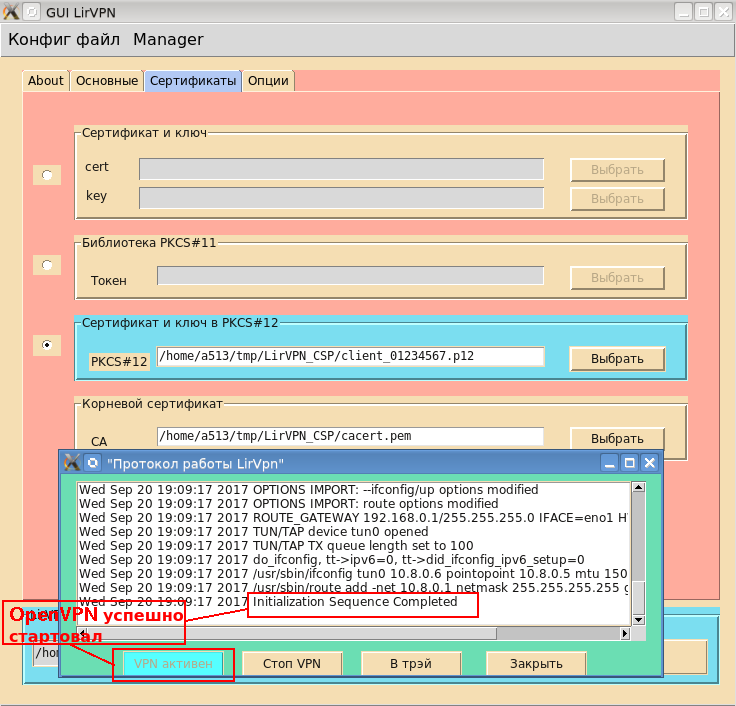

Теперь можно приступать к работе с конфигурационным файлом. Пользователь может создать новый файл или отредактировать существующий, предварительно загрузив его (см. скриншот). После того как файл загружен или новый файл сохранен, пользователь может запустить openvpn:

После ввода пароля в окне «Протокол работы» будут отображаться диагностические сообщения OpenVPN:

До тех пор пока openvpn нормально работает книопка «VPN активен» будет блокирована. Если openvpn по каким-то причинам завершит свою работу или будет остановлен пользователем (кнопка «Стоп VPN»), то кнопка разблокируется и снова станет кнопкой «Старт VPN».

Отметим, что для выпуска клиентских и серверных сертификатов для OpenVPN удобно использовать центр сертификации XCA:

Теперь, когда openvpn нормально работает, можно его убрать в трей. Для этого можно использовать как кнопку «В трей» на окне «Протокол работы» или меню главного окна (Manager->Убрать в трей):

Утилита плафтормонезависима. Бинарный код утилиты можно получить, используя пакет Nuitka. Проект утилиты VPNGui, ее исходный код на Python, а также бинарный код для Linux x86_64 можно получить здесь. Имея на руках проект, каждый может доработать утилиту по своему усмотрению.

|

|

[Перевод] Kotlin в продакшене, что мы получили, и что мы потеряли? |

Kotlin в продакшене, что мы получили, и что мы потеряли?

- Перевод

С того времени, как Google сделал Koltin новой любимой женой уже прошло достаточно времени. И сразу же после этого объявления наша команда начала новый проект полностью на Котлине. Проясню: не тестовый или просто внутренний проект, а новый модуль для живого приложения с 600+ тысячами активных пользователей в месяц. Какой опыт мы из этого извлекли? Что мы выиграли и что потеряли?

С того времени, как Google сделал Koltin новой любимой женой уже прошло достаточно времени. И сразу же после этого объявления наша команда начала новый проект полностью на Котлине. Проясню: не тестовый или просто внутренний проект, а новый модуль для живого приложения с 600+ тысячами активных пользователей в месяц. Какой опыт мы из этого извлекли? Что мы выиграли и что потеряли?Для начала, я не буду повторять обещания JetBrains на счет времени сборки, полноценного взаимодействия с Джавой и производительности. Это правда, что Котлин код практически так же быстр, и что оверхед не превышает размера типичной PNG картинки из ресурсов. Но зачем нам вообще нужен Котлин, и в чем все-таки разница?

Фан-фактор

Очевидно, Котлин надо сначала выучить. Даже несмотря на то, что кривая обучения не выглядит как гора К2, плоской она тоже не является: один из коллег заметил, что на выполнение задач на Котлине у него уходило примерно в два раза больше времени, тем не менее, никто ни разу не пожаловался. Наоборот, все были только рады возможности применить новую крутую игрушку со всеми ее свистелками в продакшене. Более того, для привлечения лучших кандидатов мы стали не сговариваясь упоминать в ходе интервью, что пишем на Котлине. Так что чистая победа в этой категории +100 очков Котлину.

Скорость

Работа с новым языком это не только изучение его синтаксиса, это — совокупность написания, чтения, рефакторинга, тестирования и т.д. Остановимся на этом немного детальнее.

Скорость написания

В среднем на то, чтобы почувствовать себя более-менее комфортно с Котлином ушло около двух недель. И еще примерно две недели понадобилось, чтобы начать писать на нем быстрее чем на Джаве. Тем, у кого был опыт Scala и Groovy было проще, так как авторы Котлина во многом вдохновлялись ими. Поддержка со стороны IDE все еще не идеальна: много удобных и привычных по Джаве рефакторингов и автоподстановок просто не работают сейчас. Но даже несмотря на эту проблему, в итоге мы все равно немного в плюсе по скорости. Слабая победа Котлина в этой категории, впрочем мы ждем большего от финальной версии Android Studio 3.0 (на момент написания статьи мы все еще пользовались бетой).

Скорость чтения

Хоть код на Котлине и получается ощутимо короче, разбирать пулл-реквесты на ГитХабе приходится дольше. Почему так? Во-первых, ни Google ни JetBrains не подготовили полноценный стайл-гайд, так что члены команды стали проводить больше времени за дискуссиями на тему «красоты». Даже официальные примера кода не во всем однородны. Во-вторых, некоторые новые (для Джавы) конструкции могут быть использованы во вред, в то время как на Джаве так написать попросту не получится. Итого: небольшой но все же проигрыш на этом направлении, хотя, опять же, мы ожидаем улучшений в ближайшем будущем, потому что по поводу 99% спорных кейсов уже пришли к согласию.

Инструменты и библиотеки

Страшная правда в том, что Checkstyle и Lint пока еще абсолютно бесполезны для Котлина, а мы их используем и активно, но тот же Dagger работает отлично. А еще мы получили Kotlin-X и собираемся втянуть в проект Anko. Тут опять проигрыш Котлина, и хоть Anko с Kotlin-X могут подсластить пилюлю, мы особо не ожидаем драматических улучшений в работе стайлчекеров в ближайшее время.

Тестирование

А вот тут мы неожиданно получили преимущество. С Котлином не поставляется никаких новых инструментов или библиотек для тестирования, но новые языковые фичи, особенно type inference, extensions, и reified-типы существенно сократили количество бойлерплейта в тестовых классах. Чистая победа тут, даже несмотря на то, что IDE иногда пытается запустить Espresso как будто это чистые JVM юнит-тесты и, очевидно, не справляется с задачей.

Саморазвитие

Новый язык программирования это не только куча новых ключевых слов, это — новые способы переписать давно знакомые паттерны, это — немного новых парадигм и, иногда, новых способов думать и выражать мысли в коде. Изучая Котлин, мы не только научились писать на другом языке, мы поняли как можно сделать лучше части кода на старом. И мы совершенно точно вытолкнули себя за границы зоны комфорта, что, если честно, тоже своего рода фан-фактор, но фан-фактор стоящий!

П.С. Изначально статья была написана на английском для корпоративного блога, но я решил, что она должна существовать и на русском языке, так что «совпадение» имен авторов не случайно.

|

Метки: author fo2rist разработка под android android android development kotlin |

35 Гбит/с — как Megafon и Huawei поставили рекорд скорости 5G |

35 Гбит/с — как Megafon и Huawei поставили рекорд скорости 5G

Приближаемся к стандарту 5G — агрегация и рефарминг

Внедрение следующего поколения мобильной связи ожидается в 2020 году (это полностью согласуется с оценкой «новая технология мобильной связи каждые 10 лет»). По мере приближения к «часу Х» стандарт 5G приобретает все более явные очертания. Одновременно операторы и производители оборудования экспериментируют с частотами и каналами связи, определяя направление дальнейшего движения. Насколько успешны эти эксперименты, показывают скорости передачи данных, демонстрируемые в рамках очередных испытаний.

Около года назад «МегаФон» вместе с Huawei демонстрировали скорость передачи данных в 1 Гбит/сек. Такой результат удалось получить за счет передачи данных на нескольких частотах одновременно (использования трех несущих), что, в свою очередь, стало возможно, благодаря рефармингу — использованию частот, которые изначально предназначались для другой технологии.

Рефарминг — неизбежное явление в ходе эволюции стандартов связи, поскольку частотный диапазон уже давно расписан между потребителями. С технической точки зрения рефарминг позволяет оптимизировать использование спектра: с развитием технологий появляется возможность «впихнуть» в одну и ту же полосу частот гораздо больше данных (достаточно сравнить GSM, 2G и последующие стандарты). В некоторых странах рефарминг может упираться в законодательные ограничения, поскольку при выделении частот фиксируется не только ее основной пользователь, но и стандарт связи, который будет на этой частоте использоваться. В России же для ряда диапазонов, переданных под мобильную связь, уже принят принцип технологической нейтральности, означающий, что в диапазоне можно использовать любое поколение стандарта связи.

В рамках упомянутого эксперимента Megafon и Huawei была задействована частота в 1800 МГц, которая ранее использовалась для сетей GSM.

Новый эксперимент — бимформинг

Однако эксперименты продолжаются. Решение, продемонстрированное в этом году на Петербургском экономическом форуме, вместо агрегации частот из разных диапазонов использует для связи прототипа базовой станции и абонентского терминала одну, но очень широкую полосу частот — 2 ГГц — в диапазоне 70 ГГц (это одна из возможных частот будущего стандарта 5G). В ходе тестирования удалось достичь скорости передачи данных в 35 Гб/сек, что является абсолютным рекордом для мобильной передачи данных.

Хотя на данном этапе речь шла о тестировании беспроводной связи между стационарным прототипом базовой станцией и условно-стационарным прототипом абонентского устройства (оно было установлено на стенде Мегафона и никуда не перемешалось), в процессе разработки приходится учитывать мобильность абонентов. Для этого в пятом поколении предусмотрен бимформинг — динамическое изменение диаграммы направленности фазированной антенной решетки в направлении наибольшего скопления абонентских терминалов. Мегафон в двух словах рассказал об особенностях этой технологии.

Если не вдаваться в технические детали, бимформинг требует создания сложной антенны, но позволяет отчасти исправить ситуацию «в толпе не работает связь» — базовая станция просто перестроит диаграмму направленности, чтобы лучше покрыть то направление, в котором находится больше устройств.

В эксперименте Мегафона толпы с абонентскими устройствами не было, был просто один излучатель и сложной формы антенна, которая формирует несколько пучков — два параллельных и один под углом. Да, сиреневая пластина с логотипом компании на полу — не часть дизайна, это отражатель для радиоволн:

Ничего сверхъестественного в ней, это просто пластина из стали:

Передача велась в режиме TDD — двусторонней связи с временным разделением сигналов приемника и передатчика.

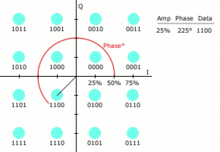

В двух словах о QAM

Как упоминалось выше, новые стандарты позволяют при прочих равных передавать больше информации. Возможно это в том числе благодаря развитию вычислительных мощностей мобильных устройств, что позволяет использовать более хитрую модуляцию. В эксперименте Мегафона и Huawei использовалась квадратурная модуляция 64-QAM.

Упрощенно QAM — это способ передать за один «такт» несколько байт данных. Достигается это, во-первых, за счет того, что меняется не только уровень сигнала, но еще и его фаза. А во-вторых, амплитуда и фаза сигнала имеют несколько уровней. Проще всего это можно показать на вот такой гифке:

Мы видим 16 состояний, полученных комбинацией разных сдвигов фаз и амплитуд сигнала. В них можно уложить все возможные комбинации 4 бит, поэтому за одно состояние сигнала мы можем передать сразу 4 бита.

Картинка иллюстрирует 16-QAM, но в 64-QAM все тоже самое, просто возможных состояний больше — 64, а значит, мы можем передать уже не 4, а 6 бит.

Ложка дегтя

Стоит отметить, что высокая частота несущей, хоть и позволяет передавать большой объем данных, очень легко заглушается любыми предметами на пути.

Достаточно поднести руку к излучателю и скорость на графике тут же падает. Одновременно мы видим, как начинает рассыпаться сигнальное созвездие — аналог глазковых диаграмм для 64-QAM (ну, строго говоря, не только для нее):

Сигнальное созвездие позволяет видеть «качество» передачи и одновременно замечать некоторые проблемы (подробнее можно посмотреть вот тут)

Когда 5G попробуют абоненты?

Тестовые зоны 5G «МегаФон» намерен развернуть уже в следующем году во время чемпионата мира по футболу. По сложившейся традиции новые стандарты мобильной связи тестируются во время крупных международных мероприятий.

|

Метки: author MegaFon стандарты связи беспроводные технологии блог компании «мегафон» 5g связь интернет |

Байки поддержки первой линии: отличная работа, если у вас крепкие нервы |

Байки поддержки первой линии: отличная работа, если у вас крепкие нервы

Мы поддерживаем офис одной сервисной компании и хотели бы немного рассказать про нашу работу. Для поднятия настроения, так сказать. В общем-то, наш день выглядит одинаково: приходим, логинимся в cisco agent, садимся за телефон и начинаем слушать хотелки юзеров. Что-то разруливаем сами, что-то передаём второй линии рядом. Несмотря на то, что офис заказчика состоит преимущественно из инженеров, тикеты не очень сильно отличаются от тикетов нефтегазовой компании или госкомпании. Конечно, без того, чтобы проехать 200 километров, чтобы включить принтер в розетку (реальный случай), но всё же.

Хотя, например, эта разница очень сильно проявилась, когда безопасники в очередной раз дали задачу пройтись по кабинетам и посмотреть, кто хранит записанные пароли на рабочих местах. Поначалу без сюрпризов — где-то каждый тридцатый записывает и клеит на монитор. Проблема была в том, что если в бухгалтерии это верные пароли («А откуда шпион узнает, что это пароль, а?»), то ушлые инженеры специально записывают какие-то случайные комбинации символов. Видимо, прикалываются над безопасниками.

Разумеется, техэксперты и техмены, обитающие в офисе, по большинству решают проблемы самостоятельно (ну или ставят очень понятные тикеты, где всё делается в пару кликов). Но есть ещё и различные «дополнительные службы», типа: столовая или спортзал. Некоторые из них вообще иногда доставляют нам море радости своими тикетами с просьбой установить World of Tanks на компьютер. Или: «Я слышу людей в мониторе, а меня никто не слышит!»

Но бывают и ситуации, когда обычные пользователи выдают что-нибудь неординарное. Например, мне особенно запомнился звонок с паникой про то, что окно не закрывается, а надо срочно. Удалённое соединение не прокинули. Ну ладно, наверное, личный ноутбук, что-то заглючило, пользователю срочно нужно. Мы отправили эникея. Оказалось, что там осталась девушка одна в большом кабинете, и она не могла дотянуться до ручки окна. А дул сильный ветер.

Пару раз выталкивали машины с парковки, один раз помогали качать колесо. Почему? Потому что к нам стучат тогда, когда не знают, к кому обращаться. Мы же поддержка. Мы всегда поможем. В ITSM рабочие часы на такие вещи списываются по графе «неподдерживаемый сервис» — раньше это были всякие штуки с прикладным ПО, которые не входят в наш SLA, а теперь по большей части — как раз вот эти вот странные запросы. Нет, конечно, мы их фильтруем, но всё равно иногда так или иначе делаем. Пользователю же очень сложно объяснить, что к нам, а что — нет. Самый яркий пример — когда человек не получает бутерброд в автомате на этаже, но не может вернуть деньги, он сначала бьёт автомат, а потом пишет тикет нам.

Естественно, всем всё нужно вчера — но это, думаю, данность у каждой первой линии.

Иногда бывают дни ада — это когда у пользователей приходит время плановой смены паролей. За такой день может поступить 70–80 звонков на сотрудника: всем нужно войти в учётки. Это ещё не считая обычных проблем вроде кончившегося тонера или сломавшегося блока питания.

Очень мало проблем с вирусами — в компании стоят хорошие NGFW и песочницы, поэтому все эпидемии проходят мимо. Единственное — опять же личные устройства. У подкованных они защищены, а вот та же охрана страдает. У меня был тикет про сходящего с ума охранника, который кликал на видео про Госдуму, а попадал на порнуху. На месте оказалось, что он смотрел какой-то отличный сайт, где блоки Ютуба были только нарисованы, а на деле это были IMG с реферальной ссылкой на порносайт. Психику человеку я тогда спас.

Ещё один человек чуть не снёс крышу нашему инженеру. Тикет такой: когда он копирует и вставляет логин и пароль, зайти получается. Когда вводит руками — нет. Искали долго. Потом почти случайно посмотрели в кодировщике — у него О в логине была русская, а не латинская, как все остальные. Кто и как это сделал — непонятно.

Часто к нам приносят личные ноутбуки на починку — перезалить после падения системы, что-то переставить и так далее. Поскольку пользователи всё равно на них в офисе работают, мы помогаем (полуофициально, опять же — «неподдерживаемый сервис»). Пользователи иногда благодарят. Опять же, если от девушек обычно бывают конфеты и тортики, то охрана всегда чётко и конкретно проставляется пивом. Одним и тем же. Как часы. Такое ощущение, что у них там внутренняя инструкция, сколько пива и за что давать.

Из-за автогенерации логинов «первая буква имени — фамилия» часто страдают невинные люди. Тикеты отличные — меньше всего везёт Евгениям. Хорошо хоть с фамилией Банный у нас никого нет. Тут мы выступаем в роли психологической поддержки и знакомим пользователя с каталогом на примерно сотню таких прекрасных логинов действующих сотрудников. Он понимает, что не одинок, и немного успокаивается.

Один раз девушку из бухгалтерии безопасники до того запугали, что она писала специальный тикет, чтобы мы подвинули монитор на столе на 11 сантиметров влево. Кстати, с мониторами частый вопрос от бухгалтерии при замене — это сохранятся ли ярлыки. Успокаиваем. Сохранятся.

Один раз просили включить Sony PlayStation4, причём в рамках поддерживаемого сервиса. Смотрим — он и правда поддерживаемый, теперь в комнате отдыха одна стоит.

Постоянно к нам стучат люди, которые застряли где-то в лифте (необязательно в офисе), когда есть проблемы с кондиционерами. Был однажды тикет «у нас тут репетиция в спортзале — нужны парни потанцевать».

Жалобы на отсутствие электричества — к нам. Экран надо поменять в корпоративном автобусе — к нам. Однажды сотрудник пошёл на балкон смотреть кабель и случайно закрылся. Позвонил на общую линию, пришлось писать как тикет. В общем, иногда отличаемся умом и сообразительностью.

Однажды связисты пожаловались на плохой приём вай-фая в кабинете. Повесили им новую точку доступа прямо внутри. Они взяли ноутбуки и пошли работать в столовую. На следующий день они притащили какой-то чемодан со склада, промерили везде поле, успокоились.

Есть забавные ситуации, когда люди не разлогиниваются, и их коллеги начинают писать дикие тикеты от их имени. «Приготовьте мне кофе» — это ещё самое простое. Один раз пользователь хотел научиться играть в настольный теннис, а у нас этажом выше как раз спортзал со столом для него. Ну и смотрим — тикет такой поставил. Потому что решил не звонить, видимо.