Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Прорыв на рынке автоматизации процессов управления бизнесом |

Роман Чёсов: «Да, мы создали интеллектуальную платформу Flexbby Parametric, на базе которой мы можем предлагать заказчику невозможное – с нашими приложениями можно работать «вечно».

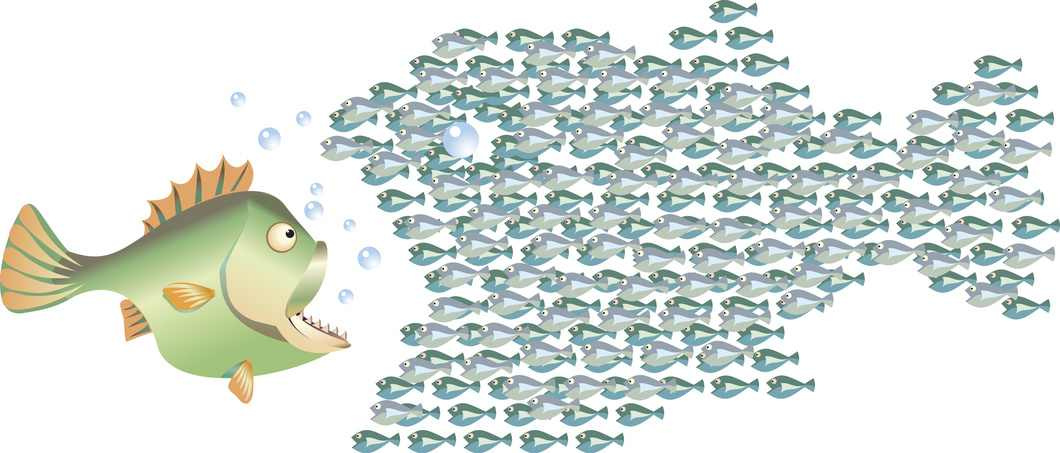

На российском ИТ-рынке большое разнообразие продуктов по автоматизации бизнеса от разработчиков как российских, так международных. Конференции, бизнес-завтраки, выставки — на любой вкус. Интернет пестрит баннерами: бесплатный CRM, прокачай воронку продаж, внедрение электронного документооборота. Реально ли выйти сейчас с новым брендом на рынок приложений по управлению процессами?

Роман Чёсов, директор по развитию компании «Флексби Солюшнс»: «Непросто пробиться сквозь информационный фон рекламы, и, конечно, многие компании имеют задел – наработали репутацию, раскрутили свой бренд. Международные компании пришли на рынок с опытом развития на других рынках, с бюджетами, именем. Предложений на рынке много, но это иллюзия, что рынок насыщен. В 2016 году наша компания начала выводить прорывную технологию в области разработки приложений по автоматизации бизнес процессов. Сейчас все более и более актуальным становится автоматизация сквозных процессов, которые раньше автоматизировались с помощью нескольких систем и внесистемных процессов, основанных на работе с «файлами по почте». Мы пионеры, создатели нового подхода к автоматизации процессов за счет параметризации бизнес логики и объектов. Это новая ниша на рынке программного обеспечения для бизнеса».

Разве можно конкурировать с акулами на этом рынке? Вы можете предложить что-то, что нет у них?

Роман Чёсов: «Да, мы создали интеллектуальную платформу Flexbby Parametric, на базе которой мы можем предлагать заказчику невозможное – с нашими приложениями можно работать «вечно».

Все компании говорят о гибкости, быстроте внесений изменений.

Роман Чёсов: «Все разработчики могут по запросу заказчика вносить изменения в программу. Но на это уходит много времени, и чем больше процессов, которые изменяются, тем дольше и дороже эта процедура. И затем программа превращается в громоздкую, и все сложнее ее дорабатывать. Наше решение снимает эту проблему: бизнес процессы прописываются не в виде «дерева», а выстраиваются как сеть, и в любой момент могут создаваться новые связи, меняться конфигурация бизнес логики. И это не требует дополнительных инвестиций в доработку программного кода.

А почему это не могут сделать другие разработчики?

Роман Чёсов: У нас есть ноу-хау – слой параметризации в нашей платформе Flexbby Parametric.

Название платформы отражает суть наших технологических возможностей – мы создаем приложения с высоким уровнем кастомизации. Параметризация существенно облегчает и ускоряет модификацию приложения под нужды компании, и позволяет приложению развиваться буквально вместе с компанией. Система настраивается и донастраивается без программирования.

Имеет ли ваша компания отраслевую специализацию, и какой уже опыт внедрения вашей технологии?

Роман Чёсов: Мы работаем с компаниями любой индустрии. Но мы работаем с крупными проектами, где пользоваться системой будут 50 пользователей и больше. Именно для крупных компаний, сложных процессов жизненно необходимо автоматизировать процессы управления по самым совершенным технологиям.

http://flexbby.com

|

Метки: author Flexbby блог компании flexbby flexbby parametric автоматизация бизнеса bpm crm time management масштабирование приложений инновации в it инновационные решения |

[Перевод] Надёжность Go в инфраструктуре Dropbox |

Как Dropbox пришёл к использованию Go

Тэмми цитирует статью Роба Пайка «Go в компании Google: языковой дизайн в службе разработки ПО» от 2012 года, поскольку она в целом хорошо передаёт, почему Go хорошо работает и в Dropbox:

«Go — эффективный, масштабируемый и производительный язык. Некоторые программисты получают удовольствие от работы с ним; другие находят его прозаическим, даже скучным. В этой статье мы расскажем, почему все эти позиции не противоречат друг другу. Go спроектирован для решения проблем, возникающих в софтверной разработке в Google, что привело к созданию языка, который не является прорывным с исследовательской точки зрения, тем не менее это прекрасный инструмент для разработки крупных софтверных проектов». — Роб Пайк, 2012

Масштаб Dropbox впечатляет:

- Более 500 млн пользователей

- 200 000 бизнес-пользователей

- 500 петабайт пользовательских данных

- Многоэкзабайтная система хранения Go

В результате, Dropbox многое требует от своих систем, языков и разработчиков. Ведущие принципы и требования следующие:

- Создавать надёжные системы

- Создавать безопасные системы

- Объединять надёжность и безопасность в изначальной архитектуре

- Надёжность 99,9999999999% (двенадцать девяток)

- Доступность 99,99%

Состояние Go в Dropbox

Сегодня б'oльшая часть инфраструктуры Dropbox написана на Go. В частности:

- У сервера репозиториев Go — 150 уникальных контрибуторов (из 500 разработчиков в компании)

- Более 15 групп создают и поддерживают работу сервисов Go в Dropbox

- По всей компании в Dropbox написано 1,3 млн строк на Go

некоторые из ключевых систем, написанных на Go:

- RAT: ограничение скорости и дросселирование (приглушение) трафика

- HAT: замена memcached

- AFS: файловая система для замены глобального Zookeeper

- Edgestore: распределённая база данных

- Bolt: для сообщений

- DBmanager: для автоматизации и мониторинга более 6000 баз данных Dropbox

- Jetstream, Telescope, маршрутизация блоков и многое другое

Многие из них представляют собой преемников предыдущих систем не на Go.

Как Dropbox начал использовать Go?

Тэмми поделилась несколькими историями, как Dropbox естественным путём перешёл на Go.

Прототип ограничителя скорости на Go с хакерской недели

До хакерской недели, которая случилась однажды, разработчики Dropbox внедряли ограничение скорости и дросселирование отдельно для каждого сервиса, где требовалось. Но для этой хакерской недели один инженер Dropbox решил создать единую реализацию этих функций. Так родился RAT (Rate limiting And Throttling).

Первый прототип RAT был создан за четыре дня и показан на пятый. В течение нескольких недель после создания RAT информация о нём распространилась по фирме. Другой инженер Dropbox написал в группу Тэмми предложение посмотреть, как они могут использовать RAT из проекта Python. Интеграция прошла плавно, сервис был принят естественным путём — и вскоре RAT начал приносить пользу. Теперь несколько команд в Dropbox используют RAT.

Dbmanager

В Dropbox более 6000 баз данных, и такая большая система требует автоматизации и мониторинга. В любой данный момент времени проходит репликация баз данных, сбои, перенос из обычной реплики в основную и т. д.

Для управления этим процессом инженер Dropbox разработал Dbmanager — UI в вебе для быстрого просмотра состояния всех более чем 6000 баз данных. Информация о статусе также передаётся в другие системы.

Обновление версий Go в Dropbox

Имея сотни разработчиков, Dropbox аккуратно координирует обновление основных версий Go. Тэмми не упомянула о каких-то определённых проблемах, что указывает на плавный процесс!

Некоторые интересные факты:

- Dropbox недавно закончил миграцию сервисов продакшна с Go 1.5 на 1.6.

- Для отслеживания процесса обновления они создали простой документ Dropbox Paper, где владелец каждого сервиса отчитывается о прогрессе и запрашивает помощь при необходимости.

- Dropbox пропускает версию Go 1.7 и сразу перейдёт на Go 1.8, когда миграция на Go 1.6 полностью завершится (включая сервисы не в продакшне).

Как инженеры Dropbox осваивают Go

Каждый инженер Dropbox проходит через один и тот же строгий процесс освоения Go, который состоит из следующих этапов:

- Чтение инфраструктурной топологии, руководства по стилю Go и руководства по стилю Protobuf

- Строгие, но дружелюбные анализы кода

- Создание маленького приложения (в App Store) на Go

- Изучение Bazel для сборки и тестирования кода Go

Для опытного программиста процесс занимает около недели.

Что прошло гладко с внедрением Go в компании Dropbox? А что нет?

В целом, использование Go в Dropbox’s было очень удачным.

- На Go легко показать высокую производительность труда.

- На Go легко писать и использовать сервисы. (И людям нравится и то, и другое!)

- Стандартная библиотека очень хороша.

- Инструменты отладки (в основном!) работают хорошо.

Здесь один из важных фактов состоит в том, что в Dropbox нет попыток переписать сервисы Go на других языках. Это знак, что люди в целом довольны. (Тэмми выдала интригующую деталь: в Dropbox немного используют Rust. Но его не считают заменой для Go).

Что сложного Dropbox нашёл в Go?

Наибольшей сложностью Тэмми назвала работу с состоянием гонки.

- Состояние гонки данных — самый трудный баг для отладки, для обнаружения, исправления и т. д.

- Несколько инженеров Dropbox особенно хороши в обнаружении таких багов, а остальные опираются на их опыт.

- Детектор состояния гонки в Go не всегда помогает. Нужно понимать, когда он беспомощен.

- Важно аккуратно проектировать программы Go, если требуется одновременный доступ к данным.

Dropbox набирает инженеров, которые заботятся о надёжности и долговечности данных, так что им это было легко понять (хотя одновременный доступ постоянно и везде труден).

|

Метки: author m1rko разработка веб-сайтов высокая производительность go dropbox bazel rust состояние гонки |

NeoDelphi`низм |

Оглавление

- Предпосылки

- Основная концепция

- Субъекты, объекты и душа

- Мироустройство

- API

Предпосылки

Сказ о том, как программирование влияет на мировоззрение.

Основой создания NeoDelphi`низм послужил Delphi`низм, основателем которого является Евгений Гусев. Он изъявил следующую проблему:

Тип чтоооо будет, если челик коснётся провода, по которому 220В + 880А идёт?

Евгений Гусев

И тут возникла идея о том, что в этот момент прикосновения (человек умрёт) освободиться память, как в огромном компьютере. Соответственно подумав над этой проблемой и появилась идея создать течение NeoDelphi`низм.

Немного из Delphi`ного писания:

Кстати

Я не основатель

Я бог

А ты тип библию написал

Моисей короч ты

TDelphi Act 0

И ш

Ты написал то библию уже?

TDelphi Act 1

Основная концепция

Как уже упоминалось ранее, всё вертится вокруг выделения и освобождения памяти.

Таким образом можно объяснить тот факт, почему мы не помним ничего из прошлых наших жизней, если таковые и были.

Отсюда можно ввести новое понятие ЖЦЧЖ:

Жизненный цикл человеческой жизни (ЖЦЧЖ) — это процесс, длящийся во времени, от самого создания (выделения памяти) субъекта типа человека, до уничтожения (освобождения) субъекта типа человек. Понятие субъекта описывается в следующем разделе.

Возникают следующие основные вопросы:

- Откуда выделяется память?

- Кто ответственен за освобождение памяти?

- Существует ли адресация?

Рассмотрим каждый из них.

Откуда выделяется память

Можно предположить, что память выделяется из атомов. Атом является единицей хранения чего-либо в нашем мире. Так как все объекты/субъекты состоят из атомов, то необходимо взять элементы таблицы Менделеева и подсчитать суммарное кол-во атомов для какого-либо объекта/субъекта.

Кто ответственен за освобождение памяти?

Ответственным за освобождения памяти является Garbage Collector. В различных культурах и верованиях его называют Смертью.

Существует ли адресация?

Да. Существуют два типа адресации.

Ещё одно из важнейших понятий — это указатель:

Указатель (Pointer) — это бесформенный объект, который не поддаётся рационализму.

Абсолютная адресация выглядит следующим образом:

Абсолютная адресация — прямое указание на Субъект. Абсолютный адрес Субъекта формируется по его уникальным хар-кам. Каждый Субъект имеет свой идентификатор, который находится в указателе Душа.

Как мы видим, Душа является единственным указателем на Субъект. Таким образом при создании (выделении памяти) создаётся душа, которая указывает на физическую оболочку Субъекта. То есть теперь мы можем объяснить, почему издавна считается, что душа покидает тело, так как Душа является бесформенным объектом, то в момент, когда Душа во сне покидает физическое тело, оно просто на время перестаёт на него указывать.

Сразу же возникает вопрос: «А может ли возникнуть утечка памяти?». Нет. Не возможна, так как указатель использует специальный метод для сохранения адреса и специальный метод для возврата по сохранённом адресу.

Относительная адресация выглядит следующим образом:

Относительная адресация — это косвенное указание на Субъект. Относительный адрес формируется по известным хар-кам Субъекта.

То есть, любой Субъект, который имеет адрес на другого Субъект, например его (ФИО + Дата Рождения) относительно указывает на него. При такой адресации, возможны неточности, так как может происходить коллизия при указании на Субъект.

Субъекты, объекты и душа

Душа — это экземпляр класса TSoul, который является указателем на Субъект.

Субъект — это совокупность классов (полиморфных шаблонов), которые в совокупности организуют собственную иерархию и систему, которая способна к осуществлению метода эксзистенциию.

Это упрощённая схема. Вспомнив биологию, схему можно дополнить различными детали. То есть любой Субъект создаётся по такому принципу:

- Определяется набор клеток необходимый для существования

- Определяется организм с необходимыми функциями для экзистенции

- Создаётся Субъект относящийся к конкретному классу

- Затем происходит создание экземпляра класса TSoul, который является указателем на наш Субъект

- Субъект вызывает метод TSubject.Existance() и выполняет до тех пор, пока Garbage Collector не освободить память.

Следующий процесс изображён на схеме:

Мироустройство

Оно изображено не схеме. Теперь надо объяснить как всё это работает.

GC (GarbageCollector) — это самое главное бесформенное устройство, которое выделяет/освобождает память под всё.

Crutch (Костыль) — это вспомогательный инструмент, через который происходит любое выделение памяти.

Никто не знает, как и когда появился Cruth. Это не поддаётся рационализму. Остаётся лишь это воспринимать как идеи.

Borland (Бог Борладн) — бесформенный Бог, под который по ошибке была выделена память и теперь весь мир существует благодаря ему.

Digia (Бог Дигиа) — бесформенный Бог, который был создан с намерением исправить деяния Бога Borland. Уже 4000 тысячи лет идут Holy Wars…

Как мы видим Бог Borland унаследовал от себя два основных класса TSoul и TEdugin:

TSoul — это основной указатель на Субъект, как уже говорилось ранее.

TEdugin — это отдельный Субъект типа челвоек, который был создан для того, чтобы установить баланс между Borland & Digia, путём изучения обоих систем. Но у Borland дургие планы на TEdugin, он является проповедником Delphi`низма, сам того не подозревая.

Затем Borland создал TSubject, чтобы создать себе армию для очередной Holy Wars с Digia. Но было бы слишком жестко создать чисто человека и заставить его воевать, поэтому Бог Borland создал всё остальное и теперь мы уже получили всё то, что наблюдаем каждый день.

Можно заметить, что Бог Digia совсем иначе подходит к решению проблемы. Он унаследовал от себя QSoul и создал QGod. То есть концепция указателя осталась прежней, но теперь во главе стоит QGod.

QGod — это человекоподобная сущность, которая имеет возможность создавать QSubject и QObject.

Но так как никто никогда не видел QGod`ов, то говорить об их существовании сомнительно, однако, такое присутствует и дошло к нам через фольклор. Иначе говоря Digia и всё с ним связанное — это легенды, который как бы были, но никто не знает правда это или нет.

В заключении об мироустройстве можно сказать, что однозначно существует GC, Cruth и Borland, Digia. Не подозревая того, вечно идёт Holy War за выделение памяти под Borland или Digia, но уже давно устоялось, что Borland вышел победителем, иначе мы бы уже давно вступили в контакт с QGod`s. Даже если и есть представители QGod`s, они прячутся и не выдают себя, чтобы GC не собрал их и не пересоздал их под Borland.

API

У мира есть API! Но чтобы получить к нему доступ мы должны получить контроль над нашим указателем (TSoul). Именно этим занимаются восточные религии.

Получив доступ к нашему указателю, мы сможешь изменять себя и пространство вокруг.

|

Метки: author sbasyrov читальный зал delphi |

[Из песочницы] Ruby on Rails для разработки маркетплейса |

Мысли и выводы, опубликованные в данной статье, сформировались на основе опыта моей компании, которая не первый год занимается разработкой онлайн маркетплейсов разного типа. Мы имеем достаточно большое количество проектов, которые создавались с использованием Ruby on Rails. Сейчас же я хочу рассказать, почему мы отдали наше предпочтение именно этому фреймворку и ни разу об этом не пожалели.

Коротко о том, что такое "маркетплейс" и его специфике

Макретплейс – это электронная торговая площадка, оформленная в виде веб- или мобильного приложения, где покупатели и продавцы могут общаться и заключать сделки. Это своего рода механизм, который помогает установить связь между провайдерами. От обычного интернет-магазина маркетплейс отличается тем, что в нем представлено не один (обычно, он же и владелец), а много различных брендов поставщиков услуг.

Для общего понимания, вот основные отличия маркетплейса от интернет-магазина:

- В маркетплейсе не один, а множество различных брендов

- Самому продавцу нет необходимости заботиться о функционале магазина. Его задача – предоставить информацию о своих товарах

- Обычно, маркетплейс со временем получает признание и статус, так что продавцу нет необходимости дополнительно раскручивать свою точку продаж. Покупатель с большой вероятностью найдет бренд в маркетплейсе

- В отличие от интернет-магазина, которому еще нужно получить доверие покупателя, маркетплейсу покупатель уже доверяет, и у него возникает меньше сомнений касательно какого-либо бренда, представленного там

И это лишь основные моменты. Таким образом, покупатель получает удобную площадку, где есть буквально всё; продавец получает больше покупателей без лишних затрат на промо (чем не дополнительный канал продаж?); владелец маркетплейса получает доход без лишних "телодвижений" (ведь, все, что ему необходимо делать – не изготовлять товары и доставлять их, а создать и поддерживать маркетплейс).

В качестве примера маркетплейса можно рассмотреть Amazon, Airbnb, Uber, Spotify или OLX. Эти гиганты давно себя зарекомндовали на рынке. Кроме того, не следует забывать и про App Store с Google Play, ведь это тоже маркетплейсы. И мы практически каждый день ими пользуемся.

Важный для понимания темы нюанс – маркетплейсы разделяются на различные типы на основе принципов взаимодействия покупателей и продавцов. Всего их насчитывается 8 на сегодняшний день:

B2B (англ. "business to business"),

mCommerce (сокращение от "мобильная коммерция"),

Crowdfunding (от англ. "crowdfund" – "финансирование посредством сбора денег у сообщества"),

C2C (англ. "customer to customer" – "потребитель для потребителя"),

eCommerce (сокращение от "электронная коммерция"),

B2C (англ. "business to customer"),

peer-to-peer (от англ. "равные для равных")

auction platforms (от англ. "аукцион")

Но давайте ближе к теме. Прежде, чем начать восхваление Ruby on Rails (далее в статье RoR), в контексте разработки маркетплейсов, наверное, нужно также упомянуть и альтернативы, которые присутствуют на рынке. Дабы материал не показался предвзятым.

Вы должны понимать, что в свое время мы использовали и другие технологии создания маркетплейсов помимо RoR. Поэтому нам есть с чем сравнить.

Способы создания онлайн маркетплейсов

Это самое интересное. На самом деле, способов предостаточно. Порой более чем, поскольку каждая компания, предоставляющая платформу для разработки, твердит, что только эта платформа идеально подходит для вашего маркетплейса. Остальные "непременно будут плохо работать или иметь ограниченный функционал". Однознаности нет, и каждый вибирает сам.

Функционал, кстати, вполне отдельная тема. Ведь чтобы пользователь остался с маркетплейсом, нужно продумать кучу вещей, начиная от удобной авторизации, заканчивая интеграцией с платежной системой. О функционале можно долго говорить, но вот основные моменты:

- Дизайн интерфейса

- База данных для веб приложения и язык программирования

- Авторизация и безопасность

- Функционал для инфтерфейсов покупателя и продавца

- Функционал товарных списков

- Процесс заказа

- Функционал совершения оплаты и получения средств на счет

- Возможность для состевления рейтингов и написания отзывов

- Напоминания и уведомления

- Организация возможности поиска

И это далеко не все...

Но вернемся к способам разработки. Поскольку их достаточно много, то удобнее всего будет отсортировать их на 3 категории:

Покупка готового решения

Здесь я имею в виду покупку решения от Shopify, Magento или Woocommerce (на самом деле, примеров больше). Просто, быстро, удобно. Но есть и минусы. Основным минусом такого способа является невозможность кастомизировать ваш маркетплейс, настроить так, как вам удобно. Он будет шаблонным, и внести в него требующиеся вам изменения будет если не невозможно, то очень дорого в итоге. И если таких потребностей у вас нет, то решение идеально подойдет.

Использование открытой платформы

Такая открытая платформа, как, например, Sharetribe, WordPress или Spree – это что-то среднее между кастомной разработкой и готовым решением. С одной стороны, здесь вы получите большую свободу для настроек и изменений. По сути, разработкой будет заниматься ваша команда. Но в то же время, создать здесь нечто более, что выходит за рамки возможностей платформы, не получится.

- Разработка с нуля

Наконец, вариант, о котором я хотела вам рассказать. Разработка с нуля предусмотрена для уникальных маркетплейсов, где функционал, технологии и прочие детали мы можем выбирать, изменять и дополнять на свое усмотрение. Таким образом мы получим свое собственное приложение, созданное с учетом всех наших потребностей и планов. Никаких ограничений.

По стоимости и времени на разработку этот вариант может показаться самым затратным. Но не стоит забывать, что в итоге мы получим продукт, не требующий дополнительных изменений (в идеале, конечно).

Для разработки с нуля используются различные фреймфорки (англ. "web application framework").

Разработка онлайн маркетплейса с Ruby on Rails

Несмотря на то, что для каждой платформы находится много любителей и противников (маркетплейсы также часто создаются на платформах Laravel, Django, Meteor), мы предпочитаем именно Ruby on Rails.

И вот почему:

Во-первых, это простота разработки. Для RoR существует огромное множество библиотек, где есть все, о чем можно только мечтать. Даже если вопрос или проблема еще не появились, для них уже есть решение.

Это очень удобно, ведь ничего не нужно изобретать.

Эта же простота разработки приводит к следующему преимуществу – значительному сокращению времени на разработку. Что может быть лучше, если проект можно запустить в два раза быстрее, чем планировалось ранее? К тому же, именно из-за простоты, команда разработчиков сравнительно невелика. А это – очевидная экономия.

RoR рассчитан на сайты с большим количеством информации. Другими словами, если нужно предусмотреть наполнение сайта контентом, то нет ничего лучше, чем Ruby on Rails. Это очень важно для CRM и CMS систем.

- У RoR одно из самых больших и активных сообществ разработчиков, которые всегда готовы помочь или прийти на выручку. Это очень важно, когда долго ломаешь голову в поисках неочевидного ответа. Вероятность, что другой разработчик уже ее поломал и нашел ответ, очень велика.

Сообщество разработчиков может прийти на выручку и тогда, когда необходимо заменить или нанять еще одного разработчика в команду. С поиском кандидата не будет проблем.

Существует огромное количество маркетплейсов, возданных на Ruby on Rails. Тот же Shopify (о котором шла речь ранее) или всемирно известный Couchserfing.

Можно долго говорить о том, как хорошо и легко работать на RoR. Однако, основная цель моей статьи – рассказать, что этот фреймворк прекрасно подходит для создания онлайн маркетплейсов. Надеюсь, что мне это удалось, и информация как про маркетплейсы, так и про Ruby on Rails была для вас полезной.

|

Метки: author IrynaKorkishko интернет-маркетинг маркетплейс маркетинг реклама в интернете фрейморк e-commerce |

[Перевод] 10 основ брендинга для начинающих предпринимателей |

Сколько у вас друзей, которые сейчас запускают свой бизнес? Shark Tank — одно из самых популярных шоу на кабельном на данный момент (американская телепередача, в которой участвуют бизнесмены (стартаперы), которым нужны инвестиции в свой бизнес), оно привлекает большое количество людей, заинтересованных в бизнесе, дизайне и фирменной символике. В то время как одни рьяные «бред-приниматели» (“want-repreneurs”) погружаются в идею вокруг основной идеи, остальные мгновенно переключают разговор на то, как их идея будет выглядеть.

- Как будет выглядеть логотип? Можно ли создать собственный логотип самому или стоит нанять дизайнера?

Как дизайнер, я люблю помогать своим друзьям и родственникам продумывать то, как пересекается их бизнес, дизайн и психология. На этой неделе мы с сестрой обсудили несколько интересовавших её вопросов касаемо развития торговой марки. Поскольку большинство людей не являются дизайнерами и их нужно обучать основным принципам данной работы, то мы подумали, что и другие начинающие бизнесмены могут также воспользоваться плодами нашего диалога.

Для начала отмечу, что моя сестра Бетани — фотограф. Она работала с разными событиями, парами и другими направлениями фотографии, нарабатывая достойное портфолио, чтобы разместить его онлайн. Она готова вывести свое портфолио на серьезный уровень и хочет знать, как раскрутить свой бизнес и бренд.

01 — Что такое фирменный стиль?

Если бизнес — это стратегия, направленная на то, чтобы сделать нечто ценное, что люди захотят купить, то брендинг — это средство, чтобы показать людям, какая ваша идея на вид, вкус, как она ощущается и звучит. Ваш бренд отображает то, какой у вас бизнес.

Мы можем приложить массу усилий к тому, чтобы повлиять на то, как мы хотим, чтобы люди нас видели, но в долгосрочной перспективе ваш бренд становится тем, что говорят о нем другие люди. Это может быть странной концепцией для большинства, но в конце концов наш бизнес не сможет существовать, если люди не будут наслаждаться тем, что мы принесли в этот мир. Мы здесь, чтобы решать проблемы других людей, а не только свои.

Задумайтесь на секунду о Nike. Я их большой поклонник и действительно принимаю на веру большую часть их маркетинга, но в 90-е люди думали о них как о компании, которая не заботится о людях по мере роста и эксплуатирует предприятия с потогонной системой. По этой причине Nike быстро сменила приоритеты и провела более результативную работу по выяснению того, как передать тот факт, что они заботятся о рабочих условиях своих сотрудников и, в результате большого труда и изменений стала, как известно, одной из самых передовых компаний с жесткими условиями по безопасности и стандартами производства. Не важно, что Nike рассказывала аудитории тогда, люди сами пришли к выводам… Вот почему торговая марка должна быть живым (и последовательным!) организмом и вот как она может существенно повлиять на успех или неудачу в бизнесе.

- Ваш бренд — это ваше видение, индивидуальная перспектива и позиция в бизнесе.

- Ваш бренд — это отчасти набор элементов дизайна, которые показывают людям, что вы являетесь тем, за кого вы себя выдаете.

- Ваш бренд — это послание, которое вы выдвигаете всему миру.

У каждого есть свой собственный бренд… хотите вы того или нет. Подумайте о своем бренде как о своей собственной репутации.

02 — У меня обычный маленький бизнес, зачем мне нужно беспокоиться о брендинге?

Как было сказано выше, благодаря четкой, честной и прямой передаче фирменной символики потенциальные клиенты понимают, кто вы и что вы можете. Вы можете генерировать самые лучшие в мире идеи касаемо заработка денег в бизнесе, но если люди не могут описать вас в одном предложении, возможно, ваше послание размыто и не понятно людям. Это может иметь серьезные последствия в долгосрочной перспективе.

Малый бизнес — это как маленькая рыбка в большом пруду. Никто не знает, кто ты. Честно говоря, никому не интересно. Использование брендинга позволяет подойти к тому, чтобы подобраться к конкретным нишам, чтобы в перспективе запустить «сарафанное радио». Вам необходимо что-то, что сможет выделить вас из толпы, вместо того, чтобы смешать со всеми остальными. Здесь идет соперничество за внимание, и выстраивая стратегию бренда вокруг того, что попадет в умы ваших клиентов — это ключевая, очень сложная задача. Пожалуйста, не совершайте ошибку, относясь к брендингу с безразличием. Слишком много малых предприятий не осознают возможности превращения брендинга в ключевого игрока на их собственном поле.

03 — Какова разница между брендингом и логотипом?

Многие люди делают ошибку, считая, что брендинг компании — это их логотип. Но это не так.

Если бренд представляет собой целостное представление о том, кто вы как компания (или как отдельное лицо), то система фирменной символики является совокупностью визуальных и конструкторских элементов, помогающих рассказать клиенту вашу историю.

Ваш логотип является одной из наиболее важных частей вашего бизнеса, это единственный цифровой элемент всей вашей торговой марки. Если ваш бренд — мать, то логотип — это ее сын.

04 — Как вы относитесь к готовым шаблонам логотипов? Почему вы не рекомендуете использовать их?

Начнем с того, почему логотип столь важен.

Ваш логотип — это визуальное средство, которое немедленно сообщает людям о том, кто вы есть. Люди — сложные существа, и они сформируют тысячи различных мнений о вас и вашей компании в те первые 5 секунд, когда посмотрят на ваш логотип.

Начнем с того, что люди простые, измученные, циничные и эгоистичные. Так, если Золушка придет на бал в разодранном в клочья платье, люди будут ставить под сомнение ее качество. Они будут думать, что она принадлежит к низшему классу. В отдельно взятом случае — это может быть правдой. По крайней мере, это то, как думают люди. Если вы экономите на качестве логотипа, вы можете рассчитывать на то, что люди будут также считать, что ваши бизнес также обладает низкими качествами. Если ваш логотип выглядит устаревшим или используется плохо читаемый шрифт, то люди не получают хорошего представления о вас.

Конечно, можно использовать типовой логотип, который может говорить с вашей аудиторией так, как вам хочется, но в большинстве случаев этого просто не произойдет. Скорее всего, это будет выглядеть как миллион других компаний, которые делают то же самое, что и вы. Помните, что если вы хотите выделиться, то прежде всего докажите самому себе то, что вы обладаете высшим уровнем навыков и качества. И как вы собираетесь достичь этого, если вы используете какой-то штампованный логотип с Fiverr? В большинстве случаев (не во всех) вы не сможете.

05 — Является ли мой логотип сложным? Каковы преимущества использования простого логотипа?

При создании логотипа необходимо помнить о нескольких вещах. Во-первых, этот знак будет использоваться с различными носителями. Скорее всего, это будет ваш веб-сайт, визитная карточка, печатные счета/бланки, фирменная униформа и прочее.

В большинстве случаев простой логотип упрощает его масштабирование в этих форматах. Вы должны понимать, как логотип будет выглядеть и в случае сверхбольшого размера, и тогда, когда он уменьшается на 100-1000%. Простота в большинстве случаев будет служить вам наилучшим образом. Однако, создание минималистичного логотипа для представления вашего стиля — это очень сложная задача. Опять же, не надо полагаться на кого-то, кто «спроектирует» ваш логотип за $5. Такие дизайнеры просто сделают что-то, что им нравится. Как это поможет вам?

06 — Какой формат файла следует запросить у дизайнера (или сделать самому), чтобы напечатать визитные карточки?

Независимо от того, разрабатываете ли вы логотип самостоятельно или платите дизайнеру, который поможет вам, убедитесь в наличии исходного файла (для внесения будущих изменений), а также файлов PDF, основанных на CMYK (цветовой формат для печати, отличный от RGB для цифровых экранов), которые нужны для типографии.

07 — Какие программы вы рекомендуете для разработки системы фирменной символики?

Бренд — это не только визуальная система, которую вы создаете (обмен сообщениями, стиль изложения и прочее). Однако, имейте в виду, что что бы вы не создавали, это необходимо создать в векторном формате. Вектор — это формат, позволяющий масштабировать без потери качества.

Вектор основан на вычислительной математике, где в формате растрового изображения (фотографии, например) задано количество пикселей, в которых он работает. Масштабирование фотографии вверх и вниз может привести к очень размытому результату и потере качества. С вектором это не проблема, ваши изображения всегда останутся абсолютно четкими.

Лучшим программным обеспечением, которое использует векторный формат для печати, является Adobe Illustrator. Также Sketch очень близок к нему, и я слышал, что Affinity Designer является также хорошим инструментом.

08 — Как дизайнер, какие ключевые вопросы вы задаете клиенту перед началом этапа проектирования логотипа? Что вы используете для вдохновения?

Этот список не является исчерпывающим, но может помочь начать беседу:

· Каким вы видите свой новый логотип?

· Каков возрастной диапазон целевой аудитории?

· Какое ощущение или сообщение вы хотите передать с помощью логотипа?

· Какие логотипы привлекают вас и почему?

Дизайнеры работают с цветами, которые говорят по разным психологическим моделям, поэтому лучше сосредоточиться на форме логотипа (сначала в сером цветовом пространстве), прежде чем наполнять логотип цветами. Вдохновляться можно на Dribbble и Behance.

09 — Распределяя бюджет на начальном этапе, какие элементы брендинга наиболее важны? (визитные карточки, веб-сайт и т.д.)

Прежде всего нужно, чтобы ваша бизнес-идея и стратегия были уже продуманы до того, как вы начали думать о проектировании визуальных элементов вашей торговой марки.

Если вы на той стадии, где необходимо погрузиться в разработку цифровых элементов, лучше всего начать с логотипа.

Вы же не хотите создать логотип, а затем задуматься о том, как ваш бизнес адаптируется к нему? Ваша эмблема изначально должна говорить за ваш бизнес.

При наличии логотипа его можно поместить на различные веб-сайты, такие как Facebook, Twitter и другие социальные платформы, чтобы начать присутствие вашей компании на рынке.

После этого переходите к визитным карточкам, а уж потом — к полному веб-сайту. Также есть отличные недорогие стартовые платформы. Отличные темы для веб-сайта можно приобрести на WordPress, Shopify и SquareSpace.

10 — Как лучше всего показать мой бренд людям?

Просто помните, что бренд никогда не закончен, поскольку это живая система, но имейте в виду, что после создания бренда приходится усердно заниматься маркетингом и продвигать свой бренд с помощью социальной стратегии.

Запустите различные учетные записи социальных сетях (Facebook, Twitter и Medium) и получите возможность часто высказываться в блогах о вашей отрасли и о вашей перспективе в ней (это то, чем я сейчас занимаюсь).

Точно так же, как и вы, люди каждую неделю конкурируют с тысячями компаний, чтобы выделиться! Нужно подойти вплотную к этому вопросу и делать все возможное, чтобы быть кем-то, кто создает ценный контент. Сделайте это и люди естественным образом будут углубляться в знания о вас, вашей марке и, возможно, поддерживая вас как новую компанию своими кровно заработанными деньгами.

|

Метки: author Logomachine брендинг блог компании логомашина дизайн логотип бизнес совет перевод |

[Перевод] Невидимые сообщения в именах свойств JavaScript |

|

Метки: author ru_vds разработка веб-сайтов javascript блог компании ruvds.com unicode разработка |

[Из песочницы] 5G Глазами Huawei |

Статья о будущей сети 5G, о которой рассказывали на Honor Cup 2016.

Содержание

- Немного истории

- Концепция

- Характеристики

- Архитектура

- Где и когда

- Заключение

История 5G

Основные различия между этими технологиями: скорость, объём передачи данных и кол-во соединений. Как заявили на конференции, что если сама концепция будет успешно реализована, то поколения 6G не будет.

Концепция

Основные направления 5G:

- Мобильный интернет (Качественное покрытие[1], hot-spot[2])

- Интернет вещей[3] (Минимальная задержка, маломощные соединения[4])

Рассмотрим более подробно. Основная концепция 5G сетей — это представление её как конвергентной технологии[5] и объединение всего между собой в единую систему, к одному облаку. Предполагается, что сама сеть будет представлять собой облако, к которому через приложения или Telco OS будут получать доступ: абоненты, разработчики, операторы, партнёры.

Как это работает? Очень просто. Вы через приложение или Telco OS получаете доступ к той части облака, которое необходимо для вашей задачи. И само выделение этой части облака происходит виртуально, то есть на программном уровне.

Помимо этого отказ от нынешней архитектуры сотовой связи. Если в кратце, то старая архитектура вынуждала абонентов сети «гоняться» за сетью, теперь же 5G хочет сделать обратное, «гоняться» за абонентом. Всё это построено на архитектуре Massive MIMO, что в свою очередь пришло от военных и использоваться будут не только вышки, которые имеются сейчас, но и военные антенны.

Характеристики

- Широкополосное соединение (Работа с очень широким диапазоном частот)

- Hot-spot (1 гигабит/секунду)

- Sensor Network — сбор информации с разных датчиков

- Tactile Internet — мгновенный отклик ( < 1 мс)

- Оповещения в чрезвычайных ситуациях

- Сверхнадёжная связь

- Streaming Service

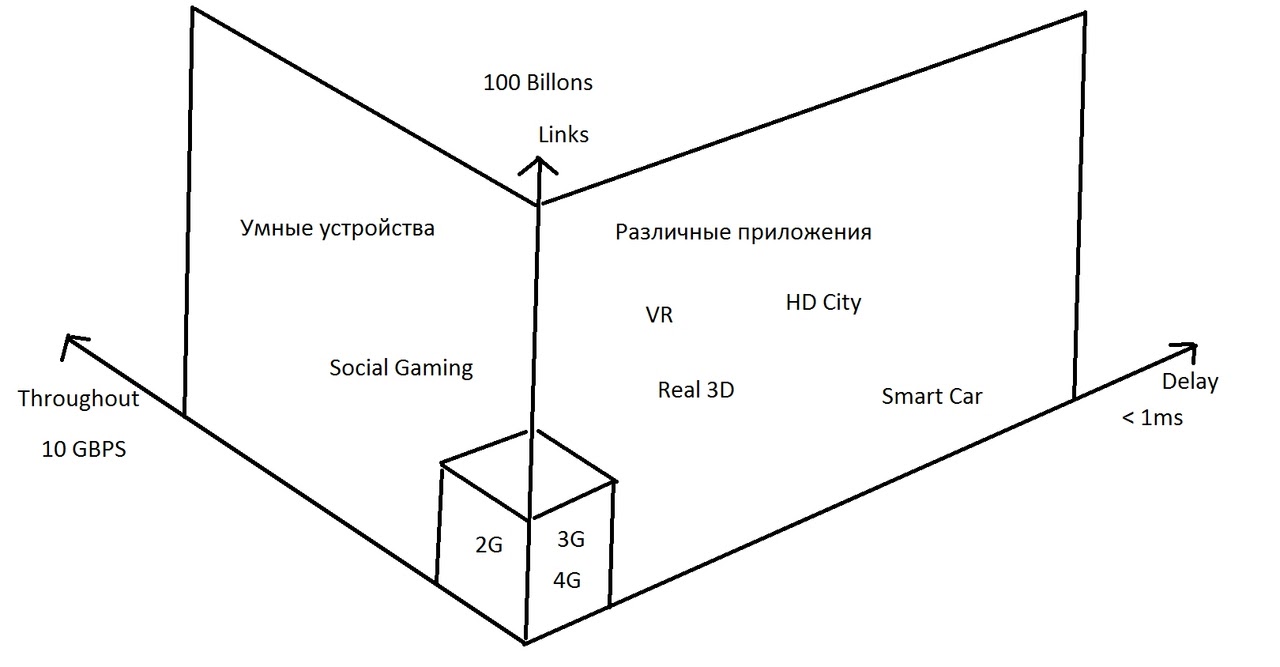

Всё это можно отобразить на следующей схеме.

Links — кол-во соединений (100 миллиардов)

Throughout — пропускная способность или кол-во передаваемых данных (10 гигабит/сек.)

Delay — задержка (< 1 мс)

Как мы видим, 5G стремиться объединить абсолютно всё. Если раньше 2G, 3G, 4G были в основном для мобильного интернета, теперь же всё стало гораздо шире.

Архитектура

Сама архитектура такой конвергентной технологии представляет собой «пирог». То есть она разделена на 3 слоя:

- Приложение — получение доступа к 5G

- Виртуализация (Выделение конкретной аппаратной части под требуемую задачу)

- Аппаратный (5G devices, 5G RAT family)

Само облако построено на SDN/NFV.

SDN (Software-defined network) — программно определяемая сеть

NFV (Network function virtualization) — виртуализация сетевых функций

За счёт такого решения мы получаем следующие достоинства:

- Удешевляется услуги, то есть не нужно закупать аппаратные средства

- В основном меняется ПО, а не аппаратные средства

Где и когда? (Применительно к России)

Первый запуск планируется в 2018 году на World Cup. Реализатором выбран Мегафон.

Заключение

Лично мне сама концепция 5G не понравилась по нескольким причинам:

- Про безопасность не было ничего сказано. Даже тогда, когда я задал вопрос лектору, то он сказал, что не задавался вопросом.

- Концепция реализации архитектуры похожа на сервис Gaikai, который на данный момент является Playstation Now

- Учитывая, что доступ будет осуществляется через приложения или Telco OS, то никто не даёт гарантии, что кто-то при проектировании (я намекаю на то что выше компаний) не поставят чудьненькие приборчики, которые в соответствии с нашим законодательством будут отлично его выполнять. Собственно фиг с ним.

- Сама концепция связывания интернет вещей, то есть no fool devices, может привести к любому голливудскому сценарию о восстании машин, если в конечном итоге всё отдадут под контроль ИИ

- И отдельный пункт, опять про безопасность. Учитывая, что разделение ресурсов облака идёт на программном уровне, никто не даёт гарантии, что кто-либо с очень «хорошими» намерениями не захочет расширить свой кусок или того получить доступ к системе или части системы

P.S. Все сведения получены с лекции 5G

[1] — то есть распространение работы сети по всей территории

[2] — высокоскоростная точка доступа

[3] — «вещи», которые имеют возможность общения с такими же «вещами»

[4] — работа с некоторыми устройствами напрямую.

[5] — представление, как единого целого.

|

Метки: author sbasyrov исследования и прогнозы в it 5g huawei |

Использование Hotspot Helper Extension |

Впрочем, сейчас многие популярные заведения предлагают приложения, облегчающие подключение к бесплатным точкам. Уверен, что каждый из нас сможет легко припомнить пару-тройку подобных примеров, поэтому обойдусь без названий и рекламы. Тем более что ниже пойдет речь о другом варианте решения этой проблемы — мы будем писать собственный Network Helper! С таким подходом больше не придется гадать, к какой сетке подключаться. Даже дополнительные действия для получения доступа в сеть можно будет производить в удобном нативном UI и гораздо быстрее, чем в браузере.

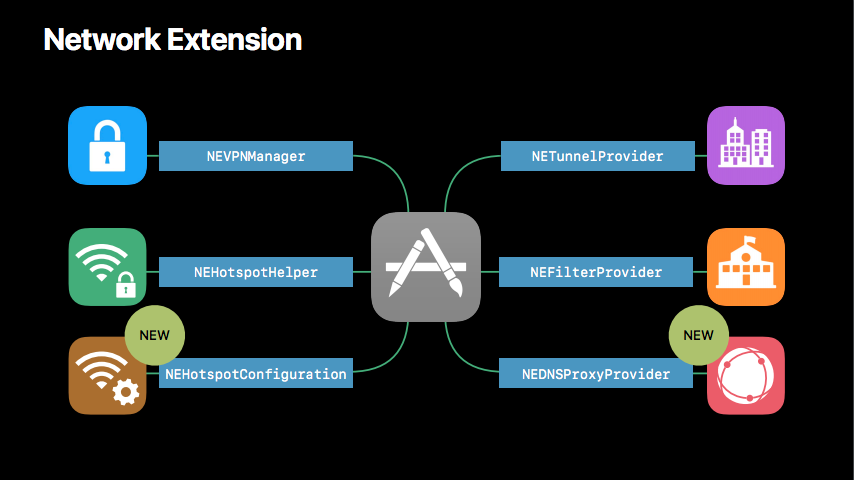

Все просто. Достаточно задействовать технологию NEHotspotHelper, которая стала доступна разработчикам еще со времен выхода iOS 9. Основная задача этого инструмента — классификация Wi-Fi-сетей и авторизация пользователя в них. NEHotspotHelper входит в состав фреймворка NetworkExtension. Чуть ниже вы найдете схему входящих в него на момент выхода iOS 11 инструментов:

Основная документация находится тут: Hotspot Network Subsystem Programming Guide. Помимо этого никакой информации в сети обнаружить не удалось, в связи с чем я и пишу эту статью. Надеюсь, мой материал поможет восполнить пробелы документации и объяснит, как реализовать свой собственный Hotspot Helper. Пример использования этой технологии можно найти на GitHub.

Принцип работы

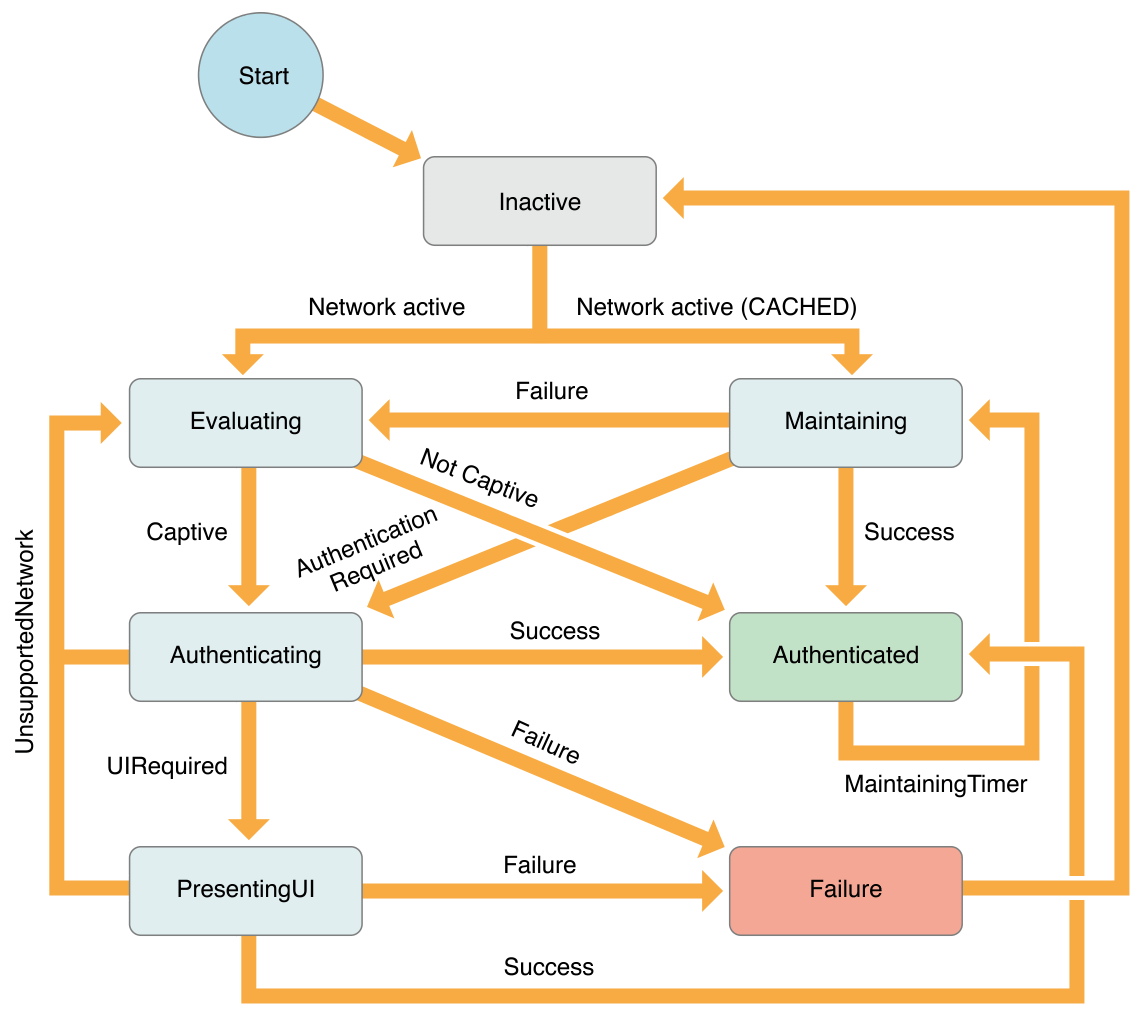

В основе работы Hotspot Helper — машина состояний Wi-Fi-соединения и посылаемые системой Helper команды, обработка которых переводит машину из одного состояния в другое. Ниже представлена приблизительная схема состояний, которую приводит сама Apple в своей документации:

Поначалу столь сложная картинка пугает, однако не стоит беспокоиться — на практике все довольно просто.

Достаточно понимать следующее:

- При первом подключении к сети после перезагрузки устройства выбирается Helper, который будет её обслуживать (Evaluate).

- Как только выбор сделан, запускается авторизация в сети с помощью выбранного Hotspot Helper (Authenticating).

- Если в процессе авторизации необходимо отобразить UI, Hotspot Helper его явно запрашивает (PresentingUI). Если такой нужды нет, Helper в фоне совершает необходимые действия по авторизации пользователя в сети (Authenticated).

- Периодически система пробуждает выбранный Hotspot Helper для поддержки сессии, если это необходимо (Maintain).

- Во время поддержки сессии Helper может ничего не делать, а может запросить повторную авторизацию или спровоцировать повторное подключение к сети.

Единственный неочевидный момент: после первого подключения к сети система кеширует выбранный для нее Hotspot Helper, поэтому при последующем подключении машина cразу переключается в состояние Maintain, минуя все предыдущие.

Hotspot Helper участвует в авторизации пользователя в Wi-Fi-сети на всех этапах — от отображения списка сетей и подключения к выбранной до поддержки авторизации и самостоятельного логаута. При этом для установки соединения Hotspot Helper обрабатывает все требуемые команды, благодаря чему система обеспечивает его запуск в любой ситуации (даже если пользователь принудительно выключит приложение (что привело бы к игнорированию silent-push уведомлений). Ведь от этого зависит работа всего устройства. Надо понимать, что для пользователя весь процесс протекает прозрачно. Таким образом, наиболее частый сценарий — это запуск приложения в фоне.

Итак, повторим: для установки Wi-Fi-соединения Hotspot Helper должен обработать все требуемые команды. Иными словами, устройство не будет считать себя подключенным к сети до тех пор, пока StateMachine не перейдет в состояние Authenticated. И это несмотря на то, что Hotspot Helper начнет видеть соединение уже при получении команды Evaluate. Этот момент отлично отслеживается средствами Reachability, о чем мы поговорим чуть ниже.

Надо сказать, что NEHotspotHelper — не отдельный target, как это часто бывает с другими extension, а основное приложение, зарегистрированное как Hotspot Helper. Это значит, что, как только ему потребуется обработать какую-либо команду, будет запущено основное приложение со всеми вытекающими последствиями. То есть у приложения будет возможность выполнять любой код, однако при запуске в фоне оно может развернуть полномасштабные действия, как будто инициированные самим пользователем. Однако такая деятельность будет означать лишь расход ресурсов впустую, поэтому за происходящим в фоне стоит следить.

Предварительная подготовка

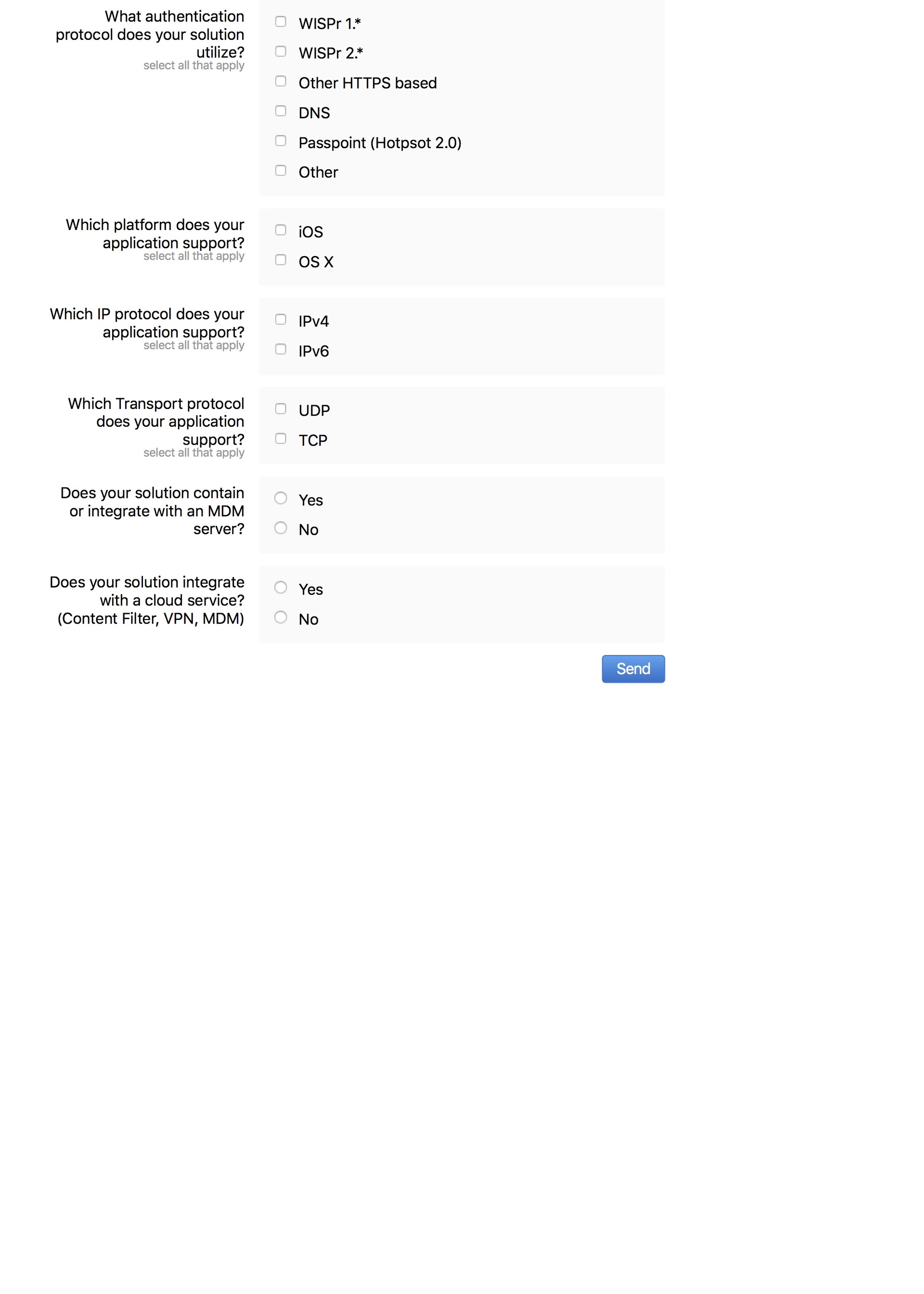

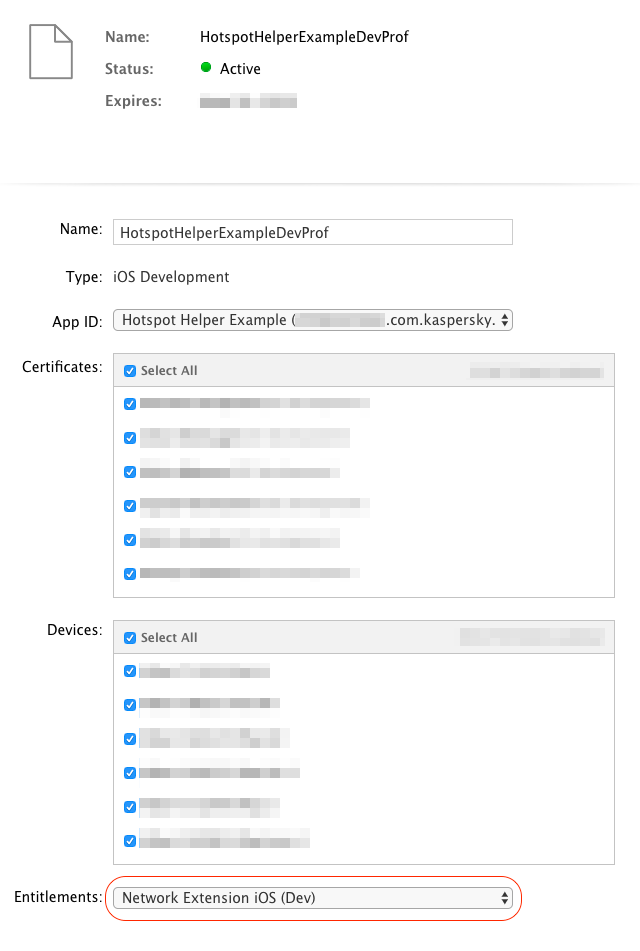

Для регистрации приложения как Hotspot Helper нужно получить разрешение у Apple. Для этого Team Agent должен перейти по ссылке и заполнить опросник.

На момент написания статьи он выглядит так:

|

|

|---|

Если все пройдет хорошо, то при создании provisioning profile на https://developer.apple.com появится возможность выбрать для него entitlement с ключом com.apple.developer.networking.HotspotHelper, дающий право на использование всех плюшек.

Кроме того, необходимо включить в проекте Background Mode Capability и прописать в Info.plist в раздел UIBackgroundModes строку network-authentication. После этого можно приступать к самому интересному — кодингу.

Регистрация

Для того чтобы приложение стало Hotspot Helper, его необходимо зарегистрировать в системе. Для этого надо вызвать следующий метод:

class NEHotspotHelper

class func register(options: [String : NSObject]? = nil, queue: DispatchQueue,

handler: @escaping NetworkExtension.NEHotspotHelperHandler) -> Bool

Метод принимает три параметра:

- Опциональный словарь параметров. Сейчас поддерживается единственный параметр: kNEHotspotHelperOptionDisplayName — имя Hotspot Helper, которое будет отображаться в списке доступных Wi-Fi-сетей рядом с теми сетями, которые HH поддерживает (об этом ниже). Сменить это имя можно только после перезапуска приложения, передав новое имя в качестве параметра. Согласно требованиям Apple, имя должно быть максимально коротким.

- Очередь, на которой будут обрабатываться команды, получаемые от системы. Её можно использовать не только для обработки команд в фоне, но и для синхронизации обработки команд с другим кодом приложения.

- Блок — обработчик команд. Это ключевой элемент конструкции. Его сигнатура проста:

typealias NEHotspotHelperHandler = (NEHotspotHelperCommand) -> Void

Он принимает команду системы в качестве единственного параметра и не возвращает ничего. Блок будет вызываться на очереди, переданной в качестве второго параметра.

Регистрировать Helper надо ровно один раз на каждом запуске. Повторный вызов в том же запуске не дает ничего и возвращает false. Важно отметить, что до завершения повторной регистрации приложение не получит команды, для обработки которой оно было запущено системой.

Отменить регистрацию никак нельзя. Можно только перестать регистрировать блок, тогда приложение никак не будет обрабатывать соединение, но запускатьcя все равно будет — подробнее тут.

Кроме того, в отличие от многих других функций системы (таких как фотогалерея, календарь и даже уведомления), обработка Wi-Fi-соединения средствами Hotspot Helper не требует никаких разрешений от пользователя и происходит прозрачно для него (он попросту не сталкивается с подобными понятиями).

Обработка команд

Команда представляет собой объект класса NEHotspotHelperCommand, содержащий тип и набор данных, характерный для каждой из команд (сеть либо список сетей, если это подразумевает команда).

После обработки каждой из команд следует создать NEHotspotHelperResponse с результатом выполнения и набором данных, который также зависит от конкретной команды.

Объект NEHotspotHelperResponse создается вызовом на полученной команде данного метода:

func createResponse(_ result: NEHotspotHelperResult) -> NEHotspotHelperResponseКроме того, использование объекта команды позволяет установить TCP- либо UDP-соединение на основании сети, к которой команда относится, вызывая соответствующие методы:

func createTCPConnection(_ endpoint: NWEndpoint) -> NWTCPConnection

func createUDPSession(_ endpoint: NWEndpoint) -> NWUDPSessionДля более высокоуровневого общения с сервером можно создать NSURLRequest. Приложив к нему команду, Hotspot Helper получает возможность взаимодействия с сервером в условиях, когда устройство не видит Wi-Fi-соединения. Установленное таким образом соединение можно использовать для авторизации «по-своему». IYKWIM

func bind(to command: NEHotspotHelperCommand)Ниже рассмотрим каждую команду, которую может получить Hotspot Helper, в порядке, соответствующем базовому сценарию подключения к сети. Большинство команд названы аналогично состояниям State Machine, при которых они вызываются.

Официально на выполнение каждой команды отводится не более 45 секунд (однако, если посмотреть на доступное время работы в фоне, можно увидеть цифру 60 секунд). После этого команда считается необработанной, а работа Hotspot Helper приостанавливается. Это ограничение необходимо, чтобы устранить излишние задержки при подключении к сети, ведь пока команда не будет обработана, пользователь не увидит заветного значка Wi-Fi в Status Bar. При этом надо понимать, что, если в системе несколько Hotspot Helper, которые обрабатывают одну и ту же сеть, будет выбран самый быстрый из них (об этом опять же ниже).

NEHotspotHelperCommandType.filterScanList

Это особенная команда, которая, в отличие от остальных, не привязана ни к одному из состояний StateMachine и может быть вызвана в любой момент. Команда вызывается на всех Hotspot Helper, известных системе, каждые 5 секунд. Происходит это все время, пока пользователь находится на экране списка Wi-Fi-сетей в системном Settings.app.

Команда служит единственной цели — продемонстрировать пользователю, какие из сетей обрабатывает Hotspot Helper. Для этого команда содержит список доступных сетей в соответствующем поле:

var networkList: [NEHotspotNetwork]? { get }Это тот же список, который увидит пользователь. При этом список сетей может меняться с каждым новым вызовом команды.

Предполагается, что Hotspot Helper должен проанализировать список сетей и в ответе на команду вернуть те из них, которые он готов обслуживать. Пустой массив в ответе будет означать, что сетей доступных для обслуживания этим Helper в списке нет. Скрыть для пользователя сети из списка не получится.

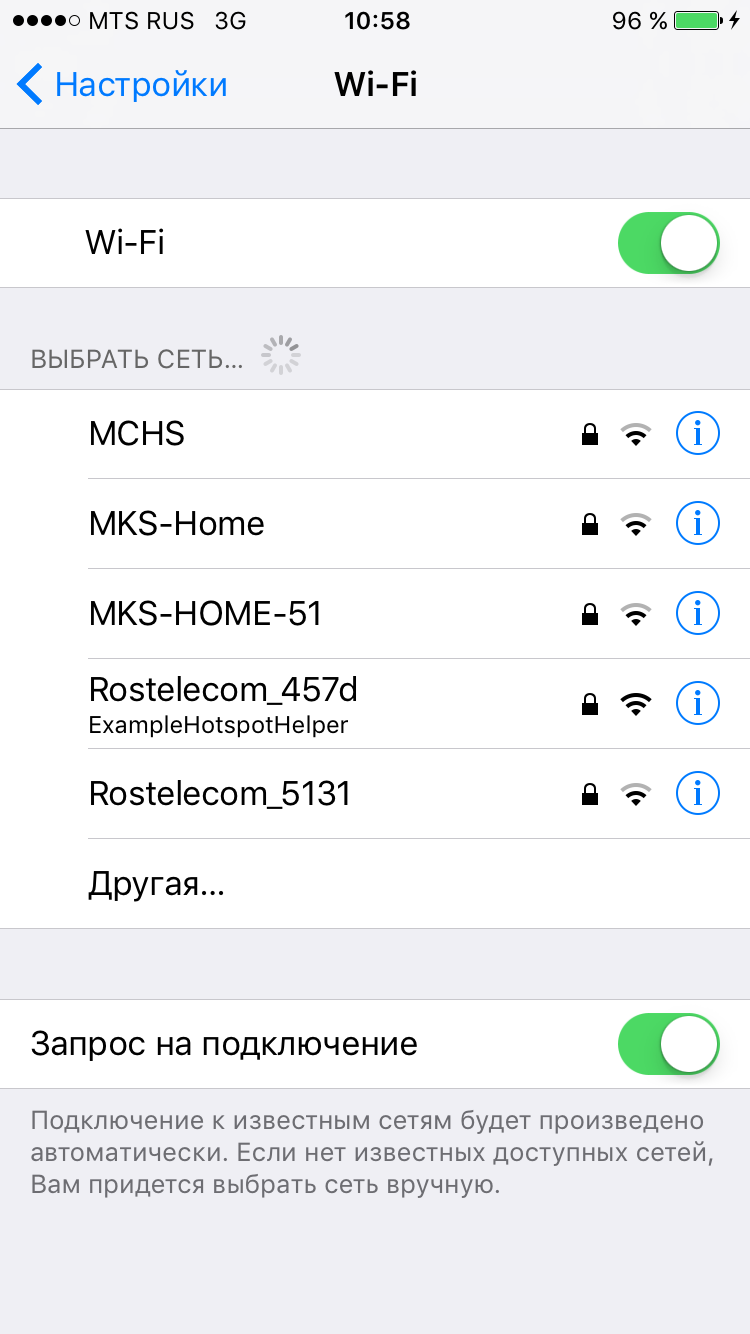

У тех сетей в списке, которые вернул Hotspot Helper в ответ на эту команду, появится подпись. Она будет соответствовать тому значению, которое было передано при последней регистрации Hotspot Helper в качестве опции kNEHotspotHelperOptionDisplayName. Значение подписи может быть только одно. Оно задается при регистрации и не может быть изменено до следующей регистрации (а это происходит после перезапуска приложения), так что подписывать сети по-разному, увы, не получится.

Важно отметить, что кроме передачи самой сети в ответ ей необходимо задать пароль, если она им защищена. Без этого подпись не появится. Если же пароль задан, то кроме появления подписи пользователю не потребуется вводить пароль самому. Надо сказать, это тот самый единственный момент, когда можно установить пароль для сети. Если не задать его сейчас, то это придется делать самому пользователю.

В итоге обрабатывать команду следует так:

let network =

network.setPassword("PASSWORD")

let response = command.createResponse(.success)

response.setNetworkList([network])

response.deliver()В результате пользователь увидит нечто подобное:

|

|

|---|

Надо понимать, что команда filterScanList целиком и полностью служит для демонстрации пользователю списка сетей и никак не влияет на остальную обработку подключения к сети. Если в ответ на команду Hotspot Helper не вернул ни одну сеть, ему все равно предложат обработать подключение к любой из них посредством команд, описанных ниже.

Интересный факт: если удалить приложение, подписи в списке сетей сохранятся вплоть до перезапуска устройства.

NEHotspotHelperCommandType.evaluate

Данная команда вызывается при первом подключении к сети на всех Hotspot Helper, известных системе.

Note: при последующих подключениях evaluate не вызовется, сразу последует maintain на том Hotspot Helper, который был выбран в процессе evaluate.

Цель этой команды — первичное выявление наиболее подходящего для обработки подключения к выбранной сети Hotspot Helper. Для этого вместе с командой Hotspot Helper получает и данные по сети, к которой производится подключение:

var network: NEHotspotNetwork? { get }Network содержит ряд свойств, однако в процессе обработки команды evaluate значения имеют только следующие:

// Идентифицируют сеть

var ssid: String { get }

var bssid: String { get }

// Отражают силу сигнала по шкале от 0.0 до 1.0 (дБ, увы, не предоставляются)

var signalStrength: Double { get }

// Признак необходимости ввода пароля для подключения к сети

var isSecure: Bool { get }

// Признак, показывающий, было ли подключение выполнено автоматически

// или пользователь явно выбрал эту сеть в настройках

var didAutoJoin: Bool { get }

Получив эту информацию, Hotspot Helper должен проанализировать сеть любым способом (начиная от локальной таблицы и заканчивая запросом на сервер) и выставить сети соответствующий уровень confidence:

// Helper уверен, что не обрабатывает эту сеть.

case none

// Helper предполагает, что сможет обработать подключение к этой сети, но не уверен полностью*.

case low

// Helper уверен, что может полноценно обработать подключение к этой сети.

case high*В этом случае ему могут предоставить возможность авторизовать пользователя, однако если в процессе Helper поймет, что он несовместим с данной сетью, то он сможет отказаться от работы с ней, и StateMachine вновь перейдет в состояние evaluate, а Helper будет добавлен в список исключений по данной сети.

Важно отметить: Apple настоятельно дает понять, что уровень confidence надо выбирать тщательно и не следует бездумно выставлять всем сетям high (и даже low), так как это напрямую сказывается на UX всей системы.

В итоге обрабатывать команду следует так:

let network = command.network

// Оценить сеть и определить уровень confidence...

network.setConfidence()

let response = command.createResponse(.success)

response.setNetwork(network)

response.deliver() На обработку команды предоставляется 45 секунд, при этом есть смысл постараться сделать это как можно быстрее. Потому что, как только система получает первый ответ с high confidence, обработка команды прекращается. Затем ответивший Hotspot Helper выбирается для дальнейший обработки подключения в сети, а все остальные прекращают свою работу и переходят в suspended state.

NEHotspotHelperCommandType.authenticate

Команда authenticate вызывается на наиболее подходящем Hotspot Helper по результатам выполнения команды evaluate.

Целью этой команды служит выполнение всех действий, необходимых для предоставления полного доступа пользователя к выбранной Wi-Fi-сети. Для этого вместе с командой Hotspot Helper получает и данные по сети, к которой производится подключение:

var network: NEHotspotNetwork? { get }В обработке этой команды и заключается основная суть работы Hotspot Helper. На этом этапе барьером между пользователем и доступом к сети является только Hotspot Helper, и он должен любым доступным фантазии разработчика способом решить, предоставлять пользователю доступ или нет.

На обработку команды дается 45 секунд, по истечении которых необходимо вернуть response с одним из следующих результатов:

.success — авторизация успешно завершена. Доступ в сеть полностью открыт. StateMachine переходит в состояние authenticated.

.unsupportedNetwork — данная сеть не поддерживается Helper: произведен неправильный анализ сети на этапе evaluate. StateMachine возвращается на этап evaluate, а Helper добавляется в исключения для данной сети. Такое может произойти, например, если Helper вернул для этой сети low confidence на этапе evaluate, а сейчас убедился, что не справится.

.uiRequired — требуется взаимодействие с пользователем. Этот результат возвращается в случае, если для авторизации требуется ввести какие-либо дополнительные данные. Однако не все так просто: UI не покажется сам собой при возвращении этого результата.

Работает это так: Hotspot Helper генерируется UILocalNotification, посредством которой сообщает пользователю о необходимости дополнительного взаимодействия. Если пользователь ее проигнорирует, ничего больше не произойдет. Получив результат обработки, StateMachine переходит в состояние presentingUI и остается в нем до завершения авторизации либо отключения от сети.

.temporaryFailure — исправимая ошибка. Например, в ходе авторизации произошла сетевая ошибка. StateMachine переходит в состояние failure, устройство отключается от выбранной сети.

.failure (или любой другой результат, а равно и его отсутствие) — неисправимая ошибка. Что-то пошло совсем не так, и обработать подключение нельзя: например, поменялся протокол авторизации на стороне сервера, а клиент к этому не готов. StateMachine переходит в состояние failure, устройство отключается от выбранной сети. Дополнительно, в отличие от temporaryFailure, для такой сети отключается функция auto-join.

В итоге обрабатывать команду следует так:

let network = command.network

// Авторизовать пользователя необходимым образом и сформировать результат обработки команды

// Вывести UILocalNotification в случае необходимости дополнительного взаимодействия (.uiRequired)

command.createResponse().deliver() NEHotspotHelperCommandType.presentUI

Эта команда вызывается на выбранном Hotspot Helper в случае, если он вернул результат uiRequired в процессе обработки команды authenticate.

Это единственная команда, которая не пробуждает приложение в фоне и имеет неограниченное время на выполнение. Прилетает она только после того, как пользователь запустит приложение, например, получив UILocalNotification о необходимости дополнительного взаимодействия в процессе обработки команды authenticate.

Как раз на этом этапе следует просить пользователя ввести его доменные креды, если сеть корпоративная, либо показывать, например, рекламу, если сеть коммерческая. Словом, варианты ограничены только фантазией и здравым смыслом разработчика.

В итоге необходимо вернуть response с одним из следующих результатов:

.success — авторизация успешно завершена. Доступ в сеть полностью открыт. StateMachine переходит в состояние authenticated.

.unsupportedNetwork — данная сеть не поддерживается Helper: произведен неправильный анализ сети на этапе evaluate. StateMachine возвращается на этап evaluate, а Helper добавляется в исключения для данной сети. Такое может произойти, например, если Helper вернул для этой сети low confidence на этапе evaluate, а сейчас убедился, что не справится.

.temporaryFailure — исправимая ошибка. Скажем, в ходе авторизации произошла сетевая ошибка. StateMachine переходит в состояние failure, устройство отключается от выбранной сети.

.failure (или любой другой результат, а равно и его отсутствие) — неисправимая ошибка. Что-то пошло не так, и обработать подключение нельзя: например, поменялся протокол авторизации на стороне сервера, а клиент к этому не готов. StateMachine переходит в состояние failure, устройство отключается от выбранной сети. Дополнительно, в отличие от temporaryFailure, для такой сети отключается функция auto-join.

В итоге обрабатывать команду следует так:

let network = command.network

// Произвести любые необходимые действия для авторизации пользователя любыми средствами

// за неограниченные период времени и сформировать результат выполнения команды

command.createResponse().deliver() NEHotspotHelperCommandType.maintain

Команда maintain, как можно догадаться по её названию, предназначена для поддержания сессии авторизации пользователя в текущей сети. Она вызывается на выбранном для сети Hotspot Helper в процессе evaluate в двух случаях:

- Каждые 300 секунд (пять минут) на протяжении всего времени подключения устройства к Wi-Fi-сети.

- При установке подключения к сети вместо команды evaluate, для обработки которой текущий Hotspot Helper был выбран ранее.

Предполагается, что в обоих случаях Hotspot Helper проанализирует текущее состояние сессии авторизации и выполнит одно из следующих действий:

- мгновенно предоставит (продолжит предоставлять) пользователю доступ в сеть, вызвав response с результатом .success;

- потребует повторной авторизации, вызвав response с результатом .authenticationRequired (в этом случае StateMachine переходит в состояние Authenticating и посылает Hotspot Helper команду authenticate).

- сообщит о невозможности продолжить сессию, завершив команду с кодом ошибки ,(.temporaryFailure/.failure или любым другим, отличным от перечисленных выше). В этом случае StateMachine переходит в состояние Evaluating для выбора того Hotspot Helper, который сможет обработать соединение.

Для отличия первого случая вызова команды maintain от второго в массиве данных по сети, передаваемых вместе с командой, предусмотрен специальный флаг — didJustJoin.

В итоге обрабатывать команду следует так:

let network = command.network

if network.didJustJoin {

// Новое подключение к сети, для обработки которой выбран данный Helper

}

else {

// Поддержка сессии в сети, в которой была произведена авторизация (раз в 300 сек.)

}

// Обеспечить авторизацию пользователя в сети любым способом

// и сформировать результат обработки команды

command.createResponse().deliver() Следует отметить, что во время повторной авторизации соединение будет недоступно для устройства вплоть до возвращения в состояние Authenticated.

NEHotspotHelperCommandType.logoff

Команда logoff, как можно было бы ожидать, не посылается при отключении от сети. Отследить отключение от сети средствами Hotspot Helper невозможно.

Эта команда предназначена для завершения внутренней сессии авторизации выбранного Hotspot Helper и посылается ему в ответ на вызов статического метода NEHotspotHelper:

class func logoff(_ network: NEHotspotNetwork) -> BoolДанный метод может быть успешно вызван только с текущей сетью в качестве параметра, только тем Hotspot Helper, который производил авторизацию в ней, и только когда приложение активно. В противном случае метод вернет false и команда не будет вызвана.

В результате StateMachine переходит в состояние LoggingOff, а Hotspot Helper получает заветную команду и 45 секунд на её выполнение.

Получить сеть, которую необходимо передать в метод, можно следующим образом:

let network = NEHotspotHelper.supportedNetworkInterfaces().first Основной use-case: выполнение логаута из UI приложения, что актуально для сценария авторизации с использованием команды presentUI.

Как только Hotspot Helper завершит выполнение команды (либо время выполнения истечет), StateMachine переходит в состояние inactive, и устройство отсоединяется от Wi-Fi-сети.

В итоге обрабатывать команду следует так:

let network = command.network

// Произвести logoff и сбросить внутренние данные сессии авторизации

let response = command.createResponse(.success).deliver()Следует отметить, что до получения этой команды приложение не должно пытаться выполнить какие-либо действия по отключению от сети, так как это негативно повлияет на UX всей системы (фактически пользователь будет видеть наличие соединения, но данные при этом ходить не будут).

Что еще полезно знать

Выше описаны принцип работы и детали реализации Hotspot Helper. Однако есть еще несколько особенностей, о которых следует знать, приступая к разработке, а именно:

- Hotspot Helper нельзя зарегистрировать на симуляторе — для разработки и отладки потребуется реальное устройство.

- Зарегистрированное как Hotspot Helper приложение будет запущено системой в фоне в любой ситуации, поскольку от этого зависит работа всей системы. Даже если приложение выгрузил пользователь, отключил background fetch, включил low power mode и т.д.

- Hotspot Helper не предоставляет никаких возможностей отслеживать отключения от сети (пусть команда logoff не вводит в заблуждение: это обработка завершения сессии авторизации самим Helper). Если необходимо мониторить отключение, следует воспользоваться уведомлениями от reachability (само собой, приложение при этом должно быть активно — в фоне система вас не поднимет).

- Сеть, к которой подключено устройство в данный момент, можно узнать следующим образом:

let network = NEHotspotHelper.supportedNetworkInterfaces().first

Следует отметить, что, несмотря на swift-сигнатуру данного метода (в которой указан non-optional-массив в качестве результата) и ожидаемое поведение (отсутствие сети представляется пустым массивом), при отсутствии соединения можно получить объект сети с пустыми строками в качестве SSID и BSSID и силой сигнала 0.0. Иногда, что еще страшнее, на выходе можно получить и nil (а вместе с ним и crash). В примере приведен код, позволяющий избежать этих ситуаций.

Note: C выходом iOS 11 эта проблема устранена.

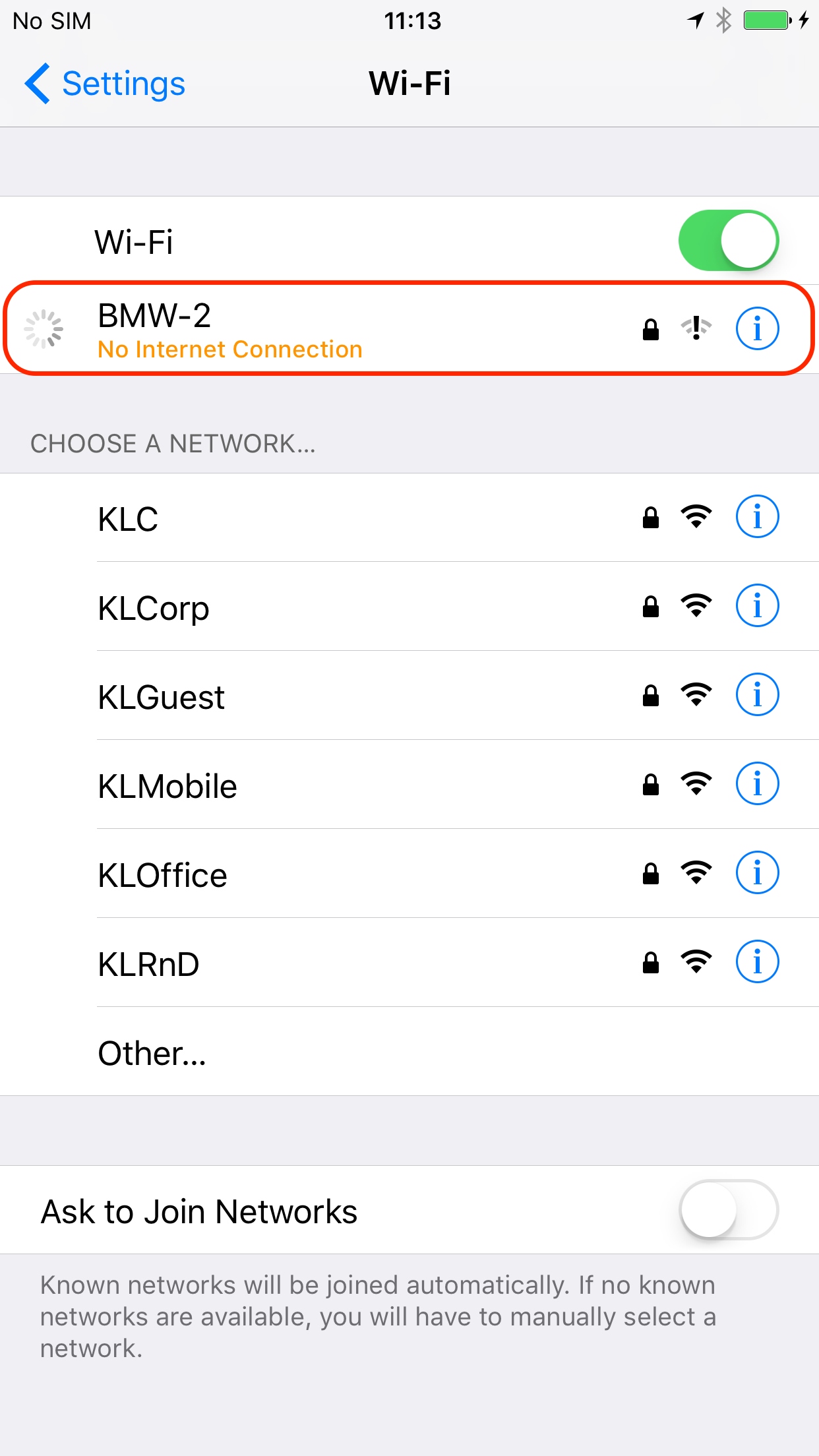

- Подключение к сети для всего устройства появляется только после того, как StateMachine перейдет в состояние Authenticated. Это хорошо видно с использованием reachbility, который не будет видеть соединения до тех пор, пока Hotspot Helper не обработает все необходимые команды.

Следует отметить, что существует единственная ситуация, в которой reachability уже видит Wi-Fi, а Hotspot Helper не получает никаких команд. Происходит это, когда пользователь может видеть следующее состояние в настройках:

Чем обусловлена такая ситуация, понять сложно. Если у вас есть идеи, поделитесь ими, пожалуйста.

- Несколько Helper в системе.

Не существует никаких ограничений на количество Hotspot Helper, одновременно зарегистрированных в системе. Это значит, что возможна ситуация, при которой за обработку одной и той же сети будут конфликтовать несколько приложений.

Конфликт решается на этапе обработки команды evaluate: выбирается тот Hotspot Helper, который вернул high-confidence для сети быстрее остальных. Вся дальнейшая обработка для этой сети происходит с использованием только этого Helper. Выбранный Helper может потом отказаться от обработки данной сети, вернув соответствующий код результата в процессе обработки очередной команды. Но если он этого не сделает, для остальных Hotspot Helper нет никакой возможности поучаствовать в обработке соединения.

Ситуация усугубляется еще и тем, что пользователь ничего не знает и не может знать о существовании каких-либо Helper. Все это происходит незаметно для него: нигде не указывается данный функционал, никакие разрешения у него не запрашиваются. Именно по этой причине одно из требований Apple заключается в необходимости предоставить пользователю в UI приложения возможность отключить обработку всех сетей либо конкретной сети (по SSID).

Следует отметить, что какого-либо надежного способа определить наличие другого Hotspot Helper в системе нет. Единственное, что можно сделать, — проверить, выбран ли в текущий момент Hotspot Helper основным для активной сети. Это можно сделать так:

let network = NEHotspotHelper.supportedNetworkInterfaces().first if !network.isChosenHelper { // Hotspot Helper не обрабатывает активную сеть }

Заметьте, false в этом флаге может означать, что для сети выбран другой Helper или даже что пока не выбран никакой (например, в процессе evaluate). Кроме того, сеть может уже появиться, но обработка подключения еще не начаться. Такая ситуация описана выше.

- В процессе обработки команды существует возможность отправки как низкоуровневых, так и высокоуровневых запросов. Для этого у команды существуют следующие методы:

func createTCPConnection(_ endpoint: NWEndpoint) -> NWTCPConnection func createUDPSession(_ endpoint: NWEndpoint) -> NWUDPSession

А также расширение на NSMutableURLRequest:

func bind(to command: NEHotspotHelperCommand)

- С выходом iOS10.3, очевидно в целях экономии ресурсов, система начала производить самовольные отключения от сети при засыпании устройства с последующим переподключением к той же сети. Интервалы отключения-подключения не поддаются прогнозированию и зависят от текущего состояния системы, устройства и установленных на нём приложений. Интервалы могут быть самые разные: от долей секунд до нескольких часов. Более того, не удаётся найти какой-либо возможности отличить автоматическое переподключение к сети от выполненного самим пользователем — для устройства они оба происходят одинаково.

Если у вас есть идеи как можно такие ситуации отличить или хотябы спрогнозировать, поделитесь ими, пожалуйста.

- С выходом iOS 11 функционал NEHotspotHelper дополнит новый класс NEHotspotConfigurationManager, с помощью которого можно подключаться к Wi-Fi прямо из приложения. Больше не надо заставлять пользователя идти в чуждые для него настройки и выбирать сеть из огромного списка с замороченными названиями. Это полезно в двух ситуациях:

- для приложений, предоставляющих публичные сервисы (кафе, бизнес-центры и др.);

- для приложений, производящих конфигурацию устройств по их собственной Wi-Fi-сети (например, видеокамеры). Для этого можно временно подключиться к заданной сетке до момента выхода из приложения.

Заключение

Технология NEHotspotHelper, появившаяся несколько лет назад, не утратила своей актуальности и по сей день. Этот инструмент позволяет значительно улучшить и облегчить процесс пользования сетевыми сервисами. Здесь я рассмотрел основные принципы работы, способы применения и все шаги, которые следует предпринять для его эффективного использования. Кроме того, рассказал и о некоторых особенностях Helper, о которых тактично умалчивает документация.

Надеюсь, теперь вы имеете полное представление о том, для чего и как стоит использовать эту штуку в вашем проекте. Впрочем, если у вас возникли какие-либо вопросы, напишите, я готов ответить на них.

Полезные ссылки

- Припер реализации на GitHub

- Hotspot Network Subsystem Programming Guide

- Network Extension

- NEHotspotHelper reference

- WWDC’15 What's New in Network Extension and VPN и её конспект

- WWDC’17 Advances in Networking, Part 1

- Forum: How to cancel register an app as a Hotspot Helper (NEHotspotHelper)?

- Forum: Как получить entitlements через почту или через прямую ссылку на форму запроса

- Forum: Как показать UI

- Небольшая статья про HotspotHelper

|

Метки: author AndreyGusev разработка под ios блог компании «лаборатория касперского» ios development wi-fi |

[Из песочницы] Оптимизация шаблонов представления в Codeigniter Framework при помощи AST трансформаций |

В последнее время, я работал с порталом, посещаемостью около 100 тысяч человек в месяц написанном на Codeigniter. Все бы ничего, но любая страница этого портала отдавалась сервером не меньше 3 секунд. При этом, железо уже не было куда расширять а об архитектуре приложения говорить не будем. Мне нужно было найти решение которое помогло бы сократить время ответа приложения с наименьшими изменениями кода.

Предыстория

Codeigniter — прекрасный фреймворк для веб-приложений, спору нет.

Он легок, гибок, и очень прост в обучении.

Но есть несколько проблем. Одной из которых является отсутствие обработчика для представлений. В качестве шаблонизатора используется чистый php (с мелкими вставками Codeigniter).

Многие скажут, что это не проблема, а преимущество — отсутствие предварительной обработки перед выводом на страницу может значительно уменьшить время ответа от приложения, особенно если шаблонизатор тоже написан на php а не в виде с-расширения.

На самом деле большой плюс шаблонизаторов в том — что они могут компилировать шаблоны и кэшировать их на диске для последующего минования процесса их обработки. То есть, если шаблоны меняются не часто, при использовании шаблонизатора мы получаем как минимум один плюс — удобство. Если шаблонов много — тогда сюда добавиться еще кэширование. Не знаю как другие разработчики, но я предпочитаю использовать шаблонизатор когда это возможно.

Проблема

Когда вы используете Codeigniter для небольшого проекта то, скорее всего никаких проблем с шаблонами не будет заметно. Но когда ваш проект разрастается до сотен шаблонов — вы будете страдать от медленной компоновки шаблонов.

Так было и в моем случае — количество файлов шаблонов подключаемых при загрузке страницы достигало 50 (информация от встроенной функции get_included_files).

Страница, которую я выбрал для опыта имеет следующий вид и является наиболее загруженой на сайте:

На странице выводиться список из 30 элементов — ресторанов и разного рода информации о них, каждый из которых, в свою очередь, компонируется из +- 35 шаблонов. Так как в качестве шаблонизатора используется php и больше ничего то никакого кеширования там нет. В итоге, нам нужно скомпонировать около 900 шаблонов.

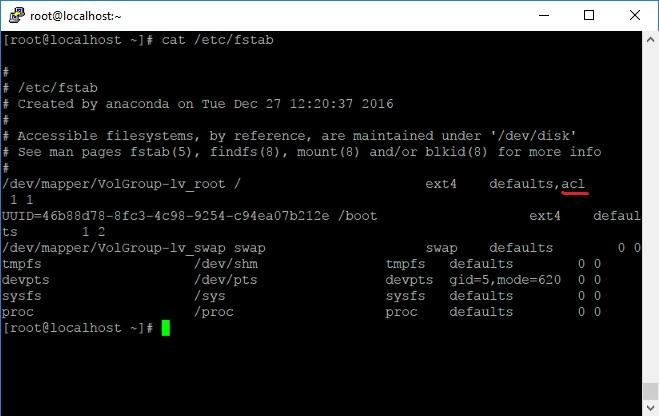

Перед работой с шаблонами, я смог, при помощи минимальных оптимизаций кода, сократить время вывода страницы на 1 секунду (30%) до +-2 секунд:

Loading Time: Base Classes 0.0274

Controller Execution Time 1.9403

Total Execution Time 1.9687Это было все еще слишком много

Решение

Понятное дело, что компоновка около 900 шаблонов дело затратное, тем более на php.

Поэтому, нужно было "склеить" все эти шаблоны в один, чтобы не делать это каждый раз когда запрашивается страница.

Использование готового шаблонизатора типа twig или smarty отпали сразу, так как пришлось бы переписывать все контроллеры, и шаблоны а их очень много.

В то время я уже был немного знаком с AST деревьями.

Шаблоны представляли что-то в следующем виде:

...

...Конструкция

$this->load->view(string $templatePath,array $params)делает "include" с передачей дополнительных параметров $params

Суть задачи была в том, чтобы заменить все такие вызовы на содержимое самих шаблонов и передачу в них параметров inline. Рекурсивно.

Интересно, подумал я и взялся за инструменты которых нашлось аж один: Nikic PHP-Parser. Это очень мощный инструмент который позволяет делать разного рода манипуляции над абстрактным синтаксическим деревом вашего кода и потом сохранять измененное дерево обратно в php код. И все это можно делать в самом же php — парсер не имеет каких-либо зависимостей от с-расширений и может работать на php 5.2+.

Реализация

PHP-Parser предоставляет удобные инструменты для работой с AST: интерфейсы NodeVisitor и NodeTraverser при помощи которых мы и будем сооружать наш оптимизатор.

Главное — это найти все вызовы метода view на свойстве класса load и понять, что за шаблон должен быть загружен. Это можно проделать с помощью NodeVisitor. Нас интересует его метод leaveNode(Node $node) который будет вызван когда NodeTraverser будет "уходить" с узла дерева AST:

class MyNodeVisitor extends NodeVisitorAbstract {

public function leaveNode(Node $node) {

// если тип узла - вызов метода то обрабатываем его

if ($node instanceof Node\Expr\MethodCall) {

// проверяем, вызов ли это нужного нам метода

if ($node->name == 'view') {

// тут также нужно проверить на чем этот метод вызывается

// возможно это не функционал Codeigniter'a, тогда у нас будет ошибка

// я это проигнорировал :)

// мы должны проверить, сможем ли мы узнать какой шаблон подключается.

// если параметр - скалярная строка, тогда без проблем

// можно достать информацию и с других типов, но это сложнее и мы это пропустим

if ($node->args[0]->value instanceof \PhpParser\Node\Scalar\String_) {

// дадим методу уникальное имя, чтобы потом можно было правильно обработать

$code = md5(mt_rand(0, 7219832) . microtime(true));

$node->name = 'to_be_changed_' . $code;

$params = null;

// сохраним параметры, которые нам нужно будет передать `inline`

if (count($node->args) > 1) {

if ($node->args[1]->value instanceof Node\Expr\Array_) {

$params = new Node\Expr\Array_($node->args[1]->value->items, [

'kind' => Node\Expr\Array_::KIND_SHORT,

]);

} else {

if ($node->args[1]->value->name != 'this') {

$params = $node->args[1]->value;

}

}

}

// сохраним место, где мы должны будем заменить шаблон

// замена происходит в другом прогоне по коду

$this->nodesToSubstitute[] = new TemplateReference($this->nodeIndex, $node->args[0]->value->value, $params, $code);

}

}

...Таким образом мы сможем выделить все элементы которые должны заменить. Также можно сделать замену и любых других элементов: явных require, include и т.д.

Не забываем что замену нужно делать рекурсивно вглубь. Для этого, нужно сделать обертку над PHP-Parser где именно и будет происходить замена на внутренности шаблона:

class CodeigniterTemplateOptimizer {

private $optimizedFiles = [];

private $parser;

private $traverser;

private $prettyPrinter;