Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Давайте поговорим про… Языки программирования и технологии |

Доброго времени суток %username%,

Давай поговорим про языки программирования.

Давай раз и на всегда выясним какой из них лучше?

Так какой язык лучше? Ответ прост: Никакой!

Все языки хороши, каждый приносит что-то свое в этот мир, у каждого свои взгляды и философия.

Как бы банально это не звучало, но это факт. Изучая все новые и новые языки разработчик развивается и познает что-то новое. Так сказать, постигает ДЗЕН.

Еще лет 5, а может и 10, назад были призывы к тому, чтобы разработчики не засиживались на одном конкретном языке, а пробовали все новые и новые языки и подходы. Чтобы не окостенеть мозгами и стать «рабом» конкретного языка/технологии, нужно изучать новое. Таков был совет тех дней.

Но сейчас тенденция поменялась. Сейчас в бой вступил маркетинг и очень много сил тратится, чтобы склонить мнение общественности на свою сторону.

Golang

Появились Гоферы, которые считают, что в их языке есть какие-то действительно новые и революционные вещи. Корутины в этом языке даже по-особому назвали: Горутины. И постоянно почему-то меряются длинной gc паузы с Java. Ребят вы серьезно?

Go – это отличный язык, но в нем из принципиально нового только две вещи: «должно быть как можно меньше ключевых слов» и «строгий кодстайл кода из коробки». Это действительно невероятно крутые идеи! Остальное – это маркетинг.

Горутины? В java это было еще в первых версиях, но ребята пошли дальше и все же заменили на «железные потоки».

В Java используют Runnable/Callable/ФоркДжоин таски, которые можно создавать тысячами и закидывать в Тредпулы/ФоркДжоин пулы, а общаться через Shared Queue, в результате получается практически тот же эффект, который называют горутинами и каналами.

Да, в Go это выглядит более изящно, но это не что-то принципиально новое. За короткими GC паузами же скрыты другие проблемы. В Go не был изобретен принципиально новый GC, там используется «стандартный» GC с поколениями со всеми вытекающими.

Golang – это действительно крутой язык, он продвигает классные идеи, но это не серебряная пуля и не панацея! Не нужно вестись на маркетинговый булщит.

C# или 1000 и 1 фича

C# очень крутой язык, и типизация есть и встроенный sql для запросов к коллекциям и не только, и паттерн-матчинг, и кортежи вот хотят ввести (или уже?).

Круто! Язык на столько выразительный, что одну и ту же вещь можно сделать минимум 5 разными способами. И он развивается в отличии от Java (классический вброс в сторону Java).

Но подождите, в C# уже наверно пару сотен фич и при этом язык и дальше пытаются наполнять новыми языковыми фичами, упуская из виду тот факт, что чем больше фич в языке, тем сложнее этот язык изучить начинающим специалистам.

Сейчас C# и .NET платформа живут за счет распространенности Windows, которая, к слову, падает с каждым годом. А интенсивный приток новых девелоперов идет за счет Unity3D движка, который позволяет делать игры (мечта каждого!, наверно) и за счет .NET Core, который обещает быть как Java, только лучше!

Но если в языке и дальше будут появляться все новые и новые языковые фичи, то начинающие специалисты будут избегать изучения этого языка. Стоит призадуматься, на нужна ли та или иная новая фича так сильно?

Java и Spring головного мозга

Java это не только

Сейчас в Java (JVM) очень многое изменилось и это одна из самых быстрых платформ с умеренным аппетитом по ресурсам.

Но сейчас не об этом.

У самого языка не так много проблем, да, он выглядит устаревшим из-за того, что у него нету огромного обилия сахара и некоторые вещи выглядят громоздко, но это даже и хорошо: у начинающих не будет проблем с изучением языка, 2 недели хватит, чтобы узнать про большинство нюансов языка.

Но у Java, как платформы есть 2 огромных недостатка:

1. Огромное количество легаси кода (и индусы)

2. Spring головного мозга.

Если с первым все относительно понятно: за 20+ лет накопилось огромное количество кода и некоторые системы, которые были написаны 15 лет назад до сих пор живут и стабильно работают, и их нужно поддерживать.

То со вторым нужно бороться. Spring – это замечательный фреймворк, который позволяет очень быстро сделать проект. Действительно невероятно быстро. В нем сейчас есть интеграция со всем, с чем только можно. Но к сожалению, есть огромное количество разработчиков, которые знают только Spring и толком ничего больше не знают. Эдакие Sinior Spring Developer. Они действительно круто все сделают на спринге, но к сожалению многие из них не могут мыслить за приделами спринга. И это очень печальный факт.

Ребята, пожалуйста, посмотрите на что-то еще, посмотрите, как можно сделать то, что вы делаете на спринге, но без него. Это даст вам огромный буст развития.

Javascript

Это один из самых популярных языков на данный момент, этот язык развивается на столько быстро, что проект, который начался с самой модной технологией к моменту сдачи становится «легаси».

Маркетинг этого языка гласит: Все должно быть написано/переписано на JS. Даже невзирая на то, что JS комьюнити вечно разделено на десяток лагерей, все они считают, что во главе IT должен стоять JS.

Я согласен с JS комьюнити, у них отличная идея! В свое время Java шла по тому же пути.

Но есть один огромный недостаток – в JS мире царит Анархия и Хаос. Разработчики из года в год переписывают один и тот же проект на «модный в этом году» фреймворк. В большинстве случаев, даже не успевают изучить все возможности фреймворка, как его уже нужно выкидывать.

Но это не так плохо, в этом хаосе рождаются новые более интересные продукты. Тут плохо другое. Плохо то, что JS разработчики не хотят учить другие языки (не связанные с JS), т.к. бешеный темп развития самого JS не сак просто дается, не то, чтобы учить еще и другие языки. Хотя, многим было бы полезно посмотреть на что-то за приделами JS мира.

JS комьюнити было бы полезно поучиться постулатам Python, в частности про то, что все должно быть явным. Еще было бы не плохо еще перенять опыт ребят из Ruby on Rails, которые с каждым новым релизом вбивают все больше гвоздей в гроб своего фреймворка (скоро этот гроб станет Железной Девой для RoR разработчиков).

Отдельно стоит отметить, что JS комьюнити бы не плохо взглянуть и на путь Java с его строгим следованием «обратной совместимости», т.к. проект не должен ломаться из-за того, что какая-то зависимость изменила версию с 4.0.2 -> 4.0.3, что бывает довольно часто.

Чтобы на JS можно было писать вообще все, нужно чтобы в JS появилось понятие скучной и унылой стабильности!

В завершении хотелось бы сказать: В каждом языке, в каждой технологии есть свои плюсы и минусы. Ребят, «Давайте жить дружно!» (с) и учиться друг у друга. Нет нужды кидать друг в друга /отходами жизнедеятельности человека/ и меряться латенси (ну или throughput). Давайте снова продвигать идею того, что нужно учить разные языки, а не зацикливаться на одном. Это приведет к взаимопониманию и всеобщему развитию.

|

Метки: author AndreyRubankov программирование php javascript java c# golang js peace |

Лекция Владимира Игловикова на тренировке Яндекса по машинному обучению |

Спустя несколько недель Владимир выступил на одной из тренировок Яндекса по машинному обучению. Он рассказал о своём подходе к участию в конкурсах, о сути Data Science Challenge и о решении, которое позволило ему занять второе место.

— Меня зовут Владимир Игловиков. Мне очень нравится, как у вас все организовано. Гораздо лучше, чем на тех митапах в Долине, где я задвигал речи.

Сегодня мы поговорим об этом конкурсе, который был, с одной стороны, наиболее простым за последние много месяцев с точки зрения сложности порога вхождения. Но с другой стороны, он так смешно разошелся по новостям, что я еще долго буду от этого оправляться.

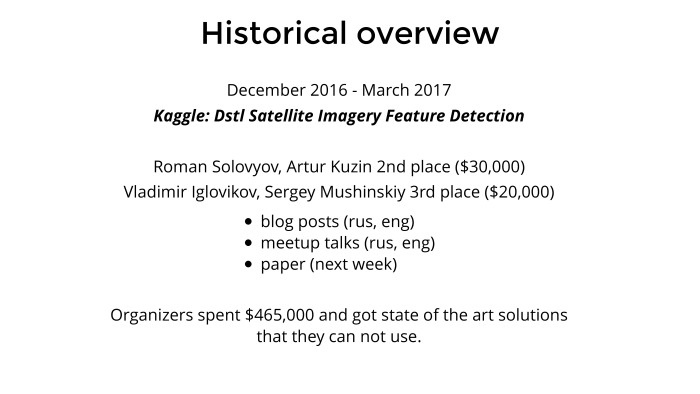

Историческая справка. На Kaggle с декабря по март проходило соревнование про спутники, которое было хорошо известно в Slack-канале Open Data Science. Мы всем коллективом его решали и достаточно хорошо выступили. Из первых десяти мест пять были заняты людьми, которые, как минимум, зарегистрированы в ODS. Второе место заняла команда Романа Соловьева и Артура Кузина, они попилили 30 штук баксов под это дело. А на третьем месте — мы с Серегой Мушинским, наш приз тоже был нормальный.

Задача достаточно интересная. Красивые картинки, интересные задачи, можно подтянуть под какой-то продукт. С ребятами контактировали различные компании, предлагали какой-то консалтинг, не консалтинг — чтобы они их знания применяли к другим картографическим задачам. Была интересная задача, и мы под это дело добавили немного пиара.

Были написаны посты — два поста на Хабре, мой и Артура. Я таки закончил и опубликовал пост на Kaggle в основном блоге, Артур до сих пор ленится. Артур прочитал речь здесь, и я две или три речи задвинул где-то в Долине. Под это дело мы опубликуем научную статью на следующей неделе, она на стадии полировки.

Организатором была британская разведка MI6, MI5 и лаборатория Defence Laboratory при Министерстве обороны. Они под это дело умудрились выбить со своего правительства достаточно большие деньги, полмиллиона долларов. В Долине это вообще ни о чем, и компания может себе это позволить, но интересно, что ученые при правительстве могли достать такие деньги даже в Британии.

Они выбили 465 штук баксов. Из них 100 пошло на призы, а остальные 365 были, в общем, освоены Kaggle за поддержку соревнования, за платформу, хостинг и т. д. Нормальный там маржинг. И организаторы в результате получили решение в том формате, который предоставляет Kaggle: куча кода и два скрипта, train и predict, а внутри куча всякой вермишели, непонятно что. Когда мы им это все презентовали, они достаточно сильно плыли в нашем решении. Не факт, что у них просто знаний и навыков хватает с этим что-то сделать. По факту они фиганули полмиллиона долларов, получили интересное решение, кучу красивых картинок, и непонятно, что с этим делать. Но сама идея им понравилась. И вообще британские ученые сейчас очень активно работают в этом отношении. Мне нравится, что они делают лучше, чем Минобороны России, США и всех остальных стран. У них много данных, много интересных задач. Правда, у них денег не очень много и они пытаются как-то пиариться и привлекать дата-саентистов.

Они нашли еще немного денег… ну, не так много. И нашли подрядчика, который запилил им копию Kaggle. Собрали каких-то данных, подготовили, почистили и сделали еще два соревнования, прямо по окончании той задачи на Kaggle про спутники. Одно было computer vision, про него чуть позже, а другое — natural language processing. Кто-то из наших участвовал, но в тройку не вошел. Но тоже говорят, что интересно. Черт его знает.

Британцы же на своей волне, тем более подрядчик к соревнованиям, к data science имеет достаточно ортогональное отношение. И они там начали чудить. Потом поговорю про метрику и про то, как они делили private и public, — что было достаточно смешно, и надо было бы этим воспользоваться, если бы мы заранее знали.

Из-за чего весь шум по новостям и как все это получилось? Правила у них написаны очень хитро: участвовать могут все, но если ты уходишь в топ на денежный приз — а в каждом соревновании денежный приз составлял 40 тыс. фунтов — то на него могли претендовать только люди определенных категорий. В общем, не все. И они сделали хитрые манипуляции на тему паспорта, места проживания, банка и т. д. Несмотря на то, что я резидент США, живу в Сан-Франциско, плачу налоги там, не спонсирую российское правительство и кого бы то ни было даже через уплату налогов, все равно мне приз не положен чисто по цвету паспорта. С другой стороны, это не такие большие деньги для меня были, все не так страшно. Зато хоть история получилась интересная, буду внукам рассказывать.

Когда мы презентовали решение задачи про спутники, которая шла зимой, мы спросили организаторов, какого лешего и доколе такая дискриминация будет твориться? Там достаточно адекватный мужик, ученый, он сказал, что это подрядчик что-то мутит, на самом деле все будет по-другому, все исправим, все будет замечательно. Так не случилось, но тем не менее.

Теперь о самой проблеме. У Kaggle в последний год то data leak, то один, то пять, то еще какая-то муть с данными, то train и test разные. В общем, куча всякой экзотики. Это задалбывает. Когда ты приходишь домой по вечерам, ты не хочешь заниматься всей этой нездоровой инженерией, а хочешь, как белый человек, стакать XGBoost или тренировать сети, что-то такое.

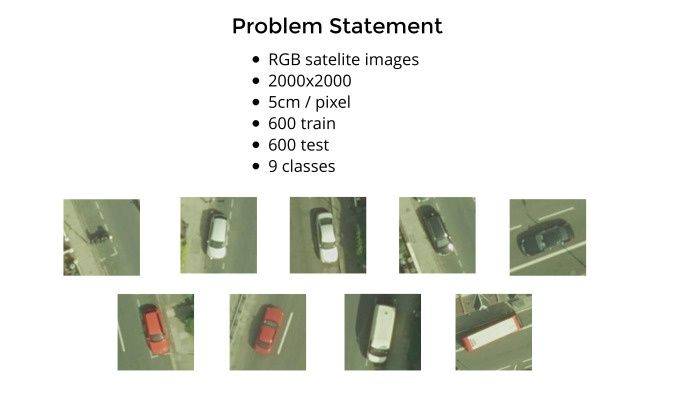

И вот британцы подготовили достаточно чистые данные. Там были вопросы к разметке, но совсем незначительные. Мы имеем 1200 спутниковых снимков, каждый сделан с высоты примерно 100 метров, думаю, чисто визуально. Каждый пиксель соответствует 5 см, и нужно было сделать стандартную задачу object detection. У нас есть девять классов, и вот примеры из их документации: мотоцикл, белая длинная машина и белая короткая машина. Сеть действительно путалась. Короткий хетчбэк или длинный хетчбэк — были вопросы к этому. Белый седан, хетчбэк, черный седан, хетчбэк, красный седан, хетчбэк, белый фургон и красно-белый автобус.

Реально по улицам еще ездят синие, желтые машинки и все остальные. Их надо было игнорировать. Почему они выбрали эти — кто их знает. В общем, надо найти машинки, но не все, а только определенные, и разбить их по классам. Плюс давайте добавим мотоциклы. Хорошо хоть не велосипеды и не самокаты. По сравнению с машиной — несмотря на то, что она 5 см на пиксель — мотоцикл достаточно шумный. Даже здесь он выглядит как некое немного расплывчатое пятно. Сама задача — стандартный object detection.

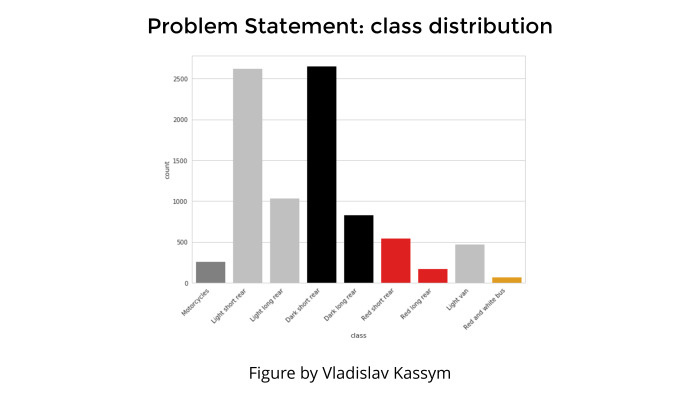

Любая задача классификации, любая презентация не обходится без картинки, которая показывает распределение классов. Это чтобы поговорить о том, что мы бы ушли в топ, но тут class inbalance, и он такой плохой, мы не смогли справиться, жизнь — печаль и все такое.

Здесь такого не было. Да, видно, что каких-то классов совсем мало — гораздо меньше, чем всех остальных. Например, крайний правый класс — автобус, или крайний левый класс — мотоциклы. Но это была не проблема, просто потому что мотоциклы от машин отличаются сильно и автобусы от всего остального отличаются сильно. И несмотря на то, что их мало, они настолько яркий класс, что с их детекцией проблем не было.

А во всяких этих белых хетчбэках и всем остальном действительно путались.

Как данные были предоставлены? Понятно, что можно маркировать данные по-разному. У нас спутниковые снимки или другие изображения, и нужно отметить машинки, ну или собачек, кошек… Можно обводить bounding boxes, целиком область, в которую входит данный объект, или просто мышкой ткнуть на точку и сказать, что это наш объект.

Применяются оба метода, и даже недавно была статья от Google, в которой они на десяти страницах размусоливали, не как новую сеть построить, а как правильно тренировать индусов, чтобы маркировать объекты, тыкая точечками так, чтобы потом восстанавливать bounding boxes, и как это все красиво. Статья довольно достойная. Правда, не очень понятно, что с ней делать, если нет специально обученных индусов.

Много статей про то, как работать и с bounding boxes, и с точками. В принципе, когда вы предсказываете и классифицируете object detection через bounding box, точность выше просто потому, что надо предсказать координаты этого четырехугольника. Loss function более точная и привязанная к самим данным. А когда у вас точка, предсказывать центр действительно сложнее. Точка и есть точка. Но в данной задаче, как и в задаче про котиков, которая проходит сейчас на Kaggle, данные отмаркированы через точки.

На этой картинке по размеру одна четверть от больших снимков 200 на 200. Они нам дают изображение, где отмечены центры машин для 600 картинок, и надо было предсказать их для других 600.

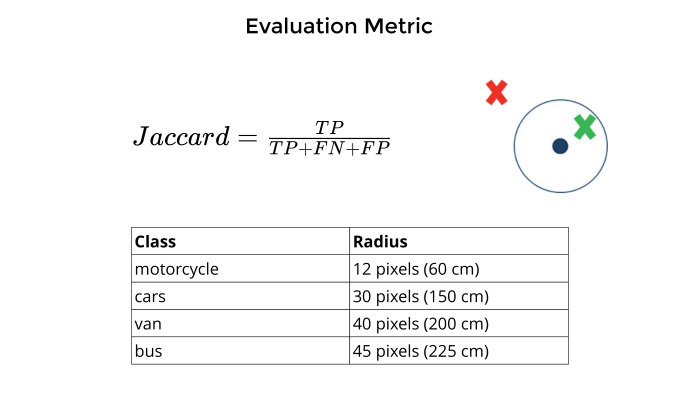

Метрика. Понятно, что любая задача не имеет смысла, пока не придумана численная оценка точности модели. Потом пытаешься ее подгонять, оптимизировать, чтобы все было прекрасно.

Метрикой в данной задаче выступал Jaccard. Как он мерился? Есть точка, которую они отмаркировали, центр машин. Вы предсказываете центр машин. Если они достаточно близко друг к другу, рядом, и это зависит от разных классов из таблицы снизу, то это true positive. Если нет — false positive. Если вообще ни черта нет — false negative.

Все это суммируется без усреднения по классам. Каждый мотоцикл вносит столько же, сколько автобус, фургон и все остальное. И Jaccard, true positive на общий union.

Соревнований сейчас море. Даже по deep learning сейчас десять соревнований проходит. У всех призы, интересные задачи, одни котики или задача про шейки матки чего стоят, какие-то тропики в Амазонии — много всего интересного. И это на Kaggle, где нормальная платформа, комьюнити и все прекрасно. Да банальный ImageNet 2017 заканчивается через пару недель, а я еще даже код не начал писать.

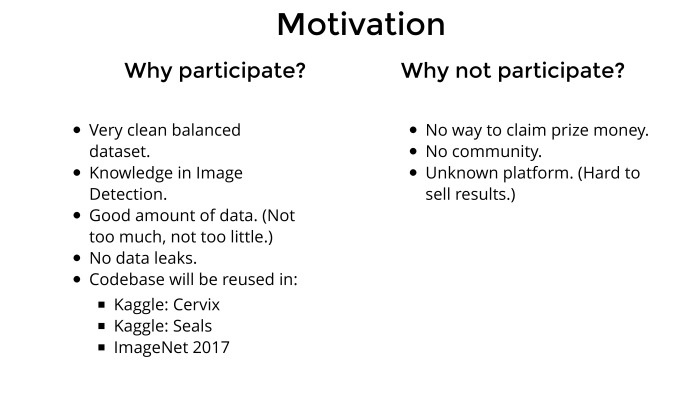

Когда я открываю какое-то соревнование, первый вопрос — зачем мне это надо? Потому что убивать свои вечера, выходные или на работе не работать, а соревнования гонять — нужны причины. Часто в голове рисуется некий список плюсов и минусов. Если мне нравится, как он выглядит, причем минусов может быть больше, — я обычно участвую.

Про минусы. Почему не стоит участвовать? Потому что денег не будет. Я на Kaggle участвовал последние два года и никогда не думал про призовые деньги, потому что участвовать в соревновании из финансовых соображений — наивный оптимизм. Уйти в топ, да еще в деньги, реально тяжело. Там 3000 участников, все брутальные ребята, хорошо подготовлены, у них куча железа и они не работают. Реально тяжело.

После того, как на спутниковых снимках нам дали приз и мне понравилось, манера мышления как-то немного изменилась в более меркантильную сторону. Так что денег не будет по правилам. Это было известно заранее, несмотря на то, о чем они после этого рассказывали в новостях.

Каждое соревнование дает очень много знаний. Но в одиночку бодаться в новую область тяжело. Поэтому гораздо удобнее, когда вас 50 человек и каждый рассказывает, что у кого получилось. В таком режиме можно за месяц-два, ничего не понимая в данной задаче, подняться до эксперта достаточно высокого уровня. Нужен коллектив. Коллектива не было, потому что это не Kaggle, а ребята из Slack не горели желанием участвовать, просто потому что денег не будет и вообще правила дурацкие. Ну и лень всем было.

Многие из этих соревнований не просто дают знания. Предположим, кто-то из вас будет искать работу на Западе. Вы неожиданно выясните, что из тех людей, которые там есть, народа, знающего о Яндексе, ШАДе, МФТИ и всех остальных, — гораздо меньше, чем народа, знающего о существовании Kaggle. Поэтому имеет смысл с перспективой продавать это при приеме на работу. Насколько интересной может быть задача для каких-то людей, стартапов и т. п.? Понятно, что любая задача про спутниковые снимки будет интересна. Любая задача про медицинские изображения будет интересна. Постакать xgboost — под большим вопросом. Kaggle знают, а какую-то доморощенную британскую площадку никто не знает. И строчка в резюме, типа я взял площадку, о которой никто из вас не знает, и там я красавчик, поэтому возьмите меня к себе, — звучит не очень хорошо. Kaggle в этом отношении гораздо лучше.

А теперь список плюсов. Зачем все это нужно? Данные реально красивые, хорошо подготовленные. Задача интересная. В этой теме я ничего не соображал на момент начала соревнований, а значит, за месяц-два можно натаскаться до действительно профессионального и серьезного уровня. И нет проблем с валидацией, валидацию мы вообще не делали. Действительно, очень красивые данные — основная мотивация. Она в том, что можно на каких-то чистых данных натренировать что-то, что важно, интересно. Можно добавить скиллов в свой инструментарий.

Image detection. Тот же ImageNet, задача про котиков и все остальное. Много где используется image detection. Я последние полгода искал работу в Долине, и про классификацию изображений никто не спрашивает, потому что это просто и пошло. А вот про detection спрашивают все подряд, очень много всяких самодвижущихся машин и прочих интересных применений в бизнесе. Jни спрашивают: «Ты в этом что-то соображаешь?» — «Нет». И дальше разговор не шел. Этот вопрос чисто по знаниям надо было закрывать. И его задача тоже добавляла.

Данных здесь достаточно много, а не как обычно — 6 картинок на public, 26 на private, какой-то shuffle на leaderboard. Здесь такого не было. Достаточно много картинок и на train, и на test, и каждый класс достаточно хорошо представлен, все хорошо. Никаких data leak. Кто участвовал в Quora, где у них обсуждение на форуме шло в режиме: «А ты помнишь, в четвертом лике ты уже подкрутил параметр?» — «Не, я над пятым ликом работаю». Такого криминала там не было, что очень приятно.

И в каждом соревновании вы работаете, пишите какой-то код, потом он копипастится или переносится в другие задачи. было бы полезно натренироваться на этих британских машинках, а потом перенести всё на другие задачи, попытаться в них гордо въехать в топ. Пока не получилось, но я над этим работаю.

Вся эта болтология в итоге сведется к тому, что решение на полстраницы. Что мы имеем? Тренировочные данные были размечены через точечки. Есть достаточно много статей о том, как все это считать, crowd counting и все остальное. И вообще: поскольку для многих компаний гораздо дешевле нанять индусов, тыкающих мышкой в какие-то объекты, нежели заставить их правильно обводить, то и точность нужна повыше, и времени больше. Просто дороже. Британцы, видимо, тоже наняли индусов, те натыкали, получились точечки — см. картинку снизу.

Как с этим работать, сходу непонятно. Про это надо читать, писать какой-то код, но мне было лень, потому что я на всю задачу отвел себе месяц. В первые две недели из четырех я собирался с мыслями. За две недели до конца решил все-таки начать что-то делать. Изобретать уже времени не оставалось, да и не хотелось. А хотелось свести эту задачу к стандартной решенной классической задаче.

Я на работе убил два рабочих дня и перебил все эти точечки под bounding boxes. Прямо взял sloth и вручную перебил train set. Слева изначальные метки, справа те, что в конце. Особо внимательный увидит, что один bounding box я таки забыл обвести. Сейчас на Kaggle — да и везде — достаточно часто проходит трюк, когда добавляется дополнительная информация, дополнительные метки к тренировочным данным. И это позволяет гордо въехать в топ.

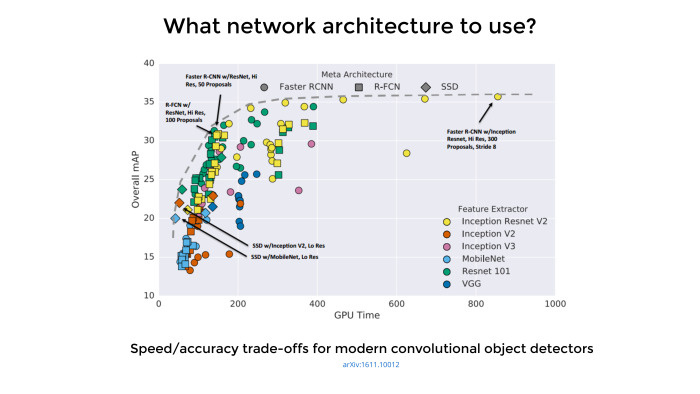

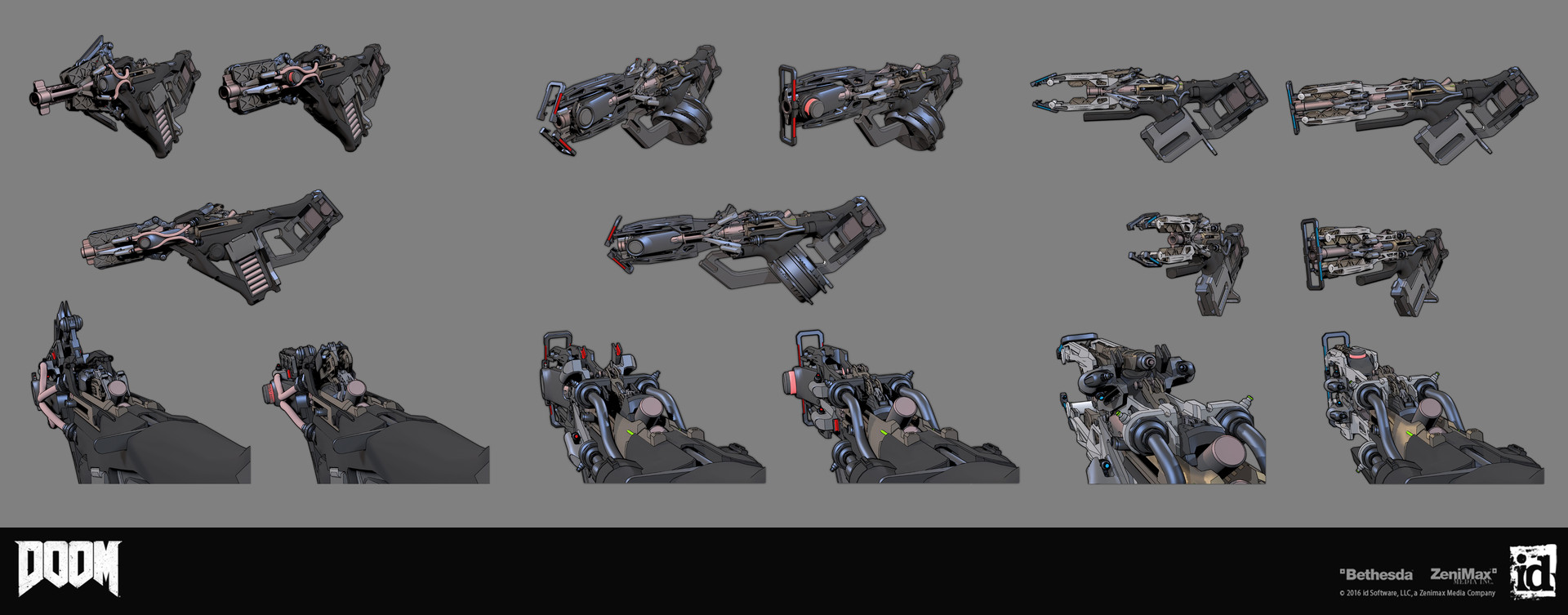

Google опубликовал достойную статью, последний выпуск был месяц назад. Там 11 авторов. Никакой новой архитектуры они не сделали, они реально воспользовались тем, что у Google много ресурсов, взяли много архитектур, чуть ли не сотню, написали под каждую код, прогнали через гугловские GPU, поставили много хороших экспериментов, собрали все в таблицу и опубликовали достаточно хорошую обзорную статью. Она объясняет, какие архитектуры чуть получше подходят для object detection, какие чуть похуже и чем можно пожертвовать.

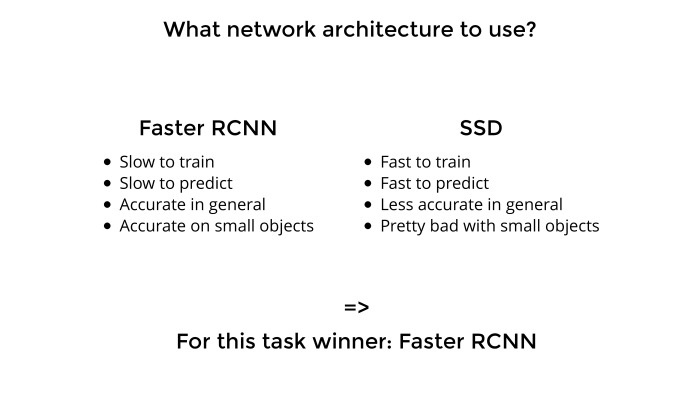

На основе этой статьи сложилось впечатление, что лучшие по точности архитектуры — на основе Faster R-CNN, а по скорости — на SSD. Поэтому в продакшен пилят SSD, а для соревнований и так далее — Faster RCNN.

Есть два основных семейства. Faster R-CNN медленная, предсказания повыше в точности. И, что было очень важно для меня, мелкие объекты тоже достаточно аккуратно предсказывают. А вы видели, что мотоцикл на этих снимках еще надо было найти. То есть нужна была сетка, которая делает аккуратные предсказания и тренировку на малых объектах. SSD достаточно быстрая: предсказывает, тренируется. Но она менее точная, и с малыми объектами в силу нюансов архитектуры сети там реально все плохо. Поэтому я остановился на Faster R-CNN.

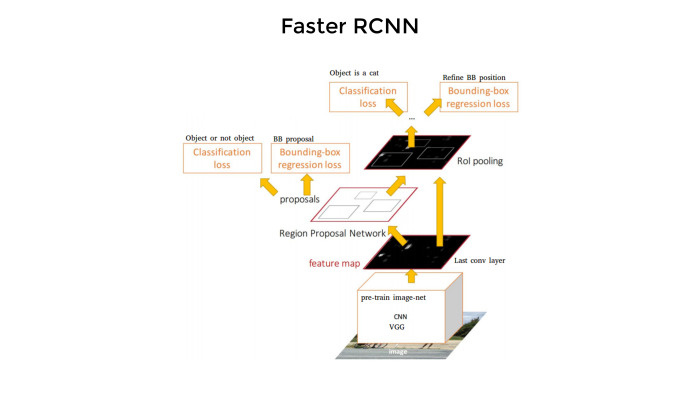

Вот сеть, архитектура выглядит вот так. Как вы видели, на этой картинке нужно найти все bounding boxes, а потом предсказать, какой класс в каждом из квадратиков там находится. Сеть работает примерно так. И она достаточно медленная — несмотря на то, что «Faster».

Сначала какие-то конволюционные слои на основе претренировочных сетей извлекают фичи. Потом одна ветвь предсказывает эти боксы. Потом идет классификация. Вот как интуитивно об этом думаешь — примерно так же тут все и происходит. Четыре loss-функции, все достаточно сложно, и с нуля писать код умаешься. Поэтому, естественно, никто этим не занимается.

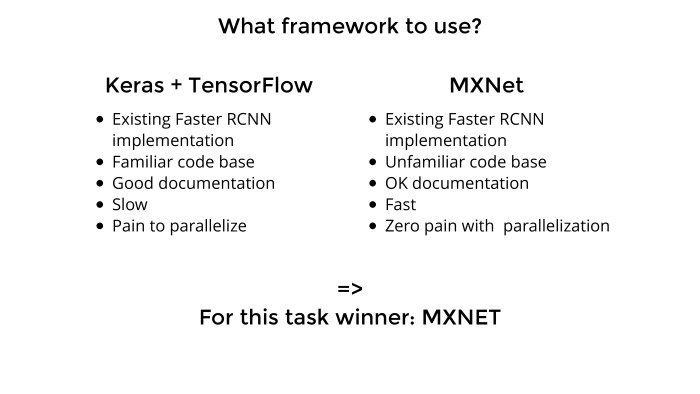

Мы выбрали, какую сеть использовать. Сейчас достаточно много на рынке всяких фреймворков: TensorFlow, Theano, Keras, MXNet, Cafe, еще какой-то зоопарк. Их реально очень много, и надо подумать, какую выбрать, какая здесь зайдет.

До этого я использовал исключительно Keras с бэкендом от Theana или TensorFlow. У Keras прекрасный API, очень удобно, там можно много штук делать из коробки, код на GitHub достаточно чистый, если надо что-то подкрутить — все достаточно просто.

Я знал код, достаточно нормальная документация, и к тому моменту, после первой задачи, я купил себе два GPU. Хотелось уже быть модным, распараллелить, чтобы все было быстро, как у мужиков в статьях, а не как у нас у всех обычно. Но с Keras была проблема. Я запустил, сделал предсказание и на тот момент даже ушел в топ-10 по этой задаче. Но он медленный, как эстонская черепаха. То ли такой overhead на вычислениях, то ли TensorFlow сам по себе медленный, а Keras добавляет overhead. Ну и имплементация, видимо, тоже была не самой удачной.

В то же время Артур Кузин очень активно в Slack топит за MXNet — что он быстрый, хороший, параллелится, все там прекрасно. В основном из-за параллелизации и хотелось этим воспользоваться. Параллелизацию остальные участники Slack подтвердили и сказали, что параллелится реально мизинцем левой ноги из коробки, все прекрасно. Faster R-CNN медленный, но у меня два GPU, хочется одно компенсировать другим. Keras не подходит — так давайте попробуем MXNet.

Что с ним плохо. Там непонятно что происходит в коде. Написан он тоже какими-то инопланетянами. Зато достаточно быстрый фреймворк. И из тех двух недель, что я работал над задачей, первую неделю я разбирался, кто там чей брат, как скормить данные, что куда скомпилировать. Скомпилировать там надо постараться. В общем, куча всякой экзотики. Но к концу недели я разобрался, подбил еще пару мужиков в чатике, и мы начали пилить MXNet. И все сразу стало хорошо. С первой же попытки уходишь в топ-5, тебе сразу приятно и ты прощаешь MXNet все.

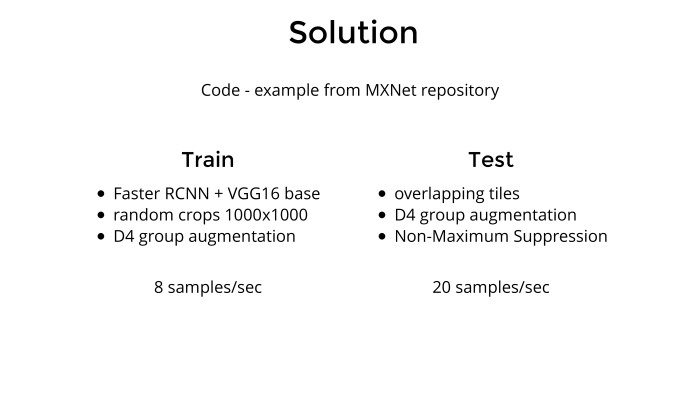

Само решение. Что было сделано? Берется MXNet, в нем, прям в самом репозитории, есть пример Faster R-CNN. Берется этот код, он сделан на примере (неразборчиво — прим. ред.), ты меняешь это на машинки. Затем взяли все спутниковые снимки, нужно было добавить батч-генератор, потому что снимки 2000 на 2000 в сеть просто так не скормишь. Надо их либо уменьшать, но тогда теряется информация и мотоцикл вообще будет не найти, либо резать на кусочки и скармливать сети.

В итоге я случайным образом вырезал из картинок куски 1000 на 1000. Потом все любят докапываться до моих D4 group augmentation. Что это такое? Кто знает математику и теорию групп, это группа симметрии квадрата. Грубо говоря, если у нас какой-то квадрат и мы его отразим вокруг центральной оси, вертикальной или горизонтальной, повернем на 90 градусов, то он в пространстве не изменится. И группа симметрий там как раз D4, 8 элементов. Если говорить на нормальном человеческом языке, это повороты на углы, кратные 90, отражение, да и всё.

Как тренировалась сеть? Берется картинка 2000 на 2000, из нее вырезается рандомный кусок 1000 на 1000, потом применяется отражение или поворот, ну и потом результат скармливается сети. Всё.

Мы все привыкли, что в классификации пролетают какие-то 90 картинок в секунду, 100, такие цифры. А здесь на двух GPU — 8. Он действительно достаточно медленный, поэтому Faster в продакшен надо прикручивать очень аккуратно.

Натренировали сеть. Как делать предсказания? Изначально 2000 на 2000 режутся на куски 1000 на 1000 с перехлестом. Опять же, можно поизвращаться и сделать такой фокус — предсказать, например, на кусочке машинки, а потом взять этот изначальный спутниковый снимок, как-то отразить, сделать предсказание и потом отразить обратно. По сути, мы предсказываем то же самое в первом и втором случае, но немножко по-разному. Можно считать это некой ансамблевую технику. И — алгоритм non-maximum suppression. По сути, если мы порезали картинку 2000 на 2000 на куски с перехлестом, то одна машинка может оказаться в различных кусках. Когда мы предсказываем, получается два предсказания одной и той же машинки. Это надо чистить — что и делает алгоритм non-maximum suppression. Если два bounding box пересекаются в предсказаниях, тот, у которого confidence повыше, остается, а остальное режется под ноль.

Короче, берутся картинки, режутся на кусочки, делается предсказание, собираются обратно. Это происходило на высоком уровне.

Всякие аугментации немного добрасывают, и именно это отделило меня по точности от других ребят в Slack, от Сергея Мушинского и Владислава Кассыма.

Про скорость предсказания. Люблю добавлять в статьях, насколько быстро все работает, потому что так можно оценить, насколько все перечисленные модели далеки от продакшена, от реальных продуктов, и что с этим всем делать. На двух GPU — у меня дома в десктопе стоит два Titan Pascal X — получается где-то 20 предсказаний, 20 картинок в секунду. Вот и все решение.

Когда все хорошо, говорить скучно. Давайте говорить о том, что не получается. Тут всякие автобусы друг к другу плотно натыканы, еще и под углами в правом нижнем углу. Зеленые bounding boxes — предсказания. Видно, что предсказаний гораздо меньше, чем автобусов. Выяснилось, да и остальные подтвердили, что когда надо предсказывать много объектов и они очень плотно упакованы, то сети как-то не хватает. Она что-то предсказывает, а что-то нет. Думаю, для людей, которые сейчас работают над задачей подсчета морских котиков на Kaggle, это будет особенно важно, потому что котики чуть ли не в три слоя друг на друге лежат. Понять, кто из них где, достаточно тяжело. Я зашел, попытался, но до топа мне еще далеко. Там такие фокусы не проходят, надо немного по-другому работать.

В ситуации close packed objects, когда объекты натыканы очень близко друг к другу, все идет не очень хорошо. Тут надо либо какие-то эвристики крутить, либо поворачивать, предсказывать и поворачивать обратно, черт его знает.

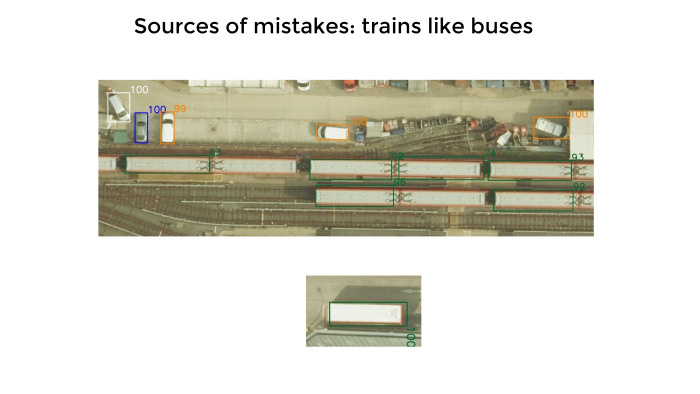

Вот, достаточно редкая ошибка, но он любил мне предсказывать вагоны поездов как автобусы. Сравните их чисто визуально. Они по размеру и по расцветке примерно одинаковые, и сеть я сильно не осуждаю. Но это потом резалось какими-то эвристиками. На верхней картинке квадратики, а рядом с ними цифры, показывающие уверенность. Она меряется от 0 до 100. Сеть вообще не стесняется: здесь на 100% уверен, здесь не очень — 99%. По факту так и было. Сеть была очень сильно уверена в предсказаниях и не лажала. Есть подозрение, что под эту задачу все работало на ура.

Был какой-то процент картинок, достаточно мало. Чтобы найти эти пять картинок, мне пришлось пролистать картинок 70–100 с предсказаниями. Да, он любил предсказывать какую-то ерунду как объекты. Красными квадратиками были отмечены мотоциклы. Их реально тяжело отмечать, просто потому что мало пикселей и мало фич можно извлекать. Слева сверху — угол здания, посередине — два рядом стоящих человека. Или больше. Может, чемодан кто-то из них держит. Сеть их может принять за мотоцикл. Справа — гараж какой-то, она его опознала как грузовик. Действительно, грузовики такого же цвета.

А снизу какой-то мусор, который был инкриминирован как красные машинки. Это, конечно, криминал. Такого, по идее, сеть не должна была делать, но я это списываю просто на то, что красных машинок было мало.

Тут я не успел, но можно было добавить много картинок. На предыдущих слайдах были скорее исключения, чем правила. Точность моей модели была где-то 0,85 из 100, и я ошибся на 1200 машинок, если оценивать в них

А когда я глазами смотрю, я не вижу 1200. Я вижу 20, или, если сильно себя заставлю, 50.

Проблема в том, что многие машины визуально не отличить, причем что мне, что сети, что, видимо, тем индусам, которые всё размечали. Банально серая машина в тени не отличается от какой-нибудь черной машины. Или та же самая машина, но на солнце, выглядит уже как светлая и белая. Где как и что отмечается — оно не обязательно будет связано с реальной жизнью.

Синие машины тоже доставляют. Если есть ярко-синяя машина, а такие были, то с ней все понятно, мы ее не детектим. А если какая-то черная с синеватым отливом? Там достаточно много было таких и непонятно, нужно ли их детектировать.

Всякие белые и длинные хетчбэки детектировались как фургоны, и прочее. Там были проблемы с разметкой, парень, занявший первое место, это отметил на форуме. Мы с ним пообщались немножко. Если бы разметка была повыше уровнем, наши модели, ничего не делая, показывали бы не мои 0,85 или его 0,87, а где-нибудь 0,95–0,97. То есть сети работали реально обалденно. Мы поражались, когда делали визуальную оценку. Может, там дерево и одни фары торчат да багажник — а он и машину находит, и класс определяет. Меня это удивило в лучшую сторону.

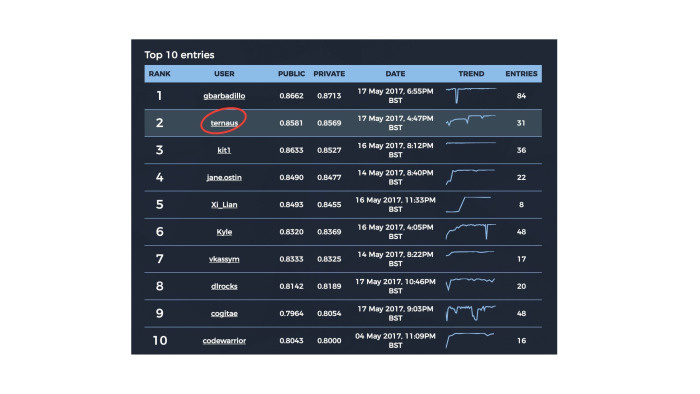

Вот табличка, которую я опубликовал в Facebook, когда британцы сказали, что по цвету паспорта денег не дадут. Она потом разошлась в новостях, где-то на «Вестях» вроде народ ее видел, еще где-то. Я эти передачи не смотрел, не знаю.

Здесь 10 участников, я второй, четвертый не будем говорить кто, хотя он назвал себя jane.ostin, ну и седьмое место — тоже наш парень из чата. Трое из десяти. Кайла все знают, легендарный альфа-гусь на Kaggle. Многие ребята из Kaggle тоже пришли сюда.

Британцы красавчики, что учудили здесь подсчет public и private. Все знают стандартные правила Kaggle: ты делаешь какой-то сабмит и тебе подсказывают оценку на private, а потом ты выбираешь два лучших сабмита, которые имеют право на жизнь. Потом соревнования оканчиваются, и по ним дается оценка того, насколько модель хороша в итоге. И только потом уже решается, кто победитель, а кто нет. Вам нужно в конце соревнования выбрать два лучших потенциальных сабмита.

Ребята, которые запиливали копию Kaggle, поняли, что должен быть private и public, разделили 33% на 66%. Они еще догадались, что public надо показывать по части public, а private — по части private. Но эту тему с двумя лучшими сабмитами они не поняли, и получилось, что public и private оценивались независимо. Можно думать, что на Kaggle надо указать два лучших сабмита, и они учитывались в private. Здесь учитывались все. И поэтому у парня на первом месте, который gbarbadillo, — у него 84 сабмита. Обычно на Kaggle нет никаких понтов, сабмить как можно больше, потому что ты же показываешь результат на public, но не на private. Здесь — нет, надо было сабмитить все подряд каждый день и по максимуму, просто потому что были шансы, что на private один из ваших рандомных сабмитов покажет чуть более удачный результат. Думаю, именно так он свои 0,87 и получил, потому что у нас разрыв где-то в 180 машинок, а 180 машинок я глазами не вижу. Наверное, модели у него получше были, раз он с б'oльшим энтузиазмом к этому подошел. Ну и факт, что он гораздо больше сабмитил все подряд, тоже ему помог.

Вот как это выглядит на картинке 2000 на 2000. Разного цвета боксы. Предсказания, судя по тому, что я глазами видел, верны. Вот так оно все и предсказывается. После этого для каждого бокса рассчитывается центр машинки, и результат уже идет в предсказание. Тут сеть тоже не стеснялась — 99, 100 и так далее, достаточно сложно. Машины тут где-то из-под дерева торчат, много интересных классов.

Итоговое решение. Что мы сделали? Я лично перебил центры машинок под bounding boxes, во многом потому что так было проще начать задачу. Если бы я этого не сделал, фиг бы кто из Slack подписался бы поучаствовать, коллективом работать удобнее. А так я им боксы набил, и они такие — ну, значит, попробуем.

С точки зрения модели используем Faster R-CNN, у которой base был VGG-16. Изначально мы пробовали ResNet, но работало гораздо хуже. Потом переключились на VGG.

Использовали D4, про которую я недавно рассказывал, аугментацию train and test, ну и всё.

С точки зрения железа я использовал свой домашний компьютер. CPU не очень важен. Оперативы у меня 32 ГБ — что тоже, наверное, не очень важно. 16 бы хватило. Ну и два Titan — это важно. Британцы мне вчера написали e-mail и через несколько дней опубликуют у себя на сайте итоги соревнования: как они все восхитились, прониклись, как все красиво получилось — ну, обыкновенный пиар. Какие-то вопросы они задают участникам, даже фотографию попросили. Надо подумать, что им отправить. Один из вопросов был: а что сделало ваш подход уникальным по сравнению с другими участниками? Хочется ответить, что у меня был другой random seed, он просто был удачнее. Но по сути что я, что Серега, что Владислав занимались примерно одним и тем же. Мы брали MXNet, пилили точно так же. Просто, видимо, из-за того, что у меня было больше железа, я чуть дольше тренировал. Аугментации они добавили немножко, но в целом я только на этом, наверное, оторвался.

На тему двух GPU в Slack достаточно частый вопрос: вот я убедился, что deep learning возбуждает, красиво, умные слова, ИИ и прочее — но какое железо надо? Я студент, денег нет, сколько мне надо украсть? Нормальный ответ: чтобы начать, одного GTX 1080 хватит за глаза и на нем можно нормально все делать, в топ уходить. Но чтобы где-то как-то усугубить и претендовать на призовые места, имеет смысл вложиться в железо. Два GPU — нормально. Причем до соревнования я не умел их параллелить, потому что в Keras это океан боли. Зато можно проверять две идеи одновременно. Как показал эксперимент, соревнования — это не несколько умная у тебя модель, насколько ты сам умный или еще что-то, а как быстро ты можешь итерировать и отсекать свои и чужие идеи. И когда у вас два GPU, можно тренировать две сети и отсекать гораздо быстрее. Думаю, домой приеду, еще парочку куплю.

Спасибо. Затаскивали мы это соревнование не в одиночку, там были еще двое ребят, они тоже в десятке. Это Сергей Мушинский — привет, Ангарск! Это Владислав Кассым, тоже привет. И Сергей Белоусов. Он сам участвовать не мог по каким-то религиозным соображениям, зато он в области object detection большой эксперт, очень хорошо меня консультировал по статьям, глупым вопросам и всему остальному. Хочется подчеркнуть, что я в задаче ни черта не понимал еще месяц назад. И за месяц натаскаться с нуля до кое-чего, второе место, новости и так далее — для этого нужно общение с теми, кто готов отвечать на твои вопросы. Спасибо.

|

|

Юзабилити карточки товара. Сценарий выгодный для бизнеса |

|

|

Типы struct, union и enum в Modern C++ |

Язык C++ сильно изменился за последние 10 лет. Изменились даже базовые типы: struct, union и enum. Сегодня мы кратко пройдёмся по всем изменениям от C++11 до C++17, заглянем в C++20 и в конце составим список правил хорошего стиля.

Зачем нужен тип struct

Тип struct — фундаментальный. Согласно C++ Code Guidelines, struct лучше использовать для хранения значений, не связанных инвариантом. Яркие примеры — RGBA-цвет, вектора из 2, 3, 4 элементов или информация о книге (название, количество страниц, автор, год издания и т.п.).

Правило C.2: Use class if the class has an invariant; use struct if the data members can vary independently

struct BookStats

{

std::string title;

std::vector authors;

std::vector tags;

unsigned pageCount = 0;

unsigned publishingYear = 0;

};Он похож на class, но есть два мелких различия:

- по умолчанию в struct действует видимость public, а в class — private

- по умолчанию struct наследует члены базовых структур/классов как публичные члены, а class — как приватные члены

// поле data публичное

struct Base

{

std::string data;

};

// Base унаследован так, как будто бы написано `: public Base`

struct Derived : Base

{

};Согласно C++ Core Guidelines, struct хорошо применять для сокращения числа параметров функции. Этот приём рефакторинга известен как "parameter object".

Правило C.1: Organize related data into structures (structs or classes)

Кроме того, структуры могут сделать код более лаконичным. Например, в 2D и 3D графике удобнее считать в 2-х и 3-х компонентных векторах, чем в числах. Ниже показан код, использующий библиотеку GLM (OpenGL Mathematics)

// Преобразует полярные координаты в декартовы

// См. https://en.wikipedia.org/wiki/Polar_coordinate_system

glm::vec2 euclidean(float radius, float angle)

{

return { radius * cos(angle), radius * sin(angle) };

}

// Функция делит круг на треугольники,

// возвращает массив с вершинами треугольников.

std::vector TesselateCircle(float radius, const glm::vec2& center, IColorGenerator& colorGen)

{

assert(radius > 0);

// Круг аппроксимируется с помощью треугольников.

// Внешняя сторона каждого треугольника имеет длину 2.

constexpr float step = 2;

// Число треугольников равно длине окружности, делённой на шаг по окружности.

const auto pointCount = static_cast(radius * 2 * M_PI / step);

// Вычисляем точки-разделители на окружности.

std::vector points(pointCount);

for (unsigned pi = 0; pi < pointCount; ++pi)

{

const auto angleRadians = static_cast(2.f * M_PI * pi / pointCount);

points[pi] = center + euclidean(radius, angleRadians);

}

return TesselateConvexByCenter(center, points, colorGen);

} Эволюция struct

В C++11 появилась инициализация полей при объявлении.

struct BookStats

{

std::string title;

std::vector authors;

std::vector tags;

unsigned pageCount = 0;

unsigned publishingYear = 0;

};Ранее для таких целей приходилось писать свой конструктор:

// ! устаревший стиль !

struct BookStats

{

BookStats() : pageCount(0), publishingYear(0) {}

std::string title;

std::vector authors;

std::vector tags;

unsigned pageCount;

unsigned publishingYear;

};Вместе с инициализацией при объявлении пришла проблема: мы не можем использовать литерал структуры, если она использует инициализацию полей при объявлении:

// C++11, C++14: будет ошибка компиляции из-за инициализаторов pageCount и publishingYear

// C++17: компиляция проходит

const auto book = BookStats{

u8"Незнайка на Луне",

{ u8"Николай Носов" },

{ u8"детская", u8"фантастика" },

576,

1965

};В C++11 и C++14 это решалось вручную написанием конструктора с boilerplate кодом. В C++17 ничего дописывать не надо — стандарт явно разрешает литеральную инициализацию для структур с инициализаторами полей.

В примере написаны конструкторы, необходимые только в C++11 и C++14:

struct BookStats

{

// ! устаревший стиль!

BookStats() = default;

// ! устаревший стиль!

BookStats(

std::string title,

std::vector authors,

std::vector tags,

unsigned pageCount,

unsigned publishingYear)

: title(std::move(title))

, authors(std::move(authors))

, tags(std::move(authors)) // ;)

, pageCount(pageCount)

, publishingYear(publishingYear)

{

}

std::string title;

std::vector authors;

std::vector tags;

unsigned pageCount = 0;

unsigned publishingYear = 0;

};В C++20 литеральная инициализация обещает стать ещё лучше! Чтобы понять проблему, взгляните на пример ниже и назовите каждое из пяти инициализируемых полей. Не перепутан ли порядок инициализации? Что если кто-то в ходе рефакторинга поменяет местами поля в объявлении структуры?

const auto book = BookStats{

u8"Незнайка на Луне",

{ u8"Николай Носов" },

{ u8"детская", u8"фантастика" },

1965,

576

};В C11 появилась удобная возможность указать имена полей при инициализации структуры. Эту возможность обещают включить в C++20 под названием "назначенный инициализатор" ("designated initializer"). Подробнее об этом в статье Дорога к С++20.

// Должно скомпилироваться в C++20

const auto book = BookStats{

.title = u8"Незнайка на Луне",

.authors = { u8"Николай Носов" },

.tags = { u8"детская", u8"фантастика" },

.publishingYear = 1965,

.pageCount = 576

};Зачем нужен тип union

Вообще-то в C++17 он не нужен в повседневном коде. C++ Core Guidelines предлагают строить код по принципу статической типобезопасности, что позволяет компилятору выдать ошибку при откровенно некорректной обработке данных. Используйте std::variant как безопасную замену union.

Если же вспоминать историю, union позволяет переиспользовать одну и ту же область памяти для хранения разных полей данных. Тип union часто используют в мультимедийных библиотеках. В них разыгрывается вторая фишка union: идентификаторы полей анонимного union попадают во внешнюю область видимости.

// ! этот код ужасно устрарел !

// Event имет три поля: type, mouse, keyboard

// Поля mouse и keyboard лежат в одной области памяти

struct Event

{

enum EventType {

MOUSE_PRESS,

MOUSE_RELEASE,

KEYBOARD_PRESS,

KEYBOARD_RELEASE,

};

struct MouseEvent {

unsigned x;

unsigned y;

};

struct KeyboardEvent {

unsigned scancode;

unsigned virtualKey;

};

EventType type;

union {

MouseEvent mouse;

KeyboardEvent keyboard;

};

};Эволюция union

В C++11 вы можете складывать в union типы данных, имеющие собственные конструкторы. Вы можете объявить свой констуктор union. Однако, наличие конструктора ещё не означает корректную инициализацию: в примере ниже поле типа std::string забито нулями и вполне может быть невалидным сразу после конструирования union (на деле это зависит от реализации STL).

// ! этот код ужасно устрарел !

union U

{

unsigned a = 0;

std::string b;

U() { std::memset(this, 0, sizeof(U)); }

};

// нельзя так писать - поле b может не являться корректной пустой строкой

U u;

u.b = "my value";В C++17 код мог бы выглядеть иначе, используя variant. Внутри variant использует небезопасные конструкции, которые мало чем отличаются от union, но этот опасный код скрыт внутри сверхнадёжной, хорошо отлаженной и протестированной STL.

#include

struct MouseEvent {

unsigned x = 0;

unsigned y = 0;

};

struct KeyboardEvent {

unsigned scancode = 0;

unsigned virtualKey = 0;

};

using Event = std::variant<

MouseEvent,

KeyboardEvent>; Зачем нужен тип enum

Тип enum хорошо использовать везде, где есть состояния. Увы, многие программисты не видят состояний в логике программы и не догадываются применить enum.

Ниже пример кода, где вместо enum используют логически связанные булевы поля. Как думаете, будет ли класс работать корректно, если m_threadShutdown окажется равным true, а m_threadInitialized — false?

// ! плохой стиль !

class ThreadWorker

{

public:

// ...

private:

bool m_threadInitialized = false;

bool m_threadShutdown = false;

};Мало того что здесь не используется atomic, который скорее всего нужен в классе с названием Thread*, но и булевы поля можно заменить на enum.

class ThreadWorker

{

public:

// ...

private:

enum class State

{

NotStarted,

Working,

Shutdown

};

// С макросом ATOMIC_VAR_INIT вы корректно проинициализируете atomic на всех платформах.

// Менять состояние надо через compare_and_exchange_strong!

std::atomic = ATOMIC_VAR_INIT(State::NotStarted);

}; Другой пример — магические числа, без которых якобы никак. Пусть у вас есть галерея 4 слайдов, и программист решил захардкодить генерацию контента этих слайдов, чтобы не писать свой фреймворк для галерей слайдов. Появился такой код:

// ! плохой стиль !

void FillSlide(unsigned slideNo)

{

switch (slideNo)

{

case 1:

setTitle("...");

setPictureAt(...);

setTextAt(...);

break;

case 2:

setTitle("...");

setPictureAt(...);

setTextAt(...);

break;

// ...

}

}Даже если хардкод слайдов оправдан, ничто не может оправдать магические числа. Их легко заменить на enum, и это по крайней мере повысит читаемость.

enum SlideId

{

Slide1 = 1,

Slide2,

Slide3,

Slide4

};Иногда enum используют как набор флагов. Это порождает не очень наглядный код:

// ! этот код - сомнительный !

enum TextFormatFlags

{

TFO_ALIGN_CENTER = 1 << 0,

TFO_ITALIC = 1 << 1,

TFO_BOLD = 1 << 2,

};

unsigned flags = TFO_ALIGN_CENTER;

if (useBold)

{

flags = flags | TFO_BOLD;

}

if (alignLeft)

{

flag = flags & ~TFO_ALIGN_CENTER;

}

const bool isBoldCentered = (flags & TFO_BOLD) && (flags & TFO_ALIGN_CENTER);Возможно, вам лучше использовать std::bitset:

enum TextFormatBit

{

TextFormatAlignCenter = 0,

TextFormatItalic,

TextFormatBold,

// Значение последней константы равно числу элементов,

// поскольку первый элемент равен 0, и без явно

// указанного значения константа на 1 больше предыдущей.

TextFormatCount

};

std::bitset flags;

flags.set(TextFormatAlignCenter, true);

if (useBold)

{

flags.set(TextFormatBold, true);

}

if (alignLeft)

{

flags.set(TextFormatAlignCenter, false);

}

const bool isBoldCentered = flags.test(TextFormatBold) || flags.test(TextFormatAlignCenter); Иногда программисты записывают константы в виде макросов. Такие макросы легко заменить на enum или constexpr.

Правило Enum.1: предпочитайте макросам перечислимые типы

// ! плохой стиль - даже в C99 этого уже не требуется !

#define RED 0xFF0000

#define GREEN 0x00FF00

#define BLUE 0x0000FF

#define CYAN 0x00FFFF

// стиль, совместимый с C99, но имена констант слишком короткие

enum ColorId : unsigned

{

RED = 0xFF0000,

GREEN = 0x00FF00,

BLUE = 0x0000FF,

CYAN = 0x00FFFF,

};

// стиль Modern C++

enum class WebColorRGB

{

Red = 0xFF0000,

Green = 0x00FF00,

Blue = 0x0000FF,

Cyan = 0x00FFFF,

};Эволюция enum

В С++11 появился scoped enum, он же enum class или enum struct. Такая модификация enum решает две проблемы:

- область видимости констант enum class — это сам enum class, т.е. снаружи вместо

Enum e = EnumValue1вам придётся писатьEnum e = Enum::Value1, что гораздо нагляднее - enum конвертируется в целое число без ограничений, а в enum class для этого потребуется static cast:

const auto value = static_cast(Enum::Value1)

Кроме того, для enum и scoped enum появилась возможность явно выбрать тип, используемый для представления перечисления в сгенерированном компилятором коде:

enum class Flags : unsigned

{

// ...

};В некоторых новых языках, таких как Swift или Rust, тип enum по умолчанию является строгим в преобразованиях типов, а константы вложены в область видимости типа enum. Кроме того, поля enum могут нести дополнительные данные, как в примере ниже

// enum в языке Swift

enum Barcode {

// вместе с константой upc хранятся 4 поля типа Int

case upc(Int, Int, Int, Int)

// вместе с константой qrCode хранится поле типа String

case qrCode(String)

}Такой enum эквивалентен типу std::variant, вошедшему в C++ в стандарте C++ 2017. Таким образом, std::variant заменяет enum в поле структуры и класса, если этот enum по сути обозначает состояние. Вы получаете гарантированное соблюдение инварианта хранимых данных без дополнительных усилий и проверок. Пример:

struct AnonymousAccount

{

};

struct UserAccount

{

std::string nickname;

std::string email;

std::string password;

};

struct OAuthAccount

{

std::string nickname;

std::string openId;

};

using Account = std::variant;Правила хорошего стиля

Подведём итоги в виде списка правил:

- C.1: организуйте логически связанные данные в структуры или классы

- C.2: используйте class если данные связаны инвариантом; используйте struct если данные могут изменяться независимо

- указывайте инициализаторы полей, без них вы получите неинициализированные поля с мусором

- не инициализируйте поля нулями в конструкторах, полагайтесь на инициализаторы полей

- в общем случае не пишите конструкторы структур, используйте литеральную инициализацию

- используйте

std::variantкак безопасную замену union вместо структуры или класса, если данные находятся строго в одном из нескольких состояний, и в некоторых состояниях некоторые поля теряют смысл - используйте

enum classилиstd::variantдля представления внутреннего состояния объектов

- предпочитайте

std::variant, если в разных состояниях класс способен хранить разные поля данных

- предпочитайте

- используйте

enum classвместоenumв большинстве случаев

- используйте старый

enumесли вам крайне важна неявная конвертация enum в целое число - используйте

enum classилиenumвместо магических чисел - используйте

enum class,enumилиconstexprвместо макросов-констант

- используйте старый

Из таких мелочей строится красота и лаконичность кода в телах функций. Лаконичные функции легко рецензировать на Code Review и легко сопровождать. Из них строятся хорошие классы, а затем и хорошие программные модули. В итоге программисты становятся счастливыми, на их лицах расцветают улыбки.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author sergey_shambir c++ c++17 |

[Из песочницы] Как просмотреть 20 млн доменных имен и остаться довольным |

Друзья, добро пожаловать! Ниже вас ждет история о том, как было проанализировано 20 миллионов доменных имен и что из этого вышло. Результаты можно посмотреть скачав csv-файл или восстановив дамп базы данных в PostgreSQL.

При желании можно поиграться с исходниками здесь или сразу с контейнерами, используя

version: "2"

services:

app:

image: danieljust/domain-finder-v1

tty: true

ports:

- "3000:3000"

rabbit:

image: rabbitmq:3

db:

image: postgres

environment:

POSTGRES_PASSWORD: example

POSTGRES_USER: postgres

POSTGRES_DB: postgresИнструкцию можно найти также на гитхабе

Приятного чтения!

Disclaimer!

Все, что вы увидите и прочтете в данной статье, не является призывом и агитацией к домейнингу, а уж тем более к киберсквоттингу. Все действия были совершены ради интереса и, как говорится, «for fun».

Вступление

У многих компаний, желающих провести ребрендинг или только-только выходящих на широкий рынок, возникает желание подобрать красивый домен.

Любопытства ради, было решено в качестве красивых доменов посмотреть короткие 1-3 символьные домены.

Терминология

- top-level domain (TLD) — домен верхнего уровня;

- second-level domain (SLD) — домен второго уровня.

Пример vk.com — в данном случае vk = SLD, com = TLD.

Структура таблицы в базе данных

| id | sldlength | tld | domain | price | roubleprice | available | definitive |

|---|---|---|---|---|---|---|---|

| 1 | 1 | actor | 1.actor | 20000 | 1199520 | True | True |

id— идентификатор записи

sldlength— длина домена второго уровня

tld— домен верхнего уровня

domain— собственно доменное имя

price— цена в долларах

roubleprice— цена в рублях

available— флаг, показывающий доступность домена

definitive— флаг, показывающий был ли флагavailableсверен с реестром

Результат

В процессе работы были замечены интересные сочетания доменных имен, ознакомиться с ними можно в таблице ниже.

| domain | roubleprice |

|---|---|

| 2.pizza | 47981 |

| 0.fail | 23991 |

| a.xyz | 1199520 |

| ab.xyz | 299880 |

| ad.money | 11876 |

| as.mba | 2400 |

| as.guru | 11996 |

| at.network | 23991 |

| js.army | 47981 |

2.pizza — Идеально подойдет для начинающей пиццерии;

0.fail — для сверхнадежного чего-нибудь;

a.xyz, ab.xyz — для желающих быть поближе к гуглу;

ad.money — для рекламной площадки;

as.guru, as.mba — для консультационных фирм;

at.network — для фирм, связанных с администрированием сетей;

js.army — пролетарии всех стран, объединяйтесь.

Большинство двухсимвольных доменов, если и оказывались свободными, то их цена кусалась.

В двухсимвольных доменах верхнего уровня стран было найдено четыре свободных домена (все в чешской зоне), да и к тому же за небольшие деньги в 1000 рублей.

В трехсимвольных доменах верхнего уровня стран нашлось куда больше свободных и по доступной цене.

Количество общих доменов верхнего уровня многократно преобладает над доменами стран (домены стран составляют лишь 4% от общего числа свободных доменных имен)

Путь к результатам

Этап 1. Начало

За основу возможных символов в SLD были взяты -1234567890abcdefghijklmnopqrstuvwxyz (всего 37 символов).

Выясняется, что имеем мы число размещений с повторениями p^n.

Итого вариантов.

Поскольку SLD не может начинаться и заканчиваться дефисом, исключим такие случаи и получим 49284.

Но это только начало.

Этап 2. Выбор API

Множество сайтов позволяют узнать, занят ли указанный домен через веб-интерфейс.

Для выполнения поставленной задачи ручного ввода данных явно недостаточно и требуется API, способное решить проблему.

В процессе поиска были встречены и отброшены следующие варианты:

- предоставьте нам паспортные данные, а мы вам доступ к API;

- заплатите нам всего лишь раз (от 5 до 15 долларов) и получите пожизненный доступ к API;

- оплата доступа к API раз в месяц;

- каждый запрос к API стоимостью около $0,01.

Но душа хотела привнести что-нибудь полезное в мир open-source да еще и максимально бесплатно.

Решением проблемы стало данное API.

Его плюсы:

- бесплатный;

- позволяет обработать до 500 доменов за один запрос;

- проработанная API документация.

Его минусы:

- ограниченное количество запросов в минуту;

- ответы от сервера не всегда совпадают с тем, что предлагает UI.

Например, ответ API может содержать информацию, что сайт занят, и его нельзя купить. В это же время, данное доменное имя может быть доступно для покупки через UI.

Как быть уверенным в доступности домена?

В процессе общения с технической поддержкой, было выяснено, что при финальном подтверждении покупки выбранного домена, производится контрольная проверка его доступности.

Из наблюдений, флаг definitive позволяет с большей вероятностью сделать вывод о занятости доменного имени.

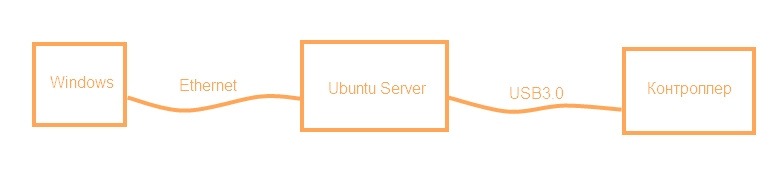

Этап 3. Выбор инструментов и подготовка решения

С помощью API godaddy можно получить список TLD, в которых возможно приобрести доменные имена.

Из них выбираются TLD состоящие из одного слова (были убраны *.com.ru и т.д.). В итоге 400 TLD. Легкая арифметика приводит нас к доменов к проверке.

API godaddy может обработать до 500 доменов за 1 запрос, но имеет ограниченное количество запросов в 1 минуту.

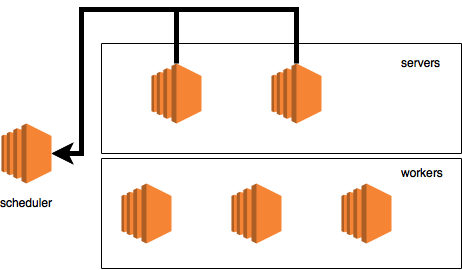

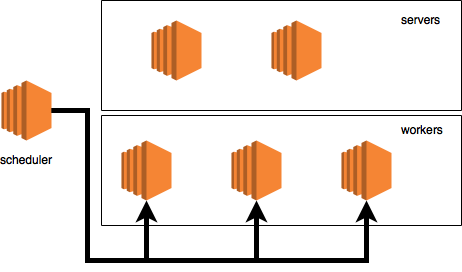

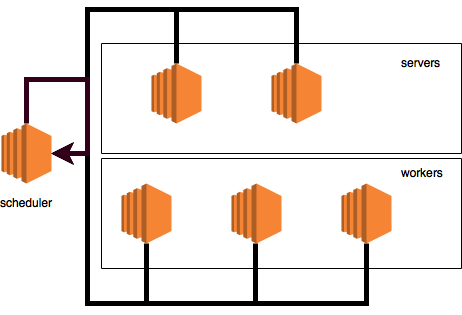

В соответствии с вышесказанным, алгоритм работы программы был следующим:

- разделить все необходимые к проверке домены на куски по 5000 доменов;

- положить полученные куски в RabbitMQ очередь;

- взять порцию данных;

- поделить по 500 доменов. Отправить 10 запросов;

- обработать данные, положить информацию о свободных доменах в базу данных;

- подождать 20 секунд;

- при наличии сообщений в очереди выполнить пункты 3-6 снова.

Для удобства PostgreSQL и RabbitMQ были подняты как docker-контейнеры.

Этап 4. Анализ данных

После того, как с работой скрипта было покончено, возникла необходимость выудить из полученных данных что-нибудь интересное и полезное.

Данные любезно помещены в domains.sql и domains.csv.

Под фильтрацией в дальнейшем подразумевается поиск найденных SLD в списке самых частых английских сочетаний букв в соответствии с этим источником

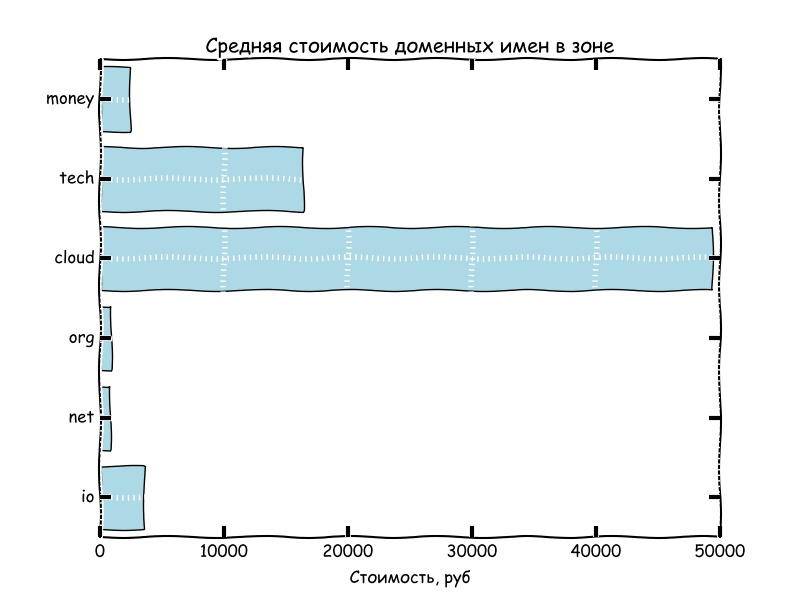

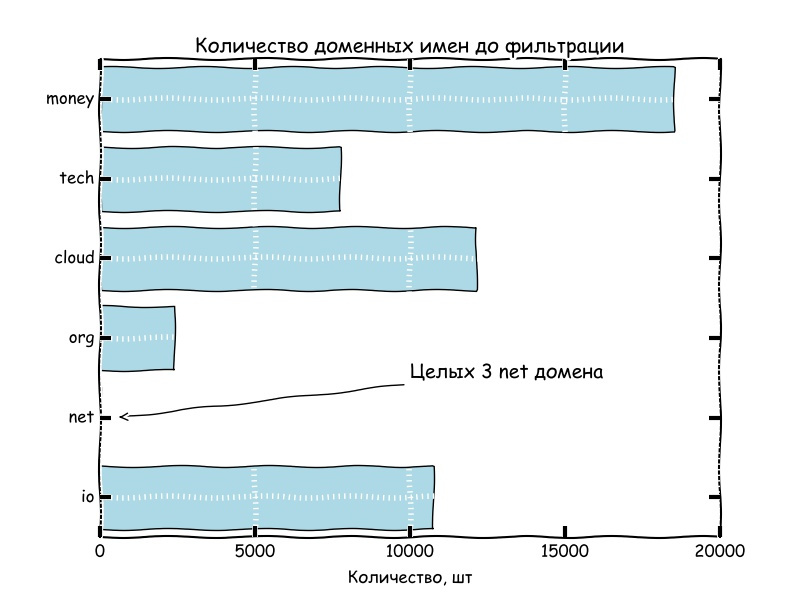

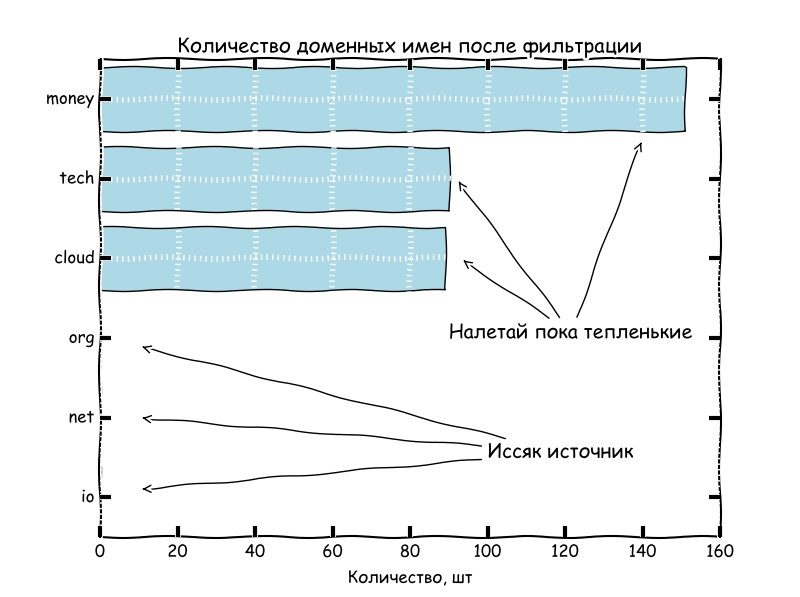

Из пары графиков выше, можно сделать вывод, что количество свободных доменных имен, содержащих частоупотребляемые сочетания букв английского алфавита стремится к нулю.

Пятерка самых дорогих доменных имен

| domain | roubleprice |

|---|---|

| ads.cloud | 11 906 200 |

| vod.cloud | 11 852 400 |

| usa.cloud | 11 852 400 |

| seo.cloud | 11 852 400 |

| vip.cloud | 11 852 400 |

Пятерка самых дешевых доменных имен

| domain | roubleprice |

|---|---|

| xt1.company | 590 |

| xt1.casa | 590 |

| xsz.company | 590 |

| xt1.click | 590 |

| xt1.business | 590 |

Заключение

That's all Folks!

Прошерстив интернет было выявлено множество забавных доменов. А самое главное, что новым компаниям не стоит отчаиваться: интересные доменные имена все еще свободны, осталось их только увидеть.

|

Метки: author danieljust исследования и прогнозы в it javascript node.js docker docker-compose |

Ресурсное планирование. Часть 1. О чем это вообще? |

Что самое ценное для IT-компании? Что является главным активом и ресурсом почти для каждой IT-компании? На что компания тратит больше всего денег? Какая статья затрат является самой большой? На обслуживание какого ресурса у вас уходит больше всего денег? Не сильно ошибусь, если скажу, что ответом на все эти вопросы является “Команда компании”. Именно ваша команда делает проекты, двигает вашу компанию вперед и зарабатывает деньги, и именно на зарплаты, бонусы, налоги, оборудование рабочих мест и прочие прямые и косвенные выплаты вашей команде приходится основная масса затрат компании.

Если в нужный момент у вас будет недостаточное количество вашего ключевого ресурса, то вы не сможете сделать важный проект и упустите выгоду. А если у вас будет избыток ресурсов, то вы будете нести убытки, оплачивая простаивающую часть вашей команды. Поговорим о ресурсном планировании.

Тема ресурсного планирования на удивление скудно представлена и в специализированной литературе и на пространствах рунета. Предполагается, что руководители проектов и компаний сами знают, что это такое и как с этим работать. Как показывает опыт, это немного не так. Безусловно, все понимают, что платить зарплату сотруднику, который ничего не делает — это плохо. Также плохо, когда у тебя не хватает нужных ресурсов. Но этого понимания не всегда достаточно для того, чтобы наладить в компании эффективное ресурсное планирование. И что же делать? Попробую поделиться своим пониманием вопроса.

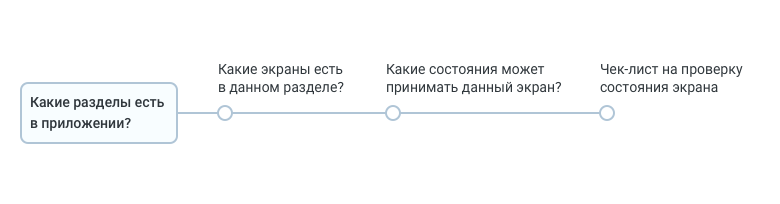

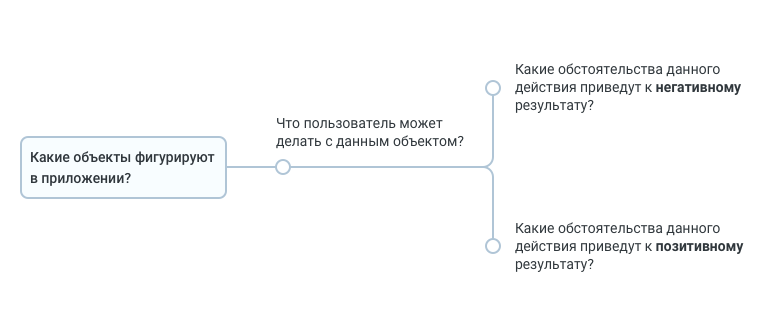

Свое понимание планирую изложить примерно так:

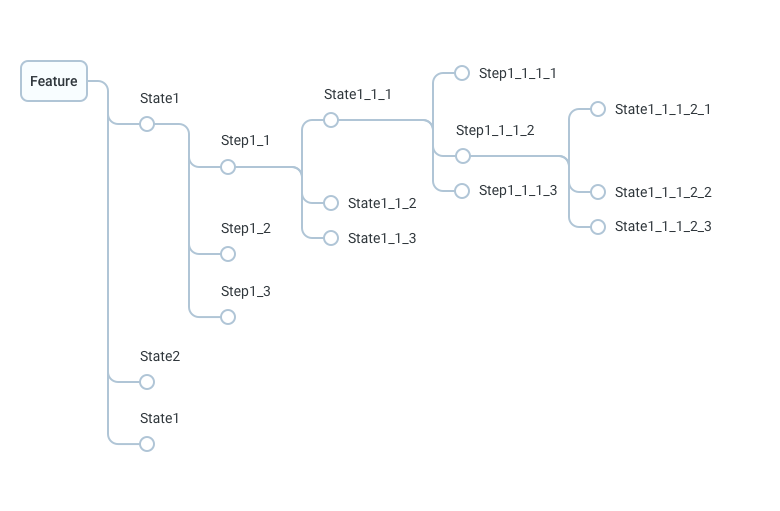

- Что такое ресурсный план? Тут нарисуем картинку, дадим некоторые определения и расскажем, чем люди отличаются от денег.

- На что влияет ресурсный план? Рассмотрим сферы деятельности IT-компаний, которые, оказывается, напрямую зависят от качества ресурсного планирования. И если у вас ресурсное планирование не осуществляется на должном уровне или вдруг у вас его вообще нет, то, может быть, после прочтения этой части у вас появятся закономерные вопросы.

- Что влияет на ресурсный план? Рассматриваем обратную задачу — от чего зависит ресурсный план, что стоит на входе и определяет форму, размер и специфику ресурсного плана

- Ресурсное планирование в рамках изолированного проекта. Это ресурсное планирование с точки зрения руководителя конкретного проекта, у которого есть понимание задачи, бюджет и нужно сформировать команду и реализовать проект. Также, тут запланирован чек-лист, пробежав по которому можно будет понять, а все ли необходимое мы включили в ресурсный план?

- Ресурсное планирование портфеля проектов или программы. А это уже ресурсное планирование с точки зрения программного директора, руководителя портфеля проектов, ресурсного менеджера или руководителя компании, где одновременно идет множество проектов, все они находятся на разных фазах и во всех них и требуются и высвобождаются ресурсы.

- Долгосрочное ресурсное планирование. Если дойдем до этого пункта, то рассмотрим задачу управления ресурсными пулами компании в долгосрочной перспективе.

Что такое ресурсный план?

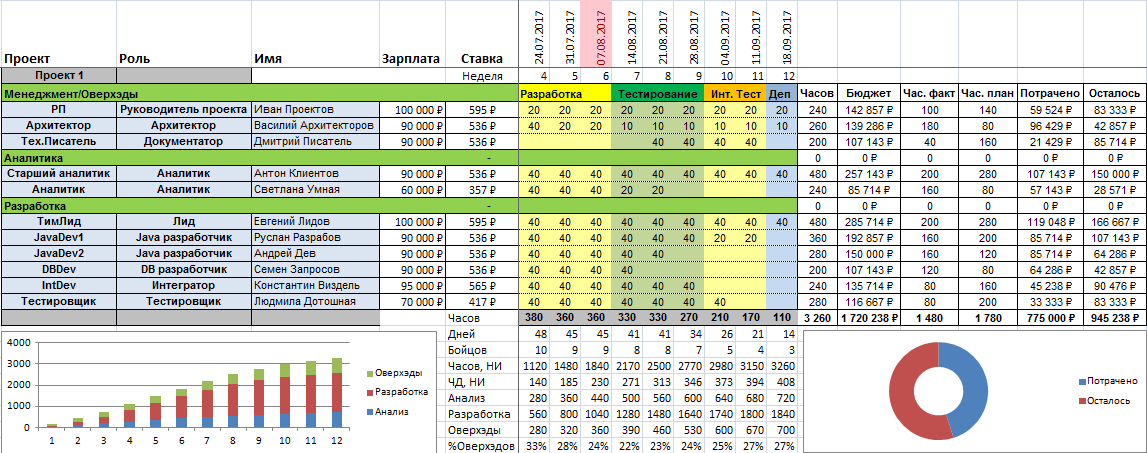

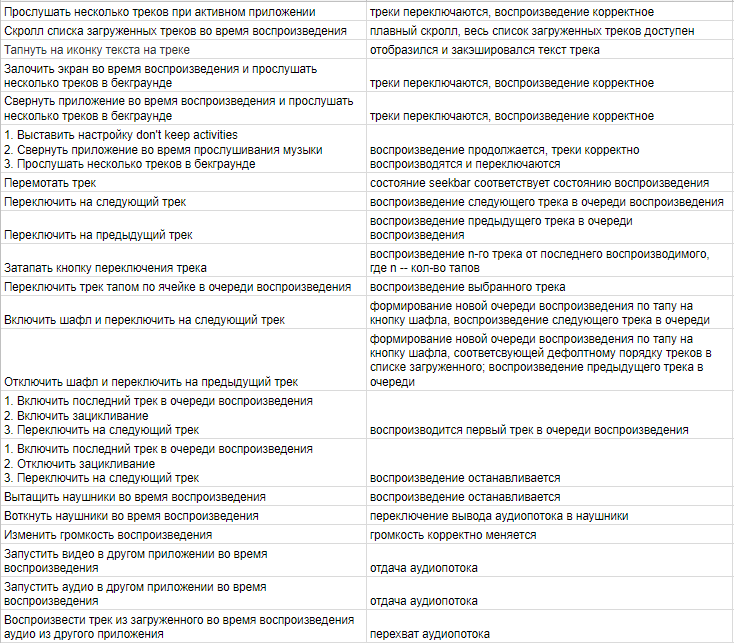

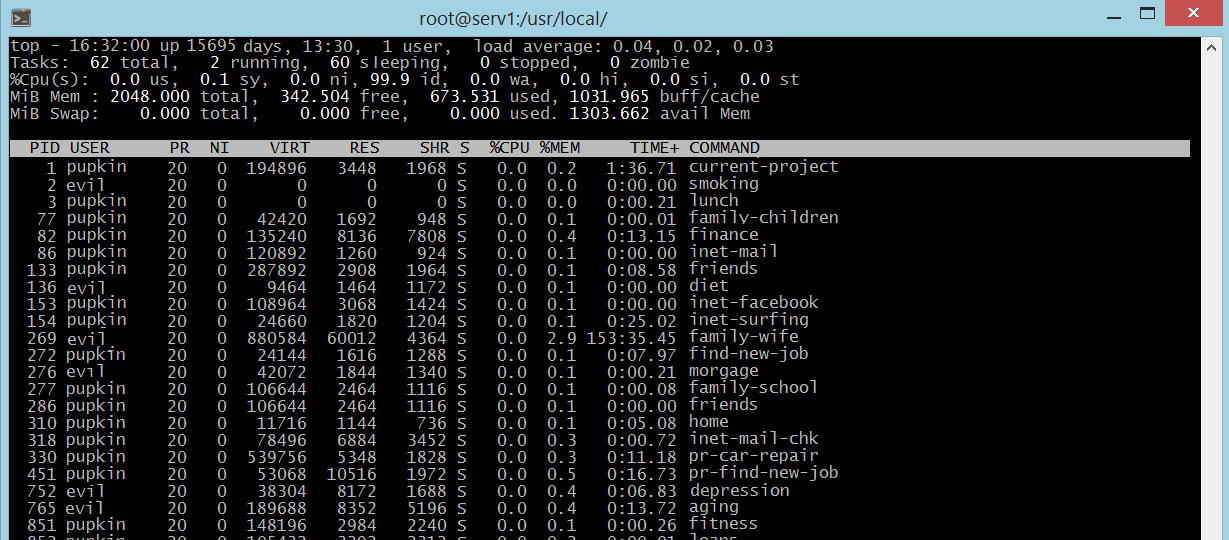

Для затравки приведу пример ресурсного плана

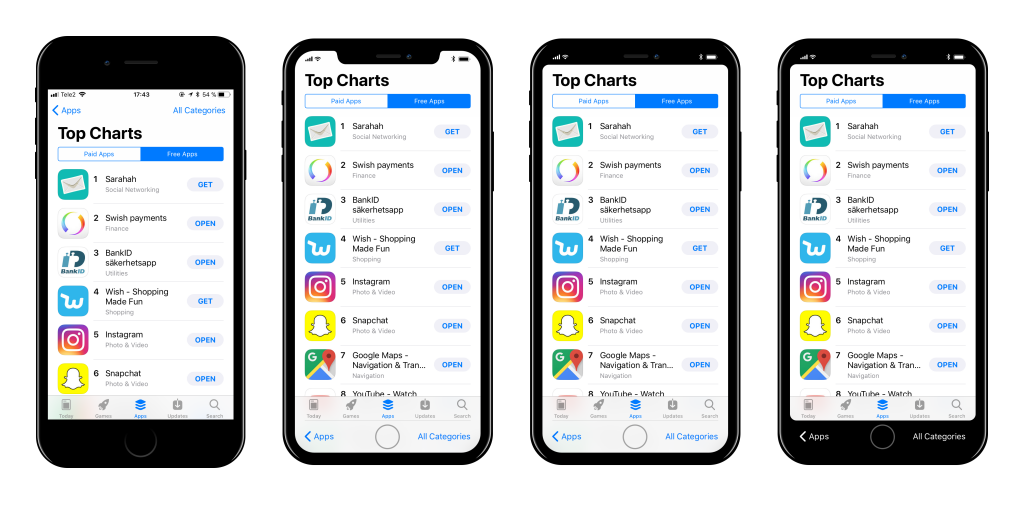

На примере мы видим ресурсный план для условного проекта вместе с финансовой информацией и некоторой аналитикой. В зависимости от уровня доступа руководителя проекта и специфики внутренних процессов, ресурсный план может видоизменяться в широких пределах. В частности, убрав зарплаты и часовые ставки, можно ограничиться только планированием человеко-часов.

Если попробовать погуглить на тему resource management/resource planning tool, то вы получите довольно внушительный список платных (в большинстве своем) и бесплатных инструментов, которые в той или иной мере помогают в решении задачи управления ресурсами. Ну а мы будем пользоваться старым добрым MS Excel.

Теперь давайте договоримся о терминах:

- Ресурс — специалист с необходимой специализацией и опытом. Причем, под опытом понимается не только совокупное количество лет, которое человек уже успел посвятить своей профессии, но и опыт работы с конкретными проектами. Это ключевой момент и мы к нему еще вернемся.

- Внутренний ресурсный пул — отдел или подразделение, обладающее необходимыми ресурсами, которые могут использоваться на проекте. Примеры: отдел/департамент FrontEnd, отдел/департамент QA, отдел/департамент управления проектами и т.п. По сравнению с внешними ресурсными пулями, плюсы внутренних — эффективные коммуникации, гарантированная квалификация, хорошая управляемость. Минусы — плохо масштабируются.

- Внешний ресурсный пул — компания или специалисты, внешние по отношению к компании, которая реализует проект, которые имеют необходимые ресурсы и готовы предоставлять их проекту во временное пользование. Примеры: сайты фрилансеров, компании, специализирующиеся на аутсорсе, партнерские компании с временно недозагруженными ресурсами. Плюсы по сравнению с внутренними ресурсными пулами: отлично масштабируются. Минусы: сложность коммуникаций, дорогое управление, негарантированное качество ресурсов, стоимость, накладные расходы на администрирование.

- Несогласованный (незастафленный) ресурсный план — это заявка на ресурсы для выполнения проекта. Такой ресурсный план говорит о том, какие ресурсы, когда, в каком количестве и на какой период нужны вам для того, чтобы вы успешно выполнили свой проект. При этом, вместо имен и фамилий в таком плане стоят прочерки или пробелы — реальных людей еще нет, вы их только хотите получить. Пока вы только можете определить требования к специалистам, которые вам нужны, и, может быть, сформулировать пожелания к ресурсным менеджерам относительно конкретных кандидатур, которых вы хотели бы видеть у себя на проекте. Некоторые позиции, конечно же, могут быть уже “застафлены” — прописаны конкретные имена людей, в отношении которых вы уже имеете подтверждение об их участии в вашем проекте.

- Согласованный (застафленный) ресурсный план — это контракт на поставку ресурсов требуемого качества на конкретное время с владельцами ресурсных пулов. Отличие от предыдущего варианта — все прочерки заменены на реальные имена и фамилии.

- Стафинг — процесс подбора и согласование ресурсов на незастафленные позиции ресурсного плана. Проще говоря, стафинг — это подбор команды на проект. Тут важно отметить, что очень редко бывает, что руководитель проекта получает на свой проект сотрудников, полностью соответствующих сформулированным требованиям. Все хотят на проект команду, на 100% состоящих из сеньерных дизайнеров, разработчиков, аналитиков и тестировщиков, но не все получают такие команды. Также не всегда удается получить людей к нужному сроку или на нужное время. По-этому, план может видоизменяться по мере стафинга. Если качество ресурсов хуже того, которое закладывалось при оценке проекта, то, очевидно, увеличивается количество часов для выполнения тех же самых работ. Если нужный ресурс высвобождается с другого проекта раньше или позже, чем вы планировали, то вы фиксируете это обстоятельство и переделываете план уже с учетом новых условий.

Так чем же люди отличаются от денег?

Для лучшего понимания сути управления ресурсами проведем аналогию с управлением финансами:

| Деньги | Ресурсы |

|---|---|

| В моменте не хватает своих денег (например, чтобы выплатить зарплату — кассовый разрыв) — занимаем в банке или у друзей. | Нужен конкретный ресурс на небольшой период времени (например, чтобы сделать срочную работу без ущерба для основного скоупа) — договариваемся “пошарить” ресурс у соседнего проекта, где ресурс недозагружен |

| Есть излишек денег — кладем их в банк или инвестируем в прибыльный проект. | Разработка “заблочена” длительным согласованием требований заказчиком — отдаем людей во временное пользование проекту, где они нужнее. При этом, затраты на этот период переносятся на соседний проект, экономим бюджет своего. |

| На рынке появились дешевые деньги — перекредитуемся. | На соседнем проекте освободились свои разработчики, стоимость которых ниже, чем используемый на нашем аутсорсный ресурс — делаем замену |

Этими кейсами аналогия не исчерпывается. Общая подмеченная закономерность — почти в каждом случае управления ресурсами можно найти аналогию из управления финансами и наоборот. Однако, между деньгами и ресурсами есть очень существенная разница, которая определяет специфику этой предметной области.

В мире денег, если вы возьмете в банке в долг 100 000 рублей, вы сразу же сможете их начать тратить, инвестировать и т.п. — деньги сразу же начнут работать, их не нужно учить. В мире управления ресурсами, если вы возьмете “в долг” двух разработчиков, они, как правило, не могут сразу же начать приносить пользу вашему проекту. Потому что, в отличие от денег, ценность ресурса определяется не только его квалификацией и уровнем владения тем или иным инструментом, но и знанием специфики конкретно вашего проекта. А это знание можно приобрести только находясь внутри вашего проекта, потратив определенное время на его изучение.

Именно на эту тему часто возникают споры с заказчиком, которому нужно в кратчайшие сроки реализовать ту или иную внеплановую функцию. Как правило, риторика заказчика бывает примерно такой “В вашей компании работает ХХХ десятков/сотен/тысяч людей, добавьте еще Y на проект и сделайте, что мы хотим”. Правда заказчика в том, что да, в вашей компании, как правило, действительно достаточно много квалифицированных людей, которые могли бы сделать то, что он хочет. Но он не учитывает тот факт, что для того, чтобы приступить к реализации этих требований, квалифицированным специалистам с других проектов нужно приобрести необходимые знания о вашем проекте, а на это нужно время, которого у вас нет.

Отсюда вывод — при управлении ресурсами всегда нужно помнить о том, что вновь добавленный ресурс, каким бы квалифицированным он не был, потребует определенного времени на погружение в проект и только потом начнет приносить результат. Время, которое требуется на погружение, зависит от квалификации ресурса, степени его знакомства с предметной областью и проектом, информационной инфраструктуры проекта и наличия людей рядом, которые смогут в доступной форме рассказать про проект и показать, как он устроен.

На этом с первой частью закончим. В следующей части поговорим о том, на что влияет ресурсный план и качество ресурсного планирования.

|

|

[Перевод] Скрытые послания в именах свойств JavaScript |

|

Метки: author m1rko отладка ненормальное программирование javascript суррогатные пары кодовая единица кодовая точка юникод charcodeat codepointat вариантные селекторы |

[Из песочницы] Доступность приложений для пользователей с нарушениями зрения |

Очень немногим известно, что существуют программы экранного доступа (скрин-ридеры), которые озвучивают любое производимое действие, любой объект под курсором мыши, любую нажатую клавишу с помощью синтезатора речи. В последнее время пресса пытается освещать этот вопрос, но во всех случаях упоминается одна программа экранного доступа — «JAWS for windows», обладающая скромными возможностями и высокой ценой.

На самом деле, существует множество подобных программ на некоммерческой основе, функционал которых иногда даже превышает возможности платных аналогов. Однако речь в статье пойдёт не об этом, а о том, как различные гаджеты помогают людям с нарушениями зрения в быту и о доступности многих приложений и сервисов для программ экранного доступа.

Немного истории

Когда появились первые компьютеры, никто и не задумывался о том, как ими будут пользоваться незрячие. Компьютер был устройством для избранных, требовал серьёзной подготовки, огромной базы знаний и навыков. Но когда компьютеры стали доступны для рядового пользователя и начали появляться в домах у каждого третьего, встал вопрос о том, как, не видя экрана, пользоваться всеми возможностями устройства. На ум сразу приходят два ответа: на слух и наощупь. И оба эти варианта были воплощены в жизнь. На слух компьютером стало возможно пользоваться с помощью тех самых программ экранного доступа, а наощупь — при помощи так называемых «дисплеев Брайля». Это название само по себе многим может быть непонятно, ведь не все знают, что такое шрифт Брайля. Это шрифт, в котором каждому символу соответствует комбинация из одной или нескольких (до шести, а в компьютерном варианте — до десяти) точек. Но дисплеи Брайля довольно громоздки и требуют специфических драйверов, поэтому их используют чаще на компьютерах в специализированных учреждениях для людей с нарушениями зрения. А вот экранные ридеры работают почти везде, и не требуют ни мощного процессора, ни драйверов. На этом с историей закончим и перейдём к основной проблеме, головной боли всех незрячих — к доступности приложений для программ экранного доступа.

Немного про способы отображения информации

Те, кто участвовал в создании хотя бы одного приложения с графическим интерфейсом, знают, что существует, по сути, два способа отображения контента на экране: средствами окружения, в котором выполняется программа (Windows Forms в Windows, XML и HTML в Android, ...) и вывод информации собственными средствами программы. Если первый вариант полностью поддерживается программами экранного доступа, так как они используют системные метаданные, то второй способ абсолютно недоступен для скрин-ридеров. Для них экран остаётся девственно чистым, потому что виртуальный курсор скрин-ридера не может найти ни одного объекта, описание которого можно получить.

Но, к сожалению, многие разработчики следуют именно по второму пути. Это происходит по разным причинам: кто-то стремится сделать своё приложение более комфортным визуально, чего не всегда можно добиться системными методами, кто-то хочет минимизировать использование платформозависимого кода.

Больше конкретики

Возьмём несколько программ из разных категорий.

Навигатор

Незрячему человеку нужно уметь самостоятельно перемещаться по городу: ходить за продуктами, приезжать в гости к друзьям, посещать музеи и т.д. Он, научившись пользоваться смартфоном, сразу пытается скачать качественный навигатор с максимально подробной информацией о маршруте.

Первые два приложения в Play Market по запросу «навигатор» — это «Яндекс Навигатор» и «CityGuide». Cтавим оба.

Открываем для начала Яндекс Навигатор. Визуально все очень удобно: комфортное меню, красивые иконки, приятная глазу карта. Для незрячего, который всего этого не видит, главный экран приложения представляет собой строку поиска, даже не подписанную как «поиск», и кнопку непонятного назначения, тоже никак не названную.

Хорошо, открываем CityGuide. В целом все то же самое: удобное, приятное глазу приложение. Однако для слепого это приложение представляет собой абсолютно пустой экран. Если Яндекс Навигатор хотя бы даёт возможность попытаться ввести адрес, то в CityGuide это невозможно.

В итоге, для человека с нарушениями зрения остаются два приложения с очень посредственным пешеходным режимом: Google Maps и OsmAnd.

Клиенты социальных сетей

Всем хочется общения, и слепые — не исключение.

ВКонтакте

Стандартный клиент VK был довольно удобен, как визуально, так и для незрячих, но последнее крупное обновление снизило его доступность почти до нуля. Вызывают трудности главное меню, вызываемое свайпом от левого края экрана, меню новостей или записей на стене, вызываемое свайпом от определённой точки правого края экрана (эту точку нужно ещё увидеть). В общем, приходится пользоваться сторонним приложением «Kate Mobile», разработчик которого очень трепетно отнёсся к доступности с самого начала, и сейчас прислушивается к советам со стороны незрячих.

Web-версия VK, кстати, неплохо оформлена с точки зрения читаемости экранными дикторами, и здесь у меня лично претензий нет.

Telegram

Не все им пользуются, но почти все о нём слышали. Позиционирует себя, как одна из самых комфортных для общения социальных сетей. Но с доступностью здесь совсем беда. Web-версия нечитаема скрин-ридерами больше чем на две трети. Мобильные приложения для iOS и Android ещё менее доступны. Главное меню читается одним контейнером, вся главная страница и страница с чатами тоже прочитывается как единый текст, из которого просто не выбрать нужную строку.

WhatsApp и Viber

Большое спасибо разработчику WhatsApp, доступность на высоте. Озвучивается даже большинство смайликов. Почти так же доступен Viber.

Facebook и Facebook Messenger

Оба эти приложения сделаны по одинаковой схеме и имеют одинаковые проблемы: слишком частое и бессмысленное обновление экрана, сбивающее и заставляющее зависать виртуальный курсор скрин-ридера, и неправильные подписи на некоторых кнопках. Пользоваться можно, но есть затруднения.

Skype

До последнего крупного обновления всё было ужасно: безумные зависания, как со скрин-ридером, так и без него, частые и бессмысленные обновления экрана, неподписанные кнопки… Но после обновления всё стало гораздо лучше. Ничего не тормозит, всё читается, и даже то самое некомфортное, открывающееся прямо поверх чатов меню теперь тоже читается.

Windows-версия приложения доступна примерно на 95%, что не может не радовать. Но Linux-версия имеет огромные проблемы с доступностью.