Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] 37 причин, почему ваша нейросеть не работает |

Почему нейросеть выдаёт мусор (например, среднее всех результатов или у неё реально слабая точность)? С чего начать проверку?

Сеть может не обучаться по ряду причин. По итогу многих отладочных сессий я заметил, что часто делаю одни и те же проверки. Здесь я собрал в удобный список свой опыт вместе с лучшими идеями коллег. Надеюсь, этот список будет полезен и вам.

Содержание

0. Как использовать это руководство?

I. Проблемы с набором данных

II. Нормализация данных/Проблемы аугментации

III. Проблемы реализации

IV. Проблемы обучения

0. Как использовать это руководство?

Многое может пойти не так. Но некоторые проблемы встречаются чаще, чем другие. Я обычно начинаю с этого маленького списка как набора экстренной помощи:

- Начните с простой модели, которая точно правильно работает для этого типа данных (например, VGG для изображений). Используйте стандартную функцию потерь, если возможно.

- Отключите все финтифлюшки, например, регуляризацию и аугментацию данных.

- В случае тонкой настройки модели дважды проверьте препроцессинг, чтобы он соответствовал обучению первоначальной модели.

- Удостоверьтесь в правильности входных данных.

- Начните с действительно маленького набора данных (2-20 образцов). Затем расширяйте его, постепенно добавляя новые данные.

- Начните постепенно добавлять обратно все фрагменты, которые были опущены: аугментация/регуляризация, кастомные функции потерь, пробуйте более сложные модели.

Если ничего не помогло, то приступайте к чтению этого длинного списка и проверяйте каждый пункт.

I. Проблемы с набором данных

Источник: http://dilbert.com/strip/2014-05-07

1. Проверьте входные данные

Проверьте, что входные данные имеют смысл. Например, я не раз смешивал в кучу высоту и ширину изображений. Иногда по ошибке отдавал в нейросеть все нули. Или использовал одну и ту же партию снова и снова. Так что напечатайте/посмотрите пару партий входных данных и плановых выходных данных — убедитесь, что всё в порядке.

2. Попробуйте случайные входные значения

Попробуйте передать случайные числа вместо реальных данных и посмотрите, останется ли та же ошибка. Если так, то это верный знак, что ваша сеть на каком-то этапе превращает данные в мусор. Попробуйте отладку слой за слоем (операция за операцией) и посмотрите, где происходит сбой.

3. Проверьте загрузчик данных

С данными всё может быть в порядке, а ошибка в коде, который передаёт входные данные нейросети. Распечатайте и проверьте входные данные первого слоя перед началом его операций.

4. Убедитесь, что вход соединяется с выходом

Проверьте, что несколько образцов входных данных снабжены правильными метками. Также проверьте, что смена местами входных образцов так же отражается на выходных метках.

5. Взаимоотношение между входом и выходом слишком случайно?

Может быть, неслучайные части взаимоотношения между входом и выходом слишком малы по сравнению со случайной частью (кто-то может сказать, что таковы котировки на бирже). То есть вход недостаточно связан с выходом. Тут нет универсального метода, потому что мера случайности зависит от типа данных.

6. Слишком много шума в наборе данных?

Однажды это случилось со мной, когда я стянул набор изображений продуктов питания с сайта. Там было так много плохих меток, что сеть не могла обучаться. Вручную проверьте ряд образцов входных значений и посмотрите, что все метки на месте.

Данный пункт достоин отдельного разговора, потому что эта работа показывает точность выше 50% на базе MNIST при 50% повреждённых меток.

7. Перемешайте набор данных

Если ваши данные не перемешаны и располагаются в определённом порядке (отсортированы по меткам), это может отрицательно отразиться на обучении. Перемешайте набор данных: убедитесь, что перемешиваете вместе и входные данные, и метки.

8. Снизьте несбалансированность классов

Может, в наборе данных тысяча изображений класса А на одно изображение класса Б? Тогда вам может понадобиться сбалансировать функцию потерь или попробовать другие подходы устранения несбалансированности.

9. Достаточно ли образцов для обучения?

Если вы обучаете сеть с нуля (то есть не настраиваете её), то может понадобиться очень много данных. Например, для классификации изображений, говорят, нужна тысяча изображений на каждый класс, а то и больше.

10. Убедитесь в отсутствии партий с единственной меткой

Такое случается в отсортированном наборе данных (то есть первые 10 тыс. образцов содержат одинаковый класс). Легко исправляется перемешиванием набора данных.

11. Уменьшите размер партий

Эта работа указывает, что слишком большие партии могут понизить у модели способность к обобщению.

Дополнение 1. Используйте стандартный набор данных (например, mnist, cifar10)

Спасибо hengcherkeng за это:

При тестировании новой сетевой архитектуры или написании нового кода сначала используйте стандартные наборы данных вместо своих. Потому что для них уже есть много результатов и они гарантированно «разрешимые». Там не будет проблем с шумом в метках, разницей в распределении обучение/тестирование, слишком большой сложностью набора данных и т.д.

II. Нормализация данных/Проблемы аугментации

12. Откалибруйте признаки

Вы откалибровали входные данные на нулевое среднее и единичную дисперсию?

13. Слишком сильная аугментация данных?

Аугментация имеет регуляризующий эффект. Если она слишком сильная, то это вкупе с другими формами регуляризации (L2-регуляризация, dropout и др.) может привести к недообучению нейросети.

14. Проверьте предобработку предварительно обученной модели

Если вы используете уже подготовленную модель, то убедитесь, что используются та же нормализация и предобработка, что и в модели, которую вы обучаете. Например, должен пиксель быть в диапазоне [0, 1], [-1, 1] или [0, 255]?

15. Проверьте предварительную обработку для набора обучение/валидация/тестирование

CS231n указал на типичную ловушку:

«… любую статистику предобработки (например, среднее данных) нужно вычислять на данных для обучения, а потом применять на данных валидации/тестирования. Например, будет ошибкой вычисление среднего и вычитание его из каждого изображения во всём наборе данных, а затем разделение данных на фрагменты для обучения/валидации/тестирования».

Также проверьте на предмет наличия различающейся предварительной обработки каждого образца и партии.

III. Проблемы реализации

Источник: https://xkcd.com/1838/

16. Попробуйте решить более простой вариант задачи

Это поможет определить, где проблема. Например, если целевая выдача — это класс объекта и координаты, попробуйте ограничить предсказание только классом объекта.

17. Поищите правильную функцию потерь «по вероятности»

Снова из бесподобного CS231n: Инициализируйте с небольшими параметрами, без регуляризации. Например, если у нас 10 классов, то «по вероятности» означает, что правильный класс определится в 10% случаев, а функция потерь Softmax — это обратный логарифм к вероятности правильного класса, то есть получается

После этого попробуйте увеличить силу регуляризации, что должно увеличить функцию потерь.

18. Проверьте функцию потерь

Если вы реализовали свою собственную, проверьте её на баги и добавьте юнит-тесты. У меня часто бывало, что слегка неправильная функция потерь тонко вредила производительности сети.

19. Проверьте входные данные функции потерь

Если вы используете функцию потерь из фреймворка, то убедитесь, что передаёте ей то что нужно. Например, в PyTorch я бы смешал NLLLoss и CrossEntropyLoss, потому что первая требует входных данных softmax, а вторая — нет.

20. Отрегулируйте веса функции потерь

Если ваша функция потерь состоит из нескольких функций, проверьте их соотношение относительно друг друга. Для этого может понадобиться тестирование в разных вариантах соотношений.

21. Отслеживайте другие показатели

Иногда функция потерь — не лучший предиктор того, насколько правильно обучается ваша нейросеть. Если возможно, используйте другие показатели, такие как точность.

22. Проверьте каждый кастомный слой

Вы самостоятельно реализовали какие-то из слоёв сети? Дважды проверьте, что они работают как полагается.

23. Проверьте отсутствие «зависших» слоёв или переменных

Посмотрите, может вы неумышленно отключили обновления градиента каких-то слоёв/переменных.

24. Увеличьте размер сети

Может, выразительной мощности сети недостаточно для усвоения целевой функции. Попробуйте добавить слоёв или больше скрытых юнитов в полностью соединённые слои.

25. Поищите скрытые ошибки измерений

Если ваши входные данные выглядят как , то легко пропустить ошибку, связанную с неправильными измерениями. Используйте необычные числа для измерений входных данных (например, разные простые числа для каждого измерения) и посмотрите, как они распространяются по сети.

26. Исследуйте Gradient Checking

Если вы самостоятельно реализовали Gradient Descent, то с помощью Gradient Checking можно убедиться в корректной обратной связи. Дополнительная информация: 1, 2, 3.

IV. Проблемы обучения

Источник: http://carlvondrick.com/ihog/

27. Решите задачу для действительно маленького набора данных

Переобучите сеть на маленьком наборе данных и убедитесь в её работе. Например, обучите её всего с 1-2 примерами и посмотрите, способна ли сеть различать объекты. Переходите к большему количеству образцов для каждого класса.

28. Проверьте инициализацию весов

Если не уверены, используйте инициализацию Ксавьера или Хе. К тому же, ваша инициализация может вывести на плохой локальный минимум, так что испытайте другую инициализацию, может поможет.

29. Измените гиперпараметры

Может вы используете плохой набор гиперпараметров. Если возможно, попробуйте grid search.

30. Уменьшите регуляризацию

Из-за слишком сильной регуляризации сеть может конкретно недообучиться. Уменьшите регуляризацию, такую как dropout, batch norm, L2-регуляризацию weight/bias и др. В отличном курсе «Практическое глубинное обучение для программистов» Джереми Говард рекомендует в первую очередь избавиться от недообучения. То есть нужно достаточно переообучить сеть на исходных данных, и только затем бороться с переобучением.

31. Дайте время

Может сети нужно больше времени на обучение, прежде чем она начнёт делать осмысленные предсказания. Если функция потерь стабильно уменьшается, дайте ей обучиться чуть подольше.

32. Переходите от режима обучения в режим тестирования

В некоторых фреймворках слои Batch Norm, Dropout и другие ведут себя по-разному во время обучения и тестирования. Переключение в подходящий режим может помочь вашей сети начать делать правильные прогнозы.

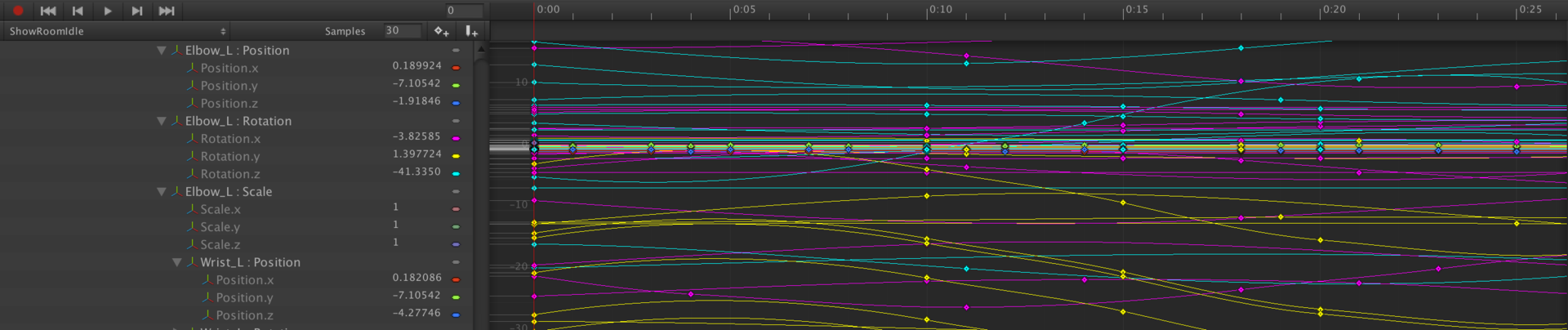

33. Визуализируйте обучение

- Отслеживайте активации, веса и обновления для каждого слоя. Убедитесь, что отношения их величин совпадают. Например, отношение величины обновлений к параметрам (весам и смещениям) должно равняться 1e-3.

- Рассмотрите библиотеки визуализации вроде Tensorboard и Crayon. В крайнем случае, можно просто печатать значения весов/сдвигов/активаций.

- Будьте осторожны с активациями сетей со средним намного больше нуля. Попробуйте Batch Norm или ELU.

- Deeplearning4j указал, на что смотреть в гистограммах весов и сдвигов:

«Для весов эти гистограммы должны иметь примерно гауссово (нормальное) распределение, спустя какое-то время. Гистограммы сдвигов обычно начинаются с нуля и обычно заканчиваются на уровне примерно гауссова распределения (единственное исключение — LSTM). Следите за параметрами, которые отклоняются на плюс/минус бесконечность. Следите за сдвигами, которые становятся слишком большими. Иногда такое случается в выходном слое для классификации, если распределение классов слишком несбалансировано».

- Проверяйте обновления слоёв, они должны иметь нормальное распределение.

34. Попробуйте иной оптимизатор

Ваш выбор оптимизатора не должен мешать нейросети обучаться, если только вы не выбрали конкретно плохие гиперпараметры. Но правильный оптимизатор для задачи может помочь получить наилучшее обучение за кратчайшее время. Научная статья с описанием того алгоритма, который вы используете, должна упомянуть и оптимизатор. Если нет, я предпочитаю использовать Adam или простой SGD.

Прочтите отличную статью Себастьяна Рудера, чтобы узнать больше об оптимизаторах градиентного спуска.

35. Взрыв/исчезновение градиентов

- Проверьте обновления слоя, поскольку очень большие значения могут указывать на взрывы градиентов. Может помочь клиппинг градиента.

- Проверьте активации слоя. Deeplearning4j даёт отличный совет: «Хорошее стандартное отклонение для активаций находится в районе от 0,5 до 2,0. Значительный выход за эти рамки может указывать на взрыв или исчезновение активаций».

36. Ускорьте/замедлите обучение

Низкая скорость обучения приведёт к очень медленному схождению модели.

Высокая скорость обучения сначала быстро уменьшит функцию потерь, а потом вам будет трудно найти хорошее решение.

Поэкспериментируйте со скоростью обучению, ускоряя либо замедляя её в 10 раз.

37. Устранение состояний NaN

Состояния NaN (Non-a-Number) гораздо чаще встречаются при обучении RNN (насколько я слышал). Некоторые способы их устранения:

- Уменьшите скорость обучения, особенно если NaN появляются в первые 100 итераций.

- Нечисла могут возникнуть из-за деления на ноль, взятия натурального логарифма нуля или отрицательного числа.

- Рассел Стюарт предлагает хорошие советы, что делать в случае появления NaN.

- Попробуйте оценить сеть слой за слоем и посмотреть, где появляются NaN.

Источники:

cs231n.github.io/neural-networks-3

russellsstewart.com/notes/0.html

stackoverflow.com/questions/41488279/neural-network-always-predicts-the-same-class

deeplearning4j.org/visualization

www.reddit.com/r/MachineLearning/comments/46b8dz/what_does_debugging_a_deep_net_look_like

www.researchgate.net/post/why_the_prediction_or_the_output_of_neural_network_does_not_change_during_the_test_phase

book.caltech.edu/bookforum/showthread.php?t=4113

gab41.lab41.org/some-tips-for-debugging-deep-learning-3f69e56ea134

www.quora.com/How-do-I-debug-an-artificial-neural-network-algorithm

|

|

Android Architecture Components. Часть 4. ViewModel |

Компонент ViewModel — предназначен для хранения и управления данными, связанными с представлением, а заодно, избавить нас от проблемы, связанной с пересозданием активити во время таких операций, как переворот экрана и т.д. Не стоит его воспринимать, как замену onSaveInstanceState, поскольку, после того как система уничтожит нашу активити, к примеру, когда мы перейдем в другое приложение, ViewModel будет также уничтожен и не сохранит свое состояние. В целом же, ViewModel можно охарактеризовать как синглтон, который гарантирует, что не будет уничтожен пока есть активный экземпляр нашей активити и освободит ресурсы после ухода с нее (все немного сложнее, но выглядит как-то так). Стоит также отметить, что мы можем привязать любое количество ViewModel к нашей Activity(Fragment).

Компонент состоит из таких классов: ViewModel, AndroidViewModel, ViewModelProvider, ViewModelProviders, ViewModelStore, ViewModelStores. Разработчик будет работать только с ViewModel, AndroidViewModel и для получения истанца с ViewModelProviders, но для лучшего понимания компонента, мы поверхностно рассмотрим все классы.

Класс ViewModel, сам по себе представляет абстрактный класс, без абстрактных методов и с одним protected методом onCleared(). Для реализации собственного ViewModel, нам всего лишь необходимо унаследовать свой класс от ViewModel с конструктором без параметров и это все. Если же нам нужно очистить ресурсы, то необходимо переопределить метод onCleared(), который будет вызван когда ViewModel долго не доступна и должна быть уничтожена. Как пример, можно вспомнить предыдущую статью про LiveData, а конкретно о методе observeForever(Observer), который требует явной отписки, и как раз в методе onCleared() уместно ее реализовать. Стоит еще добавить, что во избежания утечки памяти, не нужно ссылаться напрямую на View или Context Activity из ViewModel. В целом, ViewModel должна быть абсолютно изолированная от представления данных. В таком случае появляется вопрос: А каким же образом нам уведомить представление (Activity/Fragment) об изменениях в наших данных? В этом случае на помощь нам приходит LiveData, все изменяемые данные мы должны хранить с помощью LiveData, если же нам необходимо, к примеру, показать и скрыть ProgressBar, мы можем создать MutableLiveData и хранить логику показать\скрыть в компоненте ViewModel. В общем это будет выглядеть так:

public class MyViewModel extends ViewModel {

private MutableLiveData showProgress = new MutableLiveData<>();

//new thread

public void doSomeThing(){

showProgress.postValue(true);

...

showProgress.postValue(false);

}

public MutableLiveData getProgressState(){

return showProgress;

}

} Для получения ссылки на наш экземпляр ViewModel мы должны воспользоваться ViewModelProviders:

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

final MyViewModel viewModel = ViewModelProviders.of(this).get(MyViewModel.class);

viewModel.getProgressState().observe(this, new Observer() {

@Override

public void onChanged(@Nullable Boolean aBoolean) {

if (aBoolean) {

showProgress();

} else {

hideProgress();

}

}

});

viewModel.doSomeThing();

} Класс AndroidViewModel, являет собой расширение ViewModel, с единственным отличием — в конструкторе должен быть один параметр Application. Является довольно полезным расширением в случаях, когда нам нужно использовать Location Service или другой компонент, требующий Application Context. В работе с ним единственное отличие, это то что мы наследуем наш ViewModel от ApplicationViewModel. В Activity/Fragment инициализируем его точно также, как и обычный ViewModel.

Класс ViewModelProviders, являет собой четыре метода утилиты, которые, называются of и возвращают ViewModelProvider. Адаптированные для работы с Activity и Fragment, а также, с возможностью подставить свою реализацию ViewModelProvider.Factory, по умолчанию используется DefaultFactory, которая является вложенным классом в ViewModelProviders. Пока что других реализаций приведенных в пакете android.arch нет.

Класс ViewModelProvider, собственно говоря класс, который возвращает наш инстанс ViewModel. Не будем особо углубляться здесь, в общих чертах он являет роль посредника с ViewModelStore, который, хранит и поднимает наш интанс ViewModel и возвращает его с помощью метода get, который имеет две сигнатуры get(Class) и get(String key, Class modelClass). Смысл заключается в том, что мы можем привязать несколько ViewModel к нашему Activity/Fragment даже одного типа. Метод get возвращает их по String key, который по умолчанию формируется как: «android.arch.lifecycle.ViewModelProvider.DefaultKey:» + canonicalName

Класс ViewModelStores, являет собой фабричный метод, напомню: Фабричный метод — паттерн, который определяет интерфейс для создания объекта, но оставляет подклассам решение о том, какой класс инстанцировать, по факту, позволяет классу делегировать инстанцирование подклассам. На данный момент, в пакете android.arch присутствует как один интерфейс, так и один подкласс ViewModelStore.

Класс ViewModelStore, класс в котором и находится вся магия, состоит из методов put, get и clear. Про них не стоит беспокоится, поскольку работать напрямую мы с ними не должны, а с get и put и физически не можем, так как они объявлены как default (package-private), соответственно видны только внутри пакета. Но, для общего образования, рассмотрим устройство этого класса. Сам класс хранит в себе HashMap, методы get и put, соответственно, возвращают по ключу (по тому самому, который мы формируем во ViewModelProvider) или добавляют ViewModel. Метод clear(), вызовет метод onCleared() у всех наших ViewModel которые мы добавляли.

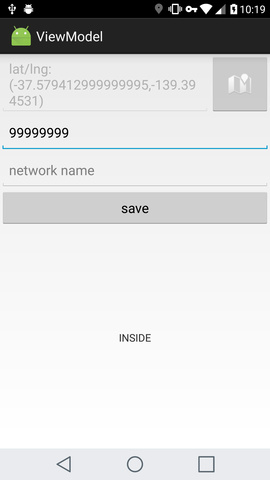

Для примера работы с ViewModel давайте реализуем небольшое приложение, позволяющее выбрать пользователю точку на карте, установить радиус и показывающее, находится человек в этом поле или нет. А также дающее возможность указать WiFi network, если пользователь подключен к нему, будем считать что он в радиусе, вне зависимости от физических координат.

Для начала создадим две LiveData для отслеживания локации и имени WiFi сети:

public class LocationLiveData extends LiveData implements

GoogleApiClient.ConnectionCallbacks,

GoogleApiClient.OnConnectionFailedListener,

LocationListener {

private final static int UPDATE_INTERVAL = 1000;

private GoogleApiClient googleApiClient;

public LocationLiveData(Context context) {

googleApiClient =

new GoogleApiClient.Builder(context, this, this)

.addApi(LocationServices.API)

.build();

}

@Override

protected void onActive() {

googleApiClient.connect();

}

@Override

protected void onInactive() {

if (googleApiClient.isConnected()) {

LocationServices.FusedLocationApi.removeLocationUpdates(

googleApiClient, this);

}

googleApiClient.disconnect();

}

@Override

public void onConnected(Bundle connectionHint) {

LocationRequest locationRequest = new LocationRequest().setInterval(UPDATE_INTERVAL).setPriority(LocationRequest.PRIORITY_HIGH_ACCURACY);

LocationServices.FusedLocationApi.requestLocationUpdates(

googleApiClient, locationRequest, this);

}

@Override

public void onLocationChanged(Location location) {

setValue(location);

}

@Override

public void onConnectionSuspended(int cause) {

setValue(null);

}

@Override

public void onConnectionFailed(ConnectionResult connectionResult) {

setValue(null);

}

}

public class NetworkLiveData extends LiveData {

private Context context;

private BroadcastReceiver broadcastReceiver;

public NetworkLiveData(Context context) {

this.context = context;

}

private void prepareReceiver(Context context) {

IntentFilter filter = new IntentFilter();

filter.addAction("android.net.wifi.supplicant.CONNECTION_CHANGE");

filter.addAction("android.net.wifi.STATE_CHANGE");

broadcastReceiver = new BroadcastReceiver() {

@Override

public void onReceive(Context context, Intent intent) {

WifiManager wifiMgr = (WifiManager) context.getSystemService(Context.WIFI_SERVICE);

WifiInfo wifiInfo = wifiMgr.getConnectionInfo();

String name = wifiInfo.getSSID();

if (name.isEmpty()) {

setValue(null);

} else {

setValue(name);

}

}

};

context.registerReceiver(broadcastReceiver, filter);

}

@Override

protected void onActive() {

super.onActive();

prepareReceiver(context);

}

@Override

protected void onInactive() {

super.onInactive();

context.unregisterReceiver(broadcastReceiver);

broadcastReceiver = null;

}

}

Теперь перейдем к ViewModel, поскольку у нас есть условие, которое зависит от полученных данных с двух LifeData, нам идеально подойдет MediatorLiveData как холдер самого значения, но поскольку перезапускать сервисы нам невыгодно, поэтому подпишемся к MediatorLiveData без привязки к жизненному циклу с помощью observeForever. В методе onCleared() реализуем отписку от него с помощью removeObserver. В свою же очередь LiveData будет уведомлять об изменении MutableLiveData, на которую и будет подписано наше представление.

public class DetectorViewModel extends AndroidViewModel {

//для хранения вводимых данных, решил создать Repository, листинг его можно посмотреть на GitHub по линке в конце материала

private IRepository repository;

private LatLng point;

private int radius;

private LocationLiveData locationLiveData;

private NetworkLiveData networkLiveData;

private MediatorLiveData statusMediatorLiveData = new MediatorLiveData<>();

private MutableLiveData statusLiveData = new MutableLiveData<>();

private String networkName;

private float[] distance = new float[1];

private Observer locationObserver = new Observer() {

@Override

public void onChanged(@Nullable Location location) {

checkZone();

}

};

private Observer networkObserver = new Observer() {

@Override

public void onChanged(@Nullable String s) {

checkZone();

}

};

private Observer mediatorStatusObserver = new Observer() {

@Override

public void onChanged(@Nullable Status status) {

statusLiveData.setValue(status.toString());

}

};

public DetectorViewModel(final Application application) {

super(application);

repository = Repository.getInstance(application.getApplicationContext());

initVariables();

locationLiveData = new LocationLiveData(application.getApplicationContext());

networkLiveData = new NetworkLiveData(application.getApplicationContext());

statusMediatorLiveData.addSource(locationLiveData, locationObserver);

statusMediatorLiveData.addSource(networkLiveData, networkObserver);

statusMediatorLiveData.observeForever(mediatorStatusObserver);

}

//Для того чтобы зря не держать LocationService в работе, мы от него отписываемся если WiFi network подходит.

private void updateLocationService() {

if (isRequestedWiFi()) {

statusMediatorLiveData.removeSource(locationLiveData);

} else if (!isRequestedWiFi() && !locationLiveData.hasActiveObservers()) {

statusMediatorLiveData.addSource(locationLiveData, locationObserver);

}

}

//считываем данные с репозитория

private void initVariables() {

point = repository.getPoint();

if (point.latitude == 0 && point.longitude == 0)

point = null;

radius = repository.getRadius();

networkName = repository.getNetworkName();

}

//метод, который отвечает за проверку того находимся мы в нужной зоне или нет

private void checkZone() {

updateLocationService();

if (isRequestedWiFi() || isInRadius()) {

statusMediatorLiveData.setValue(Status.INSIDE);

} else {

statusMediatorLiveData.setValue(Status.OUTSIDE);

}

}

public LiveData getStatus() {

return statusLiveData;

}

// методы которые отвечают за запись данных в репозиторий

public void savePoint(LatLng latLng) {

repository.savePoint(latLng);

point = latLng;

checkZone();

}

public void saveRadius(int radius) {

this.radius = radius;

repository.saveRadius(radius);

checkZone();

}

public void saveNetworkName(String networkName) {

this.networkName = networkName;

repository.saveNetworkName(networkName);

checkZone();

}

public int getRadius() {

return radius;

}

public LatLng getPoint() {

return point;

}

public String getNetworkName() {

return networkName;

}

public boolean isInRadius() {

if (locationLiveData.getValue() != null && point != null) {

Location.distanceBetween(locationLiveData.getValue().getLatitude(), locationLiveData.getValue().getLongitude(), point.latitude, point.longitude, distance);

if (distance[0] <= radius)

return true;

}

return false;

}

public boolean isRequestedWiFi() {

if (networkLiveData.getValue() == null)

return false;

if (networkName.isEmpty())

return false;

String network = networkName.replace("\"", "").toLowerCase();

String currentNetwork = networkLiveData.getValue().replace("\"", "").toLowerCase();

return network.equals(currentNetwork);

}

@Override

protected void onCleared() {

super.onCleared();

statusMediatorLiveData.removeSource(locationLiveData);

statusMediatorLiveData.removeSource(networkLiveData);

statusMediatorLiveData.removeObserver(mediatorStatusObserver);

}

} И наше представление:

public class MainActivity extends LifecycleActivity {

private static final int PERMISSION_LOCATION_REQUEST = 0001;

private static final int PLACE_PICKER_REQUEST = 1;

private static final int GPS_ENABLE_REQUEST = 2;

@BindView(R.id.status)

TextView statusView;

@BindView(R.id.radius)

EditText radiusEditText;

@BindView(R.id.point)

EditText pointEditText;

@BindView(R.id.network_name)

EditText networkEditText;

@BindView(R.id.warning_container)

ViewGroup warningContainer;

@BindView(R.id.main_content)

ViewGroup contentContainer;

@BindView(R.id.permission)

Button permissionButton;

@BindView(R.id.gps)

Button gpsButton;

private DetectorViewModel viewModel;

private LatLng latLng;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

ButterKnife.bind(this);

checkPermission();

}

@Override

public void onRequestPermissionsResult(int requestCode, @NonNull String[] permissions, @NonNull int[] grantResults) {

super.onRequestPermissionsResult(requestCode, permissions, grantResults);

if (grantResults[0] == PackageManager.PERMISSION_GRANTED) {

init();

} else {

showWarningPage(Warning.PERMISSION);

}

}

private void checkPermission() {

if (PackageManager.PERMISSION_GRANTED == checkSelfPermission(

Manifest.permission.ACCESS_FINE_LOCATION)) {

init();

} else {

requestPermissions(new String[]{Manifest.permission.ACCESS_FINE_LOCATION}, PERMISSION_LOCATION_REQUEST);

}

}

private void init() {

viewModel = ViewModelProviders.of(this).get(DetectorViewModel.class);

if (Utils.isGpsEnabled(this)) {

hideWarningPage();

checkingPosition();

initInput();

} else {

showWarningPage(Warning.GPS_DISABLED);

}

}

private void initInput() {

radiusEditText.setText(String.valueOf(viewModel.getRadius()));

latLng = viewModel.getPoint();

if (latLng == null) {

pointEditText.setText(getString(R.string.chose_point));

} else {

pointEditText.setText(latLng.toString());

}

networkEditText.setText(viewModel.getNetworkName());

}

@OnClick(R.id.get_point)

void getPointClick(View view) {

PlacePicker.IntentBuilder builder = new PlacePicker.IntentBuilder();

try {

startActivityForResult(builder.build(MainActivity.this), PLACE_PICKER_REQUEST);

} catch (GooglePlayServicesRepairableException e) {

e.printStackTrace();

} catch (GooglePlayServicesNotAvailableException e) {

e.printStackTrace();

}

}

@OnClick(R.id.save)

void saveOnClick(View view) {

if (!TextUtils.isEmpty(radiusEditText.getText())) {

viewModel.saveRadius(Integer.parseInt(radiusEditText.getText().toString()));

}

viewModel.saveNetworkName(networkEditText.getText().toString());

}

@OnClick(R.id.permission)

void permissionOnClick(View view) {

checkPermission();

}

@OnClick(R.id.gps)

void gpsOnClick(View view) {

startActivityForResult(new Intent(android.provider.Settings.ACTION_LOCATION_SOURCE_SETTINGS), GPS_ENABLE_REQUEST);

}

private void checkingPosition() {

viewModel.getStatus().observe(this, new Observer() {

@Override

public void onChanged(@Nullable String status) {

updateUI(status);

}

});

}

private void updateUI(String status) {

statusView.setText(status);

}

protected void onActivityResult(int requestCode, int resultCode, Intent data) {

if (requestCode == PLACE_PICKER_REQUEST) {

if (resultCode == RESULT_OK) {

Place place = PlacePicker.getPlace(data, this);

updatePlace(place.getLatLng());

}

}

if (requestCode == GPS_ENABLE_REQUEST) {

init();

}

}

private void updatePlace(LatLng latLng) {

viewModel.savePoint(latLng);

pointEditText.setText(latLng.toString());

}

private void showWarningPage(Warning warning) {

warningContainer.setVisibility(View.VISIBLE);

contentContainer.setVisibility(View.INVISIBLE);

switch (warning) {

case PERMISSION:

gpsButton.setVisibility(View.INVISIBLE);

permissionButton.setVisibility(View.VISIBLE);

break;

case GPS_DISABLED:

gpsButton.setVisibility(View.VISIBLE);

permissionButton.setVisibility(View.INVISIBLE);

break;

}

}

private void hideWarningPage() {

warningContainer.setVisibility(View.GONE);

contentContainer.setVisibility(View.VISIBLE);

}

} В общих чертах мы подписываемся на MutableLiveData, с помощью меnода getStatus() из нашего ViewModel. А также работаем с ним для инициализации и сохранения наших данных.

Здесь также добавлено несколько проверок, таких как RuntimePermission и проверка на состояние GPS. Как можно заметить, код в Activity получился довольно обширный, в случае сложного UI, гугл рекомендует посмотреть в сторону создания презентера(но это может быть излишество).

В примере также использовались такие библиотеки как:

compile 'com.jakewharton:butterknife:8.6.0'

compile 'com.google.android.gms:play-services-maps:11.0.2'

compile 'com.google.android.gms:play-services-location:11.0.2'

compile 'com.google.android.gms:play-services-places:11.0.2'

annotationProcessor 'com.jakewharton:butterknife-compiler:8.6.0'Полный листинг: here

Полезные ссылки: here и here

Android Architecture Components. Часть 1. Введение

Android Architecture Components. Часть 2. Lifecycle

Android Architecture Components. Часть 3. LiveData

Android Architecture Components. Часть 4. ViewModel

|

|

Колебания цен на нефть: виноват ли алгоритмический трейдинг? |

В течение первого полугодия 2017 года цены на нефть подвергались серьезным колебаниям, демонстрируя тенденции к снижению, свойственные «медвежьему рынку», даже несмотря на сокращение предложения сырья.

Обычно инвесторы и энергетические аналитики винят в непредсказуемости цен алгоритмический трейдинг, однако в сложившейся ситуации даже они были удивлены: основываясь на фундаментальной информации, рост цен казался им очевидным, пишет The Australian.

По словам нефтяных инвесторов, добыча сырья и спрос на него больше не являются движущими силами ценообразования на рынке. Они утверждают, что программный трейдинг искажает ситуацию и провоцирует ценовые перепады. Взять к примеру ситуацию от 25 мая: даже после того, как страны-члены ОПЕК решили продолжить сокращение добычи сырья, цены на нефть упали практически на 5%.

Ввиду происходящего, одни аналитики связали падение цен с, возможно, еще большим сокращением поставок со стороны ОПЕК, другие же объяснили ситуацию действиями алгоритмических трейдеров.

Премьер-министр Саудовской Аравии Халид аль-Фалих был одним из тех, кто связал события 25 мая с действиями технических трейдеров. «Тогда многие люди хотели продать акции», — сказал он после встречи ОПЕК 25 мая. «Но падение цен усилилось после того, как цена преодолела определенные технические барьеры».

По данным Комиссии по торговле товарными фьючерсами, автоматизированная торговля «энергетическими» контрактами (акциями) с конца 2014 по конец 2016 года составила 58 процентов, тогда как в предыдущем двухлетнем периоде её уровень составлял 47 процентов.

Еженедельные отчеты EIA об изменении запасов нефти и нефтепродуктов в США по-прежнему играют важную роль на рынке сырья, однако ценовые перепады усилились не из-за них, но за счет алгоритмической торговли.

8 и 9 марта запасы США продемонстрировали рекордный уровень. Однако после того, как в игру вступили алгоритмы, цена на нефть упала ниже 50 долларов за баррель – впервые за год.

«Всё больше трейдеров ведутся на кричащие заголовки, а не считают реальные объемы нефти, — сказал Майкл Тран, директор по энергетическим стратегиям RBC Capital Markets. — Многие из них — это алготрейдеры или кванты».

У каждого из фондов – свои стратегии, из-за этого влияние на них алгоритмов и автоматизации бывает крайне сложно определить. Как говорит Майкл Помада, исполнительный директор Crabel Capital Management, «люди склонны винить в происходящем те вещи, которые они не понимают».

Да, действительно, в основе алгоритмов часто лежит непростая методология. Время покупки и продажи акций определяется с помощью следующих индикаторов – скользящих средних (MA) и волатильности.

Трейдеры же могут сочетать знание математических моделей вместе с собственными наблюдениями, чтобы делать финансовые ставки на движение цен от одного дня до нескольких месяцев.

Несмотря на то, что и люди, и алгоритмы пользуются автоматизированными механизмами на бирже, увеличение числа таких операций свидетельствует о растущем влиянии и повышении скорости компьютеров в нефтяной торговле.

Автоматизированная торговля захватывает и другие сферы: например, согласно отчету CFTC, в сельском хозяйстве её уровень возрос до 49% в течение последних двух лет (до конца 2016 года) относительно 38% в прошлом периоде. То же самое можно сказать и о рынке металла, где процент алгоритмического трейдинга составил 54% в сравнении с 47% с 2012 по 2014 годы.

Однако цены на нефть всё-таки более подвержены колебаниям, нежели цены в других отраслях, в том числе, и из-за последних действий ОПЕК. Моментум-трейдеры, использующие алгоритмы, чувствуют тенденции на рынке, утверждает Питер Хан из Bridgeton Research Group. Он также сказал о том, что рынок нефти сейчас находится в переходном состоянии. «На таком рынке торговые системы на базе импульсных алгоритмом будут «выбиваться» из длинных и коротких позиций».

Некоторые алгоритмические стратегии неплохо финансируются: например, в прошлом году 25,5 млрд долларов было инвестировано в деятельность биржевых консультантов по товарным опционам (CTA, commodity trading adviser), многие из которых, по данным Preqin, используют алгоритмы для отслеживания трендов на рынке фьючерсов. В первом квартале этого года CTA привлекли еще 7,2 млрд долларов, после чего общий объём их средств составил 256 млрд долларов.

По мнению Goldman Sachs, биржевые консультанты могут создавать новые торговые возможности на рынке. «Фундаментальным инвесторам не стоит опасаться CTA-фондов. Их деятельность следует рассматривать как источник новых возможностей для заработка, поскольку они уводят рынок в сторону от жесткого следования фундаментальным показателям», пишет инвестиционный банк в своем отчете по сырьевым продуктам от 29 июня.

Другие материалы по теме финансов и фондового рынка от ITinvest:

- Образовательные ресурсы ITinvest

- Аналитика и обзоры рынка

- Как определить наилучшее время для сделки на фондовом рынке: Алгоритмы следования тренду

- Как Big Data используют для анализа фондового рынка

- Поиск неэффективностей: Что нужно знать о создании стратегий для торговли на бирже

- Эксперимент: Использование Google Trends для прогнозирования обвалов фондового рынка

|

Метки: author itinvest финансы в it блог компании itinvest нефть колебания цен биржа |

Охота на рыжего демона или пеленгатор помех спутниковой навигации |

Не подумайте, что я какой-нибудь преступный элемент, параноик или неверный муж, но как-то раз я решил купить глушилку GPS. Во-первых, был интересен сам процесс. Ведь дело вроде нелегальное, продавец как будто рискует. Хотелось в этом поучаствовать, а не просто послушать или почитать. Во-вторых, чисто технически и чисто экономически было интересно — как сделано и сколько стоит.

К чему это привело читайте дальше.

не обнаружим.

А. Азимов, «Как потерялся робот»

Ко дню рождения одного товарища

И. Царик, «Пользуясь случаем»

Зачем нужны GPS-глушилки и GPS-спуферы особо рассказывать не нужно. Сегодня все знают, что даже «новая аристократия» их использует для пущей безопасности. Особенно это знают жители Москвы. Что уж тогда говорить о простых людях. Ну когда у нас кому было какое дело до мелких неудобств соседа? «Если „Им“ наплевать, то мне тем более. Если мне нужно — врубил и поехал».

Но мир серьезно увяз в технике. Сегодня навигатор является продолжением мозга немалого числа водителей, особенно «светловолосых» их представительниц. Можно улыбаться и сетовать, но этот процесс развивается. И что будет, если им всем отрубить навигацию?

А теперь представьте себе робо-водителя будущего…

Не то чтобы я лично призывал не использовать глушилки. Напротив, мне лично без них было бы менее интересно заниматься техникой, описанной ниже. Кому война, а кому…

Резюме — врага надо знать в лицо. Я знаю, что глушилка — вещь мелкая и что есть работа профессора Эбинумы по более «тонкой настройке» спутниковой навигации, но простейший метод противника тоже мне интересен.

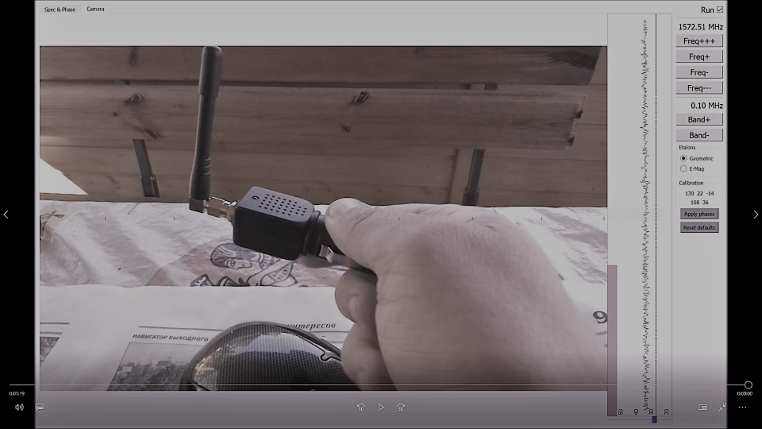

Самый дешевый способ вырубить навигацию стоил мне 2500 рублей.

Вещь простая, но в упаковке, вид которой отдает болезнями мозга. Я, по крайней мере, сразу заразился. Вот, думаю, хороший саркофаг для любимой мышки (

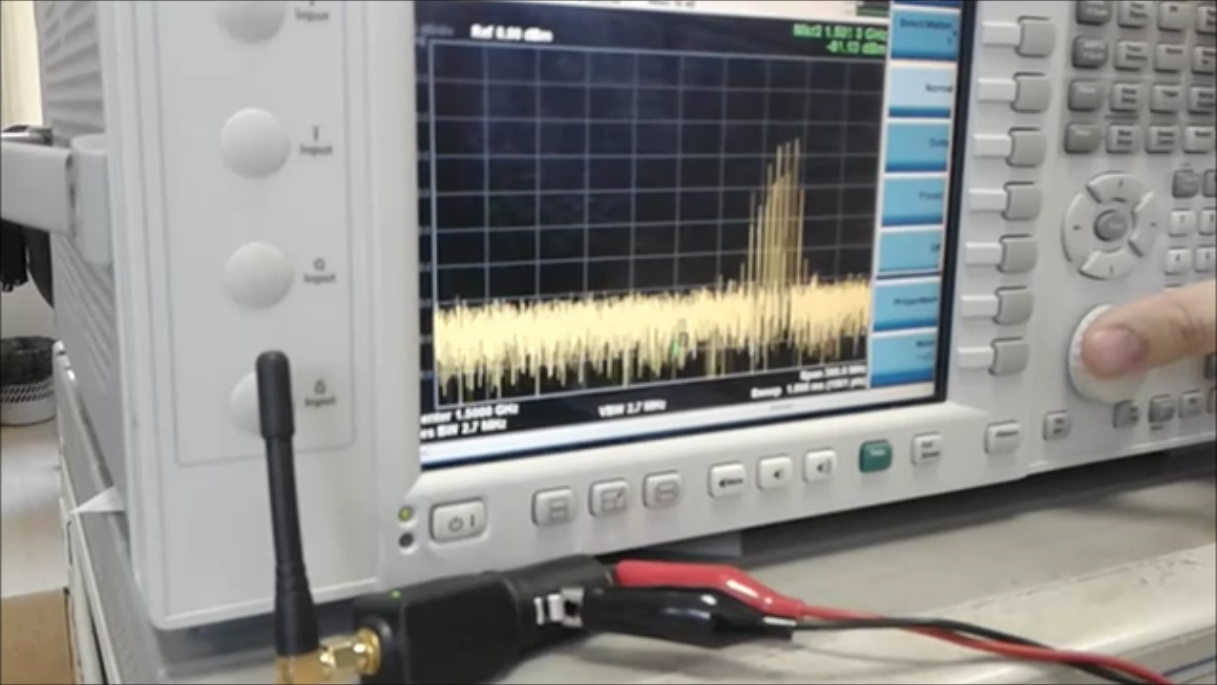

А какой богатый у него спектр (видео)!

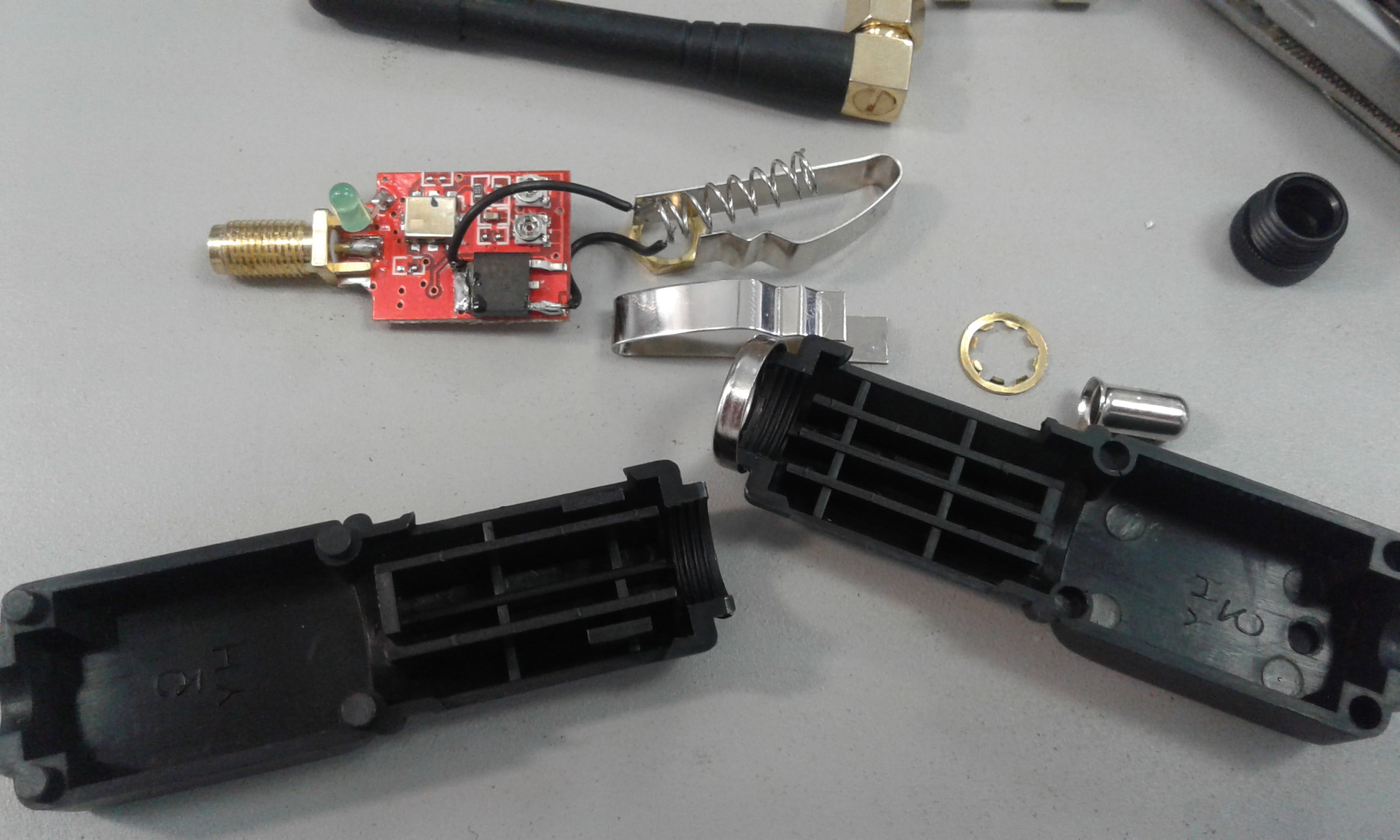

Далее эта зараза во мне прогрессировала в деструктивные действия и я разобрал его:

Все очень просто и со вкусом, почти по-деревенски)

И теперь вы все понимаете, почему демон рыжый.

(Хотя и «История рыжего демона» мне тоже нравится)

Но каково оно в действии!

Разящий огонь инквизиции! Теперь каждый пацан, сэкономив на пиве 30 раз, может «сжечь» всю навигацию на районе. Здесь хочу заметить, что запускал я эту штуку за городом. Ни один автолюбитель не пострадал.

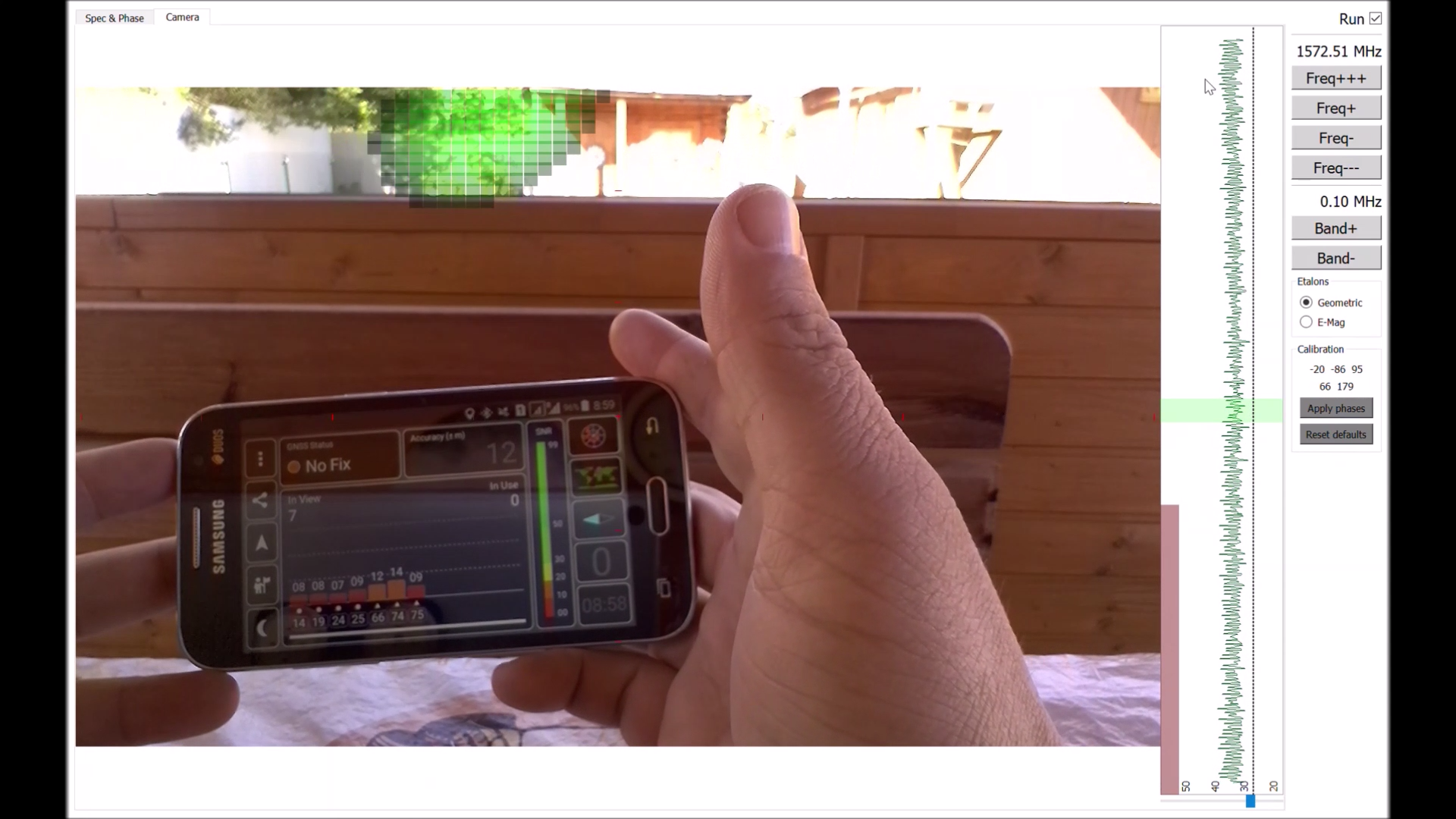

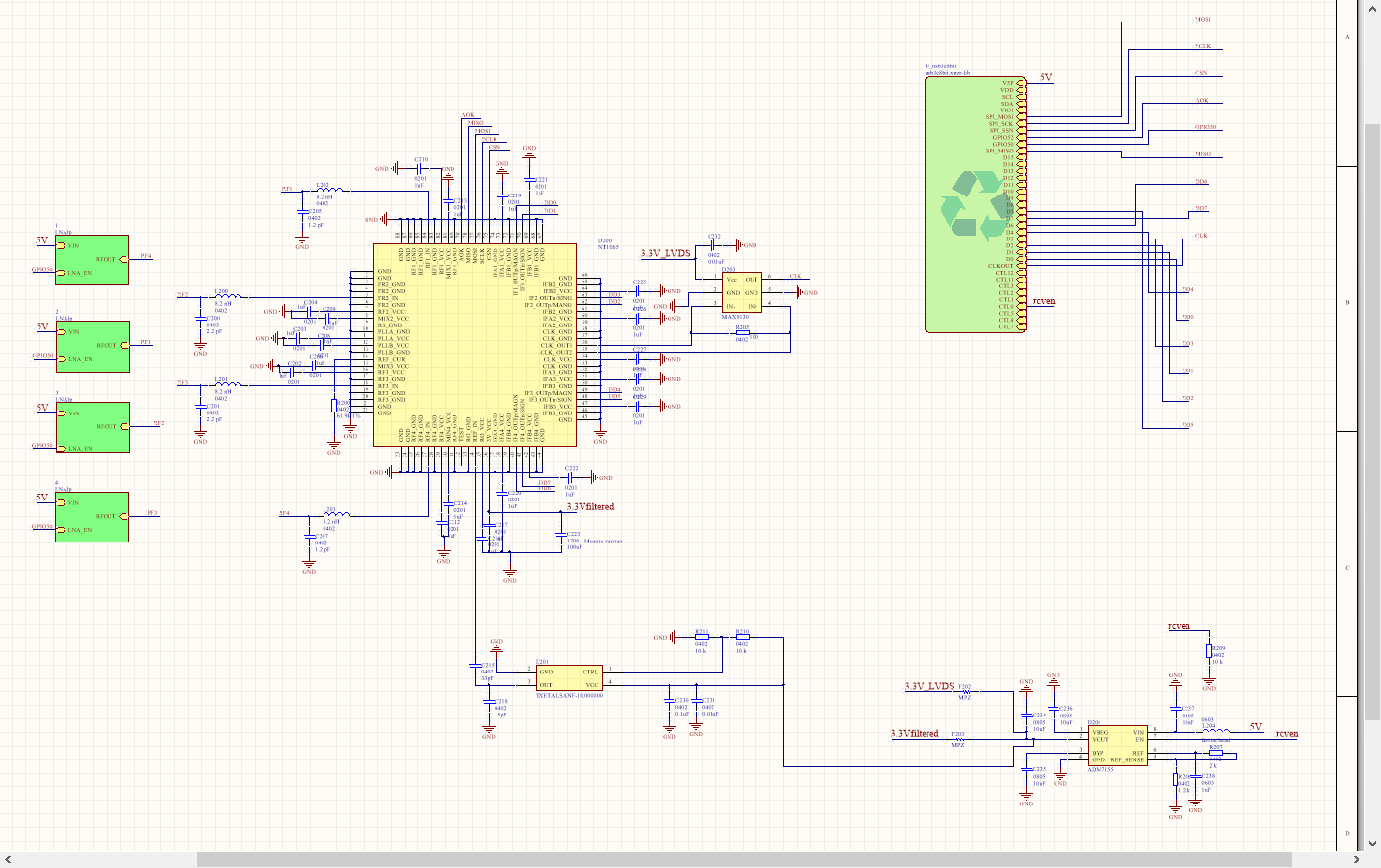

И повинуясь судьбе, я воспылал желанием запеленговать сие исчадье. Пеленгатор я стал делать с использованием моей любимой дополненной реальности и чудесной микросхемы NT1065.

NT1065 содержит четыре радио-тракта, которые можно настроить на использование одного гетеродина. Это видно по структурной схеме:

Тогда все четыре канала будут синфазны с точностью до неидентичностей радио-трактов. На рисунке ниже показан спектр разностей фаз.

Видно, что разности фаз стабильны, таким образом, возможно создание на базе NT1065 четырехканального фазового пеленгатора.

Берем плату из предыдущей статьи, добавляем к ней четыре антенны с малошумящими усилителями (МШУ). Можно было и без МШУ, но хотелось немного поднять сигнал в диапазонах, где антенна согласована плохо.

ВЧ-фильтры, рекомендуемые к установке на входе NT1065, для простоты и для гибкости пеленгатора, опускаем. Антенны настроены только на верхний навигационный диапазон (L1), но, закрыв глаза на чувствительность, можно будет попробовать использовать пеленгатор и на нижних диапазонах (L2, L3, L5 и т.д.). Позже посмотрим, что получится.

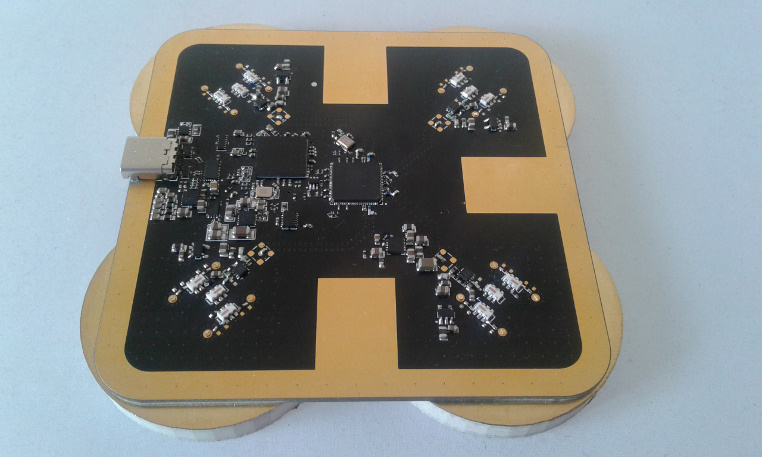

Вот такая получилась железяка:

Пришлось повозиться. чтобы уложить все на одну сторону, потому что с другой стороны только антенны. Без игнорирования рекомендаций по разводке микросхем не обошлось. Вылизывать буду потом.

А сейчас — софт (видео).

Исходники — здесь.

Вкратце софт работает так: берем сколько-то непрерывных отсчетов, делаем их БПФ (с окном, естественно), усредняем частотные отсчеты БПФ (бины) в выбранной пользователем полосе и вычисляем пеленг. Все это операции стандартные, которые скучно описывать образованной публике, кроме вычисления пеленга.

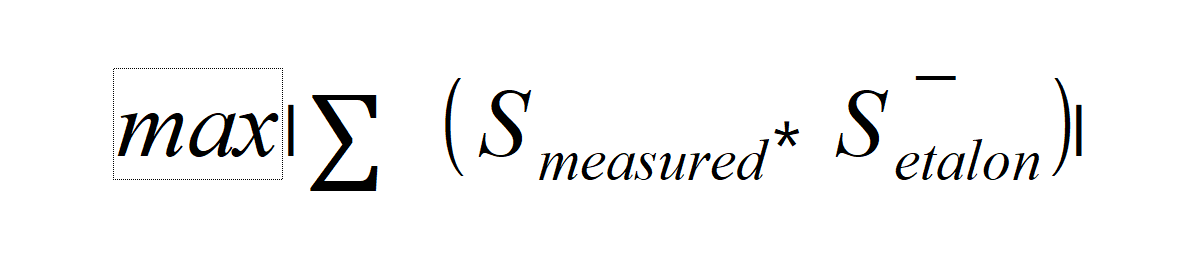

Здесь все сделано по-простому: алгоритм можно назвать «формирование диаграммы направленности», по-английски наверное будет beamformer — находим направление основного лепестка диаграммы направленности, наиболее соответствующее принятому антенной решеткой сигналу. Формула будет такая:

Конкретный код смотрите в GitHub'е, кому интересно.

Далее от максимума диаграммы направленности откладываем 1 процент и делаем срез. Получаем угловую область, некоторое «облако» углов, на которых вероятнее всего находится источник сигнала. Эту область углов затеняем на реальном видео с камеры планшета. В целом железяка выглядит так (как обычно смонтирована на задней стенке планшета):

И работает так: (видео).

Еще можно выбрать положение и ширину обрабатываемой полосы частот и установить порог по уровню сигнала. Также есть индикатор суммарной мощности в полосе, что позволяет сначала грубо найти сектор.

Если сравнивать такой фазовый пеленгатор с моим предыдущим амплитудным для WiFi, то этот принципиально более чувствителен. Ну и он уже не ручной, а автоматический. То есть в принципе им уже вращать не обязательно. Но все еще желательно это делать, так как точность лучше всего в фокусе. И с обратной стороны он не работает тоже. Там меньше всяких внутренних антенных искажений.

Но, как показывает видео, интерференцию никто не отменял. Если нет прямого луча, искажения могут быть значительными. И поляризационная зависимость тоже некоторая есть.

Вот на это я и хочу направить дальше свои усилия.

P.S.

На нижнем диапазоне, в навигационной формулировке L2, L3, L5 и т.д., пока работает не очень. Надо курить калибровку)

|

|

Security Week 31: Борец с WannaCry арестован в США, Svpeng получил новую фишку, Cisco патчит 15 дыр |

Что мы знаем о Маркусе Хатчинсе? На удивление мало. До истории с WannaCry о нем вообще ничего не было слышно, но тут его прославил блестящий ход со стоп-доменом. Парень порылся в коде троянца, нашел механизм самоуничтожения при получении ответа с захардкоденного домена, зарегал домен (затраты составили $10) и сумел существенно затормозить эпидемию Воннакрая.

Что мы знаем о Маркусе Хатчинсе? На удивление мало. До истории с WannaCry о нем вообще ничего не было слышно, но тут его прославил блестящий ход со стоп-доменом. Парень порылся в коде троянца, нашел механизм самоуничтожения при получении ответа с захардкоденного домена, зарегал домен (затраты составили $10) и сумел существенно затормозить эпидемию Воннакрая.Живет в Великобритании, работает в некоей компании Malwaretech. Ну, или сам он и есть Malwaretech. Судя по его сайту, Маркус с 2013 года реверсит вредоносный код и публикует неплохие исследования. Недавно запустил публичный ботнет-трекер, где можно посмотреть активность наиболее знаменитых ботнетов. В целом создается впечатление молодой, подающей надежды «белой шляпы».

Юное дарование приехало в Лас-Вегас – там как раз проходят конференции Black Hat и Defcon. И тут выяснилось, что парня заждались в окружном суде восточного Висконсина, причем с достаточно серьезными обвинениями на руках. Обвинительный акт содержит шесть пунктов, вменяемых Маркусу. Все они сводятся к тому, что Маркус Хатчинс, на пару с неназванным лицом ответственен за создание и распространение банковского троянца Kronos.

Кроноса заметили в даркнете в 2014 году, когда его авторы открыли предзаказ за $7000. Цена, видимо, оказалась завышена, так как после релиза его начали продавать по $3000, а уже в 2015 году он шел по $2000. На Youtube, кстати, есть ролик, рекламирующий Кроноса, предположительно снятый подельником Хатчинса.

Кроноса заметили в даркнете в 2014 году, когда его авторы открыли предзаказ за $7000. Цена, видимо, оказалась завышена, так как после релиза его начали продавать по $3000, а уже в 2015 году он шел по $2000. На Youtube, кстати, есть ролик, рекламирующий Кроноса, предположительно снятый подельником Хатчинса.Как и другие троянцы-банкеры, Kronos промышляет веб-инжектом в страницы интернет-банков. Жертва заходит в свою систему онлайн-банкинга, дабы посмотреть свой баланс, или оплатить что-либо, а ей на странице логина подсовывается пара дополнительных полей – например, ответ на секретный вопрос и PIN-код от карты. Это в дополнение к логину и паролю, которые Кронос перехватывает при помощи кейлогера.

В Кроносе есть любопытная фишка – юзермод-руткит. Используется он для сокрытия самого факта заражения, но от современного антивируса так не спрятаться. Поэтому, согласно выводам коллег из IBM, это нужно Кроносу для защиты от других банкеров, удаляющих с машины обнаруженных конкурентов.

Получается, если верить американским правоохранителям, именно этим Хатчинс зарабатывал на жизнь, по крайней мере, в 2014-2015 годы. Насколько обвинения справедливы – решит суд, но в целом эта история вполне правдоподобна. Далеко не все «белые шляпы» и их «черные» визави принципиально придерживаются своей стороны, некоторые, подобно «оборотням в погонах» пытаются добиться успеха и там и там. При этом лишь одна из этих сторон обеспечивает спокойный сон по ночам и свободное перемещение по миру.

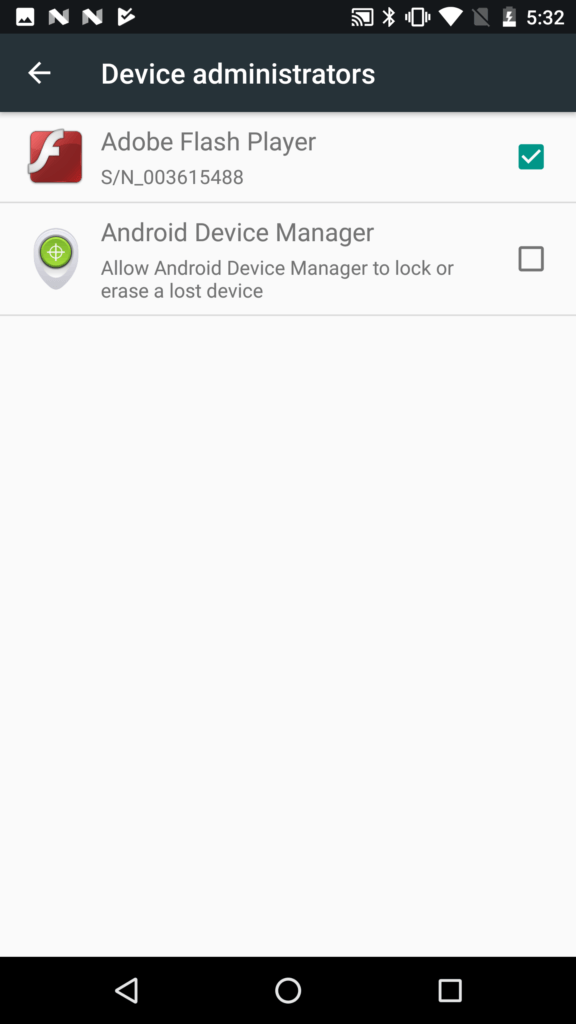

Svpeng обзавелся кейлогером

Новость. Исследование. Один из аксакалов среди мобильных банкеров, Svpeng, получил новую фичу. Не сказать, чтобы кейлогер был чем-то новым для троянцев, но Svpeng таким сроду не баловался, да и в Android-банкерах перехват клавиатурного ввода не считается необходимым. Для перехвата логина, пароля и SMS-кода достаточно отрисовать фишинговый интерфейс поверх интерфейса банковского приложения. Но авторы Svpeng, видимо, решили расширить сферу его применения – теперь он немножко шпионит и в других приложениях.

Что интересно, для перехвата клавиатурного ввода используются так называемые специальные возможности Android – функции облегчения работы со смартфоном для инвалидов. При этом Svpeng отказывается работать, если в списке клавиатурных раскладок обнаруживается русская. Роман Унучек, который у нас тут собаку съел на андроидной малвари, утверждает, что это обычная тактика для российских киберпреступников, чтобы избежать уголовного преследования. Мол, если в России ничего плохого их детище не делает, то и преступления как бы нет.

Что интересно, для перехвата клавиатурного ввода используются так называемые специальные возможности Android – функции облегчения работы со смартфоном для инвалидов. При этом Svpeng отказывается работать, если в списке клавиатурных раскладок обнаруживается русская. Роман Унучек, который у нас тут собаку съел на андроидной малвари, утверждает, что это обычная тактика для российских киберпреступников, чтобы избежать уголовного преследования. Мол, если в России ничего плохого их детище не делает, то и преступления как бы нет.Помимо кражи данных, специальные возможности ОС помогают троянцу обзавестись правами администратора устройства, не дать их у себя отобрать (ты снимаешь галку, а она снова появляется). Также Svpeng не дает предоставлять права администратора другим приложениям – то есть если жертва поздно спохватилась и решила поставить антивирус после заражения, это ей уже не особо поможет.

Распространяется эта дрянь через зараженные сайты под видом поддельного флеш-плеера и работает вплоть до самой новой версии Android включительно. Лучше не ставьте, даже если сайт будет обещать вам ооочень горячее Flash-видео.

Cisco выпустила патчи к 15 уязвимостям

Новость. Cisco – один из вендоров, которые активно занимаются безопасностью своих и немножко чужих продуктов. Это само по себе похвально и полезно для отрасли, но в случае этой замечательной компании, популярность ее решений играет с ней злую шутку. Раз Циска стоит у всех, всем интересно ее ломать.

В этот раз компания залатала больше дюжины продуктов за раз. Две из закрытых уязвимостей способны вызвать серьезную боль у админа. DOS-уязвимость к VDS (железка, поддерживающая виртуальную инфраструктуру для видеотрансляций) позволяет, как нетрудно догадаться, обрушить эту самую VDS, отправив на нее много траффика. Тактика понятная, ничего хитроумного, но вообще-то перезагружаться в таких условиях девайс не должен. После патча и не будет, если верить Cisco.

Вторая кара постигла ISE, систему контроля доступа к корпоративной сети. Речь идет о всего-навсего получении прав суперадмина нахаляву. Суть проблемы в том, что система некорректно обрабатывает внешние запросы на авторизацию и путает политики для внешних и внутренних пользователей. Атакер может вломится в сеть снаружи с именем внешнего пользователя, совпадающим с именем внутреннего пользователя, и получить его права доступа.

Еще один, трудноэксплуатируемый, но потенциально вкусный баг, позволяет менять некоторые параметры в базе данных локального состояния соединений (LSA) роутера Cisco. Злоумышленник отправляет специально сконструированные пакеты OSPF LSA type 1, меняет таким образом таблицу маршрутизации, и потенциально перехватывает или блекхолит трафик по некоторым соединениям. Все это работает для устройств с поддержкой протокола OSPF и не работает с протоколом FSPF.

Древности

«Softpanorama»

Очень опасный резидентный вирус. Стандартно поражает COM- и EXE-файлы при обращении к ним. EXE-файлы переводятся в COM-формат (см. вирус «VACSINA»). Проявляется следующим образом: стирает сектора со случайными номерами, вызывает int 5 (печать экрана). Содержит текстовые строки: «comexe», «Enola Gay is now flying to SoftPanorama!», «command». Перехватывает int 8, 21h

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 83.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw malwaretech wannacry kronos svpeng cisco ospf |

Второй Hackfest в истории ReactOS |

Мы решили продолжить традицию, поэтому второму в истории ReactOS хакфесту быть! Мероприятие пройдет с 14 по 18 августа 2017 года в Кёльне (Германия). Приглашаются желающие, для участия требуется предварительная регистрация

Всю информацию о событии можно получить на специальной вики-страничке.

Фотография с хакфеста, прошедшего в 2015 году.

ReactOS хакфест будет посвящен интенсивной работе по улучшению работоспособности операционной системы. Большое внимание будет уделено тестированию различных USB-устройств. Если вам интересно, как прошел предыдущий хакфест, то рекомендуем ознакомиться с отчетом об мероприятии 2015 года.

Свое участие уже подтвердили такие разработчики, как Colin Finck, Eric Kohl, Giannis Adamopoulos, Mark Jansen, Thomas Faber, Victor Martinez, Timo Kreuzer.

Список участников и идей для хакфеста постоянно обновляется на второй вики-страничке.

Участники самостоятельно оплачивают свой проезд до места проведения мероприятия. Однако, в исключительных случаях, несвязанных непосредственно с поездкой на хакфест, Фонд может частично или полностью покрыть издержки участника, что подлежит индивидуальному обсуждению. Фонд, тем не менее, оплачивает жилье участникам на время хакфеста, если они согласны на вариант размещения в хостеле.

Если потенциальный участник обратится заблаговременно, то есть прямо сейчас, Фонд может оказать справочно-информационную поддержку, организовать совместный трансфер из аэропорта и проживание в хостеле вместе со всеми участниками, что существенно сократит расходы. Администратор мероприятия — Colin Finck

Участвовать в хакфесте можно и удаленно, так же будет организована серия прямых трансляций из самой гущи событий.

Что в проекте произошло за 60 дней лета?

- Было начато предрелизное тестирование тестового образа для версии 0.4.6.

- Вадим Галянт выложил новую тестовую сборку с улучшениями USB-стека, которая способна работать на реальном «железе».

- Волонтер проекта, Петр Ахламов, обнаружил, что в ReactOS можно настроить работу Samba и написал инструкцию.

- Разработчик проекта, Пьер Швейцер, завершил базовые работы по внедрению клиента распределенной файловой системы NFS.

- В VirtualBox теперь вместе с ReactOS можно использовать еще и сетевую карту VirtIO.

- В ReactOS активировали поддержку файловой системы UDF. Исходный код проприетарного драйвера был пожертвован два года назад, но до сих пор не работал.

Хлеба и зрелищ

На следующем видео есть ответ на популярный вопрос — «работает ли у вас 1С: Предприятие?»

Видео прислал волонтер проекта, Андрей Шаталов.

А вот и ответ на второй по популярности вопрос — "а Кризис у вас хоть запускается?"

|

Метки: author Jeditobe блог компании фонд reactos хакфест хакатон hackfest hackathon reactos |

[Перевод] XBRL: просто о сложном - Глава 6. Погружение в XBRL - Часть 1. Приступаем |

6. Погружение в XBRL

В предыдущих главах мы потрогали пальцем воду, выясняя, что представляет из себя XBRL, и что с его помощью можно сделать. С этим багажом знаний мы готовы к полному погружению в настоящий XBRL в нашей заключительной главе. Мы рассмотрим основные шаги по созданию таксономии и отчета и покажем, как XBRL выглядит в реальной жизни.

В этой главе мы покажем процесс формирования таксономии и связанного с ней отчета на уже знакомом вам примере про демографию компании. Как и в реальной жизни, мы не сможем сделать все правильно с первой же попытки, поэтому процесс их формирования у нас будет разбит на несколько разных версий. Разработка большинства реальных таксономий занимает от нескольких недель до нескольких месяцев (и даже лет).

Примечание: Мы не будем создавать базы ссылок определений (definition linkbase) и базы ссылок на реcурсы (reference linkbase). В реальной жизни вы могли бы создать по крайней мере одну из них, чтобы более подробно описать свои концепты, но для целей данной главы они не нужны. После того, как вы освоите базы ссылок ярлыков (label linkbase) и презентаций (presentation linkbase), с пониманием баз ссылок определений и ресурсов не должно возникнуть никаких проблем.

6.1. Приступаем

Начнем с простой таксономии для нашего примера.

6.1.1. Схема таксономии

Прежде всего нам нужен документ, содержащий схему таксономии.

Хорошей практикой является использование в имени документа даты создания таксономии, чтобы легко различать созданные в разное время версии таксономии.

Давайте считать, что мы начинаем наш маленький проект в первый день года, сразу после боя курантов, тогда назовем документ с таксономией следующим образом – ‘sample-2017-01-01.xsd’. Будем обсуждать наш документ небольшими частями, создавая таксономию шаг за шагом.

6.1.1.1. Корень схемы

Как и в любой XML-схеме, мы начинаем с корневого элемента schema:

...

Обратите внимание на атрибуты внутри корневого элемента:

targetNameSpace

Определяет пространство имен (namespace) элементов схемы. Поддерживающее схему программное обеспечение, которое будет используется для обработки таксономии или связанного с ней отчета, должно использовать это пространство имен для обращения к схеме или ее частям.

Остальные атрибуты определяют префиксы элементов схемы. Префикс указывает, каким пространством имен определяется элемент:

xmlns

Пространство имен XML Schema – является значением по умолчанию для всех элементов без префикса;xmlns:xbrli

Пространство имен отчета XBRL (instance);xmlns:link

Пространство имен XBRL Link;xmlns:xlink

Пространство имен XML Schema XLink;xmlns:sample

Наконец, любые определенные нами элементы, которые находятся в целевом пространстве имен, будут иметь префиксsample.

Все приведенные ниже документы имеют одинаковые атрибуты определения пространств имен в корневом элементе. Мы не будем описывать их отдельно для каждого нового типа элемента.

Спецификация XBRL включает в себя ряд схем:

- XBRL Instance

Содержит определения (типы, атрибуты, элементы), необходимые для объявления фактов и концептов;- XBRL Linkbase

Содержит определения, необходимые для объявления ссылок от одной части таксономии (или базы ссылок) к другой;- XBRL XLink

Используется для объявления самих баз ссылок, это пространство имен понадобится вам при создании собственного расширения спецификации XBRL;- W3C XLink

Пространство имен для XML Link; обратите внимание, что схема для этой части спецификации находится на сайте xbrl.org, поскольку W3C не предоставляет эту схему, а для спецификации XBRL она необходима.

6.1.1.2. Импорт схемы отчета

Наш следующий шаг – импортировать схему отчета XBRL, чтобы мы могли использовать конструкции из нее в своих определениях элементов.

Элементimportдолжен точно определить схему, идентифицированную пространством имен. Документ схемы, на который указывает URI в атрибутеschemaLocation, должен реально существовать.

Схема отчета XBRL импортирует схему XBRL Linkbase, а она, в свою очередь, импортирует схемы XBRL XLink и W3C XLink. Это означает, что нам не нужно самостоятельно импортировать эти схемы.

Пространство имен W3C XML Schema стандартизировано и автоматически распознается поддерживающим нашу схему программным обеспечением.

6.1.1.3. Концепты

Концепты в нашей таксономии определяются как элементы схемы. Из нашего примера мы ранее получили следующие концепты:

| Имя | Тип |

|---|---|

| nr_employees_total | non-negative integer item |

| nr_employees_male | non-negative integer item |

| nr_employees_female | non-negative integer item |

| nr_employees_age_up_to_20 | non-negative integer item |

| nr_employees_age_21_to_40 | non-negative integer item |

| nr_employees_age_41_and_up | non-negative integer item |

Концепт, отражающий общее количество сотрудников, определяется следующим образом:

Разберем атрибуты концепта:

id

Этот идентификатор используется для обозначения концепта в других документах, таких как базы ссылок. Он должен быть уникальным в пределах схемы. Для id концепта мы использовали префикс ‘sample_’, чтобы сделать его глобально уникальным.name

Указанное в этом атрибуте наименование идентифицирует концепт внутри таксономии и отчета. Оно должно быть уникальным в пределах таксономии.xbrli:periodType

Каждый концепт должен иметь связанный с ним тип периода. В нашем примере количество сотрудников указывается на начало и на конец периода, то есть на дату. Для таких концептов используется значениеinstant.type

Количество сотрудников является целым числом; сотрудник, работающий неполный день, также считается как единица, а не дробь. Поскольку отрицательного количества сотрудников быть не может, мы используем типnonNegativeIntegerItemType, определенный в схеме отчета XBRL.substitutionGroup

Это простой концепт, не являющийся кортежем, поэтому здесь указываем значениеitem, определенное в схеме отчета XBRL.nillable

Рекомендуется всегда указывать концепты какnillable, это позволяет передавать по ним пустые факты.

Остальные концепты определяются аналогично, но каждый со своими значениями атрибутов id и name.

Нам также понадобится абстрактный концепт, который будет служить корнем иерархии представления нашего отчета. Ему (произвольно) присвоим тип xbrli:stringItemType. Для передачи фактов абстрактные концепты не используются, поэтому можно указать любой тип для удовлетворения требований спецификации XBRL по его наличию.

Абстрактный концепт должен иметь атрибут abstract со значением true.

6.1.1.4. Связи с базами ссылок

Если мы хотим представить полноценную таксономию или отчет, нам надо предоставить дополнительную информацию о концептах в виде баз ссылок. Начнем с двух из них – базы ярлыков и базы презентаций.

Связь с базами ссылок указывается в элементе appinfo, который размещается внутри элемента annotation:

У связи с базой ссылок есть следующие атрибуты:

xlink:type

Здесь всегда указываетсяsimple.xlink:href

В этом атрибуте указывается сама ссылка на базу. В нашем примере мы ссылаемся на базы ярлыков и презентаций, о которых поговорим позже.xlink:role

Атрибут ‘роль’ определяет тип базы ссылок. Мы используем значенияlabelLinkbaseRefиpresentationLinkbaseRef, определенные схемой XBRL Linking.xlink:arcrole

Ролью дуги к базе ссылок всегда указывается определенное в XLink значениеlinkbase.

6.1.2. База ссылок ярлыков

База ярлыков содержит три типа элементов:

- локаторы для определения концептов таксономии, которым присваивается ярлык;

- ресурсы, которые содержат сами ярлыки;

- дуги ярлыков, связывающие концепт (через его локатор) с ярлыком.

Эти элементы размещаются внутри элемента labelLink:

...

У элемента labelLink есть следующие атрибуты:

xlink:type

Здесь всегда указываетсяextended.xlink:role

Для ссылок по умолчанию используется рольlink.

6.1.2.1. Локтаторы (locator)

Локаторы размещаются в элементы loc. Они указывают на концепты связанной с ними таксономии.

xlink:type

Типом элементаlocвсегда указываетсяlocator, означающий, что он используется как локатор (концептов).xlink:href

Указывает на фактическое местоположение концепта. Обратите внимание, что тут мы используем егоid.xlink:label

Локатору присваивается ярлык для обращения к нему внутри базы ссылок. В качестве значения ярлыка мы будем использовать id концепта с префиксом ‘concept_’.

6.1.2.2. Ярлыки

Для определения ярлыков используется элемент label.

xlink:type

Типом всегда является значение ‘resource’, указывающее, что ярлык является локальным ресурсом базы ссылок.xlink:label

Как и в случае с локаторами, значение атрибутаlabelобеспечивает возможность обращаться к ярлыку внутри базы ссылок. Обратите внимание, что каждая из приведенных меток связана с одним и тем же концептом, и во всех из них используется одно и то же значение атрибута. Это позволяет использовать связь один-ко-многим от концепта к его ярлыкам. В нашем примере это три разных вида ярлыков для концепта ‘nr_employees_total’.xlink:role

Роль определяет вид используемого ярлыка. Спецификация XBRL предоставляет большое количество предопределенных ролей. В примере мы используем три вида – нормальный, краткий и развернутый ярлыки. Приложение для работы с таксономией или отчетом XBRL позволяет выбрать наиболее подходящий вид ярлыков. Базы ссылок презентаций также могут указывать предпочтительный вид ярлыка.xml:lang

В этом атрибуте указывается язык метки. В примере мы используем только английский язык, но в базу ссылок можно включать ярлыки на любых языках.

6.1.2.3. Дуги ярлыков

Наконец, после определения локаторов к концептам и ресурсов ярлыков, мы можем связать их с помощью дуг ярлыков.

xlink:type

Типом всегда указываем ‘arc’, дуга (кто бы мог подумать).xlink:arcrole

Роль дуги определяет вид связи. Для ярлыков указывается ‘concept-label’, дуга между концептом и ярлыком.xlink:from

Указывает на одну из сторон дуги, в нашем случае на концепт. Мы используемlabelлокатора в качестве значения этого атрибута.xlink:to

Указывает на вторую сторону дуги, на ресурсы ярлыка, также с использованиемlabelресурса.

Поскольку мы использовали один и тот же label для трех разных ярлыков, наша дуга образует связь один-ко-многим между концептом и его ярлыками.

6.1.3. База ссылок презентаций

Презентации содержат два типа элементов:

- Локаторы концептов таксономии, используемых в иерархии представления;

- Дуги представлений, связывающие концепты между собой через их локаторы.

Все они располагаются внутри элемента presentationLink:

...

6.1.3.1. Локаторы

Здесь все аналогично базе ссылок ярлыков, не будем повторяться.

6.1.3.2. Дуги презентаций

Дуги презентаций связывают концепты в parent-child иерархию (дерево):

xlink:type

Как и ранее, ‘arc’.xlink:arcrole

Роль дуги презентации – ‘parent-child’, она указывает на то, что база ссылок презентаций представляет собой иерархическую структуру.xlink:from

Указывает на родительский концепт иерархии через его локатор. В нашем примере не было подходящего концепта, поэтому для корня иерархии мы используем абстрактный концепт ‘presentation_root’.xlink:to

Указывает на дочерний концепт иерархии через его локатор. В нашем примере все концепты располагаются под корневым концептом ‘presentation_root’.order

Этот атрибут задает порядок следования дочерних элементов, расположенных под общим родительским элементом.priority

Используется для переопределения баз ссылок. В нашем примере мы этого не делаем (пока что).use

Указывая значениеoptional, мы обозначаем, что концепт может быть частью сети презентаций. Общепринятой практикой является указание этого значения, хотя оно же используется по умолчанию в случае отсутствия атрибута.preferredLabel

Ранее мы создали несколько видов ярлыков в нашей базе ссылок ярлыков. Здесь мы видим, как в базе ссылок презентаций указывается предпочтительный вид ярлыка для дочернего (to) концепта дуги.

Примечание: Поскольку атрибут preferredLabel может указываться только для дочерних концептов, корневой элемент иерархии презентации предпочтительного вида ярлыка иметь не может.

6.1.4. Отчет XBRL

Создав таксономию, мы можем использовать ее для создания отчета.

Документ с отчетом XBRL содержит следующие виды элементов:

- Ссылки на схему таксономии;

- Контексты для фактов;

- Единицы измерения для числовых фактов;

- Сами значения фактов.

Все эти элементы размещаются внутри элемента xbrl:

...

6.1.4.1. Ссылка на схему таксономии

Ссылка на схему указывается в элементе schemaRef:

xlink:type

Указываем тип связи ‘simple’.xlink:href

Ссылка задается какhref-атрибут. Он указывает расположение схемы таксономии на сайте ее создателя.

6.1.4.2. Контекст

У нас в примере есть два контекста – начало отчетного периода и конец отчетного периода:

12-34567

2016-01-01

12-34567

2016-12-31

id

Используется для связи факта с контекстом. Это значение должно быть уникально в пределах отчета.entity

Здесь указывается организация, по данным которой составляется отчет.

identifier

Этот элемент использует схему (scheme) для определения того, по какой организации составляется отчет. В нашем примере мы используем несуществующую схему на вымышленном сайте.

period

Здесь указывается период или дата контекста.

instant

В нашем примере у нас два instant-контекста, для дат начала и окончания отчетного периода соответственно.

Ссылка, указанная в элементе identifier, ссылается на несуществующую статистическую организацию, которая публикует идентификаторы подотчетных организаций. Наша воображаемая компания имеет идентификатор ‘12-34567’. В реальном мире мы бы использовали, к примеру, тикер фондовой биржи или идентификатор организации в национальном налоговом органе.6.1.4.3. Единицы измерения

Для всех числовых фактов должны быть указаны единицы измерения:

Person

id

Используется для связи факта с единицей измерения. Это значение должно быть уникально в пределах отчета.measure

Идентифицирует единицу измерения. В нашем примере мы определили собственную единицу измерения – ‘Person’.

6.1.4.4. Факты

Теперь мы наконец достигли финальной цели всего нашего упражнения – передачи фактов:

35

41

23

27

12

15

5

9

23

21

7

11Каждый факт – это отдельный связанный с концептом элемент. Значение элемента является значением факта.

contextRef

Каждый факт ссылается на свой контекст черезidконтекста. Наш пример содержит факты для каждого концепта в каждом из контекстов.unitRef

Поскольку для всех числовых фактов должны быть указаны единицы измерения, в нашем примере заполняем здесь ‘u_person’.decimals

Для числовых фактов должен быть задан один из атрибутов –decimals(десятичные знаки) илиprecision(точность). В нашем примере все факты целочисленные, поэтому указываемdecimalsсо значением ‘0’.

6.1.5. С гордостью представляем вам – наш отчет XBRL

После всей проделанной работы нам хотелось бы увидеть, как формируется наш отчет в привязке к таксономии и, в частности, к базам ссылок презентаций и ярлыков.

Для этого воспользуемся простым инструментом, который создает веб-страничку для нашего отчета с отображением фактов в табличном виде. Он располагает контексты в столбцах таблицы, а ярлыки концептов из базы ссылок ярлыков – слева от нее. Иерархия концептов, определенная в базе ссылок презентаций, задает порядок следования и отступы для фактов.

Полученный нами результат выглядит примерно следующим образом:

В общем, мы неплохо потрудились!

|

Метки: author r_udaltsov анализ и проектирование систем it- стандарты xbrl финансы отчетность цб рф |

Подготовка к проекту внедрения SAP HCM |

Практически все заказчики декларируют основной задачей внедрения системы унификацию процессов, документооборота и методологии. Внедрение системы должно решить задачу унификации, так как в рамках проекта появляются внешние стимулы в виде консультантов и ограниченного бюджета проекта, когда нужно быстро поменяться и однообразиться. Заказчик по умолчанию ждет от консультанта лучших практик, которых не существует. Давайте будем честным — лучшие практики это то, как бизнес уже дорос до своего текущего состояния. Нельзя перенести практики одной компании на другую, это будут не лучшие практики, а практики той, другой компании. Но это удобно, так как позволяет посмотреть, точнее подсмотреть, а как же сделано у других. Человеческое любопытство, когда сам придумать не можешь, поэтому идешь за идеями к соседу и их улучшаешь под себя.

В рамках проекта консультанты опираются на задачи проекта и требуют бизнес унифицироваться. Получается такая ситуация, когда бизнес самого себя просят самостоятельно устаканиться и отдать за это деньги чужим людям. Я также в свое время мотивировал себя ходить в спортзал — раз заплатил, то «нуна ходить». Сама по себе унификация тоже не очень понятный процесс. Представьте большой бизнес, где множество компаний, разные функции, разная иерархия управления. Простой пример: крупный завод на десятки тысяч персонала и малюсенькая компания с продавцами продукции на экспорт. И это все в рамках одного объема проекта, где должны быть унифицированные процессы, документы и методики. Для одних мельчайшее изменение аукнется численностью, фондами, эффективностью закрытия периода, другие вовсе не заметят. А упразднение одной из премий для первых пройдет просто другим видом начисления, а вторым может похоронить мотивацию продавцов. Потому что унификация.

Отчетность, особенно внутренняя, является еще одним камнем в огород обеих сторон. Бизнес говорит, что нужны отчеты, обычно в установленных формах, а консультанты предлагают «какие-то странные выгрузки из системы в кривом формате». Возникает конфликт устоев и прогресса, в котором обычно побеждает сложившаяся практика на предприятии по документообороту. Если справка по физобъемам должна лежать каждое утро у начальника цеха на столе, то никакая система не поможет пока начальник не начнет открывать систему по утрам. На западе такая практика встречается реже, когда заказчик требует формирование бумажных отчетов. Люди работают с современными технологиями дольше и больше, поэтому безбумажный документооборот развит и проекты запускаются проще. Разумеется, что это не касается законодательной отчетности.

Методология это самый большой объем работы на проекте. Скажу по секрету, что часто говорят о необходимости унифицировать процессы, а на практике процессы занимают процентов 10 от реальной работы по унификации. Основное это бумажки и расчеты, и зачастую это связано с требованиями законодательства, в то время как процессы практически не регламентируются законами. Под методологией я понимаю алгоритмы расчета тех или иных величин, правила заполнения отчетов и выходных форм. На входе в проект заказчик любит оперировать цифрами 80/20, 70/30 или иными конкретными величинами измеряющими результат унификации. С одной стороны какая разница сколько будет видов оплаты, ведь это всего лишь справочник? А с другой стороны необходимо на всех уровнях понимать что такое фонд оплаты труда, что такое затраты на персонал (это понятие обычно шире, чем фонд оплаты труда). В моем понимании идеальная унификация стремится к нулю, к упрощению до максимального уровня, не противоречащего закону и целям бизнеса.

В рамках проекта, когда дело доходит до унификации методологии, возникает множество сопряженных с HR вопросов из области налогового учета, экономики предприятия, бухгалтерского учета, юридической. Часто у этих областей нет единого держателя, который может со своей высоты принять решение о единообразии. Каждое подразделение варится в своем соку, что вскрывается на обсуждениях того же каталога видов оплаты (прошу прощения за банальный пример, но это самое больное место во всех проектах по SAP HCM).