Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как не дать отвлекать себя от работы. Советы и слэк-бот |

Отвлекаться плохо, очень плохо! Все это знают, но не все знают, что с этим делать и каков реальный масштаб проблемы. Поэтому я решил собрать вместе несколько техник по снижению числа отвлечений и даже написал небольшого бота, помогающего мне в этом.

Отвлекаться плохо, очень плохо! Все это знают, но не все знают, что с этим делать и каков реальный масштаб проблемы. Поэтому я решил собрать вместе несколько техник по снижению числа отвлечений и даже написал небольшого бота, помогающего мне в этом.Первая часть статьи — о причинах прерываний и методах борьбы с ними. Тех, кому больше интересно, как поднять своего Python-бота для Slack на Heroku с автоматизированным тестированием на Travis, прошу сразу переходить ко второй части. А мы перейдем к сути проблемы.

Проблема не в тебе, проблема во мне.

Источников отвлечений ровно два: внешний и внутренний. Первый обычно связан с неумением обрабатывать входящий поток информации и болезненной зависимостью от социальных приложений (сейчас на минуточку открою Инстаграм, там кто-то поставил новых лайков). Второй — с нашими коллегами, друзьями и родственниками (Вась, у меня буквально на пять секунд вопрос. Есть полчаса?). Значит, бороться нужно тоже по двум форнтам. Начнем с внутренних

Видеть тебя больше не хочу!

Нет видимых причин для отвлечений — нет и отвлечений. Прячем все ненужное:

— скрываем панель задач, теперь мы не видим индикаторы новых сообщений в почте, слаке, вацапе, вайбере, телеграме. Даже если оставить всплывающие сообщения, отсутствие иконки кричащей «ты еще не прочитал все важные комментарии» автоматически снизит число прерываний. Ну и заодно настраиваем сами уведомления.

— убираем иконки всех социальных сетей с главного экрана телефона. Пускай будут на втором — не страшно, теперь до них дольше тянуться, больше нам и не надо. Удивительно, но факт, этот простой способ позволил мне в два раза реже открывать проклятый вконтакт только для того, чтобы проверить, что там новенького.

— выбираем новое место для телефона. Огромный красочный AMOLED экран прямо рядом с клавиатурой отвлекает сам по себе, даже если на нем нет ни одного уведомления, поэтому находим место для девайса вне поля зрения так, чтобы доставать его было хоть немного, но лень. Важный звонок мы все равно не пропустим, а пропустим — перезвоним.

Ну че ты пилишь? Сказал же: вынесу елку!

Что если это не лайки в фейбуке, а что-то более важное и ваш раздражитель уже внешний — коллега, или может быть даже начальник? Откладываем на потом! Если сервера не загораются прямо сейчас в дата-центре, а джуниор-интерн не решает конфликт в мастер-ветке через 'git push --force', отвлечение можно отложить, и тем самым предотвратить переключение контекста. Слак позволяет о любом сообщении напомнить через несколько минут или часов. Что-то важное — откладываем на полчаса-час, что-то действительно важное — на 5–20 минут, за это время мы успеем довести задачу до точки, или хотя бы дописать метод. Ваш месенжер не поддерживает напоминания? Отмечаем сообщения непрочитанными и/или создаем таймер, теперь точно не забудем.

Почему вообще стоит откладывать дела на потом? Потому что это «потом» предполагает не больше часа-двух, а в течении часа мы все равно прервемся, но полминуты, чтобы прочитать сообщение и отложить его, лучше чем 5–10 минут, так как уже не сбивают с контекст задачи. Исследование на основе реальных рабочих сессий в Eclipse и Visual Studio показало, что два часа подряд мы работаем максимум один раз в день, при этом цена одного отвлечения равна десяти-пятнадцати минутам, чтобы снова начать писать код, и только каждый десятый программист умудряется начать снова писать код быстрее чем за минуту, если его отвлекли прямо в середине метода. А для тех, кому офисная среда совсем не позволяет поработать без отвлечений и один час придумали технику помидорок: дробим день на мелкие отрезки, каждые 25 минут фокусируемся на задаче, потом 10 минут на всем остальном, повторяем. Уж 25 минут обычно могут подождать 99% процентов даже очень важных вещей.

Дорогая, до полудня ты — у меня единственная!

Если вы уже отправили одного коллегу ждать, но уже пишет другой со своей задачей? Ваше сердце принадлежит тому, кто написал первым. Второго ставим в очередь. При этом сообщаем, что можно и нужно написать про задачу подробнее, но читать вы будете, только когда разберетесь с первой.

Если вы уже отправили одного коллегу ждать, но уже пишет другой со своей задачей? Ваше сердце принадлежит тому, кто написал первым. Второго ставим в очередь. При этом сообщаем, что можно и нужно написать про задачу подробнее, но читать вы будете, только когда разберетесь с первой.Многозадачность человеку дается гораздо хуже, чем процессору. По правде говоря, даже процессору многозадачность удается хуже, чем однозадачность (читаем прекрасных Джоэла и Демарко). Даже если вторая задача приоритетнее, но не настолько, чтобы её было нужно сделать за 10 минут, она может ждать. С меньшим числом прерываний, вы завершите обе задачи даже быстрее.

Почему ты не хочешь поговорить со мной?

Вы только что сделали, как я посоветовал, а коллега на вас обиделся? Ну да! Мало кому понравится, что его просят не мешать, особенно если он не понимает причину. Поэтому ваши коллеги должны знать и о том, насколько вредны прерывания, и о том, что вы иногда откладываете часть вопросов на потом, только для того, чтобы в итоге сделать все задачи быстрее и качественнее. Поэтому шарим линки из статьи со всем офисом, дарим директору книжку Демарко и не боимся обсуждать на работе, как общаться продуктивнее. Например, не разбивать одну мысль в чате на несколько предложений и не здороваться без дела, всегда давать контекст вместе с вопросом и т.д. Ну и самим не злоупотреблять доверием — сказали, что ответите через 10–15 минут, ответьте! Одна из причин, которую я слышал в оправдание идеи поздороваться и потом ждать, была такой: «а иначе мне могут вообще не ответить». Не будьте таким человеком! Если коллеги поймут, что вам можно доверять, они просто буду реже напоминать о своих задачах. Ну и не отвлекайте других без дела.

Возможно у вас возник вопрос, а зачем нам вообще бот? Просто я решил что мне пригодится небольшой помощник, который будет следить за тем, что пишут мне (и что пишу я) и в случае, если после привета в чате не появляется совсем ничего в течении полуминуты, отправлять возмутителю спокойствия ссылку на nohello.com. На бота уже никто не обидится, а хорошие манеры в команде надо поддерживать на уровне.

Всем спасибо, и привет!

П.С. Обкатывая бота на сотрудниках родной компании, я не исключаю выпуска его в паблик, если интресно — пишите.

|

Метки: author fo2rist gtd отвлечение внимания продуктивность slack |

[Перевод] Размышления о токенах |

Сегодня для токенов рано, но за ними — будущее технологий

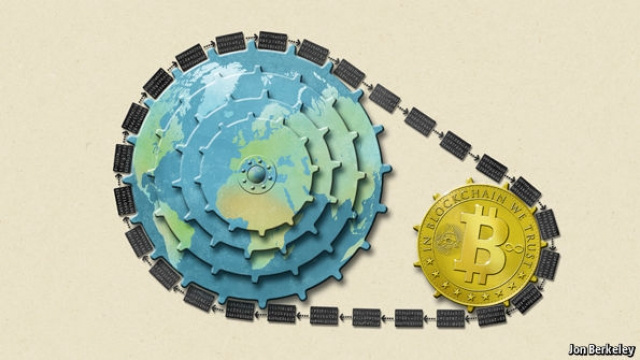

В 2014 году мы писали: «Биткойн — это больше, чем деньги, и больше, чем протокол. Это модель и платформа для настоящего краудфаундинга — полностью открытого, распределенного и легко реализуемого».

И эта новая модель уже реализована — на идее «аппкойна», или «токена», который представляет собой дефицитный цифровой актив, опирающийся на вдохновленную «Биткойном» технологию. На момент написания статьи рыночная капитализация сектора токенов оценивалось в десятки миллиардов долларов (безусловно, этот сектор переоценен, и тем не менее). Такие «толстые протоколы» могут в конечном итоге создать и привлечь больше капитала, чем интернет-компании последнего поколения.

Здесь мы обсудим многие связанные с токенами концепции: начнем с основ для новичков в этой области, а затем перейдем к более сложным понятиям.

Переведено в Alconost

Главное, что следует понимать: токены не являются акциями — они больше похожи на платные API-ключи. Тем не менее, они могут давать 1000-кратное снижение времени выхода на ликвидность и 100-кратное увеличение покупательской базы — по сравнению с традиционными средствами финансирования технологий в США (такими, как Kickstarter на самых успешных проектах). Это, в свою очередь, позволит финансировать проекты нового типа, ранее остававшиеся вне области возможностей венчурного капитала, и в их числе — протоколы с открытыми исходными кодами и проекты с потенциалом быстрого двукратного возврата.

Но давайте все-таки начнем с основ. Почему токены пришили именно сейчас?

1. Токены — результат четырехлетнего развития инфраструктуры цифровых валют

Последний раз широкая публика слышала о цифровой валюте в конце 2013 — начале 2014 года, когда цена биткойнов в последний раз коснулась тогдашнего максимума в 1242 долл. США. С тех пор кое-что произошло:

- Стоимость биткойна на протяжении нескольких лет падала вплоть до 173 долл. США и поднималась. Сейчас она находится немного ниже рекордного максимума в более чем 2900 долл. США.

- Во многих странах появились десятки обменников, которые облегчили перевод «бумажных» денег, таких как доллары и иена, в цифровые валюты: «Биткойн», «Эфириум» (Ethereum) и т. д.

- Крупные финансовые учреждения начали изучать лежащую в основе биткойнов технологию блокчейна для создания так называемых «частных блокчейнов», или распределенных реестров, — для использования самостоятельно или в рамках консорциума.

- Был запущен программируемый блокчейн «Эфириум», которые пережил крупные кризисы, получил существенную поддержку от корпораций и в начале 2017 года вырос в цене.

В 2013 году цифровая валюта все еще не имела определенного легального положения: многие предрекали ей смерть, а кто-то зашел настолько далеко, что даже назвал биткойн злом. Но в конце концов такого рода предсказуемые заголовки ушли в прошлое, и на экономическом форуме в Давосе можно было увидеть рекламный щит, приветствующий Сатоши, а журнал Economist поставил на обложку художественную интерпретацию стоящей за биткойном технологии.

К 2017 году во всех крупных странах уже есть биржи цифровых валют, а у каждого крупного финансового учреждения есть команда, работающая над блокчейнами. Становление инфраструктуры и принятие обществом цифровых валют заложили основу для следующего этапа — интернет-краудфаундинга новых биткойн-подобных токенов для новой сферы применения.

2. Токены различаются по своим блокчейнам и кодовым базам

В первую очередь следует сказать, что токен — это цифровой актив, который можно передавать (не просто копировать) между двумя сторонами-участниками через Интернет без согласия какой-либо третьей стороны. «Биткойн» — это самый первый токен: с возможностью передачи биткойнов и выпуском новых биткойнов, записываемых в соответствующий блокчейн. У других токенов тоже есть механизм передачи, а изменения в денежной базе записываются в их собственных блокчейнах.

Один из ключевых моментов состоит в том, что кодовая база токена отличается от базы данных его блокчейна. Приведем аналогию из реального мира. Представьте, что банковская инфраструктура США начала управлять австралийскими долларами: обе валюты — «доллары» и имеют общее культурное происхождение, однако у них совершенно разная денежная база. Точно так же два токена могут использовать одинаковые кодовые базы (денежные политики), но иметь разные базы данных блокчейна (денежные базы).

Благодаря успеху «Биткойна» появились несколько различных видов токенов:

- Токены, основанные на новых «цепочках» и ответвлениях кода «Биткойна». Такими были первые токены. Некоторые из них, такие как Dogecoin, просто изменили параметры в кодовой базе «Биткойна». Другие — например, ZCash и Dash, привнесли новые решения в области защиты конфиденциальности. А были и такие (например, Litecoin), которые начинались как небольшие модификации в коде «Биткойна», но в конечном итоге стали испытательным полигоном для новых функций. Все эти токены запустили собственные блокчейны, не связанные с блокчейном «Биткойна».

- Токены, основанные на новых «цепочках» и новом коде. Следующим шагом было создание токенов на основе полностью новых кодовых баз, и наиболее ярким их примером является «Эфириум». «Эфириум» — это основанный на принципах «Биткойна» проект, использующий собственный блокчейн и разработанный с нуля с целью расширить возможности программирования. При этом увеличивается число возможных видов атак, однако при этом расширяется функциональность.

- Токены, основанные на ответвленных «цепочках» и ответвлениях кода. Самый важный пример — Ethereum Classic, основанный на не совместимом с оригиналом ответвлении блокчейна «Эфириум», которое произошло после обнаружения бреши в безопасности, позволившей использовать крупный смарт-контракт непредусмотренным способом. На первый взгляд, это технический вопрос, однако по своей сути это был кризис, который заставил сообщество «Эфириума» разделиться на две группы с различными денежными политиками — в соотношении 90 на 10. Пример из реального мира: представьте, что все граждане США, не согласные с Законом об экстренной стабилизации экономики 2008 года, поменяли бы свои доллары на «классические доллары» и создали бы другую ФРС.

- Токены, выпущенные поверх блокчейна «Эфириум». Сюда можно отнести Golem и Gnosis — они основаны на ERC20-токенах, выпущенных поверх «Эфириума».

В целом, запускать совершенно новые токены на новых кодовых базах — технически сложная задача, и гораздо легче запускать новые токены посредством ответвления «Биткойна» или токенов ERC20 на основе «Эфириума».

Последнее заслуживает особого упоминания, поскольку «Эфириум» настолько упрощает выпуск токенов, что эта процедура идет первым примером в руководстве по «Эфириуму»! Однако легкость создания токенов на «Эфириуме» не означает, что они в принципе бесполезны. Часто эти токены представляют собой нечто вроде публичной долговой расписки, предназначенной для выкупа в новой цепочке, которая будет создана, или выкупа иного цифрового товара.

3. Покупатели токенов получают закрытые ключи

При создании нового токена он часто предварительно майнится и продается при запуске токена, краудсейлом или обоими способами. Здесь «предварительный майнинг» означает выделение части токенов для создателей токена и связанных с ним сторон. «Краудсейл» — похожий на Kickstarter краудфаундинг, при котором все интернет-пользователи имеют возможность купить токены.

Токены — цифровой товар. И фактически их покупатели приобретают закрытый ключ. В случае «Биткойна» он выглядит примерно так:

5Kb8kLf9zgWQnogidDA76MzPL6TsZZY36hWXMssSzNydYXYB9KFВ случае «Эфириума» — так:

3a1076bf45ab87712ad64ccb3b10217737f7faacbf2872e88fdd9a537d8fe266Можно считать закрытый ключ чем-то вроде пароля. Подобно тому, как пароль дает доступ к электронной почте, хранящейся в централизованной облачной базе данных (Gmail, например), так закрытый ключ дает доступ к цифровому токену, хранящемуся в децентрализованной базе данных блокчейна — например, «Эфириума» или «Биткойна».

Однако есть существенное различие: в отличие от пароля, никто, в том числе и вы, не сможет восстановить утерянный закрытый ключ. Есть закрытый ключ — есть токены. Нет ключа — нет и токенов.

4. Токены похожи на платные API-ключи

Пожалуй, лучшая аналогия для токенов — это концепция платного API-ключа. Например, если купить за доллары API-ключ веб-сервисов Amazon, его можно будет обменять на машинное время в облаке Amazon. Так же и покупка токена — например, «эфира» (ETH), — позволяет обменять его она вычислительное время в децентрализованной сети вычислений «Эфириум».

Такой обмен придает токенам собственную полезность.

У токенов есть еще одно общее свойство с API-ключам. Если кто-то получает доступ к вашим API-ключам сервисов Amazon, он сможет выставить счет вашему аккаунту Amazon. Точно так же, если кто-то увидит закрытые ключи ваших токенов, он сможет заполучить ваши цифровые деньги. Однако, в отличие от традиционных API-ключей, токены можно передавать другим сторонам без согласия эмитента API-ключа.

Таким образом, у токенов есть собственная полезность. И токенами можно торговать. А значит, у токенов есть цена.

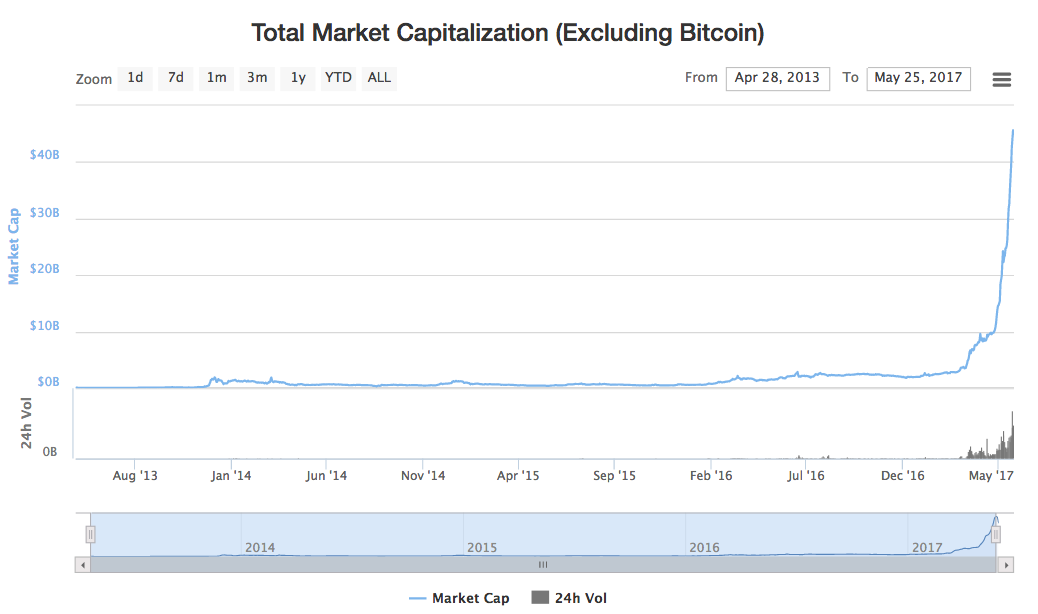

Экспоненциальный рост токенов (не относящихся к «Биткойну») до коррекции рынка. Данные — coinmarketcap.com/charts

5. Токены — это новая технологическая модель, а не просто стартапы

У токенов есть цена, поэтому их можно массово выпускать и продавать на этапе рождения нового протокола — для финансирования его развития, подобно тому, как стартапы использовали Kickstarter для финансирования разработки продуктов.

Обычно деньги в этом случае — в форме цифровой валюты — поступают в организацию, выпускающую токены, которая может быть и традиционной компанией, и проектом с открытыми исходным кодами, полностью финансируемым посредством блокчейна.

Так же, как увеличение продаж является альтернативой сбору средств, так и запуск токенов может быть альтернативой традиционному финансированию на основе выпуска акций. Причем токены позволяют финансировать распределенную инфраструктуру, которую раньше финансировать было невозможно — например, инфраструктуру с открытыми исходными кодами. Однако действовать следует осмотрительно: прежде чем приступать к запуску токенов, ознакомьтесь с этими тремя статьями и посоветуйтесь с хорошим юристом!

6. Токены — это «неразводняющая» альтернатива традиционному финансированию

Токены не являются акциями, поскольку у них есть внутренняя полезность и они не являются разводняющими в отношении таблицы капитализации компании. Продажа токенов — это скорее продажа через Kickstarter платных API-ключей, чем краудфаундинг акций.

Тем не менее, если рассматривать токены как альтернативу классическому финансированию посредством выпуска акций, то продажи токенов дают более чем 100-кратное увеличение доступной базы покупателей и более чем 1000-кратное снижение времени выхода на ликвидность по сравнению с традиционными методами финансирования стартапов. Этому есть три причины: 30-кратное увеличение числа покупателей в США, 20–25-кратное — за счет остальных стран и 1000-кратное снижение времени выхода на ликвидность.

7. Токены может купить любой американец (увеличение числа покупателей более чем в 30 раз)

Выпуск токенов отличается от продажи акций: последнее регулируется Законом США о торговле ценными бумагами 1934 года, а первое больше похоже на продажу API-ключей.

Акции могут продаваться в США только так называемым «аккредитованным инвесторам» (3% взрослого населения с собственным капиталом > 1 млн. долл. США), при этом продажа API-ключей в США не может быть таким же образом ограничена без ущерба для ИТ-индустрии США. Поэтому если токены (как API-ключи) могут продаваться 100% американского населения, это дает 33-кратное увеличение доступной покупательской базы в США по сравнению с традиционным финансированием посредством выпуска акций.

Следует, однако, заметить, что иногда токены могут выпускаться и явно рекламироваться как способ получить часть прибыли от работы компании. Например, эмитент может захотеть наделить владельцев токенов правом на корпоративные дивиденды, правом голоса, а общий акционерный капитал компании может быть выражен в этих токенах. В этих случаях речь на самом деле идет о токенизированных акциях (а именно — о выпуске ценных бумаг), что существенно отличается от примеров с «аппкойнами», которые мы обсуждали. Если вы не хотите ограничиваться аккредитованными инвесторами согласно закону США о ценных бумагах, не выпускайте токенизированные акции. Принципиальная разница заключается в том, что обычный токен является просто имеющим полезность цифровым товаром — таким, как платный API-ключ. Повторимся: сначала ознакомьтесь с этими тремя статьями, посоветуйтесь с хорошим юристом, и только потом запускайте собственные токены!

8. Токены могут продаваться по всему миру через Интернет (20–25-кратное увеличение числа покупателей)

Запуск токена обычно бывает международным, и цифровая валюта поступает со всего мира. Если недавно открытый банковский счет в течение нескольких минут получит тысячи переводов со всего мира на миллионы долларов, он, скорее всего, будет заморожен. А продажа токенов в цифровой валюте для компаний всегда открыта. Учитывая, что жители США составляют лишь около 4–5% мирового населения, международная продажа токенов умножает доступную покупательскую базу еще в 20–25 раз.

9. Токены имеют преимущество в ликвидности (более чем 1000-кратное снижение времени выхода на ликвидность)

Токен получает цену сразу после продажи, и эта цена свободно формируется на международном рынке — без выходных и перерывов на обед, чего не скажешь об акциях. До выхода на ликвидность акциям может понадобиться до 10 лет, а токен теоретически можно продать в течение 10 минут (хотя создатели токена могут и должны криптографически заблокировать токены, чтобы препятствовать краткосрочным спекуляциям).

Независимо от того, продаются токены или используются, разница между 10 годами и 10 минутами до выхода на ликвидность — это преимущество по времени в 500 000 раз, хотя, конечно, всякая оценка стоимости скорее будет выше и устойчивее в рамках 10-летнего промежутка.

Это огромное преимущество в ликвидности само по себе будет причиной того, что как токены станут доминировать всякий раз, когда они будут юридически и технически осуществимыми, поскольку в показатель степени совокупного темпа среднегодового роста входит величина, обратная времени до выхода на ликвидность. Быстрое достижение ликвидности позволяет реинвестировать в новые токены, что ускоряет рост.

10. Токены смогут децентрализовать финансирование технологий

Токены можно запустить в любой стране, поэтому для привлечения финансирования важность присутствия в Соединенных Штатах в целом, и в Кремниевой долине или на Уолл-стрит в частности, будет снижаться. Кремниевая долина, скорее всего, по-прежнему будет мировым лидером по вложенному в технологии капиталу, однако теперь не нужно будет лично ехать в Соединенные Штаты, как это было в случае с предыдущим поколением технических специалистов.

11. Токены создают новую бизнес-модель: «лучше, чем бесплатно»

Крупные технологические компании, такие как Google и Facebook, предлагают чрезвычайно полезные бесплатные продукты. Несмотря на это, их иногда жёстко критикуют за то, что они получают прибыль в миллиарды долларов, тогда как первые их клиенты получают всего лишь бесплатные услуги.

После того как будут устранены появляющиеся на раннем этапе проблемы, модель запуска токенов даст высокотехнологичным компаниям (и проектам с открытым исходным кодом в целом) технологически осуществимый способ распределить доход по базе пользователей, стоящих за успехом компании. Это и есть модель «лучше, чем бесплатно»: пользователи зарабатывают деньги за то, что стали первыми клиентами. Kik — первый пример такого подхода, но можно ожидать и другие аналогичные проекты.

12. Покупатели токенов станут для инвесторов тем, чем блогеры стали для журналистов

Токены снимут барьер между профессиональными инвесторами и покупателями токенов так же, как Интернет снял барьер между профессиональными журналистами и блогерами (в том числе микроблогерами).

И вот к чему это приведет:

- Интернет позволил каждому стать журналистом-любителем. Теперь же миллионы людей станут инвесторами-любителями.

- Как и в случае с любительской журналистикой, у некоторых будет получаться очень хорошо, и благодаря своим успехам в покупке токенов они смогут попасть в профессиональную лигу.

- В конечном итоге для профессиональных журналистов стало обязательным использовать Twitter — так же и инвесторы любого масштаба деятельности (начиная от посевных инвестиций и заканчивая хеджированием) придут к покупке токенов.

- Будут разработаны новые инструменты, аналогичные платформам Blogger и Twitter, которые позволят с легкостью использовать, покупать, продавать и обсуждать токены.

Для этого явления термина еще нет, но это можно назвать «торговыми медиа» — по аналогии с «социальными медиа» (англ. «commercial media» и «social media»).

13. Токены дают техническим специалистами еще большее преимущество перед традиционными руководителями

Со времени появления Билла Гейтса в конце 70-х годов наблюдается тенденция к увеличению технологической подкованности руководителей. С распространением продажи токенов она будет только усиливаться, поскольку ценные протоколы будут создаваться людьми, еще больше склонными к работе в области чистой теории вычислительной техники. Многие успешные создатели токенов будут обладать навыками, которые чаще встретишь у разработчиков ПО с открытым исходным кодом, чем у традиционных руководителей.

14. Токены — это мгновенное обеспечение сохранности без посредников

Покупателям токенов для обеспечения их сохранности требуется хранить только закрытые ключи, и это изменяет наше понятие имущественных прав. В случае токенов решение о том, кто какой собственностью обладает, принимается не государственной судебной системой, а международным блокчейном. Понятно, что будет множество спорных пограничных случаев, однако с течением времени блокчейны сформируют «правовое регулирование как услугу» — в качестве действующего по всему миру программируемого дополнения к Канцлерскому суду штата Делавер в США.

15. Токены можно обобщить для каждой технологической компании как платные логины

Можно ли модель токенов расширить за пределы чистых протоколов — Bitcoin, Ethereum, ZCash и др.? Нетрудно представить продажу токенов как билетов — для доступа к логинам, поездкам на машине, будущим продуктам. Также их можно распространять как вознаграждения авторам, которые делают существенный вклад в работу социальных сетей, или водителям, которые помогают развиваться сетям совместного использования авто. В конце концов, токены можно расширить и на «железо»: когда кто-то покупает место в очереди на Model 3 от Tesla или перепродает билет, он обменивается примитивными токенами. Но сначала модель должна доказать работоспособность на протоколах, и лишь затем ее можно будет обобщить.

Заключение

Токены — явление очень недавнее, и, скорее всего, еще произойдет существенная коррекция рынка (на момент публикации перевода капитализация обсуждаемых токенов прошла глобальный максимум и колеблется на уровне, близком к уровню на момент публикации исходной статьи). Чтобы разобраться с ожидаемым изобилием токенов и работать с ними, нам понадобятся информационные сайты наподобие Coinlist, инструменты управления портфелем (например, Prism), биржи (например, GDAX), а также многие другие составные части поддерживающей токены технической и правовой инфраструктуры.

Но мир уже изменился. Токены в 1000 крат лучше, чем те инструменты, что есть сейчас, а такое можно наблюдать нечасто.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией приложений, игр и сайтов на 68 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов, перевод технических текстов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Подробнее: https://alconost.com

|

|

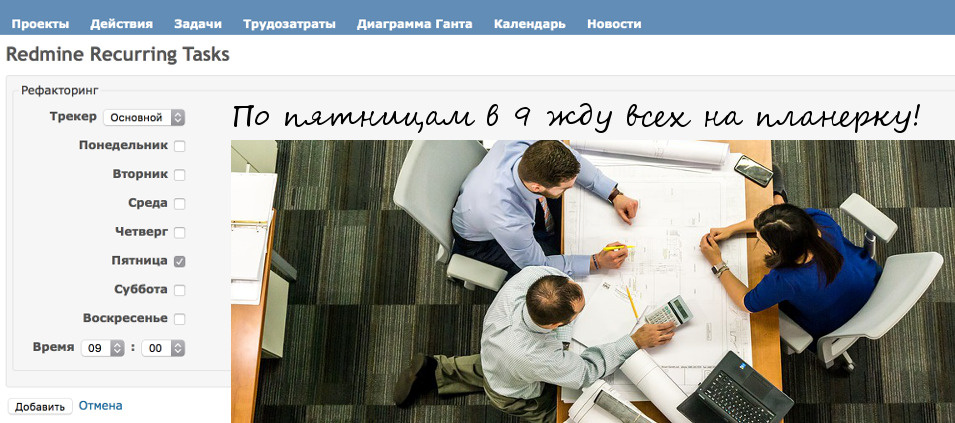

Повторяющиеся задачи в Redmine |

У вас есть регулярные задачи? Скажем, провести планерку по понедельникам в 10:30, сформировать отчет клиенту по четвергам в 18:00? Или клиент по вторникам накатывает обновления, и админ должен с 10:00 быть на постоянной связи? Нужно начинать рабочий день с чек-листа? 20 числа оплатить аренду?

Если вы работаете в Redmine, вы не можете штатными средствами поставить регулярную задачу. Придется каждый раз ставить ее вручную. Это лишнее время, лишнее внимание и риск ошибки.

Чтобы исключить человеческий фактор, мы разработали бесплатный плагин redmine_recurring_tasks, который автоматически ставит задачу ежедневно, еженедельно или ежемесячно.

Плагин совместим с другими популярными плагинами, в частности с redmine_tags и redmine_checklists. Есть возможность настроить вручную копирование атрибутов из других плагинов. Если есть вопросы по совместимости, уточняйте в комментариях.

Пользуйтесь на здоровье!

|

Метки: author olemskoi управление проектами управление персоналом блог компании southbridge redmine redmine-plugin redmine_recurring_tasks |

Истории успеха Kubernetes в production. Часть 2: Concur и SAP |

Concur

Concur Technologies — американская компания, существующая с 1993 года и насчитывающая сегодня 6800 сотрудников. Её бизнес — это SaaS для услуг в области путешествий и управления затратами для предприятий. В 2010 году ей удалось попасть в сотню лучших маленьких компаний по версии журнала Forbes, а по актуальным сведениям (2017 г.) около 70 % представителей списков Forbes 100 и Forbes 500 пользуются её услугами. В сентябре 2014 года стало известно, что SAP покупает Concur Technologies за 8,3 млрд USD, и поглощение было завершено в декабре того же года.

Статью же про SAP я решил начать с Concur, потому что эта компания, уже будучи подразделением SAP, стала прекрасным примером одних из ранних серьёзных пользователей Kubernetes в production. Первые сведения об этом появились в мае 2016 года. На проходившем тогда в Бостоне мероприятии ContainerDays 2016 ведущий инженер компании Dale Ragan дал интервью, в котором рассказал об опыте Concur.

Использовать Kubernetes в компании начали с одного фрагмента инфраструктуры — для сервиса по управлению чеками. На тот момент в Concur уже работали с Amazon Web Services и хотели запускать своё приложение как локально (on-premises), так и в облаке. Применять EC2 Container Service, который находился тогда в бета-тестировании, в Concur не захотели из-за появляющейся зависимости от одного поставщика (Amazon).

Одним из заметных препятствий при эксплуатации Kubernetes стало отсутствие поддержки AWS Availability Zones для NoSQL-хранилища etcd — проблему решили усилиями инженеров компании и обещали передать Open Source-сообществу. Результатом внедрения Kubernetes, по словам инженера Concur, стала «неизменная» инфраструктура (immutable infrastructure) — такая, что при внесении в неё изменений вместо модификации существующего кластера создаётся новый (и туда производится миграция). Это позволило им «чувствовать себя уверенными при миграциях, когда для всей инфраструктуры делается версионирование подобно тому, как деплоятся новые версии приложения». Для мониторинга производительности в компании внедрили Prometheus и Grafana, а главной проблемой проекта Kubernetes по итогам своего внедрения в Concur назвали недостаточно хорошую/подробную документацию.

Рассказывая об этом событии в своём блоге, Dale Ragan представил общую схему полученной инфраструктуры компании в AWS на базе Kubernetes:

… и пообещал рассказать подробнее об этом проекте, однако по каким-то причинам этого не произошло :-)

Несмотря на это, применение Kubernetes в Concur получило активное продолжение и развитие. Осенью того же года старший архитектор компании Dan Wilson выступил на KubeCon 2016 с докладом о масштабировании микросервисов с помощью Kubernetes, а ещё через год — на CoreOS Fest 2017 с докладом (презентация в PowerPoint) про использование Federated Cluster Selector из Kubernetes 1.7.

В последнем докладе архитектор Concur объяснил выбор Kubernetes следующими причинами:

Отдельного замечания стоит тот факт, что к 2017 году в Concur полюбили продукты CoreOS (хотя начинали с использования только «родных» компонентов Kubernetes), в том числе объясняя это «лучшей документацией для Kubernetes». Архитектура кластеров в компании получила такой вид:

В этом же докладе Dan Wilson представил и один из Open Source-проектов Concur для Kubernetes — kubegowatcher. Это шаблон плагина, который создан для запуска в контейнере внутри Kubernetes и отслеживания изменений в сервисах, подах и узлах (с возможностью добавлять свою бизнес-логику на события добавления/изменения/удаления объектов). Дополнительно отмечу, что архитектор Concur вносит свои правки и в upstream самого Kubernetes.

SAP: DevOps, микросервисы, Kubernetes (2016)

Официальных подтверждений тому, что солидный опыт с Kubernetes у Concur повлиял на инженеров SAP, нет. Однако общие идеи как минимум «витали в воздухе» — ведь ещё при покупке Concur глава SAP выражал восторг по поводу «расширения облачного портфолио SAP ведущими решениями для путешествий и управления расходами».

Так или иначе первое публичное упоминание применения Kubernetes для нужд SAP встречается летом 2016 года, когда архитектор облачной инфраструктуры компании Darren Hague выступал на DevOps Enterprise Summit 2016 (DOES16) в Лондоне с докладом «SAP’s DevOps Journey: From Building an App to Building a Cloud». К DevOps в компании пришли ещё в 2010—2013 годах (см. выступление того же автора на FlowCon San Francisco 2013), и Kubernetes стал следующим логичным шагом в её эволюции.

Представляя Kubernetes, Darren провёл заимствованную у сотрудника ЦЕРНа аналогию с домашними животными и скотом: если первые «имеют свои имена, уникальны, получают заботу с любовью и восстановление здоровья в случае проблем», то вторые — «получают номера вместо имён, практически идентичны друг другу и легко заменяются в случае болезней» (лично от себя добавлю, что совершенно не разделяю подобное отношение к животным, но это выходит далеко за рамки статьи). Так вот Kubernetes, по мнению архитектора SAP, — это возможность «обращаться с контейнерами, как со скотом, а не домашними питомцами».

Одной из особенностей применения системы Kubernetes в инфраструктуре SAP стало её использование как фундамента, поверх которого (т.е. в Docker-контейнерах которого) запускалась облачная платформа OpenStack. Уже в середине 2016 года озвучивалась задача компании по реализации такой новой платформы в 13 регионах и 18 дата-центрах с тем, чтобы её использовали одновременно «для облачных услуг SAP и для внутренних инноваций». Общение видение платформы представлялось следующим образом:

Отдельного упоминания заслуживает предпоследний пункт: инженеры компании создавали своего «агента автоматизации» под названием Arc, упоминаний в интернете о котором, к сожалению, осталось не так много. Существующий проект на Launchpad характеризует разработку как «безопасный фрейморк удалённого исполнения команд в OpenStack для настройки и запуска задач на гостевых системах в Linux и Windows», ссылаясь на ныне отсутствующий репозиторий в GitHub.

Интересной оказалась статистика по R&D создаваемой платформы: менее 10 % работы над проектом отнесены к категории «новые разработки», а более 90 % — улучшение имеющегося Open Source-кода. В частности, специалисты SAP внесли правки в upstream таких проектов, как OpenStack, Kubernetes, Docker и Grafana. (Впрочем, по данным Stackalytics, SAP не входит в сколь-нибудь значимый топ самых активных контрибьюторов ни для OpenStack в целом, ни для компонента Kubernetes в частности — проверка осуществлена для релизов OpenStack 2016—2017 годов.)

К подробностям об этой платформе мы ещё вернёмся, а пока будем следовать хронологии. В ноябре того же года на KubeCon 2016 прозвучал доклад (PDF) двух сотрудников SAP Labs о пилотном проекте по запуску в Kubernetes контейнеров с enterprise-сервисами компании. Из него можно было узнать о продолжающемся интересе инженеров SAP к переводу монолитных приложений к микросервисной архитектуре и имеющимся способам его реализации. Общую архитектуру в SAP видят так:

В примечании к этому слайду утверждается, что SAP работает и с HashiCorp, и с Mesosphere, однако выбранной реализацией контейнеров по умолчанию является Docker, а конкретный доклад посвящён их применению с Kubernetes и CoreOS. Итог же исследовательского проекта SAP Labs таков, что он на тот момент не закончен: остаётся ряд сложностей (в основном это вопросы стандартизации и интеграции различных компонентов и процессов компании), которые инженеры намерены преодолеть до того, как практики станут повсеместно адаптироваться. Отдельного упоминания в этом проекте стоит намерение SAP Labs «выпустить в ближайшем будущем Open Source-инструмент для управления Kubernetes — инструмента, который будет полезен и для разработчиков, и для команд эксплуатации».

SAP: конвергентное облако (2017)

В марте 2017 года история облачной платформы SAP на базе Kubernetes и OpenStack получила публичное продолжение: в корпоративном блоге анонсируется production-статус конвергентного облака SAP (SAP Converged Cloud, SAPCC). Заявляется, что оно предназначено только для внутреннего применения в компании, однако его масштабы всё равно впечатляют: проект объединил 23 других облачных решения, применявшихся ранее. Так много их было по разным причинам: «от быстрой инновации в разных областях бизнеса до множества приобретений, сделанных SAP за последние годы» (у таких компаний, как SuccessFactors, Ariba и, конечно, уже упомянутой Concur, были свои облака в момент их присоединения к SAP).

Как сообщается в анонсе, «OpenStack разворачивается на 100% контейнеризированным с помощью автоматизированной системы на базе Kubernetes». Некоторые подробности о технических особенностях и трудностях применения Kubernetes можно почерпнуть из доклада (кстати, это видео содержит 4-минутную демонстрацию того, как новый дата-центр может быть развёрнут в SAP Converged Cloud) архитектора компании Michael Schmidt на OpenStack Summit 2016:

Весь CI/CD pipeline в SAP (применяется Concourse) интегрирован с контейнерами из облака (применяется OpenStack Kolla), а для удобного управления инфраструктурой, разворачиваемой Kubernetes, используется пакетный менеджер Helm. В GitHub опубликованы различные Helm Charts: для разворачивания базовой IaaS на основе OpenStack, а также дополнительные, что требуются для SAP Converged Cloud.

Для работы с SAPCC создан веб-интерфейс, позволяющий управлять облачными ресурсами. Докладчик особо отмечает, что в интерфейсе управления серверами дополнительно предлагается и терминал для выполнения в нём привычных консольных команд OpenStack:

На момент анонса SAP Converged Cloud в нём была доступна лишь одна availability zone в Австралии с планами добавить ещё две европейские в течение 2 последующих недель и добиться распространения облака на 19 дата-центров в 13 регионах к концу 2018 года. В GitHub проекта SAPCC можно найти и другие интересные репозитории используемых в инфраструктуре компонентов — например, операторы для управления OpenStack на Kubernetes (подробнее об операторах для Kubernetes мы писали в этой статье) или утилиту для проверки сетевых настроек кластера Kubernetes.

Напоследок отмечу, что в этом же году СУБД SAP HANA была сертифицирована для запуска на Google Cloud Platform (GCP).

Другие статьи из цикла

|

Метки: author shurup it- инфраструктура devops блог компании флант kubernetes docker openstack sap concur истории успеха |

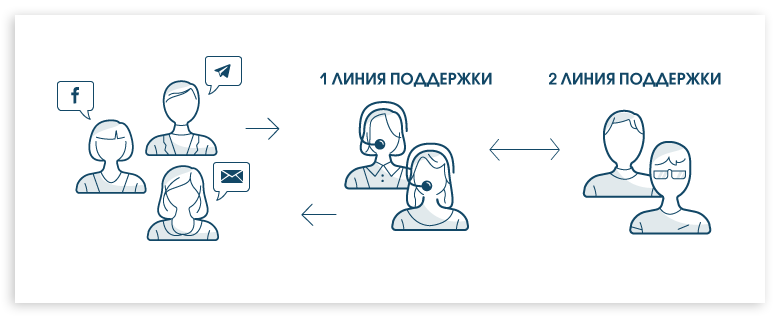

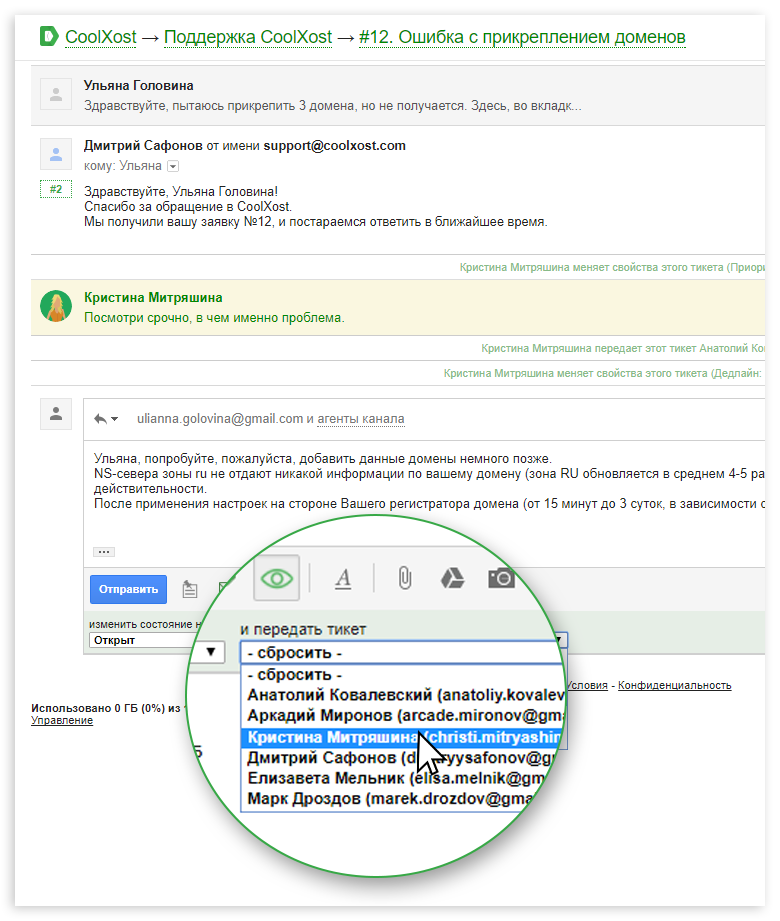

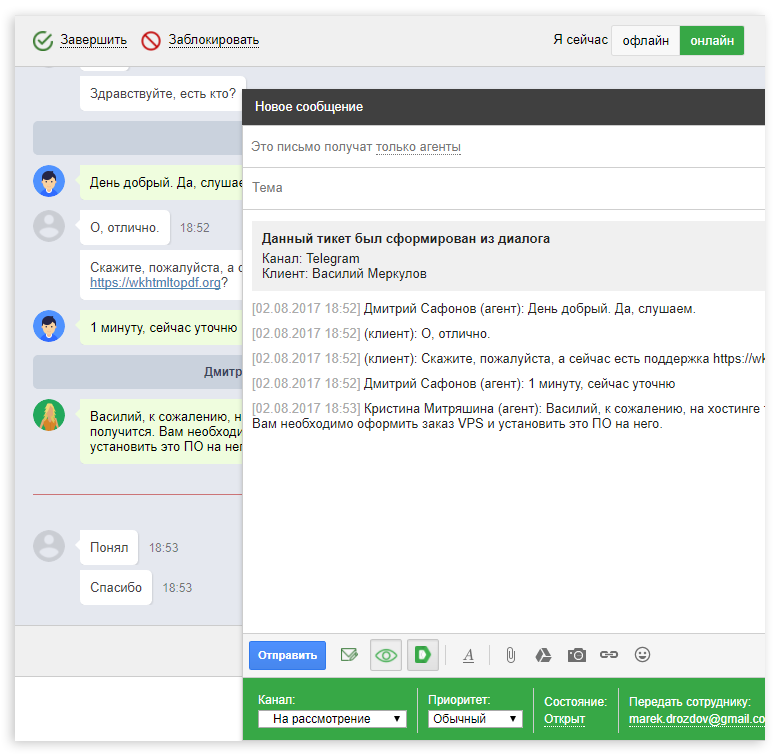

Кейс: как организовать мультиканальную поддержку клиентов на примере одного хостинг провайдера |

Описание проблемы

Хостинг провайдер CoolXost – сервис, предоставляющий услуги российским и зарубежным компаниям. Прием обращений в техподдержку происходит через форму обратной связи на сайте или отправкой письма на ящик поддержки (support@coolxost.com), после чего они поступают на общую корпоративную почту компании. Основная проблема – большой поток писем, который никак не структурирован. Все сообщения накапливаются в основном почтовом аккаунте компании в G Suite, где нет возможности назначить ответственного за решение проблемы, установить приоритет и отследить ход ее решения. На все поступающие вопросы отвечают с общего ящика разработчики сервиса, что, во-первых, негативно сказывается на их продуктивности, а, во-вторых, сильно влияет на удовлетворенность клиентов.Второстепенная проблема заключается в том, что никто не ведет отдельный учет пожеланий и запросов пользователей по улучшению функционала сервиса.

Внедрение Deskun

Руководство CoolXost поставило задачу: внедрить систему обработки заявок и расширить штат службы поддержки. В качестве helpdesk-решения был выбран сервис Deskun. Основные причины выбора – интеграция с Gmail, очень низкая цена по сравнению с аналогами и возможность подключить сразу несколько каналов связи, обрабатывая все заявки в едином месте.Для поддержки пользователей CoolXost были подключены следующие каналы:

- Электронная почта

- Онлайн чат на сайте

- Facebook, Vk.com и Telegram (для последнего канала был отдельно создан бот Telegram)

Также были созданы два канала задач: для учета предложений по улучшению сервиса и для постановки задач разработчикам. Эти каналы не относятся напрямую к службе поддержки, но играют важную роль в улучшении клиентского сервиса.

Получившаяся структура службы поддержки выглядит следующим образом:

На 1й линии поддержки специалисты обрабатывают заявки, которые поступают в онлайн чат, подключенные мессенджеры или почту, а также вручную создают тикеты в канале для учета предложений. На первую линию CoolXost наняли и обучили специальных сотрудников. Кристина и Лиза – коммуникабельные девушки с навыками слепой печати, знанием русского и английского языков, а также безупречной грамотностью; знают основы функционирования хостинг провайдера.

На 2й линии поддержки работают технические специалисты, которые также имеют доступ к общей почте. Эти сотрудники уже работали заявками в CoolXost и обладают высоким уровнем технической грамотности. Сотрудники второй линии обрабатываю те задачи, с которыми не смогли справится Кристина и Лиза.

Схема работы службы поддержки

Обращения на почту. При поступлении нового обращения на почту специалисты первой линии поддержки внимательно изучают его, и если ответ на вопрос находится в пределах их компетенции, то они отвечают клиенту самостоятельно и закрывают заявку. Максимально допустимое время ответа, установленное руководством CoolXost – 1 час. Если же вопрос требует вмешательства технических специалистов из второй линии, то агенты первой линии передают им тикет, при необходимости меняют приоритет и оставляют заметку. Агент второй линии видит уведомление, решает проблему и передает тикет обратно одному из агентов на первой линии, который отправляет ответ клиенту.

Диалоги в чате и мессенджерах. Сценарий диалога в чате во многом похож на обработку заявок по почте. Девушки из первой линии поддержки мгновенно реагируют на новые диалоги, и если проблема может быть решена прямо сейчас без вмешательства второй линии, то диалог успешно закрывается. Максимально допустимое время реакции на новый диалог – 2 минуты. Если проблема не была решена сразу, или на ее решение требуется больше времени, агенты первой линии создают тикет из выбранных сообщений диалога в email канале.

Также активно используется созданный канал задач «Пожелания и предложения». Клиенты CoolXost часто спрашивают о недостающих возможностях и делятся своими идеями по поводу улучшения сервиса. На основе разумных и адекватных предложений создаются тикеты в этом канале. Как правило, эти тикеты создают агенты первой линии поддержки, а затем при наличии свободного времени за их реализацию берутся разработчики. Для этого они переносят тикет в свой канал задач, устанавливают дедлайн и приоритет. После успешного внедрения новой функции, разработчик переносит тикет обратно в канал «Пожелания и предложения», а один из агентов первой линии отправляет клиенту письмо о том, что его запрос был выполнен.

Заключение

Мы показали лишь один из возможных сценариев работы мультиканальной службы поддержки клиентов. Итак, чтобы организовать качественную поддержку клиентов, недостаточно внедрить новое ПО. Нужна продуманная структура поддержки с грамотными и квалифицированными специалистами. В данном кейсе большим преимуществом было то, что руководство CoolXost осознавало потребность в таких специалистах, не пожалело средств на их привлечение и обучение.

Благодаря внедрению сервиса Deskun, компания CoolXost решила первичную проблему – большой поток входящих обращений был структурирован. В связи с созданием первой линии поддержки удалось повысить качество клиентского сервиса. Более того, это освободило специалистов второй линии от ненужных действий, позволило им больше времени уделять разработке и улучшению сервиса.

|

Метки: author ChiPer управление проектами управление персоналом блог компании deskun help desk service desk поддержка клиентов saas мультиканальность хелпдеск хостинг gmail |

JavaScript как праздник |

На данный момент JavaScript — самый популярный ЯП на планете. И, как бы я не уважал TypeScript, Java, C#, Go, другие языки — у них нет шансов изменить статус кво. Хотя вероятно они очень хороши для своих задач. Причина по которой JavaScript стал таким популярным (кроме монополии в веб) — его демократичность. Он позволяет программировать и в процедурном стиле, и в объектно-ориентированном и в функциональном. Он накладывает минимальные ограничения на разработчика, позволяя творить любую «глупость», но ирония состоит в том, что то, что является глупостью применимо к одному классу задач, применимо к другому является более чем целесообразным. Легенда гласит, что JavaScript был создан за 2 недели. И опять ирония жизни, в таких условиях можно заложить в язык только самое главное, оставив за бортом всё лишнее, традиционное, «правильное». Первая версия языка получилась очень компактной и лаконичной. Все эти get/set, const и await появились гораздо позже. Изначальные принципы языка были настолько хороши, что 10 лет (с 1999 по 2009) язык прожил вообще без изменений. Конечно к этому были и негативные причины, политика Microsoft и Mozilla, многое другое, но, уверен, не многие из других популярных языков смогли бы пройти такое же испытание и подняться после этого. Просто представьте, что стало бы с TypeScript или Rust после 10 лет отсутствия обновлений. Причина по которой JavaScript выжил очень проста, он решает одну задачу и делает это идеально.

JavaScript не претендует быть синтаксическим сахаром или набором клёвых фич, их программист может написать/подключить и сам. JavaScript скрывает от вас аппаратную часть устройства, даёт возможность делать что угодно с логикой и просто оставляет вас с этим. Хотите eval — пожалуйста, хотите переопределить любой объект — нет проблем, хотите передать в функцию то, что «нельзя» передавать — welcome, потому что это «нельзя» только в вашей голове. Программистам на Go или C# очень сложно понять почему это хорошо. Чтобы не вызвать на себя их хейт, это прекрасные языки, просто другие. Классически в языках ставятся барьеры, не дающие программистам отстрелить себе ногу, это и проверка типов, и различные обязательные best practices, и многое другое. В JavaScript этих барьеров нет, вы в праве стрелять куда угодно, и в 0.01% случаев стрельба в ногу тоже имеет смысл. Это можно сравнить со спортивным автомобилем, у многих языков заблокирована часть функций, а в JavaScript — нет. Если вы водите плохо — возможно это для вас минус, опасности и т.п., но если вы действительно хорошо разбираетесь и в языках, и в архитектуре, и в парадигмах, и умеете всем этим пользоваться — лучше языка чем JavaScript для общих задач вам не найти. Для частных — можно, для общих, универсального — объективно нет. Многие возразят, мол в Java тоже можно создавать словари, аналог JS-объектов, Python и Ruby тоже не типизованные, много где есть и eval и duck typing, но применять это так просто, как в JavaScript не получится нигде. В Java, например, словари это только дополнение, приделанное на типизованную класс-ориентированную основу, а в JavaScript — это основа языка, и создаётся всего двумя символами "{}". Это как если бы в спортивном автомобиле форсаж вызывался не тремя кнопками и рычажком, а одной кнопкой под большим пальцем правой руки. Свобода не просто возможна, она поощряется.

Многих это вводит в ступор, потому что они привыкли, что им не дадут расшибить лоб. Это как переход с Windows на Linux. «Я ввёл sudo rm -Rf / и всё сломалось. Не система, а г… но». С такими рассуждениями путь до мастера будет очень долгим. Порог входа в JavaScript был и остаётся очень низким, это даёт повод многим новичкам ругать то, в чём они не разобрались. Причём у человека может быть 20 лет опыта в Lisp, но по JavaScript он всё равно даже документацию не читал, типа и так умный. Этого достаточно, чтобы писать простые программы, но если человек хочет понять почему true < 2 === true, и почему это правильно и логично — прочитать про преобразования типов must have, а в идеале всю документацию (или хорошую полную книгу), это не долго.

Теперь отвечу на критику по пунктам:

Вопрос 1: однопоточный рантайм

Это очень удобно, не возникает проблем с блокировками и владением объектами и других прелестей многопоточности. Зачем вам нужна многопоточность? Выполнять программу дальше пока ждёте выполнения долгой операции? Колбеки справляются с этим гораздо лучше. NodeJS на одной средней машинке может держать по 100 000 коннектов. Сколько бы их было при замене колбеков на поточный подход? На многопроцессорных машинках js прекрасно параллелится запуском локального кластера. 8 ядер — 8 процессов, 16 ядер — 16 процессов, каждый независим друг от друга и прост внутри. Это реальный пример из практики применения, как главной серверной технологии онлайн игры с 8 миллионами пользователей. Работа с ассинхронностью/потоками это не слабость, а одно из мощнейших преимуществ JavaScript. Это может требовать переучивания и изменения привычек, но поверьте, вы приобретёте очень многое.

Вопрос 2: отсутствие единой системы / стандартов реализации модулей

В JavaScript два основных варианта работы с модулями:

- официальный, через import

- и традиционный, через require

Оба способа прекрасно работают, и полностью совместимы друг с другом. Вы можете выбирать тот способ, который вам больше нравится. Мне, например, больше нравится require, потому что его можно переопределить, и это больше соответствует философии JavaScript. Иногда это имеет смысл, например при написании своих препроцессоров. Почему я говорю, что два «основных» варианта, так это потому, что JavaScript сообщество открыто к любым новаторствам, и вы можете создать третью, четвёртую, тысячную систему работы с модулями (и многие уже создали). Другой вопрос, будут ли ей пользоваться за пределами вашего проекта. Описанные два способа являются де факто стандартом в веб-разработке, если вам интересны именно стандарты.

Вопрос 3: отсутствие единых стандартов структуры проекта (все творят как хотят, в исходниках бывает очень сложно разобраться)

Сочувствую вам с коллегами, которые «творят что хотят». Или коллегам с вами. В веб-разработке есть несколько типовых структур проекта, как правило используется одна из них, но это нигде не постулировано, и каждый действительно волен писать свою программу исходя из своего взгляда на целесообразность. А что вы хотели? Это самый популярный язык на планете, а не какой-то DSL. В разных сферах применения JS разные стандарты, и это правильно. Что касается практики, я, например, прекрасно читаю даже обфусцированный код библиотек, чего и вам желаю. Нарабатывайте опыт и изучайте распространённые паттерны.

Вопрос 4: слабые типы с неявными (и порой довольно странными) преобразованиями

Странными для кого? Программистов Java, C#, PHP, Python, Lisp или Ams? Скажете asm не странный? А Lisp? Мир гораздо богаче вашего любимого языка и то, что для одних странно, для других норма. Посмотрите хотя бы на Haskell с его монадами и функторами (очень мощные штуки, кстати. В JS тоже используются, в jQuery). В институте этому не учили, правда? ООП это только малая часть мира, настолько малая и настолько заезженная, что даже скучно говорить. А типы в JavaScript не слабые, их принципиально нет (кроме примитивных). WeakMap и прочее ввели только для того, чтобы порадовать переселенцев из других языков. Перечитайте про duck typing и научитесь им пользоваться, проблем с типами у вас не возникнет.

Вопрос 5: отсутствие нормальных классов / ООП

Опять же, специально для переселенцев с других языков и для IDE уже довольно давно введены классы. Их поддерживают все основные браузеры, не говорю уже про NodeJS. ООП в JavaScript богаче, чем в большинстве других языков. Можете наследовать через классы, можете через прототипы. Во многих случаях правильного применения JavaScript прототипы оказываются быстрее, удобнее и логичнее, а программа компактнее и более читаемой. Но опять же, этому не учат в институте, а JavaScript сообщество должно потом доказывать, что так тоже можно.

Вопрос 6: отсутствие единого вменяемого и работающего статического анализатора кода (добро пожаловать в чудесный мир глупейших ошибок типа undefined is not a function)

Это общая проблема всех интерпретируемых языков с eval, и отказываться от этой мощи ради возможности ловить 5% самых глупых ошибок — сомнительная идея. А вообще, развивайте дисциплину кода, не всё время за юбкой IDE прятаться. Это не стёб, анализаторы это хорошо, но если для вас проблема такие ошибки — как-то вы не правильно программируете.

Вопрос 7: отсутствие вывода типов в самом языке или в каком-либо инструменте

Это есть, изучайте синтаксис. Один из вариантов, в зависимости от ситуации:

typeof myVar

myVar.constructor

Вопрос 8: этот чудесный контекст this (что это значит this в этом месте кода — объект? функция?)

При правильном использовании проблем с this не возникает. Если вы вызываете функцию как myObj.func(), то можете быть уверены, что this будет равен myObj. При назначении колбеков или передаче функций как параметров, информация о myObj теряется и, если необходимо, следует задавать его явно через bind. Это логично и понятно знающим JS, так как вы, например, можете сделать так myObj2.func = myObj.func, и функция будет методом сразу нескольких сущностей. Не правильно назначать this равным myObj или myObj2, так как они симметричны. Не правильным было бы и использовать лексический контекст, так как это внесёт путаницу в миксины, прототипное наследование и многое другое. Поэтому this в таких случаях равен window или undefined, в зависимости от использования strict mode. Но это не должно вас волновать, и это принципиальный момент. Это один из типичнейших примеров стрельбы себе в ногу. На что вы надеетесь, вызывая this у функции, вызванной без контекста? Явно не на что-то хорошее. Есть много таких примеров, люди складывают массивы с числами, делят получившееся на объект и жалуются, что получают странные результаты. Во-многих странных вещах есть логика, но в особо странных это может быть просто произвол. JavaScript гибкий язык и позволяет вам делать то, с чем с C++ у вас программа даже не скомпилировалась бы, в надежде на то, что вы знаете, что делаете. Не нужно пренебрегать этим доверием и творить не весть что. Если вы хотите результат, то просто используйте this правильным логически обоснованным образом, а фразы а-ля «я воткнул себе нож в горло и у меня 2 раза потекла тёмная кровь, а 2 раза светлая, почему так?» оставьте для холиваров. И не надо хвастаться тем, что вы знаете чему в данной неочевидной ситуации равно this или как складываются несуммируемые типы. Профессионально правильной позицией будет, как ни странно, не знать это и не использовать, так как в разных браузерах и в разном контексте вы можете получить разный результат. Но JavaScript всё равно позволяет вам, если вы хотите это использовать, например для того, чтобы отличить PhantomJS c поддельным User-agent от настоящего Chrome — дорога открыта.

Вопрос 9: абсолютно дурацкая реализация pattern matching ( паттерн матчишь пустой список / объект — без проблем, извлекаешь оттуда undefined, ты же именно это имел ввиду, да? ) и здесь опять привет cannot read property foo of undefined

Два совета:

- не делайте логических ошибок. Ваши ошибки — не вина языка

- если хотите сделать регулярные выражения удобнее — используйте или напишите библиотеки. Похоже на то, что ругать C# за то, что он с Facebook не интегрирован. Руки есть, голова есть, напишите что хотите, или возьмите одну из многочисленных библиотек.

Вопрос 10: отсутствие единой технологии работы с асинхронным кодом — колбэки, примисы, фьючерсы, async (если в проекте более одной зависимости из npm то гарантированно в коде появятся все из них вперемешку)

И колбеки, и промисы, и async/await — нативные, поэтому код они не утяжеляют. Не знаю, что вы называете фьючерсами, я этим не торгую. И это прекрасно, что у вас есть выбор, что использовать. Колбэки это основа всего и ни промисы ни async/await без них не будут работать, это базовый кирпичик языка. Промисы и async/await прекрасно совместимы друг с другом и вы легко можете использовать await с любой функцией, возвращающей промис. Если же вы имели ввиду популярную библиотеку async для node, то сочувствую, ваши знания JS устарели. Библиотека хорошая, но используется всё реже ввиду появления вышеуказанного функционала в ES6. Но подтянуть её в зависимости на ноде тоже не страшно, серверные зависимости не отдаются пользователю и легко бекапятся, на случай удаления с npm (на моей практике такого не было ни разу). А ещё есть Fibers, и Sync, и много классных инструментов, используемых по назначению врача. Выбирайте тот, что больше подходит под конкретные задачи, и не жалуйтесь, что их слишком много.

Вопрос 11: const ( который на самом деле НЕ const )

Не знаю, почему вы так решили. Моя простая проверка в консоли показала обратное:

const a = 5

const a = 4

VM1825:1 Uncaught SyntaxError: Identifier 'a' has already been declared

at :1:1

Но на самом деле так это или нет — не важно, const создан не для вас, а для интерпретатора. А вам не нужно без глубокого знания языка менять const. Тем более, что на разных движках/браузерах/устройствах этот функционал может работать по разному, и вполне возможно найти какой-нибудь холодильник, программируемый на диалекте JavaScript, в котором случатся ваши самые страшные кошмары. Язык то открытый и версий реализации великое множество. В браузерах данная ошибка не подтверждена.

Вопрос 12: абсолютно безумный npm, с пакетами качества «братишка я тебе покушать принёс»

Плата за свободу творчества и отсутствие премодерации. Проблема не большая, просто всегда смотрите на число скачиваний или звёзд на github. Качество топовых пакетов очень высокое. Мало популярные тоже бывают неплохие, бывают и такие, как вы нашли. Ответственность за используемые зависимости полностью на вас. Это открытое сообщество и никто вам жёванную пищу в клюв класть не будет. На мой взгляд, эта ситуация лучше, чем в решениях от одного поставщика/судьи, так как у библиотек сотни тысяч вендоров и тысячи из них очень достойные. Если хотите однообразия — посмотрите на решения, например, от Sencha. Они платные, но про них были вполне неплохие отзывы. В npm тысячи классных библиотек, но вам надо было найти плохую и выстрелить себе в ногу. Стреляйте, кто же вам запретит.

В JavaScript нет защиты от дурака, поэтому эта категория граждан набивала шишки, набивает, и будет набивать. В этой статье я постарался больше раскрыть именно философию и принципы JavaScript. Часто люди ждут от него того-же, что привыкли ждать от своего старого языка программирования. Но JavaScript имеет свой характер, и подружится с ним не сложно. Надеюсь кому-то эта статья была полезна.

|

Метки: author rboots node.js javascript |

Конец CSRF близок? |

Пер. Под катом вас ждет перевод смешноватой и несложной статьи о CSRF и новомодном способе защиты от него.

Древний змий

Уязвимость CSRF или XSRF (это синонимы), кажется, существовала всегда. Её корнем является всем известная возможность делать запрос от одного сайта к другому. Допустим, я создам такую форму на своем сайте.

Ваш браузер загрузит мой сайт и, соответственно, мою форму. Её я могу незамедлительно отправить, используя простой javascript.

document.getElementById("stealMoney").submit(); Поэтому подобная атака буквально расшифровывается, как межсайтовая подделка запроса. Я подделываю запрос, который отправляется между моим сайтом и вашим банком. В действительности, проблема состоит не в том, что я отправлю запрос, а в том, что ваш браузер отправит вместе с запросом и ваши куки. Это означает, что запрос будет обладать всеми вашими правами, так что, если вы залогинены в текущий момент на сайте вашего банка, то только что вы пожертвовали мне тысячу долларов. Данке шон! Если же вы не были залогинены, то деньги всё еще на месте. Существуют несколько способов защиты от подобных злостных посягательств.

Способы защиты от CSRF

Не буду вдаваться в детали о способах защиты, так как в интернете полным-полно информации о них, но давайте быстро пробежимся по основным реализациям.

Проверка источника

Принимая запрос в нашем приложении, потенциально мы можем узнать о том, откуда он пришел, посмотрев на два заголовка. Они называются origin и referer. Так что мы можем проверить один или оба значения, чтобы узнать, пришёл ли запрос с нашего приложения или откуда-то ещё. Если источник запроса не ваш сайт, то можно просто на него ответить ошибкой. Проверка этих заголовков может нас защитить, но проблема в том, что они не всегда могут присутствовать.

accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8

accept-encoding: gzip, deflate, br

cache-control: max-age=0

content-length: 166

content-type: application/x-www-form-urlencoded

dnt: 1

origin: https://example.com

referer: https://example.com /login

upgrade-insecure-requests: 1

user-agent: Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36Защитные токены

Существуют два способа использования уникальных защитных токенов, но принцип их использования един. Когда пользователь посещает страницу, скажем, страницу банка, то в форму перечисления денег вставляется скрытое поле с уникальным токеном. Если пользователь действительно находится на сайте банка, то вместе с запросом он отправит этот токен, так что можно будет проверить, совпадает ли он с тем, что вы вставили в форму. При попытке CSRF атаки атакующий никогда не сможет получить это значение. Даже в случае запроса к странице Same Origin Policy (SOP) не позволит ему прочитать страницу, где есть данный токен. Такой метод хорошо себя зарекомендовал, однако он требует от приложения логики по внедрению токенов в формы и проверки их подлинности при входящих запросах. Еще один похожий метод заключается во внедрении такого же токена в форму и передачи куки, содержащего то же значение. Когда настоящий пользователь отправляет форму, то происходит сверка значения токена в куки со значением в форме. Если они не совпадают, то такой запрос не будет принят сервером.

Так в чем проблема?

Вышеописанные методы защиты давали нам достаточно надежную защиту против CSRF на протяжении довольно долгого времени. Конечно, проверка заголовков origin и referer не на 100% надежна, так что большинство сайтов полагается на тактику с уникальными токенами. Сложность состоит в том, что оба метода защиты требуют от сайта внедрения и поддержки решения. Вы скажете, что это совсем несложно. Согласен! Никогда не возникало проблем. Но это некрасиво. По сути мы обороняемся от поведения браузера хитрым способом. А можем ли мы просто сказать браузеру перестать делать вещи, которые мы не хотим, чтобы он делал?.. Теперь можем!

Same-Site Cookie

По сути Same-Site куки могут свести на нет любую CSRF атаку. Насмерть. Чуть более, чем полностью. Адьёс, CSRF! Они действенно и быстро помогают решить проблему безопасности. К тому же применить их чрезвычайно просто. Возьмем для примера какую-то куку.

Set-Cookie: sess=smth123; path=/ А теперь просто добавьте атрибут SameSite

Set-Cookie: sess=smth123; path=/; SameSiteВсё, вы закончили. Нет, правда! Используя данный атрибут, вы как-бы говорите браузеру предоставить куки определенную защиту. Существую два режима такой защиты: Strict или Lax, в зависимости от того, насколько серьезно вы настроены. Атрибут Same-Site без указания режима будет работать в стандартном варианте т.е. Strict. Вы можете выставить режим так:

SameSite=Strict

SameSite=Lax Strict

Такой режим предпочтительней и безопасней, но может не подойти для вашего приложения. Этот режим означает, что c ваше приложение не будет отправлять куки ни на один запрос с другого ресурса. Само собой в таком случае CSRF не будет возможен в корне. Однако здесь можно столкнуться с проблемой, что куки не будут пересылаться также при навигации высокого уровня (т.е. даже при переходе по ссылке). Например, если бы я сейчас разместил ссылку на Вконтакте, а Фейсбук использовал куки Вконтакте, то при переходе по ссылке вы бы оказались разлогинены, вне зависимости от того, были ли вы залогинены до этого. Такое поведение, конечно, может не порадовать пользователя, но можно быть уверенным в безопасности.

Что можно сделать с этим? Можно поступить, как Амазон. У них реализована как-бы двойная аутентификация с помощью двух куки. Первый куки позволяет амазону просто знать, кто вы и показывать вам ваше имя. Для него не используется SameSite. Второй куки позволяет делать покупки, менять что-то в аккаунте. Для него резонно используется SameSite. Такое решение позволяет одновременно предоставлять пользователям удобство и оставаться приложению безопасным.

Lax

Режим Lax решает проблемы с разлогированием описанную выше, но при этом сохраняет хороший уровень защиты. В сущности он добавляет исключение, когда куки передаются при навигации высокого уровня, которая использует “безопасные” HTTP методы. Согласно https://tools.ietf.org/html/rfc7231#section-4.2.1 безопасными методами считаются GET, HEAD, OPTIONS и TRACE.

Вернемся к нашему примеру атаки в начале.

Такая атака уже не сработает в режиме Lax, так как мы обезопасили себя от POST-запросов. Конечно, злоумышленник может использовать метод GET.

Поэтому режим Lax можно назвать компромиссом между безопасностью и удобством пользователей.

SameSite куки защищают нас от CSRF атак, но нельзя забывать про другие виды уязвимостей. К примеру XSS или браузерные атаки по времени.

От автора перевода: К сожалению, пока SameSite куки поддерживают только Chrome и Opera, а также браузер для андроида. Пруф: https://caniuse.com/#feat=same-site-cookie-attribute

Оригинал: https://www.kuoll.com/the-end-of-csrf/

До этого появлялась здесь: https://scotthelme.co.uk/csrf-is-dead/

|

Метки: author Kirylka информационная безопасность перевод csrf |

Когда нужна локализация: почему так трудно найти хорошего переводчика |

Типичные трудности перевода

Классический пример симбиоза знания языка и творческого начала в ходе перевода — деятельность братьев Стругацких. Кроме создания собственных произведений, они оба работали как переводчики с английского и японского под псевдонимами С. Бережков, С. Победин и С. Витин. И если вы читали советские издания Азимова «Как им было весело», Нортон «Саргассы в космосе» или Уиндема «День триффидов» — то это были переводы Стругацких.

Как организовать работу с текстом

Самое удивительное в работе переводчика то, что если это не инструкция к микроволновке или утюгу, то по сложности, между переводами записи в блоге и книги разница невелика. Основные отличия — в объемах. Фактически, все вышесказанное сводится к простой и банальной истине: если автор первоисточника должен обладать знаниями по теме и высоким уровнем владения языком, то переводчик — знаниями по теме и уровнем владения двумя языками.

Давайте рассмотрим сферическую ситуацию в вакууме перевода с английского на русский, когда переводчик является носителем русского языка.

Подводные камни перевода с английского на русский находятся в области принадлежности этих языков к различным группам. Английский относится к группе аналитических языков, а русский — к группе синтетических (флективных) языков. Проще говоря, каждый знает, что русский и английский имеют радикально отличные нормы словообразования, расстановки слов в предложении и так далее.

Объективно, качественный перевод на любой язык формируется из следующих аспектов:

- содержательная часть первоисточника;

- соответствие конечного перевода первоисточнику;

- уровень владения языком оригинала со стороны переводчика;

- уровень владения конечным языком со стороны переводчика.

Даже если предлагаемый к переводу текст кажется вам, как читателю, простым, как заказчику вам нужно уделить максимум внимания на нескольких этапах:

- подбор исполнителя;

- проверка результата на фактические ошибки;

- проверка результата на стилистические ошибки.

Подбор исполнителя

Назовем несколько базовых признаков, по которым предпочтительнее выбирать переводчика для локализации самого проекта и контента в нем.

Первое. Если вы переводите на неаналитический язык, то желательно, чтобы переводчик был его носителем. Очевидно, что лучше, чем сам носитель, его не может знать никто. В этих языках нет жесткого порядка слов и правил построения предложений, поэтому у иностранцев уходят годы или даже десятилетия на их полное изучение.

Второе. Избегайте экзотических направлений перевода. Если по какой-то причине менеджеру проекта «стрельнуло» устроить перевод с иврита на китайский, то налейте ему чаю и успокойте, видимо, у него стресс, и он не отдает себе отчета. Оптимальный вариант сделать «крепкую» локализацию на английском и при добавлении новых экзотических языков отталкиваться уже от нее. При этом вы вполне можете найти переводчиков, работающих в области менее стандартных языковых пар, но сформированных географически и исторически. Такими парами можно назвать испанский-португальский, немецкий-французский, немецкий-турецкий и так далее. Вас могут убеждать, что подобный подход избыточен, и в вашем распоряжении будут специалисты, которые справятся с поставленной задачей, но это неоправданный риск.

Третье. Фриланс — это минное поле. Хороший переводчик на фрилансе почти как единорог: все верят в его существование, но мало кто видел. При этом если вам нужен перевод высшего класса, то объем выполненных работ в портфолио переводчика — это совершенно не показатель того, что вы получите желаемое. Очень часто люди, которые работают качественно, банально не способны перевести такое количество текстов в пересчете на рабочие дни. Поэтому если вы в первый раз ищите исполнителя на свой проект, то вам придется потратить значительное количество времени и усилий на подбор подходящего человека.

Вы столкнетесь с тем, что часть потенциальных исполнителей откажется выполнять тестовое задание на несколько килознаков бесплатно, часть согласится, а потом пропадет с радаров, а еще часть — попытается вас обмануть, выполнив тестовое задание с особым старанием, которого не будет наблюдаться в ходе работы. Еще есть категория переводчиков, которые готовы браться за любую работу, даже не вникая в суть заказа. Уже после старта оказывается, что у них не хватает профильных знаний или желания разбираться в теме.

Четвертое. Не все агентства одинаково полезны. Агентства по переводу находятся на другом берегу от фриланса и позиционируются как более качественный сервис. Серьезным преимуществом работы с ними является то, что ваше сотрудничество может быть выведено на принципиально иной правовой уровень. Да, прямо сейчас мы говорим об официальных документах, договорах и вот всей этой бумажной волоките. Однако стоит понимать, что переводчики, по сути, везде одинаковы, а бизнес-процессы, наоборот, протекают значительно медленнее.

Проверка результата на фактические ошибки

Кроме поиска самого переводчика вам придется озаботиться поиском редактора, который бы контролировал работу локализаторов и проводил прием работы. Особенно актуально это в случаях, когда вы сами не владеете или владеете в недостаточной степени целевым языком локализации и перевода. Опять же, как и в случаях с переводчиками, лучший вариант — это носитель языка. Конечно, можно обойтись и без редактора, но оправдан подобный подход только при небольших объемах, например, при локализации интерфейса, исправить которую можно будет при помощи фидбека пользователей.

Но не стоит сваливать фактическую вычитку на потребителя: если ошибок в локализации или переводе будет слишком много, они могут отпугнуть потенциального клиента. Мы заостряем на этом внимание, так как в последние годы слишком много проектов, в погоне за сроками релиза, находятся, фактически, в состоянии «вечной беты»; разработчики на ходу «допиливают» все, что можно, начиная от функций и заканчивая дизайном и локализацией.

Проверка результата на стилистические ошибки

И если факт-чек на грубые ошибки выглядит относительно просто, то следующий аспект локализации и перевода — проверка на стилистическое соответствие нормам целевого языка, это то еще приключение.

Английский язык очень часто используется в качестве базового для UI, контентного наполнения и FAQ. Человек, который свободного говорит и читает на английском, часто не замечает различий между английским и родным вариантом текста, но для носителя целевого языка, не говорящему на языке оригинала, могут бросаться в глаза инородные элементы. Стилистические ошибки могут поджидать вас всюду: начиная от использования англоязычных конструкций, неприемлемых в целевом языке перевода, до откровенного злоупотребления англицизмами.

Англоязычные «кальки» — это отдельный бич современных переводчиков. Если приводить пример в русском языке, то очень часто в переводных материалах встречаются следующие словосочетания и конструкции. Знаете ли вы, к примеру, что устоявшаяся форма подписи «С уважением, имярек» — в действительности пример глубоко въевшегося в нашу речь англицизима?

Грамматически для постановки запятой в подписи нет никаких оснований, но ставят ее из-за «традиций», которые, как вы догадались, выросли в том числе и из англоязычной конструкции. В русском языке образца XIX века запятой не было, появилась она в веке XX, да так после «С уважением» и осталась, хотя никаких оснований быть поставленной, кроме традиций и желания выделить интонацию, у этой запятой нет. Об этом упоминается на множестве ресурсов, в том числе и на вездесущей «Грамоте.ру».

В результате англоязычный вариант:

Regards,

Ivan IvanovПревратился в:

С уважением,

Иван ИвановХотя нет никаких причин не писать просто:

С уважением Иван ИвановКальки имеют способность проникать в язык и укореняться в нем («человек-овощ» от англ. «vegetable» и глагола «to vegetate» — «прозябать», «вызовы нашего времени» от англ. «challenge» — «сложная задача», «проблема») поэтому приведем еще несколько примеров калек и буквализмов, употребление которых отличает плохого переводчика от хорошего.

В английском языке крайне распространена ситуация, когда новое предложение или даже абзац, связанный по смыслу с предыдущим текстом, начинается со слова «For», которое переводится на русский «так как». Для русского языка предложения, начинающиеся с «так как» отделяются от предыдущей конструкции не точкой, а запятой. Если вы увидите в переводе «Так как», когда в оригинале написано «For», вам стоит задуматься.

Если ваш переводчик дословно сохраняет структуру абзацев текста, особенно, если текст крайне фрагментирован — это еще один повод для беспокойства. В русском языке абзац является не только способом акцентировать внимание читателя на новом отрезке текста, но так же указывает на новый цельный смысловой блок, в котором заключены предложения, тесно связанные между собой. В английском языке абзацы используются иначе, зачастую, для выделения новой мысли, какой бы мелкой она не была. То есть, если вам нужно перевести и адаптировать не условный FAQ или руководство, а, скажем, блог вашего эксперта, в котором он делится своими соображениями и дает практические советы, то грамотный подход к формированию абзацев на целевом языке крайне важен и переводчик должен руководствоваться не структурой первоисточника, а нормами целевого языка.

Ну и очевидно, что плохого переводчика от хорошего отличает понимание и корректный перевод фразеологизмов. Справедливости ради хочется заметить, что в каждом языке есть непереводимые фразеологизмы. Например американский «Send The Elevator Back Down», который родился на Манхэтенне с его небоскребами, буквально переводится как «спустить лифт обратно вниз», а по сути означает «оказать помощь тем, кто находится ниже тебя в иерархии/в худшем положении». Или перевести «Earworm» так, чтобы он гармонично вписался в текст, если и не сложно, то уж точно бывает проблематично.

Итого

Не рассчитывайте найти хорошего переводчика с первой попытки, если только он не достался вам по надёжной рекомендации. Процесс чтения на другом языке и процесс перевода с этого языка — это абсолютно разные вещи. Если вы считаете, что это неправда — попробуйте перевести любой англоязычный текст или новость на русский так, чтобы ничего в ней не выдавало иностранное происхождение. И вы удивитесь, насколько сложно бывает письменно адаптировать текст на другой язык.

В работе по переводу и локализации всегда нужно уделять внимание не только конечной стоимости и длительности работ, но и мелочам. Практически все зависит от степени вовлеченности переводчика в процесс: чем более он замотивирован сделать идеальный перевод и адаптацию, чем больше контекста имеет, тем лучше для вас.

Объемное портфолио исполнителя не всегда означает качественную работу. Если вы считаете, что ваши тексты имеют принципиально иной уровень сложности на фоне многочисленных руководств и FAQ, которые обычно и переводят, то количество выполненных подрядчиком проектов — это не тот показатель, на который следует ориентироваться. Нужно смотреть и на их сложность.

Любая работа по переводу требует времени, причем много времени. Если вы прочитали этот текст за 15 минут, это не значит, что его можно перевести за час и даже за два. Обычная скорость хорошего переводчика — это 8-10 тысяч знаков на языке оригинала за рабочий день. Есть монстры, которые переводят в разы больше, но в этом случае увеличивается вероятность брака.

Самое главное — это внимание, терпение и наличие времени. Невозможно локализовать проект или выполнить перевод солидного пласта контента в экстремально сжатые сроки так, чтобы потом не было стыдно за результат. Поэтому никогда не следует откладывать эти мероприятия в долгий ящик в надежде, что оно «как-нибудь само по-быстрому рассосется». Не рассосется.

|

|

Геометрия в компьютерных играх |

Сейчас я увлёкся программированием под андроид и сделал примерно такую же игрушку. И столкнулся с теми же геометрическими задачками с которыми встречался тогда.

Задачка 1: нарисовать стены. И сразу возникает Задачка 2: определить касается ли точка стены или нет (проиграл ты или продолжать игру).