Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] 1C и ETL |

ETL и 1С. Извлечение данных

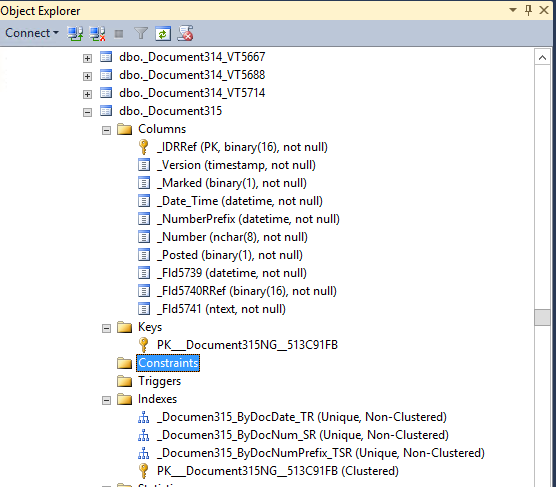

Первый взгляд

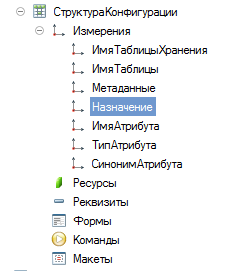

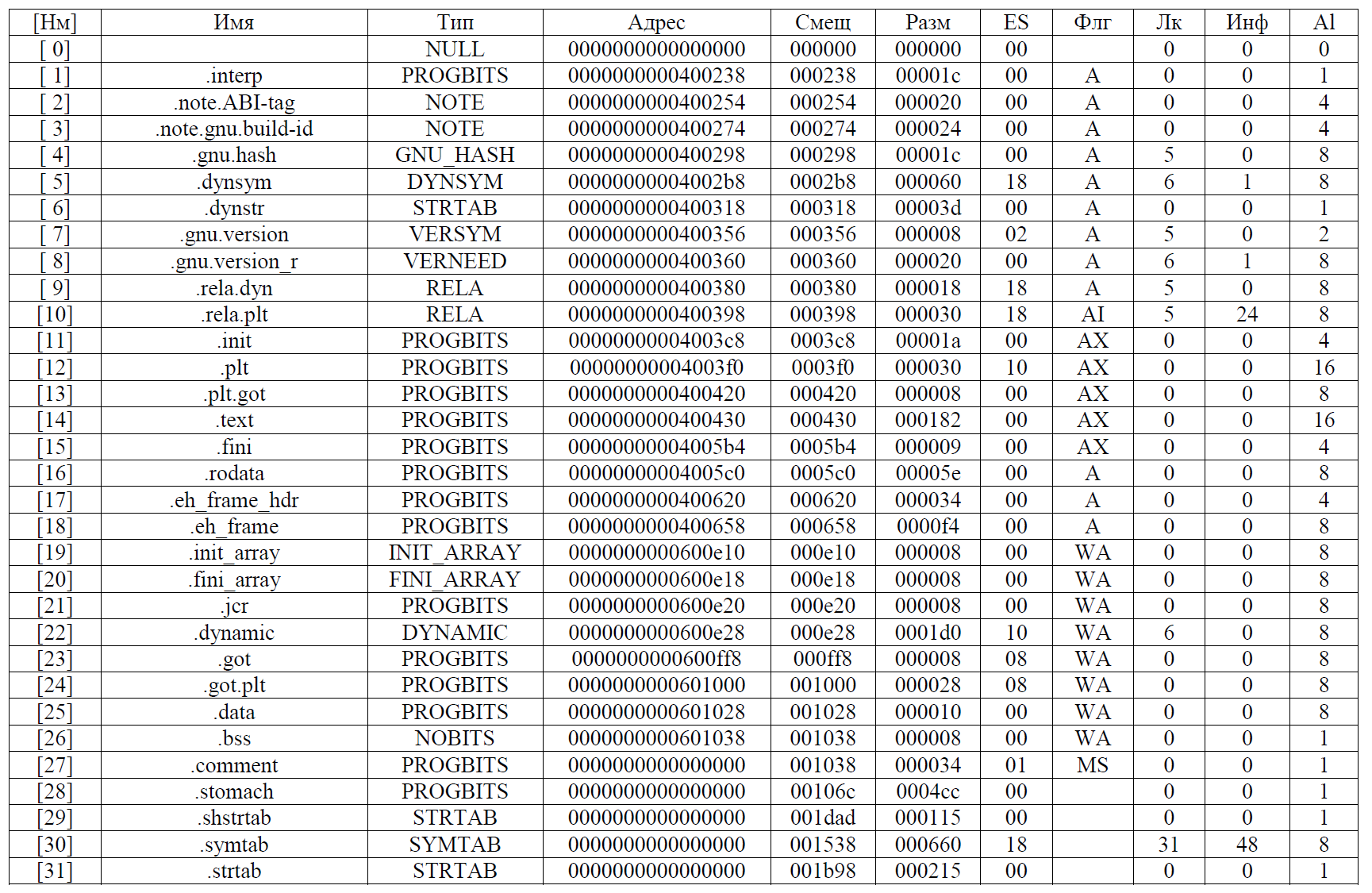

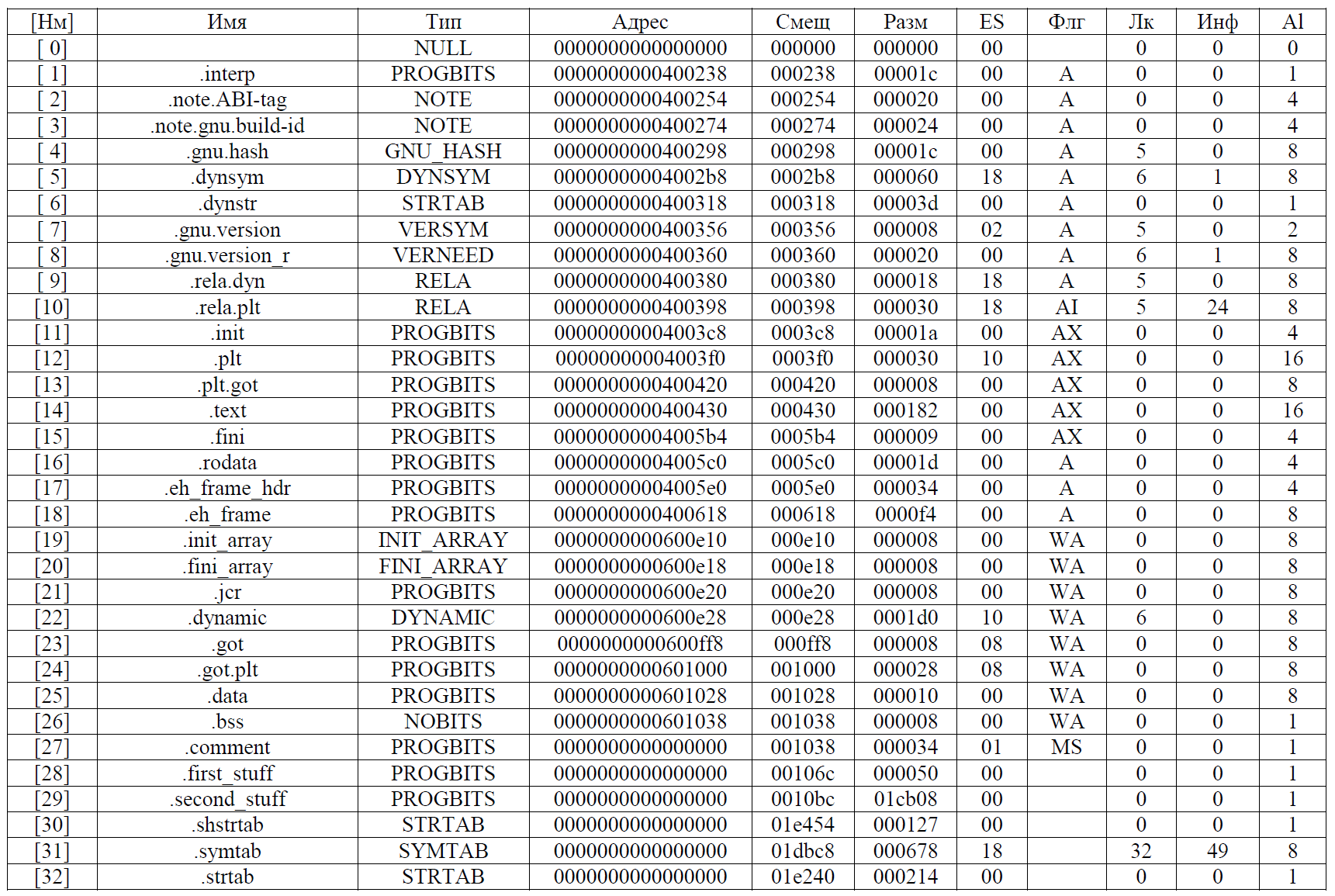

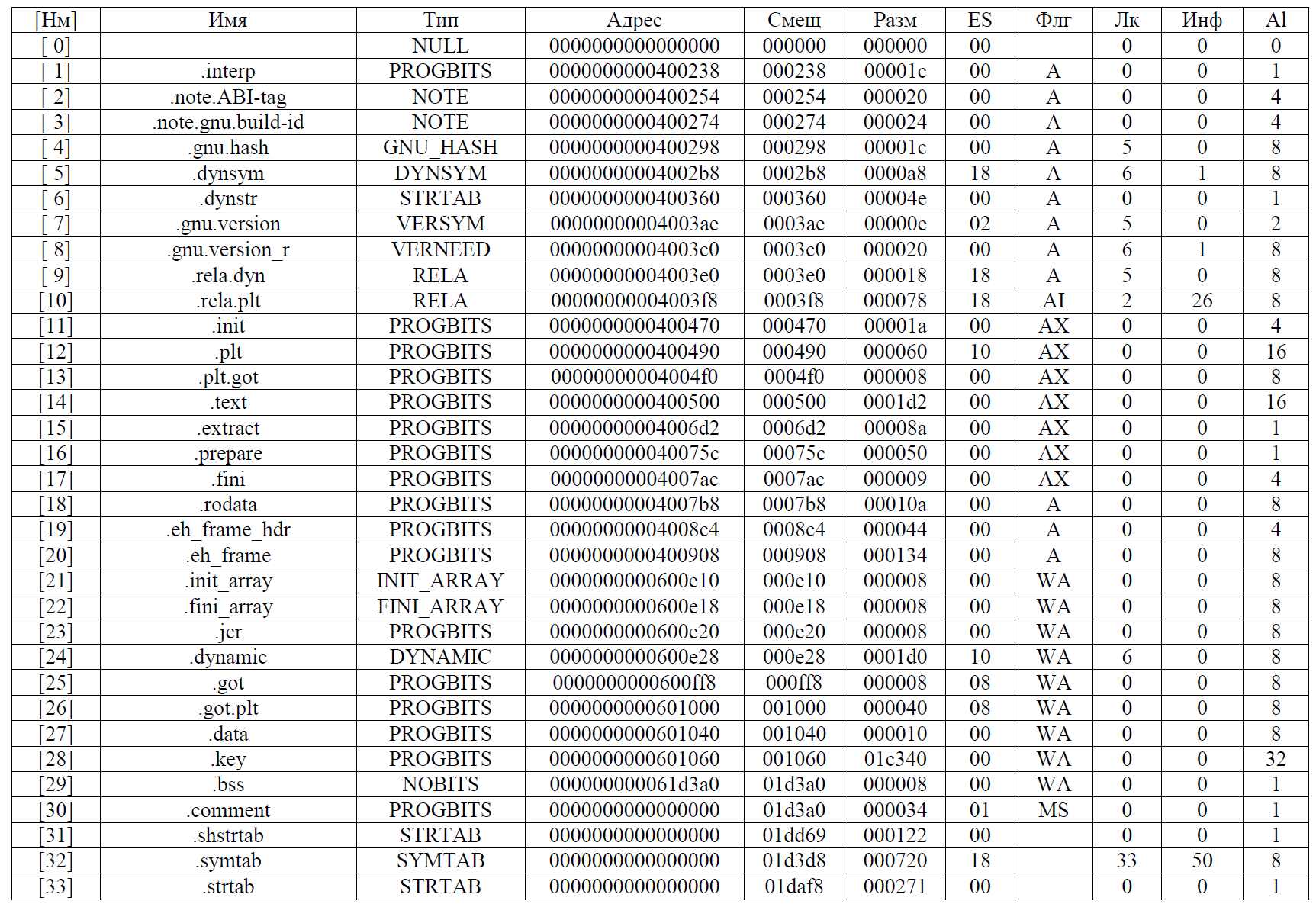

Если вы, как ETL-специалист столкнулись с необходимостью получать данные из 1С, то это первое, что вы можете увидеть, попытавшись разобраться со структурой БД (это из случае MSSQL, для других СУБД картинка аналогичная):

Бизнес-смысл в наименованиях таблиц и полей отсутствует, внешних ключей нет.

Пару ласковых о самой 1С. Реальные таблицы СУБД в ней скрыты за объектами, которые видит разработчик, который часто не догадывается о реальной структуре базы. Да… И весь код на русском языке. Кроме того, есть перечисления, строковые представления которых с помощью SQL получить практически невозможно. Об этом подробнее здесь.

Есть случаи, когда БД нет (и 1С в файловой версии), но это, разумеется ориентирует вас на интеграцию без использования средств СУБД.

Однако, не стоит впадать в отчаяние, поскольку все не так плохо, как кажется.

Внимательный взгляд

Для захвата данных из 1С у вас есть 2 пути:

Реализация «высокоуровневого» интерфейса

Вы можете воспользоваться файловыми выгрузками, web/json сервисами и прочими возможностями 1С, которые окажутся совместимы с вашим ETL.

+

- Вам не придется лезть в 1С. Все, что на стороне 1С должны сделать 1Сники

- Вы никак не нарушаете лицензионную политику 1С

—

- Появляется еще один источник для ошибок в виде дополнительных выгрузок-загрузок,

расписаний, роботизации - Это будет работать существенно медленнее из-за особенностей интерфейсов 1С

- При любых изменениях в захватываемых данных, вам придется вносить изменения в выгрузки (но это можно обойти настроечной системой)

- Это вызовет больше ошибок в целостности данных, чем работа напрямую с СУБД

Реализация на СУБД

+

- Работает быстрее

- Позволяет гарантировать полноту данных в хранилище при правильном подходе

—

- Нарушает лицензионное соглашение с 1С

Итак, взвесив за и против, вы решаете строить интеграцию через СУБД, ну или хотя бы

подумать, как вы будете это делать дальше.

Data mapping

Для того, чтобы связать бизнес-данные, как их понимают на стороне 1С с реальными таблицами БД, вам потребуется выполнить немного магии в самой 1С, а именно получить описание метаданных 1С в пригодном для использования виде (в связи бизнес-объектов и таблиц).

Опять же есть, как минимум, целых 3 подхода:

- Используя com-соединение, web/json сервис получить таблицу соответствия из 1С

- Сделать то же самое на стороне 1С, сформировав таблицу метаданных

- Разобрать бинарный файл, который хранится в той же БД

3-й путь мне кажется несколько рискованным в силу того, что 1С имеет привычку вносить изменения в свои внутренности без предупреждения. И, при этом, довольно сложным.

Выбор между 1 и 2 не столь очевиден, но на мой вкус использовать заранее сформированную таблицу гораздо удобнее, и надежнее в ежедневном использовании и нет нужды задействовать что-то, кроме чистого SQL.

Хранить и поддерживать актуальность таблицы удобнее при помощи 1С, обновляя после каждого обновления конфигурации. При этом, ETL может пользоваться View, который покажет данные уже в более удобоваримой форме.

Подготовка таблицы метаданных

Создать в 1С объект, который содержит метаданные конфигурации (к сожалению, скриптом это не сделать, но можно отдать инструкцию 1С-нику)

РегистрСведений.СтруктураКонфигурации

Поля:

ИмяТаблицыХранения

ИмяТаблицы

СинонимТаблицы

Назначение

ИмяПоляХранения

СинонимПоля

Все строки 150 символов

Получается денормализованно, но довольно удобно и просто.

Код 1С для заполнения структуры:

СтруктураБД = ПолучитьСтруктуруХраненияБазыДанных(,истина);

ЗаписиСтруктура = РегистрыСведений.СтруктураКонфигурации.СоздатьНаборЗаписей();

Для каждого СтрокаСтруктуры Из СтруктураБД Цикл

Для каждого СтрокаПолей Из СтрокаСтруктуры.Поля Цикл

Запись = ЗаписиСтруктура.Добавить();

Запись.ИмяТаблицыХранения = СтрокаСтруктуры.ИмяТаблицыХранения;

Запись.ИмяТаблицы = СтрокаСтруктуры.ИмяТаблицы;

Запись.СинонимТаблицы = Метаданные.НайтиПоПолномуИмени(СтрокаСтруктуры.Метаданные);

Запись.Назначение = СтрокаСтруктуры.Назначение;

Запись.ИмяПоляХранения = СтрокаПолей.ИмяПоляХранения;

Запись.СинонимПоля = Метаданные.НайтиПоПолномуИмени(СтрокаПолей.Метаданные);

КонецЦикла;

Конеццикла;

ЗаписиСтруктура.Записать(истина);

Опять же все довольно просто и очевидно, несмотря на русский язык. Нужно выполнять этот код при каждом обновлении конфигурации. Делать это можно руками в обработке или при помощи регламентного задания.

Таблицу можно просматривать как в режиме клиента, так и со стороны SQL, зная их имена.

SELECT * FROM _InfoReg27083 ORDER BY _Fld27085(_InfoReg27083 — имя, которое 1С дала таблице регистра со структурой, _Fld27085 — имя поля с именем таблицы хранения)

Можно сделать View, чтобы было удобнее.

Если нет возможности вносить изменения в конфигурацию, можно сделать таблицу, соединившись через com, или дописав в обработке выгрузку в таблицу базы, которая задействована в ETL.

А здесь про то, какие есть типы таблиц, и зачем они нужны (нужен доступ к ИТС 1C).

Следующий шаг — составить карту данных и описание трансформации.

| Field | Field1C | Transformation | ... |

|---|---|---|---|

| _Fld15704 | Документ.РеализацияТоваровУслуг.Вес | Check >=0, round(10,2),… | ... |

Вот мы получили таблицу маппинга, которую можно использовать в дальнейшей работе.

Захват изменений данных

Теперь с точки зрения стратегии захвата изменений данных. Здесь опять есть несколько вариантов. Проще забирать таблицы целиком, что, разумеется может стоить серверу существенных дополнительных расходов.

Однако, есть и другие способы:

- Использовать версии объектов

- Использовать план обмена

Использовать версии объектов

Для объектов «ссылочного» типа 1С поддерживает версии. Номер версии объекта записывается в бинарное поле _version, аккуратно обновляющееся при каждом обновлении записи. На MSSQL, например, это поле типа timestamp. Версии поддерживаются для объектов типа «Документ»,«Справочник»,«Бизнес-процесс»,«Задача»,«План счетов»,«План видов характеристик», «Константы». Использовать версию довольно просто, сохранив у себя в staging area значение последней версии для объекта, и при следующем обновлении выбрав объекты, большие по значению поля версии. Вместе с «основным» объектом нужно не забыть забрать его табличные части (см. Назначение — «Табличная часть») в структуре (поле вида _DocumentXXX_IDRRef или _ReferenceXXX_IDRRef — ссылка на основную таблицу).

Использовать план обмена

Для не ссылочных типов такой подход не годится, но можно воспользоваться объектом «план обмена». В таблице структуры их назначение = 'РегистрацияИзменений'. Для каждого объекта конфигурации создается отдельная таблица плана обмена.

На уровне БД это таблица, вот такой структуры:

_NodeTRef, — идентификатор типа «узла» плана обмена. Он нам не очень интересен

_NodeRRef, — идентификатор узла плана обмена

_MessageNo, — номер сообщения

Дальше идут поля ключа «основной» таблицы. Они различаются в зависимости от типа таблицы, с которой связана таблица плана обмена:

_IDRRef — в данном случае ID справочника или документа

может быть вот так вот:

_RecorderTRef

_RecorderRRef

Это будет таблица изменений регистра накопления, регистра сведений, подчиненного регистратору, или регистра бухгалтерии. Так же может быть ключ таблицы регистра сведений, если он не подчинен регистратору.

Для того, чтобы такая таблица регистрации изменений существовала, нужно включить в конфигураторе 1С нужный нам объект в план обмена. Кроме того, нужен быть создан узел плана обмена, идентификатор (_IDRRef) которого наим нужно будет использовать.

Таблицу плана обмена можно найти в структуре (см. выше). Т.к. в плане обмена регистрируются изменения для всех узлов, а не только для хранилища, нам нужно ограничить выборку нужным нам _NodeRRef. План обмена можно использовать и для ссылочных объектов, но на мой взгляд это бессмысленный расход ресурсов.

Как забирать данные через план обмена:

Для начала мы пишем update к плану обмена, где ставим произвольный _MessageNO (лучше всегда 1).

Например

UPDATE _DocumentChangeRec18901 set _MessageNO = 1 WHERE _NodeRRef = @_NodeRRefДалее выбираем данные из таблицы данных, связав ее по ключу с таблицей плана обмена

SELECT [fieldslist] FROM _Document18891 inner join _DocumentChangeRec18901 ON _Document18891._IDRRef = _DocumentChangeRec18901._IDRRef and _MessageNO = 1 AND _NodeRRef = @_NodeRRefИ подтверждаем забор изменений, удалив записи таблицы изменений

DELETE FROM _DocumentChangeRec18901 WHERE _MessageNO = 1 AND _NodeRRef = @_NodeRRefИтого: Мы научились читать на стороне ETL метаданные 1С, научились выполнять захват данных. Остальные шаги процесса ETL достаточно хорошо известны. Например, можно почитать здесь.

|

Метки: author smirnovhi хранилища данных администрирование баз данных etl 1c dwh |

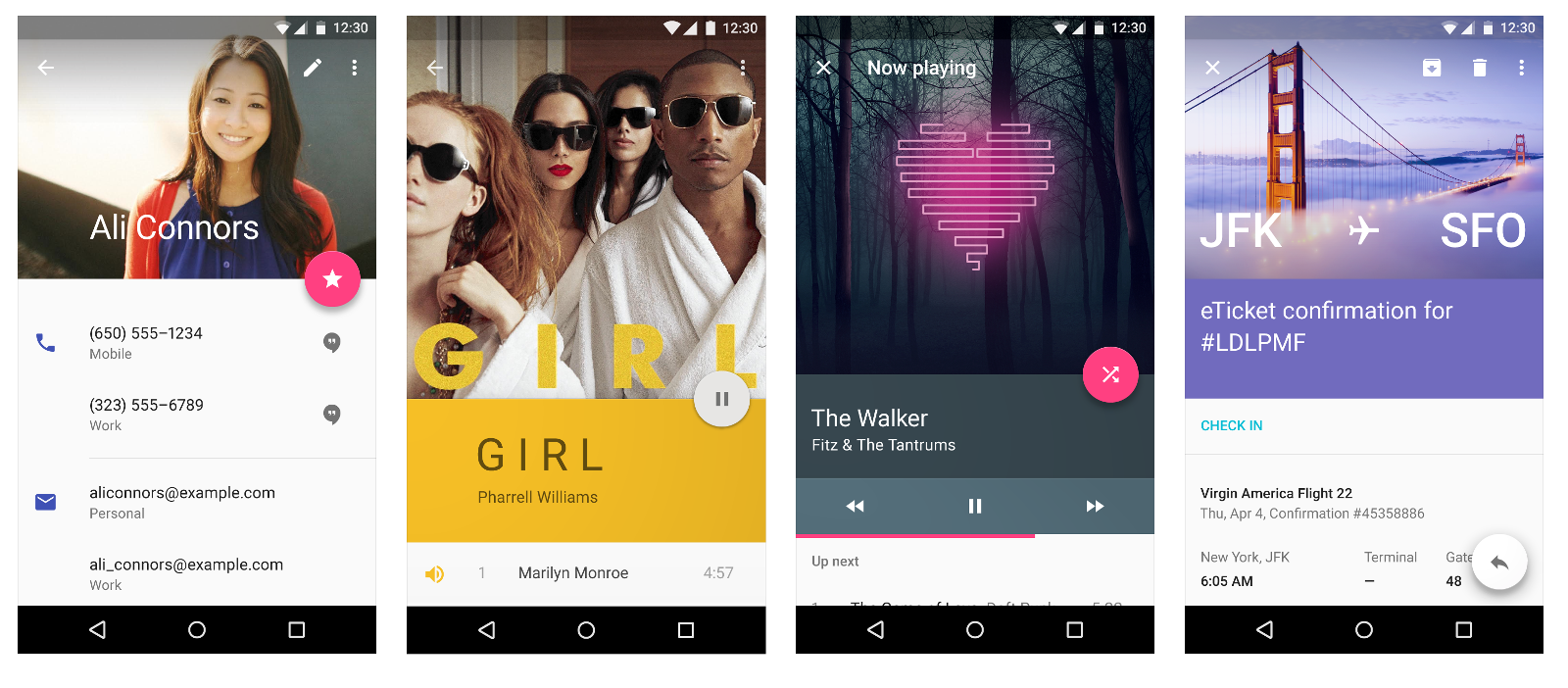

Как работает Android, часть 1 |

В этой серии статей я расскажу о внутреннем устройстве Android — о процессе загрузки, о содержимом файловой системы, о Binder и Android Runtime, о том, из чего состоят, как устанавливаются, запускаются, работают и взаимодействуют между собой приложения, об Android Framework, и о том, как в Android обеспечивается безопасность.

Немного фактов

Android — самая популярная операционная система и платформа для приложений, насчитывающая больше двух миллиардов активных пользователей. На ней работают совершенно разные устройства, от «интернета вещей» и умных часов до телевизоров, ноутбуков и автомобилей, но чаще всего Android используют на смартфонах и планшетах.

Android — свободный и открытый проект. Большинство исходного кода (который можно найти на https://source.android.com) распространяется под свободной лицензией Apache 2.0.

Компания Android Inc. была основана в 2003 году и в 2005 году куплена Google. Публичная бета Android вышла в 2007 году, а первая стабильная версия — в 2008, с тех пор мажорные релизы выходят примерно раз в год. Последняя на момент написания стабильная версия Android — 7.1.2 Nougat.

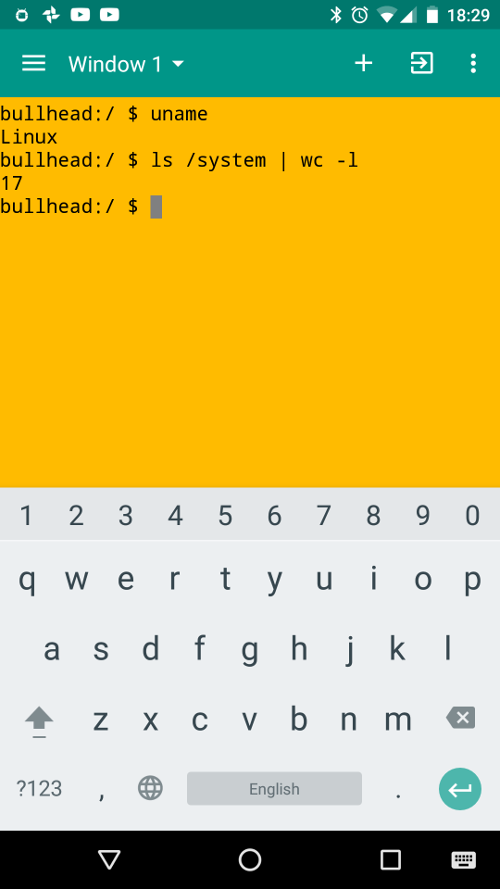

Android is Linux

По поводу такой формулировки было много споров, так что сразу поясню, что именно я имею в виду под этой фразой: Android основан на ядре Linux, но значительно отличается от большинства других Linux-систем.

Среди исходной команды разработчиков Android был Robert Love, один из самых известных разработчиков ядра Linux, да и сейчас компания Google остаётся одним из самых активных контрибьюторов в ядро, поэтому неудивительно, что Android построен на основе Linux.

Как и в других Linux-системах, ядро Linux обеспечивает такие низкоуровневые вещи, как управление памятью, защиту данных, поддержку мультипроцессности и многопоточности. Но — за несколькими исключениями — вы не найдёте в Android других привычных компонент GNU/Linux-систем: здесь нет ничего от проекта GNU, не используется X.Org, ни даже systemd. Все эти компоненты заменены аналогами, более приспособленными для использования в условиях ограниченной памяти, низкой скорости процессора и минимального потребления энергии — таким образом, Android больше похож на встраиваемую (embedded) Linux-систему, чем на GNU/Linux.

Другая причина того, что в Android не используется софт от GNU — известная политика «no GPL in userspace»:

We are sometimes asked why Apache Software License 2.0 is the preferred license for Android. For userspace (that is, non-kernel) software, we do in fact prefer ASL 2.0 (and similar licenses like BSD, MIT, etc.) over other licenses such as LGPL.

Android is about freedom and choice. The purpose of Android is promote openness in the mobile world, and we don’t believe it’s possible to predict or dictate all the uses to which people will want to put our software. So, while we encourage everyone to make devices that are open and modifiable, we don’t believe it is our place to force them to do so. Using LGPL libraries would often force them to do just that.

Само ядро Linux в Android тоже немного модифицировано: было добавлено несколько небольших компонент, в том числе ashmem (anonymous shared memory), Binder driver (часть большого и важного фреймворка Binder, о котором я расскажу ниже), wakelocks (управление спящим режимом) и low memory killer. Исходно они представляли собой патчи к ядру, но их код был довольно быстро добавлен назад в upstream-ядро. Тем не менее, вы не найдёте их в «обычном линуксе»: большинство других дистрибутивов отключают эти компоненты при сборке.

В качестве libc (стандартной библиотеки языка C) в Android используется не GNU C library (glibc), а собственная минималистичная реализация под названием bionic, оптимизированная для встраиваемых (embedded) систем — она значительно быстрее, меньше и менее требовательна к памяти, чем glibc, которая обросла множеством слоёв совместимости.

В Android есть оболочка командной строки (shell) и множество стандартных для Unix-подобных систем команд/программ. Во встраиваемых системах для этого обычно используется пакет Busybox, реализующий функциональность многих команд в одном исполняемом файле; в Android используется его аналог под названием Toybox. Как и в «обычных» дистрибутивах Linux (и в отличие от встраиваемых систем), основным способом взаимодействия с системой является графический интерфейс, а не командная строка. Тем не менее, «добраться» до командной строки очень просто — достаточно запустить приложение-эмулятор терминала. По умолчанию он обычно не установлен, но его легко, например, скачать из Play Store (Terminal Emulator for Android, Material Terminal, Termux). Во многих «продвинутых» дистрибутивах Android — таких, как LineageOS (бывший CyanogenMod) — эмулятор терминала предустановлен.

Второй вариант — подключиться к Android-устройству с компьютера через Android Debug Bridge (adb). Это очень похоже на подключение через SSH:

user@desktop-linux$ adb shell

android$ uname

LinuxИз других знакомых компонент в Android используются библиотека FreeType (для отображения текста), графические API OpenGL ES, EGL и Vulkan, а также легковесная СУБД SQLite.

Кроме того, раньше для реализации WebView использовался браузерный движок WebKit, но начиная с версии 7.0 вместо этого используется установленное приложение Chrome (или другое; список приложений, которым разрешено выступать в качестве WebView provider, конфигурируется на этапе компиляции системы). Внутри себя Chrome тоже использует основанный на WebKit движок Blink, но в отличие от системной библиотеки, Chrome обновляется через Play Store — таким образом, все приложения, использующие WebView, автоматически получают последние улучшения и исправления уязвимостей.

It’s all about apps

Как легко заметить, использование Android принципиально отличается от использования «обычного Linux» — вам не нужно открывать и закрывать приложения, вы просто переключаетесь между ними, как будто все приложения запущены всегда. Действительно, одна из уникальных особенностей Android — в том, что приложения не контролируют напрямую процесс, в котором они запущены. Давайте поговорим об этом подробнее.

Основная единица в Unix-подобных системах — процесс. И низкоуровневые системные сервисы, и отдельные команды в shell’е, и графические приложения — это процессы. В большинстве случаев процесс представляет собой чёрный ящик для остальной системы — другие компоненты системы не знают и не заботятся о его состоянии. Процесс начинает выполняться с вызова функции main() (на самом деле _start), и дальше реализует какую-то свою логику, взаимодействуя с остальной системой через системные вызовы и простейшее межпроцессное общение (IPC).

Поскольку Android тоже Unix-подобен, всё это верно и для него, но в то время как низкоуровневые части — на уровне Unix — оперируют понятием процесса, на более высоком уровне — уровне Android Framework — основной единицей является приложение. Приложение — не чёрный ящик: оно состоит из отдельных компонент, хорошо известных остальной системе.

У приложений Android нет функции main(), нет одной точки входа. Вообще, Android максимально абстрагирует понятие приложение запущено как от пользователя, так и от разработчика. Конечно, процесс приложения нужно запускать и останавливать, но Android делает это автоматически (подробнее я расскажу об этом в следующих статьях). Разработчику предлагается реализовать несколько отдельных компонент, каждая из который обладает своим собственным жизненным циклом.

In Android, however, we explicitly decided we were not going to have a main() function, because we needed to give the platform more control over how an app runs. In particular, we wanted to build a system where the user never needed to think about starting and stopping apps, but rather the system took care of this for them… so the system had to have some more information about what is going on inside of each app, and be able to launch apps in various well-defined ways whenever it is needed even if it currently isn’t running.

Для реализации такой системы нужно, чтобы приложения имели возможность общатся друг с другом и с системными сервисами — другими словами, нужен очень продвинутый и быстрый механизм IPC.

Этот механизм — Binder.

Binder

Binder — это платформа для быстрого, удобного и объектно-ориентированного межпроцессного взаимодействия.

Разработка Binder началась в Be Inc. (для BeOS), затем он был портирован на Linux и открыт. Основной разработчик Binder, Dianne Hackborn, была и остаётся одним из основных разработчиков Android. За время разработки Android Binder был полностью переписан.

Binder работает не поверх System V IPC (которое даже не поддерживается в bionic), а использует свой небольшой модуль ядра, взаимодействие с которым из userspace происходит через через системные вызовы (в основном ioctl) на «виртуальном устройстве» /dev/binder. Со стороны userspace низкоуровневая работа с Binder, в том числе взаимодействие с /dev/binder и marshalling/unmarshalling данных, реализована в библиотеке libbinder.

Низкоуровневые части Binder оперируют в терминах объектов, которые могут пересылаться между процессами. При этом используется подсчёт ссылок (reference-counting) для автоматического освобождения неиспользуемых общих ресурсов и уведомление о завершении удалённого процесса (link-to-death) для освобождения ресурсов внутри процесса.

Высокоуровневые части Binder работают в терминах интерфейсов, сервисов и прокси-объектов. Описание интерфейса, предоставляемого программой другим программам, записывается на специальном языке AIDL (Android Interface Definition Language), внешне очень похожем на объявление интерфейсов в Java. По этому описанию автоматически генерируется настоящий Java-интерфейс, который потом может использоваться и клиентами, и самим сервисом. Кроме того, по .aidl-файлу автоматически генерируются два специальных класса: Proxy (для использования со стороны клиента) и Stub (со стороны сервиса), реализующие этот интерфейс.

Для Java-кода в процессе-клиенте прокси-объект выглядит как обычный Java-объект, который реализует наш интерфейс, и этот код может просто вызывать его методы. При этом сгенерированная реализация прокси-объекта автоматически сериализует переданные аргументы, общается с процессом-сервисом через libbinder, десериализует переданный назад результат вызова и возвращает его из Java-метода.

Stub работает наоборот: он принимает входящие вызовы через libbinder, десериализует аргументы, вызывает абстрактную реализацию метода, сериализует возвращаемое значение и передаёт его процессу-клиенту. Соответственно, для реализации сервиса программисту достаточно реализовать абстрактные методы в унаследованном от Stub классе.

Такая реализация Binder на уровне Java позволяет большинству кода использовать прокси-объект, вообще не задумываясь о том, что его функциональность реализована в другом процессе. Для обеспечения полной прозрачности Binder поддерживает вложенные и рекурсивные межпроцессные вызовы. Более того, использование Binder со стороны клиента выглядит совершенно одинаково, независимо от того, расположена ли реализация используемого сервиса в том же или в отдельном процессе.

Для того, чтобы разные процессы могли «найти» сервисы друг друга, в Android есть специальный сервис ServiceManager, который хранит, регистрирует и выдаёт токены всех остальных сервисов.

Binder широко используется в Android для реализации системных сервисов (например, пакетного менеджера и буфера обмена), но детали этого скрыты от разработчика приложений высокоуровневыми классами в Android Framework, такими как Activity, Intent и Context. Приложения могут также использовать Binder для предоставления друг другу собственных сервисов — например, приложение Google Play Services вообще не имеет собственного графического интерфейса для пользователя, но предоставляет разработчикам других приложений возможность пользоваться сервисами Google Play.

Подробнее про Binder можно узнать по этим ссылкам:

- Android Binder — Embedded Linux Wiki

- Android Interface Definition Language, IBinder

- Deep Dive into Android IPC/Binder Framework

- Android Binder — Android Interprocess Communication

- An Overview of Android Binder Framework

- Binders & Window Tokens

В следующей статье я расскажу об идеях, на которых построены высокоуровневые части Android, об основных компонентах приложений и о базовых механизмах обеспечения безопасности.

|

Метки: author bugaevc разработка под android блог компании solar security android internals android linux binder |

Bluetooth mesh – архитектура и безопасность сети |

Заканчивая тему о сети bluetooth mesh (первая заметка, вторая заметка), сегодня мы вкратце рассмотрим её архитектуру и безопасность.

Добро пожаловать.

Архитектура

Архитектура сети похожа на сетевую модель OSI и состоит из 8 уровней. рассмотрим их снизу вверх.

Уровень BLE (Bluetooth Low Energy) – находится в самом низу стека. Это не просто один из слоев архитектуры, а фактически, это полный стек BLE, который необходим для обеспечения сети беспроводной связью. Таким образом, сеть полностью зависит от доступности стека BLE на устройстве.

Канальный уровень (Bearer Layer) – определяет принципы обработки PDU сети. На данный момент определены два канала:

- канал адвертизинга (Advertising Bearer) – использует возможности адвертизинга и сканирования уровня BLE для приема и передачи пакетов PDU;

- канал GATT (GATT Bearer) — позволяет устройству, которое не поддерживает «Advertising Bearer», связываться с узлами сети, использующими протокол «Proxy». «Proxy» протокол инкапсулируется в операции GATT (Generic Attributes Profile) с использованием специально определенных характеристик GATT. Прокси-узел реализует эти характеристики и поддерживает оба канала для того, чтобы иметь возможность конвертировать и передавать сообщения между двумя типами носителя.

Сетевой уровень (Network Layer) – определяет различные типы адресов сообщений и их формат, а так же переносит пакеты PDU из транспортного уровня в канальный. Уровень может поддерживать несколько каналов, каждый из которых может иметь несколько сетевых интерфейсов, включая локальный интерфейс, используемый для связи между элементами, являющимися частью одного и того же узла. Уровень так же определяет, какие сетевые интерфейсы должны передавать сообщения. К сообщениям, поступающим из канального уровня, применяется входной фильтр, для определения того, должны ли эти сообщения доставляться выше. Выходные сообщения обрабатываются выходным фильтром для и делают тоже самое только для доставки ниже. Таким образом, функции узла «Relay» и «Proxy» могут быть реализованы сетевым уровнем.

Нижний транспортный уровень (Lower Transport Layer) — принимает пакеты PDU с верхнего транспортного уровня и отправляет их на нижний транспортный уровень другого устройства. При необходимости выполняется сегментация и сборка пакетов. Для пакетов, длина которых превышает длину одного транспортного PDU, уровень выполняет сегментацию, разделяя пакет на несколько транспортных PDU. Получающая сторона будет собирать эти сегменты в один пакет PDU верхнего транспортного уровня и передавать его выше.

Верхний транспортный уровень (Upper Transport Layer) — отвечает за шифрование, дешифрование и проверку подлинности данных приложения, проходящих через уровень доступа.

Уровень доступа (Access Level) — отвечает за то, как приложения могут использовать верхний транспортный уровень путем:

- определения формата данных приложения;

- управления процессом шифрования и дешифрования, выполняемым на верхнем транспортном уровне;

- проверки перед пересылкой данных вверх того, что данные, полученные с верхнего транспортного уровня, предназначены для текущей сети и конкретного приложения.

Уровень основных моделей (Foundation Models Layer) — отвечает за реализацию тех моделей, которые связаны с конфигурацией и управлением сетью.

Уровень моделей (Models Layer) – реализует модели, тем самым реализуя поведение, сообщения, состояния, привязки состояний и т.д., в соответствие с определениями спецификаций модели.

Безопасность

BLE позволяет создателю профилей использовать целый ряд различных механизмов безопасности, от различных подходов к сопряжению, к индивидуальным требованиям безопасности, связанным с отдельными характеристиками. На самом же деле безопасность в BLE абсолютно необязательна, ее просто разрешено иметь устройству. Разработчик или производитель устройств сам несет ответственность за угрозы и сам определяет требования безопасности для своего продукта. Однако, в сети Bluetooth, безопасность является обязательным условием работы сети и это условие невозможно изменить или отключить.

Перечислим фундаментальные составляющие безопасности:

- Все сообщения сети шифруются и проверяются на подлинность.

- Безопасность сети, безопасность приложений и безопасность устройств рассматриваются как отдельные составляющие.

- Ключи безопасности можно изменить в течение срока службы сети с помощью процедуры обновления ключа (Key Refresh).

- Обфускация сообщений затрудняет их отслеживание, обеспечивая конфиденциальность.

- Процесс добавления устройства в сеть, сам по себе является процессом в контексте безопасности.

- Удаление узлов из сети происходит так, что бы исключить атаку типа «trashcan».

Разделение ответственности

В основе безопасности сети лежат три типа ключей безопасности. Эти ключи обеспечивают безопасность для различных аспектов сети, тем самым улучшая общую защищенность сети.

Для понимания термина «разграничение ответственности», рассмотрим лампу освещения, имеющую функцию ретрансляции (Relay). В качестве ретранслятора она может обрабатывать сообщения, относящиеся к дверной или оконной системе безопасности, являющейся часть данной сети. Лампа не имеет возможности получать доступ и обрабатывать детали таких сообщений, но должна их передавать другим узлам. Для обеспечения запрета доступа к таким сообщениям, сеть использует разные ключи безопасности для защиты сообщений на сетевом уровне от тех, которые используются для защиты данных, относящихся к конкретным приложениям: освещение, охрана, обогрев и т.д.

Все узлы в сети имеют сетевой ключ (NetKey). Но этот ключ делает устройство узлом и членом сети. А вот ключ шифрования и приватный ключ образуются непосредственно из ключа NetKey.

Обладание ключом NetKey позволяет узлу расшифровывать данные и аутентифицироваться до «сетевого уровня» стека сети, чтобы можно было выполнять определенные сетевые функции, такие как ретрансляция. Но обладание им не позволяет расшифровать данные приложения.

Сеть может быть разделена на подсети, и каждая подсеть имеет свой собственный ключ NetKey, принадлежащий только узлам, являющимся членами этой подсети. Такая возможность может быть использована для изоляции конкретных физических областей, например таких, как каждая комната в гостинице.

Данные конкретного приложения могут быть расшифрованы только узлами, имеющими правильный ключ приложения («AppKey»). Через узлы в сети может проходить большое количество ключей такого типа, но, как правило, определенным ключом будет обладать ограниченное множество узлов, имеющих данное приложение. Например, лампы и выключатели света будут обладать ключом AppKey приложения освещения, но не ключом для системы отопления, в которой будут находиться только термостаты, клапаны радиаторов и т.д.

Ключи «AppKey» используются верхним транспортным уровнем стека сети для дешифрования и аутентификации сообщений до того, как передать их уровень доступа.

Ключи «AppKey» ассоциируются только с одним ключом «NetKey». Эта ассоциация называется «привязка ключей» (key binding) и означает, что конкретные приложения, владеющие конкретным ключом «AppKey», могут работать только в одной конкретной сети, тогда как сеть может содержать несколько независимых приложений.

И последний ключ, ключ устройства «DevKey». Это особый тип ключа приложения. Каждый узел имеет уникальный DevKey, известный только устройству с функцией регистратора в сети (Provisioner) и ни кому другому. DevKey используется в процессе подготовки для обеспечения безопасной связи между «Provisioner» и узлом.

Удаление узла, обновление ключа и атаки типа «trashcan»

И так, узлы содержат различные ключи защиты. Если узел сломался и его необходимо утилизировать, или если владелец решает отдать узел другому владельцу, важно чтобы устройство и ключи, которые он содержит, не могли быть использованы для установки атаки на ту сеть, членом которой он прежде был. Для этого была определена процедура удаления узла из сети. Приложение на устройстве «Provisioner» добавляет узел в черный список, после чего инициирует процедуру обновления ключа (Key Refresh Procedure). Эта процедура приводит к тому, что все узлы в сети, за исключением тех, которые являются членами черного списка, получают новые сетевые ключи, ключи приложений и все остальные производные данные. Другими словами, заменяется весь набор ключей безопасности, которые составляют основу безопасности сети и приложений. Таким образом, узел, который был удален из сети и который содержит старый «NetKey» и старый набор ключей «AppKey», больше не является членом сети и не представляет никакой угрозы.

Конфиденциальность

Приватный ключ (privacy key), полученный из «NetKey», используется для обфускации значений заголовков PDU, например таких, как адрес источника. Обфускация гарантирует, что случайный, пассивный перехват сообщений не может использоваться для отслеживания устройств и людей, которые эти устройства используют. Обфускация также затрудняет атаки, основанные на анализе трафика.

Атаки, основанные на повторе сообщения

Данная атака — техника, при котором устройство-перехватчик перехватывает одно или несколько сообщений и просто повторно передает их позже, с целью обмануть получателя, выполняя то, что атакующее устройство не уполномочено делать. Пример: система бесключевого доступа автомобиля всегда имеет риск перехвата данных между владельцем автомобиля и автомобилем.

У bluetooth сети есть защита от подобных атак. Защита основана на использовании двух полей в пакете PDU:

- «номер последовательности» (Sequence Number (SEQ)). Элементы сети каждый раз при отправке сообщения, увеличивают значение SEQ. Узел, получающий сообщение со значением SEQ меньшим или равным предыдущему действительному сообщению, отменит его, так как вполне вероятно, что это сообщение относится к атаке повтора.

- «IV Index» — поле, рассматриваемое вместе с SEQ. Его значение внутри сообщения от данного элемента всегда должны быть равны или больше значению этого поля в последнем действительном сообщении данного элемента.

Вот и все.

Надеюсь, предоставленная информация дает полный обзор новой технологии.

Для желающих глубже познакомиться с ней есть 3 замечательные спецификации:

— спецификация профиля;

— спецификация модели;

— спецификация устройства.

Все они доступны вот тут.

Спасибо за внимание.

|

Метки: author Lebets_VI децентрализованные сети беспроводные технологии bluetooth ble mesh сеть bluetooth 5.0 |

Как я сделал самый быстрый ресайз изображений. Часть 3, числа с фиксированной точкой |

|

Метки: author homm обработка изображений высокая производительность python pillow pillow-simd оптимизация производительность sse sse4 avx avx2 ресайз |

Офшоры и внешнеэкономические сделки: преимущества и подводные камни |

|

Метки: author Roman_Yankovskiy развитие стартапа законодательство и it-бизнес юриспруденция валютный контроль внешнеэкономическая деятельность офшор закон стартапа |

Практические примеры атак внутри GSM сети |

В данной статье цикла про Osmocom мы рассмотрим практическую реализацию атак на абонентов GSM сетей. Будут рассмотрены атаки как с помощью голосовых вызовов и СМС так и атаки во время работы абонента с GPRS.

Для работы нам понадобится все, что я описывал ранее. Поэтому для тек, кто присоединился к нам только сейчас, рекомендую ознакомиться с материалами предыдущих статей.

Статьи цикла:

Запускаем GSM-сеть у себя дома

Анализ трафика GSM сетей в Wireshark

Добавляем GPRS в домашнюю GSM сеть

Внимание!

Данная статья предоставлена исключительно в образовательных целях и автор не несет никакой ответственности за действия других пользователей, их вмешательство в коммерческие GSM сети и порчу собственного оборудования. Прежде чем что-либо запускать, убедитесь, что Вы понимаете, что делаете.

Подготовка

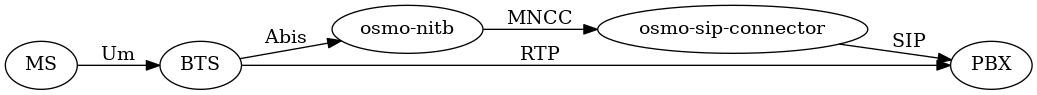

Для работы нам понадобится еще один компонент, о котором мы упоминали лишь вскользь ранее — osmo-sip-connector.

Мы подключим нашу базовую станцию на основе двух osmocombb-совместимых телефонов к IP АТС Asterisk при помощи этого компонента.

Это позволит нам записывать разговоры абонентов, работающих в нашей сети, а так же перенаправлять их исходящие вызовы на автоответчики и тому подобное.

Установить osmo-sip-connector на Ubuntu 14.04 мне не удалось из-за зависимостей и я решил пойти другим путем и просто установил все компоненты на Debian 9 (32-бита) через Nightly Builds deb-пакеты. В процессе установки пакетов я не получил никаких ошибок и проблем с зависимостями. Единственное, что я получил некоторые ошибки с texinfo при сборке старого toolchain. Но это легко исправилось правкой в gcc/doc/gcc.texi. Хочу предупредить, что сборку ветки osmocombb jolly/testing нужно проводить при помощи старого toolchain. Даже если вы исправите ошибку компиляции при использовании нового toolchain, вы получите нестабильную работу transceiver/TRX firmware в дальнейшем.

Устанавливаем osmo-sip-connector и asterisk

apt-get install osmo-sip-connector

apt-get install libsofia-sip-ua-glib-dev

apt-get install asteriskСоздаем файл osmo-sip-connector.cfg в вашей директории с другими конфигурационными файлами.

app

mncc

socket-path /tmp/bsc_mncc

sip

local 127.0.0.1 5069

remote 127.0.0.1 5060Настраиваем asterisk

Очень базовая конфигурация Asterisk может выглядеть так

Добавляем в конец файла /etc/asterisk/sip.conf

[GSM]

type=friend

host=127.0.0.1

dtmfmode=rfc2833

canreinvite=no

allow=all

context=gsmsubscriber

port=5069Добавляем в конец файла /etc/asterisk/extensions.conf

[gsmsubscriber]

exten=>_XXXXX,1,Dial(SIP/GSM/${EXTEN})

exten=>_XXXXX,n,Playback(vm-nobodyavail)

exten=>_XXXXX,n,HangUp()Перезапустим asterisk.

Захват абонента в нашу GSM сеть

2G/3G/4G

Сразу рассмотрим два варианта:

- Целевой абонент использует старый телефон без поддержки 3G/4G.

- Целевой абонент использует современный смартфон, поддерживающий 4G.

Во втором случае смартфон будет сперва искать 4G сети, затем 3G сети и только потом 2G сети. Таким образом, если вы находитесь в месте, где есть хороший сигнал от базовой станции 3G/4G домашнего оператора абонента, то он не подключится к вашей 2G базовой станции.

Чтобы решить эту проблему нужно либо создать помехи на 3G/4G частотах оператора, либо оказаться вместе с абонентом в локации, где нет покрытия 3G или 4G. Вопреки сомнениям многих людей, таким мест очень много до сих пор.

В первом же случае, когда целевой телефон не поддерживает 3G/4G все становится проще и наша базовая станция должна просто находиться в зоне досягаемости целевого телефона и иметь достаточно мощный сигнал.

MCC/MNC

Чтобы телефон автоматически подключился к нашей GSM сети, она должна являться домашней для SIM-карты, установленном в целевом телефоне.

Домашняя сеть определяется тремя параметрами:

Все эти значения не являются тайной и вы можете легко узнать их даже из Википедии.

Эти параметры транслируются базовой станции в SI (System Information) сообщениях на логическом канале BCCH (Таймслот 0).

Сейчас у нас в настройках OpenBSC указано следующее:

network country code 1

mobile network code 1

short name MyNet

long name MyNetУзнать MCC и MNC абонента можно исходя из номера телефона. Есть множество сайтов с этой информацией, например этот. Узнать имя на латинице сети тоже не составит труда. Обратите внимание, что имя чувствительно к регистру.

В домашних условиях, вам будет так же необходимо изменить auth-policy на closed, чтобы только Ваши телефоны имел право подключаться к сети с реально существующими MCC и MNC.

Для этого добавьте абонентов в HLR с IMSI своих личных SIM-карт, если их еще нет в HLR.

telnet localhost 4242

en

conf t

subscriber create imsi ВАШ_IMSI_1

subscriber imsi ВАШ_IMSI_1 authorized 1

subscriber create imsi ВАШ_IMSI_2

subscriber imsi ВАШ_IMSI_2 authorized 1

...

write file

endИ измените политику аутентификации

telnet localhost 4242

en

conf t

network

auth policy closed

write file

endПерезапустите OsmoNITB.

Теперь абоненты, не представленные в HLR, не будут иметь возможности подключиться к вашей сети.

IMEI

IMEI — International Mobile Equipment Identity.

Когда к вашей сети начнут подключаться абоненты, как узнать, кто именно вам нужен? Вы не видите номера телефонов, вы видите только IMSI и IMEI.

Зная IMEI вы можете однозначно определить модель телефона, в который вставлена SIM-карта. Например при помощи сайта http://www.imei.info/

Модель и происхождение телефона описываются первыми 8 цифрами IMEI. Телефонам, поддерживающим одновременную работу с несколькими SIM-картами, присваивается несколько номеров IMEI.

Таким образом, если вы знаете, что целевой абонент использует Apple iPhone 5, то можете скачать базу данных с TAC кодами и узнать TAC для iPhone 5.

Такая база данных есть у osmocom — http://tacdb.osmocom.org/

Чтобы не захватывать в свою сеть абонентов с неподходящим TAC, хорошо бы отказывать абонентам при регистрации, если их оборудование имеет TAC не для iPhone 5.

На текущий момент я не нашел настроек для EIR в OsmoNITB, но вскоре у нас появятся отдельно стоящие MSC, HLR, возможно и EIR, и там это будет.

На текущий момент будем вручную контролировать подключенных абонентов. Можно просто каждому выставлять «authorized 0», если его IMEI нас не устраивает.

OpenBSC# subscriber imsi 123456789012345 authorized 0Теперь, все, что остается — это оказаться рядом с абонентом и запустить CalypsoBTS.

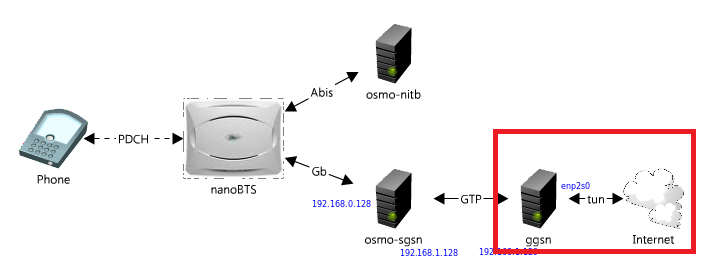

MITM во время GPRS-сёрфинга

Когда абонент попадает в нашу сеть, он становится недоступен для внешних звонков и сам никуда позвонить не может (обычно, см. ниже по тексту исключения).

Однако мы можем предоставить ему доступ в интернет при помощи GPRS/EDGE сервисов пакетных данных.

Поскольку машина, предоставляющая доступ в Интерент для абонента находится полностью под нашим контролем, мы можем делать с TCP/IP трафиком все, что угодно.

Проще всего нам будет работать с данным участком

Напоминаю, что скорость передачи данных в GPRS очень низкая, в то же время современные телефоны при получении доступа к сети тут же начинают процесс проверки обновлений, почты, новостей. Все ваши приложения начинают обновлять свои данные. Это может привести к тому, что абоненту будет затруднительно открыть что-то в браузере, так как, помимо низкой пропускной способности, могут происходить потери пакетов, если вы используете такое непроизводительное оборудование как CalypsoBTS.

Поэтому при планировании MITM-атаки нужно иметь это в виду. Можно, например, заблокировать через iptables доступ ко всему, кроме ресурса, взаимодействие жертвы с которым нам интересно.

Далее при помощи фреймворка MITMf можно проводить непосредственно атаки.

Мы перенаправим все HTTP запросы абонента на наш веб-сервер.

iptables -t nat -A PREROUTING -i tun0 -p tcp -m tcp --dport 80 -j DNAT --to-destination 192.168.1.32:80Где 192.168.1.32 — IP-адрес машины Kali Linux, которую я буду использовать для атаки.

Дополнительно можно запретить все остальные запросы, на порт 443 и прочие, чтобы увеличить скорость загрузки фишингового сайта.

Воспользуемся SE Toolkit, чтобы скопировать сайт и провести фишинговую атаку.

Запустим SET

Мы хотим получить учетные данные от определенного сайта. Настраиваем SET.

Создаем фишинговую страницу аутентификации defcon.ru

При попытке перехода на любой сайт через GPRS сервис сети атакующего, жертва попадает на фишинговую страницу (обратите внимание на URL).

В данном случае моя сеть имеет MCC 001 и MNC 01, так что мы видим значок роуминга. В этом случае чтобы получить доступ в Интернет, жертве придется разрешить пакетные данные в роуминге, что неудобно. Поэтому для этой атаки нужно использовать MCC/MNC и имя сети оператора целевого абонента (см. ниже по тексту). В лабораторных условиях можно этого не делать.

После ввода учетных данных SET отображает логин и пароль

СМС-фишинг

Когда делают фишинговые рассылки претворяясь банками или родными, то рассылка происходит с неизвестного абоненту номера, что подозрительно. Когда абонент попадает во враждебную GSM сеть, ему можно отправить СМС с любого номера.

Для отправки СМС нужно лишь сделать следующее:

Подключиться к VTY OsmoNITB и создать абонента от имени которого будет отправлена СМС.

telnet localhost 4242

OpenBSC# en

OpenBSC# subscriber create imsi 123456789012345

OpenBSC# subscriber imsi 123456789012345 extension 89001234567Где

123456789012345 — IMSI подконтрольно телефона, включенного в сеть атакующего.

89001234567 — Номер телефона, с которого жертва получит СМС.

И отправить СМС можно из того же VTY интерфейса OsmoNITB

OpenBSC# subscriber imsi 987654321987654 sms sender extension 890012345678 send Your bank...

Где 987654321987654 — IMSI телефона жертвы, захваченной в сеть.

Если жертва ответит на СМС, вы получите ответ на подконтрольный телефон.

Ответ вы также сможете легко получить просмотрев Wireshark дамп трафика, при этом не имея подконтрольного телефона в сети.

Обратите внимание, что значка роуминга на снимке экрана в этот раз нет, так как используются MCC, MNC и имя домашней сети SIM-карты целевого абонента, и СМС пришла от абонента, занесенного в телефонную книгу, т.е. обнаружить такую атаку невозможно.

Отправка Binary-SMS — еще один вектор. OsmoNITB позволяет отправлять Siltent SMS, но как отправить binary средствами OsmoNITB, я не нашел. На текущий момент можно попробовать использовать что-то такое. Однако этот вектор еще нужно изучать и реализация конкретных атак в каждом случае будет отличаться.

Перенаправление и запись голосовых вызовов

Если жертва попытается позвонить на номер, с которого пришла смс (89001234567) то ее вызов будет переадресован на телефон, контролируемый атакующим.

Чтобы использовать Asterisk для маршрутизации звонков, нужно добавить ключ -M в команду osmo-nitb

-M /tmp/bsc_mnccИ запустить osmo-sip-connector

osmo-sip-connector -c путь_до_конфигурационного_файлаТеперь наши вызовы будут маршрутизироваться через Asterisk, мы можем задать любой dialplan и полностью определить, как будет проходить звонок. Атакующий можете, к примеру, направлять все вызовы абонента на автоответчик, где роботизированный женский голос будет спрашивать у абонента конфиденциальную информацию. Никто не же подумает, что робот может навредить человеку?

Запись звонков можно выполнять при помощи стандартных конструкций Asterisk а файле /etc/extensions.conf — Monitor() и MixMonitor().

Radio Resource LCS (Location Service) Protocol

RRLP — GSM протокол, позволяющий сети запросить текущие координаты абонента.

RRLP не требует аутентификации и согласия пользователя на предоставление этих данных.

Мы, через OsmoNITB, тоже можем отправить RRLP запрос захваченному абоненту.

Если используется CalypsoBTS, то вы находитесь рядом с абонентом и это вряд ли может быть полезно, однако при использовании более мощных трансиверов RRLP позволяет выполнять слежку за абонентом.

К сожалению у меня не было достаточно времени это попробовать, но я полагаю, что нужно использовать модуль osmocom-lcs

Существуют и другие атаки, которым подвержены абоненты 2G сетей и большинство сотовых телефонов до сих пор поддерживают GSM. Чтобы не статье жертвой подобного рода атак, будьте внимательны при получении подозрительных звонков, смс или при сёрфинге с мобильного телефона, а так же обращайте внимание на значки 3G/LTE, которые обычно указывают на то, с сетью какого поколения вы в данный момент работаете.

|

Метки: author antgorka информационная безопасность блог компании pentestit osmocom calypso mitm gsm |

«Дело в мебели» – подбор проверенных мебельных фабрик для экономии времени и денег |

О чем проект

«Дело в мебели» – это сервис по подбору мебели от проверенных фабрик. Клиент получает персональный подбор 3 проверенных производителей мебели, после чего выбирает самый подходящий вариант.

Основная цель проекта – дать качественный продукт клиенту, и обеспечить добросовестных производителей заявками.

Предыстория

В 2015 году моя подруга купила новую квартиру в Москве. Отдала большие деньги на покупку мебели, но уже через год появились проблемы: диван просел, дверцы кухни начали скрипеть, а направляющие у полок заедали.

Как итог – нужно было все заменить, и он попросил помощи.

Решение проблемы

Мы с другом и партнером по другим проектам, собрали базу мебельных фабрик и привлекли опытного мебельщика, который рассказал и показал: как производители обманывают, и как скрывают дешевый материал.

Из уже отобранного списка 38 фабрик, только 4 подходили по нашим критериям цены и качества.

От идеи до старта

Тут и пришла идея помочь людям, у которых нет времени так же скрупулезно разбираться в мебельном вопросе. Ведь покупать некачественную мебель, оценивая её только по внешнему виду, тоже не вариант – обычно это приводит к неприятным последствиям.

25 ноября 2016 года я и мой друг создали сервис – «Дело в мебели», в котором отбираем фабрики в базу и берем на себя клиентский сервис.

Принцип работы и бизнес-модель

Основная выгода для клиента – экономия времени и денег при выборе производителя.

Дополнительные выгоды:

- клиентский сервис — мы отвечаем на все вопросы и запросы клиента;

- большая база проверенных фабрик под любые запросы;

- наилучшее соотношение цена/качество.

В результате формирования базы производителей, оказалось, что фабрики с наилучшим продуктом плохо представлены в интернете и далеки от понятия «сервис».

Именно поэтому мы и берем на себя обслуживание клиентов. Нам же фабрики дают %, который покрывает затраты на клиентский сервис и рекламу.

Вопросы и ответы

Как происходит весь процесс?

— Вы проходите тест на нашем сайте, в котором собраны основные вопросы по подбору мебели. Далее мы размещаем вашу заявку среди фабрик. После получения расчетов от них, мы отбираем 3 предложения и передаем их вам. Далее вы взаимодействуете лично с производителем.

Как именно мы выбираем фабрики?

— Каждый производитель чаще всего силен в каком-то одном направлении, кто-то лучше делает кухни из массива, кто-то лучше спальни и т.д. Мы проводим закрытый аукцион среди производителей и подбираем для вас 3 лучших в соотношении цена/качество.

Какое количество фабрик в базе?

— На сегодняшний день их 170. Но мы постоянно расширяем базу.

P.S. Если вы прочитали, пожалуйста уделите еще минуту и напишите ваше мнение или комментарий. Мы ценим это.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author alexmelnic хабрахабр читальный зал стартап мебель |

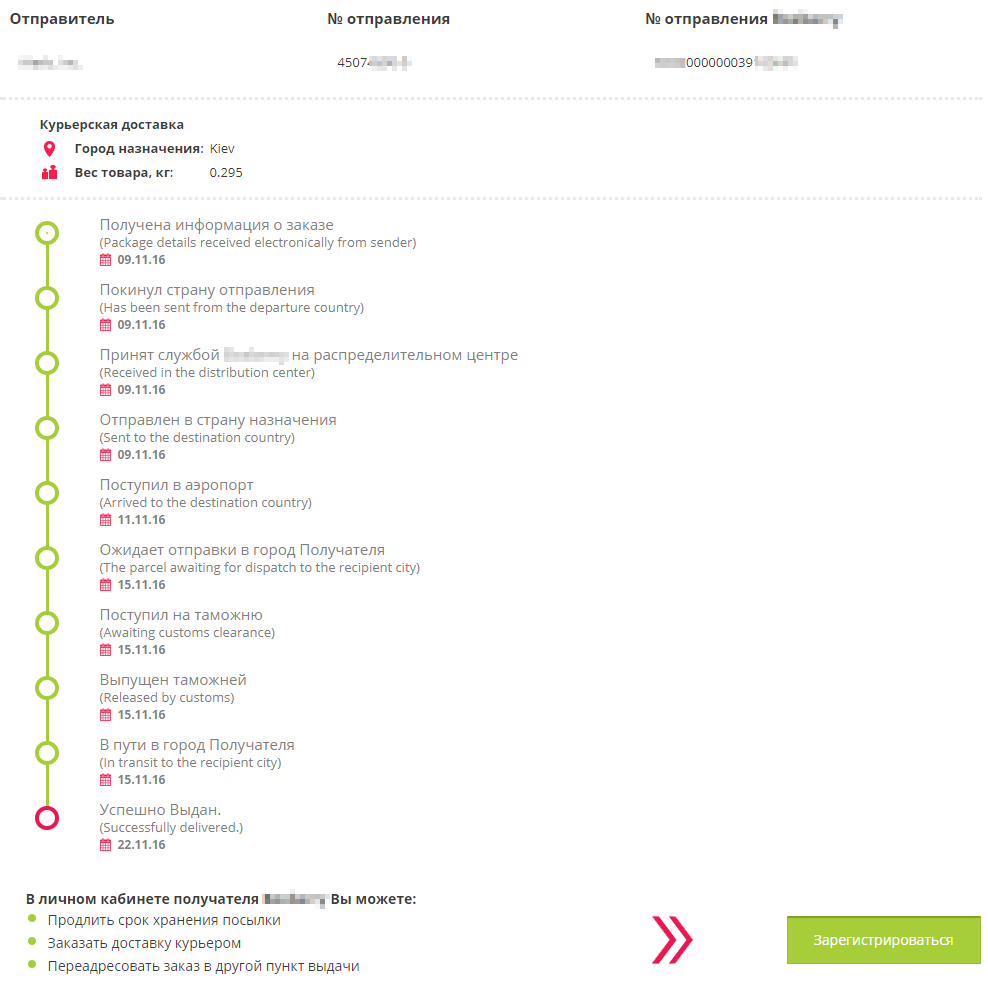

Как другая крупная курьерская компания персональные данные своих клиентов раздавала |

А тут на днях на Хабре вышла статья "Как крупная курьерская компания персональные данные своих клиентов раздавала", после выхода которой я понял, что

Что ж, опишу свой ситуацию и результаты (пост будет короче, чем указанный выше).

(картинка для привлечения внимания. Картинка не относится к описываемому мной сервису)

В конце прошлого года я воспользовался сервисом, чьё название я не буду упоминать, не смотря на то, что компания давно исправила уязвимость.

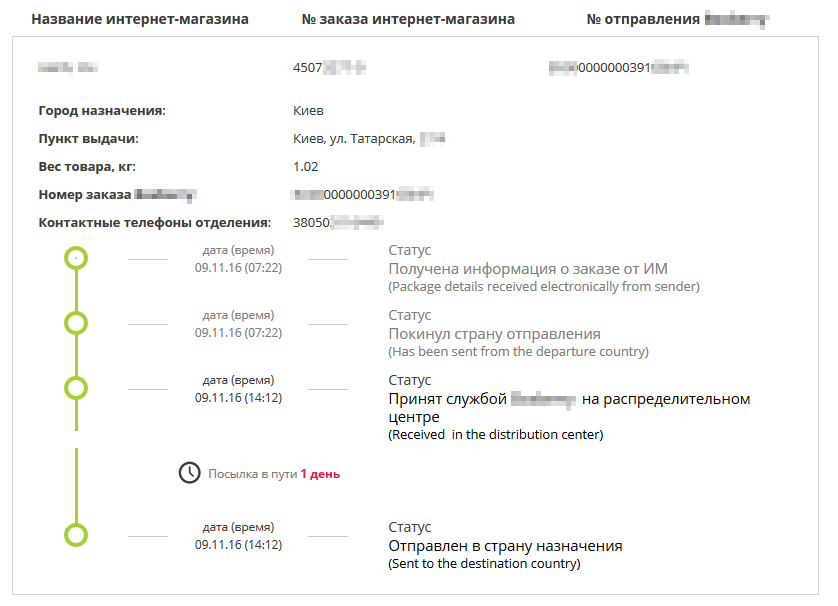

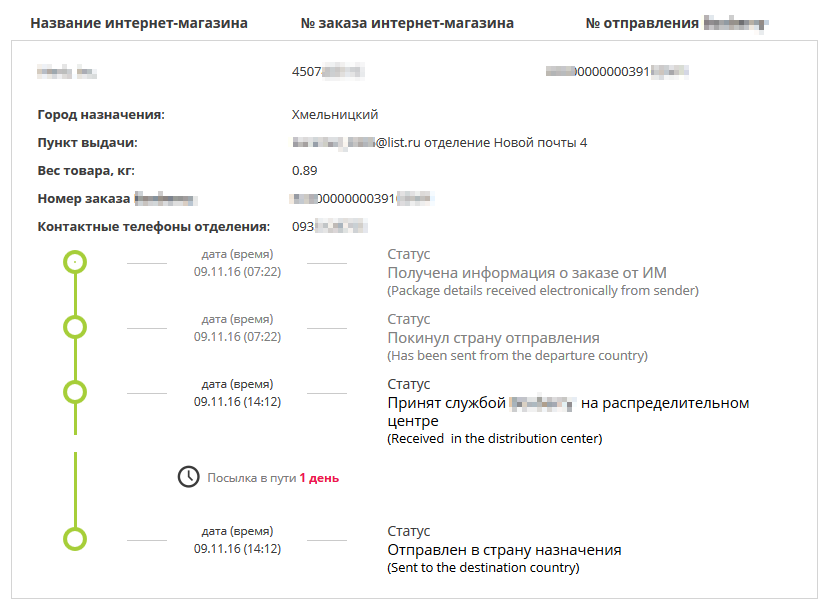

На сайте службы доставки по ссылке вида xxxxxxxx.ru/departure_track/?id=XX00000000123456YYY, которую я получил в письме от интернет-магазина, где делал заказ, была указана довольно детальная информация.

Были доступны следующие данные:

— название интернет-магазина;

— № заказа интернет-магазина;

— вес посылки;

— пункт выдачи, который часто был адресом физ. лица;

— а также контактный телефон отделения, который во многих случаях являлся не телефоном почтового отделения, а был именно личным мобильным телефоном получателя (проверено на себе).

Информация была доступна для просмотра без авторизации и без ограничений по количеству подборов номеров отправлений.

Проблема была не только в разглашении персональных данных (мобильный номер телефона и домашний адрес), а и в том, что нехорошие люди могли запросто заниматься обзвоном клиентов, которые ждут посылку, с просьбами перевести, например, сумму комиссии на их (мошенническую) банковскую карту за фиктивную доставку – вся необходимая для убеждения клиента информация была доступна.

В письме, отправленным мной компании, я указал такой пример: звонок может быть на номер +380501234567 со следующими данными:

— Добрый день, меня зовут Андрей, я сотрудник службы доставки XXXXXXXX. Вы ожидаете посылку от %COMPANY_NAME%, весом 1,02 кг, № заказа интернет-магазина 4507XXXX-X?

— Да.

— Ваш адрес Киев, улица Татарская, дом 3, квартира 15 — указано правильно?

— Да.

— Ваша посылка уже у нас. Вам необходимо оплатить 45 гривен на банковскую карту №512345678901234. Как только мы получим средства, курьер сразу же выезжает к Вам.

— Хорошо.

Ну или любой другой скрипт разговора из вариантов социальной инженерии мошенников.

Я рекомендовал ограничить показ такого количества информации неавторизированным пользователям, так как периодически нахожу ошибки в интернет-сервисах и считаю, что данная ситуация вполне реальна и опасна, так как слишком много доступной информации указано на сайте без ограничений, а мошенники, занимающиеся обзвоном, постоянно придумывают новые способы обмана доверчивых покупателей.

Что приятно, компания приняла моё письмо во внимание и исправила уязвимость (убрала лишние для отображения поля, позже добавила капчу), а также перевела мне 2000 рублей в качестве вознаграждения, пусть и не сразу.

На сегодняшний день проблема исправлена, информация на сайте отображается в усечённом виде

Так что почтовые сервисы бывают разные.

|

Метки: author Gorodnya информационная безопасность персональные данные |

Регистрация на вебинар «Как надежно и выгодно защитить предприятие от неизвестных угроз и шифровальщиков" |

9 августа в 11:00 (мск) приглашаем Вас на вебинар «Как надежно и выгодно защитить предприятие от неизвестных угроз и шифровальщиков»

На вебинаре мы расскажем Вам об единственном облачном EPP+EDR решении Panda Adaptive Defense 360, который позволит надежно защитить Ваше предприятие от шифровальщиков, эксплойтов, APT, новых и скрытых угроз, безфайловых атак и атак, не использующих вредоносные программы. Решение позволяет получить полный контроль над происходящим в сети: откуда пришла угроза, где появилась, что пыталась сделать, к каким файлам обращалась, куда что отправляла и пр.

Зарегистрируйтесь на вебинар, узнайте об уникальных возможностях Panda Adaptive Defense 360 и выгодных условиях поставки, протестируйте новое решение.

Мы расскажем, почему пользователи Panda не пострадали от WannaCry, Petya и других новых угроз, и почему они уверены в своей защите от будущих угроз.

Рассматриваемые вопросы:

1. Новые и неизвестные угрозы — серьезная опасность для предприятия

2. Уникальная модель безопасности

3. Возможности решения

4. Лицензирование и преимущества для предприятия

Дата вебинара: 9 августа в 11:00 (московское время)

Ведущий: Паздников Алексей (Panda Security в России)

|

|

Простенькая первичная авторизация с помощью iptables |

Очень простой способ прикрыть от посторонних сканеров и брутфорсеров важные сетевые порты такие как:

- SSH

- RDP

- ...

Например, я сталкивался с тем, что брутфорсеры постоянно блокировали учетки в домене windows, долбясь по RDP и передавая пары логин/пароль валидных пользователей. Разумеется, DC блокирует такие учетки, пресекая брутфорс.

Можно придумать еще кучу подобных уязвимостей.

И просто неприятно видеть когда на важных портах висят не понятные ESTABLISHED соединения.

Избежать таких ситуаций можно следующим образом:

iptables -A INPUT -p tcp --dport 65432 -m recent --set --name tuktuk

iptables -A INPUT -p tcp --syn --dport 22 -m recent --rcheck --seconds 160 --name tuktuk -j ACCEPT

iptables -A INPUT -p tcp --syn --dport 22 -j DROP

Вот и все!

Кто бы ни попробовал просканировать порт SSH, будет дропнут без разговоров.

Для установки соединения нужно предварительно постучаться на порт 65432.

Например из браузера (http://ваш_адрес:65432)

Или telnet ваш_адрес 65432

Или putty ваш_адрес -p 65432

И потом уже putty ваш_адрес -p 22

Мы же можем осуществлять попытки подключения из откуда угодно и при этом не хотим чтобы кто угодно мог установить соединение по Вашему важному порту?

Пользуйтесь )))

|

Метки: author AntonCheloshkin системное администрирование сетевые технологии серверное администрирование настройка linux it- инфраструктура iptables/netfilter ssh authentication |

[Из песочницы] Laravel — экосистема, а не просто PHP-фреймворк |

Данная статья предназначена для начинающих веб-разработчиков, а также тех, кто хочет понять, для чего стоит изучить PHP-фреймворк Laravel и какую экосистему он нам предлагает.

Статья написана на момент актуальности Laravel версии 5.4, в августе 2017 выйдет релиз Laravel 5.5, который предоставляет ещё больше возможностей.

Содержание:

- Введение в веб-разработку, что было раньше и что сегодня

- Начало создания веб-проекта

- Этап первый – процесс написания кода

- Этап второй – тестирование кода

- Этап третий – сборка проекта

- Этап четвёртый – развёртывание (deploy) кода

- Итоги

- Основные возможности PHP-фреймворка Laravel

- Полезные ссылки

Введение в веб-разработку: что было раньше и что сегодня

В данной статье хотелось бы рассказать о том, что такое PHP-фреймворк Laravel и как благодаря этому фреймворку начинающий веб-разработчик может расширить свой кругозор, а также поднять свой культурный уровень разработки. Попытаемся раскрыть тему создания веб-проекта и помочь начинающим.

Инженер, программист или веб-разработчик?

Если 30 лет назад инженер и программист был один и тот же человек, и можно было с уверенностью сказать, что он даже мог починить электронику, то сегодня, благодаря техническому прогрессу и развитию технологий мы имеем множество языков программирования, специализаций и направлений, для изучения которых одному человеку просто физически не хватит времени. Скорее всего Ваш сосед программист не в состоянии починить смартфон, хотя он может написать приложение для этого смартфона.

Сегодня существует очень много разработчиков с разным уровнем знаний: есть профессионалы с большим опытом работы и знанием как минимум нескольких языков программирования и культуры разработки, а есть новички с большими амбициями и желанием развиваться.

Не секрет, что PHP считается языком программирования для разработки, на котором необходим минимальный набор знаний. Это язык программирования с очень низким порогом вхождения.

Буквально любой может взять и тут же вывести строку на экран. Именно поэтому опытные разработчики на любых языках программирования считают PHP-разработчиков «ненастоящими» разработчиками, а PHP – «ненастоящим» языком программирования.

Но возможно ли создать на PHP серьёзный продукт и как доказать другим, что PHP можно доверять? Если Вы из тех людей, которые считают PHP «несерьёзным» языком программирования, то советую дочитать до конца и, скорее всего, Вы измените своё мнение.

Разработка любого программного продукта всегда требует нечто большего, чем просто знания самого языка разработки. Для его создания и поддержки разработчику необходимо множество других знаний и навыков.

Мы будем говорить о разработке веб-проекта и о том, что сегодня необходимо знать веб-разработчику для успешного запуска веб-проекта, а главное – я попытаюсь показать, что

Laravel – это идеальное решение для тех, кто хочет быстро и грамотно создать безопасный и надёжный веб-проект, при этом всегда оставаясь на пике технологий веб-разработки.

Начало создания веб-проекта

Прежде чем начать создавать веб-проект, необходимо задуматься не только над структурой проекта и его фишками, но и над процессом разработки и, главное, над своим рабочим окружением.

Сам Laravel хоть и является PHP–фреймворком, но не стоит его недооценивать, ведь это целая экосистема для веб-разработки.

Если Вы скачали фреймворк Laravel в .zip архиве, чтобы оценить его возможности, тогда Ваше рабочее окружение точно настроено неверно, и у Вас существует пробел в знаниях. Вам однозначно стоит внимательно прочитать данную статью до конца.

Этап первый – процесс написания кода

Вы можете работать на любой операционной системе, в том числе и на Windows.

Нам необходима хорошая IDE (Интегрированная среда разработки (англ. Integrated Development Environment)) – рекомендую PhpStorm. Можете использовать текстовый редактор Atom или Sublime Text. Конечно, можно писать код и в обычном блокноте, например, Notepad++, но хорошая IDE – незаменимая вещь.

Также после установки IDE или текстового редактора я советую потратить время и изучить как можно больше его возможностей и функций. Это поможет сэкономить массу времени в дальнейшем, а также автоматизировать многие рутинные задачи.

Многие считают, что «крутые» разработчики должны писать код в блокноте, но помнить по памяти названия функций – это одно, а не делать опечатки в коде, упростить и ускорить процесс разработки – это совсем другое. Главная задача – освоить все возможности IDE.

Кроме IDE нам необходимо будет установить Composer (https://getcomposer.org), именно через него мы и будем устанавливать (обновлять) Laravel, добавлять (обновлять) дополнительные пакеты в наш веб-проект.

Обязательно изучите работу с Composer, это очень важный и полезный инструмент.

Подробно изучите инструкцию по установке Laravel по этой ссылке.

Далее мы не будем описывать процесс написания кода, а предположим, что Вы уже установили IDE и Laravel.

После установки Laravel в коде сразу прописано отображение базовой страницы – этого достаточно, чтобы перейти к следующей части статьи.

Этап второй – тестирование кода

Для тестирования веб-проекта Вам не надо загружать файлы на FTP-сервер, устанавливать локальный Apache (тот же Denwer или XAMPP) – так делали много лет назад, а многие новички так делают до сих пор. Это неправильно и не спасёт от ошибок в коде. На сегодняшний день для этих задач есть соответствующие инструменты, которые сэкономят много времени и нервов.

Laravel предлагает нам установить Homestead.

Homestead – это образ операционной системы Ubuntu, в которой уже установлено всё необходимое.

С процессом установки и настройки Homestead Вы можете ознакомиться по ссылке.

Для установки образа нам понадобится Vagrant и VirtualBox.

Благодаря данному образу Вы точно будете знать, какие модули надо установить и как поведёт себя Ваш код на Ubuntu. Вы также можете установить любой дополнительный софт.

Если кратко, то у Вас в системе появятся общие папки с кодом, которые будут доступны внутри образа Ubuntu, и выполняться Ваш код будет именно внутри Ubuntu.

В браузере Вы набираете site.app, и у Вас отображается сайт из Ubuntu.

При этом у Вас также будет доступ к Ubuntu по SSH.

У начинающих установка и настройка Homestead займёт время, но как разработчик Вы просто обязаны это сделать.

Стоит отметить, что Homestead можно установить не только на Linux, но и на Windows.

Далее будем считать, что Homestead установлен, и сайт со свежей версией Laravel открывается у Вас в браузере.

Ваш код запускается в браузере, но действительно ли всё работает?

Ни один уважающий себя разработчик не должен писать код без тестов. Тесты позволяют нам быть точно уверенными, что всё работает так, как мы задумали. Не жалейте времени на написание тестов. Каждый профессиональный разработчик обязательно пишет тесты своего кода.

Laravel предлагает нам инструменты для полноценного тестирования веб-проекта со всех сторон. Вы можете тестировать всё: создать временную базу данных, проверить заполнение HTML-форм, проверить загрузку файлов, даже содержание PHP-сессий и отправку писем.

Laravel создан для качественного тестирования всех возможностей Вашего проекта.

Документацию по тестированию можно найти по этой ссылке.

В Laravel тесты находятся в папке tests и выполняются командой phpunit в консоле, либо сразу из IDE.

Тесты бывают нескольких типов:

- Функциональные – Feature-тесты

- Модульные – Unit-тесты

Feature-тесты – функциональные тесты.

Тесты, которые проверяют функционал веб-проекта, например: регистрацию пользователей, отправку уведомлений, заполнение веб-форм, загрузку файлов. Они позволяют нам проверить, какие именно данные отображаются в браузере. Теперь Вам не надо заполнять веб-формы вручную, чтобы узнать работают ли они.

Также Вы можете проводить тестирование с помощью Laravel Dusk, не просто отправляя HTTP-запросы, а используя реальный движок браузера Chromium.

В этом нам поможет Laravel Dusk.

Unit-тесты – модульные тесты.

Другой тип тестирования называется unit-тестированием.

Эти типы тестов проверяют логику нашего приложения, каждую функцию, отлавливают события, определяют отправлено ли письмо, а также сверяют текст письма, проверяют добавлено ли задание в очередь сообщений и всё, что может сломаться, если Вы или кто-то ещё неудачно измените Ваш код.

Каждая функция проекта должна иметь свои тесты, а когда Вы завершите проект, то все тесты должны успешно запускаться.

При изменении функционала Вы можете дописать тесты. Это спасёт Вас и Ваших коллег от ошибок и поможет проще диагностировать проблему.

Unit-тестирование позволяет избежать ошибок в логике приложения.

Стоит отметить, что существует методика разработки TDD (test-driven development) – разработка через тестирование. Сначала мы пишем тесты, а затем постепенно реализуем код. Когда все тесты выполнены, то мы можем сказать, что завершили написание кода.

Если Вы ещё не писали тесты для своих проектов, значит пора переходить на новый уровень.

Кроме тестов есть ещё другие помощники для анализа производительности веб-приложения.

Laravel предлагает нам установить Laravel Debugbar.

Это специальный пакет, который отображается на Вашем сайте в режиме отладки. С помощью него можно отследить все SQL-запросы к Вашей базе данных с целью их дальнейшей оптимизации.

Этап третий – сборка проекта

После создания веб-проекта и прохождения тестов нам необходимо подготовить наш проект к размещению на сервере.

Laravel предоставляет нам Laravel Mix.

Laravel Mix использует Webpack и умеет работать с CSS, JS, Less, Saas, Stylus, PostCSS.

Это замечательный инструмент, который, используя специальный сборщик модулей Webpack, собирает вместе все наши JS и CSS-файлы, а также, самое главное, умеет создавать версии этих файлов.

Таким образом, каждая сборка нашего проекта позволяет иметь разные названия JS и CSS-файлов в HTML-коде, что решает проблему с кешированием при изменении содержимого файла.

В шаблоне нашего проекта пишем:

После сборки он превращается в:

При этом браузер посетителя сразу загрузит новый файл с сайта.

Не правда ли, удобно? Точно также и с JS-файлами.

Стоит отметить, что Laravel замечательно работает с прогрессивным Javascript-фреймворком Vue и позволяет очень удобно создавать веб-приложения на базе этого JS-фреймворка. При этом каждый компонент можно удобно размещать в отдельном файле.

О том, как писать компоненты для Vue используя Laravel можно прочитать по этой ссылке.

Этап четвёртый – развёртывание (deploy) кода

Обычно после сборки проекта его файлы необходимо загрузить на сервер и обновить структуру таблиц в базе данных.

Заходим в phpMyAdmin и делаем изменения в БД.

Мы не станем использовать FTP и phpMyAdmin, иначе пока мы вносим изменения, все пользователи, которые зайдут на сайт веб-проекта, увидят множество ошибок об отсутствии каких-то файлов или полей в БД.

Мы можем, конечно, объявить о проведении технических работ, показав нашим пользователям насколько технически сложен наш проект, что требует полного отключения, но никого это точно не обрадует.

Есть очень простое и грамотное решение, которое позволяет обновлять код веб-проекта без его отключения, и ни один пользователь при этом не получит сообщения об ошибке.

Первое что нам необходимо изучить — Git.

Git — это распределённая система управления версиями файлов.

С помощью Git можно отслеживать изменения в файлах, возвращать старую версию файлов и работать в команде над одним и тем же кодом, при этом ничего не перепутав.

Использовать Git можно через сервис.

Вы можете создать либо общедоступный код, либо приватный (для приватных репозиториев – он платный).

Также Вы можете использовать другой бесплатный сервис BitBucket, который позволяет бесплатно создавать приватные репозитории с кодом.

Кроме этого, сам Git можно настроить так, чтобы при внесении изменений происходили определённые действия:

- запуск тестов проекта через Travis CI;

- форматирование кода по стандарту;

- анализ качества кода через инструмент.

Таким образом, весь код Вашего веб-проекта будет храниться в Git, он всегда будет качественный и проверенный.

Например, если Вы предложите внести изменения в официальный код PHP-фреймфорка Laravel, то при внесении изменений автоматически запускаются тесты, которые проверяют работу фреймворка, учитывая новый код.

Ранее мы говорили о процессе развёртывания веб-приложения. Именно для этого нам и необходим Git. С Вашей локальной машины Вы загружаете код веб-приложения в Git, после чего произойдёт автоматический запуск развёртывания приложения на сервере.

Laravel Forge – сервер без хлопот.

Для автоматического развёртывания из Git нам поможет сервис Laravel Forge.

Через Laravel Forge Вы можете создать виртуальный сервер в DigitalOcean, Linode или указать доступ к своему собственному серверу. При этом будет настроено абсолютно всё необходимое ПО для работы PHP-фреймворка Laravel.

Laravel Forge автоматически устанавливает обновления, связанные с безопасностью системы. Также Forge легко установит бесплатный SSL-сертификат от Let's Encrypt.

Вы можете дать сервису Laravel Forge доступ к Вашему Git-репозиторию и при каждом изменении в коде на сервере будет автоматически развёрнута его свежая версия.

Хотите 10 серверов? – Без проблем, Laravel Forge может установить балансировщик нагрузки, создать 10 виртуальных серверов, на каждый сервер копировать код из Git и запустить проект.

Думаете всё?

Нет, совместно с Envoyer Вы можете запускать новый код в работу без остановки сервиса совсем.

Хотя лично я не использую Envoyer, а просто написал небольшой скрипт в панели Laravel Forge, который запускается при каждом развёртывании кода и обеспечивает замену на лету, при этом сохраняя ещё несколько копий старого кода на самом сервере.

Ссылка на скрипт.

Итоги

Мы создали комфортное рабочее окружение, установили IDE, Composer, PHP-фреймворк Laravel, написали код проекта, запустили тесты, изучили систему контроля версий Git, отправили туда код, подключили сервис Laravel Forge, при желании подключили также Laravel Envoyer, сделали развёртывание проекта на рабочий сервер из нашего Git-репозитория.

Можно сказать, что Laravel направил нас на грамотный путь в веб-разработке. Впереди ещё многое предстоит изучить, но мы уже проделали большую работу и можем начинать работать в команде с другими разработчиками.

Основные возможности PHP-фреймворка Laravel

А теперь рассмотрим возможности самого PHP-фреймворка Laravel: какие веб-приложения позволяет нам создавать данный PHP-фреймворк, насколько он продвинутый в техническом плане и почему он так популярен во всём мире.

После выхода PHP7 по сравнению с PHP5, скрипты стали быстрее и начали использовать гораздо меньше оперативной памяти, а в связке с Zend OPCache показывают замечательные результаты. В частности сервис Laravel Forge настраивает Zend OPCache для достижения максимальной производительности.

Именно поэтому, когда идёт речь о производительности того или иного PHP-фреймворка, то всегда проводят тестирование без кеширования, работы с БД или файлами, в основном совершая множество вызовов к обычной PHP странице. В этом плане данный PHP-фреймворк существенно ничем не отличается от всех остальных, но когда речь идёт о масштабируемости, гибкости, универсальности встроенных механизмов кеширования и скорости разработки, именно тогда Laravel показывает всю свою гибкость и мощь.

Сам Laravel постоянно совершенствуется и следует современным тенденциям. Изучая его, Вы не отстанете от мира веб-разработки, главное – не зацикливаться на какой-то конкретной версии фреймворка, а развиваться вместе с ним. Для этого необходимо также изучать нововведения Laravel.

Ежегодно проводятся различные конференции, которые можно посмотреть также и онлайн.

Постараюсь описать основные возможности Laravel, чтобы можно было оценить масштаб:

- MVC (англ. Model View Controller – модель-представление-контроллер) PHP-фреймворк построен на базе известных и надёжных компонентов Symfony.

- Необходимые модули для фреймворка подключаются в виде пакетов-провайдеров (service provider). В версии Laravel 5.5 достаточно просто установить пакет через Сomposer, и он сразу будет доступен, без необходимости что-либо писать в коде.

- Код фреймворка отделён от кода разработчика, каждый компонент легко расширяется.

- Код веб-проекта, CSS, JS, HTML-код страниц разделены в отдельные директории. Фреймворк использует замечательный шаблонизатор Blade, который позволяет отделить вёрстку от PHP-кода. Сам шаблонизатор настолько прост, что даже начинающий HTML-верстальщик сможет легко его осилить.

- Удобная маршрутизация, валидация входящих параметров.

- Кеширование, работа с хранилищами файлов, работа с различными БД.

- Миграции для базы данных, Вы можете изменять структуру БД и откатывать изменения.

- Очереди заданий, планировщик задач, консоль, работа с SSH.

- Огромный функционал Eloquent ORM позволяет полностью обезопасить себя от атак типа SQL Injection, а также загружать данные из нескольких таблиц (решая проблему N+1) или же обрабатывать данные из БД частями.

- Laravel Collections – можно сказать, что это PHP массивы, но с очень продвинутыми возможностями, которые экономят массу времени.

- Кэширование файлов маршрутизации, файлов конфигурации, шаблонов. Это ускоряет работу фреймворка.

- Отправка уведомлений различными способами: почта, Slack и т.д., можете дописать сами.

- Поддержка WebSockets для создания настоящих интерактивных приложений.

- Поддержка мультиязычности: легко добавляйте любые языки, а пакет Laravel-lang уже содержит множество переводов.

- Интерфейс командной строки artisan, который позволяет генерировать модели, контроллеры, уведомления, запускать задания из очереди заданий и многое другое.

- Laravel Tinker – дополнительный пакет, который позволяет работать с кодом проекта из командной строки.

- Огромные возможности для тестирования веб-проекта, включая заполнение базы данных тестовыми данными.

- У фреймворка есть даже собственный сайт с библиотекой пакетов.

- Нужен полнотекстовый поиск? Пожалуйста – Laravel Scout, можно использовать Algolia, Sphinxи другие драйвера.

Впечатляет, не правда ли? А я не описал даже и половины возможностей.

С помощью Laravel можно одной командой сгенерировать систему регистрации и входа на сайт и с лёгкостью подключить сервисы OAuth аутентификации благодаря Laravel Socialite или даже создать свой с помощью Laravel Passport.

Для тех, кто не знает OAuth, – это возможность войти на сайт через социальные сети.

Это лишь малая часть того, что умеет Laravel, и если начинающий PHP-разработчик изучит его возможности, даже не углубляясь в ядро самого PHP-фреймворка, то это безусловно поднимет его уровень знаний не только в разработке на Laravel, а в веб-разработке в частности, включая навыки работы в команде и понимание принципов разработки высоконагруженных проектов.

На основном сайте PHP-фреймворка Laravel недаром присутствует девиз:

«Любите красивый код? Мы тоже. PHP-фреймворк для веб-мастеров.»

Ведь код PHP-фреймворка Laravel не только красивый, приятно читаемый, но ещё и очень грамотно продуман, а над любым изменением думает множество людей, что позволяет создавать профессиональные веб-приложения на уровне мастера своего дела.

Полезные ссылки:

Сайт PHP-фреймворка Laravel.

Основные новости PHP-фреймворка и новости о различных пакетах.

Очень рекомендую сайт https://laracasts.com, где Jeffrey Way в своих видео-уроках наглядно и без лишних слов показывает возможности Laravel, также рассказывает много полезных вещей. За 2 минуты человек успевает рассказать больше и доступнее, чем многие за час.

А также рекомендую книгу "Refactoring to Collections", где Adam Wathan подробно рассказывает о возможностях Laravel Collections. Гарантирую, Ваш код изменится в лучшую сторону.

Рекомендую в каждый веб-проект на Laravel устанавливать:

P.S.: Данная статья получилась довольно объёмной и без технических подробностей, но её основная задача – дать начинающим разработчикам вводные знания, объяснить что же такое Laravel и какие возможности он даёт, а также показать, что Laravel – это не просто PHP-фреймворк, а целая экосистема, которая постоянно развивается. Это именно тот тренд, на который должны обратить внимание PHP-разработчики.

Многие вещи могут быть непонятны для начинающих, но не стоит отчаиваться. Любой термин достаточно быстро можно найти в сети. Я лишь попытался обобщить информацию именно в том порядке, в котором должен её воспринимать начинающий разработчик.

Если Вам понравилась статья, то буду уже подробнее писать про каждый этап в данной статье с техническими деталями и кодом.

|

Метки: author SwVZFSf4fLt8NSZNfV87 разработка веб-сайтов php laravel web- разработка сила php |

[Перевод] SwiftyBeaver руководство для iOS: платформа логирования для Swift |

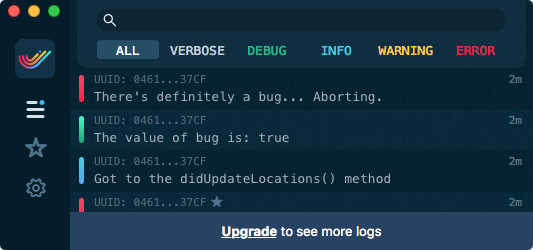

Ошибки бывают разных форм и размеров. Некоторые ошибки милые и пушистые и их легко исправить, потому что вы можете запустить ваше приложение и пойти прямо к тому месту где происходит ошибка. Если вы счастливчик, Xcode покажет вам какая строка привела к падению вашего приложения.

Ошибки бывают разных форм и размеров. Некоторые ошибки милые и пушистые и их легко исправить, потому что вы можете запустить ваше приложение и пойти прямо к тому месту где происходит ошибка. Если вы счастливчик, Xcode покажет вам какая строка привела к падению вашего приложения.Другие ошибки более зловещие. Они таятся в фоне и случаются когда вы менее всего этого ожидаете. Они ужасы ночных кошмаров и рекламных роликов Listerine.

В этом уроке вы обнаружите секретное оружие, с которым сможете разобраться с этим зловещими ошибками, которые притаились в фоне. При должном использовании это оружие похоже на свет фонарика в самых глубоких и темных расщелинах вашего приложения. У этих жутких ошибок не будет ни единого шанса.

Это оружие — SwiftyBeaver, основанная на Swift система логирования для iOS и macOS.

В этом руководстве вы узнаете как отлаживать ваше приложения используя SwiftyBeaver и получите следующие полезные умения на этом пути:

- When SwiftyBeaver logging is better than print() and NSLog()

- Как получить доступ к журналам SwiftyBeaver в Crypto Cloud

- Как использовать уровни логирования для различных типов сообщений журнала

- Как фильтровать записи, чтобы облегчить поиск ошибок

Примечание: перед началом урока вы должны быть знакомы с Cocoapods и фреймворком CoreLocation. Сначала ознакомьтесь с этими руководствами чтобы получить необходимые умения.

Начало

Загрузите начальный проект. Этот архив содержит проект и все необходимые файлы для завершения урока.

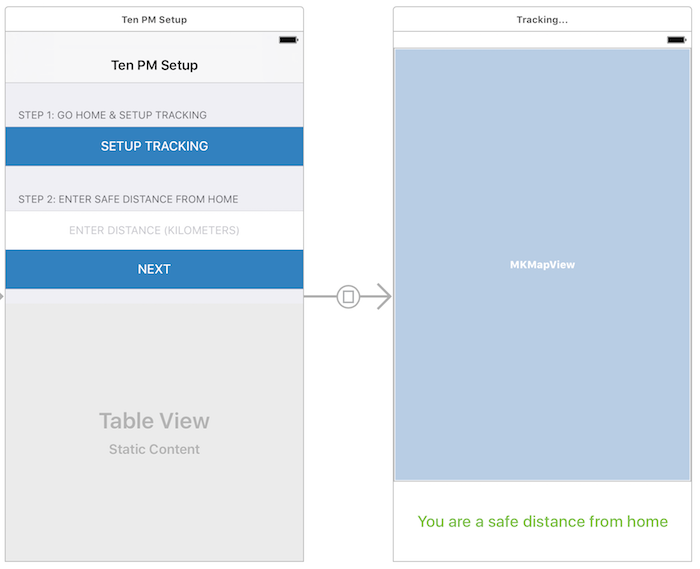

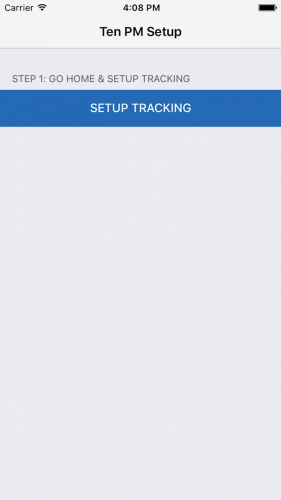

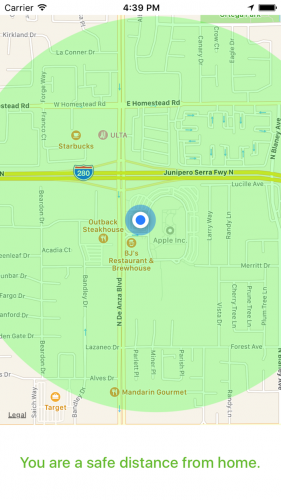

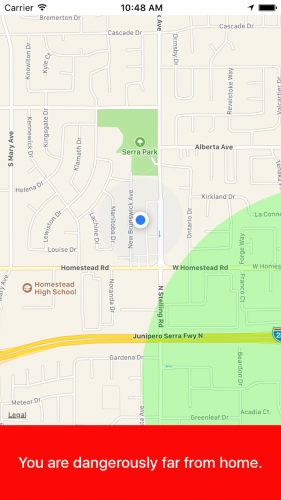

Вы собираетесь создать приложение для отслеживания ваших детей. Если они отходят слишком далеко от дома, приложение будет предупреждать их.

Это приложение названо Ten PM (Вы знаете где ваши дети?).

Откройте TenPM.xcworkspace и посмотрите проект. Теперь откройте Main.storyboard и вы увидете два view controller'а внутри navigation controller'а: