Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Поиск пакетов Go на PowerShell |

Всем привет! Одним из моих любимых языков является Go, в результате чего я задумался о написании чего-то вроде Package Manager… Ну или хотя бы поисковика пакетов. Есть идея, пора бы сесть за разработку. Конечно же в первую очередь я подумал о Go как о инструменте для решения проблемы. Но, немного поразмыслив, решил дать шанс манящему меня PowerShell, за изучение которого я садился уже раза 3, но что-то меня постоянно останавливало (скорее всего лень и отсутствие проектов, которые можно было бы на нем реализовать). Что же, сказано – сделано. Данная статья рассчитана на людей, не знакомых с PowerShell, но имеющих опыт в программировании. Если вам стало интересно, то добро пожаловать под кат.

Для начала было бы неплохо узнать, что такое PS. Википедия говорит следующее:

Теперь можно приступать к делу. Первая проблема, с которой столкнутся новички – это запрет на исполнение сторонних скриптов. Ребята из Microsoft пекутся о нашей с Вами безопасности, но мы же понимаем, что делаем ;). Так давайте исправим эту досадную заботу. Откройте окно PowerShell, которое выглядит примерно так:

И выполните следующую команду:

Set-ExecutionPolicy RemoteSigned

Система спросит у вас, осознаете ли Вы то, что делаете, отвечаем утвердительное Y.

Вообще основой PowerShell являются командлеты. Они имеют следующий синтаксис:

<Глагол>-<Существительное>

Это довольно удобно, так как вводит понимание того, что должно произойти. Помимо командлетов имеются так же Alias’ы для большинства стандартных команд, причет не только CMD, но и Bash. Например, Вы хотите очистить экран. Стандартный командлет для этого Clear-Host, но также можно воспользоваться алиасами для него: cls и clear. Со списком алиасов можно ознакомиться командой Get-Alias.

И так, мы произвели базовую настройку PowerShell и пришло время для написания скриптов. Расширением скриптов PowerShell является “*.ps1”. Создадим файл для разработки наших командлетов командой:

New-Item -Path 'C:\work\goPS.ps1' -Type File -Force

Если с параметром -Path все понятно, то с остальными придется разобраться. -Type указывает тип создаваемого файла, так как нам нужен файл, мы явно указываем это. -Force же создает пути, если они не существуют.

Вопросом: откуда брать список модулей для Go? Ответ: нам в этом поможет ресурс Go-Search, который предоставляет очень удобное, а главное бесплатное API. Спасибо им за это.

Можно переходить в любимый редактор кода, но лично я могу посоветовать Вам использовать PowerShell ISE, любезно предустановленный в систему. Нужно создать каркас нашего модуля:

function Find-GoPackage {

}

Это наш будущий командлет. PS вещь не простая, в отличии от Bash и CMD оперирует объектами, а не строками, что очень удобно при работе с конвейером. Каркас есть, теперь займемся параметрами. Переменные в PS задаются аналогично PHP с помощью $my_var. При этом они могут быть как нетипизированные, так и типизированные.

# Нетипизированная

$no_type

# Типизированная, строка

[string]$have_type

Объявим блок аргументов:

[CmdletBinding()]

Param (

[string]$Name = ""

)

Как видно, задать аргументы проще простого, да и еще значение по умолчанию есть.

Сама логика работы следующая. В первую очередь нам необходимо произвести запрос на сервер. Сделать это можно несколькими способами, но, как по мне, самый простой это использовать Invoke-WebRequest, который вернет нам объект с содержимым ответа.

Введем переменную:

$uri = "http://go-search.org/api?action=search&q=" + $Name

PowerShell поддерживает работу с конвейером. Ответ от сервера приходит в виде json, но спасибо добрым людям, которые уже подумали о нас. В PS есть стандартные сериализаторы и десериализаторы объектов. ConvertFrom-Json принимает в себя строку Json и возвращает “сырой” объект с полями нашего json. Хватит слов, больше кода, а кода будет мало.

$hits = $($(Invoke-WebRequest -Uri $uri).Content | ConvertFrom-Json).hits

Мы передаем нашу ссылку в инвокер, берем из него содержимое ответа из поля .Content и передаем по конвейеру (конвейер это “|”) в ConvertFrom-JSON. Нас же, в свою очередь, интересует поле .hits, которое содержит список найденных модулей. Всего одна строчка выполнила всю работу за нас!

Осталось только вернуть наш список, ну это уже совсем просто:

return $hits

Привожу полный листинг:

function Find-GoPackage {

[CmdletBinding()]

Param (

[string]$Name = ""

)

$uri = "http://go-search.org/api?action=search&q=" + $Name

$hits = $($(Invoke-WebRequest -Uri $uri).Content | ConvertFrom-Json).hits

return $hits

}

Теперь снова перейдем в PowerShell и импортируем наш модуль в сеанс:

PS C:\ >. “C:\work\goPS.ps1”

PowerShell проанализировал наш скрипт и готов к работе.

Выполните, например, команду “Find-GoPackage -Name json” и получите список найденных модулей для работы с json, ну а для красоты можно еще и форматирование добавить:

Find-GoPackage json | Format-Table -Wrap -AutoSize

Имеем на выходе аккуратную табличку.

Правда импортировать каждый раз модуль не удобно, поэтому можно сделать одну интересную вещь: в PS есть система профилей. Профиль – это файл, который исполняется каждый раз, когда вы открываете терминал.

Введите в PS следующее:

Test-Path $PROFILE

$PROFILE это переменная среды, содержащая путь до вашего файла профиля. Если команда выше вернула $false, значит ваш профиль не настроен. В таком случае выполните следующую команду:

New-Item -Path $PROFILE -Type File -Force

Откройте этот файл:

notepad $PROFILE

И скопируйте наш вышенаписанный код в файл, сохраните, перезапустите PowerShell и проверьте, что все работает.

На этом все, спасибо за внимание!

|

Метки: author pavelgeme2 системное администрирование powershell package management go golang |

[Перевод] Создание оффлайнового распознавания лиц с точностью 99,38% на Python и Node.js |

Это мой рассказ о том, как я создавал бесплатное, оффлайновое, работающее в реальном времени open source-приложение, предназначенное для помощи организаторам любых мероприятий в допуске/авторизации только приглашённых людей с помощью технологии распознавания лиц или QR-кода.

Если не терпится перейти сразу к коду, то вот мой репозиторий.

Так что да, распознавание лиц — лишь часть приложения, причём самая трудная часть. Так что налейте себе кофе и наслаждайтесь моим рассказом (я старался).

Часто встречаются посвящённые глубокому обучению проекты на Python, но не на Node.js. Причина в том, что под Python гораздо больше библиотек для эффективных вычислений, например, Numpy, Pandas, tensorflow и так далее. И разрыв достаточно велик. Я знаю Node.js, ну, немного знаю, и хотел использовать его в проекте, чтобы освоить получше, пока вожусь с машинным обучением.

Всё началось во время онлайн-соревнования, на котором был вопрос по работе с API AzureML (определение выражения лица). Я увидел, что там есть ещё и API для распознавания лиц, но с некоторыми ограничениями. К тому же сначала нужно загрузить изображение на сервис, затем он вычисляет результат и присылает его мне. По мне слишком медленно. Я хотел с ним поиграться, но в то время сервис был недоступен в моей стране. Так что хочу поблагодарить разработчиков, которые натолкнули меня на идею сделать что-то своё. До той поры я лишь изучал то, что уже сделали другие. У меня были определённые сомнения с точки зрения безопасности, нужна была функция бэкапа. К тому же я прочитал статью моего шефа об изучении нового языка. И подумал, что настала прекрасная возможность применить свои знания в совершенно новом проекте.

Хорошо, и что дальше? Я подключил к своему Macbook шнур питания, потому что понимал, что это будет долгая работа, и взял с собой своего приятеля Google на разгульные поиски лакомых ресурсов, с которых можно начать проект. Оказалось, что люди уже спрашивали в сети, можно ли реализовать то, что я задумал, но толковых ответов не было. В то время я был один на один с этой задачей. Потом наткнулся на отличную серию публикаций Адама Гайтгея. Раньше я читал его блог, но потом как-то увлёкся другими вещами. И тут наткнулся на замечательную статью Адама и узнал, что он создал на Python пакет face_recognition. Я скачал его и протестировал. Ну, работал он не так гладко, как хотелось бы.

Так я себя ощущал, когда устанавливал dlib. Не знаю, почему, но возникла проблема с установкой на самом последнем этапе. Я потратил много часов, пытаясь выяснить причину, даже не пошёл в тот день в спортзал.

Я был на грани того, чтобы забросить проект. Но потом выяснил, что причина была в конфликте из-за пути Python-пакета anaconda, или что-то типа того. Я всё ещё изучал экосистему, поэтому пришлось решать, оставить ли anaconda и забросить проект, или избавиться от «змеи». В конце концов я совсем убрал anaconda, и потратил день на завершение полного удаления разных версий Python, скачанных разными пакетами, оставив только системную версию. Затем с помощью Homebrew корректно скачал Python3, установил dlib, и к концу дня смог её запустить.

Тут возникла новая проблема: как интегрировать библиотеку в Node.js? Снова я встал перед дилеммой: изучать Python-фреймворк вроде Django, Flask и так далее, чтобы продолжать работу над проектом, или ввязаться в потенциально бесконечную задачу, которая может оказаться вообще нерешаемой. Когда-то я прочитал эту фразу и она всплыла у меня в голове:

Правило математики: если это выглядит простым, значит вы делаете неправильно.

Фраза вдохновила меня наравне со статьёй шефа, так что я решил продолжать с Node.js, который немного знал по некоторым веб-проектам.

Поэтому я снова занялся поиском способов интегрирования Python и Node.js. Узнал о дочерних процессах (child process) в Node.js. Но моя ситуация выглядела так:

Читал документацию со скудными примерами. Читал блоги, и везде был одно и то же. Но на этот раз я намеревался завершить проект любой ценой (читай, с помощью стажировки). Поскольку уже близилось начало сезона стажировки, мне нужно было как можно скорее закончить приготовления. К тому же мне необходимо было достаточно времени для создания следующим летом другого такого проекта, но опять самостоятельно, с помощью одного лишь Google. Если вы немного знакомы с машинным обучением, то вам будет это близко:

Если скорость обучения слишком низкая, то достижение оптимума займёт немало времени, или вы застрянете на локальном минимуме. Если скорость слишком высокая, то вы можете промахнуться. Но если скорость правильная, или регулируется в зависимости от условий, то алгоритм достаточно быстро найдёт оптимальную точку.

Для меня, как для алгоритма, стажировка была правильной скоростью обучения. Так что мне нужно было закончить проект.

Так что я усердно трудился, иногда работал до 5.45 утра. Это было удивительное время, я совершил немало дурацких ошибок. Не обновлял вкладку, когда менял код на сервере. Несколько раз менял код на клиенте, но не обновлял окно. Не знаю, почему, может быть, слишком хотелось спать, при комфортной температуре в 22 градуса Цельсия в моей уютной постели. Были удивительные моменты, вроде поиска на Stackoverflow ненужной логической ошибки, которую я позднее пофиксил, просто обновив вкладку.

Наконец я смог подружить Python и Node.js.

После того случая с AzureML я испытывал благоговение при создании полностью оффлайнового веб-приложения, способного делать всё задуманное безо всякого интернета. Мне пришлось находить альтернативные API или делать их самому. Как вы, наверное, знаете, в информатике это в порядке вещей: время обратно пропорционально пространству. Так что я старался минимизировать время, затрачиваемое на обеспечение работы тех или иных вещей. Отправка фото/видео в облачный сервис занимает время и канал, а значит приходилось увеличивать занимаемое пространство. Хотя облачные сервисы гораздо удобнее, но мне нравится писать много кода, если я делаю то, что мне интересно. Вы можете принять это, прочитав инструкции по установке для моего репозитория.

Я нашёл много пакетов, пробовал один за другим, брал в работу, иногда отбрасывал и снова искал. Например, нужно было интегрировать распознавание QR-кодов в качестве запасного варианта на случай сбоя распознавания лица. Существует много пакетов для генерирования кодов, но не для их сканирования. В конце концов я нашёл пакет Instascan. Натерпелся с ним бед. Дело в том, что я использовал OpenCV3 для распознавания лица в Python, и той же камерой (в ноутбуке она единственная) сканировал QR-коды. Для сканирования мне нужен был маленький видеокадр, но при этом изменялся и размер видео для распознавания лица. Ну, это не казалось какой-то проблемой. Я могу остановить процесс распознавания, выполнить сканирование QR-кода и снова запустить. Довольно просто, да? Но если вы читали внимательно, то заметили два момента:

- Если это выглядит простым, значит вы делаете неправильно.

- Я пытаюсь минимизировать время (главная причина, чтобы не ждать, когда станет доступен API).

Так что для решения этой проблемы мне пришлось изучить код пакетов и выполняемые ими процессы.

Парсинг библиотек

Да, я приступал к этой задаче три раза — анализировал библиотеки, чтобы разобраться со всякими сложностями. По крайней мере, сложностями для меня.

- Изучал работу пакета face_recognition, чтобы адаптировать его для своих целей. В то же время помог другим.

- Изучал маленький Instascan чтобы понять, как он работает с камерой, и как вообще работать с камерой веб-приложению. Есть много случаев, которые нужно обрабатывать: что если пользователь каким-то образом остановит работу камеры, например, кликнув мимо модального окна или вообще закрыв его. Я изменял код, много раз запускал его, каждый раз находя несколько багов. Однажды у меня на Mac практически кончилась память, и я подвис на несколько секунд. После многократных попыток я наконец-то добился успеха, но опять нашёл очередной баг.

- На этот раз баг был в модальном окне фреймворка Materialize. Коллбэк не работает. Погуглил, покопался на Github и Stackoverflow — решения не нашёл. Вычислил отвечающий за баг код, попытался в нём разобраться, несколько раз прогнал его с выражениями console.log(), стараясь понять, что происходит, всё ближе подбираясь к багу, по частям изолируя код (почувствовал себя хакером, обходящим пароль). Слышал, что формы в этом фреймворке тоже не слишком хороши, так что поиграюсь с ними в другом веб-приложении.

Event++

Это удивительный баг, возникший из-за jQuery. Количество событий увеличивается с каждым кликом: 1, 2, 3, 4, 5, 6, 7, 8… Мои уведомления в реальном времени полностью забили весь правый столбец, в который они выводились. Выяснилось, что в jQuery я использую on() вместо click(), а также использую события socket.on() вне обработчика.

Наконец, после долгой борьбы, серверная часть начала неплохо работать с клиентской.

Я подумал, что всё готово. Но тут меня посетила идея: что если добавить поддержку базы данных, чтобы пользователь мог выполнять CRUD-операции. Я хотел оставить на усмотрение пользователей, что им использовать: SQL или NoSQL. Думал, что добавлю поддержку и, кто знает, смогу делать на этом деньги (можно слишком рано начать витать в облаках, добившись небольшого успеха). Ещё чуть чуть, и у меня будет полноценная функциональность для автоматического учёта приходящих/уходящих посетителей (распознавание лица, сканирование QR-кода, отсутствие ограничений по API, трёхшаговая аутентификация). Но:

- Я всё узнал от open-source сообщества.

- Не думаю, что могу продавать свой продукт, стучась в разные компании. Для этого я слишком ленив. Я бы предпочёл разработать ещё несколько подобных продуктов.

- Представил сцену из фильма «Социальная сеть» в которой Марк написал приложение и выложил в свободный доступ, даже хотя у него были хорошие предложения о приобретении (думаю, от Microsoft), а тут я такой красивый, с маленьким веб-приложением, которые даже не написал с нуля.

Я попробовал интегрировать MongoDB, потому что был с ней немного знаком, и к тому же я ещё не изучал SQL в колледже. Это будет только в следующем семестре. Так что реализацию этой фичи я оставил для другого проекта, возможно, форка или портирования этого.

В общем, я разработал, интегрировал, потратил несколько дней на изучение, применение, отладку и так далее.

Наконец, я увидел это:

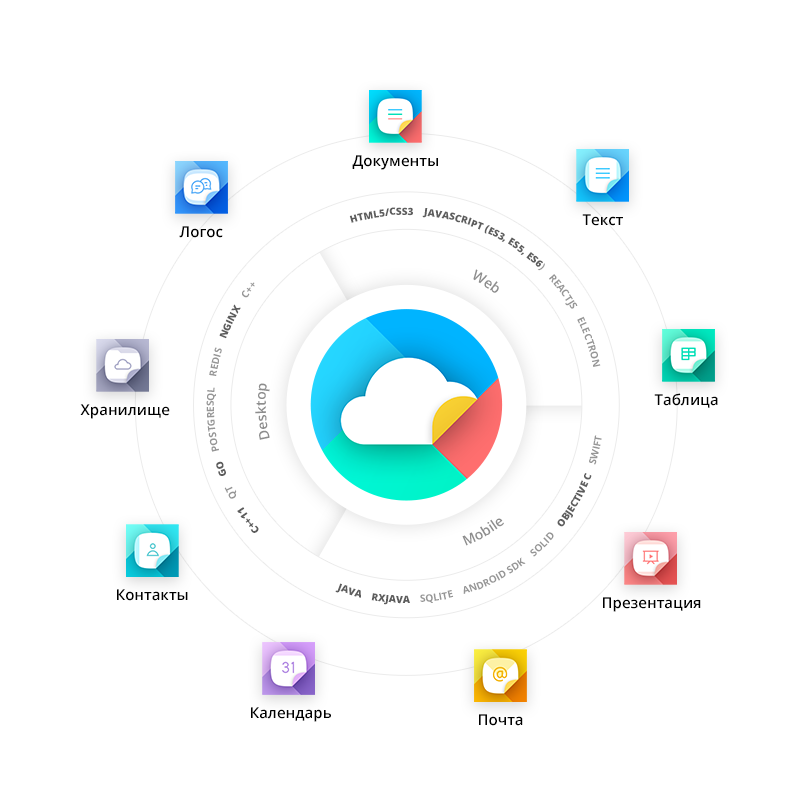

Фронтенд, бэкенд и база данных работают в унисон. Конечно, в центре — серверная часть (объединившая в себе силу Python и Node.js). Вы можете решать и другие задачи, например, обучать модель, потому что я смог интегрировать OpenCV3 (это требует установки бинарников), face_recognition, numpy, pandas с датасетом, и сохраняю результат в .csv-формате в моём Python-процессе. Так что если у вас есть подходящее железо, то можете сделать на основе моего проекта что-то совершенно другое.

Оставляю на ваше усмотрение, кто на гифке фронтенд, а кто база данных.

Signing.Off();

* * *

Ссылка на проект.

Почему я написал этот текст, хотя моя кодовая база не так велика? Что тут такого? Ну, для многих из вас это лишь несколько сотен строк кода, но для меня интегрирование всех частей, планомерное изучение, обновление имеющихся знаний, самостоятельное исправление одного база за другим в этом бессрочном проекте (для меня) — всё это задача, которую никто ещё не решал (машинное обучение на Python и Node.js). Ну, может я и плохо искал. В общем, для меня это большой проект. Надеюсь, кому-нибудь он будет полезен. Кроме того, этот пост я написал, чтобы оживить в памяти моменты разочарования и временного счастья, когда что-то ломалось или работало. Такова жизнь.

|

Метки: author Raiffeisenbank исследования и прогнозы в it блог компании райффайзенбанк распознавание лиц оффлайн |

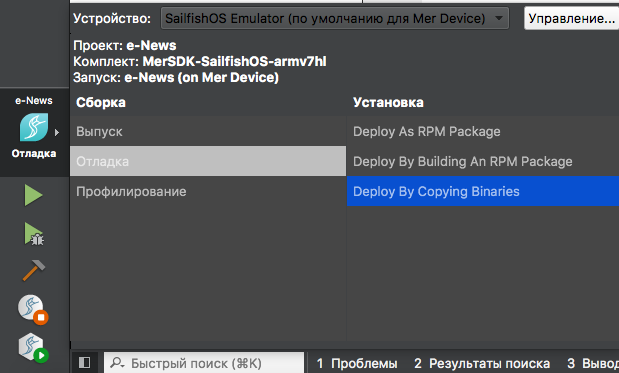

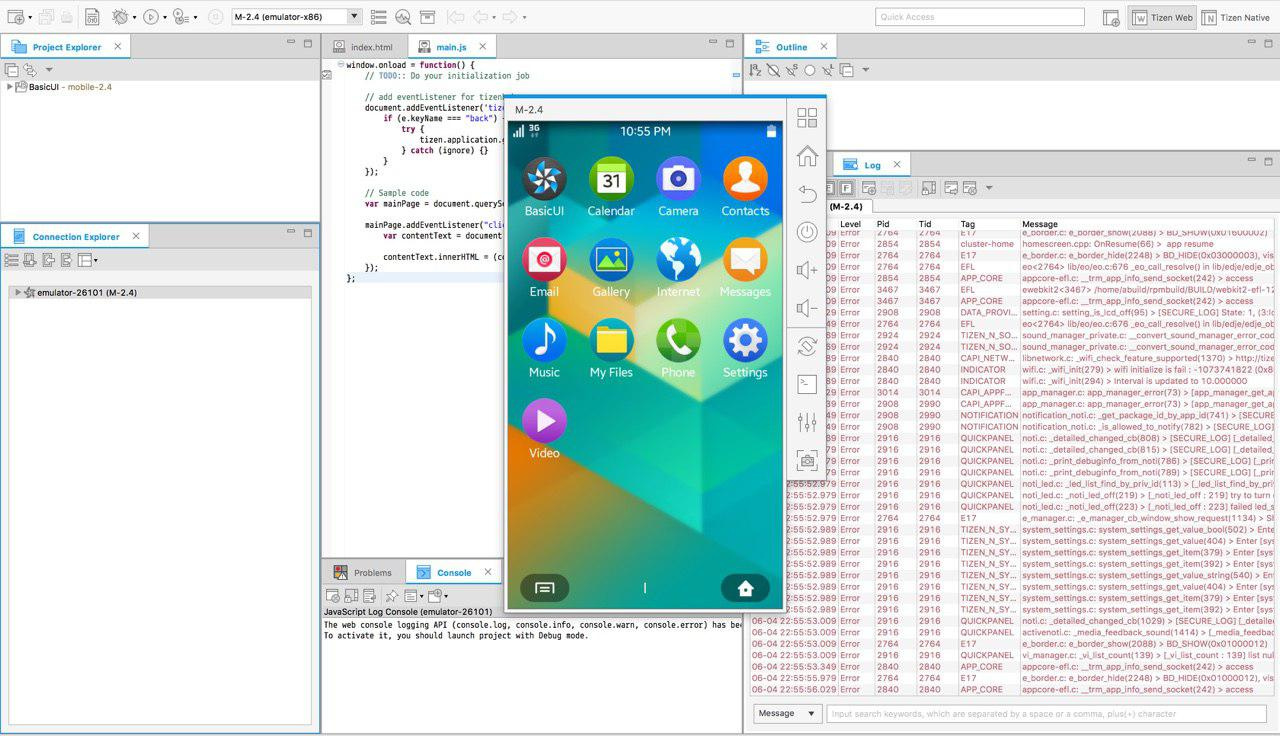

Разработка под Sailfish OS глазами iOS-разработчика |

На днях в офис e-Legion попал очаровательный смартфон, цвета #F9403E. По опознавательным знакам удалось установить его модель — Jolla C и операционку — Sailfish OS. Сайт производителя снабдил нас данными о характеристиках устройства и предоставил информацию о том, с чего начинать разработку.

Под катом вы узнаете о том, как происходил процесс создания, отладки и установки мобильного приложения для Sailfish ОС.

Характеристики для смартфона 2016 не выдающиеся, но ведь дело не только в железе, но и в том, как реализован софт.

Для ОС заявлена поддержка Android-приложений, но зачем заниматься портированием, если можно написать «шедевр», используя нативные средства для разработки.

Spin-Off: кому и зачем это нужно

В Индии и Китае крупные корпорации сотрудничают с Jolla, разработчиком Sailfish OS, для создания альтернативной ОС, которая позволит избежать проблем безопасности и лицензирования, имеющихся у Android. Также внимание акцентируется на новом UX/UI как возможности для привлечения покупателей, которые используют другие платформы. В России решили взяться за разработку под Sailfish с акцентом на государственный сектор и правительственные нужды. С этой информацией вы можете ознакомиться в других статьях на Хабре или на официальном сайте.

Среда разработки

Когда я начинал разработку для iOS, пришлось столкнуться с некоторыми сложностями. Наличие устройства под управлением Mac OS X — обязательное условие для XCode. У меня его не было. Варианта было два: хакинтош или виртуальная машина.

Теперь же macOS является моей основной операционной системой, поэтому наличие на сайте Jolla SDK, протестированного под Mac OS X, меня приятно удивило. А флешка с установщиком Windows так и осталась пылиться в столе.

Также заявлена поддержка и других платформ:

- Ubuntu 14.04 32/64 bit

- Windows 8 32/64 bit

- OS X 10.9.2

И снова линк на официальный сайт:

- Устанавливаем VirtualBox (понадобится для запуска симулятора)

- Скачиваем дистрибутив Sailfish SDK

- Выбираем компоненты для установки

- Соглашаемся с лицензионными соглашениями

- ...

- PROFIT!!!

Процесс очень простой, каких-либо «танцев с бубном» не понадобилось. Установщик самостоятельно настраивает связь с виртуальной машиной и активирует необходимые компоненты для отладки приложения.

В качестве среды разработки используется Qt Creator.

IDE не такая функциональная, как XCode из коробки, зато крашится реже и подсветка синтаксиса не отваливается :)

Код и язык

Для разработки используется QML — Qt Meta Language. Можно задействовать C++ или Python, если у вас больше опыта работы с этими языками.

Я выбрал QML, так как для реализации простого приложения его возможностей вполне достаточно. QML — декларативный язык программирования, с помощью которого описываются визуальные элементы и их взаимодействие. Синтаксис похож на JSON, код читать и воспринимать очень легко.

Для реализации базовых типов и элементов используется Qt Quick. Вы получаете:

- набор визуальных компонентов для ввода/вывода информации и возможности для анимирования этих компонентов

- инструменты для работы с сетью и локальными хранилищами данных

- средства для биндинга и обработки сигналов

По аналогии с iOS и Android, данную информацию я искал на сайте производителя. Как оказалось, для этих целей лучше подходит сайт Qt. doc.qt.io Он содержит больше документации и примеры кода там интереснее.

Jolla предлагает разработчикам использовать собственный QML-модуль “Sailfish Selica”. Модуль предназначен для создания элементов со стилистикой Sailfish. С этими компонентами можно ознакомиться из предустановленного приложения Components.

Также он служит для оформления приложения в цветах, соответствующих основной выбранной для смартфона теме.

Label {

text: "Hello habrahabr!"

color: Theme.highlightColor

x: Theme.horizontalPageMargin

width: parent.width - x*2

font.pixelSize: Theme.fontSizeSmall

wrapMode: Text.Wrap

}

Концепция чем-то напоминает использование UIAppearance из iOS, только настройки не ограничены рамками приложения.

Создавать интерфейс из стандартных элементов иногда даже проще, чем в iOS. Создаем кнопку, указываем положение и смещение относительно других элементов. Готово. Пожалуй, с той же легкостью мне удалось работать с интерфейсом только начиная с iOS 9, когда был добавлен класс NSLayoutAnchor.

К сожалению, не всё так хорошо с кастомизацией — в большинстве случаев придётся создавать элемент самостоятельно. Стабильность некоторых компонентов тоже не на высоте. SilicaWebView так и не удалось добавить в приложение, оно постоянно падало. Вместо этого я использовал стандартный WebView, входящий в состав QtWebKit.

При работе с web возникли и другие проблемы. Я запустил приложение на следующий день после начала разработки и вместо списка новостей увидел пустой экран. Несколько часов ушло на поиски решения проблемы. Как оказалось, приложение и встроенный в ОС браузер перестали загружать данные по HTTPS. Пару минуты меня мучила совесть, после чего HTTPS превратился в HTTP.

function requestUrl(source) {

var url = "http://newsapi.org/v1/articles?"

url += "source=" + source

url += "&apiKey=" + apiKey

return url

}

if (status === XMLHttpRequest.DONE) {

var objectArray = JSON.parse(req.responseText);

if (objectArray.errors !== undefined) {

console.log("Error fetching tweets: " + objectArray.errors[0].message)

} else {

for (var key in objectArray.statuses) {

var jsonObject = objectArray.statuses[key];

news.append(jsonObject);

}

}

if (wasLoading == true) {

newsObject.isLoaded()

}

}

Что касается остальных модулей приложения, их реализация не вызвала особых сложностей. Берём зарекомендовавший себя паттерн MVC, добавляем немного биндинга, щепотку делегирования, обильно посыпаем анимацией, перемешиваем… Получаем на выходе новостное приложение, написанное за пару ночей в попытках попробовать себя в разработке под новую платформу.

Симулятор (emulator) и реальный смартфон

Как я писал ранее, процесс запуска приложения практически не вызвал проблем. Перед установкой SDK размещаем на компьютере поддерживаемую версию VirtualBox, а установщик позаботится обо всём остальном.

Далее выбираем платформу для запуска, жмём кнопку Start и запускаем приложение.

Работа симулятора не вызывает нареканий: всё происходит стабильно и быстро. В своё время мне выпал шанс поработать с одной из первых версий симуляторов Android, 5-минутный запуск которого вызывал боль и приступы паники. Да, сейчас дела у него обстоят гораздо лучше, но осадок остался.

Небольшие проблемы, правда, возникли при многократном запуске приложения. Старые инстансы приложения не завершаются, в результате чего у вас оказывается 5-9 одновременно запущенных экземпляров программы. После достижения некоторого максимального числа новая версия не стартует, приходится завершать старые экземпляры вручную.

Запуск отладки на устройстве занял чуть больше времени. Соответствующую документацию обнаружить не удалось, а подключение смартфона к компьютеру не приводило волшебным образом к появлению соответствующего таргета в настройках. Впрочем, опыт сисадмина-эникейщика не прошёл зря. Побродив по настройкам и понажимав все подходящие, кнопки, я обнаружил возможность запуска приложения на устройстве с указанным IP-адресом. Подключил телефон к WiFi-сети, ввёл адрес и снова нажал на Start. Две минуты ожидания, и моя программа запустилась на Jolla C. Apple услышала наши молитвы и связка Xcode 9 + High Sierra + iOS 11 позволит нам творить такие же чудеса.

Впечатления

Не буду рассказывать о перспективах данной платформы в России, на эту тему и так хватает статей, да и начинать очередной холивар не хочется.

Как пользователю мне понравилась отзывчивость устройства, возможность взаимодействовать с приложением прямо с главного экрана, изменение оформления всех приложений после изменения главной темы и интуитивно понятный интерфейс.

С точки зрения разработчика также осталось множество положительных впечатлений.

Порог входа достаточно низкий, за пару дней удалось создать простое, но функциональное приложение. При этом есть возможность использования C++ для более ресурсоёмких и сложных задач, удручает лишь скупая документация на сайте производителя.

Интерфейс и UI-элементы легко реализуются, вот только не хватает указаний и видения со стороны Jolla. Вместо гайдлайна на сайте я обнаружил 1 страницу, посвященную UX, основная идея которой выражается тремя словами: “Simply Beatiful, Logical, Magical”. Зато какое раздолье для дизайнеров! Можно воплощать в жизнь самые смелые идеи.

Буду рад знакомству с Sailfish-разработчиками и вашим отзывам об этой статье!

Приятного дня и хорошего кода!

|

|

Модульное тестирование Pega-приложений: меняем жизнь к лучшему с Ninja |

На Хабре я нашел всего одну статью, посвященную платформе Pega. А между тем Pega ежегодно получает высокие оценки в самых авторитетных рейтингах BPM-решений и CRM-приложений.

Развивая тему работы на Pega, предлагаю вам перевод своей статьи о Ninja – инструменте для тестирования приложений Pega. По ходу комментирую терминологию, которую использовал в этом материале.

В 2015 году я участвовал в автоматизации процесса кредитования корпоративного блока на платформе Pega в одном из крупнейших финансовых институтов России и Восточной Европы.

На одном из этапов проекта команда опоздала с выпуском очередного релиза. Стало очевидно, что в столь сложном проекте необходим альтернативный подход к автоматизированному тестированию, позволяющий выявлять возможные дефекты на ранних сроках. Тогда мы решили перенести практики, применяемые в Java-проектах, на платформу Pega. О том, что из этого вышло, и пойдет речь в статье.

Однажды что-то пошло не так

Чтобы вы могли представить масштаб системы, скажу, что к февралю этого года она достигла размера более 32 тысяч рулов (rule – единица построения приложения на платформе Pega, в Java это может соответствовать методу/классу, но аналогия грубая). Сейчас ее развивают три независимые команды, которые производят более четырех тысяч чекинов в день.

В 2015 году мы вместе с коллегами из «ЛАНИТ – Би Пи Эм» завершали очередной этап проекта и готовили релиз, содержащий множество сложных интеграционных взаимодействий с back-end системами заказчика.

Проблемы начались неожиданно. Системное тестирование выявило ряд ошибок в интеграционных сценариях.

Да, я, конечно, в курсе, что в российской индустрии разработки корпоративного ПО нет единодушия в трактовке и применении данного термина. Поэтому оговорюсь, что системным тестированием я здесь буду называть тестирование всех приложений, задействованных в реализации бизнес-процесса.

Итак, до завершения системного тестирования оставалось две недели, и за это время команды всех взаимодействующих систем должны были исправить свои приложения. Пусть в этом контексте «системы» и «приложения» будут синонимами.

Список ближайших задач напоминал обычную проектную рутину. Нужно было:

- выделить проблемные интеграционные сценарии;

- выявить конфликты в интеграционных спецификациях со стороны разных систем, ставшие причиной неработающих интеграционных сценариев;

- в каждом отдельно взятом случае договориться, на чьей стороне исправлять спецификации и реализацию;

- исправить и выпустить обновления по всем приложениям.

Список сценариев, которые требовали исправлений на стороне нашей системы, не был коротким, но и не казался пугающим. Исправление интеграционного слоя нашего приложения заняло неделю работы всей команды.

Никто из нас даже не мог себе представить, что исправление всех проблем, возникших после такой существенной переработки приложения, займет еще две недели и потребует бесчисленного количества циклов внутреннего тестирования. Сроки завершения данного (очень важного для заказчика) этапа проекта сдвигались. Нам нужно было найти решение, которое, хотя и не смогло бы помочь немедленно, предотвратило бы подобные ситуации в будущем.

Источник

Анализ проблемы

Мы проанализировали этот болезненный провал и выделили следующие основные причины.

- Из-за высокой сложности приложения невозможно было проверить, что изменения, внесенные в одном месте, не ломают что-нибудь в совершенно другом (абсолютно неожиданном) месте. Это стало причиной большого количества регрессионных дефектов.

- Описание компонентов приложения, которые мы вели на wiki проекта, не были привязаны к коду и часто были неактуальны – не описывали специфичное поведение рулов при определённых условиях. Таким образом, разработчики при использовании существующих компонентов не обладали достаточной информацией о том, как обрабатывать все возможные исключения или специфичные возвращаемые значения.

- Разработчики фокусировались на обработке основных сценариев, оставляя не реализованными альтернативные ветки, обработку ошибок или поведение при отсутствии данных.

С учетом нашего опыта в Java мы прекрасно понимали, что подобные проблемы в Java-проектах обычно решаются с помощью известных практик: модульного тестирования, test-driven development и continuous integration. Нам показалось логичным применить данные практики в нашем Pega-проекте.

Проектирование модульных тестов

Мы решили начать с покрытия модульными тестами интеграционного слоя приложения, т.к. он был самой сложной частью нашего приложения и порождал до 80% всех дефектов.

Типовой интеграционный компонент нашего приложения состоял из 6 основных элементов.

- Connect activity – основной элемент, который объединял все остальные элементы и служил точкой входа для вызова интеграции из различных частей приложения.

- Request mapping data transform заполнял запрос на основе бизнес-данных.

- Stream XML преобразовывал запрос из интеграционной модели в XML.

- Connector rule взаимодействовал с внешней системой по требуемому протоколу.

- Parse XML разбирал XML ответа и преобразовывал его в интеграционную модель данных.

- Response mapping data transform преобразовывал ответ из интеграционной модели в бизнес-сущности.

Stream и Parse XML рулы обычно создавались автоматически с использованием Connector and Metadata Wizard вместе и интеграционной моделью данных. Connector рул специально оставлялся «тонким» за счёт перемещения всей логики в Connect activity. Наибольшее количество дефектов порождалось Connect activity и Request/Response mapping data transform, т.к. они содержали основную логику интеграционного компонента.

С учетом описанной выше архитектуры интеграционного слоя мы намеревались создать следующий пакет тестов для каждой точки интеграции.

- Тест Connect activity в изоляции для проверки её логики, включая нестандартные ситуации.

- Тест Request mapping data transform в изоляции.

- Тест Response mapping data transform в изоляции.

- Тест на весь интеграционный компонент с целью проверки, что исходящий XML формируется, а входящий XML обрабатывается корректно (в соответствии со спецификацией).

Элементы на диаграмме раскрашены в соответствии с «забагованностью» и желаемой степенью покрытия тестами:

- красный – элементы, в значительной степени подверженные ошибкам, должны тестироваться в изоляции для достижения большего покрытия (модульные тесты);

- зеленый – элементы, менее подверженные ошибкам, при тестировании их достаточно проверить в связке с другими элементами (речь об inner-com тестах, то есть тестах внутреннего компонента в изоляции от внешних систем);

- серый – компоненты, которые вряд ли могут содержать ошибки и могут оставаться не покрытыми пакетом тестов.

Модульное тестирование средствами платформы Pega

Первое, что мы попробовали, были Pega Test Cases – автоматизированные тесты, созданные соответствующим инструментом платформы. Хотя они полезны для простых приложений, оказалось, что в проектах корпоративного масштаба их использование существенно ограничено: они не позволяют управлять уровнем изоляции зависимых рулов в тестах.

В нашем случае это означало, что мы не сможем выполнять тестирование в изоляции не только для Connect activity, но также и для Data transform, т.к. они могут использовать (и часто используют) Data Pages, которые, в свою очередь, используют другие рулы в качестве источника данных (Activity, Report Definitions, другие Data Transform и т.д.).

Таким образом, модульное тестирование от Pega подходило для реализации только одного из четырех типов тестов – inner-com тестов. Более того, это было возможно только благодаря механизму Integration Simulation, который, в свою очередь, создавал проблемы части гибкости и сопровождения тестов.

Описанное выше ограничение было не единственным, что нас беспокоило в модульных тестах от Pega.

- До выхода Pega 7.2 (в тот момент мы использовали Pega 7.1.8) не было удобного способа управления подготовкой данных для теста и проверкой результатов. Побочным эффектом данного ограничения была необходимость пересоздания всех тестов после существенных изменений рулов.

- Низкая степень повторного использования кода тестов: даже с учетом существенных улучшений в Pega 7.2, нет возможности разбить комплексные проверки результатов теста на отдельные блоки и использовать их в нескольких сценариях.

- Нет возможности писать комплексные тестовые сценарии, включающие вызов нескольких рулов и проверку общего результата их работы.

- Pega предоставляет поддержку модульного тестирования для ограниченного набора рулов (Data Pages, Activity, Decision Table, Decision Tree, Flow, Service SOAP).

С учетом всех этих проблем мы определенно нуждались в альтернативном подходе к автоматизированному тестированию.

Research & Development

Мы начали с подбора сильной команды ветеранов из Java и Pega проектов. Через мозговые штурмы и отзывы от проектных команд мы добились кристально чистого понимания того, какие функции нам нужны. Это:

- управление изоляцией рулов;

- Mock и Stub для рулов (аналогично Mock и Stub для классов в Java);

- декомпозиция сложных тестов на маленькие, повторно используемые блоки;

- запуск модульных тестов на любом современном build-сервере.

После нескольких месяцев прототипирования и реализации выпуcтили альфа-версию и начали её пилотировать на небольшой части кода приложения. Пилотирование показало успешность нашей задумки – тесты стали приносить пользу: помогли обнаружить несколько существенных дефектов при написании тестов, а также позволили своевременно выявлять регрессионные дефекты.

Приблизительно в течение года мы внедрили новый подход к тестированию на большинстве наших Pega-проектов. Созданному инструменту требовалось название, и оно появилось само собой – Ninja.

Источник

Модульное тестирование с Ninja

Ninja предоставляет Java библиотеку, позволяющую писать JUnit тесты для рулов. Таким образом, модульное тестирование приложения на платформе Pega становится таким же простым, как в Java.

Давайте немного подробнее остановимся на том, что делает Ninja таким удобным.

Во-первых, Ninja шифрует и безопасно хранит ваши учетные данные для подключения к среде разработки Pega (представляет собой web-приложение, известное как Pega Designer Studio) и выполнения тестов от вашего имени. Это позволяет тестировать приватную версию рула, находящуюся в checkout. Здесь на всякий случай поясню: платформа Pega позволяет брать рулы в checkout и вносить в них изменения, «видимые» только автору. После того как автор проверил внесенные изменения, он выполняет check-in. Затем изменения становятся «видны» всем.

Во-вторых, Ninja использует одну и ту же сессию для последовательных запусков теста. Это позволяет определить Requestor (сессию работы с системой), используемый Ninja, и подключиться к нему с помощью Tracer – инструмента для отладки в платформе Pega, который позволяет просматривать детальную информацию о выполняемых шагах и состоянии объектов в памяти. В данном случае Tracer необходим для анализа происходящего при выполнении тестируемого рула.

Таким образом, Ninja позволяет готовить тестовое окружение легко и точно.

final String myClass = "MyOrg-MyApp-Work-MyCase";

// prepare a Top-level page

preparePage("MyTopLevelPage").create(myClass)

.prop("pyLabel", "This is my top level page for a case")

.prop("MyProp", "My value");

// prepare parameter

prepareParameter("myParam").value("My param value");Вы можете определять заглушки для рулов, прямо или косвенно вызываемых тестируемым рулом. Это позволяет тестировать рулы в управляемой изоляции.

// mock nested activity invocation

expect().activity().className("MyOrg-MyApp-Work-MyCase").name("NestedActivity").andMock(new MockBehaviour() {

@Override

public void process(MockActivityContext context) throws Exception {

// assert parameters

context.assertParameter("myParam").value("My value");

// assert Primary page

context.assertPrimaryPage().prop("MyProp", "My value");

// assert Top-level page

context.assertPage("TopLevelPage").exists().prop("pyLabel", "This is my TLP");

// set properties in Primary

context.preparePrimaryPage().prop("pyNote", "My note for this page");

// set parameters on Top-level page

context.preparePage("TopLevelPage").prop("pyLabel", "This is MODIFIED TLP");

// set parameters

context.prepareParameter("myResult").value("Success");

}

}); //mock Obj-Browse method invocation

final String opClass = "Data-Admin-Operator-ID";

expect().objBrowse().page("OperatorList").className(opClass).andMock(new MockBehaviour() {

@Override

public void process(MockObjBrowseContext context) throws Exception {

// prepare result set

final PreparePageList pxResults = context.preparePage("OperatorList").prop("pxResultCount", "2").pageList("pxResults");

pxResults.append(opClass).prop("pyUserIdentifier", "info@pegadevops.com").prop("pyLabel", "Operator ID record");

pxResults.append(opClass).prop("pyUserIdentifier", "alexander.lutay@pegadevops.com").prop("pyLabel", "Operator ID record");

}

}); В тестовом сценарии вы можете вызвать практически любой рул, обладающий поведением в Pega. Модульное тестирование не применимо для долго живущих процессов и GUI, поэтому Ninja не поддерживает Flow, Flow Action, Section и другие связанные с GUI рулы.

// what about covering a Function with a unit test?

invoke().function().ruleSet("MyRuleset").library("MyLibrary").name("Func").args().string("My string").longO(123).date(new Date());

// would you like to unit test a When rule?

invoke().when().primaryPage("pyWorkPage").name("ToBeOrNotToBe");Вы можете всесторонне проверять результаты выполнения теста.

// assert activity status

assertActivityStatus().good();

// assert Clipboard state

assertPage("MyTestPage").exists().propAbsent("ErrorCode")

.prop("ResultCode", "0").propPresent("ResultDescription");

// assert Params

assertParameter("MyParam").value("Some value");Еще больше примеров можно найти в Ninja Cookbook на GitHub.

С помощью Ninja мы покрыли основные интеграционные сценарии модульными тестами.

- Мы тестируем Connect activity в изоляции за счет имитации (mocking) других рулов. Это помогло нам сфокусироваться в этих тестах на интеграционной логике и проверить все ветки, и в том числе исключительные ситуации.

- Трансформации данных были исчерпывающе проверены в изоляции от всех других рулов (Function, различные Decision рулы, источники данных для Data Pages), вызываемых прямо или косвенно из Data Transform рулов.

- Мы делали заглушки на Connector рулы, чтобы избежать вызова внешних систем из inner-com тестов, а также для проверки XML, формируемого компонентом.

Создавая нашу базу модульных тестов, мы смогли выделить несколько общих процедур по подготовке тестового окружения и проверке результатов выполнения тестов, на основе которых мы построили библиотеку повторно используемых компонентов для написания тестов.

Уверенность в качестве приложения

По состоянию на февраль 2017 года, кредитный процесс имеет несколько параллельных веток разработки: исправление дефектов, возникающих в рамках опытной эксплуатации (Prod-ветка), и несколько веток под разработку функционала будущих релизов.

Каждая ветка покрыта собственными модульными тестами, которые развиваются вместе с приложением. Тесты хранятся в системе контроля версий и также разделены на ветки. Prod-ветка по состоянию на февраль 2017 года имела 350 тестов. Позволю себе уточнить, что на момент перевода статьи, в июле 2017 года, ветка последнего релиза содержала уже порядка 1650 тестов, время выполнения которых не превышает 15 минут.

Модульные тесты запускаются build-сервером отдельно для каждой ветки каждые 30 минут. Это означает, что команда получает «отчёт о здоровье» системы каждые 30 минут и может своевременно реагировать на появляющиеся дефекты.

Ninja позволила нам быстрее выпускать продукт более высокого качества благодаря меньшему количеству циклов Dev-QA, т.к. большинство дефектов теперь обнаруживаются на Dev-среде и сразу устраняются.

Стало меньше дефектов в опытной эксплуатации – благодаря более всестороннему тестированию командой QA, которой теперь не приходится сталкиваться с тривиальными дефектами, блокирующими прохождения тестовых сценариев.

Продолжение следует

Наш опыт подсказал нам, что модульные тесты – не единственная «слабая» область платформы Pega: если сравнивать с Java или другими «традиционными» платформами разработки ПО, инструменты Pega, которыми могут воспользоваться разработчики, обладают существенными ограничениями.

С учетом фидбека от проектных команд и по результатам многочисленных мозговых штурмов мы определили функции, которые следующими появятся в Ninja:

- Rule Refactoring – рефакторинг рулов;

- Code analysis – расширенный статический анализ кода;

- Code review – аудит кода;

- Release automation – автоматизация сборок и поставок;

- Continuous delivery pipeline – конвейер continuous delivery.

Отмечу, что сейчас большая часть этих функций уже доступна в Ninja. Уверен, что подобные функции позволят Ninja стать всеобъемлющим инструментарием для внедрения DevOps на проектах Pega.

Нашим решением заинтересовались зарубежные коллеги, и я рад, что этот кейс может служить примером для других команд разработчиков: в России можно хорошо делать нишевые решения для крутых ИТ-продуктов и успешно их экспортировать.

Более подробную информацию о Ninja ищите здесь.

Сейчас у нас открыто несколько интересных вакансий:

Аналитик BPM

Старший аналитик BPM

Разработчик PEGA

Старший разработчик PEGA

Архитектор

Руководитель проекта

В заключение предлагаю вам небольшой опрос:

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author lutalex тестирование веб-сервисов тестирование it-систем блог компании гк ланит pega тестирование корпоративные приложения |

Red Team: командное взаимодействие при проведении тестирования на проникновение |

|

Метки: author LukaSafonov информационная безопасность блог компании pentestit корпоративные лаборатории pentestit red team |

[recovery mode] Тестирование прототипов при разработке программного продукта |

В процессе разработки мы часто сталкиваемся с такой дилеммой: как сделать продукт хорошо и быстро, но при этом интересным и понятным и пользователям, и заказчикам. Никому не хочется, чтобы сыпались миллионы одинаковых вопросов о том, как это вообще работает.

Рецепт есть: тестировать продукт перед выходом на рынок.

Конечно, можно тестировать и прямо перед самым релизом. Так делают многие компании: выпускают «бету», смотрят на реакцию, собирают фидбэк, потом правят баги. Хорошая практика, но бывает так, что пользователи не понимают всю основную функциональность, а не просто интерфейсные мелочи. И получается, что нужно всё перекроить, всё переделать. Или написать огромный мануал для пользователей, который никто, кроме конкурирующих разработчиков, читать не будет.

Поэтому нужно тестировать не в конце разработки продукта, а намного раньше, может даже в начале.

Тестирование прототипа поможет обмануть время и устранить глобальные проблемы в самом начале разработки.

Нам всегда хочется избежать тестирования прототипов, прикинувшись овощем. Зачем тестировать, если и так «всё понятно»? Это ведь займёт время разработки продукта и ещё добавит организационных проблем — тот же подбор людей на тестирование чего стоит. И помещение нужно где-то взять тихое, и еще быть добрым со всеми респондентами, даже когда они, мягко говоря, несколько не ориентируются в происходящем. Кажется, что можно вычеркнуть этот небольшой «эпизод», сберечь ресурсы, и никто не заметит даже. И всё будет хорошо!

Но так не работает.

В реальности лучше потратить 30 минут на тестирование прототипа на пользователях, чем сделать дизайн, сверстать, запрограммировать, а потом обнаружить, что нужно все [censored] переделывать!

Пусть даже респондентами будут сотрудники компании, главное, не те, что отвечают за дизайн продукта.

Есть несколько проверенных временем и опытом способов тестировать продукт: начиная с этапа, когда он существует только в виде набросков, и заканчивая тестированием прототипа на пользователях, которые будут думать, что это уже готовый сайт в работе, и никакой не прототип. Иногда оно так и есть, правда.

Бумажный прототип

На бумаге идеально тестировать концепты, когда есть доступ к целевой аудитории и несколько человек для проведения исследования. Лучше всего тестировать сложные сценарии с множеством экранов, миллионом кнопок — в общем, что-то такое, что можно аналогично протестировать только на готовом продукте.

Да, прототип будет очень далек до реального результата, но зато у респондентов не будет возникать вопросов: «почему фотка не моя», «почему я нажал на картинку кроссовок, а появился ремень», «почему нет красивой анимации у этого окошка», «почему скролл не двигается», «почему тут кнопки кривые» и т. д.

Все понимают, что это бумага, и не возникает странных вопросов по поводу её интерактивности. Да, не очень похоже на вылизанный конечный продукт, но позволяет выявить громадные косяки в функциональности, взаимодействии с интерактивными элементами, навигации по интерфейсным решениям и экранам, и в понимании значений кнопок.

Из опыта

Однажды делали проект единого дизайна сайта муниципальных округов. Сначала провели исследования, чтобы понять, что можно размещать на сайте, что нельзя. Затем определили, что будет важно посетителям, а что нет, но по закону обязательно должно быть на сайте.

Сделали прототипы на бумаге: все экраны и окна. И провели тестирование на бумаге, с тремя участниками тестирования с нашей стороны:

- один «робот»,

- один модератор,

- один наблюдатель.

Модератор предлагает решить сценарий, ведёт респондента, наблюдатель внимательно следит за респондентом, записывает свои наблюдения и молчит, «робот» подкладывает нужные листочки с интерфейсами, молчит и не проявляет никаких эмоций (работа у робота такая).

Вначале нам казалось, что респонденты не поймут этот вид прототипа. Сложно представить депутата, «кликающего» на бумажные кнопки, листающего бумажные списки и карты.

Но внезапно всё пошло хорошо. Пользователи кликали прототипные кнопки, скроллили страницу, переходили по вкладкам и искали информацию в поиске. То есть действительно «работали» с бумажным прототипом. Да, немного непривычный, но вполне рабочий процесс.

Первый плюс в том, что нарисовать бумажный прототип можно за 3 часа, а вот спроектировать прототип в программе — это минимум день. А то и два. Потом понадобится вставлять контент, выравнивать всё, готовить под тестирование.

Второй плюс: если во время тестирования что-то не так «работает», на бумаге это быстро исправляется карандашом и ластиком — и можно тестировать дальше. И интернет для этого не нужен.

Кроме того, у людей не возникало отторжения, непонимания или негатива на такое тестирование. Всё было чётко и по делу. У нас получилось выявить немало косяков в навигации и взаимодействии пользователя с сайтом.

Интерактивные прототипы в мелкой детализации

С помощью интерактивных прототипов хорошо тестировать логику, особенно простую, а также ожидания пользователей. Конечно, можно взяться и за сложную навигацию, но придется потрудиться с количеством и качеством экранов. Респондент зачастую не воспринимает интерактивный прототип как прототип, поэтому ему приходится постоянно об этом напоминать.

Для чего плохо подходят такие прототипы:

- для тестирования сложной логики с серьезными скриптами и анимацией;

- для оценки визуального дизайна, о котором не выскажется разве что самый ленивый респондент.

Контент в таких прототипах должен быть максимально приближен к реальному.

В интерактивных прототипах не должно быть Lorem Ipsum, стандартных картинок с горами Axure и перечеркнутых прямоугольников.

Такое наполнение плохо воспринимается респондентом, который часто забывает, что это просто прототип для тестирования логики, и зацикливается на наполнении и визуальном оформлении.

Так делать не стоит. Да и зачем, если очень просто найти «рыбу» по теме:

- взять текст на fishtext.ru;

- скачать картинки с Яндекс.Картинки;

- поставить стандартные иконки Bootstrap;

- разместить фотографии пользователей из поиска по людям ВКонтакте;

- написать максимально реальные заголовки, чтобы потом не оказалось, что они не входят в ширину экрана.

Есть мнение, что такие прототипы стоит делать черно-белыми. И да, и нет. Да, не стоит делать в интерактивном прототипе цветовые акценты на нужных вам элементах, так как это неверно с точки зрения реальности, когда таких акцентов уже не будет. И всё же не всегда можно обойтись черно-белым прототипом. Если, например, предполагается картинная галерея и акцент на картинах, то лучше сразу делать прототип похожим на реальность, а изображения взять из поиска. Так сразу будет понятно, что это за прототип и зачем он нужен.

Интерактивные прототипы идеально тестировать на целевой аудитории. Можно по скайпу, многие прототипы беспроблемно расшариваются. Пользователь включит трансляцию экрана, а вы сможете наблюдать за его действиями.

Если невозможно найти людей из ЦА, и при этом не требуется проверять слишком сложный прототип, сделайте «коридорное тестирование». Возьмите простых сотрудников компании, которые похожи на ЦА. Главное в такой ситуации — не брать тех, кто идеально знает весь продукт или непосредственно участвует в разработке.

Не все специалисты согласны с «коридорным» подходом, аргументируя это тем, что выборка не представляет целевую аудиторию. Но я зуб даю, что лучше так, чем вообще без тестирования: часто всплывают глупые интерфейсные ошибки, которые сам ни за что не увидишь. Ни за что!

Тестирование цветного прототипа в программах типа Axure

Тут всё достаточно просто. Дизайнер делает красивый интерфейс, в котором вы размечаете области, при взаимодействии с которыми должно что-то происходить. Обычно это просто «on click» или «on move». Можно, конечно, поколдовать с резаком и вырезать различные элементы, но это слишком долго. Хотя есть и такие перфекционисты.

Вся эта красота делается интерактивной и тестируется на пользователях: насколько быстро расставленные вами цветовые акценты позволяют пользователю найти нужные элементы. Респондент может проговаривать действия вслух, а вам нужно просто дождаться, пока он сделает нужное действие. Или не дождаться и уйти плакать — если вы дизайнер. А если вы не дизайнер, то ваша задача — отправить замечания дизайнеру.

Тестируем на целевой аудитории, можно по скайпу. Есть небольшой нюанс: надо постоянно напоминать, что это прототип. Постоянно! Потому что такой прототип уж слишком похож на реальность. Кстати, в нем уже не место бессмысленной «рыбе»: нужны нормальные тексты, картинки, иконки. Можно взять их из интернета, только помните про правообладателей.

Если респонденты допускают невообразимые логические ошибки, значит, либо дизайнер сделал реально плохое решение, либо вы очень плохо протестировали прототип на предыдущем этапе.

Такое тестирование помогает оценить:

- насколько конкретный элемент, который ранее был, например, большой кнопкой, а сейчас стал красивеньким тонким баром, понятен пользователю;

- акценты и видимость всех важных элементов дизайна.

Если пользователь не замечает нужные элемент или кликает почём зря — значит, нужно править.

Учтите, что во время тестирования UI- или графический дизайнер, который это всё делал, должен молчать, а лучше вообще быть далеко от респондентов. Если рядом, то только с выражением «poker face». Ему будет сложно, он периодически будет хвататься то за топор, то за верёвку с мылом, так что лучше всего его держать чуть в стороне от самого процесса тестирования дизайна на пользователе.

Тестирование со скриптами, или MVP-тестирование на alfa-версии продукта

Всё работает как нужно, но пока вместо 1 млрд пользователей у вас 5 человек — друзей проекта, вместо базы в 5 млн SKU у вас пока 1 база на 100 товаров, а вместо выделенных серверов на Амазоне, виртуальный хостинг на 1gb.ru. Но всё работает как нужно.

Всё работает как нужно. Это главное условие!

Теперь берёте пользователя из целевой аудитории (не нужно брать программистов из соседнего помещения), даёте ему цель, и пусть он её выполняет. Всё должно пройти идеально. Мелкие баги, которые мешают реальному пользователю прийти к цели быстро и эффективно, записываем, а потом правим.

Ещё раз для тех, кто хитрый. Тестировать надо на ЦА! Не тестируйте свой продукт на работниках столовой у вас в офисе, если ЦА — это девушки с «Барвиха Лухари Вилаж».

Если очень нужно проверить сложную дорогую функциональность, которую разрабатывать минимум год, то сделайте быстрое решение и проверяйте его.

Главное, чтобы всё работало так же, как и в вашем будущем суперкалькуляторе плотности пыли 1 грамма песка Сахары. Можно также заменить готовыми решениями, которые есть на рынке.

Со стороны это всё похоже на ненужный дорогостоящий ад. Но! Вы хотите сделать мобильное приложение со сложной функциональностью. Это минимум 5000 $ на создание, а для некоторых нетривиальных решений это число может быть умножено на 100.

Решение:

- делаете за 500 $ мобильную версию сайта с той же функциональностью;

- проверяете, чтобы работало так, как нужно;

- тестируете на ЦА;

- выкладываете в дорогую разработку. Или не выкладываете — зависит от результата.

Тестирование на Big Data

Это путь Яндекса и больших компаний: придумать быстрое решение, выпустить бета-версию, сделать пререлиз, пустить миллионный суточный трафик и смотреть, как всё работает.

Здесь я не буду останавливаться, потому как это вариант вам вряд ли подойдёт. Разве только вы из компании с большим трафиком и командой из: UI-дизайнера + быстро-верстальщика + быстро-программиста + быстро-BigData-спеца + быстро-продюсера + быстро-сис. админа + быстро-арт-дира.

Если из такой компании, то собирайте команду, быстро пилите беты, заливайте на продакшен, пускайте трафик через линки и проверяйте гипотезы. Если всё ок — делайте полноценные версии на основе этих бет.

Тестирование имеющегося продукта

Тестирование схожего продукта, что уже у вас есть, или есть у ваших конкурентов отлично подходит тем, кто хочет сделать «идеально, как у конкурента».

Такой подход мало кто использует, но это реально классная штука, особенно перед любым процессом изменения дизайна продукта, если он у вас уже есть. Или у вас нет, но у вашего главного врага по рынку — есть.

Для этого требуется:

- сайт или приложение,

- целевая аудитория;

- юзабилити-исследователь;

- личное присутствие в месте обитания ЦА или Skype.

Берём, что есть, приглашаем ЦА на тестирование (или на Skype-сессию), смотрим на экране, что делает респондент. Он в этом время проговаривает действия и мысли, мы записываем косяки, составляем статистику по ошибкам.

Метод особенно рекомендуется тем, кто думает что у них плохо работает функциональность, потому что так думает сын директора (который уже через 20 лет станет великим дизайнером). Тестируем то, что есть, и видим косяки. Реальные косяки. Всем, например, безразлично, что у вас сайт бирюзовый, и что кнопочки на нем не в Material Design, а с градиентом 90-х годов. А вот баги всем заметны. Кстати, это очень хороший способ отсеивать визуальных перфекционистов, которым не нравится цвет менюшки, а также компании, которые проводят «usability-аудиты» силами аккаунт-менеджера, который вышел на работу неделю назад.

Есть еще один метод...

Называется «Прототип из разной дешевой фигни», но подходит больше для промышленного дизайна. Используется, например, IDEO. Но в рамках этой дискуссии не буду об этом говорить, так как не про дизайн-мышление мы тут.

Вывод

В работе я постоянно использую интерактивные прототипы, в том числе в цвете. Бумажные прототипы делал несколько раз на реальных проектах и ещё раза четыре на различных интенсивах и курсах. Скорее проектирую на бумаге сложные элементы, но не тестирую на ней, так как это не особо часто требуется. Однако если времени впритык, то лучше бумаги ничего нет. Тестирование со скриптами делал разок, но это долгая история создания такого MVP — нужно отрисовывать каждый экранчик и состояние кнопок, все разворачивающие списки и выполнение тех или иных сценариев. Часто это тратит очень много времени.

Вывод для себя сделайте сами: стоит ли вам использовать тестирование прототипов или нет. В любом случае это ваше решение. Вы рискуете не только собственным временем, но и деньгами компании.

Однако если вы не предложите протестировать продукт на прототипах, вряд ли руководство об этом узнает. Вряд ли вообще кто-то знает, что можно пойти путем такого тестирования: проверить на пользователях ранние решения и исправить основные косяки, которые будут совершать 9 из 10 пользователей. Или 7 из 10. Или всего лишь 1 из 10 — всего-то каких-то 10% рынка.

Именно вы принимаете это важное решение: снизить риски выпустить на рынок полное «неюзабельное» нечто. Понимаете, о чём я? Если вам страшно и лень, да и это не ваши деньги — можете не делать. Можете смело не делать. Потому что у вас просто нет трех дней на тестирование, зато есть полгода на переписывание того безобразия, которое вышло без тестирования. А три дня тестирования при участии трех человек — это ведь то же самое, что и полгода работы команды программистов, правда?

Так что всё зависит от вас.

Нетология проводит набор на курсы:

- Проектирование интерфейсов: UI-UX дизайн от стратегии до тестирования;

- UX-аналитика: исследования пользователей и здравый смысл;

- Дизайн мобильных приложений: интерфейсы, архитектура, визуальная концепция;

- Adobe XD: основы для дизайнера интерфейсов (бесплатная программа);

- Курс Python: программирование на каждый день и сверхбыстрое прототипирование.

|

|

[Перевод] Flash мертв: кто следующий? |

Такой неожиданный перелом в судьбе Flash позволяет заключить: расхожее мнение, что Apple погубил Flash, когда в 2010 году принял решение не поддерживать его на iPad, возможно, в чем-то соответствует действительности.

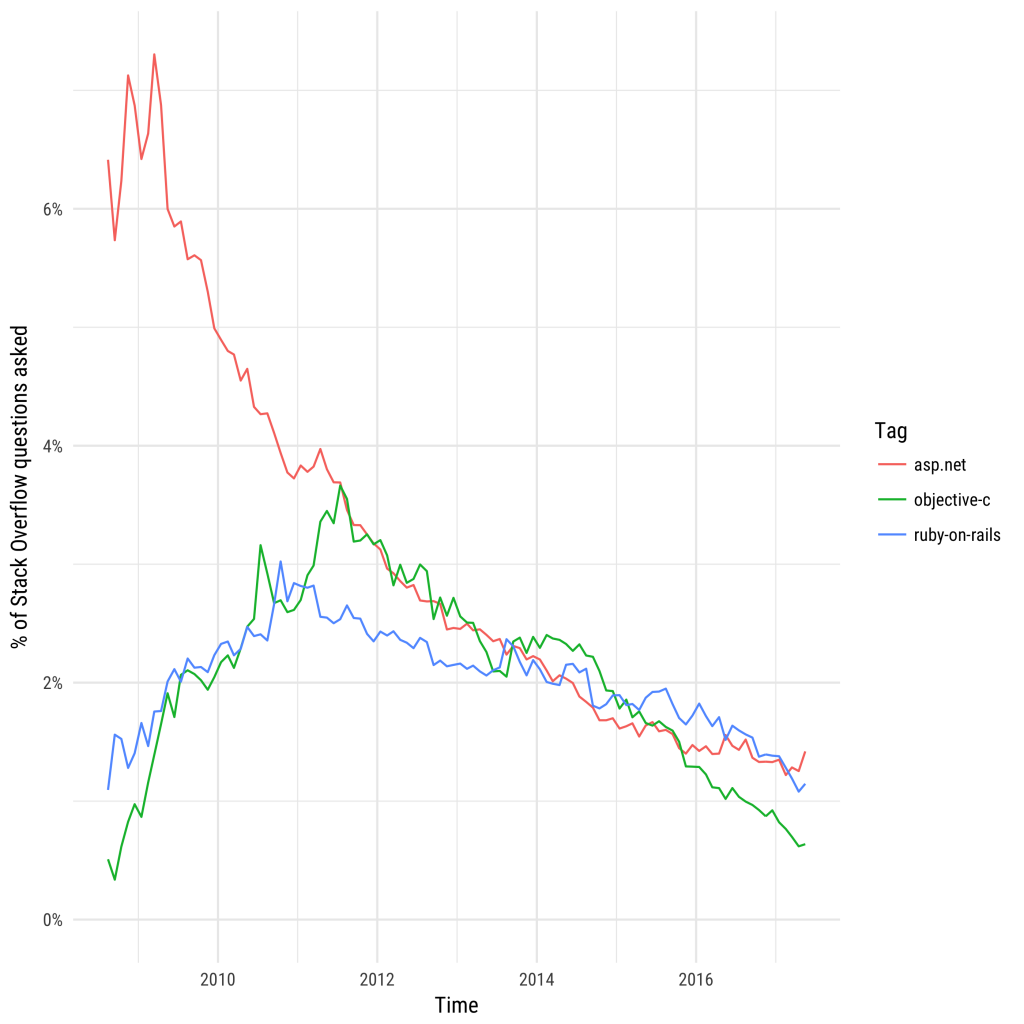

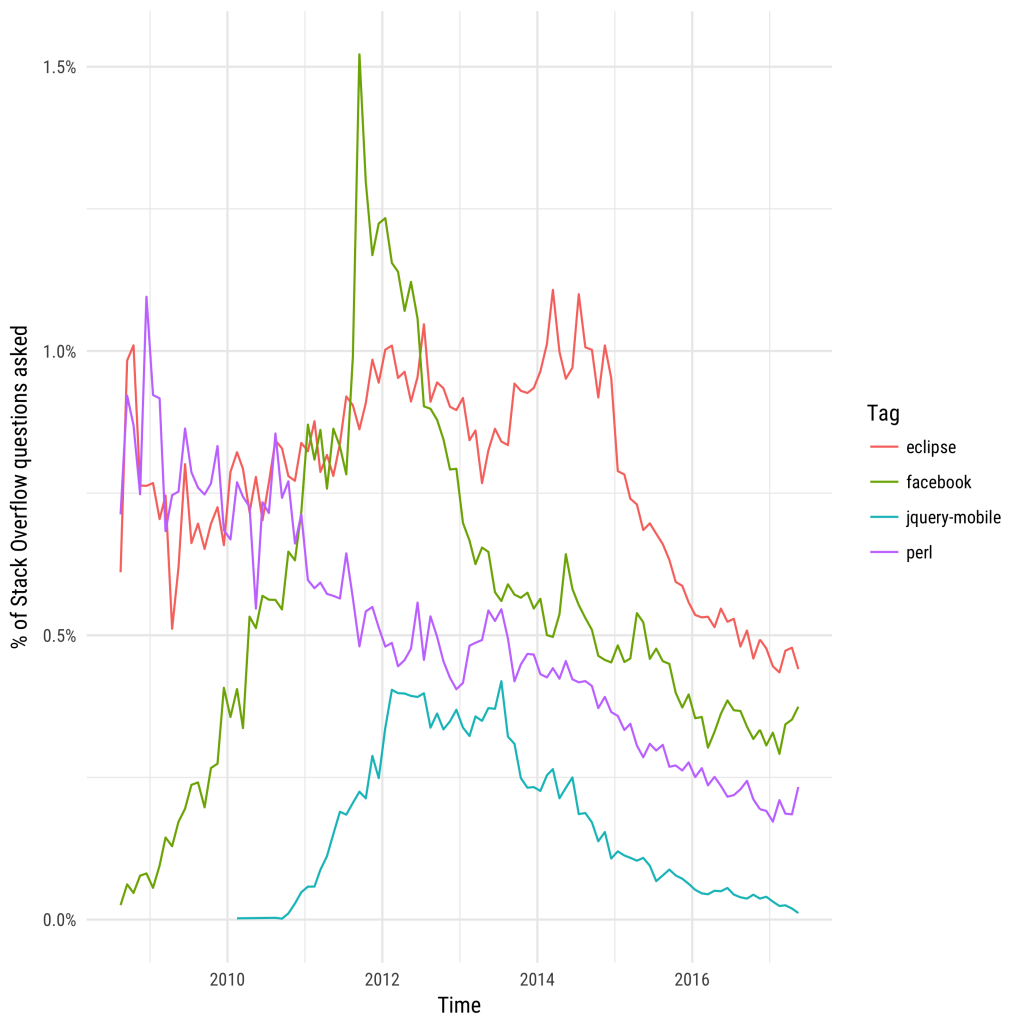

Раз у нас была возможность предугадать кризис Flash, давайте привлечем больше данных со Stack Overflow, чтобы понять, какие еще технологии сейчас на спаде.

Кто же следующий на вылет?

В последние десять лет у Flash хватало защитников (вот небольшая историческая справка), хотя то, что его все меньше и меньше используют в разработке, бросалось в глаза уже в 2011 году. Может, есть и какие-нибудь другие технологии, которые на первый взгляд еще живы-здоровы, но в последнее время начали сдавать позиции?

Чтобы ответить на этот вопрос, мы проанализировали вопросы, которые задавали на Stack Overflow в соответствующий временной промежуток — данные брались из все того же Stack Overflow Trends. Мы отслеживали тенденции за последние пять лет (чтобы включить в исследование и те тэги, которые были на подъеме, дошли до пика и пошли на спад) и делали замеры скорости падения популярности для каждой из отобранных технологий. Вся использованная информация находится в открытом доступе (вы можете скачать ее при помощи этого запроса), так что с интересом послушаю, к какими выводам придут другие разработчики.

Мы считали, что интерес к технологии угасает, если количество вопросов, связанных с ней, сокращалось в среднем на 10% в год. Если принять этот критерий, какие технологии быстрее всего теряют пользователей?

Начиная с 2010 в этом отношении лидируют тэги Flex (фреймворк для веб-приложений на базе Flash) и Silverlight от Microsoft. Тот и другой теряют позиции куда быстрее, чем Flash; Flex в особенности стал очень резко сдавать после того, как достиг пика популярности в 2010 году. Число упоминаний обеих технологий на сайте сократилось на два порядка.

Одна из них уже отходит в прошлое: в 2015 году компания Microsoft сообщила о своем намерении прекратить поддержку Silverlight к 2021 году. Flex, строго говоря, поддерживается до сих пор (только начиная с 2011 им занимается уже Apache Foundation, а не Adobe), но учитывая, что Flash списали со счетов и что Flex все реже фигурирует в вопросах разработчиков, сложно назвать его технологией, у которой есть будущее.

Среди других популярных технологией (то есть таких, которые собрали не меньше 100 000 вопросов за период с 2010 года по сегодняшний день) есть и другие претенденты, популярность которых заметно уменьшилась. Частота появления вопросов о ASP.NET, веб-фреймворке от Miscrosoft, стабильно падала с момента основания ресурса. Здесь стоит учитывать то обстоятельство, что на ранних этапах существования сайта в его аудитории преобладали разработчики на C#, однако причина может крыться также и в том, что Microsoft играет все менее значимую роль в веб-разработке.

Регулярность публикации вопросов о Ruby on Rails набирала обороты вплоть до 2011 года, а затем понемногу стала сокращаться. Objective-C тоже на спаде, так как на смену ему как любимому языку разработчиков на iOS пришел Swift. Аналогичным образом тэги «iphone» и «ipad» вытеснил общий тэг «ios» для вопросов о мобильной платформе Apple (мы подробнее разбираем эти тренды в посте о разработке мобильных приложений).

На этом список технологий, которые быстро сдают позиции, не заканчивается. Perl уже давно страдает от недостатка внимания (хотя, справедливости ради, если смотреть по месяцам, он все-таки собирает больше вопросов, чем совсем уже мертвые тэги вроде Flash или Flex). Максимум вопросов о платформе для разработчиков от Facebook пришелся на 2012, с тех пор их стабильно становится меньше. Количество постов о среде разработки Eclipse стало падать начиная с 2014 года. JQuery Mobile когда-то была популярной библиотекой для реактивной веб-разработки, но судя по тому, насколько активно люди задают вопросы, в последнее время сообщество к ней охладело.

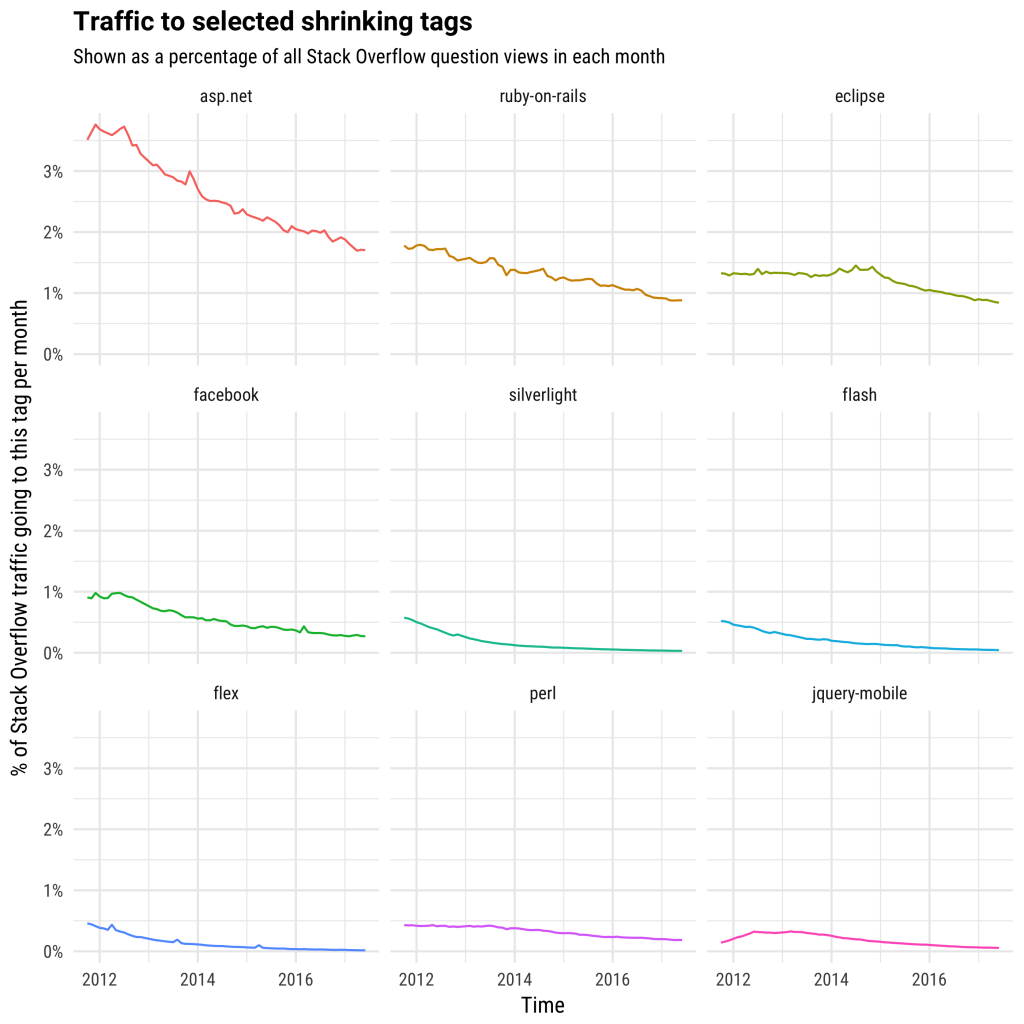

Подтверждает ли все эти выводы количество просмотров?

Конечно, число вопросов, которое задают о той или иной технологии, не всегда отражает ее распространенность. Зачастую разработчики сначала проверяют, не предлагал ли кто-нибудь решения проблемы в уже существующих постах, и только потом уже сами задают вопрос. Возможно, когда накапливается обширная база вопросов, пользователи просто обращаются к старым постам и не испытывают необходимости создавать новые. Тогда, может быть, в каких-то из этих тэгов растет количество просмотров старых вопросов?

А значит, вместо того, чтобы ориентироваться на задаваемые вопросы, мы можем проанализировать число просмотров постов за определенный временной промежуток. У нас сохранились данные по просмотрам за период с конца 2011 года.

Наблюдается ли там аналогичный спад?

В случае с теми тэгами, которые мы определили в этом посте как угасающие, можно заметить, что в целом и общем трафик говорит о том же, что и количество заданных вопросов. Число просмотров постов о Flash, Flex и Silverlight с 2012 года упало почти до нуля. Тэги ASP.NET и Ruby on Rails, хоть и привлекают по-прежнему значительную долю трафика, также со временем начали терять пользователей. Eclipse до 2014 года был стабилен, но дальше пошел на спад.

Кроме того, статистика по большинству рассмотренных тэгов свидетельствует о том, что трафик как показатель популярности проблемы немного запаздывает по сравнению с количеством вопросов. Если количество вопросов о какой-то технологии начинает сокращаться, значит в скором времени начнет падать и трафик у существующих постов. Подчеркнем, что это нельзя объяснять лишь тем, что новые вопросы получают много просмотров от людей, которые пытаются на них ответить: 98% трафика Stack Overflow приходится на вопросы, которые были заданы не в тот день, когда собирается статистика. Это скорее указывает на перемену в отношении к технологии: когда у разработчиков отпадает необходимость задавать вопросы, готовые ответы им тоже становятся ни к чему.

Вывод: можно ли судить о жизнеспособности технологии по количеству вопросов?

Как однажды сказал Бьёрн Страуструп, автор языка C++, существует два типа языков программирования — те, на которые все жалуются, и те, которыми никто не пользуется. Я бы сказал, что тот же принцип работает и для вопросов.

Команда Stack Overflow часто делает замеры по количеству вопросов, чтобы понять, насколько жизнеспособна та или иная технология. Мне часто возражают, что это не показатель, ведь статистика по вопросам и трафику на самом деле отражает только то, сколько людей не понимает, как пользоваться той или иной технологией, а продвинутые пользователи, возможно, просто не нуждаются в помощи. Действительно, в работе с любой метрикой необходимо учитывать недочеты и искажения данных, и то, насколько свободно пользователи владеют технологией — это фактор, который может влиять на результаты и который следует принимать во внимание.

Тем не менее, я считаю, что данные, которые предоставляет Trends, полезны и информативны. Во-первых, мне кажется, что так же, как нельзя написать все возможные книги, нельзя и задать все возможные вопросы. Тэг Javascript за время своего существования собрал 1.4 миллиона вопросов, и несмотря на это, частота публикаций стабильно возрастает. Если темы для обсуждения, связанные с Javascript, можно бы было исчерпать, мы бы уже определенно это сделали.

Во-вторых, если все, кто работает с технологией, знают ее от и до, значит сообщество не развивается. Жизнеспособная среда всегда предполагает приток новичков, которые осваивают основы, и наличие экспертов, которые проверяют, где проходят границы возможностей. И у тех, и у других в ходе рабочего процесса постоянно возникают вопросы. В 2011 году разработчик, использующий Flash, мог бы возразить: «Да, в последнее время Flash обсуждают не так активно, но это только потому, что документация очень толковая и мы уже разобрались с основами работы». Но время ставит все на свои места.

В будущем я планирую написать пост о тех технологиях, у которых доля вопросов в общем числе стремительно растет, и порассуждать о том, какое значение это будет иметь для всей экосистемы.

|

Метки: author nanton adobe flash блог компании everyday tools stack overflow прогнозы silverlight flex ruby on rails eclipse |

[Из песочницы] Машинное обучение в горнолыжном спорте |

В этой статье речь пойдет о возможностях применения машинного обучения для анализа биомеханики в горнолыжном спорте.

Изначально гипотеза об указанных возможностях свелась к следующему набору требований:

- способность классифицировать технические элементы;

- способность по определенной метрике сравнивать указанные элементы; находить нетривиальные особенности прохождения трассы, позволяющие минимизировать время;

- способность строить прогнозы (например, на вторую попытку).

Для начальной проверки этой гипотезы мы решили обучить искусственную нейронную сеть (далее ИНС) для распознавания простейших фаз траектории движения спортсмена-горнолыжника.

Этапы работ определили так:

1. Сбор данных.

2. Подготовка данных для обучения.

3. Тренировка сети по распознаванию целых поворотов.

4. Тренировка сети по распознаванию фаз поворотов.

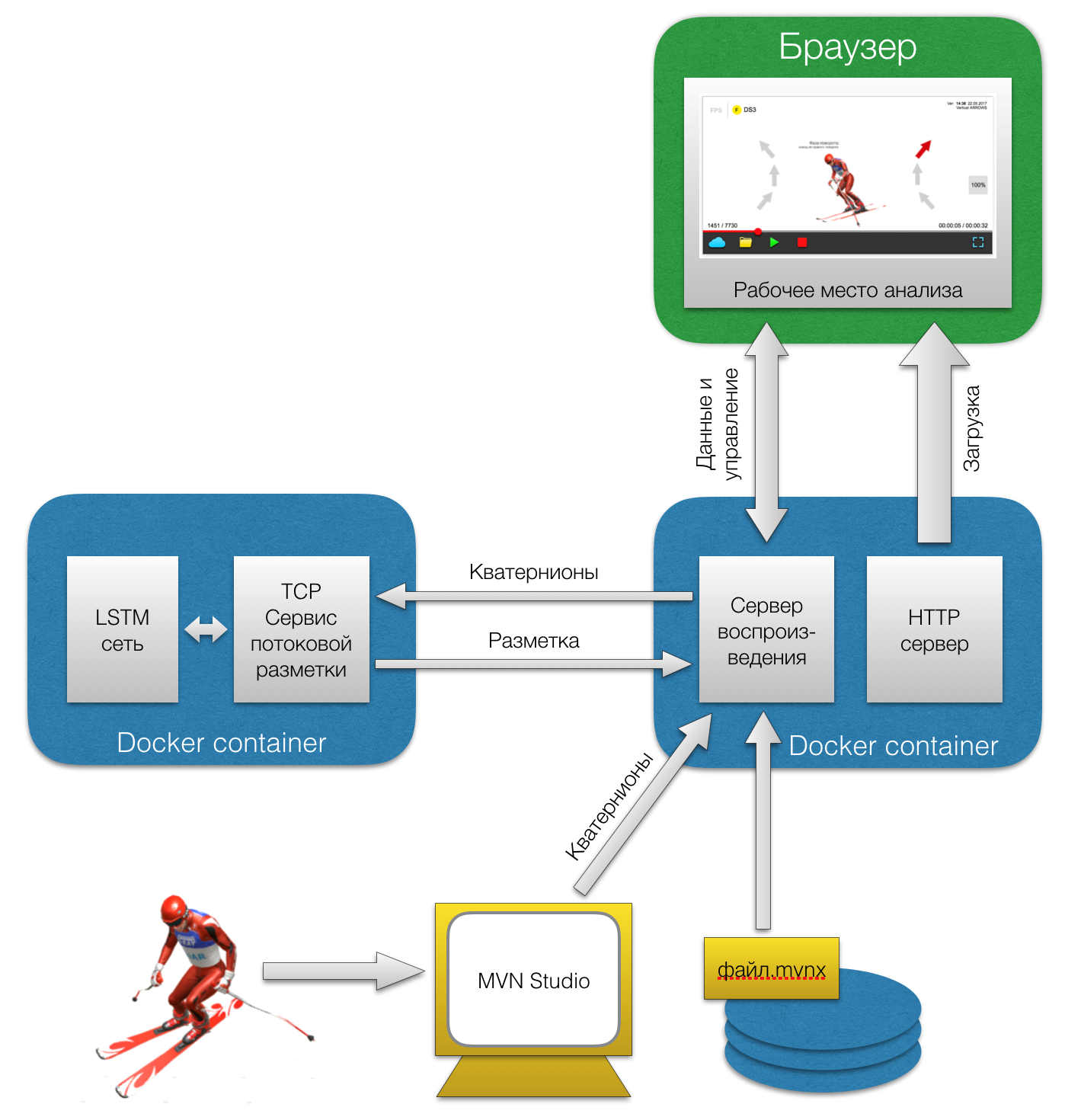

5. Разработка сервиса для пользователей по работе с получившейся системой.

Сбор данных. Motion Capture

Какие данные собирать? Как их получить?

Показателей, которые характеризуют активность спортсмена во время спуска и которые можно измерить, достаточно много, начиная от профиля давления стопы на горнолыжный ботинок (именно с этих незаметных движений и начинается всё управление движением), и заканчивая направлением взгляда (чем на более далекие от спортсмена ворота он смотрит, тем выше шанс построения оптимальной траектории). Для начала, мы решили остановиться исключительно на захвате движений (Motion Capture – MoCap), то есть получить скелетную модель движения сегментов тела, так как данный подход наиболее широко описывает физику процесса.

Захват движений производили с помощью решения (MVN Biomech ) компании Xsens,

которое представляет из себя нейлоновый комбинезон с устанавливаемыми инерционными датчиками (IMU). По своим характеристикам костюм отдаленно напоминает стандартную спортивную экипировку — «спусковой костюм», что позволяет спортсмену, с некоторыми ограничениями, просто одеть его под обычную экипировку.

В процессе эксплуатации нам пришлось адаптировать исходное решение под аутентичную горнолыжную экипировку. Сделано это было в первую очередь для повышения точности записи данных (отдельные датчики плохо крепились), а во вторую для ускорения процесса подготовки к катанию. В результате спортсмен ни при надевании формы, ни при езде практически не почувствует разницы между записью биомеханики и обычной тренировкой.

Подготовка данных

Прежде чем рассказывать о подготовке сырых данных, следует пояснить что мы под ними понимаем.

Система MoCap записывает движение фреймами, проще говоря кадрами, в каждом из которых мы имеем описание положения тела по 23 сегментам, каждый из которых, в свою очередь, определен своим кватернионом (объект линейной алгебры, с помощью которого описываются твердотельные вращения; является аналогом углов Эйлера, но проще с точки зрения операций). Каждый кватернион описывает вращение сегмента тела относительно исходного положения в глобальном пространстве. Фреймы пишутся с частотой 240Hz, что позволяет ловить достаточно быстрые движения, например, отбивку кисти в момент укола палкой.

Теперь, непосредственно, что касается подготовки.

Для начала берем и оставляем только сами проезды, выкидывая всё, что происходит между (подъемы на бугеле, ожидание и т.д.). Как итог — из десяти тренировок, пригодных для работы (было много брака из-за установки датчиков и их последующего смещения), оказались пять. В среднем на каждой тренировке записывалось двадцать проездов, полезное время каждого из которых составляет тридцать секунд. Итого получаем 5 тренировок * 20 проездов * 30 секунд * 240 Hz = 720 000 фреймов; ну или если идти дальше 720 000 фреймов * 23 сегмента * 4 вещественных числа в кватернионе = около 66 миллионов вещественных чисел. Звучит, как будто этого достаточно.

Далее, необходимо вручную разметить данные для обучения — объяснить нейросети что конкретно она должна узнавать. А целью было научить её узнавать сначала полные повороты, а затем их фазы. Для этого просматривалась визуализация движений и показатели ключевых сегментов (в нашем случае стопы, голень) и на временной шкале ставились метки начала и окончания соответствующих элементов. Таким образом, по совокупности всех записей мы получили порядка 3 500 поворотов, или 10 500 фаз.

Последним, что предстояло сделать при подготовке — привести углы поворотов сегментов из глобальных в локальные углы соединений сегментов. У биомеханической модели есть четкая иерархия сочленений сегментов, по которой и идет все построение из сырых данных. Необходимо было для каждого сегмента, кроме корневого, получить кватернион угла соединения для этого элемента. Корневым сегментом в этой иерархии является таз. Очевидно, что, зная по цепочке повороты сегментов и их длины (а эти данные есть, так как для каждого спортсмена записывается антропометрический профиль), можно восстановить всю биомеханическую модель. Оставалось выполнить для таза нормализация по азимуту в глобальном пространстве, и были получили данные, не зависящие от ориентации спортсмена в пространстве.

Качество данных

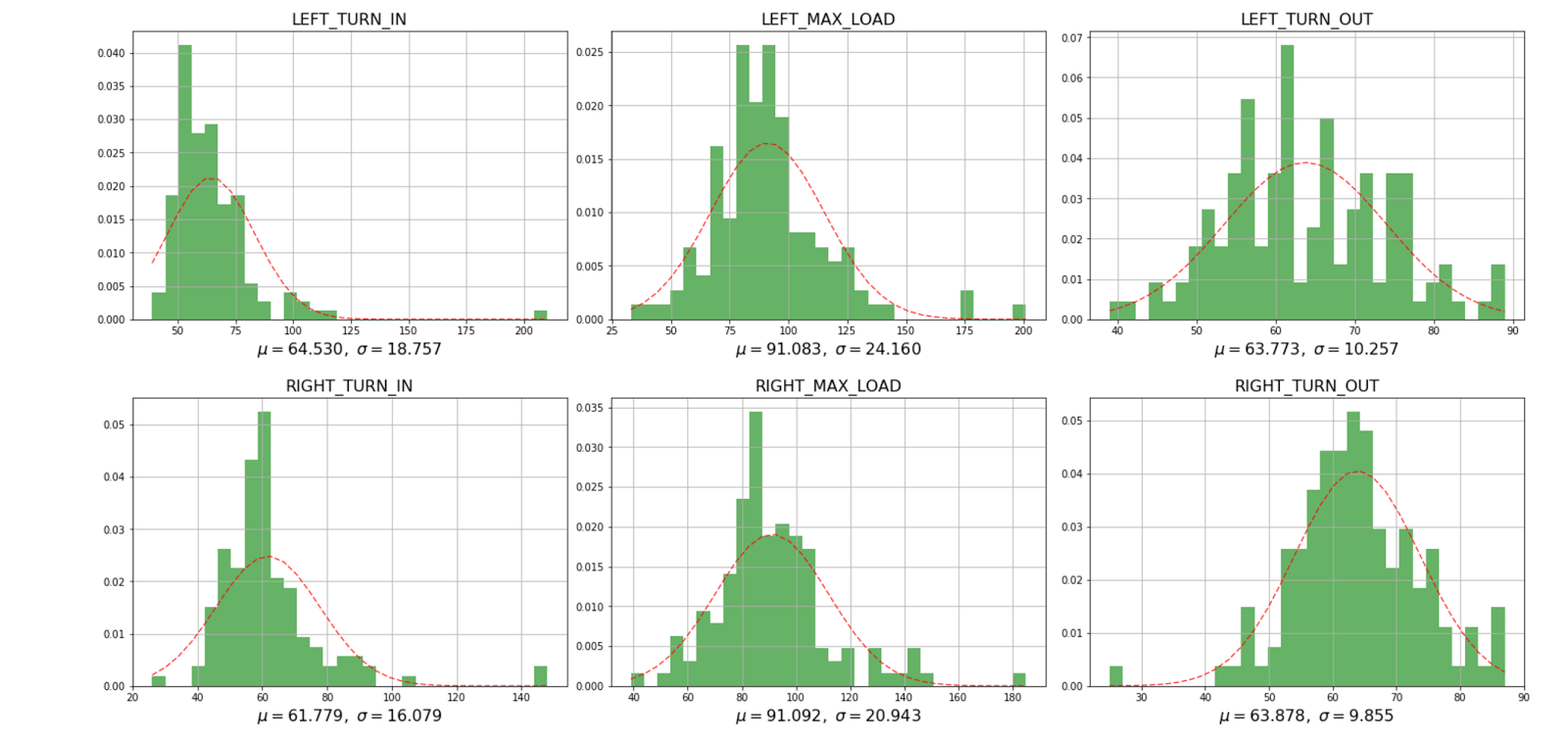

Анализ качества первичных данных проводился с помощью пакетов Python: Jupyter, NumPy, MatPlotLib и TensorFlow.

Тут стоит остановиться на двух существенных моментах.

Первый — данные от некоторых сегментов были «шумом» — менялись либо случайным образом, либо вообще никак. Также встретились сегменты, которые давали адекватные данные, но были существенно подобными на всём спектре движений, что практически означало их линейную зависимость. Например, у двух соседних сегментов позвоночника могло быть одинаковое поведение, так что использовать оба не было смысла.

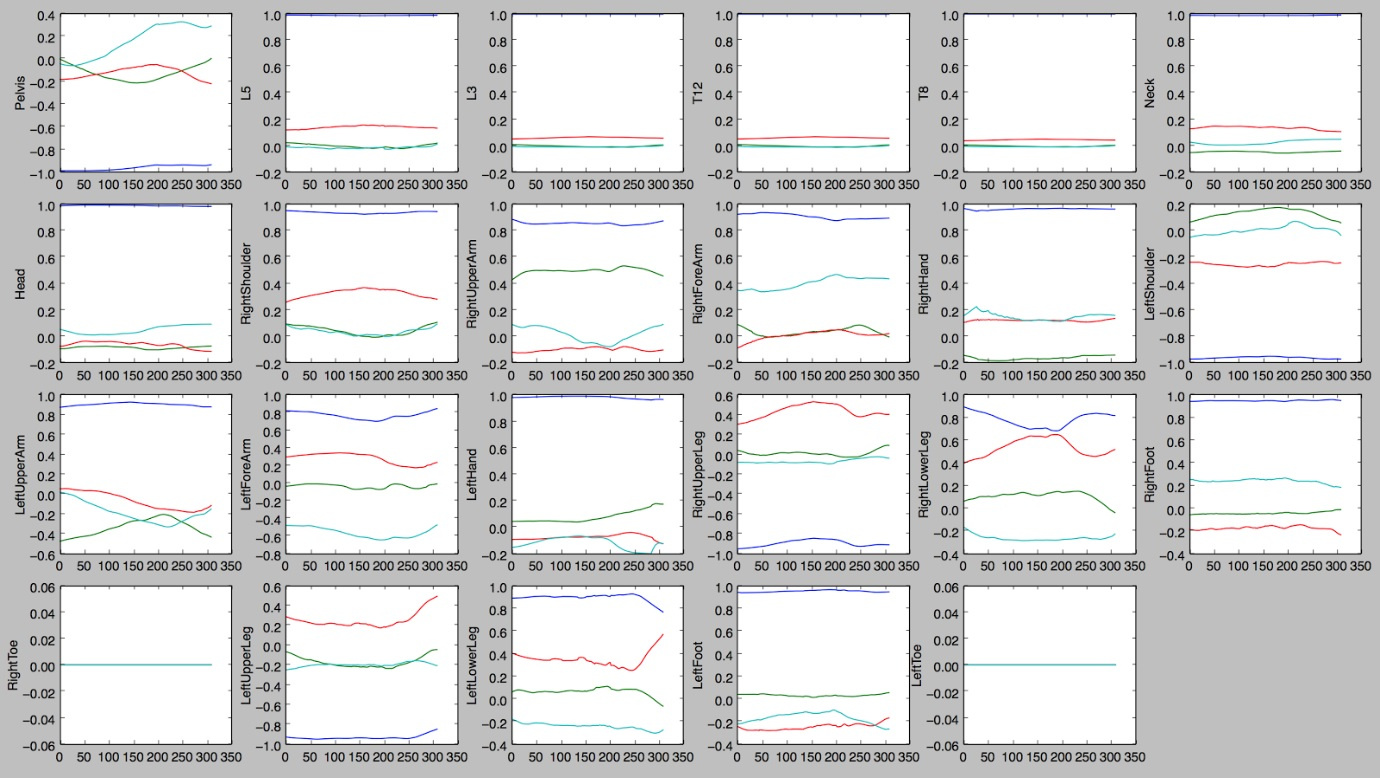

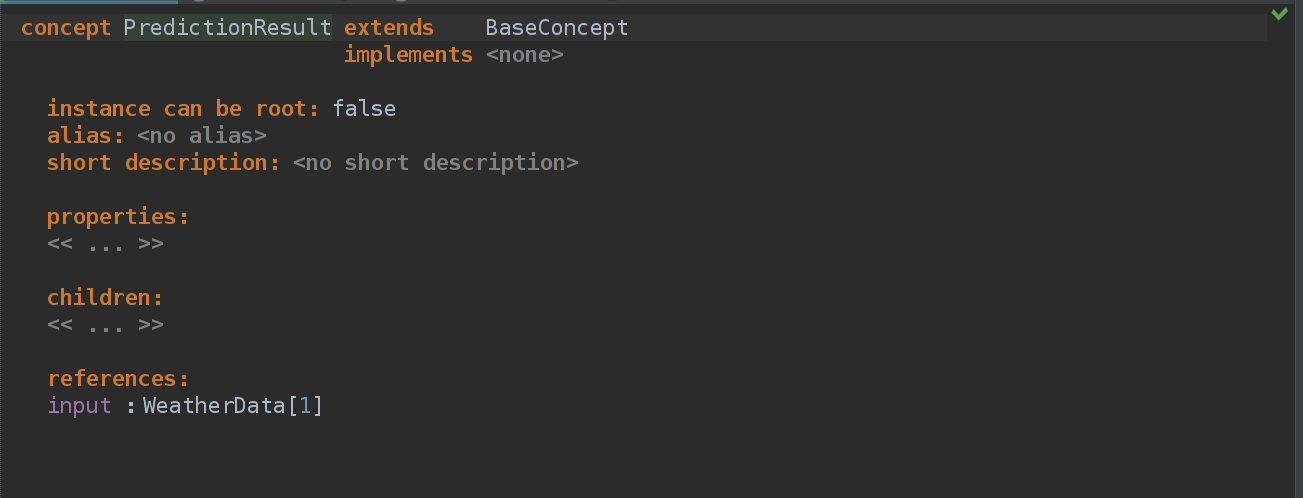

1. Графики изменений кватернионов углов соединений сегментов при выполнении правого поворот

На иллюстрации хорошо видно, что не все значения сегментов достаточно наглядно демонстрируют характер действия и полезны для обучения. Они могут пригодиться для анализа качества действия и его характеристик, но не для автоматической разметки действий.

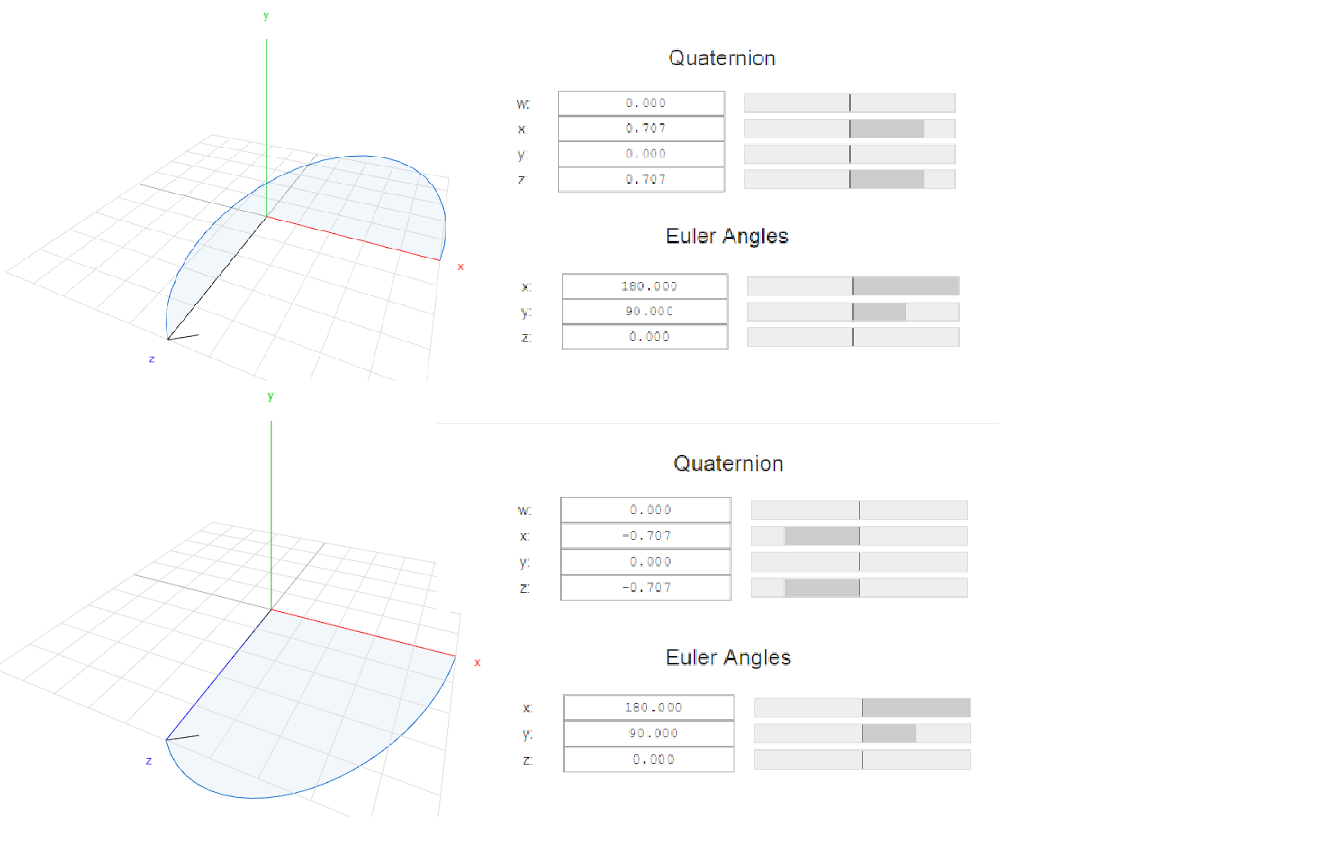

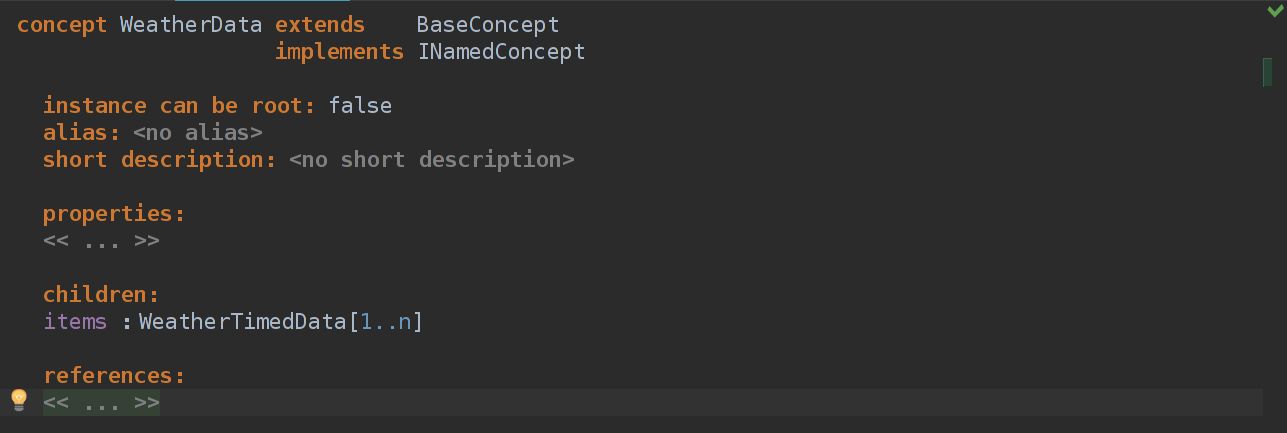

Второй существенный момент — знаковая неустойчивости компонент кватерниона. Что это такое? Один и тот же поворот на их языке может быть описан двумя разными наборами из четырех чисел. Например, один и тот же поворот вокруг оси X на 180 и вокруг оси Y на 90 может быть одинаково точно представлен следующими кватернионами: (0,0.7,0,0.7) и (0,-0.7,0,-0.7).

2. Различное представление вращение кватернионами

Почему это важно? Дело в том, что без отдельных массивов данных по разным проездам одни и те же повороты могут иметь знаковую инверсию по отдельным компонентам. Забегая вперед, отметим, что и нейронная сеть будет изначально воспринимать их как разные ситуации. А в пространстве и времени эта инверсия происходит абсолютно спонтанно.

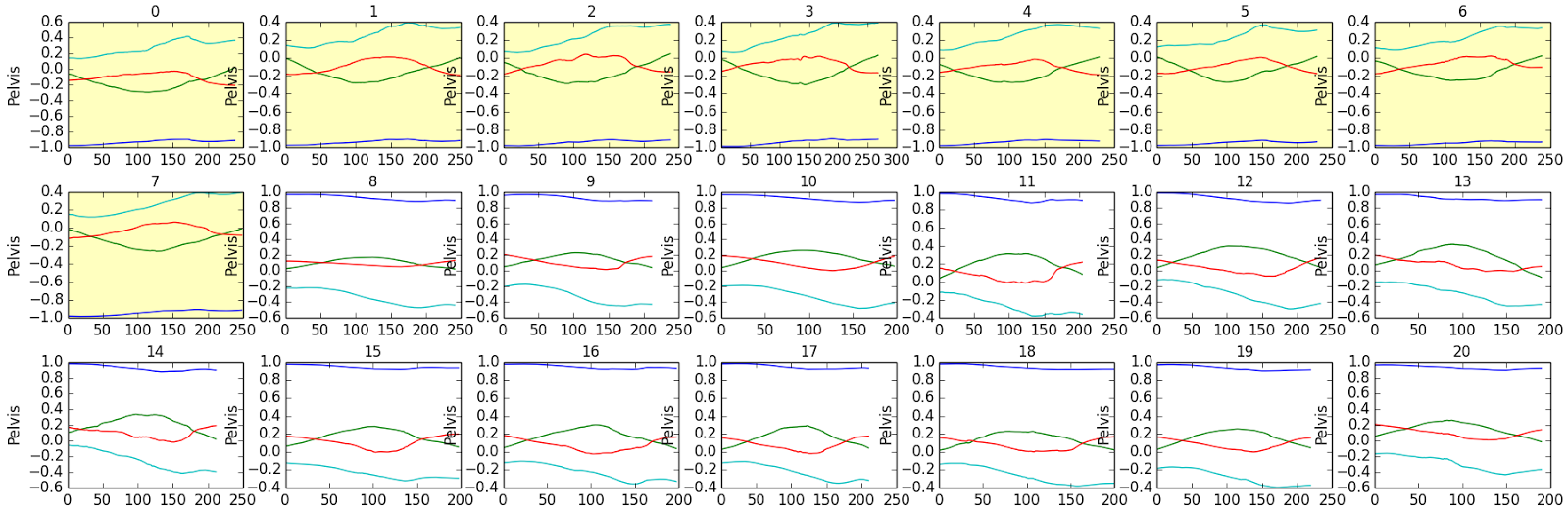

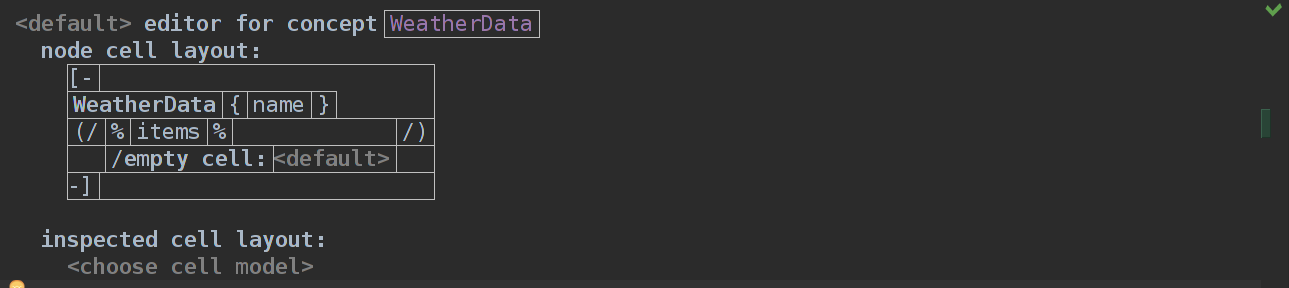

3. Пример знаковой неустойчивости входных данных

Для одного из заездов на этом рисунке графики изменения кватерниона таза спортсмена в правом повороте выделены желтым, для другого — белым. Значения эквивалентны и отображают одинаковые углы, но в силу свойств кватернионов могут иметь противоположные знаки компонент. То, как удалось справиться с этой особенностью, расскажем чуть ниже.

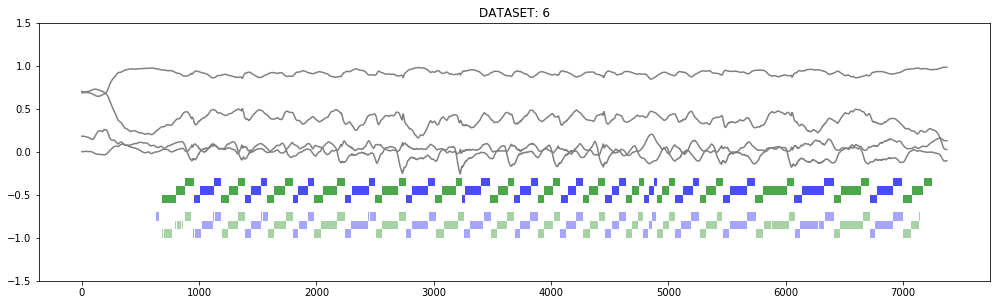

Тренировка сети на определение целых поворотов

Немного матчасти по горнолыжной дисциплине:записывались данные слаломных поворотов (слалом — наименее скоростная из горнолыжных дисциплин, для которой характерны повороты малого радиуса, близко расставленные ворота и, как следствие, большая частота поворотов), средняя продолжительность которых составляла от 0.9 до +- 0.1 секунды. Для начала очень кстати пришелся тот факт, что самый медленный и самый быстрый повороты в наших данных по продолжительности отличались менее чем в два раза.

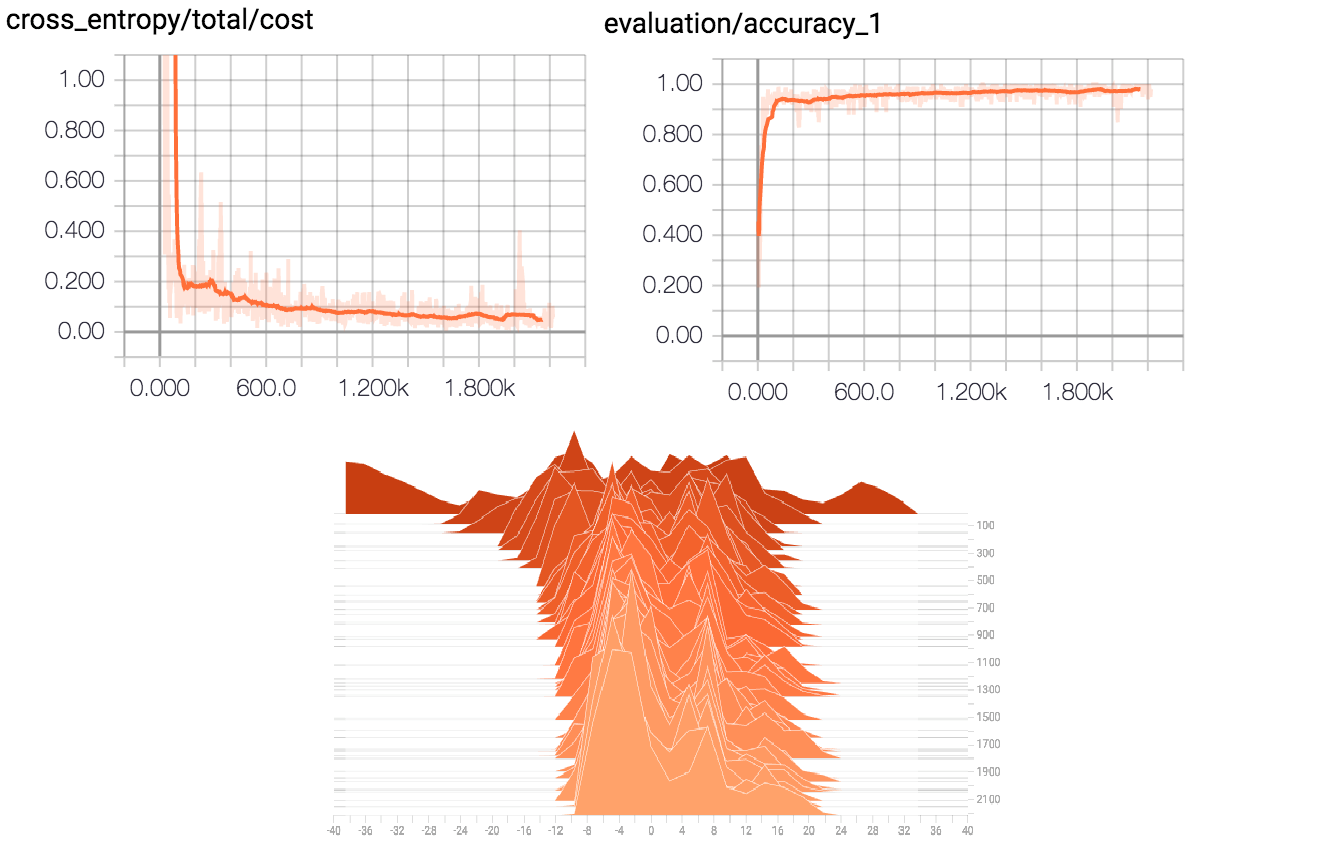

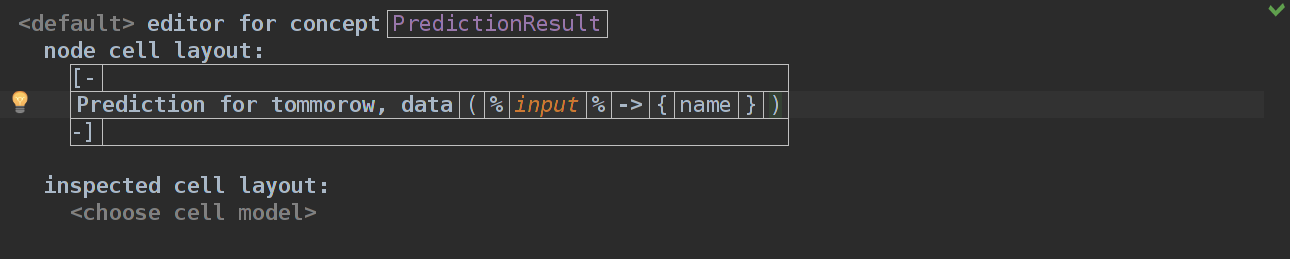

Для создания прототипа системы распознавания целых поворотов мы, используя пакет TensorFlow, создали и обучили сеть MLP (многослойный персептрон) с двумя скрытыми слоями в 256 нейронов (граф сети — на рисунке 3). Выборка данных для обучения и распознавания поворота выполнялась методом скользящего окна с размером, превышающим наибольшую известную продолжительность целого поворота. Сеть обучалась узнавать попадание целого поворота в окно данных. Скольжение окна обеспечивало распознавание начала и конца поворота.

4. Граф обученной сети MLPс двумя скрытыми слоями в 256 нейронов.

Стоит немного остановиться на том, как на этом этапе мы решали проблемы подготовки данных, описанные выше. Для этой достаточно тривиальной задачи подход и к проблемам «шумных сегментов», и знаковой неустойчивости кватернионов был единый — просто выкидываем. Объемов данных было достаточно, чтобы просто не обучать сеть не только на шумных сегментах, но и на данных, где кватернионы были инвертированными.