Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Использование Pinba в Badoo: то, чего вы еще не знаете |

Привет, Хабр! Меня зовут Денис, я – PHP-разработчик в Badoo, и сейчас я расскажу, как мы сами используем Pinba. Предполагается, что вы уже знаете, что это за инструмент, и у вас есть опыт его эксплуатации. Если нет, то для ознакомления рекомендую статью моего коллеги, Максима Матюхина.

Вообще на Хабре есть достаточно материалов об использовании Pinba в различных компаниях, включая пост Олега Ефимова в нашем блоге. Но все они касаются других компаний, а не Badoo, что немного нелогично: сами придумали инструмент, выложили в open source и не делимся опытом. Да, мы часто упоминаем Pinba в различных публикациях и в докладах на IT-конференциях, но обычно это выглядит как-то так: «А вот эти замечательные графики мы получили по данным из Pinba» или «Для измерения мы использовали Pinba», и всё.

Общение с коллегами из других компаний показало две вещи: во-первых, достаточно много людей используют Pinba, а во-вторых, часть из них не знают или не используют все возможности этого инструмента, а некоторые не до конца понимают его предназначение. Поэтому я постараюсь рассказать о тех нюансах, которые явно не указаны в документации, о новых возможностях и наиболее интересных кейсах применения Pinba в Badoo. Поехали!

Небольшое введение

В документации сказано, что «Pinba – это сервер статистики, использующий MySQL в качестве интерфейса...» Обратите внимание на понятие «интерфейс», использующееся не в значении хранилища данных, а именно в значении интерфейса. В первых версиях Pinba, автором которой был ещё Андрей Нигматуллин, не было никакого MySQL-интерфейса, и для получения данных необходимо было использовать отдельный протокол. Что, естественно, неудобно.

Позднее Антон Довгаль tony2001 добавил этот функционал, чем значительно облегчил процесс получения данных. Стало возможным не писать никакие скрипты, достаточно любым MySQL-клиентом присоединиться к базе и простыми SQL-запросами получить всю информацию. Но при этом внутри себя Pinba хранит данные в своём внутреннем формате, и MySQL-движок используется только для отображения. Что это значит? А значит это то, что на самом деле никаких реальных таблиц не существует. «Ложки нет». Вы даже можете спокойно удалить одну из так называемых таблиц с «сырыми» данными, например, requests – и после этого все ваши отчёты по-прежнему будут работать.

Ведь сами данные никуда не исчезнут. Вы просто не сможете обращаться к этой таблице в SQL-запросах. Именно поэтому основной причиной использования именно отчётов (а не «сырых» таблиц) является то, что при сложных запросах (несколько JOIN и т. п.) Pinba должна «на лету» отфильтровать и сгруппировать все данные.

Я понимаю, что, зная SQL, можно легко из таблиц с «сырыми» данными получить все выборки, но это путь к тёмной стороне силы. Этот способ крайне ресурсозатратен. Конечно, все запросы будут работать, и зачастую, когда нужно срочно что-нибудь отдебажить, можно залезть в таблицу requests или tags. Но очень не рекомендую делать это без надобности только потому, что так проще и быстрее. Вся сила Pinba – в отчётах.

Создавать отчёты достаточно просто, но и тут существуют некоторые тонкости. Как я уже сказал, никаких таблиц не существует, и когда вы создаёте отчёт, то есть выполняете запрос CREATE TABLE, вы лишь сообщаете сервису о том, какие агрегации вам будут нужны. И пока не будет сделан первый запрос в эту «таблицу», никакие агрегации не будут собираться. Тут есть один важный нюанс: если вы начали собирать какие-то данные, а потом они уже не нужны, то «таблицу» с отчётом лучше удалить. Pinba не мониторит, перестали вы пользоваться отчётом или нет: один раз запросили данные – они будут собираться всегда.

Ещё один момент, который нужно учитывать при создании отчётов: для каждого типа отчёта есть свой набор полей. При отображении в MySQL Pinba ориентируется на порядок полей, а не на их названия, поэтому нельзя просто взять и поменять местами поля или не указать часть полей:

CREATE TABLE `tag_report_perf` (

`script_name` varchar(128) NOT NULL DEFAULT '',

`tag_value` varchar(64) DEFAULT NULL,

`req_count` int(11) DEFAULT NULL,

`req_per_sec` float DEFAULT NULL,

`hit_count` int(11) DEFAULT NULL,

`hit_per_sec` float DEFAULT NULL,

`timer_value` float DEFAULT NULL,

`timer_median` float DEFAULT NULL,

`ru_utime_value` float DEFAULT NULL,

`ru_stime_value` float DEFAULT NULL,

`index_value` varchar(256) DEFAULT NULL,

`p75` float DEFAULT NULL,

`p95` float DEFAULT NULL,

`p99` float DEFAULT NULL,

`p100` float DEFAULT NULL,

KEY `script_name` (`script_name`)

) ENGINE=PINBA DEFAULT CHARSET=latin1

COMMENT='tag_report:perf::75,95,99,100'В этом примере мы создаём отчёт типа tag_report; значит, первое поле всегда будет содержать название скрипта, за ним будет идти значение тега perf, затем – полный набор всех полей и в конце – нужные нам перцентили. Это тот случай, когда не надо фантазировать, а следует просто взять структуру таблицы из документации и скопировать её. Естественно, поля с названием тегов можно и даже нужно назвать более понятно, чем tag1_value, tag2_value, и порядок тегов и перцентилей в таблице должен совпадать с их порядком в описании.

Агрегации по тегам запроса (request’s tags)

Как вы знаете, у Pinba есть несколько типов отчётов, и относительно недавно (полтора года назад) мы добавили ещё отчёты по тегам запроса. До этого по тегам запроса (не путайте с тегами таймеров, это разные вещи) можно было только фильтровать, но никаких агрегаций не было.

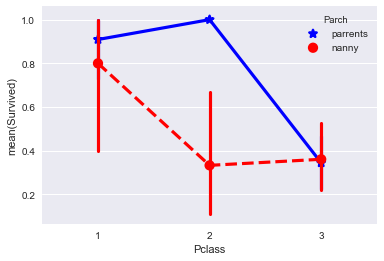

Зачем нам потребовалась такой функционал? Один из основных типов контента в Badoo – фотографии. Нашим сервисом пользуются более 350 миллионов пользователей, у большинства из которых есть фотографии. Для отдачи фотографий у нас есть два типа машин: так называемые фотокеши – машины с «быстрыми» дисками, на которых лежат только активно запрашиваемые изображения, и основные “стороджи” — машины, где хранятся все фотографии.

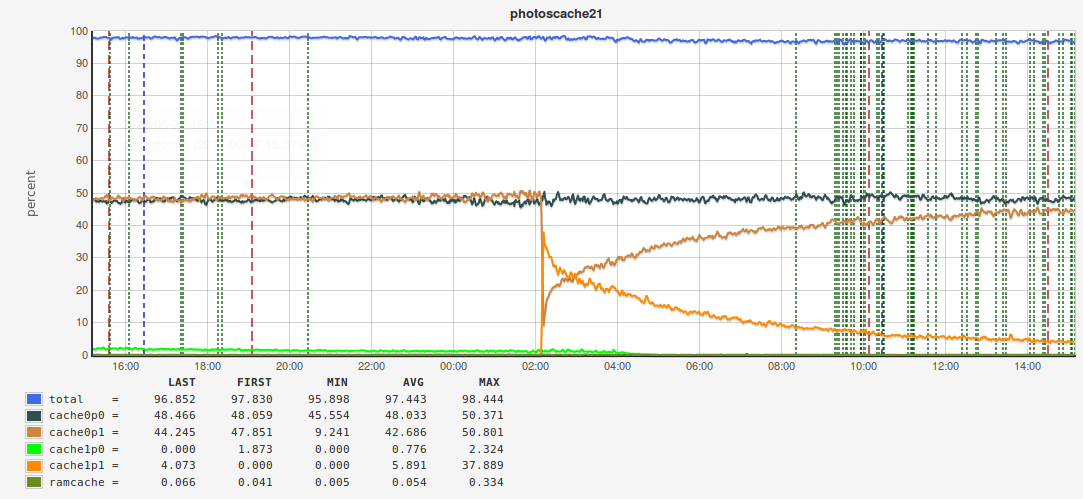

Подробнее о системе хранения фотографий рассказывал на последнем HighLoad++ Артём Денисов. Если мы откажемся от кеширования и пустим весь трафик на «медленные» фотохранилища, то в лучшем случае сущеcтвенно увеличится время отдачи фото, в худшем – мы вообще не сможем с некоторых машин отдавать контент, и запросы будут отваливаться по тайм-ауту. Сейчас хитрейт у нас порядка 98%.

Казалось бы, всё очень хорошо, но падение хитрейта, скажем, до 96% сразу увеличивает нагрузку на кластер фотохранилища в два раза. Поэтому нам очень важно следить за хитрейтом и не допускать значительных падений. И мы решили делать это с помощью Pinba. Поскольку на машинах с фотокешами не используется PHP (весь контент отдаётся через веб-сервер), мы используем плагин Pinba к nginx.

Но вот незадача – внутри nginx мы не можем использовать таймеры и агрегацию по тегам таймера, но активно можем проставлять теги на сам запрос. Причём нам очень хотелось сделать разбивку по размеру изображений, по типу приложения и по ещё нескольким параметрам. У запроса может быть несколько тегов, и по всем нам нужно агрегировать. Для этой цели были созданы следующие типы отчётов:

rtag_info– агрегация по одному тегу,rtagN_info– агрегкация по нескольким тегам,rtag_report– агрегация по одному тегу и хосту,rtagN_report– агрегация по нескольким тегам и хосту.

Вот примеры отчётов:

CREATE TABLE `photoscache_report_hitrate` (

`hostname` varchar(64) NOT NULL DEFAULT '',

`tag1_value` varchar(64) DEFAULT NULL,

`tag2_value` varchar(64) DEFAULT NULL,

`tag3_value` varchar(64) DEFAULT NULL,

`req_count` int(11) DEFAULT NULL,

`req_per_sec` float DEFAULT NULL,

`req_time_total` float DEFAULT NULL,

`req_time_percent` float DEFAULT NULL,

`req_time_per_sec` float DEFAULT NULL,

`ru_utime_total` float DEFAULT NULL,

`ru_utime_percent` float DEFAULT NULL,

`ru_utime_per_sec` float DEFAULT NULL,

`ru_stime_total` float DEFAULT NULL,

`ru_stime_percent` float DEFAULT NULL,

`ru_stime_per_sec` float DEFAULT NULL,

`traffic_total` float DEFAULT NULL,

`traffic_percent` float DEFAULT NULL,

`traffic_per_sec` float DEFAULT NULL,

`memory_footprint_total` float DEFAULT NULL,

`memory_footprint_percent` float DEFAULT NULL,

`req_time_median` float DEFAULT NULL,

`index_value` varchar(256) DEFAULT NULL,

KEY `hostname` (`hostname`)

) ENGINE=PINBA DEFAULT CHARSET=latin1 COMMENT='rtagN_report:served_by,build,img_size'

CREATE TABLE `photoscache_top_size` (

`geo` varchar(64) DEFAULT NULL,

`req_count` int(11) DEFAULT NULL,

`req_per_sec` float DEFAULT NULL,

`req_time_total` float DEFAULT NULL,

`req_time_percent` float DEFAULT NULL,

`req_time_per_sec` float DEFAULT NULL,

`ru_utime_total` float DEFAULT NULL,

`ru_utime_percent` float DEFAULT NULL,

`ru_utime_per_sec` float DEFAULT NULL,

`ru_stime_total` float DEFAULT NULL,

`ru_stime_percent` float DEFAULT NULL,

`ru_stime_per_sec` float DEFAULT NULL,

`traffic_total` float DEFAULT NULL,

`traffic_percent` float DEFAULT NULL,

`traffic_per_sec` float DEFAULT NULL,

`memory_footprint_total` float DEFAULT NULL,

`memory_footprint_percent` float DEFAULT NULL,

`req_time_median` float DEFAULT NULL,

`index_value` varchar(256) DEFAULT NULL,

`p95` float DEFAULT NULL,

`p99` float DEFAULT NULL

) ENGINE=PINBA DEFAULT CHARSET=latin1 COMMENT='rtag_info:geo:tag.img_size=top:95,99'(да в последнем отчёте мы агрегируем по тегу geo и фильтруем по тегу img_size).

В конфигурационных файлах nginx устанавливаем нужные теги:

location ~ '.....' {

...

pinba_tag fit_size '500x500';

pinba_tag is_fit 1;

pinba_tag img_size '920';

…– и в итоге можем получить вот такие графики хитрейта:

Мы плавно перешли к примерам использования. Я не буду заострять внимание на достаточно тривиальных примерах – просто перечислю некоторые основные вещи, которые мы мониторим с помощью Pinba:

- количество и время запросов на PHP-кластеры;

- потребление памяти PHP-скриптами;

- время запроса ко всем внешним сервисам (демоны на C, Go, Memcached, MySQL и т. п.);

- с помощью nginx-плагина мониторим количество запросов в секунду и время каждого запроса к nginx с разбиением по статус ответа;

- и другие.

Мониторинг очередей

Практически в каждом более-менее серьёзном проекте рано или поздно возникает задача обработки очереди событий. Определённые действия пользователя на сайте инициируют отправку события, на которое может быть подписано несколько обработчиков, и для каждого из них есть своя очередь. У нас этот процесс разделён на три части:

- транспорт – события со всех хостов собираются и отправляются на машину, где работает скрипт-клонировщик, который клонирует события в очередь для каждого подписчика;

- очередь: событие лежит в очереди (мы для очередей используем как MySQL, так и другие брокеры, например, Darner);

- процессинг: событие дошло до подписчика и начинает обрабатываться.

В какой-то момент нам захотелось измерить, сколько времени проходит с момента генерации события до его обработки. Проблема в том, что это уже не какой-то один PHP-скрипт, а несколько различных скриптов (в общем случае даже не PHP): в одном событие бросается, в другом – происходит отправка события в очередь обработчику, наконец, сам скрипт-обработчик, который получает событие из очереди. Как же быть? На самом деле, всё очень просто. В момент генерации события мы фиксируем время и записываем его в данные события и далее на каждом этапе запоминаем разницу между временем отправки и текущим временем. В итоге в самом конце, когда событие обработано, у нас есть все нужные значения таймеров, которые мы отправляем в Pinba. В результате мы можем сделать вот такой отчёт:

CREATE TABLE `tag_info_measure_cpq_consumer` (

`type` varchar(64) DEFAULT NULL,

`consumer` varchar(64) DEFAULT NULL,

`timer` varchar(64) DEFAULT NULL,

....

) ENGINE=PINBA DEFAULT CHARSET=latin1 COMMENT='tagN_info:type,consumer,timer'где timer – это название таймера для определённого этапа обработки события, consumer – название подписчика, type – в нашем случае это тип отправки события (внутри одной площадки или межплощадочный (у нас две площадки с одинаковой инфраструктурой – в Европе и в США, и события могут отправляться с площадки на площадку).

С помощью этого отчёта мы получили вот такие графики:

В этом примере рассматривается событие обновления данных о координатах пользователя. Как видно, весь процесс занимает меньше пяти секунд. Это значит, что, когда вы пришли в любимый бар, открыли приложение Badoo и попробовали найти пользователей рядом, вам действительно покажут тех, кто сейчас находится в этом месте, а не в том, где вы были полчаса назад (естественно, если ваше мобильное устройство отправляет данные о вашем местоположении).

Такой принцип (собрать все таймеры, а потом отправить их в Pinba) используется в Jinba. Jinba – это наш проект для измерения производительности клиентской части, в основе которого лежит Pinba; расшифровывается как JavaScript is not a bottleneck anymore. Подробнее о Jinba можно узнать из доклада Павла Довбуша и на сайте проекта.

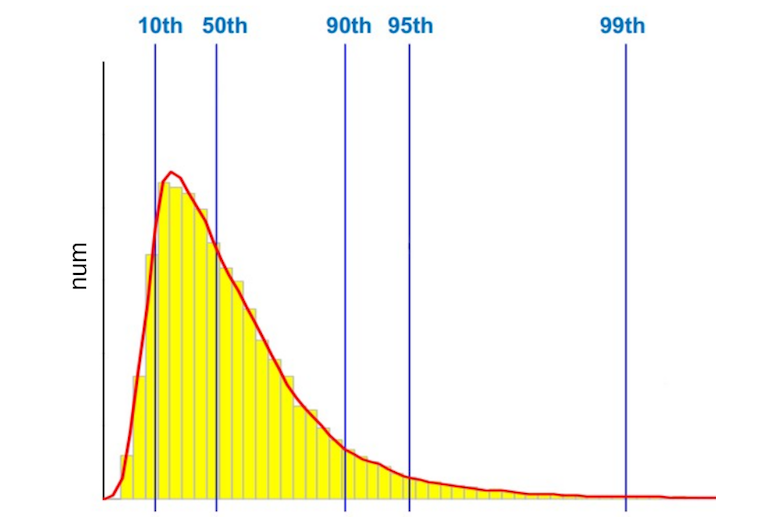

Мы собираем все таймеры на клиенте и потом одним запросом отправляем их на PHP-скрипт, который уже отсылает всё в Pinba. Помимо стандартных типов отчётов, в Jinba мы активно используем гистограммы. Я не буду подробно рассказывать про них – скажу только, что благодаря функционалу гистограмм мы имеем возможность в отчётах указывать перцентили.

По умолчанию Pinba делит весь временной интервал, в который попадали запросы, на 512 сегментов, и в гистограмме мы сохраняем количество запросов, попавших в тот или иной сегмент. Я уже говорил, что мы измеряем время работы PHP-скриптов, время ответа nginx, время обращения к внешним сервисам и т. п. Но какое время мы измеряем? Например, в секунду было 1000 запросов на какой-то скрипт, соответственно, мы имеем 1000 различных значений. Какое из них нужно отобразить на графике? Большинство скажут: «Среднее арифметическое», – кто-то скажет, что нужно смотреть, сколько выполняются самые медленные запросы. Оставим этот вопрос за рамками этого поста. Для тех, кто не знает, что такое перцентиль, приведу простейший пример: 50-й перцентиль (или медиана) – это такое значение, когда 50% запросов выполняются за время, не превышающее данное значение.

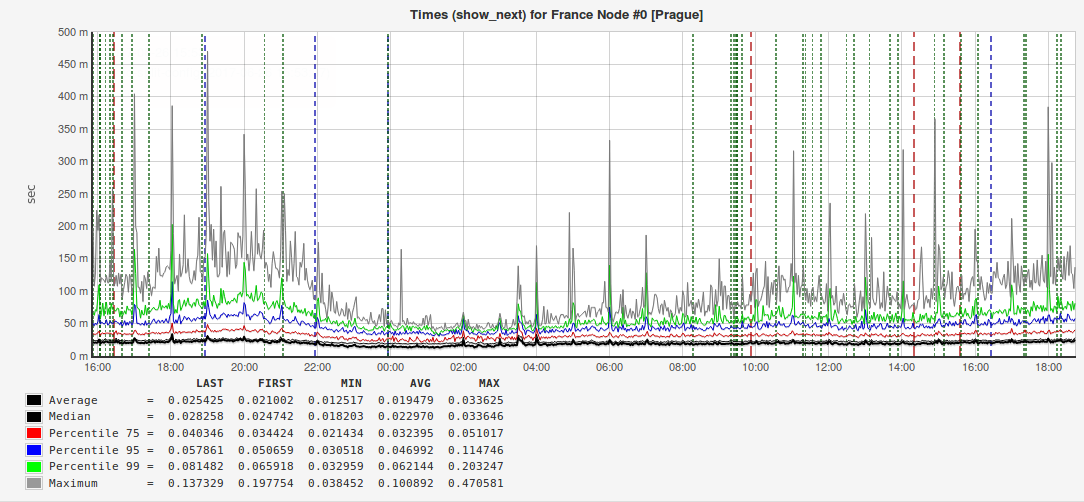

Мы всегда измеряем среднее арифметическое и старшие перцентили: 95-й, 99-й и даже 100-й (самое высокое время выполнения запроса). Почему нам так важны старшие перцентили? Вот пример графика с ответами одного из наших внешних сервисов:

Из рисунка видно, что и среднее арифметическое, и медиана (50-й перцентиль) примерно в два раза меньше, чем 95-й перцентиль. То есть, когда вы будете делать отчёт для руководства или выступать на конференции, то выгодно будет показать именно это время запроса, но если хочется сделать пользователей счастливее, то правильнее будет обратить внимание на 5% медленных запросов. Бывают случаи, когда значение 95-го перцентиля почти на порядок превышает среднее, а это значит, что где-то есть проблема, которую нужно найти и устранить.

MySQL is not a bottleneck anymore

Поскольку мы мониторим запросы ко всем внешним сервисам, то, естественно, мы не можем обойти стороной запросы к базе данных. Мы в Badoo используем MySQL. Когда у нас возникла задача её мониторинга, сначала мы решили использовать Slowlog + Zabbix. Но это оказалось очень неудобно. Slowlog может быть очень большой, и зачастую найти в нём причину возникшей проблемы довольно сложно, особенно когда это нужно сделать быстро. Поэтому мы стали рассматривать коммерческие решения.

На первый взгляд, всё было прекрасно, но смущало то, что триальная версия работала только на ограниченном количестве серверов (на порядок меньшем, чем у нас на одной площадке), и был риск, что на всём кластере решение может на заработать.

Одновременно с тестированием коммерческого решения наши DBA (кстати, у нас их всего два: основной и резервный, или мастер и слейв) сделали собственную разработку. Они использовали performance_schema, скрипты на Python, всё это отправляли в Elastic, а для отчётов использовали Kibana. И, как ни странно, всё работало, но, чтобы сделать мониторинг всего нашего кластера MySQL, потребовался бы сравнимый по мощности кластер Elasticsearch.

К сожалению, даже в Badoo нельзя по щелчку пальцев получить сотню лишних машин для кластера. И тут мы вспомнили про Pinba. Но возник следующий нюанс: как в Pinba сохранять информацию об SQL-запросе? Более того, нужно сохранять информацию не о конкретном запросе, а о «шаблоне» запроса, то есть, если у вас есть 1000 запросов вида Select * from table where field = field_value, и в каждом из них значение поля field_value разное, то нужно в Pinba сохранять данные о шаблоне Select * from table where field = #placeholder#. Для этого мы провели рефакторинг всего кода и везде, где в SQL прямо в коде подставлялись значения полей, мы проставили плейсхолдеры. Но всё равно шаблон запроса может быть слишком большой, поэтому от каждого шаблона мы берём хеш и именно его значение идёт в Pinba. Соответственно, в отдельной таблице мы храним связки «хеш – текст шаблона». В Pinba был создан вот такой отчёт:

CREATE TABLE `minba_query_details` (

`tag_value` varchar(64) DEFAULT NULL,

...

`p95` float DEFAULT NULL,

`p99` float DEFAULT NULL

) ENGINE=PINBA DEFAULT CHARSET=latin1

COMMENT='tag_info:query::95,99'В PHP-коде мы формируем для каждого запроса такой массив тегов:

$tags = [

‘query’ => $query_hash,

‘dest_host’ => ‘dbs1.mlan’,

‘src_host’ => ‘www1.mlan’,

‘dest_cluster’ => ‘dbs.mlan’,

‘sql_op’ => ‘select’,

‘script_name’ => ‘demoScript.php’,

];Естественно, в коде должно быть одно место, где выполняется запрос к БД, некий класс-обёртка; напрямую вызывать методы mysql_query или mysqli_query, конечно, нельзя.

В том месте, где выполняется запрос, мы считаем время запроса и отправляем данные в Pinba.

$config = [‘host’ => ‘pinbamysql.mlan’, ‘pinba_port’ => 30002];

$PinbaClient = new \PinbaClient($config);

$timer_value = /*Execute query and get execution time */

$PinbaClient->addTimer($tags, $timer_value);

/* Some logic */

$PinbaClient->send();Обратите внимание на использование класса \PinbaClient. Если вы собрали PHP с поддержкой Pinba, то у вас будет этот класс «из коробки» (если используется не PHP, то для других языков есть свои аналоги этого класса). Понятно, что запросов к БД будет очень много, и писать в тот же сервер Pinba, куда собирается статистика по скриптам, не получится. Хомячка разорвет. В настройках php.ini можно указать только один хост Pinba, куда будут отправляться данные по завершении работы скрипта. И тут нам на помощь и приходит класс \PinbaClient. Он позволяет указать произвольный хост с Pinba и отправлять туда значения таймеров. Кстати, для мониторинга очередей у нас тоже используется отдельный сервер Pinba. Поскольку данные в Pinba хранятся ограниченное количество времени, то и в таблице со связкой «хеш – SQL-шаблон» хранятся лишь актуальные хеши.

Запросов действительно много, поэтому мы решили отправлять в Pinba каждый второй. Это примерно сто пятьдесят тысяч запросов в секунду. И всё работает. В любой момент мы можем посмотреть, какие запросы на каких хостах тормозят, какие запросы появились, каких запросов выполняется очень много. И эти отчёты доступны каждому сотруднику.

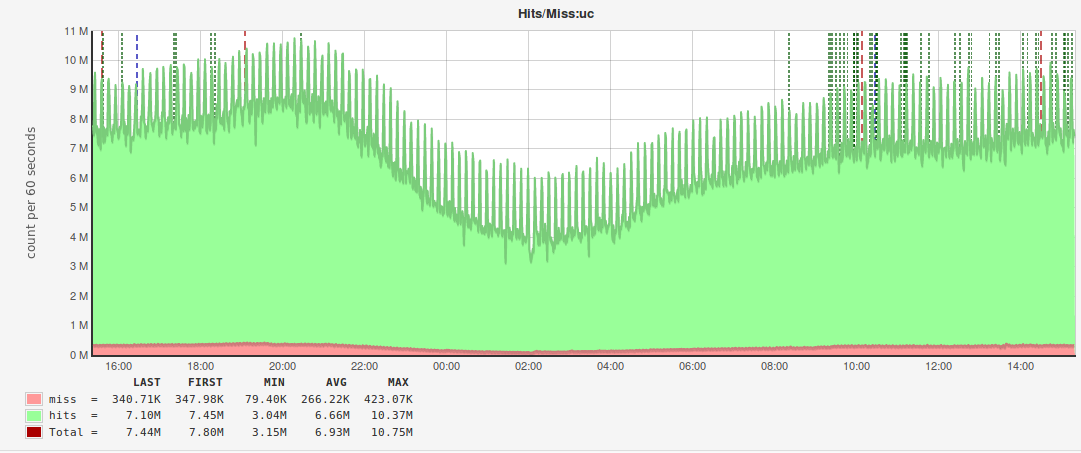

Ещё один нетривиальный кейс использования Pinba – мониторинг хитрейта мемкеша. На каждой площадке у нас есть кластер машин с Memcached, и необходимо было понять, эффективно ли мы используем мемкеш. Проблема в том, что у нас очень много различных ключей, и объём данных для каждого из них варьируется от нескольких байт до сотен килобайт. Мемкеш разбивает всю предоставленную ему память на страницы, которые затем распределяются по слабам (slabs). Слаб – это фиксированный объём памяти, выделяемый под один ключ. Например, третий слаб имеет размер 152 байта, а четвёртый – 192 байта. Это значит, что все ключи с данными от 152 до 192 байт будут лежать в четвёртом слабе. Под каждый слаб выделяется определённое количество страниц, каждая делится на кусочки (chunks), равные размеру слаба. Соответственно, может возникнуть ситуация, когда некоторым слабам выделяется больше страниц, чем нужно, и хитрейт по этим ключам достаточно высокий, а по другим ключам хитрейт может быть очень низкий, при этом у мемкеша достаточно свободной памяти. Чтобы этого не произошло, нужно перераспределять страницы между слабами. Соответственно, нам нужно знать хитрейт каждого ключа в данный момент времени, и для этого мы тоже используем Pinba.

В данном случае мы поступили аналогично мониторингу запросов к MySQL – сделали рефакторинг и привели все ключи к виду “key_family”:%s_%s, то есть выделили неизменяемую часть (семейство ключа) и отделили её двоеточием от изменяемых частей, например, messages_cnt:13589 (количество сообщений у пользователя с идентификатором 13589) или personal_messages_cnt:13589_4569 (количество сообщений от пользователя 13589 пользователю 4569).

В том месте, где происходит чтение данных по ключу, мы формируем следующий массив тегов:

$tags = [

‘key’ =>’uc’,

‘cluster’ => ‘wwwbma’,

‘hit’ => 1,

‘mchost’ => ‘memcache1.mlan’,

‘cmd’ => ‘get’,

];где key – семейство ключа, cluster – кластер машин, с которого идёт запрос в мемкеш, hit – есть данные в кеше или нет, mchost – хост с мемкешем, cmd – команда, отправляемая в мемкеш.

А в Pinba создан вот такой отчёт:

tag_info_key_hit_mchost | CREATE TABLE `tag_info_key_hit_mchost` (

`key` varchar(190) DEFAULT NULL,

`hit` tinyint(1) DEFAULT NULL,

`mchost` varchar(40) DEFAULT NULL,

...

) ENGINE=PINBA DEFAULT CHARSET=latin1

COMMENT='tagN_info:key,hit,mchost',благодаря которому мы смогли построить вот такие графики:

По аналогии с мониторингом MySQL под эти отчёты используется отдельный Pinba.

Шардинг

C ростом количества пользователей и развитием функционала мы столкнулись с ситуацией, когда на самом высоконагруженном PHP-кластере, куда приходят запросы с мобильных устройств, Pinba перестала справляться. Решение мы нашли очень простое – поднять несколько сервисов Pinba и «раунд робином» отправлять данные в произвольный. Сложность тут одна – как потом собирать данные? При сборе данных мы создали для каждого типа поля своё правило «слияния». Например, количество запросов суммируются, а для значений перцентилей всегда берётся максимальное и т. п.

Резюме

Во-первых, помните, что Pinba – это не хранилище данных. Pinba вообще не про хранение, а про агрегации, поэтому в большинстве случаев достаточно выбрать нужный тип отчёта, указать набор перцентилей – и вы получите нужную выборку в режиме реального времени.

Во-вторых, не используйте без необходимости таблицы с «сырыми» данными, даже если у вас всё работает и ничего не тормозит.

В-третьих, не бойтесь экспериментировать. Как показывает практика, с помощью Pinba можно решать широкий круг задач.

P. S. В следующий раз я постараюсь рассказать вам о граблях, на которые мы наступали во время работы с Pinba, и о том, какие проблемы могут возникнуть. И на этот раз я не ограничусь примерами из PHP.

|

Метки: author Battlecat программирование высокая производительность php блог компании badoo pinba мониторинг |

Intel Vpro или IP-KVM для десктопов |

Прежде всего, давайте договоримся: те, кому технология Intel vPro не в новинку, могут не тратить времени на всю вступительную часть статьи, сразу заказать Intel Core I7 7700 c 16 GB DDR4 240 SSD c защитой от DDOS за 3800руб в мес, без установочного платежа (ссылка в конце статьи) :)

Но нам кажется, что пока не все оценили преимущества удалённого доступа при помощи Intel vPro – который в нашем дата-центре предоставляется ко всем выделенным серверам без серверных платформ. А значит, нужно разобраться: что это за технология такая, какая она реализовывается, и какие проблемы решает.

Что такое Intel vPro?

Эта технология – настоящий аппаратно-программный комплекс, направленный на продвинутое решение проблем удалённого доступа: с учётом высоких требований к информационной безопасности, и необходимости предоставлять самые широкие возможности управления (о чём подробнее – ниже).

С аппаратной точки зрения, Intel реализовала технологию на базе собственных специальных материнских плат (с индексом Q, хотя и не все из них поддерживают все возможности vPro), процессоров и сетевых контроллеров. Поскольку компания сама производит все эти узлы, система получила уникальную целостность.

С программной стороны решение также собственное: Intel Active Management Technology (AMT). Продукт специально разработан для максимально эффективного удалённого управления, лёгкой инвентаризации оборудования, обеспечения безопасности и возможности оперативно устранять любые сбои – даже такие, при которых удалённо проблему, без применения этой технологии, решить в принципе невозможно.

В чём преимущества?

Во-первых, Intel vPro при реализации через VNC обеспечивает полноценный KVM на удалённую машину, не зависящий от операционной системы.

Таким образом, даже при перезагрузке подключение не разрывается. Можно удалённо зайти в BIOS – иными словами, без физического контакта с машиной решаются практически любые проблемы, которые могут на ней возникнуть. Наверное, излишне объяснять, насколько это полезно.

Заметим только, что поддерживается даже разрешение экрана 1920х1200 пикселей. Учитывая высокую скорость — полное ощущение, что работаешь вовсе не удалённо.

Во-вторых, безопасность. В разрезе работы с выделенным сервером важна, конечно, не система Anti-Theft, а тот факт, что vPro шифрует данные. Осуществляются шифрование и дешифровка по протоколу AES, что обеспечивает высокую производительность. К тому же, AMT позволяет, например, изолировать заражённую вредоносным ПО машину, не теряя удалённого доступа к ней.

Больше о возможностях AMT можно прочитать в Wiki

Что предлагает «Контел»?

Хорошо – но что такого необычного, спросят некоторые из вас? Те, кто и без этой статьи в курсе, что представляет собой IntelVpro, чем она так хороша, и зачем её использовать. Главное, разумеется, в деталях.

Для реализации VNC-подключения при помощи IntelVpro необходим, прежде всего, некий поддерживающий её процессор (а также материнская плата, но в данном случае важно не это). Нюанс заключается в том, что мы используем Intel Core I7, построенный на микроархитектуре Kaby Lake.

А такие процессоры, как вы знаете, в продаже-то появились только в начале года. Так что мы получаем не обычный IP-KVM, работающий на IntelVpro – а очень, очень мощный. Особенно это касается графического ядра, что в ряде задач весьма важно.

В результате, VNC-доступ обеспечивается ко всем нашим выделенным серверам, и работает безукоризненно. Смеем заметить, что IntelVpro на основе процессоров Kaby Lake пока что никто, кроме нас, в Москве не предлагает.

Так же при заказе до конца июня действует акция — DDOS защита до конца срока аренды в подарок, как реализована наша защита от DDOS, можно будет прочитать в следующих выпусках

Заказать и потестировать сервера вы можете на любом из наших проектов

StarVPS Сервера Core I7 7700 16GB DDR4 240SSD от 3800 руб. (напомню, что это с защитой от DDOS)

|

Метки: author ondys серверное администрирование серверная оптимизация it- инфраструктура блог компании контел vpro |

Использование Python и Excel для обработки и анализа данных. Часть 2: библиотеки для работы с данными |

Как читать и редактировать Excel файлы при помощи openpyxl

Эта библиотека пригодится, если вы хотите читать и редактировать файлы .xlsx, xlsm, xltx и xltm.

Установите openpyxl using pip.

Общие рекомендации по установке этой библиотеки — сделать это в виртуальной среде Python без системных библиотек. Вы можете использовать виртуальную среду для создания изолированных сред Python: она создает папку, содержащую все необходимые файлы, для использования библиотек, которые потребуются для Python.

Перейдите в директорию, в которой находится ваш проект, и повторно активируйте виртуальную среду venv. Затем перейдите к установке openpyxl с помощью pip, чтобы убедиться, что вы можете читать и записывать с ним файлы:

# Activate virtualenv

$ source activate venv

# Install `openpyxl` in `venv`

$ pip install openpyxl

Теперь, когда вы установили openpyxl, вы можете начать загрузку данных.

Но что именно это за данные? Например, в книге с данными, которые вы пытаетесь получить на Python, есть следующие листы:

Функция load_workbook () принимает имя файла в качестве аргумента и возвращает объект рабочей книги, который представляет файл. Это можно проверить запуском type (wb). Не забудьте убедиться, что вы находитесь в правильной директории, где расположена электронная таблица. В противном случае вы получите сообщение об ошибке при импорте.

# Import `load_workbook` module from `openpyxl`

from openpyxl import load_workbook

# Load in the workbook

wb = load_workbook('./test.xlsx')

# Get sheet names

print(wb.get_sheet_names())

Помните, вы можете изменить рабочий каталог с помощью os.chdir (). Фрагмент кода выше возвращает имена листов книги, загруженной в Python. Вы можете использовать эту информацию для получения отдельных листов книги. Также вы можете проверить, какой лист активен в настоящий момент с помощью wb.active. В приведенном ниже коде, вы также можете использовать его для загрузки данных на другом листе книги:

# Get a sheet by name

sheet = wb.get_sheet_by_name('Sheet3')

# Print the sheet title

sheet.title

# Get currently active sheet

anotherSheet = wb.active

# Check `anotherSheet`

anotherSheet

На первый взгляд, с этими объектами Worksheet мало что можно сделать. Однако, можно извлекать значения из определенных ячеек на листе книги, используя квадратные скобки [], к которым нужно передавать точную ячейку, из которой вы хотите получить значение.

Обратите внимание, это похоже на выбор, получение и индексирование массивов NumPy и Pandas DataFrames, но это еще не все, что нужно сделать, чтобы получить значение. Нужно еще добавить значение атрибута:

# Retrieve the value of a certain cell

sheet['A1'].value

# Select element 'B2' of your sheet

c = sheet['B2']

# Retrieve the row number of your element

c.row

# Retrieve the column letter of your element

c.column

# Retrieve the coordinates of the cell

c.coordinate

Помимо value, есть и другие атрибуты, которые можно использовать для проверки ячейки, а именно row, column и coordinate:

Атрибут row вернет 2;

Добавление атрибута column к “С” даст вам «B»;

coordinate вернет «B2».

Вы также можете получить значения ячеек с помощью функции cell (). Передайте аргументы row и column, добавьте значения к этим аргументам, которые соответствуют значениям ячейки, которые вы хотите получить, и, конечно же, не забудьте добавить атрибут value:

# Retrieve cell value

sheet.cell(row=1, column=2).value

# Print out values in column 2

for i in range(1, 4):

print(i, sheet.cell(row=i, column=2).value)

Обратите внимание: если вы не укажете значение атрибута value, вы получите

Вы используете цикл с помощью функции range (), чтобы помочь вам вывести значения строк, которые имеют значения в столбце 2. Если эти конкретные ячейки пусты, вы получите None.

Более того, существуют специальные функции, которые вы можете вызвать, чтобы получить другие значения, например get_column_letter () и column_index_from_string.

В двух функциях уже более или менее указано, что вы можете получить, используя их. Но лучше всего сделать их явными: пока вы можете получить букву прежнего столбца, можно сделать обратное или получить индекс столбца, перебирая букву за буквой. Как это работает:

# Import relevant modules from `openpyxl.utils`

from openpyxl.utils import get_column_letter, column_index_from_string

# Return 'A'

get_column_letter(1)

# Return '1'

column_index_from_string('A')

Вы уже получили значения для строк, которые имеют значения в определенном столбце, но что нужно сделать, если нужно вывести строки файла, не сосредотачиваясь только на одном столбце?

Конечно, использовать другой цикл.

Например, вы хотите сосредоточиться на области, находящейся между «A1» и «C3», где первый указывает левый верхний угол, а второй — правый нижний угол области, на которой вы хотите сфокусироваться. Эта область будет так называемой cellObj, которую вы видите в первой строке кода ниже. Затем вы указываете, что для каждой ячейки, которая находится в этой области, вы хотите вывести координату и значение, которое содержится в этой ячейке. После окончания каждой строки вы хотите выводить сообщение-сигнал о том, что строка этой области cellObj была выведена.

# Print row per row

for cellObj in sheet['A1':'C3']:

for cell in cellObj:

print(cells.coordinate, cells.value)

print('--- END ---')

Обратите внимание, что выбор области очень похож на выбор, получение и индексирование списка и элементы NumPy, где вы также используете квадратные скобки и двоеточие чтобы указать область, из которой вы хотите получить значения. Кроме того, вышеприведенный цикл также хорошо использует атрибуты ячейки!

Чтобы визуализировать описанное выше, возможно, вы захотите проверить результат, который вернет вам завершенный цикл:

('A1', u'M')

('B1', u'N')

('C1', u'O')

— END — ('A2', 10L)

('B2', 11L)

('C2', 12L)

— END — ('A3', 14L)

('B3', 15L)

('C3', 16L)

— END ---

Наконец, есть некоторые атрибуты, которые вы можете использовать для проверки результата импорта, а именно max_row и max_column. Эти атрибуты, конечно, являются общими способами обеспечения правильной загрузки данных, но тем не менее в данном случае они могут и будут полезны.

# Retrieve the maximum amount of rows

sheet.max_row

# Retrieve the maximum amount of columns

sheet.max_column

Это все очень классно, но мы почти слышим, что вы сейчас думаете, что это ужасно трудный способ работать с файлами, особенно если нужно еще и управлять данными.

Должно быть что-то проще, не так ли? Всё так!

Openpyxl имеет поддержку Pandas DataFrames. И можно использовать функцию DataFrame () из пакета Pandas, чтобы поместить значения листа в DataFrame:

# Import `pandas`

import pandas as pd

# Convert Sheet to DataFrame

df = pd.DataFrame(sheet.values)

Если вы хотите указать заголовки и индексы, вам нужно добавить немного больше кода:

# Put the sheet values in `data`

data = sheet.values

# Indicate the columns in the sheet values

cols = next(data)[1:]

# Convert your data to a list

data = list(data)

# Read in the data at index 0 for the indices

idx = [r[0] for r in data]

# Slice the data at index 1

data = (islice(r, 1, None) for r in data)

# Make your DataFrame

df = pd.DataFrame(data, index=idx, columns=cols)

Затем вы можете начать управлять данными при помощи всех функций, которые есть в Pandas. Но помните, что вы находитесь в виртуальной среде, поэтому, если библиотека еще не подключена, вам нужно будет установить ее снова через pip.

Чтобы записать Pandas DataFrames обратно в файл Excel, можно использовать функцию dataframe_to_rows () из модуля utils:

# Import `dataframe_to_rows`

from openpyxl.utils.dataframe import dataframe_to_rows

# Initialize a workbook

wb = Workbook()

# Get the worksheet in the active workbook

ws = wb.active

# Append the rows of the DataFrame to your worksheet

for r in dataframe_to_rows(df, index=True, header=True):

ws.append®

Но это определенно не все! Библиотека openpyxl предлагает вам высокую гибкость в отношении того, как вы записываете свои данные в файлы Excel, изменяете стили ячеек или используете режим только для записи. Это делает ее одной из тех библиотек, которую вам точно необходимо знать, если вы часто работаете с электронными таблицами.

И не забудьте деактивировать виртуальную среду, когда закончите работу с данными!

Теперь давайте рассмотрим некоторые другие библиотеки, которые вы можете использовать для получения данных в электронной таблице на Python.

Готовы узнать больше?

Чтение и форматирование Excel файлов xlrd

Эта библиотека идеальна, если вы хотите читать данные и форматировать данные в файлах с расширением .xls или .xlsx.

# Import `xlrd`

import xlrd

# Open a workbook

workbook = xlrd.open_workbook('example.xls')

# Loads only current sheets to memory

workbook = xlrd.open_workbook('example.xls', on_demand = True)

Если вы не хотите рассматривать всю книгу, можно использовать такие функции, как sheet_by_name () или sheet_by_index (), чтобы извлекать листы, которые необходимо использовать в анализе.

# Load a specific sheet by name

worksheet = workbook.sheet_by_name('Sheet1')

# Load a specific sheet by index

worksheet = workbook.sheet_by_index(0)

# Retrieve the value from cell at indices (0,0)

sheet.cell(0, 0).value

Наконец, можно получить значения по определенным координатам, обозначенным индексами.

О том, как xlwt и xlutils, соотносятся с xlrd расскажем дальше.

Запись данных в Excel файл при помощи xlrd

Если нужно создать электронные таблицы, в которых есть данные, кроме библиотеки XlsxWriter можно использовать библиотеки xlwt. Xlwt идеально подходит для записи и форматирования данных в файлы с расширением .xls.

Когда вы вручную хотите записать в файл, это будет выглядеть так:

# Import `xlwt`

import xlwt

# Initialize a workbook

book = xlwt.Workbook(encoding=«utf-8»)

# Add a sheet to the workbook

sheet1 = book.add_sheet(«Python Sheet 1»)

# Write to the sheet of the workbook

sheet1.write(0, 0, «This is the First Cell of the First Sheet»)

# Save the workbook

book.save(«spreadsheet.xls»)

Если нужно записать данные в файл, то для минимизации ручного труда можно прибегнуть к циклу for. Это позволит немного автоматизировать процесс. Делаем скрипт, в котором создается книга, в которую добавляется лист. Далее указываем список со столбцами и со значениями, которые будут перенесены на рабочий лист.

Цикл for будет следить за тем, чтобы все значения попадали в файл: задаем, что с каждым элементом в диапазоне от 0 до 4 (5 не включено) мы собираемся производить действия. Будем заполнять значения строка за строкой. Для этого указываем row элемент, который будет “прыгать” в каждом цикле. А далее у нас следующий for цикл, который пройдется по столбцам листа. Задаем условие, что для каждой строки на листе смотрим на столбец и заполняем значение для каждого столбца в строке. Когда заполнили все столбцы строки значениями, переходим к следующей строке, пока не заполним все имеющиеся строки.

# Initialize a workbook

book = xlwt.Workbook()

# Add a sheet to the workbook

sheet1 = book.add_sheet(«Sheet1»)

# The data

cols = [«A», «B», «C», «D», «E»]

txt = [0,1,2,3,4]

# Loop over the rows and columns and fill in the values

for num in range(5):

row = sheet1.row(num)

for index, col in enumerate(cols):

value = txt[index] + num

row.write(index, value)

# Save the result

book.save(«test.xls»)

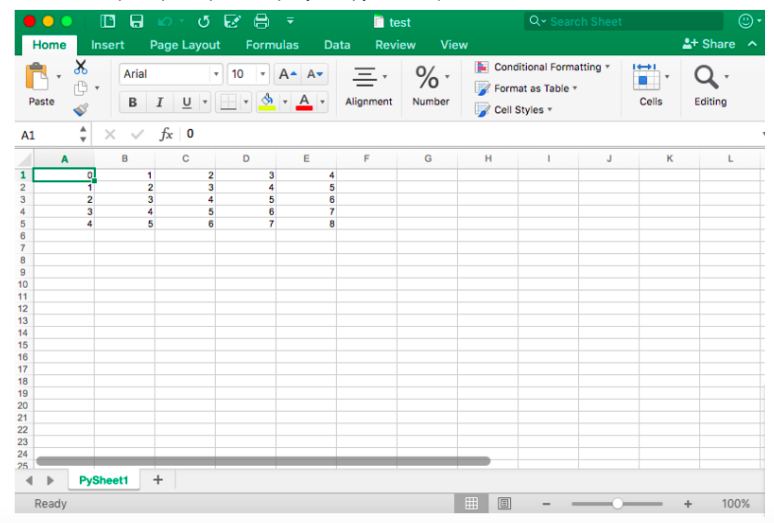

В качестве примера скриншот результирующего файла:

Теперь, когда вы видели, как xlrd и xlwt взаимодействуют вместе, пришло время посмотреть на библиотеку, которая тесно связана с этими двумя: xlutils.

Коллекция утилит xlutils

Эта библиотека в основном представляет собой набор утилит, для которых требуются как xlrd, так и xlwt. Включает в себя возможность копировать и изменять/фильтровать существующие файлы. Вообще говоря, оба этих случая подпадают теперь под openpyxl.

Использование pyexcel для чтения файлов .xls или .xlsx

Еще одна библиотека, которую можно использовать для чтения данных таблиц в Python — pyexcel. Это Python Wrapper, который предоставляет один API для чтения, обработки и записи данных в файлах .csv, .ods, .xls, .xlsx и .xlsm.

Чтобы получить данные в массиве, можно использовать функцию get_array (), которая содержится в пакете pyexcel:

# Import `pyexcel`

import pyexcel

# Get an array from the data

my_array = pyexcel.get_array(file_name=«test.xls»)

Также можно получить данные в упорядоченном словаре списков, используя функцию get_dict ():

# Import `OrderedDict` module

from pyexcel._compact import OrderedDict

# Get your data in an ordered dictionary of lists

my_dict = pyexcel.get_dict(file_name=«test.xls», name_columns_by_row=0)

# Get your data in a dictionary of 2D arrays

book_dict = pyexcel.get_book_dict(file_name=«test.xls»)

Однако, если вы хотите вернуть в словарь двумерные массивы или, иными словами, получить все листы книги в одном словаре, стоит использовать функцию get_book_dict ().

Имейте в виду, что обе упомянутые структуры данных, массивы и словари вашей электронной таблицы, позволяют создавать DataFrames ваших данных с помощью pd.DataFrame (). Это упростит обработку ваших данных!

Наконец, вы можете просто получить записи с pyexcel благодаря функции get_records (). Просто передайте аргумент file_name функции и обратно получите список словарей:

# Retrieve the records of the file

records = pyexcel.get_records(file_name=«test.xls»)

Записи файлов при помощи pyexcel

Так же, как загрузить данные в массивы с помощью этого пакета, можно также легко экспортировать массивы обратно в электронную таблицу. Для этого используется функция save_as () с передачей массива и имени целевого файла в аргумент dest_file_name:

# Get the data

data = [[1, 2, 3], [4, 5, 6], [7, 8, 9]]

# Save the array to a file

pyexcel.save_as(array=data, dest_file_name=«array_data.xls»)

Обратите внимание: если указать разделитель, то можно добавить аргумент dest_delimiter и передать символ, который хотите использовать, в качестве разделителя между “”.

Однако, если у вас есть словарь, нужно будет использовать функцию save_book_as (). Передайте двумерный словарь в bookdict и укажите имя файла, и все ОК:

# The data

2d_array_dictionary = {'Sheet 1': [

['ID', 'AGE', 'SCORE']

[1, 22, 5],

[2, 15, 6],

[3, 28, 9]

],

'Sheet 2': [

['X', 'Y', 'Z'],

[1, 2, 3],

[4, 5, 6]

[7, 8, 9]

],

'Sheet 3': [

['M', 'N', 'O', 'P'],

[10, 11, 12, 13],

[14, 15, 16, 17]

[18, 19, 20, 21]

]}

# Save the data to a file

pyexcel.save_book_as(bookdict=2d_array_dictionary, dest_file_name=«2d_array_data.xls»)

Помните, что когда используете код, который напечатан в фрагменте кода выше, порядок данных в словаре не будет сохранен!

Чтение и запись .csv файлов

Если вы все еще ищете библиотеки, которые позволяют загружать и записывать данные в CSV-файлы, кроме Pandas, рекомендуем библиотеку csv:

# import `csv`

import csv

# Read in csv file

for row in csv.reader(open('data.csv'), delimiter=','):

print(row)

# Write csv file

data = [[1, 2, 3], [4, 5, 6], [7, 8, 9]]

outfile = open('data.csv', 'w')

writer = csv.writer(outfile, delimiter=';', quotechar='"')

writer.writerows(data)

outfile.close()

Обратите внимание, что NumPy имеет функцию genfromtxt (), которая позволяет загружать данные, содержащиеся в CSV-файлах в массивах, которые затем можно помещать в DataFrames.

Финальная проверка данных

Когда данные подготовлены, не забудьте последний шаг: проверьте правильность загрузки данных. Если вы поместили свои данные в DataFrame, вы можете легко и быстро проверить, был ли импорт успешным, выполнив следующие команды:

# Check the first entries of the DataFrame

df1.head()

# Check the last entries of the DataFrame

df1.tail()

Note: Используйте DataCamp Pandas Cheat Sheet, когда вы планируете загружать файлы в виде Pandas DataFrames.

Если данные в массиве, вы можете проверить его, используя следующие атрибуты массива: shape, ndim, dtype и т.д.:

# Inspect the shape

data.shape

# Inspect the number of dimensions

data.ndim

# Inspect the data type

data.dtype

Что дальше?

Поздравляем, теперь вы знаете, как читать файлы Excel в Python :)

Но импорт данных — это только начало рабочего процесса в области данных. Когда у вас есть данные из электронных таблиц в вашей среде, вы можете сосредоточиться на том, что действительно важно: на анализе данных.

Если вы хотите глубже погрузиться в тему — знакомьтесь с PyXll, которая позволяет записывать функции в Python и вызывать их в Excel.

|

Метки: author Dmitry21 разработка веб-сайтов python блог компании отус otus.ru otus обучение образование программирование |

Раскурочивание на части особо выносливого железа линейки bullion S, где 768 Гб оперативы |

|

Метки: author Kirill_Rahimov системное администрирование серверное администрирование it- инфраструктура блог компании крок тестирование bullion s bull сервер |

[Перевод] Цифровые близнецы. Дизайн через отражение |

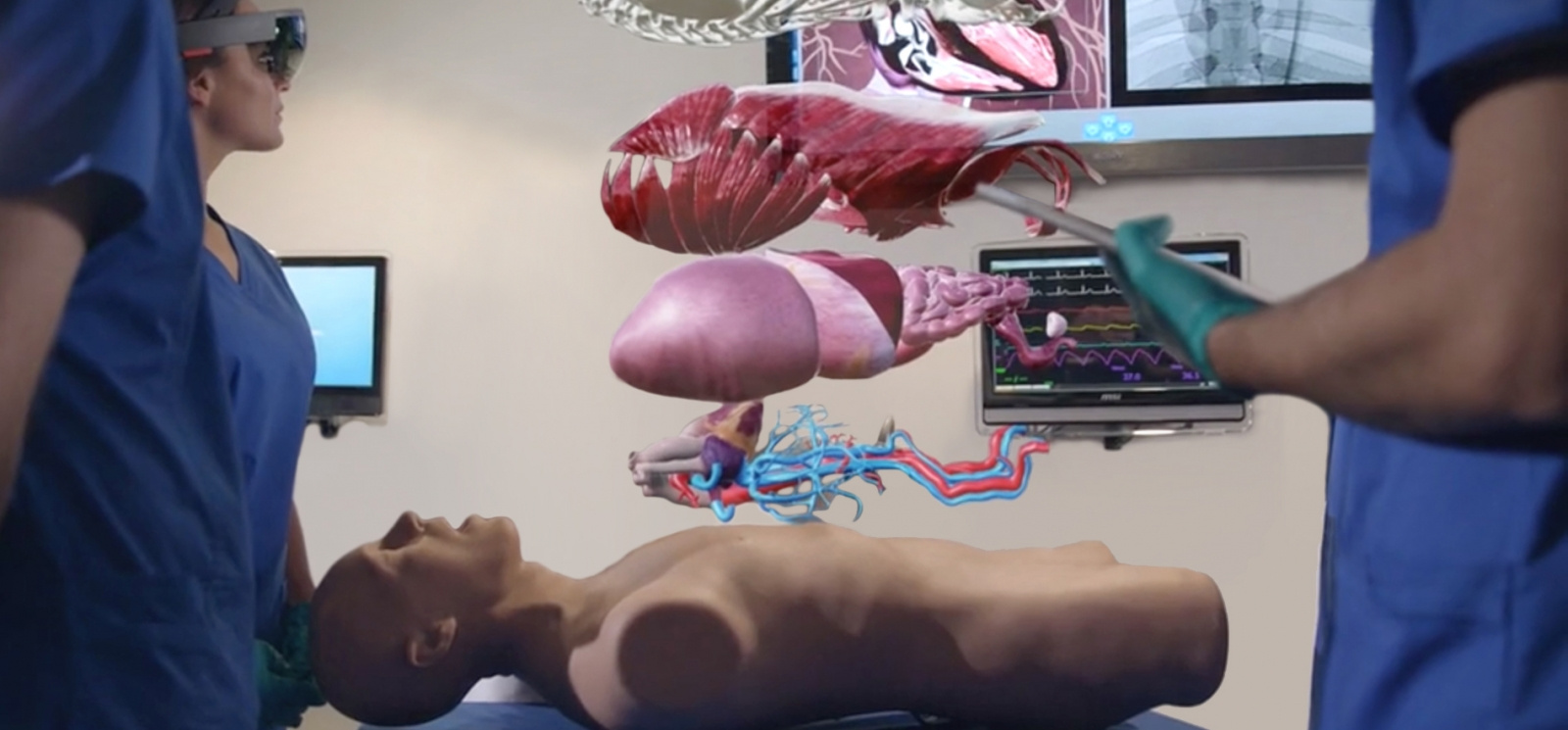

«Основная их задача — проверить все до мелочей, объяснить хирургу, что именно он должен делать во время операции. Вы же не хотите, чтобы он уже сделав надрез спросил: «Хорошо, и что мне нужно делать дальше?». Они предоставляют дополнительные возможности, и врач, работающий с коленом пациента, точно знает, какой формы имплантанты ему потребуются, до начала операции», — разъясняет Майкл Гривс (Michael Grieves), описывая применение цифровых близнецов в здравоохранении, концепцию, которую он разработал более десяти лет назад. Не смотря на то, что впервые эта идея была предложена уже в 2003 году как способ удешевления разработки продуктов с помощью цифровых моделей, только сейчас этот подход получил широкое применение. Гривс — профессор, исследователь и помощник директора Центра управленя жизненным циклом и инновациями в технологическом институте Флориды. В своей статье 2003 года «Цифровые близнецы: превосходство в производстве на основе виртуального прототипа завода» Гривс писал: «Применение цифрового двойника происходит на протяжении всего жизненного цикла изделия — чтобы обеспечить высокий уровень качества для потребителя, и предоставить информацию о том, как он на самом деле пользуется продуктом — для изготовителя».

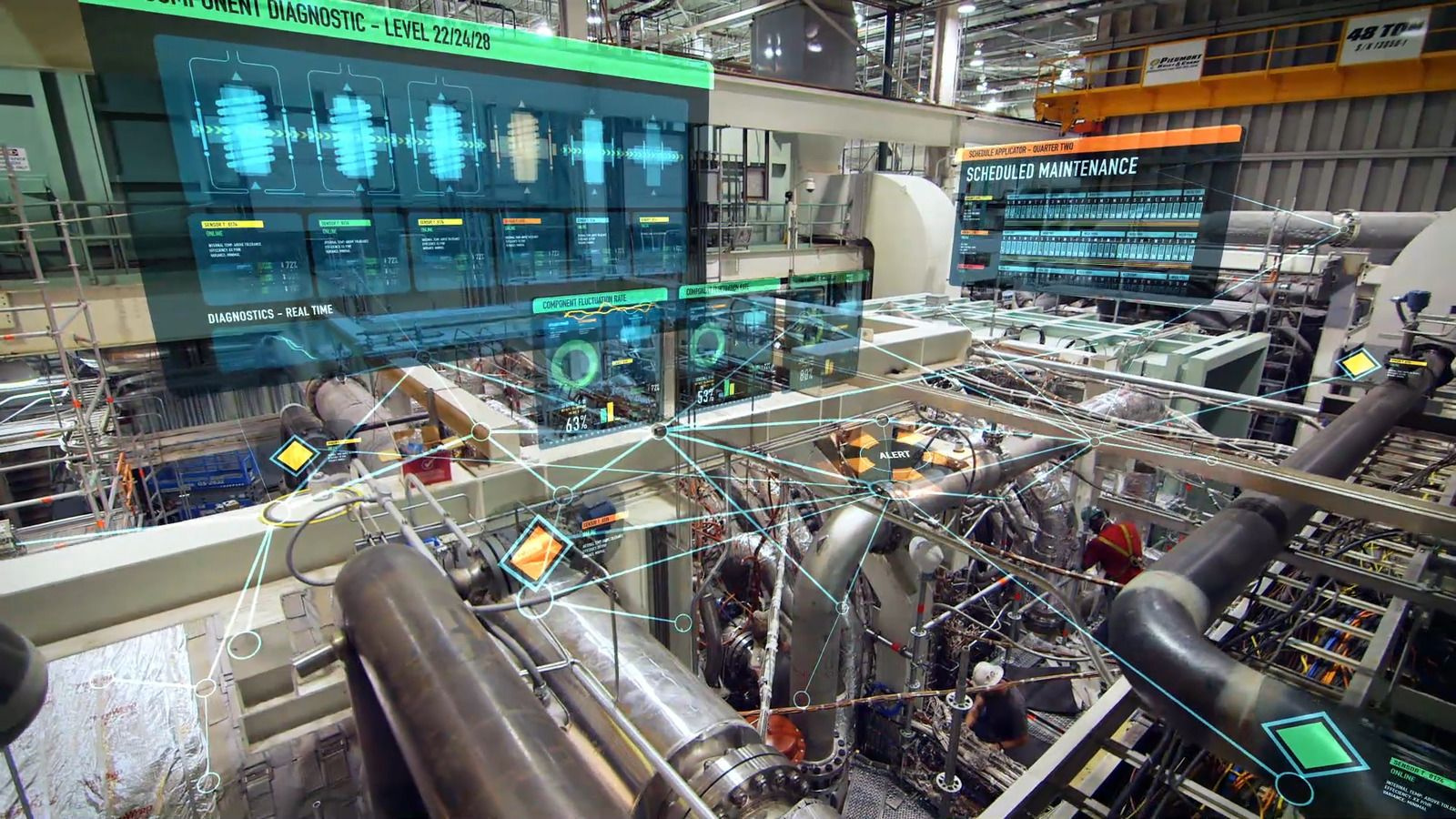

Термин «Цифровой близнец» был придуман инженером, с которым Гривс работал в НАСА. Вне зависимости от того, является ли рассматриваемый объект искусственным коленным суставом или аэродинамическим двигателем, Гривс считает, что применяя единый подход можно значительно сократить расходы на проектирование, изготовление, эксплуатацию и последующее обслуживание изделия. Целый ряд компаний, работающих в области автоматизированного проектирования (САПР) одобрили эту идею. Компания PTC, занимающаяся разработкой промышленного программного обеспечения, поддержала идею цифрового двойника физического продукта как для организации, так и для обслуживания и поддержки продукта. Совместно с этим PTC применяет технологии виртуальной реальности (VR) и дополненной реальности (AR). Так, например, наводя планшет с камерой, на машину, которая нуждается в ремонте, программное обеспечение, делает запрос к цифровому двойнику, и определяет, какие действия необходимо выполнить работнику. «Данные из САПР [созданные в ходе проектирования] могут быть использованы для формирования «инструкций дополненной реальности», которые параллельно используют реальные данные, поступающие от реально существующего изделия. Таким образом, можно найти, где произошел сбой и даже понять причину сбоя», — объясняет вице-президент подразделения САПР компании PTC Брайан Томпсон. «Это похоже наиболее перспективный промышленный вариант использования технологий Интернета Вещей и VR/AR, основанных на данных из базы САПР. Совместное использование этих технологий может дать положительный эффект. Это очень удобно, когда вы, как сервис-инженер, можете получать некое цифровое представление о том, как вам необходимо работать с изделием дальше». Задолго до того, как сервис-инженер доберется до готового изделия, был создан виртуальный близнец в виде САПР модели, которая затем, в течение нескольких лет, была значительно проработана, чтобы ее можно было считать цифровым двойником. Изначально Гривс изложил три основных требования к модели, которую можно было назвать настоящей цифровой копией. «Я предложил три требования к виртуальному двойнику, первое требование – проверка на соответствие внешнего вида, но затем я расширил это требования до соответствия оценки восприятия всеми органами чувств». Важно отметить, что основным в первом требовании является не только лишь внешний вид. Виртуальный визуальный анализ включает в себя разбор продукта на части и детальный осмотр всех его составных частей.

Второе требование Гривса — виртуальный продукт должен вести себя реалистично при проведении различных испытаний, например, таких как продувка в цифровой аэродинамической трубе или анализ напряжений.

Его третье требование заключается в получении информации от виртуального продукта с помощью физической экспертизы, как если бы пользователь мог проверить реальный продукт, например, определение величины расхода топлива двигателем.

Гривс отмечает рост промышленных возможностей для выполнения его требований: «Где же находится реализация цифрового близнеца сегодня? Когда я только начинал свою работу, мы не могли выполнить даже визуальное требование — сегодня это редко является проблемой. Сегодня вы уже не сможете отличить фотографию настоящего автомобиля от фотографичного рендеринга. Исполнительный директор «Dassault Systemes» EuroNorth Стивен Чадвик полностью согласен с этим: «Фотореалистичный рендеринг автомобилей Ауди уже давно используется в рекламных видео роликах. С использованием нашего продукта 3D Excite, полученные цифровые видео сложно отличить от снятого фильма. Рекламные видео ролики Ауди, которые вы видите по телевидению или в кинотеатрах, производятся исключительно с помощью нашей программной платформы. То, что выглядит как красивый и совершенный автомобиль Ауди, фактически представляет собой визуализацию на основе САПР модели».

Цифровое производство.

Цифровая копия, которая в значительной степени соответствует первым двум требованиям Гривса, может использоваться в работе «виртуального производства» и обновляться, дополняясь на каждой «станции». Именно в эти моменты цифровой двойник получает данные о подготовке к производству и данные автоматизированного конструирования (CAE). Каждая из заводских цифровых станций, на которых выполняются операции над виртуальным продуктом: сборка узлов продукта и конечная сборка продукта — также уже были смоделированы ранее.

«Мы можем провести сборку цифрового продукта на цифровой фабрике, проверив тем самым, что продукт собираем для заданного производственного процесса», — объясняет Зви Фейер, исполнительный вице-президент по разработке программного обеспечения Siemens. Siemens может смоделировать совместную работу нескольких машин, например, робота и конвейера, а также возможные сбои и восстановлении. Фейер объясняет, как цифровой двойник может помочь сэкономить деньги компаний с помощью технологий виртуального производства. «В первых 10-20 циклах [запуск производства нового продукта] вы с большой вероятностью столкнетесь с проблемами. Информация, предоставленная поставщику, не была достаточно точной, поставщик использовал неподходящий материал или производственный процесс. Эти части не подходят друг другу, допуск оказался больше, чем ожидалось; Мы сталкиваемся с этим, это происходит снова и снова. Сегодня у нас есть возможность спрогнозировать возможность сборки, определить допуски, которые оказывают наибольшее влияние на процесс». У Гривса есть серьезные претензии к тем компаниям, в особенности из аэрокосмической отрасли, которые не могут предоставить виртуальный продукт для моделирования производства. «Boeing и Lockheed Martin требуют от компаний-поставщиков присылать свои виртуальные модели, чтобы их можно было проверять. Я думаю, что это действительно важно для Boeing и Airbuses, они получают виртуальную информацию наряду с физическими изделиями. Они даже выбирают своих поставщиков на основе следующего критерия, «вы должны иметь возможность предоставить нам виртуальную модель», потому что это позволить избежать задержек на создание этой модели в будущем».

Виртуальное тестирование

После того как в виртуальный продукт внесли улучшения на основе моделирования его изготовления на цифровой фабрике, есть еще одна область потенциальной экономии средств — моделирование проверки качества. Вместо дорогостоящих инструментов и стендов — все моделируется внутри компьютера». Виртуальные тесты имеют преимущество перед физическими в стоимости. Когда вы проводите один или два теста для аэрокосмической отрасли, это все равно дорого, но вы можете провести достаточно много испытаний практически без дополнительных затрат», — сообщает Гривс. Чадвик добавляет: «Мы обнаружили, что многие наши клиенты используют платформу [Dassault software], чтобы иметь возможность выполнять такие проверки, и действительно многие из них отказались от физического тестирования, потому что для сертификации этого больше не требуется. Модель, основанная на цифровых данных, достаточно точная». Затем, после утверждения и на этапе эксплуатации предполагается, что с встроенных датчиков будет получена обратная связь, чтобы помочь улучшить характеристики изделия и учесть недостатки в последующих версиях продукта. В прошлом году PTC продемонстрировала, как виртуальный продукт, в их случае велосипед, может быть улучшен с использованием такого подхода. Томпсон поясняет это следующим образом: «Клиенты рассматривают то, что они могут отслеживать изменение параметров по мере эксплуатации, как достоинство. Результаты, которые мы получили на примере велосипедов, будут опубликованы осенью». Тем не менее, Томпсон уже сейчас видит сложности при обработке данных о всех параметрах продукта. «Если у вас есть 10 000 уникальных моделей продукта, которые отслеживают в режиме реального времени — 10 000 велосипедов, мы получаем большой объем данных». Решение состоит в том, чтобы выделить ключевые элементы дизайна, например, вилка велосипеда. Он отмечает, что с точки зрения бизнеса весь объем данных может оказаться излишним, а затраты, связанные с их обработкой могут оказаться неоправданными. Вместо этого — выделение ключевых параметров продукта, таких как износ вилки велосипеда, уменьшают затраты на обработку данных, обеспечивая информацию о конкретных улучшениях продукта.

Большие данные (Big Data).

Решение проблем больших данных не рассматривается Гривсом. «Меня не беспокоят структуры данных. У нас есть необходимые инструменты, чтобы решить все подобные проблемы», — говорит он. Его больше беспокоит то, что в сфере информационных технологий наблюдается недостаток сотрудничества, развитие происходит слишком быстро, быстрее чем формирование стандартов. «Лучшее, на что мы можем надеяться, это кооперация, — чтобы все разработчики играли вместе в одной песочнице, вместо того, чтобы иметь множество собственных структур данных, которые затем сложно использовать совместно». Камнем преткновения в данной ситуации является информационная безопасность. «Это одна из наиболе острых проблем», — говорит Гривс. «Когда мы создаем интеллектуальные продукты, которые отражают то, как они выглядят, мы должны быть уверены, что только авторизованные пользователи смогут получить доступ к этой информации, не все. Я предлагаю отнестись к этому с высокой степень паранойи. Необходимо определить того кто запрашивает информацию.»

Информационная безопасность также имеет фундаментальное значение для другого ИТ-направления, поддерживающего концепцию цифрового двойника – Интернет вещей (Internet of Things IoT). По мнению Томсона, cтратегия компании по использованию IoT неразрывно связана с виртуальным продуктом: «Мне кажется странным, когда вы говорите, что у вас есть стратегия для цифрового двойника, но нет стратегии для IoT. У вас должен быть способ связать эти две технологии». Подход IoT уже широко используется производителями самолетных двигателей. Это поясняет Гривс:« Компания Rolls-Royce хорошо работает именно так. Если вы спросите у них — они собирают данные для каждого отдельного двигателя и каждого отдельного полета, таким образом у них есть возможность спрогнозировать сбой продукта, с помощью гигантского механизма корреляции. Когда они видят вот этот статус и тот статус, они знают, что у них будет проблема с тем-то компонентом». Согласно Фейеру такое сопоставление данных IoT в режиме реального времени может помочь улучшить бизнес-модель компании, а не только проектирование или ремонт продукта. В пример он приводит бизнес-модель типографии. «Рассмотрим типографию: почему она умная? Потому что технологии сегодня позволяют нам установить датчики для сбора информации производителем, и теперь мы можем предложить новую бизнес-модель, например, оплата за печатную страницу или оплата только за чернила».

Цифровые близнецы и PLM

Такое использование виртуального продукта похоже на управление жизненным циклом продукта (PLM). Это также связано с тем, что концепция цифрового двойника сегодня рассматривается как часть PLM. Определение PLM рассматривается как процесс управления всем жизненным циклом продукта: инициализация, дизайн и проектирование, подготовка к производству, обслуживание и утилизация. Как и цифровой двойник Гривса, степень внедрения PLM различна от одной сферы промышленности к другой и от одной компании к другой, так и представления о виртуальном продукте также различаются. Фейер говорит: «Цифровой двойник — это решение в рамках PLM на пути к переходу к Промышленности 4.0», — концепции цифрового промышленного предприятия. Томпсон видит PLM как сочетание виртуального продукта и места, где цифровая копия будет «создана». Он также видит, что близнец является тем, что объединяет данные из PLM и таких областей, как планирование ресурсов предприятия (ERP), которое он ставит вне управления жизненным циклом. «Как только вы переходите на этап изготовления продукта, связь с PLM-системой заканчивается, и вы находитесь в сфере ERP или в подобной системе, которая отслеживает параметры близнеца». Двойник эффективно собирает всю необходимую информацию, информацию компании в рамках PLM-деятельности и прочую, такую как информацию с датчиков обслуживания, дополняя исходную модель САПР. Фейер предлагает более широко взлянуть на PLM: «PLM постоянно развивается. Если бы вы спросили моего босса 15 лет назад он сказал бы, что PLM — это управление данными CAD, а CAD это набор некоторых CAE инструментов. Но если вы спросите его сегодня, он расскажет о PLM как о системе, охватывающей всю область интеллектуального продукта, которая включает в себя требования к продукту, которые формируются еще до появления CAD моделей, затем CAD модели, CAE, производство, программное обеспечение, управление жизненным циклом и этап интеграции для электроники». Так же, как идея Гривса для цифрового двойника развивается в промышленности, PLM также не стоит на месте. Как полагает Фейер, «мы постоянно осознаем, что PLM сегодня это нечто больше, чем то, с чего это путешествие началось 35 лет назад». Концепция цифрового двойника Гривса медленно, но реализуется, технологически. С точки зрения применения этой технологии, аэрокосмическая промышленность, вероятно, является самой передовой. Понятно, что за 13 лет, прошедших с тех пор, как Гривс и его коллега из НАСА сформировали эту идею, концепция рассматривалась как имеющая преимущества по сравнению с теми подходами, которые использовались в то время. И эти отличительные преимущества в будущем будут иметь еще более сильное влияние, включая влияние на изменения в бизнес-моделях и обслуживании. Так что же будет через 35 лет?

|

Метки: author javdeev управление продуктом цифровые близнецы управление жизненным циклом изделия |

Губит людей не пиво |

Как известно из популярной песенки Вячеслава Нивинного губит людей не пиво — губит людей вода. Особенно когда вода заканчивается в самый неподходящий момент. С этим что-то надо делать, тем более, что в столе валяется не используемый микроконтроллер esp8266 и зеленый светодиод.

Как известно из популярной песенки Вячеслава Нивинного губит людей не пиво — губит людей вода. Особенно когда вода заканчивается в самый неподходящий момент. С этим что-то надо делать, тем более, что в столе валяется не используемый микроконтроллер esp8266 и зеленый светодиод. Вода, вода

Думаю, многие из читателей Хабра по традиции пьют бутылированную воду, которую мы потребляем в офисе и дома. Не то, чтобы меня как-то напрягает сам процесс заказы воды, но известным образом это как то не по айтишному, звонить куда-то, вечно занято, то просят номер договора, а куда вести, а во сколько? Решил я все это прекратить и сделать этот процесс интереснее.

Пишем письмо

Фирма, которая доставляет мне воду не очень дружит с высокими технологиями, нет ни приложений, ни заказа с сайта, но вода очень хорошая. Чтобы заказать доставку надо звонить каждый раз оператору. Пишу в службу поддержки (все-же нашелся на сайте контактный e-mail)

Через некоторое время я получаю письмо с любезным согласием принимать заказ на воду по электронной почте, чего и требовалось.

Большая красная кнопка, esp8266 и зеленый светодиод

Ну, идея, как уже многие догадались до ужаса простая. Имея контроллер esp8266, программируем его на отправку электронного письма на адрес фирмы доставки воды, нажимая и удерживая кнопку до момента, когда загорится зеленый светодиод, сигнализирующий о успешном отправлении сообщения. Удержание кнопки длится 3-5 секунд. За это время устройство коннектится с домашним WI- FI и выполняет этот простейший код.

#include

#include "Gsender.h"

#pragma region Globals

const char* ssid = "HomeWIFI"; // имя вашейсети

const char* password = ""; // пароль сети

const char* letter_message = "Здравствуйте! Пожалуйста, примите заказ на"

"2 бытылки воды и доставьте воду завтра по адресу Смоленский "

"переулок ==== в 19 часов. Спасибо. Номер договора ====== Телефон +7909=====";

uint8_t connection_state = 0;

uint16_t reconnect_interval = 10000; // если не удалось связаться - повторим через 10 секунд

#pragma endregion Globals

uint8_t WiFiConnect(const char* nSSID = nullptr, const char* nPassword = nullptr)

{

static uint16_t attempt = 0;

Serial.print("Connecting to ");

if(nSSID) {

WiFi.begin(nSSID, nPassword);

Serial.println(nSSID);

} else {

WiFi.begin(ssid, password);

Serial.println(ssid);

}

uint8_t i = 0;

while(WiFi.status()!= WL_CONNECTED && i++ < 50)

{

delay(200);

Serial.print(".");

}

++attempt;

Serial.println("");

if(i == 51) {

Serial.print("Connection: TIMEOUT on attempt: ");

Serial.println(attempt);

if(attempt % 2 == 0)

Serial.println("Check if access point available or SSID and Password\r\n");

return false;

}

Serial.println("Connection: ESTABLISHED");

Serial.print("Got IP address: ");

Serial.println(WiFi.localIP());

return true;

}

void Awaits()

{

uint32_t ts = millis();

while(!connection_state)

{

delay(50);

if(millis() > (ts + reconnect_interval) && !connection_state){

connection_state = WiFiConnect();

ts = millis();

}

}

}

void setup()

{

pinMode(5, OUTPUT);

Serial.begin(115200);

connection_state = WiFiConnect();

if(!connection_state) // if not connected to WIFI

Awaits(); // constantly trying to connect

Gsender *gsender = Gsender::Instance(); // Getting pointer to class instance

String subject = "Заказ на воду";

if(gsender->Subject(subject)->Send("water*****@mail.ru", letter_message)) {

Serial.println("Message send.");

digitalWrite(5, HIGH); // включаем зеленый светодиод - все ОК

} else {

Serial.print("Error sending message: ");

Serial.println(gsender->getError());

}

}

void loop(){}

Код использует библиотеку Gsender.h, скачать которую можно здесь. Особенностью библиотеки является то, что она отправляет сообщения с gmail, поэтому нужно открыть для проекта гугловский адрес электронной почты. В самом тексте библиотеки необходимо указать логин и пароль от вновь открытой почты, но в виде base64 зашифрованных фраз. Используем для этого, к примеру, этот сервис. Должно быть что-то подобное.

const char* EMAILBASE64_LOGIN = "Y29zbWkxMTExMUBnbWFpbC5jb20=";

const char* EMAILBASE64_PASSWORD = "TGFzZGFzZDEyMzI=";

Возможно, системы безопасности GMAIL запросят разрешения использовать подобное подключение. Разрешите.

Кнопка лишь подает питание на контроллер на время отработки кода. На любой из портов подвесим светодиод для сигнализирования успешной передачи сообщения.

Устройство коннектится и питается от двух батареек и ресурса хватит на 1000 заказов, т.е. лет на 10. Устройство можно сконфигурировать при желании из сети и навесить на него кучу всякий дополнительных примочек, что, в принципе, особо то и не нужно.

Не смотря на простоту, сама идея мне показалась симпатичной и в духе действительно реальной интернет-вещи. Используя этот принцип можно реализовать простейшие функции, к примеру, вызов такси, любимой пиццы или положить такую «умную» кнопку рядом с хворающим родственником. Нажал — смс-ка прилетела. Удобно и можно в нужный момент помочь больному. Для отправки смс можно, к примеру, использовать сервис IFTTT.

Всем хорошего дня!

|

Метки: author Uris разработка для интернета вещей программирование микроконтроллеров esp8266 интернет вещей |

Fujitsu разработали технологию управления виртуальными машинами, повышающую эффективность использования серверов |

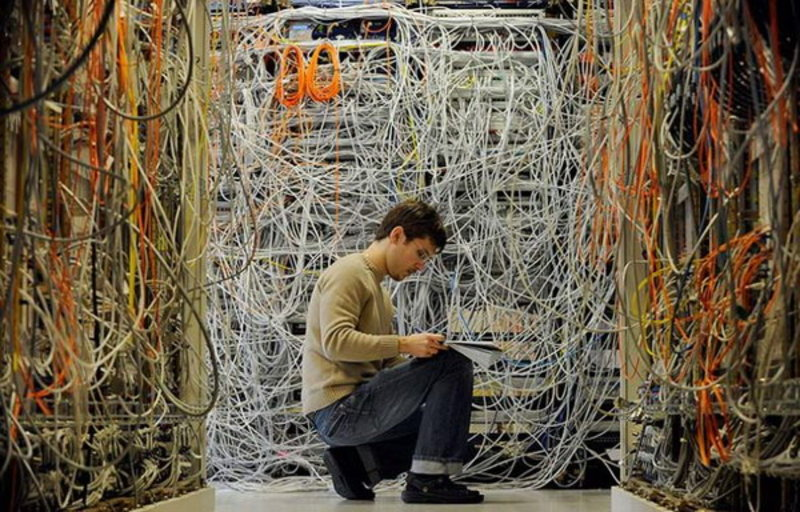

/ Flickr / Lindsay Holmwood / CC

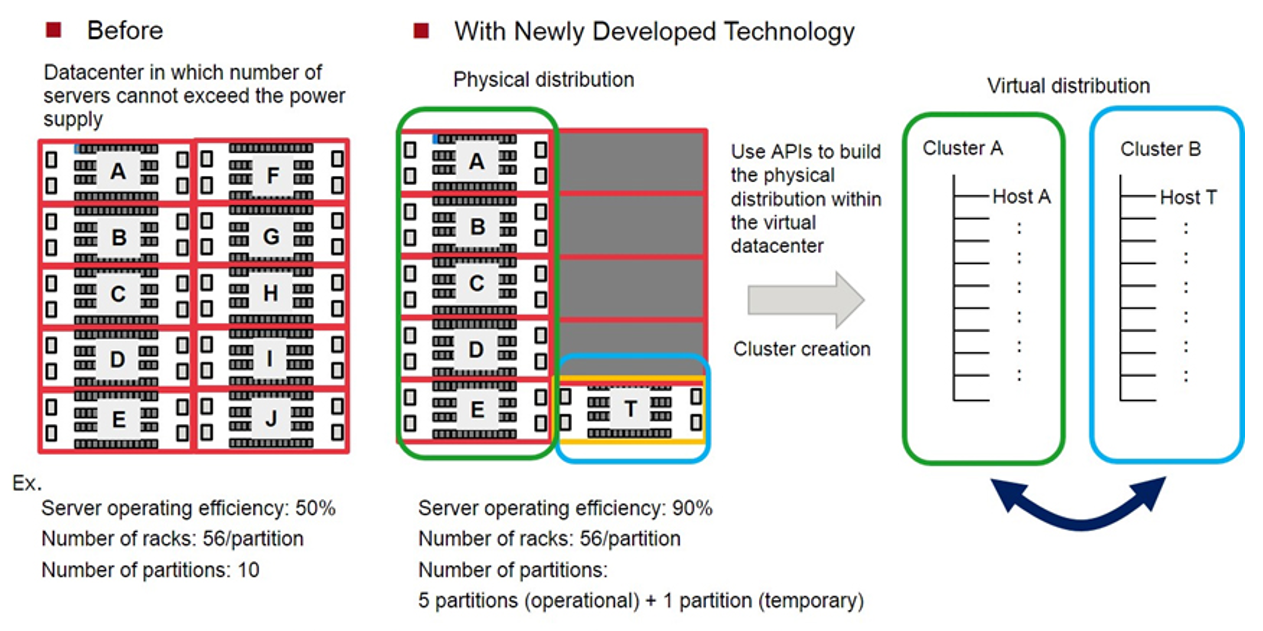

/ Flickr / Lindsay Holmwood / CCПо словам представителей Fujitsu, новый алгоритм повышает эффективность использования стоек в дата-центре до 90%, позволяя одновременно экономить пространство в машинном зале. Количество серверов в стойке ограничено значением их энергопотребления, которое должно быть меньше, чем мощность блока питания. Однако большинство серверов обычно работают на 10–50% своих возможностей, используя только часть доступной мощности блоков питания.

Повысить плотность серверов в стойке можно с помощью специального программного обеспечения, которое, чтобы сбалансировать нагрузку, ограничивает частоту машин для снижения энергопотребления. Однако такой подход имеет негативный эффект — страдает производительность, что неприемлемо для бизнес-критических приложений.

Fujitsu Laboratories разработали алгоритм, управляющий виртуальными машинами, который с помощью API мигрирует их на специально выделенные backup-разделы в зависимости от энергопотребления каждой стойки. Это гарантирует высокую производительность отдельных серверов и исключает вероятность превышения допустимого уровня электропотребления. При этом виртуальные машины автоматически мигрируют между кластерами, когда физический сервер прекращает работать из-за ошибки или во время обслуживания.

«Применив эту технологию, мы надеемся увеличить плотность серверов в дата-центрах, значительно уменьшив занимаемую стойками площадь», — говорят исследователи.

Fujitsu Laboratories также разработали технологию, способную определять число серверов, которые должны быть установлены в стойку. Делает она это на основании статистических данных (информация о нагрузке на серверы), вычисляя частоту миграций для каждой стойки.

«Новое решение позволит снизить количество занимаемого серверами места на 40% при условии, что ЦОД работает с десятью разделами при эксплуатационной эффективности серверов 50%. В результате мы получаем эффективность, приближающуюся к 90%, и пять рабочих разделов», — отмечают ученые из японской компании.

Fujitsu Laboratories планируют внедрить эту технологию в программное обеспечение ServerView Infrastructure Manager уже в 2018 году.

О компании Fujitsu

Fujitsu — крупная японская корпорация, производитель электроники и ИТ-компания. Занимается выпуском серверного оборудования, систем хранения данных, а также персональных систем — ноутбуков, рабочих станций и периферии. В состав группы Fujitsu (Fujitsu Limited) входит порядка 540 дочерних компаний и ещё 20 совместных предприятий.

P.S. О чем еще мы пишем в нашем блоге:

- VPN — типы подключения и проверка безопасности

- Как правильно внедрить BRAS

- BRAS для операторов связи

- SD-WAN как конкурент традиционному MPLS

- Новые технологии для решения проблем с блокировкой сайтов

|

Метки: author VASExperts блог компании vas experts vas experts fujitsu управление вм |

Оценка связанности событий с помощью Байеса |

Если имеется 2 предприятия, тогда вероятность того, что они оба обанкротятся и мы потеряем все вложения . Так учит стандартная теория вероятности. Но что будет, если предприятия связаны и банкротство одного ведет к банкротству другого?

Крайним случаем является ситуация, когда предприятия полностью зависимы. Вероятность двойного банкротства ( банкрот1 & банкрот2 ) = ( банкрот1 ), тогда вероятность потери всех вложений равна . Методика оценки риска имеет большой разброс от 0.05 до 0.0025 и реальное значение зависит от того насколько правильно мы оценили связанность двух событий.

При оценке инвестиций в предприятий имеем от до . То есть максимальная возможная вероятность остается большой и старая поговорка «не клади яйца в одну корзину» не сработает, если упадет прилавок со всеми корзинами сразу.

Таким образом наши оценки имеют колоссальный разброс, и сколько куда вкладывать остается вопросом. А ведь надо хорошо считать, прежде чем вкладывать. Нейт Сильвер говорит, что незнание этих простых законов аналитиками привело к крахам фондового рынка в 2008 году, когда рейтинговые агенства США оценивали риски, но не оценивали связанность рисков. Что в конце концов привело к эффекту домино, когда сначала свалился крупный игрок и увлек за собой других.

Попробуем разобрать эту проблему, решив простую математическую задачу после ката.

Давайте решим упрощенную задачу, чтобы научиться оценивать связанность двух событий методом Байеса на простом примере двух монет. Далее математика… Постараюсь разжевать, чтобы самому аж понятно стало.

Пусть имеются 2 монеты и , которые выдают 0 или 1 при бросании и возможна одна из 4х комбинаций на один бросок:

комбинация 1: 00

комбинация 2: 01

комбинация 3: 10

комбинация 4: 11

Здесь первая цифра относится к первой монете, а вторая ко второй. Я ввел такие обозначения для удобства изложения.

По условию задачи пусть первая монета независима. То есть и . А вторая может быть зависима, но мы не знаем насколько сильно. То есть зависит от .

Может есть какой-то магнит, который притягивает монеты, или бросающий является шулером и прохиндеем, коих пруд пруди. Наше незнание мы будем оценивать в виде вероятности.

Чтобы оценить связанность нужен фактический материал и модель, параметры которой будем оценивать. Давайте используем самые простые допущения, чтобы прочувствовать тему и построить модель.

Если монеты несвязны, то все четыре комбинации будут равновероятны. Тут возникает поправка из стандартной теории вероятности — такого результата можно добиться при бесконечном количестве бросаний. Но так как на практике количество бросаний конечно, то мы можем попасть в отклонение от среднего. Например, можно получить нечаянно серию трёх или пяти орлов при подбрасывании монет, хотя в среднем при бесконечном бросании будет точно 50% орлов и точно 50% решек. Отклонение можно инерпретировать как проявление связанности, а можно инерпретировать как обычное отклонение статистики от среднего. Чем меньше выборка, тем больше возможно отклонение, и поэтому можно спутать разные допущения.

Вот тут и приходит на помощь теория Байеса, которая дает возможность оценить вероятность той или иной гипотезы по конечному набору данных. Байес производит обратный процесс от того, с которым мы привыкли иметь дело в теории вероятности. По Байесу оценивается вероятность что наши домыслы совпадают с реальном положении дел, а не вероятность исходов.

Переходим к творческом процессу построения модели. К модели связанности предъявляется требование, — она как минимум должна охватывать возможные варианты. В нашем случае крайними вариантами являются полная связанность или полная независимость монет. То есть модель должна иметь как минимум один параметр k, описывающий связанность.

Опишем связанность в виде коэффициента . Если вторая монета всегда полностью совпадает с первой, то 1. Если вторая монета всегда имеет противоположные значения, то . Если монеты несвязны, тогда . Получается неплохо — одним числом описываем множество вариантов. К тому же смысл этой переменной определяем как вероятность совпадения с первой монетой.

Попробуем оценить это число по фактическим данным.

Пусть имеется конкретный набор данных , который состоит из исходов:

исход 1: 00

исход 2: 01

исход 3: 11

исход 4: 00

исход 5: 11

На первый взгляд ни о чем не говорит. Количество комбинаций:

Неспешно разберем, что значит формула Байеса. Используем стандартную запись, где знак означает вероятность выполнения события, если уже известно, что другое событие выполнилось.

В данном случае имеем комбинацию непрерывных и дискретных распределений. и являются непрерывными распределениями. А и являются дискретными. Для формулы Байеса такая комбинация возможна. Для экономии времени не расписываю все тонкости.

Если мы будем знать эту вероятность, то можно найти значение , при котором вероятность нашей гипотезы максимальна. То есть найти наиболее вероятный коэффициент .

В правой части имеем 3 члена, которые нужно оценить. Проанализируем их.

1)Надо знать или вычислить вероятность получения таких данных при той или иной гипотезе . Ведь даже если объекты несвязны (), то получить серию можно, хотя сложно. Намного вероятнее получить такую комбинацию, если монеты связаны (). — наиболее важный член и ниже разберем как его вычислять.

2) Надо знать . Вот тут натыкаемся на тонкий момент моделестроения. Мы не знаем эту функцию и будем строить предположения. Если нет дополнительных знаний, то будем считать, что равновероятно в диапазоне от 0 до 1. Если бы мы имели инсайдерскую информацию, то больше знали бы о связанности строили бы более точный прогноз. Но так как такой информации не имеется, то положим . Так как эта величина не зависит от , то при вычислении она не будет иметь значения.

3) вычисляется легко — это просто вероятность иметь такой набор данных, если все величины случайны. В данном случае . Так как эта величина не зависит от , то при вычислении она не будет иметь значения.

Разберем, как вычислять . Помним, что первая монета независима, а вторая зависима. Поэтому вероятность значения для первой монеты будет выглядеть как-то так , а для второй монеты так . Вероятность совпадения с первой монетой равна , а вероятность несовпадения равна .

Разберем возможные случаи для одного исхода:

Для проверки сложим вероятности, должна получиться единица . Это радует.

Теперь можно перейти к поиску наиболее вероятного значения по вымышленному набору данных .

Вероятность иметь такой набор

,

раскрываем

,

упрощаем

,

обобщаем для произвольного набора данных

,

.

Обозначим количество совпадений , а количество несовпадений .

Получаем такую обобщенную формулу

.

Желающие могу поиграться с графиком, вводя разные показатели степени:ссылка на wolframalpha.

Так как в этом примере , то работаем напрямую с .

Для поиска максимума дифференцируем и приравниваем к нулю:

.

Чтобы произведение было равно нулю надо, чтобы один из членов был равен нулю.

Нас не интересуют и , так как в этих точках нет локального максимума, а третий множитель указывает на локальный максимум, поэтому

.

Получаем формулу, которую можно использовать для прогнозов. То есть после дополнительного броска первой монеты пытаемся предугадать поведение второй через .

исход 6: 1?

При получении новых данных формулу корректируем и уточняем. При получении инсайдерских данных мы будем иметь более точное значение , и можно дополнительно уточнить всю цепочку расчетов.

Так как мы вычисляем вероятность, то для желательно проанализировать среднее и дисперсию. Среднее мы как раз нашли на предыдущих шагах. А вот про дисперсию можно сказать, что при увеличении количества данных — пик на графике (ссылка выше) становится более острый, что означает более однозначный прогноз значения .

В приведенном выше наборе данных имеем 4 совпадения и одно несовпадение. Поэтому . В дополнительном шестом бросании с вероятностью 80% произойдет совпадение второй монеты с первой. Допустим мы получили на первой монете 1, тогда 80%, что «исход 6» будет «11» и 20%, что «исход 6» будет «10». После каждых бросков корректируем формулу и прогнозируем вероятность еще несовершенных совпадений на шаг вперед.

На этом я бы хотел закончить свой пост. Буду рад вашим комментариям.

PS

Данный пример описан для демонстрации алгоритма. Тут много чего не учтено того, что бывает в реальности. Например, при анализе событий из реального мира надо будет анализировать временные интервалы, проводить факторный анализ и многое другое. Это уже забота профессионалов. Так же следует философски отметить, что всё в этом мире взаимосвязано, только эти связи иногда проявляются, а иногда нет. Поэтому полностью абсолютно всё учесть на сто процентов не получится, ибо пришлось бы в формулу включать все объекты этого мира, даже те, которые мы не знаем, и обрабатывать очень большой объем фактического материала.

Источники информации:

1. https://ru.wikipedia.org/wiki/Теорема_Байеса.

2. https://ru.wikipedia.org/wiki/Байесовский_вывод.

3. Нейт Сильвер, «Сигнал и шум».