Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Zyxel Nebula: обзор ключевых возможностей облачной сетевой экосистемы |

- Сетевые технологии,

- Облачные вычисления,

- Беспроводные технологии,

- IT-инфраструктура,

- Блог компании МУК

Zyxel Nebula: обзор ключевых возможностей облачной сетевой экосистемы

- Сетевые технологии,

- Облачные вычисления,

- Беспроводные технологии,

- IT-инфраструктура,

- Блог компании МУК

Введение

Все продукты под брендом Nebula, включая беспроводные точки доступа, коммутаторы и маршрутизаторы, имеют возможность управления из облака. В отличие от традиционных решений, ими можно в режиме реального времени централизовано управлять, настраивать, проводить диагностику и мониторинг с помощью приложения или через веб-портал. Таким образом можно управлять как конкретными устройствами, так и сетью в целом. Высокий уровень масштабируемости также позволяет легко разворачивать новые участки сети просто подключив новые устройства. Это не требует каких-либо специальных знаний и может быть сделано даже без участия ИТ-специалистов — нужно просто подключить устройства и они начнут работать. Также Nebula позволяет легко установить надежное защищенное VPN-соединение через интернет между несколькими сегментами сети.

Ключевые возможности системы:

— встроенные инструменты управления для быстрого разворачивания больших сетей;

— интуитивно понятный, автоматизированный интерфейс управления сетью, а также постоянное обновление функций, которые существенно облегчают управление сетью и — позволяют быстро обучиться тем специалистам, которые работают с ней впервые;

— централизованная видимость всех компонентов, которая позволяет снизить затраты на ПО и оборудование за счет оптимизации работы сети;

— полное портфолио решений от одного вендора, которое обеспечивает хорошую совместимость компонентов сети;

— модель лицензирования в кредит и по требованию обеспечивает гибкость использования системы в зависимости от текущих потребностей бизнеса;

— устройства и сама сеть продолжают работать, даже если закончилась лицензия.

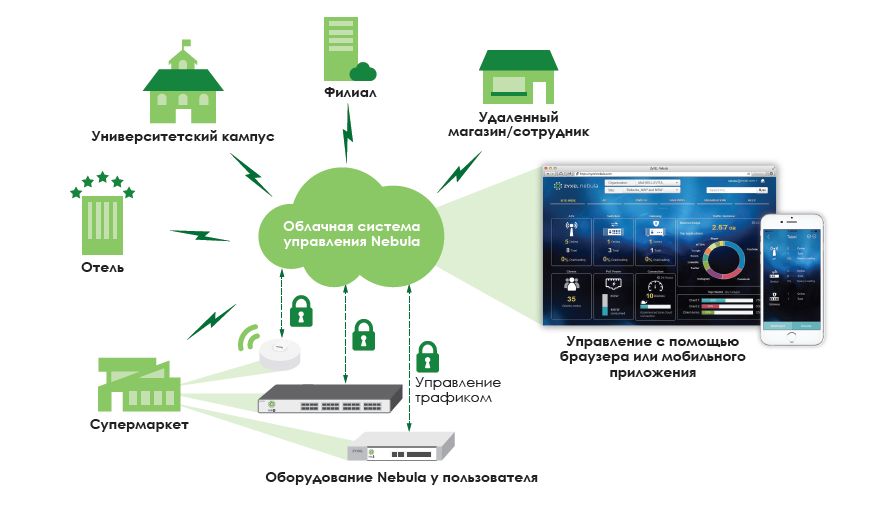

Сетевая архитектура

Nebula предоставляет архитектуру для создания и управления сетями через интернет по модели Software as a Service (SaaS). То есть, она избавляет от необходимости физического построения локальных систем для управления сетью. Все устройства Nebula управляются из облака через безопасное TLS-соединение. Таким образом можно управлять сотнями устройств из любой точки, где есть интернет и вносить изменения в политики и настройки сети через центральную панель управления.

Nebula использует инфраструктуру и сервисы построенные на базе Amazon Web Service (AWS), поэтому защита данных и трафика осуществляется службой AWS Cloud Security. Поступающие от устройств данные разделяются надвое — служебная информация (например, конфигурация, данные мониторинга, статистика и т. д.) передаются в облако при помощи защищенного соединения с использованием специализированного протокола NETCONF (о нем дальше), а пользовательский трафик (например, во время веб-серфинга или использования приложений) отправляется сразу к целевому серверу, не проходя через облако.

Стандарт NETCONF

Nebula — это первое в отрасли решение, которое использует протокол NETCONF для безопасности изменений настроек сети через облако. При передаче данных с помощью этого протокола используется протокол TLS, что гарантирует безопасность данных. До внедрения NETCONF использовались скрипты интерфейса командной строки и протокол SNMP. У этих решений есть некоторые недостатки, например, нет управления транзакциями и надежных механизмов безопасности. Протокол NETCONF как раз и был разработан для устранения этих недостатков. Он поддерживает TCP для преодоления барьера NAT и считается более надежным, чем вышеуказанные протоколы. Он также использует меньше трафика, что важно при управлении сетью через облако. Таким образом это сейчас оптимальное решение для Nebula.

Nebula Control Center

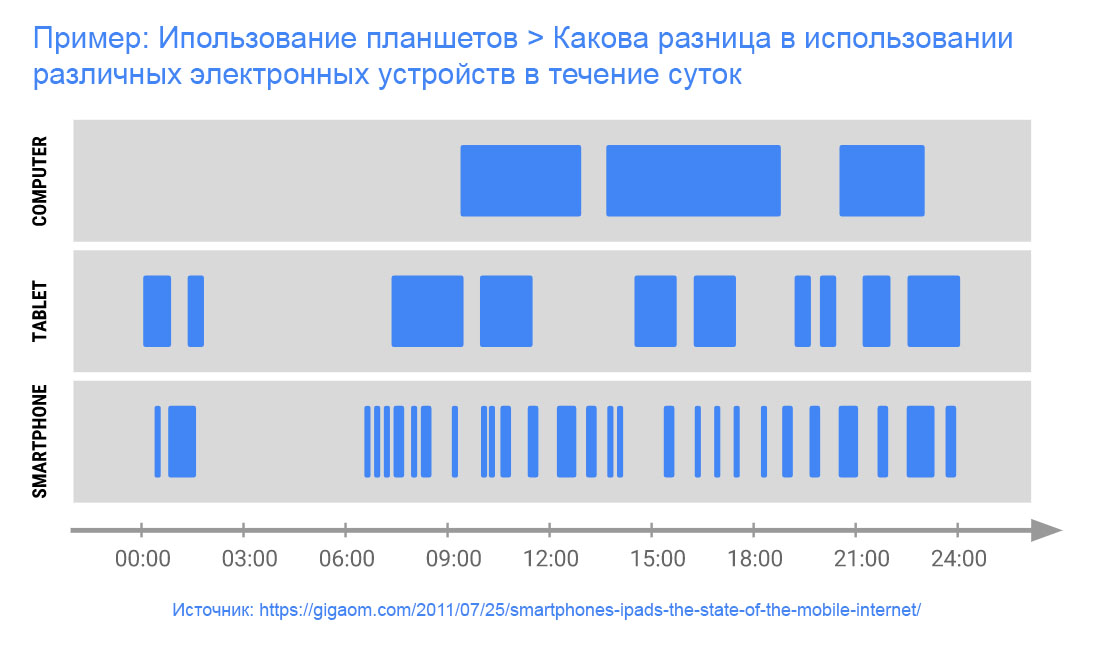

Центр управления Nebula Control Center (NCC) предоставляет пользователю обширный инструментарий для работы с сетью и четкое видение происходящих в ней процессов. Через веб-интерфейс, который доступен на компьютерах, смартфонах и планшетах, можно сразу увидеть анализ производительности сети, статус устройств, и общее состояние сети. Информация поступает в Nebula Control Center в автоматическом режиме, все, что нужно сделать администратору, это просто зайти в него. В Nebula Control Center также есть ряд инструментов обеспечения безопасности, которые обеспечивают защиту устройств и пользователей, а также предоставляют необходимую информацию для повышения уровня безопасности всей сети. Далее опишем основные возможности, которые предоставляет NCC.

Управление на базе ролей

Владелец сети может назначить разные роли для работающих с ней администраторов. Каждая роль имеет тот или иной набор функций по управлению сетью и настройке гостевого доступа. Это уберегает от того, что человек, не имеющий на то полномочий, может выполнить те или иные действия, которые могут нанести вред. Грамотное распределение ролей также обеспечивает правильную настройку сети со стороны администраторов.

Мониторинг в режиме реального времени

В Nebula мониторинг состояния сети происходив режиме 24/7. Администраторы получают информацию о всей активности в сети, в том числе о работе установленного оборудования. Подобные отчеты могут быть сохранены и впоследствии использоваться во время установки новых устройств или расширения сети. Все отчеты гибко настраиваются, так что администраторы получают только необходимую информацию.

Инструменты управления структурой сети

Интегрированные многофункциональными панелями мониторинга, картами, планами этажей и др, эти инструменты позволяют производить тонкую настройку выбранных областей через Nebula Control Center. Просто выберите нужный участок им получите подробный сетевой анализ, управление аутентификацией, проверку настроек, VPN-туннелей и других элементов.

Настройка предупреждений

Этот инструмент помогает администраторам управлять множеством сетевых устройств. Как только на одном из них произошло изменение конфигурации, администратор тут же получает уведомление. Они приходят со всей сети, насколько большой она бы ни была и позволяют поддерживать настройки и политики безопасности в актуальном состоянии.

Защита от неправильной настройки

Для предотвращения обрывов связи вызванных неправильной или некорректной настройкой, устройства Nebula могут запрашивать настройки прямо из Nebula Control Center и получать их через облако. Это позволяет всегда поддерживать сеть в рабочем состоянии.

Аудит входа в систему

Nebula Control Center автоматически записывает время входа и IP-адрес каждого зарегистрированного в системе администратора. Это позволяет отслеживать кто какие изменения внес в систему, а также когда они были сделаны.

Поддержка SSL

Связь между облачными сервисами и администраторами осуществляется по защищенным каналам с использованием протокола SSL. Это значит, что все конфиденциальные данные надежно защищены и не могут быть перехвачены третьей стороной.

Закрытие соединения после тайм-аута

В облачной архитектуре Nebula соединение может быть активным только определенный период времени. Если за установленный срок по открытому соединению не передается трафик, то пользователь будет отключен от системы, получив перед этим соответствующее предупреждение. Затем сессию можно восстановить повторно введя логин и пароль.

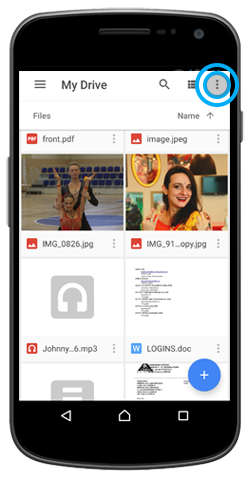

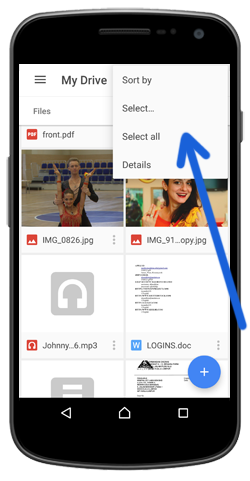

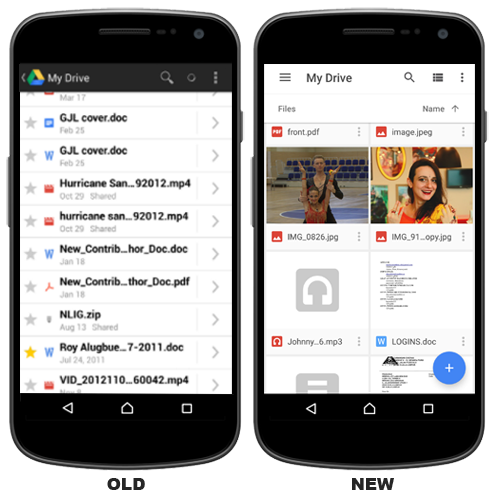

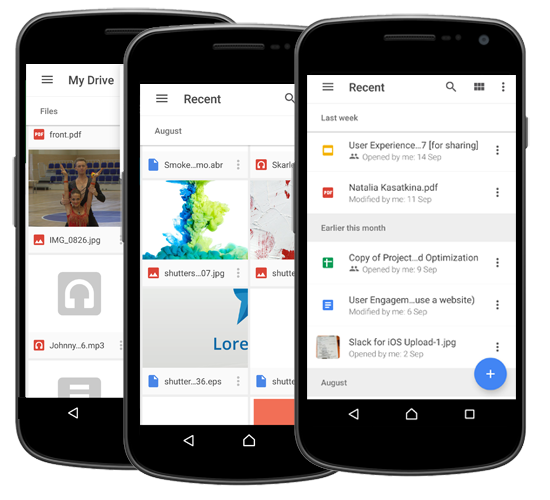

Мобильное приложение Nebula

Фирменное мобильное приложение для iOS и Android предлагает инструменты для существенного ускорения управления сетью. Например, с помощью сканера QR-кода можно оперативно регистрировать новые устройства, просто отсканировав штрих-код. Для каждого зарегистрированного устройства можно посмотреть детальную информацию, например, серийный номер и MAC-адрес, а также в какой локации оно установлено. Для каждой локации также показывается подробная информация. Например, можно посмотреть загрузку сети и узнать, сколько устройств в данный момент подключено к тому или иному сетевому девайсу (беспроводной точке доступа или маршрутизатору). Также можно сфотографировать установленные устройства и оставить изображения в приложении. Все это помогает (и существенно облегчает) айтишникм мониторить состояние сети в режиме реального времени.

Семейство продуктов

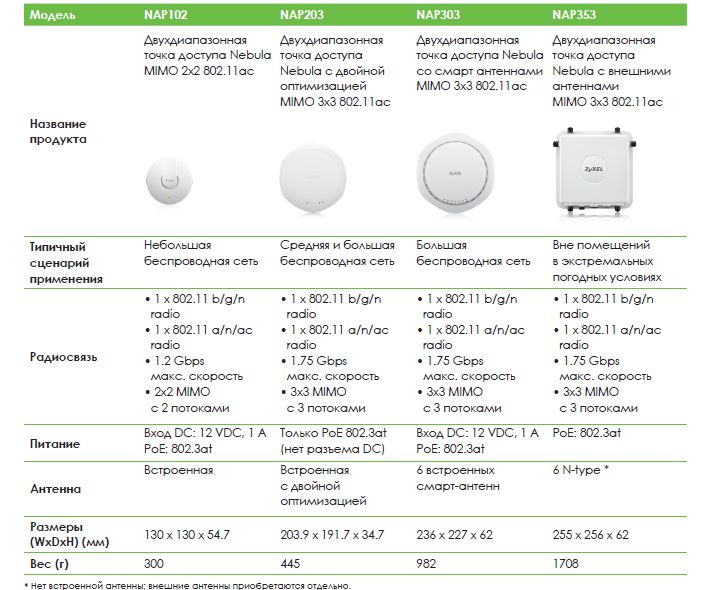

Беспроводные точки доступа

Беспроводные точки доступа Nebula предназначены для установки в офисах, школах, больницах, магазинах, ресторанах и других публичных местах, а также на предприятиях. Они поддерживают новейший стандарт 802.11ac и такие технологии, как MIMO, Smart Antenna, DCS, Load Balancing, Smart Client Steering и другие. Все это позволяет выстроить продуктивную Wi-Fi сеть и организовать надежное покрытие сигнала. Все они управляются через облако и имеют функцию автоматической настройки, что существенно облегчает разворачивание и обслуживание беспроводной сети. Ниже вы можете ознакомиться с характеристиками фирменных точек доступа Nebula.

Особенности:

• Точка доступа MIMO 2x2 802.11ac AP поддерживает скорость до 1.2 Gbps (NAP102);

• Точка доступа MIMO 3x3 802.11ac AP поддерживает скорость до 1.75 Gbps (NAP203, NAP303, NAP353);

• Антенна с двойной оптимизацией (NAP203);

• Смарт-антенна (NAP303);

• Корпус, обеспечивающий всепогодную защиту по IP66 (NAP353);

• Самоконфигурирование, автоматическое развертывание (zero-touch);

• Безопасность корпоративного классаи оптимизация радиосвязи;

• DCS, балансировка нагрузки и smart client steering;

• Поддержка регистрации в системе с учетной записью Facebook;

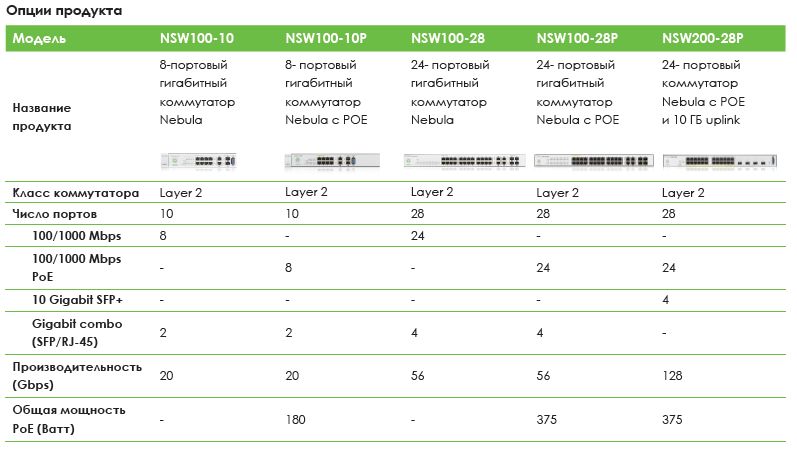

Коммутаторы

Сетевые коммутаторы Nebula с поддержкой обработки трафика уровня 2 — это хорошее решение для развертывания в филиалах с последующем управлением ими через облако. Nebula Control Center позволяет удаленно производить мониторинг и настройку всех доступных портов, а также настраивать несколько коммутаторов за пару щелчков мышки просто используя один шаблон. Также доступен ряд облачных преимуществ: упрощенное конфигурирование и управление, отображение состояния всей сети и контроль в реальном времени, что существенно ускоряет развертывание филиальной сети. Такие расширенныенастройки, как ACL, VLAN-based QoS и расписание PoE, существенно улучшают эффективность управления сетью. Ниже вы можете ознакомиться с характеристиками фирменных сетевых коммутаторов Nebula.

Особенности:

• Гигабитные коммутаторы L2 с 8/24-портами с поддержкой PoE и без PoE;

• Наличие 10GE uplink портов для подключения к высокоскоростной сети (NSW200-28P);

• Удобное конфигурирование ACL и VLAN;

• Поддержка DHCP Server Guard и IGMP snooping;

• Поддержка технологии PoE с бюджетом мощности 375 Ватт (NSW200-28P, NSW100-28P) / 180 Ватт (NSW100-10P);

• Зеркалирование портов для мониторинга сетевого трафика;

• Интеллектуальная технология PoE и сетевая топология;

• Аутентификация по RADIUS или 802.1X, static MAC forwarding;

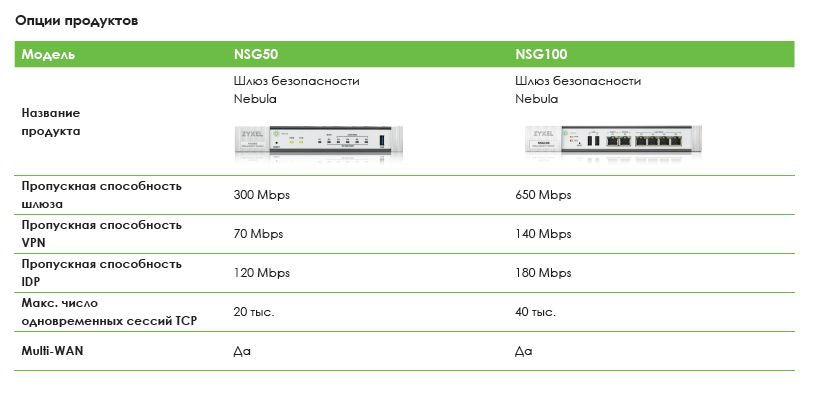

Шлюзы безопасности

Сетевые шлюзы безопасности Nebula обеспечивают для организаций надежную защиту сети. В них используются функции Next-Gen Firewall, например, IDP (система обнаружения вторжений), что обеспечивает высокий уровень защиты для предприятий малого и среднего бизнеса. Шлюзы безопасности Nebula разработаны в расчете на управление из облака и могут автоматически получать свои настройки, настраивать site-to-site VPN, автоматически получать через интернет обновления ПО и сигнатур безопасности. С помощью облачного интерфейса Nebula администраторы могут задавать политики безопасности для всей сети и легко контролировать сети во всех филиалах. Ниже вы можете ознакомиться с характеристиками фирменных сетевых шлюзов безопасности Nebula.

Особенности:

• Полный контроль из облака над сетью, безопасностью и приложениями;

• Легкая настройка site-to-site VPN

• Безопасность сети обеспечивают Next-Generation Firewall, IDP и Application Patrol;

• Встроенные функции DHCP, NAT, QoS и управления VLAN;

• Поддержка статической маршрутизации и сервисов DynDNS;

• Правила безопасности и управление приложениями;

• Поддержка аутентификации в облаке Nebula.

Лицензирование

Облачные сервисы Nebula предоставляются по нескольким вариантам подписок. Но главное, что даже если срок действия какой-либо лицензии истек, пользователи могут продолжать пользоваться базовыми функциями сервиса. Это позволяет сети всегда оставаться в работоспособном состоянии. Далее поговорим о типах предоставляемых лицензий.

Кредитное лицензирование

Для сокращения начальной стоимости эксплуатации устройства Nebula вместе с ним поставляется лицензия на Nebula Control Center сроком на один год. После окончания срока действия этой лицензии пользователи могут продлить ее с помощью баллов Nebula Points. Кредитное лицензирование уменьшает число SKU и лицензионных ключей, необходимых для активизации сервиса, поскольку кредиты на лицензии можно использовать для разных типов устройств и моделей независимо от того, используется лицензия для нового устройства или нет.

Ограниченная пожизненная лицензия на сервисы Nebula Control Center

Ограниченная пожизненная лицензия предназначена для пользователей, которым нужен полнофункциональный сервис на длительное время для конфигурирования и мониторинга устройствс помощью NCC без ежегодного продления лицензий, а также для замены ранее приобретенных устройств Nebula на новые без дополнительных затрат на лицензирование.

Кроме того, схема ограниченного пожизненного лицензирования похожа на лицензирование традиционных контроллеров, понятна и удобна. Она была разработана в дополнение к кредитной модели лицензирования, обеспечивающей предсказуемые затраты на покупку лицензий, и обеспечивает больше гибкости как заказчикам, так и партнерам в канале, и снижает затраты в долговременной перспективе.

Лицензия Nebula Security Service License

Для уменьшения первоначальных затрат на покупку лицензии, упрощения регистрации и активизации шлюзов безопасности Nebula Security Gateway (NSG), каждый NSG поставляется с лицензией IDP and Application Patrol Nebula Security Service license (NSSIDP) на 1 год. Лицензию NSS-IDP нужно приобретать в дополнение к лицензии на Центр управления. Если в компании используется несколько NSG, то сроки окончания действия их лицензий также можно синхронизировать, но их нельзя синхронизировать с лицензиями на сервис Центр управления Nebula.

Синхронное окончание срока действия лицензий

Центр управления Zyxel Nebula автоматически подстраивает даты окончания всех лицензий на один и тот же день. Когда компания закупает дополнительные лицензии на оборудование, то сроки действия старых лицензий и новых пересчитываются и корректируются так, чтобы у всех лицензий была одна и та же дата окончания действия, и в результате у компании все лицензии действуют до одной и той же даты. Обратите внимание, что использование сервиса Zyxel Nebula Service определяется условиями License Co-termination.

В сухом остатке

Zyxel Nebula — это экосистема аппаратных и программных средств, которые позволяют централизованно построить на их базе сеть и осуществлять управление из одного места при помощи простых инструментов. Семейство Zyxel Nebula включает в себя беспроводные точки доступа, коммутаторы и шлюзы безопасности, а также облачный центр управления. Построенная сеть предназначена для использования в предприятиях малого и среднего бизнеса, которые имеют несколько филиалов, а также в публичных местах (ресторанах, школах и т. д.). Для фирм, которые постоянно расширяются, очень удобно увеличивать размер сети благодаря простоте в установке новых устройств и их настройки — фактически, конфигурация оборудования происходит автоматически, что позволяет экономить как на обслуживании сети, так и на содержании ИТ-персонала. Также Zyxel предлагает гибкие модели лицензирования, а также гарантирует работоспособность базовых функций сети даже после окончания срока действия подписки. Все это делает Nebula очень привлекательной для предприятий категории SMB (small and medium business).

|

Метки: author Orest_ua сетевые технологии облачные вычисления беспроводные технологии it- инфраструктура блог компании мук zyxel nebula точки доступа облака |

[Из песочницы] Необразованная молодёжь |

Необразованная молодёжь

Так получилось, что после окончания 9 класса, я поступил в колледж по профессии «Прикладная информатика по отраслям». Колледж — филиал хорошего института в северной столице нашей страны. Выбор был осознанный и я с детства интересовался информатикой. После зачисления, радости не было придела. Воображал себя сидя за компьютером в каком-нибудь крутом офисе создавая программу. Но как бывает в жизни, она бьёт, откуда не ждёшь.

Первый курс

Обучение в таком заведении стандартное. Есть учебный план, есть преподаватели, которые обязаны следовать ему, сессия, курсовая, следующий курс. Первый курс нашего колледжа заключается в 10-11 классе с усиленной математикой и информатикой. Но уже на первом курсе я начал удивляться. На парах информатики нас заставляли писать, конспекты о клавиатуре. Заставляли делать лабораторные работы на тему «Регистрация почты в сервисе yandex». Подумал это первый курс, нормальное явление, не все такие умные, всем нужно получить азы пользования компьютера. И со спокойной душой перешёл на следующий курс.

Второй курс

Вот оно! Новые предметы, преподаватели, высшая математика и менеджмент. Первые недели все было не плохо, а дальше всё превратилось в полную ахинею. Математику нам преподавали в виде: «Вот формулы производных, сюда, туда, ответ». Хорошо, решать я их научился, а зачем они мне нужны, не объяснили. Каждая новая страница учебника именно так и преподносилась. Как можно заинтересовать студентов новой темой, просто преподнося новые формулы для новых примеров? Иногда путаешься, чем они отличаются от предыдущих, если бы учитель показал применение производных в жизни и показал их важность, было бы намного интересней изучать материал, да и отложилось бы на долгое время.

Менеджмент, преподают прямо с интернета. Преподаватель открывает книгу в интернете и диктует, а мы записываем. Такой способ пользуется довольно большой популярностью среди преподавателей и 90% теоретических занятий проводятся именно так.

Третий курс

Кончилась математика, добавились другие профильные предметы. Теория осталась прежней, лабораторные работы по html и basic весь ГОД. Конспектировали о периферийных устройствах или про текстовый процессор блокнот. Согласитесь, наверное, не ожидаешь на предпоследнем курсе, что тебя будут учить печатать в блокноте.

Появился интересный предмет «Сопровождение программного обеспечения». На нём, мы проходили 1С. Ура! Что-то нужное. Как я ошибался, ведь нам просто скинули на компьютеры инструкцию с примерами и сказали выполнить за целый год. Мало того, что инструкция не подходит по версии программы, так преподаватели сами не понимали программу. В итоге целый год вводили данные в 1С.

Была и база данных Access. Тут могу сказать спасибо, преподаватель попался хороший. Рассказывал, показывал и советовал. Было видно, что с тобой разговаривает специалист.

В конце года нас отправили на практику. Этой теме, можно посвятить целую статью. Если говорить вкратце, то нас посылали на все икс игрики. Ставили в конце оценки и печать. А потом я фантазировал на защите, как усердно я проходил практику.

.

Что я хочу этим сказать?

Сейчас я нахожусь на последнем курсе моего учебного заведения. Все осталось прежним, разве что добавился Lazarus и написание дипломной работы. Я хочу сказать, что меня ничему не научили. Всё чему я научился — последствие психов, от того что меня ничему не учат. От такого и правда появляется мотивация к самообразованию. Хоть спасибо есть за что сказать.

Не хочу ругать преподавателей, хотя из моих восьми преподавателей по информатике, нашлось только двое хороших. Я горю желанием обругать устаревшую систему образования и процесс прохождение аккредитации учебных заведений. Ведь в июле этого года я получу диплом, где гордо будет написано «Программист». Круто! Как вам программист 2018 года? Я умею регистрировать почту и печать в блокноте!

Про аккредитацию отдельная история. К нам приезжают «серьёзные» люди из университета, дают тесты и проверяют документы. Документы заранее все приведены в порядок, а ответы на тесты мы получили за час до приезда этих самых «серьёзных» людей.

Люди предлагают поступить в ВУЗ, а то, мол, учишься в захолустье. Я давно интересуюсь поступлением в университет, но с каждой новой прочитанной статьёй, комментарием и отзывом своих друзей, желание отпадает.

Конечно, какие-то полезные знания они дали, но по эффективности знания/время — в глубоком дне.— понравившийся комментарий.

Не стоит искать образование в колледжах. Тут Вы найдёте основы основ. Женщин лет 50, которые преподают предмет «Архитектура ЭВМ» и с ней Вы будете составлять кроссворд в excel. А на другом предмете, вы будете писать электронную тетрадь в word, где нужно вставить из интернета определение информатики. Если откажитесь писать определение информатики на компьютере — заставят писать в тетрадке.

Что мне делать дальше?

Сейчас после окончания, меня отправят служить родине. После службы наступает момент выбора дальнейшего пути ниндзя. Пойти работать верстальщиком, уйти в фриланс? А может поступить в ВУЗ?

Ради корочки идти в университет не особо хочу. Надеюсь, если меня всё-таки занесёт попутным ветром в высшее учебное заведение, я смогу найти там новые знакомства, хороших преподавателей и получить хорошие знания. Уже пора смириться, что даже после окончания университета, без самостоятельного обучения не стать IT-специалистом.

Вы скажете мне, что вот, мол, ты в ПТУ деревенский поступил и жалуешься. Я отвечу, что Вы абсолютно правы, но только в том случае, если бы в университетах не происходило примерно то же самое.

|

Метки: author aleshqqa1337 учебный процесс в it обучение обучение программистов молодые специалисты вуз колледжи |

[Перевод] Как создавали систему чувств ИИ в Thief: The Dark Project |

|

Метки: author PatientZero разработка игр система чувств искусственный интеллект конечные автоматы thief half-life |

Security Week 39: Вечер восхитительных историй о том, как бизнесу наплевать на безопасность |

Security Week 39: Вечер восхитительных историй о том, как бизнесу наплевать на безопасность

В этот раз новости из нашего дайджеста содержат самоочевидную мораль: многим компаниям плевать на безопасность их клиентов, пока это не наносит прямой финансовый ущерб. К счастью, это касается не всех компаний, но эта неделя выдалась особенно богатой на подобные постыдные истории.

В этот раз новости из нашего дайджеста содержат самоочевидную мораль: многим компаниям плевать на безопасность их клиентов, пока это не наносит прямой финансовый ущерб. К счастью, это касается не всех компаний, но эта неделя выдалась особенно богатой на подобные постыдные истории.Едва успела выйти новая версия MacOS (недели не прошло), как исследователь из Synack Патрик Уордл опубликовал шикарный пост о High Sierra. Оказывается, что Keychain – защищенный контейнер для учетных данных, PIN-кодов, номеров банковских карт и прочих важных данных – на самом деле уже версии три как ничего не защищает. То есть по факту Keychain это такое место, откуда можно разом украсть вот это вот все.

Товарищ Уордл заявил, что приложение, хоть подписанное, хоть неподписанное, может сливать дамп всего содержимого Keychain в открытом, незашифрованном виде. Строго говоря, приложения вполне официально имеют доступ к Keychain, но только к своим данным – а тут вроде бы ко всем. Важный нюанс: эксплойт работает только с разблокированным Keychain, однако по умолчанию он разблокируется при логине в систему.

Сразу после публикации Патрику насовали комментов в духе «что ж ты такой гад, не в Apple сообщил, а в блоге публикуешь», и что ему просто не хватает внимания окружающих. Но бедняга на самом деле сообщил в контору, и даже эксплойт готовый послал, просто контора от него отмахнулась! Мотивировали знатно – мол, нечего ставить софт из безнадежных источников, а ставьте только из MacAppStore, и читайте предупреждения безопасности от macOS. То есть в принципе это шаблонный ответ для сообщения обо всех локально-эксплуатируемых уязвимостях. Кто ставит левый софт – тот сам виноват. Кстати, программа вознаграждения за уязвимости в продуктах Apple не распространяется на MacOS.

Уордл все же не стал публиковать эксплойт и даже технических деталей об уязвимости не раскрыл. Но, если поверить ему на слово, найденная уязвимость здорово расширяет возможности малвары. Стоит подцепить где-нибудь дельного троянца (а для MacOS их все больше), и все ваши учетные и платежные данные утекают в чужие руки. Нехорошо.

По словам исследователя, он протестировал уязвимость на версиях High Sierra и Sierra, и не видит причин, почему бы ей не быть и на El Capitan. Защититься от этого можно ценой небольшой толики удобства – достаточно установить блокировку Keychain, чтобы при попытке доступа к нему запрашивался пароль. Ну и да, по возможности избегайте установки приложения из левых источников.

В мобильных приложениях для биржевой торговли нашли десятки уязвимостей

Новость. Исследование. Слова «инвестор» и «трейдер» даже звучат как-то богато. На мелочи эти ребята не размениваются, чтобы хоть чего-то добиться на бирже, нужны серьезные деньги. Но обстановка на фондом рынке меняется так быстро, что им необходима возможность заключать сделки в любое время, в любом месте. То есть через мобильник.

Соответственно, мобильных приложений для трейдинга выпущено очень много. Понятно, что их вендоры должны тщательно выстраивать систему безопасности, даже в ущерб удобству – деньги на кону большие. Но вот на поверку все оказалось не так. Исследователи из IOActive взяли 21 приложение из топа (как для iOS, так и для Android) и нашли там много веселых дыр. Очень много. Вплоть до хранения паролей открытым текстом и передачи данных по HTTP.

Соответственно, мобильных приложений для трейдинга выпущено очень много. Понятно, что их вендоры должны тщательно выстраивать систему безопасности, даже в ущерб удобству – деньги на кону большие. Но вот на поверку все оказалось не так. Исследователи из IOActive взяли 21 приложение из топа (как для iOS, так и для Android) и нашли там много веселых дыр. Очень много. Вплоть до хранения паролей открытым текстом и передачи данных по HTTP.И в этот раз исследователи продемонстрировали ответственный подход к раскрытию уязвимостей и обратились к 13 брокерским компаниям, поставляющим эти приложения. Таки что бы вы думали? Ответили только две. Им некогда – торговать надо, а тут пристают с уязвимостями. Алехандро Эрнандез из IOActive вот так выразил свою реакцию на произошедшее: «Господа, я кажется, фрустрирован! Я работал аудитором и знаю, как жестко регулируется финансовый сектор. И очень странно, что мы столкнулись с такими проблемами».

Deloitte уверяет, что кибератака затронула лишь несколько клиентов

Новость. «Большая четверка» аудиторов всегда считалась примером оптимальных бизнес-практик и политик. Понятно, что в кибербезопасности трудно подстелить солому везде, где есть вероятность упасть, но и в этой области есть правила, которые не стоит нарушать, если не хочешь подставить своих клиентов. И вот на тебе! Отличился Deloitte, один из столпов бизнес-сообщества.

По данным Guardian, контору взломали еще осенью 2016 года, а обнаружили это только в марте. Скорее всего, атака шла через учетные данные админа почтового сервера. Никакой двухфакторной аутентификации не было – пароль то ли отбрутфорсили, то ли выманили из админа каким-либо методом социальной инженерии.

По данным Guardian, контору взломали еще осенью 2016 года, а обнаружили это только в марте. Скорее всего, атака шла через учетные данные админа почтового сервера. Никакой двухфакторной аутентификации не было – пароль то ли отбрутфорсили, то ли выманили из админа каким-либо методом социальной инженерии. Утечка почты Deloitte по своим последствиям может быть катастрофической, ведь компания, проводя аудит, имеет дело с секретнейшими бизнес-данными клиентов. Однако реакция самой Deloitte обескураживает: компания уверяет, что атака никак не повлияла на бизнес клиентов. И вообще, «кибербезопасность в компании обеспечивается на высочайшем уровне». Звучит как плохая шутка, учитывая, что их почту полгода читал неизвестно кто, а они этого и не замечали.

Древности

«ZipEater-1984»

Использует «стелс»-функцию при вызове функций DOS FindFirst и FindNext. Очень опасен – иногда уничтожает файлы, у которых сумма символов расширения имени (т.е., например, у .COM-файлов: ‘C’ + ‘O’ + ‘M’) в ASCII-кодировке равна 100h, D6h, F3h, E2h или DFh. К таким файлам относятся .TXT, .STY, .BAS, .DOC,. ZIP, .EXE и .COM-файлы.

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 36.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw deloitte macos high sierra keychain |

[Перевод] «Тюльпаномания»: биржевой пузырь, которого не было |

«Тюльпаномания»: биржевой пузырь, которого не было

- Перевод

Изображение: Wikimedia commons

Научное издание Smithsonian опубликовало материал о том, что «тюльпаннную лихорадку», которую принято считать первым биржевым пузырём, выдумали голландские кальвинисты. Люди гнались за прибылью, но не настолько массово, как это описывается в учебниках и художественных произведениях. И эта гонка уж точно не вызвала крах экономики и промышленности. Мы подготовили русскоязычную адаптацию этой статьи.

Всеобщее безумие

Когда на Ближнем Востоке вырастили первые тюльпаны, весь мир сошёл с ума. Некоторые сорта стоили дороже золота. Существует легенда о том, что матроса обвинили в уголовном преступлении и посадили в тюрьму лишь за то, что он перепутал клубень редкого тюльпана с обычной луковицей и съел его на обед. Одна луковица редкого сорта Semper Augustus, с цветами из красных и белых лепестков, стоила, как особняк в фешенебельном районе Амстердама, с личным тренером и садом в придачу. Так как стоимость тюльпана на рынке выросла, началась волна спекуляции — торговцы подняли цены на луковицы до небес. А потом, как это обычно и происходит с биржевыми пузырями, рынок тюльпанов «лопнул», оставив сотни продавцов без выручки.

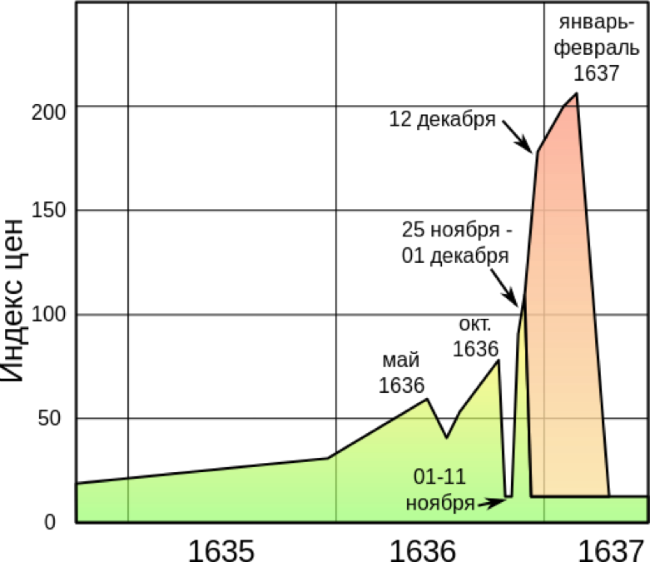

Динамика индекса фьючерсных (зелёным) и опционных (красным) цен на луковицы в 1635—1637 годы по Томпсону. Изображение: Wikimedia Commons

На протяжение нескольких десятилетий экономисты ставят историю про «тюльпаноманию» в пример опасности и нестабильности свободного рынка. Писатели и историки написали сотни книг про абсурдность событий. На эту тему даже сняли фильм, он называется «Тюльпаннная лихорадка», его сюжат основан на книге Деборы Моггч.

Есть только небольшой нюанс: эта история — неправда.

Чтобы понять правду, нужно разобраться в истории

Что же происходило на самом деле и как получилось, что история спекуляции тюльпанов в Голландии была настолько искажена? Энн Голдгар, профессор ранней современной истории Королевского колледжа Лондона, обнаружила правду, когда изучала архивы, для создания книги «Тюльпаномания: Деньги, честь и знания в Голландии Золотого Века».

«Я всегда шучу, что книга должна называться «Тюльпаномания: это скучнее, чем вы думаете», — говорит Голдгар, — людям нравится эта легенда, так как они думают, что могут извлечь из неё урок. Я считаю это мнение ошибочным».

Прежде чем ставить «тюльпанную лихорадку» в один ряд с пузырём Южного Моря, который случился в 1700-х годах в Англии, с железнодорожным пузырём XIX века, с пузырями доткомов и биткойнов, стоит изучить несколько доводов профессора Голдгара и понять, что происходило в голландском обществе на рубеже XVII века.

Стоит начать с того, что страна пережила крупный демографический сдвиг, во время войны за независимость с Испанией. В этот период купцы прибыли в крупные портовые города: Амстердам, Гарлем, Делфт и начали торговлю, в том числе знаменитую Голландскую Ост-Индийскую компанию. Это принесло огромный доход Голландии, даже несмотря на военное положение в стране. Во главе новой независимой нации стала городская олигархия, состоящая из богатых купцов, в отличие от других европейских стран той эпохи, которые контролировались дворянством. В результате новые лица, идеи и деньги помогли революционизировать голландскую экономику в конце 16 века.

Так как экономика изменилась, изменились социальные взаимодействия и культурные ценности. Растущий интерес к естественной истории и любовь к экзотике среди купечества вызвали рост цен на товары с востока, в том числе из Османской империи. Людям всех социальных классов пришлось развиваться в новых направлениях, которые появились с притоком новых товаров. Например, рыбный аукционер создал рукопись «Книга Китов» и эта работа позволила ему встретиться с президентом Голландии. Голландский ботаник Клузиус создал ботанический сад в Лейденском университете в 1590 году и тюльпан быстро поднялся на почётном месте.

«Дикорастущие тюльпаны, найденные в долинах Тянь-Шаня, начали разводить в Стамбуле в 1055 году, а в XV веке они уже стали символами османов. Например, у султана Мехмеда II было 12 садов с тюльпанами, на содержание которых требовалось 920 садоводов» — пишет в книге «Тюльпаны» Анна Паворд, корреспондент по садоводству интернет-издания The Independent.

Голландцы вывели, что тюльпаны могут быть выращены из семян и отростков материнской луковицы. Чтобы из семечки выросла луковица и цветок зацвёл, требуется от 7 до 12 лет. А уже созревшая луковица может стать тюльпаном через год. Особый интерес для ботаника Клузиуса и «тюльпановых спекулянтов» представляли «разбитые луковицы». Лепестки у тюльпанов, которые вырастали из этих луковиц, были не однотонными, а разноцветными. Предугадать, как будет выглядеть будущий цветок было невозможно. Натуралисты придумывали способы, как воспроизвести такие луковицы и бутоны, так как спрос на этот редкий вид постоянно рос. Как выяснилось позже, такой эффект получался из-за того, что луковицы болели. Они были хилыми и редко давали цветы.

«Высокая рыночная стоимость тюльпанов, про которую пишут авторы, изучающие «тюльпаноманию», была вызвана ценами на особо красивые «разбитые луковицы», — пишет экономист Питер Гарбер, — так как предугадать, как будет выглядеть цветок, проросший из такой луковицы, было невозможно, «тюльпаноманию» можно охарактеризовать, как азартную игру среди производителей, которые стремились вырастить бутоны всё более необычной раскраски».

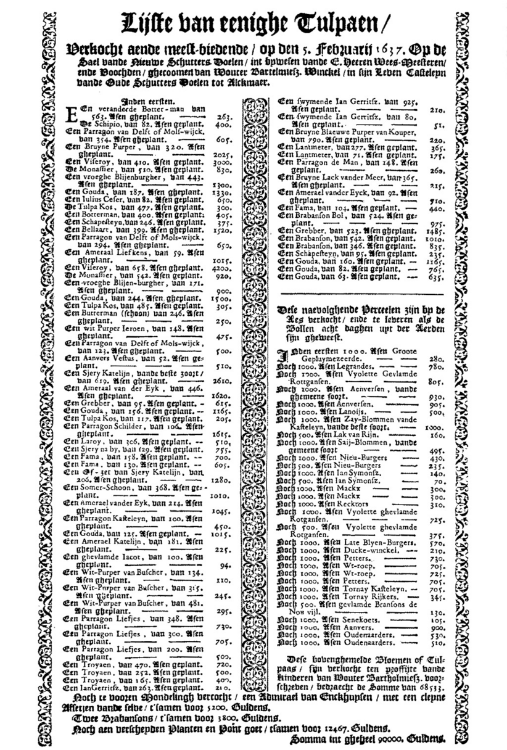

Печатный отчёт об итогах аукциона в Алкмаре 5 февраля 1637 года. Изображение: Wikimedia commons

Голландские спекулянты тратили все деньги на луковицы, а потом выращивали цветы, среди которых, возможно, только один принесёт прибыль. «Как предметы роскоши, тюльпаны хорошо вписываются в культуру больших капиталов и нового космополитизма» — пишет Голдгар. Тюльпаны требовали экспертности, опыта оценки красоты и экзотики и, конечно же, больших денег.

Начало легенды

Вот, где миф вступает в игру. Согласно популярной легенде, «тюльпаномания» охватила все уровни голландского общества в 1630 году. «Стремление голландцами обладать редкими луковицами было настолько большим, что обычная промышленность была заброшена, а население, вплоть до самых низших слоёв, стало торговать тюльпанами» — пишет шотландский журналист Чарльз Маккей в популярной работе 1841 года «Чрезвычайно популярные заблуждения и безумие толпы». Согласно этой работе, все, от самых богатейших купцов, до беднейших трубочистов, скупали луковицы тюльпанов и перепродавали их по более высокой цене. Больше всего компаний по продаже тюльпанов было в конце 1636 года, а в феврале рынок начал трещать по швам. Всё больше и больше людей разорялись, в надежде купить заветные луковицы, и всё больше торговцев, оставшись в долгу, становились банкротами. По крайней мере, так всегда считалось.

«На самом деле, в это были вовлечены немногие люди и экономические последствия были не настолько значительными, — пишет Голдгар, — я не смогла найти в архивах информацию о хотя бы одном одном банкроте. Если бы действительно было массовое уничтожение экономики, как говорит миф, найти данные не составило бы труда».

Эти доводы не означают, что всё в истории про «тюльпаноманию» вымысел. Торговцы действительно участвовали в бешенной торговле тюльпанами и платили немыслимые деньги за несколько луковиц. А когда покупатели не смогли заплатить торговцам столько, сколько заранее обещали, рынок развалился и вызвал небольшой кризис. Но только потому что это подорвало социальные ожидания.

«В данном случае, сложность состоит в том, что почти все рыночные отношения строились на доверии. Покупатели обещали выкупить луковицы у торговцев, а потом говорили «Мне всё равно, что я обещал это купить. Теперь этот товар мне не нужен». Суды не хотели в это вмешиваться и поэтому некому было заставить людей платить, за товар» — говорит Голдгар.

Но «тюльпаномания» не влияла на все слои общества и не вызывала крах промышленности. «Отсутствие данных о банкротах не позволяет сделать твёрдый вывод, но результаты проведённого исследования говорят о том, что спекуляция луковицами тюльпанов, была не настолько массовой и сумасшедшей, как принято считать» — пишет экономист Питер Гарбер.

Кто распространил миф?

Если «тюльпаномания» не была таким бедствием, зачем же её выставили в этом свете? Можно предположить, что в этом виноваты обиженные христианские моралисты. С большим богатством приходит волна социального беспокойства. «Невероятный уровень успеха вскружил им головы. Все невероятные истории, подтверждающие экономическую разруху: про моряка, брошенного в тюрьму и про трубочистов, пытающихся разбогатеть, пришли из пропагандистских брошюр. Их распространили голландские кальвинисты, боявшиеся, что тюльпановый бум приведёт к социальному гниению. Их убеждение, что это богатство было ужасным, дошло и до наших дней» — пишет историк Саймон Шам, в книге «Конфуз богатства: Интерпритация голландской культуры в Золотом Веке».

«Некоторые идеи неискоренимы, например та, что Бог не любит хитрецов и насылает на них чуму. Вот что могли сказать люди в 1630 году, — говорит Энн Голдгар, — идея, что хитрость — грех дожила до современного общества. Гордыня предшествует падению».

Голдгар не осуждает режиссёров и писателей, за неверную интерпретацию прошлого. Она недовольна неверными выводами историков и экономистов, которые те сделали в своих трудах, ещё больше распространив идею «тюльпаномании». «У меня не было никакой возможности узнать, что эта история — ложь, пока я не подняла старые архивы. Это было неожиданным сокровищем», — говорит Голдгар.

Полезные ссылки и материалы для изучения фондового рынка

|

Метки: author itinvest блог компании itinvest тюльпаномания финансы история биржа фондовый рынок спекуляции |

Пять вещей, которые нужно знать о Spring Framework 5 |

На этой неделе, сразу за релизом Java 9 вышла новая мажорная версия одного из самых популярных фреймворков для разработки приложения на Java — Spring Framework версии 5. Под катом подробности и краткое описание, что же поменялось.

Читать дальше ->|

Метки: author alek_sys программирование java spring framework |

Интернет там, где его нет, или Стационарная связь на базе 3G-LTE |

Интернет там, где его нет, или Стационарная связь на базе 3G-LTE

Задумал я сделать интернет у себя на даче, в глуши. И наконец возможность срослась с желанием! Проблем в моей глуши две: дураки частые перебои с электроэнергией (в зависимости от погоды может ещё отключиться АТС) и плохая мобильная связь. Сигнал ловится не везде, а где ловится, там нестабилен. Добавляет сложности и оцинкованная крыша дома, экранирующая радиоволны. Возможности современного оборудования и корректировка запросов сужали и улучшали подходящие свойства, что привело меня к мысли создать максимально работоспособный узел сети. Я расскажу о том, как пытался поймать LTE-сигнал, с описанием оборудования и возможными проблемами.

Подготовка и сбор информации о местности

В моей глуши нормально ловится только МТС, в связи с чем был выбран именно этот оператор. Качество покрытия я определял с помощью https://4g-faq.ru/karty-pokrytiya/. На этой карте удобно выбирать режимы сети, а также хорошо видно ориентировочное расположение вышек стандартов 3G и LTE.

Направление установки антенн выбиралось примерно так:

Коэффициент усиления антенны я выбирал в зависимости от расстояния до населённых пунктов. Подходящее направление сигнала — с помощью мобильного приложения Netmonitor. Для этого пришлось поездить к ближайшим вышкам. Netmonitor — приложение бесплатное, самое удобное и простое в управлении, аналоги меня не впечатлили. Также в нём сохраняются истории замеров, поэтому, когда я вернулся на «площадку», было удобно выбирать направление.

Интересующие и важные характеристики

Для начала необходимо понять, какой режим сети вас интересует. Диапазон частот у 3G и LTE разный, и, чтобы принимать их сигналы, необходимо выбрать антенны или облучатели, в зависимости от конфигурации, с соответствующей частотностью. Конечно, можно взять антенны с частотным диапазоном, который захватывает оба стандарта, но в таком случае выходной сигнал будет немного хуже (опять же, в зависимости от количества переходников, длины кабелей и их свойств; эти характеристики влияют на все конфигурации данной системы, в том числе это касается и затухания сигнала).

Необходимо заранее проверить на площадке уровни сигналов мобильных сетей. Как уже говорил, я выбрал МТС, потому что здесь он ловится всегда и у МТС довольно много вышек (по сравнению с другими операторами) с разными режимами сетей, в том числе и LTE, который, надеюсь, в будущем проапгрейдят до 5G. Так что своё оборудование я подобрал «на вырост».

Выбор и настройка оборудования

Лишний раз переплачивать мне не хотелось. И система с легко заменяемыми компонентами выходила дешевле, чем спутниковый интернет и предложения от фирм, которые делают готовые наборы. Вариант со «свистком» отпал на первый день подбора оборудования: такая система крайне нестабильна. Ещё я планировал поставить систему на долгосрочную работу, но этот вариант тоже не подходил, поскольку компоненты корпуса при длительной работе перегревались и выводили «свисток» из строя до его остывания. В большинстве случаев данная проблема решалась пришаманенным кулером, но нестабильность подключения и потери пакетов не склонили меня к этому варианту. По той же причине я отказался от мысли о тандеме «свисток» + роутер (с поддержкой «свистка»).

Изначально я планировал использовать «восьмёрку», она же антенна Харченко, но, учитывая зону покрытия и расстояние до ближайших населённых пунктов, есть возможность успешно ловить 3G-LTE на дистанциях, превышающих возможности «восьмёрки». Такой диапазон частот соответствует этим сетям и взят на случай непогоды, когда осадки существенно ухудшают качество сигнала. Меня удивил тот факт, что 4G-LTE работают в трёх диапазонах: около 800, около 1600 и около 2500.

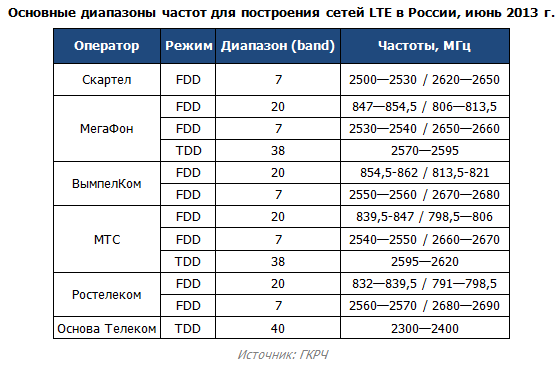

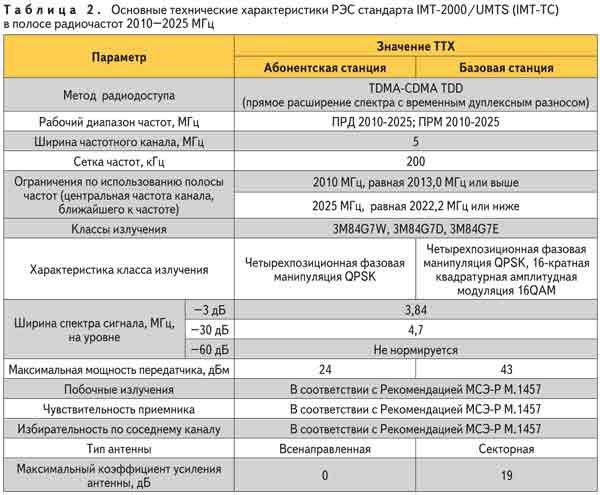

Частотные диапазоны LTE-сетей у различных провайдеров:

Здесь разобраны частотные диапазоны 3G-сетей:

Причины выбора канала относительно офсета

Офсет, как мне кажется, гораздо лучше, так что я сделал неправильный выбор, особенно учитывая свои возможности: но LTE я ловил на «волнушку», и проблема заключается в высоте. Для начала я долго и усердно выбирал оборудование и возможные связки, в том числе и различные типы антенн. В итоге мне понравились два варианта:

- Офсетный рефлектор диаметром 0,9 м или более с облучателем на частотные диапазоны от 1700 до 2700 МГц и с поддержкой технологии MIMO.

- Сдвоенный волновой канал с такой же частотностью.

Коэффициент усиления у обоих наборов — от 24 до 28 dbi. Остановился я на втором: у него гораздо меньше проблем с ловлей сигнала от телефонных вышек. Кабель взял с пониженными потерями и затуханиями, чтобы сигнал на приём был стабильнее.

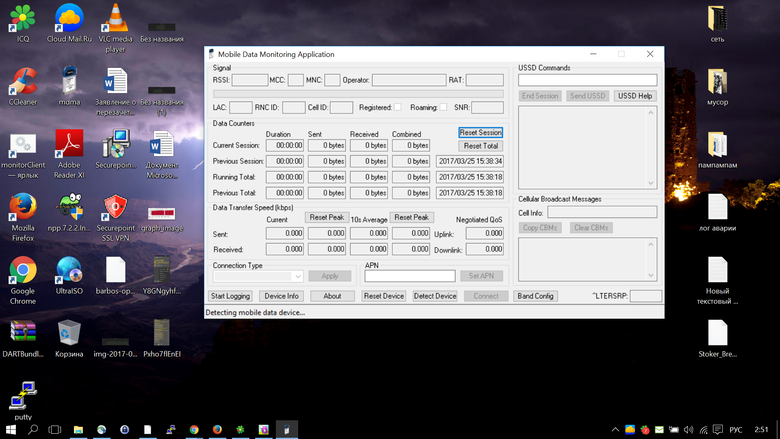

На месте я выставлял антенну с помощью Google Maps и программы MDMA. Настольная версия MDMA позволяет проверить уровень сигнала на принимающем устройстве (модуль модема в роутере). С этой программой обращаться не так просто, но если вы разобрались с Netmonitor, то у вас она вряд ли вызовет затруднения. В конце концов, есть очень неплохие рекомендации и понятные инструкции. Обратите внимание, что нужно подключение через USB «папа-папа».

Для проверки направления антенны достаточно собрать всю систему, то есть подключить антенну к роутеру, а роутер — к компьютеру, но только через USB-переходник. После чего запускаем MDMA и выбираем направление антенны.

MDMA:

Выбор конкретной модели роутера был обусловлен вышеперечисленными требованиями, но список был ограничен этими моделями:

- Huawei E5172

- Huawei B315S (есть альтернативы у провайдеров и операторов связи)

- Skylink V-FL500

- TP-LINK TL-MR6400

- ZTE MF283 (есть альтернативы у провайдеров и операторов связи)

- Huawei B310

Разброс цен — от 4 до 9 тысяч рублей за единицу. Я выбрал Huawei B315S из-за дешевизны и возможности создания IP-телефонии и подключения до 32 устройств. А ещё он может ловить LTE.

Конфигурация моего оборудования

Роутер B315s-22:

Huawei B315S изначально был привязан к Yota, но я выполнил отвязку

Поскольку, кроме МТС, у меня ничего не ловилось, то и смысла усиливать то, что не ловится, не было. Но ситуация сложилась так, что мне пришлось купить роутер Yota, привязанный к сим-картам одноименного оператора (другие не подходили, проверял). Для отвязки каждого роутера свой способ, информацию легко найти в интернете, в том числе и на 4pda.ru. Полное название модели по классификации — Huawei LTE CPE B315s-22, так что, если вам необходимы технические характеристики, ищите по названию в интернете.

Оборудование подключается почти так же, как и обычный роутер. Разница в том, что необходимо подключить внешние антенны, которые будут ловить сигнал. Чтобы у вас появился интернет, не требуется никакого стороннего ПО, но, как я уже указывал, оно необходимо для определения направления антенны. На рынке тысячи вариантов разъёмов и коннекторов, и вам нужны те, которые подходят непосредственно для вашего оборудования. В моем случае это коннекторы на кабелях SMA со стороны роутера и TS9 со стороны антенн. К счастью, оборудование я подобрал таким образом, что можно прямо из коробки провести первичную настройку и начать пользоваться интернетом. Никаких танцев с бубнами не потребовалось, только в настройках через веб-интерфейс поменял пароли и режим рабочего сигнала.

Две антенны работают в тандеме по технологии MIMO, волновой канал с 24—28 dbi. Два кабеля с пониженными потерями длиной 10 метров, стандарт 5D-FB. Соответственно, придётся либо заказать переходники, либо заменить разъёмы подходящими, с одной стороны — для антенн, с другой — для подключения роутера.

Результат трудов:

Проблемы, с которыми я столкнулся (раздел о боли, унижениях и страданиях)

Сразу хочу дать рекомендации на основании своего опыта:

- Если собираетесь повторять такое далеко от городов-миллионников, то стоит заранее озаботиться покупкой оборудования в большом городе.

- Выбирайте тип и вид антенны в зависимости от ландшафта и расстояния до населённых пунктов.

- Обратите внимание на растительность, постройки и дистанцию между точками.

- Подбирайте оборудование, максимально подходящее под ваши требования.

- Не покупайте оборудование у оператора связи, если только не планируете пользоваться его услугами или не выигрываете сильно в цене.

- Используйте минимум переходников и оборудования на открытом воздухе.

- USB «папа-папа», он же USB AM — USB AM, пригодится на любой стадии работы или настройки, поэтому всегда держите его под рукой. Я в магазинах не нашёл, так что пришлось собирать на коленке из старых запчастей.

- Отвязка роутера от оператора — это боль. На некоторых роутерах и прошивках невозможно сделать отвязку без нарушения целостности корпуса, что приводит, в свою очередь, к потере гарантии. Ознакомьтесь с ассортиментом, всегда можно найти отвязанный вариант (или ваш выбор — AliExpress).

- Если всё-таки решились на привязанный, то озаботьтесь прошиванием в городе со стабильным интернетом. То есть подготовьте оборудование к работе до отъезда на площадку.

- Выбор тарифного плана и возможности безлимита. По большому счёту можно добиться безлимитного интернета через SIM-карту, однако для этого необходимо изменить конфигурацию модуля модема в роутере.

- Подготовьте подходящий модем-расходник для использования его IMEI, чтобы упростить себе задачу. Можно взять любой подходящий по конфигурации и поддерживаемым сетям.

- Если собираетесь использовать сети выше LTE, то подбирайте роутер с двумя антеннами. Это связано с поддержкой протокола MIMO.

- Проверяйте у магазинов рабочий диапазон частот выбранной вами антенны. Велика вероятность, что вас попробуют обмануть.

Заключение

Считаю, что я молодец: всё работает, скорости хватает на комфортный онлайн-просмотр фильмов. Ещё есть куда расти: на основе этой системы я планирую создать зачатки умного дома. Сейчас интернет ловится только на 3G, поэтому нужно кое-что доделать: увеличить высоту мачты, перепрошить модуль модема для возможности подключения безлимитного интернета, купить тариф для планшетов типа «Безлимитище» или аналог.

Тем, кто пойдёт по моим стопам, рекомендую сразу брать безлимитный тариф, потому что у меня всего 30 Гб трафика. Сети 4G хоть и ловятся оборудованием, но очень плохо. Гипотез две: либо я не принял в расчёт рельеф, либо нашёл антенны, которые не подходят по диапазону рабочих частот. Полагаю, что виноваты антенны: продавец заявляет, что на них написан ошибочный частотный диапазон, но, скорее всего, это ложь, потому что сети 3G ловятся идеально, а именно их диапазон указан на антеннах.

|

Метки: author asterrios стандарты связи беспроводные технологии блог компании mail.ru group мобильный интернет lte |

[Из песочницы] Нагрузочное тестирование PostgreSQL, используя JMeter, Yandex.Tank и Overload |

Нагрузочное тестирование PostgreSQL, используя JMeter, Yandex.Tank и Overload

Пару слов для начала

Итак, данный мануал подойдет для тех, кто ищет универсальный инструментарий для тестинга большого пула систем и решения большинства задач по нагрузочному тестированию. Статья рассчитана на новичков в этом деле, поэтому постараюсь максимально детализировать и упрощать процесс. Коротко обсудим каждый из элементов в нашей связке и перейдем к их первичной установке и настройке:

- Apache JMeter – инструмент для нагрузочного тестирования, который способен проводить тесты для JDBC-соединений, FTP, LDAP, SOAP, JMS, POP3, IMAP, HTTP и TCP из коробки и еще множество других протоколов и решений, используя различные плагины.

- Yandex.Tank – это облачный инструмент для нагрузочного тестирования, использует различные генераторы нагрузки, в том числе и JMeter.

- Yandex.OverLoad – сервис для удобного мониторинга и анализа серверов под нагрузкой.

Установка и настройка

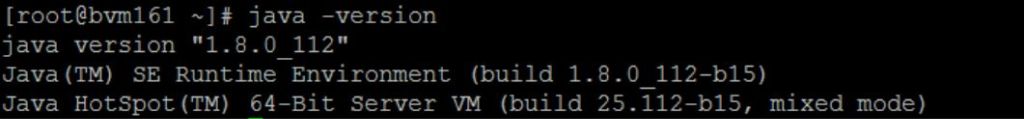

Залогом успеха для правильной установки JMeter является правильная установка java. На данном этапе стоит сказать о том, что все манипуляции дальше будут происходить под ОС Linux. На официальном сайте хорошие мануалы со всеми нюансами:

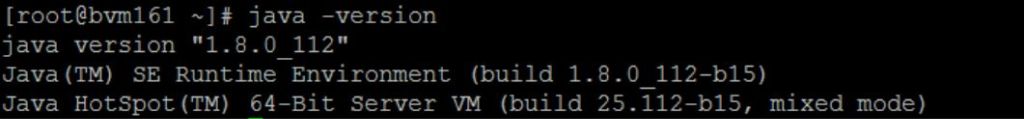

С Java разобрались для контрольной проверки сделайте java -version в консоле, ответ должен быть примерно таким:

Теперь переходим к Apache JMeter. Ставить можно любую версию JMeter, но если встречаются проблемы типа “Error in NonGUIDriver” то, скорее всего, нужен танк свежей версии или можно без проблем перейти на точно рабочую 2.13. Вернемся к установке — она аналогична для всех версий:

Скачиваем клиент:

wget https://archive.apache.org/dist/jmeter/binaries/apache-jmeter-2.13.tgz

Распаковываем:

tar -zxvf apache-jmeter-2.13.tgz

JMeter установлен и уже будет работать. Для первичной настройки достаточно будет внести только одно изменение. Идем по пути apache-jmeter-2.13/bin открываем для правки файл jmeter без расширения:

cd apache-jmeter-2.13/bin nano jmeter

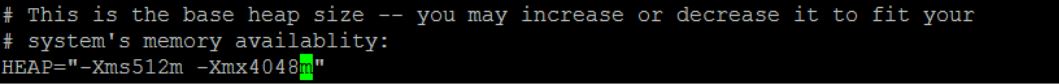

Находим строку, как на скриншоте ниже. Выставляем значения heap size в соответствии с характеристиками используемого сервера. Первое значение HEAP Xms — объем оперативной памяти выделяемый процессу при его старте, а второе Xmx — максимальное значение оперативной памяти, которое будет доступно процессу.

Если сервер без GUI и доступ к нему удаленный, как в большинстве случаев, лучше поставить JMeter локально для отладки и записи скриптов. В идеале версии должны совпадать, но в большинстве случаев JMeter понимает скрипты соседних или младших версий. Конечно, на локальной машине тоже должна стоять Java и сам JMeter.

Переходим к установке и настройке Yandex.Tank, для этого достаточным должно оказаться выполнение этих действий:

sudo apt-get install python-pip build-essential python-dev libffi-dev gfortran libssl-dev sudo -H pip install --upgrade pip sudo -H pip install --upgrade setuptools sudo -H pip install https://api.github.com/repos/yandex/yandex-tank/tarball/master

Дальше следует рассказать нашему орудию куда стрелять и чем. Для этого создадим рабочую директорию на машине с танком с конфигурационным файлом load.ini:

mkdir test cd test nano load.ini

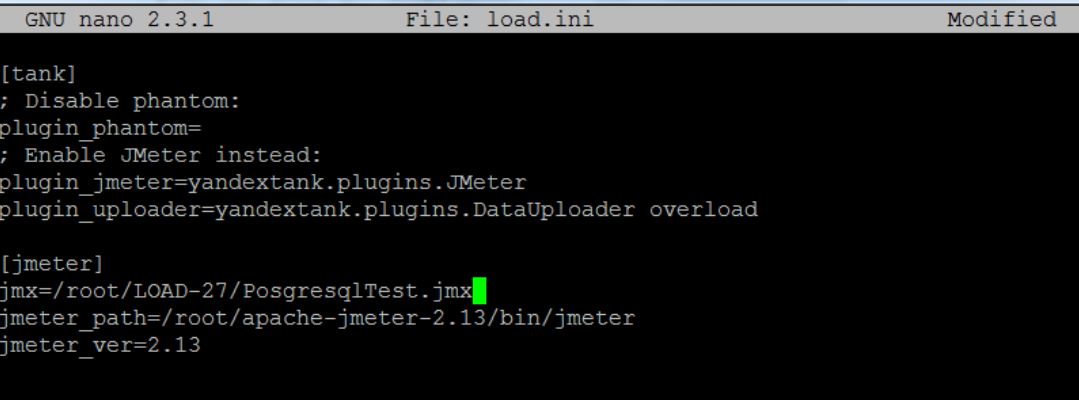

Содержимое конфигурационного файла является руководством к действиям танка, в нем необходимо отразить все ключевые моменты теста. Вот пример load.ini для теста с использованием JMeter:

Думаю, в блоке [tank] все понятно, если возникают вопросы есть описание каждого поля и блока от самих танкистов. Все самое интересное в блоке [jmeter].

Параметр jmx содержит путь непосредственно к скрипту, jmeter_path — это путь до исполнительного файла JMeter, ну и для того, чтобы танк не делал лишних движений, нужно указать версию JMeter'а в параметр jmeter_ver.

Разработка скрипта

Пришло время написать первый тест. Для этого открываем клиент JMeter - большинство Windows систем требуют запуск от имени администратора. Про то как начать осваивать JMeter, а заодно разобраться в его GUI хорошо написано в этой статье. У нас же пример с базой данных, что немного отличается от обычных http запросов. Первое отличие в том, что PostgreSQL не поддерживается в JMeter из коробки, поэтому нужно скачать драйвер нужной версии. После чего нужно подложить скаченный .jar в директорию /lib в папке с JMeter. Этот же .jar нужно подложить по аналогичному пути на машине с танком. С драйвером разобрались переходим к скрипту.

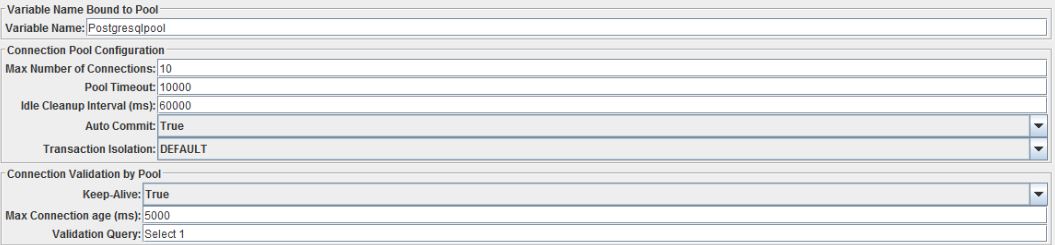

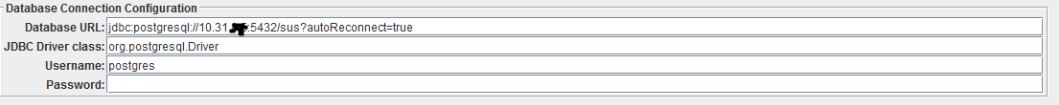

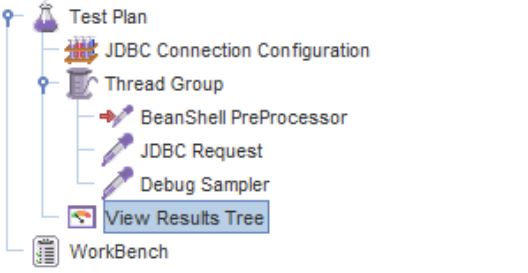

Первое, что нужно сделать это настроить подключение к БД, для этого правой кнопкой жмем на Test Plan -> Add -> Config Element -> JDBC Connection Configuration. Дерево теста пополнится конфигурационным элементом, как на скриншоте:

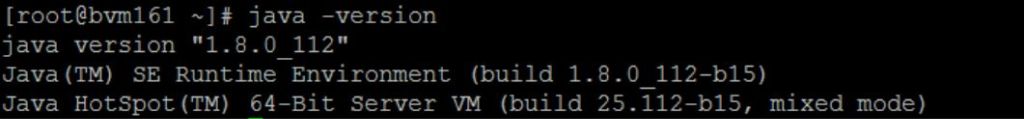

Перейдя на него, мы увидим много нужных полей. Тут нужно быть обратить внимание сначала на верхнюю часть:

Здесь важно заполнить поле Variable Name. Это имя будет использоваться в JDBC Request (Sampler) для доступа к пулу сессий. Еще стоит обратить внимание на Max Number Of Connections, этот параметр лимитирует количество одновременных подключений к БД. Остальное в этом блоке можно оставить так как есть, если нет особых требований к таймаутам и жизненному циклу коннекта.

Переходим к блоку на скриншоте выше, тут от нас потребуется ввести данные для подключения к базе. Шаблон такой:

- Database URL: jdbc:postgresql://IPAddress:PortNo/DatabaseName?autoReconnect=true;

- JDBC Driver class: org.postgresql.Driver;

- Username: username of database;

- Password: password of database.

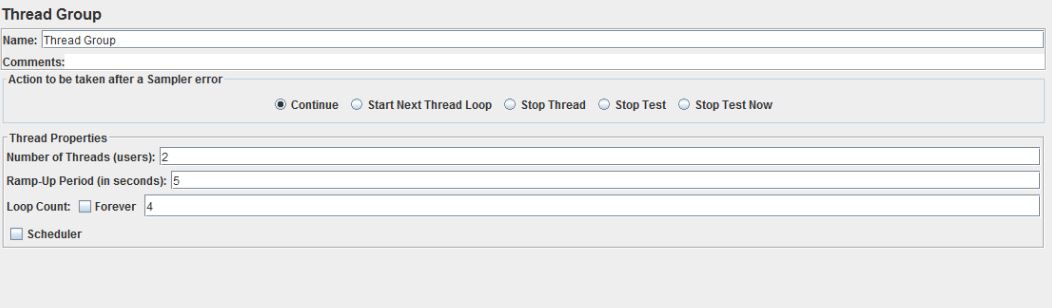

Приступаем к дальнейшему наполнению дерева теста. Опять нажимаем Test Plan -> Add -> Threads (Users) -> Thread Group.

Перед нами панель управления стрельбой, именно тут вводим какое количество пользователей — Number of Threads, за какое время будет достигнуто — Ramp-Up Period и с какой интенсивностью каждый новый пользователь вместе с предыдущим будет повторять действия.Если нам необходимо максимально часто отправлять запросы ставим галочку “forever” напротив Loop Count. Для первого теста можно выставить значение в пару пользователей, с небольшим количеством повторений. Теперь переходим непосредственно к запросам в БД.

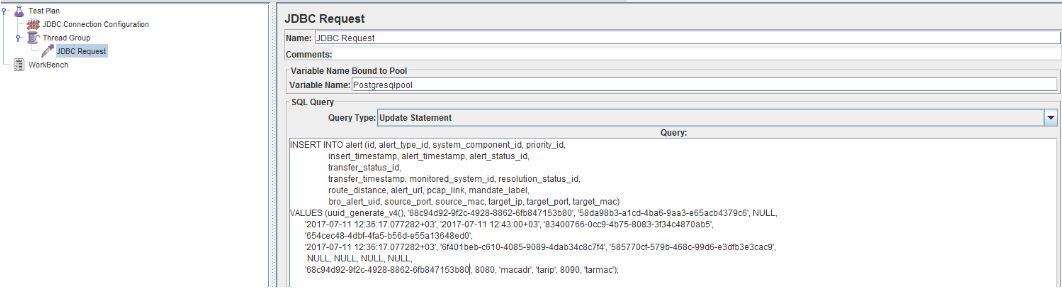

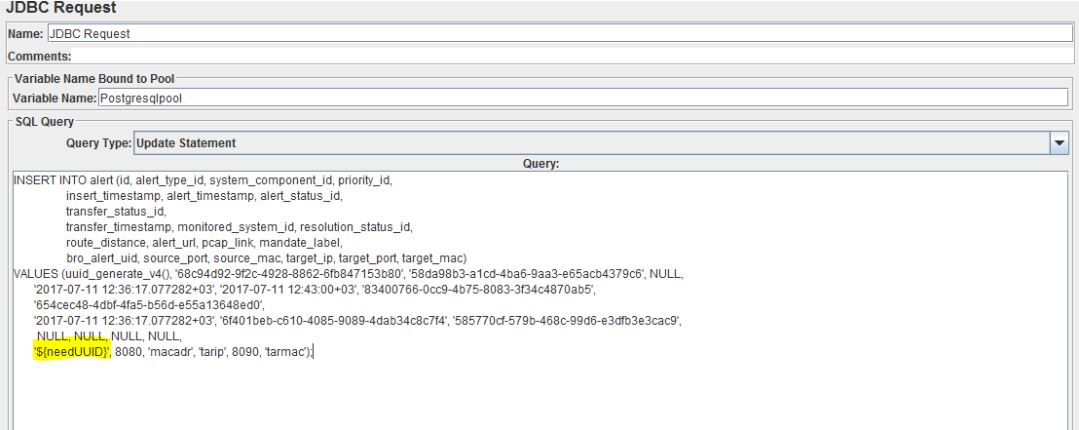

Для добавления в тест план семплера JDBC запроса нажимаем правой кнопкой на нужный нам Thread Group -> Add -> Sampler ->JDBC Request. Нас первоначально интересует поле Variable Name, оно должно совпадать с аналогичным параметром из JBDC Connection Configuration. После этого смотрим на выпадающий список Query Type, в зависимости от вашего запроса тут должно стоять соответствующее значение, например, для SELECT запроса в БД, нужно выбрать Select Statement, а для INSERT, COPY и UPDATE — Update Statement, как в нашем примере. В заключении работы с данным семплером нам необходимо задать тело запроса, которое должно соответствовать валидному SQL запросу.

В целом скрипт готов, но нам необходимо его отладить, делается это так:

- в нужный Thread Group после JDBC Request добавляем Debug Sampler. В нем будет отображаться ответ полученный после запроса к БД. Добавляется аналогично предыдущим элементам Thread Group -> Add -> Sampler -> Debug Sampler;

- для того, чтобы увидеть результаты работы того или иного семплера, в конце тест плана нам нужен мониторинг результатов — добавляется он так: Test Plan -> Add — > Listener -> View Results Tree. При запуске скрипта там будет детализация по всем выполненным запроса.

Пришло время тестового запуска пока из самого JMeter — для этого достаточно нажать

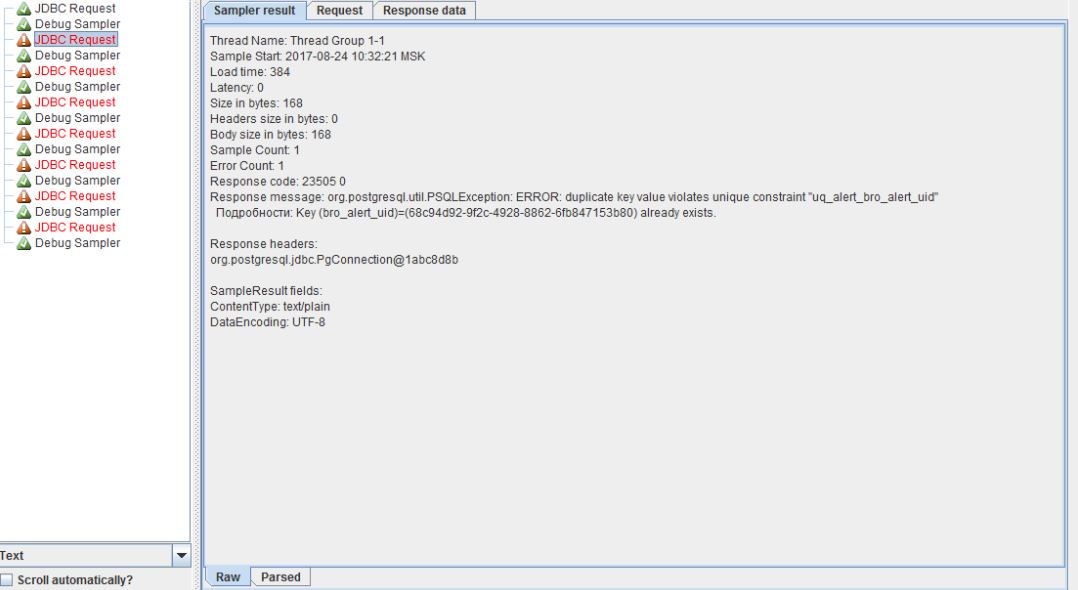

и нажать на View Results Tree. После отработки скрипта я получил следующие результаты:

Отладка скрипта

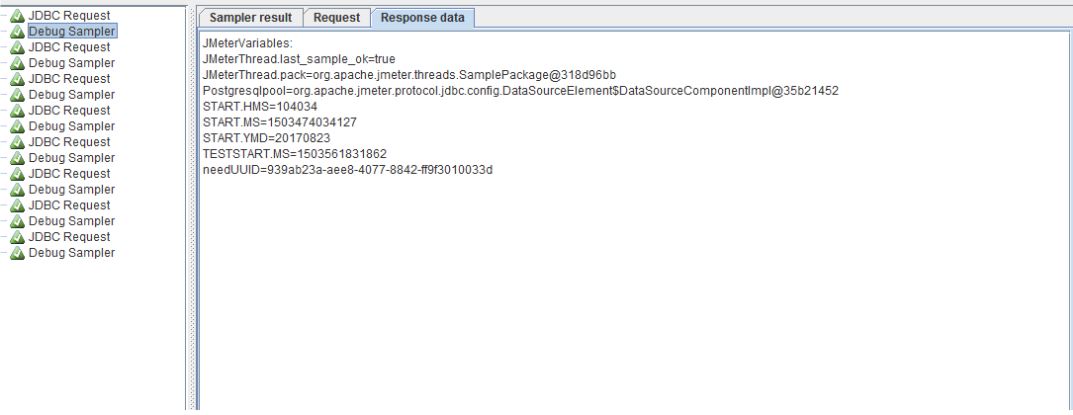

Видим, что первый отработал успешно и смотрим на поле Response message, оно говорит о том, что поле должно быть уникальным. Значит переходим к параметризации. Есть много способов как это сделать, наиболее уникальным из них является параметризация с помощью BeanShell PreProcessor. Для этого нам нужно вставить перед нашим JDBC Request указанный выше препроцессор - Thread Group -> Add -> Pre Processors -> BeanShell PreProcessor. О препроцессорах можно почитать тут или на сайте JMeter. BeanShell PreProcessor не рекомендуется использовать при больших нагрузках, как стабильный и быстрый вариант используйте JSR223 PreProcessor + Groovy.

Тут никаких изысков — пишем на java, импортируем необходимый класс, объявляем переменную, присваиваем в нее в нее рандомную переменную нужного формата. Для того, чтобы положить полученную переменную в переменную JMeter используйте vars.put(). Теперь переходим в наш JDBC Request и добавляем вместо значения в уникальном поле переменную в формате ${needUUID}, пример на скриншоте ниже:

Конечная структура нашего тест плана выглядит следующим образом:

Делаем еще один запуск из JMeter, сразу смотрим на View Results Tree, выбираем Debug Sampler и встаем на вкладку Response Data:

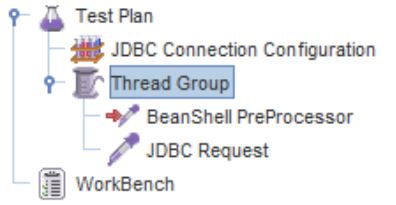

Тут можем убедиться, что наша переменная успешно сгенерировалась и для всех запросов она разная. Когда тест отлажен и готов к запуску нам необходимо убрать из него отладочные элементы, а именно Debug Sampler и View Results Tree. Делается это простым нажатием правой кнопки на элемент и выбором пункта Remove. На всякий случай прикладываю вид теста после этого:

Теперь сохраняем тест и переносим на машину с танком. Вносим его в параметр “jmx” в файле load.ini и сохраняем. Используется абсолютная адресация. У меня выглядит так:

Пришло время первого запуска, чтобы понять, что на этом этапе все работает. Перед этим нам нужно проконтролировать добавление строк в БД. Для этого можно использовать инструмент pgAdmin или просто зайти на сервер с базой и сделать count строк до и после отработки скрипта. Коннект к базе выполняется подобной командой:

psql -h IpAddress -d dbName -U UserName

Сам count делаем так:

select count(*) from alert;

Возвращаемся на машину с танком, переходим в директорию где находится load.ini и вводим команду для запуска танка:

yandex-tank

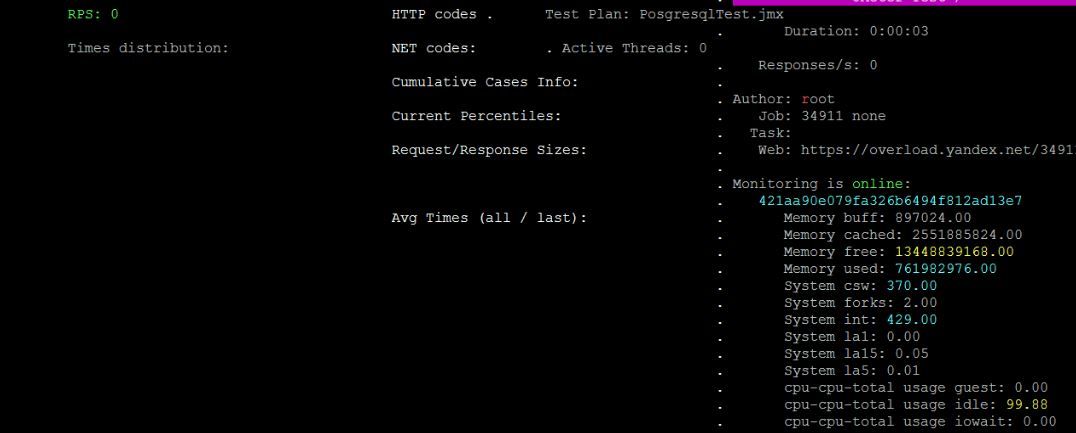

Спустя несколько секунд после запуска появится окно с текущими параметрами теста. Учитывайте, что при коротких тестах танк может не успеть получить данные о текущих параметрах.

Мониторинг

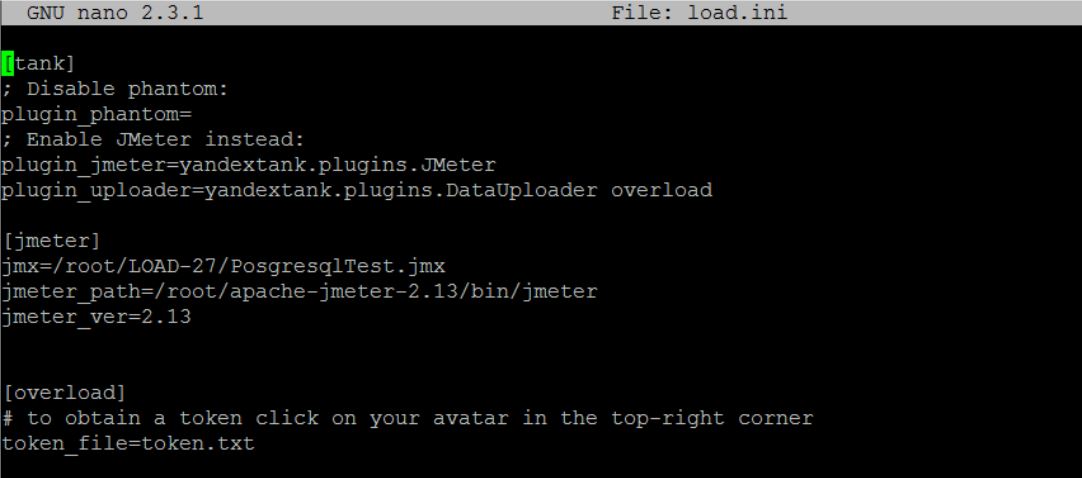

Проверив выполнение и отработку теста перейдем к настройке мониторингов. Благо для настройки мониторинга средствами Overload, потребуется минимальные усилия. Достаточно следующих действий:- регистрация на Overload;

- получаем токен путем нажатия на иконку профиля в Overload и выбором “my api token”;

- создаем token.txt в той же папке, что и load.ini на машине с танком;

- заносим полученный токен в token.txt и сохраняем;

- добавляем блок [overload] в load.ini — описание от танкистов;

Получаем примерно следующее содержимое load.ini:

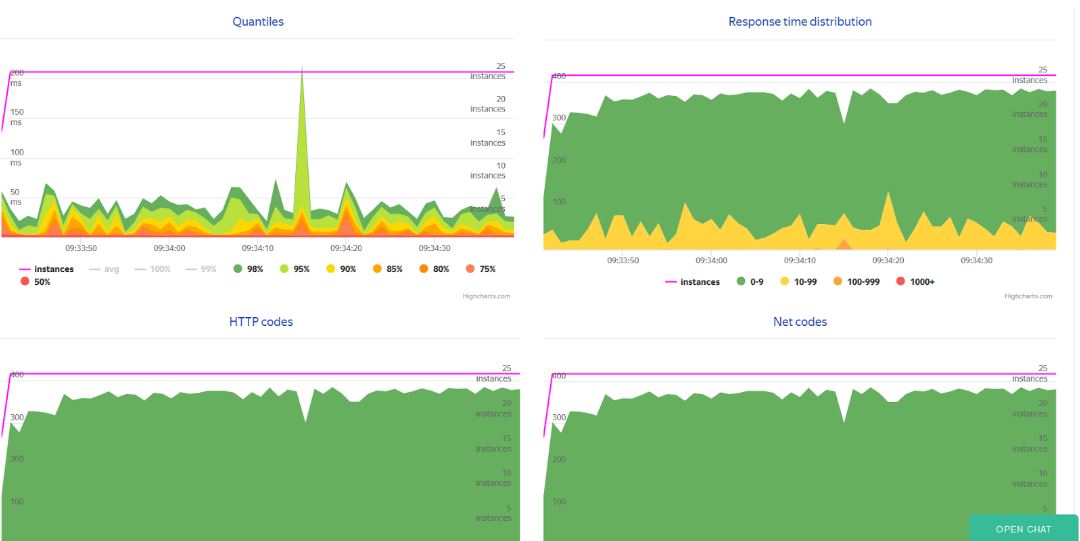

Теперь после запуска теста у нас профиле Overload будет отображаться текущий тест и все прошедшие со многочисленными полезными графиками:

C Overload закончили, теперь несколько слов о прочих метриках и их мониторинге. Существует множество гайдов для настройки мониторинга непосредственно БД, поэтому детально описывать этот процесс я не буду. Советую использовать telegraf для снятия метрик сервера и influxdb для базы данных. Вывод всех метрик можно организовать в Grafana. Для этого можно использовать процесс установки в этом гайде.

Напоследок хорошо было бы сказать о том, что с недавних пор, а именно, начиная с версии 3.2 у JMeter появились встроенное решение на базе infux для мониторинга, но там, в отличие от Overload, придется все настраивать самостоятельно.

На этом все. Всем хороших стрельб!

|

Метки: author login40k тестирование веб-сервисов postgresql jmeter yandex.tank yandex.overload нагрузочное тестирование |

Зачем нужны заголовки |

Зачем нужны заголовки

Зачем нужны заголовки и какие теги для них использовать?

Этот вопрос нам задают чаще всего.

Когда много лет назад придумали HTML, мир был совсем другим. Авторы спецификации вдохновлялись текстовыми документами, где в одном потоке подряд шли абзацы, списки, таблицы, картинки и, конечно, заголовки. Прямо как в ваших рефератах и курсовых: самый большой заголовок — название, заголовки поменьше — части или главы.

В HTML с тех пор шесть уровней заголовков: от

до

Еда

Фрукты

Классные

Яблоки

Вообще

Еда

Фрукты

Классные

Яблоки

Вообще

Но секции лучше задавать явно с помощью элемента , помните третий выпуск? Эти два фрагмента идентичны, с точки зрения семантики, но этот гораздо понятнее, хоть и многословнее.

Еда

Фрукты

Классные

Яблоки

Вообще

Из-за такой системы неявных секций, спецификация настойчиво рекомендует не использовать элементы для подписей под заголовками. Это обычный параграф, а заголовок должен обозначать отдельную часть содержимого. В спецификации есть глава с примерами разметки сложных элементов: подписи, крошки, диалоги — почитайте.

Ладно! Раз у нас есть явные секции, то по вложенности легко определить отношение частей. Так может браузеры сами догадаются какого уровня заголовки нужны? А то считать:

,

Такая же идея пришла в голову авторам HTML5 и они описали в спецификации алгоритм аутлайна. Он разрешает использовать на странице только

, а важность обозначать вложенностью структурных элементов вроде

Еда

Фрукты

Яблоки

Еда

Фрукты

Яблоки

Разработчикам идея очень понравилась, многие даже бросились её внедрять. Но вот беда: алгоритм аутлайна до сих не внедрил ни один браузер, читалка или поисковик. На таких страницах все заголовки кричат, что они №1 и самые важные. Но если важно всё, то уже ничего не важно.

Не надо так делать, об этом теперь пишет сама спецификация. За уровнем заголовков нужно следить самим. На самом деле, это не так сложно: на типичной странице вряд ли наберётся структурных частей больше, чем на 3 уровня. Так что не ленитесь.

Нет, погоди. Я ставлю класс на

Фрукты бесплатно

Только за деньги

Вы конечно правы, стили создают визуальную модель важности: крупный чёрный текст важнее, меленький серенький вообще не важен. Но только если вы смотрите на такую страницу.

Есть две важные группы пользователей, которые читают вашу страницу по тегам разметки. Они не смотрят насколько крупный и чёрный ваш

Читалками или скринридерами пользуются люди, которые плохо или совсем не видят ваши интерфейсы, или не могут управлять браузером привычным образом. VoiceOver, NVDA, JAWS читают содержимое вслух и ориентируются только по значимым тегам. Элементы div и span не значат ни-че-го, какие бы классы и стили вы не накрутили. Такой сайт — как газета без заголовков, просто месиво текста.

Да какая газета! Очнись, 2017 на дворе, я изоморфное одностраничное приложение делаю, а не стенгазету. У меня тут стейты компонентов — нафига семантика там, где нет текста? Очень хороший вопрос.

Все читалки идут по странице тег за тегом, от первого к последнему. И читают подряд всё, что внутри. Крайне неэффективно: каждая страница начинается с шапки и пока её пройдёшь, забудешь за чем шёл. Поэтому у читалок есть специальные режимы, показывающие только важные части страницы. Структурные элементы header, nav, main и другие, все ссылки, все заголовки.

Если вывести все заголовки и прочитать их, можно составить ментальную, а не визуальную модель страницы. А потом взять и сразу перейти к нужной секции, выбрав её заголовок. Меню, поиск, каталог, настройки, логин — все эти части вашего приложения можно озаглавить, чтобы упростить доступ к ним.

- Инстаграм

- Лента

- Закат

- Латте

- Настройки

- ПрофильНо бывает, что в дизайне нет заголовков для важных частей. Дизайнер рисует, ему всё ясно: меню с котлетой, поиск с полем и так далее. Но это не должно мешает вам делать доступные интерфейсы. Расставьте нужные заголовки, а потом доступно их спрячьте. Как? Только не display: none, его читалки игнорируют. Есть такой паттерн visually hidden, подробнее в описании к видео.

Думайте не только о том, как выглядит ваша вёрстка, но и о том, насколько логично организована разметка. Не забывайте о заголовках: пусть стили показывают, а заголовки рассказывают о ваших страницах или приложениях.

Видеоверсия

Вопросы можно задавать здесь.

|

|

Геометрия данных 1. Симплексы и графы |

Геометрия данных 1. Симплексы и графы

Введение

Мы собираемся доступным языком и с примерами описать построение взаимных систем координат, которые позволяют описывать как обычное геометрическое пространство, так и пространство графа (сети). Взаимность позволяет выражать свойства графов на языке геометрии и наоборот. В геометрическом пространстве граф представляет собой симплекс, вершины которого соответствуют вершинам графа.

Система координат — это описание элементов (точек) пространства в виде набора чисел и задание метрического тензора, позволяющего определять дистанцию (расстояние) между элементами и другие геометрические параметры. Графы не имеют явно выраженного центра, поэтому для их описания не подходят системы координат на базисных векторах (декартова система и ее вариации). Роль базиса играют точки пространства (реперы, якори).

Примерный план и содержание серии.

Вначале продемонстрируем взаимность симплекса и графа. Введем метрические тензоры относительно базовых точек — дистанционный и лапласовский, которые связывают параметры графов и симплексов между собой. Покажем, что описанная сфера симплекса характеризует параметры связности графа.

Далее определим системы координат на основе дистанционного и лапласовского метрических тензоров. Отличительная черта данных систем в том, что координаты точек в них имеют скалярную и векторную часть. Дистанция между двумя точками с известными координатами определяется стандартно — через билинейную форму произведения координат на метрический тензор.

Покажем преобразования ди- и би-координат — изменение базиса. В дистанционных координатах смена базовых вершин одновременно означает определение новых дистанций между точками пространства. Такой процесс имеет прикладное значение, например, в задачах локализации сенсоров (определения их координат на основе некоторых базисных).

От геометрического пространства перейдем к пространству графа. В пространстве графа алгоритм определения дистанций между вершинами (узлами) отличается от стандартного. Покажем особенности определения координат вершин на графе, роль фундаментальной матрицы (матрицы норм) для определения дистанции между точками, не принадлежащими базисному пространству.

Наконец, в заключение покажем применение введенной метрики для области положительных целых чисел, которые как известно, можно разложить на произведение простых. Каждое составное число можно рассматривать в пространстве, базисными точками которого являются простые числа. Данный пример (внезапно) помогает понять роль времени в физической концепции пространство-время.

Поехали!

Дистанционная матрица

Пусть у нас есть множество, состоящее из n элементов. Элементами могут быть геометрическая точка в пространстве, узел графа, буква, слово, документ, человек и т.д., — практически любой объект. Допустим далее, что известна степень близости элементов набора. Для точек в пространстве степенью близости является квадрат расстояния между ними. Для электрической цепи сопротивлений степень близости равна эффективному сопротивлению между узлами сети. В физике мера близости между двумя событиями именуется интервалом. Мы объединим все эти термины под общим названием — дистанция, которую обозначим как — это дистанция между элементами и .

Если элементы имеют независимые числовые характеристики (компоненты), то дистанция между ними может быть определена как сумма разностей дистанций компонент (правило Пифагора):

Верхним индексом обозначен номер компоненты.

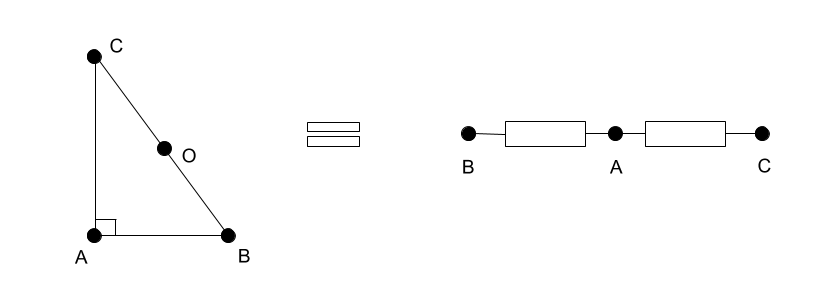

Набор точек с известными дистанциями между ними будем называть симплексом. На рисунке показан прямоугольный треугольник (2-мерный симплекс) с катетами 3, 4 и гипотенузой 5. Его дистанционная матрица имеет вид:

\begin{array}{c | c c c}

D_{ABC} & A & B & C \\

\hline

A & 0 & 9 & 16 \\

B & 9 & 0 & 25 \\

C & 16 & 25 & 0 \\

\end{array}

Точно такая же матрица будет описывать сопротивление между узлами электрической цепи из двух последовательно соединенных резисторов (показаны на рисунке). В теории графов ее принято называть матрицей сопротивлений (resistance distance matrix).

Очевидно, что симплекс в трехмерном пространстве определяется 4-мя вершинами (тетраэдр), в двумерном — 3-мя и т.д., — мерность пространства симплекса на 1 меньше количества его вершин.

Векторное окаймление матриц

Дистанционная матрица симплекса не подходит для роли метрического тензора хотя бы потому, что ее определитель не связан с объемом симплекса (в примере — с площадью треугольника). Однако еще в 19-м веке A.Cayley (Кэли) обнаружил, что если расширить (окаймить) дистанционную матрицу вектором из единиц, то определитель полученной матрицы будет пропорционален квадрату объема симплекса. Полученную таким образом матрицу называют матрицей Кэли-Менгера.

Определим операцию окаймления симметричных матриц вектором и скаляром :

Скалярное произведение векторов (результат — скаляр) — это два внутренних штриха (), внешнее произведение (результат — матрица, диада) — два внешних штриха (), точечное произведение (результат — вектор) — оба штриха с одной стороны ( или ).

Если матрица является окаймлением матрицы , то является подматрицей и называется главным (угловым) минором .

Дистанционный метрический тензор (ДМТ)

Математики (J.C.Gower) также заметили, что удобнее оперировать не с самими дистанциями между точками, а с отрицательными полудистанциями :

Знак минус нужен, чтобы избавиться в выражениях от множителей типа , а множитель «1/2» позволяет избавиться от степеней двойки.

Дистанционный метрический тензор определяется как окаймление вектором из единиц полудистанционной матрицы :

Для нашего симплекса из трех точек (прямоугольного треугольника) дистанционный метрический тензор будет иметь вид:

\begin{array}{c | c c c c}

Dm & * & A & B & C \\

\hline

* & 0 & 1 & 1 & 1 \\

A & 1 & 0 & -4.5 & -8 \\

B & 1 & -4.5 & 0 & -12.5 \\

C & 1 & -8 & -12.5 & 0 \\

\end{array}

В тензорной форме записи дистанционный тензор будем обозначать нижними индексами:

Мы используем ту же букву (), которой принято обозначать обычный (векторный) метрический тензор (с точкой начала координат и базисными векторами), чтобы продемонстрировать их аналогию. Но следует иметь ввиду, что размерность дистанционного тензора на два больше размерности векторного при описании пространства одной и той же мерности.

При матричном способе записи индексами обычно обозначают точки пространства, значения элементов. — это значение матрицы M в i-й строке и j-м столбце, — значение вектора в точке p.

В тензорной форме назначение индексов — это прежде всего определение типа (и ранга) тензора. Обозначение говорит о том, что речь идет о контравариантных координатах вектора . При этом буква может означать конкретную точку пространства.

Геометрические свойства ДМТ

Как отмечено выше, определитель метрического тензора связан с объемом симплекса . Точная формула:

где — мерность пространства, задаваемого симплексом из вершин.

Вычислим площадь нашего треугольника. Имеем . Тогда , откуда . Конечно, данную площадь можно было получить и просто перемножением длин катетов .

Другая полезная характеристика, содержащаяся в ДМТ, — это (внезапно) значение квадрата радиуса описанной сферы вокруг вершин симплекса. Данная n-мерная сфера играет важную роль в системах координат на точках. Для краткости квадрат радиуса будем называть просто радиусом и обозначим как . Радиус описанной сферы равен отношению определителей углового минора ДМТ (полудистанционной матрицы) и самого ДМТ:

В нашем треугольнике радиус сферы будет равен: .

Лапласовский метрический тензор (ЛМТ)

Известно, что метрические тензоры ходят парами. То есть для заданной метрики всегда есть взаимная, а метрические тензоры взаимных метрик обратны по отношению к друг другу. Обращение дистанционного метрического тензора дает лапласовский метрический тензор (ЛМТ): . Связь тензоров:

в матричной форме

и в тензорной

Почему обратный дистанционный метрический тензор стал лапласовским? Потому что его главным угловым минором (подматрицей) является лапласиан . Та самая матрица, которой описывают узлы и связи в графе, ее называют также матрицей Кирхгофа. Формула (1.8) связывает свойства симплексов и графов. Можно утверждать, что каждому невырожденному симплексу соответствует какой-либо граф и наоборот. Такая взаимность позволяет сопоставлять геометрические характеристики симплексов с инвариантами графов.

Структура ЛМТ

Важно то, что лапласовский метрический тензор — это не просто лапласиан, а его векторное окаймление. В структуру ЛМТ входят скаляр и вектор — характеристики описанной сферы вокруг вершин симплекса:

Здесь скаляр — это квадрат радиуса описанной сферы, про который уже упоминалось. Вектор — барицентрические координаты центра описанной сферы симплекса.

Барицентрические координаты — это весовые координаты точки относительно базовых (реперов). Базовыми здесь служат вершины симплекса (или графа). Сумма весов равна единице — условие нормировки барицентрических векторов.

Это означает, что центр O уравновешивается равными массами в точках B и C.

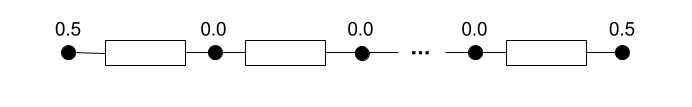

Вообще говоря для любого графа, представляющего собой цепочку последовательно соединенных звеньев, координаты вектора центра сферы будут отличны от нуля только на крайних узлах и равны 0.5.

Связь параметров ДМТ и ЛМТ

Раскрывая умножение метрических тензоров (8) по правилам произведения блочных матриц, получаем свойства их составляющих.

Здесь — полудистанционная матрица, — единичная матрица. Пришли к 4-м основным тождествам.

Сумма компонент барицентрического вектора центра сферы равна 1:

Сумма строк (и столбцов) лапласиана равна 0. Или более абстрактно — вектор единиц () является для лапласиана нулевым:

:

Свойство равноудаленности базовых вершин (симплекса или графа) от центра сферы:

, откуда

Связь полудистанционной матрицы и лапласиана через -вектор:

Построение дистанционной матрицы по лапласиану

Если мы имеем дело с графом, то для построения дистанционной матрицы на основании матрицы смежности можно использовать следующий алгоритм. Для матрицы смежности считаем лапласиан:

.

Здесь — оператор преобразования вектора в диагональную матрицу.

Определитель лапласиана равен нулю, поэтом его нельзя просто обратить. Надо либо удалить из него какой-то узел, либо дополнить (окаймить) каким-либо вектором.

Здесь рассмотрим второй способ — окаймляем лапласиан вектором из единиц и обращаем полученную матрицу. Главным минором (подматрицей) результата обращения будет матрица Грина .

Матрица Грина относится к грамианам . Из любого грамиана можно построить дистанционную матрицу по формуле (преобразование дистанции):

где вектор — это диагональ грамиана .

Геометрия лапласиана

Сопоставим геометрические параметры симплекса с инвариантами и характеристиками графа.

Объем симплекса и потенциал лапласиана

Матричная теорема о деревьях связывает количество остовных деревьев графа с определителем минора лапласиана. В предыдущих статьях мы называли данную величину скалярным потенциалом лапласиана :

Здесь через обозначен псевдодетерминант, то есть детерминант от минора лапласиана (поскольку сам лапласиан — вырожденная матрица).

Видим, что чем меньше количество остовных деревьев графа (проще его структура), тем больше объем соответствующего ему симплекса.

Элементы лапласиана

Лапласиан можно рассматривать и как характеристику симплекса, и как параметры связей узлов графа. В терминах графов значениями лапласиана является величина связи между узлами (с обратным знаком), а на диагонали расположена общая сумма связей узлов.

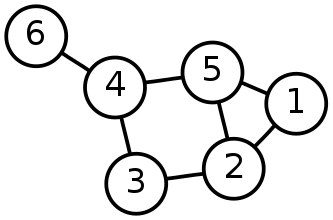

Приведем вид лапласиана для нашего примера: