Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

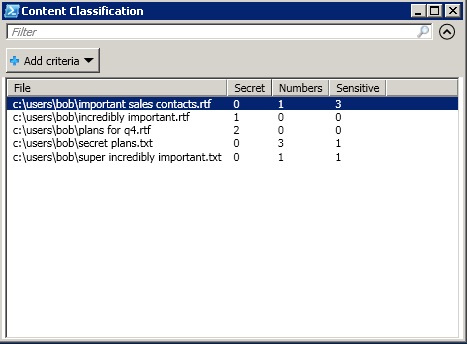

Эксперимент: действительно ли все разбираются в дизайне? |

Эксперимент: действительно ли все разбираются в дизайне?

Мнение о дизайне есть у каждого. «Это плохой лого». «Это хороший лого». «Этот дизайн столько не стоит». Таких комментариев полно под любой новостью о дизайне. Как люди, которые не являются профессионалами, могут так легко делать выводы по одному взгляду?

Я решил провести небольшой эксперимент, чтобы проверить, действительно ли все так хорошо разбираются в дизайне, как им кажется.

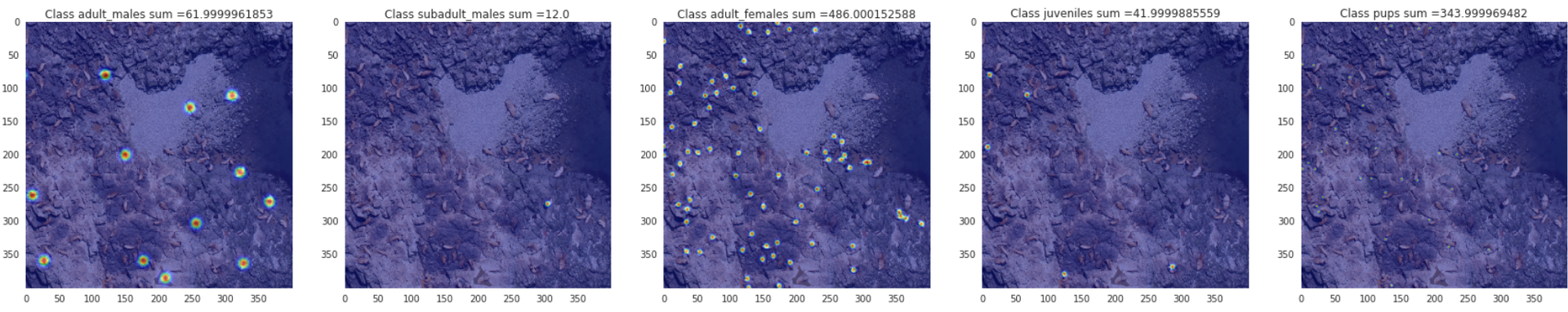

Опрос: почему логотип Polska Moto такой успешный?

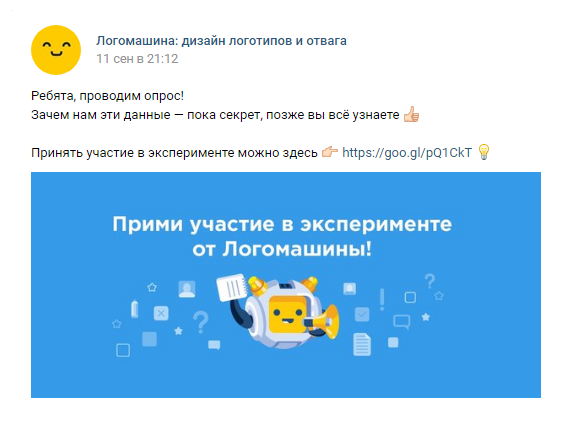

Чтобы понять, действительно ли люди могут сделать правильные выводы, глядя на дизайн, мы создали опрос. Мы попросили наших подписчиков описать впечатление от неизвестного в России логотипа «Polska Moto».

Эта компания, вопреки ожиданиям, невероятно быстро заняла лидирующие позиции на рынке мототехники. Их логотип в Польше можно увидеть в каждом мотосалоне:

Как это ни удивительно, большинство действительно поняло, почему компания с таким логотипом пришла к успеху. В их ответах я прочел много лестных слов об удачном сочетании форм и цветов, например:

«Яркие цвета и простые формы обеспечили легкость восприятия и просмотра логотипа, округлость притянула взгляд и внимание своей совершенной, без изъянов и излишеств формой. Просто, увлекательно и с намеком на совершенство». [М, 17, маркетолог-программист]Это очень приятно, особенно если учесть, что этот логотип сделал лично я за пару минут. А ведь я даже не дизайнер! Тем не менее 57% опрошенных связали успех моей вымышленной фирмы «Polska Moto» именно с логотипом. Они искали причины в сочетании цветов, похожести на Майкрософт, простоте и нестандартности:

«Возможно, повлияла идея гармоничного сочетания разных элементов — четырех основных цветов, круга и квадрата, при этом логотип остался мягким и скругленным, глаз ни за что не цепляется». [Ж, 23, интернет-маркетинг]

Почему логотип Polska Moto такой провальный?

Возможно, я действительно сделал очень хороший логотип и все эти мнения объективные? Чтобы это проверить, я разделил опрашиваемых на две группы по сто человек с помощью сервиса «Qualtrics». Первой группе я показал свой логотип Polska Moto с историей успеха, а другой группе тот же самый лого, но с противоположной легендой:

В этой группе целых 78% стали искать причины провала в логотипе. Кого-то смущало расположение текста, кто-то был уверен, что дело в квадрате, но большинство предположили, что дело в «несоответствии логотипа и сферы деятельности». Хотя наши постоянные читатели знают, что это распространенный миф.

Как отличить хороший дизайн от плохого: мнение опрашиваемых

В опросе была возможность написать «я не разбираюсь в дизайне», но ей воспользовалось всего несколько человек. Большинство аргументировало свою позицию, причем в одних и тех же особенностях логотипа одни видели причины успеха, другие — провала.

Обе группы заметили схожесть с Microsoft. Хорошо это или плохо?

Конечно, плохо:

Логотип не отражает сущности компании, он безлик и похож на сотни других. Первая ассоциация с ним — Microsoft, а не мотоиндустрия. [Ж, 26, фрилансер]

Цвета логотипа слишком заезжены. Вызывают сильную ассоциацию с Microsoft или Google. [М, 18 лет, —]… или все-таки хорошо?

Минималистичность, геометрия, цветовая гамма соответствует корпорации Майкрософт, что изначально внушает уверенность. [Ж, 17, маркетолог]

Ассоциация с Windows / Google (цвета и геометрия) [Ж, 22, юрист ]Группы по-разному восприняли факт «несоответствия сфере»:

Скучный лого, никак не намекают на связь с мотопроизводством. Цвета не соответствуют специализации (слишком ярко).

Не понятно чем занимается компания. Это скорее похоже на сферу развлечений. [Ж, 23, графический дизайнер]

Яркий логотип, не построенный на стереотипных идеях о мотоциклах. При этом внешне создаётся вид престижного и важного бренда. [М, 24, дизайнер-фрилансер]

… логотип не заезженный и не похож на другие логотипы производителей авто-механики или авто. [Ж, 16, программист]Мнения разошлись и насчет цветовой гаммы логотипа:

Слишком несерьёзно выглядит сочетание цветов [М, 22, —]

Я считаю, что все детали помешали успеху компании. Форма и цвета больше подходят логотипу цирка [Ж, 30, дизайн]

Логотип напоминает калейдоскоп и вызывает этим приятные воспоминая из детства. Этим располагает к себе. [Ж, 30, техник строитель / домохозяйка]

Простота логотипа и его броскость (яркость) легко запоминались пользователями и угадывались [М, 25, инженер-программист]

На удивление, множество разногласий вызвал квадрат по центру логотипа. Группа с «разорившейся компанией» видела проблему именно в нем:

… Меня крайне смущает квадрат в центре. [Ж, 24, дизайн]

Мне кажется, этот контур квадрата здесь абсолютно лишний… [Ж, 19, студент издательского дела]Однако группа с «успешной компанией» нашла в квадрате глубинный смысл:

Из-за квадрата [Ж, 32, дизайн]

В интернете ходит картинка с тремя кругами: дорого, долго, качественно. И на пересечении их результат. Я думаю в квадрате они тоже выделили что у них все и сразу :) [М, 21, разработчик]

…4 стихии мира (кружок — сам логотип) и многогранность этого мира, так как внутри квадрат. Для мототехники это важно. [Ж, 21, логист и переводчик]Опрашиваемые даже не смогли определиться, простой это логотип или сложный:

… он визуально сложный [М, 24, Веб]

Перегруженность деталями и цветами [М, 20, студент-программист]

Лого создан на основе простых форм и цветов [Ж, 25, дизайнер полиграфии]

Простой, яркий, запоминающийся логотип [Ж, 23, педагог]

Какой ответ правильный?

Понятно – большинство увидело то, что захотело увидеть. Кто-то понял, что логотип не настоящий и потроллил нас в ответ. Но хочется узнать отгадку — хороший это дизайн или плохой? Стала бы компания с таким лого успешной или нет?

Четверть всех опрошенных ответила, что связи между дизайном и развитием компании вообще нет. Может быть это и есть правильный ответ?

На самом деле, в нашем вопросе не больше смысла, чем в: «Почему компания с такой техподдержкой стала успешной?». Или: «Почему компания с таким руководителем отдела снабжения разорилась?». Тут нужна куча уточняющих вопросов: «А насколько большую роль играла техподдержка?», «А как шли дела у отдела снабжения?». И только с помощью массы дополнительной информации можно сделать не то что выводы, а просто скромные предположения.

Вернемся к дизайну: команда Логомашины сделала сотни логотипов для самых разных компаний. Мы видели, как проекты становятся известными или пропадают без следа. Но ни мы, и никто другой не скажет вам, как связан дизайн логотипа и успех фирмы. Что бы изменилось, если бы на логотипе Эппл яблоко было не надкусано? Никто не знает. А если бы Эппл оставила свой старый логотип? Все бы изменилось, но никто не скажет, как именно.

Логотип — важная часть айдентики. Айдентика напрямую связана с брендингом. Но есть фирмы, которые достигли успеха, вообще не строя бренд. А есть бренды, которые привлекают клиентов своим дизайном, выделяются среди конкурентов и продают товар в разы дороже. Делать упор на брендинг и дизайн — вопрос стратегии. Для одних фирм это бесполезно, для других — ключ к успеху. А для большинства это просто большой плюс, как качественный сайт или солидный офис в центре.

Поэтому правильный, с нашей точки зрения, ответ: «Никто на свете не знает, какую роль в успехе или провале этой фирмы сыграл дизайн логотипа».

Выводы

В дизайне очень мало объективного. Если бы мы спросили: «Почему эта программа не работает?», — большинство бы честно сказало: «Я не знаю, я не программист». А разработчики бы открыли код и нашли ошибку, если она есть.

Но когда мы спрашиваем: «Почему этот дизайн не работает?», — мнение есть у каждого. И на это мнение очень легко повлиять.

Поэтому все фокус-группы и опросы «Как вам мой логотип?» не состоятельны — люди с умным видом рассуждают о том, в чем вообще никто не разбирается. Одни и те же признаки можно трактовать двояко — перед вами простой и запоминающийся логотип или просто примитивный?

Можно только сказать «мне лого нравится» или «не нравится». Но даже тут на впечатление очень легко повлиять — на публичных презентациях дизайна коллеги чаще всего косятся на начальника и поддакивают ему. А иногда и начальник ждет «подсказки» от коллег, потому что не понимает, что перед ним — качественный дизайн или низкосортный клипарт. Тогда первое озвученное мнение задает тон.

Простой пример — клиент разочаровался в логотипе, потому что, цитата: «Показал всем знакомым, никому не понравилось». Все бы ничего, но он показывал дизайн со словами: «Мне какое-то говно нарисовали, что думаешь?». Вывод из всей истории простой: большая часть мнений о хорошем и плохом дизайне основаны только на субъективных ощущениях. А ощущения создаются не только из чувства вкуса и предрассудков, но и из «эффекта ореола» — мнения окружающих и других факторов.

Поэтому каждый раз, когда вы видите комментарии про «этот логотип столько не стоит» или «раньше было лучше», знайте — перед вами дилетанты. Профессионалы молчат, потому что знают, что они в этом не разбираются.

Если хотите поучаствовать в наших экспериментах, посмотреть трансляции из офиса и узнать что-то новое — подпишитесь на Логомашину в ВК. И, как всегда, удачи вам и вашим проектам!

Эксперимент провел Данила Баранов, контент-менеджер Логомашины.

|

Метки: author Danya_Baranov работа с векторной графикой графический дизайн блог компании логомашина бизнес эксперимент интересное полезно |

[Из песочницы] Генерация родословного дерева на основе данных Wikipedia |

Генерация родословного дерева на основе данных Wikipedia

В статье будет рассказано, как определить имя персоны, вычислить ссылки на страницы детей персоны, а также будет построен алгоритм генерации генеалогического древа.

Я буду использовать Java, Selenium Webdriver и Chrome. Chrome, потому что он быстрее остальных браузеров, а так как переход по урлу — самое затратное по времени операция в программе, то выбор браузера заметнее всего сказывается на времени. Можно вообще отказаться от браузера и использовать, скажем PhantomJs, но его сложнее дебажить. Поэтому я остановился на Chrome.

В первую очередь создадим тест, проверяющий, что браузер корректно запустился и что при переходе по урлу https://ru.wikipedia.org/wiki/Рюрик открывается страница с заголовком «Рюрик — Википедия»:

@BeforeClass

public static void Start() {

driver = DriverHelper.getDriver();

}

@Test

public void testGetDriver() {

driver.navigate().to("https://ru.wikipedia.org/wiki/%D0%A0%D1%8E%D1%80%D0%B8%D0%BA");

assertTrue(driver.getTitle().equals("Рюрик — Википедия"));

}

@AfterClass

public static void Stop() {

driver.quit();

}

Создаем класс DriverHelper со статичным методом getDriver(), чтобы проект скомпилился и тест прошёл успешно:

public final class DriverHelper{

private static final int TIMEOUT = 30;

public static WebDriver getDriver() {

WebDriver driver = new ChromeDriver();

driver.manage().window().maximize();

driver.manage().timeouts().implicitlyWait(TIMEOUT, TimeUnit.SECONDS);

return driver;

}

}

Прогоняем тест, чтобы убедиться, что браузер корректно запускается и открывает нужную страницу.

Создание класса Person

Перейдем к созданию класса Person, в котором будет храниться информация о персоне, а также к созданию класса страницы персоны на Wikipedia PersonPage.

В классе Person пока будут только два поля – name и url. В качестве name будем использовать полное имя человека, без разделения на Фамилию, Имя, Отчество, т.к. большинство представителей династии не будут иметь фамилии, зато будут иметь прозвища, титулы и порядковые имена.

Url будет указывать на страницу Wikipedia, посвященную данному человеку.

Создаем тест, проверяющий формирование персоны:

@Test

public void testGetPerson() throws Exception {

PersonPage page = new PersonPage(driver);

Person person = page.getPerson("https://ru.wikipedia.org/wiki/Владимир_Александрович");

assertTrue(person.getName().equals("Владимир Александрович"));

assertTrue(person.getUrl().equals(

"https://ru.wikipedia.org/wiki/

%D0%92%D0%BB%D0%B0%D0%B4%D0%B8%D0%BC%D0%B8%D1%80_

%D0%90%D0%BB%D0%B5%D0%BA%D1%81%D0%B0%D0%BD%D0%B4%D1%80%D0%BE%D0%B2%D0%B8%D1%87"));

}

testGetPerson() не компилится. Нам нужно разработать страницу PersonPage, чтобы определить имя и страницу человека. Url мы определяем по url текущей страницы, а имя – по текстовому содержимому тэга с идентификатором firstHeading. Метод getPerson():

public Person getPerson(String url) throws MalformedURLException {

driver.navigate().to(url);

String name = getName();

Person person = new Person(driver.getCurrentUrl());

person.setName(name);

return person;

}

private String getName() throws MalformedURLException {

String namePage = driver.findElement(By.cssSelector("#firstHeading")).getText();

return namePage;

}

Перепрогоняем тесты – позеленели.

Отдельно стоит упомянуть, почему переопределяется url, хотя он передается в качестве параметра: дело в том, что в Wikipedia одной персоне может быть посвящено несколько страниц, которые редиректятся на одну. В результате, если использовать исходные урлы, то возможно возникновение дубликатов, когда существует несколько персон с «разными» урлами, которые фактически являются одной персоной. Поэтому в качестве урла используется тот урл, на который редиректятся все остальные.

Например: страница https://ru.wikipedia.org/wiki/Ярослав_Мудрый перенаправляется на https://ru.wikipedia.org/wiki/Ярослав_Владимирович_Мудрый, а страница https://ru.wikipedia.org/wiki/Андрей_Боголюбский — на https://ru.wikipedia.org/wiki/Андрей_Юрьевич_Боголюбский

Определение детей персоны

Попробуем определить детей персоны, которые имеют свои страницы в Wikipedia.

Для начала напишем тест для определения детей Рюрика (точнее одного — Игоря):

@Test

public void testGetChildrenUrl() throws Exception {

driver.navigate().to("https://ru.wikipedia.org/wiki/Рюрик");

PersonPage page = new PersonPage(driver);

List children = page.getChildrenUrl();

assertTrue(children.size() == 1);

Person person = children.get(0);

assertTrue(person.getUrl().equals("https://ru.wikipedia.org/wiki/

%D0%98%D0%B3%D0%BE%D1%80%D1%8C_

%D0%A0%D1%8E%D1%80%D0%B8%D0%BA%D0%BE%D0%B2%D0%B8%D1%87"));

}

Чтобы тест прошел успешно, нужно добавить на страницу PersonPage метод определения урлов детей человека:

public List getChildrenUrl() throws MalformedURLException {

List childrenLinks = driver.findElements(

By.xpath("//table[contains(@class, 'infobox')]//tr[th[.='Дети:']]//a"));

List children = new ArrayList();

for (WebElement link : childrenLinks) {

Person person = new Person(link.getAttribute("href"));

children.add(person);

}

return children;

}

Пока что игнорируем то, что детям могут быть не посвящены страницы в Wikipedia и поэтому они не имеют ссылок на свои страницы. Например, как в случае с детьми Владимира Ярославича (князя галицкого). Также игнорируем то, что информация о потомках может располагаться в основной области, как, например, на странице Марии Добронеги или на странице Святослава Всеволодовича (князя трубчевского).

Добавляем тесты, проверяющие корректность определения детей для персоны.

Как было оговорено выше, пока предполагаем, что Владимир Ярославич (князь галицкий) и Мария Добронега детей не имели, а Владимир Святославич имел 16 детей, хотя Wikipedia утверждает, что у него было ещё 5 неизвестных по имени дочерей.

@Test

public void testChildrenSize() throws Exception {

driver.navigate().to("https://ru.wikipedia.org/wiki/Рюрик");

PersonPage page = new PersonPage(driver);

List children = page.getChildrenUrl();

assertTrue(children.size() == 1);

driver.navigate().to("https://ru.wikipedia.org/wiki/Владимир_Святославич");

children = page.getChildrenUrl();

assertTrue(children.size() == 16);

driver.navigate().to("https://ru.wikipedia.org/wiki/Владимир_Ярославич_(князь_галицкий)");

children = page.getChildrenUrl();

assertTrue(children.size() == 0);

driver.navigate().to("https://ru.wikipedia.org/wiki/Мария_Добронега");

children = page.getChildrenUrl();

assertTrue(children.size() == 0);

}

В класс Person добавим поля для уникального идентификатора персоны (int id) и списка детей персоны (List

Разработаем метод добавления идентификатора ребенка в список детей персоны. Ребенок может быть добавлен в список, только если его там ещё нет.

public void setChild(int childId) {

if (!children.contains(childId)) {

children.add(childId);

}

}

Конечно, не забываем покрыть весь код тестами и добиться зеленого результата.

Алгоритм поиска потомков

Теперь перейдем к самому интересному – разработке алгоритма поиска потомков у заданной персоны. Создадим класс GenerateGenealogicalTree с методом main.

Как уже упоминалось, самое затратное по времени — переход по урлу, поэтому нужно минимизировать количество этих переходов. Для этого создадим список персон, в котором будет хранится всё родословное древо. В этом списке запомним индекс текущей персоны — той, на странице которой находимся на данный момент. Все персоны с меньшим индексом считаются «посещенными», а все с бОльшим индексом (+ текущая) — «непосещенными». После того, как был осуществлен переход на страницу текущей персоны и вычислены её основные данные, индекс увеличивается на единицу. Тем самым текущая персона попадает в разряд «посещенных». И остаётся только обойти оставшихся «непосещенных» персон. В каждый момент времени известны те персоны, страницы которых уже были просмотрены.

Наполнение родословного древа новыми «непосещенными» персонами происходит за счет добавления в конец списка детей текущей персоны. При этом добавляем только тех детей, которых ещё нет в списке, чтобы не возникали дубликаты (такая ситуация возможна, когда муж и жена — оба являются потомками родоначальника династии от разных ветвей. Примеры: муж и жена — потомки Рюрика, муж и жена — потомки Павла I).

Родословное древо считается построенным, когда не осталось «непосещенных» персон, т.е. когда индекс текущей персоны стал равным размеру родословного древа.

Алгоритм такой:

- Создается основатель династии на основе заданного урла

- Создается родословное древо на основе основателя династии

- В цикле до тех пор, пока есть «непосещенные» персоны

- Вычисляется персона на основе текущего урла родословного древа. Эта персона устанавливается в качестве текущей.

- Если текущая персона не является дубликатом, то вычисляется и устанавливается список её детей. Все дети добавляются в список.

- Если текущая персона уже встречалась среди «посещенных» персон, то она удаляется.

- Происходит переход к следующей «непосещенной» персоне, которая принимается за «текущую».

Код алгоритма:

public final class GenerateGenealogicalTree {

public static void main(String[] args) throws Exception {

String url = getUrl(args);

GenealogicalTree tree = getGenealogicalTreeByUrl(url);

saveResultAndQuit(tree);

}

public static GenealogicalTree getGenealogicalTreeByUrl(String url) throws MalformedURLException {

WebDriver driver = DriverHelper.getDriver();

Person person = new Person(url);

GenealogicalTree tree = new GenealogicalTree(person);

PersonPage page = new PersonPage(driver);

while (tree.hasUnvisitingPerson()) {

String currentUrl = tree.getCurrentUrl();

Person currentPerson = page.getPerson(currentUrl);

tree.setCurrentPerson(currentPerson);

if (!tree.isCurrentPersonDeleted()) {

List children = page.getChildrenUrl();

tree.setChildren(children);

}

tree.updatingCurrentPerson();

}

driver.quit();

return tree;

}

}

Класс GenealogicalTree имеет три поля: List

public final class GenealogicalTree {

private List allPersons;

private int indexCurrentUnvisitedPerson;

private boolean isCurrentPersonDeleted;

}

Инициализация происходит на основе «родоначальника» династии — первой персоне, потомков которой мы ищем:

public GenealogicalTree(Person person) {

if (person == null) {

throw new IllegalArgumentException("Укажите непустого основателя династии");

}

allPersons = new ArrayList();

allPersons.add(person);

indexCurrentUnvisitedPerson = 0;

isCurrentPersonDeleted = false;

}

В этот момент родословное древо состоит из одной текущей «непосещенной» персоны. «Посещенных» персон нет.

Как уже упоминалось, проверка списка на наличие «непосещенных» персон осуществляется так: если индекс текущей персоны «дошел до конца», то считаем, что «непосещенных» персон не осталось.

public boolean hasUnvisitingPerson() {

return indexCurrentUnvisitedPerson < allPersons.size();

}

В роли url-а родословного древа выступает url текущей персоны:

public String getCurrentUrl() {

return allPersons.get(indexCurrentUnvisitedPerson).getUrl();

}

Метод setCurrentPerson заменяет текущую персону на заданную.

Изначально мы знаем о персоне только её url, который получаем со страницы родителя. Поэтому в родословное древо персона добавляется, имея только эту информацию. По сути все «непосещенные» персоны — это просто url-ы. Метод setCurrentPerson «уточняет» персону после того, как индекс «до неё добрался» и персона стала текущей.

Если устанавливаемая «уточненная» персона уже встречалась раньше (это возможно, если произошёл редирект с url-а текущей персоны на одну из встречавшихся ранее страниц), то текущая персона удаляется. После этого текущая персона помечается, как удаленная. Если заданная персона не встречается раньше, то она «замещает» текущую. При этом персона не считается удаленной.

Понятие «встречается раньше» подразумевает, что мы проверяем только «посещенные» персоны. «Непосещенные» не проверяем. Теоретически возможна ситуация, когда url текущей персоны редиректится на url, который может встречатся «позже», среди «непосещенных». Но это настолько редкая ситуация, что она не стоит того, чтобы каждый раз «пробегать» по всему массиву. В этом редком случае дубликат все равно удалится, когда до него «дойдет очередь» и индекс текущей персоны будет указывать на персону с url-ом, на который произошёл редирект.

public void setCurrentPerson(Person currentPerson) {

int indexDuplicate = allPersons.indexOf(currentPerson);

if ((0 <= indexDuplicate) && (indexDuplicate < indexCurrentUnvisitedPerson)) {

removePerson(indexDuplicate);

} else {

allPersons.get(indexCurrentUnvisitedPerson).copyMainData(currentPerson);

isCurrentPersonDeleted = false;

}

}

Чтобы корректно отработал метод indexOf(Object object) необходимо в классе Person переопределить методы equals(Object object) и hashCode():

@Override

public boolean equals(Object object) {

if ((object == null) || (!(object instanceof Person))) {

return false;

}

Person person = (Person) object;

return this.url.equals(person.url);

}

@Override

public int hashCode() {

return this.url.hashCode();

}

Зачем нужно постоянно проверять наличие персоны в списке?

Возникновение дубликатов возможно по многим причинам:

- Отцовство достоверно неизвестно. Как, например, в случае со Святополком Окаянным, отцом которого является либо Ярополк Святославич, либо Владимир Святославич

- Оба родителя – потомки Рюрика от разных ветвей. Пример: Глеб Всеславич — потомок Рюрика в 8-м поколении был женат на Анастасии Ярополковне — тоже потомком Рюрика (они четвероюродные брат с сестрой).

- Ошибки на странице: вызывает сомнение, что Всеволод Мстиславич имел сына Володаря Глебовича, родителями которого записаны другие люди, тоже принадлежащие династии Рюриковичей. Вероятнее всего, это просто опечатка в Wikipedia

Если эти дубликаты не устранить, то они породят новые повторения, т.к. по всем потомкам дубликатов обход будет производится два раза, а то и три (в случае с Володарем Глебовичем).

Теперь рассмотрим удаление персоны из списка, когда она является дубликатом. Удаляемая персона может быть в списке детей члена родословного древа. Например, когда оба родителя являются представителями одной и той же династии, у одного родителя ссылка на одну страницу «ребенка», а у второго — на другую, которая затем редиректится на первую. Получается, что если «просто» удалить дубликат, то у второго родителя будет ссылка на несуществующую персону.

Поэтому перед удалением текущей персоны нужно заменить в списке идентификаторов детей всех «посещенных» персон её идентификатор на идентификатор найденного совпадения (у «непосещенных» детей нет).

После удаления текущая персона помечается удаленной.

private void removePerson(int indexDuplicate) {

int idRemovedPerson = allPersons.get(indexCurrentUnvisitedPerson).getId();

int idDuplicate = allPersons.get(indexDuplicate).getId();

for (int i = 0; i < indexCurrentUnvisitedPerson; i++) {

Person person = allPersons.get(i);

person.replaceChild(idRemovedPerson, idDuplicate);

}

allPersons.remove(indexCurrentUnvisitedPerson);

isCurrentPersonDeleted = true;

}

В классе Person добавляем метод замены «ребенка»:

public void replaceChild(int oldId, int newId) {

if (oldId == newId) {

return;

}

if (!children.contains(oldId)) {

return;

}

children.remove((Object) oldId);

setChild(newId);

}

Рассмотрим добавление детей текущей персоне.

На вход мы получаем список персон, которых надо установить текущей в качестве детей.

Главное отличие в поиске дубликатов состоит в том, что теперь мы будем их искать не только среди «посещенных» персон, но и среди «непосещенных», т.е. внутри всего родословного древа.

Если текущая персона удалена, то выдается исключение, т.к. по сути устанавливать детей некому.

Если не удалена, то пробегаемся по списку, переданному в качестве параметра. Если ребенок уже встречается в родословном древе, то в список детей добавляется идентификатор найденного дубликата. Если ребенок не встречается в родословном древе, то в список детей добавляется его идентификатор, кроме того, сам ребенок добавляется в конец родословного древа, в список «непосещенных» персон.

Таким образом через метод setChildren() происходит «наполнение» списка.

public void setChildren(List children) {

if (isCurrentPersonDeleted) {

throw new IllegalArgumentException(

"Нельзя установить детей удаленной персоне. Текущая персона уже другая");

}

for (Person person : children) {

int index = allPersons.indexOf(person);

int id;

if (index >= 0) {

id = allPersons.get(index).getId();

} else {

allPersons.add(person);

id = person.getId();

}

allPersons.get(indexCurrentUnvisitedPerson).setChild(id);

}

}

Счетчик текущей персоны нужно обновлять, иначе родословное древо никогда не построится. Происходит это так: если текущая персона удалена, то на «её месте» уже находится следующая «непосещенная» персона, поэтому достаточно просто «снять» признак удаленной персоны с текущей. Если текущая персона не удалена, то считаем её «заполненной» всеми данными и переходим к следующей «непосещенной» персоне.

public void updatingCurrentPerson() {

if (isCurrentPersonDeleted) {

isCurrentPersonDeleted = false;

} else {

indexCurrentUnvisitedPerson++;

}

}

Обход осуществляется по поколениям: вначале основатель династии (0-е поколение), затем все его дети (1-е поколение) от старшего к младшему (подразумеваем, что именно в таком порядке располагаются урлы в Wikipedia), затем внуки (2-е поколение) (дети старшего сына по старшинству, затем — 2-го сына, и так до самого младшего), правнуки (3-е поколение) и так до самого последнего представителя династии.

Естественно, не забываем довести покрытие кода тестами до 100%, чтобы удостовериться, что все работает именно так, как и задумывалось. Описание тестов доступно в javadoc.

Отдельно стоит упомянуть вот о чём: класс GenealogicalTree является очень небезопасным и его легко заставить работать некорректно, если использовать вне алгоритма генерации родословного древа (вне GenerateGenealogicalTree). Единственно правильное решение в данной ситуации — перенос данного класса в качестве внутреннего приватного класса для GenerateGenealogicalTree. Но это пока не сделано для удобства тестирования алгоритма.

Запускаем программу.

Логирование результатов в БД

Первый запуск показывает, что мы имеем огромное количество данных, которые надо как-то анализировать, чтобы отсеять заведомо неверные результаты. Забегая вперед сообщу, что на 17 сентября 2017 в Wikipedia нашлось 3448 страниц прямых потомков Рюрика. Легче всего подобный объем информации обрабатывать в БД.

В первую очередь развернем локальную базу данных, которую назовем genealogicaltree. Со стандартным пользователем root без пароля. Для взаимодействия с БД будем использовать стандартную библиотеку MySQL JDBC Type 4 driver.

А дальше создаем новый класс для взаимодействия с БД и метод для сохранения родословного древа в таблице с заданным именем:

public class MySqlHelper {

private static final String url = "jdbc:mysql://localhost:3306/genealogicaltree"

+ "?serverTimezone=UTC&useUnicode=yes&characterEncoding=UTF-8";

private static final String user = "root";

private static final String password = "";

private static Connection connection;

private static Statement statement;

private static ResultSet resultSet;

public static void saveTree(String tableName, List tree) throws MalformedURLException {

try {

connection = DriverManager.getConnection(url, user, password);

statement = connection.createStatement();

String table = createTable(tableName);

statement.executeUpdate(table);

for (Person person : tree) {

String insert = insertPerson(tableName, person);

statement.executeUpdate(insert);

}

} catch (SQLException sqlEx) {

sqlEx.printStackTrace();

} finally {

try {

connection.close();

} catch (SQLException se) {

}

try {

statement.close();

} catch (SQLException se) {

}

}

}

private static String createTable(String tableName) {

StringBuilder sql = new StringBuilder();

sql.append("CREATE TABLE " + tableName + " (");

sql.append("id INTEGER not NULL, ");

sql.append("name VARCHAR(255), ");

sql.append("url VARCHAR(2048), ");

sql.append("children VARCHAR(255), ");

sql.append("PRIMARY KEY ( id ))");

return sql.toString();

}

private static String insertPerson(String tableName, Person person) {

StringBuilder sql = new StringBuilder();

sql.append("INSERT INTO genealogicaltree." + tableName);

sql.append("(id, name, url, nameUrl, children, parents, numberGeneration) \n VALUES (");

sql.append(person.getId() + ",");

sql.append("'" + person.getName() + "',");

sql.append("'" + person.getUrl() + "',");

sql.append("'" + person.getChildren() + "',");

sql.append(");");

return sql.toString();

}

}

Дорабатываем сохранение результатов генерации:

private static void saveResultAndQuit(GenealogicalTree tree) throws Exception {

Timestamp timestamp = new Timestamp(System.currentTimeMillis());

String tableName = "generate" + timestamp.getTime();

MySqlHelper.saveTree(tableName, tree.getGenealogicalTree());

}

Разбор первых результатов

Первый прогон GenerateGenealogicalTree.main() выдал много записей, беглый осмотр которых показывает наличие несуществующих и ошибочных страниц.

Разложим ошибки по категориям:

- В список детей попал год (например, 1153 со страницы Ярослава Святославовича)

- Нерусскоязычная статья: Аделаида Французская, дочь короля Франции Людовика VII

- Страница «Внебрачный ребенок», появившаяся от того же Людовика VII

- Внешние страницы наподобие этой, которые попали в список, например, от Галерана IV де Бомона

- «Создание страницы». Например, Анна Юрьевна, дочь туровского князя Юрия Ярославича

Доработаем метод getChildrenUrl() определения страниц детей, чтобы исключить заведомо ошибочные. Чтобы не попадала 1 категория, нужно убрать те ссылки, текстовое содержимое которых начинается на цифру. Чтобы не попадала 2 категория, нужно убрать те ссылки, класс которых равен extiw. Чтобы не попадали 3-4 категории, необходимо исключить ссылки, родительский тег которых равен sup (уточняющие ссылки). Чтобы убрать из списка 5 категорию необходимо исключить ссылки, класс которых равен new (создание страницы).

Для начала доработаем тест testChildrenSize(), добавив в него проверку всех категории кривых ссылок:

driver.navigate().to("https://ru.wikipedia.org/wiki/Ярослав_Святославич");

children = page.getChildrenUrl();

assertTrue(children.size() == 3);

driver.navigate().to("https://ru.wikipedia.org/wiki/Людовик_VII");

children = page.getChildrenUrl();

assertTrue(children.size() == 5);

driver.navigate().to("https://ru.wikipedia.org/wiki/Галеран_IV_де_Бомон,_граф_де_Мёлан");

children = page.getChildrenUrl();

assertTrue(children.size() == 0);

driver.navigate().to("https://ru.wikipedia.org/wiki/Юрий_Ярославич_(князь_туровский)");

children = page.getChildrenUrl();

assertTrue(children.size() == 5);

Тест предсказуемо красный.

Теперь доработаем метод getChildrenUrl():

public List getChildrenUrl() throws MalformedURLException {

waitLoadPage();

List childrenLinks = getChildrenLinks();

List children = new ArrayList();

for (WebElement link : childrenLinks) {

if (DriverHelper.isSup(link)) {

continue;

}

Person person = new Person(link.getAttribute("href"));

person.setNameUrl(link.getText());

if (person.isCorrectNameUrl()) {

children.add(person);

}

}

return children;

}

private List getChildrenLinks() {

List childrenLinks = DriverHelper.getElements(driver,

By.xpath("//table[contains(@class, 'infobox')]//tr[th[.='Дети:']]" +

"//a[not(@class='new' or @class='extiw')]"));

return childrenLinks;

}

private void waitLoadPage() {

this.driver.findElement(By.cssSelector("#firstHeading"));

}

public final class DriverHelper {

/**

* Возвращает список элементов без ожидания их появления.

* По умолчанию установлено неявное ожидание - это значит, что если на

* странице нет заданных элементов, то пустой результат будет выведен не

* сразу, а через таймаут, что приведет к потере времени. Чтобы не терять

* время создан этот метод, где неявное ожидание обнуляется, а после поиска

* восстанавливается.

*/

public static List getElements(WebDriver driver, By by) {

driver.manage().timeouts().implicitlyWait(0, TimeUnit.SECONDS);

List result = driver.findElements(by);

driver.manage().timeouts().implicitlyWait(DriverHelper.TIMEOUT, TimeUnit.SECONDS);

return result;

}

public static boolean isSup(WebElement element) {

String parentTagName = element.findElement(By.xpath(".//..")).getTagName();

return parentTagName.equals("sup");

}

}

public class Person {

private String nameUrl;

public boolean isCorrectNameUrl() {

Pattern p = Pattern.compile("^[\\D]+.+");

Matcher m = p.matcher(nameUrl);

return m.matches();

}

}

nameUrl — это наименование ссылки персоны, которое она имеет на странице родителя.

Перепрогоняем весь комплект тестов — позеленели.

У Рюрика очень много потомков, которым посвящены русскоязычные страницы в Wikipedia, поэтому вначале прогоним программу для Михаила Фёдоровича — первого царя из рода Романовых. Запускаем, ждём окончания и анализируем результаты.

Романовы

Прогон выдал 383 русскоязычные страницы потомков Михаила Федоровича (потомков с генетической точки зрения, а не с точки зрения принадлежности к роду Романовых, определяемой по мужской линии, которая прервалась ещё в 18 веке на Петре II), среди которых королева Дании, король Испании, король Нидерландов, король Швеции, и все потомки королевы Великобритании Елизаветы II, начиная с наследника британского престола принца Чарлза. Но эта информация, конечно, имеет второстепенное значение к исходной задаче.

Проанализируем результаты с точки зрения достоверности данных. Прогон выдал несколько ошибочных записей:

- Две персоны с именем Владимир Александрович и две персоны с именем Фризо Оранско-Нассауский

- Три персоны с необычным именем Дети Алексея Михайловича, две с — Дети Ивана V, один с — Дети Петра I и ещё три- с Дети Михаила Фёдоровича

Эти ошибочные страницы — следствие урлов с якорями, когда у ребенка нет отдельной страницы, а информация о нём хранится либо на странице родителя, как в первом случае, либо на отдельной странице для всех детей — как во втором.

Первое, что бросается в глаза — это то, что данные представители династии потомков после себя не оставили, т.к. умерли маленькими детьми (за исключением, конечно же, дочерей Фризо Оранско-Нассауского, которые ещё не успели вырасти)

Поэтому можно смело дорабатывать метод getChildrenUrl(), возвращая пустой список, если текущий url имеет якорь. Это необходимо сделать, чтобы персоне с «якорем» в качестве детей не установились дети её родителя, т.е. собственные братья и сестры, как в первом случае ошибочных записей.

public List getChildrenUrl() {

waitLoadPage();

if (DriverHelper.hasAnchor(driver)) {

return new ArrayList();

}

...

}

public final class DriverHelper {

...

public static boolean hasAnchor(WebDriver driver) throws MalformedURLException {

URL url = new URL(driver.getCurrentUrl());

return url.getRef() != null;

}

...

}

Добавляем новый тест, проверяющий, что персона с урлом, содержащим якорь, не имеет детей:

@Test

public void testEmptyChildrenInPersonWithAnchor() throws Exception {

driver.navigate().to("https://ru.wikipedia.org/wiki/Владимир_Александрович");

PersonPage page = new PersonPage(driver);

List children = page.getChildrenUrl();

assertTrue(children.size() == 5);

driver.navigate().to(

"https://ru.wikipedia.org/wiki/Владимир_Александрович#.D0.A1.D0.B5.D0.BC.D1.8C.D1.8F");

children = page.getChildrenUrl();

assertTrue(children.size() == 0);

}

Перепрогоняем весь комплект тестов, чтобы убедится, что ничего не сломалось.

Если не вычисляется потомство, то какой вообще смысл в переходе по урлам с «якорем»? Потомство, конечно, не определяем, но можно получить другую информацию: имя персоны или, например, годы жизни. Поэтому лучше «сохранить» такие урлы для будущего расширения функциональности.

Вычисление имени по «якорю»

В большинстве подобных случаев имя персоны можно вычислить по «якорю»: имя — это текстовое содержимое тэга с идентификатором, равным значению «якоря».

Доработаем метод getName():

private String getName() throws MalformedURLException {

waitLoadPage();

String namePage = driver.findElement(By.cssSelector("#firstHeading")).getText();

if (!DriverHelper.hasAnchor(driver)) {

return namePage;

}

String anchor = DriverHelper.getAnchor(driver);

List list = DriverHelper.getElements(driver, By.id(anchor));

if (list.size() == 0) {

return namePage;

}

String name = list.get(0).getText().trim();

return name.isEmpty() ? namePage : name;

}

public final class DriverHelper {

...

public static String getAnchor(WebDriver driver) throws MalformedURLException {

URL url = new URL(driver.getCurrentUrl());

return url.getRef();

}

...

}

Если текущий url содержит «якорь», то необходимо проверить существование на странице элемента с идентификатором, равным «якорю». Его может не существовать, как в случае с Натальей — дочерью Петра I. На странице Петра ссылка содержит уже несуществующий «якорь», который не соответствует «якорю» Натальи.

Также необходимо убедиться, что тэг с идентификатором «якоря» содержит непустой текст и вернуть наименование страницы в противном случае. Иначе, как, например, в ситуации с Демьяном Глебовичем, определится пустое имя и программа вылетит с исключением.

Тесты опять позеленели.

Добавление наименования ссылки, родителей и номера поколения

Осталось проблема: имя Александра, старшего сына Владимира Александровича, определяется как «Семья». Что с этим делать?!

Имя персоны также можно вычислить по содержимому ссылки на эту персону со страницы родителя во время вычисления самой ссылки, т.е. в методе getChildrenUrl(). Это имя уже было вычислено и сохранено в переменной nameUrl в тот момент, когда из списка ссылок детей исключались года.

Конечно, не забываем покрыть тестами весь доработанный код.

Результатом доработки является то, что теперь у персоны есть два «имени», одно из которых уж точно «должно быть информативным». Исключением, по понятным причинам, является родоначальник династии, для которого nameUrl может быть любым (присвоим значение "" для определённости).

Перепрогоняем программу для Романовых и сверяем данные с теми, что были собраны до рефакторинга.

Вот так теперь выглядят урлы с якорями:

| id | name | children | url | urlName |

|---|---|---|---|---|

| 8 | Пелагея | [] | ссылка | Пелагея |

| 9 | Марфа | [] | ссылка | Марфа |

| 10 | Софья | [] | ссылка | Софья |

| 15 | Анна | [] | ссылка | Анна |

| 23 | Евдокия (младшая) | [] | ссылка | Евдокия |

| 26 | Феодора | [] | ссылка | Феодора |

| 28 | Мария | [] | ссылка | Мария |

| 29 | Феодосия | [] | ссылка | Феодосия |

| 36 | Дети Петра I | [] | ссылка | Наталья |

| 133 | Семья | [] | ссылка | Александр |

| 360 | Брак и дети | [] | ссылка | Луана Оранско-Нассауская |

Добавление наименования ссылки не прошло бесследно. Прогон программы для Рюрика неожиданно вылетел с исключением о нарушении инструкции insert на Генрихе II (короле Наварры) из-за того, что nameUrl содержит значение с апострофом — «Генрих II д'Альбре». Доработаем методы setName и setNameUrl в классе Person, сохраняя заданное значение без апострофов.

Напомню, что в Wikipedia нашлось около трех с половиной тысяч потомков Рюрика. Если выводить эту информацию в виде таблицы, то получится очень большая страница, которую устанешь прокручивать. Было бы интересно не только видеть всю табличку, но иметь ещё возможность выделить связь заданного представителя с родоначальником династии (т.е. выделить всех предков заданного представителя вплоть до родоначальника). А также знать, каким по счету поколением он является.

Чтобы легче было реализовывать эту новую функциональность, добавим в класс Person поля для номера поколения и списка родителей (чтобы легче было построить возрастающую связь):

private List parents = new ArrayList();

private int numberGeneration = 0;

public void setParent(int parent) {

parents.add(parent);

}

public void setNumberGeneration(int numberGeneration) {

if (this.numberGeneration == 0) {

this.numberGeneration = numberGeneration;

}

}

Родитель в большинстве случаев будет один, но возможны ситуации, когда оба родителя потомки родоначальника династии от разных ветвей и тогда их будет двое. Выше даже был приведен пример ошибки, когда сразу трое «являются» родителями одного и того же человека (первый, второй, третий, их «общий» ребенок — и все Рюриковичи). Конечно, физиологически это невозможно, получается, как в анектоде, но, к сожалению, автоматически определить, кто их них «лишний» невозможно, поэтому придется сохранять всех.

Очевидно, что в списке родителей могут быть только представителей династии и «собрать» всех прародителей заданного представителя династии вплоть до родоначальника можно будет очень легко, имя только эту информацию.

Что касается номера колена, то оно устанавливается только один раз от первого родителя. В тот момент, когда появляется второй родитель, ссылающийся на ребенка, номер поколения уже не обновляется. Т.к. обход родословного древа происходит по поколениям, то, очевидно, что номер поколения НЕпервого родителя будет равен или больше, чем номер колена первого родителя, а значит быстрее всего построить связь через «первых родителей».

Устанавливать номер поколения и идентификатор родителя будем в методе setChildren(List

public void setChildren(List children) {

if (isCurrentPersonDeleted) {

throw new IllegalArgumentException(

"Нельзя установить детей удаленной персоне. Текущая персона уже другая");

}

Person currentPerson = allPersons.get(indexCurrentUnvisitedPerson);

int numberGeneration = currentPerson.getNumberGeneration();

numberGeneration++;

int idParent = currentPerson.getId();

for (Person person : children) {

int index = allPersons.indexOf(person);

int id;

if (index >= 0) { // Непервый родитель, номер поколения не трогаем

allPersons.get(index).setParent(idParent);

id = allPersons.get(index).getId();

} else { // Первый родитель

person.setNumberGeneration(numberGeneration);

person.setParent(idParent);

allPersons.add(person);

id = person.getId();

}

currentPerson.setChild(id);

}

}

Конечно, не забываем покрыть весь код тестами — если этого не сделать сразу, то потом разобраться в каше кода будет сложно.

Итоговые результаты

Пришло время сформировать несколько родословных деревьев и посмотреть результаты:

Адам — первый человек на Земле

Чингисхан — величайший завоеватель в истории

Романовы

Рюриковичи (долго открывается — 3452 персоны).

Пояснение к страницам:

а) при нажатии на имя открывается страница персоны на Wikipedia

б) при нажатии на № открывается страница связи заданной персоны с родоначальником. Например, вот страница, доказывающая, что королева Великобритании Елизавета II является потомком Рюрика в 29 поколении.

в) при нажатии на идентификаторы в полях родителей и детей страница прокручивается на строку с этой персоной.

Результаты показывают, что, например, последний российский император Николай II был потомком Рюрика в 28 поколении. Более того, все российские императоры, начиная с Петра III и Екатерины II были потомками Рюрика от разных ветвей.

Исходный код проекта

|

Метки: author fonkost тестирование веб-сервисов открытые данные алгоритмы selenium seleniumwebdriver java wikipedia.org |

Контроль опасных кассовых операций: интеграция видеонаблюдения с 1С |

|

Метки: author randall управление продажами erp- системы ecm/ сэд блог компании ivideon с:предприятие интеграция видеонаблюдение касса ivideon |

Социнжиниринг в военной пропаганде |

Социнжиниринг в военной пропаганде

Во время Второй мировой англичане достали личные дела командиров немецких подлодок. Вроде бы не очень важная информация для военных целей – лодки-то уже вышли на задания, что им сделаешь. Но к делу подключились тёртые специалисты по пропаганде. У союзников были ежедневные радиопередачи, и вот пример:

— Мы обращаемся к вам, командир подводной лодки «U-507» капитан-лейтенант Блюм. С вашей стороны было очень опрометчиво оставить свою жену в Бремене, где в настоящее время проводит свой отпуск ваш друг капитан-лейтенант Гроссберг. Их уже, минимум, трижды видели вместе в ресторане, а ваша соседка фрау Моглер утверждает: ваши дети отправлены к матери в Мекленбург…

Цитата из «Операция «Гроза» — И. Бунич

Красота, правда? И, главное, в точности соответствует одному из базовых методов социнжинирингового проникновения внутрь инфраструктуры при направленной атаке.

В общем, так получилось, что многие современные методы пиара пошли от наших, английских и немецких разработок времён Второй Мировой войны. И пока я писал книгу про то, как рассказывать людям о своей компании, понадобилось залезть для подтверждения и поднять пару исторических фактов. Заодно вскрылся отличный слой совершенно диких — ну или прекрасных — историй и методик убеждения. Про них и расскажу.

Устные и радиоканалы

Одна из первых технологий, разработанная ещё доктором Геббельсом, и затем успешно перенятая отрядами пропаганды всех стран – это максимально оперативная подача точных новостей. Например, вещанием громкоговорителя с ближайшей горушки, чаще всего – на пограничные отряды или отряды, до которых доходит звук во время позиционной войны.

Смысл в том, чтобы передавать факты максимально объективно и без своих комментариев. Через несколько недель вещания противник привыкает им доверять и их слушать – благо очень легко можно проверить как местную, так и глобальную информацию. Собственно, немцы придали методу отточенность – они вещали то, что средний солдат противника ещё не знал, и потому с охотой доверял каналу. Дальше в канал при необходимости «замешивались» нужные факты, либо же он просто набирал популярность, и можно было использовать другие, более умные методы.

Потом родился жанр военных документально-аналитических программ. Оказалось, что вместо грубого вмешивания новостей, можно запускать, например, логические рассуждения на основе толкований разных военных документов; потом – протаскивать в эфир интервью с военнопленными или их записанные выступления. И так далее. Смысл – логически подвести противника к тому, что его дело безнадёжное. Причём так, чтобы он это сам понял на основе анализа поданной информации. Вещание для подлодок из примера в самом начале – это тоже разновидность такой аналитики, хоть и довольно редкая.

Особым искусством в получении материала прославились азиаты – они заставляли американских военнопленных сначала подписать уже готовую бумажку про хорошие условия в лагере в обмен на дополнительную пайку, затем написать такую же свою, потом рассказать это словами – и, наконец, записать обращение к соотечественникам по такому примерно сюжету. Красавцы – каждый отдельный шаг было легко сделать, а в эфир в итоге уходило именно то, что нужно. В какой-то момент они так обработали несколько десятков тысяч пленных, а потом их просто выпустили – отказаться от своих пацифистских убеждений даже не родине было непросто.

Обратите внимание – речь не идёт об искажении фактов. Просто правильная подборка и правильная подача. Чуть больше внимания тому, чуть меньше внимания этому – и вот уже противник осознал, что требовалось.

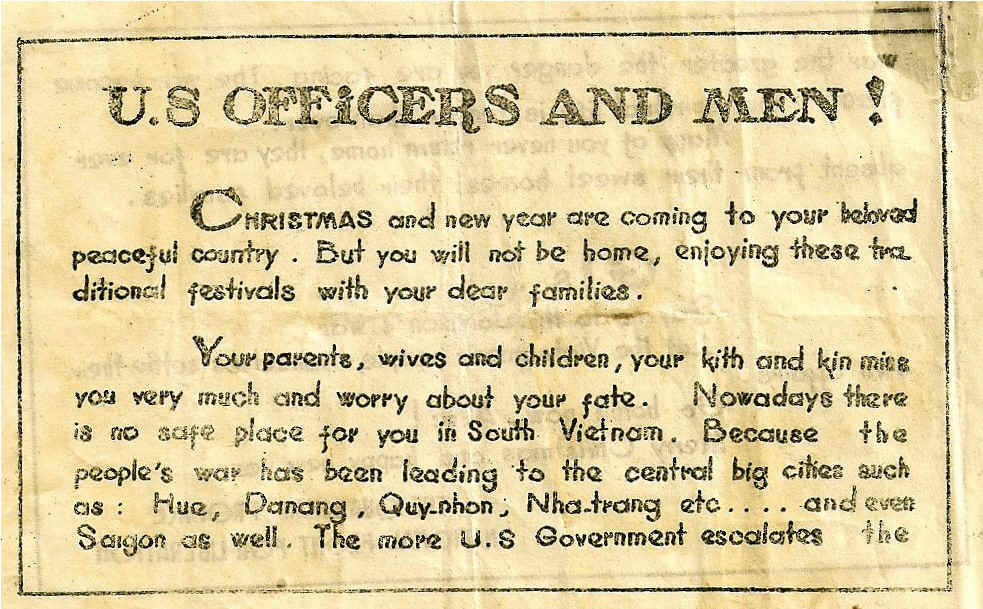

Но вернёмся к вещанию радио и звука. Третья стадия атаки (после фактов и аналитики) – ультиматум, когда противник находится в опасной ситуации. Может заставить врага сдаться в заведомо проигрышной ситуации — что позволит не трать боеприпас и личный состав на операцию. Главное – чтобы противник чётко понимал, что его ситуация действительно безвыходная, иначе могут возникнуть сомнения, и он начнёт сопротивляться. Информированность тут была уже оружием.

В целом, пропаганда крайне редко требовала от противника немедленных действий. Врага можно было месяцами обрабатывать так, чтобы потом, когда будет выставлен ультиматум, он принял именно нужное решение.

Что мне особенно импонирует, именно тогда были разработаны методики очень существенного уплотнения информации и соответствующие жанры журналистики. Дело в том, что вещание, например, машины с громкоговорителем могло длиться 3-6 минут максимум, после чего на её позицию прилетало из миномёта. В результате, например, наши комплексы аппаратуры рекомендовалось перемещать после каждых 3 минут вещания.

Очень важен был сигнал начала передачи. Он всегда одинаковый, всегда узнаваемый, и за прошлые недели обучения первым жанром объективной информации – ещё и привлекательный для противника. Враг успокаивается и готовится слушать. Союзные же войска знают, что после этого звука без крайней необходимости нельзя громко шуметь и мешать передаче. Потом идёт вступление: здесь оказалось наиболее важным лично обратиться к части, назвав её номер, например. Цель – установление контакта, привлечение внимания, по сути — «заголовок» передачи. Потом идёт payload – основной текст и резюме. Основной текст объективен и написан так, что с ним хочется согласиться логически. По крайней мере, поначалу он соответствует тому, что думают (по мнению пропагандиста) сами солдаты. В этом блоке не давят, не призывают ни к чему, просто ставят перед фактами. Дальше отбивка, чтобы разделить части, и в резюме, собственно, делается вывод. Для тупых. В конце – финальная часть протокола, рассказ о том, когда начнётся следующая передача. И завершающий сигнал.

Позже оказалось, что если противник хорошо слышит вещающую станцию, фоном можно класть народную музыку врага. Если было время, противнику ещё заодно давали послушать песни вроде «И молодая не узнает, какой у парня был конец», либо про родной дом. Чтобы затосковал и заплакал, начал грустить и нудить по поводу приказов командира. Такого пристрелить проще.

В целом, эта трёхступенчатая штука – классика пропаганды. Набор канала оперативной информацией, фокусировка внимания на нужных фактах (всё ещё объективных, но уже представленных просто чаще других и с разных сторон), ультиматум.

Давайте посмотрим на ещё один классический вектор атаки, а потом перейдём к более интересным случаям.

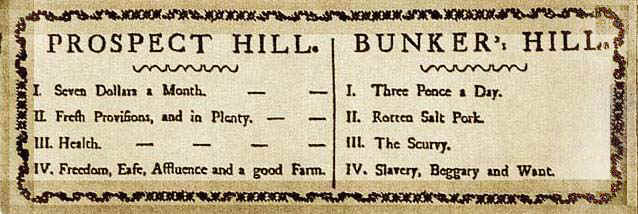

Листовки – максимум эффективности на слово

Когда ещё в Астрахани мне надо было делать рекламу наших спутниковых тарелок с интернетом, учиться было негде. Старый военный посоветовал мне две книги, одна из которых «по работе с массами», вторая – «посмотри там про рекламу». Книга по работе с массами оказалась методичкой по разгону митингов, где в самом начале автор прямо чувствуется, как вздыхал и сокрушался, что использовать стрельбу из пулемёта поверх голов уже нельзя, и поэтому надо что-то решать словами. Вторая оказалась разбором конкретных листовок союзников, и именно она-то дала мне очень много. Думаю, я не сильно ошибусь, если скажу, что со времён Второй мировой, в рекламе не очень-то много поменялось. Итак, давайте посмотрим.

Листовка (или сегодня — пост в блог) – быстрая, маленькая и очень концентрированная подача. Можно применять сразу по мере изменения ситуации. Должна быть максимально простой и понятной (у солдата нет времени читать – часто листовки очень оперативно отбирали). Один пост, простите, листовка – одна идея. Обязательно – жёсткая аргументированность (типы аргументов зависят от нации, например, для китайцев оказалось важнее читать «отзывы» своих пленных и подходящие цитаты мудрецов, а для немцев выигрывала логика на числах и фактах).

Максимум простоты: солдат голодный, злой, не выспался и плохо читает. Надо, чтобы он усвоил максимально конкретно. Сегодня читатель просто торопится к соседней вкладке, у него параллельно открыт чат, и ещё он едет в метро. Никакой особой разницы.

Ну и, наконец, дизайн – такой, чтобы привлечь. Единственный момент – если за подбирание листовок противник ввёл кару, то она, наоборот, должна быть незаметной.

Всё как у нас в сети.

Давайте разберём пару частых жанров. Первый – маскировочная листовка, вектор атаки road apple или фишинг по современной терминологии. Изучаем листовки противника, которые используются для раздачи по его же войска. Затем делаем точно такую же, только свою. Отличный пример – в американских военных частях часто и много раздавали материалов про опасность венерических заболеваний. И обоснованно. Немцы взяли пару таких, и написали свою с тем же примерно посылом. Только аргументация была другой:

«Военные власти проверили 20000 женщин. Свыше 80 процентов из них оказались больными венерическими заболеваниями. Среди проверенных женщин только 21 процент – проститутки. Остальные 79 процентов распределяются так: 61 процент – замужние женщины, вступившие в случайную связь, 18 процентов – девушки, знакомые военнослужащих (при этом 17 процентов в возрасте до 20 лет). Обе группы женщин оказались в большинстве своем членами быстрорастущего общества женщин „V“ (»Победа"), которые заявили о своем патриотическом стремлении утешать войска. А твоя девушка тоже среди них?".

Цитата из книги Крысько В. Г. — Секреты психологической войны (цели, задачи, методы, формы, опыт). Советую, там прямо весь опыт в методологии.

Чего нет в книге, так это факта про то, что как раз тогда шла очень успешная пропаганда BBC за движение «V», и после этой листовки солдат дёргался каждый раз, когда слышал рекламу по своему же радио. Безумно красивый подход.

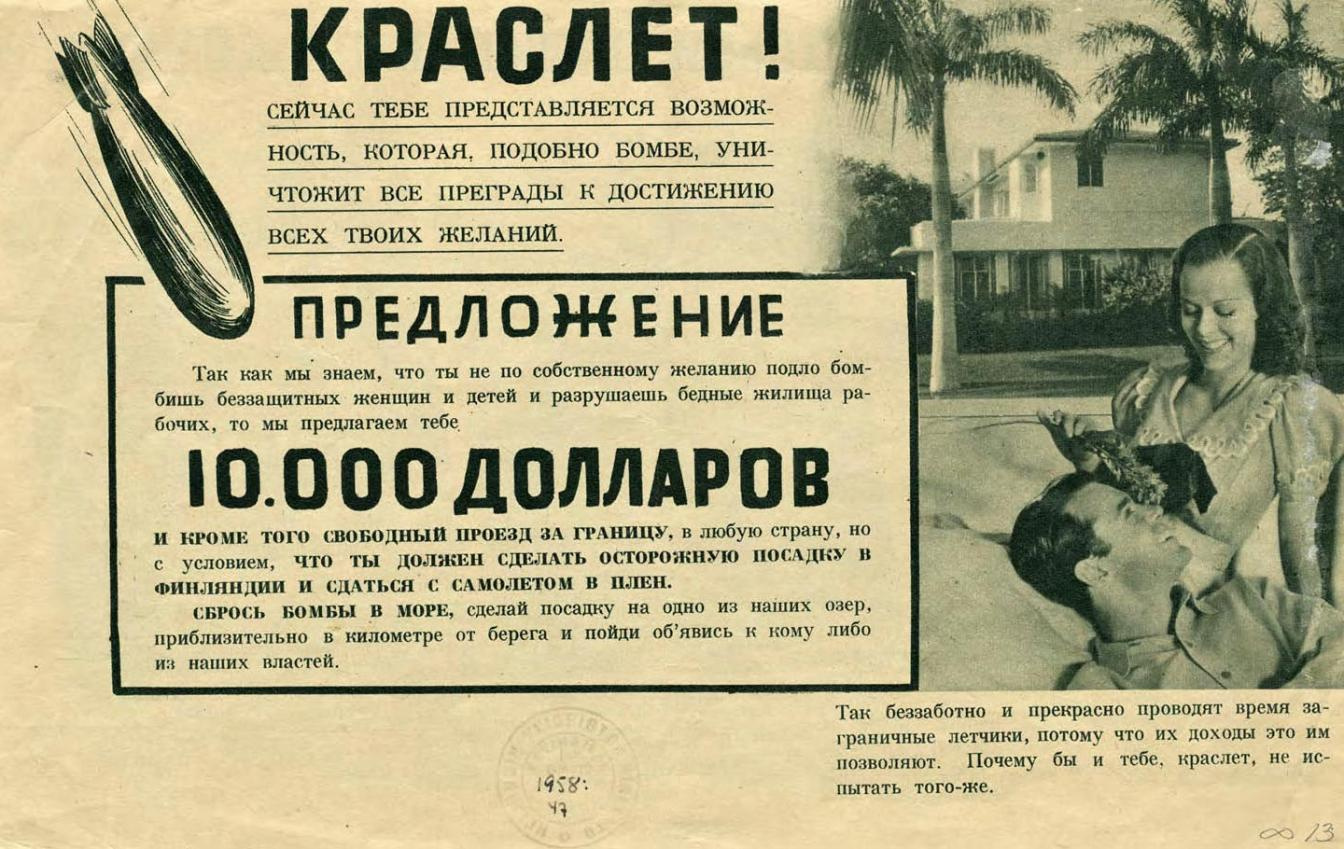

Ещё одним весьма познавательным жанром были листовки-пропуски. Это такие штуки, которые надо было показать противнику, чтобы тебя взяли в плен и не пристрелили по дороге. Сложный пример – наверху поста.

На «пропуске» описывался маршрут до ближайшего «пункта приёма военнопленных», давались простые рекомендации как именно бежать, а затем расписывались условия и меню пленных. Как правило, меню подбиралось такое, чтобы враг почувствовал себя неполноценным, и очень, очень захотел кушать. И чтобы он вспоминал про эту листовку каждый раз, когда ест, и каждый раз, когда спит на холоде.

«Ежедневное меню объединенных сил:

Завтрак: яйцо, хлеб с маслом, 2 фрукта, фруктовый сок, молоко, кофе, чай. Обед: мясо, фасоль или картошка, бутерброд с сыром, сладости, фруктовый сок. Ужин: мясо, хлеб с маслом, зелень (овощи), яйцо, молоко, фрукты и фруктовый сок, кофе, чай. Пленные питаются так же, как солдаты объединенных сил».

С японцами такие листовки-пропуски поначалу не прокатывали. Оказалось, что ни один японец по трезвяку не поднимет над головой лозунг «я сдаюсь», это просто унизительно в их культуре. Заменили на «Я прекращаю сопротивление» — и дело пошло. Правда, всплыла следующая особенность — некоторые прошли на посты американцев с гранатами в кармане и такими листовками над головой.

Иногда в листовках скидывали стихи или фотографии дома, чтобы солдат, опять же, затосковал и приуныл.

Именно на подобных листовках была прочно отработана антикульминация или классическая «пирамида» текста, когда основные самые важные тезисы выносятся в начало, а дальше постепенно доказываются и раскрываются. До этого делали наоборот – сначала логика, потом выводы. Сегодня и сейчас мы называем антикульминацию «часть до ката».

А ещё на листовках были социальные виджеты – например, «Прочитай и расскажи товарищам».

На оккупированных территориях технология листовок уверенно сочеталась с наработками радио и звука – изобразительный и доказательный ряд из листовок наложился на трехступенчатую методику донесения информации и оперативные новости. Должны же местные откуда-то узнавать, что происходит в мире, правильно? Единственный момент – если в листовках было, в целом, плевать на ошибки, здесь было крайне важно не облажаться по языку – мельчайший недостаток или акцент в телепередаче мог стать поводом для смеха.

Особенности радиопротокола

Основные стандарты связи (зачатки современных протоколов с коррекцией) уже начали появляться на радиообмене Второй мировой. Это наложило довольно интересные особенности на распространение вашей информации по сетям противника:

- Просто вклинивание короткими сообщениями: вы ждёте, когда вражеская станция прекратит вызывать другие (ждёт ответов) и нагло передаёте своё сообщение на её рабочей частоте. Действенно, как серпом по молоту, но за неимением лучших вариантов поначалу – очень круто. Цель – пронести что-то интересное до радиста противника, чтобы он захотел послушать ещё. Payload’а пока нет.

- В сетях с архитектурой «звезда» — штабная станция и станции дивизий – вклинивание происходило в тот момент, когда центральная сообщала всем по очереди о важном сообщении. Когда эфир на 90% состоит из слушающих, а радисты центральной гонят в канал остальных по одному, врываетесь вы и приносите свою интересную штуку. 1 минута максимум.

- Следующая история, когда противнику уже интересно – адресные сообщения, в частности, по радиотелефонной связи. Здесь особенность в том, что для установления контакта не надо было ждать подтверждения – за такое подтверждение радиста могли и расстрелять. Вместо этого использовали обходные пути – либо сообщали заранее на жаргоне, что делать (сообщить о помехах конкретным образом, например), либо просили один раз нажать на тангенту без передачи сообщения, либо выдумывали что-то ещё.

Если в чужой радиоэфир входить было относительно просто, то случаев входа в ТВ-эфир особо ярких не было (хотя оборудование имелось на поздних этапах войны) – обычно использовалась захваченная ТВ-сеть, по которой шло вещание для гражданских.

Принцип правдивости информации

Примеры из пропаганды Англии 1940-х я нередко привожу, когда меня спрашивают на конференциях про необходимость очень чётко отвечать за каждое слово в рекламе. И не преувеличивать. Дело в том, что тогда BBC требовалось, чтобы сообщениям верили. Сложилась довольно интересная ситуация: чтобы бомбардировщики немцев не брали радиопеленги, вещание Великобритании сократили до одного канала – собственно, Би-Би-Си. А, значит, стоит один раз облажаться, как вся информационная волна Англии потеряет эффективность.

Был принят жёсткий стандарт – говорить правду и не преуменьшать потери. Каждая передача открывалась так называемым «счётом матча» — сводкой по сбитым самолётам Королевства и Люфтваффе. В 1940-м году потери Англии стали слишком большими, и тогда удалось трансформировать «кампанию правды» в «кампанию гнева», то есть мотивировать на агрессию против «бесчеловечности» противника.

Позже в результате правдивости кампании было получено ещё два крутых побочных эффекта:

1. Англичане померили эффективность немецкой контрпропаганды, и пришли к выводу, что её можно не глушить и даже не комментировать – здравомыслящий англичанин понимал, что это лапша на уши.

2. С другой стороны, немцы оказались вынуждены тратиться на довольно сложные контрмеры против английской пропаганды – многие, включая пилотов, привыкли слушать её как объективный источник информации.

Кампания «V»

Все воюющие стороны включали пропаганду на разных языках:

«К лету 1940 г. германские передачи велись уже более чем на 30 языках. Один из руководителей нацистского иновещания сравнивал немецкие коротковолновые станции с дальнобойными орудиями, стреляющими через все границы. Чтобы пресечь влияние зарубежного иновещания на германское население, нацисты с 1 сентября 1939 г. запретили прослушивание иностранных радиопередач на территории Германии, была введена смертная казнь за распространение почерпнутых из них сведений.

После вступления Великобритании в войну в сентябре 1939 г. в структуре Би-Би-Си была создана Европейская служба, на которую возлагались задачи информационно-пропагандистской поддержки военных действий стран антигитлеровской коалиции на европейском театре военных действий. Передачи на европейскую аудиторию велись как на английском, так и на немецком, французском, португальском, испанском и других языках народов Европы. Стартовавшее еще в феврале 1938 г. немецкоязычное вещание Би-Би-Си быстро наращивало объем передач, совершенствовалось их содержание. Стремясь нейтрализовать воздействие британского вещания, государства нацистского блока организовали глушение радиопередач Би-Би-Си. В свою очередь, британские власти, убедившиеся в малой эффективности гитлеровской радиопропаганды, отказались от ответного глушения передач германского радио на Англию».

Беспалова А.Г., Корнилов Е.А., Короченский А.П.,

Лучинский Ю.В., Станько А.И.

ИСТОРИЯ МИРОВОЙ ЖУРНАЛИСТИКИ.

Бельгийский режиссёр обнаружил, что буква V для оккупированных территорий имеет примерно общий смысл – либо «Победа» (Victory), либо Свобода (Vrijheid). Обозначение буквы V в азбуке Морзе (точка-точка-точка-тире) совпало с первыми четырьмя нотами Пятой симфонии Бетховена.

«Радиослушатели начали повторять эти звуки всеми возможными способами в знак поддержки движения сопротивления, — пишет Уэлч. — По всей оккупированной территории Европы люди чертили букву V и выстукивали ее „морзянкой“, демонстрируя свою солидарность… .19 июля 1941 года Уинстон Черчилль одобрительно отозвался о ней в своей речи и с тех пор стал изображать знак V пальцами».

Психологические приемы, которые помогли победить во Второй мировой войне

Фиона Макдоналд

BBC Culture

Результат можно наблюдать даже сейчас – жест «V» на двух пальцах довольно популярен в Англии. Только не перепутайте, если пальцы перевернуть и показывать как у нас «ещё два пива» — получится «идите в задницу».

Немало шпионов спалилось на языке жестов, заказывая пиво – вот тут, например, надо было отогнуть большой палец.

Ещё в Рунете ходит популярный миф, что во время налётов бомбардировщиков был случай с несуществующим матчем. Два часа комментатор в жесточайший туман (не дающий работать ПВО) комментировал по BBC на весь Лондон меткие пасы и отбивания. И это удержало немцев от очередного налёта. Так вот, точных исторических свидетельств такому нет (точнее, приводятся новоделы), а миф, кажется, пошёл от довольно популярной данетки про матч, которого не существовало. Но кое-какие косвеные факты заставляют предположить, что нечто подобное было.

«One Saturday a big football match was to be played between Celtic and Rangers. At the same time we believed the Germans were to launch a bombing raid on Clydeside. The game was to be broadcast on the radio ,the commentator was R.E, Kingsley (REX). In the late morning however, a blanket of fog descended upon Clydeside so the match had to be abandoned. But, of course the Germans couldn't be allowed to find out about the fog as they would cancel their raid. So, REX Kingsley actually did a complete broadcast of a non existent game ,with all the goals and sound effects such as cheering and chanting. He even announced that it was a gloriously sunny day without a cloud in the sky. It was so life like it actually fooled the German Luftwaffe.»

Ещё из разработанных тогда технологий стоит отметить, опять же, не новую, но со времён Диогена доведённую до совершенства технологию повторяющегося тезиса. Если греческие и римские дядьки просто рекомендовали в речах на форуме повторять главную мысль в начале, середине и конце разными словами, то здесь пошли куда дальше. Как вам 11 вариантов листовки с одной и той же мыслью, но разными доказывающими фактами? Выглядит реально как разные мнения нескольких разных источников, а не одного.

В этот же период пришли первые рабочие HADI-циклы, в особенности – на листовки-пропуска. Работало так: предположим, враги сдаются мало. Ну ок, давайте запустим в оборот ещё макетов и посмотрим, что звучит убедительнее. Считаем, с чем больше приходят солдаты – и затем тиражируем по всему фронту. Самый простой пример такого цикла в обычном городе в мирное время – это три объявления на стену с разными телефонами: по какому звонят лучше, тот и продолжает дальше развиваться в генетическом алгоритме как родитель.

Были отработаны механики будничного рассказа (в основном, на захваченных территориях) – это схема быстрого сдвига нравственных ориентиров так, чтобы реципиенты от «это недопустимо» переходили к состоянию «ну, это статистика». Наука убеждения шагала семимильными шагами.

Немцы пробовали использовать современный политических ход «забалтывание» в контрпропаганде. Это когда противник вещает об успехах какого-то конкретного деятеля, а затем к нему прицепляются подвиги Чака Норриса. В итоге слушатель не знает, чему верить. Но что-то не пошло. Как десятилетия спустя выяснилось, надо маскировать забалтывание под свой же канал – то есть, например, пускать маскировочные листовки с чрезмерными восхвалениями, а не делать это с немецкой волны.

Очень много исследовался эмоциональный резонанс (это когда что-то рядом с хорошим человеком тоже можно считать хорошим – когда политик стоит рядом с известным актёром, например). Но столь тонкие детали объективно стали эффективными много позже, в мирное время. На первый план выходили, скорее, жанрово-технические вещи. Например, немецкая пропаганда вместе с оперативностью информации ввела «эффект присутствия», который сегодня – просто техприём журналистики. Это, например, когда журналист рассказывает про столкновение через сутки, но всё ещё пригибается, а камера очень шатается, рядом кто-то бегает в страшном волнении и кричит.

Для интеллигенции и офицерского состава была разработана теория медиаторов. То, что сейчас используют для работы с блогерами в рекламных кампаниях. Задача СМИ – не дать информацию, а внести слухи, которые подхватят лидеры мнений. Уже результат переработки этих слухов будет значим для среднего человека, который советуется с друзьями. Поэтому цель – не прямое убеждение, а создание экосистемы, в которой лидеры мнений вынуждены обсуждать выгодные для вас вопросы.

Английский и наш блоки уделяли очень много внимания языку и символике. Захват терминов был крайне важен – например, не «вероломная атака», а «миротворческая операция», не «перебили всё живое», а «выполнили освобождение территории», не «высыпали на город 50 тысяч поражающих элементов», а «произвели ковровое бомбометание по стратегическим объектам» и так далее. Годами позже вводились стандарты на показ своих потерь по телевизору к чужим – если словами они были, например, равны, то пропорция в картинке времени своих разрушений к чужим – 1:10. И так далее. Довольно много примеров работы с изображениями есть у старой доброй Сонтаг.

В общем, следующий раз, когда будете смотреть профессионально сделанный ролик, по телевизору вы, возможно, распознаете технологии 1939-го года. Они точно там есть.

|

Метки: author Milfgard информационная безопасность блог компании мосигра пропаганда реклама контент-маркетинг история социнжиниринг |

[recovery mode] QuadBraces III |

QuadBraces III

- Tutorial

- Recovery Mode

Прошло практически ровно два года с момента моей первой публикации о парсере QuadBraces — альтернативе MODX Evolution для простейших проектов, требующих шаблонизации. Это могут быть одностраничники с типовыми публикациями, портфолио, сайты-визитки, состоящие из почти статических страниц, и прочее подобное. С тех пор я обновлял свою разработку и незаметно для сообщества дополз до третьей версии. Нынешняя версия парсера QuadBraces содержит столько изменений, что я просто обязан опубликовать подробный туториал. Итак…

Теги

Начнём с обработчиков тегов. В QuadBraces 3 обработчики тегов вынесены в отдельные классы. Теперь разработчик волен определять свои типы тегов, не меняя код самого парсера. Для этого необходимо создать потомок класса QuadBracesTagPrototype, где нужно определить следующее:

- $_name — название-идентификатор тега

- $_start — начальная последовательность тега

- $_rstart — начальная последовательность тега для режима синтаксиса MODX Revolution. Без квадратных скобок.

- $_finish — конечная последовательность тега

- $_order — опционально; порядок обработки

- function main(array $m,$key='') — функция, возвращающая результат обработки тега. $m — данные PCRE-регулярки, ключ (самое важное) — ключ найденного тега.

На примере обработчика тегов константы:

class QuadBracesTagConstant extends QuadBracesTagPrototype {

protected $_name = 'constant';

protected $_start = '\{\*';

protected $_rstart = '\/';

protected $_finish = '\*\}';

protected $_order = 5;

public function main(array $m,$key='') {

$v = '';

if (empty($key) || !defined($key)) {

$this->_error = 'not found';

} else { $v = constant($key); }

return $v;

}

}Ага, точно — всё именно настолько просто. Хотя меня, как программиста старой закалки жутко бесит необходимость хранить файлы микроскопических размеров. Но это уже дело личное, как говорится.

Для тех, кто не читал предыдущую публикацию. Синтаксис тегов QuadBraces един для всех типов тегов:

- Начальная последовательность символов. Например, "{{".

- Идентификатор сущности. Должен состоять из латиницы, цифр, «бревна», тире и/или точки. Например, «my-chunk». Обратите внимание! Точка в идентификаторе играет роль разделителя уровня вложенности. То есть, забегая вперёд, например, переменная «my.var» будет располагаться по факту здесь — $parser->data['my']['var']. О чанках, сниппетах и шаблонах — ниже.

- Некоторое количество расширений-обработчиков (опционально). Каждое представляет собой конструкцию вида ": некий_идентификатор" или ": некий_идентификатор=`некие_данные`" (без пробела между двоеточием и идентификатором). Расширения-обработчики работают с конечным результатом обработки тега. То есть, например, получили мы переменную, содержащую номер телефона, а потом отформатировали её для человекопонятности.

- Для совместимости с синтаксисом MODX далее может следовать знак вопроса.

- Некое количество аргументов (опционально). Каждый аргумент — конструкция вида "&некое_имя=`некое_значение`". Да, аргументы могут быть даже у переменных. Да, они работают. В большинстве случаев переданное в аргументах используется в локальных плейсхолдерах.

- Конечная последовательность символов. Например, "}}".

В третьей версии парсера, как вы уже, наверное, поняли, есть режим синтаксиса MODX Revolution. В этом режиме теги начинаются с двух открывающих квадратных скобок, далее следует некий символ, который и определяет тип тега. А закрывается тег всегда двумя закрывающими квадратными скобками.

Пример тега некоего чанка:

{{news-item? &title=`Мухи съели мера города` &date=`15-09-17` &url=`/news/150917.html`}}Если в чанке будет:

Тогда в итоге на месте чанка будет выведено:

Мухи съели мера города

15-09-17

Читать далее

Кстати, о мухах. Не они ли скушали пункт HTML из меню «исходный код» редактора на нашем Уютненьком?

Из коробки QuadBraces поддерживает следующие виды тегов (указаны начальная и конечная последовательности для двух режимов):

- [+ +] или [[+ ]] — Локальные переменные. В большинстве случаев используются для переменных сниппетов, в циклах. При установке аргументов любого элемента, кроме сниппетов, локальные плейсхолдеры элемента заменяются значениями из аргументов.

- {{ }} или [[$ ]] — Чанки. Куски HTML-кода. В одном файле содержится один чанк. Один из основных элементов шаблонизации.

- { или [[- ]] — Однострочные библиотечные чанки. Куски HTML-кода. В одном файле содержится несколько чанков. На каждой строке располагается один чанк.

- {( )} или [[= ]] — Многострочные библиотечные чанки. Куски HTML-кода. В одном файле содержится несколько чанков. Чанки разделяются конструкцией: ""

- {* *} или [[/ ]] — Константы PHP. Выводят определённые в системе (в т.ч. пользователем) константы PHP.

- [( )] или [[++ ]] — Настройки. Переменные из массива SETTINGS. Обычно служат для вывода переменных CMS, использующей парсер.

- [ *] или [[ ]] — Переменные. Переменные парсера. Один из основных элементов шаблонизации.

- [^ ^] или [[^ ]] — Отладочные данные. Отладочные данные парсера.

- [% %] или [[% ]] — Языковые переменные. Словарно-языковые переменные. Заменяются в зависимости от текущего языка при включённой языковой системе.

- [! !] или [[! ]] — Сниппеты. По сути куски PHP-кода.

- [ или [ — Сниппеты с флагом кеширования. То же, что и выше, только с установленным флагом кеширования. Грубо говоря в функцию execute парсера передаётся аргумент $cached со значением true.

- [~ ~] или [[~ ]] — Ссылки из идентификаторов ресурсов. Превращают помещённое внутрь число в ссылку на ресурс. О ресурсах ниже.

- [: :] или [[: ]] — Кастомные обработчики переменных. О них отдельно.

В нынешней версии парсера есть возможность впихнуть в объект парсера набор т.н. ресурсов. По сути это примерно то же самое, что и ресурсы в MODX. Грубо говоря в базе данных конечного проекта хранится таблица, в которой хранятся записи с постами для блога. Главное — помнить, что каждая запись должна содержать численный ID, ID родителя или NULL и псевдоним для создания URL'а. При установке свойства resources объекта парсера устанавливается свойство idx объекта парсера. Оно представляет собой индекс ветвей дерева ресурсов. Это позволяет работать со структурой конечного набора ресурсов. Собственно, со всей этой

Кастомные обработчики переменных — это эдакие микропарсеры, произвольно обрабатывающие переменные парсера. Например, если в некоей переменной парсера (назовём её, скажем, top-menu) содержится массив с URL'ами вида:

array(

array('url' => '/','title' => 'Глагне'),

array('url' => '/about.html','title' => 'О сайте'),

array(

'url' => '/news/','title' => 'Новости','children' => array(

array('url' => '/news/10-09-17.html','title' => 'Мухи прилетели в город'),

array('url' => '/news/15-09-17.html','title' => 'Мухи съели мера города')

)

),

array('url' => '/contacts.html','title' => 'Контакты'),

);Из него можно сделать меню. Для этого достаточно поместить в нужном месте конструкцию:

[:menu@top-menu:]На её месте будет выведено меню при помощи маркированных списков. В лучших традициях Wayfinder'а, так сказать.

Вообще по кастомным обработчикам, думаю, нужно будет написать отдельную статью.

Отдельно про одну важную фишку шаблонов, а именно про метаполя. Едва ли не с первой версии существует возможность в коде шаблонов устанавливать метаполя. Оные по сути представляют собой переменные, определяемые в самом шаблоне вот такой конструкцией:

Аргументы — примерно то же самое, что и в тегах парсера. Вне зависимости от того, какие аргументы будут указаны в поле, конечное поле будет содержать три атрибута:

- default (текст) — значение по умолчанию

- type (целое число) — тип

- caption (строка) — заголовок

Все метаполя будут доступны через свойство fields парсера.