Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] DevOps с Kubernetes и VSTS. Часть 2: Облачная история |

DevOps с Kubernetes и VSTS. Часть 2: Облачная история

- Перевод

- Tutorial

Читайте перевод второй части статьи DevOps с Kubernetes и VSTS.

Цикл статей «DevOps с Kubernetes и VSTS»

1. Локальная история

2. Облачная история

В первой части я продемонстрировал подход к разработке многоконтейнерных приложений с использованием Kubernetes (k8s), а точнее minikube, полноценной среды k8s, которая запускает один узел на виртуальной машине на вашем ноутбуке. В предыдущей статье я клонировал этот репозиторий (убедитесь, что развернута ветка docker) с двумя контейнерами: DotNet Core API и frontend SPA (Aurelia) (в виде статических файлов в приложении DotNet Core app). Я показал, как создавать контейнеры локально и запускать их в minikube, а также использовать возможности ConfigMaps для работы с конфигурациями.

В этой статье я расскажу вам, как перенести локальную разработку в CI/CD и создать конвейер для автоматизированного формирования сборки/выпуска с использованием VSTS. Мы создадим реестр контейнеров и службы контейнеров в Azure, используя k8s в качестве механизма оркестрации.

CI/CD пайплайн для Kubernetes в VSTS

Настоятельно рекомендую вам изучить прекрасный начальный курс Найджела Поултона (Nigel Poulton) под названием Getting Started with Kubernetes на PluralSight (прим. переводчика — на английском языке, нужна платная подписка), а также статью Атула Малавия (Atul Malaviya) из Microsoft. Курс Найджела стал превосходным погружением в Kubernetes для новичков, а статья Атула помогла понять принципы взаимодействия VSTS и k8s, но ни курс, ни статья не охватили конвейер полностью. Из них я так и не понял, как в конвейере CI/CD реализовано обновление образов. Что ж, пришлось самому провести ряд экспериментов и подготовить эту статью!

Развертывание среды k8s с помощью служб контейнеров Azure

k8s можно запускать локально, в AWS или Google Cloud или Azure. Мы будем использовать службу контейнеров Azure (Azure Container Service). Однако, конвейер CI/CD, который я демонстрирую в этой статье, не зависит от конкретного облачного хостинга, он подходит для любого кластера k8s. Мы также создадим приватный реестр контейнеров в Azure, но вы, опять же, можете использовать любой реестр контейнеров по своему выбору.

Создать кластер k8s можно и на портале Azure. Однако Azure CLI позволяет сделать это быстрее, и вы сохраните ключи, которые понадобятся для подключения, поэтому я решил использовать этот механизм. Я также буду использовать Bash для Windows с kubectl, но подойдет любая платформа с kubectl и Azure CLI.

Вот команды:

# set some variables

export RG="cd-k8s"

export clusterName="cdk8s"

export location="westus"

# create a folder for the cluster ssh-keys

mkdir cdk8s

# login and create a resource group

az login

az group create --location $location --name $RG

# create an ACS k8s cluster

az acs create --orchestrator-type=kubernetes --resource-group $RG --name=$ClusterName --dns-prefix=$ClusterName --generate-ssh-keys --ssh-key-value ~/cdk8s/id_rsa.pub --location $location --agent-vm-size Standard_DS1_v2 --agent-count 2

# create an Azure Container Registry

az acr create --resource-group $RG --name $ClusterName --location $location --sku Basic --admin-enabled

# configure kubectl

az acs kubernetes get-credentials --name $ClusterName --resource-group $RG --file ~/cdk8s/kubeconfig --ssh-key-file ~/cdk8s/id_rsa

export KUBECONFIG="~/cdk8s/kubeconfig"

# test connection

kubectl get nodes

NAME STATUS AGE VERSION

k8s-agent-96607ff6-0 Ready 17m v1.6.6

k8s-agent-96607ff6-1 Ready 17m v1.6.6

k8s-master-96607ff6-0 Ready,SchedulingDisabled 17m v1.6.6

Примечания:

- Строки 2–4: создаем переменные.

- Строка 6: создаем каталог для ssh-ключей и файла конфигурации kubeconfig.

- Строка 9: входим в систему в Azure (запрос на открытие в браузере страницы с меню входа; если у вас нет подписки Azure, создайте бесплатную прямо сейчас!).

- Строка 10: создаем группу для размещения всех ресурсов, которые мы собираемся создать.

- Строка 13: развертываем кластер k8s с использованием только что созданной группы ресурсов и имени, которое мы передаем; генерируем ssh-ключи и помещаем в указанный каталог; нам нужны два агента (узла) с указанным размером виртуальной машины.

- Строка 16: создаем реестр контейнеров Azure в той же группе ресурсов с доступом от имени администратора.

- Строка 19: получаем учетные данные для подключения к кластеру с помощью kubectl; используем полученный ssh-ключ и сохраняем учетные данные в указанном файле kubeconfig.

- Строка 20: просим kubectl использовать эту конфигурацию вместо конфигурации по умолчанию (которая может иметь другие кластеры k8s или конфигурацию minikube).

- Строка 23: проверяем возможность подключения к кластеру.

- Строки 24–27: мы успешно подключаемся!

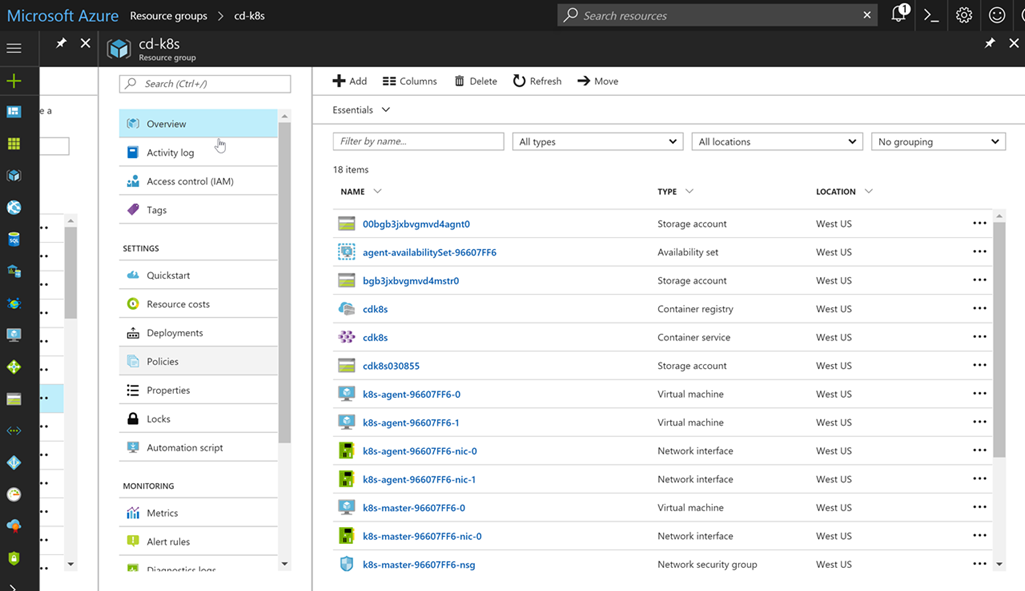

Если вы запустите браузер, перейдете на портал Azure и откроете свою группу ресурсов, то увидите, сколько всего было создано этими простыми командами:

Не беспокойтесь, самостоятельно управлять ресурсами вам не придется. Azure и кластер k8s берут это на себя!

Пространства имен

Прежде чем мы создадим сборку и выпуск для наших контейнерных приложений, давайте рассмотрим модель продвижения. Обычно схема примерно такая: разработка -> пользовательские приемочные испытания -> производственная среда (Dev -> UAT -> Prod). В случае c k8s, minikube представляет собой локальную среду разработки, и это здорово. Это полноценный кластер k8s на вашем ноутбуке, поэтому вы можете запускать свой код локально, в том числе с помощью таких конструктов k8s, как configMaps. А как быть с UAT и Prod? Вариант — развернуть отдельные кластеры, но такой подход может оказаться дорогостоящим. Также вы можете обеспечить совместное использование ресурсов кластера с помощью пространств имен.

Пространства имен в k8s выступают в качестве рубежей безопасности, но они также могут стать границами изоляции. Я могу развернуть новые версии моего приложения в пространстве имен dev, которое будет использовать ресурсы пространства имен prod, но при этом останется полностью невидимым (собственные IP-адреса и т. д.). Разумеется, не следует проводить нагрузочное тестирование в рамках такой конфигурации, поскольку мы будем потреблять значительные ресурсы, предназначенные для приложений в производственной среде. Эта концепция напоминает слоты развертывания в службах приложений Azure, которые используются для незаметного тестирования приложений перед их передачей в производственную среду.

Если вы создаете кластер k8s, то помимо пространств имен kube-system и kube-public (с подами k8s) получаете пространство имен по умолчанию. При отсутствии четких указаний с вашей стороны любые службы, развертывания или поды, которые вы создадите, попадают в это пространство имен. Но мы создадим два дополнительных пространства имен: dev и prod. Вот наш yaml:

apiVersion: v1

kind: Namespace

metadata:

name: dev

---

apiVersion: v1

kind: Namespace

metadata:

name: prod

Этот файл содержит определения для обоих пространств имен. Выполните команду Apply, чтобы создать пространства имен. Завершив все процедуры, вы можете вывести список всех пространств имен в кластере:

kubectl apply -f namespaces.yml

namespace "dev" created

namespace "prod" created

kubectl get namespaces

NAME STATUS AGE

default Active 27m

dev Active 20s

kube-public Active 27m

kube-system Active 27m

prod Active 20s

Настройка секрета для реестра контейнеров

Прежде чем переходить к коду, выполним заключительные настройки: когда кластер k8s извлекает образы для запуска, он должен обращаться к созданному нами реестру контейнеров. К этому реестру организован защищенный доступ, поскольку реестр частный. Поэтому нам нужно настроить секрет реестра, на который можно будет просто ссылаться в наших файлах развертывания yaml. Вот команды:

az acr credential show --name $ClusterName --output table

USERNAME PASSWORD PASSWORD2

---------- -------------------------------- --------------------------------

cdk8s some-long-key-1 some-long-key-2

kubectl create secret docker-registry regsecret --docker-server=$ClusterName.azurecr.io --docker-username=$ClusterName --docker-password= --docker-email=admin@azurecr.io

secret "regsecret" created

Первая команда использует az, чтобы получить ключи для пользователя с правами администратора (имя пользователя с правами администратора совпадает с именем реестра контейнеров, поэтому я создал cdk8s.azurecr.io, и имя пользователя-администратора будет cdk8s). Передайте один из ключей (неважно, какой) в качестве пароля. Адрес электронной почты не используется, поэтому можете указать какой угодно. Теперь у нас есть секрет реестра с именем regsecret, на который мы можем ссылаться, выполняя развертывание в кластере k8s. K8s будет использовать этот секрет для проверки подлинности в реестре.

Настройка конечных точек VSTS

Мы настроили кластер k8s и реестр контейнеров. Теперь добавим эти конечные точки в VSTS, чтобы мы могли передавать контейнеры в реестр при создании сборки и выполнять команды в отношении кластера k8s во время подготовки выпуска. Конечные точки позволяют нам абстрагировать проверку подлинности, чтобы не хранить учетные данные непосредственно в определениях наших выпусков. Вы также можете создать роли, чтобы ограничить доступ на просмотр и использование конечных точек.

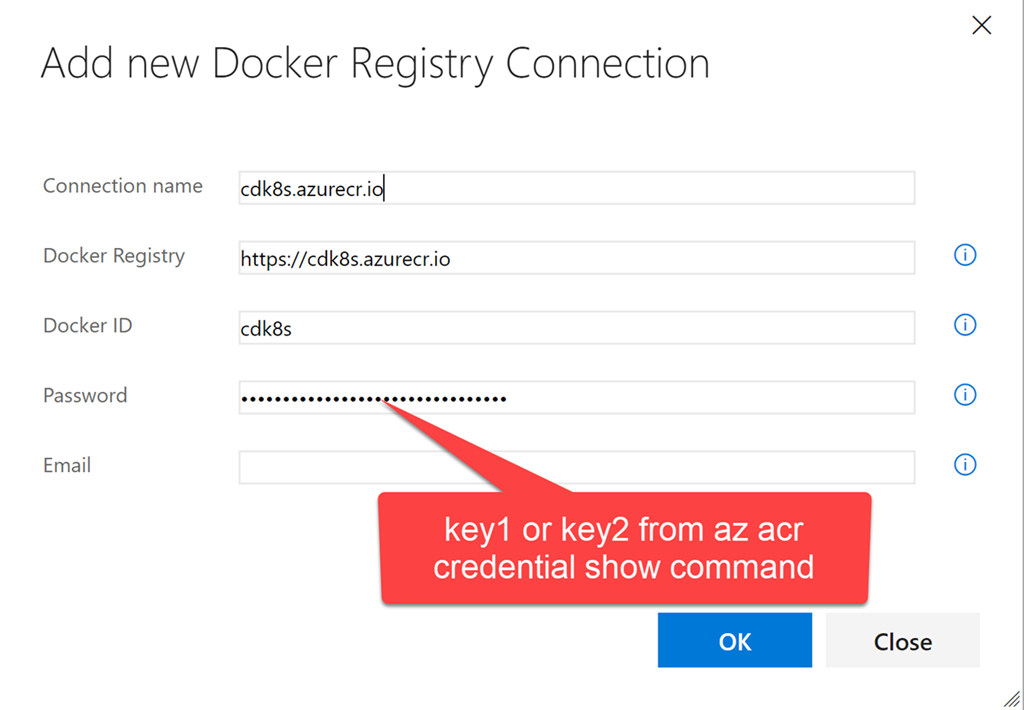

Запустите VSTS и откройте командный проект (или просто создайте новый). Перейдите в командный проект и нажмите значок шестеренки, чтобы открыть узел настроек для этого командного проекта. Щелкните Services. Щелкните + New Services и создайте новую конечную точку Docker Registry. Введите те же учетные данные, которые вы использовали для создания секрета реестра в k8s с помощью kubectl:

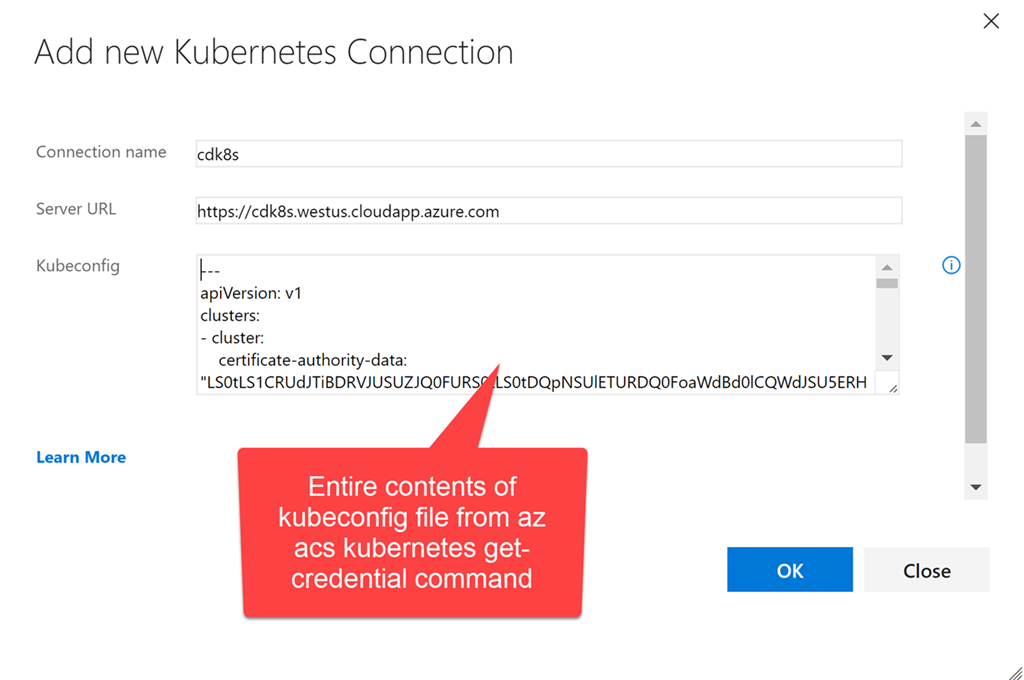

Теперь создайте конечную точку k8s. Введите URL: https://$ClusterName.$location.cloudapp.azure.com (clustername и location — переменные, которые мы использовали при создании кластера). Необходимо скопировать в текстовое поле для учетных данных все содержимое файла ~/cdk8s/kubeconfig (вы могли назвать его по-другому), который был создан после выполнения команды az acs kubernetes get-credential:

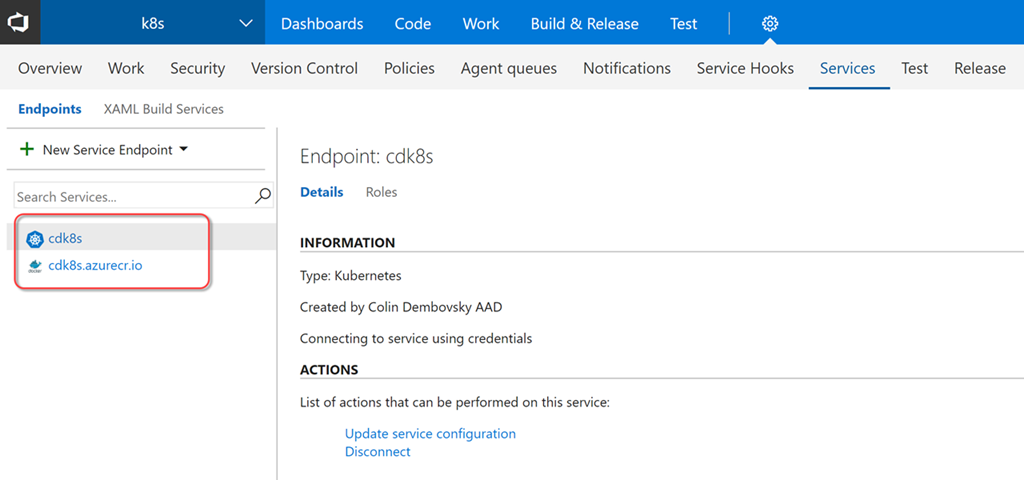

Теперь у нас есть две конечные точки, которые мы можем использовать в определениях сборки и выпуска:

Сборка

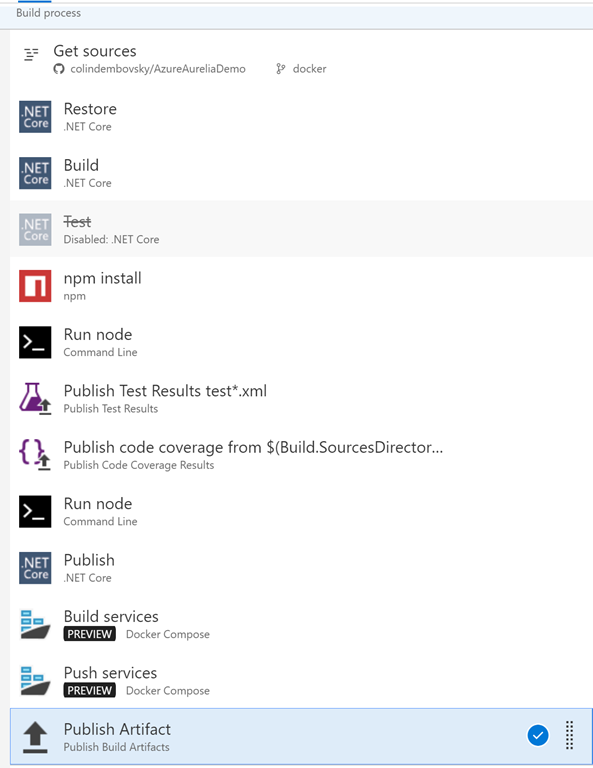

Теперь мы можем создать сборку, которая будет компилировать/тестировать наш код, создавать образы docker и помещать их в реестр контейнеров, соответствующим образом помечая их. Щелкните Build & Release, а затем — Builds, чтобы открыть узел сборки. Создайте новое определение сборки. Выберите шаблон ASP.NET Core и нажмите Apply. Необходимо выполнить следующие настройки:

- Tasks -> Process: введите имя, например k8s-demo-CI, и выберите очередь Hosted Linux Preview.

- Опционально: измените формат номера сборки на 1.0.0$(rev:.r), чтобы ваши сборки имели формат 1.0.0.x.

- Tasks -> Get Sources: выберите репозиторий Github с проверкой подлинности OAuth или PAT. Выберите AzureAureliaDemo, а затем docker в качестве ветки по умолчанию. Возможно, вам придется создать «вилку» для репозитория (или просто импортировать его в VSTS), если вы выполняете действия вместе со мной.

- Tasks -> DotNet Restore: не вносите никаких изменений.

- Tasks -> DotNet Build: добавьте --version-suffix $(Build.BuildNumber) в аргументы сборки, чтобы обеспечить соответствие версии и номера сборки.

- Tasks -> DotNet Test: отключите эту задачу, поскольку в нашем решении не применяются тесты DotNet (конечно, если у вас будут тесты, задачу можно снова включить).

- Tasks -> добавьте задачу npm. В качестве рабочего каталога выберите frontend и убедитесь, что используется команда install.

- Tasks -> добавьте задачу Command line. В качестве инструмента (tool) выберите node, укажите аргументы: node_modules/aurelia-cli/bin/aurelia-cli.js test и рабочий каталог: frontend. Так вы запустите тесты Aurelia.

- Tasks -> добавьте задачу Publish test results. В поле Test Results files укажите test*.xml, а в поле Search Folder введите $(Build.SourcesDirectory)/frontend/testresults. Так вы опубликуете результаты тестов Aurelia.

- Tasks -> добавьте задачу Publish code coverage. В поле Coverage Tool введите Cobertura, в поле Summary File — $(Build.SourcesDirectory)/frontend/reports/coverage/cobertura.xml, в поле Report Directory — $(Build.SourcesDirectory)/frontend/reports/coverage/html. Так вы опубликуете данные о покрытии тестов Aurelia.

- Tasks -> добавьте задачу Command line. В качестве инструмента (tool) выберите node, укажите аргументы: node_modules/aurelia-cli/bin/aurelia-cli.js test и рабочий каталог: frontend. Так вы скомпилируете, обработаете и упакуете приложение Aurelia SPA.

- Tasks -> DotNet Publish. В качестве аргументов введите -c $(BuildConfiguration) -o publish и снимите флажок Zip Published Projects.

- Tasks -> добавьте задачу Docker Compose. В поле Container Registry Type укажите Azure Container Registry, в качестве подписки и реестра контейнеров Azure укажите реестр, для которого мы создали конечную точку ранее. В поле Additional Docker Compose Files укажите docker-compose.vsts.yml, в поле Action — Build service images, в поле Additional Image Tags — $(Build.BuildNumber), чтобы номер сборки использовался в качестве тега для образов.

- Создайте клон задачи Docker Compose. В качестве имени укажите Push service images и выберите действие Push service images. Установите флажок Include Latest Tag.

- Tasks -> Publish Artifact. В полях Path to Publish и Artifact Name выберите k8s. Так вы опубликуете файлы k8s yaml, чтобы включить их в выпуск.

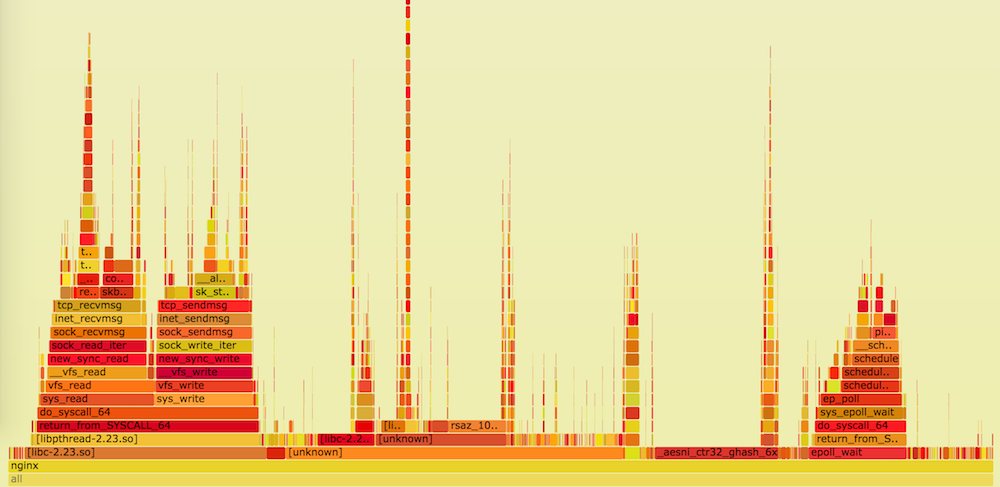

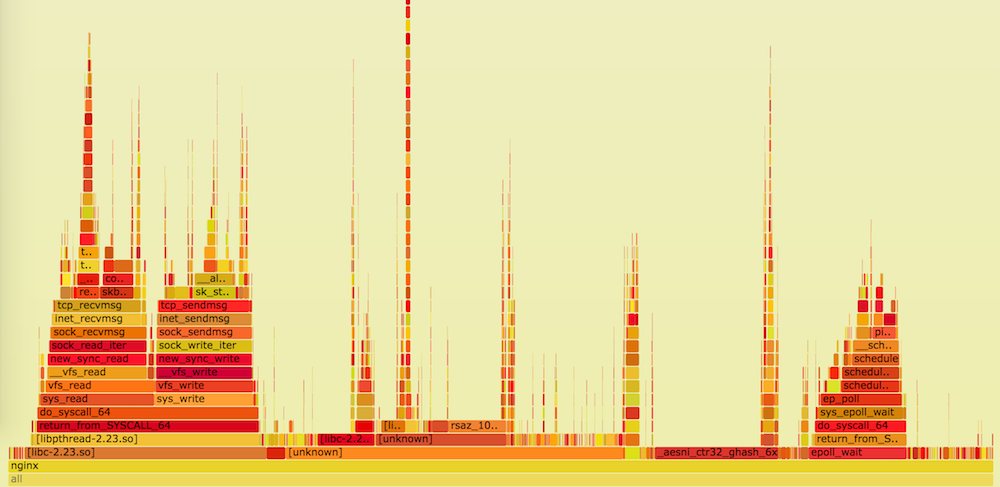

Итоговый список задач должен выглядеть следующим образом:

Теперь можно нажать Save and Queue, чтобы сохранить сборку и поставить ее в очередь. По завершении процесса создания сборки вы увидите сводную информацию о тестировании/покрытии.

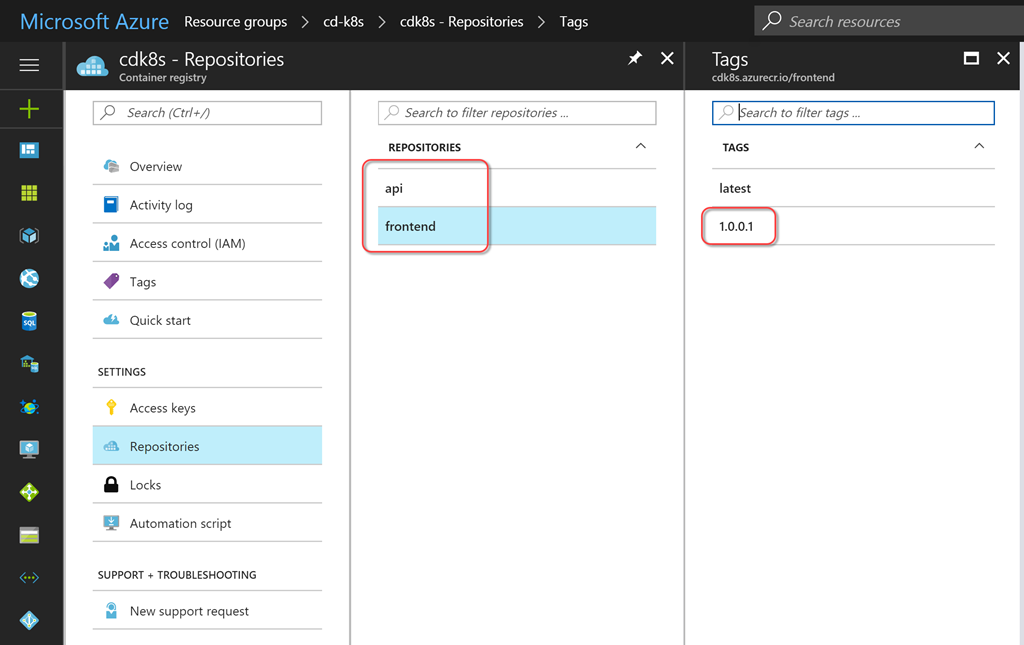

Вы также можете просмотреть содержимое своего реестра контейнеров, чтобы увидеть вновь перенесенные образы служб с меткой, соответствующей номеру сборки.

Выпуск

Теперь мы можем настроить выпуск, который будет создавать/обновлять нужные службы. Для этого следует обеспечить управление конфигурацией. Можно было просто включить конфигурацию в код, но в таком случае конфиденциальные данные (например, пароли) попали бы в инструмент управления версиями. Я предпочитаю «токенизировать» любую конфигурацию, чтобы решение для управления выпусками размещало конфиденциальные данные за пределами зоны, контролируемой инструментом управления версиями. Решение VSTS Release Management позволяет создавать секреты для отдельных сред или выпусков, также вы можете создавать их в группах переменных с поддержкой повторного использования. Кроме того, теперь поддерживается бесшовная интеграция с Azure Key Vault.

Чтобы вместо токенов использовать значения, специфичные для среды, нам нужна задача для замены токена. К счастью, у меня есть кросс-платформенная задача ReplaceTokens из модуля расширения Colin's ALM Corner Build & Release Tasks, который я скачал из магазина VSTS Marketplace. Щелкните ссылку, чтобы перейти на нужную страницу, затем нажмите Install, чтобы установить расширение для своей учетной записи.

На странице сводной информации о сборке прокрутите бегунок справа до раздела Deployments и щелкните ссылку Create release. Также можете щелкнуть Releases и создать новое определение оттуда. Начните с пустого шаблона (Empty), выберите свой командный проект и сборку, которую вы только что создали, в качестве исходной сборки. Поставьте флажок Continuous Deployment, чтобы выпуск создавался автоматически для каждой правильной сборки.

В качестве имени для определения укажите k8s или что-то описательное. На вкладке General измените формат номера выпуска на $(Build.BuildNumber)-$(rev:r), чтобы по имени выпуска всегда можно было без труда определить номер сборки. Вернитесь в раздел Environments и вместо Environment 1 введите dev. Щелкните ссылку Run on Agent и убедитесь, что в поле Deployment queue выбрано Hosted Linux Preview.

Добавьте следующие задачи:

- Replace Tokens.

- Source Path: в проводнике откройте каталог k8s.

- Target File Pattern: *-release.yml. Таким образом, токен будет заменен в любом файле yml с именем, которое оканчивается на -release. Таких файлов три: файлы службы/развертывания для сервера и клиента, а также файл конфигурации клиента. Эта задача находит токены в файле (с префиксом и постфиксом __) и ищет переменные с таким же именем. Каждая переменная заменяется своим значением. Через некоторое время мы создадим переменные.

- Kubernetes Task 1 (применить конфигурацию для клиента).

- Настройте подключение k8s к созданной ранее конечной точке. Также необходимо настроить подключение к реестру контейнеров Azure. Это касается всех задач Kubernetes. В поле Command выберите apply, поставьте флажок Use Configuration Files и укажите файл k8s/app-demo-frontend-config-release.yml с помощью средства выбора файлов. Укажите --namespace $(namespace) в текстовом поле для аргументов.

- Настройте подключение k8s к созданной ранее конечной точке. Также необходимо настроить подключение к реестру контейнеров Azure. Это касается всех задач Kubernetes. В поле Command выберите apply, поставьте флажок Use Configuration Files и укажите файл k8s/app-demo-frontend-config-release.yml с помощью средства выбора файлов. Укажите --namespace $(namespace) в текстовом поле для аргументов.

- Kubernetes Task 2 (применить определение службы/развертывания на стороне сервера).

- Задайте одинаковые параметры подключения для службы k8s и реестра контейнеров Azure. В этот раз в поле Secret Name укажите regsecret (это имя секрета, который мы создали при настройке кластера k8s, а также имя, на которое мы ссылаемся в параметре imagePullSecret в определениях развертывания). Поставьте флажок Force update secret. Это обеспечит совпадение значений секрета k8s и ключа из Azure. Этот параметр можно было пропустить, поскольку ключ мы создали вручную.

- В поле Command выберите apply, поставьте флажок Use Configuration Files и укажите файл k8s/app-demo-backend-release.yml с помощью средства выбора файлов. Укажите --namespace $(namespace) в текстовом поле для аргументов.

- Kubernetes Task 3 (применить определение службы/развертывания на стороне клиента).

- Настройки аналогичны предыдущей задаче, только выбираем файл k8s/app-demo-frontend-release.yml.

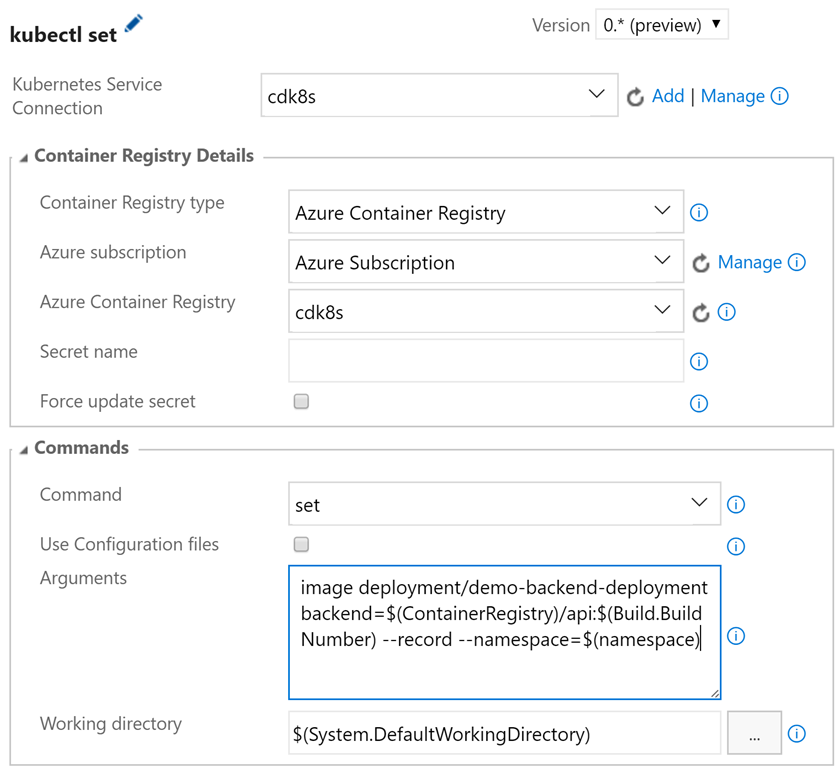

- Kubernetes Task 4 (обновить образ на стороне сервера).

- Задайте одинаковые параметры подключения для службы k8s и реестра контейнеров Azure. Секрет здесь не требуется. В поле Command выберите set, а в поле Arguments укажите image deployment/demo-backend-deployment backend=$(ContainerRegistry)/api:$(Build.BuildNumber) --record --namespace=$(namespace).

- Так вы обновите версию (тег) используемого образа контейнера. K8s выполнит последовательное обновление, запустив новые контейнеры и отключив старые, и служба все это время будет работоспособна.

- Kubernetes Task 5 (обновить образ на стороне клиента).

- Параметры аналогичны предыдущей задаче, только в поле Arguments необходимо указать image deployment/demo-frontend-deployment frontend=$(ContainerRegistry)/frontend:$(Build.BuildNumber) --record --namespace=$(namespace)

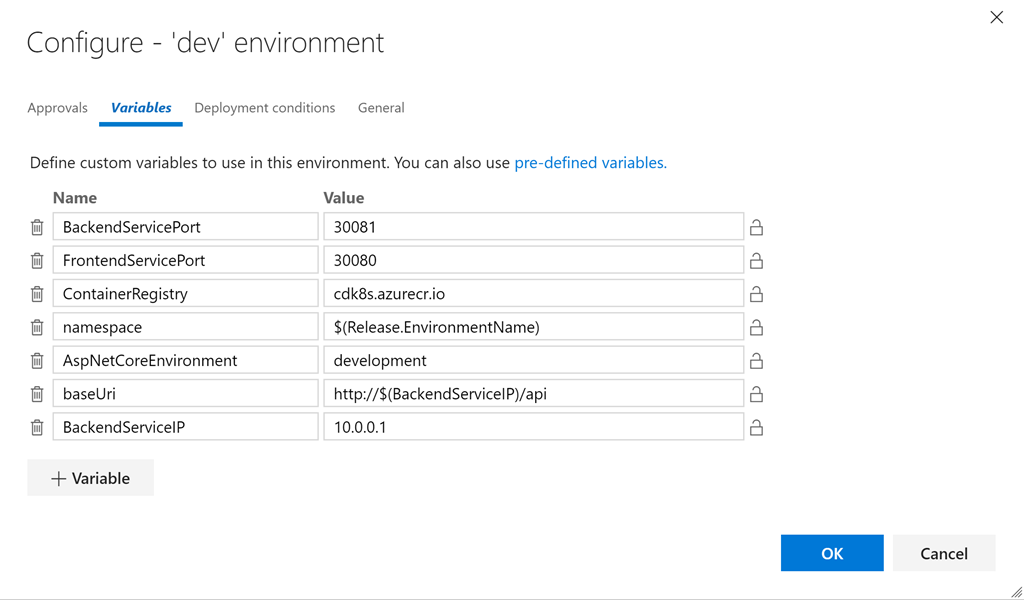

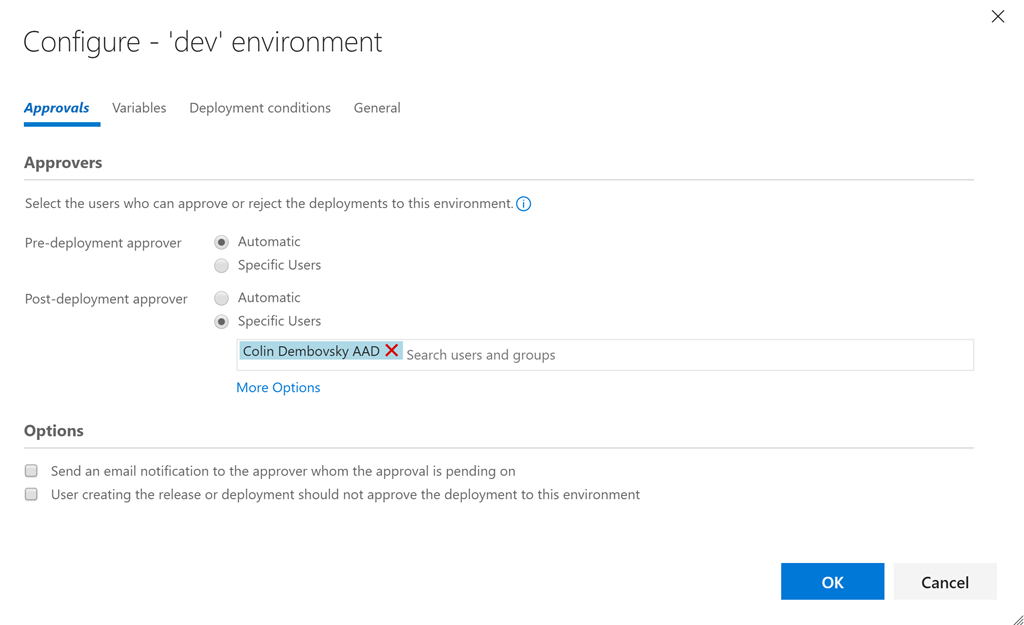

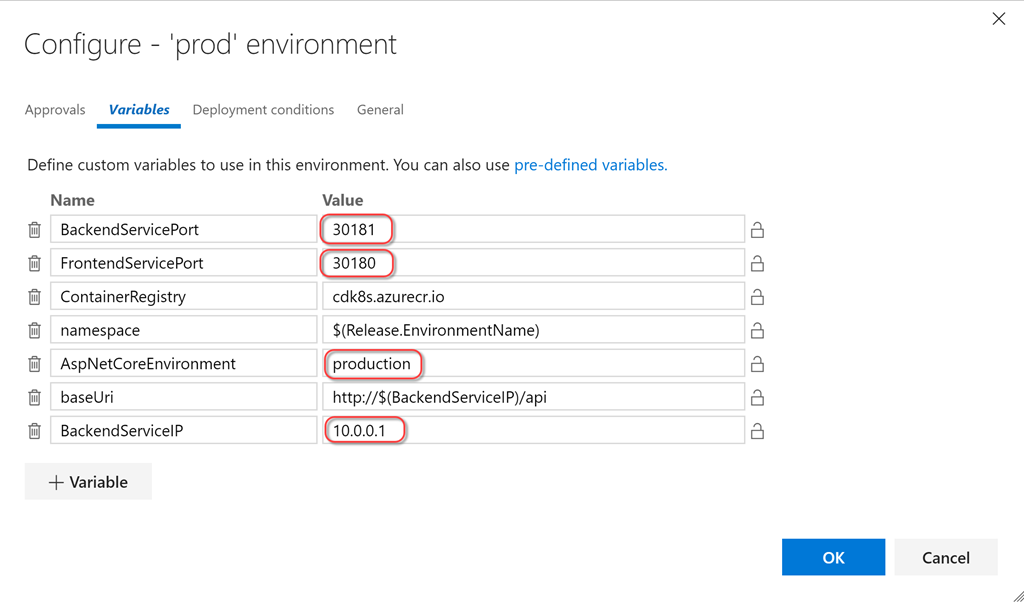

- Нажмите кнопку «…» на карточке dev и щелкните Configure Variables для настройки переменных. Задайте следующие значения:

- BackendServicePort: 30081

- FrontendServicePort: 30080

- ContainerRegistry: <ваше реестр контейнеров>.azurecr.io

- namespace: $(Release.EnvironmentName)

- AspNetCoreEnvironment: development

- baseUri: http://$(BackendServiceIP)/api

- BackendServiceIP: 10.0.0.1

Так задаются специфичные для среды значения для всех переменных в файлах yml. Задача Replace Tokens запишет для нас нужные значения в файлы. Давайте быстро посмотрим на один из токенизированных файлов (токенизированные строки выделены):

apiVersion: v1

kind: Service

metadata:

name: demo-frontend-service

labels:

app: demo

spec:

selector:

app: demo

tier: frontend

ports:

- protocol: TCP

port: 80

nodePort: __FrontendServicePort__

type: LoadBalancer

---

apiVersion: apps/v1beta1

kind: Deployment

metadata:

name: demo-frontend-deployment

spec:

replicas: 2

template:

metadata:

labels:

app: demo

tier: frontend

spec:

containers:

- name: frontend

image: __ContainerRegistry__/frontend

ports:

- containerPort: 80

env:

- name: "ASPNETCORE_ENVIRONMENT"

value: "__AspNetCoreEnvironment__"

volumeMounts:

- name: config-volume

mountPath: /app/wwwroot/config/

imagePullPolicy: Always

volumes:

- name: config-volume

configMap:

name: demo-app-frontend-config

imagePullSecrets:

- name: regsecret

Комментарий относительно значения для BackendServiceIP: мы используем 10.0.0.1 в качестве замещающего текста, так как Azure присвоит IP-адрес этой службе, когда k8s запустит службу на стороне сервера (вы увидите общедоступный IP-адрес в группе ресурсов на портале Azure). Нам нужно будет выполнить это один раз, чтобы создать службы, а затем обновить, чтобы получить реальный IP-адрес и обеспечить работоспособность службы на стороне клиента. Мы также используем $(Release.EnvironmentName) в качестве значения для namespace, поэтому для dev (а затем и для prod) пространства имен должны совпадать с теми, что создали мы (включая регистр символов).

Если служба/развертывание и конфигурация не изменяются, то первые три задачи k8s по существу не работают. Какой-то результат даст только команда set. Но это как раз здорово, поскольку файлы службы/развертывания и конфигурации можно применять идемпотентно! Они меняются, когда это необходимо, и не вносят никаких возмущений во всех остальных ситуациях — идеальный подход для повторяющихся выпусков!

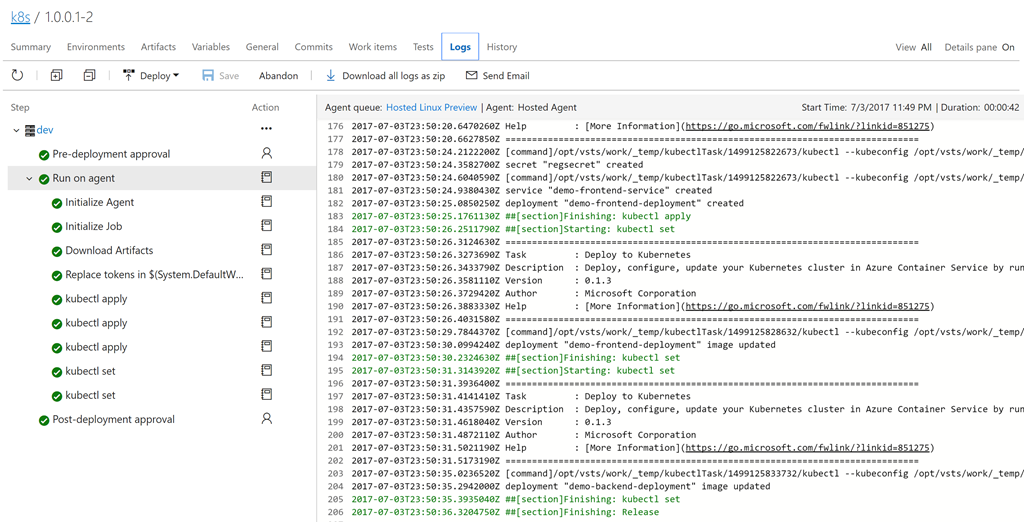

Сохраните определение. Щелкните + Release, чтобы создать новый выпуск. Щелкните по номеру выпуска (это будет что-то вроде 1.0.0.1-1), чтобы открыть его. Щелкните logs, чтобы просмотреть журналы.

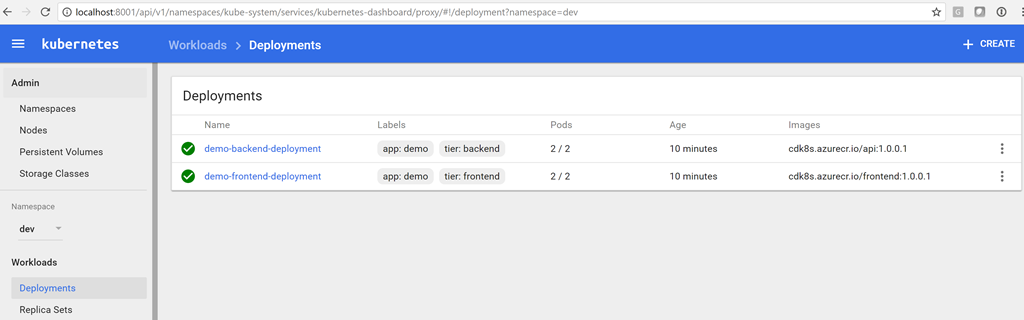

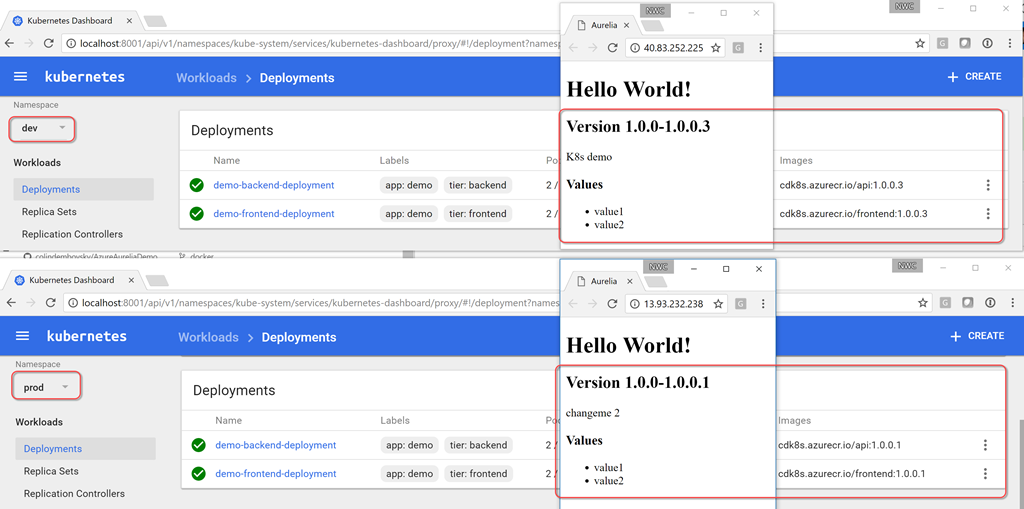

Когда создание выпуска завершится, вы увидите развертывание на информационной панели Kubernetes. Используйте следующую команду, чтобы открыть информационную панель:

az acs kubernetes browse -n $ClusterName -g $RG --ssh-key-file ~/cdk8s/id_rsa

Proxy running on 127.0.0.1:8001/ui

Press CTRL+C to close the tunnel...

Starting to serve on 127.0.0.1:8001

Последний аргумент — это путь к файлу SSH-ключа, который генерируется при создании кластера (укажите актуальный путь). Теперь можно открыть в браузере страницу http://localhost:8001/ui. В раскрывающемся меню namespace выберите dev и щелкните Deployments. Вы должны увидеть два успешных развертывания с двумя работоспособными подами в каждом. Вы также можете увидеть образы, которые запускаются в развертываниях. Обратите внимание на номер сборки, указанный в качестве тега!

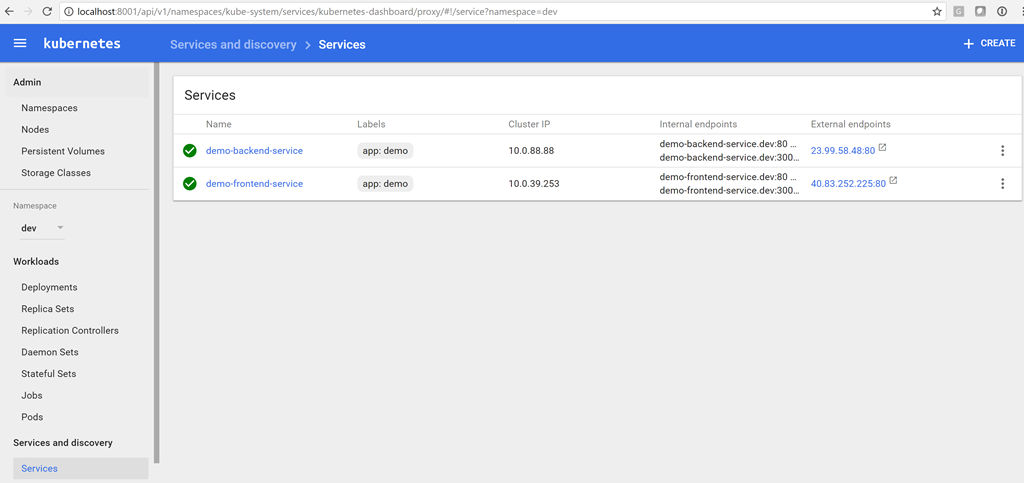

Чтобы увидеть службы, щелкните Services.

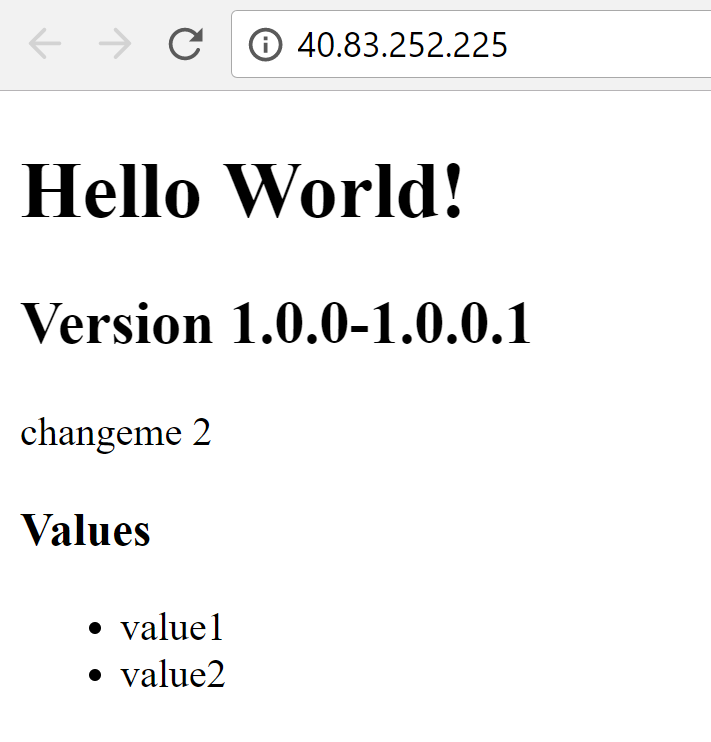

Теперь у нас есть IP-адрес службы на стороне сервера, поэтому мы можем обновить переменную в выпуске. Затем мы можем поставить в очередь новую версию, и на этот раз в конфигурации клиента будет указан правильный IP-адрес для службы на стороне сервера (в нашем случае это 23.99.58.48). Мы можем ввести IP-адрес нашей клиентской службы в браузере и убедиться, что теперь все работает!

Создание производственной среды

Теперь, когда мы убедились в работоспособности среды dev, мы можем вернуться к выпуску, клонировать среду dev и назвать копию prod. Укажите одобрение постфактум для dev (или предварительное одобрение для prod), чтобы между двумя средами была контрольная точка.

Затем мы можем просто изменить порты для узлов, а также значения переменных AspNetCoreEnvironment и BackendServiceIP, и готово! Разумеется, нам нужно сначала выполнить развертывание в пространстве имен prod, прежде чем мы увидим IP-адрес, назначенный k8s/Azure для сервера prod. Затем необходимо повторно запустить процедуру создания выпуска, чтобы обновить конфигурацию.

Мы могли бы удалить параметр nodePort из определений и позволить платформе k8s самой выбрать порт узла, но если порт указан явным образом, то мы будем точно знать, какой порт служба будет использовать в кластере (не для доступа извне).

Мне не нравится указывать --namespace для каждой команды, настолько не нравится, что я создал запрос Pull Request в репозитории vsts-tasks на Github, чтобы дать доступ к пространству имен в качестве дополнительного элемента пользовательского интерфейса!

Проход по всему CI/CD конвееру

Теперь, когда наши среды dev и prod в конвейере CI/CD настроены, мы можем внести изменения в код. Я поменяю текст под версией на «K8s demo» и применю изменения. Так мы инициируем сборку, создание более нового образа контейнера и выполнение тестов, что, в свою очередь, запустит выпуск в среде dev. Теперь я вижу изменение в среде dev (версия 1.0.0.3 или более новая, то есть больше, чем 1.0.0.1), в то время как версия prod все еще равна 1.0.0.1.

Одобрите dev в решении для управления выпусками, и процесс для prod запустится, через несколько секунд версия prod также будет равна 1.0.0.3.

Я экспортировал определения json для сборки и выпуска в этот каталог, вы можете попытаться импортировать их (я не уверен, что это сработает, но использовать их для справки можно в любом случае).

Заключение

k8s имеет большой потенциал как надежный механизм оркестрации контейнеров. Технология yml позволяет реализовать концепцию «инфраструктура как код» и отлично подходит для управления версиями. Механизм развертывания сводит к минимуму или вовсе устраняет время простоя при развертывании, а возможность использования configMaps и секретов обеспечивает безопасность всего процесса. Интерфейс командной строки Azure CLI позволяет создать кластер k8s и реестр контейнеров Azure при помощи пары простых команд. Интеграция с VSTS с помощью задач k8s упрощает настройку конвейера CI/CD, вместе они формируют оптимальный рабочий процесс разработки. А с учетом решения minikube, о котором я писал в первой части этой серии статей и который предоставляет вам полноценный кластер k8s для локальной разработки на вашем ноутбуке, вы получаете отличный рабочий процесс разработки, непрерывной интеграции и непрерывного развертывания (Dev/CI/CD).

Разумеется, конвейер CI/CD не проводит нагрузочное тестирование реальных приложений в производственной среде! Я хотел бы узнать о вашем опыте применения k8s в производственных средах. Пишите в комментариях, если у вас есть опыт запуска приложений в кластере k8s в производственной среде!

Удачи вам с k8sing!

P.S. Благодарим Константина Кичинского (Quantum Quintum) за иллюстрацию к этой статье.

|

Метки: author stasus программирование visual studio microsoft azure блог компании microsoft kubernetes k8s vsts devops acs kubectl microsoft |

ASO в Playstore: добавим немного юмора в работу, или как поэзия может помочь в росте органики на 304% за 30 дней |

Читать дальше ->

|

Метки: author belltane аналитика мобильных приложений growth hacking aso play market google play |

[Из песочницы] Пишем для UEFI BIOS в Visual Studio. Часть 1 — разворачивание среды разработки, компиляция и запуск на отладку |

Пишем для UEFI BIOS в Visual Studio. Часть 1 — разворачивание среды разработки, компиляция и запуск на отладку

Введение

В этой статье будет описано, как быстро начать программировать для UEFI во фреймворке edk2 в среде Visual Studio, не тратя массу времени на настройку среды обычным способом, по оригинальным мануалам. Достаточно дать команду git clone ... в корневом каталоге диска, и это на самом деле все, среда будет полностью установлена и готова к работе. Требуются 64-разрядная Windows 7 и выше c Visual Studio 2008-2016. Эти два условия не обязательны, но тогда придется немного потрудиться над собиранием системы edk2-Visual Studio в единое целое, краткая памятка будет приведена.

Цель статьи — провести начинающего за руку по первому UEFI проекту, оставаясь в привычной ему среде. Для более опытных людей, надеюсь, будет интересным поработать в VS вместо привычной командной строки, или разобрать подход и перенести его в любимый Eclipse.

Начнем с простых вещей, вывода строки на консоль и русификации (довольно востребованная вещь, причем простая в реализации), потом будет работа с формами в HII (то, что называлось в обиходе страницами BIOS Setup), потом графика, потом Boot Manager, а потом видно будет (с).

Желающие — прошу пожаловать под кат.

Сейчас необходимо решить, оно вам надо или нет. Потратим на это пол-страницы на старте, чтобы не тратить пол-дня и в конце понять, что вам надо совсем другое. Или, надеюсь, наоборот — загореться энтузиазмом и выкроить время на прочтение статьи.

Вначале хорошее

1) Аппаратура не понадобится от слова совсем. Никаких Evaluation Boards, никаких Intel BlueBox JTAG за $3000. Все будет отлаживаться в 32-битной виртуальной машине OVMF – портированной Интелом виртуалке qemu для отладки UEFI Firmware. Для перекомпиляции под реальную платформу достаточно потом — после отладки — переставить пару ключей в настройках компиляции, и на этом все.

2) Работать будем со всеми возможностями Visual Studio, т.е. доступны breakpoints, watch, step execution и остальное. Перекомпиляция и запуск несложного модуля занимает 8-10 секунд.

3) Файловая система виртуалки доступна на Windows-машине для записи-чтения. Очень пригодится, если надо будет редактировать скрипты UEFI Shell, после запуска посмотреть скриншоты и проанализировать логи средствами Windows.

4) Никакого ассемблера, только С/С++.

Теперь о том, что мы делать не будем

1) Мы будем работать в DXE (где уже есть UEFI Shell) и поздних фазах. В более ранние фазы не полезем, поскольку нас туда никто не пустит, по крайней мере – для Intel-процессоров. Позже будет объяснение, почему. Если хотите сделать полный цикл, от включения до загрузки ОС, причем быстро и не забивая голову кучей ненужной и неинтересной вам в данный момент информацией, а ручное конфигурирование системы вам совершенно не требуется – дальше не читайте, а наберите в Гугле «coreboot».

2) «Графического» UEFI с мышкой и кнопками, как у Dell, MSI и прочих, здесь не будет. Это платные среды, для использования в крупных компаниях. Есть, разумеется, энтузиасты, которые сами создают их своими руками, не ответив предварительно на вопрос «Зачем?», но обычно их энтузиазм заканчивается на второй форме с кнопками.

3) Мы будем работать с компилятором Visual Studio. Желающие могут настроить gcc в cygwin, или icc, но в данный момент не стоит задача получить оптимальный быстрый код, а стоит задача быстро пройти путь к началу полноценной работы.

Все, предварительные танцы закончены, кто надо – воодушевлен, кто надо – напуган.

Переходим к делу

Первым делом, скачиваем репозиторий в корень диска. Развернется он в с:/FW. Если каталог FW в корне диска уже наличествует, то лучше бы его переименовать, потому что все конфиги настроены именно туда в абсолютных путях. Не по фэн-шуй, но перфекционисты всегда могут поправить абсолютные пути на относительные, написав соответствующий скрипт, который это делает.

Итак, у кого на машине есть git в командной строке, выполняют команду в cmd окне (или в Far Commander, не суть) из корневого каталога:

git clone https://github.com/ProgrammingInUEFI/FWа те, у кого нет, идут по ссылке на github, скачивают zip-файл и раскрывают его в каталог с:/FW.

Как было ранее обещано, приведем подсказку из Интеловского тренинга по использованию другой конфигурации, отличной от указанной в начале статьи. Ищите свое сочетание в табличке, если предлагаемое по каким-то причинам не подходит:

Конфигурирование среды для версии, отличной от VS2010

Открываем файл c:\FW\edk2\Conf\target.txt и в строчке

TOOL_CHAIN_TAG = VS2010x86Заменяем VS2010x86 на тэг установленной у вас версии Visual Studio. Для Visual Studio 2010 тэг останется как есть, для других версий VS – смотрите картинку выше, или список в начале файла c:\FW\edk2\Conf\tools_def.txt

Собственно, среда разработки edk2 развернута полностью и в ней можно работать из командной строки. Некоторые так и работают всю жизнь («угорать по хардкору, поддерживать дух старой школы и всё такое» — (с) CodeRush в своей ставшей классической статье). Но мы все же пойдем дальше, пересаживать человека из MSVS обратно в командную строку — негуманно, особенно в 2017.

Настраиваем проект в Visual Studio

Открываем Visual Studio, в нем открываем Solution NT32.sln из каталога C:\FW\VS\NT32. В целях уменьшения времени входа в тему, в solution уже создан одноименный проект NT32, в котором уже сделаны описанные ниже настройки. Это если не получится создать самим – чтобы иметь гарантированно рабочие настройки проекта. Такой подход сильно сократит время поиска источника проблем, в случае их появления. Тем не менее, лучше пройти описанный ниже путь самим, и понять смысл настроек – это облегчит настройку следующих проектов.

Итак, по шагам:

Создание проекта

Создаем в Solution NT32 новый проект для Visual C++ (правой клавишей на Solution NT32, Add->New Project, выбираем опцию Makefile Project), и назовем его MyFirstUEFIProject (или как угодно еще). Жмем Finish.

Выбираем в Solution проект NT32, выбираем из контекстного меню Project->Properties и производим настройки проекта.

Настройка NMake опций

Выбираем в окне слева строку Configurarion Properties ->NMake, в окне справа — строку Build Command Line

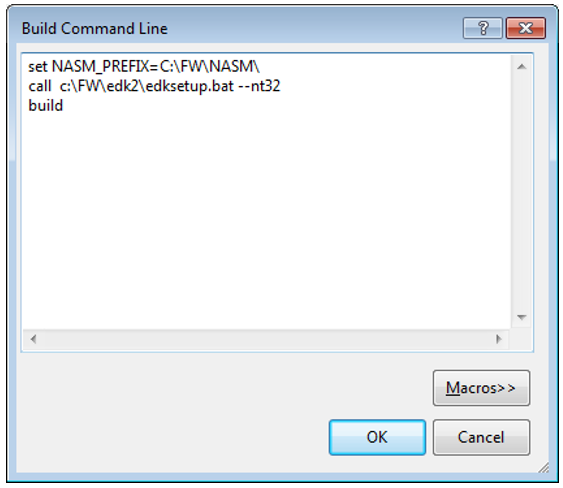

Жмем Edit… и в открывшемся текстовом окне вводим:

set NASM_PREFIX=C:\FW\NASM\

call c:\FW\edk2\edksetup.bat --nt32

buildСейчас стоит немного объяснить, что мы делаем. По сути, мы пишем в этом окне обычный пакетный bat-файл вместо makefile.

В первой строке устанавливается переменная окружения ассемблера NASM_PREFIX в том виде, как ее понимает edk2, то есть путь, по которому лежит файл nasm.exe. На ассемблере мы сами писать не будем, но нашей системе сборки ассемблер нужен обязательно.

Во второй строке вызывается скрипт настройки среды edk2 и настраиваются переменные окружения для данного сеанса компиляции и запуска (вне VS эти переменные не отражаются). Ключ –nt32 указывает системе сборки, что компилировать исходники надо для пакета (package) Nt32Pkg, расположенного в C:\FW\edk2\Nt32Pkg. Этих пакетов там много, мы их рассмотрим, но не сейчас.

В третьей строке мы даем команду на компиляцию в только что настроенной среде (build.exe лежит в C:\FW\edk2\BaseTools\Bin\Win32, этот путь прописывается в предыдущей строчке, в edksetup.bat)

Итак, вот что у нас должно появиться в итоге в текстовом окне Build Command Line:

Затем вводим в следующей строке Rebuild Command Line в открывшееся по Edit … окно следующий текст

set NASM_PREFIX=C:\FW\NASM\

call c:\FW\edk2\edksetup.bat --nt32

build clean

buildКоманда build clean означает то самое, что вы предполагаете. Она делает полную перестройку проекта с перекомпиляцией всех модулей.

Что мы вводим в окне из Clean Command Line, наверное, все уже догадались:

set NASM_PREFIX=C:\FW\NASM\

call c:\FW\edk2\edksetup.bat --nt32

build cleanЧестно говоря, особо эта опция не нужна, в 99% случаев хватит Rebuild, но пускай будет – например, очистить среду для ее переноса в другое место или заливки на github.

В итоге, у нас должно получиться вот такое окно:

Все с настройкой NMake.

Настройка опции Debugging

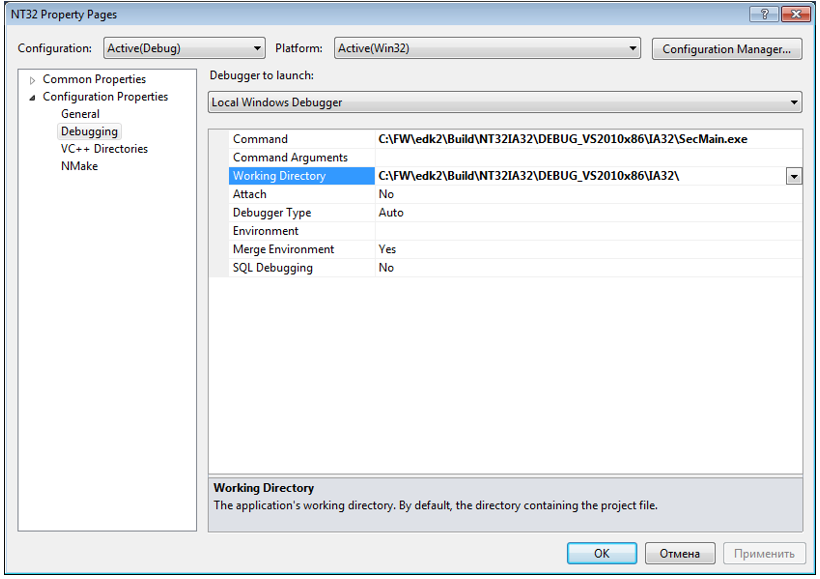

Итак, открываем строчку Debugging и вводим:

В строчке Command:

C:\FW\edk2\Build\NT32IA32\DEBUG_VS2010x86\IA32\SecMain.exeВ строчке “Working Directory”:

C:\FW\edk2\Build\NT32IA32\DEBUG_VS2010x86\IA32\Пара комментариев:

SecMain.exe – объяснять сейчас, что это такое – долго, если очень кратко и упрощенно – то это аналог bootloader-a, который запускает все остальное.

Рабочий каталог – сюда будут помещаться все успешно созданные модули, и доступны они будут все сразу из командной строки.

Итак, вот что мы должны получить после настроек в этом окне:

На этом все с настройками проекта.

Построение проекта

Вызываем Build Solution, смотрим на экран примерно минуту, в течение которой есть наибольший риск быть обруганным компилятором, и идем пить кофе – создаваться это все будет 10-15 мин, в зависимости от ресурсов вашего компьютера. Ничто нудное не вечно, и в конце концов мы получаем сообщение:

========== Build: 1 succeeded, 0 failed, 0 up-to-date, 0 skipped ==========Если же вместо этого получено что-то иное, смотрите, правильно ли вы прошли все шаги. Наиболее тяжелый случай – получить:

LINK : fatal error LNK1123: failure during conversion to COFF: file invalid or corruptэто баг среды VS2010 и означает, что VS2010 установлен без SP1. Поставьте SP1, или ищите способы затыкания этой ошибки в инете.

Если же получили ошибку и из сообщений компилятора не понятно, что это такое – переставьте дефолтный проект на NT32 и запустите его на компиляцию с отладкой. Если и там ошибка – проверьте еще раз соответствие TOOL_CHAIN_TAG предопределенным значениям, описанным в tools_def.txt. Больше ничего там упираться не может, разве что сам Visual Studio установлен, хм, не вполне стандартно, или использует сторонний компилятор.

Работа в UEFI Shell

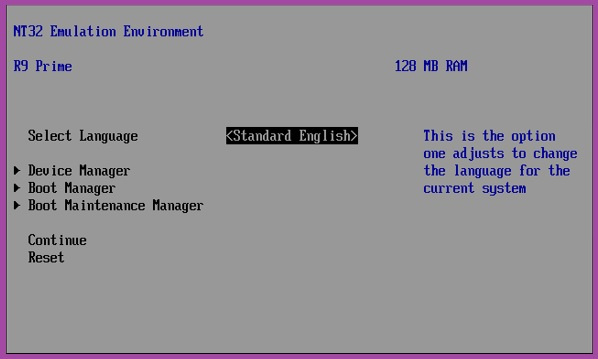

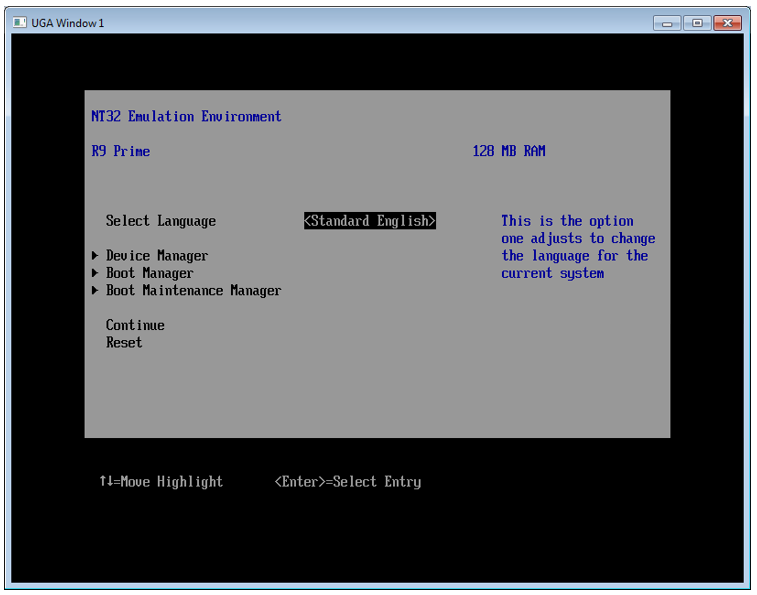

Итак, все скомпилялось хорошо, и вы читаете эти строки. Теперь жмем на любимую F5 и после примерно минуты работы с диском (чуть позже сократим и это время) получаем вот такую требуемую картинку:

Собственно, это и есть UEFI Shell. Как в нем работать – написана куча руководств, посмотрите в Гугле, а мы пока сделаем в нем несколько вещей.

1. Смотрим, что мы там накомпиляли за эти 10 минут. Вводим fs0 (UEFI Shell нечувствителен к регистру) и затем ls –b, где опция –b означает ожидание нажатия Enter для прокрутки страницы, ибо список там большой, не на один экран.

Теперь стало понятно, что означал параметр “Working Directory” в настройке опций проекта Visual Studio — C:\FW\edk2\Build\NT32IA32\DEBUG_VS2010x86\IA32\. Там этот же самый список файлов, и лучше его смотреть (и редактировать скрипты) через развитую оболочку Far Commander (или Total Commander), чем с командной строки в UEFI Shell.

2. В UEFI Shell и набираем “hel”, жмем Tab и видим на экране Helloworld.efi. Не то, чтобы мы совсем не догадывались, что будет, если нажать после этого Enter, но проверить-то надо! Жмем и получаем троекратное UEFI Hello World!. Число повторений – это конфигурируемый в настройках среды (а не в исходниках) внешний параметр и мы будем эту конфигурацию потом разбирать.

3. Набираем exit и попадаем в наше любимое и знакомое окно:

Ну вот, можно любоваться на плоды своих трудов. После этого стрелками гоним фокус на Reset и виртуалка закрывается, возвращая нас в знакомое окно MSVC.

Выводим свою строку

Создание полностью своего приложения потребует достаточно много настроек, которые лучше будет рассмотреть в следующей статье — иначе получится большой объем, а длинные простыни никто не читает. Однако же в заголовке этой статьи написано «Программирование», а мы пока занимались только настройкой. Чтобы сдержать обещание, давайте в этой статье сделаем очень простую модификацию приложения HelloWorld, используя его имеющийся набор файлов, а в следующей статье создадим свой, при помощи Интеловской утилиты UEFI Driver Wizard, поскольку прогонять начинающих по полному циклу создания набора файлов для UEFI драйвера (или приложения) — это нечеловеколюбиво, дико рутинно и несет риск потери 90% аудитории. Если человека зацепит — он сам к этому придет со временем, а если хочется просто поиграться — нет смысла тратить на это кучу времени, благо многое давно уже делается автоматически через UEFI Driver Wizard, причем по фэн-шуй, чего от новичка ждать наивно.

Итак, открываем в Visual Studio файл

C:\FW\edk2\MdeModulePkg\Application\HelloWorld\HelloWorld.cИ добавим свою простую строчку, сразу после объявления переменных в единственной функции:

Print (L"I did it in UEFI!\r\n");Разумеется, текст можно заменить на что угодно, только английскими буквами — русский шрифт edk2 еще не понимает, мы добавим его в следующих статьях. Можете поставить на эту строку обычный breakpoint и посмотреть, как себя поведет Visual Studio.

Жмем F5, после компиляции и устранения ошибок вводим «fs0», HelloWorld и получим такой вывод:

На этом все. В следующей статье мы немного поработаем в UEFI Shell, чтобы освоиться, и разберем немного теории.

Что хотелось бы узнать сейчас — как выделение жирным шрифтом влияет на восприятие? Новый материал так воспринимается легче, на мой взгляд — но люди разные.

|

Метки: author DarkTiger системное программирование uefi bios |

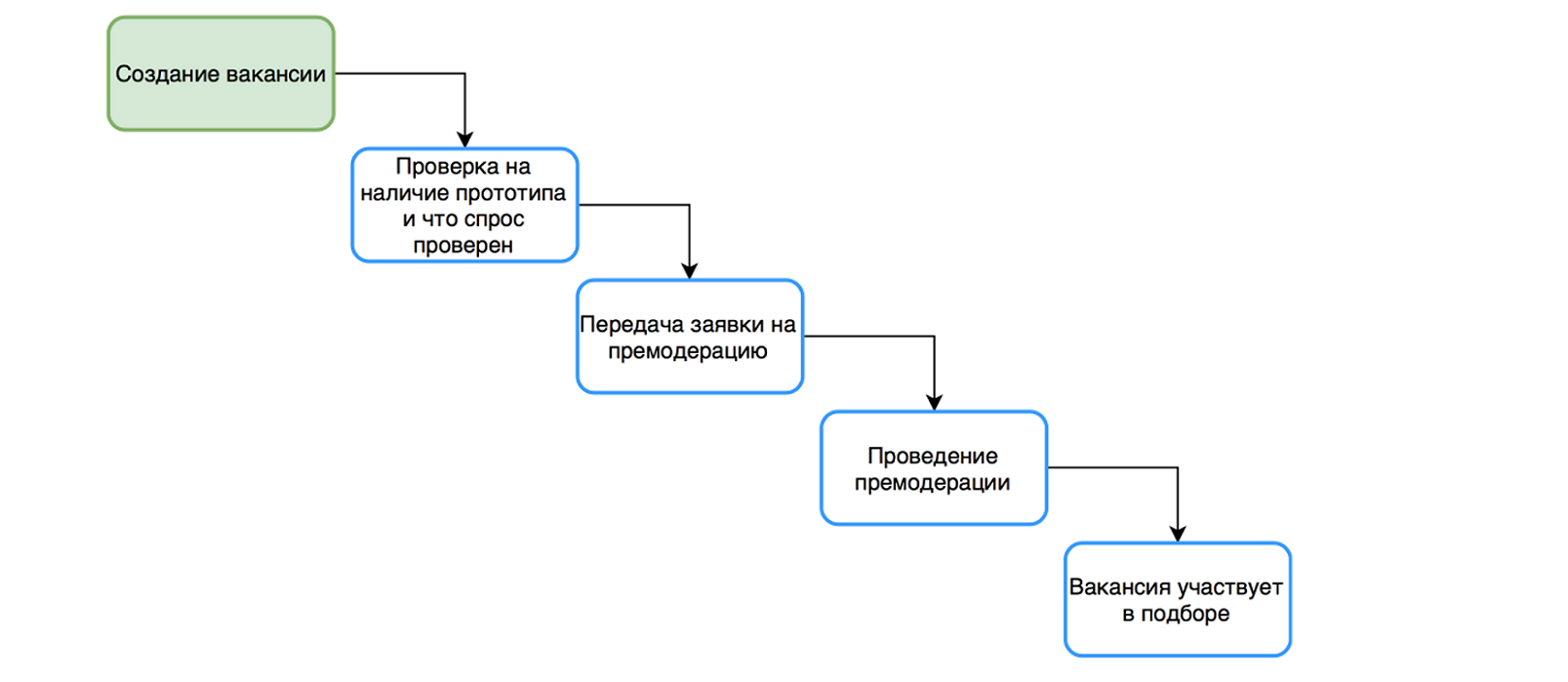

Superjob IT-meetup. Системный бизнес-анализ |

Superjob IT-meetup. Системный бизнес-анализ

На встрече обсудим работу с бизнес-требованиями к системе на ранних стадиях: организацию коммуникации, переход от бизнес-анализа к системному анализу, методы ускорения работы, инструменты повышения качества аналитических артефактов. Приглашаем системных, бизнес-аналитиков и менеджеров IT-проектов.

Что нужно, чтобы запустить новый ИТ-проект или итерацию развития системы?

- Спонсору — прогноз, сколько стоит система, как и когда окупятся инвестиции.

- Технической команде — требования для планирования и выполнения работ.

- Маркетологам — основные фишки для «упаковки» продукта.

- Конечным потребителям — понятные объяснения, что они получат.

Все это нужно

- Быстро и дешево, так как это стадия, когда особенно не любят ждать.

- Суперкачественно, так как здесь закладываются основные риски проекта.

- Понятно, так как на этом этапе происходят самые головокружительные перепады стиля коммуникации — от маркетинговых лозунгов до строгих ТЗ, от кулуарных обсуждений до публичных презентаций.

Тайминг и спикеры:

19.00—19.40 — Сергей Нужненко, ведущий аналитик Superjob

Тема: «Шаблоны сбора, анализа и коммуникации требований в предпроекте»

Речь пойдет об особенностях работы аналитика в предпроекте: как меняются акценты в общеупотребимых методиках работы с требованиями, какие шаблоны анализа и документирования позволяют сократить затраты.

19.40—20.20 — Денис Бесков, сооснователь и руководитель Школы системного анализа

Тема: «Типичные ошибки предпроектной стадии и как с ними бороться»

Расскажет о типичных ошибках предпроектной стадии и смене лексики в индустрии от требований к ценности. Откуда это берётся, зачем это надо, почему теперь мы на стадии предпроекта ищем ценность, а не разрабатываем требования.

20.20—20.40 — Елена Рожкова, CEO «АЭРОС Систем», в прошлом — бизнес и системный аналитик компаний IBS, Астерос Консалтинг, ТопС Бизнес Интегратор.

Тема: «Бизнес-аналитика на ранних стадиях проекта»

Поговорим о том, как работать с контентом, с чего начать, и рассмотрим дальнейший порядок действий. Цель — предварительный бизнес-анализ по проекту с максимальной скоростью и максимальным качеством.

20.40—21.00 — Спикер уточняется.

Вход бесплатный, количество мест ограниченно. Зарегистрироваться здесь.

В день мероприятия возьмите с собой паспорт или водительское удостоверение для прохода в наш бизнес-центр.

Отчеты с предыдущих митапов можно найти в официальной группе Superjob IT-meetup в Facebook.

|

|

Платформа ServiceNow: тематическая подборка материалов для начинающих |

Платформа ServiceNow: тематическая подборка материалов для начинающих

/ Flickr / Dean Hochman / CC

/ Flickr / Dean Hochman / CCСамые популярные вопросы при внедрении ServiceNow. Краткий ликбез по теме, с которого мы рекомендуем начать «погружение». Здесь мы рассказываем, из чего складывается стоимость платформы, почему использована модель SaaS, как и чем обеспечивается безопасность и автоматизация. Что еще есть в этом FAQ: немного о персонализации и создании отчетов.

Помимо чтения этого раздела мы рекомендуем посмотреть специальное видео. В нем мы рассказываем о принципах работы ServiceNow, технологиях платформы, даем обзор интерфейса, ролей и способах их назначения:

Аналитические обзоры

ServiceNow — лучшее решение ITSM в 2017 году по мнению Gartner. Расскажем, что позволило ServiceNow заслужить титул лучшей платформы для управления ИТ-процессами. Помимо этого — говорим об амбициозных планах на будущее и разбираемся с тем, какие технологии компания будет развивать в дальнейшем.

«На полпути»: Пятерка главных новостей компании ServiceNow за 2017 год. Из этой статьи вы узнаете подробности о таких событиях как: новый релиз Jakarta, покупка стартапа DxContinuum, сотрудничество с IBM и MapAnything, проекте Qlue и системах ИИ в ServiceNow.

ServiceNow Jakarta: обзор новых возможностей. Знакомимся с июльским релизом платформы на практике. В формате, который немного напоминает tutorial, мы прошлись по новому функционалу и рассказали о том, на какие моменты стоит обратить внимание.

ServiceNow Jakarta: для бизнеса. В этом аналитическом обзоре мы сделали акцент на управленческую составляющую. Как обычно — в формате ознакомительного tutorial'а.

ServiceNow Communities: новый сервис для повышения лояльности клиентов. Учимся управлять форумами и топиками с помощью Communities. Здесь есть все, что нужно для работы: от модерации до индивидуальных профилей клиентов.

Практические материалы

Далее мы приведем видеогайд от Ивана Жигалова, директора компании ИТ Гильдия. Он расскажет об управлении проектами на платформе ServiceNow. Речь пойдет о распределении ролей, карточке и консоли проекта, планировании спринта, отчетах и особенностях управления ресурсами.

Как создать и начать использовать каталог услуг (Service Catalog). Статья затрагивает проблемы ограниченного и неструктурированного доступа к ИТ-услугам компании. Чтобы помочь вам навсегда забыть о путанице, мы рассматриваем шаблоны описания услуг, поддержку каталога услуг в актуальном состоянии и работу с мнением сотрудников вашей компании.

Как внедрить процессы управления конфигурацией. Думаем о том, как не растрачивать человеческие ресурсы и деньги впустую, а направлять их в том числе и на оптимизацию бизнес-процессов. Это — один из наших первых материалов на Хабре. Здесь мы разбираемся с оценкой статуса инфраструктуры компании, азами успешного контроля и мониторинга изменений при внедрении процессов, отслеживанием жизненного цикла и основными вопросами для аудита.

Financial Management: Как оценить затраты на предоставляемые услуги. Затраты на обеспечение ИТ-систем в любой организации занимают отдельные статьи бюджета, но путаница в их структуре препятствует четкому пониманию их воздействия на достижение целей компании. Разберемся в механизмах управления финансами, планировании бюджета и рассмотрим два варианта расчета затрат. Все это на примере набора инструментов ServiceNow.

В видеогайде, который мы привели далее, мы говорим о более высоком уровне управления проектами — о программах проектов. Здесь мы рассматриваем инструменты визуализации и управления для более эффективной работы менеджеров проекта:

Немного о человеческих ресурсах и опыте успешных компаний

Простой способ сделать самообслуживание популярнее. Как сделать так, чтобы как можно больше ваших сотрудников пользовались порталом самообслуживания для решения своих проблем? Почему они любят прикидываться «блондинками», как провести для них грамотный ликбез или «эффект ИКЕА в действии».

5 человеческих ресурсов для успешного внедрения ServiceNow. Какие специалисты нужны для внедрения ServiceNow, и что нужно учесть при планировании человеческих ресурсов? Рассмотрим, пять групп экспертов, которые необходимы для реализации этой задачи. Плюс — подводные камни, которые могут встретиться в процессе реализации.

6 лучших сценариев обслуживания клиентов. Что делать с рассерженным клиентом, как сделать «сэндвич из комплимента» и признать, что вы не правы? Предлагаем вам проверенные тактики поведения для разрешения внештатных ситуаций.

«Вредные советы»: Как потерять клиента или 7 лучших прощальных фраз. Рассмотрим работу отдела технической поддержки и способы замены клишированных фраз при общении с клиентом. Разберемся, как вести себя в непростых ситуациях и как убедить клиента в том, что «решение его проблемы возможно, и мы непременно его найдем», даже если решения у вас пока нет.

Что еще почитать по теме

Немного о ServiceNow, ITSM и ServiceDesk в формате подборки полезных материалов. Это — наш первый дайджест полезных материалов по теме. Здесь мы постарались подобрать практические руководства, материалы об ошибках и решениях, плюс статьи об истории компании.

Знакомство с ServiceNow и управлением ИТ-инфраструктурой: Дайджест #2. Наш второй дайджест продолжает логику первого — мы стараемся дать практические материалы и не забывать о теории. Здесь вы найдете статьи об управлении инфраструктурой и разработкой, вместе с этим — разберетесь со стандартами и мифами, которые окружают тему управления услугами.

«Горшочек, вари»: 50 инструментов для управления разработкой. Мы постарались собрать максимум полезных материалов, чтобы немного разгрузить разработчиков от повседневной рутины. Здесь мы сделали ставку на системы автоматизации, инструменты для управления проектами, прототипирования и тестирования.

|

Метки: author it-guild service desk блог компании ит гильдия ит гильдия servicenow |

Рекомендации по нейтрализации угроз, связанных с уязвимостью CVE-2017-8759 |

Рекомендации по нейтрализации угроз, связанных с уязвимостью CVE-2017-8759

Общее описание угрозы

12 сентября 2017 года была опубликована информация об уязвимости CVE-2017-8759, которая связана с удаленным выполнением кода с использованием документов Microsoft Office.

Уязвимость была обнаружена компанией FireEye вследствие фиксации ряда атак с использованием ранее неизвестного эксплойта.

Уязвимости CVE-2017-8759 подвержены операционные системы семейства Microsoft Windows. Эксплуатация данной уязвимости с внедрением стороннего кода производится с помощью уязвимого компонента Microsoft.NET Framework – SOAP WSDL Parser, позволяет получить пользовательские права на уязвимой системе.

Данная уязвимость имеет высокую степень критичности по ряду причин:

1) Эксплуатация уязвимости не требует использования и включения макросов в офисных приложениях Microsoft Office;

2) Для эксплуатации уязвимости пользователю достаточно открыть вредоносный файл;

3) Код эксполойта для данной уязвимости опубликован в открытом доступе в сети Интернет и это означает, что данной уязвимостью может воспользоваться любой пользователь сети.

Наименование угрозы: CVE-2017-8759 «.NET Framework Remote Code Execution Vulnerability».

Возможные векторы атаки: рассылка целевого фишинга с вложением документа Microsoft Office (doc, rtf и др.).

Уязвимые системы: операционные системы семейства Microsoft Windows от Windows 7 до последних версий, компонент Microsoft .NET Framework от версии 2.0 до 4.72. Полный перечень уязвимых ОС и компонентов представлен по ссылке.

Масштаб распространения угрозы: на данный момент зафиксирована одна фишинговая кампания, использующая эксплойт для уязвимости CVE-2017-8759 для установки троянской программы FINSPY (FinFisher).

Превентивные меры

Для снижения рисков, связанных с уязвимостью CVE-2017-8759, рекомендуется:

1. Установить обновление безопасности, соответствующее версии операционной системы и версии Microsoft .NET Framework. Полный перечень уязвимых ОС и компонентов представлен по ссылке;

2. Обновить базы сигнатур установленного антивирусного ПО;

3. Обновить базы сигнатуры IPS, защищенных почтовых и веб-шлюзов (ESG, WSG) и других сигнатурных СЗИ.

Примечание: по ссылке представлены идентификаторы полных обновлений, в то время как для систем до Windows 8.1 и Windows Server 2012 R2 существует возможность установить только обновления безопасности – столбец Security Only Release в оригинальной таблице Microsoft.

Также необходимо обновить базы сигнатур установленного антивирусного ПО в целях предотвращения заражения FINSPY.

Описание уязвимости

Уязвимость удаленного выполнения кода, зарегистрированная с идентификатором CVE-2017-8759, обнаружена экспертами компании FireEye в модуле WSDL Parser (Web Services Description Language) в Microsoft.NET Framework. Метод модуля IsValidUrl не осуществляет корректную проверку переданных значений на предмет наличия в них последовательности CRLF (перенос строки и каретки). Таким образом атакующий, используя данную последовательность имеет возможность внедрить вредоносный код в процесс выполнения модуля.

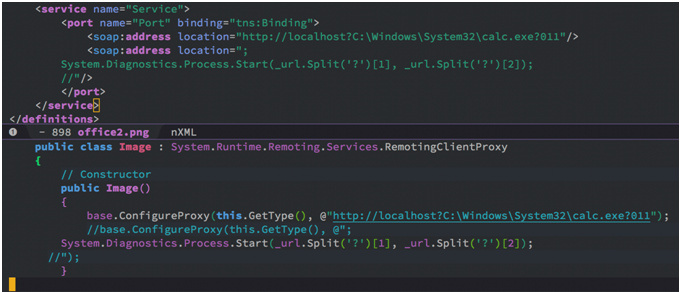

Рисунок 1. Пример использования уязвимости

Индикаторы компрометации

Известные на текущий момент хэш-суммы (MD5) вредоносных файлов:

— вредоносный файл «Проект.doc»: fe5c4d6bb78e170abf5cf3741868ea4c;

— FINSPY: a7b990d5f57b244dd17e9a937a41e7f5.

Команда экспертов «Информзащиты» готова проконсультировать все компании, обеспокоенные сложившейся ситуацией, по вопросам рисков и угроз, а также оперативно обеспечить защиту инфраструктуры.

Автор: Техническая дирекция компании «Информзащита»

|

Метки: author infosecurity_iz антивирусная защита it- инфраструктура блог компании информзащита информационная безопасность уязвимые системы нейтрализация угрозы |

[Из песочницы] learnopengl. Урок 2.6 — Несколько источников освещения |

learnopengl. Урок 2.6 — Несколько источников освещения

Несколько источников освещения

В предыдущих уроках мы выучили довольно много об освещении в OpenGL. Мы познакомились с моделью освещения по Фонгу, разобрались как работать с материалами, текстурными картами и различными типами источника света. В этом уроке мы собираемся объединить все наши знания, чтобы создать полностью освещенную сцену с 6 активными источниками света. Мы собираемся симулировать солнце как направленный источник освещения, добавим 4 точки света, разбросанные по всей сцене, и конечно мы добавим фонарик.

В предыдущих сериях

Часть 1. Начало

- OpenGL

- Создание окна

- Hello Window

- Hello Triangle

- Shaders

- Текстуры

- Трансформации

- Системы координат

- Камера

Часть 2. Базовое освещение

Чтобы использовать более чем 1 источник света в сцене, нам следует разбить расчеты типов освещения на функции. Если мы добавим расчеты всех освещений в одну функцию main, то наш код быстро испортится.

Функции в GLSL такие-же как и функции в языке C. У нас есть имя функции, возвращаемый тип и также мы можем объявить её прототип сверху, а описать её снизу. Мы создадим разные функции для каждого типа освещения: направленного источника освещения, точечного источника и прожектора.

При использовании нескольких источников освещение в сцене, подход обычно такой: у нас есть 1 вектор цвета, который представляет выходной цвет фрагмента. Результат вычисления каждого источника света добавляется к этому вектору. То есть мы будем вычислять каждый цвет фрагмента, относительно каждого источника света в сцене, и комбинировать его с выходным цветом. Сама функция main может выглядеть примерно так:

out vec4 FragColor;

void main()

{

// устанавливаем значение нашего выходного цвета

vec3 output = vec3(0.0);

// добавляем значение, полученное из направленного источника освещения

output += someFunctionToCalculateDirectionalLight();

// делаем тоже самое и с точечным источником

for(int i = 0; i < nr_of_point_lights; i++)

output += someFunctionToCalculatePointLight();

// и добавляем остальные значения так же

output += someFunctionToCalculateSpotLight();

FragColor = vec4(output, 1.0);

}Конечный код будет отличатся в зависимости от реализации, но функция main останется такой же. Мы определяем наши функции, вычисляющие их цвет для данного фрагмента и добавляем его в наш результат, который мы присваиваем выходному вектору цвета. Если для примера 2 источника света будут близко находится к фрагменту, их комбинацией будет результат более яркий освещенный фрагмент, чем фрагмент освещенный одним источником освещения.

Направленный источник освещения

Нам нужно написать функцию в фрагментальном шейдере, которая вычисляет результат направленного света на какой-либо фрагмент: функция принимает несколько параметров и возвращает вычисленное значение цвета фрагмента.

Первое, что нам нужно, это решить, какой минимальный набор переменных нам нужен для вычисления направленного источника света. Мы будем хранить переменные в структуре DirLight и объявим её объект как uniform. Эти переменные должны быть вам хорошо знакомы с

предыдущего урока:

struct DirLight {

vec3 direction;

vec3 ambient;

vec3 diffuse;

vec3 specular;

};

uniform DirLight dirLight;Мы можем передать наш объект dirLight в функцию со следующим прототипом:

vec3 CalcDirLight(DirLight light, vec3 normal, vec3 viewDir);Также как в C и C++, если мы хотим вызвать функцию (в нашем случае внутри функции main) функция должна быть объявлена где-нибудь до того момента, где мы её вызываем. В нашем случае, мы объявим прототип над функцией main, а опишем её где нибудь ниже.Вы можете видеть, что функция требует DirLight структуру и 2 вектора. Если вы успешно завершили предыдущие уроки, тогда код этой функции не должен вызывать для вас вопросов:

vec3 CalcDirLight(DirLight light, vec3 normal, vec3 viewDir)

{

vec3 lightDir = normalize(-light.direction);

// диффузное освещение

float diff = max(dot(normal, lightDir), 0.0);

// освещение зеркальных бликов

vec3 reflectDir = reflect(-lightDir, normal);

float spec = pow(max(dot(viewDir, reflectDir), 0.0), material.shininess);

// комбинируем результаты

vec3 ambient = light.ambient * vec3(texture(material.diffuse, TexCoords));

vec3 diffuse = light.diffuse * diff * vec3(texture(material.diffuse, TexCoords));

vec3 specular = light.specular * spec * vec3(texture(material.specular, TexCoords));

return (ambient + diffuse + specular);

} Пользуясь примером кода с предыдущего урока и используя вектора, которые принимает функция в качестве аргументов, вычисляем результат каждого компонента (ambient, diffuse и specular). Затем суммируем наши компоненты и получаем конечный цвет фрагмента.

Точечные источники освещения

Так же как и в направленном источнике освещения, мы также определяем функцию, вычисляющее цвет фрагмента от точечного света, включая затухание. Также как и в направленном источнике освещения, мы объявим структуру с минимальным набором

переменных для точечного источника:

struct PointLight {

vec3 position;

float constant;

float linear;

float quadratic;

vec3 ambient;

vec3 diffuse;

vec3 specular;

};

#define NR_POINT_LIGHTS 4

uniform PointLight pointLights[NR_POINT_LIGHTS];Как вы можете видеть мы использовали препроцессор GLSL, что-бы объявить число точечных источников NR_POINT_LIGHTS равное 4. Мы используем эту константу NR_POINT_LIGHTS, чтобы создать объект массив структуры PointLight. Массивы в GLSL такие же как и массивы в C и

могут быть созданы с использованием двух квадратных скобок. Прямо сейчас у нас есть 4 объекта pointLights[NR_POINT_LIGHTS] структуры PointLigh.

Мы могли также создать одну большую структуру, которая включала бы все нужные переменные для всех разных типов освещения, и использовали бы её для каждой функции, игнорируя переменные в которых бы мы не нуждались. Хотя, я лично нахожу нынешний подход более лучшим, т.к. не всем типам освещения будут нужны все переменные.Прототип функции точечного источника:

vec3 CalcPointLight(PointLight light, vec3 normal, vec3 fragPos, vec3 viewDir);Функция принимает все данные, в которых она нуждается и возвращает vec3 с вычисленным цветом фрагмента. Снова, несколько манипуляций копировать-вставить из предыдущего урока, приводит к следующему результату:

vec3 CalcPointLight(PointLight light, vec3 normal, vec3 fragPos, vec3 viewDir)

{

vec3 lightDir = normalize(light.position - fragPos);

// диффузное освещение

float diff = max(dot(normal, lightDir), 0.0);

// освещение зеркальных бликов

vec3 reflectDir = reflect(-lightDir, normal);

float spec = pow(max(dot(viewDir, reflectDir), 0.0), material.shininess);

// затухание

float distance = length(light.position - fragPos);

float attenuation = 1.0 / (light.constant + light.linear * distance +

light.quadratic * (distance * distance));

// комбинируем результаты

vec3 ambient = light.ambient * vec3(texture(material.diffuse, TexCoords));

vec3 diffuse = light.diffuse * diff * vec3(texture(material.diffuse, TexCoords));

vec3 specular = light.specular * spec * vec3(texture(material.specular, TexCoords));

ambient *= attenuation;

diffuse *= attenuation;

specular *= attenuation;

return (ambient + diffuse + specular);

} Основное преимущество функции, что мы можем рассчитать результирующий цвет, для разных точечных источников, не дублируя код. В функции main мы просто создаем цикл, в котором итерируемся по нашему массиву точечного источника и вызываем функцию CalcPointLight для каждой точки.

Объединяем всё вместе

Теперь, когда мы написали наши функции для направленного и точечного источника освещения, мы можем вызвать их в функции main.

void main()

{

// свойства

vec3 norm = normalize(Normal);

vec3 viewDir = normalize(viewPos - FragPos);

// фаза 1: Направленный источник освещения

vec3 result = CalcDirLight(dirLight, norm, viewDir);

// фаза 2: Точечные источники

for(int i = 0; i < NR_POINT_LIGHTS; i++)

result += CalcPointLight(pointLights[i], norm, FragPos, viewDir);

// фаза 3: фонарик

//result += CalcSpotLight(spotLight, norm, FragPos, viewDir);

FragColor = vec4(result, 1.0);

}Каждый тип освещения добавляет свой вклад в выходной вектор цвета, до тех пор, пока не будут обработаны все источники света. Выходной вектор цвета содержит все вычисления источников света в сцене. Если вы хотите, вы можете также добавить сами функцию прожектора, опираясь на код с предыдущего урока. Мы оставим функцию CalcSpotLight в качестве упражнения для читателей.

Установка значений uniform переменным не должна быть для вас незнакомой, но вы можете быть удивлены как мы можем установить uniform переменные для объекта структуры точечного освещения.

Удачно для нас, что это не слишком сложно. Чтобы задать значение конкретному объекту uniform массива, нужно лишь обратиться к этому объекту, как к обычному массиву (через индекс).

lightingShader.setFloat("pointLights[0].constant", 1.0f);Здесь мы обращаемся к 1 элементу нашего массива pointLights и устанавливаем значение 1.0f переменной constant. К сожалению это значит, что мы должны таким-же способом установить все переменные, всем элементам массива, что в итоге приведет к 28 строка кода. Вы можете попытаться, написать боле удобный код для этой задачи.

Не забываем, что мы также нуждаемся в position векторе, для каждого точечного источника освещения. Мы определим массив glm::vec3, который будет хранить эти позиции:

glm::vec3 pointLightPositions[] = {

glm::vec3( 0.7f, 0.2f, 2.0f),

glm::vec3( 2.3f, -3.3f, -4.0f),

glm::vec3(-4.0f, 2.0f, -12.0f),

glm::vec3( 0.0f, 0.0f, -3.0f)

}; Далее, мы просто проиндексируемся по этому массиву и установим значения position для каждого объекта массива pointLight. Также, нам нужно нарисовать 4 световых куба, вместо 1. Простой способ сделать это, передавать разные значения матрицы модели, используя наш только что созданный массив pointLightPositions.

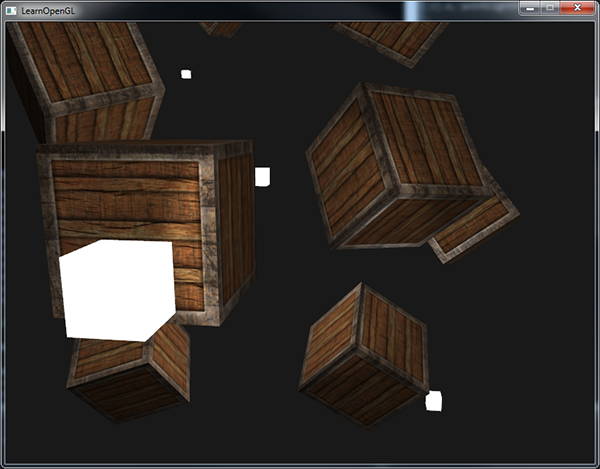

Если вы будите использовать фонарик, то наша сцена будет выглядеть примерно так:

Как вы можете видеть, эта сцена включает в себя все наши типы освещения: глобальный свет (как солнце) где-то в небе, так же есть 4 разбросанных световых ящиков по всей сцене и фонарик, светящий из камеры наблюдателя. Выглядит довольно аккуратно, не правда ли?

Вы можете найти полный код здесь.

На изображение представлены все типы освещения с настройками по умолчанию, которые мы использовали в предыдущих уроках, но если вы поиграете с этими значениями, вы можете получить довольно интересные результаты. Художники, как правило настраивают эти переменные освещения в каком нибудь редакторе, чтобы убедится, что освещения соответствуют реальной среде. Используя нашу освещенную среду, вы можете настроить разные, интересные визуальные эффекты, просто настроив их артрибуты:

Мы также изменили значение ClearColor, чтобы лучше отражать свет. Вы можете видеть, что просто регулируя некоторые параметры освещения вы можете создать совершенно разную атмосферу.

Сейчас вы должны иметь довольно хорошее понимание об освещении в OpenGL. С этими знаниями, вы уже можете создать интересную, визуально богатую и атмосферную сцену. Попробуйте поиграться с разными значениями освещения, чтобы создать свою собственную атмосферную сцену.

Задания

Воссоздайте различные типы атмосферных сцен, с последнего изображения, заменив значения артрибутов света ссылка.

-> Оригинал статьи

|

Метки: author dima19972525 разработка игр c++ перевод glsl opengl opengl 3 light casters shading |

It's a (focus) Trap |

|

Метки: author kashey javascript html aria a11y dom |

Sberbank In-Memory Computing Day |

|

Метки: author megapost высокая производительность сбер |

Трансляция конференции «HPE Genesis: инфраструктура вычислений будущего» |

Трансляция конференции «HPE Genesis: инфраструктура вычислений будущего»

Ответы на эти вопросы вы узнаете на трансляции конференции «HPE Genesis: инфраструктура вычислений будущего», которую компания Hewlett Packard Enterprise проводит в партнерстве с компанией Intel завтра, 20 сентября. Расписание трансляции ниже. Подключайтесь — будет интересно!

Расписание трансляции (по МСК):

10:00 — 10:05 Открытие мероприятия, приветственное слово

10:05 — 10:25 Стратегия Hewlett Packard Enterprise

10:25 — 10:45 Новые возможности с масштабируемыми процессорами Intel Xeon

10:45 — 11:15 HPE ProLiant Gen10 — самые производительные и безопасные серверы

11:15 — 11:45 Серверы нового поколения для HPE BladeSystem c-Class и Synergy

11:45 — 12:00 — Перерыв

12:00 — 12:20 Серверные опции для повышения производительности, надежности и эффективности

12:20 — 12:40 Управление серверной инфраструктурой c iLO5 и OneView

12:40 — 13:00 HPE SimpliVity 380 — наиболее полная гиперконвергентная платформа на рынке

13:00 — 13:20 Системы хранения данных HPE

13:20 — 13:40 Практика применения высокопроизводительных вычислений HPE: искусственный интеллект и и вычисления на МКС.

13:40 — 14:00 The Machine — вычисления, ориентированные на память

Ждем вас на трансляции! Материалы презентаций будут доступны в нашем канале Telegram: t.me/hpedigitize.

|

|

[Перевод] Создаём GTK-видеоплеер с использованием Haskell |

Создаём GTK-видеоплеер с использованием Haskell

- Перевод

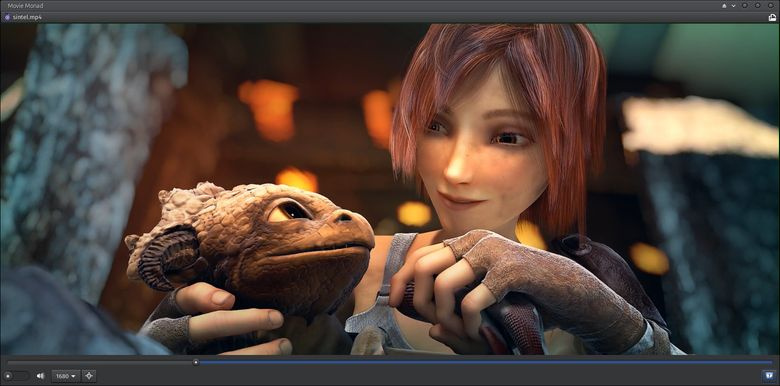

Когда мы в последний раз остановились на Movie Monad, мы создали десктопный видео-плеер, использующий все веб-технологии (HTML, CSS, JavaScript и Electron). Фокус был в том, что весь исходный код проекта был написан на Haskell.

Одним из ограничений нашего веб-подхода было то, что размер видео-файла не мог быть слишком большим, в противном случае приложение падало. Чтобы этого избежать, мы внедрили проверку размера файла и предупреждали пользователя о превышении ограничения.

Мы могли бы продолжить развивать наш подход с вебом, настроив бэкенд на стриминг видеофайла в HTML5-сервер, запустив параллельно сервер и Electron-приложение. Вместо этого мы откажемся от веб-технологий и обратимся к GTK+, Gstreamer и системе управления окнами X11.

Если вы используете другую систему управления окнами, например, Wayland, Quartz или WinAPI, то этот подход может быть адаптирован для работы с вашим GDK-бэкендом. Адаптация заключается во встраивании выходного видеосигнала GStreamer playbin в окно Movie Monad.

GDK — важный аспект портируемости GTK+. Поскольку Glib уже предоставляет низкоуровневую кроссплатформенную функциональность, то чтобы заставить GTK+ работать на других платформах вам нужно только портировать GDK на базовый графический уровень операционной системы. То есть именно GDK-порты на Windows API и Quartz позволяют приложениям GTK+ исполняться на Windows и macOS (источник).

Для кого эта статья

- Для программистов на Haskell, которые хотят реализовать пользовательский интерфейс на GTK+.

- Для программистов, интересующихся функциональным программированием.

- Для создателей GUI.

- Для тех, кто ищет альтернативы GitHub Electron.

- Для фанатов видео-плееров.

Что мы рассмотрим

- Stack.

- Привязки (bindings) haskell-gi

- Директорию различных данных и файлы с ними.

- Glade.

- GTK+.

- GStreamer.

- Как создать Movie Monad.

Настройка проекта

Сначала нам нужно настроить машину для разработки Haskell-программ, а также настроить файлы и зависимости для директории проекта.

Платформа Haskell

Если ваша машина ещё не готова к разработке Haskell-программ, то всё необходимое вы можете получить, скачав и установив платформу Haskell.

Stack

Если у вас ещё нет Stack, то обязательно установите его, прежде чем приступать к разработке. Но если вы уже пользовались платформой Haskell, то Stack у вас уже есть.

ExifTool

Прежде чем проигрывать видео в Movie Monad, нам нужно собрать кое-какую информацию о выбранном пользователем файле. Для этого воспользуемся ExifTool. Если вы работаете под Linux, то велик шанс, что у вас уже есть этот инструмент (which exiftool). ExifTool доступен для Windows, Mac и Linux.

Файлы проекта

Есть три способа получения файлов проекта.

wget https://github.com/lettier/movie-monad/archive/master.zip

unzip master.zip

mv movie-monad-master movie-monad

cd movie-monad/Можете скачать ZIP-архив и извлечь их.

git clone git@github.com:lettier/movie-monad.git

cd movie-monad/Можете сделать Git-клон с помощью SSH.

git clone https://github.com/lettier/movie-monad.git

cd movie-monad/Можете склонировать git через HTTPS.

haskell-gi

haskell-gi умеет генерировать Haskell-привязки (bindings) к библиотекам, использующим связующее ПО для самодиагностики (introspection middleware) GObject. На момент написания статьи все необходимые привязки доступны на Hackage.

Зависимости

Теперь устанавливаем зависимости проекта.

cd movie-monad/

stack install --dependencies-onlyКод

Теперь настраиваем внедрение Movie Monad. Вы можете удалить исходные файлы и создать их заново, или следовать указаниям.

Paths_movie_monad.hs

Paths_movie_monad.hs используется для поиска файла Glade XML GUI во время runtime. Поскольку мы занимаемся разработкой, то будем использовать фиктивный модуль (dummy module) (movie-monad/src/dev/Paths_movie_monad.hs) для поиска файла movie-monad/src/data/gui.glade. После сборки/установки проекта реальный модуль Paths_movie_monad будет сгенерирован автоматически. Он предоставит нам функцию getDataFileName. Она присваивает своим выходным данным префикс в виде абсолютного пути, куда скопированы или установлены data-dir (movie-monad/src/) data-files.

{-# LANGUAGE OverloadedStrings #-}

module Paths_movie_monad where

dataDir :: String

dataDir = "./src/"

getDataFileName :: FilePath -> IO FilePath

getDataFileName a = do

putStrLn "You are using a fake Paths_movie_monad."

return (dataDir ++ "/" ++ a)Фиктивный модуль Paths_movie_monad.

{-# LANGUAGE CPP #-}

{-# OPTIONS_GHC -fno-warn-missing-import-lists #-}

{-# OPTIONS_GHC -fno-warn-implicit-prelude #-}

module Paths_movie_monad (

version,

getBinDir, getLibDir, getDynLibDir, getDataDir, getLibexecDir,

getDataFileName, getSysconfDir

) where

import qualified Control.Exception as Exception

import Data.Version (Version(..))

import System.Environment (getEnv)

import Prelude

#if defined(VERSION_base)

#if MIN_VERSION_base(4,0,0)

catchIO :: IO a -> (Exception.IOException -> IO a) -> IO a

#else

catchIO :: IO a -> (Exception.Exception -> IO a) -> IO a

#endif

#else

catchIO :: IO a -> (Exception.IOException -> IO a) -> IO a

#endif

catchIO = Exception.catch

version :: Version

version = Version [0,0,0,0] []

bindir, libdir, dynlibdir, datadir, libexecdir, sysconfdir :: FilePath

bindir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/bin"

libdir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/lib/x86_64-linux-ghc-8.0.2/movie-monad-0.0.0.0"

dynlibdir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/lib/x86_64-linux-ghc-8.0.2"

datadir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/share/x86_64-linux-ghc-8.0.2/movie-monad-0.0.0.0"

libexecdir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/libexec"

sysconfdir = "/home//.stack-work/install/x86_64-linux-nopie/lts-9.1/8.0.2/etc"

getBinDir, getLibDir, getDynLibDir, getDataDir, getLibexecDir, getSysconfDir :: IO FilePath

getBinDir = catchIO (getEnv "movie_monad_bindir") (\_ -> return bindir)

getLibDir = catchIO (getEnv "movie_monad_libdir") (\_ -> return libdir)

getDynLibDir = catchIO (getEnv "movie_monad_dynlibdir") (\_ -> return dynlibdir)

getDataDir = catchIO (getEnv "movie_monad_datadir") (\_ -> return datadir)

getLibexecDir = catchIO (getEnv "movie_monad_libexecdir") (\_ -> return libexecdir)

getSysconfDir = catchIO (getEnv "movie_monad_sysconfdir") (\_ -> return sysconfdir)

getDataFileName :: FilePath -> IO FilePath

getDataFileName name = do

dir <- getDataDir

return (dir ++ "/" ++ name) Автоматически сгенерированный модуль Paths_movie_monad.

Main.hs

Main.hs — это входная точка для Movie Monad. В этом файле мы настраиваем наше окно с разными виджетами, подключаем GStreamer, а когда пользователь выходит, мы сносим окно.

Прагмы (Pragmas)

Нам нужно сказать компилятору (GHC), что нам нужны перегруженные (overloaded) строковые и лексически входящие в область видимости (lexically scoped) переменные типов.

OverloadedStrings позволяет нам использовать строковые литералы ("Literal") там, где требуются String/[Char] или Text. ScopedTypeVariables позволяет нам использовать сигнатуру типа в паттерне параметра лямбда-функции, передаваемую для перехвата при вызове ExifTool.

{-# LANGUAGE OverloadedStrings #-}

{-# LANGUAGE ScopedTypeVariables #-}Импорты

module Main where

import Prelude

import Foreign.C.Types

import System.Process

import System.Exit

import Control.Monad

import Control.Exception

import Text.Read

import Data.IORef

import Data.Maybe

import Data.Int

import Data.Text

import Data.GI.Base

import Data.GI.Base.Signals

import Data.GI.Base.Properties

import GI.GLib

import GI.GObject

import qualified GI.Gtk

import GI.Gst

import GI.GstVideo

import GI.Gdk

import GI.GdkX11

import Paths_movie_monadПоскольку мы работает с привязками Си, нам понадобится работать с типами, уже существующими в этом языке. Немалую часть импортов составляют привязки, генерируемые haskell-gi.

IsVideoOverlay

GStreamer-видеопривязки (gi-gstvideo) содержат класс типа (интерфейс) IsVideoOverlay. GStreamer-привязки (gi-gst) содержат тип элемента. Чтобы использовать элемент playbin с функцией GI.GstVideo.videoOverlaySetWindowHandle, нам нужно объявить GI.Gst.Element — экземпляр типа (type instance) IsVideoOverlay. А на стороне Cи playbin реализует интерфейс VideoOverlay.

newtype GstElement = GstElement GI.Gst.Element

instance GI.GstVideo.IsVideoOverlay GstElementОбратите внимание, что мы обёртываем GI.Gst.Element в новый тип (newtype), чтобы избежать появления потерянного (orphaned) экземпляра, поскольку мы объявляем экземпляр вне привязок haskell-gi.

main

Main — наша самая большая функция. В ней мы инициализируем все GUI-виджеты и определяем коллбэк-процедуры на основе определённых событий.

main :: IO ()

main = doGI-инициализация

_ <- GI.Gst.init Nothing

_ <- GI.Gtk.init NothingЗдесь мы инициализировали GStreamer и GTK+.

Сборка GUI-виджетов

gladeFile <- getDataFileName "data/gui.glade"

builder <- GI.Gtk.builderNewFromFile (pack gladeFile)

window <- builderGetObject GI.Gtk.Window builder "window"

fileChooserButton <- builderGetObject GI.Gtk.FileChooserButton builder "file-chooser-button"

drawingArea <- builderGetObject GI.Gtk.Widget builder "drawing-area"

seekScale <- builderGetObject GI.Gtk.Scale builder "seek-scale"

onOffSwitch <- builderGetObject GI.Gtk.Switch builder "on-off-switch"

volumeButton <- builderGetObject GI.Gtk.VolumeButton builder "volume-button"

desiredVideoWidthComboBox <- builderGetObject GI.Gtk.ComboBoxText builder "desired-video-width-combo-box"

fullscreenButton <- builderGetObject GI.Gtk.Button builder "fullscreen-button"

errorMessageDialog <- builderGetObject GI.Gtk.MessageDialog builder "error-message-dialog"

aboutButton <- builderGetObject GI.Gtk.Button builder "about-button"

aboutDialog <- builderGetObject GI.Gtk.AboutDialog builder "about-dialog"Как уже было сказано, мы получаем абсолютный путь к XML-файлу data/gui.glade, который описывает все наши GUI-виджеты. Дальше создаём из этого файла конструктор и получаем свои виджеты. Если бы мы не использовали Glade, то их пришлось бы создавать вручную, что довольно утомительно.

Playbin