Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Роботы в человеческом обществе |

Роботы в человеческом обществе

Роботы чаще всего встречаются в промышленности, где с их помощью удалось полностью автоматизировать большинство производственных задач. Но, кроме того, умные машины все больше задействуются в военной отрасли, медицине, сфере обслуживания и потребительском секторе.

И если ранее они выполняли только повторяющиеся рутинные задачи по программе, то сейчас их уровень достиг новых вершин, позволяя взаимодействовать с нами, общаясь на своем машинном языке, понимать наши жесты и эмоции. Кроме того, используя специализированные площадки уже сейчас каждый желающий имеет возможность влиять на индустрию, создавать свои программы и добавлять новые функции к роботам. Таким образом, развиваясь от простых вспомогательных механизмов, роботы имеют все шансы влиться в наше общество и стать нашими друзьями.

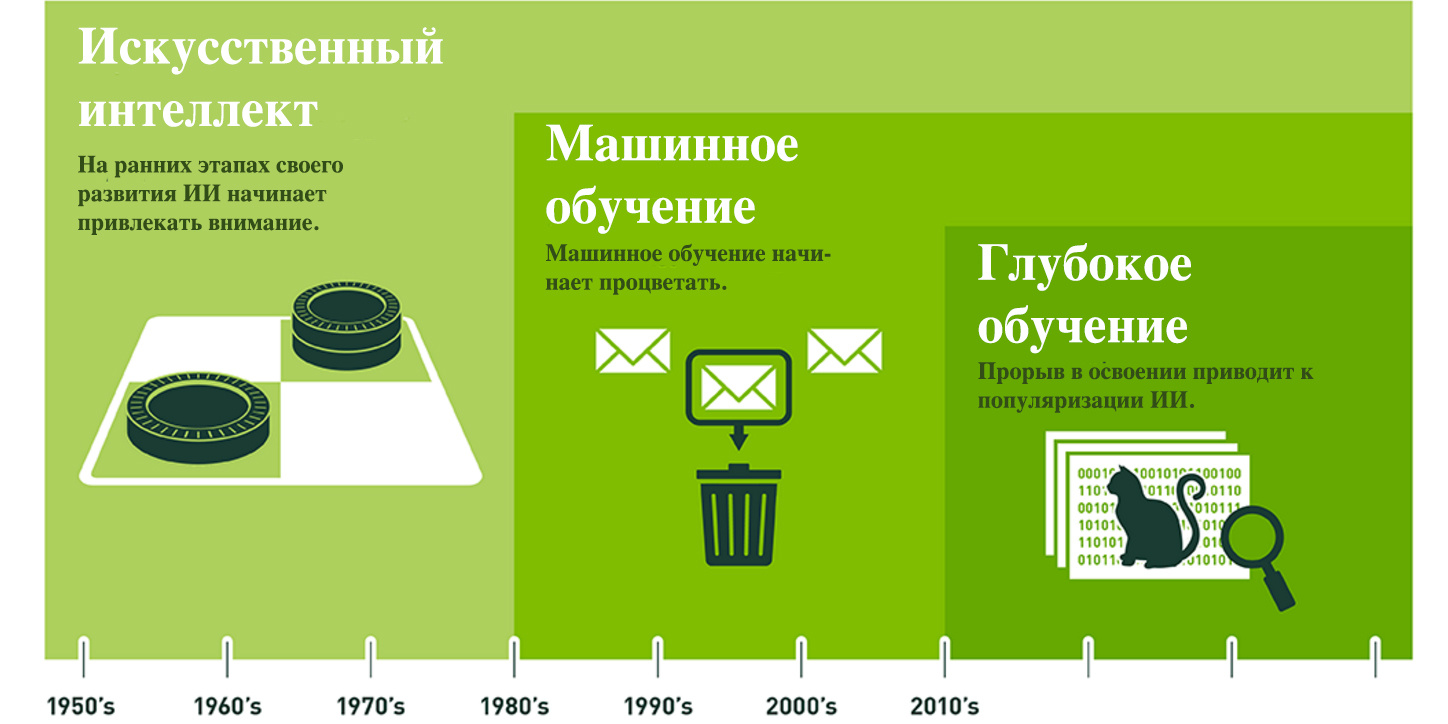

История развития

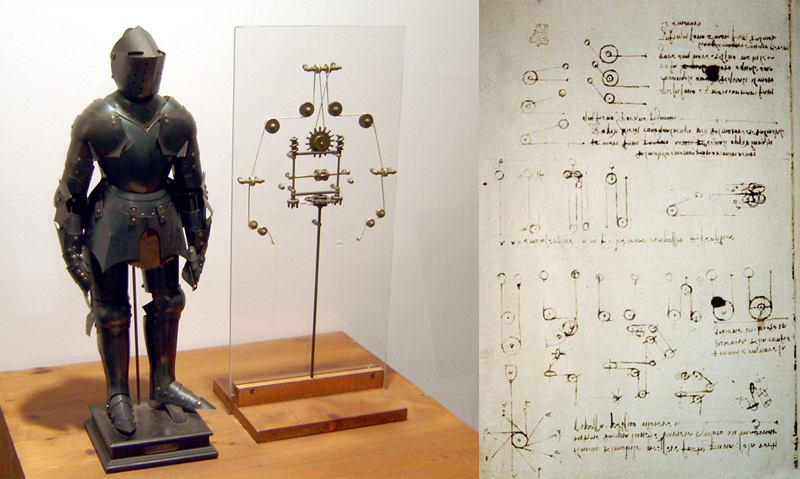

Отметим несколько интересных фактов из истории развития роботов. Первые признаки робототехники наблюдались еще с античности, когда люди мечтали о гигантских бронзовых машинах, которые смогли бы помочь им сражаться с врагами и завоевывать новые земли. Есть свидетельства, что прообразами нынешних роботов были механические фигуры, найденные в записках арабского изобретателя Аль-Джазари примерно в 1136 – 1206 годах.

Первым, кто представил чертеж человекоподобного робота, был великий Леонардо да Винчи примерно в 1495 году. Чертеж представлял модель механического рыцаря, который может сидеть, стоять, двигать руками, головой и, возможно, захватывать предметы. Но так и неизвестно, пытался ли да Винчи воплотить в реальность этот механизм.

В 16-17 веке в Западной Европе инженеры начали конструировать автоматоны — заводные механизмы наподобие человека, которые могли выполнять довольно сложные действия. Самый известный из них – робот «испанский монах», который был изобретен примерно в 1560 году механиком Хуанело Турриано для императора Карла V. Автоматон был около 40 см в высоту, способный ходить, бить себя в грудь рукой, кивать головой и даже преподносить деревянный крест к губам.

Более заметный прогресс в робототехнике наблюдался в 18 веке. К примеру, в 1738 году французский инженер Жак де Вокансон собрал первого в мире андроида, способного играть на флейте.

С 19 века изобретения стали приобретать более практический смысл. В 1898 году известный физик Никола Тесла представил общественности миниатюрное радиоуправляемое судно. Первоначально это изобретение казалось немного причудливым. Но в дальнейшем его идеи стали воплощаться в жизнь и приобрели широкое применение.

1921 год – механизмы, наконец, обрели четкий термин «робот» благодаря чешскому писателю Карлу Чапеку и его пьесе под названием «Россумские Универсальные Роботы». Примечательно, что Чапек назвал этим словом не машины, а живых людей, создаваемых на специальной фабрике. Но термин закрепился в науке и дал жизнь всем автоматизированным устройствам.

В середине 20 века, в частности, в 1950-ых стали разрабатываться механические манипуляторы для взаимодействия с радиоактивными материалами. Эти роботы копировали движения рук человека, находящегося в безопасном месте.

В 1968 году японской компанией Kawasaki Heavy Industries, Ltd был произведен первый промышленный робот. С тех пор Япония начала вовсю стремиться стать мировой столицей робототехники, и ей это удалось. Несмотря на то, что роботы изначально разрабатывались в США, они импортировались в Японию в малых количествах, где инженеры изучали их и применяли в производстве.

Коммерческое распространение роботов началось с 1980-ых годов. Технический прогресс двигался в направлении совершенствования систем управления. Такие компании как Unimate, Hitachi KUKA, Westinghouse, FANUC развивали системы датчиков для своих роботов, делая их более чувствительными к задачам, которые они выполняют.

В конце 90-ых – начале 2000-ых начался активный рост и развитие отрасли с использованием новых контроллеров, языков программирования, запуска первых роботов в космос и возникновением машин, создающих роботов.

В это время также появились новые человекоподобные роботы, такие как канадский Aiko, имитирующий человеческие чувства (осязание, слух, речь, зрение), ASIMO – гуманоид японской фирмы Honda, робот-собака AIBO, созданная компанией Sony и другие.

- В 2005 году вышел робот-гуманоид RoboThespian британской компании Engineered Arts. Пройдя несколько модификаций, он стал наилучшей платформой для общения и развлечений. В этом же году мир увидел BigDog – боевой четвероногий робот, созданный Boston Dynamics.

- В 2008 году вышел гуманоидный дружелюбный робот NAO, предназначенный для работы в домах, университетах и лабораториях и предлагающий помощь в научных исследованиях и образовании.

- В 2011 году на МКС был отправлен первый робот-космонавт НАСА Robonaut-2.

Последние пять лет наблюдается широкий всплеск робототехники во всех отраслях – от продвинутых манипуляторов до гуманоидов, которые выглядят как живые люди, имеют широкий спектр эмоций и полностью копируют нашу мимику.

Препятствия

Несмотря на всю полезность технологии, роботы пока не используются повсеместно, как это зачастую нам показывают во многих фантастических фильмах. Это связано с рядом факторов. Во-первых, для этого просто не готова наша инфраструктура: дороги, улицы, здания и наши дома. Роботы воспринимают мир иначе и пока неспособны даже отличить стул от стола, чего уж говорить о постоянно меняющихся условиях нашей жизни.

Во-вторых, не готова правовая система государств: использование роботов требует соответствующих законов, чтобы они «мирно» сосуществовали с нами. В конце концов, если не сами роботы, то кто-то другой должен нести ответственность за их действия.

В-третьих, некоторые исследователи утверждают, что нам необходимо опасаться этих механических рабочих, так как с дальнейшим активным развитием искусственного интеллекта они смогут в буквальном смысле поработить нас. Эти опасения слишком сильно сдерживают исследование и распространения робототехники.

Конечно, не стоит отрицать, что есть масса глобальных рисков, которые могут возникнуть при использовании сверхчеловеческого разума, не запрограммированного на безусловную лояльность к человеку. Но будущее пока что в наших руках, и мы в силах его изменить, тем более, что сейчас программирование роботов становится все более открытым и доступным для общественности. Нужно только научиться правильно пользоваться этими возможностями.

Роботы сегодня

Как уже упоминалось, наибольшей отраслью, где используется робототехника, является промышленность, в частности, автомобилестроение. Манипуляторы, работающие на заводах, варьируются от размеров и функциональности в зависимости от типа выполняющей задачи – сборочные, сварочные, режущие, красящие. Наряду с ними на производстве можно встретить разгрузочно-погрузочных роботов, упаковщиков, сортировщиков, формовщиков и прочие механизмы, заменяющие человека в рутинных повторяющихся задачах. Компаниями-лидерами в промышленной автоматизации являются – KUKA (Германия), Fanuc (Япония), Kawasaki (Япония), ABB (Швейцария), Denso (Япония) и другие.

Наряду с этим новых масштабов приобретает рынок совместных роботов, которые могут работать с людьми на одной производственной линии, не причиняя им вреда. Это манипуляторы компании Universal Robots, а также промышленные роботы нового поколения Baxter и Sawyer от Rethink Robotics.

В последние годы весь мир внимательно следит за разработкой автомобилей с автономным управлением, которые будут перевозить людей без их участия в процессе. Сейчас ближе всего к беспилотным машинам находится служба такси Uber. Но прогресс в разработке технологии регулярно демонстрируют такие производители, как Ford, Mercedes, Toyota, BMW и Tesla.

Роботы также активно используются в сельском хозяйстве. Зачастую, это радиоуправляемые тракторы и плуги, но все более широкого применения приобретают беспилотные летательные аппараты, которые аграрии используют для картографирования своих угодий и регулярного осмотра культур.

А какие роботы служат в быту? Безусловно, первое место здесь принадлежит роботам-пылесосам, которые стали незаменимыми помощниками по уборке в доме. Лидером среди производителей этих устройств является американская фирма iRobot и её пылесосы Roomba. Последние модели производителя отличаются улучшенной навигацией и сопряжением со смартфоном. Данное дополнение открывает новые возможности для обычных пользователей, которые могут через специальные приложения добавлять роботам больше функций.

Для ухода за газонами служат автоматизированные газонокосилки, которые оснащены массивом датчиков для безопасной езды и стрижки травы на больших площадях. За бассейнами ухаживают небольшие колесные роботы, которые самостоятельно передвигаются по дну водоема, чистят стены, ступни и фильтруют воду.

Кроме того, растущего числа набирают беспилотные летательные аппараты, которые давно перешли от исключительно военного применения к гражданскому. Дроны используются для самых различных задач – от развлечения до наблюдения и профессиональной видеосъемки. Лидерство в этом секторе за китайским производителем DJI. Их последний аппарат Spark считается самым совершенным селфи-дроном, запускаемым и управляемым жестами.

Все большего распространения также приобретают системы умного дома. Если раньше такая «автоматизация» заключалась в хлопанье ладошами чтобы включить свет, то сейчас человеку вообще не нужно ни за чем следить – вся власть в руках электронного управдома, роботизированного центра управления, которому подчинены все домашние устройства от систем безопасности и освещения до кофеварки и стиральной машины.

Более того, пользователь может сам добавлять функции в систему, которые ему нужны. К примеру, ему необходимо настроить работу стиральной машины на время, когда счетчики работают в режиме «ночь», чтобы экономить расходы на электроэнергию. Для этого нужно сконструировать соответствующее приложение для смартфона, который поможет оставаться на связи с домом и управлять домашней автоматизацией практически с любого места.

Вспомогательным гаджетом может выступать эхо-колонка (Amazon Echo, Google Home и другие), позволяющая с помощью голосовых команд управлять всей техникой в доме. Или роботы-помощники, которые выступают в роли органайзера, будильника, мультимедиа проигрывателя. Будучи подключенными к Интернету, они сообщают о погоде, рассказывают новости, предоставляют информацию о пробках в вашем городе и прочее. А благодаря открытому доступу к программированию, из них можно сделать отличных помощников для учебы детей, развлечения пожилых и даже игрушек для домашних животных.

Как видите, роботы уже вошли в нашу жизнь в виде разнообразных умных гаджетов, бытовых приборов и смарт-систем. Однако до идеального образа, созданного человеческим воображением, умным машинам еще очень далеко. Все что они могут – выполнять запрограммированные человеком команды. Но инженеры упорно стремятся к тому, чтобы сделать машины по-настоящему дееспособными, а взаимодействие с ними более легким, естественным и главное – доступным обычному человеку.

Прогнозы на будущее

С каждым годом эксперты и аналитики представляют нам новый мир, где на смену вере в сверхъестественное придет вера в науку и технику. Мир, в котором можно учиться и работать, не выходя из дома. Интернет размоет границы между странами, а роботы будут делать за нас практически все.

Если верить статистическим данным организации Tractica, число потребляемых человечеством роботов достигнет 31,2 млн единиц по всему миру к 2020 году. При этом, лидерство на рынке займут бытовые роботы, обогнав промышленных и военных.

Ученые прогнозируют, что уже к 2018 году Интернет вещей будет насчитывать около 6 млрд подключенных устройств. Эти устройства будут обращаться к сервисам и данным в Сети, что позволит людям строить новые бизнес-планы для обслуживания этих подключенных устройств. К 2020 году 40% взаимодействий с мобильными устройствами будут осуществляться через «умных» агентов. Этот прогноз основан на том, что наш мир движется к эпохе приложений, в которой такие сервисы, как Amazon Alexa, Microsoft Cortana и Apple Siri будут играть роль универсального интерфейса для взаимодействия человека с устройствами.

Технический директор Google Рэй Курцвейл в своих прогнозах по поводу развития робототехники и информационных технологий предполагает, что персональные роботы, способные на полностью автономные сложные действия, станут такой же привычной вещью, как холодильники или стиральные машины уже в 2027 году. А беспилотные автомобили заполнят полностью дороги в 2033 году.

Какими бы утешительными или наоборот пугающими не были прогнозы, перед учеными и инженерами стоит еще ряд проблем. Основная из них – жесткие ограничения правительств государств в принятии робототехники, которые сопровождаются нехваткой стандартов качества и безопасности продукции.

Еще одна проблема, которую нужно решить перед тем, как роботы будут массово внедрены в жизнь – это доступность программного и аппаратного обеспечения. Дороговизна материалов и оборудования для производства не позволяет производителям снижать цены на своих роботов. К примеру, очень дорого стоят такие медицинские устройства как экзоскелеты, которые помогли бы многим людям с ограниченными возможностями нормально жить и передвигаться.

Пока нам доступны только роботы-уборщики, дроны и персональные помощники, но радует тот факт, что вскоре у нас будет возможность делать эти устройства более функциональными, не завися от производителей.

Плюс ко всему, обычные люди пока не готовы морально к принятию роботов, похожих на них. Это связано в первую очередь с нехваткой информации о том, каких достижений добился научно-технический прогресс. Вдобавок к этому у людей сложилось ошибочное мнение о роботах, которые были неоднократно представлены в научно-фантастических фильмах. Некоторые до сих пор воспринимают слово «робот» как что-то вроде «Терминатора» или дроида из «Звездных войн». А ведь на самом деле, сейчас собрать и запрограммировать робота может даже ребенок.

Нужно расширять границы знаний, больше читать и смотреть интересные видео об устройствах из реального мира, которые могут иметь большое значение в нашей повседневной жизни.

Роботы в концепции IoT

Робототехника также затрагивает область столь нашумевшего сейчас направления – Интернета вещей. Это единая сеть, которая соединяет окружающие объекты реального мира с виртуальными.

Как это происходит: сенсоры вводятся во все подключенные к сети устройства, что позволяет им взаимодействовать с внешним миром. К примеру, «умные» шторы, которые сами регулируют свою прозрачность в зависимости от уровней внешнего и внутреннего освещения. Или холодильник, который самостоятельно регулирует температуру в разных отсеках, основываясь на том, какие продукты вы берете чаще всего. Таким образом, техника начинает подстраиваться под ежедневную жизнь пользователя и управляться исходя из его потребностей.

Интернет вещей – это не просто объединение различных приборов и датчиков через проводные и беспроводные каналы. Это более тесная интеграция реального и виртуального миров, в которых производится общение между людьми и устройствами.

Ученые уверены, что в будущем эти системы станут активными участниками информационных и социальных процессов, а также бизнеса, где они смогут взаимодействовать между собой, обмениваться информацией об окружающей обстановке, реагировать и влиять на внешние процессы без вмешательства человека.

На этом фоне появляется концепция Social IoT, которая предполагает объединение людей, роботов и устройств в одно информационно-правовое поле. Но что же нужно для осуществления этой концепции? Дело в том, что самой главной проблемой в данной области на сегодняшний день является отсутствие государственных стандартов, что затрудняет возможность применения предлагаемых на рынке решений, а также сдерживает появление новых.

Но кроме стандартов безопасности, необходимо создать доступные механизмы взаимодействия между роботами и людьми для управления и контроля. Это даст возможность полноценно управлять не одним роботом, а безопасно впустить в наше общество иную цивилизацию машин и жить в гармонии с ними.

Такие пользовательские программные сервисы, к счастью, скоро появятся и будут доступными, позволяя даже новичку добавлять к своему роботу новые интересные задачи. Хотите, чтобы робот-пылесос пел ваши любимые песни? Почему бы и нет. Для этого достаточно будет воспользоваться набором готовых базовых инструментов.

С помощью API программы каждый желающий сможет быстро создавать и комбинировать множество своих вариантов решений. При этом не нужно будет тратить свои ресурсы на создание базовых инструментов, а только фокусироваться на основной задаче.

Уже в ближайшем будущем вы сможете подключить программу, выбрать готовое приложение и сделать свой робот-пылесос говорящим и поющим. А если оснастить его видеокамерой, он сможет выступать в роли охранника. Но самое главное, что с помощью большого набора программных инструментов у вас появится возможность писать собственные уникальные приложения, чтобы добавлять бытовым роботам больше новых функций.

Стоит также отметить, что каждый отдельно взятый продукт стороннего разработчика на представленной базе будет иметь возможность привлекать к себе пользователей всей системы и распространять свой продукт. Таким образом, будет создана большая экосистема инструментов и возможностей, которые будут пользоваться ежедневно людьми со всего мира.

Заключение

В заключение стоит отметить, что по мере того как наш мир будет наполняться роботами, навыки общения с ними будут не менее полезны чем навыки общения с людьми. Мы видим, как современные технологии постепенно объединяют людей и умные машины в одну большую социально-аппаратную сеть. И это только начало сложного, но очень увлекательного путешествия в будущее.

|

Метки: author mrKron исследования и прогнозы в it блог компании unet robots iot unet |

Правильный выбор СрЗИ: от рекламных листовок к use case |

|

Метки: author alukatsky информационная безопасность блог компании cisco use case cisco проектирование систем сетевая инфраструктура сетевая безопасность выбор |

Играючи BASH'им дальше |

|

Метки: author vaniacer кодобред bash game scroller |

Просто о сложном: что нужно знать о биоинформатике |

Просто о сложном: что нужно знать о биоинформатике

Почему биология перестала справляться без информатики и при чем тут рак

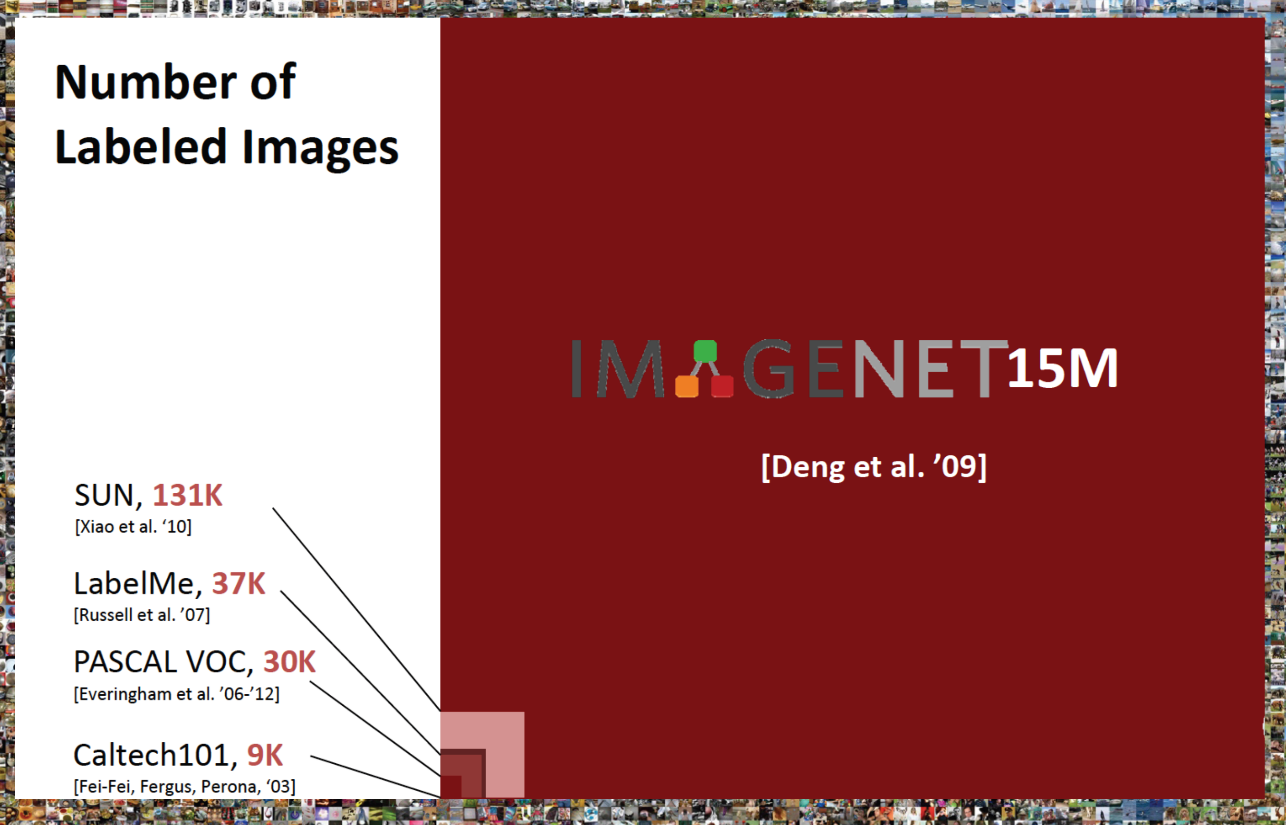

Чтобы провести исследование, биологам уже недостаточно взять анализы и посмотреть в микроскоп. Современная биология имеет дело с колоссальными объемами данных. Часто обработать их вручную просто невозможно, поэтому многие биологические задачи решаются вычислительными методами. Не будем далеко ходить: молекула ДНК настолько мала, что разглядеть ее под световым микроскопом нельзя. А если и можно (под электронным), всё равно визуальное изучение не помогает решить многих задач.

ДНК человека состоит из трех миллиардов нуклеотидов – чтобы вручную проанализировать их все и найти нужный участок, не хватит и целой жизни. Ну, может и хватит – одной жизни на анализ одной молекулы – но это слишком долго, дорого и малопродуктивно, так что геном анализируют при помощи компьютеров и вычислений.

Биоинформатика — это и есть весь набор компьютерных методов для анализа биологических данных: прочитанных структур ДНК и белков, микрофотографий, сигналов, баз данных с результатами экспериментов и т. д.

Иногда секвенировать ДНК нужно, чтобы подобрать правильное лечение. Одно и то же заболевание, вызванное разными наследственными нарушениями или воздействием среды, нужно лечить по-разному. А еще в геноме есть участки, которые не связаны с развитием болезни, но, например, отвечают за реакцию на определенные виды терапии и лекарств. Поэтому разные люди с одним и тем же заболеванием могут по-разному реагировать на одинаковое лечение.

Еще биоинформатика нужна, чтобы разрабатывать новые лекарства. Их молекулы должны иметь определенную структуру и связываться с определенным белком или участком ДНК. Смоделировать структуру такой молекулы помогают вычислительные методы.

Достижения биоинформатики широко применяют в медицине, в первую очередь в терапии рака. В ДНК зашифрована информация о предрасположенности и к другим заболеваниям, но над лечением рака работают больше всего. Это направление считается самым перспективным, финансово привлекательным, важным – и самым сложным.

Биоинформатика в ЕРАМ

В ЕРАМ биоинформатикой занимается подразделение Life Sciences. Там разрабатывают программное обеспечение для фармкомпаний, биологических и биотехнологических лабораторий всех масштабов — от стартапов до ведущих мировых компаний. Справиться с такой задачей могут только люди, которые разбираются в биологии, умеют составлять алгоритмы и программировать.

Биоинформатики – гибридные специалисты. Сложно сказать, какое знание для них первично: биология или информатика. Если так ставить вопрос, им нужно знать и то и другое. В первую очередь важны, пожалуй, аналитический склад ума и готовность много учиться. В ЕРАМ есть и биологи, которые доучились информатике, и программисты с математиками, которые дополнительно изучали биологию.

Как становятся биоинформатиками

Мария Зуева, разработчик:

«Я получила стандартное ИТ-образование, потом училась на курсах ЕРАМ Java Lab, где увлеклась машинным обучением и Data Science. Когда я выпускалась из лаборатории, мне сказали: «Сходи в Life Sciences, там занимаются биоинформатикой и как раз набирают людей». Не лукавлю: тогда я услышала слово «биоинформатика» в первый раз. Прочитала про нее на Википедии и пошла.

Тогда в подразделение набрали целую группу новичков, и мы вместе изучали биоинформатику. Начали с повторения школьной программы про ДНК и РНК, затем подробно разбирали существующие в биоинформатике задачи, подходы к их решению и алгоритмы, учились работать со специализированным софтом».

Геннадий Захаров, бизнес-аналитик:

«По образованию я биофизик, в 2012-м защитил кандидатскую по генетике. Какое-то время работал в науке, занимался исследованиями – и продолжаю до сих пор. Когда появилась возможность применить научные знания в производстве, я тут же за нее ухватился.

Для бизнес-аналитика у меня весьма специфическая работа. Например, финансовые вопросы проходят мимо меня, я скорее эксперт по предметной области. Я должен понять, чего от нас хотят заказчики, разобраться в проблеме и составить высокоуровневую документацию – задание для программистов, иногда сделать работающий прототип программы. По ходу проекта я поддерживаю контакт с разработчиками и заказчиками, чтобы те и другие были уверены: команда делает то, что от нее требуется. Фактически я переводчик с языка заказчиков – биологов и биоинформатиков – на язык разработчиков и обратно».

Как читают геном

Чтобы понять суть биоинформатических проектов ЕРАМ, сначала нужно разобраться, как секвенируют геном. Дело в том, что проекты, о которых мы будем говорить, напрямую связаны с чтением генома. Обратимся за объяснением к биоинформатикам.

Михаил Альперович, глава юнита биоинформатики:

«Представьте, что у вас есть десять тысяч экземпляров «Войны и мира». Вы пропустили их через шредер, хорошенько перемешали, наугад вытащили из этой кучи ворох бумажных полосок и пытаетесь собрать из них исходный текст. Вдобавок у вас есть рукопись «Войны и мира». Текст, который вы соберете, нужно будет сравнить с ней, чтобы отловить опечатки (а они обязательно будут). Примерно так же читают ДНК современные машины-секвенаторы. ДНК выделяют из клеточных ядер и делят на фрагменты по 300–500 пар нуклеотидов (мы помним, что в ДНК нуклеотиды связаны друг с другом попарно). Молекулы дробят, потому что ни одна современная машина не может прочитать геном от начала до конца. Последовательность слишком длинная, и по мере ее прочтения накапливаются ошибки.

Вспоминаем «Войну и мир» после шредера. Чтобы восстановить исходный текст романа, нам нужно прочитать и расположить в правильном порядке все кусочки романа. Получается, что мы читаем книгу несколько раз по крошечным фрагментам. То же с ДНК: каждый участок последовательности секвенатор прочитывает с многократным перекрытием – ведь мы анализируем не одну, а множество молекул ДНК.

Полученные фрагменты выравнивают – «прикладывают» каждый из них к эталонному геному и пытаются понять, какому участку эталона соответствует прочитанный фрагмент. Затем в выравненных фрагментах находят вариации – значащие отличия прочтений от эталонного генома (опечатки в книге по сравнению с эталонной рукописью). Этим занимаются программы – вариант-коллеры (от англ. variant caller – выявитель мутаций). Это самая сложная часть анализа, поэтому различных программ – вариант-коллеров много и их постоянно совершенствуют и разрабатывают новые.

Подавляющее большинство найденных мутаций нейтральны и ни на что не влияют. Но есть и такие, в которых зашифрованы предрасположенность к наследственным заболеваниям или способность откликаться на разные виды терапии».

Для анализа берут образец, в котором находится много клеток — а значит, и копий полного набора ДНК клетки. Каждый маленький фрагмент ДНК прочитывают несколько раз, чтобы минимизировать вероятность ошибки. Если пропустить хотя бы одну значащую мутацию, можно поставить пациенту неверный диагноз или назначить неподходящее лечение. Прочитать каждый фрагмент ДНК по одному разу слишком мало: единственное прочтение может быть неправильным, и мы об этом не узнаем. Если мы прочитаем тот же фрагмент дважды и получим один верный и один неверный результат, нам будет сложно понять, какое из прочтений правдивое. А если у нас сто прочтений и в 95 из них мы видим один и тот же результат, мы понимаем, что он и есть верный.

Геннадий Захаров:

«Для анализа раковых заболеваний секвенировать нужно и здоровую, и больную клетку. Рак появляется в результате мутаций, которые клетка накапливает в течение своей жизни. Если в клетке испортились механизмы, отвечающие за ее рост и деление, то клетка начинает неограниченно делиться вне зависимости от потребностей организма, т. е. становится раковой опухолью. Чтобы понять, чем именно вызван рак, у пациента берут образец здоровой ткани и раковой опухоли. Оба образца секвенируют, сопоставляют результаты и находят, чем один отличается от другого: какой молекулярный механизм сломался в раковой клетке. Исходя из этого подбирают лекарство, которое эффективно против клеток с “поломкой”».

Биоинформатика: производство и опенсорс

У подразделения биоинформатики в ЕРАМ есть и производственные, и опенсорс-проекты. Причем часть производственного проекта может перерасти в опенсорс, а опенсорсный проект – стать частью производства (например, когда продукт ЕРАМ с открытым кодом нужно интегрировать в инфраструктуру клиента).

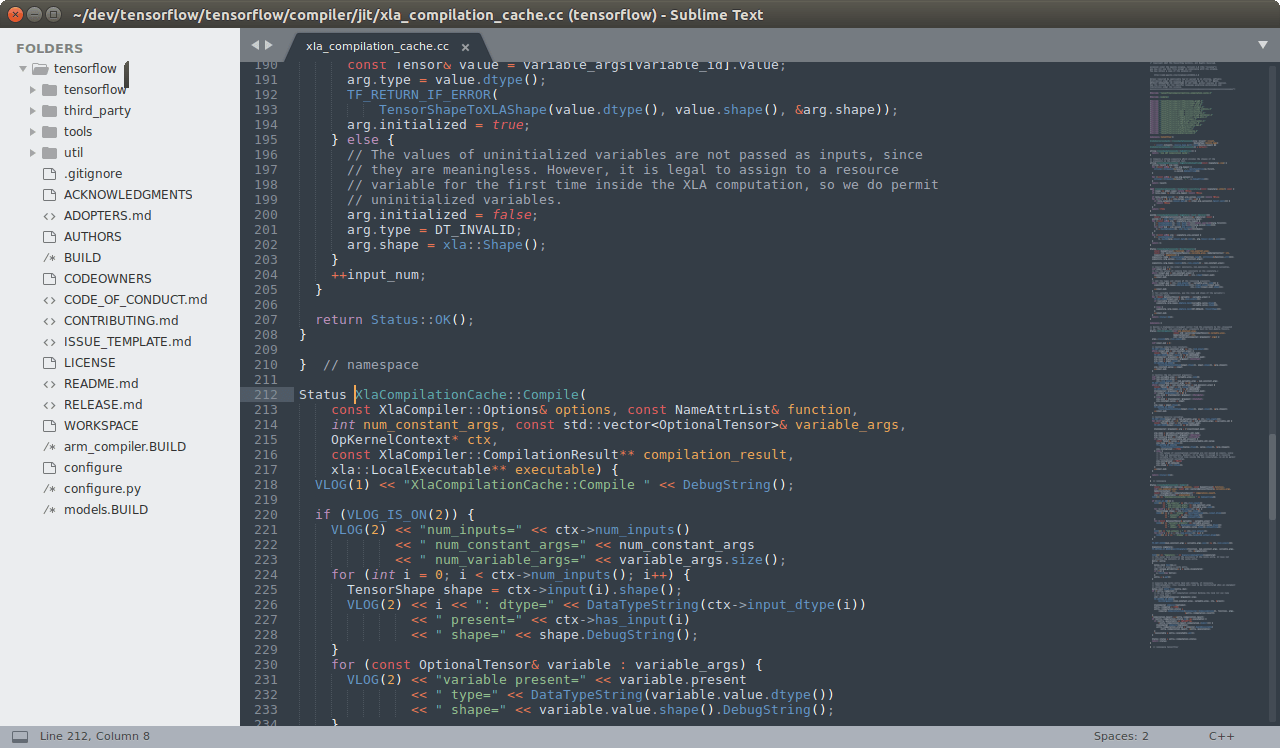

Проект №1: вариант-коллер

Для одного из клиентов – крупной фармацевтической компании – ЕРАМ модернизировал программу вариант-коллер. Ее особенность в том, что она способна находить мутации, недоступные другим аналогичным программам. Изначально программа была написана на языке Perl и обладала сложной логикой. В ЕРАМ программу переписали на Java и оптимизировали – теперь она работает в 20, если не в 30 раз быстрее.

Исходный код программы доступен на GitHub.

Проект №2: 3D-просмотрщик молекул

Для визуализации структуры молекул в 3D есть много десктоп- и веб-приложений. Представлять, как молекула выглядит в пространстве, крайне важно, например, для разработки лекарств. Предположим, нам нужно синтезировать лекарство, обладающее направленным действием. Сначала нам потребуется спроектировать молекулу этого лекарства и убедиться, что она будет взаимодействовать с нужными белками именно так, как нужно. В жизни молекулы трехмерные, поэтому анализируют их тоже в виде трехмерных структур.

Для 3D-просмотра молекул ЕРАМ сделал онлайн-инструмент, который изначально работал только в окне браузера. Потом на основании этого инструмента разработали версию, которая позволяет визуализировать молекулы в очках виртуальной реальности HTC Vive. К очкам прилагаются контроллеры, которыми молекулу можно поворачивать, перемещать, подставлять к другой молекуле, поворачивать отдельные части молекулы. Делать всё это в 3D куда удобнее, чем на плоском мониторе. Эту часть проекта биоинформатики ЕРАМ делали совместно с подразделением Virtual Reality, Augmented Reality and Game Experience Delivery.

Программа только готовится к публикации на GitHub, зато пока есть ссылка, по которой можно посмотреть ее демо-версию.

Как выглядит работа с приложением, можно узнать из видео.

Проект №3: геномный браузер NGB

Геномный браузер визуализирует отдельные прочтения ДНК, вариации и другую информацию, сгенерированную утилитами для анализа генома. Когда прочтения сопоставлены с эталонным геномом и мутации найдены, ученому остается проконтролировать, правильно ли сработали машины и алгоритмы. От того, насколько точно выявлены мутации в геноме, зависит, какой диагноз поставят пациенту или какое лечение ему назначат. Поэтому в клинической диагностике контролировать работу машин должен ученый, а помогает ему в этом геномный браузер.

Биоинформатикам-разработчикам геномный браузер помогает анализировать сложные случаи, чтобы найти ошибки в работе алгоритмов и понять, как их можно улучшить.

Новый геномный браузер NGB (New Genome Browser) от ЕРАМ работает в вебе, но по скорости и функционалу не уступает десктопным аналогам. Это продукт, которого не хватало на рынке: предыдущие онлайновые инструменты работали медленнее и умели делать меньше, чем десктопные. Сейчас многие клиенты выбирают веб-приложения из соображений безопасности. Онлайн-инструмент позволяет ничего не устанавливать на рабочий компьютер ученого. С ним можно работать из любой точки мира, зайдя на корпоративный портал. Ученому не обязательно всюду возить за собой рабочий компьютер и скачивать на него все необходимые данные, которых может быть очень много.

Геннадий Захаров, бизнес-аналитик:

«Над опенсорсными утилитами я работал частично как заказчик: ставил задачу. Я изучал лучшие решения на рынке, анализировал их преимущества и недостатки, искал, как можно их усовершенствовать. Нам нужно было сделать веб-решения не хуже десктопных аналогов и при этом добавить в них что-то уникальное.

В 3D-просмотрщике молекул это была работа с виртуальной реальностью, а в геномном браузере – улучшенная работа с вариациями. Мутации бывают сложными. Перестройки в раковых клетках иногда затрагивают огромные области. В них появляются лишние хромосомы, куски хромосом и целые хромосомы исчезают или объединяются в случайном порядке. Отдельные куски генома могут копироваться по 10–20 раз. Такие данные, во-первых, сложнее получить из прочтений, а во-вторых, сложнее визуализировать.

Мы разработали визуализатор, который правильно читает информацию о таких протяженных структурных перестройках. Еще мы сделали набор визуализаций, который при контакте хромосом показывает, образовались ли из-за этого контакта гибридные белки. Если протяженная вариация затрагивает несколько белков, мы по клику можем рассчитать и показать, что происходит в результате такой вариации, какие гибридные белки получаются. В других визуализаторах ученым приходилось отслеживать эту информацию вручную, а в NGB – в один клик».

Как изучать биоинформатику

Мы уже говорили, что биоинформатики – гибридные специалисты, которые должны знать и биологию, и информатику. Самообразование играет в этом не последнюю роль. Конечно, в ЕРАМ есть вводный курс в биоинформатику, но рассчитан он на сотрудников, которым эти знания пригодятся на проекте. Занятия проводятся только в Санкт-Петербурге, а общедоступных курсов на University и Learn пока нет. И всё же, если биоинформатика вам интересна, возможность учиться есть:

1) Вводный курс в генетическую диагностику от компании 23andme.

2) Несколько курсов на Coursera (в том числе пара курсов на русском: введение в биоинформатику и в метагеномику).

3) Курсы на Stepik от института биоинформатики: молекулярная биология и генетика, молекулярная филогенетика, генная инженерия и введение в технологии высокоэффективного секвенирования. Полный список курсов от института можно посмотреть на его официальном сайте.

4) Лекции Павла Певзнера – профессора Калифорнийского университета в Сан-Диего, специалиста в области биоинформатики.

5) Если вы живете в Санкт-Петербурге, можно прийти на гостевые лекции в институт биоинформатики – это бесплатно.

|

Метки: author AliceMir блог компании epam epam биоинформатика life sciences геном секвенирование днк |

Серверы HPE ProLiant Gen8 и Gen9 vs. Gen10 |

- Хранение данных,

- Серверное администрирование,

- Серверная оптимизация,

- IT-инфраструктура,

- Блог компании МУК

Серверы HPE ProLiant Gen8 и Gen9 vs. Gen10

- Хранение данных,

- Серверное администрирование,

- Серверная оптимизация,

- IT-инфраструктура,

- Блог компании МУК

.

.Очевидно, что IT должны работать на скоростях, которые требует современный бизнес, и быть ускорителем новых идей, продуктов и сервисов. Для построения быстро набирающих популярность гибридных решений необходима соответствующая IT инфраструктура, которая сочетает облачную экономичность и «проворство» (agility) с безопасностью локального (on-premises) информационного центра.

Серверы HPE ProLiant разработаны, чтобы упростить построение корпоративных гибридных информационных технологий (Hybrid IT). Согласно внешнему независимому тестированию, проведенному в мае 2017 г., HPE ProLiant признаны самыми безопасными серверами промышленного стандарта в мире.

Более 1 млн. клиентов во всем мире построили свой бизнес на серверах HPE ProLiant. На данный момент доступны следующие линейки серверов в стоечном (rack) и корпусном (tower) исполнении.

— HPE ProLiant Easy Connect

— HPE ProLiant MicroServer

— HPE ProLiant DL

— HPE ProLiant ML

Все четыре семейства разработаны для многих видов рабочих нагрузок, но каждое из них оптимизировано для определенных случаев использования.

HPE ProLiant Easy Connect

Внешний вид серверов EC200a (слева) и ML110 на въездной иллюстрации

=

HPE ProLiant Easy Connect Managed Hybrid Servers обеспечивают удаленно управляемые сервисы, предлагаемые партнерами HPE как подписка на 1, 3, или 5 лет с оплатой ежемесячно или ежегодно. Они обеспечивает безопасный и надежный доступ к приложениям Windows, Linux и SaaS. Эти управляемые решения уменьшают совокупную стоимость владения (Total Cost of Ownership, TCO) для удаленных точек продаж и офисов

Примечание. Здесь и далее используются официальные фотографии и таблицы с сайта https://www.hpe.com/

HPE ProLiant MicroServer

Внешний вид MicroServer Gen8 (слева) и Gen10

Компактный, тихий и стильный HPE ProLiant MicroServer позиционируется как «идеальное первое решение для предприятий микро- и малого бизнеса».

HPE ProLiant MicroServer Gen10 поддерживает потоковое медиа 4K с двумя портами для дисплеев. Он поставляется с предварительно установленной, удобной в работе ClearOS и приложениями для малого или домашнего офиса (Small Office / Home Office, SOHO).

MicroServer помогает сократить расходы, вместе с тем повышая производительность и эффективность. Его форм-факторе удобен в обслуживании, и при этом нет необходимости в специальном серверном помещении.

HPE ProLiant DL

Внешний вид серверов DL380 Gen9 (слева) и Gen10

Внешний вид серверов DL560 Gen9 (слева) и Gen10

Безопасные и универсальные оптимизированные серверы для установки в стойку, обеспечивающие высокую производительность, отличную управляемость и возможность расширения.

HPE ProLiant ML

Внешний вид серверов ML350 Gen9 в корпусном (слева) и стоечном исполнении

Идеальный выбор для удаленного офиса или подразделения, а также для растущих компаний. Если семейство серверов DL включает самые гибкие, надежные серверы с оптимизированной производительностью для размещения в стойке, то ML обеспечивает наибольшую бизнес-ценность решений на их основе.

Общая характеристика серий (1 полугодие 2017 г.)

HPE ProLiant 10 series. Серверы малого масштаба (Small Scale Servers). Они недороги и просты в развертывании.

HPE ProLiant 100 series. «Именно те серверы, которые нужны» (Right Sized Servers). Обеспечивают наилучшее сочетание производительности, эффективности, возможностей и управляемости.

HPE ProLiant 300 series. Универсальные исполнительные серверы (Versatile Performance Servers). Лучшая в отрасли конструкция с гибким выбором для разнообразных рабочих нагрузок в области вычислений и хранения данных.

HPE ProLiant 500 series. Расширяемые серверы (Scale-up Servers). Масштабируются для критических рабочих нагрузок в любом бизнесе.

Для предварительного ориентировочного расчета экономических характеристик может быть использован HPE server TCO calculator.

Дополнительная информация по архитектуре, включая полные конфигурации, калибровку, BOM и детали развертывания приведена здесь.

Для многих пользователей HPE MicroServer станет лучшим выбором, по крайней мере, на первых порах. В Gen10 его характеристики улучшены.

Варианты решений HPE ProLiant

Для построения современной и оптимизированной IT среды можно выбрать различные варианты HPE Rack и Power Infrastructure. Она содержит следующие составляющие.

— стойки с многими вариантами высоты, ширины и глубины;

— устройства распределения электропитания (Power Distribution Units, PDU), от минимальных до масштаба предприятия;

— блоки бесперебойного питания (Uninterruptable Power Supplies, UPS) различной мощности и размера;

— решения для виртуальных машин (Virtual Machine, VM);

— другие элементов оборудования стоечных решений.

Стоечные HPE ProLiant Gen10 обеспечивают 71%-е увеличение производительности с новыми процессорами Intel Xeon Processor Scalable Family и 66%-е расширение полосы пропускания памяти для интенсивно использующих память приложений.

Сравнение полосы пропускания серверов Gen10 и Gen9 (Июль 2017).

Gen10 = 12 Channels x 2666 data rate x 8 bytes = 256 GB/sec.

Gen9 = 8 channels x 2400 x 8 bytes = 154 GB/Sec.

256/154 = 1,66 т.е., полоса пропускания Gen10 на 66% больше.

Технологии серверов HPE ProLiant Gen10

Проворство. Intelligent System Tuning (IST) оптимизирует производительность. Включает средства сглаживания колебаний (Jitter Smoothing), ускорения ядра (Core Boosting) и соответствия рабочей нагрузки (Workload Matching).

— Intel Xeon Processor Scalable Family обеспечивает большее количество ядер и высокую пропускную способность.

— Увеличение производительности сервера достигается за счет HPE SmartMemory с производительностью 2666 MT/s (megatransfers per second) и технологии «быстрой отказоустойчивости» (Fast Fault Tolerance).

— Серверы оснащены наиболее быстрой постоянной памятью (Persistent Memory), объем которой может достигать терабайтного уровня.

— Обеспечивается простой выбор, развертывание, управление и поддержка инфраструктуры серверов HPE по всему жизненному циклу за счет применения HPE OneView 3.1, HPE iLO 5 и iLO Amplifier Pack.

Безопасность (Security) обеспечивается целым рядом технологий.

— Реализована защита от кибератак нападений с Silicon Root of Trust.

— Обнаруживается вредоносный код и malware с Run-time Firmware Verification.

— Восстанавливаются исходные или безопасные настройки с Secure Recovery.

— Расширенная безопасность достигается с iLO 5 Advanced Premium Security Edition.

— Опции безопасности аппаратных средств включают Trusted Platform Module (TPM), Chassis Intrusion Detection Kit и Secure NICs.

Руководство для перехода на Gen10

Семейство Gen10 предлагает варианты, которые соответствуют всем возможным потребностям рабочей нагрузки. Для большей гибкости предлагаются HPE FlexibleLOM, HPE Flexible Smart Array, HPE SmartMemory, NVMe, Persistent Memory и другие составляющие решений. Полный список вариантов и подробности можно посмотреть в QuickSpecs.

Линейка серверов Gen10 создавалась на основе опыта разработки предыдущих поколений HPE ProLiant и отзывов потребителей. В таблицах ниже приведены официальные сведения по эволюции серверов HPE ProLiant от Gen8 к Gen10, а также характеристики для HPE MicroServer Gen8, HPE DL380 Gen9 и HPE DL560 Gen9 - для тех случаев, когда возможно их корректное сравнение с аналогичными моделями Gen10. Для HPE ProLiant Easy Connect и HPE ProLiant ML такое сравнение пока не опубликовано разработчиком.

Таб. 2. Сравнительные характеристики HPE MicroServer Gen8 и Gen10

Наиболее заметными изменениями в HPE MicroServer Gen10 стала замена процессора Intel Xeon на AMD Opteron. Улучшились характеристики подсистем оперативной памяти и хранения данных.

Таб. 3. Сравнительные характеристики DL380 Gen9 и Gen10

Позиционирование универсальных серверов HPE ProLiant 300 series практически не изменилось. Характеристики DL380 Gen10 скорее оптимизированы, чем существенно улучшены.

Таб. 4. Сравнительные характеристики DL560 Gen9 и Gen10

Расширяемые серверы HPE ProLiant 500 series подверглись наиболее существенным изменениям в подсистемах работы с данными и электропитания.

Примечание. Во всех таблицах указание звездочки около характеристики обозначает ее введение во втором полугодии 2017 г.

Расширенная функциональность и дополнительные преимущества с HPE Server Options

Стандартными блоками каждого сервера HPE являются память DDR, средства хранения данных и сетевые адаптеры, которые в совокупности и называются HPE Server Options. Они разработаны так, чтобы обеспечить наивысшую производительность для любой рабочей нагрузки, работать с высокой постоянной надежностью, и быть привлекательными с точки зрения экономики.

Таким образом, серверы ProLiant Gen10, конфигурируемые с HPE Server Options, являются идеальным решением для любой прикладной рабочей нагрузки и любой IT окружающей среды, - от SMB до крупного корпоративного информационного центра.

HPE Server Options интегрируются со многими системными инструментами управления HPE для легких установки, конфигурирования и поддержки, снижая операционные затраты по сравнению с не-HPE компонентами. HPE предлагает широкий диапазон вариантов систем хранения данных, памяти, сетевых адаптеров и процессоров.

HPE Memory. Выбор соответствующей памяти является ключом к получению самых высоких потребительских свойств, системной надежности и более быстрого возврата IT инвестиций. Портфель HPE включает HPE Standard Memory для типовых рабочих нагрузок и HPE SmartMemory для нагрузок, интенсивно использующих память. Клиенты могут выбрать необходимый вариант из различных типов памяти HPE и объема модулей DIMM, чтобы оптимизировать производительность и эффективность сервера.

HPE Server Storage. HPE Server Storage для серверов ProLiant Gen10 включают жесткие диски (HDD), твердотельные диски (SSD) и Smart Array Controllers. Новая линия HPE контроллеров RAID уровня предприятия для серверов Gen10 помогает максимизировать производительность, доступность данных и вместимость систем хранения.

Они обеспечивают до 1,6 млн. операций ввода-вывода в секунду (Input/Output per Second, IOPS) и на 65% лучшую производительность, потребляя при этом до 45% меньше мощности, чем контроллеры предыдущего поколения.

Новый смешанный режим обеспечивает клиентам высокую гибкость за счет использования и HBA (Host Bus Adapter), и RAID одновременно, на единственном контроллере, что освобождает слот PCIe для другого использования. В ассортименте HPE - контроллеры Smart Array S-Class software RAID, Smart Array E-Class и P-Class.

Для решений начального уровня с дисками SATA наиболее подходящим является HPE Smart Array Software RAID. Его особенности включают уровни RAID 0/1/5/10, поддержку 6G SATA и доступ к инструменту конфигурации Unified Extensible Firmware Interface (UEFI).

Рентабельные HPE Smart Array E-Class Controllers реализуют простой RAID для определяемого ПО устройства хранения данных (Software-Defined Storage, SDS) с надежностью и безопасностью уровня предприятия. Его главные особенности - RAID on Chip (ROC) и реализация RAID levels 0/1/5/10.

Эти контроллеры работает в смешанном режиме, шифруют любой подключенный к ним диск, используя HPE Smart Array SR Secure Encryption, и предоставляют администратору инструмент конфигурации UEFI.

Максимальная производительность системы хранения данных корпоративного класса достигается применением HPE Smart Array P-Class Controllers.

Эти контроллеры поддерживаются в стойках и корпусах HPE ProLiant, BladeSystem, серверах Apollo и в Synergy Compute Modules. Их главные особенности - технология Raid-on-Chip (ROC), поддержка флеш-кэша (Flash-Backed Write Cache, FBWC) и расширенный RAID levels 0/1/5/6/10/50/60/1 ADM/10 ADM.

Контроллер работает в смешанном режиме, шифрует любой присоединенный диск с HPE Smart Array SR Secure Encryption и предоставляет UEFI. Он доступен для трех типов рабочих нагрузок - предприятие (оптимизация производительности), средний бизнес (оптимизация емкости) и малый бизнес. Имеет интерфейсы SAS (12G) и SATA (6G) и допускает два форм-фактора дисков - SFF (2,5 дюйма) и LFF (3,5 дюйма).

Жесткие диски уровня предприятия (SAS 15K и 10K) обеспечивают наивысшие уровни производительности и надежности работы приложений для решения ответственных задач с интенсивным потоком операций ввода-вывода (Input/Output, I/O).

Жесткие диски среднего уровня (SAS/SATA 7,2K) обеспечивают высокую производительность и надежность для большинства бизнес-приложений.

Жесткие диски начального уровня предназначены для некритических потребностей сегодняшних приложений в среде хранения. Эти диски имеют достаточную производительность и самое низкое значение стоимости ($/GB).

Дальнейшее ускорение выполнения приложений с интенсивным обменом данными в корпоративной среде достигается применением твердотельных дисков (Solid-State Drives, SSD) с высокой производительностью и малым временем ожидания.

HPE SSD могут иметь шесть форм-факторов - SFF (2,5 дюйма), LFF (3,5 дюйма), M.2, M.2 Enablement Kits, Mezzanine и Add-in Cards. Они доступны в трех категориях, разделенных по уровню целевых рабочих нагрузках - Read Intensive, Mixed Use и Write Intensive.

Рабочая нагрузка определяется как число записей на диск в день (Drive Writes Per Day, DWPD) и обычно рассчитывается по формуле

DWPD = (GB/Day) / Capacity

Т.е., сколько объемов диска записывается в течение суток. HPE также определяет DWPD как «максимальное количество записей хоста 4K на всю емкость диска SSD в день за пятилетний период».

Read Intensive SSD, как правило, имеют наименьшую цену и выносливость <= 1 DWPD. Они идеальны для загрузки приложений, веб-серверов и чтения кэша.

Write Intensive SSD типично имеют самую высокую производительность при чтении со значением DWPD >= 10. Идеальны для обработки транзакций онлайн (On-Line Transaction Processing, OLTP), для применения в бизнес-аналитике (Business Intelligence, и Big Data аналитике.

Mixed Use SSD используются для неопределенных рабочих нагрузок, которые нуждаются в балансе между высокой производительностью записи и чтения. Значение DWPD для них составляет 1-10. Идеальны для приложений с большими потоками I/O.

Все диски серверов HPE поддерживаются HPE Digitally Signed Firmware, которое предотвращает несанкционированный доступ к данным. Каждый диск протестирован на 3,35 млн. часов безотказной работы. Дополнительная информация приведена здесь.

Устойчивая память (HPE Persistent Memory). HPE предлагает самый широкий ассортимент устойчивой памяти на рынке, состоящий из высокопроизводительной NVDIMM и HPE Scalable Persistent Memory - интегрированного решения для хранения данных. Решение работает на скоростях DRAM, сочетая производительность памяти с устойчивостью хранения. К настоящему времени HPE Scalable Persistent Memory поддерживается только на серверах DL380 Gen10.

HPE Scalable Persistent Memory содержит три основных компонента - DRAM для ускорения работы приложений, специализированную флеш-память для обеспечения устойчивости и источник резервного питания для бесперебойного перемещения данных от DRAM к Flash.

HPE Scalable Persistent Memory реализует дополнительные функции памяти, выполняя проверку правильности выполнения операций до х27 быстрее, и до х20 сокращает время перезапуска базы данных, обеспечивая максимальную продолжительность бесперебойной работы.

HPE Scalable Persistent Memory может также быть полезна в HTAP (Hybrid Transactional / Analytical Processing), многорядном кэшировании SDS и др. Модули HPE NVDIMM объемом 8 GB и 16 GB (последние доступны со второго полугодия 2017) поддерживаются флеш DIMM. Дополнительная информация приведена здесь.

HPE Server Network Adapters. Адаптеры HPE Server Networking помогают предотвратить, обнаружить кибератаки и восстановиться после них, защищая приложения, данные и серверную инфраструктуру средствами установления подлинности (аутентификации) программируемого оборудования через архитектуру Root of Trust. Кроме того, они предлагают Secure Boot, Device-level Firewall и другие продвинутые механизмы безопасности. Дополнительная информация приведена здесь.

HPE Rack and Power Infrastructure. HPE Rack and Power Infrastructure предоставляет конфигурируемые решения для построения инфраструктуры «из коробки», чтобы соответствовать потребностям предприятий всех размеров, - сегодня и в будущем. Поставка HPE Rack and Power Infrastructure предусматривает стойку сервера, а также системы электропитания и охлаждения.

Устройства электропитания HPE Power Supplies предлагают различные варианты для определенных конфигураций сервера, системы хранения и окружающей IT среды. Такая гибкость помогает минимизировать избыточную мощность и снизить полные энергетические затраты. Дополнительная информация приведена здесь.

В данную статью не вошли сведения о дополнительных сервисах HPE для серверов HPE ProLiant Gen10, требующих отдельного описания - OneView, ASHRAE, iLO5 и других.

|

Метки: author Orest_ua хранение данных серверное администрирование серверная оптимизация it- инфраструктура блог компании мук hpe proliant сервера |

Параллельный Hystrix. Повышаем производительность распределенных приложений |

Параллельный Hystrix. Повышаем производительность распределенных приложений

Почему вставить хистрикс было легко

Все плюшки были достигнуты минимальными усилиями и очень небольшими изменениями кода — Hystrix предоставляет синхронную модель программирования, в результате только небольшой код вызова http-клиентов был перенесен из потоков приложения в пулы потоков hystrix с минимально возможным количеством проблем (я не верю, что этих проблем можно избежать полностью).

Рассмотрим простой пример — команду CommandHelloWorld, которая с задержкой извлекает очень важные данные и клиентский код, который ее использует.

public class CommandHelloWorld extends HystrixCommand {

@Override

protected String run() throws InterruptedException {

// вот тут происходит очень важное обращение во внешнюю систему

// все это работает в пуле потоков хистрикса

Thread.sleep(random.nextInt(500));

return "Hello " + name + "!";

}

}

// клиентский код

String executeCommand(String str) {

// вызов зависает на время, не большее чем установленный таймаут.

return new CommandHelloWorld(str).execute();

}

Получилось очень простое решение с контролируемым временем выполнения. Конечно, со временем любое начальное преимущество обернется недостатками. Появились клиенты, которым нужно предоставить список из 200 элементов, для формирования каждого элемента надо один раз (или не один) обратиться во внешнюю систему (иногда не одну). Не все внешние системы поддерживают батчи, не любой код так уж легко распараллелить без ошибок — затратив 20 мс на один поход во внешнюю систему получаем увесистые 4 секунды на весь запрос, в течении которых пользователь страдал, а пул потоков томката не получал свой поток назад, при этом пул потоков хистрикса практически не был заполнен запросами. Пришло время это исправить.

Как нам обустроить хистрикс

Практически все приложение было построено по следующему паттерну:

- получаем список с исходными данными

- формируем из него stream

- фильтруем/маппируем, с хистриксом в том числе

- коллекционируем из stream список

Конечно, теоретически, в java stream есть операция parallel, но по факту в ней крайне плохое управление пулами потоков, в которых будет производиться работа, что ее использования было решено отказаться. Нужно было бы какое-то понятное решение, которое бы не сломало исходный Паттерн и не сломало моск команде. В результате было предложено 2 работающих решения — на основе reactivex.io и надстройкой над java stream.

Демонстрационный пример можно найти на гитхабе, все работающие примеры помещены в тесты.

Вариант 1. Добавим реактивности

Нужно заметить, что внутри хистрикс использует реактивную (это термин, не факт что она быстрая) библиотеку " асинхронных источников данных" reactivex.io. Статья не является руководством по этой не объятной теме, но будет показано одно элегантное решение. К несчастью, я не знаком с устоявшимся русским переводом термина observable, потому буду называть его источником. И так, желая не сломать Паттерн, мы будем действовать таким образом:

- получаем список с исходными данными

- формируем из него источник

- фильтруем/маппируем источник, с хистриксом в том числе

- коллекционируем из источника список

С одной стороны последняя операция не так проста, как кажется, но раз мы знаем, что все внешние связи контролируются хистриксом, а потому строго ограничены во времени, а собственный код приложения ничего толком не делает — мы можем считать, что источник данных в течении указанного таймаута обязан поднимать значение или же исключение будет выкинуто хистриксом до истечения таймаута (1 секунда). Потому будем использовать простую функцию-коллектор:

static List toList(Observable observable) {

return observable.timeout(1, TimeUnit.SECONDS).toList().toBlocking().single();

}

Создавать команды и источники будем двумя функциями, пользуясь родным API:

/**

* создает горячую хистриксную команду-источник

*/

static Observable executeCommand(String str) {

LOG.info("Hot Hystrix command created: {}", str);

return new CommandHelloWorld(str).observe();

}

/**

* создает холодную хистриксную команду-источник

*/

static Observable executeCommandDelayed(String str) {

LOG.info("Cold Hystrix command created: {}", str);

return new CommandHelloWorld(str).toObservable();

}

И так, рассмотрим простой случай обработки списка их 6 элементов:

public void testNaive() {

List source = IntStream.range(1, 7).boxed().collect(Collectors.toList());

Observable observable = Observable.from(source)

.flatMap(elem -> executeCommand(elem.toString()));

toList(observable).forEach(el ->LOG.info("List element: {}", el));

}

Все замечательно параллельно отрабатывает приблизительно за 500мс, логи программы подтверждают одновременное использование потоков хистрикса. Как побочный эффект — элементы располагаются в списке в случайном порядке. Такова цена реактивности.

Попробуем увеличить размер списка до 49 — и получим закономерный облом:

public void testStupid() {

List source = IntStream.range(1, 50).boxed().collect(Collectors.toList());

Observable observable = Observable.from(source)

.flatMap(elem -> executeCommand(elem.toString()));

toList(observable).forEach(el ->LOG.info("List element: {}", el));

}

Вот такой смешной выхлоп в лог:

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 1

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 2

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 3

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 4

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 5

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 6

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 7

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 8

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 9

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 10

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 11

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command start: 5

[hystrix-ExampleGroup-2] INFO org.silentpom.CommandHelloWorld - Command start: 2

[hystrix-ExampleGroup-9] INFO org.silentpom.CommandHelloWorld - Command start: 9

[hystrix-ExampleGroup-8] INFO org.silentpom.CommandHelloWorld - Command start: 8

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command start: 4

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command start: 1

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command start: 6

[hystrix-ExampleGroup-10] INFO org.silentpom.CommandHelloWorld - Command start: 10

[hystrix-ExampleGroup-3] INFO org.silentpom.CommandHelloWorld - Command start: 3

[main] ERROR org.silentpom.RxHystrixTest - Ooops

com.netflix.hystrix.exception.HystrixRuntimeException: CommandHelloWorld could not be queued for execution and no fallback available.

Дело в том, что по дефолту хистрикс создает пул из 10 потоков с нулевой очередью. При подписке на источник все его элементы очень быстро эмитируются, мгновенно переполняя весь пул, не помогло даже создание холодного источника. Нам такой хистрикс не нужен. Требуется разумно ограничить жадность одного клиента.

Решение обнаружилось достаточно простое:

- Для начала мы не будет использовать flatMap, чтобы подписка на источник не вызывала создание всех команд. А создадим двойной источник методом map.

- сгруппируем эти источники методом window — получим тройной источник!

- пришло время строго упорядочить тройные источники — выпускаем их один за одним методом concatMap

- каждый двойной источник параллельно вычислим методом flatMap

Код оказался удивительно компактным, хотя на понимание его работы ушло много времени:

public void testWindow() {

List source = IntStream.range(1, 50).boxed().collect(Collectors.toList());

Observable observable = Observable.from(source)

.map(elem -> executeCommandDelayed(elem.toString()))

.window(7)

.concatMap(window -> window.flatMap(x -> x));

toList(observable).forEach(el ->LOG.info("List element: {}", el));

}

Посмотрим фрагмент логов:

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 20

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 21

[hystrix-ExampleGroup-3] INFO org.silentpom.CommandHelloWorld - Command start: 3

[hystrix-ExampleGroup-7] INFO org.silentpom.CommandHelloWorld - Command start: 7

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command start: 5

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command start: 4

[hystrix-ExampleGroup-2] INFO org.silentpom.CommandHelloWorld - Command start: 2

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command start: 6

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command start: 1

[hystrix-ExampleGroup-3] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 3

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 6

[hystrix-ExampleGroup-2] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 2

[hystrix-ExampleGroup-7] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 7

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 1

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 5

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 4

[hystrix-ExampleGroup-8] INFO org.silentpom.CommandHelloWorld - Command start: 8

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command start: 11

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command start: 12

Из логов приложения видно, что процесс запуска новых команд приостановился после запуска 7й команды. Получилась очень простая модификация кода, которая позволяет запускать запросы к внешним системам с нужной степенью параллельности, не забивая собой весь пул.

Вариант 2. Нафиг реактивность! У нас есть екзекуторы

Редкий человек понимаем rx. Если даже он говорит обратное — попросите написать код выше своими словами. Но ведь в java 8 и так есть stream и future, хистрикс вроде умеет работать с future как с родной, давайте попробуем запустить параллельную обработку с их помощью. Создавать future будем так:

// просим хистрикс запустить команду и вернуть фьючу

static Future executeCommandDelayed(String str) {

LOG.info("Direct Hystrix command created: {}", str);

return new CommandHelloWorld(str).queue();

}

// по старинке синхронно вызываем хистрикс, все в ручную

static String executeCommand(String str) {

LOG.info("Direct Hystrix command created: {}", str);

return new CommandHelloWorld(str).execute();

}

Пробуем обработать список из 49 элементов:

public void testStupid() {

IntStream.range(1, 50).boxed().map(

value -> executeCommandDelayed(value.toString())

).collect(Collectors.toList())

.forEach(el -> LOG.info("List element (FUTURE): {}", el.toString()));

}

и снова знакомая проблема.

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 2

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 3

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 4

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 5

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 6

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 7

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 8

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 9

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 10

[main] INFO org.silentpom.stream.ParallelAsyncServiceTest - Direct Hystrix command created: 11

[main] ERROR org.silentpom.stream.ParallelAsyncServiceTest - Ooops

com.netflix.hystrix.exception.HystrixRuntimeException: CommandHelloWorld could not be queued for execution and no fallback available.

В данном случае порядком создания команд управляет сплиттератор, то есть вообще совершенно непрозрачно и опасно. Постараемся решить проблему в 2 этапа, сохраняя достаточно привычную технику работы со стримом:

1) замапим стрим исходных данных в стрим фьюч. Причем с контролем реально запущенных на исполнение задач. Для этого нам потребуется промежуточный экзекьютор с нужной нам степенью параллельности

2) превратим стрим фьюч в стрим значений. держа в уме, что каждая фьюча в конечном итоге исполняется хистриксом и имеет гарантированное время выполнения.

Для реализации первого шага сделаем отдельный оператор parallelWarp по преобразованию пользовательской функции, для второго шага придется написать функцию waitStream, принимающую и возвращающую стримы:

public void testSmart() {

service.waitStream(

IntStream.range(1, 50).boxed().map(

service.parallelWarp(

value -> executeCommand(value.toString())

)

)

).collect(Collectors.toList())

.forEach(el -> LOG.info("List element: {}", el));

}получилась почти привычная для пользователей стримов запись. Посмотрим что под капотом, это последний фрагмент кода на сегодня:

// по традиции threadSize = 7

public ParallelAsyncService(int threadSize) {

ThreadFactory namedThreadFactory = new ThreadFactoryBuilder()

.setNameFormat("parallel-async-thread-%d").build();

// создаем промежуточный экзекутор, который будет создавать команды хистрикса

executorService = Executors.newFixedThreadPool(threadSize, namedThreadFactory);

}

/**

* Maps user function T -> Ret to function T -> Future. Adds task to executor service

* @param mapper user function

* @param user function argument

* @param user function result

* @return function to future

*/

public Function> parallelWarp(Function mapper) {

return (T t) -> {

LOG.info("Submitting task to inner executor");

Future future = executorService.submit(() -> {

LOG.info("Sending task to hystrix");

return mapper.apply(t);

});

return future;

};

}

/**

* waits all futures in stream and rethrow exception if occured

* @param futureStream stream of futures

* @param type

* @return stream of results

*/

public Stream waitStream(Stream> futureStream) {

List> futures = futureStream.collect(Collectors.toList());

// wait all futures one by one.

for (Future future : futures) {

try {

future.get();

} catch (InterruptedException e) {

throw new RuntimeException(e);

} catch (ExecutionException e) {

Throwable cause = e.getCause();

if (cause instanceof RuntimeException) {

throw (RuntimeException) cause;

}

throw new RuntimeException(e);

}

}

// all futures have completed, it is safe to call get

return futures.stream().map(

future -> {

try {

return future.get();

} catch (Exception e) {

e.printStackTrace();

return null; // не должен вызываться вообще

}

}

);

Метод waitStream очень прост, только обработка ошибок его испортила. Оператор parallelWarp крайне прост и наверняка имеет специальное название у адептов функционального программирования. Новые хистрикс команды создаются только внутренним экзекутором, который имеет нужную нам степень параллельности. Пруфлинк:

main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 18

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 19

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 20

[main] INFO org.silentpom.RxHystrix - Cold Hystrix command created: 21

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command start: 4

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command start: 1

[hystrix-ExampleGroup-2] INFO org.silentpom.CommandHelloWorld - Command start: 2

[hystrix-ExampleGroup-3] INFO org.silentpom.CommandHelloWorld - Command start: 3

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command start: 5

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command start: 6

[hystrix-ExampleGroup-7] INFO org.silentpom.CommandHelloWorld - Command start: 7

[hystrix-ExampleGroup-2] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 2

[hystrix-ExampleGroup-5] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 5

[hystrix-ExampleGroup-3] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 3

[hystrix-ExampleGroup-7] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 7

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 6

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 4

[hystrix-ExampleGroup-1] INFO org.silentpom.CommandHelloWorld - Command calculation finished: 1

[hystrix-ExampleGroup-4] INFO org.silentpom.CommandHelloWorld - Command start: 11

[hystrix-ExampleGroup-6] INFO org.silentpom.CommandHelloWorld - Command start: 12

[hystrix-ExampleGroup-8] INFO org.silentpom.CommandHelloWorld - Command start: 8

[hystrix-ExampleGroup-7] INFO org.silentpom.CommandHelloWorld - Command start: 13

[hystrix-ExampleGroup-9] INFO org.silentpom.CommandHelloWorld - Command start: 9

При данном подходе нам потребовался дополнительный пул потоков на каждый пул потоков хистрикса, зато список на выходе сохранил порядок. Какой из подходов выиграет в приложении — время покажет.

Повторюсь, что все примеры можно посмотреть в тестах на гитхабе. Буду рад знаменитой хаброкритике.

|

Метки: author blaze79 параллельное программирование ооп java java hystrix rx stream |

Конкурс Fintech-стартапов FINOPOLIS-2017 |

|

Метки: author FintechLab финансы в it финтех конкурс финополис finopolis fintech competition стартап startup финансы технологии банки форум finopolis 2017 |

[Перевод] О-о-очень долгожданный релиз Sublime Text 3.0 |

О-о-очень долгожданный релиз Sublime Text 3.0

- Перевод

Спустя долгие годы ожидания в beta и alpha релизах (а это около 3.5 лет) наконец-то вышел Sublime Text 3.0!

Предисловие: Sublime Text — является комерческим (хотя никто и не заставляет покупать лицензию) графическим текстовым редактором под 3 основные десктопные платформы.

В сравнении с последней бетой, версия 3.0 привносит обновленную тему пользовательского интерфейса, новые цветовые схемы и новую иконку. Помимо этого улучшена подсветка синтаксиса, поддержка тачпада на Windows, поддержка тачбара на macOS и репозитории apt/yum/pacman для Linux.

Я хочу отметить некоторые отличия от Sublime Text 2, хотя это на удивление сложно: практически каждый аспект редактора так или иначе был улучшен, так что даже список основных изменений будет очень большим. Если хотите увидеть полный список изменений, команда подготовила отдельную страницу для этого.

Определенно, в 3 версии добавили огромные фичи, например: прыжок на определение (F12), новый движок для подсветки синтаксиса, новый UI и расширенное API. Однако различия повсюду ощущаются в мелочах, которые сложно выделить самодостаточные: проверка орфографии работает лучше, автоматический отступ стал делать правильные вещи чаще, перенос слов лучше обрабатывает исходный код, правильно поддерживаются мониторы с высоким DPI, а также переход к файлам (Goto Anything ctrl+p) стал умнее. Перечислять все нудно и долго, но отличия разительны.

Одна из особенностей, за которую я особенно горд, — это производительность редактора: он значительно быстрее предшественника во всех областях. Запуск быстре, быстрее открытие файлов, более эффективная прокрутка. Несмотря на то, что 3 версия гораздо больше, она, наоборот, кажется более компактной.

|

Метки: author l4l системное программирование программирование python sublime text 3 редактор кода |

Причуды Stream API |

|

Метки: author ARG89 java блог компании jug.ru group stream |

[Из песочницы] Streaming API. Небольшой пример на PHP |

Streaming API. Небольшой пример на PHP

Более подробно здесь.

Сначала думал реализовать все на Node.Js, но потом, чтобы не тратить время на его настройку на VPS сервере, решил использовать PHP.

Всю логику проекта решил отдать клиенту, на сервере же только небольшие настройки по работе с API ВКонтакте и анализатор.

Начнем с интересного — главного:

//все понятно и стандартно

var socket = new WebSocket("wss://streaming.vk.com/stream?key=" + window.key);

var close_connect = ge("close_connect");

/*

* Здесь еще очень много кода

*/

socket.onmessage = function(event) {

var incomingMessage = event.data;

var loading = document.getElementById("loading_text");

var preview = document.getElementById("preview_text");

var serf = document.getElementById("serf");

loading.classList.add("none");

preview.classList.add("none");

serf.classList.remove("none");

parser(event.data); //вот здесь начинается вся логика

console.log(event.data);

};

socket.onclose = function(event) {

if (event.wasClean) {

console.warn('Соединение закрыто чисто');

} else {

console.warn('Обрыв соединения');

}

console.info('Код: ' + event.code + ' причина: ' + event.reason);

var loading = ge("loading_text");

if (event.code == 1006) {

loading.innerHTML = "На этой планете уже есть человек, который сидит на этом сайте.

К сожалению - это не Вы. Повторите попытку позже.

Код ошибки - " + event.code;

} else {

loading.innerHTML = "Что-то или кто-то здесь не так...

Код ошибки - " + event.code;

}

};

socket.onerror = function(error) {};

//close connect

close_connect.addEventListener("click", function() {

socket.close();

close_connect.innerHTML = "Соединение закрыто клиентом.";

ge("analiz_block").classList.remove("none");

}, false);

Как стало понятно из кода выше, на сайте одна сессия для всех пользователей, т.е. пока кто-то уже сидит и парсит правила, другой не получит доступ к сайту.

Далее разберём основную функцию parser(event.data). Я люблю шаблоны, ими легко управлять и с ними легко взаимодействовать.

var parser = function(json) {

var response = JSON.parse(json);

console.log(response);

var code = response.code;

console.log(code);

if (code != 100) return;

var tpl_block = document.getElementById("tpl");

var tpl = tpl_block.innerHTML;

var main_tpl = tpl_block.innerHTML;

var content = document.getElementById("main").innerHTML;

var main = document.getElementById("main");

var time = response.event['creation_time'];

var date = new Date(time);

var type;

var cnt = ge("cnt");

var cnt_value = +cnt.innerHTML;

cnt.innerHTML = cnt_value + 1;

var creation_time = timestampToDate(response.event['creation_time'] * 1000);

if (response.event['event_type'] == "post") {

type = "Публикация";

count['post'] = ++count['post'];

} else if (response.event['event_type'] == "comment") {

type = "Комментарий";

count['comment'] = ++count['comment'];

} else if (response.event['event_type'] == "share") {

type = "Репост";

count['share'] = ++count['share'];

}

var photo_context;

if (response.event.attachments) {

//image

if (response.event.attachments[0].type == "photo") {

photo_context = ' ';

} else {

photo_context = "";

}

} else {

photo_context = "";

}

tpl = tpl.split("{event_type}").join(type);

tpl = tpl.split("{text}").join(response.event['text']);

tpl = tpl.split("{url}").join(response.event['event_url']);

tpl = tpl.split("{date}").join(creation_time);

tpl = tpl.split("{photo}").join(photo_context);

tpl = tpl.split("{type}").join(response.event['event_type']);

tpl = tpl.split("{cnt}").join(cnt_value+1);

tpl = tpl.split("\"").join("'");

if (filter.top) main.innerHTML = tpl + "" + content;

else main.innerHTML = content + "" + tpl;

//post_id

if (response.event['event_type'] != "comment") {

var post_owner_id = response.event.event_id['post_owner_id'];

var post_id = response.event.event_id['post_id'];

var wall_id = post_owner_id + "_" + post_id;

array_post_id.push(wall_id);

}

//limit

if (cnt_value + 1 >= +filter.limit) {

socket.close();

close_connect.innerHTML = "Достигнут лимит публикаций.";

ge("analiz_block").classList.remove("none");

}

}

';

} else {

photo_context = "";

}

} else {

photo_context = "";

}

tpl = tpl.split("{event_type}").join(type);

tpl = tpl.split("{text}").join(response.event['text']);

tpl = tpl.split("{url}").join(response.event['event_url']);

tpl = tpl.split("{date}").join(creation_time);

tpl = tpl.split("{photo}").join(photo_context);

tpl = tpl.split("{type}").join(response.event['event_type']);

tpl = tpl.split("{cnt}").join(cnt_value+1);

tpl = tpl.split("\"").join("'");

if (filter.top) main.innerHTML = tpl + "" + content;

else main.innerHTML = content + "" + tpl;

//post_id

if (response.event['event_type'] != "comment") {

var post_owner_id = response.event.event_id['post_owner_id'];

var post_id = response.event.event_id['post_id'];

var wall_id = post_owner_id + "_" + post_id;

array_post_id.push(wall_id);

}

//limit

if (cnt_value + 1 >= +filter.limit) {

socket.close();

close_connect.innerHTML = "Достигнут лимит публикаций.";

ge("analiz_block").classList.remove("none");

}

}

Сам шаблон:

В коде выше происходит:

1. Парс json с информацией о записях(комментарий, репост или же публикация)

2. Парс шаблона по информации, которую мы получили из json

Один шаблон под три разновидности публикации. Удобно.

Проект работает, записи выводятся, всё шикарно, но скучно. Сдавать таким проект на конкурс — это тоже самое, что не сдавать его. Поэтому было решено написать небольшой фильтр по записям, который умел бы показывать небольшую статистику. За основу взял информацию о количестве той или иной записи, общий охват, кнопка «Мне нравится» и репосты, а также средний возраст аудитории охвата и процентное соотношение пола.

var analiz = {

start: function() {

//

if (count['post'] == 0 && count['comment'] == 0 && count['share'] == 0) {

alert("Невозможно запустить анализ. Причина - публикации не найдены.");

return;

}

var url = "/vk-competition/VKanaliz.php";

var loading = ge("loading_sp");

var button = ge("btn_analiz");

var analiz_stats = ge("analiz_stats");

loading.classList.remove("none");

button.classList.add("none");

ajax.post({

url: url,

data: "post_id=" + array_post_id.join(","),

callback: function(data) {

var resp = JSON.parse(data);

if (resp.error) {

alert(resp.error);