Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

О смарт-контрактах простыми словами |

О смарт-контрактах простыми словами

Итак давайте попробуем сегодня разобраться, что такое смарт-контракты (умные контракты). Сначала мы достаточно общо обсудим сам концепт, а потом немного копнем в реализацию смарт-контрактов на примере блокчейна Ethereum.

О концепте смарт-контрактов

Термин «смарт-контракт» уже устоялся и по сути обозначает определенный код, который выполняется на какой-либо блокчейн-платформе таким образом, что его выполнение проверяется независимыми сторонами.

Что это значит? Это распределенные вычисления? В привычном нам понимании все же нет.

Когда мы говорим о распределенных вычислениях, обычно подразумевается распределение нагрузки. Скажем, у нас есть задача посчитать в огромном текстовом файле вхождения определенного слова. Мы режем файл на несколько частей, раздаем эти части на разные ноды (например, используя Hadoop), каждая выполняет подсчет и выдает ответ. Мы суммируем ответы и получаем результат. Таким образом мы значительно ускоряем выполнение задачи.

Если же говорить о смарт-контрактах, то тут совсем другая ситуация. Тут мы не режем файл на отдельные части, мы каждой ноде отдаем весь файл целиком, и каждая нода выдает нам один и тот же результат (в идеале). Вернемся к нашему вопросу: попадает ли такое действие под определение распределенных вычислений? Ну в целом почему нет? Они же распределены и они же вычисления? Только в данном случае мы говорим не о распределении нагрузки, а о распределении доверия.

И да, необходимо отметить, что такой концепт сложно масштабируется, потому что в него изначально не заложены необходимые механизмы. Для чего же может быть нужна такая конструкция? Наиболее очевидный пример — это создание общественного договора (контракта) между двумя и более сторонами. Отсюда и название концепта — «смарт-контракт». Стороны фиксируют договоренности и условия выполнения того или иного сценария развития отношений между собой, при помощи языка программирования, таким образом, что наступление определенных событий будет автоматически вызывать выполнение предопределенного кода.

Классический пример подобного контракта, описанный еще в 1996 году Ником Сабо, — вендинг-машина. Она работает всегда автоматически по строгому набору правил: вы вносите деньги, делаете выбор — машина отдает товар. Внеся деньги, вы не можете передумать и попросить их вернуть. В случае с умным контрактом код становится своего рода законом, его нельзя оспорить, и он всегда будет выполняться при наступлении необходимых условий.

Здесь необходимо сделать уточнение, что текущие реализации смарт-контрактов (далее мы будем говорить о сети Ethereum) все же по сути история, замкнутая в блокчейн-среде. Что это значит? Нельзя написать контракт, который будет получать данные извне (например, от поставщиков данных о погоде) и реализовывать логику на этих данных. Тут есть определенный подвижки, например Microsoft работает над концептом криплетов или существуют, так называемые, ораклы, но пока, думаю, там есть куда расти.

Потому предложу другой пример смарт-контракта, который замкнут полностью в блокчейне. Лотерея, причем абсолютно честная и прозрачная. Вы отправляете транзакцию на адрес смарт-контракта, и он по заранее заложенной в нем логике (пусть в ней будет какой-то рандомизатор) принимает решение, выиграли вы или нет. Если вы выиграли, вы получаете весь накопленный в смарт-контракте куш, а если проиграли, то ваша транзакция идет в общую копилку для будущих игроков.

Все эти примеры относительно просты и несколько оторваны от реальной жизни. Какую же пользу можно извлечь из работы умных контрактов, если подходить к ним серьезно? Сам концепт проверяемого исполнения кода позволяет строить системы, которые ранее были недоступны или же их создание было сильно затруднено.

Положим, у вас есть определенное сообщество, в котором необходимо принять какое-то решение. Допустим, это решение крайне важное, и сообщество не склонно просто так довериться отдельным своим членам. Возьмем как пример консорциум банков. Логично предположить, что ни один член консорциума не захочет делегировать проведение вычислений одному банку, особенно когда на основании этих вычислений будет приниматься наше «самое важное решение». Ведь, отдав и данные, и возможность проводить эти вычисления в одни руки, вы можете поставить свой бизнес в рискованное положение, и даже открытый код вычислений не убедит вас в правильности выполнения этого кода на чужом сервере. Вы захотите это выполнение проверить. И вот тут мы получаем ту самую пользу из концепта проверяемого исполнения: участники способны объединяться для выполнения общей задачи или принятия решения без центрального оператора и таким образом повышать эффективность своих бизнесов.

Да, смарт-контракты не слишком-то масштабируются в текущих реализациях, потому что в них это не заложено. Но даже сейчас можно тяжелые вычисления проводить вне среды смарт-контрактов и фиксировать в них лишь определенные опорные точки, о которых стороны могут договориться на берегу, таким образом достигнув в каких-то сценариях необходимой скорости работы.

Техническая сторона вопроса

Теперь попробуем поговорить о технической стороне реализации смарт-контрактов на примере блокчейн Ethereum. Как выглядит процесс написания, публикации и выполнения смарт-контракта?

В этой сети для написания смарт-контрактов используется язык Solidity, который несколько похож на JS, и он является Тьюринг-полным (то есть на нем можно реализовать любую вычислимую функцию).

Сам код выполняется в так называемом Ethereum Virtual Machine (EVM). Надо обратить внимание, что код выполняется и проверяется всеми участниками системы, потому необходим некий механизм, который как-то ограничит потребление ресурсов каждым смарт-контрактом (иначе можно бесконечный цикл написать). Потому в Ethereum введена сущность gas (топливо). Контракт в Ethereum может выполнять любые инструкции, вызывать другие контракты, писать и читать данные и так далее. Все эти операции потребляют топливо, топливо оплачивается криптовалютой (Ether). Цена на топливо криптовалюты Ethеr формируется динамически рынком. Триггером выполнения контракта является транзакция. Стоимость топлива, которое сжигается в определенной транзакции, снимается с аккаунта, который транзакцию запустил. Кроме того, есть лимит потребления топлива, сделан он для того, чтобы защитить аккаунт от ошибок в написании контракта, которые могут привести к бесконтрольному сгоранию всей криптовалюты на данном аккаунте.

Важно отметить, что среда смарт-контрактов все же сильно отличается от привычной нам среды выполнения кода. Ошибка может стоить очень дорого, сами операции дорогие и медленные. Затруднен механизм обновления смарт-контракта. Вы, по сути, пишете новый и должны убедить стороны использовать этот новый смарт-контракт. Нельзя сказать, что никак не перейти на новую версию своего контракта, но это часто новый общественный договор. Если вдуматься — разительное отличие, когда вы привыкли просто выкатывать апдейты вашей централизованной системы потребителям, не слишком интересуясь их мнением. Строя какую-то систему для работы в реальных жизненных сценариях на смарт-контрактах, стоит понимать эти ограничения.

|

Метки: author Ramon алгоритмы блог компании «лаборатория касперского» ethereum blockchain |

Пару слов о неминуемом повороте в развитии IT-отрасли |

Пару слов о неминуемом повороте в развитии IT-отрасли

Мол, какой-то девайс, фреймворк или способ работы резко поднимает успешность предприятия. Например, «мы все используем MacBook, и у нас уже третий раунд инвестиций». Или «мы решили открыть travel-агентство, и нанимаем только тех программистов, которые не вылезают из путешествий; мы хотим, чтобы все сотрудники разделяли наши ценности, и у нас уже оборот 100 млн долларов». Или «как только мы внедрили React + Vue + Angular, наши дела пошли в гору, и нас купил Google». И так далее.

На первый взгляд кажется абсурдом? — Да, но признаем: хайп и гвалт есть несомненные сопутствующие элементы современного IT-мира. Любое явление, находящееся на острие общественного внимания, а IT, безусловно, из таких, не может не впитать в себя характерные черты социума своего времени. В частности, тенденцию к превалированию формы над содержанием.

Частенько происходит типичная выдача желаемого за действительное. Рынок буквально сходит с ума, чтобы залить деньгами хоть кого-то, кто сможет выдать краткосрочный результат. Те, кому повезло с подливой от инвесторов, могут программировать хоть стоя на голове: для достижения быстрого результата, который нужно предъявить спекулятивному рынку, компаниям не обязательно, а иногда даже вредно выстраивать правильные, выверенные бизнес-процессы. Путь к первому успеху виден, а всерьёз займётся делом уже портфельный инвестор или крупный IT-гигант, который за миллиарды приобретёт выстреливший стартап. Пока все ждут роста акций и очередного рекорда в показателе «сумма, уплаченная за компанию / количество разработчиков», можно, не стесняясь, заявлять о любых своих капризах. Проблемы в человеческих капризах нет, но есть в том, что только ими теперь стараются обосновать успех всего предприятия.

Поскольку поток шальных денег пока ещё весьма силён, и ручейки расходятся по отрасли, на горячее слетаются разные писаки и объясняки. Появляются целые тома с картинками на темы «как классно работать стоя», «как поднять конверсию, если твой шеф пингвин», «айкидо табуляции» и прочий бред. Тренинги эффективного парного программирования, тренинги эффективного аутичного программирования, семинары по Питону на новой технологии обучения, семинары по обучению на новой версии Питона, etc. То есть люди начинают ковыряться во второстепенных факторах, которые практически всегда являются какими-то забавными, но незначительными особенностями того или иного предприятия, ставшего успешным за счёт, как правило, вливания средств от серьёзных дядей. Если ещё короче, настоящий рыночный успех (и провал) всегда является комбинаций больших денег, власти и амбиций руководителей, а не результатом следования тем или иным умным стратегиям, которые, как правило, пишутся уже пост-фактум.

Любой, кто работает на работе хотя бы лет 10-15, наверное, вспомнит, как и он читал в своё время книжки про «100 секретов успеха», «200 причин бросить всё и сделать» и тому подобное. Единственный достоверный результат, к которому приводит следование этим остеровским советам, заключается в том, что вы болтаетесь ровно посередине. Нет, всегда есть пример васи, который выстрелил, но единичные выбросы статистики никогда не опровергали генеральную совокупность. Стало быть, теория не подтверждается практикой, и поэтому является не более чем спекуляцией.

Парируя очевидные возражения, автор сего памфлета, безусловно, разделяет тот подход, что программист так или иначе учится на протяжении всей своей карьеры. Появляются новые языки, фреймворки, подходы к работе. Никто не желает верстать таблицами, как 15 лет назад, и SPA легче и эффективнее писать на специальных фреймворках, а не на старом родном jQuery. Развитие орудий труда неостановимо, как и человеческий прогресс в целом.

Однако, суть нового орудия труда редко находится в прямой зависимости от маркетинговых факторов, которые способствуют его внедрению. Между «новый, стильный, прикольный» и «эффективный, разумный, достойный» нет прямой связи.

Рискнём произнести весьма очевидные соображения насчёт секретов долговременного успеха в IT-отрасли. Рано или поздно, когда пузырь сдуется, и интерес мирового капитала переместится в новую отрасль (космос, биологию, медицину?), IT ждёт неминуемый консервативный поворот. Вдруг окажется, что любитель путешествий и кодинга из-под пальм элементарно работает 20 часов в неделю вместо 30-40. Вдруг окажется, что от программирования стоя через 10 лет разовьётся варикоз вен (спросите у любого парикмахера), а сидение на пуфиках, скрючившись над своим любимым макбуком, означает немалые затраты на невролога и мануального терапевта в будущем. Люди с удивлением обнаружат, что Agile не является панацеей от всех бед, и вообще должен применяться в весьма ограниченном круге задач, а новомодная геймификация прежде всего является способом саморазвлечения скучающих без реальной работы сотрудников кадровых отделов. Выяснится, что любимый лектор в очках в роговой оправе являлся обычным мошенником и смылся за границу с собранными через краудфандинг деньгами.

Останутся те компании, которые будут зарабатывать на продукте и его обслуживании, а не на росте курса акций или даже просто на обещании хоть что-то сделать. Исчезнет необузданная потребность членов сообщества встречаться на митапах, конференциях, хакатонах и кэмпах. Спадёт прогрессирующий вал новых серебрянных пуль и «убийц С++». Вдруг окажется, что без человека, владеющего серьёзным, проверенным временем инструментарием разработки, трудно поддерживать существующую, уже достаточно богатую инфраструктуру отрасли. Выяснится, что новые подходы, решения, разработанные внутри компании, как правило, дают больший реальный эффект, чем модные решения извне. Под давлением обстоятельств (читай, в связи с сокращением бюджетов на эксперименты) человек, придумавший решение конкретной проблемы сам, станет цениться дороже, чем тот, кто смог продать своему руководству решение из Google или Facebook, только потому, что оно из Google или Facebook.

Кто-то скажет, что станет скучнее. Возможно, кому-то новые времена покажутся пресными. Там, где качество кода компании не зависит от пятничной пиццы и настольного хоккея в офисе, ровно как и от командировок лучших сотрудников в Долину, прикольным весёлым ребятам делать особо нечего. Новыми героями статей вокруг IT-отрасли станут деловитые инженеры, копающие каждый свою тему, и добивающиеся пусть небольших, но фундаментальных улучшений для всех. Обществу станет всё-равно, добился тот или иной герой успеха в 19 лет или в 50. Станет неважным лейбл на корпусе ноутбука и умение держать себя на презентациях. Передовые разработчики перестанут называть друг друга «гуру», и станут просто инженерами.

Крепкие IT-профессионалы, которые действительно имеют опыт решения самых разнообразных задач, возможно, как и работники других отраслей, станут задавать своим работодателям правильные вопросы: насчёт переработок, необходимой инсоляции и организации правильного питания в офисе. Возможно, ответом на вытеснение работников на надомную работу и прочие сокращения реальных благ, которые они получают, станет создание профсоюзов.

Взрыв инноваций и нововведений диалектически превратится в свою противоположность, сняв (в гегелевском смысле) все те реальные противоречия, которые накопились в отрасли в момент бурного роста. Возможно, настанет время решить давно назревшие вопросы, ведь следующий виток развития IT-технологий уже по-настоящему затронет всех и каждого: интернет вещей или кибер-терроризм не оставят выбора в вопросе «сделать быстро в надежде на будущие доработки» или «сделать сразу хорошо».

|

Метки: author botyaslonim управление сообществом управление разработкой карьера в it-индустрии венчурные инвестиции карьера программиста отрасль it- компании |

Что общего у крупных успешных Open Source-проектов? |

Что общего у крупных успешных Open Source-проектов?

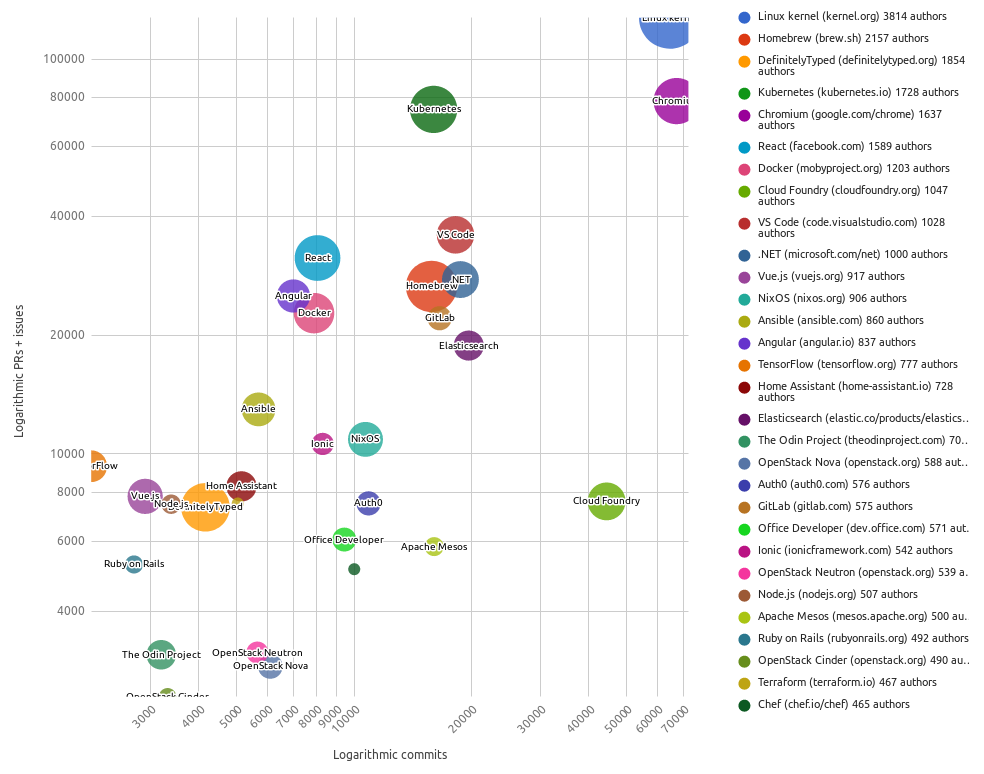

В организации The Linux Foundation задались вопросом, что объединяет проекты с открытым кодом, которым удалось собрать вокруг себя большое сообщество и добиться быстрых темпов разработки. Чтобы ответить на него, Дэн Кон (Dan Kohn), возглавляющий одно из многочисленных подразделений организации — CNCF (Cloud Native Computing Foundation), и его коллега-разработчик (Lukasz Gryglicki) создали визуализацию для 30 самых активно развивающихся Open Source-проектов, по статистическим данным с мая 2016 по апрель 2017 года. В качестве численных показателей, которые были учтены для выборки самих проектов и их визуализации, авторы использовали:

- количество коммитов (ось x на графике ниже);

- количество pull requests + issues (ось y);

- количество авторов, участвующих в разработке (величина цветного круга у названия проекта).

(Картинка с кликабельными названиями проектов и подробностями по их численным показателям доступна на сайте Linux Foundation.)

Лидер по двум показателям (количество авторов и PRs + issues) вряд ли кого удивил — это проект ядра Linux. Его ближайшие преследователи по количеству авторов — Homebrew и DefinitelyTyped. Лидер по числу коммитов, обошедший даже ядро Linux, — Chromium, а замыкает условный пьедестал по этому показателю Cloud Foundry, причём с большим отрывом от всех преследователей. И последний проект, попавший в топ-3 уже по другому показателю (числу PRs + issues), — это Kubernetes.

Кстати: Исходный код инструментов, с помощью которых собиралась эта статистика, и документация по ним опубликованы на GitHub (язык Ruby, лицензия Apache License 2.0).

Если проанализировать, кто стоит за всеми ведущими 30 проектами, то выяснится:

- 9 проектов (включая ядро Linux, Kubernetes, Cloud Foundry и др.) — создаются независимой организацией/фондом (для перечисленных примеров — Linux Foundation, CNCF и Cloud Foundry соответственно), причём 3 из них приходятся на OpenStack (Nova, Neutron и Cinder);

- 15 проектов (включая Chromium, React, Docker/Moby…) — создаются коммерческой компанией (Google, Facebook, Docker…);

- 6 проектов (включая Homebrew, DefinitelyTyped, Vue.js…) — создаются сообществом без явных компаний/фондов.

В Linux Foundation приводят слова своего исполнительного директора Джима Землина (Jim Zemlin), который считает, что управление успешным Open Source-проектом во многом зависит от качественного выполнения «функций уборщицы»: сортировки багов, ответов на вопросы новых пользователей и разработчиков, решения юридических вопросов и, конечно, урегулирования всевозможных трений, которые неизбежно возникают при любом масштабном сотрудничестве.

Очевидно, фонды и крупные компании выделяют специальных людей и средства, чтобы наладить процессы решения обозначенных проблем. Можно даже сказать, что наличие подобной организации, стоящей за проектом, — это и есть то общее, что объединяет крупные и успешные Open Source-продукты. Статистика, полученная из топ-30, подтверждает это: у 80 % проектов есть свой «покровитель». (Компания-покровитель «превращается» в фонд в тот момент, когда другие значимые игроки рынка видят для себя перспективы коммерциализации кодовой базы и ищут пути реального влияния на ход развития проекта — через общий совет, членами которого и становятся заинтересованные стороны-компании.)

Однако оставшиеся исключения — это 20 %, которые, пусть и являясь явным меньшинством, всё же доказывают, что успех проекта возможен усилиями сообщества и без явных спонсоров.

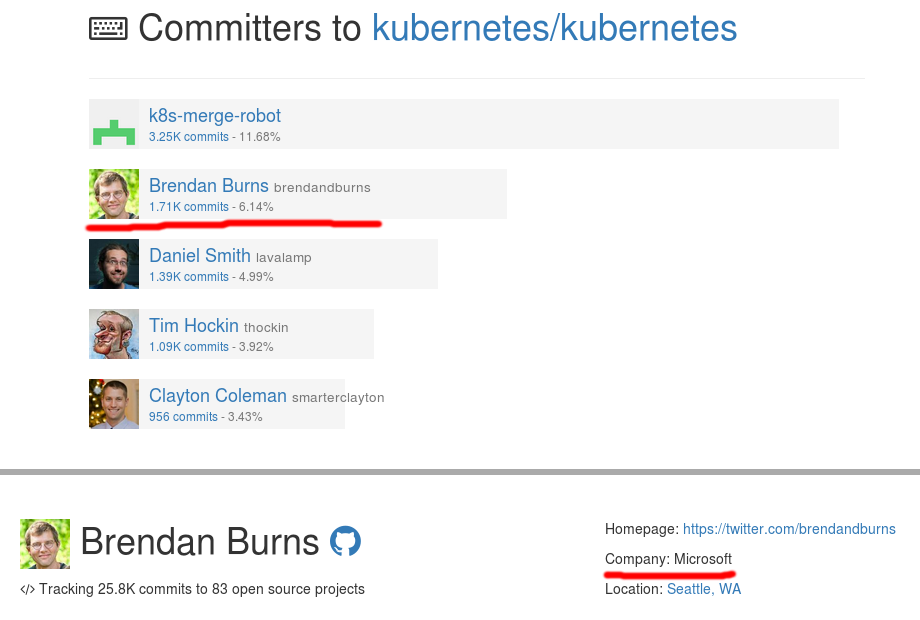

P.S. Напоследок, к вопросу о компаниях и фондах — попробуйте угадать компанию, сотрудник которой является ведущим контрибьютором в кодовую базу Kubernetes.

Если вы удивились слишком сильно, то успокою, что в действительности всё несколько сложнее. Автор (Brendan Burns) присоединился к команде Microsoft Azure лишь прошлым летом, а до этого годами работал над Kubernetes в Google.

|

Метки: author shurup управление сообществом управление проектами блог компании флант open source linux foundation сообщество статистика |

Немного из истории криптографии СССP: M-105 под кодовым названием Агат |

Немного из истории криптографии СССP: M-105 под кодовым названием Агат

Кабинет перлюстрации при почтовом отделении в Российской империи

В истории отечественной криптографии времен СССР образовалось много пробелов, так как информация находилась под семью замками, строго хранилась в тайне. Некоторые моменты освещены в статье сокровищница отечественной криптографии, в ней же упоминалось и о самых известных советских криптомашинах.

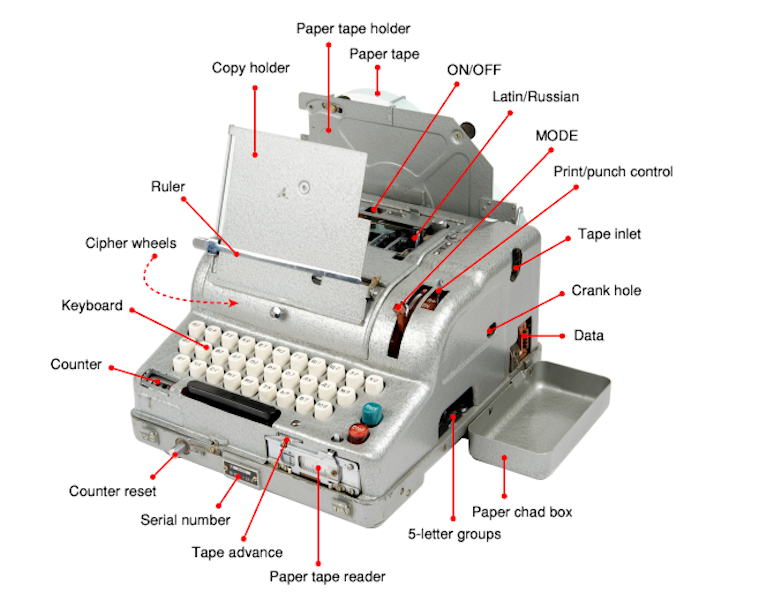

M-105: Под кодовым названием Агат

M-105 (кодовое название: Aгат) — это русская, автономная шифровальная машина, которая была разработана и создана в СССР в конце 1960 годов. Предшественницей этой криптомашины была почти идентичная M-104 (Аметист и Аметист-2). Такие машины использовались всеми странами Варшавского договора (ГДР, Чехословакия, Венгрия, Румыния, Югославия), они представляли собой электромеханические шифраторы текстовой информации с записью на бумажную перфоленту: СМ-1 Василек, СМ-2, М-104 Аметист, М-105 Агат, М-125 Фиалка, М-130 Коралл.

СМ-1 Василек

М-104 Аметист

М-105 Агат

М-125 Фиалка

М-130 Коралл

M-105 Агат — криптомашина, в которой применялся OTT – One-Time-Tape шифрование, суть такого шифрования проста: применяемый ключ одноразовый и по длине равен передаваемым данным, текст зашифрован и без ключа его никто расшифровать не сможет.

В отличие от Фиалки, в которой для генерирования ключа использовались 10 шифровальных колес (роторов), в M-105 встроен генератор механических ключей, который выводит случайные ключи на 11-уровневую перфоленту. Находится он в верхней части машины.

На первый взгляд машина несколько напоминает M-125 Фиалку. Электрическая машина, почти таких же габаритов, окрашена в серебристый серый цвет с клавиатурой на латинице/кириллице. Но на этом сходство заканчивается.

M-105 выводила результаты непосредственно на лист бумаги, который находился в каретке сзади. Усовершенствованная матричная печатающая головка позволяла напечатать любой из 30 символов (5 x 6). В зависимости от языка, который использовался для печати, некоторые символы или цифры могли отсутствовать.

Сзади справа находилось устройство для вставки перфоленты и ввода ключа (стандартная 5-уровневая перфолента), правда код Бодо не применялся.

Код Бодо — равномерный телеграфный 5-битный код, использующий два отличающихся друг от друга электрических сигнала.

Вместо него использовалась та же схема кодирования, что и в Фиалке. Спереди M-105 находилось устройство считывания с бумажной перфоленты. Перфолента направлялась через линейку, которая проходила по всей ширине машины. Для запуска и остановки — две клавиши (Запуск, Стоп), расположенные спереди справа.

На изображении ниже показано расположение полной клавиатуры: на каждой клавише — буква кириллицы и латиницы. 30 клавиш, черный одношаговый ключ внизу слева и черный управляющий символ возврата катерки CR/LF внизу справа, есть пробел (внизу).

В режиме шифрования, при вводе текста использовался пробел, а клавиша Й2 блокировалась. В режиме расшифровки все наоборот: пробел заблокирован, клавиша Й2 — доступна. Когда аппарат использовался в режиме обычного текста (MODE установлен на «O»), можно было использовать как клавишу пробела, так и клавишу Й2. Две черные клавиши («шаг » и CR/LF) не зашифрованы. Они работали только в текстовом режиме для форматирования вывода. Недостающую «Й» спокойно можно заменить на «И». Идентично Фиалке, на клавиатуре М-105 присутствуют только 30 наиболее используемых букв.

Знаков препинания — кроме символа SPACE с применением клавиши «Й» в верхнем левом углу — нет. Переключение между латиницей и кириллицей означало замену печатающей головки.

Перфолента могла использоваться для шифрования только один раз, поэтому при переключении режимов работы пробивалась Control Hole (контрольная дыра). Перфоленты, предназначенные только для дешифрования, имели Check Hole, чтобы случайным образом их не использовали в качестве ключа шифрования.

Переключение режимов работы

Спереди слева, сразу над клавиатурой находится черный поворотный регулятор, с его помощью можно выбрать необходимый режим работы:«O» для набора текста (Открытый текст), «3» для шифрования (зашифровать) и «P» для расшифровки (расшифровывать).

В режиме текста M-105 функционировала, как обычная пишущая машинка или телепринтер и использовалась для печати текста, создания 5-уровневых перфолент (5 дыр на строку). Были доступны все клавиши, включая пробел, ШАГ каретки и CR/LF.

При установке режимов шифрования (3) или расшифровки (P) происходил ряд механических изменений внутри устройства. Как и писалось ранее — в режиме шифрования клавиша Й2 заблокирована, доступен пробел, в режиме расшифровки — все наоборот.

Аббревиатуры, используемые для разных режимов, идентичны для всех машин (M-125 или M-130), как показано ниже.

На передней части 11-уровневого считывателя ключей — рычаг с тремя возможными настройками: П, ПК и К. Использовался он для выбора адресата (перфоратор, принтер, перфоратор и принтер) кодированного, декодированного или обычного текстового вывода.

Блок питания

Существовало несколько версий M-105, наиболее распространенная — устройство питалось от источника постоянного тока напряжением 24 В.

Специально, для подключения к сети постоянного тока напряжением 110 В была доступна иная версия АГАТ.

Стандартный блок питания, который использовался в M-105, подходил для сетей любого уровня напряжения (как правило, в диапазоне напряжений 110 – 220 В), мог использоваться практически в любой точке мира. Такой же блок питания применялся с M-125 Фиалка в большинстве стран Варшавского договора.

Рычаг выполнял несколько функций. С его помощью можно было работать с машиной вручную в случае сбоя питания. Поскольку процесс шифрования носил чисто механический характер, машина могла считывать 5-уровневые перфоленты, ленты с ключами, печатать на бумаге и без электричества. Рычаг также использовался для «перезагрузки» механизма, если его заклинивало.

Рычаг

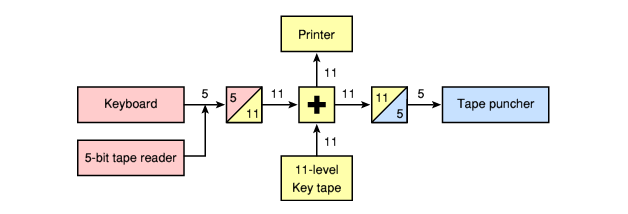

В M-105 использовалась матрица 5 x 6 (5 строк, 6 столбцов) для адресации 30 символов. Каждый 5-битный символ переводился в строку (6 бит) и столбец (5 бит), в итоге получалось 11 внутренних «бит», потому ключевая перфолента — 11-уровневая.

11-битный код с ключевой перфоленты добавлялся к 11-битовому потоку данных, результат после преобразовывался обратно в 5-разрядный цифровой код (выводился на пятиуровневые перфокарты).

В Восточной Германии (DDR) М-105 была введена в эксплуатацию в 1968 году и использовалась для связи с государствами-партнерами Варшавского договора, а также руководством ГДР для обмена сообщениями на самом высоком правительственном уровне.

В 1986 году M-105 стала полностью электронной машиной M-205 D, но многие M-105 оставались в эксплуатации до немецкого воссоединения. М-105 была заменена на Т-353 (Dudek) в 1987 году для коммуникации ГДР с Венгрией.

Т-353 (Dudek)

Найти материалы о данной криптомашине на просторах рунета крайне тяжело, потому информация была взята вот здесь: Сrypto museum и bplaced.net. Скорее всего такое скудное публичное освещение достижений в области криптографии времен СССР обусловлено рядом причин: только частичное рассекречивание, недофинансирование и другие проблемы. Будем надеяться, что в скором времени отечественные научные достижения и выдающиеся криптографы страны выйдут из под грифа «совершенно секретно».

На правах рекламы.Акция! Только сейчас получите до 4-х месяцев бесплатного пользования VPS (KVM) c выделенными накопителями в Нидерландах и США (конфигурации от VPS (KVM) — E5-2650v4 (6 Cores) / 10GB DDR4 / 240GB SSD или 4TB HDD / 1Gbps 10TB — $29 / месяц и выше, доступны варианты с RAID1 и RAID10), полноценным аналогом выделенных серверов, при заказе на срок 1-12 месяцев, условия акции здесь, cуществующие абоненты могут получить 2 месяца бонусом!

Как построить инфраструктуру корп. класса c применением серверов Dell R730xd Е5-2650 v4 стоимостью 9000 евро за копейки?

|

|

Народная Политика конфиденциальности |

По многочисленным просьбам

Решились на такой шаг, потому что данная форма Политики не предусматривает обработку персональных данных, и в результате не предполагает большой вариативности решения. Важно помнить, что она не подходит для сайтов, на которых обрабатываются ПДн. Например, интернет-магазины и прочие сервисы, на которых помимо номера телефона или email пользователем дополнительно предоставляются иные сведения о себе, требуют большего внимания к вопросам обработки персональных данных.

Поэтому мы подумали над вариантами составления «народной» Политики конфиденциальности с обработкой ПДн. Простым шаблоном здесь не обойдешься. Взяли за основу вышедшие в 2017 году Рекомендации Роскомнадзора (далее – «Рекомендации») по составлению документа, определяющего политику оператора в отношении обработки персональных данных (далее – «Политика). Дополнили ее живыми примерами.

Смотрим, что получилось. Читать дальше ->

|

|

Вторая встреча амазоновцев в Москве |

Если вы интересуетесь Amazon Web Services, или кратко AWS, то приглашаем вас посетить вторую встречу AWS Usergroup Moscow.

Что?

Темы докладов, возможно, будут меняться: но предварительно такие:

1) Программируем инфраструктуру через CloudFormation

2) Lambda + ApiGateway = ServerLess в AWS

3) Облачная автоматизация «из коробки”

4) Что можно сделать на Free Tier

Где?

Встреча будет проходить в главном офисе компании Крок по адресу:

Москва, ул. Волочаевская, д. 5, корп. 1

Когда?

28 сентября в 19.00

На объекте действует пропускная система, поэтому не забудьте прислать номера автомобилей и Фамилию/Имя своих спутников (и свои, если они на этой платформе отличаются от того что в документах).

Ссылка на встречу: www.meetup.com/awsmsk/events/242828973

Ссылка на группу: www.meetup.com/AWSmsk

|

Метки: author tonyzorin учебный процесс в it aws amazon web services обучение |

RPM-репозиторий — своими руками |

RPM-репозиторий — своими руками

Итак, начнём.

При внедрении DevOps-процесса в компании одним из возможных вариантов хранилища артефактов сборки может стать rpm-репозиторий. По существу — это просто веб-сервер, раздающий определённым образом организованное содержимое. Есть, конечно, коммерческие варианты maven-репозиториев, которые имеют плагины для поддержки rpm, но мы же не ищем лёгких путей?

Задача

Написать сервис, который будет принимать готовые rpm-пакеты по протоколу HTTP, парсить их метаданные, раскладывать файлы пакетов по каталогам в соответствии с внутренней структурой репозитория и обновлять метаданные репозитория после обработки очередного пакета. Что из этого получилось — описано под катом.

Анализ

В моей голове задача почти мгновенно распалась на несколько частей: первая — принимающая, которая должна принять rpm-пакет по HTTP; вторая — обрабатывающая, которая должна принятый RPM-пакет обработать. Ну и где-то ещё должен быть веб-сервер, который будет раздавать содержимое репозитория.

Принимающая часть

Ввиду того, что с Nginx я знаком давно, выбор веб-сервера для приёма rpm-пакетов и раздачи содержимого репозитория даже не стоял — только Nginx. Приняв это как данность, я нашёл в документации нужные опции и написал

location /upload {

proxy_http_version 1.1;

proxy_pass http://127.0.0.1:5000;

proxy_pass_request_body off;

proxy_set_header X-Package-Name $request_body_file;

client_body_in_file_only on;

client_body_temp_path /tmp/rpms;

client_max_body_size 128m;

}Результат данной конфигурации — при приёме файла Nginx сохранит его в заданный каталог и сообщит исходное имя в отдельном заголовке.

Для полноты картины — вторая крохотная

location /repo {

alias /srv/repo/storage/;

autoindex on;

}Итак, у нас есть первая часть, которая умеет принимать файлы и отдавать их.

Обрабатывающая часть

Обрабатывающая часть напиcана на Python без особых премудростей и выглядит

#!/usr/bin/env python

import argparse

import collections

import pprint

import shutil

import subprocess

import threading

import os

import re

import yaml

from flask import Flask, request

from pyrpm import rpmdefs

from pyrpm.rpm import RPM

# Сервис для поддержания репозиториев (С) Sergey Pechenko, 2017

# Лицензия - GPL v2.0. Никаких дополнительных гарантий или прав не предоставляется.

# Для лицензирования использования кода в коммерческом продукте свяжитесь с автором.

class LoggingMiddleware(object):

# Вспомогательный класс для логирования запросов и отладки

def __init__(self, app):

self._app = app

def __call__(self, environ, resp):

errorlog = environ['wsgi.errors']

pprint.pprint(('REQUEST', environ), stream=errorlog)

def log_response(status, headers, *args):

pprint.pprint(('RESPONSE', status, headers), stream=errorlog)

return resp(status, headers, *args)

return self._app(environ, log_response)

def parse_package_info(rpm):

# Обработка метаданных пакета

os_name_rel = rpm[rpmdefs.RPMTAG_RELEASE]

os_data = re.search('^(\d+)\.(\w+)(\d+)$', os_name_rel)

package = {

'filename': "%s-%s-%s.%s.rpm" % (rpm[rpmdefs.RPMTAG_NAME],

rpm[rpmdefs.RPMTAG_VERSION],

rpm[rpmdefs.RPMTAG_RELEASE],

rpm[rpmdefs.RPMTAG_ARCH]),

'os_abbr': os_data.group(2),

'os_release': os_data.group(3),

'os_arch': rpm[rpmdefs.RPMTAG_ARCH]

}

return package

# Объект приложения и его настройки

app = Flask(__name__)

settings = {}

# Тестовый обработчик - пригодится в начале настройки

@app.route('/')

def hello_world():

return 'Hello from repo!'

# Обработчик конкретного маршрута в URL

@app.route('/upload', methods=['PUT'])

def upload():

# Ответ по умолчанию

status = 503

headers = []

# Этот нестандартный заголовок мы добавили в конфигурацию Nginx ранее

curr_package = request.headers.get('X-Package-Name')

rpm = RPM(file(unicode(curr_package)))

rpm_data = parse_package_info(rpm)

try:

new_req_queue_element = '%s/%s' % (rpm_data['os_release'], rpm_data['os_arch'])

dest_dirname = '%s/%s/Packages' % (

app.settings['repo']['top_dir'],

new_req_queue_element)

# Перемещаем файл в нужный каталог

shutil.move(curr_package, dest_dirname)

src_filename = '%s/%s' % (dest_dirname, os.path.basename(curr_package))

dest_filename = '%s/%s' % (dest_dirname, rpm_data['filename'])

# Переименовываем файл

shutil.move(src_filename, dest_filename)

# Готовим ответ, который получит загружавший клиент

response = 'OK - Accessible as %s' % dest_filename

status = 200

if new_req_queue_element not in req_queue:

# Кладём запрос на обработку этого пакета в очередь

req_queue.append(new_req_queue_element)

event_timeout.set()

event_request.set()

except BaseException as E:

response = E.message

return response, status, headers

def update_func(evt_upd, evt_exit):

# Ждёт события, затем запускает обновление метаданных

while not evt_exit.is_set():

if evt_upd.wait():

# Выбираем следующий доступный запрос из очереди

curr_elem = req_queue.popleft()

p = subprocess.Popen([app.settings['index_updater']['executable'],

app.settings['index_updater']['cmdline'],

'%s/%s' % (app.settings['repo']['top_dir'], curr_elem)],

shell=False, stdout=subprocess.PIPE, stderr=subprocess.PIPE)

res_stdout, res_stderr = p.communicate(None)

pprint.pprint(res_stdout)

pprint.pprint(res_stderr)

# Сбрасываем событие обновления

evt_upd.clear()

return

def update_enable_func(evt_req, evt_tmout, evt_upd, evt_exit):

while not evt_exit.is_set():

# Ожидаем запрос

evt_req.wait()

# OK, дождались

# Теперь выдерживаем 30 секунд, а если в это время пришёл запрос....

while evt_tmout.wait(30) and (not evt_exit.is_set()):

evt_tmout.clear()

if evt_exit.is_set():

break

evt_upd.set()

evt_tmout.clear()

evt_req.clear()

return

def parse_command_line():

# Разбор агрументов командной строки

parser = argparse.ArgumentParser(description='This is a repository update helper')

parser.prog_name = 'repo_helper'

parser.add_argument('-c', '--conf', action='store', default='%.yml' % prog_name, type='file', required='false',

help='Name of the config file', dest='configfile')

parser.epilog('This is an example of Nginx configuration:\

location /repo {\

alias /srv/repo/storage/;\

autoindex on;\

}\

\

location /upload {\

client_body_in_file_only on;\

client_body_temp_path /tmp/rpms;\

client_max_body_size 128m;\

proxy_http_version 1.1;\

proxy_pass http://localhost:5000;\

proxy_pass_request_body off;\

proxy_set_header X-Package-Name $request_body_file;\

}\

')

parser.parse_args()

return parser

def load_config(fn):

with open(fn, 'r') as f:

config = yaml.safe_load(f)

return config

def load_hardcoded_defaults():

# Прибитые гвоздями настройки "по умолчанию"

config = {

'index_updater': {

'executable': '/bin/createrepo',

'cmdline': '--update'

},

'repo': {

'top_dir': '/srv/repo/storage'

},

'server': {

'address': '127.0.0.1',

'port': '5000',

'prefix_url': 'upload',

'upload_header': ''

},

'log': {

'name': 'syslog',

'level': 'INFO'

}

}

return config

if __name__ == '__main__':

try:

cli_args = parse_command_line()

settings = load_config(cli_args['configfile'])

except BaseException as E:

settings = load_hardcoded_defaults()

req_queue = collections.deque()

# Application-level specific stuff

# Exit flag

exit_flag = False

# Событие, сигналящее о пришедшем запросе

event_request = threading.Event()

# Событие, сигналящее об окончании задержки

event_timeout = threading.Event()

# Событие, сигналящее о запуске обновления метаданных

event_update = threading.Event()

# Событие, сигналящее о завершении вспомогательных потоков

event_exit = threading.Event()

# Готовим начальное состояние событий

event_request.clear()

event_timeout.clear()

event_update.clear()

# Поток, который запускает обновление метаданных репозитория

update_thread = threading.Thread(name='update_worker', target=update_func, args=(event_update, event_exit))

update_thread.start()

# Поток, отсчитывающий время задержки, и начинающий отсчёт сначала, если задержка прервана

# Если задержка прервана - начинаем отсчёт сначала

delay_thread = threading.Thread(name='delay_worker', target=update_enable_func,

args=(event_request, event_timeout, event_update, event_exit))

delay_thread.start()

# Его Величество Приложение

app.wsgi_app = LoggingMiddleware(app.wsgi_app)

app.run(host=settings['server']['address'], port=settings['server']['port'])

# Это событие заставит оба дополнительных потока завершиться

event_exit.clear()Важный и, скорее всего, непонятный с первого взгляда момент — зачем же здесь нужны потоки, события и очередь.

Они нужны для передачи данных между асинхронными процессами. Вот смотрите, ведь HTTP-клиент не обязан ждать какого-то разрешения, чтобы загрузить пакет? Правильно, он может начать загрузку в любой момент. Соответственно, в основном потоке приложения мы должны сообщить клиенту об успешности/неуспешности загрузки, и, если загрузка удалась, передать данные через очередь другому потоку, который выполняет вычитывание метаданных пакета, а затем перемещение его в файловой системе. При этом отдельный поток следит, прошло ли 30 секунд с момента загрузки последнего пакета, или нет. Если прошло — метаданные репозитория будут обновлены. Если же время ещё не вышло, а уже пришёл следющий запрос — сбрасываем и перезапускаем таймер. Таким образом, всякая загрузка пакета будет отодвигать обновление метаданных на 30 секунд.

Как пользоваться

Сначала нужно

appdirs==1.4.3

click==6.7

Flask==0.12.1

itsdangerous==0.24

Jinja2==2.9.6

MarkupSafe==1.0

packaging==16.8

pyparsing==2.2.0

pyrpm==0.3

PyYAML==3.12

six==1.10.0

uWSGI==2.0.15

Werkzeug==0.12.1

К сожалению, я не могу гарантировать, что это минимально возможный список — команда pip freeze просто берёт список доступных пакетов Python и механически переносит его в файл, не рассматривая, используется ли конкретный пакет в конкретном проекте или нет.

Затем нужно установить пакеты с nginx и c createrepo:

yum install -y nginx createrepoЗапуск проекта выглядит вот так:

nohup python app.pyПосле того, как всё будет запущено, можно пробовать загрузить rpm-пакет в репозиторий вот такой командой:

curl http://hostname.example.com/upload -T Я понимаю, что описанный сервис далёк от совершенства и являет собой скорее прототип, нежели полноценное приложение, но, с другой стороны, он может быть легко дополнен/расширен.

Для удобства желающих код выложен на GitHub. Предложения по дополнению сервиса, а ещё лучше — pull-request'ы горячо приветствуются!

Надеюсь, этот прототип окажется кому-то полезным. Спасибо за внимание!

Ну и для тех, кому очень нужно, небольшой сниппет для укрощения SELinux:

#!/bin/bash

semanage fcontext -a -t httpd_sys_rw_content_t "/srv/repo/storage(/.*)?"

restorecon -R -v /srv/repo/storage

setsebool -P httpd_can_network_connect 1|

Метки: author tnt4brain серверное администрирование devops *nix devops (*nix) nginx python rpm |

Куда податься вендору, когда Amazon не по зубам: придумываем торговую площадку для нишевых гаджетов |

Куда податься вендору, когда Amazon не по зубам: придумываем торговую площадку для нишевых гаджетов

Подпись же картинке не нужна, правда?

Представим ситуацию: вы изобрели очередной электровеник, с которым ваша команда вышла на «Кикстартер» и успешно собрала нужную сумму для производства тысячи изделий. Часть вы распродали сразу же в рамках краудфандинговой кампании, а часть – «зависла» на руках. В этот момент вы столкнулись с главной проблемой большинства энтузиастов и небольших производителей: вы слишком озабочены идеей закончить разработку, переходом от прототипирования к изготовлению рабочих устройств, и не особо задумываетесь, как вы это будете продавать.

Фактически, чуть ли не каждый второй стартап или небольшое предприятие попадает в порочный круг «прежде чем что-то продавать, нужно это изготовить». Это является классической болезнью любого малого бизнеса, что в конечном итоге приводит к банкротству и прекращению деятельности. Конечно, от подобных телодвижений может уберечь толковый директор по продажам, который подготовит все необходимые «аэродромы», на которые в итоге и «десантируется» ваш продукт, но чаще выходит совершенно иначе. Вложив немало времени, сил и иногда денег, выполнив обязательства перед инвесторами, вы остаетесь с партией никому не нужных устройств, в которых и лежит мертвым грузом прибыль всего предприятия. В подобной ситуации небольшая часть производителей запускает собственные ритейл-площадки на базе своего сайта, а все остальные — идут к Amazon или другим крупным игрокам.

И тут начинается самое неприятное.

Трудно быть маленьким

Любой крупный ритейлер зарабатывает за счет больших объемов продаж, а не на конкретных позициях, о чем, например, свидетельствуют отчеты самого Amazon, чья прибыль растет пропорционально росту объема продаж. На увеличение оборота ориентированы и все прочие торговые площадки, в том числе и в Сети, что приводит к максимальной унификации и наложению ряда ограничений на производителей и поставщиков.

Давайте поговорим об Amazon, как о более очевидном пути продажи наших электровеников. Система продаж на этой площадке базируется на нескольких ключевых аспектах. Первое – детальное описание продукции по достаточно жесткой и регламентированной форме. Второе – на позиции продукта влияет количество положительных отзывов о нем. Третье – рядовые пользователи и подписчики Prime получают разную выборку товаров (благодаря этой и другим маркетинговым уловкам, товарооборот на Amazon в денежном выражении в 2015 составил $107 млрд, а в 2016 году — $135,98 млрд).

И если с первым требованием гиганта по ведению торговли можно справиться, банально подсмотрев у других продавцов, то второй и третий пункт создают ощутимые проблемы. Если вы занимаетесь малотиражным производством и ваш оборот составляет несколько тысяч устройств в год (в лучшем случае), то есть товар является нишевым — у вас серьёзные проблемы. На Amazon, как, впрочем, и на любых других подобных площадках, существует система рейтингов, основанная на количестве и качестве положительных отзывов от реальных пользователей. Минимально необходимое количество положительных рецензий о товаре в случае американской площадки – 25 штук. Без этого числа отзывов ваш товар не будет отображаться в поисковой выдаче, а продвигать его нужно будет средствами площадки в виде баннерной рекламы или привлекать трафик извне. Подход с размещением рекламы на Amazon или в Сети оправдан, если речь идет о каком-то серийном продукте, продавать который планируется длительное время и в больших объемах. Тогда можно устроить и рекламную кампанию, привлечь СМИ, разместить рекламу в Google.

В случае с мелкой партией какого-либо уникального товара подобная рекламная кампания окончательно сожрет прибыль от продаж или загонит начинающего производителя в долговую яму.

Конечно, всегда остается вариант «сбросить» товар по цене, близкой к себестоимости, какому-нибудь крупному ритейлеру, у которого есть собственная сеть сбыта. Однако это возвращает нас к вопросу извлечения прибыли и дальнейшему росту, так как в этом случае производителю нужно будет выходить на какие-то более осмысленные объемы, чем несколько сотен устройств в месяц.

Проблема не в производителях, а в продавцах

Согласитесь, известный бренд не всегда означает высокое качество конечного товара, а предложения на рынке не всегда удовлетворяют потребности отдельной категории потребителей. Если 9 из 10 потребителей будут удовлетворены функциями некого условного продукта, то крупный производитель не будет заморачиваться штучным производством для последнего, десятого. Для производителя это невыгодно.

Эту нишу могли бы занять мелкие предприятия, которым бы вполне хватило и десятой доли «пирога» потребителей. Но все упирается в рынки сбыта: для того, чтобы обеспечить выживание мелких производств, чьи товары не на слуху у широкой аудитории, они должны свободно продаваться или продвигаться ритейлером. Но, при прочих равных, крупным ритейлерам интереснее продать сотню тысяч смартфонов известных брендов, чем сотню условных электровеников.

Мы столкнулись с описанной выше ситуацией, когда занялись поставками, а в дальнейшем и производством, детских планшетов PlayPad. Недоступность классических площадок и рынков сбыта для мелких производителей создает парадоксальную ситуацию: существует спрос на какой-то специализированный товар, существует и сам товар. Но производитель и покупатель просто не могут встретиться, потому что последний не знает о самом факте существования первого.

Конечно, основные палки в колеса реализации малотиражной продукции вставляют сами площадки и существующая доктрина сетевой интернет-торговли. Правила размещения и торговли на них писались под крупных производителей и поставщиков, однако распространяются и на мелких игроков рынка. В итоге весь механизм работы современного интернет-ритейла вызывает удушающий эффект для тех, кто не готов вкладывать сотни тысяч и миллионы долларов в маркетинг и продвижение.

Зачем мы придумали Hamster Marketplace

У нас уже есть опыт, альтернативный крупным интернет-площадкам уровня Amazon. Речь идет о собственном сайте и выстраивании персонального канала продаж. Однако, с ростом производства и доли рынка мы пришли к классической схеме сотрудничества с крупным оффлайновым ритейлером в лице М-ВИДЕО.

Этот опыт нельзя назвать однозначно травматичным, но стоит понимать, что в этом «танце» роль ведущего отводится исключительно торговой сети. Мы могли лишь соглашаться или не соглашаться на предлагаемые нам условия работы.

Именно поэтому и родилась идея создания торговой площадки, которая была бы реальным посредником между производителем и покупателем, а не псевдо-площадкой, коей сейчас является Aliexpress, Amazon, E-Bay все прочие. Почему мы заговорили о псевдо-площадке? Скажем так, глупо отрицать, что все вышеописанные ресурсы и компании, стоящие за ними, в первую очередь преследуют собственные интересы по росту и извлечению прибыли. Иногда эти интересы совпадают с интересами продавцов и производителей, а иногда – нет. Именно эту диктатуру площадки для мы и намереваемся устранить.

Что такое Hamster Marketplace? За основу мы взяли популярную нынче идею децентрализации и самоуправления сообществом через механизмы блокчейна. В большинстве аспектов площадка копирует устоявшиеся бизнес-процессы того же Amazon, за одним большим исключением: управлять ею будут не условный совет директоров Amazon или Джефф Безос, а сами продавцы и производители товаров. Таким образом мы хотим достичь самоуправления, когда решения, принимаемые площадкой, будут отражать потребности реального большинства продавцов, а не нескольких производителей-гигантов.

Вот основополагающие принципы работы Hamster Marketplace:

- Hamster Marketplace не ставит своей целью получение прибыли;

- Hamster Marketplace управляется непосредственно участниками со статусом «Производитель» с помощью токенов маркетплейса HMST;

- Развитие и функционирование площадки осуществляется исходя из бюджета, принимаемого блокчейн-голосованием владельцами токенов HMST со статусом «Производитель»;

- Бюджетные траты площадки прозрачны и зафиксированы в блокчейне.

Если мир созрел для коллективного финансирования мелких проектов, то, вероятно, пришло время и коллективно управляемой торговой площадки.

Инди-электронщики и DIY-щики всех стран, соединяйтесь!

Взглянув на наш сайт свежим взглядом, мы вдруг поняли, что он как-то совсем про деньги. Сборы — это, конечно, важно, но ещё нам очень нужна обратная связь сообщества. Нужна ли вам такая площадка? Как она должна быть устроена, на каких условиях. работать — делитесь мнениями, сомнениями и предложениями.

|

Метки: author HamsterMrkt управление e-commerce венчурные инвестиции бизнес-модели блог компании hamster marketplace hamster marketplace инди-электроника гаджеты diy |

Математика для программиста |

Математика для программиста

Нужна ли математика программисту?

Нужна. А, кроме неё, нужна сферическая геометрия, география, музыка и банковское дело. И я сейчас не шучу.

Дело в том, что программисты редко решают задачи для самих себя: мы работаем в банковских сервисах, сервисах бронирования отелей, картографических сервисах и прочих Яндекс.Почтах. Получается, что мы решаем задачи наших пользователей.

Для решения чисто программистских задач у нас есть алгоритмы и паттерны: если посмотреть на код интернет-магазина цветов и банковского сайта он будет очень похож. Будут использоваться одинаковые условия, одинаковые циклы и даже паттерн MVC будет один и тот же.

Важнее то, что стоит за этими вещами: понимание как работает система в целом. Если посмотреть на вещи с этой стороны, то станет понятно, что программист — это младший специалист в области, в которой работает сайт.

Ещё пять лет назад Артём Поликарпов доказал, что каждый фронтендер немного дизайнер. Нам нужно понимать как устроены шрифты: что такое гротеск, чем он отличается от антиквы, что такое интерлиньяж, кернинг, разрядка, капитель. Понимать, что такое сетки и что такое композиция. Кроме этого, разбираться в UX — мы должны знать что такое оптимистичный UI, где поставить прелоадер и зачем это всё нужно пользователю.

Но быть только дизайнером — мало. Дело в том, что пользователи взаимодействуют с нашими сайтами: в интернет-магазинах они вводят данные своих банковских карт, на картографических сервисах прокладывают маршруты и измеряют расстояния, на музыкальных сайтах они транспонируют тональность песен и настраивают гитару по тюнеру. И всё это должен кто-то запрограммировать. Получается, что у программиста должны быть специальные знания.

Например, правильность номера банковской карты определяется по алгоритму Луна — это теория кодирования.

Чтобы найти расстояние между двумя точками на карте, заданными широтой и долготой, нужно воспользоваться формулой дуги большого круга — это сферическая геометрия. Ещё этой формулой очень часто пользуются в морской навигации.

С картами, вообще, связано очень много интересного. Например, Яндекс.Карты используют эллиптическую проекцию Меркатора, а все остальные географические сервисы — сферическую, поэтому если вы захотите наложить слой Яндекс.Пробок на любую другую карту у вас не сойдутся улицы и вам нужно будет знать, как трансформировать одну проекцию в другую.

Кстати, о трансформациях. Помните CSS-фильтр matrix? Те самые числа в странном порядке, которые непонятно как влияют на поведение вашего блока? Это матрицы перехода из линейной алгебры. Если разобраться что такое матрицы и как перемножать их между собой, то вы сможете очень эффективно писать трансформации не пользуясь алиасами.

.neo {

transform: matrix(0, -1, 1, 0, 50px, 50px);

}С кругозором понятно — изучайте всё, что хотите, потому что в любом случае это вам пригодится. Но есть ли какая-то общая область, которая нужна всем программистам? Да, такая область есть, она называется «дискретная математика». Наука, которая лежит в основе информатики.

Я не говорю, что нужно учить диксретку досконально. Для программиста важнее широта взглядов и понимание, где посмотреть, чем узкие знания в какой-то отдельной области. Но помнить несколько основных тем не помешает.

Во-первых, изучите булеву логику. Вы пишете условия каждый день и хорошо бы понимать, как они работают, например, для того, чтобы эффективно их упрощать.

Ещё одна хорошая тема из дискретки — это графы. Очень многие программистские задачи решаются с помощью графов. Даже скучный и привычный DOM — это дерево, частный случай графа. И здесь неплохо бы понимать хотя бы как по деревьям можно ходить.

Например, вы знаете, что querySelector использует поиск в глубину? Это значит, что когда он заходит на узел DOM-дерева, он пытается посмотреть сначала его дочерние узлы и только потом соседние. Это значит если вы будете искать с помощью querySelector первый элемент на странице, то необязательно это будет элемент верхнего уровня, найденный элемент может находиться на любой вложенности.

const firstDiv = document.querySelector('div');

firstDiv.id === 'underdog';Ещё одна тема из дискретной математики — алгоритмы. Теория алгоритмов изучает что такое алгоритмы и оценку их эффективности. Представьте, у вас есть список людей, у которых вам нужно посчитать средний рост. Список задан в виде массива объектов.

const people = [

{ name: 'Иван', height: 183 },

{ name: 'Марья', height: 155 },

];Первое решение, которое может прийти в голову — это с помощью метода map собрать другой массив, массив ростов этих людей, а потом с помощью метода reduce посчитать их сумму и поделить на количество.

const averageHeight = people

.map(it => it.height)

.reduce((acc, it) => acc + it) / people.length;Но это решение будет неэффективным, потому что вы будете использовать два прохода по массиву, вместо одного. Вы могли бы сразу использовать reduce для того, чтобы сложить сразу все показатели по росту.

const averageHeight = people

.reduce((acc, it) => acc + it.height) / people.length;На деле оценка эффективности алгоритмов это немного более сложная тема, она учитывает и какой алгоритм вы используете и объём входных данных, но направление мысли вы поняли. Умение оценить эффективность алгоритмов поможет вам писать код, который будет хорошо работать или на старых телефонах и компьютерах или который не будет тормозить при работе со сложными алгоритмами, например, с большими визуализациями.

Итого: учите всё подряд, что попадётся вам под руку. Для начала изучите дискретку, потому что она будет вашим основным инструментом в работе, а потом сосредоточьтесь на задачах вашего бизнеса и вы откроете для себя очень много нового в бизнесе, математике, строительстве и медицине.

Видеоверсия

Вопросы можно задавать здесь.

|

Метки: author htmlacademy разработка веб-сайтов javascript блог компании html academy для начинающих для новичков web- программирование веб-разработка |

Обмен информацией о кибер-угрозах в реальном времени: новая платформа от ServiceNow |

Обмен информацией о кибер-угрозах в реальном времени: новая платформа от ServiceNow

/ Flickr / Wikimedia Commons / CC

/ Flickr / Wikimedia Commons / CCКак работает Trusted Security Circles

Вместе с новым релизом Jakarta платформа ServiceNow предложила предприятиям возможность делиться и получать релевантную информацию об угрозах в режиме реального времени. Обычно в борьбе с кибер-атаками сотрудники безопасности отдельных компаний оставались один на один с угрозой, однако теперь они могут запрашивать данные у поставщиков и партнеров. С помощью Trusted Security Circles организации контролируют, как и с кем они делятся своими данными.

Информация о кибер-угрозах зачастую не распространяется дальше пострадавшей компании из-за возможных репутационных потерь. Не все предприятия готовы признавать уязвимости систем безопасности, поэтому Trusted Security Circles позволяет делиться сведениями анонимно. Как поясняет пользователь ServiceNow Сьюзан Смит (Suzanne Smith), в режиме конфиденциальности компании могут выбрать возможность получать информацию об угрозах от своих коллег в конкретной индустрии или на основе местоположения. Так формируются своеобразные «круги информированности».

Когда команда безопасности видит подозрительную активность в своей сети, она может сформировать запрос в пределах определенного сообщества. Если количество таких запросов превысит установленный порог, инцидент автоматически перенаправляется в ServiceNow Security Operations, — внутренний сервис реагирования на угрозы, — что может ускорить ответ.

Таким образом, новая технология позволяет организациям-пользователям ServiceNow оставаться в курсе предстоящих атак и вооружаться необходимой информацией, поступающей от коллег.

Вице-президент ServiceNow Шон Конвери (Sean Convery) в августе рассказал о том, что основным инструментом кибер-безопасности компании является единая платформа, которая подразумевает интеграцию со сторонними поставщиками сервисов безопасности. По слова Шона, у ServiceNow на данный момент есть 40 поставщиков, которые помимо всего прочего генерируют полезную информацию для пользователей. Она лежит в основе Trusted Security Circlюes.

/ Flickr / frankieleon / CC

/ Flickr / frankieleon / CCРешения по обмену информацией — устоявшийся тренд

Помимо ServiceNow те или иные решения в той же области предлагали ранее как частные компании, так и правительственные департаменты. Например, в 2015 году компания IBM объявила о запуске своей платформы IBM X-Force Exchange на базе IBM Cloud. Это решение обеспечивает доступ к массивам данных IBM и информации о сторонних угрозах. Система работает на основе определенных индикаторов кибер-атак в реальном времени.

По схожему принципу работает Центр обмена и анализа информации в финансовом секторе от NC4. Аналогичную инициативу собирается реализовать Национальный банк Республики Беларусь для борьбы с компьютерными атаками на основе обмена информацией об угрозах. В Канаде также действует своя некоммерческая организация по добровольному обмену информации. Власти США, Великобритании и Гонконга на законодательном уровне поощряют и призывают к автоматизации предоставления сведений об угрозах.

Как отмечал руководитель отдела IT-безопасности Cubic Corp. Адам Райс (Adam Rice), основным препятствием для обмена информацией является доверие между конкурентами и партнерами на рынке. По его мнению, процесс должен гарантировать достоверность предоставляемых сведений об угрозах, инциденты должны быть доступными для проверки, и принадлежность каждого члена сообщества по обмену информацией также должна быть установлена.

В таком случае может идти речь о доверии и, следовательно, о взаимовыгодной среде. По большому счету платформа ServiceNow выступает тем самым верификатором, который делает обмен сведениями эффективным.

P.S. Дополнительное чтение по теме в нашем корпоративном блоге:

|

Метки: author it-guild информационная безопасность блог компании ит гильдия ит гильдия servicenow trusted security circles |

Анализируем требования рынка для data scientist |

Анализируем требования рынка для data scientist

В первую очередь сформулируем задачу и разработаем план:

Задача:

Посмотреть все вакансии на рынке и узнать общие требования, указанные в них.

План:

1. Собрать все вакансии по запросу Datа Scientist в удобном для обработки формате,

2. Выяснить часто встречамые в описание слова и словосочетания.

Для реализации понадобится немного знаний в SQL и Python.

Сбор данных

Источник: hh.ru

Сначала я подумал, что можно спарсить сайт. К счастью, я обнаружил, что у hh.ru есть API.

Для начало напишем функцию, которая получает список id вакансий для анализа. В параметрах функция получает текст поиска (сюда мы будем отправлять 'Datа Scientist') и зону поиска (согласно документации api), а возвращает список id. Для получения данных мы используем функцию api поиска вакансий:

def get_list_id_vacancies(area, text):

url_list = 'https://api.hh.ru/vacancies'

list_id = []

params = {'text': text, 'area': area}

r = requests.get(url_list, params=params)

found = json.loads(r.text)['found']; #кол-во всего найденных вакансий

if found <= 500: # API не отдает больше 500 вакансий за раз (на странице). Если найденно меньше 500 то получим все сразу.

params['per_page'] = found

r = requests.get(url_list, params=params)

data = json.loads(r.text)['items']

for vac in data:

list_id.append(vac['id'])

else:

i = 0;

while i <= 3: # если больше 500 то "перелистываем" страницы с 0 по 3 и получаем все вакансии поочереди. API не отдаст вам больше 2000 вакансий, поэтому тут захардкожено 3.

params['per_page'] = 500

params['page'] = i

r = requests.get(url_list, params=params)

if 200 != r.status_code:

break

data = json.loads(r.text)['items']

for vac in data:

list_id.append(vac['id'])

i += 1

return list_id

Для отладки я отправлял запосы напрямую в API. Рекомендую для этого использовать приложение chrome Postman.

После этого надо получить подробную информацию о каждой вакансии:

def get_vacancy(id):

url_vac = 'https://api.hh.ru/vacancies/%s'

r = requests.get(url_vac % id)

return json.loads(r.text)Теперь у нас есть список вакансий и функция, которая получает подробную информацию о каждой вакансии. Надо принять решение куда записать полученные данные. У меня было два варианта: сохранить все в файл csv или создать базу данных. Так как мне проще писать запросы SQL, чем анализировать в Excel я выбрал базу данных. Предварительно нужно создать базу данных и таблицы в которые мы будем делать записи. Для этого анализируем, что отвечает API и принимаем решения, какие поля нам нужны.

Вставляем в Postman ссылку api, например api.hh.ru/vacancies/22285538, делаем GET запрос и получаем ответ:

{

"alternate_url": "https://hh.ru/vacancy/22285538",

"code": null,

"premium": false,

"description": "Мы занимаемся....",

"schedule": {

"id": "fullDay",

"name": "Полный день"

},

"suitable_resumes_url": null,

"site": {

"id": "hh",

"name": "hh.ru"

},

"billing_type": {

"id": "standard_plus",

"name": "Стандарт+"

},

"published_at": "2017-09-05T11:43:08+0300",

"test": null,

"accept_handicapped": true,

"experience": {

"id": "noExperience",

"name": "Нет опыта"

},

"address": {

"building": "36с7",

"city": "Москва",

"description": null,

"metro": {

"line_name": "Калининская",

"station_id": "8.470",

"line_id": "8",

"lat": 55.736478,

"station_name": "Парк Победы",

"lng": 37.514401

},

"metro_stations": [

{

"line_name": "Калининская",

"station_id": "8.470",

"line_id": "8",

"lat": 55.736478,

"station_name": "Парк Победы",

"lng": 37.514401

}

],

"raw": null,

"street": "Кутузовский проспект",

"lat": 55.739068,

"lng": 37.525432

},

"key_skills": [

{

"name": "Математическое моделирование"

},

{

"name": "Анализ рисков"

}

],

"allow_messages": true,

"employment": {

"id": "full",

"name": "Полная занятость"

},

"id": "22285538",

"response_url": null,

"salary": {

"to": 90000,

"gross": false,

"from": 50000,

"currency": "RUR"

},

"archived": false,

"name": "Математик/ Data scientist",

"contacts": null,

"employer": {

"logo_urls": {

"90": "https://hhcdn.ru/employer-logo/1680554.png",

"240": "https://hhcdn.ru/employer-logo/1680555.png",

"original": "https://hhcdn.ru/employer-logo-original/309546.png"

},

"vacancies_url": "https://api.hh.ru/vacancies?employer_id=1475513",

"name": "Аналитическое агентство Скориста",

"url": "https://api.hh.ru/employers/1475513",

"alternate_url": "https://hh.ru/employer/1475513",

"id": "1475513",

"trusted": true

},

"created_at": "2017-09-05T11:43:08+0300",

"area": {

"url": "https://api.hh.ru/areas/1",

"id": "1",

"name": "Москва"

},

"relations": [],

"accept_kids": false,

"response_letter_required": false,

"apply_alternate_url": "https://hh.ru/applicant/vacancy_response?vacancyId=22285538",

"quick_responses_allowed": false,

"negotiations_url": null,

"department": null,

"branded_description": null,

"hidden": false,

"type": {

"id": "open",

"name": "Открытая"

},

"specializations": [

{

"profarea_id": "14",

"profarea_name": "Наука, образование",

"id": "14.91",

"name": "Информатика, Информационные системы"

},

{

"profarea_id": "14",

"profarea_name": "Наука, образование",

"id": "14.141",

"name": "Математика"

}]

}

Все, что не планируем анализировать удаляем из JSON.

{

"description": "Мы занимаемся....",

"schedule": {

"id": "fullDay",

"name": "Полный день"

},

"accept_handicapped": true,

"experience": {

"id": "noExperience",

"name": "Нет опыта"

},

"key_skills": [

{

"name": "Математическое моделирование"

},

{

"name": "Анализ рисков"

}

],

"employment": {

"id": "full",

"name": "Полная занятость"

},

"id": "22285538",

"salary": {

"to": 90000,

"gross": false,

"from": 50000,

"currency": "RUR"

},

"name": "Математик/ Data scientist",

"employer": {

"name": "Аналитическое агентство Скориста",

},

"area": {

"name": "Москва"

},

"specializations": [

{

"profarea_id": "14",

"profarea_name": "Наука, образование",

"id": "14.91",

"name": "Информатика, Информационные системы"

},

{

"profarea_id": "14",

"profarea_name": "Наука, образование",

"id": "14.141",

"name": "Математика"

}]

}

На основе этого JSON делаем БД. Это несложно, поэтому я это опущу :)

Реализуем модуль взаимодействия с базой данных. Я использовал MySQL:

def get_salary(vac): #зарплата не всегда заполена. Поэтому при обращение внутрь будет ошибка, для этого пишем отдельную функцию, которая вернет словарь с None, если данные пустые.

if vac['salary'] is None:

return {'currency':None , 'from':None,'to':None,'gross':None}

else:

return {'currency':vac['salary']['currency'],

'from':vac['salary']['from'],

'to':vac['salary']['to'],

'gross':vac['salary']['gross']}

def get_connection():

conn = pymysql.connect(host='localhost', port=3306, user='root', password='-', db='hh', charset="utf8")

return conn

def close_connection(conn):

conn.commit()

conn.close()

def insert_vac(conn, vac, text):

a = conn.cursor()

salary = get_salary(vac)

print(vac['id'])

a.execute("INSERT INTO vacancies (id, name_v, description, code_hh, accept_handicapped, \

area_v, employer, employment, experience, salary_currency, salary_from, salary_gross, \

salary_to, schedule_d, text_search) \

VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s)",

(vac['id'], vac['name'], vac['description'],

vac['code'], vac['accept_handicapped'], vac['area']['name'],

vac['employer']['name'],

vac['employment']['name'], vac['experience']['name'], salary['currency'],

salary['from'], salary['gross'],

salary['to'], vac['schedule']['name'], text))

for key_skill in vac['key_skills']:

a.execute("INSERT INTO key_skills(vacancy_id, name) VALUES(%s, %s)",(vac['id'], key_skill['name']))

for spec in vac['specializations']:

a.execute("INSERT INTO specializations(vacancy_id, name, profarea_name) VALUES(%s, %s, %s)",

(vac['id'], spec['name'], spec['profarea_name']))

a.close()

Теперь собираем все вместе, добавив в файл метод main()

text_search = 'data scientist'

list_id_vacs = get_list_id_vacancies(text_search)

vacs = []

for vac_id in list_id_vacs:

vacs.append(get_vacancy(vac_id))

conn = get_connection()

for vac in vacs:

insert_vac(conn, vac, text_search)

close_connection(conn)

Меняя переменные text_search и area мы получаем разные вакансии из разных регионов.

На этом data mining закончен и переходим к интересному.

Анализ текста

Основным вдохновителем стала статья о поиске популряных фраз в сериале How I met your mother

Для начала будем получать описание всех вакансий из базы:

def get_vac_descriptions(conn, text_search):

a = conn.cursor()

a.execute("SELECT description FROM vacancies WHERE text_search = %s", text_search)

descriptions = a.fetchall()

a.close

return descriptions

Для работы с текстом мы будем использовать пакет nltk. По аналогии с расположенной выше статьей пишем функцию получения популярных фраз из текста:

def get_popular_phrase(text, len, count_phrases):

phrase_counter = Counter()

words = nltk.word_tokenize(text.lower())

for phrase in nltk.ngrams(words, len):

if all(word not in string.punctuation for word in phrase):

phrase_counter[phrase] += 1

return phrase_counter.most_common(count_phrases)

descriptions = get_vac_descriptions(get_connection(), 'data scientist')

text = ''

for description in descriptions:

text = text + description[0]

result = get_popular_phrase(text, 1, 20)

for r in result:

print(" ".join(r[0]) + " - " + str(r[1]))

Объединяем все описанные выше методы в методе main и запускаем его:

def main():

descriprions = get_vac_descriptions(get_connection(), 'data scientist')

text = ''

for descriprion in descriprions:

text = text + descriprion[0]

result = get_popular_phrase(text, 4, 20, stopwords)

for r in result:

print(" ".join(r[0]) + " - " + str(r[1]))

main()

Выполняем и видим:

li — 2459

/li — 2459

и — 1297

p — 1225

/p — 1224

в — 874

strong — 639

/strong — 620

and — 486

ul — 457

/ul — 457

с — 415

на — 341

данных — 329

data — 313

the — 308

опыт — 275

of — 269

для — 254

работы — 233

Видим, что в результат попало очень много слов, которые характерны для всех вакансий и теги, которые используются в описание. Уберем эти слова из анализа. Для этого нам нужен список стоп слов. Сформируем его автоматически, проанализровав вакансии из другой сферы. Я выбрал «повар», «уборщица» и «слесарь».

Вернемся к началу и получим вакансии по этим запросам. После этого добавим функцию получения стоп слов.

def get_stopwords():

descriptions = get_vac_descriptions(get_connection(), 'повар') \

+ get_vac_descriptions(get_connection(), 'уборщица') + \

get_vac_descriptions(get_connection(), 'слесарь')

text = ''

for description in descriptions:

text = text + descriprion[0]

stopwords = []

list = get_popular_phrase(text, 1, None, 200) #размер списка стоп слов

for i in list:

stopwords.append(i[0][0])

return stopwordsТак же видим английские the и of. Поступим проще и уберем вакансии на английском.

Внесем изменения в main():

for description in descriptions:

if detect(description[0]) != 'en':

text = text + description[0]

Теперь результа выглядит так:

данных — 329

data — 180

анализа — 157

обучения — 134

машинного — 129

моделей — 128

области — 101

алгоритмов — 87

python — 86

задач — 82

задачи — 82

разработка — 77

анализ — 73

построение — 68

методов — 66

будет — 65

статистики — 56

высшее — 55

знания — 53

learning — 52

Ну это одно слово, оно не всегда отражает истину. Посмотрим что покажут словосочетания из 2 слов:

машинного обучения — 119

анализа данных — 56

machine learning — 44

data science — 38

data scientist — 38

big data — 34

математических моделей — 34

data mining — 28

алгоритмов машинного — 27

математической статистики — 23

будет плюсом — 21

статистического анализа — 20

обработки данных — 18

английский язык — 17

анализ данных — 17

том числе — 17

а также — 17

методов машинного — 16

области анализа — 15

теории вероятности — 14

Результаты анализа.

Более явно выдает результат запрос по двум словам, нам надо знать:

- Машинное обучение

- Математические модели

- Data mining

- Python

- Математическую статистику

- Английский язык

- Теория вероятности

Ничего нового, но было весело :)

Выводы.

Это далеко от идеального решения.

Ошибки:

1. Не надо исключать вакансии на английском, надо их перевести.

2. Не все стоп слова исключены.

3. Нужно привести все слова к базовой форме (машинного -> машинное, анализа -> анализ и т.п).

4. Придумать метод по которому вычислить более оптимальный список стоп слов. Ответить на вопрос «почему 200?», «почему уборщица?».

5. Надо придумать как анализировать результат автоматически, понимать, что одно или два слова несут смысл или больше.

|

Метки: author alexmikh python data mining data science hh.ru tutorial |

Использование различных метрик для кластеризации ключевых запросов |

|

Метки: author CalltouchForever повышение конверсии контекстная реклама веб-аналитика блог компании calltouch calltouch аналитика колтач кластеризация пулинг |

Как соответствовать требованиям к системе менеджмента качества по ISO 9001:2015 |

Как соответствовать требованиям к системе менеджмента качества по ISO 9001:2015

15 сентября 2015 года был официально опубликован стандарт ISO 9001:2015. Почти сразу же стала доступна сертификация систем менеджмента качества на соответствие этой версии стандарта. ISO 9001:2008 будет действовать до сентября 2018 года, а это значит, что для организаций, которые хотят сохранить сертификацию систем менеджмента качества по стандарту ISO 9001, но ещё не перешли на неё, остался только один год для модернизации существующей системы. Но давайте начнём по порядку, а в качестве простого примера иногда будем размышлять о процессе транспортировки воды по трубе, чтобы тема статьи была понятна даже далёкому от менеджмента читателю.

Что такое ISO 9001?

Этот стандарт является одним из трех основополагающих стандартов, разработанных техническим комитетом Международной Организации по Стандартизации ISO/TS 176.

ISO 9001 (сабж) устанавливает требования, направленные главным образом на создание доверия к продукции и услугам, предлагаемым организацией, и, посредством этого, на повышение удовлетворенности потребителей. Можно также ожидать, что надлежащее внедрение этого стандарта принесет другие выгоды для организации, такие как улучшенный внутренний обмен информацией, лучшее понимание и управление процессами организации.

ISO 9004 Менеджмент для достижения устойчивого успеха организации. Подход на основе менеджмента качества содержит руководящие указания для организаций, стремящихся превзойти требования стандарта ISO 9001, охватывая более широкий спектр вопросов стем, чтобы это могло вести к улучшению общих результатов деятельности организации. ISO 9004 включает методическое руководство по самооценке с тем, чтобы организации имели возможность оценивать уровень зрелости своих систем менеджмента качества.

Надеюсь, никого не введёт в заблуждение название стандарта «Система менеджмента качества». Это стандарты операционного менеджмента, а его целью ставится удовлетворение потребностей заказчика/покупателя товаров или услуг. Именно эта цель и является синонимом качества. Считается, что если организация будет применять эти стандарты менеджмента, то она сможет добиться бездефектного производства товаров и услуг. Эти стандарты могли бы называться и «Система качественного менеджмента», но акцент решено было сделать на результатах управления.

Процессный подход

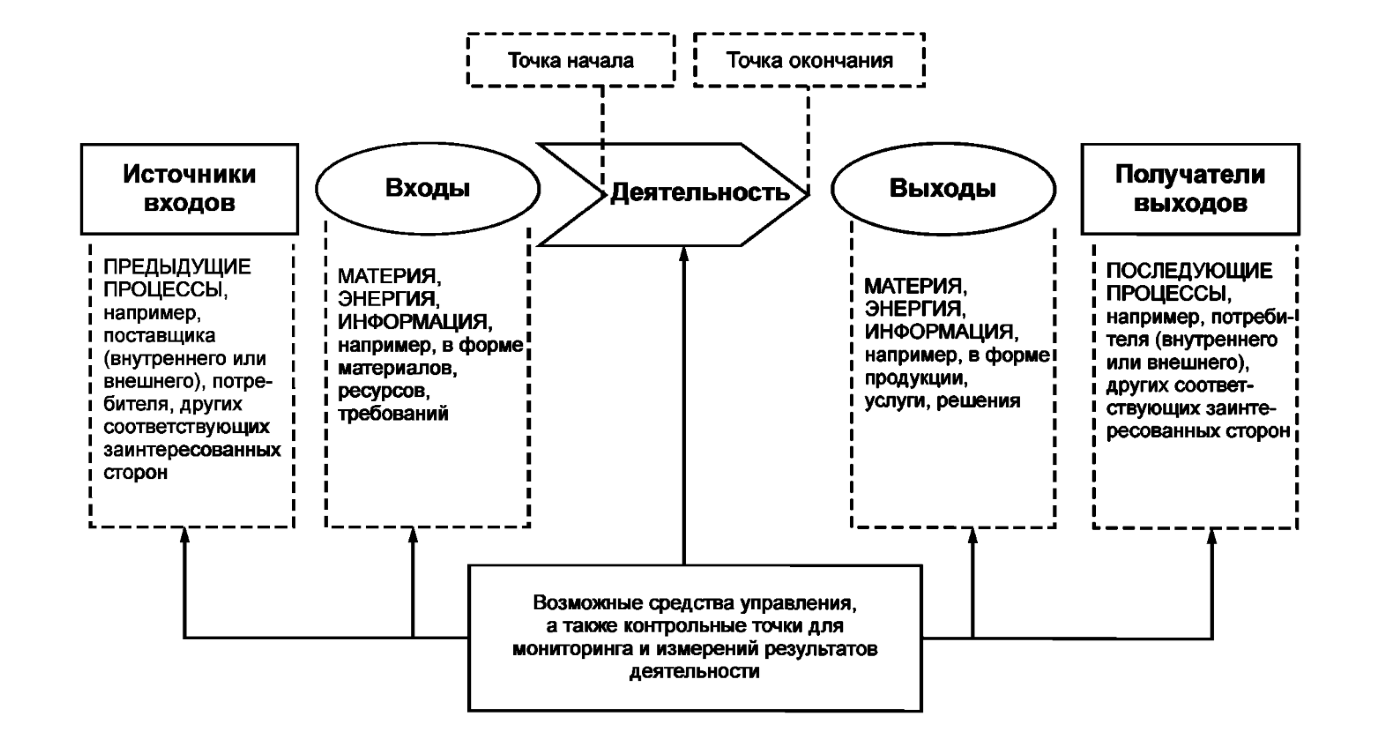

Стандарт направлен на применение «процессного подхода». Понимание и менеджмент взаимосвязанных процессов как системы способствует результативности и эффективности организации в достижении намеченных результатов.