Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Руководство по взаимопониманию между заказчиком и подрядчиком |

Руководство по взаимопониманию между заказчиком и подрядчиком

Складывается ощущение, что о клиентоориентированности и стремлении к модели «Win-Win» не заявляет только ленивый. Но притом «негласная война» продолжается: исполнители хают «наглых» клиентов, осуждая их в своих уютных бложиках, а заказчики собираются в пятницу вечером в баре, чтобы выдавить слезу разочарования и пожаловаться друзьям на «непрофессионализм» очередных горе-разработчиков / -маркетологов. Каждый тянет одеяло на себя, пытаясь сделать «Win-Lose» в свою пользу. А в итоге получается «Lose-Lose». Хотя очевидно, что 95% рынка с каждой стороны вполне адекватны, у всех есть сильные стороны, достойные уважения.

Как перестать вести эту бессмысленную «борьбу»? Разберем конкретные тезисы без воды и нудной философии.

P. S.: это не категоричные установки, претендующие на истину в последней инстанции, а скорее обращение к рынку. Буду искренне рад, если оно поможет хотя бы нескольким «дуэтам» (это и есть правильная форма сотрудничества). А если еще и случится такое, что однажды кто-то скинет кому-то ссылку на эту статью для избежания конфликта, то буду безгранично счастлив.

Парадигма и позиции

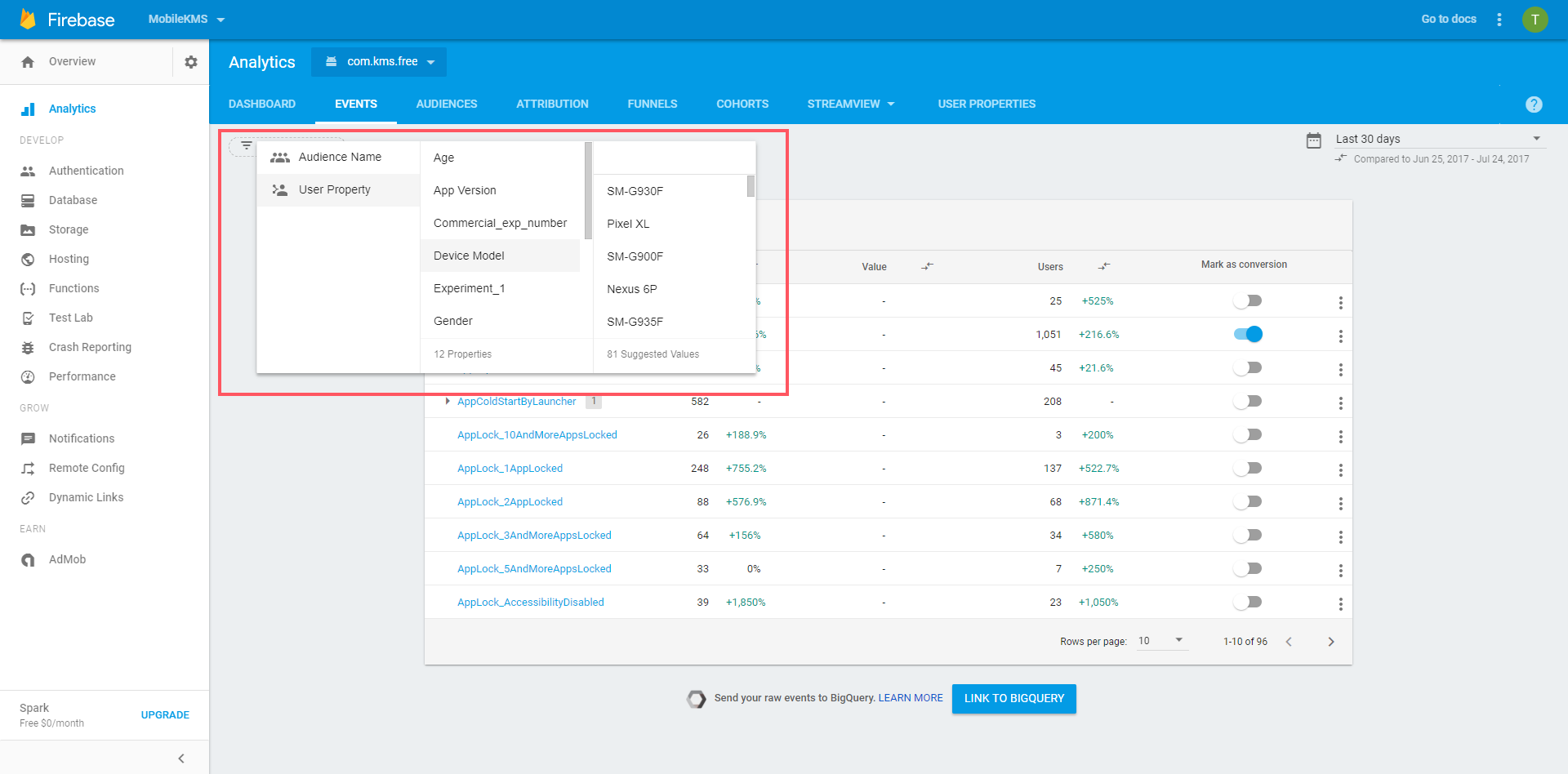

Несмотря на громкие заявления об «индивидуальном подходе», скорее всего вы сейчас работаете в режиме «взаимоотнимания» (да, это выдуманный термин, даже не пытайтесь искать).

Даже старик Google знает, что нужно не отнимать, а понимать.

Пример:

Клиент: «Попрошу-ка я у них скидку».

Подрядчик: «Попробуем раздуть смету».

Классическая ситуация, демонстрирующая попытки взаимопрогиба по цене. Даже если потенциальный заказчик не уйдет, этот прогиб даст знать о себе через месяц-другой работы. Истинные намерения так или иначе проявляются.

Почему так происходит?

Это как принцип маятника: качаешь его в одну сторону — сразу приходит ответка. Так и перекидывается ответственность. Люди создают никому не нужные границы, стараясь отстаивать свой «лагерь» (разумеется, никто не отменял жестокой реальности: рынок определяет условия, невозможно постоянно «уступать», во всем нужна умеренность).

Если в вашей картине мира не было бизнесов / команд, которые думали о другой стороне, — это печально. Уверяю, основываясь на своем опыте: они есть. Я видел многих клиентов, которые были в восторге от опережения графика работы и предлагали «не торопиться», даже несмотря на приближение дедлайна. Видел и исполнителей, которые отговаривали клиента от услуги, за которую он уже был готов заплатить. Почему? Потому что у них другое мышление.

Типичная позиция «эгоистов»:

- Главное — поменьше сделать и побольше заработать / поменьше заплатить и побольше получить.

Очевидно ведь, что нужно как минимум одной ногой быть всегда в «лагере» / «шкуре» другой стороны. Не буду объяснять банальные вещи, идем дальше.

Взаимоизучение

Относительно недавно озвучивал данный принцип — то есть он уже не нов, я не открываю Америку в рамках данного материала. Если вы не знаете, как мыслят ваши «оппоненты», и о чем у них болят головы, эта игра всегда будет заканчиваться «Lose-Lose».

Проверьте себя.

Через что лежит путь к сердцу заказчика

Цитаты:

- «Платил им 4 года, последний год уже только ради интереса… Так вот проверено колешьком — КИДАЛОВО… У меня этот проект находиться в пределах операционной погрешности, если бы он был единственным, то разорился бы давно»

Подрядчик 4 года не интересовался состоянием дел на стороне клиента. 4 года без обратной связи, не задумываясь о том, какая может быть зона риска и последствия. Ваши аккаунты тоже выходят на связь только ближе к дате выставления счета?

- «Работал 1 год с этой компанией, ощущения жуткие. Выгружали базу только 4 недели, что так — не ясно, хотя работы на час максимум. Просили, звонили — жуть… В итоге, пояснил ген директору, что проще сделать самим, в итоге еле ноги унесли...»

Клиент хочет прозрачности: если какая-то задача не выполняется в срок (пусть даже с учетом вашей производственной загруженности), он имеет право на уведомление и объяснение. Когда вы «извиняетесь» на площадке-отзовике в комментариях под негативом — это неплохо, но уже слишком поздно. Не забывайте, что кто-то кому-то уже мог надавать по шапке, запретив в бухгалтерии оплачивать следующий счет.

- «Не получился сайт, о котором я мечтал. Чуть-чуть не то, не в обиду, ребята!»

Ребята может и не обидятся, но осадочек с двух сторон остался. Не выяснили / не зафиксировали «мечты» или пообещали «золотые горы». Классика.

- «…в итоге прошло 3,5 мес. сайт не готов, сам сайт некрасивый, совершенно обычный сайт, который никак не доделают, такой сайт легко можно сделать в 4 раза!!! дешевле, обещают сделать и уже тянется и тянется, на письма часто не отвечают, менеджер **** общается плохо, много раз пишешь исправить, то что должны были исправить давным давно, каждый раз ответ «завтра завтра» и ничего… А к лету должен был быть раскрученный сайт, теперь мы останемся без клиентов к летнему сезону! Месяц назад сам директор обещал доделать сайт через десять дней, прошел месяц и НИ ОДНОГО сдвига!»

На лицо внутренние организационные проблемы, в которых и признаться побоялись, и «замаскировать» не смогли. Но беда не только в этом. Тут очевидно и одностороннее мышление: ребята закопались в свои процессы. Возможно, на выходе получился [бы] крутой продукт. Но сезонность, Карл, сезонность! Клиент ждал этого раньше.

- «Шарлатаны! Наши меня по какой-то базе, скорее холодный обзвон. Предложили продвинуть сайт за 2 месяца, занимаюсь установкой окон. Через 2 месяца ни звонков ни продаж. Звоню выяснять в чем дело, говорят поисковики поменяли там какие-то фильтры и теперь мой сайт в **** и они тут не причем Ругаться не стал, ушел в ***-***** сказали что мой сайт забанили поисковики»

Видите, некоторые не ругаются. Исполнитель может быть даже не в курсе негатива.

А как завоевать сердце подрядчика?

Ради справедливости приведем пример и другой точки зрения:

- «Один клиент «купил» у другого сайт (оба мои знакомые и бывшие партнеры друг друга) и поручил нам помочь с переоформлением домена — подготовить письма регистраторам, проинструктировать их, ничего сложного, в общем. Только из-за занятости и тёрок между знакомыми процесс затянулся на год (!). Продавец домена, не горит желанием его передавать. На созваны между ними, нашими сотрудниками потрачено в 20 раз больше оплаченного времени. А сегодня был апогей, продавец пишет нашему менеджеру: предлагаю сделку, я еду к регистратору, а вы мне правки на сайт вносите. Лол, короче»

Дорогие клиенты! Призываю не пользоваться добрым отношением подрядчиков. Вам ведь было бы как минимум «неприятно» (а как максимум — невыгодно), если бы ваших сотрудников загоняли до смерти неоплачиваемыми просьбами? Поймите их: digital-бизнес строится на продаже времени сотрудников. Их «воровство» не преследуется по закону, но это из серии «Win-Lose» — «моя хата с краю». Не обижайтесь, если потом «маятник» ударит в вашу сторону.

А еще есть и другие стороны — партнеры, подрядчики, сотрудники:

- «Я работала в этой организации-отвратительно! мы клиентов как только они проплатилт сатвили в чёрный список, если как говорил ***** *****-они ,, надоедали звонками,, а почему надоедали?? а потому что ничего они не делали… коллектив менялся через каждые 3 месяца-зарплату не выдавали!!! кстати этой фирмы юридически уже нет… он все деньги ., очищал,, разводя их по многим счетам...»

Без комментариев. Это либо очень разъяренный сотрудник, либо история намного масштабнее психологических установок, и вряд ли здесь есть один виновник.

- «Лохотрон. Написал им текстов на штуку рублей, причем писал в срок, несмотря на температуру под 39!!! Одобрили, все хорошо, говорят. Потом тянули с оплатой. То у них бухгалтерия переучет или чет такое делает, то деваха-менеджер болеет, то еще какая-нибудь лажа, которая меня, в принципе, интересовать не должна».

И еще много-много других историй (часть из которых могут быть вымышленными / с высоким содержанием субъективности, но все равно заставляющими задуматься), полных ужасов в стиле «меня интересовать не должно», «работай, пока жив», «верните мне мои кровные» и пр.

Ожидания

Это будет самый короткий абзац: создавайте общую понятийную базу, не скупясь на детали.

Подтекст

Есть лексика — это всего лишь набор букв. А есть смысл — он может быть гораздо шире и сложнее букв. И его не всегда выносят «на блюдечке». Учитесь читать между строк. Иногда оппоненты неосознанно подталкивают нас к очень важным выводам:

- «Нам нужен сайт, которому будут завидовать все конкуренты» = «Не спрашивайте меня сразу про бюджет, это для меня не первостепенный фактор».

- «Мы ориентированы на задачи другого типа» = «Давайте не будем терять наше и ваше время — не мучайте нас уговорами „поработать“. Попробуйте лучше пообщаться с другими исполнителями».

- «Нам нужно максимально дешево» = «Не ввязывайтесь в эту борьбу, если не выигрываете ценой».

Обратная сторона медали

Но всегда учитывайте, что кто-то извлекает из слов неправильные смыслы. Либо правильные, но такие, которые вы не хотели бы «палить».

- «Будем очень рады сотрудничеству с вами» = «Помогите, у нас острая нехватка работы».

- «Мне нужно посоветоваться» = «Замучаем правками и будем просить сделать еще одну бесплатную итерацию».

- «Очень хочу поработать у вас» = «Больше никуда не берут, ищу средства для оплаты кредита, ну и просто новую строчку в резюме».

Как этого избежать? Думайте, перед тем как что-то озвучивать, на 3 шага вперед.

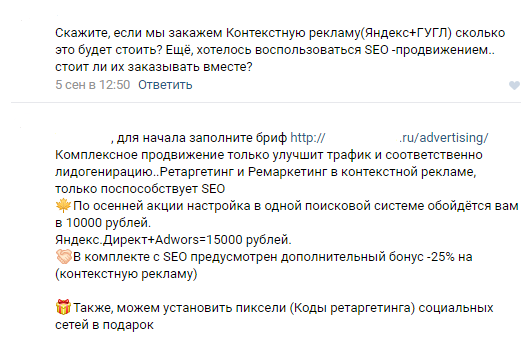

Разберем на примере конкретного диалога:

- Клиент сразу показал, что некомпетентен в вопросах выбора каналов трафика. Это нормально.

- Ожидал узнать цену, ответ (объективный, разумеется) по вопросу необходимости SEO, ну и заодно получить какое-то впечатление по адекватности заказчика.

- Итог: загрузили заполнением брифа (угадайте, насколько он был заполнен), «впарили» все, по поводу чего были сомнения, и в догонку накинули таргет (настройка — в подарок, а рекламный бюджет — тоже?).

Явно нужно обращаться к ЛОР’у — проблемы со слухом, стороны не слышат друг друга.

Критерии

Оценивая, мы часто неправильно расставляем приоритеты.

У исполнителя может быть отвратительный собственный сайт, мало отзывов, задержки с ответами. Но притом они делают очень крутой продукт (соответственно: большой спрос -> постоянная перегруженность -> нет времени на свой маркетинг).

Будучи на месте клиента, я бы обратил внимание на следующее:

- Модель работы (изучите мат. часть на примере категорий в рейтингах; например, если нужны пляски с менеджерами, то чистой воды «продакшны» вам не подойдут) — многие проекты проваливаются, потому что отсутствует понимание этой разницы.

- Средняя оценка по работам за последний год.

- Как устроены процессы изнутри (если правильно попросить, заказчику все покажут и расскажут в офисе).

- Объективно слабые стороны (важно, чтобы исполнитель их сам честно называл).

Ну и лично пообщаться с теми, кто уже работал с данным кандидатом, никогда не помешает. И это не заменит обычный мониторинг отзывов.

А исполнителям нужно учиться смотреть «глубже». Не каждый, кто приходит, скажем, за продвижением в органическом поиске, хочет просто ежемесячно покупать отчеты с красивыми цифрами. Кому-то нужно просто «сделать конкурентов» по определенным показателям. А кому-то — провести эксперимент для сравнения с другими источниками трафика (да-да, у низкого LTV могут расти ноги отсюда).

Погрешности

Учитесь отличать их от ошибок. Даже при автоматизированном измерении показателей на фабричном производстве иногда допускаются отклонения в ± 2%. Что уж говорить о человеческом факторе у нас. Просрочка на 5 минут, лишний пиксель, недостаток 0,5 часов в отчете — при больших масштабах работ подобные цифры практически не имеют значения. Если обе стороны будут заострять внимание на мелочах, то потеряют в действительно важных факторах.

«Нет» стереотипам

Сразу объясню на примере. Статьи и книги учат исполнителей откладывать озвучивание цены на максимально поздний этап. Это преподносится как универсальное правило, хотя по факту оно полезно далеко не всегда. И подрядчик ведет диалог с клиентом следующим образом:

— «А сколько у вас стоит эта услуга?»

— «Ну это зависит от ваших требований»

— «Нам как всем, хотя бы примерную стоимость назовите»

— «Вы хотите на шаблоне или индивидуальный дизайн?»

— [ Мысленно про себя: «Откуда мне знать, я же не профессионал. Сколько меня еще будут здесь мучить?» ] «Не знаю, пусть будет индивидуальный»

— «А с корзиной + онлайн-оплатой будем делать или просто каталог + форма для обратной связи?»

— «Уф, все понятно. Мы вам перезвоним»

Нет повести печальнее на свете, чем повесть о расстроенном клиенте.

Исполнитель, обращаюсь к тебе: ты бы сам выдержал эту пытку, будь на его месте? В договорах ведь пишите «сторона Заказчика» с большой буквы (а кто-то даже игнорирует правила русского языка, когда, общаясь в электронном виде, пишет «Вы»), тогда к чему это неуважение? Разумеется, продукт сложный, это B2B, здесь неприменимо сравнение с выставлением напоказ ценников в ритейле. Но от судьбы не уйдешь: если боишься «испугать ценой», то сделаешь это после презентации решения.

Поэтому call-to-action следующий: не слушайте шаблонные советы (даже вышеозвученные мной :) ). В продажах, управлении проектами и пр. на общие вопросы аля «Как?» можно ответить, только перечислив 100 500 подпунктов «Если / В случае…». В этом-то и прелесть нашей сферы — здесь всегда много альтернативных подходов.

|

Метки: author zarutskiy_k управление проектами управление продажами управление персоналом веб-студии digital- агентства |

[Из песочницы] Как понять, что ваша предсказательная модель бесполезна |

Как понять, что ваша предсказательная модель бесполезна

При создании продуктов на основе машинного обучения возникают ситуации, которых хотелось бы избежать. В этом тексте я разбираю восемь проблем, с которыми сталкивался в своей работе.

Мой опыт связан с моделями кредитного скоринга и предсказательными системами для промышленных компаний. Текст поможет разработчиками и дата-сайнтистам строить полезные модели, а менеджерам не допускать грубых ошибок в проекте.

Этот текст не призван прорекламировать какую-нибудь компанию. Он основан на практике анализа данных в компании ООО "Ромашка", которая никогда не существовала и не будет существовать. Под "мы" я подразумеваю команду из себя и моих воображаемых друзей. Все сервисы, которые мы создавали, делались для конкретного клиента и не могут быть проданы или переданы иным лицам.

Какие модели и для чего?

Пусть предсказательная модель — это алгоритм, который строит прогнозы и позволяет автоматически принимать полезное для бизнеса решение на основе исторических данных.

Я не рассматриваю:

- разовые исследования данных, которые не идут в продакшн;

- системы, которые мониторят что-нибудь (например, кликабельность объявлений), но сами не принимают решений;

- алгоритмы ради алгоритмов, т.е. не приносящие прямой пользы для бизнеса (например, искусственный интеллект, который учит виртуальных человечков ходить).

Я буду говорить об алгоритмах обучения с учителем, т.е. таких, которые "увидели" много примеров пар (X,Y), и теперь могут для любого X сделать оценку Y. X — это информация, известная на момент прогноза (например, заполненная клиентом заявка на кредит). Y — это заранее неизвестная информация, необходимая для принятия решения (например, будет ли клиент своевременно платить по кредиту). Само решение может приниматься каким-то простым алгоритмом вне модели (например, одобрять кредит, если предсказанная вероятность неплатежа не выше 15%).

Аналитик, создающий модель, как правило, опирается на метрики качества прогноза, например, среднюю ошибку (MAE) или долю верных ответов (accuracy). Такие метрики позволяют быстро понять, какая из двух моделей предсказывает точнее (и нужно ли, скажем, заменять логистическую регрессию на нейросеть). Но на главный вопрос, а насколько модель полезна, они дают ответ далеко не всегда. Например, модель для кредитного скоринга очень легко может достигнуть точности 98% на данных, в которых 98% клиентов "хорошие", называя "хорошими" всех подряд.

С точки зрения предпринимателя или менеджера очевидно, какая модель полезная: которая приносит деньги. Если за счёт внедрения новой скоринговой модели за следующий год удастся отказать 3000 клиентам, которые бы принесли суммарный убыток 50 миллионов рублей, и одобрить 5000 новых клиентов, которые принесут суммарную прибыль 10 миллионов рублей, то модель явно хороша. На этапе разработки модели, конечно, вряд ли вы точно знаете эти суммы (да и потом — далеко не факт). Но чем скорее, точнее и честнее вы оцените экономическую пользу от проекта, тем лучше.

Проблемы

Достаточно часто построение вроде бы хорошей предсказательной модели не приводит к ожидаемому успеху: она не внедряется, или внедряется с большой задержкой, или начинает нормально работать только после десятков релизов, или перестаёт нормально работать через несколько месяцев после внедрения, или не работает вообще никак… При этом вроде бы все потрудились на славу: аналитик выжал из данных максимальную предсказательную силу, разработчик создал среду, в которой модель работает молниеносно и никогда не падает, а менеджер приложил все усилия, чтобы первые двое смогли завершить работу вовремя. Так почему же они попали в неприятность?

1. Модель вообще не нужна

Мы как-то строили модель, предсказывающую крепость пива после дображивания (на самом деле, это было не пиво и вообще не алкоголь, но суть похожа). Задача ставилась так: понять, как параметры, задаваемые в начале брожения, влияют на крепость финального пива, и научиться лучше управлять ей. Задача казалась весёлой и перспективной, и мы потратили не одну сотню человеко-часов на неё, прежде чем выяснили, что на самом-то деле финальная крепость не так уж и важна заказчику. Например, когда пиво получается 7.6% вместо требуемых 8%, он просто смешивает его с более крепким, чтобы добиться нужного градуса. То есть, даже если бы мы построили идеальную модель, это принесло бы прибыли примерно нисколько.

Эта ситуация звучит довольно глупо, но на самом деле случается сплошь и рядом. Руководители инициируют machine learning проекты, "потому что интересно", или просто чтобы быть в тренде. Осознание, что это не очень-то и нужно, может прийти далеко не сразу, а потом долго отвергаться. Мало кому приятно признаваться, что время было потрачено впустую. К счастью, есть относительно простой способ избегать таких провалов: перед началом любого проекта оценивать эффект от идеальной предсказательной модели. Если бы вам предложили оракула, который в точности знает будущее наперёд, сколько бы были бы готовы за него заплатить? Если потери от брака и так составляют небольшую сумму, то, возможно, строить сложную систему для минимизации доли брака нет необходимости.

Как-то раз команде по кредитному скорингу предложили новый источник данных: чеки крупной сети продуктовых магазинов. Это выглядело очень заманчиво: "скажи мне, что ты покупаешь, и я скажу, кто ты". Но вскоре оказалось, что идентифицировать личность покупателя было возможно, только если он использовал карту лояльности. Доля таких покупателей оказалась невелика, а в пересечении с клиентами банка они составляли меньше 5% от входящих заявок на кредиты. Более того, это были лучшие 5%: почти все заявки одобрялись, и доля "дефолтных" среди них была близка к нулю. Даже если бы мы смогли отказывать все "плохие" заявки среди них, это сократило бы кредитные потери на совсем небольшую сумму. Она бы вряд ли окупила затраты на построение модели, её внедрение, и интеграцию с базой данных магазинов в реальном времени. Поэтому с чеками поигрались недельку, и передали их в отдел вторичных продаж: там от таких данных будет больше пользы.

Зато пивную модель мы всё-таки достроили и внедрили. Оказалось, что она не даёт экономии на сокращении брака, но зато позволяет снизить трудозатраты за счёт автоматизации части процесса. Но поняли мы это только после долгих дискуссий с заказчиком. И, если честно, нам просто повезло.

2. Модель откровенно слабая

Даже если идеальная модель способна принести большую пользу, не факт, что вам удастся к ней приблизиться. В X может просто не быть информации, релевантной для предсказания Y. Конечно, вы редко можете быть до конца уверены, что вытащили из X все полезные признаки. Наибольшее улучшение прогноза обычно приносит feature engineering, который может длиться месяцами. Но можно работать итеративно: брейншторм — создание признаков — обучение прототипа модели — тестирование прототипа.

В самом начале проекта можно собраться большой компанией и провести мозговой штурм, придумывая разнообразные признаков. По моему опыту, самый сильный признак часто давал половину той точности, которая в итоге получалась у полной модели. Для скоринга это оказалась текущая кредитная нагрузка клиента, для пива — крепость предыдущей партии того же сорта. Если после пары циклов найти хорошие признаки не удалось, и качество модели близко к нулю, возможно, проект лучше свернуть, либо срочно отправиться искать дополнительные данные.

Важно, что тестировать нужно не только точность прогноза, но и качество решений, принимаемых на его основе. Не всегда возможно измерить пользу от модели "оффлайн" (в тестовой среде). Но вы можете придумывать метрики, которые хоть как-то приближают вас к оценке денежного эффекта. Например, если менеджеру по кредитным рискам нужно одобрение не менее 50% заявок (иначе сорвётся план продаж), то вы можете оценивать долю "плохих" клиентов среди 50% лучших с точки зрения модели. Она будет примерно пропорциональна тем убыткам, которые несёт банк из-за невозврата кредитов. Такую метрику можно посчитать сразу же после создания первого прототипа модели. Если грубая оценка выгоды от его внедрения не покрывает даже ваши собственные трудозатраты, то стоит задуматься: а можем ли мы вообще получить хороший прогноз?

3. Модель невозможно внедрить

Бывает, что созданная аналитиками модель демонстрирует хорошие меры как точности прогноза, так и экономического эффекта. Но когда начинается её внедрение в продакшн, оказывается, что необходимые для прогноза данные недоступны в реальном времени. Иногда бывает, что это настоящие данные "из будущего". Например, при прогнозе крепости пива важным фактором является измерение его плотности после первого этапа брожения, но применять прогноз мы хотим в начале этого этапа. Если бы мы не обсудили с заказчиком точную природу этого признака, мы бы построили бесполезную модель.

Ещё более неприятно может быть, если на момент прогноза данные доступны, но по техническим причинам подгрузить их в модель не получается. В прошлом году мы работали над моделью, рекомендующей оптимальный канал взаимодействия с клиентом, вовремя не внёсшим очередной платёж по кредиту. Должнику может звонить живой оператор (но это не очень дёшево) или робот (дёшево, но не так эффективно, и бесит клиентов), или можно не звонить вообще и надеяться, что клиент и так заплатит сегодня-завтра. Одним из сильных факторов оказались результаты звонков за вчерашний день. Но оказалось, что их использовать нельзя: логи звонков перекладываются в базу данных раз в сутки, ночью, а план звонков на завтра формируется сегодня, когда известны данные за вчера. То есть данные о звонках доступны с лагом в два дня до применения прогноза.

На моей практике несколько раз случалось, что модели с хорошей точностью откладывались в долгий ящик или сразу выкидывались из-за недоступности данных в реальном времени. Иногда приходилось переделывать их с нуля, пытаясь заменить признаки "из будущего" какими-то другими. Чтобы такого не происходило, первый же небесполезный прототип модели стоит тестировать на потоке данных, максимально приближенном к реальному. Может показаться, что это приведёт к дополнительным затратам на разработку тестовой среды. Но, скорее всего, перед запуском модели "в бою" её придётся создавать в любом случае. Начинайте строить инфраструктуру для тестирования модели как можно раньше, и, возможно, вы вовремя узнаете много интересных деталей.

4. Модель очень трудно внедрить

Если модель основана на данных "из будущего", с этим вряд ли что-то можно поделать. Но часто бывает так, что даже с доступными данными внедрение модели даётся нелегко. Настолько нелегко, что внедрение затягивается на неопределённый срок из-за нехватки трудовых ресурсов на это. Что же так долго делают разработчики, если модель уже создана?

Скорее всего, они переписывают весь код с нуля. Причины на это могут быть совершенно разные. Возможно, вся их система написана на java, и они не готовы пользоваться моделью на python, ибо интеграция двух разных сред доставит им даже больше головной боли, чем переписывание кода. Или требования к производительности так высоки, что весь код для продакшна может быть написан только на C++, иначе модель будет работать слишком медленно. Или предобработку признаков для обучения модели вы сделали с использованием SQL, выгружая их из базы данных, но в бою никакой базы данных нет, а данные будут приходить в виде json-запроса.

Если модель создавалась в одном языке (скорее всего, в python), а применяться будет в другом, возникает болезненная проблема её переноса. Есть готовые решения, например, формат PMML, но их применимость оставляет желать лучшего. Если это линейная модель, достаточно сохранить в текстовом файле вектор коэффициентов. В случае нейросети или решающих деревьев коэффициентов потребуется больше, и в их записи и чтении будет проще ошибиться. Ещё сложнее сериализовать полностью непараметрические модели, в частности, сложные байесовские. Но даже это может быть просто по сравнению с созданием признаков, код для которого может быть совсем уж произвольным. Даже безобидная функция log() в разных языках программирования может означать разные вещи, что уж говорить о коде для работы с картинками или текстами!

Даже если с языком программирования всё в порядке, вопросы производительности и различия в формате данных в учении и в бою остаются. Ещё один возможный источник проблем: аналитик при создании модели активно пользовался инструментарием для работы с большими таблицами данных, но в бою прогноз необходимо делать для каждого наблюдения по отдельности. Многие действия, совершаемые с матрицей n*m, с матрицей 1*m проделывать неэффективно или вообще бессмысленно. Поэтому аналитику полезно с самого начала проекта готовиться принимать данные в нужном формате и уметь работать с наблюдениями поштучно. Мораль та же, что и в предыдущем разделе: начинайте тестировать весь пайплайн как можно раньше!

Разработчикам и админам продуктивной системы полезно с начала проекта задуматься о том, в какой среде будет работать модель. В их силах сделать так, чтобы код data scientist'a мог выполняться в ней с минимумом изменений. Если вы внедряете предсказательные модели регулярно, стоит один раз создать (или поискать у внешних провайдеров) платформу, обеспечивающую управление нагрузкой, отказоустойчивость, и передачу данных. На ней любую новую модель можно запустить в виде сервиса. Если же сделать так невозможно или нерентабельно, полезно будет заранее обсудить с разработчиком модели имеющиеся ограничения. Быть может, вы избавите его и себя от долгих часов ненужной работы.

5. При внедрении происходят глупые ошибки

За пару недель до моего прихода в банк там запустили в бой модель кредитного риска от стороннего поставщика. На ретроспективной выборке, которую прислал поставщик, модель показала себя хорошо, выделив очень плохих клиентов среди одобренных. Поэтому, когда прогнозы начали поступать к нам в реальном времени, мы немедленно стали применять их. Через несколько дней кто-то заметил, что отказываем мы больше заявок, чем ожидалось. Потом — что распределение приходящих прогнозов непохоже на то, что было в тестовой выборке. Начали разбираться, и поняли, что прогнозы приходят с противоположным знаком. Мы получали не вероятность того, что заёмщик плохой, а вероятность того, что он хороший. Несколько дней мы отказывали в кредите не худшим, а лучшим клиентам!

Такие нарушения бизнес-логики чаще всего происходят не в самой модели, а или при подготовке признаков, или, чаще всего, при применении прогноза. Если они менее очевидны, чем ошибка в знаке, то их можно не находить очень долго. Всё это время модель будет работать хуже, чем ожидалось, без видимых причин. Стандартный способ предупредить это — делать юнит-тесты для любого кусочка стратегии принятия решений. Кроме этого, нужно тестировать всю систему принятия решений (модель + её окружение) целиком (да-да, я повторяю это уже три раздела подряд). Но это не спасёт от всех бед: проблема может быть не в коде, а в данных. Чтобы смягчить такие риски, серьёзные нововведения можно запускать не на всём потоке данных (в нашем случае, заявок на кредиты), а на небольшой, но репрезентативной его доле (например, на случайно выбранных 10% заявок). A/B тесты— это вообще полезно. А если ваши модели отвечают за действительно важные решения, такие тесты могут идти в большом количестве и подолгу.

6. Модель нестабильная

Бывает, что модель прошла все тесты, и была внедрена без единой ошибки. Вы смотрите на первые решения, которые она приняла, и они кажутся вам осмысленными. Они не идеальны — 17 партия пива получилась слабоватой, а 14 и 23 — очень крепкими, но в целом всё неплохо. Проходит неделя-другая, вы продолжаете смотреть на результаты A/B теста, и понимаете, что слишком крепких партий чересчур много. Обсуждаете это с заказчиком, и он объясняет, что недавно заменил резервуары для кипячения сусла, и это могло повысить уровень растворения хмеля. Ваш внутренний математик возмущается "Да как же так! Вы мне дали обучающую выборку, не репрезентативную генеральной совокупности! Это обман!". Но вы берёте себя в руки, и замечаете, что в обучающей выборке (последние три года) средняя концентрация растворенного хмеля не была стабильной. Да, сейчас она выше, чем когда-либо, но резкие скачки и падения были и раньше. Но вашу модель они ничему не научили.

Другой пример: доверие сообщества финансистов к статистическим методам было сильно подорвано после кризиса 2007 года. Тогда обвалился американский ипотечный рынок, потянув за собой всю мировую экономику. Модели, которые тогда использовались для оценки кредитных рисков, не предполагали, что все заёмщики могут одновременно перестать платить, потому что в их обучающей выборке не было таких событий. Но разбирающийся в предмете человек мог бы мысленно продолжить имеющиеся тренды и предугадать такой исход.

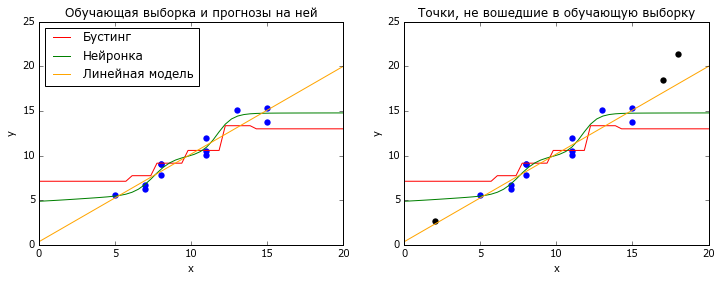

Бывает, что поток данных, к которым вы применяете модель, стационарен, т.е. не меняет своих статистических свойств со временем. Тогда самые популярные методы машинного обучения, нейросетки и градиентный бустинг над решающими деревьями, работают хорошо. Оба этих метода основаны на интерполяции обучающих данных: нейронки — логистическими кривыми, бустинг — кусочно-постоянными функциями. И те, и другие очень плохо справляются с задачей экстраполяции — предсказания для X, лежащих за пределами обучающей выборки (точнее, её выпуклой оболочки).

# coding: utf-8

# настраиваем всё, что нужно настроить

import numpy as np

import matplotlib.pyplot as plt

from matplotlib import rc

rc('font', family='Verdana')

from sklearn.ensemble import GradientBoostingRegressor

from sklearn.neural_network import MLPRegressor

from sklearn.linear_model import LinearRegression

# генерируем данные

np.random.seed(2)

n = 15

x_all = np.random.randint(20,size=(n,1))

y_all = x_all.ravel() + 10 * 0.1 + np.random.normal(size=n)

fltr = ((x_all<=15)&(x_all>=5))

x_train = x_all[fltr.ravel(),:]

y_train = y_all[fltr.ravel()]

x_new = x_all[~fltr.ravel(),:]

y_new = y_all[~fltr.ravel()]

x_plot = np.linspace(0, 20)

# обучаем модели

m1 = GradientBoostingRegressor(

n_estimators=10,

max_depth = 3,

random_state=42

).fit(x_train, y_train)

m2 = MLPRegressor(

hidden_layer_sizes=(10),

activation = 'logistic',

random_state = 42,

learning_rate_init = 1e-1,

solver = 'lbfgs',

alpha = 0.1

).fit(x_train, y_train)

m3 = LinearRegression().fit(x_train, y_train)

# Отрисовываем графики

plt.figure(figsize=(12,4))

title = {1:'Обучающая выборка и прогнозы на ней',

2:'Точки, не вошедшие в обучающую выборку'}

for i in [1,2]:

plt.subplot(1,2,i)

plt.scatter(x_train.ravel(), y_train, lw=0, s=40)

plt.xlim([0, 20])

plt.ylim([0, 25])

plt.plot(x_plot, m1.predict(x_plot[:,np.newaxis]), color = 'red')

plt.plot(x_plot, m2.predict(x_plot[:,np.newaxis]), color = 'green')

plt.plot(x_plot, m3.predict(x_plot[:,np.newaxis]), color = 'orange')

plt.xlabel('x')

plt.ylabel('y')

plt.title(title[i])

if i == 1:

plt.legend(['Бустинг', 'Нейронка', 'Линейная модель'],

loc = 'upper left')

if i == 2:

plt.scatter(x_new.ravel(), y_new, lw=0, s=40, color = 'black')

plt.show()Некоторые более простые модели (в том числе линейные) экстраполируют лучше. Но как понять, что они вам нужны? На помощь приходит кросс-валидация (перекрёстная проверка), но не классическая, в которой все данные перемешаны случайным образом, а что-нибудь типа TimeSeriesSplit из sklearn. В ней модель обучается на всех данных до момента t, а тестируется на данных после этого момента, и так для нескольких разных t. Хорошее качество на таких тестах даёт надежду, что модель может прогнозировать будущее, даже если оно несколько отличается от прошлого.

Иногда внедрения в модель сильных зависимостей, типа линейных, оказывается достаточно, чтобы она хорошо адаптировалась к изменениям в процессе. Если это нежелательно или этого недостаточно, можно подумать о более универсальных способах придания адаптивности. Проще всего калибровать модель на константу: вычитать из прогноза его среднюю ошибку за предыдущие n наблюдений. Если же дело не только в аддитивной константе, при обучении модели можно перевзвесить наблюдения (например, по принципу экспоненциального сглаживания). Это поможет модели сосредоточить внимание на самом недавнем прошлом.

Даже если вам кажется, что модель просто обязана быть стабильной, полезно будет завести автоматический мониторинг. Он мог бы описывать динамику предсказываемого значения, самого прогноза, основных факторов модели, и всевозможных метрик качества. Если модель действительно хороша, то она с вами надолго. Поэтому лучше один раз потрудиться над шаблоном, чем каждый месяц проверять перформанс модели вручную.

7. Обучающая выборка действительно не репрезентативна

Бывает, что источником нерепрезентативности выборки являются не изменения во времени, а особенности процесса, породившего данные. У банка, где я работал, раньше существовала политика: нельзя выдавать кредиты людям, у которых платежи по текущим долгам превышают 40% дохода. С одной стороны, это разумно, ибо высокая кредитная нагрузка часто приводит к банкротству, особенно в кризисные времена. С другой стороны, и доход, и платежи по кредитам мы можем оценивать лишь приближённо. Возможно, у части наших несложившихся клиентов дела на самом деле были куда лучше. Да и в любом случае, специалист, который зарабатывает 200 тысяч в месяц, и 100 из них отдаёт в счёт ипотеки, может быть перспективным клиентом. Отказать такому в кредитной карте — потеря прибыли. Можно было бы надеяться, что модель будет хорошо ранжировать клиентов даже с очень высокой кредитной нагрузкой… Но это не точно, ведь в обучающей выборке нет ни одного такого!

Мне повезло, что за три года до моего прихода коллеги ввели простое, хотя и страшноватое правило: примерно 1% случайно отобранных заявок на кредитки одобрять в обход почти всех политик. Этот 1% приносил банку убытки, но позволял получать репрезентативные данные, на которых можно обучать и тестировать любые модели. Поэтому я смог доказать, что даже среди вроде бы очень закредитованных людей можно найти хороших клиентов. В результате мы начали выдавать кредитки людям с оценкой кредитной нагрузки от 40% до 90%, но более с жёстким порогом отсечения по предсказанной вероятности дефолта.

Если бы подобного потока чистых данных не было, то убедить менеджмент, что модель нормально ранжирует людей с нагрузкой больше 40%, было бы сложно. Наверное, я бы обучил её на выборке с нагрузкой 0-20%, и показал бы, что на тестовых данных с нагрузкой 20-40% модель способна принять адекватные решения. Но узенькая струйка нефильтрованных данных всё-таки очень полезна, и, если цена ошибки не очень высока, лучше её иметь. Подобный совет даёт и Мартин Цинкевич, ML-разработчик из Гугла, в своём руководстве по машинному обучению. Например, при фильтрации электронной почты 0.1% писем, отмеченных алгоритмом как спам, можно всё-таки показывать пользователю. Это позволит отследить и исправить ошибки алгоритма.

8. Прогноз используется неэффективно

Как правило, решение, принимаемое на основе прогноза модели, является лишь небольшой частью какого-то бизнес-процесса, и может взаимодействовать с ним причудливым образом. Например, большая часть заявок на кредитки, одобренных автоматическим алгоритмом, должна также получить одобрение живого андеррайтера, прежде чем карта будет выдана. Когда мы начали одобрять заявки с высокой кредитной нагрузкой, андеррайтеры продолжили их отказывать. Возможно, они не сразу узнали об изменениях, или просто решили не брать на себя ответственность за непривычных клиентов. Нам пришлось передавать кредитным специалистам метки типа "не отказывать данному клиенту по причине высокой нагрузки", чтобы они начали одобрять такие заявки. Но пока мы выявили эту проблему, придумали решение и внедрили его, прошло много времени, в течение которого банк недополучал прибыль. Мораль: с другими участниками бизнес-процесса нужно договариваться заранее.

Иногда, чтобы зарезать пользу от внедрения или обновления модели, другое подразделение не нужно. Достаточно плохо договориться о границах допустимого с собственным менеджером. Возможно, он готов начать одобрять клиентов, выбранных моделью, но только если у них не более одного активного кредита, никогда не было просрочек, несколько успешно закрытых кредитов, и есть двойное подтверждение дохода. Если почти весь описанный сегмент мы и так уже одобряем, то модель мало что изменит.

Впрочем, при грамотном использовании модели человеческий фактор может быть полезен. Допустим, мы разработали модель, подсказывающую сотруднику магазина одежды, что ещё можно предложить клиенту, на основе уже имеющегося заказа. Такая модель может очень эффективно пользоваться большими данными (особенно если магазинов — целая сеть). Но частью релевантной информации, например, о внешнем виде клиентов, модель не обладает. Поэтому точность угадывания ровно-того-наряда-что-хочет-клиент остаётся невысокой. Однако можно очень просто объединить искусственный интеллект с человеческим: модель подсказывает продавцу три предмета, а он выбирает из них самое подходящее. Если правильно объяснить задачу всем продавцам, можно прийти к успеху.

Заключение

Я прошёлся по некоторым из основных провалов, с которыми сталкивался при создании и встраивании в бизнес предсказательных моделей. Чаще всего это проблемы не математического, а организационного характера: модель вообще не нужна, или построена по кривой выборке, или есть сложности со встраиванием её в имеющиеся процессы и системы. Снизить риск таких провалов можно, если придерживаться простых принципов:

- Используйте разумные и измеримые меры точности прогноза и экономического эффекта

- Начиная с первого прототипа, тестируйтесь на упорядоченном по времени потоке данных

- Тестируйте весь процесс, от подготовки данных до принятия решения, а не только прогноз

Надеюсь, кому-то этот текст поможет получше присмотреться к своему проекту и избежать глупых ошибок.

Высоких вам ROC-AUC и Эр-квадратов!

|

Метки: author cointegrated машинное обучение создание сервисов тестирование |

10 лет Computer Science клубу |

10 лет Computer Science клубу

В этом году Computer Science клубу в Санкт-Петербурге исполняется 10 лет. С 2007 года в клубе проходят открытые лекции и курсы, где любой желающий может познакомиться с классическими результатами, современным положением дел и открытыми задачами в различных областях computer science. Вход на все лекции свободный, регистрация не требуется. Слайды и видеозаписи всех прошедших лекций доступны с сайта клуба.

Поздравить клуб с юбилеем приедут сотрудники следующих организаций: Академический университет, Математический институт Стеклова в Санкт-Петербурге, Санкт-Петербургский государственный университет, Яндекс, JetBrains, Montpellier University, Northwestern University, Toyota Technological Institute at Chicago, University of Bergen, University of California at San Diego, Yahoo Research. Они прочитают мини-курсы по следующим темам.

Теоретические:

- коды, исправляющие ошибки;

- оптимальные алгоритмы;

- метрическая геометрия и приближённые алгоритмы;

- вычислительная геометрия;

- формальные языки;

- алгоритмы для NP-трудных задач;

- сложность пропозициональных доказательств;

- схемная сложность;

- сложность бесконечных слов и др.

Прикладные:

- биоинформатика;

- язык программирования Kotlin;

- эффективное использование С++;

- машинное обучение и рекомендательные системы;

- искусственный интеллект и беспилотные автомобили;

- нейронные сети и др.

(подробнее на сайте клуба).

Откроет осенний семестр в клубе академик РАН Юрий Владимирович Матиясевич. Он прочтёт две лекции, посвящённые алгоритму Тарского.

Присоединяйтесь к клубу: сайт клуба, группа ВК, группа FB.

|

Метки: author avsmal математика алгоритмы kotlin c++ блог компании спбау computer science графы коды теория сложности искуственный интеллект вычислительная геометрия |

Книга «Аудит безопасности информационных систем» |

|

Метки: author ph_piter профессиональная литература информационная безопасность блог компании издательский дом «питер» книга |

Как перейти на gRPC, сохранив REST |

Как перейти на gRPC, сохранив REST

- Tutorial

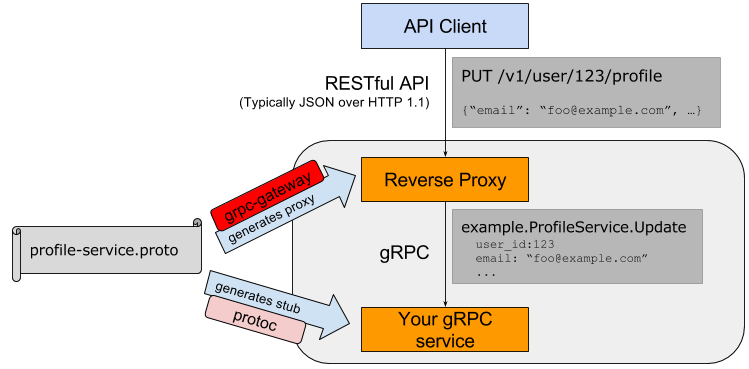

Многие знакомы с gRPC — открытым RPC-фреймворком от Google, который поддерживает 10 языков и активно используется внутри Google, Netflix, Kubernetes, Docker и многими другими. Если вы пишете микросервисы, gRPC предоставляет массу преимуществ перед традиционным подходом REST+JSON, но на существующих проектах часто переход не так просто осуществить из-за наличия уже использующихся REST-клиентов, которые невозможно обновить за раз. Нередко общаясь на тему gRPC можно услышать "да, мы у нас в компании тоже смотрим на gRPC, но всё никак не попробуем".

Что ж, этой проблеме есть хорошее решение под названием grpc-rest-gateway, которое занимается именно этим — автогенерацией REST-gRPC прокси с поддержкой всех основных преимуществ gRPC плюс поддержка Swagger. В этой статье я покажу на примере как это выглядит и работает, и, надеюсь, это поможет и вам перейти на gRPC, не теряя существующие REST-клиенты.

Но, для начала, давайте определимся о каких вообще ситуациях речь. Два самых частых варианта:

- бекенд (Go/Java/C++/node.js/whatever) и фронтенд (JS/iOS/Kotlin/Java/etc) общаются с помощью REST API

- микросервисы (на разных языках) общаются между собой также через REST-подобный API (протокол HTTP и JSON для сериализации)

Для маленьких проектов это абсолютно нормальный выбор, но по мере того, как проекты и количество людей на нём растут, проблемы REST API начинают очень явно давать о себе знать и отнимать львиную долю времени разработчиков.

Чем плох REST?

Безусловно, REST используется везде и повсюду в виду его простоты и даже размытого понимания, что такое REST. Вообще, REST начался как диссертация одного из создателей HTTP Роя Филдинга под названием "Архитектурные стили и дизайн сетевых программных архитектур". Собственно, REST это и есть лишь архитектурный стиль, а не какая-то чётко описанная спецификация.

Но это и является корнем некоторых весомых проблем. Нет единого соглашения, когда какой метод HTTP использовать, когда какой код возвращать, что передавать в URI, а что в теле запроса и т.д. Есть попытки прийти к общей договорённости, но они, к сожалению, не очень успешны.

Далее, при REST подходе, у вас есть чересчур много сущностей, которые несут смысл — метод HTTP (GET/POST/PUT/DELETE), URI запроса (/users, /user/1), тело запроса ({id: 1}) плюс заголовки (X-User-ID: 1). Всё это добавляет излишнюю сложность и возможность неверной интерпретации, что превращается в большую проблему по мере того, как API начинает использоваться между различными сервисами, которые пишут различные команды и синхронизация всех этих сущностей начинает занимать значительную часть времени команд.

Это приводит нас к следующей проблеме — сложности декларативного описания интерфейсов API и описания типов данных. OpenAPI Specification (известное как Swagger), RAML и API Blueprint частично решают эту проблему, но делают это ценой добавления другой сложности. Кто-то пишет YAML файлы ручками для каждого нового запроса, кто-то использует web-фрейморки с автогенерацией, раздувая код описаниями параметров и типов запроса, и поддержка swagger-спецификации в синхронизации с реальной реализацией API всё равно лежит на плечах ответственных разработчиков, что отнимает время от решения, собственно, задач, которые эти API должны решать.

Отдельная сложность заключается в API, которое развивается и меняется, и синхронизация клиентов и серверов может отнимать довольно много времени и ресурсов.

gRPC

gRPC решает эти проблемы кодогенерацией и декларативным языком описания типов и RPC-методов. По-умолчанию используется Google Protobuf 3 в качестве IDL, и HTTP/2 для транспорта. Кодогенераторы есть по 10 языков — Go, Java, C++, Python, Ruby, Node.js, C#, PHP, Android.Java, Objective-C. Есть также пока неофициальные реализации для Rust, Swift и прочих.

В gRPC у вас есть только одно место, где вы определяете, как будут именоваться поля, как называться запросы, что принимать и что возвращать. Это описывается в .proto файле. Например:

syntax = "proto3";

package library;

service LibraryService {

rpc AddBook(AddBookRequest) returns (AddBookResponse)

}

message AddBookRequest {

message Author {

string name = 1;

string surname = 2;

}

string isbn = 1;

repeated Author authors = 2;

}

message AddBookResponse {

int64 id = 1;

}Из этого proto-файла, с помощью protoc-компилятора генерируются код клиентов и серверов на всех поддерживаемых языках (ну, на тех, которые вы укажете компилятору). Дальше, если вы что-то изменили в типах или методах — перезапускаете генерацию кода и получаете обновлённый код и клиента, и сервера.

Если вы когда-либо разруливали конфликты в названиях полей вроде UserID vs user_id, вам понравится работать с gRPC.

Но я не буду сильно подробно останавливаться на принципах работы с gRPC, и перейду к вопросу, что же делать, если вы хотите использовать gRPC, но у вас есть клиенты, которые всё ещё должны работать через REST API, и их не просто будет перевести/переписать на gRPC. Это особенно актуально, учитывая, что официальной поддержки gRPC в браузере пока нет (JS только Node.js официально), и реализация для Swift также пока не в списке официальных.

GRPC REST Gateway

Проект grpc-gateway, как и почти всё в grpc-экосистеме, реализован в виде плагина для protoc-компилятора. Он позволяет добавить аннотации к rpc-определениям в protobuf-файле, который будут описывать REST-аналог этого метода. Например:

import "google/api/annotations.proto";

...

service LibraryService {

rpc AddBook(AddBookRequest) returns (AddBookResponse) {

option (google.api.http) = {

post: "/v1/book"

body: "*"

};

}

}После запуска protoc с указанным плагином, вы получите автосгенерированный код, который будет прозрачно перенаправлять POST HTTP запросы на указанный URI на реальный grpc-сервер и также прозрачно конвертировать и отправлять ответ.

Тоесть формально, это API Proxy, который запущен, как отдельный сервис и делает прозрачную конвертацию REST HTTP запросов в gRPC коммуникацию между сервисами.

Пример использования

Давайте, продолжим пример выше — скажем, наш сервис работы с книгами, должен уметь работать со старым iOS-фронтендом, который пока умеет работать только по REST HTTP. Другие сервисы вы уже перевели на gRPC и наслаждаетесь меньшим количеством головной боли при росте или изменениях ваших API. Добавив выше указанные аннотации, создаём новый сервис — например rest_proxy и в нём автогенерируем код обратного прокси:

protoc -I/usr/local/include -I. \

-I$GOPATH/src \

-I$GOPATH/src/github.com/grpc-ecosystem/grpc-gateway/third_party/googleapis \

--grpc-gateway_out=logtostderr=true:. \

library.protoКод самого сервиса может выглядеть вот как-нибудь так:

import (

"github.com/myuser/rest-proxy/library"

)

var main() {

gw := runtime.NewServeMux(muxOpt)

opts := []grpc.DialOption{grpc.WithInsecure()}

err := library.RegisterLibraryServiceHandlerFromEndpoint(ctx, gw, "library-service.dns.name", opts)

if err != nil {

log.Fatal(err)

}

mux := http.NewServeMux()

mux.Handle("/", gw)

log.Fatal(http.ListenAndServe(":80", mux))

}Этот код запустит наш прокси на 80-м порту, и будет направлять все запросы на gRPC сервер, доступный по library-service.dns.name. RegisterLibraryServiceHandlerFromEndpoint это автоматически сгенерированный метод, который делает всю магию.

Очевидно, что этот прокси может служить входной точкой для всех остальных ваших сервисов на gRPC, которым нужен fallback в виде REST API — просто подключаете остальные автосгенерированные пакаджи и регистрируете их на тот же gw-объект:

err = users.RegisterUsersServiceHandlerFromEndpoint(ctx, gw, "users-service.dns.name", opts)

if err != nil {

log.Fatal(err)

}и так далее.

Преимущества

Автосгенерированный прокси поддерживает автоматический реконнект к сервису, с экспоненциальной backoff-задержкой, как и в обычных grpc-сервисах. Аналогично, поддержка TLS есть из коробки, таймаутов и всё, что доступно в grpc-сервисах, доступно и в прокси.

Middlewares

Отдельно хочется написать про возможность использования т.н. middlewares — обработчиков запросов, которые автоматически должны срабатывать до или после запроса. Типичный пример — ваши HTTP запросы содержат специальный заголовок, который вы хотите передать дальше в grpc-сервисы.

Для примера, я возьму пример со стандартным JWT токеном, которые вы хотите расшифровывать и передавать значение поля UserID grpc-сервисам. Делается это также просто, как и обычные http-middlewares:

func checkJWT(h http.Handler) http.Handler {

return http.HandlerFunc(func(w http.ResponseWriter, r *http.Request) {

bearer := r.Header.Get("Authorization")

...

// parse and extract value from token

...

ctx = context.WithValue(ctx, "UserID", claims.UserID)

h.ServeHTTP(w, r.WithContext(ctx))

})

}и заворачиваем наш mux-объект в эту middleware-функцию:

mux.Handle("/", checkJWT(gw))Теперь на стороне сервисов (все gRPC-методы в Go реализации принимают первым параметром context), вы просто достаёте это значение из контекста:

func (s *LIbrary) AddBook(ctx context.Context, req *library.AddBookRequest) (*library.AddBookResponse, error) {

userID := ctx.Value("UserID").(int64)

...

}Дополнительный функционал

Разумеется, ничего не ограничивает ваш rest-proxy от реализации дополнительного функционала. Это обычный http-сервер, в конце-концов. Вы можете пробросить какие-то HTTP запросы на другой legacy REST сервис:

legacyProxy := httputil.NewSingleHostReverseProxy(legacyUrl)

mux.Handle("/v0/old_endpoint", legacyProxy)

Swagger UI

Отдельной вишенкой в подходе с grpc-gateway есть автоматическая генерация swagger.json файла. Его можно затем использовать с онлайн UI, а можно и отдавать напрямую из нашего же сервиса.

С помощью небольших манипуляций со SwaggerUI и go-bindata, можно добавить ещё один endpoint

к нашему сервису, который будет отдавать красивый и, что самое важное, актуальный и автосгенерированный UI для REST API.

Генерируем swagger.json

protoc -I/usr/local/include -I$GOPATH/src -I$GOPATH/src/github.com/grpc-ecosystem/grpc-gateway/third_party/googleapis --swagger_out=logtostderr=true:swagger-ui/ path/to/library.protoСоздаем handler-ы, которые будут отдавать статику и генерировать index.html (в примере статика добавляется прямо в код с помощью go-bindata):

mux.HandleFunc("/swagger/index.html", SwaggerHandler)

mux.Handle("/swagger/", http.StripPrefix("/swagger/", http.FileServer(assetFS())))

...

// init indexTemplate at start

func SwaggerHandler(w http.ResponseWriter, r *http.Request) {

indexTemplate.Execute(w, nil)

}и вы получаете Swagger UI, подобный этому, с актуальной информацией и возможностью тут же тестировать:

Проблемы

В целом мой опыт работы с grpc-gateway можно пока-что охарактеризовать одной фразой — "оно просто работает из коробки". Из проблем, с которыми приходилось сталкиваться, например могу отметить следующее.

В Go для сериализации в JSON используются так называемые "тэги структур" — мета информация для полей. В encoding/json есть такой тэг omitempty — он означает, что если значение равно нулю (нулевому значению для этого типа), то его не нужно добавлять в результирующий JSON. Плагин grpc-gateway для Go именно этот тег и добавляет к структурам, что приводит иногда к неверному поведению.

Например, у вас есть переменная типа bool в структуре, и вы отдаёте эту структуру в ответе — оба значения true и false одинаково важны в ответе, и фронтенд ожидает это поле получить. Ответ же, сгенерированный grpc-gateway будет содержать это поле, только если значение равно true, в противном случае оно просто будет пропущено (omitempty).

К счастью, это легко решается с помощью опций конфигурации:

customMarshaller := &runtime.JSONPb{

OrigName: true,

EmitDefaults: true, // disable 'omitempty'

}

muxOpt := runtime.WithMarshalerOption(runtime.MIMEWildcard, customMarshaller)

gw := runtime.NewServeMux(muxOpt)Ещё одним моментом, которым хотелось бы поделиться, можно назвать неочевидная семантика работы с самим protoc-компилятором. Команды вызова очень длинные, трудночитаемые, и, что самое важное, логика того, откуда берется protobuf и куда генерируется вывод (+какие директории создаются) — очень неочевидна. Например, вы хотите использовать proto-файл из другого проекта и сгенерировать каким-нибудь плагином код, положив его в текущий проект в папку swagger-ui/. Мне пришлось минут 15 перепробовать массу вариантов вызова protoc, прежде чем стало понятно, как заставить генератор работать именно так. Но, снова же, ничего нерешаемого.

Заключение

gRPC может ускорить продуктивность и эффективность работы с микросервис архитектурой в разы, но часто помехой становится требование обратной совместимости и поддержки REST API. grpc-gateway предоставляет простой и эффективный способ решения этой проблемы, автоматически генерируя обратный прокси сервер, транслирующий REST/JSON запросы в gRPC вызовы. Проект очень активно развивается и используется в продакшене во многих компаниях.

Ссылки

|

Метки: author divan0 разработка систем связи программирование go api rest swagger grpc |

Платформа для сбора донатов за две недели – итоги антихакатона |

- Управление продуктом,

- Управление медиа,

- Терминология IT,

- Развитие стартапа,

- Блог компании Яндекс.Деньги

Платформа для сбора донатов за две недели – итоги антихакатона

- Управление продуктом,

- Управление медиа,

- Терминология IT,

- Развитие стартапа,

- Блог компании Яндекс.Деньги

В нашем антихакатоне победила команда студентов Высшей школы экономики – с решением для приема донатов за стриминг. Но лучше всех о проекте расскажет Максим Дьяков, основатель сервиса «ЯСтрим» – передаю микрофон автору.

Под катом немного метаний между ChromeApps и Electron, впечатления от пробы Yandex SpeechKit и вообще о разработке в формате антихакатона.

Одним дождливым летним вечером мы с товарищами решили поучаствовать в антихакатоне Яндекс.Денег. И повод был подходящий, ведь уже давно хотелось создать приложение, связанное со стрим-сервисами и процессом отправки донатов. Наша команда состояла из четырех человек: дизайнера Наумова Александра, ответственного за мобильное приложение Джавида Халилова, главного по ПК-клиентам Александра Кобрина и меня, в качестве бэкенд-разработчика и идейного вдохновителя.

Получилось бодро – через две недели появился минимально жизнеспособный продукт «ЯСтрим».

Зачем кому-то платить за стрим

Для общего понимания немного расскажу о том, как происходит отправка доната и, главное, зачем это вообще нужно.

Под стримингом в этой статье понимается именно игровой стриминг. То есть когда некто транслирует в сеть свой игровой процесс и заодно все это комментирует. У популярных стримеров есть своя аудитория зрителей, которые следят за выходом новых «эпизодов» и порой присылают комментарии, послания или деньги. Разумеется, всё на добровольной основе и без какой-либо практической цели для зрителей – сугубо just for fun.

Раз стриминг для зрителя – это просто способ весело провести время, то нет и явных причин платить кому-то даже 50 рублей (это не кино, и билетов при подключении не спрашивают). Однако индустрия онлайн-стриминга набирает обороты едва ли не быстрее блогинга, а значит, без хорошего денежного потока там не обходится. Вообще, четкого ответа как такового нет. Кидая монетку молодым музыкантам в метро, мы не получаем какую-то услугу или товар, а лишь благодарим исполнителя за творчество – так же и тут.

Что касается технической стороны организации стрима, то уже давно есть известные продукты для захвата и трансляции видео с экрана, но нет толковой системы сбора донатов. Толковой – это такой, которая:

позволяет пользователю с минимумом усилий перевести некую сумму стримеру;

поддерживает передачу сообщения (текстового или голосового) от пользователя стримеру в процессе перевода денег;

показывает стримеру сообщение и оповещения о получении денег от конкретных пользователей;

умеет читать пользовательские сообщения вслух в прямом эфире и содержит настройки по «запикиванию» мата и других не подходящих стримеру слов;

- может работать с любым ПО для стриминга, чтобы не заставлять стримера отказываться от привычного окружения.

По крайней мере, нет продукта, который бы удовлетворял этим требованиям и не брал собственной комиссии. Кроме того, за перевод денег в большинстве продуктов отвечает их собственная разработка, что добавляет сомнений потребителю. А раз толкового продукта нет – значит, есть повод для стартапа.

Строить только один продукт для передачи донатов бессмысленно – это ограничит его возможности и сведет потенциал разработки практически к нулю. Поэтому решили делать комплексное решение «ЯСтрим», альфа-версию которого вы можете посмотреть на видео:

Так стример видит интерфейс ЯСтрима.

Главное преимущество нашего проекта над конкурентами в том, что ЯСтрим не требует какой-то интеграции с привычным стримеру приложением для захвата экрана и трансляции. Вместо этого оно просто накладывает необходимый интерфейс и пользовательские сообщения на экран, который и захватывается стриминговым приложением.

Строим счастье для стримера

Так как хотелось охватить рынок побольше, а заодно изучить что-то новое на антихакатоне, решение должно было стать кроссплатформенным – с поддержкой всех стриминговых платформ и сопутствующего ПО. В качестве основы изначально выбрали Chrome Apps, который казался почти идеальным инструментом для отладки и разработки API (особенно понравилась отладка приложений в Postman, который тоже написан под Chrome). Тогда десктопных клиентов можно было бы написать на Chrome Apps сразу под множество платформ.

Вдохновившись лучшим, на мой взгляд, инструментом для разработки Web API – Postman в версии для Chrome – я решил использовать в качестве основы Google Chrome Apps. Написанные под эту платформу приложения работают в Google Chrome и в других браузерах на движке chromium, что позволило бы сделать легкое кроссплатформенное решение.

Вот несколько мотивирующих факторов:

Google Chrome и другие браузеры на движке Chromium составляют большую часть рынка, поэтому решение стало бы «всеядным»;

- разработка на этой платформе представляет собой типичный web frontend с некоторыми нюансами, которые помещались в книге Marc Rochkind на 240 страницах.

Что касается бэкенда, то выбор для меня однозначен – ASP.NET. После некоторого опыта конфигурирования сервера на Ubuntu стоит один раз познакомиться с приятным UI Azure, и пути назад не останется. Последний гвоздь в наши сомнения вбила бесплатная подписка Azure на месяц, что в условиях антихакатона – самое оно.

Конечно, во всем этом царстве удобства и бесплатности не обошлось без бесячих моментов.

Хочется поделиться тем фактом, что все это время я находится под впечатлением от книги «Психбольница в руках пациентов» Алана Купера. Книга посвящена теории проектирования взаимодействия, поэтому, когда дело дошло до второй составляющей – зрителей, – очень хотелось опробовать в бою приемы вроде составления персонажей.

Когда мы определились с основными компонентами продукта (приложение для десктопа, веб-форма и мобильное приложение), наш фронт-разработчик внезапно выяснил, что Google прекращает поддержку Chrome Apps на Windows, Mac и Linux. Неловкая пауза, разочарование, негодование, принятие.

Король умер, да здравствует король Electron

В качестве альтернативы отлично подошел фреймворк Electron с открытым кодом. Конечно, насторожила новизна платформы, но растущая популярность компенсировала опасения. Что касается мобильного приложения, то скажем так: у меня в команде по мобильной части был только Android-разработчик. Архитектура для ЯСтрима выбрана клиент-серверная, с Microsoft SQL в качестве бэкенд-базы.

Думаю, нет смысла подробно разбирать архитектуру, рисовать блок-схемы и т.п. – это скучно и специфично для конкретного проекта. Лучше поделюсь советами по собственному опыту проб и ошибок:

В качестве идентификатора лучше выбирать нечто глобально-уникальное, для задела на будущее. Например, для ID онлайн-трансляций я выбрал URL, что позволило решить миллион проблем одним махом (уникальность, быстрый доступ, возможность в дальнейшем работать с API стриминговых платформ).

Детально прорабатывайте платформу вашего будущего сервиса – это сэкономит массу времени на более высоких уровнях реализации. Лучше потратить еще пару дней на платформу, чем на финальных этапах обнаружить, что все надо наполовину переписывать.

- Если только речь не идет о хакатоне и проекте без дальнейших перспектив, сразу документируйте все сущности, логику, взаимодействие и прочее. Чем дальше все это откладывается, тем больше информации приходится держать в голове. На большом проекте обо всем помнить не просто, поэтому лучше сразу делать правильно.

Далее наступил этап разработки WEB API нашего сервиса, где основной задачей стало обеспечение безопасности стримеров: что если кто-то изменит настройки донатов, поменяет логотип или затеет еще что-то недоброе.

Так в платформе появились следующие инструменты защиты:

При каждом переводе в поле label вносится специальная метка, а идентификатор операции (если его удается получить) попадает в данные о донате. Это было необходимо для удобной работы с API Яндекс.Денег на стороне стримера и проверки существования перевода в платежной системе.

Когда ЯСтрим получает данные о произведенном донате, пользовательский клиент запрашивает у Яндекс.Денег операцию с таким же ID либо все операции с совпадением по полю label. Донат покажется в стриме, только если транзакция будет найдена.

Все общение пользовательского клиента и стриминговой платформы происходит с использованием специального токена ЯСтрима, который выдается на этапе авторизации в платежной системе.

- Отдельно пришлось повозиться с загрузкой фотографий, так как какого-либо опыта не было, а для простоты работы с API нужно было сделать небольшой фотохостинг.

Результат всех этих изысканий можно было охарактеризовать как «бэкенд работает», что, на мой взгляд, отлично характеризует ранний прототип. Далее еще предстоял рефакторинг, рефакторинг и еще раз увлекательный рефакторинг.

Волнительный этап сборки

Когда пришло время создавать рабочий билд, у нас никак не выходило подключить React – в результате приложение при запуске выдавало дикие ошибки.

Пример того, что мы ловили при попытках сборки.

Наша команда перекопала вдоль и поперек Stackoverflow и GitHub Issues, так что осталось только открывать новый топик и искать знающих людей. Так мы познакомились с разработчиком Electron и @akashnimare, который имеет подходящий опыт и был готов им поделиться. Кроме того, открыли для себя российское комьюнити Electron, куда стоит зайти любому, кто собирается использовать эту платформу.

С хранением файлов тоже вышла заминка, из которой и родился совет уделять больше внимания фундаментам приложения. Нужно было и нам не лениться, а с самого начала подключать библиотеку electron-storage или electron-storage-json, чтобы не переписывать код, когда выяснится, что local-storage из main недоступен.

Лучиком света в темном царстве незнакомых фреймворков стал Yandex SpeechKit, который не только выдавал отличный результат, но и потребовал минимум времени на изучение документации. Фактически нужная опция озвучки сообщения из пользовательского доната получилась после трех строк кода:

const tts = new ya.speechkit.Tts({

apikey: 'ffffffff-2222-4444-0000-1111111111',

emotion: 'good',

speed: 1.2

})

...

tts.speak(donate.text_data, { speaker: 'zahar' })Достаточно указать персональный ключ API, выбрать голос (zahar), скорость, эмоциональный окрас (good) – и готово.

За плечами литры энергетиков и 3 недели плотной разработки

Подводя итог, хочется сказать, что как стартап мы еще даже не на первой ступени. Но с точки зрения первоначальной цели мы добились главного: успели реализовать практически все фичи (кроме голосовых сообщений, с которыми пока есть шероховатости), что не часто удается молодым разработчикам на реальном проекте. При этом никто не переругался, все четверо в лодке и продолжают верить в успех. Поэтому achievement unlocked, но впереди еще долгий путь.

Если наш опыт показался вам интересным – с удовольствием отвечу на вопросы в комментариях.

|

|

[Из песочницы] История 13 места на Highload Cup 2017 |

История 13 места на Highload Cup 2017

11 августа компания Mail.Ru Объявила об очередном конкурсе HighloadCup для системных программистов backend-разработчиков.

Вкратце задача стояла следующим образом: докер, 4 ядра, 4Гб памяти, 10Гб HDD, набор api, и нужно ответить на запросы за наименьшее количество времени. Язык и стек технологий неограничен. В качестве тестирующей системы выступал яндекс-танк с движком phantom.

О том, как в таких условиях добраться до 13 места в финале, и будет эта статья.

Постановка задачи

Подробно с описанием задачи можно ознакомиться в публикации одного из участников на хабре, или на официальной странице конкурса. О том, как происходило тестирование, написано здесь.

Api представляло из себя 3 get-запроса на просто вернуть записи из базы, 2 get-запроса на агрегирование данных, 3 post-запроса на модификацию данных, и 3 post-запроса на добавление данных.

Сразу были оговорены следующие условия, которые существенно облегчили жизнь:

- нет сетевых потерь (данные идут через loopback)

- данные гарантированно помещаются в память

- нет конкурирующих post-запросов (т.е. не будет одновременной попытки изменить одну и ту же запись)

- post- и get-запросы никогда не идут одновременно (либо только get-запросы, либо только post-запросы)

- данные никогда не удаляются, а только модифицируются или добавляются

Запросы были поделены на 3 части: сначала get-запросы по исходным данным, потом серия post-запросов на добавление/изменение данных, и последняя самая мощная серия get-запросов по модифицированным данным. Вторая фаза была очень важна, т.к. неправильно добавив или поменяв данные, можно было получить много ошибок в третьей фазе, и как результат — большой штраф. На данном этапе последняя стадия содержала линейное увеличение числа запросов от 100 до 2000rps.

Еще одним условием было то, что один запрос — одно соединение, т.е. никаких keep-alive, но в какой-то момент от этого отказались, и все get-запросы шли с keep-alive, post-запросы были каждый на новое соединение.

Моей мечтой всегда были и есть Linux, C++ и системное программирование (хотя реальность ужасна), и я решил ни в чем себе не отказывать и нырнуть в это удовольствие с головой.

Поехали

Т.к. о highload'e я знал чуть менее, чем ничего, и я до последнего надеялся, что писать свой web-сервер не придется, то первым шагом к решению задачи стал поиск подходящего web-сервера. Мой взгляд ухватился за proxygen. В целом, сервер должен был быть хорошим — кто еще знает о хайлоаде столько, сколько facebook?

Исходный код содержит несколько примеров, как использовать этот сервер.

HTTPServerOptions options;

options.threads = static_cast(FLAGS_threads);

options.idleTimeout = std::chrono::milliseconds(60000);

options.shutdownOn = {SIGINT, SIGTERM};

options.enableContentCompression = false;

options.handlerFactories = RequestHandlerChain()

.addThen()

.build();

HTTPServer server(std::move(options));

server.bind(IPs);

// Start HTTPServer mainloop in a separate thread

std::thread t([&] () {

server.start();

}); И на каждое принятое соединение вызывается метод фабрики

class EchoHandlerFactory : public RequestHandlerFactory {

public:

// ...

RequestHandler* onRequest(RequestHandler*, HTTPMessage*) noexcept override {

return new EchoHandler(stats_.get());

}

// ...

private:

folly::ThreadLocalPtr stats_;

}; От new EchoHandler() на каждый запрос у меня по спине вдруг пробежал холодок, но я не придал этому значения.

Сам EchoHandler должен реализовать интерфейс proxygen::RequestHandler:

class EchoHandler : public proxygen::RequestHandler {

public:

void onRequest(std::unique_ptr headers)

noexcept override;

void onBody(std::unique_ptr body) noexcept override;

void onEOM() noexcept override;

void onUpgrade(proxygen::UpgradeProtocol proto) noexcept override;

void requestComplete() noexcept override;

void onError(proxygen::ProxygenError err) noexcept override;

};Все выглядит хорошо и красиво, только успевай обрабатывать приходящие данные.

Роутинг я реализовал с помощью std::regex, благо набор апи простой и небольшой. Ответы формировал на лету с помощью std::stringstream. В данный момент я не заморачивался с производительностью, целью было получить работающий прототип.

Так как данные помещаются в память, то значит и хранить их нужно в памяти!

Структуры данных выглядели так:

struct Location {

std::string place;

std::string country;

std::string city;

uint32_t distance = 0;

std::string Serialize(uint32_t id) const {

std::stringstream data;

data <<

"{" <<

"\"id\":" << id << "," <<

"\"place\":\"" << place << "\"," <<

"\"country\":\"" << country << "\"," <<

"\"city\":\"" << city << "\"," <<

"\"distance\":" << distance <<

"}";

return std::move(data.str());

}

};Первоначальный вариант "базы данных" был такой:

template

class InMemoryStorage {

public:

typedef std::unordered_map Map;

InMemoryStorage();

bool Add(uint32_t id, T&& data, T** pointer);

T* Get(uint32_t id);

private:

std::vector> buckets_;

std::vector Идея была следущей: индексы, по условию, целое 32-битное число, а значит никто не мешает добавлять данные с произвольными индексами внутри этого диапазона (о, как же я ошибался!). Поэтому у меня было BUCKETS_COUNT (=10) хранилищ, чтобы уменьшить время ожидания на мутексе для потоков.

Т.к. были запросы на выборку данных, и нужно было быстро искать все места, в которых бывал пользователь, и все отзывы, оставленные для мест, то нужны были индексы users -> visits и locations -> visits.

Для индекса был написан следующий код, с той же идеологией:

template

class MultiIndex {

public:

MultiIndex() : buckets_(BUCKETS_COUNT), bucket_mutexes_(BUCKETS_COUNT) {

}

void Add(uint32_t id, T* pointer) {

int bucket_id = id % BUCKETS_COUNT;

std::lock_guard lock(bucket_mutexes_[bucket_id]);

buckets_[bucket_id].insert(std::make_pair(id, pointer));

}

void Replace(uint32_t old_id, uint32_t new_id, T* val) {

int bucket_id = old_id % BUCKETS_COUNT;

{

std::lock_guard lock(bucket_mutexes_[bucket_id]);

auto range = buckets_[bucket_id].equal_range(old_id);

auto it = range.first;

while (it != range.second) {

if (it->second == val) {

buckets_[bucket_id].erase(it);

break;

}

++it;

}

}

bucket_id = new_id % BUCKETS_COUNT;

std::lock_guard lock(bucket_mutexes_[bucket_id]);

buckets_[bucket_id].insert(std::make_pair(new_id, val));

}

std::vector GetValues(uint32_t id) {

int bucket_id = id % BUCKETS_COUNT;

std::lock_guard lock(bucket_mutexes_[bucket_id]);

auto range = buckets_[bucket_id].equal_range(id);

auto it = range.first;

std::vector result;

while (it != range.second) {

result.push_back(it->second);

++it;

}

return std::move(result);

}

private:

std::vector> buckets_;

std::vector bucket_mutexes_;

}; Первоначально организаторами были выложены только тестовые данные, которыми инициализировалась база данных, а примеров запросов не было, поэтому я начинал тестировать свой код с помощью Insomnia, которая позволяла легко отправлять и модифицировать запросы и смотреть ответ.

Чуть позже организаторы сжалилсь над участниками и выложили патроны от танка и полные данные рейтинговых и тестовых обстрелов, и я написал простенький скрипт, который позволял тестировать локально корректность моего решения и очень помог в дальнейшем.

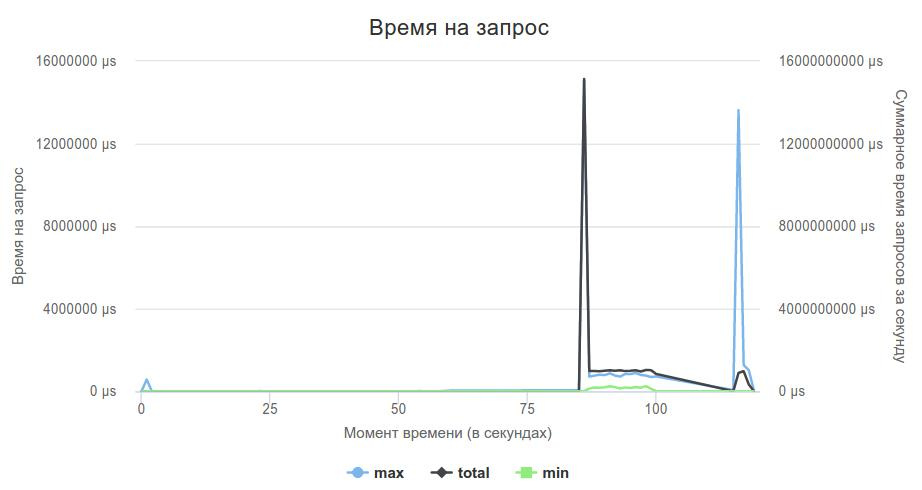

Highload, начало

И вот наконец-то прототип был закончен, локально тестировщик говорил, что все ОК, и настало время отправлять свое решение. Первый запуск был очень волнительным, и он показал, что что-то не так...

Мой сервер не держал нагрузку в 2000rps. У лидеров в этот момент, насколько я помню, времена были порядка сотен секунд.

Дальше я решил проверить, справляется ли вообще сервер с нагрузкой, или это проблемы с моей реализацией. Написал код, который на все запросы просто отдавал пустой json, запустил рейтинговый обстрел, и увидел, что сам proxygen не справляется с нагрузкой.

void onEOM() noexcept override {

proxygen::ResponseBuilder(downstream_)

.status(200, "OK")

.header("Content-Type", "application/json")

.body("{}")

.sendWithEOM();

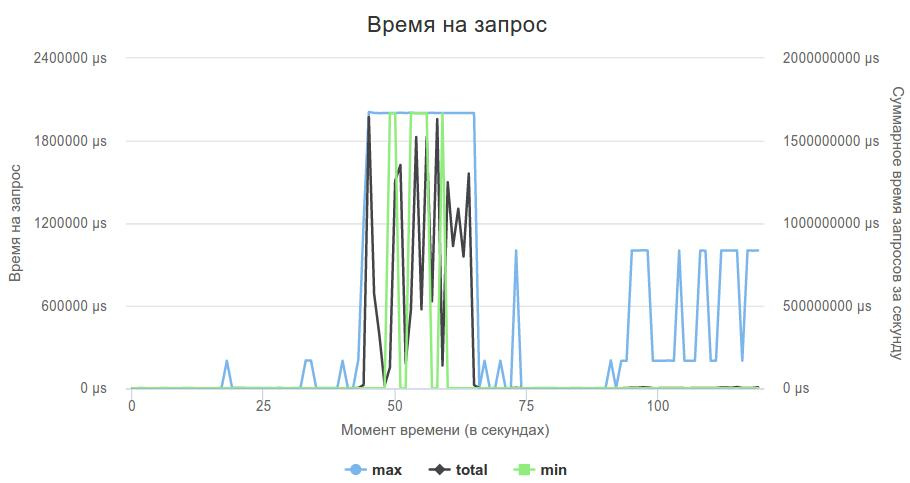

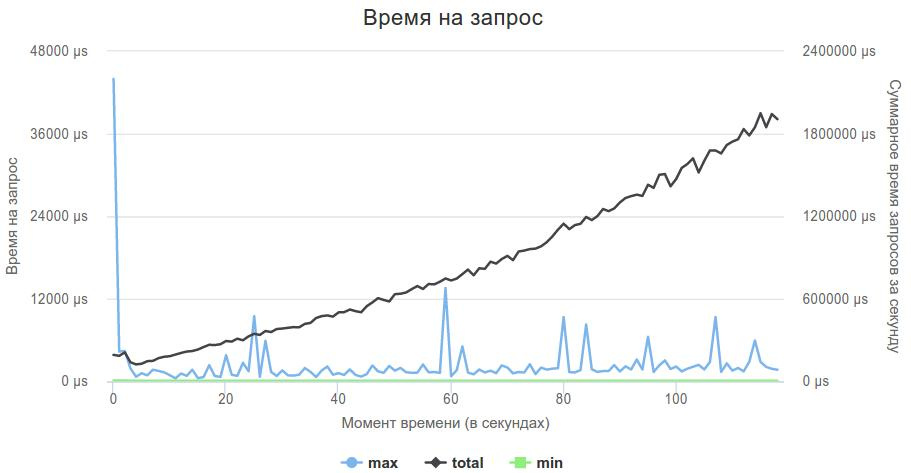

}Вот так выглядел график 3-ей фазы.

С одной стороны было приятно, что это пока еще проблема не в моем коде, с другой встал вопрос: что делать с сервером? Я все еще надеялся избежать написания своего, и решил попробовать что-нибудь другое.

Следующим подопытным стал Crow. Сразу скажу, мне он очень понравился, и если вдруг в будущем мне потребуется плюсовый http-сервер, то это будет именно он. header-based сервер, я его просто добавил в свой проект вместо proxygen, и немного переписал обработчики запросов, чтобы они начали работать с новым сервером.

Использовать его очень просто:

crow::SimpleApp app;

CROW_ROUTE(app, "/users/").methods("GET"_method, "POST"_method) (

[](const crow::request& req, crow::response& res, uint32_t id) {

if (req.method == crow::HTTPMethod::GET) {

get_handlers::GetUsers(req, res, id);

} else {

post_handlers::UpdateUsers(req, res, id);

}

});

app.bindaddr("0.0.0.0").port(80).multithreaded().run(); В случае, если нет подходящего описания для api, сервер сам отправляет 404, если же есть нужный обработчик, то в данном случае он достает из запроса uint-параметр и передает его как параметр в обработчик.

Но перед тем, как использовать новый сервер, наученный горьким опытом, я решил проверить, справляется ли он с нагрузкой. Также как и в предыдущем случае, написал обработчик, который возвращал пустой json на любой запрос, и отправил его на рейтинговый обстрел.

Crow справился, он держал нагрузку, и теперь нужно было добавить мою логику.

Т.к. логика была уже написана, то адаптировать код к новому серверу было достаточно просто. Все получилось!

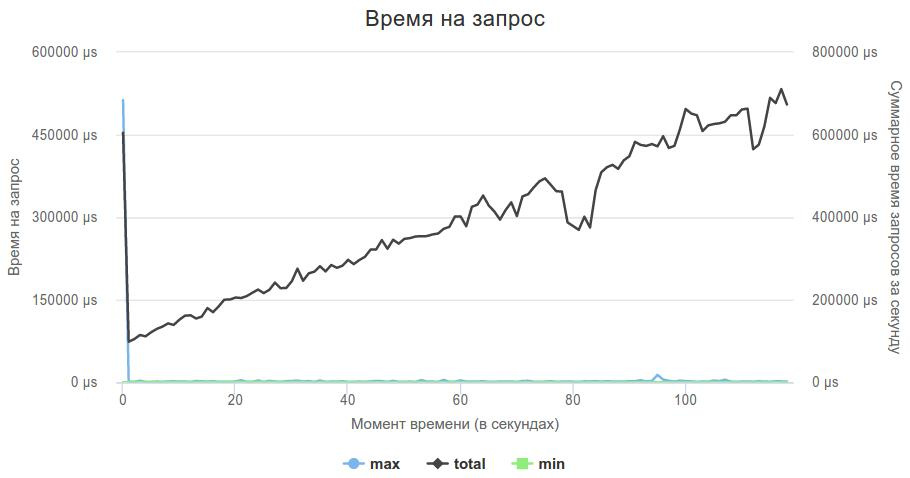

100 секунд — уже что-то, и можно начинать заниматься оптимизацией логики, а не поисками сервера.

Т.к. мой сервер все еще формировал ответы с помощью std::stringstream, я решил избавиться от этого в первую очередь. В момент добавления записи в базу данных тут же формировалась строка, содержащая полный ответ с хедером, и в момент запроса отдавал ее.

На данном этапе я решил добавить хедер полностью в ответ по двум причинам:

- убирается лишний

write() - данных всего 200мб, памяти хватает с запасом

Еще одной проблемой, о которую было сломано много копий в чатике в телеграмме и мной лично, это фильтр пользователей по возрасту. По условию задачи, возраст пользователей хранился в unix timestamp, а в запросах он приходил в виде полных лет: fromAge=30&toAge=70. Как года привести к секундам? Учитывать високосный год или нет? А если пользователь родился 29 февраля?

Итогом стал код, который решал все эти проблемы одним махом:

static time_t t = g_generate_time; // get time now

static struct tm now = (*localtime(&t));