Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Как на самом деле работает планировщик Kubernetes? |

На этой неделе мне стали известны подробности о том, как работает планировщик Kubernetes, и я хочу поделиться ими с теми, кто готов погрузиться в дебри организации того, как это в действительности работает.

Дополнительно отмечу, что этот случай стал наглядной иллюстрацией того, как без необходимости в чьей-либо помощи перейти от состояния «Не имею понятия, как эта система даже спроектирована» к «Окей, думаю, что мне понятны базовые архитектурные решения и чем они обусловлены».

Надеюсь, этот небольшой поток сознания окажется для кого-то полезным. Во время изучения данной темы мне больше всего пригодился документ Writing Controllers из замечательной-замечательной-замечательной документации Kubernetes для разработчиков.

Для чего планировщик?

Планировщик Kubernetes отвечает за назначение узлов подам (pods). Суть его работы сводится к следующему:

- Вы создаёте под.

- Планировщик замечает, что у нового пода нет назначенного ему узла.

- Планировщик назначает поду узел.

Он не отвечает за реальный запуск пода — это уже работа kubelet. Всё, что от него в принципе требуется, — гарантировать, что каждому поду назначен узел. Просто, не так ли?

В Kubernetes применяется идея контроллера. Работа контроллера заключается в следующем:

- посмотреть на состояние системы;

- заметить, где актуальное состояние не соответствует желаемому (например, «этому поду должен быть назначен узел»);

- повторить.

Планировщик — один из видов контроллера. Вообще же существует множество разных контроллеров, у всех разные задачи и выполняются они независимо.

В общем виде работу планировщика можно представить как такой цикл:

while True:

pods = get_all_pods()

for pod in pods:

if pod.node == nil:

assignNode(pod)Если вас не интересуют детали о том, как же работает планировщик в Kubernetes, возможно, на этом читать статью достаточно, т.к. этот цикл заключает в себе вполне корректную модель.

Вот и мне казалось, что планировщик на самом деле работает подобным образом, потому что так работает и контроллер

cronjob — единственный компонент Kubernetes, код которого был мною прочитан. Контроллер cronjob перебирает все cron-задания, проверяет, что ни для одного из них не надо ничего делать, ожидает 10 секунд и бесконечно повторяет этот цикл. Очень просто!Однако работает всё не совсем так

Но на этой неделе мы увеличивали нагрузку на кластер Kubernetes и столкнулись с проблемой.

Иногда под навсегда «застревал» в состоянии

Pending (когда узел не назначен на под). При перезагрузке планировщика под выходил из этого состояния (вот тикет).Такое поведение не сходилось с моей внутренней моделью того, как работает планировщик Kubernetes: если под ожидает назначения узла, то планировщик обязан обнаружить это и назначить узел. Планировщик не должен перезапускаться для этого!

Пришло время обратиться к коду. И вот что мне удалось выяснить — как всегда, возможно, что здесь есть ошибки, т.к. всё довольно сложно, а на изучение ушла только неделя.

Как работает планировщик: беглый осмотр кода

Начнём с scheduler.go. (Объединение всех нужных файлов доступно здесь — для удобства навигации по содержимому.)

Основной цикл планировщика (на момент коммита e4551d50e5) выглядит так:

go wait.Until(sched.scheduleOne, 0, sched.config.StopEverything)… что означает: «Вечно запускай

sched.scheduleOne». А что происходит там?func (sched *Scheduler) scheduleOne() {

pod := sched.config.NextPod()

// do all the scheduler stuff for `pod`

}Окей, а что делает

NextPod()? Откуда растут ноги?func (f *ConfigFactory) getNextPod() *v1.Pod {

for {

pod := cache.Pop(f.podQueue).(*v1.Pod)

if f.ResponsibleForPod(pod) {

glog.V(4).Infof("About to try and schedule pod %v", pod.Name)

return pod

}

}

}Окей, всё достаточно просто! Есть очередь из подов (

podQueue), и следующие поды приходят из неё.Но как поды попадают в эту очередь? Вот соответствующий код:

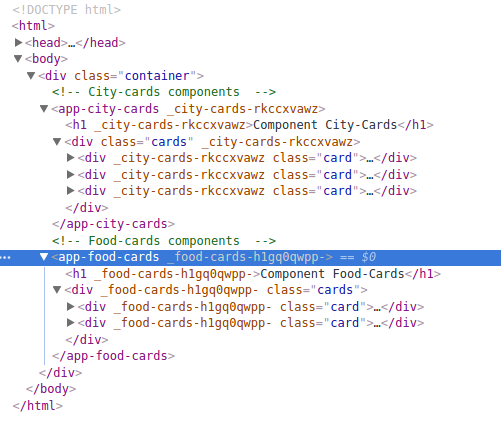

podInformer.Informer().AddEventHandler(

cache.FilteringResourceEventHandler{

Handler: cache.ResourceEventHandlerFuncs{

AddFunc: func(obj interface{}) {

if err := c.podQueue.Add(obj); err != nil {

runtime.HandleError(fmt.Errorf("unable to queue %T: %v", obj, err))

}

},То есть существует обработчик события, который при добавлении нового пода добавляет его в очередь.

Как работает планировщик: простым языком

Теперь, когда мы прошлись по коду, можно подвести итог:

- В самом начале каждый под, которому потребуется планировщик, помещается в очередь.

- Когда создаются новые поды, они тоже добавляются в очередь.

- Планировщик постоянно берёт поды из очереди и осуществляет для них планирование.

- Вот и всё!

Здесь есть интересная деталь: если по какой-либо причине под не попадает к планировщику, планировщик не станет предпринимать повторную попытку для него. Под будет убран из очереди, его планирование не выполнится, и всё на этом. Единственный шанс будет упущен! (Пока вы не перезапустите планировщик, в случае чего все поды снова будут добавлены в очередь.)

Конечно, в действительности планировщик умнее: если под не попал к планировщику, в общем случае вызывается обработчик ошибки вроде этого:

host, err := sched.config.Algorithm.Schedule(pod, sched.config.NodeLister)

if err != nil {

glog.V(1).Infof("Failed to schedule pod: %v/%v", pod.Namespace, pod.Name)

sched.config.Error(pod, err)Вызов функции

sched.config.Error снова добавляет под в очередь, поэтому для него всё-таки будет предпринята повторная попытка обработки.Подождите. Почему же тогда «застрял» наш под?

Всё очень просто: оказалось, что эта функция

Error не всегда вызывалась, когда реально происходила ошибка. Мы сделали патч (патч был опубликован в том же issue — прим. перев.), чтобы вызывать её корректно, после чего восстановление стало происходить правильно. Класс!Почему планировщик спроектирован так?

Думаю, что более надёжная архитектура выглядит следующим образом:

while True:

pods = get_all_pods()

for pod in pods:

if pod.node == nil:

assignNode(pod)Так почему же вместо такого подхода мы видим все эти сложности с кэшами, запросами, обратными вызовами? Глядя на историю, приходишь к мнению, что основная причина — в производительности. Примеры — это обновление о масштабируемости в Kubernetes 1.6 и эта публикация CoreOS об улучшении производительности планировщика Kubernetes. В последней говорится о сокращении времени планирования для 30 тысяч подов (на 1 тысяче узлов — прим. перев.) с 2+ часов до менее 10 минут. 2 часа — это довольно долго, а производительность важна!

Стало ясно, что опрашивать все 30 тысяч подов вашей системы каждый раз при планировании для нового пода — это слишком долго, поэтому действительно приходится придумать более сложный механизм.

Что на самом деле использует планировщик: informers в Kubernetes

Хочу сказать ещё об одном моменте, который кажется очень важным для архитектуры всех контроллеров Kubernetes. Это идея «информаторов» (informers). К счастью, есть документация, которая находится гуглением «kubernetes informer».

Этот крайне полезный документ называется Writing Controllers и рассказывает о дизайне для тех, кто пишет свой контроллер (вроде планировщика или упомянутого контроллера

cronjob). Очень здорово!Если бы этот документ нашёлся в первую очередь, думаю, что понимание происходящего пришло бы чуть быстрее.

Итак, информаторы! Вот что говорит документация:

ИспользуйтеSharedInformers.SharedInformersпредлагают хуки для получения уведомлений о добавлении, изменении или удалении конкретного ресурса. Также они предлагают удобные функции для доступа к разделяемым кэшам и для определения, где кэш применим.

Когда контроллер запускается, он создаёт

informer (например, pod informer), который отвечает за:- вывод всех подов (в первую очередь);

- уведомления об изменениях.

Контроллер

cronjob не использует информаторов (работа с ними всё усложняет, а в данном случае, думаю, ещё не стоит вопрос производительности), однако многие другие (большинство?) — используют. В частности, планировщик так делает. Настройку его информаторов можно найти в этом коде.Повторное помещение в очередь

В той же документации (Writing Controllers) есть и инструкции по тому, как обрабатывать повторное помещение элементов в очередь:

Для надёжного повторного помещения в очередь выносите ошибки на верхний уровень. Для простой реализации с разумным откатом естьworkqueue.RateLimitingInterface.

Главная функция контроллера должна возвращать ошибку, когда необходимо повторное помещение в очередь. Когда его нет, используйтеutilruntime.HandleErrorи возвращайтеnil. Это значительно упрощает изучение случаев обработки ошибок и гарантирует, что контроллер ничего не потеряет, когда это необходимо.

Выглядит как хороший совет: корректно обработать все ошибки может быть нелегко, поэтому важно наличие простого способа, гарантирующего, что рецензенты кода увидят, корректно ли обрабатываются ошибки. Клёво!

Необходимо «синхронизировать» своих информаторов (не так ли?)

И последняя интересная деталь за время моего расследования.

У informers используется концепция «синхронизации» (sync). Она немного похожа на рестарт программы: вы получаете список всех ресурсов, за которыми наблюдаете, поэтому можете проверить, что всё действительно в порядке. Вот что то же руководство говорит о синхронизации:

Watches и Informers будут «синхронизироваться». Периодически они доставляют вашему методуUpdateкаждый подходящий объект в кластере. Хорошо для случаев, когда может потребоваться выполнить дополнительное действие с объектом, хотя это может быть нужно и не всегда.

В случаях, когда вы уверены, что повторное помещение в очередь элементов не требуется и новых изменений нет, можно сравнить версию ресурса у нового и старого объектов. Если они идентичны, можете пропустить повторное помещение в очередь. Будьте осторожны. Если повторное помещение элемента будет пропущено при каких-либо ошибках, он может потеряться (никогда не попасть в очередь повторно).

Проще говоря, «необходимо делать синхронизацию; если вы не синхронизируете, можете столкнуться с ситуацией, когда элемент потерян, а новая попытка помещения в очередь не будет предпринята». Именно это и произошло в нашем случае!

Планировщик Kubernetes не синхронизируется повторно

Итак, после знакомства с концепцией синхронизации… приходишь к выводу, что, похоже, планировщик Kubernetes никогда её не выполняет? В этом коде всё выглядит именно так:

informerFactory := informers.NewSharedInformerFactory(kubecli, 0)

// cache only non-terminal pods

podInformer := factory.NewPodInformer(kubecli, 0)Эти числа «0» означают «период повторной синхронизации» (resync period), что логично интерпретировать как «ресинхронизация не происходит». Интересно! Почему так сделано? Не имея уверенности на сей счёт и прогуглив «kubernetes scheduler resync», удалось найти pull request #16840 (добавляющий resync для планировщика) с двумя следующими комментариями:

@brendandburns — что здесь планируется исправить? Я действительно против таких маленьких периодов повторной синхронизации, потому что они значительно скажутся на производительности.

Согласен с @wojtek-t. Если resync вообще когда-либо и может решить проблему, это означает, что где-то в коде есть баг, который мы пытаемся спрятать. Не думаю, что resync — правильное решение.

Выходит, что мейнтейнеры проекта решили не выполнять повторную синхронизацию, потому что лучше, чтобы баги, заложенные в коде, всплывали и исправлялись, а не прятались с помощью выполнения resync.

Советы по чтению кода

Насколько мне известно, нигде не описана реальная работа планировщика Kubernetes изнутри (как и многие другие вещи!).

Вот пара приёмов, которые помогли мне при чтении нужного кода:

- Объедините всё нужное в большой файл. Выше уже написано об этом, но вот действительно: переходить между вызовами функций стало намного проще по сравнению с переключением между файлами, особенно когда ещё не знаешь, как всё полностью организовано.

- Имейте несколько конкретных вопросов. В моём случае — «Как обработка ошибок должна работать? Что произойдет, если под не попадёт к планировщику?». Потому что есть много кода о близком… как выбирается конкретный узел, который будет назначен поду, но меня это мало волновало (и я до сих пор не знаю, как это работает).

Работать с Kubernetes довольно-таки здорово!

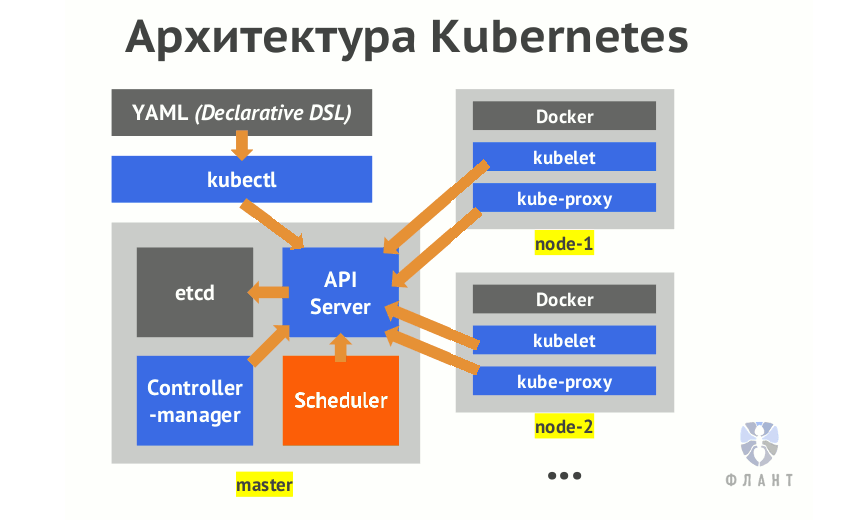

Kubernetes — по-настоящему сложное программное обеспечение. Даже для того, чтобы получить работающий кластер, потребуется настроить как минимум 6 различных компонентов: api server, scheduler, controller manager, container networking вроде flannel, kube-proxy, kubelet. Поэтому (если вы хотите понимать программное обеспечение, которое запускаете, как и я) необходимо понимать, что все эти компоненты делают, как они взаимодействуют друг с другом и как настроить каждую из их 50 триллионов возможностей для получения того, что требуется.

Тем не менее, документация достаточно хороша, а когда что-либо недостаточно документировано, код весьма прост для чтения, и pull requests, похоже, действительно рецензируются.

Мне пришлось по-настоящему и более обычного практиковать принцип «читай документацию и, если её нет, то читай код». Но в любом случае это отличный навык, чтобы стать лучше!

P.S. от переводчика: читайте также в нашем блоге:

- «Наш опыт с Kubernetes в небольших проектах» (видео доклада, включающего в себя знакомство с техническим устройством Kubernetes);

- «Зачем нужен Kubernetes и почему он больше, чем PaaS?»;

- «Начало работы в Kubernetes с помощью Minikube » (перевод).

|

Метки: author shurup системное администрирование devops *nix блог компании флант kubernetes go |

Pygest #15. Релизы, статьи, интересные проекты из мира Python [01 августа 2017 — 14 августа 2017] |

Всем привет! Это уже пятнадцатый выпуск дайджеста на Хабрахабр о новостях из мира Python.

Всем привет! Это уже пятнадцатый выпуск дайджеста на Хабрахабр о новостях из мира Python. В сегодняшнем выпуске вы найдёте интересные материалы, касающиеся Django, машинного обучения, алгоритмов, внутреннего устройства Python и многого другого. Присылайте свои актуальные материалы, а также любые замечания и предложения, которые будут добавлены в ближайший дайджест.

А теперь к делу!

Релизы

Python 3.5.4

Python 3.4.7

Django 1.11.4

PyTorch 0.2.0

Статьи

OpenDataScience и Mail.Ru Group проведут открытый курс по машинному обучению

Reverse engineer a Python object

О внутренностях объектов в Python.

Python decorators, the right way: the 4 audiences of programming languages

Интересная заметка о декораторах в Python.

The Hitchhiker’s Guide to Machine Learning in Python

Отличный вводный туториал и подборка материалов по машинному обучению для начинающих.

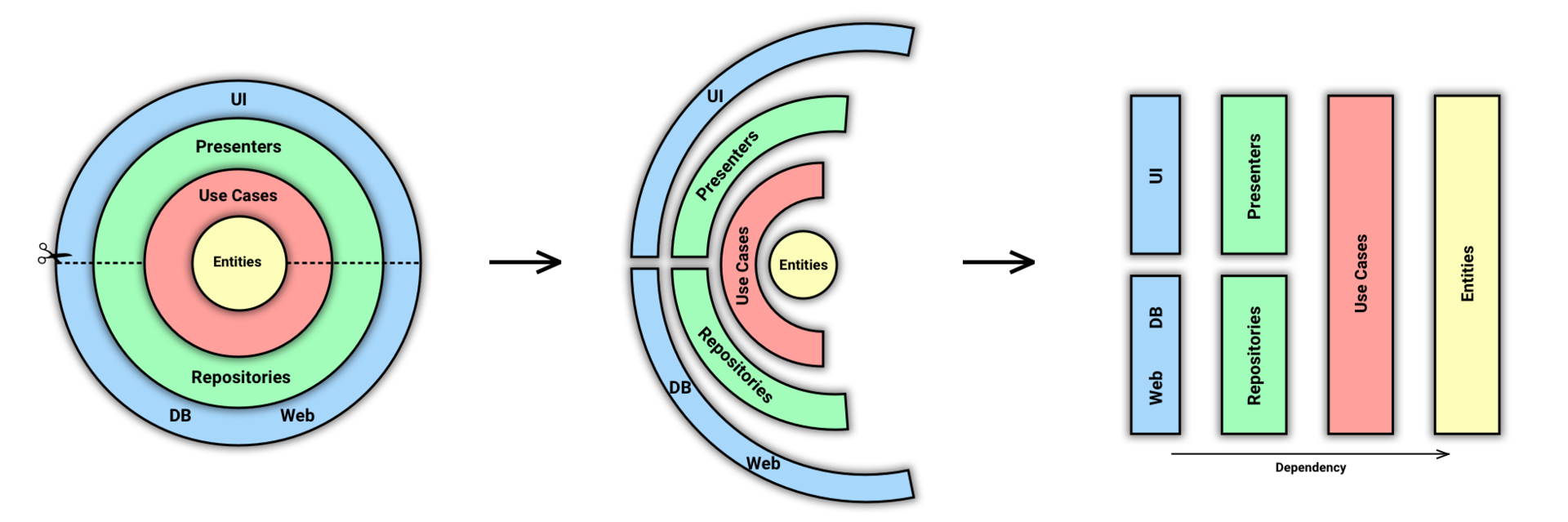

Clean Architecture in Django

Небольшая заметка о чистой архитектуре в Django-приложениях.

A Minimal Django Application

Туториал для начинающих работать с Django — как создать минимальное приложение на данном фреймворке.

Python __init__.py & modular Imports

О работе импорта модулей в Python.

Using K-Means to analyse hacking attacks

Статья об использовании алгоритма «к-средних» для анализа хакерских атак.

Python bytecode reverse-engineering

Крутая статья о реверс-инжениринге байт-кода Python.

Controlling Python Async Creep

Заметка о контролировании асинхронного выполнения кода в Python.

Demystifying Dynamic Programming

О том, что такое динамическое программирование с примерами на Python от freeCodeCamp.

Detecting fake banknotes using TensorFlow

Статья об использовании машинного обучения и TensorFlow для обнаружения фальшивых денег.

Building a Music Recommender with Deep Learning

Как создать свой сервис для рекомендации музыки?

Интересные проекты

Pygorithm

Библиотека для изучения алгоритмов «на лету»

tinychain

«Карманная» реализация Bitcoin

Aptos

Инструмент для валидации данных на основе JSON-схем

Domain Analyzer

Инструмент для анализа безопасности домена на основе всей доступной информации о нём

sandsifter

Инструмент для поиска скрытых инструкций и багов в процессорах x86

Видео

PyCon Australia 2017

Видео с конференции PyCon Australia 2017

Предыдущий выпуск дайджеста ищете здесь:

Pygest #14. Релизы, статьи, интересные проекты из мира Python [18 июля 2017 — 31 июля 2017]

Спасибо за внимание! Присылайте Ваши предложения для публикации в дайджесте!

|

Метки: author andrewnester разработка веб-сайтов программирование машинное обучение python django digest pygest machine learning flask дайджест web deep learning |

Как распознать scam ICO? Часть II. Зрим |

- Мне хорошо известна целевая аудитория Хабра и, возможно, поэтому для неё данный материал будет не просто понятен, но и прост. Но с другой стороны, именно вы, жители одного из самого большого it-сообщества в СНГ, сможете всегда дать своим знакомым или просто встретившимся в Сети людям этот материал, чтобы наконец-то избежать очередного, искусственного пузыря.

- Второй аспект заключается в том, что понимание и систематизированное знание — две качественно разные категории, поэтому мне, в рамках развития единой репутационной системы (о ней — как-нибудь в следующий раз), хотелось бы начать структурировать то, что известно.

Scam — это обман

Чтобы понять, что scam явление не новое, нужно лишь добавить к нему точку и com — http://scam.com — выдаст сотни результатов по теме. И это неудивительно: людям свойственно ошибаться, а значит всегда найдутся те, кто превратят их ошибки в бизнес.

И вот об этом поподробней.

Скам — это мошенничество: опять же, простой запрос «scam+history» преподнесет большой список из разного рода сервисов, которые тем или иным образом решили сыграть на доверии, глупости или неосторожности пользователей. Сферы будут самыми разными: от энергетики до банковского сектора. Что касается сферы ICO, несмотря на молодость, существует она с 2013 года, в ней хватает скамов.

Попробуем сначала классифицировать скамы:

Во-первых, классификация по времени: краткосрочные (таких большинство и о них ниже), долгосрочные — это в первую очередь хайпы. Ярчайший пример — OneCoin, о котором уже все наслышаны, но новые приспешники всё же появляются.

Во-вторых, по сложности:

- Самые простые. Их можно сравнить со СПАМом: бьют не целенаправленно, а массовым эффектом, в надежде, что статистика отработает и каждый сотый/ тысячный согласится что-то да внести;

- Средней сложности — здесь уже не нарисованные лица, а боты с историей, не просто описание в стиле «и так сойдёт», а вполне адекватное отображение на бумаге верований адептов блокчейна. Но тщательный анализ команды и продукта дает знать о том, что всё совсем не так хорошо, как хотелось бы;

- Сложные — в этих случая распознать скам предельно трудно: многие сегодня относят один известный крипто-банк именно к этому разряду. Впрочем, пока ни подтвердить, ни опровергнуть данные сведения не могу.

В-третьих, по субъективной стороне, как говорят юристы:

- Когда создатели изначально не хотят ничего, кроме сбора средств;

- Встречаются случаи, когда создатели по тем или иным причинам приходят к скаму уже в результате ICO или работы проекта (пожалуй, один из ярчайших примеров — MtGox, а сегодня таким может стать EOS).

В первом случае мошенники сознательно делают всё, чтобы получить побольше и исчезнуть побыстрее. Во втором возможные потери «вкладчиков» связаны с безволием создателя (режим «всё надоело!»), с ссорой внутри команды (в сети можете найти один из аналогов storj & filecoin на эту тему), с банальной жадностью, которая, как известно, приходит во время еды — получения крипто-активов.

Чтобы оценить любой ICO проект нужно акцентироваться на четырех составляющих (как-то уже писал об этом, но сегодня посмотрим шире):

- Team — команда;

- Tech — технология;

- Theme — концепция;

- Token — правовой статус реализуемых крипто-активов.

Единого рецепта в оценке не существует, поэтому остановимся на принципиальных вещах, рассматривая и детализируя которые, можно создать свою собственную модель критериев:

Команду всегда нужно проверять на истинность взаимосвязей, то есть искать не просто профиль в facebook, linkedin, но выходить на людей, которые так или иначе где-то реально засвечены. Дело в том, что в онлайн-среде наверняка должны найтись персоны, которые часто сидят в социальных сетях, имеют устойчивые группы общения и вполне открыто обсуждают свою жизнь. Если таковых нет — это очень странно. Конечно, бывают группы, где люди собираются именно потому, что они интроверты, но если из всего сонма знакомых каждого из команды нет ни одного с развёрнутой историей — это должно вызывать подозрения. Теория 6 рукопожатий в этом смысле работает: не обязательно зацикливаться на самой цифре: главное, чтобы участники были связаны с реальным миром:

- В первую очередь нужно проверять связи с адвизорами — у них репутация стоит денег и поэтому не нужно лениться писать и звонить, дабы подтвердить/опровергнуть информацию о проекте, где они участвуют.

- Далее юридическое лицо: регистрация, местонахождение (онлайн-карты вам в подарок); если речь идёт о preICO то можно даже проверить почтовый адрес отправкой приветственного письма на бумаге (по крайне мере, дважды я так делал и чутьё меня не подвело). Ассоциации и другие объединения, где должно состоять данное юридическое лицо. Недавно, например, с командой проверял COSS и из 7 запросов получили 7 ответов, подтверждающих, что данное объединение действительно является участником ряда предпринимательских сообществ (см. пример ниже).

- Есть ещё один момент, который часто приходится использовать в повседневной практике: поиск по номеру телефона или email. Конечно, найти личный адрес кого-то из команды не всегда просто, а телефон может быть создан под специальный проект. Но вероятность нахождения этих данных не так мала. Скажем, до 1/3 проектов так или иначе подобные данные в конце-концов раскрывали. Зачем это нужно? Дело в том, что всё имеет свойство индексироваться. Поэтому старые аккаунты в социальных сетях, на досках объявлений и во множестве других потаённых уголков Кибервселенной часто могут сказать о человеке больше, чем тысячи букв, написанных во славу.

Технологию оценить очень сложно, если вы не специалист. Правда, однажды мне помог банальный поиск исходника, который совпал со скриптом другого проекта почти на 100%. Хорошо, что Интернет создан именно как коллективный разум: задать вопрос на профильном форуме, сайте вопросов или чате (в телеграм, скажем, таких сейчас хватает) может каждый. Сделайте связку между первым и вторым «Т»: какой-нибудь банальный запрос в slack/telegram разработчикам и команде поддержки проекта, в который хотите вложиться: буквально на днях в чате https://t.me/bitfund появился «коэффициент глухоты» (по фамилии фаундера, который не ответил ни на один вопрос, но об этом ещё будет материал, скажу пока лишь, что в клиентах у него был даже Apple, который просил разработать маркетинговую стратегию). Фидбэк от мошенников и не- мошенников абсолютно разный. Мошенники не отвечают вовсе или отвечают предельно размыто на прямые вопросы. Исключения бывают, безусловно, но это уже иной уровень подготовки. К слову, вот небольшой перечень каналов, где можно задать вопрос:

- http://toster.ru: не удивляйтесь, т.к. Хабро-сообщество часто помогает обрисовать рамки;

- https://t.me/bitfund — хороший чат со специалистами и инвесторами ICO и оценке блокчейн-проектов в целом

- https://t.me/ICO_law — чат не такой большой, как предыдущий, но зато здесь очень много полезных ссылок и материалов для начинающих.

Можно подборку увеличить на несколько порядков, но я лично не советую: во-первых, бесконечный поток информации только отвлекает; во-вторых, много каналов-перепостов или новостных, а речь именно о тех, где живые люди анализируют живые примеры; в-третьих, пользоваться строкой поиска сейчас научены все. Плохо, что не все научены делать это правильно. И да: если всё же знаете толковые источники — пишите, дополним совместно.

Концепция. Если в технологии мы оцениваем код, возможность реализации продукта с точки зрения производства, то здесь конкурентный рынок и экономическую полезность сервиса в целом. К сожалению, даже нормальные проекты не делают анализ первой и второй составляющей (что в итоге выливается в крах многих сервисов). Но скамы можно отличить по слишком радужным описаниям или, напротив, запутанным дефинициям, из которых мало что остаётся ясным после прочтения. Давайте предметно:

- Берём Белую книгу и Дорожную карту. В первой написано: «запуск первой стадии состоится не ранее 3 марта 2018 года», Открываем Roadmap и видим: «завершение первой стадии: апрель 2018 года». Срок реализации стадии — 3 месяца. В этом смысле мне не очень нравится подход ZrCoin: «сроки окончания строительства и запуска первой линии производства намечены на весну 2018 г.». Посмотрим, но пока они выглядят завышенными.

- А теперь давайте взглянем на развитие концепта: сколько времени прошло от момента его появления на свет до первой реализации или хотя бы описания? А сколько дней, недель, месяцев между этой самой реализацией и ICO? Вот здесь можно найти хороший пример для тренировки подобных навыков https://icotracker.net/project/skyway.

- И самый главный вопрос: как блокчейн-проект победит, говоря условно, в гонке с классическими it? Скажем, как могут победить SONM & Golem команды, которые занимаются тем же самым, но не первый год? Это вопрос сомнения. А вот для скама вопрос стоит проще и жёстче: а вообще такая реализация есть в классическом бизнесе? Нет? Тогда почему?

В этом плане мне понравился подход команды Kickico, которая пытается унифицировать изучение проектов ДО их запуска, а не после.

Токен. Наконец-то, после SEC & MAS, люди стали понимать, что выпускать не ясно что, не понятно для кого — не просто странно, но и опасно. В итоге, если видим, что токены созданы по системе «купи дешевле — продай подороже» и за ними не стоит ничего иного: бонусов, доли участия, обратных выкупов и так далее, то это ещё один повод задуматься над ТЭО (технико-экономическое обоснование) и его адекватностью. Вот ещё несколько нюансов по теме:

- Есть ли соглашение о распределении токенов?

- Как вообще обозначен токен в разных документах: Дорожной карте, Белой книге, публичной оферте и т.д.?

- В этом видео вы найдёте не премер скама, а скорее пункта, который среди прочих, выглядит подозрительно: когда в White Paper написано об обратном выкупе, а документах сугубо юридических — нет. Уловка или недомолвка? Зависит от других направлений, но, как минимум, повод изучить проект подробней

- Сколько токенов эмитировано и какова их экономика? Скажем, чтобы поддерживать рост и ликвидность ETH необходим ежедневный оборот в 5 000 000 долларов и более. Если его нет, то идёт падение. В этом смысле EHT инфляционный токен, а btc — дефляционный. Стейблкоины же пока только на этапе становления. Зачем это знать? Затем, что Концепт должен учитывать экономическую сущность токена и исходить в показателях роста. Сегодня это делают далеко не все проекты даже из белого списка — это ещё один повод задуматься о возможности участия в них.

Всё, что описано выше, обычно воспринимается как некий усложненный элемент и оставляется в качестве «узнано, но не воспринято». Но это минимальные примеры фундаментального анализа, на котором должно строиться инвестирование и оценка рисков.

В России и странах СНГ в основном приоритет за анализом техническим. Давайте же и мы тоже не будем обходить его стороной.

Скажем, тот же . Здесь можно найти интересную информацию об одном из самых подозрительных среди последних. Кроме ICOtracker, есть и ещё ряд подобных проектов: ICOrating, где есть специальная вкладка с одноимённой закладкой, icostats и ряд других. На Golos Ден Иванов делал подборку по этому поводу — к нему и адресую.

Есть также подход, который по существу представляет собой следующую матрицу:

Данный подход был создан Алексом Контегна (Alex Kontegna). Автор объясняет данную структуру оценки ICO следующим образом: «наша карта делит пространство на матрицу с девятью слотами: в положительных (зелёных) и отрицательных (красных) полях, определенными на разных пересечениях. Хорошее применение этой матрицы — измерение параметра риска вашего портфолио (ICO-токенов), если вы владеете несколькими монетами».

К матрице прилагаются следующие простые правила:

- Сравните два актива, в которые хотите вложиться, по «красной зоне»: чем больше сумма денег, уже собранная проектом в отрицательной (красной) зоне, тем выше риск, связанный с обладанием подобными токенами. Принцип таков: сервисы с отрицательной зоной покрытия и без прочных оснований в первую очередь становятся ещё менее стабильными, когда растут.

- Следуйте противоположному правилу при сравнении двух активов, которые находятся на положительной территории: чем больше сумма, собранная проектом на положительной территории, тем ниже риск, связанный с владением его tokens.

- Наконец, следует избегать инвестирования в ICO с отрицательными характеристиками вообще. Конечно, иногда есть факторы, которые преобладают даже над этим. Например, более ранние проекты, которые могут сделать ICO привлекательным с точки зрения спекуляций.

Но нужно понимать, что автоматизация хороша при массовых оценках и плохо работает при индивидуальных. Поэтому здесь лучше использовать точечный подход: во-первых, применяя принципы, озвученные выше; во-вторых, обращая внимания на детали.

Скажем, регистрация домена. Если проект разрабатывался, то у него должна быть, пусть и небольшая, но история. И поэтому домен, которому от роду 1-3 месяца, даже полгода — выглядит странным (если только нет аффилированного с ним). Всегда импонирует открытость данных даже там, где делать этого не обязательно — вот всё тот же пример из последних наблюдений https://who.is/whois/coss.io. При этом: если компания заявляет некую историю по старым проектам, которые даже уже закрыты, то эти сведения можно проверить:

- http://web-arhive.ru/ — смотрим, то, что было до прихода ICO с проектами

- каталоги (раньше был DMOZ, сейчас это Яндекс и местные каталоги сайтов)

- обратные ссылки: когда удаляется сайт далеко не все удаляют ссылки на него, а таких может быть много: партнёры, новостные сайты, форумы

- есть ещё более мелкие детали: даты в sitemap старых сайтов или элементы seo-оптимизации на страницах (мошенники обычно на этом не заморачиваются, поскольку делают проекты на коленке и предельно быстро).

Если же говорим не о пер- или ретро-спективе, то можно посмотреть на прекрасный инструмент alerts (цели) от Гугл и воспользоваться им, прописав основные ключевые слова, связанные с брендом, которые исследуете.

Чтобы немного закрепить прочитанное, рассмотрим ряд примеров.

https://matchpool.co — социальная сеть, завязанная на блокчейне. Случилось с ней следующее (по данным Forbes): «В начале апреля 2017 года его создатели с помощью ICO получили $5,8 миллионов. Но уже через пару дней компанию покинул технический директор, которого заподозрили в незаконном выводе средств». Аналогичные истории случались и в других стартапах.

Соответственно, узнать об этом до момента, когда в голове у одного из участников (что важно), не сформировалась сама идея покинуть проект, фактически невозможно. Это риск, но он всегда должен быть заложен. Соответственно, в этом аспекте выигрывают проекты, у которых:

- Есть мультиподпись;

- Формируется некий стабфонд, который будет использован в каких-то неприятных ситуациях (случай с тем же Satoshi Fond);

- Существуют смарт-контракты на возврат сумм при определённых ситуациях (не прохождении нижнего порога ICO, форс-мажор и т.п.). Почитать о примерах можно в книге.

В заключение хотелось бы выделить следующие аспекты:

Прежде, чем рваться в бой, обратите внимание на уже существующие scam’ы — изучите, проанализируйте, сделайте обобщающие выводы:

- https://nodio.net/ — 2016 год, Украина; сайт не работает.

- https://www.ebitz.org/ — 2016 год, Анонимно; сайт работает номинально.

- http://www.tithecoin.com/ — 2016 год, США; сайт работает.

- https://ascendancy.io/#/ — 2016, Не выяснено; сайт не работает.

Во многих сферах (организация бизнеса, разработка антифрод-решений, маркетинг ICO и т.д.) не раз слышал о каких-то секретных техниках и приёмах. Но таковых очень и очень мало, а сам подход, что есть некий инсайт приводит нас к настоящему сокрытию информации, которая в свою очередь позволяет манипулировать рынком с одной стороны, а с другой приводит к ситуации, когда мы надеемся на что-то, чего нет. С оценкой ICO всё ровно так.

Нужно понимать, что ICO — начинающий, а значит высокорискованный бизнес. Тем более в рамках последних заявлений SEC & MAS.

Чтобы найти скам нужны не какие-то сверх-методики, машинное обучение и работа с большими данными (хотя это, безусловно, пригодилось бы каждому), а усердие, внимание к деталям и затраченное пропорционально вложениям время на исследование ICO-проектов. Нет времени тратить силы на это? Или не заходите вообще в проекты, или обратитесь хотя бы к тому же https://www.kickico.com/ru/ — ребята, по крайне мере, стараются.

Наконец, ICO — децентрализованный подход к привлечению финансов, поэтому не стоит копировать методы централизованного анализа сюда полностью, т.к. многие вопросы в блокчейн-среде по определению решаются на доверии.

Для того, чтобы правильно вложиться в ICO или стартап на блокчейне в целом, нужно, на мой взгляд, принять три простых правила:

- Сервис для вас лично должен быть понятен в принципах работы и близок по целям;

- Спекулятивная составляющая не должна быть единственной (в этом плане Мавро — как раз пример обратного);

- И, наконец, безопасно вкладывать можно только те доходы, которые идут свыше ваших личных расходов, о какой бы конкретной сумме ни шла речь.

В целом — это не всё, но базово — да. Дальше нужно варьировать полученные принципы в рамках конкретных оценок и разрабатывать собственную систему оценок, которая может быть:

- По критерию восприятия: положительно или отрицательно;

- По уровню восприятия: сложно или просто;

- По бальной шкале:

Десятибалльная — одна из самых простых и понятных: всё, что ниже нуля — ближе к скаму; всё, что выше — дальше от скама;

Стобалльная. Если в вашем личном наборе оценок сто и более элементов: подход хорош для полуавтоматической оценки;

Также можно использовать смешанную систему: скажем отрицательным факторам присваивать до 10 баллов в минус, а положительным, соответственно, в плюс. Каждый проект изначально берём за 100% и далее начинаем разбор: если итоговая оценка ниже 33-66%, то это подозрение на скам, 66-75% — норма, далее уже хорошие и отличные проекты. - По иным критериям, например, используя систему оценку ценных бумаг или же применяя подход эмоциональной окраски (негативно, нейтрально-негативно, нейтрально, нейтрально-положительно, положительно).

Таким образом, систему выявления скамов можно выстроить, но единственное, что всегда остаётся за скобками — это наша общечеловеческая жадность: если она свойственна вам в критичные моменты, то моя лично позиция проста: «ICO не для вас».

В завершении — небольшая подборка для расширения понимания темы:

- Книга об ICO. Часть 1.

- Книга об ICO. Часть 2.

- Общие вопросы ICO

- ICO и легализация средств

- ICO: основные риски

|

Метки: author Menaskop финансы в it учебный процесс в it исследования и прогнозы в it ico scam скамы оценка ico (ito tge) it- юрист |

PHP-Дайджест № 114 – свежие новости, материалы и инструменты (1 – 14 августа 2017) |

Свежая подборка со ссылками на новости и материалы. В выпуске: PHP 7.2.0 Beta 2, об истории и безопасности unserialize(), старт PSR HTTP Client, StackOverflow Driven Development, видео с конференций и митапов, и многое другое.

Приятного чтения!

Новости и релизы

Новости и релизы

- PHP 7.2.0 Beta 2 — Список новых возможностей ветки 7.2 тут, а протестировать можно из подготовленного Docker-образа. Третий и последний бета-релиз запланирован на 17 августа.

- Composer 1.5.0

- PHP 7.0.22

- PHP 7.1.8

- [PSR] HTTP Client — Согласно принятому процессу, новые предложения для PSR должны пройти входное голосование, прежде чем будет разработан черновик. Такое голосование прошло для стандарта HTTP Client, а значит в ближайшем будущем группа начнет работу над документом.

Инструменты

Инструменты

- mihaeu/dephpend — Инструмент статического анализа, который поможет выявить проблемы в архитектуре.

- spatie/phpunit-watcher — Инструмент для автоматического запуска тестов когда изменен код. Пост в поддержку.

- Imangazaliev/DiDOM — Простая и быстрая библиотека для парсинга HTML.

- hirak/prestissimo — Плагин Composer для параллельной установки пакетов. Значительно ускоряет установку зависимостей. Прислал chilic.

- clue/php-commander — Инструмент для создания простых консольных удобным с интерфейсом.

- thephpleague/json-reference — Библиотека для работы с JSON-ссылками.

- paragonie/easydb — Простая и лаконичная обертка над PDO.

- hjr3/php-rpm — Менеджер процессов для PHP на Rust.

Материалы для обучения

Материалы для обучения

Symfony

- Wishlist на Symfony и Vue.js по принципам DDD — Прислал franzose.

- Неделя Symfony #553 (31 июля — 6 августа 2017)

- Неделя Symfony #554 (7-13 августа 2017)

Yii

- yii2tech/content — CMS для Yii2 от Павла Климова.

- Cообщество Yii в Slack

- Yii development notes #12

Laravel

- tightenco/ziggy — Пакет для использования именованных Laravel-роутов на фронтенде. Пост в поддержку.

- owen-it/laravel-auditing — Позволяет отслеживать изменение моделей Eloquent. Пост в поддержку.

- sebastiaanluca/laravel-helpers — Подборка хелперов для Laravel и PHP.

- Что нового в Laravel 5.5?

Доклад Тейлора на Laracon US 2017

Доклад Тейлора на Laracon US 2017 Laracon 2017 — краткий обзор и куча полезных ссылок

Laracon 2017 — краткий обзор и куча полезных ссылок Laravel — экосистема, а не просто PHP-фреймворк

Laravel — экосистема, а не просто PHP-фреймворк Как скрестить ежа с ужом. Используем GridView из Yii 2 в проекте на Laravel

Как скрестить ежа с ужом. Используем GridView из Yii 2 в проекте на Laravel

Zend

Async PHP

- reactphp/datagram — Клиент и сервер сокеты для UDP на ReactPHP.

- Управление дочерними процессами с помощью ReactPHP

- Размышления о «запахах» кода

- Почему не стоит использовать условия Йоды

- Ароматы плохого кода

- PHP: Разбираемся с unserialize() — Статья от одного из core-разработчиков про историю unserialize()/serialize() в PHP и про вопросы их секьюрности. Прислал andrewnester. К вопросу о том, почему баги с unserialize() теперь не будут считаться ошибками безопасности:

PSA: Don't use unserialize() on untrusted input (see https://t.co/8GZb1xqE1u)

— Nikita Popov (@nikita_ppv) August 10, 2017

PHP will no longer treat unserialize() bugs are security bugs. - Тестирование приложений с Command Bus архитектурой

- Лайфхак по использованию __debugInfo

- Используем php-fpm как асинхронную очередь

- Архитектура для чистой, тестируемой логики приложения

- Очередь для Swiftmailer

Распознать и обезвредить. Поиск неортодоксальных бэкдоров

Распознать и обезвредить. Поиск неортодоксальных бэкдоров Оптимизация шаблонов представления в Codeigniter Framework при помощи AST трансформаций

Оптимизация шаблонов представления в Codeigniter Framework при помощи AST трансформаций Microservices и Модель Акторов (Actor Model)

Microservices и Модель Акторов (Actor Model) Пишем расширения для PHP 7 на C++

Пишем расширения для PHP 7 на C++ Расчет приоритета комбинаций в техасском холдеме (покере) на PHP

Расчет приоритета комбинаций в техасском холдеме (покере) на PHP

Аудио и видеоматериалы

Аудио и видеоматериалы

PHP Serbia Conference 2017

PHP Serbia Conference 2017 Интервью с Nils Adermann (Composer) о приватном Packagist

Интервью с Nils Adermann (Composer) о приватном Packagist

Видео с PHP of BY #23: Как начать контрибьютить в PHP, PHP: generics, строгая типизация массивов и ...

Видео с PHP of BY #23: Как начать контрибьютить в PHP, PHP: generics, строгая типизация массивов и ...

Занимательное

Занимательное

- Отличный чат по PHP в Telegram

- BrandonShar/stack-overflow-buddy — StackOverflow Driven Development — просто напишите что вам необходимо сделать с аргументами, и решение будет автоматически найдено на SO:

StackOverflowBuddy::substringBetweenTwoStrings('platypus', 'pl', 'us'); // atyp - PHP и другие карты —

Спасибо за внимание!

Если вы заметили ошибку или неточность — сообщите, пожалуйста, в личку.

Вопросы и предложения пишите на почту или в твиттер.

Прислать ссылку

Быстрый поиск по всем дайджестам

<- Предыдущий выпуск: PHP-Дайджест № 113

|

Метки: author pronskiy разработка веб-сайтов php дайджест php- ссылки symfony yii laravel zend reactphp psr |

Немного про ашибки в программном обеспечении и помощь теории конечного автомата |

Работая в сфере ИТ, волей-неволей замечаешь огромное количество ошибок в различном программном обеспечении. Будь то ошибки мировых вендоров Microsoft, или же в прикладных бизнес-решениях фирмы 1С, или же в хваленных Apple с детской фатальной ошибкой "1 января 1970". Что уж говорить про небольшие компании с небольшим штатом программистов?

Насколько ошибки в ПО являются естественным процессом? Давайте разберёмся. Всё ниже является исключительно авторским мнением, в том числе классификация, возможность применения теории конечного автомата, наблюдения.

Не так давно Samsung заявил о запуске сервиса Samsung Pay, а наличие у меня часов Samsung Gear 3 открывало мне новое баловство — оплачивать покупки прикосновением часов к терминалу. Не знаю какие трудности произошли при производстве продукта, но первые версии программы мне не позволяли произвести настройку. Лишь с выпуском нескольких релизов я смог использовать сервис.

Все производители делают ошибки в области программного обеспечения, какими бы они крупными и сертифицированными не были.

Умственный труд программистов постоянно требует нововведений. Они должны применять современные технологии для того, чтобы обеспечить бизнес-идею инвесторов и мечтателей. Информация и технологии очень быстро устаревают и поэтому программисту требуется быть на передовой, словно первопроходцу-исследователю преодолевать заросли в тайге, засушливые пустыни, ледяные торосы.

Сколько полегло исследователей в попытке пройти сложные маршруты: Г. Седов, Р. Скотт, В. Беринг... О чём это я?

Программист работает с новыми, не проторенными технологиями, в которых легко делать ошибки. Баги есть как в поставляемых модулях внешних разработчиков, так и в их применении в собственном ПО.

Ошибки и Теория конечного автомата

Давайте обратимся к теории конечного автомата. В своё время в институте приходилось применять данную методику как в программировании контроллеров, так и в построении систем управления.

Но что, если на базе теории показать сложность программной разработки и легкость возникновение ошибок. Например, постановка прикладной задачи — реализовать автоматический переход к статусам в заказе покупателя.

Представим стандартный граф конечного автомата производственного предприятия с состояниями:

- Расчет

- К производству

- В производстве

- Готово

- Завершён

События конечного автомата:

- a — устанавливается менеджером после подтверждения покупателем;

- b — устанавливается начальником производства, оценив производственные мощности и возможность выполнения;

- c — устанавливается работником склада в момент поступления на склад;

- d — устанавливается менеджером при поступлении денег и передачи груза;

- e — устанавливается менеджером вручную.

Описан тривиальный процесс. В конкурентной борьбе необходимо применять все современные возможности и, конечно, отправка смс заказчику была бы неплохим плюсом, а, возможно, уже и обязанностью. А как вы помните, изначальная задача — автоматизировать процесс. Например, грузчик принимает с помощью сканера штрихкода выпускаемый товар, а система шлёт sms покупателю: «Готово, приезжайте».

Это обычная задача, но для проектировщика здесь скрыто много нюансов. Например, произвели продукцию, а часть оказалось браком. Какое состояние должно быть? Учли? Заказчик приехал покупать, но при осмотре решил отказаться от части продукции - завершён или отменён? По ошибке отменили заказ, а надо вернуть в производство.

Мы не рассматриваем сложные примеры, когда может быть сборный груз, множество мест хранения и много состояний, но и в данной простой задаче многие проектировщики ПО допускают ошибки. Любая автоматизация требует аналитического подхода — прорабатывать переходы, о которых постановщик задачи не догадывается. В реальной жизни предприятия для приведенного выше процесса количество переходов гораздо больше.

Чем функциональнее ПО, тем больше ошибок. Тестировщик помогает, но не всегда — он не знаком с предметной областью так, как проектировщик.

Я для себя определил, что построение графа статусов на базе теории конечного автомата позволяет объемно взглянуть на решаемую задачу.

Помню, ко мне обратился Финансовый директор с просьбой разработать систему депремирования сотрудников. Учет поручений всех сотрудников вёлся в 1С: Документооборот (ДО), учёт рабочего времени в 1С: Управление производственным предприятием (УПП). Если сотрудник просрочил важную задачу, то его лишали премии на Х%. Для этого сверяем время завершения задачи в ДО, получаем данные сотрудника по табелю за период из УПП и определяем место запятой в «казнить нельзя помиловать».

Хорошо, но количество переходов между состояниями (согласно теории ограничения систем) возросло настолько, что пришлось ответить на десятки внеплановых сценариев, по которым система депремирования становится нерабочей. Например:

Соблазн введения такой системы был велик, ведь чем больше отожмёт зарплаты у сотрудников, тем лучше он купит машину себе на Новогодние праздники по результатам года. Поэтому для реализации этой задачи были сделаны десятки доработок 1С с учётом всех переходов.

Процедура тестирования программного обеспечения давно отлажена и стандартизирована. Но массовые продукты всё равно постоянно выпускают релизы с исправлением ошибок. Примеры:

- WordPress

- 1С: Комплексная автоматизация 2

Можно ли выпустить Функциональное ПО без ошибок? Нет, таких случаев не наблюдалось.

Связь экономики и технических знаний в области ошибок

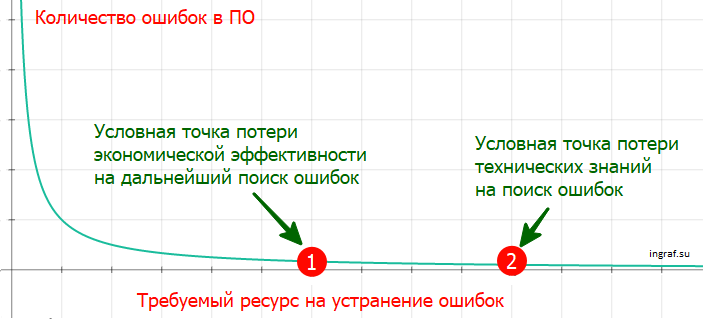

Можно ли минимизировать ошибки? Однозначно. Их количество нелинейно снижается соответственно затраченному времени на их поиск и устранение. Время означает затраты. Существует 2 причины поекращения поиска ошибок — потеря экономического эффекта на дальнейший поиск и потеря технических знаний на их устранение.

Идеально, когда они располагаются рядом на оси «требуемых ресурсов». Это означает гармонию между экономической моделью вашего бизнеса и качеством выпускаемого вами ПО.

Например, стоит задача разработать программное обеспечение для бортового компьютера нового самолёта. Учитывая колоссальное количество параметров и функций в физике полёта нельзя допустить остановку отладки ПО из-за потери финансирования. Результат будет печальный.

Если значительно раньше наступает точка «потери технических знаний», значит требуется повышать стандарты качества и профессионализм разработчиков.

При всём при этом останутся «ошибки-ниндзя», которые скроются от всех тестов и обнаружатся лишь пользователями.

Вес ошибок

Вес каждой ошибки разный. В целом, я делю их на 4 вида.

Критическая ошибка. Останавливает работу бизнеса (для учетных систем), оборудования, сервиса. Таких ошибок быть не должно. Присутствие таких «багов» говорит о слабой технической стороне разработчика (в том числе, методов тестирования).

Например, я скачал активно продвигаемую программу в Google Play Маркет. Сразу при запуске произошла ошибка.

Важная непреодолимая ошибка.

Это не останавливает работу, но приводит к неточному результату, который невозможно поправить пользователем вручную.

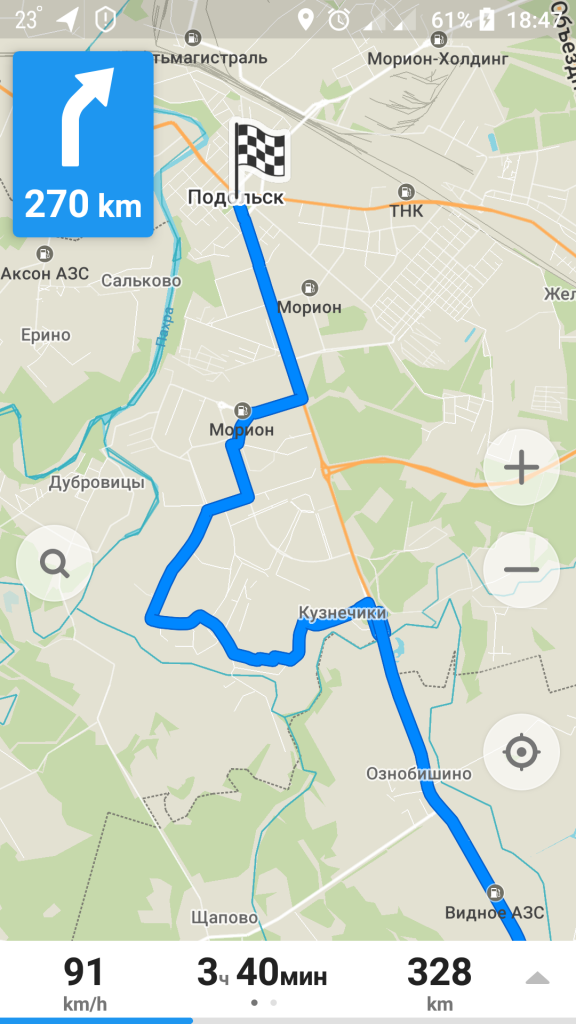

Я проложил маршрут в г. Подольск. На одном участке навигатор проложил очень странный маршрут (пробки он не объезжает, ремонта и перекрытия дороги нет). Эта ошибка не критична и я могу продолжать использовать программу, но внести изменения нет.

Важная преодолимая ошибка.

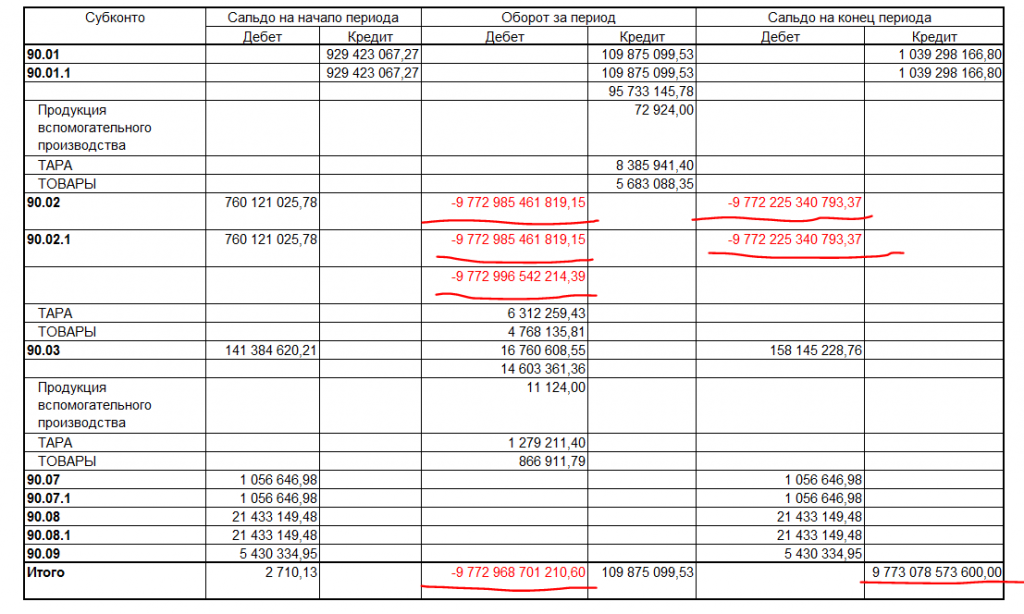

Например, расчёт себестоимости в бизнесе крайне важен, но сложен в силу решения многомерной системы уравнений с множеством неизвестных. Происходят ошибки, в том числе, как и писалось выше, в поставляемых модулях вендоров.

Расчет себестоимости даёт только конечный результат, который строится на череде предыдущих расчетов, и если на какой-то итерации произошла ошибка, то итог будет неправильный.

В программе 1С выводилась такая ошибка расчета себестоимости. Пользователь мог (естественно, путём экспериментов) её устранить — перепровести документы. В заявленных возможностях метода РАУЗ это не надо делать, но не на практике.

Замечания.

Это всё остальное. Например, приходит мне сообщение от Добродела, а ссылка неработающая. Сразу видно что тестирование не проводилось.

Анализ своих ошибок в качестве резюме

Вспоминая все свои ошибки в качестве программиста и руководителя проекта, могу выделить следующие причины их появления:

- Проблема сказанного и услышанного. Как помните проекции цилиндра, где одна круг, а другая прямоугольник. В итоге говорим про одно требование, а понимаем по-разному.

- Ограничение глубины мышления. У каждого человека есть свой уровень и если дальнейшее углубление не формализовывать (не делать заметки на листке или в коде программы), то можно попасть на функциональный разрыв.

- Не придание важности элементу кода. Написал, и даже не сомневался, что это неправильно. В лучшем случае, это выливается в неоптимальный код.

- Неполное знание средств разработки функций. Нас хоть и учили, что задача инженера работать со справочной документацией, но опыт помогает минимизировать общение с книгой.

|

|

[Из песочницы] Расчет приоритета комбинаций в техасском холдеме (покере) на PHP |

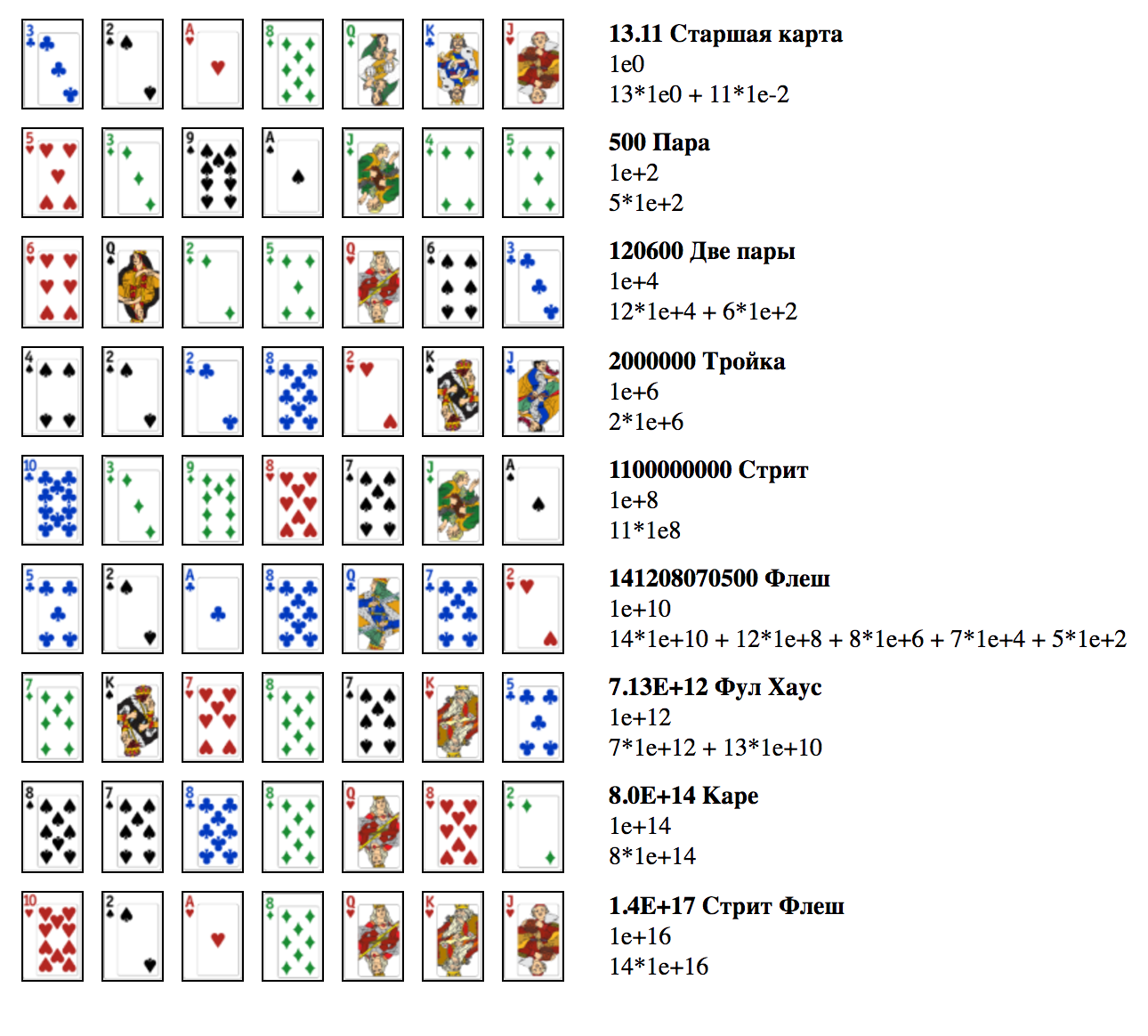

Цель: получить на выходе программы удобочитаемый результат, доступный для дебаггинга и отладки еще на стадии написания кода. Для достижения поставленной цели делаю разницу между комбинациями в 1e+2 (100) раз.

Примерный вид того, что должно получиться в итоге, где 2 последние карты считаю карманными, а первые 5 общими:

Создание массива карт

В колоде 4 масти и 13 достоинств, поэтому массив из 7 чисел буду формировать в диапазоне [2 — 14, 102 — 114, 202 — 214, 302 — 314], а далее оперировать остатками от деления на 100 (%100) этих чисел. Можно, конечно, формировать массив из чисел в диапазоне [2 — 14, 22 — 34, 42 — 54, 62 — 74], а затем сравнивать остатками от деления на 20 (%20). Но удобочитаемость первого варианта по-моему на лицо, поэтому остановлюсь на нем.

function cardsCreation()

{

$arrayCards = [];

for ($i = 0; $i < 7; $i++) {

$card = mt_rand(2, 14); // создаю случайное число в диапозоне от 2 до 14

$multiplier = mt_rand(0, 3); //формирую случайным образом множитель

if (1 == $multiplier) { //если множитель равен 1, добавляю к числу 100

$card = $card + 100;

} else if (2 == $multiplier) { //если множитель равен 2, добавляю к числу 200

$card = $card + 200;

} else if (3 == $multiplier) { //если множитель равен 3, добавляю к числу 300

$card = $card + 300;

}

if (!in_array($card, $arrayCards)) { //проверяю, есть ли в массиве такое число, если нет добавляю его в массив

$arrayCards = array_merge($arrayCards, [$card]);

} else { // если число есть в массиве, откатываю цикл, чтобы сформировать новое число

$i--;

}

}

return $arrayCards;

}

Определение и расчет комбинации Стрит

Стрит — это комбинация, где достоинства карт идут по порядку. Поэтому нет смысла учитывать при расчете все карты, составляющие данную комбинацию, достаточно лишь первой по старшинству карты.

Существует несколько вариантов определения и расчета комбинации Стрит. Думаю, большинство из них сводится к задаче отсортировать остатки от деления членов исходного массива в порядке убывания, а затем каким-либо образом выделить элементы, которые составляю комбинацию (в случае, когда более 5 карт составляют стрит, нужно выбрать наибольший).

Суть моего метода определения стрита сводится к тому, что после сортировки я буду проверять сначала первые пять карт на стрит, затем вторые и третьи. Также не забываю что туз, двойка, тройка, четверка и пятерка тоже составляю стрит. Поэтому, если в наборе есть туз (значение 14), к массиву добавляю восьмой элемент — 1. И следовательно в этом случае нужно проверить четвертую пятерку карт.

function straight(array $arrayCards) {

$newArrayCards = [];

$ace = false;

foreach ($arrayCards as $arrayCard) {

$newArrayCards = array_merge($newArrayCards, [$arrayCard % 100]); //создаю массив с остатками от деления на 100

if(14 == $arrayCard % 100) { //проверка на туз для комбинации А, 2, 3, 4, 5

$ace = true;

}

}

if($ace == true) {

$newArrayCards = array_merge($newArrayCards, [1]); //если в массиве присутствует туз, добавляю к массиву 1

}

rsort($newArrayCards); //сортирую массив с числами в порядке убывания

$count = 0; //счетчик, к которому добавляется 1 в случае, если разница между текущим элементом цикла и предыдущим = 1

$length = 4; //число, показывает до какого элемента массива проверять

$result = 0; //окончательный результат

$begin = 0; //число показывает, с какого элемента массива проверять

for($i = 1; $i <= $length; $i++) {

if (-1 == ($newArrayCards[$i] - $newArrayCards[$i - 1])) {

$count++;

}

if($length == $i) {

if(4 == $count) { //$count == 4, когда стрит

$result = $newArrayCards[$begin] * 1e+8;

}

else if($length < 6 or (6 == $length and $ace == true)) {//если стрита нет, идем еще на один круг

$length++; //увеличиваем число, до которого будем проверять

$begin++; //увеличиваем число, с которого будем проверять

$i = $begin; //при попадании в for к $i автоматически добавится 1 ($i++ в for)

$count = 0; //обнуляю счетчик

}

}

}

return $result;

}

Определение и расчет комбинаций Флеш и Стрит Флеш

Флеш — комбинация из карт одной масти. При расчете нужно учитывать все карты, составляющие комбинацию.

При расчете стрит флеша, как и при расчете стрита, можно учитывать только старшую карту комбинации.

Чтобы определить флеш, пробегусь циклом по массиву. В цикле создам 4 вспомогательных массива (по количеству мастей). В перый массив положу все карты первой масти, во второй — второй и т.д. Если какой-то масти нет, соответствующий массив будет пустой. Если количество элементов массива больше либо равно 5, значит данная масть образовала флеш.

Флеш более приоритетен, чем стрит, поэтому именно в функции флеша логично проверить не образовала ли комбинация стрит флеш. Также, думаю, понятно, что неудобно писать отдельную функцию, которая проверяет и стрит, и флеш. Лучше написать функцию, которая проверяет массив на флеш, и в ней же вызвать функцию, которая проверяет флеш на стрит.

Если флеш не образует стрит флеш, отсортирую остатки от деления на 100 (%100) исходного массива. Далее умножу первые пять членов полученного массива на 1е+10, 1е+8, 1е+6, 1е+4, 1е+2 соответственно.

Функцию по определению стрит флеша построю на основе функции по определению стрита, с той лишь разницей, что нужно учесть, что в функцию может прийти массив с количеством элементов меньше 7 (я ведь туда отправляю только те карты, которые образуют флеш).

Функция для определения Флеша:

function pokerFlush(array $arrayCards) {

$suit1 = []; //первая масть

$suit2 = []; //вторая масть

$suit3 = []; //третья масть

$suit4 = []; //четвертая масть

foreach ($arrayCards as $arrayCard) { //создаю 4 массива, содержащих разные масти исходного массива

if($arrayCard >= 2 and $arrayCard <= 14) {

$suit1 = array_merge($suit1, [$arrayCard]);

} else if($arrayCard >= 102 and $arrayCard <= 114) {

$suit2 = array_merge($suit2, [$arrayCard]);

} else if($arrayCard >= 202 and $arrayCard <= 214) {

$suit3 = array_merge($suit3, [$arrayCard]);

} else {

$suit4 = array_merge($suit4, [$arrayCard]);

}}

if(count($suit1) >= 5) { //если количество карт первой масти больше или равно 5

$result = straightFlush($suit1); //проверяю не образует ли данная комбинация стрит флеш

if(0 == $result) {//если стрит флеша нет

foreach ($suit1 as $key1 => $s1) {//выбираю остатки от деления на 100

$suit1[$key1] = $s1 % 100;

}

rsort($suit1); //сортирую массив по убыванию

$result = $suit1[0] * 1e+10 + $suit1[1] * 1e+8 + $suit1[2] * 1e+6 + $suit1[3] * 1e+4 + $suit1[4] * 1e+2;

}

} else if (count($suit2) >= 5) { //если количество карт второй масти больше или равно 5

$result = straightFlush($suit2);

if(0 == $result) {

foreach ($suit2 as $key2 => $s2) {

$suit2[$key2] = $s2 % 100;

}

rsort($suit2);

$result = $suit2[0] * 1e+10 + $suit2[1] * 1e+8 + $suit2[2] * 1e+6 + $suit2[3] * 1e+4 + $suit2[4] * 1e+2;

}

} else if (count($suit3) >= 5) { //если количество карт третьей масти больше или равно 5

$result = straightFlush($suit3);

if(0 == $result) {

foreach ($suit3 as $key3 => $s3) {

$suit3[$key3] = $s3 % 100;

}

rsort($suit3);

$result = $suit3[0] * 1e+10 + $suit3[1] * 1e+8 + $suit3[2] * 1e+6 + $suit3[3] * 1e+4 + $suit3[4] * 1e+2;

}

} else if (count($suit4) >= 5) { //если количество карт четвертой масти больше или равно 5

$result = straightFlush($suit4);

if(0 == $result) {

foreach ($suit4 as $key4 => $s4) {

$suit4[$key4] = $s4 % 100;

}

rsort($suit4);

$result = $suit4[0] * 1e+10 + $suit4[1] * 1e+8 + $suit4[2] * 1e+6 + $suit4[3] * 1e+4 + $suit4[4] * 1e+2;

}

} else {

$result = 0;

}

return $result;

}

Функция для определения Стрит Флеша (аналогична Стриту, только нужно учесть, что количество элементов массива может быть не только 7, но еще и 5, и 6, и что возвращаемый результат этой функции должен быть больше):

function straightFlush(array $arrayCards) {

$newArrayCards = [];

$ace = false;

foreach ($arrayCards as $arrayCard) {

$newArrayCards = array_merge($newArrayCards, [$arrayCard % 100]);

if (14 == $arrayCard % 100) {

$ace = true;

}

}

if ($ace == true) {

$newArrayCards = array_merge($newArrayCards, [1]);

}

rsort($newArrayCards);

$count = 0;

$length = 4;

$result = 0;

$begin = 0;

for ($i = 1; $i <= $length; $i++) {

if (-1 == ($newArrayCards[$i] - $newArrayCards[$i - 1])) {

$count++;

}

if ($length == $i) {

if (4 == $count) {

$result = $newArrayCards[$begin] * 1e+16;

} else if ((7 == count($arrayCards) and ($length < 6 or (6 == $length and $ace == true))) or

(6 == count($arrayCards) and ($length < 5 or (5 == $length and $ace == true))) or //если число элементов исходного массива = 6

(5 == count($arrayCards) and (5 == $length and $ace == true))) { //если число элементов исходного массива = 5

$length++;

$begin++;

$i = $begin;

$count = 0;

}

}

}

return $result;

}

Определение и расчет парных комбинаций

Существует пять парных комбинаций: каре (4 карты одного достоинства), фулл хаус (3 карты одного достоинства и 2 карты другого достоинства), тройка (3 карты одного достоинства), две пары (2 карты одного достоинства и 2 карты другого достоинства), пара (2 карты одного достоинства).

Важно при расчете помнить, что в комбинации фулл хаус главным является сочетание из трех карт, а из двух второстепенным, т.е., например, комбинацию из 3-х двоек и 2-х десяток будем считать, как 3*1e+12 + 10*1e+10, а не по достоинству карт.

А также при расчете парных комбинаций нужно учитывать проблемы:

1. То, что более 5 карт образуют комбинацию.

2. То, что у нас может возникнуть ситуация, при которой комбинаций более одной.

Для подсчета совпадения карт буду использовать три счетчика, которые будут считать парные карты в колоде. Там, где счетчик равен 1 — участвуют 2 карты в комбинации, где счетчик 2 — 3 карты, где 3 — 4 карты.

Рассмотрим все возможные варианты сочетания счетчиков:

100 — пара

110 — 2 пары

111 — 3 пары (нужно преобразовать к виду 110 (две пары))

200 — тройка

210 — фулл хаус

120 — фулл хаус (нужно преобразовать к виду 210 (фулл хаус))

211 (121, 112) — фулл хаус + пара (нужно преобразовать к виду 210 (фулл хаус))

220 — 2 тройки или фулл хаус + 1 карта (нужно преобразовать к виду 210 (фулл хаус))

300 — каре

310 (130) — каре + пара (нужно преобразовать к виду 300 (каре))

320 (230) — каре + тройка (нужно преобразовать к виду 300 (каре))

Далее произведу окончательный расчет парных комбинаций.

function couple(array $arrayCards) {

$newArrayCards = [];

foreach ($arrayCards as $arrayCard) {

$newArrayCards = array_merge($newArrayCards, [$arrayCard % 100]); //создаю массив с остатками от деления на 100

}

rsort($newArrayCards); //сортирую массив с числами в порядке убывания

$count1 = 0; //счетчик для первой пары

$count2 = 0; //счетчик для второй пары

$count3 = 0; //счетчик для третьей пары

$match1 = 0; //сюда положу значение первой пары

$match2 = 0; //сюда положу значение второй пары

$match3 = 0; //сюда положу значение третьей пары

for($i = 1; $i < count($newArrayCards); $i++) {

if ($newArrayCards[$i] == $match1 or $match1 == 0) { //первое парное сочетание

if ($newArrayCards[$i] == $newArrayCards[$i - 1]) {

$match1 = $newArrayCards[$i];

$count1++;

}

} else if ($newArrayCards[$i] == $match2 or $match2 == 0) { //второе парное сочетание

if ($newArrayCards[$i] == $newArrayCards[$i - 1]) {

$match2 = $newArrayCards[$i];

$count2++;

}

} else if ($newArrayCards[$i] == $match3 or $match3 == 0) { //третье парное сочетание

if ($newArrayCards[$i] == $newArrayCards[$i - 1]) {

$match3 = $newArrayCards[$i];

$count3++;

}

}

}

//здесь я преобразую 111 к 110 (2 пары) и 211 к 210 (фулл хаус)

if(($count1 == 1 or $count1 == 2) and $count2 == 1 and $count3 == 1) {

$count3 = 0;

}

//здесь я преобразую 121 сначала к 211 для простоты вычислений, а затем к 210 (фулл хаус)

else if($count2 == 2 and $count1 == 1 and $count3 == 1) {

$support = $match2;

$match2 = $match1;

$match1 = $support;

$count1 = 2;

$count2 = 1;

$count3 = 0;

}

//здесь я преобразую 112 сначала к 211 для простоты вычислений, а затем к 210 (фулл хаус)

else if($count3 == 2 and $count1 == 1 and $count2 == 1) {

$support = $match3;

$match2 = $match1;

$match1 = $support;

$count1 = 2;

$count3 = 0;

}

//здесь я преобразую 220 к 210 (фулл хаус)

else if($count1 == 2 and $count2 == 2 and $count3 == 0) {

$count2 = 1;

}

//здесь я преобразую 120 к 210 (фулл хаус)

else if ($count1 == 1 and $count2 == 2 and $count3 == 0) {

$support = $match1;

$match1 = $match2;

$match2 = $support;

$count1 = 2;

$count2 = 1;

}

//320 к 300 и 310 к 300

else if($count1 == 3 and ($count2 == 2 or $count2 == 1)) {

$count2 = 0;

}

//230 к 320 и затем к 300 и 130 к 310 и затем к 300

else if($count2 == 3 and($count1 == 2 or $count1 == 1)) {

$support = $match2;

$match2 = $match1;

$match1 = $support;

$count1 = 3;

$count2 = 0;

}

//каре

if ($count1 == 3) {

$count1 = 1e+14;

}

//фулл хаус

else if ($count1 == 2 and $count2 == 1) {

$count1 = 1e+12;

$count2 = 1e+10;

}

//тройка

else if ($count1 == 2 and $count2 == 0) {

$count1 = 1e+6;

}

//2 пары

else if ($count1 == 1 and $count2 == 1) {

$count1 = 1e+4;

$count2 = 1e+2;

}

//пара

else if ($count1 == 1 and $count2 == 0) {

$count1 = 1e+2;

}

$result = $match1 * $count1 + $match2 * $count2;// $match1 и $match2 будут равны 0, если совпадений не было

return $result;

}

Окончательный расчет

Теперь у нас имеются функции, которые проверяют массив карт на стрит, флеш, стрит флеш и парные комбинации. Вызову их вместе и посчитаю окончательный результат, не забываю также и про расчет старшей карты.

Расчет старшей карты:

1. Определю наибольшую и наименьшие по приоритетности карманные карты. Для этого сравню их остатками от деления на 100 (%100).

2. К наибольшей по приоритетности карте добавлю наименьшую по приоритетности деленную на 100.

function priority(array $arrayCards) {

//здесь я определяю старшую карту

if($arrayCards[5] % 100 > $arrayCards[6] % 100) { //условились, что две последние карты массива - карманные

$highCard1 = $arrayCards[5] % 100;

$highCard2 = $arrayCards[6] % 100;

} else {

$highCard1 = $arrayCards[6] % 100;

$highCard2 = $arrayCards[5] % 100;

}

$flush = pokerFlush($arrayCards); //вызываю функцию для расчета флеша

$straight = straight($arrayCards); //вызываю функцию для расчета стрита

$couple = couple($arrayCards); //вызываю функцию для расчета пар

//далее определяю результат согласно приоритету комбинаций

if($flush >= 1e+16) {

$result = $flush; //стрит флеш

} else if($couple >= 1e+14 and $couple < 1e+16) {

$result = $couple; //каре

} else if($couple >= 1e+12 and $couple < 1e+14) {

$result = $couple; //фулл хаус

} else if($flush >= 1e+10) {

$result = $flush; //флеш

} else if($straight >= 1e+8 and $straight < 1e+10) {

$result = $straight; //стрит

} else if($couple >= 1e+6 and $couple < 1e+8) {

$result = $couple; //тройка

} else if($couple >= 1e+4 and $couple < 1e+6) {

$result = $couple; //две пары

} else if($couple >= 1e+2 and $couple < 1e+4) {

$result = $couple; //пара

} else {

$result = $highCard1 + $highCard2 * 1e-2; //старшая карта

}

return $result;

}

О выводе на экран

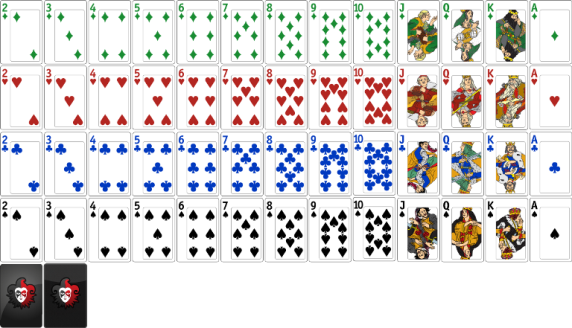

Выводила я результат в браузер, используя вот такой спрайт (брала картинку с сайта: fondhristianin.ru/?p=2941), как background-image для div.

Ширину и высоту для div задавала равными размеру одной карты, т.е. если размер изображения 572px*328px (как в данном случае), а в ширину количество карт равно 13, в высоту — 5, ширину и высоту задавала 44px*65.6px. Далее меняла background-position с учетом ранее сформированного массива карта.

Расчет background-position для любого из divов по оси х:

100/12 * ($arrayCards[$i] % 100 - 2)

где $arrayCards — ранее сформированный массив.

$i — порядковый номер карты.

Пояснения к расчету:

В ряду 13 карт, начало 1-ой карты — 0%, начало 13-ой карты — 100%, поэтому разница позиций — 100% / 12 (а не 13). Приводим числа карт из вида [2-14, 102-114, 202-214, 302-314] к [0-12]. Для этого возьмет остаток от числа карты и отнимем от остатка 2. Умножим полученное число на разницу позиций.

Расчет background-position для любого из divов по оси y:

100/4 * floor($arrayCards[$i] / 100)

Пояснение к расчету:

В ряду 5 карт, начало 1-ой карты — 0%, начало 5-ой карты — 100%, поэтому разница позиций — 100% / 4 (а не 5). Приводим числа карт из вида [2-14, 102-114, 202-214, 302-314] к [0-3]. Для этого разделим число карты на 100 и округлим в меньшую сторону (можно использовать и простую операцию округления, она сработает аналогичным образом). Умножим полученное число на разницу позиций.

|

Метки: author heartsease php poker texas holdem |

TSP problem. Mixed algorithm |

|

Метки: author Grossmend алгоритмы |

Итак, вы решили развернуть OpenStack |

Вы наверняка слышали об OpenStack. Блин, да о нем говорят на каждом более-менее связанном мероприятии. Все кому не лень пропагандируют OpenStack. Модно, молодежно, все уже есть, Open Source, вливайся давай. И вот наслушавшись тонны маркетингового булшита, вы решаетесь: Будем ставить OpenStack!

Я не проводил специальных изысканий на этот счет, но отрицательных отзывов о нем вроде бы не так много, по крайней мере на русском. На первый взгляд все выглядит просто фантастически. Что ж, извольте представить мой личный пост ненависти к OpenStack.

Предыстория

Об OpenStack я узнал на одной из конференций по OSS году примерно в 2012-м. В то время я работал в компании активно использующей большие кластера (100+ машин), однако без виртуализации, оркестрирования (kickstarter + IBM CSM в счет?) и в основном с пакетным исполнением задач: запустил, отработало, забрал результат. Полноценного понимания что такое облака и зачем они нужны еще не было, но интерес возник. Конечно сразу же возникло желание развернуть новую крутую штуку, которая вот прям сейчас сделает все хорошо.

Чуть позже в том же году, такая возможность представилась, правда уже в рамках стартапа. Нужно было развернуть проект, использующий кластеризацию и горизонтальное масштабирование, при этом нужна была изоляция окружений и совместное использование ресурсов одной машины несколькими службами — бюджет все-таки не резиновый.

В общем, в 2012-м мы развернули OpenStack, на тот момент это был Essex, запустили проект, прожили с такой облачной инфраструктурой до 2014-го года, кажется до релиза Grizzly включительно. Сил и желания поддерживать его дальше не было, и OpenStack был с позором выпилен.

Когда-то давно я даже думал написать статью как правильно его ставить, с комментариями на что обратить внимание. Но знаете, я передумал. Не ставьте его лучше вообще. Просто не связывайтесь. Вероятно, часть тезисов уже устарела, напишите в комментариях о том какой я м***к и ничего не понял, но в целом не думаю, что ситуация кардинально поменялась.

Итак, приступим, что же мне не нравится в Openstack и весьма вероятно не понравится вам.

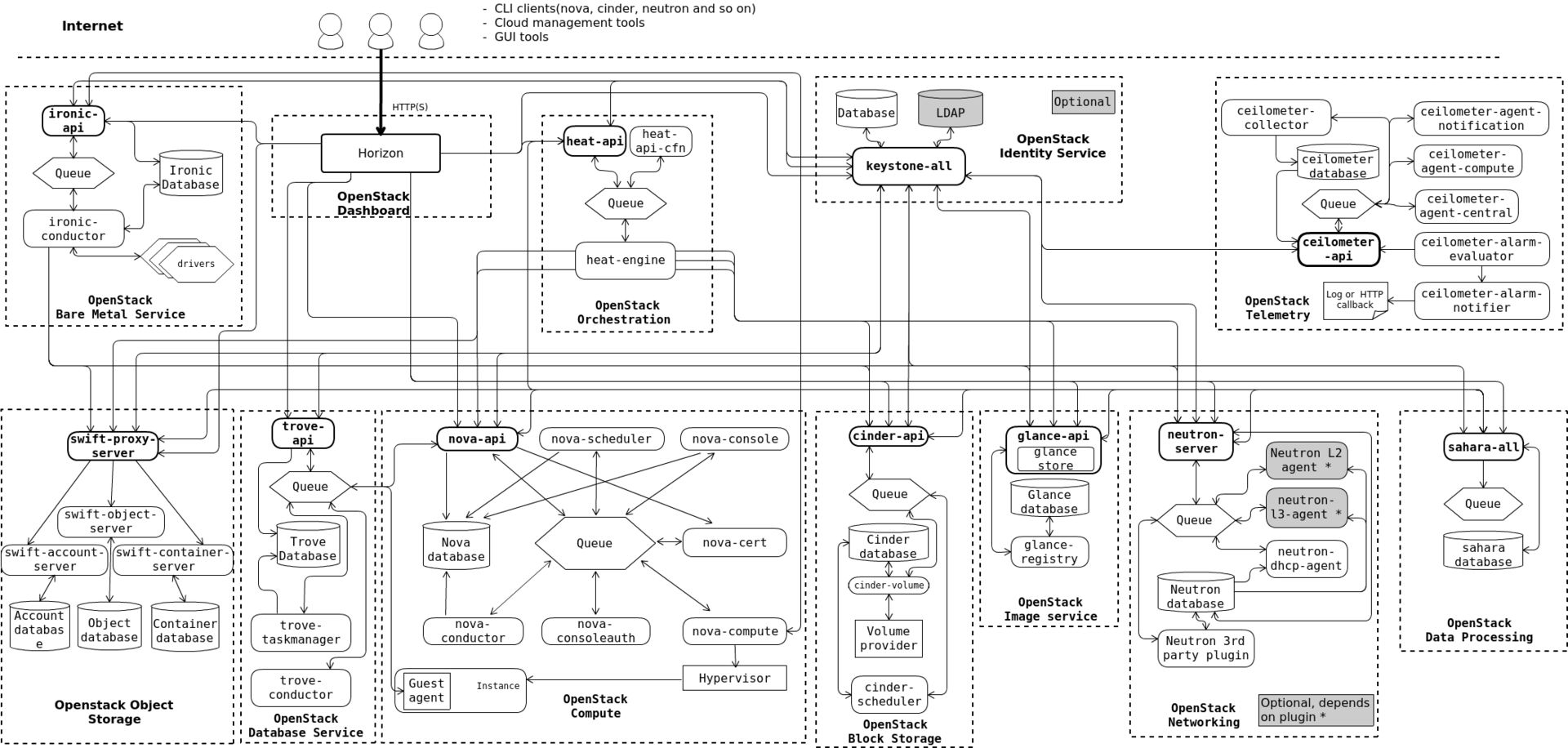

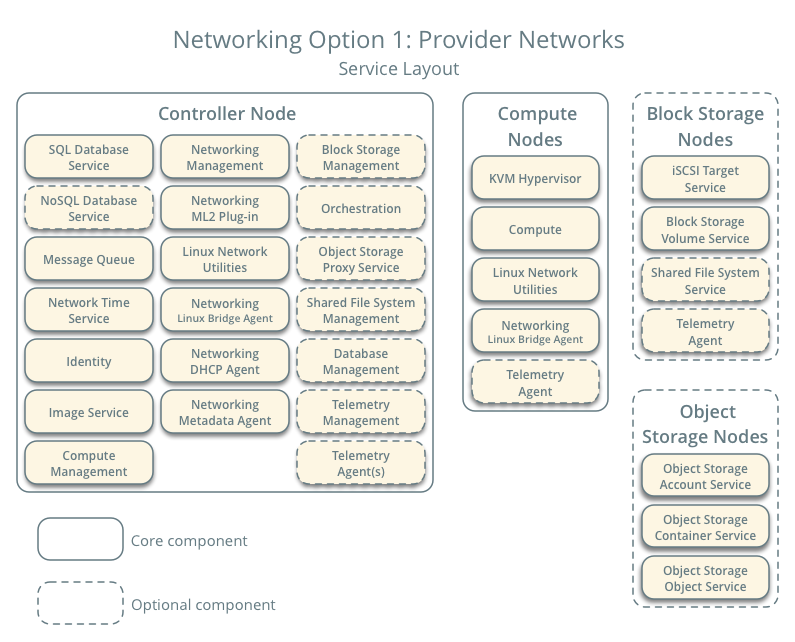

Он чересчур комплексный

Даже не так. Он, *****, МОНСТРУОЗНЫЙ. Нет, взгляните сами.

Когда-то давно, когда мы ставили Essex, там было все относительно просто и понятно. Keystone (служба авторизации), Glance (служба хранилища образов) и Nova (служба управления гипервизорами). Кроме того там еще был Horizon (дашборд) и куча мелких и не очень зависимостей. Каждый узел системы обрастает чуть ли не десятками вспомогательных демонов. На controller node через некоторое время становится страшно смотреть.

Так, когда наш виртуальный кластер приблизился к 20 серверам, controller node стал безбожно тормозить, по непонятной причине. Ну точнее понятной, но мне непонятно, зачем identity service грузила процессор на 100%?

Из комплексности происходит следующий недостаток.

Он запутанный

Архитектура OpenStack достаточно сильно фрагментирована. Есть очень большое количество «движущихся частей», взаимосвязь который между собой не всегда абсолютно ясна. У вас что-то сломалось? Окей, попробуй понять где это что-то сломалось и почему. OpenStack Foundation похоже гордится, что в OpenStack более 20 миллионов строк кода, даже на главную своего сайта вынесли. Так вот, ЭТО НИФИГА НЕ ДОСТОИНСТВО.

Код в большинстве своем написан на Python. Спасибо, OpenStack, благодаря тебе я возненавидел Python и все что с ним связано. Возможно сейчас с документацией получше, но раньше ее практически не было. Логика вполне может начинаться в одном демоне, а потом с помощью запросов через RabbitMQ исполнятся совершенно в другом и даже на другой машине. Стоит ли говорить, что писать собственные расширения для OpenStack совсем не просто. Одно дело если это просто небольшой хак, другое дело если это полноценный подключаемый модуль с новым функционалом. 5 строчками кода вы точно не обойдетесь.

Если вам надо залезть под капот, чтобы понять что там происходит…

Дело в том, что являясь OSS, OpenStack пытается быть kind of unix-way. Т.е. под капотом все эти монструозные службы на самом деле дергают десятки и сотни unix-утилит по собственной логике, которую вам придется изучить и возможно даже дебажить. С документацией, по крайней мере раньше было, все плохо. Зачем вам рассказывать какие именно правила iptables мы добавляем на хост и для чего? У нас же суперкрутое приложение которое делает все само и не требует вашего вмешательства. Хотите добавить свои правила? Нуу, удачи, исходники-то открыты.

Пока вы более-менее вписываетесь в сценарий, предполагаемый авторами — все более-менее окей. Если же вам понадобилось сделать шаг в сторону, ждите трудностей. Запасайтесь man'ами, терпением, возможно вам придется изучить еще несколько несвязанных напрямую с задачей проблем, например как работает RabbitMQ и что ему еще надо?

Из этого проистекает следующая проблема.

Он ненадежный

Казалось бы логично, чем сложнее система, тем менее она надежна. Но видимо эта истина не для всех. Готовьтесь искать источник подземных стуков, запускать демоны в ПРАВИЛЬНОЙ последовательности, много гуглить и читать логи, копаться в исходниках и вот это все.

Некоторые решения на мой взгляд просто спорные. Служба метаданных на виртуальном IP-адресе эмулируемом через iptables? Серьезно? Очень «надежная» работа dnsmasq по выдаче IP виртуалкам. Тысячи их.

И это усугубляется тем что.

Он становится еще больше

Как я уже упоминал, когда мы только начинали его использовать, служб было еще не так много, хотя некоторые проблемы были уже тогда. Но с каждым релизом служб становится еще больше.

Например, посмотрите на текущий список служб, каждая из которых добавляет еще несколько демонов на вашу машину:

- Identity service (keystone)

- Image service (glance)

- Compute service (nova)

- Networking service (neutron)

- Dashboard (horizon)

- Block Storage service (cinder)

- Bare Metal service (ironic)

- Container Infrastructure Management service (magnum)

- Database service (trove)

- DNS service (designate)

- Key Manager service (barbican)

- Messaging service (zaqar)

- Object Storage services (swift)

- Orchestration service (heat)

- Shared File Systems service (manila)

- Telemetry Alarming services (aodh)

- Telemetry Data Collection service (ceilometer)

Да, формально не обязательно ставить абсолютно все службы. Но не думайте что какой-то пустячок, которого нет в основной службе можно будет легко и просто добавить в вашу инфраструктуру.

Например, во времена Essex не было простого способа добавить запись о вашей новой виртуалке в ваш DNS-сервис. Руками — пожалуйста. Хуки? Не, не слышали. Я рождения designate так и не дождался.

А еще знаете что?

Он ломается

От релиза к релизу. Т.е. ну вот вы наконец-то запилили инфраструктуру своей мечты, все худо-бедно работает как рассчитывали, но не хватает одной мааааленькой детали. А в новом релизе она есть. Ну по крайней мере по Release Notes.

Окей гугл, давай обновим наш OpenStack. И тут выясняется, что функционал, который вы с радостью использовали — выпилили. Ну потому что. Ну некрасивый он был и вообще, мы лучше сделаем, честно-честно. В следующем релизе. Может быть. А пока вот вам попроще, но ведь работает же! Ну и плевать что не в вашем случае, но работает!

В нашем случае это был функционал сети. Сеть вообще больной вопрос, доставляющий больше всего боли в OpenStack. В общем, наше приложение потребляет трафик из интернета, иногда весьма интенсивно. Конечно это не совсем стандартное требование, но наилучшим для нас вариантом было, когда виртуалки использует собственный хост в качестве роутера, а сам хост уже напрямую отправляет трафик провайдеру. И это можно было сделать в Essex. И это худо-бедно работало.

А в следующем релизе ребята из OpenStack решили что баста, мы выпилим функционал работы с сетью в отдельный модуль (будущий neutron), реализуем что-нибудь простое вроде один роутер на виртуальную сеть ну и играйтесь пока. Т.е. нужно было бы пустить весь трафик целого кластера через единичный узел нашей сети, он бы и стал бутылочным горлышком.

В итоге, OpenStack это такая штука, которая вот действительно, работает — не трогай. Даже не пытайся туда свои рученки совать, п**р. Лучше даже на всякий случай хосты не перезагружать, а то вдруг оно больше не поднимется? Любое обновление — это аврал, нервы, ненависть.

Он сырой (местами)

А еще очень дивное чувство испытываешь, когда тебе нужен функционал, ну, скажем, деление на зоны. Ну вот есть у тебя машины с большими винтами, есть с SSD, есть с видюхами, хочу разбить кластер на зоны, чтобы виртуалка падала на ту машину, у которой необходимый ресурс есть. Ну ок, читаем доку, вроде бы availability zones подходит. Настраиваем, включаем. И ничего. В доке написано что все должно, а на практике ничего. Лезем в код, а там.

Будет реализовано. В следующем релизе. Может быть. Ну ты понял. Смотри предыдущий пункт.

Есть ли плюсы, какие будут выводы?

Лично для меня вывод простой. Ванильную версию OpenStack лучше не использовать. Я не знаю как обстоят дела с вендорскими версиями и у всяких контор, торгующих инсталляциями «под ключ», но как по мне это несколько противоречит самой идеологии «свободного облака». Мы опять получаем vendor lock-in, только под другим соусом.