Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Место Java в мире HFT |

В статье автор пытается проанализировать почему существуют торговые системы написанные на Java. Как может Java соперничать в области высокой производительности с C и C++? Далее размещены небольшие размышления о достоинствах и недостатках использования Java в качестве языка программирования/платформы для разработки систем HFT.

Небольшой дисклеймер: мир Java широк, и в статье я буду подразумевать именно HotSpot реализацию Java, если не сказано обратное.

1. Введение

Хочется намного рассказать про место Java в мире HFT. Для начала, давайте определимся с тем, что же такое HFT (High Frequency Trading). У этого термина существует несколько определений, объясняющих различные его аспекты. В контексте данной статьи я буду придерживаться объяснения, которое дал Питер Лаури (Peter Lawrey), создатель Java Performance User’s Group: «HFT — это торговля, которая быстрее скорости реакции человека (faster than a human can see)».

Торговые платформы HFT могут анализировать различные рынки одновременно и запрограммированы на проведение сделок в наиболее подходящих рыночных условиях. Применяемая прогрессивная технология дает возможность невероятно быстро обрабатывать данные тысячи транзакций в день, при этом извлекая лишь небольшую прибыль с каждой сделки.

Под данное определение подпадает вся электронная автоматической торговли с характерными временами сотни миллисекунд и меньше, вплоть до микросекунд. Но если достигнуты скорости в единицы микросекунд, то зачем в таком случае нужны системы, которые работают на порядок медленнее? И как они могут зарабатывать деньги? Ответ на этот вопрос состоит из двух частей:

- Чем быстрее должна быть система, тем проще должна быть заложенная в нее модель. Т.е. если наша торговая логика реализована на FPGA, то о сложных моделях можно забыть. И наоборот, если мы пишем код не на FPGA или plain assembler, то мы должны закладывать в код более сложные модели.

- Сетевые задержки. Оптимизировать микросекунды имеет смысл только тогда, когда это ощутимо может сократить суммарное время обработки, которое включает сетевые задержки. Одно дело, когда сетевые задержки — это десятки и сотни микросекунд (в случае работы только с одной биржей), и совершенно другое — 20мс в каждую сторону до Лондона (а до Нью-Йорка еще дальше!). Во втором случае оптимизация микросекунд, затраченных на обработку данных, не принесет ощутимого сокращения суммарного времени реакции системы, в которое входит сетевая задержка.

Оптимизация HFT систем в первую очередь преследует сокращение не суммарной скорости обработки информации (throughput), а времени отклика системы на внешнее воздействие (latency). Что это значит на практике?

Для оптимизации по throughput важна результирующая производительность на длительном интервале времени (минуты/часы/дни/…). Т.е. для подобных систем нормально остановить обработку на какой-то ощутимый промежуток времени (миллисекунды/секунды), например на Garbage Collection в Java (привет, Enterprise Java!) если это не влечет существенного снижения производительности на длительном интервале времени.

При оптимизации по latency в первую очередь интересна максимально быстрая реакция на внешнее событие. Подобная оптимизация накладывает свой отпечаток на используемые средства. Например, если для оптимизации по throughput обычно используются примитивы синхронизации уровня ядра ОС (например, мьютексы), то для оптимизации по latency зачастую приходится использовать busy-spin, так как это минимизирует время отклика на событие.

Определив, что такое HFT, будем двигаться дальше. Где же место Java в этом «дивном новом мире»? И как Java может тягаться в скорости с такими титанами, как C, C++?

2. Что входит в понятие «производительность»

В первом приближении, разделим все аспекты производительности на 3 корзины:

- CPU-производительность как таковая, или скорость выполнения сгенерированного кода,

- Производительность подсистемы памяти,

- Сетевая производительность.

Рассмотрим каждую составляющую подробнее.

2.1. CPU-performance

Во-первых, в арсенале Java есть самое важное средство для генерации действительно быстрого кода: реальный профиль приложения, то есть понимание, какие участки кода «горячие», а какие нет. Это критически важно для низкоуровневого планирования расположения кода.

Рассмотрим следующий небольшой пример:

int doSmth(int i) {

if (i == 1) {

goo();

} else {

foo();

}

return …;

}При генерации кода у статического компилятора (который работает в compile-time) физически нет никакой возможности определить (если не брать в расчет PGO), какой вариант более частый: i == 1 или нет. Из-за этого, компилятор может лишь догадываться, какой сгенерированный код быстрее: #1, #2, или #3. В лучшем случае статический компилятор будет руководствоваться какой-либо эвристикой. А в худшем просто расположением в исходном коде.

cmpl $1, %edi

je .L7

call goo

NEXT:

...

ret

.L7:

call foo

jmp NEXTcmpl $1, %edi

jne .L9

call foo

NEXT:

...

ret

.L9:

call goo

jmp NEXTcmpl $1, %edi

je/jne .L3

call foo/goo

jmp NEXT:

.L3:

call goo/foo

NEXT:

…

retВ Java же из-за наличия динамического профиля, компилятор всегда знает какой вариант предпочесть и генерирует код, который максимизирует производительность именно для реального профиля нагрузки.

Во-вторых, в Java есть так называемые спекулятивные оптимизации. Поясню на примере. Допустим, у нас есть код:

void doSmth(IMyInterface impl) {

impl.doSmth();

}Вроде бы все понятно: должен сгенерироваться вызов виртуальной функции doSmth. Единственное, что могут сделать статические компиляторы С/С++ в данной ситуации — попытаться выполнить девиртуализацию вызова. Однако на практике данная оптимизация случается относительно редко, так как для ее выполнения необходима полная уверенность в корректности данной оптимизации.

У компилятора Java, работающего в момент работы приложения, есть дополнительная информация:

- Полное дерево загруженных в данный момент классов, на основе которого можно эффективно провести девиртуализацию,

- Статистика о том, какая реализация вызывалась в данном месте.

Даже если в иерархии классов есть другие реализации интерфейса IMyInterface, компилятор выполнит встраивание (inline) кода реализации, что позволит, с одной стороны, избавиться от относительно дорогого виртуального вызова и выполнить дополнительные оптимизации с другой стороны.

В-третьих, компилятор Java оптимизирует программу под конкретное железо, на котором он был запущен.

Статические компиляторы вынуждены использовать только инструкции достаточно древнего железа для обеспечения обратной совместимости. В результате, все современные расширения, доступные в расширениях x86, остаются за бортом. Да, можно компилировать под нескольких наборов инструкций и во время работы программы делать runtime-dispatching (например, с использованием ifunc'ов в LINUX), но кто это делает?

Компилятор Java знает на каком конкретном железе он запущен и может оптимизировать код под данную конкретную систему. Например, если система поддерживает AVX, то будут использоваться новые инструкция, оперирующие новыми векторными регистрами, что значительно ускоряет работу вычислений с плавающей точкой.

2.2. Производительность подсистемы памяти

Выделим несколько аспектов производительности подсистемы памяти: паттерн доступа к памяти, скорость аллокации и деаллокации (освобождения) памяти. Очевидно, что вопрос быстродействия подсистемы памяти крайне обширен и не может быть полностью исчерпан 3 рассматриваемыми аспектами.

2.2.1 Паттерн доступа к памяти

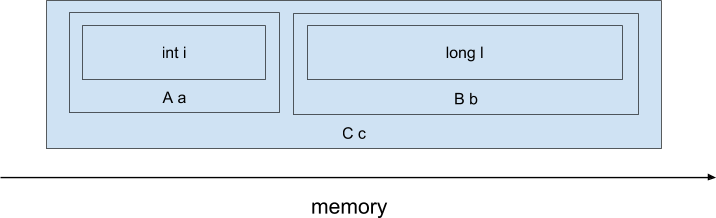

В разрезе паттерна доступа к памяти наиболее интересен вопрос в различии физического расположения объектов в памяти или data layout. И тут у языков С и С++ огромное преимущество — ведь мы можем явно управлять расположением объектов в памяти, а отличии от Java. Для примера рассмотрим следующий код на C++):

class A {

int i;

};

class B {

long l;

};

class C {

A a;

B b;

};

C c;При компиляции данного кода компилятором C/C++, поля полей-подобъектов будут физически расположены последовательно, примерно таким образом (не учитываем возможный паддинг между полями и возможные data-layout трансформации, производимые компилятором):

Т.е. выражение виде ‘return c.a.i + c.b.l’ будет скомпилировано в такие инструкции ассемблера x86:

mov (%rdi), %rax ; << чтение c.a.i

add ANY_OFFSET(%rdi), %rax ; << чтение c.b.l и сложение с c.a.i

retТакой простой код был достигнут за счет того, что объект располагается линейно в памяти и компилятор на этапе компиляции смещения требуемых полей от начала объекта. Более того, при обращении к полю c.a.i, процессор загрузит всю кэш-линию длиной 64 байта, в которую, скорее всего, попадут и соседние поля, например c.b.l. Таким образом, доступ к нескольким полям будет относительно быстрый.

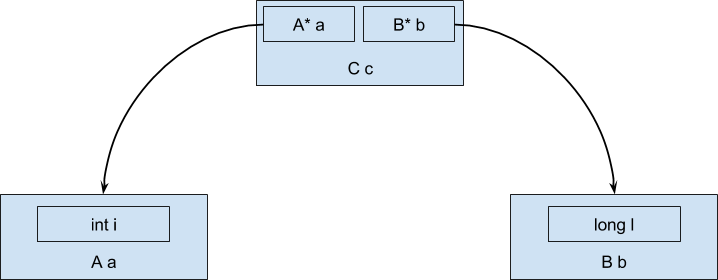

Как же будут располагаться данный объект в случае использования Java? В виду того, что объекты не могут быть значениями (в отличии от примитивных типов), а всегда ссылочные, то в процессе выполнения данные будут располагаться в памяти в виде древовидной структуры, а не последовательной области памяти:

И тогда выражение ‘c.a.i + c.b.l’ будет компилироваться в лучшем случае во что-то похожее на такой код ассемблера x86:

mov (%rdi), %rax ; << загружаем адрес объекта a

mov 8(%rdi), %rdx ; << загружаем адрес объекта b

mov (%rax), %rax ; << загружаем значение поля i объекта a

add (%rdx), %rax ; << загружаем значение поля l объекта bМы получили дополнительный уровень косвенности при обращении к данным внутри объектов-полей, так как в объекте типа С находятся всего лишь ссылки на объекты-поля. Дополнительный уровень косвенности ощутимо увеличивает количество загрузок данных из памяти.

2.2.2. Скорость аллокации (выделения)

Тут у Java значительный перевес относительно традиционных языков с ручным управлением памятью (если не брать искусственный случай, что вся память выделяется на стеке).

Обычно для аллокации в Java используются так называемые TLAB'ы (Thread local allocation buffer), то есть области памяти, уникальные для каждого потока. Аллокация выглядит как уменьшение указателя, указывающего на начало свободной памяти.

Например, указатель на начало свободной памяти в TLAB'е указывает на 0х4000. Для аллокации, скажем, 16 байт нужно изменить значение указателя на 0х4010. Теперь можно пользоваться свежевыделенной памятью в диапазоне 0х4000:0х4010. Более того, так как доступ к TLAB'у возможен только из одного потока (ведь это thread-local buffer, как следует из названия), то нет необходимости в синхронизации!

В языках с ручным управлением памятью, для выделения памяти обычно используются функции operator new/malloc/realloc/calloc. Большинство реализаций содержат ресурсы, разделяемые между потоками, и намного более сложны, чем описанный способ выделения памяти в Java. В некоторых случаях нехватки памяти или фрагментации кучи (heap) операции выделения памяти могут потребовать значительного времени, что ухудшит latency.

2.2.3. Скорость освобождения памяти

В Java используется автоматическое управление памятью и разработчик теперь не должен вручную освобождать выделенную ранее память, так как это делает сборщик мусора (Garbage collector). К достоинствам такого подхода следует отнести упрощение написания кода, ведь одним поводом для головной боли меньше.

Однако это приводит к не совсем ожидаемым последствиям. На практике разработчику приходится управлять различными ресурсами, не только памятью: сетевыми соединениями, соединениями с СУБД, открытыми файлами.

И теперь ввиду отсутствия в языке внятных синтаксических средств контроля за жизненным циклом ресурсов приходится использовать достаточно громоздкие конструкции типа try-finally или try-with-resources.

Сравним:

Java:

{

try (Connection c = createConnection()) {

...

}

}или так:

{

Connection c = createConnection();

try {

...

} finally {

c.close();

}

}С тем, что можно написать в С++

{

Connection c = createConnection();

} // деструктор будет автоматически вызван при вызоде из scope'аОднако вернемся к освобождению памяти. Для всех сборщиков мусора, поставляемых с Java, характерна пауза Stop-The-World. Единственный способ минимизации ее влияния на производительность торговой системы (не забываем, что нам нужна оптимизация не по throughput, а по latency) — это уменьшить частоту любых остановок на Garbage Collection.

В настоящий момент наиболее употребимым способом это сделать является «переиспользование» объектов. То есть когда объект нам становится не нужен (в языках C/C++ необходимо вызвать оператор delete), мы записываем объект в некоторый пул объектов. А когда нам необходимо создать объект вместо оператора new, обращаемся к этому пулу. И если в пуле есть ранее созданный объект, то достаем его и используем, как будто он был только что создан. Посмотрим, как это будет выглядеть на уровне исходного кода:

Автоматическое управление памятью:

{

Object obj = new Object();

.....

// Здесь объект уже не нужен, просто забываем про него

}И с переиспользованием объектов:

{

Object obj = Storage.malloc(); // получаем объект из пула

...

Storage.free(obj); // возвращаем объект в пул

}Тематика переиспользования объектов, как мне кажется, не достаточно освещена и, безусловно, заслуживает отдельной статьи.

2.3. Сетевая производительность

Тут позиции Java вполне сравнимы с традиционными языками C и C++. Более того, сетевой стек (уровень 4 модели OSI и ниже), расположенный в ядре ОС, физически один и тот же при использовании любого языка программирования. Все настройки быстродействия сетевого стека, релевантные для C/C++, релевантны и для приложения на Java.

3. Скорость разработки и отладки

Java позволяет намного быстрее развивать логику за счет намного большей скорости написания кода. Не в последнюю очередь, это является следствием отказа от ручного управления памятью и дуализма указатель-число. Действительно, зачастую быстрее и проще настроить Garbage Collection до удовлетворительного уровня, чем вылавливать многочисленные ошибки управления динамической памятью. Вспомним, что ошибки при разработке на C++ зачастую принимают совершенно мистический оборот: воспроизводятся в релизной сборке или только по средам (подсказка: в английском языке “среда” — самый длинный по написанию день недели). Разработка на Java в подавляющем большинстве случаев обходится без подобного оккультизма, и на каждую ошибку можно получить нормальный stack trace (даже с номерами строк!). Использование Java в HFT позволяет тратить на написание корректного кода существенно меньше времени, что влечет за собой увеличение скорости адаптации системы к постоянным изменениям на рынке.

4. Резюме

В мире HFT то, насколько успешна торговая система зависит от суммы двух параметров: скорости самой торговой системы и скорости ее разработки, развития. И если скорость работы торговой системы — критерий относительно простой и понятный (по крайней мере понятно как измерять), то скорость развития системы ощутимо сложнее в оценке. Можно представить скорость развития как сумму бесчисленного множества факторов, среди которых и скорость написания кода и скорость отладки и скорость профилирования и удобство инструментальных средств и порог входа. Также, важными факторами являются скорость интеграции идей, полученный от аналитиков-квантов (Quantitative Researcher’ов), которые, в свою очередь, могут переиспользовать код продуктовой торговой системы для анализа данных. Как мне кажется, Java — разумный компромисс между всеми этими факторами. Этот язык сочетает в себе:

- достаточно хорошее быстродействие;

- относительно низкий порог входа;

- простоту инструментальных средств (К сожаления, для C++ нет сред разработки, сравнимых с IDEA);

- возможность простого переиспользования кода аналитиками;

- простоту работы под большими технически сложными системами.

Суммируя вышеперечисленное, можно резюмировать следующее: у Java в HFT есть своя существенная ниша. Использование Java, а не С++, ощутимо ускоряет развития системы. В вопросе производительности быстродействие Java может быть сравнимо с быстродействием C++ и кроме того, в Java есть набор уникальных, недоступных для С/С++ возможностей по оптимизации.

|

Метки: author RainM высокая производительность java блог компании райффайзенбанк c++ low-latency high-performance |

Взгляд изнутри: «On Rails!» об участии в «Противостоянии» |

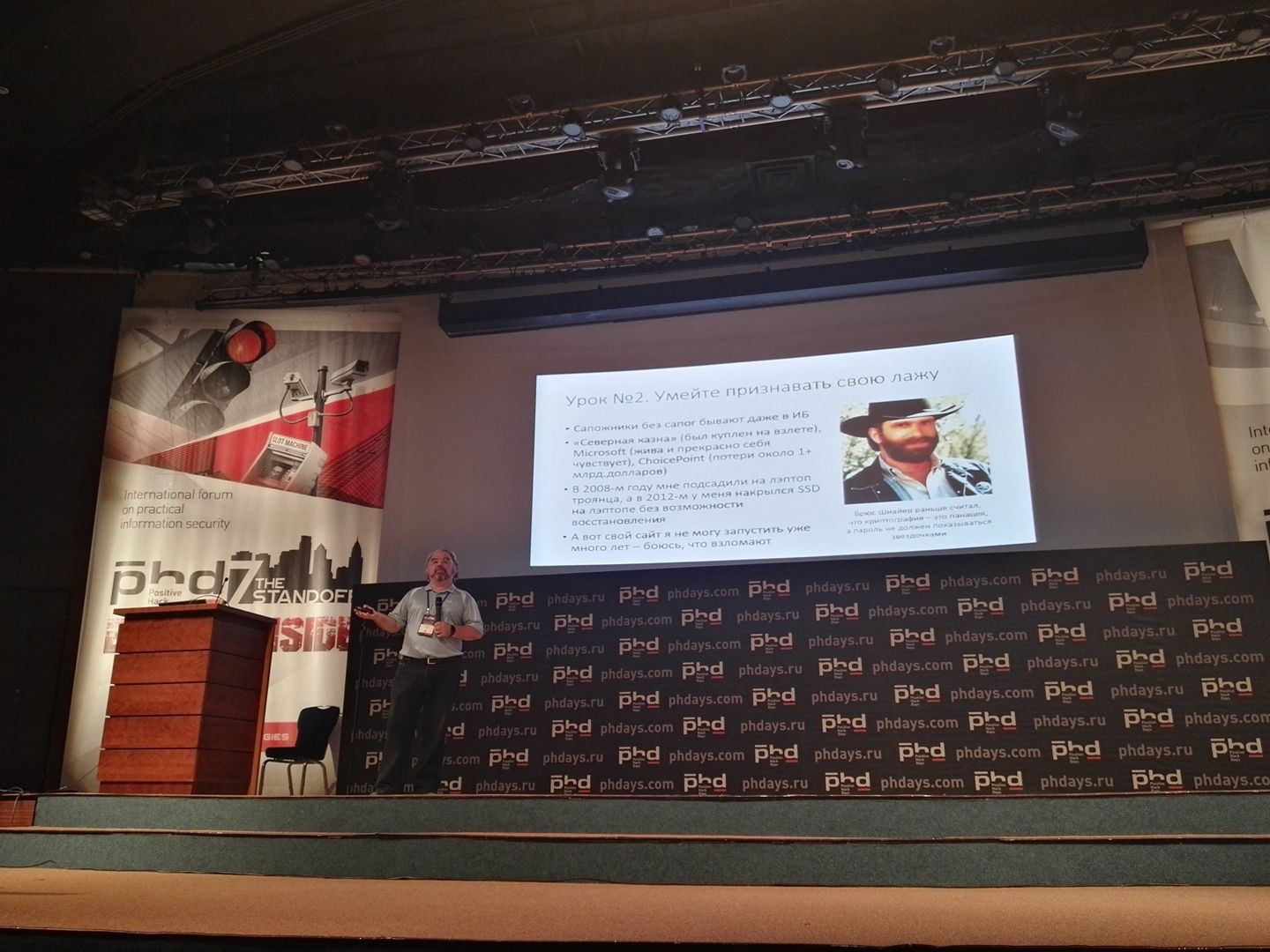

Противостояние — ежегодное мероприятие, в котором специалисты по информационной безопасности пробуют свои силы в атаке и защите, используя различные системы и программные платформы. Обычно проводится соревнование в виде реального противостояния двух команд. Первая команда атакует системы безопасности, которые поддерживаются командой защитников и экспертных центров мониторинга. Само мероприятие проводится в рамках Международного форума по практической безопасности Positive Hack Days. «Цель Противостояния — столкнуть две противоборствующие стороны в более или менее контролируемой среде, чтобы посмотреть, что победит — целенаправленные атаки или целенаправленная защита. На роль защитников и SOC пришли эксперты отрасли — интеграторы, вендоры и те, кто выполняет функцию ИБ на стороне заказчиков», — рассказывает о мероприятии член оргкомитета форума Михаил Левин.

Каждый год команды, принимающие участие в «Противостоянии», преследуют свои цели. В этом плане текущий год ничем не отличается от предыдущих. Одна из команд, On Rails!, которая представляет IBM и практикующих экспертов in-house SOC, пробовала свои силы в Противостоянии с решениями из портфеля IBM Security. Само мероприятие уже прошло, и о нем не раз и не два рассказывали в сети. Настало время и нам сделать небольшое review участия команды «On Rails!» в противостоянии «The Standoff». Команда была сформирована в конце апреля из экспертов, с которыми не страшно было пойти в бой против хакеров: Эльман Бейбутов, Роман Андреев, Андрей Курицын, Сергей Кулаков, Сергей Романов, Владимир Камышанов и другие, пожелавшие остаться неизвестными героями. Многие были знакомы между собой и даже работали в прошлом в одних компаниях, поэтому быстро удалось скоординироваться и обсудить тактику защиты.

Команде было предложено на выбор две инфраструктуры для защиты – железнодорожная или энергетическая компания. После недолго обсуждения большинство защитников отдали свои голоса за обеспечение безопасности железнодорожных перевозок. Вскоре после этого появилось название команды – «On Rails!» – и простой, но очевидный логотип дорожного знака с паровозом.

Первый момент. У команды было достаточно мало времени на подготовку, аудит защищаемой инфраструктуры и выбор средств защиты. План «А» — это упор на закрытие уязвимостей, смену дефолтных учетных записей и установку свежих версий ПО в представленной инфраструктуре. Это минимальный набор действий, который единогласно был одобрен и не требовал никаких затрат из без того ограниченного бюджета. Ключевыми технологиями защиты стали обнаружение вторжений с помощью решения IBM XGS, а в качестве системы мониторинга инцидентов ИБ использовалось решение IBM QRadar SIEM. Также использовалось opensource решение OSSEC для обнаружения вторжений на уровне хостов – им покрыли прежде всего все ноутбуки самих защитников, а также установили агентов на все ключевые сервера и рабочие станции в инфраструктуре – охватили 12 хостов сети.

Конечно, когда начался отсчет времени «The Standoff», наши средства защиты ещё не были полностью настроены, а безопасная конфигурация объектов защиты не внедрена. На самом деле это здорово: ведь, как и в реальной жизни, хакеры не будут ждать, пока безопасники наконец-то всё приведут в порядок. Поэтому в самые первые часы схватки работать пришлось в ускоренном темпе. В качестве плана «Б» Сергей Романов предложил сделать ставку на Active Response и подготовил небольшой набор скриптов для автоматизированной обратной реакции по результатам корреляции событий. Это могло пригодиться в случае, если бы хакерам удалось преодолеть периметр.

Второй момент. У нас были не все учётные записи к служебным системам. Порой организаторы их просто не предоставляли под различными предлогами, поэтому в особых ситуациях их приходилось подбирать самостоятельно. С этим проблем не возникло: все участники нашей команды пришли с Kali. Теперь мы могли вносить изменения и сразу их проверять.

Третий, самый важный момент проявился в ночь со вторника на среду, когда из участников конференции остались только хакеры, защитники и организаторы. Ночь можно было охарактеризовать фразой: «Развлекались, как могли!» Ребята из «Vulners» пытались установить свою «железку» в разрыв с нашими подключениями. Очевидно, для организации атаки типа Man-in-the-Middle. Другая команда осторожно попыталась подключиться напрямую к оборудованию в стойках защитников. Как оказалось, правила даже это допускают. Пришлось заниматься настоящей физической безопасностью и прогонять их.

Действуя под покровом ночи, несколько участников «On Rails!» получили дополнительную информацию, попросту надев толстовки с капюшонами и пересев в зону хакеров за один из освободившихся столов (наверно, некоторые хакеры решили поспать). Итогами такой партизанской контрразведки стало раскрытие карты сети, которую организаторы предоставили хакерам, а также получение ценной информации о том, что команда «ЦАРКА», лидер соревнования, до железнодорожной инфраструктуры пока не добралась.

Утро тоже было интересным. Не спать совсем нам не удалось, человеческие ресурсы были все же ограничены и держать контроль 24х7 оказалось непростой задачей. На утро мы, к сожалению для себя, обнаружили, что span порт для нашей IDS не работает. Роман Андреев экстренно переключился на непрерывный мониторинг инцидентов в IBM QRadar SIEM (мы предусмотрительно завели туда Netflow), а Сергей Романов предложил остальным заняться Threat Hunting’ом. Threat Hunting подразумевает подход, при котором считается, что система уже скомпрометирована, и задача, найти этому свидетельства.

По итогу соревнований мы показали 100% SLA. Хакеры нас не взломали.

«Участие в подобном мероприятии очень тонизирует. Сжатые сроки, обилие технических задач, как по защите, так и по взлому, позволяет оценить экспертам себя со стороны, понять, насколько хорошо ты справился. Показательным является и работа в команде профессионалов, когда каждый участник команды чувствует ответственность за других, видит, чем они занимаются, и самостоятельно берет в работу незакрытые направления. Это отличный опыт, который можно применять для развития команды информационной безопасности каждому в своих компаниях уже по возвращении на работу», — вспоминает Сергей Романов о своем участии в противостоянии с командой On Rails!

«Противостояние «The Standoff» позволят лучше понимать хакеров, корректировать приоритеты в технической составляющей защиты. В итоге, сохраненный уровень защищенности еще и подтверждает высокий уровень слаженности работы команды», — говорит Эльман Бейбутов, координатор команды On Rails!

|

Метки: author ibm информационная безопасность блог компании ibm ibm on rails! противостояние |

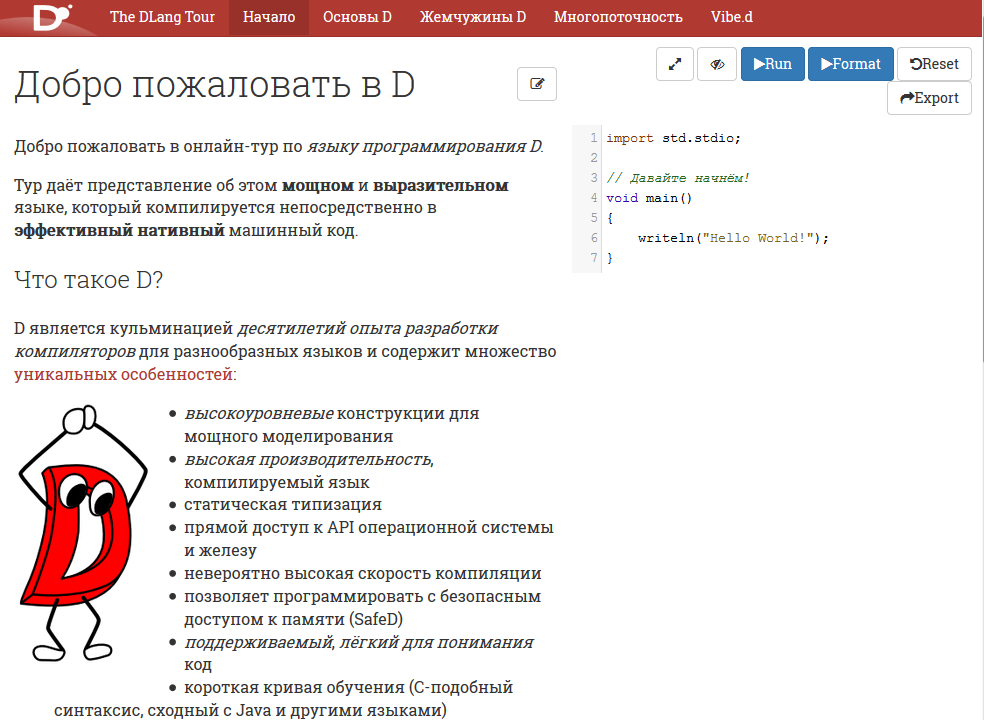

Dlang Tour переведен на русский язык |

Dlang Tour — это интерактивное введение в язык D.

Сделан по образцу Golang Tour.

В большинстве статей есть примеры кода, которые можно запустить из браузера.

Разделы тура

Начало

Helloworld, установка компилятора, компиляция и запуск программы из командной строки.

Основы D

Введение в синтаксис и основные особенности языка.

Жемчужины D

Этот раздел будет интересен даже для знающих язык.

Практически каждая статья этого раздела — описание очередной killer feature языка.

Многопоточность

Описаны особенности языка и стандартной библиотеки, облегчающие создание безопасного многопоточного кода.

Vibe.d

Асинхронный фреймворк на основе Fibers (сопрограмм, легковесных потоков).

В основном используется для Web-разработки.

Полезные ссылки

- Репозиторий DUB.

- Awesome D — список фреймворков, библиотек, приложений и различных ресурсов по D — по примеру awesome-python

- D Idioms — список полезных "фишек" языка D.

|

Метки: author Buggins программирование dlang golang |

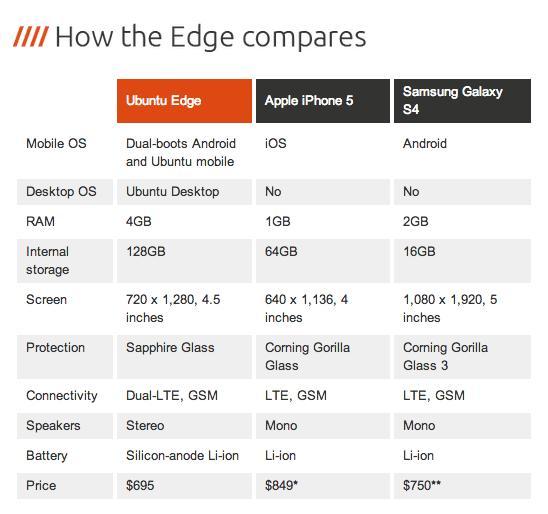

[Перевод] Ubuntu для мобильных устройств: посмертный анализ |

Так выглядела Ubuntu Touch, когда проект анонсировали 2 января 2013 года. Изображение: Canonical

Теперь, когда телефонов и планшетов Ubuntu больше нет, я бы хотел поделиться мыслями, почему проект провалился и какие уроки из этого можно извлечь.

Чтобы резюмировать моё участие в проекте: я использовал Ubuntu Touch на Nexus 7 постоянно и периодически с момента его анонса в 2013 году и до декабря 2014 года, начал работать над приложениями Click в декабре 2014-го, начал писать статью из 15-ти частей “Hacking Ubuntu Touch” об устройстве системы в январе 2015-го, был инсайдером по программе Ubuntu Phone Insider, получил Meizu MX4 от Canonical, организовал конкурс для разработчиков приложений UbuContest и был его спонсором, работал над баг-репортами и приложениями примерно до апреля 2016 года, а затем продал или переделал все мои оставшиеся устройства в середине 2016-го. Так что думаю, что могу поделиться какими-то мыслями о проекте, его проблемах и о том, где мы могли сработать лучше.

Пожалуйста, обратите внимание, что эта статья не затрагивает проект UBPorts, который продолжает работать на операционной системе телефонов, Unity 8 и другие компоненты.

1. Он не попал в прибыльную нишу

Ubuntu для ПК, ноутбуков и серверов сделал это относительно легко. Почти все эти устройства позволяют вам установить любую операционную систему, которая умеет работать с аппаратным обеспечением, так что когда Ubuntu появилась в 2004 году, её крупнейший конкурент (Microsoft) был очень уязвим. У Windows была плохая репутация, высокая цена и эта система по-свински пожирала ресурсы, так что Ubuntu оставалось всего лишь быть менее раздражающей, дешевле, легче в установке и лучше работать на более старых компьютерах. И это в точности что она сделала. У Windows и сейчас сохранилась плохая репутация, теперь даже она шпионит за пользователями, и она по-прежнему довольно дорога. Так что Ubuntu Desktop не нужно было тогда и не нужно сейчас делать многое, чтобы сохранить и увеличить аудиторию пользователей.

На серверном рынке Windows, Red Hat и особенно SUSE воспринимались как слишком консервативные решения, слишком неповоротливые и опять же слишком дорогие. Подписка Red Hat Enterprise стоит несколько сотен долларов в год, и эта подписка даже необязательно включает в себя живую человеческую поддержку. Быстроразвивающаяся, менее дорогая альтернатива с некоторой поддержкой от индустрии и гигантским количеством пакетов в репозиториях должна была заинтересовать многих, особенно для облачных решений. То, что Ubuntu выбрали образцовой операционной системой для OpenStack, тоже во многом помогло.

Но с мобильными устройствами всё иначе. Вы не можете просто прошить любую операционную систему на своём телефоне или планшете. Каждое устройство поставляется с кастомным, специально подготовленным билдом Android. Когда Ubuntu объявила о выходе на мобильный рынок в 2013 году, ни Android, ни iOS не были уязвимы, в отличие от ситуации на десктопном рынке. Люди призывали к созданию третьей альтернативы не потому что Android и iOS имели плохую репутацию или какие-то ограничения, или неудобны в использовании, а потому что они (справедливо) опасались монополии Google. Так что нападение на Android и iOS оказалось не таким простым, как на Microsoft и Red Hat на десктопном и серверном рынках.

Я помню, кто-то из Canonical говорил, что проекту нужно захватить около 1% мобильного рынка, чтобы поддерживать себя. В то время это означало продажу около 11 млн телефонов Ubuntu и пару миллионов планшетов ежегодно. Если бы вы умудрились зарабатывать хотя бы один доллар/евро на ПО и сервисах для каждого устройства, то легко оплатили бы труд более сотни разработчиков, это много денег, если правильно их использовать. В компании Jolla, которая разрабатывает Sailfish OS, было около 120 сотрудников в какой-то момент, я думаю, но там были отделы маркетинга и поддержки, которые у Canonical уже имелись в наличии. Но продажа 11 млн телефонов и пары миллионов планшетов в годы была очень амбициозной целью, учитывая, что количество пользователей Ubuntu Desktop находилось где-то в районе 20-30 млн.

- Возможность № 1 добиться одного процента. Быть настолько лучше конкурентов, что вы становитесь стандартом и уже даже не беспокоитесь о каком-то одном проценте. Думаю, мы все знали, что такое невозможно, особенно это стало ясно после того, как все важные сервисы (WhatsApp, Google, Twitter, Instagram и др.) даже не позволяли клонировать их приложения для запуска на устройствах Ubuntu. Canonical не сделала свой собственный клиент Telegram, когда первые коммерческие телефоны Ubuntu вышли на рынок, там вообще не было никакого мессенджера. И это в 2015 году, когда все обмениваются текстовыми сообщениями постоянно. Никто не хотел платить те же деньги за телефон Ubuntu, если он не может делать те же вещи, что и такая же модель под Android, даже если его позиционируют как «устройство для разработчика».

- Возможность № 2 добиться одного процента. Позиционироваться в ниши с глубокими карманами. Canonical слишком сконцентрировалась в нише «Конвергенция», которая не была интересна большому количеству людей, в то же время она игнорировала всех хакеров, мейкеров и людей, которые наелись слежкой со стороны Microsoft, Google и АНБ. Немногие были готовы платить премиальную цену за телефон, который может превратиться в тормознутый ноутбук при подключении к внешнему дисплею, но зато многие были готовы платить премиальную цену за Blackphone.

2. Неудобство для пользователя и искажённые приоритеты

Хочу быть честным: после получения первых нескольких обновлений over-the-air (OTA) я спросил себя: «Будут ли bq и Meizu, а особенно их пользователи мириться с этим?» Телефоны тормозили, их нужно было регулярно перезагружать. Meizu MX4 перегревался. Индикатор батареи часто показывал ложные данные. Мобильные данные работали ненадёжно, (национальный) роуминг часто вообще не работал. Сервис определения местоположения был очень ненадёжен. Телефон не всегда подавал сигнал при входящем звонке или вы не могли сделать исходящий вызов, потому что UI спрятал кнопки. На будильник нельзя было положиться. Bluetooth поддерживал только аудиоустройства, а позже устройства ввода, но никакой передачи файлов даже в базовом виде. WiFi не мог подключиться к сетям WPA Enterprise вплоть до пятого обновления OTA-5. Мне кажется, в какой-то момент аудиоплееер даже начал удалять файлы в процессе их индексации. И так далее.

Список вещей, которые должны были работать, но не работали, очень длинный. Что ещё хуже, несколько раз баги возвращались через несколько обновлений OTA, как регрессия. Во время существования проекта для телефонов/планшетов количество сообщений о багах на Launchpad взлетело так, как я никогда прежде не видел.

Искоренение всех этих багов не являлось главным приоритетом, а разработчики тратили основную часть времени на поддержку большего количества железа (Meizu Pro 5, bq Aquaris 10) и на обеспечение конвергенции. До последнего дня существования проекта пользователи, с которыми я разговаривал, не были довольны устройством. Только те, кто пользовался самым базовым функционалом, как мой отец, у которого даже не была включена функция передачи данных и он делал один звонок в два дня, были довольны, потому что устройство работало днями без подзарядки. Впрочем, купить смартфон за 150 евро, а затем не использовать функции, которые делают его «смарт», не имеет особого смысла.

Как должна была выглядеть конвергенция. Изображение: Canonical

Я понимаю, что не хватало разработчиков, чтобы исправить всё и сразу, но вместо выбора, сделать хороший телефон ИЛИ хороший планшет с конвергенцией, мы получили устройства, которые в реальности ничего не могли сделать как следует. Весь проект постоянно сопровождал эдакий ореол «Это устройства для разработчиков, необязательно исправлять всё быстро, мы выиграем на длинной дистанции» — пока менеджмент не осознал очевидные вещи, что всё это довольно дорого и слишком много времени уже потеряно. Вот тогда они начали сокращать убытки, перевели всех ключевых разработчиков в Snappy в районе октября 2016 года, позволили телефонам и планшетам умереть тихой смертью и несколько месяцев ничего не говорили публике.

Да, и я думаю, что дизайнеры слишком долго держались за идею Scopes. Особенно с учётом того, что никто на самом деле не мог понять, как использовать эти Scopes на десктопе.

3. Устройства было сложно раздобыть и они устаревали

Я думаю, мы все можем согласиться, что реально раздобыть устройство было слишком трудно. Я купил свой первый Nexus 7 в магазине, а Nexus 4 на eBay, но когда проект действительно вышел на серьёзные обороты, эти устройства уже устарели, их стало труднее достать, а вскоре для них перестали выходить официальные билды образов. Устройства bq хотя бы продавались по всей Европе, но чаще всего на странице стояла пометка “out of stock”. Раздобыть MX4 было практически невозможно для всякого, кто не участвовал в программе Ubuntu Phone Insiders. Если людям из США даже и удавалось получить его, то он не подключался к мобильным сетям на полной скорости.

Большую часть 2015 и 2016 годов, если разработчики приложений хотели получить официально поддерживаемое устройство, чтобы тестировать свои приложения, я не знал, что рекомендовать.

С другой стороны, то устройство, которое большинство ждали — исключительно высокопроизводительный Ubuntu Edge — оказалось другим. Устройства bq были дешёвыми, с маленьким объёмом встроенной памяти и только с поддержкой 3G. В MX4 был большой экран, высокая скорость и 4G, но больше ничего, даже отсутствовал разъём для карт SD. Выход HDMI, необходимый для конвергенции, отсутствовал на всех официальных телефонах, а Miracast/Aethercast не был равноценной заменой. Многие думали, что Ubuntu раскроет полный потенциал их железа, например, FM-радио на Aquaris E4.5/E5, но такого не было даже в планах, а без исходников драйверов под Android было практически невозможно добавить такую фичу.

Многие также ожидали, что их телефоны Ubuntu будут изначально более безопасными, чем Android, потому что здесь open source и частые обновления. Очевидно, это было не так, драйверы Android и софт для мобильного передатчика по-прежнему оставались проприетарными и небезопасными, и при этом с полным доступом к железу. Немногие это осознавали.

4. Коммуникации и маркетинг были скорее хаотическими, а иногда вводили в заблуждение

Я тратил огромное количество времени каждый день, пытаясь поспеть за разработкой, но обычно даже я не знал, что появится в следующем OTA, а что уберут. Списки почтовой рассылки, IRC, каналы Telegram, Launchpad, официальные веб-сайты, приватные разговоры между разработчиками, спринты, Ubuntu Online Summit — это было слишком. И это даже не упоминая все секретные разговоры в Canonical, когда они хотели сохранить новость в тайне, чтобы гарантировать максимальное освещение в СМИ в момент анонса.

Поскольку многие сотрудники Canonical работают из дома и в разных часовых поясах, для меня ситуация становилась только хуже. Помню, как пытался помочь с багами «Когда я нажимаю кнопку включения питания, телефон просыпается только через секунду» и «Обманный индикатор аккумулятора». Единственным надёжным местом был Launchpad, так что люди рассчитывали на него. Но иногда намного эффективнее просто поговорить с человеком минуту, прежде чем вы действительно опубликуете что-то ценное к баг-репорту, или просто чтобы решить, с какой стороны подходить к проблеме.

Человек, работающий над исходниками ядра, мог быть где-то в Азии. Сотрудник, который отвечает за все Q&A, мог быть где-то в США. Я был в Европе. Наше рабочее время в реальности не особенно пересекалось. Так что в некоторые дни мне приходилось разговаривать с парнем из Азии в 8:00 утра, пока он не ушёл с работы, а потом с человеком из США в полдень или ночью, когда там только начинается рабочий день.

Рекламируемые функции bq Aquaris E4.5 Ubuntu Edition. Заметьте отсутствие слов «конвергенция», HDMI, FM-радио и многих других вещей, которые люди ожидали, но маркетинг им этого не дал. Изображение: bq

Должен сказать, что я многое узнал от отдела маркетинга, особенно относительно «ожиданий и реальности». Например, многие предполагали как нечто само собой разумеющееся, что Aquaris E4.5/E5 и MX4 получат функцию конвергенции с более поздним обновлением OTA, но ни производители, ни Canonical не обещали это при продаже устройств. До самого момента отмены проекта большинство людей про себя предполагали, что смогут запускать те же приложения, что и на десктопе (Firefox, SIP-клиенты и др.) и управлять приложениями при помощи apt-get, и вот здесь маркетинг стал просто вводить в заблуждение. Было слишком много акцентов на том, что «это та же самая Ubuntu», хотя на самом деле это не так. Не могу припомнить, как часто мне приходилось объяснять случайным людям на различных каналах поддержки, что Firefox не запустится, а apt-get всё сломает. Часто люди очень удивлялись, узнав, что Ubuntu для мобильных настолько отличается.

5. Слишком много акцента на технических фичах, которые не нужны ни пользователям, ни разработчикам приложений

У меня такое чувство, что анонс новой и независимой мобильной операционной системы стал хорошей причиной для архитекторов сказать: «Да, давайте сделаем это, но давайте сделаем это Правильным Способом, и будем лучше остальных». Ubuntu должна была не просто предоставить графический интерфейс пользователя, но такой интерфейс, который будет работать на всех устройствах и в любых форм-факторах. Она не просто изолирует приложения друг от друга, как делает ядро Linux и Android, а реализует полноценную песочницу с защитой данных и приватности. Она магически сделает так, что работающие приложения не будут расходовать заряд батареи. И так далее. Что бы другие не сделали с технической стороны, Ubuntu должна сделать лучше и более элегантным способом.

Не всё это для меня имело смысл. Выпуск Unity 8 был необходим, потому что Unity 7 зависела от Compiz и не очень хорошо подходила для работы на множестве форм-факторов с поворотными дисплеями и т. д. Но единственным делом для Mir была замена X.Org и SurfaceFlinger, так что Unity 8 могла использовать единый API на десктопах и мобильных устройствах. Я не эксперт по графическим технологиям и API, но мне кажется, что хотя бы с точки зрения «у нас не хватает рабочих рук» разработка полностью нового графического сервера, который никто больше не хочет использовать и который не добавляет ничего особенного по сравнению с существующими альтернативами, — это то, чего следовало избегать любой ценой. Особенно если пользователь никогда не увидит разницу. Ubuntu Touch спокойно использовала Android SurfaceFlinger до конца 2013 года.

По-моему, то же самое относится к модели изоляции и жизненному циклу. Если вы усложняете дизайн, чтобы может быть сэкономить немножко энергии аккумулятора, и эта сложность ведёт к большой дополнительной работе по реализации системных сервисов, но эти сервисы никогда так и не будут реализованы, потому что ваша группа разработки слишком мала, то вряд ли ваши пользователи и разработчики приложений похвалят вас за то, что устройства работают чуть дольше. Скорее они будут бесконечно жаловаться на отсутствующие вещи. Вот почему баг-репорт «Закончить реализацию высокоприоритетных фоновых сервисов» разогрелся до 240 градусов — прошло три года с момента анонса проекта, но практически ничего не было сделано в этом отношении.

Ещё один хороший пример — запланированный фреймворк для сообщений. Вы должны были получить одно системное приложение для всех типов сообщений, будь то Jabber/XMPP, SMS, Telegram или WhatsApp, а сторонние сервисы могли выпускать плагины для своих протоколов. Этот фреймворк был одной из основных причин, почему приложениям запрещали работать в фоновом режиме. Так что вы не могли просто сделать отдельный XMPP-клиент, который бы получал сообщения в фоне. Но фреймворк для сообщений, к которому вы должны были выпустить плагин, задерживался и в итоге так никогда и не вышел. Даже клиент Telegram не мог работать в фоне, он мог показывать только всплывающие сообщения, потому что Canonical убедила разработчиков Telegram изменить их серверный код (!) для поддержки сервиса Ubuntu Push Notification.

Некоторые ключевые разработчики в Canonical действительно думали, что Ubuntu настолько важна, что все сервис-провайдеры изменят свои серверные коды для поддержки Ubuntu Push Notification, и это решит проблему. Никто кроме Telegram даже не задумался об этом.

(Кстати, я по-пренему думаю, что модель жизненного цикла не привела бы к заметной экономии батареи. Если подумать, то в ней всегда будет расходоваться такое же, а часто и большее количество циклов CPU).

6. Жизнь разработчиков приложений была слишком сложной

Современная мобильная ОС — это больше, чем ОС. Это экосистема. И вот здесь Ubuntu провалилась сильнее всего.

Ubuntu для мобильных устройств оказалась фундаментально несовместима с любым окружением для исполнения программ, какое существовало до него. Она не могла запускать приложения Android, Windows, X11 или iOS. Вы не могли просто перекомпилировать приложения Android, Windows, X11 или iOS. Графическая система, системные сервисы, песочница, набор базовых библиотек — всё было другим. Она даже полностью отличалась от Ubuntu Desktop. Можете целыми днями говорить, что «Это та же самая Ubuntu», но если я даже не могу протестировать свои приложения на десктопе, потому что там не запускается Mir, то это не та же самая Ubuntu и мне нужно разрабатывать для двух разных платформ.

Canonical пришла и сделала целый SDK, Integrated Development Environment на базе Qt Creator, плюс среду кросс-компиляции, плюс полностью новый набор компонентов Ubuntu QML. Я действительно не хочу никого здесь обидеть, но помимо неиспользования существующего кода, то, как всё это было сделано, оказалось крайне запутанным и стало разочарованием для разработчиков приложений. Ничего не работало, всё изменялось и ломалось постоянно. Иногда SDK был сломан неделями. Появились схемы версионирования, но ваше приложение всё равно не работало.

В какой-то момент мне пришлось пересобирать и обновлять моё приложение glmark2 в каталоге, потому что вышел OTA с обновлёнными клиентскими библиотеками Mir, хотя ОС заявляла тот же уровень совместимости, что и раньше. Затем стало ясно, что схема версионирования просто гарантирует, что официальный метод написания приложения гарантированно работает, но официальный метод — это просто QML и HTML5. Программа glmark2 взаимодействовала напрямую с Mir, как и многие другие (например, игры с использованием SDL). Приложения в каталоге могли просто прекратить работать, если не проверять и обновлять их после каждого OTA. Вы по-прежнему можете запускать старые Android-приложения на современном Android-смартфоне, но вот приложение Click с прошлого года может прекратить работу после следующего OTA, если вы не отслеживаете его постоянно. Я помню яркую дискуссию в IRC в конце 2015 года, во время которой несколько разработчиков Canonical были озадачены этим фактом и спрашивали у сотрудников группы SDK, как, по их мнению, разработчикам приложений работать в таких условиях.

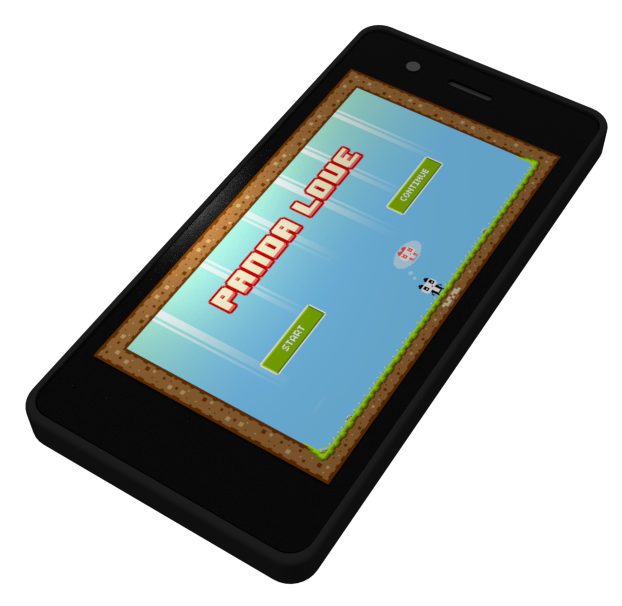

Рендеринг bq Aquaris E4.5 с игрой Panda Love, одним из моих приложений в Click Store

Я начинал как разработчик приложений. Что бы я ни хотел сделать, начинать приходилось практически с нуля. Сделать GUI? Поддерживался только QML с компонентами Ubuntu QML, а QML не назовёшь устоявшейся экосистемой с большим количеством существующего кода и хорошим инструментарием. Просто использовать одну из существующих библиотек UI? Они все предназначены для работы с X11 или, может быть, Wayland, и прошло немало времени, пока SDL и прочие получили бэкенды для Mir. Коммуникации с железом и системными сервисами? Из-за песочницы было трудно обращаться напрямую к специализированным сервисам Ubuntu через D-Bus, к большинству «стандартных» процессов вроде NetworkManager нельзя было обращаться изнутри песочницы. Скачать что-нибудь в фоновом режиме? Для этого нужно обращаться к специальному менеджеру скачиваний Ubuntu. Получить уведомления о событиях за пределами телефона? Только если интегрируете всё с сервисом Ubuntu Push Notification.

Вот почему мне пришлось начинать работу с самой базовой системы. Тогда в январе 2015-го я хотел сделать сканеры WiFi и Bluetooth, но всех необходимых API и системных сервисов просто ещё не существовало. Многие из отсутствующих API и системных сервисов так никогда и не появились.

Всё это делало платформу крайне непривлекательной для большинства сторонних разработчиков. Они не видели, как могут окупиться их инвестиции в создание ещё одной версии приложения с нуля, особенно с учётом маленькой пользовательской базы. Я не помню ни одного приложения, которое в Click Store закачал бы его «оригинальный» разработчик. Даже клиент Telegram разработала сама Canonical.

Так что многие из нас создавали простенькие веб-приложения или клонировали существующие приложения. И немедленно столкнулись с проблемой, что многие приложения полагаются на некий вид несвободного онлайнового сервиса с очень невыгодными условиями использования. Лично я разработал BD Navigator, клон Deutsche Bahn Navigator. Я провёл обратную разработку их клиент-серверного протокола до той точки, где мог копировать практически всё, кроме покупки настоящего билета на поезд, но они встроили небольшой фрагмент криптографии, а использование краденых криптографических ключей в Германии незаконно. Я спросил разрешения у Deutsche Bahn, они отказали. В конце концов всё приложение целиком деградировало до уровня величественного веб-контейнера с закладками на их мобильные веб-страницы.

Точно то же самое справедливо для WhatsApp, Twitter, Instagram, Google Plus, Google Drive и других. Мы можем скопировать много чего, но сервис-провайдеры не разрешают нам делать это. Говорят, что WhatsApp запросил семизначную сумму просто за доступ к их API, а не за разработку полноценного клиента. Instagram настолько закрыл свои API, что даже встроенный Instagram Scope пришлось удалить. У Google для многих сервисов нет публичного API.

(Также небольшое количество нердов open source никогда бы не смогли поддерживать актуальную коллекцию клонов для всех популярных приложений. Это просто не масштабируется).

7. Она не была такой открытой и не пользовалась такой общественной поддержкой, как предполагалось

Теперь я понимаю, что это заявление может быть противоречивым, и если вы не согласны, пожалуйста, имейте в виду, что это исключительно мои ощущения. Может быть, я в меньшинстве. Понятия не имею.

Ubuntu для мобильных устройств должна была стать такой же открытой, как «нормальная» Ubuntu, но этого не произошло.

- Исходный код всего, что мы разрабатывали, был где-то распределён по неизвестному количеству проектов Launchpad.

- Исходники ядра на GitHub часто были устаревшими.

- Код всех проприетарных драйверов Android и другого софта был доступен только сотрудникам Canonical.

- У Canonical и её коммерческих партнёров имелась полностью приватная зона Launchpad с приватными баг-репортами. Довольно часто в публичных баг-репортах встречались ссылки на приватные страницы, так что у вас была только половина информации.

- Большую часть информации о будущих устройствах сообщество получало с помощью поиска случайных утечек информации, по большей мере на paste.ubuntu.com.

- Узнав о будущей фиче, мы часто обнаруживали, что соответствующий проект Launchpad открыт неделями или месяцами ранее под кодовым названием или что разработчики Canonical месяцами работают над ним в приватных репозиториях. Например, так было с Aethercast.

- Не будучи сотрудником Canonical, вам было трудно понять, над чем идёт работа, что запланировано и где вы можете помочь.

- Если вы нашли, где помочь, то очень трудно установить контакт с разработчиками Canonical. У них рабочий день как минимум восемь часов, но у вас нет восьми часов свободного времени, а ваше свободное время часто не совпадает с их рабочим графиком.

- У меня никогда не возникало ощущение, что пожелания пользователей и более широкого сообщества имеет какое-то влияние на список будущих фич или на то, что войдёт в следующий OTA. Во многих случаях баг-репорты Launchpad и запросы функций с наибольшей поддержкой задерживались дольше остальных.

FAQ

Вот некоторые вопросы, которые мне иногда задают.

Сколько устройств вы купили для разработки?

Думаю, что купил два новых Nexus 7, два использованных Nexus 4, три новых bq Aquaris E4.5 и два дешёвых китайских телефона Mediatek (для реверс-инжиниринга) специально для работы с Ubuntu. Также у меня был MX4 от Canonical. Думаю, я потратил где-то больше тысячи евро на семь телефонов и два планшета.

Вы когда-нибудь оценивали затраченное время?

Да. После всех расчётов у меня вышло шесть человеко-месяцев за полуторалетний период или объём работы, аналогичный тому, если бы Canonical наняла меня на 30% ставки.

Вы жалеете, что потратили столько времени и усилий?

Нет

Когда вы впервые начали сомневаться, что всё получится?

Если не ошибаюсь, это было в районе Рождества 2015 года. Большая шумиха вроде как закончилась, и стало ясно, что мы никогда не получим полноценные приложения WhatsApp, Twitter и другие, а для многих владельцев телефонов планируется не так уже много «реально» важной функциональности. Шла работа над конвергенцией для планшета, но немногим удалось заполучить bq Aquaris M10.

Помните, что я начал работать над базовой операционной системой только потому, что не мог создать половину приложений, какие хотел. После года работы не был закончен ни один API или системный сервис, необходимый мне, и мы всё ещё спорили с некоторыми системными архитекторами о необходимости всех этих вещей в принципе. Когда ваши разработчики приложений говорят, что вам нужно нечто для создания классных приложений, просто дайте им то, с чем вы как архитектор можете ужиться в обозримом будущем. Оно необязательно должно быть идеальным, но разработчики приложений нужны вам больше, чем вы им.

Вы ушли в середине 2016-го, задолго до закрытия проекта. Почему?

С одной стороны, разработка ПО стала меньше интересовать меня. Сейчас я б'oльшую часть времени путешествую по миру, фотографирую, делаю плохие карточные игры, плохие комиксы и плохие игры.

С другой стороны, я больше не чувствовал, что работа над проектом приносит мне радость. Иногда я думал «Я делаю недостаточно, это моя вина», просидев над устройством восемь часов подряд. Не такие чувства должны быть у человека, который работает над проектом в свободное время ради удовольствия.

|

|

Когда мне вышлют оффер? Подсказки для соискателей от HR-менеджера |

Многие из нас бывали на этом месте: собеседование прошло нормально, компания — классная, HR-менеджер — адекватный, но почему-то не перезванивают. Международный HR компании Appodeal Галина Токарева поделилась инсайтами, которые спасут от тревожных мыслей и помогут лучше разобраться в процессе рекрутинга в IT и геймдеве.

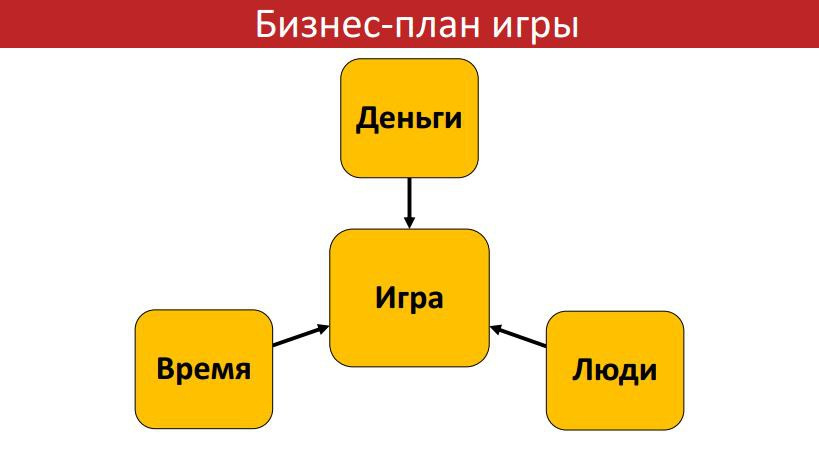

Как правило, в представлении соискателя процесс довольно прямолинейный.

Однако на деле все немного сложнее — и это не вовсе не выдумки эйчарщика, которому нравится вас пытать ожиданием. Процесс рекрутинга действительно может растянуться надолго, но при должном информировании со стороны компании и HR он должен быть не таким уж и мучительным.

Как открывается вакансия?

В Appodeal сначала определяется потребность в новом сотруднике — руководитель команды (Team Lead) обращается с запросом к HR. Потребность в вакансии согласовывается с Head of Moscow Office. Вакансия вносится в рекрутинговый план CIS-региона (это cтраны СНГ) и на нее заполняется отдельная заявка.

После инициирования вакансии мы составляем ее описание — здесь указываются общая информация и требования к кандидату, а также расписывается процесс подбора.

Работа над вакансией — стандартный процесс по поиску, привлечению и отбору кандидатов. Ничего сверхъестественного в этом этапе нет, однако при подачи заявки не стоит забывать, что кроме вас у специалиста есть от 5 до 15 кандидатов. Их заявки и резюме тоже нужно детально изучить, а после — провести одно или несколько интервью, которые занимают от 1 до 2 часов рабочего времени. Именно поэтому не стоит паниковать, если вам не перезвонили через два дня после интервью — HR просто обязан рассмотреть всех кандидатов и не может сделать стремительный выбор в вашу пользу в силу своих должностных обязательств.

Во время интервью HR-менеджер сообщает сроки, в течение которых вам дадут ответ — обычно это максимальные сроки, и они варьируются в зависимости от позиции. В порядочной компании эти сроки всегда соблюдаются, но опять же, стоит помнить, что сообщить вам о решении могут в самый последний момент — просто из-за потока кандидатов и внутреннего согласования. Вы имеете право в любое время обратиться к HR и уточнить, на каком этапе рассмотрения находится ваше резюме. Не забывайте, что кандидаты могут обозначать критичные для них сроки получения ответа от компании — для HR такой подход даже удобнее.

Что может повлиять на сроки?

Случается и так, что вакансия была приостановлена. HR-специалисты — тоже люди, и они тоже уходят в отпуска и заболевают. Соответственно, поиск кандидатов приостанавливается. Иногда в процессе поиска пересматривается рекрутинговый план — количество вакансий или требование к кандидатам, о чем вам тоже должны сообщить (по крайней мере, мы сообщаем). Вакансия считается закрытой, когда кандидат найден, принял Job Offer и вышел на работу или вакансия отменена из-за пересмотра плана и отсутствия потребности в сотруднике. HR может вздохнуть спокойно только тогда, когда его кандидат прошел испытательный срок. Как правило, вакансию переносят в архив только после выхода сотрудника на работу. Поэтому вакансия еще некоторое время может висеть на сайте компании (или на HR-ресурсах), а ваши отклики — просто разбираться, добавляться в базу. Кандидатам в этот период будет приходить стандартное сообщение о рассмотрении.

Как только принятый кандидат проходит испытательный срок, HR-специалист меняет статус вакансии на «закрыта» на всех ресурсах, фиксирует данные о сотруднике и планируемую дату выхода на работу в специальной таблице.

Чем выше уровень навыков специалиста и степень его ответственности, тем больше времени занимает его поиск и отбор кандидатов.

Ниже — таблица сроков, на которую можно ориентироваться, если вы подали резюме. Мы в Appodeal стараемся следовать потребностям бизнеса и закрываем вакансии по принципу “чем скорее, тем лучше”, то есть, HR работают на полную катушку и опережает сроки, указанные в таблице:)

Чтобы меньше волноваться о сроках, быть более уверенным в своих возможностях и не стушеваться на собеседовании, мы рекомендуем соблюдать несложный чек-лист.

Особое внимание уделите информации о компании

Невероятно, но факт: нам очень часто встречаются кандидаты, которые понятия не имеют, чем мы занимаемся. Узнать подробности и задать вопросы — отличный способ понравиться HR и понять, подходите ли вы компании и, что немаловажно, подходит ли она вам. На сайтах компании (в том числе, и на нашем) в разделе “Карьера”, “Вакансии” или “Работа у нас” часто прописаны основные ценности компании, есть фотографии офиса и потенциальных коллег. Не поленитесь вбить в поисковик название компании плюс “интервью” или “статья”, чтобы почитать, что пишут о будущем месте работы в СМИ, если пишут вообще. Полчаса потраченного времени и искренняя заинтересованность в том, чем занимается компания, могут здорово сыграть вам на руку — а вот явное безразличие не спасет даже с учетом хорошего резюме.

Почему важно найти рекомендателя среди сотрудников компании?

Это всегда повышает шансы на успех, так как во многих компаниях действует рекомендательная система. Не стоит срочно добавляться ко всем наугад в Фейсбуке, однако вспомните — возможно, на какой-нибудь конференции у вас был задушевный профессиональный разговор с кем-нибудь из девелоперов. Не стесняйтесь написать знакомому — он получит за это бонус или просто благодарность от коллег, а вы обеспечите себе подушку безопасности на случай высокой конкуренции.

С открытыми вакансиями компании Appodeal можно ознакомиться по ссылке.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

|

Автоэнкодеры в Keras, Часть 4: Conditional VAE |

Содержание

- Часть 1: Введение

- Часть 2: Manifold learning и скрытые (latent) переменные

- Часть 3: Вариационные автоэнкодеры (VAE)

- Часть 4: Conditional VAE

- Часть 5: GAN (Generative Adversarial Networks) и tensorflow

- Часть 6: VAE + GAN

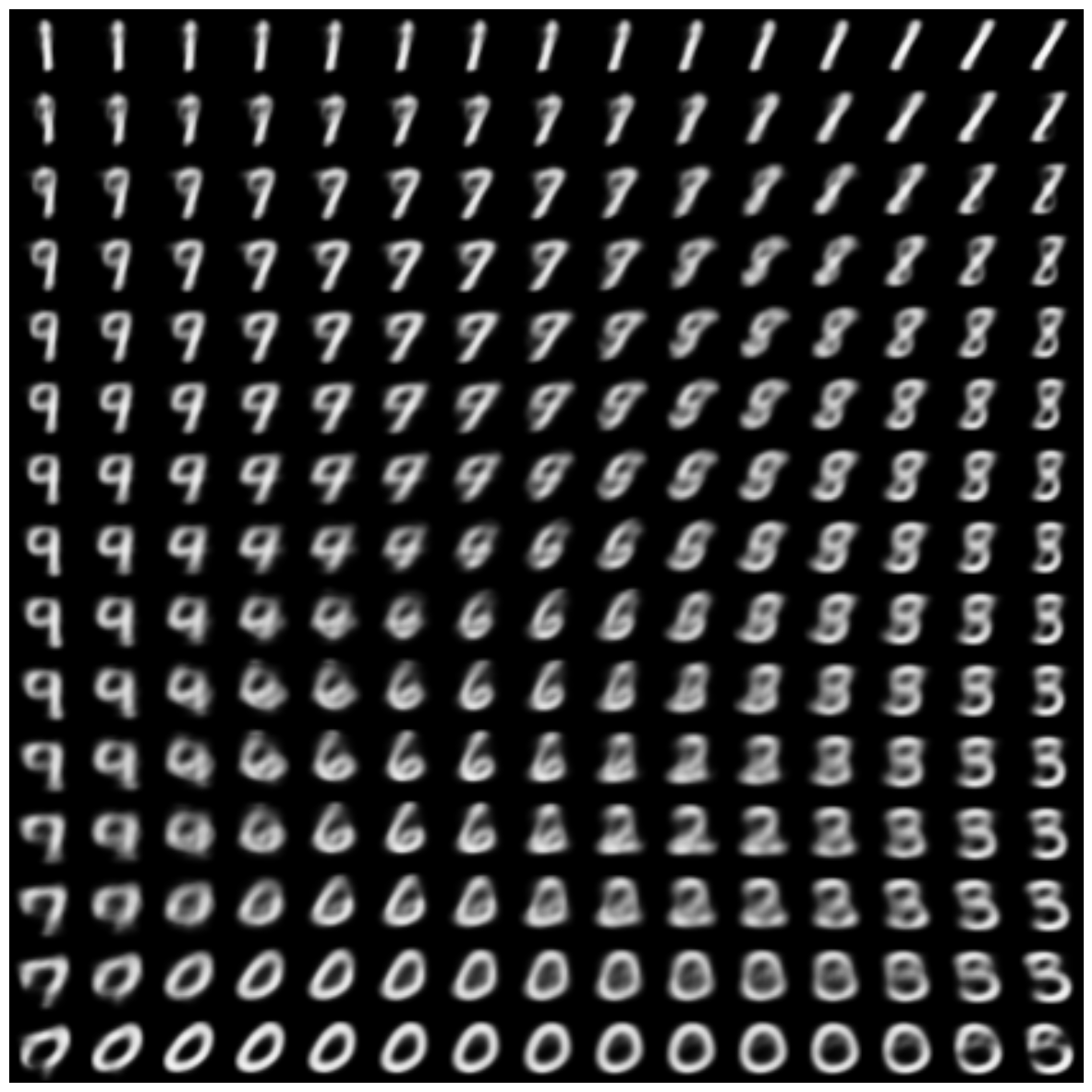

В прошлой части мы познакомились с вариационными автоэнкодерами (VAE), реализовали такой на keras, а также поняли, как с его помощью генерировать изображения. Получившаяся модель, однако, обладала некоторыми недостатками:

- Не все цифры получилось хорошо закодировать в скрытом пространстве: некоторые цифры либо вообще отсутствовали, либо были очень смазанными. В промежутках между областями, в которых были сконцентрированы варианты одной и той же цифры, находились вообще какие-то бессмысленные иероглифы.

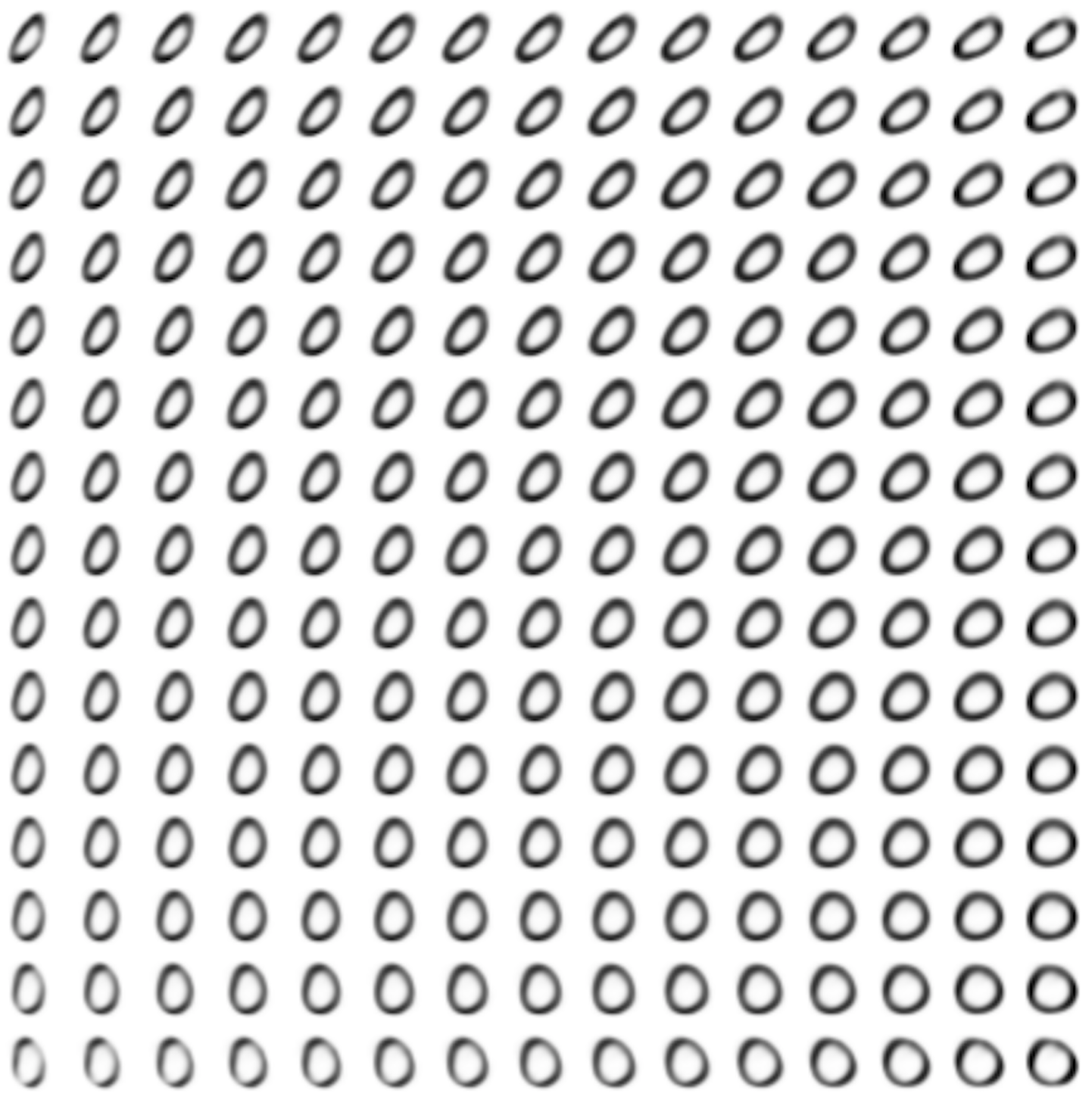

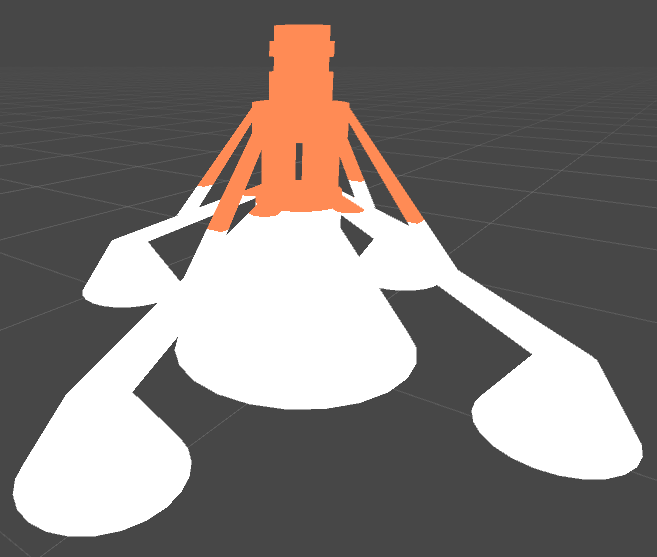

Что тут писать, вот так выглядели сгенерированные цифры:

Картинка

- Сложно было генерировать картинку какой-то заданной цифры. Для этого надо было смотреть, в какую область латентного пространства попадали изображения конкретной цифры, и сэмплить уже откуда-то оттуда, а тем более было сложно генерировать цифру в каком-то заданном стиле.

В этой части мы посмотрим, как можно лишь совсем немного усложнив модель преодолеть обе эти проблемы, и заодно получим возможность генерировать картинки новых цифр в стиле другой цифры – это, наверное, самая интересная фича будущей модели.

Сначала подумаем о причинах 1-го недостатка:

Многообразия, на которых лежат различные цифры, могут быть далеко друг от друга в пространстве картинок. То есть сложно представить, как, например, непрерывно отобразить картинку цифры „5“, в картинку цифры „7“, при том, чтобы все промежуточные картинки можно было назвать правдоподобными. Таким образом, многообразие, около которого лежат цифры, вовсе не обязано быть линейно связанным. Автоэнкодер же, в силу того что является композицией непрерывных функций, сам может отображать в код и обратно только непрерывно, особенно если это вариационный автоэнкодер. В нашем предыдущем примере все усложнялось еще и тем, что автоэнкодер пытался искать двумерное многообразие.

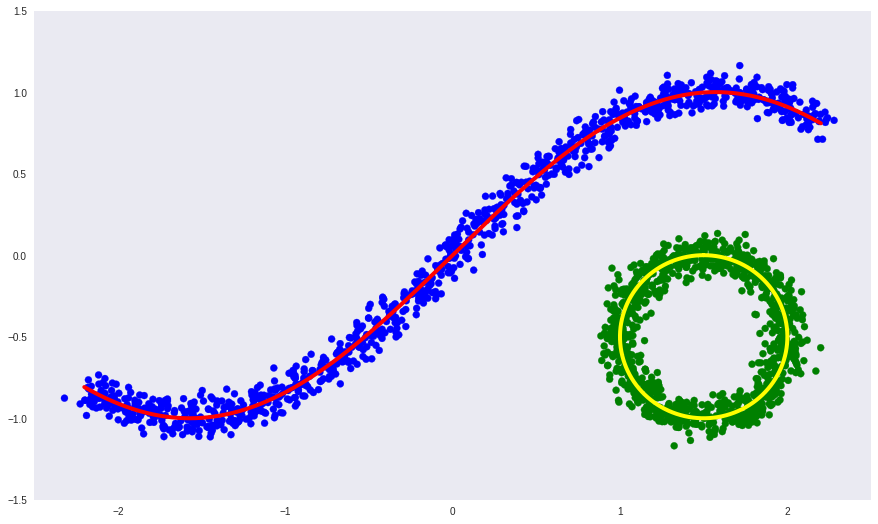

В качестве иллюстрации вернемся к нашему искусственному примеру из 2-ой части, только сделаем определяющее многообразие несвязным:

Здесь:

- синие и зеленые точки — объекты выборки,

- красная и желтая кривые — несвязанное определяющее многообразие.

Попробуем теперь выучить определяющее многообразие с помощью обычного глубокого автоэнкодера.

# Импорт необходимых библиотек

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

# Создание датасета

x1 = np.linspace(-2.2, 2.2, 1000)

fx = np.sin(x1)

dots1 = np.vstack([x1, fx]).T

t = np.linspace(0, 2*np.pi, num=1000)

dots2 = 0.5*np.array([np.sin(t), np.cos(t)]).T + np.array([1.5, -0.5])[None, :]

dots = np.vstack([dots1, dots2])

noise = 0.06 * np.random.randn(*dots.shape)

labels = np.array([0]*1000 + [1]*1000)

noised = dots + noise

# Визуализация

colors = ['b']*1000 + ['g']*1000

plt.figure(figsize=(15, 9))

plt.xlim([-2.5, 2.5])

plt.ylim([-1.5, 1.5])

plt.scatter(noised[:, 0], noised[:, 1], c=colors)

plt.plot(dots1[:, 0], dots1[:, 1], color="red", linewidth=4)

plt.plot(dots2[:, 0], dots2[:, 1], color="yellow", linewidth=4)

plt.grid(False)

# Модель и обучение

from keras.layers import Input, Dense

from keras.models import Model

from keras.optimizers import Adam

def deep_ae():

input_dots = Input((2,))

x = Dense(64, activation='elu')(input_dots)

x = Dense(64, activation='elu')(x)

code = Dense(1, activation='linear')(x)

x = Dense(64, activation='elu')(code)

x = Dense(64, activation='elu')(x)

out = Dense(2, activation='linear')(x)

ae = Model(input_dots, out)

return ae

dae = deep_ae()

dae.compile(Adam(0.001), 'mse')

dae.fit(noised, noised, epochs=300, batch_size=30, verbose=2)

# Результат

predicted = dae.predict(noised)

# Визуализация

plt.figure(figsize=(15, 9))

plt.xlim([-2.5, 2.5])

plt.ylim([-1.5, 1.5])

plt.scatter(noised[:, 0], noised[:, 1], c=colors)

plt.plot(dots1[:, 0], dots1[:, 1], color="red", linewidth=4)

plt.plot(dots2[:, 0], dots2[:, 1], color="yellow", linewidth=4)

plt.scatter(predicted[:, 0], predicted[:, 1], c='white', s=50)

plt.grid(False)

- белая линия — многообразие в которое переходят синие и зеленые точки данных после автоэнкодера, то есть попытка автоэнкодера построить многообразие, определяющее больше всего вариации в данных.

Видно, что у простого автоэнкодера не получилось выучить форму несвязного многообразия. Вместо этого он хитро продолжил одно в другое.

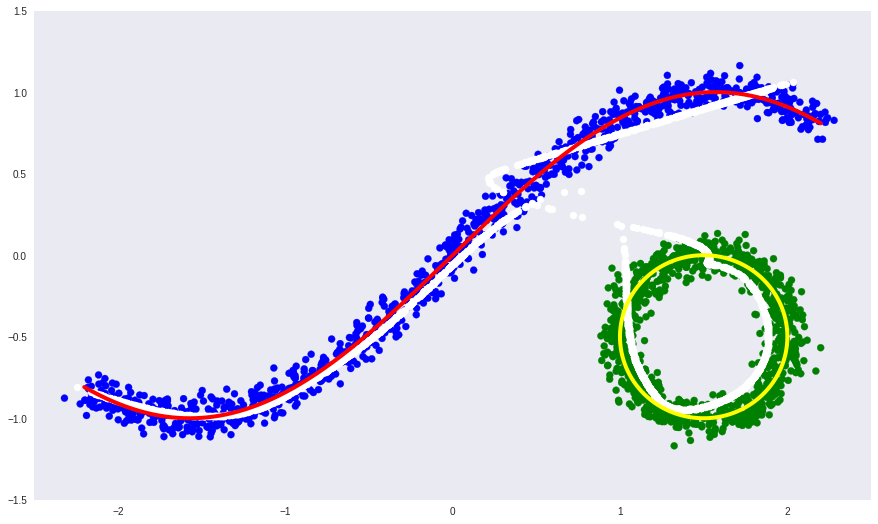

Если же мы знаем лейблы данных, которые определяют на каком из частей несвязного многообразия лежат эти данные (как с цифрами), то мы можем просто condition автоэнкодер на этих лейблах. То есть просто дополнительно с данными подавать на вход энкодеру и декодеру еще и лейблы данных. В таком случае источником разрывности в данных будет лейбл, и это позволит автоэнкодеру выучить каждую часть линейно несвязного многообразия отдельно.

Посмотрим на тот же самый пример, только теперь на вход и энкодеру, и декодеру будем передавать дополнительно еще и лейбл.

from keras.layers import concatenate

def deep_cond_ae():

input_dots = Input((2,))

input_lbls = Input((1,))

full_input = concatenate([input_dots, input_lbls])

x = Dense(64, activation='elu')(full_input)

x = Dense(64, activation='elu')(x)

code = Dense(1, activation='linear')(x)

full_code = concatenate([code, input_lbls])

x = Dense(64, activation='elu')(full_code)

x = Dense(64, activation='elu')(x)

out = Dense(2, activation='linear')(x)

ae = Model([input_dots, input_lbls], out)

return ae

cdae = deep_cond_ae()

cdae.compile(Adam(0.001), 'mse')

cdae.fit([noised, labels], noised, epochs=300, batch_size=30, verbose=2)

predicted = cdae.predict([noised, labels])

# Визуализация

plt.figure(figsize=(15, 9))

plt.xlim([-2.5, 2.5])

plt.ylim([-1.5, 1.5])

plt.scatter(noised[:, 0], noised[:, 1], c=colors)

plt.plot(dots1[:, 0], dots1[:, 1], color="red", linewidth=4)

plt.plot(dots2[:, 0], dots2[:, 1], color="yellow", linewidth=4)

plt.scatter(predicted[:, 0], predicted[:, 1], c='white', s=50)

plt.grid(False)

На этот раз автоэнкодеру удалось выучить линейно несвязное определяющее многообразие.

CVAE

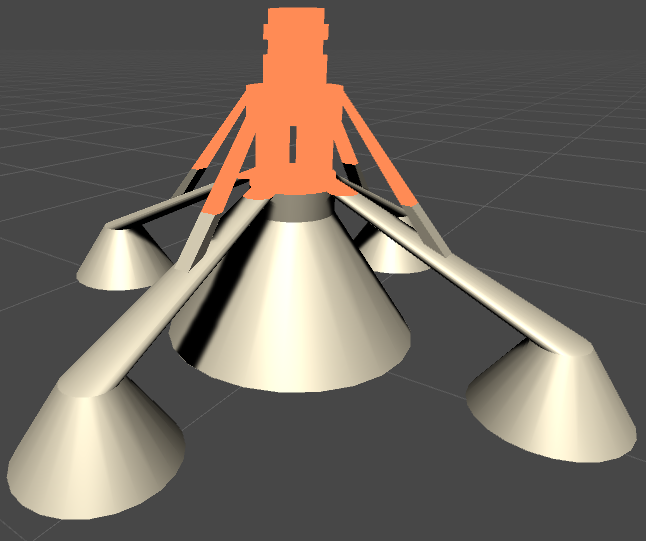

Если же теперь взять VAE, как в предыдущей части, и подавать на вход еще и лейблы, то получится Conditional Variational Autoencoder (CVAE).

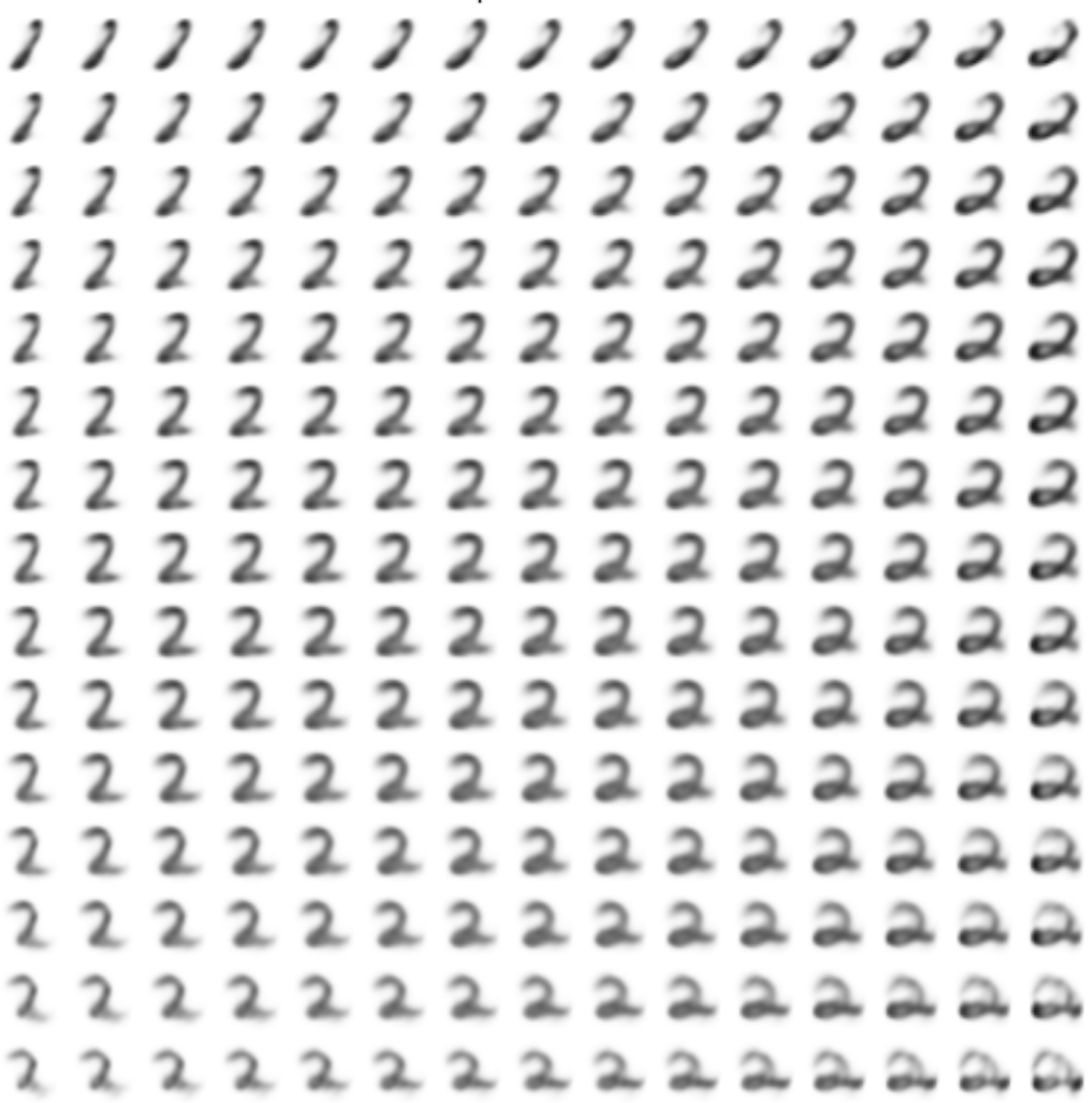

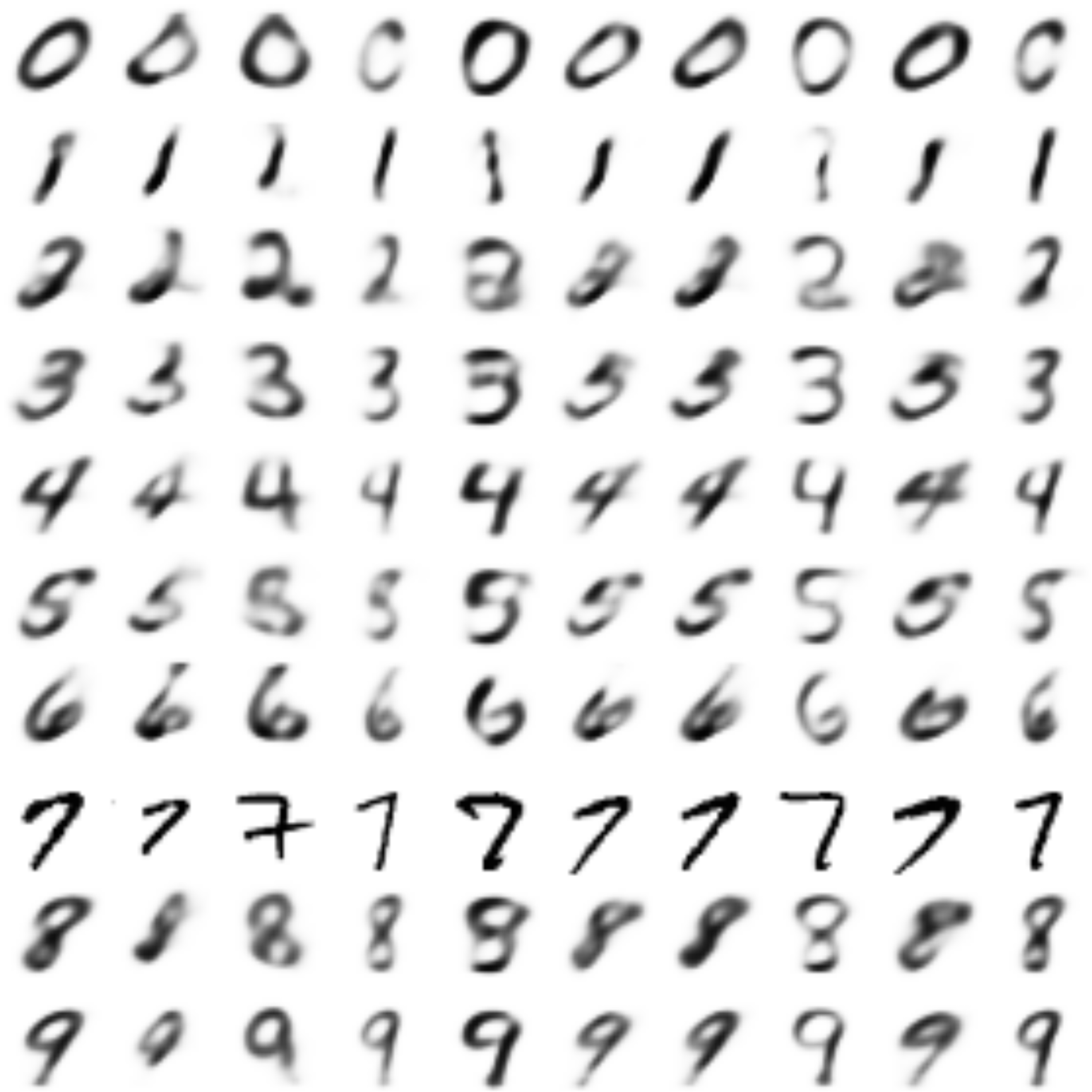

С картинками цифр получается вот так:

Картинка выше из [2]

В этом случае основное уравнение VAE из прошлой части становится просто conditioned на

Это можно интерпретировать так: для каждого

В результате получается, что CVAE кодирует в

Перенос стиля

(Комментарий: это не то же самое, что перенос стиля в Prisme, там совсем другое)

Теперь становится понятно, как создавать новые картинки в стиле заданной:

- обучаем CVAE на картинках с лейблами,

- кодируем стиль заданной картинки в

,

- меняя лейблы

, создаем из закодированного

новые картинки.

Код на Keras

Код практически идентичен коду из предыдущей части, за исключением того, что теперь в энкодер и декодер передается и лейбл цифры.

import sys

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

# import seaborn as sns

from keras.datasets import mnist

from keras.utils import to_categorical

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test .astype('float32') / 255.

x_train = np.reshape(x_train, (len(x_train), 28, 28, 1))

x_test = np.reshape(x_test, (len(x_test), 28, 28, 1))

y_train_cat = to_categorical(y_train).astype(np.float32)

y_test_cat = to_categorical(y_test).astype(np.float32)

num_classes = y_test_cat.shape[1]

batch_size = 500

latent_dim = 8

dropout_rate = 0.3

start_lr = 0.001

from keras.layers import Input, Dense

from keras.layers import BatchNormalization, Dropout, Flatten, Reshape, Lambda

from keras.layers import concatenate

from keras.models import Model

from keras.objectives import binary_crossentropy

from keras.layers.advanced_activations import LeakyReLU

from keras import backend as K

def create_cvae():

models = {}

# Добавим Dropout и BatchNormalization

def apply_bn_and_dropout(x):

return Dropout(dropout_rate)(BatchNormalization()(x))

# Энкодер

input_img = Input(shape=(28, 28, 1))

flatten_img = Flatten()(input_img)

input_lbl = Input(shape=(num_classes,), dtype='float32')

x = concatenate([flatten_img, input_lbl])

x = Dense(256, activation='relu')(x)

x = apply_bn_and_dropout(x)

# Предсказываем параметры распределений

# Вместо того чтобы предсказывать стандартное отклонение, предсказываем логарифм вариации

z_mean = Dense(latent_dim)(x)

z_log_var = Dense(latent_dim)(x)

# Сэмплирование из Q с трюком репараметризации

def sampling(args):

z_mean, z_log_var = args

epsilon = K.random_normal(shape=(batch_size, latent_dim), mean=0., stddev=1.0)

return z_mean + K.exp(z_log_var / 2) * epsilon

l = Lambda(sampling, output_shape=(latent_dim,))([z_mean, z_log_var])

models["encoder"] = Model([input_img, input_lbl], l, 'Encoder')

models["z_meaner"] = Model([input_img, input_lbl], z_mean, 'Enc_z_mean')

models["z_lvarer"] = Model([input_img, input_lbl], z_log_var, 'Enc_z_log_var')

# Декодер

z = Input(shape=(latent_dim, ))

input_lbl_d = Input(shape=(num_classes,), dtype='float32')

x = concatenate([z, input_lbl_d])

x = Dense(256)(x)

x = LeakyReLU()(x)

x = apply_bn_and_dropout(x)

x = Dense(28*28, activation='sigmoid')(x)

decoded = Reshape((28, 28, 1))(x)

models["decoder"] = Model([z, input_lbl_d], decoded, name='Decoder')

models["cvae"] = Model([input_img, input_lbl, input_lbl_d],

models["decoder"]([models["encoder"]([input_img, input_lbl]), input_lbl_d]),

name="CVAE")

models["style_t"] = Model([input_img, input_lbl, input_lbl_d],

models["decoder"]([models["z_meaner"]([input_img, input_lbl]), input_lbl_d]),

name="style_transfer")

def vae_loss(x, decoded):

x = K.reshape(x, shape=(batch_size, 28*28))

decoded = K.reshape(decoded, shape=(batch_size, 28*28))

xent_loss = 28*28*binary_crossentropy(x, decoded)

kl_loss = -0.5 * K.sum(1 + z_log_var - K.square(z_mean) - K.exp(z_log_var), axis=-1)

return (xent_loss + kl_loss)/2/28/28

return models, vae_loss

models, vae_loss = create_cvae()

cvae = models["cvae"]

from keras.optimizers import Adam, RMSprop

cvae.compile(optimizer=Adam(start_lr), loss=vae_loss)

digit_size = 28

def plot_digits(*args, invert_colors=False):

args = [x.squeeze() for x in args]

n = min([x.shape[0] for x in args])

figure = np.zeros((digit_size * len(args), digit_size * n))

for i in range(n):

for j in range(len(args)):

figure[j * digit_size: (j + 1) * digit_size,

i * digit_size: (i + 1) * digit_size] = args[j][i].squeeze()

if invert_colors:

figure = 1-figure

plt.figure(figsize=(2*n, 2*len(args)))

plt.imshow(figure, cmap='Greys_r')

plt.grid(False)

ax = plt.gca()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

n = 15 # Картинка с 15x15 цифр

from scipy.stats import norm

# Так как сэмплируем из N(0, I), то сетку узлов, в которых генерируем цифры, берем из обратной функции распределения

grid_x = norm.ppf(np.linspace(0.05, 0.95, n))

grid_y = norm.ppf(np.linspace(0.05, 0.95, n))

def draw_manifold(generator, lbl, show=True):

# Рисование цифр из многообразия

figure = np.zeros((digit_size * n, digit_size * n))

input_lbl = np.zeros((1, 10))

input_lbl[0, lbl] = 1

for i, yi in enumerate(grid_x):

for j, xi in enumerate(grid_y):

z_sample = np.zeros((1, latent_dim))

z_sample[:, :2] = np.array([[xi, yi]])

x_decoded = generator.predict([z_sample, input_lbl])

digit = x_decoded[0].squeeze()

figure[i * digit_size: (i + 1) * digit_size,

j * digit_size: (j + 1) * digit_size] = digit

if show:

# Визуализация

plt.figure(figsize=(10, 10))

plt.imshow(figure, cmap='Greys_r')

plt.grid(False)

ax = plt.gca()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

return figure

def draw_z_distr(z_predicted, lbl):

# Рисование рпспределения z

input_lbl = np.zeros((1, 10))

input_lbl[0, lbl] = 1

im = plt.scatter(z_predicted[:, 0], z_predicted[:, 1])

im.axes.set_xlim(-5, 5)

im.axes.set_ylim(-5, 5)

plt.show()

from IPython.display import clear_output

from keras.callbacks import LambdaCallback, ReduceLROnPlateau, TensorBoard

# Массивы, в которые будем сохранять результаты для последующей визуализации

figs = [[] for x in range(num_classes)]

latent_distrs = [[] for x in range(num_classes)]

epochs = []

# Эпохи, в которые будем сохранять

save_epochs = set(list((np.arange(0, 59)**1.701).astype(np.int)) + list(range(10)))

# Отслеживать будем на вот этих цифрах

imgs = x_test[:batch_size]

imgs_lbls = y_test_cat[:batch_size]

n_compare = 10

# Модели

generator = models["decoder"]

encoder_mean = models["z_meaner"]

# Функция, которую будем запускать после каждой эпохи

def on_epoch_end(epoch, logs):

if epoch in save_epochs:

clear_output() # Не захламляем output

# Сравнение реальных и декодированных цифр

decoded = cvae.predict([imgs, imgs_lbls, imgs_lbls], batch_size=batch_size)

plot_digits(imgs[:n_compare], decoded[:n_compare])

# Рисование многообразия для рандомного y и распределения z|y

draw_lbl = np.random.randint(0, num_classes)

print(draw_lbl)

for lbl in range(num_classes):

figs[lbl].append(draw_manifold(generator, lbl, show=lbl==draw_lbl))

idxs = y_test == lbl

z_predicted = encoder_mean.predict([x_test[idxs], y_test_cat[idxs]], batch_size)

latent_distrs[lbl].append(z_predicted)

if lbl==draw_lbl:

draw_z_distr(z_predicted, lbl)

epochs.append(epoch)

# Коллбэки

pltfig = LambdaCallback(on_epoch_end=on_epoch_end)

# lr_red = ReduceLROnPlateau(factor=0.1, patience=25)

tb = TensorBoard(log_dir='./logs')

# Запуск обучения

cvae.fit([x_train, y_train_cat, y_train_cat], x_train, shuffle=True, epochs=1000,

batch_size=batch_size,

validation_data=([x_test, y_test_cat, y_test_cat], x_test),

callbacks=[pltfig, tb],

verbose=1)

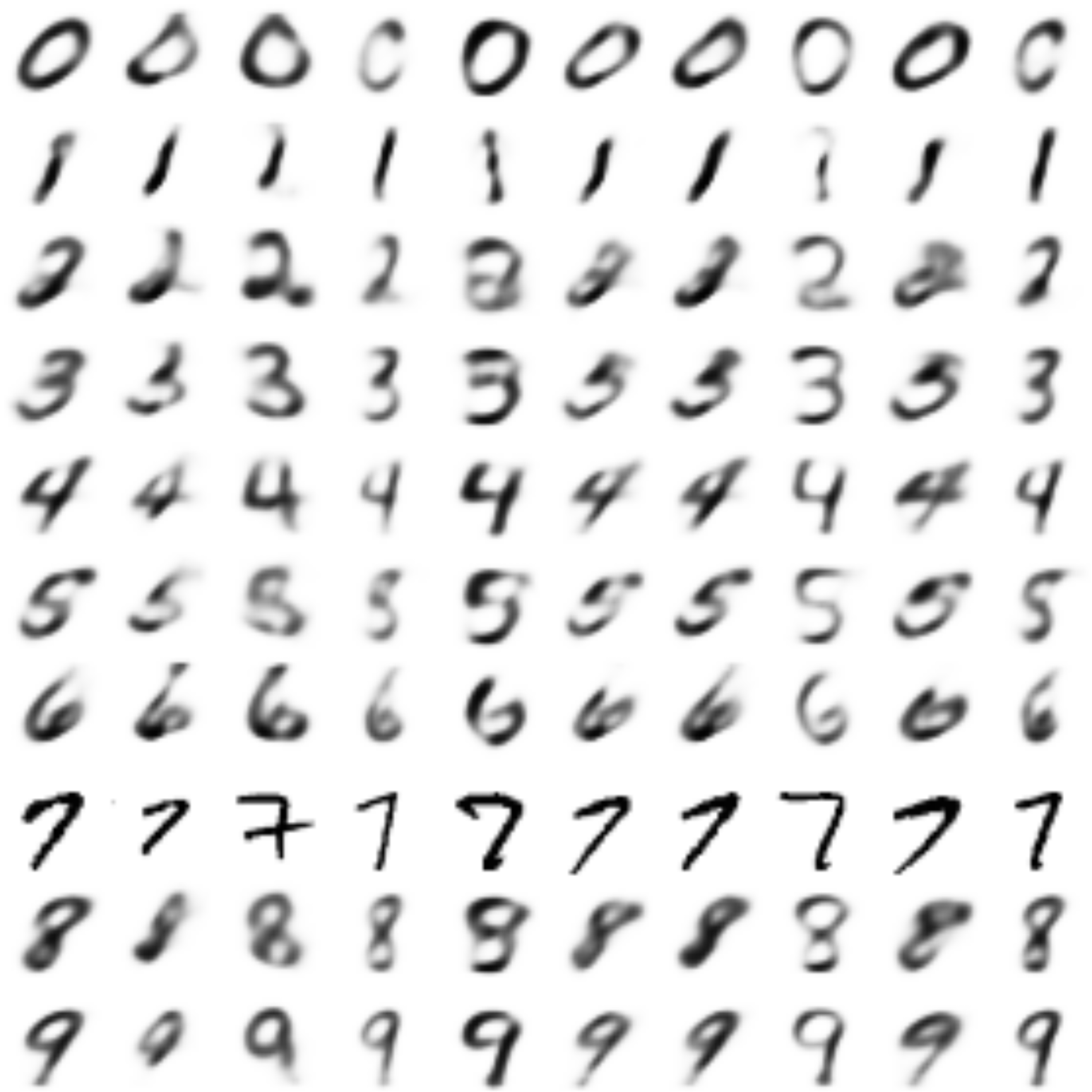

Результаты

(Извиняюсь, что местами белые цифры на черном фоне, а местами черные на белом)

Переводит цифры этот автоэнкодер вот так:

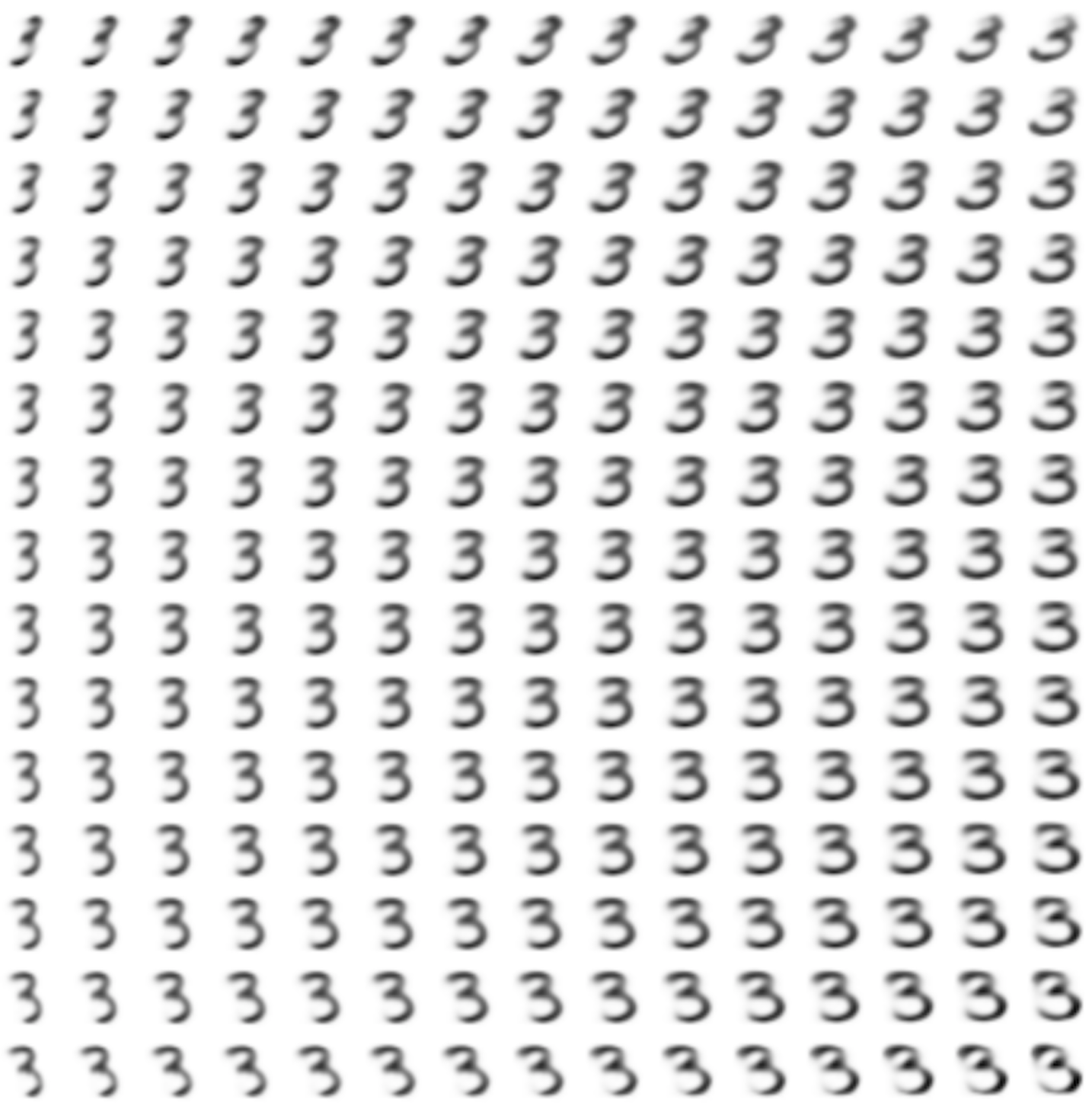

Сгенерированные цифры каждого лейбла сэмплированные из

(Отлично видно как общие черты закодированы в координатах

Генерация цифр заданного лейбла из  и распределение

и распределение  для каждого лейбла

для каждого лейбла

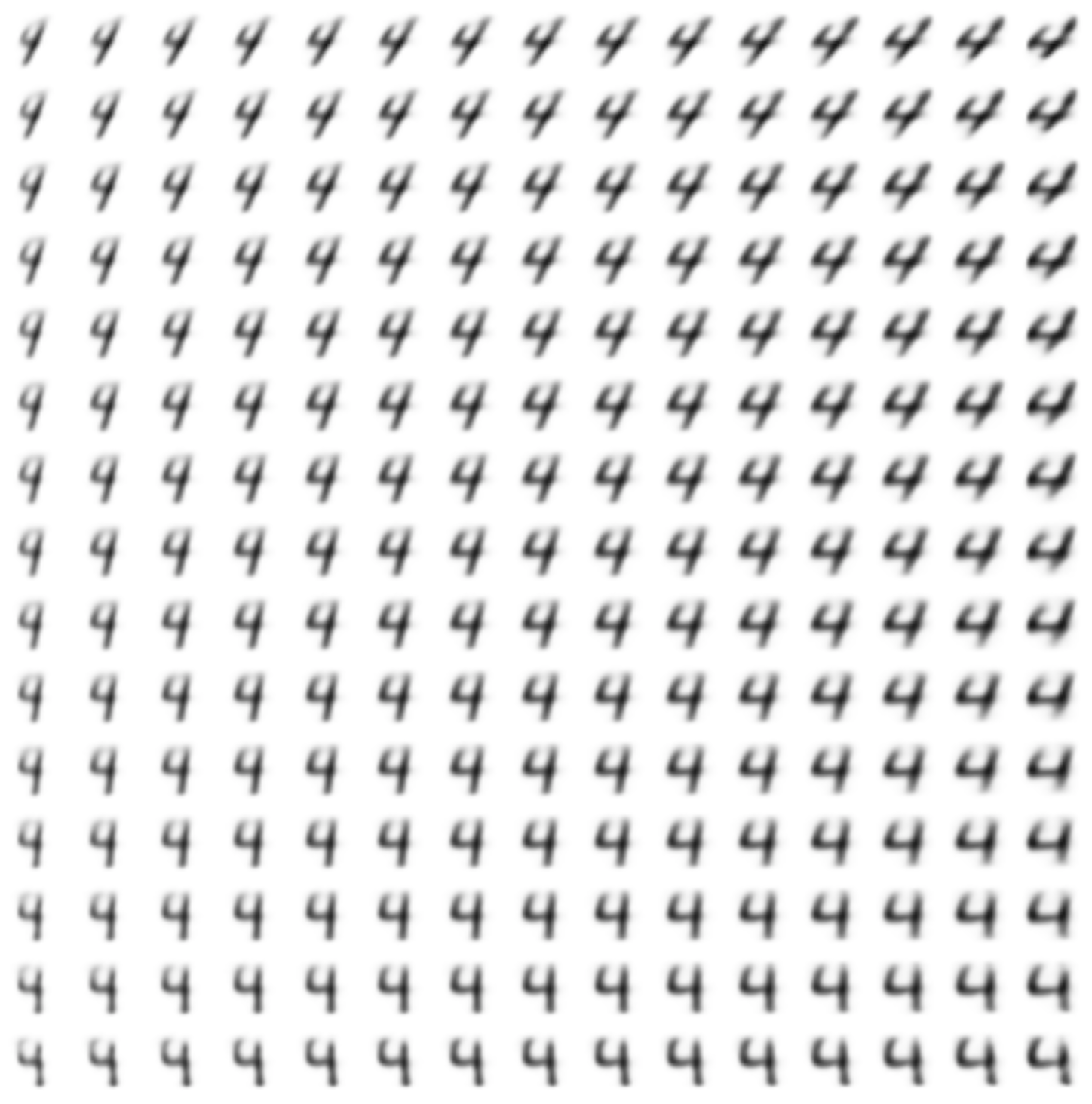

Перенос стиля этой моделью

В качестве источников стиля возьмем первые десять «7»-ок, и на основе их кода

def style_transfer(model, X, lbl_in, lbl_out):

rows = X.shape[0]

if isinstance(lbl_in, int):

lbl = lbl_in

lbl_in = np.zeros((rows, 10))

lbl_in[:, lbl] = 1

if isinstance(lbl_out, int):

lbl = lbl_out

lbl_out = np.zeros((rows, 10))

lbl_out[:, lbl] = 1

return model.predict([X, lbl_in, lbl_out])

n = 10

lbl = 7

generated = []

prot = x_train[y_train == lbl][:n]

for i in range(num_classes):

generated.append(style_transfer(models["style_t"], prot, lbl, i))

generated[lbl] = prot

plot_digits(*generated, invert_colors=True)

Стиль перенесен довольно удачно: сохранены наклон и толщина штриха.

Больше свойств стиля можно было бы переносить, просто увеличив размерность

В следующей части посмотрим, как, используя генеративные состязающиеся сети (GAN), генерировать цифры практически неотличимые от настоящих, а после этого и как объединить GAN'ы с автоэнкодерами.

Код создания гифок

from matplotlib.animation import FuncAnimation

from matplotlib import cm

import matplotlib

def make_2d_figs_gif(figs, epochs, c, fname, fig):

norm = matplotlib.colors.Normalize(vmin=0, vmax=1, clip=False)

im = plt.imshow(np.zeros((28,28)), cmap='Greys', norm=norm)

plt.grid(None)

plt.title("Label: {}\nEpoch: {}".format(c, epochs[0]))

def update(i):

im.set_array(figs[i])

im.axes.set_title("Label: {}\nEpoch: {}".format(c, epochs[i]))

im.axes.get_xaxis().set_visible(False)

im.axes.get_yaxis().set_visible(False)

return im

anim = FuncAnimation(fig, update, frames=range(len(figs)), interval=100)

anim.save(fname, dpi=80, writer='imagemagick')

def make_2d_scatter_gif(zs, epochs, c, fname, fig):

im = plt.scatter(zs[0][:, 0], zs[0][:, 1])

plt.title("Label: {}\nEpoch: {}".format(c, epochs[0]))

def update(i):

fig.clear()

im = plt.scatter(zs[i][:, 0], zs[i][:, 1])

im.axes.set_title("Label: {}\nEpoch: {}".format(c, epochs[i]))

im.axes.set_xlim(-5, 5)

im.axes.set_ylim(-5, 5)

return im

anim = FuncAnimation(fig, update, frames=range(len(zs)), interval=100)

anim.save(fname, dpi=80, writer='imagemagick')

for lbl in range(num_classes):

make_2d_figs_gif(figs[lbl], epochs, lbl, "./figs4/manifold_{}.gif".format(lbl), plt.figure(figsize=(7,7)))

make_2d_scatter_gif(latent_distrs[lbl], epochs, lbl, "./figs4/z_distr_{}.gif".format(lbl), plt.figure(figsize=(7,7)))

Полезные ссылки и литература

Теоретическая часть основана на статье:

[1] Tutorial on Variational Autoencoders, Carl Doersch, https://arxiv.org/abs/1606.05908

и фактически является ее кратким изложением.

Многие картинки взяты из блога Isaac Dykeman:

[2] Isaac Dykeman, http://ijdykeman.github.io/ml/2016/12/21/cvae.html

Подробнее прочитать про расстояние Кульбака-Лейблера на русском можно в

[3] http://www.machinelearning.ru/wiki/images/d/d0/BMMO11_6.pdf

Код частично основан на статье Francois Chollet:

[4] https://blog.keras.io/building-autoencoders-in-keras.html

Другие интересные ссылки:

http://blog.fastforwardlabs.com/2016/08/12/introducing-variational-autoencoders-in-prose-and.html

http://kvfrans.com/variational-autoencoders-explained/

|

Метки: author iphysic обработка изображений машинное обучение математика алгоритмы python autoencoder keras mnist deep learning machine learning |

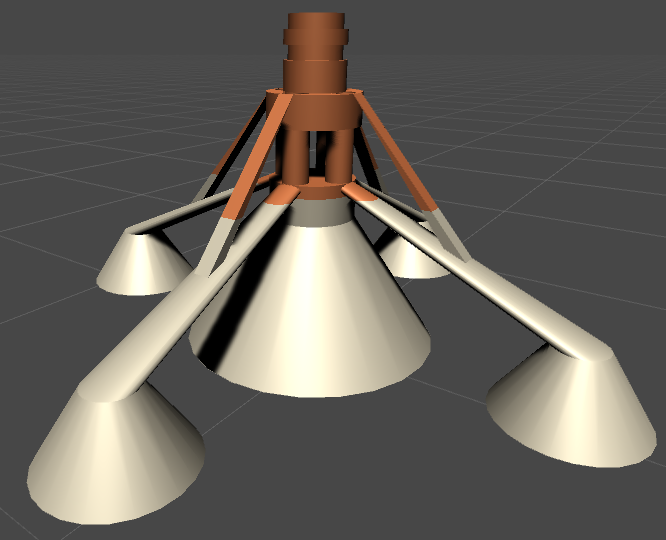

[Перевод] Создание шейдерного эффекта 3D-принтера |

Введение: первая попытка

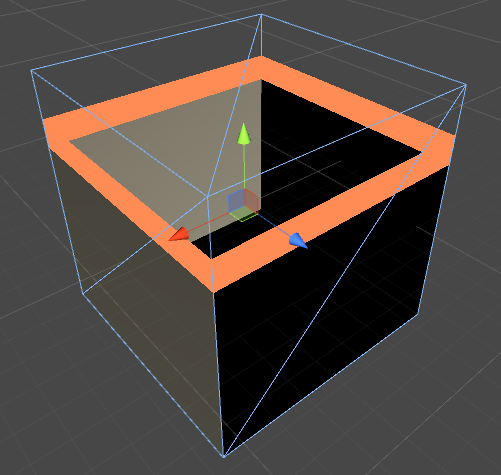

Для воссоздания этого эффекта давайте начнём с чего-нибудь попроще. Например, с шейдера, по-разному раскрашивающего объект в зависимости от его положения. Для этого необходимо получить доступ к положению отрисовываемых пикселей в мире. Это можно выполнить, добавив поле

worldPos к структуре Input поверхностного шейдера Unity 5.struct Input {

float2 uv_MainTex;

float3 worldPos;

};Затем можно использовать в функции поверхности координату Y положения в мире для изменения цвета объекта. Этого можно добиться изменением свойства

Albedo в структуре SurfaceOutputStandard.float _ConstructY;

fixed4 _ConstructColor;

void surf (Input IN, inout SurfaceOutputStandard o) {

if (IN.worldPos.y < _ConstructY)

{

fixed4 c = tex2D(_MainTex, IN.uv_MainTex) * _Color;

o.Albedo = c.rgb;

o.Alpha = c.a;

}

else

{

o.Albedo = _ConstructColor.rgb;

o.Alpha = _ConstructColor.a;

}

o.Metallic = _Metallic;

o.Smoothness = _Glossiness;

}Результатом становится первое приближение к эффекту из Astroneer. Основная проблема заключается в том, что для цветной части всё ещё выполняется затенённое отображение.

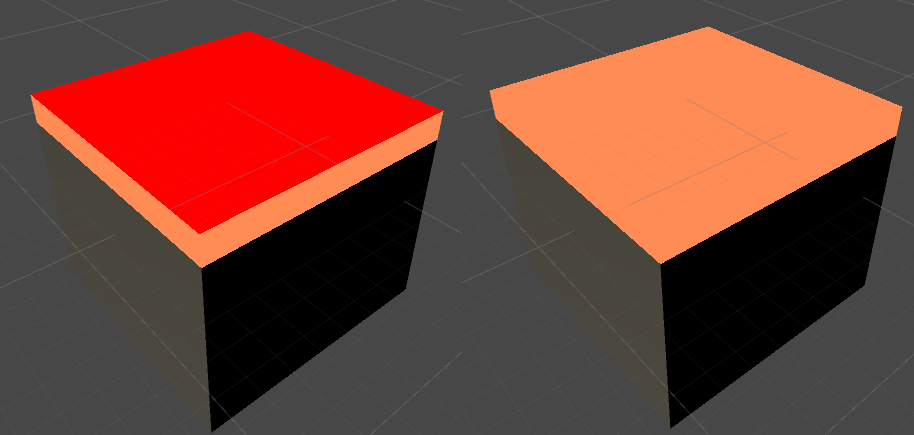

Неосвещённый поверхностный шейдер

В предыдущем туториале PBR and Lighting Models мы изучали способ создания собственных моделей освещения для поверхностных шейдеров. Неосвещённый шейдер всегда создаёт один и тот же цвет, вне зависимости от внешнего освещения и угла обзора. Можно реализовать его следующим образом:

#pragma surface surf Unlit fullforwardshadows

inline half4 LightingUnlit (SurfaceOutput s, half3 lightDir, half atten)

{

return _ConstructColor;

}Его единственная задача — возвращать единственный сплошной цвет. Как мы видим, он обращается к

SurfaceOutput, который использовался в Unity 4. Если мы хотим создать собственную модель освещения, работающую с PBR и глобальным освещением, то нужно реализовать функцию, получающую в качестве входных данных SurfaceOutputStandard. В Unity 5 для этого используется следующая функция:inline half4 LightingUnlit (SurfaceOutputStandard s, half3 lightDir, UnityGI gi)

{

return _ConstructColor;

}Параметр