Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[recovery mode] Вопросы и тестовые задания на позицию Junior PHP Developer |

Привет всем!

В последнее время побывал на многих собеседованиях, позиционируюсь я как Junior PHP Developer. До этого я нереально боялся всех собеседований, боялся завалить их, пытался готовиться к ним, гуглил примерно такого рода статьи, которую пишу сейчас (и находил не прямо так много информации). Здесь я хотел бы оставить список всех возможных вопросов, которые Вам могут задать на собеседовании с техническим специалистом, которые задавали мне в различных компаниях, а так же тестовые задания которые мне приходилось выполнять, чтобы добраться до технических собеседований. Помимо PHP сюда вставлю парочку вопросов по MySQL, конечно же. Поехали!

И так, в тех компаниях куда я позиционировался, самые частовстречающие вопросы:

- Суперглобальные массивы PHP? Какие знаете? Зачем нужны, опишите их

- Опишите язык PHP. Интерпретируемый? А как это? Чем отличается от компилируемого?

- Что такое POST и GET? Отличия? Что знаешь помимо POST и GET?

- Что означает двойное двоеточие в PHP — "::" ?

- Что такое абстрактный класс? Отличия абстрактного класса от интерфейса?

- Поддерживает ли PHP множественное наследование? Как его можно имитировать?

- Расскажите о трейтах

- Может ли быть класс абстрактным не имея абстрактных методов? (Имеется ввиду, не будет ли ошибки, если поставить классу abstract но не объявить ни одного абстрактного метода)

- Что такое статический метод?

- Расскажи про магические методы в PHP, какие знаешь

- Чем отличается запись типа:

$obj = $obj2;

от

$obj = clone $obj2 - Что такое протокол? Протоколом какого уровня является HTTP? Возможно, чтобы одно устройство было и клиентом и сервером?

- Расскажите об отличиях между == и ===

- Какая типизация в PHP?

- Знаешь что-то о замыканиях?

- На каких трех принципах базируется ООП? Расскажи о них, а также приведи примеры

- Я ввожу адрес любой адрес сайта, расскажи, что происходит внутри? Как мы попадаем на сайт?

- Какой файл откроется по стандарту на сайте, index.html или index.php, и от чего это зависит?

- Ок, допустим я хочу, чтобы мой скрипт работал долго. Где я могу поменять эти параметры?

(Я отвечал, что в самом PHP прописать ini_set('max_execution_time', 0); а также в конфигурационном файле php.ini, на что спрашивают дальше — а еще? на уровне сервера как-то можно?) - Вот у тебя есть допустим два твоих сайта. Как можно сделать так, чтобы пользователи зарегистрированные на одном твоём сайте, могли попадать на другой твой сайт с этим же логином и паролем?

- Почему выбрали именно PHP?

- Как отключить вывод ошибок в PHP? Какие бывают ошибки?

- Расскажи об отличиях между PHP 5.3, 5.4 и 5.5

- Сколько типов данных PHP? Перечисли все типы данных

- Отличия между require() и include()

- Какие знаете встроенные функции по работе с массивами? А со строками?

- Как получить первый элемент массива?

- Расскажи о сессиях и куках. Где хранятся сессии? А можно их хранить в БД?

- Вопрос с заковыркой: Как создать экземпляр абстрактного класса?

- Как удалить объект/переменную вручную?

- Как удалить файл с сервера?

- Какие движки MySQL знаете? Отличия?

- На какие параметры нужно ставить INDEX в таблице MySQL?

- Можно ли повесить индекс UNIQUE на два поля?

- Какие знаете индексы БД? Опишите каждый из них

- Вот вам массив (дают ноутбук), отсортируйте без встроенных PHP функций вручную его

- Какой командой в GIT можно загрузить Ваш код?

- Если позиционируетесь на должность как разработчик на фреймворке, попросят сравнить Ваш фреймворк с другими популярными. Допустим, почему выбрали Laravel, а не Yii2?

Ну вроде большинство всего такого я рассказал из вопросов, вас понятное дело могут погонять по особенностям вашего выбранного фреймворка, а теперь перейдем к тестовым:

- Стартовая страница сайта должна представлять собой список всех публикаций пользователя во фрейме с полосой прокрутки. Публикации должны быть представлены не полным текстом, а заголовок и 300 символов с начала поста. В конце публикации должна быть ссылка на страницу с полным текстом Read more

- На странице просмотра публикации необходимо отобразить блок поста, название и полный текст. Под ним находится блок комментариев. Комментарии добавляются с помощью ajax.

- Валидацию полей необходимо провести и со стороны сервера и со стороны браузера.

- Страница добавления/редактирования поста. При добавлении и редактировании использовать WYSIWYG редактор

- На главной странице записи должны быть отсортированы в порядке LIFO

- При выполнении задания использовать PHP 5.3+ и jQuery 1.7+

Тестовое задание второй компании:

Создайте на *название вашего фреймворка* доску объявлений.

Должен присутствовать функционал регистрации и авторизации пользователей. После того как пользователь зарегистрировался и авторизовался он может заполнить информацию о себе и загрузить свое фото, добавить объявления с фото. К профилю пользователя можно добавлять текстовые комментарии и ставить оценку (рейтинг от 1 до 5). На главной странице сайта отображаются 20 последних добавленных объявлений и присутствует пагинация.

Готовый функционал нужно выложить на Git и прислать нам.

Тестовое задание третьей компании:

Задание:

1. Создать справочник журналов, с возможностью CRUD. У каждого журнала должны быть:

1.1 Название. (Обязательное поле)

1.2 Короткое описание. (Необязательное поле)

1.3 Картинка. (jpg или png, не больше 2 Мб, должна сохраняться в отдельную папку и иметь уникальное имя файла)

1.4 Авторы (Обязательное поле, может быть несколько авторов у одного журнала, должна быть возможность выбирать из списка авторов, который создается отдельно).

1.5 Дата выпуска журнала.

2. Список авторов создается отдельно. Также должна быть возможность добавления, удаления и редактирования. У каждого автора должны быть:

2.1 Фамилия (Обязательное поле, не короче 3 символов)

2.2 Имя (Обязательное, не пустое)

2.3 Отчество (Необязательное)

3. На выходе получаем:

3.1 Просмотр отдельно страниц журналов и авторов.

3.2 На странице авторов:

3.2.1 Должна быть возможность увидеть список всех журналов определенного автора.

3.2.2 Сделать сортировку авторов по фамилии

3.3.3 Сделать сотрировку таблицы по дате выпуска журнала.

3.4 Работа с каждой отдельной страницей должна происходить без её перезагрузки с использованием jQuery (или Angularjs).

3.5 Сделать пагинацию по журналам и авторам

4. Рекомендуемое время выполнения задания — 4 часа.

Всем удачных подготовок и прохождения собеседований!

|

Метки: author Twitt php собеседование вопросы mysql тестовые задания |

Дайджест интересных материалов для мобильного разработчика #209 (19 июня — 25 июня) |

|

Как написать максимально хреновый бэкенд для мобильного приложения |

|

Google и Apple против инди-разработчиков |

|

Усатый стрелок из двадцати трёх полигонов |

Дайджест доступен и в виде рассылки. Подписаться вы можете тут.

iOS

iOS- (+22) Интегрируем Copy-Paste-Detector для Swift в Xcode

- (+16) Борьба за время сборки iOS-приложений

- (+12) Как сделать статический анализ кода в Swift

- (+9) Уроки, извлечённые из трёх миллионов загрузок на App Store

- Создатель Swift ушел из Tesla

- Apple и IKEA делают AR-приложение

Культура Apple после 10 лет существования iPhone

Культура Apple после 10 лет существования iPhone Воссоздаем новый App Store

Воссоздаем новый App Store Компьютерное зрение в iOS 11

Компьютерное зрение в iOS 11 ReplayKit в iOS 11

ReplayKit в iOS 11 Один странный совет для уменьшения размера приложения

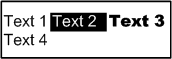

Один странный совет для уменьшения размера приложения DDViewSwitcher: скроллинг текста внутри View

DDViewSwitcher: скроллинг текста внутри View

Android

Android- (+28) Видеозаписи: Android meetup в офисе Badoo

- (+7) Сборка модуля ядра Linux без точных заголовочных файлов

- Самые популярные SDK в Android-приложениях: отчет SafeDK

Обеспечение качества кода на Android

Обеспечение качества кода на Android Android Instant Apps шаг за шагом: как их использует Vimeo

Android Instant Apps шаг за шагом: как их использует Vimeo Firefox Focus: новый браузер для Android

Firefox Focus: новый браузер для Android Google прекращает поддержку Android Market

Google прекращает поддержку Android Market Не хотдог: компьютерное зрение на Kotlin

Не хотдог: компьютерное зрение на Kotlin Быстрые, определенные и аккуратные интеграционные тесты

Быстрые, определенные и аккуратные интеграционные тесты Alligator: современная библиотека для навигации

Alligator: современная библиотека для навигации BoxLoaderView: кастомный прогресс-бар

BoxLoaderView: кастомный прогресс-бар GeoJson Viewer: просмотр GeoJson файлов на Android

GeoJson Viewer: просмотр GeoJson файлов на Android TriangulationDrawable: анимация треугольников

TriangulationDrawable: анимация треугольников Composer: Reactive Android Instrumentation Test Runner

Composer: Reactive Android Instrumentation Test Runner InfiniteCards: бесконечно листающиеся карточки

InfiniteCards: бесконечно листающиеся карточки VectorMaster: динамическое управление векторными изображениями

VectorMaster: динамическое управление векторными изображениями

Windows

Windows Разработка

Разработка- (+4) Самодостаточные контроллы на Xamarin.Forms. Часть 2

- (+1) 13 вопросов, чтобы узнать, готовы ли вы нанимать команду мобильной разработки

- Corona стала бесплатной

- Использование Firebase для отправки уведомлений в реальном времени

- Как дизайнеры UberEATS меняют будущее еды

- Google открыл мобильные модели компьютерного зрения для TensorFlow

- «Мы делали стартап два года»: 7 советов молодым стартаперам от украинской команды Flawless App

Машинное обучение на JavaScript

Машинное обучение на JavaScript Бесплатные мокапы iPhone, Mac, MacBook pro, iPad, Android

Бесплатные мокапы iPhone, Mac, MacBook pro, iPad, Android Боязнь пустого пространства

Боязнь пустого пространства Лучшие инструменты прототипирования для всех

Лучшие инструменты прототипирования для всех Смерть гамбургеру

Смерть гамбургеру Firebase Cloud Messaging: управление токенами и уведомлениями на Node.js

Firebase Cloud Messaging: управление токенами и уведомлениями на Node.js

Аналитика, маркетинг и монетизация

Аналитика, маркетинг и монетизация- (+12) Аналитические инструменты: обзор выгодных предложений

- Как Fam App получил 1,024,786 загрузок за 10 дней (почти не потратив на маркетинг)

- AppMetrica и Auto.ru: +10% к конверсиям бесплатно

- Карта мобильной рекламы 2017

- Отчет “Мобильный шопинг: приобретение пользователей 2017”

- Управление опытом взаимодействия с пользователями – задача digital-каналов

- “Отчет о мобильной монетизации” за 2 квартал от SOOMLA

- 9 способов повысить точность прогноза дохода

- Flurry: играть меньше, но дольше

- 3 стратегии персонализации, которые гарантируют успех вашего приложения

- Mislead, который мы заслужили: выбор креативной стратегии

Как монетизировать бота за 24 часа

Как монетизировать бота за 24 часа 16 стратегий от экспертов для стремительного роста загрузок

16 стратегий от экспертов для стремительного роста загрузок Как создавать рекламу в Instagram Stories

Как создавать рекламу в Instagram Stories Монетизация и маркетинг приложений: интервью Эрика Сёферта

Монетизация и маркетинг приложений: интервью Эрика Сёферта

Устройства, IoT, AI

Устройства, IoT, AI- (+13) Как переусложнить дверной замок

- (+13) Об использовании видеокамер с распознаванием символов на низкопроизводительных вычислительных устройствах

- Интернет вещей в сельском хозяйстве: мировой опыт, кейсы применения и экономический эффект

- Intel прекращает выпуск Edison, Galileo и Joule

- Qualcomm представил референсный дизайн для “умных колонок”

Контролируем свет в офисе с помощью Android Things

Контролируем свет в офисе с помощью Android Things

< Предыдущий дайджест. Если у вас есть другие интересные материалы или вы нашли ошибку — пришлите, пожалуйста, в почту.

|

|

[Из песочницы] Два в одном: как пользоваться Vim и Nano? |

Вступительное слово

Зачем нужна ещё одна, 1001я публикация на эту тему? Статей про vim и nano написано огромное количество, но как правило они касаются только одного из редакторов, либо представляют из себя общий обзор. Чтобы в одной были сжато описаны оба редактора, но при этом без углубления в дебри приведены все основные клавиши управления для полноценной работы, я не не нашёл. Поэтому, почитав найденные материалы, я начал их конспектировать, так и родилась эта статья.

Любой текстовый редактор можно освоить «методом тыка». Но только не vim.

Чем nano лучше vim?

Из nano можно выйти без reset'а! (с) Интернет

Изначально я не планировал писать об обоих редакторах, а хотел сделать краткую справку только по nano, но в процессе сбора информации накопились данные и по vim тоже. Тут я обнаружил, что Vim не так уж и страшен, если знать команды и концепцию его использования.

Что это и зачем нужно?

Когда недоступна графическая среда, например при работе по ssh, настройке системы до загрузки xserver, либо просто из любви к

Я долгое время использовал редактор от Midnight Commander mcedit, немного пользовался nano, и совсем не пользовался vim. Вызубрить все эти комбинации за гранью возможного — даже потратив на это время, через какой-то период простоя они успешно забываются. До того, как я взялся за написание этой статьи, я не мог заставить себя осилить даже азы vim, он пугает уже на стадии запуска, «пытаешься из него сразу же выйти, и не можешь!» Это как вы сейчас зайдёте в интерпретатор ZX Spectrum BASIC48, то не зная азов даже простейшей программы PRINT «Hello World!» не напишите. Я не переставал задавать себе вопрос: «Интересно, и за что гуру vim так любят? Зачем тратить кучу времени на переобучение, и главное как не растерять навыки, для каких целей его постоянно использовать, этот vim?»

Ниже я опишу самые необходимые комбинации клавиш и приёмы работы в обоих редакторах.

Nano

После комбинации Alt-6, как команды «скопировать» я даже и не знаю что сказать

Наверное автор Nano был пианистом

© из хабра-комментариев

Основой мне послужила статья на хабре: "Nano: И всё-таки его придётся выучить", а также все комментарии к ней. Они не просто её дополнили, но и заставили посмотреть в сторону vim.

В терминах nano текст, отделённый пустыми строками называется «параграф». Все команды отдаются нажатием комбинаций клавиш — функциональными кнопками или комбинацией Ctrl+буква или Alt+буква. Если в каком-либо случае комбинация с Ctrl или Alt забронирована системой, следует использовать дублирующие комбинации с Esc.

Одинарное нажатие на Esc эмулирует клавишу Alt. Двойное Esc Esc эмулирует клавишу Ctrl. То есть вместо Alt+X можно набрать Esc X, вместо Ctrl+K можно набрать поочерёдно Esc Esc K.

Самое важное:

Alt+U (Esc U) — Undo, отмена последнего действия.

Alt+E (Esc E) — Redo, повтор отменённого действия.

F1 (Ctlr+G) — Показать справкуF2 — Выход с сохранением файлаCtrl+X — Вернуться к редактированию из справки, и прочих диалоговых окон, выход из программы.

Копирование и вставка текста:

Alt-A (Ctrl-6) — установить\снять маркер начала выделения текста (либо просто стрелки с shift)

Alt+6 (Esc 6) — копировать выделение текст в буфер обмена. Комбинация alt+6 у меня занята и не заработала.

Ctrl+K (или F9) — вырезать выделенный фрагмент в буфер обмена, при отсутствии выделения удалить строку.

Ctrl+U (или F10) — вставить фрагмент из буфера обмена

Ctrl+Shift+V — вставить из GUI буфера обмена

Ins — Вставка текста из другого файла, либо вывода команды.

Поиск и замена:

Ctrl+W — Поиск

Alt+W — Повторный поиск

Ctrl+\ — Замена. Помнит последний поиск как изменяемое по умолчанию.

Навигация:

Alt+\ (Ctrl+Home) — В начало файла

Alt+/ (Ctrl+End) — В конец файла

Ctrl+Y (PgUp)— На страницу вверх

Ctrl+V (PgDn) — На страницу вниз

Alt+S — Переключение между плавной прокруткой страниц и фиксированной

Дублирование курсорных клавиш, то чем так гордится vim, только врастапырку:

Ctrl+B — Влево на символ

Ctrl+F — Вправо на символ

Ctrl+N — Вниз на символ

Ctrl+P — Вверх на символ

Ctrl+Space — На слово вперёд, можно просто Ctrl+курсор. (курсор встаёт в начале слова)

Alt+Space (ESC Space) — На слово назад.

(у меня эта комбинация вызывает строку быстрого запуска KRunner в KDE, поэтому использую ESC Space)

Alt+- — Прокрутка вверх не меняя позиции курсора

Alt+= — Прокрутка вниз не меняя позиции курсора

Alt+7 (Esc 7) — К предыдущему блоку текста, либо просто Ctrl+курсор

Alt+8 (Esc 8) — К следующему блоку текста.

Alt+0 (Esc 0) — К следующему параграфу (до первой пустой строки вниз).

Alt+9 (Esc 9) — К предыдущему параграфу (до первой пустой строки вверх).

Alt+G — Переход на строку с указанным номером.

Alt+< — Переход к предыдущему открытому файлу (Если nano запущен с несколькими файлами)

Alt+> — Переход к следующему открытому файлу.

Ещё пишут про команду Alt+F, которая не то включает такую возможность, не то позволяет зачем-то иметь отдельные буфера обмена на каждый файл, но как она работает я не понял.

Редактирование текста:Ctrl+D (Del) — стереть символ под курсором

Ctrl+H (BSp) — Стереть символ слева от курсора

Ctrl+M (Enter) — Вставка пустой строки.

Ctrl+I (Tab) — Вставка табуляции.

Alt+Shift+{ — Уменьшить отступ параграфа удалением табуляции или пробеловAlt+Shift+} — Увеличить отступ параграфа, вставкой табуляции. Если уже был отступ пробелами, добавит к нему табуляцию и подсветит красным.

Ctrl+] — Автодополнение слов, например команд в программе. Программисты оценят!

Alt+3 (Esc 3) — За(рас)комментировать символом # текущую строку, выделенный параграф.

Alt+J (F4) — Justify, выровнять текущий абзац

Разное:

Esc Esc 220 — Ввод символов по десятичному коду. Например 220 — ввод "U с умляутом.

Alt+V — Ввод ASCII последовательности комбинации или клавиши.

Alt+T — Trunkate. Стирает всё от курсора и до конца файла.

Ctrl+C (F11) — Разово выводит информацию по текущей строке, колонке, номеру символа.

Alt+D — Подсчитать количество слов, строк, символов в файле

Ctrl+L — Обновить экран

Настройки nano:

Alt+Shift+4 — Мягкий перенос длинных строк разрешить/запретитьAlt+K — переключает действие по Ctrl+K между удалением по умолчанию всей строки и удалением от курсора до конца строки.

Alt+Q — Переключиться с табуляций на ввод пробелов.

Alt+L — Включить и выключить жёсткий перенос строк.Alt+C — Переключает постоянный вывод инфо по строке по Ctrl+C

Alt+X — Показать\скрыть строку подсказки внизу экрана.

Alt+Shift+3 — Показывать номера строк.

Alt+P — Показывать пробелы символом "·"

Alt+Y — Показывать подсветку синтаксиса.

Alt+H (Esc H) — Включить умную клавишу Home (переводит курсор не в 1ю колонку, а на 1й символ строки)

Alt+I (Esc I) — Включить автоотступы (перевод строки на новую с таким же отступом, как у предыдущей)

Alt+B — Переключиться на создание резервных копий и обратно

Alt+M — Включить «поддержку мыши». лучше не использовать, ерунда!

Говорят, что nano по умолчанию не поддерживал отмену действий (undo). У меня в Manjaro всё поддерживает, но на всякий случай решение — запускать nano с ключом -u: nano -u filename.

Для включение подсветки синтаксиса в nano следует раскомментировать директивы include в файле /etc/nanorc.

На этом всё.

Другие использованные ссылки:

Раз | два | три

Vim, немного крипоты

Vim, немного крипоты

«у vi есть два режима: бибикать и всё портить»

© Холиварненько

Изначально Vim разрабатывался для аппаратного терминала ADM-3A, он слева на фото.

Приведу несколько цитат перед статьёй, которые как бы намекают читателю: "— Ужаснись и беги. Слышишь смертный? Беги! И не говори потом, что тебя не предупреждали..."

Продвинутый текстовый редактор — кошмар для случайного пользователя. Если его удается в конце концов закрыть, то вздыхаешь с облегчением и твердой уверенностью, что больше не будешь запускать эту программу ниразу в жизни. Пожалуй, Vim нельзя просто запустить и начать работать — требуется определенная подготовка. Зато стоит раз испытать его в деле и поражаешься тому, как можно было без него обходиться.

© https://ru.wikibooks.org/wiki/Vim

* * *

Ну, смотрите, человек запускает vim, курсором доползает до нужного места, стирает лишнее, начинает печатать, в какой-то момент доходит до буквы 'i'/'c' и т.д., после чего остаток введённого появляется на экране не там, где человек хотел. Он нажимает esc, q, у него начинается какая-то фигня, он нажимает несколько раз esc, esc, потом пишет :q, потом нажимает три раза Esc пишет :Q!, потом нажимает ещё пару раз Esc, пишет :q!, потом снова vim и уже редактировать. (q) Пример ада с vim

* * *

У меня кстати была обратная ситуация, когда я подошел к сотруднику подсказать что подправить в конфиге и в фаровском редакторе напечатал ему полстрочки букв j, прежде чем понял, что что-то не так, курсор двигается вправо, а не вниз и ещё и мусор какой-то появляется. (q) Байка о силе привычки

* * *

Судя по тому, что я сейчас прочел, пользователи… нет, скорее «активисты» vi — не просто придурки, а отборные мазохисты. Не знаю, может кто-то в этой статье видит преимущества vi, я же вижу убийственный гемморой, переусложняющий простой ввод кода до уровня секвенирования ДНК. (й) +15 голосов в хаброкомментах

* * *

Cейчас средства разделились на редакторы (набрать текст) и IDE (работать с проектом). Вим получается посередине, как утка. Но это уже не нужно. Если я хочу набрать текст — мне не нужен редактор который осваивать дольше чем IDE, мне нужен ee/nano. А если мне нужна работа с проектом — мне нужна нормальная IDE с большими возможностями и низким порогом вхождения, а не школа белого нидзя по освоению навороченного текстового редактора. (q) убийственный хаброкоммент

Тем не менее, мы попытаемся!

Следует запомнить, что Vim имеет два режима: командный и модальный. В первом вводятся команды, например просто введя двоеточие : можно стрелками вверх-вниз перебирать историю ранее введённых команд. Введя начало команды, по Ctrl+d можно увидеть список похожих команд, а по Tab дополнить сокращение до полного названия команды. Все команды, начинающиеся с : должны завершаться нажатием ENTER, остальные исполняются моментально. Во втором режиме правится текст. Вход в модальный режим по a, i. После правки фрагмента текста, всегда нажимайте Esc, чтобы вернуться в командный режим, и у вас никогда не возникнет вопроса, в каком режиме сейчас редактор.

Поясняющая цитата о вводе команд: Команды в vim задуманы комбинируемыми: 'd' значит «удалить», 'e' значит «переместить курсор в конец слова», поэтому 'de' завершенная команда, означающая «удалить все от текущего положения курсора до следующего конца слова» Команды регистрозависимы!

Например войдя в модальный режим (редактирование текста) по i, введя «True», и выйдя в командный по Esc, вы можете перемещаться по файлу со всей мощью команд навигации и нажимать '.' везде, где нужно повторить команду, то есть вставить слово «True» в текущую позицию курсора в данном случае. Учитывается весь введённый фрагмент с перемещениями курсора и стиранием символов. Так можно по точке автоматизировать ввод форм в одинаковые блоки.

Команды Vim:

Возможно, это только для меня стало внезапным открытием, но вся справка на русском языке по клавишам vim доступна внутри терминала в виде уроков по команде (в том числе по ней я делал этот конспект):

vimtutor ru

Перемещение:

hjkl — дублирование курсорных клавиш влево, вниз, вверх, вправо.

^ или 0 (нуль) — В начало строки

$ — В конец строки

e — В конец текущего, затем следующего, слова.w — К началу следующего слова.% — Перемещение в строке между скобками: (){}[]

Ввод числа перед оператором перемещения приведёт к его повторению заданное количество раз.

2w — Перемещение курсора вперёд к началу второго слова.

3e — Перемещение курсора вперёд к концу третьего слова.

Комбинирование команд упрощает навигацию:j$ —Вниз, в конец следующей строки.

Shift+g — Перейти в конец файла. Если перед этим ввести номер строки, то переход к ней.

507 Shift+g — Например вот так будет переход не в конец, а к строке номер 507

:45Enter — Переход к строке номер 45

mk — Пометить текущую позицию как k

‘k — Перейти к метке k

H, M, L — перемещение курсора на верхнюю, среднюю и нижнюю линию экрана.

zt, zz, zb — перемещение курсора вместе с текстом на верхнюю, среднюю и нижнюю линию экрана.

* — Переместить курсор на следующее слово, такое же, как под курсором

# — Переместить курсор на ПРЕДЫДУЩЕЕ слово, такое же, как под курсором

Вход в модальный режим редактирования текста:

i — Insert, переход в режим вставки текста левее курсора

a — Append, переход в режим вставки текста правее курсора

A — App_end, переход в режим вставки текста в конец строки

R — Replace, переход в режим замены текста.

o — создать пустую строку под текущей и перейти к её редактированию.

O — создать пустую строку НАД текущей и перейти к её редактированию.

Редактирование:

u — UNDO, отмена последнего действия

U — UNDO, отмена изменений только в последней строке

Ctrl+r — Redo, повторить отменённое действие текущего модального сеанса редактирования.

Многие команды, изменяющие текст, состоят из оператора и объекта. Например ниже оператор удаления d комбинируется с объектом направления удаления:

dw — удалить от курсора до конца слова, включая последующий пробел.

de — удалить от курсора до конца слова, НЕ включая последующий пробел.

d$ — удалить от курсора до конца строки.

d^ — удалить от курсора до начала строки.

ce — удаляет слово и переводит в режим вставки.

c$ — удалить от курсора до конца строки и перейти в режим вставки (редактирования текста).

Ввод числа перед оператором приведёт к его повторению заданное количество раз.

d2w — Удаление двух слов подряд

x — Del, стереть символ под курсором.

dd — Удаление строки

D — Очистка строки от символов

r — замена символа под курсором следующим за r

После нажатия r+символ возвращается в командный режим, что делает неудобным использование для правки русского текста без адаптации командного режима vim к русской раскладке клавиатуры.

diw — удалить слово

ciw — удалить слово

c% — Вырезание выражения в скобках. (

% этоShift+5)ce WORD Esc — вводить на первом символе какого-либо слова, чтобы заменить его на WORD. После по точке так можно будет сделать с любым.

d$ или D (Shift+d) — удаляет строку после курсора

db — удалить слово ДО курсора

di( — удаляет то что в скобочках.

di" — то, что в кавычках

dw — Удаление участка текста от курсора до конца слова.

d5d — удалить 5 строк от курсора вниз

S — Удалить все до конца строки

Ctrl+a — Увеличить число под курсором на единицу

Ctrl+x — Уменьшить число под курсором на единицу

Vu — Перевести строку в нижний регистр

VU — Перевести строку в верхний регистр

g~~ — Инвертировать регистр

Поиск:

При достижении конца файла поиск будет продолжен с начала.

/ — Поиск текста по образцу вперёд

? — Поиск текста по образцу назад

n — Следующее найденное совпадение

N — Предыдущее найденное совпадение

Ctrl+o — вернуться туда, откуда начали поиск

Ctrl+i — вернуться обратно к найденному после ctrl+o

% — Поиск парных скобок: (), [] или {}

Поиск и замена:

:s/было/стало — Поиск и замена только первого найденного совпадения в текущей строке

:s/было/стало/g — Поиск и замена всех найденных в текущей строке совпадений

:30,90s/было/стало/gc — поиск и замена с 30 по 90 строку по всей их длине, с подтверждением

:%s/было/стало/gc — поиск и замена во всём файле с подтверждением.

То есть :s/ — текущая строка, :30,90s/ — диапазон, :%s/ — весь файл.

g — во всей строке, c — с подтверждением, иначе только первое совпадение в строке, и без подтверждений.

Можно не писать каждый раз команду заново, достаточно ввести : двоеточие и стрелками курсора вверх-вниз перебирать ранее введённые варианты.

Выделение:

v — визуальный выбор, выделение фрагмента текста для операции над ним.

d — удаление выделенного фрагмента

y — копирование выделенного фрагмента

yw — копирование одного слова от позиции курсора до конца слова вместе с пробелом.

p — вставка скопированного фрагмента

vgU — выделить в визуальном режиме фрагмент и перевести его в верхний регистр.

vg~ — Выделить в визуальном режиме фрагмент и ИНВЕРТИРОВАТЬ его регистр.

Файловые операции:

:w — сохранить изменения в текущий файл

:w file.txt — сохранить в файл file.txt

:w! file.txt — сохранить и перезаписать file.txt, если существует.

:w~/file.txt — сохранить в файл file.txt в домашней папке

:e — Переоткрыть текущий файл.

:e file.txt — открыть файл file.txt.

:ene — Создать новый файл.

:ene file.txt — Создать файл file.txt.

Для сохранения фрагмента, выделить его по клавише v и сохранить с указанием имени как выше. Командная строка будет иметь вид подобный :'<,'>w file.txt

:r file.txt — вставить содержимое файла file.txt в позицию ниже курсора

:r!ls — вставить вывод внешней команды ls.

:! ls — выполнить любую внешнюю команду, в данном случае ls

Настройки:

:set ic — IgnoreCase, игнорирование регистра при поиске или замене

:set noic — вернуть регистрозависимый поиск или замену

:set hls — Hlsearch, подсвечивать найденное

:set nohls — НЕ подсвечивать найденное

:set is — Incsearch, инкрементный поиск — отображение частичных совпадений при поиске

:set nois — Отключить инкрементальный поиск, искать по enter.

Разное:

Ctrl+g — Показывает строку статуса с именем открытого файла, номером текущей строки.

Esc или Ctrl+C или Ctrl+[ — выход в командный режим.:e Enter — Выход. Именно с ДВОЕТОЧИЕМ! Я сам долго не мог выйти. Решил, что ':' это часть предложения, а не часть комбинации, которую нужно набрать и долго жал 'q'.

:e! Enter или :x или :wq — Выход без сохранения

ZQ — Моментальный выход без сохранения и подтверждения.

Настройки по умолчанию можно записать в конфигурационный файл ~/.vimrc

Например без этого я не начну писать в vim ни одной программы на Python:

set tabstop=4 # Длина табуляции

set expandtab # Замена табуляции пробелами

Окна:

Ctrl+W Ctrl+W — Переход между окнами, например при вызове справки по :help между ней и текстом.

:tab ball — Поместить все открытые файлы во вкладки

:tabnew — Создать новую вкладку

gt — Перейти на следующую вкладку

Полезные хитрости:

:%s#>[^<]\+>##g — Очистить текст от HTML-тегов

:%s/^\(.*\)\n\1$/\1/ — Удалить строки, повторяющиеся дважды

Приложение:

Обучающие карты расположения команд в картинках. Взято отсюда

|

|

Решение проблем:

Простое решение проблемы командного режима в русской раскладке, положить в файл ~/.vimrc с содержимым в одну строку:

set langmap=ФИСВУАПРШОЛДЬТЩЗЙКЫЕГМЦЧНЯЖ;

ABCDEFGHIJKLMNOPQRSTUVWXYZ:, фисвуапршолдьтщзйкыегмцчня;abcdefghijklmnopqrstuvwxyz

Однако я заметил единственный минус — в правом нижнем углу перестают отображаться вводимые символы в режиме команд.

* * *

Вот эта пара строк сильно экономит время на копание в .vimrc

" ## Edit .vimrc ##

map ,v :vsp $MYVIMRC

map ,V :source $MYVIMRC

Первая маппит на ,v открытие .vimrc в вертикальном окошке, а вторая просит VIM пересчитать файл.

* * *

О разнице, какой клавишей выходить в командный режим: Ctlr-C просто переходит в normal mode. Если на выход из insert mode какими нибудь плагинами навешаны какие-нибудь хуки, то при нажатии Ctrl-C vim их проигнорирует, а при нажатии Esc или Ctrl-[ запустит. (й)

Список использованной и рекомендуемой литературы:

- Статьи на Хабре

- Почему, ну почему, эти #?@! придурки используют vi? (отличная статья! А комменты просто жгут)

- Vim и кириллица: парочка приёмов

- Аж целую книгу запилили по этому vim, я удивляюсь. Нашёл

на файлопомойкетут - Прямая ссылка на книгу: O'Reilly — Learning the vi and Vim Editors 7th Edition (перевод).pdf

- Vimtouch под Android. Если готовый в googleplay

- 100 команд vim, которые должен знать каждый

|

Метки: author yuukoku системное администрирование *nix vim nano |

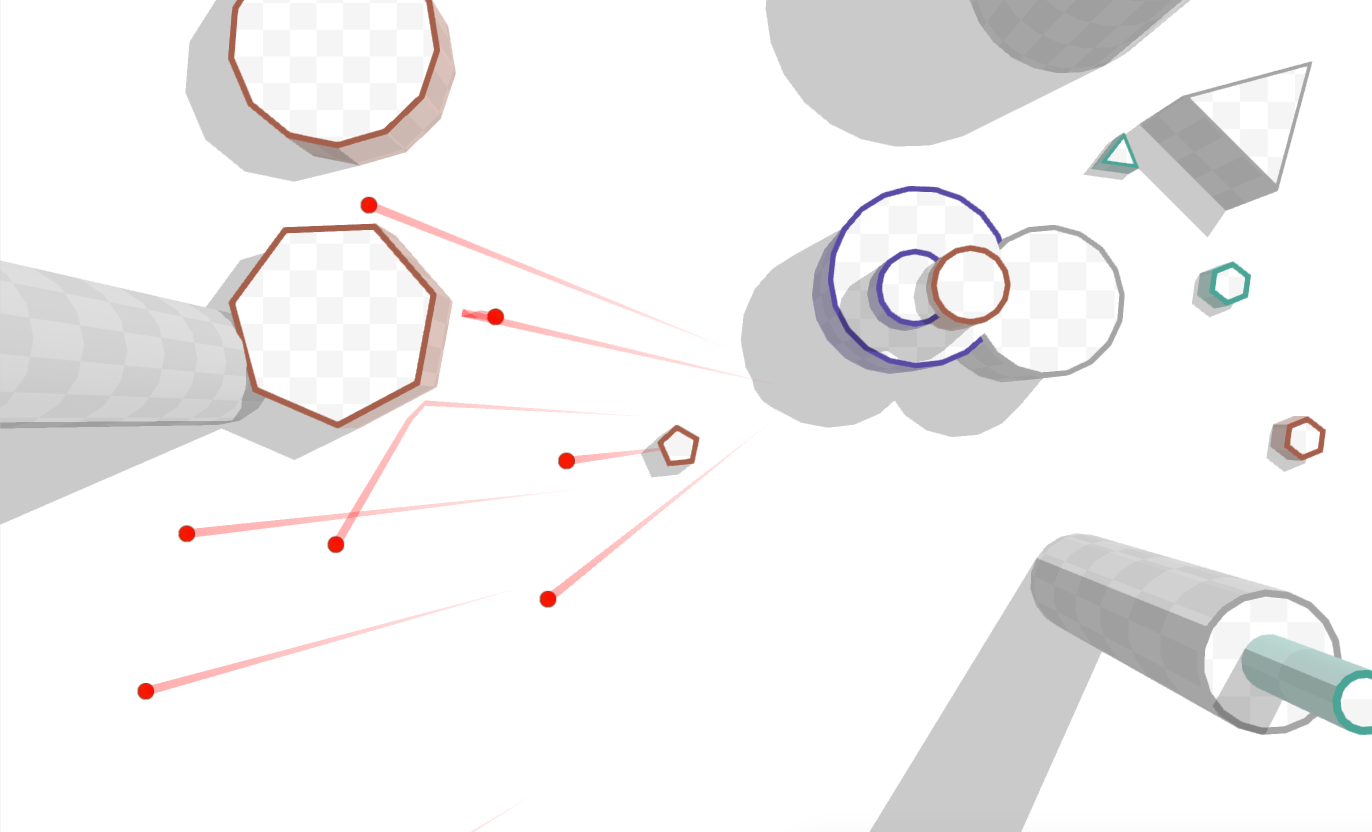

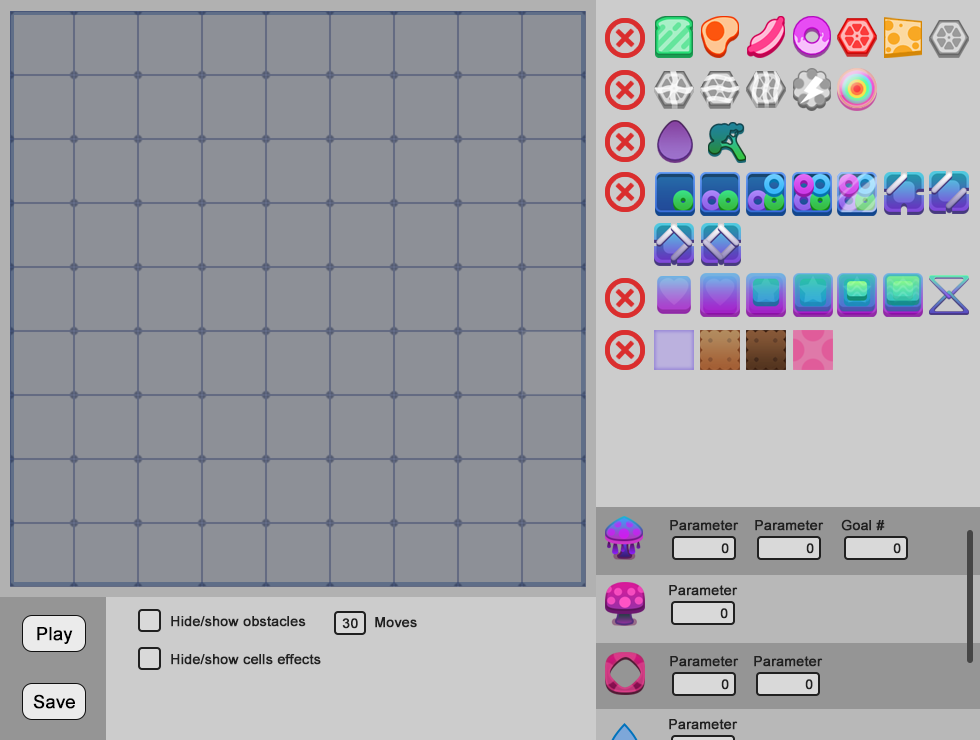

Редактор уровней для три в ряд |

В разработке всегда есть вещи, на которые уделяется меньше внимания и задачи создаются в пониженном приоритете. Одна из них — редактор уровней. Да, эта часть проекта разрабатывается далеко не последней и постоянно поддерживается в процессе, но многие вещи, которые могут заметно облегчить жизнь дизайнеру, все же менее приоритетны в команде. В статье я хочу рассмотреть оптимальную, на мой взгляд, схему редактора уровней для игры три в ряд.

Дизайн уровней для головоломок состоит из массы рутинных действий и занимает много времени. Поэтому изначально очень важно создать инструмент, которым можно будет удобно и без лишних нервов пользоваться на протяжении всей жизни проекта.

Есть ряд универсальных принципов, которые необходимо знать, перед началом проектирования редактора под ваш проект:

Все важные и часто используемые инструменты должны быть доступны в один клик. Можно использовать наборы вкладок и раскрывающихся меню, но самый эффективный редактор будет тот, у которого все элементы расположены на одном экране;

Горячие клавиши помогают ускорить процесс. Для большинства элементов есть свой инструмент для его удаления. Достаточно привязать функции создания и удаления к разным кнопкам мыши и экономия времени будет налицо. Этот пункт не актуален, если ваш редактор работает только на мобильных устройствах;

То, что видишь, то и получаешь. Если есть возможность использовать графику и анимации элементов в редакторе без изменений, работать будет удобнее. Очень много вещей и несостыковок элементов можно обнаружить только в редакторе уровней, т.к. художники вряд ли смогут предусмотреть все возможные комбинации элементов, на которые способна ваша фантазия;

Редактор должно быть легко поддерживать и добавлять новый функционал. Модульность элементов и меню обязательна, если предполагаются мало-мальские обновления контента. Шаблонность вкладок настроек и меню сэкономит много времени разработчикам, при добавлении очередного элемента в игру;

Все, что не относится к дизайну напрямую, должно быть убрано. Все меню, всплывающие окна и подсказки, которые появляются в игре должны быть отключены в редакторе. Дизайнерский процесс состоит из массы рутинных действий, поэтому любой дополнительный клик просто отнимает время и внимание;

Мобильная версия. Если проект разработан под мобильные устройства, ваш отдел контроля качества не раз скажет спасибо, если на них можно будет запустить и полноценный редактор. На деле, это очень поможет при работе со всеми смежными отделами. Для дизайнеров это поможет вести работу в более комфортном для них окружении. Иногда очень полезно сделать наброски идей пока едешь в метро или пьешь кофе на кухне. Дизайнеры люди творческие и любая возможность выйти за пределы насиженного рабочего пространства, не прекращая выполнять свои обязанности, пойдет им на пользу;

Выключите звуки и музыку по-умолчанию! Я серьезно, об этом всегда забывают.

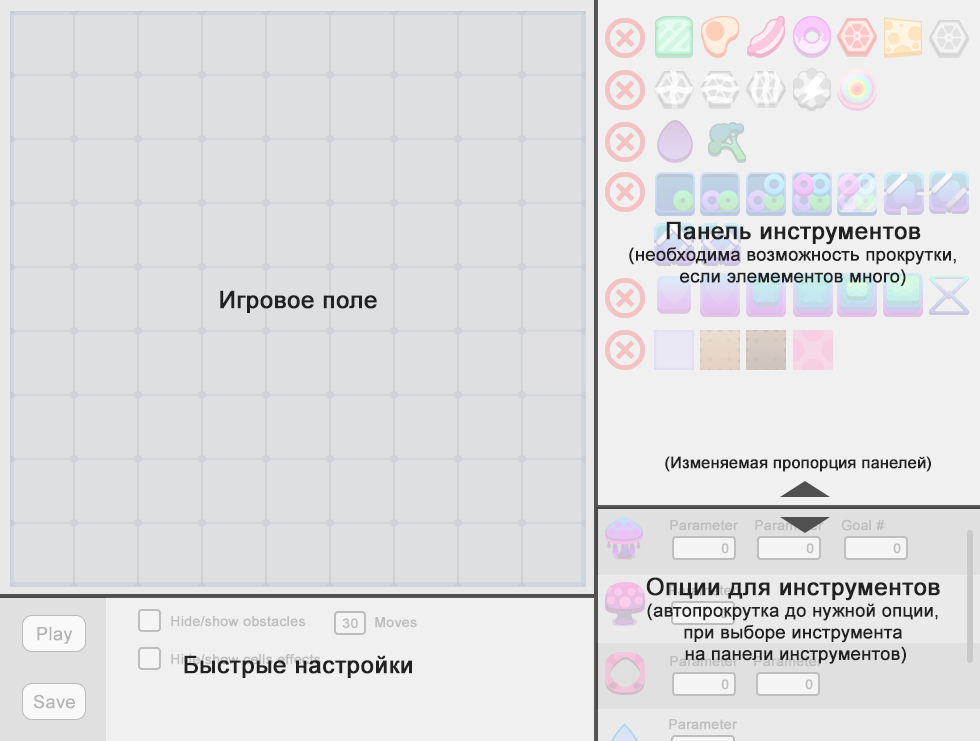

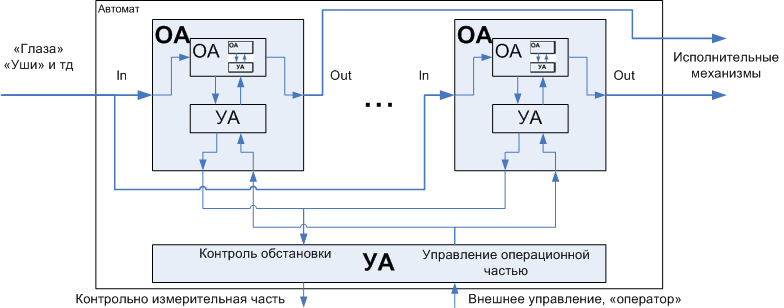

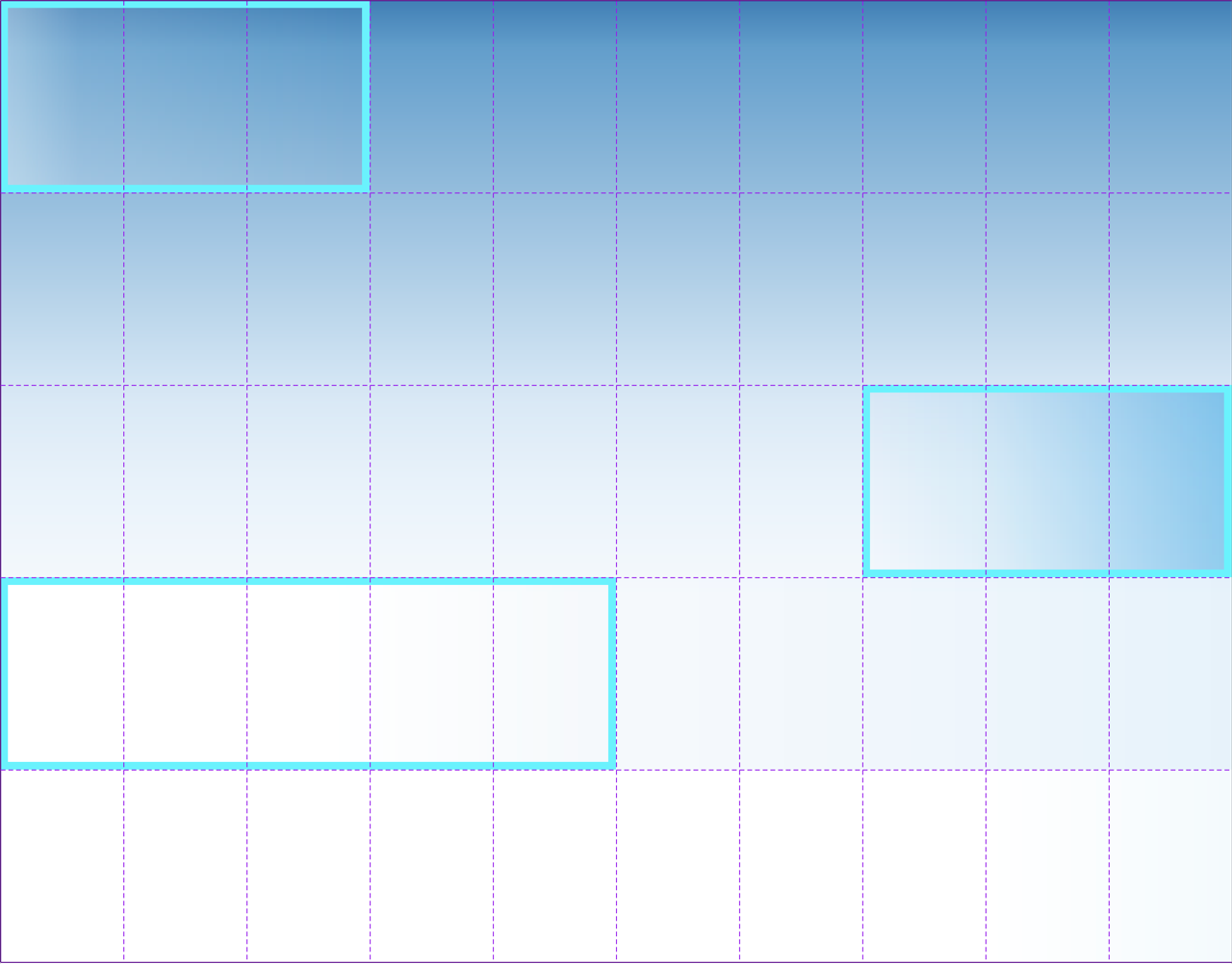

Рассмотрим принципиальную схему устройства редактора.

Наиболее распространенный подход к разработке, это оставить размер окна редактора таким же, как и в игре. Если это игра для веба, то 800х600 пикселей, это то с чем чаще всего приходится иметь дело. Для игры, издаваемой на мобильных устройствах и имеющей редактор в веб окружении, эта пропорция может быть спокойно нарушена и ограничением может быть только размер и пропорции рабочего монитора. В примере я буду рассматривать редактор для веб игры.

Грамотно спроектировать редактор довольно сложно. Нельзя просто разместить все элементы вашей игры на одном экране и надеяться, что этого будет достаточно. В долгосрочной перспективе поддержка такого проекта будет проблемой для всех отделов и прямо скажется на успешности проекта. Удобство использования редактора играет решающую роль для дизайнера при поддержке проекта.

При старте разработки дизайна редактора, необходимо начать с двух простых моментов:

Во-первых, нужно определиться с элементами, которые используются дизайнерами наиболее часто. Например, набор препятствий и бонусов будет более востребован, чем настройки количества игровых фишек, которые появляются на поле.

Во-вторых, необходимо сделать редактор максимально удобным и эффективным для нужд дизайнера и команды разработки. При поддержке проекта часто появляются новые игровые элементы и чем меньше вопросов будет возникать при их добавлении в редактор, чем быстрее будет получен результат.

Базовый редактор включает в себя несколько основных разделов:

Панель инструментов. Следуя привычке и принципам большинства популярных программ, в которых мне довелось поработать, я считаю, что правая часть экрана просто обязана быть отдана под панель инструментов. Таких инструментов для головоломок может быть несколько десятков, многие из которых могут иметь дополнительные настройки.

Панель опций. Для многих игровых элементов есть дополнительные настройки. Например, препятствие может появляться во время игры с заданной частотой и в заданном количестве. Эти настройки желательно выносить в отдельную панель, а не оставлять их рядом с самим инструментом создания этого препятствия. Панель опций вторична, поэтому удобным решением будет ее появление на экране или автоматическая прокрутка до необходимой опции, по клику на соответствующий инструмент. Для случаев, когда опции все же необходимы, пропорции двух панелей должны быть изменяемыми. Это не самое простое решение, но оно очень удобно в работе и покрывает большой процент возможных ситуаций при дизайне контента. Для самых крупных и сложных проектов, я бы рекомендовал разбить соответствующие панели на независимые вкладки, но это может сказаться на удобстве пользования редактором.

Быстрые функции. Нижняя часть редактора предназначена для управления редактором. Это кнопки запуска игры и сохранения уровня. Здесь также удобно разместить опции режимов отображения игровых элементов. Например, часть игровых элементов может быть скрыта под другими элементами, поэтому чтобы не удалять их вручную, необходимо добавить возможность их сокрытия для удобства дизайнера.

Каталог целей уровня. Отдельно стоит упомянуть раздел с целями уровня. Для проектов, в которых все цели уровня статичны и могут быть подсчитаны автоматически, этот раздел может отсутствовать в принципе. Но в большинстве игр все же есть уровни, где необходимо собрать цели, которые появляются в течении игры. Для таких игр, все цели уровня лучше сгруппировать в одну категорию и поместить их либо в быстрые настройки или в раздел опций. Все зависит от того, сколько подобных игровых режимов существует и каких параметров они требуют.

Сделать рабочий редактор уровней можно и на коленке, но я хочу затронуть тему рабочего пространства, которая включает в себя не только функции создания контента, но и управления им.

Окружение редактора это то, что делает дизайнера действительно эффективным. На начальных стадиях поддержки проекта стоит задача просто создать контент и запустить игру, но настоящая работа начинается в момент, когда нужно вносить правки. Нередко приходится править десятки уровней за раз, для этого уже недостаточно простого списка уровней и окна редактора.

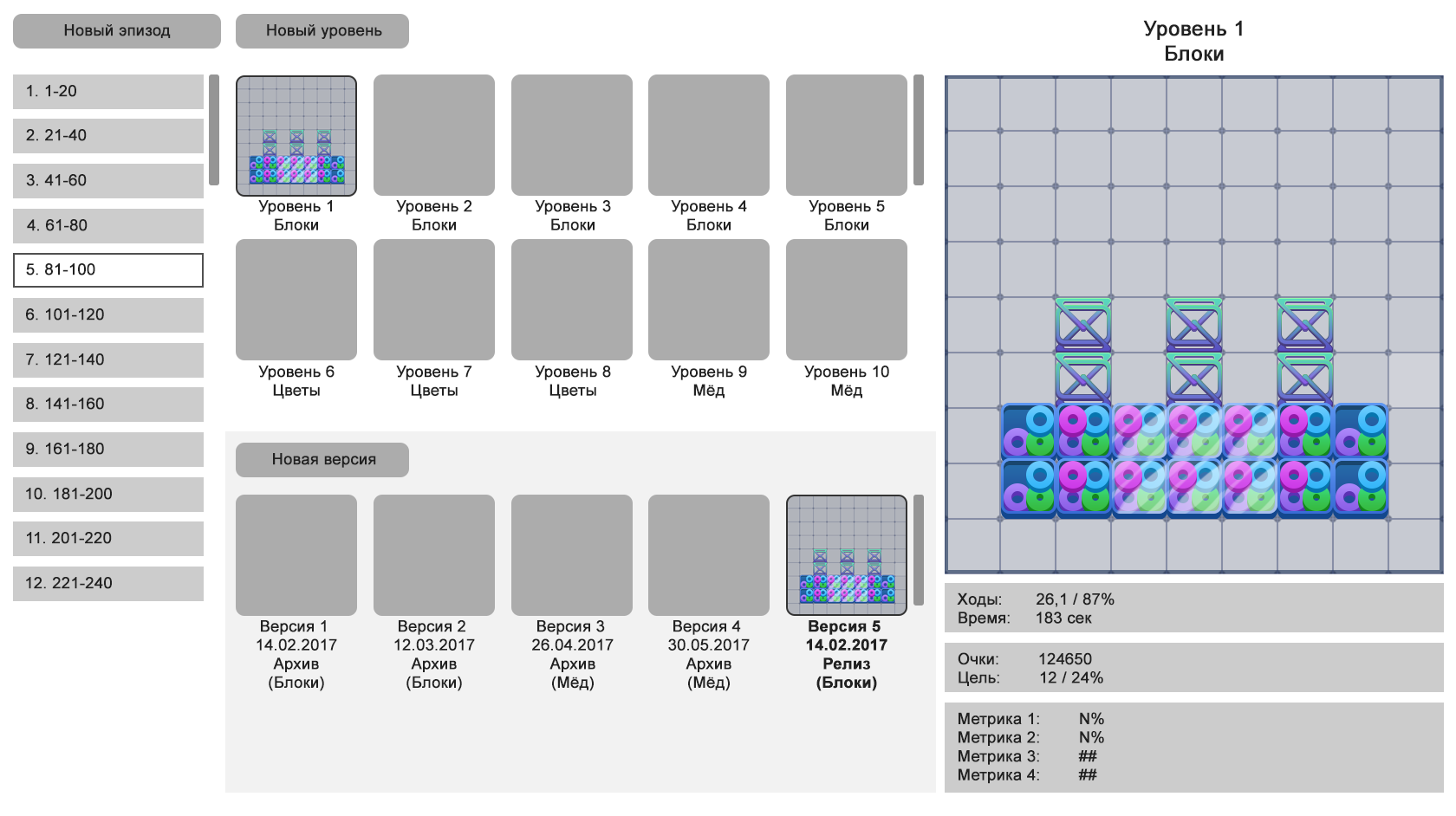

Необходимо создать менеджер уровней, систему контроля версий и быстрый доступ к метрикам проекта.

Список уровней. Это структура вашего проекта, поэтому этот раздел должен позволять легко ее менять или вносить коррективы. Например, если в игре уже 500 с лишним уровней, держать их все одним списком будет неудобно. Необходимо сразу предусматривать возможность структурирования уровней по группам с удобной нумерацией. В играх, где существует несколько возможных миров со своими наборами уровней, так же необходимо создавать свой раздел. Рекомендация здесь будет только одна — переносить уровни из одного в раздела в другой необходимо за минимальное количество телодвижений. Drag`n`Drop будет одним из неплохих решений, но влечет за собой опасность случайного переноса контента между разделами. Делать сложный менеджмент с помощью многоуровневых меню более безопасный вариант, но однозначно не самый удобный;

Контроль версий. Возможность откатить изменения спасла не одну шкуру программиста, но в деле дизайна уровней это очень мощный инструмент для создания вариантов уровней, которые впоследствии можно использовать в игре. Как правило, очень помогает для уровней, которые являются критичными для проекта — обучение механикам, стартовые уровни игры и т.д. Возможность посмотреть на предыдущие варианты и, в случае чего, откатить изменения, бесценна. Основной проблемой будет создание удобного формата переноса версий между уровнями и корректное их именование. Вспомнить, что означает название версии “Copy of level New +” явно введет вас в ступор через месяц после отправки его на релиз, а называть каждый уровень вручную тоже не самое лучшее решение. Поэтому сразу утвердите наглядный способ идентификации версий. Например, номер по порядку, дата релиза, игровой режим и количество игровых ходов;

Список метрик. Поддержка проекта — это всегда постоянный контроль контента и внесение в него правок. Можно бесконечно долго создавать сотни таблиц и списков в десятках вкладок браузера, но наиболее удобное решение, когда все это уже есть в админке. Да, работа с аналитикой, составление различных сводных таблиц и отчетов важная часть работы, но она нужна, в основном, для глобальной оценки происходящего в игре. Для внесения правок в конкретный уровень дизайнеру достаточно несколько ключевых показателей и метрик, которые удобно видеть в прямой связке с редактором. Для примера, это могут быть сложность, количество потраченных ходов, средний прогресс проигравшего игрока и т.д.

В качестве отправной точки, я бы рекомендовал начать с построения менеджмента уровней и контроля версий, т.к. это наиболее часто используемый функционал. Последующие итерации рабочего окружения уже могут включать в себя работу над дополнительными функциями, например, автотестами, удобством пользования и аналитикой.

И финальный, самый комплексный раздел — менеджер уровней. Управление контентом игры представляет собой не самую тривиальную задачу, т.к. она связана с многоуровневым менеджментом, который включает в себя, как минимум, контроль качества и подготовку контента к релизу.

Элементы управления контентом, которые необходимы конкретно дизайнеру:

Быстрый просмотр набора уровней. Возможность наглядного контроля за контентом игры бесценна в долгосрочной перспективе. Правки могут возникать на любом этапе, а возможность оценить проделанную работу визуально — бесценна. Очень удобно просматривать старые проекты, для оценки его сильных и слабых сторон;

Контроль версий. Возможность откатить изменения до предыдущей версии, если возникли проблемы, должна быть доступна без необходимости проверять каждый уровень отдельно. Сформированные наборы уровней и настроек, которые можно восстановить целиком или частями очень сильно поможет при поддержке сложных проектов;

Аннотации. Подключить аналитику к старым версиям уровней может быть не самой простой задачей, поэтому на помощь может прийти функционал аннотаций. Даже простой статичный текст, куда была скопирована актуальная на тот момент информация, поможет восстановить данные или использовать их при детальном анализе контента игры;

Безопасность. Проектируя систему менеджмента игры, необходимо озаботиться созданием уровней доступа для участников проекта. Если поиграть в любой уровень может каждый, то доступ к функциям редактирования, сортировки и контроля версий должен быть ограничен. Для начала подойдет возможность доступа по логину/паролю, позже можно развивать до более сложных систем взаимодействия участников проекта.

Полноценный редактор уровней это не просто часть клиента игры с возможностью создавать уровни, а сложная задача по созданию полноценного окружения по управлению проектом. Таким образом, процесс создания редактора уровней может сравниться по сложности с реализацией самого проекта или даже превзойти его. Итеративный подход к разработке и поэтапное добавление функционала будет лучшим решением при разработке.

Обзора какого функционала вам не хватило в статье и в реальных проектах? Если у вас есть опыт разработки подобных систем, на какие вещи стоит обратить внимание и чего однозначно не стоит делать?

|

Метки: author Pricol разработка мобильных приложений разработка игр match 3 level editor редактор уровней три в ряд дизайн уровней головоломки |

[Из песочницы] Использование MapXtreme .Net |

MapInfo MapXtreme for .Net — это комплект разработчика программного обеспечения ГИС в среде Microsoft .Net, позволяющий встраивать картографические и ГИС функции в бизнес-приложения.

Установка

Первым шагом была настройка машины к работе. Устанавливаем MS VisualStudio 2015 с сайта разработчика (на MSVS2010 работает, ниже версии не пробовал).

Скачиваем пакет установки с сайта разработчика. На портале для скачивания доступна триальная версия 7.1 на 60 дней (версия 8 доступна для покупки, разница между ними ощутимая, но затрагивает архитектуру MapXtreme. Основные операции остались неизменными).

Так же необходимо скачать карту мира, иначе зачем нам вообще нужна ГИС, не так ли? Для MapXtreme подходит карта ADC WorldMap Version 7.1.

Ставить именно в таком порядке, так как MapXtreme требует .Net.

Документация

Библиотека очень большая с большим количеством функций, но чтобы добраться до них нужна документация, а с ней у MapXtreme проблемы. После установки в каталоге с SDK можно найти

MapXtreme Developers Reference

MapXtreme Version 8.0 Developer Guide

Сами материалы содержат примеры на уровне капитана очевидность, либо отсутствуют вовсе. В интернете данная библиотека так же не содержит множества поясняющих ресурсов. Самый лучший был на сайте самого разработчика. Однако где-то полгода назад они закрыли к ней доступ и стали всех отправлять в тех.поддержку.

Кстати, пару слов о ней родимой:

Было 3-4 обращения к ним за помощью, и все разы мне говорили:

«Мы передали ваш запрос нашим разработчикам»

«Пришлите ваш исходный код нам, мы не понимаем вашу проблему» и т.д.

Для карты так же идет руководство, которое полезно. В нем описаны все теги и тпиа значений которые можно устанавливать.

Разработка

Если вы установили все верно, то VisualStudio при создание нового проекта у вас будет доступен тип проекта MapXtreme (у меня версия 8.0, т.к. мы купили лицензию).

Выбираем Windows Form App. Если в ToolBox не появились новые элементы открываем пункт меню

Tools -> Choose ToolBox Items...

И в появившемся окне выбираем нужные нам инструменты:

Итак, мы все установили, настроили и готовы писать код MapXtreme предоставляет уже готовые компоненты для создания приложения. Вы можете сразу сделать панель инструментов MapXteme добавив на главную форму компонент ToolStrip, в котором хранятся необходимые нам кнопки.

Чтобы использовать выбранные нами кнопки свойству MapControl пропишем имя нашего элемента типа MapControl. У меня называется mapControl1, у вас оно может отличаться. Либо в конструкторе формы написать

private void Form1_Load(object sender, EventArgs e)

{

addrectangleToolStripButton1.MapControl = mapControl1;

....

}Если все сделано правильно, то у вас должно получится вот так:

«Я сделал все правильно, выбрал инструмент для рисования, но у меня ничего не выходит! Почему?»

Чтобы решить данную проблему необходимо выбрать слой на котором мы будем рисовать и сделать его изменяемым. По умолчанию все слои на mapControl неизменяемые.

Мы можем решить нашу проблему средствами MapXtreme нажав кнопку «Layer Control» и поставив галочки в нужных местах.

Или сделать это прямо в коде:

var layerTemp = mapControl1.Map.Layers["wldcty25"];

LayerHelper.SetInsertable(layerTemp, true);//дает возможность рисовать на слое инструментами

LayerHelper.SetEditable(layerTemp, true); //делает наш слой изменяемым

Отмечу, что рисовать можно только на «верхнем» слое, то есть чтобы сейчас нарисовать объект мы должны наш слой «wldcty25» переместить вверх:

Или написать в коде:

mapControl1.Map.Layers.Move(lastPosition, nextPosition);

В результате нарисован наш первый объект:

Как я говорил ранее любая настройка может быть задана через интерфейс. Однако, заказчик чаще всего привередливый и ему нужны более гибкие/доступные элементы настройки поэтому далее я не буду рассказывать о том как настроить что либо через компоненты MapXtreme. Я покажу как это сделать через код.

Начать хочу со стиля. Основным классом отвечающим за оформление выступает CompositeStyle. В MapXtreme мы можем задавать стиль на слой и на объект. Отмечу, что стиль слоя перекрывает стиль объекта.

SimpleLineStyle border;//стиль линейного объекта

border= new SimpleLineStyle(<ширина линии в единицах MapXtreme>, <код стиля линии>, <цвет линии>)

SimpleInterior interior;//стиль внутренней области объекта

interior = new SimpleInterior(<код стиля>, <цвет переднего плана>,<цвет фона>)

AreaStyle polygon;//стиль который используя предыдущие два задает стиль для площадного объекта

polygon = new AreaStyle(border, interior);

SimpleLineStyle line;//стиль линейного объекта

line = new SimpleLineStyle(<ширина линии в единицах MapXtreme>, <код стиля линии>, <цвет линии>)

BasePointStyle point;//стиль точечного объекта

point = new SimpleVectorPointStyle(<код стиля>, <цвет точки>, <размер точки>)

CompositeStyle compStyle;//стиль применяемый к слою

compStyle = CompositeStyle(polygon, line, null, point);

Применим полученный стиль к слою:

FeatureOverrideStyleModifier fosm;

fosm = new FeatureOverrideStyleModifier(parStyleName, parStyleAlias, compStyle);

myLayer.Modifiers.Append(featureOverrideStyleModifier);

Применим полученный стиль к объекту:

Feature feature = null;

feature = new Feature(<класс описывающий наш объект>, compStyle);

Создание объекта

Для создания мультилинии или мультиполигона сначала создадим исходные данные:

//задаем первую часть мультиобъекта

DPoint[] pts1 = new DPoint[5];

pts1[0] = new DPoint(-20, 10);//произвольные координаты точек взятые для примера

pts1[1] = new DPoint(10, 15);

pts1[2] = new DPoint(15, -10);

pts1[3] = new DPoint(-10, -10);

pts1[4] = new DPoint(-20, 10);

//задаем вторую часть мультиобъекта

DPoint[] pts2 = new DPoint[5];

pts2[0] = new DPoint(-40, 50);

pts2[1] = new DPoint(60, 45);

pts2[2] = new DPoint(65, -40);

pts2[3] = new DPoint(25, 20);

pts2[4] = new DPoint(-40, 50);

//LineString создаем из массива элементов DPoint

LineString lineString1 = new LineString(coordSys, pts1);

LineString lineString2 = new LineString(coordSys, pts2);

Используя код выше создадим:

— мультиполигон

//Ring в заданной системе координат coordSys создается через LineString

Ring ring1 = new Ring(coordSys, lineString1);

Ring ring2 = new Ring(coordSys, lineString2);

Ring[] rng1 = new Ring[2];

rng1[0] = ring2;

rng1[1] = ring1;

//MultiPolygon состоит из массива Ring

MultiPolygon multiPol = new MultiPolygon(coordSys, rng1);

— мультилинию

//Curve в заданной системе координат coordSys создается через LineString

Curve curve4 = new Curve(coordSys, lineString1);

Curve curve5 = new Curve(coordSys, lineString2);

Curve[] crv = new Curve[2];

crv[0] = curve5;

crv[1] = curve4;

//MultiCurve состоит из массива Curve

MultiCurve mc = new MultiCurve(coordSys, crv);

Работа с картографической проекцией

Получение:

CoordSys сoordSys= mapControl1.Map.GetDisplayCoordSys();Создание и изменение текущей системы координат:

CoordSys cs = Session.Current.CoordSysFactory.CreateCoordSys("EPSG:3395", CodeSpace.Epsg);

mapControl1.Map.SetDisplayCoordSys(cs);

На самом деле там очень много перегруженных конструкторов, но обычно двух хватает так как в практических задачах необходима работа в трех-четырех системах координат.

Я еще ничего не сказал про работу с растровыми изображениями. Она здесь так же есть. Однако если вы изменили систему координат, то ваше изображение вряд ли преобразуется если не прописать след. строчку:

mapControl1.Map.RasterReprojectionMethod = ReprojectionMethod.Always;

/**

*ReprojectionMethod имеет три состояния

* None = 0, //запрет на изменение растра

* Always = 1,//изменять всегда

* Optimized = 2//так и не понял зачем нужен, в моей практике он ничем не отличался от

* предыдущего

*/

Лично я работал только с GeoTiff. MapXtreme не работает напрямую с изображениями. Для того чтобы все было хорошо системе необходим *.tab файл, который будет содержать описание растра, систему координат, координаты углов.

Как делать *.tab для растра средствами MapXtreme я так и не нашел, интернет так же подсказки не дал и мне пришлось самому писать метод, который создавал бы этот файл:

private string CreateTabFile(List parImageCoordinate)//список координат углов

{

NumberFormatInfo nfi = new CultureInfo("en-US", false).NumberFormat;

var ext = m_fileName.Split(new Char[] { '.' });

var fileExt = ext[ext.GetLength(0) - 1];

string fileTabName = m_fileName.Substring(0, m_fileName.Length - fileExt.Length) + "TAB";

StreamWriter sw = new StreamWriter(fileTabName);

string header = "!table\n!version 300\n!charset WindowsCyrillic\n \n";

sw.WriteLine(header);

string definitionTables = "Definition Table\n ";

definitionTables += "File \"" + m_fileName + "\"\n ";

definitionTables += "Type \"RASTER\"\n ";

for (var i = 0; i < parImageCoordinate.Count; i++)

{

definitionTables += "(" + parImageCoordinate[i].Longitude.ToString("N", nfi) + "," + parImageCoordinate[i].Latitude.ToString("N", nfi) + ") ";

definitionTables += "(" + parImageCoordinate[i].PixelColumn.ToString() + "," + parImageCoordinate[i].PixelRow.ToString() + ") ";

definitionTables += "Label \"Точка " + (i + 1).ToString() + " \",\n ";

}

definitionTables = definitionTables.Substring(0, definitionTables.Length - 4);

definitionTables += "\n ";

definitionTables += "CoordSys Earth Projection 1, 104\n ";

definitionTables += "Units \"degree\"\n";

sw.WriteLine(definitionTables);

string metaData = "begin_metadata\n";

metaData += "\"\\IsReadOnly\" = \"FALSE\"\n";

metaData += "\"\\MapInfo\" = \"\"\n";

string hash;

using (MD5 md5Hash = MD5.Create())

{

hash = GetMd5Hash(md5Hash, m_fileName);

}

metaData += "\"\\MapInfo\\TableID\" = \"" + hash + "\"\n";

metaData += "end_metadata\n";

sw.WriteLine(metaData);

sw.Close();

return fileTabName;

}

Метод GetMd5Hash взят с MSDN. Итак, теперь наш mapControl1 готов к работе с растром.

Пока все. Вышло и объемно, наверное. Почему решил написать? Потому что не нашел ни на хабре, ни в ру/еу сегменте интернета хорошего контента по данному вопросу.

|

Метки: author KvendyZ обработка изображений геоинформационные сервисы .net mapxtreme костыльное программирование |

Дизайн города, основанный на данных. Лекция в Яндексе |

Большая часть слайдов — тоже под катом.

Я Андрей Кармацкий, я руковожу компанией Urbica. Компания изначально задумывалась как студия по визуализации данных, но поняли, что работа с данными нужна не для того, чтобы делать красивые картинки.

Я не нашел удачного перевода этого слова. Если кто-то хорошо знает английский, то «tinkering» — что-то связанное с паянием, починением примусов, ведь чтобы получить красивую картинку для слайдов, нужно делать очень много разных хитрых хаков, экспериментов с данными. Даже сейчас модно говорить про машинное обучение. В конечном счете все сходится к тому, что нужно подбирать параметры и найти какую-то модель. В целом, кажется, мы здесь очень схожи. Я ловлю себя на том, что обычно наша команда постоянно этим занимается, так что мы находимся в экспериментально-прикладном инженерном процессе, где что-то варится-варится-варится, делается, и вдруг что-то получается.

Я хочу поделиться историей, которая меня очень вдохновляет. Она то есть из прошлого, из конца XIX века. Был такой замечательный промышленник Чарльз Бут. Если кто-то не слышал про карту бедности Лондона, то я вкратце перескажу его историю. Бут, будучи достаточно успешным предпринимателем, решил попробовать решить проблему в стране, в Англии, в конце XIX века. Что он сделал?

Он собрал команду, которая занимались исследованием городской среды. Его ассистенты ходили по городу на протяжении 17 лет со специальными блокнотами, куда записывали свои наблюдения. Они жили в семьях, интервьюировали людей, пытались понять, как город живет, какие у него проблемы, какие трудности именно в разрезе решения проблемы бедности.

В конечном счете Бут опубликовал две карты с интервалом в 10 лет. Все данные, которые они собирали в своих блокнотах и записях, они картировали. Эта карта показывает параметр, который сейчас называется «уровень дохода населения». Ранее никто этим не занимался. Они собрали карту, в которой очень хорошо видно, что черные домики — это бедные горожане, а красные — зажиточный, богатый слой населения. И он очень наглядно, доступно показал, насколько общество расслоено, насколько они соседствуют. Вы же понимаете, что конец XIX века — это не так классно. Во-первых, это индустриализация, это эпоха паровых машин, копоть, грязь, а во-вторых — антисанитария. Соседство разных слоев населения — это и обострённая криминогенная обстановка, и вообще некоторое здоровье общества. Так что если кто-то знает и хочет детально посмотреть, «карта бедности Лондона» — одна из основополагающих, по крайней мере вдохновляющих меня историй, потому что после нее, например, в парламенте произошли ряд существенных изменений законодательства. В том числе введение пенсии по старости непосредственно приписывают череде событий, которые проистекали из этого исследования.

Занимаясь данными, я пришел к одной мысли… Это не аксиома, потому что я написал два слова и фоном запустил картинку с заказом такси, чтобы не было так скучно. Потому что это просто визуализация. Но самое важное, что когда мы занимаемся какими-то проектами с данными, у нас всегда есть два суперважных ингредиента. Чтобы что-то получилось, нужно задать себе вопрос: какую проблему мы хотим решить, зачем мы это делаем, что должно получиться в итоге? Судя по куче вопросов к предыдущему докладчику, всегда возникают вопросы про данные: «А где данные? Что нужно исследовать?». И мы всегда наблюдаем две или три ситуации. Идеальная ситуация — когда у нас есть и хорошая задача, и хорошие данные, которые структурированы. Например, данные мобильных операторов. Они сложены в CSV, все суперздорово. Мы все это можем скашеварить и получить какой-то ответ.

Другая ситуация — когда, например, у нас есть только проблема и нет данных. Третья ситуация связана с фоновым слайдом. Это когда «У нас есть классные данные. Давайте что-нибудь покрутим, и будет прикольно». И получаются классные, но бесполезные визуализации.

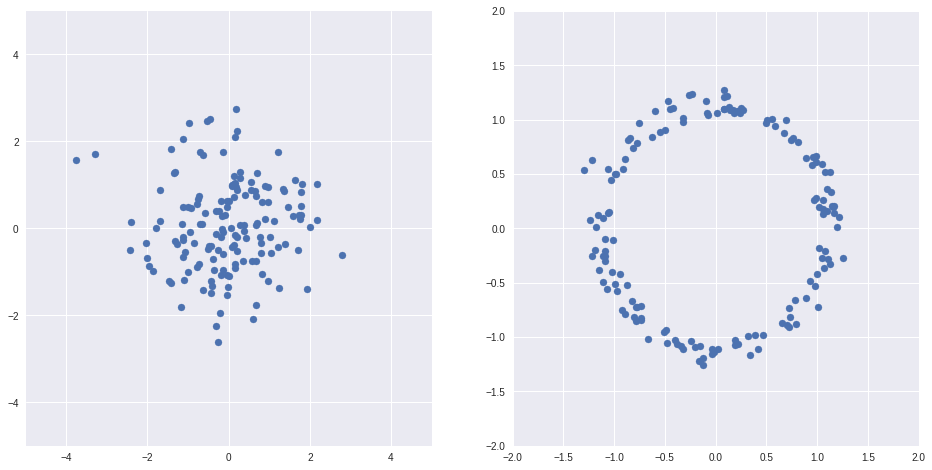

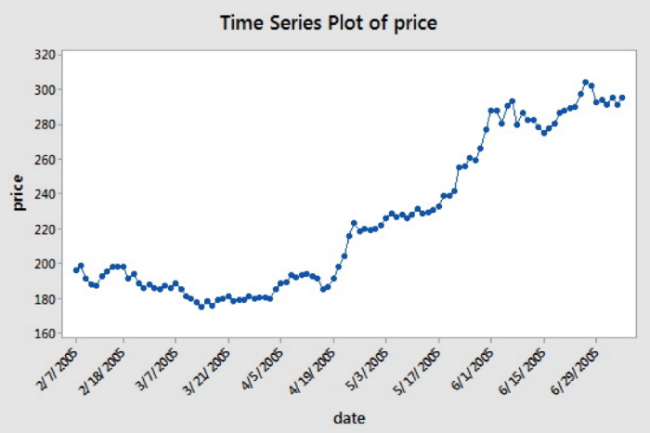

Когда данных много и когда они хорошо структурированы… Вы прекрасно знаете, поскольку многие из вас работают с данными, что можно легко перейти к стадии, когда вы можете наблюдать паттерны. Например, взяв хорошо структурированный набор данных о велопоездках в Нью-Йорке — есть открытые данные о велопрокатах и загруженности станций, — мы можем видеть паттерны и узнать, например, куда люди ездят или как балансируют велосипеды. Мой коллега после перерыва детально расскажет про московский «Велобайк», потому что там всё не так очевидно и нет такого существенного набора данных, позволяющего увидеть паттерны, и задача становится в разы интереснее.

Тем не менее, наш эксперимент с открытыми данными по Нью-Йорку говорит в том числе примерно о том, о чем говорил Егор: что есть ряд станций и если, например, взять и положить данные о загруженности станции в среднем в течение дня по будням и как-то разбить их на кучки, то мы увидим три совершенно четких паттерна. Одни станции наполнены велосипедами утром, пустеют днем, а другие работают наоборот. О чем это говорит?

Это не что иное, как трудовая маятниковая миграция.

Люди, живя, например, на каком-нибудь Ист-Сайде и работая в центре Манхэттена, берут велосипед и перемещаются на работу. Это очень хорошо видно, и такие паттерны легко проследить, когда у нас данных много и они хорошо структурированы. Мы очень легко перешли к стадии, когда мы можем взять какой-то сет данных и легко увидеть паттерны. Дальше уже некоторый простор для творчества с этими данными.

Что же делать, когда, например, данных у нас нет? Гораздо интереснее об этом поговорить, правда? Или, например, самое простое — взять данные и пойти их купить. Правда? У вас есть много денег, вы идёте, покупаете данные. Если вы не знаете, где купить данные, то находите того, кто знает. Он берет свой процент, находит данные или собирает, структурирует и т. д.

В нашем скромном опыте было участие в таком проекте… Если кто-то знает, в прошлом году был открытый конкурс на реконструкцию советских кинотеатров. Один из застройщиков купил у города 39 московских старых кинотеатров, построенных в 1960-х годах, и взял на себя некоторые обязательства на тему того, чтобы не превращать их в торговые центры, а сделать какую-то социально значимую функцию. То есть нужно было сделать эти точки непосредственно в районах, поскольку они все разбросаны по городу, более полезными — кроме торговых центров. Понятно, что здесь задача в коммерческом успехе, но еще нужно было реализовать некоторую социальную функцию. И вот этот застройщик объявил конкурс на тему «Давайте что-нибудь придумаем». Мы помогали одной из конкурсных команд «Aventica» и Nowadays Office обработать данные и предложить какое-то функциональное наполнение. Что в данном случае стоит рассматривать? Если совсем упростить, то условия очень близки к геомаркетинговой задаче. Если кто-то слышал про геомаркетинг, про развитие сети, то что нам нужно сделать? Нам нужно понять спрос в какой-то конкретной локации. То есть речь идет либо о данных БТИ, либо, например, о количестве жителей по данным мобильных операторов. В этом случае мы посчитали просто по реформе ЖКХ — вы знаете, есть открытый сет данных, можно просто, зная среднее количество человек на одно домохозяйство, каким-то образом представить, сколько людей живет на территории. И здесь важная деталь, совершенно неправильная, потому что радиус полтора километра он вроде как описывает. В данном случае это Рязанский проспект, кинотеатр «Восход». Рн там находится чуть-чуть за Рязанским проспектом. Если кто-то хорошо знает восток, то там есть железная дорога, парк «Кусково», и Разянский проспект разбивает территорию. Там идут какие-то промзоны, потому что реальная пешая доступность совсем отличается.

То есть это не 52 тыс. человек в 15-минутной доступности, а на 20% меньше, потому что на самом деле город — не поле, в котором мы можем пройти в любом направлении. Очень важно говорить о зонах пешей доступности, которые учитывают топологию. Чуть подробнее расскажу на следующем примере.

Второй набор данных — предложение. На пересечении спроса и предложения мы можем что-то предлагать или видеть какую-то зависимость и выяснять, насколько эффективным будет размещение локации. Наша задача усложнялась еще и тем, что у нас не было каких-то данных, которые были представлены. То есть мы могли использовать только открытые данные. Задача была следующей: предложить функциональное наполнение. Что такое функциональное наполнение, какой должна быть локация?

Одно дело, когда мы строим хозяйственный магазин или «Ашан». Мы прекрасно знаем, что нас интересует достаточно узкий спектр сервисов, и можем посмотреть на конкурентную среду, посмотреть, насколько люди эту потребность уже реализуют на поверхности. Мы уже можем делать какие-то выводы.

Что делать, когда этого нет? Понятно, что можно каким-то образом перебирать. В данном случае у нас не было машинного обучения, а было человеческое обучение в лице аналитиков, которые занимались исследованием.

Мы сделали суперпростую штуку — прикрутили небольшой интерфейс к API Яндекс.Карт, у которых есть справочник организаций, и дали возможность просто вбивать разные запросы. И вот хороший пример, который у нас внезапным образом получился. Мы таким образом выяснили… Там была одна из локаций, находящаяся около метро Войковская. Если знаете, там есть огромный торговый центр «Метрополис». Казалось бы, какую функцию можно предложить, когда в двух минутах у нас расположена некая махина, где есть все: еда, одежда, что еще может быть. Но при этом нам нужно сделать социально полезную функцию, и чтобы она еще была интересна застройщику и девелоперу в коммерческом плане.

Поэтому таким перебором мы выяснили, что там не реализована спортивная функция, что вокруг Войковской в 10-15-минутных зонах доступности нет хороших фитнес-центров и т. д. Одно из наших предложений… Сразу скажу, чтобы все не выглядело суперкрасиво: мы не выиграли этот конкурс, мы заняли третье место. Нас похвалили за то, что у нас была неплохая аналитика. По сути там была еще и архитектурная концепция, и ряд особых требований. Тем не менее, мы предложили сделать из кинотеатра некое спортивное учреждение, где можно заниматься йогой, либо какое-то пространство, чтобы проводить занятия. Вот один из примеров.

Другой пример про наши эксперименты с данными и их отсутствием является подтверждением тезиса, что голь на выдумку хитра. Это анализ городской среды для пешеходов. Это вообще была одна из идей на старте студии в какой-то момент времени. Очень хотелось ее развить. Мы сейчас ей занимаемся в режиме домашнего проекта, потому что нам это интересно — собрать данные о качестве городской среды для пешеходов. Понятно, что, привет, программа «Моя улица», и тротуары становятся шире, среда становится комфортнее. Но меня очень зацепил один рассказ на TEDx. Он называется «Happy Maps», его рассказывал Даниэле Куэрца, и мне это стало слишком близко. Он говорил, что вот вы идите на работу из точки А в точку Б одним и тем же маршрутом и, на самом деле, можете не подозревать, что маршрут по соседней улице гораздо счастливее, но вы потратите плюс одну-две минуты. Соответственно, стало интересно попробовать сделать город удобнее для человека, добавить ему эту минуту, но добавить и чуть больше счастья. Понятно, что счастье невозможно измерить, оно уже совсем не укладывается в графики и т. д. Но на уровне ощущений хотелось попробовать эту историю. Поэтому мы начали активно заниматься этим проектом. И понятно, что при наличии некоторой экспертизы в картах…

Приведу один простой пример. Собрать данные про озеленение, про шум — и каждый набор данных берется из разных открытых источников, поскольку это некоторый эксперимент в поле без открытых данных.

Возьмем городской шум. Совершенно понятно, что он влияет на ваше здоровье. Есть куча исследований про нарушение сна в ночное время — стройки и так далее. Но никто в Москве сейчас не измеряет городской шум системно, и во многих странах, где обращают внимание на данные, они, как правило, реагируют на измерения шума — если есть жалобы о стройках и т. д. Но, например, равномерного покрытия о том, как устроен шумовой ландшафт города, нет.

Так что самая простая идея заключалась в следующем. Берем любое приложение. У вас телефон, у него есть микрофон. На самом деле их два. Если вы знаете, они даже используют специальное шумоподавление, и уже даже есть приложения, которые меряют уровень шума. Было классное приложение, называлось InstaDB. Оно мало того, что меряет шум. Оно еще постит фотку улицы в Instagram. Я сделал специальный аккаунт, и нафоткал под 200 точек. Обработав их, я выяснил, что есть некоторые классы улиц, где можно хорошо и спокойно разговаривать, а есть некоторые классы улиц типа проспекта Вернадского, Большой Якиманки — на ней 80-85 децибел, и совершенно невозможно. Соответственно, мы уже можем наблюдать с этим некоторым экспериментальным набором данных некоторые паттерны. Мы можем их растиражировать на модель города, и, например, взять данные OpenStreetMap.

Сразу скажу — мы подсмотрели у одного парня из Швеции, который этим занимался. Он в открытом виде выложил некоторую модель, где типам дорог приписаны некоторые числовые индексы о том, которой уровень шума на них может быть. Сразу скажем, то есть наука нам говорит моделировать шумовой ландшафт по интенсивности трафика. Другими словами, нужно знать, сколько машин проехало на каждом ребре. К сожалению, нам эти данные были недоступны, поэтому мы занимались экспериментом. Но понятно, что здесь может возникнуть много вопросов к точности модели.

Задаваясь вопросом, как уточнить модель, мы опять же решили попробовать очень простую вещь: из Arduino и разных подручных средств собрать маленький датчик, который просто-напросто каждую секунду шлет вам в телефон по Bluetooth или Wi-Fi уровень шума. И мы сейчас продолжаем эксперименты, потому что железная часть оказалась самой сложной. Мы где-то на грани между точностью измерений и бюджетом. То есть понятно, что нужно уложиться. Например — сделать 10-20 устройств для заинтересованных людей, чтобы хотя бы промерить центр. Нужно уложиться в некоторые разумные рамки при наличии профессиональных устройств, которые стоят дорого.

Отвечая на вопрос, зачем эти данные собираются: можно, например, помочь жителю города строить маршруты с учетом этих параметров, чтобы как-то помочь персонально. То есть понятно, что этими данными город может интересоваться в конечном улучшении, но на самом деле каждый житель может использовать приложение и просто-напросто смотреть, где тихо, а где шумно. Мы сейчас допиливаем некоторую бету приложения. Я думаю, она дойдет до App Store. Она просто показывает, как пройти по тихим улицам, по зеленым. Данными об уровне озеленения с нами поделились ребята из «Гринпис», а о качестве воздуха — компания Aerostate. И соответственно, можно как-то вести пользователя по более классным маршрутам. Понятно, что речь идёт об одном из возможных применений этого набора данных.

Автобусы синие видели? Честно сказать, я еще год назад ничего не знал про транспорт в профессиональном ключе. Так получилось, что в Москве задумали оптимизировать маршрутную сеть. В центре города она уже была сделана, называется «Магистраль». Я хочу рассказать о нашем участии в этом процессе.

Для начала стоит отметить, что, как я уже сказал, мы ничего не знали про транспортное планирование. Очевидно, что речь идет о специальных людях, которые долгие годы этим занимаются. Но тем не менее, транспортное планирование — одна из заметных сфер применения, где есть и сложные модели, и большие наборы данных. Автобусы имеют «ГЛОНАСС», значит, билеты записываются. То есть имеются разные большие объемы данных, в разной степени структурированные.

Но стоит в том числе развеять миф, что метро в пятиминутной доступности есть везде в центре Москвы. Это не так. Но мы говорили про пешие зоны доступности. Сравните с Парижем — есть некоторая разница.

Чем мы занимались? Работали примерно как эти сотрудницы лондонской подземки. Транспортный комплекс Москвы исторически складывался достаточно долго. И понятно, что нет идеальных систем, и не сказать, что мы занимались именно этим. Мы не пересчитывали корешки билетов, чтобы понять, кто куда ездит. Тем не менее, нам удалось… Наверное, мы видели всё. Или не всё — но того, что мы видели, нам хватило, чтобы уже никого не бояться. И в принципе, мы еще можем ходить в цирк и ни разу не улыбнуться.

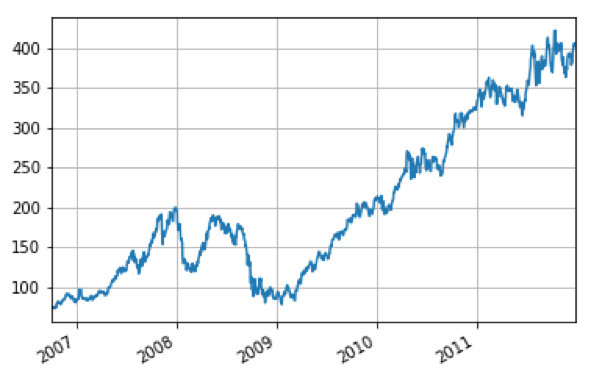

Мы взяли разные данные, которые были. Эти ребята собрались на воркшопе, транспортные планировщики. Они занимались тем, что оптимизировали маршрутную сеть, то есть они проводили некоторый воркшоп. Для них мы сделали небольшой инструмент, где все эти данные представили в каком-то едином виде, чтобы можно было посмотреть, как, например, спрос пересекается с предложением, и как едет — быстро или медленно. Сигналы «ГЛОНАСС» превратились в очень похожую и знакомую вам картину Яндекс.Пробок, только непосредственно про общественный транспорт — чтобы можно было увидеть, например, где автобус в среднем простаивает на светофорах.

Вкратце про задачу и про то, что делали эти ребята.

Они выписали некоторые принципы, которым следовали, когда оптимизировали маршрутную сеть. И совершенно понятно, что высокий платежный поток и плотность означает высокий спрос. Зачем нужен высокий спрос? Низкая стоимость эксплуатации на одного пассажира. Совершенно очевидно, что если у нас автобусы возят воздух — это неэффективно, неоптимально и, соответственно, стоит достаточно дорого для города. Пешеходная доступность — очевидный параметр. Если у вас в 10-15-минутной пешей доступности нет общественного транспорта — его для вас в принципе нет. Мы берете и покупаете машину.

Про высокий пассажиропоток и плотность. Думаю, что Егор очень детально рассказывал об изменении плотности населения в городе по мобильным операторам.

Я не буду сильно останавливаться. У меня есть такая гифка — как меняется плотность рабочих мест в центре Москвы в течение дня. То есть все более-менее понятны.

Проходы в метро. Прикладываете билет — опять же, привет, трудовая маятниковая миграция. Утром периферия приезжает в центр, вечером разгружается обратно. Днем понятно, что никто в целом не перемещается, все находятся на рабочих местах.

Что такое линейность и асимметрия? Взять, опять же, пассажиропоток. Прикладываете карточку «Тройка» к автобусу. Соответственно, есть статистика о том, сколько вы прошли, по каждой остановке. Здесь очень простой пример неоптимизированного маршрута, первого троллейбуса, который был в одну сторону. По сути, перед нами очень простой сценарий. Например, работая на Шаболовке, я мог приехать в Большой театр на этом троллейбусе, но чтобы мне на данном троллейбусе уехать, нужно было пройтись, например, до Кропоткинской и вернуться на нем обратно. Это совершенно неоптимальный маршрут, и цифры подтверждали, что у метро высокая пересадочность, и в тех местах, где у нас линия расходится, образуется не очень оптимальный трафик.

Соответственно, в инструменте, который мы создали, можно было все указанные наборы данных просто посмотреть, в том числе как меняется плотность населения по работникам и т. д.

Процесс принятия решений в некоторых случаях выглядит примерно так, что транспортные ребята собирались вокруг некоторого стенда, тыкали в какой-то конкретный маршрут, разбирали его, смотрели, три дня работали и каким-то образом принимали решение. То есть все равно понятно, что это не машинный труд, а все-таки поддержка принятия решений.

Пару слов о том, как провалидировать модель. Понятно, что маршрутная сеть — это граф, и у нас есть состояние сейчас и как могло бы быть. Каким образом можно проверить предлагаемое решение?

Очень просто. Есть такая фишка, как изохроны — зоны доступности. По сути, это линия, которая описывает некоторый временной параметр, описывает то, как далеко вы можете добраться. Соответственно, кликая в какую-то конкретную точку, вы можете посмотреть, насколько далеко вы можете уехать в новой модели маршрутной сети и в старой модели. Зная и пересекая данные о рабочих местах, мы можем легко посчитать, сколько было доступных рабочих или жилых мест и сколько их стало.

В среднем там получился буст 15–20%. После запуска первой стадии в октябре маршрутная сеть увеличилась по билетам на 20%. Но самое важное, что это очень простой и наглядный способ отвалидировать модель. В том числе у ребят, которые работают на уровне операционного принятия решений, часто возникает задача продать, презентовать эту идею, модель или предложение лицу, которое принимает решения. Если мы говорим про департаменты, то, соответственно, в них довольно понятным образом устроена модель принятия решений. Есть как бы детальное решение и проработка вопросов на уровне руководителей служб, людей, которые непосредственно занимаются транспортом. А решения так или иначе должны принимать руководители департаментов. И эта картинка на самом деле нужна руководителям департаментов, чтобы было видно, что рабочих мест там +20%. Работников в 30-минутной доступности был 905 тыс., а стало 1,015 млн. Соответственно, прибавилось 115 тыс. человек. Это очень простые цифры, которыми легко оперировать. Их можно посмотреть и легко увидеть.

«Магистраль» внедрена, она ездит, автобусы в городе. Существуют некоторые стадии ее развития. Дорисовываются новые выделенные полосы, потому что, помимо изменения маршрутов, внедряются полосы для общественного транспорта. По тому самому Кремлевскому кольцу транспорт теперь ходит в две стороны, и это является одной из главных фишек данного проекта.

Соответственно, можно посмотреть и попробовать покататься. Или, например, почитать более детальную историю о том, как указанные изменения были внедрены.

На этом всё. Спасибо большое. Не убивайте, пожалуйста, меня вопросами про методы. Я больше картинки рисую. И еще воспользуюсь эфиром. Скажу, что, интересуясь данными, я случайным образом завел Telegram-канал про городские данные. Я пощу туда всякие разные ссылки, в том числе на эту трансляцию.

Соответственно, буду очень рад какой-то обратной связи. Если знаете какой-то классный проект — присылайте, с удовольствием запощу.

|

|

История оптимизации одного IoC контейнера |