Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

iOS+Kotlin. Что можно сделать сейчас |

iOS+Kotlin. Что можно сделать сейчас

Стоит ли думать о порте своего приложения уже сейчас?

Да, но только если:

0). Вам действительно нужна общая кодовая база мобильных приложений.

1). Приложение мало завязано на платформу.

2). У Вас есть время на написание некоторого количества кода на Kotlin, который в будущем стоит переписать на Objective-C или Swift.

Причины пока не портировать

ViewController, AppDelegate и даже main-функция в примере написаны на Kotlin. Те файлы, которые написаны на Objective-C нужны только чтобы XCode не выдавал ошибку и не включаются в конечную сборку (я не нашёл способов исправить положение). Т.е. полноценный interop как с Java, видимо, пока что, недоступен. Это совсем не значит, что положение дел не изменится к релизу (сейчас проект на стадии alpha preview, а об этом примере даже поста в блоге не было). Но спектр доступных сейчас возможностей довольно ограничен.

Interop

Идиоматический подход к написанию мультиплатформенного приложения на Kotlin — отдельно написать общую часть, отдельно — часть для каждой платформы. При этом на каждой платформе, по задумке, должны быть легко доступны все библиотеки, под неё написанные. В случае с Java работает хорошо. В случае с iOS дела сейчас обстоят следующим образом:

@ExportObjCClass

class KotlinViewController : UIViewController {

constructor(aDecoder: NSCoder) : super(aDecoder)

override fun initWithCoder(aDecoder: NSCoder) = initBy(KotlinViewController(aDecoder))

@ObjCOutlet

lateinit var label: UILabel

@ObjCOutlet

lateinit var textField: UITextField

@ObjCOutlet

lateinit var button: UIButton

@ObjCAction

fun buttonPressed() {

label.text = "Konan says: 'Hello, ${textField.text}!'"

}

}То есть вполне неплохо. К каждому внешнему классу добавляем аннотацию @ExportObjCClass, к каждому графическому элементу из storyboard — @ObjCOutlet и @ObjCAction для каждого action. Классы на Objective-C доступны по их оригинальным именам.

Если нужно вызвать Kotlin из Objective-C/Swift

В этой статье описано, как это можно сделать. Через некоторое количество прослоек, с ручным преобразованием типов 2 раза, но зато можно звать Swift из Kotlin и Kotlin из Swift.

Overhead

В теории, вес приложения должен увеличиться примерно на 100 кб (отсюда).

Вместо GC будет использоваться ARC, так что особой разницы в производительности со Swift быть не должно.

Обратная совместимость

Судя по докладам участников команды разрабатывающей язык, обратная совместимость — один из их основных приоритетов. Насколько это хорошо — судить вам. Лично я считаю, что это намного лучше, чем у Swift и, в целом, язык хорош и большинство паззлеров выглядят надуманными. Но есть 1 вещь, которая, по моему мнению, может быть «бомбой замедленного действия», при этом не может быть исправлена с соблюдением обратной совместимости.

inline

Для реализации сопрограмм, которые делают так, чтобы синхронный и асинхронный код выглядели почти одинаково в язык было введено всего одно новое ключевое слово suspend, чем разработчики заслуженно гордятся. Но для того чтобы методы-расширения (forEach, map...) работали так же быстро, как и обычный for (и для вывода общих типов во время исполнения программы), было введено целых 3 (inline, crossinline, noinline). Они явно не делают код читаемее. JIT теряет часть возможностей для оптимизации (подкаст об этом), а опыт C показывает, что разработчики не умеют правильно пользоваться такими возможностями языка. В целом, не понимаю, почему то же самое нельзя было сделать аннотацией. Для меня inline выглядит как плохое решение достойной проблемы.

Заключение

— На Kotlin скоро можно будет писать под все 3 основные платформы (Android, iOS, Web).

— Скорее всего, будет хорошая совместимость с Objective-C и Swift. Возможно лучше, чем та, что есть между этими языками. Учитывая опыт JetBrains в разработке компиляторов и IDE, в это можно поверить.

— У Kotlin легковесный Runtime языка под Android и Web. Под iOS, судя по всему, тоже будет не тяжёлым.

— Уже сейчас можно что-нибудь написать.

|

Метки: author adev_one разработка под ios разработка под android kotlin android development ios development android ios |

[Перевод] Overview of Cryptoeconomics. Перевод статьи |

Overview of Cryptoeconomics. Перевод статьи

- Перевод

Наука о криптографии существует уже тысячелетия, но в формальной и систематизированной форме — всего пару десятилетий, и может быть определена как исследование коммуникации в состязательной среде (Rabah, 2004).

Аналогичным образом, мы можем определить криптоэкономику как концепцию, которая идет на один шаг дальше, т.е., изучение экономического взаимодействия в состязательной среде (Davidson, De Filippi & Potts,2016; Ernst, 2016). Чтобы отличить себя от традиционной экономики, которая, безусловно, изучает, как экономическое взаимодействие, так и противодействие, криптоэкономика обычно фокусируется на взаимодействиях, которые происходят по сетевым протоколам. Отдельные области криптоэкономики включают:

- Онлайн доверие и репутацию систем;

- Крипто-токены/ криптовалюты, и, в целом, цифровые активы;

- Смарт-контракты;

- Согласованные алгоритмы;

- Алгоритмы анти-спама и алгоритмы, устойчивые к атакам Сибиллы;

- Активизированные рынки для вычислительных ресурсов;

- Децентрализованные системы социального обеспечения /соц. помощи/ основного дохода; Децентрализованное управление (как для коммерческих, так и для некоммерческих организаций).

В течение нескольких последних лет мы стали свидетелями роста криптоэкономики,

что в значительной мере связано с увеличением количества криптовалют и цифровых токенов, которые привносят новые и интересные аспекты в такую науку как криптография (Potts, Davidson & De Filippi, 2016). Немногим ранее криптография была, по большому счету, простой вычислительной и информационной теоретической наукой, безопасность которой считали наиболее близкой к абсолютной.

Как только деньги попадают в поле зрения, идеальный мир математики должен взаимодействовать с реальным миром и социальными структурами общества, экономическими стимулами, относительной верой и многими уязвимостями, которые возможно только уменьшить,

но не удалить полностью. В то время, как криптографы привыкли к допущению типа «этот алгоритм гарантированно будет нерушимым при условии, что основные математические проблемы остаются неизменными», мир криптоэкономики вынужден довольствоваться неясными эмпирическими факторами, такими как, сложность при большом количестве атак, достаточное количество бескорыстных, а также заинтересованных в прибыли сторон, уровень концентрации различных ресурсов, и даже учитывать социально-культурные условия (Ernst, 2016; Davidson, De Filippi & Potts, 2016).

Напротив, в традиционной прикладной криптографии, меры безопасности склоняются к виду:

— Никто не может выполнить более чем 279 вычислительных шагов;

— Факторные операции остаются неизменными (т.е. полиномиальными) (Rabah,2005);

— Принятые n-ные корни композитных модулей неизменны;

— Задача дискретного логарифма эллиптической кривой не может быть решена быстрее, чем в 2n/2 раза;

С другой стороны, в криптоэкономике, основные меры безопасности от которых мы зависим выглядят примерно следующим образом (Ernst, 2016):

— Никто из лиц, контролирующих более 25% всех вычислительных ресурсов не могут вступать в сговор;

— Никто из лиц, контролирующих более 25% всех денежных ресурсов не могут вступать в сговор;

— Сумма вычислений определенного доказательства рабочей функции, которая может быть выполнена с заданной суммой денежных средств, не является сверхлинейной за пределами точки, которая расположена достаточно низко.

— Существует незначительное количество альтруистов и такое же незначительное количество сумашедших или политических оппонентов, поэтому большинство пользователей могут быть смоделированы как экономически рациональные.

— Количество пользователей в системе великое множество, и в любой момент пользователи могут появляться и исчезать, в то же время, по крайней мере, некоторые из них будут постоянными.

— Цензура невозможна, и передача сообщений между двумя узлами происходит относительно быстро.

— Достаточно легко сгенерировать множество IP-адресов, которые дают неограниченную

пропускную способность сети.

— Большинство пользователей анонимны, в связи с этим негативная репутация и появление долгов практически неосуществимы.

В связи с этим важно отметить, что существуют дополнительные предположения, касающиеся безопасности, характерные для возникающих проблем. Таким образом, нередко, даже невозможно, с уверенностью сказать, что возникшая проблема решена. Правильнее будет сказать, что необходимо будет создавать пути решения, оптимизированные для конкретных эмпирических и социальных реалий, и со временем продолжать их оптимизировать. (Ernst, 2016).

Перевод осуществляла Елена Логачева, корректировал Никита Мельников.

|

Метки: author NikMelnikov криптография информационная безопасность криптоэкономика блокчейн |

[Перевод] Overview of Cryptoeconomics. Перевод статьи |

Overview of Cryptoeconomics. Перевод статьи

- Перевод

Наука о криптографии существует уже тысячелетия, но в формальной и систематизированной форме — всего пару десятилетий, и может быть определена как исследование коммуникации в состязательной среде (Rabah, 2004).

Аналогичным образом, мы можем определить криптоэкономику как концепцию, которая идет на один шаг дальше, т.е., изучение экономического взаимодействия в состязательной среде (Davidson, De Filippi & Potts,2016; Ernst, 2016). Чтобы отличить себя от традиционной экономики, которая, безусловно, изучает, как экономическое взаимодействие, так и противодействие, криптоэкономика обычно фокусируется на взаимодействиях, которые происходят по сетевым протоколам. Отдельные области криптоэкономики включают:

- Онлайн доверие и репутацию систем;

- Крипто-токены/ криптовалюты, и, в целом, цифровые активы;

- Смарт-контракты;

- Согласованные алгоритмы;

- Алгоритмы анти-спама и алгоритмы, устойчивые к атакам Сибиллы;

- Активизированные рынки для вычислительных ресурсов;

- Децентрализованные системы социального обеспечения /соц. помощи/ основного дохода; Децентрализованное управление (как для коммерческих, так и для некоммерческих организаций).

В течение нескольких последних лет мы стали свидетелями роста криптоэкономики,

что в значительной мере связано с увеличением количества криптовалют и цифровых токенов, которые привносят новые и интересные аспекты в такую науку как криптография (Potts, Davidson & De Filippi, 2016). Немногим ранее криптография была, по большому счету, простой вычислительной и информационной теоретической наукой, безопасность которой считали наиболее близкой к абсолютной.

Как только деньги попадают в поле зрения, идеальный мир математики должен взаимодействовать с реальным миром и социальными структурами общества, экономическими стимулами, относительной верой и многими уязвимостями, которые возможно только уменьшить,

но не удалить полностью. В то время, как криптографы привыкли к допущению типа «этот алгоритм гарантированно будет нерушимым при условии, что основные математические проблемы остаются неизменными», мир криптоэкономики вынужден довольствоваться неясными эмпирическими факторами, такими как, сложность при большом количестве атак, достаточное количество бескорыстных, а также заинтересованных в прибыли сторон, уровень концентрации различных ресурсов, и даже учитывать социально-культурные условия (Ernst, 2016; Davidson, De Filippi & Potts, 2016).

Напротив, в традиционной прикладной криптографии, меры безопасности склоняются к виду:

— Никто не может выполнить более чем 279 вычислительных шагов;

— Факторные операции остаются неизменными (т.е. полиномиальными) (Rabah,2005);

— Принятые n-ные корни композитных модулей неизменны;

— Задача дискретного логарифма эллиптической кривой не может быть решена быстрее, чем в 2n/2 раза;

С другой стороны, в криптоэкономике, основные меры безопасности от которых мы зависим выглядят примерно следующим образом (Ernst, 2016):

— Никто из лиц, контролирующих более 25% всех вычислительных ресурсов не могут вступать в сговор;

— Никто из лиц, контролирующих более 25% всех денежных ресурсов не могут вступать в сговор;

— Сумма вычислений определенного доказательства рабочей функции, которая может быть выполнена с заданной суммой денежных средств, не является сверхлинейной за пределами точки, которая расположена достаточно низко.

— Существует незначительное количество альтруистов и такое же незначительное количество сумашедших или политических оппонентов, поэтому большинство пользователей могут быть смоделированы как экономически рациональные.

— Количество пользователей в системе великое множество, и в любой момент пользователи могут появляться и исчезать, в то же время, по крайней мере, некоторые из них будут постоянными.

— Цензура невозможна, и передача сообщений между двумя узлами происходит относительно быстро.

— Достаточно легко сгенерировать множество IP-адресов, которые дают неограниченную

пропускную способность сети.

— Большинство пользователей анонимны, в связи с этим негативная репутация и появление долгов практически неосуществимы.

В связи с этим важно отметить, что существуют дополнительные предположения, касающиеся безопасности, характерные для возникающих проблем. Таким образом, нередко, даже невозможно, с уверенностью сказать, что возникшая проблема решена. Правильнее будет сказать, что необходимо будет создавать пути решения, оптимизированные для конкретных эмпирических и социальных реалий, и со временем продолжать их оптимизировать. (Ernst, 2016).

Перевод осуществляла Елена Логачева, корректировал Никита Мельников.

|

Метки: author NikMelnikov криптография информационная безопасность криптоэкономика блокчейн |

Библиотека быстрого поиска путей на графе |

Библиотека быстрого поиска путей на графе

Привет, Друзья!

Я написал библиотеку поисков путей на произвольных графах, и хотел бы поделиться ей с вами: http://github.com/anvaka/ngraph.path

Пример использования на огромном графе:

Поиграться с демо можно здесь: https://anvaka.github.io/ngraph.path.demo/

В библиотеке используется мало-известный вариант A* поиска, который называется NBA*. Это двунаправленный поиск, с расслабленными требованиями к функции-эвристике, и очень агрессивным критерием завершения. Не смотря на свою малоизвестность у алгоритма отличная скорость сходимости к оптимальному решению.

Описание разных вариантов A* уже не раз встречалось на хабре. Мне очень понравилось вот это, потому повторяться в этой статье я не буду. Под катом расскажу подробнее почему библиотека работает быстро и о том, как было сделано демо.

Почему библиотека работает быстро?

"Как-то не верится что так быстро. Ты точно ниче не считаешь предварительно?"

Реакция друга, который первый раз увидел библиотеку.

Сразу должен признаться, я не верю что моя реализация — самая быстрая из возможных. Она работает достаточно быстро учитывая окружение в котором находится (браузер, javascript). Ее скорость сильно будет зависеть от размера графа. И, конечно же, то, что сейчас есть в репозитории можно ускорить и улучшить.

Статистика

Для замера производительности я взял граф дорог из Нью-Йорка ( ~730 000 ребер, 260 000 узлов). Таблица ниже показывает статистику времени, необходимого для решения одной задачи поиска пути из 250 случайно выбранных:

| Среднее | Медиана | Min | Max | p90 | p99 | |

|---|---|---|---|---|---|---|

| A* ленивый (локальный) | 32ms | 24ms | 0ms | 179ms | 73ms | 136ms |

| NBA* | 44ms | 34ms | 0ms | 222ms | 107ms | 172ms |

| A*, однонаправленный | 55ms | 38ms | 0ms | 356ms | 123ms | 287ms |

| Дейкстра | 264ms | 258ms | 0ms | 782ms | 483ms | 631ms |

Каждый алгоритм решал одну и ту же задачу. A* ленивый самый быстрый, но его решение не всегда оптимально. По-сути, это двунаправленный A* который сразу же выходит как только оба поиска встретились. NBA* двунаправленный, сходится к оптимальному решению. В 99% ему понадобилось меньше чем 172 миллисекунды, чтобы найти кратчайший путь (p99).

Оптимизации

Библиотека работает относительно быстро по нескольким причинам.

Во-первых, я изменил структуру данных в приоритетной очереди таким образом, что обновление приоритета любого элемента очереди занимает O(lg n) времени. Это достигается тем, что каждый элемент отслеживает свою позицию в куче во время перестройки очереди.

Во-вторых, во время нагрузочных тестов я заметил, что уборка мусора занимает значительное время. Это не удивительно, поскольку алгоритм создает много маленьких объектов когда он ходит по графу. Решается проблема со сборщиком мусора при помощи пула объектов. Это структура данных которая позволяет повторно использовать объекты, когда они уже не нужны.

Ну и наконец, алгоритм поиска NBA* имеет очень красивый и жесткий критерий посещения узлов.

Признаться, я думаю что это не предел совершенства. Вполне вероятно, если использовать иерархический подход, описанный Борисом удастся ускорить время для еще больших графов.

Как работает демо?

Создание библиотеки это, конечно, очень интересно. Но мне кажется демо-проект заслуживает отдельного описания. Я усвоил несколько уроков, и хотел бы поделиться с вами, в надежде, что это окажется полезным.

Прежде чем начнем. Кто-то меня спросил: "Но ведь это же граф? Как можно карту представить в виде графа?". Легче всего представить каждый перекресток узлом графа. У каждого перекрестка есть позиция (x, y). Каждый прямой участок дороги сделаем ребром графа. Изгибы дороги можно моделировать как частный случай перекрестков.

Готовим данные

Конечно, я слышал об https://www.openstreetmap.org, но их внешний вид меня не сильно привлекал. Когда же я обнаружил API и инструменты типа http://overpass-turbo.eu/ — это как новый мир открылся перед глазами :). Данные они отдают под лицензией ODbL, которая требует чтобы их упомянули (чем больше людей знают о сервисе — тем лучше становится сервис).

API позволяет делать очень сложные запросы, и дает потрясающие объемы информации.

Например, такой запрос даст все велодороги в Москве:

[out:json];

// Сохранить область в переменную `a`

(area["name"="Москва"])->.a;

// Скачать все дороги внутри a у которых аттрибут `highway == cycleway`

way["highway"="cycleway"](area.a);

// и объединить дороги с узлами графа (узлы содержат геопозицию)

node(w);

// Наконец, вернуть результаты

out meta;API очень хорошо описано здесь: http://wiki.openstreetmap.org/wiki/Overpass_API

Я написал три маленьких скрипта, чтобы автоматизировать получение дорог для городов, и сохранять их в мой формат графа.

Сохраняем граф

Данные OSM отдает в виде XML или JSON. К сожалению оба форматы слишком объемные — карта Москвы со всеми дорогами занимает около 47MB. Моя же задача была сделать загрузку сайта как можно быстрее (даже на мобильном соединении).

Можно было бы попробовать сжать gzip'ом — карта Москвы из 47МБ превращается в 7.1МБ. Но при таком подходе у меня не было бы контроля над скоростью распаковки данных — их бы пришлось парсить javascript'ом на клиенте, что тоже повлияло бы на скорость инициализации.

Я решил написать свой формат для графа. Граф разбивается на два бинарных файла. Один с координатами всех вершин, а второй с описанием всех ребер.

Файл с координатами — это просто последовательность из x, y пар (int32, 4 байта на координату). Смещение по которому находится пара координат я рассматриваю как иденификатор вершины (nodeId).

Ребра графа превращаются в обычную последовательность пар fromNodeId, toNodeId.

Последовательность на картинке означает, что первый узел ссылается на второй, а второй ссылается на третий, и так далее.

Общий размер для графа с V узлами и E ребрами можно подсчитать как:

storage_size = V * 4 * 2 + # 4 байта на пару координат на узел

E * 4 * 2 = # 4 байта на пару идентификаторов вершин

(V + E) * 8 # суммарно, в байтахЭто не самый эффективный способ сжатия, но его очень легко реализовать и можно очень быстро восстановить начальный граф на клиенте. Типизированные массивы в javascript'e работают быстрее, чем парсинг JSON'a.

Сначала я хотел добавить также вес ребер, но остановил себя, ибо загрузка на слабом мобильном соединении даже для маленьких графах станет еще медленнее.

В первую очередь мобильные телефоны

Когда я писал демо, я думал, что напишу о нем в Твиттер. Твиттер большинство людей читают с мобилок, а потому и демо должно быть в первую очередь рассчитано на мобильные телефоны. Если оно не будет загружаться быстро, или не будет поддерживать touch — пиши пропало.

Спустя пару дней после анонса, можно признать логику выше оправданной. Твит с анонсом демо стал самым популярным твитом в жизни моего твиттера.

Я тестировал демо в первую очередь на платформах iPhone и Андроид. Для тестов на Андроиде я нашел самый дешевый телефон и использовал его. Это очень сильно помогло с отладкой производительности и удобства использования на маленьком экране.

Асинхронность

Самая медленная часть в демо была начальная загрузка сайта. Код, который инициализировал граф выглядел как-то так:

for (let i = 0; i < points.length; i += 2) {

let nodeId = Math.floor(i / 2);

let x = points[i + 0];

let y = points[i + 1];

// graph это https://github.com/anvaka/ngraph.graph

graph.addNode(nodeId, { x, y })

}На первый взгляд — ничего плохого. Но если запустить это на слабеньком процессоре и на большом графе — страничка становится мертвой, пока основной поток занят итерацией.

Выход? Я знаю, некоторые используют Web Workers. Это прекрасное решение, учитывая что все сейчас многоядерное. Но в моем случае, использование web workers значительно бы продлило время, необходимое для создания демо. Нужно было бы продумать как передавать данные между потоками, как синхронизировать, как сохранить жизнь батарее, как быть когда web workers не доступны и т.д.

Поскольку мне не хотелось тратить больше времени, нужно было более ленивое решение. Я решил просто разбить цикл. Просто запускаем его на некоторое время, смотрим сколько времени прошло, и потом вызываем setTimeout() чтобы продолжить на следующей итерации цикла событий. Все это сделано в библиотеке rafor.

С таким решением у браузера появляется возможность постоянно информировать пользователя о том, что происходит внутри:

Отрисовка

Теперь, когда у нас загружен граф, нужно показать его на экране. Конечно, использовать SVG для отрисовки миллиона элементов не годится — скорость начнет проседать после первого десятка тысяч. Можно было бы нарезать граф на тайлы, и использовать Leaflet или OpenSeadragon чтоб нарисовать большую картинку.

Мне же хотелось иметь больше контроля на кодом (и подучить WebGL), поэтому я написал свой WebGL отрисовщик с нуля. Там я использую подход "scene graph". В таком подходе мы строим сцену из иерархии элементов, которые можно нарисовать. Во время отрисовки кадра, мы проходим по графу, и даем возможность каждому узлу накопить трансформации или вывести себя на экран. Если вы знакомы с three.js или даже обычным DOM'ом — подход будет не в новинку.

Отрисовщик доступен здесь, но я намеренно не документировал его сильно. Это проект для моего собственного обучения, и я не хочу создавать впечатление, что им можно пользоваться :)

Батарейка

Изначально, я перерисовывал сцену на каждом кадре. Очень быстро я понял, что это сильно греет телефон и батарея уходит в ноль с примечательной скоростью.

Писать код при таких условиях было так же неудобно. Для работы над проектом, я обычно заседал в кофейне в свободное время, где не всегда были розетки. Поэтому мне нужно было либо научиться думать быстрее, либо найти способ не сажать ноутбук так быстро.

Я до сих пор не нашел способ как думать быстрее, потому я выбрал второй вариант. Решение оказалось по-наивному простым:

Не рисуй сцену на каждом кадре. Рисуй только когда попросили, или когда знаешь, что она поменялась.

Может, это покажется слишком очевидным сейчас, но это было вовсе не так сначала. Ведь в основном все примеры использования WebGL описывают простой цикл:

function frame() {

requestAnimationFrame(frame); // Планируем следующий кадр

renderScene(); // рисуем текущий кадр.

// Ничего плохого в этом нет, но батарею мы можем так быстро посадить

}С "консервативным" подходом, мне нужно было вынести requestAnimationFrame() наружу из функции frame():

let frameToken = 0;

function renderFrame() {

if (!frameToken) frameToken = requestAnimationFrame(frame);

}

function frame() {

frameToken = 0;

renderScene();

}Такой подход позволяет кому угодно затребовать нарисовать следующий кадр. Например, когда пользователь перетащил карту и изменил матрицу преобразования, мы вызываем renderFrame().

Переменная frameToken помогает избежать повторного вызова requestAnimationFrame между кадрами.

Да, код становится немного сложнее писать, но жизнь батарее для меня была важнее.

Текст и линии

WebGL не самый простой в мире API. Особенно сложно в нем работать с текстом и толстыми линиями (у которых ширина больше одного пикселя).

Учитывая что я совсем новичок в этом деле, я быстро понял, что добавить поддержку текста/линий займет у меня очень много времени.

С другой стороны, из текста мне нужно было нарисовать только пару меток A и B. А из толстых линий — только путь который соединяет две вершины. Задача вполне по силам для DOM'a.

Как вы помните, наш отрисовщик использует граф сцены. Почему бы не добавить в сцену еще один элемент, задачей которого будет применять текущую трансформацию к… SVG элементу? Этот SVG элемент сделаем прозрачным, и положим его сверху на canvas. Чтобы убрать все события от мышки — ставим ему pointer-events: none;.

Получилось очень быстро и сердито.

Перемещаемся по карте

Мне хотелось сделать так, чтобы навигация была похожа на типичное поведение карты (как в Google Maps, например).

У меня уже была написана библиотека навигации для SVG: anvaka/panzoom. Она поддерживала touch и кинетическое затухание (когда карта продолжает двигаться по инерции). Для того чтобы поддерживать WebGL мне пришлось чуть-чуть подправить библиотеку.

panzoom слушает события от пользователя (mousedown, touchstart, и т.п.), применяет плавные трансформации к матрице преобразования, и потом, вместо того чтобы напрямую работать с SVG, она отдает матрицу "контроллеру". Задача контроллера — применить трансформацию. Контролер может быть для SVG, для DOM или даже мой собственный контроллер, который применяет трансформацию к WebGL сцене.

Как понять что кликнуто?

Мы обсудили как загрузить граф, как его нарисовать, и как двигаться по нему. Но как же понять что было нажато, когда пользователь касается графа? Откуда прокладывать путь и куда?

Когда пользователь кликнул на карту, мы могли бы самым простым способом обойти все точки в графе, посмотреть на их позиции и найти ближайшую. На самом деле, это отличный способ для пары тысяч точек. Если же число точек превышает десятки/сотни тысяч — производительность будет не приемлема.

Я использовал квад дерево чтобы проиндексировать точки. После того как дерево создано — скорость поиска ближайшего соседа становится логарифмической.

Кстати, если термин "квад дерево" звучит устрашающе — не стоит огорчаться! На самом деле квад-деревья, очень-очень похожи на обычные двоичные деревья. Их легко усвоить, легко реализовать и легко применять.

В частности, я использовал собственную реализацию, библиотека yaqt, потому что она неприхотлива по памяти для моего формата данных. Существуют лучшие альтернативы, с хорошей документацией и сообществом (например, d3-quadtree).

Ищем путь

Теперь все части на своих местах. У нас есть граф, мы знаем как его нарисовать, знаем что было на нем нажато. Осталось только найти кратчайший путь:

// pathfinder это объект https://github.com/anvaka/ngraph.path

let path = pathFinder.find(fromId, toId);Теперь у нас есть и массив вершин, которые лежат на найденном пути.

Заключение

Надеюсь, вам понравилось это маленькое путешествие в мир графов и коротких путей. Пожалуйста, дайте знать если библиотека пригодилась, или если есть советы как сделать ее лучше.

Искренне желаю вам добра!

Андрей.

|

Метки: author anvaka разработка игр разработка веб-сайтов программирование алгоритмы javascript a* pathfinding graph webgl |

Библиотека быстрого поиска путей на графе |

Библиотека быстрого поиска путей на графе

Привет, Друзья!

Я написал библиотеку поисков путей на произвольных графах, и хотел бы поделиться ей с вами: http://github.com/anvaka/ngraph.path

Пример использования на огромном графе:

Поиграться с демо можно здесь: https://anvaka.github.io/ngraph.path.demo/

В библиотеке используется мало-известный вариант A* поиска, который называется NBA*. Это двунаправленный поиск, с расслабленными требованиями к функции-эвристике, и очень агрессивным критерием завершения. Не смотря на свою малоизвестность у алгоритма отличная скорость сходимости к оптимальному решению.

Описание разных вариантов A* уже не раз встречалось на хабре. Мне очень понравилось вот это, потому повторяться в этой статье я не буду. Под катом расскажу подробнее почему библиотека работает быстро и о том, как было сделано демо.

Почему библиотека работает быстро?

"Как-то не верится что так быстро. Ты точно ниче не считаешь предварительно?"

Реакция друга, который первый раз увидел библиотеку.

Сразу должен признаться, я не верю что моя реализация — самая быстрая из возможных. Она работает достаточно быстро учитывая окружение в котором находится (браузер, javascript). Ее скорость сильно будет зависеть от размера графа. И, конечно же, то, что сейчас есть в репозитории можно ускорить и улучшить.

Статистика

Для замера производительности я взял граф дорог из Нью-Йорка ( ~730 000 ребер, 260 000 узлов). Таблица ниже показывает статистику времени, необходимого для решения одной задачи поиска пути из 250 случайно выбранных:

| Среднее | Медиана | Min | Max | p90 | p99 | |

|---|---|---|---|---|---|---|

| A* ленивый (локальный) | 32ms | 24ms | 0ms | 179ms | 73ms | 136ms |

| NBA* | 44ms | 34ms | 0ms | 222ms | 107ms | 172ms |

| A*, однонаправленный | 55ms | 38ms | 0ms | 356ms | 123ms | 287ms |

| Дейкстра | 264ms | 258ms | 0ms | 782ms | 483ms | 631ms |

Каждый алгоритм решал одну и ту же задачу. A* ленивый самый быстрый, но его решение не всегда оптимально. По-сути, это двунаправленный A* который сразу же выходит как только оба поиска встретились. NBA* двунаправленный, сходится к оптимальному решению. В 99% ему понадобилось меньше чем 172 миллисекунды, чтобы найти кратчайший путь (p99).

Оптимизации

Библиотека работает относительно быстро по нескольким причинам.

Во-первых, я изменил структуру данных в приоритетной очереди таким образом, что обновление приоритета любого элемента очереди занимает O(lg n) времени. Это достигается тем, что каждый элемент отслеживает свою позицию в куче во время перестройки очереди.

Во-вторых, во время нагрузочных тестов я заметил, что уборка мусора занимает значительное время. Это не удивительно, поскольку алгоритм создает много маленьких объектов когда он ходит по графу. Решается проблема со сборщиком мусора при помощи пула объектов. Это структура данных которая позволяет повторно использовать объекты, когда они уже не нужны.

Ну и наконец, алгоритм поиска NBA* имеет очень красивый и жесткий критерий посещения узлов.

Признаться, я думаю что это не предел совершенства. Вполне вероятно, если использовать иерархический подход, описанный Борисом удастся ускорить время для еще больших графов.

Как работает демо?

Создание библиотеки это, конечно, очень интересно. Но мне кажется демо-проект заслуживает отдельного описания. Я усвоил несколько уроков, и хотел бы поделиться с вами, в надежде, что это окажется полезным.

Прежде чем начнем. Кто-то меня спросил: "Но ведь это же граф? Как можно карту представить в виде графа?". Легче всего представить каждый перекресток узлом графа. У каждого перекрестка есть позиция (x, y). Каждый прямой участок дороги сделаем ребром графа. Изгибы дороги можно моделировать как частный случай перекрестков.

Готовим данные

Конечно, я слышал об https://www.openstreetmap.org, но их внешний вид меня не сильно привлекал. Когда же я обнаружил API и инструменты типа http://overpass-turbo.eu/ — это как новый мир открылся перед глазами :). Данные они отдают под лицензией ODbL, которая требует чтобы их упомянули (чем больше людей знают о сервисе — тем лучше становится сервис).

API позволяет делать очень сложные запросы, и дает потрясающие объемы информации.

Например, такой запрос даст все велодороги в Москве:

[out:json];

// Сохранить область в переменную `a`

(area["name"="Москва"])->.a;

// Скачать все дороги внутри a у которых аттрибут `highway == cycleway`

way["highway"="cycleway"](area.a);

// и объединить дороги с узлами графа (узлы содержат геопозицию)

node(w);

// Наконец, вернуть результаты

out meta;API очень хорошо описано здесь: http://wiki.openstreetmap.org/wiki/Overpass_API

Я написал три маленьких скрипта, чтобы автоматизировать получение дорог для городов, и сохранять их в мой формат графа.

Сохраняем граф

Данные OSM отдает в виде XML или JSON. К сожалению оба форматы слишком объемные — карта Москвы со всеми дорогами занимает около 47MB. Моя же задача была сделать загрузку сайта как можно быстрее (даже на мобильном соединении).

Можно было бы попробовать сжать gzip'ом — карта Москвы из 47МБ превращается в 7.1МБ. Но при таком подходе у меня не было бы контроля над скоростью распаковки данных — их бы пришлось парсить javascript'ом на клиенте, что тоже повлияло бы на скорость инициализации.

Я решил написать свой формат для графа. Граф разбивается на два бинарных файла. Один с координатами всех вершин, а второй с описанием всех ребер.

Файл с координатами — это просто последовательность из x, y пар (int32, 4 байта на координату). Смещение по которому находится пара координат я рассматриваю как иденификатор вершины (nodeId).

Ребра графа превращаются в обычную последовательность пар fromNodeId, toNodeId.

Последовательность на картинке означает, что первый узел ссылается на второй, а второй ссылается на третий, и так далее.

Общий размер для графа с V узлами и E ребрами можно подсчитать как:

storage_size = V * 4 * 2 + # 4 байта на пару координат на узел

E * 4 * 2 = # 4 байта на пару идентификаторов вершин

(V + E) * 8 # суммарно, в байтахЭто не самый эффективный способ сжатия, но его очень легко реализовать и можно очень быстро восстановить начальный граф на клиенте. Типизированные массивы в javascript'e работают быстрее, чем парсинг JSON'a.

Сначала я хотел добавить также вес ребер, но остановил себя, ибо загрузка на слабом мобильном соединении даже для маленьких графах станет еще медленнее.

В первую очередь мобильные телефоны

Когда я писал демо, я думал, что напишу о нем в Твиттер. Твиттер большинство людей читают с мобилок, а потому и демо должно быть в первую очередь рассчитано на мобильные телефоны. Если оно не будет загружаться быстро, или не будет поддерживать touch — пиши пропало.

Спустя пару дней после анонса, можно признать логику выше оправданной. Твит с анонсом демо стал самым популярным твитом в жизни моего твиттера.

Я тестировал демо в первую очередь на платформах iPhone и Андроид. Для тестов на Андроиде я нашел самый дешевый телефон и использовал его. Это очень сильно помогло с отладкой производительности и удобства использования на маленьком экране.

Асинхронность

Самая медленная часть в демо была начальная загрузка сайта. Код, который инициализировал граф выглядел как-то так:

for (let i = 0; i < points.length; i += 2) {

let nodeId = Math.floor(i / 2);

let x = points[i + 0];

let y = points[i + 1];

// graph это https://github.com/anvaka/ngraph.graph

graph.addNode(nodeId, { x, y })

}На первый взгляд — ничего плохого. Но если запустить это на слабеньком процессоре и на большом графе — страничка становится мертвой, пока основной поток занят итерацией.

Выход? Я знаю, некоторые используют Web Workers. Это прекрасное решение, учитывая что все сейчас многоядерное. Но в моем случае, использование web workers значительно бы продлило время, необходимое для создания демо. Нужно было бы продумать как передавать данные между потоками, как синхронизировать, как сохранить жизнь батарее, как быть когда web workers не доступны и т.д.

Поскольку мне не хотелось тратить больше времени, нужно было более ленивое решение. Я решил просто разбить цикл. Просто запускаем его на некоторое время, смотрим сколько времени прошло, и потом вызываем setTimeout() чтобы продолжить на следующей итерации цикла событий. Все это сделано в библиотеке rafor.

С таким решением у браузера появляется возможность постоянно информировать пользователя о том, что происходит внутри:

Отрисовка

Теперь, когда у нас загружен граф, нужно показать его на экране. Конечно, использовать SVG для отрисовки миллиона элементов не годится — скорость начнет проседать после первого десятка тысяч. Можно было бы нарезать граф на тайлы, и использовать Leaflet или OpenSeadragon чтоб нарисовать большую картинку.

Мне же хотелось иметь больше контроля на кодом (и подучить WebGL), поэтому я написал свой WebGL отрисовщик с нуля. Там я использую подход "scene graph". В таком подходе мы строим сцену из иерархии элементов, которые можно нарисовать. Во время отрисовки кадра, мы проходим по графу, и даем возможность каждому узлу накопить трансформации или вывести себя на экран. Если вы знакомы с three.js или даже обычным DOM'ом — подход будет не в новинку.

Отрисовщик доступен здесь, но я намеренно не документировал его сильно. Это проект для моего собственного обучения, и я не хочу создавать впечатление, что им можно пользоваться :)

Батарейка

Изначально, я перерисовывал сцену на каждом кадре. Очень быстро я понял, что это сильно греет телефон и батарея уходит в ноль с примечательной скоростью.

Писать код при таких условиях было так же неудобно. Для работы над проектом, я обычно заседал в кофейне в свободное время, где не всегда были розетки. Поэтому мне нужно было либо научиться думать быстрее, либо найти способ не сажать ноутбук так быстро.

Я до сих пор не нашел способ как думать быстрее, потому я выбрал второй вариант. Решение оказалось по-наивному простым:

Не рисуй сцену на каждом кадре. Рисуй только когда попросили, или когда знаешь, что она поменялась.

Может, это покажется слишком очевидным сейчас, но это было вовсе не так сначала. Ведь в основном все примеры использования WebGL описывают простой цикл:

function frame() {

requestAnimationFrame(frame); // Планируем следующий кадр

renderScene(); // рисуем текущий кадр.

// Ничего плохого в этом нет, но батарею мы можем так быстро посадить

}С "консервативным" подходом, мне нужно было вынести requestAnimationFrame() наружу из функции frame():

let frameToken = 0;

function renderFrame() {

if (!frameToken) frameToken = requestAnimationFrame(frame);

}

function frame() {

frameToken = 0;

renderScene();

}Такой подход позволяет кому угодно затребовать нарисовать следующий кадр. Например, когда пользователь перетащил карту и изменил матрицу преобразования, мы вызываем renderFrame().

Переменная frameToken помогает избежать повторного вызова requestAnimationFrame между кадрами.

Да, код становится немного сложнее писать, но жизнь батарее для меня была важнее.

Текст и линии

WebGL не самый простой в мире API. Особенно сложно в нем работать с текстом и толстыми линиями (у которых ширина больше одного пикселя).

Учитывая что я совсем новичок в этом деле, я быстро понял, что добавить поддержку текста/линий займет у меня очень много времени.

С другой стороны, из текста мне нужно было нарисовать только пару меток A и B. А из толстых линий — только путь который соединяет две вершины. Задача вполне по силам для DOM'a.

Как вы помните, наш отрисовщик использует граф сцены. Почему бы не добавить в сцену еще один элемент, задачей которого будет применять текущую трансформацию к… SVG элементу? Этот SVG элемент сделаем прозрачным, и положим его сверху на canvas. Чтобы убрать все события от мышки — ставим ему pointer-events: none;.

Получилось очень быстро и сердито.

Перемещаемся по карте

Мне хотелось сделать так, чтобы навигация была похожа на типичное поведение карты (как в Google Maps, например).

У меня уже была написана библиотека навигации для SVG: anvaka/panzoom. Она поддерживала touch и кинетическое затухание (когда карта продолжает двигаться по инерции). Для того чтобы поддерживать WebGL мне пришлось чуть-чуть подправить библиотеку.

panzoom слушает события от пользователя (mousedown, touchstart, и т.п.), применяет плавные трансформации к матрице преобразования, и потом, вместо того чтобы напрямую работать с SVG, она отдает матрицу "контроллеру". Задача контроллера — применить трансформацию. Контролер может быть для SVG, для DOM или даже мой собственный контроллер, который применяет трансформацию к WebGL сцене.

Как понять что кликнуто?

Мы обсудили как загрузить граф, как его нарисовать, и как двигаться по нему. Но как же понять что было нажато, когда пользователь касается графа? Откуда прокладывать путь и куда?

Когда пользователь кликнул на карту, мы могли бы самым простым способом обойти все точки в графе, посмотреть на их позиции и найти ближайшую. На самом деле, это отличный способ для пары тысяч точек. Если же число точек превышает десятки/сотни тысяч — производительность будет не приемлема.

Я использовал квад дерево чтобы проиндексировать точки. После того как дерево создано — скорость поиска ближайшего соседа становится логарифмической.

Кстати, если термин "квад дерево" звучит устрашающе — не стоит огорчаться! На самом деле квад-деревья, очень-очень похожи на обычные двоичные деревья. Их легко усвоить, легко реализовать и легко применять.

В частности, я использовал собственную реализацию, библиотека yaqt, потому что она неприхотлива по памяти для моего формата данных. Существуют лучшие альтернативы, с хорошей документацией и сообществом (например, d3-quadtree).

Ищем путь

Теперь все части на своих местах. У нас есть граф, мы знаем как его нарисовать, знаем что было на нем нажато. Осталось только найти кратчайший путь:

// pathfinder это объект https://github.com/anvaka/ngraph.path

let path = pathFinder.find(fromId, toId);Теперь у нас есть и массив вершин, которые лежат на найденном пути.

Заключение

Надеюсь, вам понравилось это маленькое путешествие в мир графов и коротких путей. Пожалуйста, дайте знать если библиотека пригодилась, или если есть советы как сделать ее лучше.

Искренне желаю вам добра!

Андрей.

|

Метки: author anvaka разработка игр разработка веб-сайтов программирование алгоритмы javascript a* pathfinding graph webgl |

PHP-Дайджест № 117 – свежие новости, материалы и инструменты (10 – 24 сентября 2017) |

PHP-Дайджест № 117 – свежие новости, материалы и инструменты (10 – 24 сентября 2017)

Свежая подборка со ссылками на новости и материалы. В выпуске: PHP 7.2.0 RC 2, о будущем HHVM, предложения из PHP Internals, подборка чатов по PHP, видео с конференций и митапов, и многое другое.

Приятного чтения!

Новости и релизы

Новости и релизы

- О будущем HHVM — Не так давно многие проекты отказались от поддержки HHVM. Теперь команда HVVM анонсировала, что в долгосрочной перспективе не планирует стремиться к полной поддержке PHP 7. Вместо этого, ребята из Facebook сосредоточатся на Hack. Тем не менее в ближайшее время планируется исправить проблемы совместимости с популярными инструментами вроде Composer и PHPUnit.

- PHP 7.2.0 RC 2 — Второй релиз-кандидат доставлен по расписанию. Следующий выпуск ожидается 28 сентября. Об изменениях ветки можно почитать тут и тут. Протестировать с помощью подготовленного Docker-образа.

- Sylius v1.0.0 — Мажорный релиз популярной е-коммерс платформы на базе Symfony.

PHP Internals

PHP Internals

- [RFC] RFC Workflow & Voting — Предлагается регламентировать процесс RFC, в частности, при голосованиях повысить порог принятия изменений до 2/3. Также обозначены критерии для тех, кто может голосовать.

- [RFC] Class Friendship — Вторая попытка реализовать концепцию дружественных классов. Дружественный класс имеет доступ к private и protected полям класса, в котором он объявлен дружественным.

- [RFC] Fiber — Интересное дополнение генераторов в PHP, которое позволило бы упростить асинхронный код.

- Pre-draft PipeOp v2 — В Internals обсуждается черновик предложения для pipe-оператора. Оригинальное предложение было раскритиковано из-за использования плейсхолдера

$$и теперь предложен более простой вариант:

$x = "hello" |> 'strtoupper' |> function($x) { return $x . " world"; }; // $x === "HELLO world"

Инструменты

Инструменты

- PoweredLocal/vrata — Реализация паттерна для микросервисов API Gateway на основе Lumen.

- jamesmoss/flywheel — База данных на основе файлов (JSON, YAML, или Markdown) и с билдером запросов.

- spatie/macroable — Трейт для динамического добавления методов в класс. Подробнее в посте.

- felixfbecker/php-language-server — PHP-реализация VS Code Language Server Protocol.

- BetterReflection 2.0.0 — Рефлексия без загрузки классов.

- tagua-vm/tagua-vm — Экспериментальная виртуальная машина PHP на Rust и LLVM.

Материалы для обучения

Материалы для обучения

Symfony

Symfony

Использование пользовательских функций в Symfony и Doctrine

Использование пользовательских функций в Symfony и Doctrine Избегание сущностей в формах Symfony и переосмысление разработки форм Symfony — Прислал seyfer.

Избегание сущностей в формах Symfony и переосмысление разработки форм Symfony — Прислал seyfer.- Добавление кастомного кода в ответы API

- Новое в Symfony 3.4

- Неделя Symfony #559 (11-17 сентября 2017)

- Неделя Symfony #560 (18-24 сентября 2017)

Laravel

Laravel

- Voyager 1.0 — Админка для Laravel.

- kjdion84/turtle — Скаффолдинг для CRUD, аутентификации, ролей, прав доступа, форм, и прочего.

- nahid/talk — Система личных сообщений для приложения на Laravel.

- Расширяем модели в Eloquent

- Конфиг Nginx Unit + Docker, PHP, и Laravel

Laravel Podcast s03e02: Интервью с Taylor Otwell

Laravel Podcast s03e02: Интервью с Taylor Otwell

Zend

Zend

- Логирование в PHP-приложениях с помощью zend-log

- Emitting Responses with Diactoros

- Неделя Zend Framework 2017-09-14

Async PHP

- clue/php-buzz-react — Асинхронный PSR-7 HTTP-клиент на основе ReactPHP.

- Введение в генераторы на PHP

- Разработка игры с помощью React.js и PHP, 2

- Кэширование с помощью промисов на ReactPHP

CMS

- Вопросы выбора JS-библиотеки в WordPress — В связи патентным нюансом в лицензии React, разработчики WordPress анонсировали отказ от React для фронтенд компонентов. Однако после официальной смены лицензии на MIT все-таки вернулись к его рассмотрению, а также фреймворк-независимого решения.

- postlight/headless-wp-starter — WordPress в качестве RESTful бекенда и React на фронте.

- Joomla 3.8

- Статистика спонсоров и контрибьюторов Drupal

- Magento Tech Digest #3 (September 4 — 19, 2017)

- Замыкания, анонимные классы и альтернативный подход к мокам

- Минитуториал по PhpSpec

- Symfony Console – хелперы и другие возможности

- Прощайте, контроллеры; привет, обработчики запросов

- О новой PHP-библиотеке для Сloudflare

- От PHP к JavaScript с Node.js

- JSON Web Token (JWT) в качестве PHP сессии

- UML-диаграммы в PhpStorm 2017.2

Как я создавал прибыльный глобальный SaaS проект, от разработки до продаж

Как я создавал прибыльный глобальный SaaS проект, от разработки до продаж PHP жив. PHP 7 на практике

PHP жив. PHP 7 на практике

Аудио и видеоматериалы

Аудио и видеоматериалы

Занимательное

Занимательное

- Подборка чатов по PHP

- [T] phpgeeks

- [T] prophp7

- [T] phpclubru

- [T] PhpFlow

- [T] laravel_pro

- [T] laravelrus

- [T] symfony_php

- [S] Larachat

- [S] Zend Framework

- [S] Yii

- [S] phpchat.co

- [S] php.ug

- [S] Drupal

- [S] WordPress

Знаете еще? Пишите в комментариях!

- Новый слоник с ZendCon 2017 —

Спасибо за внимание!

Если вы заметили ошибку или неточность — сообщите, пожалуйста, в личку.

Вопросы и предложения пишите на почту или в твиттер.

Прислать ссылку

Быстрый поиск по всем дайджестам

<- Предыдущий выпуск: PHP-Дайджест № 116

|

Метки: author pronskiy разработка веб-сайтов php блог компании zfort group дайджест php- ссылки symfony laravel zend wordpress hhvm |

PHP-Дайджест № 117 – свежие новости, материалы и инструменты (10 – 24 сентября 2017) |

PHP-Дайджест № 117 – свежие новости, материалы и инструменты (10 – 24 сентября 2017)

Свежая подборка со ссылками на новости и материалы. В выпуске: PHP 7.2.0 RC 2, о будущем HHVM, предложения из PHP Internals, подборка чатов по PHP, видео с конференций и митапов, и многое другое.

Приятного чтения!

Новости и релизы

Новости и релизы

- О будущем HHVM — Не так давно многие проекты отказались от поддержки HHVM. Теперь команда HVVM анонсировала, что в долгосрочной перспективе не планирует стремиться к полной поддержке PHP 7. Вместо этого, ребята из Facebook сосредоточатся на Hack. Тем не менее в ближайшее время планируется исправить проблемы совместимости с популярными инструментами вроде Composer и PHPUnit.

- PHP 7.2.0 RC 2 — Второй релиз-кандидат доставлен по расписанию. Следующий выпуск ожидается 28 сентября. Об изменениях ветки можно почитать тут и тут. Протестировать с помощью подготовленного Docker-образа.

- Sylius v1.0.0 — Мажорный релиз популярной е-коммерс платформы на базе Symfony.

PHP Internals

PHP Internals

- [RFC] RFC Workflow & Voting — Предлагается регламентировать процесс RFC, в частности, при голосованиях повысить порог принятия изменений до 2/3. Также обозначены критерии для тех, кто может голосовать.

- [RFC] Class Friendship — Вторая попытка реализовать концепцию дружественных классов. Дружественный класс имеет доступ к private и protected полям класса, в котором он объявлен дружественным.

- [RFC] Fiber — Интересное дополнение генераторов в PHP, которое позволило бы упростить асинхронный код.

- Pre-draft PipeOp v2 — В Internals обсуждается черновик предложения для pipe-оператора. Оригинальное предложение было раскритиковано из-за использования плейсхолдера

$$и теперь предложен более простой вариант:

$x = "hello" |> 'strtoupper' |> function($x) { return $x . " world"; }; // $x === "HELLO world"

Инструменты

Инструменты

- PoweredLocal/vrata — Реализация паттерна для микросервисов API Gateway на основе Lumen.

- jamesmoss/flywheel — База данных на основе файлов (JSON, YAML, или Markdown) и с билдером запросов.

- spatie/macroable — Трейт для динамического добавления методов в класс. Подробнее в посте.

- felixfbecker/php-language-server — PHP-реализация VS Code Language Server Protocol.

- BetterReflection 2.0.0 — Рефлексия без загрузки классов.

- tagua-vm/tagua-vm — Экспериментальная виртуальная машина PHP на Rust и LLVM.

Материалы для обучения

Материалы для обучения

Symfony

Symfony

Использование пользовательских функций в Symfony и Doctrine

Использование пользовательских функций в Symfony и Doctrine Избегание сущностей в формах Symfony и переосмысление разработки форм Symfony — Прислал seyfer.

Избегание сущностей в формах Symfony и переосмысление разработки форм Symfony — Прислал seyfer.- Добавление кастомного кода в ответы API

- Новое в Symfony 3.4

- Неделя Symfony #559 (11-17 сентября 2017)

- Неделя Symfony #560 (18-24 сентября 2017)

Laravel

Laravel

- Voyager 1.0 — Админка для Laravel.

- kjdion84/turtle — Скаффолдинг для CRUD, аутентификации, ролей, прав доступа, форм, и прочего.

- nahid/talk — Система личных сообщений для приложения на Laravel.

- Расширяем модели в Eloquent

- Конфиг Nginx Unit + Docker, PHP, и Laravel

Laravel Podcast s03e02: Интервью с Taylor Otwell

Laravel Podcast s03e02: Интервью с Taylor Otwell

Zend

Zend

- Логирование в PHP-приложениях с помощью zend-log

- Emitting Responses with Diactoros

- Неделя Zend Framework 2017-09-14

Async PHP

- clue/php-buzz-react — Асинхронный PSR-7 HTTP-клиент на основе ReactPHP.

- Введение в генераторы на PHP

- Разработка игры с помощью React.js и PHP, 2

- Кэширование с помощью промисов на ReactPHP

CMS

- Вопросы выбора JS-библиотеки в WordPress — В связи патентным нюансом в лицензии React, разработчики WordPress анонсировали отказ от React для фронтенд компонентов. Однако после официальной смены лицензии на MIT все-таки вернулись к его рассмотрению, а также фреймворк-независимого решения.

- postlight/headless-wp-starter — WordPress в качестве RESTful бекенда и React на фронте.

- Joomla 3.8

- Статистика спонсоров и контрибьюторов Drupal

- Magento Tech Digest #3 (September 4 — 19, 2017)

- Замыкания, анонимные классы и альтернативный подход к мокам

- Минитуториал по PhpSpec

- Symfony Console – хелперы и другие возможности

- Прощайте, контроллеры; привет, обработчики запросов

- О новой PHP-библиотеке для Сloudflare

- От PHP к JavaScript с Node.js

- JSON Web Token (JWT) в качестве PHP сессии

- UML-диаграммы в PhpStorm 2017.2

Как я создавал прибыльный глобальный SaaS проект, от разработки до продаж

Как я создавал прибыльный глобальный SaaS проект, от разработки до продаж PHP жив. PHP 7 на практике

PHP жив. PHP 7 на практике

Аудио и видеоматериалы

Аудио и видеоматериалы

Занимательное

Занимательное

- Подборка чатов по PHP

- [T] phpgeeks

- [T] prophp7

- [T] phpclubru

- [T] PhpFlow

- [T] laravel_pro

- [T] laravelrus

- [T] symfony_php

- [S] Larachat

- [S] Zend Framework

- [S] Yii

- [S] phpchat.co

- [S] php.ug

- [S] Drupal

- [S] WordPress

Знаете еще? Пишите в комментариях!

- Новый слоник с ZendCon 2017 —

Спасибо за внимание!

Если вы заметили ошибку или неточность — сообщите, пожалуйста, в личку.

Вопросы и предложения пишите на почту или в твиттер.

Прислать ссылку

Быстрый поиск по всем дайджестам

<- Предыдущий выпуск: PHP-Дайджест № 116

|

Метки: author pronskiy разработка веб-сайтов php блог компании zfort group дайджест php- ссылки symfony laravel zend wordpress hhvm |

Пишем для UEFI BIOS в Visual Studio. Часть 3 — русифицируем Front Page |

|

Метки: author DarkTiger системное программирование uefi bios |

Пишем для UEFI BIOS в Visual Studio. Часть 3 — русифицируем Front Page |

|

Метки: author DarkTiger системное программирование uefi bios |

Дайджест свежих материалов из мира фронтенда за последнюю неделю №281 (18 — 24 сентября 2017) |

|

|

Сложно ли сделать из мухи слона? |

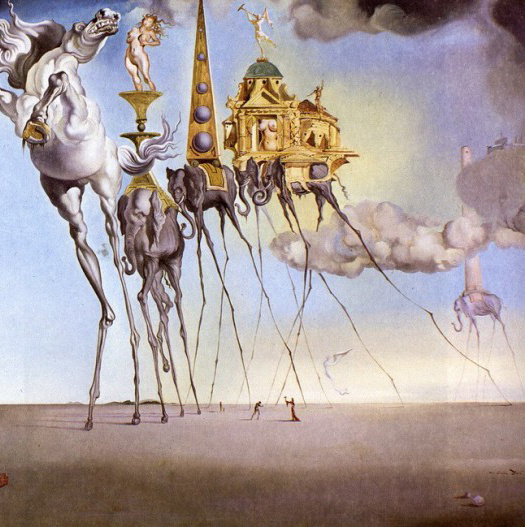

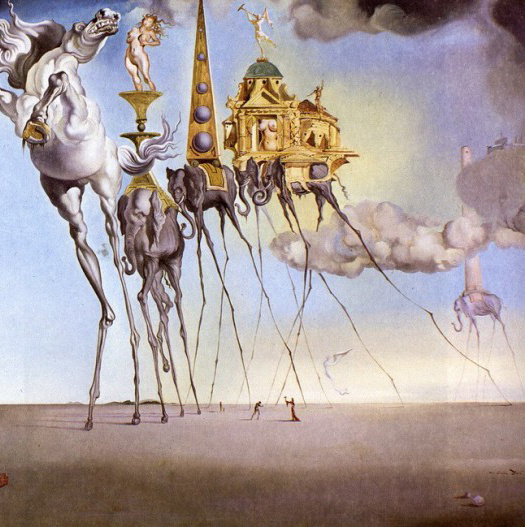

Сложно ли сделать из мухи слона?

Сальвадор Дали. Искушение св. Антония. 1946. (Фрагмент).

Бельгийский Королевский музей изящных искусств (Брюссель).

Неужели эта задача требует столь сложного решения? Может, это задача ИИ? – Исхожу из определения:

к ИИ относятся задачи, которые компьютер решает заметно хуже человека.

(О применении генетических алгоритмов в ИИ см. книгу: Д. Рутковская, М. Пилиньский, Л. Рутковский, Нейронные сети, генетические алгоритмы и нечеткие системы, М.: Горячая линия – Телеком, 2006).

Однако ларчик открывается довольно просто. Пусть длина каждого из заданных слов . Из словаря существительных выписываем все слова длиной . Число найденных слов обозначим . Эти слова будут метками вершин неориентированного графа. Каждую пару вершин, метки которых отличаются на одну букву, соединяем ребром. Для этого перебираем все пары вершин, сравнивая их метки – число пар , число побуквенных сравнений . Далее решаем типовую задачу поиска кратчайшего пути между указанными вершинами графа.

Словарь существительных взял с CD-ROM к книге Сергея Мельникова, Delphi и Turbo Pascal на занимательных примерах, СПб.: БХВ – Петербург, 2006 (к слову сказать, в этой книге можно найти много остроумных и простых решений подобных, казалось бы, сложных задач со словами):

В словаре перечислены все имена существительные «Орфографического словаря»

(106000 слов, 28-е издание, 1990 г.). [...] Набор текста осуществлён в 1996-98 годах игроками команды «Пузляры» (http://puzzle.ezakaz.ru) — Константином Кнопом, Яковом Зайдельманом, Валерием Тимониным, Виктором Кабановым, Дмитрием Филимоненковым.

Получил:

Число загруженных слов (число вершин графа): 1501

Число ребер: 2402

Решение: (8 слов) муха-мула-кула-кила-килт-киот-клот-клон-слон

Затрачено времени: 4.59 сек.

Вряд ли обычный человек сообразит быстрее. Более того, так как используются алгоритмы, корректность которых строго доказана, то очевидно, что программа гарантированно находит самое короткое решение, если оно существует в рамках данного словаря. А вот человек не сможет доказать, что его решение самое короткое, как и то, что решения не существует. Таким образом, тут компьютер вне конкуренции с человеком, и эта задача — не задача ИИ.

А вот некоторые другие метаграммы:

муха-мура-бура-бора-кора-корн-коан-клан-улан-улар-удар-удав

мышка-мошка-кошка-корка-горка

шило-кило-коло-соло-сало-рало-рыло-мыло

баран-барон-басон-басок-бачок-бочок-борок-порок-порог-ворог-ворот

Над последним решением программа думала уже 25.21сек. Интересно, что граф оказывается несвязным. Так, например, не удалось найти решения для пешка – ферзь.

Можно расширить задачу. Пусть программа находит самые длинные цепочки с заданным числом букв, то есть генерирует головоломки. Для решения этой задачи нужно принять длину ребра нашего графа равной единице и вычислить матрицу расстояний между вершинами. Это можно сделать, например, с помощью алгоритма Флойда-Уоршелла. Так, для слов в 11 букв получим:

Число загруженных слов: 3391

Число ребер: 223

Максимальное расстояние: 9

Пары на максимальном расстоянии: закатывание-запихивание, запихивание-наматывание, обсаживание-отматывание, отматывание-отсиживание

Затрачено времени: 3821.45 сек.Найдем решение для пары запихивание – наматывание:

Решение: (9 слов) запихивание-запахивание-запаривание-заваривание-заваливание-закаливание-накаливание-накалывание-накатывание-наматывание

Затрачено времени: 62.12 сек.

В заключение этой небольшой заметки стоит отметить, что совершенно справедливо программист, приступая к решению новой задачи, пытается использовать похожее известное решение. С ростом популярности методов ИИ они будут все чаще применяться к различным задачам. Но тут требуется особая осторожность – иначе из мелкой алгоритмической мухи может получиться громадный слон.

При этом все сказанное ни в коей мере не стоит воспринимать как критику указанной статьи с генетическим алгоритмом. Автор любой работы имеет безусловное право исследовать любой алгоритм на любой задаче. И такое исследование приносит свою пользу. В частности, благодаря ему стало возможным сравнение, приведенное в этой заметке.

|

Метки: author third112 разработка игр программирование математика занимательные задачки алгоритмы ai искусственный интеллект компьютерные игры теория графов головоломки из мухи слона |

Сложно ли сделать из мухи слона? |

Сложно ли сделать из мухи слона?

Сальвадор Дали. Искушение св. Антония. 1946. (Фрагмент).

Бельгийский Королевский музей изящных искусств (Брюссель).

Неужели эта задача требует столь сложного решения? Может, это задача ИИ? – Исхожу из определения:

к ИИ относятся задачи, которые компьютер решает заметно хуже человека.

(О применении генетических алгоритмов в ИИ см. книгу: Д. Рутковская, М. Пилиньский, Л. Рутковский, Нейронные сети, генетические алгоритмы и нечеткие системы, М.: Горячая линия – Телеком, 2006).

Однако ларчик открывается довольно просто. Пусть длина каждого из заданных слов . Из словаря существительных выписываем все слова длиной . Число найденных слов обозначим . Эти слова будут метками вершин неориентированного графа. Каждую пару вершин, метки которых отличаются на одну букву, соединяем ребром. Для этого перебираем все пары вершин, сравнивая их метки – число пар , число побуквенных сравнений . Далее решаем типовую задачу поиска кратчайшего пути между указанными вершинами графа.

Словарь существительных взял с CD-ROM к книге Сергея Мельникова, Delphi и Turbo Pascal на занимательных примерах, СПб.: БХВ – Петербург, 2006 (к слову сказать, в этой книге можно найти много остроумных и простых решений подобных, казалось бы, сложных задач со словами):

В словаре перечислены все имена существительные «Орфографического словаря»

(106000 слов, 28-е издание, 1990 г.). [...] Набор текста осуществлён в 1996-98 годах игроками команды «Пузляры» (http://puzzle.ezakaz.ru) — Константином Кнопом, Яковом Зайдельманом, Валерием Тимониным, Виктором Кабановым, Дмитрием Филимоненковым.

Получил:

Число загруженных слов (число вершин графа): 1501

Число ребер: 2402

Решение: (8 слов) муха-мула-кула-кила-килт-киот-клот-клон-слон

Затрачено времени: 4.59 сек.

Вряд ли обычный человек сообразит быстрее. Более того, так как используются алгоритмы, корректность которых строго доказана, то очевидно, что программа гарантированно находит самое короткое решение, если оно существует в рамках данного словаря. А вот человек не сможет доказать, что его решение самое короткое, как и то, что решения не существует. Таким образом, тут компьютер вне конкуренции с человеком, и эта задача — не задача ИИ.

А вот некоторые другие метаграммы:

муха-мура-бура-бора-кора-корн-коан-клан-улан-улар-удар-удав

мышка-мошка-кошка-корка-горка

шило-кило-коло-соло-сало-рало-рыло-мыло

баран-барон-басон-басок-бачок-бочок-борок-порок-порог-ворог-ворот

Над последним решением программа думала уже 25.21сек. Интересно, что граф оказывается несвязным. Так, например, не удалось найти решения для пешка – ферзь.

Можно расширить задачу. Пусть программа находит самые длинные цепочки с заданным числом букв, то есть генерирует головоломки. Для решения этой задачи нужно принять длину ребра нашего графа равной единице и вычислить матрицу расстояний между вершинами. Это можно сделать, например, с помощью алгоритма Флойда-Уоршелла. Так, для слов в 11 букв получим:

Число загруженных слов: 3391

Число ребер: 223

Максимальное расстояние: 9

Пары на максимальном расстоянии: закатывание-запихивание, запихивание-наматывание, обсаживание-отматывание, отматывание-отсиживание

Затрачено времени: 3821.45 сек.Найдем решение для пары запихивание – наматывание:

Решение: (9 слов) запихивание-запахивание-запаривание-заваривание-заваливание-закаливание-накаливание-накалывание-накатывание-наматывание

Затрачено времени: 62.12 сек.

В заключение этой небольшой заметки стоит отметить, что совершенно справедливо программист, приступая к решению новой задачи, пытается использовать похожее известное решение. С ростом популярности методов ИИ они будут все чаще применяться к различным задачам. Но тут требуется особая осторожность – иначе из мелкой алгоритмической мухи может получиться громадный слон.

При этом все сказанное ни в коей мере не стоит воспринимать как критику указанной статьи с генетическим алгоритмом. Автор любой работы имеет безусловное право исследовать любой алгоритм на любой задаче. И такое исследование приносит свою пользу. В частности, благодаря ему стало возможным сравнение, приведенное в этой заметке.

|

Метки: author third112 разработка игр программирование математика занимательные задачки алгоритмы ai искусственный интеллект компьютерные игры теория графов головоломки из мухи слона |

13-я статья об отрицательном опыте в работе с MS SQL Server |

13-я статья об отрицательном опыте в работе с MS SQL Server

- Tutorial

Предисловие

В данной сжатой статье будет приведен обзор ошибок, последствия которых были весьма ощутимыми и с которыми мне приходилось сталкиваться.

Статья написана с целью неповторения данных ошибок.

И как говорится, отрицательный опыт-это тоже опыт и порой даже ценнее положительного.

Ошибки

- Процентное приращение файлов БД (базы данных)

Т к рост файла (будь то данные или журнал транзакций) БД-весьма ресурсоемкая операция, то благими намерениями может показаться выставление этого роста именно в процентных соотношениях. Соглашусь, во многих рекомендациях сказано, что лучше выставлять не процентный, а фиксированный прирост, выраженный в МБ. Однако, не раскрывается почему именно так. Исходя из практики, не рекомендуется устанавливать прирост файла БД выше 1 ГБ, т к MS SQL Server быстрее выделит 2 раза по 1 ГБ, чем сразу 2 ГБ. Также, если выделять меньше 32 МБ (исходя опять же из практики), то рано или поздно сама база данных начинает просто висеть. Отлично, определились, что приращивать файлы БД стоит фиксировано от 32 до 1024 МБ. Но вот почему еще нельзя в процентах указывать прирост файлов БД? Оказывается, что как только файл станет меньше 1 МБ, то СУБД округляет эту величину до 0 МБ и прекращает увеличивать этот файл. В результате возникает простой системы. Чтобы узнать на сколько увеличивать файл, достаточно сделать анализ за сутки-на сколько вырастает каждый из файлов в МБ, и выставить соответствующее число, но в диапазоне от 32 до 1024 МБ. Сбор статистики по росту файлов БД можно получить следующим образом - Очень много внешних ключей на таблицу

Вы когда-нибудь пробовали смотреть план при удалении хотя бы одной строки из таблицы, на которую ссылаются чуть ли не сотни других таблиц? Вы удивитесь, сколько там вложенных циклов. И все они-это проверки по внешним ключам. Поэтому если таблицы большие (миллионники), то лучше выключить внешние ключи на таблицу, в которой будут удаляться данные, затем удалить все необходимые и связанные с ними данные, и после этого включить внешние ключи. Аналогичная ситуация и с каскадными обновлениями и удалениями. Если внешних связей очень много (сотни), то даже удаление 1 строки может привести к долгой и очень обширной блокировке. - Много лишних индексов

Часто можно встретить в рекомендациях, что при создании внешних ключей, необходимо для них строить индексы, особенно при использовании этих ключей для соединений. Необходимо проверить, что индексы используются, иначе эти лишние индексы будут только тормозить любые операции по модификации данных. Проверить использование индексов можно следующим запросом:

Кодselect DB_NAME(t.database_id) as [DBName] , SCHEMA_NAME(obj.schema_id) as [SchemaName] , OBJECT_NAME(t.object_id) as [ObjectName] , obj.Type as [ObjectType] , obj.Type_Desc as [ObjectTypeDesc] , ind.name as [IndexName] , ind.Type as IndexType , ind.Type_Desc as IndexTypeDesc , ind.Is_Unique as IndexIsUnique , ind.is_primary_key as IndexIsPK , ind.is_unique_constraint as IndexIsUniqueConstraint , t.[Database_ID] , t.[Object_ID] , t.[Index_ID] , t.Last_User_Seek , t.Last_User_Scan , t.Last_User_Lookup , t.Last_System_Seek , t.Last_System_Scan , t.Last_System_Lookup from sys.dm_db_index_usage_stats as t inner join sys.objects as obj on t.[object_id]=obj.[object_id] inner join sys.indexes as ind on t.[object_id]=ind.[object_id] and t.index_id=ind.index_id where (last_user_seek is null or last_user_seek 4 and t.[object_id]>0 --исключаются системные БД

- Нерациональное использование ресурсов

Часто можно встретить в рекомендациях, что необходимо журнал транзакций и файл данных БД выносить на разные носители данных. Если использовать RAID 10 с 4-мя и более SSD-дисками, то нет смысла изоляции файлов друг от друга. Для еще большей скорости, при необходимости БД tempdb можно разместить на диске, который был сформирован из ОЗУ. Также слишком большие объемы ОЗУ, которые предоставляются СУБД, приведут к тому, что последний заполнит всю память неактуальными планами запросов. - Битые резервные копии

Как это не банально может звучать, но всегда нужно не просто проверять созданные резервные копии, а также перемещать их на тестовый стенд и восстанавливать. И все это необходимо автоматизировать с последующим уведомлением администраторам как о проблемных, так и об успешных восстановлениях. - Ложная отказоустойчивость

Прежде чем делать из двух и более серверов кластер, необходимо убедиться в том, что система хранения данных тоже отказоустойчива, т к при выходе из строя последнего, сведет к нулю всю отказоустойчивость. - Сложная диагностика без простых проверок

Если происходит простой системы, то необходимо сначала проверить журналы MS SQL Server, а уже потом копаться более детально, т к зачастую все проблемы записываются именно туда. Не проводить простых проверок-это то же самое, что не померить температуру пациента, а сразу проводить сложную диагностику. - Забытые таблицы

Таблицы могут распухнуть ненужными старыми данными, которые либо необходимо архивировать в отдельную БД, либо удалять. Также таблицы могут перестать использоваться. Необходимо об этом помнить.

Это все 8 отрицательных опытов, с которыми мне приходилось сталкиваться.

Не повторяйте приведенных выше ошибок.

Источники:

» Документация по SQL

» Автоматизация по сбору данных о росте таблиц и файлов всех баз данных

|

Метки: author jobgemws администрирование баз данных ms sql server |

13-я статья об отрицательном опыте в работе с MS SQL Server |

13-я статья об отрицательном опыте в работе с MS SQL Server

- Tutorial

Предисловие

В данной сжатой статье будет приведен обзор ошибок, последствия которых были весьма ощутимыми и с которыми мне приходилось сталкиваться.

Статья написана с целью неповторения данных ошибок.

И как говорится, отрицательный опыт-это тоже опыт и порой даже ценнее положительного.

Ошибки

- Процентное приращение файлов БД (базы данных)

Т к рост файла (будь то данные или журнал транзакций) БД-весьма ресурсоемкая операция, то благими намерениями может показаться выставление этого роста именно в процентных соотношениях. Соглашусь, во многих рекомендациях сказано, что лучше выставлять не процентный, а фиксированный прирост, выраженный в МБ. Однако, не раскрывается почему именно так. Исходя из практики, не рекомендуется устанавливать прирост файла БД выше 1 ГБ, т к MS SQL Server быстрее выделит 2 раза по 1 ГБ, чем сразу 2 ГБ. Также, если выделять меньше 32 МБ (исходя опять же из практики), то рано или поздно сама база данных начинает просто висеть. Отлично, определились, что приращивать файлы БД стоит фиксировано от 32 до 1024 МБ. Но вот почему еще нельзя в процентах указывать прирост файлов БД? Оказывается, что как только файл станет меньше 1 МБ, то СУБД округляет эту величину до 0 МБ и прекращает увеличивать этот файл. В результате возникает простой системы. Чтобы узнать на сколько увеличивать файл, достаточно сделать анализ за сутки-на сколько вырастает каждый из файлов в МБ, и выставить соответствующее число, но в диапазоне от 32 до 1024 МБ. Сбор статистики по росту файлов БД можно получить следующим образом - Очень много внешних ключей на таблицу

Вы когда-нибудь пробовали смотреть план при удалении хотя бы одной строки из таблицы, на которую ссылаются чуть ли не сотни других таблиц? Вы удивитесь, сколько там вложенных циклов. И все они-это проверки по внешним ключам. Поэтому если таблицы большие (миллионники), то лучше выключить внешние ключи на таблицу, в которой будут удаляться данные, затем удалить все необходимые и связанные с ними данные, и после этого включить внешние ключи. Аналогичная ситуация и с каскадными обновлениями и удалениями. Если внешних связей очень много (сотни), то даже удаление 1 строки может привести к долгой и очень обширной блокировке. - Много лишних индексов

Часто можно встретить в рекомендациях, что при создании внешних ключей, необходимо для них строить индексы, особенно при использовании этих ключей для соединений. Необходимо проверить, что индексы используются, иначе эти лишние индексы будут только тормозить любые операции по модификации данных. Проверить использование индексов можно следующим запросом:

Кодselect DB_NAME(t.database_id) as [DBName] , SCHEMA_NAME(obj.schema_id) as [SchemaName] , OBJECT_NAME(t.object_id) as [ObjectName] , obj.Type as [ObjectType] , obj.Type_Desc as [ObjectTypeDesc] , ind.name as [IndexName] , ind.Type as IndexType , ind.Type_Desc as IndexTypeDesc , ind.Is_Unique as IndexIsUnique , ind.is_primary_key as IndexIsPK , ind.is_unique_constraint as IndexIsUniqueConstraint , t.[Database_ID] , t.[Object_ID] , t.[Index_ID] , t.Last_User_Seek , t.Last_User_Scan , t.Last_User_Lookup , t.Last_System_Seek , t.Last_System_Scan , t.Last_System_Lookup from sys.dm_db_index_usage_stats as t inner join sys.objects as obj on t.[object_id]=obj.[object_id] inner join sys.indexes as ind on t.[object_id]=ind.[object_id] and t.index_id=ind.index_id where (last_user_seek is null or last_user_seek 4 and t.[object_id]>0 --исключаются системные БД

- Нерациональное использование ресурсов

Часто можно встретить в рекомендациях, что необходимо журнал транзакций и файл данных БД выносить на разные носители данных. Если использовать RAID 10 с 4-мя и более SSD-дисками, то нет смысла изоляции файлов друг от друга. Для еще большей скорости, при необходимости БД tempdb можно разместить на диске, который был сформирован из ОЗУ. Также слишком большие объемы ОЗУ, которые предоставляются СУБД, приведут к тому, что последний заполнит всю память неактуальными планами запросов. - Битые резервные копии

Как это не банально может звучать, но всегда нужно не просто проверять созданные резервные копии, а также перемещать их на тестовый стенд и восстанавливать. И все это необходимо автоматизировать с последующим уведомлением администраторам как о проблемных, так и об успешных восстановлениях. - Ложная отказоустойчивость

Прежде чем делать из двух и более серверов кластер, необходимо убедиться в том, что система хранения данных тоже отказоустойчива, т к при выходе из строя последнего, сведет к нулю всю отказоустойчивость. - Сложная диагностика без простых проверок

Если происходит простой системы, то необходимо сначала проверить журналы MS SQL Server, а уже потом копаться более детально, т к зачастую все проблемы записываются именно туда. Не проводить простых проверок-это то же самое, что не померить температуру пациента, а сразу проводить сложную диагностику. - Забытые таблицы

Таблицы могут распухнуть ненужными старыми данными, которые либо необходимо архивировать в отдельную БД, либо удалять. Также таблицы могут перестать использоваться. Необходимо об этом помнить.

Это все 8 отрицательных опытов, с которыми мне приходилось сталкиваться.

Не повторяйте приведенных выше ошибок.

Источники:

» Документация по SQL

» Автоматизация по сбору данных о росте таблиц и файлов всех баз данных

|

Метки: author jobgemws администрирование баз данных ms sql server |

Дайджест KolibriOS #13 |

Дайджест KolibriOS #13

Между выпусками прошло достаточно много времени и накопилось достаточно изменений за 2017г.

Между выпусками прошло достаточно много времени и накопилось достаточно изменений за 2017г.

Дайджест KolibriOS #2: что нам принёс февраль

Дайджест KolibriOS #3: начало весны

Дайджест KolibriOS #4: и весна нам не помеха

Дайджест KolibriOS #5: мы снова с вами

Дайджест KolibriOS #6: последняя осень

Дайджест KolibriOS #7: как мы зиму перезимовали

Дайджест KolibriOS #8: дары весны

Дайджест KolibriOS #9: летний урожай

Дайджест KolibriOS #10 коротко о накопившемся

Дайджест по итогам 2015 года

Дайджест KolibriOS #11 все новости с последнего выпуска и Google Summer of Code 2016

Дайджест KolibriOS #12

Общесистемные изменения (ядро, драйверы, библиотеки)

- UNICODE. Очень большое и важное изменение — файловое API SysFn80 теперь полностью поддерживает Юникод (UTF-8, UTF-16LE). Причем поддерживаются все файловые системы — NTFS, FAT, ext2

- NTFS. В процессе разработки файловых утилит был сурово протестирован драйвер NTFS, и за исключением некоторых не поддерживаемых функций (шифрование, сжатие, права доступа), работает весьма стабильно

- ext2. Исправление найденных ошибок, добавлена поддержка больших файлов >4 GB

- C_layer. Библиотека С-интерфейсов для основных системных библиотек доведена до логической Беты

- libimg. Поддержка системной библиотекой сохранения в PNG

- KF-font. Поддержка шрифтовой библиотеки из Oberon

- TCP fixes. Исправление ошибок сетевого стека

- Disk subsystem. Поддержка разметки диска GUID Partition Table (GPT)

- Memory subsystem. Автоматическая инициализация кучи при первом выделении памяти

Средства разработки

- GCC. Портирована версия 5.4, в libc добавлена поддержка UNICODE

- Tiny C. Добавлена генерация отладочной информации о строках для использования MTDBG

- Freebasic. Добавлен тестовый пример использования

- Delphi7. Расширяется KolibriOS.lib — библиотека системных вызовов Колибри из D7 и различных ассемблеров (ниже). Добавлены примеры использования (поддерживаются только консольные и Kolibri API приложения)