Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Загадки и мифы SPF |

Загадки и мифы SPF

- Tutorial

SPF (Sender Policy Framework), полное название можно перевести как "Основы политики отправителя для авторизации использования домена в Email" — протокол, посредством которого домен электронной почты может указать, какие хосты Интернет авторизованы использовать этот домен в командах SMTP HELO и MAIL FROM. Публикация политики SPF не требует никакого дополнительного софта и поэтому чрезвычайно проста: достаточно добавить в зону DNS запись типа TXT, содержащую политику, пример записи есть в конце статьи. Для работы с SPF есть многочисленные мануалы и даже онлайн-конструкторы.

Первая версия стандарта SPF принята более 10 лет назад. За это время были созданы многочисленные реализации, выработаны практики применения и появилась свежая версия стандарта. Но самое удивительное, что почему-то именно SPF, более чем любой другой стандарт, оброс за 10 лет невероятным количеством мифов и заблуждений, которые кочуют из статьи в статью и с завидной регулярностью выскакивают в обсуждениях и ответах на вопросы на форумах. А протокол, казалось бы, такой простой: внедрение занимает всего пару минут. Давайте попробуем вспомнить и разобрать наиболее частые заблуждения.

TL;DR — рекомендации в конце.

1. Заблуждение: SPF защищает мой домен от подделок

На самом деле: SPF никак не защищает видимый пользователю адрес отправителя.

Объяснение: SPF вообще не работает с содержимым письма, которое видит пользователь, в частности с адресом отправителя. SPF авторизует и проверяет адреса на уровне почтового транспорта (SMTP) между двумя MTA (envelope-from, RFC5321.MailFrom aka Return-Path). Эти адреса не видны пользователю и могут отличаться от видимых пользователю адресов из заголовка From письма (RFC5322.From). Таким образом, письмо с поддельным отправителем во From запросто может пройти SPF-авторизацию.

2. Заблуждение: Я внедрю SPF и станет безопасней и меньше спама

На самом деле: скорей всего, изменений в плане безопасности и спама вы не заметите.

Объяснение: SPF изначально альтруистический протокол и сам по себе не дает преимуществ тому, кто публикует SPF-политику. Теоретически, внедрение вами SPF могло бы защитить кого-то другого от поддельных писем с вашего домена. Но на практике даже это не так, потому что результаты SPF редко используются напрямую (об этом ниже). Боле того, даже если бы все домены публиковали SPF, а все получатели запрещали получение писем без SPF-авторизации, это вряд ли привело бы к снижению уровня спама.

SPF не защищает от подделки отправителя или спама напрямую, тем не менее, он активно используется и весьма полезен и в системах спам-фильтрации и для защиты от поддельных писем, т.к. позволяет привязать письмо к определенному домену и его репутации.

3. Заблуждение: SPF отрицательно (положительно) влияет на доставляемость писем

На самом деле: Всё зависит от типа письма и пути, по которому оно доставляется.

Объяснение: SPF сам по себе не влияет на доставляемость писем обычным потоком, и отрицательно влияет при неправильном внедрении или на непрямых потоках писем (indirect flow), когда пользователь получает письма не от того сервера, с которого письмо было отправлено, например на перенаправленные письма. Но системы спам-фильтрации и репутационные классификаторы учитывают наличие SPF, что в целом, на основном потоке писем, дает положительный результат. Если, конечно, вы не рассылаете спам.

4. Заблуждение: SPF авторизует отправителя письма

На самом деле: SPF авторизует почтовый сервер, отправляющий письмо от имени домена.

Объяснение: Во-первых, SPF работает только на уровне доменов, а не для отдельных адресов электронной почты. Во-вторых, даже если вы являетесь легальным пользователем почты определенного домена, SPF не позволяет вам отправить письмо из любого места. Чтобы письмо прошло SPF-валидацию, вы должны отправлять только через авторизованный сервер. В-третьих, если вы авторизовали сервер по SPF (например, разрешили отправку писем от вашего домена через какого-либо ESP или хостинг-провайдера) и он не реализует дополнительных ограничений, то все пользователи данного сервера могут рассылать письма от имени вашего домена. Всё это следует учитывать при внедрении SPF и аутентификации писем в целом.

5. Заблуждение: письма, не прошедшие авторизацию SPF, отсеиваются

На самом деле: SPF-авторизация или ее отсутствие в общем случае не влияет кардинально на доставку писем.

Объяснение: стандарт SPF является только стандартом авторизации и в явном виде указывает, что действия, применяемые к письмам, не прошедшим авторизацию, находятся за пределами стандарта и определяются локальной политикой получателя. Отказ в получении таких писем приводит к проблемам с письмами, идущими через непрямые маршруты доставки, например, перенаправления или списки рассылки, и этот факт должен учитываться в локальной политике. На практике, строгий отказ из-за сбоя SPF-авторизации не рекомендуется к использованию и возможен только при публикации доменом политики -all (hardfail) в отсутствии других средств фильтрации. В большинстве случаев, SPF-авторизация используется как один из факторов в весовых системах. Причем вес этого фактора очень небольшой, потому что нарушение SPF-авторизации обычно не является сколь-либо достоверным признаком спама — многие спам-письма проходят SPF-авторизацию, а вполне легальные — нет, и вряд ли эта ситуация когда-нибудь кардинально изменится. При таком использовании, разницы между "-all" и "~all" нет.

Факт наличия SPF-авторизации важен не столько для доставки письма и принятия решения о том, является ли оно спамом, сколько для подтверждения адреса отправителя и связи с доменом, что позволяет для письма использовать не репутацию IP, а репутацию домена.

На принятие решения о действии над письмом, не прошедшим авторизацию, гораздо больше влияет политика DMARC. Политика DMARC позволяет отбросить (или поместить в карантин) все письма, не прошедшие авторизацию или их процент.

6. Заблуждение: в SPF надо использовать -all (hardfail), это безопасней чем ?all или ~all

На самом деле: на практике -all никак не влияет ни на чью безопасность, зато негативно влияет на доставляемость писем.

Объяснение: -all приводит к блокировке писем, отправленных через непрямые маршруты теми немногими получателями, которые используют результат SPF напрямую и блокируют письма. При этом на большую часть спама и поддельных писем эта политика существенного влияния не окажет. На текущий момент наиболее разумной политикой считается ~all (softfail), она используется практически всеми крупными доменам, даже теми, у которых очень высокие требованиями к безопасности (paypal.com, например). -all можно использовать для доменов, с которых не производится отправки легальных писем. Для DMARC -, ~ и ? являются эквивалентными.

7. Заблуждение: достаточно прописать SPF только для доменов, с которых отправляется почта

На самом деле: необходимо также прописать SPF для доменов, используемых в HELO почтовых серверов, и желательно прописать блокирующую политику для неиспользуемых для отправки почты A-записей и вайлдкарда.

Объяснение: в некоторых случаях, в частности, при доставке NDR (сообщение о невозможности доставки), DSN (сообщение подтверждения доставки) и некоторых автоответах, адрес отправителя в SMTP-конверте (envelope-from) является пустым. В таком случае SPF проверяет имя хоста из команды HELO/EHLO. Необходимо проверить, какое имя используется в данной команде (например, заглянув в конфигурацию сервера или отправив письмо на публичный сервер и посмотрев заголовки) и прописать для него SPF. Спамерам совершенно не обязательно слать спам с тех же доменов, с которых вы отправляете письма, они могут отправлять от имени любого хоста, имеющего A- или MX-запись. Поэтому, если вы публикуете SPF из альтруистических соображений, то надо добавлять SPF для всех таких записей, и желательно еще wildcard (*) для несуществующих записей.

8. Заблуждение: лучше добавлять в DNS запись специального типа SPF, а не TXT

На самом деле: надо добавлять запись типа TXT.

Объяснение: в текущей версии стандарта SPF (RFC 7208) записи типа SPF являются deprecated и не должны больше использоваться.

9. Заблуждение: чем больше всего (a, mx, ptr, include) я включу в SPF-запись, тем лучше, потому что меньше вероятность ошибиться

На самом деле: по возможности, следует максимально сократить SPF-запись и использовать в ней только адреса сетей через IP4/IP6.

Объяснение: на разрешение SPF-политики отведен лимит в 10 DNS-запросов. Его превышение приведет к постоянной ошибке политики (permerror). Кроме того, DNS является ненадежной службой, и для каждого запроса есть вероятность сбоя (temperror), которая возрастает с количеством запросов. Каждая дополнительная запись a или include требует дополнительного DNS-запроса, для include также необходимо запросить всё, что указано в include-записи. mx требует запроса MX-записей и дополнительного запроса A-записи для каждого MX-сервера. ptr требует дополнительного запроса, к тому же в принципе является небезопасной. Только адреса сетей, перечисленные через IP4/IP6, не требуют дополнительных DNS-запросов.

10. Заблуждение: TTL для SPF-записи следует сделать поменьше (побольше)

На самом деле: как и для большинства DNS-записей, лучше иметь TTL в диапазоне от 1 часа до 1 суток, заблаговременно снижая его при внедрении или планируемых изменениях и повышая при стабильно работающей политике.

Объяснение: более высокий TTL снижает вероятность ошибок DNS и, как следствие, temperror SPF, но повышает время реакции при необходимости внесения изменений в SPF-запись.

11. Заблуждение: если я не знаю, с каких IP могут уходить мои письма, то лучше опубликовать политику с +all

На самом деле: политика с явным +all или неявным правилом, разрешающим рассылку от имени домена с любых IP-адресов, негативно скажется на доставке почты.

Объяснение: такая политика не несет смысловой нагрузки и часто используется спамерами, чтобы обеспечить SPF-аутентификацию на спам-письмах, рассылаемых через ботнеты. Поэтому домен, публикующий подобную политику, имеет очень большие шансы попасть под блокировку.

12. Заблуждение: SPF бесполезен

На самом деле: SPF необходим.

Объяснение: SPF — это один из механизмов авторизации отправителя в электронной почте и способ идентификации домена в репутационных системах. В настоящее время крупные провайдеры почтовых сервисов постепенно начинают требовать наличие авторизации писем, и на письма, не имеющие авторизации, могут накладываться «штрафные санкции» по их доставке или отображению пользователю. Кроме того, на письма, не прошедшие SPF-авторизации, могут не возвращаться автоответы и отчеты о доставке или невозможности доставки. Причина в том, что эти категории ответов, как правило, идут именно на адрес SMTP-конверта и требуют, чтобы он был авторизован. Поэтому SPF необходим даже в том случае, если все письма авторизованы DKIM. Также SPF совершенно необходим в IPv6-сетях и облачных сервисах: в таких сетях практически невозможно использовать репутацию IP-адреса и письма с адресов, не авторизованных SPF, как правило, не принимаются. Одна из основных задач SPF, определенная в стандарте — как раз использование репутации доменного имени вместо репутации IP.

13. Заблуждение: SPF самодостаточен

На самом деле: необходимы также DKIM и DMARC.

Объяснение: DKIM необходим для прохождения писем через различные пересылки. DMARC необходим для защиты адреса отправителя от подделок. Кроме того, DMARC позволяет получать отчеты о нарушениях политики SPF.

14. Заблуждение: одна SPF-запись — хорошо, а две — лучше

На самом деле: запись должна быть ровно одна.

Объяснение: это требование стандарта. Если записей будет более одной, это приведет к постоянной ошибке (permerror). Если необходимо объединить несколько SPF-записей, опубликуйте запись с несколькими include.

15. Заблуждение: spf1 хорошо, spf2.0 — лучше

На самом деле: надо использовать v=spf1.

Объяснение: spf2.0 не существует. Публикация записи spf2.0 может приводить к непредсказуемым результатам. spf2.0 никогда не существовал и не был стандартом, но отсылка на него есть в экспериментальном стандарте RFC 4406 (Sender ID), который писался в предположении, что такой стандарт будет принят, ведь его принятие обсуждалось на тот момент. Sender ID, который должен был решить проблему подмены адресов, не стал общепринятым стандартом и от него следует отказаться в пользу DMARC. Даже в том случае, если вы решаете использовать Sender ID и опубликовать spf2.0 запись, она не заменит записи spf1.

Я практически закончил писать эту статью, когда меня перехватила служба поддержки пользователей и настоятельно (с угрозой применения грубой силы) рекомендовала напомнить о следующих нюансах SPF, с которыми им чаще всего приходится сталкиваться при разрешении проблем:

- SPF-политика должна заканчиваться директивой

allилиredirect. После этих директив ничего идти не должно. - Директивы

allилиredirectмогут встретиться в политике ровно один раз, они заменяют друг друга (то есть в одной политике не может бытьallиredirectодновременно). - Директива

includeне заменяет директивыallилиredirect.includeможет встретиться в политике несколько раз, при этом политику всё равно следует завершать директивамиallилиredirect. Политика, включаемая черезincludeилиredirect, также должна быть валидной политикой, оканчивающейся на директивуallилиredirect. При этом дляincludeбезразлично, какое правило (-all,~all,?all) используется дляallво включаемой политике, а дляredirectразница есть. - Директива

includeиспользуется с двоеточием (include:example.com), директиваredirect— со знаком равенства (redirect=example.com). - SPF не распространяется на поддомены. SPF. Не. Распространяется. На. Поддомены. SPF НЕ РАСПРОСТРАНЯЕТСЯ НА ПОДДОМЕНЫ. (а DMARC, по умолчанию, распространяется). Надо публиковать SPF для каждой записи A или MX в DNS, по которой производится (или может производиться) доставка почты.

Резюме

- Обязательно создайте политику для всех MX- и, желательно, A-записей.

- Добавьте SPF-политики для имен, используемых в HELO/EHLO почтового сервера.

- Публикуйте SPF-политику как TXT-запись с

v=spf1в DNS. - В политике преимущественно используйте адреса сетей заданные через

IP4/IP6. Располагайте их в начале политики, чтобы избежать лишних DNS-запросов. Минимизируйте использованиеinclude, не используйте без необходимостиa, без крайней и непреодолимой необходимости не используйтеmxи никогда не используйтеptr. - Указывайте

~allдля доменов, с которых реально отправляются письма,-all— для неиспользуемых доменов и записей. - Используйте маленькие TTL на период внедрения и тестирования, затем повысьте TTL до разумных значений. Перед необходимостью внесения изменений заблаговременно снижайте TTL.

- Обязательно тестируйте правильность SPF-политики, например, здесь.

- Не ограничивайтесь только SPF, постарайтесь внедрить DKIM и обязательно внедрите DMARC. DMARC поможет защитить ваши письма от подделок и позволит вам получать информацию по нарушениям SPF. Это позволит выявить подделки, непрямые потоки писем и ошибки конфигурации.

- После внедрения SPF, DKIM и/или DMARC проверьте их с помощью сервиса https://postmaste/security/.

- SPF и DMARC проверяются по текущему состоянию, наличие DKIM проверяется по статистическим данным за предыдущий день и будет показываться только при наличии переписки с ящиками на Mail.Ru в предшествующий день или ранее.

Пример политики SPF: @ IN TXT "v=spf1 ip4:1.2.3.0/24 include:_spf.myesp.example.com ~all"

|

Метки: author z3apa3a спам и антиспам dns блог компании mail.ru group spf электронная почта рассылки |

[Перевод] Коннектор Azure Container Instances для Kubernetes |

Коннектор Azure Container Instances для Kubernetes

- Перевод

Этот коннектор является экспериментальным и его не следует использовать для реальных проектов.

Такой подход позволяет практически мгновенно выделять кластеру необходимые ресурсы, избавляя администратора от необходимости управлять инфраструктурой ВМ и позволяя ему продолжать использовать Kubernetes API. В кластере Kubernetes можно одновременно использовать виртуальные машины и экземпляры контейнеров, тем самым получая преимущества обеих технологий.

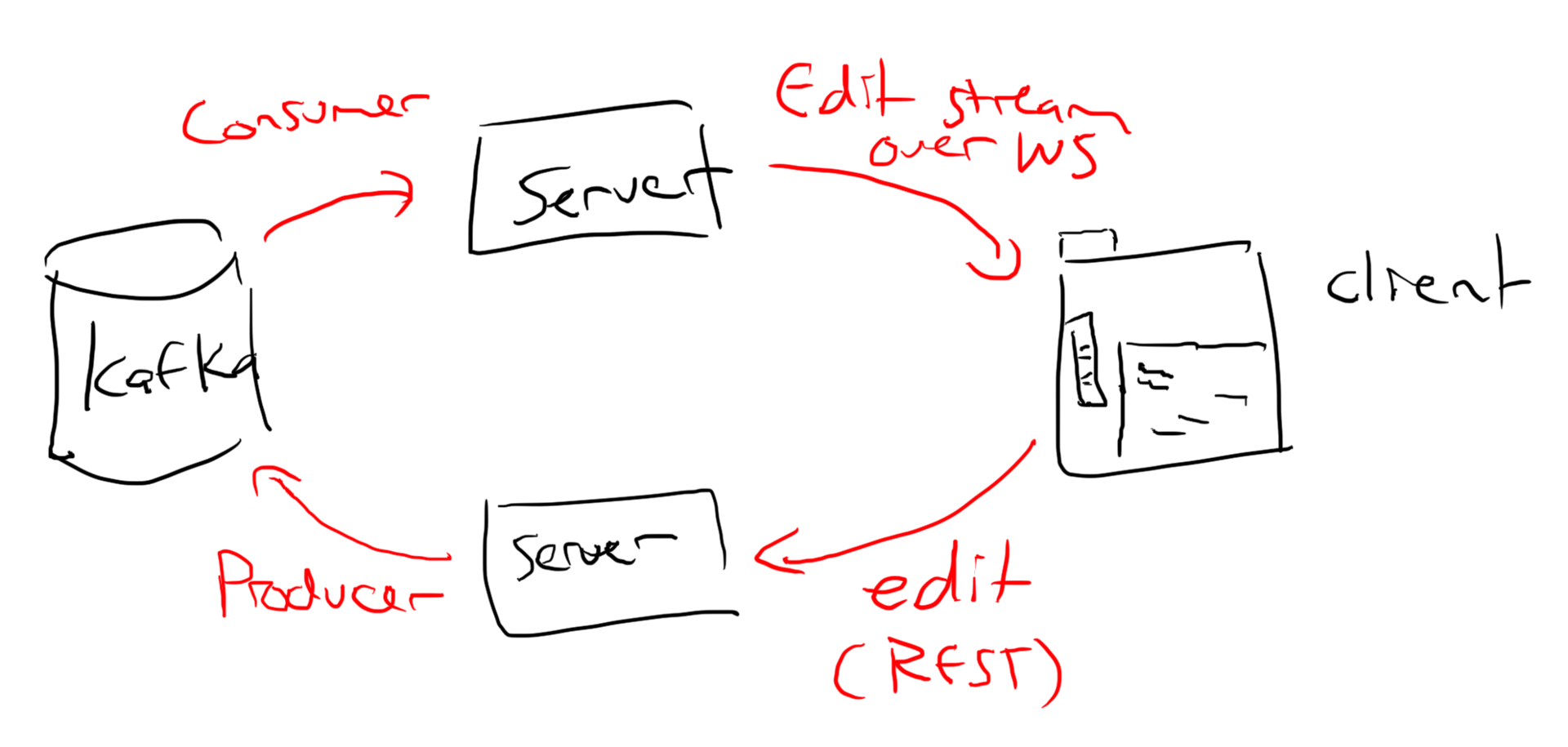

Принципы работы

Грубо говоря, коннектор ACI Connector имитирует интерфейс Kubelet следующим образом:

- регистрируется в Kubernetes как узел (node) с неограниченными ресурсами;

- отправляет поды (pod) на исполнение в службу экземпляров контейнеров Azure вместо нод на виртуальных машин.

После того как коннектор регистрируется в качестве узла с именем aci-connector, можно указать nodeName: aci-connector в конфигурации пода, чтобы запустить его через службу экземпляров контейнеров Azure. Поды, в конфигурации которых этот узел не указан, запускаются по расписанию в обычном режиме. Ниже даны инструкции по использованию соединителя ACI Connector и планировщика Kubernetes с помощью ограничений и допусков(taints и tolerations).

Требования

- Работающий клиент командной строки az — установить Azure CLI 2.0.

- Кластер Kubernetes с рабочим kubectl — настроить кластер Kubernetes в Azure.

Текущие возможности

В дополнении к примерам на текущий момент поддерживаются следующие функции Kubernetes, если они определены в манифесте пода. По мере расширения возможностей коннектора aci-connector этот список будет изменяться.

- Переменные среды

- Команды

- ImagePullSecret

- Azure Files Shared в качестве томов

Текущие ограничения

Следующие функции Kubernetes в настоящее время не поддерживаются коннектором aci-connector:

- ConfigMaps

- Secrets

- ServiceAccounts

- Volumes

- kubectl logs

- kubectl exec

Как быстро попробовать

- Отредактируйте файл examples/aci-connector.yaml и укажите переменные среды.

- Запустите коннектор ACI Connector командой kubectl create -f examples/aci-connector.yaml.

- Дождитесь, пока команда kubectl get nodes отобразит узел aci-connector.

- Запустите под NGINX через ACI командой kubectl create -f examples/nginx-pod.yaml.

- Откройте под NGINX с помощью его общедоступного адреса.

Пошаговая инструкция

Создайте группу ресурсов

Коннектор ACI Connector создаст каждый экземпляр контейнера в указанной группе ресурсов. Новую группу ресурсов можно создать следующей командой:

$ az group create -n aci-test -l westus

{

"id": "/subscriptions//resourceGroups/aci-test",

"location": "westus",

"managedBy": null,

"name": "aci-test",

"properties": {

"provisioningState": "Succeeded"

},

"tags": null

} Отредактируйте examples/aci-connector.yaml и укажите имя группы ресурсов в переменной среды ACI_RESOURCE_GROUP.

Создайте Service Principal

Service Principal необходим для создания ресурсов в вашей подписке Azure с помощью коннектора ACI Connector. Создать Service Principal можно с помощью Azure CLI в соответсвии с инструкцией ниже.

Найдите subscriptionId с помощью Azure CLI:

$ az account list -o table

Name CloudName SubscriptionId State IsDefault

----------------------------------------------- ----------- ------------------------------------ ------- -----------

Pay-As-You-Go AzureCloud 12345678-9012-3456-7890-123456789012 Enabled True

С помощью az создайте субъекта-службу, который будет оперировать вашей подпиской:

$ az ad sp create-for-rbac --role=Contributor --scopes /subscriptions//

{

"appId": "",

"displayName": "azure-cli-2017-07-19-19-13-19",

"name": "http://azure-cli-2017-07-19-19-13-19",

"password": "",

"tenant": ""

}

Отредактируйте файл examples/aci-connector.yaml и введите переменные среды, используя указанные выше значения:

- AZURE_CLIENT_ID: введите идентификатор приложения appId.

- AZURE_CLIENT_KEY: введите пароль.

- AZURE_TENANT_ID: укажите тенант.

- AZURE_SUBSCRIPTION_ID: введите идентификатор подписки subscriptionId.

Убедитесь, что провайдер Microsoft.ContainerInstance зарегистрирован

$ az provider list -o table | grep ContainerInstance

Microsoft.ContainerInstance NotRegistered

Если поставщик не зарегистрирован, то зарегистрируйте его с помощью команды:

$ az provider register -n Microsoft.ContainerInstance

$ az provider list -o table | grep ContainerInstance

Microsoft.ContainerInstance Registered

Установите коннектор ACI Connector

$ kubectl create -f examples/aci-connector.yaml

deployment "aci-connector" created

$ kubectl get nodes -w

NAME STATUS AGE VERSION

aci-connector Ready 3s 1.6.6

k8s-agentpool1-31868821-0 Ready 5d v1.7.0

k8s-agentpool1-31868821-1 Ready 5d v1.7.0

k8s-agentpool1-31868821-2 Ready 5d v1.7.0

k8s-master-31868821-0 Ready,SchedulingDisabled 5d v1.7.0

Установите соединитель ACI Connector с Helm (опционально)

Сначала укажите значения в файле values.yaml, находящемся в каталоге /charts/aci-connector.

Затем можно установить чарт:

$ helm install --name my-release ./charts/aci-connector

Значения также можно задать из командной строки, при этом все значения, указанные в файле values.yaml, будут перезаписаны:

$ helm install --name my-release --set env.azureClientId=YOUR-AZURECLIENTID,env.azureClientKey=YOUR-AZURECLIENTKEY,env.azureTenantId=YOUR-AZURETENANTID,env.azureSubscriptionId=YOUR-AZURESUBSCRIPTIONID,env.aciResourceGroup=YOUR-ACIRESOURCEGROUP,env.aciRegion=YOUR-ACI-REGION ./charts/aci-connector

Установите пример c NGINX

$ kubectl create -f examples/nginx-pod.yaml

pod "nginx" created

$ kubectl get po -w -o wide

NAME READY STATUS RESTARTS AGE IP NODE

aci-connector-3396840456-v75q2 1/1 Running 0 44s 10.244.2.21 k8s-agentpool1-31868821-2

nginx 1/1 Running 0 31s 13.88.27.150 aci-connector

Обратите внимание, что под развёрнут на узле aci-connector. Теперь он должен быть доступен через указанный открытый IP-адрес.

Использование планировщика Kubernetes

В примере в nginx-pod имя узла задано жестко, однако можно также использовать планировщик Kubernetes.

Виртуальный узел aci имеет ограничение (taint) (azure.com/aci) с эффектом NoSchedule по умолчанию. Это означает, что по умолчанию поды не запускаются на узле aci, если они не размещаются там явно.

Тем не менее планировщик Kubernetes может включать под, который допускает (tolerates) это ограничение, в график узла aci.

Ссылка на пример пода с таким допуском.

Воспользоваться этим подом легко:

$ kubectl create -f examples/nginx-pod-tolerations.yaml

Обратите внимание, что при наличии других узлов в вашем кластере этот под не обязательно размещается в службе экземпляров контейнеров Azure.

Для того чтобы принудительно развернуть под в службе экземпляров контейнеров Azure, можно явно указать NodeName, как в первом примере, либо удалить все остальные узлы кластера командой kubectl delete nodes <имя узла>. Третий вариант — развернуть в кластере другие рабочие нагрузки; в этом случае планировщик будет обязан запланировать выполнение вашей задачи через API службы экземпляров контейнеров Azure.

Использование сборок Canary

Сборки Canary — это версии коннектора, которые периодически создаются из главной ветки. Поскольку эти сборки не являются официальными выпусками, их стабильность не гарантирована, однако они позволяют тестировать новейшие функции.

Для того чтобы воспользоваться последней версией Canary, вы можете установить пакет обновлений для своего соединителя aci-connector и обновить тег контейнера, используя следующую команду:

$ kubectl set image deploy/aci-connector aci-connector=microsoft/aci-connector-k8s:canary

|

Метки: author stasus saas / s+s microsoft azure блог компании microsoft microsoft kubernetes k8s azure container instances azure |

[Перевод] Коннектор Azure Container Instances для Kubernetes |

Коннектор Azure Container Instances для Kubernetes

- Перевод

Этот коннектор является экспериментальным и его не следует использовать для реальных проектов.

Такой подход позволяет практически мгновенно выделять кластеру необходимые ресурсы, избавляя администратора от необходимости управлять инфраструктурой ВМ и позволяя ему продолжать использовать Kubernetes API. В кластере Kubernetes можно одновременно использовать виртуальные машины и экземпляры контейнеров, тем самым получая преимущества обеих технологий.

Принципы работы

Грубо говоря, коннектор ACI Connector имитирует интерфейс Kubelet следующим образом:

- регистрируется в Kubernetes как узел (node) с неограниченными ресурсами;

- отправляет поды (pod) на исполнение в службу экземпляров контейнеров Azure вместо нод на виртуальных машин.

После того как коннектор регистрируется в качестве узла с именем aci-connector, можно указать nodeName: aci-connector в конфигурации пода, чтобы запустить его через службу экземпляров контейнеров Azure. Поды, в конфигурации которых этот узел не указан, запускаются по расписанию в обычном режиме. Ниже даны инструкции по использованию соединителя ACI Connector и планировщика Kubernetes с помощью ограничений и допусков(taints и tolerations).

Требования

- Работающий клиент командной строки az — установить Azure CLI 2.0.

- Кластер Kubernetes с рабочим kubectl — настроить кластер Kubernetes в Azure.

Текущие возможности

В дополнении к примерам на текущий момент поддерживаются следующие функции Kubernetes, если они определены в манифесте пода. По мере расширения возможностей коннектора aci-connector этот список будет изменяться.

- Переменные среды

- Команды

- ImagePullSecret

- Azure Files Shared в качестве томов

Текущие ограничения

Следующие функции Kubernetes в настоящее время не поддерживаются коннектором aci-connector:

- ConfigMaps

- Secrets

- ServiceAccounts

- Volumes

- kubectl logs

- kubectl exec

Как быстро попробовать

- Отредактируйте файл examples/aci-connector.yaml и укажите переменные среды.

- Запустите коннектор ACI Connector командой kubectl create -f examples/aci-connector.yaml.

- Дождитесь, пока команда kubectl get nodes отобразит узел aci-connector.

- Запустите под NGINX через ACI командой kubectl create -f examples/nginx-pod.yaml.

- Откройте под NGINX с помощью его общедоступного адреса.

Пошаговая инструкция

Создайте группу ресурсов

Коннектор ACI Connector создаст каждый экземпляр контейнера в указанной группе ресурсов. Новую группу ресурсов можно создать следующей командой:

$ az group create -n aci-test -l westus

{

"id": "/subscriptions//resourceGroups/aci-test",

"location": "westus",

"managedBy": null,

"name": "aci-test",

"properties": {

"provisioningState": "Succeeded"

},

"tags": null

} Отредактируйте examples/aci-connector.yaml и укажите имя группы ресурсов в переменной среды ACI_RESOURCE_GROUP.

Создайте Service Principal

Service Principal необходим для создания ресурсов в вашей подписке Azure с помощью коннектора ACI Connector. Создать Service Principal можно с помощью Azure CLI в соответсвии с инструкцией ниже.

Найдите subscriptionId с помощью Azure CLI:

$ az account list -o table

Name CloudName SubscriptionId State IsDefault

----------------------------------------------- ----------- ------------------------------------ ------- -----------

Pay-As-You-Go AzureCloud 12345678-9012-3456-7890-123456789012 Enabled True

С помощью az создайте субъекта-службу, который будет оперировать вашей подпиской:

$ az ad sp create-for-rbac --role=Contributor --scopes /subscriptions//

{

"appId": "",

"displayName": "azure-cli-2017-07-19-19-13-19",

"name": "http://azure-cli-2017-07-19-19-13-19",

"password": "",

"tenant": ""

}

Отредактируйте файл examples/aci-connector.yaml и введите переменные среды, используя указанные выше значения:

- AZURE_CLIENT_ID: введите идентификатор приложения appId.

- AZURE_CLIENT_KEY: введите пароль.

- AZURE_TENANT_ID: укажите тенант.

- AZURE_SUBSCRIPTION_ID: введите идентификатор подписки subscriptionId.

Убедитесь, что провайдер Microsoft.ContainerInstance зарегистрирован

$ az provider list -o table | grep ContainerInstance

Microsoft.ContainerInstance NotRegistered

Если поставщик не зарегистрирован, то зарегистрируйте его с помощью команды:

$ az provider register -n Microsoft.ContainerInstance

$ az provider list -o table | grep ContainerInstance

Microsoft.ContainerInstance Registered

Установите коннектор ACI Connector

$ kubectl create -f examples/aci-connector.yaml

deployment "aci-connector" created

$ kubectl get nodes -w

NAME STATUS AGE VERSION

aci-connector Ready 3s 1.6.6

k8s-agentpool1-31868821-0 Ready 5d v1.7.0

k8s-agentpool1-31868821-1 Ready 5d v1.7.0

k8s-agentpool1-31868821-2 Ready 5d v1.7.0

k8s-master-31868821-0 Ready,SchedulingDisabled 5d v1.7.0

Установите соединитель ACI Connector с Helm (опционально)

Сначала укажите значения в файле values.yaml, находящемся в каталоге /charts/aci-connector.

Затем можно установить чарт:

$ helm install --name my-release ./charts/aci-connector

Значения также можно задать из командной строки, при этом все значения, указанные в файле values.yaml, будут перезаписаны:

$ helm install --name my-release --set env.azureClientId=YOUR-AZURECLIENTID,env.azureClientKey=YOUR-AZURECLIENTKEY,env.azureTenantId=YOUR-AZURETENANTID,env.azureSubscriptionId=YOUR-AZURESUBSCRIPTIONID,env.aciResourceGroup=YOUR-ACIRESOURCEGROUP,env.aciRegion=YOUR-ACI-REGION ./charts/aci-connector

Установите пример c NGINX

$ kubectl create -f examples/nginx-pod.yaml

pod "nginx" created

$ kubectl get po -w -o wide

NAME READY STATUS RESTARTS AGE IP NODE

aci-connector-3396840456-v75q2 1/1 Running 0 44s 10.244.2.21 k8s-agentpool1-31868821-2

nginx 1/1 Running 0 31s 13.88.27.150 aci-connector

Обратите внимание, что под развёрнут на узле aci-connector. Теперь он должен быть доступен через указанный открытый IP-адрес.

Использование планировщика Kubernetes

В примере в nginx-pod имя узла задано жестко, однако можно также использовать планировщик Kubernetes.

Виртуальный узел aci имеет ограничение (taint) (azure.com/aci) с эффектом NoSchedule по умолчанию. Это означает, что по умолчанию поды не запускаются на узле aci, если они не размещаются там явно.

Тем не менее планировщик Kubernetes может включать под, который допускает (tolerates) это ограничение, в график узла aci.

Ссылка на пример пода с таким допуском.

Воспользоваться этим подом легко:

$ kubectl create -f examples/nginx-pod-tolerations.yaml

Обратите внимание, что при наличии других узлов в вашем кластере этот под не обязательно размещается в службе экземпляров контейнеров Azure.

Для того чтобы принудительно развернуть под в службе экземпляров контейнеров Azure, можно явно указать NodeName, как в первом примере, либо удалить все остальные узлы кластера командой kubectl delete nodes <имя узла>. Третий вариант — развернуть в кластере другие рабочие нагрузки; в этом случае планировщик будет обязан запланировать выполнение вашей задачи через API службы экземпляров контейнеров Azure.

Использование сборок Canary

Сборки Canary — это версии коннектора, которые периодически создаются из главной ветки. Поскольку эти сборки не являются официальными выпусками, их стабильность не гарантирована, однако они позволяют тестировать новейшие функции.

Для того чтобы воспользоваться последней версией Canary, вы можете установить пакет обновлений для своего соединителя aci-connector и обновить тег контейнера, используя следующую команду:

$ kubectl set image deploy/aci-connector aci-connector=microsoft/aci-connector-k8s:canary

|

Метки: author stasus saas / s+s microsoft azure блог компании microsoft microsoft kubernetes k8s azure container instances azure |

Начальник, что мне делать для того, чтобы получать больше денег |

Начальник, что мне делать для того, чтобы получать больше денег

Представим себе программиста Ивана, который работает в компании какое-то время. По разным причинам так могло получиться, что у него уже давно не было повышения. А он его очень ждет. Ходить к менеджеру и просить повышения Ивану не хочется, не такой он человек, чтобы заводить разговор о повышении и выпрашивать, доказывать, что достоин повышения.

«Белая» версия событий

Предположим, Иван показывает свою позицию менеджеру: «Что я могу сделать в нашей компании для того, чтобы получать +30%»

Позиция Ивана:

- он ничего не просит и начинает разговор с позиции равного

- он хочет узнать о его возможных перспективах работы в компании

- возможно, Иван хочет занять более высокую должность

- возможно, Иван даже готов больше работать, чтобы получить желаемую прибавку

Позиция Менеджера (написано целенаправленно с большой буквы, т.к. речь идет именно об адекватном менеджере, который не боится развивать своих подчиненных, который уважает своих сотрудников и работает с ними на равных и открытых человеческих позициях):

- Иван – проактивный человек, проявляет лидерские качества, возможно, сможет расти в руководителя группы

- Иван лоялен к компании, ведь первым начинает разговор со своим менеджером, а не идет на собеседование

- Иван готов, возможно, к дополнительной работе

- если планировалось повышение только +10% в этом году, можно рассмотреть Ивана для продвижения по карьерной лестнице и дать ему желаемые 30%.

В таких переговорах есть большая вероятность, что Иван и Менеджер договорятся и найдут решение в стиле WIN-WIN:

- Иван получит желаемую зарплату

- Менеджер получит лояльного и мотивированного сотрудника.

Очевидно, возможны и крайние случаи:

- Иван запросит +100%, вряд ли в какой компании смогут организовать такое большое повышение

- Менеджер по разным причинам не сможет найти варианты для повышения сотрудника.

Но в любом случае, у Менеджера и Ивана есть открытая позиция по взаимодействию. Они могут договориться, как вариант, что Иван в течение 3-х месяцев ищет новую работу, а Менеджер ищет замену Ивану. В конечном итоге, они расстанутся в хороших отношениях и, возможно, когда у Менеджера появится высокооплачиваемая позиция в проекте, он снова позовет Ивана. Прощаться ведь тоже нужно хорошо, а мир IT крайне тесен.

«Нейтральная» версия событий

Менеджер (тут он тоже с большой буквы) периодически проводит встречи тет-а-тет, спрашивает, как дела у Ивана, все ли устраивает, нет ли конфликтов на работе и в личной жизни, доволен ли он текущей компенсацией оплаты труда.

При этом Менеджеру, по факту, часто приходится выуживать ответы из сотрудника, полагаться на свою Менеджерскую интуицию и опыт.

«Черная» версия событий (или как это происходит в реальности)

Ивану проще оказывается сходить на работный портал и посмотреть новые вакансии, откликнуться на те, которые удовлетворяют его текущей оценке себя на рынке труда. Далее он проходит собеседование, приходит к менеджеру с job-offer и начинается веселая игра.

Если сотрудник просто недоволен своей зарплатой и не так давно страдал от ее неповышения, в целом, хочет остаться в компании, то он говорит менеджеру:

— Смотри, у меня job-offer, я стою на рынке столько-то, а вы мне платите меньше. Что вы можете мне предложить?

Если сотрудник давно был демотивирован низкой зарплатой и считает ее гораздо ниже средней, то он просто говорит:

— У меня есть job-offer, вот заявление, я ухожу.

Если менеджер хочет сохранить сотрудника для компании, то он начнет искать пути удовлетворения его потребностей: повысить зарплату, найти интересные проекты, дать бонусы и т.д. И это невыигрышная ситуация для обоих:

- Иван понимает, что раз сейчас это сработало, то сработает в дальнейшем

- другие сотрудники, которым Иван рассказал лайфхак, смогут сделать так же

- Иван теряет доверие менеджера

Все это крайне похоже на шантаж, выход из ситуации – компромисс, который Ивану приносит краткосрочный бонус – повышение зарплаты. Итого, менеджер перестает надеяться на Ивана. Возможно, менеджер даже начитает искать Ивану замену.

Старайтесь никогда не доводить ситуацию до такого состояния, из нее очень сложно найти приемлемый выход.

А ваши сотрудники или вы сами когда-нибудь задавали вопрос из названия? Может быть, вы сами когда-то делали так? Возможно, кто-то завтра собирается подойти к своему менеджеру и задать «правильный» вопрос?

P.S. Автор однажды и сам так делал. Автору повезло, что его руководитель – Менеджер. Но это совсем другая история.

|

Метки: author digore управление разработкой управление персоналом деньги зарплатные ожидания управление людьми |

Начальник, что мне делать для того, чтобы получать больше денег |

Начальник, что мне делать для того, чтобы получать больше денег

Представим себе программиста Ивана, который работает в компании какое-то время. По разным причинам так могло получиться, что у него уже давно не было повышения. А он его очень ждет. Ходить к менеджеру и просить повышения Ивану не хочется, не такой он человек, чтобы заводить разговор о повышении и выпрашивать, доказывать, что достоин повышения.

«Белая» версия событий

Предположим, Иван показывает свою позицию менеджеру: «Что я могу сделать в нашей компании для того, чтобы получать +30%»

Позиция Ивана:

- он ничего не просит и начинает разговор с позиции равного

- он хочет узнать о его возможных перспективах работы в компании

- возможно, Иван хочет занять более высокую должность

- возможно, Иван даже готов больше работать, чтобы получить желаемую прибавку

Позиция Менеджера (написано целенаправленно с большой буквы, т.к. речь идет именно об адекватном менеджере, который не боится развивать своих подчиненных, который уважает своих сотрудников и работает с ними на равных и открытых человеческих позициях):

- Иван – проактивный человек, проявляет лидерские качества, возможно, сможет расти в руководителя группы

- Иван лоялен к компании, ведь первым начинает разговор со своим менеджером, а не идет на собеседование

- Иван готов, возможно, к дополнительной работе

- если планировалось повышение только +10% в этом году, можно рассмотреть Ивана для продвижения по карьерной лестнице и дать ему желаемые 30%.

В таких переговорах есть большая вероятность, что Иван и Менеджер договорятся и найдут решение в стиле WIN-WIN:

- Иван получит желаемую зарплату

- Менеджер получит лояльного и мотивированного сотрудника.

Очевидно, возможны и крайние случаи:

- Иван запросит +100%, вряд ли в какой компании смогут организовать такое большое повышение

- Менеджер по разным причинам не сможет найти варианты для повышения сотрудника.

Но в любом случае, у Менеджера и Ивана есть открытая позиция по взаимодействию. Они могут договориться, как вариант, что Иван в течение 3-х месяцев ищет новую работу, а Менеджер ищет замену Ивану. В конечном итоге, они расстанутся в хороших отношениях и, возможно, когда у Менеджера появится высокооплачиваемая позиция в проекте, он снова позовет Ивана. Прощаться ведь тоже нужно хорошо, а мир IT крайне тесен.

«Нейтральная» версия событий

Менеджер (тут он тоже с большой буквы) периодически проводит встречи тет-а-тет, спрашивает, как дела у Ивана, все ли устраивает, нет ли конфликтов на работе и в личной жизни, доволен ли он текущей компенсацией оплаты труда.

При этом Менеджеру, по факту, часто приходится выуживать ответы из сотрудника, полагаться на свою Менеджерскую интуицию и опыт.

«Черная» версия событий (или как это происходит в реальности)

Ивану проще оказывается сходить на работный портал и посмотреть новые вакансии, откликнуться на те, которые удовлетворяют его текущей оценке себя на рынке труда. Далее он проходит собеседование, приходит к менеджеру с job-offer и начинается веселая игра.

Если сотрудник просто недоволен своей зарплатой и не так давно страдал от ее неповышения, в целом, хочет остаться в компании, то он говорит менеджеру:

— Смотри, у меня job-offer, я стою на рынке столько-то, а вы мне платите меньше. Что вы можете мне предложить?

Если сотрудник давно был демотивирован низкой зарплатой и считает ее гораздо ниже средней, то он просто говорит:

— У меня есть job-offer, вот заявление, я ухожу.

Если менеджер хочет сохранить сотрудника для компании, то он начнет искать пути удовлетворения его потребностей: повысить зарплату, найти интересные проекты, дать бонусы и т.д. И это невыигрышная ситуация для обоих:

- Иван понимает, что раз сейчас это сработало, то сработает в дальнейшем

- другие сотрудники, которым Иван рассказал лайфхак, смогут сделать так же

- Иван теряет доверие менеджера

Все это крайне похоже на шантаж, выход из ситуации – компромисс, который Ивану приносит краткосрочный бонус – повышение зарплаты. Итого, менеджер перестает надеяться на Ивана. Возможно, менеджер даже начитает искать Ивану замену.

Старайтесь никогда не доводить ситуацию до такого состояния, из нее очень сложно найти приемлемый выход.

А ваши сотрудники или вы сами когда-нибудь задавали вопрос из названия? Может быть, вы сами когда-то делали так? Возможно, кто-то завтра собирается подойти к своему менеджеру и задать «правильный» вопрос?

P.S. Автор однажды и сам так делал. Автору повезло, что его руководитель – Менеджер. Но это совсем другая история.

|

Метки: author digore управление разработкой управление персоналом деньги зарплатные ожидания управление людьми |

Я б в программеры пошёл, пусть меня научат |

Я б в программеры пошёл, пусть меня научат

Мы получили очередное сообщение от сотрудника с просьбой дать свободный микрофон. На этот раз речь пойдёт о программировании (и немного администрировании) как о дополнительном профессиональном образовании. Об опыте, проверенном на собственной шкуре и методах получения сакральных айтишных знаний, расскажет наша сотрудница, которая учится каждый год — не иначе, как завещал великий Ленин.

Привет, Хабр! Я работаю в РегионСофт уже 4 года, и за это время успела не только пережить два мажорных релиза нашей CRM-системы, но и трижды поучиться. Сегодня расскажу о подводных камнях корпоративных университетов, вузов, курсов и попробую классифицировать возможные пути обучения и переобучения будущего айтишника. Текст больше ориентирован на тех, кто хочет сменить профессию, но и студентам, уверена, будет полезно.

Вузы, вы больны

Нашему вузовскому курсу повезло — мы были вторым годом новой специализации «Финансовый менеджмент и финансовая математика», и вуз был вынужден решать кадровую проблему довольно необычным для российского образования путем. Да, часть финансовых дисциплин нам читали всё те же старые профессора, которые начинали свой карьерный путь с политэкономии и особо с него не сворачивали. Но во всём, что касалось рынка ценных бумаг, технического анализа, биржевого дела, специализированной математики они были полные профаны. Поэтому трое преподавателей внезапно отличались от классической школы — это были практикующий программист, профессиональный трейдер и тренер, обучавший первых игроков нынешней Московской биржи (тогда ещё ММВБ). Что их отличало:

- Увязка теории и практики на всех этапах — у нас не было чистых лекций или семинаров, вся информация поступала к нам с реальными примерами, без дистиллированных задач.

- Кроме базовой информации, они разбирали нетипичные истории из практики — сразу было понятно, что в будущем всё будет немного не так, как в учебниках (совсем не так).

- Они не ошибались. В том смысле, что не было таких историй, когда после длинных формул и решений стиралась половина доски. Всё оттого, что они решали с нами практические примеры, за которые привыкли получать деньги и в которых отвечали за чужие инвестиции.

- Они показали, как применяется высшая математика в деле — и у нас уже не возникало мысли «ну и где мне этот тервер понадобится». К слову сказать, никто из нас не пошёл в биржевое дело, но на то были разные причины.

Когда я стала преподавать после пятого курса, то переняла их опыт, но, увы, на мою долю выпало вести статистику и институтские бабушки с кафедры быстро зарубили мои новомодные планы. Впрочем, через год я навсегда ушла из сферы образования в бизнес, потащив за собой лишь учёбу в аспирантуре. О чём не жалела ни секунды.

Что плохо в современном вузовском образовании?

- Устаревшая материально-техническая база и устаревшие учебные планы — согласитесь, странно изучать Windows Server 2003 или Pascal в 2017 году.

- Преподаватели-теоретики, некоторые из которых просто прошли курсы повышения квалификации и, например из математика превратились в преподавателя по алгоритмам и структурам данных.

- Отсутствие практики — согласитесь, формальный месяц, за который студенты дважды посещают базу практики, совершенно не то, что нужно разработчикам или инженерам. В то время как вуз может запросто давать первичный и довольно глубокий опыт, припахивая студентов к внутренним проектам или грантам.

Однако это не значит, что нужно вдохновиться примером известных айтишников и проигнорировать вуз. Первое базовое высшее образование должно быть, тем более, что сейчас во многих вузах открываются новые программы, направления и специальности.

Почему это важно:

- вуз учит грамотно формулировать и высказывать свои мысли

- вуз даёт бесценный навык — умение пользоваться литературой и источниками, а не просто гуглить

- вуз имеет огромную научную базу и хорошую библиотеку — и просидеть день в читальном зале отнюдь не ретроградство

- вуз развивает мышление и навыки обобщения

- вуз даёт основы, на базе которых можно продолжать развитие и обучение

- и как ни крути, вуз — это диплом гос. образца, который, вопреки многим суждениям, продолжают ждать работодатели. Ну а если в карьерном плане есть что-то типа Росатома, Газпрома и т.д., то диплом просто необходим. Не говоря уж о науке.

К слову, крупные компании в сотрудничестве с вузами открывают множество программ, проводят хакатоны, митапы и конференции для студентов. Бесплатно, но не бескорыстно — они выискивают лучших ещё со студенческой скамьи.

Корпоративный институт как не идеальная, но лучшая форма обучения

А бизнес — это другие реалии, потребности работодателя и другие схемы обучения. Провожая меня за пределы вуза, мой первый начальник, проректор по науке, сказал: «Каждый год ты должна тратить одну зарплату на обучение — курсы ли, образование, книги, — не важно. Сам процесс обучения упорядочивает мышление». Первый год работы в бизнесе я начисто забыла об этих словах — вся жизнь и без того была похожа на обучение (а точнее, гибрид армейской дедовщины с дрессурой манула). В конце второго года осенило, что работать в ИТ (коммерческая служба) и не понимать внутренностей ИТ чревато ошибками и идиотскими ситуациями, поэтому было решено — учусь.

Рассматривалось три варианта:

- магистратура мехмата — была отвергнута из-за того, что в учебном плане было до кучи ненужного, а времени ушло бы три года. Ну и дорого, конечно;

- дополнительное образование в университете — было отвергнуто из-за устаревшей программы (как вам офисное программирование VBA или Access как изучаемая СУБД?) и изученного списка преподавателей-теоретиков;

- обучение в корпоративном институте крупнейшей компании-разработчика в городе. Учебный план был актуальный, стек интересный, длина — год (по факту почти полтора), преподаватели — исключительно практики. Бонусом было 100 часов английского — на тот момент не знала его вообще, моим первым иностранным был французский. Курс назывался «Разработка программного обеспечения».

Обучение в корпоративном институте в корне отличалось от вузовского, но, как показало время, не было идеальным. Тут стоит остановиться и подробнее разобраться.

Первое и главное: корпоративный университет (даже если это базовая кафедра вуза, свой факультет и т.д.) — это всегда интерес компании. Фактически она готовит кадры для себя, и нужно быть готовым к тому, что на вас перенесут часть корпоративных стандартов. И если для студентов и молодых специалистов это шанс получить и практику, и работу, то взрослым специалистам такая «профильность» может мешать. Например, у нас С, С++ и Java превалировали над всеми предметами, а тот же Python прошёл почти мимо — мы на нём успели написать телепрограмму, турнирную таблицу матчей и календарь с рассылкой напоминалок на e-mail. Опять же, с точки зрения операционных систем нам дали только UNIX — правда, очень круто. Но об этом чуть ниже.

Итак, минусы:

- корпоративный интерес и корпоративный стек

- профильные задачи на практике

Плюсы:

- почти гарантированная возможность получить работу (всех, кто выжил, пригласили на собеседование, двое сменили работу)

- попадание на первый фронт тех, кого рассматривают на вакансии в дальнейшем — на почту периодически приходят письма с вакансиями по профилю обучения.

Группы сформированы неоднородно — видимо, руководство корпоративного университета рассчитывает на сознательность слушателей. В общем, у нас было 16 человек — 5 девушек, 11 парней, все разные: от нулевого уровня типа меня до высокого уровня профессиональных программистов (был С-шник и реально мощный тимлид 1С-овец). Закончили и защитились семеро, девушек — две. При этом перед поступлением проводится тестирование и собеседование для определения уровня английского языка и распределения по группам. А вот собеседование на уровень знания технологий — нет.

В итоге те, кто уже имели опыт разработки, уверенно вникали и опережали тех, кто не мог с первого раза переварить мысли типа «указатель на указатель», «сборщик мусора», «наследуются свойства и методы класса BaseClass». Проблема была в том, что нас сразу погрузили в язык программирования — шутка ли, но структуры данных и алгоритмы случились несколькими неделями позже.

А теперь про UNIX. И лекции, и практику вели сильнейшие парни, которые могли ответить на любой вопрос, как бы криво он ни был сформулирован. На практических занятиях на отстающих не забивали, а всей группой дотягивали того, кто запутался. Например, писали регулярки для девочки-дизайнера, разбирая с ней каждый элемент или сорок минут искали, почему у меня не компилился С-шный код в gcc (оказалось, в хедере была пропущена точка с запятой — классика). В итоге UNIX знали и сдали все, кто до него дожил, а я спустя полгода на раз-два прошла собеседование на позицию инженера по тестированию VoIP c кучей вопросов по командам bash.

Итак, минусы:

- преподаватели иногда игнорируют отстающих слушателей

- не всегда курс выстроен логично

- слабые быстро адаптируются и начинают списывать и копировать у сильных, становясь ещё слабее.

Плюсы:

- разбираются самые нелепые и одновременно сложные вопросы

- сильные, объясняя слабым, получают дополнительное развитие

- появляется стимул рыться в литературе (правда, не у всех).

А теперь о самом главном — о преподавании языков программирования и сопутствующей ИТ-инфраструктуры. Задачи отдалены от практики. Мы моделировали полёт бомбы на С, на нём же считали многочлены, программировали решето Эратосфена и работали с рядами Фибоначчи. На С++ мы писали и развивали карточку студента вплоть до применения деревьев. В этих задачах были упущены такие вопросы как безопасность, сетевая работа, проектирование и т.д. Разработка на практике выглядит, конечно же, совершенно иначе. И возможно, курс был бы ещё интереснее, если бы из наших выживших остатков группы сколотили настоящий отдел — senior, джуниоры, тестировщики, менеджер проектов. Тогда может и больше народу дошло бы до конца.

Не объяснялась структура разработки — если бы мы, новички, знали, что в реальной жизни программист пишет не всю программу, а работает над своей частью проекта, мы бы чисто психологически воспринимали задачи проще.

Для части слушателей задачи оказались непосильными с точки зрения понимания самих задач — чтобы запрограммировать решето Эратосфена или факториал, нужно понимать, что это такое. Та же история с бомбой — одно дело задачу решали мы с соседом по обучению, оба победители физических олимпиад, другое — девушка, которую направили учиться от компании и которая даже примерно не помнила, что такое ускорение свободного падения. Всё-таки в таких случаях важнее именно понимание структуры кода и алгоритмов, чем учёт скорости истребителя, ветра и сопротивления воздуха.

Преподаватели демонстрируют код, пишут его в реальном времени на лекции, всем всё понятно, а самим написать — никак. Очень хорошей находкой было давать фрагменты кода, чтобы мы разбирались и отвечали, что он делает. Замечательная наша преподавательница по С/С++ называла это «думай, как компилятор». И это всем нравилось, было живо и местами задорно, хотя и не всегда получалось.

А вот что было по-настоящему неприятно — так это требование писать код на экзаменах и зачётах (да, они были!)…на листочке бумаги. Это вызывало ступор, трепет и блокировало мозги. То есть ты привык, что есть компилятор, что он твой помощник, что есть среда разработки, подсветка кода и тут — бац и ты уже пишешь на бумажке вот это:

#include

int main()

{

int i, fact=1, n;

cin>>n;

for (i=1; i<=n; i++)

{

fact=fact*i;

}

cout << fact;

return 0;

} Это в лучшем случае. С наследованием в С++ было гораздо веселее. Однако про листочек и код есть и вторая точка зрения — на собеседованиях нередко просят написать код или команду ручкой на бумаге, и специалист должен быть к этому готов. А вот правильно ли просить решить задачу с помощью языка программирования вне ПК — это уже тема отдельного обсуждения.

Кстати, про ООП — видимо, чтобы его объяснить, его нужно понимать просто без заминок. Честно говоря, нам на пальцах его так и не объяснили, самым приемлемым было определение «всё есть объект» (аналогично в UNIX мы слышали про «всё есть файл»). Сложные вещи и правда трудно объяснять, поэтому преподавателям стоит заранее формулировать краткие и ёмкие пояснения, чтобы слушатели запоминали эту «выжимку», а потом уже наращивали понимание предмета. Короче, с ООП у большинства не сложилось.

Некоторые преподаватели были, что называется, «over qualified». Это умные и опытные тимлиды, для которых всё прозрачно и очевидно, поэтому они дают глубокий и качественный материал без основ — то есть фактически ничего, поскольку слушатели не включились в базу. Однако именно они транслировали практические ценности, рассказывали о продвинутых возможностях IDE (у нас были Visual Studio и Eclipse), открывали для тех, кто не знает, Хабр, книги Шилдта и Страуструпа. Кстати, что характерно, за почти полтора года обучения ни один преподаватель не произнёс слов «github» и «opensource». И это во многом было фатально — настолько, что даже наши решения и проекты ни у кого из нас почти не сохранились.

Под конец курса случилась особая форма извращения, которая называлась «Управление проектами». Мы радовались, думая, что перед дипломом (да, был настоящий проект с защитой на английском языке) нас разгрузили. Но вместо этого на нас обрушилась вся мощь UML-диаграмм. Выше тройки не получил никто, одна из девушек дошла почти до конца, но не сдала экзамены именно из-за этого предмета. Но с другой стороны, именно с этим малоприятным занятием пришло понимание целостности и связности программного проекта. Так что всё не зря.

Минусов и плюсов не будет — будет список того, что хотелось бы получать именно на таких узко специализированных курсах.

- Обязательно должны быть введены понятия репозитория, структуры проекта, разделения задач программистов на проекте (junior, middle, senior).

- Важно показывать роль книг, специализированных сайтов и опенсорса в обучении — только трое из нас купили учебники, только у одного был живой прокачанный аккаунт на Хабре и Тостере. И конечно, нужно обязательно рассказать о существовании курсов MIT, CS50 на русском, доступных записей лекций технических вузов. Примочки типа codecademy тоже не станут лишними в практике программирования — преподаватель просто обязан знать свой арсенал и транслировать его слушателям.

- На лекциях у каждого слушателя должен быть включён ПК — это золотое, даже платиновое правило. Одно дело смотреть на магию на проекторе, другое — повторять это перед собой и ковыряться в коде. Да, это займёт больше времени, но оно и эффективнее. Сейчас я опять же по доброй воле учусь в том же месте на потоке «Администрирования Windows Server» (RegionSoft CRM — продукт по большей части виндовый, и нужно хорошо знать инфраструктурное окружение проекта) и это очень круто — когда каждое действие, каждую команду мы отрабатываем на виртуалке, причём нередко в нескольких вариантах — например, настраиваем систему через GUI, средствами командной строки и через скрипты/командлеты Power Shell). Во-первых, подключаются все типы человеческой памяти, во-вторых, происходит дополнительное обсуждение косяков и успехов друг друга.

Кстати, отвлекусь и выскажусь по поводу онлайн-курсов. Как-то сдуру прошла довольно длинный бесплатный курс одной очень

Как войти в айти

Способ первый — полное самообразование

При кажущейся абсурдности абсолютно возможный способ. Главное — правильное мышление, усидчивость и огромное желание. Самообразование не должно быть хаотичным, стоит выбрать стек и начать заниматься в комфортном режиме: например, начать с часу или двух в день.

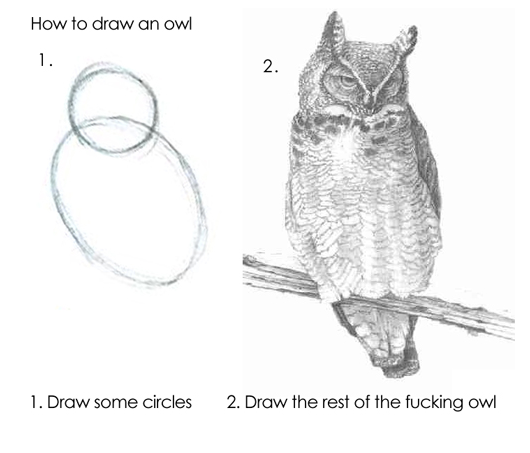

Единого алгоритма обучения не существует, но цепочка действий может быть такой:

- Определиться, зачем вам нужно программирование или администрирование — для развития мозгов, своего проекта, смены работы, эмиграции, для того, чтобы выйти на новый уровень в текущей деятельности. Исходя из этого нужно задать сроки и интервалы обучения.

- Выбрать, с чего начать. Здесь все средства хороши, но как ни парадоксально, удачнее всего начинать с приложений вроде codecademy или книги «Python для чайников». Это не испортит вам стиль (его ещё нет), но доступным языком погрузит в основы и даст попробовать код «на пальцах».

- Расширить круг читаемой литературы, начать работать в IDE.

- Перестать бояться 127 ошибок в компиляторе, стать более внимательным к синтаксису.

- Начать работать со своим или опенсорсным проектом. До этого этапа мало кто доходит. Но если дошли, будьте уверены — всё сложится.

Большое преимущество этого способа — ваша собственная мотивация, ваши собственные установки. Пока вы не работаете с кодом за деньги, это всего лишь ваше хобби — занимайтесь им в удовольствие. Даже если вы не смените работу и не станете программистом, вы совершенно иначе начнёте смотреть на разработку и на бизнес-процессы, изменится логика. Минус один — риск бросить всё на середине или в самом начале из-за недостатка мотивации, времени и интереса.

Способ первый модифицированный — самообразование + наставник в компании или стажировка

Отличается от первого способа тем, что кто-то в компании заинтересован в вашем развитии и готов выделить ресурсы или даже своё время на обучение секретам мастерства. Преимущество этого метода — в качестве, практической направленности и скорости обучения. А ещё люди склонны быстрее осваивать что-то новое, если это их работа и за неё платят деньги. Всё-таки правильная мотивация — великая вещь.

Отдельно стоит сказать о стажировках и обучении сразу в начале работы в компании. Это всегда удачный опыт и хороший способ адаптации персонала с одной стороны и источник знаний — с другой. Работу с такими компаниями всегда нужно использовать по полной — даже если вы не собираетесь долго задерживаться (мнение автора здесь не совпадает с позицией компании).

Способ второй — высшее образование (второе или дополнительное)

Да, можно взять и поступить в магистратуру или отпахать ещё несколько лет на вечернем специалитете. Это интересный процесс, освоение фундаментальных знаний и ноль практики. Она вся сводится к курсовым работам и отдельным контрольным с небольшими задачами. Плюсы — диплом государственного образца (пригодится, если вы собрались делать карьеру в гос. корпорациях или крупных компаниях) доступ к вузовской библиотеке, относительная дешевизна обучения и разнесённость во времени. Минусы — устаревший учебный план, формальность подхода, лишние предметы. Кстати, с преподавателями везёт по принципу 50/50, программы дополнительного образования и магистратуры стали в последнее время приглашать молодых преподавателей-практиков.

Способ третий — корпоративный университет

Хитрый способ, поскольку можно закончить обучение и заодно поменять работу. Вообще, откровенно говоря, наряду со стажировками — это один из способов обойти сотни резюме, стекающих в крупную компанию, и занять своё место. Но для этого нужно показать либо свои умения, навыки и опыт, либо стремление и способность обучаться. Плюсы — практически применимые знания, актуальная программа, удобное время занятий, режим диалога с преподавателем. Минусы — отсутствие диплома (только сертификат), разнородные группы, иногда не самый логичный учебный план, высокая цена и высокая нагрузка по времени.

О самом главном — без чего не обойтись

В любом случае, нет волшебной лекции или супер-чипа, который сделает вас специалистом. И знания в голову вам никто не вобьёт. Кроме самого обучения, есть вещи, без которых вы никогда не станете программистом.

- Без непрерывной работы с кодом. Вы должны его писать, разбирать, искать пути оптимизации, просить критики в экспертных сообществах и уметь прислушиваться к ней (хотя вам скажут и про «вон из профессии», и про «руки из ж…», и про «говнокод». Это совершенно нормальный путь.

- Без знания основ: позиционных систем счисления, устройства ПК, знания алгоритмов, работы с переменными, булевой алгебры, типизации и т.д. Большинство тех, кто хочет присоединиться к разработчикам, почему-то считают эти знания чем-то ненужным и погружаются сразу в готовые фрагменты кода, переделывая их и стряпая свой проект. Это неправильно — рано или поздно в проекте вы встретитесь именно с этими проблемами.

- Без книг. Ни один гугл, Тостер, Stack overflow и ламповый форум SQL-щиков не заменит книг в плане глубины и основ. Конечно, в идеале это должны быть оригиналы книг зарубежных авторов, благо что сегодня на Amazon потрясающий ассортимент — от классического С до нейросетей и NLP (который natural language processing). Но и переводные издания радуют всё больше. Не бойтесь портить книгу — читайте её с карандашом, ручкой и чем угодно. И да, если в книге приведён код, то недостаточно его разглядывать — лучше воспроизвести его на ПК, скомпилировать, разобрать и вникнуть. От простого чтения кода пользы в разы меньше.

- Без вопросов себе, преподавателю, гуглу, сообществу, наставнику. Идеальна схема выглядит так: слушаете лекцию, пишете базовые вещи, тут же отмечаете, что стоит изучить поглубже или узнать самому. На следующий день разбираете пометки, опять конспектируете самое важное. Затем практикуетесь в написании кода или, например, администрировании.

- Без изучения сопутствующего окружения и ИТ-инфраструктуры. Да, можно написать небольшой сайт и даже разместить на нём, например, красивую галерею работ, но потолок придёт быстро, если вы не озаботились изучением вопросов нагрузки, безопасности данных, форм на сайте и т.д. Поэтому стоит изучать нужную технологию комплексно, захватывая остальные.

- Без рефакторинга. При всём старании вы никогда не создадите совершенный код с первого раза. И с десятого не сотворите, это даже у опытных разработчиков не всегда быстро выходит. Но работая с кодом, продумывая варианты оптимизации, вы становитесь профессионалом, который способен не просто накодить, а сделать ПО работающим и качественным. Не бойтесь код-ревью.

- Без проектирования. Если вы садитесь писать код, но не знаете, что вы пишете и как это должно работать, то вы просто тренируетесь в запоминании синтаксиса языка. Попробуйте нарисовать схему будущего приложения, установите, какие компоненты каким образом будут взаимодействовать, пропишите особенности и фичи. Так вам легче будет собрать проект и заставить его в конце концов работать.

- Без знания устройства вашей IDE (среды разработки). Все современные среды напичканы кучей возможностей типа автоматической генерации кода, подсветки, элементов управления и т.д. Обязательно разбирайтесь с возможностями, читайте документацию, обращайте внимание на то, как вводится код, как собирается проект, как работает компилятор и отладчик.

- Без понимания того, что такое библиотеки и как они работают. Во время обучения преподаватели иногда нас троллили — например, однажды мы долго прописывали функции арифметических операций и факториала, а потом нам показали

math.h. Для целей обучения — полезный, весёлый и поучительный урок. Для целей работы — трата сил, времени и размножение костылей. Многое придумано до нас — достаточно взять, подключить и научиться использовать.

- А ещё без тестирования, DevOps, документирования и т.д. Но это продвинутый уровень — как правило, этим занимаются уже на работе.

- Без английского языка. Но это вы и без меня знаете. На английском доступны материалы, которые способны дать мощный толчок развитию профессионала. Их перевод зачастую выглядит тускло.

Но вообще самое трудное даже не начать. Самое трудное — продолжить, если не получается, не отшвырнуть в отчаянии. Как минимум, обучение вам обязательно пригодится — иногда в такой момент, когда вы даже не предполагаете. Так что не останавливайтесь ни на минуту.

|

|

Я б в программеры пошёл, пусть меня научат |

Я б в программеры пошёл, пусть меня научат

Мы получили очередное сообщение от сотрудника с просьбой дать свободный микрофон. На этот раз речь пойдёт о программировании (и немного администрировании) как о дополнительном профессиональном образовании. Об опыте, проверенном на собственной шкуре и методах получения сакральных айтишных знаний, расскажет наша сотрудница, которая учится каждый год — не иначе, как завещал великий Ленин.

Привет, Хабр! Я работаю в РегионСофт уже 4 года, и за это время успела не только пережить два мажорных релиза нашей CRM-системы, но и трижды поучиться. Сегодня расскажу о подводных камнях корпоративных университетов, вузов, курсов и попробую классифицировать возможные пути обучения и переобучения будущего айтишника. Текст больше ориентирован на тех, кто хочет сменить профессию, но и студентам, уверена, будет полезно.

Вузы, вы больны

Нашему вузовскому курсу повезло — мы были вторым годом новой специализации «Финансовый менеджмент и финансовая математика», и вуз был вынужден решать кадровую проблему довольно необычным для российского образования путем. Да, часть финансовых дисциплин нам читали всё те же старые профессора, которые начинали свой карьерный путь с политэкономии и особо с него не сворачивали. Но во всём, что касалось рынка ценных бумаг, технического анализа, биржевого дела, специализированной математики они были полные профаны. Поэтому трое преподавателей внезапно отличались от классической школы — это были практикующий программист, профессиональный трейдер и тренер, обучавший первых игроков нынешней Московской биржи (тогда ещё ММВБ). Что их отличало:

- Увязка теории и практики на всех этапах — у нас не было чистых лекций или семинаров, вся информация поступала к нам с реальными примерами, без дистиллированных задач.

- Кроме базовой информации, они разбирали нетипичные истории из практики — сразу было понятно, что в будущем всё будет немного не так, как в учебниках (совсем не так).

- Они не ошибались. В том смысле, что не было таких историй, когда после длинных формул и решений стиралась половина доски. Всё оттого, что они решали с нами практические примеры, за которые привыкли получать деньги и в которых отвечали за чужие инвестиции.

- Они показали, как применяется высшая математика в деле — и у нас уже не возникало мысли «ну и где мне этот тервер понадобится». К слову сказать, никто из нас не пошёл в биржевое дело, но на то были разные причины.

Когда я стала преподавать после пятого курса, то переняла их опыт, но, увы, на мою долю выпало вести статистику и институтские бабушки с кафедры быстро зарубили мои новомодные планы. Впрочем, через год я навсегда ушла из сферы образования в бизнес, потащив за собой лишь учёбу в аспирантуре. О чём не жалела ни секунды.

Что плохо в современном вузовском образовании?

- Устаревшая материально-техническая база и устаревшие учебные планы — согласитесь, странно изучать Windows Server 2003 или Pascal в 2017 году.

- Преподаватели-теоретики, некоторые из которых просто прошли курсы повышения квалификации и, например из математика превратились в преподавателя по алгоритмам и структурам данных.

- Отсутствие практики — согласитесь, формальный месяц, за который студенты дважды посещают базу практики, совершенно не то, что нужно разработчикам или инженерам. В то время как вуз может запросто давать первичный и довольно глубокий опыт, припахивая студентов к внутренним проектам или грантам.

Однако это не значит, что нужно вдохновиться примером известных айтишников и проигнорировать вуз. Первое базовое высшее образование должно быть, тем более, что сейчас во многих вузах открываются новые программы, направления и специальности.

Почему это важно:

- вуз учит грамотно формулировать и высказывать свои мысли

- вуз даёт бесценный навык — умение пользоваться литературой и источниками, а не просто гуглить

- вуз имеет огромную научную базу и хорошую библиотеку — и просидеть день в читальном зале отнюдь не ретроградство

- вуз развивает мышление и навыки обобщения

- вуз даёт основы, на базе которых можно продолжать развитие и обучение

- и как ни крути, вуз — это диплом гос. образца, который, вопреки многим суждениям, продолжают ждать работодатели. Ну а если в карьерном плане есть что-то типа Росатома, Газпрома и т.д., то диплом просто необходим. Не говоря уж о науке.

К слову, крупные компании в сотрудничестве с вузами открывают множество программ, проводят хакатоны, митапы и конференции для студентов. Бесплатно, но не бескорыстно — они выискивают лучших ещё со студенческой скамьи.

Корпоративный институт как не идеальная, но лучшая форма обучения

А бизнес — это другие реалии, потребности работодателя и другие схемы обучения. Провожая меня за пределы вуза, мой первый начальник, проректор по науке, сказал: «Каждый год ты должна тратить одну зарплату на обучение — курсы ли, образование, книги, — не важно. Сам процесс обучения упорядочивает мышление». Первый год работы в бизнесе я начисто забыла об этих словах — вся жизнь и без того была похожа на обучение (а точнее, гибрид армейской дедовщины с дрессурой манула). В конце второго года осенило, что работать в ИТ (коммерческая служба) и не понимать внутренностей ИТ чревато ошибками и идиотскими ситуациями, поэтому было решено — учусь.

Рассматривалось три варианта:

- магистратура мехмата — была отвергнута из-за того, что в учебном плане было до кучи ненужного, а времени ушло бы три года. Ну и дорого, конечно;

- дополнительное образование в университете — было отвергнуто из-за устаревшей программы (как вам офисное программирование VBA или Access как изучаемая СУБД?) и изученного списка преподавателей-теоретиков;

- обучение в корпоративном институте крупнейшей компании-разработчика в городе. Учебный план был актуальный, стек интересный, длина — год (по факту почти полтора), преподаватели — исключительно практики. Бонусом было 100 часов английского — на тот момент не знала его вообще, моим первым иностранным был французский. Курс назывался «Разработка программного обеспечения».

Обучение в корпоративном институте в корне отличалось от вузовского, но, как показало время, не было идеальным. Тут стоит остановиться и подробнее разобраться.

Первое и главное: корпоративный университет (даже если это базовая кафедра вуза, свой факультет и т.д.) — это всегда интерес компании. Фактически она готовит кадры для себя, и нужно быть готовым к тому, что на вас перенесут часть корпоративных стандартов. И если для студентов и молодых специалистов это шанс получить и практику, и работу, то взрослым специалистам такая «профильность» может мешать. Например, у нас С, С++ и Java превалировали над всеми предметами, а тот же Python прошёл почти мимо — мы на нём успели написать телепрограмму, турнирную таблицу матчей и календарь с рассылкой напоминалок на e-mail. Опять же, с точки зрения операционных систем нам дали только UNIX — правда, очень круто. Но об этом чуть ниже.

Итак, минусы:

- корпоративный интерес и корпоративный стек

- профильные задачи на практике

Плюсы:

- почти гарантированная возможность получить работу (всех, кто выжил, пригласили на собеседование, двое сменили работу)

- попадание на первый фронт тех, кого рассматривают на вакансии в дальнейшем — на почту периодически приходят письма с вакансиями по профилю обучения.

Группы сформированы неоднородно — видимо, руководство корпоративного университета рассчитывает на сознательность слушателей. В общем, у нас было 16 человек — 5 девушек, 11 парней, все разные: от нулевого уровня типа меня до высокого уровня профессиональных программистов (был С-шник и реально мощный тимлид 1С-овец). Закончили и защитились семеро, девушек — две. При этом перед поступлением проводится тестирование и собеседование для определения уровня английского языка и распределения по группам. А вот собеседование на уровень знания технологий — нет.

В итоге те, кто уже имели опыт разработки, уверенно вникали и опережали тех, кто не мог с первого раза переварить мысли типа «указатель на указатель», «сборщик мусора», «наследуются свойства и методы класса BaseClass». Проблема была в том, что нас сразу погрузили в язык программирования — шутка ли, но структуры данных и алгоритмы случились несколькими неделями позже.

А теперь про UNIX. И лекции, и практику вели сильнейшие парни, которые могли ответить на любой вопрос, как бы криво он ни был сформулирован. На практических занятиях на отстающих не забивали, а всей группой дотягивали того, кто запутался. Например, писали регулярки для девочки-дизайнера, разбирая с ней каждый элемент или сорок минут искали, почему у меня не компилился С-шный код в gcc (оказалось, в хедере была пропущена точка с запятой — классика). В итоге UNIX знали и сдали все, кто до него дожил, а я спустя полгода на раз-два прошла собеседование на позицию инженера по тестированию VoIP c кучей вопросов по командам bash.

Итак, минусы:

- преподаватели иногда игнорируют отстающих слушателей

- не всегда курс выстроен логично

- слабые быстро адаптируются и начинают списывать и копировать у сильных, становясь ещё слабее.

Плюсы:

- разбираются самые нелепые и одновременно сложные вопросы

- сильные, объясняя слабым, получают дополнительное развитие

- появляется стимул рыться в литературе (правда, не у всех).

А теперь о самом главном — о преподавании языков программирования и сопутствующей ИТ-инфраструктуры. Задачи отдалены от практики. Мы моделировали полёт бомбы на С, на нём же считали многочлены, программировали решето Эратосфена и работали с рядами Фибоначчи. На С++ мы писали и развивали карточку студента вплоть до применения деревьев. В этих задачах были упущены такие вопросы как безопасность, сетевая работа, проектирование и т.д. Разработка на практике выглядит, конечно же, совершенно иначе. И возможно, курс был бы ещё интереснее, если бы из наших выживших остатков группы сколотили настоящий отдел — senior, джуниоры, тестировщики, менеджер проектов. Тогда может и больше народу дошло бы до конца.

Не объяснялась структура разработки — если бы мы, новички, знали, что в реальной жизни программист пишет не всю программу, а работает над своей частью проекта, мы бы чисто психологически воспринимали задачи проще.

Для части слушателей задачи оказались непосильными с точки зрения понимания самих задач — чтобы запрограммировать решето Эратосфена или факториал, нужно понимать, что это такое. Та же история с бомбой — одно дело задачу решали мы с соседом по обучению, оба победители физических олимпиад, другое — девушка, которую направили учиться от компании и которая даже примерно не помнила, что такое ускорение свободного падения. Всё-таки в таких случаях важнее именно понимание структуры кода и алгоритмов, чем учёт скорости истребителя, ветра и сопротивления воздуха.

Преподаватели демонстрируют код, пишут его в реальном времени на лекции, всем всё понятно, а самим написать — никак. Очень хорошей находкой было давать фрагменты кода, чтобы мы разбирались и отвечали, что он делает. Замечательная наша преподавательница по С/С++ называла это «думай, как компилятор». И это всем нравилось, было живо и местами задорно, хотя и не всегда получалось.

А вот что было по-настоящему неприятно — так это требование писать код на экзаменах и зачётах (да, они были!)…на листочке бумаги. Это вызывало ступор, трепет и блокировало мозги. То есть ты привык, что есть компилятор, что он твой помощник, что есть среда разработки, подсветка кода и тут — бац и ты уже пишешь на бумажке вот это:

#include

int main()

{

int i, fact=1, n;

cin>>n;

for (i=1; i<=n; i++)

{

fact=fact*i;

}

cout << fact;

return 0;

} Это в лучшем случае. С наследованием в С++ было гораздо веселее. Однако про листочек и код есть и вторая точка зрения — на собеседованиях нередко просят написать код или команду ручкой на бумаге, и специалист должен быть к этому готов. А вот правильно ли просить решить задачу с помощью языка программирования вне ПК — это уже тема отдельного обсуждения.

Кстати, про ООП — видимо, чтобы его объяснить, его нужно понимать просто без заминок. Честно говоря, нам на пальцах его так и не объяснили, самым приемлемым было определение «всё есть объект» (аналогично в UNIX мы слышали про «всё есть файл»). Сложные вещи и правда трудно объяснять, поэтому преподавателям стоит заранее формулировать краткие и ёмкие пояснения, чтобы слушатели запоминали эту «выжимку», а потом уже наращивали понимание предмета. Короче, с ООП у большинства не сложилось.