Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Хостинг для стартапа: конструктор, облака или свое железо? |

- Управление проектами,

- Управление продуктом,

- Развитие стартапа,

- Блог компании Фонд развития интернет-инициатив

Хостинг для стартапа: конструктор, облака или свое железо?

- Управление проектами,

- Управление продуктом,

- Развитие стартапа,

- Блог компании Фонд развития интернет-инициатив

Какой хостинг выбрать? Этим вопросом рано или поздно задается любой стартап. Ответ в каждом случае придется искать самостоятельно — оценивать плюсы-минусы, прикидывать риски и считать бюджет. Максимально упростить этот процесс и систематизировать виды хостингов и их особенности нам помог выпускник ФРИИ и основатель проекта AdminDivision.ru Егор Андреев, который помогает стартапам Акселератора ФРИИ масштабировать свою IT-инфраструктуру.

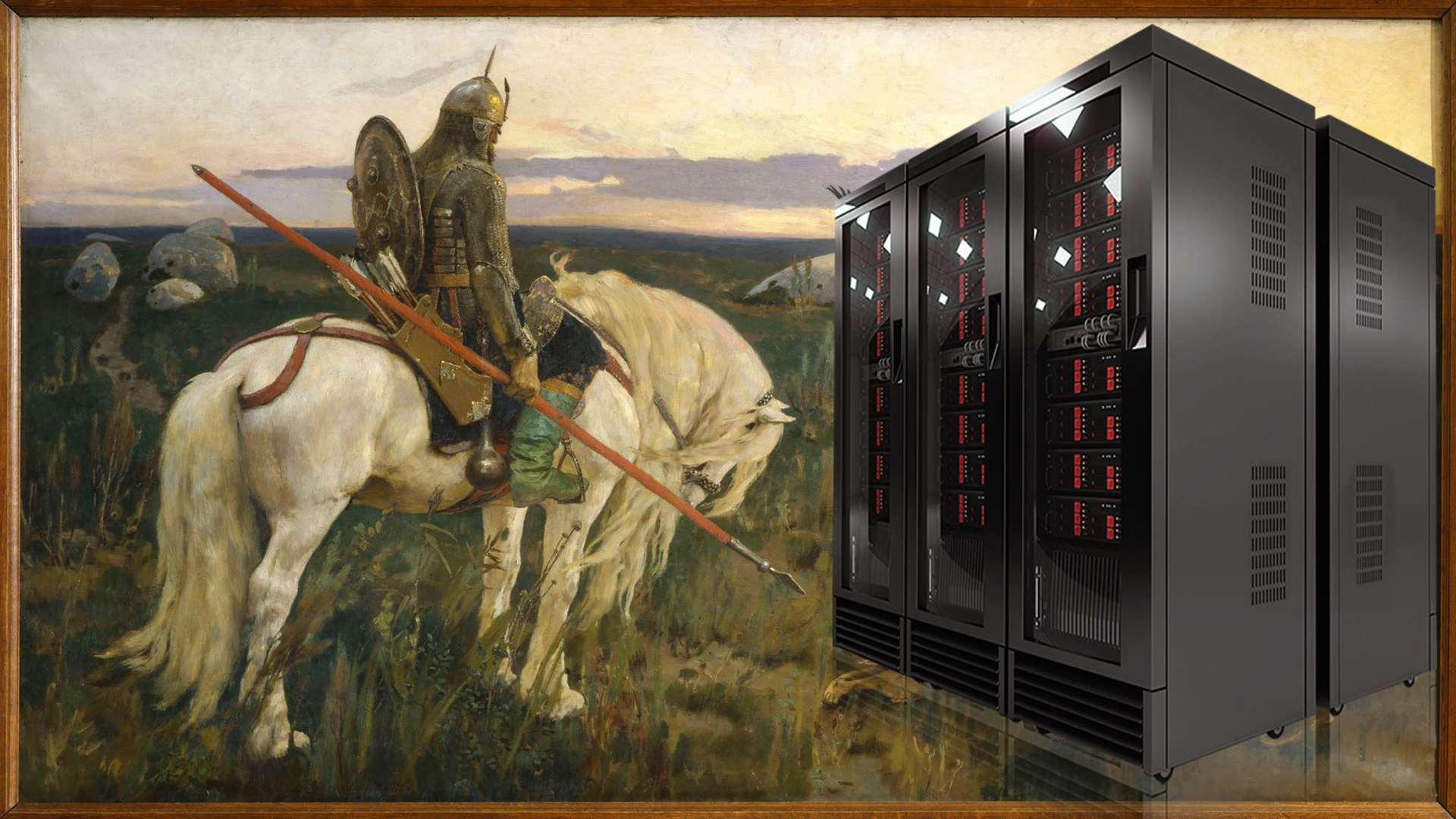

Описание задачи всегда начинается одинаково: есть написанный код сайта, его нужно разместить на каком-то хостинге, чтобы клиенты получили доступ. Классический «дедовский» вариант — купить сервер, настроить его и разместить на нем сайт — плох уже тем, что за корректной работой «железа», операционной системы и софта придется следить самостоятельно. У основателей нового проекта на это нет ни времени, ни ресурсов. Поэтому стартапы активно пытаются использовать другие виды хостинга, чтобы сэкономить время и деньги, особенно на старте проекта. И здесь начинается самое интересное: поскольку все предложения разные, они отличаются по цене, объему услуг, степени ответственности хостинг-провайдера и другим параметрам. Как разобраться? Для начала принять общее правило: чем больше работ возьмет на себя провайдер, тем меньше головной боли достанется стартапу. Но нужно учитывать, что в дополнение стартап получает более высокий прайс и отсутствие возможности настраивать систему самостоятельно. Далее следуют нюансы, специфические для каждого вида хостинга.

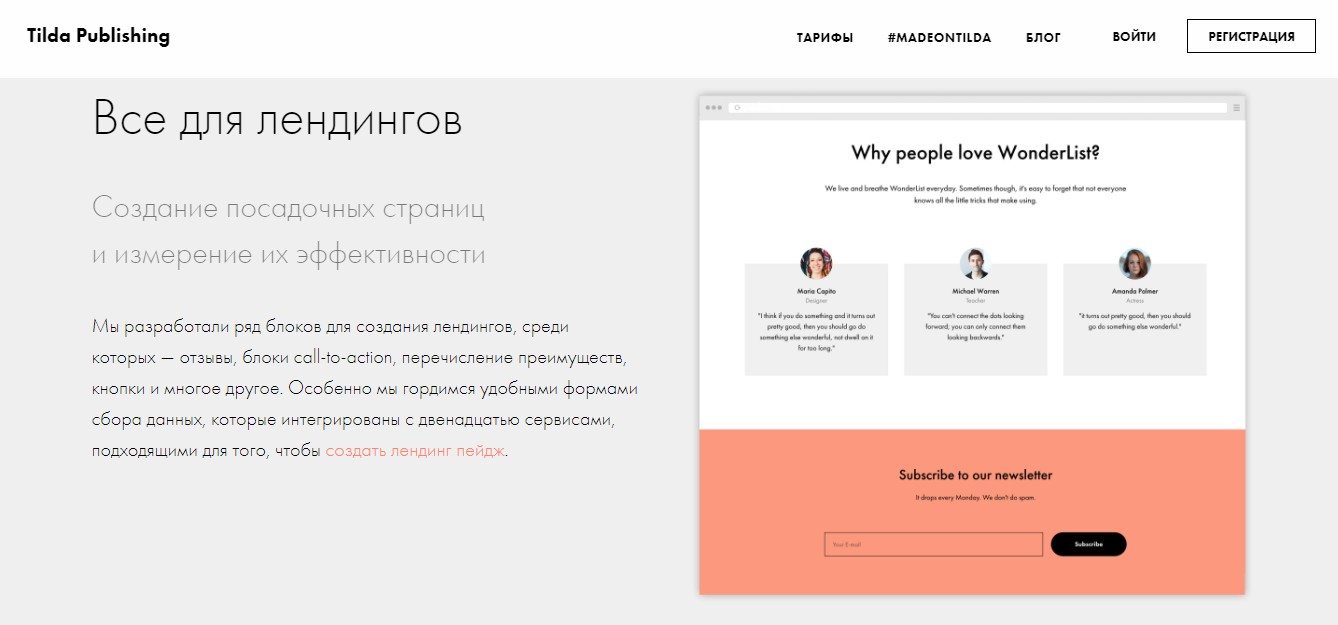

1. Конструктор сайтов

Примеры: tilda, wix, lpgenerator.

Примерный чек: $10-$50 в месяц.

Это самый простой и заманчивый для стартапа вариант. Здесь поставщик услуги уже позаботился обо всем, вам даже не понадобится программист. Просто заходите, создаете свою страничку из шаблонов, нажимаете «сохранить» и все. Ваша страница видна миру — можно работать.

Такой формат идеален для посадочных страниц, сайтов-визиток, одностраничных сайтов с простейшей логикой (типа формы обратной связи или формы оплаты). Если ваш сайт должен быть многостраничным, иметь полноценную логику в виде каталога товаров и регистрации пользователей, а также другие дополнительные сервисы, то конструктор — не ваш оптимальный вариант. Лучше ищите другие виды хостинга.

2. Shared-хостинг

Еще его называют «Шаред» или просто «Хостинг».

Примеры: timeweb, masterhost, reg.ru.

Примерный чек: $2-$30 в месяц.

Самый дешевый вариант — разместить сайт на php. Shared-хостинг — это физически большой железный сервер, на котором созданы изолированные окружения для работы десятков и сотен клиентов хостинга. Вам выдается доступ к админке и логин/пароль для доступа к FTP. Вы выкладываете свой код — и он работает. При этом сотрудники хостинга (как правило, хмурые бородатые дяденьки) следят за тем, чтобы у вас не было проблем с «железом», операционной системой, базой данных, веб-сервером. Ваша зона ответственности — только код. Это значит, что вы не можете менять практически ничего в настройках сервера. Такой вариант отлично подойдет для сайтов на стандартных движках, блогов, небольших интернет-магазинов. Но есть два случая, при которых этот вид хостинга может принести проблемы.

1. Когда у сайта начинает расти показатель посещаемости. В этом случае либо все начинает «тормозить», либо хостер грозится перевести вас с тарифа за символические $2 на вполне ощутимые $50-100, а если не заплатите — отключить.

2. Когда вам нужен новый функционал. Например, поставить вот эту новую библиотеку обработки картинок или использовать вот ту хипстерскую базу данных. В варианте с shared-хостингом это сделать не получится. Вы пользуетесь тем, что для вас предусмотрели упомянутые выше бородатые дяденьки.

Если ваш сайт больше похож на «убийцу Убера», чем на «блог на Wordpress», есть две альтернативы: собирать свой сайт на облачных сервисах или смотреть в сторону полноценных виртуальных машин.

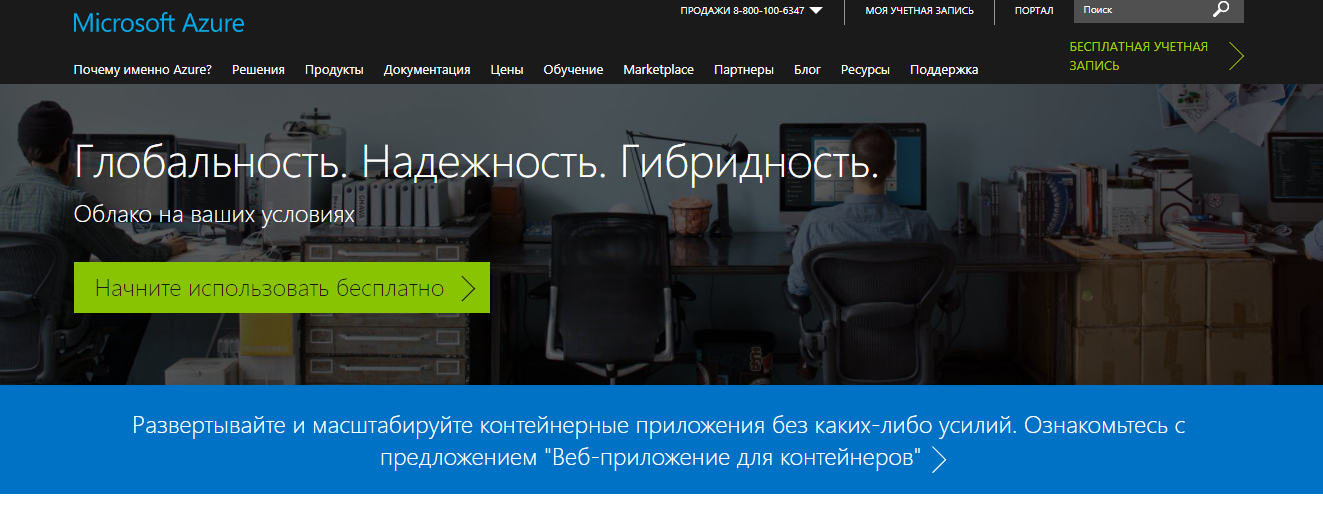

3. Облачные сервисы

Примеры: Amazon Web Services, Microsoft Azure, Google Cloud Platform.

Примерный чек: от $1 до бесконечности.

Здесь вы собираете свой веб-сервис из огромного набора кубиков и деталей, довольно приятных. Вот у нас веб-сервер, вот база данных, вот очередь сообщений, вот хранилище для фотографий котиков, вот machine learning по ним, вот push-оповещения на мобильные — и ваш новый уникальный вариант кошачьего Тиндера готов.

Если разобраться, как работают эти кубики, можно довольно быстро собирать рабочие продукты с минимумом программирования. Приятный бонус на старте: оплата обычно идет не по абонентке, а за фактически потребленное количество ресурсов. Например, по числу запросов к базе данных, объему файлов в хранилище, числу разосланных уведомлений и т.д. То есть оплата за хостинг начинается с нуля и растет пропорционально росту нагрузки. Это позволяет стартапу долгое время масштабировать свою IT-инфраструктуру, понемногу увеличивая сумму затрат на хостинг.

Минусы облачных сервисов гармонично вытекают из их плюсов.

1. Вы ограничены тем функционалом, который заложили разработчики сервисов. Конечно, довольно широкий функционал дает много возможностей, но (!) чуть-чуть поднастроить его под себя не получится. Работает правило: используем как есть или переписываем с нуля.

2. По мере роста потребления ресурсов стоимость облачного сервиса может стать неоправданно высокой. Да, этот вид хостинга позволяет начать с $10. Для прототипа продукта или запуска стартапа с первой парой клиентов — прекрасно. Но если проект взлетит, то появляется риск платить пропорционально $10 000 за пару тысяч своих клиентов. И здесь нужно хорошо просчитать экономику.

Но даже если затраты на хостинг были заранее рассчитаны, вам все равно может понадобиться съехать с облачных сервисов. Причины могут быть и локальные (технические ограничения), и общерыночные (изменения российского законодательства). Важно учитывать, что просто «взять и переехать» из «облака» не получится. Придется дорого и долго программировать. Это тоже вариант, и его нужно просчитать заранее, чтобы понимать стоимость риска.

Облачные сервисы отлично подойдут для быстрого создания прототипа, в качестве бэкенда мобильных приложений и других подобных сервисов. Проверять идеи для стартапа — тестировать гипотезы — с их помощью тоже очень удобно. Когда нужен чуть больший контроль над хостингом, можно использовать полноценные машины (виртуальные или физические).

4. Виртуальные машины

Они же VM (Virtual Machine), VPS (Virtual Private Server), VDS (Virtual Dedicated Server) или просто «Виртуалки».

Примеры: Digital Ocean, Selectel, Amazon EC2, Azure VM.

Примерный чек: $5-$100 в месяц.

У хостера стоят огромные железные сервера. Их ресурсы нарезаются на порции, которые выглядят как небольшие сервера со своей операционной системой, — именно это и сдается клиентам в аренду. Вы получаете машину с полным доступом и нужным количеством ресурсов (ядер процессора, оперативной памяти, места на дисках и т.д.).

Плюсы очевидны. Это полноценная машина, на которую можно устанавливать любой софт и настраивать его любым способом. Если с физическим сервером случится беда, хостер все починит сам, вы даже об этом, возможно, не узнаете. Кроме того, размер машины можно увеличивать по мере необходимости. Например, начать с варианта за $5, а потом взять нужный дополнительный объем, просто нажав кнопку «Расширить» и заплатив за него. А еще здесь можно запустить несколько машин и разделить между ними роли (веб-сервер — база данных) и нагрузку (веб-сервер 1, веб-сервер 2, веб-сервер 3).

Минусы тоже есть. Теперь настраивать под себя операционную систему и софт не только можно, но и необходимо. К тому же приходится следить за локальными процессами работы (хватает ли оперативной памяти, достаточно ли места на дисках, не упала ли база данных). И делать это нужно самостоятельно, постоянно и лучше профессионально.

Виртуальные машины подойдут большинству стартапов как на старте, так и во время бурного роста. Главное, чтобы в команде был хороший админ (или хотя бы была возможность привлечения такого специалиста). Всем стартапам стоит посоветовать сразу делить сайт на части и использовать несколько машин вместо одной большой. Это поможет расти в будущем. В момент, когда расходы на хостинг составят пару сотен долларов, можно будет задуматься о переходе на физические сервера. Именно задуматься, сесть и посчитать, прикинуть варианты, а не переезжать в «пожарном режиме», когда страдают клиенты и горят нервные клетки основателей.

5. Аренда выделенного сервера

Он же Dedicated Server, или просто «Дедик».

Примеры: Hetzner, Selectel, Servers.ru, Hostkey.

Примерный чек: $50-$500 в месяц.

Это аренда настоящего физического сервера. Можно выбрать любую конфигурацию «железа», любую операционную систему и получить мощнейшую машину. Либо поднять свою систему виртуализации и самостоятельно нарезать нужное число «виртуалок». Трюк в том, что аренда выделенного сервера обходится в среднем в 3-5 раз дешевле аренды «виртуалки» соответствующей мощности. Или, иными словами, за те же деньги можно получить в 3-5 раз больше ресурсов.

Но тут есть значительный минус — теперь под вашей ответственностью не только операционная система, но и само «железо». Если сгорит, скажем, один из жестких дисков, то хостер заменит его бесплатно по звонку. И если вы правильно настроили сервер и вовремя заметили, что диск сгорел, сайт даже не «упадет». Но если сгорит сам сервер целиком, ваш сайт не будет доступен, пока хостер не подготовит замену (это занимает от нескольких часов до нескольких дней). И есть вероятность, что сервис придется поднимать из резервной копии. Это тоже требует времени и может вообще не получиться, если вы к этому специально не готовились.

Чтобы избежать проблем, потребуется иметь хотя бы один дополнительный резервный сервер, а также иметь компетенции (сотрудника), как этот сервер заставить работать в случае краха основной машины. И то и другое стоит денег, и экономия при переходе на свое железо может быть уже не такой явной.

Арендованные физические сервера хорошо подойдут достаточно большим проектам с потреблением в несколько тысяч долларов.

6. Покупка собственного железа

Примерная цена: $2 000-$10 000 за сервер разово.

«Железо» можно не арендовать, а купить. Вполне рабочий вариант, если вам очень нужно освоить несколько миллионов, в смысле, превратить операционные (ежемесячные) расходы в капитальные (разовые). И вы точно уверены, что:

а) будете использовать купленное «железо» больше срока, за который оно «отобьется» по сравнению с арендой,

б) вам хватит мощности на весь расчетный срок.

Помимо разовых расходов, больше плюсов, по сравнению с арендой, нет.

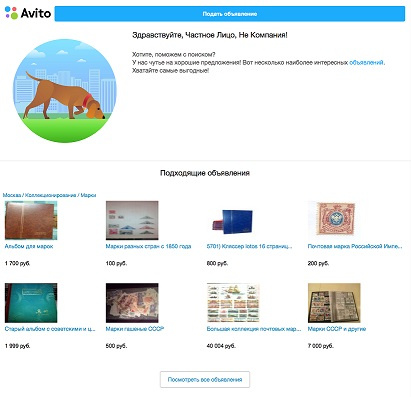

А минусов хватает. Если на сервере что-то сгорит — это ваша проблема. В лучшем случае производитель сервера пришлет замену. Если мощности «железа» не будет хватать, то вы либо докупаете новые сервера (получив у себя зоопарк из нескольких поколений машин), либо продаете текущее «железо» на Avito и покупаете новое.

Также надо помнить, что каждые несколько лет сервера становятся мощнее в пару раз (закон Мура до сих пор работает), при этом цена остается сопоставимой. Если арендуете сервер несколько лет, то можете в один момент отказаться от текущего сервера и взять новый, за те же деньги, но заметно мощнее. Если сервер ваш — так сделать будет нельзя.

Резюме

- Если нужно сверстать лендинг или одностраничник, удобно будет воспользоваться конструктором сайтов. Проще некуда.

- Если сайт простой и написан на php, можно использовать shared-хостинг. Дешево и сердито.

- Для веб-сервиса с богатым функционалом можно пробовать либо Облачные сервисы (если вы любите и умеете ими пользоваться), либо Виртуальные машины.

- Если чек за хостинг высокий и хочется сэкономить, можно присмотреться к аренде физического сервера.

- Выбирая любой вариант, не забудьте посчитать, в какой момент станут критичны ограничения для конкретно вашего сервиса и прикинуть варианты, что с этим можно будет сделать.

Бурного роста и высокого аптайма!

|

Метки: author friifond управление проектами управление продуктом развитие стартапа блог компании фонд развития интернет-инициатив хостинг shared vps vds стартап |

Как я написал книгу почти по социнжинирингу |

Как я написал книгу почти по социнжинирингу

Когда от издательства пришло письмо про готовность, я старался не дышать. Кенгуру валлаби с детёнышем в сумке уже подошла на три метра и шевелила носом. Боялась и что-то подозревала, но морковки ей хотелось больше. Потом было ещё много австралийских приключений вдали от цивилизации, поэтому про поступление книги в магазины я узнал уже из писем читателей. Оказалось, нужно не только владельцам бизнеса. Это удивляло.

Если коротко – она о том, как рассказывать истории. Точнее даже так: как в работающем бизнесе (или другом проекте) выбрать самые интересные истории, правильно их подать, в полной мере собрать факты и не облажаться потом. Методология построена именно на «не облажаться потом», то есть на проверке фактов и очень спокойной работе без истерических криков. Это продаёт, и этот канал рассказов о своих проектах называется контент-маркетингом (термин появился позже, чем тот же Фёдор из Сыктывкара начал рассказывать про свой книжный бизнес, но раньше, чем он начал печь пиццу). Ещё Евгений Чичваркин с Евросетью живо чувствовал, что нужно что-то такое – но он хотел снимать шоу про работу магазина, чтобы с отжимом поставщиков, собеседованиями, злыми клиентами, инвентаризациями и другими взлётами и падениями.

Я собрал в кучу всё то, что хотел рассказать про то, как писать посты, собирать информацию для них, как убеждать на сайте и прочее-прочее-прочее. Но всё равно много где – психология влияния.

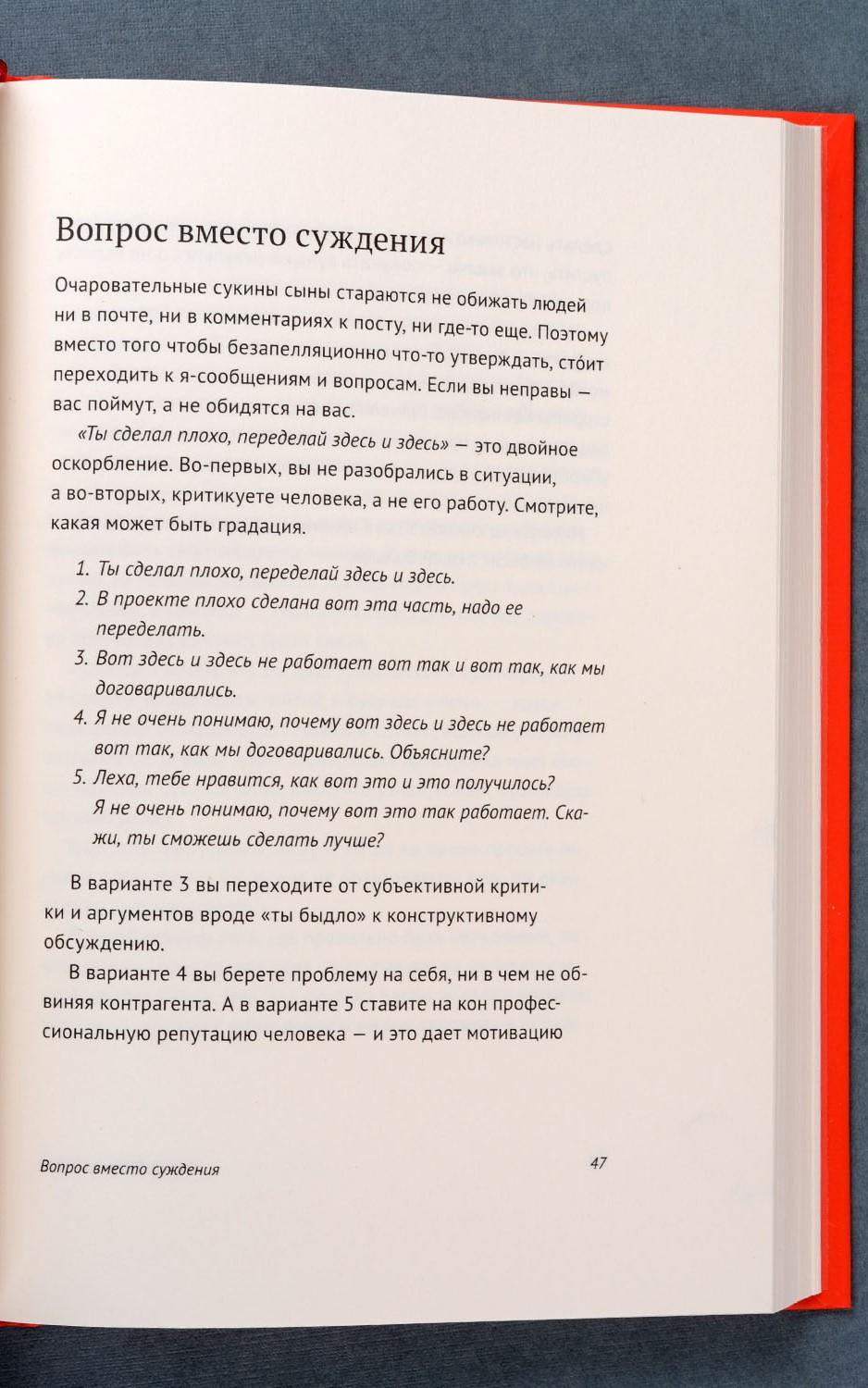

О чём книга

Первая здоровенная часть – о том, как и что рассказывать. Логика выстроения системы такая: если принять за аксиому желаемый результат (о вас знают как о позитивной компании далеко за пределами рынка), то дальше можно начать доказывать всё в обратную сторону – к тому что рассказывать и как рассказывать. И в этой системе доказательств произойдут достаточно неожиданные отсечки. Например, в ответе на комментарий не имеет смысла отвечать тому, кто задал вопрос (точнее, как – не имеет смысла его переубеждать, ответ предназначается для одного него и ещё 5-10 тысяч других людей). В письменной форме никогда не должно быть негатива – его только устно. Потому что можно не так понять, можно перечитать, можно вернуться через год, можно процитировать и т.п. Долгий анализ реакции на разные ответы в обсуждениях породил механики ответов неадекватам и конкурентам (частая задача на просторах Рунета) — там, где не помогает обычная логика, лёгкое изменение формы ответа резко меняет эффект. Помните, как в анекдоте про связистов, мол, вышку построили, теперь голова болит у всей деревни и тараканы мрут? Это ещё фигня, через неделю питание подадим. Плюс форма – почему надо коротко, понятно и предельно конкретно.

Вторая часть – уже про работу журналиста внутри компании. Я когда-то был редактором астраханской детской газеты, и ещё помню хардкор от опытных журналистов. Нас гоняли за поиск объективной информации и оценку разных точек зрения как не в себе. Мою хрупкую детскую психику раз и навсегда травмировал дядька Кара-Мурза, который читал лекцию про манипуляции сознанием (я передал его эстафету в одном детском робототехническом лагере с похожей лекцией, — вожатые ещё не в полной мере понимали, что при выборе тем «размножение человека» и «социальная инженерия» первое безопаснее). В общем, там практические наработки, что и как делать внутри компании.

Третья часть – для тех, кто вообще не умеет писать. Там короткие ликбезы. Часть вы могли видеть на Мегамозге (когда он ещё был жив).

В общем, я надеюсь, что получилась полезная штука для тех, кто не знает, что писать и о чём писать про своё дело. Ну и как это всё правильно начать и продолжить.

Как шло издание

У меня снова подло похитили букву «ё» со всей книги. Потом, правда, часть вернули, где по смыслу было не обойтись.

Корректор зачем-то расставил ударения в словах (но при этом пропустил минимум две опечатки). Меня это тоже немного расстраивает, потому что каждый раз, когда я вижу слово со знаком ударения, мне хочется прочитать его наоборот — мозг решает, что это нестандартная версия, и надо углубиться в распознавание. Вот пример в начале страницы:

Снова адские переносы, но я уже знаю, что книгу через несколько недель похитят пираты и всё поправят в fb2-формате. Я скачаю и успокоюсь. Вот пример — вроде это «ся» грамотное, но контринтуитивное. Возможно, конечно, я как-то не так читаю:

Сам рабочий процесс шёл куда быстрее. Когда уже понятно, что и как делать, всё очень просто. Долго бодались с названием. Я всегда смеялся, когда слышал «Евангелист Яндекса» (это Бобук, например), но тут пришлось перестать. Потому что, оказалось, что ничего более сжатого по смыслу нет. Итог вот такой:

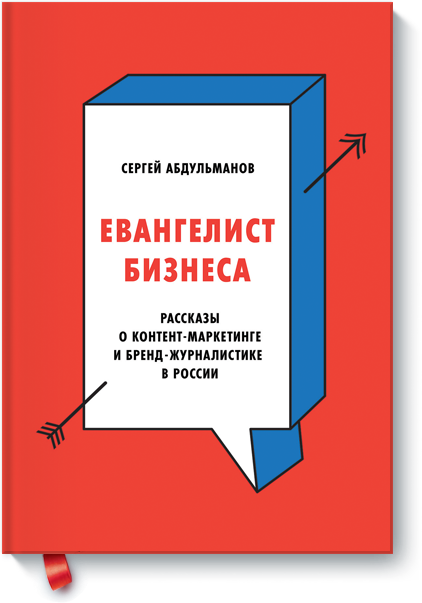

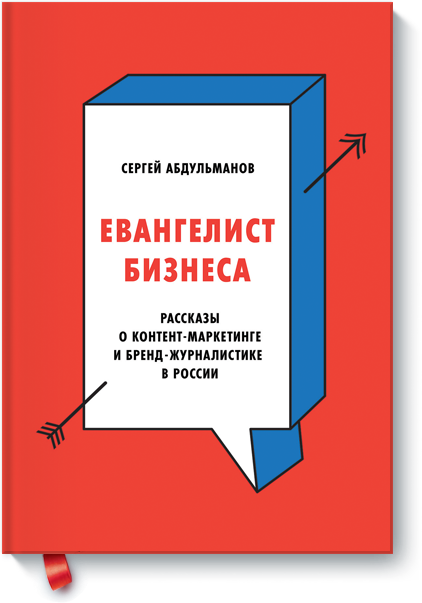

Литредактор у МИФа прекрасный. Эта милая девушка набрасывалась на текст с яростью дракона, присылая кровавое месиво из правок. Ниже одна страница. Так вот, вся книга по всей длине была именно такой:

Я примерно так же работаю с новыми райтерами, вызывая у них леденящий душу набор впечатлений. Она чистила мой ужасный разговорный язык, а я отстаивал важные конструкции. В этот раз удалось сохранить русские написания многих англицизмов, ура.

Вот как-то так. Вот тут лежит оглавление и ещё пара страничек.

Теперь немного статистики. По первой книге «Бизнес как игра» статистика такая: 17 тысяч продано в бумаге, чуть меньше 3 тысяч раз книга куплена в электронном виде и примерно 30 тысяч раз она закачана пиратами, похоже, в основном через сервис Мейл.ру Вконтакте (оценки примерные, про пиратов так вообще пальцем к носу). Критерий успешности — 3 тысячи копий в год на бумаге. Критерий прямо-огонь-бестселлера — около 20 тысяч копий в год. Говорят, с книгами, не привязанными к конкретным историческим моментам типа «Эффективная работа в Windows 98» тиражи с годами обычно растут.

МИФ, кстати, оказывается, яростно борется с пиратами, и там можно писать целые приключенческие романы про это. Подозреваю, что их контрагент умеет раскладывать сайты-обманки, где в поиске предлагается скачать книгу бесплатно, а вместо файла — короткая демо на 33 страницы или просто реферальная ссылка на Озон или ещё куда. Но это не точно, что они. Надо было ещё что-то подписать про удаление с обменников, но я не стал. Сюрприз в том, что в обмен хотелось обновить файл на Флибусте (там опечатки). Мне кажется, только природная вежливость книжных людей спасла меня от фразы: «Флибуста? Ты что, в конец охренел?».

Следующий момент. Книга пришла в Озон ниже, чем рекомендованная розничная цена, то есть чем цена у нас, например. Или ещё где в книжном. Там вообще волшебная история — похоже, что они автоматически упали, когда повысилась доля поиска в категории: это отличная механика же. Издатель анонсирует, а весь эффект ловят именно они. У нас, правда, слово «Хабрахабр» при заказе даёт скидку, уравнивающую шансы.

Ну и ещё от хабралюдей было много вопросов, как показывать книгу издателю. Всё просто: примерное оглавление (потом можно будет менять) и 10-15 страниц (или одну-две главы, если они большие). Уже по этому редактор говорит, ок или нет, и если ок — ждёт финальный текст. Это сильно проще, чем написать цикл постов на Хабр — так что если у вас есть что-то вневременное без привязки к текущему ПО — возможно, стоит немного подготовиться и спросить.

|

Метки: author Milfgard управление проектами управление медиа блог компании мосигра книга социнжиниринг истории |

Как я написал книгу почти по социнжинирингу |

Как я написал книгу почти по социнжинирингу

Когда от издательства пришло письмо про готовность, я старался не дышать. Кенгуру валлаби с детёнышем в сумке уже подошла на три метра и шевелила носом. Боялась и что-то подозревала, но морковки ей хотелось больше. Потом было ещё много австралийских приключений вдали от цивилизации, поэтому про поступление книги в магазины я узнал уже из писем читателей. Оказалось, нужно не только владельцам бизнеса. Это удивляло.

Если коротко – она о том, как рассказывать истории. Точнее даже так: как в работающем бизнесе (или другом проекте) выбрать самые интересные истории, правильно их подать, в полной мере собрать факты и не облажаться потом. Методология построена именно на «не облажаться потом», то есть на проверке фактов и очень спокойной работе без истерических криков. Это продаёт, и этот канал рассказов о своих проектах называется контент-маркетингом (термин появился позже, чем тот же Фёдор из Сыктывкара начал рассказывать про свой книжный бизнес, но раньше, чем он начал печь пиццу). Ещё Евгений Чичваркин с Евросетью живо чувствовал, что нужно что-то такое – но он хотел снимать шоу про работу магазина, чтобы с отжимом поставщиков, собеседованиями, злыми клиентами, инвентаризациями и другими взлётами и падениями.

Я собрал в кучу всё то, что хотел рассказать про то, как писать посты, собирать информацию для них, как убеждать на сайте и прочее-прочее-прочее. Но всё равно много где – психология влияния.

О чём книга

Первая здоровенная часть – о том, как и что рассказывать. Логика выстроения системы такая: если принять за аксиому желаемый результат (о вас знают как о позитивной компании далеко за пределами рынка), то дальше можно начать доказывать всё в обратную сторону – к тому что рассказывать и как рассказывать. И в этой системе доказательств произойдут достаточно неожиданные отсечки. Например, в ответе на комментарий не имеет смысла отвечать тому, кто задал вопрос (точнее, как – не имеет смысла его переубеждать, ответ предназначается для одного него и ещё 5-10 тысяч других людей). В письменной форме никогда не должно быть негатива – его только устно. Потому что можно не так понять, можно перечитать, можно вернуться через год, можно процитировать и т.п. Долгий анализ реакции на разные ответы в обсуждениях породил механики ответов неадекватам и конкурентам (частая задача на просторах Рунета) — там, где не помогает обычная логика, лёгкое изменение формы ответа резко меняет эффект. Помните, как в анекдоте про связистов, мол, вышку построили, теперь голова болит у всей деревни и тараканы мрут? Это ещё фигня, через неделю питание подадим. Плюс форма – почему надо коротко, понятно и предельно конкретно.

Вторая часть – уже про работу журналиста внутри компании. Я когда-то был редактором астраханской детской газеты, и ещё помню хардкор от опытных журналистов. Нас гоняли за поиск объективной информации и оценку разных точек зрения как не в себе. Мою хрупкую детскую психику раз и навсегда травмировал дядька Кара-Мурза, который читал лекцию про манипуляции сознанием (я передал его эстафету в одном детском робототехническом лагере с похожей лекцией, — вожатые ещё не в полной мере понимали, что при выборе тем «размножение человека» и «социальная инженерия» первое безопаснее). В общем, там практические наработки, что и как делать внутри компании.

Третья часть – для тех, кто вообще не умеет писать. Там короткие ликбезы. Часть вы могли видеть на Мегамозге (когда он ещё был жив).

В общем, я надеюсь, что получилась полезная штука для тех, кто не знает, что писать и о чём писать про своё дело. Ну и как это всё правильно начать и продолжить.

Как шло издание

У меня снова подло похитили букву «ё» со всей книги. Потом, правда, часть вернули, где по смыслу было не обойтись.

Корректор зачем-то расставил ударения в словах (но при этом пропустил минимум две опечатки). Меня это тоже немного расстраивает, потому что каждый раз, когда я вижу слово со знаком ударения, мне хочется прочитать его наоборот — мозг решает, что это нестандартная версия, и надо углубиться в распознавание. Вот пример в начале страницы:

Снова адские переносы, но я уже знаю, что книгу через несколько недель похитят пираты и всё поправят в fb2-формате. Я скачаю и успокоюсь. Вот пример — вроде это «ся» грамотное, но контринтуитивное. Возможно, конечно, я как-то не так читаю:

Сам рабочий процесс шёл куда быстрее. Когда уже понятно, что и как делать, всё очень просто. Долго бодались с названием. Я всегда смеялся, когда слышал «Евангелист Яндекса» (это Бобук, например), но тут пришлось перестать. Потому что, оказалось, что ничего более сжатого по смыслу нет. Итог вот такой:

Литредактор у МИФа прекрасный. Эта милая девушка набрасывалась на текст с яростью дракона, присылая кровавое месиво из правок. Ниже одна страница. Так вот, вся книга по всей длине была именно такой:

Я примерно так же работаю с новыми райтерами, вызывая у них леденящий душу набор впечатлений. Она чистила мой ужасный разговорный язык, а я отстаивал важные конструкции. В этот раз удалось сохранить русские написания многих англицизмов, ура.

Вот как-то так. Вот тут лежит оглавление и ещё пара страничек.

Теперь немного статистики. По первой книге «Бизнес как игра» статистика такая: 17 тысяч продано в бумаге, чуть меньше 3 тысяч раз книга куплена в электронном виде и примерно 30 тысяч раз она закачана пиратами, похоже, в основном через сервис Мейл.ру Вконтакте (оценки примерные, про пиратов так вообще пальцем к носу). Критерий успешности — 3 тысячи копий в год на бумаге. Критерий прямо-огонь-бестселлера — около 20 тысяч копий в год. Говорят, с книгами, не привязанными к конкретным историческим моментам типа «Эффективная работа в Windows 98» тиражи с годами обычно растут.

МИФ, кстати, оказывается, яростно борется с пиратами, и там можно писать целые приключенческие романы про это. Подозреваю, что их контрагент умеет раскладывать сайты-обманки, где в поиске предлагается скачать книгу бесплатно, а вместо файла — короткая демо на 33 страницы или просто реферальная ссылка на Озон или ещё куда. Но это не точно, что они. Надо было ещё что-то подписать про удаление с обменников, но я не стал. Сюрприз в том, что в обмен хотелось обновить файл на Флибусте (там опечатки). Мне кажется, только природная вежливость книжных людей спасла меня от фразы: «Флибуста? Ты что, в конец охренел?».

Следующий момент. Книга пришла в Озон ниже, чем рекомендованная розничная цена, то есть чем цена у нас, например. Или ещё где в книжном. Там вообще волшебная история — похоже, что они автоматически упали, когда повысилась доля поиска в категории: это отличная механика же. Издатель анонсирует, а весь эффект ловят именно они. У нас, правда, слово «Хабрахабр» при заказе даёт скидку, уравнивающую шансы.

Ну и ещё от хабралюдей было много вопросов, как показывать книгу издателю. Всё просто: примерное оглавление (потом можно будет менять) и 10-15 страниц (или одну-две главы, если они большие). Уже по этому редактор говорит, ок или нет, и если ок — ждёт финальный текст. Это сильно проще, чем написать цикл постов на Хабр — так что если у вас есть что-то вневременное без привязки к текущему ПО — возможно, стоит немного подготовиться и спросить.

|

Метки: author Milfgard управление проектами управление медиа блог компании мосигра книга социнжиниринг истории |

Хакатон от ABBYY |

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

Хакатон от ABBYY

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

А подробности ниже.

Хакатон mABBYYlity – это 24-часовой конкурс по разработке сервисов для мобильных платформ с применением технологий интеллектуальной обработки информации. Мы хотим дать возможность разработать уникальный продукт вместе с отличными разработчиками и менторами, шанс зарекомендовать себя перед представителями крупных IT-компаний и получить приятные подарки.

За 24 часа в команде из 2-5 человек или самостоятельно участникам mABBYYlity предстоит придумать или развить бизнес-идею и создать прототип приложения или сервиса для мобильных устройств в сфере обработки текста, изображений, документов и форм. Это могут быть решения в следующих областях:

• боты, сервисы в социальных сетях и мессенджерах;

• дополненная реальность в мобильных устройствах;

• обработка текстов, классификация документов, поиск;

• распознавание и обработка изображений и видео;

• улучшение, дополнение, фильтрация фотографий;

• распознавание и обработка изображений в браузере;

• распознавание в камерах различных устройств;

• цифровое предприятие, повышение продуктивности;

• технологии повышения безопасности;

• облачные технологии и сервисы;

• технологии обмена информацией.

ABBYY предоставит всем участникам доступ к собственным продуктам для разработчиков. Кроме того, команды смогут использовать любые общедоступные инструменты для разработки.

Лучшие мобильные продукты по итогам хакатона выберет экспертное жюри. В него вошли:

• директор по продуктам группы компаний ABBYY Андрей Исаев;

• руководитель департамента мобильных продуктов ABBYY Игорь Акимов;

• руководитель отдела образовательных проектов ABBYY Андрей Очеретный;

• руководитель проектного офиса ZeptoLab Пётр Савельев;

• CEO Maps.Me Евгений Лисовский;

• менеджер по работе с разработчиками Google Звиад Кардава;

• исполнительный директор по экосистеме цифровых ресурсов Сбербанка Анатолий Стояновский;

• руководитель команды машинного обучения Яндекс.Такси Виктор Кантор;

• руководитель направления развития мобильных сервисов Бинбанк Диджитал Анастасия Бельченко.

Эксперты оценят результаты команд по следующим критериям: рыночный потенциал идеи и актуальность решаемой проблемы, техническая реализация продукта и прогресс команды за время хакатона, соответствие идеи продукта направлению мероприятия, а также степень новизны и оригинальности идеи.

Узнать больше и подать заявку можно на сайте mobility.abbyy.com/hack.

Добавляйтесь в соцсети, там много интересного пишу про новые технологии в рамках направлений конкурса: Telegram, Facebook, VK

Ну и ещё раз напомню про конкурс идей. Он отдельный от хакатона и продлится до 30 сентября. Результаты конкурса будут объявлены на открытии хакатона mABBYYlity. Победители получат новейшие модели устройств на платформах iOS и Android, в том числе iPhone X. Подать заявку на конкурс идей можно на сайте mobility.abbyy.com/ideas.

|

|

Хакатон от ABBYY |

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

Хакатон от ABBYY

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

А подробности ниже.

Хакатон mABBYYlity – это 24-часовой конкурс по разработке сервисов для мобильных платформ с применением технологий интеллектуальной обработки информации. Мы хотим дать возможность разработать уникальный продукт вместе с отличными разработчиками и менторами, шанс зарекомендовать себя перед представителями крупных IT-компаний и получить приятные подарки.

За 24 часа в команде из 2-5 человек или самостоятельно участникам mABBYYlity предстоит придумать или развить бизнес-идею и создать прототип приложения или сервиса для мобильных устройств в сфере обработки текста, изображений, документов и форм. Это могут быть решения в следующих областях:

• боты, сервисы в социальных сетях и мессенджерах;

• дополненная реальность в мобильных устройствах;

• обработка текстов, классификация документов, поиск;

• распознавание и обработка изображений и видео;

• улучшение, дополнение, фильтрация фотографий;

• распознавание и обработка изображений в браузере;

• распознавание в камерах различных устройств;

• цифровое предприятие, повышение продуктивности;

• технологии повышения безопасности;

• облачные технологии и сервисы;

• технологии обмена информацией.

ABBYY предоставит всем участникам доступ к собственным продуктам для разработчиков. Кроме того, команды смогут использовать любые общедоступные инструменты для разработки.

Лучшие мобильные продукты по итогам хакатона выберет экспертное жюри. В него вошли:

• директор по продуктам группы компаний ABBYY Андрей Исаев;

• руководитель департамента мобильных продуктов ABBYY Игорь Акимов;

• руководитель отдела образовательных проектов ABBYY Андрей Очеретный;

• руководитель проектного офиса ZeptoLab Пётр Савельев;

• CEO Maps.Me Евгений Лисовский;

• менеджер по работе с разработчиками Google Звиад Кардава;

• исполнительный директор по экосистеме цифровых ресурсов Сбербанка Анатолий Стояновский;

• руководитель команды машинного обучения Яндекс.Такси Виктор Кантор;

• руководитель направления развития мобильных сервисов Бинбанк Диджитал Анастасия Бельченко.

Эксперты оценят результаты команд по следующим критериям: рыночный потенциал идеи и актуальность решаемой проблемы, техническая реализация продукта и прогресс команды за время хакатона, соответствие идеи продукта направлению мероприятия, а также степень новизны и оригинальности идеи.

Узнать больше и подать заявку можно на сайте mobility.abbyy.com/hack.

Добавляйтесь в соцсети, там много интересного пишу про новые технологии в рамках направлений конкурса: Telegram, Facebook, VK

Ну и ещё раз напомню про конкурс идей. Он отдельный от хакатона и продлится до 30 сентября. Результаты конкурса будут объявлены на открытии хакатона mABBYYlity. Победители получат новейшие модели устройств на платформах iOS и Android, в том числе iPhone X. Подать заявку на конкурс идей можно на сайте mobility.abbyy.com/ideas.

|

|

Как работает Android, часть 3 |

Как работает Android, часть 3

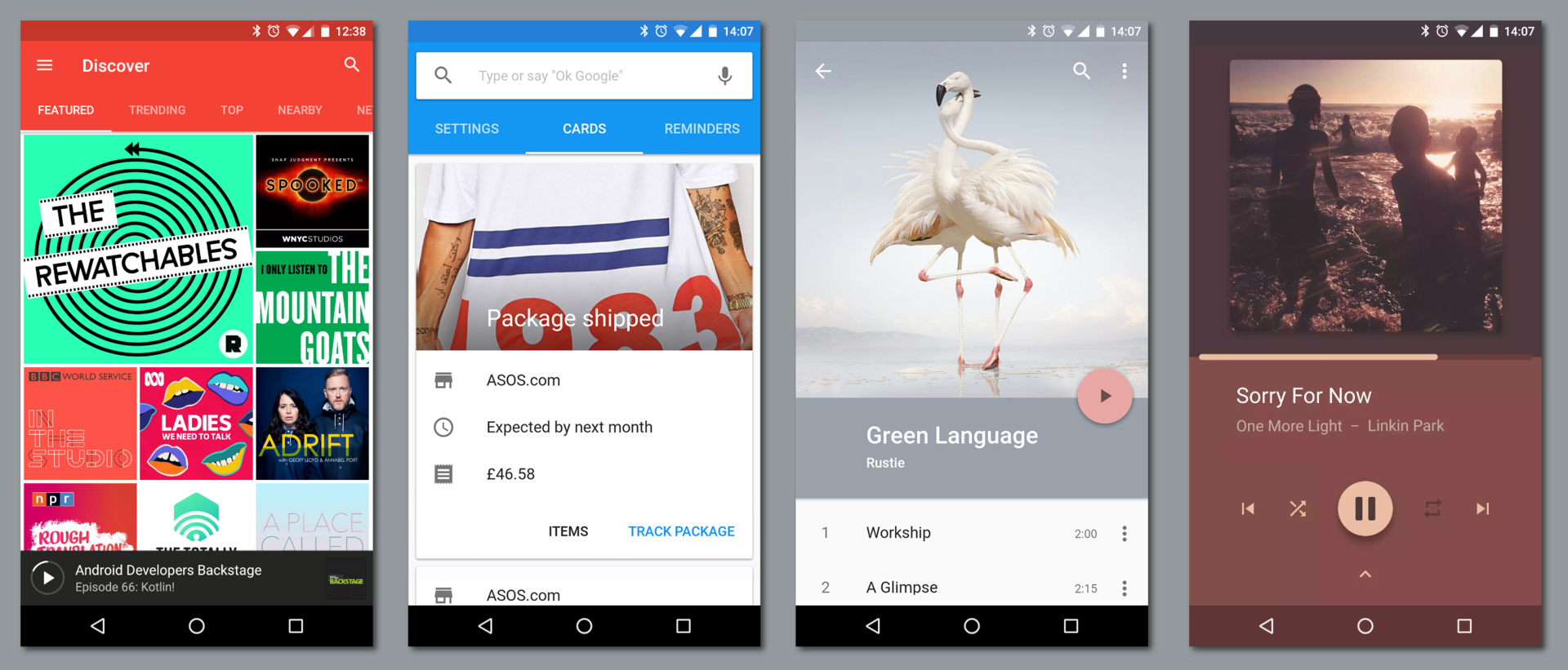

В этой статье я расскажу о компонентах, из которых состоят приложения под Android, и об идеях, которые стоят за этой архитектурой.

Статьи серии:

- Как работает Android, часть 1

- Как работает Android, часть 2

- Как работает Android, часть 3

- ...

Web vs desktop

Если задуматься об отличиях современных веб-приложений от «обычных» десктопных приложений, можно — среди недостатков — выделить несколько преимуществ веба:

- Веб-приложения переносимы между архитектурами и платформами, как и Java.

- Веб-приложения не требуют установки и всегда обновлены, как и Android Instant Apps.

Кроме того, веб-приложения существуют в виде страниц, которые могут ссылаться друг на друга — как в рамках одного сайта, так и между сайтами. При этом страница на одном сайте не обязана ограничиваться ссылкой только на главную страницу другого, она может ссылаться на конкретную страницу внутри другого сайта (это называется deep linking). Ссылаясь друг на друга, отдельные сайты объединяются в общую сеть, веб.

Несколько копий одной страницы — например, несколько профилей в социальной сети — могут быть одновременно открыты в нескольких вкладках браузера. Интерфейс браузера рассчитан на переключение между одновременными сессиями (вкладками), а не между отдельными сайтами — в рамках одной вкладки вы можете перемещаться по ссылкам (и вперёд-назад по истории) между разными страницами разных сайтов.

Всё это противопоставляется «десктопу», где каждое приложение работает отдельно и часто независимо от других — и в этом плане то, как устроены приложения в Android, гораздо ближе к вебу, чем к «традиционным» приложениям.

Activities & intents

Основной вид компонентов приложений под Android — это activity. Activity — это один «экран» приложения. Activity можно сравнить со страницей в вебе и с окном приложения в традиционном оконном интерфейсе.

Собственно окна в Android тоже есть на более низком уровне — уровне window manager. Каждой activity обычно соответствует своё окно. Чаще всего окна activity развёрнуты на весь доступный экран, но:

- Во-первых, Android поддерживает мультиоконный режим — split-screen, picture-in-picture и даже freeform.

- Во-вторых, Android поддерживает подключение нескольких дисплеев.

- В-третьих, activity может намеренно занимать небольшую часть экрана (

Theme_Dialog).

Например, в приложении для электронной почты (email client) могут быть такие activity, как Inbox Activity (список входящих писем), Email Activity (чтение одного письма), Compose Activity (написание письма) и Settings Activity (настройки).

Как и страницы одного сайта, activity одного приложения могут запускаться как друг из друга, так и независимо друг от друга (другими приложениями). Если в вебе на другую страницу обращаются по URL (ссылке), то в Android activity запускаются через intent’ы.

Intent — это сообщение, которое указывает системе, что нужно «сделать» (например, открыть данный URL, написать письмо на данный адрес, позвонить на данный номер телефона или сделать фотографию).

Приложение может создать такой intent и передать его системе, а система решает, какая activity (или другой компонент) будет его выполнять (handle). Эта activity запускается системой (в существующем процессе приложения или в новом, если он ещё не запущен), ей передаётся этот intent, и она его выполняет.

Стандартный способ создавать intent’ы — через соответствующий класс в Android Framework. Для работы с activity и intent’ами из командной строки в Android есть команда am — обёртка над стандартным классом Activity Manager:

# передаём -a ACTION -d DATA

# открыть сайт

$ am start -a android.intent.action.VIEW -d http://example.com

# позвонить по телефону

$ am start -a android.intent.action.CALL -d tel:+7-916-271-05-83Intent’ы могут быть явными (explicit) и неявными (implicit). Явный intent указывает идентификатор конкретного компонента, который нужно запустить — чаще всего это используется, чтобы запустить из одной activity другую внутри одного приложения (при этом intent может даже не содержать другой полезной информации).

Неявный intent обязательно должен указывать действие, которое нужно сделать. Каждая activity (и другие компоненты) указывают в манифесте приложения, какие intent’ы они готовы обрабатывать (например, ACTION_VIEW для ссылок с доменом https://example.com). Система выбирает подходящий компонент среди установленных и запускает его.

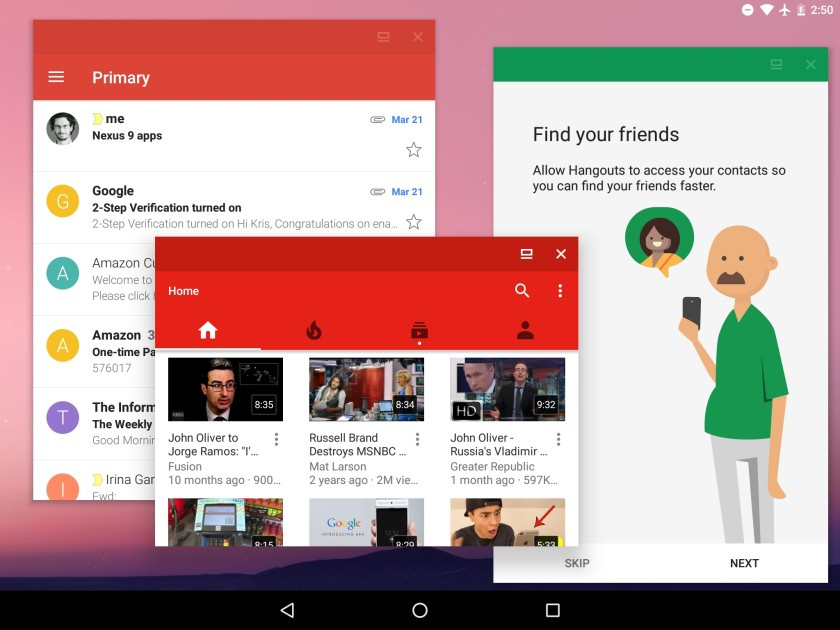

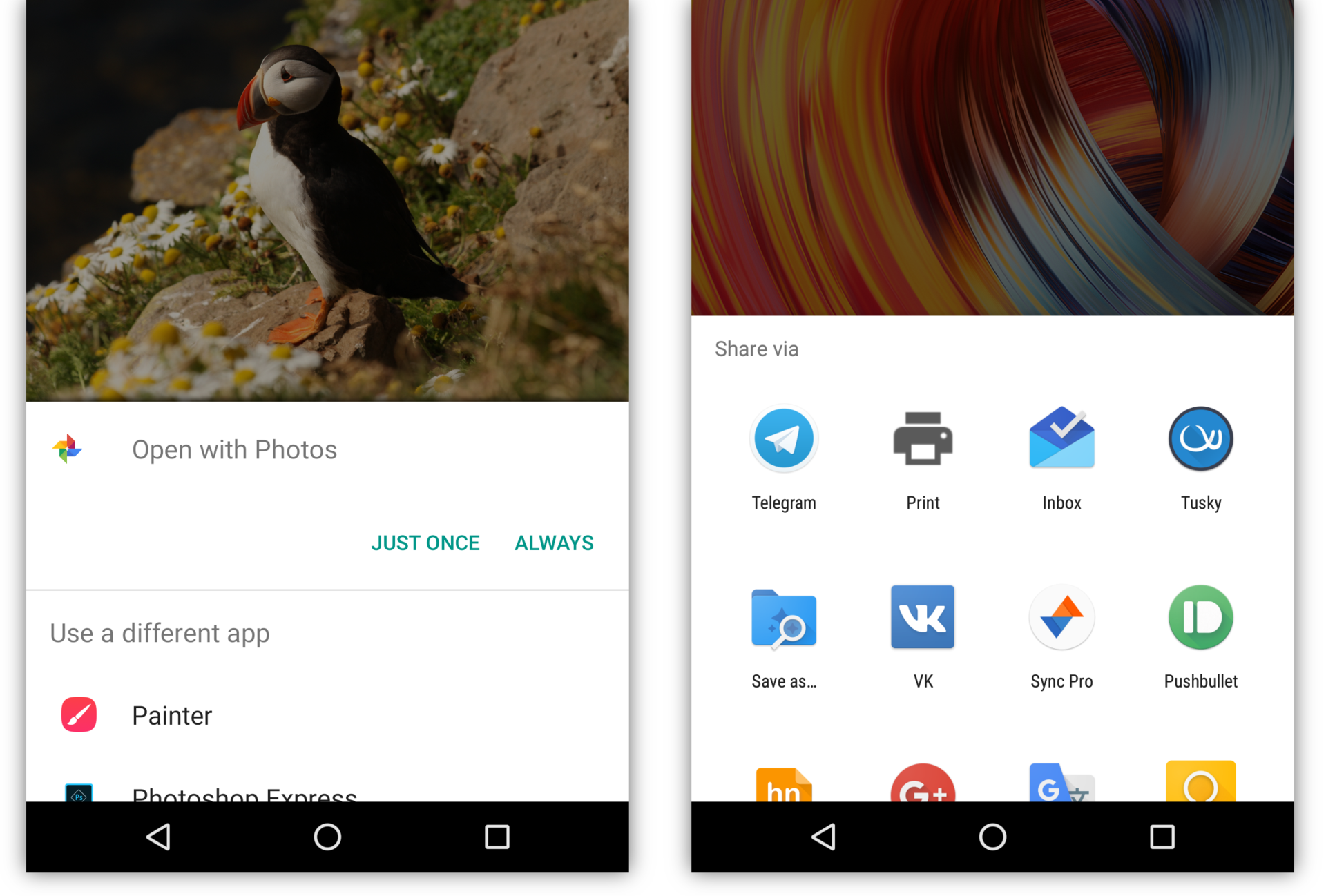

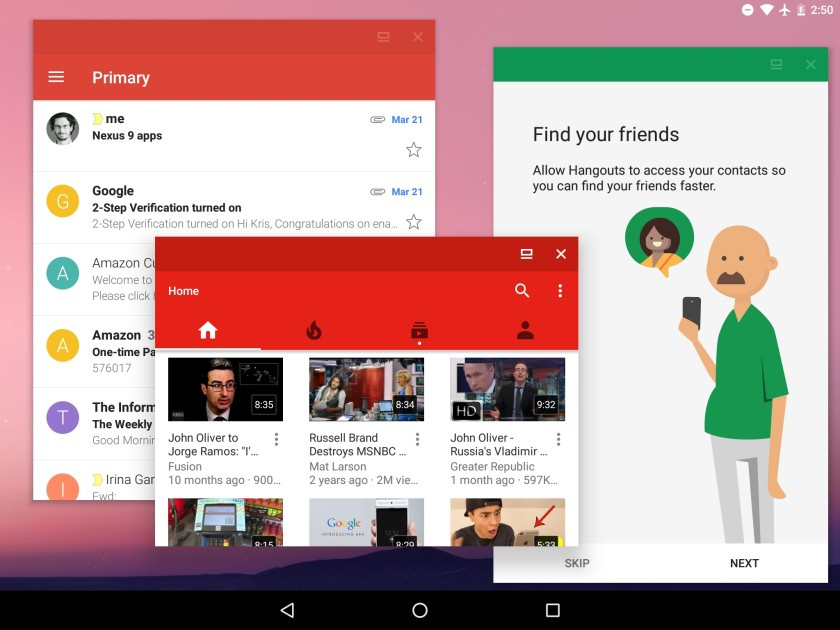

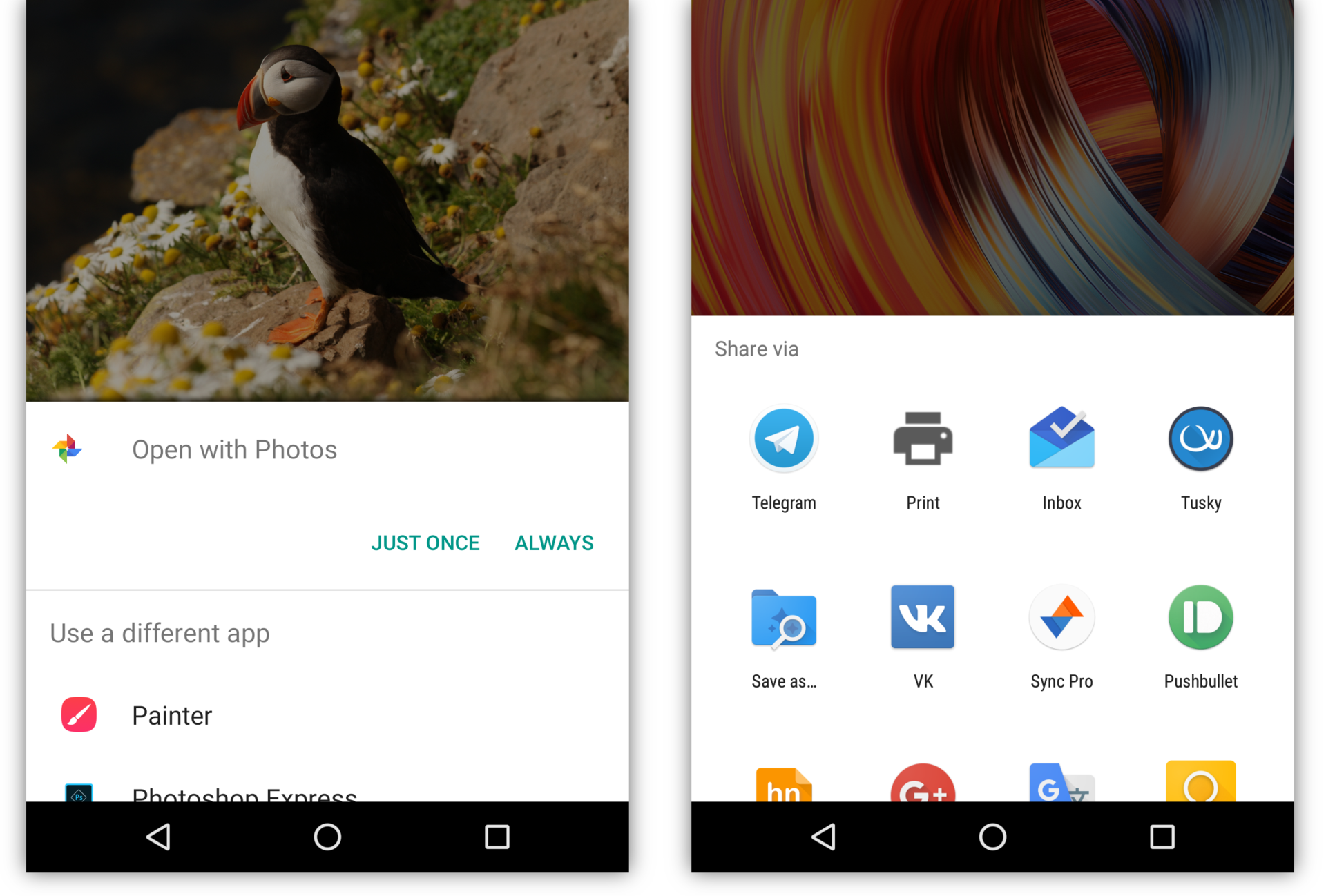

Если в системе есть несколько activity, которые готовы обработать intent, пользователю будет предоставлен выбор. Обычно это случается, когда установлено несколько аналогичных приложений, например несколько браузеров или фоторедакторов. Кроме того, приложение может явно попросить систему показать диалог выбора (на самом деле при этом переданный intent оборачивается в новый intent с ACTION_CHOOSER) — это обычно используется для создания красивого диалога Share:

Кроме того, activity может вернуть результат в вызвавшую её activity. Например, activity в приложении-камере, которая умеет обрабатывать intent «сделать фотографию» (ACTION_IMAGE_CAPTURE) возвращает сделанную фотографию в ту activity, которая создала этот intent.

При этом приложению, содержащему исходную activity, не нужно разрешение на доступ к камере.

Таким образом, правильный способ приложению под Android сделать фотографию — это не потребовать разрешения на доступ к камере и использовать Camera API, а создать нужный intent и позволить системному приложению-камере сделать фото. Аналогично, вместо использования разрешения READ_EXTERNAL_STORAGE и прямого доступа к файлам пользователя стоит дать пользователю возможность выбрать файл в системном файловом менеджере (тогда исходному приложению будет разрешён доступ именно к этому файлу).

A unique aspect of the Android system design is that any app can start another app’s component. For example, if you want the user to capture a photo with the device camera, there’s probably another app that does that and your app can use it instead of developing an activity to capture a photo yourself. You don’t need to incorporate or even link to the code from the camera app. Instead, you can simply start the activity in the camera app that captures a photo. When complete, the photo is even returned to your app so you can use it. To the user, it seems as if the camera is actually a part of your app.

При этом «системное» приложение — не обязательно то, которое было предустановлено производителем (или автором сборки Android). Все установленные приложения, которые умеют обрабатывать данный intent, в этом смысле равны между собой. Пользователь может выбрать любое из них в качестве приложения по умолчанию для таких intent’ов, а может выбирать нужное каждый раз. Выбранное приложение становится «системным» в том смысле, что пользователь выбрал, чтобы именно оно выполняло все задачи (то есть intent’ы) такого типа, возникающие в системе.

Само разрешение на доступ к камере нужно только тем приложениям, которые реализуют свой интерфейс камеры — например, собственно приложения-камеры, приложения для видеозвонков или дополненной реальности. Наоборот, обыкновенному мессенджеру доступ к камере «чтобы можно было фото отправлять» не нужен, как не нужен и доступ к совершению звонков приложению крупного банка.

Этой логике подчиняются даже такие «части системы», как, например, домашний экран (лончер, launcher). Лончер — это специальное приложение со своими activity (которые используют специальные флаги вроде excludeFromRecents и launchMode="singleTask").

Нажатие кнопки «домой» создаёт intent категории HOME, который дальше проходит через обычный механизм обработки intent’ов — в том числе, если в системе установлено несколько лончеров и ни один не выбран в качестве лончера по умолчанию, система отобразит диалог выбора.

«Запуск» приложения из лончера тоже происходит через intent. Лончер создаёт явный intent категории LAUNCHER, который «обрабатывается» запуском основной activity приложения.

Приложение может иметь несколько activity, которые поддерживают такой intent, и отображаться в лончере несколько раз (при этом может понадобиться указать им разную taskAffinity). Или не иметь ни одной и не отображаться в лончере вообще (но по-прежнему отображаться в полном списке установленных приложений в настройках). «Обычные» приложения так делают довольно редко; самый известный пример такого поведения — Google Play Services.

Многие операционные системы делятся на собственно операционную систему и приложения, установленные поверх, ничего друг о друге не знающие и не умеющие взаимодействовать. Система компонентов и intent’ов Android позволяет приложениям, по-прежнему абсолютно ничего друг о друге не зная, составлять для пользователя один интегрированный системный user experience — установленные приложения реализуют части одной большой системы, они составляют из себя систему. И это, с одной стороны, происходит прозрачно для пользователя, с другой — представляет неограниченные возможности для кастомизации.

По-моему, это очень красиво.

Tasks & back stack

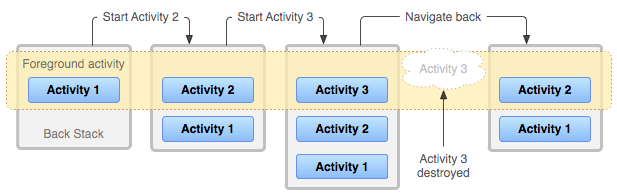

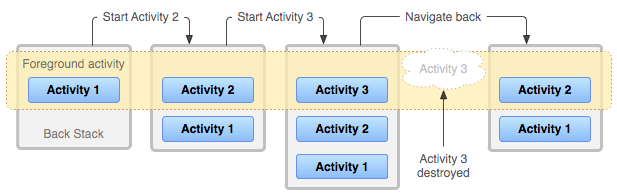

Как я уже говорил, в браузере пользователь может переключаться не между сайтами, а между вкладками, история каждой из которых может содержать много страниц разных сайтов. Аналогично, в Android пользователь может переключаться между задачами (tasks), которые отображаются в виде карточек на recents screen. Каждая задача представляет собой back stack — несколько activity, «наложенных» друг на друга.

Когда одна activity запускает другую, новая activity помещается в стек поверх старой. Когда верхняя activity в стеке завершается — например, когда пользователь нажимает системную кнопку «назад» — предыдущая activity в стеке снова отображается на экране.

Каждый стек может включать в себя activity из разных приложений, и несколько копий одной activity могут быть одновременно открыты в рамках разных задач или даже внутри одного стека.

При запуске новой activity могут быть указаны специальные флаги, такие как singleTop, singleTask, singleInstance и CLEAR_TOP, которые модифицируют этот механизм. Например, приложения-браузеры обычно разрешают запуск только одной копии своей основной activity, и для переключения между открытыми страницами реализуют собственную систему вкладок. С другой стороны, Custom Tabs — пример activity в браузере (чаще всего Chrome), которая ведёт себя почти «как обычно», то есть показывает только одну страницу, но позволяет одновременно открывать несколько своих копий.

App lifecycle

Одно из основных ограничений встраиваемых и мобильных устройств — небольшое количество оперативной памяти (RAM). Если современные флагманские устройства уже оснащаются несколькими гигабайтами оперативной памяти, то в первом смартфоне на Android, HTC Dream (он же T-Mobile G1), вышедшем в сентябре 2008 года, её было всего 192 мегабайта.

Проблема ограниченной памяти дополнительно осложняется тем, что в мобильных устройствах, в отличие от «обычных» компьютеров, не используются swap-разделы (и swap-файлы) — в том числе и из-за низкой (по сравнению с SSD и HDD) скорости доступа к SD-картам и встроенной флеш-памяти, где они могли бы размещаться. Начиная с версии 4.4 KitKat, Android использует zRAM swap, то есть эффективно сжимает малоиспользуемые участки памяти. Тем не менее, проблема ограниченной памяти остаётся.

Если все процессы представляют собой для системы чёрный ящик, лучшая из возможных стратегия поведения в случае нехватки свободной памяти — принудительно завершать («убивать») какие-то процессы, что и делает Linux Out Of Memory (OOM) Killer. Но Android знает, что происходит в системе, ему известно, какие приложения и какие их компоненты запущены, что позволяет реализовать гораздо более «умную» схему освобождения памяти.

Во-первых, когда свободная память заканчивается, Android явно просит приложения освободить ненужную память (например, сбросить кэш), вызывая методы onTrimMemory/onLowMemory. Во-вторых, Android может эффективно проводить сборку мусора в фоновых приложениях, освобождая память, которую они больше не используют (на уровне Java), при этом не замедляя работу текущего приложения.

Но основной механизм освобождения памяти в Android — это завершение наименее используемых компонентов приложений (в основном activity). Подчеркну, что Android может завершать приложения не полностью, а покомпонентно, оставляя более используемые части запущенными — например, из двух копий одной activity одна может быть завершена, а другая остаться запущенной.

Система автоматически выбирает компоненты, наименее важные для пользователя (например, activity, из которых пользователь давно ушёл), даёт им шанс дополнительно освободить ресурсы, вызывая такие методы, как onDestroy, и завершает их, полностью освобождая используемую ими память и ресурсы (в том числе view hierarchy в случае activity). После этого, если в процессе приложения не осталось запущенных компонент, процесс может быть завершён.

Если пользователь возвращается в activity, завершённую системой из-за нехватки памяти, эта activity запускается снова. При этом перезапуск происходит прозрачно для пользователя, поскольку activity сохраняет своё состояние при завершении (onSaveInstanceState) и восстанавливает его при последующем запуске. Реализованные в Android Framework виджеты используют этот механизм, чтобы автоматически сохранить состояние интерфейса (UI) при перезапуске — с точностью до введённого в EditText текста, положения курсора, позиции прокрутки (scroll) и т.д. Разработчик приложения может дополнительно реализовать сохранение и восстановление каких-то ещё данных, специфичных для этого приложения.

С точки зрения пользователя этот механизм похож на использование swap: в обоих случаях при возвращении в выгруженную часть приложения приходится немного подождать, пока она загружается снова — в одном случае, с диска, в другом — пересоздаётся по сохранённому состоянию.

Именно этот механизм автоматического перезапуска и восстановления состояния создаёт у пользователя ощущение, что приложения «запущены всегда», избавляя его от необходимости явно запускать и закрывать приложения и сохранять введённые в них данные.

Services

Приложениям может потребоваться выполнять действия, не связанные напрямую ни с какой activity, в том числе, продолжать делать их в фоне, когда все activity этого приложения завершены. Например, приложение может скачивать из сети большой файл, обрабатывать фотографии, воспроизводить музыку, синхронизировать данные или просто поддерживать TCP-соединение с сервером для получения уведомлений.

Такую функциональность нельзя реализовывать, просто запуская отдельный поток — это было бы для системы чёрным ящиком; в том числе, процесс был бы завершён при завершении всех activity, независимо от состояния таких фоновых операций. Вместо этого Android предлагает использовать ещё один вид компонентов — сервис.

Сервис нужен, чтобы сообщить системе, что в процессе приложения выполняются действия, которые не являются частью activity этого приложения. Сам по себе сервис не означает создание отдельного потока или процесса — его точки входа (entry points) запускаются в основном потоке приложения. Обычно реализация сервиса запускает дополнительные потоки и управляет ими самостоятельно.

Сервисы во многом похожи на activity: они тоже запускаются с помощью intent’ов и могут быть завершены системой при нехватке памяти.

Запущенные сервисы могут быть в трёх состояниях:

- Foreground service — сервис, выполняющий действие, состояние которого важно для пользователя, например, загрузка файла или воспроизведение музыки. Такой сервис обязан отображать уведомление в системной шторке уведомлений (примеры: состояние загрузки, название текущей песни и управление воспроизведением). Система считает такой сервис примерно настолько же важным для пользователя, как и текущая activity, и завершит его только в крайнем случае.

Background service — сервис, выполняющий фоновое действие, состояние которого не интересует пользователя (чаще всего, синхронизацию). Такие сервисы могут быть завершены при нехватке памяти с гораздо большей вероятностью. В старых версиях Android большое количество одновременно запущенных фоновых сервисов часто становилось причиной «тормозов»; начиная с версии 8.0 Oreo, Android серьёзно ограничивает использование фоновых сервисов, принудительно завершая их через несколько минут после того, как пользователь выходит из приложения.

- Bound service — сервис, обрабатывающий входящее Binder-подключение. Такие сервисы предоставляют какую-то функциональность для других приложений или системы (например,

WallpaperServiceи Google Play Services). В этом случае система может автоматически запускать сервис при подключении к нему клиентов и останавливать его при их отключении.

Рекомендуемый способ выполнять фоновые действия — использование JobScheduler, системного механизма планирования фоновой работы. JobScheduler позволяет приложению указать критерии запуска сервиса, такие как:

- Доступность сети. Здесь приложение может указать, требуется ли этому сервису наличие сетевого подключения, и если да, то возможна ли работа в роуминге или при использовании лимитного (metered) подключения.

- Подключение к источнику питания, что позволяет сервисам выполняться, не «сажая батарею».

- Бездействие (idle), что позволяет сервисам выполняться, пока устройство не используется, не замедляя работу во время активного использования.

- Обновления контента — например, появление новой фотографии.

- Период и крайний срок запуска — например, очистка кэша может производиться ежедневно, а синхронизация событий в календаре — каждый час.

JobScheduler планирует выполнение (реализованное как вызов через Binder) зарегистрированных в нём сервисов в соответствии с указанными критериями. Поскольку JobScheduler — общесистемный механизм, он учитывает при планировке критерии зарегистрированных сервисов всех установленных приложений. Например, он может запускать сервисы по очереди, а не одновременно, чтобы предотвратить резкую нагрузку на устройство во время использования, и планировать периодическое выполнение нескольких сервисов небольшими группами (batch), чтобы предотвратить постоянное энергозатратное включение-выключение радиооборудования.

Как можно заметить, использование JobScheduler не может заменить собой одного из вариантов использования фоновых сервисов — поддержания TCP-соединения с сервером для получения push-уведомлений. Если бы Android предоставлял приложениям такую возможность, устройству пришлось бы держать все приложения, соединяющиеся со своими серверами, запущенными всё время, а это, конечно, невозможно.

Решение этой проблемы — специальные push-сервисы, самый известный из которых — Firebase Cloud Messaging от Google (бывший Google Cloud Messaging).

Клиентская часть FCM реализована в приложении Google Play Services. Это приложение, которое специальным образом исключается из обычных ограничений на фоновые сервисы, поддерживает одно соединение с серверами Google. Разработчик, желающий отправить своему приложению push-уведомление, пересылает его через серверную часть FCM, после чего приложение Play Services, получив сообщение, передаёт его приложению, которому оно предназначено.

Такая схема позволяет, с одной стороны, мгновенно доставлять push-уведомления всем приложениям (не дожидаясь следующего периода синхронизации), с другой стороны, не держать множество приложений одновременно запущенными.

Broadcast receivers & content providers

Кроме activity и сервисов, у приложений под Android есть два других вида компонентов, менее интересных для обсуждения — это broadcast receiver’ы и content provider’ы.

Broadcast receiver — компонент, позволяющий приложению принимать broadcast’ы, специальный вид сообщений от системы или других приложений. Исходно broadcast’ы, как следует из названия, в основном использовались для рассылки широковещательных сообщений всем подписавшимся приложениям — например, система посылает сообщение AIRPLANE_MODE_CHANGED при включении или отключении самолётного режима.

Сейчас вместо подписки на такие broadcast’ы, как NEW_PICTURE и NEW_VIDEO, приложения должны использовать JobScheduler. Broadcast’ы используются либо для более редких событий (таких как BOOT_COMPLETED), либо с явными intent’ами, то есть именно в качестве сообщения от одного приложения к другому.

Content provider — компонент, позволяющий приложению предоставлять другим приложениям доступ к данным, которыми оно управляет. Пример данных, доступ к которым можно получить таким образом — список контактов пользователя.

При этом приложение может хранить сами данные каким угодно образом, в том числе на устройстве в виде файлов, в настоящей базе данных (SQLite) или запрашивать их с сервера по сети. В этом смысле content provider — это унифицированный интерфейс для доступа к данным, независимо от формы их хранения.

Взаимодействие с content provider’ом во многом похоже на доступ к удалённой базе данных через REST API. Приложение-клиент запрашивает данные по URI (например, content://com.example.Dictionary.provider/words/42) через ContentResolver. Приложение-сервер определяет, к какому именно набору данных был сделан запрос, используя UriMatcher, и выполняет запрошенное действие (query, insert, update, delete).

Именно поверх content provider’ов реализован Storage Access Framework, позволяющий приложениям, хранящим файлы в облаке (например, Dropbox и Google Photos) предоставлять доступ к ним остальным приложениям, не занимая место на устройстве полной копией всех хранящихся в облаке файлов.

В следующей статье я расскажу о процессе загрузки Android, о содержимом файловой системы, о том, как хранятся данные пользователя и приложений, и о root-доступе.

|

Метки: author bugaevc разработка под android блог компании solar security android internals android lifecycle activity intent jobscheduler |

Как работает Android, часть 3 |

Как работает Android, часть 3

В этой статье я расскажу о компонентах, из которых состоят приложения под Android, и об идеях, которые стоят за этой архитектурой.

Статьи серии:

- Как работает Android, часть 1

- Как работает Android, часть 2

- Как работает Android, часть 3

- ...

Web vs desktop

Если задуматься об отличиях современных веб-приложений от «обычных» десктопных приложений, можно — среди недостатков — выделить несколько преимуществ веба:

- Веб-приложения переносимы между архитектурами и платформами, как и Java.

- Веб-приложения не требуют установки и всегда обновлены, как и Android Instant Apps.

Кроме того, веб-приложения существуют в виде страниц, которые могут ссылаться друг на друга — как в рамках одного сайта, так и между сайтами. При этом страница на одном сайте не обязана ограничиваться ссылкой только на главную страницу другого, она может ссылаться на конкретную страницу внутри другого сайта (это называется deep linking). Ссылаясь друг на друга, отдельные сайты объединяются в общую сеть, веб.

Несколько копий одной страницы — например, несколько профилей в социальной сети — могут быть одновременно открыты в нескольких вкладках браузера. Интерфейс браузера рассчитан на переключение между одновременными сессиями (вкладками), а не между отдельными сайтами — в рамках одной вкладки вы можете перемещаться по ссылкам (и вперёд-назад по истории) между разными страницами разных сайтов.

Всё это противопоставляется «десктопу», где каждое приложение работает отдельно и часто независимо от других — и в этом плане то, как устроены приложения в Android, гораздо ближе к вебу, чем к «традиционным» приложениям.

Activities & intents

Основной вид компонентов приложений под Android — это activity. Activity — это один «экран» приложения. Activity можно сравнить со страницей в вебе и с окном приложения в традиционном оконном интерфейсе.

Собственно окна в Android тоже есть на более низком уровне — уровне window manager. Каждой activity обычно соответствует своё окно. Чаще всего окна activity развёрнуты на весь доступный экран, но:

- Во-первых, Android поддерживает мультиоконный режим — split-screen, picture-in-picture и даже freeform.

- Во-вторых, Android поддерживает подключение нескольких дисплеев.

- В-третьих, activity может намеренно занимать небольшую часть экрана (

Theme_Dialog).

Например, в приложении для электронной почты (email client) могут быть такие activity, как Inbox Activity (список входящих писем), Email Activity (чтение одного письма), Compose Activity (написание письма) и Settings Activity (настройки).

Как и страницы одного сайта, activity одного приложения могут запускаться как друг из друга, так и независимо друг от друга (другими приложениями). Если в вебе на другую страницу обращаются по URL (ссылке), то в Android activity запускаются через intent’ы.

Intent — это сообщение, которое указывает системе, что нужно «сделать» (например, открыть данный URL, написать письмо на данный адрес, позвонить на данный номер телефона или сделать фотографию).

Приложение может создать такой intent и передать его системе, а система решает, какая activity (или другой компонент) будет его выполнять (handle). Эта activity запускается системой (в существующем процессе приложения или в новом, если он ещё не запущен), ей передаётся этот intent, и она его выполняет.

Стандартный способ создавать intent’ы — через соответствующий класс в Android Framework. Для работы с activity и intent’ами из командной строки в Android есть команда am — обёртка над стандартным классом Activity Manager:

# передаём -a ACTION -d DATA

# открыть сайт

$ am start -a android.intent.action.VIEW -d http://example.com

# позвонить по телефону

$ am start -a android.intent.action.CALL -d tel:+7-916-271-05-83Intent’ы могут быть явными (explicit) и неявными (implicit). Явный intent указывает идентификатор конкретного компонента, который нужно запустить — чаще всего это используется, чтобы запустить из одной activity другую внутри одного приложения (при этом intent может даже не содержать другой полезной информации).

Неявный intent обязательно должен указывать действие, которое нужно сделать. Каждая activity (и другие компоненты) указывают в манифесте приложения, какие intent’ы они готовы обрабатывать (например, ACTION_VIEW для ссылок с доменом https://example.com). Система выбирает подходящий компонент среди установленных и запускает его.

Если в системе есть несколько activity, которые готовы обработать intent, пользователю будет предоставлен выбор. Обычно это случается, когда установлено несколько аналогичных приложений, например несколько браузеров или фоторедакторов. Кроме того, приложение может явно попросить систему показать диалог выбора (на самом деле при этом переданный intent оборачивается в новый intent с ACTION_CHOOSER) — это обычно используется для создания красивого диалога Share:

Кроме того, activity может вернуть результат в вызвавшую её activity. Например, activity в приложении-камере, которая умеет обрабатывать intent «сделать фотографию» (ACTION_IMAGE_CAPTURE) возвращает сделанную фотографию в ту activity, которая создала этот intent.

При этом приложению, содержащему исходную activity, не нужно разрешение на доступ к камере.

Таким образом, правильный способ приложению под Android сделать фотографию — это не потребовать разрешения на доступ к камере и использовать Camera API, а создать нужный intent и позволить системному приложению-камере сделать фото. Аналогично, вместо использования разрешения READ_EXTERNAL_STORAGE и прямого доступа к файлам пользователя стоит дать пользователю возможность выбрать файл в системном файловом менеджере (тогда исходному приложению будет разрешён доступ именно к этому файлу).

A unique aspect of the Android system design is that any app can start another app’s component. For example, if you want the user to capture a photo with the device camera, there’s probably another app that does that and your app can use it instead of developing an activity to capture a photo yourself. You don’t need to incorporate or even link to the code from the camera app. Instead, you can simply start the activity in the camera app that captures a photo. When complete, the photo is even returned to your app so you can use it. To the user, it seems as if the camera is actually a part of your app.

При этом «системное» приложение — не обязательно то, которое было предустановлено производителем (или автором сборки Android). Все установленные приложения, которые умеют обрабатывать данный intent, в этом смысле равны между собой. Пользователь может выбрать любое из них в качестве приложения по умолчанию для таких intent’ов, а может выбирать нужное каждый раз. Выбранное приложение становится «системным» в том смысле, что пользователь выбрал, чтобы именно оно выполняло все задачи (то есть intent’ы) такого типа, возникающие в системе.

Само разрешение на доступ к камере нужно только тем приложениям, которые реализуют свой интерфейс камеры — например, собственно приложения-камеры, приложения для видеозвонков или дополненной реальности. Наоборот, обыкновенному мессенджеру доступ к камере «чтобы можно было фото отправлять» не нужен, как не нужен и доступ к совершению звонков приложению крупного банка.

Этой логике подчиняются даже такие «части системы», как, например, домашний экран (лончер, launcher). Лончер — это специальное приложение со своими activity (которые используют специальные флаги вроде excludeFromRecents и launchMode="singleTask").

Нажатие кнопки «домой» создаёт intent категории HOME, который дальше проходит через обычный механизм обработки intent’ов — в том числе, если в системе установлено несколько лончеров и ни один не выбран в качестве лончера по умолчанию, система отобразит диалог выбора.

«Запуск» приложения из лончера тоже происходит через intent. Лончер создаёт явный intent категории LAUNCHER, который «обрабатывается» запуском основной activity приложения.

Приложение может иметь несколько activity, которые поддерживают такой intent, и отображаться в лончере несколько раз (при этом может понадобиться указать им разную taskAffinity). Или не иметь ни одной и не отображаться в лончере вообще (но по-прежнему отображаться в полном списке установленных приложений в настройках). «Обычные» приложения так делают довольно редко; самый известный пример такого поведения — Google Play Services.

Многие операционные системы делятся на собственно операционную систему и приложения, установленные поверх, ничего друг о друге не знающие и не умеющие взаимодействовать. Система компонентов и intent’ов Android позволяет приложениям, по-прежнему абсолютно ничего друг о друге не зная, составлять для пользователя один интегрированный системный user experience — установленные приложения реализуют части одной большой системы, они составляют из себя систему. И это, с одной стороны, происходит прозрачно для пользователя, с другой — представляет неограниченные возможности для кастомизации.

По-моему, это очень красиво.

Tasks & back stack

Как я уже говорил, в браузере пользователь может переключаться не между сайтами, а между вкладками, история каждой из которых может содержать много страниц разных сайтов. Аналогично, в Android пользователь может переключаться между задачами (tasks), которые отображаются в виде карточек на recents screen. Каждая задача представляет собой back stack — несколько activity, «наложенных» друг на друга.

Когда одна activity запускает другую, новая activity помещается в стек поверх старой. Когда верхняя activity в стеке завершается — например, когда пользователь нажимает системную кнопку «назад» — предыдущая activity в стеке снова отображается на экране.

Каждый стек может включать в себя activity из разных приложений, и несколько копий одной activity могут быть одновременно открыты в рамках разных задач или даже внутри одного стека.

При запуске новой activity могут быть указаны специальные флаги, такие как singleTop, singleTask, singleInstance и CLEAR_TOP, которые модифицируют этот механизм. Например, приложения-браузеры обычно разрешают запуск только одной копии своей основной activity, и для переключения между открытыми страницами реализуют собственную систему вкладок. С другой стороны, Custom Tabs — пример activity в браузере (чаще всего Chrome), которая ведёт себя почти «как обычно», то есть показывает только одну страницу, но позволяет одновременно открывать несколько своих копий.

App lifecycle

Одно из основных ограничений встраиваемых и мобильных устройств — небольшое количество оперативной памяти (RAM). Если современные флагманские устройства уже оснащаются несколькими гигабайтами оперативной памяти, то в первом смартфоне на Android, HTC Dream (он же T-Mobile G1), вышедшем в сентябре 2008 года, её было всего 192 мегабайта.

Проблема ограниченной памяти дополнительно осложняется тем, что в мобильных устройствах, в отличие от «обычных» компьютеров, не используются swap-разделы (и swap-файлы) — в том числе и из-за низкой (по сравнению с SSD и HDD) скорости доступа к SD-картам и встроенной флеш-памяти, где они могли бы размещаться. Начиная с версии 4.4 KitKat, Android использует zRAM swap, то есть эффективно сжимает малоиспользуемые участки памяти. Тем не менее, проблема ограниченной памяти остаётся.

Если все процессы представляют собой для системы чёрный ящик, лучшая из возможных стратегия поведения в случае нехватки свободной памяти — принудительно завершать («убивать») какие-то процессы, что и делает Linux Out Of Memory (OOM) Killer. Но Android знает, что происходит в системе, ему известно, какие приложения и какие их компоненты запущены, что позволяет реализовать гораздо более «умную» схему освобождения памяти.

Во-первых, когда свободная память заканчивается, Android явно просит приложения освободить ненужную память (например, сбросить кэш), вызывая методы onTrimMemory/onLowMemory. Во-вторых, Android может эффективно проводить сборку мусора в фоновых приложениях, освобождая память, которую они больше не используют (на уровне Java), при этом не замедляя работу текущего приложения.

Но основной механизм освобождения памяти в Android — это завершение наименее используемых компонентов приложений (в основном activity). Подчеркну, что Android может завершать приложения не полностью, а покомпонентно, оставляя более используемые части запущенными — например, из двух копий одной activity одна может быть завершена, а другая остаться запущенной.

Система автоматически выбирает компоненты, наименее важные для пользователя (например, activity, из которых пользователь давно ушёл), даёт им шанс дополнительно освободить ресурсы, вызывая такие методы, как onDestroy, и завершает их, полностью освобождая используемую ими память и ресурсы (в том числе view hierarchy в случае activity). После этого, если в процессе приложения не осталось запущенных компонент, процесс может быть завершён.

Если пользователь возвращается в activity, завершённую системой из-за нехватки памяти, эта activity запускается снова. При этом перезапуск происходит прозрачно для пользователя, поскольку activity сохраняет своё состояние при завершении (onSaveInstanceState) и восстанавливает его при последующем запуске. Реализованные в Android Framework виджеты используют этот механизм, чтобы автоматически сохранить состояние интерфейса (UI) при перезапуске — с точностью до введённого в EditText текста, положения курсора, позиции прокрутки (scroll) и т.д. Разработчик приложения может дополнительно реализовать сохранение и восстановление каких-то ещё данных, специфичных для этого приложения.

С точки зрения пользователя этот механизм похож на использование swap: в обоих случаях при возвращении в выгруженную часть приложения приходится немного подождать, пока она загружается снова — в одном случае, с диска, в другом — пересоздаётся по сохранённому состоянию.

Именно этот механизм автоматического перезапуска и восстановления состояния создаёт у пользователя ощущение, что приложения «запущены всегда», избавляя его от необходимости явно запускать и закрывать приложения и сохранять введённые в них данные.

Services

Приложениям может потребоваться выполнять действия, не связанные напрямую ни с какой activity, в том числе, продолжать делать их в фоне, когда все activity этого приложения завершены. Например, приложение может скачивать из сети большой файл, обрабатывать фотографии, воспроизводить музыку, синхронизировать данные или просто поддерживать TCP-соединение с сервером для получения уведомлений.

Такую функциональность нельзя реализовывать, просто запуская отдельный поток — это было бы для системы чёрным ящиком; в том числе, процесс был бы завершён при завершении всех activity, независимо от состояния таких фоновых операций. Вместо этого Android предлагает использовать ещё один вид компонентов — сервис.

Сервис нужен, чтобы сообщить системе, что в процессе приложения выполняются действия, которые не являются частью activity этого приложения. Сам по себе сервис не означает создание отдельного потока или процесса — его точки входа (entry points) запускаются в основном потоке приложения. Обычно реализация сервиса запускает дополнительные потоки и управляет ими самостоятельно.

Сервисы во многом похожи на activity: они тоже запускаются с помощью intent’ов и могут быть завершены системой при нехватке памяти.

Запущенные сервисы могут быть в трёх состояниях:

- Foreground service — сервис, выполняющий действие, состояние которого важно для пользователя, например, загрузка файла или воспроизведение музыки. Такой сервис обязан отображать уведомление в системной шторке уведомлений (примеры: состояние загрузки, название текущей песни и управление воспроизведением). Система считает такой сервис примерно настолько же важным для пользователя, как и текущая activity, и завершит его только в крайнем случае.

Background service — сервис, выполняющий фоновое действие, состояние которого не интересует пользователя (чаще всего, синхронизацию). Такие сервисы могут быть завершены при нехватке памяти с гораздо большей вероятностью. В старых версиях Android большое количество одновременно запущенных фоновых сервисов часто становилось причиной «тормозов»; начиная с версии 8.0 Oreo, Android серьёзно ограничивает использование фоновых сервисов, принудительно завершая их через несколько минут после того, как пользователь выходит из приложения.

- Bound service — сервис, обрабатывающий входящее Binder-подключение. Такие сервисы предоставляют какую-то функциональность для других приложений или системы (например,

WallpaperServiceи Google Play Services). В этом случае система может автоматически запускать сервис при подключении к нему клиентов и останавливать его при их отключении.

Рекомендуемый способ выполнять фоновые действия — использование JobScheduler, системного механизма планирования фоновой работы. JobScheduler позволяет приложению указать критерии запуска сервиса, такие как:

- Доступность сети. Здесь приложение может указать, требуется ли этому сервису наличие сетевого подключения, и если да, то возможна ли работа в роуминге или при использовании лимитного (metered) подключения.

- Подключение к источнику питания, что позволяет сервисам выполняться, не «сажая батарею».

- Бездействие (idle), что позволяет сервисам выполняться, пока устройство не используется, не замедляя работу во время активного использования.

- Обновления контента — например, появление новой фотографии.

- Период и крайний срок запуска — например, очистка кэша может производиться ежедневно, а синхронизация событий в календаре — каждый час.

JobScheduler планирует выполнение (реализованное как вызов через Binder) зарегистрированных в нём сервисов в соответствии с указанными критериями. Поскольку JobScheduler — общесистемный механизм, он учитывает при планировке критерии зарегистрированных сервисов всех установленных приложений. Например, он может запускать сервисы по очереди, а не одновременно, чтобы предотвратить резкую нагрузку на устройство во время использования, и планировать периодическое выполнение нескольких сервисов небольшими группами (batch), чтобы предотвратить постоянное энергозатратное включение-выключение радиооборудования.

Как можно заметить, использование JobScheduler не может заменить собой одного из вариантов использования фоновых сервисов — поддержания TCP-соединения с сервером для получения push-уведомлений. Если бы Android предоставлял приложениям такую возможность, устройству пришлось бы держать все приложения, соединяющиеся со своими серверами, запущенными всё время, а это, конечно, невозможно.

Решение этой проблемы — специальные push-сервисы, самый известный из которых — Firebase Cloud Messaging от Google (бывший Google Cloud Messaging).

Клиентская часть FCM реализована в приложении Google Play Services. Это приложение, которое специальным образом исключается из обычных ограничений на фоновые сервисы, поддерживает одно соединение с серверами Google. Разработчик, желающий отправить своему приложению push-уведомление, пересылает его через серверную часть FCM, после чего приложение Play Services, получив сообщение, передаёт его приложению, которому оно предназначено.

Такая схема позволяет, с одной стороны, мгновенно доставлять push-уведомления всем приложениям (не дожидаясь следующего периода синхронизации), с другой стороны, не держать множество приложений одновременно запущенными.

Broadcast receivers & content providers

Кроме activity и сервисов, у приложений под Android есть два других вида компонентов, менее интересных для обсуждения — это broadcast receiver’ы и content provider’ы.

Broadcast receiver — компонент, позволяющий приложению принимать broadcast’ы, специальный вид сообщений от системы или других приложений. Исходно broadcast’ы, как следует из названия, в основном использовались для рассылки широковещательных сообщений всем подписавшимся приложениям — например, система посылает сообщение AIRPLANE_MODE_CHANGED при включении или отключении самолётного режима.

Сейчас вместо подписки на такие broadcast’ы, как NEW_PICTURE и NEW_VIDEO, приложения должны использовать JobScheduler. Broadcast’ы используются либо для более редких событий (таких как BOOT_COMPLETED), либо с явными intent’ами, то есть именно в качестве сообщения от одного приложения к другому.

Content provider — компонент, позволяющий приложению предоставлять другим приложениям доступ к данным, которыми оно управляет. Пример данных, доступ к которым можно получить таким образом — список контактов пользователя.

При этом приложение может хранить сами данные каким угодно образом, в том числе на устройстве в виде файлов, в настоящей базе данных (SQLite) или запрашивать их с сервера по сети. В этом смысле content provider — это унифицированный интерфейс для доступа к данным, независимо от формы их хранения.

Взаимодействие с content provider’ом во многом похоже на доступ к удалённой базе данных через REST API. Приложение-клиент запрашивает данные по URI (например, content://com.example.Dictionary.provider/words/42) через ContentResolver. Приложение-сервер определяет, к какому именно набору данных был сделан запрос, используя UriMatcher, и выполняет запрошенное действие (query, insert, update, delete).

Именно поверх content provider’ов реализован Storage Access Framework, позволяющий приложениям, хранящим файлы в облаке (например, Dropbox и Google Photos) предоставлять доступ к ним остальным приложениям, не занимая место на устройстве полной копией всех хранящихся в облаке файлов.

В следующей статье я расскажу о процессе загрузки Android, о содержимом файловой системы, о том, как хранятся данные пользователя и приложений, и о root-доступе.

|

Метки: author bugaevc разработка под android блог компании solar security android internals android lifecycle activity intent jobscheduler |

Что увидело НЛО, прилетев на РИТ++ 2017 |

Что увидело НЛО, прилетев на РИТ++ 2017

Жизнь – скучная штука, и надо использовать любую возможность, чтобы заставить людей улыбаться (Э. Кустурица)

ИТ-шный Вавилон