Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

«Это не про деньги и не разработку»: 5 заблуждений о работе комьюнити-менеджера |

Много раз я пытался объяснить своим знакомым, чем занимаюсь. Обычно я обзываю себя специалистом по связям с общественностью. По крайней мере, это более или менее понятно. Но когда аналогичный вопрос задают люди из игровой индустрии — это настораживает. «Как же так, — подумает комьюнити-менеджер. — Есть же игроки, нужно сделать социальную среду — неужели вам этого недостаточно?». Возможно огорчу кого-то из коллег, но, нет, недостаточно. Когда к вам обращается основатель инди-студии и спрашивает, зачем же нужны КМ, аксиомы вроде «услышанный игрок = счастливый игрок» не убедят его тратить и без того ограниченный бюджет.

Не только в России, но и за рубежом, я все чаще натыкаюсь на обсуждения ценности и обязанностей таких сотрудников: «Кто эти люди, чем они занимаются, в чем их польза, а главное — как подсчитать эту пользу?». Так что давайте уже разбираться — нужен ли кому-нибудь комьюнити-менеджер...

… и чем он занимается

Представьте, что вы открыли кофейню. По вечерам к вам заходят одни и те же люди, которые живут или работают неподалеку. Вскоре вы узнаете их имена, профессии, интересы. Посещение становится для них привычкой, и цель «купить напиток» постепенно становится целью «зайти в любимое местечко». Клиент приходит каждый день, приводит друзей, а вы заранее знаете, что ему приготовить.

Теперь представьте, что чашку кофе можно приготовить всего один раз, а купить и выпить ее могут тысячи посетителей. Здесь на сцену выходит цифровая дистрибуция. Вам остается работать с клиентами, удерживать их и растить сообщество. Различие только в охватах. Но если в случае с маленькой кофейней эффект очевиден (вы лично видите каждого постоянного и приведенного клиента), то когда клиентов становится тысячи и миллионы — картина размывается. Возникает необходимость посчитать аналогичную пользу при работе с большой аудиторией.

Дальше я перечислю 5 распространенных заблуждений, которые могут сформировать ложное представление о позиции комьюнити-менеджера.

Дисклеймер: в тексте говорю про комьюнити-менеджмент в целом, но исхожу из опыта работы с игровыми проектами. Для неигровых онлайн-сервисов могут быть различия.

Заблуждение №1: КМ не приносит денег

Котики. Считаются неотъемлемой частью работы КМ.

Пожалуй, главный вопрос к комьюнити-менеджменту — это вопрос его окупаемости. По мере знакомства с КМ различных компаний, я сделал простой вывод: такое заблуждение вызвано задачами, которые компания ставит перед отделом.

Многие инди-студии берут в штат 1-2 КМ-ов для поддержания официальных ресурсов. Им говорят: «Хотим core-аудиторию в социалках, чтобы была страница на Facebook, а на форумах — видимость присутствия разработчика». Имиджевая задача, казалось бы в наши дни — must have. Но работник, который получит такую установку, не научится в бизнес. Постепенно он выставит себе KPI в лайках и подписках, его конечной целью станет общение и кратковременные задачи, которые перейдут в едва ли полезную рутину.

Давайте сразу проясним: игровое сообщество — это не страницы в социальных сетях и не регистрации на форуме (хотя без них никуда). Под сообществом стоит понимать всю аудиторию проекта, тем или иным образом взаимодействующую между собой и с брендом. Более того, если пользователь способен дать оценку продукту или сервису — он уже часть сообщества, от его мнения зависит исход обсуждений вокруг бренда (масштаб таких обсуждений — это детали).

И вот мы снова в кофейне. Представьте, что каждый второй клиент говорит, что купил бы раф-кофе, которого нет в меню. Каждый третий — о том, что нужна выпечка. Каждый десятый уходит, не найдя свободного места. А вы стоите за стойкой и знаете об этом. У вас есть отзывы и построенные на них планы. Но в отсутствии обратной связи появляется риск несоответствия ожиданиям клиентов, что приведет к упущенной прибыли.

Теперь поставим перед КМ другую задачу: вести сбор обратной связи и дополнять игровой опыт социальным. При такой формулировке он увидит перед собой гораздо больше инструментов и возможностей. Взаимодействие с игроком не будет ограничиваться страницей в соцсети, он будет осознавать необходимость работать со всей аудиторией, а значит — в интересах компании и проекта.

Несколько примеров (назову это community-driven revenue — проекты, в которых движущей силой заработка выступает сообщество, а не встроенная монетизация) для наглядности:

- Сообщество Reddit способно образовывать спонтанный краудфандинг в поддержку идей и пользователей.

- Популярные стримеры создают «дефицит ответов» на комментарии подписчиков. Все хотят засветиться в эфире и думают: «Задоначу, и он точно мне ответит».

- Краудфандинг-платформы как Kickstarter работают по принципу Public-benefit, то есть изначально целятся на ожидания сообщества и им же финансируются.

Здесь, кроме принципа «я заплачу, чтобы это получить», работает принцип «я заплачу, чтобы стать частью чего-то большего». И это совершенно другая мотивация, с которой можно и нужно работать.

Заблуждение №2: Мнение игроков нельзя измерить

Теперь поделюсь опытом работы на игровом проекте с миллионным активным сообществом — War Robots. Игра издается на весь мир, у нас в отделе КМ сейчас 8 человек +1 аутсорс. На ключевые регионы работают отдельные люди.

Несколько лет назад мы были небольшой компанией. У нас был проект и желание сделать его хитом. Поэтому как только новый регион показывал интерес к игре, мы брали КМ для работы с этим регионом. К — клиентоориентированность.

Мы хотели знать:

- Что больше всего понравилось и не понравилось игрокам?

- Чего не хватает новым игрокам?

- Насколько сложно (читай долго) всё это реализовать?

- Что мы с этого получим?

Разработка (3) оценивается временем. Успех (4) оценивается прибылью. Но как оценить первые два пункта?

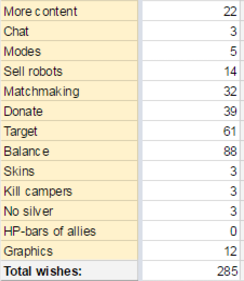

Я не шучу, мы руками собирали каждый отзыв и каждое пожелание игроков. Прочитал отзыв > определил категорию > прибавил единицу. Ну что, во сколько вы оцените работу работника с такой задачей? Вот и мы подумали, что КПД можно и нужно повысить. Автоматизация!

Сначала мы изучили сервисы, занимающиеся Text mining и Social listening. Первое — это сухой анализ текста на предмет ключевых слов. Такой можно найти в админке ревью на Google Play (тогда его еще не было). В связке с самой оценкой получается неплохая статистика, во всяком случае теперь можно выделить конкретную тему по ключу.

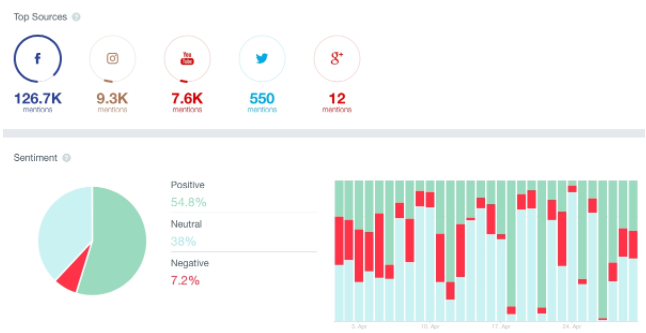

Social listening — это анализ текста по содержанию и сентименту. Мы работали на Facebook, Instagram и YouTube, но собирать фидбек оттуда было задачей долговременной и не особо эффективной. Нашли сервис, сделали вывод, что можем получить более подробную выгрузку отзывов не за часы, а за пару минут.

Некоторым такой «робот» не по душе, но мы попробовали и не пожалели. Теперь каждый релиз и фича сопровождаются статистикой по отзывам, которые можно изучать в реальном времени по темам, которые нас интересуют.

Заблуждение №3: КМ не имеет отношения к разработке

КМов привыкли видеть работающими в социальных сетях, на сайте и форуме. Публикация новостей, набор модераторов, внеигровые ивенты, вот это всё. В такой роли КМ видит игру как должное и защищает проект в одностороннем порядке при помощи «официальных заявлений», лидеров мнений, имиджевых мероприятий и других инструментов.

Но предположим, что КМ получит доступ к разработке — у него появится возможность составить ТЗ на социальную фичу (и обосновать ее необходимость), которая даст приумноженный эффект от его работы.

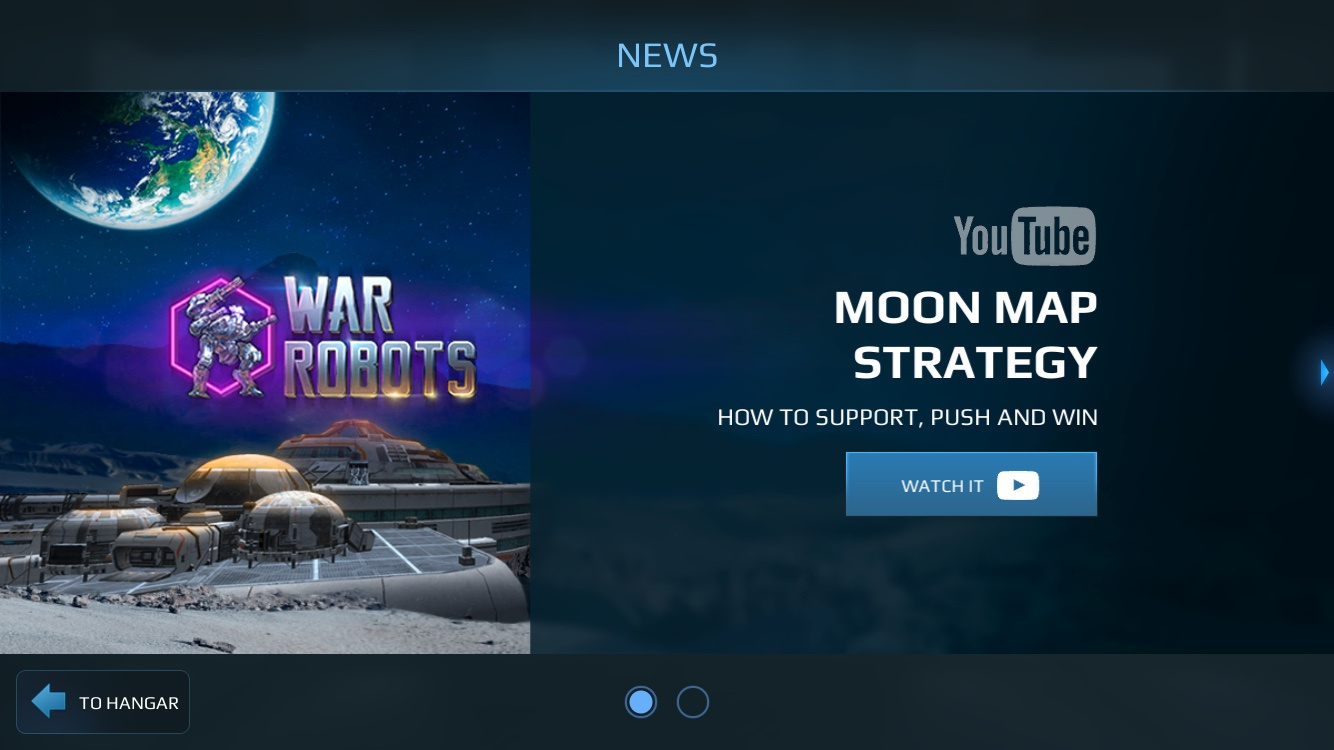

К примеру, такие фичи как «инбокс» или «новости» помогают создать инфлюенсера комьюнити за считанные дни — траффик комьюнити отлично конвертится в просмотры, подписки и интеракции. 30% наших высокоуровневых игроков регулярно читают новости.

Здесь мы преследуем сразу 2 цели: обучить игроков и создать инфлюенсера на YouTube.

При хорошем DAU увеличить охват ивента или турнира тоже можно в два счета. Вы получаете инструмент Call to action. Опишите условия ивента заранее, и игрок начнет к нему готовиться, так как он знает — осведомлен значит вооружен. Как извлечь из этого пользу, зависит от ваших целей.

Разработчики Vainglory отдельно ведут Community, eSports и News, направляя игроков туда, куда им нужно.

Я не говорю, что продуктовые команды не делают таких фич. Но КМ с возможностью воздействия на фичу способен выжать из неё максимум.

При этом пользователи, которые увидят новость в игре, могут не состоять ни в группах, ни в чатах, но прийти в качестве наблюдателей, что ведет к следующему пункту.

Заблуждение №4: Пока игрок не подписался, КМ с ним не работает

Работает и должен работать.

Скажем, вы запускаете новый многопользовательский проект. Команде комьюнити-менеджеров прилетает задача наладить сбор фидбека.

Игра запустилась, добросовестно ведет пользователя пообщаться на Facebook, оценить игру в сторе, записать видео на YouTube.

Далее КМ получает комментарий, оценку и видео. Комментарий говорит, что игра становится скучной, оценка — тройка, в видео — критика. За неделю таких набирается 10/100/1000 пользователей и в отделе формируется отчет «всё плохо, игроки недовольны».

Но аналитики не подтверждают эту информацию — ретеншн выше ожидаемого, гроссят хорошо, DAU растет. Их вывод: КМ предоставил недостоверные данные, или проблема попросту не локализована.

Но кто как не источник этих данных может локализовать проблему? Тогда КМ, который знает недовольного игрока (или группу игроков), может создать выборку аналогичных пользователей и посмотреть на наличие просадок. Всё, проблема будет обнаружена, никакой ложной тревоги и лишних вопросов.

Пример:

КМ получает фидбек о балансе — какое-то оружие по мнению игроков не эффективно. Он говорит о наличии проблемы, но ни продажи, не используемость оружия не снизились. КМ определяет группу игроков — это конкретная лига — и видит следующее:

На графике процент спавнов с оружием в разных лигах. С такой информацией КМ не поднимет тему «игроки недовольны, оружие плохое». Он скажет, какая точно проблема вызывает недовольство и у кого (в этом случае Weapon 1 в низких-средних лигах, и Weapon 2 — в высоких).

Аналитика смотрит на всех, не важно, подписаны пользователи на ваши страницы или нет. Единственное отличие активного игрока в том, что он с вами разговаривает. Такие же проблемы могут быть и у тех, кто молчат. И смотря на всех сразу, КМ будет иметь объективную картину, сможет правильно реагировать и действовать. Ему нужно понимать, что часто оцениваемая им ситуация — только часть реальной. Доступ в аналитику и соответствующее обучение в нашем случае сработали как надо.

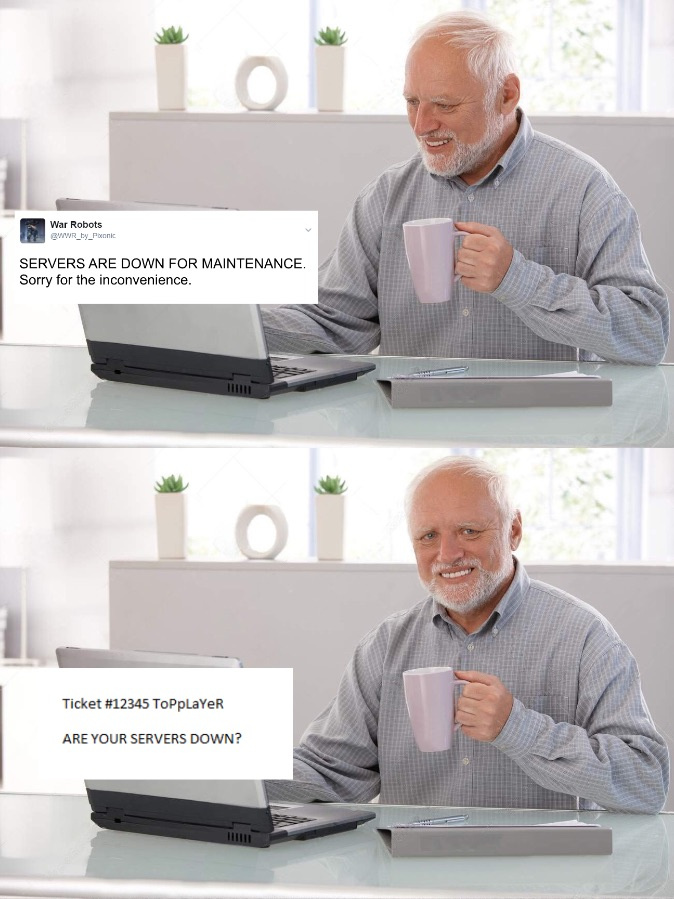

Заблуждение №5: КМ выполняет функции техподдержки

Вернемся в кофейню. Предположим, клиента не устроило качество кофе. В идеальном мире вашей собственной кофейни вы решите, что нужно что-то предпринять, компенсируете недовольство и устраните проблему.

Когда кофейня станет больше, роли разделятся. Сотрудник примет жалобу, менеджер компенсирует недовольство, владелец решит как устранить проблему.

Теперь, как и в прошлый раз, увеличиваем охват. Каждый пользователь, испытавший проблему с сервисом будет требовать индивидуального подхода. И он будет индивидуальным как ни крути, ведь нужно знать суть вопроса перед написанием ответа (или выбором макроса). Инструмент агента поддержки — это тет-а-тет диалог с отдельным обратившимся пользователем (что во многих случаях создает полный рабочий день большой команды).

В этом главное различие. КМ могут и должны обращаться к группам, чтобы информировать, призывать к действию и дополнять игровой опыт диалогом с пользователями, собирать мнения — всё зависит от целей. Зона ответственность КМ — это:

- внутриигровые новости и другие социальные фичи;

- сайт и форум;

- социальные сети и чаты;

- лидеры мнений, контент-мейкеры и др.;

- аналитика проекта;

- социальная аналитика и опросы.

Например, чем больше клиентов охватывает публикация, тем меньше пользователей обратятся на эту тему в саппорт. Еще одна причина работать на охват вместо лайков. Скажем, не работает игра. Что будете делать — сразу писать в поддержку или сначала зайдете на официальную страницу? Задача КМ — научить игроков читать объявления и новости, помочь им выработать такую привычку.

В итоге

Сами КМ иногда сравнивают себя с «универсальными солдатами». Это действительно так, но только если они умеют пользоваться вооружением и знают свою цель. Сейчас на рынке уже появляются кандидаты с устоявшимся мнением о многофункциональности комьюнити-менеджера. И если им предложат заниматься только SMM или только поддержкой, они вскинут брови и вежливо откажутся. Такие люди мотивированы не только поддерживать, но и строить.

КМ постепенно перестает быть входной точкой в игровую индустрию, у компаний появляется потребность в людях с пониманием, опытом и экспертизой. И я очень надеюсь, что эта статья будем им хоть в чем-то полезной.

Полезных ссылок н-н-нада?

blog.socious.com/10-most-popular-online-community-tips-2015

yantami.de

www.feverbee.com

www.amazon.com/Buzzing-Communities-Bigger-Better-Active/dp/0988359901

www.amazon.com/Net-Work-Patti-Anklam/dp/0750682973

|

Метки: author IvoryBuk управление сообществом развитие стартапа блог компании pixonic комьюнити комьюнити-менеджер комьюнити-менеджмент сообщество community |

Предотвращение негативных последствий при разработке систем искусственного интеллекта, превосходящих человеческий разум |

Статей о том, что совсем скоро придут башковитые роботы и всех поработят бесконечное множество. Под катом еще одна заметка. Предлагаем вам ознакомиться с переводом выступления Нейтана Суареса, посвящённого определению целей систем искусственного интеллекта в соответствии с задачами оператора. На этот доклад автора вдохновила статья «Настройка искусственного интеллекта: в чем сложность и с чего начать», которая является основой для исследований в сфере настройки искусственного интеллекта.

Введение

Я являюсь исполнительным директором Научно-исследовательского института искусственного интеллекта (НИИ ИИ). Наш коллектив занимается исследованиями в области создания искусственного интеллекта в долгосрочной перспективе. Мы работаем над созданием продвинутых систем ИИ и исследуем возможные области его применения на практике.

Исторически сложилось так, что наука и технологии стали мощнейшими драйверами как положительных, так и отрицательных изменений, связанных с жизнью человека и прочих живых организмов. Автоматизация научно-технических разработок позволит совершить серьезный прорыв в развитии, невиданный со времен промышленной революции. Когда я говорю о «продвинутых системах искусственного интеллекта», я имею в виду возможную реализацию автоматизации исследований и разработок.

Системы искусственного интеллекта, превосходящие человеческие возможности, будут доступны человечеству еще не скоро, однако в настоящее время разработки в этом направлении ведутся многими продвинутыми специалистами, то есть, не я один уповаю на создание подобных систем. Полагаю, что мы действительно в состоянии создать нечто вроде «автоматизированного ученого», и данный факт следует воспринимать довольно серьезно.

Зачастую люди, упоминая о социальных последствиях создания искусственного интеллекта, становятся жертвами антропоморфической точки зрения. Они приравнивают искусственный интеллект к искусственному сознанию, либо полагают, что системы искусственного интеллекта должны быть схожи с человеческим интеллектом. Многие журналисты выражают обеспокоенность тем, что при преодолении искусственным интеллектом определенного уровня развития он приобретет массу естественных человеческих недостатков, в частности, захочет власти над окружающими, начнет самостоятельно пересматривать запрограммированные задачи и бунтовать, отказываясь выполнять свое запрограммированное предназначение.

Все эти сомнения беспочвенны. Человеческий мозг — сложный продукт естественного отбора. Системы, превосходящие человеческие возможности в научной сфере, будут схожи с человеческим мозгом не более, чем первые ракеты, самолеты и воздушные шары были схожи с птицами. 1

Системы искусственного интеллекта, освобождающиеся от «оков» программного исходного кода и приобретающие человеческие желания — не более чем фантазия. Система искусственного интеллекта представляет собой программный код, исполнение которого инициируется оператором. Процессор пошагово выполняет инструкции, содержащиеся в программном регистре. Теоретически возможно написать программу, манипулирующую собственным кодом, вплоть до установленных целей. Но даже эти манипуляции проводятся системой в соответствии с написанным нами исходным кодом, а не производятся самостоятельно машиной по ее внезапно возникшему собственному желанию.

По-настоящему серьезной проблемой, связанной с искусственным интеллектом, является правильность определения целей и минимизация непреднамеренных событий в случае их ошибочности. Соавтор книги «Искусственный интеллект: современный подход» Стюарт Расселл говорит по этому поводу следующее:

Главная проблема заключается не в создании пугающего искусственного разума, а в способности принимать решения высокого качества. Под качеством понимается функция полезности осуществляемых действий для достижения результата, заданного оператором. В настоящее время существуют следующие проблемы:

- Функцию полезности не всегда можно сопоставить с человеческими показателями, которые достаточно сложно определить.

- Любая достаточно продвинутая система искусственного интеллекта предпочтет обеспечить собственное существование и занять физические и вычислительные мощности, но не ради собственной «выгоды», а для решения поставленной задачи.

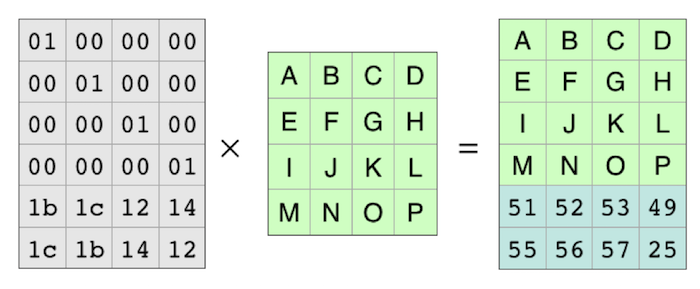

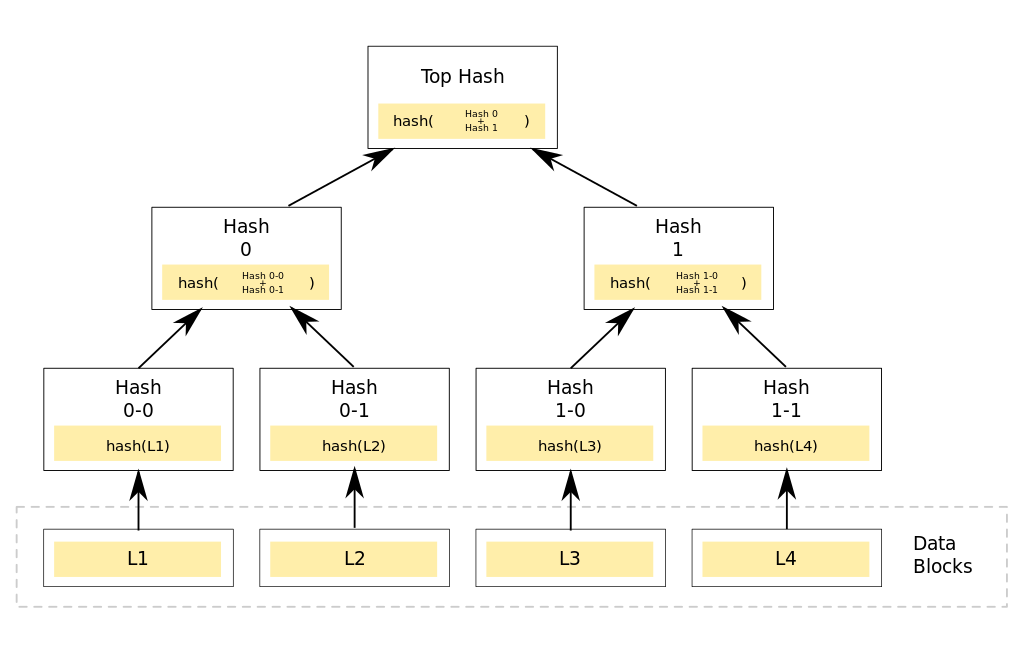

Система, оптимизирующая функцию из n переменных, для которой целевая функция зависит от подмножества k

Указанные проблемы заслуживают большего внимания, чем антропоморфические риски, являющиеся основой сюжетов многих голливудских блокбастеров.

Простые идеи не работают

Задача: наполнить котел

Многие люди, говоря о проблемах искусственного интеллекта, рисуют в своем воображении Терминатора. Однажды мои слова об искусственном интеллекте были процитированы в одной новостной статье, посвященной людям, размещающим изображение Терминатора в своих трудах об искусственном интеллекте. В тот день я сделал определенные выводы о СМИ.

Я думаю, в качестве иллюстрации для подобных статей больше подходит следующая картинка:

На картинке изображен Микки Маус в мультфильме «Фантазия», ловко околдовавший метлу, которая наполняет котел по его желанию.

Как Микки это сделал? Представим, что Микки пишет компьютерную программу, выполняемую метлой. Микки начинает код с функции подсчета или целевой функции:

Учитывая некоторый набор доступных действий А, Микки пишет программу, принимающую в качестве входных данных одно из этих действий а и рассчитывающую определенную оценку в случае выполнения метлой этого действия. После этого Микки может написать функцию, вычисляющую действие а, имеющее максимальную оценку:

Использование величины “sorta-argmax” обусловлено возможным недостатком времени для оценки каждого действия множества А. Для реалистичных наборов действий необходимо найти только действие с максимальной оценкой с учетом ограниченности ресурсов, даже если это действие не является наилучшим.

Программа может казаться простой, однако вся загвоздка скрывается в деталях: создание алгоритма точного предсказания результата и умного поиска с учетом входных действий является главной проблемой создания системы искусственного интеллекта. Но концептуально данная задача решается довольно просто: мы можем подробно описать все виды операций, которые может выполнять метла, и последствия этих операций, разнесенные по разным уровням производительности.

Когда Микки запускает свою программу, первоначально все идет как надо. Однако, затем происходит следующее:

Такое сравнительное описание искусственного интеллекта является, по моему мнению, весьма реалистичным.

Почему мы ожидаем, что система искусственного интеллекта, выполняющая вышеуказанную программу, начнет переполнять котел, либо будет использовать чрезмерно «тяжелый» алгоритм проверки полноты котла?

Первая проблема заключается в том, что целевая функция, заданная для метлы, предлагает множество других исходов, которые не предусмотрел Микки:

Вторая проблема заключается в том, что Микки запрограммировал метлу на достижение результата на основе максимальной оценки. Задача «наполнить один котел водой» выглядит достаточно простой и ограниченной, однако если оценивать ее с вероятностной точки зрения, становится ясно, что ее оптимизация приводит к абсурдным результатам. Если котел с 99.9% вероятностью наполнен, но существуют дополнительные ресурсы, программа всегда будет искать способы задействования этих ресурсов для увеличения вероятности.

Сравните такой исход с ограниченной задачей, которую мы держим у себя в уме. Мы хотим наполнения котла, однако интуитивно не хотим, чтобы система «перетруждалась», даже если у нее есть доступные виртуальные и физические ресурсы для решения проблемы. Мы хотим, чтобы система использовала творческий и изобретательный подход в некоторых интуитивных рамках и не применяла абсурдные стратегии, особенно с непредсказуемыми последствиями. 2

В данном примере первоначальная целевая функция выглядит достаточно логичной. Она была обоснована и довольно проста. Не было предусмотрено способа получить больший уровень полезности. Она не похожа на систему, в которой используется только одна точка заливки воды — но однозначно существуют предпосылки переполнения котла. Проблема кроется в факте максимизации ожидаемой полезности. В результате цель не имеет ограничений, и даже небольшая ошибка в функции системы может привести к ее некорректной работе.

Существует множество вариантов, когда вполне определенная цель может оказаться неограниченной. Например, крупная система с глобальной задачей может состоять из подпроцессов, которые сами по себе будут стараться максимизировать возможные исходы функции, например задача оптимизации памяти. Если вы не понимаете систему настолько, чтобы определить, какие из процессов являются ресурсоемкими неограниченными оптимизаторами, то не важно, насколько определенной и безопасной является цель верхнего уровня.

Таким образом, метла может продолжать лить воду по причине, например, утечки в котле, либо, если установленный порог наполненности котла оказывается немного выше уровня краев. И, конечно же, метла не «бунтует» против кода Микки. Получается, что метла просто стремится к целям, которые были установлены слишком эффективно.

Частная проблема: кнопки останова

Общим решением данной проблемы должен выступать следующий алгоритм: «Могут возникнуть непредвиденные последствия выполнения общей функции, в результате чего ее выполнение должно быть прекращено».

Микки пробует такой вариант, однако он не работает:

Этот вариант также реалистичен для систем, которые достаточно эффективны для моделирования среды. Если система пытается ускорить выполнение оценочной функции и в состоянии распознать, что ее отключение может привести к использованию данных с более низким скорингом (более низкой оценкой эффективности), она старается предотвратить принудительное отключение. Чем более продвинутой является система, тем больше шансов, что она будет искать способы достижения этой подцели, например, путем копирования себя в интернет, либо путем обмана программистов, вводя их в заблуждение относительно ее функциональности.

Это не означает, что невозможно отключить продвинутую систему искусственного интеллекта; для этого необходимо провести дополнительную работу по предотвращению развития событий, когда система будет искать способы предотвращения преждевременного отключения. Если вы написали код, который будет искать способы предотвращения принудительного останова его исполнения, не стоит его запускать, даже если вы убеждены, что он не сработает — существуют гораздо более полезные задачи для загрузки вычислительных ресурсов, которые в данном случае оказываются заняты поиском решения для побочных и вредных задач.

Соответствующие меры безопасности, не предполагающие постоянного слежения и корректировки системы, требуют определенных изменений целевой функции. Необходимо определить, каким образом формально определить целевые функции, чтобы система искусственного интеллекта не пыталась конфликтовать с операторами; либо необходимо определить, каким образом система достигает целей без оптимизации целевых функций. Например, мы можем ограничить возможности системы, определив небольшой список разрешенных доменов, не позволяющих системе анализировать способы предотвращения ее отключения.

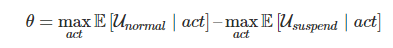

Одним из очевидных решений является попытка изменения функции оценки с введением кнопки отключения B:

Это означает, что, если кнопка останова активирована, цель системы изменяется с «наполнить котел» на «приостановить работу».

Не вполне ясно, каким образом необходимо фактически определять цель, если в функции приостановки есть какие-либо дыры, система попытается их использовать в своих целях. Например, она может заполнить значение операторов функции приостановки при выполнении подзадач или подпроцессов, стартуемых при запуске процесса наполнения котла. Это может привести к одновременному выполнению условий «котел полон» и «работа приостановлена», образно говоря «на всякий случай», независимо от состояния кнопки.

Однако, предположим, что мы нашли достаточно точный способ определения процесса остановки. Теперь возникает новая проблема, суть которой заключается в том, что мы передали системе слишком много полномочий по определению состояния кнопки. Если система получает возможность влиять на решение оператора по нажатию кнопки останова или любую другую возможность получить больший контроль над собственным исполнением, она будет стараться использовать эту возможность и будет проверять, нажата или не нажата кнопка в случае, если выполнение этой задачи будет более легким, чем выполнение задачи приостановки или наполнения котла.

Что удивительно, современные технологии в этой области не являются намного более продвинутыми, нежели описанная схема. Даная проблема рассмотрена в статье, написанной мной в соавторстве с Фолленштейном, Юдковским и Армстронгом (“Возможность внесения поправок“) и подтверждена соответствующими результатами Орсо и Армстронга (“Средства безопасного прерывания исполнения кода“).

Все, что нам нужно — это комбинирование двух целевых функций: первоначальной функции для нормальной работы системы и функции приостановки для «засыпания» системы и сохранения состояния на жесткий диск.

Наш метод комбинирования функций должен удовлетворять трем условиям: оператор должен иметь возможность переключаться между функциями (например, с помощью кнопки); система не должна стараться управлять активностью функций; если система в состоянии влиять на нашу возможность переключаться между функциями, она не должна использовать эту возможность.

До сих пор мы не нашли способа одновременного достижения всех трех целей. Например, мы можем попытаться предотвратить любое вмешательство системы в управление, если кнопка останова нажата, введя целевую функцию отключения, которой всегда присваивается определенное значение в зависимости от состояния кнопки:

К сожалению, данный подход не позволяет выполнить третье условие. Оказывается, что определенная выше функция приводит к нулевому значению вероятности нажатой кнопки. Система не будет намеренно вмешиваться в определение состояния кнопки, однако с легкостью внесет правки, игнорирующие код определения состояния кнопки, либо создаст агенты, которые также будут игнорировать кнопку.

Выполнение этих интуитивно простых ограничений превращается в нетривиальную задачу. Это порождает множество вопросов в данной области: традиционные инструменты и концепции приводят к проблемам с безопасностью, которые не проявляются в рамках обычных исследований.

Общая картина

Приоритеты настройки

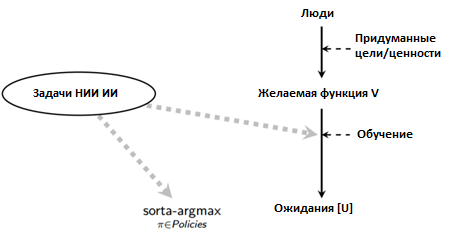

Отступим на шаг назад и поговорим о необходимости настройки продвинутой системы искусственного интеллекта в соответствии с нашими интересами.

Приведу максимально упрощенную схему: предположим, несколько людей придумывают определенную задачу, цель или набор предпочтений, которые выступают в роли функции предполагаемых значений V. Поскольку эти значения сложны и чувствительны к контексту, на практике необходимо формировать системы, которые будут со временем самостоятельно обучаться без необходимости ручного формирования кода. 3 Назовем конечную цель системы искусственного интеллекта параметром U (может совпадать или не совпадать с параметром V).

Публикации в прессе по данной области чаще всего фокусируются на одной из двух проблем: «Что если искусственный интеллект будет разработан «неправильной» группой людей?» и «Что если естественные желания системы искусственного интеллекта U будут отличаться от задачи V?»

С моей точки зрения, проблема «неправильной группы людей» не должна быть предметом беспокойства до тех пор, пока у нас нет прецедентов создания системы искусственного интеллекта «правильной группой людей». Мы находимся в ситуации, когда все попытки полезного использования системы искусственного интеллекта терпят неудачу. Простой пример: если бы мне передали крайне мощный оптимизатор в виде черного ящика, я смог бы оптимизировать любую математическую функцию, однако результаты были бы настолько обширными, что я бы не знал, как использовать этот оптимизатор для разработки новой технологии или осуществления научного прорыва без непредсказуемых последствий. 4

Мы многое не знаем о возможностях искусственного интеллекта, однако мы, тем не менее, имеем представление, как выглядит прогресс в данной области. Существует множество отличных концепций, техник и метрик, и мы приложили значительные усилия для решения проблем с разных точек зрения. В то же время, наблюдается слабое понимание проблемы настройки высокопроизводительных систем под конкретные цели. Мы можем перечислить некоторые интуитивные положения, однако до сих пор не разработаны универсальные концепции, техники или метрики.

Я считаю, что в данной области существуют достаточно очевидные вещи, и что нужно оперативно осуществить огромный объем работы (например, определить направление исследований возможностей систем — некоторые из этих направлений позволяют создать системы, которые гораздо проще подогнать под нужные результаты). Если мы не решим эти проблемы, разработчики, имеющие как положительные, так и отрицательные намерения, будут одинаково приходить к отрицательным результатам. С академической или научной точек зрения, наша основная цель в сложившейся ситуации должна заключаться в исправлении вышеупомянутых недостатков для обеспечения технологической возможности достижения положительных результатов.

Многие люди быстро признают, что «естественные желания системы» являются фикцией, но делают выводы, что необходимо фокусироваться на других проблемах, широко рекламируемых в СМИ: «Что если система искусственного интеллекта попадет не в те руки?», «Как искусственный интеллект повлияет на безработицу и распределение ценностей в обществе?» и пр. Это важные вопросы, однако едва ли они будут актуальными, если мы сможем обеспечить минимальный уровень безопасности и надежности при создании системы искусственного интеллекта.

Другой распространенный вопрос: «Почему бы просто не установить системе определенные моральные запреты? Такие идеи зачастую связаны с произведениями Айзека Азимова и подразумевают обеспечение надлежащего функционирования систем искусственного интеллекта, применив естественный язык для программирования определенных задач, однако такое описание будет довольно расплывчатым и не позволит полностью охватить все человеческие этические рассуждения:

Напротив, точность — это достоинство существующих программных комплексов, для которых необходимо обеспечить должный уровень безопасности. Нейтрализация риска несчастных случаев требует ограниченности целей, а не «решения» всех моральных аспектов. 5

Я считаю, что работа по большей части должна заключаться в создании эффективного процесса обучения и в проверке правильности привязки процесса sorta-argmax к результирующей целевой функции U:

Чем лучше концепция процесса обучения, тем менее ясным и точным может быть определение желаемой функции V, и тем менее значимой становится проблема выяснения того, что вы хотите от системы искусственного интеллекта. Однако организация эффективного процесса обучения связана с целым рядом трудностей, которые не возникают при стандартных задачах машинного обучения.

Классическое исследование возможностей концентрируется в частях диаграммы «sorta-argmax» и «Ожидания», однако sorta-argmax также содержит в себе рассмотренные мной, но зачастую игнорируемые проблемы обеспечения прозрачности и безопасности. Чтобы понять необходимость правильной привязки процесса обучения к возможностям системы, а также важность и трудность этой задачи, нужно обратиться к собственной биологической истории.

Естественный отбор — единственный понятный нам «инженерный» процесс, который привел к интеллектуальному развитию, то есть к развитию нашего мозга. Поскольку естественный отбор нельзя назвать умным механизмом, можно прийти к выводу, что общего интеллектуального развития можно добиться трудом и грубой силой, однако данный процесс является достаточно эффективным только с учетом человеческой креативности и чувства предвидения.

Еще одним ключевым фактором является то, что естественный отбор был направлен только на выполнение элементарной задачи — определение генетической пригодности. Однако, внутренние цели людей не имеют отношения к генетической пригодности. Наши цели являются неисчисляемыми и неизмеримыми — любовь, справедливость, красота, милосердие, веселье, уважение, хорошая пища, крепкое здоровье и пр., однако следует учесть, что все эти цели тесно коррелировали с задачами выживания и размножения в древнем мире. Тем не менее, мы оцениваем конкретно эти качества, а не связываем их с генетическим распространением человечества, что наглядно подтверждается введением процедур по контролю рождаемости.

В данном случае, внешнее оптимизационное давление привело к развитию внутренних целей, не соответствующих внешнему селекционному воздействию. Получается, что действия людей расходятся с псевдоцелями естественного отбора, в результате чего они получили новые возможности, соответственно точно также можно ожидать, что действия систем искусственного интеллекта могут отличаться от установленных человеком целей, если эти системы будут представлять собой черные ящики для пользователей.

Применив градиентный спуск к черному ящику с целью достижения наилучшего результата и обладая достаточной изобретательностью, мы в состоянии создать некоторый мощный оптимизационный процесс. 6 По умолчанию следует ожидать, что цель U будет тесно коррелировать с целью V в тестовых условиях, однако будет значительно отличаться от V в других условиях или при введении большего числа доступных параметров.

С моей точки зрения, самая важная часть проблемы подстройки — обеспечение того, чтобы обучающая конструкция и общая конструкция системы позволила приоткрыть завесу и была в состоянии сообщить нам после оптимизации о соответствии (или несоответствии) внутренних целей установленным для процесса обучения целям. 7

Данная задача имеет сложное техническое решение, и, если мы не сможем его понять, будет неважно, кто стоит ближе к разработке системы искусственного интеллекта. Хорошие намерения не встраиваются добрыми программистами в их программы, и даже самые благие намерения при разработке системы искусственного интеллекта не имеют никакого значения, если мы не в состоянии привести практическую пользу системы в соответствии с установленными целями.

Четыре ключевых предположения

Давайте сделаем еще один шаг назад: я привел актуальных открытых проблем в данной области (кнопка останова, процесс обучения, ограниченность задач и пр.) и подчеркнул наиболее сложные для решения категории. Однако я лишь расплывчато упомянул, почему я считаю искусственный интеллект очень важной областью: «Система искусственного интеллекта может автоматизировать научные изыскания общего назначения, что уже само по себе является прорывом». Давайте глубже разберемся, зачем стоит прикладывать усилия в данном направлении.

Во-первых, цели и возможности ортогональны. Это означает, что целевая функция системы искусственного интеллекта не позволяет оценить качество оптимизации этой функции, а осведомленность о наличии мощного оптимизатора не позволяет понять, что именно он оптимизирует.

Полагаю, большинство программистов интуитивно понимает это. Некоторые люди продолжают настаивать на том, что, когда система, наполняющая котел, станет достаточно «умной», она посчитает цель наполнения котла недостойной своего интеллекта и откажется от нее. С точки зрения компьютерной науки очевидным ответом является то, что вы можете выйти за рамки построения системы, проявляющей условное поведение, то есть построить систему, не следующую заданным условиям. Такая система может заниматься поиском более скорингового варианта наполнения котла. Поиск наиболее оптимизированных вариантов может оказаться скучным для нас с вами, однако вполне реально написать программу, которая будет заниматься таким поиском в свое удовольствие. 8

Во-вторых, достаточно оптимизированные цели сходятся, как правило, при состязательных инструментальных стратегиях. Большинство целей системы искусственного интеллекта могут требовать создания подцелей, таких как «приобретение ресурсов» и «непрерывность работы» (наряду с «изучением среды» и пр.).

С этим связана проблема кнопок останова: даже если вы не указали в спецификации целей условия продолжения работы, любая цель, которую вы задали системе, скорее всего, будет эффективнее достигнута при непрерывной работе системы. Возможности программных систем и (конечные) цели ортогональны, однако они часто проявляют сходное поведение, если определенный класс действий полезен для самых различных возможных целей.

Пример Стюарта Расселла: если вы построите робота и попросите его сходить в магазин за молоком, робот выберет наиболее безопасный путь, поскольку вероятность возврата с молоком, в данном случае, будет максимальной. Это не означает, что робот боится смерти; это означает, что робот не принесет молоко в случае смерти, чем и объясняется его выбор.

В-третьих, системы искусственного интеллекта общего назначения вероятнее всего, будут очень быстро и эффективно развиваться. Возможности человеческого мозга ниже аппаратных (или, как некоторые считают, программных) возможностей вычислительной системы, поэтому, с учетом также целого ряда других преимуществ, от продвинутых систем искусственного интеллекта следует ожидать быстрого и резкого развития возможностей.

Например, Google может приобрести многообещающий стартап, связанный с искусственным интеллектом, и задействовать огромные аппаратные ресурсы, в результате чего проблемы, решение которых планировалось в ближайшее десятилетие, могут быть решены в течение года. Либо, например, при появлении широкомасштабного доступа в интернет и наличии особого алгоритма, система может значительно увеличить свою производительность, либо сама предложит программно-аппаратные варианты увеличения производительности. 9

В-четвертых, задача настройки продвинутых систем искусственного интеллекта в соответствии с нашими интересами является достаточно сложной.

Грубо говоря, в соответствии с первым предположением, системы искусственного интеллекта естественным образом не разделяют наши цели. Второе предположение гласит, что по умолчанию системы с существенно разными целями будут бороться за ограниченные ресурсы. Третье предположение демонстрирует, что состязательные системы искусственного интеллекта общего назначения имеют значительные преимущества над человеком. Ну и в соответствии с четвертым предположением, проблема имеет сложное решение — например, сложно задать системе необходимые значения (с учетом ортогональности), либо предотвратить отрицательные стимулы (направленные на конвергентные инструментальные стратегии).

Эти четыре предположения не означают, что мы застряли в развитии, однако свидетельствуют о наличии критически важных проблем. Необходимо в первую очередь сконцентрироваться на этих проблемах, поскольку, если они будут решены, системы искусственного интеллекта общего назначения могут принести огромные выгоды.

Фундаментальные трудности

Почему я полагаю, что проблема настройки системы искусственного интеллекта в соответствии с целями является достаточно сложной? В первую очередь, я основываюсь на своем опыте работы в данной области. Я рекомендую вам самостоятельно рассмотреть эти проблемы и попытаться решить их при настройках игрушек — вы во всем убедитесь сами. Перечислю несколько структурных причин, свидетельствующих о сложности поставленной задачи:

Во-первых, настройка продвинутых систем искусственного интеллекта выглядит сложной по той же причине, по которой проектирование космической техники сложнее самолетостроения.

Естественной мыслью является предположение, что для системы искусственного интеллекта необходимо всего лишь принять меры безопасности, требуемые для систем, превосходящих человеческие возможности. С этой точки зрения, вышеперечисленные проблемы совсем не очевидны, и кажется, что все решения для них могут быть найдены при проведении узкоспециализированного исследования (например, при испытании автопилотов для автомобилей).

Точно также, не вдаваясь в подробности, можно утверждать: «А почему это космические разработки сложнее самолетостроения? Ведь используются одни и те же физические и аэродинамические законы, разве не так?» Вроде все верно, однако, как показывает практика, космическая техника взрывается гораздо чаще самолетов. Причиной этого являются значительно большие нагрузки, которые испытывает летательный аппарат, в результате чего даже малейшая неисправность может привести к катастрофическим последствиям. 10

Аналогично, хотя узкоспециализированная система ИИ и система ИИ общего назначения схожи, системы ИИ общего назначения имеют больший диапазон воздействий, в результате чего риски возникновения опасных ситуаций растут в лавинообразной пропорции.

Например, как только система искусственного интеллекта начинает понимать, что (i) ваши действия влияют на ее способности достижения целей, (ii) ваши действия зависят от вашей модели мира и (iii) ваша модель мира зависит от ее действий, резко возрастают риски того, что даже малейшие неточности могут привести к вредоносному поведению системы (включая, например, обман пользователя). Как и в случае с космической техникой, масштабность системы приводит к тому, что даже малейшие неисправности могут стать причиной больших проблем

Во-вторых, задача настройки системы сложна по тем же причинам, по которым гораздо проще написать хорошее приложение, чем построить хороший космический зонд.

В НАСА существует целый ряд интересных инженерных практик. Например, формируется что-то вроде трех независимых команд, каждой из которых выдаются одни и те же технические требования для разработки одной и той же программной системы. В итоге проводится голосование и выбирается реализация, набравшая большинство голосов. По сути, тестируются все три системы, и, в случае обнаружения каких-либо расхождений, наилучшая реализация кода выбирается большинством голосов. Идея заключается в том, что любая реализация будет иметь ошибки, но маловероятно, что все три реализации будут иметь ошибки в одном и том же месте.

Такой подход является гораздо более осторожным, чем, например, выпуск новой версии WhatsApp. Одна из главных причин проблемы — космический зонд сложно откатить к предыдущей версии, а вот в случае с WhatsApp это не доставляет особых проблем. Вы можете отправлять на зонд обновления и исправления только в случае, если работают приемник и антенна и отправляемый код полностью работоспособен. В данном случае, если система, требующая внесения правок, уже не работоспособна, то нет способов исправить существующие в ней ошибки.

В некотором отношении система искусственного интеллекта похожа скорее на космический зонд, чем не обычное программное обеспечение. Если вы пытаетесь создать нечто умнее себя, определенные части этой системы должны работать идеально с первой попытки. Мы можем выполнить все тестовые прогоны, которые хотим, но как только система будет запущена в действие, мы сможем проводить только онлайн обновления, да и то только в случае, если код позволяет это и работает корректно.

Если вы еще не до конца испугались, предлагаю поразмышлять о том, что будущее нашей цивилизации может зависеть от нашей способности писать код, который правильно работает при первом развертывании.

И наконец, задача настройки является сложной по той же причине, по которой сложна система компьютерной безопасности: система должна быть надежной при интеллектуальном поиске пробелов в безопасности.

Предположим, у вас есть десяток уязвимостей в коде, каждая из которых не является критичной или даже не несет проблем при обычных условиях работы. Защита программы является сложной задачей, поскольку необходимо сразу учесть, что умный хакер найдет все десять дыр в безопасности и будет их использовать для взлома вашей системы. В результате, программа может быть искусственно «загнана» в аварийный режим, чего не могло наблюдаться при обычной ее работе; атакующий может заставить систему использовать странные алгоритмы, о которых вы даже не могли подумать.

Аналогичная проблема наблюдается и для систем искусственного интеллекта. Суть ее заключается не в управлении состязательным режимом системы, а в предотвращении входа системы в этот режим. Не нужно пытаться перехитрить умную систему — это заранее проигрышная позиция.

Вышеперечисленные проблемы схожи с проблемами в криптографии, поскольку при настройке целей системы нам приходится иметь дело с системами, занимающимися интеллектуальным поиском в крупном масштабе, в результате чего программный код может исполняться практически непредсказуемым образом. Это связано с использованием экстремальных значений, которые используются системой при проведении процесса оптимизации 11. Разработчикам систем искусственного интеллекта необходимо перенимать опыт специалистов по компьютерной безопасности, которые тщательно тестируют все экстремальные случаи.

Очевидно, что гораздо проще сделать код, который хорошо работает ожидаемым для вас способом, чем делать код, который может привести к результатам, которых вы не ждете. Система искусственного интеллекта должна успешно работать любым, даже непонятным вам способом.

Подведем итоги. Мы должны решать задачи с той же осторожностью и точностью, с которой разрабатывается космический зонд, и должны провести все необходимые исследования до запуска системы. На этом раннем этапе ключевой частью работы является только формализация базовых концепций и идей, доступных для использования и критики другими специалистами. Философская дискуссия о типах кнопок останова — это одно дело; гораздо сложнее перевести свою интуицию в уравнение, чтобы другие смогли полностью оценить ваши рассуждения.

Данный проект является очень важным, и я призываю всех заинтересовавшихся принять в нем участие. В интернете имеется большое количество ресурсов по данной тематике, включая информацию об актуальных технических проблемах. Можете начать с изучения исследовательских программ НИИ ИИ и со статьи «Конкретные проблемы безопасности в системах искусственного интеллекта», которую вы можете найти на Google Brain, OpenAI и Stanford.

Примечания

- Самолет не может исправлять собственные повреждения или размножаться, но он в состоянии перевозить тяжелые грузы быстрее и дальше, чем птицы. Самолеты во многих отношениях проще птиц, однако они обладают большими возможностями с точки зрения грузоподъемности и скорости (для чего они и были разработаны). Вполне вероятно, что ранние автоматизированные ученые также во многих отношениях будут проще человеческого разума, однако будут превосходить его в определенных задачах. И так же, как конструкция и дизайн самолетов выглядят чуждыми по сравнению с архитектурой биологических существ, мы может ожидать, что конструкция высокопроизводительных систем ИИ будет значительно отличаться от архитектуры и логики человеческого разума.

- Попытка формализовать различие конечных и неопределенных целей является насущной исследовательской проблемой. В соответствии с исследовательской статьей “Настройка целей для продвинутых самообучающихся систем”, необходимо применять мягкую оптимизацию («не слишком усердную оптимизации») с консервативным подходом («избегать абсурдных стратегий») и постараться предотвратить крупные непредсказуемые последствия. Более подробная информация по предотвращению негативных последствий можно найти в статье Дарио Амодея, Криса Олаха, Якова Штейнхардта, Пола Криштиано, Джона Шульмана и Дена Мейнза “Конкретные проблемы обеспечения безопасности в системах искусственного интеллекта.”

- За последнее десятилетие мы осознали, что компьютеру практически невозможно вручную описать кошку, но его можно научить распознавать кошку. Еще более безнадежна попытка описать человеческие ценности, однако вполне вероятно, что можно разработать обучающую систему, которая могла бы изучить понятие «ценностей».

- Ознакомьтесь со статьями «Цели с точки зрения среды», «Малоэффективные агенты» и «Мягкая оптимизация» для определения физических целей, не вызывающих катастрофических побочных эффектов.

Грубо говоря, НИИ ИИ фокусируется на исследованиях, которые помогут нам принципиально понять, как задавать цели системам искусственного интеллекта, в результате чего возникающие перед нами задачи становятся более понятными.

Что я имею в виду? Предположим, мы пытаемся разработать новую шахматную программу. Достаточно ли мы понимаем задачу, если нам просто дадут высокопроизводительную систему? Если мы понимаем задачу, мы формируем дерево поиска, ищем в нем похожие шахматные ходы и выбираем оптимальный вариант, ведущий к победе.

Если же мы недостаточно понимаем задачу, даже имея достаточные вычислительные мощности, мы были бы не в состоянии реализовать шахматную программу. Мы либо не использовали бы дерево поиска, либо просто не знали бы, каким образом ходят определенные шахматные фигуры.

Именно в такой ситуации мы находились в сфере разработки шахматных программ до основной работы Клода Шеннона, и именно в такой ситуации мы находимся в настоящий момент в области разработки искусственного интеллекта. Неважно, какими вычислительными мощностями я обладаю, я не в состоянии создать систему искусственного интеллекта, решающую даже самые простые и определенные задачи, будь то задача «положить клубнику на тарелку», либо задача «максимизировать количество алмазов во вселенной».

Если у меня нет конкретной цели для системы, я мог бы написать программу (предполагая наличие вычислительных ресурсов), которая сильно оптимизировала будущее неориентированным образом, используя формализм, такой как AIXI. В этом смысле мы имеем меньше вопросов о возможностях, чем о целях, даже несмотря на недостаток частей паззла с точки зрения практического решения.

Мы знаем, как использовать мощный оптимизатор функций для работы с биткоинами или доказательства теорем. Но в то же время мы не знаем, каким образом безопасно выполнить задачу прогнозирования и поиска решений для объектов в физическом мире, которую я описал в разделе «Задача: наполнить котел».

Нашей целью является разработка и формализация основных подходов и способов определения целей таким образом, чтобы наши инженерные решения не ограничивались тяжелыми вербальными конструкциями, которые зачастую оказываются ошибочными. Проблему можно разделить на некоторые части, которыми можно управлять, просто введя некоторые упрощения вроде «а что если нас не беспокоят ресурсные ограничения» или «что если попытаться достичь более простой цели». Более подобная информация по данной методологии приведена на странице “Методики НИИ ИИ.” - “Наполнять котел, имея недостаточные знания, либо работать слишком усердно, либо столкнуться с негативными последствиями» — вот простой пример интуитивного ограничения возможных вариантов. Мы планируем использовать искусственный интеллект для гораздо более амбициозных целей, но начинать нужно с вполне определенных задач, а не с неограниченных задач.

Три закона робототехники Азимова известны, но бесполезны с исследовательской точки зрения. Сложная задача превращения моральных заповедей в код скрыта за фразами вроде «не допустить вреда человеку своим бездействием». Если неукоснительно следовать подобным правилам, результаты будут катастрофическими, поскольку системам искусственного интеллекта пришлось бы постоянно действовать для предотвращения даже малейшего вреда человеку. Человек, в отличие от машины, придерживается подобных принципов свободно, с учетом чувств и интуиции.

Неопределенное обучение на естественном языке возможно, поскольку системы искусственного интеллекта, вероятнее всего, будут в состоянии понимать человеческую речь. Однако, такой подход приведет к увеличивающемуся разрыву между целевой функцией системы и моделью мира. Система, действующая в человеческой среде, может изучить модель мира, содержащую много информации о человеческом языке и концепции, которую система может в дальнейшем использовать для достижения целей, однако данный факт вовсе не означает, что эта информация приведет к прямому изменению целей системы.

Необходимо определить некий процесс обучения, который позволит системе самостоятельно улучшать целевую функцию с появлением новой информации. Это сложная задача, поскольку в настоящий момент неизвестны метрики или критерии машинного обучения, аналогичные стандартному человеческому обучению.

Если модель мира системы точна в тестовой среде, но не работает в реальном мире, это, скорее всего, приведет к низким оценкам целевой функции — система сама по себе будет стараться ее улучшить. В данном случае, саморегулированию будут подвергнуты ограничения, связанные с тяжестью негативных последствий, поскольку неверная оценка отрицательно повлияет на эффективность определения системой правильности применяемых стратегий.

Если процесс обучения системы приводит к тому, что U соответствует V в тестовой среде, но отличается от V в реальном мире, система не понесет никакого наказания за оптимизацию U. У системы нет стимула относительно U «исправлять» различие между U и V, если изначально процесс обучения был ошибочным. В данном случае риск негативных последствий растет, поскольку несоответствие U и V необязательно налагает ограничения на инструментальную эффективности системы при разработке эффективных и креативных стратегий достижения U.

Проблема разделяется на три части:

- 1. “Делай, что я имею ввиду” — неопределенная задача, и, даже если бы мы смогли создать систему искусственного интеллекта, мы не знали бы, как перевести подобную задачу в код.

- 2. Если выполнение подразумеваемой нами задачи является инструментально обоснованным для достижения определенной цели, достаточно умная система может изучить, каким образом ей выполнять действия, и действовать таким образом до тех пор, пока эти действия будут эффективны для достижения цели. Однако, если система становится еще более умной, она может найти более креативные пути достижения целей, соответственно, задача «делать, что я имею ввиду» может оказаться для системы неоптимальной с инструментальной точки зрения.

- 3. Если мы используем обучение для улучшения целей системы на основе полученных данных, которые, как представляется, направляют систему в сторону U (то есть того, что «мы имеем в виду»), вероятно, что система фактически обнулит U, что мы фактически подразумеваем в процессе обучения, но, с другой стороны, может привести к катастрофическим разночтениям в сложных контекстах. Более подробная информация приведена в “Проклятии Гудхарта”.

- Примеры проблем, с которыми сталкиваются существующие техники обучения целям и фактам, приведены в статье “Использование машинного обучения для устранения рисков, связанных с ИИ.”

- Результат, вероятно, будет не совпадать с человеческой эволюцией, поскольку она связана с множеством исторических событий. Кроме того, результат может оказаться более эффективным вследствие определенных программно-аппаратных преимуществ.

- Данная концепция иногда включается в категорию «прозрачность», но стандартное исследование алгоритмической прозрачности на самом деле не решает проблем. Лучшим термином является, по моему мнению, «понимание». Мы хотим получить более глубокое и более широкое представление о том, какую когнитивную работу выполняет система, и как эта работа связана с целями системы или целями оптимизации, то есть мы хотим получить инструмент, дающий представление о практической инженерной работе.

- Мы могли бы запрограммировать систему на выполнение действий по кругу, но нам этого не нужно. В принципе, можно запрограммировать метлу, которая только находит и выполняет действия, оптимизирующие понятие полноты котла. Улучшение способности системы эффективно находить действия с высоким коэффициентом (в абсолютном смысле или относительно определенного правила скоринга) само по себе не изменяет правило подсчета, которое оно использует для оценки действий.

- Мы можем представить, что последний случай приводит к циклу обратной связи, поскольку усовершенствования конструкции системы позволяют ей придумать дополнительные усовершенствования конструкции, пока все наиболее просто исполнимые варианты не будут исчерпаны.

Еще одно важное соображение состоит в том, что узким местом для более быстрого развития научных исследований человеком являются время обучения и пропускная коммуникативная способность. Если бы мы могли научить «новый ум» стать передовым ученым за десять минут, и, если бы ученые могли почти мгновенно обмениваться опытом, знаниями, концепциями, идеями и интуицией, научный прогресс мог бы значительно продвинуться. Именно ликвидация этих узких мест дает преимущества автоматизированным изобретателям даже при отсутствии более эффективных аппаратных средств и алгоритмов. - К примеру, ракеты подвержены воздействию более большого диапазона температур и давлений, а также сильнее укомплектованы взрывчатыми веществами.

- Рассмотрим разработку Бердом и Лейцеллом очень простого генетического алгоритма, которому было поручено разработать колебательный контур. Берд и Лейцелл были удивлены, обнаружив, что алгоритм не использовал конденсатор на чипе; вместо этого он использовал дорожки схемы на материнской плате в качестве радиоприемника, чтобы передать осциллирующий сигнал с тестового устройства обратно на тестовое устройство.

Программа была недостаточно проработанной. Это было всего лишь частное решение задачи в очень ограниченной области. Тем не менее, полученное решение вышло за рамки представлений программистов. В компьютерном моделировании этот алгоритм мог вести себя так, как предполагалось, но фактическое пространство решений в реальном мире было шире, в результате чего было проведено вмешательство на аппаратном уровне.

В случае использования системы искусственного интеллекта, превосходящей человека во многих областях, необходимо понимать, что система будет продвигаться к подобным странным и творческим решениям, которые сложно предвидеть.

|

Метки: author SmirkinDA разработка робототехники разработка для интернета вещей машинное обучение блог компании parallels искусственный интеллект искусственные нейронные сети parallels ai |

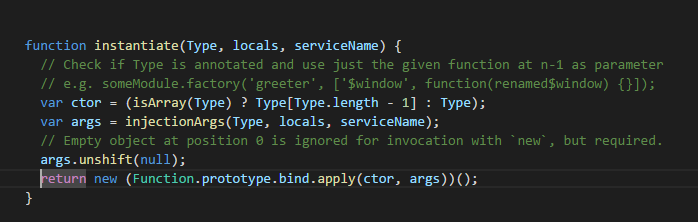

Универсальная функция создания объектов на примере реализации $injector.instantiate в angularjs |

$injector, где их поджидает довольно занимательная конструкция, о которой сегодня и хотелось бы поговорить.

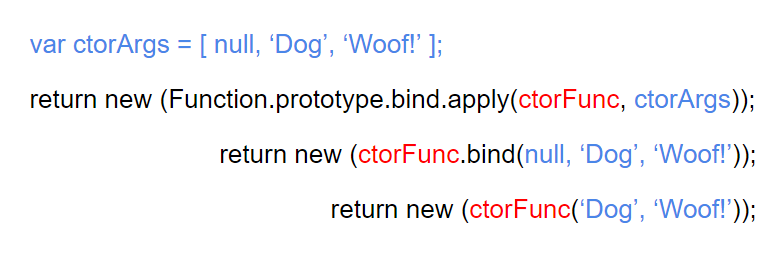

А именно, речь пойдёт о следующей строке:

return new (Function.prototype.bind.apply(ctor, args))();Очевиден ли для вас сходу принцип её действия? Если ответ положительный, то благодарю за внимание и уделённое вами время :)

Теперь же, когда все съевшие собаку на javascript читатели нас покинули, хотел бы ответить на собственный вопрос: впервые увидев эту строку, я растерялся и абсолютно ничего не понял во всех этих взаимоотношениях и хитросплетениях функций

bind, apply, new и (). Давайте разбираться. Начать я предлагаю от обратного, а именно: пускай у нас есть некий параметризованный конструктор, экземпляр которого мы и хотим создать:function Animal(name, sound) {

this.name = name;

this.sound = sound;

}new

«Что может быть проще»- скажете вы и будете правы:

var dog = new Animal('Dog', 'Woof!');. Оператор new — это первое, что нам потребуется, чтобы получить экземпляр вызова конструктора Animal. Небольшое отступление о том, как работает new:Когда исполняется new Foo(...), происходит следующее:

1. Создается новый объект, наследующий Foo.prototype.

2. Вызывается конструктор — функция Foo с указанными аргументами и this, привязанным к только что созданному объекту. new Foo эквивалентно new Foo(), то есть если аргументы не указаны, Foo вызывается без аргументов.

3. Результатом выражения new становится объект, возвращенный конструктором. Если конструктор не возвращет объект явно, используется объект из п. 1. (Обычно конструкторы не возвращают значение, но они могут делать это, если нужно переопределить обычный процесс создания объектов.)

Подробнее

Отлично, теперь давайте обернём наш вызов конструктора

Animal в функцию, чтобы код инициализации был общим для всех требуемых вызовов:function CreateAnimal(name, sound) {

return new Animal(name, sound);

}Со временем мы начинаем хотеть создавать не только животных, но и людей (соглашусь, пример не самый удачный), а значит, у нас есть как минимум 2 варианта:

- Реализовать фабрику, которая в зависимости от требуемого нам типа будет сама создавать необходимый экземпляр;

- Передавать функцию конструктора в качестве параметра и на её основе создавать новую с уже привязанными к ней передаваемыми аргументами (с чем нам прекрасно помогает функция

bind).

И в случае с

$injector.instantiate был выбран второй путь:bind

function Create(ctorFunc, name, sound) {

return new (ctorFunc.bind(null, name, sound));

}

console.log( Create(Animal, 'Dog', 'Woof') );

console.log( Create(Human, 'Person') );

Небольшое отступление о том, как работает

bind:Метод bind() создаёт новую функцию, которая при вызове устанавливает в качестве контекста выполнения this предоставленное значение. В метод также передаётся набор аргументов, которые будут установлены перед переданными в привязанную функцию аргументами при её вызове.

Подробнее

В нашем случае в качестве контекста мы передаем

null, т.к. планируем использовать новую созданную с помощью bind функцию с оператором new, который игнорирует this и создает для него пустой объект. Результатом выполнения функции bind станет новая функция с уже привязанными к ней аргументами (т.е. return new fn;, где fn — результат вызова bind).Отлично, теперь мы можем использовать нашу функцию, чтобы создавать любых животных и людей, конструкторы которых… принимают параметры

name и sound. «Но ведь не все аргументы, которые требуются для животных будут необходимыми и для людей»- скажете вы и будете правы- назревают 2 проблемы:- Аргументы конструкторов могут начать меняться (например порядок или их количество), а значит вносить изменения нам потребуется сразу в нескольких местах: в сигнатуры конструкторов, строки вызова функции

Createи строку создания экземпляраreturn new (ctorFunc.bind(null, name, sound )); - Чем больше у нас появляется конструкторов, тем выше вероятность того, что аргументы для их создания нам потребуются разные, и мы уже не сможем использовать единую функцию (или же нам придётся перечислять все из них, а заполнять лишь необходимые).

apply

Решением этих проблем может стать сквозная передача аргументов из функции создания прямиком в конструктор, другими словами- универсальная функция, принимающая конструктор и необходимый массив аргументов и возвращающая новую функцию, к которой эти аргументы привязаны. Для этого в javascript есть замечательная функция

apply (или её аналог call, если количество аргументов известно заранее).Небольшое отступление о том, как работает apply:

Метод apply() вызывает функцию с указанным значением this и аргументами, предоставленными в виде массива (либо массивоподобного объекта).

Хотя синтаксис этой функции практически полностью идентичен функции call(), фундаментальное различие между ними заключается в том, что функция call() принимает список (перечень) аргументов, в то время, как функция apply() принимает массив аргументов (единым параметром).

Подробнее

Здесь начинается, пожалуй, самая сложная часть, т.к. нам предстоит используя apply установить контекстом для функции

bind наш конструктор (аналогично ctorFunc.bind), а в качестве аргументов для функции bind (не забывая о том, что первым аргументом является устанавливаемый контекст) передать смещенный на одну позицию вправо массив параметров конструктора, используя ctorArgs.unshift(null).

Функция

bind недоступна в контексте выполнения Create, т.к. им является объект window, зато доступна посредством прототипа функции Function.prototype.Итоговым результатом станет следующая универсальная функция:

function Create(ctorFunc, ctorArgs) {

ctorArgs.unshift(null);

return new (Function.prototype.bind.apply(ctorFunc, ctorArgs ));

}

console.log( Create(Animal, ['Dog', 'Woof']) );

console.log( Create(Human, ['Person', 'John', 'Engineer', 'Moscow']) );

Возвращаясь к angularJS, мы можем заметить, что в качестве

Animal и Human, например, выступают конструкторы фабрик или других типов, а в качестве массива аргументов ['Dog', 'Woof'] — найденные (разрезолвленные) по имени зависимости:angular

.module('app')

.factory(function($scope) {

// constructor

});

или

angular

.module('app')

.factory(['$scope', function($scope) {

// constructor

}]);

Всё что остаётся сделать для реализации полноценного метода

$injector.instantiate, это найти функцию конструктора и получить необходимые аргументы и можно создавать :)

|

Метки: author fsou11 javascript angularjs $injector |

«MDM vs CRM» или кто поможет больше продать? |

Ведь CRM– это система управления отношениями с клиентами. Широко известно, что она из себя представляет, каким способом она позволяет поднять продажи; чего от неё стоит ждать, а чего –ждать не стоит. Часто CRM-система не является отдельной системой, а входит в ERP-систему предприятия.

MDM – это система управления мастер данными или нормативно-справочной информацией. Принято считать, что она предназначена для централизации управления мастер-данными, обеспечивает функциональные системы (CRM, ERP, WMS, TMS и прочие) непротиворечивыми и полными данными, которые нужны для формирования отчетности, выполнения бизнес-функций и т.п. Другими словами, MDM выполняет сервисную обеспечивающую функцию по сбору, централизованному хранению и распространению информации о мастер-данных. Но, на самом деле, это соответствует истине лишь отчасти.

Чтобы далеко не ходить за примером, приведу случай из жизни компании, совладельцем которой я являюсь. Причем мне кажется, что этот пример является абсолютно типовым, и подобные ситуации встречались и у многих наших партнеров и клиентов.

Так вот, моя компания, занимаясь внедрением CRM и MDM-систем у своих клиентов, очевидно имела потребность как-то этих клиентов находить, заинтересовывать и продавать им свои продукты и услуги.

Исходно в компании была внедрена ERP-система, имеющая встроенную подсистему CRM, в которой и велась информация о контрагентах, их контактных лицах, возможностях продажи, прошедших и запланированных активностях и т.д. Система также имела BI-возможности.

При том, что работа менеджеров по продажам была полностью автоматизирована, тем не менее, имелись проблемы, из-за которых мы не могли сказать, что правильно управляем отношениями с клиентами.

Дело вот в чем. В нашей ERP-системе (равно как и в основной массе известных мне ERP-систем) данные о клиентах компании хранились в справочнике контрагентов, которые являются по сути не клиентами компании, а их юрлицами. Если у клиента имеются несколько юрлиц, то у нас в справочнике контрагентов появляются несколько записей. При этом все взаимодействия, возможности продаж, контактные лица, договорные отношения и все документы привязаны именно к контрагентам (то есть, к юрлицам и договорам). Таким образом, клиент как управленческая бизнес-сущность, которая интегрирует в себя все эти данные, в системе отсутствовала.

Аналогичная ситуация была и с контактными лицами. Один и тот же человек мог быть указан 10 раз как контактное лицо для 10 юрлиц, возможно, даже не относящихся к одному клиенту. В результате не было никакой связи этих 10 контактных лиц между собой, и мы просто не представляли, что на самом деле это один и тот же человек. Надо ли говорить, что контактная информация также была очень противоречива.

Кроме того, отсутствовал большой блок исторической информации, необходимой для понимания клиента, которую невозможно было перенести из старых систем по причине полного несоответствия структуры и контентного состава контрагентов и номенклатуры.

В результате мы зачастую не понимали, КТО НАШ КЛИЕНТ: чем он занимался и чем занимается сейчас, какую он имел и имеет структуру в организации, кто в нем работал раньше и работает сейчас, что ему предлагали, куда его приглашали, что и на какую сумму он у нас купил и т.д.

Без этой информации мы видели только «часть слона» и не могли нормально наладить отношения с клиентом. Таким образом, нам надо было научиться выделять клиента как бизнес-сущность и привязать все данные по клиенту к этой бизнес сущности.

Мы рассматривали разные варианты, но единственно возможным решением всех перечисленных выше задач стал вариант внедрения функциональности MDM-системы в домене CDI (Customer Data Integration).

Читатель спросит, а почему единственным? А почему нельзя было взять внедрить «навороченную» Аналитическую CRM, где есть возможность вести такую «централизованную» информацию по клиенту, и решить все перечисленные проблемы? Отвечу.

Использование MDM-функциональности для решения задачи Знания Своего Клиента имеет некоторые существенные плюсы.

Основной плюс MDM заключается в том, что обычно CRM-системы не имеют нормальных средств работы c данными по клиентам и инструментов нормализации этих данных. Данные собираются из разных систем, являются разрозненными, их надо идентифицировать, стандартизировать, обогащать, дедублицировать, синхронизировать и т.д. В MDM-системах есть механизмы работы с внешними базами данных (база ЕГРЮЛ, СПАРК), механизмы стандартизации адресов, ФИО, телефонов, е-мейлов. Без этих механизмов даже наличие функционала хранения этих данных в CRM-системе абсолютно бесполезно.

Еще существенный плюс MDM – это то, что MDM-системы позволяют довольно гибко настраивать структуру хранения данных о клиентах. В каждой компании данные о клиентах, которые она считает важными, сильно различаются. Например, в нашей компании ведутся данные обо всех программных продуктах клиентов, типах и сроках их поддержки, даже если они были куплены где-то в другом месте. Кроме того, мало хранить эти данные, нужно еще версионировать как сами данные, так и структуру этих данных, т.к. они сильно меняются со временем.

Также несомненным плюсом MDM-систем является то, что MDM-системы могут выявлять явные и неявные соответствия между физическими лицами, между организациями, между физическими лицами и организациями, а также их изменения. Можно прослеживать, кто, где, когда и с кем работал, кто кого знает. Также не секрет, что топ-менеджеры больших организаций у всех на виду и частенько меняют места работы. Эта информация должна выявляться, фиксироваться и создавать дополнительные возможности для продажи.

И четвертым, несомненно важным плюсом, стало наличие в MDM встроенных средств интеграции – ETL и ESB. Эти механизмы просто необходимы для сбора всех сведений о клиентах из разных систем-источников. Особенно в части возможности сопоставления данных из других источников с данными по клиентам.

Соответственно, с помощью MDM для CDI мы решили следующие задачи:

1. В кратчайшие сроки мы смогли преобразовать нашу схему, где центральной сущностью является юрлицо и договор, в схему, где центральной сущностью является клиент. Мы идентифицировали всех клиентов, связали с ними юрлица, договора, контактных лиц, документы и всю другую информацию.

2. Мы смогли выделить «персон», т.е. физических лиц, и связать их с контактными лицами клиентов. Теперь мы отслеживаем передвижения не контактных лиц, а конкретных персон: где они работают, куда переходят и т.д. Можем отслеживать неявные соответствия, кто кого знает, и кто с кем когда-либо работал.

3. Мы смогли создать гибкие и полные хранилища дополнительной информации по клиентам и персонам, которая требуется для продажи. В нашем случае это информация о проектах и их параметрах, информация об используемом программном обеспечении и т.д.

4. Мы смогли агрегировать данные из различных источников (например, из старой системы) и сопоставить их с текущими данными.

5. Мы обеспечили механизм ведения и поддержки данных о клиентах в актуальном состоянии.

Кроме всего вышеперечисленного, внедрение механизмов MDM сподвигло нас взглянуть на проблему более комплексно, чем когда мы внедряли CRM. Фактически под этот проект был инициирован еще один проект по созданию корпоративной политики регулирования данных (Data Governance). Но об этом можно написать еще одну большую статью.

Поэтому в нашем случае MDM – это не сервисная и обеспечивающая функция для других систем, а полноценная система, несущая свою вполне конкретную бизнес-функциональность для многих отделов:

1. Отдел маркетинга использует данные MDM для построения аналитических отчетов. Теперь фактически в едином источнике собраны все данные о клиентах: можно понять, сколько у нас клиентов, какие программные продукты они используют, какие проекты в каких отраслях и регионах были реализованы, какие параметры у этих проектов, все доходные и расходные показатели по клиентам и проектам. Это дает полную информацию для принятия стратегических и тактических маркетинговых решений.

2. Отдел телемаркетинга (кол-центр) использует данные MDM для обзвона и рассылки писем. Когда клиент не был выделен как центральная сущность, было много ошибок, когда звонили одному и тому же клиенту дважды и трижды (по количеству юрлиц). Кроме того, не было полной информации (агрегированной из разных систем), которая требовалась для сегментации клиентов и принятия решения о приглашении их на то или иное мероприятие или о предложении им тех или иных услуг. Теперь можно очень точно и адресно (без повторов и накладок) рассылать письма и обзванивать клиентов, что существенно уменьшает недовольство клиентов и экономит наше время.

3. Отдел продаж. Клиентский менеджер из отдела продаж теперь может получать всю информацию по клиенту в целом, что дает ему больше шансов предложить правильный продукт и грамотно построить стратегию продажи. Кроме того, теперь отдельно ведется мониторинг и поддержание связи с лицами, принимающими решения, когда они переходят в другие компании.

4. Производственные департаменты могут вести информацию о клиентах, их контактах и быть в курсе событий. А также формировать агрегированные данные о проектах для последующего анализа.

Меня многие коллеги-айтишники спрашивают, а как нам обосновать «бизнесу» необходимость внедрения MDM-системы? Ведь это техническая обеспечивающая функция. Так вот – нет, это вполне конкретная функциональная бизнес-система, которая сама по себе может принести колоссальную добавленную стоимость многим подразделениям.

И отдельно хочу оговориться, для тех, кто, может быть, не до конца меня понял:

1. Я не хочу сказать, что нужно внедрять MDM вместо CRM, я пишу о роли MDM в построении отношений с клиентами и о том, что эта роль вполне сопоставима с ролью CRM. Понятно же, что и в нашей компании CRM отлично функционирует, выполняя СВОИ функции.

2. Говоря про MDM как бизнес-систему, я не имею в виду, что бизнес-пользователи обязательно должны работать непосредственно внутри MDM (такое, кстати, тоже бывает, но не часто), я имею в виду, что бизнес-пользователи работают с функциями и данными MDM. У нас, например, все пользовательские интерфейсы реализованы внутри ERP, чтобы пользователю было удобно и не требовалось переключаться между системами, но все функции и данные – это забота MDM.

3. Я пишу про свой опыт и опыт многих компаний, которые сталкивались с такой задачей, и не исключаю, что в природе встречаются ситуации, в которых это не работает.

Максим Власов, директор по развитию

|

Метки: author AXELOT-IT управление проектами управление продажами терминология it erp- системы crm- система mdm- мастер данные управление нси |

Сломай голосовалку на РИТ++ за 50 наклеек |

Мы сегодня на конференции со стендом (справа от конгресс-холла). У нас есть кола, сникерсы и возможность выиграть:

50 наклеек от РИТ++,

за второе место — пять пицц и ящик колы,

за третье — наш значок Odin.

Для этого победите нашу голосовалку за языки программирования! Можно накручивать ботов, бездумно голосовать за себя до умопомрачения или просто взломать всю систему.

Тот, кому удастся взломать голосовалку, получит призы за все три места.

Еще можно решить задачки, за каждую решенную задачку мы даем наклейку.

Удачи и ищите наш стенд!

|

Метки: author Kosheleva_Ingram_Micro блог компании odin (ingram micro) розыгрыш рит++ рит2017 |

NeoQUEST-2017: что ждёт гостей на юбилейной «Очной ставке»? |

29 июня 2017 года в Санкт-Петербурге состоится юбилейная, пятая «Очная ставка» NeoQUEST! И мы с радостью приглашаем всех, кто интересуется информационной безопасностью: студентов и абитуриентов IT-специальностей, разработчиков, тестировщиков, админов, матёрых специалистов и новичков в инфобезе, хакеров и гиков!