Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

В поисках оптимальной диеты методом линейного программирования |

В поисках оптимальной диеты методом линейного программирования

Должна ли диета быть экономной?

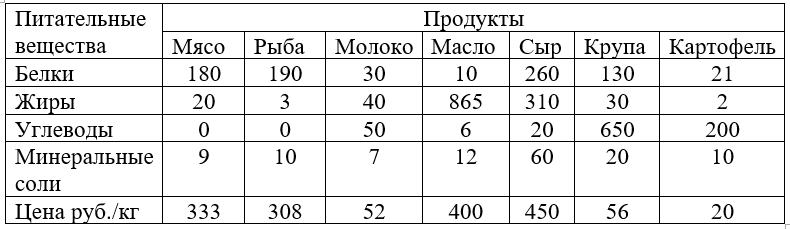

Для поддержания нормальной жизнедеятельности человеку необходимо потреблять в день не менее 118 г белков, 56 г жиров, 500 г углеводов и 28 г минеральных солей. Эти питательные вещества содержатся в разных количествах и разных пищевых продуктах.

В таблице приведено количество питательных веществ в различных продуктах в г/кг и цена этих продуктов за 1 кг. Необходимо составить дневной рацион, содержащий минимальную суточную норму питательных веществ при минимальной их стоимости.

Обозначив через: Х1 –количество мяса; Х2- количество рыбы; Х3- количество молока; Х4- количество масла; Х5- количество сыра; Х6- количество крупы; Х7- количество картофеля, потребляемых человеком в день. Можем составить уравнение общей стоимости F питания в день:

F=333*X1+308*X2+52*X3+400*X4+450*X5+56*X6+25*X7

Нам нужно найти минимум F.

Суммарное количество белков в рационе человека должно быть не меньше 118 г. Отсюда,

180*X1+190*X2+30*X3+10*X4+260*X5+130*X6+21*X7>=118

Такие же неравенства составляем для жиров, углеводов и солей. Имеем:

20*X1+3*X2+40*X3+865*X4+310*X5+30*X6+2*X7>=56

50*X3+6*X4+20*X5+650*X6+200*X7>=500

9*X1+10*X2+7*X3+12*X4+60*X5+20*X6+10*X7>=28

Решим задачу на Python

from cvxopt.modeling import variable, op

import time

start = time.time()

x = variable(7, 'x')

z=(333*x[0] + 308*x[1] +52* x[2] +400*x[3] +450*x[4] +56* x[5]+20*x[6])

mass1 =(- (180*x[0] + 190*x[1] +30* x[2] +10*x[3] +260*x[4] +130* x[5]+21*x[6]) <= -118)

mass2 =(- (20*x[0] + 3*x[1] +40* x[2] +865*x[3] +310*x[4] +30* x[5]+2*x[6]) <= -56)

mass3 =(- (50* x[2] +6*x[3] +20*x[4] +650* x[5]+200*x[6]) <= -500)

mass4 =(- (9*x[0] + 10*x[1] +7* x[2] +12*x[3] +60*x[4] +20* x[5]+10*x[6]) <= -28)

x_non_negative = (x >= 0)

problem =op(z,[mass1,mass2,mass3,mass4 ,x_non_negative])

problem.solve(solver='glpk')

problem.status

print("Результат:")

print(round(1000*x.value[0],1),'-грамм мяса, затраты -',round(x.value[0]*333,1),'руб.')

print(round(1000*x.value[1],1),'-грамм рыбы, затраты -',round(x.value[1]*308,1),'руб.')

print(round(1000*x.value[2],1),'-миллилитров молока, затраты -',round(x.value[2]*52,1),'руб.')

print(round(1000*x.value[3],1),'-грамм масла, затраты -',round(x.value[3]*400,1),'руб.')

print(round(1000*x.value[4],1),'-грамм сыр, затраты -',round(x.value[4]*450,1),'руб.')

print(round(1000*x.value[5],1),'-грамм крупы, затраты -',round(x.value[5]*56,1),'руб.')

print(round(1000*x.value[6],1),'-грамм картофеля, затраты -',round(x.value[6]*25,1),'руб.')

print(round(problem.objective.value()[0],1),"- стоимость рациона одного человека в день")

stop = time.time()

print ("Время :",round(stop-start,3))

Следует отметить некоторые особенности написания программы с использованием модуля cvxopt. Modeling: все переменные сохраняются в списках, а индексы списков начинаются не с 1, а с 0; в условиях, которые записываются в виде нестрогих неравенств должно быть установлено ограничение сверху, поэтому, для перехода от ограничения снизу, обе части неравенств умножены на -1.

Результат:

0.0 -грамм мяса, затраты — 0.0 руб.

0.0 -грамм рыбы, затраты — 0.0 руб.

0.0 -миллилитров молока, затраты — 0.0 руб.

38.0 -грамм масла, затраты — 15.2 руб.

-0.0 -грамм сыр, затраты — -0.0 руб.

679.3 -грамм крупы, затраты — 38.0 руб.

1395.9 -грамм картофеля, затраты — 34.9 руб.

81.1 — стоимость рациона одного человека в день

Время: 0.09

Анализ результатов показывает: ни мяса, ни рыбы- крупа, масло и картофель — вот такое линейное программирование. Вряд ли такой рацион можно рассматривать серьёзно, но для общности анализа пусть будет. А мы продолжим поиск.

Должна ли диета быть калорийной?

Для определённости предположим, что в качестве исходных продуктов рассмотрим хлеб, мясо, сыр, бананы, огурцы, помидоры, виноград – всего семь продуктов. В качестве питательных веществ – белки, жира, углеводы.

Калорийность одной весовой единицы каждого из продуктов следующая: c1=2060, c2=2430, c3=3600, c4=890, c5=140, c6=230, c7=650.

Содержание питательных веществ в продуктах питания поместим в следующую таблицу.

Минимальная суточная потребность человека в питательных веществах следующая: в белках b1=100, в жирах b2=70, в углеводах b3=400.

Не уменьшая общности решаемой задачи, можно считать, что калорийность продуктов измеряется в килокалориях/кг, суточная потребность в питательных веществах – в граммах, а содержание питательных веществ в продуктах– в граммах/кг. В указанных условиях становится возможным выполнить дополнительную проверку сформированных условий задачи на основе рассмотрения физической размерности целевой функции и ограничений.

Обозначив через: x1 –количество хлеба; x2- количество мяса; x3- количество сыра; x4- количество бананов; x5- количество огурцов; x6- количество помидоров; x7- количество винограда, потребляемых человеком в день в килограммах.

Можем составить уравнение общей калорийности F питания в день:

F=2060*x1 + 2430*x2 +3600* x3+890*x4 +140*x5 +230* x6+650*x7

Нам нужно найти минимум F.

Суммарное количество белков в рационе человека должно быть не меньше 100 г. Отсюда

61*x1+ 220*x2 +230* x3 +15*x4 +8*x5 +11* x6+6*x7 >=100

Такие же неравенства составляем для жиров и углеводов. Имеем:

12*x1 +172*x2 +290* x3+1*x4 +1*x5 +2* x6+2*x7 >=70

420*x1 +0*x2 +0* x3 +212*x4+26*x5 +38* x6+155*x7 >=400

Решим задачу на Python

from cvxopt.modeling import variable, op

import time

start = time.time()

x = variable(7, 'x')

z=(333*x[0] + 308*x[1] +52* x[2] +400*x[3] +450*x[4] +56* x[5]+20*x[6])

mass1 =(- (180*x[0] + 190*x[1] +30* x[2] +10*x[3] +260*x[4] +130* x[5]+21*x[6]) <= -118)

mass2 =(- (20*x[0] + 3*x[1] +40* x[2] +865*x[3] +310*x[4] +30* x[5]+2*x[6]) <= -56)

mass3 =(- (50* x[2] +6*x[3] +20*x[4] +650* x[5]+200*x[6]) <= -500)

mass4 =(- (9*x[0] + 10*x[1] +7* x[2] +12*x[3] +60*x[4] +20* x[5]+10*x[6]) <= -28)

x_non_negative = (x >= 0)

problem =op(z,[mass1,mass2,mass3,mass4 ,x_non_negative])

problem.solve(solver='glpk')

problem.status

print("Результат:")

print(round(1000*x.value[0],1),'-грамм хлеба')

print(round(1000*x.value[1],1),'-грамм мяса')

print(round(1000*x.value[2],1),'-грамм сыра')

print(round(1000*x.value[3],1),'-грамм бананов')

print(round(1000*x.value[4],1),'-грамм огурцов')

print(round(1000*x.value[5],1),'-грамм помидоров')

print(round(1000*x.value[6],1),'-грамм винограда')

print(round(problem.objective.value()[0],1),"-Калорийность рациона одного человека в день")

stop = time.time()

print ("Время :",round(stop-start,3))

Результат:

0.0 -грамм хлеба

211.5 -грамм мяса

109.4 -грамм сыра

1886.8 -грамм бананов

0.0 -грамм огурцов

0.0 -грамм помидоров

0.0 -грамм винограда

2587.1 -килокалорий -калорийность

рациона одного человека в день

Время: 0.06

Анализ результатов решения показывает, что для удовлетворения суточной потребности в питательных веществах (белки, жиры, углеводы), следует использовать 211 грамм мяса баранины, 109 грамм сыра, 1887 грамм бананов, совсем отказаться от хлеба, огурцов, помидоров и винограда. При этом общая калорийность найденной оптимальной диеты будет равна 2587 килокалорий, что вполне соответствует малоактивному образу жизни без существенных физических нагрузок. Напомним, что согласно медицинским данным, энергетические затраты работников умственного труда (программисты, юристы, врачи, педагоги, бухгалтера) лежат в пределах 3000 килокалорий.

Содержательный анализ результатов задачи об оптимальной диете явно выявляет недостатки рассмотренной математической модели. С одной стороны, для вкусной и питательной пищи не всегда приемлемым оказывается ограниченный рацион продуктов питания, который совершенно игнорирует индивидуальные предпочтения при выборе отдельных продуктов. С другой стороны, найденное оптимальное решение (мясо + сыр + бананы) для многих покажется однообразным и способным повергнуть в уныние даже пациентов больницы. Наконец, рассмотренная математическая модель задачи об оптимальной диете не учитывает суточную потребность в витаминах и микроэлементах, учет которых может существенно повлиять на выбор оптимального состава продуктов.

Что можно предложить заинтересованному читателю?

Заинтересованным читателям данной публикации в качестве упражнения предлагается рассмотреть собственную постановку задачи об оптимальной диете, отражающую их индивидуальные предпочтения в выборе тех или иных продуктов. При этом условия задачи можно несколько изменить, включив в качестве одного из ограничений общую калорийность диеты, а в качестве целевой функции рассмотреть общую массу наиболее предпочтительных продуктов.

Решение задачи на Python (только как пример)

from cvxopt.modeling import variable, op

import time

start = time.time()

x = variable(7, 'x')

z=( x[0] + x[1] +x[2] +x[3] +x[4] +x[5]+x[6])

mass1 =(- (61*x[0] + 220*x[1] +230* x[2] +15*x[3] +8*x[4] +11* x[5]+6*x[6]) <= -100)

mass2 =(- (12*x[0] +172*x[1] +290* x[2] +1*x[3] +1*x[4] +2* x[5]+2*x[6]) <= -70)

mass3 =(- (420*x[0] +0*x[1] +0* x[2] +212*x[3] +26*x[4] +38* x[5]+155*x[6]) <= -400)

mass4 =(-( 2060*x[0] + 2430*x[1] +3600* x[2] +890*x[3] +140*x[4] +230* x[5]+650*x[6]) <= -3000)

x_non_negative = (x >= 0)

problem =op(z,[mass1,mass2,mass3, mass4,x_non_negative])

problem.solve(solver='glpk')

problem.status

print("Результат:")

print(round(1000*x.value[0],1),'-грамм хлеба')

print(round(1000*x.value[1],1),'-грамм мяса')

print(round(1000*x.value[2],1),'-грамм сыра')

print(round(1000*x.value[3],1),'-грамм бананов')

print(round(1000*x.value[4],1),'-грамм огурцов')

print(round(1000*x.value[5],1),'-грамм помидоров')

print(round(1000*x.value[6],1),'-грамм винограда')

print(round(problem.objective.value()[0],1),"-килограмм-общая масса продуктов из \n рациона одного человека в день")

stop = time.time()

print ("Время :",round(stop-start,3))

Результат:

952.4 -грамм хлеба

0.0 -грамм мяса

288.4 -грамм сыра

0.0 -грамм бананов

0.0 -грамм огурцов

0.0 -грамм помидоров

0.0 -грамм винограда

1.2 -килограмм-общая масса продуктов из

рациона одного человека в день

Время: 0.051

Это мне напоминает рацион долгожителей высокогорных районов лепёшки на козьем молоке и сыр того же происхождения, но воспоминания скорее всего обманчивы, поскольку список продуктов явно не оттуда.

Вместо вывода

Несмотря на выявленные недостатки рассмотренной математической модели задачи об оптимальной диете, найденное оптимальное решение в точности соответствует исходной постановке задачи. Это свидетельствует о достаточно высокой точности решения задач линейного программирования при помощи библиотеки cvxopt. Modeling Python.

Интерфейс программы настолько простой и наглядный, что не требует каких-либо дополнительных навыков. Достаточно скачать и установить последнюю версию Python, например, с сайта [1], а библиотеку cvxopt с сайта [2]. Затем создать файл с расширением py и поместить в него любую из приведенных в статье программ, предварительно модифицировав её под свою задачу с новой функцией цели и ограничениями.

Ссылки

|

Метки: author Scorobey разработка под windows математика python диета линейное программирование библиотека cvxopt |

[Перевод] ggplot2: как легко совместить несколько графиков в одном, часть 3 |

ggplot2: как легко совместить несколько графиков в одном, часть 3

- Перевод

- Tutorial

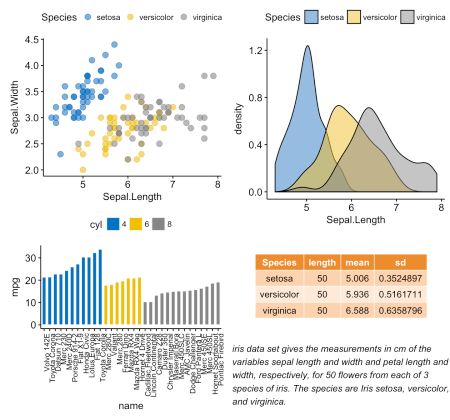

Cмешиваем таблицу, текст и ggplot2-графики

В этом разделе покажем, как вывести таблицу и текст вместе с графиком. Будем использовать набор данных iris.

Начнем с создания таких графиков:

- график плотности переменной Sepal.Length. Функция R:

ggdensity()[в ggpubr] - сводная таблица, содержащая описательные статистики (среднее, стандартное отклонение, т.д.) Sepal.Length

- Функция R для вычисления описательных статистик:

desc_statby()[в ggpubr] - Функция R для создания таблицы с текстом:

ggtexttable()[в ggpubr]

- Функция R для вычисления описательных статистик:

- абзац текста. Функция R:

ggparagraph()[в ggpubr]

Завершим, скомбинировав все три графика с помощью функции

ggarrange() [в ggpubr].# График плотности "Sepal.Length"

#::::::::::::::::::::::::::::::::::::::

density.p <- ggdensity(iris, x = "Sepal.Length",

fill = "Species", palette = "jco")

# Вывести сводную таблицу Sepal.Length

#::::::::::::::::::::::::::::::::::::::

# Вычислить описательные статистики по группам

stable <- desc_statby(iris, measure.var = "Sepal.Length",

grps = "Species")

stable <- stable[, c("Species", "length", "mean", "sd")]

# График со сводной таблицей, тема "medium orange" (средний оранжевый)

stable.p <- ggtexttable(stable, rows = NULL,

theme = ttheme("mOrange"))

# Вывести текст

#::::::::::::::::::::::::::::::::::::::

text <- paste("iris data set gives the measurements in cm",

"of the variables sepal length and width",

"and petal length and width, respectively,",

"for 50 flowers from each of 3 species of iris.",

"The species are Iris setosa, versicolor, and virginica.", sep = " ")

text.p <- ggparagraph(text = text, face = "italic", size = 11, color = "black")

# Разместить графики на странице

ggarrange(density.p, stable.p, text.p,

ncol = 1, nrow = 3,

heights = c(1, 0.5, 0.3))

Добавляем графический элемент в ggplot

Для добавления таблиц, графиков или других элементов на основе таблиц в рабочую область ggplot есть функция

annotation_custom() [в ggplot2]. Упрощенный формат:annotation_custom(grob, xmin, xmax, ymin, ymax)- grob: внешний графический элемент для отображения

- xmin, xmax: x-расположение в координатах (горизонтальное расположение)

- ymin, ymax: y-расположение в координатах (вертикальное расположение)

Помещаем таблицу в ggplot

Используем графики density.p и stable.p, созданные в предыдущем разделе.

density.p + annotation_custom(ggplotGrob(stable.p),

xmin = 5.5, ymin = 0.7,

xmax = 8)

Помещаем диаграмму рассеивания в ggplot

- Создаем диаграмму разброса для y = “Sepal.Width” по x = “Sepal.Length” из набора данных iris. Функция R:

ggscatter()[ggpubr]. - Создаем отдельно диаграмму рассеивания переменных х и у с прозрачным фоном. Функция R:

ggboxplot()[ggpubr]. - Преобразуем диаграмму рассеивания в графический объект под названием “grob” в терминологии Grid. Функция R:

ggplotGrob()[ggplot2]. - Поместим grob-ы диаграммы рассеивания внутрь диаграммы разброса. Функция R:

annotation_custom()[ggplot2].

Поскольку помещенная внутрь диаграмма рассеивания накладывается в нескольких точках, для нее используется прозрачный фон.

# Диаграмма разброса по группам ("Species")

#::::::::::::::::::::::::::::::::::::::::::::::::::::::::::

sp <- ggscatter(iris, x = "Sepal.Length", y = "Sepal.Width",

color = "Species", palette = "jco",

size = 3, alpha = 0.6)

# Диаграммы рассеивания переменных x/y

#::::::::::::::::::::::::::::::::::::::::::::::::::::::::::

# Диаграмма рассеивания переменной x

xbp <- ggboxplot(iris$Sepal.Length, width = 0.3, fill = "lightgray") +

rotate() +

theme_transparent()

# Диаграмма рассеивания переменной у

ybp <- ggboxplot(iris$Sepal.Width, width = 0.3, fill = "lightgray") +

theme_transparent()

# Создать внешние графические объекты

# под названием “grob” в терминологии Grid

xbp_grob <- ggplotGrob(xbp)

ybp_grob <- ggplotGrob(ybp)

# Поместить диаграммы рассеивания в диаграмму разброса

#::::::::::::::::::::::::::::::::::::::::::::::::::::::::::

xmin <- min(iris$Sepal.Length); xmax <- max(iris$Sepal.Length)

ymin <- min(iris$Sepal.Width); ymax <- max(iris$Sepal.Width)

yoffset <- (1/15)*ymax; xoffset <- (1/15)*xmax

# Вставить xbp_grob внутрь диаграммы разброса

sp + annotation_custom(grob = xbp_grob, xmin = xmin, xmax = xmax,

ymin = ymin-yoffset, ymax = ymin+yoffset) +

# Вставить ybp_grob внутрь диаграммы разброса

annotation_custom(grob = ybp_grob,

xmin = xmin-xoffset, xmax = xmin+xoffset,

ymin = ymin, ymax = ymax)

Добавляем фоновое изображение в ggplot2-графики

Импортировать фоновое изображение. Используйте или функцию

readJPEG() [в пакете jpeg], или функцию readPNG() [в пакете png] в зависимости от формата фоновой картинки.Чтобы протестировать пример ниже, убедитесь, что пакет png установлен. Можно его установить, используя команду

install.packages(“png”).# Импорт картинки

img.file <- system.file(file.path("images", "background-image.png"),

package = "ggpubr")

img <- png::readPNG(img.file)Скомбинировать ggplot с фоновой картинкой. Функция R:

background_image() [в ggpubr].library(ggplot2)

library(ggpubr)

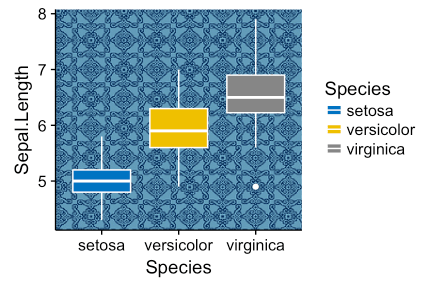

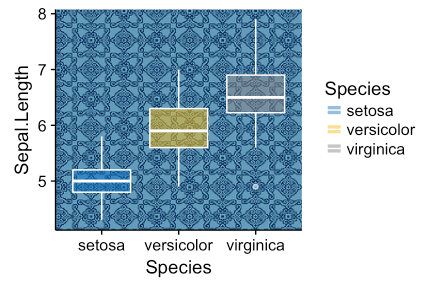

ggplot(iris, aes(Species, Sepal.Length))+

background_image(img)+

geom_boxplot(aes(fill = Species), color = "white")+

fill_palette("jco")

Изменим прозрачность заливки в диаграммах разброса заданием аргумента alpha. Значение должно быть в промежутке [0, 1], где 0 — полная прозрачность, а 1 — отсутствие прозрачности.

library(ggplot2)

library(ggpubr)

ggplot(iris, aes(Species, Sepal.Length))+

background_image(img)+

geom_boxplot(aes(fill = Species), color = "white", alpha = 0.5)+

fill_palette("jco")

Еще один пример, накладывание карты Франции на ggplot2:

mypngfile <- download.file("https://upload.wikimedia.org/wikipedia/commons/thumb/e/e4/France_Flag_Map.svg/612px-France_Flag_Map.svg.png",

destfile = "france.png", mode = 'wb')

img <- png::readPNG('france.png')

ggplot(iris, aes(x = Sepal.Length, y = Sepal.Width)) +

background_image(img)+

geom_point(aes(color = Species), alpha = 0.6, size = 5)+

color_palette("jco")+

theme(legend.position = "top")

Располагаем графики на нескольких страницах

Если у вас длинный список ggplot-ов, скажем, n=20, возможно, вы захотите упорядочить их, разместив на нескольких страницах. Если на странице будет 4 графика, для 20 понадобится 5 страниц.

Функция

ggarrange() [в ggpubr] предоставляет удобное решение, чтобы расположить несколько ggplot-ов на нескольких страницах. После задания аргументов nrow и ncol функция ggarrange() автоматически рассчитывает количество страниц, которое потребуется, чтобы разместить все графики. Она возвращает список упорядоченных ggplot-ов.Например, код ниже

multi.page <- ggarrange(bxp, dp, bp, sp,

nrow = 1, ncol = 2)возвращает две страницы с двумя графиками на каждой. Можно вывести каждую страницу вот так:

multi.page[[1]] # Вывести страницу 1

multi.page[[2]] # Вывести страницу 2Упорядоченные графики можно экспортировать в pdf-файл с помощью функции

ggexport() [в ggpubr]:ggexport(multi.page, filename = "multi.page.ggplot2.pdf")PDF-файл

Многостраничный вывод можно получить и с функцией

marrangeGrob() [в gridExtra].library(gridExtra)

res <- marrangeGrob(list(bxp, dp, bp, sp), nrow = 1, ncol = 2)

# Экспорт в pdf-файл

ggexport(res, filename = "multi.page.ggplot2.pdf")

# Интерактивный вывод

resВложенное взаиморасположение с ggarrange()

Упорядочим графики, созданные в предыдущих разделах.

p1 <- ggarrange(sp, bp + font("x.text", size = 9),

ncol = 1, nrow = 2)

p2 <- ggarrange(density.p, stable.p, text.p,

ncol = 1, nrow = 3,

heights = c(1, 0.5, 0.3))

ggarrange(p1, p2, ncol = 2, nrow = 1)

Экспорт графиков

Функция R:

ggexport() [в ggpubr].Сначала создадим список из 4 ggplot-ов, соответствующих переменным Sepal.Length, Sepal.Width, Petal.Length и Petal.Width в наборе данных iris.

plots <- ggboxplot(iris, x = "Species",

y = c("Sepal.Length", "Sepal.Width", "Petal.Length", "Petal.Width"),

color = "Species", palette = "jco"

)

plots[[1]] # Вывести первый график

plots[[2]] # Вывести второй график и т.д.После можно экспортировать отдельные графики в файл (pdf, eps или png) (один график на странице). Можно упорядочить графики (2 на страницу) при экспорте.

Экспорт отдельных графиков в pdf (по одному на странице):

ggexport(plotlist = plots, filename = "test.pdf")Упорядочьте и экспортируйте. Задайте nrow и ncol, чтобы вывести несколько графиков на одной странице:

ggexport(plotlist = plots, filename = "test.pdf",

nrow = 2, ncol = 1)|

Метки: author qc-enior визуализация данных визуализация ggplot2 |

Классический 2д квест или как прошли наши два года разработки. Часть 3 |

Классический 2д квест или как прошли наши два года разработки. Часть 3

Продолжение истории разработки нашей первой игры, начало вот здесь:

Итак, перед тем как перейти к заключительной части и рассказать, что делалось уже после релиза игры, давайте остановимся на главной части разработки, а именно – к программированию.

Как было рассказано ранее проект пережил следующие вехи развития:

- Был создан прототип на бумаге в виде диздока, были определены платформы, и примерный геймплей

- Были созданы прототипы на различных игровых движках с целью определить какой из них подойдёт лучше всего для реализации идей

- Была создана демо-версия для предварительной оценки игры со стороны коммьюнити

- Игра была реализована для основных платформ (Windows, Android OS)

- Игра была реализована для вторичных платформ (Linux, Mac, iOS)

Для начала стоит сказать, что если у вас, читатель, как у нас не было опыта в программировании игровых проектов, то скорее всего вам на начальном этапе стоит определится с главным, а именно — со свободным временем, которое вы будете готовы тратить на разработку вашего проекта. Для разработчика-программиста особенно важно учитывать этот фактор, т.к. освоение нового языка, понимание основ принятого фреймворка, пробы написать тестовый код на нём – это всё отнимает довольного много времени.

Смотрите сами – вы работаете на работе – это 8 часов, вам нужно нормально отдыхать, иначе в голове будет постоянная каша и стресс вас доконает – это как минимум еще 8 часов, еще 8 остаётся вроде как на проекты, но жизнь складывается зачастую так, что из этих 8 на проект получится выделять часа по 4 в лучшем случае. И в эти короткие сроки придётся изучать много и практически «на лету». Поэтому прежде чем начинать что-то делать постарайтесь трезво оценить, готовы ли вы писать код по 12 часов в сутки, чтобы реализовать проект.

К чему это отступление? А к тому, что сейчас оглядываясь назад, я понимаю, что работать в таком режиме – это тот еще адский труд, и будь проект более сложный в механике или больше по объему, мы бы возможно и не дошли бы до финала, либо это бы заняло еще больше времени (а мы делали игру около двух лет).

Лирическое отступление завершено, про денежную сторону этого вопроса я думаю поговорим в следующей части, а теперь собственно к коду. =]

На тот момент когда всё началось (начало 2014) жизнь в интернете происходила под лозунгами а-ля «Флеш умирает, что же делать, а давайте переходить на html5, но он однако какой-то сырой…», также на горизонтах лихо проносились андроиды выпуская всё новые версии системы, охватить хотелось конечно всё и сразу, но для начала были определены две платформы – Android и Windows (в виде Steam Greenlight, если пройдём конечно), соответственно нужен был кроссплатформенный движок. На тот момент были следующие кандидаты на которых я попробовал реализовать базовый уровень – Construct2, Libgdx, Unity3d, ImpactJS, Cocos2d, еще какая-то пара Flash-движков, AndEngine, CoronaSDK. Из всей кучи более-менее адекватными по совместимости, документации и простоте освоения были только два – это LibGDX и CoronaSDK, в Unity3d на тот момент работа с 2д графикой делалась набором костылей (но пару демок я написал и на нём, но по сравнению с теми двумя он не был таким удобным).

Как вообще выбрать движок для начального прототипирования игры? Заметьте, что для прототипа, именно прототипа, когда нужно составить виденье будущей игры, подходит фактический любой движок, который вы сумеете освоить хотя бы за пару недель и начать уже-то что-то на нём писать. LibGDX в этом плане имел хорошую wiki-документацию, отличный форум, с живым коммьюнити, а его авторов Mario Zechner написал даже две книги по программированию игр, с использованием LibGDX, (ищите на packtpub) всё это довольно сильно помогало на начальном этапе, ведь опыта программирования игр у меня не было. Примерно такая же ситуация с CoronaSDK – простая и доступная документация, сравнительно богатый для 2d набор API, язык программирования Lua – простой в освоении, но с большим количеством нюансов.

Первая демка, с тестовыми кнопками, собранная на CoronaSDK, шрифт тестовый, кнопки тоже

Сначала я вообще думал писать на CoronaSDK, но постоянная работа со сборщиком на стороне сервера, компиляция, потом загрузка на Android (всё это не быстро), да и довольно “жидкая” структура языка lua, чем то напоминающее javascript, заставили продолжить освоение движка LibGDX.

Собственно LibGDX был хорош всем. Во первых там был хороший туториал который позволял понять основной игровой цикл, были демки (около 100 шт.) с различными функциями API, которые можно было запустить и посмотреть, всё это дело собиралось на Windows и делало это очень быстро, плюс при компиляции на Android проект выглядел 100% также (у Corona бывали глюки, на эмуляторе так, а на телефоне по-другому). К тому же это была Java – мейстримовый ООП язык программирования, надо сказать очень удобный для реализации проектов любого уровня, и практически такой же как C#, на котором я писал (и пишу) на работе. К тому же это было всё управлением Android Studio (создатели Resharper и кучи других инструментов), которая была также крайне удобной IDE для разработки.

Собственно какие выводы я из всего этого сделал – если вы только начинающий в разработке игр, берите тот движок, который наиболее приемлем для вас с точки зрения простоты освоения, да, я понимаю, что выбрав бы допустим Unity3d я бы освоил более мощный инструмент, но в целом для игры, как для программного продукта, важно – сама геймплейная составляющая, на чём она будет реализована – дело вторичное, все движки примерно одинаково работают с 2д и 3д, поэтому выбирайте то, что подходит именно вам (может быть по опыту ЯП, может по удобству), единственный критерий на данном этапе – скорость разработки прототипа.

Найди AdMob на фотографии

Описывать сам процесс программирования для игры наверно нет смысла, для LibGDX всё доступно расписано в Wiki, хотя последнее время проект немного подзатих, но думаю для начинающих я бы порекомендовал его для “пробы пера”.

Итак на LibGDX мы доехали до выпуска демо-версии, здесь сыграло важную роль то, что у движка было:

- Лёгкая интеграция с рекламным API, можно было легко и без проблем встроить рекламные модули AdMob в проект с использованием готовых API.

- Это была фактически родная для Android – Java

- Собственно запуск демо прошёл фактически без всяких технических проблем, были пару вопросов почему-то криво формировалось отображение, но в целом – всё нормально.

- Далее начался марафон до релиза основной версии игры.

- На всём этом долгом пути очень полезными были следующие вещи:

- Android Studio – которая ну очень удобная штука со всеми фишками рефакторинга, подсветки синтаксиса, быстрых переходов, отладки и.т.д. JetBrains – one love! Всё это позволяло удобно управлять кодом и быстро находить ошибки экономя время и нервы.

- Структура проектов в LibGDX – так получилось, что данный фреймворк отлично спроектирован под создание 2д игр, почти под всё API были либо Demo либо статьи в Wiki, так что проблем технического характера было мало, также порадовала локализация, которая тоже имела свой API. На финальном этапе интеграции в Steam, также оказалось, что есть свободные компоненты для реализации Steam API в игре, аналогично было и с google play services. В целом LibGDX был этаким фреймворком наподобие стандартной библиотеки .NET с кучей готовых классов из которых ты можешь лепить всё, что тебе требуется, там есть практически всё (в рамках OpenGL ES, наверно =])

- Моральная Санина поддержка, особенно когда мы переписывали диалоги и тестировали всё это дела на баги. =]

В остальном особенно рассказать нечего, если вы прошли этап прототипирования и даже выпуска демо-версии, то, скорее всего, уже выбрали движок, который соответствует вашим требованиям. Если бы на данный момент (28.09.2017), я бы выбирал движок для реализации игры, я бы наверно в первую очередь шагнул в сторону Unity3d, который очень сильно эволюционировал за всё это время.

Постепенно правя последние баги мы подошли к релизу в Steam, запуск Android версии решено было отложить, поскольку там было пара технических моментов и мы всё никак не могли решить делать ли её бесплатной с рекламой или paid-app. Подготовка к запуску в Steam заняла тоже своём время, нужно было заполнит много информации – личные данные, ачивки, подготовить материалы (как оказалось нужны картинки на ачивки, значки, смайлики для чата, обои для профилей пользователей), а также протестировать работу API в игре. Steam вообще в этом плане очень удобная платформа, море документации, которая доступна после регистрации (и которая не подлежит разглашению o_O), делаю процесс довольно простым, к тому же, как я уже говорил, были готовые библиотеки для LibGDX. Вобщем пару раз нас отклоняла модерация из-за несоответствия материалов, но таки мы прошли и стартовали! :D

Тут процесс перетёк из состояния «разработка» в состояние «поддержка», и посыпались первые долгожданные «баги» — у некоторых неправильно отрабатывал FitViewport, у кого-то терялись сохранения, кому-то не давались ачивки, вобщем у кого что болит. Часть багов была оперативно поправлена, а часть… увы, но с некоторыми я так и не смог разобраться до сих пор.

Типичная отладка

Впрочем у большинства игроков игра шла стабильно, появилась первая статистика, скриншоты, отзывы, и какое-никакое моральное удовлетворение от проделанной работы. Ура мы стали разработчиками! :D

К чему я собственно в начале статьи упомянул про 4 часа… Последнее время перед релизом всё хотелось сделать уже качественно, проверить всё что надо, и выпустить нормальную рабочую версию, вобщем это было довольного много стресса. Кодинг, кропотливая работа по расталкиванию символов по карте, правки диалогов, тестирование, всем кто знает что такое кранч, те в курсе)

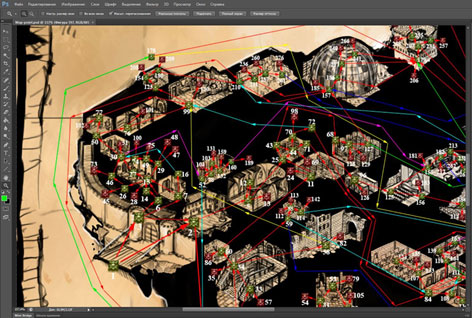

Карта замка, прототип, в начале мы хотели соединить всё это стрелочками и при прохождении чтобы отдельные области замка становились светлыми

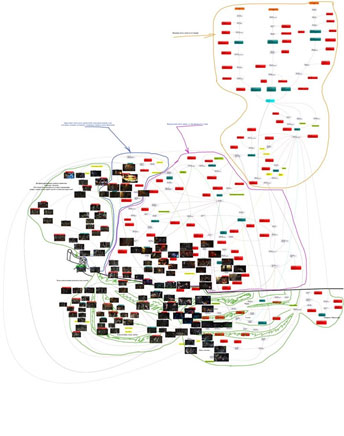

Карта всей игры

Вобщем это были напряженные деньки предфинальной полировки почти готового продукта. Спустя некоторое время была создана версия для Android, и запущена в виде paid-app, трансформация благодаря функционалу LibGDX произошла довольно безболезненно, все функции для if-else условий настройки интерфейса там были, поэтому часть управления была подстроена под пальцевый тач и всё закрутилось-завертелось.

Оставалось еще одно незаконченное дело – это версия для Mac, а именно для iOS, вообще Android для paid-приложения показал себя довольно хорошо, была надежда, что iOS версия будет как минимум не хуже.

Сейчас уже не помню в чём конкретно была причина, по которой я решил версию для iOS писать не на LibGDX, а на CoronaSDK, но вроде это были какие-то нюансы в совместимости. Был также куплен Mac, для того, чтобы пройти регистрацию на портале и для тестирования на виртуалке.

Достаточно быстро, хотя и не без проблем с Lua игра была переписана и запускалась на эмуляторе вполне хорошо, сказались некоторые отличия в компонентах, что-то пришлось оптимизировать, что-то переделать, но в целом движок с возложенной на него задачей справился, плюс CoronaSDK обладает хорошим и шустрым эмулятором. Место Android Studio заменил Sublime Text под который у CoronaSDK существует плагин, получилось что-то наподобие IDE, в котором было тоже довольно удобно. В целом у CoronaSDK плюсом и минусом является язык – это скриптовый Lua с динамической типизацией, к которой не сразу привыкаешь и иногда путаешься в областях видимости, определении переменных, и.т.д., постепенно к этому привыкаешь, всё становится таблицей в которую можно затолкать всё – начиная от данных и заканчивая функциями, в целом тут есть своя логика, но отлаживать всю эту чертовщину – не очень то круто. Коронка тоже имеет богатый API в котором есть много всего для создания 2д игр, очень проста в освоении, содержит много примеров в самой документации, плюс к этому есть плагины для встраивания монетизации, и прочих сервисов (некоторые платные). Для создания простеньких игрушек под телефоны – самое то, для чего-то более крупного, я бы наверно запутался в всём этом балагане, при отсутствии нормальной IDE.

Три тысячи чертей (на самом деле триста мечеломов) и одна маленькая сценка!

Запуск iOS версии прошёл стабильно, написав и протестировав всё под Windows на эмуляторе, осталось заполнить регистрационную информацию, сделать билд и запустить сборку на iOS. Profit! :D

На этом в принципе всё, основные моменты вроде рассказал, в следующей части Саня расскажет про поддержку игры после релиза, какие пиар-акции проводились, и что это всё итоге дало, плюс расскажем про монетизацию.

|

Метки: author MaikShamrock разработка под android разработка игр программирование libgdx corona sdk разработка игр под android программирование игр |

Liquibase: пример автоматизированного наката изменений на реляционную БД |

Liquibase: пример автоматизированного наката изменений на реляционную БД

Вместо предисловия

Статья будет интересна тем, кто хоть раз задумывался о вопросе наката изменений (патча) на реляционную БД. Статья не будет интересна тем, кто уже освоил и использует Liquibase. Главной целью данной статьи является указание ссылки на репозиторий с примером использования. В качестве примера я выбрал накат sample-схемы HR на БД Oracle (список всех поддерживаемых БД) — любой желающий может скачать себе репозиторий и поиграться в домашних условиях. Желание продемонстрировать пример вызвано обсуждением этого вопроса на ресурсе sql.ru.

Что такое Liquibase

Что такое Liquibase, можно узнать на официальном сайте продукта. Хочется отметить пару хороших статей и на этом ресурсе:

Управление миграциями БД с Liquibase

Использование Liquibase без головной боли. 10 советов из опыта реальной разработки

Почему я использую Liquibase

Мой выбор остановился на этом инструменте, так как:

1) Инструмент отслеживает, какие changeset-ы уже были применены к данному экземпляру БД и накатывает только те, которые еще не накатывались и какие нужно еще донакатить. Если в процессе наката применение какого-либо изменения упало с ошибкой, то, после устранения причины вы перезапускаете накат и Liquibase продолжает выполнение с того changeset-а, на котором остановился.

2) Возможность выставить changeset-у атрибуты runOnChange и runAlways существенно упрощает управление изменениями, в частности, recreatable-объектов.

3) Свойство context позволяет выполнять/не выполнять changeset-ы в зависимости от текущего окружения (например, не запускать юнит-тесты на проде).

Это был не полный список фич.

Репозиторий

Он здесь. В нем приведены "hard" (таблицы, индексы, ограничения целостности) и "soft" (триггеры, процедуры, представления) объекты, changeset-ы с тегами sql и sqlFile, c атрибутами runOnChange и runAlways и без.

Чего нет в репозитории

Ввиду отсутствия необходимости в репозитории нет таких полезных фич/шагов, которые я обычно использую в своих проектах:

- Preconditions — позволяют задавать условие выполнения changeset-a;

- Компилирование объектов схемы в конце наката. В Oracle это dbms_utility.compile_schema(user, false);

- Запуск юнит-тестов.

|

Метки: author akk0rd87 sql postgresql oracle microsoft sql server database migrations database tools liquibase |

Swift Generics: cтили для UIView и не только #2 |

Swift Generics: cтили для UIView и не только #2

Данная публикация является продолжением выпуска, где была затронута тема декорирования объектов. Ознакомление с первой публикацией поможет лучше вникнуть в текущий в контекст, т.к. упомянутые ранее термины и решения буду описываться с упрощениями.

Подход получился весьма удачным и был многократно протестирован на реальных проектах. Кроме этого, появились дополнения к подходу и удобство его использования значительно возросло.

Напомню, что основным элементом представленного способа задания стилей является обобщенное замыкание:

typealias Decoration = (T) -> Void Использовать данное замыкание для придания свойств UIView можно следующим образом:

let decoration: Decoration = { (view: UIView) -> Void in

view.backgroundColor = .white

}

let view = UIView()

decoration(view) Композиция декораций

Используя оператор сложения и соблюдая порядок применения декораций можно получить механизм композиции декораций:

func +(lhs: @escaping Decoration, rhs: @escaping Decoration) -> Decoration {

return { (value: T) -> Void in

lhs(value)

rhs(value)

}

} Складывать можно не только замыкания, принимающие объекты одного класса. Однако, следует учесть, что класс объекта, передаваемого в одно из замыканий, должен быть подклассом объекта, передаваемого в другое замыкание:

Decoration + Decoration = Decoration

Decoration + Decoration = Decoration

Decoration + Decoration = нельзя Создание декораций

Главным неудобством при создании декорации было написание кода самой конструкции декорации. Приходилось писать тип декорации, замыкание, тип класса внутри замыкания… Чаще всего это заканчивалось CTRL+C, CTRL+V.

Чтобы выйти из ситуации и генерировать замыкание через автокомплит была написана универсальная функция, которая принимала тип объекта:

func decor(_ type: T.Type, closure: @escaping Decoration) -> Decoration {

return closure

} Использовалось это следующим образом:

let decoration = decor(UIView.self) { (view) in

view.backgroundColor = .white

}Вот только self не автокомплитится и функцию нельзя было назвать decoration, т.к. чаще всего замыкание создавать с именем decoration и возникала ошибка:

error: variable used within its own initial value

let decoration = decoration(UIView.self) { (view) in

Более удачным решением стало создание универсальной static функции:

protocol Decorable: class {}

extension NSObject: Decorable {}

extension Decorable {

static func decoration(closure: @escaping Decoration) -> Decoration {

return closure

}

} Создавать декорирующее замыкание в итоге можно следующим образом:

let decoration = UIView.decoration { (view) in

view.backgroundColor = .white

}Состояние

class MyView: UIView {

var isDisabled: Bool = false

var isFavorite: Bool = false

var isSelected: Bool = false

}Чаще всего сочетание подобных переменные применяется лишь для того, чтобы изменить стиль конкретного UIView.

Если попытаться описать состояние стиля UIView одной переменной, то можно использовать перечисления. Однако, еще лучше подойдет OptionSet, который позволяет предусмотреть сочетания.

struct MyViewState: OptionSet, Hashable {

let rawValue: Int

init(rawValue: Int) {

self.rawValue = rawValue

}

static let normal = TextPlaceholderState(rawValue: 1 << 0)

static let disabled = TextPlaceholderState(rawValue: 1 << 1)

static let favorite = TextPlaceholderState(rawValue: 1 << 2)

static let selected = TextPlaceholderState(rawValue: 1 << 3)

var hashValue: Int {

return rawValue

}

}Применять можно следующим образом:

class MyView: UIView {

var state: MyViewState = .normal

}

let view = MyView()

view.state = [.disabled, .favorite]

view.state = .selectedВ прошлой публикации была введена обобщенная структура, которая имеет указатель на экземпляр класса, к которому будут применяться декорации.

struct Style {

let object: T

} У обобщенной структуры Style введем дополнительную переменную, которая будет отвечать за состояние стиля.

extension Style where T: Decorable {

var state: AnyHashable? {

get {

//

}

set {

//

}

}

}Сохранять состояние объекта через обобщенную структуру стало возможным при использовании runtime функций ассоциации объектов. Введем класс, который будет ассоциирован объектом декорации и будет содержать нужные переменные.

class Holder {

var state = Optional.none

}

var KEY: UInt8 = 0

extension Decorable {

var holder: Holder {

get {

if let holder = objc_getAssociatedObject(self, &KEY) as? Holder {

return holder

} else {

let holder = Holder()

let policy = objc_AssociationPolicy.OBJC_ASSOCIATION_RETAIN_NONATOMIC

objc_setAssociatedObject(self, &KEY, holder, policy)

return holder

}

}

}

} Теперь обобщенная структура Style может сохранять состояние через ассоциированный с объектом Holder класс.

extension Style where T: Decorable {

var state: AnyHashable? {

get {

return object.holder.state

}

set(value) {

object.holder.state = value

}

}

}Хранение декораций

Если можно хранить состояние стиля, то точно так же можно хранить декорации для разных состояний. Это достигается путем создания словаря декораций [AnyHashable: Decoration, ассоциированного с объектом декорации.

class Holder {

var state = Optional.none

var states = [AnyHashable: Decoration]()

} Чтобы добавлять декорации в словарь введем функцию:

extension Style where T: Decorable {

func prepare(state: AnyHashable, decoration: @escaping Decoration) {

object.holder.states[state] = decoration

}

} Использовать можно следующим образом:

let view = MyView()

view.style.prepare(state: MyViewState.disabled) { (view) in

view.backgroundColor = .gray

}

view.style.prepare(state: MyViewState.favorite) { (view) in

view.backgroundColor = .yellow

}Применение декораций

После наполнения словаря декораций, при изменении состояния стиля, следует применить соответствующую декорацию из словаря. Этого можно добиться немного изменив реализацию сеттера состояния стиля:

extension Style where T: Decorable {

var state: AnyHashable? {

get {

return object.holder.state

}

set(value) {

let holder = object.holder

if let key = value, let decoration = holder.states[key] {

object.style.apply(decoration)

}

holder.state = value

}

}

}Применяться декорация будет следующим образом:

let view = MyView()

// подготовка декораций

view.style.state = .selectedТак же стоит упомянуть случай, когда у объекта было установлено состояние стиля до того, как в словарь декораций попала соответствующая декорация. Для такой ситуации стоит доработать функцию подготовки декорации для состояния:

extension Style where T: Decorable {

func prepare(state: AnyHashable, decoration: @escaping Decoration) {

let holder = object.holder

holder.states[state] = decoration

if state == holder.state {

object.style.apply(decoration)

}

}

} Анимации?

Если внутри применяемой декорации содержится что-то, что можно анимировать,...

When positive, the background of the layer will be drawn with

rounded corners. Also effects the mask generated by the

'masksToBounds' property. Defaults to zero. Animatable.

open var cornerRadius: CGFloat

… то изменения стиля объекта внутри анимационного блока приведет к соответствующим анимациям:

UIView.animate(withDuration: 0.5) {

view.style.state = .selected

}Заключение

Получен удобный инструмент создания, хранения, применения, переиспользования, композиции декораций. Полный код инструмента можно найти по ссылке. Как обычно есть возможно установить и опробовать через CocoaPods:

pod 'Style'

|

Метки: author iWheelBuy разработка под ios разработка мобильных приложений xcode swift generics ios uiview associatedtype typealias protocol |

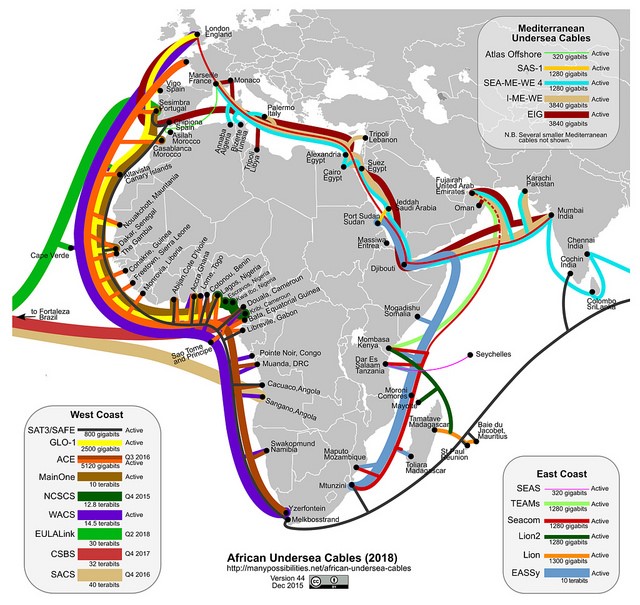

160-терабитный трансатлантический кабель Marea закончен |

160-терабитный трансатлантический кабель Marea закончен

Длина кабеля равняется 6600 километрам, а средняя глубина пролегания составляет 3,35 километра. Marea проложили меньше чем за два года, тогда как стандартный срок для подобных проектов составляет около пяти лет.

/ Flickr / Ministerio TIC Colombia / CC

Первый провод, который люди проложили через океан, — трансатлантический телеграфный кабель. Первую попытку предприняли в 1857 году, но кабель порвался.

5 августа 1858 года был проложен кабель между островами Валентия и Ньюфаундленд, но уже в сентябре он вышел из строя. Долговременную связь между Европой и Америкой обеспечил лишь кабель, проложенный в 1866 году.

Первый телефонный кабель через Атлантический океан появился в 1956 году, хотя обсуждался он еще в 1920-х. С тех пор человечество проложило огромное количество подводных коммуникационных каналов. Не дошли только до Антарктиды, там в интернет выходят через спутниковую связь.

/ Flickr / Steve Song / CC

В 2016 году группа компаний, среди которых была Google, закончила прокладывать кабель FASTER из США в Японию. По нему можно передавать до 60 Тбит данных в секунду — на момент запуска он был самым быстрым.

Формально FASTER остается самым быстрым кабелем и сейчас — использовать Marea начнут только в начале 2018 года. Полностью свой потенциал он раскроет в 2025 году. Ожидается, что к этому времени общемировое потребление трафика вырастет в восемь раз.

В условиях такого роста новый кабель нужен Microsoft и Facebook, чтобы обеспечивать стабильную работу своих сервисов. Президент Microsoft Брэд Смит (Brad Smith) уже высказался о важности Marea:

«Marea проложили вовремя. Через трансатлантические кабели проходит на 55% больше данных, чем через кабели Тихого океана. И на 40% больше, чем по кабелям, соединяющим США и Латинскую Америку.

Безусловно, поток данных через Атлантический океан будет расти, а Marea обеспечит необходимое качество соединения для США, Испании и других стран».

Еще одна причина, по которой компании инициировали проект, — природные катаклизмы. В 2006 году на острове Тайвань произошло семибалльное землетрясение, из-за чего были повреждены восемь кабелей, соединяющих остров с Китаем. Чтобы их восстановить, понадобилось 11 кораблей и 49 дней. А ураган Сэнди в 2012 году оставил без связи Восточное побережье США. С этого момента в Microsoft решили повысить отказоустойчивость трансатлантических соединений. Получается, что как раз Сэнди объединил Facebook и Microsoft.

«Мы постоянно встречались с представителями Facebook на различных мероприятиях и поняли, что пытаемся решить одну и ту же проблему. Поэтому мы объединились и улучшили трансатлантическую сеть, спроектировав новый кабель», — рассказал Фрэнк Рей (Frank Ray), руководитель инфраструктурного направления облачных решений.

Marea состоит из восьми пар оптоволоконных кабелей, защищенных медью, пластиком и водонепроницаемым покрытием. На большей части пути кабель лежит на дне океана, а рядом с берегами закопан под землю, чтобы его не порвали корабли. Так было в 2012 году, тогда за месяц два разных судна повредили кабель, связывающий Восточную Африку с Ближним Востоком и Европой.

Сообщество понимает, что подводные кабели не лишены недостатков, поэтому ведет разработку альтернативных методов соединения. Марк Цукерберг предлагает использовать дронов, компания AT&T — электрические сети, а некоторые ученые — квантовую телепортацию. Однако эти проекты находятся на ранних этапах своего развития или существуют пока лишь на бумаге.

P.S. Наши дайджесты на Хабре:

- 17 независимых блогов по математике, алгоритмам и языкам программирования

- 15 материалов по структурированию кода для разработчиков

P.P.S. О чем еще мы пишем в нашем корпоративном блоге:

|

Метки: author it_man разработка систем передачи данных блог компании ит-град трансатлантический кабель marea |

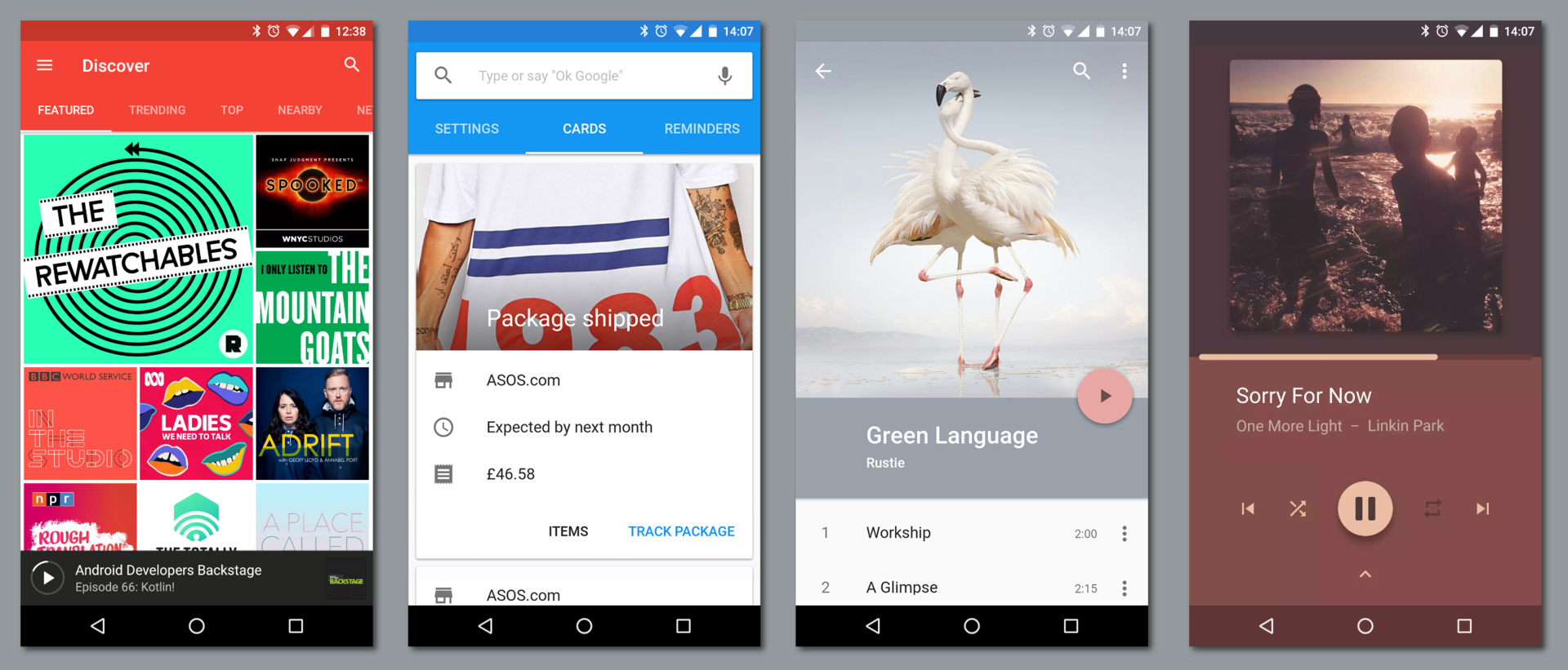

Дайджест интересных материалов для мобильного разработчика #223 (25 сентября — 1 октября) |

- Разработка под iOS,

- Разработка под Android,

- Разработка мобильных приложений,

- Разработка игр,

- Блог компании Everyday Tools

Дайджест интересных материалов для мобильного разработчика #223 (25 сентября — 1 октября)

- Разработка под iOS,

- Разработка под Android,

- Разработка мобильных приложений,

- Разработка игр,

- Блог компании Everyday Tools

|

Разработка прибыльной Android игры двумя школьниками + Продолжение |

|

Процесс релиза iOS-приложений в Badoo |

|

Как работает Android, часть 3 |

Дайджест доступен и в виде рассылки. Подписаться вы можете тут (у нас уже 2000+ подписчиков!).

iOS

iOS• (+24) Больше сюрпризов от Apple: обновленные правила размещения на App Store

• (+13) iOS+Kotlin. Что можно сделать сейчас

• (+8) Опционалы в Swift

• Podlodka #26: реактивный стиль программирования

• Stack AR: первая игра на основе ARKit, возглавившая топ App Store

• Полный разбор дизайна iOS 11: Apple все еще внимательны к деталям?

•

Первое React Native приложение: от «Hello World» до App Store

Первое React Native приложение: от «Hello World» до App Store•

Отладка Swift с LLDB

Отладка Swift с LLDB•

Как уйти из колледжа и стать iOS-фрилансером

Как уйти из колледжа и стать iOS-фрилансером•

Управление разными средами в Swift-проекте

Управление разными средами в Swift-проекте•

Руководство по ARKit для новичков

Руководство по ARKit для новичков•

Чистая Swift архитектура

Чистая Swift архитектура•

В Xcode 9 цвета можно добавлять в каталог ассетов

В Xcode 9 цвета можно добавлять в каталог ассетов•

Измерение времени компиляции в Xcode 9

Измерение времени компиляции в Xcode 9•

React Native Game Center: интеграция Game Center в React Native

React Native Game Center: интеграция Game Center в React Native•

ButtonProgressBar: прогресс бар в кнопке

ButtonProgressBar: прогресс бар в кнопке•

Detect.Location: история посещения мест по фотографиям

Detect.Location: история посещения мест по фотографиям•

LifetimeTracker: отслеживание ключевых проблем прямо во время разработки

LifetimeTracker: отслеживание ключевых проблем прямо во время разработки Android

Android• (+11) Делаем MitM с помощью openssl на Android

• (+11) Библиотека Reamp: обезболивающее для ваших Android-приложений

• (+11) Реактивные приложения с Model-View-Intent. Часть 2: View и Intent

• (+8) 30 новых ресурсов для android-разработчика (лето 2017)

• (+4) CSV-библиотека Adaptive Table Layout

• Лучшие приложения Google Play за пять лет

•

Android Dev Подкаст. Выпуск 43. Обзор Devfest Siberia 2017

Android Dev Подкаст. Выпуск 43. Обзор Devfest Siberia 2017• Победители Google Play Indie Games Festival

• Создание макета в ConstraintLayout: нормативы, барьеры и цепочки

• В Android O изменился файл хранения паролей от от wi-fi сетей

• Как парсить XML на Android

•

RxJava: делаем креш-логи лучше

RxJava: делаем креш-логи лучше•

Многопотоковый рендеринг на Android с Litho и Infer

Многопотоковый рендеринг на Android с Litho и Infer•

Flutter: от дизайна до приложения

Flutter: от дизайна до приложения•

Использование шрифтов с Support Library 26

Использование шрифтов с Support Library 26•

Android Architecture Components: тестирование ViewModel LiveData

Android Architecture Components: тестирование ViewModel LiveData•

Наслаждение тулбаром

Наслаждение тулбаром•

Воссоздаем “Бутылочку” на Android

Воссоздаем “Бутылочку” на Android•

Используем buildSrc для кастомной логики сборок Gradle

Используем buildSrc для кастомной логики сборок Gradle•

Как улучшить быстродействие Android Studio на машине с малым объемом памяти

Как улучшить быстродействие Android Studio на машине с малым объемом памяти•

Frames: готовое приложение с обоями

Frames: готовое приложение с обоями•

Tutorial View: простая организация туториалов

Tutorial View: простая организация туториалов•

Croller: круглый контрол

Croller: круглый контрол Разработка

Разработка• (+89) Иллюзия движения

• (+72) Иллюзия скорости

• (+21) Как мы за неделю создали чат-бота и подружили его с веб-приложением

• (+19) Learnopengl. Урок 3.3 — Класс 3D-модели

• (+15) Oblique frustum. Внутри скошенной пирамиды видимости

• (+11) Зачем в 2017 году писать свой движок для мобильных игр?

• (+10) Как Алексей Моисеенков дошел до Prisma и пошел дальше

• (+9) Как довести первый проект до конца. Часть 2. Мифы, ошибки и провалы

• (+8) «Нормальный у нас такой UX. UX? Не до этого нам, у нас тут сроки поджимают!» Снимаем мантию — моя интерпретация

• (+6) Как сделать gif-анимацию для Behance и Dribbble?

• Почему WebAssembly значительно изменит веб

• Как обучаются и растут junior-разработчики в BBC

• Inkdrop: как я создал редактор, зарабатывающий $1300 в месяц

• Jovo: open source фреймворк для разработки кроссплатформенных голосовых приложений

• “А что, так можно было?”: Рейтинг разработчиков будет пересмотрен

• Как tbh превратило анонимность во благо

• Мобильное Облако Mail.Ru внедрило технологии компьютерного зрения

•

Mission-driven интерфейс

Mission-driven интерфейс•

Мобильная типографика

Мобильная типографика•

Как получить работу в продуктовом или UX дизайне без портфолио

Как получить работу в продуктовом или UX дизайне без портфолио•

Вопросы и ответы по Code Review

Вопросы и ответы по Code Review•

Лучший кодинг через тестирование

Лучший кодинг через тестирование•

Понимаем Progressive Web App: стоят ли они всей шумихи?

Понимаем Progressive Web App: стоят ли они всей шумихи?•

Как неинтуитивный пользовательский интерфейс может создать превосходный пользовательский опыт

Как неинтуитивный пользовательский интерфейс может создать превосходный пользовательский опыт•

19 альтернатив Parse в 2017 году

19 альтернатив Parse в 2017 году Аналитика, маркетинг и монетизация

Аналитика, маркетинг и монетизация• (+4) Мобильные приложения: что такое предпраздничный сезон-2017 и как заработать на нем максимум?

• Игры жанра match3: как разработать такую игру и сделать её лучше

• Tune проводит увольнения

• Топ рекламных платформ для привлечения установок

• Фрод со сбросом DeviceID: новая угроза в мобильном маркетинге

•

Три стадии мобильного маркетинга

Три стадии мобильного маркетинга•

Аналитика против атрибуции — Работа с несоответствием установок

Аналитика против атрибуции — Работа с несоответствием установок Устройства, IoT, AI

Устройства, IoT, AI• (+20) Тайм-менеджмент для кинестетиков

• «Путь будущего»: бывший главный инженер Uber создал религию ИИ

• LG представила смартфон с отпугивателем комаров

• Amazon выпускает новые колонки и умные часы

• Какие языки вам стоит изучить для Data Science?

•

Microsoft запускает новые инструменты машинного обучения

Microsoft запускает новые инструменты машинного обучения<- Предыдущий дайджест. Если у вас есть другие интересные материалы или вы нашли ошибку — пришлите, пожалуйста, в почту.

|

|

[Из песочницы] Как легализовать торговлю игровыми предметами |

Как легализовать торговлю игровыми предметами

Объем российского рынка онлайн-игр по итогам 2016 года составил 56,7 млрд руб. (по данным Mail.Ru Group), общемировой объем рынка онлайн-игр в 2016 году — $99,6 млрд (по данным Newzoo), но только 6% пользователей умеют зарабатывать на внутриигровых предметах. Игровые пространства предлагают активно покупать амуницию, камуфляж, прогресс персонажа, но легально продать кому-то свою коллекцию ты не можешь, как не можешь и вывести деньги из игры, инвестировав время, скилы и удачу.

Имея большой опыт в игровой индустрии (Suntechsoft, Esforce, Na’Vi’ и др.), мы придумали, как объединить все игры и платформы и дать геймерам возможность в один клик продавать, обменивать или оценивать виртуальные предметы. Сервис DMarket будет работать на базе блокчейн, а все операции внутри маркетплейса можно будет осуществлять с помощью встроенных токенов и умных контрактов.

Но сначала мы хотели бы поговорить о том, почему необходимость в таком проекте действительно назрела.

От виртуального — к реальному

Многие собирают коллекции вещей, оружия, артефактов в видеоиграх так же, как другие в оффлайне коллекционируют монеты, марки и оружие из разных стран. Мы посчитали: 2,15 млрд геймеров в мире сталкиваются с технологическим ограничением своего права на торговлю внутриигровыми предметами. Тратя время и прилагая усилия, они зарабатывают виртуальные предметы на компьютерах, телефонах или консолях. Эти предметы имеют реальную ценность, являются редкими, привлекательными, а иногда просто нужными другим геймерам. Но все виртуальное продолжает оставаться виртуальным.

Конечно, пользователи начали придумывать различные сценарии, чтобы все-таки получить реальную выгоду от своей виртуальной жизни. Они конвертируют множество игровых предметов в один дорогой и продают его, покупают на игровые предметы ключи к играм и, опять же, продают. Наконец, они просто договариваются с другими пользователями на форумах и передают предметы или целые аккаунты там. Конечно, вопрос безопасности сделок обеспечивается весьма условно, поэтому часто и продавцы, и покупатели сталкиваются с мошенничеством.

«Честных игровых проектов и площадок с возможностью легального вывода средств из экосистемы банально не существует. Те же, что предлагают «заработать» в игре, представляют собой в большей степени финансовые пирамиды, нежели реальные игры».

Рассмотрим крупнейших игроков на глобальном рынке внутриигровых предметов.

Steam

Ежедневное количество активных пользователей: 12 853 536 (по состоянию на 15.07.2017);

Количество игр: + — 14 398 (по состоянию на 15.07.2017).

Платформа Steam была выпущена в 2003 году. За последние 4 года она завоевала огромную популярность среди игрового сообщества, прибыль в 2016 — $3,5 млрд. Steam первым обратил внимание на торговлю внутриигровыми предметами. Правда, вся полученная прибыль удерживается внутри платформы, возможности обналичить деньги нет. Более того, возможность торговать игровыми предметами ограничена и представлена всего в нескольких играх (CS:GO, Dota2, TF2, PUBG, H1Z1).

Преимущества Steam:

- крупнейший рынок для продажи видеоигр и модов;

- темп продаж увеличивается, и каталог игр стремительно расширяется. На сегодняшний день активировано почти 370 млн платных игр;

- Steam предлагает дополнительные сервисы для игроков, моддеров и разработчиков игр: торговля предметами, бета/альфа релизы, предварительная продажа игр, реестр предметов, обработка платежей и проверка кредитных карт.

Недостатки Steam:

- технологии и серверы Steam централизованы и имеют полный контроль над доступностью каждого отдельного товара или элемента в своем каталоге. Это приводит к мошенничеству в сфере безопасности (учетной записи);

- большинство игр в Steam не поддерживают внутриигровую торговлю. Только три игры оказывают значительное влияние на общий оборот внутриигровых предметов (CS:GO, Dota2, TF2);

- пользователи Steam не имеют реального влияния на развитие платформы;

- Steam не позволяет своим пользователям обналичивать виртуальную валюту платформы;

- Steam взимает высокую комиссию за торговлю игровыми предметами (до 12%);

- Steam не поддерживает мультиплатформенную торговлю и торговлю на разных игровых движках.

Opskins

Opskins – это площадка для торговли внутриигровыми предметами, которая была запущена в 2014 году. Opskins сохраняет безопасность как покупателей, так и продавцов, выступая в качестве сторонней платформы. Деньги можно вывести на счет PayPal, банковский счет, биткойн-кошелек, карту предоплаты Visa и т.д.

Сервис применяет API Steam, позволяющий торговать внутриигровыми предметами. На данный момент Opskins является крупнейшей в мире платформой для торговли скинами с 10 млн уникальных пользователей в месяц.

Преимущества Opskins:

- оборот за І и ІІ кварталы 2017 года составил около $250 млн;

- одно из самых крупных сообществ по продаже скинов (более 10 млн пользователей каждый месяц);

- обналичивание реальных денег.

Недостатки Opskins:

- не имеет официальной поддержки Steam (большое количество случаев мошенничества с аккаунтами);

- высокая комиссия за транзакции и вывод средств (до 10%);

- поддерживает всего несколько игр Steam;

- в большой степени зависит от Steam из-за использования API-интерфейса этого сервиса.

Также на рынке есть универсальные гаранты сделок, но они работают не только с игровыми предметами, но и с акаунтами и фрилансом, в целом. Вы можете прийти туда и продать что-то в индивидуальном порядке, но никакой игровой экосистемы здесь нет.

В начале статьи мы говорили о 2,15 млрд геймеров. Именно такое количество людей во всем мире играет в игры на разных платформах. Если бы все они получили возможность торговать своими виртуальными раритетами, ежегодный оборот игрового контента в денежном выражении превысил бы $450 млрд.

Возникает логичный вопрос — почему никто не создал подобную платформу, если речь идет о таком потенциале? Основная проблема, которая раньше не позволяла реализовать то, что сейчас сделали мы, – технология. Для работы универсальной платформы нужно синхронизировать сотни тысяч баз данных каждой игры и каждого издателя после очередной сделки. Чтобы решить эту проблему, мы используем базу данных блокчейн.

Второй важный момент — интерес разработчиков и издателей игр. Мы не уводим пользователей от покупки непосредственно внутри игр в сторону покупок у частных лиц, мы создаем сообщество, в котором продажа и обмен предметов будет только частью процесса. Благодаря блокчейн, будет сохраняться история каждого виртуального артефакта, можно будет проследить, кто владел раньше условным автоматом, кто был первым покупателем, где он использовался. Это создает историю каждой вещи, и из безликого инструмента для достижения игровых целей она превращается в предмет коллекционирования. Пользователи будут продавать одни предметы и покупать другие, а потом возвращаться в игру, чтобы использовать полученные возможности. Таким образом увеличится время, которое игрок проводит внутри игры, жизнь каждого предмета и жизненный цикл самой игры.

|

Метки: author Hyperevolution продвижение игр монетизация игр игры игровая индустрия внутриигровые покупки внутриигровая валюта |

[Из песочницы] Информационная безопасность в АСУ ТП: вектор атаки преобразователи интерфейсов |

Информационная безопасность в АСУ ТП: вектор атаки преобразователи интерфейсов

Размышление

Некоторое время назад я посетил одну конференцию, посвящённую информационной безопасности, там обсуждали вопросы все различной безопасности в различных системах. Я по своей основной специальности не имею прямого отношения к безопасности и у меня возникло много вопросов и мыслей по данной теме, что и послужило началом изучения вопросов ИБ в АСУ.

Выступал там один парень с докладом об ИБ в АСУ ТП, рассказывал о том, что на протяжении длительного времени эволюция систем автоматизации шла параллельным курсом с развитием ИТ систем и что с течением времени для управления системами автоматизации стали применяться системы, построенные на современных ИТ технологиях. И что в настоящее время сопряжение технологической сети с корпоративной сетью необходимо для управления производством так и для администрирования всей системы целиком. Вектор атак с систем ИТ перешел на производственные и промышленные сети. Рассказывал о заводе где-то в германии на который удалось произвести атаку и сорвать технологический процесс в результате чего литейное производство встало и понесло огромные убытки, а литейный цех пришлось разбирать и еще много страшных историй. Ну в общем доклад не произвел нужного(пугающего) впечатления. Присутствующие на данном мероприятии начали задавать вопросы и обсуждать," мол кому мы нужны маленькие компании с минимальными оборотами денег, что мол есть ли реальные подтверждения инцидентов с атаками на предприятия у нас в России".

Парень не смог привести примеры: либо не был готов, либо не имел право разглашать ту информацию которой он владел. Так к чему этот рассказ?

После данного мероприятия я задумался почему люди так отреагировали на его выступления, ведь он хорошо оперировал терминами и международной статистикой по атакам на объекты, но люди посчитали что эти атаки маловероятны и не представляют угрозы для них. Именно это побудило меня заняться исследованием в области информационной безопасности АСУ ТП.

Немного теории

Рассмотрим нетипичное направление атаки на преобразователи интерфейсов, т.к. много информации об атаках на ПК, ПЛК и системы в целом, но мало кто задумывался что почти на каждом производстве имеются все различные системы устройств, датчиков, приборов и есть проблема совместимости различных видов устройств. Существует огромное разнообразие устройств различного вида и назначения, большое количество компаний, занимающихся их производством, разные стандарты, большей частью не совместимые между собой. Выходом из этой ситуации служат преобразователи интерфейсов. Все они применяются для подключения устройств с интерфейсом RS-232/422/485, а это системы сбора данных, регистраторов, контроллеров, датчиков, терминалов и многого другого. Но мало просто соединить порты необходимо установить связь на программном уровне, что является более сложной задачей. Разные стандарты устройств способны передавать данные по различным технологиям. Унифицировать протоколы привести передаваемые данные к единому виду с помощью преобразователей не получиться, но адаптировать вид данных передаваемых между различными частями системы различными протоколами, чтобы они были успешно приняты и расшифрованы элементом, использующий другой протокол возможно.

А те, кто эксплуатирует реальные системы АСУ ТП знают насколько иногда разнообразно оборудование и части этой системы, которые в некоторых случаях работают на производстве уже порядка 10-15 лет и поверх одной системы приходиться иногда ставить другую систему и добиваться ее сращивание, что бы все взаимодействовало между собой. Вот тут преобразователи интерфейсов подходят как никогда. Преобразование пакетов, передаваемых данных происходит на программном уровне. Помимо непосредственно изменения структуры передаваемых данных, программная составляющая преобразователя отвечает за определение типов протоколов, используемых в системе и выбор алгоритма для их согласования.

Преобразователь интерфейсов современное и эффективное средство расширения функциональности информационной системы, незаменимое в условиях отсутствия единого стандарта построения все различных систем передачи данных.

А теперь давайте задумаемся мы используем преобразователи на все образных объектах, подключаем к ним все различные устройства (терминалы защиты, датчики, счетчики) и другие все возможные устройства. Но ведь вся информация от объекта до клиента проходит через них и стоит получить к ним доступ как мы можем узнать очень много информации которая, даст нам направление атаки на конечные устройства или позволит получать, подменять или отправлять информацию от имени этих устройств.

К практике

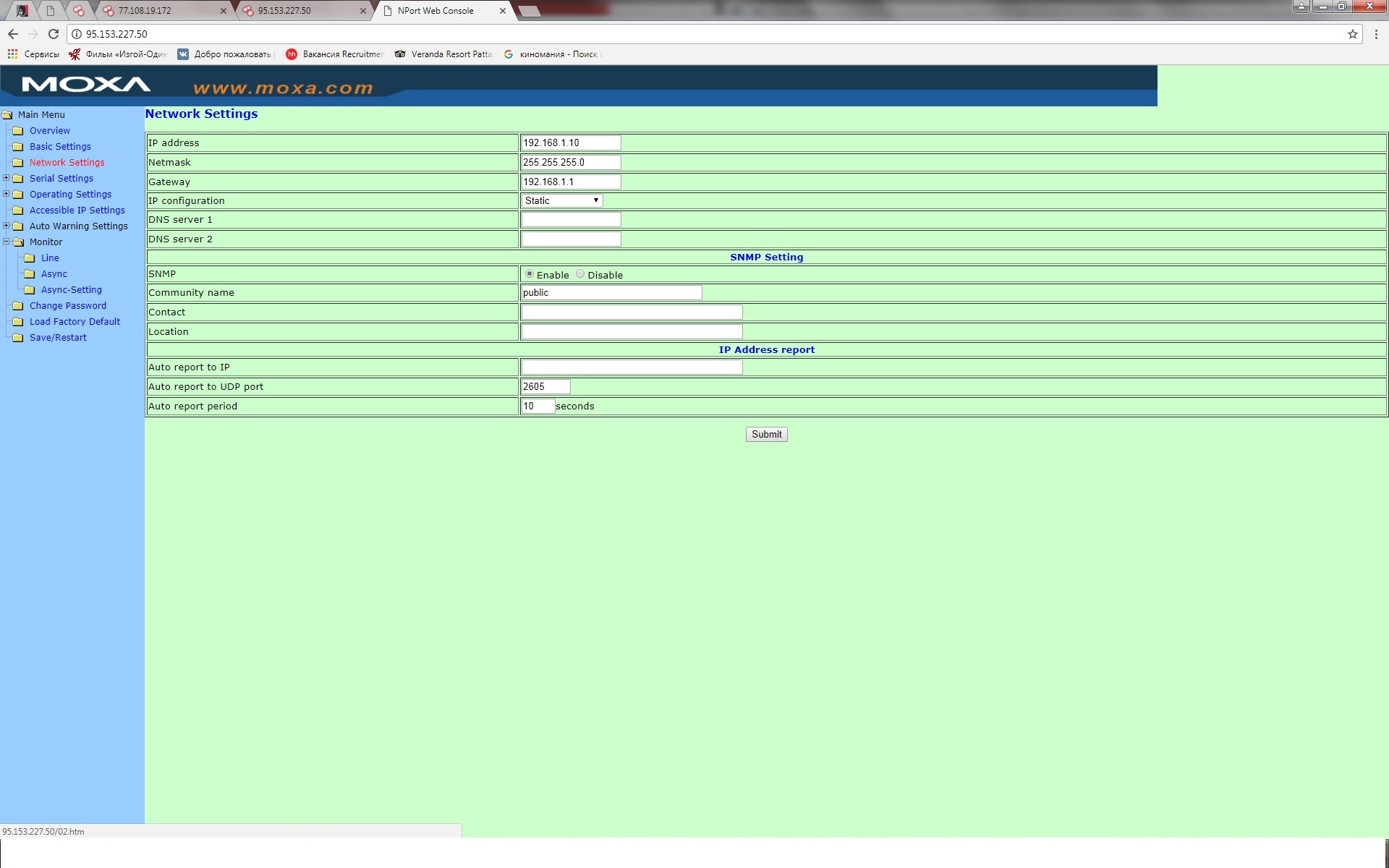

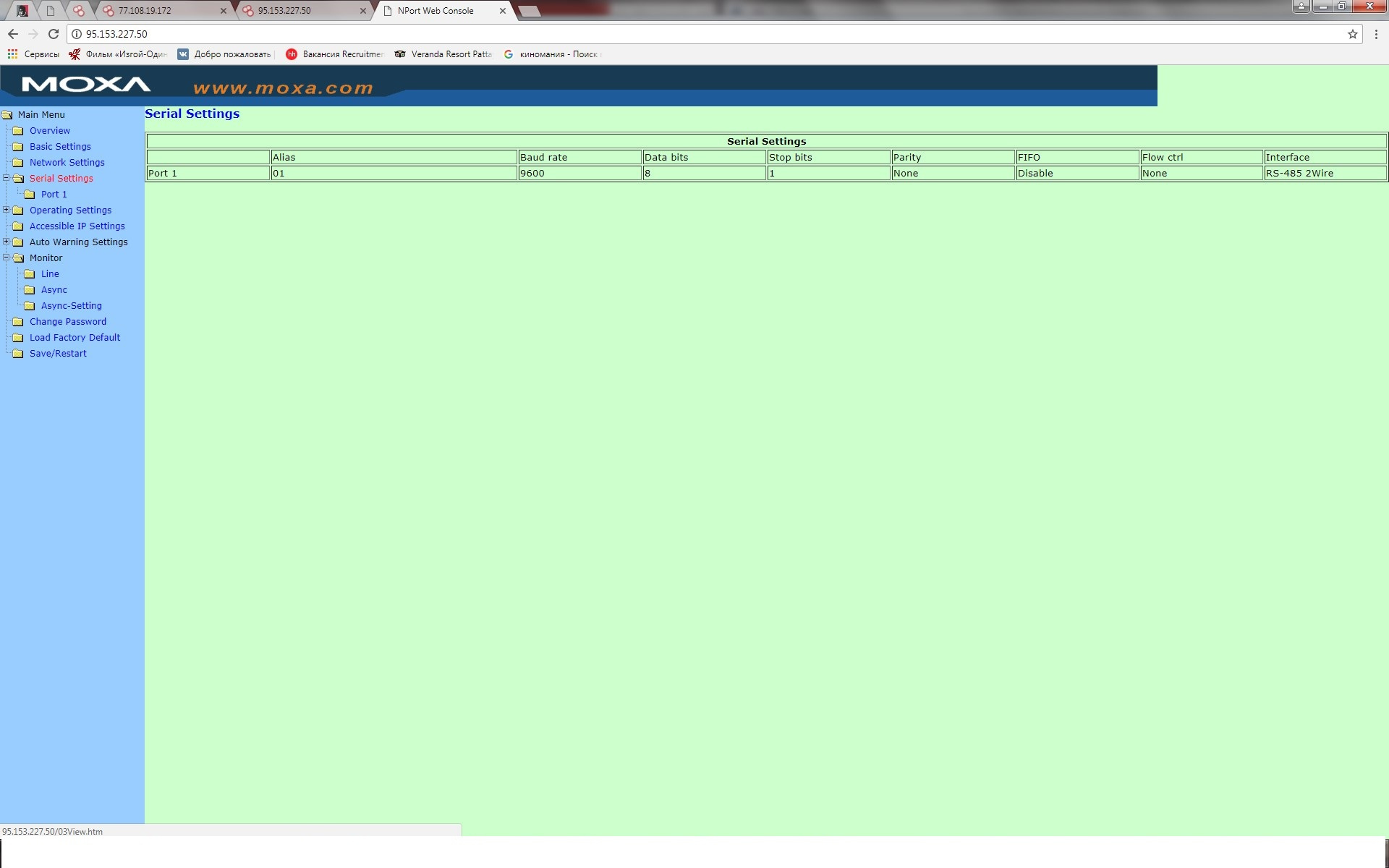

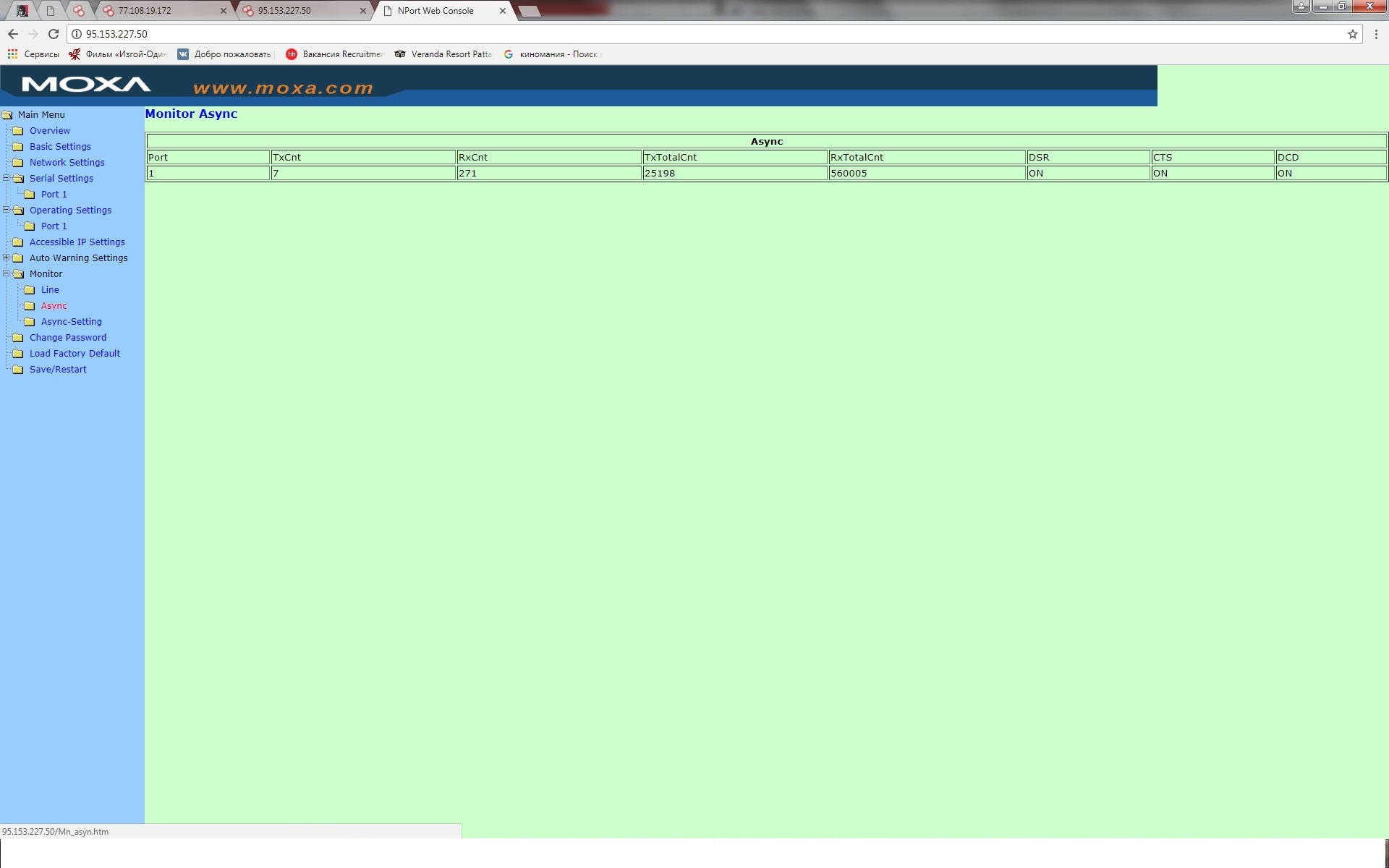

Мы проведем эксперимент с очень популярными преобразователями тайваньской фирмы MOXA Nport различных версий. Пользоваться будем свободно распространяемым ПО и разрешенными ресурсами на уровни простых пользователей.

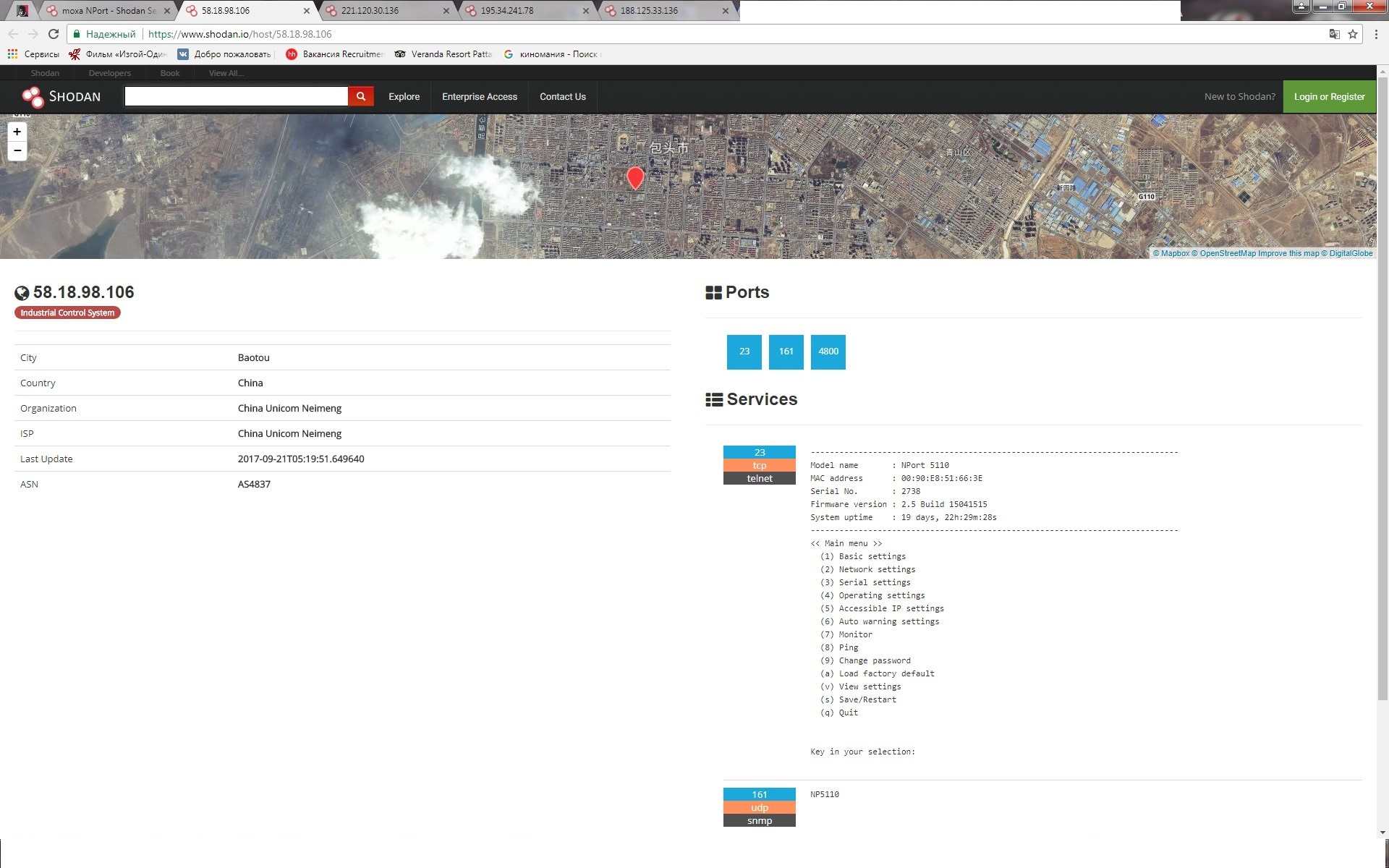

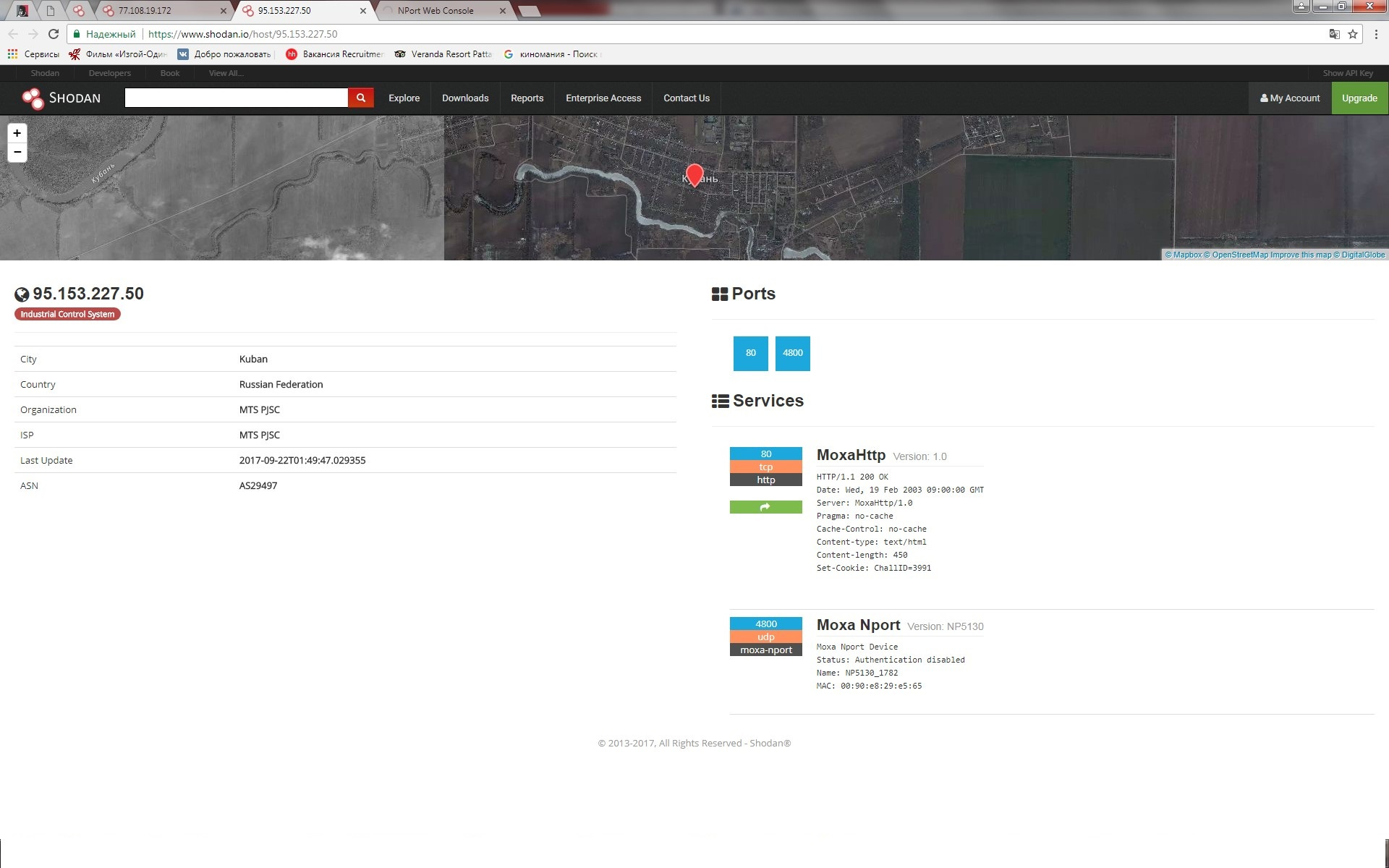

Есть в сети такой очень интересный ресурс www.shodan.io позволяет найти устройства в глобальной сети интернет, к которым есть доступ и увидеть где они находятся. Выполним простое сканирование с вводом в поисковой строке Moxa Nport. Смотрим и удивляемся тому, что происходит в мире. Стоит учитывать, что некоторые организации направляют письменный запрет на сканирование их подсети в компанию www.shodan.io.

В общем случаи мы нашли 7260 устройств по запросу Moxa Nport во всем мире. Дальше изучаем как можно попасть на устройства к которым открыт доступ. Замечаем, что в большинстве своем 22, 23, 80, 443 порты открыты и через них можно спокойно подключиться к устройствам.

Тайвань

Польша

Липецк

Китай

Казань

Тайвань

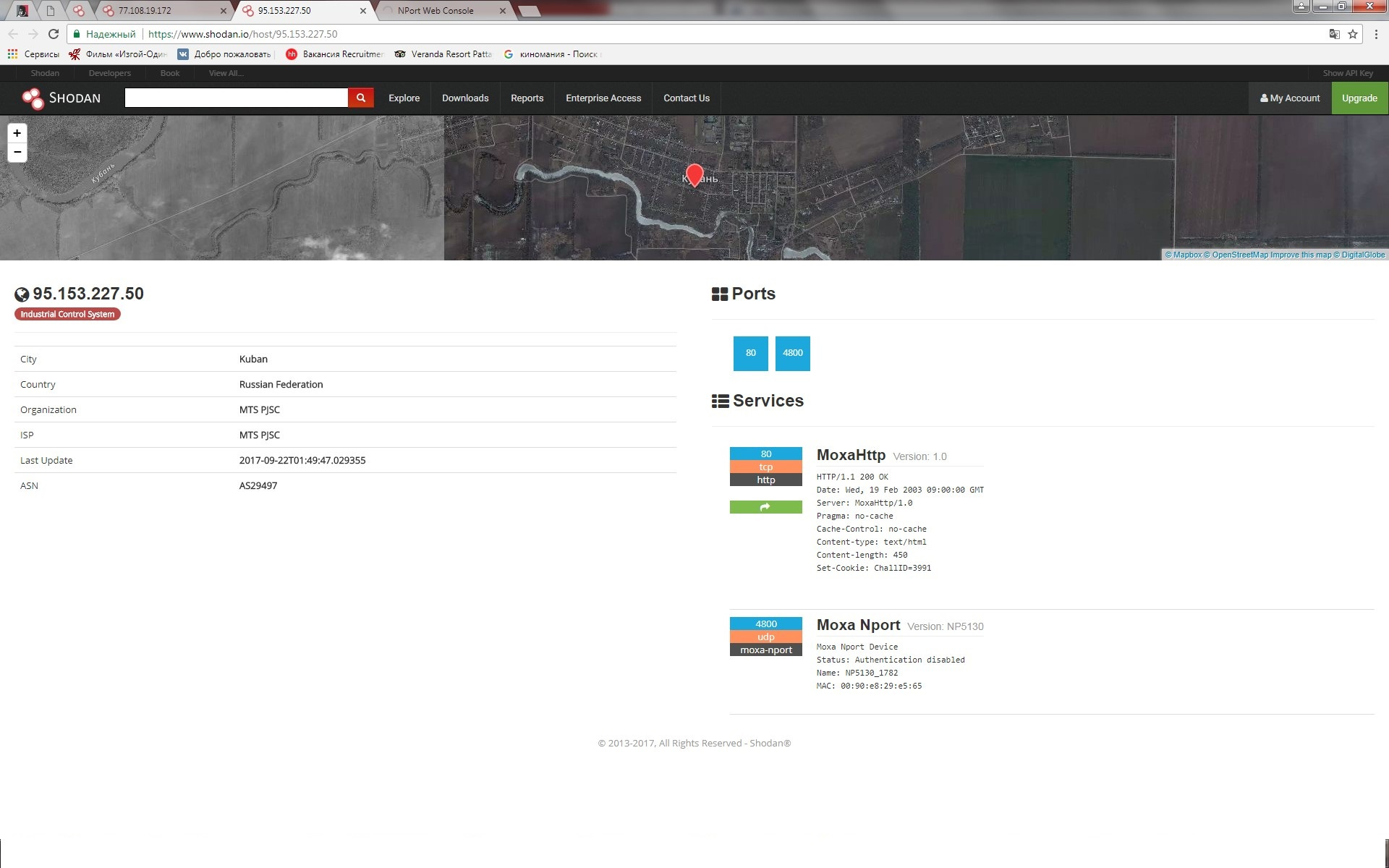

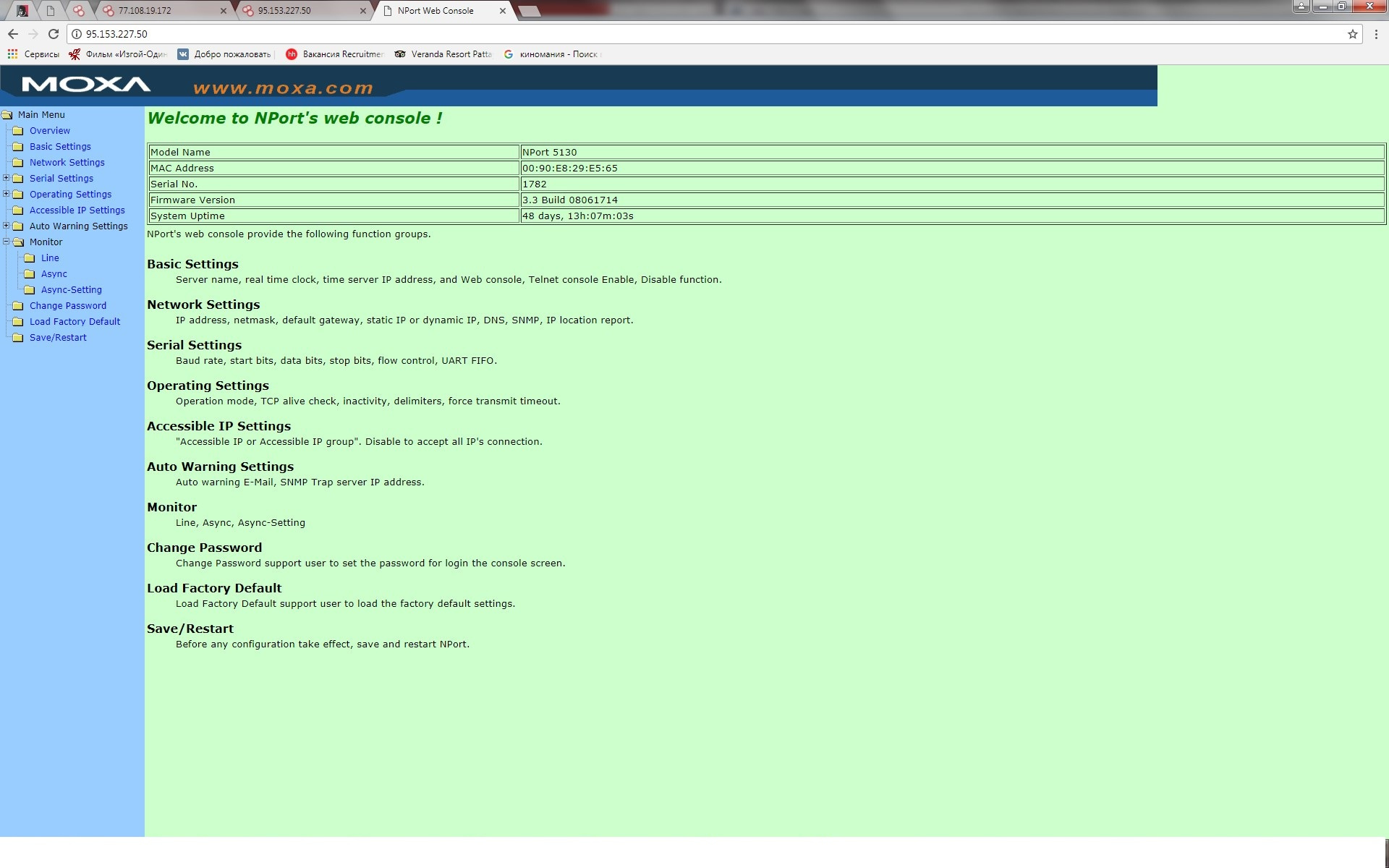

В некоторых случаях на устройствах стоят заводские учетные записи по умолчанию, узнать логин и пароль не составляет труда.

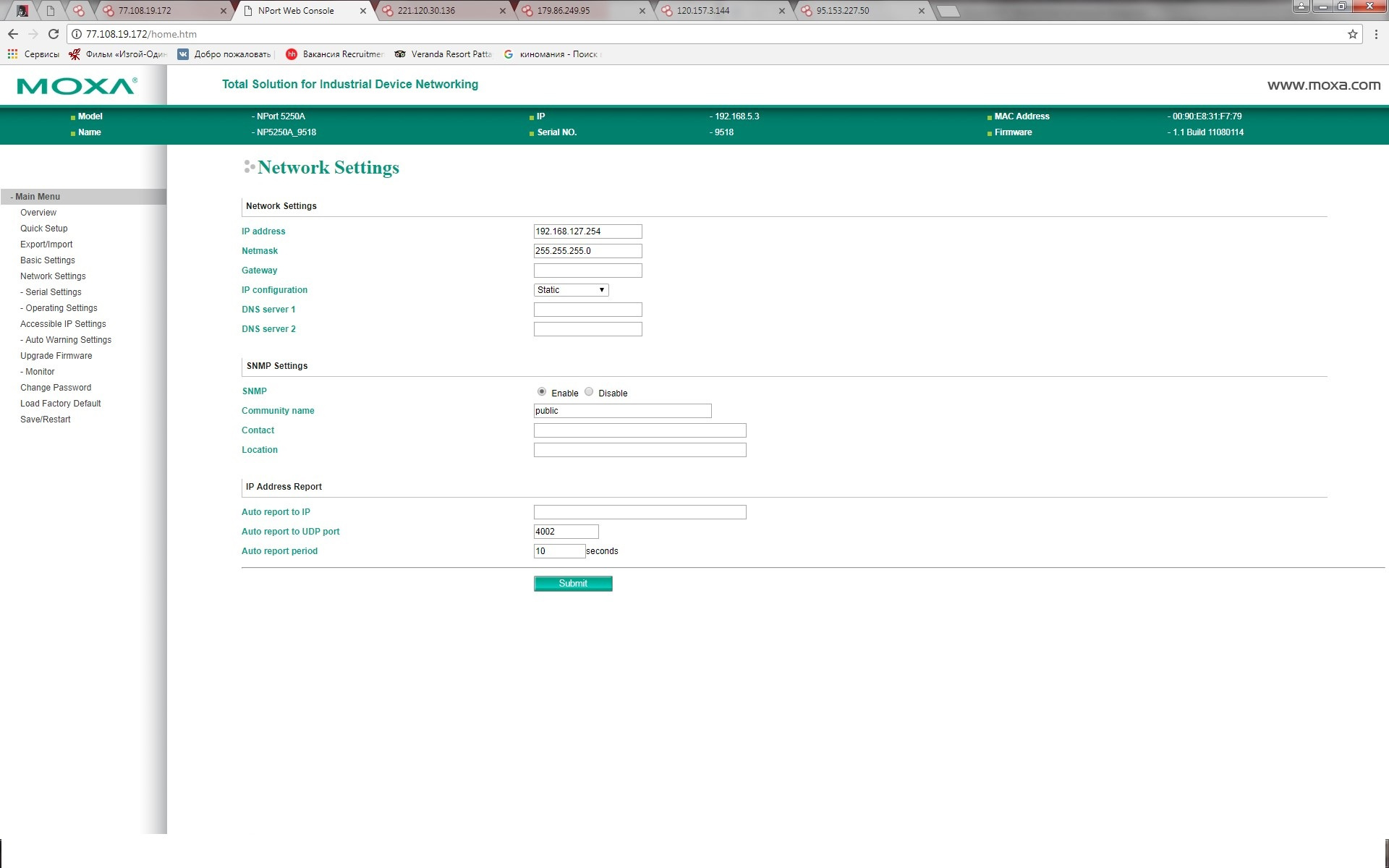

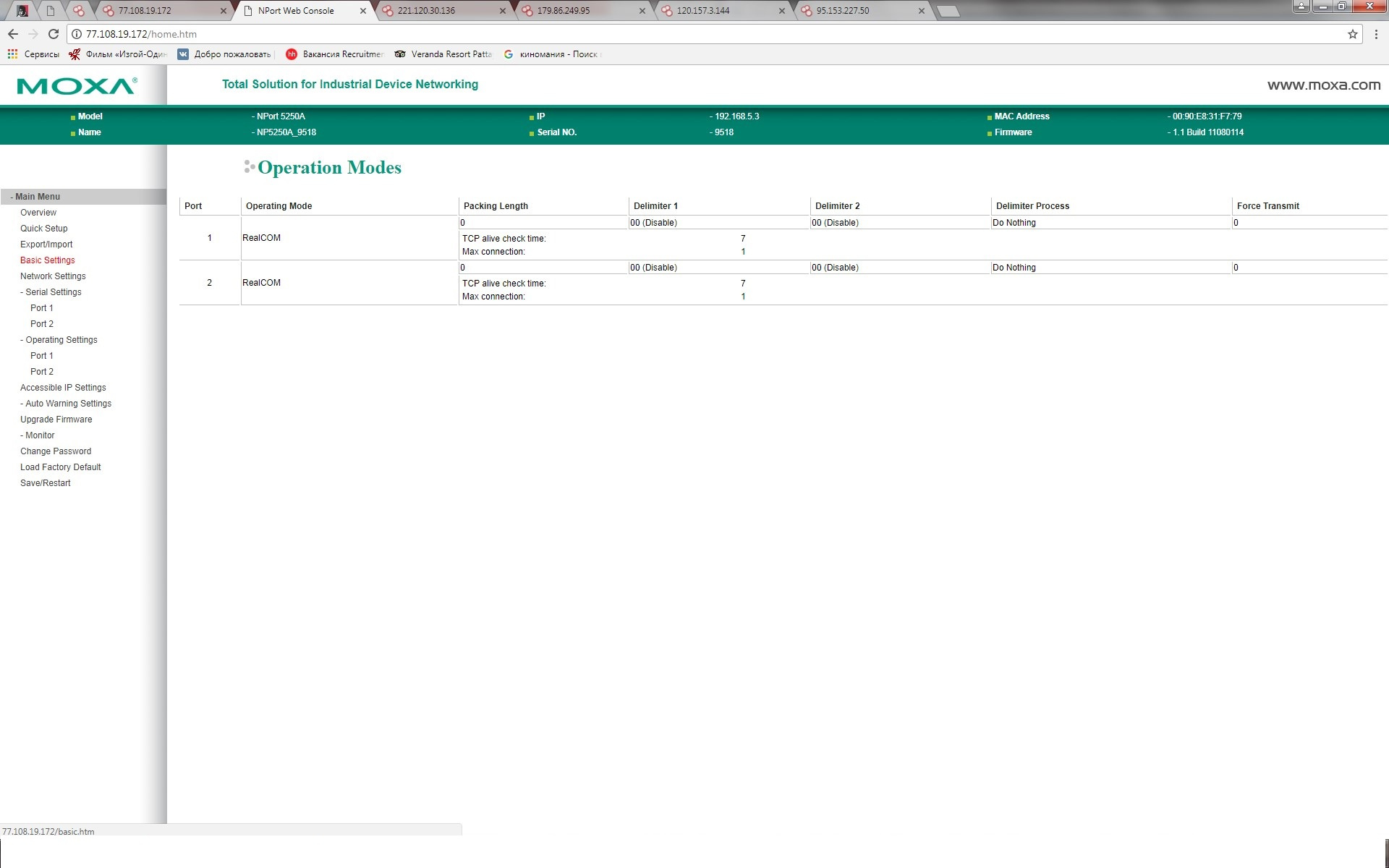

Попадаем на устройство и смотрим все что нужно, убеждаемся, что есть права администратора.

Можем как просмотреть всю информацию, так и изменить ее.

Некоторые пользователь устанавливают нестандартные пароль и закрывают 80 порт, но www.shodan.io все равно есть возможность просмотра полезной информации и по другим портам которая может быть использована для развития вектора атаки. Название устройство, его статус, мак адреса, SSL certificate его версию и многое другое.

И это все может послужить хорошим подспорьем при планировании и организации атак. Чем больше ты знаешь информации об объекте тем больше шансов, что вы сможете её использовать для атаки.

В наше время не доставит труда даже те устройства которые были запоролины взломать методом перебора, а так как в большинстве своем настройка этих устройств не всегда выполняется специалистами то нет ограничения по количеству попыток ввода пароля, что могло бы очень сильно помочь от перебора.

Но это только начало, используем стандартные пары ( а таких устройств нашлось не мало и в России, Чехии, Польше, Италии, Австралии, и во многих других странах).

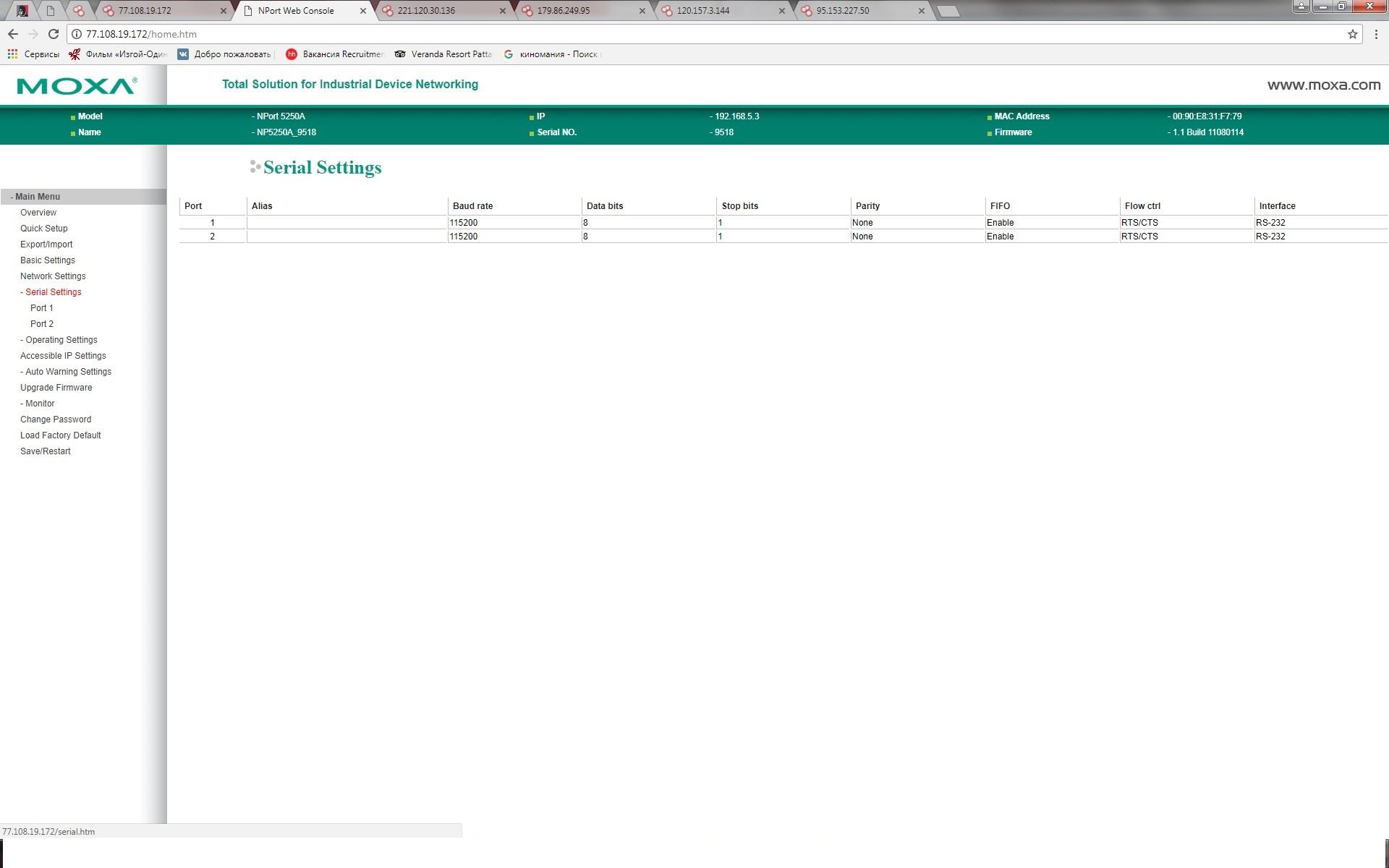

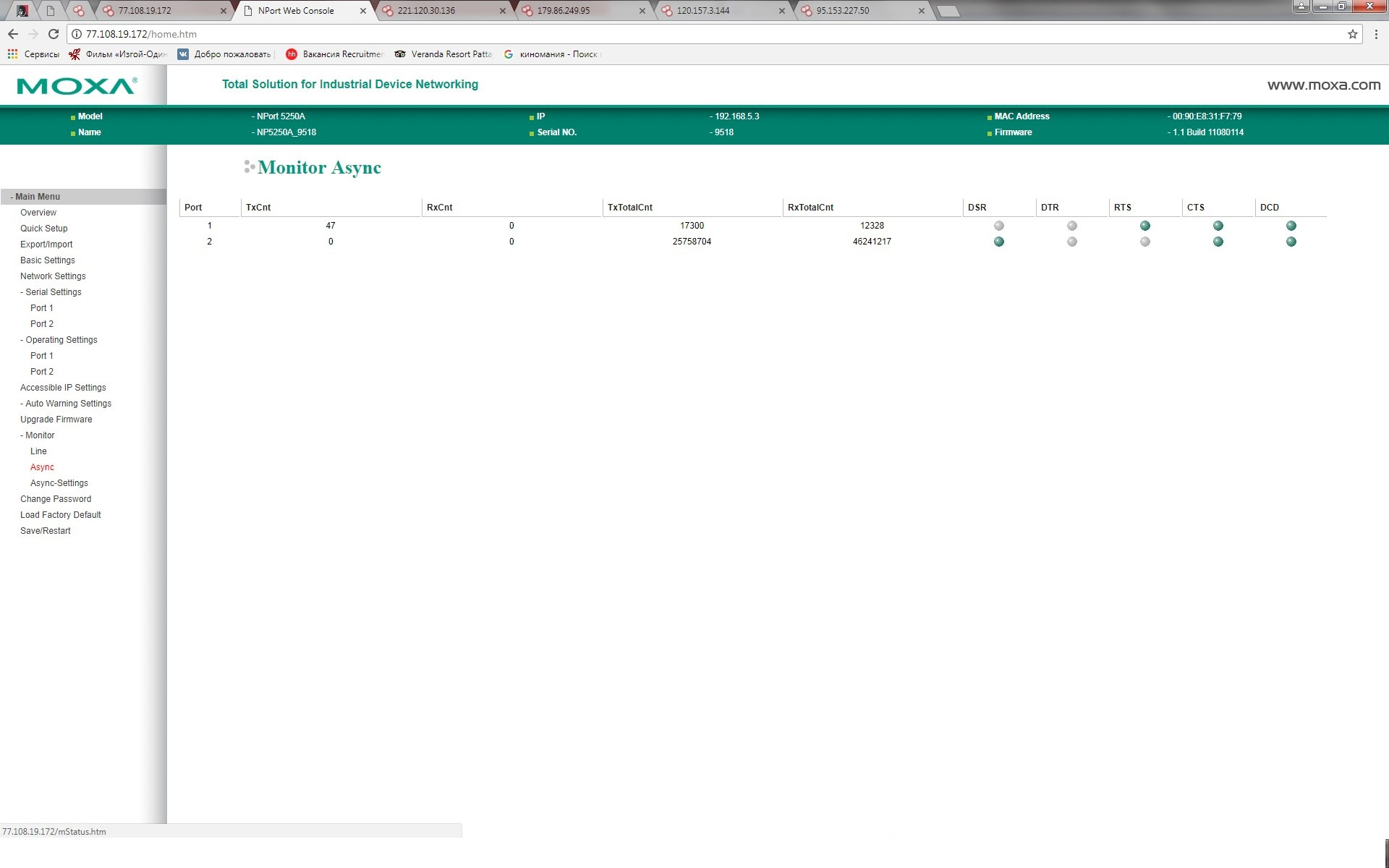

Мы получаем не ограниченный доступ к устройству и можем производить анализ как внутренней информации( внутренняя сеть в которой стоит устройство, узнаем диапазон адресов и адрес шлюза) так и провести анализ, что за устройства подключены к преобразователям, анализ количества передаваемой информации и многое другое.

И смена паролей и перезагрузка, в общем неограниченные права администратора.

Это все мы смогли сделать просто не обладая профессиональными знаниями и нужной специализацией. А теперь капнем чуть глубже, допустим что имеем опыт с этим оборудованием и устройствами, немного разбираемся в ИБ и знаем где искать официально выложенные уязвимости.

Да господа, все известные уязвимости выкладываются в сети на профессиональных, специализированных сайтах. Вы не поверите моему удивлению когда я узнал, что все в открытом доступе, а я ведь не специалист по ИБ.

Проходим на ics-cert.us-cert.gov и в поисковике просто указываем интересующее нас оборудование и имеем официальный список признанных уязвимостей от компании MOXA и этот список разнообразный.

Гуглем дальше и узнаем о том что эксплуатация уязвимостей позволяет атакующим незаметно выполнить различные действия на устройстве. Оборудование Тайваньской компании MOXA подвержено уязвимостям позволяющим удаленному неавторизованному пользователю получить доступ с правами администратора к устройствам и важной информации хранимой в незашифрованном виде. Так же злоумышленник может осуществить CSRF-атаку. Успешная эксплуатация данных уязвимостей позволяет атакующему незаметно выполнить различные команды, изменить пароль, настройки, и перезагрузить устройство.

Появление проблем является следствием недостаточной защиты систем АСУ ТП в общем. К примеру преобразователи поставляются без установленного пароля или со стандартным заводским паролем и учетной записью (CVE-2016-2286). Как и многие устройства для систем АСУ, что позволяет любому пользователю получить доступ правами администратора к устройству через TCP/80(HTTP) и TCP/23(Telnet). В настоящее время как утверждает производитель нет информации о случаях активной эксплуатации ошибок. И производитель рекомендовал в свое время просто отключать порты TCP/80(HTTP) и TCP/23(Telnet).

CVE-2016-0875 Позволяет удаленному пользователю повысить свои привилегии и получить доступ к конфигурационным и лог файлам с помощью специально сформулированного URL.

CVE-2016-087 удаленный атакующий может вызвать отказ в обслуживании путем отправки специально сформулированного запроса.

CVE-2016-0877 связана с PING функцией, а ее эксплуатация может привести к утечкам данных.

CVE-20164500 затрагивает встраиваемые компьютеры uc7408 lx plus позволяет удаленному авторизированному пользователю перепрашивать устройства и вызывать отказ в работе.

CVE-016-8717 эксперты обнаружили в устройствах MOXA жестко закодированные учетные данные которые позволяют войти в недокументированный аккаунт.

Исследователи и различные специалисты регулярно находят помимо уязвимостей, багов, и устаревшего ПО, бэкдоры. О безопасности интернет вещей в целом говорят все больше, однако от таких крупных производителей коммуникационного оборудования, как компания MOXA подобного ни кто не ожидал. Ведь проблемы обнаружены в целом ряде случаев, начиная от проблем с аутификацией которая допускает проведение словарных атак, множества XSS багов в веб интерфейсе, DoS- уязвимостями, возможностью инъекции команд.

Для большинства проблем производитель выпустил корректирующие обновления прошивок устраняющие ряд уязвимостей, в других случаях MOXA приняла решения прекратить выпуск некоторых устройств в связи с невозможностью, а иногда и не желанием устранять уязвимости.

Узнав о таких уязвимостях от такого крупного производителя, всем кто использует оборудование данной компании надо бы задуматься об обновлении прошивок, смене паролей, и настроек устройства. Но в практике АСУ ТП все гораздо сложней. На производстве работает оборудование которое вообще ни когда не обновлялось, либо не может быть обновлено в связи с технологией непрерывного производства. И тут вопросов возникает еще больше, но это уже другая история и другой вектор атаки.

Поговорим о результатах исследования: они не утешительны, не обладая специализированными знаниями и ПО нам удалось проникнуть на внушительное количество преобразователей без особого труда и это реальность, не теория. Дальше если предположить, что человек имеет опыт общения с этими устройствами и знает где искать критическую информацию об уязвимостях, то он в большинстве случаев может просто про эксплуатировать уязвимости, потому что большинство оборудования на которое мы побывали проникнуть, имело стандартную прошивку с завода без нужных обновлений и практически в 80% вероятность проникновения будет успешной.

А теперь самое интересное, рассмотрим, что мы имеем дело с группой злоумышленников, которые профессионалы в своей области и для них не составит труда как автоматизировать процесс поиска устройств и подбора паролей так и про эксплуатировать уязвимости. Получив доступ к устройствам они могут использовать как само устройство, так и информацию с него для будущих векторов атак(пере прошить устройства и использовать в бот сети, перехватывать информацию, подменять, и отправлять от имени этого устройства).

Выводы

Разработка автоматизированных систем сбора, обработки данных и управления технологическим процессом требует применения специальных решений построения сетей. Передачи данных АСУ ТП строиться по иерархическому принципу и имеет многоуровневую структуру:

— Нижний уровень- уровень датчиков и исполнительных механизмов

— Средний уровень- уровень промышленных контроллеров

— Верхний уровень- уровень промышленных серверов и сетевого оборудования

— Операторский уровень –уровень оператора и диспетчерских станций

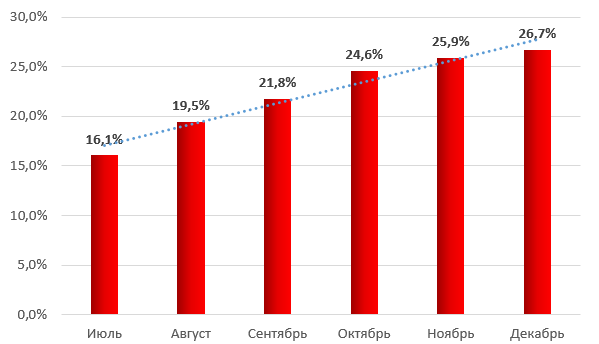

Не будем забывать, что такие не стандартные вектора атак на преобразователи могут послужить остановкой производства и технологического процесса. Из статистики атак на промышленные компьютеры видим что с каждым годом атаки растут и вектор их самый разнообразный.

Процент атакованных промышленных компьютеров по месяцам в России за 2016 год

Мы с вам в данном исследовании убедились, что такие атаки реальны и могут касаться как обычных пользователей, которые используют преобразователи для удаленного подключения, управления и конфигурирования устройств по разным интерфейсам. Так и все различные организации сеть которых очень разнообразна и имеет различное оборудование функционирующее через преобразователи интерфейсов. Я на своем опыте имел дело как с преобразователями moxa для удаленного конфигурирования АТС так и для удаленного управления терминалами различных защит, которые передают и получают информацию из промышленной сети через преобразователи.

Подход производителей промышленного ПО и оборудования к исправлению уязвимостей и ситуацию с устранением известных уязвимостей на предприятиях нельзя назвать обнадеживающим. Подавляющее большинство промышленных предприятий как малых так и больших, годами остаются уязвимы к атакам.Так какие выводы можно сделать: атаки нестандартного направления есть и будут.Защищаться от них надо и знать уязвимости тоже надо ибо информация это сила.Что касается преобразователей использующихся у меня на предприятии? Я проверил все оборудование MOXA, обновил все до последней версии, сменил и увеличил сложность паролей, изучил материалы про уязвимости данной фирмы и последовал рекомендациям экспертов, чтобы минимизировать шансы атакующих, если все таки атака будет иметь место.

P.S. В результате данного исследования ни одно устройство не пострадало. И данный эксперимент преследовал исследовательские цели (показать реальность атак и их простоту).

|