Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Используем PubNub: эмоциональный говорящий чат своими руками |

Используем PubNub: эмоциональный говорящий чат своими руками

- Tutorial

На удивление, в русскоязычном сегменте интернета (и на Хабре в том числе) до сих пор крайне мало информации о PubNub. Между тем, основанный в 2010-м году калифорнийский стартап успел за последние семь лет вырасти в то, что сама компания называет Global Data Stream Network (DSN), а по факту – IaaS-решение, направленное на удовлетворение нужд в области передачи сообщений в реальном времени. Наша компания – Distillery – является одним из на данный момент четырех development-партнеров PubNub, но сказано это не пустого бахвальства ради, а чтобы поделиться с сообществом вариантом использования PubNub на примере demo-проекта, который требовалось создать для получение оного статуса.

Те, кому не терпится посмотреть на код (C# + JavaScript), могут сразу пройти в репозиторий на GitHub. Тех же, кому интересно, что умеет PubNub, и как это работает, прошу под кат.

В целом PubNub предлагает три категории сервисов:

- Realtime Messaging. API, реализующий механизм Publish/Subscribe, за которым стоит готовая глобальная инфраструктура, включающая в себя 15 распределенных по земному шару локаций с заявленным latency не более 250мс. Все это приправлено такими вкусными вещами как, например, поддержка высоконагруженных каналов, компрессия данных и автоматический бандлинг сообщений при нестабильной связи.

- Presence. API для отслеживания состояния клиентов – от банального статуса онлайн/оффлайн до кастомных вещей вроде нотификаций о наборе сообщения.

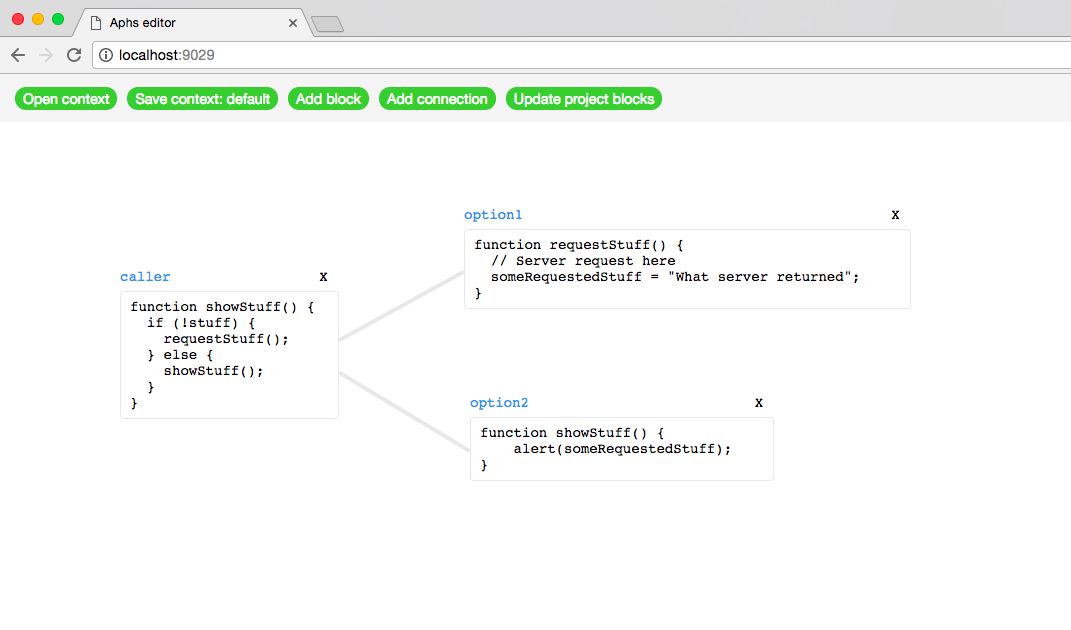

- Functions. Раньше эта функция называлась BLOCKS, но совсем недавно пережила ребрэндинг (точнее, все еще его переживает). Представляет собой скрипты, написанные на JavaScript и крутящиеся на серверах PubNub, с помощью которых можно фильтровать, агрегировать, трансформировать данные или, как мы вскоре увидим, осуществлять взаимодействие со сторонними сервисами.

Для реализации всего это дела PubNub предлагает более 70-ти SDK для самых разнообразных языков программирования и платформ, в том числе и для IoT-решений на базе Arduino, RaspberryPi и даже Samsung Smart TV (полный список можно найти тут).

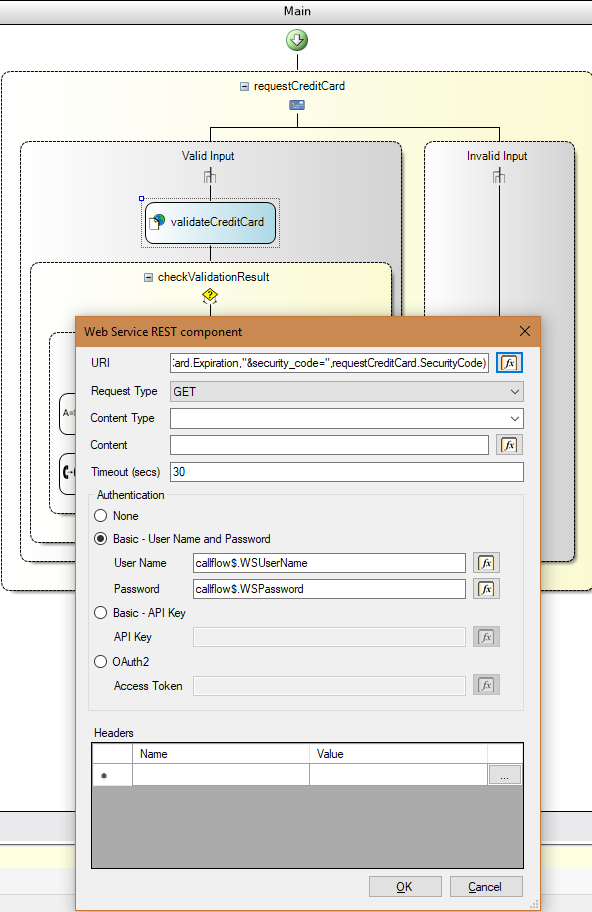

Пожалуй, достаточно теории, перейдем к практике. Тестовое задание, предваряющее получение партнерского статуса, звучит следующим образом: «Создать проект на базе PubNub, используя два любых SDK и следующие функции: Presence, PAM и один BLOCK». PAM расшифровывается как PubNub Access Manager и является надстройкой над фреймворком безопасности, позволяющей контролировать доступ к каналу на уровне приложения, самого канала или конкретного пользователя. Поскольку задание сформулировано довольно расплывчато, это предоставляет достаточную волю фантазии, полет которой в итоге привел к не самой полезной, но весьма интересной идее говорящего чата. А чтобы было веселее, чат не просто озвучивается синтезатором речи, но еще и позволяет передавать вербальные эмоции.

Собственно, само приложение концептуально простое донельзя – это двухстраничный веб-сайт. Изначально пользователь попадает на страницу логина, где и настоящей аутентификации-то на самом деле не происходит, и после ввода никнейма и выбора режима – полный или ReadOnly – переходит на страницу с чатом. На ней имеется «окно» с сообщениями канала, в том числе и системными а ля «Vasya joined the channel», поле для набора сообщений и выпадающий список с выбором эмоций. При получении новых сообщений от других пользователей оные сообщения зачитываются синтезатором речи с той эмоцией, которая была выставлена автором при отправке. Для перевода текста в речь используется стандартный BLOCK от IBM Watson, требующий минимальной настройки, в основном касающейся используемого голоса. На момент написания статьи эмоциональную речь поддерживали только три голоса: en-US_AllisonVoice (женский), en-US_LisaVoice (женский) и en-US_MichaelVoice (мужской). Еще пару месяцев назад делать это умела только Allison, так что, как говорится, прогресс налицо.

Однако перейдем к коду. Серверная часть, и в этом прелесть, балансирует где-то на грани между простотой и примитивностью:

public class HomeController : Controller

{

public ActionResult Login()

{

return View();

}

[HttpPost]

public ActionResult Main(LoginDTO loginDTO)

{

String chatChannel = ConfigurationHelper.ChatChannel;

String textToSpeechChannel = ConfigurationHelper.TextToSpeechChannel;

String authKey = loginDTO.Username + DateTime.Now.Ticks.ToString();

var chatManager = new ChatManager();

if (loginDTO.ReadAccessOnly)

{

chatManager.GrantUserReadAccessToChannel(authKey, chatChannel);

}

else

{

chatManager.GrantUserReadWriteAccessToChannel(authKey, chatChannel);

}

chatManager.GrantUserReadWriteAccessToChannel(authKey, textToSpeechChannel);

var authDTO = new AuthDTO()

{

PublishKey = ConfigurationHelper.PubNubPublishKey,

SubscribeKey = ConfigurationHelper.PubNubSubscribeKey,

AuthKey = authKey,

Username = loginDTO.Username,

ChatChannel = chatChannel,

TextToSpeechChannel = textToSpeechChannel

};

return View(authDTO);

}

}

Метод контроллера Main получает DTO от формы логина, извлекает информацию о каналах из конфигурационных данных (один канал для чата, второй для общения с IBM Watson), устанавливает уровень доступа посредством вызова соответствующих методов объекта класса ChatManager и отдает всю собранную информацию странице. Дальше всем занимается уже фронтенд. Для полноты картины приведем также листинг класса ChatManager, инкапсулирующего взаимодействие с SDK PubNub:

public class ChatManager

{

private const String PRESENCE_CHANNEL_SUFFIX = "-pnpres";

private Pubnub pubnub;

public ChatManager()

{

var pnConfiguration = new PNConfiguration();

pnConfiguration.PublishKey = ConfigurationHelper.PubNubPublishKey;

pnConfiguration.SubscribeKey = ConfigurationHelper.PubNubSubscribeKey;

pnConfiguration.SecretKey = ConfigurationHelper.PubNubSecretKey;

pnConfiguration.Secure = true;

pubnub = new Pubnub(pnConfiguration);

}

public void ForbidPublicAccessToChannel(String channel)

{

pubnub.Grant()

.Channels(new String[] { channel })

.Read(false)

.Write(false)

.Async(new AccessGrantResult());

}

public void GrantUserReadAccessToChannel(String userAuthKey, String channel)

{

pubnub.Grant()

.Channels(new String[] { channel, channel + PRESENCE_CHANNEL_SUFFIX })

.AuthKeys(new String[] { userAuthKey })

.Read(true)

.Write(false)

.Async(new AccessGrantResult());

}

public void GrantUserReadWriteAccessToChannel(String userAuthKey, String channel)

{

pubnub.Grant()

.Channels(new String[] { channel, channel + PRESENCE_CHANNEL_SUFFIX })

.AuthKeys(new String[] { userAuthKey })

.Read(true)

.Write(true)

.Async(new AccessGrantResult());

}

}

Здесь имеет смысл заострить внимание на константе PRESENCE_CHANNEL_SUFFIX. Дело в том, что механизм Presence для своих сообщений использует отдельный канал, который по имеющемуся соглашению утилизирует имя текущего канала с добавлением суффикса «-pnpres». Обратите внимание, что код PubNub Access Manager, выраженный в виде вызова функции Grant, требует явного указания Presence-канала для установки прав доступа.

var pubnub;

var chatChannel;

var textToSpeechChannel;

var username;

function init(publishKey, subscribeKey, authKey, username, chatChannel, textToSpeechChannel) {

pubnub = new PubNub({

publishKey: publishKey,

subscribeKey: subscribeKey,

authKey: authKey,

uuid: username

});

this.username = username;

this.chatChannel = chatChannel;

this.textToSpeechChannel = textToSpeechChannel;

addListener();

subscribe();

}

Первое, что нам предстоит сделать в JavaScript-коде – это провести инициализацию соответствующего SDK. Для удобства и простоты некоторые сущности вынесены в глобальные переменные. После инициализации необходимо добавить слушателя для интересующих нас событий и подписаться на каналы чата, Presence и IBM Watson. Начнем с подписки:

function subscribe() {

pubnub.subscribe({

channels: [chatChannel, textToSpeechChannel],

withPresence: true

});

}

Если код метода subscribe говорит сам за себя, то с методом addListener все немного сложнее:

function addListener() {

pubnub.addListener({

status: function (statusEvent) {

if (statusEvent.category === "PNConnectedCategory") {

getOnlineUsers();

}

},

message: function (message) {

if (message.channel === chatChannel) {

var jsonMessage = JSON.parse(message.message);

var chat = document.getElementById("chat");

if (chat.value !== "") {

chat.value = chat.value + "\n";

chat.scrollTop = chat.scrollHeight;

}

chat.value = chat.value + jsonMessage.Username + ": " +

jsonMessage.Message;

}

else if (message.channel === textToSpeechChannel) {

if (message.publisher !== username) {

var audio = new Audio(message.message.speech);

audio.play();

}

}

},

presence: function (presenceEvent) {

if (presenceEvent.channel === chatChannel) {

if (presenceEvent.action === 'join') {

if (!UserIsOnTheList(presenceEvent.uuid)) {

AddUserToList(presenceEvent.uuid);

}

PutStatusToChat(presenceEvent.uuid,

"joins the channel");

}

else if (presenceEvent.action === 'timeout') {

if (UserIsOnTheList(presenceEvent.uuid)) {

RemoveUserFromList(presenceEvent.uuid);

}

PutStatusToChat(presenceEvent.uuid,

"was disconnected due to timeout");

}

}

}

});

}

Во-первых, мы подписываемся на событие «PNConnectedCategory», чтобы отловить момент присоединения к каналу текущего пользователя. Это важно, потому что получение и отображение списка всех участников необходимо вызывать лишь однажды, в то время как Presence-событие «join» срабатывает каждый раз при присоединении нового клиента. Во-вторых, при поимке события о новом сообщении, мы проверяем канал, которому это событие адресовано, и в зависимости от результата проверки либо формируем текстовое представление путем банальной конкатенации, либо инициализируем объект Audio пришедшей от IBM Watson ссылкой на аудио-файл и запускаем проигрывание.

Еще одна интересная вещь происходит при отправке сообщения:

function publish(message) {

var jsonMessage = {

"Username": username,

"Message": message

};

var publishConfig = {

channel: chatChannel,

message: JSON.stringify(jsonMessage)

};

pubnub.publish(publishConfig);

var emotedText = '';

var selectedEmotion = iconSelect.getSelectedValue();

if (selectedEmotion !== "") {

emotedText += '';

}

emotedText += message;

if (selectedEmotion !== "") {

emotedText += '';

}

emotedText += ' ';

jsonMessage = {

"text": emotedText

};

publishConfig = {

channel: textToSpeechChannel,

message: jsonMessage

};

pubnub.publish(publishConfig);

}

Сначала мы формируем само сообщение, затем определяем конфигурацию, которую понимает SDK, и только после этого инициируем отправку. Дальше лучше. Чтобы превратить текст в синтезированную речь, еще одно сообщение мы отправляем в канал IBM Watson. Для определения эмоциональной окраски используется Speech Synthesis Markup Language (SSML), а если конкретнее — тэг . Как вы уже наверняка догадываетесь, при отправке сообщения ReadOnly-пользователем, оно будет заблокировано механизмом PAM и так никогда и не найдет своего получателя.

Среди уже имеющихся на рынке продуктов, использующих возможности PubNub, можно отметить, скажем, концепцию умного дома от Insteon или мобильное приложение для планирования семейных мероприятий от Curago. В завершении еще раз напомню, что полный код примера можно найти на GitHub.

|

Метки: author Cromathaar системы обмена сообщениями программирование javascript .net pubnub iaas |

Энергоэффективный ЦОД: знакомство с мировым опытом |

Энергоэффективный ЦОД: знакомство с мировым опытом

В некоторых случаях дело доходит до перехода на принципиально новые технологии и даже системное «озеленение» дата-центров. О том, как претворяют в жизнь и простые, и абсолютно фантастические идеи, поговорим в нашем материале.

/ кадр из видео о нашем дата-центре SDN + (подробнее об инфраструктуре 1cloud)

/ кадр из видео о нашем дата-центре SDN + (подробнее об инфраструктуре 1cloud)Для высокоуровневой оптимизации работы ЦОД применяют различные системы управления и мониторинга производительности (DCPM — Data Center Performance Management). Они анализирует информацию по расходу определенных ресурсов, рассчитывают базовые показатели энергоэффективности и другие метрики, по которым можно оценивать работу ЦОД.

В число универсальных входят следующие критерии, предложенные общими силами экспертного сообщества:

- коэффициент эффективности использования энергии (PUE — Power Usage Effectiveness);

- коэффициент эффективности инфраструктуры (DCiE — Data Center Infrastructure Efficiency);

- коэффициент эффективности использования воды (WUE — Water Usage Effectiveness);

- и коэффициент эффективности использования углерода (CUE — Carbon Usage Effectiveness).

Эксперты Green Grid публикуют аналитику и чеклисты для усовершенствования работы дата-центров и поиска новых возможностей для их «озеленения». Многие дата-центры начали активно использовать предлагаемые методики, внедрять новые решения и улучшать собственные разработки. Значительную роль в этом процессе играет встраивание ЦОД в общую энергетическую экосистему города и использование природных особенностей региона.

Название одной из популярных технологий охлаждения ЦОДов — фрикулинг. Оно перешло в русский язык в виде кальки от английского «free cooling». Термин интересен с точки зрения перевода — он отражает суть технологии: «естественное» или «бесплатное» охлаждение. В основе этой технологии лежит использование уличного воздуха, который пропускают, например через роторные теплообменники. Эту технологию внедряют все больше и больше компаний, а некоторые идут и дальше — продают избытки тепла.

Системы рекуперации тепла и фрикулинга позволяют крупным дата-центрам направлять избыточную тепловую энергию на поддержание оптимальной температуры в жилых помещениях. Один из примеров — инициатива правительства Стокгольма. Муниципалитет совместно с проектом Stockholm Data Parks намерен создать экосистему, в рамках которой «тепло ЦОД не будет расходоваться впустую». В ходе реализации проекта планируется покрыть до 10% энергии, расходуемой на отопление города. Конечно, все это уже находит соответствующую реакцию компаний — Borderlight AB объявила о запуске 5-мегаваттного ЦОДа в Стокгольме с прицелом на продажу избыточного тепла. Серверное оборудование будет поставлять GoGreenHost, дочерняя компания Borderlight, а перераспределением тепла займется Fortum V"arme.

Не отстает и Яндекс, который помогает отапливать финский город Мянтсяля. Представители компании говорят, что благодаря продаже тепла городу, компания экономит треть расходов на электроэнергию. Благодаря финскому климату дата-центр может работать за счет прямого фрикулинга. Таким образом, компания не нуждается в сложных системах охлаждения и может позволить себе установку теплообменников в районе выброса разогретого воздуха, чтобы передать разогретую воду в городскую систему теплоснабжения. В этом регионе работает и ЦОД Google, в системе охлаждения которого задействованы ледяные воды Финского залива. Ранее, в финском городке Хамина в месте, где сейчас находится дата-центр, размещалась бумажная фабрика. Общая сумма инвестиций в проект — более 350 миллионов евро.

Климат Англии, отличающийся суровым характером, и энергия ветра также позволяют локальным ЦОД снизить затраты на охлаждение и электроэнергию. Наличие в проекте ветрогенераторов и соответствующих систем увеличивает капитальные затраты на 6-10% по сравнению с классическим объемом инвестиций для возведения дата-центра. Все это окупается всего за 4 года эксплуатации. Однако, по данным Reuters, лидирующие позиции в области ветровой энергетики занимает не Великобритания, а Дания — и этим активно пользуются лидеры рынка ИТ. Уже в этом году свой «ветряной» дата-центр там запустит Apple.

/ Фото Ian D. Keating CC-BY

Помимо энергии ветра компании активно используют cолнечную энергию. Например, солнечные батареи ЦОД Apple в г. Мэйден (Северная Каролина) способны генерировать более 42 млн кВт/ч электроэнергии в год. Топ-менеджмент дата-центра утверждает, что этого объема хватает для питания 60% оборудования и системы охлаждения, а оставшиеся 40% покрываются силами биотопливной станции, расположенной неподалеку от ЦОДа.

Есть и более экзотические примеры — ЦОД Verne Global в Рейкьявике, который использует BMW. Система питания этого дата-центра задействует геотермальную энергию и мощности локальной гидроэлектростанции. Эффективной работе данного ЦОД способствует и благоприятный климат региона — он в меру холодный, а перепады температур незначительны.

Единичные примеры ЦОД обладают возможностями для комбинированного использования энергии солнца, водных ресурсов и ветра. Например, Citi Data Center во Франкфурте обладает сертификатом LEED, что позволяет ему гордо носить звание самого «зеленого» ЦОД. По словам сотрудников дата-центра, работать в нем приятно, а смотреть на него — вообще одно удовольствие: один из фасадов покрыт настоящими травяными насаждениями, а территория ЦОД напоминает обыкновенный парк.

Еще один известный пример встраивания дата-центра в окружающую экосистему — проект 1&1 Internet в штате Канзас. Для питания и охлаждения компания задействует ветер, энергию солнца, водные и геотермальные ресурсы.

Даже на столь ярких примерах эволюция ЦОД не заканчивается — компании пытаются реализовать самые неординарные идеи. Например, Microsoft работает над проектом, который, на первый взгляд, кажется невероятным — дата-центр Natick будет расположен прямо в океане. Проект можно назвать многообещающим, но прежде чем запустить его в «промышленный» режим работы, компания будет проводить всевозможные тесты и эксперименты. Если все пройдет гладко, «облако» Microsoft станет по-настоящему подводным.

Google, в отличие от своего конкурента, предпочитает наводное плавание подводному. Благодаря организации Nautilus Data Technologies, которая в ближайшем будущем запустит свой революционный дата-центр на поверхности воды, концепция барж-дата-центров — уже не новость. Однако специалисты Google решили пойти дальше и генерировать энергию с помощью гигантских воздушных змеев, которые в том числе будут приводить в движение всю плавучую конструкцию.

Дополнительное чтение в нашем корпоративном блоге:

И в нашем блоге на Хабре:

|

Метки: author 1cloud хранилища данных блог компании 1cloud.ru 1cloud цод дата-центры фрикулинг |

Как попасть в Технопарк Университета ИТМО: большое интервью |

Как попасть в Технопарк Университета ИТМО: большое интервью

В этом материале расскажем, как работает Технопарк, как получить его поддержку, и что это даёт компании — на примере проектов-резидентов.

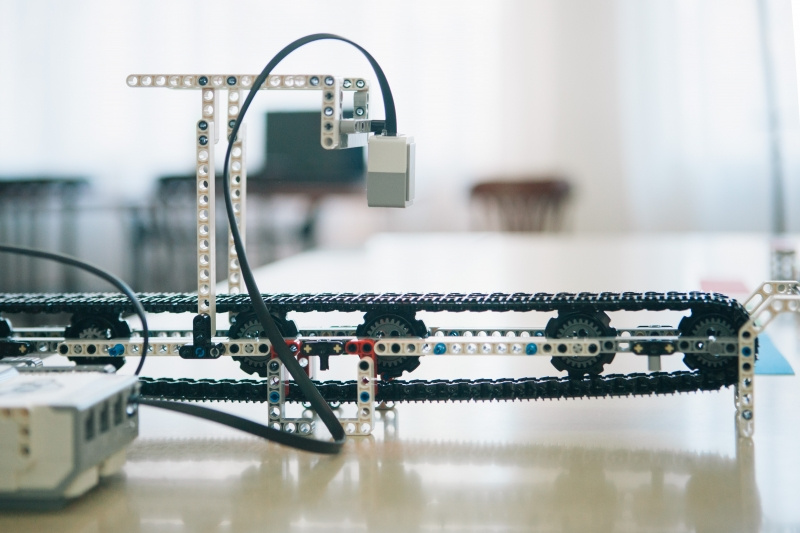

Мастерская-лаборатория ФабЛаб — подразделение Технопарка

Мастерская-лаборатория ФабЛаб — подразделение ТехнопаркаКто приходит в технопарк

Как отмечает Олеся Баранюк, заместитель директора Технопарка, профиль университета (информационные и фотонный технологии) создаёт фокус и для компаний-резидентов — в Технопарк приходят в первую очередь бизнесы, связанные с научными разработками. Но не только в области информатики и оптики — сейчас в Технопарке размещаются проекты из следующих сфер:

- AR/VR

- Робототехника

- Системами ИИ

- Микроэлектроника

- Нанотехнологии

В последнее время стало приходить больше компаний, развивающихся в области Life Science, и нам очень интересно с ними сотрудничать. У нас уже размещаются компании, создающие решения в области биофармацевтики, биомедицинских технологий и сервисов, биоинформационных технологий, медицинского приборостроения и здравоохранения, и в ближайшее время мы планируем расширить присутствие таких компаний.

— Олеся Баранюк, Технопарк Университета ИТМО

В создании сегодняшнего материала принимали участие руководители следующих проектов.

Ontodia

Ontodia — это платформа для визуализации и исследования графовых (graph-based data) данных. Графовые данные — это данные построенные по модели вершин и связей между ними. Проект работает в том числе и с наиболее известным хранилищем графовых данных — Neo4j. Один из примеров проектов, использующих технологию Ontodia, — сервис «Топология бизнеса». Проект Ontodia находится на стадии рыночного продукта, который продолжает дорабатываться и совершенствоваться.

На момент становления резидентом наш проект находился на начальной стадии. В принципе, была только базовая идея и ничего больше.

— Дмитрий Павлов, коммерческий директор VISmart (компании-создателя платформы Ontodia)

odgAssist

Проект odgAssist помогает производственным (в частности, фармацевтическим) компаниям создавать новые продукты и быстрее выводить их на рынок. А именно — позволяет автоматизировать работу персонала на нижнем уровне (за счет использования носимых устройств для сбора данных и контроля процессов на соответствие, в частности, в формате «фотографии рабочего дня» сотрудника). Такой подход позволяет сократить скорость вывода инновационного продукта на рынок на 20% и серьёзно сэкономить на расходах. У компании есть первые продажи.

[На момент получения статуса резидента проект находился на стадии:] MVP [минимально жизнеспособный продукт], 1 внедрение, 1 контракт на подходе.

—Олег Шахов директор по развитию бизнеса компании «Оптимальное движение» (разрабатывает проект odgAssist)

Orbi

Компания Orbi разрабатывает первые в мире очки для съемки видео в формате 360 градусов. Это солнечные очки, в которые встроены 4 камеры, позволяющие снимать полную панораму в формате 360. Проект провел успешную краудфандинговую кампанию на Indiegogo, а также привлек значительное финансирование от частных инвесторов. На данный момент в Orbi разработано уникальное программное обеспечение для склейки панорамы из 4-х видеопотоков, работающее на основных десктопных и мобильных платформах и позволяющее получать высококачественное панорамное видео в полностью автоматическом режиме (без участия пользователя). На данный момент в производство отправился прототип устройства в финальном дизайне. Он будет готов к середине ноября 2017 года.

[На момент появления в Технопарке] мы находились на стадии активной разработки программного обеспечения, хотя наша команда разработчиков состояла только из трех программистов. Также мы активно искали подходящее решение для самого устройства (процессор, оптику, сенсоры и так далее) и производителя, который сможет это устройство сделать. На тот момент у нас уже была запущена кампания на Indiцegogo.

— Александр Морено, технический директор Orbi

Parseq Lab

Компания занимается разработкой и внедрением комплексных биомедицинских решений, созданных на базе технологии высокопроизводительного секвенирования генома. Parseq Lab разрабатывает наборы реагентов и программное обеспечение для анализа данных. Разработки компании применяются в медицине, криминалистике, научных исследованиях в России и за рубежом. На рынок уже выведена серия продуктов, некоторые разработки находятся на стадии проектирования или испытаний.

[Состояние на момент получения статуса резидента:] вывод пилотной разработки на рынок.

— Александр Павлов, директор компании Parseq Lab

Зачем компаниям приходить в Технопарк

Некоторые проекты-резиденты изначально связаны с Университетом ИТМО (подробнее об этом чуть ниже), поэтому для них выбор площадки для размещения оказывается очевиден. Другие выбирают из множества альтернатив — вот как об этом рассказывают сами руководители компаний:

Мы подумали, что хорошо быть рядом к центру компетенций в той области, в которой мы решили развивать свой продукт. Пока что нам кажется, что наше решение стать резидентом Технопарка было верным.

— Дмитрий Павлов, VISmart

Мы искали место, где можно заниматься инновационной деятельностью. Нам нужна была инфраструктура для запуска проекта. И нам были нужны не только стол и стул, но также возможность взаимодействовать с другими инновационными предприятиями, получить доступ к интересным событиям и мероприятиям и много чего другого.

Сначала мы определились с тем, что нам нужен технопарк. Всё-таки стартовать с поддержкой немного проще. Затем мы сделали мониторинг 4 ведущих технопарков в Санкт-Петербурге. В результате Технопарк ИТМО оказался в безоговорочных лидерах. Кроме того, у основателей уже имелись контакты с резидентами, что было для нас очень удобно. Также нам понравилась атмосфера технопарка и его представители

— Олег Шахов, odgAssist

Год назад, когда проект дошел до определенной стадии, встала необходимость расширения и поиска подходящего места, для дальнейшей работы над разработкой.

Найдя в интернете Технопарк ИТМО, узнав все условия и преимущества размещения в нем, а так же обнаружив, что среди его резидентов уже есть те, кто работают в области 360 видео, мы поняли, что это именно то место, где мы сможем наиболее эффективно развивать свой проект.

— Александр Морено, Orbi

Прежде всего, [для нас важна была] готовность руководства идти навстречу при решении вопросов размещения. Хорошая инфраструктура и месторасположение Технопарка.

— Александр Павлов, Parseq Lab

Как стать резидентом

Заявку на получение статуса резидента можно подать на сайте Технопарка в любой момент. Экспертный совет рассматривает её в течение 2-3 дней, после чего принимается решение, брать проект в «семью» ИТМО или нет. За этим решением следует встреча с представителями Технопарка.

Кто становится резидентами:

- Технологические проекты (первоначальная связь с Университетом ИТМО, наличие в составе участников учёных или учащихся Университета необязательно)

- Малые Инновационные Предприятия (Университет ИТМО выступает соучредителем таких предприятий, они размещаются в Технопарке в приоритетном порядке)

- Корпоративные исследовательские центры

Довольно часто к нам обращаются крупные корпорации с просьбой разместить в Технопарке свои R&D-центры, чтобы иметь возможность находиться в эпицентре инновационной активности, сотрудничать с научными подразделениями Университета и резидентами технопарка, а также постепенно формировать портфель инновационных продуктов.

— Олеся Баранюк, Технопарк Университета ИТМО

На что обращают внимание эксперты при отборе заявок:

- Инновационная составляющая

- Конкурентные преимущества перед аналогами

- Понимание рынка, наличие первых продаж

- Возможность создавать места для прохождения студентами Университета ИТМО практики с последующим трудоустройством

Мы попросили руководителей компаний-резидентов вспомнить, как они проходили процесс отбора и что, по их мнению, оказалось наиболее важным для экспертов в их проектах:

Мы пришли в Технопарк с несколькими проектами на разных стадиях готовности, из которых уцелело только 50%. Нам кажется, что в большей степени мы заинтересовали Технопарк как команда.

В этой связи, я бы рекомендовал кандидатам в резиденты обратить внимание на представление своей команды. Направление деятельности может смениться, но команда — это величина, по моему мнению, более постоянная и важная, чем кажущийся сильным проект.

— Дмитрий Павлов, VISmart

Про наш проект могу так сказать: у нас были рекомендации от резидентов, мы подготовились к встрече. Не думаю, что сложно попасть в технопарк если у вас годный проект, есть MVP (мне кажется, это важно) и реалистичный план. И да – если вы делаете инновацию, а не интернет-магазин или рекламное агентство.

Мы прилично оделись на встречу, рассказали всю нашу историю, были честны, показали себя профессионалами, реалистами. Показали, что болеем своим делом.

— Олег Шахов, odgAssist

Мы разрабатываем инновационное устройство, находящееся действительно на переднем крае современных технологий в области камеростроения (например используемые нами процессор и объективы только появились на рынке, буквально год назад ничего подобного в принципе не существовало). Сама область 360 видео новая и очень активно развивается.

Плюс основным направлением нашей деятельности на базе Технопарка является именно разработка программного обеспечения, что явно близко как самому Технопраку так и Университету ИТМО в целом. Мы выражали готовность активно участвовать в жизни Технопарка, что также очень важно.

Совет — думаю, что на встрече важно сделать акцент на то, насколько ваш проект подходит по своей направленности Технопарку. Если среди резидентов уже присутствуют компании, с которыми вы могли бы плодотворно сотрудничать, это будет очень хорошим аргументом. Ну и важно быть готовым активно участвовать в жизни Технопарка.

Что касается потенциальных инвесторов, то наличие в их портфеле компаний, с которыми вы смогли бы плодотворно сотрудничать, также будет серьезным плюсом. Однако в первую очередь инвесторы, особенно на самых ранних стадиях, оценивают не только проект, но и вас самих. Важно презентовать не только идею — этого мало. Нужно презентовать команду, и убедить их [руководство Технопарка и/или инвесторов] что вы — именно те люди, которые лучше всех смогут данный проект реализовать.

— Александр Морено, Orbi

Близость к направлениям, на которых специализируется Технопарк и которые изучаются в Университете ИТМО, в данном случае важный критерий. «Близкий по профилю» проект сможет привлечь к своей работе студентов и аспирантов Университета — причём именно тех, кто хорошо разбирается в тематике проекта:

У нас есть несколько компаний, которые создают решения в области ДНК-диагностики тяжелых наследственных заболеваний; решения для идентификации личности на основе технологии высокопроизводительного секвенирования; занимаются вопросами создания инфраструктуры для анализа и хранения геномных данных; разработкой геннотерапии, направленной на победу над старостью, онкологией и даже ВИЧ.

Область для Университета не профильная, но, тем не менее, в Университете развивается такое направление как Биоинформатика в рамках Лаборатории и Института Биоинформатики [кстати, об этом направлении мы рассказывали в одном из наших материалов], и наличие резидентов с уникальными компетенциями в этой области значительно увеличивает исследовательские возможности студентов, аспирантов и сотрудников научных подразделений.

— Олеся Баранюк, Технопарк Университета ИТМО

Как проекты-резиденты взаимодействуют с Университетом ИТМО

Научная поддержка

Поучаствовать в проекте могут и студенты-стажеры, и крупные учёные, причём не только из Университета ИТМО:

В настоящий момент у нас сложился довольно интересный кейс взаимодействия резидентов Технопарка, сотрудников Университета и сотрудника Венского экономического Университета. Резидент Технопарка, компания VISmart занимается разработкой программного обеспечения в области семантического веба. Она довольно плотно сотрудничают с Международной лабораторией Университета ИТМО «Интеллектуальные методы обработки информации и семантические технологии» (несколько сотрудников VISmart также являются сотрудниками международной лаборатории и наоборот).

Сервис, над которым работала команда VISmart, очень заинтересовал ассистент-профессора Венского экономического университета Герхарда Вольгенаннта, что привело его вначале в компанию VISmart, а потом и в Университет ИТМО. В результате он стал участником программы ITMO Fellowship, влился в команду, в настоящий момент работает над усовершенствованием семантических технологий в области голосового управления устройствами.

— Олеся Баранюк, Технопарк Университета ИТМО

Вот как говорит об этом взаимодействии коммерческий директор VISmart:

Да, наши разработки связаны с Университетом ИТМО. Дело в том, что наш продукт Ontodia ориентирован в том числе на поддержку стандартов semantic web, выпущенных w3c, а именно RDF, OWL, SPARQL.

В России, по нашим сведениям, есть только одно сильное научное подразделение, которое учит применять эти стандарты и ведет серьезные научно-исследовательские проекты в этой сфере — это Международная лаборатория Университета ИТМО “Интеллектуальные методы обработки информации и семантические технологии”, с которой у нас установлены тесные связи. Двое наших сотрудников является аспирантами ИТМО.

— Дмитрий Павлов, VISmart

Совместные кейсы

Пример совместной работы подразделений Университета ИТМО и резидентов технопарка — создание модели транспортного обеспечения ЧМ-2018, которая была разработана совместно с Институтом Дизайна и Урбанистики. Созданная система учитывает расписание игр, а также расписание движения транспорта, прибытие и убытие гостей и другие факторы и служит, в частности, для симуляции разного рода ситуаций, связанных с перемещением людей во время Чемпионата [о других разработках Университета для ЧМ-2018 мы рассказывали здесь].

Поиск сотрудников

От резидентов Технопарка ожидается готовность принимать на стажировку студентов и аспирантов Университета. Часть стажёров впоследствии становится сотрудниками компании — например, студенты и выпускники Университета ИТМО работают на проектах odgAssist и Orbi.

Использование оборудования и лабораторий

Возможность не только консультироваться с учёными, но и решать вместе с ними практические задачи инновационных компаний — ещё одна точка соприкосновения Университета и резидентов Технопарка:

Возможность совместного использования оборудования лабораторий Университета или других резидентов Технопарка является опцией, которой довольно часто пользуются наши резиденты. Они обращаются к нам со своим запросом, мы их представляем нашим коллегам из научных подразделений, в случае, если есть взаимная заинтересованность в сотрудничестве, рождаются совместные научные и бизнес-проекты.

— Олеся Баранюк, Технопарк Университета ИТМО

Что оказалось особенно полезным: мнение резидентов

Мы решили узнать, какие возможности Технопарка оказались наиболее полезными для проектов-резидентов:

Для нас наиболее полезными оказались следующие услуги: возможность пользоваться конференц-залом Технопарка, возможности ФабЛаб. Нам удобно и приятно иметь помещения в здании Технопарка, потому что авторитет ИТМО помогает выглядеть убедительными, особенно на ранних этапах.

Но самое главное все же — это помощь инновационных менеджеров. Они знакомят нас с потенциальными клиентами, содействуют в продвижении и популяризации проекта, от них можно получить помощь практически в любом вопросе.

— Дмитрий Павлов, VISmart

Технопарк активно помогает находить интересные программы и конкурсы для стартапов. Например, Технопарк поспособствовал нашему участию в конкурсе проектов Polar Bear Pitching в Оулу (Финляндия), где мы заняли второе место. Это был интересный опыт, участие в котором дало возможность стать нам более узнаваемыми в мире, ведь на мероприятии присутствовали представители средств массовой информации со всего мира: CNN, BBC, Al Jazeera и др., многие вели он-лайн трансляцию, ведь не каждый день можно увидеть предпринимателя, вещающего о конкурентных преимуществах из ледяной проруби в феврале при температуре –25.

Также для нас очень полезна возможность общаться с другими компаниями, работающими в области 360 видео. Очень удобно, что в технопарке есть ФабЛаб, где много различных инструментов и оборудования, что позволяет, например, быстро напечатать на 3D принтере прототипы, детали и так далее.

— Александр Морено, Orbi

Куча крутых событий на которые нас зовут, крутой PR, участие в мероприятиях, бешеный нетворкинг, помощь в взаимодействии с различными инструментами гос. поддержки, трэкшн, добрый совет, тёплые слова поддержки.

— Олег Шахов, odgAssist

Советы молодым предпринимателям: что важно на старте

Олеся Баранюк советует оперативно переходить от планов к действиям: меньше прокрастинировать, не бояться, создавать команду, которая будет разделять ваши ценности. Важный момент: быть честными и с самого начала дорожить своей репутацией. Александр Павлов из Parseq Lab добавляет: не стоит опасаться ошибок — лучше «наступить на грабли», но не растерять энтузиазм, чем пытаться сделать все идеально с первого раза.

Попробуйте найти клиента. Пусть это будет не совсем профильный клиент. Но попробуйте начать зарабатывать как можно раньше. Нам на начальном этапе очень сильно помог грант от Фонда Содействия Инновациям

— Дмитрий Павлов, VISmart

Проект должен выполнять задачи, для которых он создаётся. Бизнес должен приносить деньги. То, что вы делаете, может приносить деньги? А что можно сделать, чтобы приносило больше?

Любыми способами (легальными) добейтесь первых продаж. Вы должны понимать, что вы делаете, за какие деньги, для кого и зачем (какую проблему решаете). Если всё ок, то сделайте SWOT-анализ своей идеи/бизнеса. Не стесняйтесь pivot’а и закрытия проекта.

Не взлетело – посмотрите, почему. Если ценности нет — что ж, так бывает. Если нет скорости, фокуса или execution – поработайте над собой, возможно, вам ещё рано делать стартап. И делайте CustDev, много CustDev’a, чтобы ваш продукт был кому-то нужен.

— Олег Шахов, odgAssist

Универсальных советов давать не буду. Просто приведу пример того, с чем мы столкнулись сами. Как правило, особенно когда делаешь не просто ПО, а устройство, то приходится взаимодействовать с большим количеством партнеров (фабрики, производители процессоров и других электронных компонентов и так далее).

Очень важно налаживать с ними не только деловые, но и личные отношения. Несмотря на то, что сейчас практически все можно обсудить удаленно, по почте, на звонке и так далее, не следует пренебрегать личной встречей. Во-первых, это помогает намного быстрее решить множество вопросов, а во-вторых, делает ваше партнерство более надежным.

— Александр Морено, Orbi

|

Метки: author itmo развитие стартапа блог компании университет итмо университет итмо технопарк университета итмо стартапы |

Без заголовка |

|

Метки: author kudzev разработка веб-сайтов javascript html css блог компании 2гис frontfest codefest гис iot spotify microsoft clojurescript |

[recovery mode] Переезды в облако: 5 разных историй |

Переезды в облако: 5 разных историй

Компания на 20 разработчиков жила с плотно упакованной серверной стойкой. В стойке (по сегодняшним меркам) стоит уже старый отстой, который не тянет. Когда-то он был новым и красивым, но время безжалостно. Подключились к облаку, затащили туда сначала тестовые среды, потом продакшн. А стойка пригодилась ещё для пары мелких задач по офису и тестов. Мы хорошо видим, как у них погибают старые сервера в ней: по мере отказов они заводят новые виртуальные машины в облаке.

Эта штука умеет пробрасывать аппаратные ключи 1С в разные подсети

Исторически к нам заходил ритейл, потом интернет-проекты, затем подтянулись и банки. Теперь же активно переезжают и вполне обычные компании, которые готовы вынести в облако бизнес-критичные задачи. Ниже — несколько типовых историй, которые, возможно, будут вам полезны, даже если вы ещё не планируете никаких облаков. Хотя деваться уже особо-то и некуда — это обыденность, а не новая непонятная фича.

Соцсеть LOQUI BUSINESS

Локви (business.loqui.ru) — растущая корпоративная соцсеть. Своего рода полная реализация корпоративного портала. Они поняли, что корпорациям не хватает социальной сети для общения сотрудников, и подумали, что это белое пятно стоит закрыть. Понятное дело, что понадобилась среда для разработки. Управленцы в Москве, разработчики в Германии (русские в основном). Проект изначально российский, базовый язык — русский. Распространение — SaaS, поставляют клиентам уже готовый сервис. То есть у нас развёрнута одна большая мультитенантная инсталляция. Почему мы? Потому что российскому сегменту соцсети надо быть в РФ. Облако подошло гибкостью на этапе разработки и возможностью построения катастрофоустойчивой инфраструктуры, чтобы не огорчать падениями владельцев социальных аккаунтов. Сейчас рассматривают возможность резервирования или полной миграции в виртуальный дата-центр КРОК зарубежных серверов, где лежат медиафайлы, чтобы обеспечить более надёжную защиту от сбоев и максимальную доступность.

Сделали автоматизацию тестовых сред: полная реплика основной инфраструктуры, на ней запускаются модули с автотестами, потом оттуда — в прод или в корзину. Никакое оборудование не простаивает, просто на время тестов докупается ещё мощность — сколько угодно. Раньше бы решали новой железкой, понадобилось бы ещё делать очередь тестирования, чтобы её равномерно загружать, отдельный админ.

Смартекс

Веб-разработчики, которые научились не только делать крутые сайты, но и поддерживать их, всю сознательную жизнь пользовались плюсами Амазона. Но, конечно, какой бы ты клёвый сайт ни сделал, если он будет во Франкфурте, то в Москве открываться быстро он не будет. А парням это важно, у них динамическая подгрузка контента множеством сессий. Вопрос пинга стал для них очень важен. Амазоновский CDN в Москве не работает. Парни встали к нам — им важно наличие API, которое в нашем случае на 80 процентов совпадает с амазоновским. У нас очень просто тем, кто переезжал с Амазона. Если им понадобится российский CDN — просто обратятся к российскому CDN-провайдеру, это очень просто.

Как делают банки

Банки в облака заходят только по очень своеобразным поводам. Конечно, это самые консервативные ребята. Встают в облако, но далеко не всеми сервисами. Особенно их парит PCI DSS. Мы вот-вот закроем сертификацию облачной платформы по этому стандарту, и всем процессинговым компаниями станет намного проще. А обычно в банках ничего безопасники не разрешают, поэтому не облако, а отгороженная область в машзале. Ответ почти на любое коммерческое предложение по облаку — «Давайте клетку», то есть огородку в зале, а не эластичное потребление.

Как делает розница

Пример: компания занимается торговлей косметикой в ценовом сегменте чуть ниже известной звездной сети. Даже в 70 метрах от вражеского магазина они очень хорошо растут в прибыли, причём зная, что у соседей она в кризис падает. Прославились у себя в городе как одна из самых инновационных компаний. Бизнес переформатировали и ведут всё по-новому, по уму. Если им что-то нужно, то ищут лучшего. С ИТ была сложность при расширении — возможности сильно отстали от желаний, был небольшой бардак с поддержкой, много чего делалось вручную. Команда на месте отличная, но рук не хватало. С дичайшим ростом бизнеса в кризис они решили распространяться на Москву. Очень хотели уйти от капитальных затрат к операционным (это вообще важно для всей розницы), потому что финпоток и кредит — это дешевле.

Начали переезжать. Уровень планирования у них божественный, мы такой почти ещё ни у кого не встречали. Но реальность, конечно, немного подвела: провайдер, который строил отдельный физический канал, немного не удержал дедлайн.

Е-коммерс

Один большой ритейлер захотел торговать через сеть, у них база на 100 тысяч наименований. Страшно. Но совладали со страхом и начали делать по европейской модели click-and-collect, когда сначала заказываешь издалека, а потом забираешь собранное на месте. Заодно отказались от бумажных каталогов, которые всех порядочно достали. Уровень ада по тому, как быстро всё внедрялось, — hardcore.

Мы вместе работаем уже лет 15, все магазины обеспечиваем инфраструктурой. Полевые инженеры до сих пор ездят с жёсткими дисками, комплектами для чистки блоков питания и так далее. Но дальше ни-ни, головная компания по поддержке софта — из Англии. Соответственно основные сотрудники у них из Индии. С соответствующим подходом. В частности, работают только по будням. В итоге мы один раз в субботу спасали их СУБД, вставшую намертво (забыли чистить логи, накопилось 350 Гб). Потом было ещё чёрное воскресенье, ещё и ещё… Потом у них не все сервисы стартовали, потому что они их руками пусками. Помню, я звонил их админу, и мы играли в командную строку по телефону. Ну и ещё индийский нюанс подхода — «бекапы делает только трус». Ещё эти гады индусы говорят на «хорошем» английском. Но как только что-то не так с их стороны, начинается на конференц-колах клоунада с тем, что они, типа, перестали понимать. Зато тот единственный раз, когда у нас сгорела железка, они стебали нас: «Ну что, херовые выходные были?» В общем, задолбало. Я сказал: «Парни, мы вас очень любим, но с дачи больше к вам не поедем. Давайте прикрутим нормальный мониторинг, чтобы без сюрпризов». Они почесали голову — мы сделали предложение, и они его приняли.

Плюс у каждой отрасли свои особенности. Мы сосредоточены на крупных проектах и максимальном удовлетворении заказчика. Но и с разработчиками тоже дружим. Облако КРОК — это индивидуальный портной. Наш опыт, компетенции, ресурсы позволяют приземлять большие задачи серьезных компаний в облаке, помогая бизнесу сосредоточиться на своих корневых функциях. ИТ мы отрулим.

Костюм будет сидеть идеально.

|

Метки: author SZinkevich серверное администрирование виртуализация it- инфраструктура блог компании крок крок |

Как мы отмечали 256 день года и рисовали пиксели через API |

Как мы отмечали 256 день года и рисовали пиксели через API

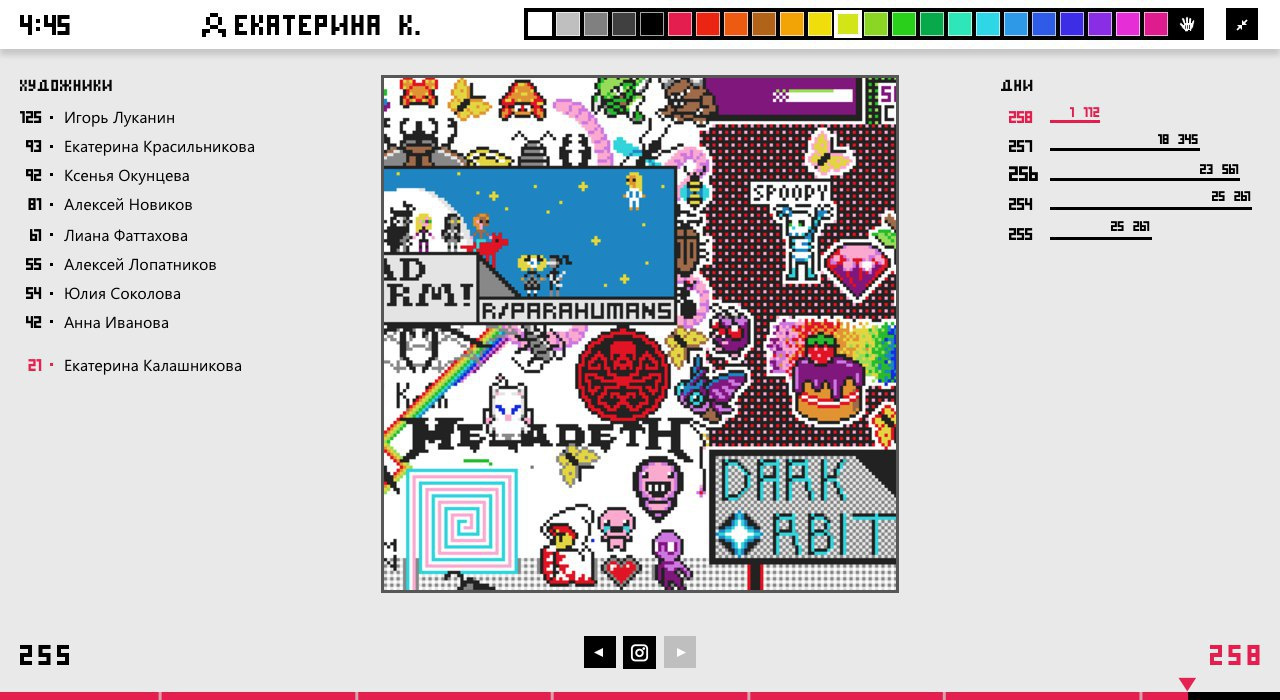

13 сентября в Контуре отмечали День программиста. В самом большом офисе разработки играли в Pac-Man и пытались съесть 280 коробок с пиццей. Одновременно полторы тысячи человек рисовали пиксели в онлайне. В этом посте четыре разработчика рассказывают, как делали праздник.

Часть 1. Рассказывает Игорь green_hippo, который стырил идею на Reddit

День программиста у нас отмечает вся компания, а не только разработчики. Поэтому была нужна идея для онлайновой игры, в которой могут участвовать все желающие. Я вспомнил, что в апреле прошёл Reddit Place — социальный эксперимент по коллективному рисованию на холсте 1000x1000 пикселей, в котором участвовал миллион человек.

Я решил, что надо сделать свой Place, с таймлапсом и API.

На Reddit миллион человек рисовал на холсте размером один мегапиксель. Каждый мог закрасить не больше одного пикселя раз в 5–20 минут. Если сделать праздничный холст 256x256 пикселей (в 15 раз меньше) и учесть, что у нас не миллион сотрудников (а в 200 раз меньше), то задержку между пикселями тоже должна быть примерно в 10 раз меньше.

Поэтому для нашего поля 256x256 пикселей я выбрал задержку от 2:56 до 0:32. А после этого рассказал об идее коллегам, которые согласились помочь.

Часть 2. Рассказывает Вероника aminopyrodin, которая поборола себя и тормозной canvas

Я сразу поняла, что на фронте будет нужен холст, палитра и зум. Но дизайнеры (Владимир dzekh и Юлия krasilnikovayu) оказались хитрее и придумали ещё перемотку, статистику, лидерборд и скриншоты.

Кстати, сначала в палитре было меньше цветов, но потом ребята добавили коричневый, чтобы не ограничивать ничьи творческие порывы.

Тем временем я, как современный фронтендер, рефлекторно начала думать о том, чтобы настроить Webpack, Babel и Autoprefixer. А когда очнулась, узнала, что бэкенд-разработчик уже всё сделал. И оно даже работало. Криво-косо, но работало: точки на canvas ставились, зум зумился. Я отпилила от прекрасного дизайна все ненужное и красивенько сверстала.

Остались две проблемы: Edge и Safari.

В Safari и правда все тормозило со страшной силой. Сначала обнаружила, что canvas не вынесен в отдельный композитный слой. Поэтому браузер при каждом обновлении холста перерисовывал весь документ. Добавила канвасу transition: translateZ(0), и все стало тормозить быстрее. Потом отрефакторила остальной бакендерский код, избавилась ещё от десятка перерисовок. Интерфейс полетел на первой космической.

Об IE я сразу не заботилась, потому что знала, что игроки будут пользоваться нормальными браузерами. Беда пришла от старшего брата. Если просишь Edge нарисовать квадрат, он категорически отказывается. Говорит: «Но плавные переходы лучше!» — и размывает весь рисунок.

Такая же проблема была у ребят из Reddit. Сначала я решила её с помощью CSS-свойства image-rendering и флага CanvasRenderingContext2D.imageSmoothingEnabled. Но перед запуском оказалось, что Edge косячит при общении с сервером через вебсокеты. Поэтому я и его объявила ненормальным браузером.

Горжусь, что трижды пыталась принести в код React, Webpack, Babel, LESS и Autoprefixer, но смогла победить себя. В итоге всё написано на чистом ES6+ и CSS, но с модными гридами, вебсокетами и fetch-ем.

Часть 3. Рассказывает Иван vansel, который попробовал новую классную библиотеку и не рад этому

Я не хотел писать всё с нуля, поэтому поискал готовое. Оригинальный Place лежит на Github, но там слишком много кода. Я взял простой клон под NodeJS и прошёлся по нему напильником. Именно поэтому, когда за дело взялась Вероника, интерфейс уже как-то работал. Вообще, есть уйма клонов, выбирайте для себя любой.

В коде выбранного клона пришлось пофиксить уязвимости и добавить недостающее: таймер, расширенную палитру, перемотку в онлайне, сбор статистики, рисование через вебсокеты вместо REST-запросов, вход через Паспорт (наш внутренний аутентификатор).

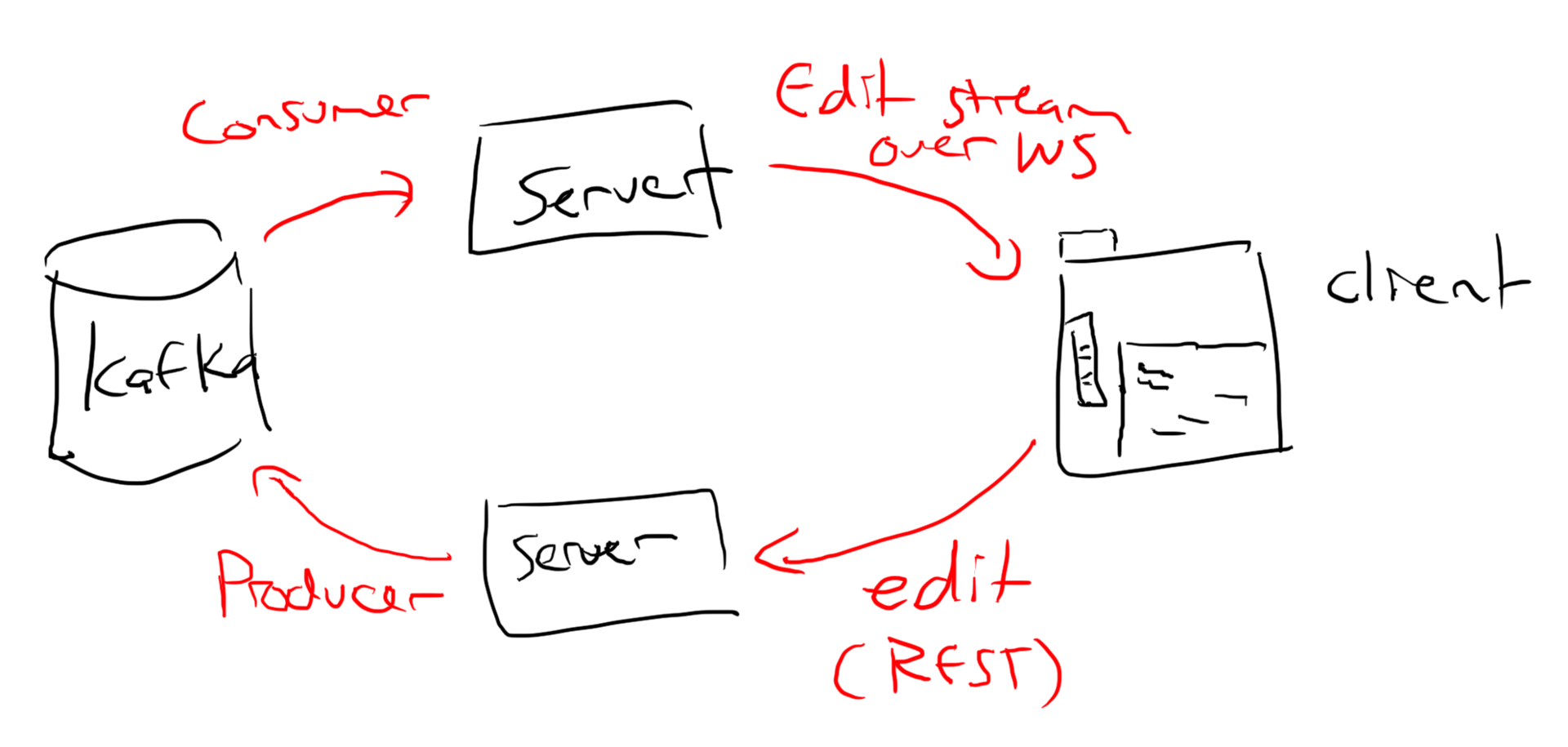

Архитектура была такая: пользователь ставил пиксель в браузере, браузер отправлял сообщение через вебсокет на сервер, сервер отправлял сообщение об изменении холста в очередь (Apache Kafka). Потом серверы забирали данные из очереди и отправляли всем клиентам. Выше оригинальная схема от автора клона, на которой клиенты ещё общаются с сервером с помощью REST-запросов.

Мы планировали сделать перемотку, поэтому я решил кэшировать снэпшоты холста с версиями. При старте сервер должен был взять последний снэпшот из кэша, а не строить его с нуля. Тот же снэпшот получал клиент при подключении к серверу, отчего загрузка холста была почти мгновенной. Можно было отправить клиенту снэпшот любой версии и таким образом организовать перемотку. Новый снэпшот сохранялся после изменения каждых ста пикселей.

Примерно через сутки после начала игры случился инцидент. Я исправил баг и перезапустил сервер. А пользователи увидели, что часть нарисованных точек пропала.

Дело было в том, что при подключении к серверу клиент запрашивал конкретную версию холста. Поэтому после старта сервер взял из кэша не последний снэпшот, а какую-то старую версию, которую запросил один из клиентов. Пользователи не увидели свежие пиксели и начали рисовать по-новой, а сервер продолжил складывать данные в очередь.

Когда я понял, в чём дело, я почистил кэш. Сервер заново загрузил данные из очереди и сгенерировал актуальную версию холста. Получился забавный эффект: новые рисунки пользователей наложились на предыдущие, так как вернулось всё потерянное и добавились новые изменения. Фикс был быстрый, поэтому ничего не испортилось:

В общем, не зря говорят, что инвалидация кэшей — это одна из двух сложнейших задач в компьютерных науках.

Забавно, что я, пока чинил кэш, случайно выключил аутентификацию. Тут же нашёлся коллега-кулхакер, который закрасил скриптом несколько тысяч пикселей за пару минут. Я выкатил фикс, но зелёная полоса осталась:

Ещё я хотел после окончания игры сделать хороший таймлапс и посчитать статистику. Для этого я решил завести базу данных и сохранять в ней для каждой нарисованной точки координаты, цвет, дату и время, а также идентификатор пользователя.

Сервер был под NodeJS, поэтому я выбрал LokiJS. Эту базу хвалили за простоту и скорость работы, потому что все данные хранятся в памяти и автоматически записываются на диск через заданные интервалы времени. Для моей задачи подходило.

Я настроил сохранение раз в 1 минуту. Протестировал локально, в том числе под нагрузкой — всё работало как часы. А на боевой площадке происходило что-то паранормальное. Данные сохранялись на диск не по расписанию, а по собственному желанию. Например, в течение нескольких часов не сохранялись ни разу. За три дня я так и не нашёл причины этого поведения. В итоге, много статистики потерялось при перезапусках сервера.

Однако я был готов к этому с самого начала, потому что таймлапс уж очень был нужен. Каждую минуту я сохранял холст в виде картинки в файл. Получилось несколько гигабайт картинок, зато видео с таймлапсом было записано и озвучено парой команд:

$ ffmpeg -pattern_type glob \

-i "*.png" \

-c:v libx264 \

-vf format=yuv420p \

timelapse.mp4

$ ffmpeg -i timelapse.mp4 \

-i sci-fi.mp3 \

256.mp4Часть 4. Рассказывает Павел xoposhiy, который загнул радугу и запустил ракету через API

После начала игры все быстро поняли, что один в поле не воин. Началась самоорганизация в Стаффе, нашей внутренней соцсети:

Я тоже в этом поучаствовал:

Но даже с командой было неинтересно рисовать масштабную картинку. Я понял это после первых семи пикселей радуги. Не радовало даже, что коллеги сделали кучу полезных инструментов:

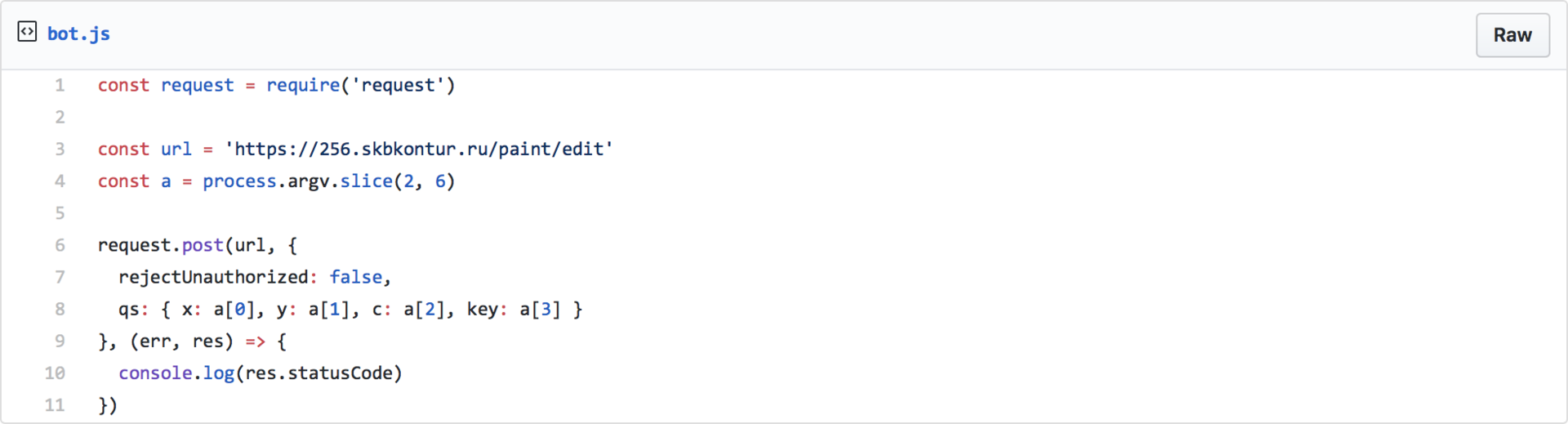

Я ждал от Дня программиста большего. И дождался — на второй день Игорь опубликовал в Стаффе такой фрагмент кода и стал раздавать желающим API-ключи:

Это было уже что-то!

Для разминки я написал бота, который рисовал заданную картинку. Это было не очень весело. Потом придумал создавать картинку алгоритмически. Получился бот, который загнул идеально круглую радугу. Но это тоже было скучно.

Я понял, что нескучный бот должен не просто рисовать пиксели, а взаимодействовать с окружающим миром и чужим творчеством. Но нужно было избежать вандализма, потому что бот — это сила, а с силой должна идти ответственность.

Можно было нарисовать часы с текущим временем. Или движущуюся картинку, которая ползёт по холсту и затирает чужие рисунки… чтобы потом их восстановить. И тут я придумал сюжет, который объединил эти две идеи.

Часы стали таймером обратного отсчёта, движущаяся картинка — взлетающей ракетой. К тому же, ракету очень удобно рисовать — сначала на пиксель удлиняешь верхнюю часть, потом на пиксель укорачиваешь нижнюю. Это не только хорошо смотрится, но и экономит пиксели, ведь задержку при рисовании через API никто не отменял.

Это должен был быть самый медленный полёт ракеты в истории человечества. С текущей задержкой за пару часов я мог сдвинуть ракету всего на несколько пикселей. Нужно было либо уменьшать ракету, либо двигать её скачками, либо смириться с тем, что лететь она будет сутки. Поделился муками выбора с Игорем, а он со словами «Твори добро!» внезапно отсыпал без малого 50 ключей для API. С таким количеством ключей ракета могла достичь скорости один пиксель в секунду!

Осталось немного: выбрать дизайн ракеты и написать весь код. Я отбросил мультяшные ракеты и выбрал ракету-носитель «Восток». Сразу стало понятно, что полёт ракеты должен заканчиваться выводом на орбиту корабля Восток-1.

Почему «Восток»? Потому что прямо сейчас куча инженеров из Контура занимается секретным проектом с кодовым названием Vostok. Я хотел, чтобы парням было приятно.

Я настроил бота, запустил таймер обратного отсчёта, позвал зрителей через Стафф. Ракета взлетела. И тут я понял, как нелепо выглядит ракета в космосе с неотделёнными разгонными блоками и первой ступенью. Чудом нашёл 10 свободных минут, чтобы добавить отделение ступени и перезапустить бота. Так что это был не только самый медленный полет ракеты в истории человечества, но и первый полёт ракеты, в середине которого поменяли её конструкцию.

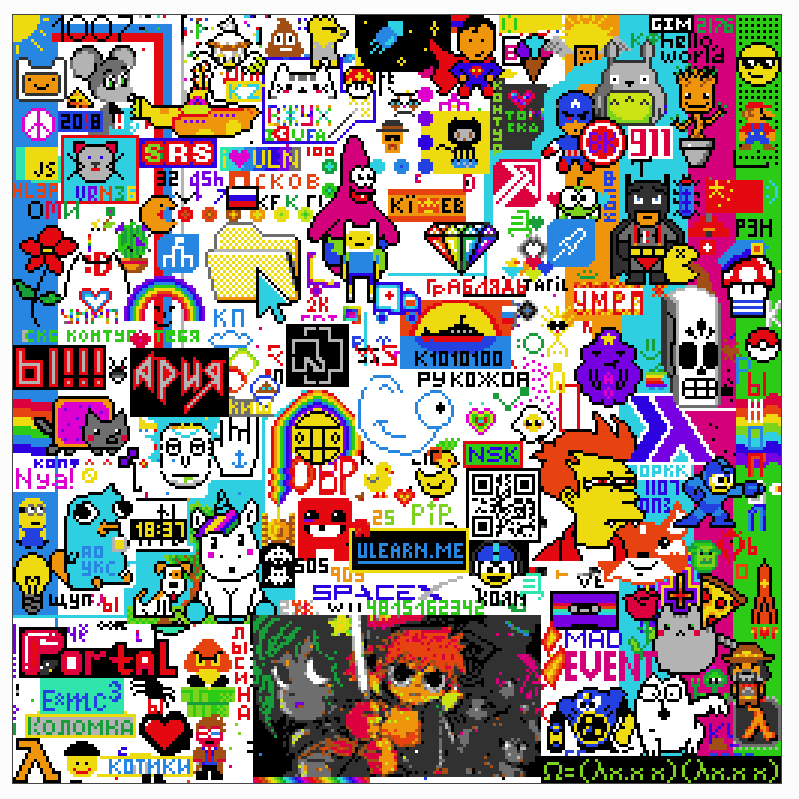

Было приятно наблюдать, как коллеги стирали копию ракеты, из-за бага оставшуюся на стартовом столе. Пририсовывают однопиксельного человечка в окошко ракеты. Переделывают слово «поехали» в «понаехали». Вообще, радовало, что все вели себя культурно, несмотря на отсутствие правил. Даже когда место на холсте закончилось:

Кстати, без NSFW-контента не обошлось. Кто-то из нарисованного моим первым нескучным ботом слова TRON упорно делал слово PRON.

Ваня потом рассказал, что 13 сентября на холсте одновременно рисовало 1630 человек и десяток ботов, то есть примерно треть всех работников компании. В среднем к серверам было подключено 440 клиентов, а в дневные часы — 840.

В итоге у нас получилась такая картинка:

И такой таймлапс. Моя ракета взлетает на 27 секунде:

А вы программируете по праздникам и для праздников? Расскажите нам в комментариях.

P. S. Если интересно, о чём мы не рассказываем на Хабре, подписывайтесь на наш канал в Телеграме.

|

Метки: author green_hippo разработка игр программирование визуализация данных canvas блог компании скб контур день программиста reddit космос восток |

Наш рецепт отказоустойчивого VPN-сервера на базе tinc, OpenVPN, Linux |

Наш рецепт отказоустойчивого VPN-сервера на базе tinc, OpenVPN, Linux

- Tutorial

Один из наших клиентов попросил разработать отказоустойчивое решение для организации защищенного доступа к его корпоративному сервису. Решение должно было:

- обеспечивать отказоустойчивость и избыточность;

- легко масштабироваться;

- просто и быстро решать задачу добавления и блокировки пользователей VPN;

- балансировать нагрузку между входными нодами;

- одинаково хорошо работать для клиентов на GNU/Linux, Mac OS X и Windows;

- поддерживать клиентов, которые находятся за NAT.

Готовых решений, удовлетворяющих всем поставленным условиям, не нашлось. Поэтому мы собрали его на базе популярных Open Source-продуктов, а теперь с удовольствием делимся полученным результатом в этой статье.

Разработка концепции

В качестве базовой VPN-технологии со стороны клиента мы выбрали OpenVPN: он прекрасно работает через NAT и поддерживает все требуемые платформы.

OpenVPN было решено развернуть в режиме TLS-сервера, а добавление и блокировку пользователей в нем сделать с помощью пакета easy-rsa, который позволяет создавать ключ и сертификат, а затем отзывать их при необходимости.

Сложнее всего было решить вопрос масштабирования, избыточности и отказоустойчивости.

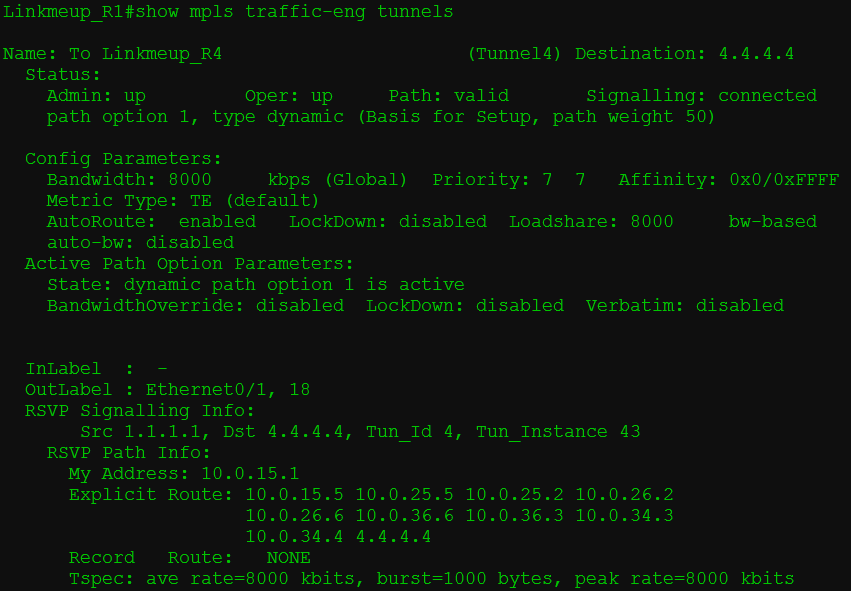

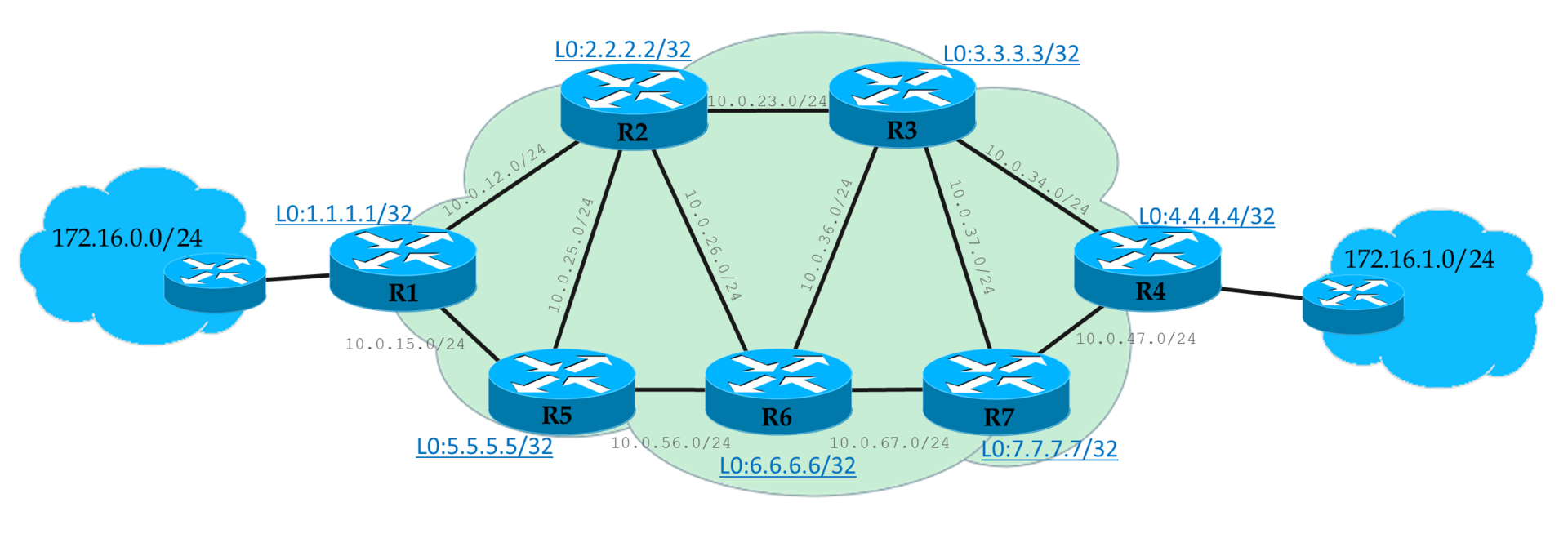

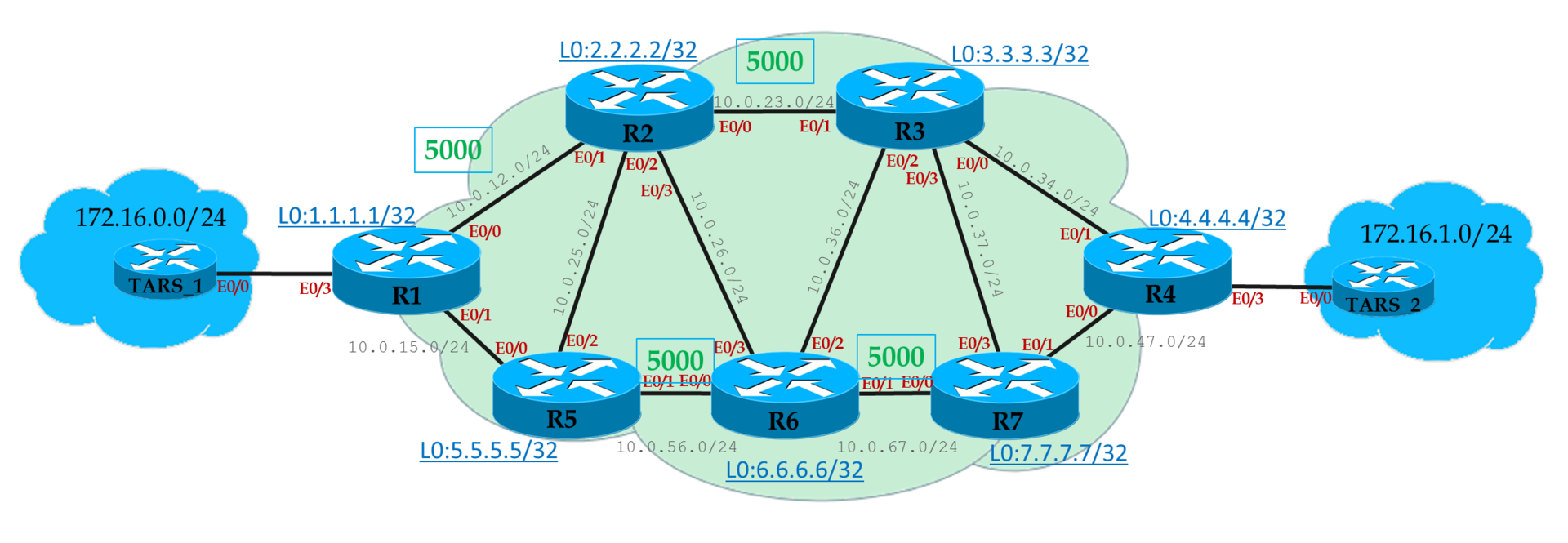

Итоговое решение вышло простым и изящным. Мы решили использовать N входных нод, адреса которых с помощью round-robin DNS выдаются клиентам. Все ноды и узлы сервиса клиентов включены в единое L2-пространство tinc VPN. Клиентские подключения (тоже L2) объединяются с tinc-интерфейсом в мост. Таким образом, получается, что, подключаясь по OpenVPN, клиент попадает на случайную ноду и оказывается в единой L2-сети со всеми остальными клиентами, нодами и сервисом клиента.

Для реализации этой схемы были выделены 3 VPS в различных дата-центрах, на которых и требовалось развернуть «точки входа» в сеть (

ep1, ep2 и ep3). Кроме того, в сети присутствовал гипервизор с сервисами клиента (hpv1). На всех машинах установили Ubuntu Server 16.04.Строим tinc VPN

Для начала устанавливаем пакеты:

$ sudo apt-get update && sudo apt-get install tinсНа этом этапе нам нужно определиться с названием сети — пусть будет

l2vpnnet. Создаем структуру каталогов:$ sudo mkdir -p /etc/tinc/l2vpnnet/hostsВ каталоге

/etc/tinc/l2vpnnet создаем файл tinc.conf и наполняем его следующим содержимым:# Имя текущей машины

Name = ep1

# Тип сети, в нашем случае — L2

Mode = switch

# Интерфейс, который мы будем использовать

Interface = tap0

# По умолчанию используется протокол UDP

Port = 655

# Записываем имена всех остальных хостов, к которым мы будем подключаться

ConnectTo = ep2

ConnectTo = ep3

ConnectTo = hpv1Создаем файл

/etc/tinc/l2vpnnet/ep1 и вносим в него параметры:# Публичный адрес и порт

Address = 100.101.102.103 655

# Используемые алгоритмы шифрования и аутентификации

Cipher = aes-128-cbc

Digest = sha1

# Для уменьшения задержек рекомендуем также выключать сжатие

Compression = 0Производим генерацию ключей. Традиционно мы используем ключи длиной 2 килобита: такая длина ключа обеспечивает хороший баланс между уровнем приватности и задержек (из-за накладных расходов на шифрование).

$ cd /etc/tinc/l2vpnnet && sudo tincd -n l2vpnnet -K2048

Generating 2048 bits keys:

............................................+++ p

.................................+++ q

Done.

Please enter a file to save private RSA key to [/etc/tinc/l2vpnnet/rsa_key.priv]:

Please enter a file to save public RSA key to [/etc/tinc/l2vpnnet/hosts/ep1]: На остальных машинах проделываем аналогичные действия. Файлы с открытым ключом и параметрами подключения (

/etc/tinc/l2vpnnet/hosts/ep1|ep2|ep3|hpv1) необходимо разместить у всех участников сети в каталоге /etc/tinc/l2vpnnet/hosts.Название сети необходимо внести в файл

/etc/tinc/nets.boot, чтобы tinc запускал VPN к нашей сети автоматически при загрузке:$ sudo cat nets.boot

#This file contains all names of the networks to be started

#on system startup.

l2vpnnetПри настройке как tinc VPN, так и OpenVPN в нашей компании принято использовать стандартные механизмы управления сетью Ubuntu. Добавим в

/etc/network/interfaces описание параметров устройства tap0:# Устройство запускается автоматически при старте системы

auto tap0

# Указываем режим конфигурации manual, так как IP мы назначим уже на bridge

iface tap0 inet manual

# Создание устройства перед запуском tinc

pre-up ip tuntap add dev $IFACE mode tap

# ... и его удаление после остановки

post-down ip tuntap del dev $IFACE mode tap

# Собственно, запуск tinc с настроенной нами сетью

tinc-net l2vpnnetТакая настройка позволит нам управлять tinc с помощью ifup/ifdown-скриптов.

Для единого L2-пространства нужно выбрать и L3-пространство. Для примера мы будем использовать сеть

10.10.10.0/24. Настроим bridge-интерфейс и назначим ему IP — для этого внесем в /etc/network/interfaces такую информацию:auto br0

iface br0 inet static

# Естественно, IP должен быть разным для хостов

address 10.10.10.1

netmask 255.255.255.0

# Указываем, что в бридже наш интерфейс tinc vpn

bridge_ports tap0

# Отключаем протокол spanning tree для bridge-интерфейса

bridge_stp off

# Максимальное время ожидания готовности моста

bridge_maxwait 5

# Отключаем задержку при форвардинге

bridge_fd 0После этого последовательно стартуем оба устройства на всех серверах и проверяем связанность любым средством диагностики (ping, mtr и т.п.):

$ sudo ifup tap0 && sudo ifup br0

$ ping -c3 10.10.10.2

PING 10.10.10.2 (10.10.10.2) 56(84) bytes of data.

64 bytes from 10.10.10.2: icmp_seq=1 ttl=64 time=3.99 ms

64 bytes from 10.10.10.2: icmp_seq=2 ttl=64 time=1.19 ms

64 bytes from 10.10.10.2: icmp_seq=3 ttl=64 time=1.07 ms

--- 10.10.10.2 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2002ms

rtt min/avg/max/mdev = 1.075/2.087/3.994/1.349 msОтлично: L2-пространство для входных нод и целевого сервера построено. Теперь нужно добавить в него удаленных клиентов.

Настраиваем OpenVPN

Для начала устанавливаем необходимые пакеты на всех серверах:

$ sudo apt-get update && sudo apt-get install openvpn easy-rsaНастроим DNS-зону, добавим 3 A-записи с одинаковым именем VPN-сервиса:

vpn.compa.ny. IN A 100.101.102.103

vpn.compa.ny. IN A 50.51.52.53

vpn.compa.ny. IN A 1.1.1.1DNS будет выступать первым механизмом балансировки нагрузки в нашей системе. Согласно документации, OpenVPN разрешает имя точки подключения и будет последовательно совершать попытки подключиться ко всем IP, в которые разрешается имя. DNS при этом будет отдавать список IP в случайном порядке.

Вторым механизмом распределения нагрузки будет служить ограничение максимального количества подключений на один сервер. Предположим, у нас порядка 50 пользователей. С учетом избыточности, мы поставим ограничение в 30 пользователей на сервер и распределим пулы IP-адресов следующим образом:

Node 1 10.10.10.100-10.10.10.129

Node 2 10.10.10.130-10.10.10.159

Node 2 10.10.10.160-10.10.10.189Создадим окружение для CA:

$ cd /etc/openvpn

$ sudo -s

# make-cadir ca

# mkdir keys

# chmod 700 keys

# exitТеперь отредактируем файл с переменными

vars, установив следующие значения:# Каталог с easy-rsa

export EASY_RSA="`pwd`"

# Путь к openssl, pkcs11-tool, grep

export OPENSSL="openssl"

export PKCS11TOOL="pkcs11-tool"

export GREP="grep"

# Конфиг openssl

export KEY_CONFIG=`$EASY_RSA/whichopensslcnf $EASY_RSA`

# Каталог с ключами

export KEY_DIR="$EASY_RSA/keys"

export PKCS11_MODULE_PATH="dummy"

export PKCS11_PIN="dummy"

# Размер ключа

export KEY_SIZE=2048

# CA-ключ будет жить 10 лет

export CA_EXPIRE=3650

# Описываем нашу организацию: страна, регион,

# город, наименование, e-mail и подразделение

export KEY_COUNTRY="RU"

export KEY_PROVINCE="Magadan region"

export KEY_CITY="Susuman"

export KEY_ORG="Company"

export KEY_EMAIL="info@compa.ny"

export KEY_OU="IT"

export KEY_NAME="UnbreakableVPN"Сохраняем и начинаем генерацию ключей:

# . vars

# ./clean-all

# ./build-ca

Generating a 2048 bit RSA private key

..........................+++

.+++

writing new private key to 'ca.key'

-----

You are about to be asked to enter information that will be incorporated

into your certificate request.

What you are about to enter is what is called a Distinguished Name or a DN.

There are quite a few fields but you can leave some blank

For some fields there will be a default value,

If you enter '.', the field will be left blank.

-----

Country Name (2 letter code) [RU]:

State or Province Name (full name) [Magadan region]:

Locality Name (eg, city) [Susuman]:

Organization Name (eg, company) [Company]:

Organizational Unit Name (eg, section) [IT]:

Common Name (eg, your name or your server's hostname) [Company CA]:

Name [UnbreakableVPN]:

Email Address [info@compa.ny]:

# ./build-dh

Generating DH parameters, 2048 bit long safe prime, generator 2

This is going to take a long time

…

# ./build-key-server server

# openvpn --genkey --secret keys/ta.keyСоздадим тестового пользователя и сразу отзовем его сертификат, чтобы создать список отзыва:

# ./build-key testuser

# ./revoke-full testuserСкопируем все необходимые для настройки сервера ключи в каталог с ключевой информацией OpenVPN:

# cd keys

# mkdir /etc/openvpn/.keys

# cp ca.crt server.crt server.key dh2048.pem ta.key crl.pem /etc/openvpn/.keys

# exitПодготовим конфигурацию OpenVPN-сервера, для чего создадим файл

/etc/openvpn/server.conf:# Устанавливаем подробность ведения журнала

verb 4

# Порт и протокол подключения

port 1194

proto tcp-server

# Режим и способ аутентификации

mode server

tls-server

# Определяем MTU

tun-mtu 1500

# Определяем имя и тип интерфейса, который будет обслуживать клиентов

dev ovpn-clients

dev-type tap

# Указываем, что TA-ключ используется в режиме сервера

key-direction 0

# Описываем ключевую информацию

cert /etc/openvpn/.keys/server.crt

key /etc/openvpn/.keys/server.key

dh /etc/openvpn/.keys/dh2048.pem

tls-auth /etc/openvpn/.keys/ta.key

crl-verify /etc/openvpn/.keys/crl.pem

# Определяем протоколы аутентификации и шифрования

auth sha1

cipher AES-128-CBC

# Опция, указывающая, что устройство будет создаваться единожды

# на все время работы сервера

persist-tun

# Указываем тип топологии и пул

topology subnet

server-bridge 10.10.10.1 255.255.255.0 10.10.10.100 10.10.10.129

# Указываем маршрут по умолчанию через туннель и определяем

# внутренние DNS

push "redirect-gateway autolocal"

push "dhcp-option DNS 10.10.10.200"

push "dhcp-option DNS 10.20.20.200"

# Проверяем доступность подключенного клиента раз в 10 секунд,

# таймаут подключения — 2 минуты

keepalive 10 120

# То самое ограничение в 30 клиентов

max-clients 30

# Локальные привилегии демона openvpn

user nobody

group nogroup

# Позволяет удаленному клиенту подключаться с любого IP и порта

float

# Путь к файлу журнала

log /var/log/openvpn-server.logДля второго и третьего сервера будем использовать тот же набор ключевой информации — конфигурационные файлы будут отличаться только пулом выдаваемых IP-адресов.

По аналогии с tinc настроим управление OpenVPN через стандартные ifup/ifdown-скрипты, добавив описание устройства в

/etc/network/interfaces:auto ovpn-clients

iface ovpn-clients inet manual

pre-up ip tuntap add dev $IFACE mode tap

post-up systemctl start openvpn@server.service

pre-down systemctl stop openvpn@server.service

post-down ip tuntap del dev $IFACE mode tapВключим интерфейс в мост вместе с tinc, изменив настройки интерфейса

br0: ...

netmask 255.255.255.0

bridge_ports tap0

bridge_ports ovpn_clients

bridge_stp off

...Приведем все в рабочее состояние:

$ sudo ifup ovpn-clients && sudo ifdown br0 && sudo ifup br0Серверная конфигурация готова. Теперь создадим клиентские ключи и ovpn-файл:

$ sudo -s

# cd /etc/openvpn/ca

# ./build-key PetrovIvan

# exitДля упрощения использования мы создадим клиентский ovpn-файл c ключевой информацией INLINE:

$ vim PetrovInan.ovpn

# Указываем тип подключения, тип устройства и протокол

client

dev tap

proto tcp

# Определяем MTU такой же, как и на сервере

tun-mtu 1500

# Указываем узел и порт подключения

remote vpn.compa.ny 1194

# Отказываемся от постоянного прослушивания порта

nobind

# Опция, которая позволяет не перечитывать ключи для каждого соединения

persist-key

persist-tun

# Корректируем MSS

mssfix

# Указываем, что будем использовать TA как TLS-клиент

key-direction 1

ns-cert-type server

remote-cert-tls server

auth sha1

cipher AES-128-CBC

verb 4

keepalive 10 40

### Сюда вставляем содержимое ca.crt

### Сюда вставляем содержимое ta.key

### Сюда вставляем содержимое PetrovIvan.crt

### Сюда вставляем содержимое PetrovIvan.key

Сохраняем и отдаем клиенту, который просто подключается к VPN, используя ovpn-файл. На этом настройка OpenVPN закончена.

Блокировка клиента

В случае, когда нам необходимо запретить подключение к VPN одному из клиентов (например, при увольнении сотрудника), мы просто отзываем сертификат:

$ ./revoke-all PetrovIvanПосле отзыва обновляем на всех серверах

crl.pem и выполняем:$ sudo service openvpn reloadОбратите внимание, что в

server.conf отсутствует опция persist-key. Это позволяет обновить ключевую информацию во время выполнения reload — иначе бы для этого потребовался рестарт демона.Для распространения списка отзыва и выполнения действия

reload для OpenVPN мы используем Chef. Очевидно, для этой цели подойдут любые другие средства автоматического развертывания конфигураций (Ansible, Puppet…) или даже простой shell-скрипт.Кроме того, мы поместили каталог с CA в Git, что позволило и нам, и клиенту совместно работать с ключевой информацией, избегая коллизий.

Заключение

Конечно, описанное решение в ходе эксплуатации развивается. В частности, мы дописали простые скрипты, которые автоматически создают клиентские ovpn-файлы во время генерации ключей, а также работаем над системой мониторинга VPN.

Если у вас есть мысли о слабых местах в этом решении или идеи/вопросы по дальнейшему развитию конфигурации — буду рад увидеть их комментариях!

P.S.

Читайте также в нашем блоге:

|

Метки: author gserge системное администрирование сетевые технологии настройка linux блог компании флант vpn openvpn tinc linux |

Разбираемся с новым sync.Map в Go 1.9 |

Разбираемся с новым sync.Map в Go 1.9

- Tutorial

Одним из нововведений в Go 1.9 было добавление в стандартную библиотеку нового типа sync.Map, и если вы ещё не разобрались что это и для чего он нужен, то эта статья для вас.

Для тех, кому интересен только вывод, TL;DR:

если у вас высоконагруженная (и 100нс решают) система с большим количеством ядер процессора (32+), вы можете захотеть использовать sync.Map вместо стандартного map+sync.RWMutex. В остальных случаях, sync.Map особо не нужен.

Если же интересны подробности, то давайте начнем с основ.

Тип map

Если вы работаете с данными в формате "ключ"-"значение", то всё что вам нужно это встроенный тип map (карта). Хорошее введение, как пользоваться map есть в Effective Go и блог-посте "Go Maps in Action".

map — это generic структура данных, в которой ключом может быть любой тип, кроме слайсов и функций, а значением — вообще любой тип. По сути это хорошо оптимизированная хеш-таблица. Если вам интересно внутреннее устройство map — на прошлом GopherCon был очень хороший доклад на эту тему.

Вспомним как пользоваться map:

// инициализация

m := make(map[string]int)

// запись

m["habr"] = 42

// чтение

val := m["habr"]

// чтение с comma,ok

val, ok := m["habr"] // ok равен true, если ключ найден

// итерация

for k, v := range m { ... }

// удаление

delete(m, "habr")Во время итерации значения в map могут изменяться.

Go, как известно, является языком созданным для написания concurrent программ — программ, который эффективно работают на мультипроцессорных системах. Но тип map не безопасен для параллельного доступа. Тоесть для чтения, конечно, безопасен — 1000 горутин могут читать из map без опасений, но вот параллельно в неё ещё и писать — уже нет. До Go 1.8 конкурентный доступ (чтение и запись из разных горутин) могли привести к неопределенности, а после Go 1.8 эта ситуация стала явно выбрасывать панику с сообщением "concurrent map writes".

Почему map не потокобезопасен

Решение делать или нет map потокобезопасным было непростым, но было принято не делать — эта безопасность не даётся бесплатно. Там где она не нужна, дополнительные средства синхронизации вроде мьютексов будут излишне замедлять программу, а там где она нужна — не составляет труда реализовать эту безопасность с помощью sync.Mutex.

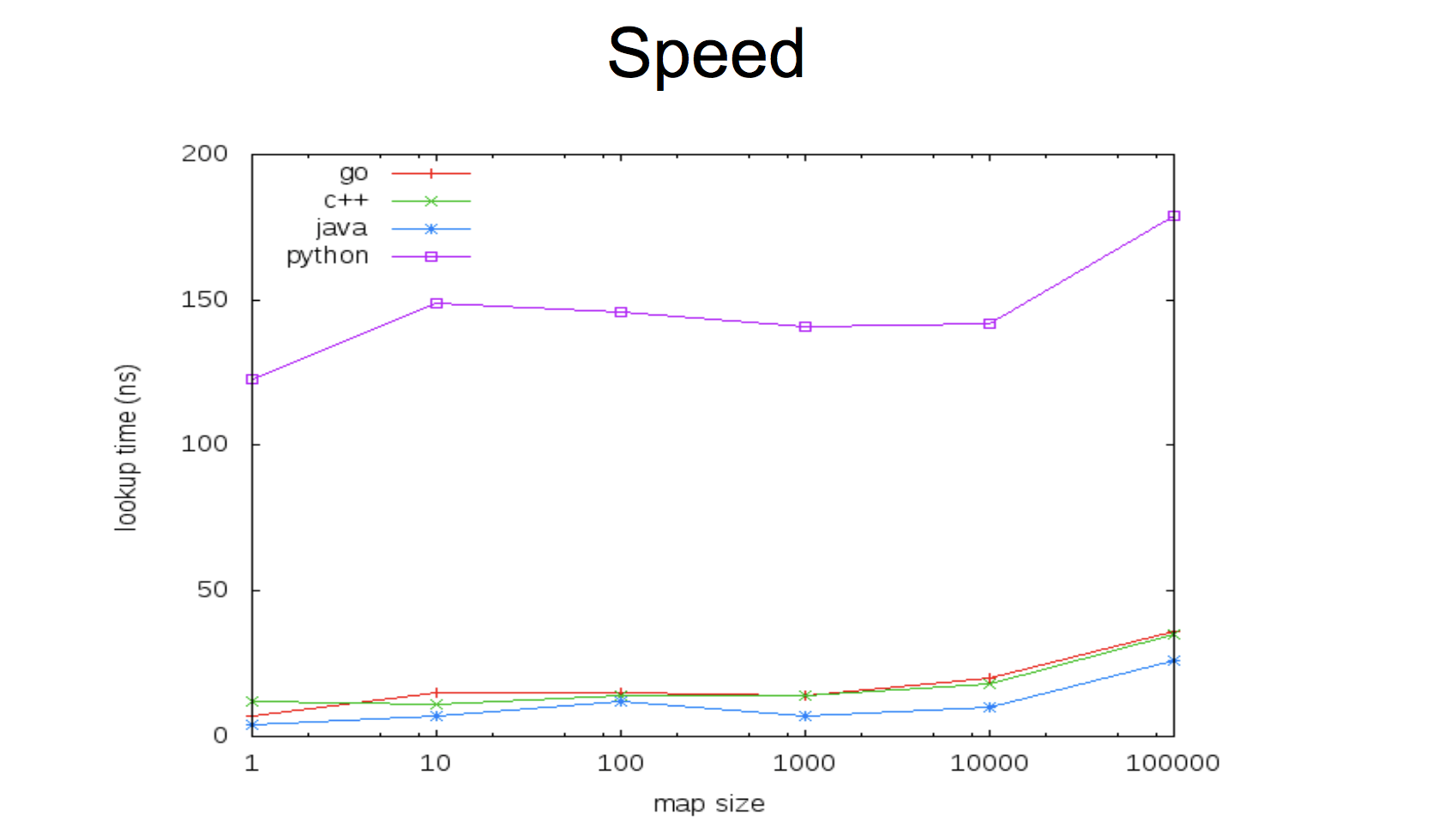

В текущей реализации map очень быстр:

Такой компромисс между скоростью и потокобезопасностью, при этом оставляя возможность иметь и первый и второй вариант. Либо у вас сверхбыстрый map безо всяких мьютексов, либо чуть медленнее, но безопасен для параллельного доступа. Важно тут понимать, что в Go использование переменной параллельно несколькими горутинами — это не далеко единственный способ писать concurrent-программы, поэтому кейс этот не такой частый, как может показаться вначале.

Давайте, посмотрим, как это делается.

Map + sync.Mutex

Реализация потокобезопасной map очень проста — создаём новую структуру данных и встраиваем в неё мьютекс. Структуру можно назвать как угодно — хоть MyMap, но есть смысл дать ей осмысленное имя — скорее всего вы решаете какую-то конкретную задачу.

type Counters struct {

sync.Mutex

m map[string]int

}Мьютекс никак инициализировать не нужно, его "нулевое значение" это разлоченный мьютекс, готовый к использованию, а карту таки нужно, поэтому будет удобно (но не обязательно) создать функцию-конструктор:

func NewCounters() *Counters {

return &Counters{

m: make(map[string]int),

}

}Теперь у переменной типа Counters будет метод Lock() и Unlock(), но если мы хотим упростить себе жизнь и использовать этот тип из других пакетов, то будет также удобно сделать функции обёртки вроде Load() и Store(). В таком случае мьютекс можно не встраивать, а просто сделать "приватным" полем:

type Counters struct {

mx sync.Mutex

m map[string]int

}

func (c *Counters) Load(key string) (int, bool) {

c.mx.Lock()

defer c.mx.Unlock()

val, ok := c.m[key]

return val, ok

}

func (c *Counters) Store(key string, value int) {

c.mx.Lock()

defer c.mx.Unlock()

c.m[key] = value

}Тут нужно обратить внимание на два момента:

deferимеет небольшой оверхед (порядка 50-100 наносекунд), поэтому если у вас код для высоконагруженной системы и 100 наносекунд имеют значение, то вам может быть выгодней не использоватьdefer- методы

Get()иStore()должны быть определены для указателя наCounters, а не наCounters(тоесть неfunc (c Counters) Load(key string) int { ... }, потому что в таком случае значение ресивера (c) копируется, вместе с чем скопируется и мьютекс в нашей структуре, что лишает всю затею смысла и приводит к проблемам.

Вы также можете, если нужно, определить методы Delete() и Range(), чтобы защищать мьютексом map во время удаления и итерации по ней.

Кстати, обратите внимание, я намеренно пишу "если нужно", потому что вы всегда решаете конкретную задачу и в каждом конкретном случае у вас могут разные профили использования. Если вам не нужен Range() — не тратьте время на его реализацию. Когда нужно будет — всегда сможете добавить. Keep it simple.

Теперь мы можем легко использовать нашу безопасную структуру данных:

counters := NewCounters()

counters.Store("habr", 42)

v, ok := counters.Load("habr")В зависимости, опять же, от конкретной задачи, можно делать любые удобные вам методы. Например, для счётчиков удобно делать увеличение значения. С обычной map мы бы делали что-то вроде:

counters["habr"]++а для нашей структуры можем сделать отдельный метод:

func (c *Counters) Inc(key string) {

c.mx.Lock()

defer c.mx.Unlock()

c.m[key]++

}

...

counters.Inc("habr")Но часто у работы с данными в формате "ключ"-"значение", паттерн доступа неравномерный — либо частая запись, и редкое чтение, либо наоборот. Типичный случай — обновление происходит редко, а итерация (range) по всем значениям — часто. Чтение, как мы помним, из map — безопасно, но сейчас мы будем лочиться на каждой операции чтения, теряя без особой выгоды время на ожидание разблокировки.