Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод - recovery mode ] Почему я перешел с React на Cycle.js |

Нетрудно догадаться, что большинство разработчиков сейчас используют какие-либо фреймворки для разработки приложений. Они помогают нам структурировать сложные приложения и экономят время. Каждый день можно наблюдать большое количество обсуждений, какой фреймворк лучше, какой нужно учить, и тому подобное. Так что, в этот раз я поделюсь своим опытом и отвечу на вопрос: «Почему я перешел на Cycle.js с React?».

React, возможно, самый популярный frontend-фреймворк (на момент 2017) с огромным сообществом. Я большой фанат этого фреймворка и он мне помог изменить взгляд на веб-приложения и их разработку. Некоторые любят его, а кто-то считает, что он не так хорош.

Большинство использует React без мысли о том, что есть лучший инструмент или способ разработки веб-приложений. Это дало мне толчок попробовать Cycle.js, как новый реактивный фреймворк, который становится все более и более популярным изо дня в день.

И в этой статье я хочу объяснить:

- Что такое реактивное программирование

- Как работает Cycle.js

- И почему он, на мой взгляд, лучше React

Что такое реактивное программирование?

Реактивное программирование (RP, РП) — это работа с асинхронными потоками данных. Если вы создавали веб-приложение, вы, возможно, уже писали много реактивного кода. В качестве примера можно привести событие клика — это асинхронный поток данных. Мы можем следить за ним и создавать побочные эффекты (side effects). Идея реактивного программирования — дать возможность создавать потоки данных где угодно и работать с ними. Тогда мы можем создать некоторые абстракции для всех побочных эффектов (side effects), которые куда проще использовать, поддерживать и тестировать.

Вы возможно зададите вопрос: «А зачем мне нужен этот новый „реактивный“ подход в программировании?». Ответ прост: Реактивное программирование помогает унифицировать код и делает его более последовательным. Больше не нужно думать о том, как что-то должно работать и как правильно это реализовать. Просто пишем код определенным образом, не беспокоясь с какими данными мы работаем (клики мышкой, http-запросы, веб-сокеты). Всё это — потоки данных, и каждый поток имеет множество методов, которые позволяют работать с этими данным, например

map или filter. Эти функции возвращают новые потоки, которые могут быть так же использованы.Реактивное программирование предоставляет абстракции, а это дает возможность концентрироваться на бизнес-логике.

Реактивное программирование в JavaScript

В Javascript есть пара замечательных библиотек для работы с потоками данных. Одна из них — это всем известный Rx-JS, расширение ReactiveX, — API для асинхронного программирования с отслеживаемыми потоками данных. Вы можете создать Observable (поток данных) и управлять им множеством функций.

Вторая библиотека — это Most.js. Она имеет лучшую производительность, что подтверждается тестами.

Также стоит отметить одну небольшую и быструю библиотеку xstream, написанную автором Cycle.js. Она содержит 26 методов и весит 30kb. Это одна из самых быстрых библиотек для реактивного программирования на JS.

Как раз, в примерах к этой статье используется библиотека xstream. Cycle.js создана быть небольшим фреймворкам и я хочу использовать именно легковесную библиотеку в паре с Cycle.js.

Что такое Cycle.js?

Cycle.js — это функциональный и реактивный Javascript-фреймворк. Он предоставляет абстракции для приложений в виде чистой функции main(). В функциональном программировании функции должны принимать на вход параметры и что-то возвращать без побочных эффектов. В Cycle.js функция main() на вход принимает параметры из внешнего мира и пишет тоже во внешний мир. Побочные эффекты реализуются с помощью драйверов. Драйверы — это плагины, которые управляют DOM'ом, HTTP-запросами, вебсокетами и так далее.

Cycle.js помогает создавать пользовательский интерфейс, тестировать его и писать повторно используемый код. Каждый компонент представляет собой чистую функцию, которые могут запускаться независимо.

Основное API имеет только одну функцию,

run() с двумя аргументами:run(app, drivers);

app — основная чистая функция, а drivers — это вышеуказанные драйверы.Функционал Cycle.js разделен на несколько небольших модулей:

- @cycle/dom – коллекция драйверов для работы с DOM; Это DOM-драйвер и HTML-драйвер, основанный на snabdom virtual DOM библиотеке

- @cycle/history – драйвер History API

- @cycle/http – драйвер HTTP запросов, основанный на superagent

- @cycle/isolate – функция создания изолированных dataflow-компонентов

- @cycle/jsonp – JSONP-драйвер

- @cycle/most-run –

run-функция для работы сmost - @cycle/run –

run-функция для работы сxstream - @cycle/rxjs-run –

run-функция для работы сrxjs

Cycle.js код

Хотите увидеть немного Cycle.js-кода? Мы создадим простое приложение, демонстрирующее как все это работает. Мне кажется, что старое доброе приложение-счетчик, будет идеальным для этого примера. Мы увидим, как работать с DOM-событиями и перерендериванием DOM-элементов.

Давайте создадим два файла:

index.html и main.js. index.html будет содержать только основной файл со скриптами, где и прописана вся логика. package.json, так что запустимnpm init -y

Затем установим основные зависимости

npm install @cycle/dom @cycle/run xstream --save

Это команда поставит

@cycle/dom, @cycle/xstream-run, and xstream. Также нужны babel, browserify и mkdirp, установим их:npm install babel-cli babel-preset-es2015 babel-register babelify browserify mkdirp --save-dev

Чтобы работать с Babel, создадим

.babelrc-файл в корне директории со следующим содержимым:{

"presets": ["es2015"]

}

Также нам нужно добавить скрипты, которые упрощают запуск команд, в

package.json"scripts": {

"prebrowserify": "mkdirp dist",

"browserify": "browserify main.js -t babelify --outfile dist/main.js",

"start": "npm install && npm run browserify && echo 'OPEN index.html IN YOUR BROWSER'"

}

Для запуска нашего Cycle.js-приложения, нужно запустить команду

npm run start

Все. Установка закончена, теперь мы можем начать писать код.

Начнем с добавления небольшого HTML-кода внутри

index.html< !DOCTYPE html>

Мы создали

div с идентификатором main. Cycle.js свяжется с этим элементом и будет в него рендерить все приложение. Мы также подключили dist/main.js-файл. Это проведенный через babel, транспайленный и объединенный js-файл, который будет создан из main.js-файла.Время написать немного Cycle.js-кода. Откроем

main.js и импортируем все необходимые зависимости:import xs from 'xstream';

import { run } from '@cycle/run';

import { div, button, p, makeDOMDriver } from '@cycle/dom';

Мы включили

xstream, run, makeDOMDriver и функции, которые помогут нам работать с Virtual DOM (div, button и p).Напишем основную

main-функцию:function main(sources) {

const action$ = xs.merge(

sources.DOM.select('.decrement').events('click').map(ev => -1),

sources.DOM.select('.increment').events('click').map(ev => +1)

);

const count$ = action$.fold((acc, x) => acc + x, 0);

const vdom$ = count$.map(count =>

div([

button('.decrement', 'Decrement'),

button('.increment', 'Increment'),

p('Counter: ' + count)

])

);

return {

DOM: vdom$,

};

}

run(main, {

DOM: makeDOMDriver('#main')

});

Это наша основная

main-функция. Она берет на вход параметры и возвращает результат. Входные параметры — это потоки DOM (DOM streams), а результат — это Virtual DOM. Давайте начнем объяснение шаг за шагом:const action$ = xs.merge(

sources.DOM.select('.decrement').events('click').map(ev => -1),

sources.DOM.select('.increment').events('click').map(ev => +1)

);

Здесь мы объединяем два потока в один поток, называемый

action$ (здесь используем соглашение о суффиксе "$" тех переменных, которые представлют собой поток данных). Один из потоков является кликом по кнопке (.decrement) уменьшающей на единицу счетчик, второй — по другой, увеличивающей счетчик, кнопке (.increment). Мы связываем эти события c числами -1 и +1, соответственно. В конце слияния, поток action$ будет выглядеть следующим образом:----(-1)-----(+1)------(-1)------(-1)------

Создадим еще один поток

count$const count$ = action$.fold((acc, x) => acc + x, 0);

Функция

fold прекрасно подходит для этой цели. Она принимает два аргумента: accumulate и seed. seed is firstly emitted until the event comes. Следующее событие комбинируется с первым, основываясь на accumulate-функции. Это практически функция-reduce() для потоков.Наш поток

count$ получает 0 как начальное значение, затем при каждом новом значении из action$-потока, мы суммируем с текущим значением count$-потока.В самом конце, завершая цикл работы функции, нужно запустить функцию

run под main.Последний шаг — создать Virtual DOM:

const vdom$ = count$.map(count =>

div([

button('.decrement', 'Decrement'),

button('.increment', 'Increment'),

p('Counter: ' + count)

])

);

Мы сопоставляем данные в потоке

count$ и возвращаем Virtual DOM для каждого элемента в потоке. Virtual DOM содержит одну div-обертку, две кнопки и параграф. Как можно заметить, Cycle.js работает с DOM с помощью JS-функций, но JSX также можно использовать.В конце

main-функции нужно возвратить наш Virtual DOM:return {

DOM: vdom$,

};

Мы передаем

main-функцию и DOM-драйвер, который подключен к и получаем поток событий для этого div-элемента. Мы завершаем наш цикл и создаем прекрасное Cycle.js-приложение.Вот как это работает:

Вот и все! Таким образом и можно работать с DOM-потоками. Если вы хотите посмотреть как работать с HTTP-потоками в Cycle.js, я написал статью[eng]об этом.

Весь код можно найти на GitHub-репозитории.

Почему я перешел с React на Cycle.js?

Сейчас вы поняли базовые принципы реактивного программирования и уже увидели простой пример на Cycle.js, так что давайте поговорим, почему я буду использовать эту связку для следующего моего проекта.

При разработке веб-приложений управление огромным количеством кода и данными из разных источников является большой проблемой. Я фанат React и у меня было множество проектов, но React не решал всех моих проблем.

React хорошо себя проявлял, когда дело доходило до рендеринга небольших данных и изменения состояния приложения. На самом деле, его методология компонентов потрясающа и реально помогает писать качественный, поддерживаемый и тестируемый код. Но все время чего-то не хватало.

Давайте рассмотрим плюсы и минусы использования Cycle.js вместо React.

Плюсы

1. Большая кодовая база

Когда приложение становится большим, при использовании React возникают проблемы. Представим, что у нас 100 компонентов внутри 100 контейнеров, и каждый из них имеет собственный функционал, тесты и стили. Это очень много строк кода внутри множества файлов внутри кучи директорий. В таком случае трудно переключаться между всеми этими файлами.

2. Потоки данных

Для меня наибольшая проблема React — это потоки данных. React изначально не разрабатывался для работы с потоками данных, и этого нет в ядре React. Разработчики пытались решить это, и у нас есть множество библиотек и методологий, которые решают эту проблему. Наиболее популярный — это Redux. Но он не совершенен. Вам нужно потратить много времени, чтобы сконфигурировать его и нужно написать много кода, что позволит просто работать с потоками данных.

С Cycle.js же, другая история, создатель хотел сделать фреймворк таким, чтобы он изначально работал с потоками данных, так что вам не нужно думать о этой реализации. Все что вам нужно — это писать функции, которые оперируют с данными и Cycle.js возьмет на себя все остальное.

3. Побочные эффекты функций (Side effects)

React имеет некоторые проблемы в работе с побочными эффектами (side effects). Нет стандартизированного подхода в работе с побочными эффектами (side effects) в React-приложениях. Есть множество инструментов, которые помогают работать, но это так же отнимает время на установку и изучения их. Наиболее популярные — это redux-saga, redux-effects, redux-side-effects, и redux-loop. Видите, что я имею ввиду? Их множество. И вам нужно выбирать, что учить и что внедрять в ваш проект.

4. Функциональное программирование

Создатели React утверждают, что React использует функциональный подход в программировании, но это не совсем правда. Там много ООП, классов, использования

this, что порождает головную боль, если что-то пойдет не так.Cycle.js построен на функциональной парадигме. Все в нем — это функции, которые не зависят от внешнего состояния. Там даже нет классов. Это куда проще тестировать и поддерживать.

Минусы

1. Сообщество

В настоящее время React является наиболее популярным фреймворком и используется повсюду. Cycle.js — нет. Он все еще не очень популярный, и это будет проблемой, когда вы столкнетесь с проблемой, и найти решение в сети будет не таким легким. Временами решения проблемы нет, и вам придется решать ее самому.

Это не проблема, когда вы работаете над своим проектом и у вас много свободного времени. Но что будет, если вы работаете в компании и у вас дедлайн на носу? Вы потратите много времени на дебаггинге вашего же кода.

Но это меняется. Много разработчиков начинают использовать Cycke.js и говорить о нем, о проблемах. Решать их вместе. Cycle.js также имеет хорошую документацию со множеством примеров. У меня не было настолько сложных ошибок, которые было трудно дебажить.

2. Изучение нового подхода

Реактивное программирование отличается от обычного и вам нужно сперва потратить некоторое время, чтобы понять как работать. В результате будет легко, но если у вас скорый дедлайн, то изучение нового подхода будет проблемой.

3. Некоторые приложения не нуждаются в реактивном подходе

Да, некоторые приложения не должны быть «реактивными». Блоки, продающие сайты, лэндинги и многие другие статичные сайты с ограниченной функциональностью остро не нуждаются в реактивном подходе. Здесь нет данных, которые проходят через все приложение в реальном времени, нет стольких форм и кнопок. Используя реактивный фреймворк, возможно, вы сделаете такие сайты медленнее. Вы должны понимать, когда приложение нуждается в Cycle.js и реактивном подходе, а когда — нет.

Заключение

Идеальный фреймворк должен помогать фокусироваться на создании функционала, а не должен принуждать к написанию шаблонного кода. Мне кажется, что Cycle.js показывает, что это реально возможно и дает толчок к поиску лучших подходов к написанию кода и созданию функционала. Но нужно помнить, что нет ничего совершенного и всегда есть место для улучшений.

А вы пробовали реактивное программирование или Cycle.js? Убедил ли я вас попробовать? Дайте знать, что вы думаете в комментариях

|

Метки: author Carduelis reactjs javascript react.js reactive programming cycle.js |

Canvas & SVG: работаем с графикой |

SVG

Масштабируемая векторная графика (Scalable Vector Graphics — SVG) является языком разметки, расширенным из XML для описания двухмерной векторной графики.

Для создания изображения в векторной графике используются геометрические примитивы (точки, линии, кривые, многоугольники). С их помощью можно создавать масштабируемые изображения, которые не теряют в качестве при масштабировании.

SVG — технология рисования с хранением объектов в памяти (Retained mode graphics). Как и HTML, SVG имеет объектную модель документа (DOM). DOM в SVG, как и в HTML, имеется модель событий. Это значит, что при использовании этой технологии для реализации интерактивных действий (таких как управление мышью и т.п.) со стороны программиста требуется меньше усилий, поскольку события привязываются непосредственно к элементам DOM.

SVG имеет как обычные атрибуты, так и атрибуты представления. Ключевым моментом является то, что к атрибутам представления можно применять стили в соответствии с правилами использования стилей CSS. К примеру, для изменения цвета фигуры можно применять свойство fill.

Для встраивания SVG в документ используется элемент .

Пример 1: Рисование линии

Пример 2: Рисование круга с заливкой

HTML:

CSS:

svg {

fill: blue;

}

Canvas 2d

<Сanvas> — это HTML элемент, который используется для создания растровой графики при помощи JavaScript. Элемент предоставляет удобный API для рисования 2D графики с помощью JavaScript.

В отличии от svg, canvas работает с растровой графикой. Это технология мгновенного рисования, она не хранит свои элементы в дереве DOM, следовательно нет никакого способа изменить существующий рисунок или реагировать на события. Это означает, что, когда потребуется новый кадр, необходимо будет отрисовать всю сцену заново.

Элемент имеет только два атрибута — ширину и высоту. Если атрибуты высоты и ширины не установлены, то согласно спецификации html5 ширина элемента canvas будет равна 300 пикселям, а высота 150. При изменении этих атрибутов canvas очищается.

Также можно выставить размеры произвольно в CSS, но во время рендеринга изображение будет масштабироваться в соответствии с его размером и ориентацией. Это может привести к тому, что изображение будет выглядеть искаженным.

Для рисования в первую очередь необходимо получить доступ к контексту, который предоставляет API для создания графики. Контекст можно получить при помощи метода getContext() элемента canvas. В качестве первого параметра необходимо указать тип контекста, который мы хотим использовать. На данный момент большинство современных браузеров поддерживает 2 типа контекста «2d» ( позволяет создавать 2-х мерную графику) и «webgl» (позволяет использовать технологию WebGL для создания трехмерной графики). Если указанный тип контекста не поддерживается браузером, метод getContext() возвращает null.

Пример: Рисование линии

const canvas = document.getElementById('canvas');

const context = canvas.getContext('2d');

context.beginPath();

context.moveTo(5, 5);

context.lineTo(500, 60);

context.lineWidth = 3;

context.strokeStyle = '#b4241b';

context.stroke();

WebGL

WebGL — это еще одна новая технология, которая использует элемент canvas для создания графики. WebGL позволяет веб-контенту использовать API, основанный на OpenGL ES 2.0, для визуализации трехмерной графики, но возможно работать и с двухмерной графикой.

Для начала рисования так же, как и в предыдущем случае, необходимо получить доступ к контексту. Это делается при помощи метода getContext. В качестве типа контекста необходимо указать webgl либо experimental-webgl. Контекст, именуемый как «experimental-webgl» — это временное имя для контекста, используемое на время процесса разработки спецификации.

WebGL работает с растровой графикой, соответственно, особенности описанные в предыдущем абзаце, применимы и к этой технологии. Но для WebGL характерна более высокая производительность (сравнимая с производительностью нативных приложений), поскольку WebGL использует средства аппаратного ускорения графики.

Сравнение технологий

Выбор конкретной технологии зависит от задач и целей конкретного проекта. На одном из проектов была поставлена задача отриcовки графиков с большим количеством точек (порядка 10 000 точек), должна была быть предусмотрена возможность масштабирования и перемещения графиков, а также перерисовка графиков в случае изменения данных на сервере.

Один из самых важных параметров, который учитывался при выборе технологии, была производительность. Этот параметр зависит от количества объектов и площади поверхности. В общем случае, по мере увеличения числа объектов на экране производительность SVG падает, поскольку объекты постепенно добавляются в модель DOM, тогда как производительность canvas почти не изменяется. WebGL имеет очень хорошую производительность, однако не все современные браузеры поддерживают данную технологию, к примеру IE начал поддерживать webGL начиная только с 11 версии. Поддержка WebGL на мобильных браузерах достаточно ограниченна, большинство мобильных браузеров начали поддерживать WebGL только с 2017 года. Некоторые мобильные браузеры на данный момент вообще не поддерживают данную технологию.

К тому же, помимо поддержки WebGL браузером, необходима также его поддержка графическим процессором клиента. Некоторые браузеры могут отключить поддержку WebGL на устройствах со старыми графическими процессорами. Подробнее об этих ограничениях можно узнать в этой статье.

По причине слабой поддержки технологии WebGL далее будут рассматриваться только две технологии: canvas 2d и svg.

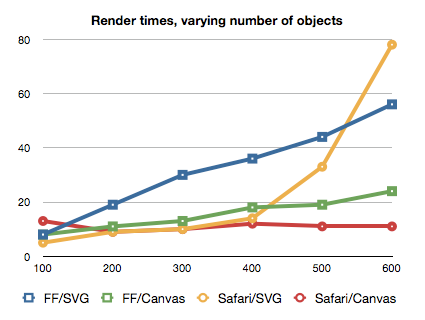

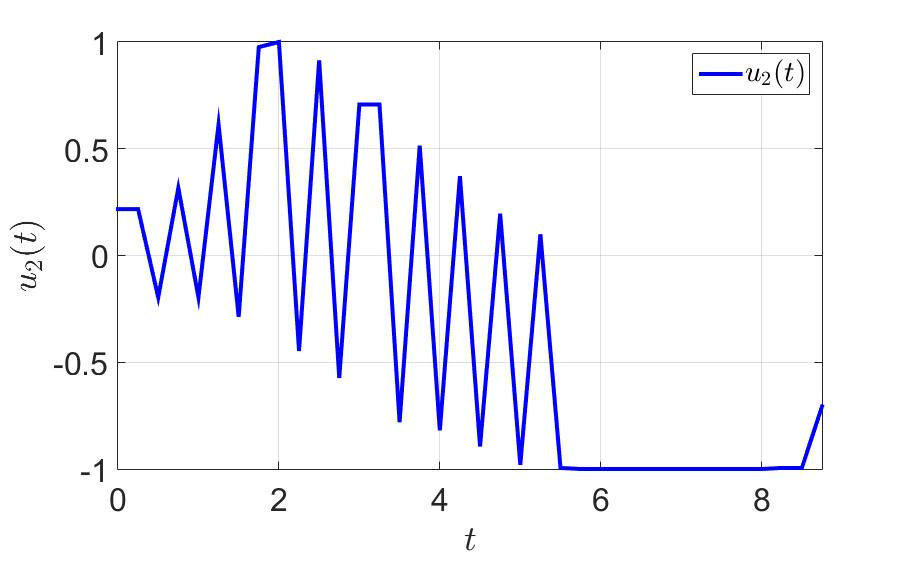

Рис.1 Время рендеринга(y) в зависимости от количества объектов(х).

Так как работа с SVG требует много манипуляций с DOM эта технология не подходит для тяжелой анимации, к примеру для построения быстро изменяющихся детализированных графиков.

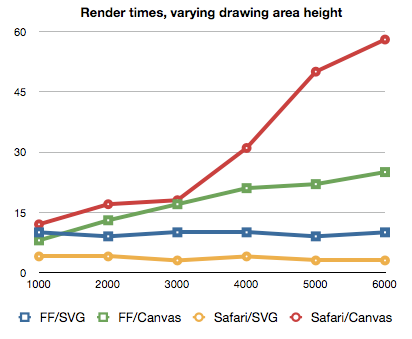

Однако canvas не очень хорошо подходит для экранов с высоким разрешением. Из графика ниже видно, что по мере увеличения размера экрана производительность Canvas падает, поскольку требуется обработать больше пикселей.

Рис.2 Время рендеринга(y) в зависимости от высоты области рисования(х).

Также необходимо учитывать, что при увеличении изображения, созданные при помощи canvas, сильно теряют качество. На рисунке ниже показаны линии, нарисованные при помощи svg и canvas.

Рис.3 Линии нарисованные при помощи SVG(сверху) и Canvas(снизу) при увеличении.

Еще одна проблема с которой можно столкнуться при работе с canvas — ограниченные возможности отслеживания событий и определения расположения указателя мыши на изображении. Существует встроенный API isPointInPath, который позволяет определить попадает ли указанная точка в последний нарисованный элемент path.* Существуют сторонние библиотеки, позволяющие достаточно комфортно работать с событиями.

Несмотря на перечисленные выше недостатки, было принято решение использовать именно canvas, в первую очередь из-за его высокой производительности по сравнению с svg при отрисовке большого количества объектов.

* Существует экспериментальный интерфейс Path2D, который можно использовать для создания пути, который в дальнейшем можно будет переиспользовать. К примеру этот объект можно передать в качестве первого аргумента метода isPointInPath. На данный момент эта технология поддерживается браузерами Firefox, Google Chrome и Opera.

Особенности работы с Canvas

При работе с сanvas в первую очередь необходимо учитывать то, что мы работаем с растровым изображением. В первую очередь это значит, то что при изменении размера области отрисовки (к примеру при изменении размеров окна) изображение на canvas масштабируется, что приводит к искажениям и потере качества. На рисунке ниже в первом случае css свойства width и height элемента canvas в два раза больше соответствующих атрибутов указанных изначально. Рядом изображен тот же график без масштабирования. Для избежания подобных проблем следует при изменении размеров окна выставлять необходимые значения для атрибутов width и height элемента canvas и перерисовывать текущую сцену с учетом новых размеров.

С похожей проблемой можно столкнуться при работе с экранами с увеличенной плотностью пикселей. Изображения на canvas могут выглядеть размытыми. Причиной этого является разница между разрешением дисплея в физических пикселях и разрешением в логических (CSS) пикселях. Отношение двух этих величин можно получить при помощи свойства window.devicePixelRatio. К примеру при devicePixelRatio равным двум ширина канваса в физических пикселях в 2 раза больше, чем его ширина в логических пикселях (указанная в атрибуте width). То есть мы получим тот же эффект, что и в первом случае. Один из возможных способов решения этой проблемы: указывать значения в атрибутах canvas большее чем в стилях в величину devicePixelRatio. Пример:

canvas.width = canvasWidth * window.devicePixelRatio;

canvas.height = canvasHeight * window.devicePixelRatio;

canvas.style.width = canvasWidth + 'px';

canvas.style.height = canvasHeight + 'px';В этом случае при отрисовке необходимо учитывать, что такие величины, как толщина линии и размер шрифта уменьшаться на величину devicePixelRatio. Следовательно, при задании размера шрифта его необходимо умножать на devicePixelRatio, чтобы текст не казался слишком мелким на дисплеях с увеличенной плотностью пикселей.

Оптимизация работы canvas:

Одной из самых дорогих операций при работе с canvas является рисование. Следовательно лучше избегать перерисовки больших изображений.

Один из способов это сделать — применять элементы canvas в несколько слоев. Это позволяет перерисовывать только те части сцены, которые необходимо, а не всю сцену целиком.

Пример: Расположение элементов canvas в 2 слоя:

Еще один способ уменьшить время затрачиваемое на отрисовку — это отказ от координат с плавающей запятой и использование целочисленных координат. При использовании дробных координат на элементе canvas применяется субпиксельный рендеринг. Это приводит к тому, что для создания эффекта сглаживания производятся дополнительные вычисления.

Существует достаточно много приемов оптимизации элемента canvas. Их эффективность зависит от особенностей проекта и желаемого результата. Подробнее о различных подходах к оптимизации можно прочитать в этой статье.

Заключение

SVG хорошо подходит для создания статических изображений, высококачественных сложных векторных документов (к примеру чертежей, схем) интерактивных графиков. Но стоит учитывать, что при возрастании количества объектов, скорость отрисовки будет сильно снижаться. Использование элемента canvas позволяет достаточно быстро отрисовывать изображения на экране, именно поэтому эта технология хорошо подходит для отображения сложных сцен и анимации в режиме реального времени. Canvas может применяться для создания различных визуальных эффектов и сложных 3D сцен. Но при использовании данной технологии достаточно сложно сделать изображение или график интерактивным.

|

Метки: author SSul html canvas блог компании simbirsoft html5 верстка html5 canvas canvas2html css svg графика |

Первая российская материнская плата массового сегмента |

Как мы уже писали, степень локализации отечественной серверной продукции массового сегмента выражена в большей степени в предоставлении различного рода услуг, нежели чем в производстве комплектующих. Комплектующие для серверов традиционно производятся в Китае, к какому бренду они не принадлежали бы. У одной российской компании была попытка создания полностью отечественной платформы, но продукт получился нишевой, так как платформа обладала характеристиками избыточными для классического применения серверов.

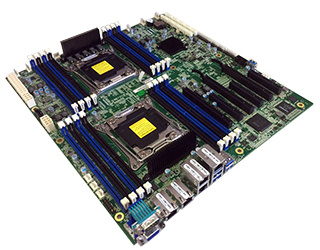

Как мы уже писали, степень локализации отечественной серверной продукции массового сегмента выражена в большей степени в предоставлении различного рода услуг, нежели чем в производстве комплектующих. Комплектующие для серверов традиционно производятся в Китае, к какому бренду они не принадлежали бы. У одной российской компании была попытка создания полностью отечественной платформы, но продукт получился нишевой, так как платформа обладала характеристиками избыточными для классического применения серверов.Но вот, в начале года мы получили образец серверной 2-процессорной материнской платы, разработанной и произведённой на территории России. Эта модель вызвала интерес в первую очередь из-за того, что по характеристикам и стоимости полностью подходила для массового применения. Обзору и тестированию первой российской материнской платы Rikor R-BD-E5R-V4-16.EA и посвящается эта статья.

Характеристики

- CPU support: Intel Xeon E5-2600 V3/V4 series (135W maximum)

- MB chipset: Intel Wellsburg C612PCH

- Memory slots: 16 (each CPU can support 4 x DDR4 channel x 2 DDR4 DIMM)

- Memory support: Maximum 1024GB DDR4 2133/1866/1600/1333 RDIMM/LRDIMM/NVDIMM

- PCI-E slots: 6

- PCH SATA ports: 10 x SATA3.0

- HDD RAID feature: RAID 0, 1, 5, 10

- Graphics: Aspeed AST2400

- IPMI: Support for Intelligent Platform Management Interface v.2.0 with virtual media over

LAN and KVM over LAN support ASPEED AST2400 BMC - Network: 5 x 1Gb LAN (1 x 1Gb LAN is BMC dedicated management port)

- USB: 5 x USB 3.0 (1 x internal) + 4 x USB 2.0(internal)

- DOM: Support SATA DOM power connector

- Input/output interface: 1 x COM port, 1 x VGA port, 1 x dedicated IPMI port, 4 x 1000Mbps port, 4 x USB2.0 + 4 x USB3.0

- Fan power supply socket: 8 x 4 pin smart FAN

- Power supply interface: 1 x 24pin SSI power interface power supply interface + 2 x 8pin SSI 12Vpower supply interface

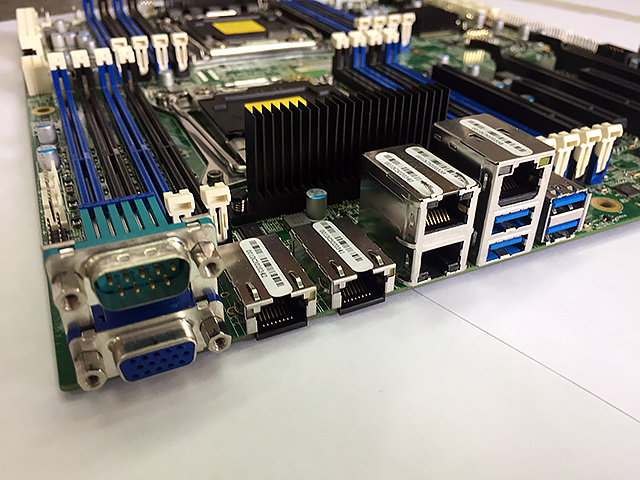

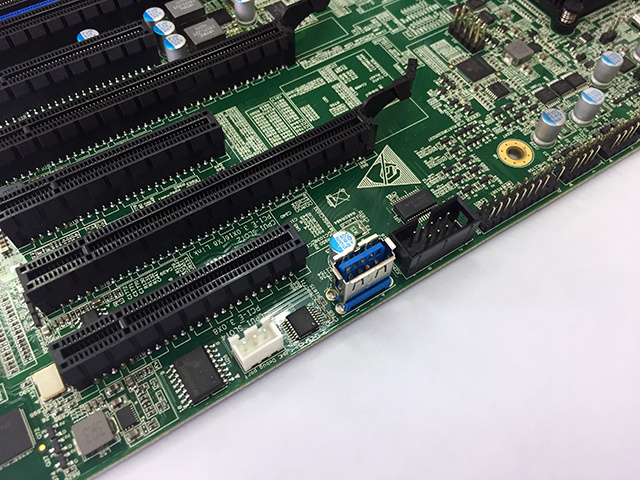

Фотографии

Тестирование

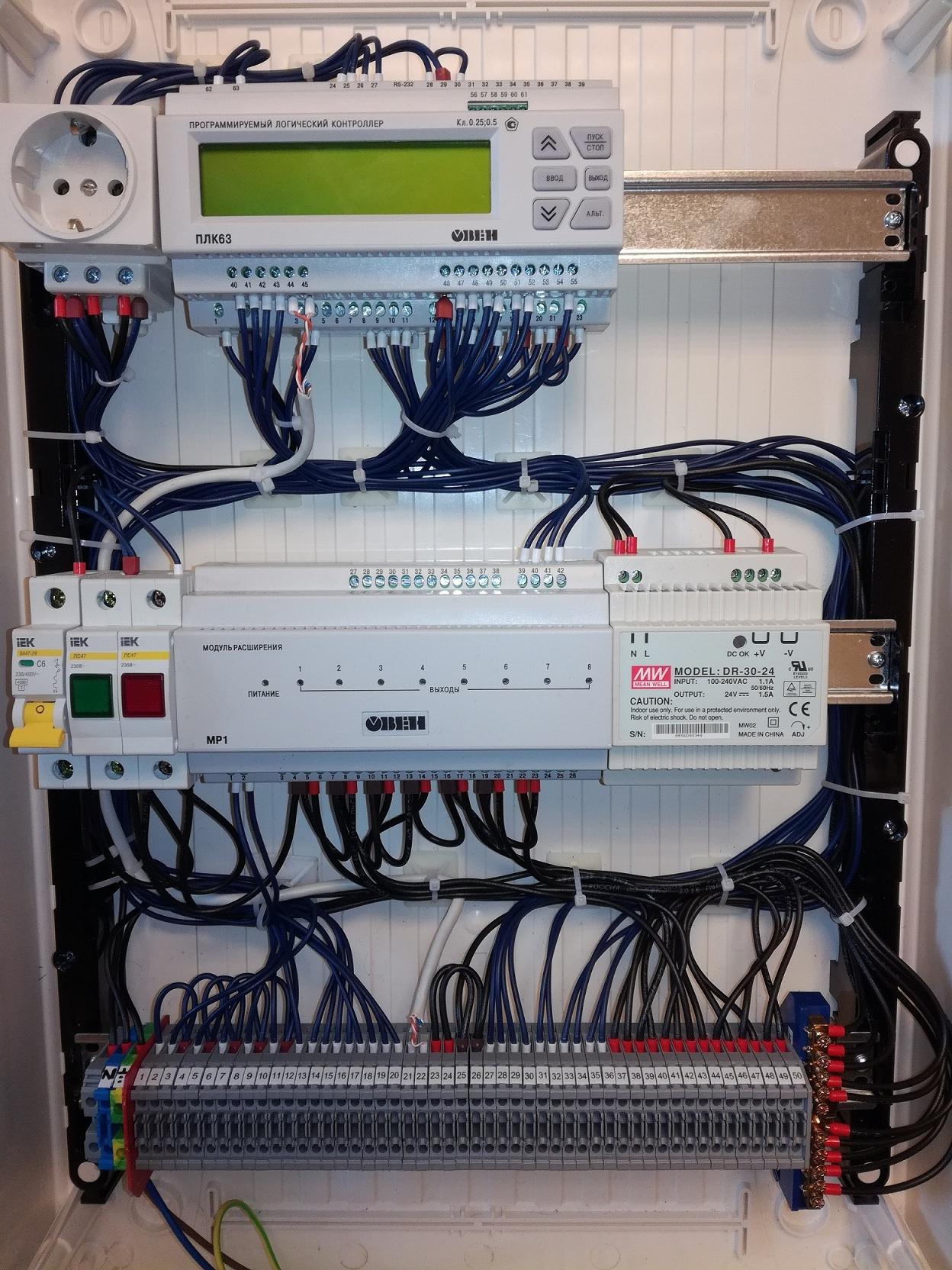

Для тестирования собрали две аналогичные платформы на базе Rikor и Supermicro.

Стенд Rikor:

- Rikor R-BD-E5R-V4-16.EA

- 2 x Intel Xeon E5-2620V4

- 8 x 8Gb ECC REG

- 2 x 150Gb Enterprise SSD

- Windows 2012 R2

Стенд Supermicro:

- Supermicro X10DRi

- 2 x Intel Xeon E5-2620V4

- 8 x 8Gb ECC REG

- 2 x 150Gb Enterprise SSD

- Windows 2012 R2

Результаты тестирования PerformanceTest 9.0

Результаты процессорных тестов заметно отличаются. Подобное снижение производительности платформы Rikor скорее всего связано с тем, что производитель искусственно занизил характеристики в пользу надёжности с стабильности работы.

Результаты тестирования CINEBENCH R15

Результаты тестирования 7ZIP

Результаты тестирования производительности отечественной платформы при рендеринге и архивировании имеют аналогичное отставание.

Заключение

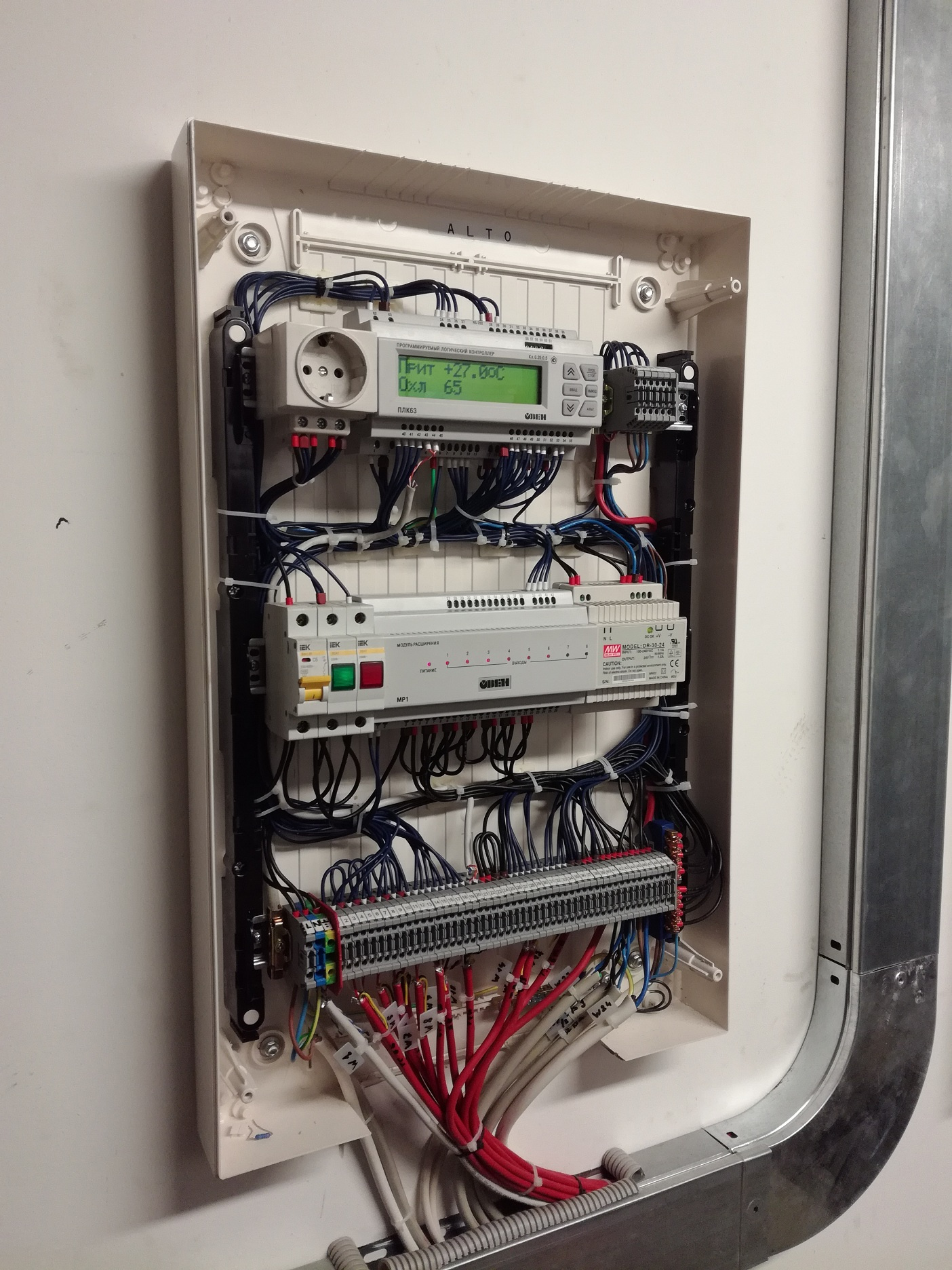

Система на базе Rikor R-BD-E5R-V4-16.EA, не смотря на отставание в бенчмарках, показала высокую стабильность и надёжность при месячных нагрузочных тестах всех подсистем. Интерфейс IPMI материнской платы классический от Intel, такой можно увидеть и в материнских платах Asus, например. BIOS к осени планируется отечественный. Разработка и производство материнской платы (разумеется, за исключением компонентов), повторюсь, у нас — в России.

Помимо материнской платы, к нам на тесты попал и корпус 2U полностью российского производства. Всё (кроме БП), в плоть до корзин с горячей заменой, производится у нас в стране. Бэкплейны тоже. Т.к. корпус был совсем-совсем образцом, по нему появилось много нареканий, но недостатки уже были исправлены на момент написания статьи. Поэтому обзор корпуса будет чуть позже.

Спасибо за внимание, жду Ваших комментариев!

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

|

Анонс Гейзенбаг 2017 Moscow: удваиваем пользу |

В 2016-м в Москве впервые прошла конференция по тестированию Гейзенбаг — тогда она длилась один день. В декабре конференция состоится в Москве уже во второй раз — и станет двухдневной. Если вспомнить выпуск xkcd про экстраполяцию, то получится, что Гейзенбаг-2380 будет длиться круглый год! А если серьёзнее, то мы готовы анонсировать новое мероприятие. Под катом подробно рассказываем, чего именно ждать 8-9 декабря.

Двухдневный формат

Переход к двухдневной конференции — это не просто «то же самое два дня подряд». Когда есть только один день и множество интересных докладчиков, хочется вместить в него столько докладов, сколько в принципе возможно. А когда всё не так жёстко ограничено во времени, появляется возможность «вдохнуть полной грудью» — например, сделать перерывы между докладами длиннее.

И тогда становятся полезнее другие составляющие мероприятия вроде дискуссионных зон. Каждый спикер после своего доклада отправляется в специально оборудованное место, где есть возможность вволю поотвечать на вопросы зрителей (а не как обычно, когда вопросам уделяется пять минут в конце выступления). И в случае с короткими перерывами, расспрашивая одного спикера, легко пропустить доклад другого, а более продолжительные помогают успеть везде.

Перерывы полезны и для другого: пообщаться с коллегами, поучаствовать в активности на стендах или просто отдохнуть от потока информации, чтобы затем вернуться посвежевшим и усвоить больше. И даже зрителям онлайн-трансляции, не присутствующим лично на конференции, в длинных перерывах не придётся скучать: для них мы собираемся делать интервью со спикерами в прямом эфире.

Так что число докладов по сравнению с прошлым годом увеличится, но не в два раза — а вот польза от посещения конференции вполне может удвоиться.

Темы

Здесь принципиальных изменений не планируется: это по-прежнему «конференция о тестировании, но не только для тестировщиков». Мы хотим приносить пользу разным специалистам, не строя стену между тестировщиками и разработчиками, а помогая им найти общий язык. Нас интересует тестирование во всех его проявлениях: хоть автоматизированное, хоть ручное, от мобильного до геймдева, от нюансов нагрузочного тестирования до общих советов, полезных всем (при этом постараемся как можно чётче указывать, кому подходит каждый доклад, чтобы вы не оказывались случайно на неподходящем для вас).

Единственное, чего мы не хотим — буллшита: бесполезных маркетинговых докладов, невнятных рассуждений ни о чём, разжёвывания всем известных азов. Мы за техническую конкретику.

Спикеры

Список выступающих сейчас формируется, и окончательный будет готов ближе к конференции. Но уже можем назвать ряд имён, дающий общее представление «чего стоит ждать»:

Саймон Стюарт известен как участник команды Selenium и создатель WebDriver. Неудивительно, что и тема доклада на Гейзенбаге будет связана с Selenium: речь пойдёт о масштабировании при его использовании. С какими проблемами можно столкнуться, когда число тестов устремляется в космос, и как решать эти проблемы?

Саймон Стюарт известен как участник команды Selenium и создатель WebDriver. Неудивительно, что и тема доклада на Гейзенбаге будет связана с Selenium: речь пойдёт о масштабировании при его использовании. С какими проблемами можно столкнуться, когда число тестов устремляется в космос, и как решать эти проблемы? Артём Ерошенко имеет прямое отношение к проекту Allure, и в июне на петербургском Гейзенбаге его доклад об Allure 2 оказался фаворитом зрителей. Но интересы Артёма не ограничиваются Allure — и выступление на московской конференции, вероятно, будет посвящено чему-то новому.

Артём Ерошенко имеет прямое отношение к проекту Allure, и в июне на петербургском Гейзенбаге его доклад об Allure 2 оказался фаворитом зрителей. Но интересы Артёма не ограничиваются Allure — и выступление на московской конференции, вероятно, будет посвящено чему-то новому. Илари Хенрик Эгертер выступал на обоих прошедших Гейзенбагах (московском и петербургском), оба его выступления понравились публике — неудивительно, что мы рады будем увидеть его в третий (и узнать, какой окажется длина его бороды в этот раз). Впрочем, мы получали и комментарии о том, что два его выступления слишком пересекались друг с другом. Учтём это: третье не окажется повторением двух первых.

Илари Хенрик Эгертер выступал на обоих прошедших Гейзенбагах (московском и петербургском), оба его выступления понравились публике — неудивительно, что мы рады будем увидеть его в третий (и узнать, какой окажется длина его бороды в этот раз). Впрочем, мы получали и комментарии о том, что два его выступления слишком пересекались друг с другом. Учтём это: третье не окажется повторением двух первых.  Владимир Ситников — эксперт в вопросах производительности. Многие знают его как коммиттера инструмента для нагрузочного тестирования JMeter, но в декабре он расскажет о другом. Зачастую под словами «тестирование производительности» подразумевают только тестирование серверной части, а непосредственно работу браузера тестируют гораздо реже — Владимир намерен устранить несправедливость и раскрыть на Гейзенбаге эту тему.

Владимир Ситников — эксперт в вопросах производительности. Многие знают его как коммиттера инструмента для нагрузочного тестирования JMeter, но в декабре он расскажет о другом. Зачастую под словами «тестирование производительности» подразумевают только тестирование серверной части, а непосредственно работу браузера тестируют гораздо реже — Владимир намерен устранить несправедливость и раскрыть на Гейзенбаге эту тему. Николай Алименков в июне на петербургском Гейзенбаге навёл шороху своей бурной дискуссией с Алексеем Виноградовым, а его доклад тогда получил от зрителей очень хорошие отзывы. В Москве в декабре он тоже будет очень активен: мало того, что выступит с докладом, так ещё и проведёт тренинг (об этом читайте ниже).

Николай Алименков в июне на петербургском Гейзенбаге навёл шороху своей бурной дискуссией с Алексеем Виноградовым, а его доклад тогда получил от зрителей очень хорошие отзывы. В Москве в декабре он тоже будет очень активен: мало того, что выступит с докладом, так ещё и проведёт тренинг (об этом читайте ниже). Алексей Лавренюк известен своей работой над проектом Яндекс.Танк, и неудивительно, что на петербургском Гейзенбаге рассказывал о нагрузочном тестировании. Но Алексей разбирается и в мобильном тестировании — так что не удивляйтесь, если тема его зимнего выступления в Москве будет сильно отличаться.

Алексей Лавренюк известен своей работой над проектом Яндекс.Танк, и неудивительно, что на петербургском Гейзенбаге рассказывал о нагрузочном тестировании. Но Алексей разбирается и в мобильном тестировании — так что не удивляйтесь, если тема его зимнего выступления в Москве будет сильно отличаться. Антон Архипов, которого Java-разработчики уже могли видеть на наших Java-конференциях, расскажет о том, как TestContainers помогает справляться с насущной проблемой — разворачиванием тестовой среды при интеграционном тестировании.

Антон Архипов, которого Java-разработчики уже могли видеть на наших Java-конференциях, расскажет о том, как TestContainers помогает справляться с насущной проблемой — разворачиванием тестовой среды при интеграционном тестировании.  Никита Макаров — руководитель группы автоматизации тестирования в Одноклассниках. А это значит, что его выступления становятся заведомо интересны: при работе над таким гигантским проектом неизбежно получаешь много ценного опыта, так что есть чем поделиться.

Никита Макаров — руководитель группы автоматизации тестирования в Одноклассниках. А это значит, что его выступления становятся заведомо интересны: при работе над таким гигантским проектом неизбежно получаешь много ценного опыта, так что есть чем поделиться.Дистанционный доклад

Помимо перечисленных спикеров, есть ещё и один особый случай. Джеймс Бах умеет так бодро и живо рассказывать о тестировании, что одно из его выступлений собрало на YouTube сотни тысяч просмотров:

Видимо, талант рассказчика у него от отца: Джеймс — сын Ричарда Баха, известного повестью «Чайка по имени Джонатан Ливингстон». В общем, мы были бы ради видеть его на Гейзенбаге, но единственный вариант, в котором его выступление на конференции возможно — прямая онлайн-трансляция. Ранее мы не проводили выступления в таком формате и не знаем точно, насколько вам это интересно, поэтому хотим у вас это и узнать. Если у вас есть мнение по этому поводу — ткните в один из трёх вариантов по ссылке.

Тренинг Николая Алименкова

Связанное с конференцией событие: в следующие после неё два дня, 10-11 декабря, пройдёт тренинг Николая Алименкова «Секреты успешной автоматизации тестирования». Это отдельное мероприятие с отдельными билетами (их продажа начнётся позже) — но это удобная возможность, выделив четыре дня подряд, повысить свою квалификацию по полной, начав с конференции и продолжив тренингом.

Call for Papers

Если в списке спикеров вам хочется видеть и своё имя — сейчас самое время подать нам доклад! Наш строгий программный комитет включает в программу только по-настоящему хорошие выступления, но тот же самый комитет и помогает спикерам довести их перспективные наработки до подходящего уровня — поэтому, даже если у вас нет соответствующего опыта, но есть интересная тема, не бойтесь обращаться.

А если опыт есть, ссылайтесь на видеозаписи докладов, которые делали ранее, и это значительно ускорит принятие решения программным комитетом.

Главное требование: ваш доклад должен быть полезен другим разработчикам. Нам интересны следующие темы:

- Автоматизация тестирования;

- Нагрузочное тестирование;

- Performance-тестирование, бенчмаркинг;

- Интеграционное тестирование модульных/распределённых систем;

- Concurrency testing;

- Тестирование мобильных приложений;

- Ручное тестирование;

- UX, Security, A/B, статический анализ кода, метрики кода и продукта, etc.;

- Инструментарий, окружение для тестирования;

- Сравнение инструментов для тестирования;

- Тестирование в gamedev.

Программа и регистрация

До декабря в программе появится ещё множество докладов, и в первую очередь информация о них будет публиковаться на сайте конференции. Так что, если вам требуется больше информации, просто заглядывайте туда. Но у тех, кто решится уже сейчас, есть важное преимущество: билеты будут постепенно дорожать, поэтому сейчас самое удачное время обзавестись билетом.

|

|

[Перевод] Инструменты для разработчика Go: знакомимся с лейблами профайлера |

Привет. Меня зовут Марко. Я системный программист в Badoo. Представляю вашему вниманию перевод поста замечательной rakyll о новой фиче в Go 1.9. Мне кажется, что лейблы будут очень полезны для профилирования ваших Go-программ. Мы в Badoo, например, используем аналогичную штуку для того, чтобы тегировать куски кода в наших программах на С. И если срабатывает таймер и в лог выводится стек-трейс, то в дополнение к нему мы выводим такой вот тег. В нем, например, может быть сказано, что мы обрабатывали фотографии пользователя с определенным UID. Это невероятно полезно, и я очень рад, что похожая возможность появилась и в Go.

Привет. Меня зовут Марко. Я системный программист в Badoo. Представляю вашему вниманию перевод поста замечательной rakyll о новой фиче в Go 1.9. Мне кажется, что лейблы будут очень полезны для профилирования ваших Go-программ. Мы в Badoo, например, используем аналогичную штуку для того, чтобы тегировать куски кода в наших программах на С. И если срабатывает таймер и в лог выводится стек-трейс, то в дополнение к нему мы выводим такой вот тег. В нем, например, может быть сказано, что мы обрабатывали фотографии пользователя с определенным UID. Это невероятно полезно, и я очень рад, что похожая возможность появилась и в Go.

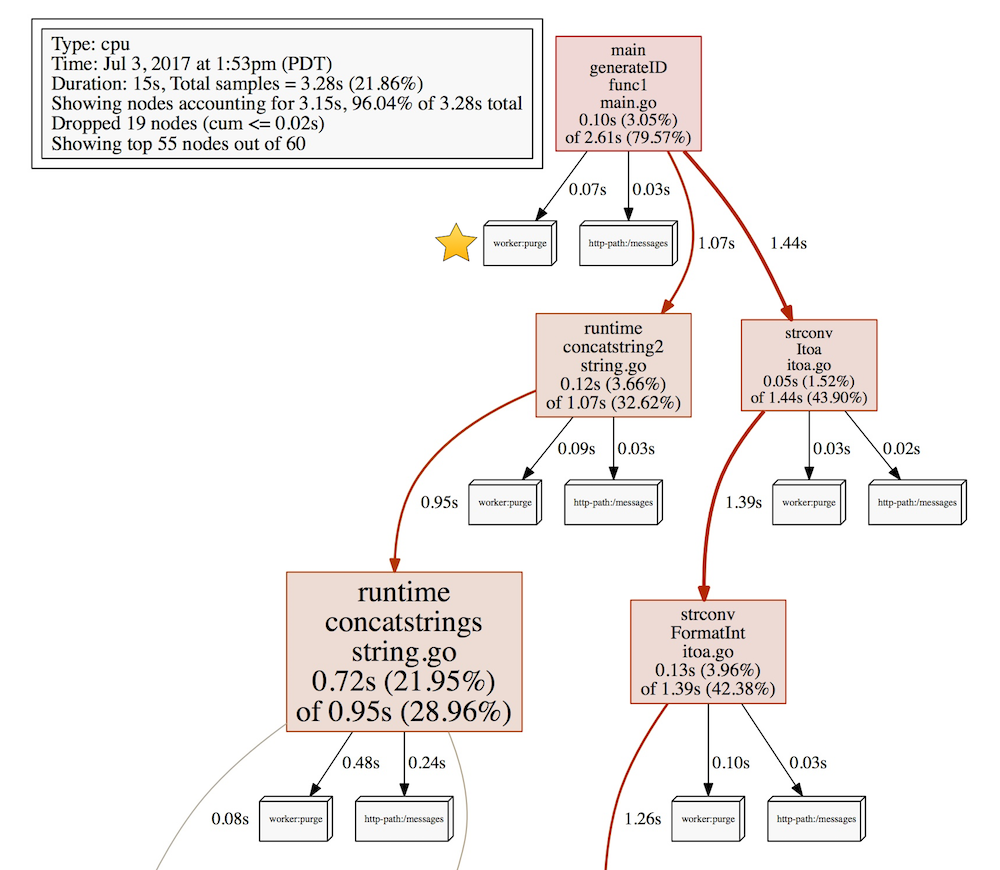

В Go 1.9 появились лейблы профайлера: возможность добавить пару ключ-значение к семплам, которые делает CPU-профайлер. Профайлер собирает и выводит информацию о самых горячих функциях, где процессор проводит больше всего времени. Вывод обычного CPU-профайлера состоит из имени функции, названия файла исходника и номера строки в этом файле, и так далее. Из этих данных можно также понять, какие части кода вызвали эти горячие функции. Вы даже можете отфильтровать вывод, чтобы получить более глубокое представление о тех или иных ветках исполнения.

Информация о полном стеке вызовов очень полезна, но этого не всегда достаточно для поиска проблемы в производительности. Большое количество Go-программистов используют Go для написания серверов, а понять, где находится проблема производительности в сервере, еще труднее. Сложно отделить одни ветки исполнения от других или сложно понять, когда только одна ветвь исполнения вызывает проблемы (какой-то пользователь или определенный хэндлер). Начиная c Go 1.9 у нас появилась возможность добавлять дополнительную информацию о контексте того, что происходит в данный момент, и использовать в дальнейшем эту информацию в профайлере, чтобы получить более изолированные данные.

Лейблы могут быть полезны во многих случаях. Вот только самые очевидные из них:

- вы не хотите, чтобы абстракции из вашей программы утекали в процесс профилирования, но данные о ваших объектах были бы там полезны. Например, для веб-сервера гораздо полезнее было бы видеть URL в профайлере вместо голых имён функций.

- Стек-трейса недостаточно для того, чтобы понять, кто был инициатором работы. К примеру, обработчик очередей обрабатывает события, которые были созданы кем-то ранее. Обработчик мог бы пометить свою работу именем этого кого-то.

- Для поиска проблемы в производительности критично иметь контекст обработки.

Добавление лейблов

В пакете runtime/pprof появятся несколько новых функций для добавления лейблов. Большинство пользователей будут использовать функцию Do, которая берет контекст, добавляет в него лейблы и передает новый контекст в функцию f:

func Do(ctx context.Context, labels LabelSet, f func(context.Context))Do записывает набор лейблов только в рамках текущей горутины. Если вы создаете новые горутины в f, вы можете передать контекст в качестве аргумента.

labels := pprof.Labels("worker", "purge")

pprof.Do(ctx, labels, func(ctx context.Context) {

// Делаем какую-либо работу...

go update(ctx) // пробрасывает лейблы дальше

})Работа выше будет помечена лейблом worker:purge.

Смотрим на вывод профайлера

Этот раздел продемонстрирует использование профайлера с лейблами. После того, как вы пометили все интересующие вас куски кода лейблами, время отпрофилировать код и посмотреть на вывод профайлера.

Я буду использовать пакет net/http/pprof в этом примере. Смотрите статью Profiling Go programs, если вам интересны подробности.

package main

import _ "net/http/pprof"

func main() {

// Много кода...

log.Fatal(http.ListenAndServe("localhost:5555", nil))

}Соберем данные по использованию CPU...

$ go tool pprof http://localhost:5555/debug/pprof/profileПосле того, как утилита переходит в интерактивный режим, вы можете посмотреть все записанные лейблы командой tags. Заметьте, что pprof-утилита называет из тэги, несмотря на то, что в стандартной библиотеке Go они называются лейблами.

(pprof) tags

http-path: Total 80

70 (87.50%): /messages

10 (12.50%): /user

worker: Total 158

158 ( 100%): purgeКак видите, тут два ключа (http-path, worker) и несколько значений для каждого. Ключ http-path указывает на HTTP-хендлеры, а worker:purge указывает на код из примера выше.

Фильтруя по лейблам, мы можем сфокусироваться, например, только на коде из хендлера /user.

(pprof) tagfocus="http-path:/user"

(pprof) top10 -cum

Showing nodes accounting for 0.10s, 3.05% of 3.28s total

flat flat% sum% cum cum%

0 0% 0% 0.10s 3.05% main.generateID.func1 /Users/jbd/src/hello/main.go

0.01s 0.3% 0.3% 0.08s 2.44% runtime.concatstring2 /Users/jbd/go/src/runtime/string.go

0.06s 1.83% 2.13% 0.07s 2.13% runtime.concatstrings /Users/jbd/go/src/runtime/string.go

0.01s 0.3% 2.44% 0.02s 0.61% runtime.mallocgc /Users/jbd/go/src/runtime/malloc.go

0 0% 2.44% 0.02s 0.61% runtime.slicebytetostring /Users/jbd/go/src/runtime/string.go

0 0% 2.44% 0.02s 0.61% strconv.FormatInt /Users/jbd/go/src/strconv/itoa.go

0 0% 2.44% 0.02s 0.61% strconv.Itoa /Users/jbd/go/src/strconv/itoa.go

0 0% 2.44% 0.02s 0.61% strconv.formatBits /Users/jbd/go/src/strconv/itoa.go

0.01s 0.3% 2.74% 0.01s 0.3% runtime.memmove /Users/jbd/go/src/runtime/memmove_amd64.s

0.01s 0.3% 3.05% 0.01s 0.3% runtime.nextFreeFast /Users/jbd/go/src/runtime/malloc.goЭтот вывод содержит только сэмплы, отмеченные лейблом http-path:/user. И вот в таком выводе мы с легкостью можем понять, где самые нагруженные места /user-хэндлера.

Также вы можете попробовать команды tagshow, taghide и tagignore для дополнительного фильтрования. Например, tagignore дает вам возможность получить данные по всем лейблам, кроме заданного. Фильтр ниже выдаст все, кроме /user хэндлера. В этом случае это worker:purge и http-path:/messages.

(pprof) tagfocus=

(pprof) tagignore="http-path:/user"

(pprof) tags

http-path: Total 70

70 ( 100%): /messages

worker: Total 158

158 ( 100%): purgeЕсли вы попробуете визуализировать отфильтрованные данные, вывод покажет сколько каждый лейбл привносит к полной “стоимости”.

Тут видно что worker:purge привнес 0.07s, а хэндлер messages 0.03s в функции generateID.

Попробуйте сами!

Лейблы позволяют вам добавить дополнительную информацию к профайлеру, которая не доступна из простого стека вызовов. Попробуйте, скачав Go 1.9 beta, если вам нужны дополнительные размерности в вашем профайлере. Также попробуйте пакет pprofutil, чтобы автоматически обернуть ваши HTTP-пути лейблами.

На текущий момент доступна версия Go 1.9 beta 2. Известных багов в ней нет, но команда разработчиков просит попробовать ее на своих программах, а при возникновении проблем сообщить в баг-трекер. Я же хочу сказать, что собрать Go и быть на острие разработки очень и очень просто. Сама же сборка занимает не больше минуты. Дерзайте!

|

Метки: author mkevac программирование отладка go блог компании badoo профайлер лейблы |

[Перевод] Как создать свою метроидванию |

Метроидвания: стиль игры (2D или 3D), в котором часто присутствует исследование и где управляемый игроком персонаж получает новые способности, позволяющие ему продвигаться дальше. Такие игры часто являются экшн-адвенчурами с пересечением маршрутов движения. В них используется система «роста», открывающая важные апгрейды, необходимые для прохождения игры. Название «метроидвания» произошло от смешения слов Metroid и Castlevania, однако существуют и другие игры, в которых используется та же фундаментальная философия дизайна. К этим играм можно отнести все игры франшизы Zelda, Shadow Complex и Cave Story. На самом деле нет значительной разницы в структуре игрового процесса между играми Zelda, Metroid или Castlevania: Symphony of the Night.

Эта статья предназначена для создателей игр, желающих взяться за трудную задачу написания игры в жанре «метроидвания». Если вы никогда раньше не делали игр, и ищете советов о том, как начать создавать игры, рекомендую познакомиться с такими инструментами, как Unity, Unreal Engine, Construct 2 или любыми другими инструментами игростроительства. Вам сначала стоит научиться делать игры, потому что я не буду учить их созданию с нуля.

Если вы продолжили чтение, то, полагаю, у вас есть необходимые навыки и вы ищете информацию о планировании игры в жанре «метроидвания».

Основы метроидвании

Планирование игры в жанре «метроидвания» может быть пугающей задачей. В этом процессе есть множество ловушек, в которые вы можете угодить, если не спланируете всё правильно до начала разработки. Мы видим не так много игр этого жанра потому, что при использовании линейной модели разработки они обычно получаются неудачными. Для создания хорошей метроидвании разработчику нужно разобраться в том, как работают все способности и апгрейды, и только потом приступать к изготовлению уровней. (Примечание: можно начать работу над метроидванией без предварительной реализации всех способностей, но тогда с большой вероятностью очень немногое удастся добавить позже без значительной переработки уже готовой части проекта.) Нужно не только реализовать все получаемые игроком способности, но и создать ряд тестовых уровней для имитации прохождения игры и роста персонажа в её процессе (подробнее я расскажу об этом после).

Здесь я приведу свою собственную философию и мысли о разработке метроидвании, так что не считайте статью строгой моделью планирования. Только вы будете знать, что вам нужно и как достичь этого лучше всего, поэтому воспринимайте статью как совет, а не как правило. Некоторые самые инновационные решения потребуют время от времени нарушать правила. Рассматриваемые здесь стратегии создания дизайна подходят для двухмерных и трёхмерных игр, а также любых стилей камеры (сайдскроллер, камера над головой, вид от первого лица и т.д.).

1. Планирование геймплейных систем

Перед началом работы над уровнями нам нужно создать фундамент игры.

А. Замысел/уникальность

Определитесь с замыслом игры и с тем, что делает её уникальной.

- 2D или 3D?

- Как работает камера? (Камера со скроллингом, над головой персонажа, управляемая игроком, с видом от первого лица, от третьего лица, перемещающаяся по кривой, управляемая скриптом, статичная, и т.д.)

- Чем управляет игрок? (Персонажем, машиной, объектом и т.д.)

- Каким будет стиль игры? (Sci-fi, фэнтези, реалистичный, мультяшный, гротескный, уникальный)

- Что главное в вашей игре и что выделяет её из толпы? (Механика, задумка, внешний вид, история, персонажи) (вы можете сделать или что-то уникальное и запоминающееся, или то, что уже создано, но реализовать это качественней)

Б. Свойства игрока

Выберите базовые свойства игрока. (Что может делать персонаж до получения новых способностей?)

- Как двигается персонаж? (Летает, ходит, катается, скользит, и т.д.)

- Что делает персонаж для взаимодействия с миром? (Прыгает, стреляет, рубит, хватает, целует, пукает и т.д.) (Взаимодействия в игре должны соответствовать её замыслу. Такие стандартные взаимодействия определяют персонаж в игре. Они могут быть новыми или производными.)

В. Способности, оружие, инструменты, оборудование

Решите, какие способности, оружие, инструменты и оборудование будет получать персонаж в процессе игры. Эти способности могут усовершенствовать его предыдущие умения, или использоваться поверх имеющихся, их можно экипировать, они могут иметь ограничения, например, боеприпасы. Самое важное — определить, что отличает способности друг от друга.

- Сколькими уникальными способами могут усовершенствоваться способности к движению персонажа? (Может ли он прыгать выше, летать, ускоряться, бегать, ползать, катиться, скользить, раскачиваться, вращаться, плавать и т.д.?) (Все свойства движения требуют ограничений и уникальных механик. Нельзя, чтобы одно обесценивало другое.)

- Сколькими уникальными способами может преображаться персонаж? (Меняет ли он форму, становится ли другим персонажем, изменяет своё состояние и т.д.) (Транформации могут полностью менять свойства движения персонажа, коллизии и его уязвимости.) (Все трансформации требуют ограничений и уникальных механик. Не стоит делать так, чтобы одна обесценивала другие.)

- Сколько есть уникальных способов расширения функций взаимодействия персонажа? (Оружие, снаряды, магия, типы стихийного урона, контакт, особые свойства и т.д.) (Все взаимодействия требуют ограничений и уникальных механик. Нельзя, чтобы одно обесценивало другое.)

- Если персонаж использует снаряды, то сколькими разными способами они могут двигаться? (Летят ли они по дуге или прямо, исчезают ли со временем, выстреливаются быстро, прилетают из-за края экрана, летят зигзагом, отскакивают, отражаются, останавливают объекты, взрываются и т.д.)

- Сколькими уникальными способами видит мир персонаж и как враги видят персонажа? (Визоры, опции видимости, невидимость, освещение, измерения, секреты и т.д.) (Все опции видимости требуют ограничений и уникальных механик. Нельзя, чтобы одна обесценивала другую.)

- Сколько уникальных опасностей есть в игре и может ли игрок получить что-то, защищающее его от этих опасностей? (Костюмы, заклинания, броня, форма, шляпы и т.д.) (Чтобы защититься или снизить урон от таких угроз, как огонь, лава, вода, враги, электричество, космос и т.д.)

- Сколько особых способностей, изменяющих мир, может получить или использовать персонаж? (Остановка времени, изменение гравитации, телепортация, быстрое перемещение, активация и т.д.)

- Есть ли у игрока здоровье, нужны ли ему топливо или боеприпасы, увеличивающиеся или уменьшающиеся со временем? (С каким количеством игрок начинает игру и какой максимум он может получить?)

Не забывайте, что способности, инструменты и оборудование можно реализовать различными способами. Они могут быть активными, требующими нажатия игроком кнопки или выполнения команды. Пассивными, автоматически выполняющими свою задачу в нужный момент. Их можно надевать и снимать по выбору игрока. Они могут иметь ограничения, не позволяющие использовать их повторно или в определённых местах. Их можно использовать для взаимодействия с окружением, врагами или препятствиями. Они могут иметь ограниченное количество или быть одноразовыми.

2. Реализация систем

Теперь, когда мы спланировали концепцию того, что хотим сделать с главным персонажем и процессом его роста, пора начинать. Помните, что в качественной метроидвании есть нюансы работы всех механик. Лучшие механики — это те, у которых есть разные варианты использования. Они создают новые геймплейные возможности и имеют ограничения, чтобы их можно было реализовывать в конфигурациях, создающих сложности для игрока. В этой точке происходит большинство неудач при создании игр жанра «метроидвания». Все получаемые игроком способности должны быть уникальными и награждать его продуманной и отточенной механикой. Настало время творить.

У вас должен быть полный список способностей, похожий на приведённый ниже.

А. Пример списка способностей — в этом примере я использую простые и стандартные способности. Надеюсь, что ваш список будет более креативным и уникальным.

- Способности по умолчанию — удар, прыжок. ходьба

- Апгрейды способностей — высокий прыжок, выстрел снарядом, превращение в кошку, ядовитый костюм, ночное зрение, обратная гравитация, ледяной удар, бег

Количество получаемых игроком способностей зависит от вас. Вы можете любое число, необходимое для вашей игры. Список на этом этапе ещё не имеет порядка.

Б. Стандарты способностей — вам нужны стандарты построения уровней, показывающие, какой дальности могут достигнуть способности при использовании. Это поможет в дизайне уровней и настройке. (Пример: максимальная высота прыжка по умолчанию: 2 метра, для высокого прыжка: 5 метров) (Иллюстрации и схемы помогают в планировании)

- Сначала создайте заготовку основного персонажа и настройте базовые свойства движения персонажа. (Вам не нужна графика или анимация, достаточно прямоугольника для отображения коллизий.) Создайте небольшой тестовый уровень, достаточно близкий к настоящему игровому пространству, чтобы добиться правильных параметров. Он пока некрасив, но, по-крайней мере, в него можно поиграть и прочувствовать. Иногда даже хорошо, что он уродлив. (Постройте сетку, не нужно измерять всё «на глазок».)

- Затем нужно реализовать все способности, изменяющие способы перемещения персонажа в мире. Это самая важная для завершения часть, потому что она будет определять все ограничения, которые нужно учитывать при создании уровней и их содержимого.

- Реализовав и настроив все изменяющие движение способности и добившись их хорошей взаимной работы, можно начать набрасывать простую последовательность уровней или комнат.

(На этом этапе ещё нет никакого взаимодействия с врагами, но всё равно, стоит начать работу над способностями взаимодействия персонажа. Они будут использоваться и для взаимодействия с миром.)

3. Тестовая последовательность прохождения

Механика реализована, поэтому теперь нужно наметить расширенную тестовую среду для ответа на некоторые вопросы. Стоит создать ресурсы для уровней, чтобы они имели стандартизированный вид. (Используйте одинаковые размеры и стройте их по сетке.) Таким образом вы сможете перемещать ресурсы уровней и менять порядок, в котором они соединяются.

Тестовая последовательность прохождения будет набором комнат, соединённых вместе, одна за другой. Такую последовательность мы используем для выяснения того, какие способности будут открывать игроки и в каком порядке.

Каждая комната выполняет следующие цели.

- Позволяет игрокам войти в комнату и увидеть графическое представление способности, которую они откроют.

- Ставит игрока в ситуацию с единственным выходом, в которой у него нет других вариантов, кроме получения предмета.

- Позволяет игрокам прикоснуться к предмету, чтобы получить новую способность.

- Ставит игрока в ситуацию, в которой ему приходится использовать способность, чтобы покинуть комнату.

- Позволяет игрокам покинуь эту комнату только после использования способности для попадания в следующую комнату.

Игрок падает в комнату, в которой не может допрыгнуть до выхода. Игрок подбирает предмет «Высокий прыжок». Он видит уступ, до которого допрыгнуть с новой способностью. Игрок вынужден использовать способность высокого прыжка, чтобы выбраться из комнаты.

Эти комнаты должны быть самодостаточным игровым процессом. Это не должны быть большие комнаты и им необязательно красиво выглядеть. Всю необходимую игрокам информацию нужно немедленно показать камерой по умолчанию. Она должна показать наиболее стандартное использование способности, которую получил игрок. Комната и ситуация должны быть простыми и понятными. Единственной интересной частью в комнате должна быть та, в которой нужно применить новую способность. (НА ЭТОМ ЭТАПЕ НЕ СТРЕМИТЕСЬ СДЕЛАТЬ СТРУКТУРУ УРОВНЯ ИНТЕРЕСНОЙ ИЛИ СЛОЖНОЙ! Это может отвлечь вас от ваших целей в фазе разработки.)

Наметив все комнаты со всеми открываемыми способностями, попробуйте выстроить их в порядке, в котором их будет интересно получать.

Начало — тестирование бега — тестирование высокого прыжка — тестирование превращения в кошку — тестирование обратной гравитации — конец

4. Тестирование последовательности

Теперь, когда вы можете протестировать последовательность, вы начнёте видеть какой будет игра в сжатом виде. (Вы поймёте ощущения от персонажа в любой момент его «роста».)

- Может ли игрок завершить всю последовательность и получить все способности

- Ощущается ли правильным порядок, в котором игрок получает новые способности? Может быть, что-то выбивается из ряда?

- Где можно остановить прохождение игры, пока игрок не получит новую возможность?

- Каковы ощущения от способности, когда её используют в созданной вами комнате?

- Путается ли игрок в том, как или где использовать способность в последовательности?

- Удалось ли игрокам повернуть назад или пройти последовательность неправильно?

В процессе ответа на эти вопросы начните думать над тем, как улучшить всё, что требует улучшения. Если игроки получают интересные возможности слишком рано, попробуйте изменить порядок комнат и последовательность получения способностей. Если игроки «ломают» прохождение, то постарайтесь исправить пример или настройте механику так, чтобы она обеспечивала ограничение. Если игроки запутываются, исправьте комнату или механику способности. Если что-то ощущается неправильным или неприятным, исправьте или уберите это.

На этом этапе вполне нормально отказаться от идеи, потому что создавать игру вы ещё не начали. Нужно сделать её правильно.

Если всё работает и вы можете без проблем пройти всю последовательность уровней, то можно двигаться дальше. Если всё кажется хорошим и вы довольны порядком прохождения с использованием способностей движения, то пришло время работать над способностями взаимодействия. Сделайте так, чтобы вы могли в любой момент включать любые способности в опциях отладки. Это сэкономит вам кучу времени.

5. Тестирование взаимодействий с миром, объектами и врагами

Итак, мы уже знаем все способы движения персонажа и настало время определиться во взаимодействиях с врагами и объектами. Создайте ещё одно простое тестовое окружение для настройки взаимодействия с миром и объектами.

Скорее всего, у вас будут:

- Двери — они разделяют области и являются отличным способом блокировки областей, пока игрок не получит нужную способность или предмет. (Особое оружие, ключ, костюм, предметы и т.д., которые нужны для разблокировки.) Создайте в вашем тестовом окружении все типы дверей! Попробуйте использовать единый стандартный размер дверей с разным внешним видом, показывающим, что нужно сделать игроку, чтобы открыть их. Помните, что двери могут:

- Открываться и закрываться несколько раз

- Закрываться за игроком, чтобы заставить его справиться с ситуацией

- Разблокироваться при решении головоломки или убийстве врага.

- Требовать для открытия способности, оружия или ключа.

- Использоваться для маскировки загрузки уровня или помогать при переходе между областями

- Разрушающиеся объекты — такие объекты могут ломаться, растворяться или пропадать, чтобы игроки проходили дальше или находили скрытые предметы.

- Препятствия — эти объекты могут ранить игрока. Он должен уметь проходить через них с помощью полученных способностей. Каждое должно служить своей цели и настроено таким образом, чтобы игрок мог с лёгкостью его преодолеть после получения нужного инструмента.

- Устройства/подвижные объекты — это предметы, требующие для активации определённых способностей. Они перемещают игрока из одной точки в другую и их нужно обязательно использовать для попадания в новую локацию. (Канаты, лифты, подвижные платформы, шестерёнки, поршни, источники питания и т.д.)

Помните что, некоторые из этих предметов можно и нужно использовать до получения новых способностей. Пользование другими требует применения способностей. Для каждой способности должен быть хотя бы один интерактивный элемент, с которым она хорошо работает. (Или который требует этой способности для применения)

6. Враги

С каждым врагом должно быть интересно сражаться при помощи любых имеющихся по умолчанию у персонажа способностей. Их должно быть непросто победить, но всё равно возможно. Нужно запланировать достаточное количество врагов, чтобы на каждую способность приходилось по крайней мере по одному уязвимому к ней врагу. Вам нужны такие враги, с которыми интересно бороться даже полностью «прокачанным» персонажем. Вам решать, какие враги подойдут лучше к вашей игре и уровням.

Враги нужны для поддержания чувства роста персонажа. Они являются важной частью уравнения.

7. Завершение последовательности тестирования способностей

Завершив хотя бы один тип двери или препятствия, требующего для прохождения нового взаимодействия, можно закончить последовательность тестирования способностей.

Теперь можно создавать новые тестовые комнаты, в которых игроки смогут разблокировать или получать способности, позволяющие им взаимодействовать с миром. Вы будете добавлять эти комнаты в первоначальную созданную вами тестовую последовательность. Задача заключается в том, чтобы вставить все двери и сделать так, чтобы темп разблокировки взаимодействий и модификаторов движения совпадал и они хорошо подходили друг другу.

Чаще всего взаимодействия (новое оружие или атаку) располагают равномерно между апгрейдами движения, чтобы темп был плавным. Но вы можете выбрать другой темп, потому что игра с ровным темпом предсказуема. А людей утомляет предсказуемость.

Воспользуйтесь при расположении всех способностей в тестовой последовательности собственным вкусом. В результате у вас получится микроверсия всей создаваемой вами игры. Вы сможете входить во все комнаты, в одну за другой, и разблокировать способности, которые позволят продвинуться дальше и открыть двень в следующую комнату. Должно быть по одной комнате на каждую получаемую способность только с одним требуемым для прохождения взаимодействием. На этом этапе вы найдёте правильный порядок, в котором игроки должны будут получать способности для прохождения игры по оптимальному маршруту.

Начало — тест бега — тест высокого прыжка — тест стрельбы снарядами — тест ядовитого костюма — тест превращения в кошку — тест ледяной атаки — тест ночного видения — тест обратной гравитации — конец

Не беспокойтесь о разрушении последовательности в этих тестовых уровнях. Если вы сделали всё правильно, то это будет невозможно.

На этом этапе вы будете знать, как ощущается игровой процесс и что делают способности. Вы будете знать, что можно прервать прохождение, пока игрок не получит способность, предмет или оружие. Также вы будете знать, когда открывается каждая способность и получите хорошее представление об этом порядке. У вас будет набор взаимодействий и врагов для начала работы. Качество игры зависит от механик, и если на этом этапе персонажем скучно управлять, то обязательно нужно добиться интересного управления.

Теперь у вас есть список всех завершённых способностей и порядок их открытия игроком для прохождения игры. Готовый список прохождения может выглядеть так:

- Бег

- Высокий прыжок

- Стрельба

- Ядовитый костюм

- Превращение в кошку

- Ледяная атака

- Ночное видение

- Обратная гравитация

Пример дизайна уровня

Мне показалось, что стоит добавить это руководство, полезное при планировании схем отдельных уровней.

Прохождение базового цикла взаимодействий

Это изображение — пример того, как планирования уровни для игры в стиле «метроидвания». Из легенды понятно, что означают символы на карте. Эта схема подходит для сайдскроллера, игры с камерой над головой или даже полностью трёхмерной игры.

Масштабы и формы комнат не имеют значения. При начале работы они могут быть любого размера. Это схема просто помогает мысленно пройти всю игру на этапах планирования и запомнить, как нужно располагать объекты. Для своего примера я сделал схему почти полностью линейной. Теперь мы рассмотрим философию дизайна, использованную для создания этой схемы.

1. Начало

Игроки попадают в этот мир там, где расположена пометка START.

2. Двери

Стандартные точки входа — это двери, которые игроки могут открывать с помощью способностей, имеющихся на текущем этапе игры. Они помечены зелёным.

3. Точки сохранения

Если в вашей игре нельзя сохраняться в любом месте и вместо этого используются точки сохранения, то стоит расположить одну из них прямо в начале мира. Так игрокам после смерти придётся проходить заново как можно меньший путь.

4. Вход в комнату A1

Комната A1 знакомит игроков с миром. Это самая первая комната, в которой игроки встречаются с тематикой мира. Эта комната должна впечатлять и в ней должен быть элемент, привлекающий внимание игроков.

5. Исследование комнаты A1

Исследование комнаты A1 может вознаградить игроков нахождением секрета. Он может быть важным или тривиальным, в зависимости от того, что вы можете предложить игроку.

6. Выход из комнаты A1 + вход в переходную область

Игроки выходят из A1 и проходят перед входом в A2 через промежуточную область. Переходные области можно использовать для создания разнообразия, они помогают игрокам отдохнуть от активных действий. Их можно также использовать для маскировки загрузки следующей комнаты, если этого требует движок.

7. Вход в комнату A2 (в ней требуется способность, которой у игрока пока нет)

A2 — это комната, служащая одной цели. Эта комната гарантирует, что игроки сразу же увидят область, в которой нужно использовать способность, пока отсутствующую у игрока. Это барьер, не позволяющий игроку пройти дальше. Я пометил его красным. Эта комната ведёт игроков так, что они обязательно увидят этот барьер. Он непременно должен выделяться. Нужно оформить его таким образом, чтобы он запечатлелся в памяти игроков. Это должна быть единственная важная, привлекающая внимание часть комнаты. (Для выделения этого барьера у вас есть разные инструменты. Можно использовать освещение, чтобы подчеркнуть важность области. Можно разместить рядом примечательный объект (статую или символ). Можно также придать комнате такую форму, чтобы расположение барьера было очевидным. Сделайте всё необходимое, чтобы игрок заметил точку, ведущую в недоступную ему пока область.)

8. Выход из комнаты A2

Увидев барьер в комнате A2, игроки продолжают путь к единственному доступному новому выходу. Здесь они могут увидеть ещё один барьер, но его выделять не следует. (Позже вы поймёте, почему второй барьер поставлен именно здесь.)

9. Вход в комнату A3 (головоломка или область для исследования)

Игроки наконец попадают в A3. Её можно сделать головоломкой или областью исследования. Игроки очевидным образом решают головоломку, чтобы получить доступ к A4. Если игроки умные, они могут додуматься, как добраться до дополнительной комнаты B1 (Optional B1). Маршрут через неё необязателен, но его можно сделать ценным, разместив в B1 секрет.

10. Вход в A4 (комната для боя)

Наконец, игроки попадают в A4. Это может быть комната с серьёзным боем или область, в которой начинают появляться опасные враги. Она не должна быть слишком сложной, чтобы игрок не умер прямо перед точкой сохранения.

11. Вход в комнату сохранения

Если в игре есть точки сохранения, то за комнатой с боями следует комната сохранения. Если игрок погибнет в следующей комнате или в битве с боссом, ему не придётся слишком далеко возвращаться. Не стоит размещать сохранения слишком близко к комнате с боссом, иначе близкая встреча с боссом станет слишком предсказуемой.

12. Вход в комнату A5 (дразнящая будущая способность + возможность пополнить боеприпасы/нафармить ресурсов)

A5 — это последняя область перед битвой с боссом. Схема этой комнаты служит двум целям. Первое: она дразнит игрока использованием будущей способности. Это даст ему мотивацию вернуться в этот мир, получив способность позже в игре. Второе: она создаёт небольшую сложность перед встречей с боссом. Также она позволяет пополнить боеприпасы или ресурсы, нафармив их прямо перед боссом. (В этой комнате должен быть секрет, которого игроки пока не могут достичь. Так вы можете добавить в игру то, что не запланировали раньше. Таким секретом может быть увеличение боезапаса, расширение возможностей или даже путь назад на этот уровень из другого мира.)

13. Вход в переходную область (перед комнатой с боссом)

Вы видите, что на двери в комнату босса есть значок одностороннего входа. Этот односторонний вход может быть просто дверью, закрывающейся за игроком, или более сложным переходом. Например, игрок может падать на арену. В этой точке мы хотим, чтобы игрок не мог вернуться назад тем же путём, которым пришёл.

14. Вход в комнату с боссом

Если в вашей игре есть боссы, то именно в этом месте стоит устроить встречу с одним из них. Если в игре нет боссов, то просто сделайте эту комнату областью получения новой способности. Победив босса, игрок получает хорошо оформленную «особую вещь».

15. Получение новой способности

Новая способность должна быть заманчивой для игрока. Её нужно расположить в месте, которое кажется преднамеренным и особым.

16. Использование новой способности для выхода из комнаты

Получив эту новую способность, игрок должен использовать её для выхода из комнаты. Так вы вынуждаете игрока научиться использованию способности. Чаще всего даже не нужно использовать подсказки, потому что игроки не могут здесь проиграть. Они должны использовать способность, чтобы преодолеть барьер, помеченный красным. И это действие должно быть очевидно игрокам.

17. Повторное использование новой способности в переходной области

После того, как игроки использовали способность, чтобы пройти сквозь барьер, они должны снова воспользоваться ею в следующей переходной области. В этот момент нужно просто напомнить им, что делает новая способность. Именно в этом заключается магия.

18. Повторный вход в комнату A2 (по срезке)

Выход, через который игроки только что вышли с помощью новой способности, только что создал короткий путь именно туда, куда нужно идти дальше. То есть он направляет их в правильную сторону. Теперь они снова вошли в A2, столкнувшись лицом к лицу с самым запоминающимся объектом на уровне.

19. Создание уровней, создающих срезки после получения новых возможностей

Игроки прошли долгую последовательность уровней, чтобы получить новую способность, и теперь им необязательно возвращаться через уровень, по которому они только что пробились с боем. (Это важная часть качественного игрового процесса метроидвании.) Уровни должны строиться таким образом чтобы создавать срезки после получения новых способностей. Это происходит не случайно. Нужно намеренно стремиться к этому.

20. Повторное использование новой способности в комнате A2

Затем игроки используют свою новую способность, чтобы преодолеть привлёкшее особое внимание барьер. За это игра награждает их попаданием в новую область. Они использовали новую способность уже трижды. Игроки скорее всего запомнят наличие этой способности, даже если не будут использовать её какое-то время.

В заключение

Я изложил основы подхода. который можно использовать для создания уровня. Не стоит повторять одни и те же приёмы, стоит быть всё более и более изобретательными в варьировании схем.

Об авторе: Кинан Пирсон в качестве лида работал над такими играми, как Halo 4/5, Metroid Prime 2/3, Donkey Kong Country Returns.

|

Метки: author PatientZero разработка игр метроидвания metroidvania гейм-дизайн |

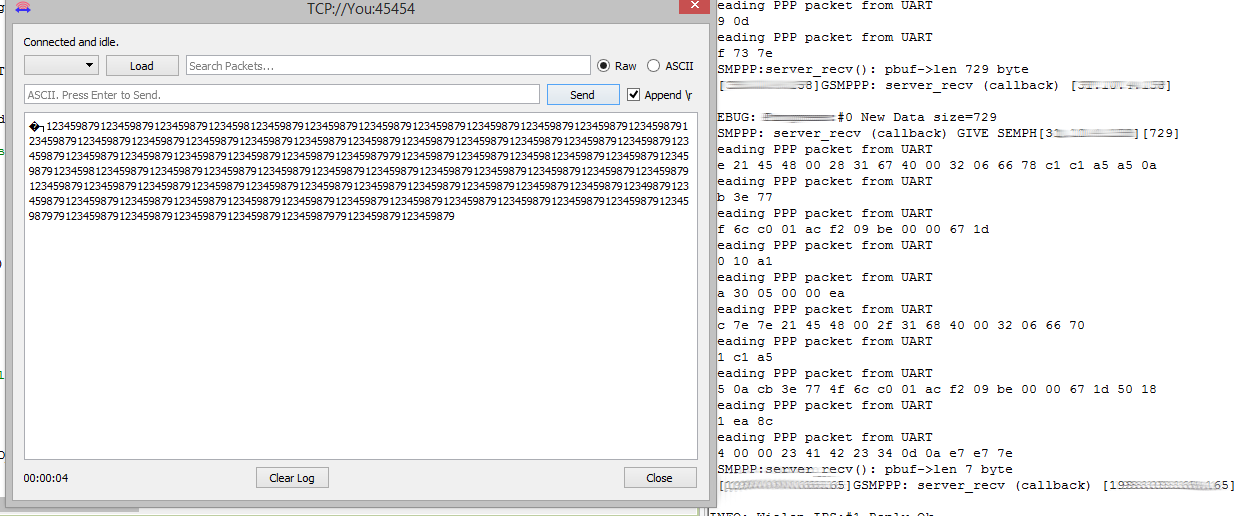

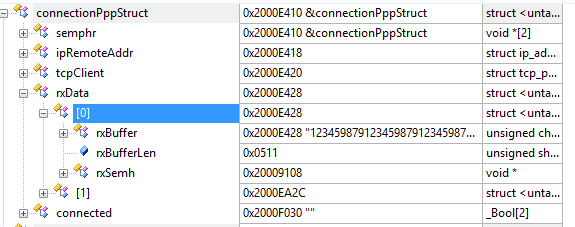

[Из песочницы] STM32 + PPP (GSM) + LwIP |

• контроль и обработка ошибок

• результат выполнения команды возвращается с длительной задержкой

• необходимо разбирать входящие строки налету

Нужно понимать, что с результатом выполнения команды, в буфер может попасть URC-код от входящего звонка, SMS, принятые данные и пр. Входной буфер с принятыми строками, приходится разбирать опираясь лишь на символы переносов и «эхо» команды, а сами команды зачастую сильно отличаются форматом. По этим причинам, использование AT вносит дополнительную задержку, алгоритмически ее устранить практически невозможно, ведь причина находится в самом модуле и несовершенстве его встроенного ПО

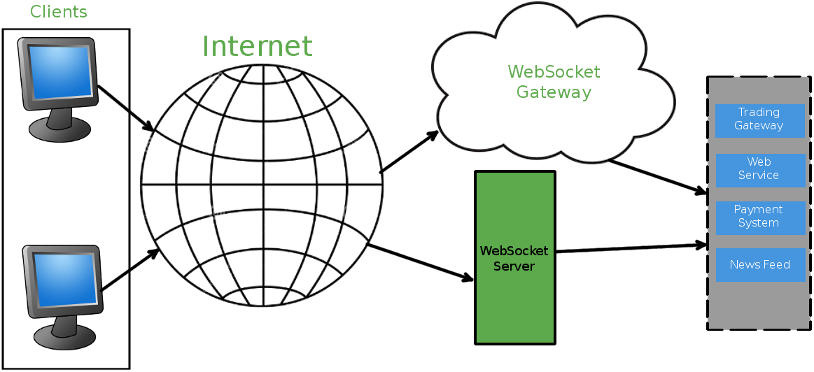

В этом примере я использовал SIM800C. Посмотрев спецификацию и убедившись в поддержке PPP, стал изучать способы реализации. Для использования PPP, модуль переключается несколькими настроечными командами, после этого режим AT становится недоступным и фактически идет общение с вышкой оператора напрямую, минуя внутренний стек модуля, что позволяет значительно ускорить обмен данными.

Пример PPP-пакета:

Каждый пакет PPP начинается и заканчивается символом ~ (0x7E). Протокол поддерживает аутентификацию соединения, шифрование и сжатие данных, по этому довольно сложен для написания собственного решения. Логичнее использовать готовый стек, поддерживающий PPP, например LwIP. Он поддерживает PPPOS и PPPOE (Over serial и Ethernet), протоколы аутентификации PAP и CHAP, имеет хорошую репутацию и широко распространен.

Демо проект

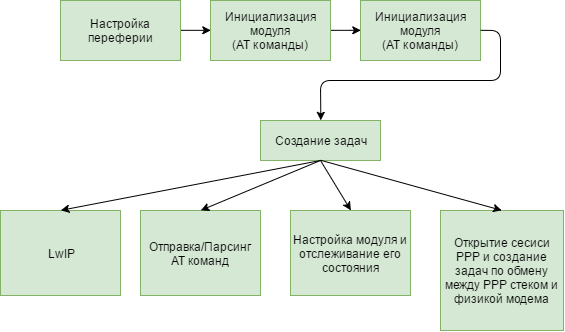

Блок-схема:

Примеры разрабатывались для микроконтроллера STM32 под FreeRTOS.

int main(void) {

HAL_Init();

SystemClock_Config();

MX_GPIO_Init();

MX_DMA_Init();

// Настройка gsm, периферии модуля и LwIP

InitGsmUart();