Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Перевод книги Appium Essentials. Глава 4 |

Если вы только включились, тут у нас предыдущие 3 главы:

Глава 4. Поиск элементов по разным локаторам

У Appium есть несколько способов локализовать элементы в мобильном приложении. В этой главе, некоторые техники поиска элементов для нативных и гибридных приложений, с использованием uiautomator и Appium inspector. Чтобы определять элементы в web-приложениях, мы рассмотрим add-on для Chrome, чтобы удаленно локализовать элементы.

В этой главе:

- Поиск элементов с использованием Chrome ADB plugin

- Поиск элементов с использованием Safari Develop

- Поиск элементов с использованием UIAutomator и Appium Inspector

- Поиск элементов по id, Name, LinkText, Xpath, cssSelector, ClassName, AccessibilityId, AndroidUIAutomator и IosUIAutomation

Поиск элементов с использованием Chrome ADB plugin

Для поиска элементов в web-приложении, необходимо установить add-on. Браузер Chrome предоставляет ADB (add-on) к исходному коду [разметке] мобильного приложения. Скачать можно отсюда.

Установив add-on, выполните следующие шаги для подключения устройства:

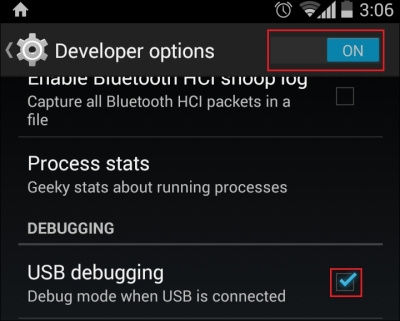

- Перейдите [в смартфоне] в Settings | About Phone и тапните по Build number 7 раз (предполагается, что у вас Android версии 4.2 или выше). Затем, вернитесь на предыдущий экран и найдите Developer options:

(если на вашем смартфоне этот шаг ничего не дал, гуглите «How to enable developer options» и укажите модель своего телефона.)

- Тапните Developer options, затем на ON в настройках разработчика (всплывет диалог для подтверждения включения режима; нажмите OK); убедитесь, что чек-бокс USB debugging включен:

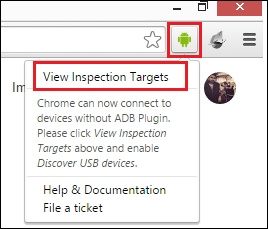

- Теперь откройте десктопную версию Chrome (предполагается, что вы уже поставили ADB плагин), кликните на иконку ADB plugin в правом верхнем углу браузера, затем, на View Inspection Targets:

- Подключите устройство Android к компьютеру (убедитесь, что на компьютер установлен подходящий USB-драйвер для вашего устройства). После подключения, на экране устройства должен появиться запрос на отладку по USB; нажмите OK.

- Откройте Chrome на девайсе и перейдите на нужный сайт (у нас это будет www.google.com).

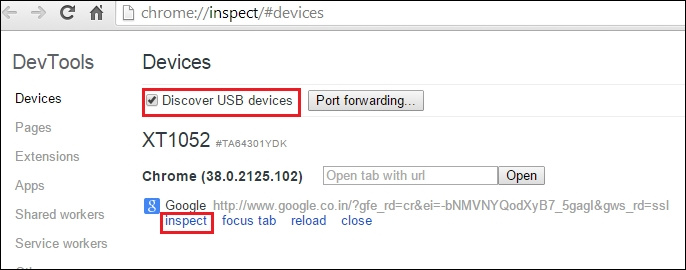

- Теперь по адресу [на десктопе] chrome://inspect/#devices будут отображаться все подключенные девайсы с открытыми вкладками. Убедитесь, что Discover USB devices выбран:

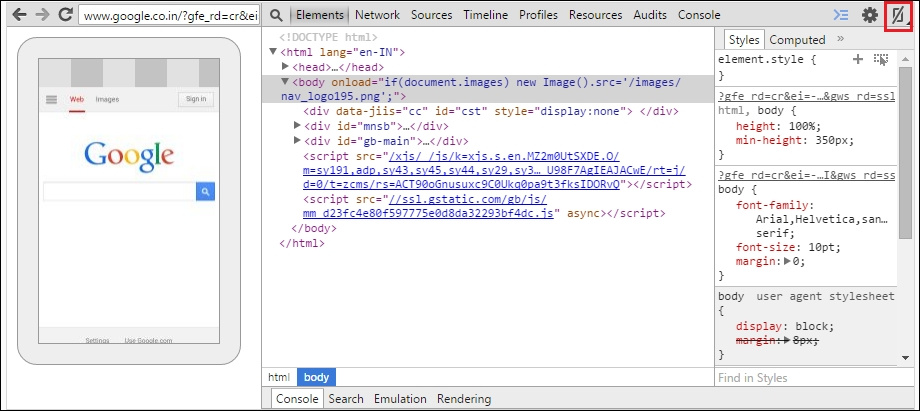

- Кликните на inspect, чтобы открыть инструменты разработчика; Должно открыться такое окно. Кликните на иконку screencast, в правом верхнем углу, чтобы отобразить экран устройства:

Поиск элементов в iOS веб-приложениях с использованием возможности Safari Develop

Safari поставляется со встроенным решением для поиска элементов, нам остается только выполнить несколько шагов, чтобы подготовить девайс к удаленной отладке:

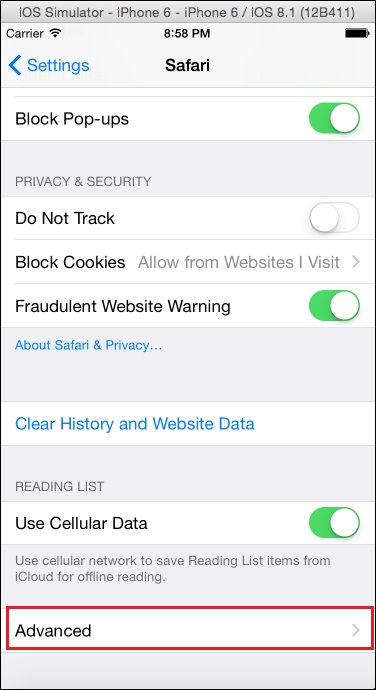

- Перейдите в Settings | Safari | Advanced:

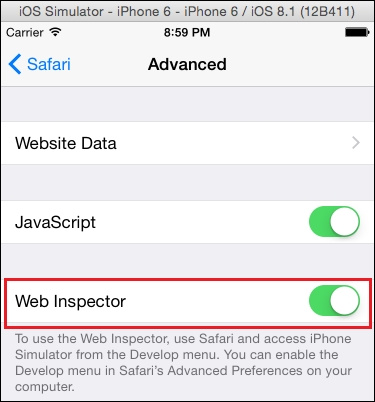

- Включите Web Inspector:

- Откройте Safari на устройстве или симуляторе и перейдите по нужной ссылке.

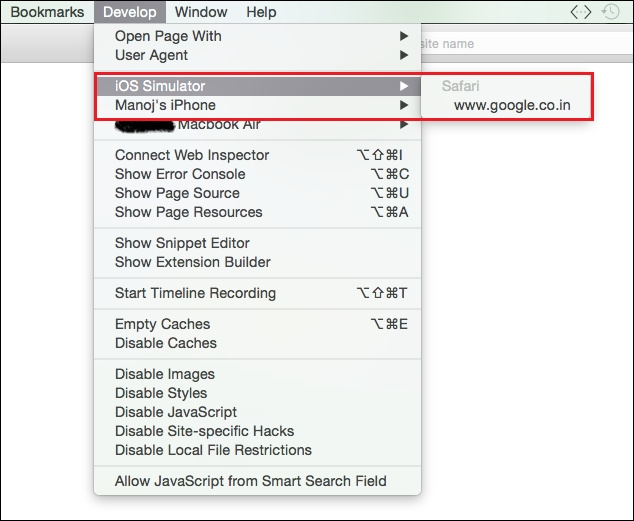

- Теперь, откройте Safari на Mac, в меню кликните Develop, выберите нужный девайс(симулятор) (предполагается, что девайс подключен к Mac), и кликните на URL:

- Вы должны получить вот такой экран с разметкой:

Поиск по ID

Для взаимодействия с веб-страницей, сперва нам потребуется найти элементы на ней. Всем функциям клиента Appium client требуется какой-либо инструмент для работы с веб-страницей.

Поиск элемента по ID используется для поиска одного конкретного элемента в приложении.

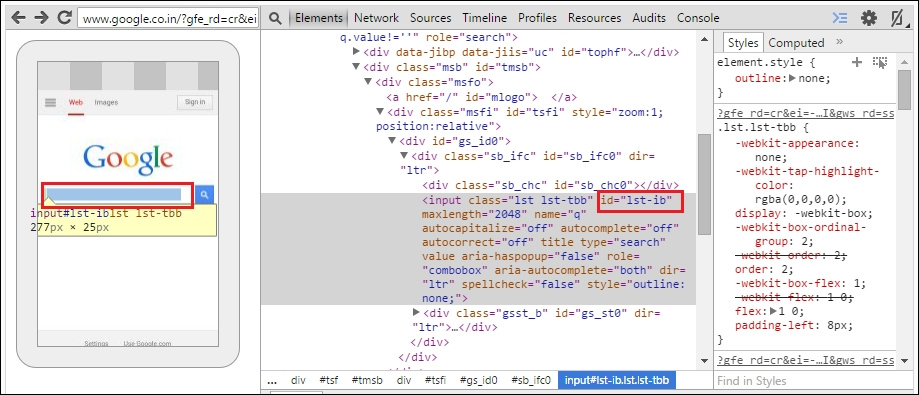

findElement(By.id(String id));Нам нужно передать ID элемента, с которым мы хотим работать. Теперь давайте узнаем ID элемента, используя плагин Chrome ADB. Ниже приведен пример работы со страницей поиска Google:

- В мобильном браузере Chrome, перейдите по адресу www.google.com.

- В плагине ADB нажмите кнопку Inspect element.

- Наведите курсор на строку для ввода Google-запроса, как показано на скриншоте:

Мы можем использовать выделенный id для взаимодействия с веб-элементом. Пример использования команды:

WebElement searchBox=driver.findElement(By.id("lst-ib"));Если хотите ввести текст в поисковую строку, используйте переменную. Например, вот так:

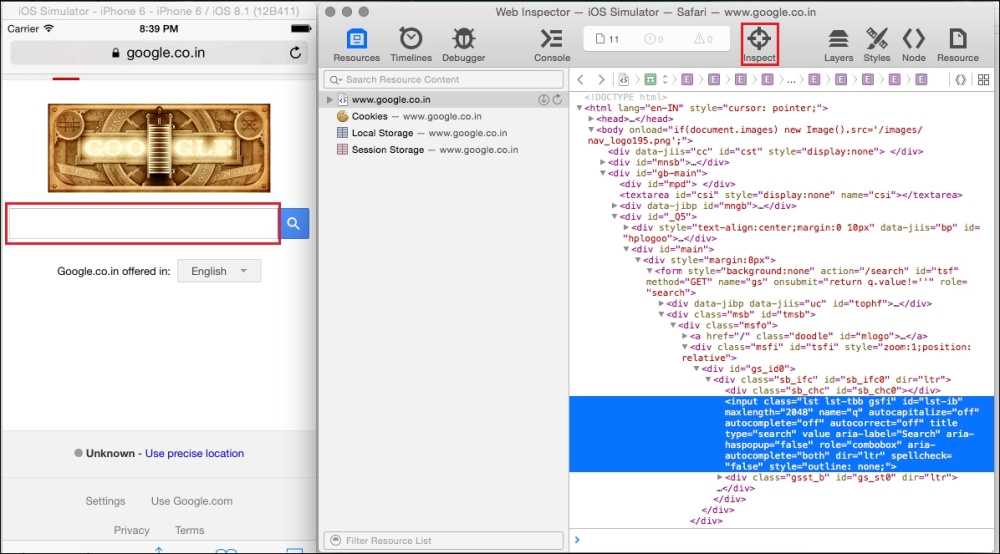

searchBox.sendKeys("Manoj Hans");Теперь давайте посмотрим этот же пример для работы с Safari на iOS device. Нужно выполнить следующие шаги:

- В Safari перейдите по адресу www.google.com.

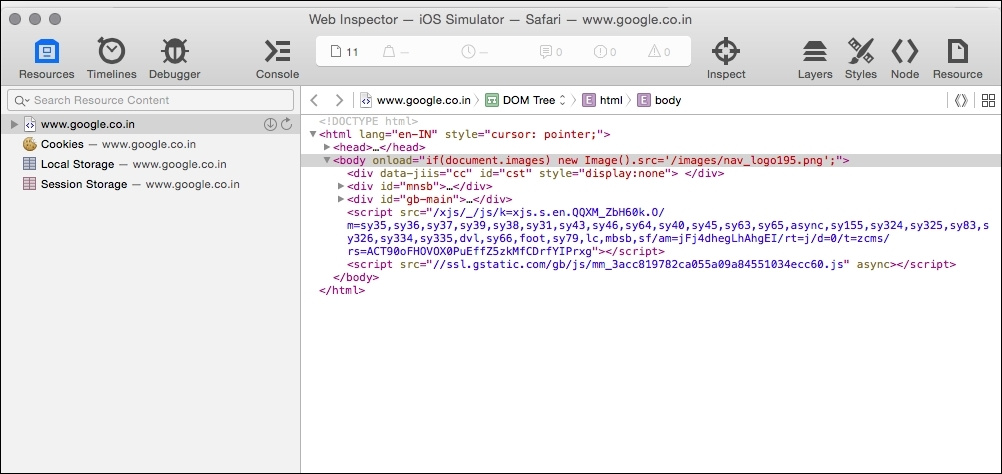

- Кликните по URL под симулятором iOS во вкладке Develop браузера Safari для Mac.

- Кликните на иконку Inspect, а затем на поисковую строку на экране iOS симулятора, как показано здесь:

Поиск элементов по name

Еще один способ обнаружить элемент — поиск по имени; вот так будет выглядеть соответствующий метод:

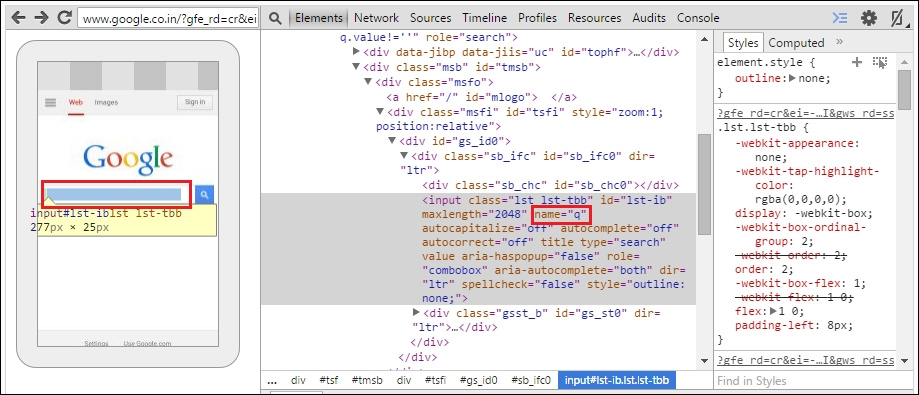

findElement(By.name(String Name));Как и в случае с id, нам нужно передать имя элемента, который мы ищем. Вернется экземпляр класса WebElement, с которым мы и будем дальше работать. Снова обратимся к примеру с Google, у поисковой строки, кроме id, есть еще и имя. Шаги такие же, как в работе с ID:

Вот как будет выглядеть команда:

WebElement searchBox=driver.findElement(By.name("q"));Поиск элемента по linkText

Этот метод полезен, когда вы ищите на странице ссылку. Сигнатура метода:

findElement(By.linkText(String text));Нужно передать текст, который должен быть у искомой ссылки. Так же, вернется экземпляр WebElement.

Мы попробуем найти ссылку на странице Google, у которой текст — «Images»:

WebElement imagesLink=driver.findElement(By.linkText("Images"));Поиск по Xpath

Xpath работает и с XML и с HTML структурами для поиска элементов. Он чуть медленнее, чем методы работ с ID и именем, но это — очень хороший способ найти элемент на странице, где ID генерируется автоматически. Мы не будем подробного изучать Xpath, по необходимости, поищите туториал в Google. Сигнатура метода:

findElement(By.xpath(String XPath));Необходимо передать Xpath для элемента, который мы ищем. Здесь мы построили Xpath, опираясь на атрибуты:

WebElement searchBox=driver.findElement(By.xpath("//input[@id='lst-ib']"));Поиск по cssSelector

cssSelector работает строго с HTML, и он быстрее Xpath. Сигнатура метода:

findElement(By.cssSelector(String cssSelector);В метод необходимо передать селектор элемента.

Построим cssSelector поисковой строки Google:

WebElement searchBox=driver.findElement(By.cssSelector("#lst-ib"));Поиск элементов для нативных и гибридных приложений

Есть множество способов найти элементы для нативных и гибридных приложений, такие как UIAutomatorviewer (для Android) и Appium Inspector. Начнем с первого.

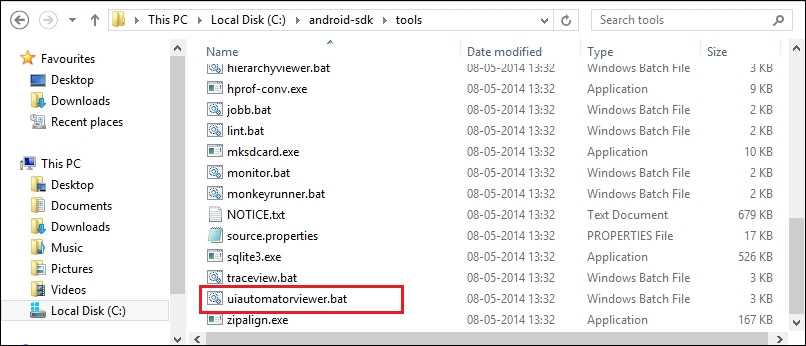

Поиск элементов с UIAutomatorviewer

UIAutomatorviewer можно найти в папке Android SDK (C:\%android-sdk%\tools); на Mac можно найти в папке tools:

При открытии, вы увидите такой экран:

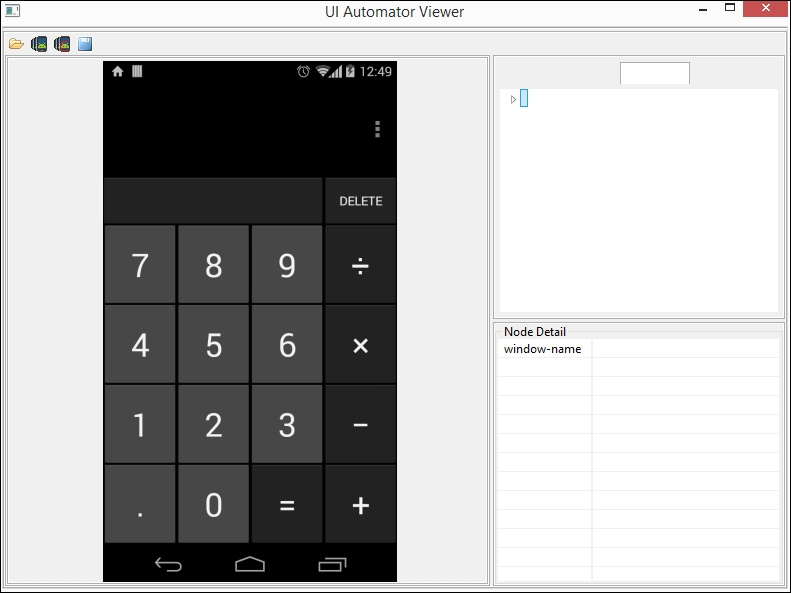

Рассмотрим пример со стандартным калькулятором Android:

- Откройте эмулятор Android или реальное устройство.

- Запустите калькулятор.

- В окне UIAutomatorviewer, кликните на иконку скриншота девайса. Если запущено больше одного устройства, UIAutomatorviewer попросит вас выбрать девайс.

Теперь нужно найти элементы приложения, используя разные локаторы.

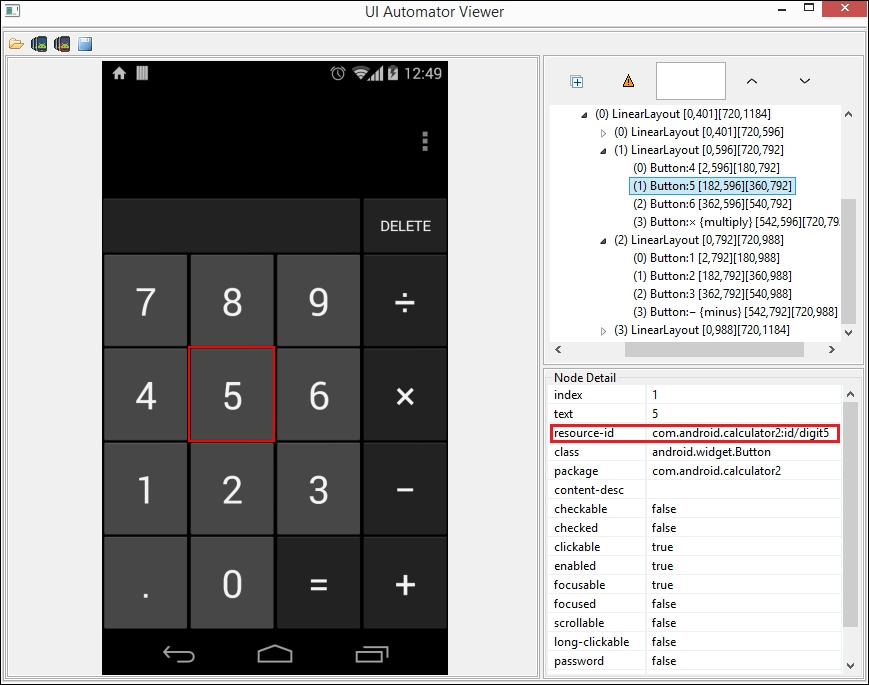

Поиск по ID

Сигнатура метода такая же, как поиск элемента по ID в web-приложении:

findElement(By.id(String id));В метод передается ID элемента, с которым мы хотим работать. Ниже пример идентификации клавиши «5» в калькуляторе с использованием UI Automator Viewer:

- Открыть UI Automator Viewer и нажать на клавишу «5» в приложении.

- В разделе Node Details, вы получите resource-id вида com.android.calculator2:id/digit5:

- Мы можем resource-id как ID, чтобы взаимодействовать с клавишей:

WebElement digit_5=driver.findElement(By.id("com.android.calculator2:id/digit5")); - Чтобы кликнуть на клавишу, используйте команду:

digit_5.click();

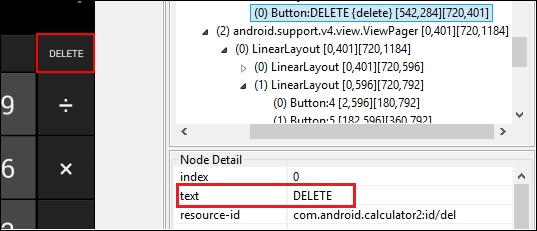

Поиск по name

Сигнатура метода нам уже знакома:

findElement(By.name(String Name));Нужно передать имя элемента, с которым хотим работать. Ниже пример поиска кнопки DELETE:

- Кликнуть на кнопку DELETE в UI Automator Viewer.

- В разделе Node Details, вы увидите поле text со значением DELETE:

- Чтобы найти и кликнуть кнопку DELETE, используйте следующий код:

delete.click(); WebElement delete=driver.findElement(By.name("DELETE"));

Поиск по className

Сигнатура:

findElement(By.className(String ClassName));Ниже пример поиска окна ввода по className:

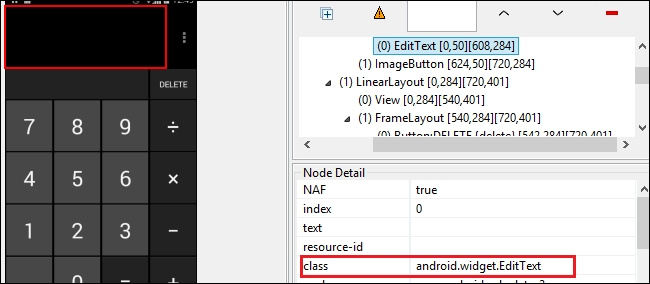

- Кликнуть на EditBox в UI Automator Viewer.

- В разделе Node Detail, найти class со значением android.widget.EditText:

- Пример поиска элемента по className:

WebElement editBox=driver.findElement(By.className("android.widget.EditText")); - Чтобы получить значение элемента EditBox, используйте команду:

editBox.getText();

Если этот класс используется для нескольких элементов, мы можем обратиться к элементу по индексу в возвращаемой коллекции. Например, мы хотим обратится к клавише «7» по имени класса:

List editBox=driver.findElements(By.className("android.widget.Button"));

editBox.get(1).click(); Мы использовали метод findElements вместо findElement; так мы получим больше одного элемента по селектору. В нашем примере, у клавиши «7» значение индекса — 1. Поэтому, мы обратились к 1му элементу.

Поиск по AccessibilityId

Разработчики Appium хотели дать нам больше возможностей для локализации элементов, поэтому они создали AccessibilityId. Этот локатор определяет элементы так же, как ID и name. Сигнатура метода:

findElement(By.AccessibilityId(String AccId));Ниже пример взаимодействия к кнопкой "+":

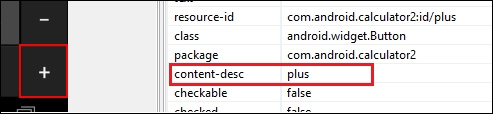

- Откройте UI Automator Viewer и кликните в калькуляторе на "+".

- В разделе Node Details, вы найдете content-desc со значением «plus»:

- Этот content-desc можно использовать как AccId:

WebElement plusSign=driver. findElementByAccessibilityId("plus"); plusSign.click();

Поиск по AndroidUIAutomator

AndroidUIAutomator очень мощный локатор. Он использует библиотеку Android UIAutomator для поиска элементов.

findElement(By.AndroidUIAutomator(String UIAuto));Ниже пример взаимодействия с кнопкой "=":

- В UI Automator Viewer кликните на "=".

- В Node details мы можем выбрать любое поле. Например, resource-id со значением com.android.calculator2:id/equal. Мы можем использовать resource-id как UIAuto для работы с клавишей "=":

WebElement equal=driver. findElementByAndroidUIAutomator("new UiSelector().resourceId(\"com.android.calculator2:id/equal\")"; - Другой пример — выбрать content-desc со значением equals, теперь команда будет выглядеть так:

WebElement equal=driver. findElementBy.AndroidUIAutomator("new UiSelector().description(\"equals\")");

Чтобы узнать больше об этом локаторе, посетите эту и эту страницу.

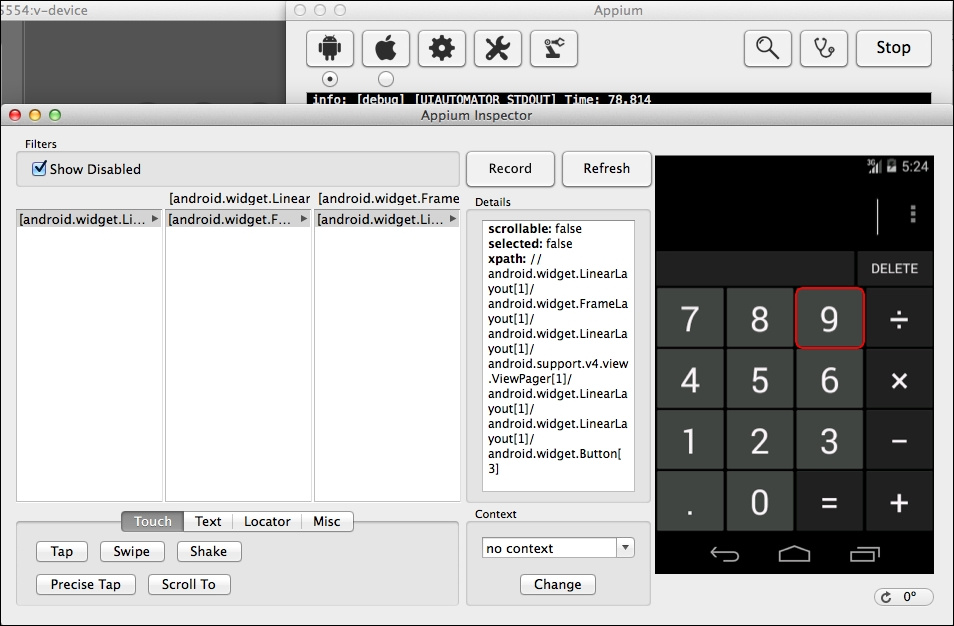

Поиск элементов с Appium Inspector

В предыдущей главе мы уже узнали, что Appium Inspector хорошо работает на Mac. Работая на Mac, мы можем его использовать для поиска элементов. Чтобы запустить Appium Inspector для Android, нам нужно выполнить следующие шаги:

- Нужно определить путь до приложения, пакета или имя активити в Appium GUI при работе с эмулятором. Если работаем с девайсом, достаточно имени пакета или активити.

Как определить имя пакета или активити, если приложение выполняется на девайсе? Можете установить на девайс APK Info из Play Store. Если у вас есть тестируемое приложение на компьютере, то Appium server автоматически подтянет все имена после указания пути к приложени. - В разделе General Settings, должна быть выбрана опция Prelaunch Application.

- Если вы работаете с эмулятором, тогда должна быть выбрана опция Launch AVD в разделе Android Settings (предполагается, что эмулятор вы уже создали). Если же вы работаете с девайсом, он должен быть подключен и должен быть разрешен USB debugging.

- Нажмите на кнопку запуска.

- Нажмите кнопку Inspector. Запустится Appium Inspector.

Мы уже изучили много способов нахождения элементов. Сейчас мы воспользуемся поиском по Xpath

Поиск по Xpath

Сигнатура:

findElement(By.xpath(String XPath));Ниже пример работы с клавишей «9»:

WebElement digit_9=driver.findElement(By.xpath("//android.widget.LinearLayout[1]/ android.widget.FrameLayout[1]/ android.widget.LinearLayout[1]/ android.support.v4.view.viewPager[1]/ android.widget.LinearLayout[1]/ android.widget.LinearLayout[1]/ android.widget.Button[3]"));

Вы можете работать с переменной digit_9, чтобы взаимодействовать с элементом.

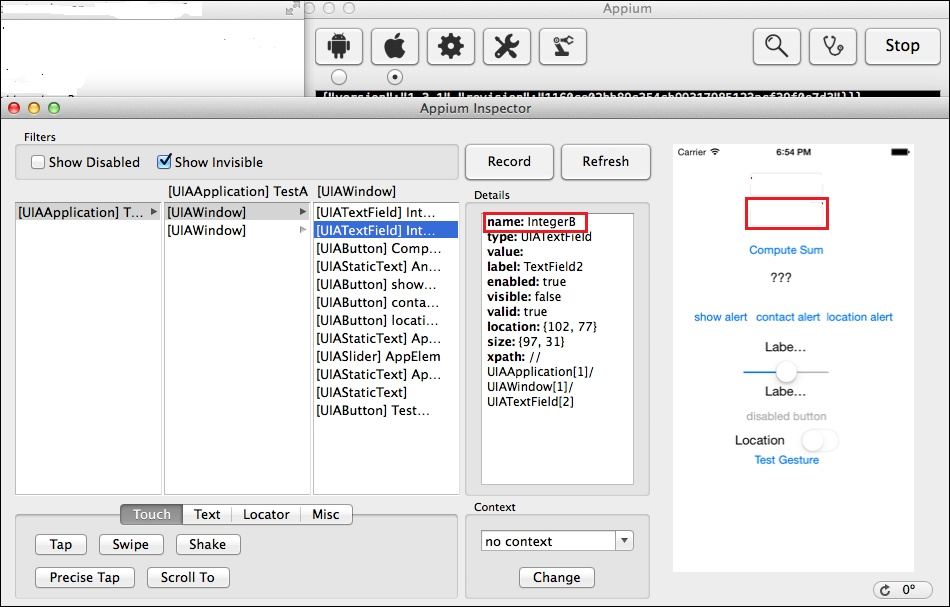

Теперь о том, как работать с Appium Inspector для iOS:

- В Appium GUI нужно указать путь до приложения.

- Опция Prelaunch Application должна быть включена ( в разделе General Settings).

- Если вы работаете с симулятором, должна быть еще и включена опция Force Device в разделе iOS Settings.

- Нажмите на кнопку запуска.

- Нажмите на кнопку Inspector.

В примере мы будем работать с TestApp, его можно скачать с Appium GitHub.

Поиск по name

Сигнатура метода:

findElement(By.name(String Name));Ниже пример работы со вторым EditBox в приложении TestApp:

- Кликните на второй EditBox в Appium Inspector.

- В вкладке Details найдите поле name со значением IntegerB. Мы можем использовать значение для обнаружения второго EditBox:

WebElement editBox=driver.findElement(By.name("IntegerB")); - Чтобы ввести текст в EditBox, используйте команду:

editBox.sendKeys("12");

Поиск по IosUIAutomation

UIAutomation — JavaScript библиотека, использующаяся для поиска элементов в Apple's Automation Instruments. Разработчики Appium дали нам похожий способ поиска элементов в Appium, используя IosUIAutomation:

findElements(By.IosUIAutomation(String IosUIAuto));Для того, чтобы начать использовать IosUIAutomation, нужно:

- Нужно передать значение IosUIAuto для элемента, с которым хотим работать. Ниже пример поиска первого EditBox в приложении TestApp:

WebElement editBox=driver. findElements(By.IosUIAutomation(".elements()[0]")); //Здесь '0' - это индекс элемента - Чтобы ввести текст в первый EditBox, используем команду:

editBox.sendKeys("10"); - Другой пример — поиск элемента по textFields:

WebElement editBox=driver. findElements(By.IosUIAutomation(".textFields()[0]"));

Чтобы узнать больше о библиотеке UIAutomation, посетите эту страницу.

Вот и все. пришло время автоматизировать наше приложение. В следующей главе, мы будем работать с Appium driver.

|

Метки: author EreminD читальный зал appium automation testing тестирование тестирование мобильных приложений |

[Из песочницы] Программный сбор данных о котировках |

Эффективные действия на бирже связаны с тщательным анализом происходящего на рынке. Что кроется за динамикой цифр, котировок?

Отсутствие такого анализа, либо сумбурное принятие решений по сделке может привести к потерям. Мне не раз приходилось наблюдать за тем, как люди принимали решения — правильные… или не правильные — в дилинговом зале брокерской конторы.

Дилинговые залы брокерских контор… там существует своя, особая атмосфера. Атмосфера общения, обмена опытом, эмоциями. Мне нравятся дилинговые залы. По тому как человек входит в сделку, трейдеров можно разделить на две группы. Я буду говорить о тех, чей результат, как правило, печален. И таких трейдеров — большинство. Итак — описываю процесс входа в рынок трейдера соответствующей группы. В дилинговый зал вбегает мужчина лет 20-60 выкрикивает: «Куда идем?! Вверх?! Вниз?!» Со стороны встречающих слышаться неоднозначные выкрики «Вверх! Вниз!» Новоприбывший присоединяется к наиболее громко крикнувшей группе и… делает ТЫЦ. ТЫЦ по кнопке покупки или продажи. Все. Теперь человек в рынке. С этого момента он рискует своими деньгами. С этого момента трейдер не похож на трейдера. Он похож на болельщика. Вувузела в руках такого трейдера, думаю, была бы уместным инструментом торговли.

И теперь он уже в составе группы переживает, и со стоном воспринимает все движения рынка. А на новостях получает такой всплеск адреналина, который парням, карабкающимся по склонам горных хребтов, может только сниться.

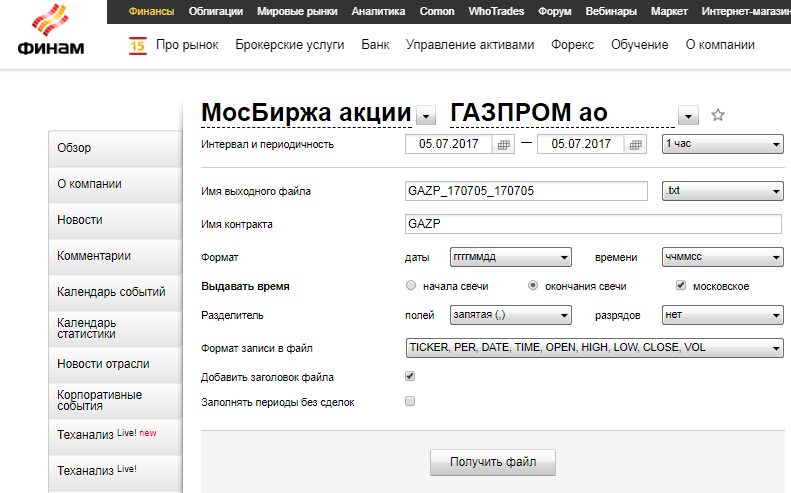

Результат таких сделок вполне предсказуем. Но… есть ли более счастливый исход? Конечно. И связан он с анализом данных котировок. Как получить эти данные? Как получить эти данные в больших объемах? Как здорово, что есть такая замечательная компания «ФИНАМ» и их интернет-ресурс finam.ru! Сервера «ФИНАМ» предоставляют замечательную возможность — скачивать котировки, например вот по такой форме (например):

Однако, таким образом предоставляется возможность скачать лишь один файл за одну загрузку. А что если мы хотим получить больше данных для анализа? Гораздо больше? Практически по всем инструментам! По всем периодам! Это даст богатейшие возможности для анализа данных. Оу… возможно ли такое? Ответ: да возможно.

Пока же определимся с перечнем бумаг (инструментов), а также с основными принципиальными моментами, которые позволят нам получить данные о котировках. Перечень бумаг (инструментов) которые предоставляться компанией «ФИНАМ» будем брать отсюда:

Эта страница интересна для нас тем, что на ней есть, во-первых, большая часть инструментов которые дает «ФИНАМ»; во-вторых, веб-ссылки, по которым можно перейти непосредственно на страницу каждой ценной бумаги (инструмента).

Ссылки имеют следующий вид:

www.finam.ru/profile/moex-akcii/polymetal-international-plc/export

www.finam.ru/profile/moex-akcii/pllc-yandex-n-v/export

www.finam.ru/profile/moex-akcii/alrosa-ao/export

Пропарсив соответствующую станицу получим файл ссылок. Теперь мы знаем где «живут» инструменты. Файл можете скачать по этой ссылке. Зачем нам место жительства каждого инструмента? Этот параметр нам еще пригодится. Запаситесь терпением. Пока имеем ссылки по 6131 бумаге (инструменту).

Что требует сервер «ФИНАМ»? Какие параметры для получения данных? Давайте попробуем получить один файл, и посмотрим параметры запроса. Скачивая котировки компании Polymetal, имею вот такой GET запрос:

__http://export.finam.ru/POLY_170620_170623.txt?market=1&em=175924&code=POLY&apply=0&df=20&mf=5&yf=2017&from=20.06.2017&dt=23&

mt=5&yt=2017&to=23.06.2017&p=8&f=POLY_170620_170623&e=.txt&cn=POLY&dtf=1&tmf=1&

MSOR=1&mstime=on&mstimever=1&sep=1&sep2=1&datf=1&at=1

Среди всего перечня хотелось бы акцентировать внимание на параметрах em, market, code. Параметр em следует понимать как индекс, своеобразную метку бумаги (инструмента). Если мы хотим скачивать не один инструмент, а массив данных по нескольким бумагам (инструментам) мы должны знать em каждого из них. Переменная market говорит о том, где вращается данная бумага (инструмент) – на каком рынке? Маркетов много: МосБиржа топ***, МосБиржа пифы***, МосБиржа облигации***, Расписки и т.д. Параметр code – это символьная переменная по инструменту.

Итак, для получения файла котировок нам нужно добыть эти три параметра: em и market и code. По всем бумагам (инструментам). Вопрос — где их взять? Ответ: вспоминаем о файле со ссылками. В файле есть, например, такая ссылка:

www.finam.ru/profile/moex-akcii/polymetal-international-plc/export

Зайдем на нее и в исходном коде страницы увидим то, что нам нужно — в элементах javascript сидят наши искомые параметры, которые относятся к данной бумаге (инструменту):

Finam.IssuerProfile.Main.issue = {"quote": {"id": 175924, "code": "POLY", "fullUrl": "moex-akcii/polymetal-international-plc", "title": "Polymetal", "decp": 1, "testDriveEnabled": false, "market": {"id": 1, "title": "МосБиржа акции", "volumeEnabled": true},"info": {"decp": 1, "last": 680, "pchange": 1.87266, "change": 12.50001, "bid": null, "ask": null, "open": 668, "high": 686, "low": 666, "close": 667.5, "volume": 53037, "date": "05.07.2017 18:47:18", "weekMin": 653.5, "weekMax": 688, "monthMin": 653.5, "monthMax": 753, "yearMin": 572, "yearMax": 1009.5,"currency": "руб.","volumeCode": "шт."},"

/*…тут еще куча важных параметров, но они нам не нужны …*/

175924, "url": "/profile/moex-akcii/polymetal-international-plc/secondary/", }, "corporativeEvents": {"quote": 175924, "url": "/profile/moex-akcii/polymetal-international-plc/corporate/", }, "blogsAndGraphs": {"quote": 175924, "url": "__http://whotrades.com/markets/instrument/polymetal-international-plc", "count": "1", "pageSize": 1, "pageNumber": 1, "pagesCount": 1}}};

Заметим, что в данном кусочке кода id — это и есть em; имеется параметр code, а также параметры маркета – id и его русскоязычное название. Данный кусок кода с вариациями присутствует у каждого бумаги (инструмента). Сходим, например, на:

www.finam.ru/profile/moex-akcii/pllc-yandex-n-v/export

www.finam.ru/profile/moex-akcii/alrosa-ao/export

и увидим все то же самое. Теперь, думаю, общая цепочка получения данных понятна: в цикле перебираем ссылки, где живут отдельные бумаги (инструменты). Парсим кусочки javascript, собирая параметры em, market и code для каждой позиции. Имея на руках эти данные, можем программно заходить на сервер «ФИНАМ» и получать файлы котировок. Осталось дело за техникой исполнения.

Чем будем парсить? Парсить будем, используя Java. И… из всех велосипедов я выбираю тот, который стоит у меня в гараже. А именно Jsoup. Хотя можно было бы использовать и htmlunit.

Небольшое уточнение. При парсинге страницы мною были получены также данные – русскоязычное название бумаги (1) и раздел, в который «ФИНАМ» определили данную бумагу (инструмент) (2). Таким образом, на входе парсера имеется три файла. Напомню, имеем 6131 позиций — бумаг (инструментов). Всю эту информацию, а также результаты парсинга объединим в один файл. Код парсера можно скачать по этой ссылке.

В результате выполнения имеем файл function_parameters.csv. Каждая строка файла при построчном считывании может использоваться как перечень параметров для функции обращения к серверу «ФИНАМ» за котировками. Файл function_parameters.csv можно скачать по этой ссылке.

Для того чтобы написать функцию обращения к серверу «ФИНАМ» (а писать мы будем ее на Python), еще раз рассмотрим параметры GET запроса:

__http://export.finam.ru/POLY_170620_170623.txt?market=1&em=175924&code=POLY&apply=0&df=20&mf=5&yf=2017&from=20.06.2017&dt=23&

mt=5&yt=2017&to=23.06.2017&p=8&f=POLY_170620_170623&e=.txt&cn=POLY&dtf=1&tmf=1&

MSOR=1&mstime=on&mstimever=1&sep=1&sep2=1&datf=1&at=1

POLY_170620_170623 – очевидно, что данная строка представляет параметр code, а также временные характеристики.

.txt – расширение файла; расширение упоминается в параметре e; при написании функции следует помнить об этом нюансе.

Примем также во внимание содержимое исходного кода страницы типа www.finam.ru/profile/moex-akcii/gazprom/export внутри тэга form (где name=«exportdata»). Характеризуем показатели.

market, em, code – об этих параметрах, упоминал ранее, при обращении к функции их значения будут приниматься из файла.

df, mf, yf, from, dt, mt, yt, to – это параметры времени.

p — период котировок (тики, 1 мин., 5 мин., 10 мин., 15 мин., 30 мин., 1 час, 1 день, 1 неделя, 1 месяц)

e – расширение получаемого файла; возможны варианты — .txt либо .csv

dtf — формат даты (1 — ггггммдд, 2 — ггммдд, 3 — ддммгг, 4 — дд/мм/гг, 5 — мм/дд/гг)

tmf — формат времени (1 — ччммсс, 2 — ччмм, 3 — чч: мм: сс, 4 — чч: мм)

MSOR — выдавать время (0 — начала свечи, 1 — окончания свечи)

mstimever — выдавать время (НЕ московское — mstimever=0; московское — mstime='on', mstimever='1')

sep — параметр разделитель полей (1 — запятая (,), 2 — точка (.), 3 — точка с запятой (;), 4 — табуляция (»), 5 — пробел ( ))

sep2 — параметр разделитель разрядов (1 — нет, 2 — точка (.), 3 — запятая (,), 4 — пробел ( ), 5 — кавычка ('))

datf — Перечень получаемых данных (#1 — TICKER, PER, DATE, TIME, OPEN, HIGH, LOW, CLOSE, VOL; #2 — TICKER, PER, DATE, TIME, OPEN, HIGH, LOW, CLOSE; #3 — TICKER, PER, DATE, TIME, CLOSE, VOL; #4 — TICKER, PER, DATE, TIME, CLOSE; #5 — DATE, TIME, OPEN, HIGH, LOW, CLOSE, VOL; #6 — DATE, TIME, LAST, VOL, ID, OPER).

at — добавлять заголовок в файл (0 — нет, 1 — да)

После того, как определен перечень параметров, а также установлены источники получаемых данных, пишем вот такую функцию получения котировок. На примере одной бумаги – полюбившегося Polymetal.

# -*- coding: utf-8 -*-

"""

Created on Sat Jun 24 01:46:38 2017

@author: optimusqp

"""

import urllib

code='POLY';

e='.txt';

market='1'

em='175924';

e='.txt';

p='3';

yf='2017';

yt='2017';

month_start='05';

day_start='20';

month_end='06';

day_end='20';

dtf='1';

tmf='1';

MSOR='1';

mstimever='0'

sep='1';

sep2='3';

datf='1';

at='1';

year_start=yf[2:];

year_end=yt[2:];

mf=(int(month_start.replace('0','')))-1;

mt=(int(month_end.replace('0','')))-1;

df=(int(day_start.replace('0','')))-1;

dt=(int(day_end.replace('0','')))-1;

def quotes(code,year_start,month_start,day_start,year_end,month_end,day_end,e,market,em,df,mf,yf,dt,mt,yt,p,dtf,tmf,MSOR,mstimever,sep,sep2,datf,at):

page = urllib.urlopen('http://export.finam.ru/'+str(code)+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+str(e)+'?market='+str(market)+'&em='+str(em)+'&code='+str(code)+'&apply=0&df='+str(df)+'&mf='+str(mf)+'&yf='+str(yf)+'&from='+str(day_start)+'.'+str(month_start)+'.'+str(yf)+'&dt='+str(dt)+'&mt='+str(mt)+'&yt='+str(yt)+'&to='+str(day_end)+'.'+str(month_end)+'.'+str(yt)+'&p='+str(p)+'&f='+str(code)+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+'&e='+str(e)+'&cn='+str(code)+'&dtf='+str(dtf)+'&tmf='+str(tmf)+'&MSOR='+str(MSOR)+'&mstimever='+str(mstimever)+'&sep='+str(sep)+'&sep2='+str(sep2)+'&datf='+str(datf)+'&at='+str(at))

f = open("company_quotes.txt", "w")

content = page.read()

f.write(content)

f.close()

qq = quotes(code,year_start,month_start,day_start,year_end,month_end,day_end,e,market,em,df,mf,yf,dt,mt,yt,p,dtf,tmf,MSOR,mstimever,sep,sep2,datf,at)

Код функции можно скачать также по этой ссылке.

Что дальше? Теперь возможно использовать данную функцию в цикле по имеющимся у нас позициям. Всего имеем, напомню, 6131 позицию. Из файла function_parameters.csv подгружаем параметры, указываем дату, выбираем нужный формат. И, используя данный код, не забудьте о правилах хорошего тона – поставьте задержку в пару секунд в итерацию цикла, дабы не перегружать сервер-источник.

Данных для анализа рынка, думаю, у вас будет предостаточно. Искренне надеюсь, что клиентов у компании «ФИНАМ» после написания данной статьи только прибавится!

|

Метки: author optimusqp машинное обучение python data mining программирование котировки данные парсинг финам трейдер phython java анализ |

Дайджест интересных материалов для мобильного разработчика #210 (03 июля — 09 июля) |

|

Тестирование и обзор Core ML |

|

Сказ о том, как Android-разработчика спамеры задолбали, и что и из этого вышло |

Дайджест доступен и в виде рассылки. Подписаться вы можете тут.

iOS

iOS- (+13) Libdispatch. Как сделать приложение отзывчивым

- (+12) Mocking в swift при помощи Sourcery

- (+5) Опыт создания реалтайм видео-секвенсора на iOS

- (+3) Moya — как перестать беспокоиться о сетевой части и начать жить

- Джейлбрейк «мертв»

Лучшие книги по Swift 2017

Лучшие книги по Swift 2017 Топ-5 iOS-библиотек июля

Топ-5 iOS-библиотек июля Руководство по Safe Area Layout

Руководство по Safe Area Layout TNTutorialManager: интерактивные туториалы внутри iOS-приложения

TNTutorialManager: интерактивные туториалы внутри iOS-приложения ARTetris: тетрис с помощью ARKit и SceneKit

ARTetris: тетрис с помощью ARKit и SceneKit Legend Wings: Open Source игра на Swift и SpriteKit

Legend Wings: Open Source игра на Swift и SpriteKit LGButton: красивые кнопки

LGButton: красивые кнопки ZIPFoundation: библиотека для работы с архивами

ZIPFoundation: библиотека для работы с архивами AXPhotoViewer: красивый просмотрщик для фотографий

AXPhotoViewer: красивый просмотрщик для фотографий

Android

Android- (+7) Android Architecture Components. Часть 1. Введение

- (+6) LibGDX + Scene2d (программируем на Kotlin). Часть 1 и Часть 0

- (+5) Чему я научился, конвертируя проект в Kotlin при помощи Android Studio

- (+4) Simple Field Validation

Android и сохранение данных в безопасности

Android и сохранение данных в безопасности Преимущества RxJava (примеры на Kotlin)

Преимущества RxJava (примеры на Kotlin) Топ-5 Android-библиотеку июля

Топ-5 Android-библиотеку июля Маленький секрет android:animateLayoutChanges

Маленький секрет android:animateLayoutChanges Инструменты и библиотеки для распространенных задач

Инструменты и библиотеки для распространенных задач Контролируем размер APK используя нативные библиотеки

Контролируем размер APK используя нативные библиотеки Android NDK: вызов Kotlin из нативного кода

Android NDK: вызов Kotlin из нативного кода RubberStamp: водяные знаки для изображений

RubberStamp: водяные знаки для изображений MultiContactPicker: выбор контактов в материальном дизайне

MultiContactPicker: выбор контактов в материальном дизайне FABsMenu: плавающая кнопка с меню

FABsMenu: плавающая кнопка с меню SQL Brite: оболочка для SQLiteOpenHelper и ContentResolver

SQL Brite: оболочка для SQLiteOpenHelper и ContentResolver

Windows

Windows- (+11) Xamarin.Forms для WPF и UWP разработчиков

- (+9) Расширение, изменение и создание элементов управления на платформе UWP. Часть 2

- Конкурс на разработку игр для UWP с призовым фондом $200,000

Разработка

Разработка- (+37) Как повторить сервис anyroom.io в несколько строк JS и без бэкенда

- (+14) 5 бесплатных ассетов для Unity3D, которые облегчат процесс разработки

- Blocks от Google: простое создание 3D объектов в VR

- Как работает человеческая память: советы для UX-дизайнеров

- NVIDIA и Baidu объявляют о масштабном сотрудничестве в области ИИ

- Отсрочки и переносы не так плохи, как вы думаете

- Как мы делали игру про зомби и сами себя загнали в угол

- Как стать разработчиком игр

- Сколько стоит разработать приложение, похожее на WhatsApp?

- Победители Alexa Skills Challenge

- R.I.P. нативные приложения или почему компаниям стоит обратить внимание на PWA

- Mr Mobister: Инстаграмм аккаунт по мобильной разработке

- UX-дизайн через 5 лет?—?5 прогнозов

Как создавать скилы для Amazon Echo Show

Как создавать скилы для Amazon Echo Show Индустрия промышленного UX 2017-2018

Индустрия промышленного UX 2017-2018 Открытая платформа для автономных автомобилей Apollo

Открытая платформа для автономных автомобилей Apollo Чему я научился за 5 лет разработки

Чему я научился за 5 лет разработки Исследование игрового пространства

Исследование игрового пространства Тестирование дейтинг приложений

Тестирование дейтинг приложений ELF: платформа для тренировки Ai в играх

ELF: платформа для тренировки Ai в играх Как мы сделали игру за 7 недель и не сошли с ума

Как мы сделали игру за 7 недель и не сошли с ума

Аналитика, маркетинг и монетизация

Аналитика, маркетинг и монетизация- (+8) Rewarded Video: лучшие сценарии показа или как сделать так, чтобы вашу рекламу посмотрели

- Эмодзи в бизнес-документах

- Дмитрий Худой (Zorka.Mobi): что ещё нужно агентству для счастья

- Отчёт «Цифровая Россия: новая реальность»

- Google экономит трафик и продвигает приложения

- Смартфоны изменили то, как ходят люди

- Медитации Headspace получили $36.7 млн в новом раунде

Почему онбординг самая важная часть вашей стратегии роста

Почему онбординг самая важная часть вашей стратегии роста Запуск приложения с маленьким бюджетом

Запуск приложения с маленьким бюджетом Геймификация в 2017: 5 ключевых приницпов

Геймификация в 2017: 5 ключевых приницпов Как реализовать рост за 0 долларов

Как реализовать рост за 0 долларов Минимально жизнеспособная аналитика

Минимально жизнеспособная аналитика KPI для ASO

KPI для ASO

Устройства, IoT, AI

Устройства, IoT, AI- (+17) Цифровой датчик температуры TSic: адреса, пароли, явки

- (+10) Интеграция TI SensorTag, Eclipse kura и веб части через Apache Camel

- Jawbone закрывается

- Яндекс разрабатывает свою умную колонку

- Дайджест интернета вещей: Июнь 2017

< Предыдущий дайджест. Если у вас есть другие интересные материалы или вы нашли ошибку — пришлите, пожалуйста, в почту.

|

|

[recovery mode] Настройка BGP Looking glass на базе OpenBSD 6.1 |

В процессе настройки выяснилось несколько ньюансов, не раскрытых в полной мере в официальной документации. В результате получилась вот такая инструкция по настройке сервиса BGP looking glass на базе свежеустановленной OpenBSD 6.1

0. Устанавливаем OpenBSD

1. Кладем SSL-ключ в /etc/ssl/private/server.key и цепочку сертификатов в /etc/ssl/server.crt

2. Настраиваем /etc/httpd.conf

ext_addr="0.0.0.0"

ext_addr6="::"

prefork 2

domain="lg.example.net"

server $domain {

listen on $ext_addr port 80

listen on $ext_addr6 port 80

block return 301 "https://$domain$REQUEST_URI"

}

server $domain {

listen on $ext_addr tls port 443

listen on $ext_addr6 tls port 443

tls {

certificate "/etc/ssl/server.crt"

key "/etc/ssl/private/server.key"

}

location "/cgi-bin/*" {

fastcgi

root ""

}

location "/" {

block return 302 "/cgi-bin/bgplg"

}

}

3. Настраиваем /etc/bgpd.conf

AS XXX

fib-update no

listen on 0.0.0.0

route-collector yes

router-id A.B.C.D

socket "/var/www/run/bgpd.rsock" restricted

neighbor D.E.F.G {

remote-as XXX

descr "r1"

announce none

}

neighbor D:E:F::G {

remote-as XXX

descr "r1v6"

announce none

}

4. Выставляем права, настраиваем chroot. Последней командой вы разрешаете выполнение ping и traceroute с вашего сервиса, однако при этом устанавливаете флаг SUID на исполняемые файлы.

chmod 0555 /var/www/cgi-bin/bgplg chmod 0555 /var/www/bin/bgpctl mkdir /var/www/etc cp /etc/resolv.conf /var/www/etc chmod 4555 /var/www/bin/ping* /var/www/bin/traceroute*

5. Если на предыдущем шаге вы включали ping и traceroute, то проверьте /etc/fstab на отсутствие флага nosuid для /var. Не забудьте перемонтировать /var либо перезагрузиться.

6. Настраиваем pf.conf

ext_if = "vio0" table{ 192.168.0.0/24 2001:67c:aaaa::/64 } table { 192.168.2.0/24 2001:67c:bbbb::/64 } set block-policy drop set skip on lo #block return # block stateless traffic #pass # establish keep-state match in all scrub (no-df random-id max-mss 1440) block all pass out quick pass in on egress proto tcp from to (egress) port { 22 } pass in on egress proto tcp from to (egress) port { 179 } pass in on egress proto tcp from any to (egress) port { 80 443 } pass in on egress proto icmp from any to (egress) pass in on egress proto icmp6 from any to (egress)

7. Запускаем демоны

rcctl enable httpd rcctl enable slowcgi rcctl enable bgpd rcctl start httpd rcctl start slowcgi rcctl start bgpd pfctl -f /etc/pf.conf

8. Вуаля!

|

Метки: author ugenk сетевые технологии openbsd bgp looking glass |

Автоматизация IP-сети. Часть2 – Мониторинг скорости открытия Веб страниц |

Продолжаем серию статей по доступной автоматизации в IP-сети. У каждого из инженеров, работающих с сетью Интернет, так или иначе периодически возникает потребность измерения скорости загрузки Веб странницы. Для этого существует множество инструментов, один из них это утилита wget. Например, для измерения скорости загрузки можно из консоли (Unix/Linux) воспользоваться такой командой:

Продолжаем серию статей по доступной автоматизации в IP-сети. У каждого из инженеров, работающих с сетью Интернет, так или иначе периодически возникает потребность измерения скорости загрузки Веб странницы. Для этого существует множество инструментов, один из них это утилита wget. Например, для измерения скорости загрузки можно из консоли (Unix/Linux) воспользоваться такой командой:[root@localhost ~]# wget -E -H -p -Q300K --user-agent=Mozilla --no-cache --no-cookies --delete-after --timeout=15 --tries=2 habrahabr.ru 2>&1 | grep Downloaded

Downloaded: 7 files, 411K in 0.3s (1.22 MB/s)Следует отметить, что ограничение Q300K достаточное чтобы понять скорость загрузки, особенно если сетевая задержка до сайта более 10мс. При этом результаты скорости будут не очевидны если количество скаченной информации меньше 100K.

Но что, если есть потребность отслеживать скорость загрузки ресурса на постоянной основе? Вопрос можно попробовать решить при помощи небольшого скрипта, системы мониторинга (умеющей запускать скрипты) и гидроизоляционного скотча.

Для написания скрипта возьмем Python3, в качестве системы для примера возьмем Cacti 0.8.8h.

Скрипт будет выглядеть следующим образом:

#!/usr/bin/env python

# -*- coding: utf-8 -*-

import datetime

import re

import os

import subprocess

import argparse

parser = argparse.ArgumentParser()

parser.add_argument("-h_page", "--hostname_page", dest = "hostname_page")

args = parser.parse_args()

curent_time=str(datetime.datetime.now().strftime("%Y-%m-%d_%H:%M:%S_"))

pid=os.getpid()

fweb=open('/usr/TEST_Script/TMP_FILES/web_temp'+curent_time+str(pid)+'.txt', 'w')

web=subprocess.call(["timeout 120 wget -E -H -p -Q300K --user-agent=Mozilla --no-cache --no-cookies --delete-after --timeout=15 --tries=2 "+args.hostname_page+" 2>&1 | grep '\([0-9.]\+ [KM]B/s\)'"], bufsize=0, shell=True, stdout=(fweb))

fweb.close()

fweb=open('/usr/TEST_Script/TMP_FILES/web_temp'+curent_time+str(pid)+'.txt', 'r')

data=fweb.read()

os.remove('/usr/TEST_Script/TMP_FILES/web_temp'+curent_time+str(pid)+'.txt')

speed_temp=re.findall(r's \((.*?)B/s', str(data))

speed_temp_si=re.findall(r's \((.*?) [KM]B/s', str(data))

try:

if re.findall(r'M', str(speed_temp))==[] and re.findall(r'K', str(speed_temp))==[]:

speed_="{0:.3f}".format(float(speed_temp_si[0])*0.001*8)

elif re.findall(r'M', str(speed_temp))!=[]:

speed_="{0:.3f}".format(float(speed_temp_si[0])*1000*8)

elif re.findall(r'K', str(speed_temp))!=[]:

speed_="{0:.3f}".format(float(speed_temp_si[0])*1*8)

except:

speed_='no_data'

print ('web_speed_test:'+speed_)

Для проверки работоспособности, его можно запустить с консоли:

[root@localhost ~]# python3.3 /usr/TEST_Script/web_open.py -h_page habrahabr.ru

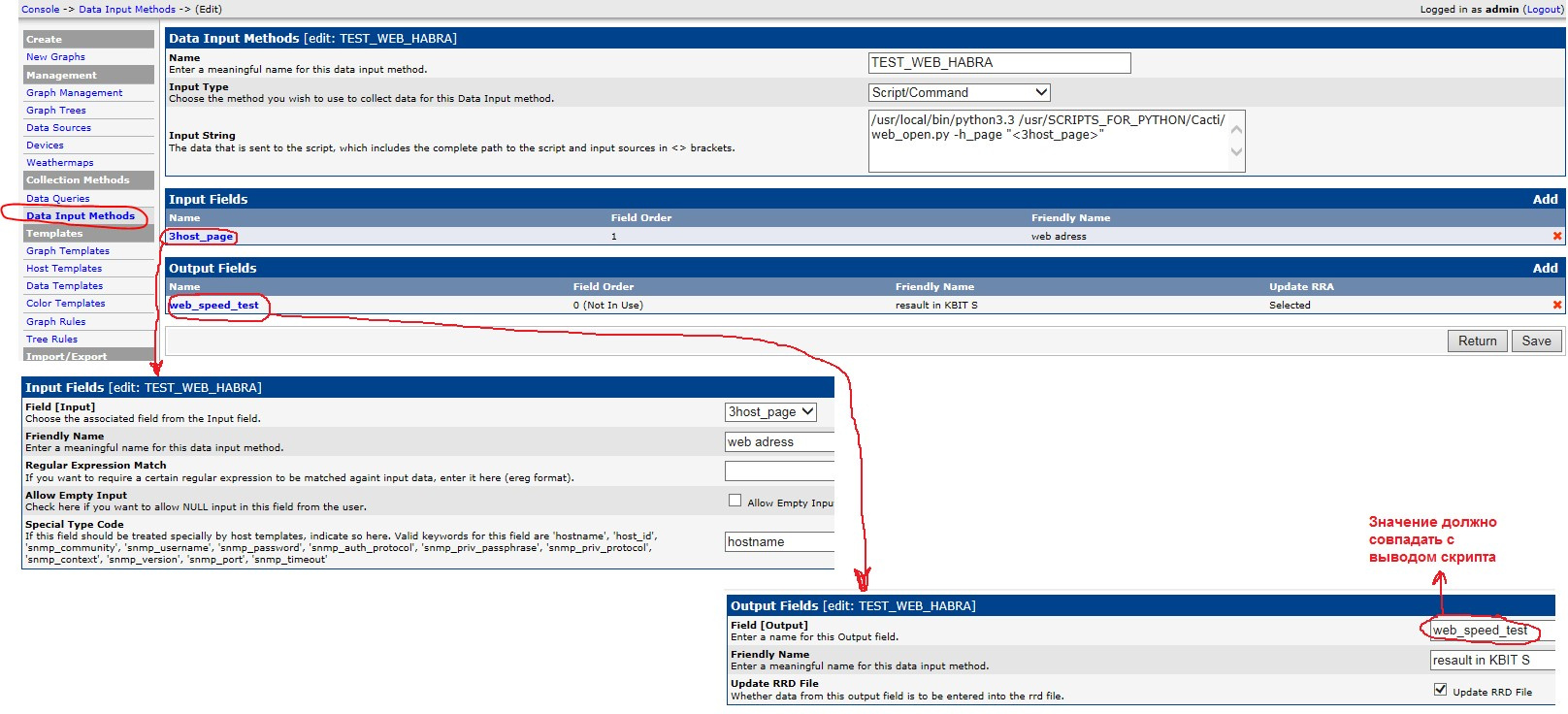

web_speed_test:10160.000Теперь необходимо выполнить стандартные манипуляции в Cacti для запуска скриптов, они хорошо задокументированы на сайте Cacti, также можно воспользоваться подсказкой ниже.

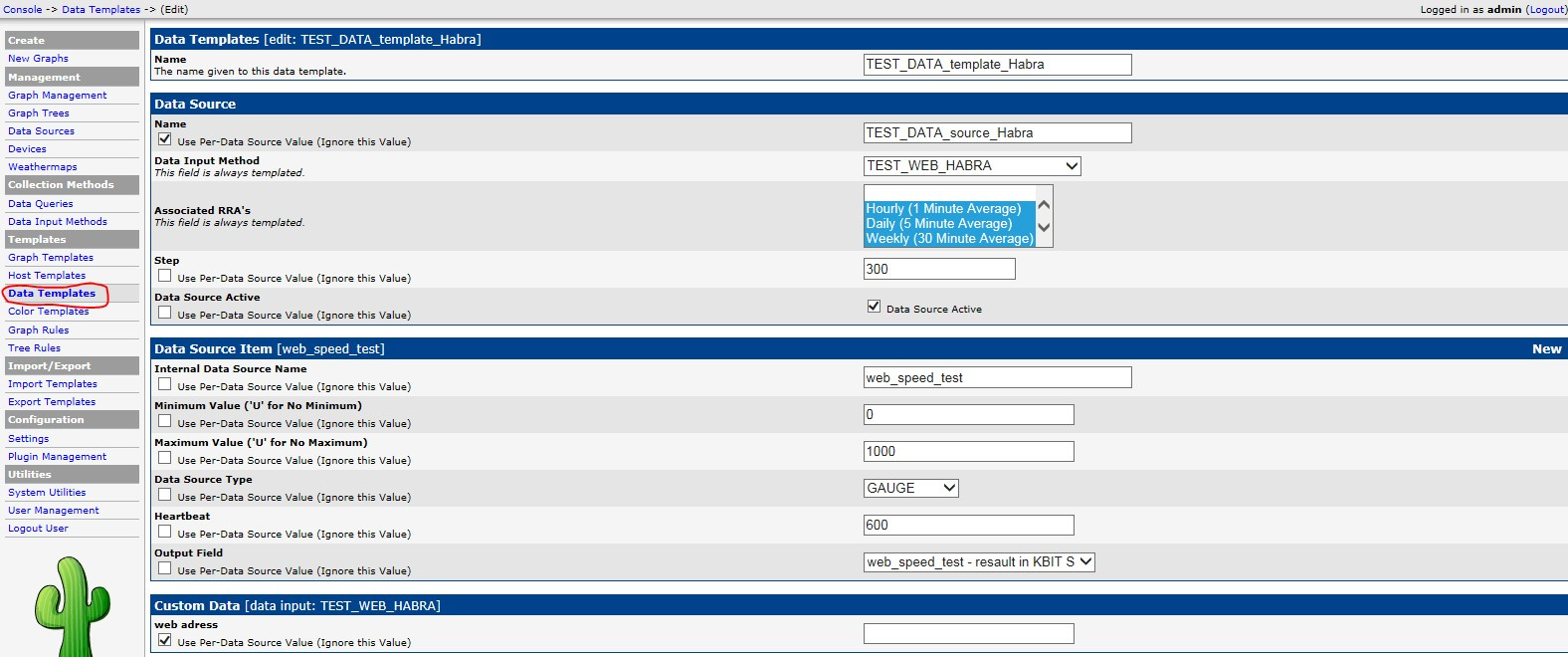

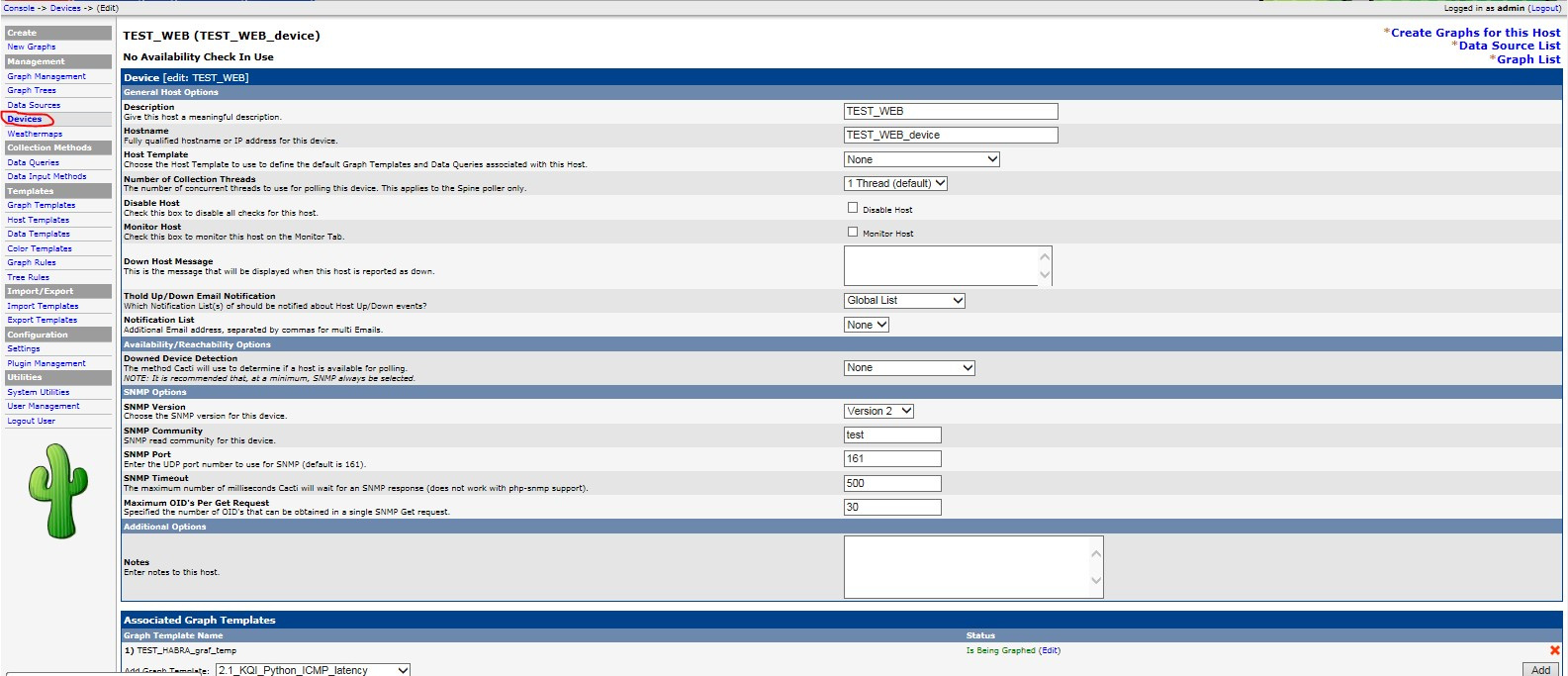

2. Console -> Data Templates

3. Console -> Graph Templates

4. Console -> Devices

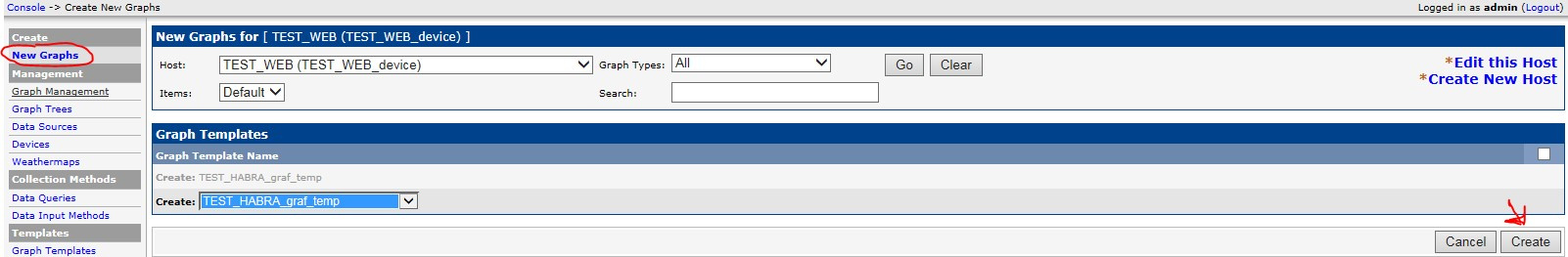

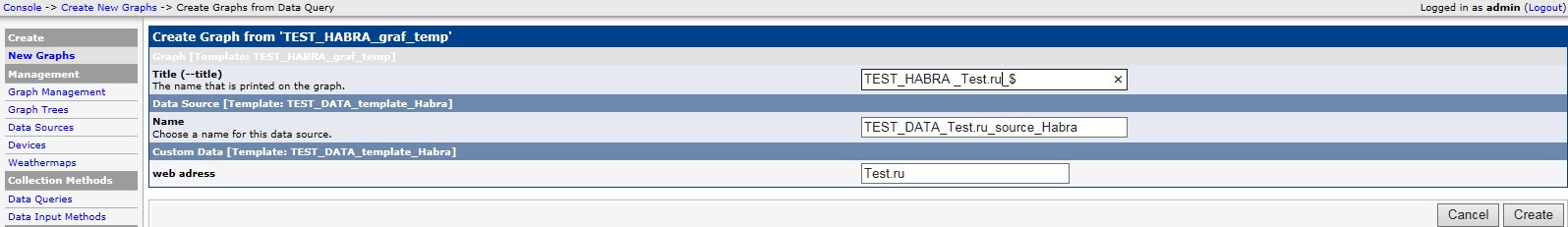

5. Console -> Create New Graphs

Если все сделано правильно, в итоге должны получиться подобные графики:

Тонкая линия — это измеренные данные, имеют пилообразный вид т.к. измерение в данном случае происходит одномоментно и отображается на графике, в то время как при загрузке например сетевых интерфейсов мы видим усредненное значение скорости за измеряемый период (обычно по умолчанию 5 минут). Толстая линия — это линия тренда, которая помогает аппроксимировать визуализацию. На представленном графике, реально измеренные значения для одного из Веб сайтов. Просадка по центру, подтвержденные администратором сайта технические неполадки и далее частичное восстановление.

Если Вы нашли для себя эту статью полезной, то возможно в этом разделе Вам также будут интересны следующие возможности нестандартного мониторинга:

— Мониторинг TCP retransmission при измерении скорости загрузки сайта.

— Мониторинг ICMP RTD с любого маршрутизатора Вашей Интернет сети (Juniper, Huawei, Cisco) до Веб ресурсов.

— Мониторинг RTD задержки до сайтов, с закрытым протоколом ICMP.

Пишите в комментариях если нужно продолжение.

Спасибо за потраченное время.

|

Метки: author Lost63 визуализация данных python python3 мониторинг сайта сетевые технологии juniper cisco huawei wget ip |

Алгоритм поиска наилучшего маршрута в linux |

Обычно говорят, что все маршруты находятся в таблице маршрутизации, в которой и выполняется поиск наилучшего маршрута. Здесь может возникнуть терминологическая путаница. Дело в том, что под таблицей маршрутизации можно понимать две разные вещи, которые иногда обозначаются терминами Routing Information Base (RIB) и Forwarding Information Base (FIB). И RIB и FIB действительно хранят ip-маршруты, но предназначение этих структур и алгоритмы выбора лучших маршрутов в этих структурах отличаются.

Routing Information Base (RIB)

Маршруты на маршрутизатор могут попадать из различных источников: быть настроены статически, попадать из протоколов динамической маршрутизации OSPF, BGP и т.д. При этом из различных источников могут приходить маршруты с одним и тем-же префиксом. Из этих маршрутов нужно выбрать какой-то один и добавить его в FIB. Эта задача как раз и решается в RIB. Обычно маршрутам из разных источников присваивается разная Административная Дистанция и наилучшим считается маршрут с наименьшей Административной Дистанцией. Важно, что конкурируют между собой маршруты с одним и тем-же префиксом. Маршруты с разными префиксами между собой не сравниваются. Например, префиксы 10.0.0.0/8 и 10.0.0.0/16 это разные префиксы и в FIB попадут оба маршрута. Таким образом, в RIB выполняется поиск КОНКРЕТНОГО префикса. Поиск префиксов в RIB выполняется при добавлении или удалении маршрутов, что происходит относительно редко.

Forwarding Information Base (FIB)

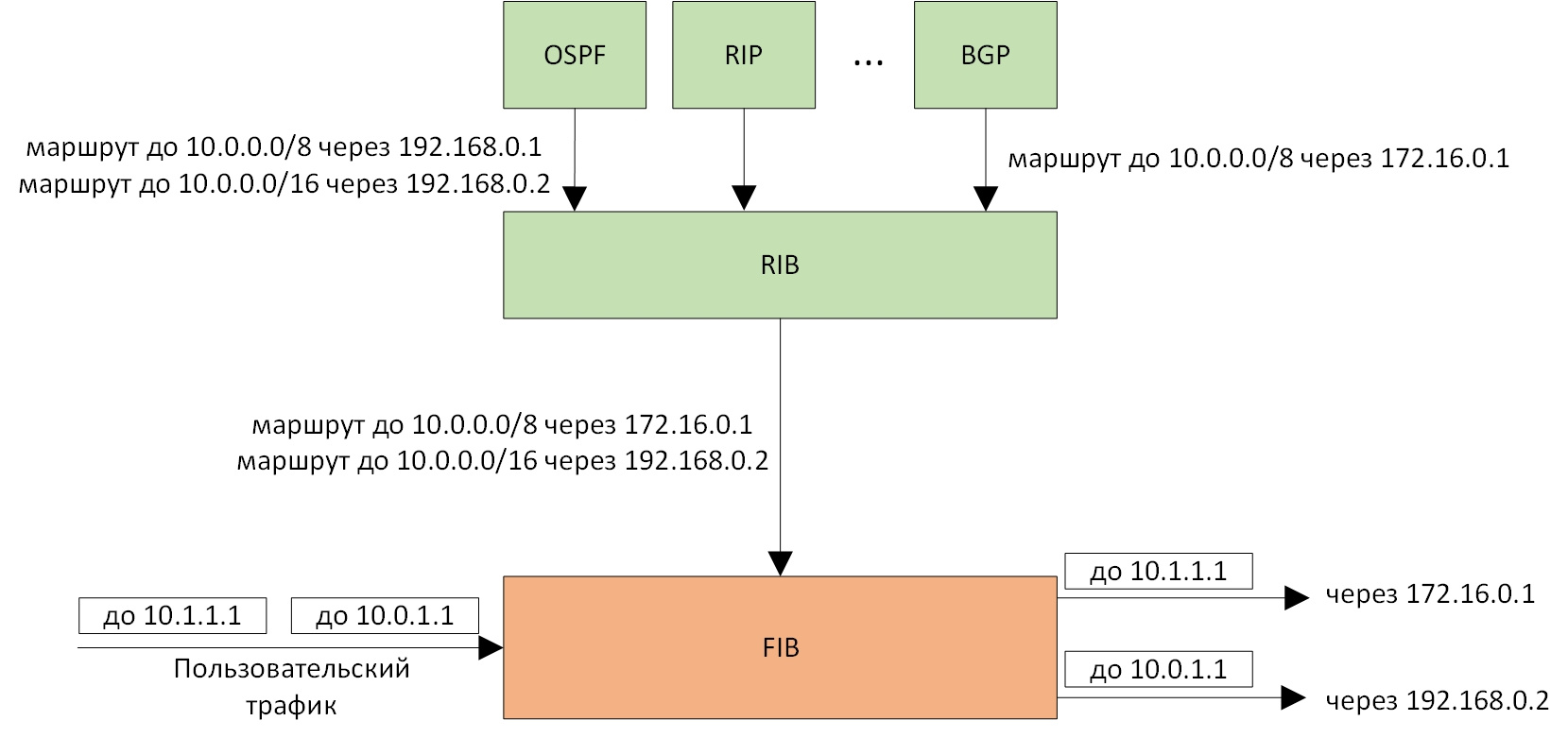

FIB служит собственно для маршрутизации ip-пакетов. Здесь лучшим маршрутом считается маршрут с наиболее длинным префиксом, совпадающим с адресом назначения в ip-пакете. Совместная работа RIB и FIB показана на рисунке:

Рисунок 1. Совместная работа RIB и FIB. В RIB попадают и отбираются маршруты от разных протоколов маршрутизации. В FIB выполняется маршрутизация пакетов согласно наиболее длинным префиксам.

Поиск лучшего маршрута в FIB происходит для каждого нового ip-пакета. От того, насколько эффективно происходит поиск маршрута в FIB напрямую зависит скорость маршрутизации устройства. Поэтому поиск в FIB должен производиться максимально быстро и эффективно. В FIB может содержаться несколько сот тысяч маршрутов с разными префиксами, поэтому задача выглядит довольно нетривиальной. Для ее оптимизации было предложено много различных алгоритмов. В настоящей статье я хочу рассказать, как поиск в FIB реализован в ядре linux.

Формулировка задачи

IP-префикс обычно обозначают в виде ip-адреса и длины префикса, например: 10.0.0.0/8. Для нас будет удобнее представлять префикс в двоичном виде, оставив только левую часть, равную длине префикса и опустив его правую несущественную часть: 00001010. Маршрут по-умолчанию (т.е. префикс нулевой длины будем обозначать звездочкой *. Задача поиска выглядит следующим образом. У нас есть набор различных префиксов: *, 00, 10, 0000, 1000, 1001, 1010, 10111. Нам дается адрес назначения, который в двоичном виде выглядит, например, так: 1010110001110100010001000010111. Среди имеющихся префиксов нужно найти лучший, т.е. наиболее длинный, который совпадает с левой частью адреса назначения. В нашем примере это будет префикс 1010. К каждому префиксу привязан ip-адрес следующего маршрутизатора (next-hop), исходящий интерфейс и другая информация, достаточная отправки пакета дальше. В дальнейшем, для простоты, я буду использовать вышеуказанный набор префиксов и адреса назначения длины 6. Все нижеизложенное также применимо и для реальных ip-адресов длины 32. Как может выглядеть реальный список префиксов в FIB (в двоичном виде) можно посмотреть здесь.

Мы будем последовательно строить алгоритмы поиска лучшего префикса начиная с самого простого, постепенно улучшая их, пока не придем к алгоритму, используемому в ядре linux.

Тривиальный алгоритм

Очевидным и самым простым алгоритмом является простой перебор всех имеющихся префиксов и выбора из них лучшего. Такой алгоритм легко реализовать, но на большом количестве префиксов скорость его работы совершенно неудовлетворительна. Если в FIB у нас содержится 500000 префиксов, то нам нужно перебрать и проверить их всех.

Скорость поиска можно несколько повысить, храня префиксы в порядке убывания их длины. Тогда первый совпадающий префикс будет самым длинным и, следовательно, лучшим.

Префиксное дерево

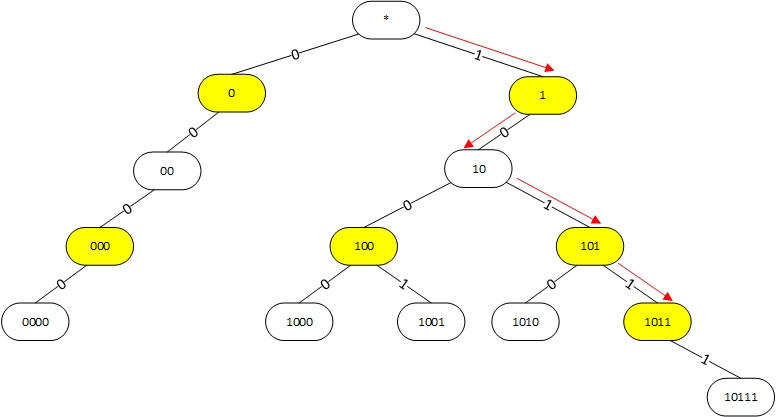

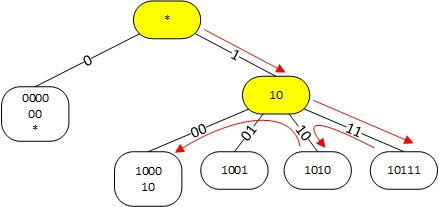

Естественным способом организации префиксов является префиксное дерево (trie). Пример префиксного дерева для префиксов *, 00, 10, 0000, 1000, 1001, 1010, 10111 приведен на рисунке:

Рисунок 1. Использование префиксного дерева для поиска наиболее длинного префикса. Красными стрелками показана последовательность поиска для адреса 101100.

Белые узлы соответствуют интересующим нас префиксами. В них также хранится ссылка на информацию о том куда отправлять пакет дальше (next-hop и т.д.). Желтые узлы являются промежуточными и служат для правильной организации структуры дерева. Верхний узел является корнем дерева и соответствует префиксу 0.0.0.0/0. Для поиска лучшего префикса проверяется самый левый бит адреса назначения пакета. Если он равен 0, то спускаемся налево, если равен 1, то направо. Далее проверяем второй бит и т.д., постепенно спускаясь по дереву пока есть возможность. Спускаясь по дереву, запоминаем последний пройденный белый узел, он и будет наилучшим. Например, при поиске наилучшего префикса для адреса 101100 последовательно проходим узлы *, 1, 10, 101, 1011. Последний пройденный белый префикс равен 10, он и будет наилучшим.

Максимальное количество сравнений, очевидно, не превышает высоты дерева и для ipv4 равняется 32.

Сжатие пути

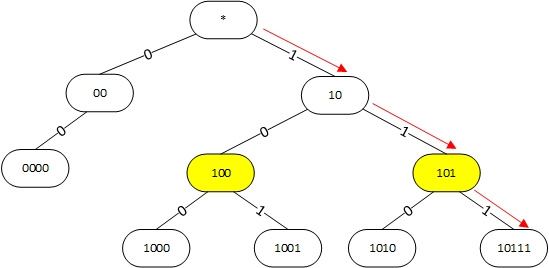

Если префиксов не очень много, то в префиксном дереве могут образовываться цепочки без ветвлений. В такой цепочке можно пропустить желтые узлы с одним дочерним префиксом, как показано на рисунке. Этот механизм называется сжатие пути (Path compression) а дерево построенное таким образом — Path compressed trie (PC-trie).

Рисунок 2. Использование Path compressed trie для поиска наиболее длинного префикса для адреса 101100.

Алгоритм поиска остается практически без изменений. Для поиска наилучшего префикса для адреса 101100 также сначала проверяем 1-й бит адреса. Поскольку он равен 1, то спускаемся вправо в префикс 10. Убеждаемся, что префикс 10 подходит. Далее проверяем 3-й бит адреса, спускаемся в узел 101, проверяем 4-й бит, и попадаем в узел 10111. Префикс 10111 не совпадает с адресом и последний посещенный нами белый префикс, как и в предыдущем случае, равен 10.

Сжатие уровня

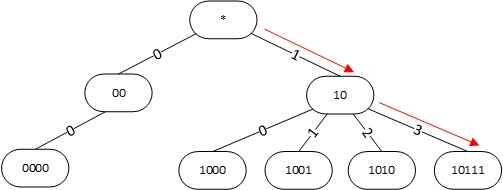

Сжатие пути эффективно когда префиксов относительно немного. Когда же количество префиксов возрастает полезной становится другая оптимизация, называемая сжатие уровня (Level Compression). Здесь мы для некоторых узлов дерева храним не два дочерних элемента, а больше, например, 4, 8, 16 и т.д. В качестве индекса для выбора дочернего элемента используем сразу несколько битов в проверяемом адресе. Дерево использующее сжатие пути и уровня называется Level and Path Compressed Trie (LPC-Trie).

Рисунок 3. Использование Level and Path compressed trie для поиска наиболее длинного префикса для адреса 101100.

В данном случае узел 10 имеет не два дочерних узла, а четыре. Для выбора дочернего узла в адресе назначения проверяются сразу два бита: 3-й и 4-й, и используются в качестве индекса для выбора дочернего узла. Так, в адресе 101100 эти биты равны 11 (десятичное 3), т.е. после узла 10 спускаемся в дочерний узел с индексом 3, т.е. в узел 10111. Поскольку он не подходит, то наиболее длинный префикс равен 10.

Чем больше используется битов адреса назначения для нахождения очередного узла, тем меньше высота дерева и быстрее поиск. Однако при этом для некоторых индексов дочерние узлы отсутствуют и часть памяти тратится впустую.

Реализация в linux

Для проверки я брал ядро linux 4.4.60. В ядре linux для поиска лучшего префикса используется модифицированное LPC-Trie. При сжатии уровня используется максимальное количество битов, при котором количество отсутствующих дочерних узлов не превышает количество существующих дочерних узлов.

Модификация заключается в том, что все белые префиксы перемещаются в конечные узлы дерева. Промежуточные узлы используются исключительно для организации структуры дерева. В одном конечном узле может содержаться цепочка из нескольких префиксов, отличающихся друг от друга количеством нулей справа, т.е., например: 1, 10, 1000, как показано на рисунке:

Рисунок 4. Реализация trie в Linux для поиска наиболее длинного префикса для адреса 101100.

Поиск конечного узла производится при помощи LPC-алгоритма. Затем последовательно перебираются все префиксы в конечном узле, начиная с самого длинного. Ситуация при этом усложняется тем, что в некоторых случаях наилучший маршрут оказывается пропущенным при спуске по дереву и для его нахождения необходима проверка узлов слева (backtracking). Так, для адреса 101100 мы спускаемся к узлу 10111. Поскольку в нем нет нужного префикса, мы должны проверить узел 1010 (в нем может храниться префикс 101), а затем узел 1000 и в нем находим префикс 10. К счастью, необходимость в backtracking возникает, по-видимому не очень часто и не сильно снижает скорость поиска.

Для каких целей сделана данная модификация, усложняющая и замедляющая поиск, мне не совсем понятно, возможно она облегчает построение дерева при добавлении или удалении маршрутов, а может просто является унаследованной из какого-то алгоритма.

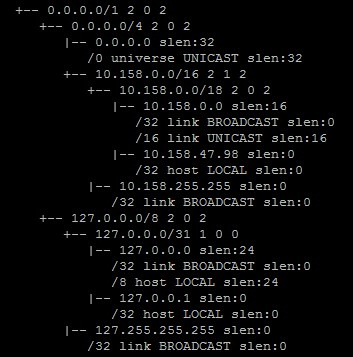

В linux есть возможность посмотреть дерево FIB. Для этого нужно ввести команду cat /proc/net/fib_trie. При этом выдается что-то похожее на:

Рисунок 5. Вывод команды cat /proc/net/fib_trie

Промежуточные узлы дерева обозначены символами +--, конечные узлы символами |--. В конечных узлах видны префиксы, упорядоченные по длине.

DIR-24-8

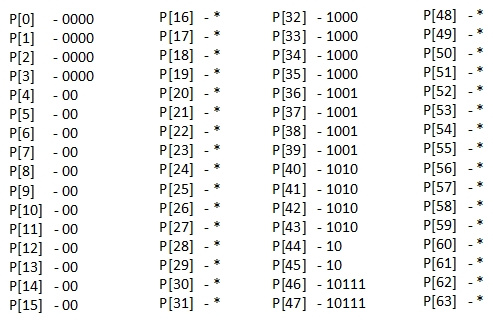

Можно ли еще ускорить поиск наилучшего префикса? Оказывается можно, если при этом пожертвовать памятью. Если предположить, что у нас есть сколько угодно памяти, то можно организовать поиск наилучшего префикса за единственное обращение к памяти. Для этого нужно создать большой массив, в ячейках которого хранить ссылки на наилучшие префиксы, а в качестве индекса при выборе ячейки использовать адрес назначения. Для нашего примера массив будет выглядеть следующим образом:

Рисунок 6. Массив для поиска наиболее длинного префикса за одно обращение.

Чтобы найти наилучший префикс для адреса 101100 мы просто смотрим в ячейку с индексом 101100 в двоичном виде, т.е. с индексом 44, и немедленно получаем, что наилучший префикс равен 10.

Для такого хранения префиксов нужен массив с количеством ячеек 2 в степени длины адреса назначения, т.е. для адресов длины 6 понадобилось 64 ячейки, а для реальных ip-адресов длины 32 понадобится более 4 млрд. ячеек.

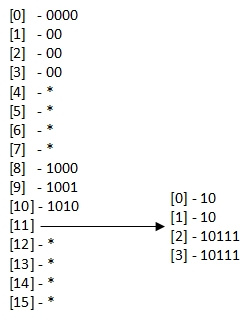

Для сокращения количества ячеек заметим, что в нашем случае практически все префиксы равны длине 4 или меньше. Поэтому практически для всех адресов назначения достаточно посмотреть только первые четыре бита. Модернизированная схема поиска выглядит следующим образом:

Рисунок 7. Массивы для поиска наиболее длинного префикса за максимум два обращения.

В данном случае используются два массива. Сначала поиск осуществляется в левом массиве (из 16-ти ячеек), используя в качестве индекса первые четыре бита адреса назначения. Во всех случаях, когда адрес назначения не начинается с 1011 (одиннадцать в десятичном виде) мы сразу получаем наилучший префикс. Иначе мы смотрим последние два бита адреса и используем их в качестве индекса во второй таблице (из 4-х ячеек). Видно, что для адреса 101100 мы снова получаем наилучший префикс 10. Таким образом, при поиск наилучшего префикса в большинстве случаев выполняется за одно обращение, в худшем случае за два.

В случае реальных ip-адресов может использоваться аналогичная схема. Большинство префиксов в FIB являются длины 24 или меньше. Поэтому в качестве левого массива логично использовать массив, индексируемый старшими 24-мя битами адреса (16 777 216 ячеек). Для редких случаев, когда длина хранимых префиксов оказалась длиннее 24, используются дополнительные таблицы, индексируемые последними 8-ю битами префикса (256 ячеек для каждой дополнительной таблицы).

Данный быстрый способ поиска (максимум за два обращения) называется DIR-24-8 и используется, например, в DPDK.

|

Метки: author andrew526d системное программирование математика высокая производительность алгоритмы trie linux таблица маршрутизации fib rib |

[Из песочницы] Бинарная сегментация изображений методом фиксации уровня (Level set metod) |

|

Метки: author 22dla обработка изображений математика алгоритмы сегментация matlab метод фиксации уровня level set method фильтрация машинное зрение компьютерная графика |

Признаки проблемного дизайна |

- Жесткость (трудно менять код, так как простое изменение затрагивает много мест);

- Неподвижность (сложно разделить код на модули, которые можно использовать в других программах);

- Вязкость (разрабатывать и/или тестировать код довольно тяжело);

- Ненужная Сложность (в коде есть неиспользуемый функционал);

- Ненужная Повторяемость (Copy/Paste);

- Плохая Читабельность (трудно понять что код делает, трудно его поддерживать);

- Хрупкость (легко поломать функционал даже небольшими изменениями);

Их нужно уметь понимать и различать для того, чтобы избежать проблемного дизайна либо предвидеть возможные последствия его использования. Эти признаки описаны в книге Роберта Мартина «Agile Principles, Patterns, And Practices in C#». Однако в ней, как и в некоторых других обзорных статьях по этой теме (которых, кстати, не очень много), приведено довольно краткое их описание и как правило отсутствуют примеры кода.

Попробуем исправить этот недостаток, более или менее подробно остановившись на каждом из этих признаков.

Жесткость

Как уже было обозначено выше, жесткий код бывает сложно менять, даже по мелочам. Это может и не быть проблемой в случае, если код меняется нечасто либо не меняется вообще. Таким образом, код получается вовсе даже неплохим. Но если он периодически требует изменений и делать это становится трудно, он становится проблемным. Даже если он работает.

Одним из распространенных случаев жесткости является явное указание типов классов вместо использования абстракций (интерфейсов, базовых классов и т.п.). Ниже приведен пример кода.

class A

{

B _b;

public A()

{

_b = new B();

}

public void Foo()

{

// Do some custom logic.

_b.DoSomething();

// Do some custom logic.

}

}

class B

{

public void DoSomething()

{

// Do something

}

}

Здесь класс A жестко зависит от класса B. То есть если в будущем будет принято решение использовать вместо B другой класс, это потребует изменение класса A и, следовательно, его повторного тестирования. Кроме того, если от B жестко зависит множество других классов, ситуация может многократно осложниться.

Выходом из ситуации может быть введение абстракции, то есть некоего интерфейса IComponent и внедрение такой зависимости через конструктор (либо как-то еще) класса A. В этом случае класс A перестает зависеть от конкретного класса B, а зависит лишь от интерфейса IComponent. Класс B, в свою очередь, должен реализовывать интерфейс IComponent.

interface IComponent

{

void DoSomething();

}

class A

{

IComponent _component;

public A(IComponent component)

{

_component = component;

}

void Foo()

{

// Do some custom logic.

_component.DoSomething();

// Do some custom logic.

}

}

class B : IComponent

{

void DoSomething()

{

// Do something

}

}

Давайте приведем более конкретный пример. Пусть есть некоторый набор классов, которые логируют информацию — ProductManager и Consumer. Их задача сохранить некоторый продукт в базе данных и заказать его соответственно. Оба класса логируют релевантные события. Пусть сначала логирование осуществлялось в файл. Для этого использовался класс FileLogger. При этом классы располагались в разных модулях (сборках).

// Module 1 (Client)

static void Main()

{

var product = new Product("milk");

var productManager = new ProductManager();

productManager.AddProduct(product);

var consumer = new Consumer();

consumer.PurchaseProduct(product.Name);

}

// Module 2 (Business logic)

public class ProductManager

{

private readonly FileLogger _logger = new FileLogger();

public void AddProduct(Product product)

{

// Add the product to the database.

_logger.Log("The product is added.");

}

}

public class Consumer

{

private readonly FileLogger _logger = new FileLogger();

public void PurchaseProduct(string product)

{

// Purchase the product.

_logger.Log("The product is purchased.");

}

}

public class Product

{

public string Name { get; private set; }

public Product(string name)

{

Name = name;

}

}

// Module 3 (Logger implementation)

public class FileLogger

{

const string FileName = "log.txt";

public void Log(string message)

{

// Write the message to the file.

}

}

Если в начале было достаточно только файла, а затем возникает необходимость логировать и в другие хранилища, такие как база данных или облачный сервис сбора и хранения информации, то потребуется изменение всех классов в модуле бизнес логики (Module 2), использующих FileLogger. В конечном итоге это может оказаться сложным. Для решения этой проблемы можно ввести абстрактный интерфейс для работы с логгером, как показано ниже.

// Module 1 (Client)

static void Main()

{

var logger = new FileLogger();

var product = new Product("milk");

var productManager = new ProductManager(logger);

productManager.AddProduct(product);

var consumer = new Consumer(logger);

consumer.PurchaseProduct(product.Name);

}

// Module 2 (Business logic)

class ProductManager

{

private readonly ILogger _logger;

public ProductManager(ILogger logger)

{

_logger = logger;

}

public void AddProduct(Product product)

{

// Add the product to the database.

_logger.Log("The product is added.");

}

}

public class Consumer

{

private readonly ILogger _logger;

public Consumer(ILogger logger)

{

_logger = logger;

}

public void PurchaseProduct(string product)

{

// Purchase the product.

_logger.Log("The product is purchased.");

}

}

public class Product

{

public string Name { get; private set; }

public Product(string name)

{

Name = name;

}

}

// Module 3 (interfaces)

public interface ILogger

{

void Log(string message);

}

// Module 4 (Logger implementation)

public class FileLogger : ILogger

{

const string FileName = "log.txt";

public virtual void Log(string message)

{

// Write the message to the file.

}

}

В этом случае при смене типа логгера достаточно поменять код клиента (Main), который инициализирует логгер и подкладывает его в конструктор ProductManager и Consumer. Таким образом мы закрыли классы бизнес логики от модификации в отношении типа логгера, что и требовалось сделать.

Кроме прямых ссылок на используемые классы, жесткость может проявляться любыми другими вариантами, приводящими к сложностям при изменении кода. Таковых может быть бесконечное множество, но попробуем привести еще один пример. Пусть есть некий код, который выводит на консоль площади геометрических фигур.

static void Main()

{

var rectangle = new Rectangle() { W = 3, H = 5 };

var circle = new Circle() { R = 7 };

var shapes = new Shape[] { rectangle, circle };

ShapeHelper.ReportShapesSize(shapes);

}

class ShapeHelper

{

private static double GetShapeArea(Shape shape)

{

if (shape is Rectangle)

{

return ((Rectangle)shape).W * ((Rectangle)shape).H;

}

if (shape is Circle)

{

return 2 * Math.PI * ((Circle)shape).R * ((Circle)shape).R;

}

throw new InvalidOperationException("Not supported shape");

}

public static void ReportShapesSize(Shape[] shapes)

{

foreach(Shape shape in shapes)

{

if (shape is Rectangle)

{

double area = GetShapeArea(shape);

Console.WriteLine($"Rectangle's area is {area}");

}

if (shape is Circle)

{

double area = GetShapeArea(shape);

Console.WriteLine($"Circle's area is {area}");

}

}

}

}

public class Shape

{ }

public class Rectangle : Shape

{

public double W { get; set; }

public double H { get; set; }

}

public class Circle : Shape

{

public double R { get; set; }

}

Из этого кода видно, что при добавлении новой фигуры придется менять методы класса ShapeHelper. Одним из вариантов может быть перенесение алгоритма отрисовки в сами классы геометрических фигур (Rectangle и Circle), как показано ниже. Этим мы изолируем релевантную логику в соответствующих классах, сузив тем самым ответственность класса ShapeHelper до вывода информации на консоль.

static void Main()

{

var rectangle = new Rectangle() { W = 3, H = 5 };

var circle = new Circle() { R = 7 };

var shapes = new Shape[]() { rectangle, circle };

ShapeHelper.ReportShapesSize(shapes);

}

class ShapeHelper

{

public static void ReportShapesSize(Shape[] shapes)

{

foreach(Shape shape in shapes)

{

shape.Report();

}

}

}

public abstract class Shape

{

public abstract void Report();

}

public class Rectangle : Shape

{

public double W { get; set; }

public double H { get; set; }

public override void Report()

{

double area = W * H;

Console.WriteLine($"Rectangle's area is {area}");

}

}

public class Circle : Shape

{

public double R { get; set; }

public override void Report()

{

double area = 2 * Math.PI * R * R;

Console.WriteLine($"Circle's area is {area}");

}

}

Как результат, мы фактически закрыли класс ShapeHelper для изменений по добавлению новых типов фигур за счет использования наследования и полиморфизма.

Неподвижность

Неподвижность проявляется в сложности разделения кода на переиспользуемые модули. В результате проект может потерять способность эволюционировать и как результат перестанет быть конкурентноспособным.

В качестве примера рассмотрим десктопную программу, весь код которой реализован в исполняемом файле приложения (exe) и был спроектирован таким образом, что вынесение бизнес логики в отдельные модули либо классы не предусмотрено. Затем, какое-то время спустя перед разработчиком программы возникли следующие бизнес требования:

- Изменить пользовательский интерфейс, сделав его Web приложением;

- Опубликовать функционал программы в виде набора Web сервисов, доступных сторонним клиентам для использования в их собственных приложениях.

В этом случае данные требования трудновыполнимы, поскольку весь код программы зашит в исполняемом модуле.

На рисунке ниже показан пример неподвижного дизайна в противовес тому, который этим признаком не страдает. Они разделены пунктирной линией. Как видно из рисунка, распределение кода по повторно используемым модулям (Logic), а также публикация функционала на уровне Web сервисов позволяет использовать его в различных клиентских приложениях (App), что является несомненным плюсом.

Неподвижность также можно назвать монолитностью дизайна. Его как каменную глыбу трудно раздробить на более мелкие и полезные куски кода. Как избежать этой проблемы? На этапе проектирования лучше подумать, насколько вероятно использование того или иного функционала в других системах. Потенциально переиспользуемый код лучше сразу поместить в отдельные модули и классы.

Вязкость

Вязкость можно подразделить на два типа:

- Вязкость разработки;

- Вязкость окружения.

Вязкость разработки проявляется в относительной трудности следования выбранному дизайну приложения. Это может происходить оттого, что к программисту предъявляется слишком много требований, которые необходимо исполнять, в то время как есть намного более удобный путь разработки.

Вязкость окружения может проявляться в неэффективности процесса сборки, развертывания и тестирования приложения.

В качестве простого примера, где переплетаются оба типа вязкости, можно привести работу с константами, которые требуется (By Design) помещать в отдельный модуль (Module 1) для использования другими компонентами (Module 2 и Module 3).

// Module 1 (Constants)

static class Constants

{

public const decimal MaxSalary = 100M;

public const int MaxNumberOfProducts = 100;

}

// Finance Module

#using Module1

static class FinanceHelper

{

public static bool ApproveSalary(decimal salary)

{

return salary <= Constants.MaxSalary;

}

}

// Marketing Module

#using Module1

class ProductManager

{

public void MakeOrder()

{

int productsNumber = 0;

while(productsNumber++ <= Constants.MaxNumberOfProducts)

{

// Purchase some product

}

}

}

Данный дизайн может оказаться вязким. Если по какой-то причине процесс сборки модуля констант занимает значительное время, разработчикам будет сложно ожидать его окончания (Вязкость окружения). Кроме того, можно обратить внимание на то, что в модуле констант содержатся достаточно разнородные сущности, относящиеся к принципиально разным частям бизнес логики (финансовый и маркетинговый модули). То есть модуль констант может меняться довольно часто по независимым друг от друга причинам, что может привести к дополнительным проблемам в виде процесса синхронизации изменений (Вязкость разработки).

Все это замедляет процесс разработки и может напрягать программистов. Вариантами менее вязкого дизайна было бы создание отдельных модулей констант — по одному на соответствующий модуль бизнес логики, либо перенос констант в нужное место без выделения под них отдельного модуля.

Еще одним примером Вязкости Окружения можно считать разработку и тестирование приложения на удаленной виртуальной машине клиента. Иногда такой рабочий процесс становится невыносимым из-за медленного интернет соединения, в связи с чем разработчик может систематически пренебрегать интеграционным тестированием написанного кода, что в итоге может привести к проблемам на клиентской стороне при использовании этого функционала (Bugs).

Ненужная Сложность

В этом случае дизайн имеет неиспользуемый в данный момент функционал (так сказать на будущее, а вдруг пригодится). Этот факт может затруднять поддержку и сопровождение программы, а также увеличивать время разработки и тестирования. Например, рассмотрим программу, которая требует чтения некоторых данных из базы. Для этого был написан специальный компонент DataManager, который используется в другом компоненте.

class DataManager

{

object[] GetData()

{

// Retrieve and return data

}

}

Если разработчик добавит в DataManager новый метод для записи данных в базу (WriteData), который на данный момент не используется, но с очень малой вероятностью может пригодиться в будущем, это будет проявлением признака Ненужная Сложность. Зачем тратить время на написания потенциально неиспользуемого кода? QA иногда обязаны тестировать такой код, потому что он фактически публикуется и становится доступным для использования сторонними клиентами. Это тоже отъедает время релиза. Закладывать функционал на будущее стоит лишь при условии того, что возможная выгода от его наличия превысит затраты на его разработку и тестирование.

Ненужная Повторяемость

Наверное большинство разработчиков сталкивалиcь или столкнуться с этим признаком, который заключается в множественном копировании либо одной и той же логики, либо некоторого участка кода целиком. Основной угрозой при этом является уязвимость такого кода при внесении изменений — поправив что-то в одном месте, можно забыть сделать это в другом. Кроме того, требуется больше времени при внесении изменений по сравнению с ситуацией, когда код лишен этого признака.

Ненужная Повторяемость может быть как следствием нерадивости разработчиков, так и Жесткости/Хрупкости дизайна, когда не повторять код гораздо труднее и рискованнее, чем делать это. Однако в любом случае нельзя попускать повторяемость и необходимо постоянно улучшать код, перенося повторно используемые участки в общие методы и классы.

Плохая Читабельность

Этот признак проявляется в том, что код трудно читать и понимать что он делает (и почему он делает именно так). Причинами плохой читабельности может быть несоблюдение требований к оформлению кода (синтаксис, именование переменных, классов и т.д.), запутанная логика реализации и другое.

Ниже приведен пример трудночитаемого кода, который реализует метод, оперирующий булевой переменной.

void Process_true_false(string trueorfalsevalue)

{

if (trueorfalsevalue.ToString().Length == 4)

{

// That means trueorfalsevalue is probably "true". Do something here.

}

else if (trueorfalsevalue.ToString().Length == 5)

{

// That means trueorfalsevalue is probably "false". Do something here.

}

else

{

throw new Exception("not true of false. that's not nice. return.")

}

}

Здесь можно выделить сразу несколько проблем. Во-первых, названия методов и переменных не подчиняются общепринятым конвенциям. Во-вторых, реализация метода не самая лучшая.

Возможно стоит сразу принимать булево значение, а не строку. Но даже если принимать строку, ее лучше сконвертировать в булеву величину в начале метода, а не пользоваться методом определения длины строки. В третьих, текст исключения (that's not nice) не соответствуют официально деловому стилю. Читая такие тексты, может сложиться ощущение, что код написан непрофессионалом (может быть спорный момент, но все же). Метод можно было бы переписать так (при условии, что он будет принимать булево значение, а не строку):

public void Process(bool value)

{

if (value)

{

// Do something.

}

else

{

// Do something.

}

}

Вот другой вариант рефакторинга (если принимать строку все же необходимо).

public void Process(string value)

{

bool bValue = false;

if (!bool.TryParse(value, out bValue))

{

throw new ArgumentException($"The {value} is not boolean");

}

if (bValue)

{

// Do something.

}

else

{

// Do something.

}

}

Над трудно читабельным кодом следует проводить рефакторинг, если он начинает приносить проблемы. Например в случае, если его сопровождение и размножение приводит к возникновению большого количества багов.

Хрупкость

Хрупкость программы означает простоту ее поломки в случае внесения изменений. Поломки бывают двух типов — ошибки компиляции и ошибки времени выполнения. Первые могут являться оборотной стороной Жесткости, вторые наиболее опасны, так как часто находятся уже на стороне клиента. Вот они то и являются показателем Хрупкости.

Показатель, бесспорно, относительный. Кто-то правит код очень внимательно и вероятность поломки низкая. Кто-то наоборот — в спешке и невнимательно. Но все же при одних и тех же исполнителях разный код может порождать разное количество ошибок. Наверное можно говорить о том, что чем неразборчивее он, чем сложнее, чем больше полагается на время выполнения программы нежели на этап компиляции, тем более он хрупок.

При этом часто ломается функционал, который даже не собирались менять. Он может пострадать из-за высокой связности логики различных компонентов между собой.

Рассмотрим конкретный пример. Здесь логика авторизации пользователя с некоторой ролью (определяется параметром roleId) по доступу к некоторому ресурсу (resourceUri) вынесена в статический метод.

static void Main()

{

if (Helper.Authorize(1, "/pictures"))

{

Console.WriteLine("Authorized");

}

}

class Helper

{

public static bool Authorize(int roleId, string resourceUri)

{

if (roleId == 1 || roleId == 10)

{

if (resourceUri == "/pictures")

{

return true;

}

}

if (roleId == 1 && roleId == 2 && resourceUri == "/admin")

{

return true;

}

return false;

}

}

Можно заметить, что логика довольно «волосатая». Очевидно, что при добавлении новых ролей и ресурсов ее будет несложно поломать. В результате, некоторая роль может получить либо потерять доступ к некоторому ресурсу. Уменьшить хрупкость помогло бы создание класса Resource, который внутри себя хранил бы идентификатор ресурса и список поддерживаемых ролей, как показано ниже.

static void Main()

{

var picturesResource = new Resource() { Uri = "/pictures" };

picturesResource.AddRole(1);

if (picturesResource.IsAvailable(1))

{

Console.WriteLine("Authorized");

}

}

class Resource

{

private List _roles = new List();

public string Uri { get; set; }

public void AddRole(int roleId)

{

_roles.Add(roleId);

}

public void RemoveRole(int roleId)

{

_roles.Remove(roleId);

}

public bool IsAvailable(int roleId)

{

return _roles.Contains(roleId);

}

}

В этом случае для добавления новых ресурсов и ролей вообще не требуется модификации кода логики авторизации, то есть ломать по сути остается нечего.

Что может помочь отловить ошибки времени выполнения? Ручное, автоматическое и юнит тестирование. Чем лучше организован процесс тестирования, тем больше защиты от того, что хрупкий код проявит себя на стороне клиента.

Часто хрупкость является оборотной стороной других признаков плохого дизайна, таких как Жесткость, Плохая Читабельность, Ненужная повторяемость.

Заключение

Мы попытались выделить и описать основные признаки проблемного дизайна. Некоторые их них взаимосвязаны. Нужно четко понимать, что проблемность дизайна не всегда неизбежно приводит к трудностям, она лишь указывает на вероятность их наступления. Чем меньше прослеживаются эти признаки, тем ниже эта вероятность.

|

Метки: author szolotarev проектирование и рефакторинг ооп c# .net solid design patterns |

[Из песочницы] Уязвимость ВКонтакте: отправляем сообщение с кодом восстановления страницы на чужой номер |

Обычным весенним днем, занимаясь «подготовкой» к ЕГЭ по информатике, наткнулся на статью об уязвимости Facebook, позволявшей взломать все аккаунты в социальной сети, за которую выплатили 15000$. Суть уязвимости заключалась в переборе кодов восстановления на тестовом домене компании. Я подумал, а чем собственно ВКонтакте хуже? И решил попробовать провернуть подобный трюк у них. Зная, что веб-версия уже достаточно хорошо исследована, жертвой должен был стать Android клиент, а что из этого вышло можно прочитать под катом.

Смотрим трафик

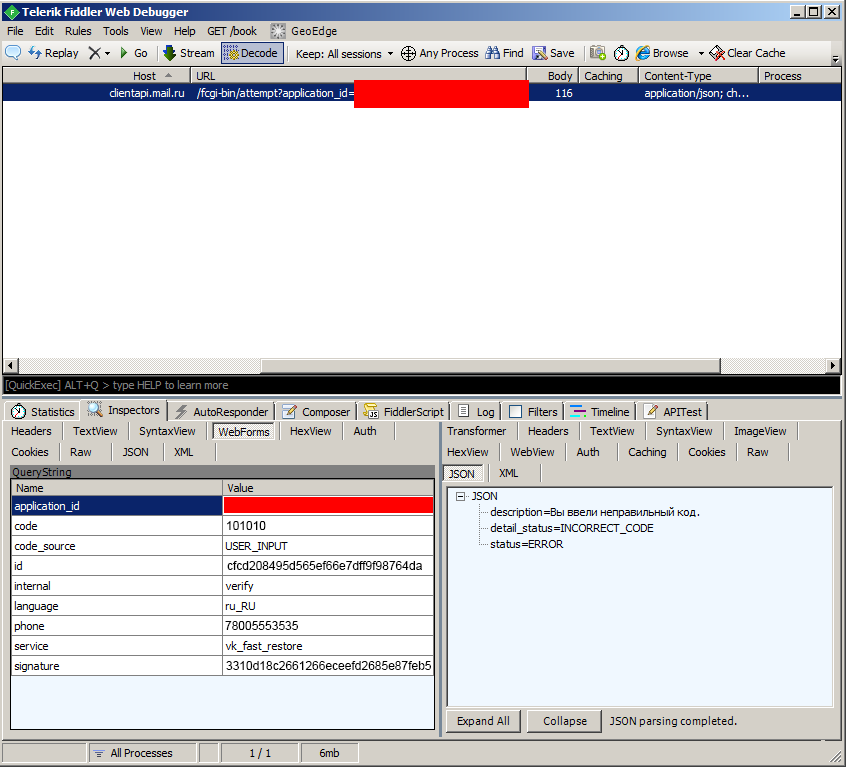

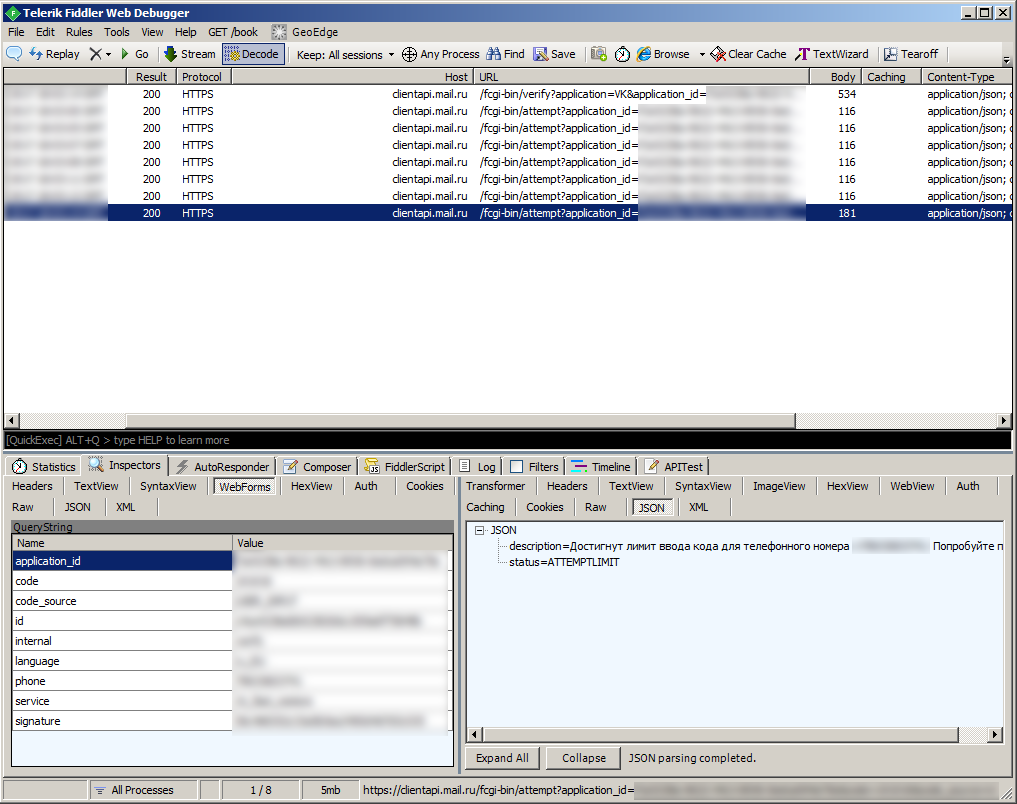

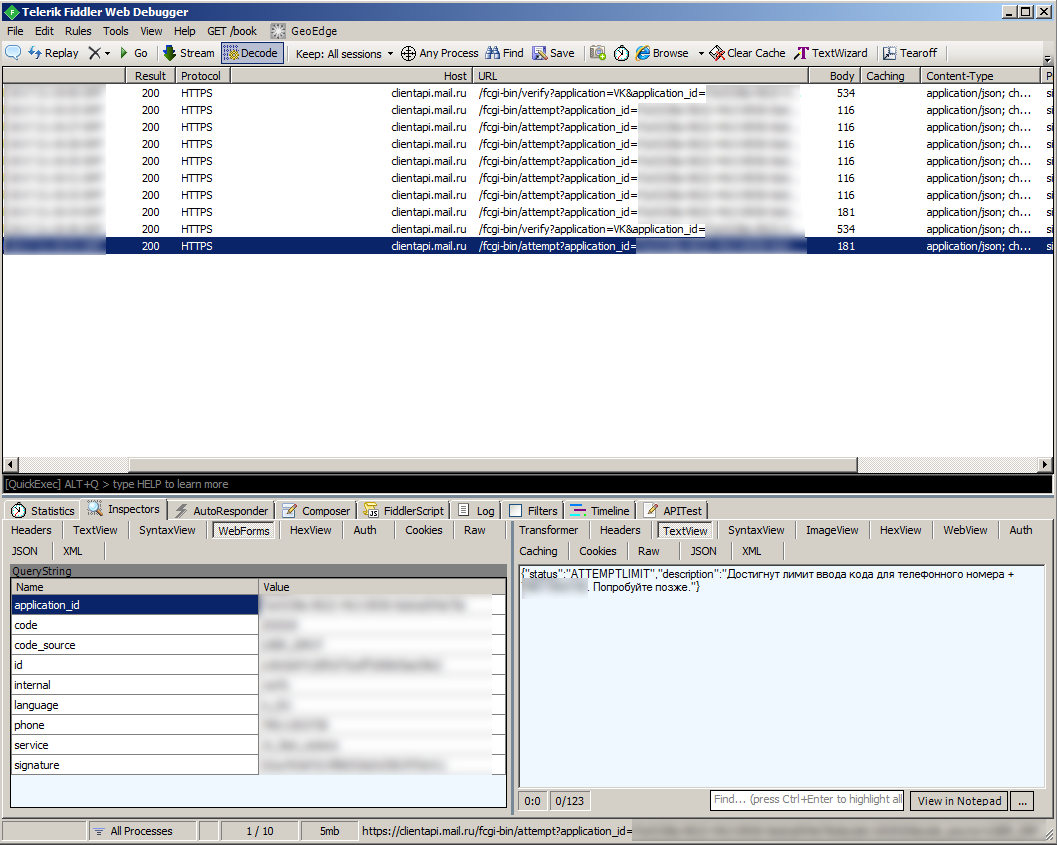

Первым делом я захотел узнать, какую информацию приложение передает в сеть во время процесса восстановления страницы. Помощником в этом деле выступил Fiddler, я настроил его и Android устройство, как написано в официальной документации. Таким образом в Fiddler становятся доступны все HTTP/HTTPS запросы c устройства. Теперь, в приложении, смело выходим из аккаунта ВКонтакте и нажимаем на кнопку «Забыли пароль?». После ввода номера телефона приложение отправляет 2 HTTPS запроса. Особую ценность представляет второй, потому что именно он отвечает за отправку SMS с кодом восстановления.

Особое внимание стоит обратить на некоторые параметры запроса:

phone — номер на который отправляется SMSПопытка отправить запрос изменив его не увенчалась успехом. Мешает параметр «signature», который выступает в роли «подписи», как она генерируется разберемся немного позже.

session_id — рандомно генерирующаяся сессия операции восстановления

Для последующего анализа, в приложении, введём случайный код восстановления и продолжим наблюдать за сетевой активностью. Видим следующий запрос, он проверяет правильность введенного кода. Так как код был случайным — проверка не пройдена.

Честно говоря на этом моменте мне хотелось начать перебирать коды восстановления, меняя значение параметра «code». К сожалению, и этот запрос защищен от изменения с помощью «signature». Придётся разобраться, как генерируется эта подпись.

Реверс инжиниринг: декомпиляция

Для первоначального анализа можно попробовать декомпилировать приложение ВКонтакте. Так можно получить некоторые части исходного кода на Java.

Открываем в jd-gui все полученные .jar файлы. И не долго думая, делаем поиск по строке «signature».

Библиотека libverify за авторством Mail.Ru явно выпадает из общего списка найденного. Смотрим и не ошибаемся, формируемая строка очень похожа на url из предыдущих запросов.

localObject3 = String.format(Locale.US, "%s%s?%s&signature=%s", new Object[] { d(), e(), localObject3, URLEncoder.encode(ru.mail.libverify.utils.m.b(f() + (String)localObject4 + ru.mail.libverify.utils.m.c(a.b())), "UTF-8") });Эта библиотека сделана в лучших традициях security through obscurity, весь код надежно обфусцирован. Поэтому, через jd-gui мне удалось узнать только то, что за «signature» прячется MD5-хэш от неизвестной строки.

Реверс инжиниринг: дизассемблирование