Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Пять главных аспектов плохой безопасности интернета вещей |

Рынок безопасности интернета вещей к 2021 году достигнет $37 млрд, согласно аналитическому отчёту Marketsandmarkets.com. Где разрастается хаос в сфере кибербезопасности, там и тратятся большие деньги на обеспечение этой безопасности.

В начале 2017 года эксперты предсказывали, что зияющие в IoT бреши приведут к разрушению критически важной инфраструктуры, росту конкурентной разведки и краж интеллектуальной собственности. Также прогнозировалось, что многократное увеличение DDoS-атак парализует Dyn DNS-систему, а с ней и многие важные веб-домены.

Давайте рассмотрим пять основных аспектов плачевного состояния IoT-безопасности, вытекающего из взрывного роста, масштабов, уязвимости, ёмкости и доступности устройств.

Первый аспект

Сегодня ежедневно в сеть выходят не менее 6 миллионов новых IoT-устройств, что означает постоянное появление всё новых уязвимостей. К примеру, в прошлом году на DefCon в 23 IoT-устройствах 21 производителя обнаружили 47 новых уязвимостей. Учитывая, что в одном устройстве обычно по несколько дыр, то ситуация складывается плачевная.

Уязвимость IoT-устройств обусловлена несколькими факторами: отсутствием у производителей достаточного опыта по обеспечению надёжной защиты своей продукции; скромные вычислительные и дисковые мощности, ограничивающие спектр доступных механизмов безопасности; непростые процедуры обновления ПО; отсутствие пользовательского внимания к угрозам, провоцируемым IoT-устройствами.

Второй аспект

IoT-устройства — очень привлекательная, мощная, и повсеместно распространённая среда для злоумышленников. Растущее количество легко взламываемых потребительских устройств повышает вероятность, частоту и тяжесть сценариев атак, включая атаки на корпоративные данные, предприятия, оборудование, сотрудников и потребителей.

Для атакующего несложно получить контроль над целыми сетями, начав с компрометации одного из многочисленных уязвимых потребительских IoT-устройств. Яркий пример — популярный термостат NEST. В 2015-м инженеры компании TrapX Security подключились к miniUSB-порту термостата и провели атаку man-in-the-middle (MITM), в ходе которой с помощью специального приложения заспуфили ARP-адрес сетевого шлюза. Хакеры используют MITM-атаки для получения контроля над системами на одном или обоих концах коммуникаций, включая корпоративные сети.

Описанная дыра — лишь один из множества примеров того, как вроде бы невинные IoT-устройства могут стать причиной компрометации целых сетей и организаций, краж, а возможно и возможно и нарушения текущих процессов. Обретя контроль над IoT-сетью дома или в организации, хакеры могут не только украсть данные, но поставить под угрозу жизнь, здоровье и собственность.

Третий аспект

IoT — ключ к огромным массивам персональной пользовательской информации, которая помогает хакерам в выборе целей и векторов атак. Им становится проще подобрать пароли, используемые в ключевых компаниях, правительственных, военных, политических и общественных организациях.

Пользовательские данные собираются в интернете вещей, чтобы помочь компаниям проводить целевой маркетинг путём создания цифрового представления всех пользовательских предпочтений и особенностей. Злоумышленники похищают и комбинируют данные из разных источников, чтобы выявить интересы и привычки людей, благодаря чему можно подобрать пароли и ответы на секретные вопросы. При этом люди зачастую используют свои привычные пароли и в корпоративных сетях.

Четвертый аспект

Увеличение доступности SCADA и управления промышленными системами посредством IoT делает возможными широкие опустошительные атаки. Когда промышленные управляющие системы на базе IoT подключены к интернету, то становится крайне тяжело защитить от атак национальную инфраструктуру — объекты коммунального хозяйства, энергосистемы и так далее.

В качестве примера такого сценария можно вспомнить недавнюю атаку на украинские энергообъекты, в результате которой без электричества остались десятки тысяч человек. В данном случае объектом атаки стала система управления критически важной инфраструктурой, что привело к её выходу из строя. И это была довольно небольшая по своим масштабам и последствиям атака.

Пятый аспект

Распространённый и по большей части открытый IoT позволяет сегодня как никогда легко проводить одновременные атаки “Fire Sale” на любое агентство, сервис или предприятие, как показано в фильме «Крепкий орешек 4». Благодаря интернету вещей хакеры могут создавать и использовать настолько большие ботнеты, что одновременное глушение многочисленных инфраструктур с помощью DDoS-атак превращается чуть ли не в рутину.

Представьте, что будет, если 10-15% устройств какой-то страны использовать для DDoS-атаки против ресурсов одного из мировых финансовых центров, например, Уолл Стрит.

Согласно прогнозу Gartner, с 5,5 млн IoT-устройств в 2016 году, к 2020-му мы придём к общему парку в 20,8 млрд устройств, работающих ежедневно. Чтобы обезопасить это оборудование, компании должны в первую очередь сопоставлять удобство и эффективность с рисками, внедрять политики и процедуры безопасности, разработанные для каждого типа устройств, и обучать персонал правильной работе с интернетом вещей. Технологии DS/IPS-безопасности, учитывающие поведенческий фактор, тоже должны стоять на страже потенциально зловредного поведения IoT-устройств.

Когда компания устанавливает и использует потребительские устройства вроде того же термостата NEST, то она должна внедрять и новые файрволы второй генерации, позволяющие подключаться только по определённым IP-адресам, применять политики безопасности к конечным точкам второй генерации, а также технологии маскировки. Появление в домах уязвимых устройств и возможные последствия этой тенденции являются важной причиной для просвещения сотрудников о рисках.

Не имеет значения, как злоумышленники подбирают пароли и ответы на секретные вопросы: можно защититься с помощью дополнительной аутентификации. Например, использовать PINы и отправлять коды на почту. Сами компании должны адаптироваться к изменениям в подходах к подбору паролей. Для этого нужны профессионалы, осознающие риски новой технологии, и постоянное обновление программно-аппаратной инфраструктуры (без привнесения новых рисков).

Тяжело обезопасить SCADA и промышленные легаси-системы управления, потому что подобные системы тяготеют к закрытости при отсутствии даже базовых механизмов обеспечения кибербезопасности. Как минимум, компании должны изолировать их в своих сетях, плотно мониторить и регулировать доступ к ним. Промышленные системы управления имеют высокие требования по доступности. Это означает, что простой при обновлениях недопустим. В идеальном мире подобные системы должны дополняться совершенной защитой и быть изолированными от интернета.

Как и при отражении “Fire Sale”-атак, защита IoT от DDoS-атак включает в себя обеспечение безопасности устройств из расчёта враждебности сети, и обеспечение безопасности сети из расчёта враждебности отдельных устройств. Такой подход согласуется с моделью безопасности, подразумевающую нулевое доверие к минимальным привилегиям.

Организации могут защищаться от хакеров, использующих IoT-ботнеты, ужесточая безопасность в сетях, содержащих IoT-устройства. Но для этого необходимо тщательно тестировать имеющиеся инструменты, насколько эффективно они защищают. С помощью новых технологий маскировки можно будет обнаруживать злоумышленников.

Что начать делать?

Будущее обеспечения безопасности интернета вещей не безоблачно, но и не безнадёжно. Уже сейчас хорошо бы начать делать следующие шаги:

• Регуляторы должны штрафовать компании, продающие оборудование с проблемами в безопасности, пока они не отзовут и не внесут исправления в свои продукты.

• Законодатели должны ввести законы, требующие периодически возвращать ПО IoT-устройств в исходное состояние. Это позволит периодически избавляться от зловредов, используемых для проникновения в сети.

• Наконец, новое оборудование может использовать ограниченный диапазон IPv6-адресов, чтобы тем, кто оказался под атакой ботнетов, было легче заставить своего провайдера отклонять все пакеты, исходящие от IoT-устройств.

|

Метки: author SmirkinDA разработка робототехники разработка для интернета вещей информационная безопасность блог компании parallels iot parallels security интернет вещей |

[Из песочницы] GraphQL запросы. От простого к более сложному |

Привет Мир! Много было сказано о сути GraphQL, но гораздо меньше о самих запросах. От простого к более сложному, я раскрою тему. Заинтересованным, — добро пожаловать под кат.

Если кто то не знаком с GraphQL, наберитесь терпения и ознакомьтесь с моими вводными туториалами или статьями на Хабре. Так будет гораздо проще разобраться с запросами.

- Tutorial: GraphQL server with Koa2 and MongoDB

- Tutorial: GraphQL subscriptions for real-time app

- Tutorial: GraphQL authentication, register, profile

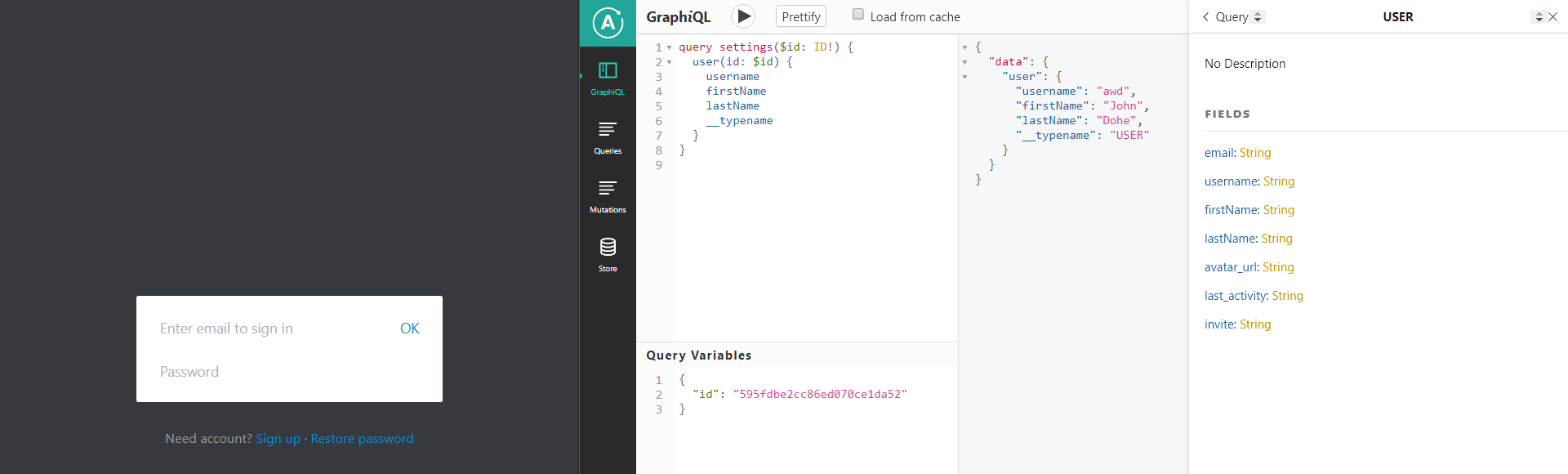

Среды тестирования

- GraphiQL — встроенный пакет для тестирования на сервере.

- Apollo Client Developer Tools — тот же GraphiQL завернутый в chrom расширение.

Запросы

После любых изменений на сервере, документация запросов будет обновляться, если кто не в курсе. Также будет автоматически подсвечивать о наличии ошибок.

Начнем с двух простых типов запросов, это Queries(получение данных) и Mutations(изменение данных).

Queries

Простым запросом можно обратились к полю

user и сказать, какие значения сервер должен вернуть: firstName и lastName.query myQuery{

user {

firstName

lastName

}

}При работе с GraphiQL, можно не указывать

query перед фигурными скобками. При этом, при написании запросов на клиенте, если вы НЕ укажите явно тип запроса, будет ошибка. Mutations

Для изменения данных необходимо указать, что именно мы хотим заменить и чем:

mutation myMutation{

UserCreate(data: {firstName: "Jane", lastName: "Dohe"})

}Queries выполняются асинхронно, а mutations — последовательно.

Subsciptions

У GraphQL есть третий тип — subscriptions(подписки).

subscriptions mySubscription{

user {

firstName

lastName

}

}Они полностью аналогичны queries и все что применимо к queries, подходит для subscriptions.

Пока все просто, но это не подходит для разработки проекта.

Аргументы

Аргументы позволяют сделать очевидные вещи — подставить свои значения и сделать запрос. Абсолютно не важно будет это queries, mutation или subscription.

Сначала определяем, какие аргументы нужно использовать. Далее, применяем их к полю запроса.

query myQuery($id: '1'){

user (id:$id){

firstName

lastName

}

}Такой запрос найдет пользователя с

id = '1' и вернет нам его firstName и lastName.Переменные

Здесь интересней, можно подставлять свои значения. На голом GraphiQL нужно определить переменную и обозначить ее тип, в полном соответствии с документацией.

query myQuery($id: ID){ // запрос

user (id:$id){

firstName

lastName

}

}

{

"id": "595fdbe2cc86ed070ce1da52" // переменные

}На рабочем проекте, это будет выглядеть так:

ID! — восклицательный знак в конце типа говорит GraphQL, что это поле обязательное.Простому юзеру, не нужно переживать о том, как сформировать запрос на клиенте. Для популярных JS фрейморков все уже готово: vue-apollo, react-apollo, apollo-angular.

Вложенные запросы

Вышеописанные подходы применим, когда искомое поле БД находится на первом уровне(без вложенностей). Пример модели на MongoDB:

// MongoDB schema

const schema = new mongoose.Schema({

firstName: {

type: String

},

lastName: {

type: String

},

})

export const USER_MODEL = mongoose.model('users', schema)

// GraphQL type

const user = {

firstName: {

type: GraphQLString

},

lastName: {

type: GraphQLString

},

}

export const USER = new GraphQLObjectType({

name: 'USER',

fields: user

})

Пример со вложенной схемой:

// MongoDB schema

const schema = new mongoose.Schema({

firstName: {

type: String

},

lastName: {

type: String

},

secure: {

public_key: {

type: String

},

private_key: {

type: String

},

},

})

. . .

const secure = new GraphQLObjectType({

name: "public_key",

fields: {

public_key: {

type: GraphQLString

}

}

})

export const USER = new GraphQLObjectType({

name: "USER",

fields: {

firstName: {

type: GraphQLID

},

secure: {

type: secure

}

}

})

Query запрос будет выглядит так:

query myQuery($id: ID){

user (id:$id){

firstName

secure {

public_key

}

}

}

Mutations + Queries

Мутации не обязательно должны возвращать булевские значения

true/false. Если на сервере в тип поля вместо GraphQLBolean указать тип из модели, то получиться следующее:mutation auth($email: String!, $password: String!) {

auth(email: $email, password: $password) {

id

secure {

public_key

}

}

}

Заключение

Я рассмотрел основные запросы, с которыми можно столкнуться в процессе разработки. Пишите свои предложения, пожелания в комментариях и жмите стрелку вверх, если статья оказалась полезной.

Спасибо за внимание.

|

Метки: author nikitamarcius0 node.js javascript graphql |

Pathfinder: как мы делаем интерфейс для CRPG |

Привет, Хабр! У нас в компании уже около года существует направление экспериментальных игровых разработок, и сегодня хотим рассказать об одной из них. Мы Owlcat Games, и в рамках кикстартерной компании разрабатываем игру Pathfinder: Kingmaker — это однопользовательская CRPG с изометрической графикой (привет, олдскульщики!). В этом посте расскажем о том, как мы делаем интерфейс для нашей игры.

Интерфейсы — очень большая часть игр жанра CRPG. В таких играх есть персонажи, навыки, умения, заклинания, характеристики — и это малая часть того, что требует внимания игрока. Неизбежна высокая насыщенность информацией, и наша задача — сделать так, чтобы таблицы цифр, формулы и бесконечные колонки текста обрели легкую и понятную форму. Мы постоянно балансируем между информативностью и тем, как это выглядит и насколько удобно этим пользоваться. Поэтому в работе над каждым интерфейсом мы руководствуемся двумя основными принципами: удобство и погружение. Причем в самом начале пути мы решили отдавать предпочтение погружению там, где эти два принципа будут конфликтовать и при этом не найдется хорошего компромисса.

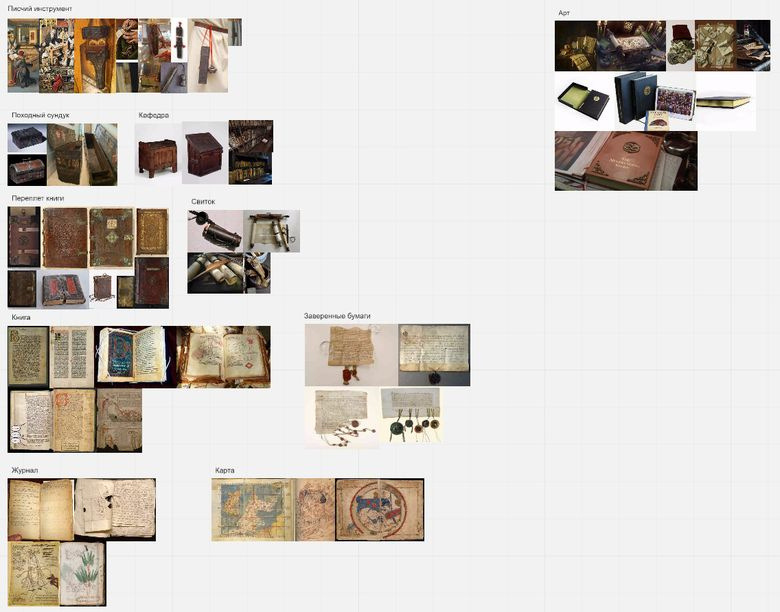

Для реализации принципа «погружение» до начала работы над оформлением интерфейсов мы смотрим на реальные вещи той эпохи, которая ближе всего подходит к Pathfinder: Kingmaker. Это могут быть старые книги, свитки, сундуки, поясные кошельки и книги, письменные инструменты и кафедры, карты и походные журналы. Все это находит отражение в интерфейсах.

- The NeverEnding Story (1984) — IMDb

- Scroll of the Masters (Fate Reforged) — Gatherer — Magic: The Gathering

- Deepwater Metal Coins (60) — The Broken Token

- Art of Cornelis Norbertus Gysbrechts

- Dragon Age — The World of Thedas Volume 02 Limited Edition HC (Hardcover Book)

- Medieval Books and Maps

- Wallace family prayer book. Page 1. Copyright Richard Wallace

- Voynich manuscript

- H. P. Lovecraft art

- Art of Gabriel M"alesskircher

- The Temptation of St. Anthony

- Rogier van der Weyden

- Une rose pour loyer by Ellis Peters

Для реализации принципа «удобство» нам помогают UX-исследования и правильно построенный pipeline производства.

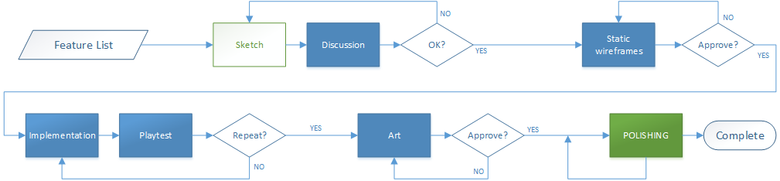

Итак, давайте поговорим о том, как же мы ведем нашу работу. Каждый интерфейс — от больших, насыщенных окон до маленьких тултипов — проходит несколько этапов и итераций.

Мы придерживаемся следующей схемы работы. Вначале тщательно анализируем будущий контент и делаем первые наброски, которые представляем команде. Далее разрабатываем схемы взаимодействия и на основе этого создаем первые static wireframes, т. е. фактически «чертеж» интерфейса, чтобы понять, как он будет выглядеть, оценить информативность и компоновку элементов. Как правило, за этим следует горячее обсуждение. Например, наш геймдизайнер хочет видеть больше цифр, ВЕЗДЕ, чем больше цифр — тем лучше. При этом технический художник упорно настаивает на том, чтобы интерфейс был максимально атмосферным, а с информацией — как пойдет. И отказать ему бывает сложно. В общем, лавируя между мнениями, как Одиссей между Сциллой и Харибдой, мы находим удовлетворяющий всех баланс. Далее — реализация функционала, арт и плейтесты, после них — снова доработка функционала и арта. И так до того момента, пока результат не удовлетворит всю команду и игроков на фокус- и UX-тестах.

Внутри команды иногда бывает сложно оценить результат работы. Специально для этого мы проводим UX-исследования, привлекая и активных членов сообщества Pathfinder Society, и людей, которые просто любят игры в целом и CRPG в частности. Исследования помогают нам реализовывать принцип «удобство». Для первого тестирования в начале марта этого года мы пригласили своих коллег и друзей, отчасти — чтобы похвастаться, отчасти — для экспертной оценки. И хотя версия была довольно сырой и неполной, мы смогли получить много материала для анализа.

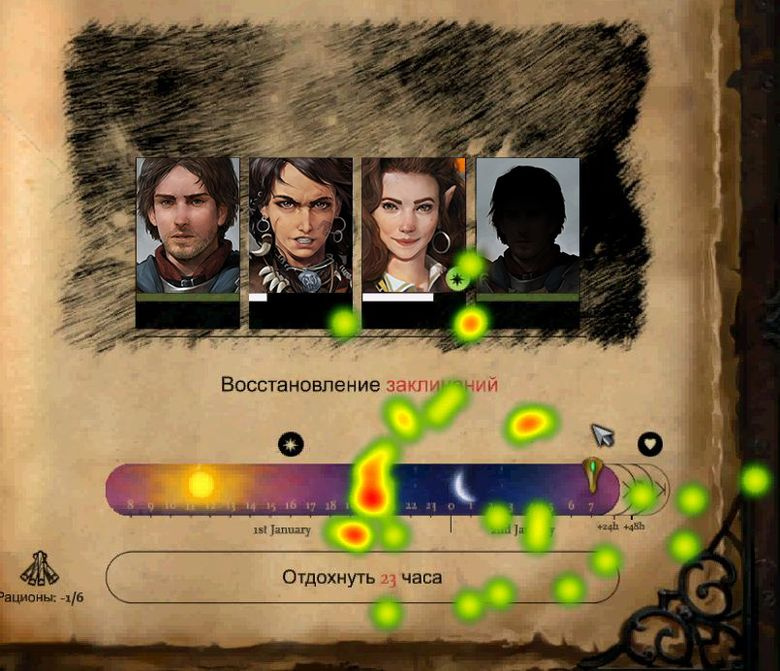

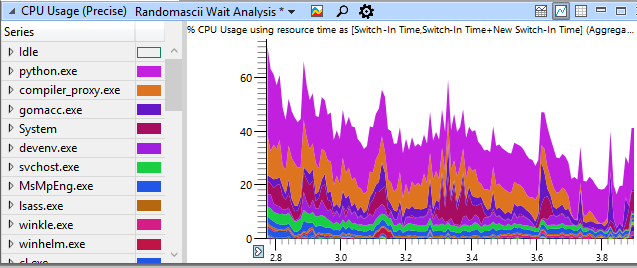

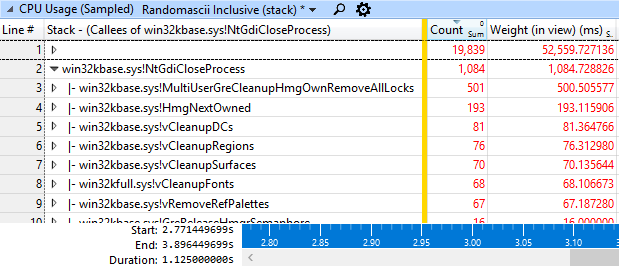

Heat map интерфейса Rest

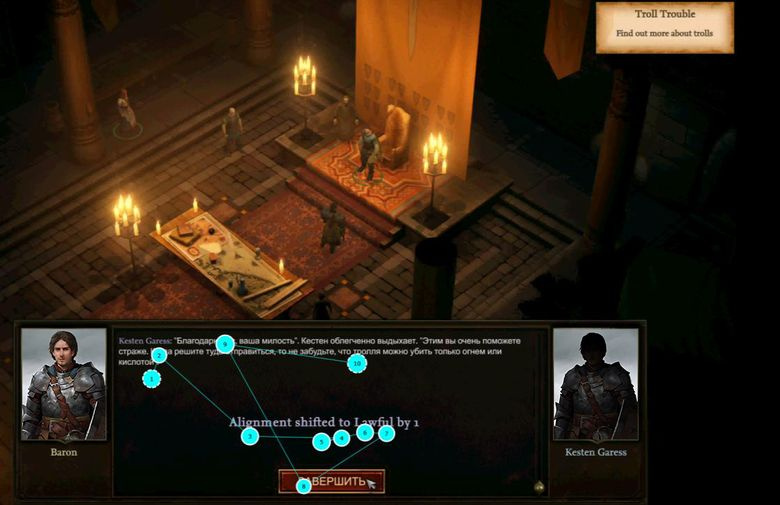

Eye tracking в диалоге

Heat map боевки

По результатам последнего исследования был составлен отчет на 66 страницах. При его разборе появилось более сотни уникальных задач. Часть из них выявила очевидные проблемы, а часть показала, что наши решения не всегда работают так, как мы ожидали. Например, при анализе интерфейса Rest мы обнаружили следующие проблемы (см. Heat map интерфейса Rest). Респонденты не понимали:

- что можно навести курсор мыши на иконку статуса и получить подсказку;

- как отдохнуть до полного восстановления здоровья;

- сколько еды требуется для полного восстановления здоровья персонажей;

- сколько реального времени уйдет на восстановление.

Вскоре мы будем проводить следующее исследование, в нем хотим сделать упор не на интерфейс, а на прохождение и ощущения, которые игрок испытывает при этом.

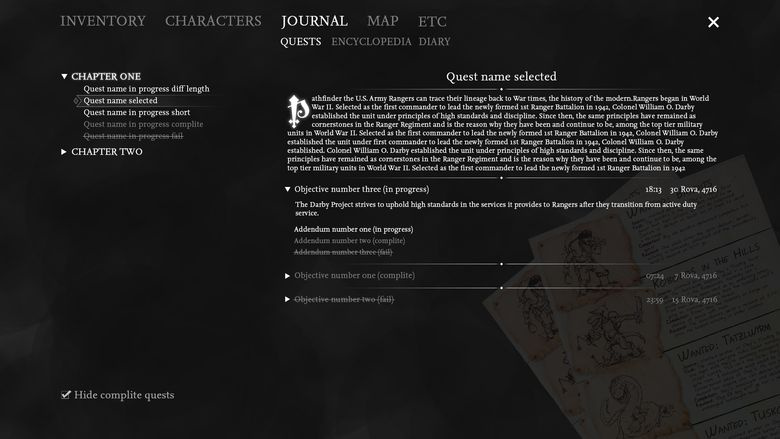

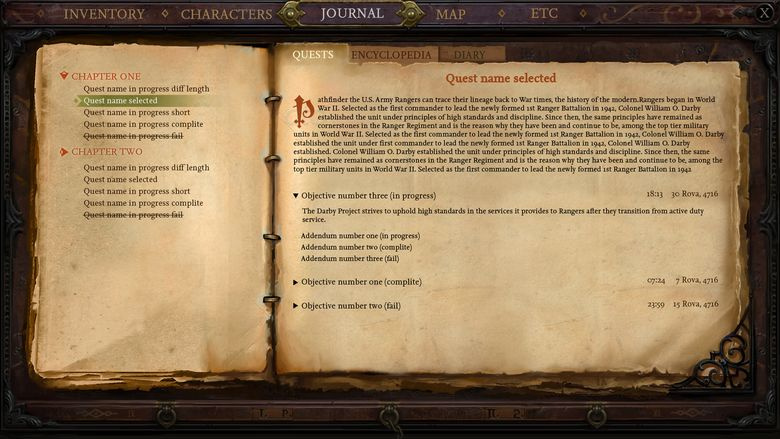

Одним из наших первых интерфейсов был журнал заданий. В нем мы экспериментировали и с формой, и с содержанием. И если с содержанием все оказалось более-менее понятно (список заданий, их описание и т. д.), то с формой было не так просто.

Скетч журнала

Поиски

В итоге мы пришли к следующему варианту, который и будем развивать в дальнейшем.

Благодаря интерфейсу журнала заданий мы создали концепцию полноэкранного интерфейса для системных окон и нашли свой стиль.

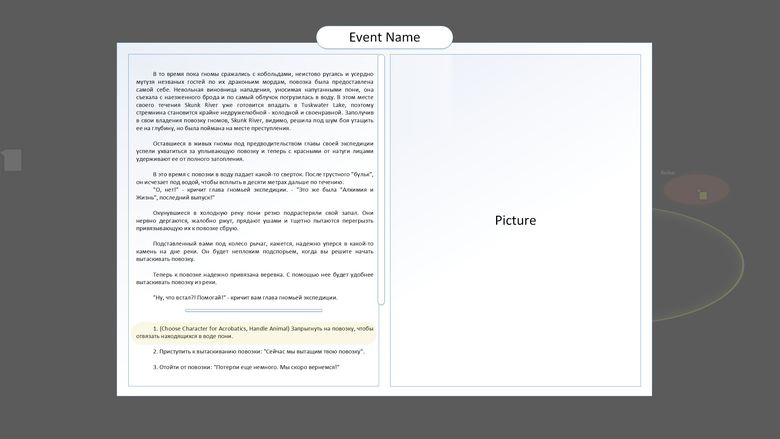

Следующим большим интерфейсом, о котором хочется рассказать, стал интерфейс текстовых событий, который внутри студии мы называем BookEvent. С виду все просто: текст, варианты ответов, картинка.

Но на деле все оказалось несколько сложней. Поиски были долгими и нелегкими.

В итоге, найдя форму, мы начали экспериментировать с содержанием.

И вот что у нас получилось в конце. Кажется, неплохо.

Но работа не заканчивается никогда, всегда есть возможность улучшить как арт, так и UX в целом.

И напоследок. Отдельным вызовом был основной шрифт. Мы устроили целое состязание, с финалистами и призовыми местами. Критериями отбора были поддержка разных языковых групп, варианты начертания, удобочитаемость (строчными и капителью), емкость, цифры и, самое главное, подходит шрифт к нашей игре или нет. Может ли он передать дух путешествия и приключений.

В итоге мы остановились на Book Antiqua. Он нам показался компромиссом между всеми требованиями.

Мы хотим, чтобы наша игра всеми своими сторонами показывала, что мы знаем и любим Pathfinder. И интерфейс как никакая другая часть игры помогает нам в этом.

|

Метки: author Barka дизайн игр usability блог компании mail.ru group mail.ru pathfinder |

Проблема непрерывной защиты веб-приложений. Взгляд со стороны исследователей и эксплуатантов. Часть 2 |

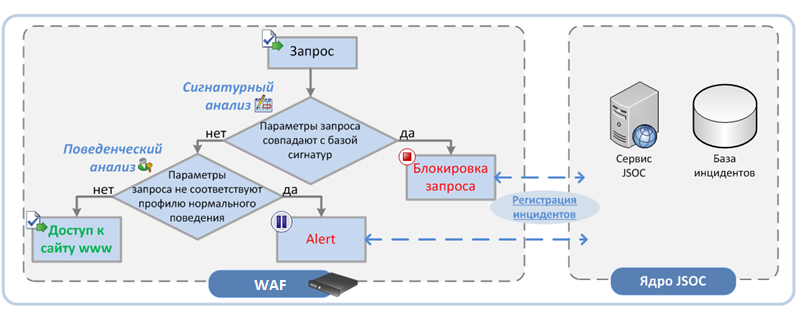

Одним из наиболее важных аспектов, связанных с WAF, помимо выбора вендора и внедрения продукта, является дальнейшая эксплуатация. При этом классический подход к эксплуатации Web Application Firewall подходит очень условно и имеет ряд важных особенностей.

Во-первых, в силу расположения WAF и типа защищаемых им ресурсов, оперативное обновление сигнатур и установка патчей на нем – намного более приоритетная задача, чем в случае с другим оборудованием. Веб-сайт всегда «торчит» наружу, что делает его особо уязвимым для различных вновь публикуемых уязвимостей. Промедление на несколько дней может грозить серьезными потерями и взломом защищаемого ресурса. Вендоры выпускают сигнатуры оперативно, но процесс их запуска в режим блокировки обычно проходит в несколько этапов. Сначала проходит процедура обучения, когда мы наблюдаем за количеством сработок и анализируем пакеты, на которые сигнатура сработала. Далее осуществляется ее перевод в другой режим. Но в случае критичных уязвимостей требуется либо сразу перевести сигнатуру в блок, либо, не дожидаясь обновления вендора, написать сигнатуру самостоятельно.

Во-вторых, с WAF на передний план выходит проактивная эксплуатация – реагирование на инциденты в режиме, близком к онлайн, анализ и оперативный тюнинг политик и профилей. Это особенно актуально в случае гибридного режима работы, когда часть сработок не блокируется, а лишь фиксируется WAF`ом. Делается это для минимизации рисков блокировки легитимных запросов.

В-третьих, в силу сокращения релизного цикла проблема динамического контента и профилирования требует наличия специалистов по эксплуатации, работающих в режиме full-time.

Эксплуатация WAF

Что же входит в задачи эксплуатации? Я выделил четыре основных направления:

- Обновление – отслеживание патчей, в том числе закрывающих ошибки. Об этом было сказано выше, поэтому двигаемся дальше.

- Написание частных сигнатур:

- Отслеживание новых критичных сигнатур, совместные с заказчиком тестирование и подготовка контрмер на период, пока не выпущены официальные обновления (если нет возможности написать кастомные).

- написание сигнатур в качестве компенсационных мер по закрытию уязвимостей исходного кода приложений:

- уязвимости, известные разработчикам, закрытие которых требует масштабных доработок исходного кода;

- уязвимости, выявленные в результате анализа исходного кода приложений.

- Профилирование запросов, обращений к страницам сайта, приложению.

- Validation – проверка и анализ параметров запросов/ответов на защищаемый ресурс/приложение.

При этом лишь первый из перечисленных выше пунктов можно выполнять автономно от отдела разработки. Все остальные функции эксплуатации неразрывно связаны с разработчиками защищаемого веб-сайта или приложения. Не менее важную роль играет тестирование собранных профилей и созданных политик, в том числе в режиме блокировки запросов.

Думаю, не вызывает сомнений то, что вариант «пришел-настроил-включил-работает» в 99% случаев не жизнеспособен и не работает на динамически изменяющемся контенте. Исключения составляют те заказчики, которые включают блокировку запросов по статическим сигнатурам, исключают тестирование обновлений, прилетающих на WAF и сразу «накатывают» их в продакшн. То есть если мы не говорим об обучающем функционале WAF, цикле обновлений, установки патчей по RFC, создания политики под конкретный защищаемый ресурс – возможно вам и не требуется специалист на full time или сервис по эксплуатации.

Режим работы WAF

Первый вариант: только блокирование – по сигнатурам и профилю. Здесь надо учитывать два момента: 1) есть достаточно высокий риск заблокировать легитимные запросы; 2) и, наоборот, WAF может пропустить запросы, эксплуатирующие уязвимости и дыры. Может случиться так, что при масштабном сканировании 99,9% запросов будет заблокировано, а 0,1% пройдет, но и этого будет достаточно для успешной атаки. По факту анализа 0,1 % пишутся и добавляются в блок новые кастомные сигнатуры.

Второй вариант: только уведомление. В этом случае по факту срабатывания сигнатур необходимо проводить комплексное расследование и коррелировать данные с другими источниками, например, с базами данных в случае использования SQL-инъекций. Учитывая огромный объем срабатываний WAF, проанализировать их все вручную практически невозможно.

Именно поэтому чаще всего используется третий вариант – гибридный.

В этом случае осуществляется анализ срабатываний статических сигнатур, и при отсутствии либо минимальном количестве ложных срабатываний они переводятся в режим блокировки.

Параллельно аналитики профилируют работу сайта и активностей пользователей с целью дальнейшего выявления аномалий. Здесь следует отметить, что перевод политики, созданной на основе профиля сайта, в блокирующий режим невозможен без серьезной аналитики и взаимодействия с разработкой. Иначе это грозит блокировкой легитимных запросов, что обернется для заказчика репутационными потерями.

При этом в силу как динамического контента, так и вновь возникающих ситуаций, связанных с активностями клиентов, доработка политики, кастомных сигнатур, списка исключений не заканчивается никогда – это непрерывный процесс.

Ниже пример настройки групп сигнатур одного из наших клиентов. В рамках оказания сервиса мы подключили WAF и логи веб-сервера (IIS) к SIEM-системе Solar JSOC. Критичные сигнатуры ставятся в блокирующий режим, логируются и добавляются в список обучения, на тот случай, если необходимо будет внести исключения:

Настройки параметров контента:

Неправильные заголовки запросов пока не блокируются, но идет обучение и происходит логирование таких запросов:

Какой бы вариант вы ни выбрали, важно помнить о необходимости анализировать как запросы, вызвавшие срабатывания, так и пропущенные запросы к приложению. Причем заставлять WAF логировать пропущенные запросы – довольно трудоемко с точки зрения нагрузки, поэтому целесообразнее смотреть на логи самого приложения или веб-сервера.

Кастомные сигнатуры

Одним из важнейших моментов в эксплуатации Web Application Firewall является написание кастомных сигнатур. Требуется это в нескольких случаях: появление новой уязвимости, регистрация аномалий, требующих дополнительного анализа, и сбор долговременной статистики аутентификации в приложении.

В случае появления серьезной уязвимости, какой, например, была shellshock, требуется оперативная доработка политики. Обычно служба эксплуатации WAF может реализовать ее в течение 1-2 часов, в то время как вендору может потребоваться до нескольких суток. Промедление в таких ситуациях грозит успешной эксплуатацией уязвимости, так как злоумышленники работают практически мгновенно, запуская сканирование всех белых адресов в интернете на подверженность уязвимости.

Примером выявления аномалий с помощью ручного анализа служит сбор статистики по большому объему отдаваемого и получаемого трафика. В общем случае большой объем сессии не говорит об инциденте, но при просмотре общей статистики можно найти действительно важные срабатывания. Аналогично с мониторингом загрузок файлов с нестандартными расширениями – в общем случае блокировка таких вложений нецелесообразна, но их анализ, в том числе с использованием песочницы, является рекомендуемым.

Работа с динамическим контентом

Правильный цикл работы с постоянно изменяющимся контентом, как мне кажется, должен выглядеть следующим образом:

- Сформированная политика выгружается с боевого сервера в тестовую среду.

- В процессе тестирования обновленного контента одновременно тестируется совместимость с текущей политикой WAF, в случае необходимости производится ее корректировка.

- В идеальной схеме обновление приложения или сервиса тестируется на пилотной группе (регионе). На этом этапе политика WAF переводится в блокирующий режим и тестируется в боевых условиях. Так же осуществляется тюнинг и тонкая настройка конфигурации политики.

- Далее обновление и политика применяется глобально ко всем клиентам заказчика и становится эталонной до следующего обновления.

В идеальном мире есть предпродуктивные среды, функциональные и нагрузочные тесты длительностью примерно в 2 недели. Но жизнь иногда расставляет все по-другому. Примерно в 30% случаев нам приходится работать с сокращенным режимом разработки приложений и веб-сайтов у заказчиков, когда обновление сразу «накатывается» на продуктивные серверы. В этом случае необходимо оперативно подстроить политику WAF под новые условия работы. Для этого профилирование запускается на короткий промежуток времени – полдня-день. Из-за большого объема трафика этого зачастую достаточно для обучения. Спустя это время «допрофилированная» обновленная политика переводится в блокирующий режим.

Оба метода требуют дополнительного внимания со стороны службы эксплуатации в период перевода в блокирующий режим. Это делается для ручного анализа заблокированных запросов, так как никакая интеллектуальная система обучения и профилирования не может работать идеально без ложноположительных срабатываний.

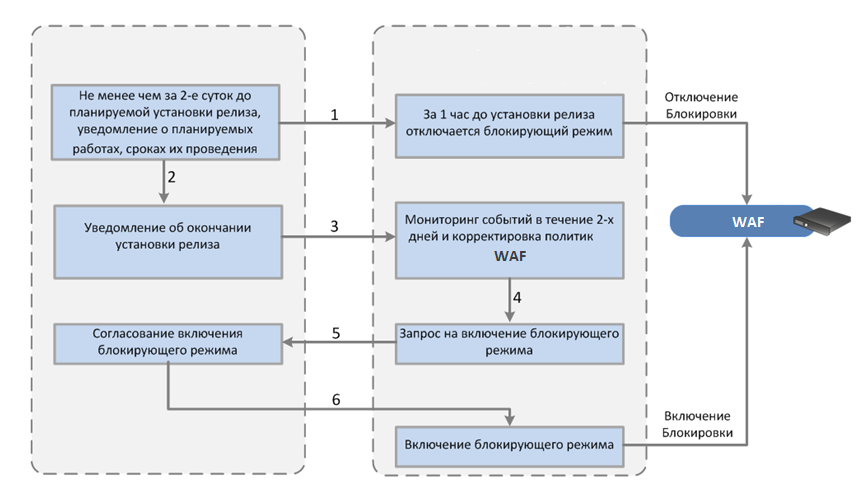

Вот два ярких примера цикла разработки у наших клиентов:

Первый случай – заказчик выпускает один релиз в неделю. При этом взаимодействие между заказчиком и подрядчиком не предусматривает детального release notes, по которому можно понять, нужна ли корректировка политики. Единственный вариант – работа «на горячую» с коротким и оперативным циклом тюнинга политики WAF:

В другом нашем клиенте часть сайта меняется несколько раз в день в рамках размещения новых продуктов, акций и т.д. Включать на эту часть контента сайта какое-либо профилирование и блокирование по собранному профилю невозможно. Поэтому по ней мы работаем в режиме мониторинга аномалий и создания кастомных сигнатур.

Интеграция WAF с SIEM: как правильно и что нужно?

Если компания использует собственный или аутсорсинговый Security Operations Center, подключение WAF к SIEM-системе позволит наладить оперативное уведомление и разбор по всем типам инцидентов, в том числе и веб-атакам, из одной точки – SIEM-системы.

Для фиксации и дальнейшего расследования инцидентов в SIEM-системе необходимо подключение следующих источников:

- Непосредственно сам WAF.

- Логи веб-сервера. Как и говорилось выше, включение логирования всех запросов на WAF может вызвать чрезмерную нагрузку, поэтому проще подключить журналирование на IIS или Apache.

- Логи приложения, защищаемого WAF, для отслеживания запросов.

- Логи БД для отслеживания запросов.

Важным моментом в сборе логов веб-сервера или приложения является не только полнота сбора информации, но и анализ ретроспективы. SIEM-системы заточены под хранение больших объемов данных с возможностью быстрого поиска по ретроспективе с глубиной в несколько месяцев, в том числе с помощью регулярных выражений по запросам. Это еще один весомый аргумент в пользу интеграции WAF с SIEM.

При подключении WAF необходимо понимать, какие поля, заголовки и метаданные пригодятся в расследовании инцидентов. В качестве примера рассмотрим подключение F5 ASM к ArcSight.

Из необходимых полей стоит выделить:

Дата и время фиксации события

Имя сигнатуры – для примера, «Illegal request length»

Тип атаки – для примера, «Session Hijacking»

Запрашиваемый URL:

/login?_*********=/sitebuilder/****/myaccount/login/*******formМетод запроса – GET, POST, etc.

Адрес, с которого пришел запрос

Адрес, на который пришел запрос

Протокол соединения

Код ответа сайта

Имя политики, по которой сработала сигнатура

Дата и время применения этой политики

Несмотря на ограничение в 1024 символа в customstring-полях ArcSight, мы «замапили» туда весь запрос, анализ которого очень часто пригождается в расследовании:

Специалисты первой линии мониторинга обрабатывают потенциальные инциденты, настроенные по различным сценариям:

- Аномальное количество различных сработавщих на WAF сигнатур с внешнего хоста – потенциальное сканирование на уязвимости.

- Срабатывание сигнатур в течение нескольких дней подряд с одного внешнего хоста – медленное сканирование.

- Срабатывание порогового значения сигнатур за короткий промежуток времени с разных хостов – распределенное сканирование/DDoS уровня приложения.

- Попытка эксплуатации критичной уязвимости. В случае сработки этого сценария, наши специалисты, совместно с заказчиками, анализируют не только логи WAF, но и успешные запросы с того же адреса на веб-сайт. Далее, по результатам анализа и при возникшей необходимости, происходит доработка политики WAF.

После того как специалисты первой линии оповестят службу эксплуатации WAF, последние имеют возможность подключиться уже к интерфейсу СЗИ и в режиме реального времени «тюнить» политики для противодействия атаке. Подключение к SIEM-системе позволяет не только наладить оперативное оповещение о потенциальных инцидентах, но и обогащать информацию об атаках сведениями из других систем, а также производить сложную корреляцию по цепочкам событий. Например, для понимания успешности атаки информацию с Web Application Firewall можно коррелировать с запросами в SQL-базах данных или локальными логами веб-сервера.

Наш подход к обработке инцидентов:

Например, в одном из наших заказчиков ключевым бизнес-компонентом является интернет-магазин. Все существующие бизнес-процессы «завязаны» на логику работы с клиентами и обработку заказов. В качестве программы лояльности компания использует виртуальные баллы, которые могут применяться для расчета с магазином, в том числе частичного. Клиент при оформлении покупки на этапе выбора способа оплаты имеет возможность ввести в поле число баллов, которое будет использовано вместо реальных денег.

Заказчику необходимо контролировать подозрительные операции – слишком большое количество списанных бонусов или транзакций с бонусами за определенное время. В качестве инструмента для сбора сводной статистики используется отдельная таблица (Active List в ArcSight). Ежедневная выгрузка из этого листа отправляется аналитику для изучения аномалий, не попадающих в текущие корреляционные срабатывания.

В одной из таких выгрузок была обнаружена запись:

modify_order_bonus ":"{\"bonusAvailable\":18.0,\"bonus\":-20000}" reason: success

При разборе этой аномалии выяснилось, что один из клиентов пытался POST-запросами, содержащими различные вариации требуемых к списанию бонусов, обмануть логику веб-сайта. И добился своего! При отправке отрицательного значения система сравнивала количество имеющихся бонусов с числом бонусов к списанию и при выполнении математического неравенства одобряла процесс.

Но и это еще не все: при дальнейшей обработке заказа в специализированных системах, куда передавалась информация с веб-сайта, значение требуемых к списанию бонусов бралось по модулю! Так клиент успешно получил скидку в 20 тысяч рублей при наличии на счету 18 баллов.

Web Application Firewall не увидел ничего аномального, так как структура запроса была правильной, и количество запросов не было подозрительным. Лишь последующий сбор статистики и просмотр событий глазами живого аналитика позволил выявить успешную попытку мошенничества в ключевом бизнес-приложении клиента.

Отсюда можно сделать следующий вывод: любые важные запросы к ключевому приложению, такие как списание баллов, денежных средств и пр., необходимо логировать с помощью настроек кастомных политик на WAF либо с помощью подключения логов приложения и дальнейшего анализа в SIEM-системе.

Защита окружения приложений

Далеко не все хакеры атакуют приложение «в лоб». В части случаев значительно проще проникнуть в инфраструктуру компании и атаковать приложение или его базу изнутри, чтобы вносить изменения напрямую. Помимо этого, существуют внутренние злоумышленники, в том числе имеющие доступ к приложению, и за ними необходим не меньший контроль.

Решить эту задачу силами WAF невозможно, это работа для SIEM-системы. Кейс по защите ключевого приложения решается комплексно и обычно к подключаемым в SIEM источникам относятся:

- Логи операционных систем серверов приложений, баз данных, вспомогательных систем, терминальных серверов.

- Логи межсетевых экранов, отделяющих сегмент приложения от остальных.

- Логи WAF.

- Логи приложения (front-end, back-end).

- Логи веб-серверов.

- Логи базы данных приложения, хотя бы на уровне аутентификации, а лучше – на уровне запросов в саму базу.

- Логи VPN в случае работы подрядчиков с приложением через удаленные соединения.

Далее происходит анализ текущих рисков и векторов потенциальных атак, мошеннических операций и нарушений в работе приложения:

- Контроль работы подрядчиков с приложением.

- Контроль работы привилегированных сотрудников.

- Выявление внешних атак на приложение.

На основе определенных выше векторов определяются необходимые к подключению источники и точки контроля в виде корреляционных правил, настраиваемых в SIEM-системе.

Состав правил выявления инцидентов обычно включает три блока:

- Контроль действий пользователей – обращения к приложению/базе данных, работе в нем всех типов пользователей, в том числе привилегированных.

- Контроль целостности ключевых таблиц, файлов, веток реестра, настроек окружения, запущенных служб и процессов.

- Выявление аномалий – сбор профилей на основе статистики и дальнейший мониторинг отклонений от него.

Подавляющая часть правил выявления инцидентов в окружении приложения не сильно меняется в базовой логике, а кастомизация заключается в изменении конфигураций в Active List. То же самое относится к профилирующим правилам.

Контент, связанный с работой самого приложения, создается в большинстве случаев индивидуально и включает в себя и обследование системы, и проведение интервью с владельцами и разработчиками, и дальнейшую аналитику по поиску «узких мест».

В качестве подведения итогов статьи хотелось бы подчеркнуть, что безопасность ключевых приложений и сайтов лишь отчасти связана с внешними прямыми угрозами, и всегда стоит учитывать более широкий вектор потенциальных атак и мошеннических операций.

|

|

Исследование устойчивости национальных сегментов сети |

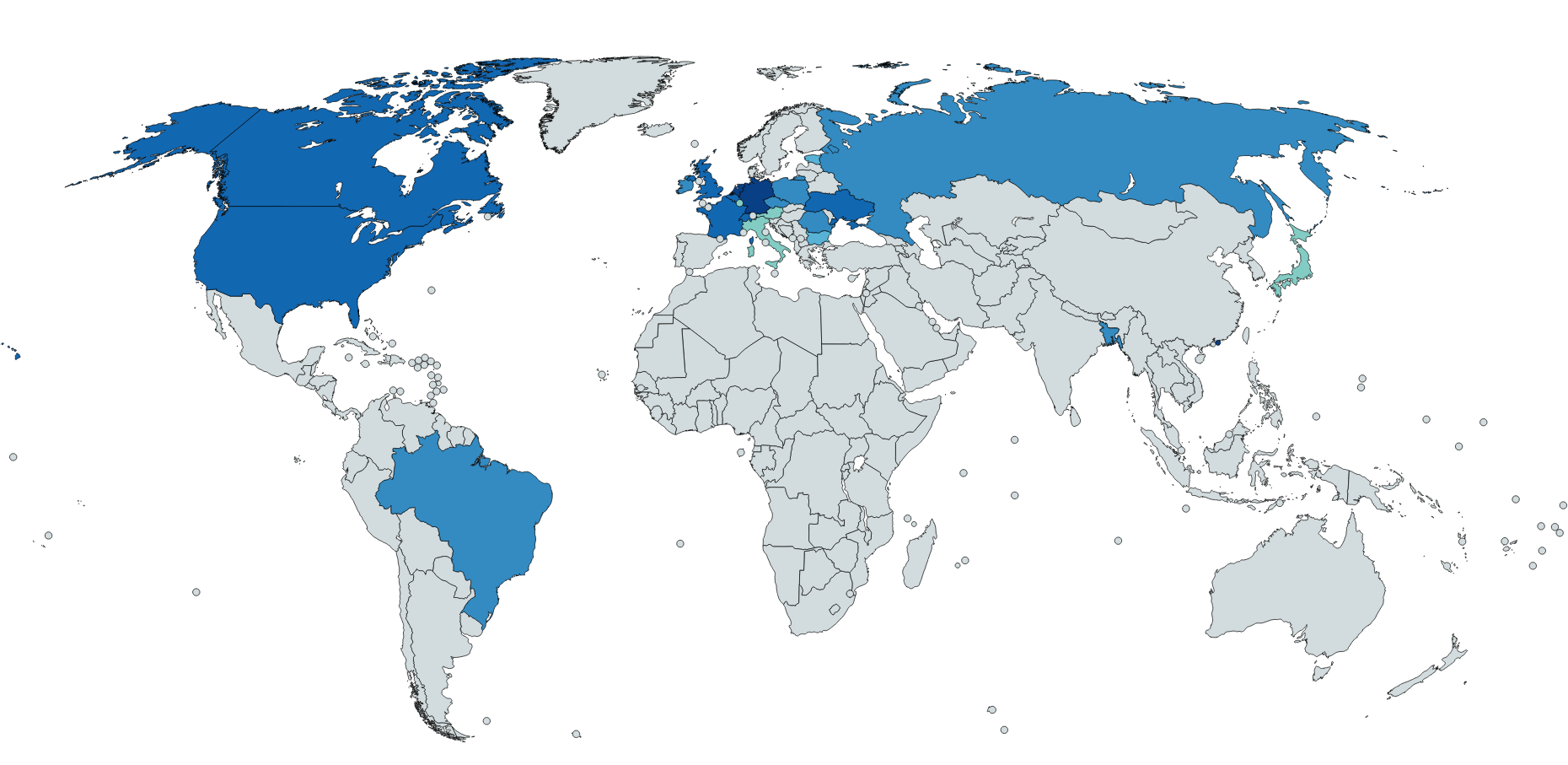

Топ-20 устойчивых регионов за 2017 год на карте мира

Интернет как система сетей, взаимодействующих через узлы операторов связи (автономных систем — АС), тем устойчивее, чем больше альтернативных маршрутов между АС — простой принцип отказоустойчивости. Данное исследование демонстрирует, как отказ единичного, но наиболее значимого в регионе оператора влияет на глобальную доступность национального сегмента.

На глобальную доступность любого оператора связи влияют его пути до Tier-1 операторов. Tier-1 — транснациональные/трансконтинентальные операторы, обеспечивающие глобальную связность между континентами и странами.

Если отсутствуют пути до Tier-1 операторов — оператор не будет иметь глобальную доступность.

Предположим, что заданный оператор испытывает проблемы, и, соответственно, проход трафика через него затруднён или невозможен. Мы решили найти ответ на вопрос: «Какой процент остальных операторов связи в регионе потеряет опосредованную связь с Tier-1 операторами, а следовательно и глобальную доступность?».

Зачем мы моделируем такую ситуацию? Строго говоря, когда задумывалась современная сеть Интернет, предполагалось, что у каждого оператора будет по крайней мере два независимых вышестоящих поставщика, что гарантирует отказоустойчивость в случае проблем у одного из них. Однако, для многих сетей это так и осталось рекомендацией на бумаге. Поэтому отказ единичного оператора может привести к системным проблемам у целого набора нижестоящих операторов связи, вплоть до недоступности целых национальных сегментов. Но возникают ли в реальном мире отказы крупных транзитных операторов? Ответ — да, и с завидной регулярностью. А если еще не было ни единого разрыва, то стоит помнить закон Мерфи: «То, что может случиться — случится».

Процесс моделирования был разбит на следующие этапы:

- Мы построили альтернативные маршруты до Tier-1 операторов для каждой АС в мире с использованием модели отношений между АС проекта Qrator.Radar;

- С использованием геобазы Maxmind мы сопоставили адресное пространство АС различным странам.

- Для каждой АС мы осуществили нормировку полученных геоданных, чтобы избежать ситуации, когда АС имеет вырожденное присутствие в регионе. Примером подобного вырожденного присутствия может служить Гонконг, где на крупнейшем азиатском Internet Exchange, HKIX, присутствуют сотни операторов, при этом никакого отношения к доступности в самом Гонконге они не имеют.

- Далее оценивалось влияние гипотетического отказа заданной АС на других операторов связи, и как следствие на национальные сегменты.

- Для каждой страны была выделена АС, эффект от отказа которой окажет наибольшее влияние на другие АС данной страны.

Ниже представлена таблица топ-20 устойчивых стран 2017 и пересчитанный по новой схеме топ-20 за 2016 год.

| % отказа |

2016 год |

Изменение 2016 — 2017 |

2017 год |

% отказа |

| 2.57478 |

Германия (DE) |

1 место |

Германия (DE) |

2.29696 |

| 3.14068 |

Канада (CA) |

Вниз на 2 позиции |

Гонконг (HK) |

2.65659 |

| 3.46469 |

Швейцария (CH) |

3 место |

Швейцария (CH) |

3.57245 |

| 4.03446 |

Великобритания (GB) |

Вниз на 2 позиции |

Канада (CA) |

3.67367 |

| 4.19754 |

Гонконг (HK) |

Вверх на 3 позиции |

Франция (FR) |

3.68254 |

| 4.34753 |

Украина (UA) |

Вниз на 2 позиции |

Великобритания (GB) |

3.76297 |

| 4.39691 |

США (US) |

Вниз на 2 позиции |

Бельгия (BE) |

3.93768 |

| 4.83975 |

Бельгия (BE) |

Вверх на 1 позицию |

Украина (UA) |

3.95098 |

| 5.68121 |

Испания (ES) |

Вниз на 8 позиций |

США (US) |

3.97103 |

| 5.78643 |

Польша (PL) |

Вниз на 6 позиций |

Бангладеш (BD) |

5.29293 |

| 5.99955 |

Франция (FR) |

Вверх на 6 позиций |

Румыния (RO) |

5.35451 |

| 6.00547 |

Россия (RU) |

Вниз 1 на позицию |

Бразилия (BR) — новичок |

5.39138 |

| 6.39252 |

Австралия (AU) |

Вылет из топ-20 |

Россия (RU) |

5.73432 |

| 6.88687 |

Ирландия (IE) |

14 место |

Ирландия (IE) |

5.87254 |

| 7.0508 |

Румыния (RO) |

Вверх на 4 позиции |

Чехия (CZ) — новичок |

5.88389 |

| 7.43945 |

Австрия (AT) |

Вниз на 3 позиции |

Польша (PL) |

5.99655 |

| 7.84456 |

Италия (IT) |

Вылет из топ-20 |

Болгария (BG) |

6.20975 |

| 7.97141 |

Бангладеш (BD) |

Вверх на 8 позиций |

Испания (ES) |

6.58064 |

| 8.14681 |

Болгария (BG) |

Вверх на 2 позиции |

Австрия (AT) |

7.14221 |

| 8.15989 |

Филиппины (PH) |

Вылет из топ-20 |

Люксембург (LU) — новичок |

7.28208 |

Отдельно стоит отметить сильное влияние AS 174, оператора Cogent, на целый ряд европейских национальных сегментов: Францию, Великобританию, США, Ирландию только в топ-20 устойчивых регионов. То есть возникновение проблем в автономной системе 174 может привести к проблемам в группе соседних регионов. Хотя и не полной недоступности, так как мы говорим о хорошо развитых и активно децентрализованных национальных сетях.

В России сюрпризов не наблюдается. Системообразующим оператором остаётся Ростелеком, но даже его гипотетический оффлайн выльется в недоступность не более чем у 5,73% российских операторов связи. В то же время, сравнимый с прошлогодним процент отказа обеспечивает России лишь 14-е место в рейтинге. На территории России практически отсутствуют сети международных Tier-1 операторов, однако внутренний рынок представлен целым набором крупных и средних Tier-2 сетей, что и обеспечивает столь высокую устойчивость.

Всегда ли наибольшее влияние на доступность других операторов оказывает влияние крупнейший оператор региона? Как показывают наши расчеты — не обязательно. К примеру, в Германии крупнейшим оператором связи является Deutsche Telecom, однако с точки зрения глобальной связности именно отказ AS8881, принадлежащей Versatel, окажет наибольшее влияние на АС в регионе. И по нашей оценке, тренд к повышению значимости Tier-2 операторов сохранится в ближайшем будущем.

Говоря про общемировые тренды, средняя «неустойчивость» в 2017 составила 41%, что на 1.6% ниже, чем годом ранее.

Градиентом от тёмно-зелёного (0%), через жёлтый (25%) к красному (50%) цвету, обозначающему степень зависимости сегмента от единственного поставщика.

Наибольшие положительные изменения за год произошли на территории развивающегося рынка Африки. Так, устойчивость в нескольких странах региона, включая Гамбию и Либерию, возросла практически на 40%. Однако движение в сторону повышения устойчивости национальных сегментов нельзя назвать однонаправленным. Например, зависимость национального сегмента Ямайки к отказу единичного оператора возросла с 34% до 91%, внешняя связность этой страны теперь практически полностью зависит от работы АС 23520 (Columbus Networks).

Регионы с 99% и более зависимостью от единственного поставщика.

В самом низу нашего рейтинга 10 территорий, которые в случае отказа единичного оператора/автономной системы испытают 100% недоступность с точки зрения всего остального мира. Из стран постсоветского пространства к ним наиболее всего близок Узбекистан, располагающийся на 235 месте со значением в 99,94% недоступности вследствие отказа AS 28910. Остальные же страны представляют собой островные микрогосударства.

Помимо уже упомянутых стран, Куба и Южный Судан являются наиболее известными читателю странами с более чем 99% зависимостью от одного провайдера связи. У Северной Кореи 92%. Любопытно, что Монако обладает очень плохой связностью (единственная красная точка в Европе), при этом другое микрогосударство, Люксембург, замыкает топ-20 устойчивых стран 2017 года.

На фоне растущих киберугроз и всё чаще появляющихся новостей об атаках на инфраструктуру Интернета, правительствам, компаниям и пользователям из стран, где отказоустойчивость составляет менее 50%, а по-хорошему — 25%, стоит всерьёз задуматься о собственном положении. Мы уже видели масштабные атаки на крупнейших национальных провайдеров и крупных поставщиков услуг связности и доступности, таких как DNS-провайдеры, а также последствия подобных атак с точки зрения доступности сетевого ресурса для конкретного пользователя из любой точки мира.

Результаты исследования демонстрируют, что рынок операторов связи, построенный на принципе конкуренции, в итоге оказывается куда более устойчивым как к проблемам внутри региона, так и вовне его. В обратном случае отключение одного-единственного провайдера может привести к недоступности сетевых ресурсов у значительной доли пользователей целой страны или региона.

|

|

Знакомьтесь, Apache BookKeeper — реплицируемый сервис журналов |

По роду своей деятельности мне достаточно часто приходится участвовать в проектах, в которых создаются высокодоступные, высокопроизводительные системы для различных рынков — реклама, финтех, сервисы классов SaaS, PaaS. В таких системах применяется вполне устоявшийся набор архитектур и компонентов, которые позволяют эффективно обеспечить соответствие продукта требованиям, например, lambda-архитектура для поточной обработки данных, масштабируемый микросервисный дизайн программного обеспечения, ориентированный на горизонтальное масштабирование, noSQL СУБД (Redis, Aerospike, Cassandra, MongoDB), брокеры сообщений (Kafka, RabbitMQ), распределенные серверы координации и обнаружения (Apache Zookeeper, Consul). Такие базовые инфраструктурные блоки чаще всего позволяют успешно решить большую часть задач и команда разработки не сталкивается с задачами разработки компонентов среднего уровня (middleware), которые, в свою очередь, будут использованы бизнес-ориентированной частью разрабатываемой системы.

В некоторых случаях возникают такие задачи, которые проектной команде не удается реализовать с помощью существующих решений, являющихся стандартными, тогда появляется потребность в поиске или разработке узкоспециализированных продуктов, предназначенных для решения специфических задач.

Задача

В одном из проектов у команды возникла достаточно специфичная задача, в рамках которой была необходимость организации строго-упорядоченной очереди данных, которое бы позволяло осуществлять "проигрывание" данных, поддерживало репликацию, горизонтальное масштабирование и было отказоустойчивым. Это классическая структура данных, которая называется журнал операций (Commit Log) и применяется практически во всех более-менее сложных СУБД.

Основное требования к журналу операций — это фиксация изменений в строгом порядке, таким образом структура гарантирует, что тот клиент, который инициировал запись первым гарантированно получит меньший порядковый номер записи в журнале, даже если запись заняла большее время чем у некоторого другого клиента. Широкое применение журналы операций имеют в системах, в которых имеется конкурентный доступ к объектам, который должен быть упорядочен. Обычная очередь, поддерживающая конкурентный доступ — это пример такого журнала (например, LinkedBlockingQueue в Java).

Ценность такой структуры в том, что она гарантирует неизменность конечного состояния при повторных проходах и часто используется именно для того, чтобы корректно отразить конечное состояние объекта при множественных изменениях.

Сложности начинаются в том случае, если множество агентов должны распространить упорядоченное изменение состояний на множестве узлов для множества объектов. Очевидный и самый низкопроизводительный подход основывается на использовании сервиса распределенных блокировок, например, Apache Zookeeper, с помощью которого осуществляется упорядоченный доступ к некоторому хранилищу. Вариант является рабочим, если изменения объектов происходят редко, однако, для реализации высокопроизводительной системы, в которой состояния объектов меняются часто, данный вариант не подходит. Частный случай с двумя агентами и двумя узлами изображен на рисунке.

Если внимательно посмотреть на вводное изображение с Риком, Морти и Саммер, то можно как раз это и заметить… Все вроде похоже, но уже есть небольшие рассогласования.

Нам требовалось разработать реплицируемую систему типа Leader/Followers, каждый узел которой бы поддерживал актуальное состояние объектов в RocksDB, а при потере узла его можно было бы легко восстановить из другого узла и существующего журнала операций, абстрактный вид представлен на диаграмме:

Основная инженерная проблема, которая существует в рамках данной задачи — это разработка распределенного реплицируемого журнала операций.

Распределенный реплицируемый журнал операций

Сначала, как обычно, мысль пошла по пути — "нам нужен свой бар... мы же крутые разработчики — давайте сами все сделаем!". У нас была реализация для локального журнала и мы подумали, что, наверное, мы сможем расширить ее на сетевую и реплицируемую реализацию. Честно говоря, объем работы вызывал притупленную зубную боль, а ведь это был не основной продукт, а компонент нижележащего слоя.

Постойте, но есть же Apache Kafka, скажет удивленный читатель! И будет почти прав. Apache Kafka — прекрасная штука, но в рамках данной задачи ей не хватает следующих функций:

- Подтверждения завершения операции

- Гарантии порядка и уникальности данных

В большинстве случаев Apache Kafka будет работать так, как нужно, но при потере пакетов TCP или падении мастера Вы не имеете никаких гарантий, что ваше сообщение не продублируется. Это связано с тем, что сообщения в Kafka отправляются по принципу "fire-and-forget", а клиент не управляет порядком записей на сервере, что логично, поскольку Apache Kafka оптимизирована на пропускную способность.

Однако, начав анализ и обдумывание деталей решения, я обнаружил, что решение уже есть, просто мы о нем не знали. И это — Apache BookKeeper. Более того, он реализован идеологически и технологически практически так, как бы мы это стали делать сами — Apache Zookeeper, Java, Netty (наш проект на Scala, но стек Java сильно порадовал). Как результат, была инициирована новая фаза, в ходе которой мы протестировали Apache BookKeeper на предмет соответствия нашим потребностям.

Apache BookKeeper

Далее, я постараюсь рассказать о принципах и подходе, который используется в системе Apache BookKeeper для решения задачи реплицируемых, масштабируемых журналов операций.

Итак, продукт не так чтобы сильно известный, однако пользователи у него имеются. К примеру:

Возможно, надо было просто сделать перевод первой статьи, но, чукча в душе — писатель.

Сначала посмотрим на концептуальную архитектуру Apache BookKeeper, которая отображена на следующем рисунке:

Ключевые элементы схемы:

- Bookie — сервер, на котором хранятся данные журналов;

- Ledger — "гроссбух", которые организует некоторое количество записей в единый том, в рамках которого определяются серверы Bookie, на которые происходит репликация данных;

- Ledger Entry — запись в гроссбухе, полезная информация;

- BK Client — клиентский код на Java, который реализует API;

- Zookeeper — сервер Apache Zookeeper, который хранит в себе записи о гроссбухах (номер, серверы Bookie, где хранятся реплики).

Теперь рассмотрим ключевые элементы подробнее, чтобы понять как устроена модель взаимодействия с Apache BookKeeper и его архитектура управления данными.

Bookie

Сервер хранения данных. В рамках BookKeeper мы развертываем и запускаем множество серверов Bookie, на поле которых возникает реплицируемая среда хранения данных. Данные распределяются в рамках гроссбухов, способ распределения плоский, система не позволяет задавать какие-либо топологические метки (а жаль). Добавление серверов Bookie позволяет осуществлять горизонтальное масштабирование системы.

Ledger / Гроссбух

Организует набор строго упорядоченных записей, реплицируемых на одни и те же серверы. Гроссбухи упорядочены по возрастанию идентификаторов. Данные о серверах реплик хранятся в записи гроссбуха в Zookeeper.

Важное ограничение 1. В гроссбух может писать только один писатель. Таким образом, гроссбух — это единица масштабирования. Если ряд операций не позволяет разнести их по разным гроссбухам, то лимит производительности — это скорость записи в гроссбух, которая зависит от фактора репликации (хотя не линейно, поскольку BK Client пишет параллельно).

При записи в гроссбух каждой записи выдается уникальный возрастающий порядковый целочисленный номер, выдаваемый клиентом, что позволяет организовывать асинхронный подход к записи. При этом BookKeeper гарантирует, что операция записи с номером (n+1) завершится только тогда, когда все операции записи с младшими номерами завершились. Это очень полезное свойство, которое позволяет существенно улучшить производительность операций записи в некоторых кейсах, даже, если требуется упорядоченное уведомление клиентов о завершении операций.

Важное ограничение 2. Из гроссбуха может читать параллельно неограниченное количество читателей, при этом чтение разрешено тогда, когда гроссбух закрыт, то есть, в настоящий момент никем не пишется.

Вообще, вышеуказанные ограничения для гроссбухов — это существенные ограничения, которые в некоторых случаях могут значительно сузить сферу применения.

К примеру, вы открываете новый гроссбух каждую секунду, пишете в него и закрываете. Это означает, что обработка чтения будет отставать на 1 секунду. Поскольку гроссбух имеет тип идентификатора Long, то можно открывать каждую 1мс без особых проблем, но тогда вы столкнетесь с ситуацией, что возрастет нагрузка на Zookeeper, для которого это будет уже существенной нагрузкой. В решаемой нами задаче, это ограничение было допустимым.

Другой пример, интенсивность записи такова, что производительности серверов в рамках одного гроссбуха недостаточно, а логика приложения такова, что партиционировать запись по нескольким гроссбухам не представляется возможным. Все, как говорится, приехали. Данное ограничение в рамках нашей задачи тоже обходилось, мы смогли партиционировать все объекты таким образом, и у нас остался только один поток данных, для которого мы не смогли обойти данное ограничение.

Хранение идентификаторов гроссбухов

Идентификаторы гроссбухов хранятся в Zookeeper, что позволяет осуществить по ним итерирование, однако, не все так просто. Если мы хотим иметь несколько параллельных цепочек гроссбухов, то необходимо хранить идентификаторы гроссбухов, которые относятся к конкретной цепочке где-то отдельно, BookKeeper нам с этим не поможет. Другой вариант — осуществлять развертывание изолированных серверов Bookie под каждую задачу отдельно, чтобы у них был отдельный путь в Zookeeper (что нам не подходило).

Надо отметить, что сам Apache Zookeeper накладывает дополнительные ограничения, которые тоже необходимо учесть:

- Вся база данных должна помещаться в памяти сервера (если открывать много гроссбухов и не удалять их), вполне возможно, что когда-нибудь на сервере не хватит RAM (маловероятно, конечно, но списывать со счетов данный факт не стоит).

- Если в родительском каталоге Zookeeper находится много элементов, то при получении листинга каталога может произойти ошибка, если он не поместится в максимальный размер пакета Zookeeper равный 1MB.

Создатели Apache BookKeeper предоставляют решение для проблемы 2, вводя иерархический менеджер гроссбухов (Hierarchical Ledger Manager), который организует плоское пространство идентификаторов в иерархическое дерево путем дробления Long по уровням. По умолчанию используется Flat Ledger Manager, который явно неприменим при частом порождении новых гроссбухов.

Ledger Entry / Запись

Запись представляет собой элемент гроссбуха. Каждая запись в рамках гроссбуха имеет последовательный, возрастающий идентификатор — от 0… Запись содержит произвольные данные в виде байтового массива. Добавление записи может производиться в синхронном и асинхронном режиме. В асинхронном режиме, как обычно, можно добиться более высокой производительности для многопользовательских приложений. Как уже ранее упоминалось, вызов асинхронной части происходит тогда, когда запись добавляется в гроссбух, то есть упорядоченно.

Пожалуй, эти три концепта — Bookie, Ledger (гроссбух) и Ledger Entry (запись) являются важнейшими элементами для понимания работы Apache BookKeeper.

Вместо заключения

Надо сказать, что Apache BookKeeper не выглядит как серебряная пуля или как волшебная таблетка, это вполне специфическое решение, которое никак не противоречит CAP теореме и накладывает существенное количество ограничений на решаемую задачу, которые часто невозможно обойти. К счастью для нас, мы смогли обеспечить с помощью данного компонента горизонтальное масштабирование системы, но для поддержки наших требований пришлось решить попутно несколько инженерных задач, например, как корректно читать данные из двух гроссбухов и как хранить в Zookeeper "просеянные" списки для непересекающихся гроссбухов.

Эта статья носит вводный, ознакомительный характер. Сделать на Apache BookKeeper Hello World достаточно легко, авторы предоставляют подробное стартовое руководство, пока мы разбирались, переписали его реализацию на Scala.

О RocksDB

RocksDB была выбрана в связи с тем, что она обладает высокой производительностью и поддерживает атомарную пакетную запись (все или ничего), что позволяет обеспечить корректное поведение при возникновении нештатных ситуаций. В рамках нашей задачи мы загружали предыдущее состояние из RocksDB, вычитывали все действия из гроссбуха (ов), формировали итоговое состояние в RAM и записывали атомарно в RocksDB, при этом в запись так же шли номера гроссбухов, которые мы обработали.

|

|

Superjob PHP-meetup |

Это мероприятие мы посвятим разработке на PHP, увеличению производительности и разработке API.

Спикеры:

Антон Довгаль, Senior C Developer Badoo, с докладом «Как мы разрабатываем модули в Badoo»

Документация на тему архитектуры языка PHP скудна и разрозненна, несмотря на то что тема интересна многим. В моем докладе я постараюсь заполнить этот пробел и рассказать о модулях PHP: как они работают, зачем и как их пишут. В процессе мы рассмотрим опыт Badoo в этой сфере на примерах двух модулей. И еще напишем очень небольшой собственный модуль.

— Что такое модули PHP, как они работают

— Как начать писать свой модуль PHP

— Скелет модуля — Функции, классы, методы

— Разбор параметров функции

— Сборка модуля

— Подгрузка модуля

— Простой пример модуля из Badoo

— Сложный пример модуля из Badoo

Алексей Коротин, старший разработчик Superjob, с докладом «Внедрение RESTful в mature проект»

В своём докладе я расскажу, как мы в Superjob разрабатываем лаконичный и чистый RESTful API для проекта с многолетней историей, как автоматизируем документацию и тестирование нашего API и как облегчаем жизнь программисту.

— Как мы внедрили чистый и прозрачный REST поверх легаси

— Как нам удалось привести зоопарк технологий к единому виду

— Как отвязались от структуры хранения и перестали писать тонны DTO

— Как распараллелили разработку между командами благодаря единым стандартам

— Как стандарт помог нашим автотестам и документации

— Как сократили время на разработку нового и перестали думать о рутине

— Как при этом удалось соблюсти баланс между автоматизацией и эффективностью

— Как при всем этом оставили свободу действий программисту

Надежда Рябцова, Senior DevOps Engineer Skyeng, с докладом «Как медиа сервисы Skyeng переехали на Symfony 4»

Я расскажу, как мы приняли решение и внедрили в продакшн новый инструмент для сборки бекенда приложений – Symfony Flex – менее чем за один месяц. О преимуществах и недостатках подхода для сборки бандлов с помощью рецептов. Сейчас нам удалось укротить зоопарк подключаемых бандлов, и оформить схему переезда на Symfony 4 для последователей внутри компании и за ее пределами.

В своем проекте мы реализовали легковесное api для браузерных расширений и сопровождаем его стопроцентным покрытием автотестами. И я расскажу, как вписать Symfony Flex в процессы непрерывной интеграции, схожие с нашими. А также, как развивать и эксплуатировать проект на альфа версии фреймворка в продакшне.

Вход бесплатный, количество мест ограниченно. Регистрация и подробная информация здесь.

В день мероприятия возьмите с собой паспорт или водительское удостоверение для прохода в наш бизнес-центр.

Отчеты с предыдущих митапов можно найти в официальной группе Superjob IT-meetup в Facebook.

|

|

Defender на стероидах: комплексная защита корпоративной сети в Windows 10 Fall Creators Update. Интервью с Робом Леффертсом |

|

Метки: author megapost информационная безопасность microsoft defender безопасность windows atp wdatp advanced threat protection |

Как организовать защищённый доступ при помощи VPN |

Кому нужен VPN?

На март 2017 г. доля вакансий о работе с удаленным доступом, размещенных на hh.ru составляла 1,5% или 13 339 вакансий. За год их число удвоилось. В 2014 г. численность удаленных сотрудников оценивалась в 600 тыс. чел или 1% от экономически-активного населения (15–69 лет). J'son & Partners Consulting прогнозирует, что к 2018 г. около 20% всех занятых россиян будут работать удаленно. Например, до конца 2017 г. Билайн планирует перевести на удаленное сотрудничество от 50% до 70% персонала.

Зачем компании переводят сотрудников на удаленку:

- Сокращение затрат компании на аренду и содержание рабочих мест.

- Отсутствие привязки к одной локации дает возможность собирать команду

проекта, которую никогда нельзя было бы собрать в пределах одного города. Дополнительный плюс – возможность использования более дешевой рабочей силы. - Удовлетворение потребности сотрудников в связи с их семейными обстоятельствами.

Мы для себя открыли потребность в VPN более 10 лет назад. Для нас мотиватором предоставления VPN доступа сотрудникам была возможность оперативного доступа в корпоративную сеть из любой точки мира и в любое время дня и ночи.

Путь выбора идеального VPN решения

Вариантов решений достаточно много. Зачастую решение стоит принимать исходя из того, какое оборудование и софт уже используются в компании, навыком настройки какого ПО обладает системный администратор. Начну с того от чего мы отказались сразу, а затем расскажу что мы попробовали в на чем мы в итоге остановились.

VPN в роутерах

Так называемых “китайских решений” на рынке много. Практически любой роутер имеет функциональность встроенного VPN сервера. Обычно это простое вкл/выкл функционала и добавление логинов паролей для пользователей, иногда интеграция с Radius сервером. Почему мы не стали рассматривать подобное решение? Мы прежде всего думаем о своей безопасности и непрерывности работе сервиса. Подобные же железки не могут похвастаться ни надежной защитой (прошивки выходят обычно очень редко, или не выходят в принципе), да и надежность работы оставляет желать лучшего.

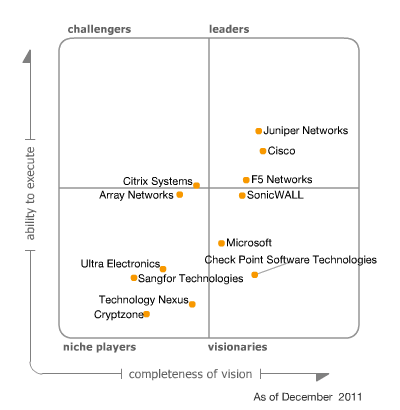

VPN Enterprise класса

Если посмотреть на квадрат Гартнера то на VPN рынке уже давно лидирующие позиции занимают компании, которые производят сетевое оборудование. Juniper, Cisco, Check Point: все они имеют комплексные решения решения в составе которых есть и VPN сервис.

Минусов у подобных решений пожалуй два. Первый и главный — высокая стоимость. Второй — скорость закрытия уязвимостей оставляет желать лучшего, а если не платить ежегодные взносы за поддержку, то обновлений безопасности ждать не стоит. Не так давно появился и третий момент — закладки, встроенные в ПО крупных сетевых вендоров.

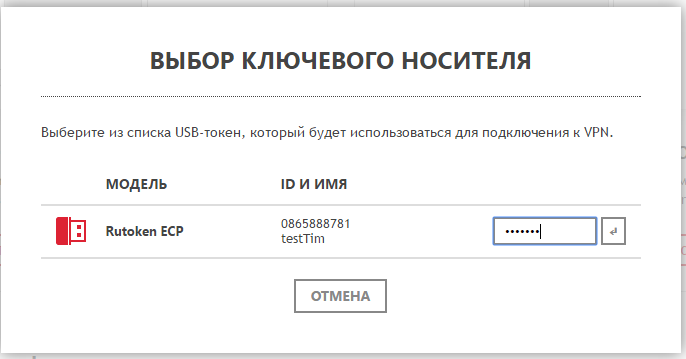

Microsoft VPN

10 лет назад мы были компанией, ориентированной прежде всего на Windows. Microsoft предлагает бесплатное решение для тех, у кого вся инфраструктура построена на их базе. В простых случаях настройка не вызывает сложностей даже у начинающего системного администратора. В нашем случае мы хотели выжать из VPN все с точки зрения безопасности, соответственно использование паролей было исключено. Мы естественно хотели использовать сертификаты вместо паролей и для хранения ключевой пары использовать свой продукт Рутокен ЭЦП. Для реализации проекта нам нужно было: контроллер домена, радиус сервер и правильно поднятая и настроенная инфраструктура PKI. Подробно на настройке я останавливаться не буду, в интернете есть достаточно много информации по данным вопросам, а правильная настройка PKI вообще может потянуть на десяток статей. Первым протоколом,

который мы использовали у себя, был протокол PPTP. Долгое время данный вариант VPN нас устраивал, но в конечном итоге нам пришлось отказаться от него по двум причинам: PPTP работал далеко не везде и мы начинали пользоваться не только Windows, но и другими операционными системами. Поэтому мы стали искать альтернативы. Замечу, что поддержка PPTP не так давно была прекращена apple. Для начала мы решили посмотреть, что еще из протоколов может предложить на Microsoft. SSTP/L2TP. SSTP нас устраивал всем, за исключением того, что он работал только на Windows. L2TP данным недостатком не обладал, но его настройка и поддержание его в работе показались нам достаточно затратными и мы решили попробовать альтернативы. Хотелось более простого решения, как для пользователей, так и для администраторов.

OpenVPN

Мы в компании “Актив” искренне любим open source. Выбирая замену Microsoft VPN мы не могли обойти стороной решение OpenVPN. Основным плюсом для нас было то, что решение из коробки работает на всех платформах. Поднять сервер в простом случае достаточно просто. Сейчас, используя docker и, к примеру готовый образ, это можно сделать за несколько минут. Но нам хотелось большего. Нам хотелось добавить в проект интеграцию с Microsoft CA, для того, чтобы использовать выданные ранее сертификаты. Нам хотелось добавить поддержку используемых нами токенов. Как настраивать связку OpenVPN и токены описано к примеру вот в этой статье. Сложнее было настроить интеграцию Microsoft CA и OpenVPN, но в целом тоже вполне реализуемо. Получившимся решением мы пользовались около трех лет, но все это время продолжали искать более удобные варианты. Пожалуй главной возможностью, которую мы получили, перейдя на OpenVPN, был доступ из любой ОС. Но остались еще две претензии: сотрудникам компании нужно пройти 7 кругов ада Microsoft CA для выписывания сертификата, а администраторам по-прежнему приходилось поддерживать достаточно сложную инфраструктуру VPN.

Рутокен VPN

У нас есть знание, как использовать токены в любых операционных системах, у нас есть понимание, как правильно готовить инфраструктуру PKI, мы умеем настраивать разные версии OpenVPN и мы имеем технологии, которые позволяют управлять всем этим удобным для пользователя образом из окна браузера. Так возникла идея нового продукта.

Настройка Рутокен VPN

Мы действительно постарались сделать настройку простой и понятной. Вся настройка занимает всего несколько минут и реализована как мастер начальной настройки. На первом шаге нужно настроить сетевые настройки устройства, думаю комментарии здесь будут лишними.

На втором шаге нужно ввести название компании и подождать несколько минут, пока устройство произведет настройку встроенного центра сертификации.

3м шагом необходимо настроить сам VPN сервис. Указать внешний IP, на который будет происходить подключение. Выбрать тип шифрования и адресацию сети.

4м шагом настройки мы создаем локальных пользователей, или добавляем их из AD

На этом настройку можно считать завершенной, все остальные действия может произвести сам сотрудник (хотя все может сделать и администратор).

Личный кабинет сотрудника

После того, как администратор добавил пользователей, сотрудник может воспользоваться порталом самообслуживания.

В зависимости от операционной системы и браузера сотрудника, понадобится установить плагин и расширение для браузера, которые необходимы для работы с токенами.

После установки плагина/расширения нам остается лишь сгенерировать сертификат себе на Рутокен ЭЦП.

И установить клиент под нужную операционную систему,

Как все это работает?

Немного об аппаратной части. Изначально мы долго думали, какую “базу” использовать для нашего решения, так как нужно было соблюдать баланс между стоимостью, удобством, производительностью. После исследований, что предлагается на рынке, мы остановились на двух вариантах реализации и дальнейшего распространения решения:

- x86 (Enterprise) – программное решение, которое предоставляется конечному потребителю в виде образа виртуальной машины, который можно развернуть в рамках своей ит-инфраструктуры.

- Raspberry Pi – уже достаточно известный микрокомпьютер, который обладает вполне неплохой производительностью при не самой высокой стоимости и который можно начать использовать как VPN-сервер уже через 10 минут после того, как его в прямом смысле вынули из коробки.

Итак, теперь рассмотрим то, как работает наше решение. Первично хочется напомнить, что у нас реализована двухфакторная аутентификация. В качестве носителей клиентских закрытых ключей и сертификатов используются токены собственного производства, а также программное обеспечение для работы с ними.

Но изначально, нам все же нужно осуществить настройку сервисов, которые требуются для корректной работы продукта. Настройка сервисов осуществляется на текущий момент специалистами нашей компании в полуавтоматическом режиме. Это значит, что автоматизирован процесс деплоя программного обеспечения и первичных настроек, но инициализация данного процесса пока остается привилегией человека. Во время первичной настройки устанавливаются системные пакеты, python, django, OpenVPN, supervisor, OpenSSL и проч.

А что же дальше? Далее необходимо настроить всю инфраструктуру, которая собственно и отвечает в целом за безопасность. А именно: CA (центр сертификации), PKI (инфраструктура открытых ключей), выписать необходимые ключи и сертификаты.

Создание PKI и CA, а также формирование файла конфигурации OpenVPN-сервера, генерацияключей ивыписываниесертификатовосуществляетсяужепослепередачи продукта клиенту. Но это не значит, что для этого необходимо иметь какие-то специфические знания и прямой доступ к операционной системе. Все реализовано в бизнес-логике бэкенда системы администрирования, доступ к которой предоставляется через Web-интерфейс. От клиента требуется только ввести минимальный набор атрибутов (описано выше), после чего стартует процесс инициализации PKI и создания СА. Описывать конкретные вызовы системных команд смысла особого нет, так как уже давно все описано и разжевано до нас. Главное, что мы сделали — это автоматизировали данный процесс, избавив пользователя от необходимости обладать специфическими знаниями в администрировании.

Для работы с ключами и сертификатами мы решили не изобретать велосипед (хотя очень хотелось и до сих пор вынашиваем мысль его изобрести исходя из наших дальнейших планов развития продукта) и используем easy-rsa.

Самый долгий процесс при настройке инфраструктуры – это генерация файла Diffie-Hellman. Мы долго экспериментировали с параметрами и пришли к балансу “качество-производительность”. Хотя были мысли вообще избавиться от данного шага, нагенерировать таких файлов заранее, используя наши серверные мощности и просто “раздавать” их во время первичной инициализации. Тем более, что данные, содержащиеся в этом файле не являются приватными. Но пока мы оставили эти мысли для дальнейших “изысканий”.

Дальше необходимо предоставить конечному пользователю механизм самостоятельного создания ключевых пар, формирования запросов на выписку сертификата в CA и собственно получение данного сертификата с записью на токен. А так же необходим клиент, позволяющий установить VPN-соединение с предварительной аутентификацией на токене.

Первую задачу мы решили благодаря нашему плагину который реализует функциональность электронной подписи, шифрования и двухфакторной аутентификации для Web- и SaaS-сервисов. Для того, чтобы выписать сертификат и записать его на токен, пользователь должен установить данный плагин, перейти по ссылке чтобы попасть в личный кабинет сервиса RutokenVPN, предварительно подключив токен к компьютеру (подробнее о плагине можно прочитать на нашем ресурсе )

При инициализации процесса выписывания сертификата, осуществляется запрос на токен для генерации ключевой пары а также запрос на выписку сертификата в CA. Приватный ключ записывается на токен, а запрос на выписку сертификата отправляется в СА, который в свою очередь осуществляет его выписывание и возвращает в ответе. После чего сертификат так же записывается на токен.

Почти все готово для установления VPN-соединения. Не хватает клиента, который “знает”, как работать с сервером и нашими токенами.

Наш клиент реализован на Electron. Кто не в курсе, что это за зверь, то если совсем кратко – возможность реализовать десктопное приложение, используя js, css и html. Не вдаваясь в подробности, клиент является неким “враппером” над OpenVPN-клиентом, позволяющим осуществлять его вызовы с нужными параметрами. Почему именно так? На самом деле нам было так удобней, хотя выбранное решение и накладывает определенные ограничения.

Так как мы используем токен как носитель ключевой информации, необходимой для аутентификации при установлении VPN-сессии, то нам нужно сконфигурировать OpenVPN-клиент для работы с ним. Провайдером PKCS#11 является библиотека собственной разработки для работы с нашими токенами, путь к которой и прописывается в настройках OpenVPN клиента. Подробнее о ней можно почитать здесь.

При запросе на установку VPN-соединения, запрашивается PIN-код ключа, при корректном вводе извлекается сертификат для аутентификации клиента, осуществляется хэндшейк клиента с сервером и устанавливается VPN-соединение. Знающие люди могут возразить, что не все так просто, но целью данного описания не является рассказать все тонкости работы OpenVPN, а только осветить основные моменты нашей реализации.

Ну и немного о наших планах. Основное, над чем сейчас мы работаем — это реализация ГОСТ-шифрования. Уже пройден достаточно большой путь исследований, позволивший нам максимально приблизиться к ее реализации и сможем удовлетворить интерес потенциальных клиентов в данной функциональности в ближайшее время.

|

Метки: author shriek сетевые технологии децентрализованные сети it- инфраструктура блог компании «актив» vpn openvpn raspberry pi рутокен openssl |

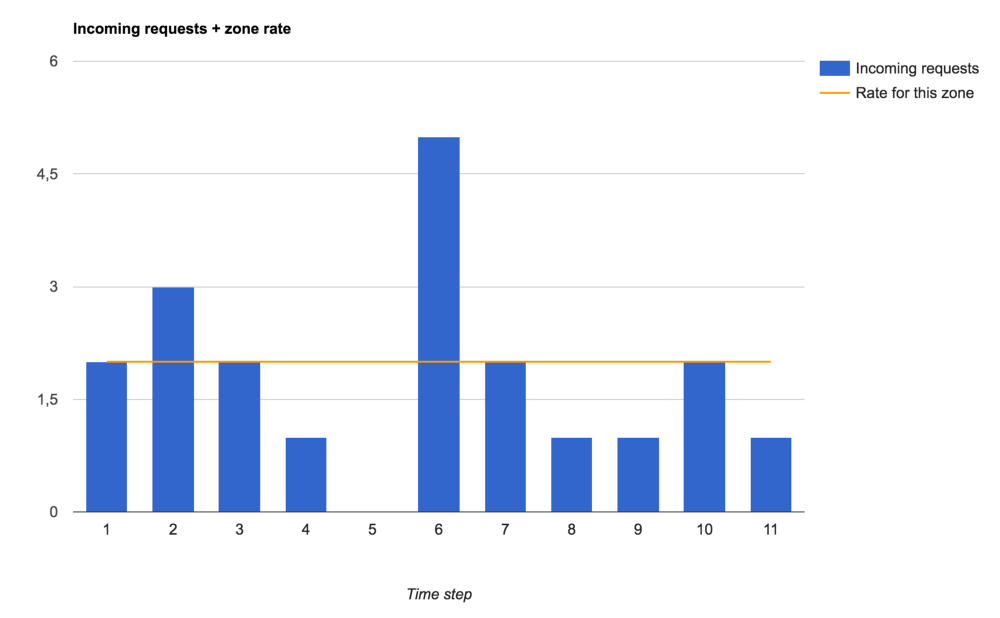

[Перевод] Ограничение скорости в nginx |

Фотография пользователя Wonderlane, Flickr

NGINX великолепен! Вот только его документация по ограничению скорости показалась мне, как бы это сказать, несколько ограниченной. Поэтому я решил написать это руководство по ограничению скорости (rate-liming) и шейпингу трафика (traffic shaping) в NGINX.

Мы собираемся:

- описать директивы NGINX,

- разобраться с accept/reject-логикой NGINX,

- визуализировать обработку всплесков трафика на различных настройках.

В дополнение я создал GitHub-репозиторий и Docker-образ, с которыми можно поэкспериментировать и воспроизвести приведенные в этой статье тесты. Всегда легче учиться на практике.

Директивы NGINX по ограничению скорости

В этой статье мы будем говорить о ngx_http_limit_req_module, в котором реализованы директивы limit_req_zone, limit_req, limit_req_status и limit_req_level. Они позволяют управлять значением кода состояния HTTP-запроса для отклоненных (rejected) запросов, а также логированием этих отказов.

Чаще всего путаются именно в логике отклонения запроса.

Сначала нужно разобраться с директивой limit_req, которой требуется параметр zone. У него также есть необязательные параметры burst и nodelay.

Здесь используются следующие концепции:

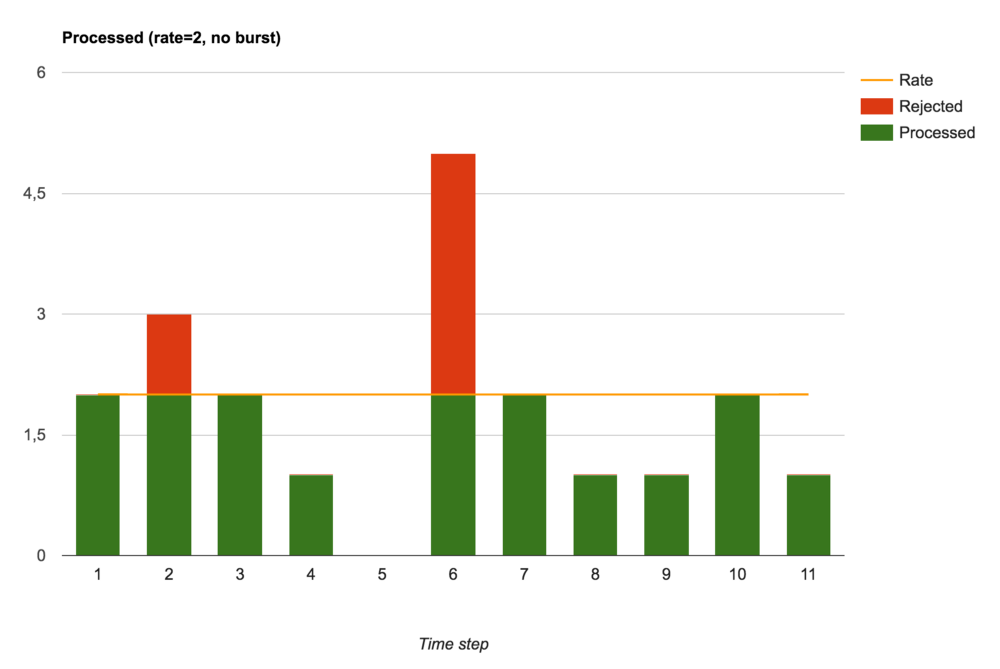

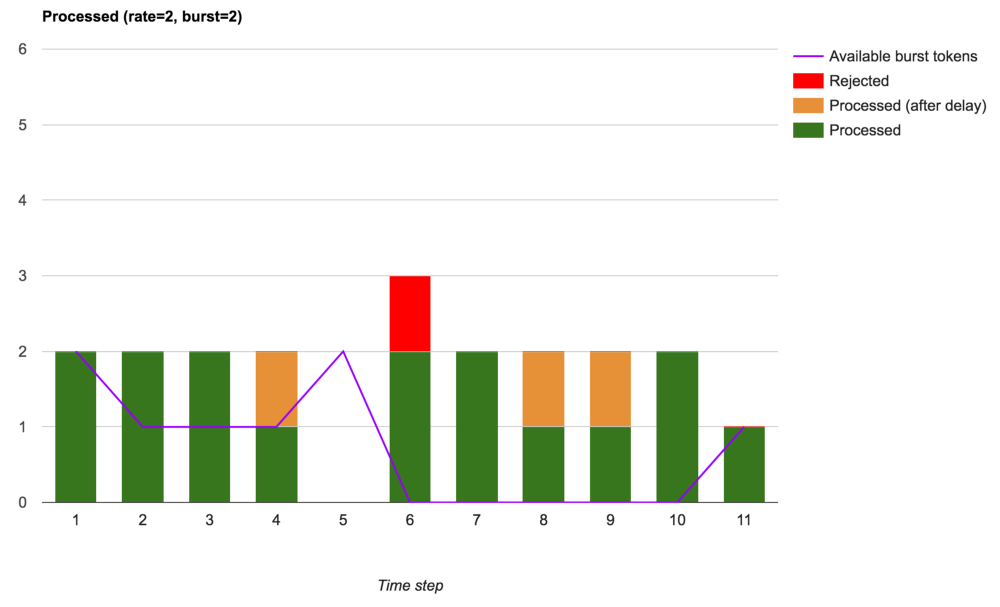

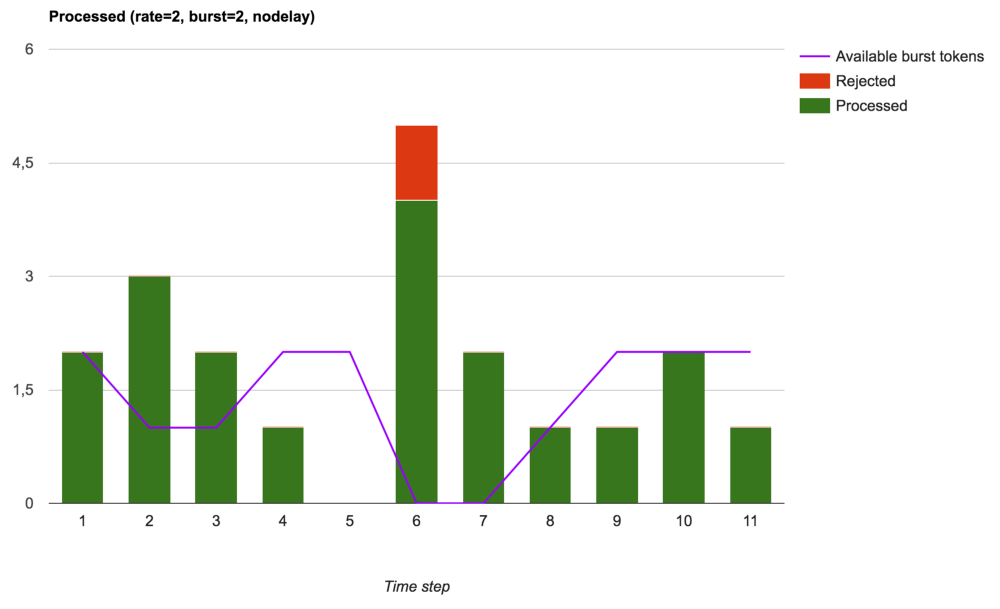

zoneопределяет «ведро» (bucket) — разделяемое пространство, в котором считаются входящие запросы. Все запросы, попавшие в одно «ведро», будут посчитаны и обработаны в его разрезе. Этим достигается возможность установки ограничений на основе URL, IP-адресов и т. д.