Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Стек, который позволил Medium обеспечить чтение на 2.6 тысячелетия |

Предлагаю общественности мой перевод статьи Dan Pupius'а об архитектура сервиса Medium и используемых технологиях. Хочу особо отметить, что статья является переводом, поэтому местоимение "я", используемое в тексте далее относится к автору оригинального текста, а не к переводчику.

Фон

Medium это сеть. Это место, где обмениваются историями и идеями, которые важны — место, где вы развиваетесь, и где люди провели 1.4 миллиарда минут — 2.6 тысячелетия.

У нас более 25 миллионов уникальных читателей в месяц, и каждую неделю публикуются десятки тысяч постов. Но мы хотим, чтобы на Medium мерилом успеха было не количество просмотров, а точки зрения. Чтобы значение имело качество идеи, а не квалификация автора. Чтобы Medium был местом, где обсуждения развивают идеи, а слова по-прежнему важны.

Я руковожу инженерной командой. Раньше я работал в качестве инженером в Google, где я работал над Google+ и Gmail, а также был одним из со-основателей проекта Closure. В прошлой жизни я гонял на сноуборде, прыгал из самолёта и жил в джунглях.

Команда

Я не мог бы гордиться командой сильнее, чем сейчас. Это потрясающая группа талантливых, любознательных, внимательных людей, которые собрались вместе, чтобы делать великие вещи.

Мы работаем в многофункциональных, нацеленных на решение конкретной задачи, командах, благодаря чему, когда некоторые специализируются, у нас всякий может обратиться к любому компоненту стека. Мы верим, что обращение к различным дисциплинам делает инженера лучше. О других наших ценностях я писал ранее.

Команды имеют много свободы в том, как они организуют работу, однако как компания в целом, мы ставим квартальные цели и поощряем итеративный подход. Мы используем GitHub для код-ревью и отслеживания багов, а также Google Apps для электронной почты, документов и электронных таблиц. Мы интенсивно используем Slack — и его ботов — а многие команды используют Trello.

Первоначальный стек

С самого начала мы использовали EC2. Основные приложения были написаны на Node.js, и мы мигрировали на DynamoDB перед публичным запуском.

У нас был node-сервер для обработки изображений, который делегировал GraphicsMagick фактические задачи по обработке. Другой сервер выступал в роли обработчика очереди SQS, и выполнял фоновые задачи. Мы использовали SES для электронной почты, S3 для статичных ресурсов, CloudFront в качестве CDN и nginx как обратный прокси. Для мониторинга мы использовали DataDog и PagerDuty для оповещений.

В качестве основы редактора, используемого на сайта был TinyMCE. К моменту запуска мы уже использовали Closure Compiler и некоторые компоненты Closure Library, но для шаблонизации использовали Handlebars.

Текущий стек

Для такого, на первый взгляд, простого сайта как Medium, может быть удивительно, как много сложного находится за сценой. Это же просто блог, так? Вы, вероятно, можете просто выкатить что-то на Rails за пару дней. :)

В любом случае, довольно рассуждений. Начнём с самого низа.

Производственное окружение

Мы используем Amazon Virtual Private Cloud. Для управление конфигурацией мы используем Ansible, что позволяет хранить конфигурации в системе управления версиями и легко и контролируемо выкатывать изменения.

Мы придерживаемся сервис-ориентированной архитектуры, поддерживая дюжину сервисов (в зависимости от того, как их считать, несколько из них существенно мельче остальных). Основной вопрос при развёртывании нового сервиса в специфичности работы, которую он выполняет, какова вероятность того, что придётся вносить изменения в несколько других сервисов, а также характеристики потребления ресурсов.

Наше основное приложение по-прежнему написано на Node, что позволяет нам использовать один код как на сервере, так и на клиенте, так, кое-что мы активно используем как в редакторе, так и в обработке поста. С нашей точки зрения Node не плох, но проблемы возникают если мы блокируем цикл обработки событий (event loop). Чтобы сгладить эту проблему, мы запускаем несколько экземпляров на одной машине и распределяем "дорогие" подключения по разным экземплярам, изолируя их таким образом. Мы также обращаемся к среде исполнения V8, чтобы понять, какие задачи занимают много времени; в целом, задержки связаны с восстановлением объектов при десериализации JSON.

У нас есть несколько вспомогательных сервисов, написанных на Go. Мы обнаружили, что приложения на Go очень легко собирать и развёртывать. Нам нравится его типобезопасность без избыточности JVM и необходимости тонкой настройки, как в случае с Java. Лично я — фанат использования командой "упрямых" языков; это повышает согласованность, снижает неоднозначность и определённо снижает шанс выстрелить себе в ногу.

Сейчас мы раздаём статику через CloudFlare, хотя мы пропускаем 5% трафика через Fastly и 5% через CloudFront, чтобы держать их кеши прогретыми на случай если нам понадобится переключиться в экстренной ситуации. Недавно мы включили CloudFlare и для трафика приложений — в первую очередь для защиты от DDOS, но нас также порадовало повышение производительности.

Мы используем nginx и HAProxy совместно в качестве обратных прокси и балансировщиков нагрузки, чтобы перекрыть всю дианаграмму Венна наших потребностей.

Мы по-прежнему используем DataDog для мониторинга и PagerDuty для уведомлений, но теперь мы интенсивно используем ELK (Elasticsearch, Logstash, Kibana) для отладки возникших на продакшене проблем.

Базы данных

DynamoDB по-прежнему является нашей основной базой данных, однако это не было спокойным плаванием. Одной из извечных проблем, с которыми мы сталкнулись были ["горячие ключи"] (https://medium.com/medium-eng/how-medium-detects-hotspots-in-dynamodb-using-elasticsearch-logstash-and-kibana-aaa3d6632cfd) (Прим. переводчика: имеются ввиду ключи по которым выболняется большое количество запросов за небольшой промежуток времени), во время событий, ставших вирусными или при отправке постов миллионам подписчиков. У нас есть кластер Redis, который мы используем в качестве кеша перед Dynamo, что решает проблему для операций чтения. Оптимизации с целью повысить удобство разработчиков часто расходятся с таковыми для повышения стабильности, но мы работаем над этим.

Мы начали использовать Amazon Aurora для хранения новых данных из-за того, что она позволяет более гибко, чем Dynamo, извлекать и фильтровать данные.

Для хранения отношений между сущностями, которые представляют сеть Medium мы используем Neo4j, у нас запущен один мастер и две реплики. Люди, посты, теги и коллекции — это узлы графа. Рёбра создаются при создании сущности и при выполнении действий, таких как подписки, рекомендации или подсвечивания. Мы обходим граф чтобы фильтровать и рекомендовать посты.

Платформа данных

С самого начала мы были очень жадными до данных, инвестировали в нашу инфраструктуру анализа данных, чтобы облегчить принятие бизнес и продуктовых решений. В последнее время мы также может использовать существующий конвейер данных для обратной связи с продакшеном, позволяя работать таким функциям, как Explore.

В качестве хранилища данных мы используем Amazon Redshift, он предосталвяет масштабируемую систему хранения и обработки данных, поверх которой строятся наши приложения. Мы постоянно импортируем наши основные данные (пользователи, посты) из Dynamo в Redshift и логи событий (просмотр поста, прокручивание страницы с постом) из S3 в Redshift.

Выполнение задач планируется Conduit, нашим внутренним приложением, которое управляет планированием, зависимостями данных и мониторингом. Мы используем планирование, основанное на требованиях (assertion-based scheduling), когда задачи запускаются только если их зависимости удовлетворены (например, ежедневная задача, которая зависит от логов со всего дня). Эта система доказала свою незаменимость — генераторы данных отделены от потребителей, что упрощает конфигурирование и делает систему предсказуемой и отлаживаемой.

Хотя SQL-запросы в Redshift нас устраивают, нам требуется загружать и выгружать данные в и из Redshift. Для ETL мы всё чаще обращаемся к Amazon Spark благодаря его гибкости и возможности масштабироваться в соотстветствии с нашими нужнами. С течением времени Spark скорее всего станет основным компонентом нашего конвейера данных.

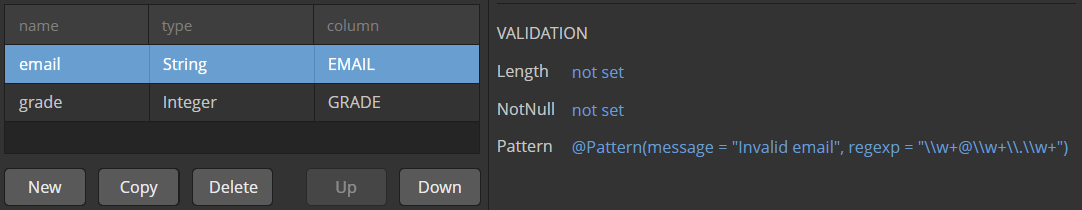

Мы используем Protocol Buffers для схем данных (и правил изменения схем) чтобы держать все слои распределённой системы синхронизированными, включая мобильные приложения, веб-сервисы и хранилище данных. Мы аннотируем схемы деталями конфигурации, такими как имена талиц и индексов, правилами валидации записей, такими как максимальная длина строк или допустимые диапазоны значений чисел.

Людям хотятбыть на связи, так что разработчики мобильных и веб приложений могут подключатсья к нам единым образом, а исследователи данных (Data Scientists) могут интерпретировать поля единым образом. Мы помогаем нашим людям работать с данными, рассматривая схемы в качестве спецификаций, тщательно документируя сообщения и поля, и публикуя документацию, сгенерированную на основе .proto файлов.

Изображения

Наш сервер обработки изображений написан на Go и использует стратегию "водопад" (waterfall strategy) для отдачи обработанных изображений. Серверы используют groupcache, который предоставляет альтернативу memcache и позволяет снизить объём выполняемой дважды работы. Кеш в памяти резервируется постоянным кешем в S3; после чего изображения обрабатываются по запросу. Это даёт нашим дизайнероам свободу изменять способы отображения изображений и оптимизировать для разных платформ без необходимости запускать большие пакетные задачи по генерированию масштабированных изображений.

Хотя в настоящий момент сервер обработки изображений, в основном, используется для масштабирования и обрезки изображений, ранние версии сайта поддерживали светофильтры, размытие и другие эффекты. Обработка анимированных GIF-файлов доставляла огромную боль, но это тема отдельного поста.

TextShots

Прикольная функция TextShorts реализуется небольшим сервером на Go, использующим PhantomJS в качестве рендерера.

Мне всё время хотелось поменять движок рендеринга на что-нибудь вроде Pango, но на практике возможность выводить изображения в HTML гораздо более гибкая и удобная. А частота, с которой эта функция используется позволяет там довольно легко справляться с наргузкой.

Произвольные домены

Мы позволяем людям настроить произвольные домены для их публикаций на Medium. Мы хотели, чтобы можно было авторизовываться один раз и для всех доменов, а также HTTPS для всех, так что заставить это всё работать было не тривиально. У нас есть набор серверов HAProxy, которые управляют сертификатами и направляют трафик на основные серверы. При настройке домена по-прежнему требуется ручная работа, но мы автоматизировали большую часть, за счёт интеграции с Namecheap. Сертификаты и связывание с публикациями выполняется выделенными серверами.

Веб фронтенд

В веб части мы предпочитаем оставаться близко к железу. У нас есть собственный фреймворк для одностраничных приложений (SPA), который использует Closure в качестве стандартной библиотеки. Мы используем Closure Templates для рендеринга как на стороне клиента, так и на стороне сервера, и Closure Compiler для минификации кода и разделения на модули. Редактор — это самая сложная часть нашего приложения, Ник о нём уже писал.

iOS

Оба наших приложения нативные, и минимально используют web view.

На iOS мы используем смесь и самодельных фреймворком и встроенных компонентов. На сетевом уровне мы используем NSURLSession для выполнения запросов и Mantle для парсинга JSON и восстановления моделей. У нас есть уровень кеширования, построенный поверх NSKeyedArchiver. Мы используем общий механизм рендеринга элементов списка с поддержкой произвольных стилей, что позволяет нам легко создавать новые списки с различными типами содержимого. Просмотр поста выполнен с помощью UICollectionView с собственным внешним видом (layout). Мы используем общие компоненты для рендеринга всего поста целиком и предпросмотра поста.

Мы собираем каждый коммит и распространяем сборку среди наших сотрудников, так что мы можем опробовать приложение так быстро, настолько это возможно. Частота выкладок приложения в AppStore привязана к циклу проверки приложений, но мы стараемся публиковать приложения даже если изменения минимальны.

Для тестов используем XCTest и OCMock.

Android

На Android мы используем последнюю версию SDK и вспомогательных библиотек. Мы не используем всеохватывающие фреймворки, предпочитая вместо этого использовать стандартные подходы к решению распространённых проблем. Мы используем guava для всего, чего не хватает в Java. В то же время, мы предпочитаем использовать сторонние средства для решения более узких задач. Мы используем свой API на основе protocol buffers, а затем генерируем объекты, которые используем в приложении.

Мы используем mockito и robolectric. Мы пишем высокоуровневые тесты в которых обращаемся к активити и исследуем, что и как — мы создаём базовые версии тестов когда только добавляем экран или готовимся к рефакторингу. Они развиваются по мере того, как мы воспроизводим баги для защиты от регрессии. Мы пишем низкоуровневые тесты для исследования конкретных классов, по мере того, как мы добавляем новые возможности. Они позволяют судить о том, как наши классы взаимодействуют.

Каждый коммит автоматически выкладывается в Play Store как алфа-версия и разаётся нашим сотрудникам. (Это относится и к приложению для нашего внутреннего варианта Medium — Hatch). Как правило, по пятницам мы пердаём альфа версию нашим бета-тестерам и даём им поиграться с нею на выходных, после чего, в понедельник, выкладываем для всех. Так как последняя версия кода всегда готова к релизу, то если мы находим серьезный баг, то мы сразу же публикуем исправление. Если мы беспокоимся о новой функции, то даём бета-тестерам поиграть с ней подольше; если нам всё нравится, то релизим ещё чаще.

A|B тестирование & Feature Flags

Все наши клиенты использую флаги функций (feature flags), выданные сервером и называемые variants. Они используются для A|B тестирования и отсключения не завершённых функций.

Разное

Есть ещё много всего вокруг продукта, о чём я не сказал: Algolia, которая позволяет быстрее работать с функциями поиска, SendGrid для входящей и исходящей электронной почты, Urban Airship для уведомлений, SQS для обработки очередей, Bloomd для фильтров Блума, PubSubHubbub и Superfeedr для RSS и так далее, и так далее.

Сборка, тестирование и выкладка

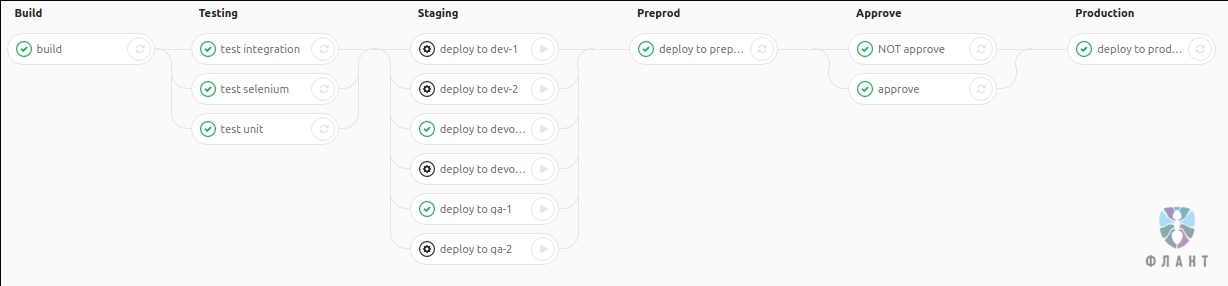

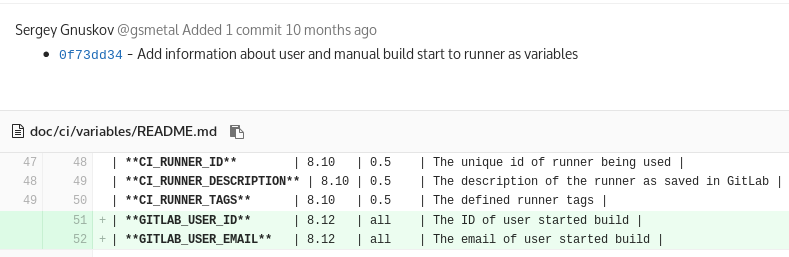

Мы используем непрерывную интеграцию и доставку (continuous integration and delivery), выкладывая как можно быстрее. Всем этим управляет Jenkins.

Исторически, в качестве системы сборки мы использовали Make, но для более новых проектов мы мигрируем на Pants.

У нас есть как модульные тесты, так и функциональные тесты уровня HTTP. Все коммиты тестируются перед мерджем. Совместно с командой из Box мы работали над использованием Cluster Runner, чтобы распределять тесты и делать тестирование быстрее, у него есть также интеграция с GitHub.

Мы выкладываем в тестовое окружение так быстро, как только можем — в настоящий момент каждые 15 минут, успешные редакции затем становятся кандидатами для выклдывания на продакшен. Основные серверы приложений обновляются примерно пять раз в день, в некоторых случаях до 10 раз.

Мы используем синие/зелёные сборки (blue/green builds). Перед выкладкой на продакшен мы направляем трафик на тестовый экземпляр и отслеживаем частоту ошибок прежде чем продолжать. Откатывание назад выполняется средствами DNS.

Что дальше?

Много всего! Есть много всего, что нужно сделать для усовершенствования продукта и чтобы сделать чтение и написание постов лучше. Мы также начинаем работать над монетизацией для авторов и издателей. Это новое для нас поле и мы вступаем на него с открытым разумом. Мы считаем, что будущему требуются новые механизмы для финасирования контента, и мы хотим убедиться, что наши функции стимулируют качество и ценность.

Присоединяйтесь к нам

Обычно мы всегда заинтересованы в общении с целеустремлёнными инженерами, у которых есть опыт работы над приложениями для конечных потребителей. У нас нет требований касательно языков, которые вы знаете, так как мы считаем, что хорошие инженеры могут быстро разобраться в новой дисциплине, но вы должны быть любопытными, знающими, решительными и чуткими. За основу можно принять iOS, Android, Node или Go.

Мы также готовим команду Product Science, так что мы ищем людей с опытом построения конвейеров данных и больших аналитических систем.

Ещё я ищу инженерных лидеров, которые помогут развивать команду. Они должны интересоваться теорией управления организацией, хотеть работать руками и быть готовыми руководить подичнёнными.

Вы можете прочитать больше в Medium Engineering.

Блогадарности Nathaniel Felsen, Jamie Talbot, Nick Santos, Jon Crosby, Rudy Winnacker, Dan Benson, Jean Hsu, Jeff Lu, Daniel McCartney и Kate Lee.

|

Метки: author IvaYan разработка веб-сайтов программирование node.js amazon web services medium архитектура приложений блогинг-платформы elk golang |

Летайте самолетами UNIGINE: новый авиатренажер для МАКС-2017 |

Подробности, хайрезы из нового проекта и секретные фотографии, как водится, под катом.

При чем тут тренажеры, вы же делаете 3D-движок?

На самом деле 3D-графикой для профессиональных тренажеров мы занимаемся почти 10 лет, для них даже существует отдельная версия движка — платформа UNIGINE 2 Sim. Помимо разработки платформы визуализации, мы сами делаем на ней проекты — например, тренажер вертолета Bell 206 (возили на I/ITSEC в 2013 году), или демо VR-тренажера для экипажей МКС, который показывали на SIGGRAPH 2015. И это только публичные собственные проекты, наши клиенты на UNIGINE 2 Sim сделали уже несколько десятков профессиональных тренажеров.

Этот кадр из демо Port Angeles 2014 года. Тогда площадь террейна была 2500 квадратных километров. В авиатренажере для МАКС виртуальное пространство в 100 раз больше, 500х500 км.

Зачем тренажерам нужна реалистичная 3D-графика?

Новое поколение пилотов выросло на современных играх, они привыкли видеть реалистичную картинку и ждут того же от авиатренажеров. Чем лучше графика — тем глубже погружение и тем качественнее подготовка пилотов, у которых ошибка иногда стоит сотен человеческих жизней. Реалистичная визуализация помогает отточить каждое действие до рефлексов и отработать все варианты внештатных ситуаций, когда из-за отказа авионики пилоту приходится полагаться только на зрительные ориентиры.

Большинство существующих профессиональных систем визуализации не блещет качественной 3D-графикой — именно это мы и стараемся изменить.

Тезис про реализм отлично доказывает это видео. Для того, чтобы сделать такие объемные многослойные 3D-облака, перед релизом UNIGINE 2.4 программистов движка «забрасывали» в небо на разных самолетах, чтобы лучше изучить, как ведут себя настоящие облака.

Чтобы добиться большего правдоподобия атмосферных эффектов, в процессе работы мы многократно консультировались с пилотами и экспертами от авиации.

Где и на чем будем летать?

На стадии концепции у авиатренажера были разные варианты сценария, так что этот пост вполне мог бы быть о войне с сомалийскими пиратами. Но в итоге мы выбрали более миролюбивый вариант: тушение лесных пожаров в районе Байкала с самолета-амфибии Бе-200. Все же мы сами из Сибири, тема в прямом смысле близкая. И злободневная: по поводу горящей тайги этим летом бьют тревогу даже в NASA, называя сибирские пожары самыми масштабными за 10 000 лет.

Всего две недели назад Сибирь пылала от Красноярского края до Дальнего востока. Если вы сейчас перейдете по ссылке на карту fires.ru, увидите насколько их стало меньше. Самые сложные из них удалось потушить только с помощью авиации: самолетов Бе-200 и вертолетов Ми-8.

Работа Авиалесоохраны вообще пропитана суровой романтикой настоящих мужчин — про это есть отличная статья в National Geographic, например. Прыгать с парашютом на бушующий лесной пожар — это точно не для слабых духом. Поэтому мы сделали тренажер, который в перспективе поможет пилотам МЧС лучше подготовиться к тяжелой работе.

В главной роли — Бе-200, уникальный российский самолет-амфибия. Он может на лету забирать воду из озер и рек, нести до 12 тонн воды, с помощью тепловизионной камеры находить очаги пожаров на расстоянии в десятки километров, даже если огонь скрыт завесой дыма.

Из чего сделан тренажер?

Стенд для МАКС-2017 получился намеренно минималистичным — рама, кресло, симмерские контроллеры, компьютеры и UNIGINE 2 Sim inside. Раму делали под заказ по нашим чертежам. Начинка собрана из четырех компьютеров: три генератора изображений рисуют вид из кабины, один CIGI-сервер обеспечивает аэродинамику и имитирует приборную панель с тепловизором. Да, у тренажера пока нет точной реплики кокпита Бе-200 и подвижной платформы, хотя предложения от партнеров по созданию аппаратной части уже имеются. Но чтобы продемонстрировать возможности движка и погрузиться в полет на UNIGINE 2 Sim этого железа достаточно.

Внутри системников — i5 4570 / 16 GB / GTX 1080 / SSD.

UNIGINE 2 Sim поддерживает режим многоканальной визуализации с частотой 60 Гц. Для синхронизации между хостом и тремя IG мы используем протокол CIGI — широко распространенный в индустрии профессиональных тренажеров стандарт, одним из его разработчиков является компания Boeing.

Вид из кабины выводится на мониторы 32" с разрешением 2560x1440. Управляется все с помощью РУД/РУС Thrustmaster Hotas Warthog и одноименных педалей.

И напоследок видео проекта на стадии «work in progress».

Тренажер будет дорабатываться, к концу года планируем вывести его на еще более высокий уровень.

Приходите посмотреть и попробовать, а заодно поговорить о 3D-графике как разработчики с разработчиками. МАКС в этом году проходит с 18 по 23 июля в подмосковном Жуковском. Наш стенд D9-7 в павильоне D9. Билеты на МАКС-2017 можно купить на сайте авиасалона.

Предварительную перепись желающих ведем в комментариях!

|

Метки: author Beatrix c++ блог компании unigine unigine макс-2017 3d- графика и анимация авиация авиатренажер авиасимулятор авиасалон |

Решение promo task от BI.ZONE CTF |

31 мая компания BI.ZONE анонсировала новость о «CTFzone presidential election». И уже 1-го июня на Хабрахабр появилась публикация BI.ZONE объявляет выборы президента CTFzone, в которой, как и в прошлом году, спрятана «пасхалка». Если присмотреться к тексту публикации, можно заметить, что в предложении «Всем удачи на выборах!» есть ссылка ведущая на веб-страницу содержащую QR-код:

QR сканер выдал сообщение:

try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r_try_h4rd3r

Первое, что пришло в голову найти пользователя «try_h4rd3r» в twitter. Вторая попытка «try hard» заключалась в том, что мы попробовали разбить большой оригинальный QR-код на несколько маленьких:

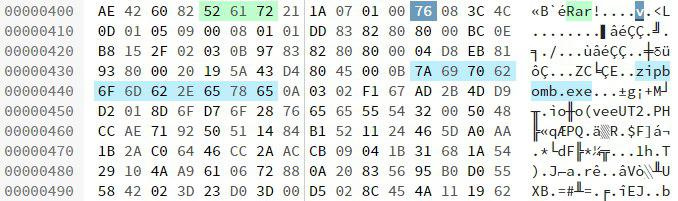

Но все попытки были тщетны. Было принято решение скачать файл promo_task.png и исследовать в Hexed.it Сильно привлекла внимание строка:

Таким образом, поменяв расширение на

.7z, получаем архив, который можем открыть 32-x битным 7-Zip. Содержимое архива: zipbomb.exe — самая настоящая ZIP-бомба. «Перерезав красный провод» и поменяв расширение на .zip, получаем архив, в котором лежит файл "-" размером 38,1 ГБ (40 959 016 020 байт). Ясно было сразу, что такой файл не прочесть разом. Было принято решение написать простенький скрипт на языке Python, который бы читал его по частям.def read_in_chunks(file_object, chunk_size=1024):

while True:

data = file_object.read(chunk_size)

if not data:

break

yield data

Результатом работы было множество строк, содержащих нули, среди которых тяжело было найти что-то особенное. Тогда скрипт модифицировали простой проверкой:

def read_in_chunks(file_object, chunk_size=1024):

while True:

data = file_object.read(chunk_size)

if not data:

break

yield data

f = open('-')

for piece in read_in_chunks(f):

if piece.count("0") < 1023:

print(piece)

Результат работы скрипта:

Видим строчку: @cc77af5382e431dc_bot и первым делом вбиваем имя бота в Telegram. Получаем инструкции бота и задачу:

Подобрав кодировку Base64, мы декодируем и получаем:

Далее отправив результат боту

/solve <ответ> можно получить flag. Однако сегодня Вы получите только это: «Sorry all flags are gone». Всем удачи на CTFzone presidential election!

Спасибо tugric tammio за командную работу над задачей. Если они вам ответят в комментариях — им можно верить.

|

Метки: author malchikserega информационная безопасность ctf блог компании перспективный мониторинг ctfzone zip- бомбы python |

[Из песочницы] Реализация Elliptic curve Menezes-Vanstone cryptosystem на базе OpenSSL API |

К сожалению, этот алгоритм оказался единственным в openssl, который допускает шифрование/дешифровку маленьких блоков данных (предполагается по смыслу статьи — ключей для алгоритмов симметричного шифрования) с помощью асимметричных криптоалгоритмов.

Прогулявшись по просторам интернета, удалось выяснить, что:

1. El-Gamal может успешно шифровать/расшифровывать, но эти операции не реализованы в openssl (есть реализация в libgcrypt). В плане быстродействия El-Gamal раза в 3 быстрее RSA

при той-же длине ключа и той-же криптостойкости на 1 бит ключа.

2. Elliptic Curve cryptosystem (ECC) приятно удивили скоростью и криптостойкостью на 1 бит ключа, но операции шифрования/дешифрования на основе ECC не реализованы в openssl.

Реализация ECC шифрования в libgcrypt есть, но очень специфична. Если коротко, то шифруемое сообщение m отображается на точку эллиптической кривой mG, из которой исходное сообщение m не может быть получено иначе, как взломом ECC или перебором всех возможных значений m.

3. В литературе [1] описана Menezes-Vanstone ECC, но есть уведомления о ее «уязвимости» [2]

Разберем этот вопрос подробнее.

Немного математики:

Для простоты будем говорить только о эллиптических кривых, вид которых описывается уравнением Вейершрасса над полями целых чисел, определенных как Zp, где Zp — множество целых чисел, меньших некоторого простого числа р и больших нуля.

Тогда E(p,a,b) — где a,b принадлежат Zp — эллиптическая кривая над полем Zp, определяемая простым числом p и числами a,b. Далее нужно определить абстрактный нулевой элемент O (если коэффициент уравнения Вейершрасса b не равен 0, то за условную точку O можно принять координаты x=0,y=0 даже если эта точка и не является решением уравнения) и операцию сложения элементов кривой(точек), которая даст новую точку, принадлежащую этой-же кривой.

Естественно, должно получиться, что P+Q=Q+P, (P+Q)+R = P+(Q+R), P+O=O+P=P и если есть P(x,y), то есть -P=(x,-y) и P+(-P)=P-P=O.

Это — все математические операции, которые определены для группы точек эллиптической кривой.

В литературе [1] можно найти математические подробности, как определяются эти операции.

Складывать можно разные точки (P=G+Q) или точку с собой (P=Q+Q). То, что мы будем говорить о «умножении» — лишь способ сократить запись, и не писать P=Q+Q+Q+Q+...+Q m раз, а просто написать, что P=mQ. На самом деле нет операции «умножение» и, соответственно «деление», также как нет «возведения в степень» и «взятия логарифма».

Эта терминология часто используется, но для эллиптических кривых обозначает она не то, что обычно под этим понимается. Суммирование точки на эллиптической кривой с собой m раз можно назвать «умножением на m» или даже «возведением в степень m». Суть от этого не меняется, а поскольку обратной операции, «деления» или «взятия логарифма» не существует, получить m из точки m*G, даже зная G невозможно, говорят о «проблеме дискретного логарифма на эллиптических кривых». Такова устоявшаяся терминология.

На этой кривой выбирается (произвольная) точка G(Gx,Gy) которая является генератором группы точек, то есть, задавая разные m, получаем результат умножения mG, который образует циклическую группу точек (поскольку мы в конечном поле Zp). Размер этой циклической группы называется порядком (order) точки генератора G.

Таким образом, эллиптическая группа полностью описывается параметрами кривой E(p,a,b), точкой генератора G(Gx,Gy), и порядком группы ord, при этом ord*G=O. Это все называется параметрами эллиптической кривой, которые обычно являются общеизвестными, и идентифицируется по именам, например secp192k1 или prime256v1.

Приватным ключом пользователя является (секретное, случайное) число 1 < d < ord-1

Публичным ключом пользователя является точка Q, которая является произведением приватного ключа d и генератора группы G, Q=dG.

Что предлагает Elliptic curve Menezes-Vanstone cryptosystem [1] (MVC)?

Сторона отправителя:

1. Шифруемое сообщение m разбивается на две части x1 и x2, каждая из которых должна быть элементом поля Zp, для этого достаточно проверить их длину и сравнить с длиной параметра кривой p.

2. Отправитель выбирает (секретное, случайное) число 1 < ks < ord-1.

3. Отправитель умножает точку генератора G на число ks, y0=ks*G

4. Отправитель вычисляет точку Z(Zx,Zy), умножая публичный ключ получателя Q на число ks, Z=ks*Q

5. Отправитель вычисляет y1=x1*Zx(mod p), y2=x2*Zy(mod p)

Вычислительные затраты отправителя: генерация случайного числа нужной длины, 2 операции умножения точки на число, 2 операции умножения по модулю p.

Шифротекстом является точка y0, число y1, число y2. Точка содержит 2 числа — координаты x,y. Общий объем шифротекста приблизительно равен 4*p, для ключа ECC длиной 192 бита (24 байта) приблизительно 24*4=96 байт.

Сторона получателя:

1. Получатель проверяет принадлежность точки y0 кривой, заданной параметрами E(p,a,b),G,ord.

2. Получатель вычисляет точку Z, умножая шифротекст y0 на свой приватный ключ d, Z=d*y0=d*ks*G=ks*d*G=ks*Q.

3. Получатель вычисляет мультипликативную инверсию компонентов Z(Zx,Zy), e1=inv(Zx)(mod p), e2=inv(Zy)(mod p).

4. Получатель восстанавливает x1, x2: x1=y1*e1(mod p), x2=y2*e2(mod p).

Вычислительные затраты получателя: проверка принадлежности точки к кривой, 1 операция умножения точки на число, 2 операции вычисления мультипликативной инверсии по модулю p,

2 операции умножения по модулю p.

Уязвимость или слабость MVC

В 1997г Klaus Kiefer [2] показал, что MVC не является системой, использующей вероятностное шифрование, вопреки своему дизайну. Зная шифротекст, зная параметры кривой, можно провести «known plaintext attack» (атака с угадыванием открытого текста).

Как это выглядит:

Известны параметры кривой E(p,a,b),G,ord. Известен шифротекст y0,y1,y2. Мы предполагаем, что открытым текстом является x1,x2.

Если точка F(f1,f2) f1=y1*(inv(x1))(mod p), f2=y2*(inv(x2))(mod p) принадлежит кривой E(p,a,b), то с вероятностью ошибки 1/p x1,x2 действительно есть искомый открытый текст.

Что это означает на практике?

То, что возможно устроить перебор всех значений x1,x2 с вычислительными затратами 2 операции вычисления мультипликативной инверсии по модулю p, 2 операции умножения по модулю p на каждый вариант x1,x2 и с вероятностью ошибки 1/p найти открытый текст, соответствующий зашифрованному. Отрицательный результат проверки всегда верен, положительный может содержать ошибочное распознавание с вероятностью 1/p. Операция перебора x1,x2 хорошо распареллеливается, много процессов могут независимо перебирать свои неперекрывающиеся диапазоны значений x1,x2.

Для справки: я бы хотел посмотреть на перебор (просто перебор, без вычислений) всех возможных значений ключа 192 или 256 бит. Да, даже и 128-168 бит.

Понятно, что перебором можно вскрыть только небольшие кусочки зашифрованных данных, до 48-64 бит. И перебор этот можно устроить без MVC, для задачи найти ключ перебором всех возможных значений использование MVC не нужно, это лишняя сущность.

Что мы имеем в итоге?

Если шифровать достаточно большие (128 бит и более) тексты, исключающие возможность за разумное время и приемлемые затраты найти их перебором, данная «уязвимость» не играет никакой роли.

На сегодняшний день минимальная рекомендуемая длина ключа ECC — 192 бита (24 байта). Длина шифруемых данных MVC в этом случае не должна превышать 2*24=48 байт, а самый стойкий ключ AES или GOST, имеет длину 256 бит (32 байта).

Зато мы получаем криптостойкий и достаточно быстрый (по моим прикидкам, ECC-224 в 5 раз быстрее RSA-2048, в 3 раза быстрее ElGamal-2048) алгоритм асимметричного шифрования.

Я считаю, что Elliptic curve Menezes-Vanstone cryptosystem совершенно незаслуженно забыта.

Пытаясь восполнить этот пробел, выкладываю исходники на языке C с использованием openssl API.

Литература:

1. COMPUTER SECURITY AND CRYPTOGRAPHY, ALAN G. KONHEIM, Published by John Wiley & Sons, Inc., Hoboken, New Jersey, 2007. ISBN-13: 978-0-471-94783-7 ISBN-10: 0-471-94783-0

2. «A Weakness of Menezes-Vanstone Cryptosystem», Klaus Kiefer, member of research group of prof. J. Buchmann, 1997

//

// DESCRIPTION 'EC Menezes-Vanstone cryptosystem functions openssl/Linux'

// COMPILER 'gcc (GCC) 4.8.2'

// FILE 'ecmv.h'

// AUTHOR "Nick Korepanov"

// Linux-3.10.104, glibc-2.17, OpenSSL 1.0.1u

// ECC-192/224/256

// This program is free software; you can redistribute it and/or modify

// it under the terms of the GNU General Public License as published by

// the Free Software Foundation; either version 2 of the License, or

// (at your option) any later version.

//

// This program is distributed in the hope that it will be useful,

// but WITHOUT ANY WARRANTY; without even the implied warranty of

// MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE. See the

// GNU General Public License for more details.

//

// You should have received a copy of the GNU General Public License

// along with this program; if not, write to the Free Software

// Foundation, Inc., 675 Mass Ave, Cambridge, MA 02139, USA.

//

// Author of this program can be contacted by electronic mail

// korepanovnd@gmail.com

// Copyright (c) 2017 Nick Korepanov. All rights reserved.

// This product includes software developed by the OpenSSL Project

// for use in the OpenSSL Toolkit. (http://www.openssl.org/)

// COMPUTER SECURITY AND CRYPTOGRAPHY, ALAN G. KONHEIM

// Published by John Wiley & Sons, Inc., Hoboken, New Jersey, 2007

// Library of Congress Cataloging-in-Publication Data:

// Konheim, Alan G., 1934–

// Computer security & cryptography / by Alan G. Konheim.

// p. cm.

// Includes bibliographical references and index.

// ISBN-13: 978-0-471-94783-7

// ISBN-10: 0-471-94783-0

// 1. Computer security. 2. Cryptography. I. Title.

// QA76.9.A25K638 2007

// 005.8--dc22 2006049338

// 15.9 THE MENEZES–VANSTONE ELLIPTIC CURVE CRYPTOSYSTEM, p. 443

// Another very significant source - "A Weakness of Menezes-Vanstone Cryptosystem", Klaus Kiefer, member of research group of prof. J. Buchmann, 1997

// Shortly, this work show ability of "known plain text attack (KPTA)", with probability O(1/p) of false detection.

// What does it mean? If we encrypt 128-bit session key, for success KPTA we must search in 2^128 combinations of session key ...

// Known plaintext attack for EC MV cryptosystem

// Curve E(p,a,b) known from public key,

// y0, y1, y2 - ciphertext

// random select 1 < x1 < p and 1< x2 < p

// calculate inversion a=inv(x1)(mod p), b=inv(x2)(mod p)

// c1=a*y1(mod p), c2=b*y2(mod p)

// if C(c1,c2) is point of curve E, x1 and x2 is plaintext with error probability O(1/p)

// z=((c1)^3 + a*c1 + b)(mod p)

// if (z^((p-1)/2))(mod p) == 1 there are 2 points (c1,+-c2) in curve E(p,a,b)

//#include

#include

#include

//#include

#include //

// DESCRIPTION 'EC Menezes-Vanstone cryptosystem functions openssl/Linux'

// COMPILER 'gcc (GCC) 4.8.2'

// FILE 'ecmv.c'

// AUTHOR "Nick Korepanov"

// Linux-3.10.104, glibc-2.17, OpenSSL 1.0.1u

// ECC-192/224/256

// This program is free software; you can redistribute it and/or modify

// it under the terms of the GNU General Public License as published by

// the Free Software Foundation; either version 2 of the License, or

// (at your option) any later version.

//

// This program is distributed in the hope that it will be useful,

// but WITHOUT ANY WARRANTY; without even the implied warranty of

// MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE. See the

// GNU General Public License for more details.

//

// You should have received a copy of the GNU General Public License

// along with this program; if not, write to the Free Software

// Foundation, Inc., 675 Mass Ave, Cambridge, MA 02139, USA.

//

// Author of this program can be contacted by electronic mail

// korepanovnd@gmail.com

// Copyright (c) 2017 Nick Korepanov. All rights reserved.

// This product includes software developed by the OpenSSL Project

// for use in the OpenSSL Toolkit. (http://www.openssl.org/)

#include "ecmv.h"

int EC_MV_pubkey_encrypt(unsigned char *cipher, EC_KEY* pubkey, unsigned char* plaintext, size_t len, int format)

{

const EC_GROUP *curve; // curve, q and g are part of pubkey, it was allocated and free with pubkey

const EC_POINT *q;

EC_POINT *y0, *z;

BIGNUM *p, *a, *b, *ks, *o1, *z1, *z2, *y1, *y2, *x1, *x2, *ord;

int bits, i=0, err;

unsigned char buffer[250];

//size_t length;

BN_CTX *ctx;

curve=EC_KEY_get0_group(pubkey);

if(curve)

bits = EC_GROUP_get_degree(curve);

else

return 1; // no curve in key?

if(len%2)

return 2; // wrong plaintext has odd length

if(len > 2*bits/8)

return 3; // plaintext too long for this key

if( !(bits == 192 || bits == 224 || bits == 256) && format)

return 8; // binary format of encrypted block not defined for this key length

//prepare bignums

p=BN_new(); a=BN_new(); b=BN_new(); ks=BN_new(); o1=BN_new(); z1=BN_new(); z2=BN_new(); y1=BN_new(); y2=BN_new(); x1=BN_new(); x2=BN_new(); ord=BN_new();

ctx=BN_CTX_new();

//prepare points

//q=EC_POINT_new(curve); g=EC_POINT_new(curve);

y0=EC_POINT_new(curve); z=EC_POINT_new(curve);

// split plaintext at two parts, and assign it to BIGNUMs

BN_bin2bn(plaintext, len/2, x1);

BN_bin2bn(plaintext+len/2, len/2, x2);

// get public key q

q=EC_KEY_get0_public_key(pubkey);

// get generator point g

//g=EC_GROUP_get0_generator(curve);

// get order of g

EC_GROUP_get_order(curve, ord, ctx );

// get prime p

EC_GROUP_get_curve_GFp(curve, p, a, b, ctx );

BN_sub(o1, ord, BN_value_one()); // o1=ord-1

do

{

if( i>= 10)

break;

// make secret session key ks > 1 and ks < (o-1)

RAND_bytes(buffer, bits/8);

BN_bin2bn(buffer, bits/8, ks);

i++;

}

while( BN_cmp(BN_value_one(), ks) >=0 || BN_cmp(o1,ks) <=0 );

if(i>=10)

return 4; // ks is wrong, error in do-while

// y0=ks*g

err=EC_POINT_mul(curve, y0, ks, NULL, NULL, ctx );

if(err == 0)

return 5; // error in EC_POINT_mul y0=ks*g

// z=ks*q

err=EC_POINT_mul(curve, z, NULL, q, ks, ctx );

if(err == 0)

return 6; // error in EC_POINT_mul z=ks*q

// get z1,z2 = Z(z1,z2)

err=EC_POINT_get_affine_coordinates_GFp(curve, z, z1, z2, ctx );

if(err == 0)

return 7; //error EC_POINT_get_affine_coordinates_GFp

//y1 = z1*x1(modulo p)

//y2 = z2*x2(modulo p)

BN_mod_mul(y1, z1, x1, p, ctx);

BN_mod_mul(y2, z2, x2, p, ctx);

/* if bits=192, 24 bytes per every BIGNUM, point contains 2 Bignum + 1 byte header */

if(format)

{ // bin format

if(bits == 192)

{

struct BinFmt192 *out;

out=(struct BinFmt192 *)cipher;

EC_POINT_point2oct(curve, y0, POINT_CONVERSION_UNCOMPRESSED, (unsigned char*)&out->y0, sizeof(out->y0), ctx);

BN_bn2bin(y1, (unsigned char*)&out->y1);

BN_bn2bin(y2, (unsigned char*)&out->y2);

out->z1=out->z2=out->z3=0;

}

if(bits == 224)

{

struct BinFmt224 *out;

out=(struct BinFmt224 *)cipher;

EC_POINT_point2oct(curve, y0, POINT_CONVERSION_UNCOMPRESSED, (unsigned char*)&out->y0, sizeof(out->y0), ctx);

BN_bn2bin(y1, (unsigned char*)&out->y1);

BN_bn2bin(y2, (unsigned char*)&out->y2);

out->z1=out->z2=out->z3=0;

}

if(bits == 256)

{

struct BinFmt256 *out;

out=(struct BinFmt256 *)cipher;

EC_POINT_point2oct(curve, y0, POINT_CONVERSION_UNCOMPRESSED, (unsigned char*)&out->y0, sizeof(out->y0), ctx);

BN_bn2bin(y1, (unsigned char*)&out->y1);

BN_bn2bin(y2, (unsigned char*)&out->y2);

out->z1=out->z2=out->z3=0;

}

}

else

{ // hex format

strcpy((char*)cipher, EC_POINT_point2hex(curve, y0, POINT_CONVERSION_UNCOMPRESSED, ctx));

strcat((char*)cipher, "\n");

strcat((char*)cipher, BN_bn2hex(y1));

strcat((char*)cipher, "\n");

strcat((char*)cipher, BN_bn2hex(y2));

strcat((char*)cipher, "\n");

}

// free points

//EC_POINT_free(q); EC_POINT_free(g);

EC_POINT_free(y0); EC_POINT_clear_free(z);

BN_CTX_free(ctx);

BN_clear(ks);

BN_clear(x1);

BN_clear(x2);

BN_clear(z1);

BN_clear(z2);

//free bignums

BN_free(p); BN_free(a); BN_free(b); BN_free(ks); BN_free(o1); BN_free(z1); BN_free(z2); BN_free(y1); BN_free(y2); BN_free(x1); BN_free(x2); BN_free(ord);

return 0;

}

int EC_MV_privkey_decrypt(unsigned char* cipher, EC_KEY *privkey, unsigned char* plaintext)

{

const EC_GROUP *curve; // curve, d are part of privkey, it was allocated and free with privkey

const BIGNUM *d;

EC_POINT *y0, *z;

BIGNUM *p, *a, *b, *z1, *z2, *y1, *y2, *x1, *x2;

int err, bits, format;

unsigned char *ptr;

BN_CTX *ctx;

ctx=BN_CTX_new();

curve=EC_KEY_get0_group(privkey);

if(!curve)

return 1; // no curve in key?

bits = EC_GROUP_get_degree(curve);

if( cipher[0] == 0x04 )

format=FORMATBIN;

if( cipher[0] == 0x30 )

format=FORMATHEX;

if(cipher[0] != 0x04 && cipher[0] != 0x30)

return 8; // unknown format of ECMV encrypted block

if( !(bits == 192 || bits == 224 || bits == 256) && format)

return 9; // binary format of encrypted block not defined for this key length

if(format && bits == 192 && (cipher[48+1] || cipher[48+1+24+1] || cipher[48+1+24+1+24+1] ))

return 10; //wrong format of binary encrypted block

if(format && bits == 224 && (cipher[56+1] || cipher[56+1+28+1] || cipher[56+1+28+1+28+1] ))

return 10; //wrong format of binary encrypted block

if(format && bits == 256 && (cipher[64+1] || cipher[64+1+32+1] || cipher[64+1+32+1+32+1] ))

return 10; //wrong format of binary encrypted block

//prepare bignums

p=BN_new(); a=BN_new(); b=BN_new(); z1=BN_new(); z2=BN_new(); y1=BN_new(); y2=BN_new(); x1=BN_new(); x2=BN_new();

//prepare points

y0=EC_POINT_new(curve); z=EC_POINT_new(curve);

// get private key d

d=EC_KEY_get0_private_key(privkey);

// get prime p

EC_GROUP_get_curve_GFp(curve, p, a, b, ctx);

if(format)

{

if(bits == 192)

{

struct BinFmt192 *in;

in=(struct BinFmt192 *)cipher;

EC_POINT_oct2point(curve, y0, (const unsigned char *)&in->y0, sizeof(in->y0), ctx);

BN_bin2bn((const unsigned char *)&in->y1, sizeof(in->y1), y1);

BN_bin2bn((const unsigned char *)&in->y2, sizeof(in->y2), y2);

}

if(bits == 224)

{

struct BinFmt224 *in;

in=(struct BinFmt224 *)cipher;

EC_POINT_oct2point(curve, y0, (const unsigned char *)&in->y0, sizeof(in->y0), ctx);

BN_bin2bn((const unsigned char *)&in->y1, sizeof(in->y1), y1);

BN_bin2bn((const unsigned char *)&in->y2, sizeof(in->y2), y2);

}

if(bits == 256)

{

struct BinFmt256 *in;

in=(struct BinFmt256 *)cipher;

EC_POINT_oct2point(curve, y0, (const unsigned char *)&in->y0, sizeof(in->y0), ctx);

BN_bin2bn((const unsigned char *)&in->y1, sizeof(in->y1), y1);

BN_bin2bn((const unsigned char *)&in->y2, sizeof(in->y2), y2);

}

}

else

{

// read y0

ptr=cipher;

y0=EC_POINT_hex2point(curve, (const char *)ptr, y0, ctx);

if(y0 == NULL)

return 2; //invalid hex point representation

//read y1,y2

ptr=strchr((const char *)ptr,'\n');

if(ptr == NULL)

return 3; //wrong format of encrypted data

ptr++;

BN_hex2bn(&y1, (const char *)ptr);

ptr=strchr((const char *)ptr,'\n');

if(ptr == NULL)

return 4; //wrong format of encrypted data

ptr++;

BN_hex2bn(&y2, (const char *)ptr);

}

if( !EC_POINT_is_on_curve(curve, (const EC_POINT *)y0, ctx) )

return 11; // point is not on curve

// z=d*y0=d*ks*g=ks*q

err=EC_POINT_mul(curve, z, NULL, y0, d, ctx );

if(err == 0)

return 6; // error in EC_POINT_mul z=ks*q

// get z1,z2 = Z(z1,z2)

err=EC_POINT_get_affine_coordinates_GFp(curve, z, z1, z2, ctx );

if(err == 0)

return 7; //error EC_POINT_get_affine_coordinates_GFp

// a=inv(z1)(mod p)

BN_mod_inverse(a, z1, p, ctx);

// b=inv(z2)(mod p)

BN_mod_inverse(b, z2, p, ctx);

//x1 = a*y1(modulo p)

//x2 = b*y2(modulo p)

BN_mod_mul(x1, a, y1, p, ctx);

BN_mod_mul(x2, b, y2, p, ctx);

// decode plaintext from two parts

BN_bn2bin(x1, plaintext);

BN_bn2bin(x2, plaintext+BN_num_bytes(x1));

// free points

EC_POINT_free(y0); EC_POINT_clear_free(z);

BN_CTX_free(ctx);

BN_clear(x1);

BN_clear(x2);

BN_clear(z1);

BN_clear(z2);

BN_clear(a);

BN_clear(b);

//free bignums

BN_free(p); BN_free(a); BN_free(b); BN_free(z1); BN_free(z2); BN_free(y1); BN_free(y2); BN_free(x1); BN_free(x2);

return 0;

}

Спасибо за внимание!

|

Метки: author NickKorepanov программирование криптография elliptic curve cryptography openssl public key |

Интервью с программистом из Тинькофф Банка Андреем Степановым о языке Python и ML |

— Андрей, как ты пришел к разработке на Python?

— В основном, как и многие в моей отрасли, через ML. Но это будет не совсем честный ответ. Питоном я увлекался до этого, можно даже сказать, со школы. А еще был классный курс в ШАДе. Поначалу меня пугал синтаксис, до этого я изучал лишь C-подобные языки, и после них казалось, что полагаться на пробелы и табы для структурирования программы не совсем разумно. Но потом привык, понравилась простота, а через некоторое время пришло понимание, какой же это на самом деле богатый и многогранный язык, какие сумасшедшие вещи можно с ним делать. Это не то, что приходится часто делать на работе, но приятно осознавать, что инструмент, с которым ты работаешь, достаточно гибок и мощен.

— У тебя интересная должность — разработчик-аналитик. Чем занимаются разработчики-аналитики? Над чем ты сейчас работаешь?

— Нас, разработчиков-аналитиков, в банке не очень много. Это что-то среднее между специалистом по работе с большими данными и промышленным разработчиком. Здесь надо и код уметь писать красивый и поддерживаемый, и с данными уметь работать, ML эксперименты проводить, анализировать результаты и соответствующим образом обновлять математические модели. Ну, или искать новые подходы к решению задачи, если текущие не работают. А если работают, и со стороны бизнеса все ок, то пробовать реализовать прототип для продакшена. Соответственно, стек технологий очень широкий. Работа интересная и довольно трудоемкая, очень много приходится читать доков про новые технологии и вообще в принципе следить за новостями в области ML и выбранных технологий для продакшен стека.

Сейчас я работаю на проекте по распознаванию речи для банка.

— Какие технологии использует Тинькофф? Много ли у вас ML? Какое место в инфраструктуре занимает Python?

— Из тех, что используем мы: Python, Tensorflow, Docker, Protocol Buffers, GRPC, Cython. У других команд, конечно, может быть другой стек технологий.

ML много, в продакшене особенно ценятся простые и быстрые, хорошо интерпретируемые ML модели. Сейчас развиваем и модный Deep Learning. Распознавание речи, диалоговые системы — все это как раз использует глубокие нейросети. Применение нейронных сетей может дать в будущем качественный скачок в создании клиентских продуктов и сервисов, поэтому мы уделяем им отдельное внимание.

Python в инфраструктуре наших ML решений пока занимает роль языка для проведения экспериментов и тренировки первоначальных моделей. В нём есть все для ML продакшена, и мы пытаемся исследовать эту тему. В идеале хотелось бы иметь инструмент, который позволит аналитикам экспортировать обученные модели и предоставлять быстрый внешний API для их расчета. Для Deep Learning что-то такое отчасти уже есть, я сейчас говорю про Tensorflow Serving. Было бы круто, если такой инструмент существовал для всех часто используемых ML моделей.

На прошлогоднем PyCon Martin Gorner из Google подробно рассказал про TensorFlow

— Насколько страшно писать код для банка?

— В RnD вообще не страшно, а должно быть? :) Ребятам, которые ближе к персональным данным и деньгам, наверное, страшнее, но у них там и внешнего контроля над процессом больше.

— Насколько я знаю, Тинькофф стал первым в России, кто внедрил у себя технологию распознавания клиентов по голосовому слепку. Это так? Ты принимал участие в разработке? Расскажи поподробнее про эту фичу?

— Если я правильно понял, вы говорите про совместный проект с NICE Systems. Мы внедрили распознавание по голосу в 2014 г, это произошло до того, как я пришел работать в Тинькофф.

Внедрение этой технологии позволило сократить количество дополнительных вопросов к клиенту или вообще обойтись без них. Продолжительность звонков в среднем уменьшается на 40-60 секунд за звонок, что позволяет нам существенно экономить на трафике.

Система распознавания голоса повышает уровень сервиса, так как клиентам не нужно отвечать на однотипные вопросы при каждом звонке в банк, и эффективность работы службы поддержки, поскольку операторы сразу переходят к решению вопроса. А еще голосовая биометрия позволяет повысить уровень безопасности при проведении операций.

— Стоит ли ждать, что голосовые помощники и голосовые технологии станут нормальными собеседниками?

— Со временем, думаю, да. Но сколько времени должно пройти для этого, никто не знает.

Сейчас всё, даже с учетом последних наработок в области GPGPU, упирается в вычислительные способности современного железа и разработку эффективных нейросетевых архитектур. Основная проблема заключается даже не в тренировке, хотя и в этой области развитие железа помогло бы, а в предоставлении миллионам пользователей вычислительного времени для обсчёта нейросети на их данных. Представленные недавно Tensor Processing Unit (TPU) от Google и специализированные вычислительные юниты для Deep Learning в GPU ядре новой архитектуры от NVIDIA позволяют частично решить эту проблему, но должно пройти еще много времени, чтобы эти технологии освоили разработчики и ученые.

Да, человечество сделало огромный шаг в области AI по сравнению с тем, что было, например, 10 лет назад, но до полноценного искусственного интеллекта, думаю, еще далеко.

— На твой взгляд, в каком направлении будут развиваться эти технологии в ближайшие годы?

— Думаю, в ближайшее время произойдёт серьезное усиление человеческих способностей с помощью AI в тех областях, где сейчас традиционно человек считается превосходящим компьютер (это как раз голосовые помощники, чатботы, диалоговые системы). Интерфейсы взаимодействия всё еще сохранят отчасти искусственный, компьютерный «облик», то есть естественно разговаривать с голосовым помощником на произвольную тему пока ещё не получится, но в рамках фиксированного домена разговор, даже естественный, может вполне состояться.

— Ты наверняка знаешь, что происходит в мире финтеха. Какова роль Python в этой отрасли?

— Python зарекомендовал себя как отличный язык для экспериментов с ML. В продакшене не все так просто, я сейчас в основном про скорость работы. Но computationally-intensive часть кода всегда можно реализовать на Cython или как C extension. Тогда проблем со скоростью быть не должно. У Python очень классное комьюнити, и возникшие потребности можно всегда решить внешними пакетами.

— Какие инструменты ты используешь для организации работы (в том числе для планирования времени, организации рабочего пространства и т.п.)?

— Я предпочитаю почти пустой рабочий стол с минимальным количеством самого необходимого. Для планирования использую листок бумаги и голову, иногда Google Keep для долгосрочных задач.

— Ты читаешь какой-нибудь профессиональный блог? Какие информационные ресурсы ты мог бы порекомендовать коллегам для развития скиллов?

— Если про ML и Deep Learning, то мне нравятся блоги Andrej Karpathy и WildML. Они, правда, уже давно не обновлялись. Еще есть классный блог про Tensorflow от одного француза. Также мне очень понравилась видеолекция от David Beazley про метапрограммирование в Python 3. А еще у Python-а и стандартной библиотеки очень классные доки, я всегда нахожу в них что-то новое.

17 июля на PyConRu Андрей проведет большой мастер-класс «Распознавание речи на Python без PhD» на котором расскажет о том, как написать и натренировать свой простой движок для распознавания речи с Tensorflow и нейросетями в максимально сжатые сроки.

Спасибо нашим спонсорам, которые делают конференцию возможной: золотому спонсору — компании Adcombo, партнеру энергии и хорошего настроения компании ЦИАН, серебряным спонсорам — Rambler&Co и ДомКлик, бронзовому спонсору — MediaScope. Спасибо за поддержку Python Software Foundation.

|

Метки: author shulyndina программирование машинное обучение python блог компании it-people machine learning |

Константин Будник, EPAM: “Apache Hadoop перешел в фазу commodity — там почти не появляется ничего нового.” |

Вы почти 15 лет работали в Sun Microsystems, потом долгое время работали над Hadoop. Как развивалась ваша карьера?

Я работал в Sun начиная с 1994 года, с момента открытия офиса в Санкт-Петербурге — был сотрудником номер 6. Там я проработал 15 лет и занимался всем — от компиляторов до распределенных и кластерных системам. Я работал над операционной системой, над разными частями Java stack — в частности, в команде JVM, участвовал в разработке виртуальной машины, создал несколько фреймворков для разработчиков JVM.

Если рассматривать open-source, то я работал с открытыми технологиями примерно с 1994 года. В частности в середине 2000-х я помогал добавить Java в Linux Software Foundation, который создали незадолго до этого. Java стала частью LSB – Linux Standard Base. Тогда же немного поработал с Яном Мердоком — создателем Linux-дистрибутива Debian.

Начиная с 2000-х я начал заниматься распределенными системами, и за время работы в Sun я получил порядка 15 американских патентов в области распределенных вычислений и технологий.

В 2009 году я перешел в Yahoo и начал работать над Apache Hadoop — писал код, который шел в проект Apache. За первые 3 года работы в проекте Hadoop, я написал больше кода, чем, на тот момент, было у компании IBM. Конкретнее, я работал над HDFS – дистрибутивной файловой системой, для хранения данных в Hadoop, и системой распределенного fault-injection. После этого прошло некоторое время, и вот уже год я сотрудничаю с EPAM.

Над чем вы там работаете?

В EPAM есть департамент Big Data Practice. На сегодня он насчитывает около 300 экспертов в области обработки «больших данных». Часть из них занимается data science, еще часть — построением архитектуры для обработки больших объемов данных. Я Chief Technologist этого подразделения, и помимо этого, веду направление open-source software development для всей компании. ЕРАМ активно привлекает инженеров для поддержки open-source проектов на базе открытых систем и платформ, с помощью которых решает задачи по разработке продуктов.

Примечательно, что доля открытого ПО в Big Data составляет около 94-95%. «Закрытого» ПО коммерческого происхождения, которое используется для решения задач обработки «больших данных», очень мало.

Почему так?

У бизнесов появляется все больше уверенности в том, что коммерческие производители ПО могут — и делают — их заложниками своих решений. Инвестиции в одну конкретную технологию приводят потере гибкости всей технологической базы. Решение проблемы за счет привлечения дополнительных технологий других производителей приводит к несовместимости интерфейсов, форматов хранения данных, языков реализации и другим «симптомам».

Помимо этого, попадая в зависимость от одного производителя ПО, компания делает его «внутренним монополистом». Вендор, не советуясь с клиентом, поднимает цену лицензий или произвольно меняет набор технологических возможностей программного продукта. Чтобы избавиться от такого vendor lock-in нужны новые инвестиции: в смену оборудования, ПО, ротацию сотрудников.

Использование open-source решений гарантирует отсутствие таких проблем. Если вы работаете с Linux и Red Hat и эти решения вас больше не устраивают, вы можете перейти на открытые и бесплатные CentOS, Fedora, Debian, или купить поддержку Canonical для Ubuntu. С точки зрения бизнеса, особых изменений не произойдет. Когда речь идет об обработке критических для бизнеса объемов данных, уход от vendor lock-in превращается в насущную необходимость.

Вы уже двадцать лет в open-source сообществе. За это время оно изменило мир благодаря Linux и Android. Помимо этого, технологии open-source стали базой для разработки продуктов крупных компаний. В чем сила открытого сообщества, что его двигает вперед? Как крупным компаниям правильно строить взаимодействие с такими сообществами?

Идея довольно проста: людям интересно работать над тем, над чем им интересно работать. Это гениальный в своей простоте принцип. Open-source позволяет людям, даже если на основной работе они занимаются чем-то скучным, выразить себя. Человек приходит в такое сообщество и находит единомышленников, получает возможность сделать что-то уникальное — например, изменить направление разработки всего проекта в ту сторону, которую он считает нужной. Это очень мощный стимул для людей креативных и технологических.

Проследите за Линусом Торвальдсом: человек действительно поменял мир, потому что он умен, настойчив, продуктивен, увлекет людей своим примером и компетенциями. Этим open-source выгодно отличается от некоторых коммерческих разработок: здесь ценится что и как ты делаешь, а не как много и красиво ты говоришь и обещаешь. Такой принцип называется meritocracy и он — отличная альтернатива традиционной структуре управления. Его активно использует GitHub и ряд других компаний.

Если посмотреть на принципиальную разницу между коммерческой разработкой и open-source, то первая всегда основывается на том, ЧТО клиент будет покупать. Бизнес должен быть прибыльным. И если ты не политик или CEO компании Tesla, то заработать деньги можно только предложив людям то, что им действительно нужно. При этом сам инженер чаще всего «не видит» клиента и не понимает его потребностей — этим занимаются отделы технического маркетинга, продаж и тп. При этом разработчик чаще всего занимается очень специфическим направлением продукта в течение довольно долгого времени.

В открытых проектах таких ограничений нет. Сами разработчики и есть первые пользователи своих систем, которые разрабатываются в атмосфере открытого сотрудничества и отсутствия границ между группами разработчиков.

Конечно же остается конкуренция на уровне бизнеса. Есть разные стратегии коммерциализации open-source проектов. На рынке Hadoop-платформ есть три основных основных коммерческих игрока: Hortonworks (группа разработчиков Hadoop-системы в Yahoo!), Cloudera и MapR (очень мал). Все остальные, кто пытался строить свои дистрибутивы (IBM, Intel), в итоге либо ушли на какую-то из первых двух, либо пользуются Apache Bigtop для построения своих собственных платформ из канонического кода Апачи-проектов (Google DataProc и Amazon EMR).

Но они по-разному продают эти платформы своим клиентам. Cloudera добавляет поверх open-source какие-то коммерческие закрытые компоненты вроде системы для менеджмента кластеров. MapR, например, добавил свою файловую систему, до боли напоминающую NFS. Hortonworks, с другой стороны, абсолютно все отдает в открытую — все их новые разработки идут в Apache. Этим они привлекают клиентов, демонстрируя, что у них все открыто и клиент может сам взять код и продолжать делать свое решение независимо.

Есть такое хорошее выражение: «There is no boss in open-source». Единственное требование — чтобы сообщество принимало твои наработки. Есть определенные стандарты, которым нужно соответствовать: качество кода, следование определенным технологическим принципам. Как только разработчик начинает соответствовать этим требования, он можешь участвовать в любом кусочке проекта и никто его не остановит. При этом, никто не заставляет заниматься этим конкретным фрагментом всю оставшуюся жизнь. Это дает возможность профессионально расти, улучшать свои навыки и наращивать технологическую базу.

А вы как open-source fellow в EPAM можете сказать, сколько процентов разработчиков компании коммитят в какие-то open-source проекты?

Процент оценить довольно тяжело, у нас все-таки больше 20 тысяч разработчиков. Но за последние шесть месяцев мы запустили интересный проект, в рамках которого целенаправленно контрибьютим в Apache Ignite, Apache Flink, Apache Zeppelin. Для понимания — в последней версии Apache Flink, из 100 contributors 10 человек сотрудничает с EPAM. У компании есть порядка 20-30 продуктовых проектов в open-source — начиная от управления тестовыми отчетами, веб-проектов, до анализа генома человека и обработки Big Data в облачных технологиях. Мы наращиваем экспертизу в стратегически интересных направлениях обработки Big Data для разработки продуктов и платформ для наших клиентов. На проекты можно посмотреть и поучаствовать через github.com/epam.

Если вернуться к big data и Hadoop, вы говорили, что смотрите на то, какие технологии интересны клиентам. Что это значит и как дальше будет развиваться Hadoop? Все-таки это уже достаточно зрелая технология.

Я может скажу не совсем то, что ожидают от человека, который много лет занимался разработкой компонент Hadoop-экосистемы — Hadoop стабилизировался. Технология стала «взрослой», отработанной. Ее начали признавать в больших компаниях, стали использовать для внутренних инфраструктурных решений. Но активный цикл разработки ПО не бесконечен. Какое-то время происходит всплеск разработки, улучшений, а потом все стабилизируется. Вот эта фаза, когда наступает стабильность, называется commodity phase: технология становится обычной и доступной для всех. Hadoop перешел именно в эту фазу.

Кстати, забавно, что даже спустя 11 лет после появления Hadoop остается для многих мантрой: «надо его поставить и тогда все можно будет решить». На самом деле, нужен трезвый расчет — многие задачи решаются без распределенных вычислений или массивных кластерных платформ хранения данных. Например, весь веб-сайт StackOverflow живет на 4 серверах с SSD-дисками: мастер-копия самого StackOverflow, мастер-копия всего остального и две реплики. И они обслуживают 200 миллионов запросов в день. Сколько бизнесов в мире сталкивается с подобными объемами?

Как только технология становится commodity, в ней перестают появляться качественные улучшения. Hadoop изначально состоял из файловой системы для хранения данных и вычислительной системы для обработки этих данных — MapReduce. Он мало используется сегодня в силу своей неэффективности. Вместо MapReduce появился TEZ, Spark. Файловая система выжила, но ничего революционно нового там так не появляется. Файловая система HDFS делалась для создания больших хранилищ данных в дата-центрах. Компании вроде Amazon, Facebook, Yahoo!, Google, мобильные операторы хранят очень много данных. Но не все используют HDFS. Например, Google Spanner хорошо зарекомендовавшая себя глобально-распределенная файловая система. И все больше и больше не-инфраструктурных компаний начали уходить из своих дата-центров в облака Amazon, Microsoft или Google. А те кто остается в своих дата-центрах зачастую используют Open Stack с файловой системой Ceph.

Базовый слой, который был изначально Apache Hadoop, потихоньку начинает растворяться. Новые компоненты, которые изначально работали поверх него, начинают переключаться на работу в облачных технологиях. Это все по-прежнему называется Hadoop, хотя там уже больше 30 компонентов, из которых только два — это оригинальный Apache Hadoop. Hadoop перестал быть центром Вселенной. Не стал им и Apache Spark — он просто повторил историю Hadoop на немного другом уровне.

Сейчас идет активная миграция от собственно Hadoop в облачную область — и сокращение сегмента, где Hadoop используется для хбранения данных. Если очень нужно, можно взять кластер Spark задеплоить на AWS и не волноваться, есть ли там HDFS. Большинство бизнесов и разработчиков фокусируются на обработке данных, бизнес-игроков мало интересует как они хранятся. Скорость обмена данными с клауд файловой системой ниже чем с HDFS. И даже сильно ниже, если Вы не боитесь использовать решения Microsoft и пошли в Azure. Зато не надо тратить деньги на собственных специалистов, системных администраторов, покупать железо, которое устаревает быстрее, чем ломается. Побеждает простое и эффективное решение.

Например, Amazon много работал над реализацией self-serving system. Такая система не требует специалистов для запуска и обслуживания — любой человек может зайти в ее консоль, «нажать кнопочку», поднять кластер для обработки данных, закачать их и обработать. Набор навыков тоже становится commodity. Компании не нужен свой системный администратор для обслуживания сотни компьютеров, если есть 5 сисадминов в Amazon, которые обслуживают 100 тысяч серверов. Для запуска ресурсов в облаке и, может быть, релизов ПО нужен Devops.

Вычислительная мощности тоже становятся данностью — и люди фокусируются на том, какую пользу можно извлечь из данных: лучше продавать товары в магазинах или оптимизировать маркетинговое предложение, предсказав поведение клиентов. Технологическая часть обработки данных активно двигается в направлении predictive analytics — моделирования поведения, к примеру, покупателей. Мы обрабатываем исторические данные и строим модель, которая подскажет нам, что может случится. Второе актуальное направление — prescriptive analytics, когда мы обрабатываем объемы данных и делаем вывод, что для того, чтобы сделать на 10% больше продаж, нам нужно определенным образом поменять нашу маркетинговую стратегию.

Невозможно на 100% точно предсказать или смоделировать будущее. Но при условии, что подобные подходы позволяют поднять доверительный интервал результата с 25% до 60% — это, пусть и небольшая, но победа.

Одна из интересных реализаций такого подхода применяется в промышленности, где задействуюется много сложных агрегатов — а именно, построение аналитики даты и типа поломки, которая с ними случится. Один из примеров – добыча нефти и газа. Представьте себе океанскую платформу для добычи нефти — она состоит из миллиона различных компонентов. Если в насосе ломается произвольный подшипник — вся платформа останавливается на неделю. Деталь закажут, изготовят и доставят вертолетом с континента. Вместо этого, благодаря анализу информации с сенсоров, мы можем заранее заметить аномальные признаки, например повышение температуры насоса или вибрацию.

Используя методы машинного обучения и анализируя исторические данные с оборудования, мы теоретически можем предсказать с доверительным интервалом в, например, 94%, что этот подшипник выйдет из строя в следующие 4 дня. Заказав и получив этот подшипник заранее, производственный процесс можно планово приостановить на 30 минут, в итоге сэкономив миллионы.

Все эти технологии становятся все более доступными для не-программистов и все более ориентированными на типичного пользователя. В связи с тем, что данных становится все больше, должна расти и скорость из обработки — иначе теряется смысл всей игры. Поэтому все чаще можно встретить in-memory computing платформы, которые полностью работают в компьютерной памяти. Среди них Apache Ignite, изначально разработанный в компании GridGain, и Apache Geode, пришедший из Pivotal.

Распределенная обработка данных в памяти получает все больше внимания больших технологических компаний. Удивительный факт: компьютерная память подешевела за последние 20 лет почти в 100 000 раз. В номинальных долларах, без учета инфляции в почти 60% за то же время. Как мне кажется, это одно из направлений, где будет происходить много увлекательного и интересного в следующие годы — о других направлениях и трендах мы поговорим на JavaDay 2017.

|

Метки: author NadiaMatukhno open source java блог компании epam epam hadoop big data amazon yahoo javaday java conference longread |

No rest for the wicked. Фотоотчет из дальних уголков России, где мы оказались благодаря Росгидромету |

сюжеты, признаюсь, это уж совсем непостижимо, это точно…

нет, нет, совсем не понимаю.

Н. В. Гоголь

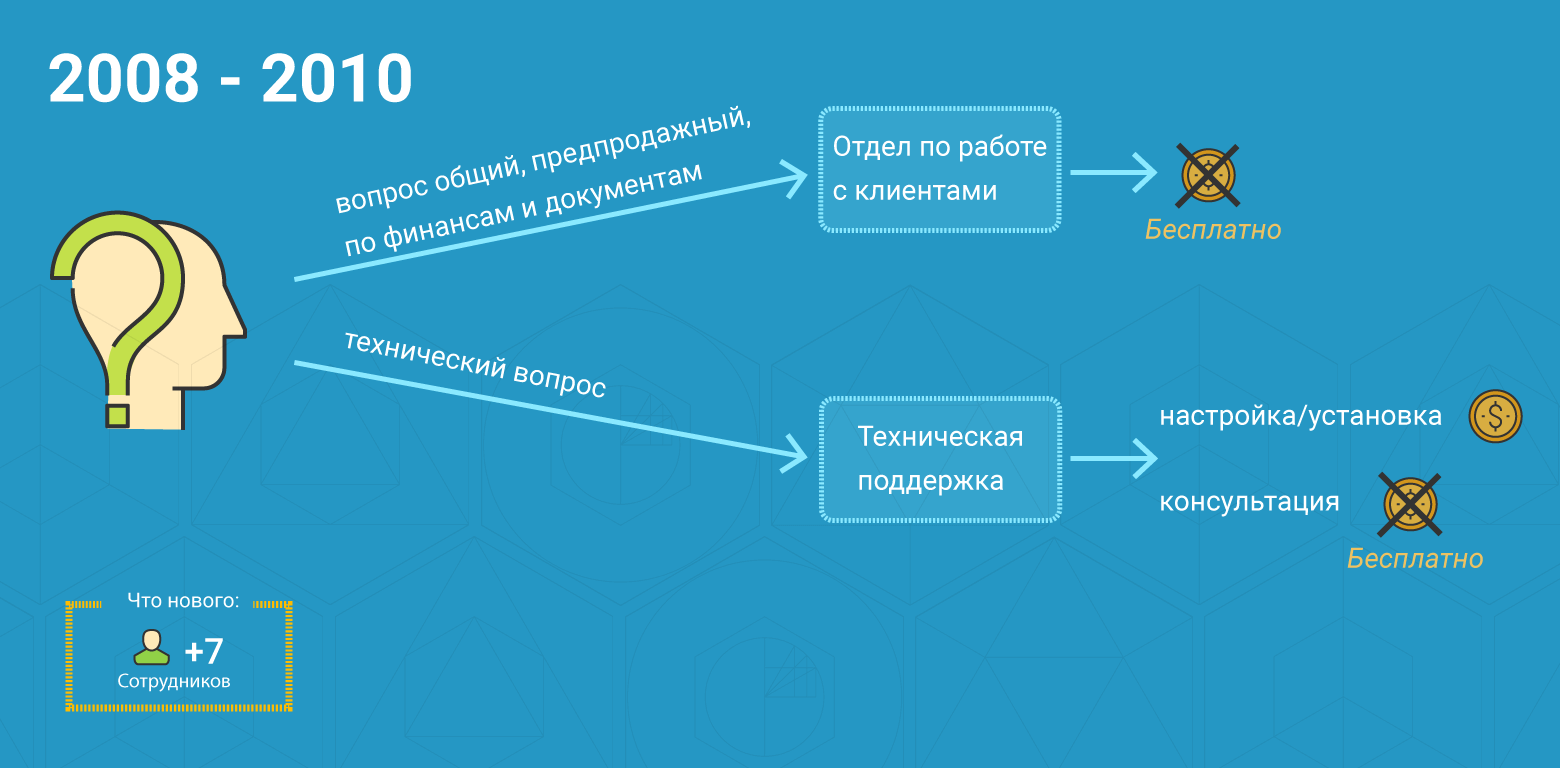

Волею судеб я стал участником грандиозного проекта ЛАНИТ – модернизации метеорологической сети Росгидромета. Практически нигде в цивилизованном мире наблюдатели не носятся по площадке, чтобы снять приборные показания – все, что можно, автоматизировано. В России с этим подзадержались, но благодаря проекту модернизации Росгидромета случилось и переоснащение метеосети. Таких масштабов не было нигде и никогда, но мы реализовали проект всего за два года (2008-2009 гг.). А это, на минуточку, поставка 1842 метеостанций плюс прочего связного и энергетического обвеса. Еще нужно было собрать станции, скомплектовать и упаковать, доставить их в каждый из 85 областных центров, а оттуда уже развозить на станции, устанавливать и настраивать.

В настоящий момент вовсю идет второй этап модернизации. Раскопки в архивах документов и натолкнули меня на мысль о таком посте.

В целом, весь проект модернизации организаций и учреждений Росгидромета состоял из нескольких контрактов: по метеорологии, гидрологии, аэрологии, океанологии и т. д. Дальше я покажу фотографии, которые касаются самых примечательных из них.

Та часть проекта, которую мы охватили, включала поставку оборудования для более 2000 объектов наблюдательной сети и проведение инсталляций более, чем на 500 площадках.

1. Метеосеть

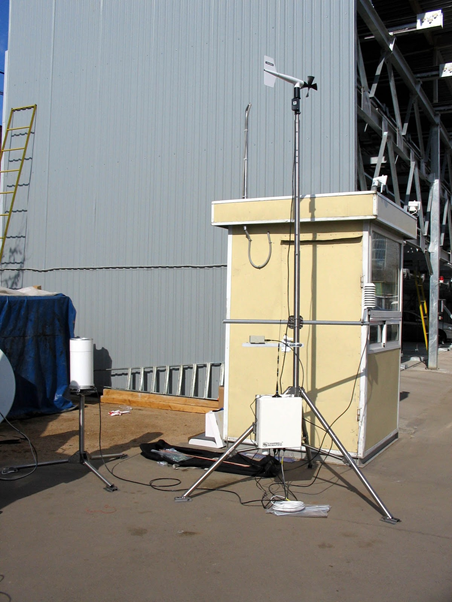

Оборудование

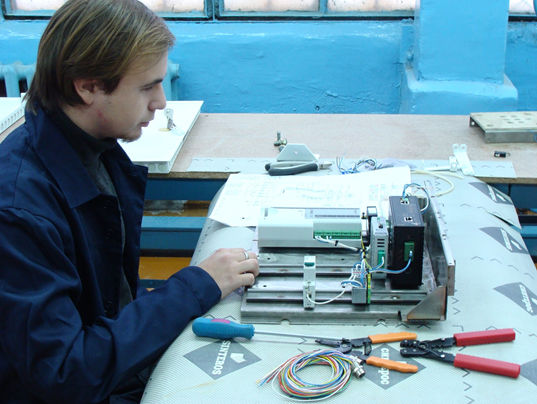

Чтобы реализовать проект, ЛАНИТ стал производителем метеостанций. Мы решили, что развернем это производство своими силами на базе завода «Луч» в Новосибирске. Компоненты везли со всего мира, мы получали и российские составляющие (с ними, по традиции, было больше всего проблем).

На заводе организовали целую линию сборки, на которой трудилось 10-15 человек. Ради этого мы несколько раз привозили толпы спецов по организации производства из компании Vaisala, кои делились своими знаниями, не ведая страха и упрека.

Потом станции проходили через упаковочный цех. Также «Луч» делал металлические изделия – мачты, боксы, стойки, траверсы и т. д. Они же собирали станции, тестировали и упаковывали.

Завод снимал с нас серьезную часть забот. Если бы мы все делали сами, то до сих пор бы реализовывали этот проект. Отдельно стоит поблагодарить этих замечательных людей за избавление от проблем с комплектацией и упаковкой оборудования. Не было практически ни одной ошибки. Зато мы от души нахлебались с другим складом в последующих проектах, например, задача отправки оборудования определенному получателю с заданными серийными номерами оказалась практически нерешаемой.

Типичное поведение складского персонала

Чтобы уложиться в бюджет, в проект вписали шеф-монтаж. Мы объехали 23 территориальных управления (УГМС) Росгидромета. Собирали там местных специалистов управлений, учили технарей, как устанавливать и обслуживать станции, а методистам рассказывали, как работать с новым оборудованием и ПО. Практику закрепляли как раз шеф-монтажами. Дальше уже эти подготовленные инженеры управлений самостоятельно устанавливали комплексы и обучали на метеостанциях наблюдателей.

У нас под шеф-монтаж было задействовано до 12 бригад, в каждой по 2 человека.

Забыть про бабушкины методы

Раньше наблюдатель, который (а обычно — которая) получает несколько тысяч рублей в месяц, должен был 8 раз в сутки в любую погоду пойти на площадку, залезть на лесенку, достать термометры, записать показания и т.д. Сейчас на большинстве объектов Росгидромета современные автоматизированные станции сменили ртутные барометры, гигрографы и прочие устаревшие инструменты метеоролога.

Ручные наблюдения в итоге никуда не делись (классический пример – определение формы облаков), но на отдельных пунктах, не относящихся к основной наблюдательной сети, станции переводят на полностью автоматический режим.

Есть любимая байка из советских времен, которую нам рассказывали в Гидромете. Она хорошо характеризует актуальность нашего проекта.

Студенты учились в каком-то метеорологическом вузе и задумали поехать на юг. Раньше все было проще — позвонили на одну из южных метеостанций:

— Мы – студенты, скоро приедем. Будем у вас тут жить.

— Да, пожалуйста, приезжайте.

Приезжают – никого нет, только один маленький мальчик лет 10-11 ходит.

Студенты спрашивают:

— Мальчик, а где все?

— А они в соседнюю деревню поехали на свадьбу.

Проходит пара дней, а родителей все нет. Идут к мальчику:

— Мальчик, а родители-то где?

— Так они на две недели уехали.

— Хорошо, но это же метеостанция, здесь каждый день нужно дежурить, в сроки все записывать и передавать.

— А, ничего. Они на две недели вперед все написали.

В нашей метеостанции самое уникальное – это программная составляющая. Я о скриптах, или конфигурации. Логгер QML201 весьма наворочен. Вот мы и делали всякие невообразимые штуки, которые вряд ли кто-то с тех пор повторял. Пример: Есть ключевой код для передачи метеорологической информации. Речь о КН-01, который придуман в лохматых годах и был заточен исключительно под телеграф. Основная обработка данных лежала на наблюдателе, а в нашем случае надо было изрядно подгрузить логгер, вместо того, чтобы посылать первичные данные в центр и обрабатывать уже там.

Несмотря на наши бурные протесты, нам пришлось реализовывать это чудо в логгере. Да еще и с досылкой данных от наблюдателя. Не прошло и 8 лет, как нам удалось что-то изменить.

Помимо метеостанций, в продолжение проекта попало 18 актинометрических станций, которые измеряют все виды солнечной радиации.

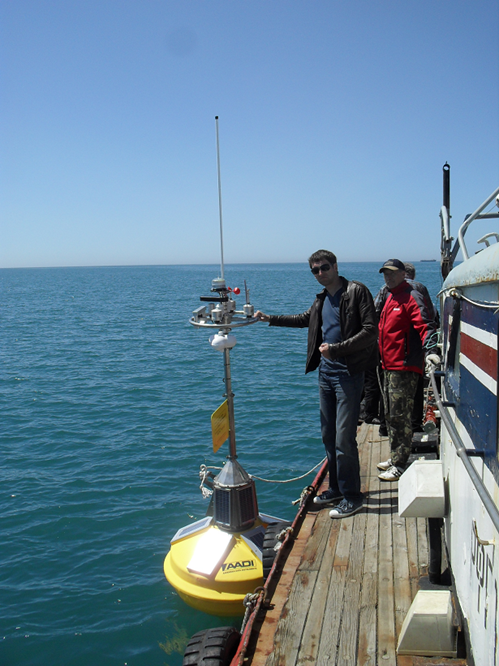

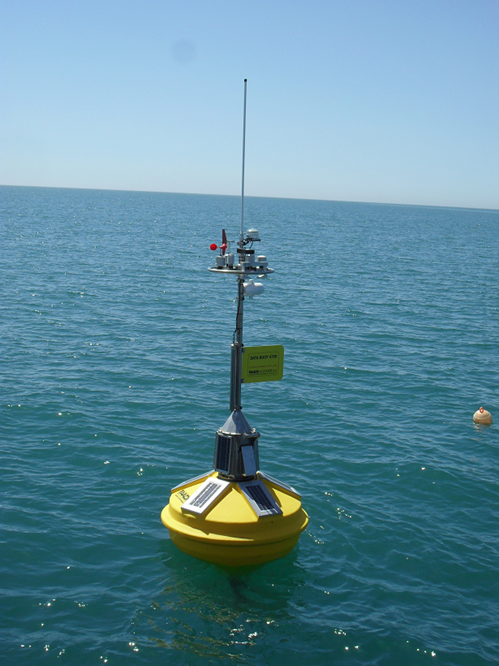

И морские надводные станции:

Вот эта табличка, кстати, сэкономила нам всем много денег. Через пару месяцев после установки буй сорвало с якоря штормом. Отправился он, надо думать, в Стамбул, но был перехвачен доблестными пограничниками и доставлен владельцам.

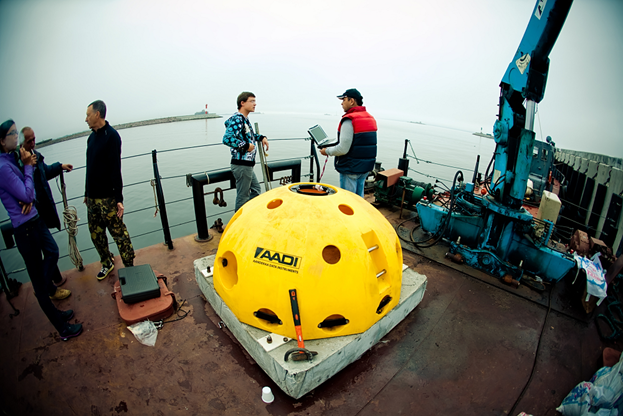

И подводные:

Into the great wide open

Карачаево-Черкесия

Конечно, до всех станций руководитель проекта не может доехать – на это просто нет времени. Но однажды я махнул на все рукой и сам поехал в Карачаево-Черкесию, на Клухорский перевал. Это рядом с Домбаем. У этой местности статус труднодоступной территории. По определению, грубо, «труднодоступная станция» – это куда на машине не доехать, на коне не доскакать. А на Клухорский перевал вполне можно доехать и пожить жизнью местных. Единственное, чего там нет, так это связи.

Поселок Клухор

Клухорский перевал — самый высокогорный участок Военно-Сухумской дороги (высота 2781 м), ведущей от великих Кавказских гор к Черноморскому побережью. Здесь проходит граница России с Абхазией. Именно в этом месте во время Второй мировой войны проходили жесточайшие бои с немецкими оккупантами за перевал Клухор.

После Клухора решил остаться на монтаж автоматической станции в Зеленчукской обсерватории.

А точнее – в специальной астрофизической обсерватории научно-исследовательского института Российской академии наук на Северном Кавказе.

В настоящее время это крупнейший российский астрономический центр наземных наблюдений за Вселенной. На фотке — оптический рефлектор БТА и я. Постарайтесь не перепутать.

А дальше, как в анекдоте про Буратино и сломанную ногу, пошло-поехало…

2. Модернизация аэрологической сети

Этот контракт включал поставку и установку 60 аэрологических локаторов по всей стране. Ниже – про одну из локаций.

Якутия, остров Котельный

Наш проект коснулся таких мест, куда действительно ни на чем не доберешься, кроме вертолета.

Так, команда ЛАНИТ отправилась на остров Котельный в Якутии. Он расположен между Восточно-Сибирским морем и морем Лаптевых и является наиболее крупным в архипелаге Новосибирских островов.

Добраться из Москвы до Котельного предельно просто. Почти 7 часов лететь до Якутска на рейсовом самолёте. Затем необходимо долететь до Тикси – это еще три часа, а оттуда до Котельного «рукой подать» – еще всего лишь три часа на вертолете над морем с дозаправкой на острове Столбовой или судном денек-другой.

Пару раз в год экспедиция забрасывает на станцию консервы и топливо. Под это дело закинули и локатор с материалами.

Доставить оборудование на корабле можно только в короткий сезон навигации.

Климат на острове арктический, суровый. Снег лежит 9-10 месяцев в году. Средняя температура июля составляет +2,9 С. Температура ниже -30 градусов С может наблюдаться с октября по апрель.

Многие спрашивают, сложно ли было таким проектом руководить.

Ответ – да. Если бы на меня свалилось сразу несколько таких контрактов, я бы, наверное, скрипнул и до сих пор бегал в каске и улыбался.

Но в целом, я достаточно плавно погружался в эту историю и, по аналогии с детскими сочинениями, погружал туда свою команду. Да и мне было очень интересно этим заниматься: о таком проекте можно детям-внукам рассказывать. Это в общем-то и грело, по большей части.

3. Метео-2