Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Moby/Docker в продакшене. История провала |

Примечание переводчика: в предыдущей статье о подготовке к девопс-конференциям, Gryphon88 задал резонный вопрос: как отличить cutting-edge и хайп? Нижеследующая статья наполнена сочной незамутненной истерикой, которую так приятно читать с утра, попивая чашечку кофе. Минус в том, что она написана в ноябре 2016, но нетленка не стареет. Если после прочтения захочется добавки, есть комментарии на Hacker News. А у тебя, юзернейм, такой же ад? Пиши в комментариях. Итак, начнем.

В первый раз я встретился с Докером в начале 2015. Мы экспериментировали с ним, чтобы понять, для чего бы его можно употребить. В то время нельзя было запустить контейнер в фоне, не было команд чтобы посмотреть что запущено, зайти под дебагом или SSH внутрь контейнера. Эксперимент оказался быстрым, Докер был признан бесполезным и более похожим на альфу или прототип, чем на релиз.

Промотаем нашу историю до 2016. Новая работа, новая компания, и хайп вокруг докера поднялся безумный. Разработчики уже выкатили докер в продакшен, так что сбежать с него не удастся. Хорошая новость в том, что команда run наконец-то заработала, мы можем запускать и останавливать контейнеры. Оно шевелится!

У нас 12 докеризованных приложений, бегающих на проде прямо в момент написания этой заметки, размазанные на 31 хост на AWS (по одному приложению на хост, дальше объясню — почему).

Эта заметка рассказывает, как мы путешествовали вместе с Докером — путешествие полное опасностей и неожиданных поворотов.

Докер: Проблемы в продакшене

Докер: Поломки и регрессии в обновлениях

Мы использовали следующие версии (или по крайней мере, попытались это сделать):

1.6 => 1.7 => 1.8 => 1.9 => 1.10 => 1.11 => 1.12

Каждая новая версия что-нибудь да ломала. В начале гда на докере 1.6 мы запустили одно приложение.

И обновились только через 3 месяца, потому что необходим был фикс, доступный только в свежих версиях. Ветка 1.6 оказалась уже заброшеной.

Версии 1.7 и 1.8 не запускались. Мы перешли на 1.9 только чтобы спустя две недели найти критический баг в этой версии, поэтому пришлось (снова!) обновляться до 1.10.

Между версиями Докера постоянно случаются небольшие регрессии. Он постоянно ломается непредсказуемым способом в неожиданных местах.

Большая чатсь хитрых регрессий, на которые мы напоролись, оказалась связанной с сетью. Докер полностью абстрагирует хостовую сеть. От этого случается большая заваруха с пробросом портов, хаками DNS и виртуальных сетей.

Бонус: Докер убрали из официальных репозиториев Debian, поэтому покет переименовался из docker.io в docker-engine. Документация созданная до этого изменения — устарела.

Докер: Старые образы нельзя удалять

Наиболее желаемая, и болезненно отсутствующая фича — команда для удаления старых образов (старше чем X дней, или не используемых Х дней, неважно). Дисковое пространство — это критическая проблема, учитывая что образы часто обновляются и могут занимать более 1 Gb.

Единственный способ очищать место — это запускать следующий хак каждый день, скорей всего по крону:

docker images -q -a | xargs --no-run-if-empty docker rmi Она перебирает все образы и удаляет их. Остаются только те, которые прямо сейчас используются в работающих контейнерах, она не может удалить их и валится с ошибкой. Грязный способ, но дело делает.

Путешествие по миру докера начинается с очищающего скрипта. Это — ритуал инициации, сквозь который должна пройти любая организация.

В интернете можно найти множество попыток сделать это, ни одна из них не работает хорошо. Нет никакого API чтобы показывать образы с датами, иногда есть но они устаревают за 6 месяцев. Например, часто используемая стратегия — читать аттрибут "дата" из файла образа и запускать docker rmi. Но она не работает, когда меняется имя. Другая стратегия — вычитывать дату и удалять файлы напрямую, но она приводит к повреждением если прошла неидеально, и это просто нельзя сделать идеально никому кроме самого Докера.

Докер: Поддержка в ядре (точнее, ее отсутствие)

Бесконечное количество проблем, посвященных взаимодействию ядра, дистрибутива, докера и файловой системы.

Мы используем Debian Stable c backports в проде. Мы начали с Debian Jessie 3.16.7-ckt20-1 (ее релизнули в ноябре 2015). У нее был большой критичный баг, из-за которого хаотично крашились хосты (в среднем, каждые несколько часов).

Докер: Нестабильные драйвера файловой системы

У докера есть куча драйверов для подсистемы хранения. Единственный (якобы) ревностно поддерживаемый — AUFS.

Драйвер AUFS нестабилен. Включая критические баги, приводящие к панике ядра и повреждениям данных.

Он сломан (как минимум) на всех ядрах linux-3.16.x. Лечения не существует.

Мы часто обновляемся вслед за Дебианом и ядром. Дебиан выложил специальные патчи вне обычного цикла. Был один большой багфикс AUFS где-то в марте 2016. Мы думали, что это ТОТ САМЫЙ ФИКС, но нет. После него паники начали случаться реже (каждую неделю вместо каждого дня), но баг никуда не исчез.

Однажды летом случилась реграессия прямо в мажорном обновлении, которая притащила с собой предыдущий критичный баг. Он начал убивать сервера CI один за другим, со средним перерывом в 2 часа между умерщвлениями.

В 2016 случилось множество фиксов AUFS. Некоторые критичные проблемы починилсь, но куча других всё еще существует. AUFS нестабилен как минимум на всех ядрах linux-3.16.x.

- Debian Stable сосет на 3.16. Нестабильно. Нельзя ничего сделать кроме как переключиться на Debian Testing (который использует четвертое ядро).

- Ubuntu LTS работает на 3.19. Нет никаких гарантий, что последнее обновление починило на нем проблему. Менять нашу основную операционную систему было бы огромной проблемой, но мы так отчаялись, что даже рассматривали этот вариант какое-то время.

- RHEL/CentOS-6 работает на ядре 2.x, RHEL/CentoS-7 — на ядре 3.10 (с кучей бэкпортов от рэдхата RedHat).

Linux 4.x: ядро официально прекратило поддержку докера

Широко известен факт, что у AUFS бесконечно проблем, что разработчики считают ее мертвым грузом. Ради будущих поколений, AFUS выбросили из четвертого ядра.

Не существует никакого неофициального патча для ее поддержки, нет никакого опционального модуля, бэкпорта или чего-то такого, ничего. AUFS полностью исчезла.

(драматическая пауза)

.

.

.

Как тогда докер работает без AUFS? Ну, он не работает.

(драматическая пауза)

.

.

.

Поэтому чуваки из докера написали новую файловую систему, называющуюся overlay.

"OverlayFS — это современная union файловая система, похожая на AUFS. В сравнении с AUFS, OverlayFS спроектирована проще, присутствует в мейнлайне ядра Linux с версии 3.18, и потенциально работает быстрее". — Docker OverlayFS driver

Заметьте, что ее не бэкпортнули в существующие дистрибутивы. Докер не то чтобы заботится об обратной совместимости.

Кстати, "overlay" — это имя как для модуля ядра (разработанного мантейнерами Linux), и для докерного драйвера, который ее использует (является частью докера и разрабатывается докером). Они — два совершенно разных компонента (возможно, с пересечением в истории и списке разработчиков). Проблемы в основном относятся к драйверу, а не к файловой системе как таковой.

Overlay: история неуспеха

Драйвер файловой системы — это сложное программное обеспечение, и оно требует огромного уровня надежности. Старички помнят, как Linux мигрировал с ext3 на ext4. Его не сразу написали, еще больше времени дебажили, и в конце концов ext4 стал основной файловой системой во всех популярных дистрибутивах.

Сделать новую файловую систему за 1 год — невыполнимая миссия. Это даже забавно, учитывая что задача легла не на кого-нибудь, а на Докер, с его послужным списком из нестабильностей и жутких поломманных обновлений — в точности того, чего не хочется видеть в файловой системе.

Короче. В этой истории всё пошло не так. Жуткие истории до сих пор населяют кэш Гугла.

Разработку Overlay бросили в течение года после первого релиза.

драматическая пауза

.

.

.

Время для Overlay2!

"Драйвер overlay2 призван решить ограничения overlay, но он совместим только с ядрами Linux 4.0 и старше, и docker 1.12" — статья "Overlay vs Overlay2 storage drivers"

Сделать файлуху за год — всё еще невыполнимая миссия. Докер попытался и опростоволосился. Тем не менее, они продолжают пробовать! Посмотрим, как это обернется на дистанции в несколько лет.

Сейчас она не поддерживается ни на каких используемых нами системах. Не то что использовать, даже протестировать ее мы не можем.

Выводы: как мы видим на примере Overlay и Overlay2. Нет бэкпортов. Нет патчей. Нет совместимости со старыми версиями. Докер просто идет вперед и ломает вещи :) Если вы хотите использовать Докер, придется тоже двигаться вперед, успевая за релизами докера, ядра, дистрибутива, файловых систем, и некоторых зависимостей.

Бонус: всемирное падение Докера

2 июня 2016, примерно в 9 утра (по Лондонскому времени). Новые ключи пушатся в публичный репозиторий докера.

Прямым следствием этого является то, что любой apt-get update (или аналог) на системе, в которую подключен сломанный репозиторий, падает с ошибкой "Error https://apt.dockerproject.org/ Hash Sum mismatch".

Это проблема случилась по всему миру. Она повлияла на ВСЕ системы на планете, к которым подключен репозиторий Докера. На всех версиях Debian и Ubuntu, вне запвисимости от версии операционной системы и докера.

Все пайплайны непрерывной интеграции в мире, основывающиеся на установке/обновлении докера или установке/обновлении системы — сломались. Невозможно запустить обновление или апгрейд существующей системы. Невозможно сделать новую систему, на которую устанавливался бы докер.

Через некоторое время. Новость от сотрудника докера: "Есть новости. Я поднял этот вопрос внутри компании, но люди, которые могут это починить, находятся в часовом поясе Сан Франциско (8 часов разницы с Лондоном — прим. автора), поэтому их еще нет на работе."

Я лично рассказываю эту новость разработчикам внутри нашей компании. Сегодня не будет никакого CI на Докере, мы не сможем делать новые системы, или обновлять старые, у которых есть зависимость на Докер. Вся наша надежда — на чувака из Сан-Франциско, который сейчас спит.

Пауза, в ходе которой мы употребили всю наличную еду и выпивку.

Новость от чувака из Докера во Флориде, примерно 3 часа дня по Лондонскому времени. Он проснулся, обнаружил ошибку, и работает над фиксом.

Позже были переопубликованы ключи и пакеты.

Мы попробовали и подтвердили работоспособность фикса примерно в 5 дня (по Лондону).

По сути случилось 7 часовое общемировое падение систем, исключительно по причине поломки Докера. Всё что осталось от этого события — несколько сообщений на страничке бага на GitHub. Никакого постмортема. Немного (или вообще никаких?) технических новостей или освещения в прессе, несмотря на катастрофичность проблемы.

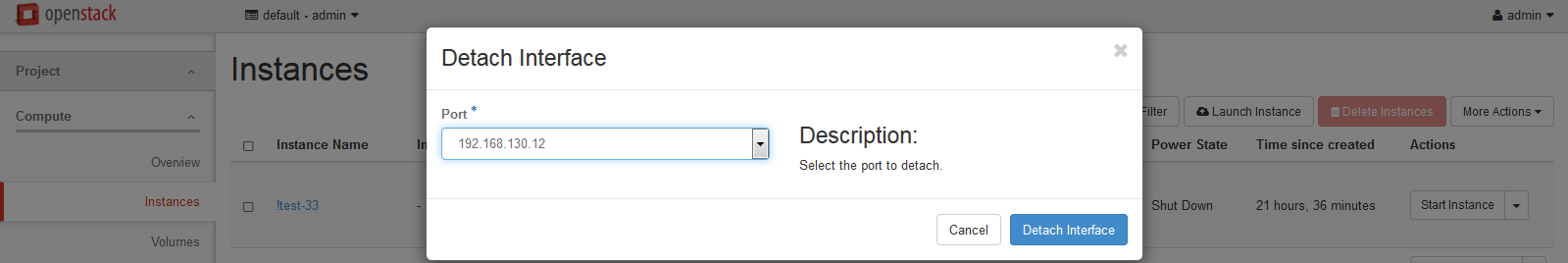

Docker Registry

Реестр хранит и обслуживает образы докера.

Автоматическая сборка CI ===> (при удаче) заливка образа в ===> docker registry

Команда на разворачивание <=== залить образ из <=== docker registry

Существует публичный реестр, обслуживаемый докером. Как организация, у нас тоже есть наш внутренний реестр. Он является образом докера, запущенным внутри докера на докерном хосте (это прозвучало довольно метауровнево!). Образ реестра докера является наиболее часто используемым докерным образом.

Существует 3 версии реестра:

- Registry v1 — устаревший и заброшенный

- Registry v2 — полностью переписанный на Go, впервые релизнутый в апреле 2015

- Trusted Registry — (платный?) сервис, на который много раз ссылается документация, не уверен что понимаю — что это, просто пропускаем его.

Реестр: Забросить и Сломать

Реестр v2 — это полностью переписанный софт. Реестр v1 был отправлен на пенсию сразу же после выпуска v2.

Мы обязаны установить новую штуку (снова!) просто чтобы докер продолжал работать. Они поменяли конфигурацию, урлы, пути, ендпоинты.

Переход к v2 был не бесшовным. Нам пришлось починить нашу установку, билды, скрипты развертывания.

Выводы: не доверяй никакому инструменту или API из докера. Они постоянно забрасываются и ломаются.

Одна из целей реестра v2 была в создании более качественного API. Это задокументировано здесь, 9 месяцев назад существовала документация, о которой мы уже и не помним.

Реестр: Нельзя очищать образы

Невозможно удалять образы из реестра докера. Нет сборки мусора — документация о ней упоминает, но она не существует. (Образы действительно умеют в компрессию и дедупликацию, но это совершенно другая вещь).

Реестр просто растёт вечно. Наш реестр может расти на 50 GB в неделю.

У нас нет сервера с бесконечным размером диска. Наш реестр несколько раз переполнял свободное место, превращая пайплайн сборки в ад, а потом мы перешли на S3.

Выводы: Необходимо использовать S3 для хранения образов (это поддерживается из коробки).

Мы делали ручную зачистку всего 3 раза. Во всех случаях нам приходилось остановить реестр, стереть всё на диске и запустить новый контейнер. (К счастью, мы можем пересобирать последние докерные образы с помощью CI).

Выводы: ручное удаление любого файла или директории с диска реестра ПОВРЕДИТ его.

И на сегодняшний день всё так же невозможно удалить образ из реестра. Никакого API тоже нет. (Одна из главных целей создания v2 была в дизайне хорошего API. Миссия провалилась).

Докер: релизный цикл

Релизный цикл докера является единственной константой в экосистеме Докера:

- Забросить что-то готовое

- Сделать вместо этого новую штуку и зарелизить

- Заигнорить существующих пользователей и совместимость с прошлыми версиями

Релизный цикл применим, но не ограничивается следующим: докер, фичи, файловые системы, реестр, всё API…

Судя по истории Докера, мы можем оценить время жизни чего угодно из Докера полураспадом в 1 год, считая что половина того, что сейчас существует, будет заброшена (и уничтожена) в течение года. Будет существовать замена, не полностью совместимая с тем, что предназначена заменять, и это может (или может не) выполняться на той же экосистеме (если она вообще сохранится).

"Мы делаем софт не для того, чтобы его кто-то использовал, а потому что нам нравится делать новые вещи" — будущая эпитафия Докера

Текущий статус-кво Докера в нашей компании

Рост в вебе и микросервисах

Докер впервые появился через веб-приложение. В то время, это был простой путь разработчику запаковать и развернуть его. Они попробовали и быстро научились применять. Как только мы начали использовать микросервисную архитектуру, докер распространился и на микросервисы.

Веб-приложения и микросервисы — похожи. Они не имеют состояния, они могут быть запущены, остановлены, убиты, перезапущены, совершенно без раздумий. Вся тяжелая работа делегируется внешним системам (базам данных и бэкендам).

Применение докера началось с небольших новых сервисов. Вначале, всё нормально работало в деве, и в тестинге, и в продакшене. По мере докеризации всё большего количества веб-сервисов и веб-приложений, понемногу начали случаться паники ядра. Чем больше мы росли, тем большее явными и важными становились проблемы со стабильностью.

В течение года появилось несколько патчей и регрессий. С тех пор мы начали играться с поиском проблем Докера и методами их обхода. Это боль, но не похоже чтобы она оттолкнула людей от внедрения Докера. Внутри компании постоянно существует запрос на использование Докера, и на его поддержку.

Заметка: никакие из этих проблем не коснулись наших клиентов и их денег. Мы довольно успешно сдерживаем буйство Докера.

Запрещено использовать в ядре

Имеются критические приложения, написанные на Эрланге, поддерживаемые и управляемые несколькими ребятами из команды "core".

Они попробовали запускать некоторые из них в Докере. Это не сработало. По какой-то причине, приложения на Эрланге и Докер вместе не сосуществуют.

Это делалось очень давно, и мы не помним всех подробностей. У Эрланга есть конкретные идеи на тему, как должна работать система и сеть, и ожидаемая нагрузка была в тысячах запросов в секунду. Любая нестабильность или несовместимость может считаться выдающейся неудачей. (Мы точно знаем, что в версиях, которые мы использовали для тестирования, присутствовала куча важных проблем со стабильностью).

Тестирование запустило тревожный звонок. Докер не готов ни для чего критичного. Это был правильный звоночек. В дальнейшем, краши и баги подтвердили это.

Мы используем Эрланг только для критичных приложений. Например, его юзают чуваки из ядра, которые отвечают за систему оплаты, которая провела в этом месяце 96 миллионов баксов. Кроме того, на нем работает парочка приложений и баз данных, находящихся под их ответственностью.

Докер — это опасный актив, за который приходится отвечать, и который может поставить на кон миллионы баксов. Поэтому он забанен во всех системах ядра.

Запрещено использовать в DBA

Докер задуман быть stateless. Контейнеры не имеют хранилища на диске, всё что происходит — эфемерно и уходит, когда контейнер останавливатеся. Не подразумевается, что контейнеры будут хранить данные. На самом деле, они спроектированы чтобы НЕ ХРАНИТЬ данные. Любоая попытка действовать против этой философии приводит к несчастьям.

Более того. Докер прячет процессы и файлы с помощью своих абстракций, они недоступны как если бы вообще не существовали. Это позволяет предотвращает использования любой процедуры восстановления в случае, если что-то пошло не так.

Короче. Докер НЕ ДОЛЖЕН ЗАПУСКАТЬ базы данных в продакшене, by design.

Всё хуже. Помните постоянные паники ядра при использовании докера?

Краш уничтожит базу данных и повлияет на все системы, которые с ней соединены. Этот баг случается хаотически, но срабатывает чаще при интенсивном использовании. База данных — это предельно интенсивная по IO нагрузка, и значит — гарантированная паника ядра. Плюс, существует другой баг, который может поломать маунт докера (уничтожая все данные) и, возможно, системную файловую систему хоста (если они находятся на одном диске).

Фильм ужасов: хост покрашился, диски развалились, вместе с ними умерла операционная система хоста, и все данные, которые в данный момент находятся в обработке.

Заключение: Вы ОБЯЗАНЫ НЕ ЗАПУСКАТЬ на Докере базы данных в продакшене, НИКОГДА.

Время от времени, всегда находится человек, который подойдет и спросит: "почему бы нам не засунуть эти базы данных в докере", и мы в ответ рассказываем одну из многих боевых историй. Пока что никто не подходил дважды.

Заметка: мы начали рассказывать историю внедрения Докера как часть курса молодого бойца для новых сотрудников. Это — новая философия контроля повреждений: убить любую идею использования докера прежде, чем эта идея вырастет, и у нее появится шанс убить нас.

Личное мнение

Докер получил импульс, ему оказывается безумная фантастическая поддержика. Хайп вокруг докера больше не является ответственностью исключительно технарей, он эволюционировал в социалогическую проблему.

В данный момент периметр контролируется, охраняется, ограниченный несколькими stateless веб-приложениями и микросервисами. Это всё неважные вещи, они могут докеризовываться и крашиться каждый день, мне наплевать.

До сих пор, все люди, которые хотели использовать докер для важных вещей, останавливались сразу же после короткой дискуссии. Мой ночной кошмар в том, что однажды какой-то докерный фанатик не послушает голоса рассудка, и продолжит проталкивать своё. Мне придется защищаться, и это будет выглядеть некрасиво.

Сценарий кошмара: обновление кластера с бухгалтерским софтом, сейчас держащего на себе 23M денег клиентов (M — сокращение для миллионов долларов). Люди постоянно спрашивают архитектора, почему бы не переложить эту базу в докер, и лицо архитектора в такие моменты словами не передать.

Мой долг — перед клиентами. Защищать их, и их деньги.

Выживаем с Докером на продакшене

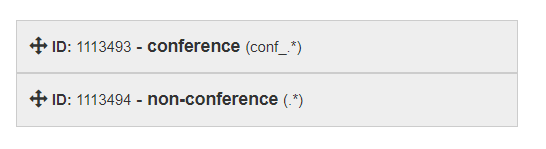

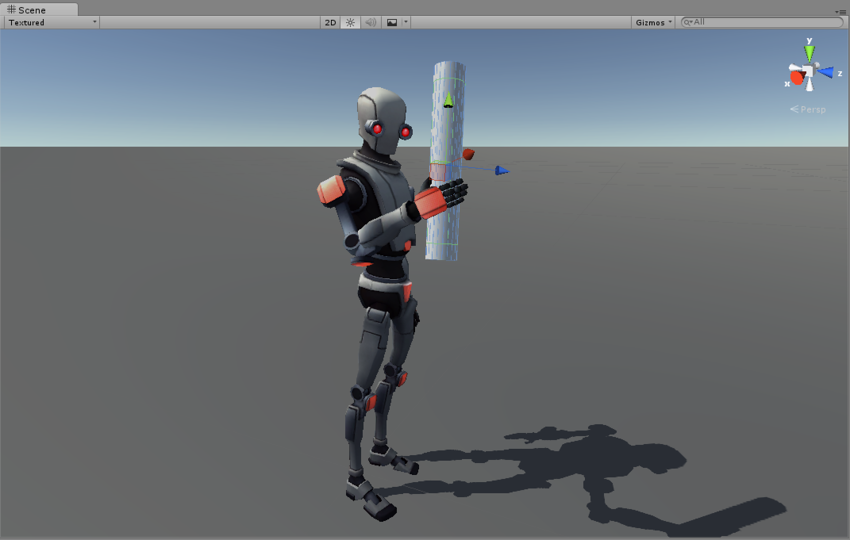

Как Докер хочет выглядеть:

Что такое Докер на самом деле:

Следите за релизами и ченжлогами

Внимательно следите за версиями и ченжлогами для ядра, операционной системы, дистрибутива, докера, и всего в промежутке между ними. Изучайте баги, описания как люди ждут патчи, читайте всё что можете максимально внимательно.

ansible '*' -m shell -a "uname -a"

Позвольте докеру умирать

Позвольте докеру умирать. Не требует пояснений.

Время от времени мы мониторим сервера, находим мертвые и перезапускаем с форсом.

Имейте по 3 инстанса всего на свете

Требование высокой доступности подразумевает, что у вас есть хотя бы 2 инстнаса каждого сервиса, чтобы пережить падение одного из них.

Когда докер используется для чего-то хотя бы приблизительно важного, мы должны иметь по 3 инстанса этой штуки. Докер умирает постоянно, и мы обазаны переживать хотя бы 2 краша одного и того же сервиса подряд.

Большую часть времени, крашатся CI и тестовые инстансы. (На них работает куча интенсивных тестов, и проблемы там возникают особо адовые). У нас их много. Бывают вечера, когда они крашатся по 3 штуки одновременно.

Не кладите данные в Докер

Сервисы, которые держат в себе данные, не докеризуются.

Докер спроетирован так, чтобы НЕ ХРАНИТЬ данные. Не пытайтесь идти против этого, это рецепт боли и унижений.

Прямо сейчас существуют баги, которые приводят к тому, что при убийстве сервера уничтожаются и данные, и это уже достаточная причина чтобы не пытаться так делать.

Не запускайте ничего важного в Докере

Докер ОБЯЗАТЕЛЬНО сломается. Докер УНИЧТОЖИТ всё, к чему притронулся.

Использовать его можно только в приложениях, краши которых не приводят к даунтайму. Это значит, в основном stateless приложения, которые можно перезапустить где-нибудь еще.

Кладите докер на масштабирующиеся группы

Докеризованные приложения должны работать на автомасштабирующихся группах. (Заметка: у нас это сделано всё еще не до конца.)

Каждый раз, когда инстанс крашится, он автоматически заменяется новым в течение 5 минут. Не должно быть никаких ручных действий. Автоматическая починка.

План на будущее

Docker

Невероятное испытание при использовании Докера — прийти к работающей комбинации ядро + дистрибутив + версия докера + файловая система.

Прямо сейчас. Мы не знаем, НИКАКОЙ комбинации, которая является действительно стабильной (может быть, такой не существует?). Мы активно ищем её, постоянно тестируя новые системы и патчи.

Цель: найти стабильную экосистему для запуска докера.

Требуется 5 лет чтобы сделать хороший, стабильный софт, а Docker v1.0 имеет возраст всего лишь 28 месяцев, и у него не было времени повзрослеть.

Время обновления железа — 3 года, цикл релизов дистрибутив — 18-36 месяцев. Докер не существовал на предыдущем цикле, поэтому мы не можем оценить совместимость с ним. Хуже того, он зависит от множества продвинутых внутренних систем, которые довольно новы и тоже не успели ни повзрослеть, ни добраться до дистрибутивов.

Он может стать хорошим продуктом лет через 5. Подождем и посмотрим.

Цель: подождать, пока ситуцация станет лучше. В это время заняться делами, и постараться не обанкротиться.

Используйте автоматически масштабирующиеся группы

Докер ограничен stateless приложениями. Если приложения может быть пакетизировано в Docker Image, оно может быть пакетизировано в AMI (Amazon Machine Image — прим. пер.). Если приложение может запускаться в докере, оно также может запускаться в автоматически масштабирующейся группе.

Большинство людей игнорируют это, но Docker бесполезен на AWS, и на самом деле это шаг назад.

Во-первых, смысл контейнеров — в экономии ресурсов, благодаря запуску множества контейнеров на одном (большом) хосте. (Давайте проигнорирует на минутку, что у текущего докера есть баг, который крашит и хост, и все контейнеры на нем, заставляя нас запускать лишь 1 контейнер на хост из соображений надежности).

Контейнеры бесполезны на облачных провайдерах. Всегда существует инстанс правильного размера. Просто создайте его с тем количеством памяти/процессора, которое реально нужно приложению. (Минимально на AWS можно сделать t2.nano, который стоит 5 баксов в месяц за 512MB и 5% CPU).

Во-вторых, наибольшее преимущество контейнеров проявляется в системах с системой полной оркестрации всего, позволяющей автоматически управлять всеми командами (create/stop/start/rolling-update/canary-release/blue-green-deployment). Таких систем оркестрации в данный момент не существует. (В этот момент на сцену выходят всякие Nomad/Mesos/Kubernetes, но они пока недостаточно хороши).

AWS предоставляет автоматически масштабирующиеся группы, которые управляют оркестрацией и жизненным циклом инстансов. Этот инструмент совершенно никак не связан с экосистемой Докера, и при позволяет достигать куда лучшего результата без всех этих проблем и факапов.

Создавайте автоматически масштабирующиеся группы для каждого сервиса, и собирайте AMI на каждую версию (совет: используйте Packer чтобы собирасть AMI). Люди уже знакомы с управлением AMI и инстансами на AWS, здесь нечего особо изучать, и тут нет никакого подвоха. В результате развертывание получается преотличное и полностью автоматизированное. Автомасштабируемые группы года на три опередили экосистему Докера.

Цель: класть докерные сервисы в автомасштабируемые группы для того, чтобы отказы обрабатывались автоматически.

CoreOS

Важно: Docker and CoreOS созданы различными компаниями, это нужно учитывать.

Чтобы еще раз пнуть Докер, он зависит от кучи новых внутренних подсистем. Классический дистрибутив не может обновлять их вне выпуска мажорных релизов, даже если бы очень хотел.

Для докера имеет смысл иметь специальную операционную систему (или быть ей?) с соответствующим циклом обновлений. Возможно, это вообще единственный способ иметь рабочий набор из ядра и операционной системы, которые могли бы хорошо выполнять Докер.

Цель: проверить стабильность экосистемы CoreOS.

Во всеобщей схеме всего, возможно отделить сервера для запуска контейнеров (на CoreOS) от обычных серверов (на Debian). Не предполагается, что контейнеры должны знать (или беспокоиться) о том, на какой операционной системе они выполняются.

Буча случится при попытке управлять новым семейством операционных систем (установка, провиженинг, обновление, учетки пользователей, логирование, мониторинг). Пока никаких идей, как мы с этим справимся, и сколько вообще будет работы.

Цель: исследовать разворачивание CoreOS в целом.

Kubernetes

Один из (будущих) крупных прорывов в возможности управлять флотами контейнеров, абтрагированно от машин, на которых они в конце концов оказываются, с автоматическим стартом, стопом, роллинг-апдейтом, изменением мощности, итп.

Проблема с Докером в том, что он ничего из этого не делает. Это просто тупая контейнерная система. Она имеет все недостатки контейнеров без каких-либо преимуществ.

Сейчас не существует ни одной хорошей, проверенной в бою, готовой для продакшена системы оркестрации.

- Mesos не предназначен для Docker

- Docker Swarm не заслуживает доверия

- Nomad умеет только самые простые фичи

- Kubernetes новый и экспериментальный

Kubernetes — единственный из этих проектов, предназначенный для решения сложных проблем с контейнерами. У него есть ресурсы, которых нет ни у кого больше (например, Google имеет долгую историю использования контейнеров на больших масштабах, они имеют гугол денег и других ресурсов в собственном пользовании, и они знают, как писать работающий софт).

В данный момент Kubernetes молод и экспериментален, и у него не хватает документации. Порог входа болезненный, и ему очень далеко от совершенства. Тем не менее, это уже хоть что-то работающее, и уже сослужило добрую службу куче людей.

В долгосрочной перспективе, Kubernetes — это будущее. Он — главный технологический прорыв этого времени (или чтобы поаккуратней, это последний кирпичик, которого не хватает контейнерам, чтобы стать важной (р)еволюцией в инфраструктурном управлении).

Вопрос не в том, стоит ли внедрять Kubernetes. Вопрос в том, когда это делать?

Задача: продолжать наблюдать за Kubernetes.

Заметка: Kubernetes требует для своего запуска докер. Он будет подвержен всем проблемам докера. (Например, не пытайтесь запустить Kubernetes ни на чем, кроме CoreOS).

Google Cloud: Google Container Engine

Как мы говорили раньше, не существует никакой известной стабильной комбинации: операционная система + дистрибутив + версия докера, поэтому не существует стабильной экосистемы для запуска на ней Kubernetes. Это — проблема.

Но существует потенциальный вокрэраунд: Google Container Engine. Он хостится на Kubernetes (и Docker) как сервис, часть Google Cloud.

Google должен был решить проблемы Докера, чтобы предлагать то, что они предлагают, других вариантов нет. Внезапно, они могут оказаться единственными людьми, разобравшимися как найти стабильную экосистему для Докера, починить баги, и продать это готовое решение как облачный сервис. Получается, однажды у нас были общие цели.

Они уже предлагают этот серивис, что означает — они придумали обходные пути для починки проблем Докера. Поэтому самым простым способом иметь контейнеры, которые будут работать в продакшене (ну, или будут работать вообще), может оказаться использование Google Container Engine.

Цель: перейти на Google Cloud, начиная с филиалов, не привязанных к AWS. Игнорирвать оставшуюся часть перечисленных здесь задач, т.к. они становятся нерелевантными.

Google Container Engine: еще одна причина, почему Google Cloud — это будущее, и AWS — это прошлое (в т.ч. на 33% более дешевые инстансы со в 3 раза большей скоростью и IOPS в среднем).

Disclaimer (прочитайте, прежде чем комментировать!)

Небольшой кусочек контекста потерялся где-то между строк. Мы — небольшая контора с несколькими сотнями серверов. По сути, мы делаем финансовую систему, которая перемещает миллионы долларов в день (или миллиарды — в год).

Честно сказать, у нас были ожидания выше среднего, и мы воспринимаем проблемы с продакшеном довольно (слишком?) серьезно.

В общем, это "нормально", что у вас никогда не было этих проблем, если вы не используете докер на больших масштабах в продакшене, или не использовали его достаточно долго.

Хочется отдельнро отметить, что все эти проблемы и обходные пути были пройдены за период более года, а сконцентрированы в заметке, которую вы успели прочитать отсилы за 10 минут. Это сильно нагнетает градус драматизма, и боль от прочитанного.

В любом случае, чтобы ни случилось в прошлом — прошлое уже в прошлом. Наиболее важная часть — план на будущее. Это то, что вам точно нужно знать, если собираетесь внедрять Докер (или использовать Амазон вместо этого).

|

Метки: author olegchir devops docker kubernetes aufs overlay |

«Доктор Веб»: M.E.Doc содержит бэкдор, дающий злоумышленникам доступ к компьютеру |

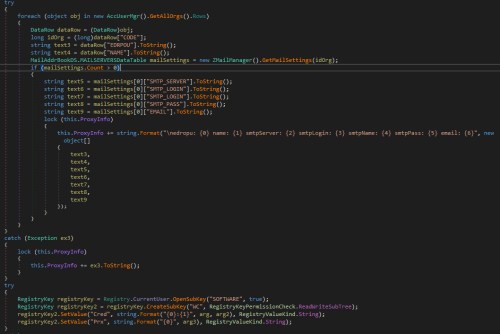

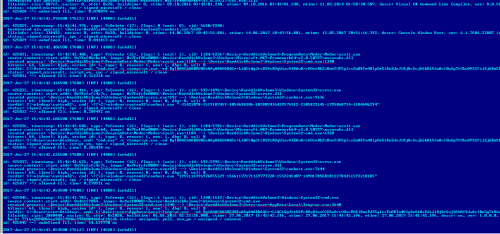

В сообщениях утверждается, что первоначальное распространение червя Trojan.Encoder.12544 осуществлялось посредством популярного приложения M.E.Doc, разработанного украинской компанией Intellect Service. В одном из модулей системы обновления M.E.Doc с именем ZvitPublishedObjects.Server.MeCom вирусные аналитики «Доктор Веб» обнаружили запись, соответствующую характерному ключу системного реестра Windows: HKCU\SOFTWARE\WC.

Специалисты «Доктор Веб» обратили внимание на этот ключ реестра в связи с тем, что этот же путь использует в своей работе троянец-шифровальщик Trojan.Encoder.12703. Анализ журнала антивируса Dr.Web, полученного с компьютера одного из наших клиентов, показал, что энкодер Trojan.Encoder.12703 был запущен на инфицированной машине приложением ProgramData\Medoc\Medoc\ezvit.exe, которое является компонентом программы M.E.Doc:

id: 425036, timestamp: 15:41:42.606, type: PsCreate (16), flags: 1 (wait: 1), cid: 1184/5796:\Device\HarddiskVolume3\ProgramData\Medoc\Medoc\ezvit.exe

source context: start addr: 0x7fef06cbeb4, image: 0x7fef05e0000:\Device\HarddiskVolume3\Windows\Microsoft.NET\Framework64\v2.0.50727\mscorwks.dll

created process: \Device\HarddiskVolume3\ProgramData\Medoc\Medoc\ezvit.exe:1184 --> \Device\HarddiskVolume3\Windows\System32\cmd.exe:6328

bitness: 64, ilevel: high, sesion id: 1, type: 0, reason: 1, new: 1, dbg: 0, wsl: 0

curdir: C:\Users\user\Desktop\, cmd: "cmd.exe" /c %temp%\wc.exe -ed BgIAAACkAABSU0ExAAgAAAEAAQCr+LiQCtQgJttD2PcKVqWiavOlEAwD/cOOzvRhZi8mvPJFSgIcsEwH8Tm4UlpOeS18o EJeJ18jAcSujh5hH1YJwAcIBnGg7tVkw9P2CfiiEj68mS1XKpy0v0lgIkPDw7eah2xX2LMLk87P75rE6 UGTrbd7TFQRKcNkC2ltgpnOmKIRMmQjdB0whF2g9o+Tfg/3Y2IICNYDnJl7U4IdVwTMpDFVE+q1l+Ad9 2ldDiHvBoiz1an9FQJMRSVfaVOXJvImGddTMZUkMo535xFGEgkjSDKZGH44phsDClwbOuA/gVJVktXvD X0ZmyXvpdH2fliUn23hQ44tKSOgFAnqNAra

status: signed_microsoft, script_vm, spc / signed_microsoft / clean

id: 425036 ==> allowed [2], time: 0.285438 ms

2017-Jun-27 15:41:42.626500 [7608] [INF] [4480] [arkdll]

id: 425037, timestamp: 15:41:42.626, type: PsCreate (16), flags: 1 (wait: 1), cid: 692/2996:\Device\HarddiskVolume3\Windows\System32\csrss.exe

source context: start addr: 0x7fefcfc4c7c, image: 0x7fefcfc0000:\Device\HarddiskVolume3\Windows\System32\csrsrv.dll

created process: \Device\HarddiskVolume3\Windows\System32\csrss.exe:692 --> \Device\HarddiskVolume3\Windows\System32\conhost.exe:7144

bitness: 64, ilevel: high, sesion id: 1, type: 0, reason: 0, new: 0, dbg: 0, wsl: 0

curdir: C:\windows\system32\, cmd: \??\C:\windows\system32\conhost.exe "1955116396976855329-15661177171169773728-1552245407-149017856018122784351593218185"

status: signed_microsoft, spc / signed_microsoft / clean

id: 425037 ==> allowed [2], time: 0.270931 ms

2017-Jun-27 15:41:43.854500 [7608] [INF] [4480] [arkdll]

id: 425045, timestamp: 15:41:43.782, type: PsCreate (16), flags: 1 (wait: 1), cid: 1340/1612:\Device\HarddiskVolume3\Windows\System32\cmd.exe

source context: start addr: 0x4a1f90b4, image: 0x4a1f0000:\Device\HarddiskVolume3\Windows\System32\cmd.exe

created process: \Device\HarddiskVolume3\Windows\System32\cmd.exe:1340 --> \Device\HarddiskVolume3\Users\user\AppData\Local\Temp\wc.exe:3648

bitness: 64, ilevel: high, sesion id: 1, type: 0, reason: 1, new: 1, dbg: 0, wsl: 0

curdir: C:\Users\user\Desktop\, cmd: C:\Users\user\AppData\Local\Temp\wc.exe -ed BgIAAACkAABSU0ExAAgAAAEAAQCr+LiQCtQgJttD2PcKVqWiavOlEAwD/cOOzvRhZi8mvPJFSgIcsEwH8Tm4UlpOeS18oE JeJ18jAcSujh5hH1YJwAcIBnGg7tVkw9P2CfiiEj68mS1XKpy0v0lgIkPDw7eah2xX2LMLk87P75rE6U GTrbd7TFQRKcNkC2ltgpnOmKIRMmQjdB0whF2g9o+Tfg/3Y2IICNYDnJl7U4IdVwTMpDFVE+q1l+Ad92 ldDiHvBoiz1an9FQJMRSVfaVOXJvImGddTMZUkMo535xFGEgkjSDKZGH44phsDClwbOuA/gVJVktXvDX 0ZmyXvpdH2fliUn23hQ44tKSOgFAnqNAra

fileinfo: size: 3880448, easize: 0, attr: 0x2020, buildtime: 01.01.2016 02:25:26.000, ctime: 27.06.2017 15:41:42.196, atime: 27.06.2017 15:41:42.196, mtime: 27.06.2017 15:41:42.196, descr: wc, ver: 1.0.0.0, company: , oname: wc.exe

hash: 7716a209006baa90227046e998b004468af2b1d6 status: unsigned, pe32, new_pe / unsigned / unknown

id: 425045 ==> undefined [1], time: 54.639770 msЗапрошенный с зараженной машины файл ZvitPublishedObjects.dll имел тот же хэш, что и исследованный в вирусной лаборатории «Доктор Веб» образец. Таким образом, наши аналитики пришли к выводу, что модуль обновления программы M.E.Doc, реализованный в виде динамической библиотеки ZvitPublishedObjects.dll, содержит бэкдор. Дальнейшее исследование показало, что этот бэкдор может выполнять в инфицированной системе следующие функции:

- сбор данных для доступа к почтовым серверам;

- выполнение произвольных команд в инфицированной системе;

- загрузка на зараженный компьютер произвольных файлов;

- загрузка, сохранение и запуск любых исполняемых файлов;

- выгрузка произвольных файлов на удаленный сервер.

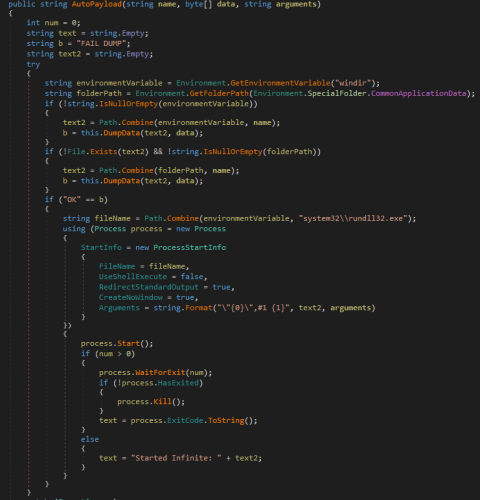

Весьма интересным выглядит следующий фрагмент кода модуля обновления M.E.Doc — он позволяет запускать полезную нагрузку при помощи утилиты rundll32.exe с параметром #1:

Именно таким образом на компьютерах жертв был запущен троянец-шифровальщик, известный как NePetya, Petya.A, ExPetya и WannaCry-2 (Trojan.Encoder.12544).

В одном из своих интервью, которое было опубликовано на сайте агентства Reuters, разработчики программы M.E.Doc высказали утверждение, что созданное ими приложение не содержит вредоносных функций. Исходя из этого, а также учитывая данные статического анализа кода, вирусные аналитики «Доктор Веб» пришли к выводу, что некие неустановленные злоумышленники инфицировали один из компонентов M.E.Doc вредоносной программой. Этот компонент был добавлен в вирусные базы Dr.Web под именем BackDoor.Medoc.

Подробнее о троянце

P.S. На Украине изъяли серверы у распространившей вирус Petya компании: www.rbc.ru/technology_and_media/04/07/2017/595bb1bc9a7947bc8356a6a3

|

|

Процитировано 1 раз

Bitfury Group провела первую успешную multi-hop-транзакцию в сети Lightning Network |

/ изображение Vadim Kurland CC

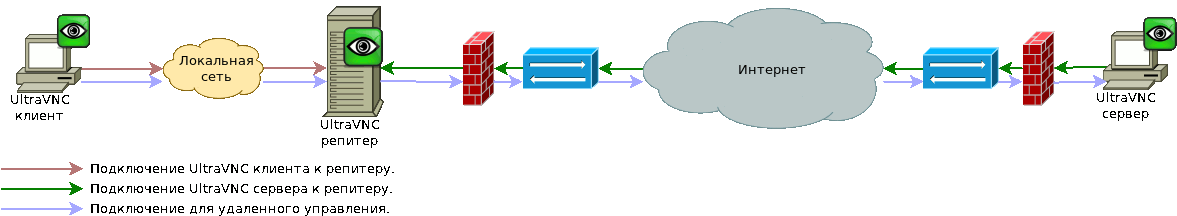

/ изображение Vadim Kurland CCLightning Network — это сеть двухсторонних платежных каналов, позволяющих совершать множество транзакций, не записывая каждую из них в блокчейн, то есть проводить обмен криптовалютой вне блокчейна.

Сеть при этом является распределенной и децентрализованной, поскольку построена по принципу mesh-сети. Такой подход позволяет исключить проблему цензурирования транзакций и нарушения приватности пользователей, централизации рынка обработки транзакций, а также избежать наличия единой точки отказа.

Одной из определяющих особенностей LN является способность отправлять валюту любому участнику сети через цепочку платежных каналов, открытых между пользователями, простроив маршрут от получателя к отправителю.

Возможность реализации этой концепции на практике проверили в компании Bitfury, успешно проведя multi-hop-транзакцию, то есть транзакцию, включающую в себя еще несколько узлов, помимо двух, являющихся отправителем и реципиентом платежа. В тесте при переводе криптовалюты участвовали три узла: лайткойны перешли с первого узла на третий через посреднический второй по двум предварительно открытым двунаправленным платежным LN-каналам.

Хеши фундирующих транзакций, сформированных командой Bitfury, выглядят следующим образом:

af3bc396cc6ea9fe10ae6c0b2691e40635f0286b356dcb962488ea6d9e15b0c8

87d25c3a6d895f5fff6892495e57814db58280e32eb4697428ac1e8c61a8a5c7

В тесте маршрутизация проводилась вручную, поскольку в транзакции участвовали всего три узла, «расположение» которых было заранее известно. В будущем, когда сеть «разрастется» до тысяч участников, для этого потребуется алгоритм Flare, разработанный компанией Bitfury совместно с командой Lightning Network и представленный в июле 2016 года (о котором мы писали здесь). Алгоритм уже был протестирован компанией ACINQ.

Сама концепция Lightning Network в ближайшем будущем позволит проводить огромное количество маршрутизируемых микротранзакций практически без издержек, что серьезно разгрузит блокчейны. Кроме того, LN позволит ускорить проведение платежей: временной порог «упадет» с 30 минут до нескольких секунд. Однако на пути к этому необходимо преодолеть ряд трудностей.

В контексте биткойна первой и самой большой сложностью остается принятие SegWit. Этот процесс длится достаточно долго, но уже близок к завершению. Сам код для LN уже практически написан и проходит этап тестирования, устранения багов и финализирования последних функций.

«Однако задержка выхода Segregated Witness блокирует реальный выпуск софта. Также неизвестно, сколько времени потребуется на то, чтобы сеть смогла обрабатывать значительный поток транзакций, — отмечает Вячеслав Жигулин из Bitfury. — На мой взгляд, пройдет как минимум полгода после принятия SegWit, прежде чем пользователи биткойна увидят реальные «дешевые и быстрые» транзакции».

Вторая сложность — распространение технологии, поскольку новый протокол придется внедрять в существующие пользовательские приложения и гарантировать исправность функционирования сети. А в начале распространения технологии, сеть может работать плохо ввиду своей малоразвитости (не все транзакции можно будет совершить, из-за отсутствия подходящего маршрута).

Однако после полного внедрения технологии, транзакции маленького размера значительно расширят применимость криптовалют. В частности, они могут начать использоваться в ритейл-индустрии — для оплаты кофе, покупок в магазинах, посекундной тарификации просмотра контента и т. д. Сейчас комиссия за одну транзакцию составляет порядка 3 долларов, что делает нецелесообразным переводы меньше определенной суммы.

Пользователи Reddit уже назвали факт реализации multi-hop-транзакции в сети Lightning «чрезвычайно важным» и отметили, что нужно как можно скорее внедрить эту технологию в главные криптовалютные кошельки и блокчейны. И работу над первыми пользовательскими приложениями уже ведет большое количество разработчиков, в том числе Blockstream, ACINQ, Lightning Labs, MIT DCI и Bitfury.

Дополнительное чтение:

- Как запустить надстройку над биткойн-блокчейном

- Как масштабировать биткойн-блокчейн

- Что такое эксклюзивные блокчейны

|

Метки: author alinatestova платежные системы блог компании bitfury group bitfury lightning network |

[Из песочницы] Интеграция TI SensorTag, Eclipse kura и веб части через Apache Camel |

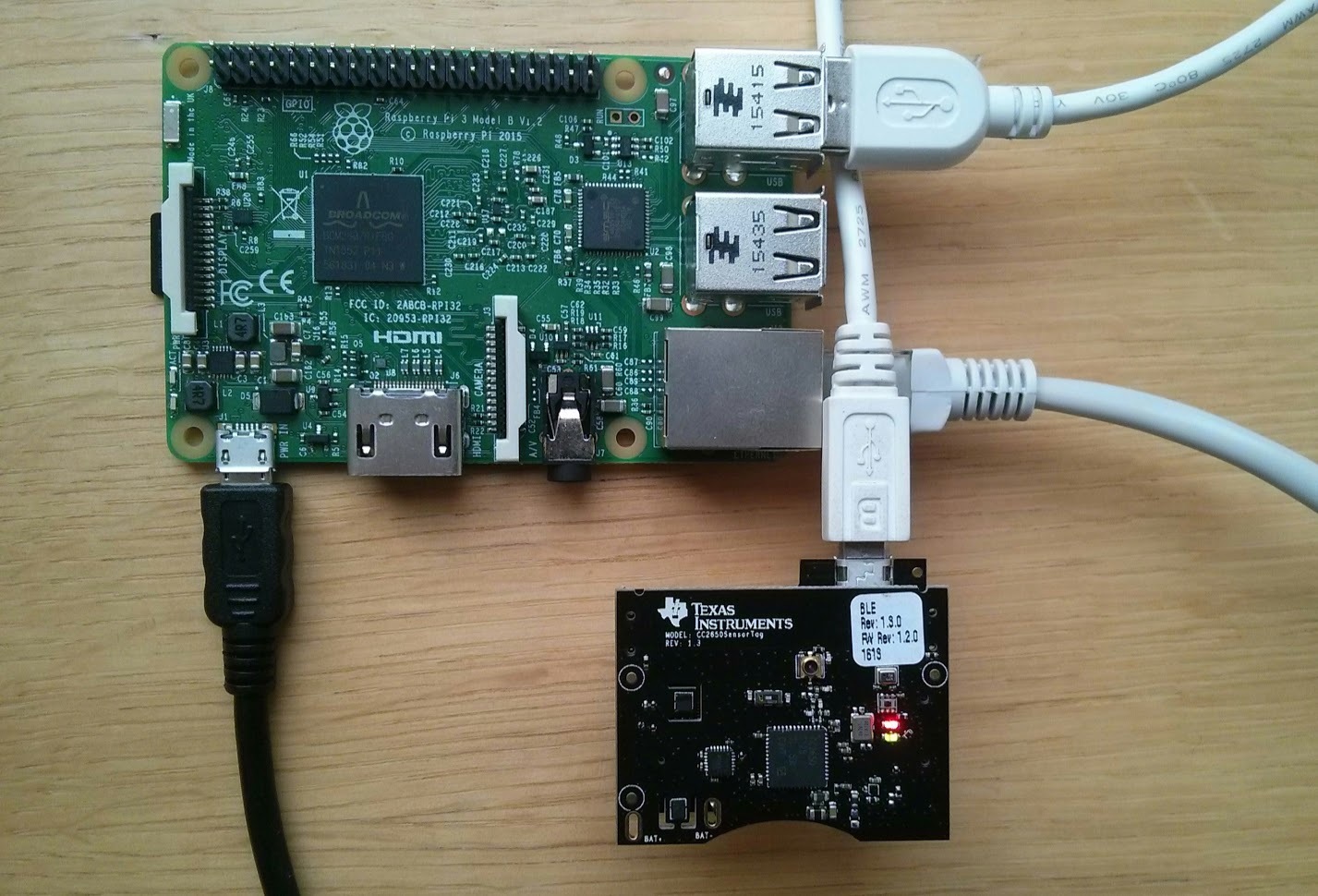

Привет всем. В данной статье я бы хотел показать пример использования связки TI SensorTag, Raspberry PI, Apache Camel с выводом в веб часть. В результате будет веб приложение, отображающее в реальном времени данные с сенсоров и бд хранящая показания, с промежуточным связующим узлом в виде Apache Camel приложения.

Подготовка

Для работы использовались:

- Raspberry PI 3

- TI SensorTag 2650 (Можно использовать и TI SensorTag 2541, только будет меньше сенсоров)

Настраиваем TI SensorTag

- Если вы еще не перезаписывали стандартную прошивку, то она подойдет для работы.

- Или нужно скачать BLE Stack и прошить с помощью SmartRF Flash Programmer образ CC2650SensorTag_BLE_All_v1_20.hex, лежащий в %programfiles(x86)%\Texas Instruments\SmartRF Tools\BLE Device monitor\firmware\cc26xx\sensortag

Настраиваем Raspberry PI

Устанавливаем Raspbian на Raspberry PI отсюда.

Eclipse Kura

Eclipse Kura — это фреймворк для создания приложений, работающих с IoT на таких платформах как Raspberry PI. Позволяет настраивать приложения через веб интерфейс или через API. Приложения разворачиваются через OSGi. Так же берет на себя заботу об работе с mqtt брокером. [1]

Установка Eclipse Kura

Для простоты станем рутом и обновим список пакетов sudo -i && apt-get update. Установим Java (лучше использовать Oracle java, apt-get install oracle-java8-jdk). Скачаем Kura версии Raspbian (Model 2) — Stable отсюда (скачать последную версию на момент статьи: wget http://mirror.onet.pl/pub/mirrors/eclipse//kura/releases/3.0.0/kura_3.0.0_raspberry-pi-2-3_installer.deb) и установим: dpkg -i kura_*_installer.deb && apt-get install -f. Перезапускаем Raspberry PI: shutdown -r now.

Теперь можно открыть Kura WEB UI по адресу http://\ c логином и паролем admin/admin. Здесь можно настроить сеть, wi-fi точку доступа, имя устройства и другие параметры.

Установка BlueZ для связи по BLE с SensorTag

Версия из менеджера пакетов должна вполне подойди. Поэтому выполняем:

apt-get install -y libusb-dev libdbus-1-dev libglib2.0-dev libudev-dev libical-dev libreadline-devapt-get install bluezЗапустим и добавим в автозагрузку bluetooth сервис: systemctl enable bluetooth && systemctl start bluetooth. Включим беспроводной интерфейс: hciconfig hci0 up. Проверим, что интерфейс включился и все работает: hciconfig -a. При возникновении ошибок в bluez, можно попробовать скачать и скомпилировать последнюю версию, например по статье [3][4].

Установка Mosquitto

Mosquitto — опенсорный брокер сообщений по протоколу MQTT. Он нам нужен для отправки данных с SensorTag на Camel backend приложение.

Его можно установить, как на Rasperry PI, так и на другую машину, или использовать облачные решения (IBM, Azure). Но для работы web части, необходимо, чтобы mosquitto был настроен на работу через mqtt over websockets (Это можно сделать на другом экземпляре брокера, а не на локальном брокере).

Установка на Raspberry PI:

Версия из стандартного репозитория

apt-get install mosquitto

systemctl enable mosquittoЧтобы включить websocket в mosquitto добавим следующие строки в /etc/mosquitto/mosquitto.conf

# Websocket

listener 1883

listener 9001

protocol websocketsи запустим systemctl start mosquitto. Чтобы установить самую новую версию mosquttio с поддержкой websockets. [2]

wget http://repo.mosquitto.org/debian/mosquitto-repo.gpg.key

apt-key add mosquitto-repo.gpg.key

cd /etc/apt/sources.list.d/

wget http://repo.mosquitto.org/debian/mosquitto-jessie.list

apt-get update

apt-get install mosquittoСборка и развертывание BLE TI SensorTag example приложения

Kura содержит пример приложения для работы с TI SensorTag. Оно раз в n секунд подключается по BLE к устройству, считывает данные с помощью Generic Attribute Profile (GATT) и отправляет их в брокер. Получается довольно медленно, но для начала пойдет.

Для начала склонируем репозиторий с kura. Можете воспользоваться или оригинальным https://github.com/eclipse/kura или форкнутым проектом https://github.com/leadex/kura, в котором добавлено считывание метрики температуры с барометра.

Выкачиваем:

git clone https://github.com/leadex/kura

cd kuraУ меня скомпилировать код удалось только на linux. Для сборки выполняем ./build-all.sh. Для последующей сборки только ble example:

cd kura/kura/examples/org.eclipse.kura.example.ble.tisensortag

mvn clean install -Dmaven.test.skip=trueДалее скопируем полученный jar на Raspberry PI.

cd kura/examples/org.eclipse.kura.example.ble.tisensortag

scp target/org.eclipse.kura.example.ble.tisensortag-*-SNAPSHOT.jar pi@:/tmpРазвертывание

Подключаемся к OSGi console из Raspberry PI telnet localhost 5002 или удаленно telnet 5002. Вводим команду на установка нашего скомпилированного приложения install file:///tmp/org.eclipse.kura.example.ble.tisensortag-1.0.3-SNAPSHOT.jar и потом вводим для проверки ss. Видим установленный, но не запущенный bundle в конце: 75 INSTALLED org.eclipse.kura.example.ble.tisensortag.

Запустим командой start 75, где 75 — id приложения с предыдущего шага. Теперь он запущен: 75 ACTIVE org.eclipse.kura.example.ble.tisensortag и можно просмотреть логи на Raspberry PI: tail -f /var/log/kura.log [5].

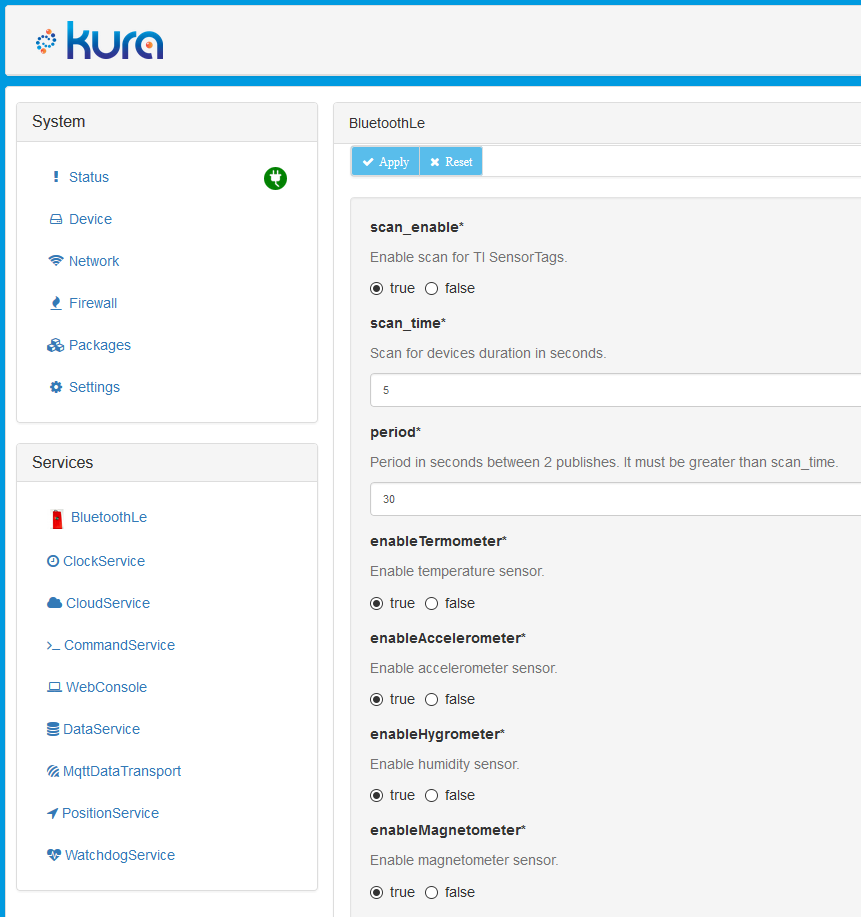

В Kura web UI появился новый сервис BluetoohLe. Откроем и настроим его.

После перезапуска Kura, наш развернутый бандл пропадет, поэтому можно воспользоваться инструкцией по постоянной работе бандла.

Настроим Kura:

- В CloudService установим encode.gzip в false

- В MqttDataTransport укажите broker-url, topic.context.account-name

Интеграция с помощью Camel и Web часть

Для быстрого запуска MongoDB + Mosquitto + Webview можно выполнить docker-compose up -d в корне проекта. Это создаст 3 контейнера и забиндит mqtt, websocket, http (8081) порты на localhost. Сразу после этого будет доступна веб часть по адресу http://localhost:8081. И mqtt broker на localhost:1883, поэтому можно будет указать в Kura MqttDataTransport ваш IP.

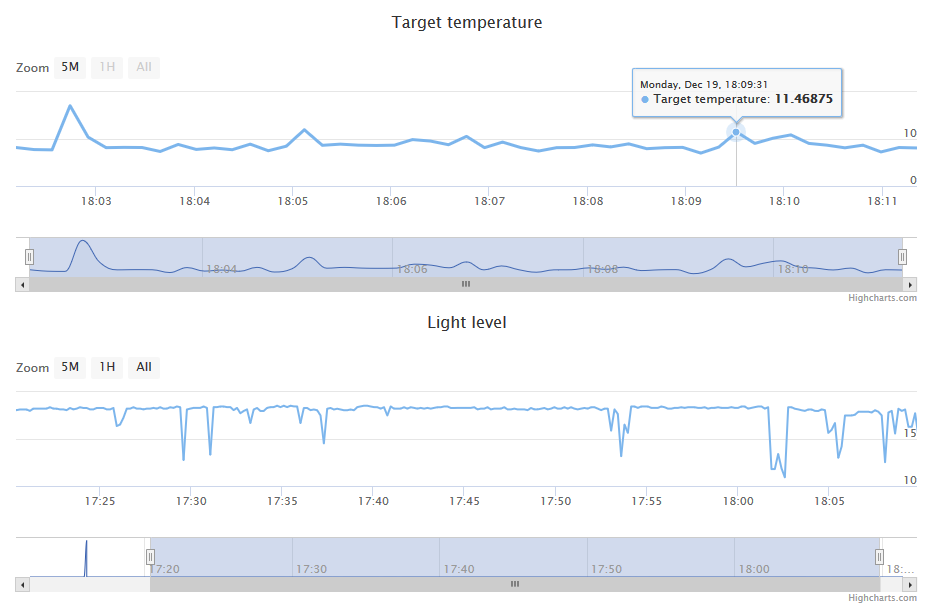

Пример веб части:

Camel интеграция

iot-backend-camel содержит Apache Camel проект, который подписывается к брокеру сообщений и получает KuraPayload.

EclipseKura сообщения передаются в закодированном формате Google Protobuf. Поэтому нам понадобится библиотека от Google для декодирования com.google.protobuf:protobuf-java.

Далее из сообщения достаются метрики, сериализуются в json и отправляются подписчикам веб части в брокер, а так же сохраняются в базу MongoDB.

Для запуска Camel приложения выполним: gradlew clean build и java -jar ./build/libs/iot-backend-camel-1.0.0-SNAPSHOT.jar.

Веб часть

webview содержит докер образ на основе nginx с html & js. Веб часть использует mqtt over websocket Paho библиотеку и highcharts для динамического отображения значения сенсоров (Температура с ИК сенсора и уровень освещения).

Сайт подписывается у брокера на обновления данных. Вероятно для работы, вам придется сменить mqtt хост в webview. Это можно сделать в webview/dist/view.js. В строке:

// Create a client instance

client = new Paho.MQTT.Client("localhost", Number(9001), "webview_" + parseInt(Math.random() * 1000000, 10));Перезапустить webview можно с помощью docker-compose up -d --build. Это пересобирет docker образ и перезапустит, если он изменился.

Ссылки

- http://eclipse.github.io/kura/doc/intro.html

- https://mosquitto.org/2013/01/mosquitto-debian-repository/

- http://blog.mrgibbs.io/bluez-5-39-ble-setup-on-the-raspberry-pi/

- http://wiki.beyondlogic.org/index.php?title=Cross_Compiling_BlueZ_Bluetooth_tools_for_ARM

- http://eclipse.github.io/kura/doc/deploying-bundles.html

|

Метки: author quckly разработка под linux разработка для интернета вещей eclipse kura raspberry pi apache camel texas instruments bluez sensortag mosquitto |

Создаем UWP приложение на языке SPL |

Теперь язык программирования SPL, который я разрабатываю, также может использоваться для создания UWP приложений благодаря наличию SPL SDK. Расскажу об этом подробнее.

В этой статье я продемонстрирую процесс создания самостоятельного UWP приложения на простом примере — браузере фрактала Мандельброта. Сначала я приведу текст программы, потом поясню его, потом расскажу о том, как это станет UWP приложением.

Можно было бы, конечно, ограничиться примером программы всего в одну строчку:

#.output("Hello, world!")но это было бы слишком просто :)

Приведенная ниже программа является простым браузером фрактала Мандельброта, навигация по которому осуществляется с помощью стандартных мультитачевых жестов перемещения и масштабирования. Также в этом примере показана возможность выполнения задач в параллельных потоках, работа закадрового буфера для графических функций и использование мультитачевых жестов для работы интерфейса программы. Этот пример специально не перегружен дополнительным функционалом, чтобы сосредоточиться на главном — продемонстрировать, как программа на SPL может стать самостоятельным UWP приложением, которое потом может быть загружено в магазин Microsoft Store.

Текст программы браузера фрактала:

w,h = #.scrsize()

sfx = -2.5; sfy = -2*h/w; sfs = 4

#.aaoff()

:again

end,redo,update = 0

-> draw() 'посчитаем фрактал в отдельном потоке

>

moved = 0

> #.pan() 'мультитач навигация

moved = 1

x,y,s = #.pan(3)

x -= (s-1)/2*w

y -= (s-1)/2*h

#.drawoff(x,y,s)

<

? moved 'пересчитаем фрактал заново

sfs /= s

sfx -= x*sfs/w

sfy -= y*sfs/w

again -> end

redo = 1

.

? update & !redo 'отобразим фрактал

update = 0

#.drawoff(0,0)

.

wn,hn = #.scrsize()

? wn!=w | hn!=h 'изменился размер экрана

w = wn; h = hn

again -> end

redo = 1

.

<

draw()=

:loop

#.offon() 'рисуем в закадровом буфере

#.scrclear(0,0,0)

.redo = 0

sfx = .sfx; sfy = .sfy; fs = .sfs/.w

> y, 1...h

> x, 1...w

fx = sfx + x*fs

fy = sfy + y*fs

#.drawpoint(x,y,color(fx,fy):3)

<

loop -> .redo

.update = 1

<

.end = 1

.

color(x,y)=

zr = x; zi = y; n = 0

maxn = #.int(200*(1-#.log10(.sfs/4)))

> zr*zr+zi*zi<4 & n

Теперь разберем подробнее этот пример.

w,h = #.scrsize()

sfx = -2.5; sfy = -2*h/w; sfs = 4

#.aaoff()

:again

end,redo,update = 0

-> draw() 'посчитаем фрактал в отдельном потокеВ первых двух строчках получаем размер экрана, который нужен для рисования фрактала во весь экран, а также устанавливаем начальное положение и масштаб фрактала. В третьей строке выключаем антиалиасинг графики (который по умолчанию включен). В последней строке запускаем функцию расчета фрактала draw в параллельном потоке.

В данном примере основной поток занят навигацией, управлением расчета фрактала и его отображением на экран, а сам расчет ведется в другом потоке в закадровый буфер. Основной поток берет то изображение, которое посчитано на данный момент, и либо просто отображает его на экран в виде прогрессивно рисующегося фрактала, либо отображает его смещенным и смасштабированным, если пользователь его двигает и масштабирует мультитачевыми жестами.

Основное тело программы представляет собой бесконечный цикл, оформленный командами > и < без всяких условий, потому что нам нужно просто непрерывно циклить в ожидании действий пользователя, по ходу дела отображая нарисованную картинку фрактала.

moved = 0

> #.pan() 'мультитач навигация

moved = 1

x,y,s = #.pan(3)

x -= (s-1)/2*w

y -= (s-1)/2*h

#.drawoff(x,y,s)

<Этот цикл включается и работает, если пользователь совершает мультитачевый жест. Во второй строке условием работы цикла является индикатор работы мультитача. В четвертой строке мы получаем параметры мультитачевого жеста — координаты смещения и масштаб. Затем функцией #.drawoff отображаем закадровый буфер с нарисованным в нем фракталом таким образом, чтобы картинка соответствовала текущему смещению и масштабу мультитача. Таким образом получаем интерактивную навигацию по фракталу.

? moved 'пересчитаем фрактал заново

sfs /= s

sfx -= x*sfs/w

sfy -= y*sfs/w

again -> end

redo = 1

.Здесь срабатывает условие, если пользователь только что закончил жест навигации. Пересчитываются новые параметры фрактала: масштаб sfs и координаты sfx,sfy. В пятой строке программа идет на метку again, чтобы заново запустить расчет фрактала, если он уже успел завершиться, то есть переменная end не равна нулю. Если же фрактал еще считается, то он просто отправляется на пересчет благодаря установке переменной redo в 1.

? update & !redo 'отобразим фрактал

update = 0

#.drawoff(0,0)

.Это условие срабатывает, если фрактал просто продолжает свой расчет и уже есть, что нового отобразить, то есть переменная update не равна нулю.

В третьей строке содержимое закадрового буфера отображается на экран.

wn,hn = #.scrsize()

? wn!=w | hn!=h 'изменился размер экрана

w = wn; h = hn

again -> end

redo = 1

.Назначение этого условия — определить, не изменился ли размер экрана — пользователь может развернуть окно на весь экран, просто изменить размер окна или повернуть планшет в другую ориентацию — тогда новые значения ширины и высоты окна wn,hn не совпадут со старыми w,h. Если такое произошло, то аналогично тому, что мы уже делали ранее, либо перезапускаем поток с расчетом фрактала в четвертой строке, либо в пятой строке сигнализируем этому потоку, что ему нужно начать расчет заново.

draw()=

:loop

#.offon() 'рисуем в закадровом буфере

#.scrclear(0,0,0)

.redo = 0

sfx = .sfx; sfy = .sfy; fs = .sfs/.w

> y, 1...h

> x, 1...w

fx = sfx + x*fs

fy = sfy + y*fs

#.drawpoint(x,y,color(fx,fy):3)

<

loop -> .redo

.update = 1

<

.end = 1

.Это основной цикл рисования фрактала. В третьей строке поток графических команд перенаправлется в закадровый буфер, чтобы потом именно оттуда отображать фрактал с учетом его текущего смещения и масштаба при интерактивной навигации. Как видно из этого примера, работа с графикой безопасна для многопоточных расчетов в SPL.

Основной функцией рисования здесь является функция #.drawpoint, которая в качестве аргумента цвета принимает три переданных значения из функции color.

Далее мы видим, что расчет начинается заново путем перехода на метку loop, если глобальная переменная .redo не ноль.

Далее, устанавливая значение глобальной переменной .update в единицу, мы указываем основному потоку, что уже есть, что нового можно отобразить во фрактале.

Если расчет фрактала закончился, то значение глобальной переменной .end устанавливается равной единице. Зная это, при необходимости пересчета фрактала мы заново запустим поток расчета фрактала.

color(x,y)=

zr = x; zi = y; n = 0

maxn = #.int(200*(1-#.log10(.sfs/4)))

> zr*zr+zi*zi<4 & nЭто последняя функция в нашем примере, она выполняет самое важное — возвращает цвет фрактала в каждой точке экрана. В качестве входных параметров x,y функция color принимает координаты точки во фрактале.

Далее в цикле идет расчет фрактала Мандельброта, а в последних двух строках функции возвращается цвет точки в зависимости от полученного расчета фрактала — либо 0,0,0, если фрактал так и не вышел за установленный лимит maxn, либо цвет из цветового пространства HSV в соответствии с полученным значением фрактала.

Здесь лирическая часть статьи заканчивается и переходим к технической части.

Сделаем из программы на SPL самостоятельное UWP приложение.

Дело в том, что интерпретатор языка SPL сначала генерирует промежуточный бинарный код, а потом уже выполняет его. Это все происходит «за кадром» и пользователь может даже не иметь понятия о существовании этого промежуточного кода — файла COD. Но, включив соответствующую опцию в программе, этот COD файл можно увидеть и скопировать из SPL. После чего берем SPL SDK, выполненный в виде уже готового проекта Visual Studio 2017, и копируем в него этот COD файл в виде ресурса.

Затем указываем имя программы в первой строке. В нашем случае это «fractal.txt». Расширение COD-файла .cod указывать не нужно.

Сам же SPL SDK представляет собой просто «выполнитель» COD-файлов, который автоматически при старте запустит вашу программу на SPL.

В общем-то, это все. Самостоятельное UWP приложение готово! Теперь его можно компилировать и запускать на любом устройстве на Windows 10. При желании можно отправить это приложение в Microsoft Store.

Сейчас язык программирования SPL находится в стадии активной разработки. Назначение языка SPL (Simple Programming Language) — любительское программирование в качестве хобби. SPL — это язык программирования, который придумал и разрабатываю лично я. Также «SPL» — это мое приложение для Windows 10, которое сейчас находится в стадии закрытой беты. Те пользователи, которых интересует язык программирования SPL и кто хотел бы принять участие в его развитии с помощью тестирования, а также своими предложениями — добро пожаловать на сайт языка SPL. Там вы найдете документацию по SPL и другую полезную информацию.

Всем упехов в программировании!

|

Метки: author Mr_Kibernetik программирование spl |

Проведение ретроспективы по методу шести шляп |

Интересно будет тем, кто ищет новые способы проведения ретроспектив, кто интересуется командной работой, подходами к принятию решений и генерации идей.

Цель текста — рассказать, что такой метод есть, на основе простого примера показать, как его можно использовать для организации ретроспективы; вызвать интерес у читателя для дальнейшего самостоятельного изучения этого метода.

Вместо вступления

Идея использования метода шести шляп для проведения ретроспективы возникла, когда я искала интересные варианты проведения ретроспективы для студентов-разработчиков: перед ребятами стояла задача сделать студенческий портал, спринт = 1 неделя, в конце недели — ретроспектива на одну пару (пара — 1.5 часа). Очень хотелось организовать пару в таком формате, чтобы заинтересовать даже тех, кто не принимает активного участия в непосредственной разработке, и тех, у кого сам процесс разработки портала не вызвал какого-то воодушевления. Ещё одно из немаловажных условий — поделиться знанием, которое в дальнейшем ребята могли бы использовать в том числе в своей повседневной жизни (как оказалось, никто из присутствующих до пары об этом методе не слышал).

Что такое метод шести шляп

О методе шести шляп достаточно много написано в самых различных источниках и применительно к решению самых разнообразных задач. Ниже я лишь вкратце расскажу, что это такое.

Метод шести шляп — это метод организации мышления, один и популярных способов проведения мозгового штурма.

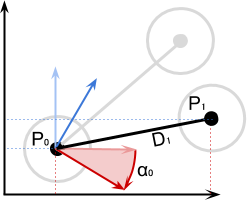

Не секрет, что человеческое мышление очень хаотично: тут и эмоции вперемешку со здравым смыслом, и интуиция, и факты. А что, если в следующий раз, когда нужно будет принять решение или сгенерировать идею, последовательно применять: факты; чувства; критическое мышление; позитивный взгляд на проблему; творческое мышление? Если говорить в контексте метода — примерить каждую из шести шляп: белую (информация и факты), красную (эмоции и чувства), чёрную (критическое суждение), жёлтую (оптимистичность), зелёную (креативность). Ещё есть синяя шляпа — в ней осуществляется обсуждение организации процесса последовательной «примерки» шляп (более подробно можно прочитать, например, в статье на Википедии — там отлично расписана каждая из шести шляп и приведены примеры).

Круто, а как это поможет при проведении ретроспективы?

В самом незамысловатом понимании Ретроспектива — встреча с командой проекта по завершению спринта с целью обсуждения этого самого спринта, его результатов: классические «Что было хорошо?», «Какие были проблемы», «Какие идеи по улучшению?», «Что запланировали на следующий спринт?». Т.е. нужно озвучить и осознать командой проблемы, с которыми команда столкнулась во время спринта, отметить позитивные моменты, придумать, как эффективно жить дальше, при этом очень важно, чтобы ни один член команды в стороне от обсуждения не остался.

И круто взглянуть и на прошедший спринт с разных позиций и по возможности не упустить ничего важного. Не слукавлю, если скажу, что ретроспектива — это ещё и возможность сплотить команду. И метод шести шляп может стать эффективным инструментом во всём этом.

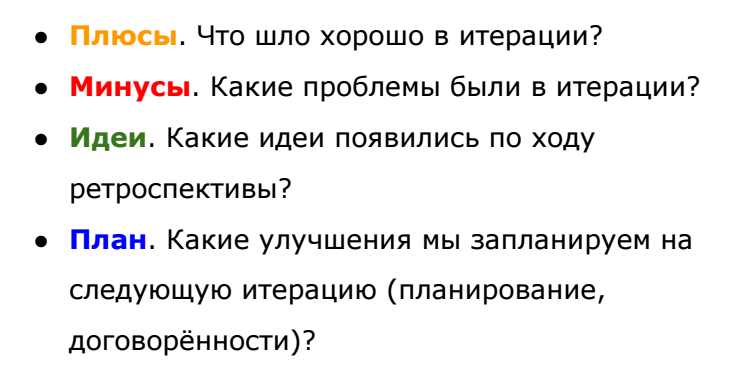

Например, расскажу, как это происходило у нас. В первую очередь очень важно было, чтобы ребята не забывали, какова цель нашей встречи. Для этого, например, можно перед глазами поместить план ретроспективы:

Всё это — основные цели проведения ретроспективы (взято отсюда).

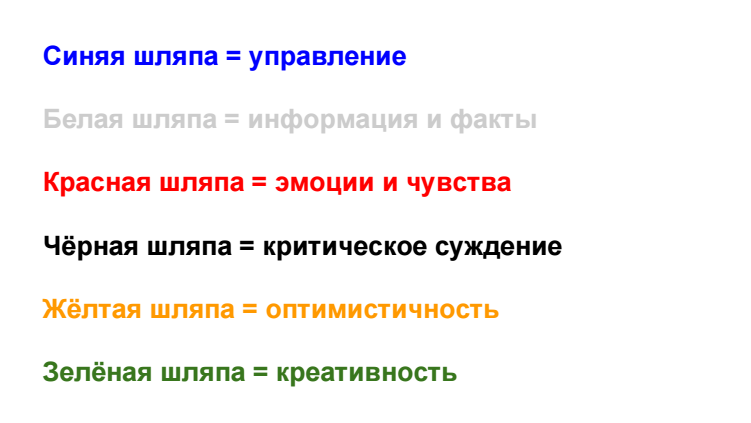

Ну а метод шести шляп — это то, что поможет этой цели достигнуть, и тут самое время объяснить команде, что это такое — этот метод, и зачем оно нам нужно. Здесь, я думаю, достаточно ограничиться сжатым объяснением на минуты 4 с краткими простыми примерами (понятнее, чем при непосредственном погружении в ретроспективу по методу шести шляп, всё равно на этом этапе сделать не получится). Чтобы информация не потерялась в головах и дальше не тратилось время на вопросы, можно повесить перед глазами простую шпаргалку, например:

После того, как у команды есть общее представление о методе, самое время погрузиться в него, и начать с синей шляпы.

Синяя шляпа = управление

Как я уже отметила выше, синяя шляпа — организация и обсуждение процесса, в нашем случае ретроспективы. В контексте аджаила синяя шляпа — шляпа скрам-мастера на время всей ретроспективы (именно он организует процесс обсуждения и следит за его последовательностью и эффективностью).

На этом шаге нужно рассказать, как сегодня будет проходить ретроспектива по методу, например: команда поочерёдно примерит каждую из шляп, это поможет взглянуть под разным углом на основные вопросы ретроспективы (те, что на картинке выше). При этом очень важно ограничить по времени пребывание в каждой из шляп (на сколько — зависит от того, какая продолжительность ретроспективы запланирована изначально) — так команда успеет обсудить важное и не успеет погрузиться в ненужные дебри. Ну не забыть оставить время на подведение итогов.

Важно, чтобы вся полученная на ретроспективе информация была зафиксирована, а при использовании метода шести шляп, ещё и структурирована. С этой целью я вывела на маркерную достку слайд:

— предполагается, что все озвученные мысли будут записываться под каждой из шляп (в зависимости от того, в какой шляпе мысль была сгенерирована).

Белая шляпа = информция и факты

Здесь каждый озвучивает факты о текущем спринте, например:

- Мы не успели сделать такую-то и такую-то задачи,

- Показ прошёл хорошо, заказчик остался доволен,

- Коля (Петя, Каюм) был перекинут на фронтэнд, т.к. ребята не успевали.

Факты должны быть объективные, могут быть как положительные, так и негативные — важно отделять их друг от друга.

Красная шляпа = эмоции и чувства

В этой шляпе участники команды озвучивают свои чувства от прошедшего спринта, демонстрируют эмоции (важно при этом, чтобы не было переходов на личности). Как и факты, эмоции и чувства могут быть как позитивные, как и негативные, но главное, чётко сформулированные.

Критическое суждение

Тут можно бросить взор на уже зафиксированные факты и критиковать их (объективно критиковать). Например,

- Если бы при планировании задач были учтены навыки исполнителей, то мы бы не потратили время на попытки обучить Петю работе с системой сборки,

- Если бы качество юзкейсов было выше, то не было бы потрачено столько времени на попытки разобраться (при этом должно быть обозначено, что такое «качество юзкейсов выше»!),

и т.д.

Жёлтая шляпа = оптимистичность

В этой шляпе мы выделяем позитивные моменты: что было хорошего в спринте («По итогу спринта команда отлично сработалась», «Петя, оказывается, крутой фронтенщик! Очень помог нам с такой-то задачей», «Показ прошёл здорово, мы молодцы»), что будет хорошего («С таким фронтенщиком как Петя...» — ну вы поняли).

Зелёная шляпа = креативность

К этому этапу у команды уже зафиксированы факты о работе во время спринта, выделены минусы и плюсы. Самое время взглянуть на всё это ещё раз: как избежать озвученных минусов в следующем спринте? Как не растерять и использовать плюсы в следующем спринте? Здесь мы генерируем и фиксируем идеи того, как улучшить работу команды на следующий спринт.

Подведение итогов

По результатам проведения ретроспективы у команды должен быть план улучшений на следующий спринт — он формируется из того, что было нагенерировано в зелёной шляпе. О том, как должен выглядеть план улучшений по результатам ретроспективы, писать не буду — в рамках этой статьи такой задачи не стоит.

Вместо заключения

Выше — небольшое описание того, как можно провести ретроспективу по методу шести шляп. Надеюсь, что статья помогла открыть что-то новое для себя и/или структурировать существующее восприятие. Не было целью рассказать, что такое ретроспектива, и даже цели написать инструкцию, как проводить ретроспективу по методу шести шляп не стояло, просто хотелось рассказать, что бывает ещё вот так — знайте это и используйте это знание. Крутых и занимательных ретроспектив вам :)

P.S. То, как это выглядело у нас:

|

Метки: author arwres agile ретроспектива мозговой штурм командная работа |

Про Гауди — разработчика из девятнадцатого века, добившегося всего, чего может добиться разработчик |

Его здания описывают как «бионические дома», некоторые говорят о «летящей пластичной материи». За морем восторгов художников и дизайнеров, как мне показалось, упущена некоторая невероятная рационализация и прагматичность. Гауди был в первую очередь отличным разработчиком, математиком и геометром. Но чтобы объяснить это, сначала я покажу другую картинку:

Это два крепления. Первое производится серийно — оно просто в проектировании, просто в изготовлении, дёшево и невероятно уродливо. Второе красивое, и требует на 25% меньше материала для того, чтобы выдержать тот же вес (то есть — куда прочнее). Только его трудно рассчитать, оно будет дороже в серии — и придётся подумать.

Примерно то же самое делал Гауди. Ему пришлось обойтись без математического аппарата и современных материалов. И ещё действовать в рамках строго ограниченного бюджета. Он, фактически, заложил новые принципы всего от фасада до последней дверной ручки, создал шедевры оптимизации — в общем смёл все стереотипы как сухие листья, создал с нуля теорию и воплотил её. В девятнадцатом веке всё то, что он делал, было просто диким. Некоторые даже считали его сумасшедшим.

Начнём с нагрузок на несущие конструкции здания

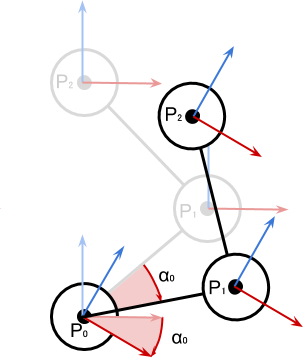

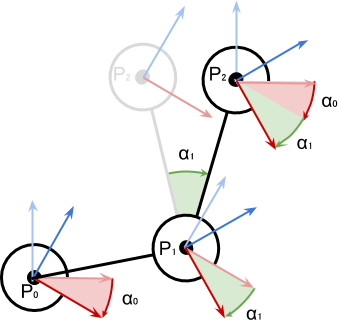

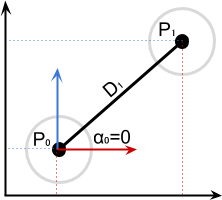

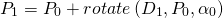

Представьте, что вы строите дом в девятнадцатом веке. Первое, что вы делаете — это уходите от готической избыточности и нефункциональных украшений. Каждый элемент должен нести прямой функциональный смысл. Вы начинаете с прототипирования зданий по его несущим осям. Вот первая гениальная догадка Гауди. Смотрите, как он делал макеты:

Он интуитивно понял, что оптимальная форма несущей конструкции близка к парабалоиду. Чтобы рассчитать все парабалоиды в здании, он подвешивал грузики на верёвках или цепочках. Каждый грузик — это масса стены, масса конструкции на крыше, масса чего-то ещё. Потом он смотрел, как именно выгибаются арки будущего здания — получался перевёрнутый макет. Затем он подкладывал зеркало и перерисовывал его. Потому что этот макет представлял, по сути, перевёрнутое здание.

Самое важное — это был «живой» макет из верёвочек, куда вы могли подвесить новые грузы по мере получения новых данных. То есть если готический архитектор имел две-три попытки на макет, и каждая его переделка была серьёзной работой, Гауди имел возможность проверять тысячи вариантов разработки. Захотел убрать стену — снял цепочку, сдвинулись все остальные. Захотел построить тяжёлую надстройку на куполе — подвесил камень нужной массы, поменялся изгиб арки к оптимальному. Матмодель бы сошла с ума, а верёвочки всё решали. Быстро, невероятно дёшево и настолько эффективно, что мы с вами вот только с компьютерами научились считать примерно похожим образом. И вот результат:

Фасад дома Мила, я знаю, архитекторы убьют меня за такую съёмку

Продолжаем аналогию с ваии в девятнадцатом веке. Как вы шли к финалу? Сначала повезло. Всё детство вы наблюдали за животными и растениями, и знаете, как они замечательно умеют держать нагрузки. Природа подсказывает вам оптимальные формы для разных конструкций.

Вам везёт второй раз, потому что ваш дядя — кузнец. Он учит вас работать с материей так, чтобы она принимала именно ту форму, которая нужна для задачи. Вы научились двум вещам: тому, что именно воля человека определяет форму материи, и тому, что сначала нужно определить суть вещи, а потом делать её нужной формы — а не идти на поводу у того, что удобнее изготовить.

Материал диктует вам форму зданий. Всё ваше образование говорит вам, что есть определённые практики расчётов, и нужно пользоваться ими. Есть проработанные веками оптимальные формы. А потом наступает самое интересное. Появляется ограничение в задаче. У вас есть заданный бюджет, и в рамках этого бюджета вам нужно спроектировать здание, внутри которого будет свободная планировка. Потому что богатая буржуазная чета Мила заказала себе дом на главной улице Барселоны. Они хотят несколько собственных помещений — и что-то вроде отеля во всём остальном доме. Это нормальная практика в те годы — каждый дом строился как самообеспечивающийся проект. Все затраты на поддержание дома окупались тем, что часть «квартир» (или этажей) сдавалась жильцам на долгие годы. Техническая сложность была в том, что каждый жилец делал под себя довольно серьёзный ремонт.

Почему это проблема? Тогда здание держалось на внутренних перегородках. Это сегодня мы представляем себе здание как прочную коробочку, внутри которой можно что-то двигать. В восемнадцатом веке и начале девятнадцатого только-только расцвела неоготика и поднимал голову модерн. А это значит — ни одного самонесущего фасада. С точки зрения конструкций, здания — это крыша, стоящая на колоннах, и не проваливающаяся благодаря им. Стены строили как у крепости, с контрфорсами.

В общем, решить задачу дёшево и при этом правильно было невозможно. И, похоже, именно это прекрасное слово — «невозможно» — вас вдохновило. Вы знаете, что материя в природе эту задачу решает. У вас есть куча растений, которые устроены совсем по другим принципам. Один только вид позвоночика с рёбрами заставляет предположить, что внешний несущий каркас вполне себе возможен. Осталось воплотить это в здании.

Но вы не знаете, что это невозможно. И ищете способ. И чем больше вы думаете, тем больше понимаете, что не так устроен весь процесс строительства зданий. И начинаете — шаг за шагом — приходить к нужному, выстраивая всё с нуля.

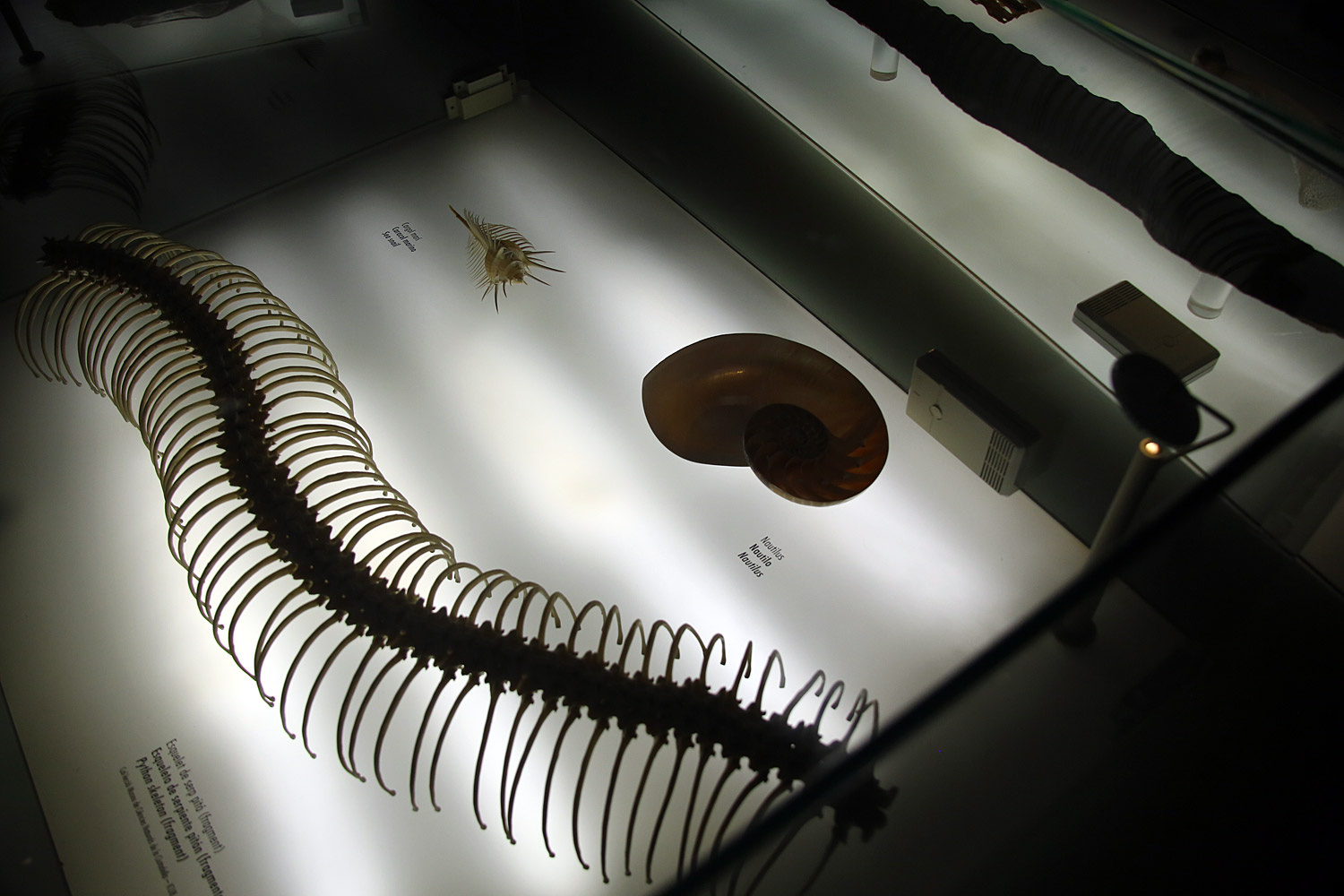

Вот, смотрите: арки чердачных помещений дома Батло:

Они сделаны из кирпича — невероятно дёшевы, невероятно (по тем временам) прочны, идеально рассчитаны. А вот прототип из мира живой природы, конструкция, которая отточена тысячелетиями непрерывной оптимизации:

И вот невероятно красивое решение по свету — арки чердака дома Мила:

На фото видно этот самый кирпич — самый что ни на есть обычный для тех времён, но уложенный в структуру, которая наиболее хорошо сопротивляется статической нагрузке сверху. Как куриное яйцо — легко разбить ударом слабого клюва цыплёнка изнутри, но куда сложнее раздавить снаружи. Там же целая курица сидит.

Эргономика

Общая промышленная ситуация в самом начале двадцатого века требовала развития дизайна. Напомню, именно тогда в обиход широко входили автомобили и электричество (Гауди даже перепроектировал подвал одного из своих домов из конюшни в гараж — понадобилась более прочная и сложная рампа для заезда). Одним из важнейших запросов промышленности была эстетика. Через эстетичный внешний вид фабричных объектов предполагалось завоёвывать рынок. Напомню, электричество ещё лет двадцать было страшилкой типа ГМО и прививок в современном обществе — в Европе его реально боялись и связывали с привидениями. Но важно то, что в этот самый момент от готического фреймворка разработки мы переходим в два следующих варианта:

- Или в неомодерн (Гауди, эстетика, биоформы и эргономика)

- Или в конструктивизим (Баухаус и ВХУТЕМАС, линейные формы для серийного производства, минимализм).

Гауди работал с эргономикой, а мэтры Баухаса — с тем, что можно было производить серийно. Победил, конечно, немецкий фабричный гений — всё же в тех условиях делать нечто не квадратно-гнездовое было очень и очень сложно.

Гауди же, в свою очередь, очень быстро понял, что его не устраивает практически ничего из стандартных элементов и фурнитуры для домов. Тогда никто не знал, что делает архитектор, а что не делает, поэтому Антонио Гауди залез в процесс с самого-самого начала. Ему пришлось заново продумывать формы поручней так, чтобы за них было легко и удобно держаться:

Или вот посмотрите на двери:

Позже он улучшил и смотровое отверстие, сделав его похожим на глаз мухи

Здесь нас интересует форма ручки (за неё чертовски удобно браться), глазок, метка с «номером» квартиры. Сейчас эти смотровые отверстия стали уже частью современной культуры Каталонии (я нашёл эту дверь районе Монжуик):

В центр этих «глазков» иногда монтируют маленькую камеру.

Вот ещё его двери и мебель:

Сдвоенное кресло, кстати, идеально для разговора молодой пары, как это ни странно. И ещё обратите внимание, как он отлично спрятал массивные несущие элементы и рёбра жесткости конструкции стульев.

А вот фурнитура поближе: всё рассчитано под руку:

Ни одной прямой линии при потрясающем удобстве:

Очень интересное у него было управление светом:

Здесь, фактически, использован тот принцип, который стал основным для строительства современных торговых центров. В доме Батло был большой внутренний дворик — и высокие дома рядом. Гауди накрыл дворик стеклом и сделал там лестницу и шахту лифта в середине. Получился источник света для всех этажей — и «пустой» рассеивющий внутренний элемент, который безумно хорошо сочетался с наружными несущими конструкциями. Этот же опыт позже был повторён в доме Мила.

Про металлические элементы типа ограждений (есть на фото дома Мила выше) была даже смелая теория про то, что Антонио научился считать фракталы. На деле, скорее всего, ситуация проще: он собирал виды и типы животной материи (компактные пространства — лотос и кукуруза, несущие — позвоночники и стебли, эластичные — ткани растений и т.п). И использовал совершенно нормальную идею фрактального роста деревьев в отливках. Плюс вкус. Да, получается сложный фрактал. Но не потому, что так хотелось, а потому, что это оказалась оптимальная форма для решения задачи.

Проект-менеджмент

В парке Гуэль было очень много интересных управленческих решений, которые потом пошли и в другие проекты. Во-первых, максимальное переиспользование материалов и сохранение ландшафта. Участок семьи Гуэль был с довольно большим перепадом по высоте — Гауди решил не выравнивать его, а использовать перепады высот в качестве особенностей проекта. В частности, это очень помогло системе водоснабжения. Во-вторых, большинство каменных элементов сделаны из тех камней, которые нашлись непосредственно на участке:

Позже Антонио использовал похожую методику для украшения объектов на крышах зданий:

Кстати, сами эти штуки хоть и служат очень крутым украшением здания, но на деле — дымоходы. Сзади видно входные отверстия вентшахты. Решается две задачи: маскировка технологических портов здания и украшение крыши. Напомню, тогда крыши украшали бедно и без привязки к функционалу, плюс не знали, как считать нагрузки.

Вот эти купола на переднем плане было очень сложно сделать из чего-то современного архитектору — навыков изготовления криволинейных покрытий не было. В итоге надо было делать мозаику из стекла. Здесь использован мусор с объекта — битые бутылки шампанского. Часто он использовал битую облицовку сносимых зданий, то есть, фактически, переиспользовал старый материал. Фанаты экологичного строительства в Испании считают, что он был пионером экологии в архитектуре.