Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Автоэнкодеры в Keras, Часть 5: GAN(Generative Adversarial Networks) и tensorflow |

Содержание

- Часть 1: Введение

- Часть 2: Manifold learning и скрытые (latent) переменные

- Часть 3: Вариационные автоэнкодеры (VAE)

- Часть 4: Conditional VAE

- Часть 5: GAN (Generative Adversarial Networks) и tensorflow

- Часть 6: VAE + GAN

При всех преимуществах вариационных автоэнкодеров VAE, которыми мы занимались в предыдущих постах, они обладают одним существенным недостатком: из-за плохого способа сравнения оригинальных и восстановленных объектов, сгенерированные ими объекты хоть и похожи на объекты из обучающей выборки, но легко от них отличимы (например, размыты).

Этот недостаток в куда меньшей степени проявляется у другого подхода, а именно у генеративных состязающихся сетей — GAN’ов.

Формально GAN’ы, конечно, не относятся к автоэнкодерам, однако между ними и вариационными автоэнкодерами есть сходства, они также пригодятся для следующей части. Так что не будет лишним с ними тоже познакомиться.

Коротко о GAN

GAN’ы впервые были предложены в статье [1, Generative Adversarial Nets, Goodfellow et al, 2014] и сейчас очень активно исследуются. Наиболее state-of-the-art генеративные модели так или иначе используют adversarial.

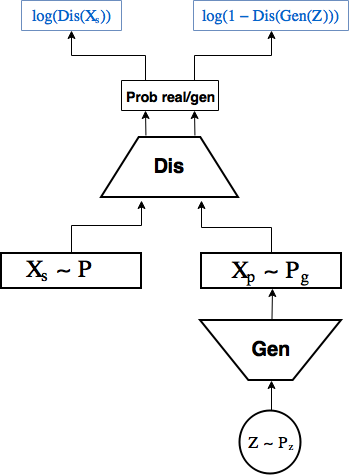

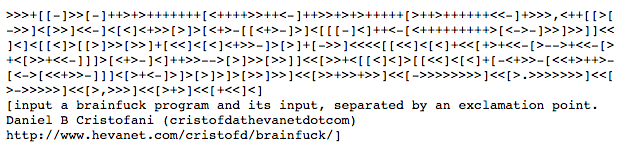

Схема GAN:

GAN’ы состоят из 2 нейронных сетей:

- 1-ая — генератор сэмплит случайные числа из какого-то заданного распределения

, например

и генерируют из них объекты

, которые идут на вход второй сети,

- 2-ая — дискриминатор получает на вход объекты из выборки

и созданные генератором

, и учится предсказывать вероятность того, что конкретный объект реальный, выдавая скаляр

.

При этом генератор тренируется создавать объекты, который дискриминатор не отличит от реальных.

Рассмотрим процесс обучения GAN.

Генератор и дискриминатор обучаются отдельно, но в рамках одной сети.

Делаем k шагов обучения дискриминатора: за шаг обучения дискриминатора параметры

Далее шаг обучения генератора: обновляем параметры генератора

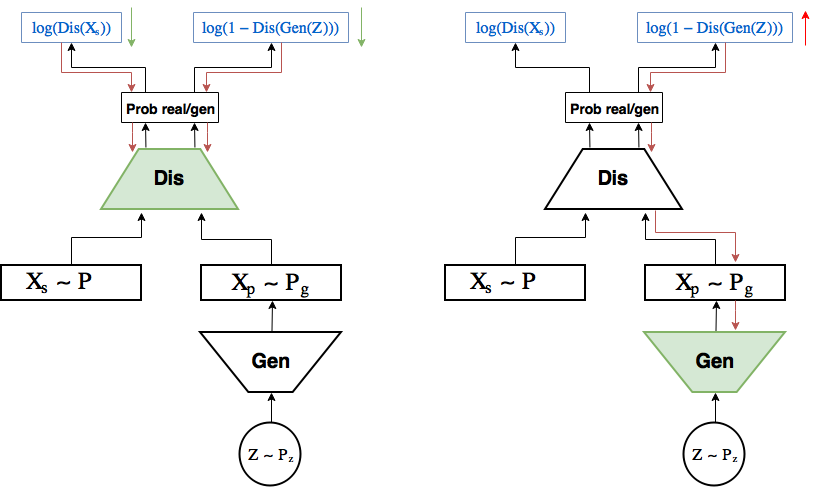

Схема обучения:

На левой картинке шаг обучения дискриминатора: градиент (красные стрелки) протекает от лосса только до дискриминатора, где обновляются

Задача, которую решает GAN формулируется так:

При заданном генераторе оптимальный дискриминатор выдает вероятность что почти очевидно, предлагаю задуматься об этом немножно.

В [1] показывается, что при достаточной мощности обеих сетей у данной задачи есть оптимум, в котором генератор научился генерировать распределение

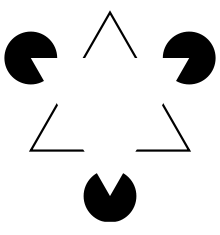

Иллюстрация из [1]

Обозначения:

- черная точечная кривая — настоящее распределение

,

- зеленая — распределение генератора

,

- синяя — распределение вероятности

дискриминатора предсказать класс реального объекта,

- нижняя и верхняя прямые — множество всех

и множество всех

, стрелочки олицетворяют отображение

.

На картинке:

- (a)

и

довольно разные, но дискриминатор неуверенно отличает одно от другого,

- (b) дискриминатор после k шагов обучения уже отличает их увереннее,

- (с) это позволяет генератору

, руководствуясь хорошим градиентом дискриминатора

, на границе двух распределений подвинуть

ближе к

,

- (d) в результате многих повторений шагов (а), (b), (с)

совпало с

, и дискриминатор более не способен отличать одно от другого:

. Точка оптимума достигнута.

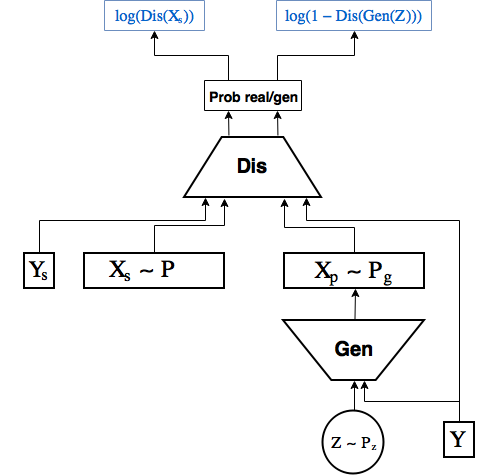

Conditional GAN

Точно как в прошлой части мы сделали Conditional VAE, просто передавая в энкодер и декодер лейбл цифры, здесь мы будем передавать его в генератор и дискриминатор [2]

Код

В отличие от предыдущих частей, где получалось обходиться одним keras’ом, здесь с этим возникает проблема. А именно, нужно в одной и той же сети по очереди обновлять либо только параметры генератора, либо только дискриминатора. Если исхитриться, то можно сделать это и чисто в keras’е, но по мне проще и полезнее подключить сюда и tensorflow.

В блоге keras’а есть небольшой туториал [3], как это делать.

Благо keras легко сочетается с tensorflow — не даром он попал в tensorflow.contrib.

Начнем с импортирования нужных модулей и загрузки датасета.

from IPython.display import clear_output

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

from keras.layers import Dropout, BatchNormalization, Reshape, Flatten, RepeatVector

from keras.layers import Lambda, Dense, Input, Conv2D, MaxPool2D, UpSampling2D, concatenate

from keras.layers.advanced_activations import LeakyReLU

from keras.models import Model, load_model

from keras.datasets import mnist

from keras.utils import to_categorical

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test .astype('float32') / 255.

x_train = np.reshape(x_train, (len(x_train), 28, 28, 1))

x_test = np.reshape(x_test, (len(x_test), 28, 28, 1))

y_train_cat = to_categorical(y_train).astype(np.float32)

y_test_cat = to_categorical(y_test).astype(np.float32)

Для работы в keras и tensorflow одновременно надо зарегистрировать tensorflow сессию в keras, это нужно для того чтобы keras создавал все внутренние переменные в рамках используемой сессии.

from keras import backend as K

import tensorflow as tf

sess = tf.Session()

K.set_session(sess)

Определим основные глобальные константы:

batch_size = 256

batch_shape = (batch_size, 28, 28, 1)

latent_dim = 2

num_classes = 10

dropout_rate = 0.3

Обучать модель мы теперь будем не с помощью метода .fit, а напрямую из tensorflow, поэтому напишем итератор, возвращающий очередной батч:

def gen_batch(x, y):

n_batches = x.shape[0] // batch_size

while(True):

for i in range(n_batches):

yield x[batch_size*i: batch_size*(i+1)], y[batch_size*i: batch_size*(i+1)]

idxs = np.random.permutation(y.shape[0])

x = x[idxs]

y = y[idxs]

train_batches_it = gen_batch(x_train, y_train_cat)

test_batches_it = gen_batch(x_test, y_test_cat)

Оборачиваем placeholder’ы для картинок, лейблов и скрытых переменных во входящие слои для keras моделей:

x_ = tf.placeholder(tf.float32, shape=(None, 28, 28, 1), name='image')

y_ = tf.placeholder(tf.float32, shape=(None, num_classes), name='labels')

z_ = tf.placeholder(tf.float32, shape=(None, latent_dim), name='z')

img = Input(tensor=x_)

lbl = Input(tensor=y_)

z = Input(tensor=z_)

Реализовывать будем сразу CGAN, так как он лишь минимально отличается от обычного.

Напишем модель генератора. Keras работает со scope’ами, а нам нужно разделить генератор и дискриминатор, чтобы потом обучать их по-отдельности

with tf.variable_scope('generator'):

x = concatenate([z, lbl])

x = Dense(7*7*64, activation='relu')(x)

x = Dropout(dropout_rate)(x)

x = Reshape((7, 7, 64))(x)

x = UpSampling2D(size=(2, 2))(x)

x = Conv2D(64, kernel_size=(5, 5), activation='relu', padding='same')(x)

x = Dropout(dropout_rate)(x)

x = Conv2D(32, kernel_size=(3, 3), activation='relu', padding='same')(x)

x = Dropout(dropout_rate)(x)

x = UpSampling2D(size=(2, 2))(x)

generated = Conv2D(1, kernel_size=(5, 5), activation='sigmoid', padding='same')(x)

generator = Model([z, lbl], generated, name='generator')

Далее модель дискриминатора. Здесь нам нужно добавить ко входящему изображению еще лейбл цифры. Для этого после применения первого сверточного слоя добавим к фильтрам лейблы. Сперва функция, которая это делает, потом модель дискриминатора.

def add_units_to_conv2d(conv2, units):

dim1 = int(conv2.shape[1])

dim2 = int(conv2.shape[2])

dimc = int(units.shape[1])

repeat_n = dim1*dim2

units_repeat = RepeatVector(repeat_n)(lbl)

units_repeat = Reshape((dim1, dim2, dimc))(units_repeat)

return concatenate([conv2, units_repeat])

with tf.variable_scope('discrim'):

x = Conv2D(128, kernel_size=(7, 7), strides=(2, 2), padding='same')(img)

x = add_units_to_conv2d(x, lbl)

x = LeakyReLU()(x)

x = Dropout(dropout_rate)(x)

x = MaxPool2D((2, 2), padding='same')(x)

l = Conv2D(128, kernel_size=(3, 3), padding='same')(x)

x = LeakyReLU()(l)

x = Dropout(dropout_rate)(x)

h = Flatten()(x)

d = Dense(1, activation='sigmoid')(h)

discrim = Model([img, lbl], d, name='Discriminator')

Определив модели, мы можем применять их напрямую к placeholder’ам как обычные tensorflow операции.

generated_z = generator([z, lbl])

discr_img = discrim([img, lbl])

discr_gen_z = discrim([generated_z, lbl])

gan_model = Model([z, lbl], discr_gen_z, name='GAN')

gan = gan_model([z, lbl])

Теперь лосс ошибки определения реального изображения, и лосс сгенерированного, а также на их основе лоссы генератора и дискриминатора.

log_dis_img = tf.reduce_mean(-tf.log(discr_img + 1e-10))

log_dis_gen_z = tf.reduce_mean(-tf.log(1. - discr_gen_z + 1e-10))

L_gen = -log_dis_gen_z

L_dis = 0.5*(log_dis_gen_z + log_dis_img)

Обычно в tensorflow, передавая в оптимизатор лосс, он будет пытаться минимизировать сразу все переменные, от которых он зависит. Нам сейчас этого не надо: при обучении генератора, ошибка не должна трогать дискриминатор, хотя должна сквозь него течь и наоборот.

Для этого дополнительно в оптимизатор надо передать список переменных, которые он будет оптимизировать. Достанем эти переменные из нужных scope’ов с помощью tf.get_collection

optimizer_gen = tf.train.RMSPropOptimizer(0.0003)

optimizer_dis = tf.train.RMSPropOptimizer(0.0001)

# Переменные генератора и дискриминаторы (отдельно) для оптимизаторов

generator_vars = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, "generator")

discrim_vars = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, "discrim")

step_gen = optimizer_gen.minimize(L_gen, var_list=generator_vars)

step_dis = optimizer_dis.minimize(L_dis, var_list=discrim_vars)

Инициализируем переменные:

sess.run(tf.global_variables_initializer())

Отдельно напишем функции, которые будем вызывать для обучения генератора и дискриминатора:

# Шаг обучения генератора

def step(image, label, zp):

l_dis, _ = sess.run([L_dis, step_gen], feed_dict={z:zp, lbl:label, img:image, K.learning_phase():1})

return l_dis

# Шаг обучения дискриминатора

def step_d(image, label, zp):

l_dis, _ = sess.run([L_dis, step_dis], feed_dict={z:zp, lbl:label, img:image, K.learning_phase():1})

return l_dis

Код сохранения и визуализации картинок:

# Массивы, в которые будем сохранять результаты, для последующей визуализации

figs = [[] for x in range(num_classes)]

periods = []

save_periods = list(range(100)) + list(range(100, 1000, 10))

n = 15 # Картинка с 15x15 цифр

from scipy.stats import norm

# Так как сэмплируем из N(0, I), то сетку узлов, в которых генерируем цифры, берем из обратной функции распределения

grid_x = norm.ppf(np.linspace(0.05, 0.95, n))

grid_y = norm.ppf(np.linspace(0.05, 0.95, n))

grid_y = norm.ppf(np.linspace(0.05, 0.95, n))

def draw_manifold(label, show=True):

# Рисование цифр из многообразия

figure = np.zeros((28 * n, 28 * n))

input_lbl = np.zeros((1, 10))

input_lbl[0, label] = 1.

for i, yi in enumerate(grid_x):

for j, xi in enumerate(grid_y):

z_sample = np.zeros((1, latent_dim))

z_sample[:, :2] = np.array([[xi, yi]])

x_generated = sess.run(generated_z, feed_dict={z:z_sample, lbl:input_lbl, K.learning_phase():0})

digit = x_generated[0].squeeze()

figure[i * 28: (i + 1) * 28,

j * 28: (j + 1) * 28] = digit

if show:

# Визуализация

plt.figure(figsize=(10, 10))

plt.imshow(figure, cmap='Greys')

plt.grid(False)

ax = plt.gca()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

return figure

n_compare = 10

def on_n_period(period):

clear_output() # Не захламляем output

# Рисование многообразия для рандомного y

draw_lbl = np.random.randint(0, num_classes)

print(draw_lbl)

for label in range(num_classes):

figs[label].append(draw_manifold(label, show=label==draw_lbl))

periods.append(period)

Обучим теперь наш CGAN.

Важно, чтобы в самом начале дискриминатор не слишком стал побеждать, иначе обучение остановится. Поэтому здесь добавлены внутренние циклы как для дискриминатора, так и для генератора, и выход из них, когда одна сеть почти догоняет другую.

Если дискриминатор сразу выигрывает у декодера, и обучение даже не успевает начаться, то можно попробовать замедлить обучение дискриминатора, либо несколько раз начинать заново.

batches_per_period = 20 # Как часто сохранять картинки

k_step = 5 # Количество шагов, которые могут делать дискриминатор и генератор во внутреннем цикле

for i in range(5000):

print('.', end='')

# Достанем новый батч

b0, b1 = next(train_batches_it)

zp = np.random.randn(batch_size, latent_dim)

# Шаги обучения дискриминатора

for j in range(k_step):

l_d = step_d(b0, b1, zp)

b0, b1 = next(train_batches_it)

zp = np.random.randn(batch_size, latent_dim)

if l_d < 1.0:

break

# Шаги обучения генератора

for j in range(k_step):

l_d = step(b0, b1, zp)

if l_d > 0.4:

break

b0, b1 = next(train_batches_it)

zp = np.random.randn(batch_size, latent_dim)

# Периодическое рисование результата

if not i % batches_per_period:

period = i // batches_per_period

if period in save_periods:

on_n_period(period)

print(l_d)

Код рисования гифок:

from matplotlib.animation import FuncAnimation

from matplotlib import cm

import matplotlib

def make_2d_figs_gif(figs, periods, c, fname, fig, batches_per_period):

norm = matplotlib.colors.Normalize(vmin=0, vmax=1, clip=False)

im = plt.imshow(np.zeros((28,28)), cmap='Greys', norm=norm)

plt.grid(None)

plt.title("Label: {}\nBatch: {}".format(c, 0))

def update(i):

im.set_array(figs[i])

im.axes.set_title("Label: {}\nBatch: {}".format(c, periods[i]*batches_per_period))

im.axes.get_xaxis().set_visible(False)

im.axes.get_yaxis().set_visible(False)

return im

anim = FuncAnimation(fig, update, frames=range(len(figs)), interval=100)

anim.save(fname, dpi=80, writer='imagemagick')

for label in range(num_classes):

make_2d_figs_gif(figs[label], periods, label, "./figs4_5/manifold_{}.gif".format(label), plt.figure(figsize=(10,10)), batches_per_period)

Результаты:

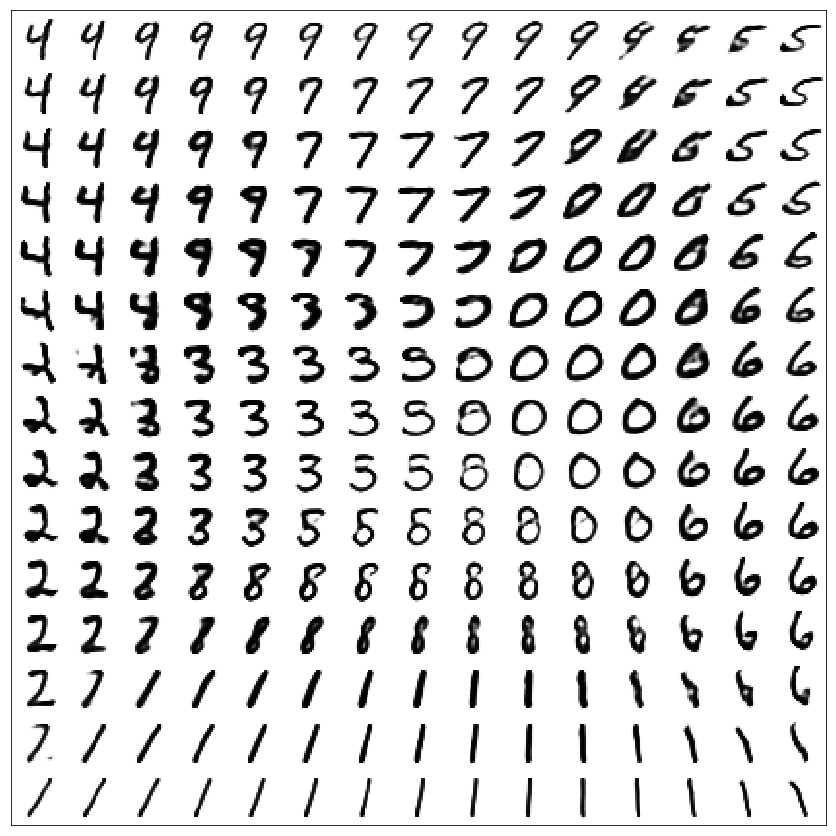

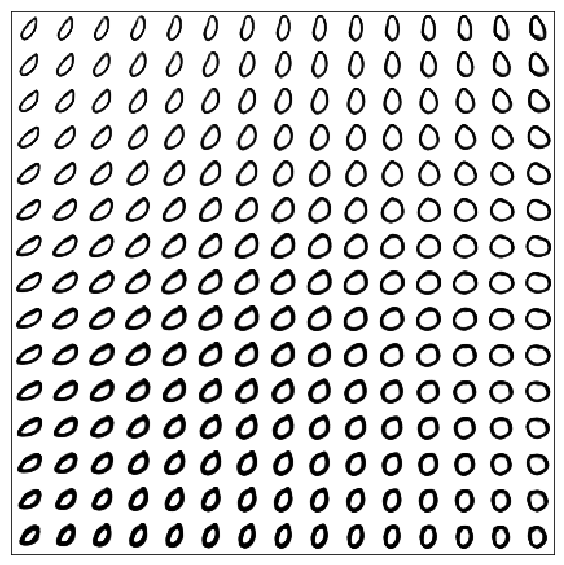

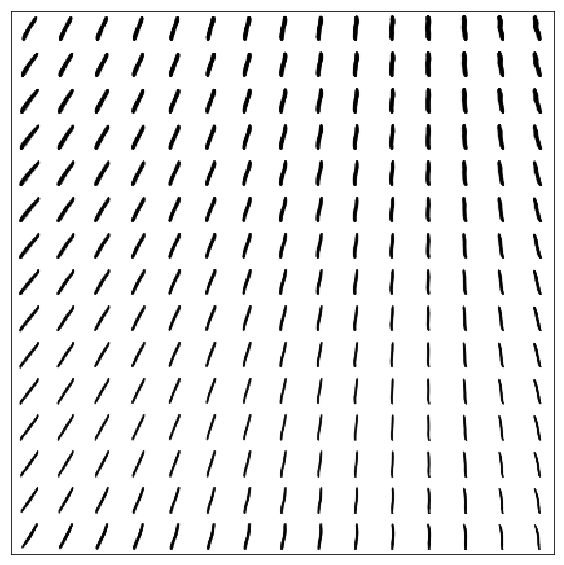

GAN

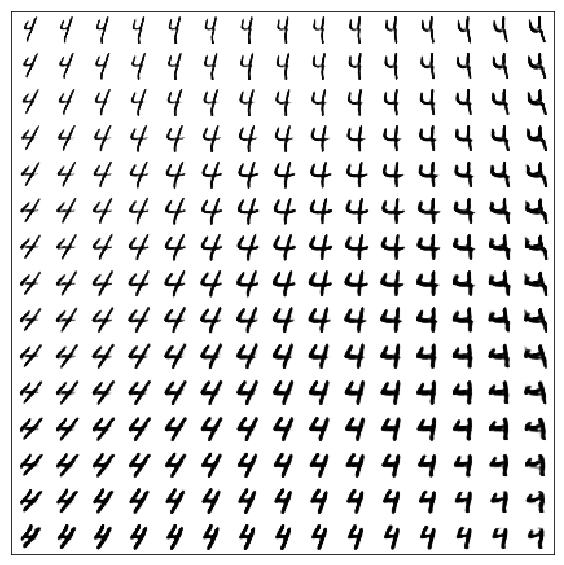

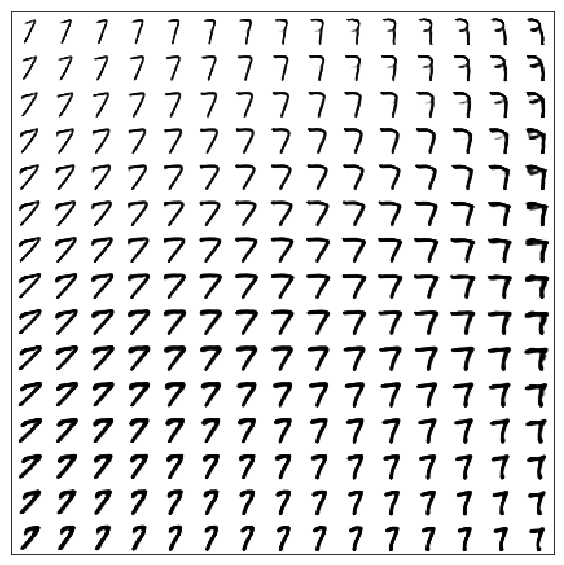

Многообразие цифр для обычного GAN (без передачи лейблов)

Стоит отметить, что цифры получаются лучше, чем в VAE (без лейблов)

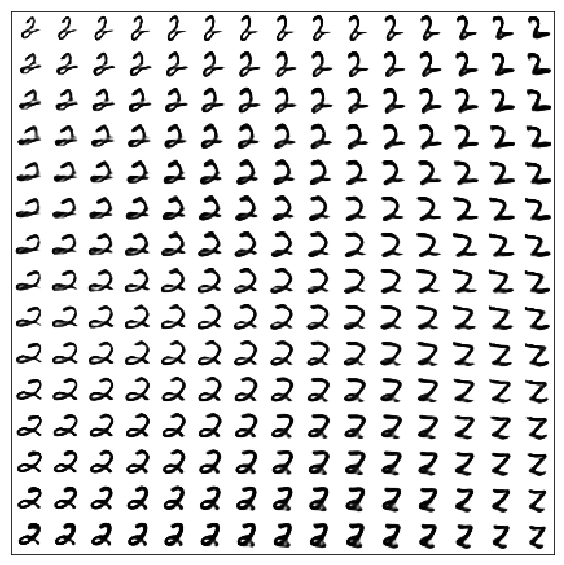

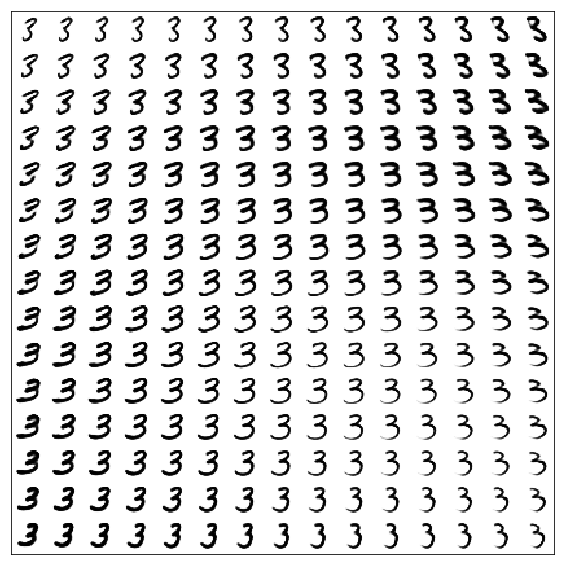

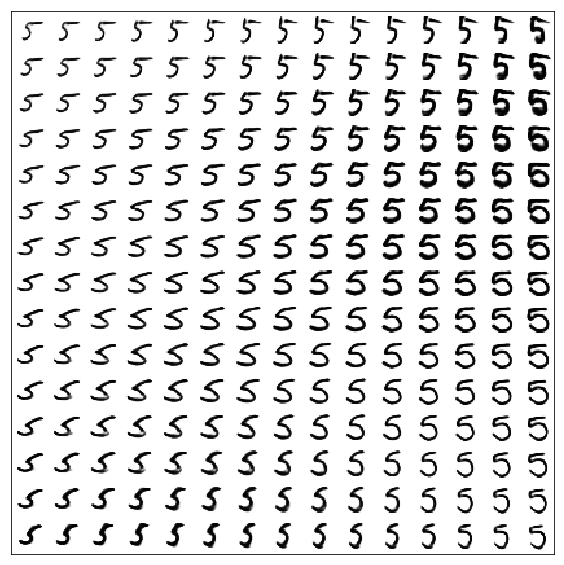

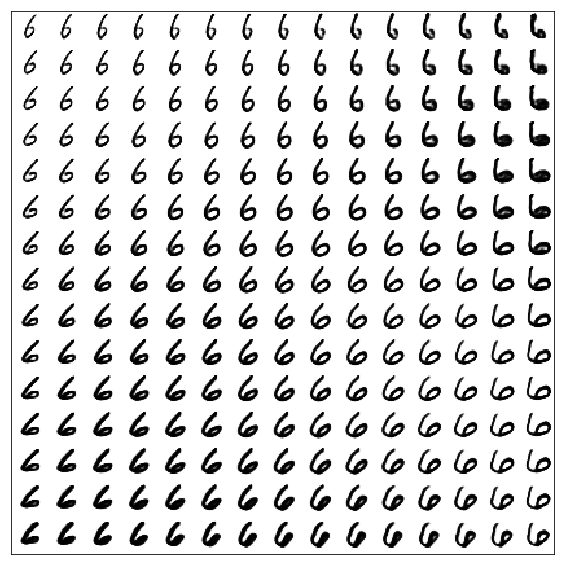

CGAN

Многообразия цифр для каждого лейбла

Полезные ссылки и литература

Оригинальная статья:

[1] Generative Adversarial Nets, Goodfellow et al, 2014, https://arxiv.org/abs/1406.2661

Conditional GANs:

[2] Conditional Generative Adversarial Nets, Mirza, Osindero, 2014, https://arxiv.org/abs/1411.1784

Туториал про использование keras вместе с tensorflow:

[3] https://blog.keras.io/keras-as-a-simplified-interface-to-tensorflow-tutorial.html

|

Метки: author iphysic обработка изображений машинное обучение математика алгоритмы python keras mnist deep learning machine learning gan |

Переход в двоичную систему |

Нет, здесь не будет текстов про героев нашего времени, выдающихся изобретателей или программистов. Всё это вы можете прочитать без моей помощи.

За прошедшие 99 постов и несколько десятков статей для разных изданий, написанных за прошедший год, заметила, что в мире каждый день создаётся что-то интересное. К сожалению, мы зачастую упускаем это из виду из-за тонн информации, окружающей нас. Поэтому хочу рассказать вам про 5 проектов, которые поразили меня, а после этого поделюсь одной идеей.

«Следующий Рембрандт»

Коллаборация технологий и искусства порой даёт интересные результаты, как это случилось в прошлом году. Агентство JWT Amsterdam, совместно с Microsoft, разработало проект «Следующий Рембрандт» для ING Bank, который был призван подчеркнуть приверженность банка инновациям и поддержке классического искусства.

Изначально было проанализировано 346 доподлинно известные картин Рембрандта, из которых получили 168263 фрагментов изображений (или 150 ГБ). Далее, с помощью алгоритмов распознавания изображений определили наиболее типичные штрихи и геометрические узоры мастера, что позволило максимизировать идентичность стилистики будущего произведения со стилем Рембрандта. Ещё один интересный момент: для придания объёма мазкам на картине, потребовалось проанализировать 3D-сканы картин. На итоговую обработку данных ушло больше 500 часов.

Подробнее про проект можно прочитать здесь.

Восьмибитная музыка в ритме VR

Неконтролируемые рейвы 80-ых позволяли музыкантам со скоростью звука набирать популярность и собирать поклонников вокруг себя. За последние 30 лет ситуация сильно изменилась. Сегодня, чтобы проникнуть в сердце аудитории, нужно быть чем-то большим, чем просто крутым диджеем или мелодичным певцом. У Microsoft есть программа Music x Technology, которая с помощью технологий помогает преобразовывать музыку в нечто осязаемое.

В моей статье для Rolling Stone описаны 6 проектов, реализованные совместно с M83, Childish Gambino, Broods, Grimes, Matthew Dear и Phantogram. Например, в результате работы над первым из них была выпущена браузерная игра «Meet Me at Go!» в которой игрок участвуете в гонке за утраченной любовью, перемещаясь на машине по городу с ретро-футуристическим пейзажем, собирая предметы и обходя препятствия. Она создана на движке Unity и экспортирована на платформу UWP. Интересный момент, который вы сможете заметить во время игры — звуковые эффекты трека полностью соответствуют тому, что происходит на экране: когда машина ускоряется, музыка также начинает ускорятся, и аналогично с замедлением.

Лицом в клавиатуру

В Microsoft есть научно-исследовательское подразделение Microsoft Research, существующее более 25 лет. В конце прошлого года они проанализировали анонимные данные об активности пользователей в интернете, чтобы понять, как качество сна влияет на скорость реакции людей в течение дня. После чего были получены результаты, основанные на анализе данных о скорости ввода поисковых запросов и перехода по ссылкам в поисковике.

Источник изображения giphy.com

В Microsoft Research доказали, что люди, которые две ночи подряд спали меньше шести часов, испытывают вялость в течение следующих шести дней. Интересная статистика, на мой взгляд.

Детальные подробности об этом исследовании можно прочитать в статье.

Кто такие фузионисты

Зачастую для создания чего-то выдающегося, человек должен выйти за границы разумного. Следующая статья про Асту Розуэй — человека, которому это удалось. Она разработала татуировки DuoSkin для управления IoT-устройствами, а в далёком 2011 году стала идеологом «Печатающего платья» (The Printing Dress). Также она является одним из основателей выставки FoodFutures, созданной для решения проблем городского сельского хозяйства.

Подробнее про её проекты можно почитать RB, а я хочу поделиться небольшой историей, возникшей по результатам этого материала. Конечно же хотелось «приземлить» эти кейсы в российские реалии, для этого мы нашли двух человек, которые согласились прокомментировать статью. Одной из них была Оксана Селендеева, основатель школы программирования для детей CODDY. В нашей переписке ещё до выхода она восхитилась идеей фузионизма и она сказала, что хочет запустить курсы по этой теме. Тогда я подумала, что это просто временный запал, но как оказалось потом, они правда появились. Не знаю насколько они популярны и будут ли востребованы, но приятно знать, что статья о фузионистах действительно вдохновила кого-то.

Облачные сервисы могут спасти нашу планету

Часто вижу материалы, в которых идут дискуссии «Что лучше: облако или локальный сервер?» Даже сейчас в топе висит статья dracon134 на эту тему. Если отвлечься от технических проблем, то есть другие темы вокруг облачных платформ, о которых можно поспорить. Экология — одна из них.

Весной прошлого года на Хабре вышла статья про экономию энергии в процессе сбора данных при использовании облачных технологий, на которую захотелось взглянуть под другим углом. Помимо видимых и «прямых» доводов о вреде технологий, существуют кейсы, доказывающие обратное. Так, например, есть истории использования облачных сервисов во благо экологии, описанные в ещё одной моей статье для RB. Например, один из кейсов о том, что рост популярности здорового питания приводит к повышению угрозы для целостности экосистемы по всему миру, за счёт увеличения количества обрабатываемых земель. Для того, чтобы фермеры могли более эффективно использовать уже существующие поля и продавать максимальное количество урожая, была разработана облачная платформа для оптимизации процесса и обмена опытом среди фермеров по всему миру.

Про идею

По совместительству я администратор официальных сообществ Microsoft Developer в социальных сетях (если вдруг не встречали: VK, Fb, Twitter, YouTube, Telegram + Telegram Chat). Как я уже писала в начале, многие интересные идеи и проекты остаются без внимания, поэтому предлагаю провести эксперимент. Вы можете делиться в соц. сетях (VK, Twitter) идеями своих проектов с использованием любых технологий MS с тегом #msdevproject, или написать о них в комментариях к этой записи. В зависимости от количества участников, раз в период (например, неделю) мы будем рассказывать в своих сообществах о самом интересном проекте. А по результатам квартала проведём голосование и напишем в блог на Хабр про проект-победитель.

Буду рада услышать ваше мнение по поводу этой идеи и ответить на любые вопросы. :)

|

Метки: author Schvepsss блог компании microsoft microsoft |

Как начинать тушить огонь до пожара или наш список общих принципов IT безопасности |

Разбирая последствия работы вирусов WannaCry и Petya, а так же то, как они повлияли на наших клиентов, представляем здесь выводы и советы, которые мы можем дать уважаемому сообществу. В основном эти советы будут относится к системным администраторам Windows, а они, как известно, и пострадали от этих вирусов.

1. Сервера:

- Уровень леса Active Directory должен быть не менее 2012r2, а пользователи должны находится в группе защищенных пользователей, в этом случае перехват паролей mimikatz невозможен.

- Доступ к общим файлам должен быть реализован через систему с поддержкой версионности или снапшотов, например, Sharepoint + OneDrive Pro

- На гипервизорах должен быть включен secure boot, шифровальщик не сможет запуститься вместо родной ОС.

- Настройки почтовых серверов должны запрещать получение исполняемых файлов и неоткрываемых архивов, крайней мерой можно сделать изменение формата писем на plain text, что исключит ссылки в теле писем.

- Обновления должны ставится регулярно, не реже раза в две недели. Проведение регламентного обновления ОС серверов, драйверов, прошивок. Это один из самых важных пунктов ИБ, один он очень серьезно усилит вашу защиту. У вас должен быть четкий план выполнения обновлений с указанием даты последнего выполнения и ответственного.

- Вынесение системы резервного копирования вне границ текущей среды. Настройка репликации на резервную площадку.

2. Рабочие станции:

- Клиентские компьютеры должны работать на Windows 10 LTSB. LTSB имеет меньше потенциально опасных компонентов и, теоретически, не следит за пользователем, хотя запретить телеметрию все равно не помешает.

- Включить UEFI и secure boot. Как и на серверах шифровальщик не сможет запустится вместо родной ОС. Вирус Petya перегружает машину для начала шифрования. Эти две настройки не дадут ему запустится. Есть большой шанс, что будущие шифровальщики будут использовать эту стратегию.

- Обновления должны автоматически ставится не только на саму операционную систему, но и на все приложения, особенно на офис. С WSUS или напрямую с серверов Микрософт - не принципиально. Этот пункт не нуждается в комментариях: если на серверах обновления надо ставить вручную, контролируя процесс чтобы не остановить работу, то на рабочих станциях надо ставить автоматически.

- Системные администраторы не должны работать на рабочих станциях с правами доменного администратора.

3. Общее:

- Разделение рабочей среды и интернет серфинга, разделение разных направлений/отделов компании в изолированные среды, например, как указанно здесь

- Разделение инфраструктурных сред по VLAN, между которыми должна быть настроена фильтрация трафика. В этом случае перекрыв доступ по определённым портам можно остановить сетевое распространение зловреда, как в случае Petya блокируют 135, 139, 445 TCP-порты (служб SMB и WMI)

- Желательно не пользоваться серверными программами требующим сетевой доступ к общим папкам. Бизнес софт, такой как 1С должен быть на SQL Server.

- На пользовательский станциях и серверах должен быть настроен сетевой фильтр на запрещение исходящего доступа всем приложениям кроме необходимых. Подробная информация как и зачем в статье

- На серверах и рабочих станциях должен быть выключена SMBv1, а по возможности и SMBv2

- Специализированные и редкие программы, типа M.E.doc интернет банкинг(особенно на Java), должны запускаться на отдельной виртуальной машине с жестко настроенным фаерволом.

- Не полагайтесь на антивирусы, они создают ложное ощущения безопасности, пример последних вирусов и реакции на них ведущих производителей. Например даже стандартный Windows Defender обновился одними из первых.

- Способствуйте получению технических сертификатов вашего IT штата. Аутсорсера выбирайте с действующими профессиональными сертификатами по требуемым вами направлениям.

- Проводите семинары и другие мероприятия для повышения уровня IT осведомленности и IT культуры всех сотрудников, с обязательным приведением реальных примеров и последствий.

Замечания, дополнения рады обсудить в комментариях.

|

Метки: author MazayZaycev сетевые технологии серверное администрирование антивирусная защита it- инфраструктура ваня петя информационная защита превентивные меры |

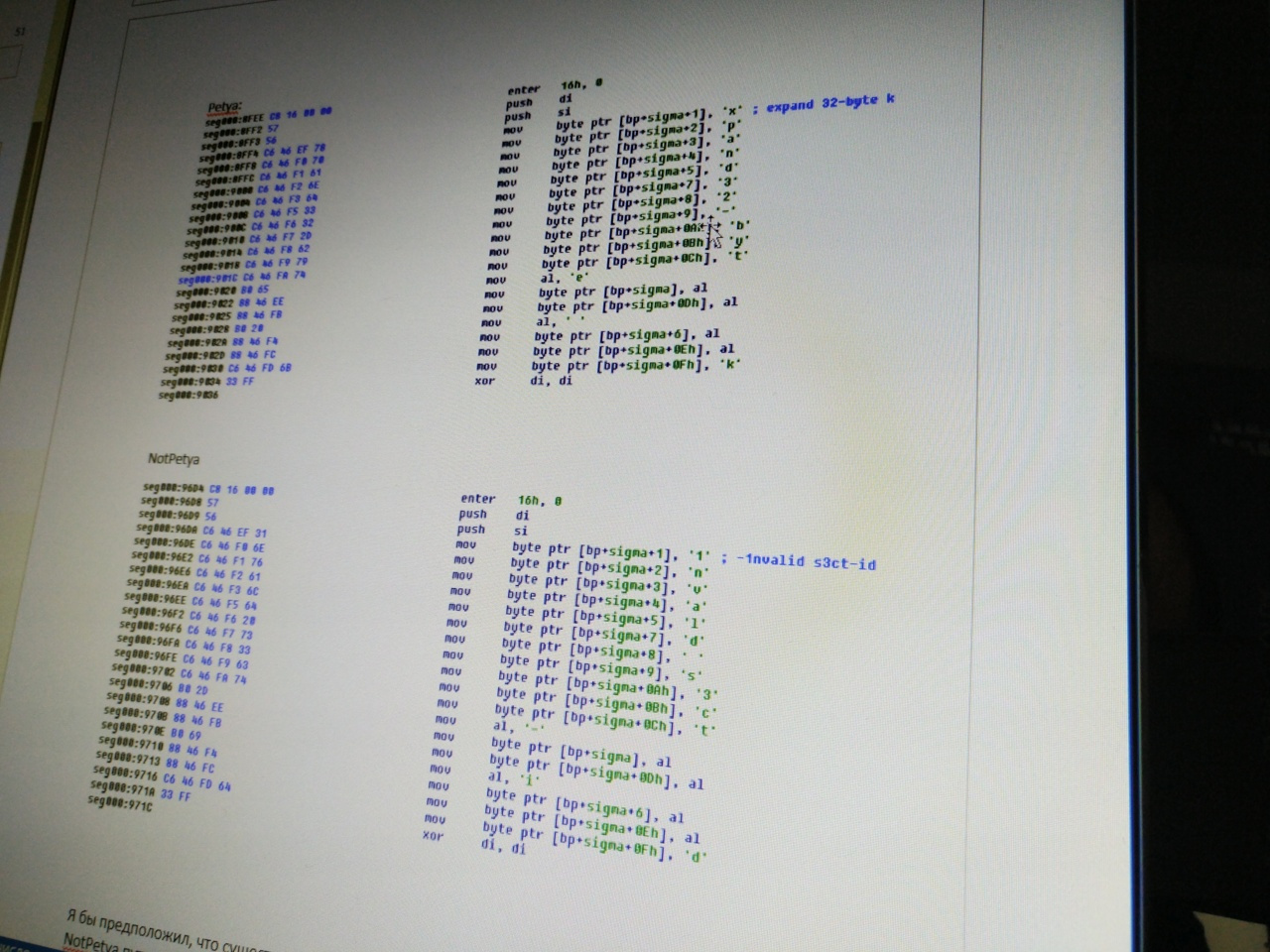

Сравниваем #NotPetya и #Petya — реально ли расшифровать свои файлы? |

Эксперт Positive Technologies Дмитрий Скляров представил сравнительный анализ нашумевшего вируса-вымогателя NotPetya, атаковавшего компании в этот вторник, с образцом Petya от 2016 года, и поделился своими наблюдениями по поводу возможности восстановления зашифрованных ими данных.

Мы исследовали части двух вирусов, отвечающие за шифрование MFT. Данное шифрование выполняется при наличии у вымогателя прав администратора.

Что делает NotPetya

В момент заражения (еще под Windows) вирус пишет в начало диска код, который будет запущен после перезагрузки, а в определенные сектора — свою конфигурацию, данные для проверки и оригинальный MBR.

В первую очередь, посмотрим на сектор 0x20 диска, который является чем-то вроде «конфига» для конкретной машины. При заражении в сектор 0x20 записываются следующие значения:

— Признак того, что MFT не была зашифрована (значение 0)

— EncryptionKey (случайная последовательность длиной 32 байта)

— Nonce (случайная последовательность длиной 8 байт)

— Personal installation key (случайная последовательность длиной 60 символов из алфавита «123456789ABCDEFGHJKLMNPQRSTUVWXYZabcdefghijkmnopqrstuvwxyz»)

Случайные данные получаются через функцию CryptGenRandom, которая считается криптографически стойкой.

В сектор 0x21 записывается 512 байт со значением 0x07.

В сектор 0x22 записывается оригинальный MBR, в котором каждый байт поXORен со значением 0x07.

После первой перезагрузки происходит зашифрование MFT. Перед этим:

— читается сектор 0x20,

— устанавливается признак зашифрования MFT (значение 1),

— EncryptionKey копируется во временный буфер,

— поле с EncryptionKey затирается нулевыми байтами

— сектор 0x20 записывается на диск,

— читается сектор 0x21 (все 0x07),

— его содержимое зашифровывается на EncryptionKey + Nonce,

— сектор 0x21 записывается на диск.

Затем сектора MFT зашифровываются на том же EncryptionKey + Nonce. Код алгоритма шифрования очень похож на алгоритм Salsa20, но есть отличия. Вместо константы «expand 32-byte k» используется константа «-1nvalid s3ct-id». И пока мне не удалось повторить результаты зашифрования на известном ключе. Возможно, у них где-то ошибка, что, похоже, подтверждается этим постом: twitter.com/kryptoslogic/status/880058211516260352

Алгоритм Salsa20 считается стойким.

Когда все зашифровано, машина снова перезагружается, показывается текст с требованием выкупа и предлагается ввести ключ расшифрования.

Ключ должен быть строкой символов из набора «0123456789abcdef» длиной 32. Эта строка прогоняется через некую функцию, принимающую на вход произвольное кол-во байт, и выдающую 32 бата. Предположительно это хеш-функция SPONGENT (надо проверять). Затем выход циклически прогоняется через ту же функцию 128 раз, и этот результат принимается как EncryptionKey. Для проверки правильности ключа делается попытка расшифровать содержимое сектора 0x21, и если там оказывается ожидаемый открытый текст (все 0x07) – запускается процесс расшифрования MFT и восстановления MBR.

Могут ли злоумышленники расшифровать файлы пользователей

На мой взгляд, возможность восстановления после оплаты не была предусмотрена авторами. И вот почему:

- Personal installation key, который надо сообщить авторам вируса после выплаты выкупа, никак не связан с EncryptionKey. И то, и другое — случайные данные. Из одного невозможно получить другое, если только злоумышленники не знают что-то про CryptGenRandom. Еще вариант — они должны отправлять пару EncryptionKey + Personal installation key на свой сервер, но о такой активности вроде никто не сообщал (и я ее в коде не видел, хотя это не исключено на 100%).

- Если я угадал с хеш-функцией SPONGENT, ключ расшифрования должен быть выходом хеша, и чтобы вычислить то, что должен ввести пользователь, надо этот хеш обратить (129 раз), что вряд ли реализуемо на современной технике.

- Энтропия EncryptionKey составляет 32*8 == 256 бит. Энтропия hex-ключа, вводимого пользователем, составляет 32*4 == 128 бит. Любая операция может только уменьшить энтропию. Из 32 шестнадцатеричных символов невозможно получить 32 байта с определенными значениями.

Отличия от Petya образца 9 января 2016

Petya не захотел инфицировать мою тестовую машину. Может ему нужна сеть или что-то еще. Пришлось дампить из памяти.

Я не успел посмотреть код, который формирует сектора, используемые из устанавливаемого вредоносом MBR, но посмотрел скриншоты и код, который выполнится после перезагрузки.

Отличия:

- Используются сектора 0x36-0x39 (против 0x20-0x23 у NotPetya).

- Большинство сервисных функций (вывод текста, чтение/запись секторов) идентичны Petya.

- Присутствует функция и строки для вывода баннера с черепом. В NotPetya очень похожая функция тоже есть, но, вероятно, она никогда не вызывается, а строки обнулены.

- Длина Personal installation key составляет 90 символов (15 групп по 6 символов) против 60 у NotPetya. Используя алфавит из 58 символов можно закодировать максимум 527 бит информации (против 351 у NotPetya).

- В дампе Petya видны строки secp256k1 и secp192k1, что подталкивает к мысли о том, что Personal installation key является производным от EncryptionKey, вычисленной при помощи криптографии на эллиптических кривых.

- Ключ, вводимый пользователем для запуска расшифрования, должен быть строкой из алфавита «123456789abcdefghijkmnopqrstuvwxABCDEFGHJKLMNPQRSTUVWX» длиной 16 символов.

- Нет ничего похожего на SPONGENT (или какой-то другой хеш).

- В Salsa20 используется оригинальная константа «expand 32-byte k». При этом, код функций почти идентичен, и если код Petya наверняка был сгенерирован компилятором (сработала оптимизация на повторяющихся символах), то в NotPetya, похоже, просто заменили константы.

Petya:

NotPetya

Я бы предположил, что существовал другой образец Petya, на базе которого и был создан NotPetya путем замены констант и строк.

Еще раз повторюсь, что в NotPetya скорее всего не была предусмотрена возможность расшифровки файлов своих жертв, а в Petya с этим все было нормально. Что касается самостоятельного восстановления диска — это может оказаться реальным. Оба вируса имеют очень похожие ошибки реализации алгоритмов шифрования, что приводит к возможности быстрого подбора ключа шифрования и восстановления всех зашифрованных данных. В 2016 году исследователи описали метод восстановления данных, зашифрованных Petya, без уплаты выкупа.

|

Метки: author ptsecurity информационная безопасность блог компании positive technologies notpetya petya вирус-вымогатель |

Использование GAP-анализа для выявления и согласования задач по проекту |

Существует множество методов оценки эффективности работы компании в целом или на уровне определенных бизнес-процессов, которые включают в себя выявление «узких мест», описание непосредственно проблематики, выявление разницы между желаемым уровнем эффективности и реальной ситуацией. Я уже рассказывал о том, как на практике можно использовать использовать различные методы для выявления проблемных «узких мест», для планирования работы, для взаимодействия с заказчиком и демонстрации предложенных решений. Все это и многое другое вы можете прочитать в статьях Краткое описание BPMN с примером и Знакомство с нотацией IDEF0 и пример использования.

Существует множество методов оценки эффективности работы компании в целом или на уровне определенных бизнес-процессов, которые включают в себя выявление «узких мест», описание непосредственно проблематики, выявление разницы между желаемым уровнем эффективности и реальной ситуацией. Я уже рассказывал о том, как на практике можно использовать использовать различные методы для выявления проблемных «узких мест», для планирования работы, для взаимодействия с заказчиком и демонстрации предложенных решений. Все это и многое другое вы можете прочитать в статьях Краткое описание BPMN с примером и Знакомство с нотацией IDEF0 и пример использования.Сейчас я хочу рассказать еще об одной из распространенных сегодня методик – использовании GAP-анализа. В переводе с английского «gap» означает «разрыв», т.е. этот вид анализа можно назвать полностью по-русски анализом разрывов. Здесь в наглядной графической форме показаны графики желаемого развития событий и реального, видны проблемные «узкие места» в бизнес-процессах, что дает возможность руководителю сконцентрироваться на том участке, который действительно требует переосмысления и внедрения изменений, и, как следствие, принятию грамотных управленческих решений.

Для специалистов в сфере бизнес-консалтинга этот инструмент может стать эффективным помощником в следующих вопросах:

- Определение участка приложения усилий;

- Постановка задач и планирование действий;

- Оценка стоимости проведения работ;

- Согласование необходимых работ и решений с заказчиком.

Но давайте обо всем по порядку. И для начала, нужно разобраться, как вообще строится сотрудничество консалтинговых специалистов и заказчиков. Причем, речь здесь идет о любых видах консалтинга в сфере бизнеса: IT-консалтинг, бизнес-консультирование, оптимизация бизнес-процессов, внедрение различных аппаратных и программных решений и т.д.

Основные этапы работы по проекту

Сотрудничество компании с приглашенными на условиях консалтинга специалистами чаще всего реализуется в одном из двух вариантов – постоянное сервисное обслуживание и некий проект, ограниченный выполнением определенной задачи в определенных сроки. И если при обслуживании просто оговариваются обязанности, которые на постоянной основе и по мере необходимости должны выполнять приглашенные специалисты, то этапы проекта стоит рассмотреть подробнее.

Основные этапы сотрудничества по проекту (Источник “Управленческое консультирование. Введение в профессию” под редакцией Милана Кубра):

- Знакомство;

- Диагностика;

- Планирование действий;

- Внедрение;

- Завершение сотрудничества.

Если этап знакомства обычно вопросов не вызывает, как и внедрение или завершение сотрудничества, то о диагностике стоит поговорить подробнее. Я считаю диагностику – важнейшим этапом работы, который условно можно также разделить на некую последовательность действий:

- Анализ цели;

- Анализ проблемы;

- Сбор информации;

- Обратная связь с клиентом.

Именно грамотный анализ и понимание, что именно нужно сделать и какие результаты должны получить, являются залогом качества на выходе. Далее идет планирование – на основе понимания реальной ситуации и поставленных задач создается последовательность необходимых действий. Утвержденный план реализуют на этапе внедрения. После чего заказчик принимает выполненную работу, и проект завершается.

Почему так важна диагностика?

Для начала, давайте разберемся, что ожидает от диагностики заказчик, и какой результат этого этапа важен для исполнителя-специалиста.

Основная цель диагностики – это получение готового перечня задач, согласованных с клиентом, на основе которых можно будет реализовывать последующие этапы работы.

Для заказчика помимо этого также важна стоимость выполнения работ, которую ни один настоящий специалист не сможет назвать до того, как перечень задач будет точно сформирован. Как известно, услуга без цены – это не услуга, а просто перечень идей. А потому согласованный перечень задач и сумма – одинаково важные составляющие результатов диагностики.

В различных случаях этап диагностики может занимать и менее 1 дня, и 2 недели и даже более. Все зависит от сложности поставленных задач и необходимых работ, относящихся к этому этапу. В отдельных случаях (при выполнении предпроектного обследования и т.д.) этап диагностики может быть очень трудоемким, а результат этого этапа будет отдельной оплачиваемой услугой.

Но в любом случае результаты должны быть следующие:

- Список задач (на основе обсуждения с заказчиком или по итогам проведенного обследования ситуации в компании);

- Предлагаемые решения и их обоснование;

- Цена каждой задачи и срок ее выполнения.

Именно такой перечень необходим заказчику для принятия решения, а исполнителю для реализации следующих этапов работ после согласования всех нюансов.

Виды диагностики

В зависимости от сложности необходимых работ, а также от того, что желает получить заказчик, диагностика может быть как очень простой и даже «символической», так и полноценным и сложным этапом.

Самые распространенные варианты я разделяю следующим образом:

- Экспресс-диагностика;

- Разработка технического задания (ТЗ);

- Предпроектное обследование;

- GAP-анализ.

Давайте разберем каждый из этих видов подробнее.

Экспресс-диагностика

В этом случае заказчик высылает или озвучивает перечень задач, которые с точки зрения исполнителя являются типовыми. Т.е. исполнитель понимает, каким образом будут реализованы поставленные задачи, может быстро оценить сроки и озвучить цену выполнения работ. Максимум, что может потребоваться в процессе экспресс-диагностики, это проведение интервью с заказчиком или руководителем подразделения, с которым будет проводиться работа, для уточнения тех или иных особенностей работы компании.

Например, может понадобиться уточнить, с какой учетной системой работает компания, на какой CMS реализован сайт, кто является телефонным провайдером или уточнить еще какие-то моменты, способные повлиять на методы реализации и, как следствие, на общую стоимость работ. Этот вид диагностики можно применять в случаях, когда заказчику требуются какие-то виды типовых услуг, которые будут проводиться по шаблону. Длительность этого вида диагностики – до 1 рабочего дня (чаще 1-2 часа). Результат – калькуляция для клиента или выставленный счет к оплате.

Разработка технического задания (ТЗ)

В некоторых случаях клиент высылает готовое ТЗ, тогда диагностика и даже планирование сводятся к минимуму. Но часто специалистам приходится составлять техзадание самостоятельно, на основе интервью с заказчиком и анализа проблем. В этом документе описываются все требования, желаемый результат, полный перечень задач по проекту, необходимых технических решений и т.д. Техническое задание также является основанием для оценки сроков и подсчета стоимости выполнения работ.

ТЗ от заказчика: плюсы и минусы:

- Плюс получения готового техзадания очевиден – экономия времени специалистов. Готовый документ с перечнем всех задач, которые максимум, могут потребовать небольших корректировок со стороны специалиста, причем, далеко не всегда.

- Основной минус заключается в том, что заказчики редко являются достаточно компетентными, чтобы составить качественное ТЗ. Если бы у них были необходимые знания, скорей всего, они бы не стали обращаться к сторонним специалистам, за исключением отдельных технических исполнителей с узкой специализацией (специалист 1С, веб-разработчик и т.д.).

Желание заказчика добросовестно описать все свои пожелания иногда выливается даже в анекдотичные случаи. Так, когда-то я получил техническое задание, состоящее из 300 страниц! К нему прилагалось письмо от заказчика, который сетовал, что он никак не может выбрать исполнителя, так как все, к кому он обращался, либо отказываются от работы, либо выставляют счета, явно очень завышенные. Очевидно, что такие ТЗ просто никто не читает, именно потому и возникли перечисленные в письме проблемы.

В результате очень часто заказчик чаще всего в свободной форме перечисляет все свои пожелания, исполнитель составляет техническое задание самостоятельно, после чего этот документ согласоваться с заказчиком (возможно с привлечением экспертов).

Предпроектное обследование

Такое обследование является само по себе отдельным видом работы, сравнительно сложным и трудоемким. В процессе обследования специалист:

- Изучает работу компании на основе документальной информации;

- Проводит интервью с руководителем компании, начальниками и сотрудниками различных подразделений;

- Часто лично бывает на производстве или наблюдает работу склада, отдела продаж, магазина и пр.

В результате обследования сторонний специалист (бизнес-консультант) самостоятельно анализирует существующие бизнес-процессы, их различные этапы, оценивает эффективность работы, выявляет «узкие места». Оценивает возможности тем или иным методом решить задачи, поставленные заказчиком в процессе предварительных переговоров (на этапе знакомства), может выявить какие-то сопутствующие проблемы и продолжить варианты их решения.

В отличие от техзадания, результатом предпроектного обследования становится отчет, в котором отражаются описание окружения, проблематики, существующей ситуации. Также в отчете описывается, что нужно сделать для решения поставленных задач, какие могут быть стратегические предложения и т.д.

Это уже не просто задание, а некий всеобъемлющий документ, который описывает что имеется в реальности, что нужно сделать, что будет на выходе, и сколько это все будет стоить. Такой документ может занимать от 2-3 страниц до 15 и более. Причем, часто предпроектный отчет при всей своей информационной насыщенности оказывается менее объемным, чем техническое задание.

Причина такого явления – отсутствие в отчете предпроектного обследования необходимых в ТЗ технических данных, часто собранных в таблицы: соответствие и описание определенных параметров, например, соответствие полей в CRM и 1С при постановке задачи интеграции, другие таблицы с техническими параметрами. Одно такое описание вместе с комментариями к нему может занимать 3-5 страниц.

В отчете таких подробных описаний технических деталей нет. Они и не нужны клиенту для принятия решения. Зато здесь присутствует все, что необходимо заказчику: выявленная проблематика, подробное описание решения, информация для оценки возможных рисков. Такой документ содержит много полезной информации и решений, но он сам по себе обычно стоит сравнительно дорого.

GAP-анализ

При проведении GAP-анализа составляется некая нотация бизнес-процессов, где отражается одновременно существующая ситуация в реальности и результатом, который хотел бы получить заказчик. Чаще всего результаты GAP-анализа отображаются в графическом виде. Текстовое описание разрывов также возможно, но в этом случае результаты анализа теряют свою наглядность.

Нотации GAP-анализа позволяют в сжатые сроки оценить наиболее проблемные места, так называемые «разрывы», сконцентрировать на них максимум внимания при выборе решения и подробной разработкой этапов его реализации. В некоторых случаях к GAP-анализу для заказчиков также прилагается вариант решения.

Здесь очень важно понимать грань. Часто специалисты, которые сами выявляют «тонкие места» в бизнесе, предлагают решения для реализации бизнес-процессов так, как они видят, что и как должно быть. При работе с GAP-анализом я всегда показываю разрыв между ситуацией реальной и тем, как должно быть с точки зрения заказчика, в его формулировках, в его видении. Т.е. концентрируюсь на решении поставленных задач. И здесь графические нотации нужны именно для понимания заказчиком всех нюансов.

Свое видение того, как должно быть, я могу предлагать заказчикам в рамках предпроектного обследования, так как в таком случае часто заказывают услуги бизнес-консультанта именно для выявления проблем и поиска решений с точки зрения специалиста. Но если поставлена четкая задача, то и работать надо в рамках того, как именно заказчик видит желаемый результат.

Также я обычно предлагаю определенные решения, которые помогут исправить «разрывы», т.е. перейти от того, что есть сейчас, к тем результатам, которые являются желаемыми для заказчика.

Чаще всего подобный вариант анализа проводится в случае работы с определенным сегментом бизнеса, например, описывается отдельно бизнес-процесс отгрузки товара, обработки заявки с сайта и т.д.

Графические решения оформляются в удобном формате, я лично предпочитаю формат BPMN. В любом случае в результате заказчики видят наглядно существующие проблемные места в бизнес-процессе, а также идеи и решения. Заказчик видит в простой и наглядной форме, что вы точно поняли поставленную задачу и предлагаете ее решение.

Преимущества GAP-анализа

О том, что графические нотации – это один из очень удобных и эффективных вариантов работы с заказчиками при обсуждении любых изменений в бизнесе (внедрение IT-программ, оборудования для автоматизации, внедрение изменений в управленческий процесс и т.д.). Графические нотации позволяют избавиться от тысячи слов, а взаимопонимание с заказчиком будет намного выше, чем при отправке многостраничного текстового отчета. При этом экономится время – и ваше, и вашего клиента.

При этом GAP-анализ или, иначе говоря, анализ разрывов – это возможность показать на одной графической диаграмме одновременно и реальную ситуацию, и желаемую, а также увидеть наглядно, на каких именно этапах происходит снижение качества работы. Применение такого вида нотаций удобно и в процессе анализа и поиска эффективных решений поставленной задачи, и на этапе обоснования ваших решений заказчику.

При этом как инструмент в работе GAP-анализ достаточно прост, чтобы им сумел пользоваться не только профессиональный маркетолог, но также и разработчик ПО, занимающийся консалтингом, или любой другой специалист, который предлагает для бизнеса те или иные решения.

|

Метки: author JustRamil управление проектами управление продажами бизнес-модели gap- анализ gap графические нотации постановка задач консалтинговый проект |

Безопасная флешка. Миф или реальность |

Привет, Хабр!

Сегодня мы расскажем вам об одном из простых способов сделать наш мир немного безопаснее.

Флешка — привычный и надежный носитель информации. И несмотря на то, что в последнее время облачные хранилища все больше и больше их вытесняют, флешек все равно продается и покупается очень много. Все-таки не везде есть широкий и стабильный интернет-канал, а в каких-то местах и учреждениях интернет вообще может быть запрещен. Кроме того, нельзя забывать, что значительное количество людей по разным причинам с недоверием относятся к разного рода «облакам».

К флешкам мы все давно уже привыкли и многие из нас помнят, как сначала робко появилась поддержка usb mass storage в Windows 2000, а потом, немного погодя и в Windows Me. Многие понимают, насколько удобно сейчас пользоваться флешками и помнят, как раньше мы все мучались с ненадежными дискетами и непрактичными оптическими дисками.

Автор этих строк примерно в 2004-м году был счастливейшим обладателем симпатичного 128-мегабайтного носителя в моднейшем корпусе с металлической вставкой. Он был моим верным спутником и хранителем ценной для меня информации долгие годы, пока я наконец не потерял его вместе со связкой ключей, к которой он был прицеплен.

И, казалось бы, потеря ключей — это довольно рядовое событие, которое наверняка происходило с каждым, но меня оно заставило срочным образом поменять все замки в доме.

Все дело в том, что в дебрях файловой системы моей флешки лежали сканы моего паспорта, сделанные на всякий случай (кто же знает, когда могут пригодиться сканы паспорта?). А в сочетании с настоящими ключами от реальной квартиры, данные о прописке превращаются в заманчивую возможность даже для тех людей, которые раньше может быть и не помышляли о квартирных кражах.

Чему этот инцидент меня научил?

В первую очередь — бережнее относиться к своим вещам, а во вторую — тому, что любую информацию, которую хоть каким-либо даже косвенным образом можно использовать во вред тебе, необходимо защищать.

Что могут предложить флешки в плане защиты?

Первый, самый очевидный вариант, флешки с аппаратной защитой и без внешнего программного управления, у них обычно клавиатура на корпусе — все в них вроде бы неплохо, но стоят они в большинстве своем совершенно диких денег, может быть за счет своей малосерийности, а может быть и жадности продавцов. Очевидно, ввиду высокой стоимости, особого распространения не нашли.

Второй вариант — навесная программная защита для обычной флешки.

Вариантов много (их можно легко нагуглить), но все они имеют явный плюс в виде почти нулевой стоимости и неизбежные ограничения, связанные с необходимостью установки специального программного обеспечения на компьютер. Но главный минус навесной защиты — это ее слабость.

В чем же слабость — спросите вы.

А дело в том, что любая шифрующая диски программа использует в качестве ключа шифрования последовательность полученную по особому алгоритму, например PBKDF, из пароля, который вы будете использовать для разблокировки. И что-то мне подсказывает, что вряд ли пароль, который придется часто набирать, будет длинным и сложным.

А если пароль короткий и простой, то подобрать его по словарю будет не таким уж и сложным делом.

Злоумышленник, завладев вашей зашифрованной флешкой даже на короткое время, может скопировать с нее криптоконтейнер. Вы так и будете думать, что данные по-прежнему в безопасности. А на самом деле все это время кто-то усиленно подбирает ключ к вашему контейнеру и с каждой минутой подходит все ближе к своей цели.

Поэтому, если вы не враг самому себе, то пароль должен быть «стойким». Но поскольку вам же потом этот же «стойкий» пароль придется многократно набирать — это начинает противоречить утверждению на предыдущей строке.

Что же делать — спросите вы.

Можно ли поставить между защищаемой флеш-памятью и компьютером аппаратную защиту так, чтобы это было удобно, надежно и более-менее доступно? Чтобы хотя бы можно было обойтись без монструозного корпуса с аппаратными кнопками.

Оказывается, да, можно, если вы российский производитель устройств электронной подписи (токенов и смарт-карт).

Безопасная флешка все-таки существует

В устройствах Рутокен ЭЦП 2.0 Flash флеш-память подключена через специальный защищенный контроллер, прошивка которого, карточная операционная система Рутокен, целиком и полностью разработана специалистами компании «Актив» (карточная ОС Рутокен находится в реестре отечественного ПО Минкомсвязи).

В эту прошивку встроен специальный управляющий модуль, который контролирует потоки данных, входящие на флешку и выходящие из нее.

А так как в карточной операционной системе Рутокен испокон веков есть функциональность, обеспечивающая доступ к криптографическим ключам электронной подписи по PIN-кодам, мы реализовали в ней своего рода «вентиль», который может быть открыт, закрыт или открыт в одностороннем режиме (например, только для чтения). Вентиль этот как раз и управляется PIN-кодом. Не зная его, этот вентиль невозможно повернуть.

Теперь представьте, что такой вентиль по умолчанию находится в положении «закрыт». А чтобы открыть его, нужно предъявить PIN-код, который знаете только вы. Причем, вентиль автоматически закрывается при извлечении устройства из компьютера. И количество попыток ввода неправильного PIN-кода жестко ограничено. Причем, устройство защищено от физического взлома и извлечения флеш-карты.

Получается вполне безопасная, надежная и удобная система. Мы реализовали ее в виде небольшой управляющей программы, которая называется — «Рутокен Диск».

Флеш-память устройства Рутокен ЭЦП 2.0, на котором работает «Рутокен Диск», разбита на 2 области: одна служебная, для эмулирующего CD-ROM раздела с управляющей программой; вторая — для пользовательских данных.

При подключении такого устройства к компьютеру вы увидите два физических диска. CD-ROM раздел сразу доступен для чтения и автоматически монтируется, а в операционных системах Windows еще и всплывает симпатичное окошко.

Защищенный раздел выглядит как ридер карт памяти, но без вставленной в него карты, доступа к данным нет.

Однако, запустив приложение и введя простой PIN-код, вы моментально получаете доступ к своим файлам.

Сам токен уже много лет продается и возможность реализации защищенной флешки в нем была изначально. Но сейчас мы написали удобное приложение и если у кого-то из читателей уже есть такое устройство – программное обеспечение «Рутокен Диск» можно загрузить с нашего сайта и инсталлировать на устройство по инструкции.

Вместо резюме:

Если вы доверяете свою информацию обычной флешке — храните ее, как зеницу ока. В случае же с Рутокеном ЭЦП 2.0 Flash и Рутокен.Диском — можно быть гораздо спокойнее за конфиденциальность своих данных. Хотя и полностью расслабляться никогда не стоит.

Заранее отвечу на некоторые вопросы, которые обязательно у кого-нибудь появятся:

- GUI под macOS и linux — будет.

- Возможность открывать защищенный раздел в режиме read-only, чтобы без опаски засовывать флешку в самые непредсказуемые места — будет.

- Кнопочка для безопасного извлечения раздела, чтобы не тыкать мышкой в трей — будет.

Остальные вопросы, пожелания и замечания оставляйте в комментариях — постараемся ответить на все вопросы.

|

Метки: author aktiv_company криптография информационная безопасность блог компании «актив» флешка с паролем |

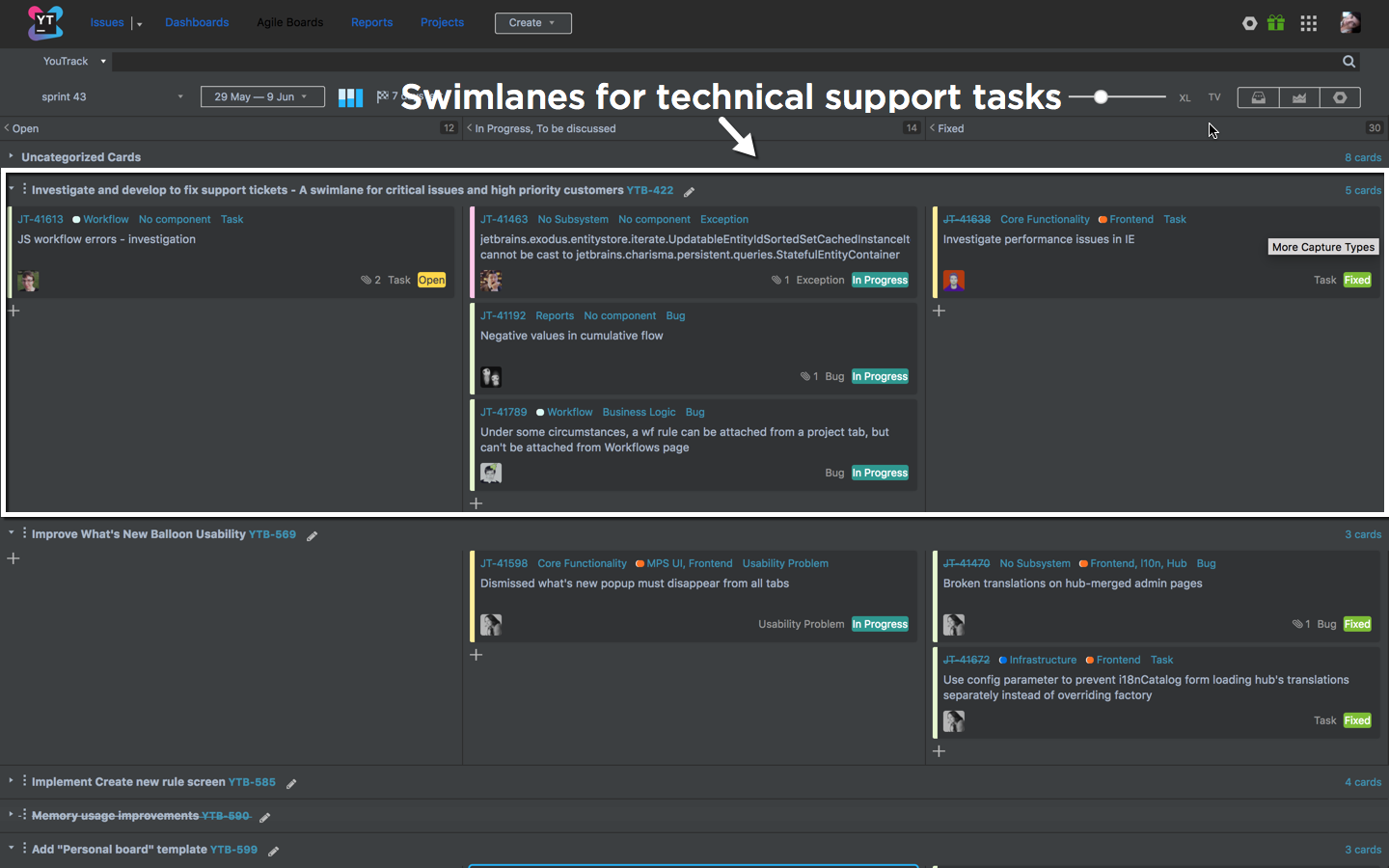

Baking Boards или секретный ингредиент идеальной Agile кухни |

Сегодня мы расскажем о том, как разные команды в JetBrains “готовят” Agile и работают с Agile досками.

За продуктами JetBrains стоит множество команд: продуктовые, команды маркетинга, технической документации, дизайна и многие другие. Каждая команда придерживается собственного процесса, в зависимости от целей, ресурсов и особенности самой команды. На примере нашей компании мы расскажем о том, насколько гибкие бывают процессы, как найти подходящий для своей команды, и как настроить свою Agile доску, на примере YouTrack.

Как “готовит” Scrum Команда YouTrack

Начнем с описания целей, которые ставит перед собой команда, внедряя тот или иной процесс. В нашем случае, цели можно сформулировать так:

- Перейти на цикл постоянных релизов: мажорный релиз каждые 2-3 месяца.

- Ускорить процесс разработки.

- Улучшить качество кода (в рамках постоянных релизов).

- Вовлечь в процесс всех участников команды.

Наша команда практикует методологию Scrum c некоторыми дополнениями. Спринты длятся две недели. Начинаем работу над спринтом с планирования, а по истечении двух недель проводим демо и ретроспективу. Планирование состоит из двух частей: общей, где присутствует вся команда, включая маркетологов, технических писателей и инженеров тех. поддержки, и технической. В рамках общей части мы обсуждаем истории, которые собираемся взять на спринт, а в технической части программисты разбивают их на подзадачи. Каждый день мы проводим стендап, на котором каждый член команды в течение минуты рассказывает, над чем работает, и поднимает вопрос для обсуждения, после чего мы смотрим на состояние задач на доске и обсуждаем возникшие вопросы.

Колонки на доске разбиты по состоянию задач: open, in progress/to be discussed и fixed. Если задача находится в прогрессе более чем три дня, мы разбиваем ее на подзадачи. Мы ввели это правило, чтобы разработчик не “зависал” на задаче и двигался дальше. Ежедневно мы получаем запросы в тех. поддержку. Чтобы мониторить прогресс по тем, которые требуют внимания разработчиков, на доске есть отдельный swimlane для запросов от пользователей.

Планирование задач мы ведем в бэклоге. В YouTrack бэклог — это сохраненный поиск, который можно открыть прямо на доске и приоритизировать задачи вручную. Благодаря тому, что вся команда активно вовлечена в процесс и следит за состоянием задачам на доске, нам удается их правильно приоритезировать, оперативно решать проблемы пользователей, чинить важные баги и разрабатывать новую функциональность. Переход на цикл постоянных релизов позволил нам получать фидбэк от внутренних и внешних пользователей на самом раннем этапе (в рамках экспериментальной функциональности) и вносить нужные изменения на этапе разработки, а не после релиза.

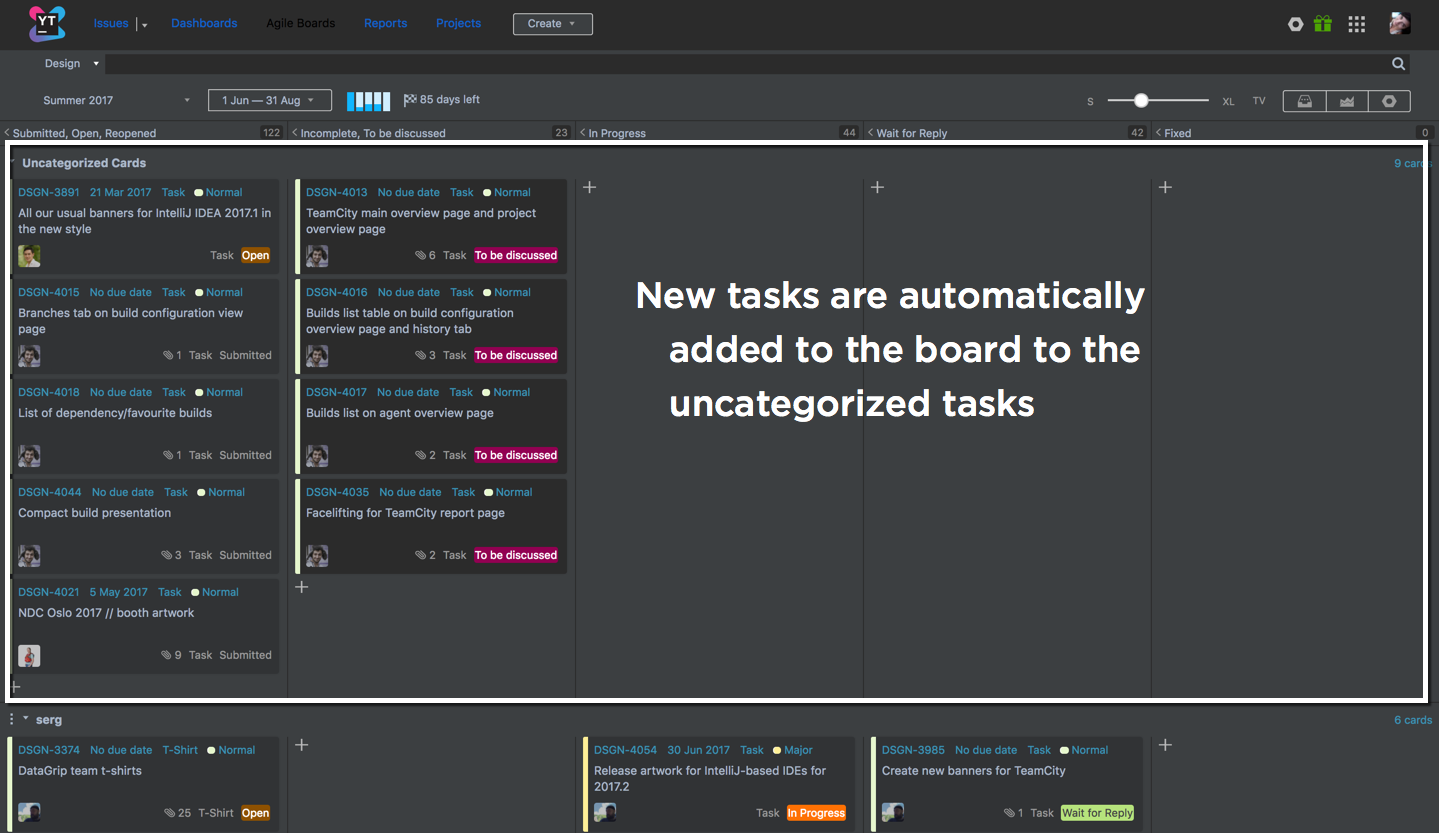

Как команда дизайна создает материалы для 23 продуктов

Речь идет о команде дизайна, которая обеспечивает визуальное представление всех наших продуктов на рынке, начиная с сайта, маркетинговых материалов, и заканчивая печатными материалами. UI/UX дизайнеры входят в продуктовые команды и являются частью их процессов.

В основном дизайнеры получают задания от коллег (PMM) из продуктовых команд, которым нужен дизайн чего-то, желательно вчера. При таком процессе важно отслеживать поступление новых задач и равномерно распределять их внутри команды.

Цели:

- Взаимодействовать со всеми продуктовыми командами.

- Равномерно распределять задачи.

- Следить за поступлением новых задач.

- Приоритезировать задачи в зависимости от срока исполнения.

Спринты на доске соответствуют сезонам: зима, весна, лето, осень. Все новые созданные задачи автоматически попадают на доску на текущий спринт. Задачи объединяются в свимлэйны по членам команды. Назначать исполнителя на задачу может только руководитель команды. Это правило реализуется при помощи custom workflow. Таким образом, новая задача сначала попадает в свимлейн uncategorized, а “переплывает” в свимлейн определенного дизайнера, как только его назначили исполнителем.

Каждый дизайнер работает в рамках своего свимлэйна, а руководитель, окинув взглядом доску, оценивает загруженность каждого сотрудника и равномерно распределяет задачи. Благодаря такому процессу задачи не задерживаются в состоянии open и завершаются в срок, а каждый заказчик может легко отследить место своей задачи в очереди дизайнера.

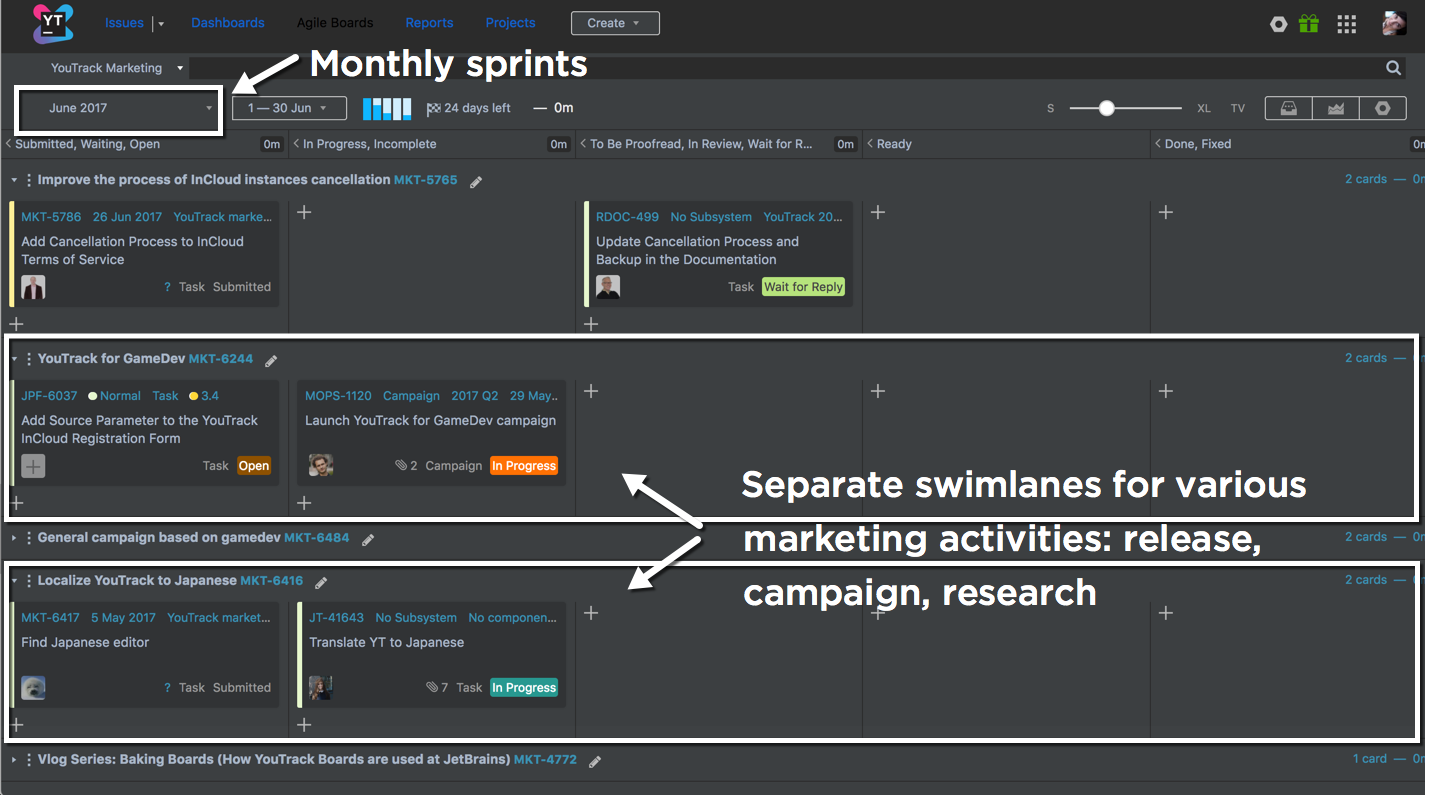

Как работают продуктовые менеджеры по маркетингу YouTrack и Hub

Маркетологи в JetBrains взаимодействуют с множеством коллег из разных команд. Чтобы следить за исполнением своих задач, необходимо держать около 20 проектов на доске: маркетинг, дизайн, локализация, веб, аналитика, интернет-маркетинг и так далее.

Цели:

- Следить за своими задачами в разных проектах.

- Вовремя давать обратную связь исполнителям.

- Приоритезировать задачи в зависимости от дедлайна.

Маркетинговая доска представляет собой набор задач из 20 проектов, объединенных в свимлейны по разным активностям. Например, релиз продукта, рекламная кампания, исследование, серия блог постов или видео, и т. д. В качестве колонок мы используем значения поля Состояние из разных проектов. Поскольку набор состояний может отличаться от проекта к проекту, добавить на доску нужно все значения, которые важно отслеживать, а затем объединить несколько состояний в одну колонку. Таким образом у нас на доске 5 колонок. Свимлейны мы определяем по типу задачи. Каждая задача типа Epic или Feature образует свимлейн. Задачи, которые не относятся к крупной активности, попадают в нижнюю часть доски (uncategorized cards).

Когда коллеги из других проектов начинают работать над нашей задачей, они меняют ее состояние, задача перемещается по доске и мы следим за ее прогрессом. Если необходима обратная связь или задача выполнена и ждет проверки с нашей стороны, ее переводят в состояние in review. Таким образом работа над задачами становится более продуктивной и мы лишний раз не “дергаем” коллег. Для нас же ключевым моментом является визуализация наших активностей: в каждый момент времени наглядно видно, что сделано, а что осталось для завершения каждой активности. Например, глядя на свимлейн с рекламной кампанией, я сразу могу сказать, что нам не хватает только баннеров для запуска.

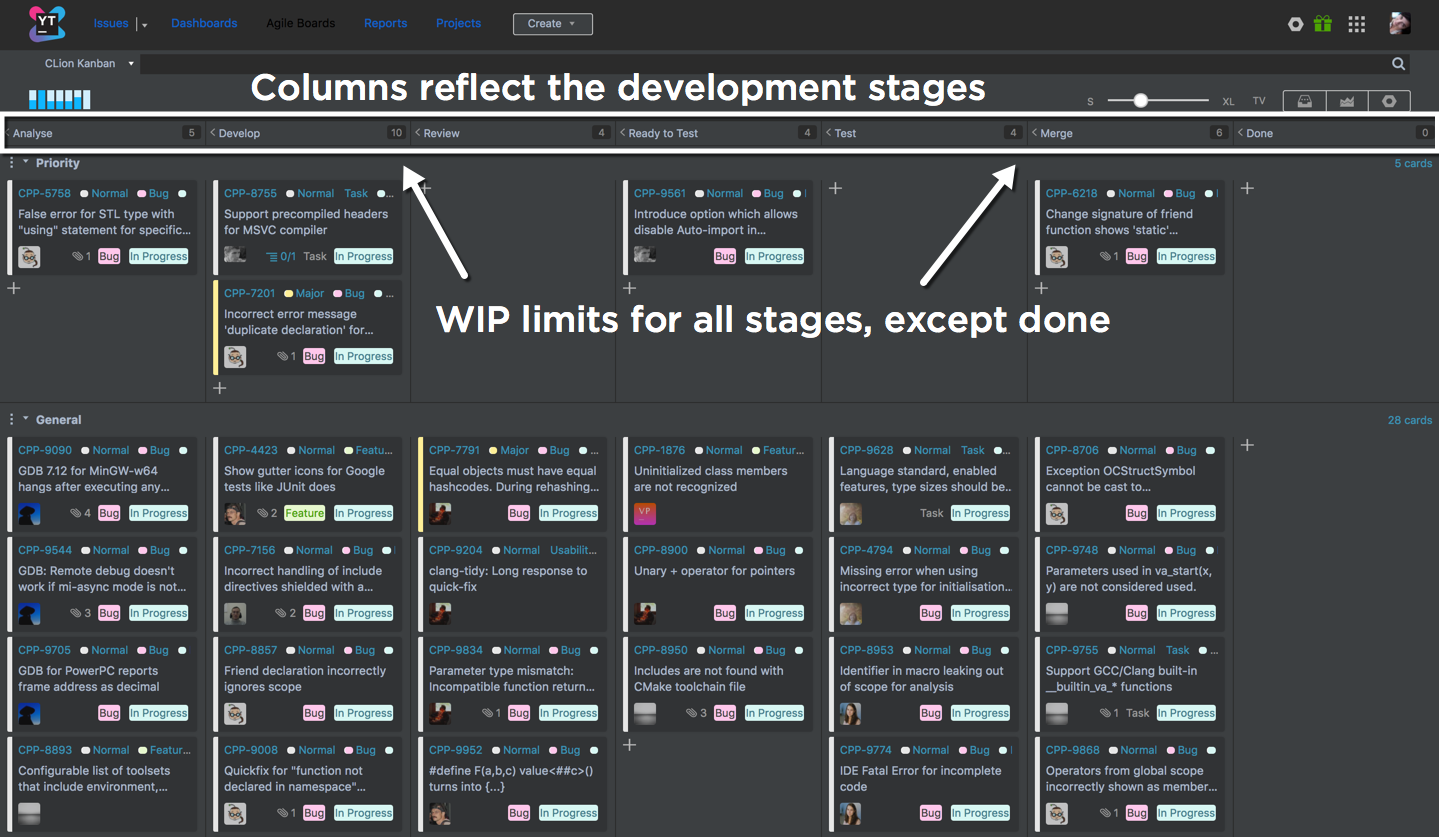

Как готовят Kanban Команды CLion и AppCode

Эти команды придерживаются методологии Kanban. Их процессы очень похожи между собой, потому что во многом их задачи пересекаются и работают над ними одни и те же сотрудники.

Цели:

- Планировать задачи в условия частых релизов (3 раза в год).

- Вовлечь в процесс всех членов команды.

- Управлять нагрузкой на команду на всех стадиях разработки.

- Визуально приоритезировать задачи.

Команды работают с Kanban доской без спринтов. Однако задачи объединены в свимлейны по приоритету задач (general и priority). Колонки отражают этапы разработки. Планирование задач ведется в бэклоге, а их приоритет обсуждается на ежедневных стендапах. В каждой колонке заданы ограничения на WIP (количество задач в колонке). Это помогает команде контролировать нагрузку на каждом этапе и визуализировать проблемы с нагрузкой на каждом шаге. Если количество задач превышает допустимое значение, команда не начинает работу над новыми задачами, пока не справится с текущей нагрузкой.

Чтобы автоматизировать процесс, команды используют набор custom workflow. Например, если разработчик перетащил задачу из бэклога на доску, он автоматически назначается исполнителем задачи. Если задача переходит в колонку QA, то она автоматически назначается на QA-инженера.

Персональная доска продуктового менеджера по маркетингу IntelliJ IDEA

Цели:

- Взаимодействовать с различными командами.

- Следить за своими маркетинговыми активностями.

- Управлять собственными задачами.

Андрею, как и остальным нашим PMM, необходимо следить за задачами во многих проектах, чтобы координировать различные активности для продвижения IntelliJ IDEA.

Задачи на доске объединены в свимлейны по проектам. Колонок на доске нет, точнее все состояния задачи объединены в одну колонку. Настроить доску таким образом можно, выбрав шаблон “Персональная доска”.

Андрей также использует расширение для Chrome “YouTrack Tweaks”, которое позволяет добавлять на карточку поля и раскрашивать их в разные цвета. Расширение также позволяет использовать доску в режиме Darcula. Карточки не перемещаются по доске, а просто присутствуют на ней до тех пор, пока задача не выполнена. Выполненные задачи просто пропадают с доски. Такой процесс позволяет сконцентрировать на открытых задачах и отслеживать прогресс по своим задачам в разных проектах.

Итак, каких же правил нужно придерживаться, чтобы наладить процесс в своей команде? Что общего между всеми этими примерами?

- Agile — это игра, а мы все любим играть. В этой игре важно установить правила и обязательно их соблюдать.

- Agile вовлекает каждого члена команды, дает возможность влиять на принятие решений и совершенствовать процесс. Участие в принятии решений накладывает ответственность за решение, в той или иной степени. Это заставляет серьезнее относиться к своей работе и работе команды в целом.

- Каждый участник Agile команды способен самоорганизовываться.

- Agile процесс очень динамичен, его нельзя зафиксировать, и необходимо постоянно улучшать.

И помните: продукт, который вы выбираете для управления задачами, должен быть гибким настолько, чтобы подстроиться под ваш процесс.

Если тема вас заинтересовала, то вы можете прочитать всю серию статей или посмотреть видео с подробной инструкцией по настройке досок в нашем блоге.

Ваша команда YouTrack JetBrains

The Drive to Develop

|

|

Дни открытых дверей перед запуском нового курса по Python |

Формат проведения — онлайн, подключайтесь из любой точки мира!

На Дне открытых дверей познакомимся с преподавателем курса Станиславом Ступниковым — программистом Mail.ru с более чем 6-ти летним стажем промышленной разработки, в том числе для крупных государственных заказчиков и более 4-х лет преподавания студентам МГТУ им. Баумана, который ответит на все вопросы касаемо программы курса, и не только.

Также расскажем почему OTUS больше, чем просто образовательный проект, какие перспективы готовы предложить выпускникам компании-партнеры, обсудим все подробности обучения, а также ответим на все интересующие вопросы.

В планах курса по Python 5 месяцев обучения с домашними заданиями, являющимися иллюстрацией навыков и знаний для новых работодателей, с выпускным проектом, который можно будет представить в качестве портфолио, масса новых знаний, приятное и полезное общение с преподавателем и одногруппниками.

А еще по доброй традиции среди успешно прошедших тест мы разыграем бесплатные места в новой группе!

Проходите тест и регистрируйтесь на День открытых дверей.

|

Метки: author Tully программирование python блог компании отус otus otus.ru обучение |

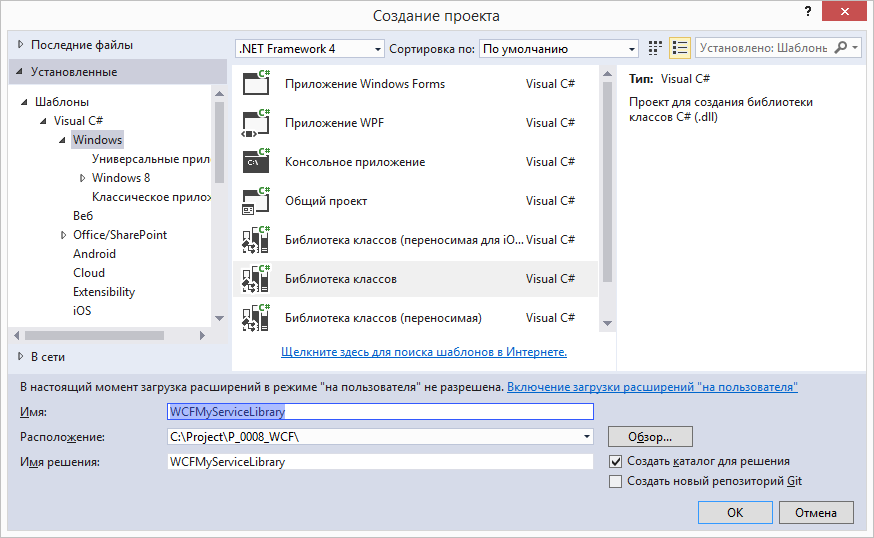

[Из песочницы] Пример создания WCF-сервиса, работающего внутри службы Windows |

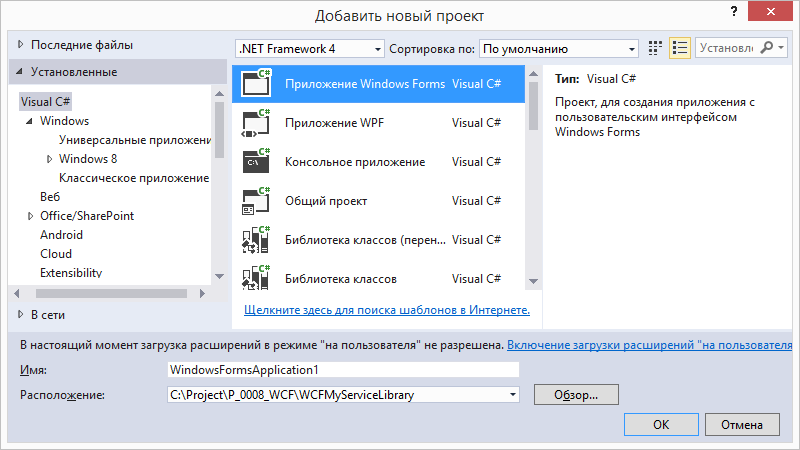

Открываем Visual Studio 2015 и создаём новый проект типа Class Library. Проект назовём WCFMyServiceLibrary.

Файл Class1.cs переименуем в MyService.cs и добавим ещё один класс, файл для которого назовём IMyService.cs.

Добавим ссылку на сборку System.ServiceModel.

using System.ServiceModel;

namespace WCFMyServiceLibrary

{

[ServiceContract]

public interface IMyService

{

[OperationContract]

string Method1(string x);

[OperationContract]

string Method2(string x);

}

}

namespace WCFMyServiceLibrary

{

public class MyService : IMyService

{

public string Method1(string x)

{

string s = $"1 You entered: {x} = = = 1";

return s;

}

public string Method2(string x)

{

string s = $"2 you entered: {x} = = = 2";

return s;

}

}

}На этом разработка сервиса завершена. Переходим к созданию службы Windows, которая будет контейнером для данного сервиса.

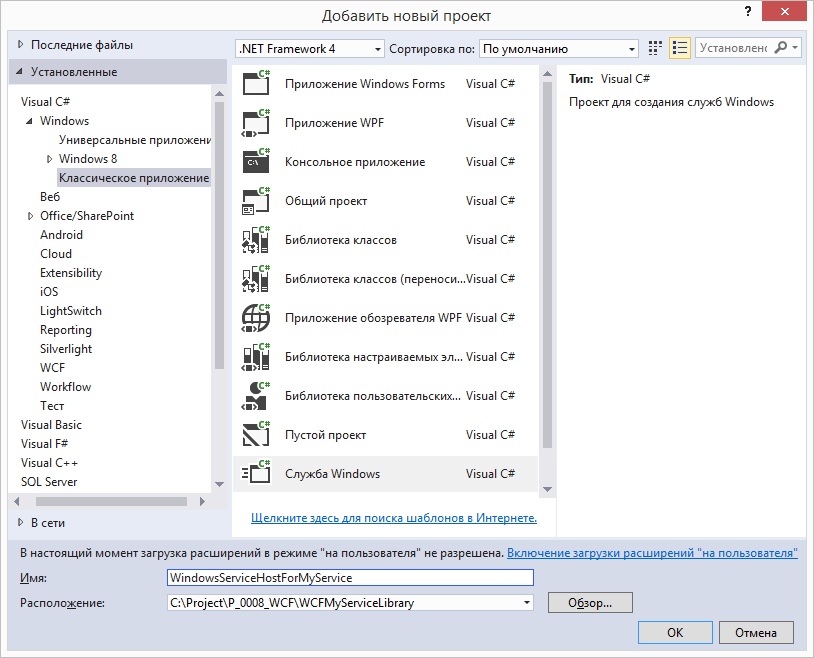

В том же решении (Solution) создадим новый проект типа «Служба Windows». Называем проект WindowsServiceHostForMyService.

Затем файл Service1.cs (только что созданного проекта) переименуем в MyService.cs. В этот проект добавим ссылку на сборку System.ServiceModel, а также не забываем указывать в файле MyService.cs директивы:

using System.ServiceModel;

using System.ServiceModel.Description;

В классе MyService добавляем новый член:

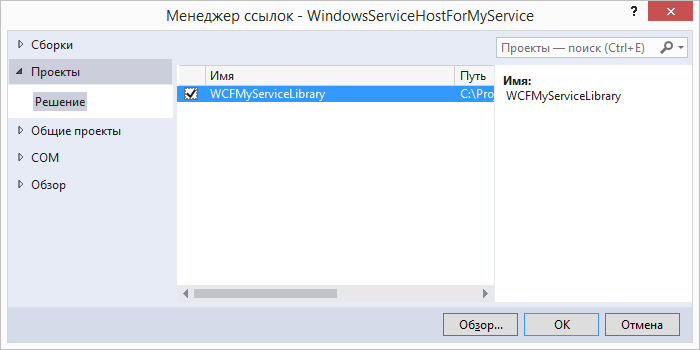

private ServiceHost service_host = null;Также необходимо добавить ссылку на проект WCFMyServiceLibrary, который находится в этом же решении:

Затем в классе MyService изменим метод OnStart таким образом, чтобы в этом методе добавлялись конечные точки нашего сервиса (endpoint):

protected override void OnStart(string[] args)

{

if (service_host != null) service_host.Close();

string address_HTTP = "http://localhost:9001/MyService";

string address_TCP = "net.tcp://localhost:9002/MyService";

Uri[] address_base = { new Uri(address_HTTP), new Uri(address_TCP) };

service_host = new ServiceHost(typeof(WCFMyServiceLibrary.MyService), address_base);

ServiceMetadataBehavior behavior = new ServiceMetadataBehavior();

service_host.Description.Behaviors.Add(behavior);

BasicHttpBinding binding_http = new BasicHttpBinding();

service_host.AddServiceEndpoint(typeof(WCFMyServiceLibrary.IMyService), binding_http, address_HTTP);

service_host.AddServiceEndpoint(typeof(IMetadataExchange), MetadataExchangeBindings.CreateMexHttpBinding(), "mex");

NetTcpBinding binding_tcp = new NetTcpBinding();

binding_tcp.Security.Mode = SecurityMode.Transport;

binding_tcp.Security.Transport.ClientCredentialType = TcpClientCredentialType.Windows;

binding_tcp.Security.Message.ClientCredentialType = MessageCredentialType.Windows;

binding_tcp.Security.Transport.ProtectionLevel = System.Net.Security.ProtectionLevel.EncryptAndSign;

service_host.AddServiceEndpoint(typeof(WCFMyServiceLibrary.IMyService), binding_tcp, address_TCP);

service_host.AddServiceEndpoint(typeof(IMetadataExchange), MetadataExchangeBindings.CreateMexTcpBinding(), "mex");

service_host.Open();

}

Затем реализуем остановку сервиса в методе OnStop:

protected override void OnStop()

{

if (service_host != null)

{

service_host.Close();

service_host = null;

}

}

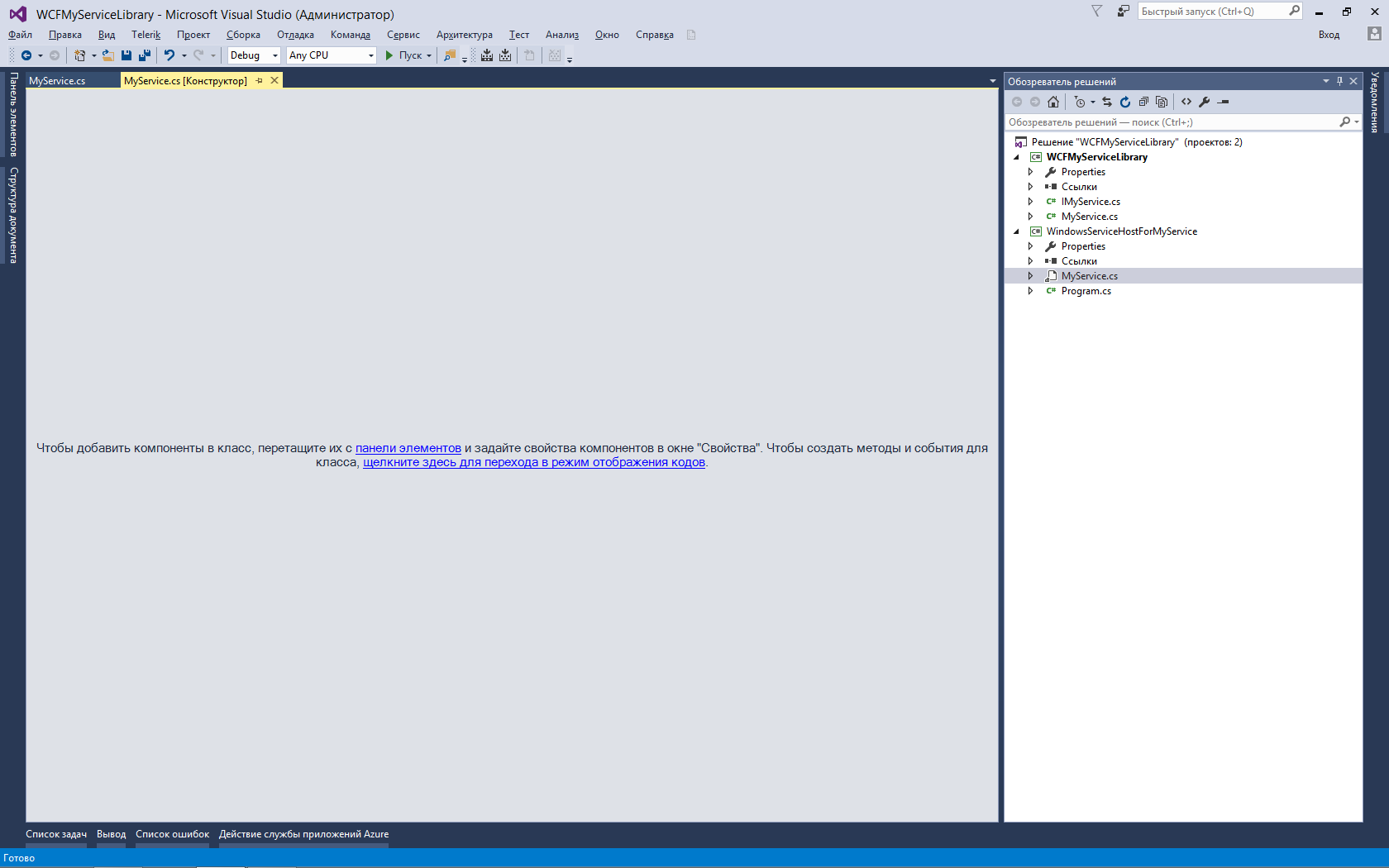

Затем в Обозревателе решения — двойной клик на файле MyService.cs (проекта WindowsServiceHostForMyService) откроет этот файл в режиме конструктора (Design Mode).

На пустом пространстве вызываем контекстное меню (щелчок правой кнопкой мыши) и выбираем «Добавить установщик».

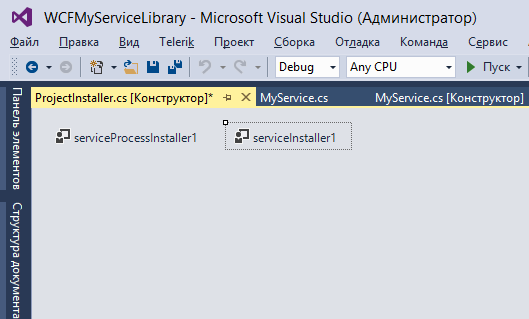

При этом будет создан новый класс ProjectInstaller.cs

Переименуем файл ProjectInstaller.cs в MyServiceInstaller.cs.

При этом выйдет окно с вопросом, следует ли переименовать зависимые объекты – отвечаем «Да».

Добавим в файл ссылку

using System.ServiceProcess;

Затем изменим код конструктора класса MyServiceInstaller:

public MyServiceInstaller()

{

// InitializeComponent();

serviceProcessInstaller1 = new ServiceProcessInstaller();

serviceProcessInstaller1.Account = ServiceAccount.LocalSystem;

serviceInstaller1 = new ServiceInstaller();

serviceInstaller1.ServiceName = "WindowsServiceHostForMyService";

serviceInstaller1.DisplayName = "WindowsServiceHostForMyService";

serviceInstaller1.Description = "WCF Service Hosted by Windows NT Service";

serviceInstaller1.StartType = ServiceStartMode.Automatic;

Installers.Add(serviceProcessInstaller1);

Installers.Add(serviceInstaller1);

}

Заметим, что вызов метода InitializeComponent() мы заблокировали с помощью комментария.

На этом разработка службы Windows завершена. Собираем всё решение (Build Solution) и переходим к следующему этапу – установка службы Windows.

Для установки нашей службы создадим bat-файл (с произвольным названием, например Install_Windows_Service.bat) следующего содержания:

C:\Windows\Microsoft.NET\Framework\v4.0.30319\InstallUtil.exe WindowsServiceHostForMyService.exe

Нужно скопировать этот bat-файл в ту же папку, где находится скомпилированный файл WindowsServiceHostForMyService.exe (вам нужно заранее продумать, в какой папке будет лежать этот файл, который будет всегда запущен в качестве службы Windows).

Запускаем bat-файл, после чего наша программа WindowsServiceHostForMyService.exe будет установлена в качестве службы Windows.

Запустим эту службу с помощью стандартной программы управления службами.

Следующий этап – разработка клиентского приложения для использования предоставляемых сервисом услуг.

Для этого прежде всего нужно организовать так называемый «переходник» — Service Proxy – набор настроек, описывающих сервис для клиентского приложения.

Воспользуемся для этого стандартной утилитой SvcUtil.exe. Создадим файл Generate_Proxy.bat следующего содержания

SvcUtil http://localhost:9001/MyService /out:MyServiceProxy.cs /config:App.config

Запустим этот файл (стандартная утилита SvcUtil.exe находится в папке C:\Program Files\Microsoft SDKs\Windows\v7.0\Bin).

Этот файл нужно запустить во время работы нашего сервиса, т.е. в данном случае, после успешного запуска службы Windows WindowsServiceHostForMyService.

В случае успешного запуска, программа SvcUtil.exe сгенерирует 2 файла — MyServiceProxy.cs и App.config.

Эти файлы необходимо добавить для клиентского приложения, чтобы это приложение могло вызывать методы нашей службы (чуть ниже вы узнаете, что файл App.config я решил не добавлять — обойдёмся и без него).

Примечание. Аналогичного результата можно было добиться, запустив

SvcUtil net.tcp://localhost:9002/MyService /out:MyServiceProxy.cs /config:App.config

Т.е. можно запускать эту утилиту, указав только одну конечную точку, либо http либо net.tcp.

В том же решении (Solution) создадим обычное приложение Windows Forms. Назовем его WindowsFormsApplication1

Добавим в этот проект ссылку на System.ServiceModel и, конечно же,

using System.ServiceModel в файле формы.

Добавим в этот проект файл MyServiceProxy.cs (именно его мы сгенерировали утилитой SvcUtil.exe). При этом следует добавить в файл MyServiceProxy.cs следующие строки:

namespace ServiceReference1

{

using System.Runtime.Serialization;

using System;

… затем идёт содержимое файла MyServiceProxy.cs …

и конечно, не забываем поставить завершающую скобку для namespace

}После этого, мы сможем ссылаться на класс MyServiceClient (этот класс создан программой SvcUtil.exe), указав в файле формы директиву.

using ServiceReference1;

namespace ServiceReference1

{

using System.Runtime.Serialization;

using System;

[System.CodeDom.Compiler.GeneratedCodeAttribute("System.ServiceModel", "3.0.0.0")]

[System.ServiceModel.ServiceContractAttribute(ConfigurationName="IMyService")]

public interface IMyService

{

[System.ServiceModel.OperationContractAttribute(Action="http://tempuri.org/IMyService/Method1", ReplyAction="http://tempuri.org/IMyService/Method1Response")]

string Method1(string x);

[System.ServiceModel.OperationContractAttribute(Action="http://tempuri.org/IMyService/Method2", ReplyAction="http://tempuri.org/IMyService/Method2Response")]

string Method2(string x);

}

[System.CodeDom.Compiler.GeneratedCodeAttribute("System.ServiceModel", "3.0.0.0")]

public interface IMyServiceChannel : IMyService, System.ServiceModel.IClientChannel

{

}

[System.Diagnostics.DebuggerStepThroughAttribute()]

[System.CodeDom.Compiler.GeneratedCodeAttribute("System.ServiceModel", "3.0.0.0")]

public partial class MyServiceClient : System.ServiceModel.ClientBase, IMyService

{

public MyServiceClient()

{

}

public MyServiceClient(string endpointConfigurationName) :

base(endpointConfigurationName)

{

}

public MyServiceClient(string endpointConfigurationName, string remoteAddress) :

base(endpointConfigurationName, remoteAddress)

{

}

public MyServiceClient(string endpointConfigurationName, System.ServiceModel.EndpointAddress remoteAddress) :

base(endpointConfigurationName, remoteAddress)

{

}

public MyServiceClient(System.ServiceModel.Channels.Binding binding, System.ServiceModel.EndpointAddress remoteAddress) :

base(binding, remoteAddress)

{

}

public string Method1(string x)

{

return base.Channel.Method1(x);

}

public string Method2(string x)

{

return base.Channel.Method2(x);

}

}

} Поступим неординарно – и не будем добавлять файл App.Config в проект клиента!

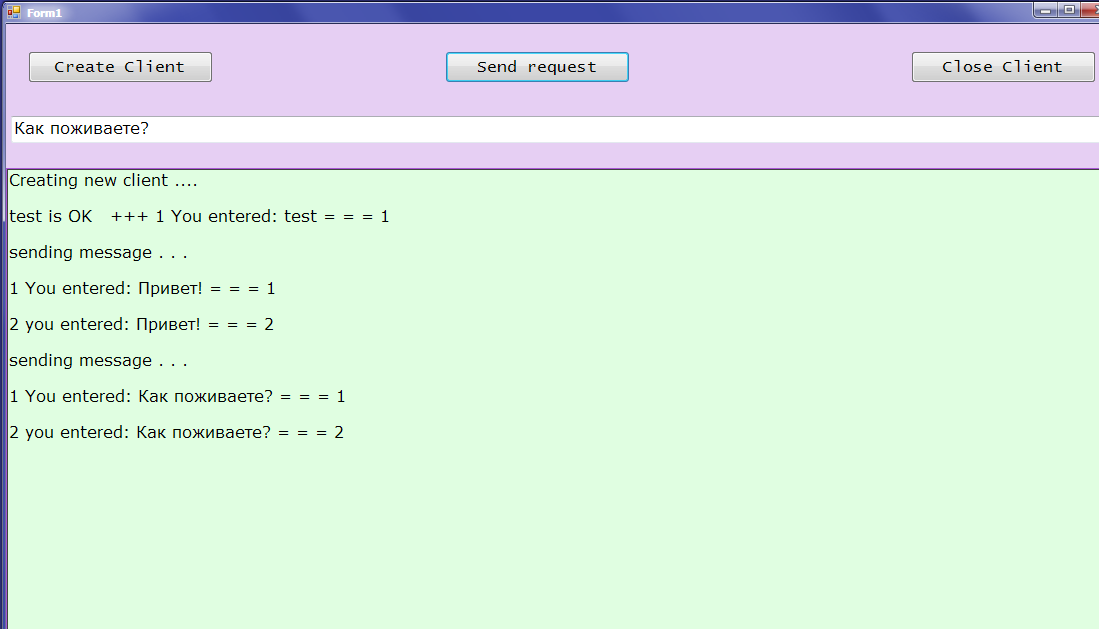

Затем набросаем на форму 3 кнопки, текстовое поле textBox1 (пользователь вводит сюда строку для отправки на сервер) и поле richTextbox1 (имитация подсистемы сообщений нашего приложения – именно в это поле будут поступать сообщения от программы, в том числе и те, что вернул нам сервис)

Кнопка btn_Start – создаёт клиента

Кнопка btn_Send – отправляет сервису текстовую строку из текстового поля

Кнопка btn_Close – удаляет клиента из памяти и закрывает приложение

using System;

using System.ServiceModel;

using System.Windows.Forms;

using ServiceReference1;

namespace WindowsFormsApplication1

{

public partial class Form1 : Form

{

MyServiceClient client = null;

public Form1()

{

InitializeComponent();

}

private void Print(string text)

{

richTextBox1.Text += text + "\n\n";

richTextBox1.SelectionStart = richTextBox1.Text.Length;

richTextBox1.ScrollToCaret();

}

private void Print(Exception ex)

{

if (ex == null) return;

Print(ex.Message);

Print(ex.Source);

Print(ex.StackTrace);

}

private void Create_New_Client()

{

if (client == null)

try { Try_To_Create_New_Client(); }

catch (Exception ex)

{

Print(ex);

Print(ex.InnerException);

client = null;

}

else

{

Print("Cannot create a new client. The current Client is active.");

}

}

private void Try_To_Create_New_Client()

{

try

{

NetTcpBinding binding = new NetTcpBinding(SecurityMode.Transport);

binding.Security.Message.ClientCredentialType = MessageCredentialType.Windows;

binding.Security.Transport.ClientCredentialType = TcpClientCredentialType.Windows;

binding.Security.Transport.ProtectionLevel = System.Net.Security.ProtectionLevel.EncryptAndSign;

string uri = "net.tcp://192.168.1.2:9002/MyService";

EndpointAddress endpoint = new EndpointAddress(new Uri(uri));