Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Марк, Джек и Алишер! Миру нужен новый фейсбук — образовательный |

Дорогие Марк, Джек и Алишер!

Новый — образовательный — фейсбук нужен людям для исхода из вековой бедности. Каждому человеку новый сервис должен дать шанс. Шанс на современные знания, шанс на развитие талантов и способностей, шанс на обретение силы и уверенности, а значит, и шанс на изменение своей судьбы и судьбы своего окружения.

Кому, как не вам, возглавить исход человечества из бедности? Вы разбогатели и создали крупнейшие электронные сервисы с нуля. А значит, вам по силам и создание мировой онлайн-платформы с ясной миссией — образование ради процветания.

Проблема бедности и ответственность богатых

Бедность — одна из причин войн и конфликтов. Сообщество людей на планете подобно единому организму. Ни один орган не процветает за счет болезней других, и поэтому нет оправдания дисбалансу доходов как между странами, так и внутри народов. Ангус Дитон, нобелевский лауреат, называет крайности богатства и бедности источником разрушительных междоусобных войн.

Бедность — это неравенство: материальное, образовательное и цифровое. Бедные не тратят время на учебу, а добывают хлеб насущный. Поэтому в мире до сих пор 750 млн неграмотных, из них 250 млн детей и подростков школьного возраста. А образовательное и цифровое неравенство вновь ведет к неравенству материальному. Замыкается дьявольский порочный круг: богатые снова богатеют, а бедные — беднеют.

Бедность — это личные и социальные привычки. Ученые из Массачусетского технологического университета выяснили, что старые привычки никогда не забываются, а только скрываются образованием новых. А на формирование новых нейронных связей нужно до 8,5 месяцев. Поэтому, чтобы заменить привычки поколенческой бедности — привычками процветания, человечеству понадобятся десятилетия напряженной и терпеливой работы. И этот путь сродни Исходу — 40-летнему обретению свободы под водительством Моисея.

Бедность — зона ответственности преуспевающих. Да, многие богачи агрессивно защищают личные состояния, несправедливо закрывая для остальных путь к процветанию. А многие бедняки, в свою очередь, не усердствуют в личностном развитии, не развиваются, грубят, обижаются и довольствуются малым. При этом очевидно, что человек — существо благородное. И ему нужны справедливые общественные модели, которые разрушат сложившиеся неравенства, например, образовательный фейсбук, который могут создать только сильные и преуспевающие люди.

10 атрибутов образовательного фейсбука

Почему нужен новый сервис, а не подойдут уже сложившиеся социальные сети? Потому что социальные медиа не изменяют судьбу человека, его биографию. Опросы показывают, что почти 80% пользователей задумывались об удалении аккаунта из соцсетей, потому что устали от бессмысленной траты времени. Другие исследования утверждают, что 99% публикуемого контента бесполезно. Кроме того, в социальных медиа сложились устойчивые стереотипы поведения, изменить которые практически невозможно.

Философия новых отношений для выхода из бедности — Equal Educational Exchange (Равноправный Образовательный Обмен). Ему соответствует 10 атрибутов образовательного фейсбука.

Атрибут первый: глобальная электронная образовательная инфраструктура

В доцифровую эру образование полностью зависело от зданий, учебников, ручек, тетрадей, учебных программ, школьных администраторов, учителей и преподавателей. Бедные страны были почти не способны создать образовательную оффлайн инфраструктуру. Неравенство возможностей приводило к неравенству результатов. Новая образовательная инфраструктура — смартфоны. Эти мобильные устройства вскоре будут у каждого, независимо от дохода. А значит образовательный фейсбук сможет аккумулировать большинство платных и бесплатных курсов на одной платформе. Чтобы пользователь мог почувствовать себя на «водительском месте».

Насколько неклассическое образование эффективно? Кениец Джулиус Йего стал чемпионом мира по метанию копья, а свои первые уроки он брал, просматривая ролики на Youtube. Самый богатый человек Китая ездил на велосипеде к гостинице для проведения бесплатных экскурсий для иностранцев, чтобы попрактиковаться в английском языке. А самый молодой миллиардер планеты ушел со второго курса Гарвардского университета.

Атрибут второй: учителем и учеником может стать каждый

Как учителем, так и учеником в образовательном фейсбуке может стать каждый. Каждый может создать свою образовательную программу для других. Онлайн-платформа нового фейсбука для создания учебных курсов, вебинаров, онлайн-тренингов и коуч-консультаций аналогична WordPress для личных сайтов. А большое количество добровольцев и организаций по всему миру будут оперативно выявлять и решать потребности пользователей для укрепления привычек процветания: от азов чтения до риторики, от Duolingo до Coursera. Кроме того, быть учителем в 9 раз эффективнее, чем учеником. «Хочешь изучить предмет —

Атрибут третий: непрерывное образование на протяжении всей жизни

В мире VUCA — volatility (нестабильность), uncertainty (неопределенность), complexity (сложность) и ambiguity (неоднозначность) — следует признать, что учиться нужно всю жизнь. Традиционная образовательная траектория — одно высшее образование до 25 лет — устарела. Правильно говорить о трехпиковой модели: второй трудоспособный возраст 30–55 лет и третий — 55+. В среднем человек за жизнь меняет 8 сфер деятельности. Поэтому образовательный фейсбук должен стать площадкой для непрерывного обучения на протяжении всей жизни.

Атрибут четвертый: образование ради процветания, полезное для жизни

Основная миссия образовательного фейсбука: образование ради процветания. Обретение полезных знаний, навыков и компетенций для жизни, для самозанятости, для бизнеса, для открытия новых рабочих мест. Ради формирования интегральной способности решать сложные вопросы жизни.

Атрибут пятый: персонализация обучения для раскрытия потенциала

В фокусе внимания образовательного фейсбука — раскрытие врожденного потенциала пользователей. Большой массив данных образовательной онлайн-платформы позволит предложить каждому те курсы и программы, что наиболее полно раскроют их таланты, склонности и способности. Это схоже с тем, как поведение покупателей в интернет-маркетинге фиксирует Google Analytics и делают предложения нейронные сети.

Атрибут шестой: добровольческая поддержка изменений

Привычки, а особенно социальные, меняются медленно, и требуется постоянная поддержка. В Германии 30% студентов не справляются с учебой и бросают вузы из-за высоких нагрузок и низкой мотивации. Новым пользователям образовательного фейсбука обязательно потребуется поддержка наставников, тренеров, тьюторов, советников, как платная, так и безвозмездная. Тысячи волонтеров создали Wikipedia, потому что участие в благотворительных программах повышает самооценку, уверенность в себе и повышает конкурентоспособность на рынке труда. Поэтому стать добровольным наставником захотят многие.

Атрибут седьмой: практика уважительного диалога

Для становления привычек процветания нужна хорошая диалоговая практика, в которой формируются коммуникативные навыки, навыки переговоров и убеждения, навыки формулирования идей и др. Задача ресурса — создать плодотворную среду групповых диалогов, но при этом не допустить конфликтов. Каждый заслуживает уважение, и особенно больно, когда клевещут за то, что ты не совершал. Без пространства доверия, понимания и поддержки невозможно формирование новых позитивных привычек. Образовательный фейсбук призван стать местом уважительного и содержательного диалога.

Атрибут восьмой: система достижений, признаваемая оффлайн

Полезные привычки формируются поощрением. Поэтому значимые действия должны быть вознаграждены за достижения и усердие. При этом ученый из Европы и австралийский бушмен должны быть равны в оценке динамики развития. А накапливаемые результаты должны вести к системе званий, признаваемой офлайн, как доктор философии, например. Рейтинг также повлияет на процент оплаты за некоторые профессиональные услуги тренеров, консультантов, репетиторов, психоаналитиков и пр.

Атрибут девятый: непрерывное развитие сервиса и научный подход

Мир совершенен в своем несовершенстве. Поэтому и через 100, и через 300, и через 10 000 лет образование как отрасль будет столь же востребована, как и сегодня. Вместе с тем у каждого народа и каждого человека свой уровень учебных запросов. Поэтому нужно учитывать предложения по развитию от самих пользователей. И использовать научный подход к развитию ресурса, в том числе для создания программ, целенаправленно раскрывающих индивидуальные таланты и способности.

Атрибут десятый: прибыльная бизнес-модель сервиса

Источники прибыли: рекламные системы, процент от стоимости платных образовательных услуг, курсов, вебинаров, консультаций и др. по схеме «защита клиента», а также бонусы от использования массива данных. Рентабельная бизнес-модель обеспечит образовательному фейсбуку независимое развитие в достижении высших целей: победы над мировой бедностью и предоставления каждому шанса на образование, дающее современные знания, раскрывающее потенциал и укрепляющее внутреннюю силу.

Будем начинать?

Марк Цукерберг, Джек Ма и Алишер Усманов, давайте начнем Исход из бедности. Начнем работу по созданию образовательного фейсбука. Сильные должны научить процветанию слабых. Быть первыми — полное сумасшествие, но может быть, поэтому имена первых переживают века. Марк, Джек и Алишер, отправляемся в путь?

|

Метки: author Svyatoslav_Abramov читальный зал исследования и прогнозы в it фейсбук образование марк цукерберг алишер усманов джек ма |

Постквантовая реинкарнация алгоритма Диффи-Хеллмана |

|

Метки: author Crittografo криптография информационная безопасность алгоритмы блог компании «актив» |

Мониторинг задержек системы с помощью JHiccup |

О JHiccup

JHiccup это простая программа, которая позволяет измерить задержки операционной системы с точки зрения конечного приложения. Она была написана CTO компании Azul — Гилом Тени для измерения задержек ОС.

Почему задержки так важны

Мы в живем во времена сетевых приложений. Большинство программ запущенных на нашем компьютере регулярно ходят в интернет. Если мы запустим браузер и откроем google.com, то произойдет 50–60 запросов.

Для открытия google.com произошло 56 запросов

Если мы говорим о более сложных сайтах, то количество запросов будет исчисляться сотнями. И задержка любого из этого запросов может задержать отрисовку всего сайта.

Рассмотрев пример с сайтами, мы можем легко провести аналогию с клиент-серверным приложение или популярными микро-сервисами. Если в цепочке вызова микро-сервисом один из микро-сервисов вернет ответ позже обычного, то это может затормозить всю логику. Например, медленный ответ о цене продукта из БД может замедлить весь процесс покупки в интернет магазине.

Поэтому когда мы говорим о производительности и задержках программы, важен не только лучший и средний результат, но и худшие результаты.

Зачем нужен мониторинг ОС

Часто разработчикам поступают жалобы от клиентов или других систем о том, что приложение обрабатывало запрос слишком долго. К сожалению, такую проблему бывает трудно воспроизвести локально или даже заметить в реальном окружении.

Многие разработчики в этом случае сразу начинают искать проблемы в коде. Для этого используется например логи, метрики и профайлер. Но правильный анализ производительности должен начинаться снизу-вверх, начиная с уровня железа и ос и заканчивая программой.

Большинство ос не являются операционными системами реального времени. А значит они не могут давать гарантии на определенное время выполнение операций. Значит производительность программ, запущенный на таких ос, может сильно отличаться в течение времени работы программы. Попросту говоря, программа может даже не получать процессорное время в какой-то момент. И тогда абсолютно не важно какой код выполняется в программе.

Вот несколько причин почему программа может “спать” не имея возможности выполнять полезные действия:

- ОС может выполнять внутреннюю сборку мусора;

- Другое ресурсоемкое приложение может использовать CPU или другие ресурсы;

- ОС может выполняться поверх гипервизора и не зная об этом быть не единственной ос запущенной на этом железе.

Почему jHiccup?

Существует множество утилит и метрик, позволяющих увидеть загруженность разных компонентов системы с разной степенью детализации. Проблема в том, что таких метрик очень много и для каждой программисту нужно ответить на два вопроса:

- Может ли эта метрика быть причиной задержки?

- Является ли конкретное значение этой метрики аномальным?

jHiccup позволяет посмотреть на систему с точки зрения приложения. jHiccup это маленькое приложение с простой функцией : бесконечный поток засыпает и просит ос разбудить его через определенный период, например 1 секунду. Если ос была занят через 1 секунду и не смогла разбудить поток, то приложение это увидит сравнив время пробуждения с расчетным временем пробуждения (время засыпания + 1 сек). Мы можем построить график, где мы увидем задержки системы в течение выполнения программы.

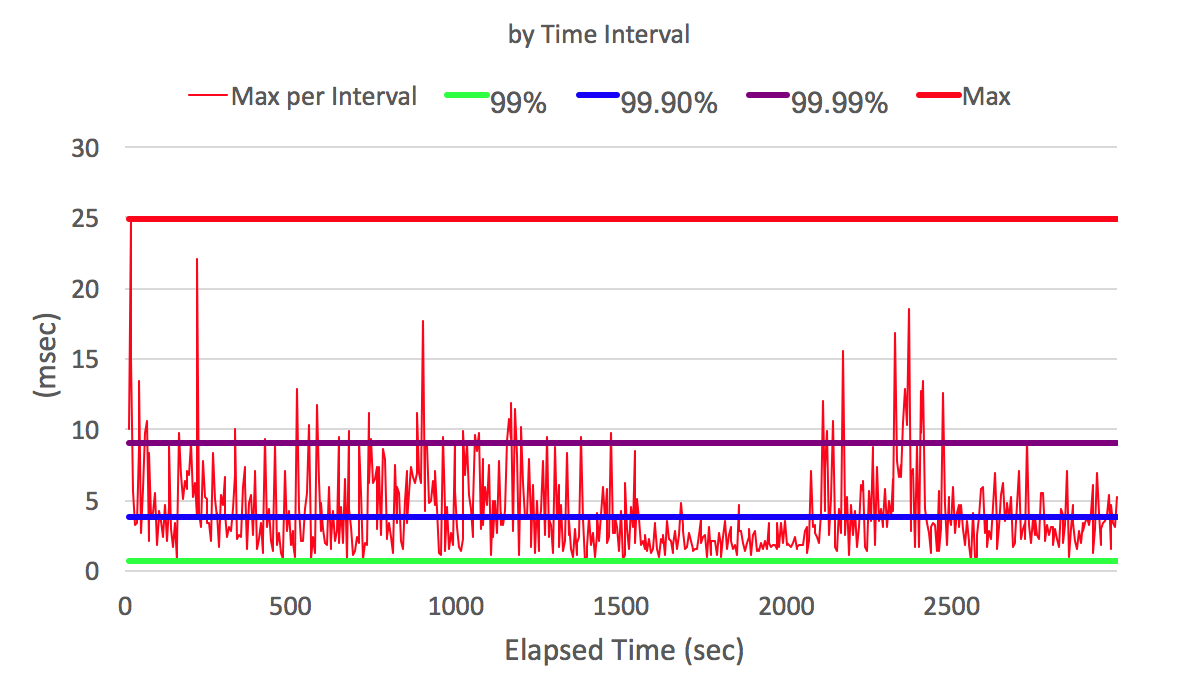

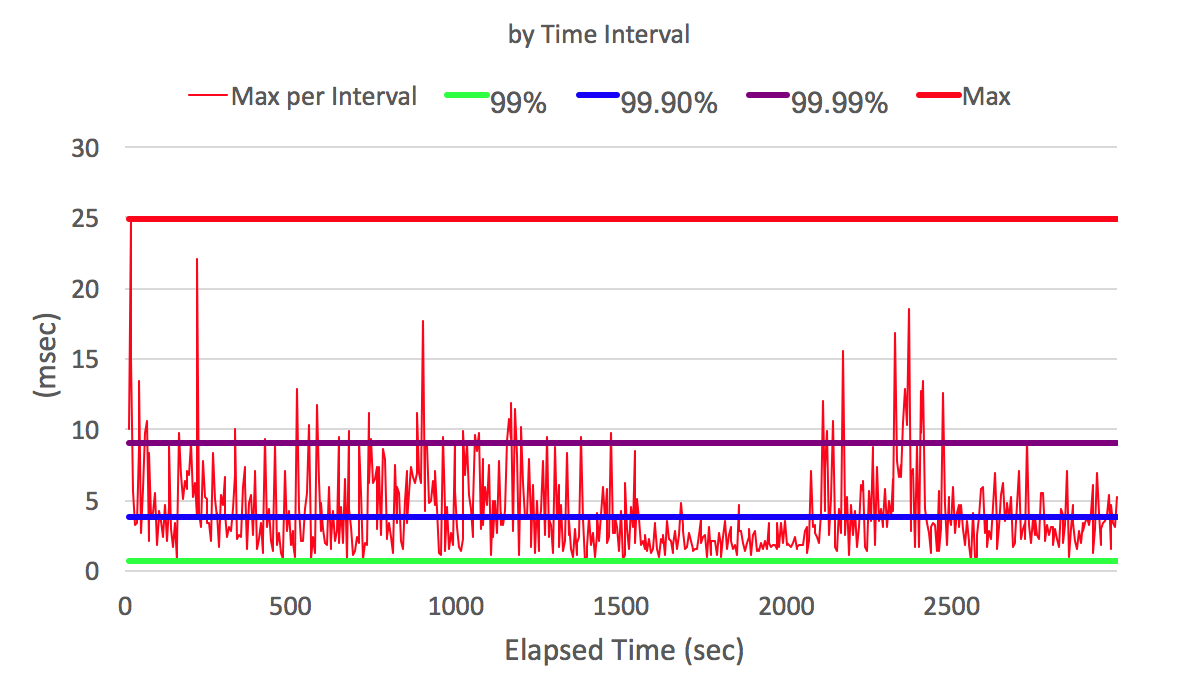

На оси X время выполнения программы в секундах. На оси Y задержка пробуждения в миллисекундах (то сколько программа ждала, когда ОС даст ей возможность выполняться)

Зная время жалобы на медленный ответ нашей системы клиенту и видя график задержек пробуждения нашей программы, мы можем сказать, была ли ос причиной задержки или нет.

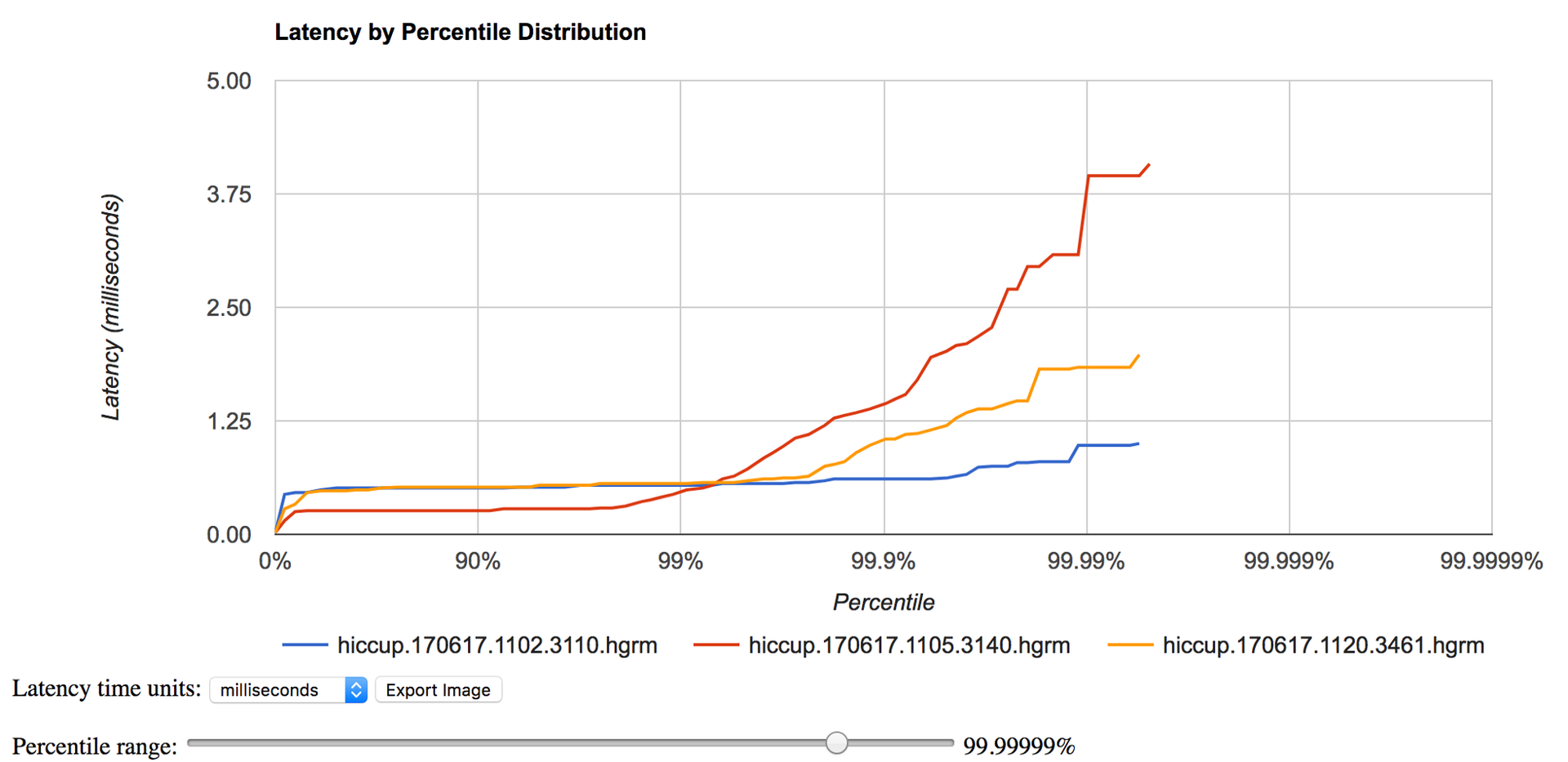

На предыдущем графике мы рассмотрели задержки относительно времени выполнения программы. Кроме этого бывает удобно взять все задержки и отсортировать по возрастанию. Это даст нам представление о распределении задержек и их вероятности.

Задержка в миллисекундах на оси y и ее вероятность на оси x

Некоторые особенности JHiccup:

- не страдает проблемой Coordinate Omission хорошо описанной Гилом Тене в его видео

Внутри jHiccup использует гисторгамму как структуру данных. Обычная гисторамма разбивает весь интервал задержек (например от 1мс до 1 сек) на отрезки и подсчитывает сколько задержек попало в определенный интервал. Это позволяет представить данные о задержках в более компактном виде, чем просто список наблюдаемых значений (1.55мс, 2.6мс и тд).

На самом деле в jHicuup используется специальная имплементация гистограммы — HDR-Histogram, которая обладает следующими свойствами:

- Гистограммы имеют высокое разрешение. Мы можем видеть не только 95% и 99% худших результатов, но и намного более подробные данные ( 99.999%).

- Хранит данные в компактном виде, что позволяет измерять производительность в течение долгого времени. Для этого размер сегмента гистограммы увеличивается экспоненциально. Благодаря этому получается более компактно хранить аномальные значения.

Библиотека HDR-Histogram получило широкое распространение. Можно найти имплементации на разных языках. Разные системы для сбора метрик стали поддерживать hdr-historgram как один из внутренних форматов, благодаря ее компактности и точности.

Зачем такая точность?

На графиках выше мы видели данные о 99.9999% случае. У многих возникает вопрос, нужна ли такая точность и надо ли рассматривать данные дальше 95% или 99% персентиля. Давайте рассмотрим два примера. В обоих примерах мы возьмем вероятность аномальной задержки P(A) как 5% и 1% соответственно. Нам надо ответь на вопрос, какова вероятность того, что пользователь увидит аномальный запрос P(B):

- Мы видели что google.com делает около 60 запросов. Для примера рассмотрим сайт онлайн-магазина где для покупки необходимо выполнить 200 запросов. В случае P(A)=5%, P(B)=1–(0.95 в степени 200)=99.997%. В случае P(A)=1%, P(B)=1-(0.99 в степени 200)=86.6%

- Пусть у нас есть 10 микро-сервисов. И каждый вызывается дважды во время выполнения определенного сценария, то есть происходит 20 вызовов. В случае P(A)=5%, P(B)=1–(0.95 в степени 20)=64.15%. В случае P(A)=1%, P(B)=1-(0.99 в степени 20)=18.2%.

Как мы видим, рассматривать данные только до 95-ого или 99-ого персентеля недостаточно.

Пример использования jHiccup

Скачать jhiccup можно с http://www.azul.com/downloads/jhiccup/ или https://github.com/giltene/jHiccup.

./jHiccup -d 4000 /usr/bin/java org.jhiccup.Idle -t 300000

# первые 4 секунды старта не буду записаны, всего будет записано 300 секунд. По умолчанию поток будет просыпаться каждые 5 секунд (настраивается с помощью параметра -i).

# создан hiccup.170617.1120.3461.hlog

./jHiccupLogProcessor -i hiccup.170617.1120.3461.hlog -o hiccup.170617.1120.3461

# создан hiccup.170617.1120.3461 и hiccup.170617.1120.3461.hgrmФайл hiccup.170617.1120.3461 можно просмотреть с помощью excel-файла jHiccupPlotter.xls.

Для просмотра hiccup.170617.1120.3461.hgrm можно воспользоваться онлайн приложением https://hdrhistogram.github.io/HdrHistogram/plotFiles.html. Оно также удобно для сравнения нескольких hdrm файлов (например, во время разной загрузки системы или с разных серверов).

Сравнивая график производительности нашей программы (например, задержки http-ответов) с полученной hdr-диаграммой, мы можем понять работала ли вся система медленно в определенный период или только наша программа.

Мы запускали jhiccup как отдельный процесс. Другой способ это запуск javaagent-а вместе с нашей программой.

java -javaagent:jHiccup.jar="-d 0 -i 1000 -l hiccuplog -c" MyProgram.jar -a -b -cВ этом случае jhiccup будет просыпаться и сохранять информацию о задержках в течении всего времени выполнения программы.

В этих двух способах запуска есть одно важное различие. В первом случае jHiccup запускается на отдельной JVM в другом на той же JVM. То есть во втором случае мы увидим задержки связанные с работой JVM (например паузы GC), на которой запущено основное приложение.

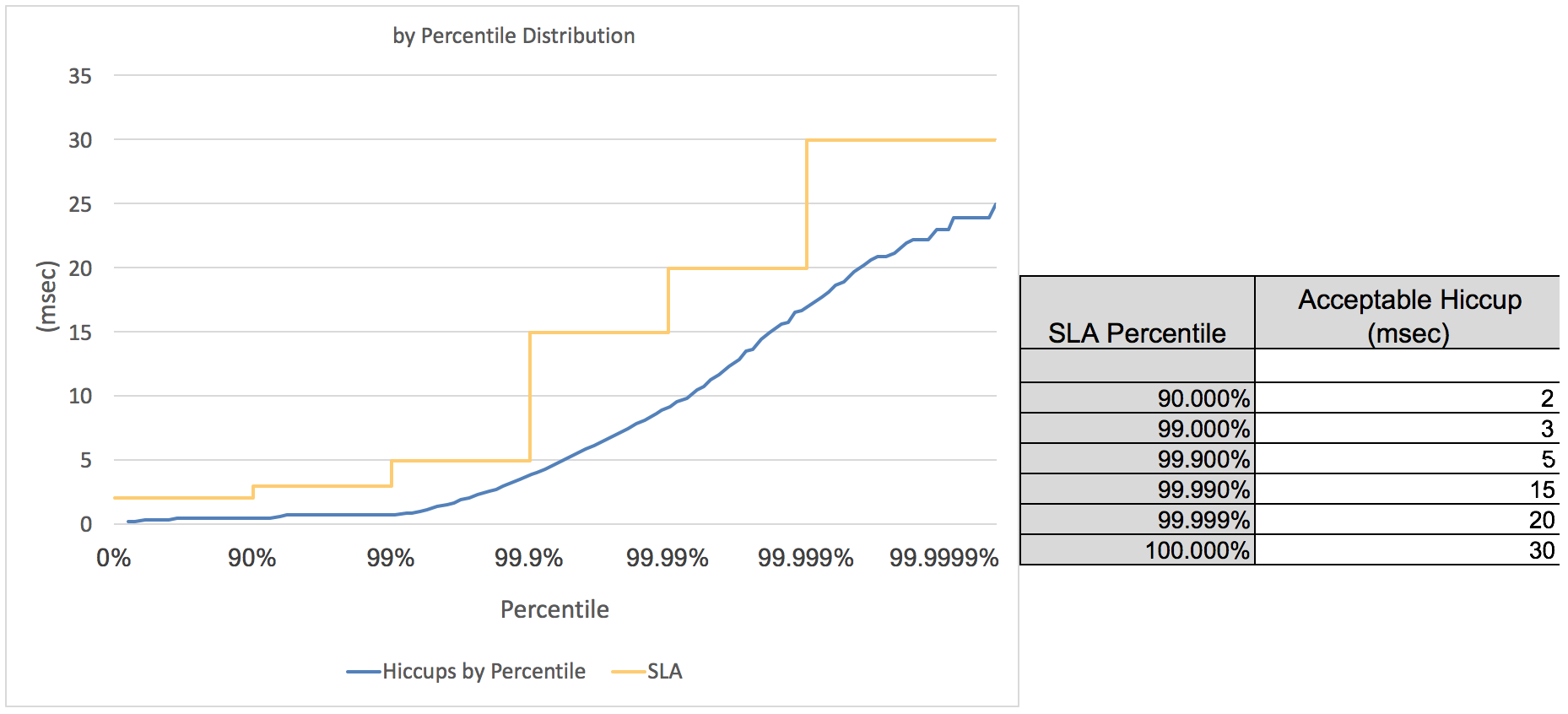

В файле jHiccupPlotter.xls есть возможность добавить линии SLA на график.

Я вижу два удобных применения для SLA:

jHiccup удобная утилита для мониторинга задержек системы. В отличии от системных метрик, jHiccup позволяет взглянуть на загрузку системы с точки зрения приложения.

|

Метки: author AlexeyPi визуализация данных java мониторинг производительность задержки |

[recovery mode] На каких проектах становятся хорошими инженерами, а на каких – менеджерами? |

Почему ты занимаешься именно мобильной разработкой?

Она нравится мне потому, что можно написать приложение и сразу же увидеть, как оно работает на мобильном телефоне. Но я начинал свою карьеру как веб-девелопер, пока руководитель команды не уговорил меня перейти в мобильную разработку. В то время еще не было сматрфонов, и мы создавали приложения для обычных кнопочных телефонов, используя Java 2 Micro Edition.

Такой опыт дал хорошие знания в работе с многопоточностью и коллекциями, в том числе с архитектурной точки зрения. А сейчас, благодаря современным фреймворкам, уже не нужно думать о низкоуровневых вещах. Однако если ты не знаешь, как система работает изнутри, есть большая вероятность сделать то, что «свалится» через год, причем по неизвестным тебе причинам. Люди, у которых горят глаза, всегда стараются докопаться до сути. Иногда к нам приходят ребята, которым, к примеру, 25 лет, а в некоторых областях они не уступают техническому лиду. Поскольку я отвечаю за технические интервью на Android-разработку в Минске, как раз стараюсь присмотреть ребят, у которых есть потенциал. Пусть сейчас они могут допустить какие-то ошибки, но видно, что через год они вырастут на уровень выше благодаря своему любопытству и старанию.

Приведи, пожалуйста, пример проекта, работа над которым помогла тебе увеличить твою инженерную экспертизу?

Один из моих недавних проектов – создание приложения, которое по функционалу напоминает Skype for Business. Изначально общая логика была написана на JavaScript, и мы работали с такими развивающимися технологиями, как WebRTC для передачи аудио- и видеоинформации между смартфонами для организации онлайн-конференций. В нашей команде было около 10 разработчиков и 4 QA-специалиста. Работали по классическому Scrum с правильными процессами. Мы предлагали клиенту много архитектурных решений, 90% которых он одобрил. Это и перевод архитектурной логики на Clean Architecture, и внедрение архитекторного паттерна Model-View-Presenter, который позже перешел в VIPER, и переход на Rx (реактивный подход), и плавный перевод кода с Java на Kotlin. Проект следовал лучшим мировым практикам разработки и прошел соответствующую сертификацию в нашей компании.

Скажу честно, такие проекты помогают не столько нарастить экспертизу в управлении командой, сколько научиться следовать современным процессам разработки. А вот если говорить об экспертизе тим-лида, то ее помогают получить не самые удачные с точки зрения бизнеса проекты. Мне всегда нравились проекты с изъяном. Когда работаешь на идеальном проекте, где все катится по рельсам, рано или поздно становится скучно. А вот если обнаружилась червоточинка, то можно сразу же мотивировать команду – мол, а давайте-ка мы перепишем эту криво работающую штуку. Сразу же появляется экшен и азарт – с моей точки зрения, важные составляющие рабочего процесса.

Мне неоднократно доставались проекты не лучшего качества, и постепенно, силами всей команды, их удавалось вывести в зеленую зону. Решение зависит от заказчика и цели, которую он преследует, – 1) хочет быстро получить продукт сомнительного качества и через два года, образно выражаясь, выкинуть его в мусорницу либо 2) качественное приложение, создание которого потребует больше времени и финансовых затрат. Здесь важен скоординированный подход, когда работает вся команда, включая технического лидера, который должен объяснить заказчику, во что выльется то или иное решение в будущем. Большинство заказчиков доверяет технической экспертизе команды и считается с ее рекомендациями, видит перспективу и готовы дать свободу команде, чтобы она успела создать качественное решение.

Над чем ты работаешь сейчас?

Пока занимаюсь Research and Development-активностями – пресейлами, инвестигированием различных библиотек, архитектурными подходами и сервисами в области мобильной разработки. Цель – нарастить экспертизу в сфере интеграции с крупными сервисами, так как облачные вычисления только начинают набирать силу. Пресейлы включают митинги с заказчиками, изучение разных технологий, оценку проектов и создание прототипов. Работы действительно очень много. Такой опыт учит видеть проблемы, которые ты как инженер раньше просто не замечал.

Скоро стартует интересный проект, на котором я буду собирать команду вокруг себя. Клиент – австралийская компания-производитель имплантов для слабослышащих людей. Они вживляются в ухо и «подключаются» к нерву, благодаря чему человек имеет возможность слышать и жить полноценной жизнью.

Продукт, над которым мы будем работать, – мобильное приложение для настройки индивидуальных параметров саунд-процессора, который примагничивается к ушному импланту. Приложение соединяется с саунд-процессором через Bluetooth. С помощью этого продукта доктор настраивает слуховой саунд-процессор для пациента. Или же человек сам может отрегулировать некоторые параметры, чтобы сделать звук максимально комфортным – например, находясь в метро, отсечь шумы и хорошо слышать собеседника. И хотя само приложение не такое уж сложное, оно должно быть хорошо защищенным от «падений» и хакерских атак. Поэтому разработка будет чередоваться с многоуровневым тестированием. Им занимается собственный QA-отдел заказчика. Приложение уже написано на iOS, и мы будем разрабатывать его на Android. Меня очень вдохновляет, когда я создаю не просто измеритель пульса, а продукт, который поможет улучшить уровень жизни человека. Только представьте – родился ребенок с нарушением слуха, и от качества импланта и его настройки зависит, научится ли он говорить и какой будет его жизнь. Ответственность мотивирует – вот почему мне нравится направление Health Care.

Какой ты видишь свою дальнейшую карьеру в компании?

Поскольку любой проект начинается с Solution Architecture, мне интересно развиваться в этом направлении. Стараюсь следить за тем, что происходит в Mobile-домене – быть в курсе новых практик и архитектур. Вижу себя как специалиста, который делает скелет приложения, а с ним уже в дальнейшем работает команда. Было полезно поучаствовать в Mobile Architecture School в EPAM, чтобы посмотреть, чем занимаются Solution Architects и повысить свой уровень знаний в этой сфере, так как архитектура охватывает и Clouds, и back-ends, и другие домены. Если заниматься мобильной разработкой, все время нужно держать ухо востро и следить за новинками, чтобы не выпасть из этой сферы.

|

Метки: author Volgafe87 разработка под android блог компании epam android mobile development epam epam systems личный опыт |

Книга «Сценарии командной оболочки. Linux, OS X и Unix. 2-е издание» |

Сценарии командной оболочки помогают системным администраторам и программистам автоматизировать рутинные задачи с тех самых пор, как появились первые компьютеры. С момента выхода первого издания этой книги в 2004 году многое изменилось, однако командная оболочка bash только упрочила свои лидирующие позиции. Поэтому умение использовать все ее возможности становится насущной необходимостью для системных администраторов, инженеров и энтузиастов. В этой книге описываются типичные проблемы, с которыми можно столкнуться, например, при сборке программного обеспечения или координации действий других программ. А решения даются так, что их легко можно взять за основу и экстраполировать на другие схожие задачи.

Сценарии командной оболочки помогают системным администраторам и программистам автоматизировать рутинные задачи с тех самых пор, как появились первые компьютеры. С момента выхода первого издания этой книги в 2004 году многое изменилось, однако командная оболочка bash только упрочила свои лидирующие позиции. Поэтому умение использовать все ее возможности становится насущной необходимостью для системных администраторов, инженеров и энтузиастов. В этой книге описываются типичные проблемы, с которыми можно столкнуться, например, при сборке программного обеспечения или координации действий других программ. А решения даются так, что их легко можно взять за основу и экстраполировать на другие схожие задачи.Цель этой книги — продемонстрировать практические приемы программирования сценариев на bash и познакомить с самыми распространенными утилитами на коротких и компактных примерах, не вдаваясь в излишние подробности. Экспериментируйте с этими сценариями — ломайте, исправляйте и приспосабливайте их под свои нужды, чтобы понять, как они работают. Только так вы сможете решать самые сложные задачи.

Что исчезло во втором издании

В этой книге описываются типичные сложности, с которыми можно столкнуться при попытке написать переносимое автоматизированное решение, например, для сборки программного обеспечения или координации действий других программ, и способы их преодоления. Решения в книге подаются так, чтобы вы могли взять их за основу и экстраполировать на другие схожие задачи. Например, в главе 1 мы напишем переносимую версию программы echo в виде небольшого сценария-обертки. Многим системным администраторам может пригодиться этот конкретный сценарий, но основная идея заключается в том, чтобы создать сценарий-обертку, гарантирующий единообразие поведения на разных платформах. Далее в книге мы разберем некоторые интересные особенности сценариев на языке bash и типичные утилиты, доступные в системах Unix и дающие нам самые широкие возможности.

Эта книга для вас, если...

Bash остается основным инструментом для всех, кто работает с серверами или рабочими станциями, действующими под управлением Unix-подобных операционных систем, в том числе и для веб-разработчиков (многие из которых ведут разработку в OS X и развертывают свои приложения на серверах под Linux), аналитиков, разработчиков мобильных приложений и программистов. Кроме того, все больше появляется энтузиастов, запускающих Linux на своих микрокомпьютерах с открытой архитектурой, таких как Raspberry Pi, для автоматизации бытовых приборов. Сценарии командной оболочки отлично походят для всех этих случаев.

Представленные в книге сценарии будут, безусловно, полезны и тем, кто желает расширить и без того немалый опыт владения bash за счет изучения практических примеров, и тем, кто пользуется терминалом или сценариями командной оболочки лишь изредка. Если вы принадлежите ко второму лагерю, вам, вероятно, потребуется освежить знания или дополнить их, прочитав введение в продвинутые возможности bash.

Эта книга — не учебник! Наша цель — продемонстрировать практические приемы программирования сценариев на bash и познакомить с распространенными утилитами на (в большинстве) коротких и компактных примерах, но мы не описываем их строку за строкой. Мы объясняем только самые основные части, а опытные создатели сценариев смогут сами понять, как действует остальной код, прочитав его. Мы надеемся, что вы, уважаемый читатель, будете экспериментировать с этими сценариями — ломать их, исправлять и приспосабливать под свои нужды — чтобы понять, как они работают. Главная наша цель — показать, как решать типичные задачи, такие как управление сетью или синхронизация файлов, которые встают перед любым техническим специалистом.

Структура книги

Это второе издание включает дополненные оригинальные 12 глав и 3 новые главы. Каждая глава демонстрирует новые особенности или варианты использования сценариев командной оболочки, и вместе они охватывают всю широту возможностей сценариев для более простой работы в Unix. Большинство сценариев, представленных в книге, будет работать и в Linux, и в OS X. В иных случаях мы напишем об этом прямо.

Глава 0: Краткое введение в сценарии командной оболочки

Это совершенно новая глава, появившаяся во втором издании, которая послужит начинающим пользователям Unix кратким введением в синтаксис языка командной оболочки bash и особенности его использования. Эта глава быстро и без лирических отступлений расскажет все, что потребуется для успешного чтения главы 1: от простого определения сценариев командной оболочки до создания и выполнения незамысловатых примеров.

Глава 1: Отсутствующая библиотека

Языки программирования, широко используемые в окружении Unix, такие как C, Perl и Python, имеют обширные библиотеки разнообразных функций и утилит для проверки форматов чисел, вычисления интервалов времени между датами и решения многих других задач. Но, работая с командной оболочкой, мы почти со всем вынуждены справляться самостоятельно, поэтому в данной главе рассказывается об инструментах и приемах, которые сделают сценарии командной оболочки более дружественными. Все, что вы узнаете в первой главе, поможет вам читать сценарии, с которыми вы встретитесь в этой книге, и писать свои. Мы включили сюда разные функции проверки ввода, простой и мощный интерфейс к bc, инструмент быстрого добавления запятых для улучшения читаемости больших чисел, прием для разновидностей Unix, в которых команда echo не поддерживает полезный флаг -n, и сценарий для использования ANSI-последовательностей определения цвета в сценариях.

Главы 2 и 3: Усовершенствование пользовательских команд и Создание утилит

Эти две главы представляют новые команды, дополняющие и расширяющие стандартный инструментарий Unix. В конце концов, постоянное развитие и совершенствование — одна из отличительных черт Unix. Мы также причастны к этому процессу и в главах 2 и 3 предлагаем сценарии, которые реализуют: дружественный интерактивный калькулятор, инструмент удаления файлов, не стирающий их с диска, две системы напоминаний и слежения за событиями, усовершенствованную версию команды locate, команду date с поддержкой нескольких часовых поясов и новую версию команды ls, добавляющую в списки содержимого каталогов дополнительные данные.

Глава 4: Тонкая настройка Unix

Может прозвучать как ересь, но некоторые аспекты Unix выглядят недоработанными даже спустя десятилетия развития. Если вам доведется пользоваться разными версиями Unix, например переходить со свободно распространяемых дистрибутивов Linux на коммерческие версии Unix, такие как OS X, Solaris или Red Hat, вы столкнетесь с отсутствующими флагами и командами, с противоречивым поведением некоторых команд и другими подобными проблемами. Поэтому в данной главе будут представлены переделанные версии и интерфейсы к командам Unix, которые делают их чуть более дружественными или более согласованными с другими разновидностями Unix. Среди всего прочего здесь описывается способ добавления длинных флагов в стиле GNU в команды, не являющиеся командами GNU. Здесь же вы найдете пару интеллектуальных сценариев, упрощающих работу с разными утилитами сжатия файлов.

Главы 5 и 6: Системное администрирование: управление пользователями и обслуживание системы

Если вас заинтересовала наша книга, вполне вероятно, что у вас есть привилегии администратора и вы несете ответственность за администрирование одной или нескольких систем Unix, даже если речь идет всего лишь о персональном компьютере с Ubuntu или BSD. Эти две главы содержат несколько сценариев, которые помогут вам в администрировании, в том числе: утилиты для анализа использования дискового пространства, система дисковых квот, которая автоматически извещает пользователей по электронной почте о превышении выделенного им места на диске, улучшенная реализация команды killall, сценарий проверки crontab, инструмент ротации файлов журналов и пара утилит для создания резервных копий.

Глава 7: Пользователи Интернета

Эта глава включает пакет по-настоящему интересных сценариев командной оболочки, демонстрирующих некоторые замечательные и простые приемы использования командной строки Unix для работы с ресурсами в Интернете. В том числе: инструмент для извлечения адресов URL из любой веб-страницы, инструмент для получения прогноза погоды, инструмент поиска в базах данных видеофильмов и инструмент для обнаружения изменений на веб-сайте, который автоматически сообщает о них по электронной почте.

Глава 8: Инструменты веб-мастера

Если вы веб-мастер и поддерживаете веб-сайт, действующий в вашей собственной системе Unix или на удаленном сервере где-то в сети, в этой главе вы найдете очень интересные инструменты для конструирования веб-страниц на лету, создания веб-альбомов с фотографиями и даже журналирования результатов веб-поиска.

Главы 9 и 10: Администрирование веб-сервера и Администрирование интернет-сервера

Эти две главы описывают решение проблем, с которыми часто сталкиваются администраторы серверов, имеющих выход в Интернет. Здесь вы найдете два сценария, анализирующие разные аспекты журналирования трафика веб-сервера, инструменты для выявления недействительных внутренних или внешних ссылок, имеющихся на веб-сайте, а также удобный инструмент управления паролями на веб-сервере Apache, упрощающий поддержку файлов .htaccess. Помимо этого исследуются приемы зеркалирования каталогов и целых веб-сайтов.

Глава 11: Сценарии для OS X

OS X, с ее коммерчески успешным и привлекательным графическим интерфейсом, стала огромным шагом вперед в превращении Unix в дружественную операционную систему. Что еще более важно, OS X — это полноценная операционная система Unix, скрытая за симпатичным интерфейсом, а значит, для нее можно написать много полезных и поучительных сценариев. Именно об этом рассказывается в данной главе. В дополнение к инструменту для автоматизации захвата изображения на экране, в этой главе представлены сценарии, помогающие исследовать структуру библиотеки музыкальных произведений iTunes, изменять заголовки окон программы Terminal и усовершенствовать команду open.

Глава 12: Сценарии для игр и забав

Что это за книга о программировании, если в ней не будет хотя бы пары игрушек? Глава 12 объединяет многие идеи и приемы, представленные ранее, и описывает создание шести забавных и довольно сложных игр. Хотя глава написана, чтобы вас развлечь, код каждой игры весьма поучителен. Особенно примечательна игра «Виселица», демонстрирующая некоторые хитрости и необычные приемы программирования сценариев.

Глава 13: Работа в облаке

С момента выхода первого издания этой книги Интернет занимал все больше и больше места в нашей повседневной жизни. Особенно важна для нас тема синхронизации устройств и файлов с облачными службами, такими как iCloud, Dropbox и Google Drive. В главе демонстрируются сценарии командной оболочки, позволяющие в полной мере использовать эти службы и гарантировать своевременную синхронизацию и копирование файлов и каталогов. Кроме того, здесь вы найдете пару сценариев, использующих особенности OS X для работы с фотографиями и озвучивания текста.

Глава 14: ImageMagick и обработка графических файлов

Приложения командной строки могут обрабатывать не только текстовые данные, но и графику. Эта глава посвящена идентификации и обработке изображений из командной строки с использованием комплекта инструментов для работы с графикой, включая открытое программное обеспечение ImageMagick. Сценарии в этой главе реализуют типичные операции с изображениями, от определения их типов до кадрирования и добавления водяных знаков, плюс еще несколько случаев использования.

Глава 15: Дни и даты

Заключительная глава демонстрирует приемы, упрощающие операции с датами и временем: сколько дней разделяют две даты, на какой день недели приходится число или сколько дней осталось до него. Мы решим эти задачи с помощью простых в использовании сценариев командной оболочки.

Приложение A: Установка Bash в Windows 10

Пока мы работали над вторым изданием, компания Microsoft существенно изменила свое отношение к открытому программному обеспечению и в 2016 году даже выпустила полноценную систему bash для Windows 10. Несмотря на то что примеры из книги не тестировались в этой версии bash, многие идеи и решения будет нетрудно перенести в нее. В приложении мы опишем установку bash в Windows 10, чтобы вы могли попробовать свои силы в создании сценариев на компьютере с Windows!

Приложение Б: Дополнительные сценарии

Любой хороший скаут знает, что всегда должен быть запасной план! Работая над этой книгой, мы создавали запасные сценарии на случай, если нам понадобится заменить какой-нибудь из основных. В итоге резервные сценарии нам не потребовались, но с нашей стороны было бы некрасиво держать их в секрете от вас, наших друзей. Это приложение включает три дополнительных сценария: для массового переименования файлов, для массового выполнения команд и для вычисления фаз луны, — которые мы не могли утаить после того, как показали вам 101 сценарий.

Об авторах

Дейв Тейлор (Dave Taylor) работает в компьютерной индустрии с 1980 года. Участвовал в создании BSD 4.4 UNIX, его программы включены во все основные дистрибутивы UNIX. Выдающийся оратор и автор тысяч статей для журналов и газет. Написал более 20 книг, включая «Learning Unix for OS X» (O’Reilly Media), «Solaris 9 for Dummies» (Wiley Publishing) и «Sams Teach Yourself Unix in 24 Hours» (Sams Publishing). Популярный колумнист журнала «Linux Journal» и основатель веб-сайта askdavetaylor.com, где осуществляет техническую поддержку пользователей и выкладывает обзоры новых гаджетов.

Брендон Перри (Brandon Perry) начал писать приложения на C# с выходом открытой реализации .NET — Mono. В свободное время любит писать модули для фреймворка Metasploit, исследовать двоичные файлы и тестировать всякие штуки.

О научном рецензенте

Джорди Гутьеррес Эрмосо (Jordi Guti'errez Hermoso) — программист, математик и вольный хакер. Начиная с 2002 года пользуется исключительно Debian GNU/Linux не только дома, но и на работе. Джорди участвует в разработке GNU Octave, бесплатной вычислительной среды, во многом совместимой с Matlab, а также Mercurial, распределенной системы управления версиями. Увлекается чистой и прикладной математикой, катанием на коньках, плаванием и вязанием. В последнее время много думает о проблемах выброса парниковых газов и участвует в акциях по сохранению носорогов.

» Более подробно с книгой можно ознакомиться на сайте издательства

» Оглавление

» Отрывок

Для Хаброжителей скидка 25% по купону — Shell Scripts

|

Метки: author ph_piter разработка под os x разработка под linux профессиональная литература блог компании издательский дом «питер» книги |

[Перевод] Табы, пробелы и ваша зарплата — какая связь? |

|

Метки: author AloneCoder открытые данные математика визуализация данных open source блог компании mail.ru group пробелы табуляция никто не читает теги |

Как соответствовать ФЗ-152 «О персональных данных» c «Битрикс24» и «1С-Битрикс» |

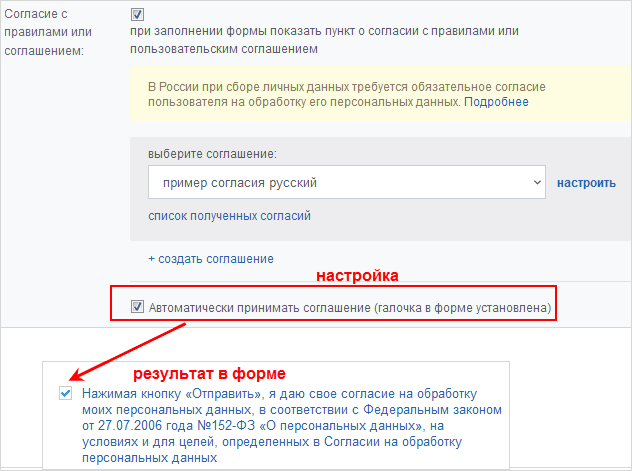

Мы подготовили универсальное «Согласие на обработку персональных данных» для и разместили его в CRM-формах и Открытых линиях.

В CRM-формах

Что нужно сделать:

- Заполнить реквизиты своей компании в настройках CRM. Также это можно будет сделать при настройке согласия в CRM-форме.

- Указать e-mail, на который клиенты смогут отправлять запросы на удаление персональной информации. Согласно закону, на такие запросы необходимо отреагировать. Сейчас указан только пример e-mail адреса, можно оставить его или сменить в настройках формы.

- Проверить в настройках активных форм, что согласие подключено и корректно отображается для клиента.

Что вы получите:

- Два варианта подтверждения:

- под формой стоит галочка — соответствует согласию «Нажимая кнопку «Отправить», я даю свое согласие...»

- под формой нет галочки — ее нужно будет поставить перед отправкой заполненной формы.

- под формой стоит галочка — соответствует согласию «Нажимая кнопку «Отправить», я даю свое согласие...»

- Поля CRM-формы будут автоматически включены в текст согласия как относящиеся к персональным данным, даже если это просто комментарий.

- В настройках формы по умолчанию есть галочка на согласие передачи персональных данных третьим лицам. Там можно указать эти лица (например, ООО «Почта России» или курьерская служба) — их тоже включат в текст согласия.

- Можно выбрать или добавить собственные варианты использования и сроков хранения персональных данных.

- В текст согласия также включается указанный e-mail для удаления данных. Если на портале меньше 20 пользователей, то автоматически будет проставлен e-mail администратора портала.

В итоге согласие будет выглядеть так:

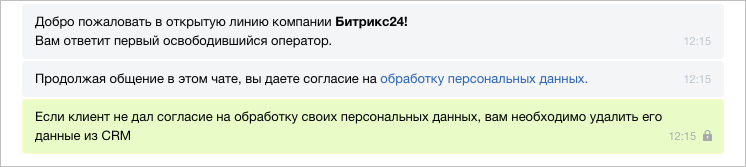

В Открытых линиях

Сначала в настройках открытой линии нужно включить отправку предупреждения о сборе персональных данных.

Когда начнётся разговор с клиентом, появится сразу два сообщения, предупреждающих о необходимости согласия на обработку персональных данных.

Если человек продолжит писать в открытую линию, то это будет считаться согласием. А если промолчит или прямо ответит, что не согласен, то его данные нужно удалить.

|

Метки: author 1cbitrix управление проектами управление e-commerce законодательство и it-бизнес блог компании 1с-битрикс битрикс24 фз-152 персональные данные |

Скорочтение: работает или нет? Часть 3: простые советы |

|

Метки: author itmo gtd блог компании университет итмо университет итмо скорочтение |

[Из песочницы] Тестирование или парсинг сайтов с динамическим дом и многое другое. Nightmare.js — ему все равно |

В двух словах:

1. Пакет можно использовать для тестирования сайтов.

2. Пакет можно использовать для парсинга данных.

3. Пакет можно использовать для автоматизации ввода данных на сайты.

Альтернативы:

Casper.js, phantom.js, watir и много кто еще, в гугле полно всех и вся. Почему я за nightmare.js:

- Простота использования.

- Полная поддержка html5, никаких конфликтов с сайтами.

- Расширяемый через экшены.

Структура библиотеки

Nightmare класс использует фреймворк electron, для каждой страницы создавая объект (BrowserWindow) который запускает браузер оболочку Chromium.

Принцип работы

- Nightmare инициализирует новое приложение electron с стартовой страницей, которую необходимо подвергнуть дальнейшей обработке.

- Перед загрузкой исследуемой страницы загружаются скрипты, которые позволяют поддерживать двустороннее взаимодействие программиста и страницы через серию эмиттеров.

- Nightmare предоставляет программисту набор апи (цепочки действий), позволяющие произвести любые манипуляции с сайтом и получить требуемые данные.

Плюсы

- Код на стороне клиента и сайта написан на одном языке, никаких шаблонизаторов не требуется.

- Возможность расширять модулями через создание экшенов. Экшен может создаваться на уровне класса nightmare или на уровне класса nightmare и уровне electron (что в свою очередь дает возможность использовать devapi Chromium). В npm уже достаточно готовых модулей расширений, которые можно подключать к себе в проект (например realMouse полностью эмулирующую наведение мыши или работа с ифреймами, что блокируется безопасностью браузера).

- Все команды являются цепочками, каждая из которых возвращает промис, это позволяет писать код как в стиле промисов, так и внутри асинк функций или генераторов.

- Относительно небольшая нагрузка на процессор и память, нужно помнить, что сравнивать такой инструмент с простыми гет и пост запросами не этично, по скорости и памяти браузерные парсеры проигрывают без вариантов).

- Работа nightmare возможна в двух режимах, режим отображения браузера и режим фонового процесса.

- Поддерживает прокси. Установка юзерагента, выставление расширения браузера.

- Можно включать или отключать отображение изображений, поддержку webGL и еще кучу всего.

- Можно создавать прелоад скрипты, что позволяет добавлять на страницу до загрузки свои функции, библиотеки. Как частный пример можно переписать функцию addEventListener сделав ее декоратором для реальной + инжектировать аналитические функции для проверки того. Что в действительности делает сайт, когда вы на нем находитесь или бороться с навязчивостью фингер принт, который столь сильно полюбили все кому не лень, забывая о вашей «анонимности».

От эмоций к делу

Классический пример использования модуля из документации:

var Nightmare = require('nightmare');

var nightmare = Nightmare({ show: true });

nightmare

.goto('https://duckduckgo.com')

.type('#search_form_input_homepage', 'github nightmare')

.click('#search_button_homepage')

.wait('#zero_click_wrapper .c-info__title a')

.evaluate(function () {

return document.querySelector('#zero_click_wrapper .c-info__title a').href;

})

.end()

.then(function (result) {

console.log(result);

})

.catch(function (error) {

console.error('Search failed:', error);

});

В двух словах о происходящем

Подключение библиотеки, создание объекта с режимом видимого браузера. Заход на страницу, поиск элемента по ЦСС селектору, ввод текста, нажатие кнопки, ожидание появления нового цсс сетектора, выполнение функции на стороне бразуера и возвращение ее, после завершения цепочки заданий в then будет передан результат работы или сработает исключение. На мой взгляд все просто и удобно, но как только скрипт обхода страницы становится большим, такое описание команд становится неудобным, потому предлагаю хороший вариант использования в асинк функции:

const Nightmare = require('nightmare');

(async ()=>{

let nightmare;

try {

nightmare = Nightmare({ show: true });

await nightmare

.goto('https://duckduckgo.com')

.type('#search_form_input_homepage', 'github nightmare')

.click('#search_button_homepage')

.wait('#zero_click_wrapper .c-info__title a');

let siteData = await nightmare.evaluate(function () {

return document.querySelector('#zero_click_wrapper .c-info__title a').href;

});

// последующая работа с данными

} catch (error) {

console.error(error);

throw error;

} finally {

await nightmare.end();

}

})();В чем преимущества такого варианта написания кода? Можно получать сколько угодно раз данные с сайта через evaluate, анализировать их и применять различные поведенческие сценарии, описывая это в вашем скрипте.

Можно последовательно переходить по страницам через await nightmare.goto(….), при том Nightmare будет дожидаться загрузки дом.

О задокументированных возможностях

Описывать все функции в примерах считаю бессмысленным, так как все это хорошо указано в документации. Скажу лишь то, что модуль умеет считывать любые данные, делать скриншоты, сохранять html страницы, pdf страницы, передавать на сайт данные. Через доп модули доступна загрузка файлов на сервер через form input type=”file”. Умеет реагировать на alert, prompt, confirm, может транслировать в виде событий данные из консоли.

Какие особенности стоит учитывать при работе с nightmare

Нужно понимать, что каждое действие будет либо совершено либо произойдет выброс исключительной ситуации, а потому в местах, где нет уверенности, что код пройдет 100% нужно обертывать запросы в try catch и обрабатывать из соответственно. Как пример wait(selector) данная инструкция даст команду приостановить выполнение скрипта до появления html элемента с соответствующим цсс селектором, но в модуле есть дефолтный таймаут, его можно изменять опционально, при наступлении которого будет выброшено исключение, соответственно можно будет обработать почему на странице нет чего-либо и как-то на это среагировать.

Резюме

На мой взгляд nightmare.js очень серьезная библиотека, с хорошим функционалом. Простая в изучении, гибкая, позволяющая выполнять практически любые задачи в тестировании сайтов и их анализе. К строгим критикаам отношусь с пониманием, кому будет интересна тема, по комментариям соберу идеи для следующий статей.

Ссылки

-> Nigthmare.js

-> Electron

Спасибо за внимание!

|

Метки: author vshvydky javascript javascript library nightmare.js парсинг scraping site test |

[Перевод] Как HBO делала приложение Not Hotdog для сериала «Кремниевая долина» |

|

|

Использование Python и Excel для обработки и анализа данных. Часть 1: импорт данных и настройка среды |

В какой-то момент вы неизбежно столкнетесь с необходимостью работы с данными Excel, и нет гарантии, что работа с таким форматами хранения данных доставит вам удовольствие. Поэтому разработчики Python реализовали удобный способ читать, редактировать и производить иные манипуляции не только с файлами Excel, но и с файлами других типов.

Отправная точка — наличие данных

Когда вы начинаете проект по анализу данных, вы часто сталкиваетесь со статистикой собранной, возможно, при помощи счетчиков, возможно, при помощи выгрузок данных из систем типа Kaggle, Quandl и т. д. Но большая часть данных все-таки находится в Google или репозиториях, которыми поделились другие пользователи. Эти данные могут быть в формате Excel или в файле с .csv расширением.

Данные есть, данных много. Анализируй — не хочу. С чего начать? Первый шаг в анализе данных — их верификация. Иными словами — необходимо убедиться в качестве входящих данных.

В случае, если данные хранятся в таблице, необходимо не только подтвердить качество данных (нужно быть уверенным, что данные таблицы ответят на поставленный для исследования вопрос), но и оценить, можно ли доверять этим данным.

Проверка качества таблицы

Чтобы проверить качество таблицы, обычно используют простой чек-лист. Отвечают ли данные в таблице следующим условиям:

- данные являются статистикой;

- различные типы данных: время, вычисления, результат;

- данные полные и консистентные: структура данных в таблице — систематическая, а присутствующие формулы — работающие.

Ответы на эти простые вопросы позволят понять, не противоречит ли ваша таблица стандарту. Конечно, приведенный чек-лист не является исчерпывающим: существует много правил, на соответствие которым вы можете проверять данные в таблице, чтобы убедиться, что таблица не является “гадким утенком”. Однако, приведенный выше чек-лист наиболее актуален, если вы хотите убедиться, что таблица содержит качественные данные.

Бест-практикс табличных данных

Читать данные таблицы при помощи Python — это хорошо. Но данные хочется еще и редактировать. Причем редактирование данных в таблице, должно соответствовать следующим условиям:

- первая строка таблицы зарезервирована для заголовка, а первый столбец используется для идентификации единицы выборки;

- избегайте имен, значений или полей с пробелами. В противном случае, каждое слово будет интерпретироваться как отдельная переменная, что приведет к ошибкам, связанным с количеством элементов в строке в наборе данных. Лучше использовать подчеркивания, регистр (первая буква каждого раздела текста — заглавная) или соединительные слова;

- отдавайте предпочтение коротким названиям;

- старайтесь избегать использования названий, которые содержат символы ?, $,%, ^, &, *, (,),-,#, ?,,,<,>, /, |, \, [ ,] ,{, и };

- удаляйте любые комментарии, которые вы сделали в файле, чтобы избежать дополнительных столбцов или полей со значением NA;

- убедитесь, что любые недостающие значения в наборе данных отображаются как NA.

После внесения необходимых изменений (или когда вы внимательно просмотрите свои данные), убедитесь, что внесенные изменения сохранены. Это важно, потому что позволит еще раз взглянуть на данные, при необходимости отредактировать, дополнить или внести изменения, сохраняя формулы, которые, возможно, использовались для расчета.

Если вы работаете с Microsoft Excel, вы наверняка знаете, что есть большое количество вариантов сохранения файла помимо используемых по умолчанию расширения: .xls или .xlsx (переходим на вкладку “файл”, “сохранить как” и выбираем другое расширение (наиболее часто используемые расширения для сохранения данных с целью анализа — .CSV и.ТХТ)). В зависимости от варианта сохранения поля данных будут разделены знаками табуляции или запятыми, которые составляют поле “разделитель”. Итак, данные проверены и сохранены. Начинаем готовить рабочее пространство.

Подготовка рабочего пространства

Подготовка рабочего пространства — одна из первых вещей, которую надо сделать, чтобы быть уверенным в качественном результате анализа.

Первый шаг — проверка рабочей директории.

Когда вы работаете в терминале, вы можете сначала перейти к директории, в которой находится ваш файл, а затем запустить Python. В таком случае необходимо убедиться, что файл находится в директории, из которой вы хотите работать.

Для проверки дайте следующие команды:

# Import `os`

import os

# Retrieve current working directory (`cwd`)

cwd = os.getcwd()

cwd

# Change directory

os.chdir("/path/to/your/folder")

# List all files and directories in current directory

os.listdir('.')

Эти команды важны не только для загрузки данных, но и для дальнейшего анализа. Итак, вы прошли все проверки, вы сохранили данные и подготовили рабочее пространство. Уже можно начать чтение данных в Python? :) К сожалению пока нет. Нужно сделать еще одну последнюю вещь.

Установка пакетов для чтения и записи Excel файлов

Несмотря на то, что вы еще не знаете, какие библиотеки будут нужны для импорта данных, нужно убедиться, что у все готово для установки этих библиотек. Если у вас установлен Python 2> = 2.7.9 или Python 3> = 3.4, нет повода для беспокойства — обычно, в этих версиях уже все подготовлено. Поэтому просто убедитесь, что вы обновились до последней версии :)

Для этого запустите в своем компьютере следующую команду:

# For Linux/OS X

pip install -U pip setuptools

# For Windows

python -m pip install -U pip setuptools

В случае, если вы еще не установили pip, запустите скрипт python get-pip.py, который вы можете найти здесь (там же есть инструкции по установке и help).

Установка Anaconda

Установка дистрибутива Anaconda Python — альтернативный вариант, если вы используете Python для анализа данных. Это простой и быстрый способ начать работу с анализом данных — ведь отдельно устанавливать пакеты, необходимые для data science не придется.

Это особенно удобно для новичков, однако даже опытные разработчики часто идут этим путем, ведь Anakonda — удобный способ быстро протестировать некоторые вещи без необходимости устанавливать каждый пакет отдельно.

Anaconda включает в себя 100 наиболее популярных библиотек Python, R и Scala для анализа данных в нескольких средах разработки с открытым исходным кодом, таких как Jupyter и Spyder. Если вы хотите начать работу с Jupyter Notebook, то вам сюда .

Чтобы установить Anaconda — вам сюда .

Загрузка файлов Excel как Pandas DataFrame

Ну что ж, мы сделали все, чтобы настроить среду! Теперь самое время начать импорт файлов.

Один из способов, которым вы будете часто пользоваться для импорта файлов с целью анализа данных — импорт с помощью библиотеки Pandas (Pandas — программная библиотека на языке Python для обработки и анализа данных). Работа Pandas с данными происходит поверх библиотеки NumPy, являющейся инструментом более низкого уровня. Pandas — мощная и гибкая библиотека и она очень часто используется для структуризации данных в целях облегчения анализа.

Если у вас уже есть Pandas в Anaconda, вы можете просто загрузить файлы в Pandas DataFrames с помощью pd.Excelfile ():

# Import pandas

import pandas as pd

# Assign spreadsheet filename to `file`

file = 'example.xlsx'

# Load spreadsheet

xl = pd.ExcelFile(file)

# Print the sheet names

print(xl.sheet_names)

# Load a sheet into a DataFrame by name: df1

df1 = xl.parse('Sheet1')

Если вы не установили Anaconda, просто запустите pip install pandas, чтобы установить пакет Pandas в вашей среде, а затем выполните команды, приведенные выше.

Для чтения .csv-файлов есть аналогичная функция загрузки данных в DataFrame: read_csv (). Вот пример того, как вы можете использовать эту функцию:

# Import pandas

import pandas as pd

# Load csv

df = pd.read_csv(«example.csv»)

Разделителем, который эта функция будет учитывать, является по умолчанию запятая, но вы можете, если хотите, указать альтернативный разделитель. Перейдите к документации, если хотите узнать, какие другие аргументы можно указать, чтобы произвести импорт.

Как записывать Pandas DataFrame в Excel файл

Предположим, после анализа данных вы хотите записать данные в новый файл. Существует способ записать данные Pandas DataFrames (с помощью функции to_excel ). Но, прежде чем использовать эту функцию, убедитесь, что у вас установлен XlsxWriter, если вы хотите записать свои данные на несколько листов в файле .xlsx:

# Install `XlsxWriter`

pip install XlsxWriter

# Specify a writer

writer = pd.ExcelWriter('example.xlsx', engine='xlsxwriter')

# Write your DataFrame to a file

yourData.to_excel(writer, 'Sheet1')

# Save the result

writer.save()

Обратите внимание, что в фрагменте кода используется объект ExcelWriter для вывода DataFrame. Иными словами, вы передаете переменную writer в функцию to_excel (), и указываете имя листа. Таким образом, вы добавляете лист с данными в существующую книгу. Также можно использовать ExcelWriter для сохранения нескольких разных DataFrames в одной книге.

То есть если вы просто хотите сохранить один файл DataFrame в файл, вы можете обойтись без установки библиотеки XlsxWriter. Просто не указываете аргумент, который передается функции pd.ExcelWriter (), остальные шаги остаются неизменными.

Подобно функциям, которые используются для чтения в .csv-файлах, есть также функция to_csv () для записи результатов обратно в файл с разделителями-запятыми. Он работает так же, как когда мы использовали ее для чтения в файле:

# Write the DataFrame to csv

df.to_csv(«example.csv»)

Если вы хотите иметь отдельный файл с вкладкой, вы можете передать a \ t аргументу sep. Обратите внимание, что существуют различные другие функции, которые можно использовать для вывода файлов. Их можно найти здесь.

Использование виртуальной среды

Общий совет по установке библиотек — делать установку в виртуальной среде Python без системных библиотек. Вы можете использовать virtualenv для создания изолированных сред Python: он создает папку, содержащую все необходимое для использования библиотек, которые потребуются для Python.

Чтобы начать работу с virtualenv, сначала нужно его установить. Потом перейти в директорию, где будет находится проект. Создать virtualenv в этой папке и загрузить, если нужно, в определенную версию Python. После этого активируете виртуальную среду. Теперь можно начинать загрузку других библиотек и начинать работать с ними.

Не забудьте отключить среду, когда вы закончите!

# Install virtualenv

$ pip install virtualenv

# Go to the folder of your project

$ cd my_folder

# Create a virtual environment `venv`

$ virtualenv venv

# Indicate the Python interpreter to use for `venv`

$ virtualenv -p /usr/bin/python2.7 venv

# Activate `venv`

$ source venv/bin/activate

# Deactivate `venv`

$ deactivate

Обратите внимание, что виртуальная среда может показаться сначала проблематичной, если вы делаете первые шаги в области анализа данных с помощью Python. И особенно, если у вас только один проект, вы можете не понимать, зачем вообще нужна виртуальная среда.

Но что делать, если у вас несколько проектов, работающих одновременно, и вы не хотите, чтобы они использовали одну и ту же установку Python? Или если у ваших проектов есть противоречивые требования. В таких случаях виртуальная среда — идеальное решение.

Во второй части статьи мы расскажем об основных библиотеках для анализа данных.

Продолжение следует…

|

Метки: author Dmitry21 разработка веб-сайтов python блог компании отус otus.ru otus обучение образование программирование |

Как организовать Performance Review в IT-компании: опыт Badoo |

Привет, Хабр! Меня зовут Алексей Рыбак, я – глава разработки в Badoo. В феврале в нашем московском офисе Badoo проходил Techleads-митап, где я рассказывал про наш процесс Performance Review. Эта статья написана по мотивам моего выступления.

Performance review – тема крайне спорная. В России до сих пор распространено мнение, что никакие KPI, “измерения”, performance review – в программистских компаниях не только не работают, но и вовсе вредны. Эта категоричность меня всегда удивляла, но окончательное решение осветить эту тему подробно созрело у меня после прочтения статьи аж на самом РБК.

В статье описывается отрицательный опыт компании ABBYY и делается достаточно распространенный вывод о том, что программистов лучше не измерять, а нужно просто дать им интересную работу и оставить в покое. И, дескать, всё будет замечательно. И ведь ABBYY – далеко не единственная компания, опыт которой приводится в качестве аргумента, есть и куда более известная история про Microsoft.

Бесспорную ценность этих отрицательных примеров для объективности стоить дополнить примерами других компаний: Google, Facebook и многих других, – в которых Performance Review как раз успешно работает. Это лишь иллюстрирует, что можно внедрить процесс ревью как успешно, так и неуспешно. Поэтому основной целью этой статьи является рассказать об одном из подходов, который приводит к работающему ревью. В Badoo этот подход работает уже почти семь лет, и, пользуясь случаем, я хочу выразить большую благодарность Жене Соколову (ex-Google, ex-Badoo), который нас этим подходом “заразил”.

В этом посте я:

- расскажу о том, зачем нужно review с точки зрения инжиниринг-менеджера;

- вкратце опишу, как этот процесс происходит в Badoo;

- сформулирую вопросы, на которые стоит ответить, чтобы понять, необходим вашей компании этот инструмент или нет;

- и с удовольствием отвечу на ваши вопросы в комментариях.

Ревью и ценности компании

Performance review, если очень кратко, – это один из системных методов повышения эффективности организации. Механически, максимально упрощая, ревью представляет собой ретроспективный процесс, позволяющий выявить “слабые” и “сильные” места в компании и подтянуть “слабые”. Каждый сотрудник рассказывает о своих результатах, получает “оценку” и комментарий, на какие проекты или личностные качества необходимо обратить внимание (иногда в форме общих рекомендаций, но лучше в виде конкретных верифицируемых целей).

Ценности Badoo

Однако прежде чем приступить к ревью, необходимо рассказать пару слов о Badoo и о наших ценностях. У каждой компании есть какие-то свойства – внешние или внутренние – которые нельзя или очень сложно изменить. Примерами таких “граничных условий” могут быть направление деятельности, как именно компания зарабатывает деньги, какие ценности превалируют в ее корпоративной культуре. В разных компаниях “быть эффективным” означает разное, поэтому обсуждение ревью в отрыве от ценностей практического смысла не имеет.

Badoo занимается разработкой dating-приложений и социальных сетей для знакомства с новыми людьми. Наши основные продукты находятся в нише “dating”, но мы также развиваем проекты в области social discovery – поиск поблизости людей по интересам. В некотором смысле Badoo представляет платформу, на базе которой делается много разных приложений. Внутри проекты могут быть очень сложные, но снаружи всё выглядит достаточно просто. Очень большое количество команд в мире одновременно делают примерно такие же проекты. Таким образом, на рынке, на котором мы работаем, нужно быть очень быстрым: очень быстро пилить фичи, тестировать их, если они не пошли – закрывать, если пошли – что-то подкручивать и снова повторять цикл экспериментов. Это определяет всю культуру нашей компании. И всю боль инженеров: им достаточно сложно найти баланс между этой скоростью и комфортной неспешной разработкой, когда везде, что называется, соломка постелена.

Когда в процессе тестирования проекта на аудитории начинаются меняться требования, то на уровне идеи кажется, что ничего особенно не поменялось: одни синтаксические предложения заменяются другими, однако на уровне дизайна изменения могут потребовать серьезной переработки интерфейсов, а уж на уровне программирования и вовсе дело может закончиться неделями работы. Именно поэтому инженеры болезненно воспринимают изменения в требованиях, и требуется особенное сопровождение этих изменений, чтобы у команд сохранялась высокая мотивация. Поскольку одна из составляющих мотивации инженера – авторская, и инженеру комфортнее работать на «долгоиграющих» проектах, испытывать гордость за то, что он делает годами, – ему бывает тяжело расставаться с какими-то классными штуками, которые нужно было сделать в достаточно короткий срок, но они не выстрелили.

Таким образом баланс между скоростью и инженерными ценностями определяет культуру компании. И мы стараемся всем сотрудникам регулярно объяснять свои ценности; человеку со стороны они могут показаться варварскими. Нельзя сказать, что они идеально подходят всем инженерам: это сильно зависит от характера.

На данном этапе наша система ценностей состоит из трёх составляющих.

Ценность 1: Delivery

Самое главное для нас – это delivery, доставка рабочего продукта до пользователей. В какой-то степени нам даже неважно, насколько он идеален в использовании во всех аудиториях. Мы стараемся максимально использовать всякие фичи-флаги для запуска в какой-то части кластера или в какой-то аудитории, что-то измерять в процессе. Если мы не понимаем, как фича должна работать на какой-то части аудитории, нам будет проще пустить её только на “понятной” нам части: вдруг она вообще окажется бесполезной.

Самое главное для нас – это delivery, доставка рабочего продукта до пользователей. В какой-то степени нам даже неважно, насколько он идеален в использовании во всех аудиториях. Мы стараемся максимально использовать всякие фичи-флаги для запуска в какой-то части кластера или в какой-то аудитории, что-то измерять в процессе. Если мы не понимаем, как фича должна работать на какой-то части аудитории, нам будет проще пустить её только на “понятной” нам части: вдруг она вообще окажется бесполезной.

Достаточно много времени тратится на проведение А/В-тестов, чтобы практически без участия программистов обкатывать разные идеи. Мы в первую очередь пишем софт в экспериментальном ключе: в этом преимущество разработчиков “неотчуждаемого” софта (строго говоря, небыстрый цикл публикации в магазинах мобильных приложений нашу скорость существенно ограничивает, но серверная разработка и веб/мобильный веб могут релизиться очень быстро, обычно мы релизимся строго два раза в день, за исключением дней перед выходными).

Ценность 2: Quality

На втором месте quality – качество. Один из наших подходов заключается в том, что quality и QA в целом – это часть организации, которая владеет процессами наравне с инженерами и программистами, и даже в большей степени, чем они. Таким образом, мы получаем сбалансированное распределение ролей, потому что программисты (особенно те, кто работают быстро) на какие-то вещи, которые их ограничивают, попросту забивают, и без баланса в виде QA – полностью независимого от разработки – мы рискуем получить продукт низкого качества. А это совсем не то, к чему мы стремимся.

На втором месте quality – качество. Один из наших подходов заключается в том, что quality и QA в целом – это часть организации, которая владеет процессами наравне с инженерами и программистами, и даже в большей степени, чем они. Таким образом, мы получаем сбалансированное распределение ролей, потому что программисты (особенно те, кто работают быстро) на какие-то вещи, которые их ограничивают, попросту забивают, и без баланса в виде QA – полностью независимого от разработки – мы рискуем получить продукт низкого качества. А это совсем не то, к чему мы стремимся.

Ценность 3: Retention

Наконец, как я сказал выше, нам очень важно, чтобы люди в компанию приходили и оставались в компании подольше. Эта ценность – retention, удержание. Порог вхождения у нас довольно высокий, и найти людей непросто.

Наконец, как я сказал выше, нам очень важно, чтобы люди в компанию приходили и оставались в компании подольше. Эта ценность – retention, удержание. Порог вхождения у нас довольно высокий, и найти людей непросто.

Когда компания маленькая, все друг друга знают, работают одной командой, празднуют дни рождения и другие праздники и даже обмениваются подарками, всё происходит естественным образом просто – ведь размер компании укладывается в привычные всем масштабы – семьи, группы друзей, класса или студенческой группы. Но когда она (компания) начинает расти, и количество сотрудников увеличивается, “привычные” методы мгновенно перестают работать, вместо найма пары человек в год нужно нанимать десятки. И ключевым параметром успеха (в первую очередь – в разработке) становится то, с какой скоростью вы можете расти, нанимать и удерживать людей. Поэтому вопрос найма и удержания квалифицированных и эффективных сотрудников для нас очень важен.

Кому и для чего нужно ревью?

Дайте теперь вернемся к Performance Review. Какие бы хорошие люди в компании ни работали, чем больше она становится, тем сильнее усложняется взаимодействие. Если представить любую компанию в виде модели, мы получим такую ветвистую структуру, когда из одной части в другую идёт много условных стрелочек. Чем больше компания, тем больше этих стрелочек и тем больше потерь на этих стрелочках – на взаимодействии, коммуникации.

Если у вас маленькая компания, вам достаточного одного человека – лидера, энтузиаста – который в состоянии всех обежать и «зажечь». Когда компания большая, очень важно иметь «прослойку» техлидов, желательно синхронизированных между собой, каждый из которых решает задачи в своей области. Если что-то в этой схеме не работает – нечеткие цели, слабые неактивные лиды, криво разделенные полномочия, провоцирующие вялое сотрудничество либо вовсе вражду и саботаж – производительность начинает проседать, а в особенно запущенных случаях компания попросту начинает “протухать”.

Так вот ревью – это процесс, позволяющий системно бороться с подобным “протуханием”. Ревью не является панацеей, но я смотрю на него как на один из способов обеспечить регулярную проверку производительности по всей компании. И сделать это ценой небольшого “налога” (бонусной системы).

Badoo уже больше десяти лет, и нам важно, чтобы люди у нас росли, оставаясь с нами надолго. Некоторые ребята работают здесь по девять–десять лет. Мы стремимся всегда держать руку на пульсе и быть в курсе ожиданий сотрудников, знать, что происходит в их жизни. Конечно, не всегда их ожидания совпадают с позицией руководителей, но, по крайней мере, мы гарантируем регулярное взаимодействие и предоставляем сотрудникам возможность расти внутри компании. Проецируя на общество в целом, можно сказать, что оно счастливо, если его лучшие представители имеют возможность возглавить общество и повести за собой. А отсутствие социальных лифтов для наиболее активных представителей общества может привести к тому, что эти люди будут в лучшем случае апатичны, а в худшем – склонны к революционным настроениям.

Но вернёмся к “ревью”. Это некий процесс, часть фреймворка, который показывает вам, где у вас что тупит. Ключевой вопрос здесь – наличие людей, которые оценивают других людей и не просто дают фидбэк, а получают детальную информацию об их проектах.

Среди прочего ревью актуализирует ожидания, о которых я говорил выше. Каждый раз после него происходит разговор между руководителями и членами их команд. Когда компания растёт быстро и менеджерами становятся бывшие айтишники, важно, чтобы люди понимали смысл этих регулярных разговоров, общения, регулярного выражения благодарности за проделанную работу, нельзя этот процесс пускать на самотёк. В первую очередь, это имеет большое значение как раз для удержания сотрудников в компании. Если где-то есть фреймворк, который всех к этому подталкивает, то число таких взаимодействий и число сказанных “спасибо” неуклонно растёт. И это число очень важно для компании.

К сожалению, в некоторых организациях ревью делается в отрыве от бонусной системы: чаще всего получается «для галочки». Это плохо и неэффективно – я убеждён, что оно обязательно должно приводить к каким-то поощрениям, люди должны участвовать в этом процессе, чтобы в итоге что-то получить.

Итак, ревью:

- регулярно показывает, что где “глохнет”;

- рассказывает об успехах (или неудачах);

- актуализирует долгосрочные и краткосрочные ожидания, учит “хорошему”;

- принуждает регулярно говорить “спасибо” и замечать недостатки;

- всё удовольствие за небольшой “налог”.

Ревью плохое и хорошее

Несколько слов о плохом ревью. Самое ужасное – когда оно слишком бюрократичное и сложное. «Оно бюрократично всегда», – скажете вы и будете правы. Но здесь, как и во всём, должна быть мера.

Ещё одно свойство плохого ревью – неактуальность. Например, когда премия выплачена за то, что было сделано давно, уже потерялся фокус, уже нет возможности качественно ни собрать информацию, ни получить фидбэк. В этом случае люди наверняка будут считать ревью несправедливым. Заметьте, что большой процент таких людей будет всегда – полностью удовлетворить всех не получится, поэтому очень важно прийти к консенсусу.

Наконец, плохое ревью не содержит явных ценностей, и нет никакого смысла в нём участвовать. Этих ценностей может быть много, но все-таки основная (что бы вы думали?) – деньги.

Каким должно быть хорошее ревью? Прежде всего – максимально простым; оно должно быть применимо абсолютно к любой ситуации. Кроме того, оно должно быть актуальным и желательно (если мы говорим о бонусной составляющей или о сборе обратной связи) максимально приближенным к тому, что подвергается анализу. А поскольку наши проекты существуют какое-то определённое время (пусть даже очень долго, условно месяц, две недели из которого мы что-то делали, ещё две – смотрели, как это живёт в проде, и в итоге решили, что нужно полностью менять или выкидывать), сдвигать по времени ревью в данном случае очень неправильно.

Таким образом, хорошее ревью

- просто;

- применимо к любой ситуации;

- быстро/актуально и регулярно;

- понятно;

- приятно ($).

Из чего состоит ревью

Я смотрю на ревью как на процесс вокруг какого-то фреймворка. Из чего он состоит? 3 части:

- peers – коллеги;

- сам процесс review;

- ladders – карьерные уровни; а также brackets – привязанные к ним зарплатные “вилки”.

Ревью – это сложный процесс, и за него должен кто-то отвечать. В идеале – эйчар-специалист, кто-то с административной функцией. Правильное ревью проходит в несколько этапов, и, поскольку, как мы выяснили, это всегда некая бюрократия, само по себе оно двигаться не будет – кто-то должен постоянно подталкивать людей, смотреть, что где осталось, и переводить систему из одного состояния в другое.

Сам по себе процесс состоит из выдачи оценок – грейдов (grades); это могут быть грейды за ревью-период (хорошо/не очень), или глобальные грейды относительно прогресса в профессиональном росте. Существуют разные подходы к формированию шкал грейдов, но в целом они все построены вокруг неких ожиданий.

Есть совсем простые формулы, есть улётные варианты с хитрыми KPI. Я придерживаюсь принципа простоты, поэтому считаю что лучше всего выстроить шкалу либо вокруг степеней “хорошо”, либо вокруг степеней “соответствия ожиданиям”. Например, сотрудник полностью соответствует ожиданиям, или с какими-то предложениями по улучшению, или не соответствует им, или наоборот превышает ожидания, или превышает ожидания настолько, что заслуживает продвижения (promotion) и так далее. Promotion – это долгосрочная часть фреймворка, которая позволяет двигать человека по карьерной лестнице.

Карьерная лестница в больших компаниях зачастую достаточно длинная, с кучей цифр: вице-президент №1, вице-президент №2 и так далее. Мы в Badoo практикуем более простую систему и, как многие софтверные компании, даём возможность инженерам двигаться как по карьерной лестнице менеджера, так и по карьерной лестнице инженера. И одна из самых важных составляющих документа, который это регламентирует, – работа с ожиданиями сотрудника. Если он хочет расти как эксперт, вот ему описание уровней по этой лестнице. Таким образом, у человека есть понимание, на какой ступени карьерной лестницы он находится. Это довольно скучная история, но в компаниях с большим количеством сотрудников без этого не обойтись.