Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

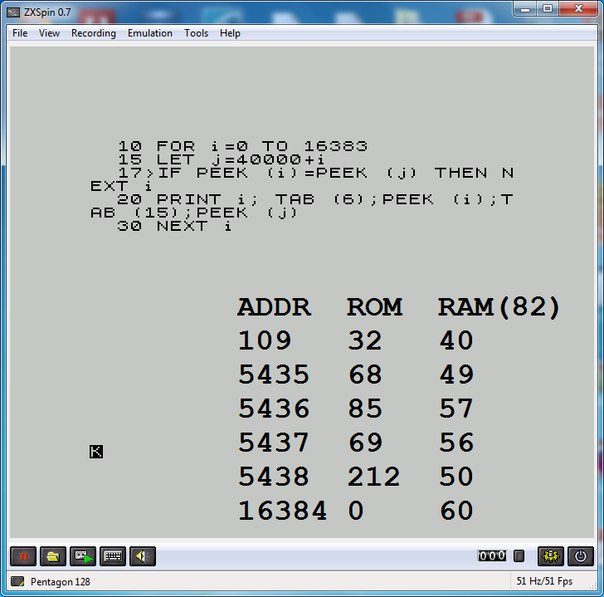

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Как переусложнить дверной замок |

|

Метки: author m1rko разработка для интернета вещей iot дверной замок raspberry pi |

Тринадцатый опрос Developer Economics |

Это 13-й опрос среди разработчиков, посвященный инструментам, обучению и профессиональному развитию. Каждый год более 40 000 разработчиков со всего мира принимают участие в исследовании Developer Economics, так что вам предлагается шанс стать частью большого события и внести свой вклад в сообщество разработчиков.

По результатам опроса формируется большой отчет, который доступен всем бесплатно. Заполнение анкеты займет у вас не больше 15 минут, а высказать свое мнение в определяющем индустриальном отчете очень важно – Россия один из ведущих IT-рынков в мире и надо подкрепить это цифрами и фактами. Кроме того, среди прошедших опрос разыгрываются интересные призы.

Опрос доступен по ссылке (в том числе и на русском): http://vmob.me/DE3Q17

|

Метки: author RoboForm разработка под ios разработка под android разработка мобильных приложений опрос разработка |

[Перевод] Вебинар: Как будут развиваться направленные кибер-атаки? |

Есть один момент, на который мы постоянно обращаем внимание: вредоносные программы непрерывно развиваются. И делают это быстро. Точнее говоря, развиваются сами по себе атаки, особенно направленные атаки.

Как было отмечено экспертами Verizon в своем отчете 2017 Data Breach Investigations Report, вредоносные программы использовались в 51% случаев, в результате которых происходила утечка данных (фигурирует в отчете как «подтвержденное раскрытие данных несанкционированному лицу»). Но на эти данные можно взглянуть с другой стороны: в почти половине случаев нарушений безопасности НЕ использовались вредоносные программы, а акцент ставился на усовершенствованные техники взлома.

Другими словами, традиционный антивирус оказывается бесполезным инструментом против таких атак, т.к. в них не участвуют вредоносные программы.

Возможно, следующие поколения направленных атак будут реже использовать вредоносные программы как таковые, а сами атаки станут более индивидуальными, адаптированными под конкретную жертву. Решения безопасности следующего поколения с опциями расширенной защиты от неизвестных угроз, использующие контекстный анализ, приобретут еще более высокую значимость в борьбе против таких атак.

Чтобы ознакомиться с полным анализом будущего направленных кибер-атак, мы предлагаем Вам запись вебинара, который недавно провел Технический директор антивирусной лаборатории PandaLabs Луис Корронс.*

*Вебинар на английском языке, также для удобства можно включить субтитры.

|

Метки: author PandaSecurityRus системное администрирование антивирусная защита блог компании panda security в россии pandalabs направленные атаки вебинар кибератаки |

Машинное обучение для страховой компании: Исследуем алгоритмы |

Цикл статей «Машинное обучение для страховой компании»

1. Реалистичность идеи

2. Исследуем алгоритмы

3. Оптимизация модели

Использование возможности встраивания скриптов Python в Azure для предобработки данных

В первой статье мы говорили о том, что Azure поддерживает использование Python-скриптов. Необходимый для этого модуль может принимать на вход два массива данных и zip-архив с дополнительными материалами (например, другими скриптами, библиотеками и пр).

Простой пример: в первой статье в конечной оценке была ремарка о несбалансированной по классам тестовой выборке. Исправить ситуацию можно, введя в схему несложный скрипт, который отфильтрует лишние строки во всей выборке. В качестве демонстрации сделаем это следующим способом (возможны и другие).

Модуль возвращает измененный массив данных, в котором (как будет видно позже) содержится равное для обоих классов количество записей.

Анализ используемых данных. Использование MS Analysis Service

Практически в любой задаче машинного обучения необработанные данные не дают удовлетворительного результата. Для выделения наиболее информативных для модели признаков потребуется data mining.

В прототипе, о котором шла речь в предыдущей статье, было использовано два типа данных: количество посещений пациентом врача за последние три месяца и последняя потраченная на этот визит сумма. Для начала добавим:

- возраст;

- id диагнозов;

- количество пиков затрат за последние 3 месяца.

Однако так мы только увеличим количество признаков, никак их не обработав. Для этого используем MS Analysis Services, в котором для извлечения признаков применяется машинное обучение — в частности, упрощенный алгоритм Байеса.

По результатам можно выбрать границы для бинарного представления входных данных. Например, «возраст младше 19» и «количество обращений к врачу меньше 5» свидетельствуют о большей вероятности отсутствия пика. В то время как «возраст старше 64» и «количество обращений больше 14» чреваты затратами в следующем месяце.

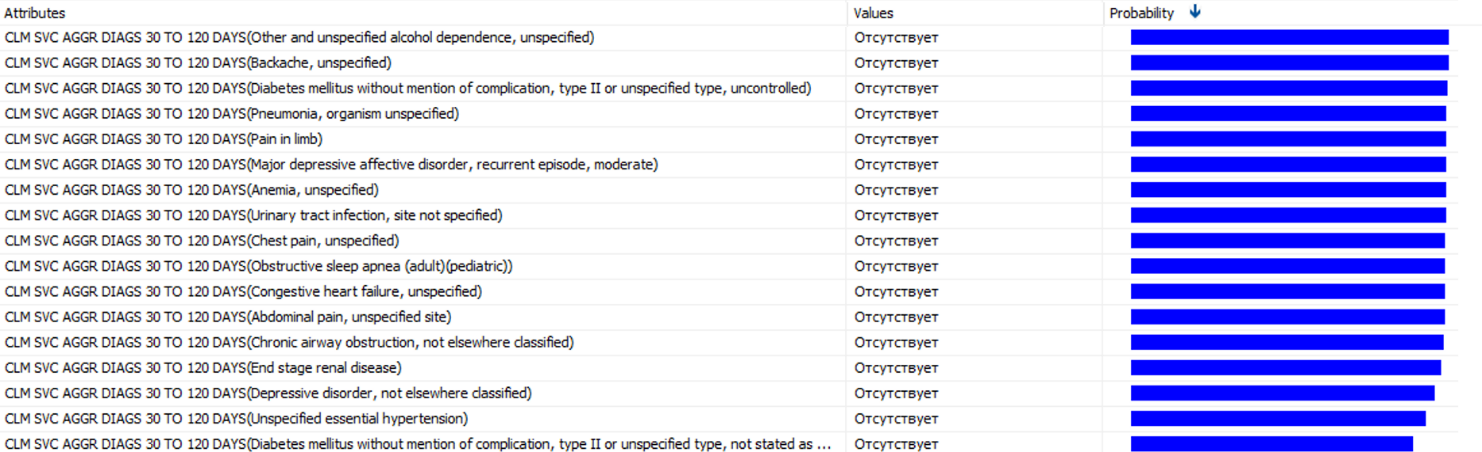

Можно получить список диагнозов, которые чаще других предшествуют большим тратам.

Это только часть выбранных диагнозов. В каждом из диагнозов, с вероятностью от 85% до 100%, последует пик затрат. Их наличие стоит вынести в отдельный признак. Не стоит упускать и наличие обычных диагнозов, которые не обойдутся компании дорого. Поэтому следует провести нормировку найденных вероятностей и ввести новый признак, который будет представлять собой взвешенную сумму количества диагнозов за последние 90 дней.

В результате получено семь параметров в векторе входных признаков. Сравним их с тем, что было получено в прошлый раз с использованием разных алгоритмов.

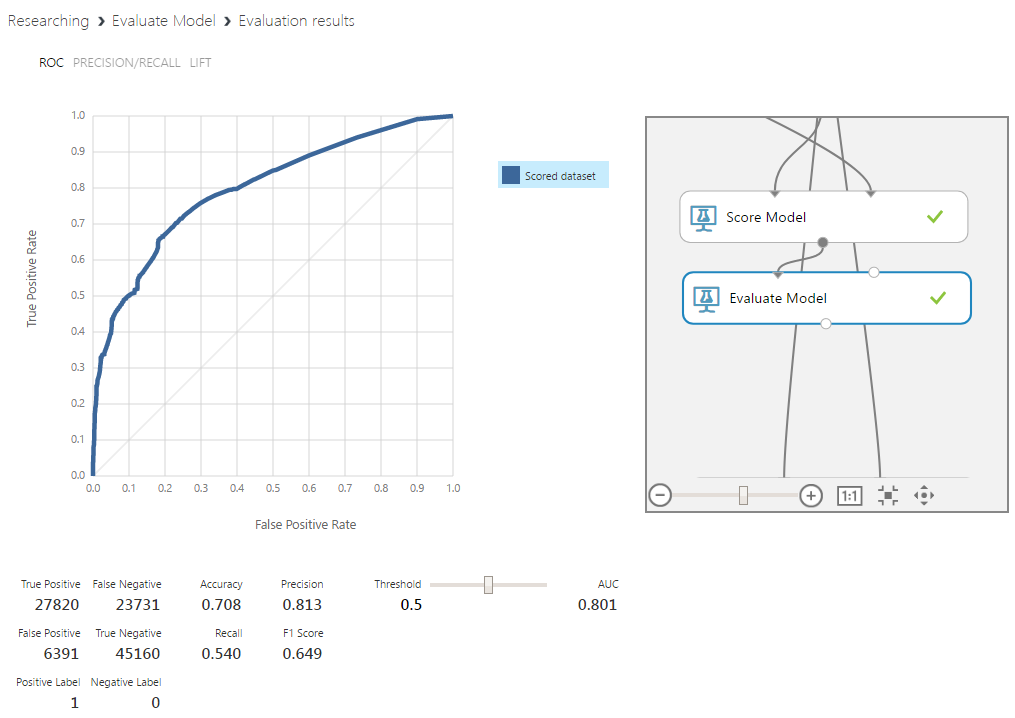

Тестирование различных алгоритмов и выставление их параметров

Мы определись с параметрами, которые будут использованы для обучения. Рассмотрим несколько разных алгоритмов классификации: logistic regression, support vector machine, decision jungle/random forest, Bayesian network. Очевидным вариантом также являются нейронные сети, но это отдельная сложная тема и в данном случае этот алгоритм будет излишним.

Поскольку была проведена фильтрация данных для получения сбалансированной выборки, граничное значение для присвоения классов пока менять не будем. К этому вопросу мы вернемся в следующей статье.

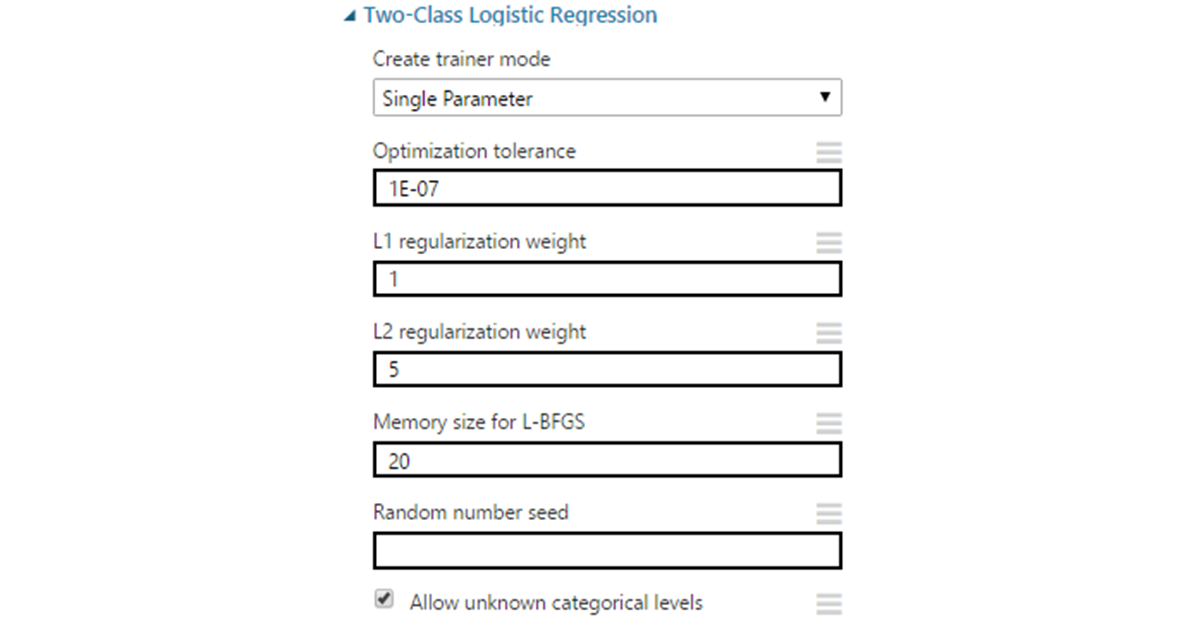

Logistic regression

Это частный случай линейного регрессора, приспособленного к задачам классификации. Алгоритм уже упоминался в первой статье, где он использовался для построения простейшей модели в качестве прототипа.

На начальном этапе он позволяет получить исходное значение в промежутке от минус до плюс бесконечности. Далее осуществим преобразование, используя сигмоидальную функцию вида 1/(1+e^(-score) ),, где score — это полученное ранее значение, осуществляем преобразование. Результатом будет число в пределах от -1 до +1. Решение о принадлежности к классу принимается на основании выбранного порогового значения.

Параметры:

- Optimization tolerance — граница для минимального изменения точности. Если разница между итерациями становится меньше указанного значения, обучение останавливается. В большинстве случаев можно оставить значение по умолчанию равное 1Е-7.

- L1 & L2 regularization — регуляризация по нормам 1 и 2 порядка. L1 используется для уменьшения размерности входных данных через удаление признаков, наименее влияющих на результат. L2 «штрафует» признаки c большими коэффициентами, сводя эти коэффициенты к нулю на бесконечности. Указанные значения являются коэффициентами для норм и для начала могут по умолчанию оставаться равными 1.

- L-BFGS — метод оптимизации для нахождения локального максимума (минимума) нелинейного функционала без ограничений с ограниченной памятью. Это квазиньютоновский метод (основанный на накоплении информации о кривизне целевой функции по изменению ее градиента), используемый для взвешивания параметров модели. Тут выбор зависит от предпочтений: выставляемое значение влияет на количество данных, используемых для инверсии гессиана функции. По сути, берется указанное количество последних векторов. Увеличение этого значения улучшает точность. Улучшает до определенных пределов (не следует также забывать про переобучение). При этом может сильно увеличить время выполнения, поэтому часто выставляется в окрестности 10.

- Random seed можно выставить в случае необходимости получения одинаковых результатов на разных запусках алгоритма.

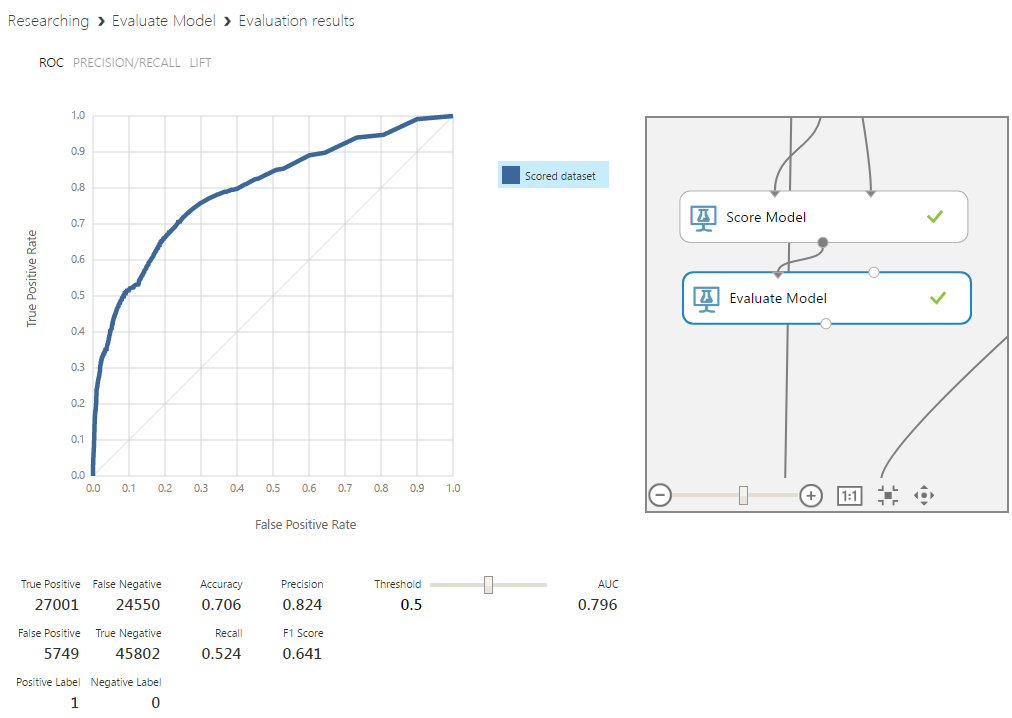

Этот алгоритм был использован в прототипе модели, поэтому сравнение будет наиболее показательно. Даже без настройки границы определения классов и с небольшими добавками в вектор входных признаков, процент верно предсказанных пиков увеличился на 5%, а их отсутствия — на 15%. Такой важный показатель, как площадь под кривой этого графика, тоже существенно вырос. Этот параметр отражает, насколько хорошо при разных граничных значениях соотносятся друг с другом значения классов. Чем дальше кривая находится от диагонали — тем лучше.

Support Vector Machine

Метод опорных векторов входит в группу линейных классификаторов, хотя некоторые модификации в основную часть алгоритма позволяют строить и нелинейные классификаторы. Суть заключается в переводе исходных данных в более высокую размерность и построении разделяющей гиперплоскости. Увеличение размерности необходимо, так как исходные вектора часто линейно неразделимы. После перевода гиперплоскость ищется с условием максимального зазора до гиперплоскостей, обозначающих границу классов.

Параметры:

- Number of iterations — количество итераций обучения алгоритма. Представляет собой параметр для размена точности и скорости алгоритма. Для начала можно поставить значение в диапазоне от 1 до 10.

- Lambda — аналог веса для L1 в логистической регрессии

- Normalize features — нормализация данных перед обучением. В связи со спецификой метода в большинстве случаев следует оставить параметр включенным по умолчанию.

- Project to unit sphere — нормализация коэффициентов. Этот параметр опционален и чаще всего его использование не понадобится.

- Allow unknown category — по умолчанию включенный параметр, который позволяет обработку неизвестных модели параметров. Он ухудшает работу модели с теми данными, которые известны классификатору, при этом улучшает точность для неизвестных.

- Random seed — аналогично с логистической регрессией.

По графику видно, что это не самый удачный алгоритм для данной задачи. Точность и площадь под кривой низкие. К тому же, сама кривая имеет нестабильный характер, что могло бы быть допустимо для прототипа, но не для модели с обработанными данными.

Bayesian network

Байесовские сети — это вероятностная модель данных, представленная в виде ациклического направленного графа. Вершинами графа являются переменные, отражающие истинность некоего суждения, а ребра — степень зависимости между ними. Настройка модели заключается в подборе этих переменных и взаимосвязи между ними. В нашем случае, конечным оцениваемым суждением, на котором сходится граф, будет наличие пика затрат.

Параметры:

- Number of training iterations — аналогично параметру в SVM.

- Include bias — введение постоянной величины во входные параметры модели. Это необходимо, когда ее нет в исходном векторе.

- Allow unknown values — аналогично параметру в SVM.

Байесовский классификатор показал результаты, очень похожие на результаты логистической регрессии. Поскольку регрессия более простая, между ними остановимся на ней.

Random Forest

Этот метод представляет собой комитет классических деревьев решений. В данном алгоритме деревья не подвергаются прунингу (прунинг — метод снижения сложности модели через урезание ветвей дерева после того, как оно полностью построено). Тем не менее, условия ранней остановки остаются. Разнообразие достигается за счет выбора случайных подмножеств исходных данных. Размер остается тем же, но в этих подмножествах допускаются повторные использования одних и тех же данных.

В каждом дереве используется случайное подмножество признаков размера m (m — настраиваемый параметр, однако часто предлагается использовать значение, близкое к корню из размера исходного вектора признаков). Классификация проходит через голосование. Класс, получивший наибольшее количество голосов, побеждает.

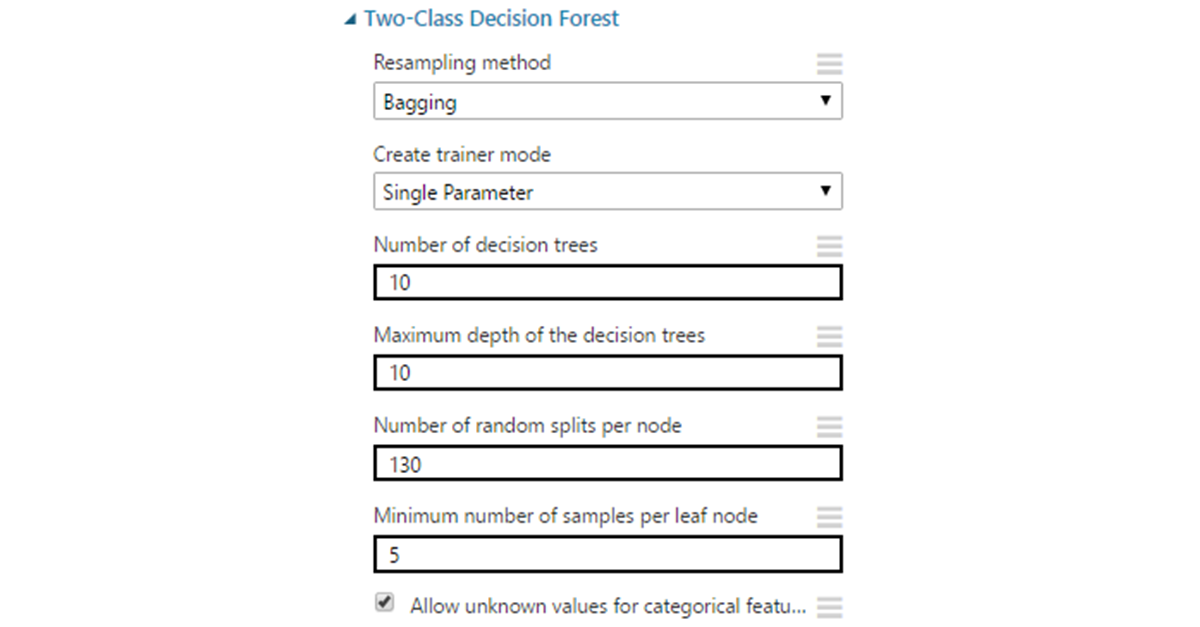

Параметры:

- Resampling method по умолчанию выставлен на bagging, что дает для каждого дерева уникальную выборку данных описанным выше способом. Можно также выставить replicate, если есть необходимость обучать все деревья на одинаковых данных.

- Number of decision trees. Увеличение количества деревьев может дать большее покрытие выборки, но не всегда, и ценой увеличения времени обучения.

- Maximum depth — максимальная глубина дерева. Значение по умолчанию — 32 — достаточно большое и во многих ситуациях приведет к переобучению. Чаще всего нет необходимости делать глубину больше десяти.

- Number of random splits per node — определяет количество случайных разделений признаков при построении вершин. Слишком большое количество может привести к переобучению, поэтому стоит для начала ограничиться значением в пределах от 10 до 30.

- Minimum number of samples per leaf node — минимальное количество записей для образования «листа» (вершины которая уже не подлежит разделению на ветви). Практически никогда нет смысла оставлять в этом месте 1, поскольку подобные листья избыточны и часто приводят модель к переобучению.

- Allow unknown values — аналогично с SVM.

Random forest оказался наиболее результативным алгоритмом, дав прирост к определению пиков на 8% и их отсутствия на 13%. Немаловажным в контексте задачи является и лучшая интерпретируемость причин определения данных к какому-либо из классов. Конечно, этот алгоритм в целом является черным ящиком, однако для него есть относительно несложные способы извлечения необходимой информации.

Во всех описанных выше алгоритмах, кроме байесовских сетей, есть параметр “create trainer mode”. Выставив его на Parameter Range, можно включить режим, в котором алгоритм обучится на различных вариантах комбинаций параметров в пределах заданных диапазонов, и выдаст лучший вариант. Эту особенность осветим позже.

Использование cross-validation для проверки variance

Кросс-валидационная оценка может использоваться для решения различных задач. Например, ее используют для борьбы с переобучением в условиях малого количества данных для выделения отдельной валидационной выборки. Сейчас она потребуется в качестве инструмента для проверки способности текущей модели к обобщению. Для этого разделим данные на десять частей и рассмотрим каждую из них как тестовую. Далее необходимо будет обучить модель на каждом варианте разделения.

Возьмем алгоритм, показавший лучшие результаты среди остальных — Random Forest.

По всем выборкам результат устойчивый и достаточно высокий. Модель имеет хорошую способность к обобщению, а на обучение подается достаточное количество данных.

Итог

Во этой части из цикла статей о машинном обучении мы рассмотрели:

- Встраивание Python-скриптов в общую схему проекта на примере получения уравновешенной по классам выборки данных.

- Использование MS Analysis Services для извлечения новых признаков из сырых данных.

- Кросс-валидацию модели для оценки стабильности результата и полноты данных в обучающей выборке.

Полученные результаты говорят о явном улучшении точности и стабильности модели. В заключительной статье мы затронем вопросы переобучения, статистических выбросов и комитетов.

Об авторах

Команда WaveAccess создаёт технически сложное, высоконагруженное и отказоустойчивое программное обеспечение для компаний из разных стран. Комментарий Александра Азарова, руководителя направления machine learning в WaveAccess:

Машинное обучение позволяет автоматизировать области, где на текущий момент доминируют экспертные мнения. Это дает возможность снизить влияние человеческого фактора и повысить масштабируемость бизнеса.

|

Метки: author Schvepsss машинное обучение алгоритмы microsoft azure блог компании microsoft microsoft waveaccess страховая компания |

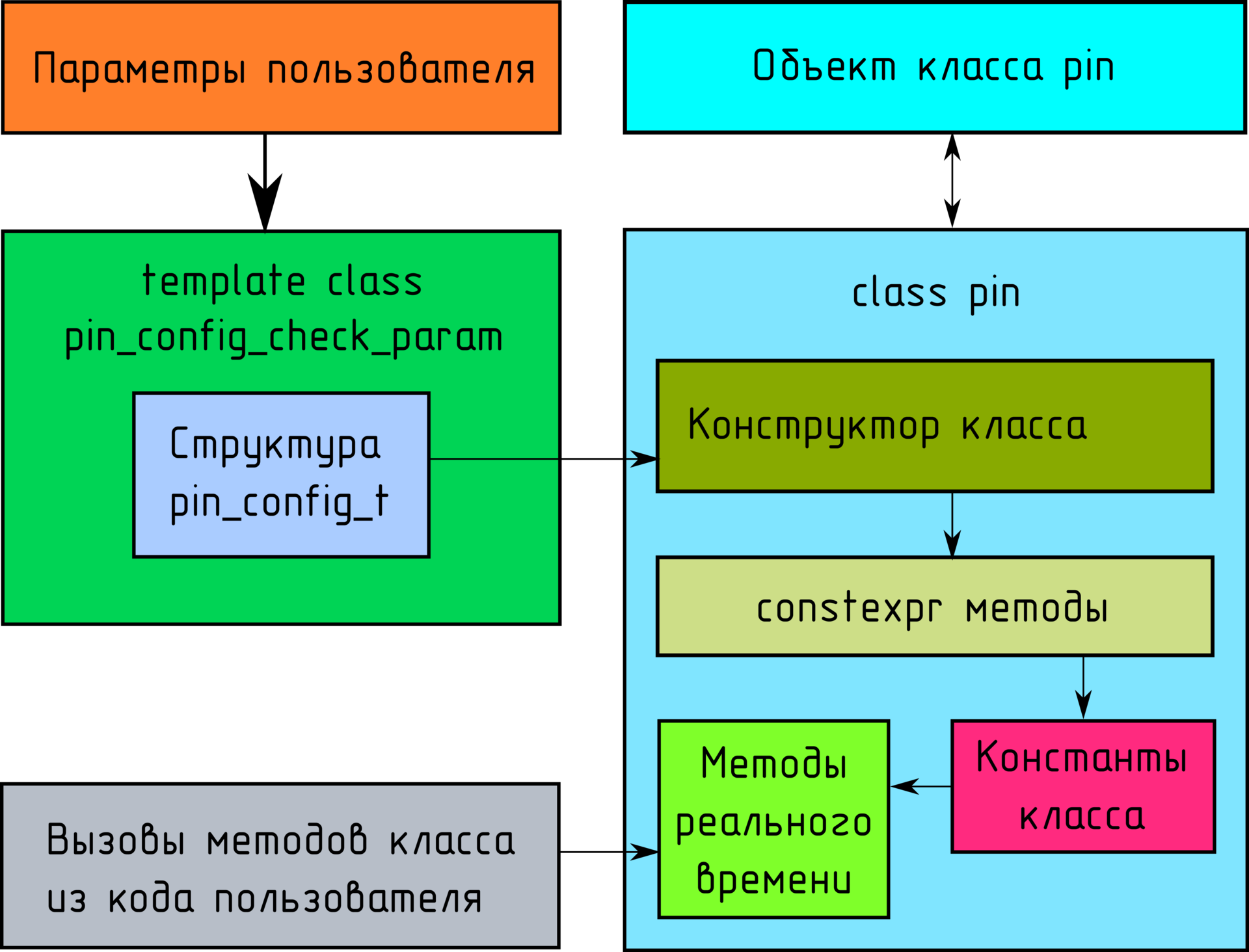

Используем template + constexpr для создания масок регистров периферии микроконтроллера на этапе компиляции (C++14) |

Введение

Эта небольшая заметка содержит не очевидное решение поставленной ниже задачи, до которого мне пришлось доходить несколько бессонных ночей.

Задача: на основе заданных пользователем данных о том, как должен работать периферийный блок микроконтроллера, получить на этапе компиляции массив масок конфигурации его регистров, которые можно было бы использовать в реальном времени. При этом требуется на этапе компиляции проверить, что все параметры заданные верно (периферия микроконтроллера будет сконфигурирована верна).

Заинтересовавшихся в том, как это можно сделать, прошу под кат.

Оглавление:

- Основные проблемы и ограничения C++14.

- Решение, основывающиеся на том, что пользователь никогда не ошибается.

- Учет пользовательских ошибок.

- Расширим возможности класса.

- О сокращенных записях.

- Итог.

Основные проблемы и ограничения C++14

Как только я столкнулся с задачей, описанной во введении, я сразу же вспомнил про спецификатор языка C++ — constexpr. Поскольку необходимость решения данной задачи была выявлена еще на этапе проектирования библиотеки, то были учтены все ограничения стандарта C++11, на котором изначально планировалось построить библиотеку (невозможность использовать внутри constexpr методов циклы и т.д.), и в качестве языка библиотеки был выбран стандарт C++14, в котором убраны многие ограничения C++11 (C++17 не был выбран намеренно, т.к. он, с точки зрения поставленных перед библиотекой задач, не слишком отличался от C++14, при этом его поддержка у GCC, так же выбранным в качестве основного компилятора библиотеки, на момент написания статьи, не слишком стабильна).

Но несмотря на то, что constexpr функции в C++14 стали практически такими же гибкими, как и функции реального времени, у них остался один жирный минус, перечеркивающий большинство достоинств — отсутствие какой-либо отладки. Об этом писалось на Хабре тут. Из данной статьи я почерпнул основную мысль:

Но на этом проблемы не заканчиваются. Когда пишешь какую-то constexpr-функцию, которую потом будут часто использовать, хорошо бы возвращать читабельную ошибку. Тут можно ошибочно предположить, что static_assert как раз для этого подходит. Но static_assert использовать не получится, так как параметры функций не могут быть constexpr, из-за чего значения параметров не гарантированно будут известны на этапе компиляции.А так как исключения не поддерживаются в constexpr методах, то мы просто будем получать ошибку о том, что использование throw в constexpr невозможно. В случае, если мы обрабатывали что-то в цикле, то мы никогда не сможем узнать, на каком именно элементе мы упали (при проверке какого элемента мы вызвали исключение).

Как же выводить ошибки? Единственный более-менее нормальный способ, который я нашел, заключается в выбрасывании исключения:

И того, ситуация следующая: static_assert нельзя, throw нельзя, printf и прерывание компиляции — нельзя.

Решение, основывающиеся на том, что пользователь никогда не ошибается

Как же быть со всеми этими ограничениями и невозможностью отладки? Для начала предположим, что ПОЛЬЗОВАТЕЛЬ НИКОГДА НЕ ОШИБАЕТСЯ (да, футуристично, но пока примем это за аксиому). Тогда constexpr, выходит, в принципе не нуждается в отладке и выбрасыванию исключений о том, что параметры входных данных неверны.

Для примера рассмотрим класс объекта управления выводом порта микроконтроллера, изначально кем-то включенным (подан тактовый сигнал на блок периферии) и с настроенным на выход выводом с нужной скоростью (самое то, чтобы мигать светодиодом). По сути, объект нашего класса должен иметь методы для переключения состояния вывода из 1 в 0 и обратно. Большего от нашего объекта не требуется.

Однако для того, чтобы не плодить сущности, предположим, что у нас есть некоторая структура, описывающая конфигурацию одного вывода целиком. Эту структуру использует не только класс нашего объекта, но и другие (например те, которые заранее для нас инициализировали модуль и сконфигурировали вывод в нужное состояние). Структура эта будет выглядеть так:

/*

* Структура конфигурации вывода.

*/

struct __attribute__( ( packed ) ) pin_config_t {

EC_PORT_NAME port; // Имя порта

// ( пример: EC_PORT_NAME::A ).

EC_PORT_PIN_NAME pin_name; // Номер вывода

// ( пример: EC_PORT_PIN_NAME::PIN_0 ).

EC_PIN_MODE mode; // Режим вывода

// ( пример: EC_PIN_MODE::OUTPUT ).

EC_PIN_OUTPUT_CFG output_config; // Режим выхода

// ( пример: EC_PIN_OUTPUT_CFG::NOT_USE ).

EC_PIN_SPEED speed; // Скорость вывода

// ( пример: EC_PIN_SPEED::MEDIUM ).

EC_PIN_PULL pull; // Подтяжка вывода

// ( пример: EC_PIN_PULL::NO ).

EC_PIN_AF af; // Альтернативная функция вывода

// ( пример: EC_PIN_AF::NOT_USE ).

EC_LOCKED locked; // Заблокировать ли настройку данного

// вывода во время инициализации

// global_port объекта

// ( пример EC_LOCKED::NOT_LOCKED ).

EC_PIN_STATE_AFTER_INIT state_after_init; // Состояние на выходе после инициализации

// ( в случае, если вывод настроен как выход ).

// (пример EC_PIN_STATE_AFTER_INIT::NO_USE).

};

/**********************************************************************

* Область enum class-ов.

**********************************************************************/

/*

* Перечень выводов каждого порта.

*/

enum class EC_PORT_PIN_NAME {

PIN_0 = 0,

PIN_1 = 1,

PIN_2 = 2,

PIN_3 = 3,

PIN_4 = 4,

PIN_5 = 5,

PIN_6 = 6,

PIN_7 = 7,

PIN_8 = 8,

PIN_9 = 9,

PIN_10 = 10,

PIN_11 = 11,

PIN_12 = 12,

PIN_13 = 13,

PIN_14 = 14,

PIN_15 = 15

};

/*

* Режим вывода.

*/

enum class EC_PIN_MODE {

INPUT = 0, // Вход.

OUTPUT = 1, // Выход.

AF = 2, // Альтернативная функция.

ANALOG = 3 // Аналоговый режим.

};

/*

* Режим выхода.

*/

enum class EC_PIN_OUTPUT_CFG {

NO_USE = 0, // Вывод не используется как вывод.

PUSH_PULL = 0, // "Тянуть-толкать".

OPEN_DRAIN = 1 // "Открытый сток".

};

/*

* Скорость выхода.

*/

enum class EC_PIN_SPEED {

LOW = 0, // Низкая.

MEDIUM = 1, // Средняя.

FAST = 2, // Быстрая.

HIGH = 3 // Очень быстрая

};

/*

* Выбор подтяжки

*/

enum class EC_PIN_PULL {

NO_USE = 0, // Без подтяжки.

UP = 1, // Подтяжка к питанию.

DOWN = 2 // Подтяжка к земле.

};

/*

* Выбираем альтернативную функцию, если используется.

*/

enum class EC_PIN_AF {

AF_0 = 0,

NO_USE = AF_0,

SYS = AF_0,

AF_1 = 1,

TIM1 = AF_1,

TIM2 = AF_1,

AF_2 = 2,

TIM3 = AF_2,

TIM4 = AF_2,

TIM5 = AF_2,

AF_3 = 3,

TIM8 = AF_3,

TIM9 = AF_3,

TIM10 = AF_3,

TIM11 = AF_3,

AF_4 = 4,

I2C1 = AF_4,

I2C2 = AF_4,

I2C3 = AF_4,

AF_5 = 5,

SPI1 = AF_5,

SPI2 = AF_5,

I2S2 = AF_5,

AF_6 = 6,

SPI3 = AF_6,

I2S3 = AF_6,

AF_7 = 7,

USART1 = AF_7,

USART2 = AF_7,

USART3 = AF_7,

AF_8 = 8,

UART4 = AF_8,

UART5 = AF_8,

USART6 = AF_8,

AF_9 = 9,

CAN1 = AF_9,

CAN2 = AF_9,

TIM12 = AF_9,

TIM13 = AF_9,

TIM14 = AF_9,

AF_10 = 10,

OTG_FS = AF_10,

AF_11 = 11,

ETH = AF_11,

AF_12 = 12,

FSMC = AF_12,

SDIO = AF_12,

AF_13 = 13,

DCMI = AF_13,

AF_14 = 14,

AF_15 = 15,

EVENTOUT = AF_15

};

/*

* Разрешено ли блокировать конфигурацию вывода методами set_locked_key_port и

* set_locked_keys_all_port объекту класса global_port.

* Важно! Блокировка применяется только один раз объектом global_port. Во время последующей

* работы заблокировать иные выводы или же отключить блокировку текущих - невозможно.

* Единственный способ снять блокировку - перезагрузка чипа.

*/

enum class EC_LOCKED {

NOT_LOCKED = 0, // Не блокировать вывод.

LOCKED = 1 // Заблокировать вывод.

};

/*

* Состояние на выходе после инициализации

* (в случае, если вывод настроен как выход).

*/

enum class EC_PIN_STATE_AFTER_INIT {

NO_USE = 0,

RESET = 0,

SET = 1

};Как говорилось ранее, объект нашего класса должен только менять состояние на выходе вывода (ножки). Так как библиотека пишется под stm32f2 (и только), то разумным будет использовать для этих целей имеющийся в физическом блоке GPIO каждого порта регистр BSR, который позволяет записью единицы (1) в биты 0-15 устанавливать соответствующий бит (запись единицы (1) в 0-й бит выставит состояние вывода порта 0 в 1), а записью единицы (1) в 16-31 сбрасывать соответствующий бит — 16 (запись единицы (1) в 31-й бит сбросит 31-16 = 15-й вывод порта в 0).

Как видно, задача установки нужного вывода в 1 сводится к записи в BSR регистр 1 << номер_вывода, а сброса в записи 1 << номер_вывода + 16.

Для этих целей нам достаточно взять из полученной от пользователя структуры поля port и pin_name. Все остальные поля нам не нужны.

Обозначим общий вид класса нашего объекта:

class pin {

public:

constexpr pin ( const pin_config_t* const pin_cfg_array );

void set ( void ) const;

void reset ( void ) const;

void set ( uint8_t state ) const;

void set ( bool state ) const;

void set ( int state ) const;

private:

constexpr uint32_t p_bsr_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t set_msk_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t reset_msk_get ( const pin_config_t* const pin_cfg_array );

const uint32_t p_bsr;

const uint32_t bsr_set_msk, bsr_reset_msk;

};Как видно, класс имеет следующие методы:

- set без параметров — устанавливает состояние на выходе вывода в 1;

- reset — сбрасывает состояние на выходе вывода в 0;

- set c параметрами разных типов — на деле представляет из себя одну функцию (о чем будет далее), которая устанавливает заданное состояние на выходе используя функции выше.

Все эти методы используются пользователем в реальном времени. Рассмотрим их.

/*

* Метод устанавливает вывод порта в <<1>>,

* если вывод настроен как выход.

*/

void pin::set ( void ) const {

*M_U32_TO_P(this->p_bsr) = this->bsr_set_msk;

}

/*

* Метод устанавливает вывод порта в <<0>>,

* если вывод настроен как выход.

*/

void pin::reset ( void ) const {

*M_U32_TO_P(this->p_bsr) = this->bsr_reset_msk;

}

/*

* Метод выставляет на выход заданное состояние,

* если вывод настроен как выход.

*/

void pin::set ( uint8_t state ) const {

if ( state ) {

this->set();

} else {

this->reset();

}

}

void pin::set ( bool state ) const {

this->set( static_cast< uint8_t >( state ) );

}

void pin::set ( int state ) const {

this->set( static_cast< uint8_t >( state ) );

}Методы set и reset используют приведенный ниже define для явного преобразования значения в uint32_t переменной в указатель на uint32_t переменную.

// Преобразует число в uint32_t переменной в указатель на uint32_t.

// Данные по указателю можно изменять.

#define M_U32_TO_P(point) ((uint32_t *)(point))На данный момент мы разобрались с тем, как методы объекта работают с готовыми масками, осталось самое главное (то, ради чего и писалась данная статья) подготовить их.

Класс имеет три метода:

- set_msk_get — возвращает значение uint32_t переменной, являющееся маской регистра BSR для установки заданного пользователем вывода в <<1>>.

- reset_msk_get — возвращает значение uint32_t переменной, являющееся маской регистра BSR для сброса заданного пользователем вывода в <<0>>.

- p_bsr_get — возвращает значение uint32_t переменной, содержащее в себе адрес регистра BSR на физической карте памяти микроконтроллера.

Зная, что пользователь точно не ошибся при указании параметров структуры, можем написать следующий код:

/**********************************************************************

* Область constexpr функций.

**********************************************************************/

/*

* Метод возвращает маску установки выхода в "1" через регистр BSR.

*/

constexpr uint32_t pin::set_msk_get ( const pin_config_t* const pin_cfg_array ) {

return 1 << M_EC_TO_U8(pin_cfg_array->pin_name);

}

/*

* Метод возвращает маску установки выхода в "0" через регистр BSR.

*/

constexpr uint32_t pin::reset_msk_get ( const pin_config_t* const pin_cfg_array ) {

return 1 << M_EC_TO_U8( pin_cfg_array->pin_name ) + 16;

}

/*

* Метод возвращает указатель на регистр BSR, к которому относится вывод.

*/

constexpr uint32_t pin::p_bsr_get( const pin_config_t* const pin_cfg_array ) {

uint32_t p_port = p_base_port_address_get( pin_cfg_array->port );

return p_port + 0x18;

}Эти функции используют define для преобразования значения enum class-а в uint8_t переменную.

// Преобразует enum class в uint8_t.

#define M_EC_TO_U8(ENUM_VALUE) ((uint8_t)ENUM_VALUE)Так же метод p_bsr_get используют не принадлежащий никакому конкретному классу метод p_base_port_address_get, который принимая значение enum class-а EC_PORT_NAME (имя порта) возвращает физический адрес начала расположения регистров этого порта на физической карте микроконтроллера. Выглядит он следующим образом:

/*

* Возвращает указатель на базовый адрес выбранного порта ввода-вывода

* на карте памяти в соответствии с выбранным контроллером.

*/

constexpr uint32_t p_base_port_address_get( EC_PORT_NAME port_name ) {

switch( port_name ) {

#ifdef PORTA

case EC_PORT_NAME::A: return 0x40020000;

#endif

#ifdef PORTB

case EC_PORT_NAME::B: return 0x40020400;

#endif

#ifdef PORTC

case EC_PORT_NAME::C: return 0x40020800;

#endif

#ifdef PORTD

case EC_PORT_NAME::D: return 0x40020C00;

#endif

#ifdef PORTE

case EC_PORT_NAME::E: return 0x40021000;

#endif

#ifdef PORTF

case EC_PORT_NAME::F: return 0x40021400;

#endif

#ifdef PORTG

case EC_PORT_NAME::G: return 0x40021800;

#endif

#ifdef PORTH

case EC_PORT_NAME::H: return 0x40021C00;

#endif

#ifdef PORTI

case EC_PORT_NAME::I: return 0x40022000;

#endif

}

}/**********************************************************************

* Область constexpr конструкторов.

**********************************************************************/

constexpr pin::pin ( const pin_config_t* const pin_cfg_array ):

p_bsr ( this->p_bsr_get( pin_cfg_array ) ),

bsr_set_msk ( this->set_msk_get( pin_cfg_array ) ),

bsr_reset_msk ( this->reset_msk_get( pin_cfg_array ) ) {};Технически, уже сейчас можно пользоваться данным классом, но мы ведь помним, что пользователь далеко не всегда может ввести все параметры структуры правильно…

Учет пользовательских ошибок.

Теперь, когда у нас имеется рабочий и отлаженный класс, осталось только доработать проверку входной структуры и можно спокойно использовать объекты нашего класса. Но, как говорилось ранее, сделать это в constexpr комфортно — невозможно. Но решение есть — template. Так как все объекты в коде пользователя должны задаваться глобально (это основное условие использования библиотеки, о котором можно будет почитать в документе ее (библиотеки) описания, ссылку на которую дам в конце статьи), то использование template-ов кажется наиболее разумным. Дело в том, что в template-ах разрешен static_assert. Так же в них можно использовать разного рода код для проведения более сложных проверок. И, что самое главное:

Если создать template class, унаследованный от структуры, провести в конструкторе этого класса все необходимые проверки, а затем объявить объект данного template класса глобально в коде пользователя, то компилятор разрешит применить не явное преобразование типов к той самой структура, от которой класс был унаследован.

Такую возможность просто нельзя не использовать!

/**********************************************************************

* Область template оболочек.

**********************************************************************/

template < EC_PORT_NAME PORT,

EC_PORT_PIN_NAME PIN_NAME,

EC_PIN_MODE MODE,

EC_PIN_OUTPUT_CFG OUTPUT_CONFIG,

EC_PIN_SPEED SPEED,

EC_PIN_PULL PULL,

EC_PIN_AF AF,

EC_LOCKED LOCKED,

EC_PIN_STATE_AFTER_INIT STATE_AFTER_INIT >

class pin_config_check_param : public pin_config_t {

public:

constexpr pin_config_check_param(): pin_config_t( {

.port = PORT,

.pin_name = PIN_NAME,

.mode = MODE,

.output_config = OUTPUT_CONFIG,

.speed = SPEED,

.pull = PULL,

.af = AF,

.locked = LOCKED,

.state_after_init = STATE_AFTER_INIT

} ) {

/*

* Проверяем введенные пользователем данные в структуру инициализации.

*/

#if defined(STM32F205RB)|defined(STM32F205RC)|defined(STM32F205RE) \

|defined(STM32F205RF)|defined(STM32F205RG)

static_assert( PORT >= EC_PORT_NAME::A &&

PORT <= EC_PORT_NAME::H,

"Invalid port name. The port name must be A..H." );

#endif

static_assert( PIN_NAME >= EC_PORT_PIN_NAME::PIN_0 &&

PIN_NAME <= EC_PORT_PIN_NAME::PIN_15,

"Invalid output name. An output with this name does not"

"exist in any port. The output can have a name PIN_0..PIN_15." );

static_assert( MODE >= EC_PIN_MODE::INPUT &&

MODE <= EC_PIN_MODE::ANALOG,

"The selected mode does not exist. "

"The output can be set to mode: INPUT, OUTPUT, AF or ANALOG." );

static_assert( OUTPUT_CONFIG == EC_PIN_OUTPUT_CFG::PUSH_PULL ||

OUTPUT_CONFIG == EC_PIN_OUTPUT_CFG::OPEN_DRAIN,

"A non-existent output mode is selected. "

"The output can be in the mode: PUSH_PULL, OPEN_DRAIN." );

static_assert( SPEED >= EC_PIN_SPEED::LOW &&

SPEED <= EC_PIN_SPEED::HIGH,

"A non-existent mode of port speed is selected. "

"Possible modes: LOW, MEDIUM, FAST or HIGH." );

static_assert( PULL >= EC_PIN_PULL::NO_USE &&

PULL <= EC_PIN_PULL::DOWN,

"A non-existent brace mode is selected."

"The options are: NO_USE, UP or DOWN." );

static_assert( AF >= EC_PIN_AF::AF_0 &&

AF <= EC_PIN_AF::AF_15,

"A non-existent mode of the alternative port function is selected." );

static_assert( LOCKED == EC_LOCKED::NOT_LOCKED ||

LOCKED == EC_LOCKED::LOCKED,

"Invalid port lock mode selected." );

static_assert( STATE_AFTER_INIT == EC_PIN_STATE_AFTER_INIT::NO_USE ||

STATE_AFTER_INIT == EC_PIN_STATE_AFTER_INIT::SET,

"The wrong state of the output is selected."

"The status can be: NO_USE, UP or DOWN." );

};

};Теперь мы можем объявить в коде пользователя объект данного класса:

const pin_config_check_param< EC_PORT_NAME::C, EC_PORT_PIN_NAME::PIN_4,

EC_PIN_MODE::OUTPUT, EC_PIN_OUTPUT_CFG::PUSH_PULL,

EC_PIN_SPEED::MEDIUM, EC_PIN_PULL::NO_USE,

EC_PIN_AF::NO_USE, EC_LOCKED::LOCKED,

EC_PIN_STATE_AFTER_INIT::SET > lcd_res;После чего, при создании объекта класса pin сослаться не него, как на обычную структуру:

const constexpr pin pin_lcd_res( &lcd_res );После чего, в коде пользователя можно пользоваться методами этого объекта:

void port_test ( void ) {

pin_lcd_res.reset();

pin_lcd_res.set();

}Расширим возможности класса

Мы получили класс, который вполне годиться для управления ножкой в режиме выхода. Однако, не создавать же отдельный класс для входа? Немного доработаем класс, чтобы им можно было пользоваться как для выводов, сконфигурированных на выход, так и на вход. Так же добавим еще и метод инвертирования состояния на выходе.

Дополним класс двумя (2) константами:

- p_bb_odr_read — здесь будет находиться указатель на бит вывода объекта в регистре ODR (выставленное пользователем положение на выходе вывода, если вывод используется на выход). Используется bit-banding область.

- p_bb_idr_read — здесь будет находиться указатель на бит вывода объекта в регистре IDR (в данном регистре содержится реальное состояние на входах вывода, в не зависимости от того, как настроен вывод). Используется bit-banding область.

Напишем методы, которые возвращают значения этих констант для конкретного вывода.

/*

* Метод возвращает указатель на bit_banding

* область памяти, в которой находится бит состояния входа.

*/

constexpr uint32_t pin::bb_p_idr_read_get ( const pin_config_t* const pin_cfg_array ) {

uint32_t p_port = p_base_port_address_get( pin_cfg_array->port );

uint32_t p_idr = p_port + 0x10;

return M_GET_BB_P_PER(p_idr, M_EC_TO_U8(pin_cfg_array->pin_name));

}

/*

* Метод возвращает указатель на bit banding область памяти,

* с выставленным пользователем состоянием на выходе вывода.

*/

constexpr uint32_t pin::odr_bit_read_bb_p_get ( const pin_config_t* const pin_cfg_array ) {

uint32_t p_port = p_base_port_address_get( pin_cfg_array->port );

uint32_t p_reg_odr = p_port + 0x14;

return M_GET_BB_P_PER(p_reg_odr, M_EC_TO_U8(pin_cfg_array->pin_name));

}Здесь используется define M_GET_BB_P_PER который по uint32_t значению адреса регистра в области периферии и uint32_t номера бита порта возвращает bit-banding адрес этого бита.

//*********************************************************************

// Определения, не касающиеся основных модулей.

//*********************************************************************

#define BIT_BAND_SRAM_REF 0x20000000

#define BIT_BAND_SRAM_BASE 0x22000000

//Получаем адрес бита RAM в Bit Banding области.

#define MACRO_GET_BB_P_SRAM(reg, bit) \

((BIT_BAND_SRAM_BASE + (reg - BIT_BAND_SRAM_REF)*32 + (bit * 4)))

#define BIT_BAND_PER_REF ((uint32_t)0x40000000)

#define BIT_BAND_PER_BASE ((uint32_t)0x42000000)

// Получаем адрес бита периферии в Bit Banding области.

#define M_GET_BB_P_PER(ADDRESS,BIT) \

((BIT_BAND_PER_BASE + (ADDRESS - BIT_BAND_PER_REF)*32 + (BIT * 4)))Допишем в конструктор инициализацию этих команд.

/**********************************************************************

* Область constexpr конструкторов.

**********************************************************************/

constexpr pin::pin ( const pin_config_t* const pin_cfg_array ):

p_bsr ( this->p_bsr_get( pin_cfg_array ) ),

p_bb_odr_read ( this->odr_bit_read_bb_p_get( pin_cfg_array ) ),

bsr_set_msk ( this->set_msk_get( pin_cfg_array ) ),

bsr_reset_msk ( this->reset_msk_get( pin_cfg_array ) ),

p_bb_idr_read ( this->bb_p_idr_read_get( pin_cfg_array ) ) {};Ну и допишем функции реального времени, которые будут работать с этими константами:

/*

* Метод инвертирует состояние на выходе вывода,

* если вывод настроен как выход.

*/

void pin::invert( void ) const {

if (*M_U32_TO_P_CONST(p_bb_odr_read)) { // Если был 1, то выставляем 0.

this->reset();

} else {

this->set();

}

}

/*

* Метод возвращает состояние на входе вывода.

*/

int pin::read() const {

return *M_U32_TO_P_CONST(p_bb_idr_read);

}

Здесь используется еще 1 define (M_U32_TO_P_CONST), который преобразует значение, хранящееся в uint32_t переменной в указатель на uint32_t переменную, защищенную от записи.

// Преобразует число в uint32_t переменной в указатель на uint32_t.

// Причем запрещает переписывать то, что по указателю (только чтение).

#define M_U32_TO_P_CONST(point) ((const uint32_t *const)(point))В конечном итоге, наш класс приобрел следующий вид:

class pin {

public:

constexpr pin ( const pin_config_t* const pin_cfg_array );

void set ( void ) const;

void reset ( void ) const;

void set ( uint8_t state ) const;

void set ( bool state ) const;

void set ( int state ) const;

void invert ( void ) const;

int read ( void ) const;

private:

constexpr uint32_t p_bsr_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t set_msk_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t reset_msk_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t odr_bit_read_bb_p_get ( const pin_config_t* const pin_cfg_array );

constexpr uint32_t bb_p_idr_read_get ( const pin_config_t* const pin_cfg_array );

const uint32_t p_bsr;

const uint32_t bsr_set_msk, bsr_reset_msk;

const uint32_t p_bb_odr_read, p_bb_idr_read;

};О сокращенных записях.

Зачастую бывает, что нужно создать структуру конфигурации объекта под определенную задачу (например, под вход ADC). Если таких выводов много, то писать каждый раз все параметры утомительно. Для этого можно использовать template class, который будет использовать наш template class. Для ADC это будет выглядеть следующем образом:

template < EC_PORT_NAME PORT,

EC_PORT_PIN_NAME PIN_NAME >

class pin_config_adc_check_param : public pin_config_check_param< PORT, PIN_NAME,

EC_PIN_MODE::INPUT,

EC_PIN_OUTPUT_CFG::NO_USE,

EC_PIN_SPEED::LOW,

EC_PIN_PULL::UP,

EC_PIN_AF::NO_USE,

EC_LOCKED::LOCKED,

EC_PIN_STATE_AFTER_INIT::NO_USE > {

public:

constexpr pin_config_adc_check_param() {};

};Объявление в коде займет многократно меньше места:

const pin_config_adc_check_param< EC_PORT_NAME::B, EC_PORT_PIN_NAME::PIN_1 > adc_left;Итог

Таким образом, на выходе, мы получили возможность создавать объекты на этапе компиляции, которые никак не используют ОЗУ и не требуют вызова конструктора в реальном времени. При этом мы будем точно уверены в том, что инициализированы они верно.

В данном конкретном случае ошибиться сложно, согласен. Может быть, проверки тут и излишни, но например, когда речь идет о создании настроек конфигурации PLL, тут уже сложнее. Можно что-то не учесть. Например, что какой-то делитель не может быть выставлен в какое-то значение, хотя поле для его ввода позволяет его принять, или же выставленный делитель получает частоту, которая превышает, или наоборот, не дотягивает до границ рекомендуемых значений. В таких случаях возможность проверки на этапе компиляции очень сильно помогают.

Так же стоит заметить, что созданная глобальная структура инициализации объекта класса pin не пойдет в файл основной прошивки. Она будет отброшена компоновщиком как не используемая. В flash пойдут только uint32_t переменные, заполненные конструктором и методы, реально вызванные в программе пользователя.

Приведенный в статье код — часть этой библиотеки. Библиотека еще в начальной стадии разработки. Как будет альфа версия — будет отдельная статья на эту тему.

Отдельное спасибо madcomaker за ответ на Тостере, натолкнувший на идею.

|

Метки: author Vadimatorikda программирование микроконтроллеров отладка c++ stm32 микроконтроллеры constexpr c++14 |

Apache Cassandra + Apache Ignite — как совместить лучшее |

Apache Ignite — это In-Memory Computing Platform, платформа для распределенного хранения данных в оперативной памяти и распределенных вычислений по ним в реальном времени с поддержкой JCache, SQL99, ACID-транзакциями и базовой алгеброй машинного обучения.

Apache Cassandra является классическим решением в своей области. Как и в случае с любым специализированным решением, её преимущества достигнуты благодаря ряду компромиссов, значительная часть которых вызвана ограничениями дисковых хранилищ данных. Cassandra оптимизирована под максимально быструю работу с ними в ущерб остальному. Примеры компромиссов: отсутствие ACID-транзакций и поддержки SQL, невозможность произвольных транзакционных и аналитических транзакций, если под них заранее не адаптированы данные. Эти компромиссы, в свою очередь, вызывают закономерные затруднения у пользователей, приводя к некорректному использованию продукта и негативному опыту, либо вынуждая разделять данные между различными видами хранилищ, фрагментируя инфраструктуру и усложняя логику сохранения данных в приложениях.

Возможное решение проблемы — использование Cassandra в связке с Apache Ignite. Это позволит сохранить ключевые преимущества Cassandra, при этом скомпенсировав ее недостатки за счет симбиоза двух систем.

Как? Читайте дальше, и смотрите пример кода.

Ограничения Cassandra

Для начала хочу кратко пройтись по основным ограничениям Cassandra, с которыми будем работать:

- Пропускная способность и время отклика ограничены характеристиками жесткого диска или твердотельного накопителя;

- Специфическая структура хранения данных, оптимизированная под последовательные запись и чтение, не адаптирована под оптимальное выполнение классических реляционных операций над данными. Это не позволяет нормализовать данные и эффективно сопоставлять при помощи JOIN-ов, а также накладывает значительные ограничения, например, на такие операции, как GROUP BY и ORDER;

- Как следствие из п. 2 — отсутствие поддержки SQL в пользу своей более ограниченной вариации — CQL;

- Отсутствие ACID-транзакций.

Можно поспорить, что я хочу использовать Cassandra не по назначению, и я полностью соглашусь. Моя цель — показать, что если решить эти проблемы, “назначение” Cassandra можно значительно расширить. Совмещая человека и лошадь, получаем всадника, который может уже совсем иной перечень вещей, нежели человек и лошадь по-отдельности.

Как же можно обойти эти ограничения?

Я бы сказал, что классическим вариантом является фрагментация данных, когда часть лежит в Cassandra, а часть — в других системах, которые поддерживают необходимые гарантии.

Минусы этого подхода, которые видны навскидку: увеличение сложности (а значит, потенциально, и ухудшение скорости и качества) разработки и поддержки приложений. Намного проще стучаться в одни ворота, нежели на уровне приложения или слоя микросервисов совмещать разрозненную информацию из различных источников. Также деградация любой из двух систем может приводить к значительным негативным последствиям, вынуждая инфраструктрную команду гнаться сразу за двумя зайцами.

Apache Ignite

Ещё один способ — поставить другую систему поверх Cassandra, разделив ответственность между ними. Я считаю, что Apache Ignite — идеальный кандидат для этой схемы:

- Исчезает накладываемое диском ограничение производительности: Apache Ignite работает с оперативной памятью, сейчас нет ничего быстрее. Кроме того, она дешевеет настолько стремительно, что поставить достаточное количество RAM на пул серверов (Apache Ignite — распределенная система, как и Cassandra) — посильная задача;

- Полная поддержка классического SQL99, включая JOIN-ы, GROUP BY, ORDER BY, а также INSERT, UPDATE, DELETE, MERGE и так далее, позволяет нормализовать данные, облегчает аналитику, а с учетом производительности при работе с RAM — открывает потенциал HTAP, аналитики в реальном времени по операционным данным;

- Поддержка стандартов JDBC и ODBC облегчает интеграцию с существующими инструментами, например, Tableau, и фреймворками вроде Hibernate или Spring Data;

- Поддержка ACID-транзакций, гибкие и глубокие настройки обеспечения отказоустойчивости и дублирования данных;

- Распределенные вычисления, потоковая обработка данных, машинное обучение — можно легко реализовать множество новых для бизнеса сценариев использования, приносящих дивиденды.

В такой схеме Apache Ignite встает поверх Apache Cassandra, которая играет роль слоя постоянного энергонезависимого хранения. Несмотря на то, что уже в ближайших версиях Apache Ignite появится свое собственное решение Persistence с поддержкой расширения памяти диском, lazy run и сквозным SQL, Cassandra всё равно может быть интересна в этой роли за счет своей вылизанности за долгие годы развития, распространенности и возможности разделить ответственность, не складывая все яйца в одну корзину там, где это не нужно.

Кластер Apache Ignite вбирает в себя из Apache Cassandra все или часть данных (например, за исключением архивных), по которым нужно выполнять запросы, после чего работает в режиме write-through, самостоятельно обслуживая API- или SQL-запросы на чтение, и дублируя в синхронном или асинхронном режиме запросы на запись в Cassandra, надежно сохраняя их на диск.

Далее эти данные анализируются в реальном времени, могут использоваться средства визуализации наподобие Tableau, применяться распределенные алгоритмы машинного обучения, а также формироваться витрины.

А на примере?

Далее я приведу пример простой «синтетической» интеграции Apache Cassandra и Apache Ignite, чтобы показать, как это работает и что это совсем не сложно, пусть и требует определенной доли boilerplate-кода.

Для начала я создам необходимые таблицы в Cassandra и заполню их данными, затем инициализирую Java-проект и напишу DTO-классы, после чего покажу основную часть — конфигурирование Apache Ignite для работы с Cassandra.

Я буду использовать Mac OS Sierra, Cassandra 3.10 и Apache Ignite 2.0. В Linux команды должны быть аналогичны.

Cassandra: таблицы и данные

Для начала загрузим дистрибутив Cassandra в директорию ~/Downloads, пройдя по ссылке, либо используя curl/wget.

Далее зайдем в директорию и распакуем его:

$ cd ~/Downloads

$ tar xzvf apache-cassandra-3.10-bin.tar.gz

$ cd apache-cassandra-3.10Запустим Cassandra с настройками по умолчанию, для тестирования этого будет достаточно.

$ bin/cassandraДалее запустим интерактивный шелл Cassandra и создадим тестовые структуры данных (выберем обычный суррогатный id как ключ — для таблиц в Cassandra зачастую имеет смысл выбирать ключи, более осмысленные с точки зрения последующего извлечения данных, но мы упростим пример):

$ cd ~/Downloads/apache-cassandra-3.10

$ bin/cqlshCREATE KEYSPACE IgniteTest WITH replication = {'class': 'SimpleStrategy', 'replication_factor' : 1};

USE IgniteTest;

CREATE TABLE catalog_category (id bigint primary key, parent_id bigint, name text, description text);

CREATE TABLE catalog_good (id bigint primary key, categoryId bigint, name text, description text, price bigint, oldPrice bigint);

INSERT INTO catalog_category (id, parentId, name, description) VALUES (1, NULL, 'Бытовая техника', 'Различная бытовая техника для вашего дома!');

INSERT INTO catalog_category (id, parentId, name, description) VALUES (2, 1, 'Холодильники', 'Самые холодные холодильники!');

INSERT INTO catalog_category (id, parentId, name, description) VALUES (3, 1, 'Стиральные машинки', 'Замечательные стиралки!');

INSERT INTO catalog_good (id, categoryId, name, description, price, oldPrice) VALUES (1, 2, 'Холодильник Buzzword', 'Лучший холодильник 2027!', 1000, NULL);

INSERT INTO catalog_good (id, categoryId, name, description, price, oldPrice) VALUES (2, 2, 'Холодильник Foobar', 'Дешевле не найти!', 300, 900);

INSERT INTO catalog_good (id, categoryId, name, description, price, oldPrice) VALUES (3, 2, 'Холодильник Barbaz', 'Люкс на вашей кухне!', 500000, 300000);

INSERT INTO catalog_good (id, categoryId, name, description, price, oldPrice) VALUES (4, 3, 'Машинка Habr#', 'Стирает, отжимает, сушит!', 10000, NULL);Проверим, что все данные записались корректно:

cqlsh:ignitetest> SELECT * FROM catalog_category;

id | description | name | parentId

----+--------------------------------------------+--------------------+-----------

1 | Различная бытовая техника для вашего дома! | Бытовая техника | null

2 | Самые холодные холодильники! | Холодильники | 1

3 | Замечательные стиралки! | Стиральные машинки | 1

(3 rows)

cqlsh:ignitetest> SELECT * FROM catalog_good;

id | categoryId | description | name | oldPrice | price

----+-------------+---------------------------+----------------------+-----------+--------

1 | 2 | Лучший холодильник 2027! | Холодильник Buzzword | null | 1000

2 | 2 | Дешевле не найти! | Холодильник Foobar | 900 | 300

4 | 3 | Стирает, отжимает, сушит! | Машинка Habr# | null | 10000

3 | 2 | Люкс на вашей кухне! | Холодильник Barbaz | 300000 | 500000

(4 rows)Инициализация Java-проекта

Есть 2 способа работы с Ignite: можно скачать дистрибутив с сайта ignite.apache.org, подложить ему необходимые Jar-файлы с собственными классами и XML с конфигурацией, либо использовать Ignite как зависимость в Java-проекте. В этой статье я рассмотрю второй вариант.

Создадим новый проект — я буду использовать maven как классический и понятный максимально широкой, на мой взгляд, аудитории инструмент.

В зависимости пропишем:

- ignite-cassandra-store для обеспечения интеграции с Cassandra;

- ignite-spring для загрузки XML-конфигурации в формате Spring Context, отсюда транзитивно нам прилетит кусок Spring, альтернативно можно не включать данный пакет и самим создать необходимые классы (в первую очередь IgniteConfiguration).

Транзитивно будет также загружен ignite-core, который содержит основные классы Apache Ignite.

org.apache.ignite

ignite-spring

2.0.0

org.apache.ignite

ignite-cassandra-store

2.0.0

Далее необходимо создать DTO-классы, которые будут представлять таблицы Cassandra в мире Java:

import org.apache.ignite.cache.query.annotations.QuerySqlField;

public class CatalogCategory {

@QuerySqlField private long id;

@QuerySqlField private Long parentId;

@QuerySqlField private String name;

@QuerySqlField private String description;

// public getters and setters

}

public class CatalogGood {

@QuerySqlField private long id;

@QuerySqlField private long categoryId;

@QuerySqlField private String name;

@QuerySqlField private String description;

@QuerySqlField private long price;

@QuerySqlField private long oldPrice;

// public getters and setters

}import org.apache.ignite.cache.query.annotations.QuerySqlField

data class CatalogCategory(@QuerySqlField var id: Long,

@QuerySqlField var parentId: Long?,

@QuerySqlField var name: String?,

@QuerySqlField var description: String?) {

constructor() : this(0, null, null, null)

}

data class CatalogGood(@QuerySqlField var id: Long,

@QuerySqlField var categoryId: Long,

@QuerySqlField var name: String?,

@QuerySqlField var description: String?,

@QuerySqlField var price: Long,

@QuerySqlField var oldPrice: Long) {

constructor() : this(0, 0, null, null, 0, 0)

}Мы помечаем аннотацией @QuerySqlField те поля, которые будут участвовать в SQL-запросах. Если поле не помечено данной аннотацией, его невозможно будет извлечь его посредством SQL или фильтровать по нему.

Также можно сделать более тонкие настройки для определения индексов и полнотекстовых индексов, которые выходят за рамки данного примера. Подробнее о настройке SQL в Apache Ignite можно прочитать в соответствующем разделе документации.

Конфигурация Apache Ignite

Создадим в src/main/resources нашу конфигурацию в файле apacheignite-cassandra.xml (название выбрано произвольно). Я приведу полную конфигурацию, которая достаточно объемна, после чего рассмотрю ее по частям:

java.lang.Long

com.gridgain.test.model.CatalogCategory

java.lang.Long

com.gridgain.test.model.CatalogGood

Формат конфигурации — Spring Beans.

Конфигурацию можно поделить на два раздела: определение DataSource для установки связи с Cassandra и определение настроек Apache Ignite, которые сводятся в данном примере к указанию рабочих кешей, полностью соответствующих таблицам в Cassandra.

Первая часть конфигурации лаконична:

Мы определяем источник данных Cassandra, указываем адреса, по которым можно попытаться установить соединение.

Далее задается конфигурация Apache Ignite. В рамках этого теста будет минимальное отклонение от настроек по-умолчанию, поэтому переопределяем только свойство

cacheConfiguration, которое будет содержать список кешей, запускаемых на кластере:

...

Первый кеш — представляющий таблицу catalog_category:

В нем включаем режим сквозных чтения и записи (если будем что-то писать в кеш, операция записи будет автоматически дублироваться в Cassandra), указываем, что в SQL будет использоваться схема catalog_category, а также перечисляем типы, которые будут храниться в этом кеше и должны быть обработаны для обращения к ним через SQL. Типы указываются всегда парами ключ-значение, поэтому количество элементов списка всегда должно быть четным.

java.lang.Long

com.gridgain.test.model.CatalogCategory

Наконец, зададим связь с Cassandra, здесь будет два основных подраздела. Во-первых, укажем ссылку на созданный ранее DataSource: cassandra. Во-вторых, нам нужно будет указать, как соотносить между собой таблицы Cassandra и записи «ключ-значение» Ignite. Это будет делаться через свойство

persistenceSettings, в котором лучше сослаться на внешний XML-файл с конфигурацией меппинга, но для простоты встроим этот XML непосредственно в Spring-конфигурацию как CDATA-элемент:

Конфигурация меппинга выглядит достаточно интутивно понятно:

На верхнем уровне (тег

persistence) указывается Keyspace (IgniteTest в данном случае) и Table (catalog_category), которые мы будем соотносить. Затем указывается, что ключом Ignite-кеша будет тип Long, который является примитивным и должен соотноситься с колонкой id в таблице Cassandra. При этом значением является класс CatalogCategory, который должен при помощи Reflection (stategy="POJO") формироваться из колонок таблицы Cassandra.Подробнее о более тонких настройках меппинга, которые выходят за рамки данного примера, можно прочитать в соответствующем разделе документации.

Конфигурация второго кеша, содержащего данные о товарах аналогична.

Запуск

Для запуска создадим класс

com.gridgain.test.Starter:package com.gridgain.test;

import org.apache.ignite.Ignite;

import org.apache.ignite.Ignition;

public class Starter {

public static void main(String... args) throws Exception {

final Ignite ignite = Ignition.start("apacheignite-cassandra.xml");

ignite.cache("CatalogCategory").loadCache(null);

ignite.cache("CatalogGood").loadCache(null);

}

}

Здесь мы используем инструкцию

Ignition.start(...) для запуска узла Apache Ignite, указав в качестве источника конфигурации лежащий на classpath файл apacheignite-cassandra.xml.SQL

Для выполнения SQL-запросов можно использовать любой клиент, который поддерживает JDBC, например, встроенный в IntelliJ IDEA, либо SquirrelSQL. В последнем случае, например, нужно будет добавить драйвер Apache Ignite (который находится в Jar-файле ignite-core, его можно скачать в составе дистрибутива):

Создадим новое соединение по URL вида jdbc:ignite://localhost/CatalogGood, где localhost — адрес одного из узлов Apache Ignite, а CatalogGood — кеш, к которому будут идти по умолчанию запросы.

Пара примеров возможных SQL-запросов:

SELECT cg.name goodName, cg.price goodPrice, cc.name category, pcc.name parentCategory

FROM catalog_category.CatalogCategory cc

JOIN catalog_category.CatalogCategory pcc

ON cc.parentId = pcc.id

JOIN catalog_good.CatalogGood cg

ON cg.categoryId = cc.id;| goodName | goodPrice | category | parentCategory |

|---|---|---|---|

| Холодильник Buzzword | 1000 | Холодильники | Бытовая техника |

| Холодильник Foobar | 300 | Холодильники | Бытовая техника |

| Холодильник Barbaz | 500000 | Холодильники | Бытовая техника |

| Машинка Habr# | 10000 | Стиральные машинки | Бытовая техника |

SELECT cc.name, AVG(cg.price) avgPrice

FROM catalog_category.CatalogCategory cc

JOIN catalog_good.CatalogGood cg

ON cg.categoryId = cc.id

WHERE cg.price <= 100000

GROUP BY cc.id;| name | avgPrice |

|---|---|

| Холодильники | 650 |

| Стиральные машинки | 10000 |

Заключение

На этом простом примере можно видеть, как используя Apache Ignite можно поверх Apache Cassandra поднять распределенный SQL-движок с ACID-транзакциями и скоростью оперативной памяти.

Столкнувшись с Apache Cassandra в существующей инфраструктуре либо в greenfield-проекте, вспомните об этой статье и о том, что Cassandra хороша со вкусом Ignite. Или можно уже сейчас попробовать сочинить какой-то проект, например, из мира интернета вещей, использующий сильные стороны Ignite и Cassandra.

|

Метки: author artemshitov программирование java big data блог компании gridgain apache ignite cassandra |

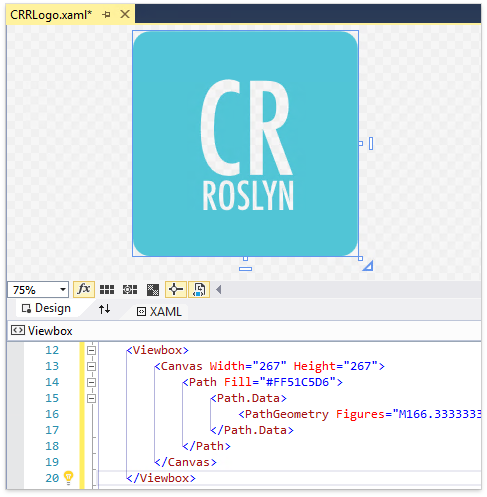

Возможности CodeRush for Roslyn для XAML |

Редактировать XAML-разметку в Visual Studio достаточно удобно благодаря таким фичам как IntelliSense, автозакрытие тэгов, сворачивание тэгов. Но при реальной работе с этими фичами приходит понимание, что XAML в чистой студии достаточно обособлен: например, плохо отслеживаются связи между кодом и разметкой. Это не позволяет чистой студии делать многие полезные вещи, которые умеет делать студия c CodeRush for Roslyn. Под катом подробности...

Навигация

Find References

Одна из наиболее важных задач среды разработки — поиск ссылок. В Visual Studio он есть, но CodeRush for Roslyn делает его полноценным: с этим расширением вы можете искать вхождения идентификатора не только в XAML, но и по коду во всем солюшне.

Tab to Next Reference

У нас также есть лёгкая версия поиска ссылок. Просто нажмите Tab. Если курсор находится на идентификаторе, он мгновенно переместится к следующему его использованию и одновременно подсветятся все вхождения. Чтобы перемещаться назад, можно использовать Shift+Tab.

Jump to Resource

F12 работает в XAML. Можно переходить на ResourceDictionary.Source или на Image.Source.

Jump to Symbol Declaration

Помимо референсов, можно быстро перейти к месту объявления идентификатора, причем не важно где идентификатор объявлен, в коде или в разметке.

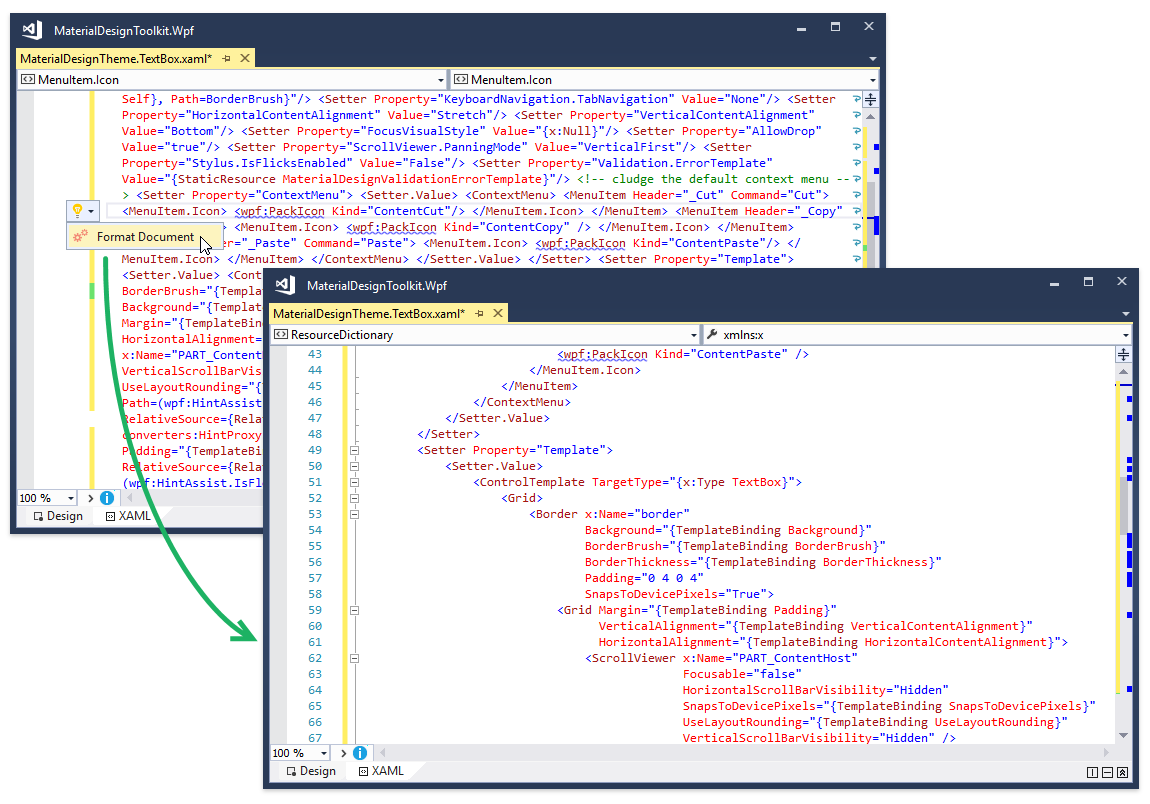

Форматирование разметки

Format XAML Document

XAML полезно форматировать. Есть разные подходы к форматированию XAML: можно вручную, можно использовать онлайн-инструменты для форматирования XML, а можно воспользоваться фичей CRR.

Прямо в Visual Studio.

У нашего форматтера гибкая конфигурация и он крайне удобен в работе.

Break Apart/LineUp Attributes

Часть возможностей форматтера доступна в виде отдельных фич, например одним кликом можно разбивать атрибуты по одному на строку, или сворачивать все в одну строку.

Рефакторинги

Import Type/All Types

При копировании фрагмента кода в проект, CRR помогает правильно заполнить заголовок XAML файла.

Optimize Namespace References

У нас есть рефакторинг Optimize Namespace References, он приводит в порядок референсы на пространства имен в XAML: сортирует их и убирает ненужные.

Этот рефакторинг будет полезен тем, кто еще работает в Visual Studio 2015. В последней версии студии он есть из коробки.

Convert Nested Element to Attribute/Attribute to Nested Element

Этот рефакторинг позволяет вытащить аттрибут из тэга и сделать его вложенным элементом. Так же, у нас есть обратный рефакторинг — можно сделать вложенные элементы аттрибутами.

Визуализация

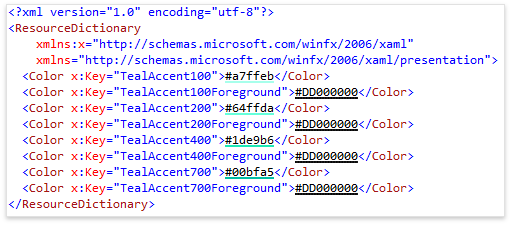

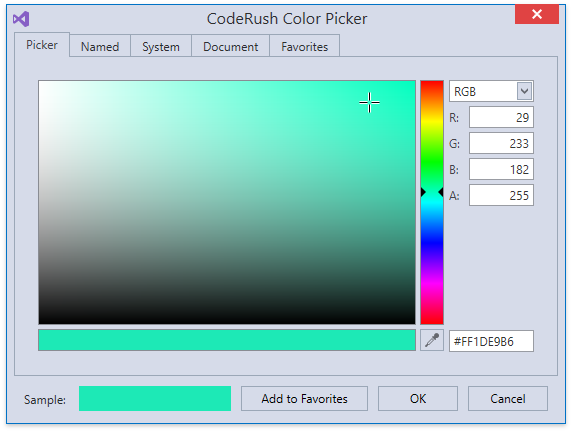

Show Color

Эта фича представляет собой декоратор, который визуализирует цвет, заданный шестнадцатеричным значением в XAML.

По клику на полосу открывается диалог в котором можно поменять цвет.

Region Painting

В CRR по-своему реализованна отрисовка регионов. Наша версия удобнее тем, что имя региона отображается на закрывающем тэге.

Помощь в написании разметки

Templates

Шаблоны CodeRush работают в XAML в полном объеме. Можно использовать встроенные шаблоны или писать свои с учётом ваших потребностей.

Selection Embedding

Когда нужно положить определённый блок разметки внутрь какого-либо тэга, приходится несколько раз перемещать курсор, потом форматировать. Чтобы упростить этот процесс у нас есть фича Selection Embedding, которая помещает выделение внутрь тэга одним кликом. Благодаря фичам Selection Expand и Include Previous/Next Element, можно даже не выделять необходимый блок мышкой/стрелочками, а просто нажимать горячие клавиши для управления выделением.

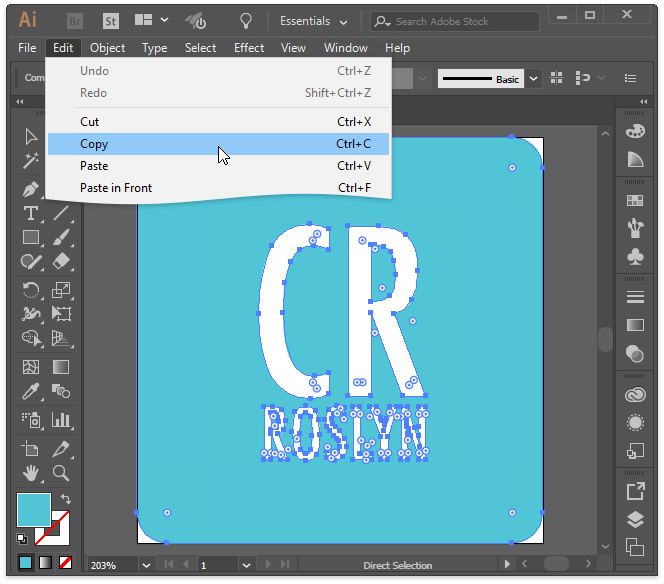

Paste Vector Drawing as XAML

Копируем из иллюстратора

Переключаемся на Visual Studio и вставляем в XAML-файл. Рисунок вставится в векторном формате, его можно дальше масштабировать и менять как угодно.

Также мы поддерживаем копирование векторов из Microsoft Visio, Microsoft PowerPoint.

Smart Duplicate Line

Для ускорения написания однотипных конструкций с небольшими изменениями у нас есть Smart Duplicate Line пытается определить изменяемые части в дублированной строке и помогает, например, инкрементирует числа и создает филды на переменных частях.

Большинство примеров этой статьи было сделано на исходных текстах открытой библиотеки Material Design in XAML Toolkit.

Скачать попробовать можно в Visual Studio Marketplace.

|

Метки: author xtraroman xml visual studio .net блог компании devexpress coderush xaml |

Как провести розыгрыш призов среди Java программистов |

А какие у вас ассоциации от слов «лотерея» и «розыгрыш»? У меня — разноцветные шары с номерами и лотерейная машина, из которой разноцветные шары выпадают по одному и определяют победителя.

Вот и мне некоторое время назад понадобилось “определить” победителей розыгрыша бесплатных места на курс “Разработчик Java” в Otus.ru. Задача звучала просто: есть N email-ов, нужно выбрать среди них случайным образом M email-ов тех, кто будет учиться бесплатно.

Сложность задачи была в том, что это были email-ы всех, кто успешно прошел входное тестирование курса. То есть email-ы программистов. Я представил себе, как я “достаю из кармана” M email-ов и говорю: “Вот эти победили”. И… мне никто не верит. Даже если победители начинают радостно писать в общий чат: “Спасибо, как мы рады!”, мне все равно никто из оставшихся не поверит.

Да я бы и сам не поверил, если бы мне просто сказали «победили эти».

Программистам мало сказать кто победил, надо доказать что это действительно случайные победители, и что в общем списке действительно был их email, и что вероятность попасть в победители у всех равна.

Вот в таких условиях нужно было придумать как разыграть места. В этой заметке, я хочу предложить вам мое решение этой задачи. Буду рад комментариям и особенно замечаниями об убедительности моего решения. Вы бы стали обоснованно спорить с результатами, если бы ваш email был в общем списке?

Итак, как провести розыгрыш призов среди программистов:

- Убрать из выбора организатора розыгрыша. Выбирать должен робот.

- Сделать робота открытым, чтобы любой мог посмотреть как он выбирает.

- Сделать случайный выбор псевдослучайным. Так, чтобы любой, кто знает зерно последовательности, его мог повторить.

- И при этом, формировать зерно псевдослучайности на случайности материальной.

- Выложить в общий доступ… email-ы? Чтобы каждый мог найти себя в списке? Нет, этого наши пользователи не оценили бы. Но каким-то образом дать проверить, что ты в списке, нужно.

Первое, что было логично сделать — поручить выбор программе. Написать лотерейную машину, которая бы решала кто победил. Коды моей машины вы можете посмотреть в моем аккаунте на github.

Она состоит из класса для чтения email-ов, класса который производит выбор “шаров” с индексами победителей и класса, который все запускает.

С получением списка email-ов все просто. Их надо прочитать из файла. Сначала я хотел читать email-ы и имена из csv файла, но потом оставил только email-ы, а csv и библиотека, которая его читает, остались.

Результат прочтения email-ов — List я передаю в лотерейную машину. Кроме этого, она на вход получает количество победителей. И еще ей можно задать seed — зерно псевдослучайной последовательности. Его можно задать числом, или строкой. Во втором случае зерном будет hash от строки.

Если у вас есть seed, то лотерейная машина будет выдавать одну и туже “случайную” последовательность победителей при каждом запуске. Случайную, но псевдо. Что, собственно, нам и надо.

Хорошо, список с email-ми у нас есть, лотерейная машина есть, и она использует в работе класс java.util.Random, который дает нам псевдослучайную последовательность на основе seed-а.

Теперь, для успеха нам недостает простой вещи: случайного seed-a — зерна последовательности. Так чтобы он был случайный, но чтобы мы могли его запомнить. Я решил в качестве источника такой материальной случайности использовать содержимое чата. Последние несколько сообщений передать в машину, чтобы она вычислила себе seed.

Все, кто пришли на розыгрыш, могли писать в чат когда угодно и что угодно. Подделать сообщения в чате, так чтобы подгадать с определением hash-а? Я не знаю как это сделать. Кроме того, я попросил желающих что-нибудь в чат написать прямо перед запуском машины.

Как это было, можно посмотреть в записи Дня открытых дверей на youtube.

Мы запустили лотерейную машину и получили победителей. Потом запустили ее еще раз и получили тех же самых.

После чего я предложил изменить текст, и удалил последнее сообщение. Со словами: “а теперь посмотрим как повлиял этот последний комментарий на результат”, я запустил машину и среди результатов был email того кто этот последний комментарий написал. Если бы он его не писал, приз был бы у него. Конечно он это заметил. Конечно мы все это заметили. И победители поблагодарили автора комментария за подарок.

Выкладывать в github email-ы мы конечно не стали. Но в репо вы можете посмотреть файл в котором записаны “обфусцированные” email-ы.

А как бы вы разыграли призы среди программистов? Понятен ли код и принцип работы машины?

|

Метки: author Tully программирование java блог компании отус online education online- курс lottery |

Видеозаписи: Android meetup в офисе Badoo |

В прошлую субботу, 17 июня, мы снова проводили митап в офисе. На этот раз принимали Android-сообщество. Эта встреча, вероятно, была самой разнообразной по темам докладов, поэтому каждый интересующийся найдет что-то для себя.

Спикеры

Филипп Уваров, Avito

Тема: Компонентные тесты: как сделать жизнь вашего QA немного проще?

Филипп говорил о компонентных тестах, о лучших практиках, которые выработала команда Филиппа в Avito. И как эти самые практики помогают делать качественный продукт.

Аркадий Гамза, Badoo

Тема: Android Studio умеет больше, чем вы думаете

Я провел небольшой воркшоп в Android Studio. Показал некоторые полезные приемы, которые помогают разработчику не тратить время впустую.

Андрей Сидоров, Яндекс

Тема: Измерение энергопотребления мобильных и внедрение в Continuous Integration

Андрей рассказал о том, как команда Яндекс.Браузера спроектировала устройство, с помощью которого измеряла энергопотребление приложением, о том, как автоматизировали процессы тестирования энергопотребления, как оптимизировали и контролировали потребление энергии в браузере.

Григорий Джанелидзе, OK.ru

Тема: Как перестать беспокоиться и начать запускать фичи

Гриша рассказал о том, как Android-команда Одноклассников запускает новые фичи и о том, с какими проблемами приходится сталкиваться.

Фотоотчет вы можете найти в нашей группе на Facebook, а посмотреть все видео в одном плейлисте – на нашем Youtube-канале.

|

Метки: author ArkadyGamza тестирование мобильных приложений разработка под android разработка мобильных приложений блог компании badoo android мобильная разработка митап meetup |

Знакомство с ServiceNow и управлением ИТ-инфраструктурой: Дайджест #2 |

Изображение Bruno Cordioli CC

Изображение Bruno Cordioli CCЧто читать в 2017 году для успешного внедрения ServiceNow

- 5 основных книг, которые помогут познакомиться с новыми способами предоставления ИТ-услуг и по-новому взглянуть на организацию управления ИТ вашей компании.

Лучшие бесплатные ресурсы для специалиста ServiceNow

- Еще одна подборка источников, которые помогут быстро разобраться с принципами работы ServiceNow. Здесь есть канал в Slack, официальные форумы и многое другое.

Знакомство с интерфейсом платформы ServiceNow (видео)

- Авторизация, основные элементы пользовательского экрана и работа с панелью приложений, а также порталом самообслуживания ServiceNow.

О платформе ServiceNow и как она помогает в работе (видео)

- Здесь мы рассказываем о платформе ServiceNow для тех, кто только знакомится с темой. Мы говорим об основной концепции и автоматизации рабочих процессов.

Инновационные способы использования ServiceNow

- Интересные примеры итеграции, огранизации обслуживания клиентов и управления магазином. Плюс немного об автоматизация автогонок.

Бюджетирование и оценка затрат в ServiceNow

- Как использовать модуль Financial Management — говорим о финансовой составляющей ИТ, расчете стоимости сервиса и других возможностях ServiceNow.

Как внедрить процесс управления конфигурацией (часть 1)

- Зачем нужно управлять конфигурацией, с чего стоит начать и как подойти к планированию этого процесса с точки зрения масштабирования.

Как внедрить процесс управления конфигурацией (часть 2)

- Продолжение первой части, в котором мы рассказываем про этапы определения, контроля, учета состояния и аудита. Плюс немного о том, как задействовать ServiceNow.

4 мифа об управлении услугами, в которые вы не должны верить

- Популярность темы Service Management порождает мифы, которые в большинстве случаев оказываются совершенно безосновательными. Разберемся, в чем тут дело.

Совместно используемые услуги

- Говорим о преимуществах совместно используемых услуг для кейсов, когда несколько подразделений компании работают с однообразными бизнес-процессами.

К 2030 году ITSM перестанет быть только «IT»

- Анализируем исследование «The Future IT Service Management Professional», которое открывает обсуждение будущего управления ИТ-процессами (ITSM) и роли ITIL.

Управление разработкой ПО — Agile Development

- Как активировать Agile Development на платформе ServiceNow, немного о бэклоге релизов (Release Backlog), спринта (Sprint Backlog) и других нюансах.

IT Operations Management — управление ИТ-инфраструктурой

- Как меняются корпоративные ИТ, с какими трудностями сталкиваются компании, как ITOM помогает ИТ-подразделению и сценарии его использования.

Корпоративный портал самообслуживания

- Как построить канал коммуникации с потребителем, предоставить централизованный доступ ко всем услугам и поддерживать обратную связь с помощью Service Portal.

Про стандарт ISO 20000

- Данный стандарт опирается на мировой опыт организации управления ИТ-сервисами и может быть применен к компании любого размера: от небольшой фирмы до огромной корпорации, вне зависимости от сферы ее деятельности.

|

Метки: author it-guild service desk help desk software блог компании ит гильдия ит гильдия дайджест servicenow |

[Перевод] Google и Apple против инди-разработчиков |

TL;DR: технологические гиганты Google и Apple доминируют на рынке магазинов приложений, ведь у них практически нет конкурентов. Поэтому они предоставляют инди-разработчикам очень слабую поддержку. Вашу игру или приложение могут внезапно удалить, и вы почти ничего не можете с этим сделать.

Нашу игру Fake Slap! засуспендили в Google Play за нарушение Политики в отношении насилия. Мы получили автоматическое письмо, сообщающее, что игра засуспенжена, и — бам! Она исчезла. Для нас это стало серьёзным шоком, игра находилась в Google Play и App Store уже больше месяца без каких-либо проблем. Политика в отношении насилия гласит: «Запрещается публиковать приложения, изображающие безнаказанное насилие или другие опасные действия». Ниже приводится несколько примеров, таких как: инструкции по причинению себе вреда, документирование своих атак террористическими группами, изготовление взрывных устройств и другого оружия и реалистичные изображения или подробные описания насильственных действий. Наша игра точно ничему из этого НЕ соответствует. Да, наша игра про политику, и её персонажем является президент США, но она определённо не относится к перечисленным видам насилия.

Важно то, что блокировка (suspension) приложения считается «страйком» и влияет на репутацию аккаунта разработчика. Вот как это формулируется: «Повторные или серьезные нарушения этих правил и Соглашения о распространении программных продуктов… приведет к удалению соответствующих аккаунтов». Вы даже не можете вернуться к своей игре, чтобы понять, в чём ошиблись — она полностью заблокирована. Не нужно говорить, что мы разгневаны. Представьте, что вы потеряете не только свой аккаунт разработчика, но и все свои аккаунты Google — от электронной почты, Google Drive, YouTube, вообще от всего. Проблема. Мы поспешили заявить апелляцию, и были уверены, что игру мгновенно восстановят, потому что произошла какая-то ошибка. Мы решили, что кому-то не понравилась идея приложения и он пометил игру, что запустило весь этот автоматический процесс. Google поймёт свою ошибку и вернёт приложение, правда?