Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

«Я не могу просто ходить с флагом «Postgres – наше всё». Нужно руками доказывать, что это работает» – Алексей Лустин |

Алексей и его коллеги занимаются профессиональным обслуживанием бизнесов, работающих с платформой 1С. Они обучают клиентов, как эффективно использовать 1C на связке PostgreSQL + Linux. Оказывается, что очень часто проблема заключается не в самой платформе, а в неумелой эксплуатации. На PG Day'17 Russia Алексей проведет мастер-класс по переходу на PostgreSQL для 1С под кодовым названием Борьба со страхами.

В рамках сегодняшней публикации, Алексей наглядно покажет, почему методология, которую они предлагают, является успешной. И не менее подробно объяснит, какие именно практические навыки вы приобретете на мастер-классе.

PG Day: Алексей, расскажите о себе. Кто вы, чем занимаетесь, как пришли к своей специализации?

PG Day: Алексей, расскажите о себе. Кто вы, чем занимаетесь, как пришли к своей специализации?Алексей: Я называю себя евангелистом Automation Driven Development. Это такая концепция “от автоматизации деятельности айтишников”, чтобы разработчики и инфраструктурщики избавлялись от рутины и освобождали время для интересной работы. Последние четыре года стараюсь подружить два мира с помощью концепции CICD (Continuous Integration и Continuous Delivery): разработчиков и инфраструктурщиков. Ради этого и была организована наша команда. Причем основной приоритет именно на “мир 1С”, как наименее автоматизированный с точки зрения процесса.

Как мы к этому пришли? В больших компаниях очень много регламентов. Чтобы их соблюдать, требуется ручной процесс. Для этого выделяют «ручных» людей. Когда мы приходим на крупные предприятия с аудитом, обнаруживаем, что 80-90% времени сотрудников тратится вот на эту рутину: обновить базу, измерить производительность, помониторить, сделать выводы, тесты ручные провести. 80% времени совершенно неэффективной работы. Она обоснована с точки зрения рисков предприятия, с этим соглашусь. Мы же понимаем, что в большой компании такое количество регламентов родилось как ответ на какие-то аварии и всё остальное. Только вот эти 80% – явный кандидат на автоматизацию.

Кстати, “айтишники” почему-то часто считаются обслуживающим подразделением, а не зарабатывающим. Никто не думает, что, сократив рутину, можно начать делать интересные вещи. Более эффективно бизнес автоматизировать, придумать что-то прорывное для собственного стартапа – новую гипотезу проверить или бабла срубить.

От этого “отпрыгивает всё”, что мы делаем руками.

Для бизнеса, еще с 2000-х годов наиболее эффективной считается платформа 1С, которая, начиная со старой версии 7.7, работает на контуре Microsoft и на СУБД MS SQL. У меня есть некое свое видение, почему так происходит. Изначально Microsoft был достаточно прорывной технологией в мире СУБД. Postgres тогда был уделом Linux (8 редакция и так далее), и, наверно, самой компании 1С был не очень интересен. Тогда главное было получить быстрый результат. Это MS SQL делал. Принято считать, что MS SQL стабилен для 1С. В целом, это, наверное, так. Его оптимизатор запросов начинает справляться, и не показывает ошибки в проектировании таблиц и связей между ними. Логически ошибочный проект на 1С в связке с MS SQL, запускаемый на каком-то минимальном объеме данных, начинает сбоить только после определенных порогов. А в Postgres эти ошибки выявляются еще на начальном этапе старта информационной системы – логические ошибки в структуре СУБД сразу вылетают, ты тут же видишь непонятки, все работает медленно. Поэтому обычно все начинают ругать Postgres, никто никогда не ругает разработчиков.

Я говорю так: 1С и Postgres работают хорошо! Проблема не в них, проблема в компетентности владельцев контура. Даже на больших объемах баз данных есть прецеденты. Например, когда общий объем баз данных со сжатием – терабайт и более (есть и такие инсталляции). Но, как показывает практика, они прямо пропорциональны уровню компетентности владельцев этого контура – разработчиков и devops. Уровень компетенции их намного выше, чем тех, кто владеет такой же инсталляцией с таким же объемом данных и транзакций в секунду на MS SQL. Там можно посадить непонятных товарищей, и они будут что-то кодить, низкий уровень их компетентности компенсирует сам MS SQL. Разница не в Postgres и MS SQL – разница только в компетентности.

Отсюда вся история с курсами, github-аккаунтами и различными публикациями скриптов. Лично моя социальная цель такова – чтобы эксперты по производительности в 1С-мире (на самом деле, системные администраторы, которые администрируют весь контур – и сервер приложения 1С, и СУБД) повышали свой уровень компетентности.

Как я к этому пришел? Представьте, что у вас двести 1С-ников в обучении, и задача – запустить хотя бы 100 информационных систем на linux. Последние пять лет назад у меня был такой волшебный опыт: надо было сместить стратегический фокус с MS SQL контура на Postgres. В 2006 году в рамках «Инфостарта» мы организовали сообщество 1C+Postgres (рассчитанное больше на гиков). Нам поставили задачу смигрировать хотя бы часть систем на Postgres. Выяснилось, что проблема вообще не в Postgres и не в 1С. Проблема именно в уровне компетентности администраторов, которые ответственны за СУБД, и 1С-ников, и разработчиков, и так далее. Они просто не умеют проверять свои гипотезы, когда в качестве СУБД используется PostgreSQL. Им кажется, что развернут быстренько на продуктиве – и все само заработает. Потом только останется что-нибудь подкрутить. С Postgres так нельзя.

Ну и про себя могу сказать. Раз я евангелист инженерных практик DevOps, мне приходится руками доказывать, что это работает. Я не могу просто ходить с флагом «Postgres – наше всё». Мне говорят: «Докажи». Сажусь совместно с командой (нас не очень много, кстати), и мы через вагранты, докеры, всякие автоматизированные скрипты доказываем, что правы. Убеждаем, что мы не просто популисты.

PG Day: Вы затронули интересную тему – проблематику перехода с платформы Windows MsSQL на Linux с Postgres. Какие советы, исходя из вашей практики, вы даете для устранения этих проблем, когда вас просят помочь с осуществлением такого перехода?

Алексей: У нас выстроен некий чек-лист, называется «борьба с возражениями при переходе». 1С производят типовые информационные системы. Сейчас же обычно как: если хочешь развернуть комплексную автоматизацию предприятия (начиная с зарплаты и заканчивая финансовым учетом). Инсталлируй 1С – получишь полную ERP и вперед, занимайся бизнесом, не заморачивайся автоматизацией. В таком случае ты выигрываешь.

Но когда «бизнесменишь», то вынужден дорабатывать под себя, «подрихтовывать». Приходится нанимать разработчиков и инфраструктурщиков разного уровня. И они тебе «допиливают». За последние пятнадцать лет 95% инсталляций 1С – нетиповые. Есть статистика, что в России существует около полумиллиона различных нетиповых инсталляций. Их «допиливали» какие-то товарищи под конкретного бизнесмена, с разным уровнем качества. Если «материнская» компания выпускает информационную систему, в которой структура таблиц более-менее отлажена (потому что внутри компании 1С отладка моделей все-таки идет: и IDEF-диаграммы, и ERwin, наверное – там всё нормально работает). Когда оно приходит к конкретному бизнесмену, разработчики «допиливают», и могут ничего не знать ни про модель данных, ни про теорию множеств. Могут накатать схему данных просто невозможную.

Поэтому первое возражение, с которым мы боремся, – запустится ли система вообще. Приходится сначала просто показать. Можно всю информационную систему выгрузить и загрузить в другой контур СУБД, это у них такая классная фишка в мире 1С: можно сделать перенос не с помощью pg_dump или бекапов MS SQL, а собственным внутренним инструментом. Так вот, берешь и переносишь на контур Postgres.

Однако там есть одна особенность – 1С-сервер лучше ставить все-таки не на Linux, а на Windows – из-за проблем с active directory и kerberos-библиотекой. Это связано не с Postgres, а с особенностью статической линковки библиотеки kerberos под CentOS, под Ubuntu и не только. Вообщем, есть такая рекомендация, что на Linux ставишь только Postgres. При этом очень сильно сопротивляешься, чтобы не запустить его на Windows. Windows-сервер оставляешь под управлением 1С и переносишь базу. Замеряешь сколько времени будет переноситься база – развертываться из бэкапа и переходить в продуктивное состояние. Если база у тебя – терабайт, то наш волшебный замер – 36 часов. Сторонними средствами, когда из MS SQL в Postgres, – конечно, получилось бы быстрее. Но, все-таки, мы выбираем штатный инструмент, он хоть и дольше, но наименее рискованный.

Разворачиваешь и запускаешь тупые вещи – какой-нибудь отчет, например. Это самое показательное. Отчеты начинают работать быстрее на 15-20%. Это доказуемо. Ты берешь на одном контуре и на втором, запускаешь, и у тебя на 20% отчеты формируются быстрее. Это первый такой wow-эффект. Кстати, известна даже причина, почему так происходит. В итоге – это доказывает, что “оно” работает.

Все обычно боятся Linux, от слова «совсем». Ты им развернул Postgres, доказал, что он работает быстрее на некоторых операциях, но они все равно продолжают боятся Linux. Приходится убеждать, что здесь нет Linux, здесь есть Postgres. Есть установленный пакет и несколько команд – apt-get install или yum. Ты обучаешь администратора базовым командам – что тут есть блочные устройства, они немножко по-другому выглядят, чем в Windows, и это скриптуешь в виде vagrant-файла. Показываешь ему, как это работает, чтобы он мог виртуальную машину с Linux для игр развернуть в виде vagrant, который примерно повторяет его настройки Postgres в продуктиве. И он начинает с ним играться: запускает различные команды Linux, смотрит, как вообще апдейты работают, как работать с бэкапами, с консольным pg_dump и еще с чем-то.

Обычно администраторы – выходцы из Windows-мира, которые раньше “админили” MS SQL. Они говорят: «А как бэкапить?» (ведь у него есть некий Maintenance Plan, который принят в MS SQL). Готовишь ему табличку, которая показывает, как он это делал на MS SQL, и как это делается на Postgres: как пересчитывать статистику (и как она вообще в PostgreSQL называется), как посмотреть план запроса косячного длинного и так далее. Она обычно состоит из 15 – 20 основных пунктов. В итоге, ему перестает быть страшно – всё, что он делал раньше, в той или иной степени присутствует и в контуре PostgreSQL.

А потом начинаешь веселиться с Postgres-контуром. Это тоже основная беда, когда ты объясняешь, что, на самом деле, нет принятого в Microsoft «мышководства». У тебя есть либо nano, либо vim, и ты меняешь параметры. Причем, если есть возможность запустить более новую версию, то уже показываешь ему конструкцию alter system. Для большинства DBA это понятная конструкция – что можешь поменять системные переменные, почти что но, конечно, не совсем) аналог trace flag MS SQL. Показываешь, как память рассчитывать, учишь, как рассчитывать в Excel объем коннектов, считаешь транзакции в секунду, вообщем, учишь работать с Postgres-контуром, что это не магия никакая. Естественно, тут же даешь ссылки на видео Бартунова или каких-то открытых тренингов Postgres Pro. Достаточно быстро группируешь список из небольших 5-6 вебинаров – и они проникаются тем, как это всё работает. Ссылки, опять же, на Github даешь.

А эксперименты, я напомню, проводятся на vagrant. Один из примеров: тормозит СУБД (1С и СУБД расположены на нескольких инфраструктурных серверах), все привыкли, что это якобы 1С, и никто ничего не делает. А когда ты на Postgres запускаешь – сразу видно, что есть проблемы по сетевой инфраструктуре. Тебе надо померять ее iperf’ом и еще какими-то инструментариями Linux. Так часто выявляется наличие странных сетевых маршрутов между выделенной инфраструктурой. Получается проблема не в 1С и не в MS SQL, а проблема – в сети между ними, но MS SQL как-то жил, а на PG уже так нельзя. Странные прыжки, переходы между непонятными узлами – это тоже достаточно быстро выявляется. Почему-то средства мониторинга Postgres настолько веселые и низкоуровневые, что показывают эти цифры достаточно быстро. Такую магию начинаешь ребятам рассказывать про инфраструктуру, они быстро проникаются. Вот и всё.

Основная цель же – перевести базу и научиться ею владеть в продуктиве. Продуктивный контур они настраивают сами, повторяют скрипты, которые сделали на vagrant. В продуктив мы не лезем – такова наша методика. Фактически это получается их продуктив. Если они не уверены в том, что мы им показали, значит, продолжаем обучение, доказательства и так далее.

А поддержкой продуктива мы не занимаемся, кстати. Есть люди, которые делают это более профессионально – мы лучше порекомендуем их. Они прям админы. В мире Postgres всем известно, кто и на чем специализируется – мы специализируемся на общем контуре и на vagrant, то есть на приемочных контурах Postgres и 1С. Но как только идет передача в продуктив, я говорю: «Ребята, вот список людей кто специализируется на PG в продуктиве – туда все вопросы. Не верите российским – пожалуйста, обращайтесь к 2ndQuadrant». Там есть люди, которые сразу родились с бородой и с клавиатурой, заточенной под vim, в одной руке. При этом ночью они мысленно пересобирают ядра Linux. Поэтому в продуктив я с командой не лезу, хотя мониторинг оттуда забираю, чтобы выявить проблемы разработчиков тем же pgBadger, который, кстати, я всем рекомендую.

Это киллер-фича из мира Postgres для инфраструктурщиков: покажет, как живет твоя БД с репликами. В этот отчет можно “погрузиться на месяц” и исследовать. Да, в MS SQL есть такие штуки, но они стоят очень дорого. А здесь прямо с коробки github docker, почти как инсталлятор: запустил и забыл.

Если подытожить – берешь и пошагово борешься “со стандартными возражениями”. Показываешь, что на Postgres – работает, а в некоторых сценариях работает быстрее, и показываешь сам сценарий.

Борьба с возражениями против Linux происходит так: 1С сервер оставляешь на привычной им винде, а Postgres делаешь на Linux. Так закрываешь первое возражение – типа, не-не-не, не всё на Linux, только Postgres! Чуть-чуть Linux.

Запустил, немножко добавил Linux, продемонстрировал, что это всё работает и выделил – на каких сценариях быстрее. Сначала показал экосистему, где почерпнуть бесплатную информацию, если понадобится, затем подключенные расширения, которые позволяют более комфортно всем этим делом управлять. Далее последовательно – показал как работает оптимизатор, восстановил план обслуживания, чтобы это было понятно. Все делаешь последовательно, чтобы убедить, что Postgres – это не страшно, это легко.

Задача – погрузить в принципы, которые приняты при владении контуром Postgres, чтобы было понятно, где брать информацию и как ее отлаживать. Работаем в парадигме – на продуктиве ничего не меняем, сначала смотрим, потом применяем.

Доказательством у нас являются скрипты на github. Это тоже такая позиция – выкладывать даже первоначальные наработки в открытый доступ.

PG Day: Расскажите подробнее про cвой workshop на конференции. Как будет строиться работа? Предубеждения касательно эксплуатации 1С на платформе будут решаться по такому вот чек-листу, про который вы рассказывали?

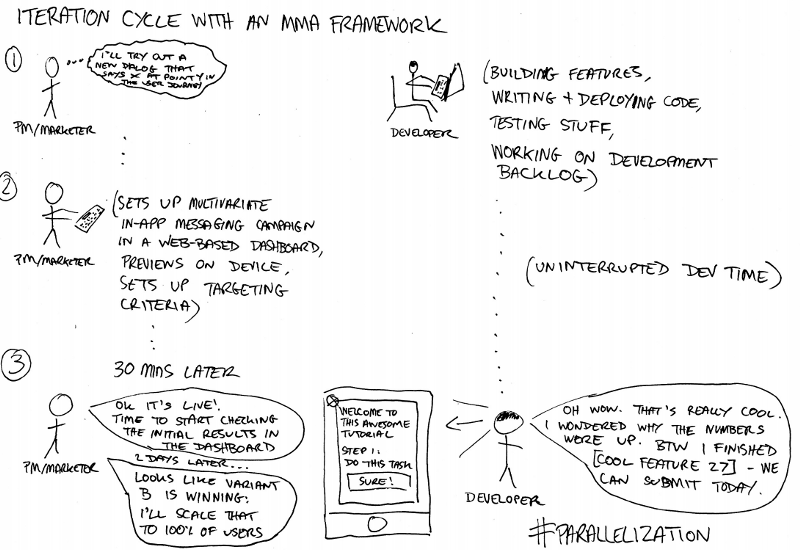

Алексей: Да, идеология будет такая: разверните контур Postgres – появится несколько боксов в режиме «стоковый». У нас есть специнструмент, который показывает результаты – он, например, показывает, как ведет себя 1С на стоковом Postgres Pro, без ничего, без базовых настроек, в режиме “микроволновки”.

Потом разделяем работу на 4 раздела: данные, логи PostgreSQL, WAL и pg_dump. И смотрим результаты на тех же сценариях, которые были перед этим. После этого третий бокс настраивается уже в postgres.conf, именно под типовых пользователей в тестовом контуре, с их обычной нагрузкой. Они рассчитывают регистры, отчетики запускают, справочники пишут, читают их активно и так далее. Отчет покажет, по каким принципам живет наш проверочный контур, чтобы каждый потом сам мог повторить. После этого покажем результаты правильной настройки базовой инфраструктуры postgres.conf.

Затем следующий раздел – как увидеть основные «грабли» в 1С, основные ошибки? Это про то, какими экстеншенами вы можете увидеть типовые ошибки программистов 1С (причем на типовых конфигурациях ЗУП, УТ и так далее). Они известны, – это веселая работа с temp каталогом, с временными таблицами во вложенных запросах (1С-ники любят так ошибаться), непонятные составные джойны, когда у тебя неявный джойн 1С преобразовывает и идет классическое непопадание в индекс (это прямо беда 1С, 1С-программисты «терпеть ненавидят» ставить индексы и в них попадать). Как это выявить быстро, как увидеть, где ошибся разработчик – это мы показываем во втором разделе.

То есть у нас есть сценарий, как ведет себя 1С, и как посмотреть, как выявить, найти место. В 1С есть штатный инструмент, но он платный. Поэтому рекламировать его не будем, все 1С-ники и так знают, что это Центр управления производительностью, он парсит планы запросов. Но есть бесплатный, он называется «инструмент разработчика». Запускаешь и смотришь план запроса с Postgres и участок кода в 1С, который его вызвал. Если знаешь критерии запроса, который тебя волнует, то можешь найти проблемное место бесплатно. Тебе не нужно покупать за 300 тысяч корпоративный инструментальный пакет. Соответственно, выдать рекомендации. Либо, если ты сам разраб… Бывает такое, что ты эксперт по производительности, имеешь доступ к Postgres и сам же эту конфу пилишь (в мире 1С такое очень часто случается), то можешь сам поправить. Становится понятно, где ошибся.

Следующий раздел: как собирать экстеншены из внешних исходников, и, вообще, как собрать свою версию Postgres, например, под Alpine, для 1С – где патчи найти, где их применить, какие контрибы нужны и так далее. Как это вообще выстроить. Скрипты тоже передаем. Это уже четвертый раздел, когда начинается низкоуровневый тюнинг, уже на уровне ядра, и опять же для 1С. Всё это через призму того, как меняется поведение 1С при применении этих настроек.

Кстати, по модели нагрузки, “1С” очень много пишет и тут же очень много читает. Он дает гибридную нагрузку. Там нет нагрузки OLAP или OLTP. Они могут писать сразу массово по 2,5 тысячи записей за транзакцию – и тут же их читать в следующей транзакции. Причем транзакция в данном контексте подразумевается как “бизнес-транзакция”.

Это надо просто посмотреть. Проведение одного документа в 1С вырождается в огромное количество последовательных запросов. Пользователь нажал одну кнопку, а сервер приложений сформировал много служебных вызовов на уровне СУБД. Это важно понимать, потому что там могут неожиданно создаваться временные таблицы, хотя ты их не создавал кодом. Может произойти массовая вставка, тут же распухание. То есть при записи одного документа сразу сработает bloat. Вакуум не отработает – не успеет. Он тут же запишет, следующую итерацию начнет читать. Прямо видно, как происходит фактически версионирование записей на 1С. Будет расти распухание таблиц. Автовакуум нужен, но он не всегда отрабатывает под высокой нагрузкой 1С. Это воспроизводимо визуально.

Вот такие разделы.

Последнее, что я бы хотел донести до людей, которые придут на мастер-класс. Postgres – охрененная штука. Но, чтобы нормально им владеть, нужно еще кучу всего дополнительно изучить. Поставить, как MS SQL, и забыть – не получится. С Postgres ты живешь в комьюнити, с экстеншенами, расширениями, дополнительным инструментарием (в основном, открытым, в исходниках). Это прямо комьюнити с микроинструментами для каждой мелкой задачи. Хочется донести, что MS SQL можно повторить полнофункционально и добиться охрененных результатов. Но ты должен понимать, что не будет одного инсталлятора. Не будет от слова «совсем».

Я по программе пробежался примерно. Будем идти вот так.

PG Day: На самом деле, очень подробное и отличное описание. Наверное, лучшее, которое я получил от ведущего мастер-класса за весь прошедший опыт, за последние два месяца. Спасибо, Алексей!

|

Метки: author rdruzyagin блог компании pg day'17 russia postgresql 1c interview интервью vagrant |

Ставим Selenium Grid на колеса Apache Mesos |

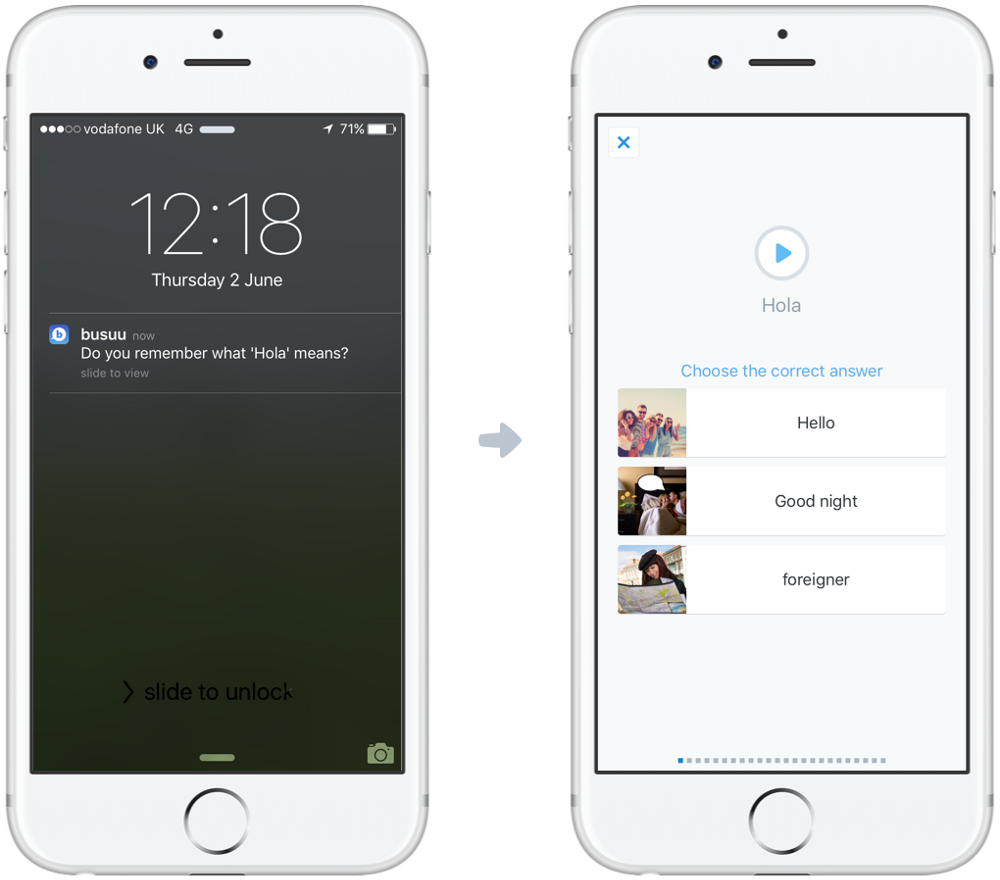

Прежде чем начну рассказывать про сам selenium grid и все, что связано с ним, я хочу пояснить суть проблемы, которую мы пытались решить.

В прошлом году мы внедряли DevOps как процесс. И в один момент, автоматизируя все и вся, мы поняли, что time to market для каждого артефакта на этапе тестирования не должен превышать 30 минут. Концептуально мы хотели, чтобы некоторые релизы проходили автоверификацию, если приемочное тестирование им не нужно. Для тех артефактов, которые нужно проверять руками, 30 минут — это время, за которое тестировщик получает результаты прогона автотестов, анализирует их, а также делает приемочное тестирование. При этом автотесты должны автоматически запускаться в рамках нашего pipeline.

Чтобы достичь поставленной цели, нам необходимо было ускорить прогон автотестов. Но помимо ускорения автотестов, нужно было еще сделать так, чтобы при всем обилии проектов у нас не возникали очереди на их запуск.

Чаще всего задача ускорения прогона автотестов решается двумя способами:

- Подход богачей — заливание проблемы деньгами: покупка дополнительного железа, клаудов, найм новых людей.

- Подход для простолюдинов — инженерный способ решения этой задачи.

Мы у себя в компании придерживаемся второго подхода, но не потому, что у нас нет денег. Я — инженер, и, как многие инженеры, ленива в отношении таких вопросов. Поэтому решила пойти по более сложному и интересному пути. И при этом сэкономить банку тот самый мешочек с деньгами.

Итак, цель ясна: ускорить и устранить очереди на запуск автотестов без привлечения дополнительного финансирования.

В самом начале у нас был довольно небольшой парк, состоящий из 15 виртуальных машин.

- Средняя конфигурация машинки была следующая: 4RAM/2 core/50 HDD

- И в один момент времени на одной машинке без потерь в скорости мы могли выполнять не более 2-х потоков тестов. Т.е. запускать не более 2-х сессий с браузерами. В противном случае — скорость выполнения тестов проседала.

- Все машинки были виндовые, что тоже накладывало на нас определенные ограничения (например, кроссбраузерность мы вообще не тестировали)

- И машинки находились в разных подсетях Банка (разные дата-центры). Поэтому управлять их конфигурациями было крайне сложно, так как пересоздание и управление происходило на стороне сисадминов.

В общей сложности у нас около 20 проектов с автотестами, которые в разное время и с разной частотой запускаются.

Наши команды:

- хотят релизиться от 3-х до 5-ти раз в день

- выпускают релизы не чаще раза в 1-2 недели

И у всех команд фокус на быструю доставку ценности до клиента. Само собой, никто не хочет “висеть” в очереди на запуск автотестов.

Ресурсов катастрофически не хватало. Почему? Давайте рассмотрим на конкретном примере:

- У нас есть проект, в котором порядка 30 тестов (это средняя цифра)

- Если мы запускаем тесты в один поток — то это как минимум 30 минут.

- Наша цель уложиться в 10 минут — значит, надо параллелить прогон тестов на несколько браузеров, а соответственно — на несколько машин.

- Значит, запускаем эти тесты в параллели как минимум в 3 потока. На практике же выходит, что каждый проект генерирует от 5 до 10 потоков.

- А теперь вспомним о наших 20 проектах. Если у нас возникает ситуация, когда все одновременно хотят запустить автотесты, чтобы избежать очереди, нужно минимум поднять 60 сессий с тестами.

- 40 еще поднимутся, с учетом того, что по 2 сессии на виртуалку.

- А остальные попадут в очередь — минимум на 10 минут.

Заметьте, мы рассмотрели очень положительный случай, когда тестов в проекте немного, и всего-то 3 потока. Железа не хватает, нужно думать о том, как облегчить нагрузку на виртуалки. Что если мы переедем с виртуальных машин в докер-контейнеры?

Посчитали:

- Возьмем наши 15 машин и построим из них единое пространство, где будем создавать докер-контейнеры, в которых будут прогоняться наши тесты.

- 15 виртуальных машин = это 60 RAM, 30 core и 750 HDD, причем это все находится в трех дата центрах, т.е. мы можем создать отказоустойчивое пространство.

Давайте рассмотрим конфигурацию одного докер-контейнера, который позволит прогнать тесты в 1 поток, и сравним с тем, что у нас было при использовании виртуальных машин:

500 RAM, 0,01% core, и HDD 400 мб.

Получается, что в один момент времени мы можем создать 120 контейнеров!

Это не только перекрывает наши запросы в 60 сессий, но и страхует на будущее. Ведь количество команд растет, а значит — количество запускаемых проектов тоже постоянно растет. Итак, стало достаточно очевидно, что нам нужно взять имеющиеся ресурсы и объединить их в единое пространство вычислительных мощностей, это еще называют песочницей. Объединяя, мы при этом не хотим думать о нем именно в парадигме каких-то хостов/виртуальных машин. Мы хотим иметь просто пространство, к которому мы сможем подключаться с помощью какого-нибудь api, и создавать в нем свои докер-контейнеры, на которых потом будем запускать тесты.

Динамическая песочница

Итак, нам необходимо создать песочницу вычислительных ресурсов. При этом она должна быть динамической: т.е. мы должны иметь возможность в любой момент подключить/отключить от нее ресурсы, которые у нас есть. Причем все хосты, которые мы подключаем, могут иметь разную конфигурацию и быть в различных подсетях, для нас лишь главное, чтобы между ними можно было установить связь по определенным ip и портам. Динамическую песочницу называют еще облаком или кластером, и в нем мы имеем интерфейс для создания и управления докер-контейнерами.

Когда мы поняли, как хотим решить задачу, мы построили нашу песочницу, объединив наши хосты в кластер с помощью Apache Mesos и Marathon.

Таким образом мы получаем общее пространство с вычислительными ресурсами, у которого есть свое api. API нам предоставляет Marathon, а Apache Mesos как раз таки и объединяет хосты.

Оркестратор тестов: Selenium grid спешит на помощь

Мы определились с тем, что нам нужен кластер, и даже его создали. Но вот вопрос, как же мы будем запускать тесты в кластере? Вы же помните, что мы хотим в любом случае получать результаты тестов не больше, чем за 10 минут?

И тут на помощь нам должна прийти параллелизация запуска тестов.

Для решения этой задачи нам нужен централизованный инструмент, который позволит запускать и параллелить тесты в несколько потоков для каждого проекта. Есть несколько популярных инструментов.

- Jenkins

- нативный оркестратор Selenium

Хоть мой рассказ и про то, как мы запускали selenium grid в докер-контейнерах — сначала рассмотрим, как вообще работает грид на виртуальных машинах.

Фактически вся процедура представляет из себя 3 действия:

1. Мы копируем Selenium Standalone Server (нужной нам версии) в какую-нибудь директорию.

2. Затем выполняем команду, которая запускает этот сервер в нужном нам режиме: хаба, либо режим ноды. Обратите внимание, что за эти две функции отвечает один и тот же физический jar-ник, который вы продублировали на разные хосты.

$ java

-jar selenium-server-standalone.jar

-role hub3. Конфигурируем ноду. Либо через командную строку, либо в json-файле указываем набор браузеров и их параметры.

$ java \

-jar selenium-server-standalone.jar \

-role node \

-hub http://host1:4444/grid/registerЧто делает хаб после старта грида

- Создает новые сессии с нодами

- Отправляет тестовые запросы в очередь, если все ноды заняты;

- Отвечает ошибкой, если у него нет нод или ноды с конкретными параметрами

Что делает нода

- После того как мы запустили сервер в режиме ноды на виртуалке и указали в параметрах команды адрес хаба, задача ноды — зарегистрировать на хабе. То есть сообщить ему, что она находится в его гриде, и о том, какие браузеры с драйверами у нее есть.

- Сама регистрация выглядит как посыл http-запроса с отправкой json-массива, в котором содержится вся информация по ноде.

- Следующая задача ноды — это исполнение тех запросов, которые она принимает через хаб после того, как тот создал сессию с этой нодой.

- Под запросами я подразумеваю те команды, которые шлет наш jar-ник с автотестами. Как пример, командой будет какой-нибудь шаг типа “Найди мне кнопку на данной странице со следующим id”. Соответственно, хабу чтобы выполнить такой шаг теста, нужно знать, к какому вообще тесту относится данный шаг. Ведь в один момент он может выполнять несколько тестов. И этот шаг подразумевает, что тот, кто будет выполнять эту команду, уже выполнил какую-то предысторию из других команд, например, перешел как раз таки на соответствующую страницу. Вот именно для этого и нужен уникальный идентификатор сессии с браузером в ноде, который создает хаб и затем по этому ИД понимает, на какую ноду ему распределять запросы.

- Нода же просто ждет команды от хаба, и при получении http-запросов, которые он перенаправляет на нее — она их выполняет.

Чем же отличается старт грида в докер-контейнерах?

1. Нода на момент старта уже сконфигурирована.

Давайте посмотрим на содержимое ноды. Файл с json-конфигом для ноды находится в контейнере с ней, затем мы его переименовываем, и наш сервер узнает о своих параметрах из этого файла:

/opt/selenium/generate_config > /opt/selenium/config.json При этом если мы посмотрим на содержимое Dockerfile самой ноды, то увидим, что при конфигурировании окружения ноды мы сразу задаем переменные окружения, которые потом записываются в этот конфиг. Таким образом, нам не нужно лезть в “кишки” самого контейнера, чтобы изменить параметры запуска ноды, нам достаточно в Dockerfile переопределить значения указанных переменных. И все.

2. Когда мы стартуем ноду в контейнере, мы всегда можем быть уверены в том, что у нашего окружения уже есть браузер и драйвер для него. Потому что все это настраивается и устанавливается в момент сборки самого образа.

$ /opt/selenium$ ls

chromedriver-2.29

selenium-server-standalone.jar

config.json

3. Также у нас есть скрипт sh, который выполняется после старта контейнера. И в этом скрипте мы видим, что после того, как у нас поднялся контейнер — у нас сразу же стартует наш java сервер.

$ java ${JAVA_OPTS} -jar /opt/selenium/selenium-server-standalone.jar \

-role node \

-hub http://$HUB_HOST:$HUB_PORT/grid/register \

-nodeConfig /opt/selenium/config.json \

${SE_OPTS} &

Аналогично все по отношению к хабу.

В итоге запуск selenium grid в контейнере сводится к одной команде — старт докер-контейнера.

Проблема статического грида

Несмотря на то, что хаб хорошо умеет работать с очередями и тайм-аутами, в самом начале использования статического грида мы испытали проблемы из-за тайм-аутов. Если хаб и нода долго не использовались, то при последующем коннекте мы ловили ситуации, когда при создании сессии на ноде эта самая сессия отваливалась именно по тайм-аутам или по причине того, что remotewebdriver не может поднять браузер. И все эти проблемы лечились рестартом грида, именно тогда мы и поняли, что для нас on-demand selenium grid будет решением проблемы.

Также мы не хотели, чтобы статический грид просто занимал место в кластере, который у нас и так небольшой. Как решить ситуацию, когда для разных проектов нам нужны разные конфигурации грида? Когда для одного проекта нужна одна версия браузера, для другого — другая? Очевидно, что держать включенными гриды — не самая хорошая идея.

Selenium Grid On-Demand

Поэтому мы захотели поднимать selenium grid по запросу: объясню на примере

- Допустим, мы хотим запустить тесты для проекта с 30-ю тестами, которые разложены в 3 тест-сьюита.

- Значит, мы запускаем джоб, который сначала нам создает selenium grid в кластере для этого прогона, и в качестве значения параметра о количестве нод в гриде он передает количество наших тест-сьюитов. То есть, для каждого проекта — конфигурация грида своя.

- После того как отработала команда поднятия selenium grid-а, происходит запуск тестов.

- После прогона тестов — грид удаляется.

Казалось бы, идеальная концепция. Мы таким подходом решаем сразу две проблемы: и с деградацией грида, и с нехваткой места в кластере для хранения различных конфигураций грида.

Автоматизация создания Selenium Grid On-Demand

Чтобы решить эту задачу, надо было написать скрипт автоматизированного создания грида. Мы ее решили с помощью ansible, написав нужные роли. Я не буду рассказывать, что такое ansible. Но могу сказать, что написать подобный скрипт вы у себя сможете также и на bash-e или на другом языке программирования, который на выходе вам предоставляет две команды на создание и удаление грида.

Помним, что запуск грида состоит из запуска парочки команд. И у каждой команды есть свои параметры. И чтобы автоматизировать запуск этих команд, эти параметры надо лишь автоматически вычислять до запуска команды. Либо же хардкодить.

Мы не можем хардкодить, потому что мы априори не знаем, на каком хосте и порту поднимутся компоненты Selenium Grid, так как за нас это решает Apache Mesos.

Мы, конечно, можем извернуться и вручную следить за открытыми портами и хостами, на которых поднимаем Selenium Grid, но тогда зачем нам вообще Apache Mesos и Marathon, если все будем делать вручную?

Итак, надо было автоматизировать вычисление следующих параметров:

- количество нод, которые мы поднимаем

- определение адреса хаба (его хост и порт, на котором он поднялся), чтобы передавать это значение ноде, иначе она не сможет зарегистрироваться.

В этом нам помогло api Marathon-а, с его помощью мы получали данные о том, на каком хосте и порту поднялся хаб. И потом уже это значение передавали перед стартом нод. Итак, что у нас получилось:

Deploy Selenium Grid

$ ansible-playbook -i inventory play-site.yml \

-e test_id=mytest \

-e nodes_type=chrome \

-e nodes_count=4test_id: уникальный идентификатор проекта с тестами

nodes_count: количество нод

nodes_type: тип браузера [chrome|firefox]

Delete Selenium Grid

$ ansible-playbook -i inventory play-site.yml \

-e test_id=mytest \

-e clean=true Shell-скрипты, исполняемые на Jenkins, перед запуском ansible playbook рассчитываются автоматически и передают значение переменной. Прогон тестов встроен в pipeline с помощью job dsl.

export grid_name=testproject

export nodes_count=$(find tests -name "*feature" \

| grep -v build | grep -v classes | grep features | wc -l)

cd ansible

ansible-playbook -i inventory play-site.yml \

-e test_id=$grid_name \

-e nodes_type=chrome \

-e nodes_count=$nodes_count

export hub_url=$(cat hub.url)

currentdir=$(pwd)

cd ../tests

./gradlew clean generateCucumberReport \

-i -Pbrowser=$browser -PremoteHub=$hub_url

Как только мы решили эту задачу и научились поднимать selenium grid в нашем кластере, то поспешили запустить тесты, и тут-то нас ожидало разочарование. Тесты не запускаются, более того — хаб даже не поднимает сессию с нодой.

Проблема поднятия Selenium Grid On-Demand в распределенном кластере

Давайте разберемся, чего же не хватало нашим скриптам.

Еще раз взглянем, как бы выглядела команда, если бы мы запускали каждый раз ноды в Docker-контейнере для selenium grid вручную:

$ docker run -d -p 6666:5555 selenium/node-chromeВы видите два порта? Наверное, некоторым из вас интересно, откуда появился второй порт. Так вот, у докера есть внутренний порт и внешний порт. Внешний порт слушает сам контейнер. А внутренний порт прослушивается самим процессом selenium server standalone, который запускается в режиме -node.

В этом примере все запросы на порт 6666 контейнера будут пересылаться на порт 5555 ноды внутри него.

Запуск ноды в Marathon

При настройке Apache Mesos-кластера мы для каждого хоста указываем диапазон портов. Этот диапазон используется для контейнеров, которые поднимаются Marathon’ом.

К примеру, если мы ставим диапазон 20000-21000, то наши контейнеры будут получать случайный порт из этого диапазона.

Marathon-агент запускает примерно такую команду.

$ docker run -d -p |

Метки: author Travieso тестирование веб-сервисов тестирование it-систем блог компании «альфа-банк» selenium grid selenium mesos инфраструктура apache mesos |

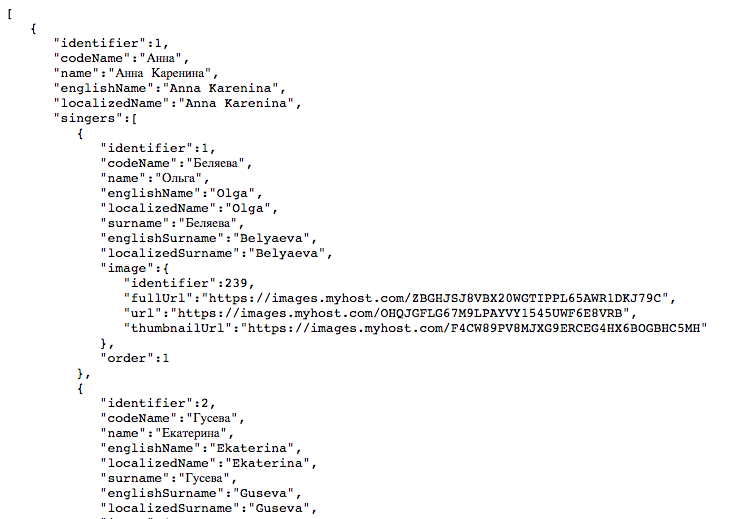

Как написать максимально хреновый бэкенд для мобильного приложения |

Известно, что практически ни одно мобильное приложение не обходится без бэкенда.

Если вы мобильный разработчик, то наверняка сталкивались с такими бородатыми дядями, которые меланхолично тянут логику на перле и вечно что-то пишут в консоли. Или может это был сутулый анимешник с длинными волосами, всосавший php с молоком матери.

Так или иначе, большинство из них ни разу не сталкивалось с мобильной разработкой, а кое-кто считает себя при этом гуру.

Специально для таких случаев, я подготовил список вредных советов о том как угробить бэкенд вашего приложения.

Приятного чтения.

Итак, если вы серверный разработчик:

- Не обращайте внимания на строение приложения, вам абсолютно не должно быть дело до того, как будет выглядеть продукт для пользователя. Ведь вы не хипстер, чтобы задумываться о таких вещах. Если данные для одного экрана надо получать через 10 разных запросов, это проблемы дизайнера, который рисовал интерфейс, не согласовывая его с вашим API. В следующий раз пусть не думает об удобстве пользователя, все-таки в проекте есть вещи поважнее.

- Ни в коем случае не пишите документацию. Простого вордовского файла на дропбоксе будет достаточно. В конце концов ваша работа — это струящиеся потоки данных, элегантные и высокопроизводительные. Пусть беспомощные мобильные разработчики почаще обращаются к вам за разъяснениями. Простого списка запросов без малейших примеров и описания им будет вполне достаточно. Ведь всегда можно заглянуть в ваш код и посмотреть все параметры и аргументы.

- Не заморачивайтесь с названиями полей. Это нормально, что одна и та же сущность в разных местах называется по-разному, пусть поле, обозначающее количество объектов, в одном месте будет count, а в другом koli4estvo_kek. И так понятно, неужели не распарсят?

И в смысле приходит разный тип данных? Ну да, в одном случае число, а в другом строка. Что не так? - Меняйте логику без предупреждения. Если вас озарило, то не медлите — срочно внедряйте. Не задумывайтесь о совместимости, не торопитесь обсуждать, просто делайте. И обязательно выкатывайте в релиз, дальше сами разберутся. Документацию тоже обновлять не обязательно, это все суррогат.

- Ни в коем случае не пишите тесты и не проверяйте собственное API. Помните, вы не допускаете ошибок, это в приложениях вечно едут экранчики и что-то вылетает. Да и потом, понять, что найденная проблема находится все-таки на бэкенде — дело пары минут.

- Не присылайте пояснения к ошибкам. Во-первых, они случаются крайне редко. Все должно идти идеально. Во-вторых, всем и так понятно почему что-то пошло не так. Простого http 400 или 500 (вишенка на торте) должно быть достаточно.

- Отдавайте ответы в разных форматах. Пусть где-то будет json, а в другом месте xml. В конце концов, природа любит разнообразие.

Цитата замечательных людей: 'А тут тоже в json ответ нужен что ли?' - Для авторизации используйте только cookie. Вас так вас в институте учили, когда вы делали свой первый интернет магазин. Ведь Android и iOS — это просто еще один браузер, не нужно преувеличивать их сложность.

- Запомните: никаких тестовых данных, пусть разработчики руками генерируют весь контент. И не забывайте при этом каждый день очищать базу, это только добавляет азарта в работу.

- Будьте бунтарем: принимайте параметры в POST через URL, ведь это тот же GET, только другой. Дайте волю воображению. И игнорируйте любые мольбы коллег привести все к стандартному виду, они просто не могут мыслить нестандартно.

- Выносите максимальное количество логики на клиент. Сервер должен быть настолько легковесным, насколько возможно. Надо сделать рассылку по расписанию? На клиент, пусть крутит у себя таймер. Агрегация данных из трех разных источников? Туда же. У вас тут вообще-то нет фонового потока, который можно безнаказанно нагружать.

Когда показывал эту статью коллегам, то многие бэкенд разработчики тоже решили поделиться парой наболевших моментов:

- Не читайте документацию, всегда проще и быстрее спросить у коллеги. Даже если вас пятнадцать человек, он будет рад каждому объяснить еще раз.

(Может быть, им просто одиноко и не с кем поговорить?) - Прося коллегу что-то переделать в API, не объясняйте причину. Если для него это не очевидно, то и объяснять бессмысленно, все равно не поймет.

Полезные рекомендации

Вместе посмеяться над знакомыми ситуациями — это здорово, но кроме этого хотелось бы поделиться еще действенными практиками, которые мы используем у себя. Даже когда приходится работать с внешними мобильными разработчиками, они всегда благодарят нас за исключительно удобное API и профессионализм.

Все дальнейшие советы относятся к бэкенду, но если вы мобильный разработчик, то вам тоже будет интересно и полезно это прочитать. Ведь в первую очередь именно вы заинтересованы в изменениях.

Документация

Это интерфейс для мобильного разработчика. Она должна быть не просто информативна, но еще легко читаться и быть приятной глазу. Звучит странно, но чем легче воспринимается документ, тем быстрее и проще с ним работать, и тем меньше возникает к вам вопросов в процессе.

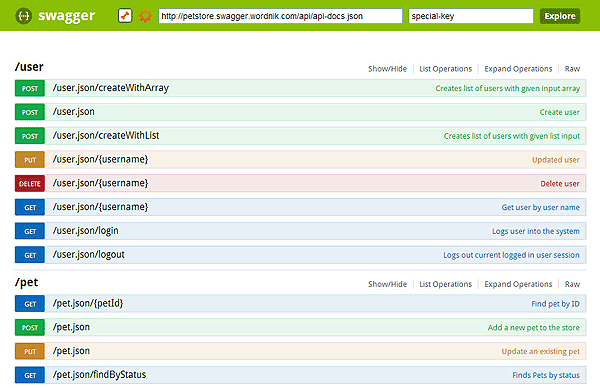

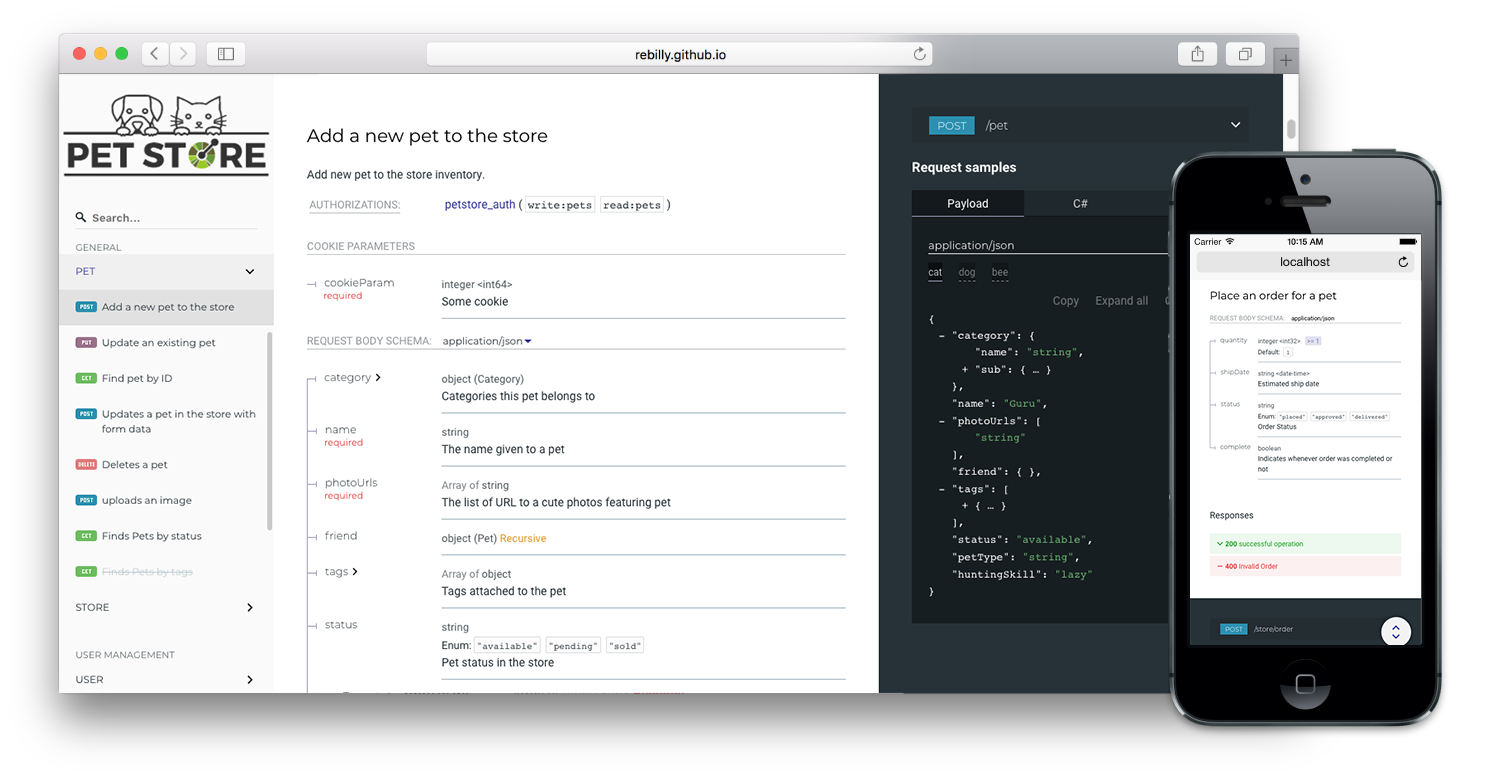

Самый простой и удобный вариант — это использовать Swagger.

Хоть его изначальный внешний вид и оставляет желать лучшего:

Но его можно без проблем облагородить с помощью форматтера:

Получается симпатично и удобно. В качестве альтернатив можно использовать Apiary, но придется разделять код и документацию, что нежелательно, либо заморачиваться с рендерингом.

Единообразие

В мобильной разработке есть сложность — многие решения и фреймворки крайне неповоротливы. Нельзя просто взять и поменять формат для какого-то одного конкретного запроса, либо это предельно сложно. Как и нельзя изменить название определенного поля только для определенного случая: бедный девелопер будет орать в голосину, пытаясь воткнуть под это костыль.

Все должно быть целостно: везде одинаковые названия, один формат взаимодействия (предпочтительно JSON), и тп.

Особенно хорошо, если названия параметров в запросе и ответе идеально совпадают с полями соответствующих классов в мобильном приложении. Звучит странно, но это настолько упрощает жизнь разработчикам, что они будут вам за это шоколадки таскать из магазина.

В некоторых местах упрощение доходит до абсурда: например, сохранение в Realm (мобильная база данных) может быть произведено практически сразу из json. Если будет интересно, то отдельно расскажу о том, как мы избавлялись от middleware в мобильном приложении.

Пример кода по сохранению любых пришедших объектов на iOS:

Один generic метод на любую запись в базу с сервера. Классно, правда?

Тоже самое касается и изображений. Лучше всего, когда на картинку сразу приходит ссылка, которую не нужно 'доделывать'. И по тому же правилу — название ссылки должно быть везде одинаковым.

У нас был случай, когда нужно было искать изображения в гугле для определенных информационных блоков в мобильном приложении. В итоге мы просто сделали псевдо-ссылку на картинку, к которой приложение обращается, а внутри сервак ищет подходящее изображение в гугле и делает на нее редирект. А для приложения это выглядит как самая обыкновенная пикча, которая просто немного дольше соображает.

Достаточность

Когда работаешь над сервером, то привычно, что все находится в едином scope запроса, где достаточно просто открыть транзакцию на запись и в нее последовательно протолкнуть данные. Все изолированно, предсказуемо и линейно.

В мобильном приложении такого нет. Все крутится асинхронно, а если требуется соблюсти целостность данных из разных запросов, то это выливается в сложнейшие манипуляции с многопоточностью, злющими критическими секциями и распределением приоритетов, чтобы не было и намека на тормоза. Не зря вопрос про синхронизацию потоков в собеседовании на мобильного разработчика задают одним из первых.

Теперь понимаете, почему мобильные девелоперы стараются, чтобы все приходило в едином запросе? От этого зависит, уйдут они сегодня домой или нет)

И конечно, если какие-то данные нужно загрузить асинхронно, то не надо их пихать в общую кучу, это надо понимать.

В конце концов, не поленитесь открыть дизайн приложения и посмотреть из чего состоит экран для которого вы делаете API. Посоветуйтесь с вашими мобильными коллегами, определите как лучше вам отдавать им данные и какие последующие запросы будут от них зависеть. Может быть, в данном конкретном запросе нужно выдать чуть больше информации, чем кажется достаточным. Но зато это сделает последующую работу удобнее и приятнее на клиенте. Помогая в таких мелочах, вас потом будут вспоминать с теплотой всю профессиональную жизнь.

В этот же пункт хочется отнести отладочную информацию. Если вы сделали запрос для получения списка комментариев, то озаботьтесь, чтобы эти комментарии там были. Вам накопипастить однотипных данных — дело одной минуты, а для напарника из мобильного отдела — это целый выдох облегчения.

Стабильность

Просто архиважный пункт на который хочется отдельно обратить внимание. Всегда проверяйте свое API, а еще лучше — пусть тесты делают это за вас. Каждый баг на бэкенде равен десяти на клиенте. Ведь между сервером и пользователем находится множество уровней абстракций, которые надо исключить перед тем, как винить сервер.

Каждый баг тратит время пользователя, тестировщика, мобильного разработчика и только потом — вас. На вас возложена наибольшая ответственность, и ваши ошибки обходятся компании дороже всего.

В качестве бонуса хочется добавить, что здорово, когда есть pretty print, хотя бы на время разработки. Бывает, что надо разобраться с тем, что пришло от сервера, не заглядывая в документацию.

А что приятнее читать, такое:

Или такое:

Разница, мне кажется, на лицо.

Главное, не забудьте отключить Pretty Print на боевом сервере, поскольку ресурсов он жрет как не в себя.

Заключение

Хочется всем просто сказать, что правило на самом деле одно и довольно простое — не заставляйте коллег скрежетать зубами от вашей работы.

В следующий раз планирую рассказать о том, как мы переезжали на Go и избавились от огромного куска бизнес логики на клиенте, сократив бинарник приложения больше, чем на треть.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author Mehdzor разработка под ios разработка под android разработка мобильных приложений api backend ios android |

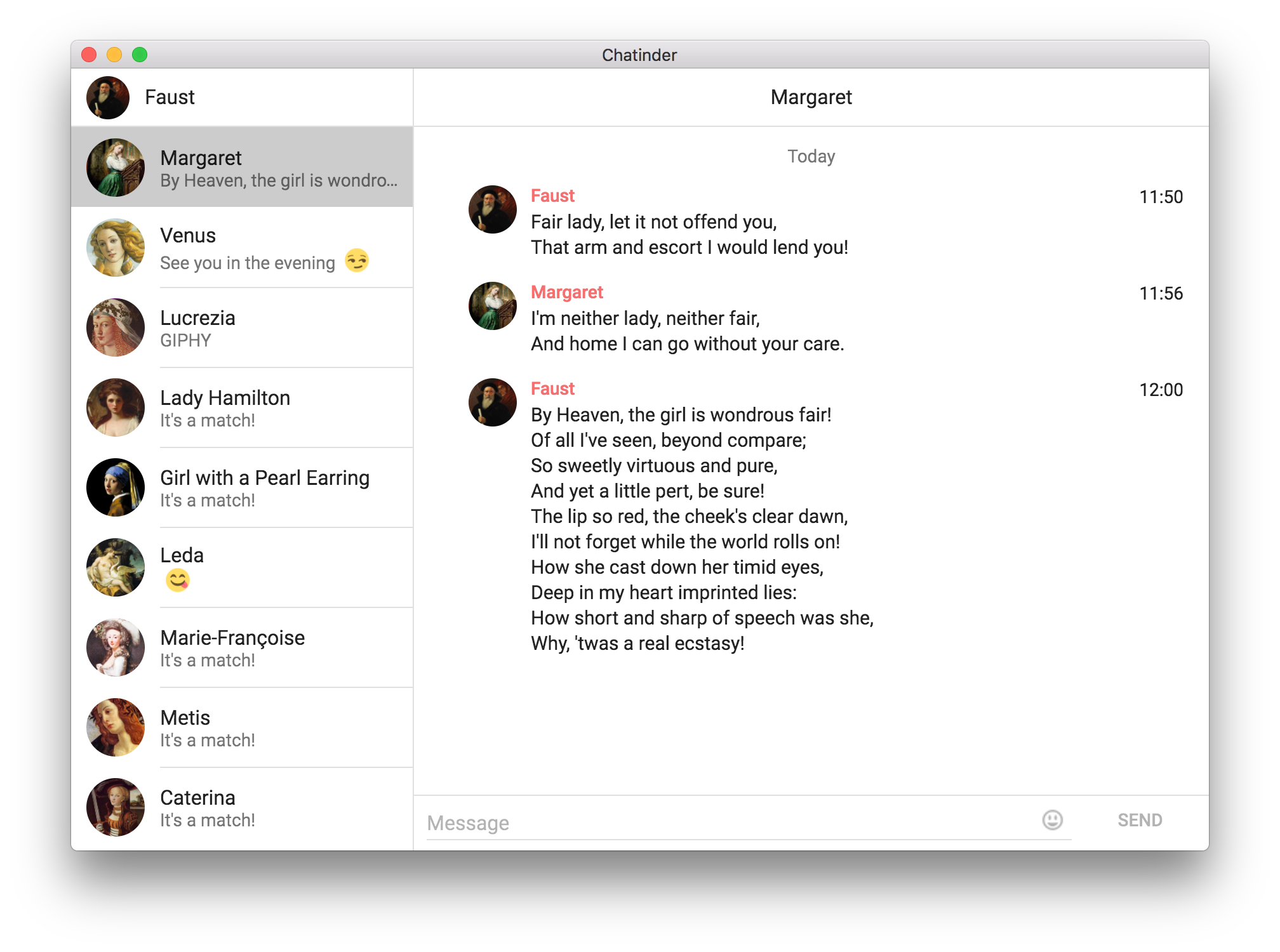

[Из песочницы] Ненормальный GraphQL в Electron или как я писал десктопный клиент для Tinder |

Предыстория

Привет, Хабр. В начале зимы 2016 года я снова стал одинок. Спустя какое-то время я решил завести себе профиль в Tinder. Всё бы ничего, но постепенно стала накапливаться усталость из-за невозможности нормально печатать на физической клавиатуре. Мне виделось несколько решений этой проблемы:

- Смириться и продолжать использовать официальное приложение для смартфона

- Использовать BlueStacks с официальным приложением на Android

- Использовать существующие клиенты для десктопа (Tinder++)

- Написать свой

Первый вариант меня не устраивал из-за принципиального превосходства реальной клавиатуры над экранной. Второй вариант не подходил из-за того, что всё-таки это было бы приложение, не оптимизированное под десктоп. Третий вариант был всем хорош кроме дизайна, багов, и малой активности в репозитории. Позже Tinder++ получил письмо от юристов Tinder и проект был и вовсе свёрнут. Таким образом, лично для меня выбор был очевиден.

Старт

Прежде всего стоит отметить, что у Tinder нет открытого API, однако оно было вскрыто в 2014 году при помощи MITM. Этого оказалось вполне достаточно для написания клиента.

Пожалуй, единственным, что почти не претерпело изменений во время нелёгкой судьбы проекта, был Electron.

Мне не терпелось поиграться с React, поэтому была выбрана стандартная связка react + redux + redux-saga + immutable. К маю была написана первая версия, но возникли проблемы с моими кривыми руками архитектурой. Выяснилось, что для того, чтобы сделать redux быстрым требуется много ручной работы: мемоизация, shouldComponentUpdate, фабрики селекторов и тому подобное.

Также, пожалуй, не стоило каждый раз запрашивать всю историю и сливать её с существующим store при помощи Immutable.Map.mergeDeep

В любом случае, многословность redux и redux-saga стала утомлять меня. Моим постоянным впечатлением было, что библиотека борется со мной вместо того, чтобы помогать.

Я не хочу сказать, что redux — плохая библиотека. С эстетической точки зрения она очень элегантна. И если она позволяет вам писать хороший код, то это самое главное. Однако нельзя отрицать, что обычно с ней требуется попутно создавать очень много вспомогательного кода даже для простых вещей.

Итак, стиль redux не устраивал меня, а в лагах я винил его и react. Мне оставалось только одно.

Перестать писать

Конечно, заголовок слегка провокационный. На самом деле подошёл период защиты диплома, сессия, сбор документов для магистратуры, военные сборы, и переезд в другую страну. Но как только всё слегка устаканилось, я перешёл к следующему пункту.

Переписать всё №1

Новый стек включал в себя Inferno и MobX. Обе эти библиотеки обещали хорошую производительность при минимуме работы руками (как позже выяснилось, не совсем). В целом с ними было приятно работать, благодаря MobX код стал гораздо лаконичнее, но параллельно росли три проблемы.

Где хранить историю?

Первым очевидным решением было использования localStorage. Для этого я использовал замечательную библиотеку localForage. Однако JSON.stringify и JSON.parse при каждом сохранении и извлечении истории (а история сохранялась каждый раз заново целиком при каждом обновлении) не добавлял радости. Даже то, что теперь я запрашивал лишь обновления с сервера и сливал их с историей, не позволяло добиться желаемой производительности.

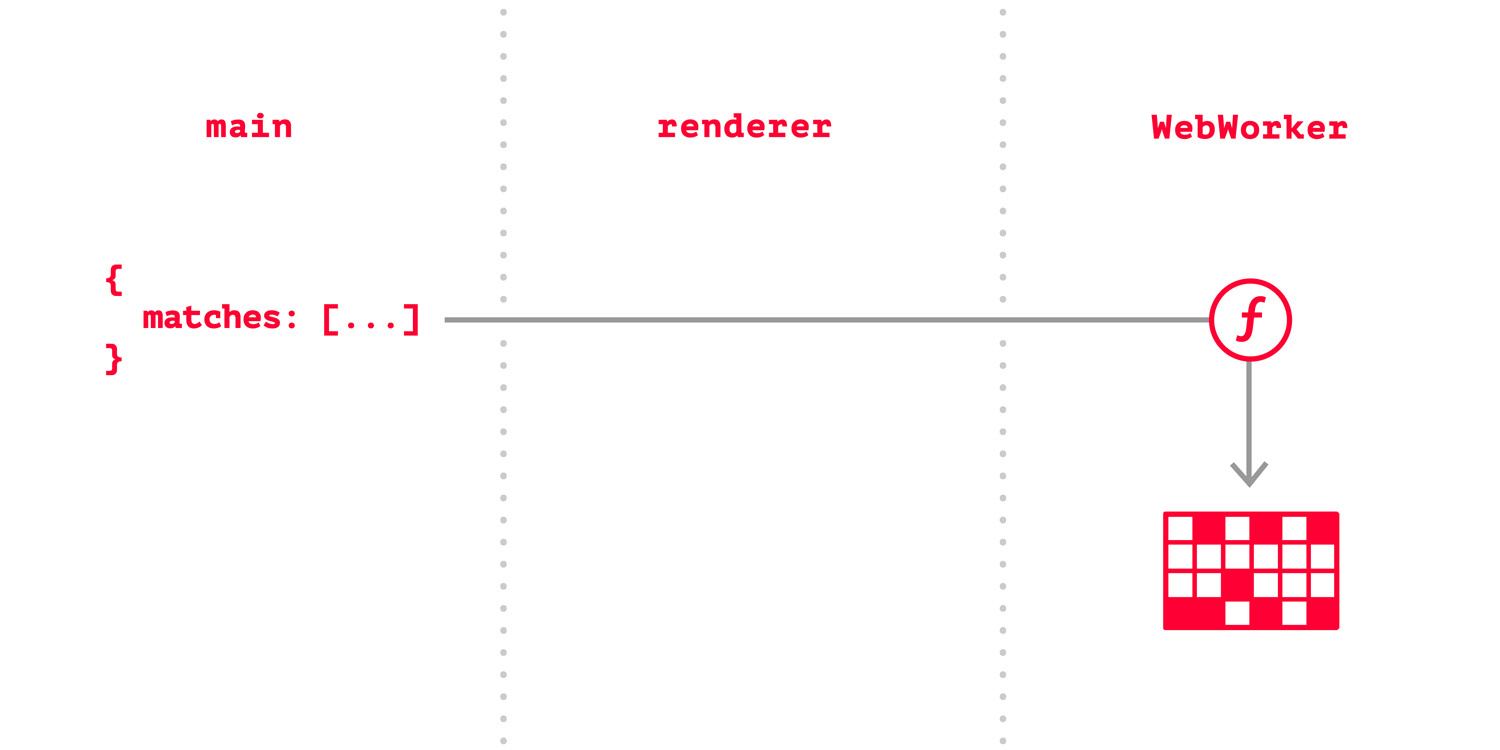

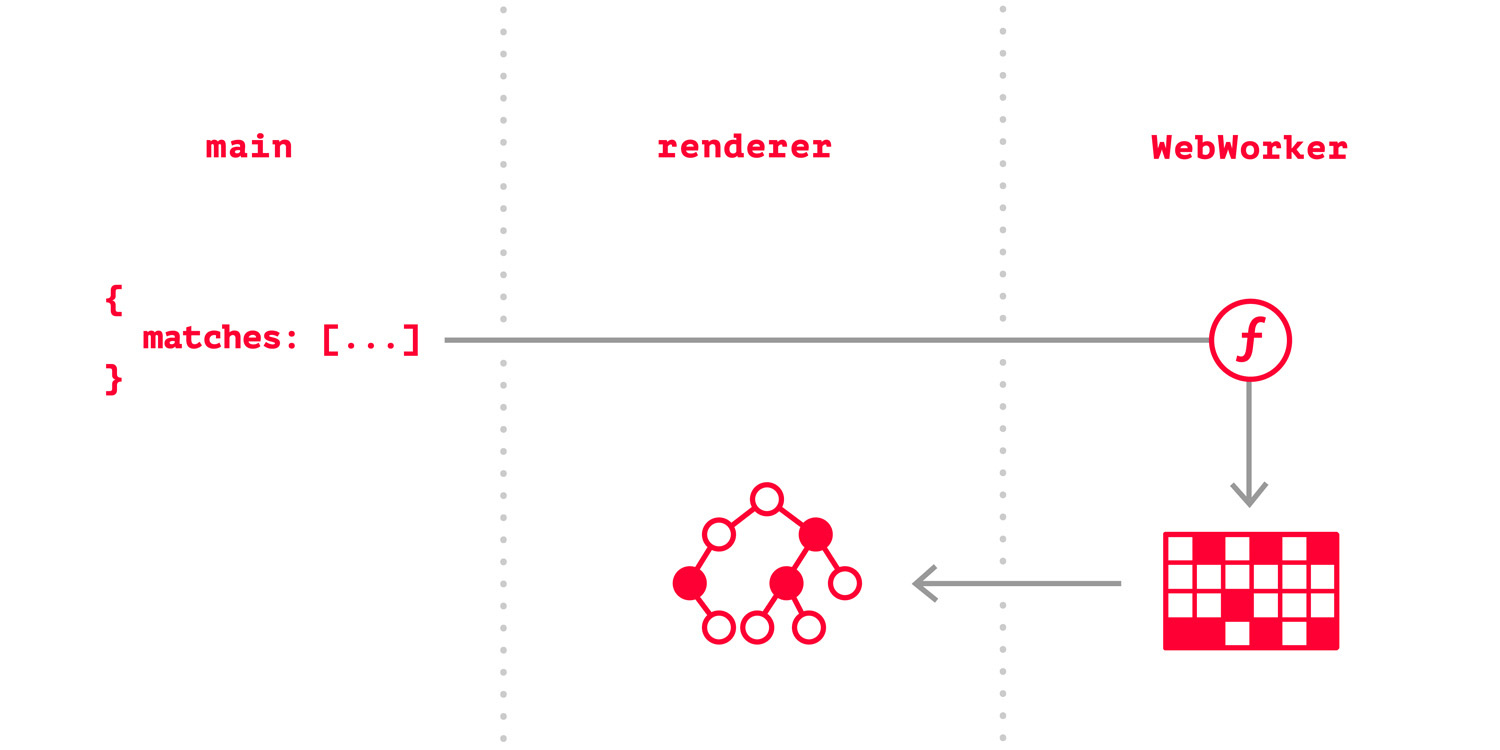

Следующим решением было использование IndexedDB, а для максимальной производительности была выбрана библиотека Dexie.js. Быстро выяснилось, что обновление лишь изменившихся данных существенно добавляет скорости, но лаги интерфейса всё ещё были заметны. Тогда я вынес всю работу с IndexedDB в WebWorker и вроде бы всё наладилось.

Как синхронизировать данные?

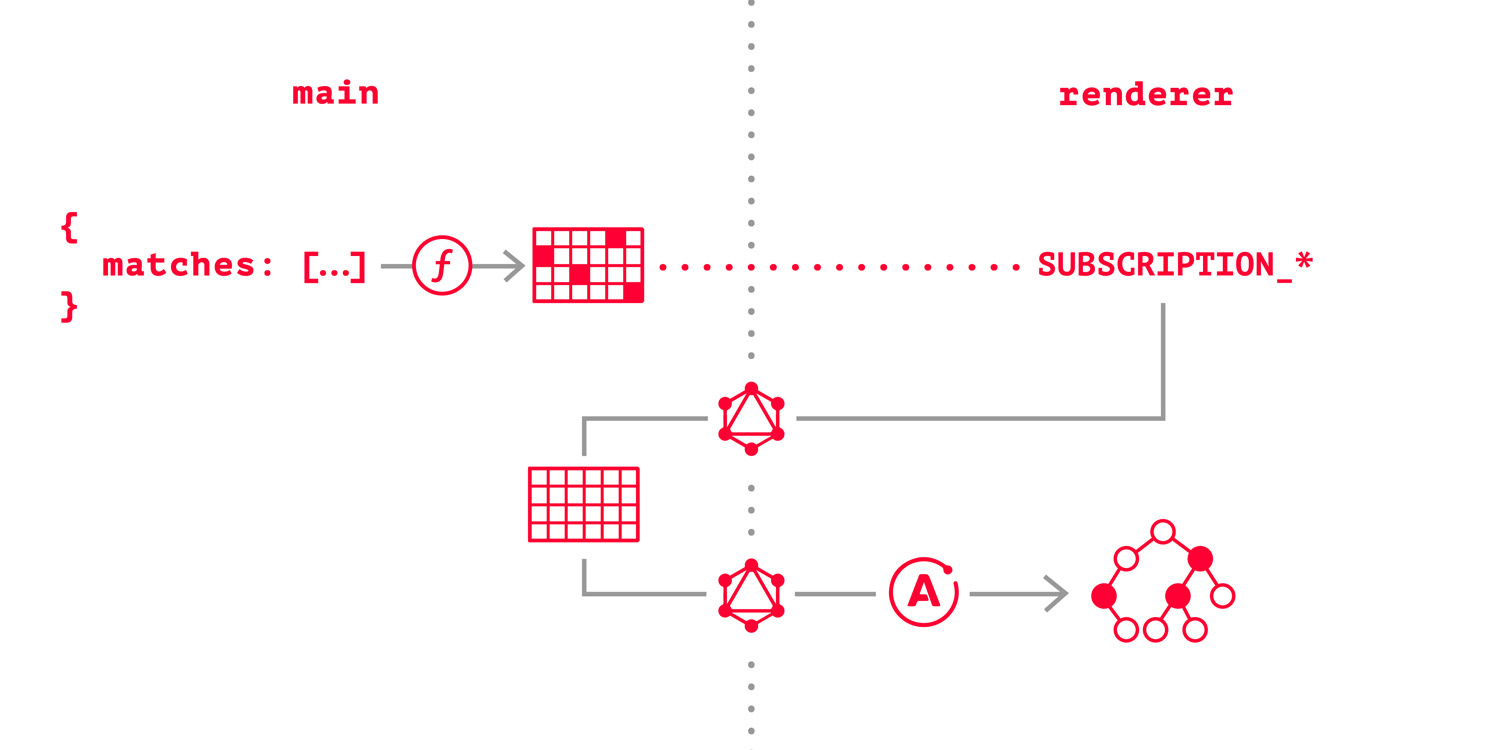

Для запроса к API Tinder необходимо устанавливать специальные заголовки для мимикрии под их Android-клиент. Из соображений безопасности браузерный JS не поддерживает такие трюки, так что все запросы выполнялись из main процесса Electron.

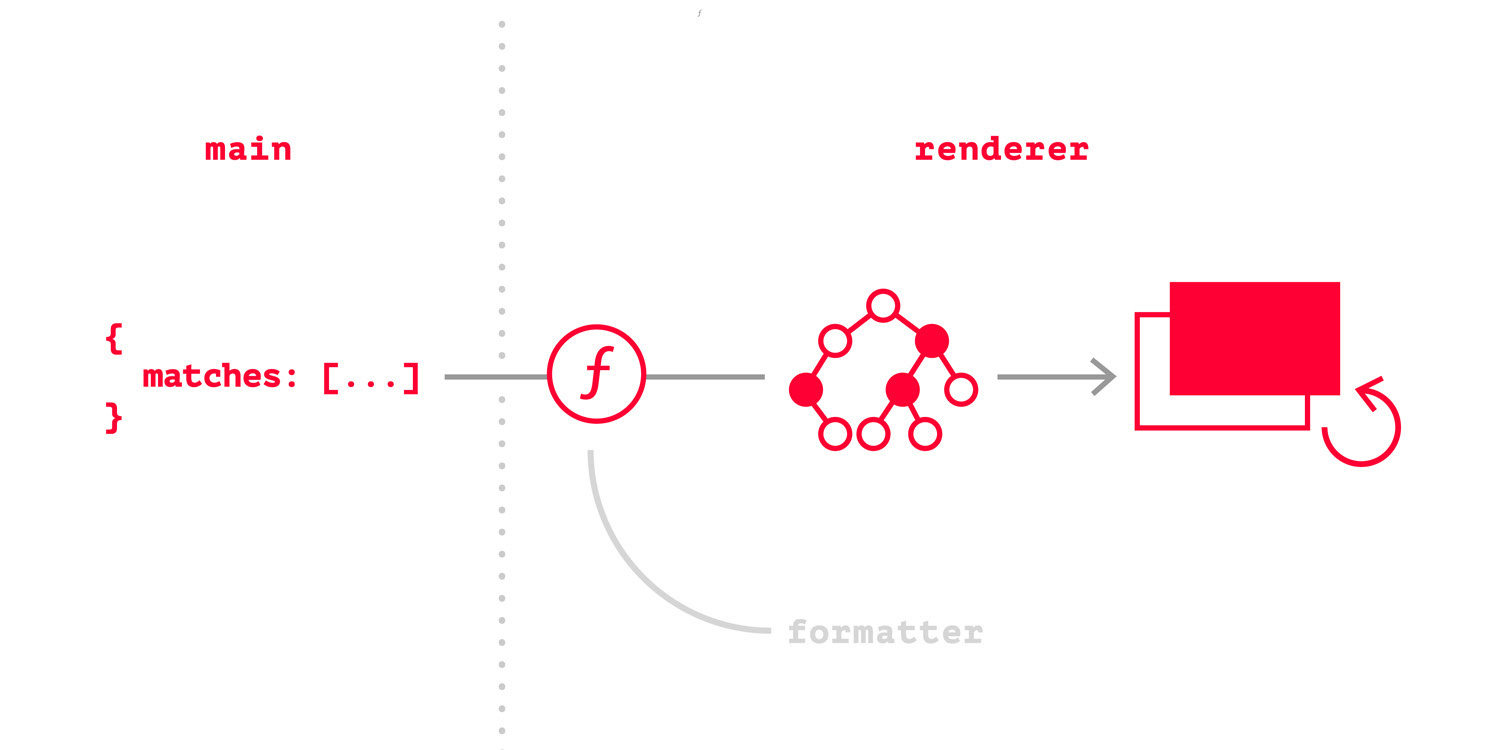

Таким образом, данные проходили следующий путь:

- Получение с сервера в main процессе и отправление в WebWorker

- Обработка, запись в IndexedDB, и отправление в renderer

- Запись в хранилища MobX, что обеспечивало обновление интерфейса

Это позволило добиться приемлемой производительности, но stores разрослись и каждый раз аккуратно сливать данные в IndexedDB, а затем и в MobX означало делать одну и ту же работу дважды руками. Кроме того, была и третья проблема.

Сырая инфраструктура Inferno

Inferno побеждает конкурентов по скорости почти во всех бенчмарках, но производительность разработчика не менее важна. Несмотря на существование inferno-compat, многие React-библиотеки всё равно не работали. С трудом получалось запустить material-ui, не подгружалась react-vistualized.

Решение о переходе

Конечно, большая часть отсутствующих вещей была довольна простой и легко писалась самостоятельно. Кое-где получалось завести React-библиотеки при помощи пары грязных хаков. Но в целом эта ситуация стала утомлять меня, как и ручная синхронизация базы данных и реактивного хранилища. Я старался вносить вклад в репозиторий Inferno, но надолго меня не хватило. Три процесса для такого простого приложения тоже казались перебором. Мне хотелось чего-нибудь декларативного и не требующего кучи кода для поддержки.

Переписать всё №2

На этот раз решение было более взвешенным. Нужна совместимость с React — просто используем React, подобные бенчмарки важны лишь если отображать тысячи элементов. Не нравится слишком много процессов — значит данные нужно хранить там же, откуда они и приходят, в main процессе. В целом нравится MobX и его преимущества, но с большими хранилищами становится не очень удобно работать — следовательно MobX остаётся в качестве менеджера локального состояния компонентов, а для глобальных данных используется что-то ещё.

Если вы прочитали заголовок статьи, то что-то ещё будет для вас очевидным. Разумеется, это GraphQL. В качестве клиента используется Apollo. Сперва решение покажется необычным, но призадумавшись, вы обнаружите много плюсов:

- Данные передаются не по сети, а через IPC, значит задержка практически отсутствует

- Apollo автоматически сливает данные в своём redux хранилище

- Декларативная подача данных к компонентам

- Готовые решения для сложных вещей вроде optimistic updates

Разумеется, в Apollo по умолчанию нет поддержки IPC, однако есть возможность создать свой сетевой интерфейс. Это очень просто:

import { ipcRenderer } from 'electron'

import { GRAPHQL } from 'shared/constants'

import uuid from 'uuid'

import { print } from 'graphql/language/printer'

export class ElectronInterface {

ipc

listeners = new Map()

constructor(ipc = ipcRenderer) {

this.ipc = ipc

this.ipc.on(GRAPHQL, this.listener)

}

listener = (event, args) => {

const { id, payload } = args

if (!id) {

throw new Error('Listener ID is not present!')

}

const resolve = this.listeners.get(id)

if (!resolve) {

throw new Error(`Listener with id ${id} does not exist!`)

}

resolve(payload)

this.listeners.delete(id)

}

printRequest(request) {

return {

...request,

query: print(request.query)

}

}

generateMessage(id, request) {

return {

id,

payload: this.printRequest(request)

}

}

setListener(request, resolve) {

const id = uuid.v1()

this.listeners.set(id, resolve)

const message = this.generateMessage(id, request)

this.ipc.send(GRAPHQL, message)

}

query = request => {

return new Promise(this.setListener.bind(this, request))

}

}Далее приведён код обработки запросов в main процессе. Все фабрики создают методы класса ServerAPI.

Код для выполнения GraphQL запроса:

// @flow

import { ServerAPI } from './ServerAPI'

import { graphql } from 'graphql'

export default function callGraphQLFactory(instance: ServerAPI) {

return function callGraphQL(payload: any) {

const { query, variables, operationName } = payload

return graphql(

instance.schema,

query,

null,

instance,

variables,

operationName

)

}

}

Код для создания ответного сообщения:

// @flow

export default function generateMessage(id: string, res: any) {

return {

id,

payload: res

}

}Код, обрабатывающий запрос и возвращающий данные:

// @flow

import { ServerAPI } from './ServerAPI'

import { GRAPHQL } from 'shared/constants'

type RequestArguments = {

id: string,

payload: any

}

export default function processRequestFactory(instance: ServerAPI) {

return async function processRequest(event: Event, args: RequestArguments) {

const { id, payload } = args

const res = await instance.callGraphQL(payload)

const message = instance.generateMessage(id, res)

if (instance.app.window !== null) {

instance.app.window.webContents.send(GRAPHQL, message)

}

}

}И, наконец, в конструкторе создаём подписчик на сообщение:

import { ipcMain } from 'electron'

ipcMain.on(GRAPHQL, instance.processRequest)Теперь при получении каждого обновлении оно записывается в базу данных NeDB, затем main процесс при помощи IPC шлёт в renderer процесс сообщение о необходимости перезапросить актуальные данные.

Дополнения

Навигация

Я очень долго не хотел использовать react-router. Дело в том, что я застал их масштабное переписывание API и не горел желанием наступать на те же грабли в очередной раз. Поэтому сперва я подключил router5 + самописное middleware, синхронизирующее состояние в MobX. Внутри Electron де-факто нет URL в привычном смысле, так что идея хранить состояние навигации в реактивном хранилище была отличной. Однако несмотря на то, что такая связка даёт вам полный контроль над навигацией, порой она требует слишком много лишнего кода.

Переход на react-router@v4 я совместил с частичным переходом с Flexbox на CSS Grid. Эти вещи будто созданы друг для друга. Похоже, что в этот раз у команды react-router действительно получилось!

Система сборки

Сперва я использовал webpack и electron-packager, но во время последнего крупного изменения перешёл на electron-forge. Насколько я понимаю, в будущем этот пакет станет стандартным решением для сборки и распространения приложений на Electron. Он включает в себя electron-packager для сборки и electron-compile, позволяющий транспилировать JS/TS, компилировать другие форматы (Less, Stylus, SCSS), и многое другое практически без конфигурации.

Результаты

При помощи GraphQL я избавился от большого количества моего кода (значит и от моих багов). Добавлять новые возможности в код стало гораздо проще. Я и приложение стали работать быстрее.

Я надеюсь, что этот подход поможет кому-нибудь в создании его приложений на Electron. Я планирую выделить реализацию GraphQL-over-IPC в отдельный npm пакет, чтобы её можно было удобно использовать.

Планы развития

К версии 2.0 мне хотелось бы

- Переписать на TypeScript хотя бы main процесс

- Добавить поиск по сообщениям и контактам

- Добавить возможность блокировки пользователя и редактирования своего профиля

Для интересующихся

- Декларативное лучше императивного

- Если вы уверены, что хотите переписать всё на X, то сперва подумайте:

- Стоит ли переписывать?

- Является ли X лучшим выбором?

- Потратьте неделю на поиск альтернатив и взвесьте все плюсы и минусы

Спасибо Юле Курди за замечательные иллюстрации!

|

Метки: author wasd171 reactjs node.js javascript web react electron redux mobx graphql разработка приложений никто не читает теги |

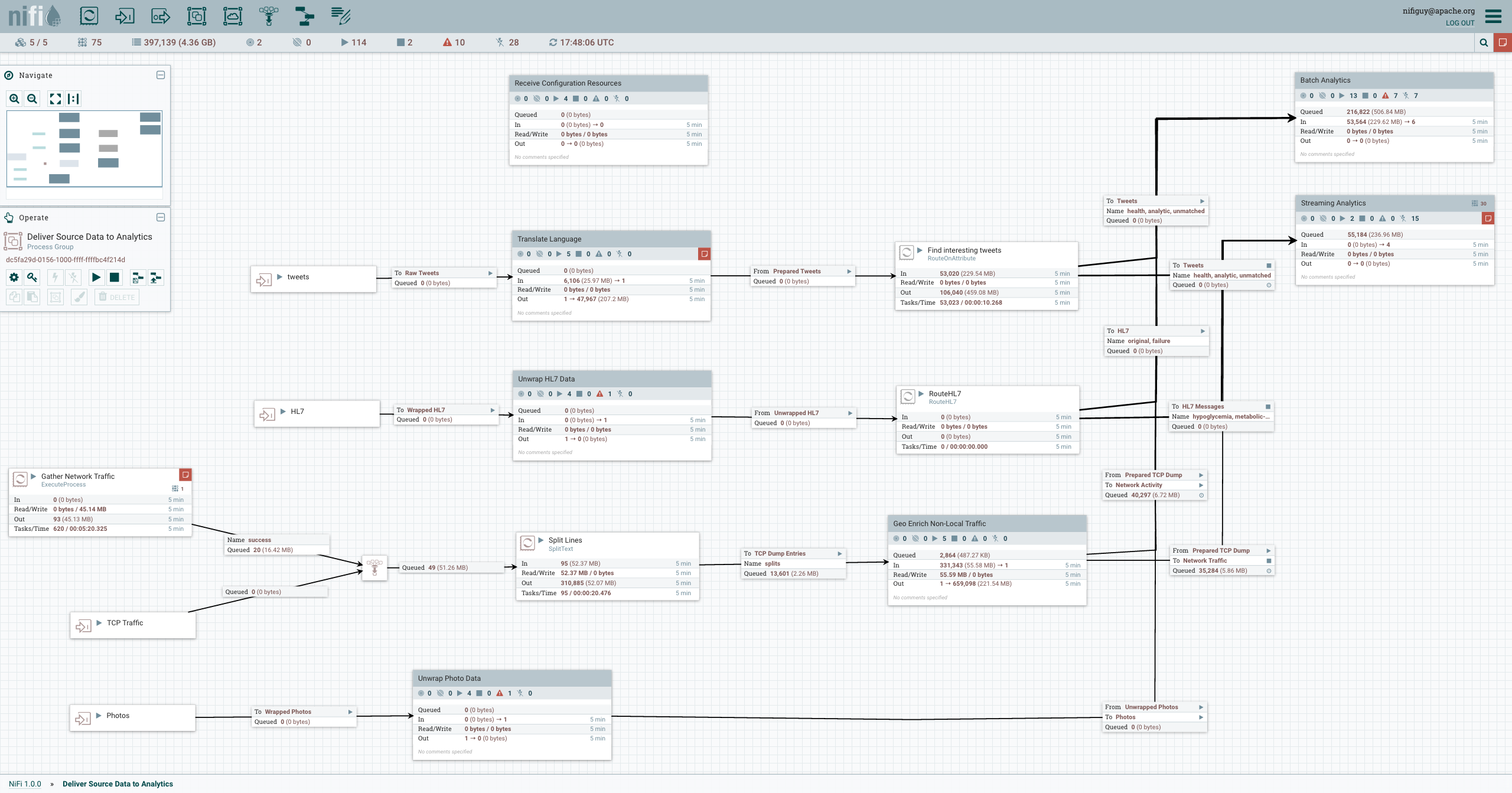

Динамическое создание кластера Apache NiFi |

Целью данной статьи является описание возможностей создания кластера Apache NiFi.

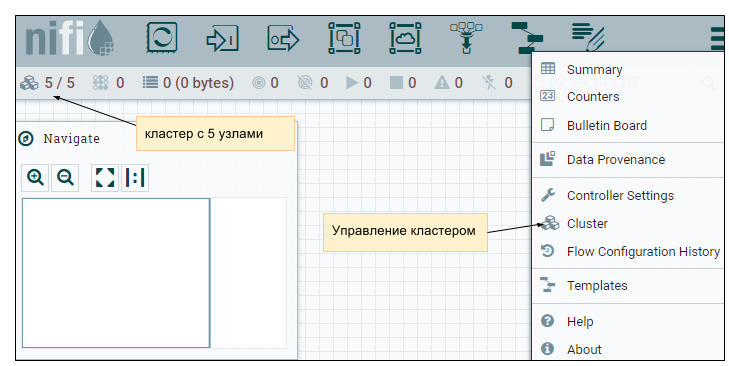

Рис. 1. GUI Apache NiFi.

Рис. 1. GUI Apache NiFi.Особенности:

- Визуальное создание и управление направленными графиками процессоров.

- Асинхронный, что обеспечивает высокую пропускную способность и естественную буферизацию, даже когда скорость потока и обработки расходятся.

- Дает возможность создания связанных и слабо-связанных компонентов, которые затем могут быть повторно использованы в других контекстах.

- Удобная обработка ошибок, которая облегчает работу и поиск проблемных мест.

- Источники, по которым поступают данные, а также то, как они протекают и обрабатываются, визуально видимы и легко отслеживаются.

Подробнее тут: nifi.apache.org/docs/nifi-docs/html/overview.html

Настройка кластера Apache NiFi

Для запуска кластера Apache NiFi может использоваться встроенный или внешний Apache Zookeeper, можно задать в настройках conf/nifi.properties. Мы будем использовать встроенный.

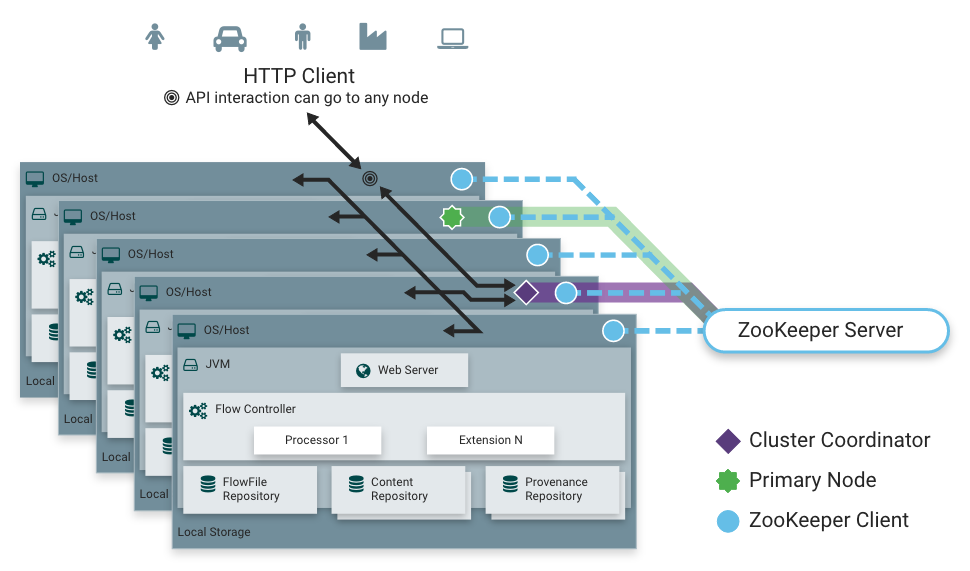

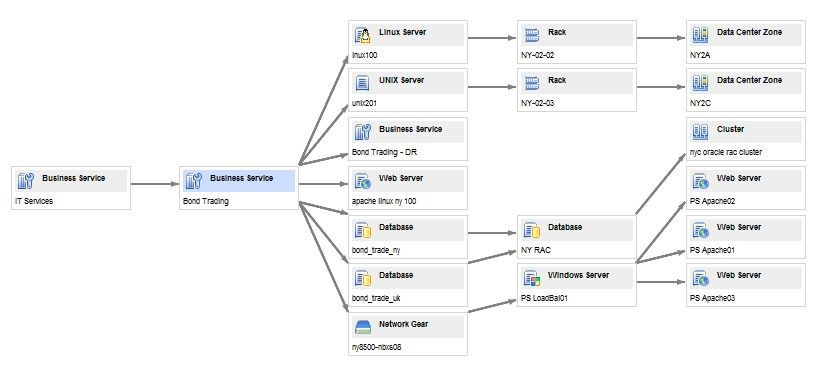

Рис. 2. Схема кластера Apache NiFi

Рис. 2. Схема кластера Apache NiFi Для настройки кластера Apache NiFi нам нужно как минимум 3 узла, для того чтобы обеспечить кворум. Как правило, рекомендуется запускать ZooKeeper на 3 или 5 узлах. Работа на менее чем 3 узлах обеспечивает меньшую долговечность перед сбоем. Запуск на более чем 5 узлах обычно приводит к большему сетевому трафику, чем это необходимо. Для всех трех экземпляров общие свойства кластера можно оставить с настройками по умолчанию. Однако обратите внимание, что при изменении этих параметров они должны быть одинаковыми для каждого будущего узла кластера.

Для минимальной настройки кластера Apache NiFi необходимо выполнить следующее операции на каждом узле будущего кластера:

- задать в nifi.properties необходимые параметры

- указать сервера кластера в zookeeper.properties

- задать id для Zookeeper у локального узла

- указать строку подключения к Zookeeper кластеру в state-management.xml

Опишем каждый шаг более детально

1. Задать в nifi.properties:

nifi.cluster.is.node=true

nifi.cluster.node.address=

nifi.cluster.node.protocol.port=3030

nifi.state.management.embedded.zookeeper.start=true

nifi.remote.input.host=

nifi.web.http.host=

nifi.zookeeper.connect.string=

connect-string список серверов с zk через запятую.

Например: nifi01:2181,nifi02:21818,nifi03:2181

2. В zookeeper.properties прописать сервера кластера:

server.1=:2888:3888

server.2=:2888:3888

server.3=:2888:3888

initLimit=5

syncLimit=2

3. Задать id в файле ./state/zookeeper/myid, если локальный узел является частью Zookeeper кластера.

4. Прописать в файле state-management.xml строку подключения к кластеру

Для запуска Apache NiFi на каждом узле достаточно запустить команду:

bin/nifi.sh startПри этом не важно в какой последовательности будет запущен Apache NiFi на каждом из узлов. Отслеживать процесс запуска кластера можно по файлу logs/nifi-app.log

Запуск локального кластера в виртуальной среде

Для изучение работы с кластером нам необходима возможность локального запуска кластера Apache NiFi в виртуальной среде. Для запуска в виртуальной среде были использованы Hashicorp Vagrant и Oracle VM VirtualBox. Необходимо установить плагины vagrant-vbguest и vagrant-hostmanager. Для ускорения и облегчения процесса запуска были написаны специальные скрипты vagrant provision, которые позволяют запустить кластер Apache NiFi в виртуальной среде одной командой:

vagrant upПосле запуска, в течении пяти-семи минут, в браузере будет доступен пользовательский интерфейс по адресу localhost:8080/. Так же, можно проверить, открыв VirtualBox, должны быть видны три виртуальных машины под управлением nifi01, nifi02 и nifi03.

Исходники скриптов провизии vagrant для запуска кластера NiFi доступны на github.

Динамическое формирование кластера

В некоторых ситуациях, необходимо, чтобы подключаемое устройство само находило кластер в сети и подключалось к нему. Для этих целей была написана программа «агент», которая выполняет поиск устройств в сети, и при нахождении кластера (проверяет через Apache NiFi REST API) подключается к нему. Исходники данной программы доступны на github.

Пример запуска агента:

java -cp cluster-joiner-0.0.1-jar-with-dependencies.jar ru.itis.suc.NodeAgent /home/user/nifi/nifi-1.2.0 8085где аргументы путь к Nifi и порт, который агент будет слушать при необходимости создания нового кластера.

После запуска, будет произведен поиск кластера в локальной сети и подключение к нему.

В случае если кластер не найден, будет попытка создания кластера, если найдутся еще 2 устройства готовые стать частью нового кластера.

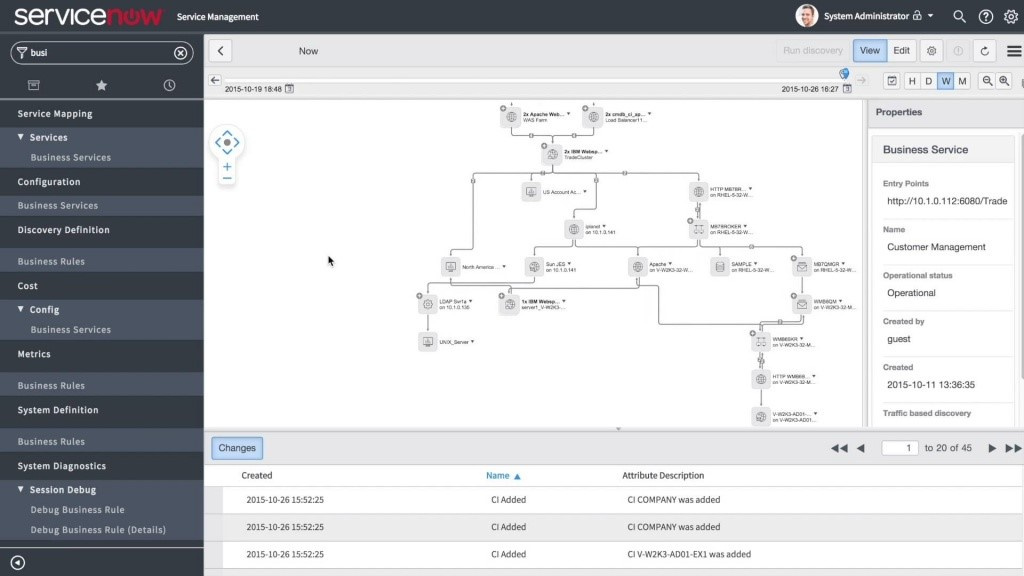

Рис. 3. GUI Apache Nifi запущенного в кластере.

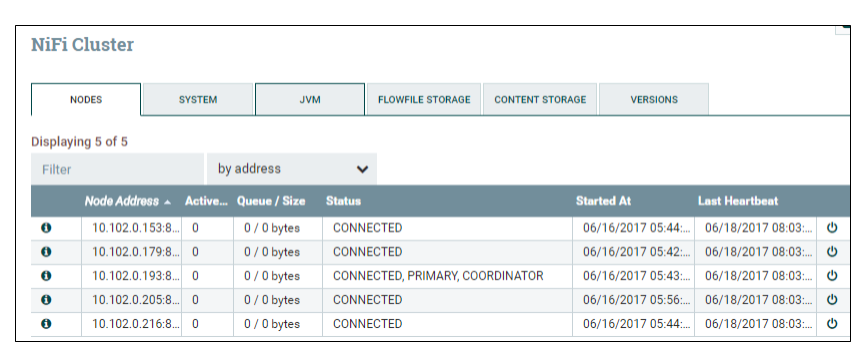

Рис. 4. Список узлов кластера.

Заключение

Данная работа была проделана в целях эксперимента и проверки возможности автоматического создания кластера Apache NiFi в локальной сети.

Конечно, были использованы примитивные алгоритмы для поиска и подключения, однако целью работы была только проверка подобной возможности.

|

Метки: author DeFacto разработка для интернета вещей big data nifi flow-based programming |

[Из песочницы] Эффект Медичи или можно ли скрестить персик и дыню или Windows и iOs |

Подробно «Эффект Медичи» описан в книге Йоханнсона. Тем же, кому лень читать книгу, рекомендую посмотреть этот минутный ролик. Вся суть «Эффекта» там достаточно доходчиво и, главное, лаконично, передана.

Сегодня мы живем в эпоху, в которой объектов для пересечений и скрещивания на порядки больше, чем во времена Медичи. На лицо очевидное ускорение динамики размножения скрещиваемых сущностей, а темп такого размножения усиливается с каждым днем. Отсюда и сегодняшний разгул стартаперства. Еще совсем недавно телефон был скрещен с фотоаппаратом, а теперь уже речь идет о скрещивании «фототелефоноаппарата» с блендером, который, в свою очередь уже был скрещен с микроволновкой.

Области пересечений плодятся как бесконечная геометрическая прогрессия.

Последовательность площадей квадратов, где каждый следующий квадрат получается соединением середин сторон предыдущего — бесконечная геометрическая прогрессия со знаменателем.

Для нас, стартаперов, девелоперов и просто активных людей, такое развитие событий безусловный подарок судьбы. Ведь скрестить можно что угодно с чем угодно. Казалось бы, это же клондайк для изобретателя. Составляй списки успешных сущностей и прекрещивай их: Uber и церковь, автомобиль и вертолет, телефон и секс и тп. Метод подобного поиска идей, кстати, Йоханссон весьма подробно описывает в своей книге. Но там нет важной детали. А что скрещивать нельзя? Точнее, что скрещивать бессмысленно или вредно для создателя и общества, в котором он находится? Давайте порассуждаем.

Вот несколько групп этого «нельзя».

1. «Впихнуть невпихуемое»

На днях участвовал в сессии по вопросам Энтерпрайз Архитектуры нашей уже не молодой компании. Попытки хаотичного скрещивания разных подходов в погоне за быстрым результатам приводят в Enterprise Architecture вот к такому результату.

Думаю, не стоит объяснять, чем такой подход грозит на практике.

Другой пример вредного скрещивания идеально иллюстрируется на примере всем известных мультифункциональных ножей.

Вывод из этих примеров таков: скрещивать нельзя функции, объединение которых приведет к невозможности использования итогового продукта. В случае с запутанной энтерпрайз архитектурой все может рухнуть в один момент при нарушении любой из связей между любыми, даже самыми незначительными элементами. В случае с ножом все до банальности просто – он не помещается в руку, а значит смысла в нем нет.

2. Бессмыслица

Нет смысла скрещивать идентичные сущности. Да простят меня сексуальные меньшинства, но от скрещивания мужика с мужиком ничего не получится. В этом попросту нет смысла. Точно также и в других сферах. Смысла в пересечении Windows и iOs, Mailchimp и MailGun, Ubera и Gett попросту нет. У них одинаковые потребительские характеристики. Ничего принципиально нового от такого соития мы не получим. В лучшем случае что-то точно такое же.

3. Опасность

Давайте поговорим об опасном виде пересечений. Простейший пример этого явления – скрещивание сандаликов и носочков.

Такой подход опасен для любителя подобного «комфорта» в одежде. Его попросту не воспримут в обществе. И пусть со мной не согласятся тренсеттеры современной моды.

В дискуссии под упомянутым в начале статьи роликом, несколько уважаемых господ привели два отличных примера из области химии и физики.

«Нельзя скрещивать концентрированные (или горячие) растворы кислот и щелочей. Это важное правило техники безопасности, нарушение которого грозит химику, ну или просто криворукому экспериментатору серьезными неприятностями»(с) Alex Sol. Также, как и

«нельзя скрещивать атомные ядра одних частиц с другими ядрами или элементарными частицами. Последствием взаимодействия может стать деление ядра и испускание новых элементарных частиц. Кинетическая энергия вновь образованных частиц может быть гораздо выше первоначальной»(с) Andrey Alekseev.

Что это значит для девелопера? Все как и с элементарными частицами и ядерным оружием, которое сначала увлеченно создавали, а теперь пишут тома документов, регламентирующих всеобщее разоружение. Американские АНБ и ЦРУ разрабатывают передовое ПО для слежки за всем миром в целях общей безопасности и мира во всем мире, а на деле, минимальная утечка кода, приводит к созданию вирусов типа нашумевшего недавно Wannaсry. Как сказал один мудрый человек, нельзя соединять добро со злом. Вывод, перед созданием чего то нового путем скрещивания старого – посмотрите, не убьет ли это вас. Стоит только учитывать, что подобные опасения не должны тормозить технический прогресс и автоматизацию, замещающую рутинный человеческий труд.

Итак, если:

- Впихивание невпихуемого в область пересечения не сломает итоговых потребительских характеристик и продуктом можно будет пользоваться,

- Мы не пытаемся «поженить» одинаковые сущности,

- Мы трезво отдаем себе отчет в том, что плод скрещивания не взорвется и не погубит всех вокруг;

Вперёд! Составляем списки возможных «родителей» и двигаем мир вперед. Вполне возможно, что приложение для заказа такси, которое параллельно будет измерять твое артериальное давление и делать тебе МРТ пока ты стоишь на обочине, станет очередным проектом-единорогом.

Источники:

- Frans Johansson. The Medici Effect: Breakthrough Insights at the Intersection of Ideas, Concepts, and Cultures.

- Инвестория. Коллекция минутных видео.

|

Метки: author IlyaVv читальный зал разработка девеломпент стартапы финансирование идеи для стартапов |

Финал конкурса SAP Кодер 2017 пройдёт в прямом эфире |

Прямая трансляция финала конкурса SAP Кодер 2017 состоится 28 июня с 10:00 до 14:00 (по московскому времени).

Чтобы не пропустить прямую трансляцию, добавьте мероприятие в свой календарь.

SAP Кодер 2017 – это конкурс для всех, кто стремится осваивать самые современные подходы к разработке. В этом году САП СНГ проводит этот конкурс первый раз. В рамках конкурса участники разрабатывают собственные приложения для решения реальных бизнес-задач, предоставленных российскими клиентами SAP. Разработка ведется на SAP Cloud Platform – инновационной открытой облачной платформе SAP, предлагающей цифровые сервисы для Интернета вещей, машинного обучения, прогнозной аналитики и других передовых бизнес-сценариев. Подробнее о конкурсе читайте на сайте.

В ходе трансляции Вы услышите о технологических трендах, ознакомитесь со стратегией SAP в области платформенных технологий, узнаете о примерах развития бизнеса с помощью облачной платформы SAP.

Расписание:

10:00 — На что SAP потратит 2,2 млрд. долларов в ближайшие 5 лет? Куда направить взгляд, Рольф Шуманн, вице-президент по платформе и инновациям SAP SE

11:00 — Взгляд клиента: промышленная разработка приложений на платформе SAP Cloud Platform, Сорен Лоингер, директор по продажам и инновациям в сфере обслуживания, Aesculap/B. Braun, Germany

11:30 — Перерыв

11:45 — Выступление финалистов конкурса

13:30 — Награждение победителей конкурса

SAP Cloud Platform – это открытая облачная платформа SAP, которая предоставляет возможности для хранения и обработки данных в SAP HANA и ASE, а также в open source-системах PostgreSQL, MongoDB и Hadoop. SAP Cloud Platform прекрасно подходит для разработки мобильных и HTML-приложений, которые могут быть легко интегрированы с любыми облачными или локальными системами благодаря встроенному в SAP Cloud Platform сервису интеграции. В настоящее время SAP Cloud Platform предоставляет порядка 40 различных сервисов, включая IoT, алгоритмы прогнозирования, машинный перевод и другие методы машинного обучения, имеет собственную веб-среду разработки WebIDE и инструмент для быстрого прототипирования Build, поддерживает разработку приложений на Java, XSJS, C++, Python, Ruby, Node.js, Go, PHP, .Net.

|

Метки: author SAP разработка для интернета вещей программирование блог компании sap sap кодер 2017 sap cloud platform |

[Перевод] SIP: этот рост не остановить |

«Сонь, на «прогнившем западе» уже через 3 года умрет TDM, а у нас только лет через 50», — утирая слезы зависти, говорит мне SvyatoslavVasiliev. Мы с ним обсуждаем статью коллег из GetVoIP о мировых трендах развития VoIP, вытесняющего традиционные технологии из ТфОП/PSTN (телефонные сети общего пользования). Под катом — ее перевод. Слово автору, Matt Grech.

SIP- и VoIP-технологии существенно развились с момента возникновения. Фактически, на их долю сегодня приходится почти половина трафика корпоративных коммуникаций — как малого, так и крупного бизнеса. И все же большая часть трафика последних все-таки еще идет мимо IP-каналов, поскольку крупные компании традиционно медленно адаптируются к изменениям.

Ожидается, что SIP-технологии продолжат стремительно расти в течение ближайших нескольких лет и уже к концу этого года корпоративный IP-трафик обгонит по своим объемам бизнес-коммуникации, проходящие через ТфОП с использованием традиционных для этой сети технологий. Возможно, это случится даже быстрее с учетом того, что крупные провайдеры вообще собираются отключить старую схему работы ТфОП. Eastern Management Group провела исследование участия IT-специалистов компаний в формировании глобальных SIP-технологий в период до 2020 года и пришла к интересным результатам.

Как дела у SIP?

Можно прямо сходу ответить, что дела у SIP обстоят просто прекрасно. Даже с учетом того, что уже сложилась инфраструктура сервисов, предоставляющих услуги по SIP-транкингу и SIP-телефонии, золотые дни SIP-протокола, лежащего в основе решений по IP-коммуникациям, все еще впереди.

Исследование Eastern Management Group показывает, что в настоящий момент более 60% компаний уже используют технологии SIP в коммуникациях, хотя уровень ее проникновения в бизнес разнится в зависимости от его масштабов. Благодаря большому размеру выборки, исследователям удалось учесть данные по IT-подразделениям компаний всего рыночного спектра.

«Исследование Eastern Management Group было проведено среди 3 500 IT-специалистов в январе 2017. Оно показывает, что мировой рынок SIP (включая SIP-транки, SIP-телефонию, SBC, аудио- и видеоприложения) растет. И в течение следующих 5 лет статья расходов на SIP будет расти быстрее темпов роста IT-бюджетов в целом».

Данные по компаниям с разным размером бизнеса:

Такой быстрый рост

Мы можем видеть, что как в маленьких компаниях, так и в больших корпорациях ожидается стремительный рост проникновения SIP. Только в SMB-сегменте мы видим скачок по приросту трафика c 55% (а это уже большая его доля) до 59% всего за один год. Но что более интересно — к 2020 году SIP-трафик в SMB сравняется с объемами аналогичного трафика в крупном бизнесе (его доля в обоих сегментах составит 71%).

Вполне естественно, что крупный бизнес медленно адаптируется к технологиям, имея сложную и разветвленную структуру представительств, в том числе, международных. Такая структура требует времени для реконфигурации. При этом потребность в экономии расходов на связь, являясь важной, может быть не столь экстренной для крупного бизнеса, как, скажем, для стартапа с командой из десяти человек.

Хотя уже даже в 2017 году мы увидим, как крупный бизнес достигнет отметки в 51% по объемам использования SIP-коммуникаций, что является весьма существенным скачком по сравнению с 44% в предыдущем году. Это логично: корпорации видят, что IP-решения начинают все больше затачиваться под их структуру, при этом осознавая, что преимущества SIP — это нечто гораздо большее, чем способ сэкономить ресурсы на связь.

Увеличение продуктивности бизнеса

Существует целый ряд преимуществ SIP по сравнению с традиционными технологиями проводной телефонии. Я разговаривал с Джоном Малоуном, президентом и CEO Eastern Management Group, и он был решительно убежден в том, насколько SIP-технологии лучше — особенно для малого бизнеса.

«Если у вас малый бизнес, то вы просто спятили, если еще не сделали все возможное для того, чтобы использовать SIP».

Я и сам не очень понимаю, зачем малому бизнесу хотеть тратить лишние деньги на традиционные технологии — одна только экономия ресурсов за счет внедрения виртуальной АТС покроет все, не говоря уже о внедрении системы Unified Communications в целом. Как мы знаем, ТфОП, основанная на традиционной технологии, умеет только это — совершать телефонные звонки. На основе же SIP в рамках ТфОП могут быть выстроены решения по организации командного общения и взаимодействия, автоматическому определению статуса сотрудников в телефонии, видеоконференциям. Тот же SIP лежит в основе концепции BYoD (прим.: bring your own device — концепция, предусматривающая возможность использования сотрудниками собственных мобильных устройств для решения рабочих задач) и вообще мобильности бизнеса, на которой выстраивается сегодня командная работа.

Возможно, BYoD пока не самая предпочтительная политика IT-команд в крупных корпорациях, но не так трудно разработать достаточно защищенные решения в этой области и для этого сегмента. Тем не менее, трудно спорить с тем, что, по сути, все эти преимущества SIP по сравнению с традиционными технологиями — это и не преимущества вовсе, а скорее вещи другого порядка, с которыми в принципе невозможно конкурировать.

Одни только видеоконференции — яркий пример того, как SIP прокачивает командное взаимодействие. То же самое соединение, которое используется для передачи голоса лежит в основе организации видеосвязи. Для этого существует множество решений — от бесплатных провайдеров до сервиса Chime от Amazon, так что любой бизнес не только может, но и должен ими пользоваться. SIP — драйвер корпоративных видеорешений, а они, в свою очередь — драйвер увеличения продуктивности бизнеса.

Звучавшие некоторое время назад жалобы на качество связи на основе SIP больше не актуальны. Из разговора с Джоном я узнал, что большая часть провайдеров IP-телефонии находится в рейтингах на одном уровне с операторами традиционной телефонии. И, как мы уже говорили, операторы даже собираются отказаться от поддержки традиционных технологий в рамках ТфОП и организовать ее в структуру из связанных IP-сетей по всему миру.

Самое время для SIP