Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] 67 полезных инструментов, библиотек и ресурсов для экономии времени веб-разработчиков |

67 полезных инструментов, библиотек и ресурсов для экономии времени веб-разработчиков

- Перевод

В данной статье я не буду вам рассказывать о больших веб-фреймворках, таких как React, Angular, Vue и т.д… не будет в ней и перечня наиболее популярных текстовых редакторов – Atom, VS Code, Sublime… В данной статье я поделюсь с вами инструментами, которые, по моему мнению, могут сделать рабочий процесс веб-разработчиков более простым и быстрым.

Вероятно, что кто-то из вас уже знаком с некоторыми такими инструментами. Тем не менее, будет очень круто, если кто-нибудь из читателей найдет что-то новое и полезное для себя в моей статье.

Ниже представлены различные веб-ресурсы, которые я разбил по группам для большего удобства.

Ресурсы

Ghost — Простая платформа для блогов, разработанная с помощью node.js

What runs — Плагин Chrome, предназначенный для изучения технологий, используемых для создания современного веб-сайта

Learn anything — Диаграмма связей для выбора дисциплины (например физика, химия и т.д.) и вывода ее подразделов

LiveEdu.tv — Стриминговый сервис для программистов и дизайнеров, который сфокусирован на реальных проектах. Здесь вы сможете найти сотни каналов по следующим темам: разработка программного обеспечения, искусственный интеллект, наука о данных, разработка игр, дизайн, VR & AR разработка, криптовалюты, на которых разрабатывают реальные проекты, в режиме реального времени и в процессе разработки авторы объясняют каждый шаг.

head cheatsheet — Список всего, что можно включить в тег head

JavaScript библиотеки и фреймворки

Particles.js — Библиотека, в который вы найдете много интересного для создания плавающих элементов на вашей веб-странице.

Three.js — Библиотека для создания на веб-странице 3D-объектов и 3D-визуализации

Fullpage.js — Набор простых для реализации полностраничных скролл-свойств

Typed.js — Эффект пишущей машинки для вашего веб-сайта

Waypoints.js — Примеры кода для запуска функции при прокрутке страницы

Highlight.js — Подсветка синтаксиса для страниц

Chart.js — Набор красивых диаграмм, созданных на чистом JavaScript

Instantclick — Библиотека, полезная для ускорения загрузки вашего сайта с предварительной загрузкой ресурсов при наведении мыши

Chartist — Еще одна библиотека с диаграммами

Motio — Библиотека для создания анимации и панорам с помощью спрайтовой графики

Animstion — Плагин jQuery для создания переходов страниц с помощью CSS

Barba.js — Ресурс для создания перетекающих переходов на странице

TwentyTwenty — Инструмент для создания визуальных различий

Vivus.js — Библиотека для создания начерченных анимаций с помощью SVG

Wow.js — Инструмент для показа рисунков по мере прокрутки страницы

Scrolline.js — Инструмент, благодаря которому вы можете отследить, сколько вам нужно прокрутить до конца страницы

Velocity.js — Инструмент для создания очень быстрых JavaScript-анимаций с плавным переходом

Animate on scroll — Простой пример создания анимаций при прокрутке страницы

Handlebars.js — Разработка шаблонов для JavaScript

jInvertScroll — Эффект горизонтальной прокрутки Parallax

One page scroll — Прокрутка в пределах одной страницы

Parallax.js — Свойство Parallax, реагирующие на ориентацию вашего смарт-устройства

Typeahead.js — Продвинутый поиск и авто-заполнение

Dragdealer.js — Библиотека с множеством крутых эффектов для перемещения анимаций

Bounce.js — Инструмент для создания CSS-анимаций

Pagepiling.js — Прокрутка в пределах одной страницы

Multiscroll.js — Пример кода для создания двух вертикально-прокручивающихся секций

Favico.js — Динамические фавиконы

Midnight.js — Пример кода для изменения неподвижных заголовков при прокрутке страницы

Anime.js — Библиотека различных анимаций для JavaScript

Keycode — JavaScript-код для отображения числовых значений при нажатии клавиш

Sortable — Примеры кода для перетаскивания и удаления элементов на странице

Flexdatalist — Примеры кода для авто-заполнения поиска

JQuerymy — Двусторонняя привязка данных с помощью jQuery

Cleave.js — Форматирование содержимого при наборе текста

Page — Маршрутизация на стороне клиента для одностраничных приложений

Selectize.js — Поля смешанного выбора для добавления тегов

Nice select — Библиотека jQuery для создания красивых полей выбора

Tether — Эффективное прикрепление элементов страницы с абсолютным расположением

Shepherd.js — Путеводитель для пользователей вашего сайта

Tooltip — Название говорит само за себя...

Select2 — Настройка полей выбора с помощью jQuery

IziToast — Простые в реализации JS-уведомления

IziModal — Всплывающие окна, реализованные с помощью простого JavaScript

Библиотеки CSS / Дизайн-инструменты

Animate.css — Библиотека анимаций

Flat UI Colors — Список простых и эффективных цветовых гамм

Material design lite — Фреймворк, основанный на материальном веб-дизайне от Google

Colorrrs — Генератор случайных цветовых гамм

Section separators — Создание границ разных форм с помощью CSS

Topcoat — Фреймворк для создания веб-приложений

Create ken burns effect — Создание эффекта «Ken burns»

DynCSS — Добавление функций в CSS, необходимых для добавления динамических свойств веб-страницам

Magic animations — Что ж, из названия и так все ясно…

CSSpin — Коллекция виртуальных CSS-спиннеров для вашего сайта

Feather icons — Иконки

Ion icons — Иконки

Font awesome — Иконки

Font generator — Эффективный подбор и объединение шрифтов

On/Off switch — Создание переключателя «on/off» с помощью CSS

UI Kit — Фреймворк

Bootstrap — Фреймворк

Foundation — Фреймворк

Ну что ж, вот я и привел вам список наиболее эффективных инструментов, фреймворков и библиотек, которые я использую в повседневной работе.

Если вы нашли подобные ресурсы, которые показались вам интересными, оставьте их в комментарии!

|

Метки: author Arturo01 разработка веб-сайтов программирование библиотеки фреймворки инструменты ресурсы |

Автоматизируй это: десять применений пользовательского API для QIWI Кошелька |

Автоматизируй это: десять применений пользовательского API для QIWI Кошелька

В эту субботу в нашем блоге QIWI на Хабре мы объявили конкурс «По тысяче рублей за идею». Нами предлагалось изложить идею приложения, которое возможно реализовать на базе QIWI API в рамках грядущего всероссийского конкурса QIWI API Contest, а в качестве награды получить за хорошую идею 1000 рублей на свой QIWI Кошелек. Чтобы сбор идей был абсолютно прозрачным, он проходил в комментариях к самой публикации. Несмотря на выходные, пользователи Хабра нас приятно удивили: к реализации было предложено почти два десятка идей.

Победителями конкурса стали пользователи:

equity с идеей создания двухстороннего «мотивирующего календаря встреч», согласно которому за опоздание одной из сторон на каждые N минут, опоздавший будет терять небольшую сумму денег. Опционально возможно перечисление средств на благотворительные нужды.

Followww с идеей мини-игры «нужное-ненужное» по аналогии с «съедобное-несъедобное». По задумке пользователи могут выбирать из предложенных групп товаров определенной стоимости самые привлекательные, таким образом корректируя продуктовую линейку заинтересованной стороны.

Gorodnya с идеей поддержки приложением QIWI Кошелька функции NFC для перевода денег с банковской карты другого пользователя одним касанием пластика к смартфону.

int27h с идеей автоматизации учёта личных финансов из истории покупок, переводов, платежей, а также автоматической оплаты штрафов и сохраненных сборов.

MrSunny с идеей создания сервиса платных голосований на базе QIWI Кошелька. Плата взимается ради создания еще одного уровня защиты от накруток.

Samouvazhektra с идеей приложения «коллективного кошелька» для сбора средств на определенные нужды. Например, для родителей школьников, студентов и т.д.

Talean с идеей создания кошелька-приложения для сотрудников (курьеров) с автоматической оплатой из расчета пройденного автомобилем пути.

TrusTT с идеей автоматической оплаты услуг SMM-щиков из расчета опубликованных им записей. Данные собираются в «тихом» режиме ботом или предоставляются вручную ссылками. Ориентировано на работу с проверенными людьми.

val_potapov с идеей создания приложения-гаранта для совершения оффлайновых покупок «с рук» через посредников. Дает возможность подтвердить поступление средств на счет продавца, что гарантирует исполнение обязательств по сделке обеими сторонами.

padonnak с идеей создания авторизационного бота в качестве альтернативы СМС-идентификации платежей.

Это — лучшие идеи из опубликованных в комментариях. Однако нам особенно хочется отметить идеи следующих хабраюзеров: Gorodnya, Talean и TrusTT. Их предложения можно прямо сейчас брать и регистрироваться с одним из них на наш конкурс — мы будем рады увидеть реализацию этих предложений. В целом, при отборе победителей мы ориентировались на те идеи, которые можно успешно воплотить в жизнь с использованием открытого API QIWI Кошелька. Причем у всех вышеописанных предложений есть реальный шанс получить главный приз грядущего хакатона — поездку в Сингапур.

Дерзайте! Встретимся на QIWI API Contest.

Чтобы получить свой приз в размере 1000 рублей, победители должны связаться с автором этой публикации в личных сообщениях и выслать ему номер своего QIWI Кошелька.

|

Метки: author d_garmashev хакатоны блог компании qiwi qiwi qiwi api contest конкурс по тысяче рублей за идею конкурс идей |

Экспресс Купертино — Москва. Новые фичи iOS 11, обсуждение Apple Special Event и конкурс от Avito |

Экспресс Купертино — Москва. Новые фичи iOS 11, обсуждение Apple Special Event и конкурс от Avito

Мы все знаем, что почти каждый iOS-разработчик хотел бы оказаться вечером 12 сентября в театре Стива Джобса в Купертино. Вместо фокусов с телепортацией и материализацией приглашений на это событие мы устроили Avito Special iOS Event.

Сначала послушаем короткие тематические доклады от iOS-разработчиков из ведущих российских компаний, а затем будет совместный просмотр конференции Apple. Специально для Хабра будем вести здесь прямую видеотрансляцию той части, что с докладами, у нас в Avito, а затем — текстовую трансляцию из Калифорнии. Чтобы было ещё веселее, мы подготовили конкурс для тех, кто способен предвидеть будущее.

Итак, под катом:

- прямая трансляция докладов про новые фичи iOS 11 (главным образом про Drag and Drop), ARKit, Vision;

- слайды докладов (скоро появятся);

- конкурс для пользователей Хабра (с 18:00 до 20:00 12.09 по Мск);

- текстовая трансляция конфы (начиная с 20:00 12.09 по Мск);

- свежие картинки с Тимом Куком.

Конкурс

Все большие события Apple окружены атмосферой тайны. Все пытаются угадать, что именно расскажут и покажут на конференции. Предлагаем вам сделать свои ставки в этой форме. Каждый ответ имеет свой вес в баллах. Тому (или тем), у кого наиболее развита интуиция/дар предвидения/etc, мы подарим сувенир от Avito. Ответы закончим принимать с началом трансляции конференции Apple. Теперь — к докладам.

Доклады

Итак, максимально быстро окунаемся в дивный новый мир iOS 11. Мы позвали на митап специалистов из Rabler&Co, Avito и App in the Air. Сегодняшние рассказы — о практическом опыте реализации новых фич iOS 11. Даже если вы сильно не следили за обновлениями, после этого поста вы будете чётко знать, чего не хватает вашим приложениям, чтобы стать полностью iOS 11-совместимыми.

Трансляция из офиса Avito (YouTube)

(UPD 18:28: Мы впервые решили вставить прямую трансляцию с YouTube в пост на Хабре, поэтому ниже уже есть запасная ссылка. Просто на всякий случай).

ARKit в приложении Афиша Рестораны. Самвел Меджлумян, Дмитрий Антышев (Rambler&Co)

Разработчики приложения Афиша Рестораны, Самвел Меджлумян и Дмитрий Антышев, рассказывают о том, как они смогли прикрутить ARKit к своему проекту. Помимо тонны хайпа, видеодемок и кривой Гаттнера много внимания уделено вопросам алгоритмов расчета положения точек в пространстве и построения маршрутов. Если вы до сих пор сомневаетесь, что ARKit можно с пользой встроить в ваше приложение — опыт ребят может помочь вам изменить свое решение.

Анонимизация фото с помощью Vision. Тимофей Хомутников, Avito

В Avito сильно развита традиция внутренних хакатонов, о чем мы уже писали в нашем блоге. На одном из них команда мобильных разработчиков решила известную боль пользователей — при подаче объявления они всеми возможными способами пытаются скрывать лица и номера машин. Кто-то одевает пакеты, кто-то прикрывается руками, наиболее продвинутые делают это в графическом редакторе, но суть остается — для обеспечения конфиденциальности люди тратят слишком много усилий.

Тимофей Хомутников рассказывает о том, как при помощи нового фреймворка Vision и набора костылей эта проблема была решена. И чтобы доклад не сводился к простому использованию системного SDK, Тимофей проводит ликбез по существующим способам и алгоритмам определения автомобильных номеров.

iOS 11 в App in the Air. Сергей Пронин, App in the Air

Разработчики App in the Air известны тем, что каждый год одними из первых реализуют все новые плюшки из обновления iOS – и неважно, насколько они на первый взгляд релевантны приложению, получается стабильно круто. Этот год тоже не стал исключением. Сергей Пронин, CTO компании, рассказывает про ключевую функциональность, реализованную командой до релиза iOS 11. В нее вошли Drag and Drop, iMessage Live Messages, ARKit, SiriKit и Notifications Privacy.

Особое внимание в докладе Сергей уделяет Drag and Drop. И на примере кейса из своего приложения показывает, что встроить его и кастомизировать для своих нужд достаточно просто.

Купертино live

Текстовая трансляция из телеграм-канала Tolstoy Live будет обновляться и здесь:

• 1:50:03 PM

Всем привет! Смело отписывайтесь от канала — сегодня по мере возможности буду вести трансляцию Apple Special Event для тех, кому лень или некогда смотреть самому. Ну и вообще, началась осень, куча ивентов и все такое.

Бонус

И напоследок бонус: свежие картинки с Тимом Куком. Сделано с любовью.

Пишите в комментариях, что думаете о сегодняшней конференции, докладах и практическом применении iOS 11!

|

|

[Перевод] DevOps с Kubernetes и VSTS. Часть 1: Локальная история |

DevOps с Kubernetes и VSTS. Часть 1: Локальная история

- Перевод

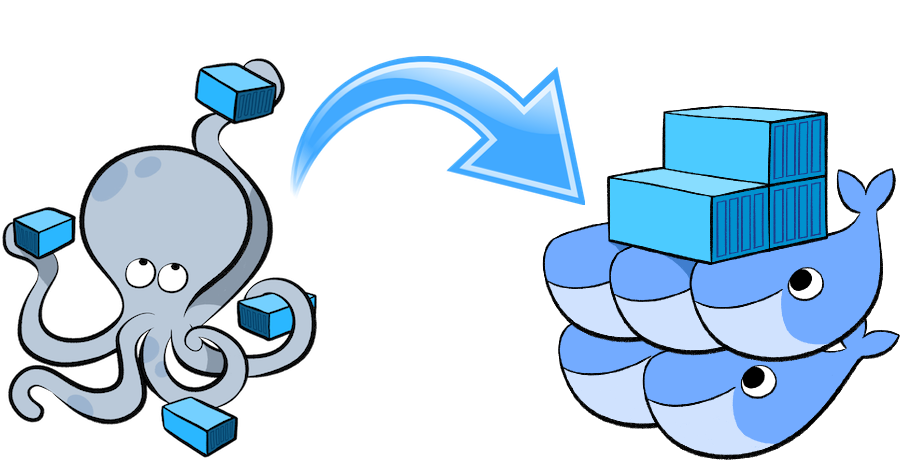

- Tutorial

Если вы читаете мой блог, то знаете, что я фанат контейнеров в целом и Docker в частности. Когда вы в последний раз ставили софт на «голое железо»? Может быть, только на ноутбук, но и то шансы невелики. Виртуализация кардинально изменила наше отношение к ресурсам центра обработки данных, значительно увеличив их плотность и эффективность использования. Следующим этапом повышения плотности стали контейнеры, только ВМ размещаются на физических серверах, а контейнеры — в самих ВМ. Очень скоро большинство из нас не будет работать не только на уровне серверов, но даже на уровне ВМ, все рабочие нагрузки переместятся в контейнеры. Но это в перспективе.

Несмотря на все преимущества контейнеров с точки зрения упаковки приложений, многим до сих пор непонятно, как запускать контейнеры в производственной среде. Установка одного контейнера станет интересным и воодушевляющим опытом для любого разработчика, но как насчет масштабирования контейнеров или объединения их в кластер? Как вы будете наблюдать за своими контейнерами? Как выявлять и устранять сбои? Здесь мы плавно переходим к проблеме оркестрации контейнеров.

В этой статье мы рассмотрим подходы к локальной разработке с использованием Kubernetes и minikube. Часть 2 посвящена вопросам создания конвейеров CI/CD для кластера Kubernetes в Azure.

Поле битвы — оркестрация

Существуют три популярные системы оркестрации контейнеров — Mesos, Kubernetes и Docker Swarm Mode. Я не буду призывать вас встать под чей-то флаг (по крайней мере пока), концептуально они все похожи. Они все используют концепцию «конфигурация как код» для развертывания множества контейнеров на множество узлов. Kubernetes предлагает ряд возможностей, которые, на мой взгляд, станут настоящим прорывом в области DevOps: карты конфигурации (ConfigMaps), секреты (Secrets) и пространства имен (namespaces).

Не вдаваясь в подробности, скажу, что пространства имен позволяют создавать различные логические среды в одном кластере. В качестве примера приведу пространство имен DEV, где вы сможете запускать небольшие копии своей среды PROD в целях тестирования. Пространства имен также применяются для реализации мультитенантности или различных контекстов безопасности. Карты конфигурации (ConfigMaps) и секреты (Secrets) позволяют хранить конфигурацию за пределами контейнеров, то есть вы сможете запускать один образ в различных контекстах без встраивания специфичного кода для конкретной среды в сами образы.

Kubernetes Workflow (рабочий процесс) и Pipeline (конвейер)

В этой статье я продемонстрирую подход к разработке с ориентацией на Kubernetes. В первой части мы рассмотрим рабочий процесс разработки, а во второй — конвейер DevOps. К счастью, благодаря MiniKube (кластеру с одним узлом Kubernetes, который запускается на ВМ) мы можем работать с полноценным кластером на ноутбуке! Это означает, что вам доступны преимущества кластерной технологии (вроде ConfigMaps) без подключения к производственному кластеру.

Итак, рассмотрим рабочий процесс разработчика. Это будет что-то вроде:

- Разработать код.

- Создать образ на основе файла Dockerfile или пакета файлов, сформированного с помощью команды docker-compose.

- Запустить службу в MiniKube (запускаем контейнеры из ваших образов).

Как показывает практика, благодаря Visual Studio 2017 (и (или) VS Code), Docker и MiniKube на этом пути вам не встретятся подводные камни.

Затем вы перейдете к конвейеру DevOps, начиная с его создания. На основе ваших исходных файлов и файлов Dockerfile создаются образы, которые регистрируются в приватном реестре контейнеров. Далее необходимо передать конфигурацию в кластер Kubernetes, чтобы запустить/развернуть новые образы. Благодаря Azure и VSTS мы создадим конвейер DevOps буквально за пару-тройку кликов! Но это тема второй части нашей статьи, сейчас же мы изучаем рабочий процесс разработчика.

Подготовка среды разработки

Для демонстрации я буду использовать Windows, но в Mac или Linux настройки аналогичные. Для развертывания локальной среды разработки вам нужно установить:

Можете воспользоваться ссылками и выполнить установку. В процессе я столкнулся с небольшой проблемой при запуске MiniKube на Hyper-V — по умолчанию команда MiniKube start, создающая ВМ для MiniKube, подключается к первой найденной виртуальной сети Hyper-V. Сетей у меня было несколько, и MiniKube подключился ко внутренней, что привело к сбою. Я создал новую виртуальную сеть с именем minikube в консоли Hyper-V и убедился, что это внешняя сеть. Для создания ВМ MiniKube я воспользовался следующей командой:

c:

cd \

minikube start --vm-driver hyperv --hyperv-virtual-switch minikube

Внешняя сеть подключена к моей точке доступа Wi-Fi. Это означает, что когда я подключаюсь к новой сети, ВМ minikube получает новый IP-адрес. Вместо того чтобы каждый раз обновлять kubeconfig, я просто добавил строку хоста в свой файл hosts (в Windows это c:\windows\system32\drivers\etc\hosts): kubernetes, где IP — это IP-адрес ВМ minikube, полученный с помощью команды minikube ip. Для обновления kubeconfig используйте следующую команду:

kubectl config set-cluster minikube --server=https://kubernetes:8443 --certificate-authority=c:/users//.minikube/ca.crt Теперь при подключении к новой сети вы просто обновите IP-адрес в файле hosts, и команда kubectl по-прежнему будет работать. Сертификат генерируется для узла с именем kubernetes, поэтому используйте это имя.

Если все работает нормально, вы получите лаконичный ответ на команду kubectl get nodes:

PS:\> kubectl get nodes

NAME STATUS AGE VERSION

minikube Ready 11m v1.6.4

Чтобы запустить UI Kubernetes, просто введите команду minikube dashboard. В браузере откроется следующее окно:

Наконец, для «повторного использования» контекста minikube docker выполните следующую команду:

minikube docker-env | Invoke-ExpressionТаким образом обеспечивается совместное использование сокета minikube docker. Выполнив команду docker ps, вы получите информацию о нескольких работающих контейнерах, это базовые системные контейнеры Kubernetes. Это также означает возможность создания здесь образов, которые могут запускаться кластером minikube.

Теперь у вас есть кластер с одним узлом. Можете приступать к разработке!

Переходим к коду

Не так давно я опубликовал в блоге статью Разработка проекта Aurelia с помощью Azure и VSTS. И поскольку у меня уже была пара готовых сайтов .NET Core, я решил попробовать запустить их в кластере Kubernetes. Выполните клонирование этого репозитория и проверьте ветку docker. Я добавил несколько файлов в репозиторий, чтобы обеспечить возможность создания образов Docker и указать конфигурацию Kubernetes. Давайте посмотрим, как это выглядит.

Файл docker-compose.yml определяет составное приложение из двух образов: api и frontend:

version: '2'

services:

api:

image: api

build:

context: ./API

dockerfile: Dockerfile

frontend:

image: frontend

build:

context: ./frontend

dockerfile: DockerfileФайл Dockerfile для каждой службы максимально прост: запуск из образа ASP.NET Core 1.1, копирование файлов приложения в контейнер, открытие порта 80 и запуск dotnet app.dll (frontend.dll и api.dll для каждого сайта) в качестве точки входа для каждого контейнера:

FROM microsoft/aspnetcore:1.1

ARG source

WORKDIR /app

EXPOSE 80

COPY ${source:-obj/Docker/publish} .

ENTRYPOINT ["dotnet", "API.dll"]Создание образов

Проще всего для создания образов использовать Visual Studio. Настройте проект docker-compose как стартовый и запустите его. Образы будут созданы. Если вы не работаете с Visual Studio, создавайте образы, выполняя следующие команды из корневого каталога репозитория:

cd API

dotnet restore

dotnet build

dotnet publish -o obj/Docker/publish

cd ../frontend

dotnet restore

dotnet build

dotnet publish -o obj/Docker/publish

cd ..

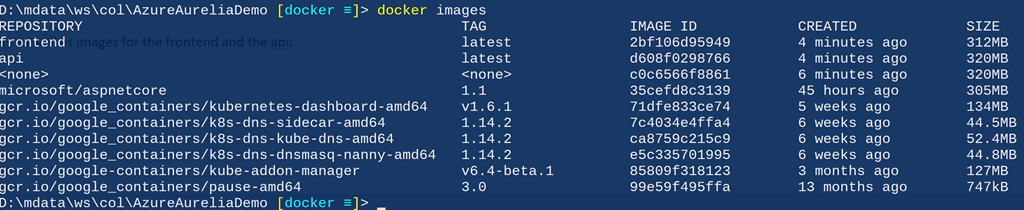

docker-compose -f docker-compose.yml buildТеперь после выполнения команды docker images вы увидите контейнеры minikube, а также образы для frontend и api:

Объявление служб — конфигурация как код

Теперь мы можем указать, какие службы запускать в кластере. На мой взгляд, одно из преимуществ Kubernetes заключается в том, что вы должны объявлять свою среду, вместо того чтобы запускать скрипт. Такая декларативная модель намного лучше императивной, и в настоящее время она распространяется все шире благодаря Chef, Puppet и PowerShell DSC. Kubernetes позволяет нам указывать запускаемые службы, а также определять методы их развертывания. Различные объекты Kubernetes можно определять с помощью простого файла yaml. Мы объявляем две службы: api и frontend. Серверные службы (backend) обычно недоступны за пределами кластера, однако в данном случае наш демонстрационный код представляет собой одностраничное приложение, поэтому служба api должна быть доступна извне.

Перечень служб будет меняться очень редко, это службы, доступные в кластере. Однако базовые контейнеры (в Kubernetes их называют подами), из которых состоит служба, будут меняться. Они меняются при обновлении, а также при масштабировании. Для управления контейнерами, из которых состоит служба, используется конструкция Deployment. Поскольку служба и развертывание довольно тесно связаны, я поместил их в один файл. То есть у нас есть файл для службы/развертывания frontend (k8s/app-demo-frontend-minikube.yml) и файл для службы/развертывания api (k8s/app-demo-backend-minikube.yml). Если вы посчитаете нужным, можете поместить определения служб и развертываний в отдельные файлы. Изучим содержимое файла app-demo-backend.yml:

apiVersion: v1

kind: Service

metadata:

name: demo-backend-service

labels:

app: demo

spec:

selector:

app: demo

tier: backend

ports:

- protocol: TCP

port: 80

nodePort: 30081

type: NodePort

---

apiVersion: apps/v1beta1

kind: Deployment

metadata:

name: demo-backend-deployment

spec:

replicas: 2

template:

metadata:

labels:

app: demo

tier: backend

spec:

containers:

- name: backend

image: api

ports:

- containerPort: 80

imagePullPolicy: NeverПримечания:

- Строки 1–15 объявляют службу.

- В строке 4 указано имя службы.

- В строках 8–10 описан селектор для этой службы. Любой под с метками app=demo и tier=frontend будет использоваться для балансировки нагрузки этой службы. Служба будет знать, как перенаправить на свои базовые модули трафик, связанный с запросами для этой службы, которые попадают в кластер. Это упрощает добавление, удаление и обновление контейнеров, поскольку все, что нам нужно сделать, — изменить селектор. Служба получит статический IP-адрес, а ее базовые модули — динамические адреса, которые будут меняться на разных этапах жизненного цикла модулей. Тем не менее этот процесс абсолютно прозрачен для нас, потому мы будем просто посылать запросы службе, и все должно работать.

- Строка 14 — мы хотим, чтобы эта служба была доступна через порт 30081 (сопоставленные с портом 80 на подах, как указано в строке 13).

- Строка 15 — NodePort указывает, что мы хотим, чтобы Kubernetes предоставлял службе порт на том же IP-адресе, который использует кластер. Для «реальных» кластеров (на ресурсах поставщика облачных услуг, например Azure) мы изменили бы эту настройку, чтобы получить IP-адрес от облачного хоста.

- В строках 17–34 объявляется конструкция Deployment, которая обеспечит наличие контейнеров (подов) для этой службы. Если под неработоспособен, Deployment автоматически запускает новый под. Эта конструкция гарантирует нормальную работу службы.

- Строка 22 указывает, что нам постоянно требуются два экземпляра контейнера для этой службы.

- Строки 26 и 27 важны, они должны соответствовать меткам селектора из службы.

- В строке 30 указано имя контейнера в поде (в нашем случае в этом поде всего один контейнер, как мы и планировали).

- В строке 31 указано имя запускаемого образа — это же имя мы указали в файле docker-compose для образа backend.

- В строке 33 мы открываем порт 80 на этом контейнере для кластера.

- Строка 34 указывает, что мы не хотим, чтобы Kubernetes извлекал образ, поскольку собираемся создавать образы в контексте minikube docker. В производственном кластере мы планируем указать другие политики, чтобы кластер мог получать обновленные образы из реестра контейнеров (мы увидим это во второй части).

Определение клиентской службы (службы frontend) практически аналогичное, за исключением того, что для настройки придется немного поколдовать. Давайте посмотрим, как это выглядит.

spec:

containers:

- name: frontend

image: frontend

ports:

- containerPort: 80

env:

- name: "ASPNETCORE_ENVIRONMENT"

value: "Production"

volumeMounts:

- name: config-volume

mountPath: /app/wwwroot/config/

imagePullPolicy: Never

volumes:

- name: config-volume

configMap:

name: demo-app-frontend-configПримечания:

- Строка 30: имя контейнера в поде.

- Строка 31: укажите имя образа для этого контейнера, оно должно совпадать с именем в файле docker-compose.

- Строки 34–36: пример указания переменных среды для службы.

- Строки 37–39: ссылка для монтирования тома (указано ниже) для подключения файла конфигурации, из которого Kubernetes узнает, где в файловой системе контейнера должен быть смонтирован файл. В данном случае Kubernetes смонтирует том с именем config-volume по следующему пути в контейнере: /app/wwwroot/config.

- Строки 41–44: они указывают том, в нашем случае — том configMap для конфигурации (подробнее об этом чуть ниже). Здесь мы просим Kubernetes создать том с именем config-volume (на который ссылается volumeMount контейнера) и использовать для тома данные из configMap с именем demo-app-frontend-config.

Управление конфигурацией

Теперь у нас есть несколько образов контейнеров и мы можем запускать их в minikube. Но прежде чем начать, давайте обсудим конфигурацию. Если вы слышали мои выступления или читали мой блог, то вы знаете, что я — один из главных пропагандистов концепции «создаем один раз, разворачиваем многократно». Это базовый принцип правильного DevOps. В случае с Kubernetes и контейнерами ситуация аналогичная.

Однако для этого вам нужно будет размещать конфигурацию за пределами своего скомпилированного кода, то есть понадобятся такие механизмы, как файлы конфигурации. Если вы выполняете развертывание в службах IIS или Azure App, то можете просто использовать файл web.config (для DotNet Core это будет appsettings.json) и указать разные значения для разных сред. Но как тогда быть с контейнерами? Весь код приложения находится в контейнере, поэтому вы не можете использовать разные версии конфигурационного файла, в противном случае вам понадобятся разные версии самого контейнера, то есть принцип однократного создания будет нарушен.

К счастью, мы можем использовать подключаемые тома (концепция контейнеров) в сочетании с секретами и (или) configMaps (концепция Kubernetes). Мы можем указать configMaps (по сути это пары ключ — значение) или секреты (маскированные или скрытые пары ключ — значение) в Kubernetes, а затем просто смонтировать их путем подключения томов в контейнерах. Это действительно мощный инструмент, поскольку определение пода остается прежним, но если у нас есть другой configMap, мы получаем другую конфигурацию! Мы увидим, как это работает, когда будем выполнять развертывание в облачном кластере и использовать пространства имен для изоляции среды разработки и производственной среды.

configMaps также можно указать с помощью метода «конфигурация как код». Вот конфигурация нашего configMap:

apiVersion: v1

kind: ConfigMap

metadata:

name: demo-app-frontend-config

labels:

app: demo

tier: frontend

data:

config.json: |

{

"api": {

"baseUri": "http://kubernetes:30081/api"

}

}Примечания:

- Строка 2: мы указываем, что это определение configMap.

- Строка 4: имя этой карты.

- Строка 9: мы указываем, что эта карта использует формат file format, и задаем имя файла — config.json.

- Строки 10–14: содержимое конфигурационного файла.

Отступление: проблема символьных ссылок на статические файлы

Я действительно столкнулся с одной проблемой при монтировании конфигурационного файла с помощью configMaps: внутри контейнера путь /app/www/config/config.json оканчивается символической ссылкой. Идею использовать configMap в контейнере я подсмотрел в отличной статье Энтони Чу (Anthony Chu), где он описывает, как подключал файл application.json для использования в файле Startup.cs.

Очевидно, с проблемой символической ссылки в файле Startup он не сталкивался. Однако для своего демонстрационного клиентского приложения я создаю конфигурационный файл, который используется SPA-приложением, и поскольку он находится на стороне клиента, конфигурационный файл должен предоставляться из приложения DotNet Core, просто в виде html или js. Нет проблем. У нас уже есть вызов UseStaticFiles в Startup, поэтому он должен просто предоставлять файл, верно? К сожалению, это не так. Скорее всего, он перешлет только первые несколько байтов из этого файла.

Я потратил пару дней, чтобы разобраться с этим. На Github есть специальная тема, можете почитать, если вам интересно. Если коротко, длина символической ссылки — это не длина самого файла, а длина пути к файлу. Промежуточное ПО StaticFiles считывает FileInfo.Length байт при запросе файла, но поскольку эта длина не равна полной длине файла, то возвращаются только первые несколько байтов. Я создал средство FileProvider для обхода этой проблемы.

Запуск образов в Kubernetes

Чтобы запустить вновь созданные службы в minikube, мы можем просто использовать kubectl для применения конфигураций. Вот список команд (выделенные строки):

PS:\> cd k8s

PS:\> kubectl apply -f .\app-demo-frontend-config.yml

configmap "demo-app-frontend-config" created

PS:\> kubectl apply -f .\app-demo-backend-minikube.yml

service "demo-backend-service" created

deployment "demo-backend-deployment" created

PS:\> kubectl apply -f .\app-demo-frontend-minikube.yml

service "demo-frontend-service" created

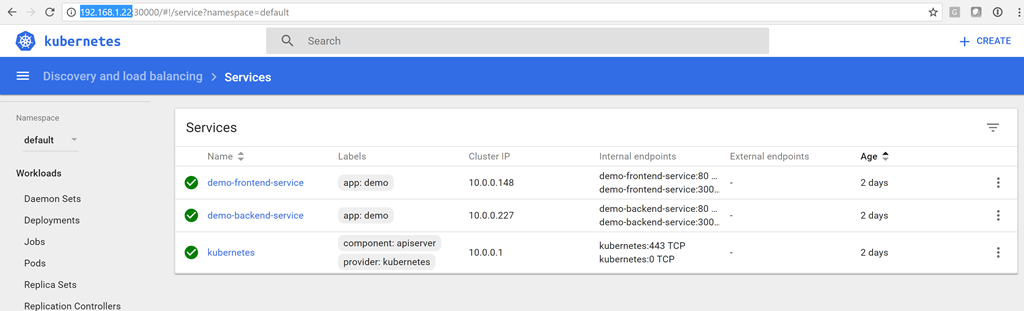

deployment "demo-frontend-deployment" createdТеперь у нас есть службы! Вы можете открыть информационную панель командой minikube dashboard и убедиться, что статус служб — зеленый:

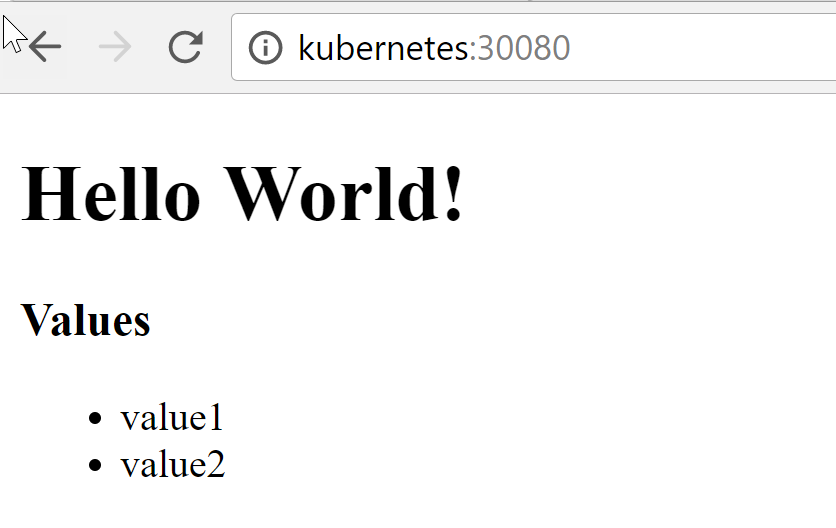

Чтобы подключиться к клиентской службе, введите адрес http://kubernetes:30080:

Список (value1 и value2) — это значения, возвращаемые службой API, то есть клиент смог успешно подключиться к серверной службе в minikube!

Обновление контейнеров

После обновления своего кода вам придется пересоздавать контейнер(ы). Обновив конфигурацию, снова запустите команду kubectl apply для обновления configMap. Затем, поскольку нам не нужна высокая доступность в среде разработки, мы можем просто удалить запущенные поды и дать возможность службе репликации перезапустить их, но на этот раз с обновленной конфигурацией и (или) кодом. Конечно, в производственной среде такие вольности недопустимы, и во второй части я покажу вам, как выполнять последовательные обновления, когда мы будем работать с CI/CD в кластере Kubernetes.

Но в среде разработки я получаю список подов, удаляю их все, а затем наблюдаю, как Kubernetes волшебным образом перезапускает контейнеры (с новыми идентификаторами). В итоге я получаю обновленные контейнеры.

PS:> kubectl get pods

NAME READY STATUS RESTARTS AGE

demo-backend-deployment-951716883-fhf90 1/1 Running 0 28m

demo-backend-deployment-951716883-pw1r2 1/1 Running 0 28m

demo-frontend-deployment-477968527-bfzhv 1/1 Running 0 14s

demo-frontend-deployment-477968527-q4f9l 1/1 Running 0 24s

PS:> kubectl delete pods demo-backend-deployment-951716883-fhf90 demo

-backend-deployment-951716883-pw1r2 demo-frontend-deployment-477968527-bfzhv demo-frontend-deployment-477968527-q4f9l

pod "demo-backend-deployment-951716883-fhf90" deleted

pod "demo-backend-deployment-951716883-pw1r2" deleted

pod "demo-frontend-deployment-477968527-bfzhv" deleted

pod "demo-frontend-deployment-477968527-q4f9l" deleted

PS:> kubectl get pods

NAME READY STATUS RESTARTS AGE

demo-backend-deployment-951716883-4dsl4 1/1 Running 0 3m

demo-backend-deployment-951716883-n6z4f 1/1 Running 0 3m

demo-frontend-deployment-477968527-j2scj 1/1 Running 0 3m

demo-frontend-deployment-477968527-wh8x0 1/1 Running 0 3mОбратите внимание, что идентификаторы подов меняются, поскольку и сами поды уже другие. Если мы переключимся на клиентскую часть, то увидим обновленный код.

Заключение

Я действительно впечатлен возможностями Kubernetes и тем, как эта платформа способствует популяризации концепции «инфраструктура как код». Вы можете достаточно просто развернуть кластер локально на вашем ноутбуке с помощью minikube и начать разработку в среде, максимально приближенной к производственной, а это всегда хорошая идея. Вы можете использовать секреты и карты configMaps, аналогичные тем, что применяются в производственных контейнерах. В целом это отличный подход к разработке, позволяющий придерживаться лучших практик с самого начала.

P.s. Благодарим Константина Кичинского (Quantum Quintum) за иллюстрацию к этой статье.

|

Метки: author stasus программирование visual studio microsoft azure блог компании microsoft microsoft kubernetes k8s vsts devops minikube kubectl |

Конкурс идей от ABBYY – куда бежать и что делать |

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

Конкурс идей от ABBYY – куда бежать и что делать

- Разработка под AR и VR,

- Разработка мобильных приложений,

- Обработка изображений,

- Машинное обучение,

- Блог компании ABBYY

Всем привет. Меня зовут Игорь Акимов, я руководитель направления мобильных продуктов ABBYY. Наверное, многие знают ABBYY по лучшим словарям Lingvo и помощнику любого студента FineReader, но кроме этого мы занимаемся ещё много чем интересным в сфере интеллектуальной обработки информации и лингвистики. За 28 лет накопили огромный багаж в сфере машинного обучения и нейросетей, а новых проектов и идей так много, что кажется, нам нужна помощь :) Поэтому мы приглашаем вас принять участие в конкурсе. Мы ищем идеи по применению новых технологий в мобильной разработке, которые будут близки большому числу людей. И назвали конкурс мы смело – mABBYYlity (тут и ABBYY, и мобильность, и ability – способность). Короче, всё основное тут – mobility.abbyy.com. А в статью за подробностями.

Всем привет. Меня зовут Игорь Акимов, я руководитель направления мобильных продуктов ABBYY. Наверное, многие знают ABBYY по лучшим словарям Lingvo и помощнику любого студента FineReader, но кроме этого мы занимаемся ещё много чем интересным в сфере интеллектуальной обработки информации и лингвистики. За 28 лет накопили огромный багаж в сфере машинного обучения и нейросетей, а новых проектов и идей так много, что кажется, нам нужна помощь :) Поэтому мы приглашаем вас принять участие в конкурсе. Мы ищем идеи по применению новых технологий в мобильной разработке, которые будут близки большому числу людей. И назвали конкурс мы смело – mABBYYlity (тут и ABBYY, и мобильность, и ability – способность). Короче, всё основное тут – mobility.abbyy.com. А в статью за подробностями.Почему идеи?

Итак, конкурс идей от ABBYY. Есть мнение, что реализация идеи, особенно в стартапе, гораздо важнее гениального озарения. Но идея с точки зрения человеческого знания – настоящий акт творения, перенос в наш мир вещей чего-то абсолютно нового. Это вызывает уважение! Мы понимаем, что можем решить множество интересных задач образования и бизнеса, но какие из них действительно самые интересные и полезные? Вы, стоя на самой кромке края этого процесса, знаете о нём гораздо больше лучше наших клиентов и сотрудников. А потому нам важно ваше мнение о том, как сделать мир лучше с помощью технологий ABBYY.

Понимаем, что просто так взять и придумать или скомбинировать что-то новое сложно, а потому есть весь остаток сентября на подумать. Заявки принимаются до 30 сентября, а о результатах скажем довольно быстро – 7 октября (да, наша команда будет спать в офисе эту неделю). Ну и плюс можно будет реализовать идею на хакатоне, который мы анонсируем чуть позднее.

Зачем вообще участвовать?

Когда я учился в вузе на 3 курсе, помню, сделал для студентов бесплатную рассылку расписания через SMS (GMS-модем и небольшая программулина с базой), потому что серверные API для этого были просто люто неудобные и дорогие. Уверен, что и вы видите крутые масштабные возможности каждый день, возможно, пользуетесь нашими продуктами и уверен, часто думаете, как было бы круто, если бы сейчас в ABBYY запилили … Теперь такая возможность есть!

Ну и конечно, не обделим мы самых творческих и призами. Главная радость — новейший iPhone Edition, который ещё даже не представлен (купим за любые деньги и подарим вам).

Направления идей

Итак, давайте пробежимся по направлениям, которыми мы занимаемся сами и видим большой потенциал:

Боты, сервисы в социальных сетях и мессенджерах

Мы понимаем, что несмотря на ограниченность интерфейсов и узкие сценарии, такие сервисы могут быть весьма удобны. Если вы знаете, как лучше использовать наши или будущие технологии в мессенджерах, – пишите.

Дополненная реальность в мобильных устройствах

С iOS 11 практически на миллионах девайсов будут открыты возможности простой в разработке и довольно качественной дополненной реальности с помощью ARKit и мы конечно же добавим интересную штуку в наши мобильные приложения (следите за анонсами), а буквально неделю назад случился ответный ход Google с ARCode и стало ясно, что это всерьёз и надолго. Дополненную реальность в бизнесе пока можно слабо связать с какой-либо полезностью (кроме 3d-моделирования и архитектуры), но я уверен, что полезные сценарии есть.

Обработка текстов, классификация документов, поиск

О, тут можно много чего рассказывать. Во-первых, есть интеллектуальные технологии ABBYY, которые позволяют в слабоструктурированных текстах искать взаимосвязи и выделять сущности. Во-вторых, нейросеточки ещё больше улучшают результаты работы и упрощают получение хороших данных. Здесь желательно использовать всё, что хорошо конвертится в CoreML – Caffe, TensorFlow, Keras, scikit-learn 0.18, XGBoost 0.6, LIBSVM 3.22.

Распознавание и обработка изображений и видео

Это альфа и омега ABBYY. В распознавании мы съели уже столько собак, что кажется, что удивить уже нечем, но нет :) С каждой новой научной статьёй и патентом наших инженеров понимаю, что развиваться ещё есть куда. Самый важный анонс последнего времени – это Real-Time Recognition – распознавание в реальном времени, а значит и быстро, и качественно, и из видеопотока. Сценариев тут много: от сканирования документов и пропусков до перевода текста в незнакомой стране в дополненной реальности.

Улучшение, дополнение, фильтрация фотографий

Чтобы качество распознавания росло и документ даже в самых дичайших условиях съёмки выглядел так, как будто экспортирован из только что свежераспечатанного Word-а, нужно много чего полезного сделать с фотографией: от подбора правильного фильтра до определения, где же на фото картиночки, а где наш замечательный текст. Ну и конечно поиск из нескольких фотографий самой крутой для распознавания, или, например, поиск фотографий паспорта в вашей ленте – тоже актуальные задачи, которые мы решаем каждый день. И ваши идеи тоже будут к месту.

Распознавание и обработка изображений в браузере

Браузеры развиваются такими темпами, что кажется, что “не будет скоро ни балета, ни театра, одно сплошное телевидение” – в браузерах будут работать все. И тут можно подумать о технологии WebAssembly, а также обо всех крутых JavaScript-библиотеках, которые занимаются распознаванием и обработкой изображений.

Распознавание в камерах различных устройств

Сканером в телефоне уже никого не удивить (есть же FineScanner), а вот разные дроны, роботы, дорожные камеры и автомобили – другой зверь. Пролетая дроном над гнездом кукушки, можно, например, считать кукушат, а также (что более полезно) – распознавать номера вагонов.

Технологии обмена информацией

Получив информацию в одном месте не всегда получается быстро передать её, куда нужно. Попытки придумать колесо здесь идут о-о-очень давно. Можно вспомнить ту же передачу данных на мобильниках. Сначала по инфракрасному порту (ох, до сих пор помню, как заливал рингтоны в Siemens S35i и Samsung аж с 16 инструментами!), потом по Bluetooth, потом Wi-Fi Direct, NFC, AirDrop, облака и так далее и тому подобное. А счастья всё нет. То же и со связкой мобилки с десктопом. Десятки прикольных технологий, но идёт со скрипом… Но вместе с вами победим!

Технологии повышения безопасности

Мы много работаем с компаниями, занимающимися безопасностью и защитой важной информации. Наши технологии распознавания и определения чувствительной информации используются в решениях нескольких известных вам компаний по ИБ, но работы тут ещё вагон и маленькая тележка.

Цифровое предприятие, повышение продуктивности

Это вообще то, чем мы занимаемся круглосуточно и уже много-много лет. От оцифровки тонн бумаги и превращения её в знания до цифровизации целых отраслей, например, банков (практически все топовые в России используют наши решения). А для персональной продуктивности у нас есть мобильные решения, которые позволяют делать типичные задачи с текстом, визитками, документами быстрее и мобильнее. И если что-то можно сделать лучше или вообще по-другому – не держите в себе.

Облачные технологии и сервисы

Для мобилок облака – единственная возможность манипулировать гигантскими объемами данных и распрямлять, например, загнутые страницы книги, как это делает BookScanner. Можно как придумать такой сервис, так и “прикрутить” хорошее API к нашим текущим технологиям. Разных идей и комбинаций миллион.

Как и кто оценивает?

Мы старались не перегружать заявку лишним, но постараться выбрать наиболее жизнеспособные вещи. А потому критериев 4:

- Актуальность (проблема не решена полноценно, а на костыльные решения тратятся миллионы);

- Новизна и оригинальность (конкуренты пока спят);

- Техническая (технологическая) реализуемость (можно сделать на уровне прототипа за пару дней – отлично!);

- Оценка рыночного потенциала (каждый день сталкиваются миллионы людей).

В экспертное жюри конкурса постарались подобрать людей, которые оценят идеи с разных сторон. Их в итоге 6:

- Вице-президент по продуктовому маркетингу ABBYY Сергей Павлов;

- Директор по продуктам группы компаний ABBYY Андрей Исаев;

- Ваш покорный слуга – руководитель отдела мобильных продуктов ABBYY Игорь Акимов;

- Управляющий инвестиционным портфелем ФРИИ Сергей Негодяев;

- Главный редактор технологического лайфстайл-ресурса TechFusion.ru Марина Эфендиева;

- Директор по развитию и международным отношениям Физтехпарка Екатерина Елисеева.

Вроде всё. Если будут какие-то вопросы – пишите, отвечу в комментариях.

Заходите в группы конкурса VK, Facebook и Telegram

Ну и обязательно расскажите о своей идее тут mobility.abbyy.com.

|

|

Охота на кремлевского демона |

- Разработка под AR и VR,

- Информационная безопасность,

- Глобальные системы позиционирования,

- Геоинформационные сервисы

Охота на кремлевского демона

- Разработка под AR и VR,

- Информационная безопасность,

- Глобальные системы позиционирования,

- Геоинформационные сервисы

Нельзя сказать, что я не искал с этим демоном встречи. Я дождался пока он вылезет и выследил его логово. Поиграл с ним немного. Потом демон исчез, как обычно, по расписанию — в 9.00. Я успокоился и занялся своими бытовыми делами.

Дело было в том, что у нас в Питере не найти в книжных магазинах рабочую тетрадь по английскому языку "Планета знаний" 3 класс. Ну как в Союзе было, дефицит. И мне жена дала задание — зайти в книжные в Москве. Дескать, в столице все есть, тетки на форуме оттуда заказывают, платят 500 рублей за доставку, а ты, пользуясь случаем, купишь сам и сэкономишь для семьи. Хоть какой-то толк от неудачника будет. Я включаю Гугль-карту, задаю фразу "книжные магазины" и не понимаю. Ни Красной площади, ни реки, какие-то непонятные улицы.

Черт! Он вылез опять! Я ведь еще успел только до Варварки дойти.

И, повинуясь зову природы, я расчехлил опять свое оружье.

Каждый охотник желает знать где сидит фазан.

Народная запоминалка по физике

Нам кажется, даже приятно оказаться испуганными. Не потому, что страх предупреждает нас о реальной опасности или побуждает предпринять какое-то действие против нее, но потому, что он делает наш опыт необычайно интенсивным.

Кори Робин. "Страх. История политической идеи"

Пока расчехляю — думаю так.

Он ведь, собака, мешает мне жить, выполнять простые бытовые надобности. И всем этим туристам, которые поднимаются из Китай-города на площадь тоже мешает. И тем парням, которые на Кремлевской набережной попали в ДТП тоже мешает. И бегунам, и таксистам, и их пассажирам. И еще многим людям, о которых я не вспомнил. А кто это у нас в России отвечает за радио частоты? Чтобы чисто все было, без помех. Кажется ГРЧЦ называется, Главный Радичастотный Центр. И сайт у него имеется — http://www.grfc.ru/grfc/. И он ведь может по массовой жалобе, например, людей в интернете проверить наличие демона и найти его, но не делает. А ну как президент спросит на следующей прямой линии, кто это кошмарит его население. Но я эти Радичастотные Центры могу понять. У них на носу мероприятие мощное в месте хорошем, на природе — Спектр-Форум. Бархатный сезон, курортный роман и все такое. Обсудят там чистоту спектра и с новыми силами за работу. Эх, где мои шестнадцать лет...

Но я их не буду ждать и все равно расчехляю, так как адреналин уже зашкаливает.

Где я еще смогу половить живого демона, как не на Родине? Вот возьмем Европу — скучно живут, бедолаги. Довольствуются, можно сказать, резиновыми демонами, благо стоят недорого. Настоящие-то у них вот так не гуляют по улицам. А если и прошмыгнут, то быстро и прячась, чтобы не дай бог не заметили.

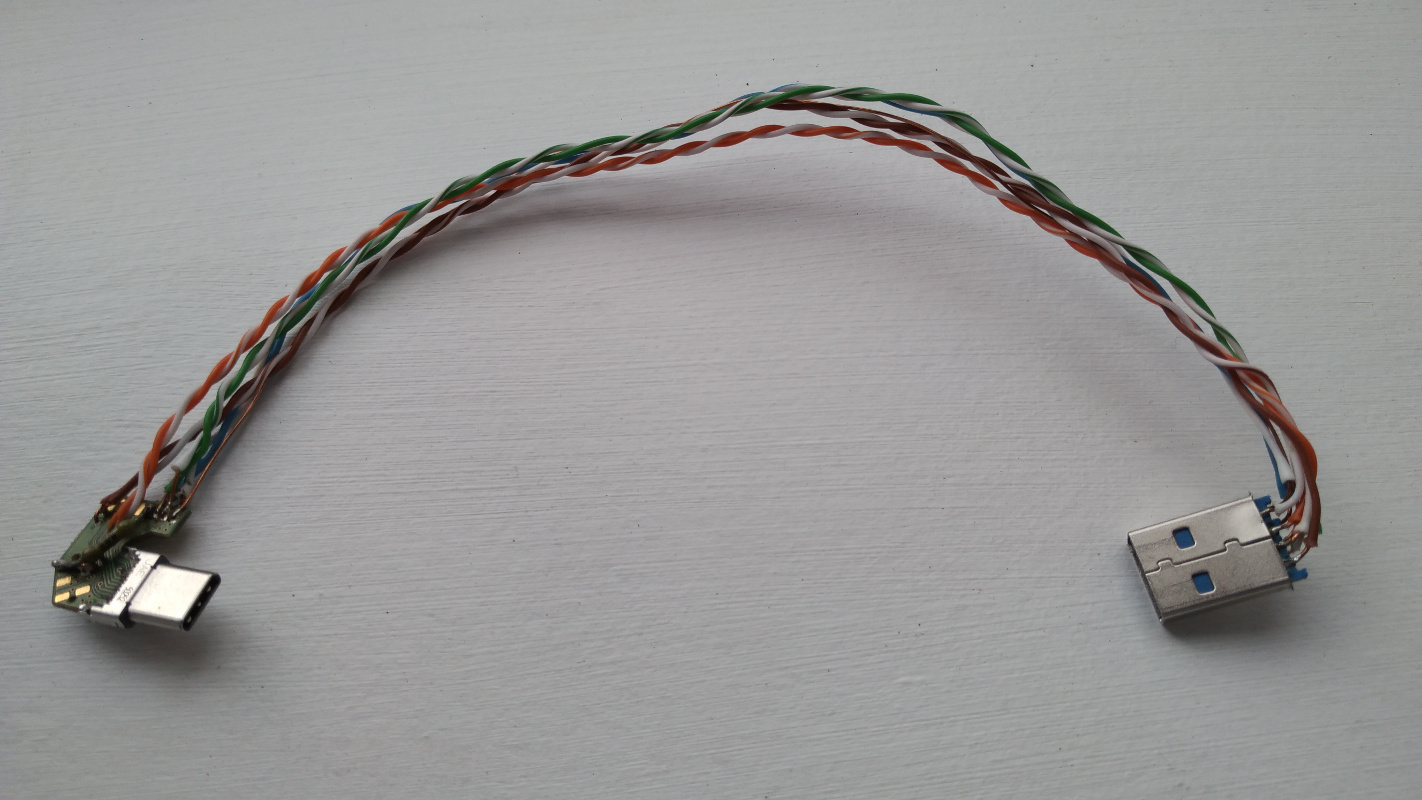

Оружье мое выглядит так:

Про его внутреннее устройство можно прочитать в моей предыдущей статье.

Сейчас мне осталось рассказать только про кабель. Он кажется неказистым с виду, но по нему ходит целых 5 ГГц.

Пеленгатор подключается к планшету по USB3, а у него требования к качеству кабеля довольно серьезные. Благо кабель у меня должен быть не очень длинный, я беру кусочки простой витой пары UTP и соединяю разъем типа A с разъемом типа C. На пеленгаторе стоит тип C, так как нельзя толщину сильно увеличивать, будет некрасиво. Получается вот такая скрутка всех цветов радуги. И самое главное — надо добавить еще отдельных земляных проводов в эту скрутку. С одним, например, даже на такой длине USB-интерфейс выдает ошибки и связи с платой нет.

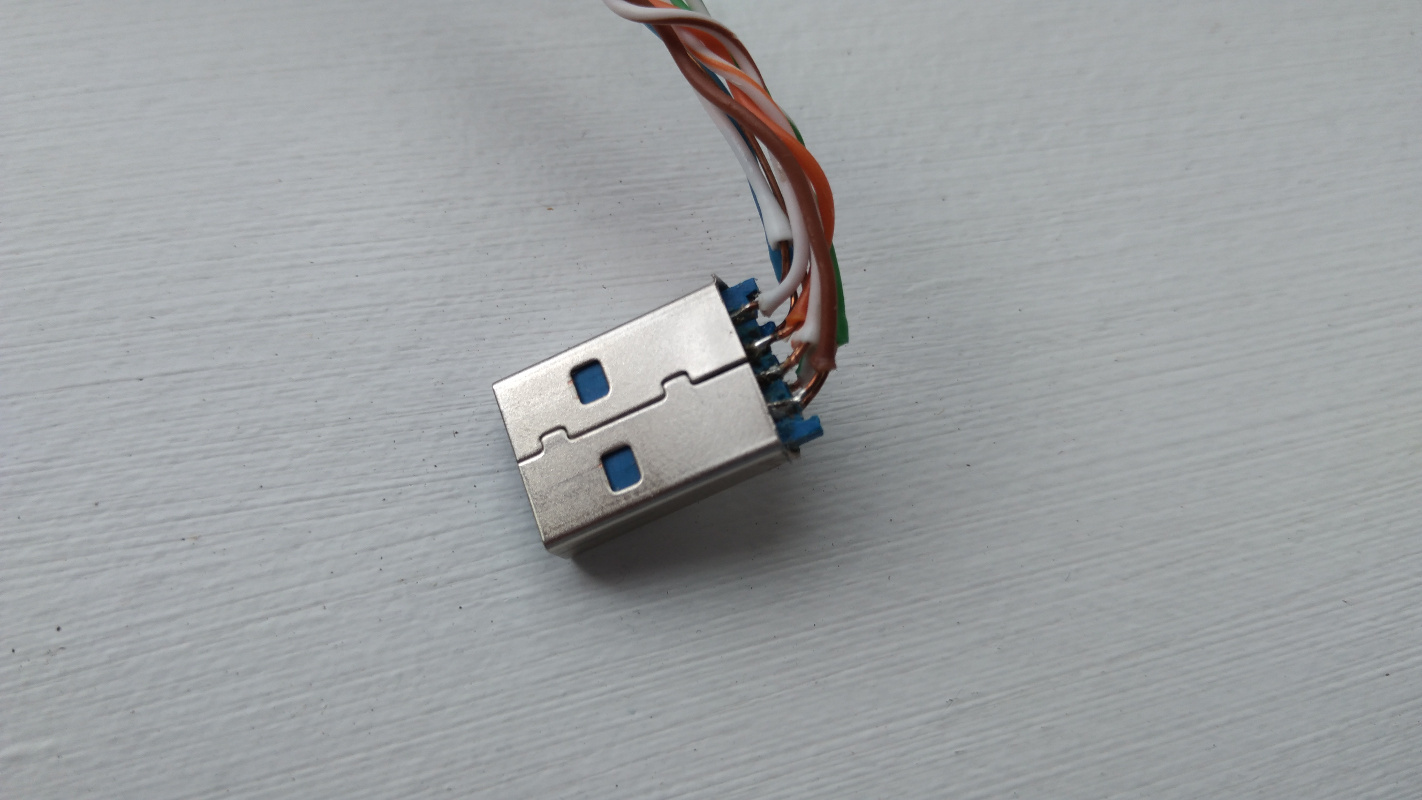

На стороне A все очень просто.

А на стороне C нужен еще резистор (согласно стандарта на type C), который я в формате SMD не нашел, поэтому поставил большой советский. Вот как спасают иногда старые запасы наших отцов!

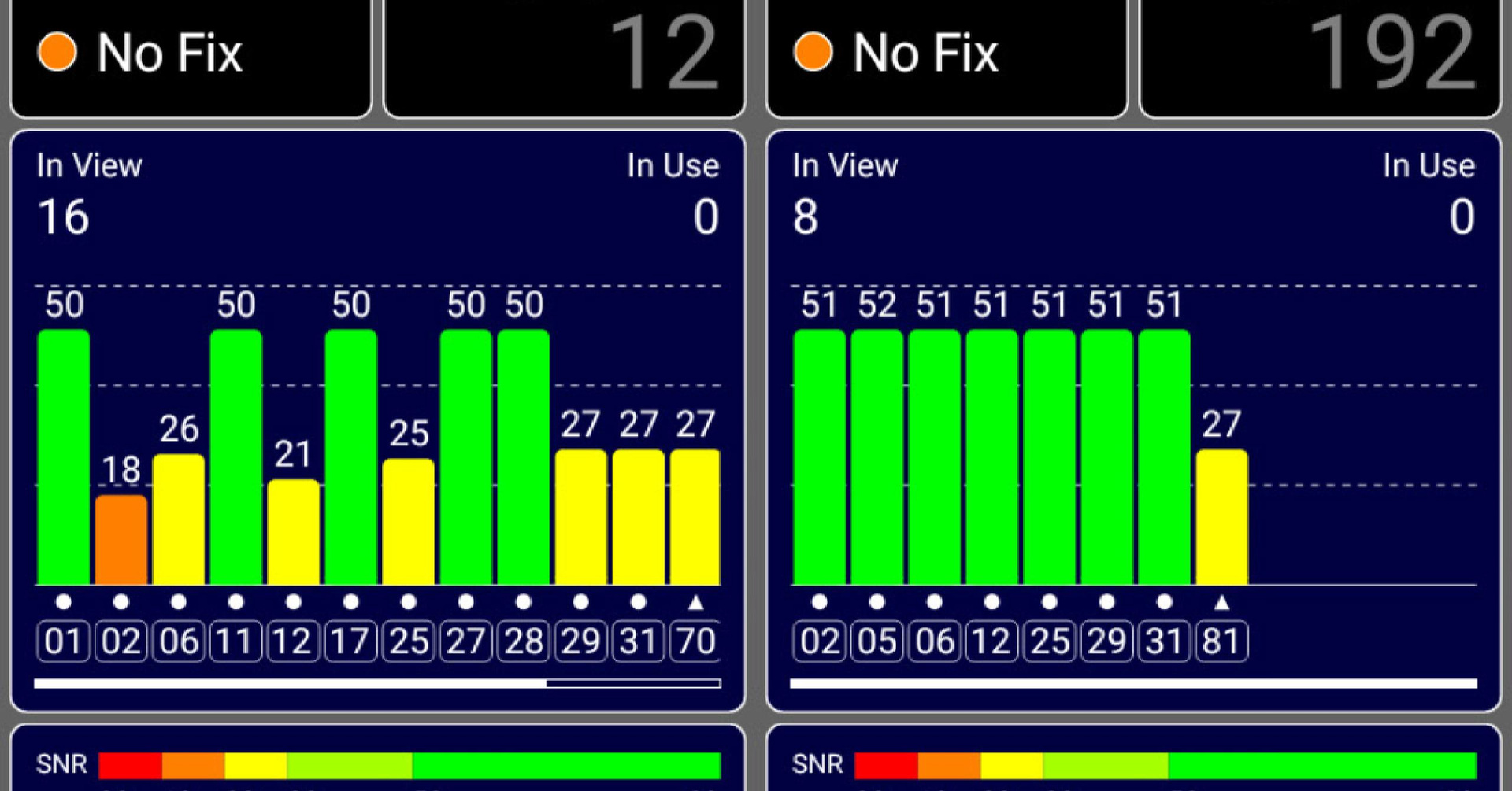

Вернемся же к нашему подопечному, пока вы совсем не заскучали. Разные мобильные устройства реагируют на демона сильно по разному. У меня на руках был Samsung Duos и Lenovo Phab 2 Pro (звезда будущих статей про AR-пеленгаторы). Samsung даже в непосредственной близости от демона редко улетал во Внуково. Он просто не мог найти навигационное решение. Экран его GPSTest выглядел так:

Здесь особо примечательно то, что значение ОСШ (SNR) около 50 дБ на этом смартфоне не бывает в принципе. Потери в антенне этого устройства приводят к довольно большому системному коэффициенту шума (System Noise Floor). Я при открытом небе видел всего 40 дБ с небольшим. И это является одним из признаков пришествия демона, наблюдаемым на обычных мобильных устройствах.

Еще необходимо заметить, что, наряду с поддельными спутниками, принимаются и настоящие. У них ОСШ (SNR) значительно меньше. Правый скриншот снят под Москворецким мостом, поэтому там есть только один настоящий спутник, но остальные (поддельные) принимаются так, как будто они все у меня в кармане.

А вот более новый гаджет — Lenovo Phab 2 Pro тупо показывает Внуково:

Вот в этот гаджет я и вставил московскую СИМку и планировал нормально ориентироваться в Москве. Но ...

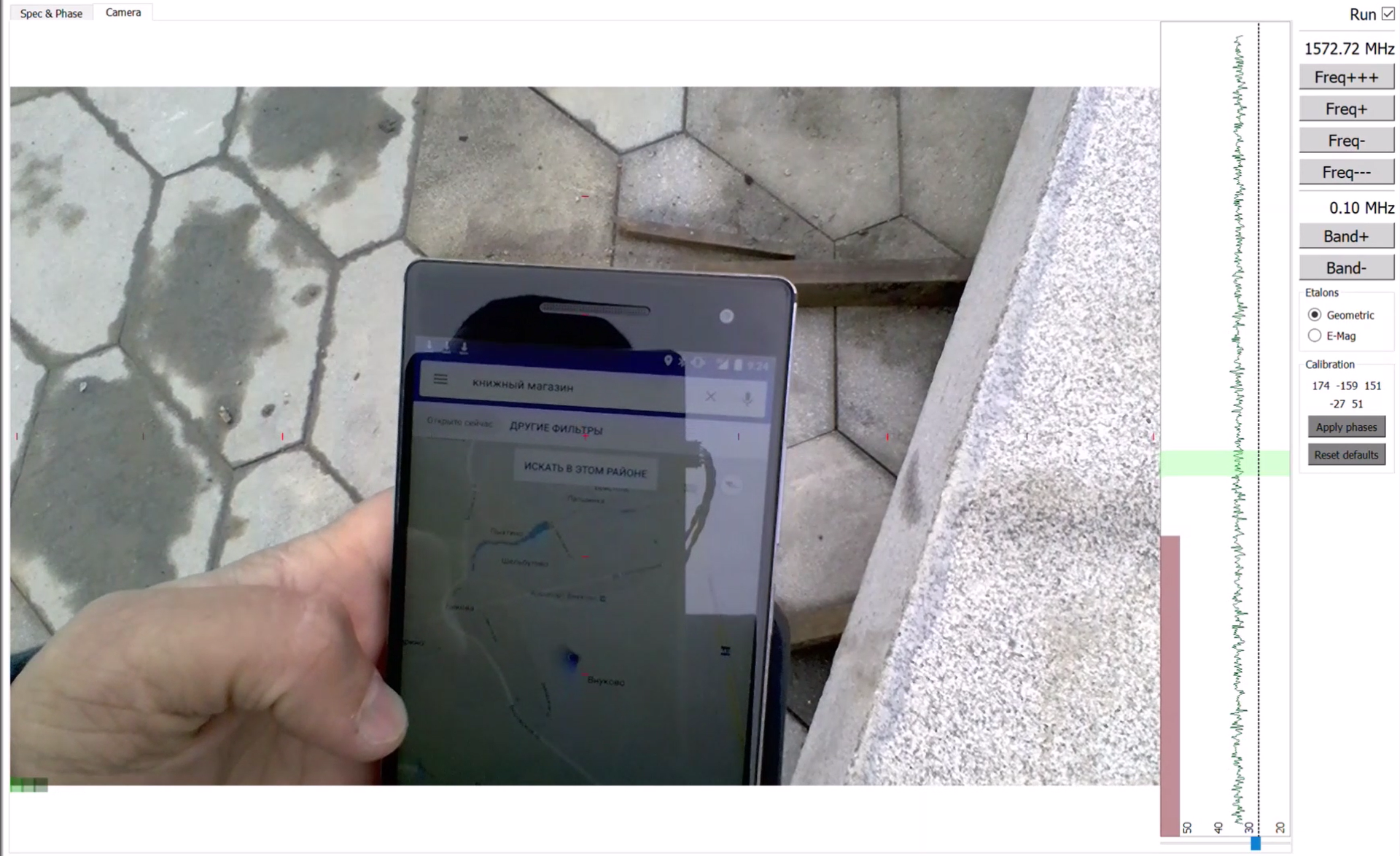

Давайте рассмотрим спектр демона. Ниже на видео вы увидите его справа вертикально. Я развернул картинку, чтобы было нагляднее.

Во-первых, есть рог демона центральный гармонический сигнал, который, видимо, должен забивать приемники, чтобы они хуже принимали настоящие спутники. Ниже на 20 дБ идет уже тело демона широкий сигнал, который имитирует спутниковый.

Чувствую, что вы уже достаточно разогрелись, приступим в основному блюду. Так как пеленгатор построен на дополненной реальности, я предлагаю просто посмотреть пару видео с поля боя.

На первом я спускаюсь по парку Зарядье, который отмывают от строительной грязи. Это поэтому у меня ботинки такие грязные.

На втором я прогуливаюсь по Кремлевской набережной.

Я внимательно читал статью на Медузе и не вижу смысла не верить авторам. Раз коллеги нашли демона там, значит он там и был.

Просто он переехал.

P.S.

Может мой Phab 2 Pro так завис, но я увидел, что демон пропал только в 10.30, ровно. И было это аж возле хакспейса Нейрон на Хохловском. Меня удивляет и возмущает, как же далеко он бьет. Зачем? Также я подозреваю демона в формализме. Почему он включается и выключается в моменты времени, кратные часу или получасу? Нехорошо все это. Демон, надо бы поберечь население.

|

|

Робоотчет о GDD Europe 2017 |

Робоотчет о GDD Europe 2017

Конференция длилась 2 дня и проходила в 5 трэков: 2 трэка с докладами, 2 с воркшопами и 1 комьюнити. Доклады частично пересекались с прошедшим I/O, по некоторым из них стало понятно, на сколько продвинулся Google в каждой из дисциплин.

Блинов Александр (@Xanderblinov), ведущий Android-разработчик Redmadrobot

Основная задача, которую я ставил перед собой — общение с гуглерами и GDE. Мне было интересно, как с точки зрения инженеров Google правильно решать те или иные задачи и сравнить их мнение с нашим видением подхода. К примеру, мы с инженерами Google пришли к консенсусу по архитектуре Android приложений — для больших приложений нужно использовать Clean Architecture с MVP / MVVM и роутингом. К сожалению, Ben Weiss и Florina Muntenescu не знали ни про Moxy ни про Cicerone, но мы исправили это досадное недоразумение ;)

Огромное внимание Google уделяет вычислениям в облаке и Firebase — данный технологический стек промелькнул в значительной части докладов и кодлабов. Кроме активного промоутинга Firebase предоставляется и отличная поддержка. Если у вас есть какие-либо вопросы по этому стеку технологий, смело пишите их в релевантный канал Firebase Community on Slack . Если вы не получили ответа в канале, то можете задавать вопросы даже в личку к GDE и инженерам Google

В целом инженеры Google и GDE оказались очень коммуникабельными и доброжелательными ребятами, которые используют Clean, Rx, Dagger, Kotlin и пьют смузи!

Кулаков Артем (@Fi5t), ведущий Android-разработчик Redmadrobot

Я давно интересуюсь темой IoT и Android Things, поэтому на конференции ходил на доклады по этой теме. Из докладов стало ясно, что Google продолжает развивать платформу Android Things и сопутствующую инфраструктуру для нее. Подобные шаги положительно влияют на снижение порога вхождения в тему разработки устройств на базе микроконтроллеров. Приятным сюрпризом стала коробочка с NXP Pico Pro Maket Kit, которую получили участники конференции. Этот жест, вдохновил людей не касавшихся мира железа попробовать себя в этой области.

Отдельно стоит отметить ML направление компании. Как говорили на Google I/O 2017 — компания взяла курс AI-first и призывает других делать так же. Призывы подкрепляются соответствующими инструментами, которые предназначены для разработчиков и аналитиков. Помимо уже привычного Tensorflow и Cloud ML API (Vision, NLP и т.д.), я узнал о существовании курса Machine Learning Nanodegree на Udacity, в котором используется Tensorflow. Конференция показала текущий уровень интереса к ML со стороны сообщества. Больше всего людей я видел как раз возле стенда, где гуглеры отвечали на вопросы по ML.

Ну и вишенкой на торте, лично для меня, стала презентация ARCore. Достойный ответ «некоторой другой компании» и ее ARKit ;) Приятно, что это теперь работает не на одном определенном устройстве как раньше, а на вполне себе обычных Pixel&Nexus. Для неискушенных в графическом моделировании представили набор инструментов Blocks, который помогает создавать 3D модели. Искушенным же предложили rendering engine Rajawali, а для полных джедаев оставили сырой OpenGL ES.

Тимошилов Дмитрий (@HellBurund), ведущий Android-разработчик Redmadrobot

Sundar Pichai считает, что в ближайшие годы Mobile-first сменится на AI-fst. Google Assistant, персональный помощник, – один из ключевых продуктов Google в этом направлении. Он был представлен на Google I/O 2017, и сейчас видно, что Assistant активно развивается. Во время демонстрации Google Assistant выглядел потрясающе. Разработчики идут к тому, чтобы с устройством можно было говорить так же, как с человеком: длинными или короткими фразами, не подбирая слова, вести полноценную беседу. Сейчас уже корректно обрабатываются длинные разговорные фразы типа:

“can you please tell me how is the weather going to be tomorrow in Krakow”

При этом Assistant учитывает контекст разговора. Например, если спросить:

“tell me about Spartak football team”

Assistant расскажет про команду и её игроков. Чтобы узнать какие-то подробности, не нужно опять упоминать Спартак. Достаточно спросить:

“what is the stadium”

и помощник расскажет про Открытие Арену, стадион команды.

Контекст учитывается и для корректного распознавания речи. Из нескольких похожих на слух слов система выберет то, которое больше подходит к теме разговора.

При этом Assistant встраивается в приложения. Если сказать:

“OK Google, talk to...”

и назвать приложение, управление будет передано ему. Подробнее о том, как это работает, можно узнать из видео с конференции.

К сожалению, Assistant пока не поддерживает русский язык. Но, как удалось узнать у гуглеров, поддержка планируется. Можно надеяться, что появится она в течение года.

Ещё одна из громких тем Google I/O 2017 – Instant Apps, приложения, запускаемые сразу из Google Play, без установки на устройство. Долгое время технология находилась в закрытой бете, но теперь гуглеры готовы рассказывать подробности.

Суть технологии в том, что, когда пользователь хочет воспользоваться какой-то функцией приложения, оно не загружается и не устанавливается на устройство целиком. Google Play загружает тот модуль, который содержит новую функцию, и это происходит быстрее.

Главное, что должно измениться – на смену монолитному apk файлу приходит zip архив, содержащий несколько apk: один базовый и по одному на каждую фичу. Для этого приложение придётся разбить на модули по фичам.

Тут есть важное ограничение. Суммарный объем базового apk и любого из apk с фичами не должен превышать 4 MB. Например, если размер базового apk 3 MB, то остальные должны быть не больше 1 MB каждый.

Про Instant Apps остались открытые вопросы. Как подружить такую архитектуру с Dagger? Насколько комфортно пользователю будет переходить из функционала уже загруженного модуля в функционал ещё не загруженного? Как совместить модульность Instant Apps с модульностью Clean Architecture?

Подробнее про реализацию Instant Apps здесь.

В целом конференция была отлично организована и каждый участник мог найти для себя что-то интересное. Каждый участник получил в подарок IoT набор.

|

Метки: author redmadrobot разработка под android блог компании redmadrobot redmadrobot мобильная разработка |

[Перевод] JavaScript: загадочное дело выражения null >= 0 |

|

Метки: author ru_vds разработка веб-сайтов javascript блог компании ruvds.com разработка стандарты |

[Перевод] JavaScript: загадочное дело выражения null >= 0 |

|

Метки: author ru_vds разработка веб-сайтов javascript блог компании ruvds.com разработка стандарты |

Импортозамещение в нефтегазовом секторе: как добывающие компании на «Эльбрус» собрались |

Найти замену импортным решениям из русских аналогов важно по двум причинам. Во-первых, в современных условиях никто не может гарантировать доступность технологий, а во-вторых, встает вопрос информационной безопасности на национальном уровне. Как «потенциальному противнику» многие западные компании не хотят поставлять в Россию новейшую технику и технологии, а ведущие российские нефтегазовые компании опасаются наличия «закладок» в поставляемых системах – то есть промышленного шпионажа, искажения результатов работы и возможности взлома сетей.

Читать дальше ->

|

|

Импортозамещение в нефтегазовом секторе: как добывающие компании на «Эльбрус» собрались |

Найти замену импортным решениям из русских аналогов важно по двум причинам. Во-первых, в современных условиях никто не может гарантировать доступность технологий, а во-вторых, встает вопрос информационной безопасности на национальном уровне. Как «потенциальному противнику» многие западные компании не хотят поставлять в Россию новейшую технику и технологии, а ведущие российские нефтегазовые компании опасаются наличия «закладок» в поставляемых системах – то есть промышленного шпионажа, искажения результатов работы и возможности взлома сетей.

Читать дальше ->

|

|

[Из песочницы] Как понять, что ваша предсказательная модель бесполезна |

Как понять, что ваша предсказательная модель бесполезна

При создании продуктов на основе машинного обучения возникают ситуации, которых хотелось бы избежать. В этом тексте я разбираю восемь проблем, с которыми сталкивался в своей работе.

Мой опыт связан с моделями кредитного скоринга и предсказательными системами для промышленных компаний. Текст поможет разработчиками и дата-сайнтистам строить полезные модели, а менеджерам не допускать грубых ошибок в проекте.

Этот текст не призван прорекламировать какую-нибудь компанию. Он основан на практике анализа данных в компании ООО "Ромашка", которая никогда не существовала и не будет существовать. Под "мы" я подразумеваю команду из себя и моих воображаемых друзей. Все сервисы, которые мы создавали, делались для конкретного клиента и не могут быть проданы или переданы иным лицам.

Какие модели и для чего?

Пусть предсказательная модель — это алгоритм, который строит прогнозы и позволяет автоматически принимать полезное для бизнеса решение на основе исторических данных.

Я не рассматриваю:

- разовые исследования данных, которые не идут в продакшн;

- системы, которые мониторят что-нибудь (например, кликабельность объявлений), но сами не принимают решений;

- алгоритмы ради алгоритмов, т.е. не приносящие прямой пользы для бизнеса (например, искусственный интеллект, который учит виртуальных человечков ходить).

Я буду говорить об алгоритмах обучения с учителем, т.е. таких, которые "увидели" много примеров пар (X,Y), и теперь могут для любого X сделать оценку Y. X — это информация, известная на момент прогноза (например, заполненная клиентом заявка на кредит). Y — это заранее неизвестная информация, необходимая для принятия решения (например, будет ли клиент своевременно платить по кредиту). Само решение может приниматься каким-то простым алгоритмом вне модели (например, одобрять кредит, если предсказанная вероятность неплатежа не выше 15%).

Аналитик, создающий модель, как правило, опирается на метрики качества прогноза, например, среднюю ошибку (MAE) или долю верных ответов (accuracy). Такие метрики позволяют быстро понять, какая из двух моделей предсказывает точнее (и нужно ли, скажем, заменять логистическую регрессию на нейросеть). Но на главный вопрос, а насколько модель полезна, они дают ответ далеко не всегда. Например, модель для кредитного скоринга очень легко может достигнуть точности 98% на данных, в которых 98% клиентов "хорошие", называя "хорошими" всех подряд.

С точки зрения предпринимателя или менеджера очевидно, какая модель полезная: которая приносит деньги. Если за счёт внедрения новой скоринговой модели за следующий год удастся отказать 3000 клиентам, которые бы принесли суммарный убыток 50 миллионов рублей, и одобрить 5000 новых клиентов, которые принесут суммарную прибыль 10 миллионов рублей, то модель явно хороша. На этапе разработки модели, конечно, вряд ли вы точно знаете эти суммы (да и потом — далеко не факт). Но чем скорее, точнее и честнее вы оцените экономическую пользу от проекта, тем лучше.

Проблемы

Достаточно часто построение вроде бы хорошей предсказательной модели не приводит к ожидаемому успеху: она не внедряется, или внедряется с большой задержкой, или начинает нормально работать только после десятков релизов, или перестаёт нормально работать через несколько месяцев после внедрения, или не работает вообще никак… При этом вроде бы все потрудились на славу: аналитик выжал из данных максимальную предсказательную силу, разработчик создал среду, в которой модель работает молниеносно и никогда не падает, а менеджер приложил все усилия, чтобы первые двое смогли завершить работу вовремя. Так почему же они попали в неприятность?

1. Модель вообще не нужна

Мы как-то строили модель, предсказывающую крепость пива после дображивания (на самом деле, это было не пиво и вообще не алкоголь, но суть похожа). Задача ставилась так: понять, как параметры, задаваемые в начале брожения, влияют на крепость финального пива, и научиться лучше управлять ей. Задача казалась весёлой и перспективной, и мы потратили не одну сотню человеко-часов на неё, прежде чем выяснили, что на самом-то деле финальная крепость не так уж и важна заказчику. Например, когда пиво получается 7.6% вместо требуемых 8%, он просто смешивает его с более крепким, чтобы добиться нужного градуса. То есть, даже если бы мы построили идеальную модель, это принесло бы прибыли примерно нисколько.

Эта ситуация звучит довольно глупо, но на самом деле случается сплошь и рядом. Руководители инициируют machine learning проекты, "потому что интересно", или просто чтобы быть в тренде. Осознание, что это не очень-то и нужно, может прийти далеко не сразу, а потом долго отвергаться. Мало кому приятно признаваться, что время было потрачено впустую. К счастью, есть относительно простой способ избегать таких провалов: перед началом любого проекта оценивать эффект от идеальной предсказательной модели. Если бы вам предложили оракула, который в точности знает будущее наперёд, сколько бы были бы готовы за него заплатить? Если потери от брака и так составляют небольшую сумму, то, возможно, строить сложную систему для минимизации доли брака нет необходимости.

Как-то раз команде по кредитному скорингу предложили новый источник данных: чеки крупной сети продуктовых магазинов. Это выглядело очень заманчиво: "скажи мне, что ты покупаешь, и я скажу, кто ты". Но вскоре оказалось, что идентифицировать личность покупателя было возможно, только если он использовал карту лояльности. Доля таких покупателей оказалась невелика, а в пересечении с клиентами банка они составляли меньше 5% от входящих заявок на кредиты. Более того, это были лучшие 5%: почти все заявки одобрялись, и доля "дефолтных" среди них была близка к нулю. Даже если бы мы смогли отказывать все "плохие" заявки среди них, это сократило бы кредитные потери на совсем небольшую сумму. Она бы вряд ли окупила затраты на построение модели, её внедрение, и интеграцию с базой данных магазинов в реальном времени. Поэтому с чеками поигрались недельку, и передали их в отдел вторичных продаж: там от таких данных будет больше пользы.

Зато пивную модель мы всё-таки достроили и внедрили. Оказалось, что она не даёт экономии на сокращении брака, но зато позволяет снизить трудозатраты за счёт автоматизации части процесса. Но поняли мы это только после долгих дискуссий с заказчиком. И, если честно, нам просто повезло.

2. Модель откровенно слабая

Даже если идеальная модель способна принести большую пользу, не факт, что вам удастся к ней приблизиться. В X может просто не быть информации, релевантной для предсказания Y. Конечно, вы редко можете быть до конца уверены, что вытащили из X все полезные признаки. Наибольшее улучшение прогноза обычно приносит feature engineering, который может длиться месяцами. Но можно работать итеративно: брейншторм — создание признаков — обучение прототипа модели — тестирование прототипа.

В самом начале проекта можно собраться большой компанией и провести мозговой штурм, придумывая разнообразные признаков. По моему опыту, самый сильный признак часто давал половину той точности, которая в итоге получалась у полной модели. Для скоринга это оказалась текущая кредитная нагрузка клиента, для пива — крепость предыдущей партии того же сорта. Если после пары циклов найти хорошие признаки не удалось, и качество модели близко к нулю, возможно, проект лучше свернуть, либо срочно отправиться искать дополнительные данные.

Важно, что тестировать нужно не только точность прогноза, но и качество решений, принимаемых на его основе. Не всегда возможно измерить пользу от модели "оффлайн" (в тестовой среде). Но вы можете придумывать метрики, которые хоть как-то приближают вас к оценке денежного эффекта. Например, если менеджеру по кредитным рискам нужно одобрение не менее 50% заявок (иначе сорвётся план продаж), то вы можете оценивать долю "плохих" клиентов среди 50% лучших с точки зрения модели. Она будет примерно пропорциональна тем убыткам, которые несёт банк из-за невозврата кредитов. Такую метрику можно посчитать сразу же после создания первого прототипа модели. Если грубая оценка выгоды от его внедрения не покрывает даже ваши собственные трудозатраты, то стоит задуматься: а можем ли мы вообще получить хороший прогноз?

3. Модель невозможно внедрить

Бывает, что созданная аналитиками модель демонстрирует хорошие меры как точности прогноза, так и экономического эффекта. Но когда начинается её внедрение в продакшн, оказывается, что необходимые для прогноза данные недоступны в реальном времени. Иногда бывает, что это настоящие данные "из будущего". Например, при прогнозе крепости пива важным фактором является измерение его плотности после первого этапа брожения, но применять прогноз мы хотим в начале этого этапа. Если бы мы не обсудили с заказчиком точную природу этого признака, мы бы построили бесполезную модель.

Ещё более неприятно может быть, если на момент прогноза данные доступны, но по техническим причинам подгрузить их в модель не получается. В прошлом году мы работали над моделью, рекомендующей оптимальный канал взаимодействия с клиентом, вовремя не внёсшим очередной платёж по кредиту. Должнику может звонить живой оператор (но это не очень дёшево) или робот (дёшево, но не так эффективно, и бесит клиентов), или можно не звонить вообще и надеяться, что клиент и так заплатит сегодня-завтра. Одним из сильных факторов оказались результаты звонков за вчерашний день. Но оказалось, что их использовать нельзя: логи звонков перекладываются в базу данных раз в сутки, ночью, а план звонков на завтра формируется сегодня, когда известны данные за вчера. То есть данные о звонках доступны с лагом в два дня до применения прогноза.

На моей практике несколько раз случалось, что модели с хорошей точностью откладывались в долгий ящик или сразу выкидывались из-за недоступности данных в реальном времени. Иногда приходилось переделывать их с нуля, пытаясь заменить признаки "из будущего" какими-то другими. Чтобы такого не происходило, первый же небесполезный прототип модели стоит тестировать на потоке данных, максимально приближенном к реальному. Может показаться, что это приведёт к дополнительным затратам на разработку тестовой среды. Но, скорее всего, перед запуском модели "в бою" её придётся создавать в любом случае. Начинайте строить инфраструктуру для тестирования модели как можно раньше, и, возможно, вы вовремя узнаете много интересных деталей.

4. Модель очень трудно внедрить

Если модель основана на данных "из будущего", с этим вряд ли что-то можно поделать. Но часто бывает так, что даже с доступными данными внедрение модели даётся нелегко. Настолько нелегко, что внедрение затягивается на неопределённый срок из-за нехватки трудовых ресурсов на это. Что же так долго делают разработчики, если модель уже создана?

Скорее всего, они переписывают весь код с нуля. Причины на это могут быть совершенно разные. Возможно, вся их система написана на java, и они не готовы пользоваться моделью на python, ибо интеграция двух разных сред доставит им даже больше головной боли, чем переписывание кода. Или требования к производительности так высоки, что весь код для продакшна может быть написан только на C++, иначе модель будет работать слишком медленно. Или предобработку признаков для обучения модели вы сделали с использованием SQL, выгружая их из базы данных, но в бою никакой базы данных нет, а данные будут приходить в виде json-запроса.

Если модель создавалась в одном языке (скорее всего, в python), а применяться будет в другом, возникает болезненная проблема её переноса. Есть готовые решения, например, формат PMML, но их применимость оставляет желать лучшего. Если это линейная модель, достаточно сохранить в текстовом файле вектор коэффициентов. В случае нейросети или решающих деревьев коэффициентов потребуется больше, и в их записи и чтении будет проще ошибиться. Ещё сложнее сериализовать полностью непараметрические модели, в частности, сложные байесовские. Но даже это может быть просто по сравнению с созданием признаков, код для которого может быть совсем уж произвольным. Даже безобидная функция log() в разных языках программирования может означать разные вещи, что уж говорить о коде для работы с картинками или текстами!

Даже если с языком программирования всё в порядке, вопросы производительности и различия в формате данных в учении и в бою остаются. Ещё один возможный источник проблем: аналитик при создании модели активно пользовался инструментарием для работы с большими таблицами данных, но в бою прогноз необходимо делать для каждого наблюдения по отдельности. Многие действия, совершаемые с матрицей n*m, с матрицей 1*m проделывать неэффективно или вообще бессмысленно. Поэтому аналитику полезно с самого начала проекта готовиться принимать данные в нужном формате и уметь работать с наблюдениями поштучно. Мораль та же, что и в предыдущем разделе: начинайте тестировать весь пайплайн как можно раньше!

Разработчикам и админам продуктивной системы полезно с начала проекта задуматься о том, в какой среде будет работать модель. В их силах сделать так, чтобы код data scientist'a мог выполняться в ней с минимумом изменений. Если вы внедряете предсказательные модели регулярно, стоит один раз создать (или поискать у внешних провайдеров) платформу, обеспечивающую управление нагрузкой, отказоустойчивость, и передачу данных. На ней любую новую модель можно запустить в виде сервиса. Если же сделать так невозможно или нерентабельно, полезно будет заранее обсудить с разработчиком модели имеющиеся ограничения. Быть может, вы избавите его и себя от долгих часов ненужной работы.

5. При внедрении происходят глупые ошибки

За пару недель до моего прихода в банк там запустили в бой модель кредитного риска от стороннего поставщика. На ретроспективной выборке, которую прислал поставщик, модель показала себя хорошо, выделив очень плохих клиентов среди одобренных. Поэтому, когда прогнозы начали поступать к нам в реальном времени, мы немедленно стали применять их. Через несколько дней кто-то заметил, что отказываем мы больше заявок, чем ожидалось. Потом — что распределение приходящих прогнозов непохоже на то, что было в тестовой выборке. Начали разбираться, и поняли, что прогнозы приходят с противоположным знаком. Мы получали не вероятность того, что заёмщик плохой, а вероятность того, что он хороший. Несколько дней мы отказывали в кредите не худшим, а лучшим клиентам!

Такие нарушения бизнес-логики чаще всего происходят не в самой модели, а или при подготовке признаков, или, чаще всего, при применении прогноза. Если они менее очевидны, чем ошибка в знаке, то их можно не находить очень долго. Всё это время модель будет работать хуже, чем ожидалось, без видимых причин. Стандартный способ предупредить это — делать юнит-тесты для любого кусочка стратегии принятия решений. Кроме этого, нужно тестировать всю систему принятия решений (модель + её окружение) целиком (да-да, я повторяю это уже три раздела подряд). Но это не спасёт от всех бед: проблема может быть не в коде, а в данных. Чтобы смягчить такие риски, серьёзные нововведения можно запускать не на всём потоке данных (в нашем случае, заявок на кредиты), а на небольшой, но репрезентативной его доле (например, на случайно выбранных 10% заявок). A/B тесты— это вообще полезно. А если ваши модели отвечают за действительно важные решения, такие тесты могут идти в большом количестве и подолгу.

6. Модель нестабильная

Бывает, что модель прошла все тесты, и была внедрена без единой ошибки. Вы смотрите на первые решения, которые она приняла, и они кажутся вам осмысленными. Они не идеальны — 17 партия пива получилась слабоватой, а 14 и 23 — очень крепкими, но в целом всё неплохо. Проходит неделя-другая, вы продолжаете смотреть на результаты A/B теста, и понимаете, что слишком крепких партий чересчур много. Обсуждаете это с заказчиком, и он объясняет, что недавно заменил резервуары для кипячения сусла, и это могло повысить уровень растворения хмеля. Ваш внутренний математик возмущается "Да как же так! Вы мне дали обучающую выборку, не репрезентативную генеральной совокупности! Это обман!". Но вы берёте себя в руки, и замечаете, что в обучающей выборке (последние три года) средняя концентрация растворенного хмеля не была стабильной. Да, сейчас она выше, чем когда-либо, но резкие скачки и падения были и раньше. Но вашу модель они ничему не научили.

Другой пример: доверие сообщества финансистов к статистическим методам было сильно подорвано после кризиса 2007 года. Тогда обвалился американский ипотечный рынок, потянув за собой всю мировую экономику. Модели, которые тогда использовались для оценки кредитных рисков, не предполагали, что все заёмщики могут одновременно перестать платить, потому что в их обучающей выборке не было таких событий. Но разбирающийся в предмете человек мог бы мысленно продолжить имеющиеся тренды и предугадать такой исход.

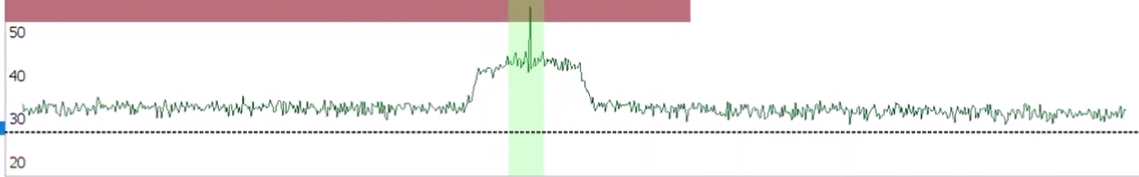

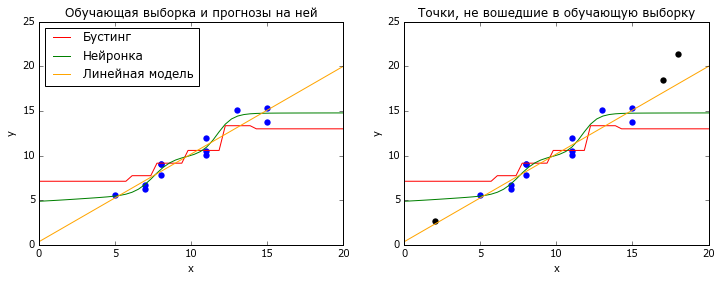

Бывает, что поток данных, к которым вы применяете модель, стационарен, т.е. не меняет своих статистических свойств со временем. Тогда самые популярные методы машинного обучения, нейросетки и градиентный бустинг над решающими деревьями, работают хорошо. Оба этих метода основаны на интерполяции обучающих данных: нейронки — логистическими кривыми, бустинг — кусочно-постоянными функциями. И те, и другие очень плохо справляются с задачей экстраполяции — предсказания для X, лежащих за пределами обучающей выборки (точнее, её выпуклой оболочки).

# coding: utf-8

# настраиваем всё, что нужно настроить

import numpy as np

import matplotlib.pyplot as plt

from matplotlib import rc

rc('font', family='Verdana')

from sklearn.ensemble import GradientBoostingRegressor

from sklearn.neural_network import MLPRegressor