Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Начальник, хочу работать из дома |

Начальник, хочу работать из дома

Я понимал, что данное решение никак не повлияет на производительность и результаты работы Ивана, все знали, насколько он крут. С одной стороны, сотрудник получил возможность работать из дома 2 дня в неделю и сильно смещенный к утру график в остальные дни. С другой стороны, мы договорились о бонусе, который удерживает ведущего специалиста в нашем отделе от перехода куда-либо. Win-win, как ни крути!

Через некоторое время, когда мы искали в команду Ивана крутого программиста, возможность поработать два дня удаленно сыграла для нового человека Василия решающую роль в принятии предложения о работе.

Тогда я задумался, почему остальные команды разработки не могут также работать удаленно. Чем они отличаются от Ивана и Василия?

Но для руководства в компании всегда проще, чтобы люди сидели в офисе и были под контролем. Большинство страхов к удаленной работе вызвано недоверием к подчиненным:

- А вдруг они перестанут работать?

- А вдруг мне что-то резко понадобится от сотрудника и я не смогу найти его на месте?

Можно подумать, если сотрудник будет в офисе, он не найдет возможности пинать балду и смотреть котиков. Большинство аргументов против удаленной работы основаны на страхе потерять контроль, давайте говорить об этом прямо. У меня не было проблем с доверием к людям, которых нанимал на работу.

Посмотрим, какие бонусы получают сотрудники от удаленной работы:

- Возможность не тратить на дорогу до работы драгоценное время. Конечно, у нас не Москва, но пробки большие. Про стресс, который приносит общественный транспорт, можно также много говорить. Все это сказывается на продуктивности и здоровье сотрудников.

- Возможность работать в комфортных условиях. Согласитесь, мало кто на вопрос «где вам хорошо работается» ответит «в офисе». Или уточнит про раннее утро, когда никого нет. Не все понимают, что работа программиста – это творческая работа, которая требует сосредоточенности и концентрации внимания.

Таким образом, у меня не было внутренних противоречий против удаленной работы. Сперва я поговорил с руководителями групп разработки и тестирования и получил от них восторженный аппрув по предложению удаленной работы. Оставалось самое сложное – убедить руководство.

Моими доводами в этом стали:

- Иван с Василием работают из дома, почему остальным нельзя? Мы же команда, делающая общее дело!

- Давай судить по результату работы, а не по тому месту, где был достигнут результат.

- Дополнительная нематериальная мотивация, которая для многих сотрудников может стать решающей в решении уйти или остаться.

Нужно отдать должное моему боссу, он во многих вопросах поддержал меня, так что на первое время мы договорились с ним на один удаленный день для всех сотрудников подразделения. Победа? – Да, маленькая, но победа!

Я решил двигаться маленькими шажками: удаленный день для некоторых сотрудников -> удаленный день для всех сотрудников -> 2 удаленных дня для всех сотрудников -> ???

Основная идея: доказать, что удаленная работа не вредит бизнесу, а только помогает ему.

Итого, текущий результат, возможность работать понедельник и пятницу удаленно для всех сотрудников подразделения.

- Сотрудники получают возможность в четверг вечером уехать куда-то за город и вернуться в город только в понедельник вечером. Заметьте, без пробок!

- Сотрудники сами могут выбрать свой рабочий график.

- Производительность труда нисколько не просела.

- Мотивация и общий эмоциональный фон улучшились.

- На общение с коллегами с глазу на глаз и проведение собраний остается 3 дня. Этого достаточно, чтобы не потерять себя для социума.

А как вы работаете в больших компаниях? Есть ли у вас удаленные дни и возможность поработать из дома?

Фрилансеров, работающих полностью удаленно, призываю также оставить комментарии.

Напоследок, приведу всем сомневающимся отличную книгу про плюсы удаленной работы «Remote: офис не обязателен» Джейсон Фрайд, Дэвид Хенссон.

|

Метки: author digore управление разработкой управление персоналом удаленная работа процесс разработки |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка

Своя платформа чат-ботов появилась в СберТехе благодаря внутреннему социальному проекту «Сбербанк-Попутчик», затем получила дальнейшее развитие в платежном боте.

Теперь же платформа дала начало сразу двум пилотным проектам — чат-боту на сайте и в мобильном приложении и более интеллектуальной системе анализа обратной связи от клиентов. Обо всем по порядку — под катом.

Стоит признать, что наработок в области чат-ботов и распознавания естественного языка запросов уже довольно много. Однако большая часть открытых библиотек и крупных проектов по трансформации речи ориентируется на английский язык. Русский язык с этой точки зрения имеет свои нюансы. И хотя в России тоже есть заинтересованные команды, в частности, в крупных технических вузах или частных компаниях, вроде Яндекса, Мейл.Ру и СберТеха, пока готовых промышленных решений не так много. А задачи перед русскоязычным бизнесом стоят не менее амбициозные, чем перед англоязычным.

Сегодня мы хотим рассказать о том, каких успехов нам удалось добиться на поприще чат-ботов и машинного обучения.

Надо сказать, что коммерческих решений, достаточно кастомизируемых под нужды конкретной компании, пока еще не существует — сама отрасль еще слишком молода. Есть проекты от частных исследователей, например, для техподдержки, но это все еще начальная версия технологии, позволяющая проводить категоризацию обращений. При этом ни одно решение не готово к таким масштабам работы, как у Сбербанка, — к анализу столь больших объемов информации при огромном количестве клиентов. В мире только появляются инструменты глубокого анализа. И по сути из этих базовых инструментов специалисты нашей компании разрабатывают собственные кастомизированные продукты под задачи Сбербанка.

На текущий момент значимых для компании проектов четыре. Далее — подробнее о каждом из них.

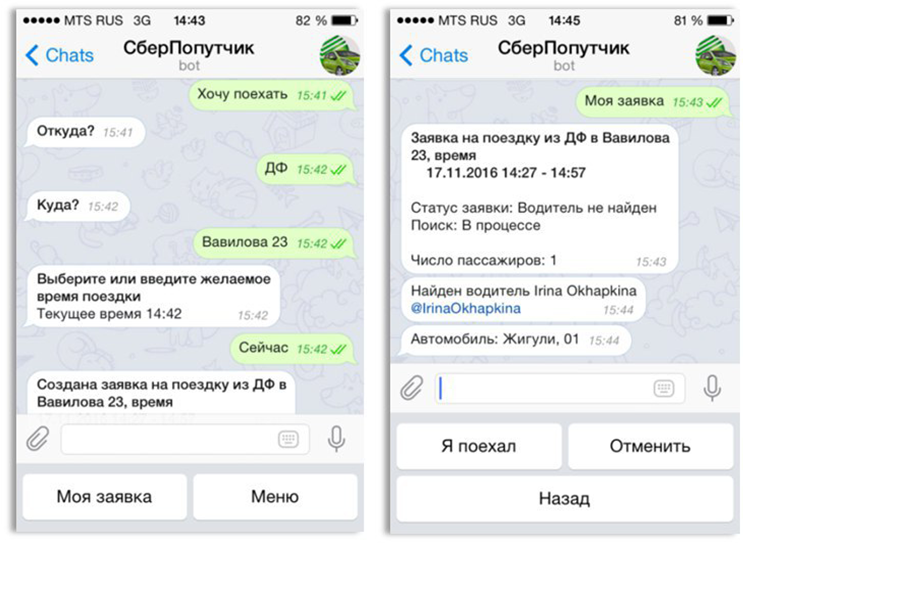

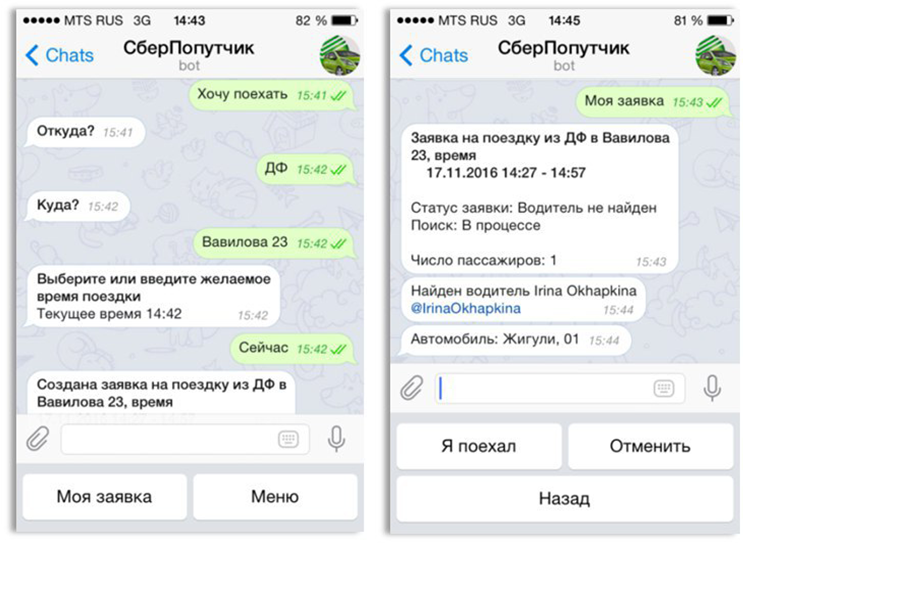

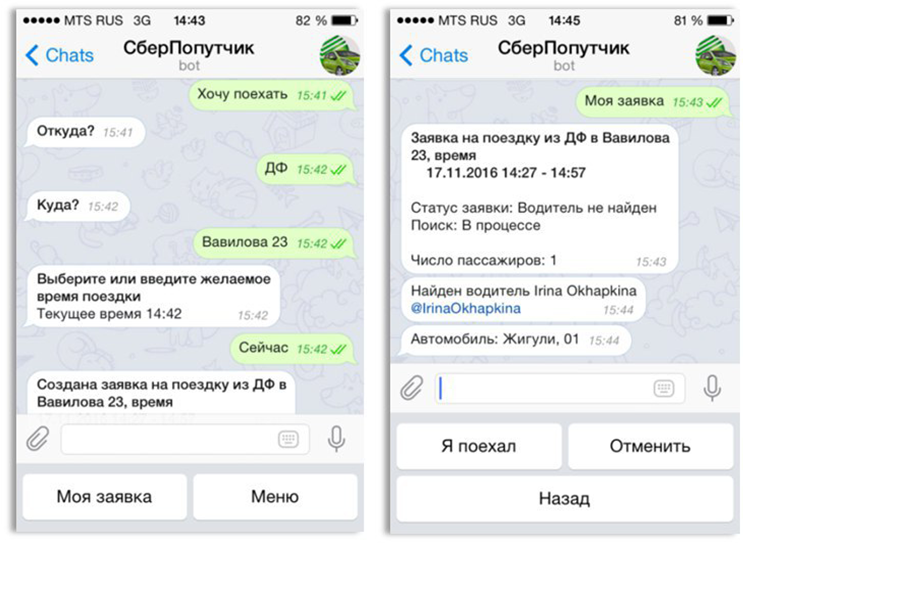

Сбербанк Попутчик

С проекта «Сбербанк Попутчик» началась вся история чат-ботов в компании. По долгу службы сотрудники Сбербанка вынуждены порой добираться в удаленные отделения, иногда используя несколько видов общественного транспорта. В то же время их коллеги ездят примерно в том же направлении на машине, имея несколько свободных мест. Было бы здорово объединить эти потоки сотрудников, предложив компанию для поездки одним и возможность быстрее добраться до работы другим.

При этом в нашей стране люди не очень любят подвозить друг друга, беспокоясь о своей безопасности. Но внутренний Customer Development показал, что коллеги по работе в компании с сильной службой безопасности в большей степени доверяют друг другу, даже если не знакомы лично. Так возникла идея создать некое внутреннее community, с помощью которого люди могли бы искать друг друга для совместных поездок на работу и с работы.

В качестве движка сообщества была разработана платформа чат-бота.

Уже около года сотрудники ряда офисов обкатывают пилотный проект. Получившийся сервис так хорошо зарекомендовал себя, что теперь мы обсуждаем расширение его функционала. В частности, к проекту уже готовы подключиться сторонние перевозчики — службы такси. Также планируется тиражировать проект на все отделения.

Более того, проект готовится выйти за рамки внутренней кухни Сбербанка. Сбербанковское комьюнити, конечно же, наружу открываться не будет, но организации-партнеры (перевозчики) вполне могут тиражировать этот удачный опыт на другие компании или создавать собственные комьюнити.

Платежный бот

Еще один ранний проект, задействовавший разработанную платформу чат-бота, — платежный бот. Он был запущен в пилотную эксплуатацию в начале этого года (т.е. появился на свет примерно на полгода раньше, чем аналогичное решение, представленное весной Google на конференции Google I/O 2017).

В принципе о выборе каких-то услуг при помощи ботов разговор шел довольно давно — такие системы уже распространены по миру. Но основная фишка заключалась в возможности использовать свободные формулировки (а не предписанный набор команд), а также в оплате через бота.

Мы не склонны доверять конфиденциальную информацию (платежные данные банковской карты) незащищенным каналам, поэтому первый бот был запущен на базе мессенджинга платформы Сбербанка. Пилот проводился в прошлом году и продолжит своё существование в виде ботов в чате Сбербанк онлайн («Диалоги Сбербанка»).

Пилотный проект был реализован совместно с рестораном доставки еды Тануки. Он работает по сей день. Через чат можно выбрать товары из каталога ресторана, при этом бот подсказывает оптимальные варианты под запрос пользователя, запоминает его вкусы и потребительскую корзину, так что в будущем, если пользователь забудет заказать какую-то из привычных позиций, бот ему напомнит. Главный козырь бота — возможность привязать к нему банковскую карту для оплаты заказа также в режиме разговора. После оплаты еда просто доставляется — больше ничего от пользователя не требуется.

Фактически бот выполняет функции приложения службы доставки еды. Однако служб много — приложений много (под каждого поставщика приходится скачивать и устанавливать свое). А чат-бот — это лишь один из контактов в привычном приложении мессенджера, по сути это просто новый канал получения той же услуги.

Чат-бот контактного центра

Чат-бот для корпоративного сайта стал первым подобным проектом, который вышел за рамки «песочницы» в большой мир. Здесь, безусловно, используются наработки из Попутчика и платежного бота, но реализованы более «взрослые» и Machine Learning алгоритмы анализа запросов и поиска подходящих ответов.

Задача чат-бота — общаться с клиентами через чат на сайте, отвечая на вопросы по продуктам компании, а также счетам, кредитам и платежным поручениям самого клиента (в пилотной версии спектр решаемых вопросов ограничен данными о продуктах и открытием счета). Для этого чат-бот анализирует полученную от клиента информацию, выдает ответы на простые вопросы, сформулированные естественным языком, или запрашивает дополнительные данные, если в первоначальном запросе их не хватает.

Бот построен на технологии латентно-семантического анализа, обеспечивающей поиск ответа на вопрос клиента с учетом контекста. Методика позволяет по ключевым словам и контексту диалога найти в базе готовых ответов, куда входят разнообразные FAQ по продуктам, наиболее релевантный ответ.

В деталях это выглядит следующим образом. Сначала клиентский запрос на естественном языке превращается в набор ключевых слов. Каждое слово в модели имеет определенный вес. Распространенные слова, входящие в большинство запросов, имеют меньший вес, а слова уникальные для данного запроса, — больший. Таким образом запрос трансформируется в набор ключевых слов с определенным весом, по которым и осуществляется поиск в базе: по специальному алгоритму определяется вероятность того, что документ из базы ответов соответствует поставленному вопросу. Клиенту выдается наиболее релевантный ответ, а при его отсутствии чат переключается на оператора.

Для оценки решения собирается обратная связь от клиентов по работе чат-бота — понравился ли им ответ, который подобрал алгоритм. Вместе с этой оценкой каждый чат позволяет уточнить существующую модель и базу ответов. Если чат переключается на оператора, ответ, подобранный сотрудником, также попадает в базу знаний бота.

Пилотный проект будет запущен в ближайшее время. Пока «пилотное» общение сопровождает оператор, контролируя корректность подобранных ботом ответов. Когда будет достигнут определенный уровень удовлетворенности клиентов, получающих такие автоматические ответы (и, соответственно, достаточно высокие оценки сотрудников, сопровождающих пилот), будет приниматься решение о вводе чат-бота в полноценную эксплуатацию. В перспективе планируется, с одной стороны, расширить спектр вопросов, которыми занимается бот, а с другой — полностью заменить ботом часть общения операторов, по крайней мере, по типовым вопросам.

Система обработки клиентских обращений

В некотором смысле этот пилотный проект можно назвать следующим эволюционным шагом всей платформы чат-ботов. Если предыдущие решения каким-то образом обрабатывали запросы, категоризировали их и искали для них соответствие в имеющейся базе знаний, то конечная задача системы обработки клиентских обращений — делать собственные выводы, которые вполне могут повлиять на стратегию менеджмента Сбербанка.

Вокруг публичных компаний, таких как Сбербанк, всегда существует некий информационный фон. Это могут быть как прямые обращения в компанию через форму обратной связи или телефон, так и оценки услуг или продуктов, публично выраженные в интернете — на личных страницах клиентов в социальных сетях, на сайтах с отзывами. Причем мнения могут содержать как позитивную, так и негативную оценку работы Банка. Предполагается, что система будет обрабатывать все обращения, поступающие по доступным каналам, классифицировать их (отделять жалобы или, наоборот, благодарности, определять тематику) и фиксировать тенденции на более высоком уровне абстракции — выявлять проблемы, которые более всего волнуют клиентов, определять продукты и услуги, требующие пристального внимания, расставлять приоритеты. Поскольку развитие услуг и продуктов в Сбербанке идет по методологии agile, в идеале мы надеемся, что система станет дополнительным источником идей в бэклог извне на тот случай, если у команды, развивающей тот или иной продукт, замылится взгляд.

В каком-то смысле разрабатываемая платформа похожа на систему анализа потребительского мнения. Но она не просто собирает данные и проводит верхнеуровневую каталогизацию по тому же методу, что и чат-бот, но и выявляет суть. В качестве дополнительного «бонуса» мы с ее помощью можем формировать профиль клиента, который интересуется теми или иными услугами — получаем детальную каталогизацию того, какой сегмент аудитории и какими продуктами интересуется. Кроме того, данные можно смотреть в различных разрезах. К примеру, анализируя все каналы в комплексе можно выявить жалобы на разные продукты, суть которых будет сводится к тому, что в каком-то отделении просто плохо обслуживают клиентов. Т.е. значимым фактором может быть офис, а вовсе не параметры какой-то отдельной услуги.

Выше приведены примеры анализа собранных массивов данных на основе предположения, что мы знаем, что ищем. Важный момент заключается в том, что система самообучается. Мы строим модель на основе истории обращений клиентов, дополняя ее новыми данными по мере их поступления, т.е. в определенной степени каждое новое обращение влияет на эту модель. В результате сервис позволяет решать огромный пласт проблем, связанных с выделением тематик, о которых мы изначально ничего не знаем. К примеру, в обращении клиент может поднять тему, которой ранее в списке интересующих не было. Система позволяет добавить эту тему к перечню для мониторинга, чтобы будущие обращения проверять на соответствие также и новой тематике.

Основной потребитель для этой системы анализа обращений — менеджмент банка, т.е. ее никак нельзя оценить «снаружи». Менеджменту же система позволит держаться ближе к реальному положению дел: лучше понимать общую ситуацию, отношение клиентов к банку и к его услугам.

Пока, как и другие проекты, система существует в пилотной версии. На данный момент она сосредоточена на анализе обращений, поступивших через форму обратной связи. Сейчас это текстовые обращения, но в перспективе будет обрабатываться и голос, поскольку основной канал общения с клиентами — как раз голосовые звонки, которые будут переводиться в текст и обрабатываться теми же инструментами.

Важный аспект — оценка работы пилота. Выполняться она будет при помощи сравнения автоматической каталогизации некого обращения с эталоном (нашим знанием о том, к какой теме относится обращение). В ходе развития модели будет оцениваться и минимизироваться эта «удаленность» от эталона. Предполагается и экспертная оценка со стороны сотрудников банка.

В целом платформа чат-ботов позволяет воплотить на практике множество идей, затрагивающих тему взаимодействия с клиентом на естественном языке. По мере развития заложенных в нее алгоритмов, мы имеем возможность дорабатывать и предшествующие проекты. К примеру, если появится бизнес, заинтересованный в партнерстве в рамках платежного бота, мы можем дополнить его более современными алгоритмами, разработанными для чат-бота на сайте и системы анализа обращений клиентов. При этом мы уверены, что все это — лишь первый шаг в направлении масштабных и интересных проектов на базе machine learning.

Материал подготовили сотрудники ЦК развития биллинговых технологий СберТеха:

nill2, Данил Кабанов, директор ЦК

aspera, Руслан Халимов, ведущий инженер

Станислав Ким, руководитель разработки

|

Метки: author Sberbank платежные системы машинное обучение биллинговые системы блог компании сбербанк боты сбербанк machine learning |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка

Своя платформа чат-ботов появилась в СберТехе благодаря внутреннему социальному проекту «Сбербанк-Попутчик», затем получила дальнейшее развитие в платежном боте.

Теперь же платформа дала начало сразу двум пилотным проектам — чат-боту на сайте и в мобильном приложении и более интеллектуальной системе анализа обратной связи от клиентов. Обо всем по порядку — под катом.

Стоит признать, что наработок в области чат-ботов и распознавания естественного языка запросов уже довольно много. Однако большая часть открытых библиотек и крупных проектов по трансформации речи ориентируется на английский язык. Русский язык с этой точки зрения имеет свои нюансы. И хотя в России тоже есть заинтересованные команды, в частности, в крупных технических вузах или частных компаниях, вроде Яндекса, Мейл.Ру и СберТеха, пока готовых промышленных решений не так много. А задачи перед русскоязычным бизнесом стоят не менее амбициозные, чем перед англоязычным.

Сегодня мы хотим рассказать о том, каких успехов нам удалось добиться на поприще чат-ботов и машинного обучения.

Надо сказать, что коммерческих решений, достаточно кастомизируемых под нужды конкретной компании, пока еще не существует — сама отрасль еще слишком молода. Есть проекты от частных исследователей, например, для техподдержки, но это все еще начальная версия технологии, позволяющая проводить категоризацию обращений. При этом ни одно решение не готово к таким масштабам работы, как у Сбербанка, — к анализу столь больших объемов информации при огромном количестве клиентов. В мире только появляются инструменты глубокого анализа. И по сути из этих базовых инструментов специалисты нашей компании разрабатывают собственные кастомизированные продукты под задачи Сбербанка.

На текущий момент значимых для компании проектов четыре. Далее — подробнее о каждом из них.

Сбербанк Попутчик

С проекта «Сбербанк Попутчик» началась вся история чат-ботов в компании. По долгу службы сотрудники Сбербанка вынуждены порой добираться в удаленные отделения, иногда используя несколько видов общественного транспорта. В то же время их коллеги ездят примерно в том же направлении на машине, имея несколько свободных мест. Было бы здорово объединить эти потоки сотрудников, предложив компанию для поездки одним и возможность быстрее добраться до работы другим.

При этом в нашей стране люди не очень любят подвозить друг друга, беспокоясь о своей безопасности. Но внутренний Customer Development показал, что коллеги по работе в компании с сильной службой безопасности в большей степени доверяют друг другу, даже если не знакомы лично. Так возникла идея создать некое внутреннее community, с помощью которого люди могли бы искать друг друга для совместных поездок на работу и с работы.

В качестве движка сообщества была разработана платформа чат-бота.

Уже около года сотрудники ряда офисов обкатывают пилотный проект. Получившийся сервис так хорошо зарекомендовал себя, что теперь мы обсуждаем расширение его функционала. В частности, к проекту уже готовы подключиться сторонние перевозчики — службы такси. Также планируется тиражировать проект на все отделения.

Более того, проект готовится выйти за рамки внутренней кухни Сбербанка. Сбербанковское комьюнити, конечно же, наружу открываться не будет, но организации-партнеры (перевозчики) вполне могут тиражировать этот удачный опыт на другие компании или создавать собственные комьюнити.

Платежный бот

Еще один ранний проект, задействовавший разработанную платформу чат-бота, — платежный бот. Он был запущен в пилотную эксплуатацию в начале этого года (т.е. появился на свет примерно на полгода раньше, чем аналогичное решение, представленное весной Google на конференции Google I/O 2017).

В принципе о выборе каких-то услуг при помощи ботов разговор шел довольно давно — такие системы уже распространены по миру. Но основная фишка заключалась в возможности использовать свободные формулировки (а не предписанный набор команд), а также в оплате через бота.

Мы не склонны доверять конфиденциальную информацию (платежные данные банковской карты) незащищенным каналам, поэтому первый бот был запущен на базе мессенджинга платформы Сбербанка. Пилот проводился в прошлом году и продолжит своё существование в виде ботов в чате Сбербанк онлайн («Диалоги Сбербанка»).

Пилотный проект был реализован совместно с рестораном доставки еды Тануки. Он работает по сей день. Через чат можно выбрать товары из каталога ресторана, при этом бот подсказывает оптимальные варианты под запрос пользователя, запоминает его вкусы и потребительскую корзину, так что в будущем, если пользователь забудет заказать какую-то из привычных позиций, бот ему напомнит. Главный козырь бота — возможность привязать к нему банковскую карту для оплаты заказа также в режиме разговора. После оплаты еда просто доставляется — больше ничего от пользователя не требуется.

Фактически бот выполняет функции приложения службы доставки еды. Однако служб много — приложений много (под каждого поставщика приходится скачивать и устанавливать свое). А чат-бот — это лишь один из контактов в привычном приложении мессенджера, по сути это просто новый канал получения той же услуги.

Чат-бот контактного центра

Чат-бот для корпоративного сайта стал первым подобным проектом, который вышел за рамки «песочницы» в большой мир. Здесь, безусловно, используются наработки из Попутчика и платежного бота, но реализованы более «взрослые» и Machine Learning алгоритмы анализа запросов и поиска подходящих ответов.

Задача чат-бота — общаться с клиентами через чат на сайте, отвечая на вопросы по продуктам компании, а также счетам, кредитам и платежным поручениям самого клиента (в пилотной версии спектр решаемых вопросов ограничен данными о продуктах и открытием счета). Для этого чат-бот анализирует полученную от клиента информацию, выдает ответы на простые вопросы, сформулированные естественным языком, или запрашивает дополнительные данные, если в первоначальном запросе их не хватает.

Бот построен на технологии латентно-семантического анализа, обеспечивающей поиск ответа на вопрос клиента с учетом контекста. Методика позволяет по ключевым словам и контексту диалога найти в базе готовых ответов, куда входят разнообразные FAQ по продуктам, наиболее релевантный ответ.

В деталях это выглядит следующим образом. Сначала клиентский запрос на естественном языке превращается в набор ключевых слов. Каждое слово в модели имеет определенный вес. Распространенные слова, входящие в большинство запросов, имеют меньший вес, а слова уникальные для данного запроса, — больший. Таким образом запрос трансформируется в набор ключевых слов с определенным весом, по которым и осуществляется поиск в базе: по специальному алгоритму определяется вероятность того, что документ из базы ответов соответствует поставленному вопросу. Клиенту выдается наиболее релевантный ответ, а при его отсутствии чат переключается на оператора.

Для оценки решения собирается обратная связь от клиентов по работе чат-бота — понравился ли им ответ, который подобрал алгоритм. Вместе с этой оценкой каждый чат позволяет уточнить существующую модель и базу ответов. Если чат переключается на оператора, ответ, подобранный сотрудником, также попадает в базу знаний бота.

Пилотный проект будет запущен в ближайшее время. Пока «пилотное» общение сопровождает оператор, контролируя корректность подобранных ботом ответов. Когда будет достигнут определенный уровень удовлетворенности клиентов, получающих такие автоматические ответы (и, соответственно, достаточно высокие оценки сотрудников, сопровождающих пилот), будет приниматься решение о вводе чат-бота в полноценную эксплуатацию. В перспективе планируется, с одной стороны, расширить спектр вопросов, которыми занимается бот, а с другой — полностью заменить ботом часть общения операторов, по крайней мере, по типовым вопросам.

Система обработки клиентских обращений

В некотором смысле этот пилотный проект можно назвать следующим эволюционным шагом всей платформы чат-ботов. Если предыдущие решения каким-то образом обрабатывали запросы, категоризировали их и искали для них соответствие в имеющейся базе знаний, то конечная задача системы обработки клиентских обращений — делать собственные выводы, которые вполне могут повлиять на стратегию менеджмента Сбербанка.

Вокруг публичных компаний, таких как Сбербанк, всегда существует некий информационный фон. Это могут быть как прямые обращения в компанию через форму обратной связи или телефон, так и оценки услуг или продуктов, публично выраженные в интернете — на личных страницах клиентов в социальных сетях, на сайтах с отзывами. Причем мнения могут содержать как позитивную, так и негативную оценку работы Банка. Предполагается, что система будет обрабатывать все обращения, поступающие по доступным каналам, классифицировать их (отделять жалобы или, наоборот, благодарности, определять тематику) и фиксировать тенденции на более высоком уровне абстракции — выявлять проблемы, которые более всего волнуют клиентов, определять продукты и услуги, требующие пристального внимания, расставлять приоритеты. Поскольку развитие услуг и продуктов в Сбербанке идет по методологии agile, в идеале мы надеемся, что система станет дополнительным источником идей в бэклог извне на тот случай, если у команды, развивающей тот или иной продукт, замылится взгляд.

В каком-то смысле разрабатываемая платформа похожа на систему анализа потребительского мнения. Но она не просто собирает данные и проводит верхнеуровневую каталогизацию по тому же методу, что и чат-бот, но и выявляет суть. В качестве дополнительного «бонуса» мы с ее помощью можем формировать профиль клиента, который интересуется теми или иными услугами — получаем детальную каталогизацию того, какой сегмент аудитории и какими продуктами интересуется. Кроме того, данные можно смотреть в различных разрезах. К примеру, анализируя все каналы в комплексе можно выявить жалобы на разные продукты, суть которых будет сводится к тому, что в каком-то отделении просто плохо обслуживают клиентов. Т.е. значимым фактором может быть офис, а вовсе не параметры какой-то отдельной услуги.

Выше приведены примеры анализа собранных массивов данных на основе предположения, что мы знаем, что ищем. Важный момент заключается в том, что система самообучается. Мы строим модель на основе истории обращений клиентов, дополняя ее новыми данными по мере их поступления, т.е. в определенной степени каждое новое обращение влияет на эту модель. В результате сервис позволяет решать огромный пласт проблем, связанных с выделением тематик, о которых мы изначально ничего не знаем. К примеру, в обращении клиент может поднять тему, которой ранее в списке интересующих не было. Система позволяет добавить эту тему к перечню для мониторинга, чтобы будущие обращения проверять на соответствие также и новой тематике.

Основной потребитель для этой системы анализа обращений — менеджмент банка, т.е. ее никак нельзя оценить «снаружи». Менеджменту же система позволит держаться ближе к реальному положению дел: лучше понимать общую ситуацию, отношение клиентов к банку и к его услугам.

Пока, как и другие проекты, система существует в пилотной версии. На данный момент она сосредоточена на анализе обращений, поступивших через форму обратной связи. Сейчас это текстовые обращения, но в перспективе будет обрабатываться и голос, поскольку основной канал общения с клиентами — как раз голосовые звонки, которые будут переводиться в текст и обрабатываться теми же инструментами.

Важный аспект — оценка работы пилота. Выполняться она будет при помощи сравнения автоматической каталогизации некого обращения с эталоном (нашим знанием о том, к какой теме относится обращение). В ходе развития модели будет оцениваться и минимизироваться эта «удаленность» от эталона. Предполагается и экспертная оценка со стороны сотрудников банка.

В целом платформа чат-ботов позволяет воплотить на практике множество идей, затрагивающих тему взаимодействия с клиентом на естественном языке. По мере развития заложенных в нее алгоритмов, мы имеем возможность дорабатывать и предшествующие проекты. К примеру, если появится бизнес, заинтересованный в партнерстве в рамках платежного бота, мы можем дополнить его более современными алгоритмами, разработанными для чат-бота на сайте и системы анализа обращений клиентов. При этом мы уверены, что все это — лишь первый шаг в направлении масштабных и интересных проектов на базе machine learning.

Материал подготовили сотрудники ЦК развития биллинговых технологий СберТеха:

nill2, Данил Кабанов, директор ЦК

aspera, Руслан Халимов, ведущий инженер

Станислав Ким, руководитель разработки

|

Метки: author Sberbank платежные системы машинное обучение биллинговые системы блог компании сбербанк боты сбербанк machine learning |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка |

Как платформа чат-ботов наделяет разумом ИТ-проекты Сбербанка

Своя платформа чат-ботов появилась в СберТехе благодаря внутреннему социальному проекту «Сбербанк-Попутчик», затем получила дальнейшее развитие в платежном боте.

Теперь же платформа дала начало сразу двум пилотным проектам — чат-боту на сайте и в мобильном приложении и более интеллектуальной системе анализа обратной связи от клиентов. Обо всем по порядку — под катом.

Стоит признать, что наработок в области чат-ботов и распознавания естественного языка запросов уже довольно много. Однако большая часть открытых библиотек и крупных проектов по трансформации речи ориентируется на английский язык. Русский язык с этой точки зрения имеет свои нюансы. И хотя в России тоже есть заинтересованные команды, в частности, в крупных технических вузах или частных компаниях, вроде Яндекса, Мейл.Ру и СберТеха, пока готовых промышленных решений не так много. А задачи перед русскоязычным бизнесом стоят не менее амбициозные, чем перед англоязычным.

Сегодня мы хотим рассказать о том, каких успехов нам удалось добиться на поприще чат-ботов и машинного обучения.

Надо сказать, что коммерческих решений, достаточно кастомизируемых под нужды конкретной компании, пока еще не существует — сама отрасль еще слишком молода. Есть проекты от частных исследователей, например, для техподдержки, но это все еще начальная версия технологии, позволяющая проводить категоризацию обращений. При этом ни одно решение не готово к таким масштабам работы, как у Сбербанка, — к анализу столь больших объемов информации при огромном количестве клиентов. В мире только появляются инструменты глубокого анализа. И по сути из этих базовых инструментов специалисты нашей компании разрабатывают собственные кастомизированные продукты под задачи Сбербанка.

На текущий момент значимых для компании проектов четыре. Далее — подробнее о каждом из них.

Сбербанк Попутчик

С проекта «Сбербанк Попутчик» началась вся история чат-ботов в компании. По долгу службы сотрудники Сбербанка вынуждены порой добираться в удаленные отделения, иногда используя несколько видов общественного транспорта. В то же время их коллеги ездят примерно в том же направлении на машине, имея несколько свободных мест. Было бы здорово объединить эти потоки сотрудников, предложив компанию для поездки одним и возможность быстрее добраться до работы другим.

При этом в нашей стране люди не очень любят подвозить друг друга, беспокоясь о своей безопасности. Но внутренний Customer Development показал, что коллеги по работе в компании с сильной службой безопасности в большей степени доверяют друг другу, даже если не знакомы лично. Так возникла идея создать некое внутреннее community, с помощью которого люди могли бы искать друг друга для совместных поездок на работу и с работы.

В качестве движка сообщества была разработана платформа чат-бота.

Уже около года сотрудники ряда офисов обкатывают пилотный проект. Получившийся сервис так хорошо зарекомендовал себя, что теперь мы обсуждаем расширение его функционала. В частности, к проекту уже готовы подключиться сторонние перевозчики — службы такси. Также планируется тиражировать проект на все отделения.

Более того, проект готовится выйти за рамки внутренней кухни Сбербанка. Сбербанковское комьюнити, конечно же, наружу открываться не будет, но организации-партнеры (перевозчики) вполне могут тиражировать этот удачный опыт на другие компании или создавать собственные комьюнити.

Платежный бот

Еще один ранний проект, задействовавший разработанную платформу чат-бота, — платежный бот. Он был запущен в пилотную эксплуатацию в начале этого года (т.е. появился на свет примерно на полгода раньше, чем аналогичное решение, представленное весной Google на конференции Google I/O 2017).

В принципе о выборе каких-то услуг при помощи ботов разговор шел довольно давно — такие системы уже распространены по миру. Но основная фишка заключалась в возможности использовать свободные формулировки (а не предписанный набор команд), а также в оплате через бота.

Мы не склонны доверять конфиденциальную информацию (платежные данные банковской карты) незащищенным каналам, поэтому первый бот был запущен на базе мессенджинга платформы Сбербанка. Пилот проводился в прошлом году и продолжит своё существование в виде ботов в чате Сбербанк онлайн («Диалоги Сбербанка»).

Пилотный проект был реализован совместно с рестораном доставки еды Тануки. Он работает по сей день. Через чат можно выбрать товары из каталога ресторана, при этом бот подсказывает оптимальные варианты под запрос пользователя, запоминает его вкусы и потребительскую корзину, так что в будущем, если пользователь забудет заказать какую-то из привычных позиций, бот ему напомнит. Главный козырь бота — возможность привязать к нему банковскую карту для оплаты заказа также в режиме разговора. После оплаты еда просто доставляется — больше ничего от пользователя не требуется.

Фактически бот выполняет функции приложения службы доставки еды. Однако служб много — приложений много (под каждого поставщика приходится скачивать и устанавливать свое). А чат-бот — это лишь один из контактов в привычном приложении мессенджера, по сути это просто новый канал получения той же услуги.

Чат-бот контактного центра

Чат-бот для корпоративного сайта стал первым подобным проектом, который вышел за рамки «песочницы» в большой мир. Здесь, безусловно, используются наработки из Попутчика и платежного бота, но реализованы более «взрослые» и Machine Learning алгоритмы анализа запросов и поиска подходящих ответов.

Задача чат-бота — общаться с клиентами через чат на сайте, отвечая на вопросы по продуктам компании, а также счетам, кредитам и платежным поручениям самого клиента (в пилотной версии спектр решаемых вопросов ограничен данными о продуктах и открытием счета). Для этого чат-бот анализирует полученную от клиента информацию, выдает ответы на простые вопросы, сформулированные естественным языком, или запрашивает дополнительные данные, если в первоначальном запросе их не хватает.

Бот построен на технологии латентно-семантического анализа, обеспечивающей поиск ответа на вопрос клиента с учетом контекста. Методика позволяет по ключевым словам и контексту диалога найти в базе готовых ответов, куда входят разнообразные FAQ по продуктам, наиболее релевантный ответ.

В деталях это выглядит следующим образом. Сначала клиентский запрос на естественном языке превращается в набор ключевых слов. Каждое слово в модели имеет определенный вес. Распространенные слова, входящие в большинство запросов, имеют меньший вес, а слова уникальные для данного запроса, — больший. Таким образом запрос трансформируется в набор ключевых слов с определенным весом, по которым и осуществляется поиск в базе: по специальному алгоритму определяется вероятность того, что документ из базы ответов соответствует поставленному вопросу. Клиенту выдается наиболее релевантный ответ, а при его отсутствии чат переключается на оператора.

Для оценки решения собирается обратная связь от клиентов по работе чат-бота — понравился ли им ответ, который подобрал алгоритм. Вместе с этой оценкой каждый чат позволяет уточнить существующую модель и базу ответов. Если чат переключается на оператора, ответ, подобранный сотрудником, также попадает в базу знаний бота.

Пилотный проект будет запущен в ближайшее время. Пока «пилотное» общение сопровождает оператор, контролируя корректность подобранных ботом ответов. Когда будет достигнут определенный уровень удовлетворенности клиентов, получающих такие автоматические ответы (и, соответственно, достаточно высокие оценки сотрудников, сопровождающих пилот), будет приниматься решение о вводе чат-бота в полноценную эксплуатацию. В перспективе планируется, с одной стороны, расширить спектр вопросов, которыми занимается бот, а с другой — полностью заменить ботом часть общения операторов, по крайней мере, по типовым вопросам.

Система обработки клиентских обращений

В некотором смысле этот пилотный проект можно назвать следующим эволюционным шагом всей платформы чат-ботов. Если предыдущие решения каким-то образом обрабатывали запросы, категоризировали их и искали для них соответствие в имеющейся базе знаний, то конечная задача системы обработки клиентских обращений — делать собственные выводы, которые вполне могут повлиять на стратегию менеджмента Сбербанка.

Вокруг публичных компаний, таких как Сбербанк, всегда существует некий информационный фон. Это могут быть как прямые обращения в компанию через форму обратной связи или телефон, так и оценки услуг или продуктов, публично выраженные в интернете — на личных страницах клиентов в социальных сетях, на сайтах с отзывами. Причем мнения могут содержать как позитивную, так и негативную оценку работы Банка. Предполагается, что система будет обрабатывать все обращения, поступающие по доступным каналам, классифицировать их (отделять жалобы или, наоборот, благодарности, определять тематику) и фиксировать тенденции на более высоком уровне абстракции — выявлять проблемы, которые более всего волнуют клиентов, определять продукты и услуги, требующие пристального внимания, расставлять приоритеты. Поскольку развитие услуг и продуктов в Сбербанке идет по методологии agile, в идеале мы надеемся, что система станет дополнительным источником идей в бэклог извне на тот случай, если у команды, развивающей тот или иной продукт, замылится взгляд.

В каком-то смысле разрабатываемая платформа похожа на систему анализа потребительского мнения. Но она не просто собирает данные и проводит верхнеуровневую каталогизацию по тому же методу, что и чат-бот, но и выявляет суть. В качестве дополнительного «бонуса» мы с ее помощью можем формировать профиль клиента, который интересуется теми или иными услугами — получаем детальную каталогизацию того, какой сегмент аудитории и какими продуктами интересуется. Кроме того, данные можно смотреть в различных разрезах. К примеру, анализируя все каналы в комплексе можно выявить жалобы на разные продукты, суть которых будет сводится к тому, что в каком-то отделении просто плохо обслуживают клиентов. Т.е. значимым фактором может быть офис, а вовсе не параметры какой-то отдельной услуги.

Выше приведены примеры анализа собранных массивов данных на основе предположения, что мы знаем, что ищем. Важный момент заключается в том, что система самообучается. Мы строим модель на основе истории обращений клиентов, дополняя ее новыми данными по мере их поступления, т.е. в определенной степени каждое новое обращение влияет на эту модель. В результате сервис позволяет решать огромный пласт проблем, связанных с выделением тематик, о которых мы изначально ничего не знаем. К примеру, в обращении клиент может поднять тему, которой ранее в списке интересующих не было. Система позволяет добавить эту тему к перечню для мониторинга, чтобы будущие обращения проверять на соответствие также и новой тематике.

Основной потребитель для этой системы анализа обращений — менеджмент банка, т.е. ее никак нельзя оценить «снаружи». Менеджменту же система позволит держаться ближе к реальному положению дел: лучше понимать общую ситуацию, отношение клиентов к банку и к его услугам.

Пока, как и другие проекты, система существует в пилотной версии. На данный момент она сосредоточена на анализе обращений, поступивших через форму обратной связи. Сейчас это текстовые обращения, но в перспективе будет обрабатываться и голос, поскольку основной канал общения с клиентами — как раз голосовые звонки, которые будут переводиться в текст и обрабатываться теми же инструментами.

Важный аспект — оценка работы пилота. Выполняться она будет при помощи сравнения автоматической каталогизации некого обращения с эталоном (нашим знанием о том, к какой теме относится обращение). В ходе развития модели будет оцениваться и минимизироваться эта «удаленность» от эталона. Предполагается и экспертная оценка со стороны сотрудников банка.

В целом платформа чат-ботов позволяет воплотить на практике множество идей, затрагивающих тему взаимодействия с клиентом на естественном языке. По мере развития заложенных в нее алгоритмов, мы имеем возможность дорабатывать и предшествующие проекты. К примеру, если появится бизнес, заинтересованный в партнерстве в рамках платежного бота, мы можем дополнить его более современными алгоритмами, разработанными для чат-бота на сайте и системы анализа обращений клиентов. При этом мы уверены, что все это — лишь первый шаг в направлении масштабных и интересных проектов на базе machine learning.

Материал подготовили сотрудники ЦК развития биллинговых технологий СберТеха:

nill2, Данил Кабанов, директор ЦК

aspera, Руслан Халимов, ведущий инженер

Станислав Ким, руководитель разработки

|

Метки: author Sberbank платежные системы машинное обучение биллинговые системы блог компании сбербанк боты сбербанк machine learning |

Конференция VMworld 2017 Europe. День 1 |

Конференция VMworld 2017 Europe. День 1

Продолжаю свой рассказ о самом интересном на конференции VMworld 2017 Europe (первая часть рассказа о конференции).

Первый день начался с генеральной сессии под воодушевляющим заголовком: Good Technologists Solve Problems. Great Innovators Create Opportunities. Генеральный директор VMware Пэт Гелсингер (Pat Gelsinger) рассказал о том, как технологии меняют окружающий нас мир. Он привел в пример то, как быстро люди могут адаптироваться ко всему новому. Например, первоначальный страх перед беспилотными автомобилями сменяется интересом: «А как же это внутри работает?», что приводит к возникновению новых потребностей: «Почему эта штука не может ехать быстрее?». В результате именно ИТ становится основным источником роста для компаний. И если 100 лет назад человек должен был уметь делать три вещи: читать, писать и считать, то теперь это выглядит скорее, как «читать, писать код и считать».

VMware предоставляет решения, обеспечивающие работу любого приложения в любом облаке (частном или публичном) с возможностью доступа с любого устройства. Одним из таких решений является VMware HCX, обеспечивающий связь между on-premise инфраструктурой и публичными облачными сервисами (вроде IBM Cloud или OVH) и позволяющий в реальном времени переносить виртуальные машины туда и обратно без простоя (zero-downtime migration).

Однако далеко не все заказчики готовы с головой ринутся в публичное облако. Многие практикуют гибридный подход, когда часть инфраструктуры развернута on-premise, а часть — в облаке. Для улучшения возможностей по управлению такими гибридными средами VMware предлагает набор продуктов, распространяемых по модели SaaS — VMware Cloud Services, в число которых входят решения по мониторингу, анализу стоимости, организации сетевой связности, защите приложений и обеспечению единой точки подключения к приложениям.

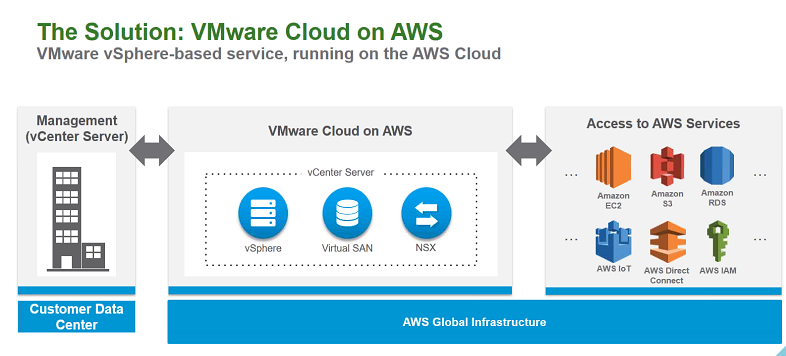

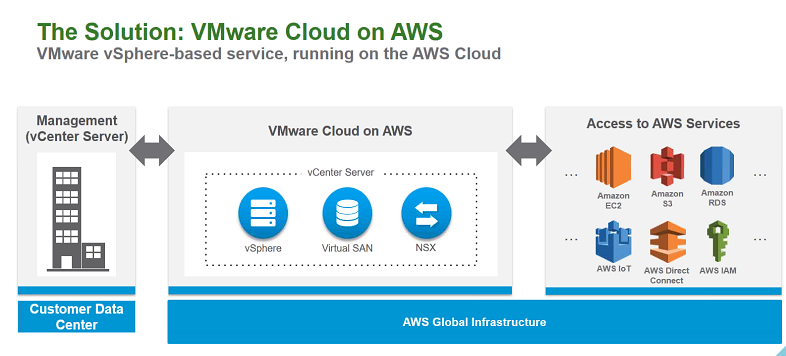

Дальше речь зашла о публичном облаке VMware Cloud on AWS. Вкратце: Amazon предоставляет свои виртуальные ЦОД, расположенные во всех уголках мира, а также инженерную, сетевую инфраструктуру и серверное оборудование, на которое устанавливается набор продуктов VMware SDDC.

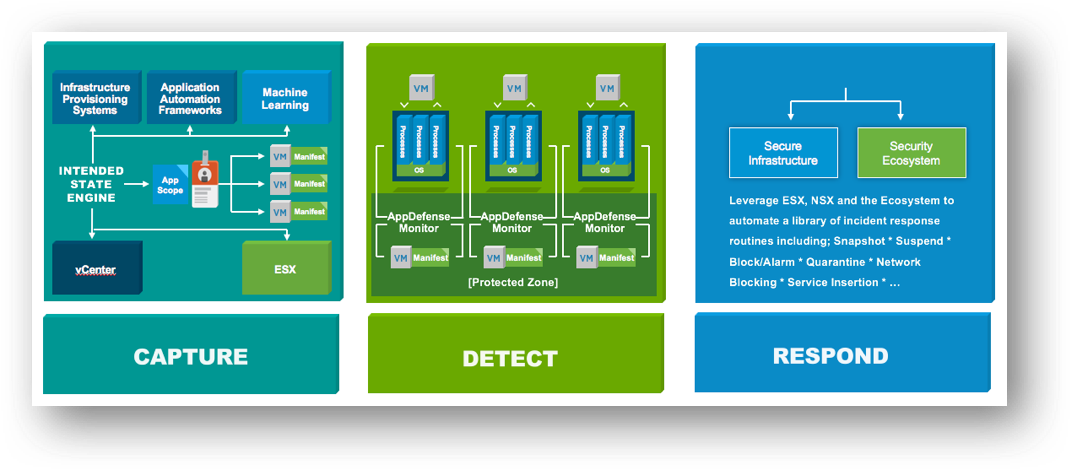

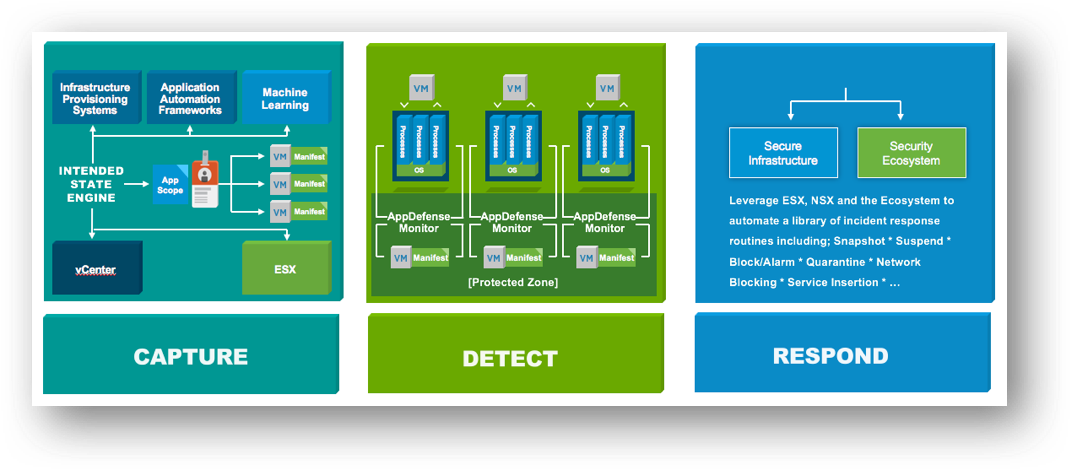

Также VMware напомнила о других недавно анонсированных продуктах, работающих внутри виртуальных сред: VMware Integrated OpenStack 4.0 (собственном дистрибутиве OpenStack) и VMware AppDefense (решении по организации защиты приложений).

Выставка

После завершения генеральной сессии посетители стали расходиться. Одни спешили на другие сессии, другие расслаблялись в lounge-зоне, третьи направились на выставку партнерских решений Solutions Exchange.

Ежегодно на VMworld более 100 компаний развёртывают стенды для демонстрации всевозможных продуктов и решений. Например, здесь можно побывать на стендах Dell, HPE, NetApp, IBM, Hitachi, Red Hat, Arista, Nutanix, а также перспективных стартапов. Особенно приятно, что на выставке представлены ИТ-компании, имеющие российские корни: Kaspersky и Veeam.

Вендоры всеми правдами и неправдами стараются зазвать посетителей на свои стенды:

Игра на стенде Intel, в котором участникам на время требовалось подобрать сервер в оптимальной конфигурации для решения потребностей бизнеса:

Первым мое внимание привлек стенд компании VMware, в первую очередь благодаря своим гигантским размерам (почему-то вспомнилась поговорка про «кто ужинает девушку, тот её и танцует»).

Здесь были представлены все направления работы компании: от десктопных гипервизоров VMware Workstation до недавно анонсированного AppDefense

Отдельного упоминания заслуживают стилизованные под различные отрасли стенды, где демонстрировались решения для конечных пользователей (End-User Computing).

Например, для банковского сектора демонстрировались смартфоны Samsung, поддерживающие работу в режиме декстопа (Samsung DEX). После установки смартфона в крэдл к нему можно подключить клавиатуру, мышь и монитор и работать практически как с полноценным настольным компьютером. Или можно запустить на нем клиент Horizon View, подключиться к VDI-инфраструктуре и получить доступ к опубликованным приложениям и виртуальным рабочим станциям, превратив устройство в мобильный тонкий клиент.

Далее я посетил стенд компании Amazon, на котором можно было подробнее узнать о реализации совместного облачного сервиса VMware и Amazon.

Cloud on AWS был анонсирован еще на прошлогоднем VMworld, и, наконец, решение стало доступным для конечных заказчиков.

В этом облаке любой заказчик может нажать пару кнопок и развернуть свой виртуальный ЦОД в облаке Amazon. Каждый такой ЦОД включает в себя:

- кластер VMware vSphere (не менее четырех физических серверов),

- сервер управления vCenter Server,

- распределенное хранилище VSAN,

- программно-конфигурируемую сеть NSX.

Каждый сервер имеет типовую конфигурацию: два процессора по 18 ядер в каждом, 512 Гб ОЗУ, 10,7 Тб дискового пространства на flash. При необходимости заказчик может наращивать вычислительные ресурсы виртуального ЦОД, добавляя дополнительные узлы вручную или в автоматическом режиме по мере роста нагрузки (так называемый Elastic DRS). Cloud on AWS предоставляет механизмы интеграции с on-premise инфраструктурой заказчика, позволяя управлять локальными и облачными кластерами vSphere и виртуальными машинами из единой консоли vSphere Client (Hybrid Linked Mode).

VMware полностью берет на себя поддержку облачной инфраструктуры, включая настройку, патч-менеджмент и обслуживание оборудования.

Поскольку облако VMware размещается в тех же ЦОД, что и облачные сервисы Amazon, заказчики получают дополнительные преимущества в виде широкой полосы пропускания, низких сетевых задержек и отсутствия учета трафика при работе с сервисами EC2, S3 и другими.

VMware выделяет три основных сценария использования Cloud on AWS:

- расширение существующей виртуальной инфраструктуры или организация резервной площадки для обеспечения аварийного восстановления без необходимости построения собственного ЦОД;

- консолидация нескольких существующих ЦОД или полная миграция в облако с минимальным влиянием на существующие приложения и ВМ;

- быстрое предоставление вычислительных ресурсов для задач тестирования/разработки или при цикличной нагрузке (пики в сезон продаж).

На текущий момент развертывание виртуальных ЦОД доступно только в одном регионе (US West Oregon), однако уже в ближайшем будущем список регионов будет расширен.

На стенде HPE демонстрировалось новое поколение серверов ProLiant GEN10. В частности, был представлен 1U rackmount-серер HPE ProLiant DL360 GEN10.

Среди нововведений GEN10

- Поддержка процессоров архитектуры Intel Xeon Scalable. Новые процессоры имеют большее количество ядер (28 у старшей модели Intel Xeon Platinum 8150M вместо 22 ядер у Intel Xeon E5-2699A v4), большие тактовые частоты и кэш-память третьего уровня, а также возросший до 205 Вт тепловой пакет.

- Поддержка установки большего числа flash-накопителей с интерфейсом NVMe, которые обеспечивают более высокие скорости передачи данных и меньшие задержки по сравнению с накопителями с SATA/SAS интерфейсами. В 1U-сервер можно установить до 10 таких накопителей, выполненных в форм-факторе 2,5 дюйма. В более вместительный 2U-сервер — уже 20. Если учесть, что в портфолио HPE есть NVMe-накопители объемом до 2 ТБ, нетрудно подсчитать итоговую ёмкость.

Серверы HPE поддерживают технологии доверенной загрузки, позволяющей блокировать загрузку на сервер неподписанных версий микрокода и операционных систем, а также возможность очистки (зануления) локальных накопителей, предотвращающую утечку конфиденциальных данных.

Стоит отметить постепенный переход производителей серверов к сетевым адаптерам 25 Гбит/с и, соответственно, к портам 100 Гбит/с на сетевом оборудовании. Помимо двух с половиной кратного увеличения полосы пропускания и уменьшения задержек по сравнению с 10 GbE, что может быть полезно для современных гиперконвергентных решений и программно-определяемых СХД, такие адаптеры могут похвастаться наличием разъемов стандарта SFP28, которые по размерам совпадают с обычными SFP+ и занимают меньше места, чем QSFP+.

На стенде Intel демонстрировалась гиперконвергентная платформа на базе серверов, процессоров и flash-накопителей производства Intel и ПО VMware (vSphere и vSAN).

Невзрачные, на первый взгляд, серверы содержат по два процессора Intel Xeon Gol 6152, 768 ГБ ОЗУ, четыре накопителя Intel Optane DC P4800X объемом 375 ГБ на базе памяти 3D XPoint и 12 «классических» NVMe flash-накопителей Intel DC P4500.

Накопители выполнены в форм-факторе 2,5 дюйма, поддерживают горячую замену и подключаются напрямую к шине PCI-E через специальные host-адаптеры.

Один такой сервер способен обеспечивать производительность на уровне 380 тысяч IOPS при случайной нагрузке блоками 4 Кб и соотношении чтения/записи равном 70/30.

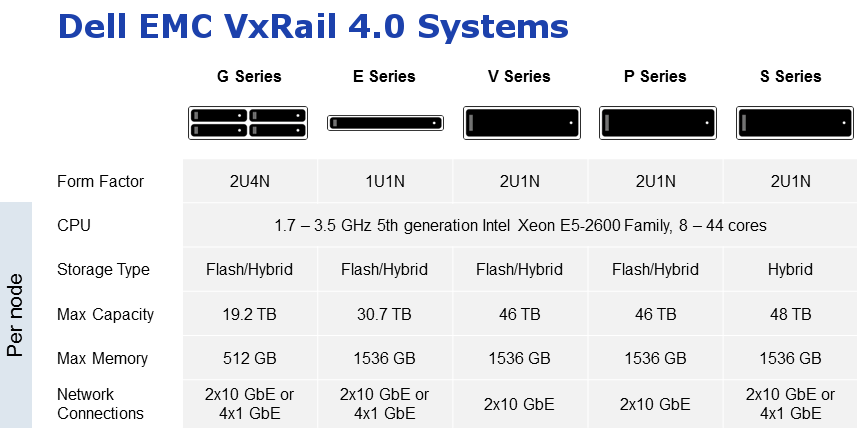

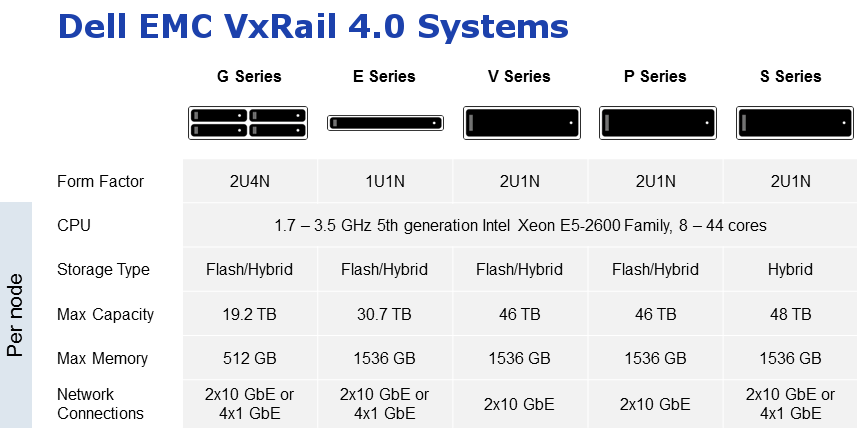

Следующей на очереди была зона HCI (HyperConverged Infrastructure) — гиперконвергентных решений, совмещающих вычислительные ресурсы и ресурсы хранения в рамках одного конструктивного блока. Помимо партнерских решений Intel, Lenovo и Fujitsu, на стенде демонстрировалась HCI-платформа Dell-EMC VxRail 4.0.

VxRail представляет собой законченное решение, построенное на базе серверов Dell и программного обеспечения VMware vSAN. На текущий момент в линейке VxRail присутствуют 5 типов конфигураций, предназначенных для решения разных задач: от высокоплотных серверов G-серии и типовых 1U-серверов E-серии (Entry level) до серверов серии V, поддерживающих установку графических ускорителей и оптимизированных для запуска виртуальных рабочих станций, высокопроизводительных (серия P) или емких (серия S) серверов.

VxRail, как и большинство других HCI-решений, поставляются заказчикам в уже готовом к работе виде. Достаточно на месте скоммутировать сервер, включить питание, пройти простой мастер первоначальной настройки — и «Voila!», полностью функционирующая виртуальная инфраструктура готова к работе.

Для популяризации HCI и других решений среди молодежи Dell EMC выпустила серию комиксов.

Прямо на выставке записывался подкаст Virtually Speaking Podcast (https://soundcloud.com/virtuallyspeakingpodcast) о виртуализации и облачных технологиях.

На стенде Mellanox демонстрировались всевозможные сетевые и конвергентные адаптеры серии ConnectX, поддерживающие 10, 25, 40, 100 Гбит/с и даже 200 Гбит/с подключения. Обратите внимание, как растут требования к шине PCI-E по мере увеличения количества и скорости портов.

Рядом с Mellanox расположился стенд Supermicro, на котором демонстрировались современные серверы Twin-формата (позволяющие размещать два или четыре сервера в одном шасси), поддерживающие процессоры Intel Xeon Scalable и AMD EPYC. Серверы Supermicro пользуются неизменной популярностью у экономных заказчиков, сборщиков оборудования и производителей апплайнсов, например, платформа Web Scale от Nutanix строится именно на таких серверах.

Серверы имеют заменяемый адаптер LOM (Lan-on-board), позволяющий подобрать необходимую конфигурацию сетевых портов без замены материнской платы и без использования PCI-E слота расширения.

Вот так побродив по стендам, я не заметил, как подошел к концу очередной день конференции. Продолжение в следующей части.

Андрей Коновалов, начальник отдела виртуализации компании «Инфосистемы Джет»

|

Метки: author omnimod хранилища данных хранение данных виртуализация it- инфраструктура блог компании инфосистемы джет vmworld виртуализация серверов vmware |

Конференция VMworld 2017 Europe. День 1 |

Конференция VMworld 2017 Europe. День 1

Продолжаю свой рассказ о самом интересном на конференции VMworld 2017 Europe (первая часть рассказа о конференции).

Первый день начался с генеральной сессии под воодушевляющим заголовком: Good Technologists Solve Problems. Great Innovators Create Opportunities. Генеральный директор VMware Пэт Гелсингер (Pat Gelsinger) рассказал о том, как технологии меняют окружающий нас мир. Он привел в пример то, как быстро люди могут адаптироваться ко всему новому. Например, первоначальный страх перед беспилотными автомобилями сменяется интересом: «А как же это внутри работает?», что приводит к возникновению новых потребностей: «Почему эта штука не может ехать быстрее?». В результате именно ИТ становится основным источником роста для компаний. И если 100 лет назад человек должен был уметь делать три вещи: читать, писать и считать, то теперь это выглядит скорее, как «читать, писать код и считать».

VMware предоставляет решения, обеспечивающие работу любого приложения в любом облаке (частном или публичном) с возможностью доступа с любого устройства. Одним из таких решений является VMware HCX, обеспечивающий связь между on-premise инфраструктурой и публичными облачными сервисами (вроде IBM Cloud или OVH) и позволяющий в реальном времени переносить виртуальные машины туда и обратно без простоя (zero-downtime migration).

Однако далеко не все заказчики готовы с головой ринутся в публичное облако. Многие практикуют гибридный подход, когда часть инфраструктуры развернута on-premise, а часть — в облаке. Для улучшения возможностей по управлению такими гибридными средами VMware предлагает набор продуктов, распространяемых по модели SaaS — VMware Cloud Services, в число которых входят решения по мониторингу, анализу стоимости, организации сетевой связности, защите приложений и обеспечению единой точки подключения к приложениям.

Дальше речь зашла о публичном облаке VMware Cloud on AWS. Вкратце: Amazon предоставляет свои виртуальные ЦОД, расположенные во всех уголках мира, а также инженерную, сетевую инфраструктуру и серверное оборудование, на которое устанавливается набор продуктов VMware SDDC.

Также VMware напомнила о других недавно анонсированных продуктах, работающих внутри виртуальных сред: VMware Integrated OpenStack 4.0 (собственном дистрибутиве OpenStack) и VMware AppDefense (решении по организации защиты приложений).

Выставка

После завершения генеральной сессии посетители стали расходиться. Одни спешили на другие сессии, другие расслаблялись в lounge-зоне, третьи направились на выставку партнерских решений Solutions Exchange.

Ежегодно на VMworld более 100 компаний развёртывают стенды для демонстрации всевозможных продуктов и решений. Например, здесь можно побывать на стендах Dell, HPE, NetApp, IBM, Hitachi, Red Hat, Arista, Nutanix, а также перспективных стартапов. Особенно приятно, что на выставке представлены ИТ-компании, имеющие российские корни: Kaspersky и Veeam.

Вендоры всеми правдами и неправдами стараются зазвать посетителей на свои стенды:

Игра на стенде Intel, в котором участникам на время требовалось подобрать сервер в оптимальной конфигурации для решения потребностей бизнеса:

Первым мое внимание привлек стенд компании VMware, в первую очередь благодаря своим гигантским размерам (почему-то вспомнилась поговорка про «кто ужинает девушку, тот её и танцует»).

Здесь были представлены все направления работы компании: от десктопных гипервизоров VMware Workstation до недавно анонсированного AppDefense

Отдельного упоминания заслуживают стилизованные под различные отрасли стенды, где демонстрировались решения для конечных пользователей (End-User Computing).

Например, для банковского сектора демонстрировались смартфоны Samsung, поддерживающие работу в режиме декстопа (Samsung DEX). После установки смартфона в крэдл к нему можно подключить клавиатуру, мышь и монитор и работать практически как с полноценным настольным компьютером. Или можно запустить на нем клиент Horizon View, подключиться к VDI-инфраструктуре и получить доступ к опубликованным приложениям и виртуальным рабочим станциям, превратив устройство в мобильный тонкий клиент.

Далее я посетил стенд компании Amazon, на котором можно было подробнее узнать о реализации совместного облачного сервиса VMware и Amazon.

Cloud on AWS был анонсирован еще на прошлогоднем VMworld, и, наконец, решение стало доступным для конечных заказчиков.

В этом облаке любой заказчик может нажать пару кнопок и развернуть свой виртуальный ЦОД в облаке Amazon. Каждый такой ЦОД включает в себя:

- кластер VMware vSphere (не менее четырех физических серверов),

- сервер управления vCenter Server,

- распределенное хранилище VSAN,

- программно-конфигурируемую сеть NSX.

Каждый сервер имеет типовую конфигурацию: два процессора по 18 ядер в каждом, 512 Гб ОЗУ, 10,7 Тб дискового пространства на flash. При необходимости заказчик может наращивать вычислительные ресурсы виртуального ЦОД, добавляя дополнительные узлы вручную или в автоматическом режиме по мере роста нагрузки (так называемый Elastic DRS). Cloud on AWS предоставляет механизмы интеграции с on-premise инфраструктурой заказчика, позволяя управлять локальными и облачными кластерами vSphere и виртуальными машинами из единой консоли vSphere Client (Hybrid Linked Mode).

VMware полностью берет на себя поддержку облачной инфраструктуры, включая настройку, патч-менеджмент и обслуживание оборудования.

Поскольку облако VMware размещается в тех же ЦОД, что и облачные сервисы Amazon, заказчики получают дополнительные преимущества в виде широкой полосы пропускания, низких сетевых задержек и отсутствия учета трафика при работе с сервисами EC2, S3 и другими.

VMware выделяет три основных сценария использования Cloud on AWS:

- расширение существующей виртуальной инфраструктуры или организация резервной площадки для обеспечения аварийного восстановления без необходимости построения собственного ЦОД;

- консолидация нескольких существующих ЦОД или полная миграция в облако с минимальным влиянием на существующие приложения и ВМ;

- быстрое предоставление вычислительных ресурсов для задач тестирования/разработки или при цикличной нагрузке (пики в сезон продаж).

На текущий момент развертывание виртуальных ЦОД доступно только в одном регионе (US West Oregon), однако уже в ближайшем будущем список регионов будет расширен.

На стенде HPE демонстрировалось новое поколение серверов ProLiant GEN10. В частности, был представлен 1U rackmount-серер HPE ProLiant DL360 GEN10.

Среди нововведений GEN10

- Поддержка процессоров архитектуры Intel Xeon Scalable. Новые процессоры имеют большее количество ядер (28 у старшей модели Intel Xeon Platinum 8150M вместо 22 ядер у Intel Xeon E5-2699A v4), большие тактовые частоты и кэш-память третьего уровня, а также возросший до 205 Вт тепловой пакет.

- Поддержка установки большего числа flash-накопителей с интерфейсом NVMe, которые обеспечивают более высокие скорости передачи данных и меньшие задержки по сравнению с накопителями с SATA/SAS интерфейсами. В 1U-сервер можно установить до 10 таких накопителей, выполненных в форм-факторе 2,5 дюйма. В более вместительный 2U-сервер — уже 20. Если учесть, что в портфолио HPE есть NVMe-накопители объемом до 2 ТБ, нетрудно подсчитать итоговую ёмкость.

Серверы HPE поддерживают технологии доверенной загрузки, позволяющей блокировать загрузку на сервер неподписанных версий микрокода и операционных систем, а также возможность очистки (зануления) локальных накопителей, предотвращающую утечку конфиденциальных данных.

Стоит отметить постепенный переход производителей серверов к сетевым адаптерам 25 Гбит/с и, соответственно, к портам 100 Гбит/с на сетевом оборудовании. Помимо двух с половиной кратного увеличения полосы пропускания и уменьшения задержек по сравнению с 10 GbE, что может быть полезно для современных гиперконвергентных решений и программно-определяемых СХД, такие адаптеры могут похвастаться наличием разъемов стандарта SFP28, которые по размерам совпадают с обычными SFP+ и занимают меньше места, чем QSFP+.

На стенде Intel демонстрировалась гиперконвергентная платформа на базе серверов, процессоров и flash-накопителей производства Intel и ПО VMware (vSphere и vSAN).

Невзрачные, на первый взгляд, серверы содержат по два процессора Intel Xeon Gol 6152, 768 ГБ ОЗУ, четыре накопителя Intel Optane DC P4800X объемом 375 ГБ на базе памяти 3D XPoint и 12 «классических» NVMe flash-накопителей Intel DC P4500.

Накопители выполнены в форм-факторе 2,5 дюйма, поддерживают горячую замену и подключаются напрямую к шине PCI-E через специальные host-адаптеры.

Один такой сервер способен обеспечивать производительность на уровне 380 тысяч IOPS при случайной нагрузке блоками 4 Кб и соотношении чтения/записи равном 70/30.

Следующей на очереди была зона HCI (HyperConverged Infrastructure) — гиперконвергентных решений, совмещающих вычислительные ресурсы и ресурсы хранения в рамках одного конструктивного блока. Помимо партнерских решений Intel, Lenovo и Fujitsu, на стенде демонстрировалась HCI-платформа Dell-EMC VxRail 4.0.

VxRail представляет собой законченное решение, построенное на базе серверов Dell и программного обеспечения VMware vSAN. На текущий момент в линейке VxRail присутствуют 5 типов конфигураций, предназначенных для решения разных задач: от высокоплотных серверов G-серии и типовых 1U-серверов E-серии (Entry level) до серверов серии V, поддерживающих установку графических ускорителей и оптимизированных для запуска виртуальных рабочих станций, высокопроизводительных (серия P) или емких (серия S) серверов.

VxRail, как и большинство других HCI-решений, поставляются заказчикам в уже готовом к работе виде. Достаточно на месте скоммутировать сервер, включить питание, пройти простой мастер первоначальной настройки — и «Voila!», полностью функционирующая виртуальная инфраструктура готова к работе.

Для популяризации HCI и других решений среди молодежи Dell EMC выпустила серию комиксов.

Прямо на выставке записывался подкаст Virtually Speaking Podcast (https://soundcloud.com/virtuallyspeakingpodcast) о виртуализации и облачных технологиях.

На стенде Mellanox демонстрировались всевозможные сетевые и конвергентные адаптеры серии ConnectX, поддерживающие 10, 25, 40, 100 Гбит/с и даже 200 Гбит/с подключения. Обратите внимание, как растут требования к шине PCI-E по мере увеличения количества и скорости портов.

Рядом с Mellanox расположился стенд Supermicro, на котором демонстрировались современные серверы Twin-формата (позволяющие размещать два или четыре сервера в одном шасси), поддерживающие процессоры Intel Xeon Scalable и AMD EPYC. Серверы Supermicro пользуются неизменной популярностью у экономных заказчиков, сборщиков оборудования и производителей апплайнсов, например, платформа Web Scale от Nutanix строится именно на таких серверах.

Серверы имеют заменяемый адаптер LOM (Lan-on-board), позволяющий подобрать необходимую конфигурацию сетевых портов без замены материнской платы и без использования PCI-E слота расширения.

Вот так побродив по стендам, я не заметил, как подошел к концу очередной день конференции. Продолжение в следующей части.

Андрей Коновалов, начальник отдела виртуализации компании «Инфосистемы Джет»

|

Метки: author omnimod хранилища данных хранение данных виртуализация it- инфраструктура блог компании инфосистемы джет vmworld виртуализация серверов vmware |

Проблемы React UI Kit-а и единой дизайн-системы, о которых вы не знали |

Проблемы React UI Kit-а и единой дизайн-системы, о которых вы не знали

2 сентября 2017 прошла конференция Moscow Frontend, где я на примере React UI Kit рассказывала о проблемах, которые встречаются при внедрении UI Kit в компании. Тема оказалась актуальнее, чем я могла предположить, поэтому решила опубликовать статью по этой же тематике, преследуя две цели: донести материал до людей, которые не смогли оказаться на конференции лично, и предоставить отличную возможность провести жаркую дискуссию на эту тему в комментариях.

Приятный бонус заключается в том, что после выступления и дискуссий в кулуарах в моем материале к докладу появились дополнения и нововведения. Поэтому, даже если вы были на конференции, вам все равно будет интересно прочитать статью. В конце материала я оставила несколько вопросов, на которые я попрошу ответить в комментариях. Приятного чтения!

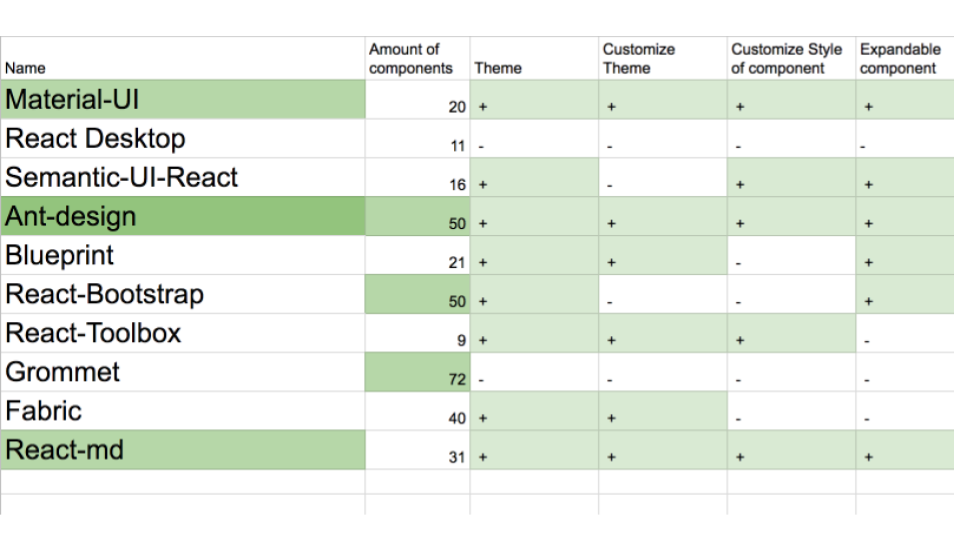

Что такое UI Kit?

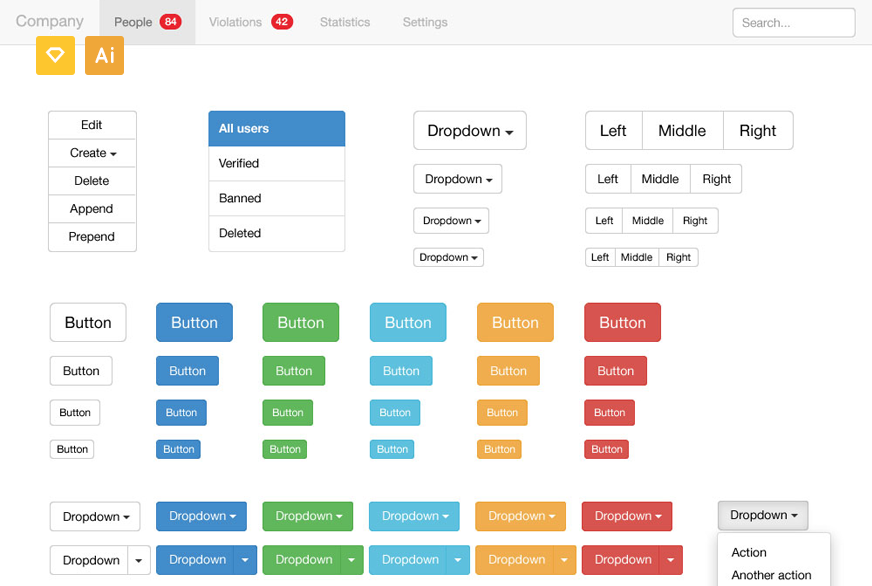

Как показал опрос зала, не все присутствующие на профильной конференции по frontend знают, что такое UI Kit. Если говорить простым языком, UI Kit – это набор элементов пользовательского интерфейса в едином стиле. Еще проще: кнопки, поля для ввода текста, выпадающее меню и прочее в одном цвете.

Из историй успеха крупных компаний мы знаем о пользе единых дизайн-систем и единых библиотек компонентов. Однако мало кто знает о подводных камнях и ключевых проблемах их внедрения в процессы, дизайн и разработку. О них, а еще о возможных решениях возникающих проблем, и пойдет речь в этой статье.

Пройдемся по всему процессу внедрения шаг за шагом:

- Определение необходимости Kit в компании

- Анализ уже существующих решений

- Разработка дизайна

- Организация библиотеки компонентов

- Создание компонентов

- Использование

Определение необходимости Kit в компании

Если вы только что узнали, что такое UI Kit, у вас сразу возникнет первая проблема – как понять, нужен ли он нам? UI Kit точно не нужен, если:

- Вы работаете в одиночку или в небольшой команде. В таком случае стоит переиспользовать код внутри проекта и не тратить время и нервы на разработку кита.

- У вас один небольшой продукт или вы занимаетесь созданием «разовых» проектов/фриланс. Можно создать своего рода UI Kit в виде единого стилевого файла, который можно подключать от проекта к проекту, и этого будет достаточно. Но в разрезе этой статьи мы говорим о UI Kit как о глобальной библиотеке компонентов.

- У вас только один дизайнер, после которого не нужно приводить все макеты к одному стилю. Синхронизация дизайна в различных макетах одного или нескольких продуктов одной компании и есть проблема, которую решает единая дизайн-система. Только убедитесь, что макеты вашего единственного в компании дизайнера не зависят от его настроения или метеоусловий.

Но если все-таки у вас в компании более одного продукта, большая команда, большая кодовая база, каждый новый функционал/продукт отличается от предыдущих по стилю, и вы уже физически ощущаете боль от релизов из-за дублирования компонентов и вереницы непонятных в них свойств, то вам определенно нужна единая библиотека компонентов. В таком случае перед вами возникает новая проблема.

Как объяснить бизнесу и компании, что вам нужен UI Kit

Для нас может быть очевидно, почему единая библиотека компонентов необходима, а также то, что она упростит работу и ускорит разработку. Но вот бизнесу не всегда может быть понятно, почему мы должны отложить список задач, от которых напрямую зависит выручка компании, и пойти делать какой-то UI Kit.

Приводите аргументы, которые будут понятны всем. Возможно, в вашей компании уже давно есть проблема с тем, что все продукты различаются визуально, и пора синхронизовать их дизайн. В качестве весомого аргумента можно предложить прочитать статью «And You Thought Buttons Were Easy?» , в которой рассказывается о материальной выгоде использования единой дизайн-системы. И объясните на пальцах, что страстно желаемые фичи будут создаваться и выкатываться намного быстрее, чем раньше.

Возможно, в вашей компании есть другие, более острые проблемы, которые может помочь решить Kit. Обратите внимание на них. Помните, что все проблемы и ситуации всегда будут уникальными, и предлагаемые в этой статье решения послужат только вектором к размышлению.

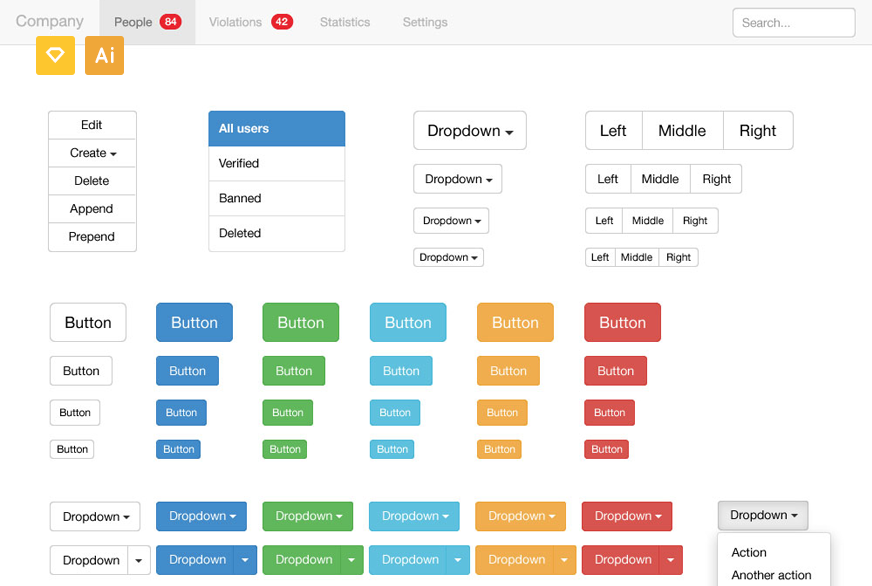

Анализ существующих решений

Допустим, мы поняли, что Kit нам нужен, и бизнес полностью с нами солидарен. Теперь перед нами стоит новая проблема – определить, создавать кит самим, или использовать один из существующих на рынке. При этом мы хотим исключить лишнюю работу по разработке и использовать существующую библиотеку компонентов. В этом случае нужно изучить рынок и понять, какую использовать.

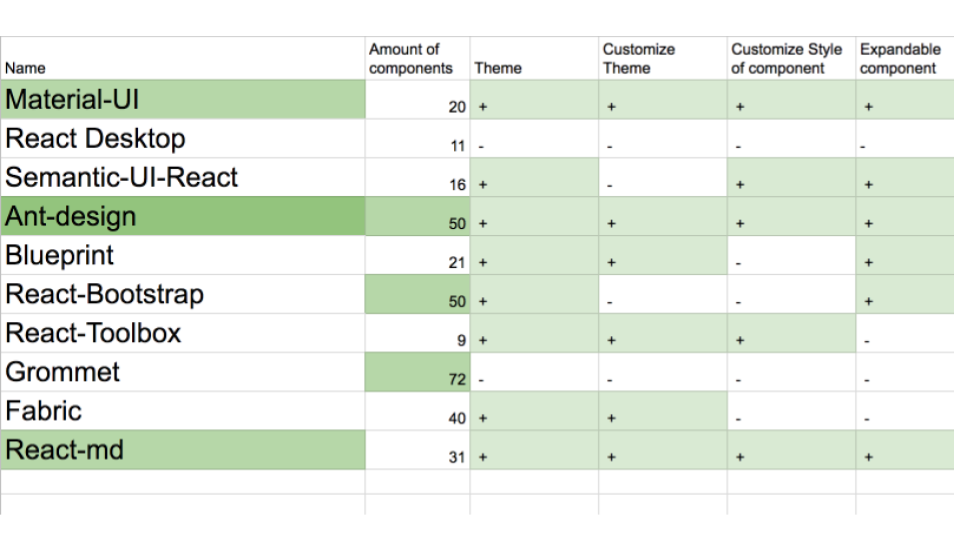

Библиотек компонентов во frontend на порядок больше, чем фреймворков, и не шутят о них только потому, что уже не смешно. Для простоты я создала небольшую подборку основных библиотек компонентов React и провела сравнительный анализ по трем критериям: кастомизация стилей, производительность и количество компонентов.

Зеленым выделены характеристики, которые нам подходят. В результате определились три лидера: Material-UI, Ant-design и React-md. Дальше вы можете проводить уже свои сравнения по скорости работы, функциональности или весу компонентов. Но я могу вас заранее предупредить: нельзя предугадать будущие потребности продуктов, находясь на старте разработки. Поэтому, если у компании есть ресурсы и заинтересованность в гибких решениях, то лучше создавать свой Kit.

Создавать свой Kit с нуля или вывозить компоненты из уже существующих продуктов – это выбор, который остается за вами. Но не лишним будет посмотреть на опыт других и обратиться к коллегам из других компаний с вопросом, как они справлялись с теми проблемами, которые есть у вас. Вряд ли об этом напишут в «статьях успеха», поэтому лучше обращаться лично.

Разработка дизайна

Самая серьезная проблема, которая встречается на этом этапе, заключается в отсутствии коммуникации между разработкой и дизайнерами. В результате получается целый ряд побочных проблем: трудности дальнейших коммуникаций разработки и дизайна, несоответствие дизайна компонентов техническому ограничению, непонимание на уровне разработки дизайна, понятия компонента и множество других.

Этого можно легко избежать, если разработка дизайна начинается со «стола переговоров» с разработкой, где формируется ряд соглашений о будущем ките, которого будет придерживаться и разработка, и дизайн.

Вот мой рекомендованный список к соглашению, который нужно обсудить:

- наименования;

- процессы;

- документацию;

- композиции компонентов;

- технические ограничения;

- контроль версий;

- список, количество и свойства компонентов.

В зависимости от ситуации список можно сокращать или дополнять.

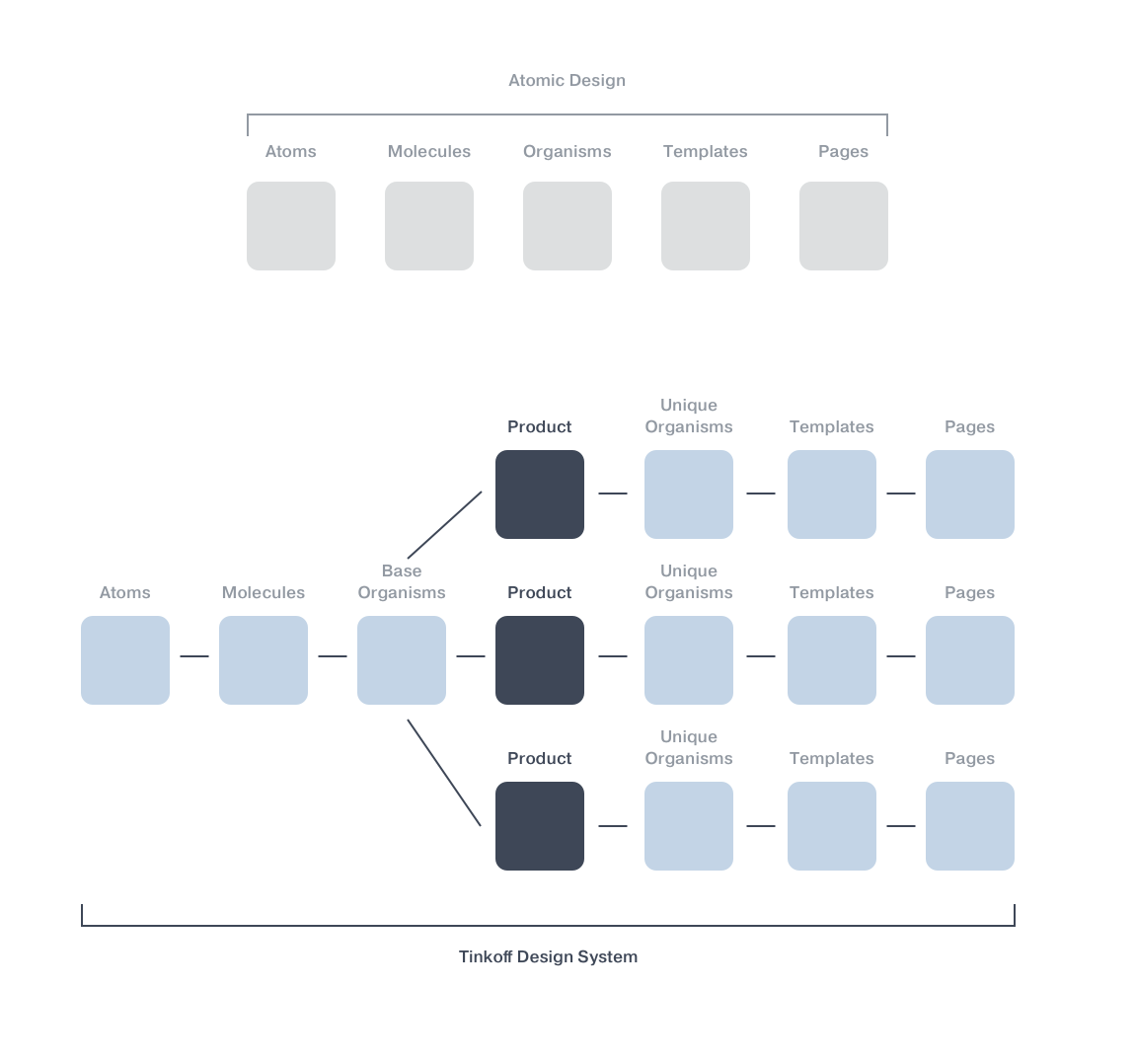

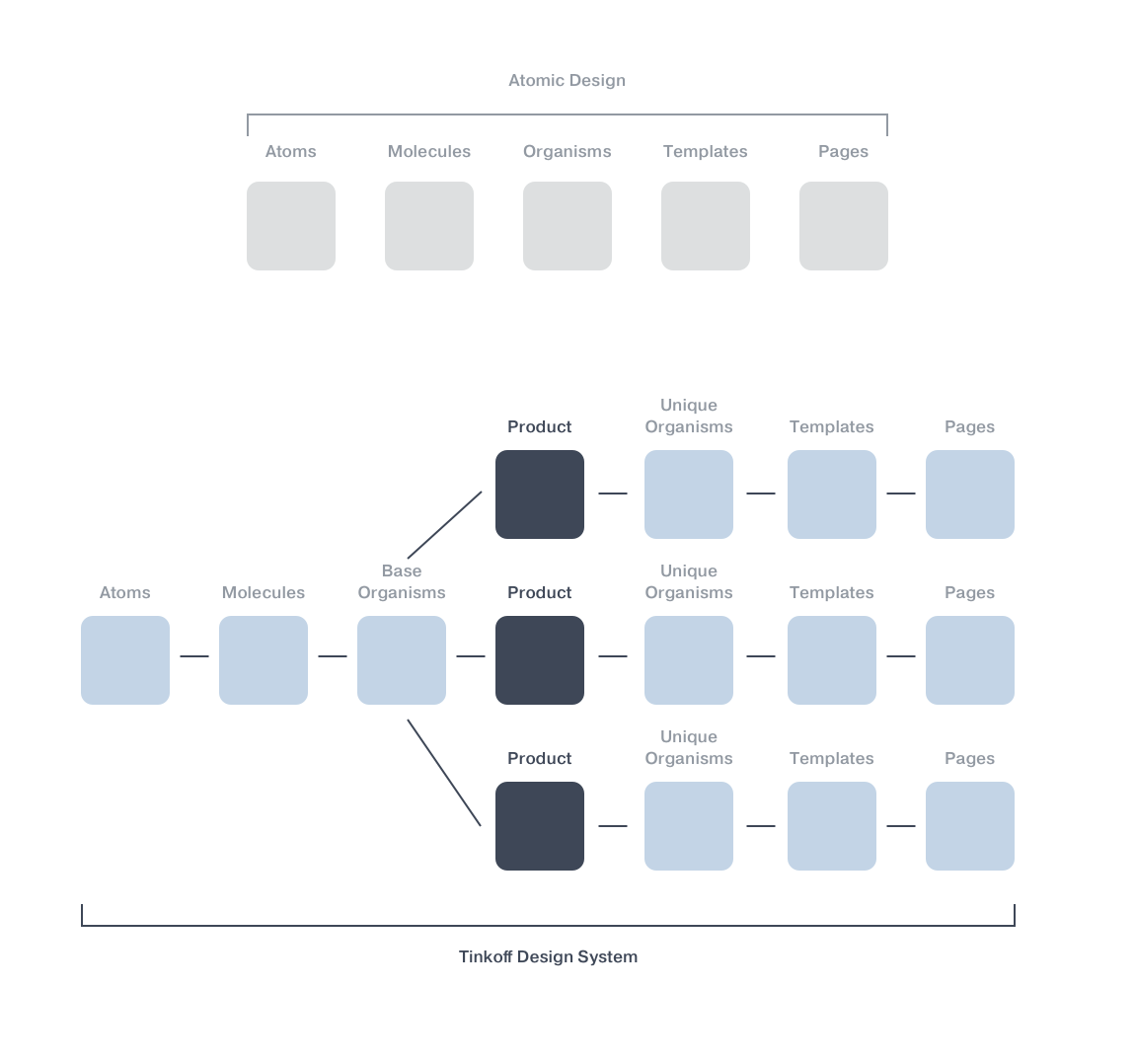

Очень важным моментом, на который сейчас обращают внимание далеко не все, является понимание разработки дизайном. Например, далеко не все дизайнеры знают, что такое компонент, что разработчикам может казаться удивительным. Но это факт! Пример общего подхода и к дизайну и к разработке – Tinkoff.ru, где в дизайне и в разработке используется методология atomic design, которая легка в понимании и хорошо соотносится с дизайном и разработкой UI Kit.

Все методологии, о которых я пишу, всего лишь вектор, в котором стоит начать думать или работать, но никак не ультимативное руководство к действию. Так поступили в Tinkoff.ru с atomic design: в методологии появляется новая сущность под названием «продукт».

Организация библиотеки компонентов

Шаг, который стоит под четвертым номером, но к которому стоит обратиться в разработке одновременно с третьим (разумеется, после «стола переговоров» с дизайном).

Перед вами так или иначе будет стоять выбор: создавать UI Kit как единую библиотеку или каждый компонент как отдельный npm-пакет. И, что бы вы ни выбрали, вас все равно ожидает ряд проблем.

Проблемы единой библиотеки:

- при изменении одного компонента публикуется вся библиотека;

- если нужен только один компонент, то приходит подтягивать всю библиотеку;

- зависимость от глобальных релизов;

- появление неявных зависимостей.

Проблемы компонентов как отдельных пакетов:

- появление расхождения в версиях дизайна разных компонентов;

- зависимости от других компонентов;

- сложности в публикации нескольких компонентов разом.

Я указала не все проблемы и не все возможные решения, поскольку каждая компания уникальна. Но многие из них можно решить версионированием или договоренностью о возможности делать Pull request-ы всем командам, как в OpenSource. Если вы выбрали подход, при котором каждый компонент это отдельный пакет, то я могу предложить отличный инструмент для работы с разными пакетами в одном монорепозитории – Lerna. Если вы с ним еще не знакомы, обязательно сходите по ссылке и изучите все возможности. Возможно, это инструмент может оказаться вам полезным не только в контексте создания UI Kit.

Проблема, которая вам, как разработчику, не понравится больше всего, – построение процесса работы с Kit-ом. Кто будет создавать и контролировать Kit? Будет ли это отдельная команда или мейнтейнеры из разных продуктовых команд? Здесь, как и в ситуации с организацией библиотеки, вне зависимости от выбора у вас будет ряд проблем.

Если создавать и контролировать будет единая команда Kit-a, то:

- создание кита происходит в отрыве от реальных продуктов;

- большой список продуктовых задач, который упирается в одну команду;

- постоянные вопросы: «Создается ли компонент, нужный только одной команде?», «Что происходит при конфликте требований разных продуктов?» и т.п.

Если мейнтейнеры из разных команд, то:

- рассинхронизируются общие подходы;

- случается перевес в сторону требований собственного продукта;

- возникают сложности в формирования единого соглашения.

Какой подход выбрать и с какими из проблем бороться, решать вам. Я могу предложить вам совместить эти два подхода и тем самым избежать большинства из указанных проблем. Если у вас будут мейнтейнеры компонентов в разных продуктах, то создание Kit-a не будет оторвано от актуальной разработки. Если плюсом к мейнтейнерам компонентов будет и отдельная команда Kit-а, которая будет отвечать за соблюдением соглашений и контроль качества, то и конфликтные ситуации можно будет решать через нее. И проблемы с процессами в дизайне в том числе.

Создание компонентов

Казалось бы, что на этом этапе не может возникнуть трудностей у специалистов, которые каждый день создают компоненты. Но существует множество проблем, вроде дублирования компонентов, неоправданно большого списка свойств компонентов, необходимости в разном функционале одного компонента в разных командах и прочего. Некоторых из них можно избежать, договорившись в самом начале о едином подходе за «столом переговоров» разработки и дизайна. А вот от использования разных технологий или отсутствия тестирования некоторых компонентов это не спасет. Поэтому до разработки самих компонентов, вне зависимости от того, кто будет создавать Kit (команда или ряд мейнтейнеров), нужно придти к единому соглашению о его создании.

Вот мои небольшие рекомендации к обсуждению соглашение:

- покрыть весь функционал;

- максимально глупые компоненты;

- Pure Component;

- масштабируемые компоненты;

- переиспользуемые компоненты;

- тесты;

- кастомизация;

- версионирование;

- технологии/подходы.

Рекомендую также ознакомиться с книгой «Design of everyday things». В ней рассказывается о дизайне вещей, с которым мы сталкиваемся каждый день, и почему нам сразу понятно, как ими пользоваться. Например, двери, стулья или чайники. Эта книга в действительности изменила мое мышление о вещах, которые меня окружают и которые я создаю. А создаем мы все (разработчики) программы, компоненты и их интерфейсы. Так вот, интерфейсы наших компонентов должны быть понятны нам в использовании так же, как чайник, с которым мы точно знаем, что делать.

Использование

В процессе использования UI Kit также то и дело возникают проблемы и вопросы, решение которых не всегда очевидно. Например, что делать, если появилась потребность в новом компоненте? Кто его будет рисовать и создавать? Как понять, какой мне нужен компонент и какие у него свойства, если я только пришел в компанию? Что делать если компонентов много? и т.д.