Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Опыт внедрения PSR стандартов в одном легаси проекте |

Опыт внедрения PSR стандартов в одном легаси проекте

Всем привет!

В этой статье я хочу рассказать о своем опыте переезда на “отвечающую современным трендам” платформу в одном legacy проекте.

Все началось примерно год назад, когда меня перекинули в “старый” (для меня новый) отдел.

До этого я работал с Symfony/Laravel. Перейдя на проект с самописным фреймворком количество WTF просто зашкаливало, но со временем все оказалось не так и плохо.

Во-первых, проект работал. Во-вторых, применение шаблонов проектирования прослеживалось: был свой контейнер зависимостей, ActiveRecord и QueryBuilder.

Плюс, был дополнительный уровень абстракции над контейнером, логгером, работе с очередями и зачатки сервисного слоя(бизнес логика не зависела от HTTP слоя, кое-где логика была вынесена из контроллеров).

Далее я опишу те вещи, с которыми трудно было мириться:

1. Логгер log4php

Сам по себе логгер работал и хорошо. Но были жирные минусы:

- Отсутствие интерфейса

- Сложность конфигурации для задач чуть менее стандартных (например, отправлять логи уровня error в ElastickSearch).

- Подавляющее большинство компонентов мира opensource зависят от интерфейса Psr\Log\LoggerInterface. В проекте все равно пришлось держать оба логгера.

2-6. Контроллеры были вида:

|

Метки: author Fantyk php slim |

Криптоалгоритмы. Классификация с точки зрения количества ключей |

|

Метки: author den_golub математика криптография информационная безопасность алгоритмы it- стандарты криптографические алгоритмы карманный справочник вместо конспекта |

На шаг ближе к С++20. Итоги встречи в Торонто |

На шаг ближе к С++20. Итоги встречи в Торонто

Главные новости:

- Расширению Concepts быть в C++20!

- Ranges, Networking и Coroutines/сопрограммы: выпущены в эксперимент в виде TS.

- Модули: черновик TS готов.

Что всё это значит, как это упростит написание кода и что было ещё — читайте под катом.

Concepts

Замечательная вещь под названием Concepts внесена в черновик будущего стандарта С++20. Это большая радость для разработчиков обобщенных библиотек, использующих идиому SFINAE.

- `*_fast` — сильно соптимизированы, но требуют, чтобы следующие операции возвращали T& и были валидны:

v += data; v -= data; v *= data; v /= data; - `*_slow` — медленные, но работают со всеми типами данных.

Задача — написать функции `*_optimal`, которые используют версию `*_fast`, если это возможно:

#include

template

void compute_vector_fast(Container& v, const Data& data) {

std::cout << "fast\n";

// ...

}

template

void compute_vector_slow(Container& v, const Data& data) {

std::cout << "slow\n";

// ...

}

template

void compute_vector_optimal(Container& v, const Data& data) {

// ??? call `compute_vector_slow(v, data)` or `compute_vector_fast(v, data)` ???

}

Без концептов эта задача, например, решается через `std::enable_if_t` и множество нечитаемого шаблонного кода.

С концептами всё намного проще:

#include

template

concept bool VectorOperations = requires(T& v, const Data& data) {

{ v += data } -> T&;

{ v -= data } -> T&;

{ v *= data } -> T&;

{ v /= data } -> T&;

};

template

requires VectorOperations

void compute_vector_optimal(Container& v, const Data& data) {

std::cout << "fast\n";

}

template

void compute_vector_optimal(Container& v, const Data& data) {

std::cout << "slow\n";

}

Концепты позволяют:

- писать более простой шаблонный код,

- выдавать более короткие сообщения об ошибках при использовании неверных шаблонных параметров (в теории, пока что это не так!).

С концептами уже можно поэкспериментировать в GCC, если использовать флаг -fconcepts, например, тут. Вот последний доступный proposal на Concepts.

Ranges TS

Ranges увидят свет в виде технической спецификации. Это значит, что поэкспериментировать с ними можно будет еще до C++20.

С Ranges можно писать `sort(container)` вместо `sort(container.begin(), container.end())`, нужно только заиспользовать нужный namespace.

А еще расширяются возможности стандартных алгоритмов. Например, можно искать быстрее, если мы точно знаем, что элемент содержится в контейнере:

#include

#include v2 = get_some_values_and_delimiter();

// Необходимо найти число 42 и отсортировать все элементы, идущие после него:

auto it = ranges::find(v.begin(), ranges::unreachable{}, 42);

ranges::sort(++it, v.end());

}

Нечто подобное Александреску делал для получения супербыстрого поиска.

Любителям SFINAE и обобщённых библиотек Ranges тоже принесут счастье, так как они определяют огромное количество концептов: Sortable, Movable, Copyable, DefaultConstructible, Same…

Можно поэкспериментировать, скачав библиотеку отсюда. Вот последний доступный черновик Ranges.

Networking TS

Все, что необходимо для работы с сокетами (в том числе для асинхронной работы), будет выпущено в эксперимент еще до C++20. В основе Networking TS лежит доработанный и улучшенный ASIO.

Вот пара приятных различий:

- В Networking TS можно передавать move-only callback. В ASIO для этого надо было на свой страх и риск поплясать с

бубноммакросом BOOST_ASIO_DISABLE_HANDLER_TYPE_REQUIREMENTS. Так что если у вас есть функциональный объект с unique_ptr, то его можно спокойно использовать для callback. - Больше constexpr для базовых типов (например, для ip::address).

- Вменяемые способы передачи аллокаторов: можно в класс-callback добавить allocator_type и метод allocator_type get_allocator(); можно специализировать шаблон associated_allocator и описать, какие методы класса надо дергать вместо get_allocator().

Можно поэкспериментировать, скачав библиотеку отсюда. Вот последний доступный черновик Networking.

Coroutines TS

Сопрограммы — это «возможность сохранить текущий стек, переключиться на другой стек и поработать там, а потом вернуться». В основном они используются для создания генераторов и асинхронной работы.

Самый смак получается, если смешать Coroutines TS и Networking TS. Тогда вместо асинхронного нечитабельного кода на +100 строк можно получить то же самое, но на 40 строк:

#include

#include

#include

#include Но вот плохие новости: такую интеграцию Coroutines TS и Networking TS в стандарт еще не привнесли. Пока что придется реализовывать ее самим.

С сопрограммами уже можно поэкспериментировать в CLANG-6.0, если использовать флаги -stdlib=libc++ -fcoroutines-ts, например, тут. Вот последний доступный черновик Coroutines.

Модули

Подготовлен черновик TS. Дело сдвинулось и есть шансы увидеть модули уже в течение года!

Однако, как правило, вы используете одни и те же заголовочные фалы в каждом файле cpp. За счет того, что компиляция различных файлов cpp никак не связана друг с другом, при каждой компиляции компилятор разбирает одни и те же заголовочные файлы снова и снова. Именно этот разбор и тормозит (заголовочный файл iostream весит более мегабайта, подключите 20 подобных заголовочных файлов — и компилятору придётся просмотреть и разобрать около 30 мегабайт кода при компиляции одного файла cpp).

И тут на сцену выходят модули! Модуль — это набор файлов, собранных воедино и сохранённых на диск в понятном для компилятора бинарном виде. Таким образом, при подключении модуля компилятор просто считает его с диска в свои внутренние структуры данных (минуя этапы открытия нескольких фалов, парсинга, препроцессинга и некоторых другие вспомогательные этапы).

Дополнительный прирост скорости при компиляции будет получен за счёт того, что в модуле вы явно указываете его публичный интерфейс. То есть компилятор сможет сделать ряд оптимизаций ещё при создании модуля. Это сильно уменьшит затраты оперативной памяти, ускорит поиск подходящих перегруженных функций, структур и т. д. за счёт того, что их попросту будет меньше.

И наконец, финальная стадия сборки проекта — линковка. В данный момент линковщик может тратить много времени на выкидывание одинаковых блоков скомпилированного кода (вы написали функцию inline/force_inline, 100 раз её использовали, а компилятор решил её не встраивать — линкер выкинет 99 скомпилированных тел вашей функции и оставит одно). С модулями такого происходить не должно, поскольку файл модуля не будет «вкомпиливаться» внутрь собранного файла cpp.

Модули в черновике не экспортируют макросы, поэтому будет сложновато использовать их для системных файлов с множеством макросов (``, я на тебя намекаю!) и поддерживать код, использующий модуль и его старый заголовочный файл (если у вас std::string описан в модуле и в заголовочном файле , то при подключении модуля и заголовочного файла будет multiple definitions, поскольку макрос для include guards не экспортируется из модуля). Это как раз такие модули, за которые вы проголосовали в прошлом посте (ваши голоса мы донесли до комитета).

Вот последний доступный черновик Modules.

Мелочи, принятые в C++20

В C++20 можно будет инициализировать bitfields в описании класса:

struct S {

unsigned x1:8 = 42;

unsigned x2:8 { 42 };

};

Можно будет понимать платформы endianness стандартными методами:

if constexpr (std::endian::native == std::endian::big) {

// big endian

} else if constexpr (std::endian::native == std::endian::little) {

// little endian

} else {

// mixed endian

}

Можно будет инициализировать поля структур, прям как в чистом C:

struct foo { int a; int b; int c; };

foo b{.a = 1, .b = 2};

У лямбд можно будет явно указывать шаблонные параметры:

auto bar = [](Args&&... args) {

return foo(std::forward(args)...);

};

Заслуги РГ21

На встречу в Торонто мы ездили с несколькими предложениями:

- P0652R0 — конкурентные ассоциативные контейнеры. Комитет хорошо встретил предложение, посоветовал провести эксперименты для улучшения ряда мест, посоветовал улучшения в интерфейсе. Начали работу над следующей версией предложения.

- P0539R1 — integers, размер (количество байт) которых задаётся на этапе компиляции. Возникли споры по поводу интерфейса (указывать шаблонным параметром биты, байты или машинные слова), так что в следующей итерации необходимо будет привести плюсы и минусы различных подходов.

- P0639R0 — наше предложение направить усилия в сторону разработки `constexpr_allocator` вместо `constexpr_string + constexpr_vector`. Встретили крайне благосклонно, проголосовали за. Следующие наши шаги — прорабатывать тему вместе с Давидом.

- P0415R0 — constexpr для std::complex. Предложение было одобрено и теперь находится в подгруппе LWG (вместе с предложением на constexpr для стандартных алгоритмов). Должно быть в скором времени смержено в черновик C++20.

Зачем вообще эти constexpr?В комитете С++ активно работают над идеями рефлексии и метаклассов. Обе эти идеи требуют хорошей поддержки constexpr-вычислений от стандартной библиотеки, так что предложения на добавление constexpr — это в основном задел на будущее, чтобы при принятии в стандарт рефлексии можно было использовать стандартные классы и функции.

Кроме того, ряду библиотек уже нужны constexpr-функции: [1], [2].

Вдобавок нас попросили представить комитету два предложения, непосредственно над написанием которых мы не работали:

- P0457R0 — starts_with и ends_with для строк. Комитет предложил сделать это в виде свободных функций. Один из присутствующих сказал, что у них в компании есть эти методы и их используют чаще, чем остальные алгоритмы вместе взятые. Все с нетерпение ждут новой версии proposal, уже со свободными функциями.

- P0458R0 — функция contains(key) member для классов [unordered_]map/set/multimap/multiset. Комитету идия пришлась по душе, почти отправили в LWG для внедрения в C++20.

На подходе

Обсуждали предложение по форматированию текста, и многим понравились предлагаемые возможности (вероятно, потому, что людям нравится Python):

fmt::format("The answer is {}", 42);Обсуждали ring_span, который по функциональности напоминает boost::circular_buffer, но не владеет элементами (является view над контейнером).

На подходе битовые операции. Когда их примут, правильным ответом на вопрос «Как подсчитать количество выставленых битов в переменной X?» на собеседованиях станет «std::popcount(X)».

Планы и прочее

РГ21 планирует в ближайшее время написать предложения на std::stacktrace (в качестве прототипа послужит Boost.Stacktrace), доработать предложение на std::shared_library и на экспорт символов из динамических библиотек.

Если у вас есть идеи для C++20, если вы нашли проблемы в C++17/14/11 либо просто хотите подстегнуть разработку той или иной фичи C++ — заходите на сайт рабочей группы stdcpp.ru. Добро пожаловать!

Есть желание помочь с написанием предложений и внести своё имя в историю? Мы подготовили мини-инструкцию по написанию предложений.

|

|

Запуск регулярных задач на кластере или как подружить Apache Spark и Oozie |

Запуск регулярных задач на кластере или как подружить Apache Spark и Oozie

Давно уже витала в воздухе необходимость реализовать запуск регулярных Spark задач через Oozie, но всё руки не доходили и вот наконец свершилось. В этой статье хочу описать весь процесс, возможно она упростит Вам жизнь.

Содержание

- Задача

- Оборудование и установленное ПО

- Написание Spark задачи

- Написание workflow.xml

- Написание coordinator.xml

- Размещение проекта на hdfs

- Запуск регулярного выполнения

- Заключение

Задача

Мы имеем следующую структуру на hdfs:

hdfs://hadoop/project-MD2/data

hdfs://hadoop/project-MD2/jobs

hdfs://hadoop/project-MD2/statusВ директория data ежедневно поступают данные и раскладываются по директориям в соответствие с датой. Например, данные за 31.12.2017 запишутся по следующему пути: hdfs://hadoop/project/data/2017/12/31/20171231.csv.gz.

Формат входных данных

- Разделитель строк: “\n”

- Разделитель столбцов: “;”

- Способ сжатия: gzip

- Количество столбцов: 5 (device_id; lag_A0; lag_A1; flow_1; flow_2)

- Заголовок в первой строке отсутствует

- Данные за предыдущие сутки гарантированно записывается в соответствующую директория в интервал времени с 00:00 до 03:00 следующих суток.

В директории jobs располагаются задачи, которые имеют непосредственное отношение к проекту. Нашу задачу мы также будем размещать в этом каталоге.

В директорию status должна сохраняться статистика по количеству пустых полей за каждый день в формате json. Например, для данных за 31.12.2017 должен будет появиться файл hdfs://hadoop/project-MD2/status/2017/12/31/part-*.json

Примет json файла:

{

"device_id_count_empty" : 0,

"lag_A0_count_empty" : 10,

"lag_A1_count_empty" : 0,

"flow_1_count_empty" : 37,

"flow_2_count_empty" : 100

}Оборудование и установленное ПО

В нашем распоряжение есть кластер из 10 машин, каждая из которых имеет 8-и ядерный процессор и оперативную память в размере 64 Гб. Общий объём жёстких дисков на всех машинах 100 Тб. Для запуска задач на кластере отведена очередь PROJECTS.

Установленное ПО:

- Apache Hadoop 2.7.3 (Hortonworks)

- Apache Spark 2.0.0

- Apache Oozie 4.2.0

- Scala 2.11.11

- Sbt 1.0.2

Написание Spark задачи

Создадим структуру проекта, это можно очень просто сделать в любой среде разработки, поддерживающей scala или из консоли, как показано ниже:

mkdir -p daily-statistic/project

echo "sbt.version = 1.0.2" > daily-statistic/project/build.properties

echo "" > daily-statistic/project/plugins.sbt

echo "" > daily-statistic/build.sbt

mkdir -p daily-statistic/src/main/scalaЗамечательно, теперь добавил плагин для сборки, для этого в файле daily-statistic/project/plugins.sbt добавляем следующую строку:

addSbtPlugin("com.eed3si9n" % "sbt-assembly" % "0.14.5")Добавил описание проекта, зависимости и особенности сборки в файл daily-statistic/build.sbt:

name := "daily-statistic"

version := "0.1"

scalaVersion := "2.11.11"

libraryDependencies ++= Seq(

"org.apache.spark" %% "spark-core" % "2.0.0" % "provided",

"org.apache.spark" %% "spark-sql" % "2.0.0" % "provided"

)

assemblyJarName in assembly := s"${name.value}-${version.value}.jar"Перейдём в директорию daily-statistic и выполнил команду sbt update, для обновления проекта и подтягивания зависимостей из репозитория.

Создаём Statistic.scala в директории src/main/scala/ru/daily

Код задачи:

package ru.daily

import org.apache.spark.sql.SparkSession

import org.apache.spark.sql.DataFrame

import org.apache.spark.sql.functions._

object Statistic extends App {

// инициализация

implicit lazy val spark: SparkSession = SparkSession.builder()

.appName("daily-statistic")

.getOrCreate()

import spark.implicits._

val workDir = args(0)

val datePart = args(1)

val saveDir = args(2)

try {

val date = read(s"$workDir/$datePart/*.csv.gz")

.select(

'_c0 as "device_id",

'_c1 as "lag_A0",

'_c2 as "lag_A1",

'_c3 as "flow_1",

'_c4 as "flow_2"

)

save(s"$saveDir/$datePart", agg(date))

} finally spark.stop()

// чтение исходных данных

def read(path: String)(implicit spark: SparkSession): DataFrame = {

val inputFormat = Map("header" -> "false", "sep" -> ";", "compression" -> "gzip")

spark.read

.options(inputFormat)

.csv(path)

}

// построение агрегата

def agg(data: DataFrame):DataFrame = data

.withColumn("device_id_empty", when('device_id.isNull, lit(1)).otherwise(0))

.withColumn("lag_A0_empty", when('lag_A0.isNull, lit(1)).otherwise(0))

.withColumn("lag_A1_empty", when('lag_A1.isNull, lit(1)).otherwise(0))

.withColumn("flow_1_empty", when('flow_1.isNull, lit(1)).otherwise(0))

.withColumn("flow_2_empty", when('flow_2.isNull, lit(1)).otherwise(0))

.agg(

sum('device_id_empty) as "device_id_count_empty",

sum('lag_A0_empty) as "lag_A0_count_empty",

sum('lag_A1_empty) as "lag_A1_count_empty",

sum('flow_1_empty) as "flow_1_count_empty",

sum('flow_2_empty) as "flow_2_count_empty"

)

// сохранение результата

def save(path: String, data: DataFrame): Unit = data.write.json(path)

} Собираем проект командой sbt assembly из директории daily-statistic. После успешного завершения сборки в директории daily-statistic/target/scala-2.11 появится пакет с задачей daily-statistic-0.1.jar.

Написание workflow.xml

Для запуска задачи через Oozie нужно описать конфигурацию запуска в файле workflow.xml. Ниже привожу пример для нашей задачи:

oozie.launcher.mapred.job.queue.name

${queue}

${jobTracker}

${nameNode}

yarn-client

project-md2-daily-statistic

ru.daily.Statistic

${nameNode}${jobDir}/lib/daily-statistic-0.1.jar

--queue ${queue}

--master yarn-client

--num-executors 5

--conf spark.executor.cores=8

--conf spark.executor.memory=10g

--conf spark.executor.extraJavaOptions=-XX:+UseG1GC

--conf spark.yarn.jars=*.jar

--conf spark.yarn.queue=${queue}

${nameNode}${dataDir}

${datePartition}

${nameNode}${saveDir}

Statistics job failed [${wf:errorMessage(wf:lastErrorNode())}]

В блоке global устанавливается очередь, для MapReduce задачи которая будет находить нашу задачи и запускать её.

В блоке action описывается действие, в нашем случае запуск spark задачи, и что нужно делать при завершении со статусом ОК или ERROR.

В блоке spark определяется окружение, конфигурируется задача и передаются аргументы. Конфигурация запуска задачи описывается в блоке spark-opts. Параметры можно посмотреть в официальной документации

Если задача завершается со статусом ERROR, то выполнение переходит в блок kill и выводится кратное сообщение об ошибки.

Параметры в фигурных скобках, например ${queue}, мы будем определять при запуске.

Написание coordinator.xml

Для организации регулярного запуска нам потребуется ещё coordinator.xml. Ниже приведу пример для нашей задачи:

${workflowPath}

datePartition

${coord:formatTime(coord:dateOffset(coord:nominalTime(), -1, 'DAY'), "yyyy/MM/dd")}

Здесь из интересного, параметры frequency, start, end, которые определяют частоту выполнения, дату и время начала выполнения задачи, дату и время окончания выполнения задачи соответственно.

В блоке workflow указывается путь к директории с файлом workflow.xml, который мы определим позднее при запуске.

В блоке configuration определяется значение свойства datePartition, которое в данном случае равно текущей дате в формате yyyy/MM/dd минус 1 день.

Размещение проекта на hdfs

Как уже было сказано ранее нашу задачу мы будем размещать в директории hdfs://hadoop/project-MD2/jobs:

hdfs://hadoop/project-MD2/jobs/daily-statistic/lib/daily-statistic-0.1.jar

hdfs://hadoop/project-MD2/jobs/daily-statistic/workflow.xml

hdfs://hadoop/project-MD2/jobs/daily-statistic/coordinator.xml

hdfs://hadoop/project-MD2/jobs/daily-statistic/sharelibЗдесь в принципе всё понятно без комментариев за исключением директории sharelib. В эту директорию мы положим все библиотеки, которые использовались в процессе создания зашей задачи. В нашем случае это все библиотеки Spark 2.0.0, который мы указывали в зависимостях проекта. Зачем это нужно? Дело в том, что в зависимостях проекта мы указали "provided". Это говорит системе сборки не нужно включать зависимости в проект, они будут предоставлены окружением запуска, но мир не стоит на месте, администраторы кластера могут обновить версию Spark. Наша задача может оказаться чувствительной к этому обновлению, поэтому для запуска будет использоваться набор библиотек из директории sharelib. Как это конфигурируется покажу ниже.

Запуск регулярного выполнения

И так сё готово к волнительному моменту запуска. Мы будем запускать задачу через консоль. При запуске нужно задать значения свойствам, которые мы использовали в xml файлах. Вынесем эти свойства в отдельный файл coord.properties:

# описание окружения

nameNode=hdfs://hadoop

jobTracker=hadoop.host.ru:8032

# путь к директории с файлом coordinator.xml

oozie.coord.application.path=/project-MD2/jobs/daily-statistic

# частота в минутах (раз в 24 часа)

frequency=1440

startTime=2017-09-01T07:00Z

endTime=2099-09-01T07:00Z

# путь к директории с файлом workflow.xml

workflowPath=/project-MD2/jobs/daily-statistic

# имя пользователя, от которого будет запускаться задача

mapreduce.job.user.name=username

user.name=username

# директория с данными и для сохранения результата

dataDir=/project-MD2/data

saveDir=/project-MD2/status

jobDir=/project-MD2/jobs/daily-statistic

# очередь для запуска задачи

queue=PROJECTS

# использовать библиотеке из указанной директории на hdfs вместо системных

oozie.libpath=/project-MD2/jobs/daily-statistic/sharelib

oozie.use.system.libpath=falseЗамечательно, тереть всё готово. Запускаем регулярное выполнение командой:

oozie job -oozie http://hadoop.host.ru:11000/oozie -config coord.properties -runПосле запуска в консоль выведется id задачи. Используя это id можно посмотреть информацию о статусе выполнения задачи:

oozie job -info {job_id}Остановить задачу:

oozie job -kill {job_id}Если Вы не знаете id задачи, то можно найти его, показав все регулярные задачи для вашего пользователя:

oozie jobs -jobtype coordinator -filter user={user_name}Заключение

Полечилось немного затянуто, но на мой взгляд лучше подробная инструкция чем квест-поиск по интернету. Надеюсь описанный опыт будет Вам полезен, спасибо за внимание!

|

Метки: author entony big data apache spark apache oozie |

Опционалы в Swift |

Опционалы в Swift

- Tutorial

Несмотря на некоторый опыт в мобильной разработке (в том числе с применением Swift), регулярно на почве свифтовых опционалов возникали ситуации, когда я знал что нужно делать, но не совсем внятно представлял, почему именно так. Приходилось отвлекаться и углубляться в документацию — количество "заметок на полях" пополнялось с удручающей периодичностью. В определенный момент они достигли критической массы, и я решил упорядочить их в едином исчерпывающем руководстве. Материал получился довольно объемным, поскольку предпринята попытка раскрыть тему максимально подробно. Статья будет полезна как начинающим Swift-разработчикам, так и матерым профессионалам из мира Objective-C — есть ненулевая вероятность, что и последние найдут для себя что-то новое. А если не найдут, то добавят свое новое в комментарии, и всем будет польза.

Что такое Optionals?

Optionals (опционалы) — это удобный механизм обработки ситуаций, когда значение переменной может отсутствовать. Значение будет использовано, только если оно есть.

Зачем нужны Optionals, когда есть проверка на nil?

Во-первых, проверка на равенство/неравенство nil применима только к nullable-типам и не применима к примитивным типам, структурам и перечислениям. Для обозначения отсутсвия значения у переменной примитивного типа приходится вводить спецзначения, такие как NSNotFound.

NSNotFound не только нужно рассматривать как спецзначение, но и следить, чтобы оно не входило в множество допустимых значений переменной. Ситуация усложняется еще и тем, что NSNotFound считается равным NSIntegerMax, т.е. может иметь разные значения для разных (32-bit/64-bit) платформ. Это значит, что NSNotFound нельзя напрямую записывать в файлы и архивы или использовать в Distributed Objects.

Соответственно, пользователь этой переменной должен учитывать, что спецзначения возможны. В Swift даже примитивный тип можно использовать в опциональном стиле, т.е явным образом указывать на то, что значения может не быть.

Во-вторых: явная опциональность проверяется на этапе компиляции, что снижает количество ошибок в runtime. Опциональную переменную в Swift нельзя использовать точно так же, как неопциональную (за исключением неявно извлекамых опционалов, подробности в разделе Implicit Unwrapping). Опционал нужно либо принудительно преобразовывать к обычному значению, либо использовать специальные преобразующие идиомы, такие как if let, guard let и ??. Опционалы в Swift реализуют не просто проверку, но целую парадигму опционального типа в теории типов.

В-третьих, опционалы синтаксически более лаконичны, чем проверки на nil, что особенно хорошо видно на цепочках опциональных вызовов — так называемый Optional Chaining.

Как это работает?

Опционал в Swift представляет из себя особый объект-контейнер, который может содержать в себе либо nil, либо объект конкретного типа, который указывается при объявлении этого контейнера. Эти два состояния обозначаются терминами None и Some соответственно. Если при создании опциональной переменной присваемое значение не указывать, то nil присваивается по умолчанию.

В документации значение по умолчанию в случае отсутсвия явного присвоения не упоминается, но сказано, что опционал represents either a wrapped value or nil, the absence of a value. Если опциональная переменная объявлена без явного присвоения (какое-либо Some не присваивалось), то логично следует, что неявно присваивается None — третьего "неинициализрованного" состояния у опционалов нет.

Опционал объявляется посредством комбинации имени типа и лексемы ?. Таким образом, запись Int? — это объявление контейнера, экземпляр которого может содержать внутри nil (состояние None Int) либо значение типа Int (состояние Some Int). Именно поэтому при преобразовании Int? в Int используетя термин unwrapping вместо cast, т.е. подчеркивается "контейнерная" суть опционала. Лексема nil в Swift обозначает состояние None, которое можно присвоить любому опционалу. Это логично приводит к невозможности присвоить nil (состояние None) переменной, которая не является опционалом.

По факту опционал представляет собой системное перечисление:

public enum Optional : ExpressibleByNilLiteral {

/// The absence of a value.

///

/// In code, the absence of a value is typically written using the `nil`

/// literal rather than the explicit `.none` enumeration case.

case none

/// The presence of a value, stored as `Wrapped`.

case some(Wrapped)

/// Creates an instance that stores the given value.

public init(_ some: Wrapped)

...

/// Creates an instance initialized with `nil`.

///

/// Do not call this initializer directly. It is used by the compiler

// when you initialize an `Optional` instance with a `nil` literal.

public init(nilLiteral: ())

...

} Перечисление Optional имеет два возможных состояния: .none и some(Wrapped). Запись Wrapped? обрабатывается препроцессором (Swift’s type system) и трансформируется в Optional, т.е. следующие записи эквивалентны:

var my_variable: Int?var my_variable: OptionalЛексема nil по факту обозначает Optional.none, т.е. следующие записи эквивалентны:

var my_variable: Int? = nilvar my_variable: Optional = Optional.none var my_variable = Optional.none Перечисление Optional имеет два конструктора. Первый конструктор init(_ some: Wrapped) принимает на вход значение соответсвующего типа, т.е. следующие записи эквивалентны:

var my_variable = Optional(42) // тип .some-значения Int опеределен неявноvar my_variable = Optional(42) // явное указание типа Int для наглядности var my_variable = Int?(42) // тип Int необходимо указать явноvar my_variable: Int? = 42 // тип Int необходимо указать явноvar my_variable = Optional.some(42) // тип Int опеределен неявноvar my_variable = Optional.some(42) // явное указание типа для наглядности Второй конструктор init(nilLiteral: ()) является реализацией протокола ExpressibleByNilLiteral

public protocol ExpressibleByNilLiteral {

/// Creates an instance initialized with `nil`.

public init(nilLiteral: ())

}и инициализирует опциональную переменную состоянием .none. Этот конструктор используется только компилятором. Согласно документации его нельзя вызывать напрямую, т.е следующие записи приведут к ошибкам компиляции:

var my_variable1 = Optional(nil) // ошибка компиляции

var my_variable2 = Optional.none(nil)// ошибка компиляции Вместо них следует использовать

var my_variable: Int? = nil // или var my_variable: Int? = Optional.noneили вообще не использовать явное присвоение

var my_variable: Int?поскольку nil будет присвоен по умолчанию.

Перечисление Optional также содержит свойство unsafelyUnwrapped, которое предоставляет доступ на чтение к .some-значению опционала:

public enum Optional : ExpressibleByNilLiteral {

...

/// The wrapped value of this instance, unwrapped without checking whether

/// the instance is `nil`.

public var unsafelyUnwrapped: Wrapped { get }

} Если опционал находится в состоянии .none, обращение к unsafelyUnwrapped приведет к серьезному сбою программы.

В режиме отладки debug build -Onone будет ошибка рантайма:

_fatal error: unsafelyUnwrapped of nil optional_В релизной сборке optimized build -O будет ошибка рантайма либо неопределенное поведение. Более безопасной операцией является Force Unwrapping (или Explicit Unwrapping) — принудительное извлечение .some-значения, обозначаемое лексемой !. Применение Force Unwrapping к опционалу в состоянии .none приведет к ошибке рантайма:

_fatal error: unexpectedly found nil while unwrapping an Optional value_let my_variable1 = Int?(42) // содержит 42, тип Optional Int

let my_value1A = my_variable1! // содержит 42, тип Int

let my_value1B = my_variable1.unsafelyUnwrapped // содержит 42, тип Int

let my_variable2 = Int?.none // содержит nil, тип Optional Int

let my_value2A = my_variable2! // ошибка рантайма

// ошибка рантайма в режиме -Onone, НЕОПРЕДЕЛЕННОЕ ПОВЕДЕНИЕ в режиме -O

let my_value2B = my_variable2.unsafelyUnwrappedИдиомы использования

Нет особого смысла использовать обычное перечисление с двумя состояниями. Вполне можно реализовать подобный механизм самостоятельно: создать enum c двумя состояниями и конструкторами для соответствующих значений, добавить какой-нибудь постфиксный оператор для Force Unwrapping (например, как это сделано здесь), добавить возможность сравнения с nil или вообще придумать "свой" nil и т.д. Опционалы должны быть интегрированы непосредственно в сам язык, чтобы их использование было естественным, не чужеродным. Разумеется, можно рассматривать такую интеграцию как "синтаксический сахар", однако языки высокого уровня для того и существуют, чтобы писать (и читать) код на них было легко и приятно. Использование опционалов в Swift подразумевает ряд идиом или особых языковых конструкций, которые помогают уменьшить количество ошибок и сделать код более лаконичным. К таким идиомам относятся Implicit Unwrapping, Optional Chaining, Nil-Coalescing и Optional Binding.

Implicit unwrapping

Безопасное использование Force Unwrapping подразумевает предварительную проверку на nil, например, в условии if:

// getOptionalResult() может вернуть nil

let my_variable: Int? = getOptionalResult() // тип Optional Int

if my_variable != nil {

// my_value получит .some-значение опционала из getOptionalResult()

let my_value = my_variable!

} else {

// ошибка рантайма

let my_value = my_variable!

}Иногда из структуры программы очевидным образом следует, что переменная технически является опционалом, но к моменту первого использования всегда находится в состоянии .some, т.е. не является nil. Для использования опционала в неопциональном контексте (например, передать его в функцию с параметром неопционального типа) приходится постоянно применять Force Unwrapping с предварительной проверкой, что скучно и утомительно. В этих случаях можно применить неявно извлекаемый опционал — Implicitly Unwrapped Optional. Неявно извлекамый опционал объявляется посредством комбинации имени типа и лексемы !:

let my_variable1: Int? = 42 // тип Optional Int

let my_variable2: Int! = 42 // тип Implicitly Unwrapped Optional Int

var my_variable3: Int! = 42 // тип Implicitly Unwrapped Optional Int

...

my_variable3 = nil // где-то непредвиденно присвоен nil

...

func sayHello(times:Int) {

for _ in 0...times {

print("Hello!")

}

}

sayHello(times: my_variable1!) // обязаны извлекать значение явно

sayHello(times: my_variable1) // ошибка компиляции

sayHello(times: my_variable2!) // можем, но не обязаны извлекать значение явно

sayHello(times: my_variable2) // неявное извлечение

sayHello(times: my_variable3) // ошибка рантаймаВ вызове sayHello(times: my_variable2) извлечение значения 42 из my_variable2 все равно осуществляется, только неявно. Использование неявно извлекаемых опционалов делает код более удобным для чтения — нет восклицательных знаков, которые отвлекают внимание (вероятно, читающего код будет беспокоить использование Force Unwrapping без предварительной проверки). На практике это скорее анти-паттерн, увеличивающий вероятность ошибки. Неявно извлекаемый опционал заставляет компилятор "закрыть глаза" на то, что опционал используется в неопциональном контексте. Ошибка, которая может быть выявлена во время компиляции (вызов sayHello(times: my_variable1)), проявится только в рантайме (вызов sayHello(times: my_variable3)). Явный код всегда лучше неявного. Логично предположить, что такое снижение безопасности кода требуется не только ради устранения восклицательных знаков, и это действительно так.

Неявно извлекаемые опционалы позволяют использовать self в конструкторе для иницализации свойств и при этом:

- не нарушать правил двухэтапной инициализации (в конструкторе все свойства должны быть инициализированы до обращения к

self) — иначе код просто не скомпилируется; - избежать излишней опциональности в свойстве, для которого она не требуется (по своему смыслу значение свойства не может отсутствовать).

Наглядный пример, где требуется использовать self в конструкторе для иницализации свойств, приведен в документации:

class Country {

let name: String

var capitalCity: City!

init(name: String, capitalName: String) {

self.name = name

self.capitalCity = City(name: capitalName, country: self)

}

}

class City {

let name: String

unowned let country: Country

init(name: String, country: Country) {

self.name = name

self.country = country

}

}

var country = Country(name: "Canada", capitalName: "Ottawa")

print("\(country.name)'s capital city is called \(country.capitalCity.name)")

// Prints "Canada's capital city is called Ottawa"В этом примере экземпляры классов Country и City должны иметь ссылки друга на друга к моменту завершения инициализации. У каждой страны обязательно должна быть столица и у каждой столицы обязательно должна быть страна. Эти связи не являются опциональными — они безусловны. В процессе инициализации объекта country необходимо инициализировать свойство capitalCity. Для инициализации capitalCity нужно создать экземпляр класса City. Конструктор City в качестве параметра требует соответствующий экземпляр Country, т.е. требует доступ к self. Сложность в том, что экземпляр Country на этот момент еще не до конца инициализирован, т.е. self использовать нельзя.

Эта задача имеет изящное решение: capitalCity объявляется мутабельным неявно извлекаемым опционалом. Как и любой мутабельный опционал, capitalCity по умолчанию инициализируется состоянием nil, т. е. к моменту вызова конструктора City все свойства объекта country уже инициализированы. Требования двухэтапной инициализации соблюдены, конструктор Country находится во второй фазе — можно передавать self в конструктор City. capitalCity является неявным опционалом, т.е. к нему можно обращаться в неопциональном контексте без добавления !.

Побочным эффектом использования неявно извлекаемого опционала является "встроенный" assert: если capitalCity по каким-либо причинам останется в состоянии nil, это приведет к ошибке рантайма и аварийному завершению работы программы.

Другим примером оправданного использования неявно извлекаемых опционалов могут послужить инструкции @IBOutlet: контекст их использования подразумевает, что переменной к моменту первого обращения автоматически будет присвоено .some-значение. Если это не так, то произойдет ошибка рантайма. Автоматическая генерация кода в Interface Builder создает свойства с @IBOutlet именно в виде неявных опционалов. Если такое поведение неприемлемо, свойство с @IBOutlet можно объявить в виде явного опционала и всегда обрабатывать .none-значения явным образом. Как правило, все же лучше сразу получить "падение", чем заниматься долгой отладкой в случае случайно отвязанного @IBOutlet-свойства.

Optional Chaining

Optional Chaining — это процесс последовательных вызовов по цепочке, где каждое из звеньев возвращает опционал. Процесс прерывается на первом опционале, находящемся в состоянии nil — в этом случае результатом всей цепочки вызовов также будет nil. Если все звенья цепочки находятся в состоянии .some, то результирующим значением будет опционал с результатом последнего вызова. Для формирования звеньев цепочки используется лексема ?, которая помещается сразу за вызовом, возвращающим опционал. Звеньями цепочки могут любые операции, которые возвращают опционал: обращение к локальной переменной (в качестве первого звена), вызовы свойств и методов, доступ по индексу.

Optional сhaining всегда работает последовательно слева направо. Каждому следующему звену передается .some-значение предыдущего звена, при этом результирующее значение цепочки всегда является опционалом, т.е. цепочка работает по следующим правилам:

- первое звено должно быть опционалом;

- после лексемы

?должно быть следующее звено; - если звено в состояни

.none, то цепочка прерывает процесс вызовов и возвращаетnil; - если звено в состояни

.some, то цепочка отдает.some-значение звена на вход следующему звену (если оно есть); - если результат последнего звена является опционалом, то цепочка возвращает этот опционал;

- если результат последнего звена не является опционалом, то цепочка возвращает этот результат, "завернутый" в опционал (результат вычислений присваивается

.some-значению возвращаемого опционала).

// цепочка из трех звеньев: первое звено — опционал `country.mainSeaport?`,

country.mainSeaport?.nearestVacantPier?.capacity

// ошибка компиляции, после `?` должно быть следующее звено

let mainSeaport = country.mainSeaport?

// цепочка вернет `nil` на первом звене

country = Country(name: "Mongolia")

let capacity = country.mainSeaport?.mainPier?.capacity

// цепочка вернет опционал — ближайший незанятый пирс в Хельсинки

country = Country(name: "Finland")

let nearestVacantPier = country.mainSeaport?.nearestVacantPier

// цепочка вернет опционал — количество свободных мест, даже если capacity

// является неопциональным значением

country = Country(name: "Finland")

let capacity = country.mainSeaport?.nearestVacantPier?.capacityВажно отличать цепочки опциональных вызовов от вложенных опционалов. Вложенный опционал образуется, когда .some-значением одного опционала является другой опционал:

let valueA = 42

let optionalValueA = Optional(valueA)

let doubleOptionalValueA = Optional(optionalValueA)

let tripleOptionalValueA = Optional(doubleOptionalValueA)

let tripleOptionalValueB: Int??? = 42 // три `?` означают тройную вложенность

let doubleOptionalValueB = tripleOptionalValueB!

let optionalValueB = doubleOptionalValueB!

let valueB = optionalValueB!

print("\(valueA)") // 42

print("\(optionalValueA)") // Optional(42)

print("\(doubleOptionalValueA)") // Optional(Optional(42))

print("\(tripleOptionalValueA)") // Optional(Optional(Optional(42)))

print("\(tripleOptionalValueB)") // Optional(Optional(Optional(42)))

print("\(doubleOptionalValueB)") // Optional(Optional(42))

print("\(optionalValueB)") // Optional(42)

print("\(valueB)") // 42Optional сhaining не увеличивает уровень вложенности возвращаемого опционала. Тем не менее, это не исключает ситуации, когда результирующим значением какого-либо звена является опционал с несколькими уровнями вложенности. В таких ситуациях для продолжения цепочки необходимо прописать ? в количестве, равном количеству уровней вложенности:

let optionalAppDelegate = UIApplication.shared.delegate

let doubleOptionalWindow = UIApplication.shared.delegate?.window

let optionalFrame = UIApplication.shared.delegate?.window??.frame // два '?'

print("\(optionalAppDelegate)") // Optional( ... )

print("\(doubleOptionalWindow)") // Optional(Optional( ... ))

print("\(optionalFrame)") // Optional( ... )Вообще говоря, необязательно, чтобы все уровни вложенности были "развернуты" с помощью лексемы ?.Часть из них можно заменить на принудительное извлечение !, что сократит количество "неявных" звеньев в цепочке. Отдельный вопрос, есть ли в этом смысл.

Цепочка UIApplication.shared.delegate?.window??.frame фактически состоит из четырех звеньев: UIApplication.shared.delegate?, .frame и два звена, объединенных в одном вызове .window??. Второе "двойное" звено представлено опционалом второго уровня вложенности.

Важной особенностью этого примера также является особый способ формирования двойного опционала, отличающийся от способа формирования doubleOptionalValue в предыдущем примере. UIApplication.shared.delegate!.window является опциональным свойством, в котором возвращается опционал. Опциональность свойства означает, что может отсутствовать само свойство, а не только .some-значение у опционала, возвращаемого из свойства. Опциональное свойство, также как и все прочие свойства, может возвращать любой тип, не только опциональный. Опциональность такого рода формируется в @objc-протоколах с помощью модификатора optional:

public protocol UIApplicationDelegate : NSObjectProtocol {

...

@available(iOS 5.0, * )

optional public var window: UIWindow? { get set } // модификатор optional

...

}В протоколах с опциональными свойствами и методами (иначе, опциональными требованиями) модификатор @objc указывается для каждого опционального требования и для самого протокола. На протокол UIApplicationDelegate из примера выше это требование не распространяется, т.к. он транслируется в Swift из системной библиотеки на Objective-C. Вызов нереализованного опционального требования у объекта, принимающего такой протокол, возвращает опционал соответствующего типа в состоянии .none. Вызов реализованного опционального требования возвращает опционал соответсвующего типа в состоянии .some. Таким образом, опциональные свойства и методы, в отличие от optional сhaining, увеличивают уровень вложенности возвращаемого опционала. Опциональный метод, как и свойство, "заворачивается" в опционал полностью — в .some-значение помещается метод целиком, а не только возращаемое значение:

@objc

public protocol myOptionalProtocol {

@objc

optional var my_variable: Int { get }

@objc

optional var my_optionalVariableA: Int? { get } // ошибка компиляции:

// модификатор @objc не применим к опционалу типа Int?, т.к. Int

// не является классом

@objc

optional var my_optionalVariableB: UIView? { get }

@objc

optional func my_func() -> Int

@objc

optional func my_optionalResultfuncA() -> Int? // ошибка компиляции:

// модификатор @objc не применим к опционалу типа Int?, т.к. Int

// не является классом

@objc

optional func my_optionalResultfuncB() -> UIView?

@objc

optional init(value: Int) // ошибка компиляции:

// модификатор optional не применим инициализаторам

}

@UIApplicationMain

class AppDelegate: UIResponder, UIApplicationDelegate, myOptionalProtocol {

var window: UIWindow?

func application(_ application: UIApplication,

didFinishLaunchingWithOptions launchOptions:

[UIApplicationLaunchOptionsKey: Any]?) -> Bool {

let protocolAdoption = self as myOptionalProtocol

// Optional

print("\(type(of: protocolAdoption.my_variable))")

// Optional>

print("\(type(of: protocolAdoption.my_optionalVariableB))")

// Optional<() -> Int>

print("\(type(of: protocolAdoption.my_func))")

// Optional

print("\(type(of: protocolAdoption.my_func?()))")

// Optional<() -> Optional>

print("\(type(of: protocolAdoption.my_optionalResultfuncB))")

// Optional

print("\(type(of: protocolAdoption.my_optionalResultfuncB?()))")

return true

}

} Для опциональных @objc-протоколов имеется ряд ограничений, в виду того, что они были введены в Swift специально для взаимодействия с кодом на Objective-C:

- могут быть реализованы только в классах, унаследованных от классов Objective-C, либо других классов с аттрибутом

@objc(т.е. не могут быть реализованы в структурах и перечислениях); - модификатор

optionalнеприменим к требованиям-конструкторамinit; - cвойства и методы с аттрибутом

@objcимеют ограничение на тип возвращаемого опционала — допускаются только классы.

Попытка применить Force Unwrapping на нереализованном свойстве или методе приведет к точно такой же ошибке рантайма, как и применение Force Unwrapping на любом другом опционале в состоянии .none.

Nil-Coalescing

Оператор Nil-Coalescing возвращает .some-значение опционала, если опционал в состоянии .some, и значение по умолчанию, если опционал в состоянии .none. Обычно Nil-Coalescing более лаконичен, чем условие if else, и легче воспринимается, чем тернарный условный оператор ?:

let optionalText: String? = tryExtractText()

// многословно

let textA: String

if optionalText != nil {

textA = optionalText!

} else {

textA = "Extraction Error!"

}

// в одну строку, но заставляет думать

let textB = (optionalText != nil) ? optionalText! : "Extraction Error!"

// кратко и легко воспринимать

let textC = optionalText ?? "Extraction Error!"Тип значения по умолчания справа должен соответствовать типу .some-значения опционала слева. Значение по умолчанию тоже может быть опционалом:

let optionalText: String?? = tryExtractOptionalText()

let a = optionalText ?? Optional("Extraction Error!")Возможность использовать выражения в качестве правого операнда позволяет создавать цепочки из умолчаний:

let wayA: Int? = doSomething()

let wayB: Int? = doNothing()

let defaultWay: Int = ignoreEverything()

let whatDo = wayA ?? wayB ?? defaultWayOptional Binding и приведение типов

Optional Binding позволяет проверить, содержит ли опционал .some-значение, и если содержит, извлечь его и предоставить к нему доступ через с помощью локальной переменной (обычно константной). Optional Binding работает в контексте конструкций if, while и guard.

В официальной документации детали реализации Optional Binding не описаны, но можно построить модель, хорошо описывающую поведение этого механизма.

В Swift каждый метод или функция без явно заданного return неявно возвращает пустой кортеж (). Оператор присваивания = является исключением и не возвращает значение, тем самым позволяя избежать случайного присвоения вместо сравнения ==.

Допустим, что оператор присваивания также обычно возвращает пустой кортеж, но если правый операнд является опционалом в состоянии nil, то оператор присваивания вернет nil. Тогда эту особенность можно будет использовать в условии if, так как пустой кортеж расценивается как true, а nil расценивается как false:

var my_optionalVariable: Int? = 42

// условие истинно, my_variable "привязана" к .some-значению my_optionalVariable

if let my_variable = my_optionalVariable {

print("\(my_variable)") // 42

}

my_optionalVariable = nil

// условие ложно, my_variable не создана

if let my_variable = my_optionalVariable {

print("\(my_variable)")

} else {

print("Optional variable is nil!") // Optional variable is nil!

}Переменную, сформированную в контексте ветки true, можно будет автоматически объявить неявно извлекаемым опционалом или даже обычной переменной. Не-nil как результат операции присвоения будет являться следствием .some-состояния правого операнда. В ветке true .some-значение всегда будет успешно извлечено и "привязано" к новой переменной (поэтому механизм в целом и называется Optional Binding).

Область видимости извлеченной переменной в условии if ограничивается веткой true, что логично, поскольку в ветке false такая переменная не может быть извлечена. Тем не менее, существуют ситуации, когда нужно расширить область видимости извлеченного .some-значения, а в ветке false (опционал в состоянии .none) завершить работу функции. В таких ситуациях удобно воспользоваться условием guard:

let my_optionalVariable: Int? = extractOptionalValue()

// чересчур многословно

let my_variableA: Int

if let value = my_optionalVariable {

my_variableA = value

} else {

return

}

print(my_variableA + 1)

// лаконично

guard let my_variableB = my_optionalVariable else {

return

}

print(my_variableB + 1)В Swift гарантированное компилятором приведение типов (например, повышающее приведение или указание типа литерала) выполняется с помощью оператора as. В случаях, когда компилятор не может гарантировать успешное приведение типа (например, понижающее приведение), используется либо оператор принудительного приведения as!, либо оператор опционального приведения as?. Принудительное приведение работает в стиле Force Unwrapping, т.е. в случае невозможности выполнить приведение приведет к ошибке рантайма, в то время как опциональное приведение в этом случае вернет nil:

class Shape {}

class Circle: Shape {}

class Triangle: Shape {}

let circle = Circle()

let circleShape: Shape = Circle()

let triangleShape: Shape = Triangle()

circle as Shape // гарантированное приведение

42 as Float // гарантированное приведение

circleShape as Circle // ошибка компиляции

circleShape as! Circle // circle

triangleShape as! Circle // ошибка рантайма

circleShape as? Circle // Optional

triangleShape as? Circle // nil Таким образом, оператор опционального приведения as? порождает опционал, который часто используется в связке с Optional Binding:

class Shape {}

class Circle: Shape {}

class Triangle: Shape {}

let circleShape: Shape = Circle()

let triangleShape: Shape = Triangle()

// условие истинно, успешное приведение

if let circle = circleShape as? Circle {

print("Cast success: \(type(of: circle))") // Cast success: (Circle #1)

} else {

print("Cast failure")

}

// условие ложно, приведение не удалось

if let circle = triangleShape as? Circle {

print("Cast success: \(type(of: circle))")

} else {

print("Cast failure") // Cast failure

}map и flatMap

Методы map и flatMap условно можно отнести к идиомам Swift, потому что они определены в системном перечислении Optional:

public enum Optional : ExpressibleByNilLiteral {

...

/// Evaluates the given closure when this `Optional` instance is not `nil`,

/// passing the unwrapped value as a parameter.

///

/// Use the `map` method with a closure that returns a nonoptional value.

public func map(_ transform: (Wrapped) throws -> U) rethrows -> U?

/// Evaluates the given closure when this `Optional` instance is not `nil`,

/// passing the unwrapped value as a parameter.

///

/// Use the `flatMap` method with a closure that returns an optional value.

public func flatMap(_ transform: (Wrapped) throws -> U?) rethrows -> U?

...

} Данные методы позволяют осуществлять проверку опционала на наличие .some-значения и обрабатывать это значение в замыкании, полученном в виде параметра. Оба метода возвращают nil, если исходный опционал nil. Разница между map и flatmap заключается в возможностях замыкания-параметра: для flatMap замыкание может дополнительно возвращать nil (опционал), а для map замыкание всегда возвращает обычное значение:

let my_variable: Int? = 4

let my_squareVariable = my_variable.map { v in

return v * v

}

print("\(my_squareVariable)") // Optional(16)

let my_reciprocalVariable: Double? = my_variable.flatMap { v in

if v == 0 {

return nil

}

return 1.0 / Double(v)

}

print("\(my_reciprocalVariable)") // Optional(0.25)Выражения с map и flatmap обычно более лаконичны, чем конструкции с предварительной проверкой в if или guard, и воспринимаются легче, чем конструкции с тернарным условным оператором:

let dateFormatter = DateFormatter()

dateFormatter.dateFormat = "dd MMM yyyy"

let date: Date? = extractOptionalDate()

// многословно

let dateStringA: String

if date != nil {

dateStringA = dateFormatter.string(from: date!)

} else {

dateStringA = "Unknown date"

}

// в одну строку, но сложно воспринимать

let dateStringB =

(date == nil ? nil : dateFormatter.string(from: date!)) ?? "Unknown date"

// лаконично, с непривычки сложно воспринимать (если map используется редко)

let dateStringC = date.map(dateFormatter.string) ?? "Unknown date"Уместность той или иной идиомы во многом зависит от договоренностей по стилю кодирования, принятых на проекте. Вполне возможно, что явные проверка опционала и работа с извлеченным .some-значением будут выглядеть естественнее, чем применение map или flatmap:

// отдельно Optional Binding и явный вызов метода у извлеченного объекта

func prepareForSegue(segue: UIStoryboardSegue, sender: AnyObject?) {

if let cell = sender as? UITableViewCell,

let indexPath = tableView.indexPathForCell(cell) {

let item = items[indexPath.row]

}

}

// В одном вызове 3 этапа:

// 1) опционал как результат приведения типов;

// 2) передача неявного замыкания в метод flatMap полученного опционала;

// 3) Optional Binding к результату flatMap.

func prepareForSegue(segue: UIStoryboardSegue, sender: AnyObject?) {

if let indexPath =

(sender as? UITableViewCell).flatMap(tableView.indexPathForCell) {

let item = items[indexPath.row]

}

}Опционалы и обработка исключений

Swift поддерживает несколько способов обработки исключений, и один из них — это преобразование исключения в nil. Такое преобразование можно осуществить автоматически с помощью оператора try? (примеры из документации):

func someThrowingFunction() throws -> Int {

// ...

}

// многословно

let y: Int?

do {

y = try someThrowingFunction()

} catch {

y = nil

}

// лаконично

let x = try? someThrowingFunction()Обе переменные x и y являются опциональными, независимо от того, какой тип возвращает someThrowingFunction(). Таким образом, семантика поведения оператора try? такая же, как и у оператора as?. Логично также наличие оператора try!, который позволяет проигнорировать возможность выброса исключения из функции. Если исключение все же будет выброшено, то произойдет ошибка рантайма:

// ошибка рантайма, если loadImage будет выброшено исключение

// photo не является опционалом (в отличие от x и y)

let photo = try! loadImage(atPath: "./Resources/John Appleseed.jpg")Опционалы и Objective-C

В Objective-C нет понятия опциональности. Лексема nil в Objective-C обозначает нулевой указатель, т.е. обращение к любой переменной ссылочного типа потенциально может вернуть nil. В Swift nil обозначает опционал в состоянии .none, неопциональная переменная не может быть nil, поэтому до Xcode 6.3 любой указатель из Objective-C транслировался в Swift как неявно извлекаемый опционал. В Xcode 6.3 в Objective-C для совместимости с семантикой опционалов были введены так называемые nullability annotations:

@interface myObject : NSObject

@property (copy, readonly) NSArray * _Nullable myValuesA;

@property (copy, readonly) NSString * _Nonnull myStringA;

@property (copy, readonly, nullable) NSArray * myValuesB;

@property (copy, readonly, nonnull) NSString * myStringB;

@endК ним относятся nullable (или _Nullable), nonnull (или _Nonnull), а также null_unspecified и null_resettable. Nullability-aннотациями могут быть обозначены ссылочные типы в свойствах, а также в параметрах и результатах функций. Помимо отдельных аннотаций можно использовать специальные макросы NS_ASSUME_NONNULL_BEGIN и NS_ASSUME_NONNULL_END для пометки участков кода целиком. Аннотации не являются полноценными модификаторами указателей или аттрибутами свойств, поскольку не влияют на компиляцию кода на Objective-C (если не считать предупреждений компиляции, например, при попытке присвоить nil свойству с аннотацией nonnull).

Аннотация null_resettable подразумевает, что сеттер свойства может принимать nil, но при этом геттер свойства вместо nil возвращает некоторое значение по умолчанию.

Трансляция из Objective-C в Swift осуществлятся по следующим правилам:

- значения из области между

NS_ASSUME_NONNULL_BEGINиNS_ASSUME_NONNULL_ENDимпортируются в виде неопциональных (обычных) значений; - значения с аннотациями

nonnullили_Nonnullимпортируются в виде неопциональных (обычных) значений; - значения с аннотациями

nullableили_Nullableимпортируются в виде опционалов; - значения с аннотацией

null_resettableимпортируются в виде неявно извлекаемых опционалов; - значения без nullability-aннотаций или аннотацией

null_unspecified(аннотация по умолчанию) импортируются в виде неявно извлекаемых опционалов.

Правила передачи опционалов из Swift в Objective-C несколько проще:

- если опционал в состоянии

.none, то возвращается экземпляр NSNull; - если опционал в состоянии

.some, то возвращается указатель на.some-значение.

Резюме, синтаксис

Лексема ! может быть использована в четырех контекстах, связанных с опциональностью:

- для принудительного извлечения значения из опционала;

- для объявления неявного опционала;

- для принудительной конвертации типов в операторе

as!; - для принудительного подавления исключения в операторе

try!.

Унарный оператор логического отрицания ! не считается, поскольку относится к другому контексту.

Лексема ? может быть использована в четырех контекстах, связанных с опциональностью:

- для объявления явного опционала;

- для использования опционала в optional chaining;

- для опциональной конвертации типов в операторе

as?; - для преобразования исключения в

nilв оператореtry?.

Тернарный условный оператор ? не считается, поскольку относится к другому контексту.

Лексема ?? может быть использована в двух контекстах:

- в Optional сhaining для обращения к опционалу второго уровня вложенности;

- в качестве оператора Nil-Coalescing.

Заключение

Нулевой указатель — это ошибка на миллиард долларов. Вызывающая сторона все равно должна учитывать контекст и проверять результат на равенство специфичной константе, означающее отсутствие данных. Тот факт, что константа null всего одна, принципиально ситуацию не меняет и лишь добавляет неожиданностей при приведении типов.

Факт отсутствия данных должен обрабатываться отдельной сущностью, внешней по отношению к самим данным. В С++ или Java в область допустимых значений указателя включено специальный "адрес", обозначающий отсутствие адресата. "Правильный" указатель не может существовать без адресата, следовательно, не может "осознать" отсутствие адресата. Даже человеку, т.е. довольно сложной системе, приходится довольстоваться аксиомой Cogito, ergo sum (лат. — "Мыслю, следовательно существую"). У человека нет достоверных признаков собственного бытия или небытия, но у внешних по отношению к человеку сущностей эти критерии есть. В Swift такой внешней сущностью является опционал.

Дополнительные материалы

- Generic Enumeration: Optional (developer.apple.com)

- Instance Property: unsafelyUnwrapped (developer.apple.com)

- Swift Language Guide: Optionals (developer.apple.com)

- Unowned References and Implicitly Unwrapped Optional Properties (developer.apple.com)

- Nil-Coalescing Operator (developer.apple.com)

- Optional Chaining (developer.apple.com)

- Optional Protocol Requirements (developer.apple.com)

- The as! Operator (developer.apple.com)

- Converting Errors to Optional Values (developer.apple.com)

- Nullability and Objective-C (developer.apple.com)

- Nullability and Optionals (developer.apple.com)

- Xcode 6.3 Release Notes: Objective-C Language Enhancements (developer.apple.com)

- Option type (en.wikipedia.org)

- Nullable type (en.wikipedia.org)

- Re-implementing Optionals using Swift’s powerful enum type (jamesonquave.com)

|

Метки: author IFITOWS разработка под ios разработка мобильных приложений программирование swift разработка |

[Из песочницы] Micromaster's degree как новая форма образования. Краткий обзор первого пилота программы |

Micromaster's degree как новая форма образования. Краткий обзор первого пилота программы

Micromaster's degree как новая форма образования. Краткий обзор первого пилота программы.

В данной статье освещено понятие micromaster's degree – нового направления в онлайн образовании. Цель статьи – ознакомить читателя с общей информацией о данном феномене и указать на новые возможности в образовании, которые он открывает.

Массачусетский технологический институт

Отступительное слово

Онлайн образование ни для кого уже не новость. Само направление существует на рынке услуг около 20 лет, но на этап экспоненциального роста было выведено относительно недавно, а точнее в 2011 году, после запуска курса в так называемом формате MOOC – massive open online courses (массовые открытые онлайн-курсы) Стэндфордским университетом, на который записалось около 160 тысяч человек. С тех пор возникло несколько больших агрегаторов, на которых сконцентрированы курсы от различных образовательных организаций, позволяющие освоить тот или иной материал. Среди них можно выделить две полярные группы: с более академическим уклоном (coursera, edx), или значительной долей неформальных направлений (udacity, udemy). При этом платформы с академическим уклоном, являющие собой следующий виток эволюции дистанционного обучения, продолжительное время работали по модели бесплатного образования с платными сертификатами, а на edx до 2016 года даже был фейл с тем, что на ряду с платными сертификатами выдавали бесплатные, которые, за редкими исключениями, не уступали в полезности платным, (и те и те, по большому счету, не давали никаких преимуществ своим обладателям). В желании монетизировать такие курсы, платным сертификатам начали присваивать новую ценность, сначала в виде дополнительного контента, далее в виде возможности закрыть несколько кредитов будучи студентом кампуса пройдя онлайн-курс. Идея с зачислением результатов прохождения MOOC по дисциплине вместо традиционного офлайн обучения в итоге выросла в создание первых серий курсов, которые могут официально заменить целый семестр обучения на магистратуре и по завершению дают право продолжить образование в кампусе и получить классический диплом. Пионером выступил MIT с циклом курсов Supply Chain Management, развернутом на платформе edx. Они же и ввели понятие Micromaster’s degree, о прелестях которого пойдёт речь дальше.

Что такое Micromaster’s degree?

Это серия из онлайн-курсов связанных единой сферой применения, которые направлены на изучение определённого объема материала, имеют сравнительно высокое признание в отрасли, результаты которого эквивалентны 25-50% кредитам необходимым для получения степени магистра и дают право продолжить обучение в кампусе в рамках образовательной программы, частью которой они являются. Так, программа Supply Chain Management состоит из 5 MOOC, длительностью 10 недель каждый и финального экзамена. На прохождение одной недели тратиться от 4 до 12 часов, и еще 4 часа отводиться на финальный экзамен. Таким образом прохождение данной программы в спокойном темпе длиться около года, из которых на занятия суммарно тратиться около 400 часов времени.

Что даёт Micromaster’s degree?

Выгоды данной программы рационально рассматривать на всё том же примере Supply Chain Management Micromaster’s degree, первый в мире выпуск которой состоялся в августе 2017 года. Всего на все курсы цикла зарегистрировалось более 180 000 человек, однако до конца дошли далеко не все – сертификаты micromasters получили только 622 человек (из 1100 сдававших финальный экзамен). Данные сертификаты действуют 3 года с момента получения и с точки зрения академического потенциала позволяют своим обладателям следующее:

1) засчитать часть кредитов по таким программам, как:

- Rochester Institute of Technology Master’s Program in Professional Studies (USA);

- University of Queensland Master of Business (Australia);

- Curtin University Master of Supply Chain Management and the Master of Commerce (Supply Chain Management) (Australia)

2) подать свою кандидатуру на продолжение обучения в кампусе, с зачислением результатов micromasters как одного семестра обучения и фактическим стартом во втором семестре по таким программам как:

- MIT’s SCM Blended Master's Program — Online and On Campus (USA);

- MIT Zaragoza Blended Master of Engineering in Logistics and Supply Chain Management (ZLOG), Zaragoza Logistics Center (Spain).

Самые главные преимущества могут ощутить те, кто выбрал для себя второй вариант. Их, по большому счету, два:

- Упрощенная схема подачи документов на поступление, исключающая необходимость предоставления результатов GRE/GMAT;

- Значительное сокращение времени обучения в кампусе (на 50%), и самое главное – огромная разница в цене в пользу студента.

Так, полная стоимость аналогичной программы в кампусе MIT для 2017-2018 года официально оценивается в 102 012 долларов США, тогда как программа на базе онлайн курсов обойдется студенту в 58 059 долларов США. Менее выгодно данное сравнение выглядит для варианта с обучением в испанском филиале MIT Global Scale Network – Сарагоском Логистическом Центре, стоимость полной программы в кампусе для которого неофициально оценивается в 37 000 евро, тогда как программа на базе онлайн курсов обойдется студенту в 25 000 евро. Однако стоит отметить, что в случае с обучением в Сарагосе, первых три недели студент всё же проведет в США, поэтому второй семестр данной программы выходит значительно дороже, чем первый и в данном случае достигается не такой высокий процент экономии, как в случае с обучением в MIT. Стоимость онлайн-курсов оплачивается отдельно по мере их прохождения, и составляет 150 долларов за каждый курс, плюс 600 долларов за экзамен, то есть 1350 долларов в сумме. Предполагается, что если студент работает в отрасли и может доказать применимость результатов в деятельности, то его курсы может оплатить работодатель. Практика показывает, что так и происходит.

PLaza logistics park – место дислокации Zaragoza Logistics Center

Почему это так важно?

В то время как стоимость гибридных программ обучения на базе MOOCs остается неприемлемо большой для многих потенциальных студентов, Micromaster’s degree является значительным шагом вперед в образовании, с точки зрения его доступности и качества. Необходимость зачисления результатов прохождения онлайн-курсов наравне с программой в кампусе требует от их создателей максимальной взаимозаменяемости, а значит уравнивает их образовательную ценность. В то же время такие курсы постепенно получат признание от большего количества работодателей, а значит могут стать весомым конкурентным преимуществом на рынке труда. На сегодняшний день в рамках платформы edx доступно более 30 программ «микромастера», в сферах IT, менеджмента, робототехники, бизнеса, биоинформатики и прочих. Выпускников, имеющих сертификат micromaster, готовы принять к себе на обучение в рамках гибридных программ такие университеты как: Массачусетский Технологический Институт, Беркли, Рочестерский Институт Технологий, Колумбийский Университет, Гонконгский политехнический институт, Лёвенский Католический Университет (Бельгия), Дельфтский Технологический Университет (Нидерланды), и многие другие.

Платформа edx

Итог

Первый набор на гибридные программы по управлению цепями поставок в Массачусетском Технологическом Институте и Сарагосском Логистическом Центре уже завершен, и около 40 человек получивших свой Micromaster’s degree продолжат обучение в кампусах уже с 4 января 2018 года. Окончательное мнение о подобных программах удастся сложить уже в ближайшие 2-5 лет, когда их выпускники закончат обучение и какое-то время поработают в отрасли. В ближайшие годы также стоит ожидать рост доступности гибридных программ, с появлением возможностей частично или полностью компенсировать стоимость такого обучения посредством стипендий и грантов.

|

Метки: author reedrefucher образование за рубежом учебный процесс в it образование онлайн mit mitx edx |

V8 под капотом |

V8 под капотом

Материал подготовлен на основе доклада автора на конференции HolyJS 2017, которая проходила в Санкт-Петербурге 2-3 июня. Презентацию в pdf можно найти по этой ссылке.

Несколько месяцев назад вышел фильм «Последний убийца драконов». Там, если протагонист убивает дракона, то в мире исчезает магия. Я хочу сегодня выступить протагонистом, я хочу убить дракона, потому что в мире JavaScript нет места для магии. Все, что работает, работает явно. Мы должны разобраться, как оно устроено, чтобы понимать, как оно работает.

Я хочу поделиться с вами своей страстью. В какой-то момент времени я осознал, что плохо знаю, как устроен под капотом V8. Я начал читать литературу, смотреть доклады, которые в основном на английском, накопил знания, систематизировал и хочу их довести до вас.

Интерпретируемый или компилируемый у нас язык?

Я надеюсь, все знают отличие, но повторю. Компилируемые языки: в них исходный код преобразуется компилятором в машинный код и записывается в файл. В них используется компиляция до выполнения. В чем преимущество? Его не нужно повторно компилировать, он максимально автоматизирован для той системы, под которую скомпилирован. В чем недостаток? Если у вас меняется операционная система, и если у вас нет исходников, вы теряете программу.

Интерпретируемые языки – когда исходный код исполняется программой-интерпретатором. Преимущества в том, что легко достичь кроссплатформенности. Мы поставляем наш исходный код как есть, и если в этой системе есть интерпретатор, то код будет работать. Язык JavaScript, конечно, интерпретируемый.

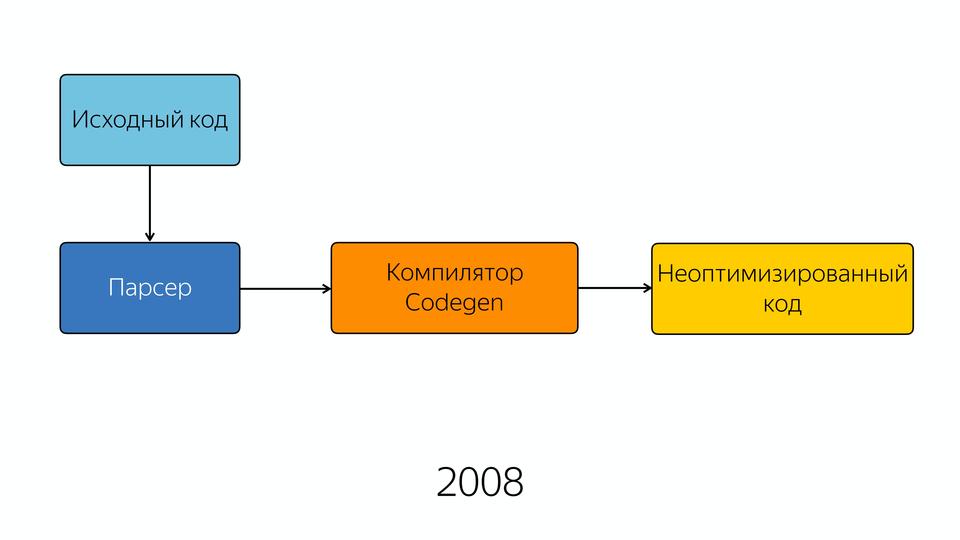

Погрузимся в историю. В 2008 выходит браузер Chrome. В том году Google презентовал новый движок V8. В 2009 году на том же самом движке была представлена Node.js, которая состояла из V8 и библиотеки libUV, которая обеспечивает io, т.е. обращение к файлам, сетевые какие-то вещи и т.д. В общем, две очень важные вещи для нас построены на движке V8. Посмотрим, из чего он состоит.

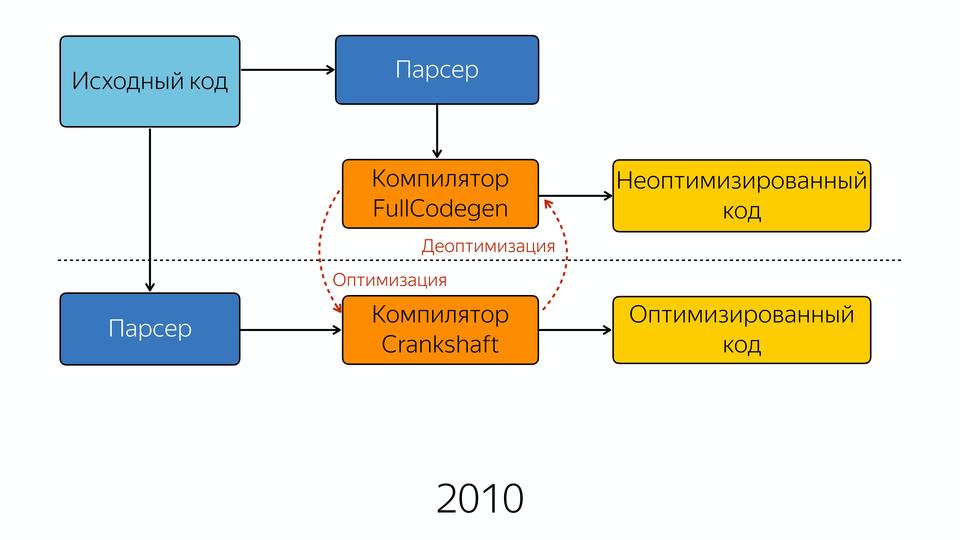

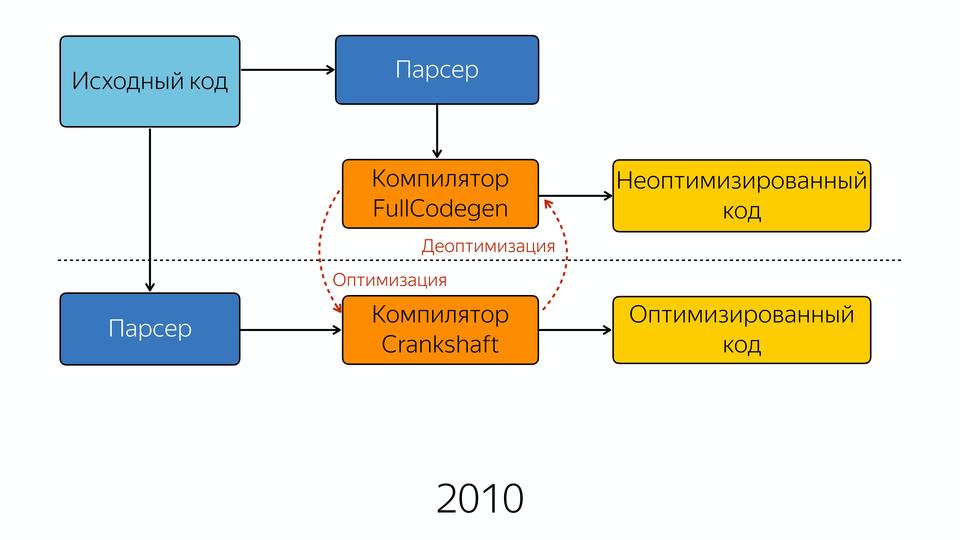

В 2008 году движок был довольно прост внутри. Ну, относительно прост — схема его была простая. Исходный код попадал в парсер, из парсера — в компилятор, и на выходе мы получали полуоптимизированный код. Полуоптимизированный, потому что хорошей оптимизации тогда еще не было. Возможно, в те годы приходилось писать лучший JavaScript, потому что нельзя было надеяться на то, что оптимизатор его сам внутри заоптимизирует.

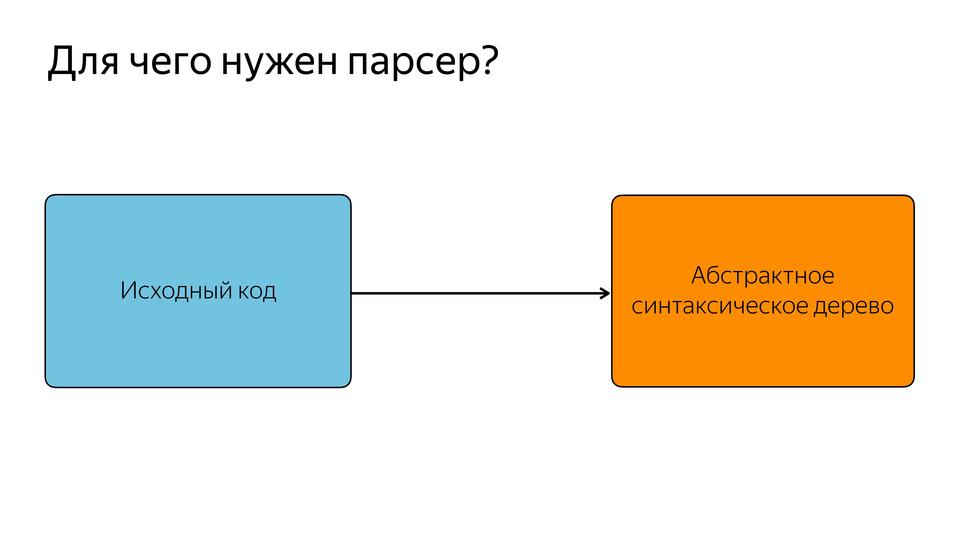

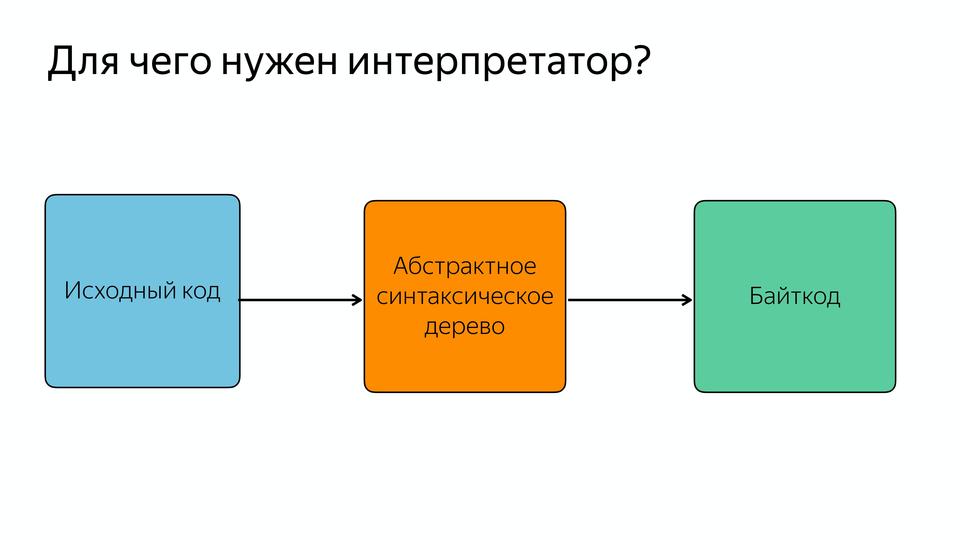

Для чего в этой схеме нужен парсер?

Парсер нужен для того, чтобы превращать исходный код в абстрактное синтаксическое дерево или AST. AST – такое дерево, в котором все вершины — операторы, а все листья — это операнды.

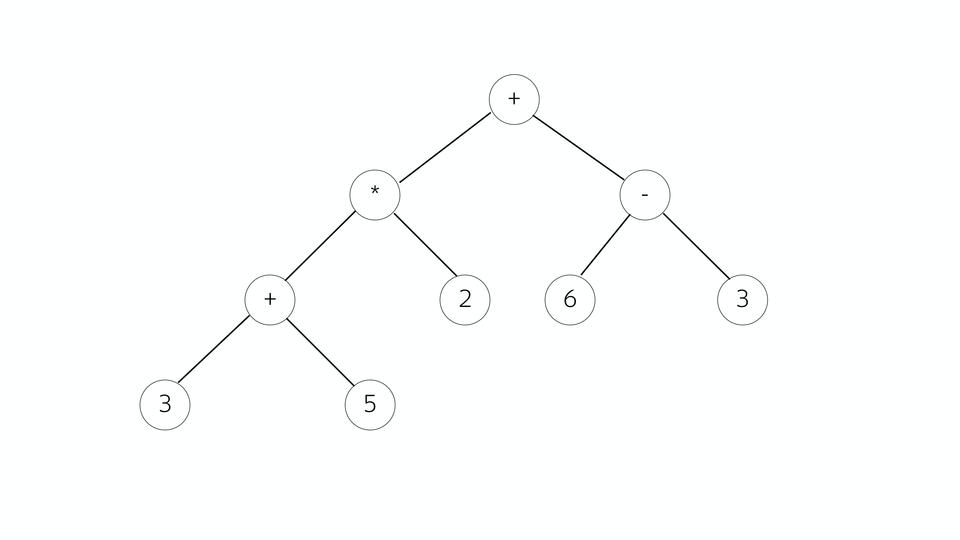

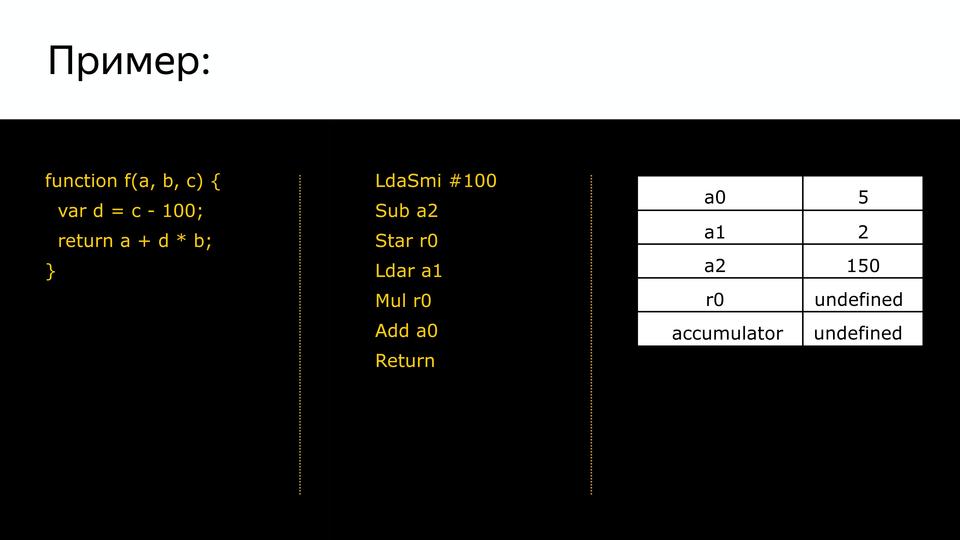

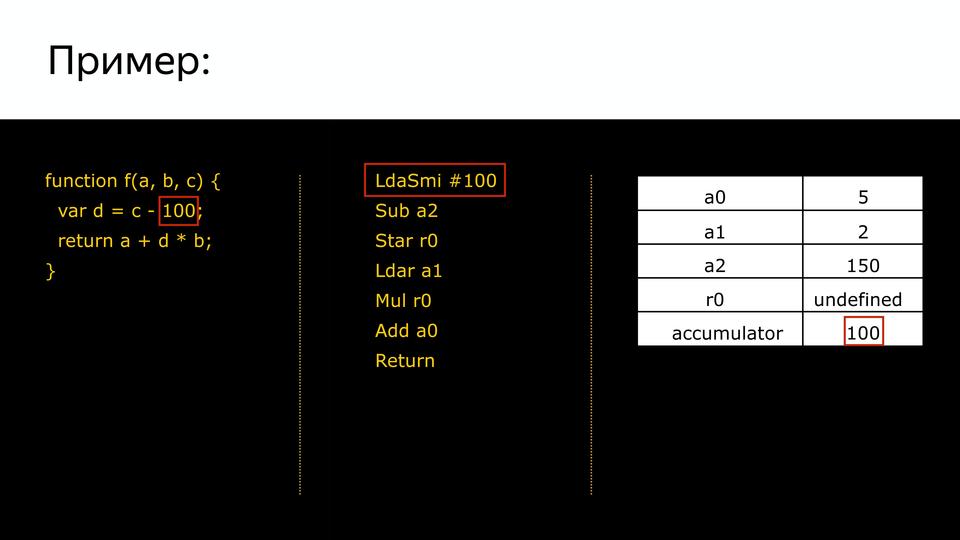

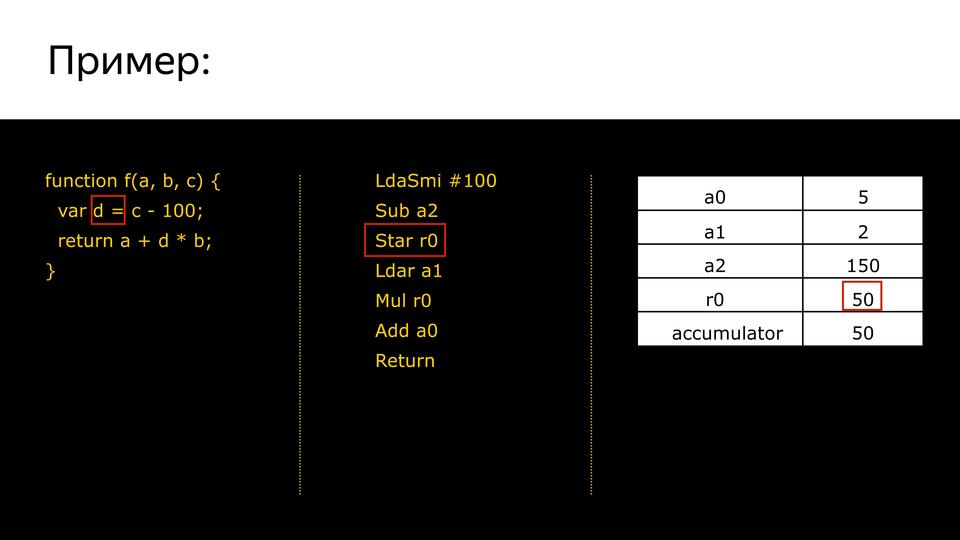

Посмотрим на примере математического выражения. У нас такое дерево, все вершины – операторы, ветви – операнды. Чем оно хорошо — тем, что из него очень легко генерировать позже машинный код. Кто работал с Assembler, знает, что чаще всего инструкция состоит из того, что сделать и с чем сделать.

И вот здесь как раз мы можем смотреть, являемся ли мы в текущей точке оператором или операндом. Если это оператор, смотрим его операнды и собираем команду.

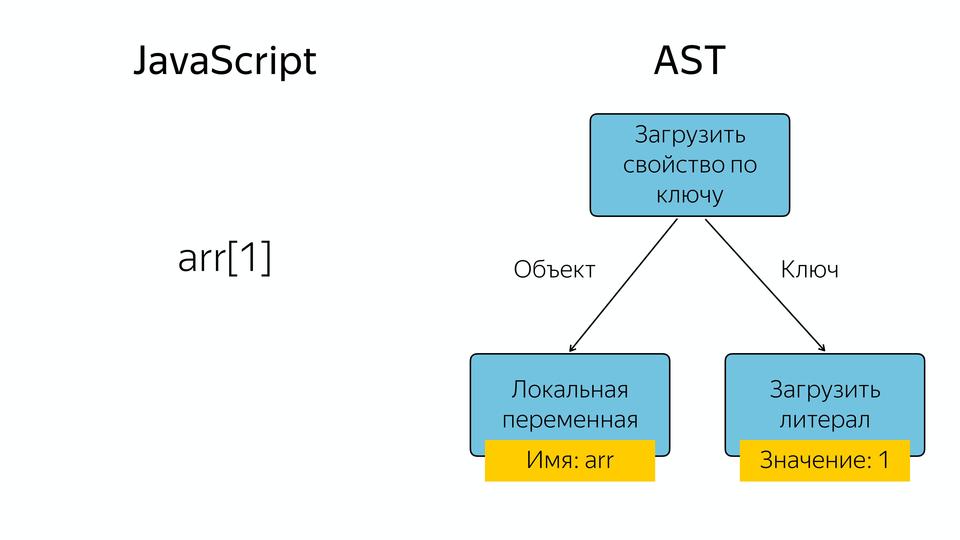

Что в JavaScript происходит, если у нас есть, например, массив, и мы запрашиваем из него элемент по индексу 1? Появляется такое абстрактное синтаксическое дерево, у которого оператор «загрузить свойство по ключу», а операнды – это объект и ключ, по которому мы загружаем это свойство.

Зачем в JavaScript компилятор?

Как я сказал, язык у нас интерпретируемый, но в его схеме мы видим компилятор. Зачем он? На самом деле есть два типа компиляторов. Есть компиляторы (ahead-of-time), которые компилируют до выполнения, и компиляторы JIT, которые компилируют во время выполнения. И за счет JIT-компиляции получается хорошее ускорение. Для чего это нужно? Давайте сравним.

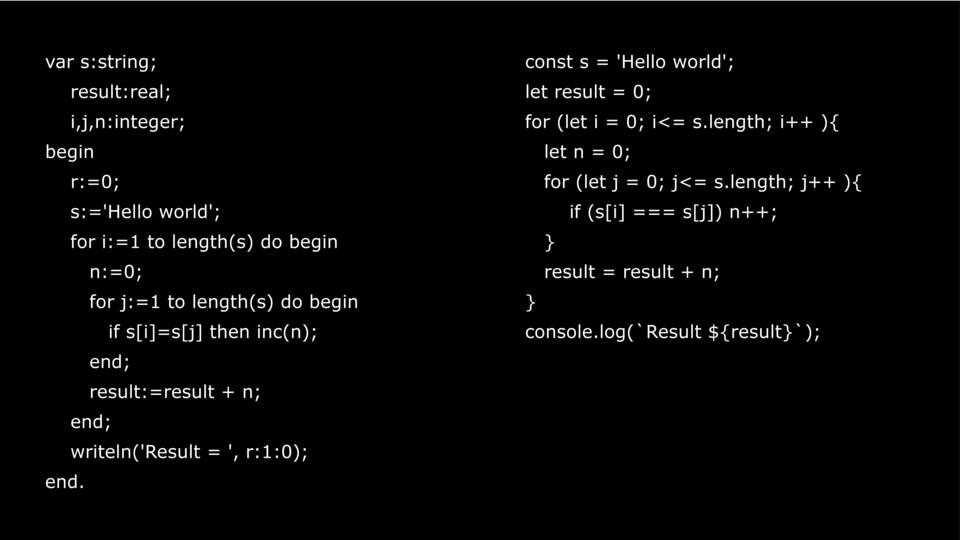

Есть один и тот же код. Один на Pascal, другой на JavaScript. Pascal — прекрасный язык. Я считаю, что с него и надо учиться программировать, но не с JavaScript. Если у вас есть человек, который хочет научиться программировать, то покажите ему Pascal или C.

В чем отличие? Pascal может быть и компилируемым и интерпретируемым, а JavaScript требует уже интерпретации. Самое важное отличие – это статическая типизация.

Потому что, когда мы пишем на Pascal, мы указываем переменные, которые необходимы, а потом пишем их типы. Потом компилятору легко построить хороший оптимизированный код. Как мы обращаемся к переменным в память? У нас есть адрес, и у нас есть сдвиг. Например, Integer 32, то мы делаем сдвиг на 32 по этому адресу в память и получаем данные.

В JavaScript нет, у нас типы всегда меняются во время выполнения, и компилятор, когда выполняет этот код, первый раз он его выполняет как есть, но собирает информацию о типах. И второй раз, когда он выполняет ту же самую функцию, он уже основываясь на данных, которые он получил в прошлый раз, предположив, какие были там типы, может сделать какую-то оптимизацию. Если с переменными все понятно, они определяются по значению, то что у нас с объектами?

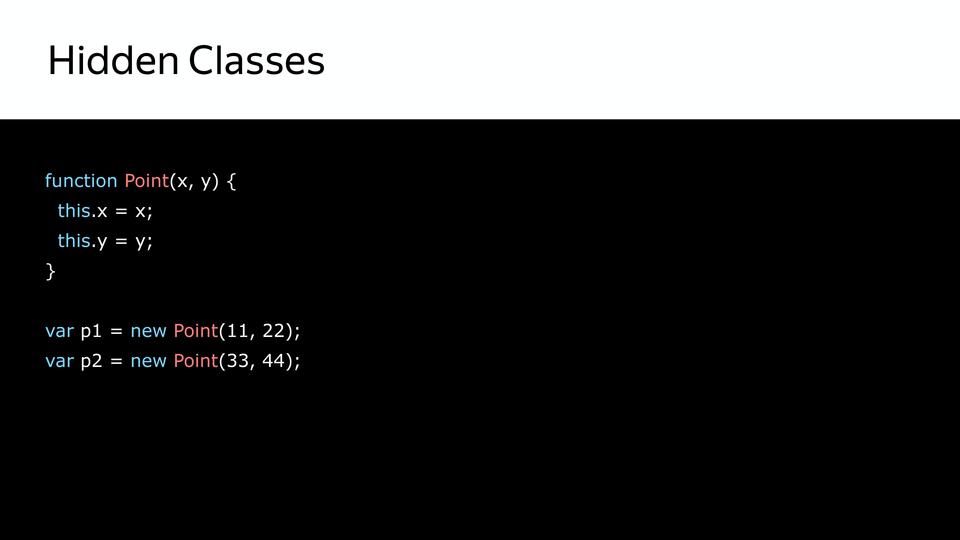

Ведь у нас JavaScript, у него прототипная модель, и классов для объектов у нас нет. На самом деле есть, но они не видны. Это так называемые Hidden Classes. Они видны только самому компилятору.

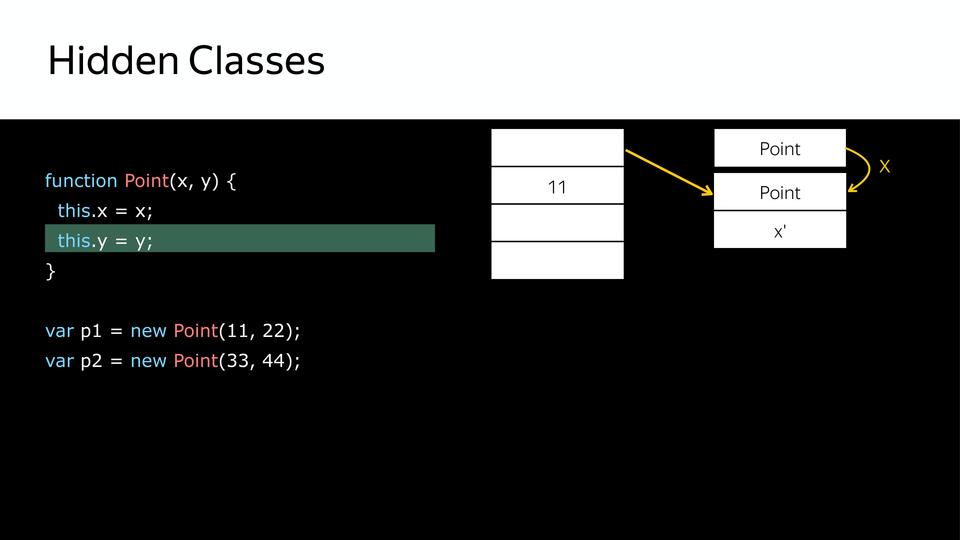

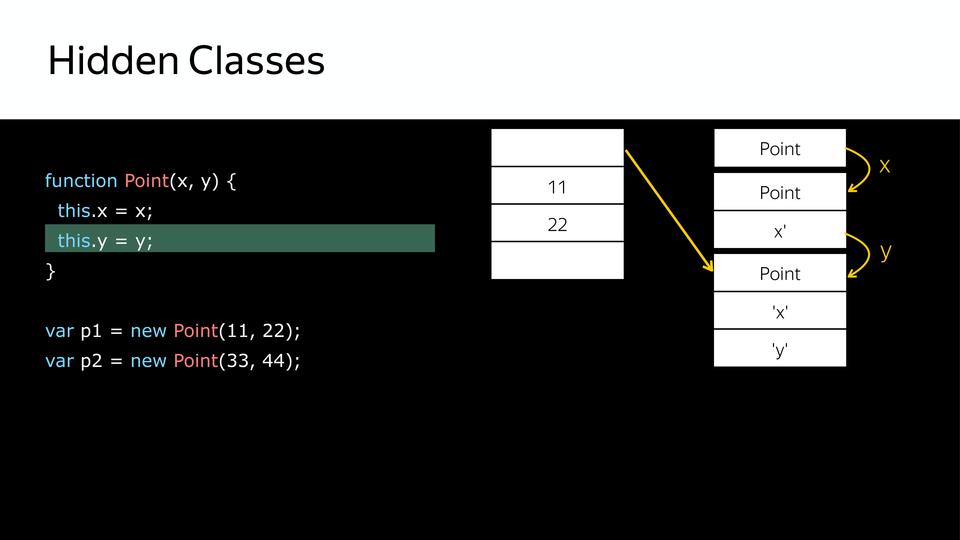

Как создаются Hidden Classes?

У нас есть point – это конструктор, и создаются объекты. Сначала создается hidden class, который содержит только сам point.

Дальше у нас устанавливается свойство этого объекта x и из того, что у нас был hidden class, создаётся следующий hidden class, который содержит x.

Дальше у нас устанавливается y и, соответственно, мы получаем еще один hidden class, который содержит x и y.

Так мы получили три hidden class. После этого, когда мы создаем второй объект, используя тот же самый конструктор, происходит то же самое. Уже есть hidden classes, их уже не нужно создавать, с ними необходимо только сопоставить. Для того, чтобы позже мы знали, что эти два объекта одинаковы по структуре. И с ними можно похоже работать.

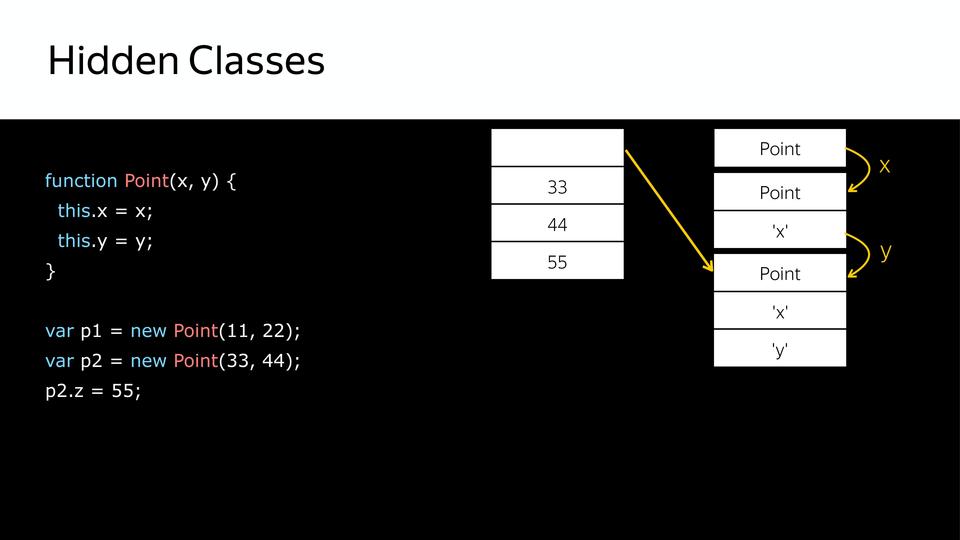

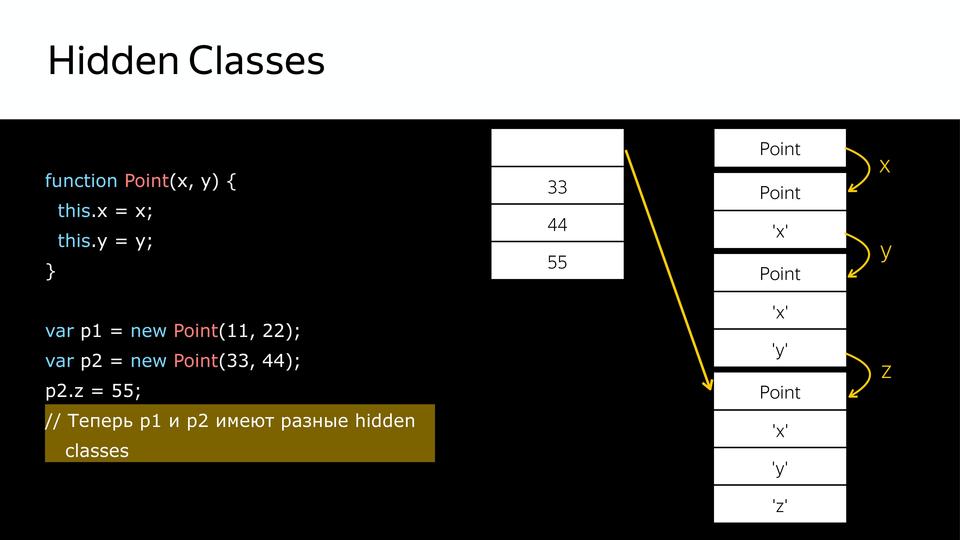

Но что происходит, когда мы позже еще добавляем свойство в объект p2? Создается новый hidden class, т.е. p1 и p2 уже не похожи. Почему это важно? Потому что, когда компилятор будет перебирать в цикле point, и вот у него будут все такие же, как p1, он их крутит, крутит, крутит, натыкается на p2, а у него другой hidden class, и компилятор уходит в деоптимизацию, потому что он получил не то, что ожидал.

Это так называемая утиная типизация. Что такое утиная типизация? Выражение появилось из американского сленга, если что-то ходит как утка, крякает как утка, то это утка. Т.е. если у нас p1 и p2 по структуре одинаковы, то они принадлежат к одному классу. Но стоит нам добавить в структуру p2 еще, и эти утки крякают по-разному, соответственно, это разные классы.