Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Генерация документов. Проблемы и решения |

Текст части 1.

Постоянно присутствующий текст. Текст части 2.

Передадим генератору в параметрах, что надо удалить (или оставить ). В результате получим:

Постоянно присутствующий текст. Текст части 2.

Для логической операци И (не удалять, если выбраны и ) разметка может быть следующей:

Текст части 1.

Постоянно присутствующий текст. Текст части 2.

Для логической операци ИЛИ (удалять, если выбраны или ) разметка может быть следующей:

||Текст части 1.

Постоянно присутствующий текст. Текст части 2.

Перечислим достоинства и недостатки данного способа разметки шаблонов.

Достоинства:

— в одном шаблоне может содержаться множество тематически связанных документов.

— разметка достаточна простая и может быть выполнена сотрудниками, не связанными с ИТ. При наличии хорошего инструмента для разработки шаблонов выполнить подобную разметку сможет сотрудник, компетентный в предметной области, и ему не нужно будет работать с некомпетентным в предмете посредником из ИТ.

— есть возможность получить из всего списка полей для заполнения информацией, содержащихся в шаблоне, список полей, которые останутся после удаления лишних фрагментов из шаблона.

Недостатки:

— разметка без специального инструмента разработчика плохо читается.

— размеры шаблонов становятся очень большими, что может привести к снижению скорости генерации, если не предпринять специальных мер.

Для борьбы с большими размерами шаблонов можно применить способ разбивки шаблона на части, где части хранятся отдельно от шаблона и вставляются в него только при наличии параметров, переданных генератору. Это значительно сокращает размеры шаблона, а значит и время генерации. Разбивка шаблона на части осуществляется автоматически средой разработки шаблонов при наличии в шаблоне специальной разметки, в которой указывается в каких случаях часть должна вставляться в основной шаблон.

|

Метки: author PennyLane читальный зал генерация документа |

[Перевод] Руководство для начинающих по прогрессивным веб-приложениям и фронтенду |

Разрабатывать веб-фронтенд, придерживаясь JavaScript-экосистемы, всех этих новомодных штучек и пафосных фреймворков, может быть пугающим занятием, если не сказать больше. Я давно уже хотел окунуться в это, и наконец собрался с духом. К концу этой статьи, надеюсь, вы узнаете что-нибудь новое, или хотя бы чуть больше отточите свои навыки веб-разработки. Какая ирония, что длина статьи и обширное количество информации тоже могут отпугивать. Но я очень надеюсь, что вы найдёте время осилить хотя бы интересующие вас главы. В конце каждого раздела есть абзац TL;DR, так что вы можете быстро ориентироваться в содержании.

RESTful API

Первое, о чём я хочу рассказать, это концепция RESTful API. Термин REST, или RESTful API, всплывает во многих беседах между веб-разработчиками, и на то есть веская причина. REST (REpresentational State Transfer, передача состояния представления) API и веб-сервисы предоставляют простой способ взаимодействия с архитектурой бэкенда без необходимости разбираться в этой самой архитектуре.

Проще говоря, как фронтенд-разработчик вы будете взаимодействовать с одной или несколькими конечными точками (то есть URI), являющимися частью API, расположенного на сервере, в кластере или каком-то ином бэкенде, который кто-то создал для вас. Если API хорошо проработан, то в получите ясную и понятную документацию по запросам, созданию и редактированию ресурсов на бэкенде (при условии, что вы авторизованы), без необходимости писать код или лезть в базу, лежащую на упомянутом бэкенде.

RESTful API бывают самыми разными. Наиболее популярные из них возвращают JSON-объекты, которыми можно легко манипулировать посредством JavaScript на стороне клиента, что позволяет фронтенд-разработчикам эффективно работать с одними лишь частями View и Controller паттерна MVC (Model-View-Controller).

TL;DR: RESTful API очень популярны и предоставляют фронтенд-разработчикам возможность взаимодействовать с ресурсами в вебе, сосредоточившись на разработке фронтенда и не беспокоясь об архитектуре.

AJAX

AJAX (Asyncronous JavaScript And XML) существует уже немало лет, и каждый разработчик так или иначе использовал его в своей работе (большинство из нас — посредством jQuery). Здесь я не будут углубляться в устройство AJAX, поскольку в сети есть сотни источников получше, но хочу отнять у вас минутку времени, чтобы просто восхититься теми возможностями, которые эта технология даёт фронтенд-разработчикам.

С помощью AJAX мы можем запрашивать ресурсы из одного одного или нескольких мест (или локально, если страница расположена на том же сервере, что и запрашиваемый URI) и в любое время, без замедления работы веб-приложений или необходимости начать отрисовку всех данных. Фактически, мы можем не грузить любой контент на страницу, а затем просто запрашивать его, как только будет загружена пустая HTML-страница. В сочетании с RESTful API получается невероятно гибкое, высокопортируемое и удобное в сопровождении решение для веб-приложений.

TL;DR: AJAX — очень мощный инструмент, который в сочетании с RESTful API позволяет создавать по-настоящему динамичные веб-приложения, которые быстро загружаются и отображают контент из ресурсов в вебе.

Получение контента из веба

Поначалу создание вашей первой веб-страницы может показаться довольно трудной задачей, так что будем идти постепенно. Начнём с получения контента из RESTful API с помощью AJAX-вызовов.

Первым делом нужно найти высококачественный API, желательно такой, который возвращает JSON. Вот для примера несколько ресурсов, которые выводят placeholder-контент и пригодны для создания примера веб-приложения:

- JSON Placeholder — placeholder-текст, выдаваемый в JSON-формате, подходящий для многих вариантов использования. Очень прост для начинающих, идеально подходит для заполнения макета (mockup) веб-приложения, вроде того, что мы с вами сделаем.

- Unsplash It — placeholder-контент не будет полным без изображений, и именно отсюда их надо брать. Документация очень понятная и простая в применении, так что можно сразу начинать пользоваться.

- Random User Generator — ещё один высококачественный ресурс, предоставляющий сгенерированные пользовательские профили, которые можно сконфигурировать под свои нужды. Здесь есть куча настроек, но для целей статьи нужно совсем немного.

Мы воспользуемся этими тремя ресурсами, но вы можете прошерстить список в конце статьи в поисках более интересных API, пригодных для генерирования placeholder-контента для вашей страницы.

Первое, что нужно сделать, прежде чем начать писать код, это посетить конечную точку одного из API и посмотреть, что вы будете получать. Давайте отправим GET-запрос в Random User Generator, просто для проверки. Вы получите что-то подобное:

Это называется JSON-файл (JavaScript Object Notation), который должен выглядеть для вас знакомым, если вы когда-либо использовали объекты в JavaScript. Давайте запросим тот же ресурс программным способом:

// Отправляем 'GET'-запрос на заданный URL и после его завершения исполняем callback-функцию

function httpGetAsync(url, callback) {

var xmlHttp = new XMLHttpRequest();

xmlHttp.onreadystatechange = function() {

if (xmlHttp.readyState == 4 && xmlHttp.status == 200)

callback(xmlHttp.responseText);

};

xmlHttp.open('GET', url, true);

xmlHttp.send(null);

}Именно это и делает приведённый код, который занимает всего 10 строк (9 без комментария). Скармливаем соответствующую URL конечную точку API и функцию callback, и мы увидим какой-то контент. Допустим, вы создали пустую HTML-страницу и залинковали вышеприведённый JS-код. Теперь просто выполним её в браузерном инструментарии для разработчиков:

httpGetAsync(

'https://randomuser.me/api/',

function(e){console.log(e)}

);Вы получите результат, аналогичный предыдущему, только теперь он будет обёрнут в двойные кавычки. Естественно, ведь это строковое значение. И что ещё естественнее, теперь мы можем конвертировать его в JS-объект посредством JSON.parse(), а затем использовать так, как предполагалось.

Мы только что получили от API какой-то контент и вывели его в консоли. Прежде чем пойти дальше, давайте немного изучим этот API, чтобы впоследствии эффективнее его использовать.

В частности, я бы сосредоточился на параметрах seed и results, которые можно встроить в наш URL, чтобы каждый раз получать тот же набор пользователей. Для их добавления нужно просто добавить после URL знак ?, а затем {parameter_name}={value}, разделяя параметры с помощью &. Полагаю, все об этом знают, но всё же нужно было об этом упомянуть. В этой статье я также воспользуюсь параметром nationalities, чтобы быть уверенным, что в HTML не будет не-латинских символов, которые усложнят мне жизнь. Отныне и впредь, моей целевой конечной точкой для получения пользователей будет эта, она поможет мне получить тех же 25 пользователей, и всех из США.

TL;DR: Чтобы начать разрабатывать веб-приложение, нужно найти высококачественный JSON API. С помощью 10 строк JavaScript-кода можно легко запрашивать ресурсы у RESTful API, которые выдают случайных пользователей, и потом конвертировать их в JavaScript-объекты.

Представление и головоломка с CSS-фреймворком

Решив задачу получения какого-то контента от API, мы теперь можем отрисовать его, чтобы показать пользователю. Но работа с CSS-стилями и селекторами может быть той ещё головной болью, так что многие прибегают к помощи CSS-фреймворка. Весьма популярен Bootstrap, он хорошо задокументирован, имеет большое и приятное сообщество, и богат своими возможностями. Но я воспользуюсь mini.css, который разработал сам и знаю лучше, чем Bootstrap. Подробнее об этом фреймворке можете почитать в других моих статьях.

Инструкции по использованию классов и селекторов фреймворка применимы только к mini.css, но с очень небольшими правками они будут верны и для Bootstrap (считайте представление веб-приложения своей домашней работой, потому что здесь я не буду вдаваться в подробности относительно CSS).

Прежде чем мы сможем что-то вывести на экран, нам нужно создать оболочку приложения. Ничего особенного, только панель навигации и маленький заголовок, ну ещё может быть футер. Я воспользуюсь элементом .drawer, который может быть заменён какими-нибудь кнопками, и, наконец, , чтобы приложение выглядело чисто и аккуратно:

Я буду понемногу показывать свой код (после добавления карточки пользователя), но сначала скажу, почему использование CSS-фреймворка является хорошей идей. Попросту говоря, когда вы строите для веба, то существует слишком много тестовых вариантов, и некоторые комбинации устройства/ОС/браузера получаются более своеобразными, чем другие. CSS-фреймворк работает с этим особенностями по своему усмотрению, хотя в то же время предоставляет вам базовый каркас, который поможет создать адаптивное приложение (responsive application). Адаптивность крайне важна в разработке для мобильных устройств, так что почитайте об этом побольше.

Допустим, нас всё устраивает в оболочке приложения, давайте перейдём к отрисовке данных, полученных от Random User Generator. Я не собираюсь усложнять эту процедуру и выведу для каждого пользователя имя, изображение, ник, почту, местоположение и день рождения. Но вы можете придумать свой набор позиций. Не забудьте обратиться к ключу .results вашего объекта после парсинга JSON-данных, потому что в него всё обёрнуто. Чтобы всё выглядело красиво, я воспользуюсь замечательным пакетом иконок Feather, а также классом .card из mini.css и кое-какими CSS-трюками.

Пример приложения с карточками случайно сгенерированных пользователей.

Теперь наше приложение динамически заполняется контентом, который мы выводим на экран с помощью JavaScript и HTML. Мы только что создали наше первое представление (View), являющееся причудливым способом сказать, что мы создали визуальное отображение данных, запрошенных у API.

TL;DR: Отзывчивость и стили крайне важны для любого веб-приложения, так что будет хорошей идеей использовать CSS-фреймворк для создания простой HTML-оболочки приложения, а затем отрисовки с помощью JavaScript данных, полученных от API.

JavaScript-библиотеки

Наш макет веб-приложения работает хорошо, но JavaScript-код, особенно метод renderUsers(), получился довольно запутанным и выглядит очень трудным в сопровождении. К счастью, есть хороший способ сделать всё то же самое, но с помощью инструмента, которым сегодня пользуются все клёвые пацаны — React. Если кто-то из вас о нём не слышал: это очень мощная JavaScript-библиотека, сильно облегчающая отрисовку и обновление страницы, при этом повышая скорость её работы с помощью виртуального DOM и методики, известной как diffing. В сети есть куча толковых публикаций на этот счёт.

Преобразовать наш код в React не сложно. Фактически, нужно лишь вынести цикл из процесса отрисовки, чтобы можно было извлекать функцию, которая отрисовывает по одному пользователю за раз, а затем итерировать по нашему массиву пользователей, отрисовывая их как раньше. Здесь несколько специфических для React моментом, вроде того факта, что имя нашей новой функции должно начинаться с прописной буквы, мы должны передавать её единственный аргумент props, а элементы из списка должны быть привязаны к ключам. Звучит громоздко, но на самом деле это совсем не трудно соблюдать.

Также React позволяет использовать JSX, благодаря чему мы можем писать HTML внутри JavaScript без необходимости оборачивать его в кавычки. Так что наш код может стать ещё немного чище. Однако помните, что придётся сделать некоторые преобразования, например из class в className. Но со временем вы привыкните, а отладочные сообщения в консоли действительно очень помогают в решении таких проблем.

Я также взял на себя смелость преобразовать три инлайненых SVG в их собственные функции, так что теперь весь процесс отрисовки выглядит так:

// Функциональный компонент для иконки почты.

function SvgMail(props){

return ;

}

// Функциональный компонент для иконки календаря.

function SvgCalendar(props){

return ;

}

// Функциональный компонент для иконки прикрепления к карте.

function SvgMapPin(props){

return ;

}

// Функциональный компонент для иконки пользовательской карточки.

function UserCard(props){

var user = props.user;

return

{user.name.title} {user.name.first} {user.name.last}

{user.login.username}

;

}

// Отрисовка списка пользователей в виде карточек.

function renderUsers(){

var userCards = users.map(

function(user, key){

return ;

}

);

ReactDOM.render( {userCards} ,contentArea);

} Мы просто извлекли из предыдущего кода функциональный компонент, сделав его многократно используемой сущностью. Стоит взглянуть, что происходит под капотом, когда Babel преобразует HTML, предоставленный по вызовам React.createElement():

function SvgMapPin(props) {

return React.createElement(

'svg',

{ xmlns: 'http://www.w3.org/2000/svg', width: '24', height: '24', viewBox: '0 0 24 24', fill: 'none', stroke: '#424242', strokeWidth: '2', strokeLinecap: 'round', strokeLinejoin: 'round' },

React.createElement('path', { d: 'M21 10c0 7-9 13-9 13s-9-6-9-13a9 9 0 0 1 18 0z' }),

React.createElement('circle', { cx: '12', cy: '10', r: '3' })

);

}C другой стороны, если вы хотите начать с более лёгкой версии React, без JSX и некоторых более причудливых и сложных вещей, то я очень рекомендую обратиться к Preact, потому что это прекрасная альтернатива, которая может уменьшить время загрузки на одну-две секунды.

TL;DR: Преобразование с помощью React неструктурированных вызовов HTML-отрисовки в функциональные компоненты — задача простая, и результат получается гораздо удобнее в сопровождении. При этом разработчик получает больше контроля над своим кодом, и повышается степень повторного использования.

Добавляем второе представление (view)

В большинстве веб-приложений больше одного представления, так что этим мы и займёмся. Воспользуемся другими двумя API, упомянутыми в начале, чтобы создать второе представление, которое динамически заполняется и содержит текст и изображения, при перезагрузке страницы каждый раз новые. Если вы читали внимательно, то сделаете это без подсказок, но я очерчу направление действий:

- Мы будем отправлять GET-запрос на адрес

https://jsonplaceholder.typicode.com/comments?postId={id}, что позволит получить 5 сегментов текста за раз в JSON-формате, инкрементируя{id}. - Также мы будем отправлять GET-запросы на адрес

https://unsplash.it/800/800?image={id}, при этом будем каждый раз получать какую-то картинку. Для этого воспользуемся кодом, который будет генерировать случайный{id}для каждого запроса. В моём Codepen-примере я также добавил массив неправильных значений{id}, которые я извлёк из API, так что у нас не будет ни одного ответа без изображения. - После выполнения обоих запросов будем создавать карточку для каждого поста, случайным образом приписывая пользователя из списка в качестве автора, и затем отрисуем с помощью React.

- Также добавим кнопку переключения между двумя представлениями, чтобы иметь возможность перейти к списку пользователей. Я добавлю её в выпадающее меню, но вы можете делать на свой вкус.

После аккуратного кодирования всего упомянутого и последующего совершенствования, у вас получится нечто, схожее с Singe Page Application (SPA): https://codepen.io/chalarangelo/pen/zzXzBv

TL;DR: Чтобы ваш макет выглядел как настоящее веб-приложение, достаточно добавить второе представление и некоторые интерактивные элементы.

Загружаем ещё больше контента

Если вы уже занимались веб-разработкой, то сразу же заметите, чего не хватает в нашем приложении: бесконечной прокрутки. Её суть: когда вы пролистываете вниз до определённой границы, подгружается новая порция контента, и так происходит до тех пор, пока не кончится контент. В нашем примере мы установим границу в 80 %, но вы можете настроить этот параметр. Для этого нам понадобится очень простой метод, вычисляющий долю прокрутки страницы.

// Получает степень прокрутки страницы.

function getScrollPercent() {

return (

(document.documentElement.scrollTop || document.body.scrollTop)

/ ( (document.documentElement.scrollHeight || document.body.scrollHeight)

- document.documentElement.clientHeight)

* 100);

}Метод подсчитывает все кейсы и возвращает значение в диапазоне [0,100] (включительно). Если забиндить на window события scroll и resize, то можно быть уверенным, что когда пользователь достигнет конца страницы, то будет подгружен ещё контент. Вот как выглядит наше веб-приложение после добавления бесконечной прокрутки в представление с постами.

TL;DR: Бесконечная прокрутка — главное свойство любого современного веб-приложения. Она легка в реализации и позволяет динамически подгружать контент по мере необходимости.

Примечание: Если вы всё читаете и следуете всем рекомендациям, то сделайте 10-минутный перерыв, потому что следующие несколько глав довольно сложны и требуют больше усилий.

Манифест веб-приложения

Прежде чем мы сможем сказать, что действительно сделали веб-приложение (не говоря уже о прогрессивном веб-приложении), нам нужно поработать с файлом manifest.json, который состоит из кучи свойств нашего приложения, включая name, short_name, icons. Манифест предоставляет клиентскому браузеру информацию о нашем веб-приложении. Но прежде чем мы им займёмся, нам нужно с помощью npm и настройки React поднять приложение и запустить на localhost. Полагаю, что с обеими вещами вы уже знакомы и не столкнётесь с трудностями, поэтому переходим к манифесту.

По моему опыту, чтобы получилось работающее приложение, вам понадобится заполнить так много полей, что я предлагаю воспользоваться Web App Manifest Generator и заполнить, что хотите. Если у вас есть время, чтобы сделать аккуратную иконку, то в этом вам поможет Favicon & App Icon Generator.

После того как всё сделаете, ваш манифест будет выглядеть так:

{

"name": "Mockup Progressive Web App",

"short_name": "Mock PWA",

"description": "A mock progressive web app built with React and mini.css.",

"lang": "en-US",

"start_url": "./index.html",

"display": "standalone",

"theme_color": "#1a237e",

"icons": [

{

"src": "\/android-icon-48x48.png",

"sizes": "48x48",

"type": "image\/png",

"density": "1.0"

},

{

"src": "\/android-icon-72x72.png",

"sizes": "72x72",

"type": "image\/png",

"density": "1.5"

}

]

}Создав манифест, мы «отполировали» наше веб-приложение, сделав его поведение таким, как нужно. Но это только начало пути по превращению нашего веб-приложения в прогрессивное.

TL;DR: Файл manifest.json используется для определения конкретных свойств веб-приложения, прокладывая нам путь к созданию прогрессивного веб-приложения.

Сервис-воркеры (Service Workers)

Последним шагом является создание сервис-воркеров. Это одно из ключевых требований к прогрессивному веб-приложению, чтобы оно в какой-то степени работать автономно. Хотя сервис-воркеры используются уже давно, документация для них выглядит всё ещё слишком технической и сложной. Но в последнее время эта тенденция начала меняться. Если хотите больше почитать о прогрессивных веб-приложениях и сервис-воркерах, обратитесь к источникам в конце статьи.

Мы будем создавать самый простой вариант сервис-воркера, позволяющий кэшировать ответы на запросы, передавая их по мере доступности. Сначала создадим файл service-worker.js, который и будет нашим сервис-воркером.

Теперь давайте разберёмся с тремя основными событиями, с которыми нам придётся работать:

installгенерируется при первой загрузке и используется для выполнения начальной установки сервис-воркера, вроде настройки оффлайн-кэшей.activateгенерируется после регистрации сервис-воркера и его успешной установки.fetchгенерируется при каждом AJAX-запросе, отправленном по сети, и может использоваться для обслуживания закэшированных ресурсов (особенно полезно при отсутствии сети).

Первое, что нам нужно сделать при установке, это воспользоваться CacheStorage Web API для создания кэша для веб-приложения и хранения любого статичного контента (иконок, HTML, CSS и JS-файлов). Это очень просто сделать:

// caches — это глобальная переменная только для чтения, являющаяся экземпляром CacheStorage

caches.open(cacheName).then(function(cache) {

// Что-нибудь делаем с кэшем

});

// Источник: https://developer.mozilla.org/en-US/docs/Web/API/CacheStorage/openМожно быстро создать простой обработчик события install, который кэширует наши index.html, JavaScript-файл и manifest.json. Но сначала нужно задать имя кэша. Это позволит нам отделить версии тех же файлов или данных от оболочки приложения. Здесь мы не будем вдаваться в подробности относительно кэшей, но в конце статьи есть полезные ссылки. Помимо имени кэша, нужно определить, какие файлы будут кэшироваться с помощью массива. Вот как выглядит обработчик install:

var cacheName = 'mockApp-v1.0.0';

var filesToCache = [

'./',

'./index.html',

'./manifest.json',

'./static/js/bundle.js'

];

self.addEventListener('install', function(e) {

e.waitUntil(caches.open(cacheName)

.then(function(cache) {

return cache.addAll(filesToCache)

.then(function() {

self.skipWaiting();

});

}));

});Меньше чем в 20 строках мы сделали так, что наше веб-приложение использует кэш для своих ресурсов. Позвольте пояснить оду вещь. В ходе разработки наш JS-код компилируется в файл ./static/js/bundle.js. Это одна из причуд нашего development/production-окружения, и мы разберёмся с ней на следующем этапе.

Обработчик activate тоже довольно прост. Его главная задача: обновлять кэшированные файлы, когда что-то меняется в оболочке приложения. Если нам нужно обновить любые файлы, то нам придётся изменить cacheName (желательно в стиле SemVer). Наконец, обработчик fetch проверит, хранится ли в кэше запрошенный ресурс. Если он там есть, то будет передан из кэша. В противном случае ресурс будет запрошен как обычно, а ответ будет сохранён в кэше, чтобы его можно было использовать в будущем. Соберём всё вместе:

self.addEventListener('activate', function(e) {

e.waitUntil(caches.keys()

.then(function(keyList) {

return Promise.all(keyList.map(function(key) {

if (key !== cacheName)

return caches.delete(key);

}));

}));

return self.clients.claim();

});

self.addEventListener('fetch', function(e) {

e.respondWith(caches.match(e.request)

.then(function(response) {

return response || fetch(e.request)

.then(function (resp){

return caches.open(cacheName)

.then(function(cache){

cache.put(e.request, resp.clone());

return resp;

})

}).catch(function(event){

console.log('Error fetching data!');

})

})

);

});Мы построили сервис-воркер, но его нужно зарегистрировать изнутри веб-приложения, чтобы воспользоваться его преимуществами. Достаточно добавить несколько строк кода в наш основной JS-файл, и мы готовы превратить наше веб-приложение в прогрессивное:

if ('serviceWorker' in navigator) {

navigator.serviceWorker

.register('./service-worker.js')

.then(function() { console.log('Registered service worker!'); });

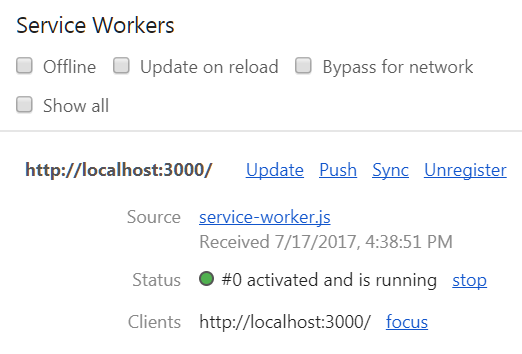

}После всех настроек, откройте в Chrome Dev Tools окно Application и посмотрите, всё ли работает как нужно. Сервис-воркер должен правильно зарегистрироваться, активироваться и запуститься. Если пролистаете вниз, поставите галочку Offline и обновите, то начнёт работать оффлайн-версия страницы, использующая закэшированные ресурсы.

Мы только что превратили наше веб-приложение в прогрессивное, но разработка ещё не закончена. Последним шагом будет сборка для production.

TL;DR: Сервис-воркеры позволяют веб-приложениям настраивать кэши и использовать их для загрузки ресурсов без использования сети, превращая веб-приложения в прогрессивные.

Сборка для production

Всё, что мы сделали, прекрасно работает на localhost, но осмотр production-файлов после быстрого выполнения npm run build обнаруживает кучу ошибок, которые нужно исправить. Прежде всего, многие файлы неправильно залинкованы на/из HTML-страницы. Для решения этой проблемы нужно добавить одну строку в package.json:

"homepage" : "."После пересборки и открытия HTML-страницы в браузере мы видим, что большая часть заработала правильно. Добавив строку со свойством "homepage", мы сказали системе собрать скрипт так, чтобы в ссылках все пути были изменены на ., то есть теперь они являются относительными путями.

Следующая проблема: наш сервис-воркер указывает на неправильные JS-файлы, потому что static/js/bundle.js больше не существует. Если внимательнее посмотреть на собранные файлы, то станет понятно, что наш JS был преобразован в файл main.{hash}.js, где часть {hash} отличается для каждой сборки. Нам нужно иметь возможность загружать из сервис-воркера файл main.js. Следовательно, нужно переименовать его, но этого сломает ссылку внутри index.html, чего мы не хотим. Для решения обеих проблем воспользуемся сборочными инструментами из реестра npm — renamer и replace. Также нам нужно минифицировать наш service-worker.js, поскольку по умолчанию он не слишком компактен, потому что является частью папки public, так что воспользуемся ещё и утилитой uglify-js.

npm install --save-dev renamer

npm install --save-dev replace

npm install --save-dev uglify-jsТри простые команды, и мы получаем нужные нам инструменты. Пользоваться ими сравнительно легко после ознакомления с документацией, так что я продолжу и покажу, как выглядит свойство "scripts" в моём package.json после создания всех необходимых скриптов.

"scripts": {

"start": "react-scripts start",

"build": "react-scripts build && npm run build-rename-replace && npm run build-sw",

"test": "react-scripts test --env=jsdom",

"eject": "react-scripts eject",

"build-sw" : "npm run build-replace-sw-refs && npm run build-minify-sw",

"build-rename-replace": "npm run build-rename && npm run build-replace",

"build-rename": "npm run build-rename-js && npm run build-rename-css",

"build-rename-js": "renamer --regex --find main\\.\\w+\\.js --replace main.js build/static/js/*.js",

"build-rename-css": "renamer --regex --find main\\.\\w+\\.css --replace main.css build/static/css/*.css",

"build-replace": "npm run build-replace-js && npm run build-replace-css",

"build-replace-js": "replace main\\.\\w+\\.js main.js build/index.html",

"build-replace-css": "replace main\\.\\w+\\.css main.css build/index.html",

"build-replace-sw-refs": "replace './static/js/bundle.js' './static/js/main.js','./static/css/main.css' build/service-worker.js",

"build-minify-sw" : "uglifyjs build/service-worker.js --output build/service-worker.js"

}Давайте разберёмся, что тут происходит:

build-renameзапускает два скрипта, каждый из которых меняет имена JavaScript- и CSS-файлов, которые были созданы с желаемыми наименованиями (main.jsиmain.cssсоответственно).build-replaceзапускает два скрипта, каждый из которых меняет меняет ссылки на JavaScript- и CSS-файлы на переименованные версии.build-rename-replaceсобирает предыдущие две команды в одну.build-swобновляет в сервис-воркере ссылку наstatic/js/bundle.js, которая теперь указывает на новый файлmain.js, а также добавляет ссылку наmain.css. Затем минифицирует сервис-воркер.- Наконец,

buildсобирает вместе всё вышеперечисленное в наш процесс сборки по умолчанию, так что все файлы попадают в папкуbuildи готовы к выкладыванию на сайт.

Теперь при запуске npm run build должна генерироваться готовая к production версия нашего прогрессивного веб-приложения, которую можно хостить где угодно, просто копируя файлы из папки build.

TL;DR: Создание веб-приложения для production является интересной проблемой, требующей использования сборочных инструментов и разрешения скриптов. В нашем случае достаточно было обновить имена и ссылки.

Последние шаги

Это был трудный путь, но теперь наше прогрессивное веб-приложение готово к production. Прежде чем поделиться им с миром, выложив куда-нибудь на Github, хорошо бы оценить его качество с помощью инструмента Lighthouse, который выставляет приложению баллы и выявляет проблемы.

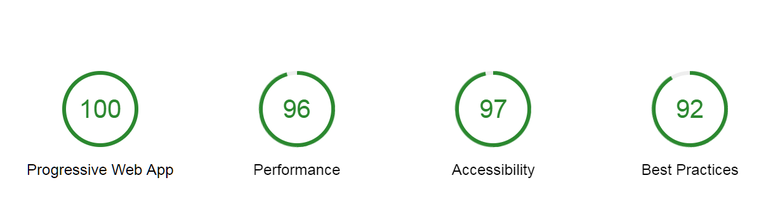

После прогона моей development-сборки на localhost я обнаружил несколько моментов, требующих исправления, вроде того, что у картинок нет атрибутов alt, внешние ссылки не имеют атрибута rel="noopener", а само веб-приложение не имеет географической привязки (landmark region), что было легко исправлено с помощью HTML-тега . Исправив всё, что мог, я получил такой результат в Lighthouse:

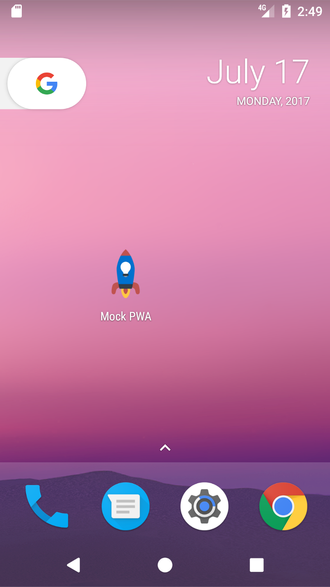

Как видите, приложение получилось хорошо оптимизированным и качественным. Теперь я могу с гордостью выложить его на Github. Вот ссылка на законченное приложение; а вот ссылка на исходный код. Я взял на себя смелость добавить индикаторы Online/Offline, но вы можете их выкинуть. Теперь я могу установить приложение на смартфон и показать друзьям!

TL;DR: Прежде чем релизить веб-приложение, стоит проверить его качество с помощью Lighthouse и оптимизировать, насколько возможно.

Вот и всё мы создали с нуля прогрессивное веб-приложение. Надеюсь, вы чему-то научились. Спасибо за уделённое время!

Ссылки

- MDN’s Getting started with AJAX — отличный ресурс для тех, кто хочет больше узнать об AJAX и как его использовать в веб-приложениях.

- Если выбираете JSON API, то вас могут заинтересовать эти:

UI Names — ещё один ресурс для генерирования случайных пользователей с большим количеством настроек.

Robohash — генерирует аватары роботов на основании заданной строки. Удобно при создании пользовательских профилей или placeholder-изображений.

Adorable Avatars — генерирует смешные аватары на основании заданной строки. Настроек чуть меньше, чем в Robohash, но задачу выполняет. - Из огромной экосистемы CSS-фреймворков можно выделить такие популярные продукты, как Bootstrap, Semantic UI, Bulma и Foundation. Предлагаю и свою альтернативу, mini.css, если вам нужно что-то более лёгкое.

- Для UI-иконок обычно берут FontAwesome, но я рекомендую Feather, более лёгкие и минималистичные.

- Если хотите больше узнать о diffing виртуального DOM, то очень рекомендую почитать эту статью.

- Среди всех современных JavaScript-библиотек, React является самой популярной. Но хороши также Preact и VueJS, выбирайте, что больше нравится.

- Манифесты веб-приложений хорошо задокументированы на сайтах MDN и Google Developers. Также можете воспользоваться Web App Manifest Generator, если хотите легко и быстро сгенерировать manifest.json.

- Говоря о сервис-воркерах и прогрессивных веб-приложениях, я очень рекомендую создавать своё первое приложение так, как описано здесь и здесь. Также обратите внимание на жизненный цикл сервис-воркера. А если хотите заняться этой темой ещё плотнее, почитайте Indicating Offline (я его использовал для создания Online/Offline-индикаторов) и Offline Recipes for Service Workers.

- Относительно CacheStorage Web API я рекомендую почитать эту статью, а также а также держать под рукой документацию MDN.

- Если хотите оценить своё веб-приложение и исправить найденные проблемы, воспользуйтесь Lighthouse и Mobile Speed Test.

- Наконец, изучите исходный код и демку на Github.

|

Метки: author AloneCoder разработка веб-сайтов reactjs javascript css блог компании mail.ru group react js никто не читает теги |

[Перевод] Генеративные модели от OpenAI |

|

Метки: author mr-pickles машинное обучение алгоритмы блог компании wunder fund openai generative models deep learning gan machine learning wunder fund wunderfund |

Zimbra — выстраиваем коммуникации в компании |

Существует два вида внутренних коммуникаций: с вертикальными и с горизонтальными связями.

Вертикальные связи устанавливаются между руководителями и подчиненными и служат для передачи решений, постановки задач и контроля за их исполнением, информационного взаимодействия и получения отчетов. В свою очередь вертикальные связи бывают двух видов и зависят от стиля управления и традиций компании:

- «сверху вниз» (от руководителя к подчиненным);

- «снизу вверх» (от подчиненных к руководителю).

Горизонтальные связи служат для обмена информацией между подразделениями компании и сотрудниками. Они необходимы прежде всего для нормального функционирования внутренних бизнес-процессов и должны быть подробно регламентированы. Несвоевременное или неполное получение информации, искажение и даже потеря каких-то данных, а также отсутствие обратной связи может привести к несогласованности действий между подразделениями. Поэтому горизонтальные связи между сотрудниками не менее важны, чем вертикальные.

Внутренние коммуникации обычно зависят от этапа развития компании. На этапе создания, когда количество сотрудников невелико и все знают друг друга, проблем с коммуникациями не возникает. Для работы хватает обычной электронной почты и мессенджера. По мере роста компании создаются новые подразделения, нанимаются сотрудники и появляется необходимость продумывания бизнес-процессов и налаживания горизонтальных связей между подразделениями. Тогда же становится очевидно, что каналы коммуникации в каждом отделе могут использоваться совершенно разные. Возникает несогласованность и работа начинает тормозиться. Появляется осознание того, что компании нужна единая почта, внутренние чаты и файлообменники. При этом все корпоративные каналы коммуникаций должны быть надежно защищены, а руководство компании могло их контролировать.

Как это сделать

Для любой компании важны два направления связи:

Почта

Как внутренняя для обмена информацией между сотрудниками, так и внешняя — для общения с клиентами, пользователями и поставщиками продукции и услуг. Стандартными возможностями различных почтовых сервисов уже сейчас являются большой объем пересылаемых файлов (не нужно «дробить» письма и архивировать) и внушительный объем места под хранение писем (количество места, предлагаемого системой, растет с каждым днем — не всегда можно занять и половину такого объема). Правильная почта также должна уметь различать спам и письма с вирусами, не отдавая эти функции на откуп антивирусам.

Zimbra Collaboration Suite — программный продукт, аналог Microsoft Exchange, который представляет собой электронную почту корпоративного уровня, календарь и средство совместной работы. Zimbra одинаково подходит как крупным компаниям, так и небольшим фирмам. Включает в себя ряд бесплатных и открытых продуктов (Nginx, Apache, MySQL, Postfix и др.) и имеет очень удобный веб-клиент — Zimbra Web Client, который построен с использованием технологии AJAX, обеспечивающей всплывающие подсказки, перемещаемые объекты и контекстные меню. Также включены продвинутые возможности поиска и временные зависимости. Сюда же входят онлайн-документация, модули Zimlet и полноценный интерфейс для администраторов, написанные с помощью Zimbra Ajax Toolkit.

Почту Zimbra Collaboration можно настраивать «под себя», создавая необходимые папки, в которые можно открыть доступ коллегам для совместной работы или правки документов. Ваша почта теперь и календарь, в котором можно не только планировать свои задачи на дни, месяцы или годы вперед, но и назначать задания в календарях своих коллег и контролировать их выполнение. Можно создавать мероприятия, совещания, собрания и приглашать коллег или лиц из списка контактов адресной книги.

За счет этих и многих других возможностей почта Zimbra Collaboration позволяет повысить эффективность взаимодействия в коллективе компании путем ухода от бумажного документооборота. Zimbra защищает почтовые ящики от спама, а за счёт системы резервного копирования информации от Zextras вы сможете найти и восстановить любой, даже давно стёртое, письмо.

За безопасность почты отвечает персонализированная антиспам система SpamAssassin. Zimbra использует SpamAssassin для определения нежелательной коммерческой электронной почты и оценки сообщений. «Спамность» определяется в процентах. Любые сообщения, помеченные между 33-75% считаются спамом и перемещаются в папку Нежелательная почта. Сообщения с процентом «спамности» выше 75% всегда считаются спамом и отбрасываются. Функция Postscreen для фильтрации спама снижает нагрузку на инфраструктуру, отвечающую за SMTP процессы.

Чаты и видеоконференции

Мессенджеры плотно вошли в современную жизнь, а значит нужно поощрять и общение между сотрудниками в таком формате. Зимлет ZeXtras Chat добавляет в Zimbra Web Client полностью интегрированный IM-клиент, с помощью можно общаться как в текстовом чате, так и в формате видеоконференций. ZeXtras Chat Zimlet поддерживает два режима просмотра: компактная и сжимаемая «док-панель» и расширенная «боковая панель», подходящая при большом числе собеседников. Можно устанавливать статусы, управлять контактами и многое другое.

Таким образом с помощью Zimbra Collaboration можно обеспечить коммуникации в компании любого уровня.

Zimbra Collaboration

|

Метки: author levashove управление персоналом блог компании zimbra zimbra zextras почта чат chat |

5 свежих примеров разбора и улучшения дизайна простыми способами |

Всем привет!

В сообществе Логомашины ВКонтакте есть рубрика, в рамках которой мы даем подписчикам советы по дизайну. Мы показываем, что можно изменить в графике, чтобы дизайн выглядел аккуратнее и понятнее. Сегодня на примере участников нашей рубрики, рассмотрим, какие приемы могут освежить ваш дизайн. Следующих участников мы выберем из комментариев на Хабре — кидайте свой дизайн и вопросы прямо в комментарии к этой статье.

Стоп Обман: отделяем элементы

Этот логотип нам прислал Стоп Обман — команда энтузиастов, которая занимается разоблачением мошеннических интернет-курсов.

Знак неплохой, но у него есть один недочет — он плохо читается, мелкие детали сливаются.

Чтобы улучшить читаемость, упростим знак — оставляем от персонажа только шляпу и очки и отделяем все элементы друг от друга.

Проверим, как это выглядит в маленьком формате и при размытости:

Отдельные элементы не сливаются в темное пятно, как было в старом варианте лого.

Примерим логотип на наклейки разного формата:

Пофантазируем о логотипе и его применении в жизни:

Как итог:

+ Знак стал лучше читаться

— Шляпа и маска не всегда ассоциируется с преступником. Может быть похоже на режим «инкогнито».

Интернет хостинг центр: успокаиваем композицию

Нам прислали такой логотип:

Здесь каждое слово выглядит по разному, у них разное межбуквенное расстояние и толщина букв. Поэтому стоит успокоить шрифтовую часть — набрать название аккуратным шрифтом.

С цветами знака тоже можно поиграть — в исходном варианте много черных блоков. Можно использовать 3 основных цвета и оттенки.

Итог:

+ Композиция стала уверенней

— Сама задумка довольно скучная

3. SOHO: улучшаем читаемость и добавляем экспрессии

SOHO занимается разработкой сайтов. Первоначальный логотип выглядит интересно, но прочесть название не так просто, а форма буквы «S» может ассоциироваться с кофейным зерном.

Если читаемость названия не важна, можно пойти дальше, и сделать его более экспрессивным и минималистичным. Уберем ассоциацию с кофе и добавим элементы, похожие на цифровые часы:

Такой логотип будет выделяться и привлекать внимание, но он абсолютно не читается.

Если нужно, чтобы название читалось, лучше выбрать более классическую форму букв. Например, буквы с большой площадью. Их можно использовать как основу для разных узоров:

Применим к SOHO:

А букву «S» с фирменным паттерном можно использовать как отдельный знак.

Итог:

+ Название можно прочитать

+ Нет ассоциации с кофе

— Нет ассоциации с чем-то компьютерным, а это может быть важно

Glitch: усиливаем идею

Глитч — это анимационная лаборатория, ребята безумные креативщики и отобразили это в логотипе.

Здесь можно посоветовать максимально усилить логотип. “Glitch” — означает сбой, помеха, глюк, так добавим же этого по максимуму!

Для случаев, когда нельзя использовать полную версию логотипа, можно использовать его более спокойную версию — на плашке.

Социальные сети, их тоже можно оформить безумно!

Как итог:

+ Теперь идея логотипа считывается сходу

— Такой логотип сложно использовать на носителях

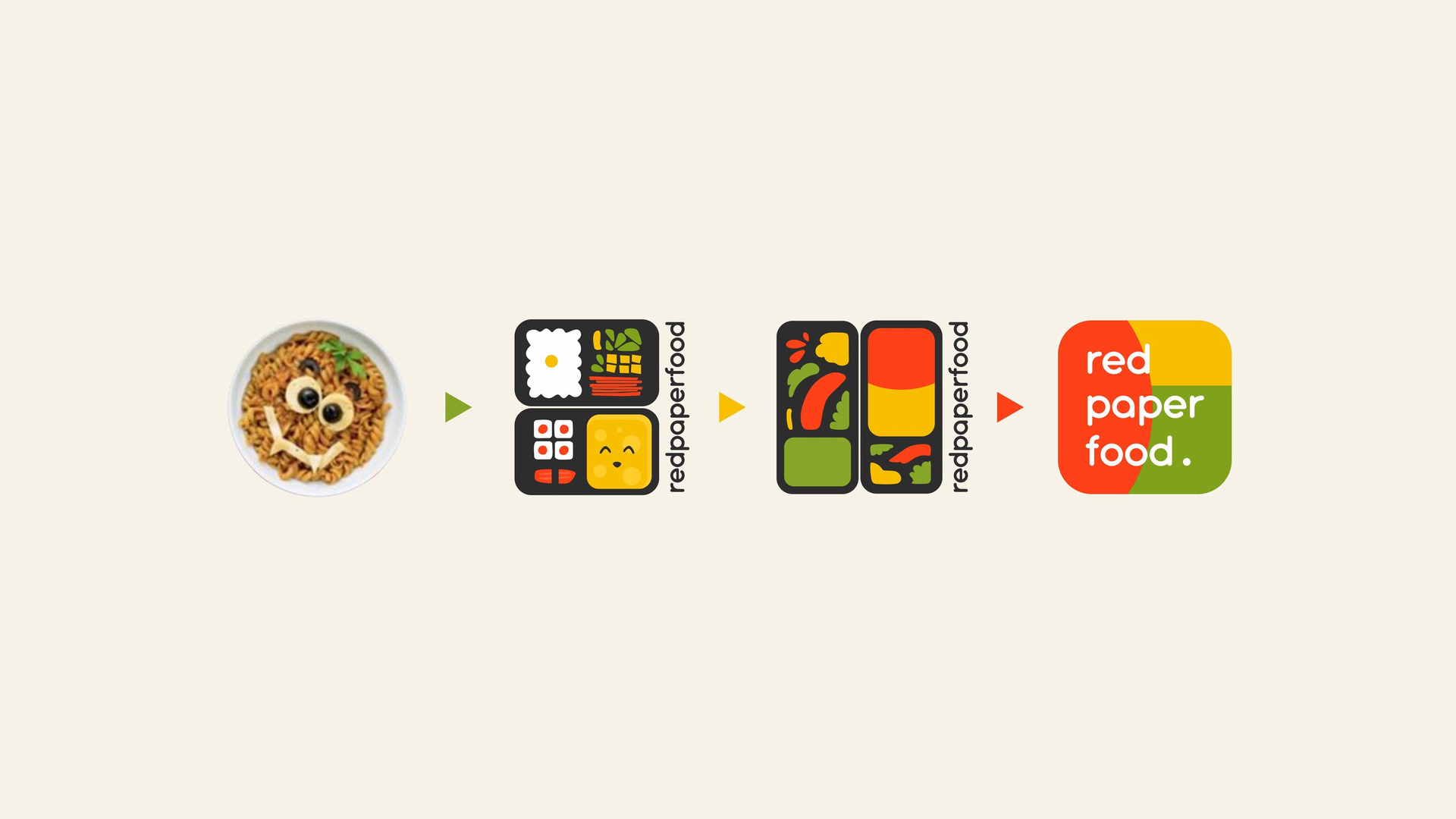

Red Paper Food: развиваем идею

Red Paper Food — очень интересный проект. Это инстаграм-аккаунт программиста, в котором автор размещает фотографии своих бенто-ланчей. Выглядит ярко и безумно вкусно!

На аватарке в качестве логотипа, была использована фотография улыбающейся тарелки с лапшой. Идея этой фотографии очень нравилась нашему участнику, поэтому мы предложили несколько вариантов переосмысления идеи, от более сложной до простой.

Главное, что у канала появится фирменное сочетание цветов, которое поможет ему стать узнаваемым.

Подведем общий итог:

Мы рассказали о нескольких простых приемах, с помощью которых можно улучшить свой дизайн. Не забывайте — это неполноценный редизайн, а просто быстрые советы и направления, которые нам кажутся перспективными.

А теперь внимание! Для пользователей Хабрахабр есть возможность легко попасть в следующий выпуск. Выкладывайте свой дизайн и вопросы в комментарии под этим постом, расскажите немного о проекте, и в следующий раз мы выберем участников из комментариев.

Мы поможем графическим советом, исходники можно будет забрать бесплатно — естественно.

Почитать предыдущие выпуски можно по ссылкам:

Первый выпуск

Второй выпуск

До встречи, и конечно же, удачного дизайна вашим проектам!

Виктория Слепчевич для Логомашины

|

Метки: author Logomachine типографика работа с векторной графикой графический дизайн блог компании логомашина дизайн логотип бизнес советы помощь |

[Перевод] Сравнение цен на трафик у облачных провайдеров |

В этой статье я сравниваю цены на внешний трафик из Amazon EC2, Google Cloud Platform, Microsoft Azure и Amazon Lightsail.

В этой статье я сравниваю цены на внешний трафик из Amazon EC2, Google Cloud Platform, Microsoft Azure и Amazon Lightsail.Стоимость внешнего трафика — один из самых возмутительно завышенных тарифов в облачных хостингах, и есть серьёзные противоречия в индустрии, особенно у Amazon.

Для начала сравним два альтернативных варианта.

Вариант 1 — Колокейшн в дата-центре

100 Мбит/с (32,85 ТБ / месяц) за $950 = $28,91 за ТБ или $0,028 за ГБ / месяц

Примерно три цента за гигабайт — это типичная цена, которую вы заплатите за колокейшн на 100 Мбит/с, если не заключать специальных договоров, и такой вариант легко найти.

Вариант 2 — Google Fiber for Business

1000 Мбит/с (328,5 ТБ / месяц) за $250 = $0,76 за ТБ или $0,00076 за ГБ / месяц

Это небольшой проблеск будущего, где трафик будет гораздо дешевле. Это будущее уже доступно примерно в 27 регионах США. Хорошо, если вы там живёте, но не каждому такое доступно.

Microsoft Azure

1 ТБ / месяц — $88,65 или $0,09 за ГБ

Вот где всё становится безобразным. Цена в 3 раза выше, чем на колокейшне, и в 116 раз выше, чем на Google Fiber.

Google Cloud Platform

1 ТБ / месяц — $122,88 или $0,12 за ГБ

Как такое может быть? Я даже не могу представить, как Google может выставлять такую высокую цену на своей платформе. Это в 4 раза выше, чем на колокейшне, и в 162 раз выше, чем на её собственном сервисе Google Fiber.

Что-то здесь кардинально неправильное, учитывая глобальную инфраструктуру Google, масштаб её бизнеса. Цены Azure ужасны, но у Google намного хуже.

Amazon EC2

1 ТБ / месяц — $90 или $0,09 за ГБ

Снова в 3 раза дороже, чем на колокейшне, и в 116 раз дороже, чем на Google Fiber, а если к вас идут входящие данные, то они будут брать ещё $10 в месяц, поднимая цену до $0,10 за гигабайт.

Amazon Lightsail

2 ТБ / месяц — $10 или $0,005 за ГБ

На первый взгляд выглядит отлично, но это меня и бесит, потому что здесь гигантское «пошёл ты» для клиентов Amazon EC2, которые платят в 18 раз больше за свои первые 2 ТБ трафика.

Amazon даёт бесплатно 2 ТБ подписчикам на план Lightsail за $10 в месяц и только 1 ГБ в месяц бесплатно лояльным пользователям EC2.

Любой, кто сидит на EC2 с пятью или менее серверами t2.micro и использует хоть сколько-то трафика, должен немедленно перейти на Lightsail, если нет какой-то непреодолимой причины не делать этого. И я не могу представить, что это за непреодолимая причина может быть, потому что инстансы Lightsail могут работать с другими сервисами AWS.

На самом деле, даже не важно, какого размера у вас инстансы. Можно просто использовать инстансы Lightsail как маршрутизаторы и поставить перед ними Cloudflare, у вас может быть до пяти инстансов Lightsail на аккаунт.

За $50 в месяц вы можете получить 10 ТБ исходящего трафика по $0,005 за гигабайт.

Заключение

Amazon EC2, Microsoft Azure и Google Gloud Platform — все они серьёзно дурят своих пользователей с тарифами на трафик.

У каждого из трёх больших игроков есть огромные ресурсы, в то же время в среднем у них стоимость трафика в 3,4 раза выше, чем на колокейшне.

Если у вас серьёзные объёмы трафика, то лучше дважды подумать, прежде чем переезжать в облако, эти тарифы действительно несуразные, и их никак не оправдать, если сравнивать с колокейшном.

Хотите сегодня расшевелить рынок облачного хостинга? Дайте трафик по нормальным ценам.

Для записи: «Я люблю Amazon AWS!». Это супергибкий и прекрасный сервис — мне просто не нравятся их тарифы на трафик ;)

|

Метки: author m1rko хостинг облачные вычисления it- инфраструктура microsoft azure google cloud platform amazon ec2 amazon lightsail |

Поиграем в Firebase |

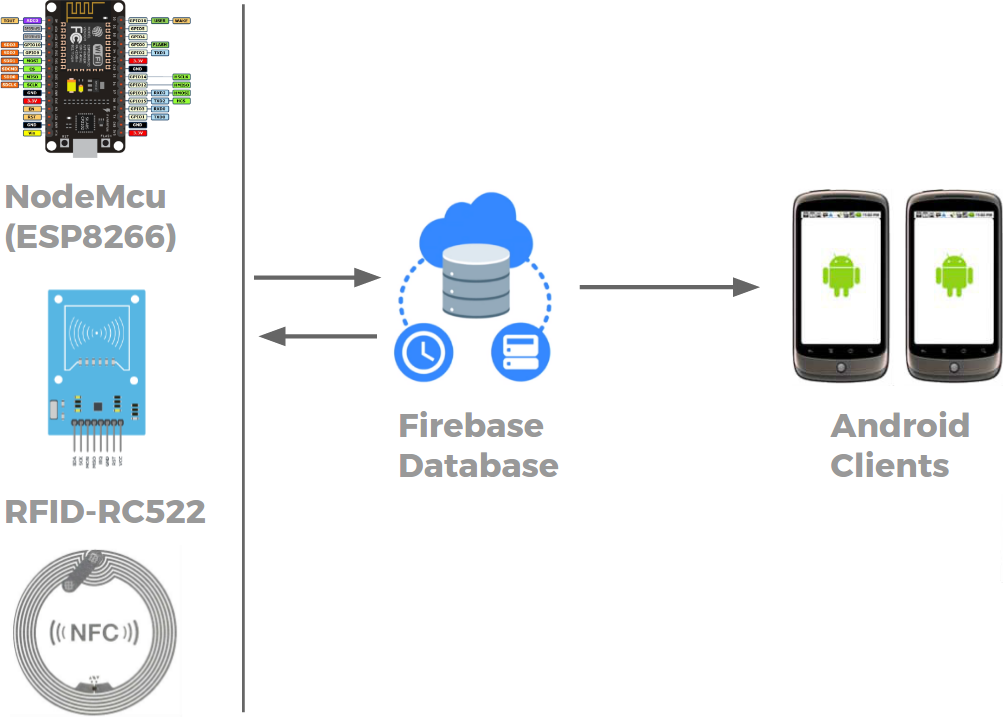

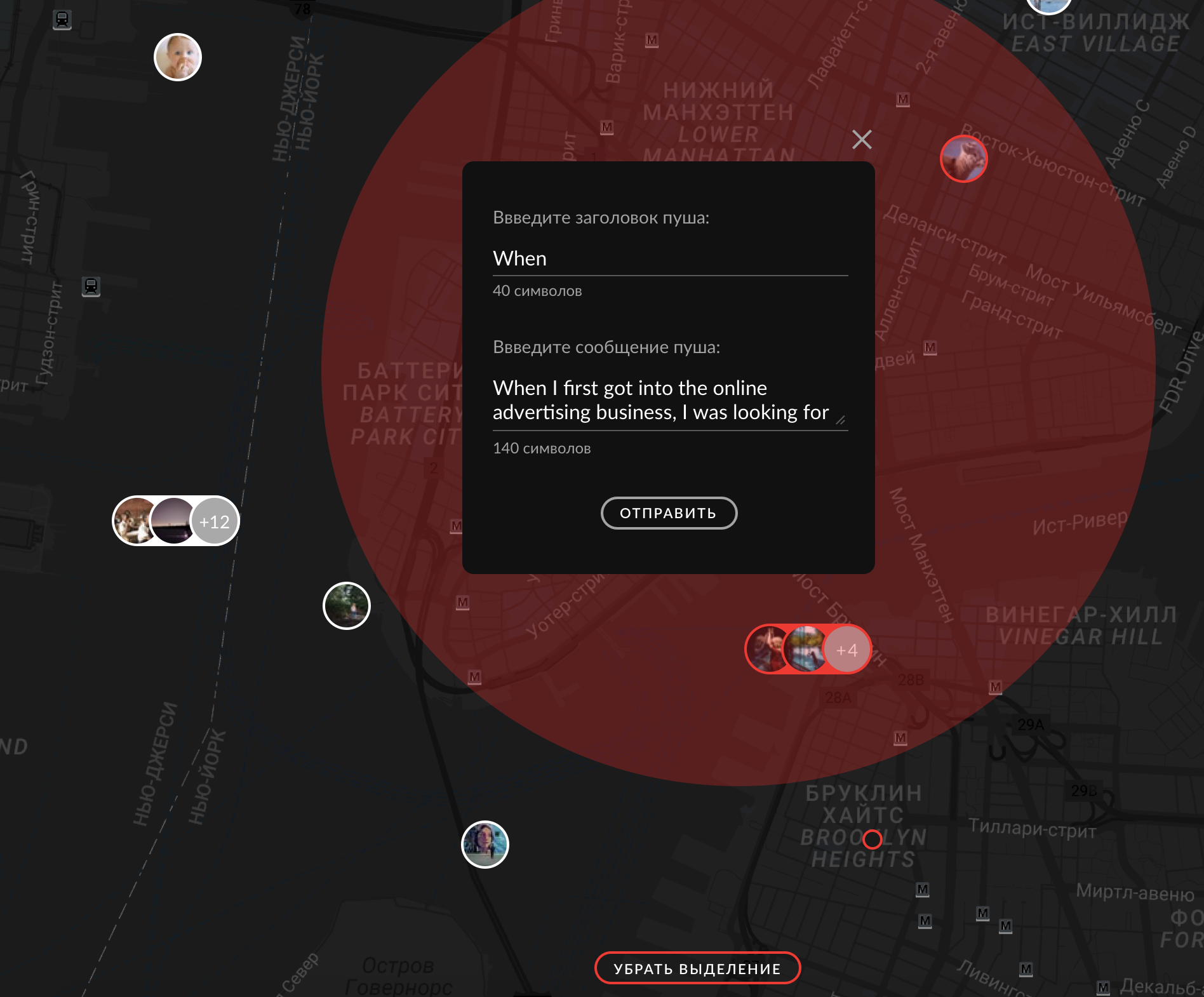

Меня зовут Оксана и я Android-разработчик в небольшой, но очень классной команде Trinity Digital. Тут я буду рассказывать об опыте создания настольной игрушки на базе Firebase и всяких разных железяк.

Меня зовут Оксана и я Android-разработчик в небольшой, но очень классной команде Trinity Digital. Тут я буду рассказывать об опыте создания настольной игрушки на базе Firebase и всяких разных железяк. Так уж вышло, что желание запилить что-то забавное у нас совпало с необходимостью провести митап по Firebase в формате Google Developer Group в Петрозаводске. Стали мы думать, что бы такое устроить, чтобы и самим интересно, и на митапе показать можно, и на развитие потом работать, а в итоге увлеклись не на шутку и придумали целую интеллектуальную настольную игру.

Идея:

Допустим, есть целая куча игр разной степени “настольности” — MTG, Манчкин, DND, Эволюция, Мафия, Scrabble, тысячи их. Мы очень любим настолки за их атмосферность и “материальность”, то есть за возможность держать в руках красивые карточки/фишки, разглядывать, звучно хлопать ими об стол. И все настолки по-разному хороши, но имеют ряд недостатков, которые мешают погрузиться в игру с головой:

- Необходимость запоминать правила: вы должны держать в уме, какие действия корректны, а какие нет, как определяется порядок ходов, какие есть исключения по ходу процесса, в какой момент нужно считать очки еще кучу всего;

- Подсчет значений: а сколько у меня сейчас осталось здоровья? А какой бонус даст мне вот эта карта с учетом всех моих статов? а прошел ли я сейчас проверку скилла при вот этих условиях окружения?

- Трата времени на разбирательства в системе, записи, бросание кубиков…

- Невозможность создать достаточно полную и реалистичную модель, потому что она живет у игроков в головах, а головы ограничены по вместимости;

- Наличие у игроков мета-информации о системе и правилах: вы не сможете наслаждаться познанием системы и открывать для себя новое в игровом мире, потому что должны знать все заранее, ведь вы сами контролируете игровой процесс.

Все эти штуки немного выбивают из колеи, заставляют отвлекаться, снижают динамику. И мы придумали что нужно сделать: засунуть их… в сервер! Базовая идея нашей игрушки такая: пусть все правила, последовательность ходов, подсчет значений, рандомайзер и прочие логические части будут ответственностью некоторой внешней системы. А игроки будут с полной отдачей делать ходы, узнавать закономерности игрового мира, выстраивать стратегии, пробовать новое и эмоционально вовлекаться.

Про концепцию той игрушки, к которой мы хотим прийти в финале, я здесь даже рассказывать не буду: это, конечно, интересно, но зачем делить шкуру неубитого проекта. Я расскажу про демку, которую мы наваяли с целью выяснить, а реально ли вообще сделать то, что задумано.

Proof of concept, так сказать.

Задача:

Надо сделать маленькую, простенькую игру вроде “магического боя”. Парочка оппонентов швыряет друг в друга заклинаниями, выигрывает тот, кто первым прикончит соперника. У игроков есть некоторые статы, допустим, здоровье и мана. Каждое заклинание — это карта, заклинание стоит сколько-то маны и производит какой-то эффект (лечит, калечит, или еще что-нибудь).

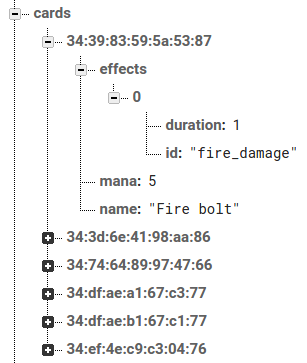

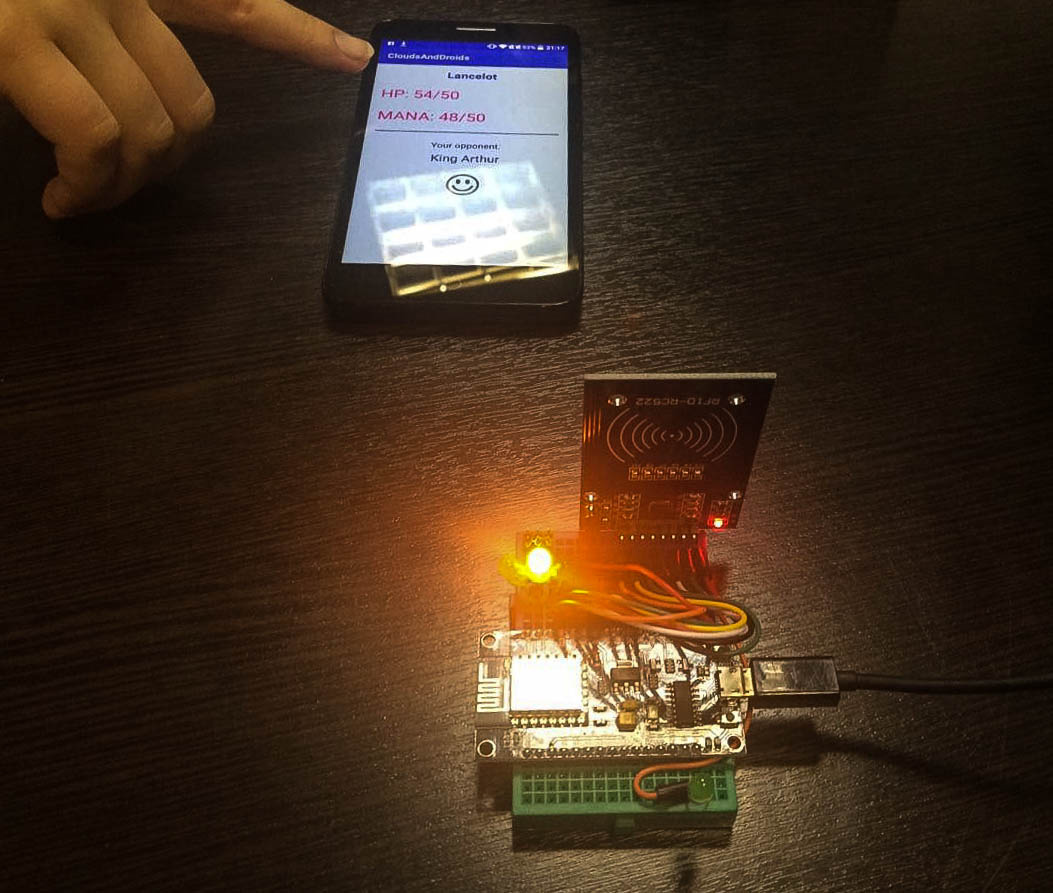

Для реализации нам понадобится следующее:

- куча NFC меток чтобы сделать из них карты (привет билеты московского метро!);

- две штуки (для каждого игрока) ESP8266 + RFID-RC522 чтобы их считывать, когда делается ход и слать в сеть;

- Firebase — чтобы хранить данные, обрабатывать ходы и изменять значения в модели в соответствии правилам;

- Android — чтобы отображать все происходящее (свои статы, чужие статы) для игроков.

Всякие штуки типа “hello world” про Firebase я освещать не буду, благо материалов на этот счет итак достаточно, в том числе и на хабре. Всякие тонкости модели тоже не буду упоминать, чтобы не загружать деталями. Интереснее, как мы будем читать, записывать и обрабатывать данные.

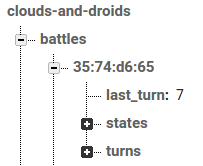

Немножко про модель

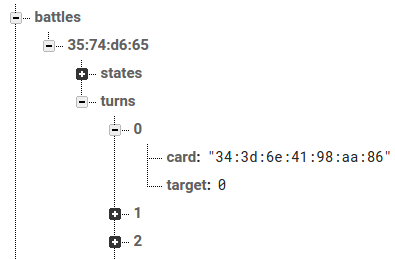

Так в нашей базе выглядят игровые партии.

”35:74:d6:65” — это id партии

states — это игроки

turns — это последовательность ходов

Кроме информации о самих партиях, нам нужно хранить список карт и какие-то предварительные настройки (например, максимально возможные значения здоровья и маны).

Каждая NFC метка может запоминать немного информации. Так как в качестве карточек мы используем билеты московского метро, в каждом из них уже есть уникальный ключ, а нам того и нужно. Считать эти ключи можно, например, любым приложением под андроид, которое умеет в NFC.

Вот кусок из базы, который ставит в соответствии уникальному ключу карточки ее имя, количество маны, необходимое для каста, и набор эффектов, каждый со своей длительностью (в ходах).

Ход происходит следующим образом:

- игрок выбирает карту, подносит ее к одному из считывателей (смотря к кому он хочет применять эффекты — к себе или к оппоненту);

- тот пишет в Firebase Database — “сыграна карта N на игрока M”;

- Firebase функция видит, что в последовательности ходов появилась новая запись, и обрабатывает ее: отнимает у игрока ману за сыгранную карту, приписывает целевому игроку эффекты с текущей карты, а потом применяет все эффекты, которые уже висят на игроках и уменьшает их длительность на 1;

- ну а Android клиент просто отслеживает изменения в Firebase Database и отображает актуальные статы игроков в удобочитаемом виде.

Плавно продвигаемся к железкам и коду

А железки у нас такие: микроконтроллер ESP 8266 и считыватель RFID/NFC RFID-RC522. ESP 8266 в нашем случае хорош тем, что он небольшого размера, кушает мало, есть встроенный WI-FI модуль, а также Arduino совместимость (что позволит писать прошивки в привычной Arduino IDE).

Для прототипа мы взяли плату Node MCU v3, которая сделана на основе ESP 8266. Она позволяет заливать прошивки и питаться прямо через USB, что в рамках прототипирования вообще красота. Писать для нее можно на C и на Lua. Оставив в стороне нашу любовь к скриптовым языкам в целом и к Lua в частности, мы выбрали C, т.к. практически сразу нашли необходимый стек библиотек для реализации нашей идеи.

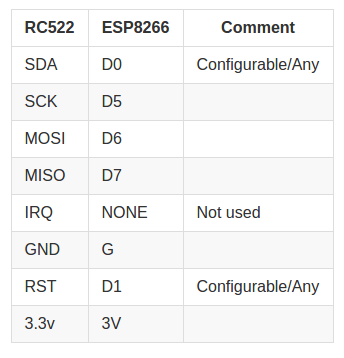

Ну а RFID-RC522 — это, наверное, самый простой и распространенный считыватель карт. Модуль работает через SPI и имеет следующую распиновку для подключения к ESP 8266:

Talk is cheap, show me the code!

Задача у нас такая:

- Прочитать карточку;

- Если это карточка-ключ для создания партии, создать в Firebase новую партию;

- Если это игровая карта, то получить карту и заслать ее в Firebase (создать новый ход);

- Помигать лампочкой.

Сканнер

Используется библиотека MFRC522. Взаимодействие со сканером идет через SPI:

void Scanner::init() {

SPI.begin(); // включаем шину SPI

rc522->PCD_Init(); // инициализируем библиотеку

rc522->PCD_SetAntennaGain(rc522->RxGain_max); // задаем максимальную мощность

}

String Scanner::readCard() {

// если прочитали карту

if(rc522->PICC_IsNewCardPresent() && rc522->PICC_ReadCardSerial()) {

// переводим номер карты в вид XX:XX

String uid = "";

int uidSize = rc522->uid.size;

for (byte i = 0; i < uidSize; i++) {

if(i > 0)

uid = uid + ":";

if(rc522->uid.uidByte[i] < 0x10)

uid = uid + "0";

uid = uid + String(rc522->uid.uidByte[i], HEX);

}

return uid;

}

return "";

}

Firebase

Для Firebase есть замечательная библиотека FirebaseArduino, которая из коробки позволяет отправлять данные и отслеживать события. Поддерживает создание и отправку Json запросов.

Взаимодействие с Firebase получилось ну очень простым и вкратце может быть описано двумя строчками:

Firebase.setInt("battles/" + battleId + "/states/" + player + "/hp", 50);

if(firebaseFailed()) return;Где firebaseFailed() это:

int Cloud::firebaseFailed() {

if (Firebase.failed()) {

digitalWrite(ERROR_PIN, HIGH); // мигаем лампочкой

Serial.print("setting or getting failed:");

Serial.println(Firebase.error()); // печатаем в консоль

delay(1000);

digitalWrite(ERROR_PIN, LOW); // мигаем лампочкой

return 1;

}

return 0;

}Json запрос можно отправить следующим образом:

StaticJsonBuffer<200> jsonBuffer;

JsonObject& turn = jsonBuffer.createObject();

turn["card"] = cardUid;

turn["target"] = player;

Firebase.set("battles/" + battleId + "/turns/" + turnNumber, turn);

if(firebaseFailed()) return 1; Вот в принципе и все, что нам нужно было от “железной части”. Мы изначально хотели максимально абстрагироваться от нее и в целом это у нас получилось. С момента написания первой прошивки она менялась только 1 раз, и то незначительно.

Теперь про специально обученные Firebase функции

Это кусочек базы где хранятся ходы текущей партии. В каждом ходе указывается, что за карта сыграна, и на какого игрока она направлена. Если мы хотим, чтобы при новом ходе что-то происходило, пишем Firebase функцию, которая будет отслеживать изменения на узле “turns”:

exports.newTurn = functions.database.ref('/battles/{battleId}/turns/{turnId}').onWrite(event => {

// нас интересует только создание нового хода, а не обновления

if (event.data.previous.val())

return;

// читаем ходы

admin.database().ref('/battles/' + event.params.battleId + '/turns').once('value')

.then(function(snapshot) {

// выясняем, кто кастит в этот ход

var whoCasts = (snapshot.numChildren() + 1) % 2;

// читаем игроков

admin.database().ref('/battles/' + event.params.battleId + '/states').once('value')

.then(function(snapshot) {

var states = snapshot.val();

var castingPlayer = states[whoCasts];

var notCastingPlayer = states[(whoCasts + 1) % 2];

var targetPlayer;

if (whoCasts == event.data.current.val().target)

targetPlayer = castingPlayer;

else

targetPlayer = notCastingPlayer;

// сколько маны нужно отнять

admin.database().ref('/cards/' + event.data.current.val().card).once('value')

.then(function(snapshot) {

var card = snapshot.val();

// отнимаем

castingPlayer.mana -= card.mana;

// применяем эффекты с текущей карты

var cardEffects = card.effects;

if (!targetPlayer.effects)

targetPlayer.effects = [];

for (var i = 0; i < cardEffects.length; i++)

targetPlayer.effects.push(cardEffects[i]);

// применяем все эффекты, которые уже есть на игроках

playEffects(castingPlayer);

playEffects(notCastingPlayer);

// обновляем игроков

return event.data.adminRef.root.child('battles').child(event.params.battleId)

.child('states').update(states);

})

})

})

});

Функция playEffects выглядит следующим образом (да, там eval, но мы думаем что в демо-проекте это вполне допустимо):

function playEffects(player) {

if (!player.effects)

return;

for (var i = 0; i < player.effects.length; i++) {

var effect = player.effects[i];

if (effect.duration > 0) {

eval(effect.id + '(player)');

effect.duration--;

}

}

}

Каждый из эффектов будет примерно таким:

function fire_damage(targetPlayer) {

targetPlayer.hp -= getRandomInt(0, 11);

}

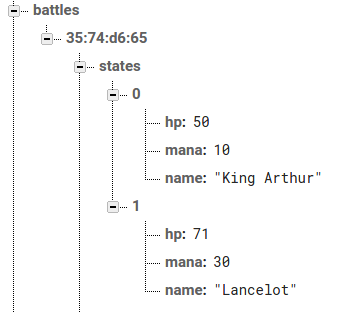

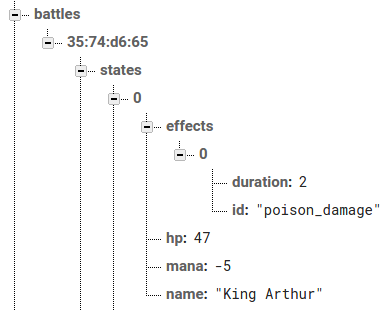

Тут, наверное, стоит пояснить, что игроки в нашей базе представлены так:

То есть у каждого из них есть имя, здоровье и мана. А если в них что-то прилетит, то появятся еще и эффекты:

Кстати, есть еще одна задача, связанная с эффектами: те, что уже отработали свою длительность, надо убирать. Напишем еще одну функцию:

exports.effectFinished = functions.database.ref('/battles/{battleId}/states/{playerId}/effects/{effectIndex}')

.onWrite(event => {

effect = event.data.current.val();

if (effect.duration === 0)

return

event.data.adminRef.root.child('battles').child(event.params.battleId).child('states')

.child(event.params.playerId).child('effects').child(event.params.effectIndex).remove();

});

И осталось сделать так, чтобы вся эта красота была видна на экране телефона.

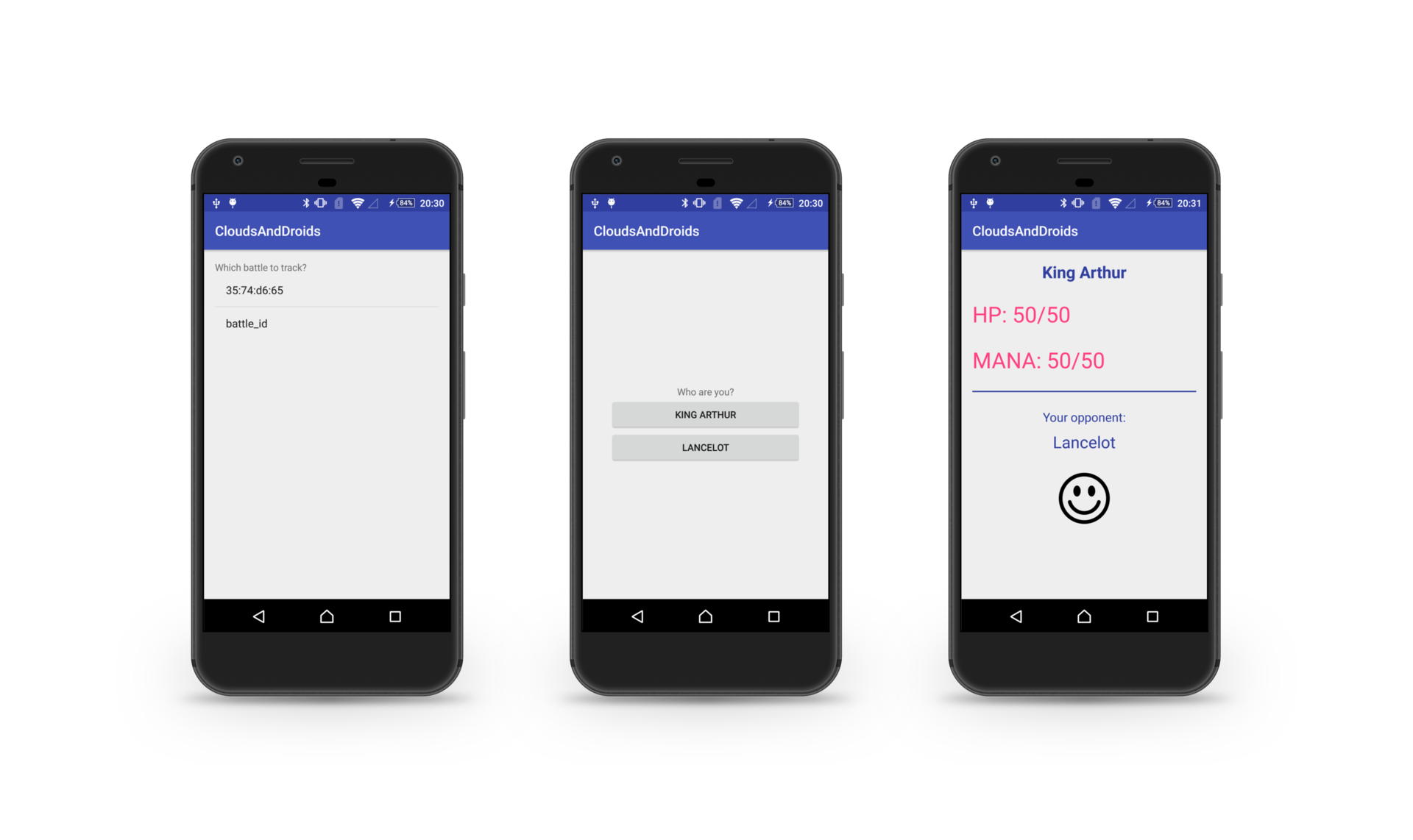

Например, вот так:

Да, именно так:

Выбираем партию и кого из оппонентов отслеживать и потом наблюдаем свои статы цифрами, а статы оппонента в обобщенном виде (пусть это будет смайлик разной степени веселости).

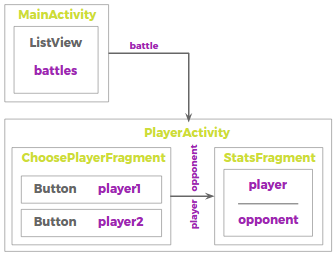

Вот тут условная схемка приложения, чтобы дальше код легче читался:

С чтением данных из Firebase на Android все достаточно просто: вешаем слушатели на определенные узлы в базе, ловим DataSnapshot`ы и отправляем их в UI. Вот так будем показывать список партий на первом экране (я сильно сокращаю код, чтобы выделить только моменты про получение и отображение данных):

public class MainActivity extends AppCompatActivity {

// ...

@Override

protected void onCreate(Bundle savedInstanceState) {

// ...

FirebaseDatabase database = FirebaseDatabase.getInstance();

// слушатель на узле "battles" нашей базы (он получает данные когда добавлен,

// и потом каждый раз когда что-то изменилось в списке партий)

database.getReference().child("battles").addValueEventListener(new ValueEventListener() {

@Override

public void onDataChange(DataSnapshot battles) {

final List battleIds = new ArrayList();

for (DataSnapshot battle : battles.getChildren())

battleIds.add(battle.getKey());

ArrayAdapter adapter = new ArrayAdapter<>(MainActivity.this,

android.R.layout.simple_list_item_1,

battleIds.toArray(new String[battleIds.size()]));

battlesList.setAdapter(adapter);

battlesList.setOnItemClickListener(new AdapterView.OnItemClickListener() {

@Override

public void onItemClick(AdapterView |

Метки: author DaryaGhor разработка под android разработка для интернета вещей android iot game development firebase |

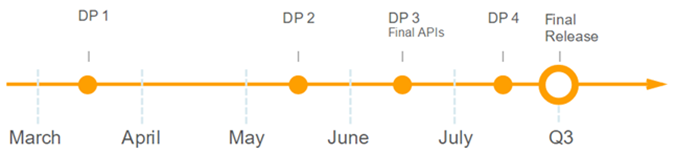

Android O: особенности поддержки новой операционной системы |

Всем привет! Совсем скоро состоится важное событие – выход Android O. Поддержка новых версий операционной системы – обязанность любого серьезного продукта. Каждое обновление Android заставляет многих разработчиков серьезно поработать для сохранения работоспособности имеющихся функций и привнесения нового благодаря возможностям новых версий Android.

В данной статье мы рассмотрим основные изменения Android O и оценим их возможное влияние.

Работая над Android O, разработчики Google в первую очередь решали проблему быстрого расхода заряда аккумулятора на Android-устройствах, поэтому основные изменения связаны с оптимизацией фоновых задач и расхода ресурсов приложения.

Изменения в Android O можно разделить на две категории:

Потенциально «ломающие» текущую работоспособность и требующие дополнительных усилий для поддержки;

Угроза Target >= O Target < O Эффект Background Location Limits Affected Affected Ограничение на запрос геолокации Background Execution Limits Affected OK Изменение списка доступных бродкастов в манифесте;

Изменение времени работы сервисов в фоне.Notification Channels Affected OK Доработки для каналов нотификаций WindowManager Affected OK Влияние на работу перекрывающих окон Privacy (Build.Serial/net.dns/e.t.c.) Affected Affected Изменение доступности пользовательских идентификаторов AccountManager.

getAccounts()Affected OK Запрос списка аккаунтов на устройстве возвращает null

- Возможности для реализации новых функций.

Новые возможности Применение Android Enterprise Улучшение контроля над девайсом Autofill Framework Автозаполнение полей ввода Notification Channels Улучшение UX Picture in Picture Улучшение UX Adaptive Icon Консистентность с прошивкой вендора Accessibility button and fingerprint gestures Улучшение UX (accessibility кнопка в navigation bar, отлавливание жестов по сканеру отпечатка пальцев) Webview Apis (напр., Safebrowsing) Улучшение встроенных возможностей Webview Pinning shortcuts and Widgets Программное создание ярлыков и виджетов в лаунчере

На наш взгляд это наиболее значимые (по крайней мере для «Лаборатории Касперского») изменения в Android O. Рассмотрим каждое по отдельности.

Background Location Limits

Это ограничение на количество запросов местоположения для приложений, находящихся в фоне. Так, начиная с Android O и независимо от установленного TargetSDK, приложения смогут получать всего несколько обновлений местоположения в час. При этом, эти ограничения не распространяются на приложения, для которых справедлив хотя бы один из следующих параметров:

- Приложение не в фоне (запущено Activity, которое находится в состоянии Started или Paused);

- Приложение имеет активный Foreground-сервис;

- Другое Foreground-приложение имеет соединение с текущим (как через bind service, так и через content provider).

Таким образом, для Foreground-приложений поведение будет таким же, как и на предыдущих версиях Android.

В случае, если foreground service отсутствует, то запрос геолокации будет изменен:

- Fused Location Provider (FLP)

- Для Background-приложений система будет определять новое местоположение только несколько раз в час, даже если приложение явно запросило больше обновлений

- Для Foreground-приложений логика работы останется без изменений

- Geofencing

- Background-приложения смогут получать обновления от geofencing-api чаще, чем обновления от Fused Location Provider

- GNSS Measurements and GNSS Navigation Message

- Для приложений, находящихся в фоне не будут приходить обновления для сервисов GnssMeasurement и GnssNavigationMessage

- Location Manager

- Для Background-приложений система будет определять новое местоположение только несколько раз в час

Background execution limits

Ограничение на фоновую работу приложения – ключевое изменение Android O, которое будет заметно в большой степени лишь при переходе на targetSdk “O”. В случае, если targetSdk <= 25, то если приложение находится в фоне и было переведено системой в Cached-состояние (когда система может свободно убить процесс в любой момент), и при этом оно не имеет активных компонентов, система отпустит все WakeLock (индикатор, что приложение не должно быть в состоянии сна) этого приложения. Важно отметить, что в случае, если приложение не targetSDK < O, то в настройках можно выставить политику поведения такую же, как если бы приложение было бы с targetSDK O.

Для приложений с targetSdk “O” background execution limits состоят из двух категорий:

- Ограничение фоновых сервисов

После того как приложение перешло в background, у него есть «окно» в несколько минут, в течение которого сервисы могут запускаться и работать. После истечения этого интервала все сервисы останавливаются, а запуск новых будет приводить к падению приложения. Google старается минимизировать количество работающих фоновых сервисов и предлагает использовать JobScheduler и GcmNetworkManager.

В случае если необходимо выполнять длительные задачи в фоне, рекомендуется использовать foregroundService, который будет явно говорить пользователю, что приложение работает.

Стоит обратить внимание, что после того как вызвалиContext.startForegroundService()необходимо в течение 5 секунд вызватьstartForeground(), в противном случае система может показать ANR. - Ограничений на регистрацию broadcasts в манифесте

Новая версия Android продолжает дело, начатое Android 7.0 (наверняка все помнят приложения, которые переподнимались при каждой смене мобильной станции). Но если в 7-ой версии в манифесте нельзя было зарегистрировать всего лишь несколько бродкастов, то теперь таких бродкастов стало большинство.

Notification Channels

Notification Channels — инструмент для группировки нотификаций в тематические группы, которыми пользователь сможет управлять напрямую. Если приложение собрано с target >= O, тогда необходимо поддержать хотя бы один из каналов нотификаций. В случае, если targetApi < O, тогда работа с нотификациями внутри продукта останется прежней.

WindowManager

В Android O вводится новый тип окон (для targetSDK O), которые могут быть выведены поверх других окон – TYPE_APPLICATION_OVERLAY. При этом несколько старых типов окон стали deprecated, и теперь при их использовании генерируется RuntimeException.

Эти типы окон теперь могут использоваться только системными приложениями:

Privacy (Build.Serial/net.dns/e.t.c.)

В Android O появляются некоторые улучшения, призванные помочь пользователю управлять доступом к своим идентификаторам. Эти улучшения включают:

- Ограничение на использование постоянных (не сбрасываемых) устройство-зависимых идентификаторов

- Обновление системой Wi-Fi стека, связанного с изменениями прошивки Wi-Fi-чипсета на устройствах типа Pixel, Pixel XL и Nexus 5x для рандомизации MACадресов во время сканирований сетей

- Обновление в механизме, при помощи которого приложения запрашивали информацию об учётной записи и предоставление большего контроля над данными пользователя

AccountManager.getAccounts()

Начиная с Android O, разрешения GET_ACCOUNTS недостаточно для получения доступа к списку учетных записей. Теперь существует два варианта для приложений с targetSDK O:

- Использовать

AccountManager.newChooseAccountIntent(). - Использовать метод, определяемый аутентификатором, для доступа к учетной записи.

Android Enterprise

Google активно развивает Android for Work. В Android O они предоставили больше возможностей для контроля устройства. Например, для рабочего профиля можно заводить отдельную блокировку со своими настройками, узнавать информацию о доступных обновлениях системы.

Autofill Framework

C появлением Autofill Framework API появилась возможность более удобного заполнения пользовательских данных в приложения, чем при использовании Accessability. При вызове фреймворка нужно будет сопоставить packageName продукта, для которого произошел вызов на автозаполнение, после чего предоставить данные для ввода. Для верной идентификации полей логина и пароля нужно создать и поддерживать базу с resourceId контролов или другой служебной информацией, позволяющей верно идентифицировать UI-элементы для автозаполнения.

Picture in Picture

Android O позволяет запускать активности в режиме Picture-In-Picture, который является специальным типом multi-window mode. Google рекомендует использовать данный режим исключительно для приложений, отображающих видео.

Adaptive Icon

Начиная с Android O для приложения можно предоставить еще один вариант Launcher Icon, который система сможет по маске легко обрезать до формы, которая используется производителем устройства. Также при наличии такой иконки система сможет делать некоторые анимации иконок приложений.

Pinning shortcuts and Widgets

Новая возможность Android O — программное создание ярлыков и виждетов в лаунчере. Ярлык представляет собой отдельную иконку, позволяющую по клику выполнить задачу в приложении по заданному интенту. Для успешного прикрепления виджета или ярлыка требуется согласие пользователя в системном диалоге-подтверждении.

Вывод

Время, когда Android позволял делать все что угодно, уходят в прошлое. Android расширяет «легальные» инструменты для создания новых функций, закрывает бреши для хаков и заставляет работать честно. Android O ломает часть существующих приложений, но старается сделать конечных пользователей счастливее. Ура, спасибо!

Желаю всем писать хорошие приложения, думать о пользователях и быть счастливыми владельцами Android-устройств.

P.S.

Автор статьи — Александр Шиндин ayushindin.

Саша написал статью и смело заболел, поэтому доверил выложить статью на Хабр мне =)

Пожелаем ему скорейшего выздоравления!

|

Метки: author xoxol_89 разработка под android разработка мобильных приложений java блог компании «лаборатория касперского» android android development mobile development android o |

Подлинность ваших видео теперь неоспорима благодаря Prover |

Четыре миллиарда людей по всему миру владеют гаджетами. Создаваемый ими видеоконтент давно перестал использоваться лишь в развлекательных целях – сегодня это необходимая часть медийной, финансовой, страховой, юридической и медицинской отраслей. Выдаваемые за правду “фейки” не раз приводили к скандалам, а то и трагедиям, поэтому потребность в подтверждении подлинности видео-файлов необычайно высока. Сервис Prover (https://prover.io), подтверждающий достоверность видео с привязкой к конкретному времени и устройству, был создан именно с этой целью.

Технология Prover гарантирует, что контент был записан в конкретное время в конкретном месте камерой конкретного устройства, и подтверждает отсутствие признаков подлога и редактирования. Это стало возможным благодаря использованию сразу двух ведущих блокчейн-платформ: Emercoin и Ethereum.

Для верификации видео-материалов Prover предлагает два способа верификации видео-материалов. Первый — использование swype-кода. Пользователь, включивший камеру смартфона, видит сгенерированный в блокчейне swype-код – координатную сетку из 9 точек по 3 в ряд. Для его ввода пользователю необходимо перемещать в пространстве телефон, чтобы виртуальная линия swype прошла по требуемой траектории. После завершения съемки хэш полученного видеофайла со всеми данными автоматически сохранится в Prover.

Второй способ, не требующий никаких дополнительных действий пользователя, — запись информации со всех датчиков, имеющихся в мобильном устройстве: акселерометра, гироскопа, магнитометра, GPS и др. Математический аппарат, разрабатываемый командой Prover, сможет в мельчайших деталях восстановить движения мобильного устройства в руках пользователя и сопоставить эти движения с видеоконтентом. Математическая модель такого аппарата уже создана.

Из каких же элементов состоит Prover? Во-первых, Prover – это мобильное приложение для смартфонов, синхронизирующееся с работой видеокамеры и сохраняющее информацию в блокчейн Emercoin. Во-вторых, это набор алгоритмов и реализующих их утилит, необходимых для интеграции со сторонними сервисами. В-третьих, смарт-контракт Proof, реализованный на базе платформы Ethereum.

При использовании приложения Prover, пользователям будет всегда доступна информация, сохраняемая в блокчейн, такая, как:

- дата и время получения индивидуального swype-кода;

- сгенерированный swype-код;

- хэш файла видеоданных (сам файл видеоданных хранится у пользователя);

- дата и время загрузки хэша.

В блокчейне Emercoin формирование swype-кода осуществляется на основе хэша последнего блока в цепи, адреса клиента блокчейн-сети и другой необхоодимой информации. После завершения видеозаписи осуществляется вычисление хеша полученного видеофайла. Хэш сохраняется в блокчейне Emercoin вместе с указанием номера блока, на основе которого сформирован swype, а также идентификатора мобильного устройства, которым снято видео.

Где же все это может пригодиться?

- Автострахование (КАСКО) — в случае наступления страхового случая, в качестве доказательства клиент сможет представить видеозапись, заверенную системой Prover;

- Подтверждение авторства видео — ведя запись видео, пользователь может навсегда закрепить за ней свое авторство и иметь возможность его подтвердить;

- Удаленный контроль пациентов — клиники и страховые компании смогут подтверждать, что больной получил должную терапию в полном объеме. Пациент же сможет доказать, что он надлежащим образом выполнил все предписания врачей;

- Онлайн-игры и квесты — технология Prover встраивается в мобильные приложения, позволяя регистрировать наступление игровых событий;

- Отчеты о проделанной работе — удаленная проверка производства работ (строительство, монтаж, уборка, патрулирование, курьерская доставка и т.п.).;

- Фиксация нарушений ПДД и общественного порядка — время, дата и место записи видео-свидетельства для предоставления правоохранительным органам;

- Образовательные проекты — удаленная идентификация пользователей и верификация их действий внутри образовательной платформы;

- Видео-сообщения юридического характера — защита и подтверждение видео-сообщений без очного визита к должностным лицам.

Проинвестировать в технологию Prover в скором времени сможет любой: краудсейл будет осуществляться в рамках экосистемы Ethereum. Инвесторы смогут приобрести токены Proof по фиксированной ставке, получая право пользоваться услугами сервиса бесплатно или со скидками, а также претендовать на часть накопленных смарт-контрактом Proof средств пропорционально количеству токенов в общей эмиссии.

Сайт проекта Prover — https://prover.io

Рекомендую обязательно взглянуть

|

|

[Из песочницы] Кластеризация маркеров на карте Google Maps API |

Вот что мне предстояло сделать:

Первое что пришло мне на ум, поискать готовое решение для react.js. Я нашел 2 топовых библиотеки google-map-react и react-google-maps. Они представляют собой обертки над стандартным API Google maps, представленные в виде компонент для react.js. Мой выбор пал на google-map-react потому-что она позволяла использовать в качестве маркера любой JSX элемент, напомню что стандартные средства google maps api позволяют использовать в качестве маркера изображение и svg элемент, в сети есть решения, описывающие хитрую вставку html конструкций в качестве маркера, но google-map-react представляет это из коробки.

Едем дальше, на макете видно что если маркеры находятся близко к друг другу, они объединяются в групповой маркер — это и есть кластеризация. В readme google-map-react я нашел пример кластеризации, но он был реализован с помощью recompose — это утилита, которая создает обертку над function components и higher-order components. Создатели пишут чтобы мы думали что это некий lodash для реакта. Но тем, кто незнаком с recompose врятли сразу будет все понятно, поэтому я адаптировал этот пример и убрал лишнюю зависимость.

Для начала зададим свойства для google-map-react и state компоненты, отрендерим карту с заранее подготовленными маркерами:

(api key получаем здесь)

const MAP = {

defaultZoom: 8,

defaultCenter: { lat: 60.814305, lng: 47.051773 },

options: {

maxZoom: 19,

},

};

state = {

mapOptions: {

center: MAP.defaultCenter,

zoom: MAP.defaultZoom,

},

clusters: [],

};

//JSX

{this.state.clusters.map(item => {

if (item.numPoints === 1) {

return (