Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Vivaldi 1.10 — маленькие радости широких возможностей |

Всем привет!

Мы продолжаем следовать своим принципам — совершенствовать браузер, добавляя востребованные пользователями функции. И в сегодняшней финальной версии Vivaldi 1.10 вы найдёте несколько новинок, которые давно ждали своей очереди. Список наиболее заметных новшеств выглядит следующим образом:

- Добавление собственных эскизов в ячейки Экспресс-панели

- Управление количеством столбцов ячеек Экспресс-панели

- Закрепление средств разработки в окне браузера

- Возможность управления стартовой страницей с помощью расширений

- Сортировка списка загруженных файлов

Теперь давайте подробнее ознакомимся с этими улучшениями.

Расширяем возможности Экспресс-панели

Экспресс-панель — это первое, что видит пользователь, запустив только что установленный браузер. Также в большинстве случаев именно эта панель является стартовой при ежедневной работе в Vivaldi. Поэтому логично, что мы уделяем улучшению этого элемента большое значение. Сегодня Экспресс-панель становится ещё чуть более удобной в работе благодаря новым возможностям по управлению ячейками закладок. В частности, мы добавили возможность устанавливать собственные эскизы для ячеек:

Вы можете подготовить собственную картинку (стандартный размер — 440х360 пикселей, но браузер масштабирует рисунок под размер ячейки):

Также вы можете использовать и анимированные картинки в формате GIF. Также вы можете аналогично менять картинку и для папок Экспресс-панели — соответствующий пункт можно найти в контекстном меню правой кнопки мыши.

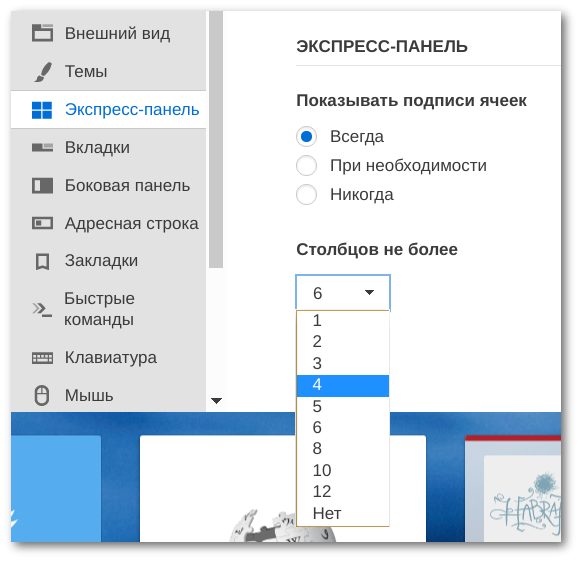

Ещё одно улучшение — вы можете теперь сами устанавливать, какое максимальное число столбцов ячеек может быть представлено на Экспресс-панели. Также вы можете отключить эту функцию — тогда браузер будет автоматически подбирать количество столбцов исходя из размера окна браузера.

Пока ячейки не масштабируются — данное улучшение будет реализовано чуть позднее.

Закреплённые средства разработчика

Запрос на данную функцию стал регулярным после каждого выхода новой версии с тех пор, как мы добавили в браузер средства разработки. Да, речь идёт о том, чтобы была возможность закреплять эти инструменты непосредственно в окне браузера. Несмотря на то, что запрос этот был, в общем, вполне логичным и справедливым, мы не могли его реализовать на скорую руку — слишком многое нужно было поменять в коде браузера. Но задача эта постепенно была решена — сегодня мы готовы представить вам средства разработки, закрепляемые в окне браузера:

При этом у вас есть возможность как выбрать место расположения инструментов (слева-внизу-справа), так и открепить их от окна браузера:

Другие мелочи

Помимо этого мы добавили ещё немного полезных новинок, как, например, возможность управления вновь открываемой вкладкой с помощью расширений или отключение отображения в выпадающем списке адресной строки закладок и введённых адресов. А ещё мы добавили опцию сортировки списка загруженных файлов, что сделает более комфортным поиск нужных загрузок.

Впрочем, конечно, мы помним и про ещё два больших запроса — на синхронизацию и почтовый клиент. Могу сказать, что работа над этими функциями идёт очень активно и уже в текущем году мы сможем показать вам результаты своей работы в этом направлении. Но это уже ближе к осени: летом пора отпусков, поэтому активность разработки немного снижается.

На этом пока всё. Как всегда, список всех изменений и исправлений содержит много интересного. Если же вы не нашли мешающую вам проблему в списке исправленных — не стесняйтесь рассказать нам о ней через соответствующую форму отправки сообщений об ошибках.

Загрузить новую версию браузера можно с официальной страницы загрузки.

|

Метки: author Shpankov разработка веб-сайтов браузеры блог компании vivaldi technologies as vivaldi vivaldi technologies финал 1.10 |

Microsoft Azure Media Services — обзор основных возможностей платформы |

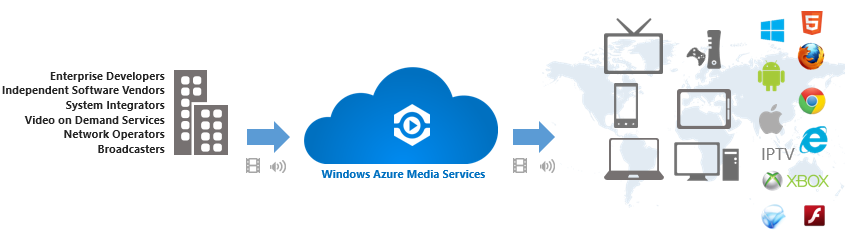

Azure Media Services — это сервисы технологии платформы Microsoft Media Platform, которые доступны из облака в формате SaaS (Software as Service) и PaaS (Platform as Service). Среди преимуществ работы с ними — возможность масштабирования, а также использования их совместно с собственными средствами кодирования, вещания и распространения контента. Также платформа позволяет загружать контент, проводить его перекодирование и конвертацию, организовывать прямые трансляции, вещание по расписанию и просто встраивать видео на сайты. Также пользователям доступана защита контента, работа с рекламой и аналитикой.

Эти и многие другие полезные функции сделали Azure Media Services очень популярной платформой. Например, с ее помощью велась трансляция соревнований Олимпийских игр 2016 года в Рио-де-Жанейро, сервисами Azure Media пользуется один из самых титулованных футбольных клубов мира Реал (Мадрид).

Интерфейс

Работа со всеми функциями Azure Media Services происходит во вкладке браузера. Нужно просто залогиниться в свою учетную запись и запустить службу. Интерфейс довольно простой — слева панель меню, сверху адресная панель и панель уведомлений и настроек, посредине — рабочее пространство. На скриншоте внизу, например, вы видите процесс перекодирования и обработки видео.

Работа с мультимедиа

Перед тем, как видео появляется на том или ином сайте, оно проходит несколько этапов подготовки. Начинается все с загрузки исходного видео на сервер, его обработки, конвертации, и т. д. Для этих и многих других действий в Azure Media Services есть специальные инструменты REST API, .NET и Java SDK. Также присутствует ряд клиентских инструментов, разработанные специалистами Microsoft. С помощью этого обширного инструментария можно настроить и контролировать каждый аспект подготовки и воспроизведения видео, например, перемотку или добавление рекламы. Расскажем вкратце о всех этих этапах по порядку.

Загрузка

Отправлять файлы в облако Azure для дальнейшей обработки можно через веб-интерфейс. Для этого нужно просто выбрать пункт Ресурсы, а затем нажать кнопку Отправить. Затем нужно выбрать файлы с компьютера (для загрузки доступны видео, аудио, изображения, коллекции эскизов, текстовые каналы, файлы скрытых субтитров и метаданные этих файлов) и отправить их в облако. При этом размер файлов не ограничен, а хранится они будут в безопасной облачной среде, доступные для последующих изменений и потоковой передачи.

Ресурсы также могут быть отправлены в облако при помощи инструментов .NET и REST. В этом случае данные могут быть сразу зашифрованы, также будут доступны некоторые другие возможности. Подробности и примеры вы можете найти на сайте Microsoft.

При необходимости отправки множества больших файлов также можно воспользоваться функцией массовой загрузки из библиотеки .NET. Альтернатива —сторонние инструменты, например, Aspera, — программное обеспечение для высокоскоростной передачи файлов. Это средство должно быть куплено отдельно в Azure Marketplace. После регистрации продукта, установки модуля для браузера и клиента, а также настройки инструмента вы сможете без проблем отправлять большие объемы файлов в облако. Подробнее об Aspera читайте здесь.

Также отправлять файлы в учетную запись можно с помощью Azure StorSimple — решения интегрированного хранилища, которое управляет его задачами на локальных устройствах и в облаке Azure. В Azure StorSimple облачное хранилище используется в качестве расширения локального решения и автоматически связывает их данные. Перед отправкой файлов в облако StorSimple дублирует и сжимает их, таким образом обеспечивается эффективная передача данных большого объема. Подробнее о работе с Azure StorSimple вы узнаете здесь.

Кодировка

У Windows Azure Media Services есть инструменты для перекодировки файлов в разнообразные мультимедийные форматы. Система поддерживает FLV, MXF, GXF, MPEG2, 3GP, Windows Media Video, Microsoft Digital Video Recording, AVI, MP4, Matroska/WebM, WAVE/WAV и QuickTime (все поддерживаемые видео- и аудиокодеки смотрите по ссылке).

Одним из главных преимуществ платформы Azure Media Services перед конкурентами является то, что она использует динамичную упаковку контента. Каждый файл в облаке хранится в одном варианте и перекодируется уже непосредственно перед доставкой на конечное устройство, вместо того, чтобы хранить по экземпляру файла для каждой платформы (например, для Android, iOS, и XboX). Это позволяет существенно экономить место в облаке и, как следствие, средства.

Скорость обработки мультимедиа можно регулировать вручную. Таким задачам присваиваются значения — S1, S2 и S3. Например, если использовать тип зарезервированной единицы S2, задание по кодированию выполняется быстрее по сравнению заданием, для которого выбран тип S1. В разных типах учетных записей количество параллельных задач обработки варьируется. Например, если в учетной записи имеется пять зарезервированных единиц, то можно запустить пять одновременно выполняемых задач. Остальные задания, если они были поставлены, будут дожидаться своей очереди и как только один из потоков будет обработан, задание из очереди станет выполняться автоматически. Более подробную информацию о кодировании вы найдете на сайте Microsoft.

Проигрыватель

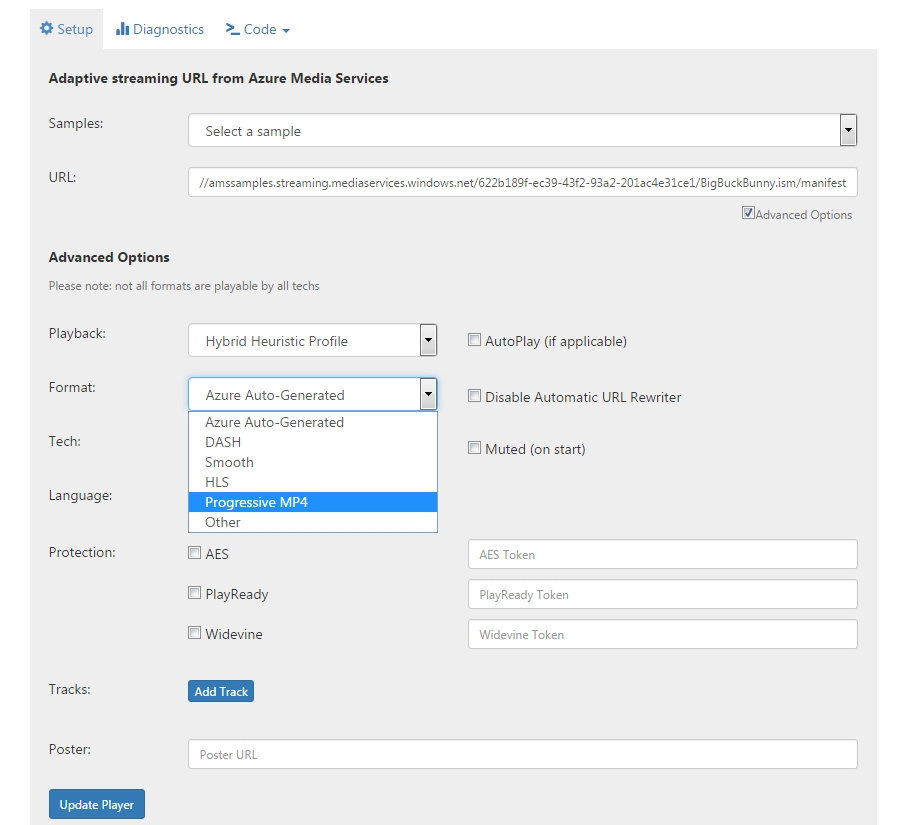

Еще одна отличительная особенность Azure Media Services — это универсальность фирменного проигрывателя. Сервис поддерживает практически все современные устройства и платформы — Mac и ПК, iOS и Android, HTML5, Flash, Silverlight, XboX и т. д. Для работы с разнообразными встраиваемыми устройствами, которые имеют собственный фреймворк разработки, можно лицензировать пакеты для портирования Smooth Streaming Client Porting Kit и Microsoft PlayReady Device Porting Kit. Примеры таких устройств — медиаплееры, Smart TV и т. д.

Проигрыватель в своей работе также использует отраслевые стандарты Media Source Extensions (MSE) и Encrypted Media Extensions (EME), которые лучше всего подходят для адаптивной потоковой передачи. Если же они недоступны на устройстве или в браузере, проигрыватель переходит на Flash и Silverlight. Эти опции задаются в расширенных настройках проигрывателя путем выбора соответствующих пунктов из выпадающего списка. Причем для трансляции можно задать как описанную выше возможность автовыбора, так и использование конкретной технологии.

Службы мультимедиа Microsoft Azure поддерживают форматы потоковой передачи DASH, Smooth Streaming и HLS для воспроизведения содержимого. Azure Media Player учитывает эти различные форматы и автоматически воспроизводит наиболее подходящую ссылку в зависимости от возможностей платформы или браузера. Но можно также задать работу с конкретным форматом. Какую-бы технологию и платформу не выбрал бы разработчик, он получает единый интерфейс JavaScript для доступа к интерфейсам API. Все это позволяет проигрывателю Azure обслуживать содержимое для воспроизведения на самом широком спектре устройств и в различных браузерах. Говоря проще, не стоит волноваться, что видео не будет работать или отображаться некорректно на каком-то типе устройств.

Если транслятор хочет зашифровать свои ресурсы от несанкционированного доступа, сделать это можно при помощи технологий PlayReady, Widevine или 128-битного алгоритма шифрования AES. Все что для этого нужно сделать — это поставить галочку напротив соответствующего пункта в настройках плеера и указать необходимый маркер. Больше вы можете узнать на сайте Microsoft.

Схема кодирования 128-битным алгоритмом шифрования AES и другими средствами Azure Media Services

Для применения всех выбранных опций, значений и параметров выставлены нажать кнопку Update Player. Затем можно получить код ролика со всеми заданными параметрами для вставки на ресурсы.

Фирменные коннекторы

В службе Azure Media Services доступны удобный и простой в использовании коннектор для интеграции со сторонними сервисами. Он доступен для таких сервисов и платформ, как Dropbox, Facebook, Twitter и другие. Коннектор позволяет клиентам подготавливать и размещать видео и мультимедийные материалы в своих приложениях и сервисах не беспокоясь о сложностях, связанных с подготовкой и размещением видео на разнообразных устройствах. Вот несколько примеров того, где он может использоваться:

— Приложения, в которых видео является ключевым элементом. Это, например, могут быть обучающие приложения.

— Вертикальные решения для предприятий, базирующиеся вокруг видео. Как пример — система управления обучением или сервисы типа Enterprise Tube.

— Веб-сайты с видео. Для тех, кто хочет сделать маркетинговый веб-сайт с разнообразными видеоматериалами.

— Решения с прямыми трансляциями. Это могут быть приложения для совещаний, проведения опросов, вебинаров — везде, где клиент хочет получить широкий охват аудитории.

Выводы

Платформа Azure Media Services это простая и удобная облачная служба для обработки и доставки на устройства видео и других мультимедиа данных. Она позволяет в несколько кликов подготовить видео к публикации на разных устройствах, при этом можно быть уверенным, что на любом девайсе под разные операционные системы это видео будет проигрываться корректно.

|

Метки: author Orest_ua разработка веб-сайтов microsoft azure it- стандарты блог компании мук microsoft azure media services |

Межпланетная файловая система — больше нет необходимости копировать в сеть |

InterPlanetary File System — это новая децентрализованная сеть обмена файлами (HTTP-сервер, Content Delivery Network). О ней я рассказывал в статье "Межпланетная файловая система IPFS".

Всем хороша идея IPFS но вот только был один недостаток у неё. Данные загружаемые в сеть копировались в хранилище блоков удваивая занимаемое ими место. Более того файл резался на блоки которые мало пригодны для повторного использования.

Появилась экспериментальная опция --nocopy, которая избавляет от этого недостатка. Для того чтобы пользоваться ей необходимо выполнить несколько условий.

Также появился новый тип идентификаторов. Его мы тоже разберём.

--nocopy

Это опция заставляет IPFS использовать как источник блоков исходные файлы. Тем самым файлы не копируются в хранилище блоков и не занимают в 2 раза больше места.

Для использования этой опции выполним следующие действия:

необходимо включить Filestore

ipfs config --json Experimental.FilestoreEnabled true

в каталог ".ipfs"(он в каталоге пользователя) нужно сделать ссылку на каталог или файл который надо загрузить в сеть

Файл можно связать hardlink'ом:

fsutil hardlink ".ipfs\[имя файла]" "[путь к файлу]\[имя файла]"

или

mklink /h ".ipfs\[имя файла]" "[путь к файлу]\[имя файла]"

Каталог можно связать символьной ссылкой:

linkd ".ipfs\[имя каталога]" "[путь к каталогу]\[имя каталога]"

или

mklink /j ".ipfs\[имя каталога]" "[путь к каталогу]\[имя каталога]"

И теперь добавляем

ipfs add -w --nocopy ".ipfs\[имя каталога или файла]"

Ключ

-wоборачивает цель в каталог тем самым сохраняя её имя.

Результатом будут идентификаторы CIDv1 и CIDv0 (мультихеш)

WebSeed

Теперь в магнит или торрент можно будет добавить WebSeed.

Для файла:

http://127.0.0.1:8080/ipfs/[идентификатор]/[имя файла]

http://ipfs.io/ipfs/[идентификатор]/[имя файла]Для каталога:

http://127.0.0.1:8080/ipfs/[идентификатор]/

http://ipfs.io/ipfs/[идентификатор]/Пример магнита c WebSeed

magnet:?xt=urn:btih:2F825A27112B0E5C89D20B656045920F1C10830C28&ws=https://ipfs.io/ipfs/QmPbs8syAxac39bcNuMLpHXnqjKUguqakCM8LN8sZVPD9R/Magnet-ссылка.txtИдентификатор контента (CID)

В связи с этими изменениями в IPFS появились RAW блоки. Ключ --nocopy автоматически включает использование RAW блоков. Но можно включить этот режим и ключом --raw-leaves. В связи с этим появился новый CID (Content IDentifier) или по русски "идентификатор контента".

Старый идентификатор

Называется CIDv0 и обычно имеет постоянный префикс "Qm".

CIDv0 это просто мультихеш в Base58

[varint ID хеша][varint длинна хеша][хеш]Пример CIDv0: QmPbs8syAxac39bcNuMLpHXnqjKUguqakCM8LN8sZVPD9R

Новый идентификатор

У RAW блоков свой CID. Его можно отличить по постоянному префиксу "zb2rh".

CIDv1 содержит в себе больше информации.

[префикс основания][varint версия CID][varint тип контента][varint ID хеша][varint длинна хеша][хеш]Пример CIDv1: zb2rhe143L6sgu2Nba4TZgFMdPidGMA6hmWhK9wLUoVGWYsR7

Разберём его на части

z— base58 Bitcoin [префикс основания]

base58:

b2rhe143L6sgu2Nba4TZgFMdPidGMA6hmWhK9wLUoVGWYsR7

переводим в

HEX:01 55 12 20 6D542257CBD1BE7FD0AE8914F42066BCBF1E79487EF67B959A86DBEE4670B386

01— v1 [varint версия CID]55— raw binary [varint тип контента]12— sha2-256 [varint ID хеша]20— 32 байта [varint длинна хеша]6D542257CBD1BE7FD0AE8914F42066BCBF1E79487EF67B959A86DBEE4670B386— sha2-256 digest [хеш]

Заключение

Опция --nocopy очень помогает когда вы хотите поделиться с миром например дампом Википедии. Или другими полезными но очень большими по объёму массивами информации.

Ссылки

Ссылки в Windows, символьные и не только

ipfs command reference

List of experimental IPFS features

Другие части

- Межпланетная файловая система IPFS

- Публикуем сайт в межпланетной файловой системе IPFS

- Хостим сайт в межпланетной файловой системе IPFS под Windows

|

Метки: author ivan386 децентрализованные сети ipfs magnet links |

[Из песочницы] Система управления проектами Redmine + Mercurial на Ubuntu 16.04 |

Redmine, действительно, обладает большими возможностями: управление несколькими проектами, отслеживание ошибок, интеграция с репозиториями, перекрёстные ссылки на исправленные баги в коммитах и на коммиты в баг-репортах, назначение разных ролей пользователей в каждом проекте и т.д. Однако процедура установки довольна сложна, а для некоторых очень полезных функций требуется небольшая доработка или использование плагинов. Надеюсь, что предлагаемое ниже руководство поможет желающим использовать Redmine в своих проектах.

Компоненты

Система управления проектами Redmine

-> Официальный сайт

Основные возможности:

- ведение нескольких проектов

- система отслеживания событий (bug, feature)

- разные роли пользователей (менеджер, разработчик, репортер) по каждому проекту

- поддержка новостей, документов, файлов, wiki, форумов для каждого проекта

- интеграция с системами управления версиями (SVN, Git, Mercurial)

- уведомления о событиях по электронной почте

- возможность учёта времени работы

Система контроля версий Mercurial

-> Официальный сайт

Кросс-платформенная распределённая система управления версиями.

Также понадобится

Web-сервер и система управления базами данных. Использованы Mysql и Apache.

Установка

Инструкция составлена на основе полезной, но сильно устаревшей инструкции

HowTo Install Redmine 1.2.x with Mercurial and Subversion on Ubuntu Server 10.04.

Также использовалась официальная инструкция по установке

Redmine Installation Guide.

Предполагаем что у нас уже есть сервер с предустановленным на нём Ubuntu Server 16.04. Дальнейшие инструкции описывают установку системы управления и вспомогательного ПО.

Итак, начнём. Сначала устанавливаем LAMP server:

$ sudo tasksel install lamp-serverВо время установки понадобится ввести пароль root-пользователя базы данных MySQL (не путать с паролем root операционной системы).

Создаём базу данных MySQL и пользователя redmine для работы с ней. Вместо [password] вставляем желаемый пароль пользователя.

$ mysql -u root -p

(вводим пароль root базы данных MySQL)

> create database redmine character set utf8;

> create user 'redmine'@'localhost' identified by '[password]';

> grant all privileges on redmine.* to 'redmine'@'localhost';

> exitСкачиваем Redmine со страницы www.redmine.org/projects/redmine/wiki/Download или командой

$ wget http://www.redmine.org/releases/redmine-3.3.3.tar.gzРаспаковываем Redmine в каталог /usr/share/redmine. Находим подкаталог config и копируем config/database.yml.example в config/database.yml. После этого редактируем файл, для того чтобы установить «production» режим базы данных:

$ sudo cp /usr/share/redmine/config/database.yml.example /usr/share/redmine/config/database.yml

$ sudo nano /usr/share/redmine/config/database.ymlВводим текст и сохраняем файл (ctrl+x):

production:

adapter: mysql2

database: redmine

host: localhost

username: redmine

password: "[password]"

encoding: utf8Устанавливаем необходимые пакеты:

$ sudo apt install ruby ruby-dev build-essential libmysqlclient-devУстанавливаем Bundler:

$ gem install bundlerТеперь можно установить gems, необходимые для Redmine:

$ cd /usr/share/redmine

$ bundle install --without development test rmagickСоздаём случайный ключа, который Rails будет использовать для шифрования данных в cookie:

$ cd /usr/share/redmine

$ bundle exec rake generate_secret_token

Дальше создаём структуру базы данных (выполняем в /usr/share/redmine):

$ RAILS_ENV=production bundle exec rake db:migrate

$ RAILS_ENV=production bundle exec rake redmine:load_default_data

Устанавливаем необходимые права доступа:

$ cd /usr/share/redmine

$ sudo chown -R www-data:www-data files log tmp public/plugin_assets

$ sudo chmod -R 755 files log tmp public/plugin_assets

При желании можно протестировать установку Redmine с помощью веб-сервера WEBrick:

$ sudo -u www-data bundle exec rails server webrick -e productionПосле запуска WEBrick стартовая страница Redmine должна быть доступна в браузере по адресу

http://localhost:3000/Интеграция с Apache

Установить Passenger:

$ sudo apt-get install libapache2-mod-passengerДобавить символьную ссылку на public каталог Redmine:

$ sudo ln -s /usr/share/redmine/public /var/www/redmineНеобходимо настроить пользователя Passenger по умолчанию, для этого редактируем файл:

$ sudo nano /etc/apache2/mods-available/passenger.confНужно добавить следующую строчку и сохранить (ctrl+x):

PassengerDefaultUser www-dataВ итоге файл должен выглядеть так:

PassengerRoot /usr/lib/ruby/vendor_ruby/phusion_passenger/locations.ini

PassengerDefaultRuby /usr/bin/ruby

PassengerDefaultUser www-data

Далее создать конфигурационный файл redmine.conf для apache:

$ sudo nano /etc/apache2/sites-available/redmine.conf Добавить следующий текст и сохранить (ctrl+x):

ServerAdmin webmaster@localhost

DocumentRoot /var/www

ServerName myservername

RewriteEngine on

RewriteRule ^/$ /redmine [R]

Подключить модули Passenger и Rewite:

$ sudo a2enmod passenger

$ sudo a2enmod rewriteОтключить default вебсайт и подключить redmine:

$ sudo a2dissite 000-default

$ sudo a2ensite redmineУстановить права доступа на /tmp/cache Redmine:

sudo chmod 777 /usr/share/redmine/tmp/cacheПерезапустить Apache:

$ sudo service apache2 reloadТеперь можно открыть любимый браузер и зайти на

http://[my site or ip]/redmine или просто http://[my site or ip]. Должна появиться стартовая страничка системы Redmine.Установка Mercurial

Необходимо установить пакеты:

$ sudo apt-get install mercurial libapache2-mod-perl2 libapache-dbi-perl libdbd-mysql-perlСоздать директорию, в которой будут храниться репозитории проектов:

$ sudo mkdir -p /var/hg/Теперь мы хотим сделать репозитории доступными по http протоколу. Для этого необходимо создать cgi-скрипт:

$ sudo nano /var/hg/hgwebdir.cgiДобавить следующий текст и сохранить:

#!/usr/bin/python

from mercurial import demandimport; demandimport.enable()

from mercurial.hgweb.hgwebdir_mod import hgwebdir

import mercurial.hgweb.wsgicgi as wsgicgi

application = hgwebdir('hgweb.config')

wsgicgi.launch(application)Теперь нужно создать файл hgweb.config:

$ sudo nano /var/hg/hgweb.config

Добавить следующее содержимое и сохранить:

[paths]

/=/var/hg/**

[web]

allow_push = *

push_ssl = false

allowbz2 = yes

allowgz = yes

allowzip = yesУстановить разрешения для файлов:

$ sudo chown -R www-data:www-data /var/hg/*

$ sudo chmod gu+x /var/hg/hgwebdir.cgiТеперь надо создать conf файл для Apache:

$ sudo nano /etc/apache2/conf-available/hg.confДобавить следующее содержимое и сохранить:

PerlLoadModule Apache2::Redmine

ScriptAliasMatch ^/hg/(.*) /var/hg/hgwebdir.cgi/$1

Ещё необходимо создать ссылки:

$ sudo ln -s /etc/apache2/conf-available/hg.conf /etc/apache2/conf-enabled/

$ sudo ln -s /usr/share/redmine/extra/svn/Redmine.pm /usr/lib/x86_64-linux-gnu/perl5/5.22/Apache2/Включить CGI модуль и перезапустить Apache:

$ sudo a2enmod cgi

$ sudo service apache2 reloadРепозитории будут доступны по адресам

http://[my site or ip]/hg/*. Например, для проекта project адрес будет таким http://[my site or ip]/hg/project. Если у проекта project будет подпроект subproject1, то его репозиторий будет доступен по адресу http://[my site or ip]/hg/project/subproject1.Чтобы клонировать репозиторий надо будет выполнить:

$ hg clone http://[my site or ip]/hg/projectЕсли клонируемый проект не публичный (устанавливается в настройках проекта через веб-интерфейс системы Redmine), то потребуется ввести имя пользователя и пароль.

Авторизация осуществлятся по проектам, т.е. доступ будет возможен только для участников проекта (менеджеры и разработчики).

Для того чтобы всё корректно работало, каталоги репозиториев в /var/hg/ должны совпадать с Identifier репозиториев, которые задаются в настройках репозитория Redmine при его создании (через веб-интерфейс). Также при создании реопзитория в Redmine необходимо указать путь к нему, например /var/hg/project. Репозитории в /var/hg необходимо создать вручную для каждого проекта и инициализировать командой (

hg init). После создания нового репозитория надо убедиться, что у него установлены нужные права доступа:

$ sudo chown -R www-data:www-data /var/hg/[repository name]В принципе, есть возможность автоматизировать создание репозиториев. Информация об этом есть в руководстве по ссылке HowTo Install Redmine 1.2.x with Mercurial and Subversion on Ubuntu Server 10.04

Уведомления о фиксации изменений по email

Redmine поддерживает уведомления о разных событиях (изменениях в жизни баг/фич и т.п.). Для того чтобы пользоваться этим функционалом достаточно настроить способ отправки email-сообщений. Делается это в файле /usr/share/redmine/config/configuration.yml В файле имеются шаблоны для разных конфигураций. Нужно разкомментировать и отредактировать нужный.

Например, так:

email_delivery:

delivery_method: :smtp

smtp_settings:

address: "10.11.12.13"

port: 25

authentification: :none

enable_starttls_auto: false

openssl_verify_mode: 'none'

Обратите внимание, что каждая секция в файле configuration.yml сдвинута на два пробела. Это важно.

Базовые уведомления должны быть доступны после указания способа рассылки электронных писем. Однако для уведомлений об изменениях в репозитории необходимо использовать внешний плагин. Скачать его можно с сайта github.com/lpirl/redmine_diff_email.

Установим этот плагин. Для этого скопируем содержимое плагина в каталог /usr/share/redmine/plugins/redmine_diff_email. В соответствии с инструкцией по установке плагина изменяем файл /usr/share/redmine/app/views/repositories/_form.html.erb:

--- OLD

+++ NEW

@@ -23,6 +23,7 @@

+

Оригинальный плагин работает с устаревшей версией redmine. Для redmine-3.3 нужно внести изменения в файл

/usr/share/redmine/plugins/redmine_diff_email/db/migrate/002_add_repositories_is_diff_email_attached.rb. Содержимое файла должно быть таким:

class AddRepositoriesIsDiffEmailAttached < ActiveRecord::Migration

def self.up

add_column :repositories, :is_diff_email_attached, :boolean, :default => false, :null => false

Repository.update_all(["is_diff_email_attached = ?", true])

Repository.update_all(["is_diff_email = ?", true])

end

def self.down

remove_column :repositories, :is_diff_email_attached

end

end

После этого в каталоге /usr/share/redmine выполнить команду для обновления базы данных:

bundle exec rake redmine:plugins:migrate RAILS_ENV=productionПерезапускаем Redmine:

$ sudo service apache2 reloadЕсли плагин установлен правильно, то в списке плагинов Administration -> Plugins появится Redmine Diff Email Plugin, а также в веб-интерфейсе Redmine SomeProject -> «Settings» Tab -> «Repositories» Tab -> «Edit» появятся настройки уведомлений.

Кроме того, чтобы информация об изменениях в репозиториях автоматически отслеживалась Redmine, необходимо выполнить дополнительные действия. Сначала нужно включить WS для управления репозиториями и сгенерировать API key. Как это делается:

* В web-интерфейсе Redmine в меню Administration выбрать Settings

* Перейти на вкладку Repositories

* Включить 'Enable WS for repository management'

* Кликнуть на ссылку 'Generate a key'

* Сохранить изменения кнопкой 'Save'

Далее создаём скрипт:

$ sudo nano /var/hg/fetch_changesДобавляем следующий текст и сохраняем: (необходимо заменить [your API key] сгенерированным в API-ключом)

#!/bin/sh

curl "http://localhost/redmine/sys/fetch_changesets?key=[your API key]" > /dev/null 2>&1Устанавливаем права доступа для созданного файла:

$ sudo chown www-data:www-data /var/hg/fetch_changes

$ sudo chmod ug+x /var/hg/fetch_changesОстаётся добавить в /var/hg/hgweb.config секцию [hooks], чтобы скрипт fetch_changes выполнялся после каждого коммита:

[hooks]

changegroup = /var/hg/fetch_changesТеперь при изменениях в репозитории Redmine будет автоматически отсылать уведомления участникам проекта.

|

Метки: author polytechnic системы управления версиями mercurial redmine apache2 |

Replication Framework • глубинное копирование и обобщённое сравнение связных графов объектов |

Хочу познакомить тебя с молодой, но многообещающей библиотекой Replication Framework для платформы .NET (возможно, при наличии достаточного интереса к теме в дальнейшем будет также реализована Java-версия). Библиотека является портабельной (portable) и может быть использована в любом проекте под Microsoft .NET или Mono.

Назначение библиотеки — глубинное копирование любых объектов и сколь угодно сложных графов, их обобщённое сравнение, сериализация и десериализаци без искажений, трекинг мутаций и манипулирование состоянием.

Прежде всего определимся с терминологией и основными сущностями

• Снимок (Snapshot) — это мгновенный слепок состояния объекта, изолированный от источника и достаточно статичный в процессе выполнения программы, благодаря чему защищённый от случайных мутаций. Это как чертёж или эскиз по которому можно в дальнейшем воссоздать новый объект [граф] с прежним состоянием или же установить определённое состояние уже имеющемуся.

Снимки можно делать с различных ракурсов, то есть по-разному интерпретировать состояние объектов, к примеру, собирать значения абсолютно всех свойств и полей экземпляров или же только публичных, но зачастую лишь тех членов, что отмечены специальным атрибутом DataMember. То, каким образом делать снимок, зависит от ReplicationProfile [профиля репликации] и в особенности от его внутреннего списка MemberProviders [провайдеров членов].

* По умолчанию, если класс имеет атрибуты DataContract или CollectionDataContract, то на снимок транслируются лишь члены с атрибутом DataMember, в ином же случае на снимок попадают все поля и свойства класса как публичные, так и нет.

var snapshot0 = instance0.CreateSnapshot(); /* use default ReplicationProfile */

var customReplicationProfile = new ReplicationProfile

{

MemberProviders = new List

{

//new MyCustomMemberProvider(), /* you may override and customize MemberProvider class! */

new CoreMemberProviderForKeyValuePair(),

//new CoreMemberProvider(BindingFlags.Public | BindingFlags.Instance, Member.CanReadWrite),

new ContractMemberProvider(BindingFlags.NonPublic | BindingFlags.Public | BindingFlags.Instance, Member.CanReadWrite)

}

};

var snapshot1 = instance1.CreateSnapshot(customReplicationProfile );

Snapshot.DefaultReplicationProfile = customReplicationProfile; В общих чертах снимок представляет собой json-подобную структуру данных, в которой сложные составные объекты разобраны на примитивы и преобразованы в словари, где ключом является имя члена (свойства или поля), а значением — соответствующий примитив (string, int, DateTime, etc.). Все коллекции, включая массивы, — это особый род объектов, у которых помимо обычных свойств есть ещё одно неявное для операции перечисления (foreach), а его значение является эквивалентом json-массива.

• Реконструкция (Reconstruction) — операция перевода графа объектов в исходное состояние на основе снимка и уже имеющихся закэшированных экземпляров объектов. Обычно в процессе исполнения программы объекты и состоящие из них графы видоизменяются, то есть мутируют, но иногда полезно иметь возможность вернуть [откатить] граф и входящие в него объекты к какому-то определённому состоянию зафиксированному ранее.

var cache = new Dictionary();

var snapshot0 = graph0.CreateSnapshot(cache);

/* modify 'graph0' by any way */

var graphX = snapshot0.ReconstructGraph(cache);

/* graphX is the same reference that graph0, all items of the graph reverted to the previous state */* Следует помнить, что кэшированные объекты удерживаются от сборки мусора, а во время реконструкции все они возвращаются в исходное состояние.

• Репликация (Replication) — операция глубинного копирования графа объектов на основе снимка в результате которой создаётся новая копия графа изолированная от исходной.

var snapshot0 = graph0.CreateSnapshot(cache);

/* modify 'graph0' by any way */

var graph1 = snapshot0.ReplicateGraph(cache);

/* graph1 is a deep copy of the source graph0 */Копирование бывает двух видов — поверхностное и глубинное. Пускай даны объекты А и Б, причём А содержит ссылку на Б (граф А=>Б). При поверхностном копировании объекта А будет создан объект А', который также будет ссылаться на Б, то есть в итоге получится два графа А=>Б и А'=>Б. У них будет общая часть Б, поэтому при изменении объекта Б в первом графе, автоматически его состояние будет мутировать и во втором. Объекты же А и А' останутся независимы. Но наибольший интерес представляют графы с замкнутыми (циклическими) ссылками. Пускай А ссылается на Б и Б ссылается на А (А<=>Б), при поверхностном копировании объекта А в А' получим весьма необычный граф А'=>Б<=>А, то есть в итоговый граф попал изначальный объект, который подвергался клонированию. Глубинное же копирование предполагает клонирования всех объектов, входящих в граф. Для нашего случая А<=>Б преобразуется в А'<=>Б', в итоге оба графа совершенно изолированы друг от друга. В некоторых случаях достаточно поверхностного копирования, но далеко не всегда.

• Сопоставление (Juxtaposition) — рекурсивная операция сравнения эталонного снимка объекта со снимком текущего образца.

var snapshot0 = instance0.CreateSnapshot(); /* etalon */

var snapshot1 = instance1.CreateSnapshot(); /* sample */

var juxtapositions = snapshot0.Juxtapose(snapshot1).ToList();

var differences = juxtapositions.Where(j=>j.State == Etalon.State.Different);Сравнение объектов — обширная тема в программирования, а сопоставления — это попытка её обобщить на весь класс задач. Насколько попытка удачна, ты можешь оценить самостоятельно.

Пускай нам задан экземпляр любого объекта. В начальный момент времени мы делаем снимок его состояния, спустя какое-то время можем снимок повторить и, сопоставляя оба снимка, выявить все интересующие нас мутации, которые произошли с данным экземпляром, то есть реализовать трекинг состояния. Стоит отметить, что на практике скопировать объект не всегда возможно или просто, чтобы следить за изменениями, но всегда легко сделать его снимок.

В случае, когда у нас два и более экземпляров объектов, например: эталонный и рабочие, — они могут быть как одного типа, так и разных. Их снимки можно делать в произвольные моменты времени и сопоставлять в любых комбинациях без ограничений. Сопоставление происходит по именам членов (свойств и полей).

* Что немаловажно, результатом операции сопоставления является, что даёт возможность прервать процесс рекурсивного сопоставления в любой момент по достижении определённых условий, а не производить его полностью, это в свою очередь значимо для производительности.IEnumerable

Перейдём к практике и обратим внимание на ключевые моменты

using System;

using System.Collections.Generic;

using System.Runtime.Serialization;

namespace Art.Replication.Diagnostics

{

[DataContract]

public class Role

{

[DataMember] public string Name;

public string CodePhrase;

[DataMember] public DateTime LastOnline = DateTime.Now;

[DataMember] public Person Person;

}

public class Person

{

public string FirstName;

public string LastName;

public DateTime Birthday;

public List Roles = new List();

}

public static class DiagnosticsGraph

{

public static Person Create()

{

var person0 = new Person

{

FirstName = "Keanu",

LastName = "Reeves",

Birthday = new DateTime(1964, 9 ,2)

};

var roleA0 = new Role

{

Name = "Neo",

CodePhrase = "The Matrix has you...",

LastOnline = DateTime.Now,

Person = person0

};

var roleB0 = new Role

{

Name = "Thomas Anderson",

CodePhrase = "Follow the White Rabbit.",

LastOnline = DateTime.Now,

Person = person0

};

person0.Roles.Add(roleA0);

person0.Roles.Add(roleB0);

return person0;

}

}

} using Art;

using Art.Replication;

using Art.Replication.Replicators;

using Art.Replication.MemberProviders;

using Art.Serialization;

using Art.Serialization.Converters; public static void CreateAndSerializeSnapshot()

{

var person0 = DiagnosticsGraph.Create();

var snapshot0 = person0.CreateSnapshot();

string rawSnapsot0 = snapshot0.ToString();

Console.WriteLine(rawSnapsot0);

Console.ReadKey();

}{

#Id: 0,

#Type: "Art.Replication.Diagnostics.Person, Art.Replication.Diagnostics, Version=1.0.0.0, Culture=neutral, PublicKeyToken=null",

FirstName: "Keanu",

LastName: "Reeves",

Birthday: "1964-09-02T00:00:00.0000000+03:00",

Roles: {

#Id: 1,

#Type: "System.Collections.Generic.List`1[[Art.Replication.Diagnostics.Role, Art.Replication.Diagnostics, Version=1.0.0.0, Culture=neutral, PublicKeyToken=null]], mscorlib, Version=4.0.0.0, Culture=neutral, PublicKeyToken=b77a5c561934e089",

#Set: [

{

#Id: 2,

#Type: "Art.Replication.Diagnostics.Role, Art.Replication.Diagnostics, Version=1.0.0.0, Culture=neutral, PublicKeyToken=null",

Name: "Neo",

LastOnline: "2017-06-14T14:42:44.0000575+03:00",

Person: {

#Id: 0

}

},

{

#Id: 3,

#Type: "Art.Replication.Diagnostics.Role, Art.Replication.Diagnostics, Version=1.0.0.0, Culture=neutral, PublicKeyToken=null",

Name: "Thomas Anderson",

LastOnline: "2017-06-14T14:42:44.0000575+03:00",

Person: {

#Id: 0

}

}

]

}

}

• Класс Person имеет атрибут DataContract, поэтому все его поля с атрибутом DataMember, кроме CodePhrase, попали на снимок.

• Каждому объекту ставится в соответствие свой идентификатор #Id: 0, если ссылка на объект встречается в графе объектов более одного раза, то вместо повторной репликации подставляется следующая конструкция

Person: {

#Id: 0

}Это защищает от множественной репликации одного и того же экземпляра объекта, а в случаях циклических ссылок от захода в бесконечную рекурсию и Stack Overflow Exception (примечание: далеко не все сериализаторы справляются с подобными ситуациями).

• К каждому объекту добавляется полная информация о типе по ключу #Type.

• Некоторые примитивы также содержат информацию о типе

Birthday: "1964-09-02T00:00:00.0000000+03:00"• Коллекция List сериализована как объект, но у неё есть свойство #Set, которое используется для перечисления вложенных объектов.

Однако не стоит думать, что серализация и десериализация поддерживаются библиотекой лишь в таком полном формате, возможно также использование и более классического json путём настроеки профилей репликации и сохранения (могут возникнуть незначительные искажения присущие обычным сериализаторам).

public static void UseClassicalJsonSettings()

{

Snapshot.DefaultReplicationProfile.AttachId = false;

Snapshot.DefaultReplicationProfile.AttachType = false;

Snapshot.DefaultReplicationProfile.SimplifySets = true;

Snapshot.DefaultReplicationProfile.SimplifyMaps = true;

Snapshot.DefaultKeepProfile.SimplexConverter.AppendTypeInfo = false;

Snapshot.DefaultKeepProfile.SimplexConverter.Converters

.OfType().First().AppendSyffixes = false;

}

public static void CreateAndSerializeSnapshotToClassicJsonStyle()

{

UseClassicalJsonSettings();

var person0 = DiagnosticsGraph.Create();

var snapshot0 = person0.CreateSnapshot();

string rawSnapsot0 = snapshot0.ToString();

Console.WriteLine(rawSnapsot0);

var person0A = rawSnapsot0.ParseSnapshot().ReplicateGraph();

Console.WriteLine(person0A.FirstName);

Console.ReadKey();

} {

FirstName: "Keanu",

LastName: "Reeves",

Birthday: "1964-09-02T00:00:00.0000000+03:00",

Roles: [

{

Name: "Neo",

LastOnline: "2017-06-14T18:31:20.0000205+03:00",

Person: {

#Id: 0

}

},

{

Name: "Thomas Anderson",

LastOnline: "2017-06-14T18:31:20.0000205+03:00",

Person: {

#Id: 0

}

}

]

}О сохранении и восстановление состояния без искажений

Конечно, всегда удобно иметь возможность сохранять состояния объектов (графов) в строку или массив байт для последующего восстановления. Как правило для этого используются механизмы сериализации. Они довольно функциональны, однако при их ближайшем рассмотрении зачастую выявляется ряд жёстких ограничений, которые накладываются конкретным сериализатором на объекты, например, бывает необходимо наличие атрибутов или аннотаций, специальных методов, отсутствие замкнутых ссылок в графе, наличие конструктора без параметров или что-то ещё.

Но существуют также два неявных минуса, которые присущи многим сериализаторам. Во-первых, как упоминалось чуть ранее, при наличии в графе нескольких ссылок на один и тот же экземпляр объекта некоторые сериализаторы сохраняют его повторно, из-за чего при десериализации уже получается несколько копий одного и того же объекта (граф значительно видоизменяется). Во-вторых, в некоторых случаях может происходить потеря информации о типе объекта, что ведёт к искажённому восстановлению типов объектов при десериализации, например, long превращается в int, Guid в строку или наоборот.

public class Distorsion

{

public object[] AnyObjects =

{

Guid.NewGuid(), Guid.NewGuid().ToString(),

DateTime.Now, DateTime.Now.ToString("O"),

123, 123L,

};

}Replication Framework использует свой собственный json-сериализатор, который сохраняет метаданные о типах объектов, поддерживает множественные и циклические ссылки в графе, благодаря чему возможна полная десериализация без искажений.

Основные сценарии использования

Репликация:

public static void Replicate()

{

var person0 = DiagnosticsGraph.Create();

var snapshot0 = person0.CreateSnapshot();

var person1 = snapshot0.ReplicateGraph();

person1.Roles[1].Name = "Agent Smith";

Console.WriteLine(person0.Roles[1].Name); // old graph value: Thomas Anderson

Console.WriteLine(person1.Roles[1].Name); // new graph value: Agent Smith

Console.ReadKey();

} Реконструкция:

public static void Reconstract()

{

var person0 = DiagnosticsGraph.Create();

var cache = new Dictionary();

var s = person0.CreateSnapshot(cache);

Console.WriteLine(person0.Roles[1].Name); // old graph value: Thomas Anderson

Console.WriteLine(person0.FirstName); // old graph value: Keanu

person0.Roles[1].Name = "Agent Smith";

person0.FirstName = "Zion";

person0.Roles.RemoveAt(0);

var person1 = (Person)s.ReconstructGraph(cache);

Console.WriteLine(person0.Roles[1].Name); // old graph value: Thomas Anderson

Console.WriteLine(person1.Roles[1].Name); // old graph value: Thomas Anderson

Console.WriteLine(person0.FirstName); // old graph value: Keanu

Console.WriteLine(person1.FirstName); // old graph value: Keanu

Console.ReadKey(); // result: person0 & person1 is the same one reconstructed graph

}Сопоставление:

public static void Justapose()

{

// set this settings for less details into output

Snapshot.DefaultReplicationProfile.AttachId = false;

Snapshot.DefaultReplicationProfile.AttachType = false;

Snapshot.DefaultReplicationProfile.SimplifySets = true;

Snapshot.DefaultReplicationProfile.SimplifyMaps = true;

var person0 = DiagnosticsGraph.Create();

var person1 = DiagnosticsGraph.Create();

person0.Roles[1].Name = "Agent Smith";

person0.FirstName = "Zion";

var snapshot0 = person0.CreateSnapshot();

var snapshot1 = person1.CreateSnapshot();

var results = snapshot0.Juxtapose(snapshot1);

foreach (var result in results)

{

Console.WriteLine(result);

}

Console.ReadKey();

}

[this.FirstName] {Zion} {Keanu}

[this.LastName] {Reeves} {Reeves}

[this.Birthday] {9/2/1964 12:00:00 AM} {9/2/1964 12:00:00 AM}

[this.Roles[0].Name] {Neo} {Neo}

[this.Roles[0].LastOnline] {6/14/2017 9:34:33 PM} {6/14/2017 9:34:33 PM}

[this.Roles[0].Person.#Id] {0} {0}

[this.Roles[1].Name] {Agent Smith} {Thomas Anderson}

[this.Roles[1].LastOnline] {6/14/2017 9:34:33 PM} {6/14/2017 9:34:33 PM}

[this.Roles[1].Person.#Id] {0} {0} О производительности

На текущий момент библиотека имеет достаточно хорошую производительность, но стоит понимать, что использование обобщённого промежуточного механизма снимков накладывает дополнительные издержки как по памяти, так и по скорости выполнения в некоторых задачах. Однако на деле не всё столь однозначно, поскольку механизм снимков может давать и выигрыш в ряде сценариев.

Проигрыш:

— большее потребление памяти при сериализации объектов

— приблизительно в 2-2.5 раза меньшая скорость сериализации и последующей десериализации (зависит от настроек сериализации и рода тестов)

Выигрыш:

— копирование графа посредством снимка без применения сериализации и десериализации (не нужно конвертировать примитивы в строку или массив байт, за счёт чего достигается ускорение)

— лучшее использование памяти при частичном хранении на снимках состояния больших объектов вместо их полного копирования

* Сравнение производительности производилось с BinaryFormatter, Newtonsoft.Json, а также с DataContractJsonSerializer.

Несколько слов в заключение о Replication Framework

Разработано решение в маленькой студии творческого программирования «Мэйклофт» [Makeloft]. Сейчас проект находится на стадии предварительной версии, но и её возможности впечатляют, хотя реализован только лишь базовый функционал. На разработку было потрачено очень много сил и времени, поэтому фреймворк является бесплатным лишь для учебных и некоммерческих проектов.

На текущий момент коммерческая лицензия на использование в отдельном проекте стоит 15$ (при покупке лицензии предоставляется доступ к исходным кодам, а при необходимости более подробные консультации по техническим тонкостям, например, как реплицировать объекты с параметризированными конструкторами). Вероятно, в дальнейшем с развитием решения цена вырастет. Если планируется использование фреймворка на постоянной основе во множестве проектов, то о стоимости такой лицензии можно договориться лично.

Скачать триал-версию можно с Nuget, она функциональна до сентября 2017 года. Проект с примерами кода из статьи можно скачать отсюда. Если библиотека оставит хорошее впечатление и ты решишь использовать её в каком-либо своём решении, то отправь, пожалуйста, запрос на получение бесплатной или платной лицензии по адресу makeman@tut.by. В запросе укажи название и род проекта, в котором планируется использование библиотеки.

Большое спасибо за внимание! Смело задавай вопросы и пиши пожелания!

|

|

[Из песочницы] Шифрование БД под управлением Firebird 3.0 |

В апреле 2016 года вышла новая версия СУБД Firebird под номером 3. Из нововведений, среди прочего, появилось и немало механизмов защиты хранимых и передаваемых данных. Там есть и защита канала передачи данных, есть управление пользователями, а также есть шифрование самой БД, которое реализовано как прозрачное шифрование на уровне страниц данных. Реализуется это всё с помощью написания специальных расширений для Firebird. Можно конечно и самому разобраться и написать эти расширения, но почему бы не взять существующие. Тем более, что для написания, как минимум, нужно понимать в криптографии, иметь на вооружении знания какого-нибудь криптографического пакета и разобраться с новым С++ Firebird API.

Можно воспользоваться существующим готовым решением, скачав по этой ссылке для платформы Windows x64. В бесплатном ознакомительном варианте оно ограничено используемым алгоритмом шифрования — поддерживается Triple DES (3DES). Но для защиты своей БД этого вполне достаточно. В состав пакета входит 4 библиотеки и файлы с описанием интерфейсов.

| Наименование файла | Описание |

|---|---|

| CiKeyHolder.dll | расширение Firebird – хранитель секретного ключа |

| CiDbCrypt.dll | расширение Firebird – шифрования данных |

| CiFbEnc_x86.dll | модуль активации ключа шифрования для платформы 32 bit. |

| CiFbEnc_x86-64.dll | модуль активации ключа шифрования для платформы 64 bit. |

| ICiFbEncActivator.h | описание интерфейса модуля для С++ |

| CI.ICiFbEncActivator.pas | описание интерфейса модуля для Delphi |

Дабы не захламлять статью лишними деталями реализации подобной задачи, при которой необходимо обеспечить получение ключа и организации обновления файла БД, будем предполагать, что это есть, а ключ будет просто как переменная массив в программе и файл БД сами зашифруем, используя этот ключ.

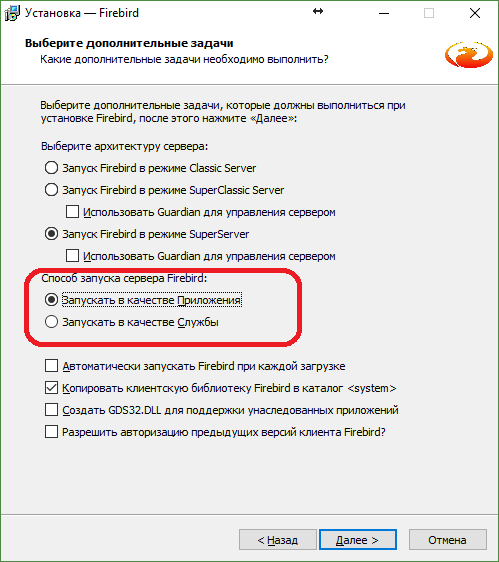

В качестве платформы возьмём ОС Windows 10 x64, а в качестве инструментов реализации задачи будем использовать IDE Embarcadero RAD Studio (на данный момент была доступна версия 10.2 Tokyo — 30-дневная пробная), поскольку она содержит удобные компоненты для работы с БД Firebird и применяется часто для разработки прикладных решений (пробную версию можно скачать по ссылке) и СУБД Firebird 3.0.2 x64, которую можно скачать по ссылке https://www.firebirdsql.org/en/firebird-3-0-2 для своей платформы. Так как нам в режиме разработки не нужен постоянно выполняемый сервер, да и перезапуск его может понадобиться неоднократно, то во время инсталляции выбираем способ запуска сервера как приложения.

Пароль для

SYSDBA делаем по старинке masterkey и снимаем галочку отвечающую за запуск сервера после установки – пока не нужно.После того, как был проинсталлирован пакет Firebird, необходимо произвести его настройку. Если же планируется использование Firebird в Embedded режиме, то такие же настройки нужно будет проделать в директории, где будет находиться используемая библиотека клиент fbclient.dll. Базовые файлы настроек находятся в корневой директории установленного Firebird —

%ProgramW6432%\Firebird\Firebird_3_0.Пропишем псевдоним (алиас) БД в файле databases.conf, добавив строку с указанием полного пути к будущей БД:

TESTDB = C:\TESTAPP\DB\TESTDB.FDBДля того, чтобы Firebird знал, где ему искать ключи, необходимо определить параметр

KeyHolderPlugin. Его можно указать или конкретно для выше описанного псевдонима или в файле firebird.conf. Добавляем или изменяем параметр конфигурации файла firebird.conf, определяя плагин хранитель секретного ключа:KeyHolderPlugin = CiKeyHolderГде искать плагины Firebird узнаёт также из конфигурационных файлов. Изменим файл plugins.conf, добавив следующие строки:

Plugin = CiKeyHolder {

# Прописываем путь к плагину хранителю

Module = $(dir_plugins)/CiKeyHolder

}

Plugin = CiDbCrypt {

# Прописываем путь к плагину шифрования

Module = $(dir_plugins)/CiDbCrypt

}Директория под псевдонимом $(dir_plugins) подразумевает директорию plugins в корневом каталоге Firebird. Копируем туда ранее скачанные плагины CiKeyHolder.dll и CiDbCrypt.dll.

Поскольку мы предполагаем, что БД справочник у нас уже есть, создадим её средствами пакета Firebird, а именно, используя приложение isql. Жмём

Win + R и выполняем следующую команду:%ProgramW6432%\Firebird\Firebird_3_0\isql -q -user SYSDBA -password masterkeyИли же как-то по-другому запускаем isql, например, используя программу Far.

Следующие команды создадут БД TESTDB, псевдоним которой ранее был прописан в настройках и выведут информацию о созданной БД:

SQL> create database 'TESTDB';

SQL> create table t_1 (i1 int, s1 varchar(15), s2 varchar(15));

SQL> insert into t_1 values (1,'value 1-1','value 1-2');

SQL> insert into t_1 values (2,'value 2-1','value 2-2');

SQL> commit;

SQL> select * from t_1;

I1 S1 S2

============ =============== ===============

1 value 1-1 value 1-2

2 value 2-1 value 2-2

SQL> show db;

Database: TESTDB

Owner: SYSDBA

PAGE_SIZE 8192

Number of DB pages allocated = 196

Number of DB pages used = 184

Number of DB pages free = 12

Sweep interval = 20000

Forced Writes are ON

Transaction - oldest = 4

Transaction - oldest active = 5

Transaction - oldest snapshot = 5

Transaction - Next = 9

ODS = 12.0

Database not encrypted

Default Character set: NONE

SQL> quit;Как видно из полученной информации по команде

show db;, созданная БД в данный момент не зашифрована — Database not encrypted.Теперь всё настроено и можно приступить к написанию приложения.

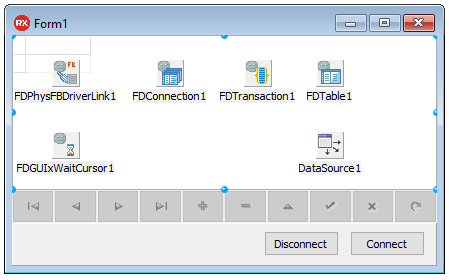

Создаём новый проект VCL Forms Application в IDE Embarcadero RAD Studio. Сохраняем проект, например, как testapp в директории C:\TESTAPP.

Для начала мы можем просто связать наше приложение с БД, обеспечив подключение и отключение к ней. Наша тестовая БД имеет одну таблицу, данные которой можно вывести при подключении. Из визуального оформления достаточно пары кнопок, таблица и навигатор с управлением данными. Для доступа к БД Firebird воспользуемся компонентами FireDAC. Далее представлена таблица с компонентами и их настраиваемыми параметрами.

| Класс компонента | Наименование компонента | Параметр | Значение параметра |

|---|---|---|---|

| TFDPhysFBDriverLink | FDPhysFBDriverLink1 | - | - |

| TFDConnection | FDConnection1 | DriverName | FB |

| LoginPrompt | False | ||

| Params\Database | TESTDB | ||

| Params\UserName | SYSDBA | ||

| Params\Password | masterkey | ||

| Params\Protocol | ipTCPIP | ||

| Params\Server | localhost | ||

| TFDGUIxWaitCursor | FDGUIxWaitCursor1 | - | - |

| TFDTransaction | FDTransaction1 | - | - |

| TFDTable | FDTable1 | TableName | T_1 |

| TDataSource | DataSource1 | DataSet | FDTable1 |

| TDBGrid | DBGrid1 | DataSource | DataSource1 |

| TDBNavigator | DBNavigator1 | DataSource | DataSource1 |

| TButton | Button1 | Caption | Connect |

| TButton | Button2 | Caption | Disconnect |

Пропишем обработку нажатия на кнопку “Connect”:

FDConnection1->Connected = true;

FDTable1->Active = true;И для “Disconnect”:

FDTable1->Active = false;

FDConnection1->Connected = false;В случае использования Delphi всё аналогично:

FDConnection1.Connected := True;

FDTable1.Active := True;

. . .

FDConnection1.Connected := False;

FDTable1.Active := False;Прежде чем подключиться к БД, необходимо запустить сервер. Для этого необходимо вызвать командную строку администратора:

Win + X -> Командная строка (администратор)И выполнить команду:

“%ProgramW6432%\Firebird\Firebird_3_0\firebird” –aВ трее появится значок запущенного сервера. Из контекстного меню вызванном над этим значком можно завершить его работу или посмотреть свойства запущенного сервера.

Теперь можно собрать и запустить приложение для проверки возможности подключения к БД. После подключения к БД в таблице отобразятся данные.

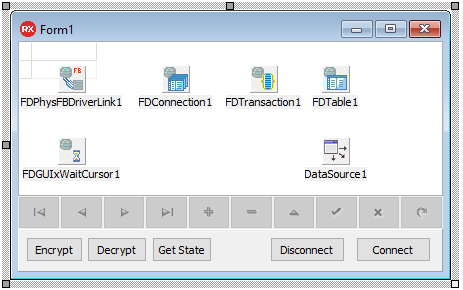

Настало время подключить модуль активации ключа и управления шифрованием к нашему приложению. Для этого копируем файлы CiFbEnc_x86.dll и ICiFbEncActivator.h, CI.ICiFbEncActivator.pas в директорию C:\TESTAPP. Стоит обратить внимание, что поскольку по умолчанию в среде разработки создаётся проект под 32-bit Windows и триал версия среды разработки не позволяет изменить целевую платформу, приложению необходим именно файл-модуль CiFbEnc_x86.dll.

Подключим заголовочный файл с описанием интерфейса модуля активации к файлу приложения:

#include "ICiFbEncActivator.h"Или файл Ci.ICiFbEncActivator.pas в случае Delphi.

uses

. . . , CI.ICiFbEncActivator;Добавим на форму ещё три кнопки: “Encrypt”, “Decrypt” и “Get State”.

Для начала рассмотрим обработчик кнопки “Get State”. Что следует из названия, это даст нам возможность получить текущее состояние БД.

Самое главное, — это получить доступ к интерфейсу модуля активации. Его можно получать как для каждой операции, так и глобально или агрегируя в некий объект. Чтобы не городить классы-обертки, будем предполагать, что получаем объект модуля активации при каждой операции. Ниже представлен один из возможных способов сделать это.

// C++ Builder

// Загружаем модуль

std::unique_ptr mHandle(

::LoadLibraryEx(L"C:\\TESTAPP\\CiFbEnc_x86.dll",0,LOAD_WITH_ALTERED_SEARCH_PATH),

&::FreeLibrary);

if (!mHandle)

{

MessageBox(

NULL,

L"Модуль CiFbEnc_x86.dll не найден или рядом с ним нет fbclient.dll",

L"Загрузка модуля",

MB_OK|MB_ICONERROR);

return;

}

// Получаем активатор

typedef CALL_CONV int(__stdcall *CREATEFUNCPTR)(CI::ICiFbEncActivator**);

CREATEFUNCPTR GetActivator =

(CREATEFUNCPTR)::GetProcAddress(mHandle.get(), "createCiFBEncActivator");

if (!GetActivator)

{

MessageBox(

NULL,

L"Не удалось получить из модуля CiFbEnc_x86.dll процедуру"

"createCiFBEncActivator"

" - попробуйте посмотреть, что пишет tdump.",

L"Загрузка модуля",

MB_OK|MB_ICONERROR);

return;

}

CI::ICiFbEncActivator* pActivator = NULL;

GetActivator(&pActivator);

if (!pActivator) { ShowMessage("ERROR GetActivator!"); return; }

// . . .

//

// обращения к объекту модуля активации

//

// . . .

// Уничтожаем экземпляр активатора

pActivator->Destroy();

pActivator = NULL;// Delphi

var

pActivator : ICiFbEncActivator;

res : Integer;

CreateActivator: TActivatorFunction;

mHandle : HINST;

. . .

begin

// Загружаем модуль

mHandle := LoadLibraryEx(

PChar('C:\TESTAPP\CiFbEnc_x86.dll'), 0, LOAD_WITH_ALTERED_SEARCH_PATH);

if mHandle = 0 then

begin

MessageBox(

Application.Handle,

'Модуль CiFbEnc_x86.dll не найден или рядом с ним нет fbclient.dll',

'Загрузка модуля',

MB_OK OR MB_ICONERROR);

Exit;

end;

// Получаем активатор

CreateActivator := GetProcAddress(mHandle, 'createCiFBEncActivator');

if not Assigned(CreateActivator) then

begin

MessageBox(

Application.Handle,

'Не удалось получить из модуля CiFbEnc_x86.dll процедуру createCiFBEncActivator'

+

' - попробуйте посмотреть, что пишет tdump.',

'Загрузка модуля',

MB_OK OR MB_ICONERROR);

Exit;

end;

pActivator := nil;

res := CreateActivator(pActivator);

if not Assigned(pActivator) then begin ShowMessage('ERROR CreateActivator!'); Exit; end;

// . . .

//

// обращения к объекту модуля активации

//

// . . .

// Уничтожаем экземпляр активатора

pActivator.Destroy;

pActivator := nil;

FreeLibrary(mHandle);

end;Далее будем предполагать, что для каждого из обработчиков нажатия на кнопку будет добавлен вышеуказанный код.

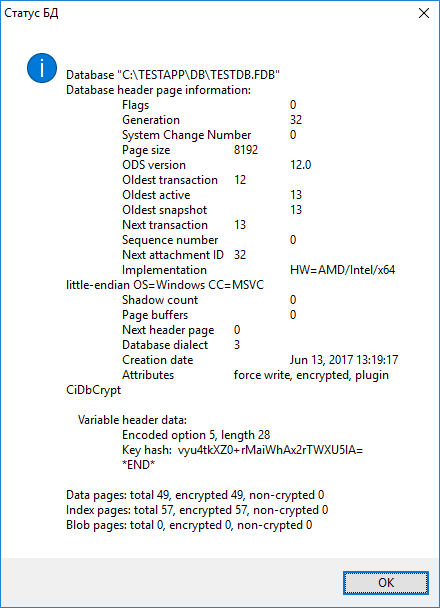

Теперь можно перейти и к получению состояния БД.

// C++ Builder

. . .

// Устанавливаем параметры подключения к БД

pActivator->SetDBAccess("localhost:TESTDB", "SYSDBA", "masterkey");

// Посмотрим, что нам расскажет о БД сервис Firebird

char stat_buf[1024] = { 0 };

size_t bufsize = sizeof(stat_buf);

int res = pActivator->GetStateSVC(stat_buf, bufsize);

String sStatMsg = (String)stat_buf;

if (Err_OK == res)

{

MessageBox(NULL, sStatMsg.c_str(), L"Статус БД", MB_OK|MB_ICONINFORMATION);

}

else

{

String sErrMsg = L"ERROR GetStateSVC: " + sStatMsg;

MessageBox(

NULL,

sErrMsg.c_str(),

L"Статус БД",

MB_OK|MB_ICONERROR);

}

. . .// Delphi

var

. . .

stat_buf : array[0..1023] of AnsiChar;

bufsize : NativeUInt;

. . .

// Устанавливаем параметры подключения к БД

res := pActivator.SetDBAccess('localhost:TESTDB', 'SYSDBA', 'masterkey');

// Посмотрим, что нам расскажет о БД сервис Firebird

bufsize := SizeOf(stat_buf);

ZeroMemory(@stat_buf, bufsize);

res := pActivator.GetStateSVC(stat_buf, bufsize);

if Err_OK = res then

begin

MessageBox(Application.Handle, PChar(String(stat_buf)),

'Статус БД', MB_OK OR MB_ICONINFORMATION);

end

else

begin

MessageBox(Application.Handle, PChar(String(stat_buf)),

'Ошибка', MB_OK OR MB_ICONERROR);

end;

. . .В случае, если удалось подключиться к БД и получить информацию, мы увидим сообщение с детальной информацией о текущем состоянии.

Как видно, БД всё ещё не зашифрована. Пора это исправить. Но для шифрования необходим ключ. И мы его определим как глобальную константу в рамках примера.

// C++ Builder

// От куда-то у нас есть ключ 192 бита

const uint8_t key[24] =

{

0x06,0xDE,0x81,0xA1,0x30,0x55,0x1A,0xC9,

0x9C,0xA3,0x42,0xA9,0xB6,0x0F,0x54,0xF0,

0xB6,0xF9,0x70,0x18,0x85,0x04,0x83,0xBF

};// Delphi

const

key : array [0..23] of Byte =

(

$06,$DE,$81,$A1,$30,$55,$1A,$C9,

$9C,$A3,$42,$A9,$B6,$0F,$54,$F0,

$B6,$F9,$70,$18,$85,$04,$83,$BF

);Кроме получения текущего состояния БД, все остальные операции, такие как зашифровать, расшифровать и получить доступ к зашифрованным данным, требуют активации секретного ключа. Для этого добавим после получения объекта модуля активации следующий код:

// C++ Builder

. . .

// Устанавливаем параметры подключения к БД

pActivator->SetDBAccess("localhost:TESTDB", "SYSDBA", "masterkey");

// Устанавливаем ключ активатору

int res = pActivator->SetKey(&key, sizeof(key));

if (Err_OK != res) { ShowMessage("ERROR SetKey!"); pActivator->Destroy(); return; }

// Активируем доступ к ключу

res = pActivator->Activate();

if (Err_OK != res)

{

// Обрабатываем ошибку

char errmsg[512] = {0};

size_t esize = sizeof(errmsg);

pActivator->GetFBStat(errmsg, esize);

String sErrMsg = "ERROR Activate: " + String(errmsg);

MessageBox(

NULL,

sErrMsg.w_str(),

L"Активация доступа к ключу",

MB_OK|MB_ICONERROR);

pActivator->Destroy();

return;

}

. . .// Delphi

. . .

// Устанавливаем параметры подключения к БД

res := pActivator.SetDBAccess('localhost:TESTDB', 'SYSDBA', 'masterkey');

// Устанавливаем ключ активатору

res := pActivator.SetKey(@key, Length(key));

if Err_OK <> res then begin ShowMessage('ERROR SetKey!'); pActivator.Destroy; Exit; end;

// Активируем доступ к ключу

res := pActivator.Activate;

if Err_OK <> res then

begin

bufsize := SizeOf(errmsg);

ZeroMemory(@errmsg, bufsize);

pActivator.GetFBStat(errmsg, bufsize);

MessageBox(

Application.Handle,

PChar('ERROR Activate: ' + String(errmsg)),

'Активация доступа к ключу',

MB_OK OR MB_ICONERROR);

pActivator.Destroy;

Exit;

end;

. . .Как видно, происходит передача ключа активатору и вызов функции активации. При этом модуль регистрирует функцию обратного вызова для доступа к ключу средствами расширения хранителя ключа. И это не зависит от режима работы Firebird. А безопасность передачи ключа гарантируется шифрованием на сессионных ключах. В вышеизложенном коде после вызова функции активации показан пример обработки возникновения возможной ошибки на уровне Firebird библиотеки. Подобным образом можно считывать текущий статус выполненной задачи для любой из операций с обращением к функционалу Firebird.

Теперь можем написать обработчики кнопок “Encrypt” и “Decrypt”. Если опустить проверку статуса выполненной задачи и предварительную активацию ключа, то достаточно только добавить вызов у объекта активации одноимённой функции:

// C++ Builder

// зашифровать

res = pActivator->Encrypt();

. . .

// расшифровать

res = pActivator->Decrypt();// Delphi

// зашифровать

res := pActivator.Encrypt;

. . .

// расшифровать

res := pActivator.Decrypt;

В итоге мы получим идентичные обработчики за исключением одного вызова.

Теперь мы можем зашифровать БД. А вызов её статуса расскажет нам о том, что она уже зашифрована.

После этого, попытка выполнить подключение к БД не меняя обработчик кнопки “Connect” приведёт к ошибке.

Последний шаг – это изменение обработчика кнопки подключения к БД. Туда нужно добавить получение объекта интерфейса модуля и вызов активации ключа. Ниже представлен полностью код обработки подключения к зашифрованной БД.

// C++ Builder

void __fastcall TForm1::Button1Click(TObject *Sender)

{

// Загружаем модуль

std::unique_ptr mHandle(

::LoadLibraryEx(L"C:\\TESTAPP\\CiFbEnc_x86.dll", 0,

LOAD_WITH_ALTERED_SEARCH_PATH),

&::FreeLibrary);

if (!mHandle)

{

MessageBox(

NULL,

L"Модуль CiFbEnc_x86.dll не найден или рядом с ним нет fbclient.dll",

L"Загрузка модуля",

MB_OK|MB_ICONERROR);

return;

}

// Получаем активатор

typedef CALL_CONV int(__stdcall *CREATEFUNCPTR)(CI::ICiFbEncActivator**);

CREATEFUNCPTR GetActivator =

(CREATEFUNCPTR)::GetProcAddress(mHandle.get(), "createCiFBEncActivator");

if (!GetActivator)

{

MessageBox(

NULL,

L"Не удалось получить из модуля CiFbEnc_x86.dll"

" процедуру createCiFBEncActivator"

" - попробуйте посмотреть, что пишет tdump.",

L"Загрузка модуля",

MB_OK|MB_ICONERROR);

return;

}

CI::ICiFbEncActivator* pActivator = NULL;

GetActivator(&pActivator);

if (!pActivator) { ShowMessage("ERROR GetActivator!"); return; }

// Устанавливаем параметры подключения к БД

pActivator->SetDBAccess("localhost:TESTDB", "SYSDBA", "masterkey");

// Устанавливаем ключ активатору

int res = pActivator->SetKey(&key, sizeof(key));

if (Err_OK != res) { ShowMessage("ERROR SetKey!"); pActivator->Destroy();return; }

// Активируем доступ к ключу

res = pActivator->Activate();

if (Err_OK != res)

{

// Обрабатываем ошибку

char errmsg[512] = {0};

size_t esize = sizeof(errmsg);

pActivator->GetFBStat(errmsg, esize);

String sErrMsg = "ERROR Activate: " + String(errmsg);

MessageBox(

NULL,

sErrMsg.w_str(),

L"Активация доступа к ключу",

MB_OK|MB_ICONERROR);

pActivator->Destroy();

return;

}

// Подключаемся к БД

try

{

FDConnection1->Connected = true;

FDTable1->Active = true;

}

catch(EFDDBEngineException &e)

{

String sErrMsg = L"Не удалось подключиться к БД. " + e.Message;

MessageBox(

NULL,

sErrMsg.w_str(),

L"Подключение к БД",

MB_OK|MB_ICONERROR);

}

// Уничтожаем экземпляр активатора

pActivator->Destroy();

pActivator = NULL;

}// Delphi

procedure TForm2.Button1Click(Sender: TObject);

var

pActivator : ICiFbEncActivator;

res : Integer;

CreateActivator: TActivatorFunction;

mHandle : HINST;

errmsg : array[0..511] of AnsiChar;

bufsize : NativeUInt;

begin

// Загружаем модуль

mHandle := LoadLibraryEx(PChar('C:\TESTAPP\CiFbEnc_x86.dll'), 0,

LOAD_WITH_ALTERED_SEARCH_PATH);

if mHandle = 0 then

begin

MessageBox(

Application.Handle,

'Модуль CiFbEnc_x86.dll не найден или рядом с ним нет fbclient.dll',

'Загрузка модуля',

MB_OK OR MB_ICONERROR);

Exit;

end;

// Получаем активатор

CreateActivator := GetProcAddress(mHandle, 'createCiFBEncActivator');

if not Assigned(CreateActivator) then

begin

MessageBox(

Application.Handle,

'Не удалось получить из модуля CiFbEnc_x86.dll процедуру createCiFBEncActivator'

+

' - попробуйте посмотреть, что пишет tdump.',

'Загрузка модуля',

MB_OK OR MB_ICONERROR);

Exit;

end;

pActivator := nil;

res := CreateActivator(pActivator);

if not Assigned(pActivator) then begin ShowMessage('ERROR CreateActivator!');Exit; end;

// Устанавливаем параметры подключения к БД

res := pActivator.SetDBAccess('localhost:TESTDB', 'SYSDBA', 'masterkey');

// Устанавливаем ключ активатору

res := pActivator.SetKey(@key, Length(key));

if Err_OK <> res then begin ShowMessage('ERROR SetKey!'); pActivator.Destroy;Exit; end;

// Активируем доступ к ключу

res := pActivator.Activate;

if Err_OK <> res then

begin

bufsize := SizeOf(errmsg);

ZeroMemory(@errmsg, bufsize);

pActivator.GetFBStat(errmsg, bufsize);

MessageBox(

Application.Handle,

PChar('ERROR Activate: ' + String(errmsg)),

'Активация доступа к ключу',

MB_OK OR MB_ICONERROR);

pActivator.Destroy;

Exit;

end;

// Подключаемся к БД

try

FDConnection1.Connected := True;

FDTable1.Active := True;

except

on E: EFDDBEngineException do begin

MessageBox(

Application.Handle,

PChar('Не удалось подключиться к БД. ' + String(E.Message)),

'Подключение к БД',

MB_OK OR MB_ICONERROR);

end;

end;

// Уничтожаем экземпляр активатора

pActivator.Destroy;

pActivator := nil;

FreeLibrary(mHandle);

end;Вот так вот достаточно просто можно работать с зашифрованной БД.

Полностью проект можно взять тут.

Демо-пакет — тут.

|

Метки: author cipher-bis криптография информационная безопасность firebird/interbase firebird шифрование данных конфиденциальность данных |

MyTaskHelper.ru на практике: создание бесплатной БД для проверки результатов ОГЭ |

С конца мая до конца июня в российских школах проходит ОГЭ (основной государственный экзамен) по всем возможным предметам и ученики с нетерпением ждут своих результатов.

Раздумывая над темами будущих публикаций о нашем проекте MyTaskHelper, мы никак не могли остановиться на чем-то конкретном. Но идея пришла сама собой в тот момент, когда наш сервис начало использовать Министерство образования и науки Астраханской области. Да-да, вам не показалось: MTH активно используется государственными структурами. А в описанном выше конкретном случае администратор сайта astrcmo.ru создал и добавил на ресурс форму входа, позволяющую получить доступ к записи после заполнения требуемых данных (логина и пароля).

Рис. 1 Встроенный на сайт astrcmo.ru виджет

Алгоритм создания такого модуля: на сайте mytaskhelper.ru создается или импортируется база данных с персональной информацией учеников и их оценками и настраивается доступ к виджету записи по логину и паролю.

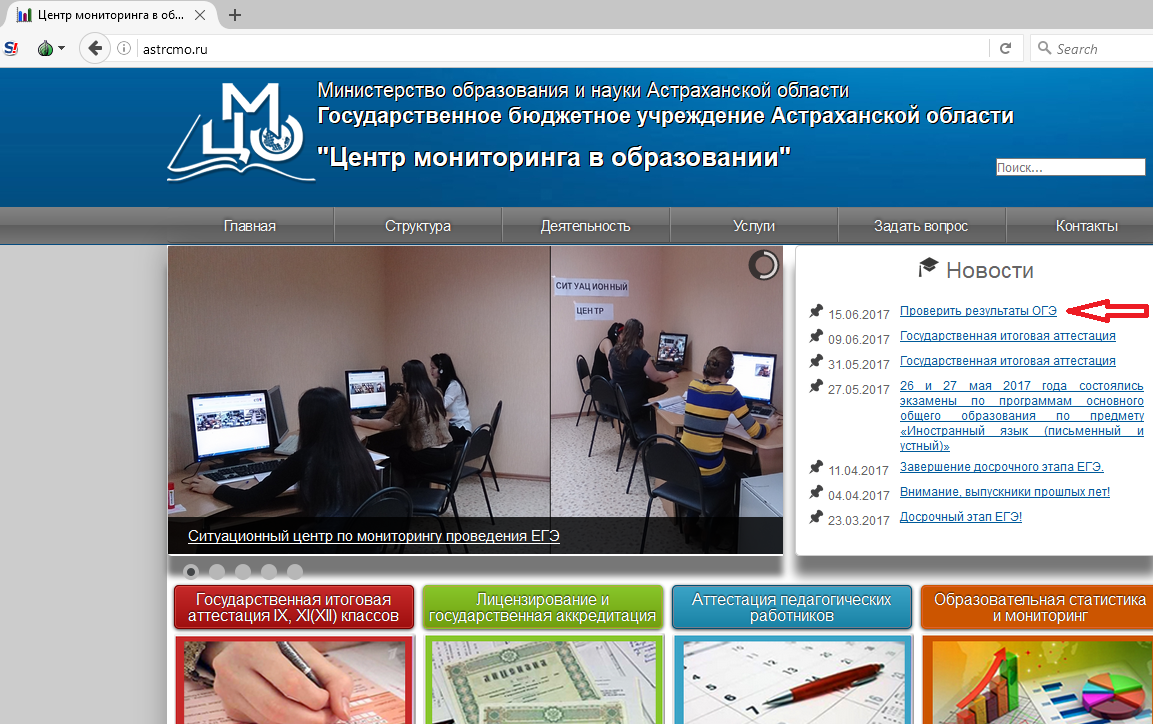

Выглядит это следующим образом (мы создали тестовую веб-форму с нуля (глянуть, как это делается, можно в теме, но можно и просто экспортировать свою готовую базу данных в формате CSV или Excel):

Рис.2 Поля сконструированной в MTH веб-формы, посредством которой можно добавлять информацию в БД.

В настройках поля под названием «Серия документа» выбираем тип данных «Логин», а «Номер документа» — «Пароль».

А так выглядит заполненная база данных.

Рис. 3 Заполненная база данных с персональными данными и оценками

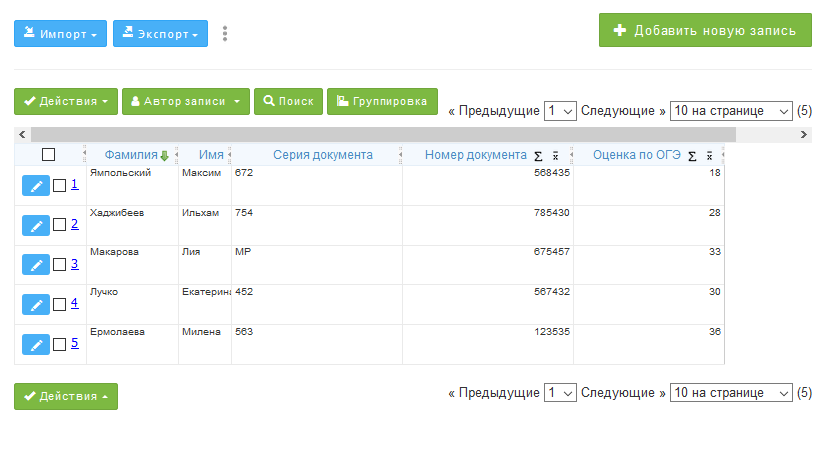

Для того, чтобы настроить доступ к записи по логину и паролю, переходим в меню Виджеты=>Форма входа и настраиваем режим доступа. После редактирования формы входа получаем следующий результат, который встраивается в любую страницу сайта. Для этого на вкладке «Интеграция» достаточно скопировать ссылку, iFrame или выбрать другой вариант поделиться виджетом и встроить в нужное место сайта.

Рис. 4 Форма входа на виджет записи

Отметим, что в настройках виджета можно выбрать следующие опции:

- разрешить редактировать запись после логина;

- разрешить экспорт записей в Excel;

- разрешить экспорт записей в PDF.

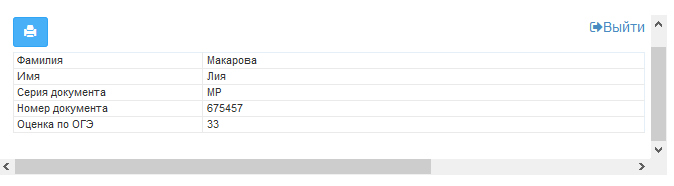

ВСЕ! Далее ученик, желающий узнать свои баллы, переходит на страницу сайта и введя логин (в нашем случае это – серия документа) и пароль (номер документа) (Рис. 4), получает доступ к записи из базы данных, в которой хранится искомый результат (Рис.5).

Рис. 5 Запись из базы данных, которую видит ученик, введя логин и пароль

Очевидно, что данная функция может применяться где угодно. Например, она востребована у владельцев интернет-магазинов, где с ее помощью можно настроить доступ клиентов к записям о товарах, их статусе и т.п. Полезной функция окажется и для учителей, которые смогут легко предоставить доступ родителям своих учеников к их текущим оценкам по логину (например, это будет фамилия) и паролю (индивидуальный числовой или буквенно-числовой код).

Для того, чтобы протестировать, как это выглядит в живую, можно перейти на виджет и введя логин/пароль из таблицы указанной выше или же test/test, убедиться, что функционал рабочий. Заметьте, что если в БД имеется одна запись с определенной комбинацией логина и пароля, на выходе мы и получим одну эту запись, если же их несколько (как для test/test), они будут выводиться в табличном варианте с возможностью осуществлять поиск и группировку по таблице (Рис. 6).

Пользуйтесь с удовольствием, а мы будем рады ответить на любые вопросы.

|

|

[recovery mode] Verizon завершили поглощение Yahoo |

JD Hancock / Flickr / CC

JD Hancock / Flickr / CCПоглощение Yahoo

13 июня стало известно об официальном закрытии сделки. Активы Yahoo, в том числе новостные, спортивные, финансовые сайты и сервисы прочих тематик, присоединятся к портфелю Verizon в качестве дочернего предприятия под новым именем Oath. Руководить им будет бывший генеральный директор медиахолдинга AOL Тим Армстронг. Oath объединяет свыше 50 медиа- и технологических брендов, в том числе и популярное интернет-издание Huffington Post.

Стоимость сделки по поглощению Yahoo составляет $4,48 млрд. Это на $250 млн меньше первоначальной суммы. Причиной изменения условий стала череда скандалов, которая сопровождала Yahoo в последнее время.

История поглощения Yahoo

Предпосылкой для покупки Yahoo послужило приобретение Verizon компании AOL в 2014 году за $4,4 млрд. Так компания обозначила свою готовность к расширению медиаактивов. Yahoo на тот момент также зарекомендовала себя как медийная организация. По следам сделки с AOL Фран Шаммо (Fran Shammo), главный финансовой директор Verizon, в 2015 году во время медиаконференции намекнул на заинтересованность компании в Yahoo.

«Все, что я могу сказать сейчас, мы не знаем, что решит совет директоров Yahoo. Пока еще рано об этом говорить», — заявил он тогда. И годом позднее (в июне 2016) Verizon объявила о планах приобрести основной интернет-бизнес Yahoo за $4,8 млрд.

На тот момент и до самого окончания сделки президентом и главным исполнительным директором Yahoo была Марисса Майер. В июле 2016 года она выразила готовность остаться на посту после завершения сделки, но теперь покидает компанию с «золотым парашютом» в размере $186 млн. Именно ее решения и действия привели к падению оценки Yahoo за последний год.

На фото: Марисса Майер TechCrunch CC

На фото: Марисса Майер TechCrunch CCПричиной стало публичное раскрытие ряда инцидентов, произошедших несколькими годами ранее. Сначала в сентябре 2016 года представители Yahoo объявили, что в ходе хакерской атаки в 2014 году были похищены личные сведения по меньшей мере 500 млн пользователей сервисов компании. Представитель Verizon Боб Вареттони (Bob Varettoni) дал понять, что эта информация стала неприятным сюрпризом для холдинга. По версии Yahoo, обнаружить следы взлома удалось только летом 2016 года. Масштаб утечки был отмечен даже на уровне американского Сената.

Вскоре стало ясно, что открывшаяся информация может стать причиной изменения условий сделки. Но прошло чуть более двух месяцев, и в декабре Yahoo пришлось признать куда более серьезный промах в системе безопасности. В декабре 2016 года стало известно о взломе миллиарда учетных записей, произошедшем в 2013 году. Эти две атаки являются крупнейшими известными взломами сети одной компании.

Verizon не заставила себя долго ждать, подтвердив, что эти события оказали «существенное» влияние на оценку бизнеса Yahoo, и условия сделки будут пересмотрены. Изначально Verizon просили скидку в $1 млрд, но затем размер скидки был снижен до $250 млн.

Причины заката Yahoo