Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Создаем самодостаточный Docker-кластер |

Самодостаточная система — это та, которая способна восстанавливаться и адаптироваться. Восстановление означает, что кластер почти всегда будет в том состоянии, в котором его запроектировали. Например, если копия сервиса выйдет из строя, то системе потребуется ее восстановить. Адаптация же связана с модификацией желаемого состояния, так чтобы система смогла справиться с изменившимися условиями. Простым примером будет увеличение трафика. В этом случае сервисам потребуется масштабироваться. Когда восстановление и адаптация автоматизировано, мы получаем самовосстанавливающуюся и самоадаптирующуюся систему. Такая система является самодостаточной и может действовать без вмешательства человека.

Как выглядит самодостаточная система? Какие ее основные части? Кто действующие лица? В этой статье мы обсудим только сервисы и проигнорируем тот факт, что железо также очень важно. Такими ограничениями мы составим картину высокого уровня, которая описывает (в основном) автономную систему с точки зрения сервисов. Мы опустим детали и взглянем на систему с высоты птичьего полёта.

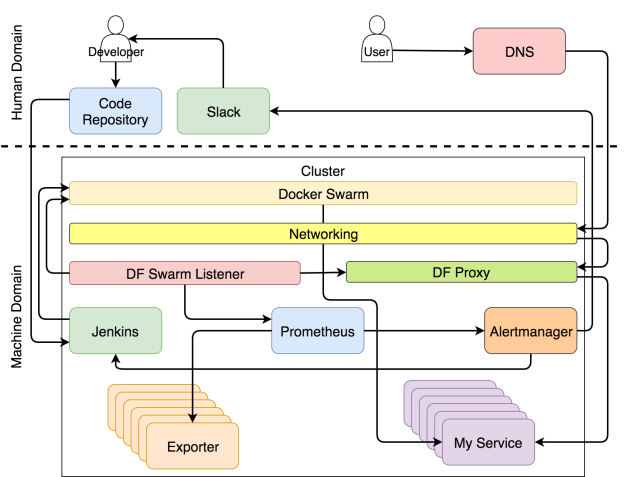

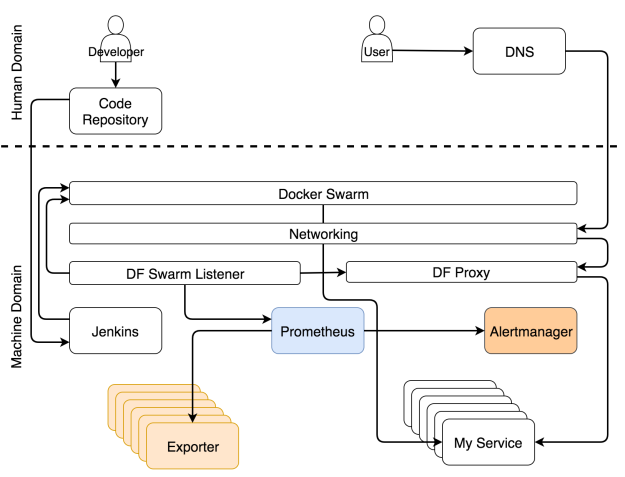

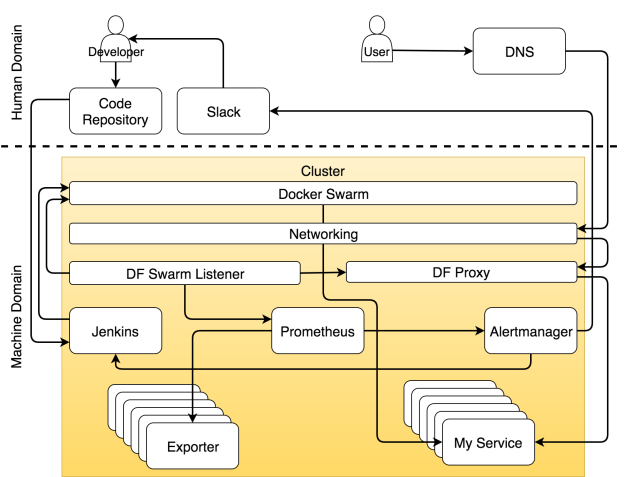

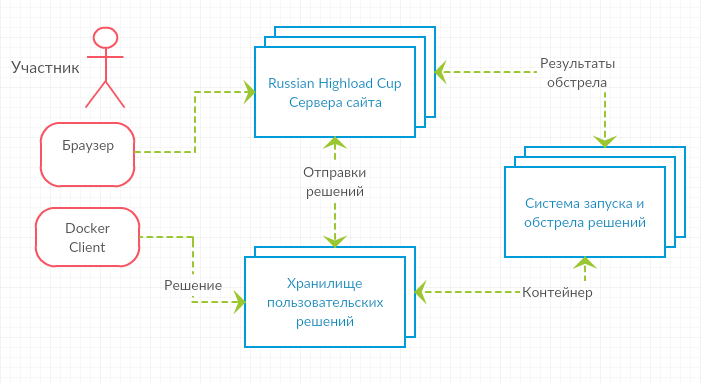

Если вы хорошо разбираетесь в теме и хотите сразу всё понять, то система изображено на рисунке ниже.

Система с самовосстанавливающимися и самоадаптирующимися сервисами

Возможно, в такой диаграмме сложно разобраться с ходу. Если бы я отделался от вас таким рисунком, вы могли бы подумать, что сопереживание — не самая яркая черта моего характера. В таком случае вы не одиноки. Моя жена думает так же даже безо всяких там диаграмм. Но в этот раз я сделаю всё возможное, чтобы поменять ваше мнение и начать с чистого листа.

Мы можем разделить систему на две основные области — человеческую и машинную. Считайте, что вы попали в Матрицу. Если вы не видели этот фильм, немедленно отложите эту статью, достаньте попкорн и вперёд.

В Матрице мир поработили машины. Люди там мало что делают, кроме тех немногих, которые осознали, что происходит. Большинство живут во сне, который отражает прошедшие события истории человечества. Тоже самое сейчас происходит с современными кластерами. Большинство обращается с ними, как будто на дворе 1999 год. Практически все действия выполняются вручную, процессы громоздкие, а система выживает лишь за счёт грубой силы и впустую затраченной энергии. Некоторые поняли, что на дворе уже 2017 год (по крайней мере на время написания этой статьи) и что хорошо спроектированная система должна выполнять большую часть работы автономно. Практически всё должно управляться машинами, а не людьми.

Но это не означает, что для людей не осталось места. Работа для нас есть, но она больше связана с творческими и неповторяющимися задачами. Таким образом, если мы сфокусируется только на кластерных операциях, человеческая область ответственности уменьшится и уступит место машинам. Задачи распределяются по ролям. Как вы увидите ниже, специализация инструмента или человеком может быть очень узкой, и тогда он будет выполнять лишь один тип задач, или же он может отвечать за множество аспектов операций.

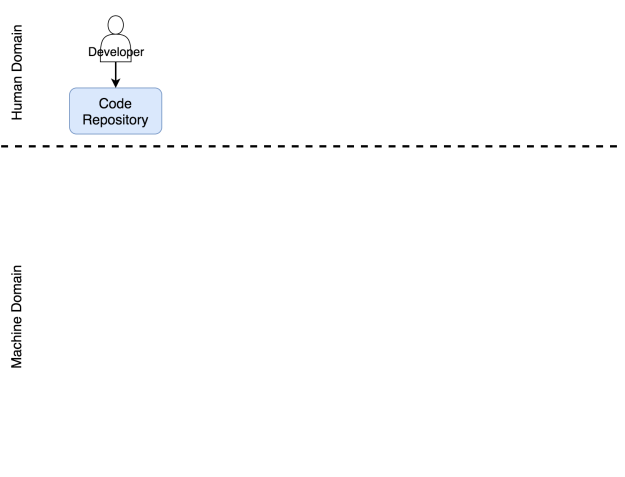

Роль разработчика в системе

В область ответственности человека входят процессы и инструменты, которыми нужно управлять вручную. Из этой области мы пытаемся удалить все повторяющиеся действия. Но это не означает, что она должна вовсе исчезнуть. Совсем наоборот. Когда мы избавляемся от повторяющихся задач, мы высвобождаем время, которое можно потратить на действительно значимые задачи. Чем меньше мы занимаемся задачами, которые можно делегировать машине, тем больше времени мы можем потратить на те задачи, для которых требуется творческий подход. Эта философия стоит в одном ряду с сильными и слабыми сторонами каждого актера этой драмы. Машина хорошо управляется с числами. Они умеют очень быстро выполнять заданные операции. В этом вопросе они намного лучше и надежнее, чем мы. Мы же в свою очередь способны критически мыслить. Мы можем мыслить творчески. Мы можем запрограммировать эти машины. Мы можем сказать им, что делать и как.

Я назначил разработчика главным героем в этой драме. Я намеренно отказался от слова “кодер”. Разработчик — это любой человек, который работает над проектом разработки софта. Он может быть программистом, тестировщиком, гуру операций или scrum-мастером — это всё не важно. Я помещаю всех этих людей в группу под названием разработчик. В результате своей работы они должны разместить некий код в репозиторий. Пока его там нет, его будто бы и не существует. Не важно, располагается ли он на вашем компьютере, в ноутбуке, на столе или на маленьком кусочке бумаги, прикрепленном к почтовому голубю. С точки зрения системы этот код не существует, до тех пор пока он не попадет в репозиторий. Я надеюсь, что этот репозиторий Git, но, по идее, это может быть любое место, где вы можете хранить что-нибудь и отслеживать версии.

Этот репозиторий также входит в область ответственности человека. Хоть это и софт, он принадлежит нам. Мы работаем с ним. Мы обновляем код, скачиваем его из репозитория, сливаем его части воедино и иногда приходим в ужас от числа конфликтов. Но нельзя сделать вывод о том, что совсем не бывает автоматизированных операций, ни о том, что некоторые области машинной ответственности не требуют человеческого вмешательства. И всё же если в какой-то области большая часть задач выполняется вручную, мы будем считать ее областью человеческой ответственности. Репозиторий кода определённо является частью системы, которая требует человеческого вмешательства.

Разработчик отправляет код в репозиторий

Посмотрим, что происходит, когда код отправляется в репозиторий.

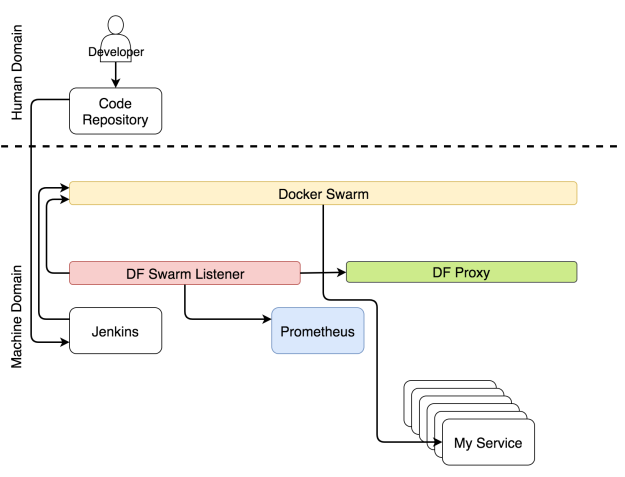

Роль непрерывного развертывания в системе

Процесс непрерывного развертывания полностью автоматизирован. Никаких исключений. Если ваша система не автоматизирована, то у вас нет непрерывного развертывания. Возможно, вам понадобится вручную деплоить в продакшн. Если вы вручную нажимаете на одну единственную кнопку, на которой жирным написано “deploy”, то ваш процесс является непрерывной доставкой. Такое я могу понять. Такая кнопка может потребоваться с точки зрения бизнеса. И все же уровень автоматизации в таком случае такой же, как и при непрерывном развертывании. Вы здесь только принимаете решения. Если требуется делать что-то еще вручную, то вы либо выполняете непрерывную интеграцию, либо, что более вероятно, делаете что-то такое, в чьем названии нет слова “непрерывный”.

Неважно, идет ли речь о непрерывном развертывании или доставке, процесс должен быть полностью автоматизированным. Все ручные действия можно оправдать только тем, что у вас устаревшая система, которую ваша организация предпочитает не трогать (обычно это приложение на Коболе). Она просто стоит на сервере что-то делает. Мне очень нравятся правила типа “никто не знает, что она делает, поэтому ее лучше не трогать”. Это способ выразить величайшее уважение, сохраняя безопасное расстояние. И все же я предположу, что это не ваш случай. Вы хотите что-нибудь с ней сделать, желание буквально раздирает вас на кусочки. Если же это не так и вам не повезло работать с системой аля “руки прочь отсюда”, то вам не стоит читать эту статью, я удивлён, что вы не поняли этого раньше сами.

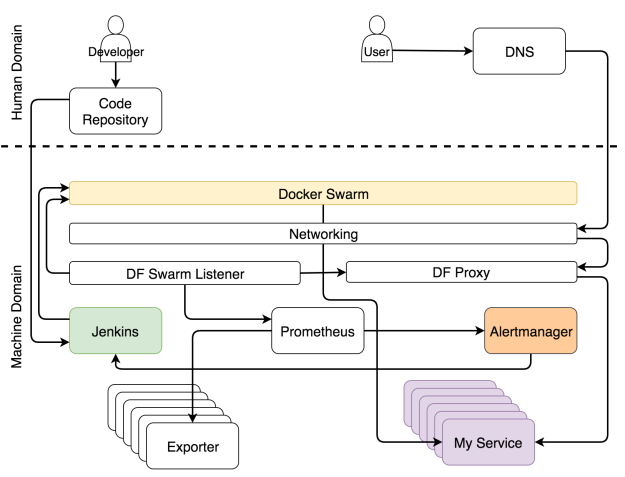

Как только репозиторий получает commit или pull request, срабатывает Web hook, который в свою очередь отправляет запрос инструменту непрерывного развертывания для запуска процесса непрерывного развертывания. В нашем случае этим инструментом является Jenkins. Запрос запускает поток всевозможных задач по непрерывному развертыванию. Он проверяет код и проводит модульные тесты. Он создает образ и пушит в регистр. Он запускает функциональные, интеграционные, нагрузочные и другие тесты — те, которым требуется рабочий сервис. В самом конце процесса (не считая тестов) отправляется запрос планировщику, чтобы тот развернул или обновил сервис в кластере. Среди прочих планировщиков мы выбираем Docker Swarm.

Развертывание сервиса через Jenkins

Одновременно с непрерывным развертыванием работает еще другой набор процессов, которые следят за обновлениями конфигураций системы.

Роль конфигурации сервисов в системе

Какой бы элемент кластера ни поменялся, нужно заново конфигурировать какие-то части системы. Может потребоваться обновить конфигурацию прокси, сборщику метрик могут быть нужны новые цели, анализатору логов — обновить правила.

Не важно, какие части системы нужно поменять, главное — все эти изменения должны применяться автоматически. Мало кто будет с этим спорить. Но вот есть большой вопрос: где же найти те части информации, которые следует внедрить в систему? Самым оптимальным местом является сам сервис. Т.к. почти все планировщики используют Docker, логичнее всего хранить информации о сервисе в самом сервисе в виде лейблов. Если мы разместим эту информацию в любом другом месте, то мы лишимся единого правдивого источника и станет очень сложно выполнять авто-обнаружение.

Если информация о сервисе находится внутри него, это не означает, что эту же информацию не следует размещать в других местах внутри кластера. Следует. Однако, сервис — это то место, где должна быть первичная информация, и с этого момента она должна передаваться в другие сервисы. С Docker-ом это очень просто. У него уже есть API, к которому любой может подсоединиться и получить информацию о любом сервисе.

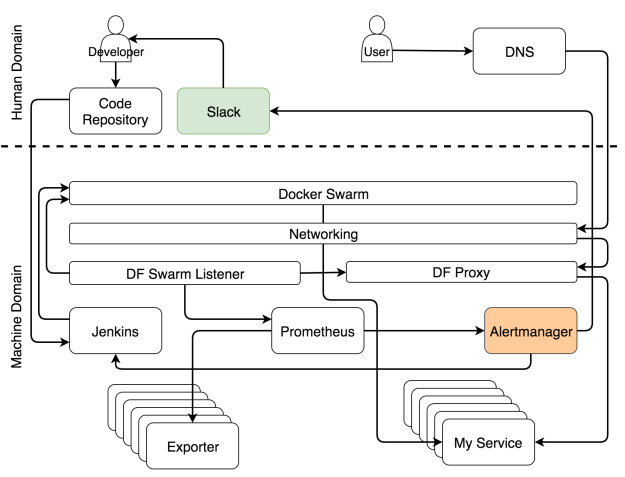

Есть хороший инструмент, который находит информацию о сервисе и распространяет ее по всей системе, — это Docker Flow Swarm Listener (DFSL). Можете воспользоваться любым другим решением или создать свое собственное. Конечная цель этого и любого другого такого инструмента — прослушивать события Docker Swarm. Если у сервиса есть особый набор ярлыков, приложение получит информацию, как только вы установите или обновите сервис. После чего оно передаст эту информацию всем заинтересованным сторонам. В данном случае это Docker Flow Proxy (DFP, внутри которого есть HAProxy) и Docker Flow Monitor (DFM, внутри есть Prometheus). В результате у обоих всегда будет последняя актуальная конфигурация. У Proxy есть путь ко всем публичным сервисам, тогда как у Prometheus есть информация об экспортерах, оповещениях, адресе Alertmanager-а и других вещах.

Реконфигурация системы через Docker Flow Swarm Listener

Пока идет развертывание и реконфигурация, пользователи должны иметь доступ к нашим сервисам без простоев.

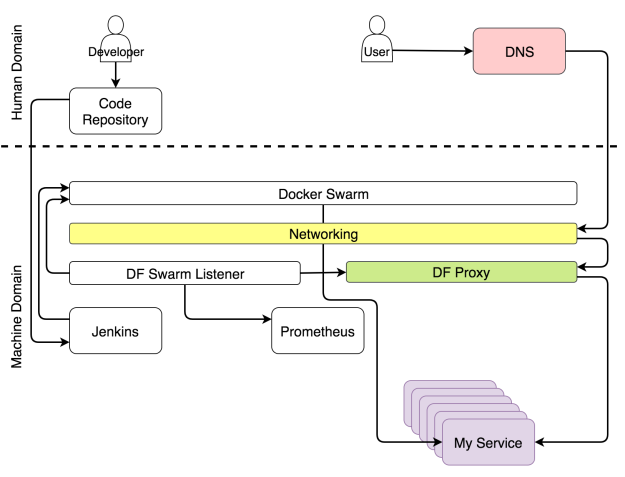

Роль Proxy в системе

У каждого кластера должен быть прокси, который будет принимать запросы от единого порта и перенаправлять их в назначенные сервисы. Единственным исключением из правила будет публичный сервис. Для такого сервиса под вопросом будет не только необходимость прокси, но и кластера вообще. Когда запрос приходит в прокси, он оценивается и в зависимости от его пути, домена и некоторых заголовков перенаправляется в один из сервисов.

Благодаря Docker-у некоторые аспекты прокси теперь устарели. Больше не нужно балансировать нагрузку. Сеть Docker Overlay делает это за нас. Больше не нужно поддерживать IP-ноды, на которых хостятся сервисы. Service discovery делает это за нас. Все, что требуется от прокси, — это оценить заголовки и переправить запросы, куда следует.

Поскольку Docker Swarm всегда использует скользящие обновления, когда изменяется какой-либо аспект сервиса, процесс непрерывного развертывания не должен становиться причиной простоя. Чтобы это утверждение было верным, должны выполняться несколько требований. Должно быть запущено по крайней мере две реплики сервиса, а лучше еще больше. Иначе, если реплика будет только одна, простой неизбежен. На минуту, секунду или миллисекунду — неважно.

Простой не всегда становится причиной катастрофы. Все зависит от типа сервиса. Когда обновляется Prometheus, от простоя никуда не деться, потому что программа не умеет масштабироваться. Но этот сервис нельзя назвать публичным, если только у вас не несколько операторов. Несколько секунд простоя никому не навредят.

Совсем другое дело — публичный сервис вроде крупного интернет-магазина с тысячами или даже миллионами пользователей. Если такой сервис приляжет, то он быстро потеряет свою репутацию. Мы, потребители, так избалованы, что даже один-единственный сбой заставит нас поменять свою точку зрения и пойти искать замену. Если этот сбой будет повторяться снова и снова, потеря бизнеса практически гарантирована. У непрерывного развертывания много плюсов, но так как к нему прибегают довольно часто, становится все больше потенциальных проблем, и простой — одна из них. В самом деле, нельзя допускать простоя в одну секунду, если он повторяется несколько раз за день.

Есть и хорошие новости: если объединить rolling updates и множественные реплики, то можно избежать простоя, при условии, что прокси всегда будет последней версии.

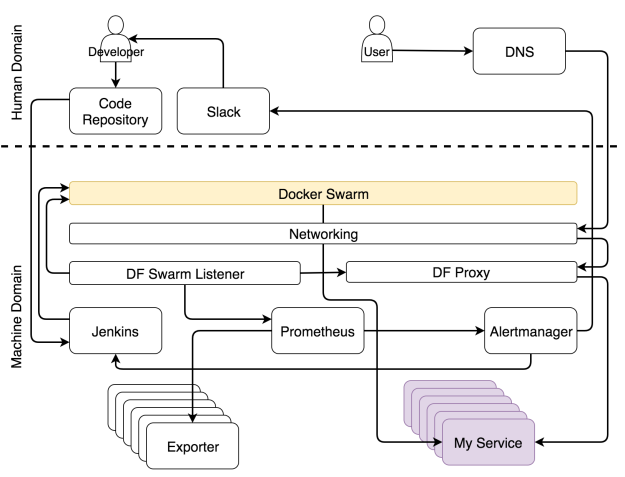

Если объединить повторяющиеся обновления с прокси, который динамически перенастраивает сам себя, то мы получим ситуацию, когда пользователь может в любой момент отправить запрос сервису и на него не будет влиять ни непрерывное развертывание, ни сбой, ни какие-либо другие изменения состояния кластера. Когда пользователь отправляет запрос домену, этот запрос проникает в кластер через любую работающую ноду, и его перехватывает сеть Ingress Docker-а. Сеть в свою очередь определяет, что запрос использует порт, на котором слушает прокси и перенаправляет его туда. Прокси, с другой стороны, оценивает путь, домен и другие аспекты запроса и перенаправляет его в назначенный сервис.

Мы используем Docker Flow Proxy (DFP), который добавляет нужный уровень динамизма поверх HAProxy.

Путь запроса к назначенному сервису

Следующая роль, которую мы обсудим, связана со сбором метрик.

Роль метрик в системе

Данные — ключевая часть любого кластера, особенно того, который нацелен на самоадаптацию. Вряд ли кто-то оспорит, что нужны и прошлые, и нынешние метрики. Случись что, без них мы будем бегать как тот петух по двору, которому повар отрубил голову. Главный вопрос не в том, нужны ли они, а в том, что с ними делать. Обычно операторы бесконечными часами пялятся на монитор. Такой подход далек от эффективности. Взгляните лучше на Netflix. Они хотя бы подходят к вопросу весело. Система должна использовать метрики. Система генерирует их, собирает и принимает решения о том, какие действия предпринять, когда эти метрики достигают неких порогов. Только тогда систему можно назвать самоадаптирующейся. Только когда она действует без человеческого вмешательства, они самодостаточна.

Самоадаптирующейся системе надо собирать данные, хранить их и применять к ним разные действия. Не будем обсуждать, что лучше — отправка данных или их сбор. Но поскольку мы используем Prometheus для хранения и оценки данных, а также для генерации оповещений, то мы будем собирать данные. Эти данные доступны от экспортеров. Они могут быть общими (например, Node Exporter, cAdvisor и т.д.) или специфичными по отношению к сервису. В последнем случае сервисы должны выдавать метрики в простом формате, который ожидает Prometheus.

Независимо от потоков, которые мы описали выше, экспортеры выдают разные типы метрик. Prometheus периодически собирает их и сохраняет в базе данных. Помимо сбора метрик, Prometheus также постоянно оценивает пороги, заданные алертами, и если система достигает какого-то из них, данные передаются в Alertmanager. В большинстве случаев эти пределы достигаются при изменении условий (например, увеличилась нагрузка системы).

Сбор данных и оповещений

Роль оповещений в системе

Оповещения разделяются на две основные группы в зависимости от того, кто их получает — система или человек. Когда оповещение оценивается как системное, запрос обычно направляется сервису, который способен оценить ситуацию и выполнить задачи, которые подготовят систему. В нашем случае это Jenkins, который выполняет одну из предопределенных задач.

В самые частые задачи, которые выполняет Jenkins, обычно входит масштабировать (или демасштабировать) сервис. Впрочем, прежде чем он предпримет попытку масштабировать, ему нужно узнать текущее количество реплик и сравнить их с высшим и низшим пределом, которые мы задали при помощи ярлыков. Если по итогам масштабирования число реплик будет выходить за эти пределы, он отправит уведомление в Slack, чтобы человек принял решение, какие действия надо предпринять, чтобы решить проблему. С другой стороны, когда поддерживает число реплик в заданных пределах, Jenkins отправляет запрос одному из Swarm-менеджеров, который, в свою очередь, увеличивает (или уменьшает) число реплик в сервисе. Это процесс называется самоадаптацией, потому что система адаптируется к изменениям без человеческого вмешательства.

Уведомление системы для самоадаптации

Хоть и нашей целью является полностью автономная система, в некоторых случая без человека не обойтись. По сути, это такие случаи, которые невозможно предвидеть. Когда случается что-то, что мы ожидали, пусть система устранит ошибку. Человека надо звать, только когда случаются неожиданности. В таких случаях Alertmanager шлет уведомление человеку. В нашем варианте это уведомление через Slack, но по идее это может быть любой другой сервис для передачи сообщений.

Когда вы начинаете проектировать самовосстанавливающуюся систему, большинство оповещений попадут в категорию “неожиданное”. Вы не можете предугадать все ситуации. Единственное, что вы можете в данном случае — это убедиться, что неожиданное случается только один раз. Когда вы получаете уведомление, ваша первая задача — адаптировать систему вручную. Вторая — улучшить правила в Alertmanager и Jenkins, чтобы когда ситуация повторится, система могла бы справиться с ней автоматически.

Уведомление для человека, когда случается что-то неожиданное

Настроить самоадаптирующуюся систему тяжело, и эта работа бесконечная. Ее постоянно нужно улучшать. А как насчет самовосстановления? Так ли сложно достичь и его?

Роль планировщика в системе

В отличие от самоадаптации, самовосстановления достичь сравнительно легко. Пока в наличии достаточно ресурсов, планировщик всегда будет следить, чтобы работало определенное число реплик. В нашем случае это планировщик Docker Swarm.

Реплики могут выходить из строя, они могут быть убиты и они могут находиться внутри нездорового нода. Это все не так важно, поскольку Swarm следит за тем, чтобы они перезапускались при необходимости и (почти) всегда нормально работали. Если все наши сервисы масштабируемы и на каждом из них запущено хотя бы несколько реплик, простоя никогда не будет. Процессы самовосстановления внутри Docker-а сделают процессы самоадаптации легко доступными. Именно комбинация этих двух элементов делает нашу систему полностью автономной и самодостаточной.

Проблемы начинают накапливаться, когда сервис нельзя масштабировать. Если у нас не может быть нескольких реплик сервиса, Swarm не сможет гарантировать отсутствие простоев. Если реплика выйдет из строя, она будет перезапущена. Впрочем, если это единственная доступная реплика, период между аварией и повторным запуском превращается в простой. У людей все точно так же. Мы заболеваем, лежим в постели и через какое-то время возвращаемся на работу. Если мы единственный работник в этой компании и нас некому подменить, пока мы отсутствуем, то это проблема. То же применимо и к сервисам. Для сервиса, который хочет избежать простоев, необходимо как минимум иметь две реплики.

Docker Swarm следит, чтобы не было простоев

К сожалению, наши сервисы не всегда проектируются с учетом масштабируемости. Но даже когда она учитывается, всегда есть шанс, что ее нет у какого-то из сторонних сервисов, которыми вы пользуетесь. Масштабируемость — это важное проектное решение, и мы обязательно должны учитывать это требование, когда мы выбираем какой-то новый инструмент. Надо четко различать сервисы, для которых простой недопустим, и сервисы, которые не подвергнут систему риску, если они будут недоступны в течение нескольких секунд. Как только вы научитесь их различать, вы всегда будете знать, какие из сервисов масштабируемы. Масштабируемость — это требование беспростойных сервисов.

Роль кластера в системе

В конце концов все, что мы делаем, находится внутри одного и более кластеров. Больше не существует индивидуальных серверов. Не мы решаем, что куда направить. Это делают планировщики. С нашей (человеческой) точки зрения самый маленький объект — это кластер, в котором собраны ресурсы типа памяти и CPU.

Все является кластером

|

|

Как настроить командную работу и сохранять спокойствие в чатах Телеграма, если всё горит, и все в аду |

Что такое авария? Может закончиться место на диске (или похоже, скоро закончится), может увеличиться время ответа. Если мы говорим, что среагируем за 15 минут, это означает, что дежурный администратор должен сделать это за 7-8 минут. За это время он получает оповещение, подтверждает, что принял, расследует его и в случае необходимости начинает чинить.

Сейчас таких оповещений от 100 до 500 в час на человека. Днем их бывает больше, ночью меньше, в «черную пятницу» их безумно много, потому что интернет-магазины почему-то любят начать «черную пятницу» на день раньше каждый год, и не всегда это планируется заранее (каждый раз они говорят, что не будут вообще в ней участвовать; один наш клиент как-то запустил рассылку на 300 тыс. человек через полчаса после того, как сказал, что в этой «черной пятнице» не участвует, и мы получили в итоге порядка 900 алертов в час на трех дежурных админов).

Основная работа по поддержке у нас идет через чаты (в среднем за десять минут могут прийти уведомления в десять чатов). Ни тикетная система, ни клиент не должен говорить, что что-то упало, это мы должны заметить первыми и сказать клиенту. Это выглядит так:

или так:

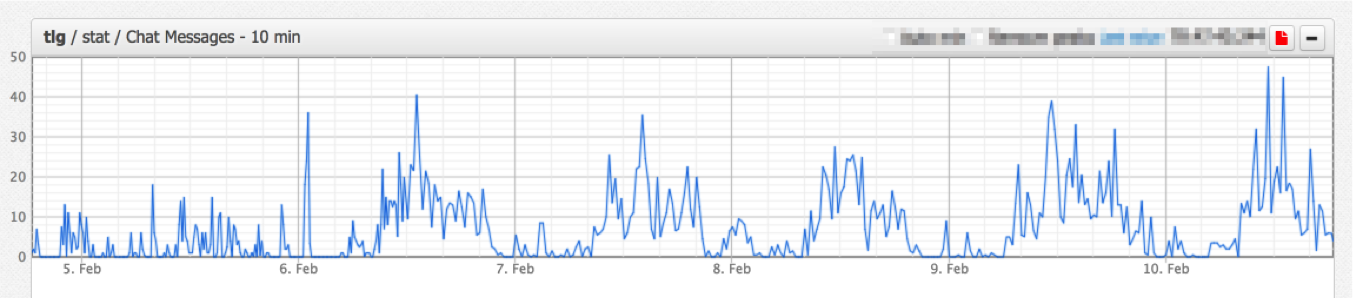

В таких чатах у нас получается до 50 сообщений каждые 10 минут. До восьми задач ставится через каждый чат одновременно. Это ускоряет работу — если попросить клиента написать задачу в тикете, клиент долго будет ее формулировать, и потом еще какое-то количество времени уйдет на то, чтобы сформулировать эту задачу для исполнителей правильно. Если клиент начинает разговаривать в чате, то это можно обсудить немедленно, а потом уже как-то перенести в систему управления проектами. Клиенту проще поставить задачу в диалоге, нам проще попытаться уточнить, что он имеет в виду, но возникают определенные проблемы, связанные с тем, что задача в чате не выглядит как полноценная задача для администратора. Таких задач у сотрудника возникает около пяти в час — это может быть какое-то изменение конфигурации на сервере, установка какого-нибудь софта, создание дополнительного бэкапа и т.д.

Сейчас у нас в среднем 90 активных чатов каждый день, и общение в них неравномерно по времени:

В чатах возникает много задач, и за ними трудно уследить, их очень просто потерять. Оповещений очень много, на них надо реагировать вовремя — иначе мы нарушим SLA. Ну и в конце концов, когда у вас получается порядка 500 алертов в час, вы немножко устаете, потому что нужно с этим как-то жить.

Мы долго жили в скайпе. Сначала было очень плохо, потом стало очень-очень плохо, потом стало совсем плохо. В какой-то момент все, и наши клиенты тоже, стали переходить на Телеграм. И поскольку нас было довольно большая экспертиза в разработке, мы решили попробовать переписать его для себя так, чтобы это решало наши проблемы.

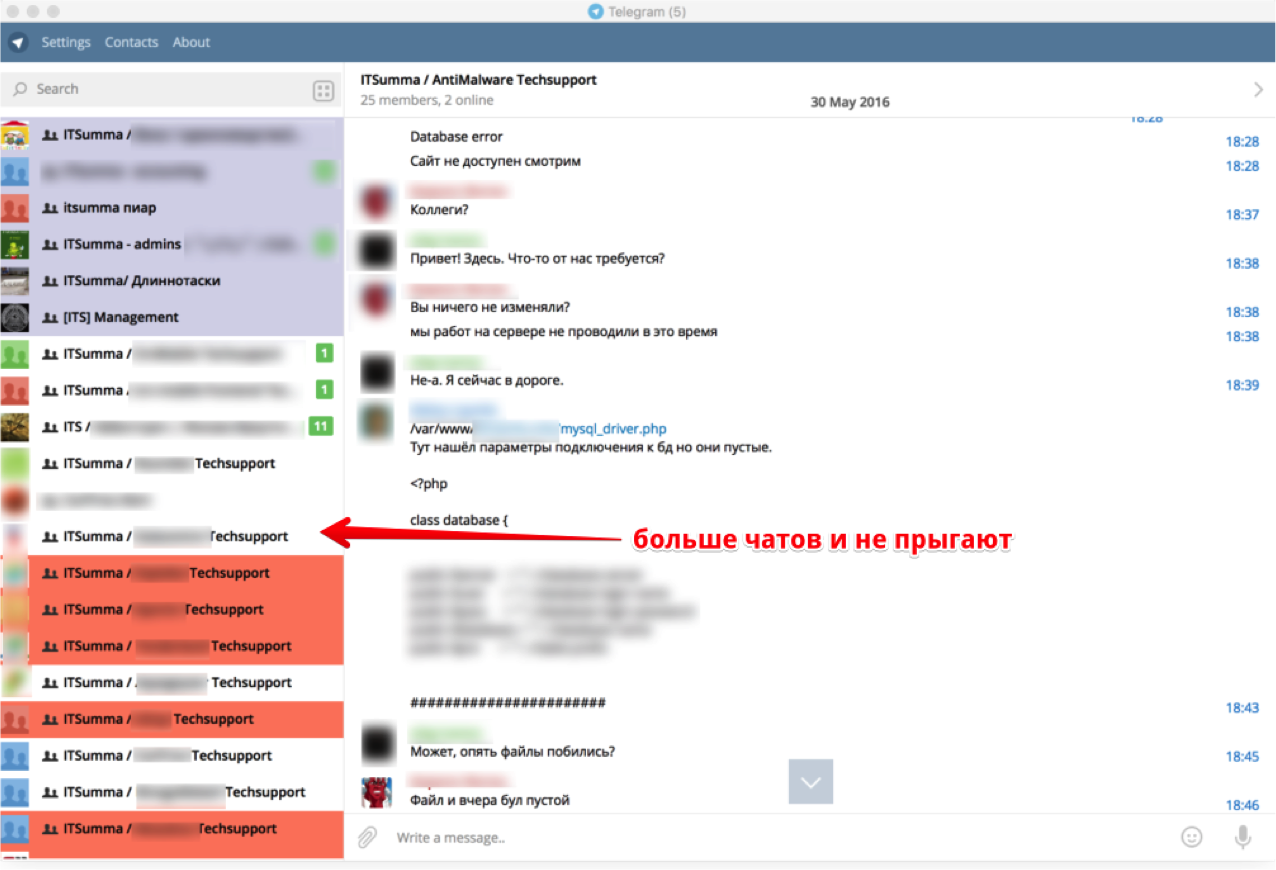

Почему нас не устроил Телеграм, или любой другой мессенджер, как он есть? Никто из разработчиков не думает, что у человека может быть 80 чатов одновременно. Слева в окне мессенджера показывается малое количество чатов — не то, которое нам нужно для нашей работы. В обычной жизни, по сравнению с нами, человек пишет довольно редко. У нас же в пики постоянно меняется очередность чатов, между ними как минимум неудобно переключаться (ну легко что-то потерять). По списку часто непонятно, где мы не успели ответить или еще не отвечали, и где приближается время, что нужно срочно ответить.

В своем клиенте Телеграма мы уменьшили высоту каждого чата в отдельности.

Стали отслеживать SLA по тому, где в чате последним написал клиент, и стали подсвечивать чаты, где нужно ответить нам.

Сгруппировали чаты по необходимости ответа, добавили функцию отметить все чаты как прочитанные. Зачем это сделали? У нас за день накапливается, если сотрудник не дежурил, порядка 150 чатов, в которых что-то писали — это уже неактуально.

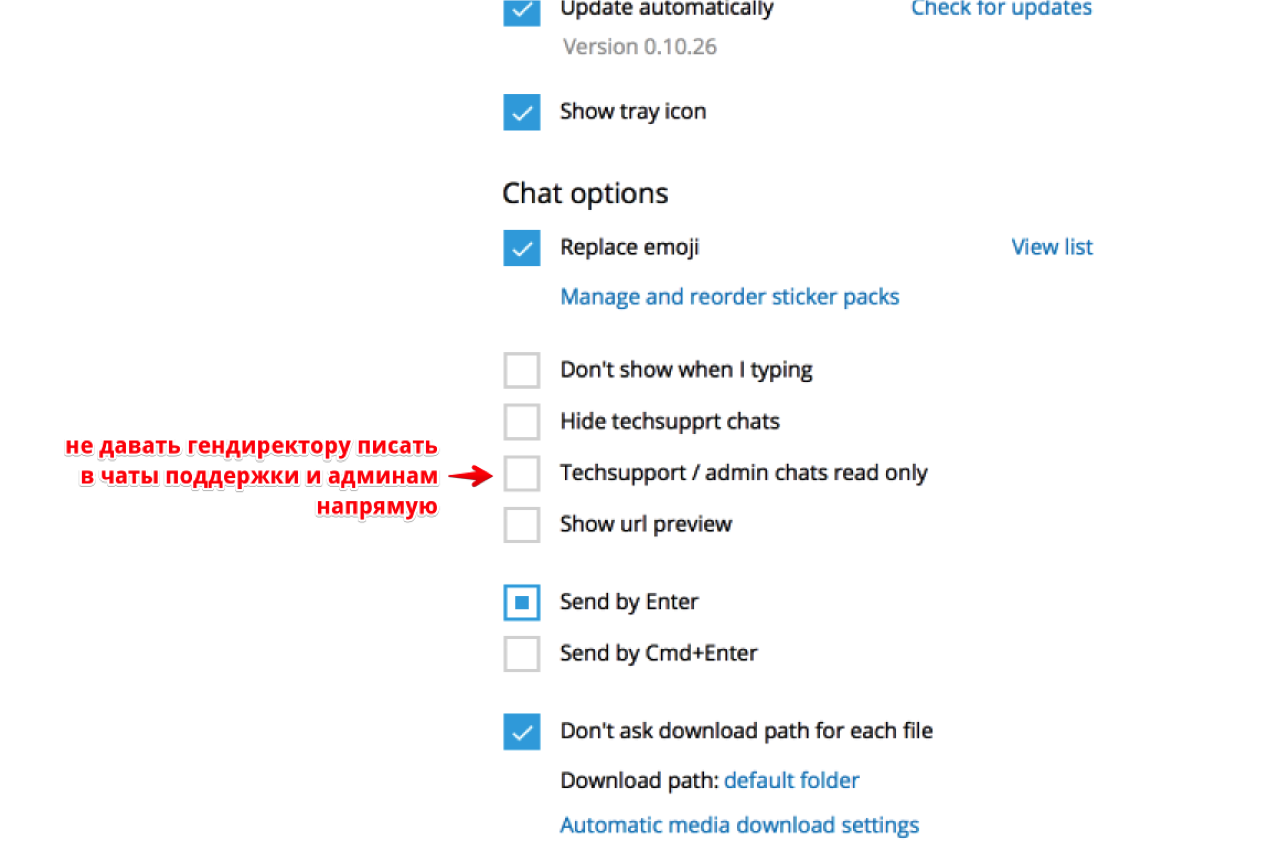

Специально для меня сделали в настройках чата техсаппорта запрет для моих сообщений. Потому что иногда я туда прихожу, пытаюсь что-то решать, они нажимают галочку, и я больше такой возможности не имею.

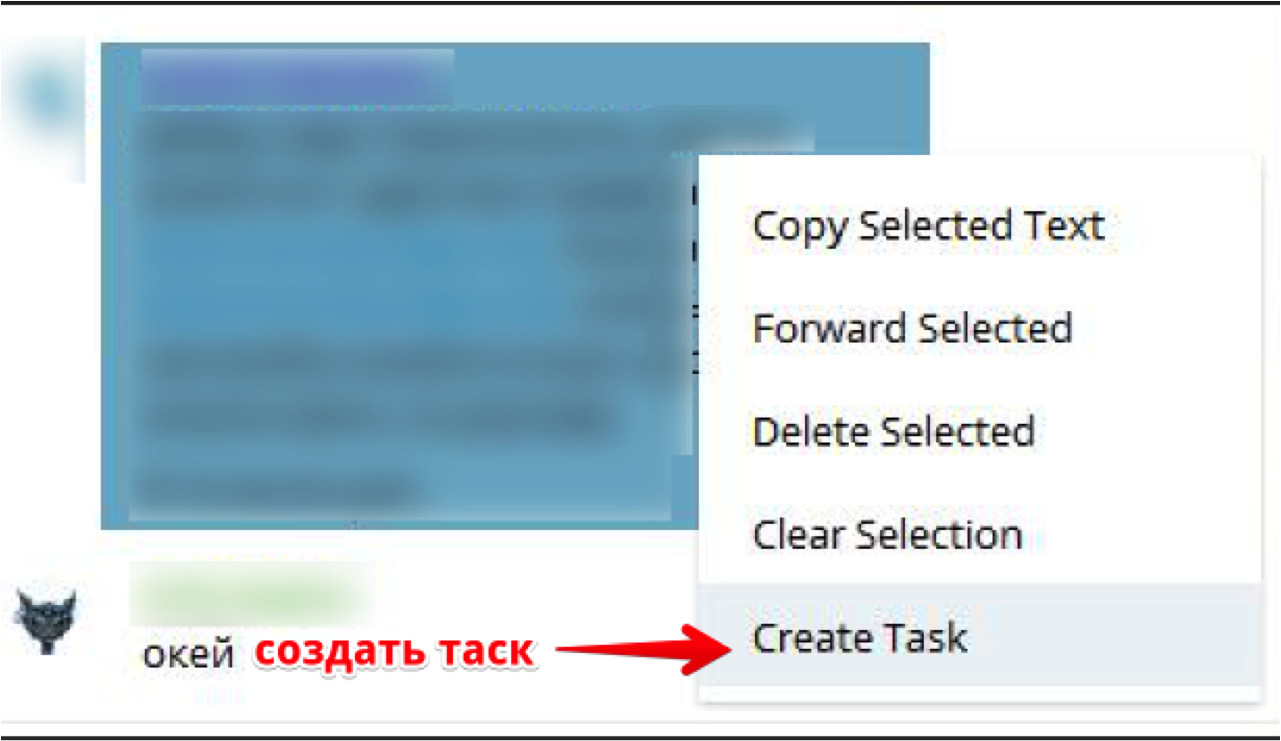

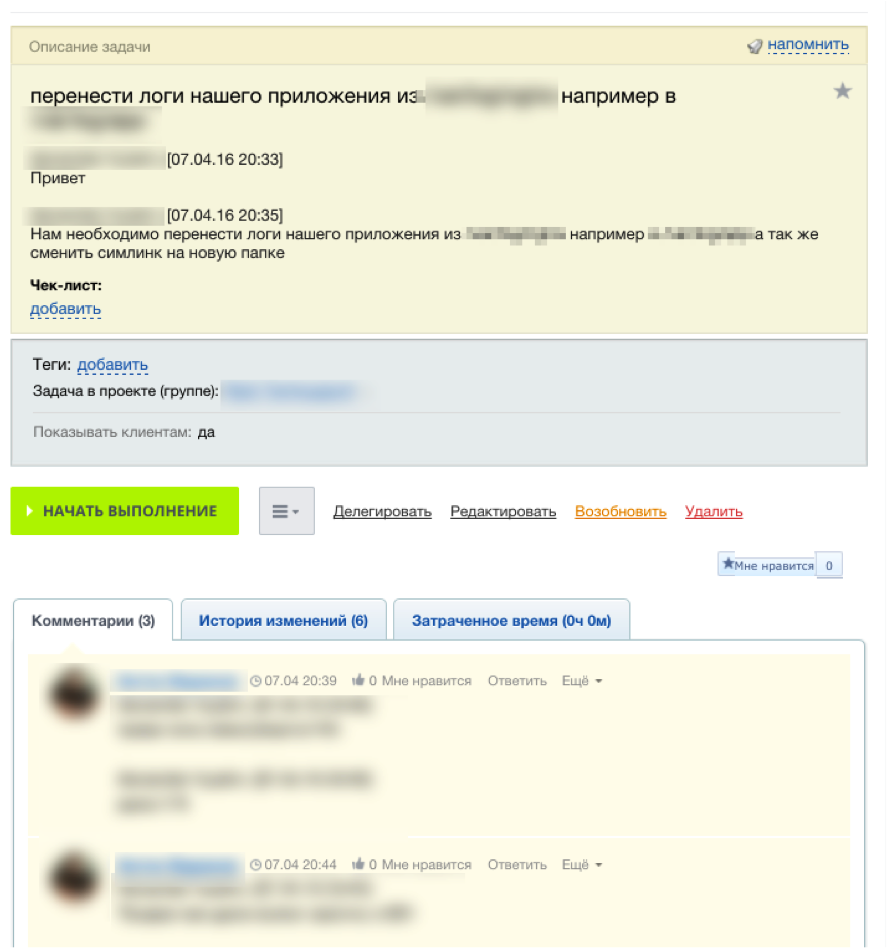

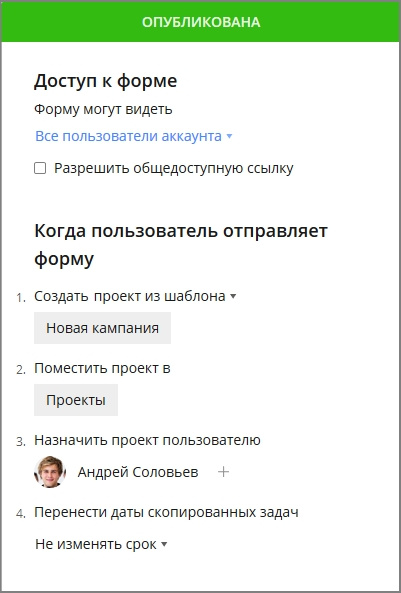

Если клиент просит сделать что-то в чате, дежурный по чатам правым кликом создает из этого диалога таск в Битрикс24 (его мы тоже переписали для себя — взяли за основу «Битрикс 24 в коробке», он написан на php, у него есть тикеты, API).

Клиент может внести в тикет какие-то дополнительные данные, отслеживать выполнение, там же ведется дальнейшая работа.

У дежурного по смене есть список тасков, которые есть сейчас в работе. В течение суток по нашему SLA мы должны сказать клиенту, когда мы этот таск выполним.

Что еще сделали:

- «звездочку»: если хочется не забыть про чат (например, в нем есть какая-то информация, к которой надо вернуться), то можно пометить его звездочкой, и позже заметить и вернуться;

- настройку «отключить создание preview» для ссылок (для того, чтобы не засорять чат превьюшками);

- несколько настроек, которые позже сделал сам Телеграм — закрепленные чаты, настройку «не уведомлять, когда я печатаю».

Скачать наш клиент Телеграма для Mac OS можно тут, а для Windows — тут.

От безумного ритма работы люди устают, поэтому с 2010 года (момента, когда поддержка сайтов стала нашей основной услугой) и до оптимизации рабочих коммуникаций в Телеграме мы сделали много шагов, облегчивших сотрудникам жизнь, и не дающих забыть, что вместе мы делаем важное дело:

- наняли больше людей и ввели восьмичасовые смены, чтобы все успевали поспать (а были времена, когда не успевали);

- начали вести базу знаний и ретроспективу по инцидентам, чтобы передавать знания новичкам;

- формализовали работу поддержки (сделали расписание дежурств, правила постановки задач, чеклисты);

- открыли офисы в других часовых поясах (главный находится в Иркутске, еще два — в Москве и Санкт-Петербурге)

- переключаем сотрудников на разные задачи, если они устали и хотят развития — есть дежурные админы, которые работают с горящими задачами, админы для более долгосрочных и сложных задач, админы в бэк-офисе, которые делают наши внутренние задачи (у нас есть собственная система мониторинга, системы бэкапов, Isolate и т.д.), а с недавних пор и R&D отдел — скоро расскажем, чем он занимается.

А еще у нас в штате есть директор по здравому смыслу. Серьезно, в трудовой книжке так и написано — «директор по здравому смыслу». Когда кто-то что пытается сделать не что-то то, все приходят к Вите и говорят: «Витя, нам нужен здравый смысл». Кстати, Витю на самом деле зовут Андрей, но все его зовут Витя.

|

Метки: author eapotapov системное администрирование блог компании itsumma мониторинг администрирование работа в команде |

Учим робота готовить пиццу. Часть 1: Получаем данные |

Автор изображения: Chuchilko

Не так давно, после завершения очередного конкурса на Kaggle — вдруг возникла идея попробовать сделать тестовое ML-приложение.

Например, такое: "помоги роботу сделать пиццу".

Разумеется, основная цель этого ровно та же — изучение нового.

Захотелось разобраться, как работают генеративные нейронные сети (Generative Adversarial Networks — GAN).

Ключевой идеей было обучить GAN, который по выбранным ингредиентам сам собирает картинку пиццы.

Ну что ж, приступим.

Начало

Разумеется, для тренировки любого алгоритма машинного обучения, нам первым делом нужны данные.

В нашем случае, вариантов не так много — либо находить готовый датасет, либо вытаскивать данные из интерента самотоятельно.

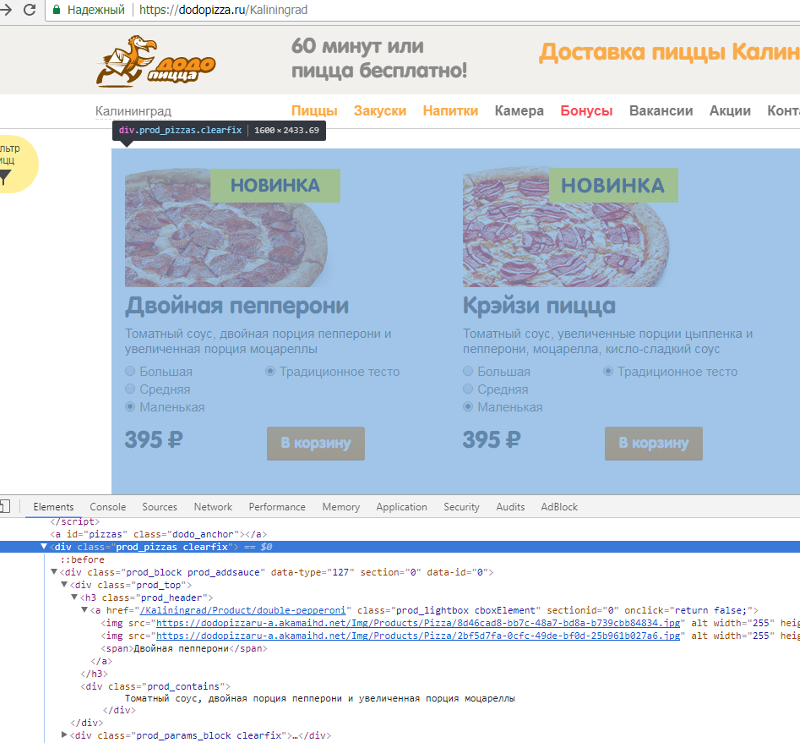

И тут я подумал — а почему бы не дёрнуть данные с сайта Додо-пиццы.

Я не имею никакого отношения к данной сети пиццерий.

Честно говоря, даже их пицца мне не особенно нравится — тем более по цене (и размерам), в моём городе (Калининград) найдутся более привлекательные пиццерии.

Итак, в первом пункте плана действий появилось:

- получить с сайта нужные данные

Загрузка данных

Так как вся нужная нам информация доступна на сайте Додо-пиццы, применим так называемый парсинг сайтов (он же — Web Scraping).

Здесь нам поможет статья: Web Scraping с помощью python.

И всего две библиотеки:

import requests

import bs4Открываем сайт додо-пиццы, щелкаем в браузере "Просмотреть код" и находим элемент с нужными данными.

На заглавной странице можно получить только базовый список пицц и их состав.

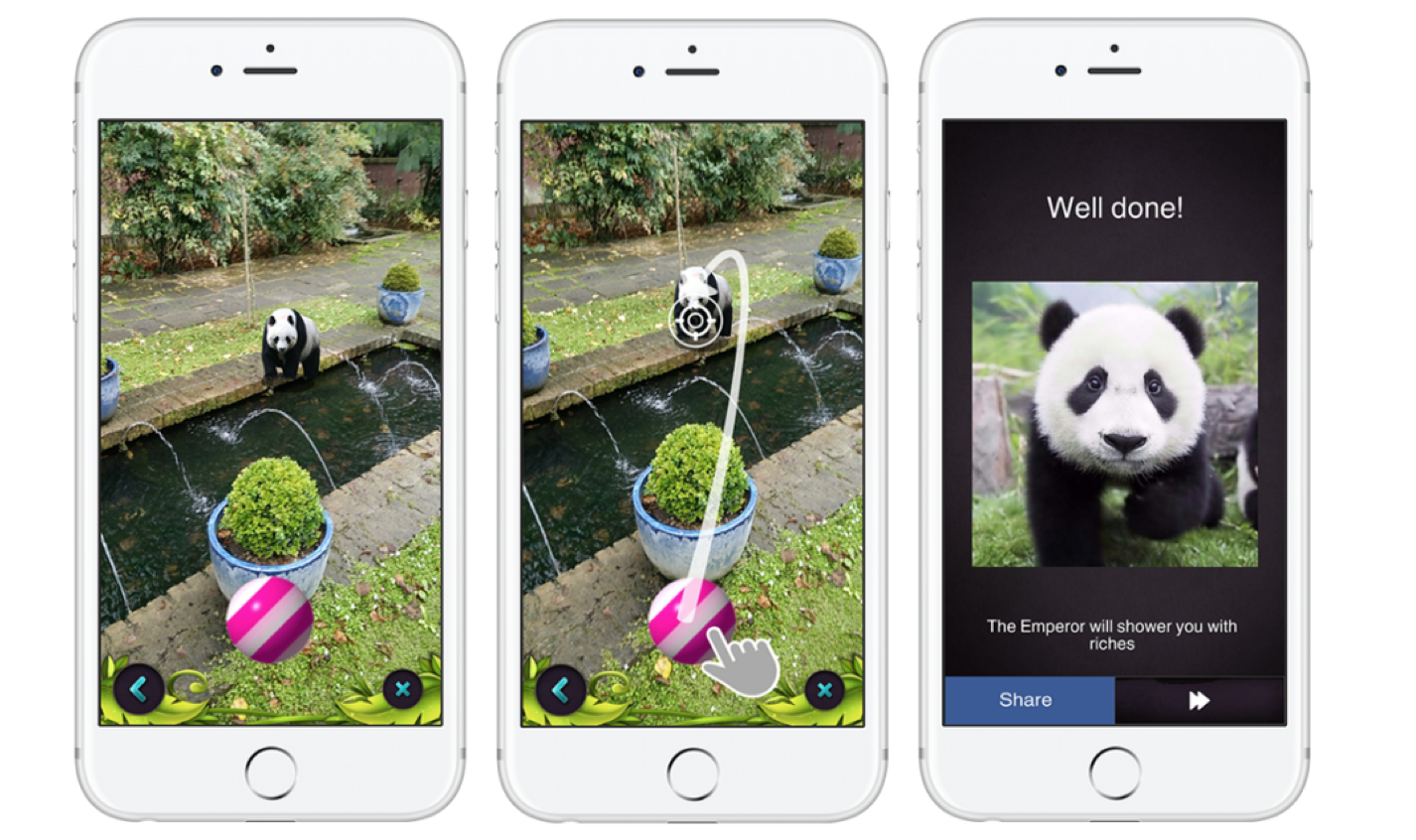

Более подробную информацию можно получить, кликнув на понравившийся товар. Тогда появится всплывающее окошко, с подробной информацией и красивыми картинками о пицце.

Это окошко появляется в результате GET-запроса, который можно эмулировать, передав нужные заголовки:

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36',

'Referer': siteurl,

'x-requested-with': 'XMLHttpRequest'

}

res = requests.get(siteurl, headers = headers)в ответ получаем кусок html-кода, который уже можно распарсить.

Сразу же можно обратить внимание, что статический контент распространяется через CDN akamaihd.net

После непродолжительных эспериментов — получился скрипт dodo_scrapping.py, который получает с сайта додо-пиццы название пицц, их состав, а так же сохраняет в отдельные директории по три фотографии пицц.

На выходе работы скрипта получается несколько csv-файлов и директорий с фотографиями.

Для этого выполняются следующие действия:

- получение списка городов (на тот момент — 146)

- получение списка пицц (для Города)

- получение информации о пицце

- загрузка фотографий пиццы

Информацию о пицце сохраняется в табличку вида:

город, URL города, название, названиеENG, URL пиццы, содержимое, цена, калории, углеводы, белки, жиры, диаметр, вес

Что хорошо в программировании скриптов автоматизации — их можно запустить и откинувшись на списку кресла наблюдать за их работой...

На выходе получилось всего 20 пицц.

На каждую пиццу получается по 3 картинки. Нас интересует только третья картинка, на которой есть вид пиццы сверху.

Разумеется, после получения картинок, их нужно дополнительно обработать — вырезать и отцентровать пиццу.

Думаю, это не должно составить особых проблем, так как все картинки одинаковые — 710х380.

Обработка данных

После scraping-а сайта, получили привычные по kaggle — csv-файл с данными (и директории с картинками).

Настала пора изучить пиццы.

Подключаем необходимые библиотеки.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

np.random.seed(42)

import cv2

import os

import sysdf = pd.read_csv('pizzas.csv', encoding='cp1251')

print(df.shape)(20, 13)df.info()

RangeIndex: 20 entries, 0 to 19

Data columns (total 13 columns):

city_name 20 non-null object

city_url 20 non-null object

pizza_name 20 non-null object

pizza_eng_name 20 non-null object

pizza_url 20 non-null object

pizza_contain 20 non-null object

pizza_price 20 non-null int64

kiloCalories 20 non-null object

carbohydrates 20 non-null object

proteins 20 non-null object

fats 20 non-null object

size 20 non-null int64

weight 20 non-null object

dtypes: int64(2), object(11)

memory usage: 2.1+ KB df.head()| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | Калининград | /Kaliningrad | Двойная пепперони | double-pepperoni | https://dodopizza.ru/Kaliningrad/Product/doubl... | Томатный соус, двойная порция пепперони и увел... | 395 | 257,52 | 26,04 | 10,77 | 12,11 | 25 | 470±50 |

| 1 | Калининград | /Kaliningrad | Крэйзи пицца | crazy-pizza | https://dodopizza.ru/Kaliningrad/Product/crazy... | Томатный соус, увеличенные порции цыпленка и п... | 395 | 232,37 | 31,33 | 9,08 | 7,64 | 25 | 410±50 |

| 2 | Калининград | /Kaliningrad | Дон Бекон | pizza-don-bekon | https://dodopizza.ru/Kaliningrad/Product/pizza... | Томатный соус, бекон, пепперони, цыпленок, кра... | 395 | 274 | 25,2 | 9,8 | 14,8 | 25 | 454±50 |

| 3 | Калининград | /Kaliningrad | Грибы и ветчина | gribvetchina | https://dodopizza.ru/Kaliningrad/Product/gribv... | Томатный соус, ветчина, шампиньоны, моцарелла | 315 | 189 | 23,9 | 9,3 | 6,1 | 25 | 370±50 |

| 4 | Калининград | /Kaliningrad | Пицца-пирог | pizza-pirog | https://dodopizza.ru/Kaliningrad/Product/pizza... | Сгущенное молоко, брусника, ананасы | 315 | 144,9 | 29,8 | 2,9 | 2,7 | 25 | 420±50 |

Приведём данные к более удобному виду.

df['kiloCalories'] = df.kiloCalories.apply(lambda x: x.replace(',','.'))

df['carbohydrates'] = df.carbohydrates.apply(lambda x: x.replace(',','.'))

df['proteins'] = df.proteins.apply(lambda x: x.replace(',','.'))

df['fats'] = df.fats.apply(lambda x: x.replace(',','.'))

df['weight'], df['weight_err'] = df['weight'].str.split('±', 1).strdf['kiloCalories'] = df.kiloCalories.astype('float32')

df['carbohydrates'] = df.carbohydrates.astype('float32')

df['proteins'] = df.proteins.astype('float32')

df['fats'] = df.fats.astype('float32')

df['weight'] = df.weight.astype('int64')

df['weight_err'] = df.weight_err.astype('int64')df.head()| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | Калининград | /Kaliningrad | Двойная пепперони | double-pepperoni | https://dodopizza.ru/Kaliningrad/Product/doubl... | Томатный соус, двойная порция пепперони и увел... | 395 | 257.519989 | 26.040001 | 10.77 | 12.11 | 25 | 470 | 50 |

| 1 | Калининград | /Kaliningrad | Крэйзи пицца | crazy-pizza | https://dodopizza.ru/Kaliningrad/Product/crazy... | Томатный соус, увеличенные порции цыпленка и п... | 395 | 232.369995 | 31.330000 | 9.08 | 7.64 | 25 | 410 | 50 |

| 2 | Калининград | /Kaliningrad | Дон Бекон | pizza-don-bekon | https://dodopizza.ru/Kaliningrad/Product/pizza... | Томатный соус, бекон, пепперони, цыпленок, кра... | 395 | 274.000000 | 25.200001 | 9.80 | 14.80 | 25 | 454 | 50 |

| 3 | Калининград | /Kaliningrad | Грибы и ветчина | gribvetchina | https://dodopizza.ru/Kaliningrad/Product/gribv... | Томатный соус, ветчина, шампиньоны, моцарелла | 315 | 189.000000 | 23.900000 | 9.30 | 6.10 | 25 | 370 | 50 |

| 4 | Калининград | /Kaliningrad | Пицца-пирог | pizza-pirog | https://dodopizza.ru/Kaliningrad/Product/pizza... | Сгущенное молоко, брусника, ананасы | 315 | 144.899994 | 29.799999 | 2.90 | 2.70 | 25 | 420 | 50 |

Учитывая, что пищевая ценность продукта приводится в расчёте на 100 грамм, то для лучшего понимания — домножим их на массу пиццы.

df['pizza_kiloCalories'] = df.kiloCalories * df.weight / 100

df['pizza_carbohydrates'] = df.carbohydrates * df.weight / 100

df['pizza_proteins'] = df.proteins * df.weight / 100

df['pizza_fats'] = df.fats * df.weight / 100df.describe()| pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| count | 20.00000 | 20.000000 | 20.000000 | 20.000000 | 20.00000 | 20.0 | 20.000000 | 20.0 | 20.000000 | 20.000000 | 20.000000 | 20.000000 |

| mean | 370.50000 | 212.134491 | 25.443501 | 8.692500 | 8.44250 | 25.0 | 457.700000 | 50.0 | 969.942043 | 115.867950 | 39.857950 | 38.736650 |

| std | 33.16228 | 34.959122 | 2.204143 | 1.976283 | 3.20358 | 0.0 | 43.727746 | 0.0 | 175.835991 | 8.295421 | 9.989803 | 15.206275 |

| min | 315.00000 | 144.899994 | 22.100000 | 2.900000 | 2.70000 | 25.0 | 370.000000 | 50.0 | 608.579974 | 88.429999 | 12.180000 | 11.340000 |

| 25% | 367.50000 | 188.250000 | 23.975000 | 7.975000 | 6.05000 | 25.0 | 420.000000 | 50.0 | 858.525000 | 113.010003 | 35.625000 | 28.159999 |

| 50% | 385.00000 | 212.500000 | 24.950000 | 9.090000 | 8.20000 | 25.0 | 460.000000 | 50.0 | 966.358490 | 114.779002 | 39.580000 | 35.930001 |

| 75% | 395.00000 | 235.527496 | 26.280001 | 9.800000 | 9.77500 | 25.0 | 485.000000 | 50.0 | 1095.459991 | 120.597001 | 45.707500 | 47.020001 |

| max | 395.00000 | 274.000000 | 31.330000 | 12.200000 | 14.80000 | 25.0 | 560.000000 | 50.0 | 1243.960000 | 128.453000 | 60.999999 | 68.080001 |

Настала пора узнать, какие же пиццы самые-самые...

Итак, самая калорийная пицца

df[df.pizza_kiloCalories == np.max(df.pizza_kiloCalories)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 2 | Калининград | /Kaliningrad | Дон Бекон | pizza-don-bekon | https://dodopizza.ru/Kaliningrad/Product/pizza... | Томатный соус, бекон, пепперони, цыпленок, кра... | 395 | 274.0 | 25.200001 | 9.8 | 14.8 | 25 | 454 | 50 | 1243.96 | 114.408003 | 44.492001 | 67.192001 |

Самая жирная пицца:

df[df.pizza_fats == np.max(df.pizza_fats)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 14 | Калининград | /Kaliningrad | Мясная | myasnaya-pizza | https://dodopizza.ru/Kaliningrad/Product/myasn... | Томатный соус, охотничьи колбаски, бекон, ветч... | 395 | 268.0 | 24.200001 | 9.1 | 14.8 | 25 | 460 | 50 | 1232.8 | 111.320004 | 41.860002 | 68.080001 |

Самая богатая углеводами:

df[df.pizza_carbohydrates == np.max(df.pizza_carbohydrates)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | Калининград | /Kaliningrad | Крэйзи пицца | crazy-pizza | https://dodopizza.ru/Kaliningrad/Product/crazy... | Томатный соус, увеличенные порции цыпленка и п... | 395 | 232.369995 | 31.33 | 9.08 | 7.64 | 25 | 410 | 50 | 952.71698 | 128.453 | 37.228 | 31.323999 |

Самая богатая белками:

df[df.pizza_proteins == np.max(df.pizza_proteins)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 7 | Калининград | /Kaliningrad | Гавайская | gavayskaya-pizza | https://dodopizza.ru/Kaliningrad/Product/gavay... | Томатный соус, ананасы, цыпленок, моцарелла | 315 | 216.0 | 25.0 | 12.2 | 7.4 | 25 | 500 | 50 | 1080.0 | 125.0 | 60.999999 | 37.0 |

Самая тяжёлая по весу пицца:

df[df.weight == np.max(df.weight)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 8 | Калининград | /Kaliningrad | Додо | pizza-dodo | https://dodopizza.ru/Kaliningrad/Product/pizza... | Томатный соус, говядина (фарш), ветчина, пеппе... | 395 | 203.899994 | 22.1 | 8.6 | 8.9 | 25 | 560 | 50 | 1141.839966 | 123.760002 | 48.160002 | 49.839998 |

Самая лёгкая по весу пицца:

df[df.weight == np.min(df.weight)]| city_name | city_url | pizza_name | pizza_eng_name | pizza_url | pizza_contain | pizza_price | kiloCalories | carbohydrates | proteins | fats | size | weight | weight_err | pizza_kiloCalories | pizza_carbohydrates | pizza_proteins | pizza_fats | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 3 | Калининград | /Kaliningrad | Грибы и ветчина | gribvetchina | https://dodopizza.ru/Kaliningrad/Product/gribv... | Томатный соус, ветчина, шампиньоны, моцарелла | 315 | 189.0 | 23.9 | 9.3 | 6.1 | 25 | 370 | 50 | 699.3 | 88.429999 | 34.410001 | 22.57 |

Получаем названия пицц

pizza_names = df['pizza_name'].tolist()

pizza_eng_names = df['pizza_eng_name'].tolist()

print( pizza_eng_names )['double-pepperoni', 'crazy-pizza', 'pizza-don-bekon', 'gribvetchina', 'pizza-pirog', 'pizza-margarita', 'syrnaya-pizza', 'gavayskaya-pizza', 'pizza-dodo', 'pizza-chetyre-sezona', 'ovoshi-i-griby', 'italyanskaya-pizza', 'meksikanskaya-pizza', 'morskaya-pizza', 'myasnaya-pizza', 'pizza-pepperoni', 'ranch-pizza', 'pizza-syrnyi-cyplenok', 'pizza-cyplenok-barbekyu', 'chizburger-pizza']Получаем путь до картинок — нас интересует 3-я картинка (вид сверху)

image_paths = []

for name in pizza_eng_names:

path = os.path.join(name, name+'3.jpg')

image_paths.append(path)

print(image_paths)['double-pepperoni\\double-pepperoni3.jpg', 'crazy-pizza\\crazy-pizza3.jpg', 'pizza-don-bekon\\pizza-don-bekon3.jpg', 'gribvetchina\\gribvetchina3.jpg', 'pizza-pirog\\pizza-pirog3.jpg', 'pizza-margarita\\pizza-margarita3.jpg', 'syrnaya-pizza\\syrnaya-pizza3.jpg', 'gavayskaya-pizza\\gavayskaya-pizza3.jpg', 'pizza-dodo\\pizza-dodo3.jpg', 'pizza-chetyre-sezona\\pizza-chetyre-sezona3.jpg', 'ovoshi-i-griby\\ovoshi-i-griby3.jpg', 'italyanskaya-pizza\\italyanskaya-pizza3.jpg', 'meksikanskaya-pizza\\meksikanskaya-pizza3.jpg', 'morskaya-pizza\\morskaya-pizza3.jpg', 'myasnaya-pizza\\myasnaya-pizza3.jpg', 'pizza-pepperoni\\pizza-pepperoni3.jpg', 'ranch-pizza\\ranch-pizza3.jpg', 'pizza-syrnyi-cyplenok\\pizza-syrnyi-cyplenok3.jpg', 'pizza-cyplenok-barbekyu\\pizza-cyplenok-barbekyu3.jpg', 'chizburger-pizza\\chizburger-pizza3.jpg']Загружаем картинки

images = []

for path in image_paths:

print('Load image:', path)

image = cv2.imread(path)

if image is not None:

images.append(image)

else:

print('Error read image:', path)Load image: double-pepperoni\double-pepperoni3.jpg

Load image: crazy-pizza\crazy-pizza3.jpg

Load image: pizza-don-bekon\pizza-don-bekon3.jpg

Load image: gribvetchina\gribvetchina3.jpg

Load image: pizza-pirog\pizza-pirog3.jpg

Load image: pizza-margarita\pizza-margarita3.jpg

Load image: syrnaya-pizza\syrnaya-pizza3.jpg

Load image: gavayskaya-pizza\gavayskaya-pizza3.jpg

Load image: pizza-dodo\pizza-dodo3.jpg

Load image: pizza-chetyre-sezona\pizza-chetyre-sezona3.jpg

Load image: ovoshi-i-griby\ovoshi-i-griby3.jpg

Load image: italyanskaya-pizza\italyanskaya-pizza3.jpg

Load image: meksikanskaya-pizza\meksikanskaya-pizza3.jpg

Load image: morskaya-pizza\morskaya-pizza3.jpg

Load image: myasnaya-pizza\myasnaya-pizza3.jpg

Load image: pizza-pepperoni\pizza-pepperoni3.jpg

Load image: ranch-pizza\ranch-pizza3.jpg

Load image: pizza-syrnyi-cyplenok\pizza-syrnyi-cyplenok3.jpg

Load image: pizza-cyplenok-barbekyu\pizza-cyplenok-barbekyu3.jpg

Load image: chizburger-pizza\chizburger-pizza3.jpgПосмотрим на картинку

def plot_img(img):

img_rgb = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

plt.imshow(img_rgb)

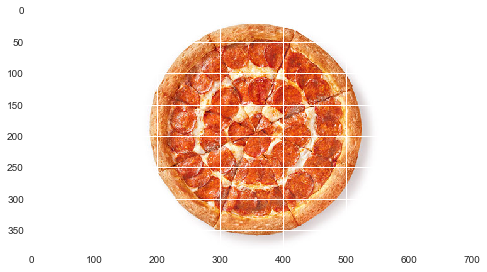

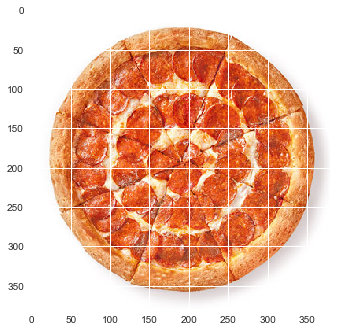

print(images[0].shape)

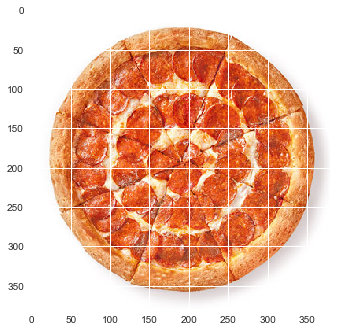

plot_img(images[0])(380, 710, 3)

Пиццы располагаются в одной и той же области — вырезаем

pizza_imgs = []

for img in images:

y, x, height, width = 0, 165, 380, 380

pizza_crop = img[y:y+height, x:x+width]

pizza_imgs.append(pizza_crop)

print(pizza_imgs[0].shape)

print(len(pizza_imgs))

plot_img(pizza_imgs[0])(380, 380, 3)

20

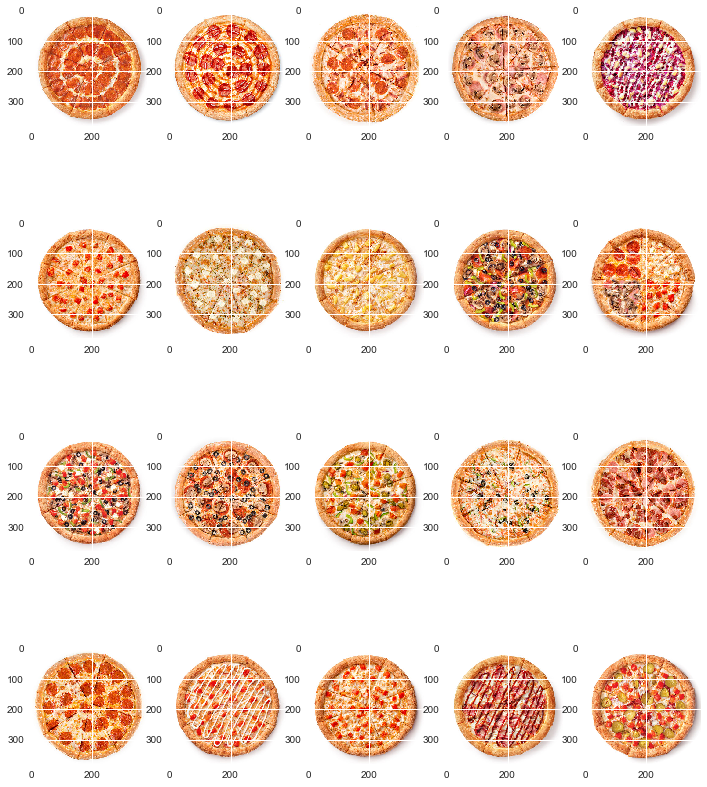

Посмотрим все фотографии

fig = plt.figure(figsize=(12,15))

for i in range(0, len(pizza_imgs)):

fig.add_subplot(4,5,i+1)

plot_img(pizza_imgs[i])

Пицца четыре сезона явно выбивается по своей структуре, так как, по сути, состоит из четырёх разных пицц.

Изучим ингредиенты

def split_contain(contain):

lst = contain.split(',')

print(len(lst),':', lst)

for i, row in df.iterrows():

split_contain(row.pizza_contain)2 : ['Томатный соус', ' двойная порция пепперони и увеличенная порция моцареллы']

4 : ['Томатный соус', ' увеличенные порции цыпленка и пепперони', ' моцарелла', ' кисло-сладкий соус']

6 : ['Томатный соус', ' бекон', ' пепперони', ' цыпленок', ' красный лук', ' моцарелла']

4 : ['Томатный соус', ' ветчина', ' шампиньоны', ' моцарелла']

3 : ['Сгущенное молоко', ' брусника', ' ананасы']

4 : ['Томатный соус', ' томаты', ' увеличенная порция моцареллы', ' орегано']

4 : ['Томатный соус', ' брынза', ' увеличенная порция сыра моцарелла', ' орегано']

4 : ['Томатный соус', ' ананасы', ' цыпленок', ' моцарелла']

9 : ['Томатный соус', ' говядина (фарш)', ' ветчина', ' пепперони', ' красный лук', ' маслины', ' сладкий перец', ' шампиньоны', ' моцарелла']

8 : ['Томатный соус', ' пепперони', ' ветчина', ' брынза', ' томаты', ' шампиньоны', ' моцарелла', ' орегано']

9 : ['Томатный соус', ' брынза', ' маслины', ' сладкий перец', ' томаты', ' шампиньоны', ' красный лук', ' моцарелла', ' базилик']

6 : ['Томатный соус', ' пепперони', ' маслины', ' шампиньоны', ' моцарелла', ' орегано']

8 : ['Томатный соус', ' халапеньо', ' сладкий перец', ' цыпленок', ' томаты', ' шампиньоны', ' красный лук', ' моцарелла']

6 : ['Томатный соус', ' креветки', ' маслины', ' сладкий перец', ' красный лук', ' моцарелла']

5 : ['Томатный соус', ' охотничьи колбаски', ' бекон', ' ветчина', ' моцарелла']

3 : ['Томатный соус', ' пепперони', ' увеличенная порция моцареллы']

6 : ['Соус Ранч', ' цыпленок', ' ветчина', ' томаты', ' чеснок', ' моцарелла']

4 : ['Сырный соус', ' цыпленок', ' томаты', ' моцарелла']

6 : ['Томатный соус', ' цыпленок', ' бекон', ' красный лук', ' моцарелла', ' соус Барбекю']

7 : ['Сырный соус', ' говядина', ' бекон', ' соленые огурцы', ' томаты', ' красный лук', ' моцарелла']Проблема, что в нескольких пиццах указываются модификаторы вида:

- "двойная порция"

- "увеличенная порция"

При этом, после модификаторов может идти перечисление ингредиетов через союз И.

Гипотезы:

- модификатор двойная порция можно заменить указав нужный ингредиент два раза.

- модификатор увеличенная порция пока можно опустить (так как на фотографиях разница не заметна)

Видим, что модификатор "увеличенная порция", относится только к сыру моцарелла.

Так же один раз встречается:

"увеличенная порция сыра моцарелла"

Кстати, сразу же бросается в глаза, что основной используемый соус — томатный, а сыр — моцарелла.

Почистим ингедиенты, чтобы привести к нормальному виду

def split_contain2(contain):

lst = contain.split(',')

#print(len(lst),':', lst)

for i in range(len(lst)):

item = lst[i]

item = item.replace('увеличенная порция', '')

item = item.replace('увеличенные порции', '')

item = item.replace('сыра моцарелла', 'моцарелла')

item = item.replace('моцареллы', 'моцарелла')

item = item.replace('цыпленка', 'цыпленок')

and_pl = item.find(' и ')

if and_pl != -1:

item1 = item[0:and_pl]

item2 = item[and_pl+3:]

item = item1

lst.insert(i+1, item2.strip())

double_pl = item.find('двойная порция ')

if double_pl != -1:

item = item[double_pl+15:]

lst.insert(i+1, item.strip())

lst[i] = item.strip()

# last one

for i in range(len(lst)):

lst[i] = lst[i].strip()

print(len(lst),':', lst)

return lst

ingredients = []

ingredients_count = []

for i, row in df.iterrows():

print(row.pizza_name)

lst = split_contain2(row.pizza_contain)

ingredients.append(lst)

ingredients_count.append(len(lst))

ingredients_countДвойная пепперони

4 : ['Томатный соус', 'пепперони', 'пепперони', 'моцарелла']

Крэйзи пицца

5 : ['Томатный соус', 'цыпленок', 'пепперони', 'моцарелла', 'кисло-сладкий соус']

Дон Бекон

6 : ['Томатный соус', 'бекон', 'пепперони', 'цыпленок', 'красный лук', 'моцарелла']

Грибы и ветчина

4 : ['Томатный соус', 'ветчина', 'шампиньоны', 'моцарелла']

Пицца-пирог

3 : ['Сгущенное молоко', 'брусника', 'ананасы']

Маргарита

4 : ['Томатный соус', 'томаты', 'моцарелла', 'орегано']

Сырная

4 : ['Томатный соус', 'брынза', 'моцарелла', 'орегано']

Гавайская

4 : ['Томатный соус', 'ананасы', 'цыпленок', 'моцарелла']

Додо

9 : ['Томатный соус', 'говядина (фарш)', 'ветчина', 'пепперони', 'красный лук', 'маслины', 'сладкий перец', 'шампиньоны', 'моцарелла']

Четыре сезона

8 : ['Томатный соус', 'пепперони', 'ветчина', 'брынза', 'томаты', 'шампиньоны', 'моцарелла', 'орегано']

Овощи и грибы

9 : ['Томатный соус', 'брынза', 'маслины', 'сладкий перец', 'томаты', 'шампиньоны', 'красный лук', 'моцарелла', 'базилик']

Итальянская

6 : ['Томатный соус', 'пепперони', 'маслины', 'шампиньоны', 'моцарелла', 'орегано']

Мексиканская

8 : ['Томатный соус', 'халапеньо', 'сладкий перец', 'цыпленок', 'томаты', 'шампиньоны', 'красный лук', 'моцарелла']

Морская

6 : ['Томатный соус', 'креветки', 'маслины', 'сладкий перец', 'красный лук', 'моцарелла']

Мясная

5 : ['Томатный соус', 'охотничьи колбаски', 'бекон', 'ветчина', 'моцарелла']

Пепперони

3 : ['Томатный соус', 'пепперони', 'моцарелла']

Ранч пицца

6 : ['Соус Ранч', 'цыпленок', 'ветчина', 'томаты', 'чеснок', 'моцарелла']

Сырный цыплёнок

4 : ['Сырный соус', 'цыпленок', 'томаты', 'моцарелла']

Цыплёнок барбекю

6 : ['Томатный соус', 'цыпленок', 'бекон', 'красный лук', 'моцарелла', 'соус Барбекю']

Чизбургер-пицца

7 : ['Сырный соус', 'говядина', 'бекон', 'соленые огурцы', 'томаты', 'красный лук', 'моцарелла']

[4, 5, 6, 4, 3, 4, 4, 4, 9, 8, 9, 6, 8, 6, 5, 3, 6, 4, 6, 7]Посмотрим минимальное и максимальное количество ингредиентов

min_count = np.min(ingredients_count)

print('min:', min_count)

max_count = np.max(ingredients_count)

print('max:', max_count)min: 3

max: 9print('min:', np.array(pizza_names)[ingredients_count == min_count] )

print('max:', np.array(pizza_names)[ingredients_count == max_count] )min: ['Пицца-пирог' 'Пепперони']

max: ['Додо' 'Овощи и грибы']Интересно, больше всего ингредиентов (9 штук) в пиццах: Додо и Овощи и грибы.

Заполним табличку ингредиентов.

df_ingredients = pd.DataFrame(ingredients)

df_ingredients.fillna(value='0', inplace=True)

df_ingredients| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

|---|---|---|---|---|---|---|---|---|---|

| 0 | Томатный соус | пепперони | пепперони | моцарелла | 0 | 0 | 0 | 0 | 0 |

| 1 | Томатный соус | цыпленок | пепперони | моцарелла | кисло-сладкий соус | 0 | 0 | 0 | 0 |

| 2 | Томатный соус | бекон | пепперони | цыпленок | красный лук | моцарелла | 0 | 0 | 0 |

| 3 | Томатный соус | ветчина | шампиньоны | моцарелла | 0 | 0 | 0 | 0 | 0 |

| 4 | Сгущенное молоко | брусника | ананасы | 0 | 0 | 0 | 0 | 0 | 0 |

| 5 | Томатный соус | томаты | моцарелла | орегано | 0 | 0 | 0 | 0 | 0 |

| 6 | Томатный соус | брынза | моцарелла | орегано | 0 | 0 | 0 | 0 | 0 |

| 7 | Томатный соус | ананасы | цыпленок | моцарелла | 0 | 0 | 0 | 0 | 0 |

| 8 | Томатный соус | говядина (фарш) | ветчина | пепперони | красный лук | маслины | сладкий перец | шампиньоны | моцарелла |

| 9 | Томатный соус | пепперони | ветчина | брынза | томаты | шампиньоны | моцарелла | орегано | 0 |

| 10 | Томатный соус | брынза | маслины | сладкий перец | томаты | шампиньоны | красный лук | моцарелла | базилик |

| 11 | Томатный соус | пепперони | маслины | шампиньоны | моцарелла | орегано | 0 | 0 | 0 |

| 12 | Томатный соус | халапеньо | сладкий перец | цыпленок | томаты | шампиньоны | красный лук | моцарелла | 0 |

| 13 | Томатный соус | креветки | маслины | сладкий перец | красный лук | моцарелла | 0 | 0 | 0 |

| 14 | Томатный соус | охотничьи колбаски | бекон | ветчина | моцарелла | 0 | 0 | 0 | 0 |

| 15 | Томатный соус | пепперони | моцарелла | 0 | 0 | 0 | 0 | 0 | 0 |

| 16 | Соус Ранч | цыпленок | ветчина | томаты | чеснок | моцарелла | 0 | 0 | 0 |

| 17 | Сырный соус | цыпленок | томаты | моцарелла | 0 | 0 | 0 | 0 | 0 |

| 18 | Томатный соус | цыпленок | бекон | красный лук | моцарелла | соус Барбекю | 0 | 0 | 0 |

| 19 | Сырный соус | говядина | бекон | соленые огурцы | томаты | красный лук | моцарелла | 0 | 0 |

df_ingredients.describe()| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

|---|---|---|---|---|---|---|---|---|---|

| count | 20 | 20 | 20 | 20 | 20 | 20 | 20 | 20 | 20 |

| unique | 4 | 13 | 10 | 12 | 6 | 7 | 4 | 4 | 3 |

| top | Томатный соус | пепперони | пепперони | моцарелла | 0 | 0 | 0 | 0 | 0 |

| freq | 16 | 4 | 3 | 5 | 8 | 10 | 15 | 16 | 18 |

Как и ожидалось — самый используемый соус — томатный. Стандартный рецепт — состоит из 4 ингредиентов.

Забавно, что образовался новый рецепт для пиццы.

Посмотрим сколько раз встречается тот или иной ингредиент:

df_ingredients.stack().value_counts()0 69

моцарелла 19

Томатный соус 16

пепперони 8

томаты 7

цыпленок 7

красный лук 7

шампиньоны 6

ветчина 5

сладкий перец 4

бекон 4

орегано 4

маслины 4

брынза 3

ананасы 2

Сырный соус 2

чеснок 1

кисло-сладкий соус 1

базилик 1

соус Барбекю 1

креветки 1

халапеньо 1

Сгущенное молоко 1

соленые огурцы 1

говядина (фарш) 1

охотничьи колбаски 1

брусника 1

говядина 1

Соус Ранч 1

dtype: int64Опять же: моцарелла, Томатный соус, пепперони.

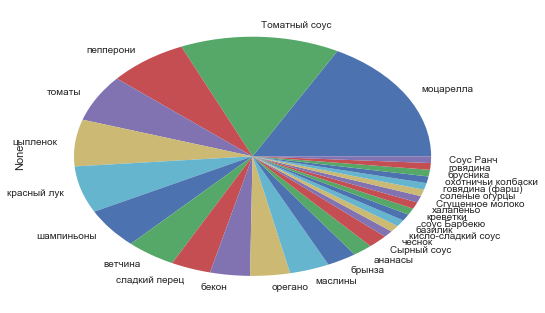

df_ingredients.stack().value_counts().drop('0').plot.pie()

Теперь закодируем ингредиенты.

from sklearn.preprocessing import LabelEncoder

from sklearn.preprocessing import OneHotEncoder

ingredients_full = df_ingredients.values.tolist()

# flatten lists

flat_ingredients = [item for sublist in ingredients_full for item in sublist]

print(flat_ingredients)

print(len(flat_ingredients))

np_ingredients = np.array(flat_ingredients)

#print(np_ingredients)

labelencoder = LabelEncoder()

ingredients_encoded = labelencoder.fit_transform(np_ingredients)

print(ingredients_encoded)

label_max = np.max(ingredients_encoded)

print('max:', label_max)['Томатный соус', 'пепперони', 'пепперони', 'моцарелла', '0', '0', '0', '0', '0', 'Томатный соус', 'цыпленок', 'пепперони', 'моцарелла', 'кисло-сладкий соус', '0', '0', '0', '0', 'Томатный соус', 'бекон', 'пепперони', 'цыпленок', 'красный лук', 'моцарелла', '0', '0', '0', 'Томатный соус', 'ветчина', 'шампиньоны', 'моцарелла', '0', '0', '0', '0', '0', 'Сгущенное молоко', 'брусника', 'ананасы', '0', '0', '0', '0', '0', '0', 'Томатный соус', 'томаты', 'моцарелла', 'орегано', '0', '0', '0', '0', '0', 'Томатный соус', 'брынза', 'моцарелла', 'орегано', '0', '0', '0', '0', '0', 'Томатный соус', 'ананасы', 'цыпленок', 'моцарелла', '0', '0', '0', '0', '0', 'Томатный соус', 'говядина (фарш)', 'ветчина', 'пепперони', 'красный лук', 'маслины', 'сладкий перец', 'шампиньоны', 'моцарелла', 'Томатный соус', 'пепперони', 'ветчина', 'брынза', 'томаты', 'шампиньоны', 'моцарелла', 'орегано', '0', 'Томатный соус', 'брынза', 'маслины', 'сладкий перец', 'томаты', 'шампиньоны', 'красный лук', 'моцарелла', 'базилик', 'Томатный соус', 'пепперони', 'маслины', 'шампиньоны', 'моцарелла', 'орегано', '0', '0', '0', 'Томатный соус', 'халапеньо', 'сладкий перец', 'цыпленок', 'томаты', 'шампиньоны', 'красный лук', 'моцарелла', '0', 'Томатный соус', 'креветки', 'маслины', 'сладкий перец', 'красный лук', 'моцарелла', '0', '0', '0', 'Томатный соус', 'охотничьи колбаски', 'бекон', 'ветчина', 'моцарелла', '0', '0', '0', '0', 'Томатный соус', 'пепперони', 'моцарелла', '0', '0', '0', '0', '0', '0', 'Соус Ранч', 'цыпленок', 'ветчина', 'томаты', 'чеснок', 'моцарелла', '0', '0', '0', 'Сырный соус', 'цыпленок', 'томаты', 'моцарелла', '0', '0', '0', '0', '0', 'Томатный соус', 'цыпленок', 'бекон', 'красный лук', 'моцарелла', 'соус Барбекю', '0', '0', '0', 'Сырный соус', 'говядина', 'бекон', 'соленые огурцы', 'томаты', 'красный лук', 'моцарелла', '0', '0']

180

[ 4 20 20 17 0 0 0 0 0 4 26 20 17 13 0 0 0 0 4 7 20 26 14 17 0

0 0 4 10 28 17 0 0 0 0 0 1 8 5 0 0 0 0 0 0 4 24 17 18 0

0 0 0 0 4 9 17 18 0 0 0 0 0 4 5 26 17 0 0 0 0 0 4 12 10

20 14 16 21 28 17 4 20 10 9 24 28 17 18 0 4 9 16 21 24 28 14 17 6 4

20 16 28 17 18 0 0 0 4 25 21 26 24 28 14 17 0 4 15 16 21 14 17 0 0

0 4 19 7 10 17 0 0 0 0 4 20 17 0 0 0 0 0 0 2 26 10 24 27 17

0 0 0 3 26 24 17 0 0 0 0 0 4 26 7 14 17 23 0 0 0 3 11 7 22

24 14 17 0 0]

max: 28Получается, что для приготовления, используется целых 27 ингредиентов.

for label in range(label_max):

print(label, labelencoder.inverse_transform(label))0 0

1 Сгущенное молоко

2 Соус Ранч

3 Сырный соус

4 Томатный соус

5 ананасы

6 базилик

7 бекон

8 брусника

9 брынза

10 ветчина

11 говядина

12 говядина (фарш)

13 кисло-сладкий соус

14 красный лук

15 креветки

16 маслины

17 моцарелла

18 орегано

19 охотничьи колбаски

20 пепперони

21 сладкий перец

22 соленые огурцы

23 соус Барбекю

24 томаты

25 халапеньо

26 цыпленок

27 чеснокlb_ingredients = []

for lst in ingredients_full:

lb_ingredients.append(labelencoder.transform(lst).tolist())

#lb_ingredients = np.array(lb_ingredients)

lb_ingredients[[4, 20, 20, 17, 0, 0, 0, 0, 0],

[4, 26, 20, 17, 13, 0, 0, 0, 0],

[4, 7, 20, 26, 14, 17, 0, 0, 0],

[4, 10, 28, 17, 0, 0, 0, 0, 0],

[1, 8, 5, 0, 0, 0, 0, 0, 0],

[4, 24, 17, 18, 0, 0, 0, 0, 0],

[4, 9, 17, 18, 0, 0, 0, 0, 0],

[4, 5, 26, 17, 0, 0, 0, 0, 0],

[4, 12, 10, 20, 14, 16, 21, 28, 17],

[4, 20, 10, 9, 24, 28, 17, 18, 0],

[4, 9, 16, 21, 24, 28, 14, 17, 6],

[4, 20, 16, 28, 17, 18, 0, 0, 0],

[4, 25, 21, 26, 24, 28, 14, 17, 0],

[4, 15, 16, 21, 14, 17, 0, 0, 0],

[4, 19, 7, 10, 17, 0, 0, 0, 0],

[4, 20, 17, 0, 0, 0, 0, 0, 0],

[2, 26, 10, 24, 27, 17, 0, 0, 0],

[3, 26, 24, 17, 0, 0, 0, 0, 0],

[4, 26, 7, 14, 17, 23, 0, 0, 0],

[3, 11, 7, 22, 24, 14, 17, 0, 0]]onehotencoder = OneHotEncoder(sparse=False)

ingredients_onehotencoded = onehotencoder.fit_transform(ingredients_encoded.reshape(-1, 1))

print(ingredients_onehotencoded.shape)

ingredients_onehotencoded[0](180, 29)

array([ 0., 0., 0., 0., 1., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.,

0., 0., 0.])Теперь у нас есть данные с которыми мы можем работать.

Автоэнкодер

Попробуем загрузить фотографии пиц (вид сверху) и попробуем натренировать простой сжимающий автоэнкодер.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

np.random.seed(42)

import cv2

import os

import sys

import load_data

import prepare_imagesЗагружаем фотографии пицц

pizza_eng_names, pizza_imgs = prepare_images.load_photos()Read csv...

(20, 13)

RangeIndex: 20 entries, 0 to 19

Data columns (total 13 columns):

city_name 20 non-null object

city_url 20 non-null object

pizza_name 20 non-null object

pizza_eng_name 20 non-null object

pizza_url 20 non-null object

pizza_contain 20 non-null object

pizza_price 20 non-null int64

kiloCalories 20 non-null object

carbohydrates 20 non-null object

proteins 20 non-null object

fats 20 non-null object

size 20 non-null int64

weight 20 non-null object

dtypes: int64(2), object(11)

memory usage: 2.1+ KB

None

['double-pepperoni', 'crazy-pizza', 'pizza-don-bekon', 'gribvetchina', 'pizza-pirog', 'pizza-margarita', 'syrnaya-pizza', 'gavayskaya-pizza', 'pizza-dodo', 'pizza-chetyre-sezona', 'ovoshi-i-griby', 'italyanskaya-pizza', 'meksikanskaya-pizza', 'morskaya-pizza', 'myasnaya-pizza', 'pizza-pepperoni', 'ranch-pizza', 'pizza-syrnyi-cyplenok', 'pizza-cyplenok-barbekyu', 'chizburger-pizza']

['double-pepperoni\\double-pepperoni3.jpg', 'crazy-pizza\\crazy-pizza3.jpg', 'pizza-don-bekon\\pizza-don-bekon3.jpg', 'gribvetchina\\gribvetchina3.jpg', 'pizza-pirog\\pizza-pirog3.jpg', 'pizza-margarita\\pizza-margarita3.jpg', 'syrnaya-pizza\\syrnaya-pizza3.jpg', 'gavayskaya-pizza\\gavayskaya-pizza3.jpg', 'pizza-dodo\\pizza-dodo3.jpg', 'pizza-chetyre-sezona\\pizza-chetyre-sezona3.jpg', 'ovoshi-i-griby\\ovoshi-i-griby3.jpg', 'italyanskaya-pizza\\italyanskaya-pizza3.jpg', 'meksikanskaya-pizza\\meksikanskaya-pizza3.jpg', 'morskaya-pizza\\morskaya-pizza3.jpg', 'myasnaya-pizza\\myasnaya-pizza3.jpg', 'pizza-pepperoni\\pizza-pepperoni3.jpg', 'ranch-pizza\\ranch-pizza3.jpg', 'pizza-syrnyi-cyplenok\\pizza-syrnyi-cyplenok3.jpg', 'pizza-cyplenok-barbekyu\\pizza-cyplenok-barbekyu3.jpg', 'chizburger-pizza\\chizburger-pizza3.jpg']

Load images...

Load image: double-pepperoni\double-pepperoni3.jpg

Load image: crazy-pizza\crazy-pizza3.jpg

Load image: pizza-don-bekon\pizza-don-bekon3.jpg

Load image: gribvetchina\gribvetchina3.jpg

Load image: pizza-pirog\pizza-pirog3.jpg

Load image: pizza-margarita\pizza-margarita3.jpg

Load image: syrnaya-pizza\syrnaya-pizza3.jpg

Load image: gavayskaya-pizza\gavayskaya-pizza3.jpg

Load image: pizza-dodo\pizza-dodo3.jpg

Load image: pizza-chetyre-sezona\pizza-chetyre-sezona3.jpg

Load image: ovoshi-i-griby\ovoshi-i-griby3.jpg

Load image: italyanskaya-pizza\italyanskaya-pizza3.jpg

Load image: meksikanskaya-pizza\meksikanskaya-pizza3.jpg

Load image: morskaya-pizza\morskaya-pizza3.jpg

Load image: myasnaya-pizza\myasnaya-pizza3.jpg

Load image: pizza-pepperoni\pizza-pepperoni3.jpg

Load image: ranch-pizza\ranch-pizza3.jpg

Load image: pizza-syrnyi-cyplenok\pizza-syrnyi-cyplenok3.jpg

Load image: pizza-cyplenok-barbekyu\pizza-cyplenok-barbekyu3.jpg

Load image: chizburger-pizza\chizburger-pizza3.jpg

Cut pizza from images...

(380, 380, 3)

20 def plot_img(img):

img_rgb = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

plt.imshow(img_rgb)

plot_img(pizza_imgs[0])

Замечательно, что пицца обладает осевой симметрией — для аугментации, её можно будет вращать вокруг центра, а так же отражать по вертикали.

img_flipy = cv2.flip(pizza_imgs[0], 1)

plot_img(img_flipy)

Результат поворота вокруг центра на 15 градусов:

img_rot15 = load_data.rotate(pizza_imgs[0], 15)

plot_img(img_rot15)

Сделаем аугментацию для первой пиццы в списке (предварительно уменьшив до размеров: 56 на 56) — вращение вокруг оси на 360 градусов с шагом в 1 градус и отражением по вертикали.

channels, height, width = 3, 56, 56

lst0 = load_data.resize_rotate_flip(pizza_imgs[0], (height, width))

print(len(lst0))720plot_img(lst0[0])

Попробуем автоэнкодер

Преобразуем список с картинками к нужному виду и разобьём его на тренировочную и тестовую выборки.

image_list = lst0

image_list = np.array(image_list, dtype=np.float32)

image_list = image_list.transpose((0, 3, 1, 2))

image_list /= 255.0

print(image_list.shape)(720, 3, 56, 56)x_train = image_list[:600]

x_test = image_list[600:]

print(x_train.shape, x_test.shape)(600, 3, 56, 56) (120, 3, 56, 56)from keras.models import Model

from keras.layers import Input, Dense, Flatten, Reshape

from keras.layers import Conv2D, MaxPooling2D, UpSampling2D

from keras import backend as K

#For 2D data (e.g. image), "channels_last" assumes (rows, cols, channels) while "channels_first" assumes (channels, rows, cols).

K.set_image_data_format('channels_first')Using Theano backend.Создаём автоэнкодер

def create_deep_conv_ae(channels, height, width):

input_img = Input(shape=(channels, height, width))

x = Conv2D(16, (3, 3), activation='relu', padding='same')(input_img)

x = MaxPooling2D(pool_size=(2, 2), padding='same')(x)

x = Conv2D(8, (3, 3), activation='relu', padding='same')(x)

encoded = MaxPooling2D(pool_size=(2, 2), padding='same')(x)

# at this point the representation is (8, 14, 14)

input_encoded = Input(shape=(8, 14, 14))

x = Conv2D(8, (3, 3), activation='relu', padding='same')(input_encoded)

x = UpSampling2D((2, 2))(x)

x = Conv2D(16, (3, 3), activation='relu', padding='same')(x)

x = UpSampling2D((2, 2))(x)

decoded = Conv2D(channels, (3, 3), activation='sigmoid', padding='same')(x)

# Models

encoder = Model(input_img, encoded, name="encoder")

decoder = Model(input_encoded, decoded, name="decoder")

autoencoder = Model(input_img, decoder(encoder(input_img)), name="autoencoder")

return encoder, decoder, autoencoder

c_encoder, c_decoder, c_autoencoder = create_deep_conv_ae(channels, height, width)

c_autoencoder.compile(optimizer='adam', loss='binary_crossentropy')

c_encoder.summary()

c_decoder.summary()

c_autoencoder.summary()_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_1 (InputLayer) (None, 3, 56, 56) 0

_________________________________________________________________

conv2d_1 (Conv2D) (None, 16, 56, 56) 448

_________________________________________________________________

max_pooling2d_1 (MaxPooling2 (None, 16, 28, 28) 0

_________________________________________________________________

conv2d_2 (Conv2D) (None, 8, 28, 28) 1160

_________________________________________________________________

max_pooling2d_2 (MaxPooling2 (None, 8, 14, 14) 0

=================================================================

Total params: 1,608

Trainable params: 1,608

Non-trainable params: 0

_________________________________________________________________

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_2 (InputLayer) (None, 8, 14, 14) 0

_________________________________________________________________

conv2d_3 (Conv2D) (None, 8, 14, 14) 584

_________________________________________________________________

up_sampling2d_1 (UpSampling2 (None, 8, 28, 28) 0

_________________________________________________________________

conv2d_4 (Conv2D) (None, 16, 28, 28) 1168

_________________________________________________________________

up_sampling2d_2 (UpSampling2 (None, 16, 56, 56) 0

_________________________________________________________________

conv2d_5 (Conv2D) (None, 3, 56, 56) 435

=================================================================

Total params: 2,187

Trainable params: 2,187

Non-trainable params: 0

_________________________________________________________________

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

input_1 (InputLayer) (None, 3, 56, 56) 0

_________________________________________________________________

encoder (Model) (None, 8, 14, 14) 1608

_________________________________________________________________

decoder (Model) (None, 3, 56, 56) 2187

=================================================================

Total params: 3,795

Trainable params: 3,795

Non-trainable params: 0

_________________________________________________________________c_autoencoder.fit(x_train, x_train,

epochs=20,

batch_size=16,

shuffle=True,

verbose=2,

validation_data=(x_test, x_test))Train on 600 samples, validate on 120 samples

Epoch 1/20

10s - loss: 0.5840 - val_loss: 0.5305

Epoch 2/20

10s - loss: 0.4571 - val_loss: 0.4162

Epoch 3/20

9s - loss: 0.4032 - val_loss: 0.3956

Epoch 4/20

8s - loss: 0.3884 - val_loss: 0.3855

Epoch 5/20

10s - loss: 0.3829 - val_loss: 0.3829

Epoch 6/20

11s - loss: 0.3808 - val_loss: 0.3815

Epoch 7/20

9s - loss: 0.3795 - val_loss: 0.3804

Epoch 8/20

8s - loss: 0.3785 - val_loss: 0.3797

Epoch 9/20

10s - loss: 0.3778 - val_loss: 0.3787

Epoch 10/20

10s - loss: 0.3771 - val_loss: 0.3781

Epoch 11/20

9s - loss: 0.3764 - val_loss: 0.3779

Epoch 12/20

8s - loss: 0.3760 - val_loss: 0.3773

Epoch 13/20

9s - loss: 0.3756 - val_loss: 0.3768

Epoch 14/20

10s - loss: 0.3751 - val_loss: 0.3766

Epoch 15/20

10s - loss: 0.3748 - val_loss: 0.3768

Epoch 16/20

9s - loss: 0.3745 - val_loss: 0.3762

Epoch 17/20

10s - loss: 0.3741 - val_loss: 0.3755

Epoch 18/20

9s - loss: 0.3738 - val_loss: 0.3754

Epoch 19/20

11s - loss: 0.3735 - val_loss: 0.3752

Epoch 20/20

8s - loss: 0.3733 - val_loss: 0.3748

#c_autoencoder.save_weights('c_autoencoder_weights.h5')

#c_autoencoder.load_weights('c_autoencoder_weights.h5')Посмотрим на результаты работы автоэнкодера

n = 5

imgs = x_test[:n]

encoded_imgs = c_encoder.predict(imgs, batch_size=n)

decoded_imgs = c_decoder.predict(encoded_imgs, batch_size=n)

def get_image_from_net_data(data):

res = data.transpose((1, 2, 0))

res *= 255.0

res = np.array(res, dtype=np.uint8)

return res

#image0 = get_image_from_net_data(decoded_imgs[0])

#plot_img(image0)fig = plt.figure()

j = 0

for i in range(0, len(imgs)):

j += 1

fig.add_subplot(n,2,j)

plot_img( get_image_from_net_data(imgs[i]) )

j += 1

fig.add_subplot(n,2,j)

plot_img( get_image_from_net_data(decoded_imgs[i]) )

Продолжение следует...

Ссылки

|

Метки: author noonv машинное обучение python machine learning keras autoencoder |

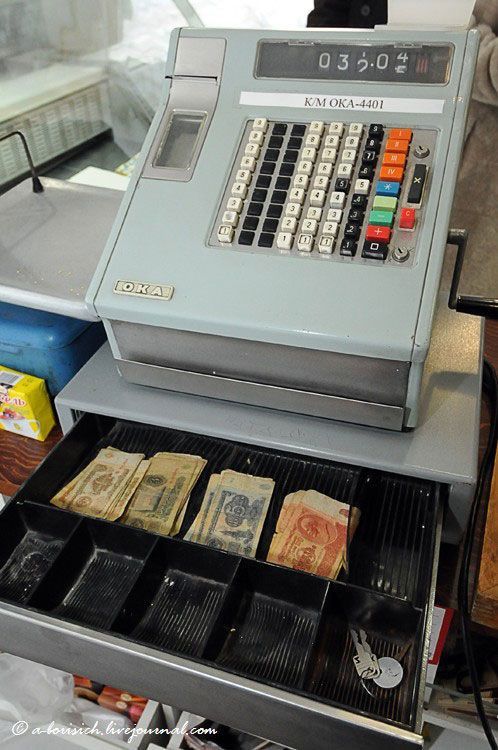

История торговых кассовых аппаратов |

Появление новых машин для приема денег в корне изменило представление о розничной торговле, которая до конца XIX века велась по упрощенной схеме. До изобретения кассового аппарата покупатель отдавал продавцу деньги, взамен получал товар (или услугу), а все обязанности по учету финансовых поступлений брал на себя продавец. Не нужно быть очень проницательным, чтобы понять – такой контроль доходов от продаж был очень условным.

1871-1884: первые кассы Джеймса Якоба Ритти

Первым человеком, который задумался о необходимости контроля денежных поступлений, был Джеймс Якоб Ритти. Будущий изобретатель кассового аппарата в 1871 году открыл в городе Дайтон (штат Огайо) бар под названием Pony House. Несмотря на немалое число посетителей, денег бизнес не приносил, так как персонал заведения постоянно утаивал выручку от владельца. Решить проблему увольнением нечистых на руку продавцов не получалось – с новыми людьми происходило то же самое.

Джеймс Ритти – изобретатель первого кассового аппарата

Решение пришло неожиданно, во время морского путешествия Ритти из США в Европу. Джеймс зашел в машинное отделение корабля и увидел там тахометр – круглый датчик, который отсчитывал число оборотов гребного вала. Глядя на этот датчик, Джеймс подумал, что можно собрать похожее устройство, которое бы точно так же отсчитывало деньги, принимаемые от клиентов Pony House. Вернувшись домой, воодушевленный Джеймс сконструировал прототип кассового аппарата.

Это устройство было совершенно не похоже на привычные для нас кассы. Для индикации суммы дохода использовался круглый циферблат, из-за чего устройство издалека можно было принять за обычные часы в деревянном корпусе. Тем более что у первой кассы, как и у часов, были стрелки: длинная («минутная») показывала центы, а короткая («часовая») отображала доллары. Под этим циферблатом располагались кнопки, каждая из которых соответствовала цене на тот или иной товар. Например, если посетитель приобретал выпивку на 35 центов, кассир должен был нажать на кнопку с этим значением, после чего счетчик корректировал положение стрелок на циферблате.

Первая рабочая модель кассового аппарата

Первая модель кассового аппарата оказалась несовершенной. Хитрый продавец мог лишь сделать вид, что использует кассу, или нажать на кнопку с меньшим номиналом. А когда никто не видел, он поступал еще проще – переводил стрелки обратно. Поэтому Джеймс внес изменения в конструкцию – в кассе появились колесики с цифрами, а их движение было синхронизировано передаточным механизмом. Благодаря «сумматору» аппарат научился подсчитывать общую сумму заказа, а также приобрел форму, которая впоследствии не менялась в течение многих лет.

Чтобы приучить посетителей заведения к кассе, Ритти повесил на устройство колокольчик, который издавал звон после расчета посетителя. Эта модель получила прозвище «Неподкупный кассир Ритти».

Однако и во второй модификации кассового аппарата со временем обнаружился существенный недостаток. Как-то раз в заведении разразился сильный скандал – недовольный посетитель обвинил бармена в том, что тот его обсчитал. Доказательств, понятное дело, не было – кассовый аппарат показывал новую сумму выручки, и только. Тогда Джеймс решил доработать свое детище, наделив его специальной бумажной лентой, на которой фиксировалась каждая операция, проведенная кассиром.

Так в третьей модификации кассового аппарата все операции сопровождались перфорацией бумаги, по которой можно было отследить действия кассира. Вероятно, с той поры и появилось хорошо известное выражение «пробить чек».

Кроме того, под кассой теперь в обязательном порядке находился ящик для денег – поначалу самый простой выдвижной, поделенный на секции для разного номинала. Также в нем имелись прижимные ролики для купюр. Со временем в ящике появился и замок. Интересно, что за более чем сто лет ящик для наличности практически не изменился.

После того как все основные недостатки первых модификаций кассового аппарата были устранены, Джеймс Ритти запатентовал свое изобретение. Затем он попробовал наладить серийный выпуск, но быстро отказался от этой затеи и продал патент, сосредоточившись на развитии ресторанного бизнеса.

Джеймс Ритти с братом создают первые образцы кассовых аппаратов

Первые кассы современности: «Национальная кассовая компания» Джона Паттерсона

В 1884 году права на изготовление кассовых аппаратов выкупил Джон Паттерсон, которого по праву называют человеком, создавшим современную технологию продаж. Получив патент на производство перспективного устройства, бизнесмен создал компанию The National Cash Register Company (которая, кстати, и сегодня выпускает POS-оборудование).

В 1906 году в NCR был изобретен первый кассовый аппарат на электромоторе с кнопочным приводом. Его создал один из самых талантливых инженеров NCR – Чарльз Кеттеринг, который всего за пять лет работы в компании получил более двадцати патентов на разные изобретения. Команда инженеров NCR вносила все новые усовершенствования в кассовые аппараты, и именно под началом Джона Паттерсона эти устройства стали такими, какими мы их привыкли видеть.

Классический кассовый аппарат фирмы The National Cash Register Company

Когда Паттерсон занялся кассовыми аппаратами, ему пришлось влезть в долги и полагаться на свою интуицию предпринимателя. Но он твердо верил в то, что за кассовыми аппаратами будущее. Интересно, что Паттерсон не навязывал покупателям сами кассовые аппараты, а работал над созданием потребности в кассовых чеках (то есть по сути продавал не сам продукт, а выгоду от его использования). Для продавцов NCR был написан целый учебник, который они обязаны были выучить наизусть, прежде чем идти к потенциальным клиентам. В итоге с 1884 по 1911 год в мире было продано более миллиона кассовых аппаратов, а к 1917 году The National Cash Register Company контролировала около 95% рынка.

Некоторые методы, которые использовал в своей бизнес-стратегии Джон Паттерсон, были действительно новаторскими (и применяются по сей день). Так, компания NCR часто попросту скупала своих конкурентов. Как только Джон видел в продаже модель кассового аппарата с функциями, которых недоставало в собственной продукции, он тут же делал все, чтобы выкупить производителя или вынудить его свернуть бизнес.

Во-вторых, в компании дотошно изучали кассы конкурентов, чтобы лучше понять их недостатки. Так, например, достоверно известно, что в феврале 1892 года внутри компании было распространен циркуляр с инструкциями по взлому денежного ящика кассового аппарата конкурирующей марки – Simplex Cash Register.

Эта касса работала достаточно необычно. У нее не было кнопок, зато имелись отверстия под шарики. Каждое отверстие соответствовало определенной сумме. После установки шариков в нужное положение в небольшом окне поднимался флажок с ценником. Так покупатель мог увидеть выставленный ему счет. Попав внутрь кассы, шарики накапливались, и в конце дня владелец мог сравнить выручку с числом шариков.

Альтернативный тип кассового аппарата от Simplex Cash Register