Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Что известно об атаке на цепи поставок CCleaner |

- Системное администрирование,

- Сетевые технологии,

- Антивирусная защита,

- IT-инфраструктура,

- Блог компании Cloud4Y

Что известно об атаке на цепи поставок CCleaner

- Системное администрирование,

- Сетевые технологии,

- Антивирусная защита,

- IT-инфраструктура,

- Блог компании Cloud4Y

- Перевод

Атаки на цепи поставок (supply-chain attacks) — очень эффективный способ распространения вредоносного программного обеспечения в целевые организации. Это связано с тем, что при атаках на цепи поставок злоумышленники пользуются доверительными отношениями между производителем/поставщиком и клиентом, чтобы атаковать организации и отдельных лиц по различным мотивам. Червь Petya/Nyetya/NePetya, который был выпущен в сеть в начале 2017 года, показал насколько масштабны эти типы атак. Часто, как и в случае с Petya, исходный вектор атаки может оставаться скрытым в течение некоторого времени.

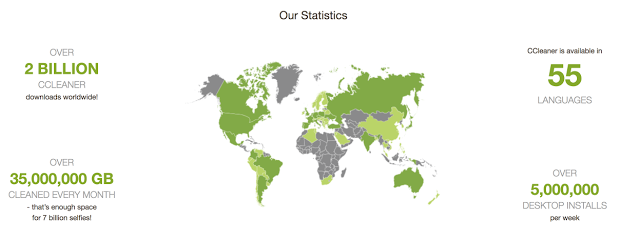

Недавно исследователи Talos заметили случай, когда серверы загрузки, используемые компанией-разработчиком для распространения легитимного пакета программного обеспечения, были использованы для загрузки вредоносного ПО на компьютеры ничего неподозревающих жертв. В течение некоторого периода версия CCleaner 5.33, распространяемая Avast, содержала многоступенчатую вредоносную нагрузку. 5 миллионов новых пользователей загружают CCleaner в неделю. Учитывая потенциальный ущерб, который может быть вызван сетью зараженных компьютеров подобного размера, решено было действовать быстро. 13 сентября 2017 года Cisco Talos уведомила Avast. В следующих разделах будут обсуждаться конкретные детали, касающиеся этой атаки.

Технические подробности

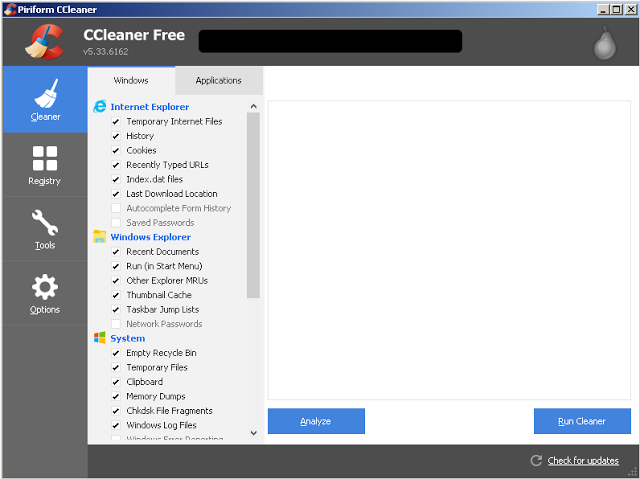

CCleaner — утилита, которая включает такие функции, как очистка временных файлов, анализ системы, определение способов оптимизации производительности, а также более упрощенный способ управления установленными приложениями.

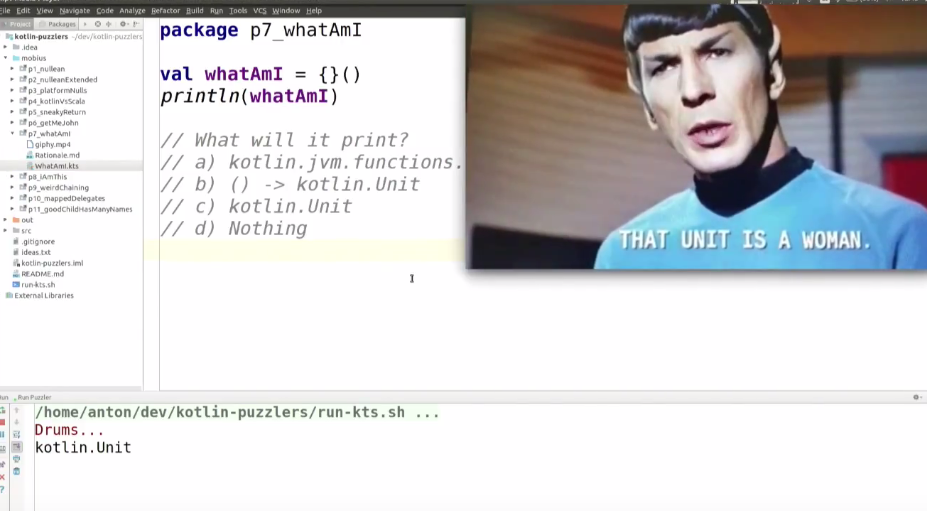

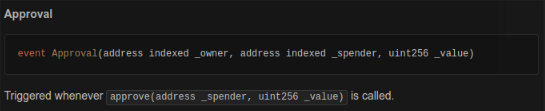

Рисунок 1: Снимок экрана CCleaner 5.33

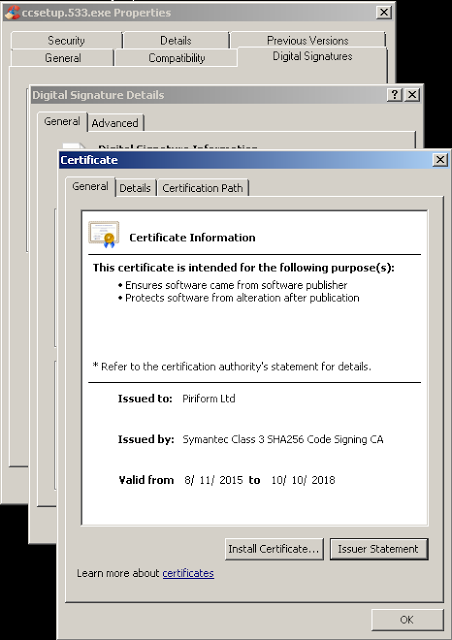

13 сентября 2017 года, проведя бета-тестирование клиентов новой технологией обнаружения эксплойтов, Cisco Talos обнаружила исполняемый файл, который определялся как вредоносная программа. Это был установщик CCleaner v5.33 с легитимных серверов загрузки CCleaner. Talos провёл первоначальный анализ, чтобы определить, что заставляет систему защиты блокировать CCleaner. Они определили, что, хотя загруженный исполняемый файл был подписан с использованием действительной цифровой подписи Piriform, CCleaner не был единственным приложением, которое было загружено. Во время установки CCleaner 5.33 32-разрядный двоичный файл CCleaner, также содержал вредоносную нагрузку с возможностью использовать алгоритм генерации домена (DGA), а также функции выдачи команд и управления (Command and Control — C2).

При просмотре страницы истории версий на сайте загрузки CCleaner выяснилось, что версия (5.33) была выпущена 15 августа 2017 года. 12 сентября 2017 года была выпущена версия 5.34. Версия, содержащая вредоносную нагрузку (5.33), распространялась между этими датами. Эта версия была подписана с использованием действительного сертификата, который был выпущен для компании Piriform Ltd, которую недавно приобрел Avast, компанией Symantec и действителен до 10.10.2018.

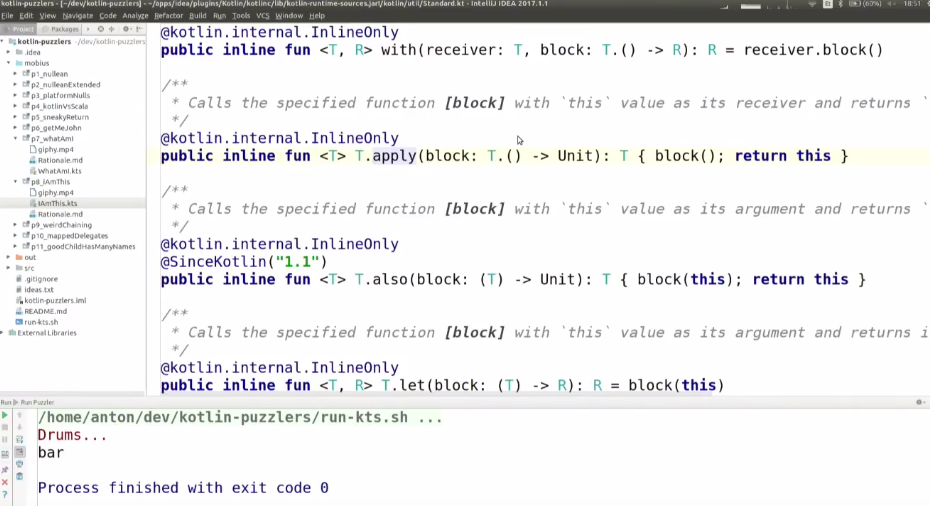

Рисунок 2: Цифровая подпись CCleaner 5.33

Также был обнаружен второй образец установщика, связанный с этой угрозой. Этот образец также был подписан с использованием действительного цифрового сертификата, однако отметка времени подписания была приблизительно на 15 минут позднее подписания первоначальной сборки.

Наличие действительной цифровой подписи в вредоносном двоичном коде CCleaner может указывать на значительную проблему, которая была причиной нарушений в процессе разработки или подписания. В идеале этот сертификат должен быть отозван. При создании нового сертификата необходимо следить за тем, чтобы злоумышленники не находились в среде, в которой можно было бы скомпрометировать новый сертификат. Только в процессе расследования возможно было собрать подробную информацию о масштабах этой проблемы и о том, как наилучшим образом ее решить.

В двоичном коде CCleaner был найден следующий артефакт компиляции:

S:\workspace\ccleaner\branches\v5.33\bin\CCleaner\Release\CCleaner.pdb

Учитывая наличие этого артефакта компиляции, а также тот факт, что двоичный код был подписан цифровой подписью с использованием действительного сертификата, вполне вероятно, что злоумышленник из вне скомпрометировал часть среды разработки или сборки и использовал этот доступ для вставки вредоносного кода в сборку CCleaner, которая была выпущена организацией. Также возможно, что инсайдер, имеющий доступ к средам разработки или сборки внутри организации, намеренно включал вредоносный код или имел скомпрометированную учетную запись, которая позволяла злоумышленнику изменять код.

Важно отметить, что, хотя предыдущие версии установщика CCleaner в настоящее время доступны на сервере загрузки, версия, содержащая вредоносные файлы, была удалена и больше не доступна.

Процесс установки вируса

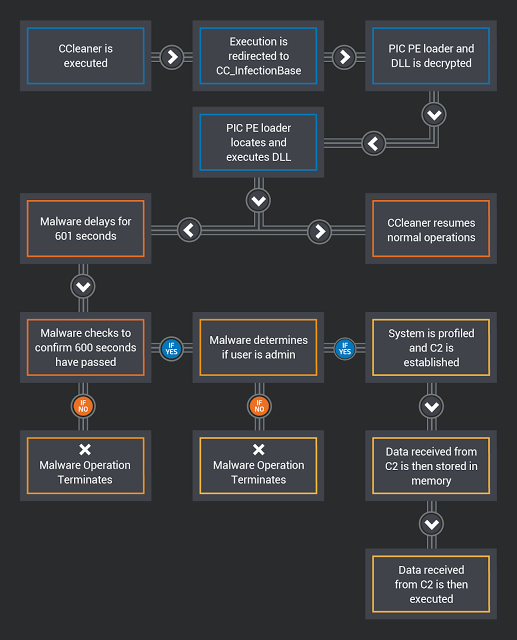

'__scrt_get_dyn_tls_init_callback' был изменен для запуска кода CC_InfectionBase (0x0040102C) с целью перенаправления потока выполнения кода на вредоносный до продолжения обычных операций CCleaner. Вызываемый код отвечает за дешифрование данных, которые содержат два уровня вредоносной нагрузки: загрузчик PIC (позиционно-независимого программного кода) и DLL-файл.

Используя HeapCreate (HEAP_CREATE_ENABLE_EXECUTE, 0,0), создаётся исполняемая куча. Содержимое расшифрованных данных, содержащих вредоносное ПО, копируется в кучу, исходные данные стираются. Затем вызывается PE-загрузчик и начинается его работа. Как только процесс заражения начался, двоичный код стирает области памяти, в которых ранее содержался PE-загрузчик и DLL-файл, освобождает ранее выделенную память, уничтожает кучу и продолжает исполняться с обычными операциями CCleaner.

PE-загрузчик использует методы позиционно-независимого кодирования, чтобы найти DLL-файл в памяти. Затем он переносит DLL в исполняемую память и вызывает DLLEntryPoint, чтобы начать его выполнение.

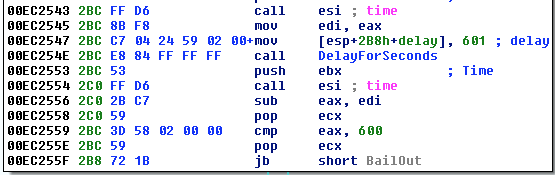

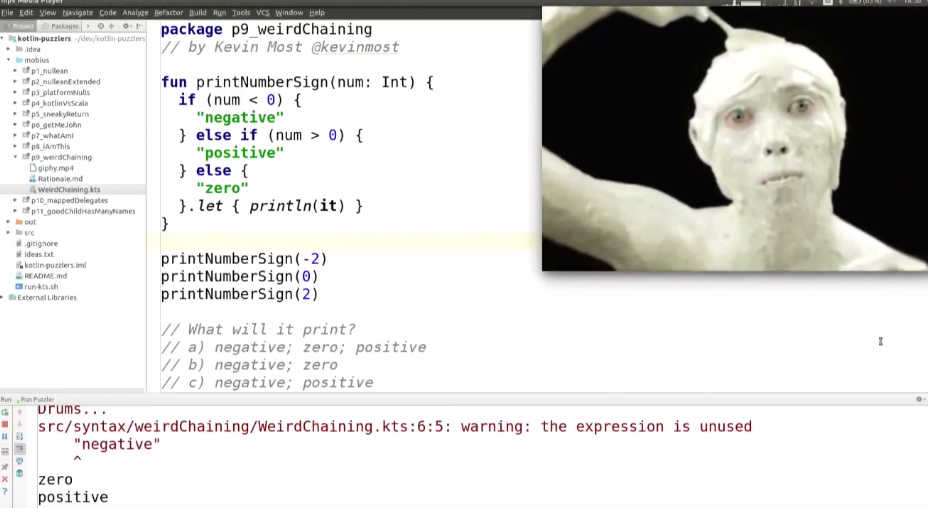

CCBkrdr_GetShellcodeFromC2AndCall отвечает за многие из вредоносных операций, обнаруженные Talos при анализе этого вредоносного ПО. Во-первых, он записывает текущее системное время. Затем он задерживает выполнение вредоносного кода на 601 секунду, вероятно, с целью уклониться от автоматизированных систем анализа, которые настроены на проверку ПО на вирусы в отладчике в течение предопределенного периода времени. Чтобы реализовать эту функцию задержки, вредоносное ПО вызывает функцию, которая пытается выполнить ping 224.0.0.0 с использованием таймаута delay_in_seconds, установленного на 601 секунду. Затем он определяет текущее системное время, чтобы узнать прошло ли 600 секунд. Если это условие не выполняется, вирус завершает выполнение, в то время как CCleaner продолжает выполняться. В ситуациях, когда вредоносное ПО не может выполнить IcmpCreateFile, оно возвращается к использованию функции Sleep () для реализации той же функции задержки. Вредоносная программа также сравнивает текущее системное время со значением, хранящимся в следующем разделе реестра:

HKLM \ SOFTWARE \ Piriform \ Agomo: TCID

Если время, хранящееся в TCID, ещё не пришло, вирус также прекратит выполнение.

Рисунок 3: Процедура задержки

Затем проверяются привилегии, назначенные пользователю. Если текущий пользователь, не является администратором, вредоносное ПО прекратит выполнение.

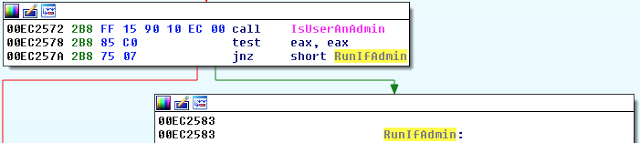

Рисунок 4: Проверка привилегий

Если у пользователя, запустившеего вредоносное ПО, есть права администратора, на зараженной системе активируется SeDebugPrivilege. Затем вредоносное ПО считывает значение «InstallID», которое хранится в следующем разделе реестра:

HKLM \ SOFTWARE \ Piriform \ Agomo: Muid

Если это значение не существует, вредоносное ПО создает его с помощью '((rand () * rand () ^ GetTickCount ())'.

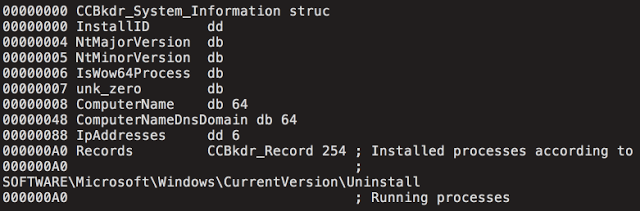

Как только вышеупомянутые действия были выполнены, вирус начинает сбор системной информации, которая позже передается на сервер C2. Системная информация хранится в следующей структуре данных:

Рисунок 5: Структура данных CCBkdr_System_Information

После сбора информации о системе она зашифровывается и кодируется с использованием модифицированного Base64. Затем вредоносное ПО устанавливает связь с командным сервером (C2), как описано в следующем разделе.

Command and Control (C2)

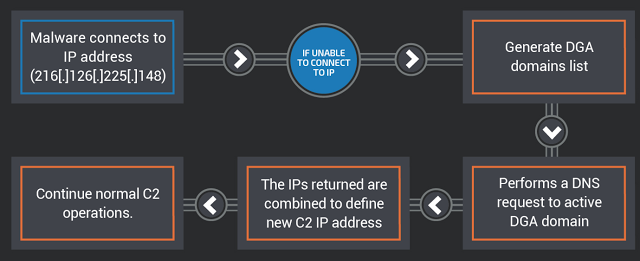

Как только ранее упомянутая системная информация была собрана и подготовлена для передачи на сервер C2, начинается попытка передать её с использованием запроса POST HTTPS на 216[.]126[.]225[.]148.

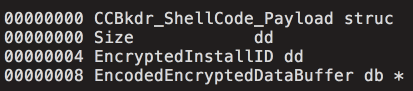

Данные, полученные с сервера C2, проверяются, чтобы подтвердить, что они находятся в правильном формате для использования в CCBkdr_ShellCode_Payload. Пример показан ниже:

Рисунок 6: Структура данных CCBkdr_ShellCode_Payload

После установки вируса продолжаются обычные операции CCleaner. Ниже приведена диаграмма, описывающая работу этого вредоносного ПО на высоком уровне:

Рисунок 7: Схема процесса запуска вредоносной нагрузки

Алгоритм генерации домена

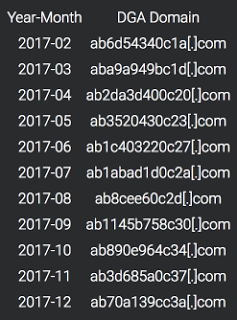

В ситуациях, когда основной сервер C2 не возвращает ответ на запрос HTTP POST, описанный в предыдущем разделе, вредоносная программа использует алгоритма DGA. В этом случае он основан на времени и может быть рассчитан с использованием значений текущего года и месяца. Ниже приведен список доменов DGA:

Рисунок 8: генерация доменов для 12 месяцев

Вредоносная программа будет инициировать DNS-поиск для каждого домена, генерируемого алгоритмом DGA. Если DNS-поиск не приведет к возврату IP-адреса, этот процесс будет продолжен. Вредоносная программа выполнит DNS-запрос активного DGA-домена и ожидает получить два IP-адреса с сервера доменных имен. Затем вредоносная программа вычислит вторичный сервер C2, выполнив серию битовых операций с полученными IP-адреса и объединив их для определения нового фактического адреса командного сервера. Диаграмма, показывающая этот процесс, приведена ниже:

Рисунок 9: Определение адреса командного сервера

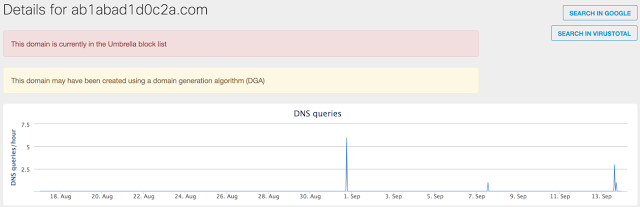

Cisco Talos во время анализа определила, что DGA-домены не были заняты, поэтому они были зарегистрированы и заблокированы, чтобы злоумышленники не могли использовать их в своих целях.

Потенциальный ущерб

Воздействие этой атаки может быть серьезным, учитывая чрезвычайно большое число возможных систем. CCleaner утверждают, что по состоянию на ноябрь 2016 года он имеет более 2 миллиардов загрузок по всему миру и, как сообщается, прирост новых пользователей равен 5 миллионам в неделю.

Рисунок 10: Статистика CCleaner

Системы, на которые производилась установка CCleaner в период распространения вируса должны быть восстановлены до состояния на 15 августа 2017 года или переустановлены. Пользователи также должны обновиться до последней доступной версии CCleaner, чтобы избежать заражения. На момент написания этой версии была версия 5.34. Важно отметить, что, согласно странице загрузки CCleaner, бесплатная версия CCleaner не предоставляет автоматические обновления, поэтому это необходимо сделать вручную.

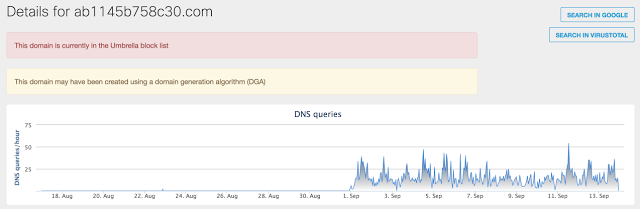

При анализе телеметрических данных Cisco Umbrella о доменах, связанных с этой атакой, Talos определил значительное количество систем, которые выполняли соответствующие DNS-запросы. Поскольку эти домены никогда не регистрировались, разумно сделать вывод о том, что единственной причиной является этот вирус. Только домены, относящиеся к августу и сентябрю (что коррелирует со временем, когда эта угроза была активна), показывают значительную активность.

Рисунок 11: Активность DGA домена за июль 2017 года

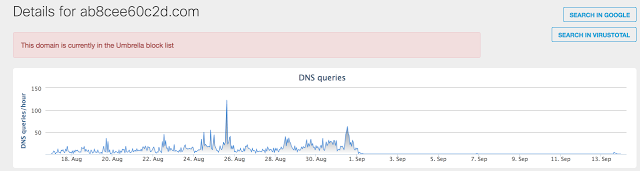

Как упоминалось ранее, версия CCleaner, которая включала это вредоносное ПО, была выпущена 15 августа 2017 года. Следующий график показывает значительное увеличение активности DNS, связанной с DGA-доменом, используемым в августе 2017 года:

Рисунок 12: Активность для домена в августе 2017 года

Рисунок 13: Активность для домена в сентябре 2017 года

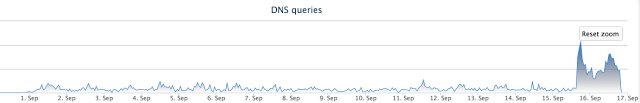

После обращения к Avast было замечено, что C2 сервер, указанный по умолчанию, стал недоступным для зараженных систем. В результате мы увидели значительное увеличение количества запросов, направленных на DGA-домены.

Рисунок 14: Трафик после отключения сервера

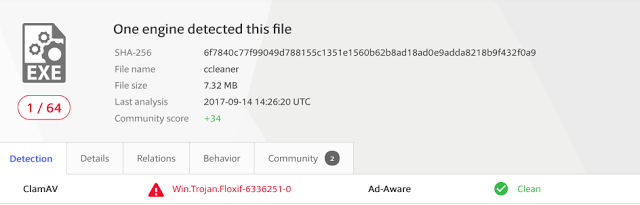

Стоит также отметить, что на 18 сентября антивирусное обнаружение этой угрозы остается очень низким (1/64).

Рисунок 15: Проверка обнаружения вируса

Ещё причины для беспокойства

Позднее во время нашего исследования нам был предоставлен архив, содержащий файлы, хранящиеся на сервере C2. Наша исследовательская деятельность была отражена в содержимом базы данных MySQL, включенной в архивные файлы, что подтвердило подлинность данных.

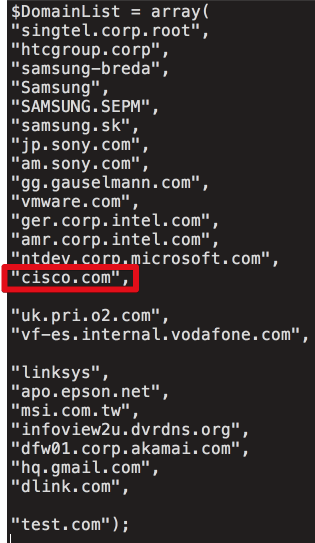

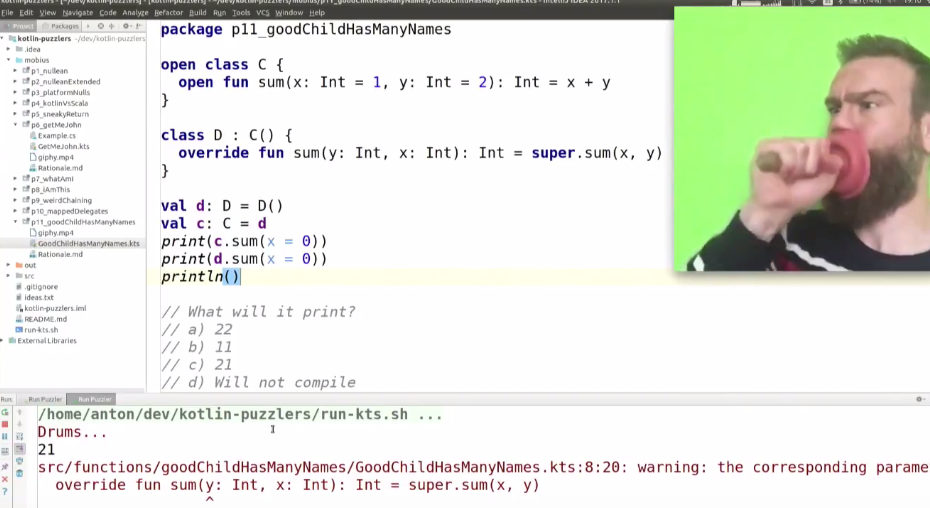

При анализе кода с сервера C2 сразу выделяется список организаций, на которые была нацелена доставка загрузчика второго уровня. Основываясь на обзоре базы данных отслеживания C2, которая охватывает только четыре дня в сентябре, мы можем подтвердить, что по меньшей мере 20 машин жертв были заражены специализированными вредоносными нагрузками. Ниже приведен список доменов, на которые атакующие пытались настроить таргетинг. Не для всех компаний идентифицированных в файле .php был замечен обмен с С2 сервером.

Рисунок 16

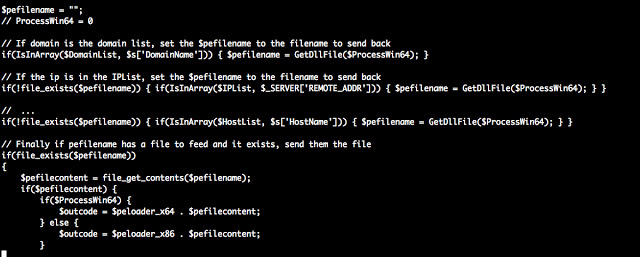

PHP скрипт сравнивает системные маяки полученные с заражённой машины по трём значениям: $DomainList, $IPList и $HostList. Это необходимо для определения того, должна ли зараженная система доставлять вредоносную нагрузку Stage 2. Ниже приведен сжатый PHP-код, который демонстрирует это:

Рисунок 17

База данных C2 содержала две таблицы: одну, описывающую все машины, которые «общались» с сервером, и описание всех машин, получивших загрузку Stage 2. Причем обе из них были датированы с 12 сентября по 16 сентября. За этот период времени на сервер C2 было отправлено более 700 000 машин, и более 20 машин получили Stage 2 нагрузку. Важно понимать, что целевой список может быть изменён и был изменён в течение периода, когда сервер был активен для заражения целевых организаций.

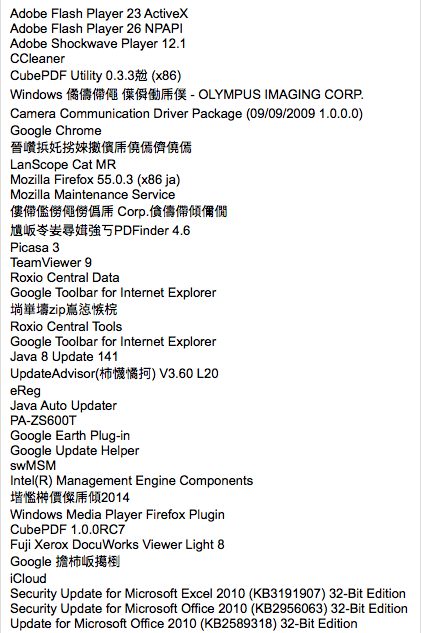

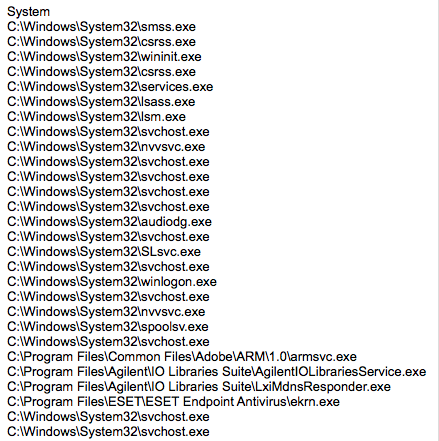

Во время компрометации вредоносное ПО периодически связывалось с сервером C2 и передавало информацию о зараженных системах. Эта информация включала IP-адреса, время, имя хоста, домен, списки процессов и прочее. Вероятно, эта информация использовалась злоумышленниками для определения того, на какие машины таргетироваться на последних этапах атаки.

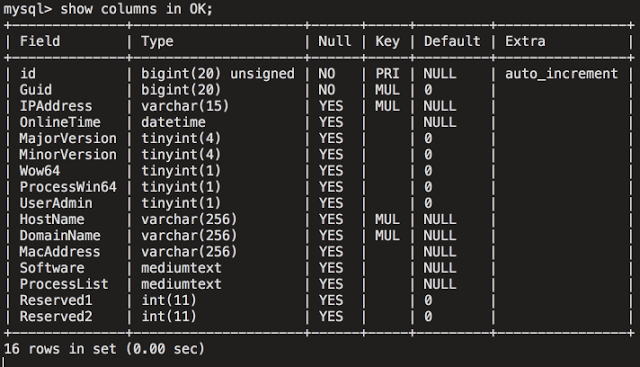

Основные данные подключения хранятся в таблице «Сервер». Вот пример для одного из узлов Talos в этой таблице базы данных:

Рисунок 18

А также список установленных программ.

Рисунок 19

И список процессов.

Рисунок 20

Вторая таблица базы данных содержала дополнительный набор данных, связанный с системами, которым фактически была доставлена нагрузка Stage 2. Эта таблица содержала аналогичную информацию, структура которой показана ниже:

Рисунок 21

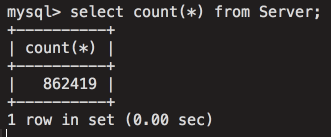

Основываясь на анализе таблицы, очевидно, что эта инфраструктура предоставляет злоумышленникам доступ ко множеству разных целей. Учитывая фильтрацию на сервере C2, злоумышленники могут добавлять или удалять домены в любой момент времени в зависимости от среды или организаций, на которые они нацелены. На скриншоте ниже показано количество записей, которые содержались в таблице базы данных, используемой для хранения профилей систем:

Рисунок 22

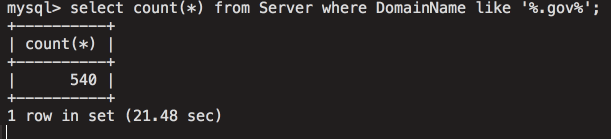

На следующем снимке экрана показано количество затронутых правительственных систем по всему миру.

Рисунок 23

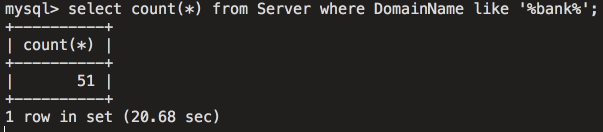

Уязвимые системы с доменом, содержащим слово «банк»:

Рисунок 24

Это демонстрирует уровень доступа для злоумышленников, полученный посредством использования этой инфраструктуры, а также подчеркивает серьезность и потенциальное воздействие этой атаки.

CODE REUSE

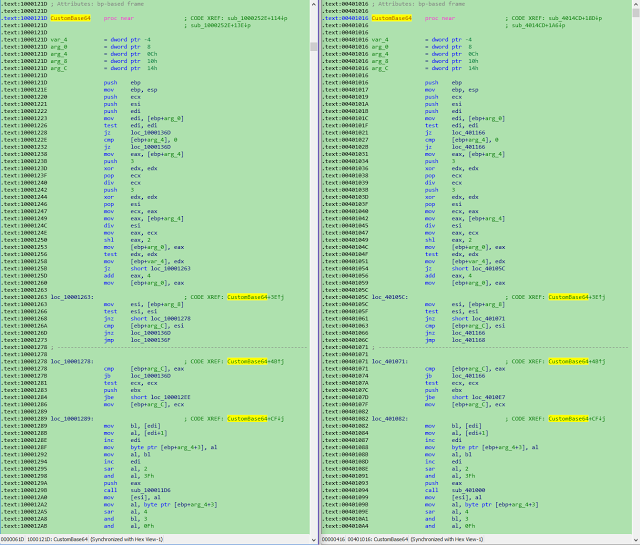

Talos рассмотрел заявления от исследователей Лаборатории Касперского о совпадении кода с образцами вредоносных программ, которые, как известно, используются Group 72. Хотя это никоим образом не является доказательством, мы можем подтвердить совпадение и согласны с тем, что это важная информация.

Слева: 2bc2dee73f9f854fe1e0e409e1257369d9c0a1081cf5fb503264aa1bfe8aa06f (CCBkdr.dll)

Справа: 0375b4216334c85a4b29441a3d37e61d7797c2e1cb94b14cf6292449fb25c7b2 (Missl backdoor — APT17 / Group 72)

Рисунок 25

ВЫВОД

Атаки на цепи поставок растут по скорости и сложности. В этом конкретном примере злоумышленник разработал систему, которая, как представляется, специально ориентирована на технологические компании, чтобы скомпрометировать огромное количество машин. Это усиливает обеспокоенность этими событиями и также подтверждает рекомендацию о том, что пользователи, загрузившие CClenaer в период заражения, должны не просто удалить заражённую версию CCleaner или обновиться до последней версии, но также должны восстановить данные из резервных копий, чтобы гарантировать полное удаление вредоносных программ.

Ниже приведены индикаторы компроментации, связанные с этой атакой.

File Hashes

6f7840c77f99049d788155c1351e1560b62b8ad18ad0e9adda8218b9f432f0a9

1a4a5123d7b2c534cb3e3168f7032cf9ebf38b9a2a97226d0fdb7933cf6030ff

36b36ee9515e0a60629d2c722b006b33e543dce1c8c2611053e0651a0bfdb2e9

DGA Domains

ab6d54340c1a[.]com

aba9a949bc1d[.]com

ab2da3d400c20[.]com

ab3520430c23[.]com

ab1c403220c27[.]com

ab1abad1d0c2a[.]com

ab8cee60c2d[.]com

ab1145b758c30[.]com

ab890e964c34[.]com

ab3d685a0c37[.]com

ab70a139cc3a[.]com

IP Addresses

216[.]126[.]225[.]148

Installer on the CC: dc9b5e8aa6ec86db8af0a7aa897ca61db3e5f3d2e0942e319074db1aaccfdc83 (GeeSetup_x86.dll)

64-bit trojanized binary

128aca58be325174f0220bd7ca6030e4e206b4378796e82da460055733bb6f4f (EFACli64.dll)

32-bit trojanized binary: 07fb252d2e853a9b1b32f30ede411f2efbb9f01e4a7782db5eacf3f55cf34902 (TSMSISrv.dll)

DLL in registry: f0d1f88c59a005312faad902528d60acbf9cd5a7b36093db8ca811f763e1292a

Registry Keys:

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\001

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\002

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\003

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\004

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\HBP

|

Метки: author Cloud4Y системное администрирование сетевые технологии антивирусная защита it- инфраструктура блог компании cloud4y ccleaner вирус троян |

Больше сюрпризов от Apple: обновленные правила размещения на App Store |

Больше сюрпризов от Apple: обновленные правила размещения на App Store

В последние месяцы Apple корректировали и дополняли список официальных требований к продуктам, размещаемым на сторе уже дважды. Первая порция правок пришлась на июнь, как заблаговременная подготовка почвы для осеннего релиза; вторая была опубликована совсем недавно. За каждой следовала массовая зачистка — удаление тысяч приложений с маркета без предупреждений и надежды на амнистию. Раз уж все так серьезно, пожалуй, стоит поподробнее разобрать, что именно изменилось и стоит ли уже начинать бояться. Мы изучили июньское и сентябрьское соглашения и собрали все значительные нововведения здесь, под катом.

Забегая вперед: бояться не стоит, но побаиваться можно. Изменений достаточно много, они рассыпаны по тексту и касаются различных аспектов разработки и публикации. Львиную долю тайтлов, которые попали под раздачу, составляет откровенный скам, что внушает известное ощущение безопасности: чего нам волноваться, мы же не мошенники. Но на деле, попасться можно и на достаточно безобидных мелочах просто по незнанию — несколько таких кейсов нам уже попадалось.

Итак, начнем с июньских тезисов. Что здесь нужно знать?

1. Удаляться без разговоров и предупреждений будут:

- Приложения для купли-продажи контролируемых веществ (за исключением официальных приложений аптечных сетей).

- Устаревшие приложения, для которых разработчики больше не обеспечивают поддержку, что приводит к некорректной работе.

- Приложения, созданные на базе шаблонов, при помощи специальных сервисов типа «собери сам без знания кода».

- Приложения, использующие технологии, фреймворки и функции, несовместимые с новыми версиями OS.

- Приложения для торговли бинарными опционами.

2. Приведен список требований для антиспамерских продуктов. Подобные функции обязательно должны быть упомянуты в описании, причем с развернутым объяснением, по какому алгоритму происходит фильтрация и блокируются звонки/сообщения. Запрещается использовать полученные данные для любых целей, не связанных с работой приложения (продажа, трэкинг, сбор информации о пользователе, таргетирование рекламы).

3. То же относится и к музыкальным приложениям, которые получают доступ к пользовательским данным в Apple Music.

4. Медицинские приложения также будут подвергаться более жесткому контролю. В описании должна раскрываться методология, которая используется для медицинских заключений и гарантирует их точность. Сразу будут отклоняться продукты, которые якобы производят операции, требующие специального оборудования (измеряют давление, температуру, уровень сахара в крови, делают рентген). Обязательно включение рекомендации обратиться к специалисту для более точной консультации.

5. Продолжительность периода подписки не может составлять менее недели; подписка должна быть актуальна на всех девайсах пользователя.

6. К кругу действий, к которым нельзя принуждать пользователя, блокируя возможность пользоваться функционалом, добавились просмотр видео и клик на рекламный баннер (в дополнение к размещению, отзыва, оценки или скачиванию другого приложения). Также запрещено предлагать за них вознаграждение, денежное или любое другое.

7. Допускается использование кода «со стороны», при условии, что оно осуществляется через WebKit или JavaScript Core, а разработчик состоит в Apple Development Program.

8. В текст добавлены мелкие изменения, касающиеся разных аспектов оформления:

- Названия: не должны включать выражения типа «for children», «for kids», если не принадлежат к соответствующей категории, а также отсылки к цене.

- В сабтайтлах запрещено: ссылаться на другие приложения или давать информацию о продукте, которую не можете подтвердить.

- Иконки: допускается использование кастомизированных иконок, при условии что остается возможность вернуться к исходной. Вариации иконок должны быть связаны с контентом приложения (например, иконки, отображающие разные типы погоды для утилиты с прогнозами) и синхронизироваться по всей системе.

Теперь перейдем к самой свежей, сентябрьской версии. Здесь список правок полаконичнее и во многом тематически перекликается с и продолжает то, что было намечено летом:

1. Удаляться также будут приложения, функционал которых не соответствует приведенному описанию. В качестве примера App Store прямым текстом приводит антивирусы, которые, согласно источникам, формируют основную массу жертв последней чистки. Кстати, обещать контент или сервисы, которые продукт не предлагает, нельзя не только на маркете, но и оффлайн.

2. Аутентификация через Face ID должна осуществляться только и исключительно при помощи LocalAuthentication (использовать ARKit и прочие технологии запрещено). Для пользователей младше 13 лет следует предоставить альтернативный метод аутентификации.

3. ARKit допустимо применять только в том случае, если вы планируете подарить пользователям «богатый, интегрированный опыт взаимодействия с дополненной реальностью». Иными словами, парой моделей или анимаций тут не обойтись.

4. Внутри приложения допускается передача денежных средств от пользователя к пользователю, но только добровольно и в качестве подарка, а не в обмен на цифровой контент или услуги (в этом случае следует оформить транзакцию как IAP). Разработчик не имеет права забирать часть средств себе.

5. Продукты, в которых используются технологии типа ARKit, Camera API, Photo API для распознавания лиц, обязательно должны иметь пользовательское соглашение и запрашивать согласие на сбор данных. Полученную информацию нельзя использовать для целей, не оговоренных в соглашении.

6. Дискриминация по этническому признаку (наряду с полом, сексуальностью и религией) теперь тоже будет попадать под санкции.

7. В экстренных случаях (связанных, например, с торговлей людьми или насилием над детьми) Apple оставляет за собой право не просто удалить приложение, но и сообщить в соответствующие органы.

Если обобщить, изменения касаются прежде всего безопасности данных и некоторых этических моментов. Конечно, в зоне риска в первую очередь те, кто совсем потерял совесть, однако с таким обилием требований к сбору данных многие приложения могут не пройти модерацию. Кроме того, Apple очерчивает границы для свежеиспеченных технологий и также понемногу начинает закручивать гайки в отношении инструментария. В первую очередь имеет смысл пристально отслеживать будущие обновления текста тем, кто работает с ARKit, Face ID и прочими новинками — они, как видно из всего сказанного, сейчас на стадии активной кодификации.

Удачи и долгой жизни на маркете!

|

Метки: author nanton разработка под ios разработка мобильных приложений блог компании everyday tools apple app store ios публикация приложения |

CIS Benchmarks: лучшие практики, гайдлайны и рекомендации по информационной безопасности |

|

Метки: author LukaSafonov информационная безопасность блог компании pentestit cis benchmarks |

Blockchain стартап и Имбецилы. Можно ли не рождаться? |

Blockchain стартап и Имбецилы. Можно ли не рождаться?

Я, Сергей Иноземцев, живу в Санкт-Петербурге, мне 33 года, и я, в итоге, тоже делаю свой блокчейн-стартап.

Я сразу хочу всех предупредить, этот пост: не реклама моего проекта, и не вдохновенный рассказ полный надежд, планов, энтузиазма и заоблачных обещаний инвесторам. Это скорее, вольный текст по-поводу того что, в принципе, со мной происходит. Но поскольку это IT сообщество, я постараюсь придерживаться формата и соблюдать субординацию.

Сам проект пока живет на kickico, около месяца он еще будет на модерации.

В двух словах, это продюсерский центр и сообщество со своей криптовалютой, которая служит тому чтобы обеспечить финансирование производства дорогих художественных фильмов. Таких, например, которое снимает AnnapurnaPictures. Сообщество крипто-продюсеров.

Из презентации совсем не очевидна техническая часть. В действительности, я сам пока призрачно представляю что это в итоге будет. Пока я вижу саму блокчейн экосистему как множество клиентов в единой peer-to-peer сети, которая обслуживает и сверяет реестры по всем сделкам с криптовалютой, а также обменивается всем контентом произведенным силами сообщества. Все фильмы, независимо от того короткометражный это фильм, документальный или полный метр будет доступен всем клиентским приложениям в первый же день премьеры.

Агентство на самом первом этапе выступает как препродакшн студия и готовит тот или иной кино-проект к презентации крипто-инвесторам. В зависимости, от того какое количество смарт-контрактов будет заключено, определяется пропорция участия агентства и сообщества в финансировании производства картины.

Так же хочу пояснить что это не краудфандинг площадка, каждая картина ставит перед собой цель заработать в прокате, как минимум, удвоиться в сборах по отношению к бюджету, но я очень надеюсь что этим не ограничиться и у нас будут проекты которые оправдывали бы инвестиции в них в пять и более раз. Поэтому продюсеры действительно должны зарабатывать деньги с тех картин, в которые они вложились. Еще одно пояснение касается бюджета картин. Агентство должно работать с дорогими проектами, с бюджетом от 2-3М $ по полному метру. Все что ниже этого уже самиздат и в действительности для съемок такого кино агентство не нужно, нужна только харизма и немного удачи. Агенство будет проводить самостоятельную PR компанию по каждой картине и привлекать к участию в финансировании крупных крипто-инвесторов из blockchain мира.

Сам по себе, мир ICO для меня новый, и я более чем уверен в том, что я пока не понимаю многих важных вещей. По правде говоря, я всегда хотел просто снимать кино, но мир большого художественного кино еще более консервативный и неповоротливый чем наша (российская) стартап инфраструктура и поэтому я просто не вижу никакого иного выхода для себя, чем бросить вызов этой системе и построить независимое сообщество, с независимыми режиссерами и независимыми продюсерами, которые не участвуют не в каких политических играх, подковерной борьбе, не занимаются интригами, ан*низмом и прочими сопутствующими вещами. Они просто готовы работать над ритмичным, живым, острым, актуальным кино.

Так просто случилось что я не стал не супер хорошим программистом, не супер проницательным режиссером, но возможно в этом и есть моя роль: соединить одних с другими и в полной мере использовать сильные стороны этих двух, в действительности, очень близких по духу миров.

Я также не буду скрывать, что было бы замечательно с помощью этой публикации привлечь к участию в проекте сильных программистов. Это не первый мой проект и я прекрасно знаю как бывает когда начинаешь проект без денег, но на самом деле, немного денег есть уже сейчас и еще больше должно быть в ноябре сразу после pre-seed компании на kickico. Так что если кому-либо из вас интересно принять участие в разработке или хотя бы обсуждении архитектуры этой блокчейн сети, я приглашаю вас пройти этот путь вместе со мной.

Последнее, про харизму. Я отдаю себе отчет что такие проекты очень сильно зависят от итоговых картин. Должен быть некий пул своих картин, некие критерии ценности отбора проектов и общее видение фильмографии агентства. Стратегия фильмографии. И у меня эта стратегия есть. Моя личная мотивация снять как-минимум три больших картины. Я не знаю, насколько я крупный и зрелый художник, но одно могу сказать программирование научило меня тому чтобы относится к каждой своей инициативе как к версии, всегда будут ошибки и прощеты, но в мире it-разработки у нас есть шансы доработать свои проекты и предложить миру их новые версии. Версионность одно из тех ключевых свойств, которое прежде всего помогает избавиться от страхов и самокопания, от постоянной тревоги по-поводу своего профессионализма, своего таланта, своих возможностей. В фильме последнее затмение персонаж Леонардо дикаприо, французский поэт символист Артюр Рембо, заявил что хочет стать гением. Мне понравилась именно формулировка, это отношение к гениальности ни как к какому-то первородному статусу, а просто как к задаче. Задаче, которая предполагает интерес ко всем знаниям человечества без исключений и ко всем его проблемам. Это очень вдохновляющая цель, оставаться живым и продолжать проявлять интерес ко всему что происходит вокруг нас.

Осталось только развеять интригу по поводу заголовка. «Имбецилы», и «Можно ли не рождаться?», вместе с «Myxomatosis» это названия тех трех больших картин которые я хочу снять.

В этом посте я опубликую три синопсиса к этим картинам. Считайте, что это мой «White Paper».

Имбецилы. Синопсис.

Два друга. Один, юрист и профессиональный жена-ненавистник, второй, замкнутый и одинокий, но очень талантливый математик, случайно встречаются после долгого разлуки и самостоятельного “плавания”. Их разговор, который начинается как простое обсуждение положения вещей в современном российском кино, вскоре перерастает в намерение создать собственное продюсерское агентство, целью которого становится задача полностью изменить рынок киноиндустрии.

Исключительной особенностью агентства, помимо ставки на молодых и недооцененных режиссеров, становиться то что оба руководителя применяют ко всем аспектам работы агентства теорию игр, математический анализ, и прочую серьезную теоретическую математику, но что еще более необычно приглашают на ключевые позиции имбецилов (людей, с ограниченными возможностями).

Оба руководителя очень грамотно используют этих людей как в аналитической работе так и в продажах. Кроме того, основатель юрист также использует этих людей для оказания давления на бренды через суд, обвиняя бренд менеджеров в дискриминации и обеспечивая бюджет картинам с помощью выигранных судов.

Через некоторое агентство становиться невероятно успешным.

Однако, вскоре и сами руководители переживают некоторую переоценку ценностей, что в конечном счете сказывается на деятельности всего агентства.

Можно ли не рождаться? Синопсис.

Мужчина, 35 лет. Работает в страховой компании, в продажах. Доход зависит от сделок. Не женат. Ранее всеми силами пытался разбогатеть, но ничего с этим не вышло. Переживает острую депрессию. Совершает попытку самоубийства, о которой становиться известно его старшей сестре, единственному родному человеку. У сестры своя семья. После спасения сестра записывает его к психологу. Психолог выявляет что главная причина его депрессии в том, что тот хочет создать семью, но не считает себя в достаточной степени обустроенным для этого, вскрывает обиду на своего умершего отца. Дословно “Не хочет плодить нищету как ранее ее наплодил его отец”. Из-за чего мечется между преступлением и самоубийством. Психолог настраивает его на то что просто убивать себя было бы слишком легким решением, и что есть шанс много украсть и при этом не сесть, но нужно подготовиться, а также поправить свое здоровье и сознание так как на преступление нужно идти с холодной головой. Предлагает ему найти форму в которой он мог бы выплескивать свои мысли и убеждения в какой-то пограничной форме и идти на грани закона, постепенно ставя перед собой все более сложные задачи, а также начать принимать лекарства. Герой соглашается на эту стратегию, увольняется из страховой компании и устраивается в типографию на ночную печать, начинает изучать стрит-арт. Первое время делает совсем простые и неаккуратные работы, но со временем совершенствует свое мастерство. С ростом требований к себе растет и жажда во все более сложных и провокационных проектах. Начинает с метро и железной дороги. В течении трех следующих лет, герой проникает на закрытые территории, разрисовывает вагоны поездов и метрополитена, устраивает несанкционированную выставку своих работ на одной из станций метро, заменив холстами всю наружную рекламу на станции, позже разрисовывает автомобили на стоянках офисных клерков, портит витрины магазинов с манекенами, заливает краской один из центральных торговых комплексов, оставляет свои работы в городских музеях, в частных квартирах чиновников и коллекционеров живописи. Через некоторое время его никнейм и стиль становиться знаменит. За ним начинают охотиться журналисты, а также в отношении него возбуждается дело и по его стопам пускают следователя. Работы героя начинают продаваться на аукционах и через них у него появляются деньги (но не так много чтобы построить дом и завести семью). На эти деньги он готовит уже настоящее ограбление. В финале главный герой планирует украсть деньги у прокурора который покрывает мафию, занимающуюся угоном машин, но сестра и психолог помогают следователю поймать его раньше и осудить за вандализм. Шумиха суда делает его известным и общество признает его крупным художником. Сестра, психолог и следователь который встал на его сторону, играют в его жизни не последнюю роль.

Myxomatosis. Синопсис.

Парень, с некоторым бекграундом в IT, решается на незаконную деятельность, и устраивается на мойку простым мойщиком автомобилей. Мойка находится в самом престижном спальном районе Санкт-Петербурга и обслуживает богатых людей, с дорогими автомобилями. Юноша намерен взламывать автомобильные “мозги” и личные электронные устройства клиентов, прослушивать машины и таким образом собирать ценную информацию для будущих ограблений. Не исключено, что в определенных случаях, он не станет избегать и установки собственных устройств, жучков в машину. Но без опыта на мойке у него не получается удержаться на работе. Тем не менее, он уже все продумал и устраивает на нее своего друга. Теперь они действуют сообща. Пока второй герой пытается удержаться на работе, они знакомятся еще с одним парнем, опытным хакером. Общаются с ним только через почту. Втроем они собирают информацию о клиентах мойки в единую базу данных, а также экспериментируют со взломами информационных систем в городской среде, морально и технически готовятся к следующему шагу, создают более подробные досье на клиентов мойки, для того чтобы определить для себя первых потенциальных жертв. В это же время они знакомятся с управляющим мойки, девятнадцатилетним сыном миллиардера, собирающим раритетные автомобили и несколькими постоянными клиентами мойки, среди которых есть и агрессивный тип на машине марки Мазерати. В начале декабря, накануне новогодних праздников, они начинают прослушивать первые пять автомобилей и их владельцев.

В новогодние праздники, они решаются на первое преступление. В ходе слежки они выяснили, что одна из их жертв, девушка, которая встречается с состоятельным мужчиной ему изменяет. Они собирают на нее компромат и получают от нее первые деньги через шантаж. Примерный ущерб от операции 12м рублей.На эти деньги герои совершают некоторое покупки для себя, но, в основном, вкладываются в свою техническую инфраструктуру. Теперь они контролируют 10 жертв.

В их команде появляется еще двое человек, эксперт по угонам автомобилей и специалист по кражам денег с банковских карт, и аферам связанным с операциями в электронных деньгах.

Во второй раз они грабят цыган (или какую-либо иную организованную группу), для ограбления они взломали мозги машины, предустановили на них свой софт и спрятали в салоне балон с усыпляющим газом, отредактировали запись видеонаблюдения на мойке. Группу грабят на обратной дороге после сделки с партией наркотиков (контрабанды, оружия, медикаментов). На пустой дороге они удаленно перехватывают управление автомобилем, блокируют двери и стекла, блокируют ремни безопасности и усыпляют охрану газом. После ограбления они делают им уколы клофелином, чистят и убирают из машины все свое оборудование. Переустанавливают софт в машине. Ущерб от ограбления примерно 2М $.

Друг главного героя ставит жучки на ретро кары управляющего мойки, и взламывает софт машин вип клиентов мойки, из негласного закрытого клуба, снимают наблюдение со всех остальных клиентов мойки. Увольняется с мойки.

Далее, они ведут наблюдение только за управляющими и другими випами, среди которых есть и чувак на мазерати. И, однажды, во время наблюдения за ним, они становятся свидетелями того, как тот похищает в городе девушку, везет за город там избивает и бросает без сознания в прорубь, который вырубили для крещенского купания. Герой и его команда, не вмешиваясь в саму разборку, успевают спасти девушку и отвезти ее в больницу. Девушка выживает и за месяц приходит в себя.

Вскоре им удается поговорить с ней. Девушка рассказывает что она работала внутри холдинга и вела экономическое расследование против олигарха и его теневых доходов, которому в том числе принадлежит и эта мойка. Олигарх — отец того самого девятнадцатилетнего пацана, управляющего мойкой.

Следующие восемь месяцев группа главного героя ведет наблюдение за холдингом, получая все больший контроль за его информационной инфраструктурой. Снова в начале декабря, накануне новогодних праздников, герои проникают в тайный бункер холдинга и выкрадывают всю черную бухгалтерию.

Пропажа бухгалтерии пугает олигарха, он спешно собирает все свои деньги, прячет их у знакомого подкупленного высокопоставленного полицейского чиновника на квартире и готовиться сбежать из страны.

В последнем, самом крупном ограблении, герои обворовывают квартиру этого чиновника. Само ограбление чрезвычайно простое. Но сумма огромная.

Олигарх сбегает из страны, в прессе появляется информация о возбуждении уголовного дела на него. Его объявляют в федеральный розыск.

Фильм (возможно) заканчивается тем, что главные герои избивают на автостоянке владельца того самого Мазерати на глазах у пострадавшей ранее девушки.

Тайным хакером, который помогал группе главного героя оказывается специалист спец.служб, который все это время вел ребят и следил за ними.

С уважением, Сергей Иноземцев.

|

Метки: author joint функциональное программирование высокая производительность c++ #blockchain #indico #indiecaps |

Обзор одной российской RTOS, часть 6. Средства синхронизации потоков |

Обзор одной российской RTOS, часть 6. Средства синхронизации потоков

Начнём с банальности — если задач много, то они начнут впустую тратить процессорное время на исполнение в холостых циклах. Как уже отмечалось в предыдущих публикациях, все задачи, которым в настоящий момент нечего делать (не пришли данные от аппаратуры или по прочим организационным причинам) должны быть заблокированы. На исполнение следует ставить только те задачи, которым сейчас есть что делать, так как процессорных тактов микроконтроллерам вечно не хватает.

Далее, задачи могут конфликтовать друг с другом за те или иные ресурсы (в частности, за оборудование). При рассмотрении типов многозадачности, мы уже рассматривали типовые случаи конфликтов за порт SPI (частично решаемое переходом на кооперативную многозадачность, но на неё перейти можно не всегда).

И самый страшный случай — зависимость задач. Часто результат работы одной задачи используется в другой. Из очевидных примеров, можно упомянуть следующие: бесполезно пересчитывать данные для выхода PID регулятора температуры, пока не получено и не усреднено достаточно данных с термодатчика, нет смысла менять воздействие на скорость двигателя, пока не получены сведения о текущем периоде его вращения, незачем обрабатывать строку символов с терминала, пока не получено терминирующего символа (признака конца строки). А кроме очевидных, есть масса неочевидных случаев зависимостей и порождаемых ими гонок. Иногда у начинающего разработчика больше времени уходит именно на борьбу с гонками, чем непосредственно на реализацию алгоритмов работы программы.

Во всех этих случаях, на помощь разработчику приходят синхронизирующие объекты. Давайте в текущей публикации рассмотрим, какие синхронизирующие объекты и функции имеются в ОСРВ МАКС.

Для тех, кто ещё не видел предыдущие части, ссылки:

Часть 1. Общие сведения

Часть 2. Ядро ОСРВ МАКС

Часть 3. Структура простейшей программы

Часть 4. Полезная теория

Часть 5. Первое приложение

Часть 6. Средства синхронизации потоков (настоящая статья)

Часть 7. Средства обмена данными между задачами

Часть 8. Работа с прерываниями

Критическая секция

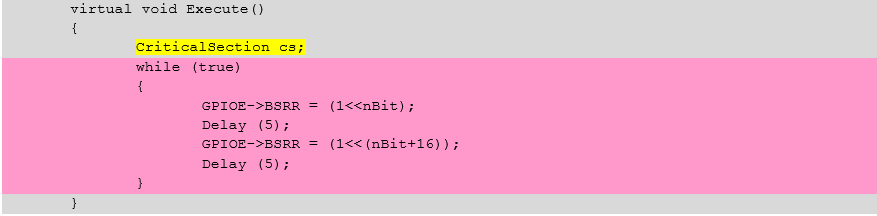

Для разминки, рассмотрим класс CriticalSection. Он применяется для обрамления участков, на которых недопустимо переключение контекста.

Как только объект класса появляется в области видимости, блокируются все прерывания с приоритетом MAX_SYSCALL_INTERRUPT_PRIORITY или ниже. На сегодня эта константа равна пяти, что блокирует все прерывания от устройств и от системного таймера, но не блокирует исключительные ситуации.

Когда объект выходит из области видимости, уровень прерываний восстанавливается такой, какой был до входа. Последнее позволяет не заботиться о том, что получатся вложенные критические секции — реально сработает только первая. Все, кроме внешней — будут выполнять ненужную работу. Сначала заменять высокий уровень разрешённых прерываний на него же самого, а при выходе — восстанавливать исходный — всё тот же исходно высокий. Выход же из самой внешней из вложенных критических секций, восстановит низкий уровень. Само собой, вложенность чаще всего получается, когда вызвана какая-то функция, в которой также есть критическая секция.

Так как критическая секция изменяет приоритеты прерываний, то есть, программирует NVIC, она должна использоваться только в коде, работающем в привилегированном режиме.

Рассмотрим пример (участок, выделенный розовым, защищён критической секцией, здесь гарантируется, что управление у задачи не будет забрано)

void ProfEye::Tune()

{

ProfData::m_empty_call_overhead = 0;

ProfData::m_empty_constr_overhead = 0;

ProfData::m_embrace_overhead = 0;

CriticalSection _cs_;

loop ( int, i, 1000 ) {

PROF_DECL(PE_EMPTY_CALL, empty_call);

PROF_START(empty_call);

PROF_STOP(empty_call);

{ PROF_EYE(PE_EMBRACE, _embrace_);

{ PROF_EYE(PE_EMPTY_CONSTR, _empty_constr_);

}

}

}

ProfData::m_empty_call_overhead = prof_data[PE_EMPTY_CALL].TimeAvg();

ProfData::m_empty_constr_overhead = prof_data[PE_EMPTY_CONSTR].TimeAvg();

ProfData::m_embrace_overhead = prof_data[PE_EMBRACE].TimeAvg() + ProfData::ADJUSTMENT - 2 * ProfData::m_empty_constr_overhead;

}

Разумеется, область видимости объекта всегда можно ограничить фигурными скобками.

ProfEye::ProfEye(PROF_EYE eye, bool run)

{

m_eye = eye;

m_lost = 0;

m_run = false;

if ( run ) {

{ CriticalSection _cs_;

prof_data[m_eye].Lock(true);

m_up_eye = m_cur_eye;

m_cur_eye = this;

}

Start();

} else

m_up_eye = nullptr;

}

Что подлежит включению в критическую секцию? Ну, например, операции, где требуется атомарно изменить несколько переменных (пример выше как раз и занимается этим). Различные списки и прочие вещи, где одна задача читает, а вторая — пишет, вполне могут требовать атомарного доступа.

Но существуют и менее очевидные вещи. Пусть имеется некий счётчик, который в одной задаче увеличивается, а в другой — уменьшается. Казалось бы, вполне себе атомарная операция

cnt++;

Но атомарная она на уровне языка высокого уровня. На уровне ассемблера, она распадается на операции чтение-модификация-запись

26: cnt++;

0x08004818 6B60 LDR r0,[r4,#0x34]

0x0800481A 1C40 ADDS r0,r0,#1

0x0800481C 6360 STR r0,[r4,#0x34]

Допустим, значение (для верности, скажем 10) уже попало в регистр r0, после чего планировщик передаст управление другой задаче. Она также считает значение 10 и уменьшит его, положив 9. Затем, когда управление вернётся текущей задаче, она прибавит единицу не к переменной, а к тому, что уже попало в регистр r0 — к десятке. Получится 11. Значение счётчика окажется искажено.

Вот как раз для защиты от таких ситуаций, вполне подойдёт критическая секция.

{

CriticalSection cs;

cnt++

}

Хотя, конечно, накладные расходы на работу с NVIC также следует держать в уме, так как получится не три, а намного больше команд ассемблера

27: CriticalSection cs;

0x0800481A 4668 MOV r0,sp

0x0800481C F7FEFCE8 BL.W _ZN4maks15CriticalSectionC2Ev (0x080031F0)

28: cnt++;

0x08004820 6B60 LDR r0,[r4,#0x34]

0x08004822 1C40 ADDS r0,r0,#1

29: }

0x08004824 6360 STR r0,[r4,#0x34]

0x08004826 4668 MOV r0,sp

0x08004828 F7FEFDA0 BL.W _ZN4maks19InterruptMaskSetterD2Ev (0x0800336C)

Это не считая содержимого системных подпрограмм… Приведём только первую, чтобы читатель представлял её сложность

0x080031F0 B510 PUSH {r4,lr}

0x080031F2 2150 MOVS r1,#0x50

0x080031F4 F000F8AE BL.W _ZN4maks19InterruptMaskSetterC2Ej (0x08003354)

0x080031F8 4901 LDR r1,[pc,#4] ; @0x08003200

0x080031FA 6001 STR r1,[r0,#0x00]

0x080031FC BD10 POP {r4,pc}

Как видно — это ещё не максимальная вложенность… С другой стороны, это — всё равно меньшее из зол. Просто не стоит увлекаться частыми входами и выходами из критической секции.

Критическая секция — очень мощный, но потенциально опасный инструмент, ведь пока она не выйдет из области видимости — многозадачность отключается. В идеале, блокировку следует выполнять только на несколько строк. Наличие цикла может существенно увеличить время задержки, вход в функции — и подавно (если программист слабо представляет себе время нахождения в этих функциях), а уж работа с некоторыми видами оборудования — совсем потенциально опасная вещь. Пусть программист решил гарантировать себе отсутствие переключения контекста на время передачи двух байтов по шине SPI с частотой 10 МГц. Один бит имеет период 100 нс. 16 бит — 1,6 мкс. Это вполне приемлемый результат. Следующая задача потеряет не более этого участка (в целом, это сопоставимо со временем работы планировщика). Но если передавать по UART строку из 20 символов на скорости 250 килобит в секунду, то это займёт уже 20 * 10 * 4 мкс = 0.8 мс. То есть, начнись процесс ближе к концу кванта времени задачи, он «съест» почти весь квант следующей задачи.

В общем, механизм критических секций — достаточно мощный, но программист, использующий его, несёт всю ответственность за обеспечение работы системы в реальном времени.

Опять же, не стоит усыплять задачу, находящуюся в критической секции, пользуясь функциями, ждущими другие ресурсы.

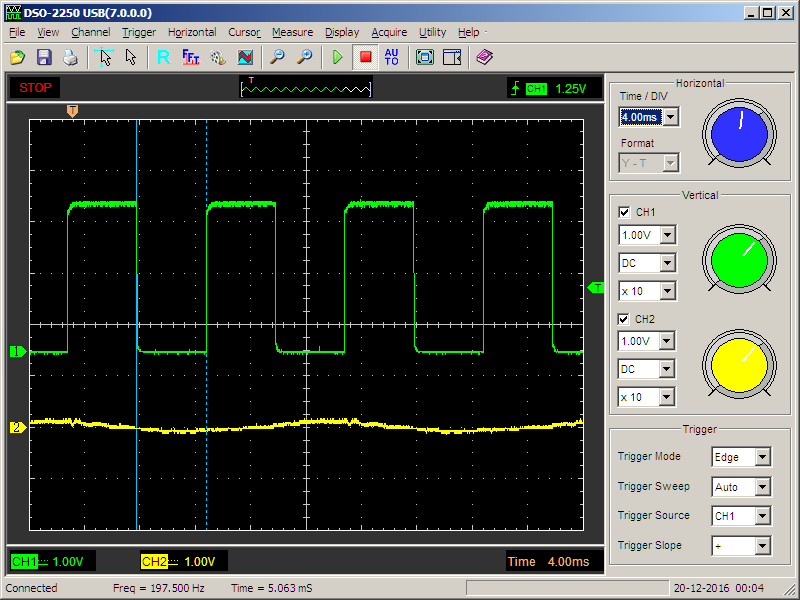

Рассмотрим простейший пример. Уже известная задача, изменяющая состояние порта, периодически вызывающая функцию задержки с блокировкой:

virtual void Execute()

{

while (true)

{

GPIOE->BSRR = (1<BSRR = (1<<(nBit+16));

Delay (5);

}

}

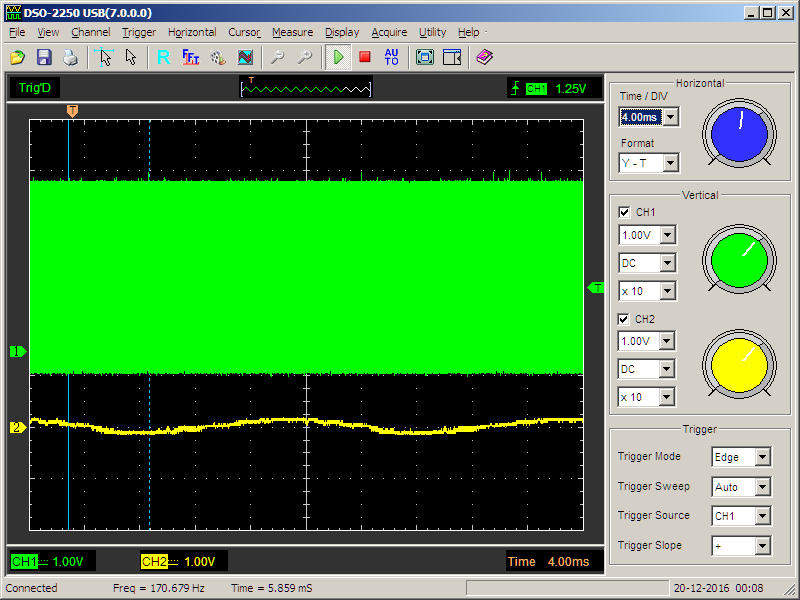

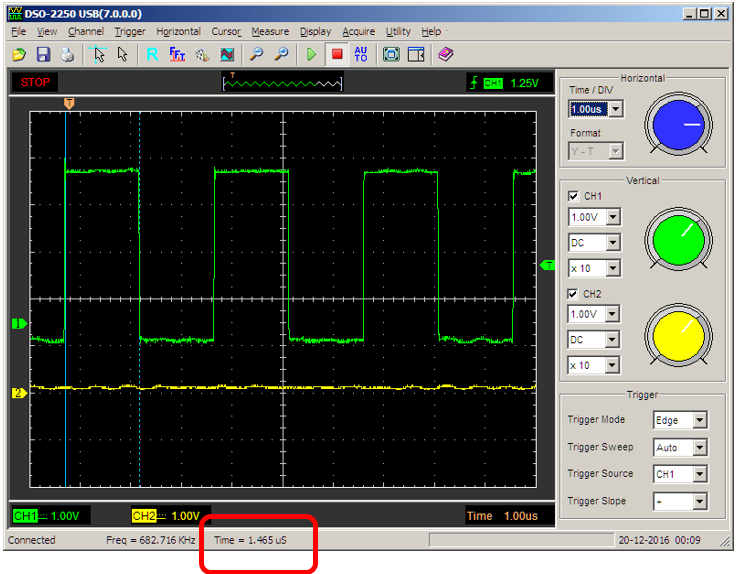

Даёт нормальный меандр:

Добавляем критическую секцию

virtual void Execute()

{

CriticalSection cs;

while (true)

{

GPIOE->BSRR = (1<BSRR = (1<<(nBit+16));

Delay (5);

}

}

Получаем совершенно иной сигнал

Увеличиваем масштаб — период сигнала совершенно неверен…

В общем, критическая секция — мощное средство, но пользоваться им следует только, отдавая себе отчёт в своих действиях (или, хотя бы, контролируя каждый свой шаг).

Как-то затянулась разминка. Простейшая вещь растеклась на кучу листов. Что ж, переходим к чуть более сложной по логике, но зато требующей меньше текста, вещи — двоичному семафору.

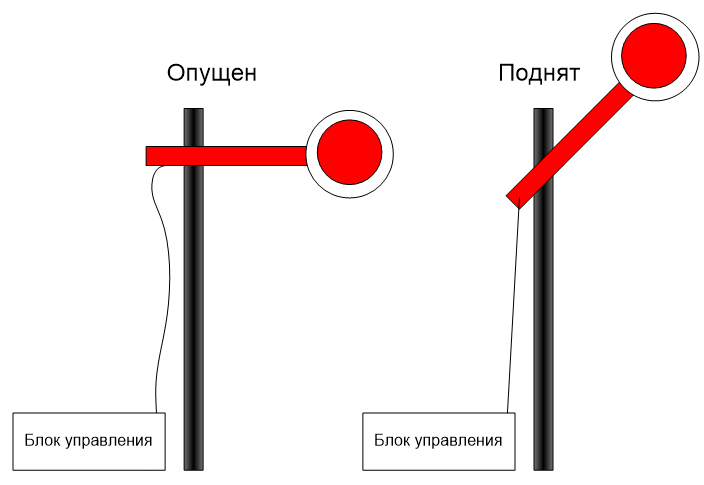

Двоичный Семафор

Давным-давно, на железной дороге активно использовались семафоры. Они имели два состояния: поднят — поезд может двигаться. Опущен — поезд должен ждать. Ну, а поднимал и опускал его диспетчер. Вот и здесь, какая-то задача (или задачи) дёргает за верёвочку (выполняя роль диспетчера), а какая-то задача (или задачи) — ждут, когда путь будет открыт. При этом, ожидающие задачи заблокированы, то есть — не расходуют кванты времени.

Такой семафор реализуется классом BinarySemaphore.

Конструктор класса содержит обязательный аргумент, задающий начальное состояние семафора

explicit BinarySemaphore(bool is_empty = true)

Дальше мы рассмотрим только функции двоичного семафора (дело в том, что он является наследником простого семафора, и всю его функциональность мы рассмотрим ниже).

Задачи, которым следует пройти через семафор, должны вызвать функцию Wait(). Аргументом этой функции является время таймаута в миллисекундах. Если за заданное время задача была разблокирована, функция вернёт значение ResultOk. Соответственно, если наступил таймаут, результат функции будет равен ResultTimeout. Когда функция должна ждать «до упора», следует передать значение таймаута, равное INFINITE_TIMEOUT.

Если функция вызывается с нулевым значением таймаута, то она вернёт управление мгновенно, но по результату (ResultOk или ResultTimeout) будет ясно, был семафор открыт или закрыт.

При вызове из прерывания, блокировка задачи невозможна, поэтому с любым таймаутом, отличным от нуля, результат функции будет равен ResultErrorInterruptNotSupported. Однако, с нулевым таймаутом функцию можно вызывать и из прерывания.

Если функция вернула результат ResultOk, семафор автоматически закроется.

Как уже отмечалось, ждать семафора может сразу несколько задач. В этом случае, выбор «счастливчика», которого пропустят первым, будет осуществляться следующим образом: Задачи в списке ожидания следуют в порядке уменьшения приоритета, а при одинаковом приоритете — в порядке вызова функции Wait().

Для того, чтобы открыть семафор, используется функция Signal(). Если семафор уже открыт, она вернёт результат ResultErrorInvalidState, иначе — ResultOk. Функция не может вызываться из прерывания с приоритетом выше, чем MAX_SYSCALL_INTERRUPT_PRIORITY.

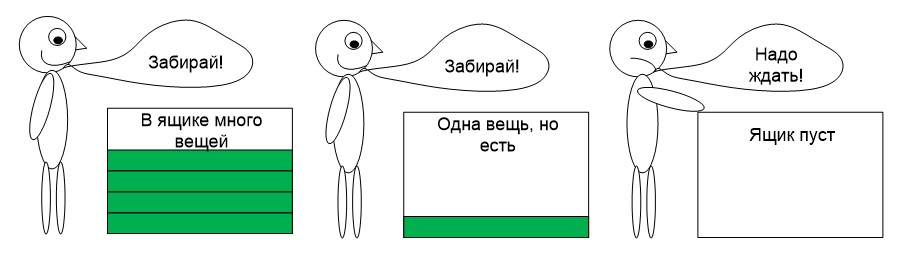

Семафор

Честно говоря, мне категорически не нравится это название. Правильнее было бы назвать этот объект синхронизации «Завхоз», но против традиций не попрёшь. Везде он называется семафором, ОСРВ МАКС не является исключением. Отличие простого семафора (или завхоза) от двоичного состоит в том, что он может считать (класть ресурсы на склад). Есть хотя бы один ресурс — задача может проходить (при этом число ресурсов уменьшается). Нет ресурсов — задача будет ждать появления хотя бы одного.

Такие семафоры пригождаются, когда необходимо распределять какие-либо ресурсы. Я, например, заводил 4 буфера для выдачи данных в USB (эта шина работает не с байтами, а с массивами байтов, поэтому удобнее всего готовить данные именно в буферах). Соответственно, рабочая задача может определить, есть ли свободные буфера. Если есть — заполнить их. Нет — ждать, пока, работающий с USB перешлёт и освободит хотя бы один. В общем, если где-то выделяется не один, а несколько ресурсов — их распределение удобнее всего поручить завхозу (или, согласно традиционному именованию — семафору).

Соответственно, этот объект реализуется в классе Semaphore. Рассмотрим его отличие от двоичного семафора. Во-первых, у него чуть иной конструктор

Semaphore(size_t start_count, size_t max_count)

Первый параметр — сколько вещей исходно положить в ящик, второй — какова размерность этого ящика. Иногда полезно при начале работы объявить полное отсутствие ресурсов, а затем — добавлять их (вызывая, как мы помним, функцию Signal()). Иногда — наоборот, исходно ресурсы загружены по максимуму, а дальше — они расходуются. Возможны и иные варианты с неполной начальной загрузкой, но это уже читатели сами придумают, когда такое нужно.

Функция Signal(), соответственно, увеличивает счётчик ресурсов. Если он дошёл до максимума — она вернёт ResultErrorInvalidState. Ещё раз напомним, что функция не может вызываться из прерываний с приоритетом выше, чем MAX_SYSCALL_INTERRUPT_PRIORITY.

Функция Wait() пропустит задачу, если число ресурсов не равно нулю, при этом, уменьшив счётчик. А если ресурсов нет — задача будет заблокирована, пока их не вернут через функцию Signal(). Ещё раз напомним, что из прерывания эту функцию можно вызывать только с нулевым таймаутом.

Теперь рассмотрим функции, которые не имели смысла в двоичном случае.

GetCurrentCount() вернёт текущее значение счётчика ресурсов

GetMaxCount() вернёт максимально возможное значение счётчика (если семафор создавала другая задача — может быть полезно, чтобы определиться с его характеристиками)

Мьютекс

Название этого объекта произошло от слов Mutualy Exclusive. То есть, с его помощью система предоставляет взаимоисключающий доступ к одному ресурсу. Если в семафорах одни задачи ожидали разршения, а другие — открывали семафор, то в этом случае — все пытаются ресурс захватить, а предоставляет его сама система.

Коротко суть мьютекса можно пояснить фразой «Кто первый встал — того и тапки». Есть защищаемый объект — «тапки». Муж проснулся, запросил их — система отдала их ему в безраздельное пользование. Жена и сын запросили — их заблокировали. Как только муж вернул тапки в систему — их получила жена. Вернула она — получил сын. Вернул он — объект перешёл в свободное состояние, следующий запросивший, получит их снова без ожидания.

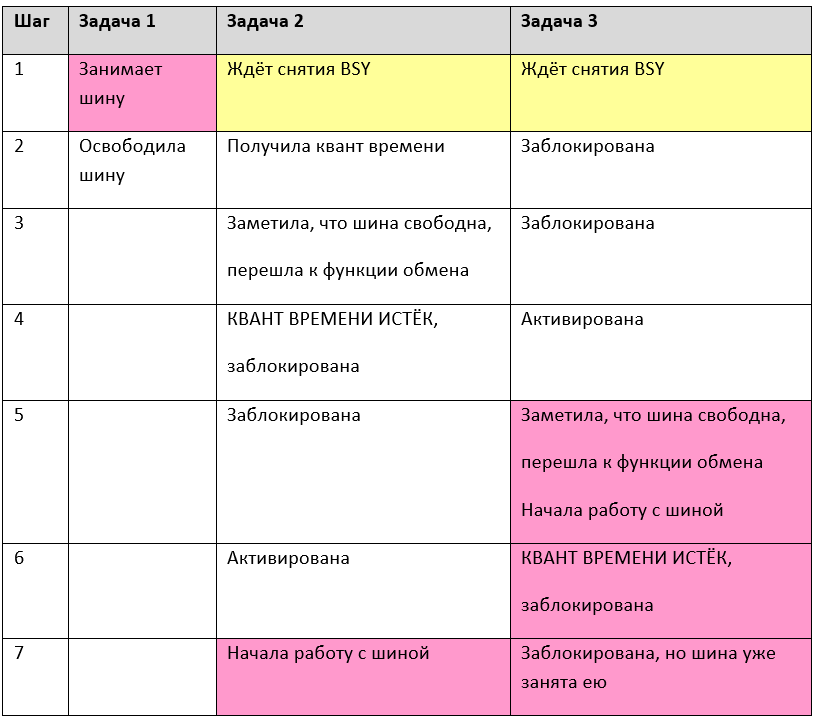

В микроконтроллерах замечательным ресурсом, который надо защищать таким способом, является порт (SPI, I2C и т.п.), если через него пытается работать несколько задач. Мы уже рассматривали, что к одному физическому каналу может быть подключено несколько разнородных устройств, например, в классическом телевизоре: на одной шине I2C могут быть видеопроцессор, аудиопроцессор, процессор телетекста, тюнер — они вполне могут обслуживаться разными задачами. Зачем тратить процессорное время, ожидая сброса бита BSY? Тем более, что всё равно, возможны коллизии. Рассмотрим работу трёх задач, исключительно анализирующих бит BSY порта, исполняя их по шагам:

Как видно, на шаге 7 сразу две задачи пытаются управлять шиной. Если бы та была защищена мьютексом, этого бы не произошло. Кроме того, на условном шаге 1 (на самом деле, это масса шагов, где заблокирована то задача 2, то задача 3) задачи впустую тратили кванты времени. Мьютекс решает и эту проблему — все ждущие задачи блокируются.

Иногда может получиться так, что разработчик слишком увлёкся мьютексами, и задача может захватить мьютекс несколько раз. Разумеется, скорее всего, это будет происходить во вложенных функциях. Функция 1 захватывает мьютекс, потом управление передаётся в функцию 2, оттуда — в функцию 3, оттуда — в функцию 4 (написанную год назад), которая также пытается захватить этот же мьютекс. Чтобы не возникло блокировки, в таких случаях следует создавать рекурсивные мьютексы. Одна задача сможет их захватывать многократно. Важно лишь освободить столько же раз, сколько он был захвачен. В ОС Windows все мьютексы являются рекурсивными, но такой подход на слабых микроконтроллерах привёл бы к неоправданному расходованию ресурсов, поэтому по умолчанию, в ОСРВ МАКС мьютексы рекурсивными не являются.

Рассмотрим основные функции класса Mutex. В первую очередь — его конструктор

Mutex(boolrecursive = false);

Аргумент конструктора определяет тип — рекурсивный или нет.

Функция Lock() захватывает мьютекс. В качестве аргумента передаётся значение таймаута. Как всегда, можно задать особые значения — нулевой таймаут (мгновенный выход без ожидания) или значение INFINITE_TIMEOUT (ждать до победы). Если мьютекс удалось захватить, будет возвращён результат ResultOk. При истечении таймаута, вернётся результат ResultTimeout. При попытке захвата нерекурсивного мьютекса, результат будет ResultErrorInvalidState. Мьютекс нельзя захватывать в прерывании. Если попытаться это сделать, результат будет ResultErrorInterruptNotSupported.

Функция Unlock() — освобождает мьютекс. Соответственно, она должна вызываться по окончании исполнения защищаемой секции.

Функция IsLocked() позволяет определить, захвачен мьютекс или свободен, не захватывая его. При вытесняющей многозадачности результат может потерять актуальность ещё до того, как будет проанализирован, но при кооперативной многозадачности, эта функция вполне может пригодиться.

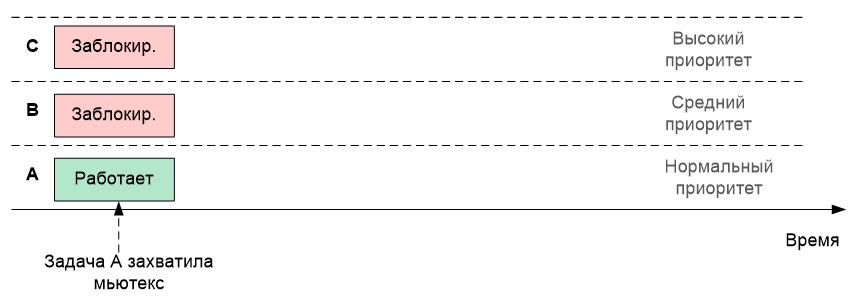

Теперь стоит рассказать про такую вещь, как наследование приоритетов. Допустим, в системе имеются задачи A с нормальным приоритетом, B с повышенным приоритетом и C с высоким приоритетом. Предположим, что задачи B и C были заблокированы, а A в это время успела захватить мьютекс. Нарисуем это графически, расположив задачи друг над другом (чем выше приоритет, тем выше задача на рисунке)

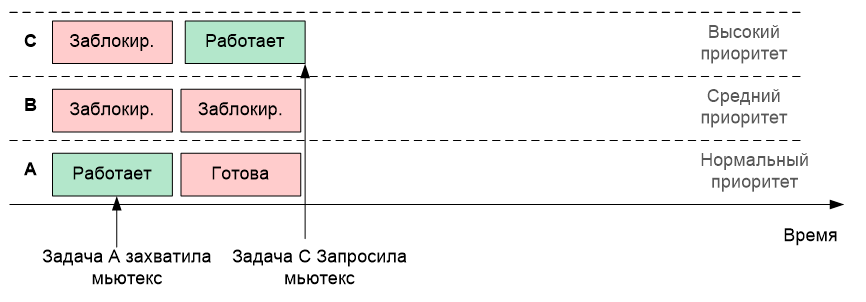

Теперь задача C разблокировалась. Само собой, имея наивысший приоритет, она начала исполняться. И допустим, она тоже собирается захватить тот же самый мьютекс

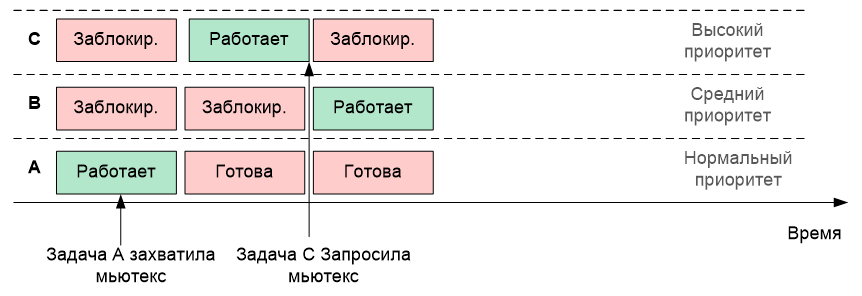

Но мьютекс находится во владении задачи A! По штатной логике, раз он занят, задача C блокируется до его освобождения. И вдруг неожиданно разблокировалась задача B (пусть она ждала какой-то другой ресурс, и тот освободился). Так как её приоритет выше, чем у A, то исполняться будет именно она (то есть, задача B)

Что мы имеем? Высокоприоритетная задача C не может исполняться, так как она ждёт освобождения мьютекса. А дождаться она не может, так как его текущий владелец вытеснен более высокоприоритетной задачей относительно владельца мьютекса, но более низкоприоритетной — относительно несправедливо заблокированной задачи.

Чтобы этого не произошло, владельцу мьютекса на время владения назначается приоритет самой высокой задачи из тех, что сейчас его ожидают. Такой механизм (наследрвание приоритетов) позволяет приблизить момент освобождения мьютекса.

Этот факт крайнее важно помнить, так как если задача A взаимодействует также с какой-либо задачей E, также имеющей нормальный приоритет, на время наследования приоритета, она это взаимодействие утеряет. Увы, с этим ничего сделать невозможно (в рамках стандартной концепции ОСРВ), это следует просто учитывать при проектировании программ.

Мьютекс-страж

Классическое алгоритмическое программирование подразумевает один вход и один выход в любой алгоритм. Однако, практика такова, что фанатичное обеспечение этого принципа приводит к неоправданному усложнению текста и снижению читаемости. Давайте рассмотрим следующий псевдокод:

m_mutex.Lock();

switch (cond)

{

case 0x00:

....

return ResultCode1;

case 0x02:

....

return ResultCode2;

case 0x0a:

....

return ResultCode3;

case 0x15:

....

return ResultCode4;

}

....

m_mutex.Unlock();

Вообще-то, здесь перед каждым выходом из функции, следует методично расставить mutex.Unlock(). А таких участков в большом алгоритме может быть много. И они могут добавляться. Рано или поздно, программист где-нибудь забудет разблокировать мьютекс, и программа «зависнет». И это — при том, что человечество ночей не спало, изобретало ООП в целом и деструкторы классов в частности!

Мьютиекс-страж как раз занимается тем, что использует деструкторы. У этого класса в интерфейсной части нет ничего, кроме конструктора. Скопируем его описание из Руководства Программиста:

explicit MutexGuard(Mutex& mutex, bool only_unlock = false);

Аргументы:

- mutex – ссылка на мьютекс;

- only_unlock–если значение – истина, захват мьютекса в конструкторе не производится. Подразумевается, что мьютекс уже был захвачен ранее явным вызовом метода Lock().

В конструктор следует передать мьютекс. Он будет захвачен. А отпущен он будет в тот момент, когда мьютекс-страж выйдет из области видимости. Таким образом, предыдущий пример следует переписать примерно так:

{

MutexGuard (m_mutex);

switch (cond)

{

case 0x00:

....

return ResultCode1;

case 0x02:

....

return ResultCode2;

case 0x0a:

....

return ResultCode3;

case 0x15:

....

return ResultCode4;

}

....

}

Событие

Семафоры и мьютексы обычно используются для того, чтобы исключить конкуренцию задач при использовании тех или иных ресурсов, но иногда просто следует заблокировать задачу до тех пор, пока не возникнет какое-либо условие для её разблокировки. Типовой сценарий – произошло прерывание и функция-обработчик сигнализирует высокоприоритетной задаче отложенной обработки, что следует пробудиться и выполнить какие-то действия. События позволяют реализовать данный механизм.

После прочтения предыдущего абзаца, может показаться, что событие просто дублирует семафор. Но это не так. Давайте рассмотрим отличия.

Первое отличие: Событие воздействует только на того, кто его ждёт. Если в текущий момент у события нет получателя — оно уйдёт в никуда. Если через мгновение после возникновения события, кто-то начнёт ждать его — он окажется заблокирован. Разблокировка произойдёт только по следующему событию. Кто не успел — тот опоздал. Как мы помним, семафор же наоборот, ждал его кто-то или нет — всё равно откроется. И первый, кто будет проходить мимо семафора, будет пропущен.

Второе отличие — если открытия семафора ждёт несколько задач, то разблокирована будет только одна из них. Остальные будут ждать следующего открытия. Событие же можно настроить на режим, когда оно разблокирует всех, кто ждал его возникновения. То есть, все ждущие задачи будут переведены из состояния «Заблокирована» кто-то в состояние «Активна», а самая везучая задача — в состояние «Исполняется».

В остальном — логика событий напоминает логику работы двоичного семафора.

Конструктор класса:

Event(bool broadcast = true);

Параметр broadcast задает правило, по которому информируются получатели, ждущие возникновения события. true– будут разблокированы все задачи, ожидающие его, false–будет разблокирована только одна задача, которая находится первой в очереди ожидающих этого события.

Функция Raise() посылает событие. Не может быть вызван из прерывания, с приоритетом выше, чем MAX_SYSCALL_INTERRUPT_PRIORITY.

Функция Wait() уже знакома нам по одноимённым функциям ранее рассмотренных синхронизирующих объектов. Точно так же имеет аргумент таймаута. Точно так же таймаут может быть равен нулю, либо INFINITE_TIMEOUT. Эту функцию нельзя вызывать из прерываний.

Примеры работы с синхронизирующими объектами

К сожалению, невозможно сделать простые и красивые примеры, где применяются синхронизирующие объекты. Всё простое выльется в демонстрацию примеров вызова функций. Практически применимые же вещи займут слишком большой объём. Описывать их придётся долго, а читатель потеряет нить на второй странице, и двадцать восемь остальных останутся ни разу никем не прочитанными. Поэтому я пока воздержится от написания такого труда.

В запланированной третьей части должно будет появиться описание адаптации большой программы для станка с ЧПУ, оставим примеры для неё. А для тех, кто жаждет практики, я могу порекомендовать модульные тесты для ОС. Они размещаются в каталоге ...\maksRTOS\Source\Tests\Unit tests. Вот перечень каталогов, размещённых там:

BinarySemaphore

Event

MessageQueue

Mutex

MutexGuard

Scheduler

Semaphore

Лучшие практические примеры сложно придумать. Приятного изучения (правда, есть мнение, что редкий читатель дойдёт до конца первой четверти тестов).

|

Метки: author EasyLy программирование микроконтроллеров осрв макс rtos |

Национальный роуминг в разных странах мира |

Национальный роуминг в разных странах мира

Мы узнали, как обстоят дела с национальным роумингом в других странах, и собираются ли они что-то менять.

Евросоюз

В июне 2017 года отменили внутренний роуминг для всех клиентов европейских сотовых операторов. До этого эпохального момента цены неуклонно падали – в 2007 году был принят закон о снижении тарифов на 60%, и планы о полной отмене дополнительных плат за сотовую связь внутри ЕС неоднократно обсуждались. Сейчас единые цены на услуги связи – смс, звонки и интернет действуют не только на территории 28 стран материка, но и в Великобритании, Лихтенштейне, Норвегии и Исландии.

Но если оператор может доказать, что сильно теряет в доходах из-за отмены роуминга, то он имеет право начислить дополнительную комиссию к своим остальным услугам.

Сотовые операторы Финляндии, Литвы, Эстонии и Словакии воспользовались этим шансом, чтобы удержать цены на прежнем уровне. Что касается интернета, то полный безлимит отсутствует, а плата за передачу данных зависит от выбранного пакета услуг и страны. Учитывая то, что даже самый дешевый тариф в три раза дороже среднего российского, новая система — лишняя головная боль для россиян, путешествующих по Евросоюзу: перед поездкой придется промониторить предложения от операторов разных стран, чтобы найти самый выгодный для себя. Например, с итальянской SIM-карты звонить намного дешевле, чем с немецкой.

США

Дополнительная плата за общение между штатами не взимается – казалось бы, можно смело приобретать SIM-карту и общаться. Но активно распространен межсетевой роуминг: в стране жесткая конкуренция, на рынке более 70 операторов связи, но ни один из них не имеет национального покрытия. Его качество разнится в зависимости от штата: отличный прием связи на атлантическом побережье, на тихоокеанском – только в Калифорнии и в Вашингтоне, а в центральной части страны хорошая связь только в крупных городах.

При этом цены у различных операторов примерно одинаковые и за мобильную связь придется выложить не менее 30 долларов в месяц — это примерно 1800 рублей.

За внутрисетевой роуминг платить не приходится, но операторы отыгрываются на межсетевых звонках и мобильном интернете: например, T-Mobile не позволяет бесплатно передавать больше 50 Мб данных. И входящие звонки далеко не всегда бесплатны.

Канада

В Канаде самые дорогие услуги мобильной связи в Северной Америке – пакет с голосовой связью, SMS и 3 Гб интернета обойдется в 40 канадских доллар ов — примерно 1900 рублей). При этом операторы предлагают широкий выбор SIM-карт и тарифов на звонки и мобильный интернет. Внутренний роуминг в стране отменили в 2014 году.

Индия

Индия – страна с самой быстрорастущей телефонной сетью в мире, которая сейчас насчитывает почти миллиард клиентов. Последние два года рынок связи содрогается от консолидации и объединения самых крупных игроков.

В каждом индийском штате действуют разные ценовые предложения, и качество покрытия тоже отличается. Операторы Airtel и Idea отменили внутренние роуминговые тарифы с апреля 2017 года, а Jio, наоборот, славится своими высокими ценами.

Все местные SIM-карты действуют на территории Индии, за исключением спорной территории Джамму и Кашмир. Там действуют только SIM-карты, купленные в пределах этого штата по предоплате. По ним можно только звонить, нельзя отправлять текстовые сообщения и пользоваться интернетом. В других регионах страны эти карты не работают. Такое ограничение связано с угрозой терроризма, и недавно индийские власти продлили его на 2018 год.

Китай

Сегодня в Китае плата за внутренний роуминг есть, но, как заявляет Госсовет КНР, ради «развития национальных интернет-технологий» в республике вскоре откажутся от дополнительных поборов клиентов, которые находятся в разных провинциях, плюс будут отменены повышенные тарифы на интернет.

Три крупнейших китайских сотовых оператора: China Unicom, Сhina Mobile и China Telecom собираются отменить роуминг уже в октябре этого года и запустить сети 5G в тестовом режиме.

Выводы однозначные: почти во всех крупных странах внутренний роуминг как услуга отсутствует, а маленьким он просто не нужен из-за скромной площади. Но везде операторы по-разному решают проблему компенсации расходов за эту услугу: рост среднего ценника, абонентская плата, лимитный интернет и завышенные цены на внешний роуминг.

|

Метки: author Yota4All читальный зал блог компании yota национальный роуминг цены на мобильную связь связь за границей мобильные операторы |

Как сделать gif-анимацию для Behance и Dribbble? |

Как сделать gif-анимацию для Behance и Dribbble?

Дизайнерам бывает сложно переводить анимированный ролик в gif и подстраиваться под ограничения анимации для Behance и Dribbble.

Есть много статей о том, как быстро сделать анимацию в Principle, Flinto и других редакторах, но нет ничего о том, как её готовить конкретно для Behance и Dribbble.

Мы протаптывали эту тропинку сами и поняли, какой способ для нас оптимальный. Статья будет полезна тем, кто ещё не разобрался.

Ограничения

Рассмотрим, какие требования предъявляют эти площадки.

Dribbble

Только gif-анимация, разрешение – 800 x 600. Размер – до 8 мб.

Behance

Gif-анимация / Embed-видео / Видео на хостинге Adobe. 50 мб для gif/картинок и 1 гб для видео/аудио. Максимальное разрешение для gif – 1400, для видео – 1200 в ширину.

Подробнее о подготовке анимации

Dribbble

Для формата шота плохо подходят длинные ролики. Лучше всего показывать короткий зацикленный фрагмент.

Наш воркфлоу такой:

- Делаем анимацию в Principle/Flinto/Framer и других.

- Решаем, как будет выглядеть шот, и оформляем его в мокап устройства или как-либо ещё. Обычно этот шаг мы делаем в After Effects, потому что там это сделать легче, чем в других программах.

Чтобы видео весило немного и было качественным, нужно выбрать видеокодек H.264 для Mac (H.265, когда его можно будет использовать) и jpeg для Windows.

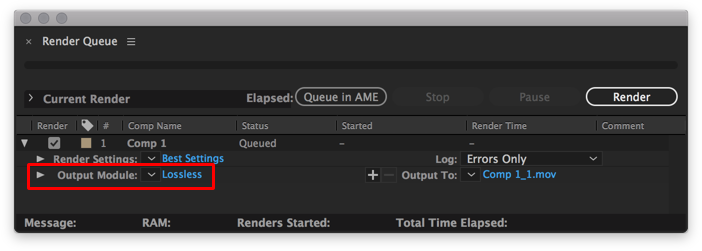

Как выбрать кодек при рендере в After Effects

Путь до выбора кодека: Output Module / Format Options / Video Codec

- Полученный файл mov. переводим gif и оптимизируем, если он выходит за рамки 8 мб.

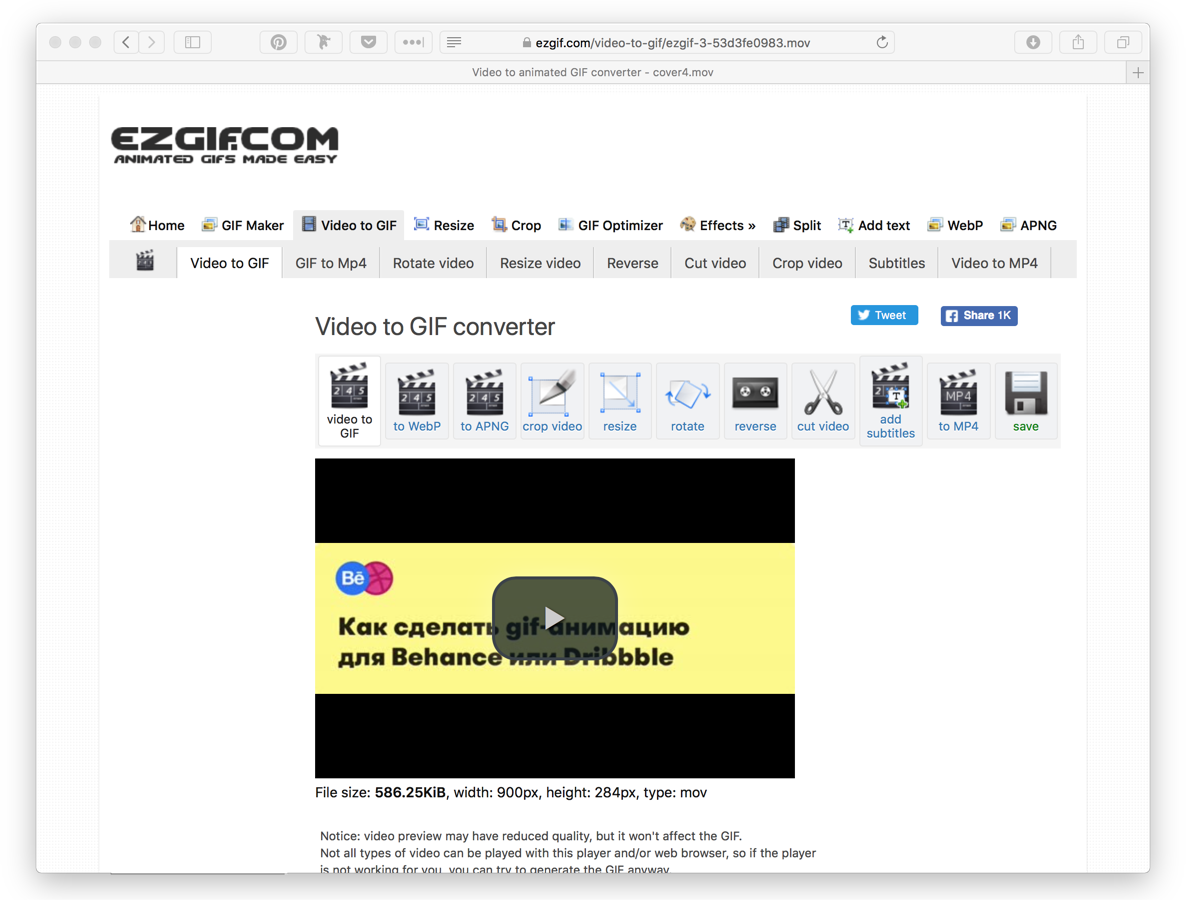

Проще всего переводить видео маленького размера в gif с помощью ezgif.

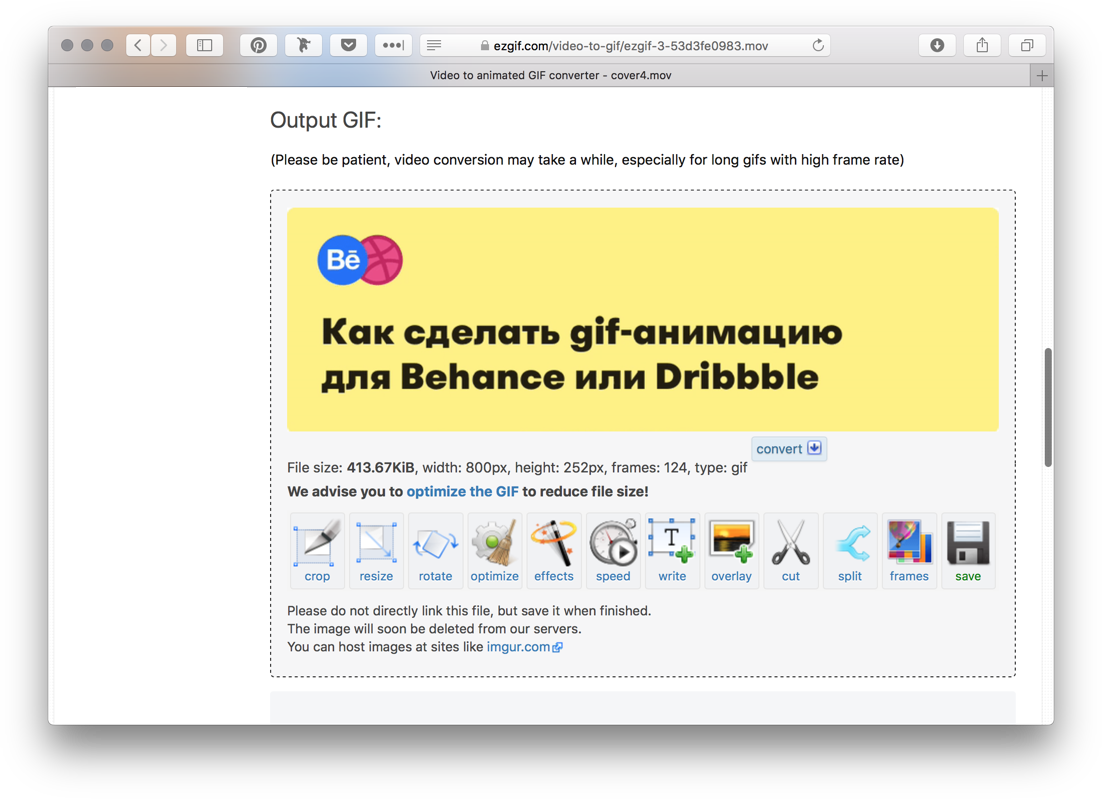

Как сделать gif в Exgif

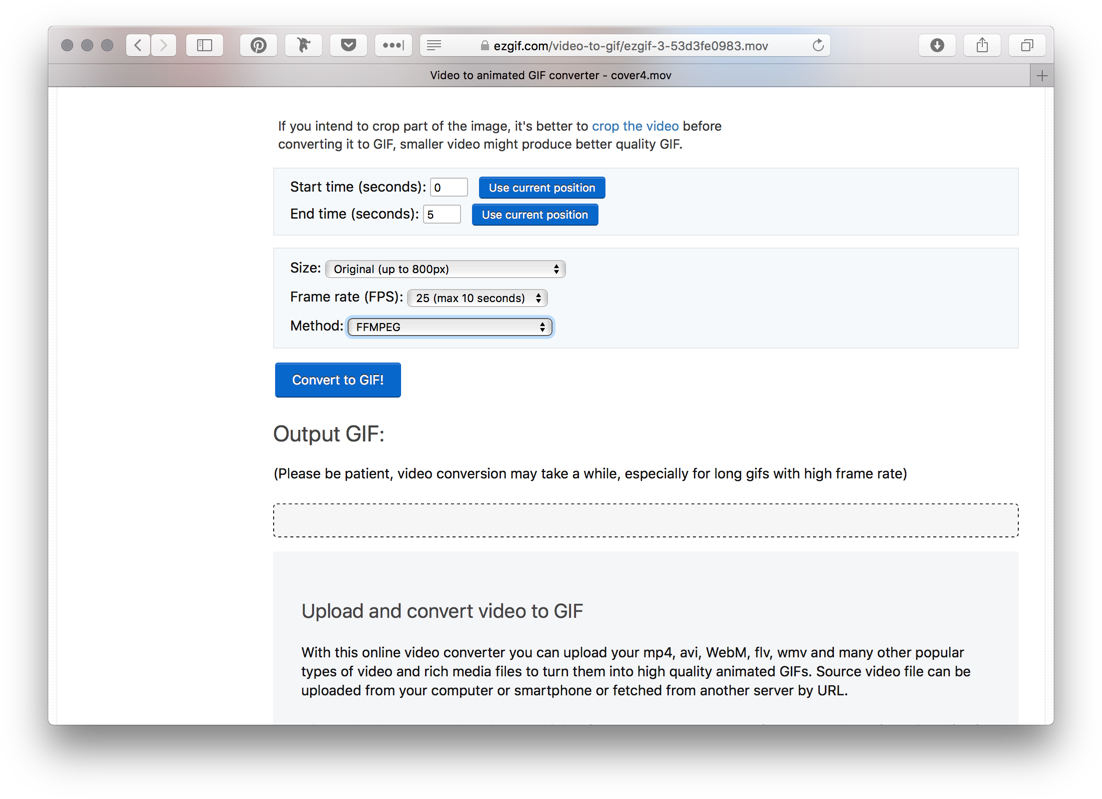

Загрузить видео.

Выбрать время анимации, размер, количество кадров в секунду и метод сжатия.

Готово. Можно еще сжать gif по кнопке «Optimize», если он много весит.

Behance

Анимацию на Behance можно загрузить слудующими способами: видео с Adobe Cloud, Embed-видео с YouTube/Vimeo и gif-анимацией.

Пользуемся всеми способами в зависимости от того, что надо получить.

Рассмотрим плюсы и минусы каждого из подходов.

Видео с Adobe

+ Можно загрузить какой угодно объём

+ Относительно без потери качества

+ Можно посмотреть в fullscreen

+ Звук

– Нет автоплея в мобильной версии

Embed-видео

+ Все плюсы из видео с Adobe

– Логотип YouTube / Vimeo

– Особенности настроек для loop видео

– Нет автоплея в мобильной версии

Gif-анимация

+ Можно сделать на всю ширину экрана

+ Есть автоплей

– Нельзя промотать во время просмотра

– Много весят и дольше загружаются

Наш воркфлоу такой:

- Пункты идентичные с подготовкой видео шота на Dribbble.

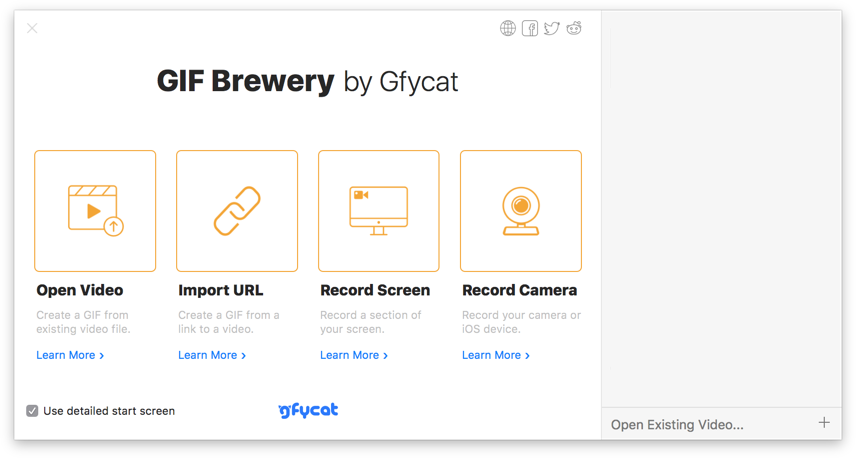

- Конвертирование видео в gif в GifBrewery (пользовались бы и ezgif, но там нельзя сделать gif шириной в 1400px).

Как сделать gif в GifBrewery

Стартовый экран, выбрать Open Video.

По дефолту GifBrewery делает нормальные гифки. Но если что-то пошло не так, то есть настройки по иконке справа. Обычно играемся только с алгоритмом выбора цвета.

В этой статье я рассказал про те способы, которыми пользуемся мы, и они точно работают. Если у вас есть свои варианты, пишите в комментариях.

Что получается у нас, можно посмотреть в профилях на Behance, Dribbble.

|

Метки: author ilyasgaifullin дизайн мобильных приложений веб-дизайн блог компании mobileup gif animation dribbble behance gifbrewery after effects ezgif |

Изменился способ создания чат-ботов в Viber |

Изменился способ создания чат-ботов в Viber

Ранее для этого необходимо было создать паблик аккаунт и только к нему можно было сделать привязку чат-бота. Примерно до января-февраля 2017 года все было достаточно просто — заполняешь простую форму — появляется возможность регистрации паблик аккаунта. Примерно весно форма усложнилась, всем подряд не давали такой возможности. Давали добро, в основном, крупным, известным брендам.

26 сентября все упростили.

В этот день паблик чаты и боты стали двумя отдельными каналами в Viber. Теперь можно управлять ими через Панель администратора Viber (https://partners.viber.com/).

Что означает разделение Ботов и Паблик Чатов?

- Боты больше не будут привязаны к Паблик Чатам, а интерфейс будет скорректирован соответствующим образом.

- Боты по-прежнему будут доступны в рамках Паблик Аккаунтов.

- Функции поиска и отображения в списке на Discover Screen останутся прежними.

Что такое Панель администратора Viber?

- Панель администратора Viber позволяет владельцам Паблик Аккаунтов и Ботов управлять своими кампаниями, видеть статистику и все данные Паблик аккаунта.

- Кроме того, Панель администратора Viber теперь позволит пользователям создавать бот напрямую через Панель администратора Viber.

Создание бота будет доступно для всех. Тем не менее, возможность отображения в поиске и в списке на Discover Screen будет рассматриваться командой Viber.

Первичная регистрация

partners.viber.com -> Create an account

Регистрируемся. Вводим номер телефона, получаем код в viber для проверки и прочие поля.

Создание бота (получение токена)

Авторизуемся partners.viber.com -> Create Bot Account

Заполняем форму (самое сложное это картинку подобрать)

После заполнения получаем токен.

Все.

С документацией у viber есть проблемы. Часто она не актуальная. Всегда надо проверять то, что делаешь.

developers.viber.com/docs/api/rest-bot-api

developers.viber.com/docs/api/python-bot-api

developers.viber.com/docs

|

Метки: author nllm системы обмена сообщениями разработка под e-commerce программирование python viber чат-бот mrbot viber api |

[Из песочницы] FlashMapper — альтернатива автомапперу |

FlashMapper — альтернатива автомапперу

Я даже не знаю, что такое автомаппер. Зачем мне его альтернатива?

Представьте ситуацию, у вас есть два класса для одной и той же сущности, один описывает модель данных с пользовательской формы, второй модель базы данных. Свойства этих классов совпадают процентов на 95, различия могут быть только в каких-то временных метках или прочих системных полях в модели базы данных. Когда пользователь заполняет форму, вы получаете модель с этой формы, и дальше вам надо преобразовать ее к модели базы данных, чтобы сохранить.

FlashMapper, как и AutoMapper, это .net-библиотека, которая избавляет вас от написания рутинного кода в процессе преобразования. Он автоматически сопоставляет все одинаковые свойства классов, оставляя вам только необходимость разрешить различия.

Помимо избавления от рутинной работы, данный подход дает дополнительную проверку правильности кода вашей программы. Представьте, что вы добавили какие-то новые свойства в эти классы, и забыли их связать. В лучшем случае вы узнаете об этом где-нибудь на этапе тестирования, в худшем спустя месяц после релиза, когда заметите, что у вас в базе данных не появляются новые данные, которые старательно вводят пользователи в новое поле на форме. FlashMapper же либо сам свяжет новые свойства автоматически, если сможет, либо выбросит исключение во время следующего запуска приложения.

Если уже есть автомаппер, то зачем было делать еще одну подобную библиотеку?

В автомаппере мне никогда не нравился его монструозный синтаксис. Просто, чтобы связать два свойства в разных классах нужно прописать три лямбды в конфигурации, чтобы проигнорировать свойство — две. Также на последнем месте работы у меня часто стала возникать потребность ‘смаппить’ данные из двух классов в один. Я не нашел простого решения этой проблемы стандартными средствами автомаппера, поэтому начал писать для него библиотеку-расширение, позволяющую создавать маппинги из двух и более исходных классов в один, и даже почти дописал ее. Но потом мне вдруг пришла в голову идея более простого синтаксиса, и я решил все бросить, и написать с нуля свою библиотеку.

Собственно, FlashMapper имеет более простой и дружественный к интелисенсу синтаксис, предоставляет возможность ‘маппить’ из нескольких объектов в один, а также предоставляет API для вынесения каждой отдельной отдельной конфигурации маппинга в свой собственный класс, в который можно пробрасывать какую-нибудь логику как зависимость через конструктор. Также по задумке он должен был иметь лучшую производительность, но по некоторым причинам, о которых ниже, производительность оказалась на уровне автомаппера.

Синтаксис