Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Обзор дефектов кода музыкального софта. Часть 1. MuseScore |

Программирование — занятие творческое, поэтому среди разработчиков встречается много талантливых людей, имеющих своеобразное хобби. Вопреки распространённому мнению, это не всегда программирование (ну или не только оно :D). На основе своего увлечения записью/обработкой музыки и профессиональной деятельности, я решил проверить качество кода популярных музыкальных программ с открытым исходным кодом. Первой для обзора выбрана программа для редактирования нот — MuseScore. Запасайтесь попкорном… серьёзных багов будет много!

Читать дальше ->

|

Метки: author SvyatoslavMC open source c++ блог компании pvs-studio статический анализ кода компиляторы pvs-studio static code analysis musescore |

Загрузка ОС на ARM |

- Системное программирование,

- Разработка под Linux,

- Криптография,

- Информационная безопасность,

- Блог компании Аладдин Р.Д.

Загрузка ОС на ARM

- Системное программирование,

- Разработка под Linux,

- Криптография,

- Информационная безопасность,

- Блог компании Аладдин Р.Д.

Загрузка ARM в четырех прямоугольниках — под катом.

Сразу ограничим уровень детализации. Нас интересует, что происходит, а не как, то есть конкретные инструкции процессора оставим в стороне. Постараемся найти общее у всех процессоров и всех ОС. Поищем угрозы безопасности.

Разновидности процессоров ARM

Если вы знаете про ARM, то этот раздел можно смело пропустить.

В производстве и эксплуатации сейчас встречаются процессоры ARM пяти архитектур: ARMv4, ARMv5, ARMv6, ARMv7 и ARMv8. Компания ARM дает этим архитектурам коммерческие названия, поэтому ARMv4 называется, например, ARM7, ARMv5 – ARM9, а название Cortex имеют процессоры на архитектурах ARMv6, v7, v8. Следующая таблица перечисляет основные разновидности.

| Архитектура | Коммерческое название | Распространенные виды | Запуск Linux |

| ARMv4 | ARM7 | ARM7TDMI | Нецелесообразно |

| ARMv5 | ARM9 | ARM926EJ-S | Да |

| ARMv6 | ARM11 | ARM1176JZF-S | Да |

| Cortex-M0 | Cortex-M0 | Нет | |

| ARMv7 | Cortex-M | Cortex-M3 | Нецелесообразно |

| Cortex-A | Cortex-A9 | Да | |

| Cortex-R | Cortex-R4 | Да | |

| ARMv8 | Cortex-A | Cortex-A53 | Да |

Например, кнопочные телефоны в основном используют ARM7, а смартфоны – Cortex-A. Современные смартфоны строятся преимущественно на ARMv8, единственных 64-битных. Процессоры ARM7 и ARM9 широко применялись в различных промышленных контроллерах, сетевом оборудовании, а сейчас фокус переходит на использование в них Cortex-A. В различной бытовой технике, мелких электронных приборах, в области безопасности и т.п. применяются микроконтроллеры Cortex-M.

Вообще все устройства ARM можно условно разбить на микроконтроллеры и Application Processor.

- Микроконтроллеры отличаются наличием на кристалле Flash-памяти и рабочего ОЗУ. Применяются для задач относительно малой автоматизации.

- Application Processor преимущественно пользуется внешней памятью — DDRAM и Flash. Мы их дальше будем называть просто — процессоры. Масштаб задач у них больше.

Долгое время одни и те же архитектуры ARM7, ARM9 использовались как для построения процессоров, так и микроконтроллеров. С появлением линейки Cortex произошло разделение, и теперь микроконтроллеры называются Cortex-M, а процессоры Cortex-A и Cortex-R.

Виды ОС

Какие есть варианты запуска ОС:

- на микроконтроллерах обычно запущена маленькая ОС реального времени (RTOS) или просто программа без ОС;

- на процессорах чаще запущена ОС общего применения (Linux, Android), иногда маленькая RTOS, иногда полнофункциональная RTOS (типа vxWORKS).

Например, в планшетах и смартфонах используется Android, iOS или вариант Linux. В телекоммуникационном оборудовании может быть Linux или один из вариантов RTOS. В более простом оборудовании может применяться RTOS или программа без ОС.

В дальнейшем мы будем говорить только о запуске ОС (Linux, Android) или RTOS на ARM. По способу запуска “большие” RTOS попадают в одну группу с Linux, а “малые” RTOS объединяются с программами без ОС.

Для запуска Linux хорошо подходят процессоры ARM9, ARM11, Cortex-A. Усеченную версию Linux также можно загрузить на ARM7, Cortex-M4 и Cortex-M7, но это нецелесообразно.

Для запуска малых RTOS подходят микроконтроллеры и процессоры ARM7, ARM9, Cortex-M. В некоторых случаях для RTOS используют начальные модели Cortex-A, например, Cortex-A5. Большинство же процессоров Cortex-A столь сложны, что их возможности можно использовать только совместно с поставляемым производителем Linux/Android SDK, что и определяет выбор в пользу Linux.

Загрузчик ОС

С точки зрения разработчика системное ПО устройства делится на загрузчик и ОС. Основную функцию всегда выполняет программа, работающая под управлением ОС или RTOS.

Загрузчик обеспечивает загрузку ОС и сервисные функции, такие, как:

- проверка целостности образа ОС перед запуском;

- обновление программ;

- сервисные функции, функции первоначальной инициализации устройства;

- самотестирование.

В случае RTOS загрузчик зачастую пишется разработчиком устройства и представляет собой небольшую специализированную программу. В случае с ОС общего применения широко применяются загрузчики с открытым исходным кодом, например, u-boot.

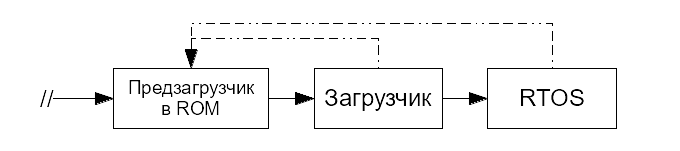

Таким образом, с точки зрения разработчика изделия запуск ОС выглядит следующим образом:

Здесь знаком // отмечен момент подачи питания или сброса процессора. Такой простой способ запуска был у некоторых процессоров ARM7. В последовавших за ними версиях процесс запуска в реальности сложнее, чем на приведенной схеме, но для разработчика конечного решения это обычно не существенно.

Схема “Загрузчик-ОС” очень удобна из практических соображений, ведь загрузчик берет на себя всю низкоуровневую работу:

- инициализирует память перед запуском ОС и загружает ядро ОС в память;

- инициализирует часть периферии;

- часто реализует хранение двух образов ОС: текущего и резервного, или образа для восстановления;

- контролирует образ ОС перед загрузкой;

- дает сервисный режим работы даже при испорченном образе ОС.

Например, для запуска Linux на ARM загрузчик должен инициализировать память, хотя бы один терминал, загрузить образ ядра и Device Tree в память и передать управление на ядро. Все это описано в <https://www.kernel.org/doc/Documentation/arm/Booting>. Код инициализации ядра Linux не будет делать сам то, что должен делать загрузчик.

В то же время, загрузчик зачастую слабо защищен или не защищен вовсе. В большинстве домашних роутеров достаточно открыть крышку и подключиться к разъему UART, чтобы войти в меню управления загрузчиком. В телекоммуникационном оборудовании более высокого класса вход в меню загрузчика зачастую возможен по недокументированной комбинации клавиш или нажатой кнопке в момент включения устройства. Иными словами, зачастую загрузчик не защищен от локального нарушителя.

Рассмотрим работу загрузчика на примере u-boot, загружающего Linux, по шагам.

- После включения или сброса процессор загружает образ u-boot, хранимый в Flash-памяти, в ОЗУ и передает управление на первую команду этого образа.

- u-boot инициализирует DDRAM.

- u-boot инициализирует драйверы загрузочного носителя (ЗН), например, eMMC, NAND Flash.

- u-boot читает с ЗН область переменных конфигураций. В конфигурации задан скрипт загрузки, который u-boot далее исполняет.

- u-boot выводит в консоль предложение прервать процесс загрузки и сконфигурировать устройство. Если за 2-3 секунды пользователь этого не сделает, запускается скрипт загрузки.

- Иногда скрипт начинается с поиска подходящего образа ОС для загрузки на всех доступных носителях. В других случаях ЗН задается в скрипте жестко.

- Скрипт загружает с ЗН в DDRAM образ ядра Linux (zImage), файл Device Tree с параметрами ядра (*.dtb).

- Дополнительно скрипт может загрузить в DDRAM образ initrd – маленькой файловой системы с необходимыми для старта драйверами устройств. Современные дистрибутивы Linux иногда используют initrd, а иногда – нет.

- Разместив загруженные 2 или 3 файла в памяти, скрипт передает управление на первую команду образа zImage (ядро Linux).

- zImage состоит из распаковщика и сжатого образа ядра. Распаковщик развертывает ядро в памяти, и загрузка ОС начинается.

Запуск загрузчика – предзагрузчик

Однако в реальности почти никогда не бывает, чтобы команды загрузчика выполнялись первыми после включения или сброса процессора. Это еще было на процессорах ARM7, но почти не встречалось далее.

Любое ядро процессора ARM при сбросе начинает исполнение с адреса 0, где записан вектор “reset”. Старые серии процессоров буквально начинали загружаться с внешней памяти, отображенной по нулевому адресу, и тогда первая команда процессора была командной загрузчика. Однако для такой загрузки подходит только параллельная NOR Flash или ROM. Эти типы памяти работают очень просто – при подаче адреса они выдают данные. Характерный пример параллельной NOR Flash – микросхема BIOS в персональных компьютерах.

В современных системах используются другие виды памяти, потому что они дешевле, а объем больше. Это NAND, eMMC, SPI/QSPI Flash. Эти типы памяти уже не работают по принципу: подал адрес — читаешь данные, а значит, для прямого исполнения команд из них не подходят. Даже для простого чтения тут требуется написать драйвер, и мы имеем проблему «курицы и яйца»: драйвер нужно откуда-то заранее загрузить.

По этой причине в современные процессоры ARM интегрировано ПЗУ с предзагрузчиком. ПЗУ отображено в памяти процессора на адрес 0, и именно с него начинает исполнение команд процессор.

В задачи предзагрузчика входят следующие:

- определение конфигурации подключенных устройств;

- определение загрузочного носителя (ЗН);

- инициализация устройств и ЗН;

- чтение загрузчика с ЗН;

- передача управления загрузчику.

Конфигурация предзагрузчика обычно устанавливается одним из двух способов:

- схемотехнически, подключением определенных выводов процессора к земле или шине питания;

- записывается в однократно-программируемую память процессора на этапе производства.

В целом почти всегда есть возможность задать единственный вариант загрузки или основной и несколько альтернативных. При этом в числе альтернативных может быть первичная загрузка через USB или последовательный порт, что очень удобно при первоначальной инициализации на производстве.

Подобный предзагрузчик устанавливается как в процессорах ARM, таких, как Cortex-A, так и в микроконтроллерах, даже таких маленьких, как Cortex-M0. Вместе с предзагрузчиком процедура запуска ОС выглядит так:

Анализ угроз на этом этапе

Исходный код предзагрузчика пишется производителем процессора, а не компанией ARM, является частью микросхемы как продукта компании-производителя и защищен авторским правом. Например, в процессорах ARM компаний Atmel и NXP предзагрузчики написаны, соответственно, Atmel и NXP.

В некоторых случаях предзагрузчик можно прочитать из ROM и проанализировать, но иногда доступ к нему ограничен. Например, предзагрузчик процессора серии Psoc4000 компании Cypress был закрыт несколькими слоями защиты (но был взломан талантливым хакером).

Использования предзагрузчика в большинстве сценариев избежать нельзя. Можно рассматривать его как вариант BIOS, которого в ARM-системах нет.

Сам по себе предзагрузчик в ROM несет в себе угрозу нарушения порядка загрузки и выполнения произвольного кода. Но после того как управление передано загрузчику ОС, предзагрузчик уже безвреден. Мы можем просто не передавать ему управление, перенастроить все обработчики прерываний и так далее.

В некоторые небольшие микроконтроллеры производители интегрируют в ROM-библиотеки для работы с периферийными устройствами, которые требуется вызывать на протяжении всей работы микроконтроллера. В этом случае системное ПО (загрузчик и ОС) само периодически передает управление куда-то в область предзагрузчика, и схема передачи управления получается следующей:

Это в общем случае небезопасно, но встречается только в некоторых микроконтроллерах на архитектуре ARM. На таких микроконтроллерах обычно запускаются программы без ОС или малые RTOS, и дизайнер системы может оценить риски.

Загрузка с TrustZone

В процессоры ARM Cortex-A и Cortex-R встраивается технология TrustZone. Эта технология позволяет на аппаратном уровне выделить два режима исполнения: Secure (Безопасный) и Non-Secure (Гостевой).

Эти процессоры в основном нацелены на рынок смартфонов и планшетных компьютеров, и TrustZone используется для создания в режиме Secure доверенной “песочницы” для исполнения кода, связанного с криптографией, DRM, хранением пользовательских данных.

В режиме Secure при этом запускается специальная ОС, называемая в общем случае TEE (Trusted Execution Environment, доверенная среда исполнения), а нормальная ОС, такая, как Linux, Android, iOS, запускается в режиме Non-Secure. При этом права доступа к некоторым устройствам ограничены для нормальной ОС, поэтому ее еще называют гостевой ОС.

Из-за наложенных ограничений гостевая ОС вынуждена время от времени вызывать функции TEE для исполнения некоторых операций. TEE продолжает существовать параллельно с гостевой ОС все время, и гостевая ОС не может ничего с этим поделать.

Например, гостевая ОС использует функции TEE для:

- включения и выключения ядер процессора (в ARMv8-A это происходит через PSCI — часть ARM Trusted Firmware, а в ARMv7 — по-разному для каждого производителя процессоров);

- хранения ключей, данных банковских карт и т.п.;

- хранения ключей полнодискового шифрования;

- операций с криптографией;

- отображения DRM-контента.

При этом, с точки зрения безопасности, на время таких вызовов управление передается в неизвестный нам, непроверенный код. Мы не можем однозначно сказать, что делают Samsung KNOX или QSEE от Qualcomm.

Почему же разработчики систем соглашаются на такой режим функционирования? В процессоры с поддержкой TrustZone встроен и механизм Secure Boot в том или ином виде.

С Secure Boot предзагрузчик проверяет подпись загружаемого образа с помощью прошитого на этапе производства открытого ключа. Таким образом, гарантируется, что загружен будет только подписанный образ. Это функция безопасности.

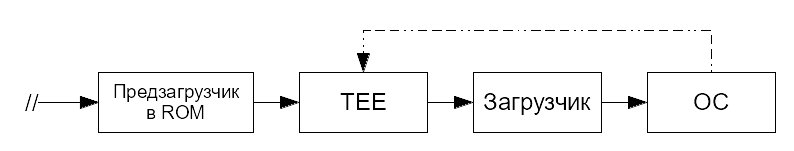

То есть загрузка ОС становится следующей:

- стартует предзагрузчик в ROM. Он загружает ключи для проверки подписи TEE из ROM;

- предзагрузчик загружает в память образ TEE, проверяет подпись. Если проверка прошла успешно, запускается TEE;

- TEE настраивает режимы Secure и Non-Secure. Далее TEE загружает основной загрузчик ОС и переходит на него в режиме Non-Secure. Сам TEE остается в режиме Secure и ждет;

- загрузчик основной ОС загружает ОС как обычно;

- ОС вынуждена время от времени вызывать функции TEE для выполнения некоторых задач.

Однако производитель, как правило, поставляет подписанные образы загрузчика и TEE в составе SDK для процессора и поставляет процессоры, уже “зашитые” ключом производителя. В этом случае предзагрузчик из ROM не станет выполнять любой загрузчик, если он не подписан производителем. Все основные процессоры для смартфонов сейчас поставляются уже “прошитыми” под исполнение собственного TEE перед исполнением загрузчика ОС.

Далее действует лень — c TEE все работает, а без TEE даже не запускается. Разработчики используют SDK с TEE, вызывают закрытый бинарный код из ядра Linux и не волнуются.

Как проверить свой проект на обращения к TrustZone

Может даже показаться, что всей этой TrustZone не существует, по крайней мере, в вашей конкретной разработке. Проверить это совсем несложно.

Дело в том, что все процессоры с TrustZone стартуют в режиме Secure, а только потом переключаются в Normal. Если ваша ОС запущена в режиме Normal, то какая-то Secure OS (TEE) существует в системе и перевела ее в этот режим.

Лакмусовой бумажкой является обращение к TEE для включения кэш-памяти 2-го уровня. По какой-то причине архитектура ARM не позволяет этого делать из Normal World. Поэтому для включения кэша ядру ОС потребуется сделать хоть один вызов к TrustZone. Делается это единственной командой: smc #0, и вы можете поискать ее сами в ядре Linux или Android.

Разумеется, мы и сами поискали, и нашли такие вызовы в коде поддержки ряда процессоров Qualcomm, Samsung, Mediatek, Rockchip, Spreadtrum, HiSilicon, Broadcom, Cavium.

Загрузка ARM Cortex-A и анализ угроз

Итак, обещанный процесс загрузки ОС на ARM (здесь — Cortex-A) в четыре блока:

На схеме пунктиром обозначен путь обращения из ядра ОС в TEE.

В двух блоках — неизвестный нам код. Посмотрим, чем это грозит.

Технически, любой из компонентов системного ПО может содержать ошибки, намеренные закладки и так далее. Однако в большинстве случаев загрузчик, ОС и системное ПО можно проверить, изучив исходные коды. Сконцентрируемся на возможных угрозах, исходящих от предзагрузчика и TEE, исходные коды к которым закрыты.

Предзагрузчик работает на самом раннем этапе, когда схема подключения к процессору различных периферийных устройств еще не известна, никакие коммуникационные устройства (WiFi, 3G и т.д.) не настроены, коммуникационные протоколы не работают. При этом предзагрузчик – небольшая программа, с размером кода порядка нескольких десятков килобайт, и сложно представить размещение в нем полных стеков протоколов или серьезной эвристики по определению подключенных устройств. Поэтому предзагрузчик вряд ли таит в себе серьезные закладки, связанные со слежкой, передачей данных и т.п.

Гораздо более интересной точкой атаки является TEE, так как его функции вызываются в процессе работы ОС, когда все периферийные устройства работают, а коммуникационные протоколы настроены. Создание шпионской закладки в коде TEE позволяет практически неограниченно следить за пользователем СВТ.

В небольшом исследовании мы показали реализуемость закладки в TEE, незаметно перехватывающей системные вызовы ОС Linux. Для активации закладки нужно только одно обращение из ядра Linux в TEE (например, то самое, для кэша второго уровня), после чего система становится полностью управляемой. Это позволяет:

- контролировать чтение и запись файлов, модифицировать данные «на лету»;

- перехватывать пользовательский ввод, причем введенные символы перехватываются даже с экранной клавиатуры;

- незаметно внедрять свои данные при коммуникации с удаленными серверами, в том числе по протоколу https, маскируя передачу шпионской информации под обычный зашифрованный Web-трафик.

Несомненно, выявленные возможности – только вершина айсберга, и создание закладок не было целью исследования.

Выводы

Мы рассмотрели процесс загрузки различных микроконтроллеров и процессоров ARM.

У микроконтроллеров наиболее уязвимым местом в процессе загрузки является загрузчик ОС.

Современные процессоры ARM Cortex-A включают в себя TrustZone — и от этого никуда не уйти. TrustZone предполагает запуск перед ОС доверенной среды исполнения TEE.

TEE является самой уязвимой точкой в процессе загрузки ОС на ARM Cortex-A, потому что обращения к TEE приводят к выполнению закрытого системного кода, известного производителю, но скрытого от нас.

Без контроля над TEE невозможно обеспечить безопасность и доверенность исполнения любой ОС на ARM Cortex-A.

|

|

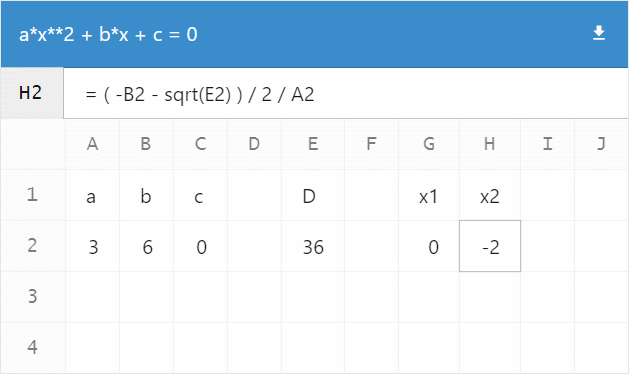

[recovery mode] $mol_app_calc: вечеринка электронных таблиц |

$mol_app_calc: вечеринка электронных таблиц

- Tutorial

- Recovery Mode

Здравствуйте, меня зовут Дмитрий Карловский и я… обожаю математику. Однажды мне не спалось и я запилил сервис для таких же отбитых как и я — легковесную электронную таблицу с пользовательскими формулами, шарингом и скачиванием.

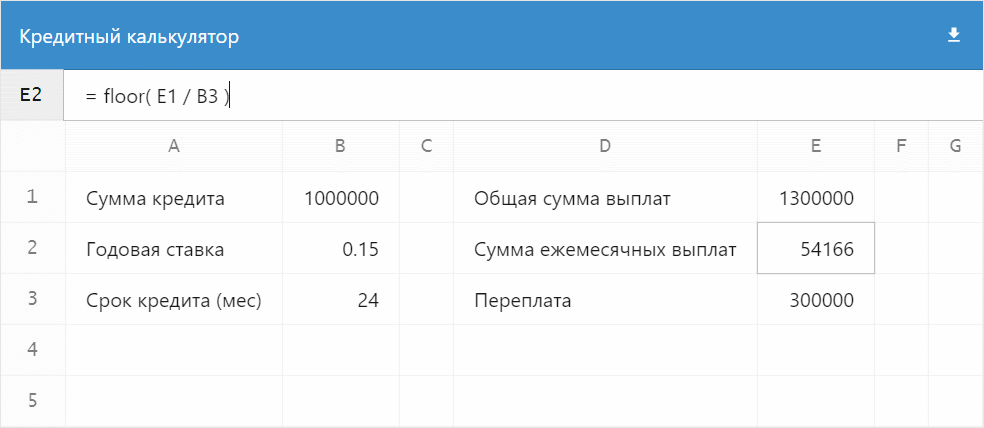

Живой пример с расчётом кредита:

А дальше я расскажу, как сотворить такое же за вечер используя фреймворк $mol...

Это что за покемон?

$mol — современный фреймворк для быстрого создания кроссплатформенных отзывчивых веб-приложений. Он базируется на архитектуре MAM устанавливающей следующие правила для всех модулей:

- Модуль — это директория, содержащая исходные коды.

- Исходные коды могут быть на самых разных языках.

- Все языки равноправны в рамках модуля.

- Модули могут образовывать иерархию.

- Имя модуля жёстко соответствует пути к нему в файловой системе.

- Между модулями могут быть зависимости.

- Информация о зависимостях модуля получается статическим анализом его исходных кодов.

- Любой модуль можно собрать как набор независимых бандлов на разных языках (js, css, tree...).

- В бандлы попадают только те модули, что реально используются.

- В бандл попадают все исходные коды модуля.

- У модулей нет версий — всегда используется актуальный код.

- Интерфейс модулей должен быть открыт для расширения, но закрыт для изменения.

- Если нужен другой интерфейс — нужно создать новый модуль. Например

/my/file/и/my/file2/. Это позволит использовать оба интерфейса не путаясь в них.

Рабочее окружение

Начать разработку на $mol очень просто. Вы один раз разворачиваете рабочее окружение и далее клепаете приложения/библиотеки как пирожки.

Для начала вам потребуется установить:

- GIT

- NodeJS

- Какой-либо редактор. Рекомендуемый: VSCode

- Плагин к редактору для подсветки tree синтаксиса.

- Плагин к редактору для поддержки EditorConfig.

Если вы работаете под Windows, то стоит настроить GIT, чтобы он не менял концы строк в ваших исходниках:

git config --global core.autocrlf inputТеперь следует развернуть MAM проект, который автоматически поднимет вам девелоперский сервер:

git clone https://github.com/eigenmethod/mam.git

cd mam

npm install

npm startВсё, сервер разработчика запущен, можно открывать редактор. Обратите внимание, что в редакторе нужно открывать именно директорию MAM проекта, а не проекта конкретного приложения или вашей компании.

Как видите, начать разрабатывать на $mol очень просто. Основной принцип MAM архитектуры — из коробки всё должно работать как следует, а не требовать долгой утомительной настройки.

Каркас приложения

Для конспирации наше приложение будет иметь позывной $mol_app_calc. По правилам MAM лежать оно должно соответственно в директории /mol/app/calc/. Все файлы в дальнейшем мы будем создавать именно там.

Первым делом создадим точку входа — простой index.html:

Ничего особенного, разве что мы указали точку монтирования приложения специальным атрибутом mol_view_root в котором обозначили, что монтировать надо именно наше приложение. Архитектура $mol такова, что любой компонент может выступать в качестве корня приложения. И наоборот, любое $mol приложение — не более, чем обычный компонент и может быть легко использовано внутри другого приложения. Например, в галерее приложений.

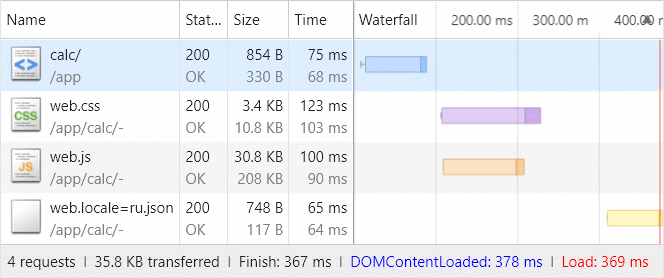

Обратите внимание, что мы уже сразу прописали пути к скриптам и стилям — эти бандлы будут собираться автоматически для нашего приложения и включать в себя только те исходные коды, что реально ему необходимы. Забегая вперёд стоит заметить, что общий объём приложения составит каких-то 36KB без минификации, но с зипованием:

Итак, чтобы объявить компонент, который будет нашим приложением, нам нужно создать файл calc.view.tree, простейшее содержимое которого состоит всего из одной строчки:

$mol_app_calc $mol_pageВторое слово — имя базового компонента, а первое — имя нашего, который будет унаследован от базового. Таким образом каждый компонент является преемником какого-либо другого. Самый-самый базовый компонент, от которого происходят все остальные — $mol_view. Он даёт всем компонентам лишь самые базовые стили и поведение. В нашем случае, базовым будет компонент $mol_page представляющий собой страницу с шапкой, телом и подвалом.

Из calc.view.tree будет автоматически сгенерирован TypeScript класс компонента и помещён в -view.tree/calc.view.tree.ts, чтобы среда разработки могла его подхватить:

namespace $ { export class $mol_app_calc extends $mol_page {

} }Собственно, сейчас приложение уже можно открыть по адресу http://localhost:8080/mol/app/calc/ и увидеть пустую страничку c позывным в качестве заголовка:

Синтаксис view.tree довольно необычен, но он прост и лаконичен. Позволю себе процитировать один из отзывов о нём:

Синтаксис tree очень легко читать, но нужно немного привыкнуть и не бросить всё раньше времени. Мой мозг переваривал и негодовал около недели, а потом приходит просветление и понимаешь как сильно этот фреймворк упрощает процесс разработки. © Виталий Макеев

Так что не пугаемся, а погружаемся! И начнём с общей раскладки страницы — она будет состоять у нас из шапки, панели редактирования текущей ячейки и собственно таблицы с данными.

У каждого компонента есть свойство sub(), которое возвращает список того, что должно быть отрендерено непосредственно внутри компонента. У $mol_page туда рендерятся значения свойств Head(), Body() и Foot(), которые возвращают соответствующе подкомпоненты:

$mol_page $mol_view

sub /

<= Head $mol_view

<= Body $mol_scroll

<= Foot $mol_viewВ данном коде опущены детали реализации подкомпонент, чтобы была видна суть. Объявляя подкомпонент (он же "Элемент" в терминологии БЭМ) мы указываем его имя в контексте нашего компонента и имя класса, который должен быть инстанцирован. Созданный таким образом экземпляр компонента будет закеширован и доступен через одноимённое свойство. Например, this.Body() в контексте нашего приложения вернёт настроенный экземпляр $mol_scroll. Говоря паттернами, свойство Body() выступает в качестве локальной ленивой фабрики.

Давайте преопределим свойство sub(), чтобы оно возвращало нужные нам компоненты:

$mol_app_calc $mol_page

sub /

<= Head -

<= Current $mol_bar

<= Body $mol_gridТут мы оставили шапку от $mol_page, добавили $mol_bar в качестве панельки редактирования текущей ячейки, в качестве тела страницы использовали $mol_grid — компонент для рисования виртуальных таблиц, а подвал так и вовсе убрали, так как он нам без надобности.

Давайте взглянем, как изменился сгенерированный класс:

namespace $ { export class $mol_app_calc extends $mol_page {

/// sub /

/// <= Head -

/// <= Current -

/// <= Body -

sub() {

return [].concat( this.Head() , this.Current() , this.Body() )

}

/// Current $mol_bar

@ $mol_mem

Current() {

return new this.$.$mol_bar

}

/// Body $mol_grid

@ $mol_mem

Body() {

return new this.$.$mol_grid

}

} }Визитная карточка $mol — очень "читабельный" код. Это касается не только генерируемого кода, но и кода модулей самого $mol, и прикладного кода создаваемых на его базе приложений.

Возможно вы обратили внимание на то, что объекты создаются не прямым инстанцированием по имени класса new $mol_grid, а через this.$. Поле $ есть у любого компонента и возвращает глобальный контекст или реестр, говоря паттернами. Отличительной особенностью доступа ко глобальным значениям через поле $ является возможность любому компоненту переопределить контекст для всех вложенных в него на любую глубину компонентов. Таким образом $mol в крайне практичной и ненавязчивой форме реализует инверсию контроля, позволяющую подменять реализации использующиеся где-то в глубине переиспользуемого компонента.

Формирование таблицы

Что ж, давайте нарастим немного мясца и настроим вложенные компоненты под себя: гриду нужно объяснить, какие у нас будут идентификаторы столбцов, какие идентификаторы строк, а также списки ячеек в шапке и теле таблицы.

Body $mol_grid

col_ids <= col_ids /

row_ids <= row_ids /

head_cells <= head_cells /

cells!row <= cells!row /Генерируемый класс расширится следующим описанием:

/// Body $mol_grid

/// col_ids <= col_ids -

/// row_ids <= row_ids -

/// head_cells <= head_cells -

/// cells!row <= cells!row -

@ $mol_mem

Body() {

const obj = new this.$.$mol_grid

obj.col_ids = () => this.col_ids()

obj.row_ids = () => this.row_ids()

obj.head_cells = () => this.head_cells()

obj.cells = ( row ) => this.cells( row )

return obj

}Как видите, мы просто переопределили соответствующие свойства вложенного компонента на свои реализации. Это очень простая, но в то же время мощная техника, позволяющая реактивно связывать компоненты друг с другом. В синтаксисе view.tree поддерживается 3 типа связывания:

- Левостороннее (как в коде выше), когда мы указываем вложенному компоненту какое значение должно возвращать его свойство.

- Правостороннее, когда мы создаём у себя свойство, которое выступает алиасом для свойства вложенного компонента.

- Двустороннее, когда указываем вложенному компоненту читать из и писать в наше свойство, думая, что работает со своим.

Для иллюстрации двустороннего связывания, давайте детализируем панель редактирования текущей ячейки:

Current $mol_bar

sub /

<= Pos $mol_string

enabled false

value <= pos \

<= Edit $mol_string

hint \=

value?val <=> formula_current?val \Как видно оно у нас будет состоять у нас из двух полей ввода:

- Координаты ячейки. Пока что запретим их изменять через свойство

enabled— оставим этот функционал на будущее. - Поле ввода формулы. Тут мы уже двусторонне связываем свойство

valueполя ввода и наше свойствоformula_current, которое мы тут же и объявляем, указав значение по умолчанию — пустую строку.

Код свойств Edit и formula_current будет сгенерирован примерно следующий:

/// Edit $mol_string

/// hint \=

/// value?val <=> formula_current?val -

@ $mol_mem

Edit() {

const obj = new this.$.$mol_string

obj.hint = () => "="

obj.value = ( val? ) => this.formula_current( val )

return obj

}

/// formula_current?val \

@ $mol_mem

formula_current( val? : string , force? : $mol_atom_force ) {

return ( val !== undefined ) ? val : ""

}Благодаря реактивному мемоизирующему декоратору $mol_mem, возвращаемое методом formula_current значение кешируется до тех пока пока оно кому-нибудь нужно.

Пока что у нас было лишь декларативное описание композиции компонент. Прежде чем мы начнём описывать логику работы, давайте сразу объявим как у нас будут выглядеть ячейки:

Col_head!id $mol_float

dom_name \th

horizontal false

sub / <= col_title!id \

-

Row_head!id $mol_float

dom_name \th

vertical false

sub / <= row_title!id \

-

Cell!id $mol_app_calc_cell

value <= result!id \

selected?val <=> selected!id?val falseЗаголовки строк и колонок у нас будут плавающими, поэтому мы используем для них компонент $mol_float, который отслеживает позицию скроллинга, предоставляемую компонентом $mol_scroll через контекст, и смещает компонент так, чтобы он всегда был в видимой области. А для ячейки заводим отдельный компонент $mol_app_calc_cell:

$mol_app_calc_cell $mol_button

dom_name \td

sub /

<= value \

attr *

^

mol_app_calc_cell_selected <= selected?val false

mol_app_calc_cell_type <= type?val \

event_click?event <=> select?event nullЭтот компонент у нас будет кликабельным, поэтому мы наследуем его от $mol_button. События кликов мы направляем в свойство select, которое в дальнейшем у нас будет переключать редактор ячейки на ту, по которой кликнули. Кроме того, мы добавляем сюда пару атрибутов, чтобы по особенному стилизовать выбранную ячейку и обеспечить ячейкам числового типа выравниванием по правому краю. Забегая верёд, стили для ячеек у нас будут простые:

[mol_app_calc_cell] {

user-select: text; /* по умолчанию $mol_button не выделяемый */

background: var(--mol_skin_card); /* используем css-variables благодаря post-css */

}

[mol_app_calc_cell_selected] {

box-shadow: var(--mol_skin_focus_outline);

z-index: 1;

}

[mol_app_calc_cell_type="number"] {

text-align: right;

}Обратите внимание на одноимённый компоненту селектор [mol_app_calc_cell] — соответствующий атрибут добавляется dom-узлу автоматически, полностью избавляя программиста от ручной работы по расстановке css-классов. Это упрощает разработку и гарантирует консистентность именования.

Наконец, чтобы добавить свою логику, мы создаём calc.view.ts, где создаём класс в пространстве имён $.$$, который наследуем от одноимённого автоматически сгенерированного класса из пространства имён $:

namespace $.$$ {

export class $mol_app_calc_cell extends $.$mol_app_calc_cell {

// переопределения свойств

}

}Во время исполнения оба пространства имён будут указывать на один и тот же объект, а значит наш класс с логикой после того как отнаследуется от автогенерированного класса просто займёт его место. Благодаря такой хитрой манипуляции добавление класса с логикой остаётся опциональным, и применяется только, когда декларативного описания не хватает. Например, переопределим свойство select(), чтобы при попытке записать в него объект события, оно изменяло свойство selected() на true:

select( event? : Event ) {

if( event ) this.selected( true )

}А свойство type() у нас будет возвращать тип ячейки, анализируя свойство value():

type() {

const value = this.value()

return isNaN( Number( value ) ) ? 'string' : 'number'

}Но давайте вернёмся к таблице. Аналогичным образом мы добавляем логику к компоненту $mol_app_calc:

export class $mol_app_calc extends $.$mol_app_calc {

}Первым делом нам надо сформировать списки идентификаторов строк row_ids() и столбцов col_ids():

@ $mol_mem

col_ids() {

return Array( this.dimensions().cols ).join(' ').split(' ').map( ( _ , i )=> this.number2string( i ) )

}

@ $mol_mem

row_ids() {

return Array( this.dimensions().rows ).join(' ').split(' ').map( ( _ , i )=> i + 1 )

}Они зависят от свойства dimensions(), которое мы будем вычислять на основе заполненности ячеек, так, чтобы у любой заполненной ячейки было ещё минимум две пустые справа и снизу:

@ $mol_mem

dimensions() {

const dims = {

rows : 2 ,

cols : 3 ,

}

for( let key of Object.keys( this.formulas() ) ) {

const parsed = /^([A-Z]+)(\d+)$/.exec( key )

const rows = Number( parsed[2] ) + 2

const cols = this.string2number( parsed[1] ) + 3

if( rows > dims.rows ) dims.rows = rows

if( cols > dims.cols ) dims.cols = cols

}

return dims

}Методы string2number() и number2string() просто преобразуют буквенные координаты колонок в числовые и наоборот:

number2string( numb : number ) {

const letters = 'ABCDEFGHIJKLMNOPQRSTUVWXYZ'

let str = ''

do {

str = letters[ numb % 26 ] + str

numb = Math.floor( numb / 26 )

} while ( numb )

return str

}

string2number( str : string ) {

let numb = 0

for( let symb of str.split( '' ) ) {

numb = numb * 26

numb += symb.charCodeAt( 0 ) - 65

}

return numb

}Размерность таблицы мы вычисляем на основе реестра формул, который берём из свойства formulas(). Возвращать оно должно json вида:

{

"A1" : "12" ,

"B1" : "=A1*2"

}А сами формулы мы будем брать и строки адреса, вида #A1=12/B1=%3DA1*2:

@ $mol_mem

formulas( next? : { [ key : string ] : string } ) {

const formulas : typeof next = {}

let args = this.$.$mol_state_arg.dict()

if( next ) args = this.$.$mol_state_arg.dict({ ... args , ... next })

const ids = Object.keys( args ).filter( param => /^[A-Z]+\d+$/.test( param ) )

for( let id of ids ) formulas[ id ] = args[ id ]

return formulas

}Как видно, свойство formulas() изменяемое, то есть мы можем через него как прочитать формулы для ячеек, так и записать обновление в адресную строку. Например, если выполнить: this.formulas({ 'B1' : '24' }), то в адресной строке мы увидим уже #A1=12/B1=24.

Адресная строка

Кроссплатформенный модуль $mol_state_arg позволяет нам работать с параметрами приложения как со словарём, но как правило удобнее получать и записывать конкретный параметр по имени. Например, позволим пользователю изменять название нашей таблицы, которое мы опять же будем сохранять в адресной строке:

title( next? : string ) {

const title = this.$.$mol_state_arg.value( `title` , next )

return title == undefined ? super.title() : title

}Как можно заметить, если в адресной строке имя таблицы не задано, то будет взято имя заданное в родительском классе, который генерируется из calc.view.tree, который мы сейчас обновим, добавив в шапку вместо простого вывода заголовка, поле ввода-вывода заголовка:

head /

<= Title_edit $mol_string

value?val <=> title?val @ \Spreedsheet

<= Tools -head() — свойство из $mol_page, которое возвращает список того, что должно быть отрендерено внутри подкомпонента Head(). Это типичный паттерн в $mol — называть вложенный компонент и его содержимое одним и тем же словом, с той лишь разницей, что имя компонента пишется с большой буквы.

Tools() — панель инструментов из $mol_page, отображаемая с правой стороны шапки. Давайте сразу же заполним и её, поместив туда кнопку скачивания таблицы в виде CSV файла:

tools /

<= Download $mol_link

hint <= download_hint @ \Download

file_name <= download_file \

uri <= download_uri?val \

click?event <=> download_generate?event null

sub /

<= Download_icon $mol_icon_load$mol_link — компонент для формирования ссылок. Если ему указать file_name(), то по клику он предложит скачать файл по ссылке, сохранив его под заданным именем. Давайте же сразу сформируем это имя на основе имени таблицы:

download_file() {

return `${ this.title() }.csv`

}Локализация

Обратите внимание на символ собачки перед значением по умолчанию на английском языке:

download_hint @ \DownloadВставка этого символа — это всё, что вам необходимо, чтобы добавить вашему приложению поддержку локализации. В сгенерированном классе не будет строки "Download" — там будет лишь запрос за локализованным текстом:

/// download_hint @ \Download

download_hint() {

return $mol_locale.text( "$mol_app_calc_download_hint" )

}А сами английские тексты будут автоматически вынесены в отдельный файл -view.tree/calc.view.tree.locale=en.json:

{

"$mol_app_calc_title": "Spreedsheet",

"$mol_app_calc_download_hint": "Download"

}Как видно, для текстов были сформированы уникальные человекопонятные ключи. Вы можете отдать этот файл переводчикам и переводы от них поместить в фалы вида *.locale=*.json. Например, добавим нашему компоненту переводы на русский язык в файл calc.locale=ru.json:

{

"$mol_app_calc_title" : "Электронная таблица" ,

"$mol_app_calc_download_hint" : "Скачать"

}Теперь, если у вас в браузере выставлен русский язык в качестве основного, то при старте приложения, будет асинхронно подгружен бандл с русскоязычными текстами -/web.locale=ru.json. А пока идёт загрузка, компоненты, зависящие от переводов, будут автоматически показывать индикатор загрузки.

Заполняем ячейки

Итак, у нас есть идентификаторы строк и столбцов. Давайте сформируем списки ячеек. Сперва заголовки колонок:

@ $mol_mem

head_cells() {

return [ this.Col_head( '' ) , ... this.col_ids().map( colId => this.Col_head( colId ) ) ]

}Обратите внимание, мы добавили лишнюю колонку вначале, так как в ней у нас будут располагаться заголовки строк. А вот и ячейки для строк:

cells( row_id : number ) {

return [ this.Row_head( row_id ) , ... this.col_ids().map( col_id => this.Cell({ row : row_id , col : col_id }) ) ]

}Далее, вспоминаем, про свойства, которые мы провязывали для ячеек:

Cell!id $mol_app_calc_cell

value <= result!id \

selected?val <=> selected!id?val falseУ ячейки это просто обычные свойства, а у нас они принимают ключ — идентификатор ячейки.

Введём свойство current() которое будет хранить идентификатор текущей ячейки:

current?val *

row 1

col \AА в реализации selected() мы просто будем сравнивать ячейку по переданному идентификатору и по текущему:

@ $mol_mem_key

selected( id : { row : number , col : string } , next? : boolean ) {

return this.Cell( this.current( next ? id : undefined ) ) === this.Cell( id )

}Разумеется, если в selected() передано true, то будет установлен новый идентификатор в качестве текущего и сравнение ячеек тоже даст true.

Последний штрих — при выборе ячейки было бы не плохо переносить фокус с её самой на редактор значения:

@ $mol_mem

current( next? : { row : number , col : string } ) {

new $mol_defer( ()=> this.Edit().focused( true ) )

return next || super.current()

}Тут мы с помощью $mol_defer ставим отложенную задачу перенести фокус на редактор всякий раз когда меняется идентификатор текущей ячейки. Отложенные задачи выполняются в том же фрейме анимации, а значит пользователь не увидит никакого мерцания от перефокусировки. Если бы мы перенесли фокус сразу, то подписались бы на состояние сфокусированности редактора и при перемещении фокуса — сбрасывался бы и идентификатор текущей ячейки, что нам, разумеется, не надо.

Клавиатурная навигация

Постоянно тыкать мышью в ячейки для перехода между ними не очень-то удобно. Стрелочками на клавиатуре было бы быстрее. Традиционно в электронных таблицах есть два режима: режим навигации и режим редактирования. Постоянно переключаться между ними тоже напрягает. Поэтому мы сделаем ход конём и совместим редактирование и навигацию. Фокус будет постоянно оставаться на панели редактирования ячейки, но при зажатой клавише Alt, нажатие стрелочек, будет изменять редактируемую ячейку на одну из соседних. Для подобных выкрутасов есть специальный компонент $mol_nav, который является компонентом-плагином.

В $mol есть 3 вида компонент:

- Обычные компоненты, которые создают dom-узел и контролируют его состояние.

- Призрачные компоненты, которые не создают dom-узлов, а используют dom-узел переданного им компонента, для добавления поведения/отображения.

- Компоненты-плагины, которые тоже не создают dom-узлов, а используют dom-узел компонента владельца для добавления поведения/отображения.

Добавляются плагины через свойство plugins(). Например, добавим клавиатурную навигацию нашему приложению:

plugins /

<= Nav $mol_nav

mod_alt true

keys_x <= col_ids /

keys_y <= row_ids /

current_x?val <=> current_col?val \A

current_y?val <=> current_row?val 1Тут мы указали, что навигироваться мы будем по горизонтали и по вертикали, по идентификаторам столбцов и колонок, соответственно. Текущие координаты мы будем синхронизировать со свойствами current_col() и current_row(), которые мы провяжем с собственно current():

current_row( next? : number ) {

return this.current( next === undefined ? undefined : { ... this.current() , row : next } ).row

}

current_col( next? : number ) {

return this.current( next === undefined ? undefined : { ... this.current() , col : next } ).col

}Всё, теперь нажатие Alt+Right, например, будет делать редактируемой ячейку справа от текущей, и так пока не упрётся в самую правую ячейку.

Копирование и вставка

Так как ячейки у нас являются ни чем иным, как нативными td dom-элементами, то браузер нам здорово помогает с копированием. Для этого достаточно зажать ctrl, выделить ячейки и скопировать их в буфер обмена. Текстовое представление содержимого буфера будет ни чем иным, как Tab Separated Values, который легко распарсить при вставке. Так что мы смело добавляем обработчик соответствующего события:

event *

paste?event <=> paste?event nullИ реализуем тривиальную логику:

paste( event? : ClipboardEvent ) {

const table = event.clipboardData.getData( 'text/plain' ).trim().split( '\n' ).map( row => row.split( '\t' ) ) as string[][]

if( table.length === 1 && table[0].length === 1 ) return

const anchor = this.current()

const row_start = anchor.row

const col_start = this.string2number( anchor.col )

const patch = {}

for( let row in table ) {

for( let col in table[ row ] ) {

const id = `${ this.number2string( col_start + Number( col ) ) }${ row_start + Number( row ) }`

patch[ id ] = table[ row ][ col ]

}

}

this.formulas( patch )

event.preventDefault()

}Славно, что всё это работает не только в рамках нашего приложения — вы так же можете копипастить данные и между разными табличными процессорами, такими как Microsoft Excel или LibreOffice Calc.

Выгрузка файла

Частая хотелка — экспорт данных в файл. Кнопку мы уже добавили ранее. Осталось лишь реализовать формирование ссылки на экспорт. Ссылка должна быть data-uri вида data:text/csv;charset=utf-8,{'url-кодированный текст файла}. Содержимое CSV для совместимости с Microsoft Excel должно удовлетворять следующим требованиям:

- ";" в качестве разделителя

- Каждое значение должно быть в кавычках.

- Кавычки экранируются посредством удвоения.

download_generate( event? : Event ) {

const table : string[][] = []

const dims = this.dimensions()

for( let row = 1 ; row < dims.rows ; ++ row ) {

const row_data = [] as any[]

table.push( row_data )

for( let col = 0 ; col < dims.cols ; ++ col ) {

row_data[ col ] = String( this.result({ row , col : this.number2string( col ) }) )

}

}

const content = table.map( row => row.map( val => `"${ val.replace( /"/g , '""' ) }"` ).join( ';' ) ).join( '\n' )

this.download_uri( `data:text/csv;charset=utf-8,${ encodeURIComponent( content ) }` )

$mol_defer.run()

}После установки новой ссылки, мы форсируем запуск отложенных задач, чтобы произошёл рендеринг в dom-дерево до выхода из текущего обработчика событий. Нужно это для того, чтобы браузер подхватил свежесгенерированную ссылку, а не предлагал скачать предыдущую версию файла.

Формулы

Самое главное в электронных таблицах — не сами данные, а формулы, через которые можно связывать значения одних ячеек со значениями других. При этом за актуальностью вычисляемых значений электронная таблица следит сама, реактивно обновляя значения в ячейках зависимых от редактируемой в данный момент пользователем.

В нашем случае пользователь всегда редактирует именно формулу. Даже если просто вводит текст — это на самом деле формула, возвращающая этот текст. Но если он начнёт свой ввод с символа =, то сможет использовать внутри различные математические выражения и, в том числе, обращаться к значениям других ячеек.

Реализовывать парсинг и анализ выражений — довольно сложная задача, а вечеринке уже мерещится ДедЛайн, так что мы не долго думая воспользуемся всей мощью JavaScript и позволим пользователю писать любые JS выражения. Но, чтобы он случайно не отстрелил ногу ни себе, ни кому-то ещё, будем исполнять его выражение в песочнице $mol_func_sandbox, которая ограничит мощь JavaScript до разрешённых нами возможностей:

@ $mol_mem

sandbox() {

return new $mol_func_sandbox( Math , {

'formula' : this.formula.bind( this ) ,

'result' : this.result.bind( this ) ,

} )

}Как видите, мы разрешили пользователю использовать математические функции и константы, а также предоставили пару функций: для получения формулы ячейки и вычисленного значения ячейки по её идентификатору.

Песочница позволяет нам преобразовывать исходный код выражения в безопасные функции, которые можно безбоязненно вызывать.

@ $mol_mem_key

func( id : { row : number , col : string } ) {

const formula = this.formula( id )

if( formula[0] !== '=' ) return ()=> formula

const code = 'return ' + formula.slice( 1 )

.replace( /@([A-Z]+)([0-9]+)\b/g , 'formula({ row : $2 , col : "$1" })' )

.replace( /\b([A-Z]+)([0-9]+)\b/g , 'result({ row : $2 , col : "$1" })' )

return this.sandbox().eval( code )

}Заставлять пользователя писать вызов функции result вручную — слишком жестоко. Поэтому мы слегка изменяем введённую формулу, находя комбинации символов, похожие на кодовые имена ячеек вида AB34, и заменяя их на вызовы result. Дополнительно, вместо значения, можно будет получить формулу из ячейки, приписав спереди собачку: @AB34. Создание таких функций — не бесплатно, так что если в ячейке у нас просто текст, а не выражение, то мы так его и возвращаем безо всяких песочниц.

Осталось дело за малым — реализовать свойство result() с дополнительной постобработкой для гибкости:

@ $mol_mem_key

result( id : { row : number , col : string } ) {

const res = this.func( id ).call()

if( res === undefined ) return ''

if( res === '' ) return ''

if( isNaN( res ) ) return res

return Number( res )

}Тут мы избавились от возможного значения undefined, а так же добавили преобразование строк похожих на числа в собственно числа.

Финальный аккорд

На этом основная программа нашей вечеринки подходит к концу. Полный код приложения $mol_app_calc доступен на ГитХабе. Но прошу вас не спешить расходиться. Давайте каждый возьмёт по электронной таблице в свои руки и попробует сделать с ней что-нибудь эдакое. Вместе у нас может получиться интересная галерея примеров её использования. Итак...

|

Метки: author vintage разработка веб-сайтов программирование open source javascript $mol $mol_app_calc typescript табличный процессор |

[Перевод] Опасная игра. Стоит ли полагаться на команду из джуниоров |

- Управление разработкой,

- Управление проектами,

- Управление персоналом,

- Карьера в IT-индустрии,

- Блог компании Alconost

Опасная игра. Стоит ли полагаться на команду из джуниоров

- Управление разработкой,

- Управление проектами,

- Управление персоналом,

- Карьера в IT-индустрии,

- Блог компании Alconost

- Перевод

Как это влияет на коллектив, менторство, качество кода, а также вопрос денег

Очевидно, что любая компания предпочитает брать в команду опытных разработчиков. Отдача от них лучше. Они предлагают более надежные и творческие решения, которые удобно масштабировать. Заправский senior-разработчик понимает проблемы и, вероятно, умеет не попадать впросак и минимизировать количество багов. Кроме того, код у таких разработчиков работает быстрее, чем у начинающих, и они умеют трудиться самостоятельно.

С другой стороны, деньги правят миром, а джуниоры стоят значительно дешевле. Зарплата опытного разработчика может вдвое превышать зарплату начинающего. Кроме того, начинающих разработчиков много, и иногда так и хочется нанять одного из них.

Мы в Alconost перевели статью о том, насколько рискованно полагаться на команду молодых разработчиков и как такая ситуация влияет на опытных разработчиков, менторов и качество продукта.

Проблеееемы, как минимум некоторые

Молодому разработчику нужен наставник. Не каждый обстрелянный разработчик справится с такой задачей без руководства и четкого понимания. Многие менеджеры совершают одну и ту же ошибку: набирают в одну команду много молодых разработчиков. Они думают, что если отдать новичков в подчинение сильному наставнику — все проблемы решены. Но наставник — это не волшебник. Быть наставником — тяжкий труд.

Не всякий разработчик годится в менторы. Как правило, среднестатистический разработчик не должен брать на себя такую миссию, не потренировавшись в менторстве. Способности у всех джуниор-разработчиков разные, и наставник не может учить их всех одновременно, тем более, если джуниоры подключались к команде в разное время. Создание команды, чрезмерно завязанной на множестве начинающих разработчиков, может привести к деструктивным последствиям, а менеджеры порой пропускают момент истины и не успевают справиться с ситуацией.

На проект требуются дополнительные разработчики — что делать? Перетасуем

Обычно на зарождающемся проекте заняты считанные разработчики. Проходит время, и — бууум! — проект перешел к стабильному развитию. В него вкладывается все больше времени и денег, на вас наседают заказчики, чувствуется прессинг. Тогда рекрутеры-технари принимаются круглосуточно искать новых разработчиков. Нельзя же собрать команду из одних новичков — поэтому приходится прибегать к перетасовке. Команды перекомпоновываются.

Итак, теперь работы много, требуется руководить множеством разработчиков. Иной менеджер решает: «Брошу их в дело, пусть выплывают». Такая ошибка может оказаться фатальной, и вы вскоре об этом узнаете. Что тогда? Снова кого-нибудь нанимаем и снова перетасуем. Людям не нравятся изменения, тем более — частые. Такие меры могут по-настоящему тряхнуть членов команды. Коллеги должны срабатываться, чувствовать друг друга и знать сильные стороны соратников.

Выгорание наставника

Любой менеджер, берущий человека в команду, принимает решение. Если новобранец опытный, наставник ему зачастую не требуется. Даже при наличии ментора опытный разработчик обычно независим и умеет учиться сам. Когда разработчик неопытен, наставнику придется туже. У него есть основные обязанности и в нагрузку — педагогические. Каждый час ему могут поступать новые вопросы. Ментор должен не только помогать разработчику решать возникающие проблемы, но и учить, как учиться. В противном случае наставник не успеет выполнять свои основные обязанности.

Когда у наставника несколько подопечных, они могут засыпать его просьбами о помощи и совершенно не оставить времени на основную работу. Хороший ментор должен быть терпелив и уметь слушать. Длительное наставничество порой бывает изнурительным, и иногда чувствуется выгорание.

Бремя опытных разработчиков

Не все опытные разработчики — менторы, и это не упрощает ситуацию. Естественно, наставник получает меньшую нагрузку, нежели остальные. Поэтому типичный менеджер осознает, что, если не нагружать опытного разработчика менторством, то он будет трудиться продуктивнее.

Железное правило: когда часть сокомандников занята молодняком, другие должны перераспределить между собой их нагрузку. Они получают больше ключевых задач и тем самым позволяют наставникам — учить, а новичкам — учиться. Они отвечают за прогресс в разработке продукта. Со временем такая роль может стать очень обременительной. Менеджер, руководящий процессом, должен не лишать таких разработчиков контакта с другими членами команды.

Как это сказывается на качестве кода

Менеджер не может держать планку по качеству кода, если на одного опытного разработчика приходится четверо начинающих. Он не в силах, а если вы — в силах, то дорогого стоите. Компания жива, пока подпитывается деньгами, и когда деньги иссякают — с ней все кончено. Все — начинающие, обстрелянные, опытные разработчики и даже уборщики — ходят на работу, потому что хотят кормить семью.

Итак, насколько меняется качество кода? Сильно. Шкала в данном случае варьируется, все зависит от того, насколько джуниоров заставляют быть продуктивными, и от периода обучения. Как правило, наставник скажет: «Будет рефакторинг — поправим».

Обычно это чепуха. По тем самым причинам никакого рефакторинга обычно не наступает, и качество кода в данном приложении становится «стандартом» для всего проекта. Где удобнее всего добыть образец кода? В нашем же приложении. Все стандарты оформления кода там соблюдены. Префиксы тоже как надо, так почему бы нет? Ctrl+C & Ctrl+V, прощайте, стандарты программирования, се ля ви.

Хрупкий код

Качество кода пострадало. А что насчет хрупкости? Когда новичок пишет блок кода, он еще не знает, где этот код может сломаться. Код называется хрупким, если в нем легко возникают баги. Пример: функция не проверяет значения аргументов, их тип или диапазон валидации. Это простой пример. Но порой баг выловить сложнее, например, если в коде JS инструкция проверяет на undefined, но не на null, либо если условие if получилось сложным, и программист не учел в нем порядок предшествования операций. Редактор, просматривающий код, должен быть в курсе таких изъянов и настороженно их выискивать. Тестирование кода позволяет радикально снизить риски.

Наш месседж — ДОЗИРУЙТЕ, причем аккуратно.

Новички, опытные разработчики, наставники, менеджеры, баги, клиенты и деньги. Каждый из них важен и играет свою роль. Как бы там ни было, все когда-то начинают с самых первых шагов. Ни один senior-разработчик не родился сразу с достаточными знаниями и опытом.

Нельзя кусать руку, которая тебя кормит. Нужно понимать, что перетряска и перетасовка команды — это вмешательство, которое может дорого обойтись. Здесь важно знать меру и строго ее соблюдать. Если без перетасовки не обойтись — добейтесь, чтобы она происходила не чаще, чем с интервалом от девяти месяцев до года. Убедитесь, что наставники не выгорают, а остальные разработчики не трудятся на износ.

Набор молодых разработчиков — это тактика со множеством преимуществ. Если как следует наладить наставничество и подобрать подходящий учебный план, такая работа может оказаться очень плодотворной. Начинающего разработчика легче сформировать по своему вкусу, чем опытного. Новички знают, что не пользуются бешеным спросом. Поэтому у них выше стремление и мотивация тратить собственное время на прокачку навыков и выстраивание карьеры.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией игр, приложений и сайтов на 68 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Подробнее: https://alconost.com

|

|

20 полезных сервисов для продакт-менеджеров |

20 полезных сервисов для продакт-менеджеров

digital-продукта» собрали подборку сервисов, которые помогут тимлиду, продакту или проджекту наладить работу в команде и сделать свою жизнь лучше. Возможно, многие из них будут вам знакомы — по рабочему процессу или по слухам. Будем рады, если в комментариях вы предложите свои варианты или расскажете, чем понравился/не понравился тот или иной сервис.

Когда каждый день занимаешься не только текучкой, но и вещами, направленными на улучшение работы продукта, внедрение фич и искоренение багов, то волей-неволей хочется сделать жизнь проще. Сделать так, чтобы команда работала сплоченнее, были видны все этапы работы и не было бы развала-схождения в каждую минуту работы.

В таком случае приходят на помощь сервисы. Мы опросили четырех преподавателей курса «Руководитель digital-продукта» и сделали подборку сервисов, которые облегчат жизнь и помогут наладить эффективную работу.

Пять сервисов Кати Текуновой — руководителя сервиса «Рамблер/платформа» в Rambler&Co

1. Excel — использует для всего: от вычислений до сбора аналитики. Удобно, всем известно, работает на всех устройствах. Сейчас его отлично заменяют Гугл Таблицы, что намного удобнее. Можно открывать и закрывать доступ, делать все то же самое, что и в Excel, функциональность не ограничена, а доступ к файлу возможен из любой точки мира. Плюс возможность редактирования, комментирования и даже постановки задач через @.

2. Jira — для постановки и отслеживания задач незаменима. Считается одним из лучших продуктов для agile-команд. В ней можно создавать пользовательские истории и задачи, планировать спринты и распределять задания по командам. Создавать подзадачи и распределять по отделам. Можно расставлять приоритеты, релизить продукты и быть уверенным, что информация останется под рукой. К тому же есть возможность создавать отчеты, визуализировать данные.

К тому же можно оптимизировать работу, интегрируясь с Confluence, Bitbucket, Stride и сотнями других инструментов для разработки.

Jira пользуются Airbnb, Spotify, Ebay, Cisco и многие другие.

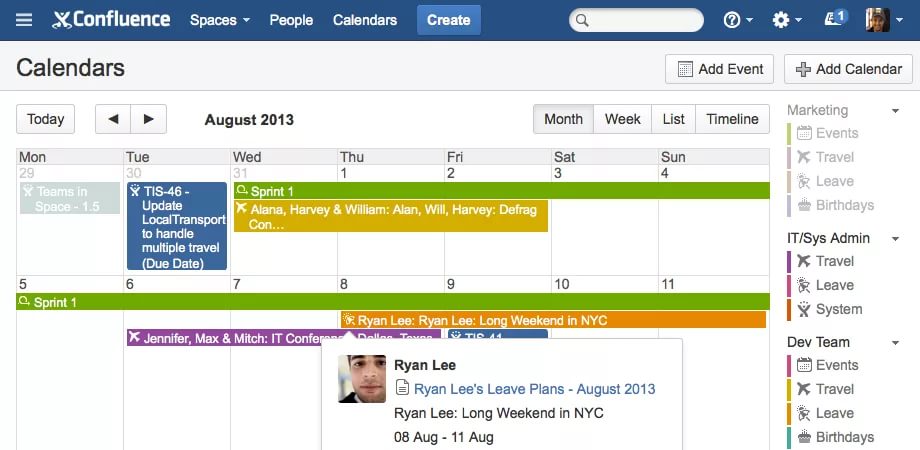

3. Confluence — создан для всей документации по продуктам: описания сервисов и продуктовые требования, техническая документация, описания релизов. Одним кликом интегрируется с Jira. Сделан той же командой Atlassian.

Это тиражируемая вики-система для внутреннего использования организациями с целью создания единой базы знаний. Confluence любит Nasa, Docker и Lufthansa.

4. Zeplin — для работы с макетами. Идеальное взаимодействие между дизайнером, продактом и фронтенд-разработкой. Больше никаких огромных количеств встреч, созвонов и так далее. Отлично работает со Скетч, Фотошопом. О Zeplin на Хабре можно прочесть тут.

Zeplin пользуются Slack, Pinterest, Zendesk, MailChimp и множество других компаний.

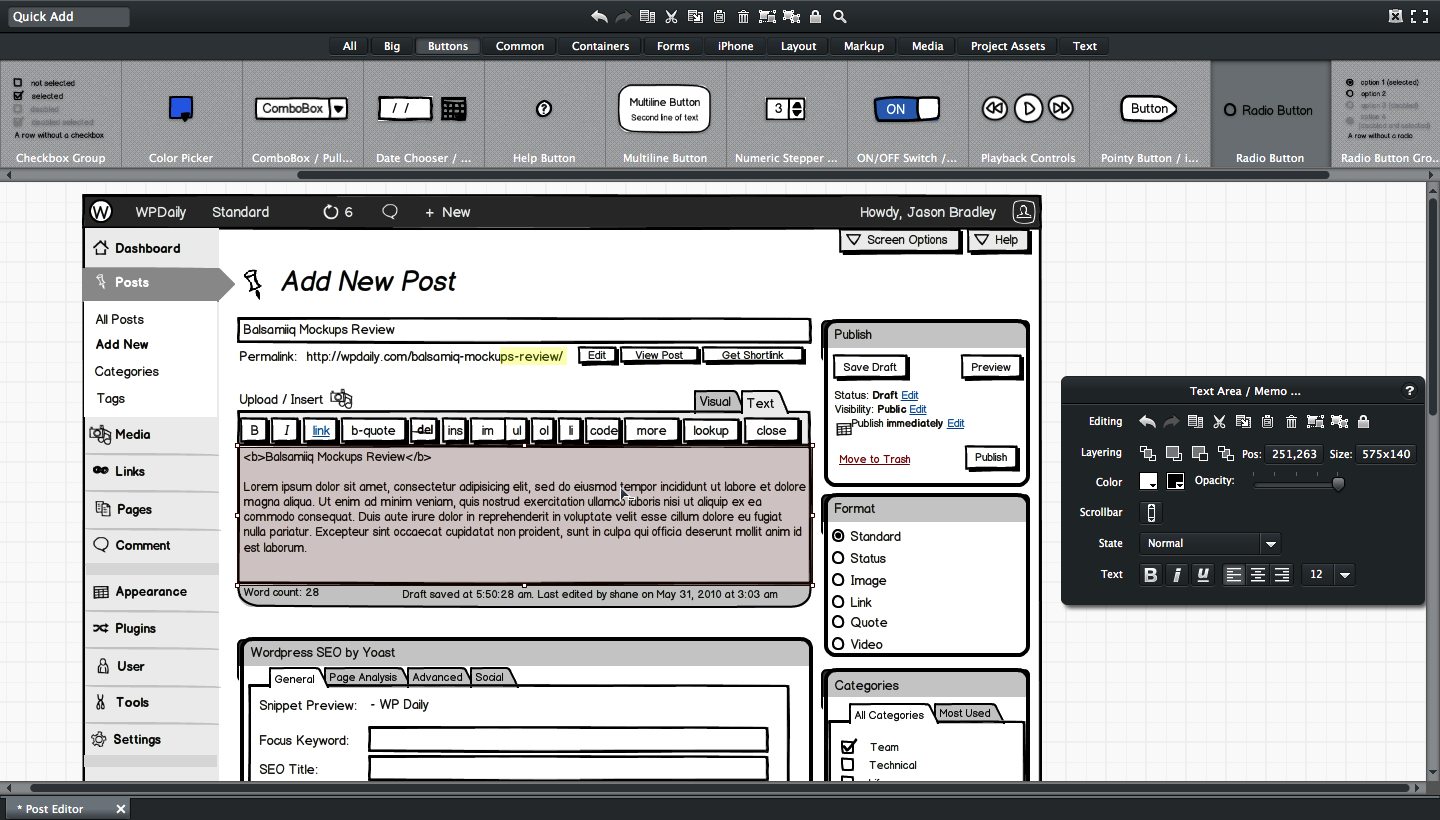

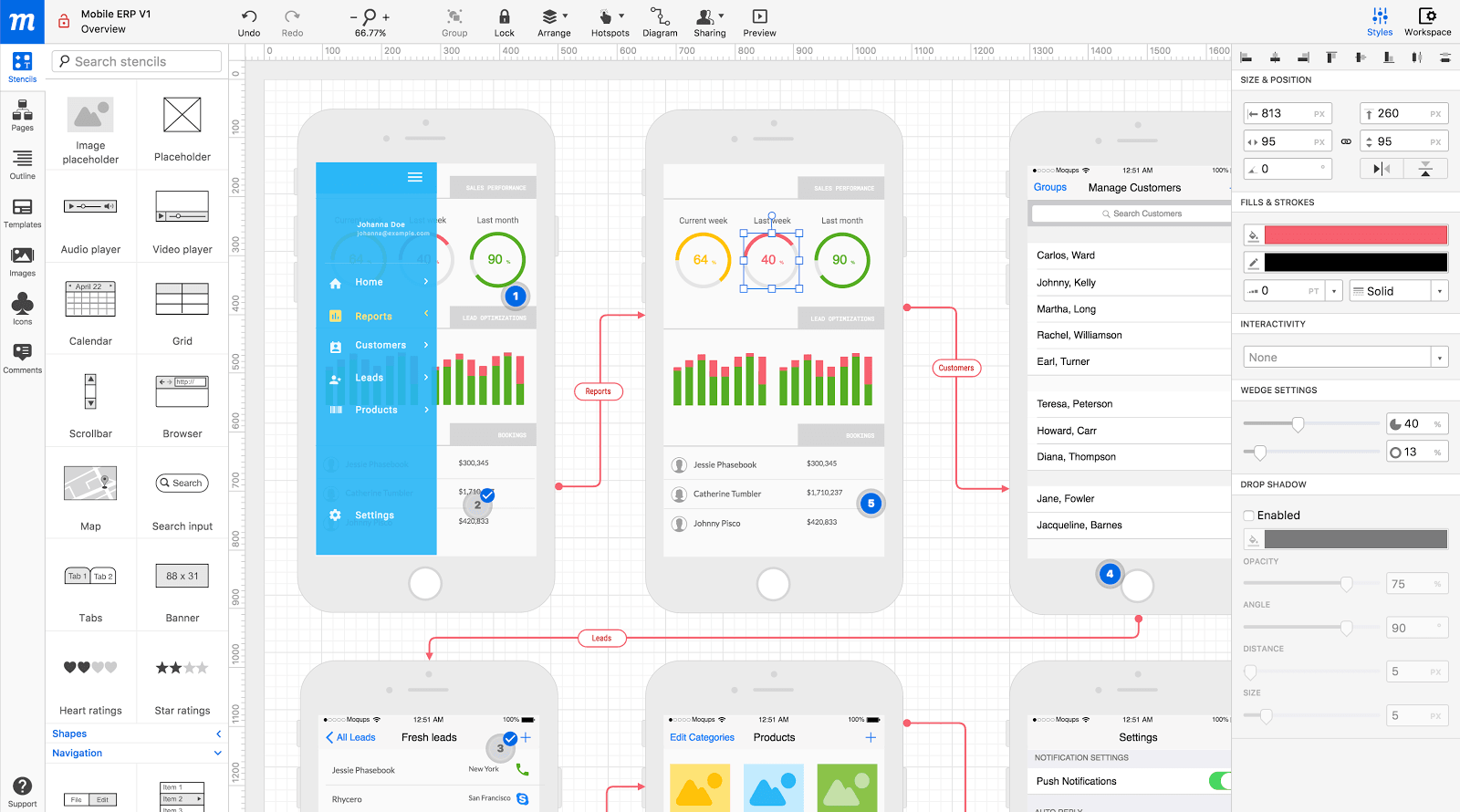

5. Balsamiq — для мокапов и прототипов. Очень удобен и интересен как инструмент. Имеет библиотеку пользовательского интерфейса. Имеется контроль версий, возможности для A/B-теста. Имеет расширения и помогает работать одновременно продуктологам, дизайнерам и фронтендерам.

Balsamiq любят в Cisco, Zappos, Apple, Adobe, Ebay, Skype, Sony и других компаниях.

Пять сервисов Михаила Карпова — менеджера по продукту во ВКонтакте

1. Zeplin пропускаем, потому что оду ему спели выше. Разберем другие четыре сервиса.

2. Как использовать Google Docs продакту? В нем удобно составлять роадмапы сервисов и сводить данные по статистике в Гугл Таблицах.

3. Dropbox Paper — очень удобный инструмент чтобы вести продуктовую документацию по запускаемой функциональности. При этом он интегрируется со множеством других сервисов: от SoundCloud и Spotify до Youtube и Google Docs. При этом есть чаты и возможна совместная работа, что идеально для любого продакта.

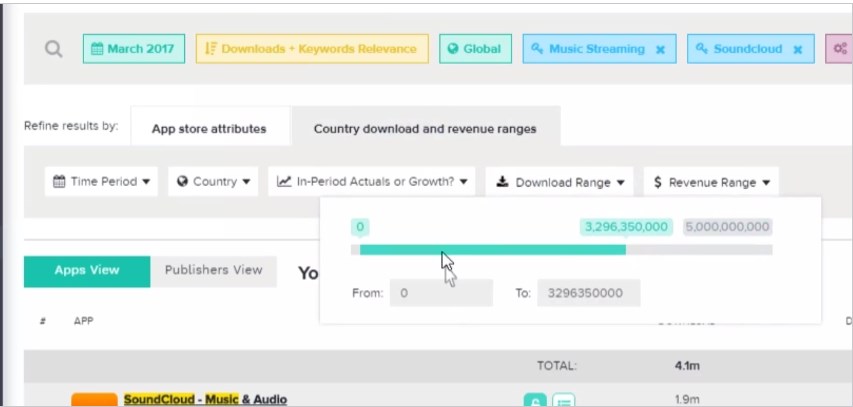

4. PrioriData — удобный инструмент для изучения конкурентов на мобильных платформах. Позволяет ранжировать ключевые слова, делать выгрузки и проверять расходы. И помогает исследовать рынок и развивать собственное приложение.

5. Moqups — простой и комфортный сервис для быстрого прототипирования идей. Помогает команде работать над макетами, мокапами, прототипами и диаграммами. Все в одном: от дизайна до сотрудничества.

Пять сервисов Ивана Замесина — менеджера по продукту в Chatfuel

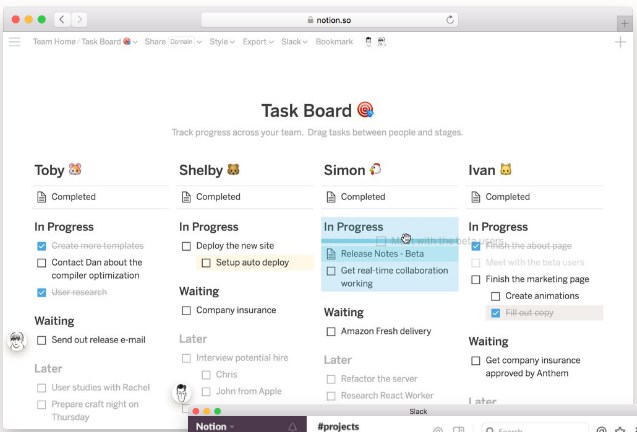

1. Лучший сервис последних двух лет — Notion.so. Это сервис организации информации и процессов как для команд, так и для личного использования. Он невероятно удобен для написания текстов, работы над проектами, ведения личного дешборда. Он заменил Evernote и все текстовые редакторы. Плюсик в карму за внимание к UX микродействий вроде добавления нового элемента. Кстати, в TestFlight сейчас крутится бета приложения под iOS и оно восхитительно!

2. Sketch. Продакт должен уметь проектировать базовые пользовательские сценарии в интерфейсе и чтобы не отвлекать дизайнера уметь быстро собрать нужный интерфейс в Sketch из готовых компонентов. Применение: быстрые фиксы интерфейсных косяков или missing scenarios минуя дизайнера, корректировка текстов в макетах, прототипирование вместе с клиентом во время customer development.

3. Trello. Незаменимый мультитул для продакта. Прелесть Trello в простоте и гибкости. С помощью Trello можно вести список фичереквестов от пользователей и удобно ранжировать их в течение времени, планировать работы команды на горизонте недель и месяцев, вести оперативную работу команды.

4. Clear. Это банальный todo-app. Продакту не нужны due dates, группировка по проектам, теги, делегирование и прочие навороты. Главный атрибут для тудушки — минимизация накладных расходов на обращение к тудушке, а это значит что она должна постоянно висеть на экране. Clear одно из немногих no-UI туду-приложений и легко занимает любое отведённое ему место. Clear всегда висит на моём экране справа, занимая 25% экранной площади и экономит тонну времени и внимания.

5. Zoom.us. Последняя команда была распределённой и конференс-коллы были настоящей болью. Skype нужно было постоянно перезапускать, часто он просто не работал или собеседники не слышали друг друга. Hangouts победил в номинации «самая идиотская организация групп», но никак не в номинации «удобен для использования в команде». Zoom.us единственный инструмент, который просто работает — у него хорошее качество картинки и звука, адекватный интерфейс и логика работы.

Пять сервисов Микаэла Гелецяна — менеджера по продукту в «Детском мире» и «Кидзания Москва»

1. Product Hunt используется для вдохновения, нахождения в тренде и проверки «а нету ли уже такого продукта?».

2. Moqups — мокапы и прототипы, которые хранятся в вебе. Используется для иллюстрации требований. На любой проект можно дать ссылку. При этом хранение данных в облаке, удобно для работы с удаленной командой, неограниченное количество пользователей с одной подпиской. В общем, целая экосистема проектирования в одном инструменте.

3. Mindmeister. Работает для продакта как карта памяти — лучший формат для структурирования любых данных. От встречи с заказчиком или стейкхолдером до фичей сайта.

4. Usabilityhub — инструмент для того самого случая, когда нужно показать прототип настоящим людям, а искать — нет времени. А еще лучшая штука для удаленного тестирования пользователей. Сервис используют Amazon, Groupon, Hubspot, Nasa.

5. Getabstract, чтобы читать выжимки из кучи книг, на которые бы не нашлось времени. Образование для продакта важно, потому что каждый день появляется что-то новое. А поспевать за временем, идеями и новыми веяниями надо.

|

|

Дайджест IT событий на октябрь |

Дайджест IT событий на октябрь

Всероссийский форум «Блокчейн: формула будущего»

Когда: 1-3 октября

Где: Уфа, ул. Менделеева, 158, ВДНХ-Экспо

Условия участия: бесплатно, требуется регистрация

Уфимский форум 5-в-1 по блокчейну отличается разнообразием форматов: здесь параллельно с привычными лекциями и выставкой финтех-продуктов пройдет также хакатон и два конкурса стартапов. Насыщенная трехдневная программа позволяет желающим поспеть везде — и посоревноваться за денежные призы, и послушать выступления экспертов, и оценить экспонаты.

Курс «Основы построения фреймворка автоматизированного тестирования на HP UFT»

Когда: 7 октября

Где: Москва, 1-й Волоколамский проезд, 10, стр. 3

Условия участия: Москва — 14 200 руб., Санкт-Петербург — 12 780 руб. Омск — 10 650 руб.

Если вы QA-инженер и читаете это, возможно, стоит не пожалеть двух рабочих дней на освоение HP UFT. Краткий курс целиком посвящен искусству писать легко сопровождаемые, доступные, предназначенные для многоразового использования автоматизированные тесты. Достигается это путем подробного рассмотрения синаткиса VBS со всеми базовыми командами, принципов работы с объектами и применения классов в UFT, основ VBScript, параметризации и распознавания объектов и других премудростей. По завершению вы сможете добавить в свою коллекцию еще один сертификат.

HackCV

Когда: 7 октября

Где: Санкт-Петербург, Большой Сампсониевский проспект, 61

Условия участия: бесплатно

Хакатон, на котором вы сможете воплотить мечту целой армии фантастов и вдохнуть жизнь в автомобиль при помощи технологии Computer Vision. Организаторы предложат командам ознакомиться с теоретическими материалами по нейросетям, поработать с библиотеками компьютерного зрения и специфическими для safety critical embedded system фреймворками и совместными усилиями научить автомобиль ездить так, чтобы в случае восстания машин он могу без проблем получить права. Требования к кандидатам включают знание C++ и хорошую математическую подготовку, опыт участия в подобных проектах опционален.

Blockchain Club Moscow

Когда: 10 октября

Где: Москва, Павелецкая набережная, 2, стр. 2

Условия участия: 800 руб.

Небольшая встреча единомышленников для тех, кто спит и видит себя в блокчейне. Спикеры — представители сектора с соответствующими компетенциями — поднимут три, пожалуй, самые животрепещущие темы: как вообще приступить к проведению ICO, какой должна быть команда, чтобы осилить это процесс, и все, что нужно знать о его юридической стороне.

INTERNATIONAL BLOCKCHAIN FORUM

Когда: 12 октября

Где: Москва, Берсеневская набережная, 6, стр. 3, 6 этаж

Условия участия: 14 700 руб.

Тоже блокчейн, но помасштабнее. Эксперты из России и СНГ соберутся на крупнейшем отечественном форуме, чтобы обменяться мнениями касательно того, что происходит в сфере криптовалюты в данный момент и чего ждать от будущего. Программа включает пять основных блоков. Первый посвящен прогнозам, перспективам, подробному обзору последних новшеств и их влияния на рынок. В ходе второго блокчейн будет рассматриваться как способ получения прибыли: участники — и в первую очередь новички — смогут узнать о связанных с ICO рисках и сложностях, ознакомиться с чужим успешным и не успешным опытом и получить рекомендации от опытных игроков. Следующий блок отведен теме криптовалютных фондов, инвестиционных возможностей, которые они дают, правовых нюансов и обзора популярных вариантов в России и зарубежье. Далее речь пойдет о биржах и прочих площадках торговли, причем слушатели смогут не только взглянуть на нелегкую профессию трейдера изнутри, но и присоединиться к рядам торгующих, записавшись в школу, или же блеснуть талантами на особом конкурсе для начинающих, который будет проведен с рамках форума. Наконец, в заключение спикеры коснутся майнинга и познакомят аудиторию со спецпредложениями по формированию майнинг-пула.

Форум GoTech

Когда: 12 октября

Где: Москва, Долгопрудненское шоссе, 3

Условия участия: 3900 руб.

Площадка — рай для стартапов, где можно послушать о том, как росли и добивались успеха предшественники, зондировать почву с инвесторами и журналистами, рассказывать о своем проекте и открывать новые возможности. Общая тема форума — развитие глобального бизнеса. Заявлен также конкурс проектов с рядом номинаций от крупных компаний, которые обеспечат победителям менторскую поддержку и ресурсы для роста.

BIT-2017

Когда: 12 октября

Где: Новосибирск, ул. Ленина, 26

Условия участия: бесплатно по итогам отбора

Сибирское мероприятие на стыке бизнеса и IT предлагает сообществу обсудить, как современные технологии уживаются с меняющимися реалиями рынка и юридической системы. В докладах будут затрагиваться такие сферы, как облачное хранение, ЦОД, IoT, IP и другое.

Pizza Pitch

Когда: 12 октября

Где: Москва, ул. Кирпичная, 33, стр. 2

Условия участия: 200 руб.

Рады сообщить, что сходка анонимных стартаперов от ВШЭ состоится и в октябре. Как и в первый раз, на повестке — презентации от тех, у кого есть идея, проект или проблема, общая дискуссия с советами от местных экспертов и пицца на закуску всего этого.

Yappi Days’17

Когда: 13 октября

Где: Ярославль, Волжская набережная, 4

Условия участия: от 400 руб.

Ярославские программисты, работающие с Big Data, имеют возможность обменяться опытом с представителями крупных компаний (EPAM, JetBrains) на октябрьской Yappi Days. Речь войдет о современным технологиям в обработке данных и архитектуре ПО. Спикеры обещают поделиться лучшими практиками из своего опыта в докладах и вступить о слушателями в свободный диалог в экспертной зоне, а организаторы намекают на подарки участникам и прочие приятные бонусы.

INDEX TECH

Когда: 13 октября

Где: Москва, ул. Мясницкая, 13, стр. 18

Условия участия: 6000 руб.

Интересная конференция по одному из самых болезненных вопросов в IT сообществе — вопросу совместной работы кадровиков и девов в процессе отбора и оценки соискателей. Организаторы оптимистично рассчитывают на цивилизованное обсуждение таких тем, как роли представителей HR и IT отделов в процессе, необходимый уровень технический знаний для проводящего собеседования, стандартные и нестандартные каналы поиска кадров, правила составления вакансии, обучение на рабочем месте. Само собой, не обойдется и без примеров из жизни и, что особенно ценно, слово в ходе выступлений получат все три вовлеченные стороны.

#UFADEVCONF

Когда: 14 октября

Где: Уфа, ул. Менделеева, 158

Условия участия: бесплатно, требуется регистрация

В рамках проекта «День Интерента» состоится первая уфимская IT-конференция, на которой местные и приглашенные специалисты смогут обсудить широкий круг тем, касающихся IT-сферы. Программа включает секции Frontend (локализация, JavaScript, MobX, шаблонизация), Backend (Postgres, PHP, практические кейсы) и Mobile (повышение производительности, кроссплатформенность, Vision framework). В регулярных перерывах между докладами аудитории предлагается заняться нетворкингом и оценить заготовленную организаторами развлекательную программу.

#ITSUBBOTNIK: TECHNICAL MIX

Когда: 14 октября

Где: Рязань, Первомайский проспект, 54, конгресс-отель «АМАКС»

Условия участия: бесплатно, требуется регистрация

Микс — это не для красного словца, рязанская конференция действительно обещает крайне разношерстный набор тем. Что-нибудь интересное найдется для программиста любого профиля: тут и DevOps, и реактивное программирование, веб-разработка рука об руку с machine learning, да и тестирование не осталось в стороне. Докладчики — специалисты из компании EPAM.

SeedStars Moscow

Когда: 14 октября

Где: Москва, ул. Мясницкая, 13 стр. 18

Условия участия: бесплатно, требуется регистрация

Ощущаете себя лучшим стартапом в Европе? Бывает, но если серьезно: не упустите свой шанс доказать это международной экспертной комиссии и получить миллион на развитие. В ходе русского этапа Seedstars World будут отобраны 10 финалистов, которые отправятся в Швейцарию на заключительный этап, бороться за приз и мировую славу. К участию приглашаются стратапы из сфер AgriTech, IoT, EdTech, FinTech, TravelTech, HealthTech, AdTech не старше двух лет, с объемом инвестиций не более 500 000 $ и обязательным наличием MVP.

Найти IT

Когда: 14 октября

Где: Санкт-Петербург, набережная Обводного канала, 60, креативное пространство «ТКАЧИ»

Условия участия: бесплатно

Отличная возможность для разработчиков культурной столицы, заинтересованных в новых карьерных возможностях, людей посмотреть, себя показать и между делом поиграть с роботами. На площадке будут присутствовать представители ведущих отечественных IT-компаний, которые будут рады рассказать о вакансиях и стажировках и оценить ваши компетенции. Помимо общения с возможными работодателями посетители могут принять участие в бесплатных лекциях и мастер-классах, посетить game зону и выставку робототехники.

Курсы «Базы данных. SQL. Junior», «Разработка кроссплатформенных мобильных приложений», «Разработка highload приложений на PHP»

Когда: 16-31 октября

Где: Ижевск, ул. 30 лет Победы, 2

Условия участия: бесплатно, требуется регистрация

В октябре в рамках проекта IT Univer в Ижевске планируется три курса для студентов и начинающих программистов, которые хотят получить прикладные знания и глубже вникнуть в выбранную сферу. Подробная информация об организаторах и программе каждого представлена на странице проекта.

Cloud Services Russia 2017

Когда: 17 октября

Где: Москва, ул. Тверская, д. 26/1, отель «Марриотт Москва Гранд Отель»

Условия участия: 13 500 руб.

Облачное хранение данных — тема неиссякаемая, что доказывает и очередная тематическая конференция от COMNEWS. Дискуссия будет вращаться вокруг последних тенденций на рынке, умного хранения данных в свете новых разработок в области искусственного интеллекта и Интернета вещей, совмещения частных и публичных сред и вытекающих вопросов безопасности, специфики применения облака в ПО. Также будут рассмотрены некоторые одобренные экспертами решения и технологии, приведены случаи из практики успешных компаний.

DevOops

Когда: 20 октября

Где: Санкт-Петербург, ул. Стартовая, 6, литера А

Условия участия: от 14 000 руб.

Первая конференция, целиком и полностью сосредоточенная на DevOps и всем том, что он привносит в нашу жизнь. В частности: оркестрация, виртуализация, мониторинг и аудит приложений, секрьюти. Разделенные по трем трэкам, выступления будут объединять широкую проблематику с решением частных проблем, а теорию — с реальными кейсами. Общение с русскими и зарубежными экспертами продолжится в специально оборудованных дискуссионных зонах.

SECR 2017

Когда: 20-22 октября

Где: Санкт-Петербург, пр. Медиков, 3, к.1, Конгресс-центр ClubHouse

Условия участия: от 17 250 руб.

Конференция «полного цикла» для команд, работающих над ПО — освещение получат практически все аспекты процесса создания и выпуска на рынок IT-продукта. Выступления и мастер-классы от русских и зарубежных представителей действительно авторитетных компаний разбиты на три дня и пять потоков и покрывают все от собственно разработки, тестирования и UX дизайна до DevOps и управления проектами.

SmartData

Когда: 21 октября

Где: Санкт-Петербург, ул. Стартовая, д. 6 литера А

Условия участия: 14 000 руб.

Октябрь в сфере IT оказался урожаен на и большие данные — встречайте еще одну конференцию на эту тему. SmartData предлагает взглянуть на big data как на уже сложившуюся, зрелую индустрию и проследить, как наработанный стек решений справляется с реальными задачами, насколько сейчас актуальны те или иные технологии.

Russian Вlockchain Week

Когда: 26-27 октября

Где: Москва, Стремянный пер., 36

Условия участия: 18 000 руб. (23 после 28.09)

Три дня блокчейна в самых разных проявлениях: здесь будут доклады от трех десятков экспертов со всего света, шоу и выставка, на которых представят свои проекты пятьдесят молодых команд, открытые для сотрудничества инвесторы и поставщики и вечеринка Blockchain.Night как завершающий аккорд в неформальной обстановке. Круг тем знакомый — криптовалюты, майнинг, ICO, законодательство.

MBLTdev 2017

Когда: 27 октября

Где: Москва, Берсеневская наб. 6, строение 3

Условия участия: 7 500 руб.

То, чего, вероятно, ждали все мобильные разработчики — общий сбор специалистов, от столичных до экспортированных ради такого случая из Кремниевой долины, для обсуждения последних трендов и вечных проблем разработки на iOS и Android. В темах фигурируют AR, архитектура, инструменты разработки, производительность и скорость, а также викторины и прочие интригующие мероприятия.

Workshop. IoT

Когда: 28 октября

Где: Москва, Берсеневская набережная, 6, стр.3