Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Межпланетная файловая система — Переходим на localhost (локальный шлюз IPFS) |

Мало смысла в IPFS если использовать его только как бесплатный хостинг для сайта в сети интернет. Поэтому мы научимся здесь загружать наш сайт через локальный IPFS шлюз пользователя.

Пользователю это даст быстрый доступ к его локальной копии нашего сайта.

Также мы научимся переключать на локальный шлюз IPFS сайты которые этого ещё не делают.

Напомню: InterPlanetary File System — это новая децентрализованная сеть обмена файлами (HTTP-сервер, Content Delivery Network). О ней я рассказывал в статье "Межпланетная файловая система IPFS".

Переключаем наш сайт

DNS

У нашего сайта на данный момент уже есть как минимум 3 DNS записи:

A [Наш домен] [IP адрес хостинга]

TXT [Наш домен] dnslink=/ipfs/[CID контента]

TXT _dnslink.[Наш домен] dnslink=/ipfs/[CID контента]Добавим к ним ещё 3:

A l.[Наш домен] 127.0.0.1

TXT l.[Наш домен] dnslink=/ipfs/[CID контента]

TXT _dnslink.l.[Наш домен] dnslink=/ipfs/[CID контента][CID контента] — Это идентификатор контента (CID) раньше назывался мультихеш. Его мы получаем публикуя сайт командой ipfs add в сети IPFS.

Скрипты и стили

В HTML тегах script и link появились поля integrity и crossorigin. Они отвечают за проверку хеша до запуска скрипта или применения стилей. Их мы и используем для определения рабочего шлюза у посетителя сайта.

Расположить их лучше в конце страницы чтоб они не задерживали загрузку и отображение.

Варианты адресов которые нам надо проверить:

http://l.[наш домен]:8080

8080 это стандартный порт на котором по умолчанию запускается IPFS.

Если всё настроено правильно то с http версии сайта браузер загрузит скрипт или стиль.

https://l.[наш домен]:8443

8443 это порт на который пользователь может настроить stunnel.

Данный вариант нам понадобится если запрос идёт с HTTPS сайта и наш домен добавлен в локальный сертификат.

http://127.0.0.1:8080/ipns/[наш домен]

Этот вариант на случай если мы не задалиlдомен для нашего сайта и запрос идёт с http.

https://127.0.0.1:8443/ipns/[наш домен]

Этот вариант на случай запроса с https. Этот вариант сработает если не заданlдомен или не добавлен в локальный сертификат.

Аналогичным образом мы можем проверить порты 80 для http и 443 для https.

Проверяем локальный шлюз и переключаемся на него скриптом

Добавив этот скрипт к странице вашего сайта вы автоматически переключите посетителя на его локальный IPFS шлюз.

redirect_to_ipfs_gateway.js

var redirect_to_local;

/*

Эта функция добавляет к текущему домену третьим уровнем домен ```l```

*/

function l_hostname()

{

var l_hostname = window.location.hostname.split(".");

l_hostname.splice(-2,0,"l");

return l_hostname.join(".");

}

/*

Эта функция создаёт новый элемент script и с адресом скрипта который должен загрузиться через локальный шлюз пользователя.

Также она создаёт функцию которая будет вызвана этим скриптом в случае удачной загрузки.

В случае не удачи выполниться функция из переменной onerror которая присваивается соответствующему полю элемента script.

*/

function add_redirect_script(prtocol, port, use_ip, onerror){

var script = document.createElement("script");

script.onerror = onerror;

script.setAttribute("integrity", "sha384-dActyNwOxNY9fpUWleNW9Nuy3Suv8Dx3F2Tbj1QTZWUslB1h23+xUPillTDxprx7");

script.setAttribute("crossorigin", "anonymous");

script.setAttribute("defer", "");

script.setAttribute("async", "");

if ( use_ip )

script.setAttribute("src", prtocol+"//127.0.0.1:"+port+"/ipns/"+window.location.hostname+"/redirect_call.js");

else

script.setAttribute("src", prtocol+"//"+l_hostname()+":"+port+"/redirect_call.js");

redirect_to_local = function()

{

var a = document.createElement("a");

a.href = window.location;

a.protocol = prtocol;

a.port = port;

if ( use_ip ){

a.pathname = "/ipns/" + a.hostname + a.pathname;

a.hostname = "127.0.0.1";

}else{

var hostname = a.hostname.split(".");

hostname.splice(-2,0,"l");

a.hostname = hostname.join(".");

}

window.location = a.href;

};

document.head.appendChild(script);

}

/*

Это главная функция которая запускается сразу. Она проверяет не находимся ли мы уже по адресу шлюза. Если нет то начинает проверять его доступность перебирая варианты адресов и протоколов.

*/

!function(location){

if ( location.protocol.indexOf("http") == 0 &&

location.hostname.length > 0 &&

location.hostname.indexOf("l.") != 0 &&

location.hostname.indexOf(".l.") < 0 &&

location.hostname != "127.0.0.1" )

{

add_redirect_script( "http:", 8080, false,

function(){

add_redirect_script( "https:", 8443, false,

function(){

add_redirect_script( "http:", 8080, true,

function(){

add_redirect_script( "https:", 8443, true );

} );

} );

} );

}

}(window.location)В пару ему идет скрипт:

redirect_call.js (sha384-dActyNwOxNY9fpUWleNW9Nuy3Suv8Dx3F2Tbj1QTZWUslB1h23+xUPillTDxprx7)

redirect_to_local();Integrity этого скрипта можно посчитать командой:

openssl dgst -sha384 -binary < "redirect_call.js" | openssl enc -base64 -AУ меня соответственно результат этой команды:

dActyNwOxNY9fpUWleNW9Nuy3Suv8Dx3F2Tbj1QTZWUslB1h23+xUPillTDxprx7Если у вас результат другой замените это значение в скрипте выше на своё.

Теперь пользователь будет автоматически перенаправлен на подходящий локальный адрес шлюза с сохранением остальных параметров адреса.

Определяем рабочий шлюз при помощи CSS

Создадим CSS файл который будет маяком работы шлюза.

httpl.css (sha384-9LLp4PYTHwNvd5whc7IOL6JLDJ4aoPufAFts3rMLZOg5b//BLQZTfe7krAzWAm+a)

.httpl{display: block;}

Скрываем элементы страницы которые будут показаны только при доступности локального шлюза.

Добавляем CSS маяк в конце страницы

- Этот элемент будет отображаться если загрузиться "httpl.css"

Use your gateway: http://l.[ваш домен]:8080/

Теперь даже если у пользователя отключены скрипты он сможет перейти на шлюз самостоятельно по ссылке. Аналогично можно проверить и остальные варианты адреса шлюза.

Локализуем глобальный шлюз или сайты в IPFS

Возьмём к примеру глобальный IPFS шлюз gateway.ipfs.io и перенаправим этот адрес на наш локальный IPFS шлюз.

Условие: У нас уже установлен и работает на стандартном порту 8080 IPFS шлюз.

В файл hosts добавляем домен который хотим загружать с IPFS шлюза.

127.0.0.1 gateway.ipfs.io

Устанавливаем и настраиваем Stunnel.

stunnel.conf:

; Открываем дополнительный защищённый порт шлюза для того чтобы сайты могли сами на него переключиться [https gateway] accept = 127.0.0.1:8443 connect = 127.0.0.1:8080 cert = stunnel.pem TIMEOUTclose = 0 ; Открываем стандартный порт 443 для HTTPS [https] accept = 127.0.0.1:443 connect = 127.0.0.1:8080 cert = stunnel.pem TIMEOUTclose = 0 ; Открываем стандартный порт 80 для HTTP [http] client = yes accept = 127.0.0.1:80 connect = 127.0.0.1:443

Таким образом мы открываем 3 дополнительных порта (433, 8443, 80) которые подключают клиента к шлюзу IPFS.

Создаём сертификаты и ключи.

3.1. В директорию c конфигом копируем

makecert.cmd

echo off %~d0 cd %~p0 set STUNNELBIN = ..\bin set PATH=%STUNNELBIN%;%PATH%; rem // Первый вызов openssl создаст ключ и корневой сертификат в формате PEM rem // openssl попросит пользователя задать пароль которым будет защищён ключ и при каждой новой подписи сертификата шлюза этот пароль потребуется rem // Второй вызов openssl конвертирует сертификат из PEM в DER формат понятный Windows rem // Корневой сертификат в PEM формате понадобиться для Firefox if not exist "rootkey.pem" ( echo [ req ] >openssl.root.cnf echo distinguished_name = req_distinguished_name >>openssl.root.cnf echo [v3_ca] >>openssl.root.cnf echo subjectKeyIdentifier = hash >>openssl.root.cnf echo authorityKeyIdentifier = keyid:always,issuer:always >>openssl.root.cnf echo basicConstraints = critical, CA:TRUE >>openssl.root.cnf echo keyUsage = keyCertSign, cRLSign >>openssl.root.cnf echo [ req_distinguished_name ] >>openssl.root.cnf openssl.exe req -newkey rsa:4096 -x509 -sha256 -days 5480 -config openssl.root.cnf -extensions v3_ca -utf8 -subj "/CN=127.0.0.1" -out rootcert.pem -keyout rootkey.pem openssl.exe x509 -outform der -in rootcert.pem -out rootcert.crt del openssl.root.cnf ) rem // Теперь создаём ключ который будет использоваться шлюзом if not exist "gatewaykey.pem" ( openssl genpkey -algorithm RSA -pkeyopt rsa_keygen_bits:2048 -out gatewaykey.pem ) rem // Делаем запрос сертификата шлюза if not exist "gateway.csr" ( echo [ req ] >openssl.req.cnf echo req_extensions = v3_req >>openssl.req.cnf echo distinguished_name = req_distinguished_name >>openssl.req.cnf echo [ req_distinguished_name ] >>openssl.req.cnf echo [ v3_req ] >>openssl.req.cnf echo basicConstraints = CA:FALSE >>openssl.req.cnf echo keyUsage = nonRepudiation, digitalSignature, keyEncipherment >>openssl.req.cnf openssl req -new -key gatewaykey.pem -days 1096 -batch -utf8 -subj "/CN=127.0.0.1" -config openssl.req.cnf -out gateway.csr del openssl.req.cnf ) rem // Если это не первое выполнение данного скрипта то в index.txt может храниться индекс следующей DNS записи. if exist "index.txt" ( set /p index=/ Мы создаём openssl.cnf один раз и в дальнейшем дополняем его новыми доменами. if not exist "openssl.cnf" ( echo basicConstraints = CA:FALSE >openssl.cnf echo extendedKeyUsage = serverAuth >>openssl.cnf echo subjectAltName=@alt_names >>openssl.cnf echo [alt_names] >>openssl.cnf echo IP.1 = 127.0.0.1 >>openssl.cnf echo DNS.1 = localhost >>openssl.cnf set index=2 del "index.txt" ) rem // В цикле добавляем в openssl.cnf домены которые заданы в командной строке либо будут введены пользователем. :NEXT set /a aindex=%index% + 1 set /a bindex=%index% + 2 set domain=%1 if !%domain% == ! ( set /p domain=enter domain name or space: ) if not !%domain% == ! ( echo DNS.%index% = %domain% >>openssl.cnf echo DNS.%aindex% = *.%domain% >>openssl.cnf echo %bindex% >index.txt set index=%bindex% shift goto NEXT ) del gateway.pem rem // Создаём сертификат IPFS шлюза openssl x509 -req -sha256 -days 1096 -in gateway.csr -CAkey rootkey.pem -CA rootcert.pem -set_serial %RANDOM%%RANDOM%%RANDOM%%RANDOM% -extfile openssl.cnf -out gateway.pem rem // Записываем ключ и сертификат в stunnel.pem который по умолчанию используется программой stunnel copy /b gateway.pem+gatewaykey.pem stunnel.pem rem // Даём пользователю прочитать ошибки или информацию pause

3.2. Запускаем

makecert.cmd ipfs.io

При первом запуске данного скрипта будет создан корневой сертификат (rootcert.pem для firefox и rootcert.crt для остальных) ключ которому надо задать пароль. Корневой сертификат надо добавить в хранилище доверенных корневых сертификатов в браузере и операционной системе.

Далее автоматически будет создан сертификат для шлюза которому надо задать домены которые он будет обслуживать.

Пере/Запускаем stunnel

reload.cmd

echo off %~d0 cd %~p0 set STUNNELBIN = ..\bin set PATH=%STUNNELBIN%;%PATH%; stunnel -install -quiet stunnel -start -quiet stunnel -reload -quiet

Теперь gateway.ipfs.io будет работать на локальном шлюзе. Аналогично можно поступить с любым сайтом который размещён в IPFS.

Сайт для теста: ivan386.tk

Другие мои статьи о "межпланетной файловой системе":

- "Межпланетная файловая система IPFS"

- Публикуем сайт в межпланетной файловой системе IPFS

- Хостим сайт в межпланетной файловой системе IPFS под Windows

- Больше нет необходимости копировать в сеть

|

Метки: author ivan386 децентрализованные сети ipfs stunnel localhost dns ssl |

Использование вулканизации для polymer-модулей |

Проекте, над которым я сейчас работаю, имеет виджетоподобную клиентскую архитектуру. Причем виджеты системы могут использовать любую библиотеку для своей реализации, например, ReactJS, PolymerJS, VueJS, d3JS и другие. Несколько виджетов системы реализованы, как раз, как вэб-компоненты на базе PolymerJS.

Поэтому предлагаю вашему вниманию один из подходов для оптимизации polymer-виджетов.

Содержание:

1. Описание проблемы

2. Какие сложности возникают?

3. Как их можно решить?

4. Библиотека vulcanize-polymer-module

4.1. Структура

4.2. Описание bower.json

4.3. Описание package.json

4.3.1. Установка утилит

4.3.2. Настройка RollupJS

4.4. vulcanize-utils.js

5. Выводы

1. Описание проблемы

Одним из главных проблем polymer-приложений — это множественная подгрузка, используемых компонентов и всех зависимых компонентов, которые в свою очередь, могут состоять из вспомогательных стилей, behavior-ов, подгружаемых так же дополнительно. В результате консоль в network-разделе будет «засыпана» данными файлами. В виду всего этого, первая загрузка такого виджета может быть достаточно долгой, в зависимости от количества используемых составных вэб-компонентов.

Для этих целей в polymer-приложениях применяется вулканизация. Подразумевается, что у данного приложения, есть точка входа в виде, например, index.html, в котором разворачивается главный компонент-контейнер, например

2. Какие сложности возникают?

- Первой сложностью является то, что у меня не polymer-приложение, а несколько составных компонентов(назовем их умными компонентами — УК), которые обернуты в виджет системы, то есть нет единой точки входа.

- Второй сложностью — что в течении работы с приложением может быть и не вызвана вовсе страница с данными виджетами, и соответсвенно ни один из polymer-компонентов будет просто не нужен в текущей сессию работы, не говоря уж о самом ядре polymer.

- Третьей — один УК использует один набор атомарных (paper-, iron- и другие) компонентов(назовем их глупыми компонентами — ГК), а другой — другой набор. Причем могут быть пересечения, то есть два разных УК используют одни и те же ГК.

3. Как их можно решить?

Если рассмотреть первую сложность, я бы мог вулканизировать отдельно каждый УК, но тогда, если взять третью проблему возможно дублирование одних и тех же ГК, и точно будет дублирование ядра polymer, если рассмотреть ситуацию, при которой за одну сессию были использованы как минимум два УК. Поэтому необходимо другое решение.

Если рассмотреть вторую сложность, нужно сделать так, что бы ядро polymer и ГКы загружались только один раз, при первом обращении к одному из УК, и на момент обращения ко второму, нет необходимости загружать заново все, а только загрузить динамически сам УК.

Если рассмотреть третью сложность, то нам нужно составить список всех используемых глупых компонентов в умных, который в итоге мы и будем вулканизировать вместе с самим polymer.

4. Библиотека vulcanize-polymer-module

Все выше сказанные тезисы я оформил в виде библиотеки vulcanize-polymer-module.

Хочу рассказать о ней подробней.

4.1. Структура

vulcanize-polymer-module/

+-- imports.html

+-- vulcanize-utils.js

+-- rollup.config.js

+-- bower.json

+-- package.json4.2. Описание bower.json

В нем мы описываем все ГК, которые нам необходимы, как зависимости, включая так же само ядро polymer.

Например, раздел dependencies может выглядеть так:

"dependencies": {

"polymer": "Polymer/polymer#^2.0.0",

"polymer-redux": "^1.0.0",

"iron-flex-layout": "PolymerElements/iron-flex-layout#^2.0.0",

"paper-button": "PolymerElements/paper-button#^2.0.0",

"paper-badge": "PolymerElements/paper-badge#^2.0.0",

"paper-icon-button": "PolymerElements/paper-icon-button#^2.0.0",

"paper-input": "PolymerElements/paper-input#^2.0.0",

"paper-item": "PolymerElements/paper-item#^2.0.0",

"paper-checkbox": "PolymerElements/paper-checkbox#^2.0.0",

"paper-tabs": "PolymerElements/paper-tabs#^2.0.0",

"paper-listbox": "PolymerElements/paper-listbox#^2.0.0",

"iron-a11y-keys": "PolymerElements/iron-a11y-keys#^2.0.0",

"iron-list": "PolymerElements/iron-list#^2.0.0",

"iron-icons": "PolymerElements/iron-icons#^2.0.0",

"paper-progress": "PolymerElements/paper-progress#^2.0.0",

"vaadin-split-layout": "vaadin/vaadin-split-layout#^2.0.0",

"vaadin-grid": "^3.0.0",

"iron-pages": "PolymerElements/iron-pages#^2.0.0",

"iron-collapse": "PolymerElements/iron-collapse#^2.0.0",

"iron-overlay-behavior": "PolymerElements/iron-overlay-behavior#^2.0.0",

"vaadin-context-menu": "^3.0.0"

}

Так как я совместно с polymer использую redux, я включил библиотеку polymer-redux.

4.3. Описание package.json

В нем прописаны зависимости, необходимые нам для сборки, в частности RollupJS, который используется для промежуточной очистки кода выходного файла. Так же описаны команды, используемые для вулканизации, давайте рассмотрим их подробнее.

"scripts": {

"build": "rollup -c",

"vulcanize": "vulcanize imports.html --inline-scripts --inline-css --strip-comments",

"run-vulcanize": "npm run vulcanize > imports.vulcanize.html",

"vulcanized": "vulcanize imports.html --inline-scripts --inline-css --strip-comments | crisper --html imports.vulcanized.html --js imports.vulcanized.js > imports.vulcanized.html",

"html-minifier": "html-minifier imports.vulcanized.html --remove-optional-tags --collapse-whitespace --preserve-line-breaks -o imports.vulcanized.min.html",

"build-all": "npm run vulcanized && npm run build && npm run html-minifier"

}Команды, в порядке и приоритетности их использования:

- build-all — основная команда, которая и запускает весь процесс вулканизации.

- vulcanized — выполняет саму вулканизация, то есть объединение всех компонентов и ядра в один файл, затем разбивает всю сборку отдельно на .js и .html файлы.(Используется утилита vulcanize и crisper)

- build — очистка кода js-файла от комментариев.(используется RollupJS)

- html-minifier — минификация html-файла.(используется html-minifier)

4.3.1. Установка утилит

Как видим используется множество дополнительных утилит, которые нам необходимо предварительно установить в систему.

npm install -g vulcanize

npm install -g crisper

npm install -g html-minifier4.3.2. Настройка RollupJS

Так как rollup используется только для очистки js-кода я использую только один плагин к нему- rollup-plugin-cleanup. Плагин rollup-plugin-progress используется для визуализации процесса сборки.

import progress from 'rollup-plugin-progress';

import cleanup from 'rollup-plugin-cleanup';

export default {

entry: 'imports.vulcanized.js',

dest: 'imports.vulcanized.js',

plugins: [

cleanup(),

progress({

}),

]

};4.4. vulcanize-utils.js

Для решения второго требования был написан утилитарный метод loadVulcanized, который загружает УК, но перед этим загружает вулканизированный файл, причем делает это один раз и в случаи повторного вызова загружает только сам УК.

Рассмотрим подробнее его параметры.

- url — путь к умному компоненту. Является обязательным.

- urlVulcanized -путь к вулканизированной сборке. По умолчанию — путь к данной сборке — ../vulcanize-polymer-module/imports.vulcanized.min.html

- controller — в моем случаи это контроллер системного виджета. Опционально.

- html — html-объект умного компонента. Имеет смысл, если задан контроллер.

- store — redux store. Опционально.

5. Выводы

Конечно можно использовать polymer-cli с параметром build, но при сборке с его помощью подразумевается, что билдится polymer-проект, а так как мы используем компоненты не в одном контейнере

Один из возможных минусов можно рассмотреть, как избыточность ГК в вулканизированном файле, так как в нем собраны все ГК всех УК, используемых

в системе, но при этом не все УК могут быть использованы за сессию работы, в виду чего не все ГК будут использованы в загруженом вулканизированном файле.

Так же, как небольшое неудобство, можно рассмотреть тот факт, что после добавления нового компонента необходимо запустить сборку заново, после чего сделать обновление репозитория(push), а другие пользователи должны обновить данную библиотеку через bower update.

Несмотря на все это данная библиотека решает свою задачу в данном проекте, а значит может пригодится и кому-то еще.

Так что форкайте, милости просим.

|

Метки: author kolesoffac разработка веб-сайтов javascript polymer.js projection minification |

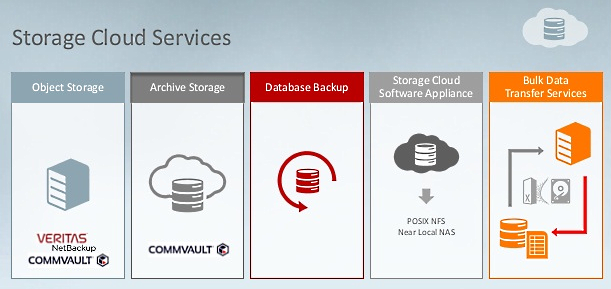

Oracle Storage Cloud Services - все, в чем нуждается корпоративное хранилище данных |

Oracle разрабатывает и поставляет хранилища данных, которые позволяют уменьшить затраты на хранение, а также обеспечить минимальное время доступа к данным, которые хранятся на любом уровне, - за счет оптимизации их размещения и единого интерфейса доступа к ним.

В данной статье описаны сервисы хранения данных, их отличия от других систем данного класса, структура архитектуры решения и практический пример использования Oracle Database Cloud Service.

1. Oracle Storage Cloud Service - Object Storage

Это решение обеспечивает хранение наборов данных любого типа, включая структурированные и неструктурированные данные. Копию данных можно хранить в локальных (on-premise) системах, переместить ее в облако, или использовать совместно.

Такой подход обеспечивает упрощение работы датацентра, масштабирование без необходимости приобретения новых аппаратных средств, уменьшение капитальных вложений и эксплуатационных расходов за счет меньшей потребляемой мощности и требований к системам охлаждения.

Общая инфраструктура учитывает возможность практически бесконечной масштабируемости. Это устраняет необходимость постоянного прогнозирования и длительные циклы приобретения новых мощностей.

Простое управление на основе OpenStack и RESTful API упрощает интеграцию, освобождая ресурсы для других облачных проектов. Оплата «Pay-as-You-Go» и подписные модели уменьшают затраты по сравнению с долгосрочными контрактами.

Шифрование данных клиента, объединенное с дополнительным шифрованием в информационном центре Oracle, обеспечивает многоуровневую защиту информации. На стороне клиента шифрование выполняется Oracle Storage Cloud Software Appliance и Java SDK. Все перемещаемые данные шифруются на уровне SSL (Secure Sockets Layer). Уровень доступа пользователей и администраторов к данным осуществляется на контейнерном уровне.

Интеграция с главной резервной копией и архивными приложениями упрощает развертывание и восстановление данных с минимальными повреждениями. Возможно соединение как через публичный интернет, так и FastConnect, - для самых тяжелых рабочих нагрузок.

Поддерживается технология георепликации - автоматического создания копии данных в географически удаленном информационном центре. При этом соблюдаются правила приватности данных - хранимые данные не могут быть перемещены из указанных администратором географических областей.

Стандарты разработки - RestAPI на Open Stack Swift, Java Applications (File Transfer Manager и Java API), Shell scripting (Upload CLI).

Решение имеет «одиннадцать девяток надежности», т.е., обеспечивается 99,999999999%-ная надежность за счет поддержки нескольких копий каждого объекта на различных устройствах. Периодическая целостность данных сверяется средствами самовосстановления.

Oracle Storage Cloud Software Appliance - простое в использовании облачное хранилище данных с NFS совместимым интерфейсом POSIX. Является шлюзом NAS к облаку.

2. Oracle Storage Cloud Service - Archive Storage

Это - самые рентабельные хранилища данных в промышленности. Они специально разработаны для данных, к которым не требуется частый доступ, с безопасностью корпоративного уровня и эластичной масштабируемостью.

Типичное применение - архив в облаке для больших наборов данных и их долгосрочного хранения, а также разнородного мультимедийного контента, результатов научных исследований и цифровых копий культурного наследия.

К основным преимуществам решения можно отнести максимальное упрощение операций датацентра, низкие капитальные вложения и эксплуатационные расходы за счет меньшей потребляемой мощности и требований к системам охлаждения. Практикуется также оплата «Pay-as-You-Go» и подписные модели, а общая плата за хранение архивов - самая низкая среди аналогов ($12/TB в год).

Данные клиента хранятся в зашифрованном виде, трафик шифруется SSL, ролевой доступ осуществляется на контейнерном уровне. Доступ, стандарты разработки, возможности соединения, надежность, георепликация такие же, как для Object Storage.

3. Oracle Database Backup Service

Сервис защиты данных спроектирован для уникальных потребностей клиентов Oracle Database, с прямой интеграцией с RMAN (Oracle Recovery Manager). Таким образом, можно использовать в своих интересах основанную на облаке защиту данных в IT процессах.

Резервные копии шифруются непосредственно в источнике данных, надежно передаются и хранятся в облаке. Данные всегда сохраняются в указанных географических регионах. Используется встроенная избыточность - зеркалирование осуществляется тремя способами, что обеспечивает постоянную доступность данных. Резервные копии легко шифруются из RMAN. Постоянно осуществляется мониторинг данных, что предотвращает их деградацию.

Резервные копии подвергаются компрессии перед перемещением в облако. Емкость хранилища данных изменяется по требованию простым кликом по кнопке. Управление данными включает ролевое управление доступом и автоматическое удаление данных по указываемым критериям (за давностью хранения и пр.).

4. Oracle Storage Cloud Software Appliance

Решение предоставляет ролевое шифрование, обеспечивает целостность данных за счет проверки контрольных сумм, осуществляет автоматическое преобразование между файлами и объектами, имеет производительность на уровне локальной NAS за счет кэширования данных и docker-технологии.

Решение имеет привычный, хорошо понятный интерфейс. Обеспечивается соединение приложений с облачным хранилищем данных на основе протокола NFS, а также совместимость с POSIX и Unix/Linux NFS клиентами. Реализовано автоматическое преобразование данных, - интерфейс позволяет работу с данными как с файлами, в то время как они сохраняются в облаке как объекты.

Средства защиты информации хорошо развиты. Перед передачей данные шифруются. Возможно шифрование со стороны клиента, в том числе гранулированное (выборочное). Используется многоуровневая архитектура с симметричными и асимметричными ключами для максимальной защиты информации. Пользователь может принести свои собственные ключи, или сгенерировать их непосредственно перед шифрованием.

Доступность данных обеспечивается за счет регулярного резервного копирования метаданных в облако, а производительность на уровне локальной NAS - буферным кэшированием. Кэш можно конфигурировать в соответствии с рабочими нагрузками. Алгоритм Least Recently Used (LRU) сохраняет в кэше актуальные данные и удаляет ненужные.

Для управления используется технология N-Way Management (N-Way - телекоммуникационный протокол для управления сетевыми устройствами Ethernet и данными пользователя). Возможна работа из Admin UI на основе браузера, или интерфейса командной строки (Command Line Interface). Для автоматизации могут применяться скрипты. REST API, которые обеспечивает множественное развертывание из единого централизованного местоположения.

5. Oracle Public Cloud Data Transfer Services

Сервисы обеспечивают быструю передачу первоначального набора данных в облако и формирование хранилища данных в публичном облаке Oracle. Это - самый быстрый способ начать работать с данными в облаке. Сервис Storage Appliance Import надежно переносит большие наборы данных (исторические архивы, озера данных, большие базы наследуемых данных). За один раз может быть перемещено до 400 TB данных.

При этом нет необходимости платить за построение более быстрой сети для одноразовой «оптовой» передачи данных. Передача безопасна, поскольку трафик шифруется по стандарту AES-256. Для загрузки данных объектного или архивного хранилища используется простой стандартный интерфейс NFSv3. Одновременно формируется многорядная структура. Возможно также копирование данных внутри облака для создания реплики рабочей базы.

Oracle Storage Cloud Service и традиционные решения

Традиционные решения для хранения данных, как правило, имеют определенные проблемы с масштабируемостью, производительностью и управлением. Oracle Storage Cloud Service помогает их преодолеть.

1. В системе с непосредственно присоединенным устройством хранения (таким, как обычный жесткий диск в десктопе или ноутбуке), хранением данных, их поиском и упорядочиванием через файловую систему управляет ОС.

Такое устройство обеспечивает малое время ожидания и достаточно надежное длительное хранение данных. Однако, при необходимости большой емкости накопителя, она распределяется между отдельными дисковыми устройствами, что затрудняет масштабирование и снижает производительность.

2. В сетевых устройствах хранения данных (Network-Attached Storage, NAS) аппаратные средства хранения физически отделены от серверов, на которых выполняются приложения. Устройства хранения при этом доступны как сетевые диски. Хранением данных, их поиском и упорядочиванием управляет сетевая файловая система (Network File System, NFS). Приложения, работающие на различных серверах, совместно используют NAS для хранения данных. Управление ресурсами хранения в локальной сети осуществляется централизованно.

Как и в непосредственно присоединенных устройствах хранения, в NAS приложения также полагаются на основную ОС, - но и на сетевую файловую систему. Но такая архитектура может быть реализована только в ограниченном географическом районе, и имеет ограниченные возможности масштабирования.

3. Блочный принцип хранения используется в таких приложениях, как базы данных OLTP с высоким показателем скорости входных / выходных операций (Input / Output Operations per Second, IOPS). Это позволяет эффективно сохранять и восстанавливать данные в обход ОС, непосредственно взаимодействуя с виртуальными блочными устройствами.

Фрагменты данных сохраняются в блоках, каждый со своим адресом, но без других метаданных. Где хранятся данные, решают приложения. Они восстанавливают данные по соответствующим адресам блока.

Блочный принцип хранения оптимизирует системы хранения для IOPS и обеспечивает совместимые с POSIX файловые системы для Oracle Compute Cloud Service. Вместе с тем такой подход имеет ограничения с точки зрения масштабируемости и не поддерживает гранулирование метаданных.

4. Объектное хранилище данных обеспечивает оптимальное сочетание производительности, масштабируемости и управляемости при хранении больших объемов неструктурированных данных. Множественные узлы (ноды) хранения формируют единый общий, горизонтально масштабируемый пул, в котором данные хранятся как объекты («капли данных в бассейне данных»).

Все объектно хранимые данные ассоциированы с метаданными и имеют уникальный идентификатор. Таким образом, можно назначать пользовательские метаданные контейнерам и объектам, что существенно облегчает поиск, анализ данных и управление ими. Приложения используют идентификаторы объектов для непосредственного доступа к данным через вызовы REST API.

Объектное хранилище просто в использовании, хорошо выполняет свою работу и может практически неограниченно виртуально масштабироваться.

Подытоживая перечисленное выше, следует отметить, что Oracle Storage Cloud Service обеспечивает недорогое, надежное, безопасное, и масштабируемое решение для хранения объектов. Это позволяет хранить неструктурированные данные и получать доступ к ним в любое время и отовсюду.

Такой подход идеален для резервного и архивного копирования данных, совместного использования файлов, а также для того, чтобы хранить большое количество неструктурированных данных, - таких, как логи, данные, получаемые от датчиков и образы виртуальных машин.

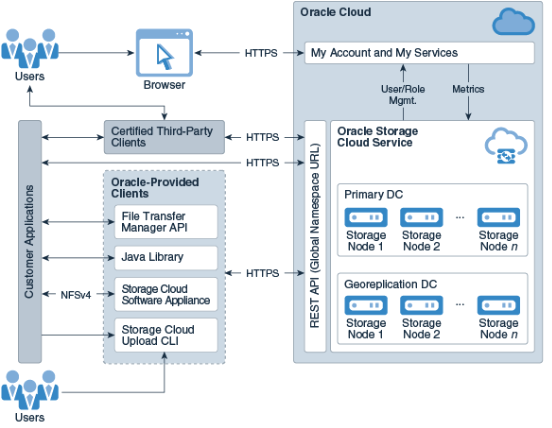

Краткий обзор архитектуры

Архитектура Oracle Storage Cloud Service очень доступна и избыточна. Она хорошо подходит для внешнего доступа, включая пользовательские приложения, Java SDK и REST клиенты.

Когда объекты хранятся в Oracle Storage Cloud Service, данные реплицируются через многочисленные ноды устройств хранения в датацентре. Такая стратегия гарантирует, что хранимые объектные данные смогут выдержать отказ аппаратных средств.

Типовая архитектура Oracle Cloud Storage Service

|

Метки: author Orest_ua хранилища данных хранение данных серверное администрирование серверная оптимизация блог компании мук oracle облачные технологии |

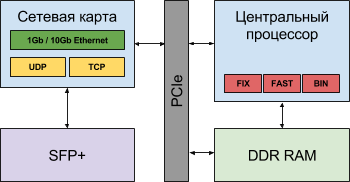

[Из песочницы] Как мы создали устройство быстрой обработки потока событий на FPGA |

Затеяли мы его в далеком 2010 году как хобби, трудясь над ним после основной работы долгими вечерами, плавно переходящими в короткие ночи, и по выходным дням. За 5 лет такой работы мы создали 3 прототипа в поисках решения с минимальными задержками и простой моделью программирования логики обработки данных.

В 2015 году мы осознали, что у нас получилось достойное творение, которое позволяет обрабатывать потоки данных с гарантированной задержкой в 2-3 микросекунды. И мы начали искать возможности превратить начатое в коммерческий продукт и, вероятно, перестать работать на “дядю”, заняться только нашим продуктом, посвящая ему все свое время. В конце 2015 мы нашли первого клиента, оставили “дядей” и пустились в “свободное плавание”.

Сегодня мы можем точно сказать, что устройство у нас получилось. Мы еще не реализовали всего задуманного и нам по-прежнему приходится много работать, чтобы добавлять новый функционал, иногда исправлять ошибки. Но наше устройство уже год работает в промышленной эксплуатации.

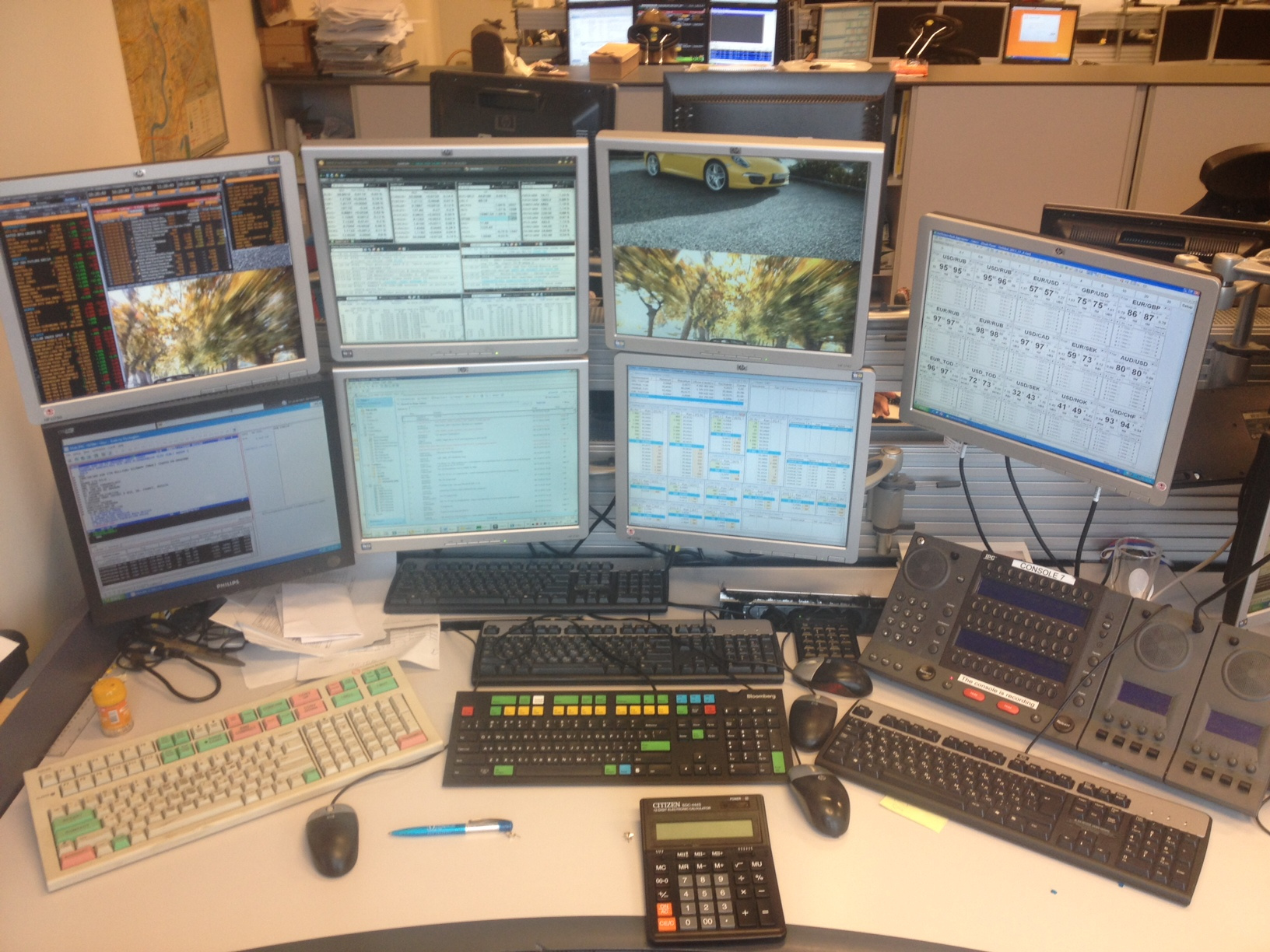

Работая на “дядей” мы неплохо изучили технические аспекты и потребности торговли финансовыми инструментами на биржах и ориентировались в первую очередь на них. Это автоматизированная торговля (HFT, Algo Trading), контроль рисков (Pre-trade), организация “прямого” доступа к торгам (Direct Market Access) и т.п.

Но нам удалось сделать CEPappliance достаточно универсальным устройством, применимым в областях, где нужно прокачивать много данных и делать это не только быстро, но и с гарантированными малыми задержками. Благодаря встроенной поддержке стандартных сетевых протоколов и внесению минимальных задержек устройство применимо в телекоммуникациях для обнаружения нарушений безопасности в сетях, управления загрузкой сетей. Устройство может применяться в телематике, когда нужно за нескольких микросекунд принять решение и среагировать на поступление сигналов с датчиков. При этом логика обработки данных устройством может быть сложной. Для ее описания (программирования) мы используем некоторые приемы технологии Complex Event Processing (CEP).

CEPappliance было задумано и создавалось для решения задач, которые в упрощенном виде можно сформулировать так: с суммарной задержкой менее 3 микросекунд

- получить входные данные (сигнал) по сетевому интерфейсу в формате протоколов Ethernet, TCP/IP, UDP, FIX, FAST, TWIME (FIX SBE) и т.п.;

- разобрать и извлечь пользовательские данные;

- проанализировать пользовательские данные;

- сформировать выходные данные (реакцию) и отправить их по сетевому интерфейсу.

CEPappliance отличается от программного решения, выполняемого на архитектурах с центральным процессором тем, что ядром архитектуры устройства является программируемая пользователем вентильная матрица (ППВМ, FPGA), на которой реализованы все без исключения этапы решения описанных задач.

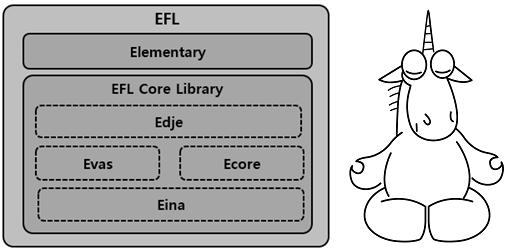

Архитектуры с центральным процессором развиваются. Появляются гибридные варианты (см. рис. 1, рис. 2 и рис. 3), в которых время доставки данных от сетевых интерфейсов до процессора (и обратно) сокращается за счет переноса обработки протоколов сетевого и прикладного уровней с центрального процессора в сетевые карты. Тем не менее, время доставки данных составляет 1 — 3 микросекунды (в одну сторону) и вносит ощутимый вклад в задержку, которая отдаляет момент реакции от момента поступления сигнала1.

На FPGA мы разместили компоненты для разбора, извлечения, анализа входных данных и формирования выходных данных на одном кристалле образно говоря «без посредников» (см. рис. 4), которые обязательно присутствуют в решениях с центральным процессором.

Рис. 1. Логическая схема традиционного решения с центральным процессором

Рис. 2. Логическая схема гибридного решения с центральным процессором и TCP Offload Engine на сетевой карте

Рис. 3.Логическая схема гибридного решения с центральным процессором, TCP Offload Engine и реализацией протоколов прикладного уровня в сетевой карте

Рис. 4. Логическая схема CEPappliance

В CEPappliance компоненты для разбора, извлечения, анализа входных данных и формирования выходных данных, расположены на кристалле FPGA и непосредственно взаимодействуют между собой.

Для этого пришлось “изобрести велосипед” заново. Напомню, что начинали мы работу (в далеком 2010 году) над CEPappliance в режиме хобби. Все делали сами “как надо и правильно”. В итоге, помимо прочего, мы реализовали Ethernet, TCP/IP, UDP, FIX и FAST “с нуля”.

Нам удалось создать эти компоненты так, что разбор входных данных происходит со скоростью их поступления (at wire speed). Компоненты реализуют соответствующие стандарты, которые “высечены в камне” и не часто изменяются. Для стандартных протоков мы предусмотрели механизм настройки. Например, модули протоколов FIX, FAST, TWIME и др. настраиваются с помощью параметров, задаваемых пользователем, и шаблонов или схем, описывающих структуру сообщений.

В то же время мы исходили из того, что (пользовательскте) алгоритмы обработки данных могут изменяться. Например, торговые стратегии или проверки, выполняемые брокером для минимизации рисков (pre-trade risk checks), следуют за изменением ситуации на рынке, модернизацией микроархитектуры биржи или требованиями регуляторов.

Разработка алгоритмов для FPGA непосредственно на “железячных” языках (VHDL, Verilog и т.п.) требует значительно больше времени для кодирования, отладки и тестирования, чем разработка на языках высокого уровня [2]. Для этого также необходимы специальные навыки, которыми программисты, пишущие программы на языках высокого уровня, как правило, не обладают. И если вы планируете использовать FPGA для ускорения выполнения своих алгоритмов, то вам придется передать детальное описание алгоритма FPGA-разработчику, который будет его реализовывать. Иногда это крайне нежелательно, так как передача описания алгоритма создает для его обладателя риск потери конкурентного преимущества.

Наше устройство предоставляет пользователю возможность самому описать алгоритм обработки данных. Для этого мы разработали

- алгоритмический язык высокого уровня,

- процессор оригинальной архитектуры и

- оптимизирующий компилятор, транслирующий программы с языка высокого уровня в коды процессора, и который может автоматически распараллеливать выполнение программы на несколько процессоров, работающих одновременно.

Собственный язык программирования, процессор и компилятор позволяют нам реализовывать на FPGA (аппаратно) функции, доступные пользователю. Эти функции могут представлять из себя части алгоритма или весь алгоритм целиком — зависит от целесообразности такой реализации, пожеланий и возможностей пользователя. Такой подход может значительно ускорить выполнение программ в CEPappliance в некоторых случаях.

Предоставив пользователю возможность самостоятельно программировать CEPappliance мы, очевидно, должны были предоставить и инструментарий для отладки этих программ. Без такого инструментария трудно будет воспользоваться всеми преимуществами CEPappliance. Поэтому мы разработали эмулятор устройства, который на 100% совместим с самим устройством. Отладив программу на эмуляторе, можно изменить конфигурацию (в большинстве случаев это смена IP адреса) и сходу запустить программу на устройстве.

Помимо средств отладки эмулятор устройства позволяет оценить задержки выполнения программы самим устройством. Используя полученные таким образом измерения задержки можно оптимизировать программу.

А для автоматического тестирования пользовательских программ, написанных для CEPappliance, у нас есть специальный инструмент — Test Bench, который читает тестовые сценарии в табличном виде и выполняет их. Один и тот же набор тестов можно выполнять как с устройством, так и с его эмулятором.

Ну и подводя некоторые итоги… Наши платы стоят в датацентре Московской биржи и успешно торгуют. Про результаты торгов рассказать не можем — это не наша тема, но клиент весьма доволен (и этот текст с ним согласован).

Впереди много работы по развитию устройства, поиск клиентов в областях за пределами биржевой торговли и много новых идей!

1Про то, как образуется эта задержка в случае обмена данными по TCP/IP можно почитать в [1]. А здесь рассказано, как эту задержку можно уменьшить за счет реализации гибридной архитектуры с применением FPGA.

Ссылки

1. S. Larsen and P. Sarangam, “Architectural Breakdown of End-to-End Latency in a TCP/IP Network,” International Journal of Parallel Programming, Springer, 2009.

2. David F. Bacon, Rodric Rabbah, and Sunil Shukla. FPGA Programming for the Masses. ACM Queue, Vol 11(2), February 2013.

|

Метки: author cepappliance я пиарюсь fpga low latency algorithmic trading hft- трейдинг high performance стартапы; команда; опыт pre-trade risk checks |

10 шагов настройки Create React App + TypeScript + Ant-Design |

В какой-то момент борьбы со Flow-Type на VSCode, я согласился, что нужно переезжать на TypeScript. Поддержка Flow-Type обеспечивается сторонним плагином и совсем-совсем не устраивает. Если файл невалиден с точки зрения Flow-Type, то переходы внутри кода между файлами перестают работать, например. А возвращаться на WebStorm после знакомства с VSCode — я не могу себя заставить. Microsoft, как обычно, затягивает полностью. Любишь VSCode, получи TypeScript.

Если бы мне кто сказал год назад, что я вернусь в поклонники Microsoft — сложно было такое представить. Но случаются и более удивительные вещи. Я в полном восторге от качества китайского набора React-компонентов от Ant-Design. И хотя он написан на TypeScript, чтобы его прикрурить, нужен babel-plugin-import.

Но как же остаться на Create React App (CRA) — у форка для TypeScript (CRA-TS) выпилили Babel. Поддерживать собственную вариацию CRA представляется безумием. Многообещающий Preact-CLI (как замена CRA) не обеспечивает необходимый уровень совместимости с React. Но, играясь с Preact-CLI, заметил, что preact.config.js очень похож на react-app-rewired, которым я активно пользуюсь для обхода ограничений конфигурации Webpack в CRA. Сопоставил этот факт с идеей перевода CRA-TS c ts-loader на awesome-typescript-loader, внутри которого можно включить Babel. И вуаля!

0) установить create-react-app

$ npm install -g create-react-app1) создать проект

$ create-react-app cra-ts-antd --scripts-version=react-scripts-ts

$ cd cra-ts-antd/2) добавить пакеты

$ yarn add react-app-rewired react-app-rewire-less awesome-typescript-loader babel-core babel-plugin-import babel-preset-react-app -D3) добавить config-overrides.js

module.exports = function override(config, env) {

const tsLoader = config.module.rules.find(conf => {

return conf.loader && conf.loader.includes('ts-loader')

})

tsLoader.loader = require.resolve('awesome-typescript-loader')

tsLoader.query = {

useBabel: true,

}

const tsLintLoader = config.module.rules.find(conf => {

return conf.loader && conf.loader.includes('tslint-loader')

})

tsLintLoader.options = tsLintLoader.options || {}

// FIXED Warning: The 'no-use-before-declare' rule requires type infomation.

tsLintLoader.options.typeCheck = true

const rewireLess = require('react-app-rewire-less')

config = rewireLess(config, env)

const path = require('path')

// For import with absolute path

config.resolve.modules = [path.resolve('src')].concat(config.resolve.modules)

return config

}4) изменить package.json; код подключает враппер react-app-rewired

"scripts": {

- "start": "react-scripts-ts start",

- "build": "react-scripts-ts build",

+ "start": "BROWSER=none react-app-rewired start --scripts-version react-scripts-ts",

+ "build": "react-app-rewired build --scripts-version react-scripts-ts",

}5) изменить tsconfig.json; код включает настройки для абсолютного импорта, помимо прочего

{

"compilerOptions": {

+ "allowSyntheticDefaultImports": true,

+ "baseUrl": ".",

+ "paths": {

+ "*": ["*", "src/*"]

+ },

- "jsx": "react",

+ "jsx": "preserve",

},

"exclude": [

+ "config-overrides.js",

]

}6) добавить .babelrc; код назначает требуемый пресет и подключает babel-plugin-import

{

"presets": ["react-app"],

"plugins": [

["import", { "libraryName": "antd", "style": false }]

]

}7) добавить antd; версия фиксированная, т.к. в следующей версии 2.12.3 обнаружена ошибка

$ yarn add antd@2.12.28) добавить src/resources/main.less; код переопределяет переменную

@import "~antd/dist/antd.less"; // import official less entry file

@primary-color: #1DA57A;9)… и подключить в index.tsx; импорт по абсолютному пути от src

+ import 'resources/main.less';10) изменить App.tsx

import * as React from 'react';

import './App.css';

+ import { Button } from 'antd';

const logo = require('./logo.svg');

class App extends React.Component<{}, {}> {

render() {

return (

Welcome to React

To get started, edit `src/App.tsx` and save to reload.

+

);

}

}

export default App;PS Ищу работу.

|

Метки: author comerc разработка веб-сайтов reactjs javascript вискас |

Обновление инфраструктуры рабочих мест трейдеров |

В то время мы долго искали выход из сложившейся ситуации и в итоге пришли к очень

интересному и технологичному решению, о котором сегодня расскажем.

2014 год:

Итак, мы поняли, что пора что-то менять, и сформулировали основные цели обновления инфраструктуры рабочих мест трейдеров в Райффайзенбанке:

• Замена имеющихся компьютеров на новые и их размещение в отдельном техническом помещении с оптимальными условиями эксплуатации, обеспечивающими необходимый температурный режим, вентиляцию, влажность, защиту от пыли.

• Продление срока эксплуатации установленного оборудования.

• Замена обычных клавиатур на рабочем месте каждого пользователя на одну профессиональную мультифункциональную клавиатуру трейдера.

• Обеспечить возможность сотрудникам трейдинга “бэкапить” коллег в момент их отсутствия с помощью функции просмотра и перехвата управления источников информации.

• Внедрение высокопроизводительного решения и организация распределенного доступа ко всем источникам информации в режиме реального времени.

Виртуализация

Самый очевидный вариант решения проблемы — развертывание виртуальных рабочих станций WmWare на серверах компании. Однако тут мы очень быстро столкнулись с проблемами, которые были несовместимы с нормальной работой трейдера. В первую очередь — это задержка при работе тонкого клиента. Если, к примеру, обычный сотрудник её и не заметит, то для трейдера даже секундная задержка может привести к крупным финансовым потерям. И минимальные системные требования к трейдинговым терминалам обычно соответствуют уровню очень высокопроизводительных рабочих стнций, что сильно уменьшает привлекательность применения виртуализации. К тому же размещение программного обеспечение на виртуальных серверах очень часто запрещается (в том числе и техническими средствами) компаниями, которые разрабатывают трейдинговые терминалы (программное обеспечение).

WEY

Затем мы обратили внимание на комплексное решение от компании WEY, которое представляет собой комплекс аппаратных средств, который позволяет интегрировать различные системы: торговые, информационные, аналитические, риск-менеджмент системы управления, контроля, — и организовать современный трейдинг в банке, центр управления и контроля различными системами безопасности и сетями. Оно включало в себя интеграцию большого количества разнородных систем и источников данных на каждом рабочем месте. С его помощью можно было объединить Thomson Reuters Dealing (впоследствии FX Trading), Bloomberg, Moex (MICEX +RTS), Quik и многие другие трейдинговые площадки. Технологически же, WEY — платформа распределенного доступа, которая состоит из передающих и приемных интерфейсных карт, коммутационном сетевым оборудовании HUAWEY, управляющих консолей WEY, адаптированных и настроенных под определенные банковские торговые системы, а в качестве рабочих станций мы применили сервера HP семейства SL.

Решение WEY полностью аппаратное. Работает на технологии передачи данных по WEY протоколу, обеспечивающему real-time передачу данных с возможностью инкапсуляции в IP для передачи в режиме unicast и multicast. Связь компьютеров в техническом помещении с трейдинговым залом осуществляется на уровне интерфейсов компьютеров через платформу WEY, по отдельному специально организованному (выделенному) сегменту сети на базе проприетарного протокола WEY.

Построенный программно-аппаратный комплекс позволяет интегрировать большое количество различных систем, серверов, источников информации в единую платформу, создавать из них группы, создавать группы пользователей, раздавать права доступа и приоритеты доступа, создавать специализированные клавиши управления под разные системы и управлять системами ими с любого рабочего места в режиме реального времени.

Сервера HP были выбраны не случайно. Их можно было поставить в стойку и тем самым сократить используемое место в техническом помещении. Однако изначально с ними возникла серьезная проблема: серверное оборудование не особенно предназначено для работы как полноценная рабочая станция, например поставлялось без видео и звуковых карт. Если с видеокартами особых проблем не возникло, мы использали профессиональные решения от Nvidia, то со звуком возникли проблемы – звуковую карту банально некуда было вставлять… Решение было найдено неожиданное — USB-карты, которые подключались и устанавливались внутри самих серверов в свободный USB порт на материнской плате.

Мультифункциональная клавиатура WEY MK 06

Вместо нескольких клавиатур и манипуляторов “мышь” на каждом рабочем месте была установлена одна мультифункциональная клавиатура WEY MK 06 на основе FPGA с клавишами и цветным ЖК дисплеем. Специальные встроенные блоки и функциональные клавиши в дисплее для работы с системами ведущих поставщиков информационно-аналитических и торговых сервисов позволяют значительно ускорить работу трейдера. Функциональные настройки клавиатуры и раскладки клавиш могут быть изменены персонально в зависимости от требований пользователя, максимально обеспечивая удобство работы при осуществлении ежедневных операций.

Благодаря интуитивно понятному интерфейсу клавиатуры трейдеры могут приступать к работе с новой системой сразу после ее установки. Управление всеми данными осуществляется мгновенно, что критически важно при работе на валютных и фондовых рынках.

Безопасность

Очень важно было обеспечить безопасность решения. В трейдинговом зале могут находиться несколько различных систем от разных провайдеров, которые находятся в разных сетях. Некоторые из этих сетей могут быть публичными и небезопасными. С WEY нет необходимости устанавливать все системы в одну подсеть для того, чтобы пользователь мог комфортно работать со всем множеством систем. Платформа позволяет оставить каждую систему в своей подсети и работать пользователю со всеми необходимыми системами и быстро переключаться между ними. При этом все сети остаются изолированными, а система WDP работает в отдельном изолированном специально организованном сегменте. Для передачи сигналов используется специально разработанный проприетарный протокол WEY, инкапсулированный в IP для транспортировки через Ethernet для соединения карт sender-receiver применяются универсальные платы с SFP модулями, которые позволяют адаптировать систему под любую кабельную систему в зависимости от предпочтений клиента и технических ограничений ( требований ) объекта.

В системе предусмотрена возможность создания логинов и паролей для пользователей, логирование использования систем пользователями. В последних моделях клавиатур SmartTouch предусмотрены датчики “присутствия” пользователей на рабочем месте, которые позволяют автоматически «разлогинить» пользователя из системы, как только он покидает рабочее место. В этот момент все мониторы становятся темными.

Информационная безопасность обеспечивается выделением отдельного сегмента сети для передачи данных WEY. По этому сегменту передаются зашифрованные данные открытых интерфейсов компьютеров, фактически удлиняя соединения ПК с мониторами и органами управления. Компьютеры продолжают оставаться в своих сетях. То есть сами данные, которыми оперирует та или иная система в этом сегменте сети, не видны и не доступны для возможных атак. Вопросы безопасности остаются такими же, как если бы компьютеры продолжали оставаться на рабочих местах. Переместив всё оборудование в закрытое и защищенное техническое помещение, удалось обеспечить его безопасность, продлить срок службы и ограничить несанкционированный доступ становится гораздо проще.

Как обеспечивается просмотр и перехват управления источниками информации?

В системе создаются группы источников и группы пользователей. Система позволяет гибко организовать права доступа и приоритеты доступа не только различных групп пользователей к системам, но и внутри каждой группы. Существует 5 разновидностей прав доступа:

• отсутствуют права доступа

• полный доступ

• только просмотровый режим

• приватный режим

• режим доступа только по разрешенным интерфейсам

В процессе присвоения прав и приоритетов доступа, например, руководителям присваиваются более высокие права и приоритеты доступа, что позволяет руководителю отдела (департамента) в процессе операционной деятельности подключиться к любой системе в режиме просмотра и в случае необходимости перехватить управление системой на себя. При этом на ЖК дисплее клавиатуры руководителя будет видно, кто из пользователей в данный момент пользуется данной системой.

Для каждого пользователя определяется его уровень доступа к ресурсам. Руководители имеют более высокий уровень, чем их сотрудники и, в соответствии с этим, могут перехватывать управление системами в критических ситуациях одним нажатием клавиши на управляющей консоли.

Расширение трейдингового зала

Для того чтобы добавить новое рабочее место, необходимо просто подключить приёмные карты и клавиатуру к сети WEY и создать в системе нового пользователя, присвоить ему права и приоритеты доступа. После этого на рабочем месте могут быть доступны абсолютно все источники, интегрированные в систему. То же самое касается и самих источников — компьютеров. Устанавливается новая передающая карта, к которой подключаются интерфейсы систем. И всё, система с этого момента доступна к просмотру или управлению с любого рабочего места (в зависимости от настроек прав доступа конкретного пользователя). При этом пользователь может зайти в систему WEY с любого рабочего места. Он не привязан ни к какому из них. Поэтому рабочие места можно расположить даже в другом здании. Таким образом, система может расширяться минимальными шагами.

2017 год:

|

Метки: author GPeter блог компании райффайзенбанк wey трейдинг |

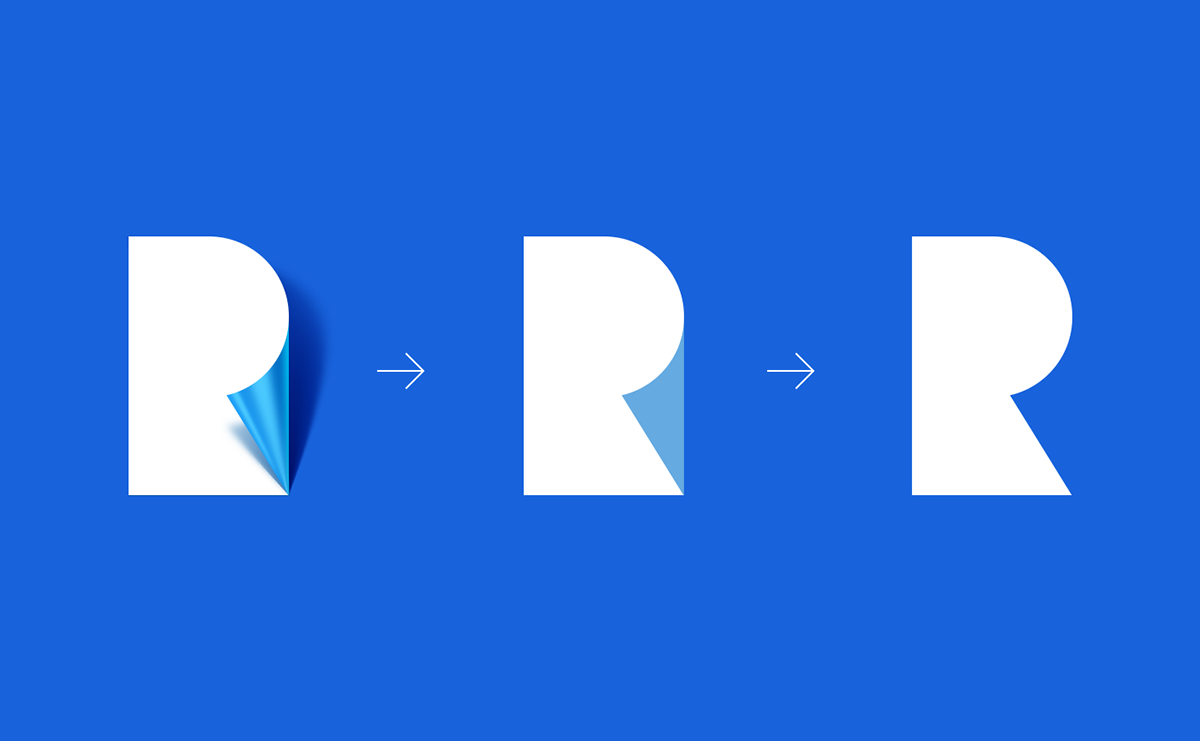

7 способов использования синего в цветах вашей фирмы |

Эта статья о том как использовать синий цвет в логотипе и фирменном стиле.

Мы собрали самые популярные оттенки и сочетания синего,

вы узнаете где их применяют чаще всего и какого эффекта можно добиться с их помощью. Эта статья будет полезна всем, кто использует синий в дизайне своего проекта или еще думает, какой цвет выбрать.

Классический синий

Источник

Источник

Источник

Роль классического синего — хороший парень. Он консервативный, выглядит чисто, опрятно, успокаивает и вызывает доверие. Главные ассоциации с синим — небо и вода, холод и спокойствие. Синий цвет отлично сочетается с белым, его удобно использовать как фон.

Это любимый цвет ай-ти индустрии и соцсетей, производителей электроники, автомобильных гигантов и банков. В качестве иллюстраций выступают компании с мировым именем: Twitter, Ford, Intel, Yota, Вконтакте, логотипы Windows 8, 10 и многие, многие, многие другие.

Логомашина, к примеру, использовала классический синий, чтобы создать легкий, воздушный стиль для компании Pixel. Мы опирались на принадлежность к ай-ти индустрии, открытость и профессионализм проекта. Несложные элементы округлой формы на большом расстоянии друг от друга и теплый оттенок синего дали нужный эффект.

Источник

Классический синий не вызывает отторжения. Он подойдет, если вы позиционируете свой проект как надежного партнера, которому можно доверять.

Это символ креативности, открытости и новизны. Дизайнер используют осветленность оттенка чтобы показать настроение компании — Ford использует более темный, Twitter наоборот — более светлый, легкий.

Синий + красный

Источник

Источник

Источник

Дизайнеры любят использовать оттенки синего в сочетании с яркими, активными цветами. Самый популярный симбиоз — пара синий + красный. Это контрастное сочетание привлекает внимание на фоне одноцветных конкурентов.

Известные примеры легко найти в индустрии моторных масел: Mobil, Chevron, Valvoline. Любят двуколор и автопроизводители. Самый популярный пример сочетания синего и красного —PEPSI. В этом случае красный на втором месте. Упаковки и рекламные баннеры «пепси» — сочетание синего и белого.

Синий и красный можно использовать в разных пропорциях, в зависимости от эмоций, которые вы хотите вызвать. Например, красный фон с синим знаком, может шокировать и резать глаза. Синий фон и красный знак — наоборот, успокаивает, только намекает на агрессивное настроение. Фирменный стиль построенный на сочетании этих цветов похож на мужчину в классическом костюме, который надел галстук с Микки Маусом.

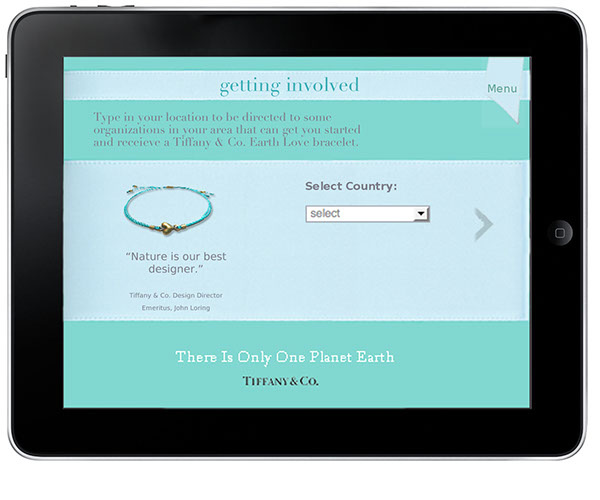

Ментоловый

Источник

Источник

Источник

Ментоловый расположен на границе между зеленым и синим. Так называют оттенки,

от аквамарина до цвета морской волны.

Он создает ощущение свежести, легкости, нежности и чистоты.

Самые популярные ассоциации с ним — мята и тропическое море.

Кофейный бренд Matiz использует ментоловый как основной цвет, в сочетании с желтым, коричневым, красным и фиолетовым — в зависимости от сорта кофе.

Производитель натуральной косметики — 2b (Bio & Beauty) построил фирменный стиль на сочетании ментолового с темно-серым. Melez Tea, Made Coffee, создатели пользовательских интерфейсов Blank — используют его как фон. Для американских ювелиров Tiffany & Co ментоловый вообще стал настоящим культом.

Наши дизайнеры тоже выбрали ментоловый цвет, создавая фирменный стиль для продавцов мороженого Мятный Слон. Ассоциации с легкостью, свежестью и близостью к природе подошли компании лучше всего. Ментоловый дополняют соломенный и белый цвета, а также мелкие разноцветные элементы.

Источник

Ментоловый подходит тем, кто производит еду или открывает кафе, креативным агентствам, дизайнерам интерьера, продавцам нижнего белья. Он поможет проекту стать узнаваемым в любой другой сфере.

Ультрамарин

Источник

Источник

Источник

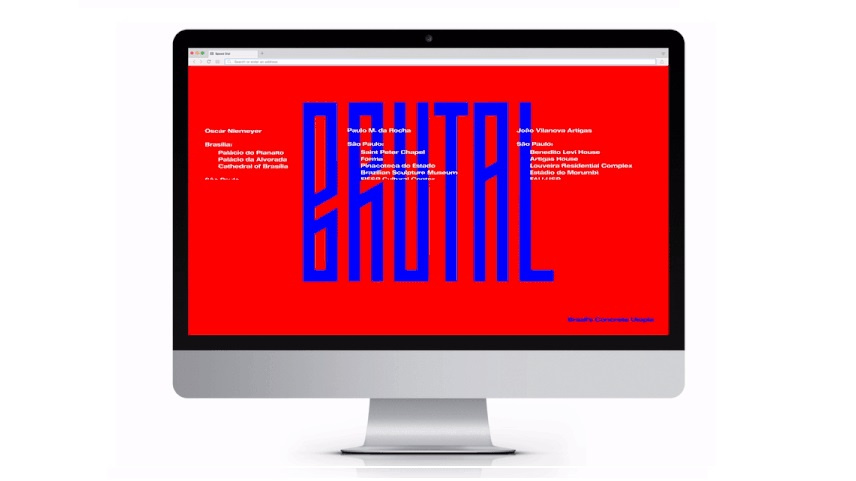

Цвет-провокатор. Последние двадцать лет он ассоциируется с экраном компьютера времен DOS, поэтому иногда его называют «компьютерным синим».

Сегодня это намек на связь с прошлым ай-ти индустрии и ее основами.

Представьте себе девушку, которая пришла в вечернем платье и, например, кроссовках — это провокация или акт протеста, которые привлекают внимание и запоминаются.

Компьютерный синий — это холодный и строгий цвет, с ним часто используют рубленый шрифт без засечек, который имеет общий размер для всех букв алфавита, он легко читается и называется гротескным.

Компьютерный синий чуть темнее классического, ненатуральный и очень насыщенный.

Его редко используют крупные компании, на ум приходит только Western Digital, зато небольшие креативные команды или агентства которые организуют концерты, создатели сайтов и программного обеспечения выделяются на общем фоне своими яркими синими «экранами».

Когда мы разрабатывали фирменный стиль для Digital Motion, то использовали холодный синий в сочетании с белым и голубыми оттенками.

Образ дополнили колоритные «системные» шрифты, создав ассоциацию с интерфейсом Windows.

Источник

Компьютерный синий — рискованный шаг, который в первую очередь говорит о вашей оригинальности. Он нравится не всем, зато это отличный способ выделиться на фоне конкурентов. Это цвет для проектов с узкой целевой аудиторией, например производителей субкультурной одежды или выставок современного искусства.

В любой другой сфере его также можно использовать для уничтожения шаблонов. Ультрамарин выполнит свою задачу, если вы, во-первых, хотите показать что занимаетесь чем-то особенным, а во-вторых, что у вас есть вкус.

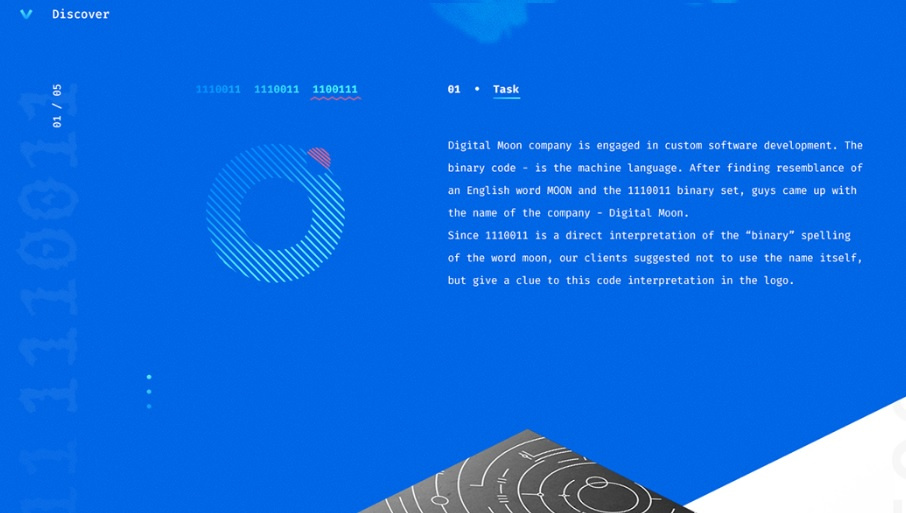

Синий в основе, со многими

Источник

Источник

Популярный прием, который используют чтобы создать ощущение яркости и многообразия.

Издательства и производители программного обеспечения выбирают основным цветом темно-синий. Туристические компании, кафе и производители одежды — более пастельные тона, подчеркивающие легкость и отношение к продукту, как к чему-то сделанному своими руками. И тот и другой приемы вызывают у многих людей доверие, создают позитивное настроение.

На основе этого сочетания выстраивают свой фирменный стиль туристические компании Eccentric Travels, Sankeo, студия анимации Gotham Pro Animated, финансисты Open View и многие другие

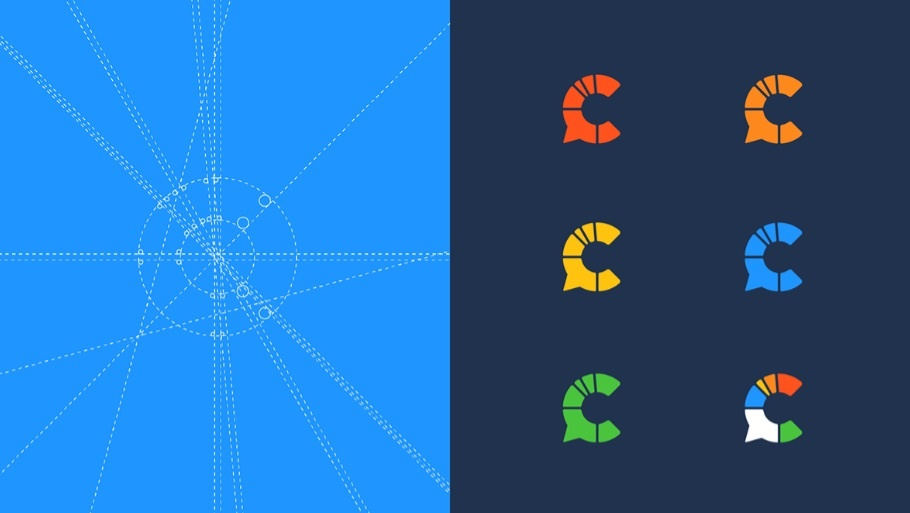

Интересным для наших дизайнеров была работа над фирменным стилем Crowd Back, платформы для создания опросов и голосований.

Образ строился на ассоциации с прямой речью и круговой диаграммой, намек на множество существующих мнений. Центральным элементом стиля стала буква “C”,

стилизованная под графический значок прямой речи.

Источник

Сочетание основного синего с множеством других цветов — хороший способ привлечь внимание к вашему бренду. Используйте пестро оформленные баннеры, постеры и другие носители. Прием подходит крупным компаниям, у которых широкий выбор предложений для клиента — это могут быть оптовые продажи, интернет-магазины или рекламное агентства с тысячами креативных решений.

Благородный синий

Источник

Источник

Источник

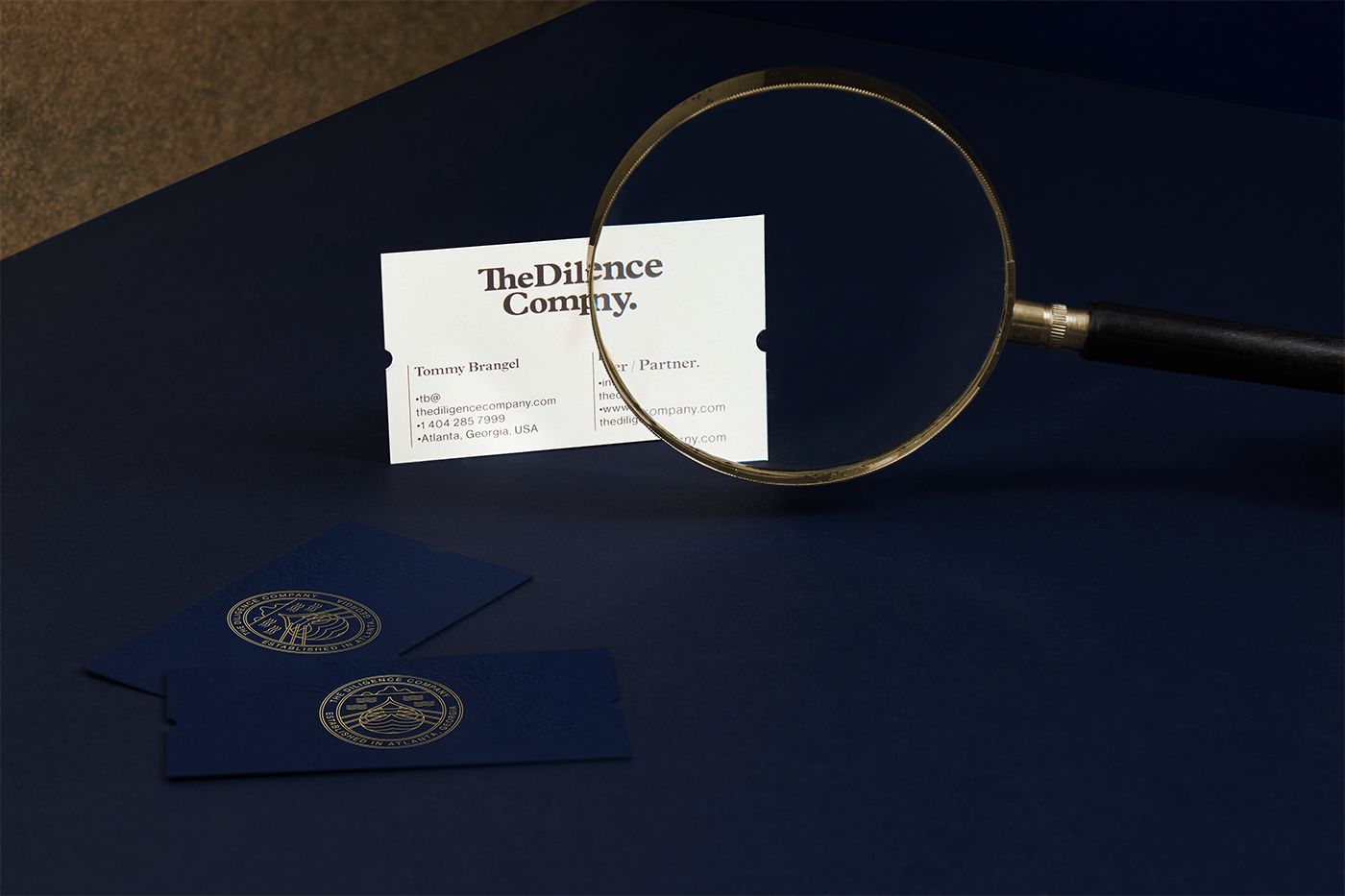

У многих людей темно-синий ассоциируется с богатством и привилегированным положением. Это отличная основа для белого, серебряного или золотого и в этой роли темно-синий успешно заменяет черный цвет.

На его фоне хорошо выделяются элементы окрашенные в серебряный, белый или золотой цвет. Он легко сочетается с другими оттенками синего.

Темно-синий используют бренды, фундамент имиджа которых — качество продукции или изначально высокий статус. Королевский синий популярен среди государственных учреждений, банков, адвокатских контор, элитных гостиниц и ресторанов. Образы элитарности, строгости и оправданного консерватизма которые несет темно-синий цвет используются в качестве «демонстрации силы». Самые известные примеры: GAP, Nivea, Maserati.

Ruthenium Asset Managment — заказали у нас фирменный стиль, ядром которого должен был стать высокий статус фирмы, их особое отношение к продукту и покупателю. Как итог — строгие шрифты и прямые линии, носители оформлены в сочетании стального серого и благородного синего.

Источник

«Я отношусь к тому что делаю максимально серьезно» — вот главный посыл этого оттенка.

Под темно-синим флагом вы можете продавать элитный алкоголь или икру, оказывать юридические услуги, шить на заказ классические костюмы.

Королевский синий — не кричит, не зазывает и не продает. Но если вы хотите выглядеть и быть серьезным, ответственным партнером, который заслуживает особенного отношения покупателя — это большой шаг к созданию такого имиджа.

Вывод

Используя синий цвет вы расскажете о себе главное, остается выбрать способ который подходит больше всего. Перед вами море возможностей создать запоминающийся и узнаваемый фирменный стиль.

|

Метки: author Logomachine работа с векторной графикой графический дизайн блог компании логомашина бизнес дизайн цвет цветовая схема фирменный стиль логотип |

[Из песочницы] Дефейс ask.mcdonalds.ru |

Полистав стену, я заинтересовался и решил посмотреть, что же из себя представляет эта платформа для общения с пользователями — ask.mcdonalds.ru.

Краткий экскурс:

Согласно информации, опубликованной у них же, «Сайт призван максимально подробно ответить на вопросы, которые наиболее часто возникают у наших гостей: о составе, безопасности и качестве продукции Макдоналдс — от поля до прилавка. Поэтому в рамках Сайта мы отвечаем на вопросы, имеющие непосредственное отношение к продукции Макдоналдс.»

Я действительно порадовался, с точки зрения клиента здорово, когда я могу задать вопрос о продукции и получить на него адекватный ответ.

Обнаружение уязвимости

Далее я решил зарегистрироваться и попутно проверил, как экранируются символы, передающиеся посредством формы регистрации. Какого же было мое удивление, когда я увидел, что на страницу в итоге все выводится «как есть». Простой пример:

Таким образом мы видим сразу наличие Stored XSS, которую может использовать каждый, кто пожелает, поскольку обнаружить ее очень просто (кстати, ну и кроме этого, на сайте также присутствует пресловутая logout CSRF).

То есть мы вместе с обычными на первый взгляд именем и фамилией также передаем посредством формы что-нибудь наподобие

и получаем возможность выполнения любого нашего скрипта на главной странице сайта при выполнении далее нехитрых действий, но обо всем по порядку.

Я решил проверить уязвимость снова:

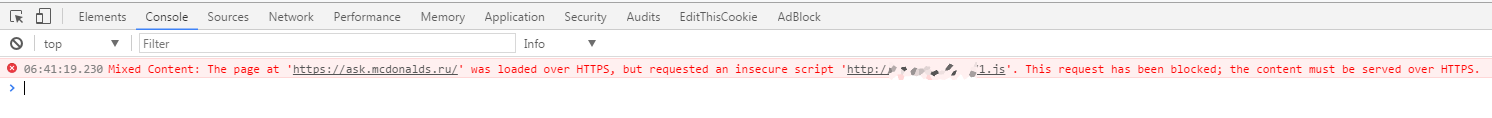

Но в этот раз код не выполнился. Открыв консоль, я увидел следующее:

В данном случае, страница передана по протоколу HTTPS, но также содержит контент, передаваемый по обычному, открытому HTTP (мой скрипт). Тогда соединение считается частично зашифрованным, а сама страница называется страницей со смешанным содержимым.

То есть здесь важно, чтобы и скрипт тоже передавался через HTTPS.

Я задумался, где же будет проще всего разместить файл скрипта в таком случае и вспомнил про Google Диск. И именно облачное хранилище от Google здесь придет на помощь, и нужный файл я без проблем получу по защищенному протоколу.

Любой файл, хранящийся у вас на гугл диске, может быть доступен непосредственно по прямой ссылке. Получить ее совсем не сложно:

Делаем файл доступным по ссылке и получаем что-то вроде

https://drive.google.com/file/d/AAAAAAAAAAAAAAAAAAA/view?usp=sharingзатем берем значение после drive.google.com/file/d/, в нашем случае «AAAAAAAAAAAAAAAAAAA», и подставляем его как значение параметра id в ссылку вида

https://drive.google.com/uc?export=download&id=Вот и все, теперь нам достаточно зарегистрировать аккаунт, имя которого будет содержать наш код, затем задать какой-либо незатейливый вопрос, дождаться, пока на него ответят и он будет размещен на главной странице.

То есть мы получаем возможность выполнить любой код на главной странице сайта.

Последствия наличия такой уязвимости

Говорить о том, что такое компания Макдоналдс, я думаю, будет излишним. Для настолько крупной компании наличие подобной уязвимости, а точнее эксплуатация ее злоумышленниками, может привести к серьезному экономическому ущербу.

Поскольку это хранимая уязвимость, происходит внедрение собственного (возможно, вредоносного кода) на сервер, выполняющегося каждый раз у пользователя при обращении к оригинальной странице.

И если представить, вариантов использования масса:

- слежка за посетителями

- фишинг

- добавление своих рекламных партнерских программ на сайт

- распространение вредоносного ПО

- и многое другое.

А если бы такая уязвимость попала в руки их конкурентов на рынке? Здесь можно действовать еще интереснее, поскольку таким образом имеется полный доступ ко всему содержимому страницы, они могут к тому же изменять текст как вопросов, так и ответов, формируя фальшивые вопросы-ответы, выставляющие всю компанию в дурном свете, или даже рекламируя свою продукцию, что приведет к формированию отрицательного имиджа, потере лояльности клиентов и в перспективе потере части клиентов клиентов вообще. Такое использование может быть незаметно на первый взгляд и обнаружение могло бы затянуться.

Да и сам по себе deface сайта опасен, поскольку содержимое именно главной страницы сайта, куда заходит больше всего людей, может быть изменено.

Сообщение компании о наличии уязвимости и итог

Проверив все еще раз и убедившись, что уязвимость присутствует стабильно и не является результатом моего субъективного взаимодействия с сайтом, я решил сообщить компании о ее наличии.

Я обращался на различные электронные адреса, указанные на сайте, писал в сообщения официального сообщества ВКонтакте и на Фейсбук, ответили мне только на Фейсбук, сказав, что все подробности я могу отправить непосредственно им, что я и сделал. Прошло некоторое время, но ничего исправлено не было, я еще раз написал напоминание, что уязвимость все еще присутствует, но ответа не последовало. На данный момент прошло уже более 2 месяцев с момента сообщения всех подробностей, к сожалению, ничего так и не исправлено.

Эксплуатировать уязвимость я не намерен, посему надеюсь, что эта статья также поможет донести информацию до компании, и уязвимость будет исправлена.

|

Метки: author anador тестирование веб-сервисов разработка веб-сайтов информационная безопасность уязвимость mcdonalds макдоналдс xss deface |

[Из песочницы] Разграничение прав доступа в PostgreSQL |

Хочу описать один из способов разграничения доступа к данным в СУБД, который мне кажется довольно гибким и интересным. Этот способ позволяет получать информацию о текущем пользователе с помощью вызова простой хранимой процедуры. Но сперва рассмотрим известные существующие способы с их плюсами и минусами, среди которых можно выделить использование встроенных механизмов аутентификации СУБД и контроль доступа на уровне приложения.

Способ 1. Встроенные механизмы аутентификации

Для каждого бизнес-пользователя создаётся соответствующий пользователь в СУБД, которому раздаются необходимые права.

Плюсы такого подхода: его простота и прозрачность. По логам СУБД легко увидеть, какие запросы выполняют пользователи, несколько прав можно объединять в роли и раздавать их пользователям прямо "из коробки". Основной минус такого подхода — отсутствие контроля доступа на уровне строк. Да, в 9.5 появилась row-level security, но этот механизм работает не так быстро, как хотелось бы, особенно для JOIN.

К встроенным механизмам аутентификации также относятся LDAP, PAM, GSSAPI и прочие.

Способ 2. Проверка на уровне приложения

Многие осуществляют разграничение доступа прямо на уровне приложения. При этом можно использовать как внешний сервис для авторизации пользователей так и хранить хеши паролей непосредственно в базе и проверять их в приложении. Это не имеет значения. Главное то, что все пользователи в конечном итоге ходят в базу под одним пользователем. В таком подходе я вообще не вижу никаких плюсов, зато минусов предостаточно:

- Отсутствует контроль доступа на уровне строк, либо он становится очень сложным.

- В случае компрометации пароля пользователя СУБД злоумышленник получает полный доступ ко всем данным, причём он сможет не только читать их, но и изменять.

- Приложение становится единственной звеном, контролирующим доступ и если вы, допустим, захотите реализовать ещё какой-нибудь сервис, работающий с базой, вам придётся писать весь код, выполняющий проверки, заново.

Несмотря на такое большое количество минусов, по моим наблюдениям это самый распостранённый способ разграничения доступа на сегодняшний день.

Способ 3. Введение сессии на уровне СУБД

Об этом способе я сегодня и хочу рассказать поподробнее. Суть его проста: в базе данных создаётся процедура авторизации, которая проверяет логин и пароль пользователя и в случае успеха устанавливает значение некоторой сессионной переменной, которая была бы доступна на чтение до конца текущей сессии. Для хранения значения переменной будем использовать глобальный массив GD, доступный процедурам на языке Pl/Python:

create or replace

function set_current_user_id(user_id integer) as $$

GD['user_id'] = user_id

$$ language plpythonu;Сама же процедура авторизации будет выглядеть следующим образом:

create or replace

function login(user_ text, password_ text) returns integer as $$

declare

vuser_id integer; vis_admin boolean;

begin

select id, is_admin

into vuser_id, is_admin

from users where login = login_ and password = password_;

if found then

perform set_current_user_id(vuser_id);

/* код функции set_is_admin() аналогичен

коду функции set_current_user_id() */

perform set_is_admin(vis_admin);

else

raise exception 'Invalid login or password';

end if;

return vuser_id;

end;

$$ language plpgsql security definer;После этого осталось реализовать функцию, которая будет возвращать ID залогиненного пользователя:

create or replace

function get_current_user_id() returns integer as $$

return GD.get('user_id')

$$ language plpythonu stable;Теперь о том, как это всё использовать. А использовать очень просто. После авторизации пользователя внутри любой функции теперь можно легко узнать, что за пользователь запрашивает доступ к данным и какие у него есть права. Например:

create or replace

function delete_branch(branch_id_ integer) returns void as $$

begin

if not current_user_is_admin() then

raise exception 'Access denied: this operation needs admin privileges';

end if;

...

end;

$$ language plpgsql;Для демонстрации того, как будет работать разграничение доступа на уровне строк, напишем функцию, которая будет возвращать список счетов в банке, причём только тех, которые открыты в филиале, к которому принадлежит пользователь (branch_id).

create or replace

function get_accounts() returns table (account_number text) as $$

begin

return query

select a.account_number

from accounts a

join users u on u.branch_id = a.branch_id

where u.id = get_current_user_id();

end;

$$ language plpgsql;В чём плюсы и минусы такого подхода? Плюсы:

- Удобство использования, гибкость, расширяемость.

- Обеспечение разграничения доступа на уровне строк практически без ущерба для производительности СУБД.

- Вся логика сосредоточена в СУБД, таким образом можно предоставлять доступ к базе данных нескольким приложениям, в которых придётся реализовать лишь механизм авторизации.

- Кроме информации о самом пользователе, можно оперативно получать любые метаданные, связанные с ним — например, является ли текущий пользоватль администратором, его имя для отображения в каком-нибудь личном кабинете, группы, к которым он принадлежит, и так далее.

Несмотря на это, есть также и минусы:

- Всю логику работы с данными необходимо оборачивать в хранимые процедуры (на самом деле, для меня это плюс).

- Необходимость авторизации пользователя в начале каждой сессии, а если код обёрнут в транзакции, то в начале каждой транзакции. Это может быть некритично для так называемых "толстых клиентов", но для веб приложений уже становится актуальным. В этом случае проблема решается оборачиванием драйвера, который предоставляет доступ к СУБД кастомным кодом таким образом, чтобы авторизация выполнялась перед выполнением каждого запроса. Звучит не очень красиво, но на самом деле всё не так страшно. Я в своих проектах использовал Flask и модуль flask_login, который сильно упрощает эту задачу.

Резюме

Конечно, наверняка существуют проекты где описанный мной подход будет неуместен и я буду рад, если вы поделитесь своими мыслями на этот счёт, — возможно, данный метод можно доработать и улучшить. Но, в целом, такой подход кажется мне довольно интересным.

|

Метки: author pensnarik postgresql безопасность |

Машинное обучение для страховой компании: Оптимизация модели |

|

|

Четверть миллиона за «жука»: Microsoft начинает активную борьбу с багами |

/ Flickr / Mike Mozart / CC

/ Flickr / Mike Mozart / CCИскусственный интеллект на страже безопасности

Облачное решение по поиску уязвимостей было запущено на базе сервиса Microsoft Security Risk Detection. Ранее известный как Project Springfield, он создан для обнаружения критических ошибок в безопасности программного обеспечения методом фаззинга. Microsoft использовала эту технологию для поиска критических ошибок в Windows и Office.

В 2016 году, помимо Springfield, у проекта было и неофициальное название — «баг-детектор на миллион». Сообщалось, что он помог Microsoft выявить серьезные уязвимости, которые оценивались приблизительно в $1 млн. Сейчас приложение готовится к массовому релизу на платформе Azure.

В основе работы нового облачного сервиса лежит искусственный интеллект, который используется для поиска ошибок в программном обеспечении до его выпуска. Он проектирует сценарии по модели «что, если», дабы сузить число вероятных источников критических ошибок в ходе стресс-теста кода клиента.

AI-служба способна выявить слабые стороны программы перед предварительным запуском, чтобы разработчики смогли подготовить необходимые патчи и оказаться во всеоружии в случае атаки.

По словам исследователя из Microsoft Дэвида Молнара (David Molnar), этот инструмент подходит для компаний, которые сами создают программное обеспечение, модифицируют готовое ПО или предлагают лицензии с открытым исходным кодом.