Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Ядро автоматизации тестирования в микросервисной архитектуре |

Вместо вступления

“An implementation should be conservative in its sending behavior, and liberal in its receiving behavior”.

Jonathan Bruce Postel, computer scientist

Что такое микросервисная архитектура?

Чтобы мой рассказ был полным, начнем с основ. Если упростить, микросервисная архитектура — это способ организации сервера приложений. Как он работает? По сути, это просто ответ сервис-ориентированной архитектуры на появление такой практики, как DevOps. Если в SOA не регламентированы размеры сервисов и то, что именно они должны делать, то в рамках микросервисной архитектуры есть некоторые умозрительные ограничения. Микросервис — это некоторая сущность, которая заключает в себе одну небольшую функциональность, которой она заведует и предоставляет внешним сервисам какие-то данные.

Иногда приводят информацию, что микросервис — это 500 строк кода. Но это не обязательно; смысл заключается в том, что сервисы эти достаточно маленькие и образуют те же бизнес-процессы, что и монолитный бэк-энд, который работает на многих проектах. Функционально — то же самое, отличия — в организационной структуре.

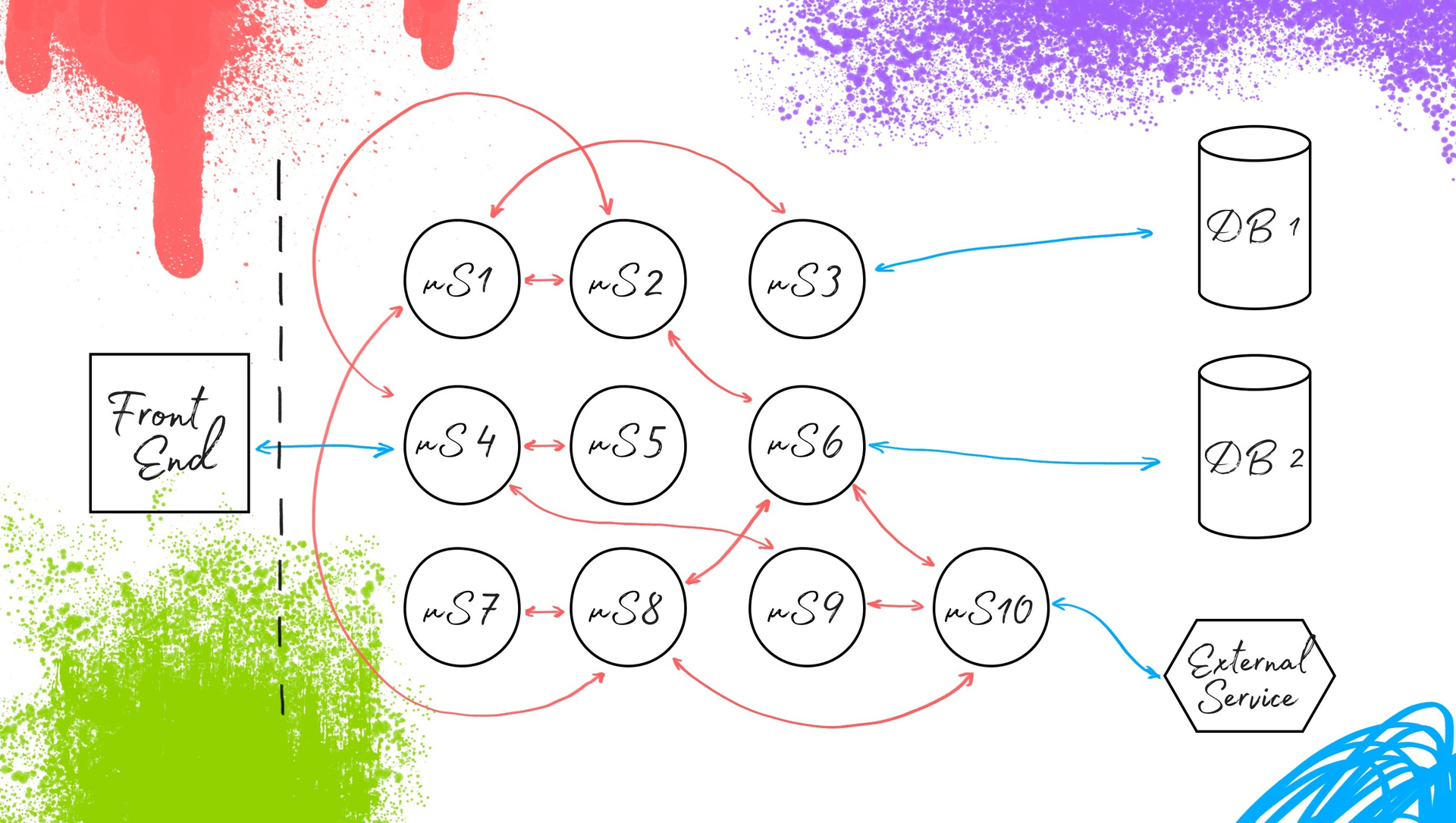

В чем здесь могут возникать проблемы? Сервисов быстро становится много, повышается их связность. Это осложняет тестирование: проверка изменения одного микросервиса влечет за собой необходимость поднять довольно толстый слой инфраструктуры из множества сервисов, с которыми взаимодействует изменяемый микросервис. В определенный момент развития проекта количество связей и зависимостей сильно вырастает и выполнять быстрое и изолированное тестирование становится затруднительно. Мы начинаем работать медленнее. Разработка замедляется. Эти и некоторые другие проблемы можно решить с помощью автоматизации тестирования.

Переход к микросервисам

Для начала рассмотрим переход от монолита к микросервисной архитектуре. В случае с монолитом для того, чтобы заменить какой-либо кусочек в этой системе, мы не можем выкатить его отдельно. Нужно делать сборку заново и полностью обновлять бэк-энд. Это не всегда рационально и удобно. Что происходит при переходе на микросервисную архитектуру? Мы берем бэк-энд и делим его на составляющие компоненты, разделяя их по функциональности. Определяем взаимодействия между ними, и получается новая система с тем же фронт-эндом и теми же базами данных. Микросервисы взаимодействуют между собой и обеспечивают всё те же бизнес-процессы. Для пользователя и системного тестирования всё осталось таким, как и прежде, изменилась внутренняя организация.

Что это дает? Можно сделать изменение в микросервисе X, которое реализует какую-то его функциональность, и сразу выкатить его в работу. Всё это звучит очень хорошо. Но, как и всегда, есть нюанс: нужно проверять то, как микросервисы взаимодействуют друг с другом.

Контракты для микросервисной архитектуры

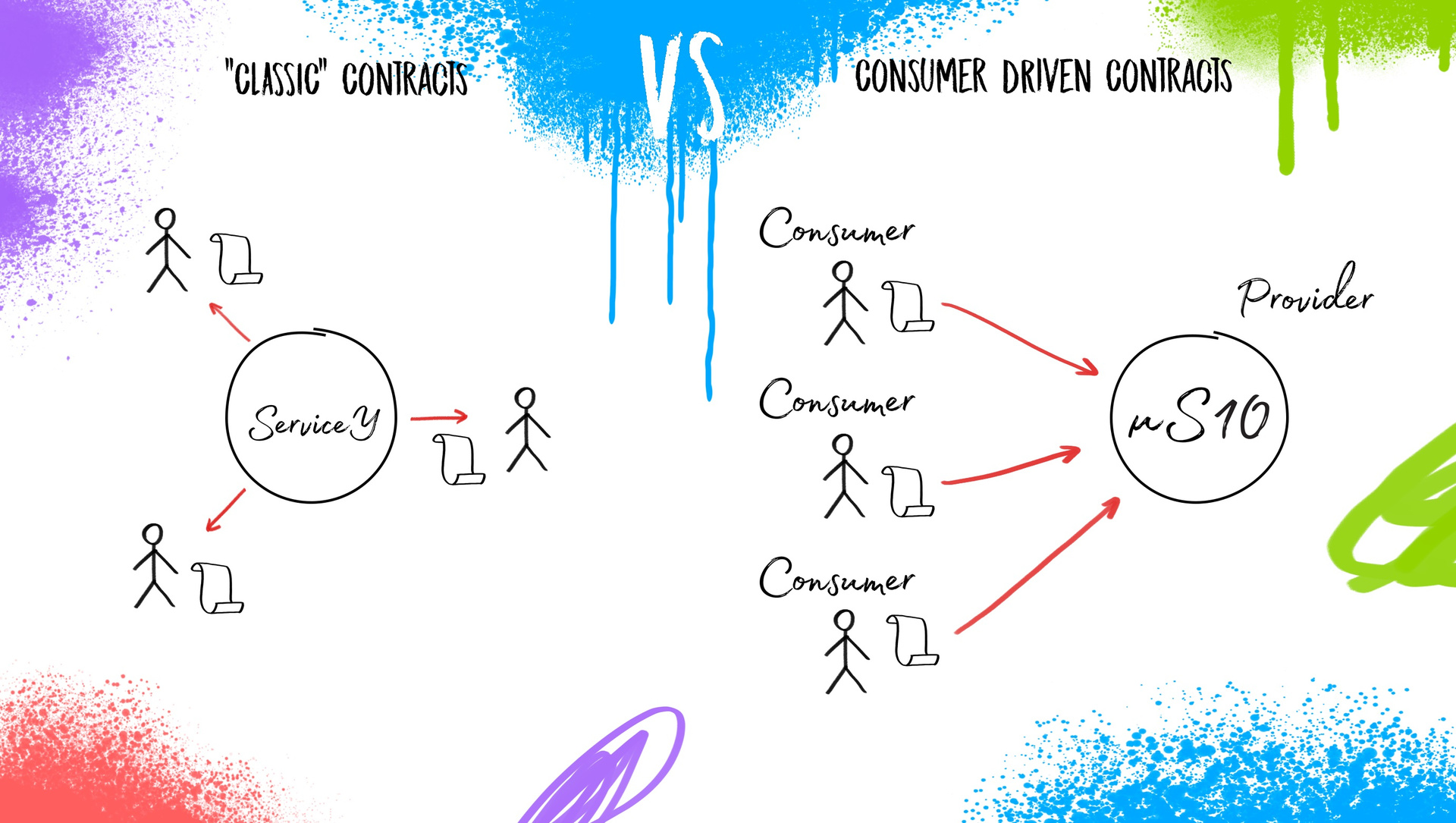

Взаимодействия микросервисов между собой реализуются посредством контрактов. Что это значит для сервис-ориентированной архитектуры? Контракт — это некоторое соглашение, которое разработчики сервиса создают для взаимодействия между собой внешних пользователей. Разработчики сервиса сами решают, что вы можете запросить у них “X”, а они вам предоставят “Y”. Сервис может предоставлять внешним пользователям яблоки, помидоры, плутоний, продавать детскую одежду или телевизоры — ему не декларируется чёткий фокус на функционал. Внутреннее наполнение регламентируется только на уровне здравого смысла. И соответственно, это сервис диктует внешним пользователям то, что они будут получать, и как к нему необходимо обращаться.

Если увеличивать комплексность этой задачи, когда сервисов будут не десятки (10-20-50), а сотни (200, 400…2000), то традиционные, “классические” контракты перестают работать в функциональном смысле. И тогда уже возникает необходимость модернизации контрактов под микросервисную архитектуру. Разработан шаблон работы для разработчиков, в котором они и “конечные пользователи” микросервиса меняются местами — этот подход называется consumer driven contacts. Теперь запросы делают внешние пользователи. Это можно представить как такого рода беседу:

Пользователь 1: “Я слышал, вы поставляете яблоки. Мне нужны маленькие и зелёные”.

Пользователь 2: “А мне нужны огромные красные яблоки”.

Пользователь N: “А мне нужно, чтобы вы привезли три тонны яблок”.

Таким образом получается, что пользователи создают контракты, задают требования и направляют их к провайдеру, который их реализует. В чем плюс? Так как у каждого сервиса достаточно ограниченное количество потребителей, получить от каждого по три спецификации и реализовать их гораздо проще, чем пытаться угадать, какие именно “яблоки” нужно предоставить в каждом конкретном случае и что еще им может понадобиться к этим “фруктам” дополнительно.

Вот для этого подхода мы, как отдел обеспечения качества, должны предоставить достойный ответ в области тестирования так, чтобы не замедлить процесс быстрых выкаток микросервисов.

Предикаты для CDC-testing (Consumer Driven Contracts)

Без чего нельзя начать работать по принципам CDC-testing? Первое. У нас не получится помочь, если мы видим что у нас в разработке не соблюдается процесс работы по контрактам. Вторая вещь более техническая: это система post-commit (post-PR, если хотите) hook-ов, которая обрабатывает этот поток общения между девелоперами с помощью контрактов и сигнализирует нашей системе тестирования об их обновлении, удалении, появлении новых. Соответственно, заводятся соответствующие таски в Jira, чтобы автоматизаторы успели это все “переварить”. К этому базовому процессу можно добавить еще все что угодно — дополнительные проверки, процессные примочки, но без контроля изменения контрактов взаимодействия между микросервисами жить будет достаточно сложно. Выполнив в каком-то виде эти два пункта, мы можем приступить к имплементации.

Имплементация автоматизации под CDC

В основу нашей системы автоматизации тестирования ляжет такое решение, как PACT-фреймворки. Что нужно о них знать? Это протокольное взаимодействие с API: JSON over HTTP, в этом нет ничего сложного. Эти решения взаимодействуют с нашими микросервисами и дают некоторый дополнительный функционал для изоляции и организации тестирования. Что сказать еще? Я видел, как это реализовано в том или ином виде на семи языках программирования (Java, Javascript, Ruby, Python, Go, .NET, Swift). Но если вашего нет в этом списке, не пугайтесь: можно взять базовую библиотеку и сделать свой велосипед, или написать что-то подобное тому, что уже реализовано.

Что ещё нас ждёт почти в 100% случаев? Первое — это мокирование внешних сервисов. Проблема в том, что сложно поддерживать релевантность того, как себя ведет внешний сервис, и поддерживать это во всех заглушках. Как решать эту проблему? Это зависит от вас. Скорее всего, потребуется направить на это больше ресурсов или ограничить покрытие тестами. И второе: сэмплированные базы данных. Понадобится нарезать боевые базы данных в облегченном виде так, чтобы в них были все необходимые данные для тестирования в рамках нашей системы. Тогда получится наглядный релевантный результат.

Идем далее. Первое, что я сразу захотел сделать в этом проекте — это информативное логирование. Всегда необходима репрезентативность итогов тестирования. Простая истина: если результаты невозможно прочитать и понять — их никто не будет смотреть. Надо сказать, что базовое логирование в PACT-фреймворках реализовано очень убого.

Я предпочел бы вынести его в отдельный модуль, сделать обёртку и навертеть там то, что нам нужно. В первую очередь сделать разделение ошибок по источникам их появления. Далее — всё, что вы можете реализовать, например, решения наподобие Allure (решение от компании Яндекс для повышения простоты анализа результатов тестирования). Делать можно что угодно, но необходимость информативных логов нужно учесть.

Следующий, возможно, “капитанский” момент — это Config Reader. Но в рамках тестирования микросервисной архитектуры это может быть немного заковыристой вещью. Для Config Reader у нас есть два источника. Первый — это PACT-файлы, а второй — State.

Что это такое PACT-файл? Это не какой-то шифрованный бинарник, а обычный JSON-файл, который имеет специфичную структуру. В нем выделяется consumer, provider (т.е. кто именно и с кем взаимодействует в рамках этого контракта и в какой роли). Далее описываются взаимодействия (это делают разработчики): я — consumer, и хочу от этого сервиса (provider), чтобы он отдавал мне “маленькие зеленые яблоки”; жду такой-то код ответа, статус, header, body и так далее. Есть поле description — это просто описание, повод напомнить разработчикам о чём шла речь в контракте, какой смысл в него вкладывался.

И самое интересное — это State Provider. Что это? По сути, это состояние, в котором должен пребывать тестируемый микросервис на момент обращений к нему по конкретной итерации тестирования, по конкретному запросу. В States могут описываться как SQL-запросы (или другие механизмы приведения сервиса в некоторое состояние), так и создание каких-то данных в нашей сэмплированной базе. States — это сложный модуль, который может содержать в себе всякого рода сущности, приводящие наш сервис в нужное надлежащее состояние.

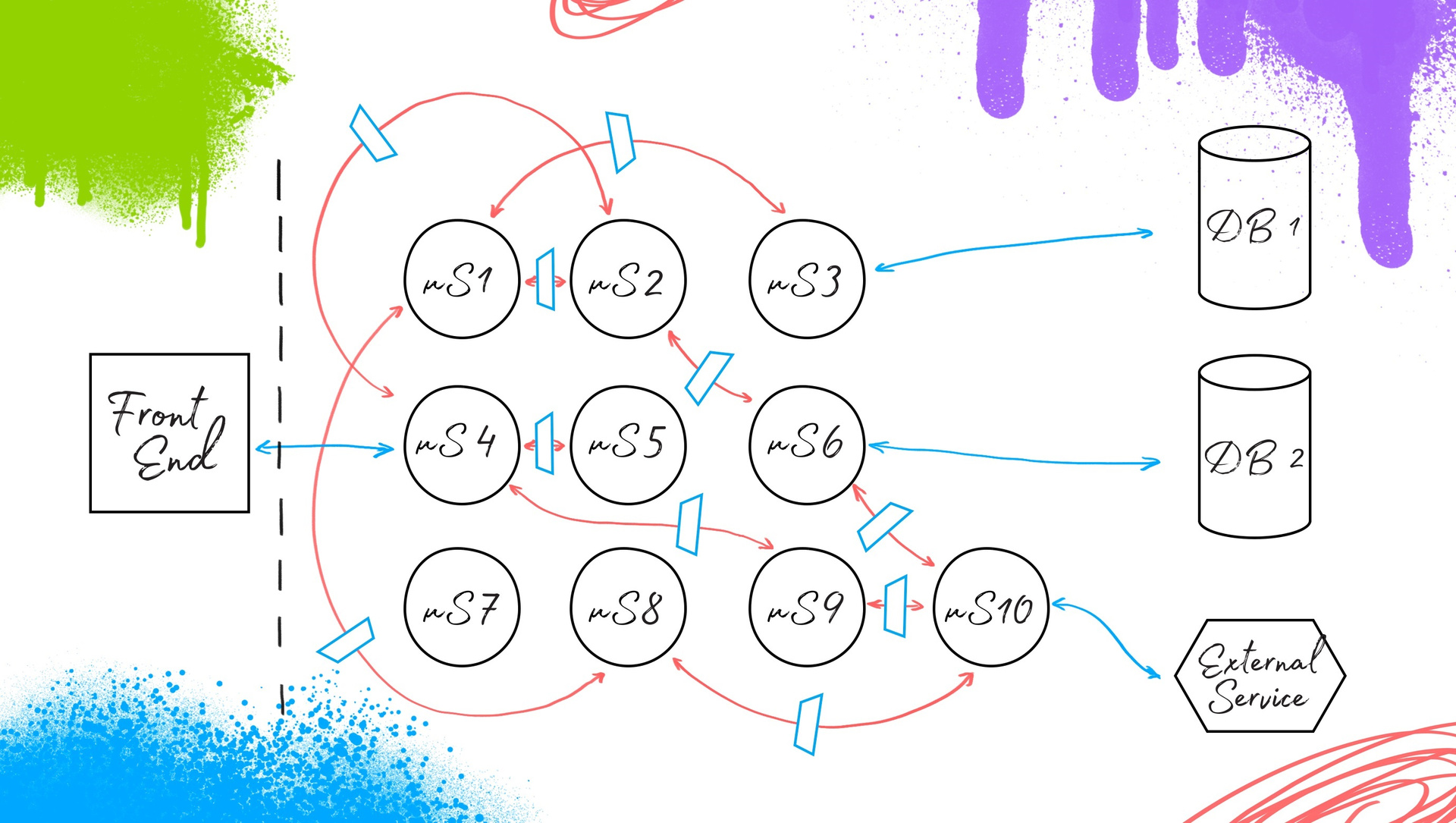

Важно отметить, что здесь появляется Suite runner (см. схему ниже). Это — та сущность, которая будет отвечать за запуск и конфигурирование тестов в удобном для разработчика/тестировщика виде. Её можно и не писать, но я бы все-таки выделил этот момент, так как сложно предвидеть какие тесты необходимо будет прогонять в тот или иной момент времени на проекте. В итоге у нас получается вот такое ядро автоматизации тестирования под микросервисную архитектуру:

Теперь самое важное — внедрение. Мы должны предоставить эту схему с требованиями по наличию описанных контрактов разработчикам. Что мы получаем после?

У нас есть информация по каждому сервису: о том, что он выдает и то, что он запрашивает у своих “соседей”. Соответственно, с помощью нашей системы автоматизации тестирования, с помощью PACT-файлов мы изолируем наш микросервис для обеспечения изоляции его тестирования вне зависимости от внешних сервисов, с которыми он интегрирован. И предоставляем states через моки, заглушки, сэмплированные базы данных, или напрямую как-то изменяем сервис. Получаем, соответственно, изолированное тестирование. Вуаля: у нас есть ответ на вопрос, что делать с автоматизацией тестирования во время перехода от монолита к микросервисной архитектуре.

Что учесть при имплементации?

Что же нужно учесть при имплементации? Первое — это использование контейнеризации и виртуализации в процессе сборки/деплоя микросервиса. И наша система автоматизации тестирования точно так же закручивается в контейнер. Как будете обеспечивать взаимодействие микросервиса и системы автоматизации тестирования — это уже не столь важно: как удобнее, так и делайте.

Второе — актуализация файлов требований по контрактам. Есть такая проблема, что требования консьюмеров к провайдеру начинают копиться, а разработчики занимаются только тем, что им насущно необходимо сейчас. Здесь нужно на уровне тест-менеджмента или управления продуктом ставить задачу разработчикам: например, час в неделю работать с этим “хвостом”, чтобы он не разрастался. Конечно, эти тесты быстрые, они могут проходить за несколько секунд. Но если их количество будет измеряться тысячами, это будет осложнять актуализацию тестирования. А мы со своей стороны, через систему commit hook-ов будем получать информацию и убирать ненужные автотесты. По сути, CDC — это documentation-driven development, если так можно выразиться.

Третье: нужно ввести обязательно ввести в эту работу процесс актуализации states и data suites. Что такое data suites? Девелоперы в процессе разработки пишут некоторые базовые сценарии взаимодействия. К примеру: “мне нужен такой запрос и такой ответ”. А обо всем остальном — в каких рамках он должен существовать, какие значения параметров возможны, а какие — нет, забывают. Это необходимо проверять. И сюда мы должны входить с нашим data-driven подходом к тестированию, реализуя это в нашем конфигураторе: позитивные, пограничные и негативные тесты, для того, чтобы обеспечить отказоустойчивость работы нашей микросервисной архитектуры на продакшене. Без этого она вряд ли будет работать, любой шаг вправо/влево — и ошибка взаимодействия.

Соответственно при появлении новых pact-файлов, через hook мы получаем таски и наполняем новые/изменённые взаимодействия большим количеством наборов данных в interactions, что равно целому ряду проведенных тестов. Мы можем наполнять и редактировать interactions вручную, а можем делать генераторы, которые будут параметризировать их и гнать тесты.

Что касается States: если брать автоматизацию тестирования веба, то это preconditions, setUps, FixTure; для микросервисов есть проблема — готового механизма нет: надо продумать то, как вы будете сопрягать изменение названия States в PACT-файлах в этом модуле. Самый простой из механизмов — использовать Aliases, по сути KDT (keyword driven testing), говоря на языке автоматизации тестирования. Рассказать сейчас про более красивое и элегантное решение не готов: пока что его не придумал.

Итоги

- То, что касается post-commit-hooks, автоматизации мониторинга, появления и изменения, удаления контрактов между сервисами — это все необходимо автоматизировать, это часть системы. Я бы сказал, что это кусочек ядра, который стоит на уровне репозиториев.

- CDC-паттерн для разработчиков обязателен. Это фундамент, без него ничего работать не будет.

- Вы заметите снижение склонности системы к появлению дефектов. По сути, у нас все её части окутаны изолирующим тестированием. Мы быстро локализуем дефекты, их быстро исправляют, мы располагаем высоким тестовым покрытием. Если будут появляться дефекты на уровне системного тестирования, они, скорее всего, будут связаны с фронт-эндом или какими-то внешними сервисами.

- Вы имеете возможность уйти от ручного тестирования изменений. Ключевые моменты: быстрое и изолированное тестирование. Тогда мы получим профит от того, что мы можем хорошо локализовать проблему или дефект.

P.S.

Если вы больше любите не читать, а смотреть видео, то эта информация доступна в формате доклада по ссылке. А в конце августа у нас в Avito пройдет тематический митап для профессионалов в области тестирования. Поговорим о векторах развития систем автоматизации в целом, обсудим применение прикладных инструментов и их влияние на изменение инфраструктуры тестирования. Если интересно — следите за обновлениями на нашей странице в FB, или напишите в комментариях: дадим знать, когда будут подробности о мероприятии.

|

Метки: author dkhimion тестирование it-систем блог компании avito автоматизация тестирования микросервисы тестирование consumer driven contracts cdc-testing |

Когда деревья были большими: как маленький дата-центр ураган пережил |

Лето 2017 года выдалось богатым на ураганы. А вот у нас тоже был случай. Ровно 7 лет назад наш первый дата-центр на Боровой пережил ураган, который похоронил чиллеры под слоем 10 тонн железа, прилетевшего с соседней крыши. Душещипательные фотографии искореженных чиллеров разошлись по интернету уже давно, а история про восстановление ЦОДа, оставшегося без холода, никогда не публиковалась. Решил поднять архивы и восполнить пробел.

В 2010 году DataLine был начинающим оператором дата-центров. На площадке OST успели запустить только три зала на 360 стоек, на севере Москвы (NORD) был один корпус с одним залом на 147 стоек.

Вот как изменились масштабы нашей инфраструктуры с 2010 года.

Хотя мы сами проектировали и строили, тогда у нас не было выделенной службы эксплуатации. Не было, как сейчас, отдельных специалистов по ДГУ, кондиционерам, электриков – отдавали все по максимуму подрядчикам. Объемы инфраструктуры были небольшие, как, впрочем, и наш опыт. За инженерку тогда отвечали директор по производству, главный энергетик и я, технический директор. На подхвате были еще дежурные инженеры (трое в смене), но они занимались клиентскими запросами и мониторингом.

Один из первых залов дата-центра OST-1 в конце 2009 года.

Так выглядят новые залы в OST сегодня.

Три зала на Боровой были заполнены только наполовину. Клиентов было немного, для пересчета хватило бы пальцев одной руки.

На площадке работала чиллерная схема на этиленгликоле с тремя чиллерами Emicon в схеме резервирования 2+1. Надо сказать, эти чиллеры так и не вышли на заявленную производителем мощность, но, поскольку нагрузка была небольшая, одного чиллера почти хватало на все три зала.

День первый

20 июля стояла жара за тридцать. В такую погоду чиллерам было плохо, поэтому, когда ближе к концу рабочего дня пошел дождь, я обрадовался, надеясь, что чиллерам полегчает. Вместе с дождем поднялся сильный ветер, и вот я из окна своего кабинета вижу, как мимо пролетают листы металла. Вышел на улицу, а на другой стороне дороги валяются куски крыши. Удивительно, но ни одна из машин сотрудников, запаркованных рядом с ЦОД, сильно не пострадала.

Кровельное железо свисало с проводов, как белье.

Тут я подумал, что надо бы проверить чиллеры, потому что металл летел с их стороны. Вместе с коллегами залезли на крышу и увидели жуткую картину: все три чиллера завалены железными балками и листами.

По записи системы видеонаблюдения видно, что все железо прилетело за один мощный порыв ветра. Вот что мы потом увидели c записи одной из камер:

На видео часы отстают. Когда все произошло, было уже 18.18.

Масштабы бедствия оказались внушительными. У одного чиллера прилетевшее железо пробило теплообменник фрикулинга (внешний контур чиллера), у второго повреждены вентиляторы, у третьего, помимо всего перечисленного, вращающиеся искореженные вентиляторы успели задеть и порубить фреоновые трубки внутри чиллера. К тому моменту, как мы оказались на крыше, два чиллера из трех уже остановились.

Поврежденная рама и теплообменник фрикулинга первого чиллера. Теплообменник представляет собой “бутерброд”: снаружи рубашка фрикулинга, внутри, с зазором сантиметров пять, такой же на вид теплообменник фреонового конденсатора.

Искореженные вентиляторы одного из чиллеров.

Из пробитых теплообменников фрикулинга хлестал гликоль. Давление в системе холодоснабжения резко упало. Насосы остановились по защите от сухого хода, вырубился последний рабочий чиллер, и вся система холодоснабжения встала (времени было 18:32, две минуты как закончился рабочий день). Несколько секунд мы пребывали в ступоре и не знали, что делать. Потом позвонили подрядчику по холодоснабжению и вызвали аварийную бригаду. По телефону подрядчик посоветовал перекрыть внешний контур, объяснил, где находятся нужные вентили и краны системы подпитки. Мы перекрыли вентили, питающие внешние теплообменники, гликоль перестал течь.

В холодных коридорах машинных залов становилось жарко. Осознав, что быстро восстановить холодоснабжение мы не сможем, в 19:10 начали звонить клиентам уже не просто с оповещением об аварии, а с просьбой отключить вычислительное оборудование, чтобы избежать его выхода из строя. Иного варианта мы не видели. Некоторые клиенты отказались выключаться и взяли риски на себя. Некоторые привезли на площадку переносные кондиционеры для своих стоек.

В 18:51 начали дозаправлять гликолевые контуры водопроводной водой и постепенно довели давление в системе до рабочего.

В 19.45 приехала аварийная бригада.

В 19.53 насосы запустились, но заработал только один чиллер из трех. У другого были повреждены вентиляторы, а у третьего – еще и фреоновый контур.

Пока мы проделывали все эти упражнения, температура гликоля успела вырасти с рабочих значений (7–12° С) до 20 градусов. Один живой чиллер работал с перегрузкой, и периодически один из двух его контуров останавливался по ошибке. После этого нужно было вручную сбросить ошибку на пульте, и через пять минут (защитный интервал) компрессор запускался. Или не запускался. Тогда помогало полное обесточивание чиллера с перезагрузкой.

Все, кто был в этот момент в офисе, участвовали в освобождении чиллеров от “летающего” металлолома и помогали подъехавшей аварийной бригаде собрать из двух убитых чиллеров еще один рабочий.

Директор по капитальному строительству тогда сорвал спину, скидывая стальные балки с чиллеров.

С чиллера с пробитыми фреоновыми трубками сняли вентиляторы. Не обошлось без пауэрлифтинга – каждый вентилятор весит под 30 кг.

К 23:00 худо-бедно собрали и запустили второй чиллер, и температура в залах начала медленно опускаться.

К тому времени стемнело, но самое интересное только начиналось. Чиллеры стало вышибать по защите из-за перегрева компрессоров: температура гликоля по-прежнему была высокой несмотря на отключение большей части клиентов.

Начальник производства съездил и купил керхеры, шланги и налобные фонари, чтобы можно было работать ночью. Мы поливали компрессоры чиллеров холодной водой, но это не очень помогало, так как компрессор – это кусок железа весом больше тонны и быстро его не охладить. Теперь, когда чиллер останавливался по ошибке, вместо пяти минут приходилось ждать несколько десятков минут, пока компрессор остынет и ошибка Compressor Overload пропадет.

Сообщение об ошибке, которое нам по очереди показывали то один, то другой чиллер.

Глубокой ночью случилось то, чего мы боялись: по аварии одновременно остановились оба чиллера и завести их вместе больше не удавалось. Из четырех юнитов первого и второго чиллеров работало один-два, остальные по очереди пребывали в коматозном состоянии по случаю перегрузки. Температура в залах остановилась на уровне около 30 градусов. Все двери в машинные залы были открыты. Это позволяло хоть как-то избавиться от накопившегося тепла.

Мы вместе с подрядчиками пошли изучать схемы чиллеров. После долгих и тяжких раздумий они предложили под нашу ответственность сделать то, чего делать нельзя: обойти защиту, поставив перемычки, т.е. накоротко замкнуть реле тепловой защиты. Это был прямой путь к тому, чтобы окончательно убить компрессоры, но других вариантов не было. В три часа ночи чиллеры завелись и больше не останавливались. Температура в холодных коридорах начала приходить в соответствие с SLA.

Изменение температуры в холодных коридорах с начала аварии и до ее устранения.

1 — время первой остановки всех чиллеров; 2 — время запуска первого чиллера; 3 — время запуска второго чиллера; 4 — повторная остановка чиллеров; 5 — запуск чиллеров с отключенной тепловой защитой.

С начала этого безобразия у нас впервые появилась возможность перевести дыхание и в чуть более спокойном режиме подумать, что делать дальше. По прогнозам завтра снова обещали жаркий день, а у нас два чиллера, работающих на честном слове.

День второй

Утро следующего дня застало нас за монтажом самодельной системы орошения: на крышу подвели трубы с водой и прокололи в садовом шланге дырки.

Гидрометцентр не обманул: снова пекло под 30° С. Из этой собранной на коленке системы и керхеров мы практически без остановки поливали чиллеры, которые продолжали работать с отключенной тепловой защитой.

А вот исторический кадр: чиллеры спасает дежурный сетевой инженер Григорий Атрепьев, ныне руководитель отдела комплексных проектов.

Температуру гликоля удалось вернуть в норму. В общей сложности в таком режиме проработали дня три, после чего восстановили тепловую защиту компрессоров. В течение пары дней запаяли пробитые фреоновые трубки третьего чиллера, вакуумировали и заправили фреоном. Пока ждали поставки вентиляторов взамен разбитых, работала только половина третьего чиллера.

Замена вентиляторов на третьем чиллере. Чиллер Emicon RAH1252F с опцией фрикулинга (свободного охлаждения) состоит из двух модулей, в каждом из которых стоит 8 осевых вентиляторов и компрессор Bitzer.

Заправка фреоном.

Вид на задний двор на следующий день. Еще долго вывозили металлолом.

Что было дальше

Чиллеры. Повреждения были серьезными, и мы потратили еще какое-то время на ремонт. Компрессоры после пережитого издевательства прослужили около года, после чего начали выходить из строя: для двух чиллеров сказалась работа без защиты, в третьем чиллере мы, похоже, поторопились с заправкой фреонового контура (недостаточно хорошо вакуумировали, оставив следы влаги). Пробы масла, взятые из еще живых фреоновых контуров, показывали высокий уровень кислотности, предвещавший скорый конец обмотки электродвигателя. В течение второго года после аварии мы заменили почти все компрессоры пострадавших машин. Пробовали починить один из компрессоров, отдав его в перемотку, но после ремонта он протянул считанные месяцы и снова сгорел, так что мы сочли за благо в дальнейшем покупать новые.

Вода, которой мы дозаправили гликолевый контур, не повлияла на морозоустойчивость системы. Замеры показали, что концентрация этиленгликоля осталась на достаточном уровне.

Поскольку чиллеры так и не выдавали заявленной холодильной мощности (а ИТ-нагрузка росла по мере заполнения ЦОДа), приходилось и дальше поливать их в жару. Теплообменники не пережили водных процедур: с годами они обросли известковыми отложениями, а в зазор между теплообменником фрикулинга и фреоновым конденсатором набилась всякая грязь, удалить которую конструкция не позволяла. Через несколько лет мы планово заменили два из трех чиллеров (про это тоже будет увлекательная история, на этот раз без жертв), а на оставшемся срезали теплообменники фрикулинга. Сейчас на площадке OST работает 4 чиллера: два Stulz, Hiref (добавился, когда дата-центр подрос) и один старый Emicon.

Чиллеры на площадке OST в 2017 году.

Клиенты. Несмотря на этот кошмар эксплуататора, клиенты отнеслись с нашей беде с пониманием и даже никто от нас не съехал.

Запомнилось, что для получения страховки на чиллеры и для отчета перед пострадавшими клиентами долго добывали у Гидрометцентра справку о локальному урагане.

Оргвыводы

К таким форс-мажорам сложно подготовиться заранее, но важно из любой аварии сделать правильные выводы. Наши, добытые потом и кровью, были такими:

В Москве тоже бывают ураганы. Это сейчас что ни день, то штормовое предупреждение, а тогда это было в новинку. После той аварии при выборе площадки или готового здания под ЦОД особенно тщательно смотрим, нет ли в опасной близости условных сараев и прочих хлипких строений. Конечно, крышу, которая прилетела на наши чиллеры, соседи перекрывали уже под нашим чутким контролем.

Мы стали сами закупать ЗИП (вентиляторы, компрессоры, запас фреона и пр.) и хранить его у себя. Восстановление прошло бы быстрее, если бы у нас на площадке были хотя бы запасные вентиляторы. В тот раз поставку нужного количества пришлось ждать несколько недель.

Волей-неволей разобрались в устройстве чиллеров, они перестали быть для нас “черными ящиками”. Это нам пригодилось впоследствии, потому что замечательные холодильные машины не перестали ломаться.

Провели на крышу воду. Для новых дата-центров делаем это по умолчанию. Вода пригодится для промывки чиллеров или внешних блоков от грязи, скопившейся за осень-зиму, поможет отбиться от тополиного пуха летом и облегчит жизнь системе холодоснабжения в условиях аномальной жары.

Прокачали мониторинг и стали измерять все, что можно: давление в нескольких точках, состояние насосов, температуру прямого и обратного гликоля, электропотребление чиллеров и т.д. В той ситуации оповещения помогли бы нам обнаружить проблему раньше и начать действовать быстрее.

Настроили удаленное управление чиллерами из центра мониторинга.

Синхронизировали часы на всех системах, чтобы при разборах аварий иметь понятную картину развития событий.

- Стали очень внимательно, даже скептично смотреть на цифры, которые заявляют производители оборудования. Мощность чиллера – не просто число, она сложным образом зависит от температуры уличного воздуха и холодоносителя и, как водится, она ниже всего в жару, когда более всего нужна.

Еще мы с особым тщанием занялись проработкой всех ключевых процессов, задокументировали и сопроводили схемами все, до чего смогли дотянуться, и ввели регулярные боевые учения. И если завтра случится какой-нибудь армагеддон, наши ЦОДы будут спасать не 3,5 человека в жанре импровизации, а большая и опытная служба эксплуатации с четкими, отработанными инструкциями. Это позволяет нам не только управлять постоянно растущей сетью из семи дата-центров, но и успешно проходить аудиты и сертификации самых уважаемых и строгих организаций вроде Uptime institute.

А какие стихийные бедствия пришлось пережить вашей серверной/дата-центру и какие полезные выводы вы для себя сделали?

|

Метки: author dataline it- инфраструктура блог компании dataline дата-центр цод чиллеры авария ураган dataline даталайн холодоснабжение |

Дели — сокращай, или как мы делали мобильный 2ГИС Онлайн |

Мобильный веб развивается семимильными шагами. На дворе 2017 год. Мобильный трафик превысил десктопный — больше половины всех страниц теперь открываются через телефоны или планшеты. В 2015 году Google объявил о предпочтении mobile-friendly сайтов при ранжировании выдачи, а в 2016 это сделал Яндекс. Юзеры проводят в интернете 60-70 часов в месяц с мобильных устройств и не готовы идти на компромисс и пользоваться неадаптивными сайтами. И 2ГИС — не исключение. За 2 года рост мобильного трафика 2ГИС Онлайн составил 74%, а месячная аудитория превысила 6 миллионов человек.

17 апреля мы зарелизили новый мобильный онлайн («Монлайн») — одностраничное приложение, доступное по адресу m.2gis.ru. Приложение запущено в двух городах: Уфе и Новосибирске, а в ближайшее время планируется релиз на всю Россию.

Мы знали, что при мобильной разработке столкнемся с тремя проблемами:

Мобильный интернет

Мобильный интернет (2G, 3G, 4G) или Wi-Fi медленнее и не такой стабильный, как кабельный.

Мобильные устройства

Проблема мобилок — слабый процессор. Это влияет на парсинг JS, рендеринг и анимации.

Мобильные браузеры

Некоторые популярные мобильные браузеры не поддерживают часть CSS-свойств или методов JS API. Иногда мы думали, что вернулись в темные времена разработки под IE8. Мобильный интернет и процессор не позволяли использовать полифилы, а значит, приходилось выкручиваться самостоятельно.

Мы сохранили функциональность десктопной онлайн-версии и заставили Монлайн работать даже на убитом телефоне вашего дедушки под Пензой. О том, как мы это сделали, расскажем ниже.

Дели — сокращай

В мире мобильного веба JS-разработчик следует одному кредо: дели — сокращай. Конечный бандл мобильного приложения должен мало весить и быть разбит на куски.

Выбор фреймворка и библиотек

Главным и единственным фреймворком фронтенда является Preact. Это не опечатка. Preact — легковесная альтернатива React, использующая тот же API и работающая с Virtual DOM. Преимуществами фреймворка является небольшой вес (3 kB gzip против 45 kB у React) и более высокая скорость рендеринга. Благодаря использованию Preact вместо React размер нашего вендора сократился на 90%.

Preact отличается от React. Например, у него отсутствуют propTypes, но эта проблема решилась введением статической типизации, о которой расскажем в п. 3. Подробно различия между фреймворками описаны в официальном репозитории на github.

Кроме того, мы стараемся писать самостоятельно и не подключать сторонние полифилы и тяжелые библиотеки. Необходимые полифилы грузятся асинхронно через require.ensure и не попадают в бандл. Каждый полифил подключается только в зависимости от условий. Например, в случае с полифилом для Android Browser — мы сэкономили 5 kB кода в gzip.

Ленивая загрузка

JS сформирован. Теперь пришло время его разбить. JS код делится на 3 группы:

- вендор — сторонние библиотеки;

- app-бандл, в котором хранится главный код приложения;

- либы и полифилы, подключаемые в зависимости от условий, таких как версия браузера;

Вендор минимизировали через выбор Preact, либы и полифилы подключаем асинхронно и по потребности. Остался последний герой. Гзипнутый app-бандл весом в 143 килобайта в gzip. Это роскошь для мобильной разработки. Так, если пользователь зашел в карточку организации, нет смысла моментально грузить код, отвечающий за рендеринг карточки метро или достопримечательности. Чтобы уменьшить размер app-бандла и доставлять клиенту как можно меньше кода, мы сделали ленивую загрузку.

Требования к коду № 1 в Монлайне гласит: «Код должен быть максимально простым и не знать или делать лишнего». На этом правиле базируется структура UI. В проекте 11 контейнеров и 85 «глупых» компонентов. «Глупые» компоненты не знают о существовании друг друга. Контейнеры объединяют компоненты в структуры и передают данные через пропсы. Карточка организации или отзыва, выдача зданий — примеры контейнеров. 6 контейнеров из 11 не связаны друг с другом, что позволяет разбить app-бандл на… интрига… 6 дополнительных чанков. При восстановлении браузер загружает app-бандл и нужный чанк, а затем асинхронно подгружаются остальные JS-файлы, отвечающие за неактивные контейнеры. Это не блокирует работу приложения. После релиза ленивой загрузки вес app-бандла сократился на 38%.

Хранение и нормализация данных на клиенте

В мобильном вебе критически важно быстро отображать страницы. В Монлайне, как и у 99,9% SPA, часть информации в контейнерах пересекается. Возьмем выдачу фирм и карточку отдельной организации. В выдаче выводится заголовок, адрес, расписание и т. д. Та же информация отображается и в карточке фирмы. Такая информация не меняется, пока юзер пользуется приложением. Нет смысла ждать ответа от сервера, если пользователь уже просматривал эту информацию в прошлом, ведь ее можно хранить на клиенте в единственном экземпляре и показывать данные здесь и сейчас.

Нормализация данных на клиенте — это хранение уникальных данных в стейте, переиспользуемых в контейнерах. Хранение данных на клиенте увеличивает скорость отображения контента, а нормализация убирает дубли и разделяет статические данные и данные, зависящие от контекста.

Нормализация держит стейт в чистоте. Если статические данные просмотрены, то они сохраняются в стейте в отдельной таблице. Например, если пользователь открывает одну фирму несколько раз, то в стейте она хранится в одном экземпляре с доступом по id. И информация об этой фирме используется для любых нужд: в карточке самой организации, выдачах, отзывах, фотографиях и т. д. За форматирование данных отвечают селекторы контейнеров.

Приведем еще один пример. Попасть в карточку компании можно через поисковый запрос, переход по рубрике или просто восстановившись по ссылке с ее id. Поисковый запрос или id рубрики добавляется в URL, который роутер распарсивает при восстановлении. Если в URL есть что-то помимо id фирмы, в стейт сохраняются как информация о ней, так и данные о первых 10 фирмах, соответствующих поисковому запросу или рубрике. При переходе из карточки компании в выдачу пользователь мгновенно получает список организаций и так же быстро может открывать страницу каждой фирмы.

Люди не любят ждать не только загрузку контента, но и ответа при отправке данных через формы. Хранение данных на клиенте уменьшает время ожидания при сохранении информации. Информация в стейте развязывает руки при создании оптимистичных интерфейсов. Оптимистичный UI-дизайн показывает конечное состояние до того, как приложение в действительности заканчивает (или даже начинает) операцию. После сабмита данных пользователь мгновенно получает информацию об их сохранении благодаря тому, что информация юзера сохраняется в стейте и отправляется на сервер в фоновом режиме. Только если с сервера пришел ответ с ошибкой, приложение оповестит юзера соответствующим сообщением, в остальных случаях ответ сервера не выводится на экран.

Облегчаем себе разработку

В создании Монлайна поучаствовали 34 разработчика. В мастер слили 2 000 коммитов, написали 77 000 строк кода и создали 1425 файлов. В проекте участвовали люди из других команд, ребята приходили на стажировки. Мы хотели ускорить процесс разработки, сделать код понятным и документированным. Поэтому решили отказаться от динамической типизации в JavaScript.

Статическая типизация

Клиентская часть приложения написана на TypeScript. Статическая типизация — главное преимущество TypeScript над JS. Она бьет по рукам в случае ошибок при компиляции, документирует код изнутри и облегчает рефакторинг и отладку.

Для управление состоянием приложения в проекте используется Redux. Redux сочетается с TypeScript. Разработчик знает, что передается в payload или meta и, соответственно, что приходит в редьюсер. Например:

export const setScrollTop = (payload: number) => ({

type: APPCONTEXT_CHANGE_SCROLL_TOP,

payload

});

export const setErrorToFrame = (errorCode: ErrorCodeType) => ({

type: APPCONTEXT_SET_ERROR_TO_FRAME,

payload: { errorCode }

});TypeScript упрощает работу с редьюсерами (чистые функции, которые вычисляют новую версию стейта и возвращают ее). Например, редьюсер, отвечающий за обновления информации о текущем контексте приложения в стейте, обрабатывает 69 экшнов. На выходе получаем метод со свитчем в 100 строк кода, возвращающий новый стейт. Критически важно в таком большом полотне обрабатывать только нужные экшны.

export default function (state: AppContext = defaultState, action: AppAction): AppContext {

switch (action.type) {

case APPCONTEXT_ADD_FRAME:

return appAddFrame(state, action.payload);

case APPCONTEXT_REMOVE_ACTIVE_FRAME:

return appRemoveActiveFrame(state);

....

case APPCONTEXT_HIDE_MENU:

return { ...state, isSideMenuShown: false };

default:

return state;Избежать путаницы с набором экшнов в редьюсере и данными в payload или meta помогает Discriminated Unions. В коде выше видно, что аргумент action описан типом AppAction, который выглядит так:

export type AppAction = AppAddFrameAction | AppRemoveActiveFrame | AppChangeFramePos | AppChangeMode | AppChangeLandscape…AppAction объединяет в себя 60 интерфейсов (appAddFrameAction, AppRemoveActiveFrame и т. д.). Каждый интерфейс описывает экшн. Тип (type) экшна — строковый литерал — это дискриминант. Он определяет наличие и содержание внутренностей объекта, таких как payload или meta.

export interface AppAddFrameAction {

type: 'APPCONTEXT_ADD_FRAME';

payload: Frame;

}

export interface AppRemoveActiveFrame {

type: 'APPCONTEXT_REMOVE_ACTIVE_FRAME';

}

export interface AppChangeFramePos {

type: 'APPCONTEXT_CHANGE_FRAME_POS';

payload: FramePos;

}Так TypeScript понимает, что для экшна с дискриминантом 'APPCONTEXT_ADD_FRAME' нужно передать payload с интерфейсом Frame, а в случае 'APPCONTEXT_REMOVE_ACTIVE_FRAME' ничего передавать не нужно.

Preact также сочетается с TypeScript. В Preact отсутствуют реактовские propTypes, решающие проблемы проверки типов у компонента. Но TypeScript восполняет потерю. Например, разработчик знает, что передается через пропсы компоненту и что хранится в стейте.

export interface IconProps {

icon: SVGIcon;

width?: number;

height?: number;

color?: string;

className?: string;

}

export class Icon extends React.PureComponent {

constructor(props: IconProps) {

super(props);

}

public render() {

const { color, icon } = this.props;

const iconStyle = color ? { color: this.props.color } : undefined;

return (

);

}

}TypeScript задокументирован и имеет песочницу. Разумеется, язык не всесилен, на июль 2017 года открыто 2200 issues. Продукт Microsoft не поддерживает часть нововведений в ES6. Но медленно и верно эти проблемы решаются в каждом новом релизе.

Создание и тестирование верстки

В мобильном онлайне — 85 «глупых» компонентов. «Глупые» компоненты — визуальные сущности, отвечающие за представление полученных данных. В первую очередь мы хотели разделить верстку и интеграцию этих компонентов в приложении. Это позволило бы ускорить code review и тестирование ресурсом разработчиков. Для достижения этих целей используется Makeup.

Makeup — графический интерфейс для быстрого и комфортного ручного регрессионного тестирования верстки. Подробно почитать об инструменте можно здесь, а потрогать — здесь.

С помощью Makeup верстка компонентов делается на отдельном хосте с замоканными данными без привязки к приложению. Это позволяет тестировать визуализацию компонента на уровне разработки, подгонять верстку под pixel perfect и уже позже заниматься интегрированием.

Так в Makeup выглядят различия между тем, что нарисовал дизайнер, и тем, что сверстал разработчик.

А так мы проверяем «одиннадцатиклассницу» и видим, что ничего не поехало:

Заключение

Подытожим. Мы проделали большую работу по уменьшению бандла и увеличению скорости загрузки страницы. Данные хранятся на клиенте. Вендор весит на 90% меньше, чем изначально мог бы. Бандл не включает лишних библиотек и полифилов, а нужные отдаются кусочками по потребности. TypeScript дает больше контроля над приложением, а Makeup упрощает работу с визуальной составляющей Монлайна.

В планах разбить «жирные» модули в зависимости от контекста (например, карточку фирмы или геообъекта разделить на отдельные чанки) и попробовать разбить редьюсеры.

Статья посвящена JS-коду. Но разработческое кредо «дели — сокращай» распространяется и на CSS-бандл. В будущем мы также планируем заняться и сплиттингом стилей.

|

Метки: author galtr javascript блог компании 2гис typescript preact react makeup |

[Перевод] Мировые рынки: как добиться успеха в Индии и Бразилии |

Продолжаем наш обзор растущих мобильных рынков с огромными возможностями для издателей и рекламодателей. На очереди — Индия и Бразилия. Обеим странам свойственно сочетание постоянно улучшающейся инфраструктуры, все более дешевых тарифов и очень быстрого распространения смартфонов среди населения, а также успехи местных компаний с хорошим чувством рынка.

Переведено в Alconost

В цифрах

Индия

Сейчас в Индии более 1 миллиарда пользователей мобильной связи. На конец 2016 года около 200 миллионов из них — пользователи со смартфонами (больше только в Китае), и это, на самом-то деле, только начало.

Планшетофоны (мобильные устройства с экраном с диагональю от 5 до 7 дюймов) занимают 61% рынка, намного больше, чем в США. И хотя самая популярная категория устройств ясна, на рынке присутствует как минимум десяток производителей, включая лидера, Samsung (с долей в 40%), а также менее известные бренды, вроде Redmi и Micromax.

Цены на мобильный трафик высоки, но все увеличивающееся количество смартфонов и расширяющаяся зона покрытия в сельских районах приводят к снижению цен (примерно на 50% за прошлый год) — и это ключевой фактор для увеличения числа пользователей и развития электронной коммерции (см. ниже).

Пик использования мобильных устройств в Индии в личных целях в приходится на 9 часов вечера. Индийцы не очень активны утром. Мобильные пользователи Индии заботятся о своей конфиденциальности, и, на сегодняшний день, не очень часто пользуются мобильными платежами (примерно 360 миллионов долларов в 2016, лишь малая толика от 27 миллиардов долларов мобильных платежей только в США), но в ближайшие месяца и годы эта цифра будет быстро расти по мере распространения смартфонов среди населения, снижения цен на мобильный Интернет и распространения эффектов демонетизации.

Бразилия

Последние несколько лет экономика Бразилии находилась в состоянии спада, но сейчас видны признаки того, что ситуация изменится. На самом деле, уже предсказано, что спад закончился и в 2017 году экономика Бразилии снова будет расти.

Страсть бразильцев к мобильных технологиям может быть одной из причин этого роста. Около 64 миллионов из 208 миллионов пользователей мобильной связи владеют смартфонами, это более трети всех пользователей в Латинской Америке. Как и в Индии, это цифра растет — к 2018 году ожидается, что проникновение смартфонов достигнет 48%, на 10 пунктов выше, чем в 2015. Это отличная новость для торговли и рынка мобильной рекламы, поскольку бразильцы — поистине ненасытные потребители цифрового контента.

Бразилия уже является самым большим розничным рынком в Латинской Америке, несмотря на экономический спад. Электронная коммерция в Бразилии уже на первом месте среди стран Латинской Америки и объемы ее продолжат расти примерно на 12,5% в год. Одной из важных причин такого роста является высокое проникновение кредитных карт (50%) и альтернативных методов оплаты, предлагаемых местными компаниями, включая Boleto Bancario, работающую при поддержке правительства систему электронных платежей, через которую проходит примерно четверть цифровых платежей в стране.

Бразильцы относятся к рекламе куда спокойнее, чем индийцы, и рекламодатели тратят 50% рекламных бюджетов всей Латинской Америки в одной только Бразилии — а прогноз на 2019 год составляет 5,8 миллиарда долларов. Помимо этого, в Бразилии самый высокий процент полного просмотра видеорекламы в мире.

Тенденции в использовании приложений

Индия

Использование приложений в Индии растет почти в четыре раза быстрее, чем по всему миру (Индия = 43% год от года; весь мир = 11%). Это создает взрывной спрос пропускной способности и доступности мобильного Интернета. А пока инфраструктура не может удовлетворить потребности рынка, индийские потребители используют UC Browser от Softonic, очень маленькое приложение, способное отфильтровывать более 80% трафика и снижать расходы на связь.

Android доминирует в Индии (97% по состоянию на второй квартал 2016 года), здесь доступны несколько магазинов приложений, включая Amazon и Opera, а также местные магазины, вроде GetJar, самый большой из открытых магазинов приложений в мире. UC Browser с огромным отрывом лидирует среди браузеров в Индии, являясь 6 по популярности приложением в Топ 10 приложений Индии, по порядку: WhatsApp, YouTube, Google, Gmail, SHAREit, UC, Google Maps, MX Player, Facebook и Facebook Messenger. Интересно, что Индия — единственная страна, в топе которой находятся сразу два видеоприложения (YouTube и MX Player): для издателей и рекламодателей это очевидный намек на эффективность и потенциал видеорекламы на этом огромном и растущем рынке.

В 2016 году категория «Музыка, мультимедиа и развлечения» похвасталась самым большим приростом объемов использования (188%), на втором месте была категория «Бизнес и финансы» (176%), на третьем — «Утилиты и продуктивность» (99%). Еще одной особенностью индийского рынка является популярность приложений для здоровья и фитнеса (рост в 27%), которые очень нравятся индийским потребителем, вместе с носимыми устройствами для отслеживания состояния здоровья и достижения фитнес-целей.

Бразилия

В Бразилии очень социальная культура и это находит свое отражение в рейтинге — на первых местах Top 10 социальные приложения и мессенджеры (YouTube, WhatsApp, Google, Facebook, Facebook Messenger, Chrome, Google Maps, Hangouts, Gmail chat, Google+).

На самом деле, 92% пользователей Интернета в Бразилии, как мобильного, так и в целом, пользуются социальными сетями. Бразильцы — это 10% всего социального трафика в мире. Такая социализация создает огромное количество трафика: целых 34% сессий приложений во всей Латинской Америке исходят из Бразилии, намного больше, чем из любой другой страны, включая Мексику. Конфиденциальность зачастую не важна, реклама, которая подстраивается под тон социальных бесед, обычно достигает успеха.

Как и в Индии, Android доминирует с примерно 90% рынка (тут, конечно, помогает тот факт, что iPhone в Бразилии дороже, чем где бы то ни было). Помимо Google Play, популярными вариантами для поиска и скачивания приложений, рингтонов и другого контента являются местные маркеты Aptoide, Mobile9 и Mobogenie. Требования к мобильному Интернету — не проблема в Бразилии, где все гораздо лучше, чем в Индии. Примерно 20% пользователей смартфонов имеют постоянный доступ к сетям 4G, а WiFi (любимый способ бразильцев выходить в сеть) доступен повсеместно.

Активные игроки этих рынков

Индия

Прогноз проникновения смартфонов в 66% в 2018 — огромный скачок на 40 пунктов по сравнению с 2015 годом — говорит о том, что мобильный рынок Индии чрезвычайно активен. В сфере телекоммуникаций ведущим инноватором является Jio, в то время как Vodafone и Airtel начали процесс консолидации рынка через серию сделок по поглощению и объединению.

Если посмотреть на общественные процессы, стоит отметить вложение правительством 3 миллиардов долларов в создание национальной оптической сети National Fiber Optic Network, а также планы по организации бесплатного WiFi-доступа в более чем 1000 отдаленных деревень. Эти и другие смелые инициативы индийский предпринимателей, конечно же, лишь ускоряют распространение приложений.

Lookup, стартап из Бангалора, который с помощью чата связывает покупателей с магазинами поблизости, один из потенциальных лидеров рынка. Получившая посевные инвестиции от таких источников как Vinod Khosla и Biz Stone от Twitter, компания быстро была куплена NowFloats.

Бразилия

Бразильский мобильный рынок насыщен местными приложениями. Стоит покинуть первую десятку, названную выше, и вы тут же повстречаете очень сильные и популярные у бразильцев местные продукты, такие как Palco — музыкальный стриминговый сервис. Это шестое, социальное чувство бразильцев и становится причиной того, что у них так популярны местные продукты. Другой причиной успеха местных компаний является их понимание того, как работает бразильская экономика.

Несмотря на то, что большая часть из 208 миллионов граждан Бразилии живет в городах, целых 40% жителей Бразилии не являются частью традиционной банковской системы. Но как вы помните, в Бразилии очень широко распространены (и продолжают распространяться) смартфоны. Поэтому финансовые технологии, а в особенности мобильные финансовые технологии — очень горячая отрасль. Бренды и издатели приложений идут на все, чтобы создать надежное и доступное финансовое приложение, которое бы завлекало бразильских потребителей и отвечало их уникальным потребностям.

Nubank может стать лидирующим кандидатом, уже получив более 234 миллионов долларов за четыре раунда инвестиций и от продажи долей. Этот мобильный бизнес по работе с кредитными картами — лишь вершина айсберга из сотен других участников бразильского бума финансовых технологий.

Прогнозы

К 2020 на растущих рынках будет более 2,5 миллиардов пользователей смартфонов, а потребности в мобильном Интернете возрастут почти в 10 раз.

В то время как демонетизация и развивающаяся инфраструктура являются ключевыми причинами роста Индии как глобального рынка, будущее этого рынка определяют изменения в поведении пользователей, такие как распространение контента в социальных медиа и быстрый рост онлайн-продаж и мобильных платежей. Есть очевидная связь между распространением смартфонов и экономическим благополучием, и самый быстро растущий мобильный рынок обречен ставить новые рекорды в мобильной коммерции.

В Бразилии, где к 2019 году смартфоны будут почти у 80 миллионов человек (половина из них с доступом к 4G), стимулами роста будут даже не развлечения и коммерция, а полезные и практичные приложения. Бразильцы, очень социальные по своей натуре, быстро принимают и распространяют новые технологии, (включая мобильные финансовые технологии), и чатботы, внедренные в невероятно популярные по всей стране мессенджеры, станут обычным делом в жизни бразильских потребителей.

Судьбу этих уникальных, разнообразных и захватывающих рынков в конечном итоге определят те самые отдельные потребители со смартфоном или планшетофоном в руках — именно они определяют направление и траекторию роста этих рынков.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией приложений, игр и сайтов на 68 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов, перевод технических текстов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Подробнее: https://alconost.com

|

|

Deep Learning, теперь и в OpenCV |

Данная статья является кратким обзором возможностей dnn — модуля OpenCV, предназначенного для работы с нейросетями. Если вам интересно, что это такое, что оно умеет и как быстро работает, добро пожаловать под кат.

Пожалуй, многие согласятся, что OpenCV является наиболее известной библиотекой компьютерного зрения. За долгое время своего существования она приобрела обширную аудиторию пользователей и стала, де-факто, стандартом в области компьютерного зрения. Множество алгоритмов, работающих «из коробки», открытость исходного кода, замечательная поддержка, большое сообщество пользователей и разработчиков, возможность пользоваться библиотекой на языках C, C++, Python (а также Matlab, C#, Java) под различными операционными системами — это далеко не полный список того, что позволяет OpenCV оставаться востребованной. Но OpenCV не стоит на месте — постоянно добавляется функционал. И сегодня я хочу рассказать о новых возможностях OpenCV в области Deep Learning. Загрузка и получение результатов (предсказаний) с помощью моделей, созданных в любом из трех популярных фреймворков (Caffe, TensorFlow, Torch), быстрая работа на CPU, поддержка основных слоев нейронных сетей и, как всегда, кроссплатформенность, открытость исходного кода и поддержка — об этом я собираюсь рассказать в данной статье.

Прежде всего, хотелось бы представиться. Меня зовут Рыбников Александр. Я являюсь инженером компании Intel и занимаюсь реализацией функциональности Deep Learning в библиотеке OpenCV.

Пару слов о том, как устроена OpenCV. Эта библиотека представляет собой набор модулей, каждый из которых связан с определенной областью компьютерного зрения. Существует стандартный набор модулей — так сказать, «must have» для любой задачи компьютерного зрения. Реализуя известные алгоритмы, данные модули хорошо проработаны и протестированы. Все они представлены в основном репозитории OpenCV. Также существует репозиторий с дополнительными модулями, реализующими экспериментальную или новую функциональность. Требования к экспериментальным модулям, по понятным причинам, мягче. И, как правило, когда какой-то из таких модулей становится достаточно развитым, сформировавшимся и востребованным, он может быть перенесен в основной репозиторий.

Данная статья связана с одним из модулей, совсем недавно занявшим почетное место в основном репозитории — с модулем dnn (далее просто dnn).

(N+1)-й фреймворк для deep learning, это вообще зачем?

Зачем вообще понадобился Deep Learning в OpenCV? В последние годы во многих областях глубокое обучение (в некоторых источниках глубинное обучение) показывает результаты, значительно превосходящие аналогичные у классических алгоритмов. Это касается и области компьютерного зрения, где масса задач решается с применением нейронных сетей. В свете данного факта кажется логичным дать пользователям OpenCV возможность работы с нейросетями.

Почему был выбран путь написания чего-то своего вместо использования уже существующих реализаций? Этому есть несколько причин.

Во-первых, так можно добиться легковесности решения. Оставляя только возможность выполнения прямого прохода (forward pass) по сети, можно упростить код, ускорить процесс установки и сборки.

Во-вторых, имея свою реализацию, можно свести внешние зависимости к минимуму. Это упростит распространение приложений, использующих dnn. И, если ранее в проекте использовалась библиотека OpenCV, не составит труда добавить в такой проект поддержку глубоких сетей.

Так же, разрабатывая свое решение, есть возможность сделать его универсальным, не привязанным к какому-то конкретному фреймворку, его ограничениям и недостаткам. При наличии собственной имплементации доступны все пути для оптимизации и ускорения кода.

Собственный модуль для запуска глубоких сетей значительно упрощает процедуру создания гибридных алгоритмов, сочетающих в себе быстроту классического компьютерного зрения и замечательную обобщающую способность глубоких нейронных сетей.

Стоит заметить, что модуль не является, строго говоря, полноценным фреймворком для глубокого обучения. На данный момент в модуле представлена исключительно возможность получения результатов работы сети.

Основные возможности

Основная возможность dnn заключается, конечно же, в загрузке и запуске нейронных сетей (inference). При этом модель может быть создана в любом из трех фреймворков глубокого обучения — Caffe, TensorFlow или Torch; способ ее загрузки и использования сохраняется независимо от того, где она была создана.

Поддерживая сразу три популярных фреймворка, мы можем достаточно просто комбинировать результаты работы загруженных из них моделей без необходимости создавать все заново в одном единственном фреймворке.

При загрузке происходит конвертация моделей во внутреннее представление, близкое к используемому в Caffe. Так произошло в силу исторических причин — поддержка Caffe была добавлена самой первой. Однако взаимно однозначного соответствия между представлениями нет.

Поддерживаются все основные слои: начиная от базовых (Convolution и Fully connected) и заканчивая более специализированными — всего более 30.

AveragePooling

BatchNormalization

Concatenation

Convolution (with dilation)

Crop

DetectionOutput

Dropout

Eltwise

Flatten

FullConvolution

FullyConnected

LRN

LSTM

MaxPooling

MaxUnpooling

MVN

NormalizeBBox

Padding

Permute

Power

PReLU

PriorBox

ReLU

RNN

Scale

Shift

Sigmoid

Slice

Softmax

Split

TanH

Если вы не обнаружили в этом списке слой, который требуется именно вам, не стоит отчаиваться. Вы можете создать запрос на добавление поддержки интересующего вас слоя (и наша команда постарается помочь вам в ближайшее время), либо реализовать все самостоятельно и подать pull request.

Кроме поддержки отдельных слоев, важна также и поддержка конкретных архитектур нейронных сетей. Модуль содержит примеры для классификации (AlexNet, GoogLeNet, ResNet, SqueezeNet), сегментации (FCN, ENet), детектирования объектов (SSD); многие из указанных моделей проверены на исходных датасетах, но об этом позднее.

Сборка

Если вы — опытный пользователь OpenCV, то можете смело пропустить этот раздел. Если нет, то я постараюсь максимально кратко рассказать о том, как же получить работающие примеры из исходного кода для Linux или Windows.

Начнем с клонирования репозитория:

mkdir git && cd git

git clone https://github.com/opencv/opencv.gitНа Windows клонирование репозиториев также можно выполнить, например, с помощью TortoiseGit или SmartGit. Далее, приступим к генерации файлов для сборки:

cd ..

mkdir build && cd build

cmake ../git/opencv -DBUILD_EXAMPLES=ON(для Windows здесь и далее нужно заменить cmake на полный путь до запускаемого файла cmake, например на «C:\Program Files\CMake\bin\cmake.exe» или использовать cmake GUI)

Теперь непосредственно сборка:

make -j5 (Linux)

cmake --build . --config Release -- /m:5 (Windows)После этого dnn готов к использованию.

Приведенная выше инструкция достаточно краткая, поэтому приведу также ссылки на пошаговые инструкции по установке OpenCV на Windows и Linux.

Примеры использования

По хорошей традиции, каждый модуль OpenCV включает в себя примеры использования. dnn — не исключение, примеры на С++ и Python доступны в поддиректории samples в репозитории с исходным кодом. В примерах присутствуют комментарии, да и в целом все достаточно просто.

Приведу здесь краткий пример, выполняющий классификацию изображений с помощью модели GoogLeNet. На языке Python наш пример будет выглядеть следующим образом:

import numpy as np

import cv2 as cv

# read names of classes

with open('synset_words.txt') as f:

classes = [x[x.find(' ') + 1:] for x in f]

image = cv.imread('space_shuttle.jpg')

# create tensor with 224x224 spatial size and subtract mean values (104, 117, 123)

# from corresponding channels (R, G, B)

input = cv.dnn.blobFromImage(image, 1, (224, 224), (104, 117, 123))

# load model from caffe

net = cv.dnn.readNetFromCaffe('bvlc_googlenet.prototxt', 'bvlc_googlenet.caffemodel')

# feed input tensor to the model

net.setInput(input)

# perform inference and get output

out = net.forward()

# get indices with the highest probability

indexes = np.argsort(out[0])[-5:]

for i in reversed(indexes):

print('class:', classes[i], ' probability:', out[0][i])Данный код загружает картинку, проводит небольшую предобработку и получает для изображения выход сети. Предобработка заключается в масштабировании изображения таким образом, чтобы наименьшая из сторон стала равной 224, вырезании центральной части и вычитании среднего значения из элементов каждого канала. Данные операции необходимы, так как модель была натренирована на изображениях заданного размера (224 x 224) с именно такой предобработкой.

Выходной тензор интерпретируется как вектор вероятностей принадлежности изображения к тому или иному классу и имена для 5 классов с наибольшими вероятностями выводятся в консоль.

Выглядит несложно, не так ли? Если записать то же самое на C++, код получится немного более длинным. Однако, самое главное — имена функций и логика работы с модулем — останутся одними и теми же.

Точность

Как понять, что одна натренированная модель лучше другой? Необходимо сравнить метрики качества для обеих моделей. Очень часто борьба на вершине рейтинга лучших моделей идет за доли процентов качества. Поскольку dnn читает и преобразует модели из различных фреймворков в свое внутреннее представление, возникают вопросы сохранения качества после преобразования модели: не «испортилась» ли модель после загрузки? Без ответов на эти вопросы, а значит без проверки сложно говорить о полноценном использовании dnn.

Я провел тестирование моделей из имеющихся примеров для различных фреймворков и различных задач: AlexNet (Caffe), GoogLeNet (Caffe), GoogLeNet (TensorFlow), ResNet-50 (Caffe), SqueezeNet v1.1 (Caffe) для задачи классификации объектов; FCN (Caffe), ENet (Torch) для задачи семантической сегментации. Результаты приведены в Таблицах 1 и 2.

| Модель (исходный фреймворк) |

Опубликованное значение acc@top-5 |

Измеренное значение acc@top-5 в исходном фреймворке |

Измеренное значение acc@top-5 в dnn |

Средняя разница на элемент между выходными тензорами фреймворка и dnn |

Максимальная разница между выходными тензорами фреймворка и dnn |

| AlexNet (Caffe) |

80.2% |

79.1% |

79.1% |

6.5E-10 |

3.01E-06 |

| GoogLeNet (Caffe) |

88.9% |

88.5% |

88.5% |

1.18E-09 |

1.33E-05 |

| GoogLeNet (TensorFlow) |

— | 89.4% |

89.4% |

1.84E-09 |

1.47E-05 |

| ResNet-50 (Caffe) |

92.2% |

91.8% |

91.8% |

8.73E-10 |

4.29E-06 |

| SqueezeNet v1.1 (Caffe) |

80.3% |

80.4% |

80.4% |

1.91E-09 |

6.77E-06 |

| Модель (фреймворк) |

Опубликованное значение mean IOU |

Измеренное значение mean IOU в исходном фреймворке |

Измеренное значение mean IOU в dnn |

Средняя разница на элемент между выходными тензорами фреймворка и dnn |

Максимальная разница между выходными тензорами фреймворка и dnn |

| FCN (Caffe) |

65.5% |

60.402874% |

60.402879% |

3.1E-7 |

1.53E-5 |

| ENet (Torch) |

58.3% |

59.1368% |

59.1369% |

3.2E-5 |

1.20 |

Результаты для FCN вычислены для валидационного набора сегментационной части PASCAL VOC 2012 (736 примеров). Результаты для ENet вычислены на валидационном наборе Cityscapes (500 примеров).

Следует сказать несколько слов о том, какой смысл имеют указанные выше числа. Для задач классификации общепринятой метрикой качества моделей является точность для топ-5 ответов сети (accuracy@top-5, [1]): если правильный ответ имеется среди 5 ответов сети с максимальными показателями уверенности (confidence), то данный ответ сети засчитывается как верный. Соответственно, точность — это отношение числа верных ответов к числу примеров. Данный способ измерения позволяет учесть не всегда корректную разметку данных, когда, например, отмечается объект, занимающий далеко не центральное положение на кадре.

Для задач семантической сегментации используются несколько метрик — попиксельная точность (pixel accuracy) и среднее по классам отношение пересечения к объединению (mean intersection over union, mean IOU) [5]. Попиксельная точность — это отношение количества правильно классифицированных пикселей к количеству всех пикселей. mean IOU — более сложная характеристика: это усредненное по классам отношение правильно отмеченных пикселей к сумме числа пикселей данного класса и числа пикселей, отмеченных как данный класс.

Из таблиц следует, что для задач классификации и сегментации разница в точности между запусками модели в оригинальном фреймворке и в dnn отсутствует. Этот замечательный факт означает, что модуль можно смело использовать, не опасаясь непредсказуемых результатов. Все скрипты для тестирования также доступны здесь, так что можно самостоятельно убедиться в правильности полученных результатов.

Разницу между опубликованными и полученными в экспериментах числами можно объяснить тем, что авторы моделей проводят все вычисления с использованием GPU, в то время как я использовал CPU-реализации. Также было замечено, что различные библиотеки могут по-разному декодировать формат jpeg. Это могло сказаться на результатах для FCN, так как датасет PASCAL VOC 2012 содержит изображения именно данного формата, а модели для семантической сегментации оказываются достаточно чувствительны к изменению распределения входных данных.

Как вы заметили, в Таблице 2 присутствует аномально большая максимальная разница выходов dnn и Torch для модели ENet. Меня также заинтересовал данный факт и далее я кратко расскажу о причинах его возникновения.

К сожалению, устранить данную ошибку не представляется возможным, так как первопричины ее появления связаны, скорее всего, с немного различающимися реализациями алгоритмов, использованных при тренировке и при inference и не связаны с наличием ошибки в реализации.

Однако, справедливо отметить, что средняя ошибка на элемент выходного тензора остается низкой (см. Таблицу 2) — то есть ошибки в индексах возникают достаточно редко. Более того, наличие данной ошибки не приводит к ухудшению качества работы модели, о чем свидетельствуют числа в той же Таблице 2.

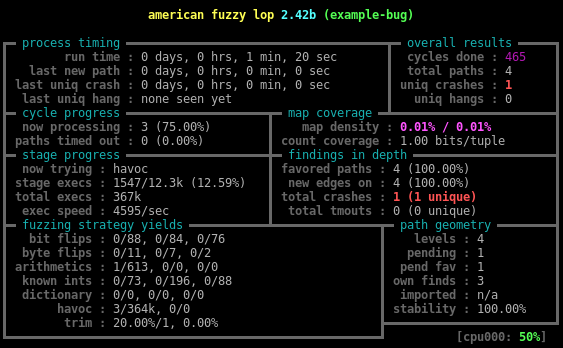

Производительность

Одна из целей, которую мы ставим перед собой, разрабатывая dnn, заключается в достижении достойной производительности модуля на различных архитектурах. Не так давно была проведена оптимизация под CPU, в результате чего сейчас dnn показывает неплохие результаты по скорости работы.

Я провел замеры времени работы для различных моделей при их использовании — результаты в Таблице 3.

| Модель (исходный фреймворк) |

Разрешение изображения |

Производительность исходного фреймворка, CPU (библиотека акселерации); потребление памяти |

Производительность dnn, CPU (ускорение относительно исходного фреймворка); потребление памяти |

| AlexNet (Caffe) |

227x227 |

23.7 мс (MKL); 945 МБ |

14.7 мс (1.6x); 713 МБ |

| GoogLeNet (Caffe) |

224x224 |

44.6 мс (MKL); 197 МБ |

20.1 мс (2.2x); 172 МБ |

| ResNet-50 (Caffe) |

224x224 |

70.2 мс (MKL); 386 МБ |

58.8 мс (1.2x); 224 МБ |

| SqueezeNet v1.1 (Caffe) |

227x227 |

12.4 мс (MKL); 113 МБ |

5.3 мс (2.3x); 38 МБ |

| GoogLeNet (TensorFlow) |

224x224 |

17.9 мс (Eigen); 310 МБ |

21.1 мс (0.8x); 135 МБ |

| FCN (Caffe) |

различное (500x350 в среднем) |

3873.6 мс (MKL); 4453 МБ |

1229.8 мс (3.1x); 1332 МБ |

| ENet (Torch) |

1024x512 |

1105.0 мс; 828 МБ |

218.7 мс (5.1x); 190 МБ |

Замеры времени производились с усреднением по 50-ти запускам и выполнялись следующим образом: для dnn использовался встроенный в OpenCV таймер; для Caffe использовалась утилита caffe time; для Torch и TensorFlow использовались существующие функции замера времени.

Как следует из Таблицы 3, dnn в большинстве случаев превосходит по производительности оригинальные фреймворки. Актуальные данные по производительности dnn из OpenCV на различных моделях в сравнении с другими фреймворками также можно найти здесь.

Дальнейшие планы

Глубокое обучение заняло в компьютерном зрении значительное место и, соответственно, у нас есть большие планы по развитию этой функциональности в OpenCV. Они касаются улучшения удобства использования, переработки внутренней архитектуры самого модуля и улучшения производительности.

В улучшении user experience мы ориентируемся, в первую очередь, на пожелания самих пользователей. Мы стремимся добавить функциональность, которая требуется разработчикам и исследователям в реальных задачах. Помимо этого, в планах есть добавление визуализации сетей, а также расширение набора поддерживаемых слоев.

Что касается производительности, то несмотря на многие выполненные оптимизации, у нас все еще есть идеи, как улучшить результаты. Одна из таких идей — уменьшить разрядность вычислений. Данная процедура носит название квантизации. Грубо говоря, выкинуть часть разрядов у входа и весов слоя перед вычислением сверток (fp32->fp16), либо вычислить масштабирующие коэффициенты, переводящие диапазон входных чисел в диапазон int или short. При этом возрастет скорость (за счет использования более быстрых операций с целыми числами), но, возможно, немного пострадает точность. Однако публикации и эксперименты в этой области показывают, что даже достаточно сильная квантизация в определенных случаях не приводит к заметному падению качества.

Параллельное выполнение слоев — еще одна из идей оптимизации. В текущей реализации в каждый момент времени работает только один слой. Каждый слой по возможности максимально использует распараллеливание при проведении вычислений. Однако, в некоторых случаях граф вычислений может быть распараллелен на уровне самих слоев. Потенциально это может дать каждому потоку больше работы, уменьшив тем самым накладные расходы.

Сейчас к релизу готовится нечто достаточно интересное. Думаю, немногие слышали о языке программирования Halide. Он не является Тьюринг-полным — некоторые конструкции реализовать на нем не получится; возможно поэтому он и не пользуется популярностью. Однако указанный недостаток является одновременно и его преимуществом — написанный на нем исходный код может быть автоматически превращен в высокооптимизированный под разные «железки»: CPU, GPU, DSP. При этом нет нужды быть гуру оптимизации — специальный компилятор все сделает за вас. Уже сейчас Halide позволяет получить ускорение некоторых моделей — и, например, семантическая сегментация с моделью ENet работает 25 fps для разрешения 512x256 на Intel Core i7-6700k (против 22 fps у dnn без Halide). И, что самое приятное, без переписывания кода можно задействовать интегрированную в процессор GPU, получив дополнительно еще пару кадров в секунду.

В действительности, мы возлагаем большие надежды на Halide. Благодаря своим уникальным характеристикам он позволит получать ускорение работы, не требуя от пользователя дополнительных манипуляций. Мы стремимся к тому, чтобы для использования Halide вместе с OpenCV у пользователя не возникало необходимости в установке дополнительного программного обеспечения для использования Halide — принцип работы «из коробки» должен сохраняться. И, как показывают наши эксперименты, у нас есть все шансы реализовать это.

Заключение

Уже сейчас dnn имеет все, чтобы оказаться полезным. И с каждым днем все большее число пользователей открывает для себя его возможности. Тем не менее, нам еще есть над чем трудиться. Я продолжу свою работу над модулем, расширяя его возможности и совершенствуя функционал. Надеюсь, что данная статья оказалась для вас интересной и полезной.

Если у вас есть вопросы, появились предложения, возникли проблемы или вы хотите внести свой вклад путем подачи pull request — добро пожаловать в github-репозиторий, а также на наш форум, где я и мои коллеги постараемся вам помочь. Если ни один из указанных способов не подошел, на нашем сайте можно найти дополнительные пути коммуникации. Я всегда буду рад сотрудничеству, конструктивным замечаниям и предложениям. Спасибо за внимание!

P.S. Выражаю огромную благодарность моим коллегам за помощь в работе и написании данной статьи.

Ссылки

- ImageNet Classification with Deep Convolutional Neural Networks

- Going deeper with convolutions

- Deep Residual Learning for Image Recognition

- SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5MB model size

- Fully Convolutional Networks for Semantic Segmentation

- ENet: A Deep Neural Network Architecture for Real-Time Semantic Segmentation

- SSD: Single Shot MultiBox Detector

- Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman Coding

- OpenCV github

- Официальный сайт OpenCV

- Форум OpenCV

- Halide

- Caffe

- TensorFlow

- Torch

|

Метки: author arrybn обработка изображений open source блог компании intel opencv deep learning intel dnn |

ICO: основные юрисдикции и вопросы |

Где-то год назад я начал изучать тему ICO (кто не в курсе — это первичное размещение токенов: аналогия взята из аббревиатуры IPO): как оказалось — не зря. На сегодня рынок ICO вышел (уже вышел — а год ещё не закончился) за 1 000 000 000 долларов. При этом рынок crypto по объёму выходил за 100 000 000 000 (но сейчас — колеблется возле цифры в 85 миллиардов). Это, конечно, не триллионы, но уже серьёзно.

В этой заметке хотелось бы ответить на три вопроса:

- ICO — это пузырь или нет?

- В каких юрисдикция и почему регистрируются те, кто проводят ICO?

- Есть ли у ICO будущее и каково оно?

Ответ на первый вопрос прост: да. Да, ICO — это пузырь и тому есть несколько причин:

- Большинство сервисов (на сегодня плотно проанализировал — 54, всего просматривал — 117) не имеют под собой чёткой технологической основы и порой — даже проработанного концепта: создатели ограничиваются Белой книгой и Дорожной картой, сбивая на ICO деньги на разработку и маркетинг;

- Спекулянтом слишком сильны, потому как рынок очень мелкий и манипулировать ценой — весьма просто (ниже будет несколько примеров).

- Если сравнивать доткомы или тюльпаноманию с ICO — то найдётся очень много общего: большое количество того, что растёт; огромные спекуляции на этом; вера в том, что это никогда не закончится и т.д.

- Команды, которые выходят на ICO, — очень молодые и это на запуске видится положительным фактором, но, когда возникают операционные сложности, — трудности возрастают троекратно. И я даже не про Matchpool и иже с ним, когда кто-то похищает средства, а о том, что слаженность команды — это не тот фактор, которым можно пренебречь. В блокчейне, возможно, даже сильнее он себя проявляет, так сфера строится как сверх-технологичная, а значит — риск от человеческого фактора только возрастает, как это ни парадоксально: думаю, пример The DAO всем знаком.

Безусловно, это не всё: но даже этих критериев при оценке хватит, чтобы понять всю зыбкость первичного накопления капитала в ICO. К тому же, сейчас (в 2017 году в смысле) этот инструмент стал просто хайповым: деньги от банков, инвесторов и того же IPO стоят не мало, а вот деньги от краудфандинга (не будем сейчас вдаваться в подробный анализ, так как явлений, поясняющих ICO — несколько: всё зависит от правового статуса токена).

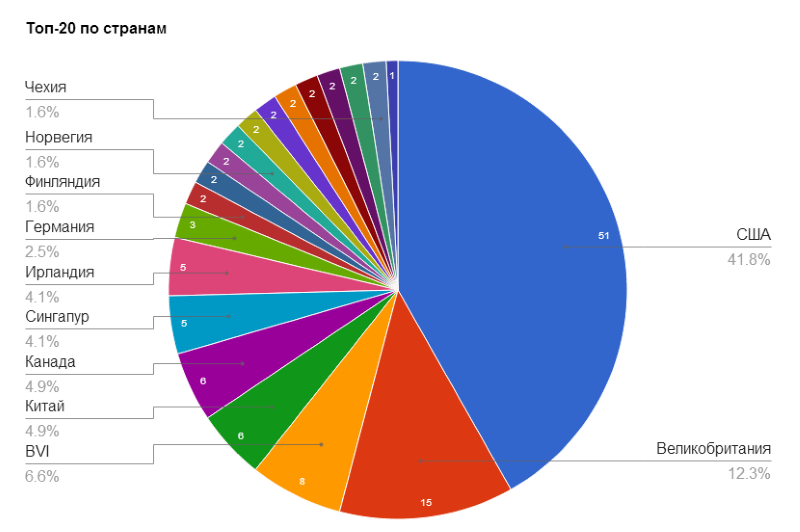

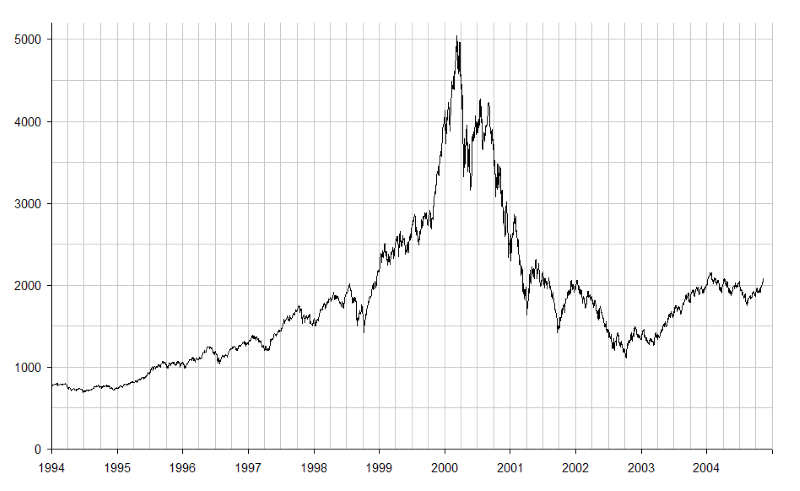

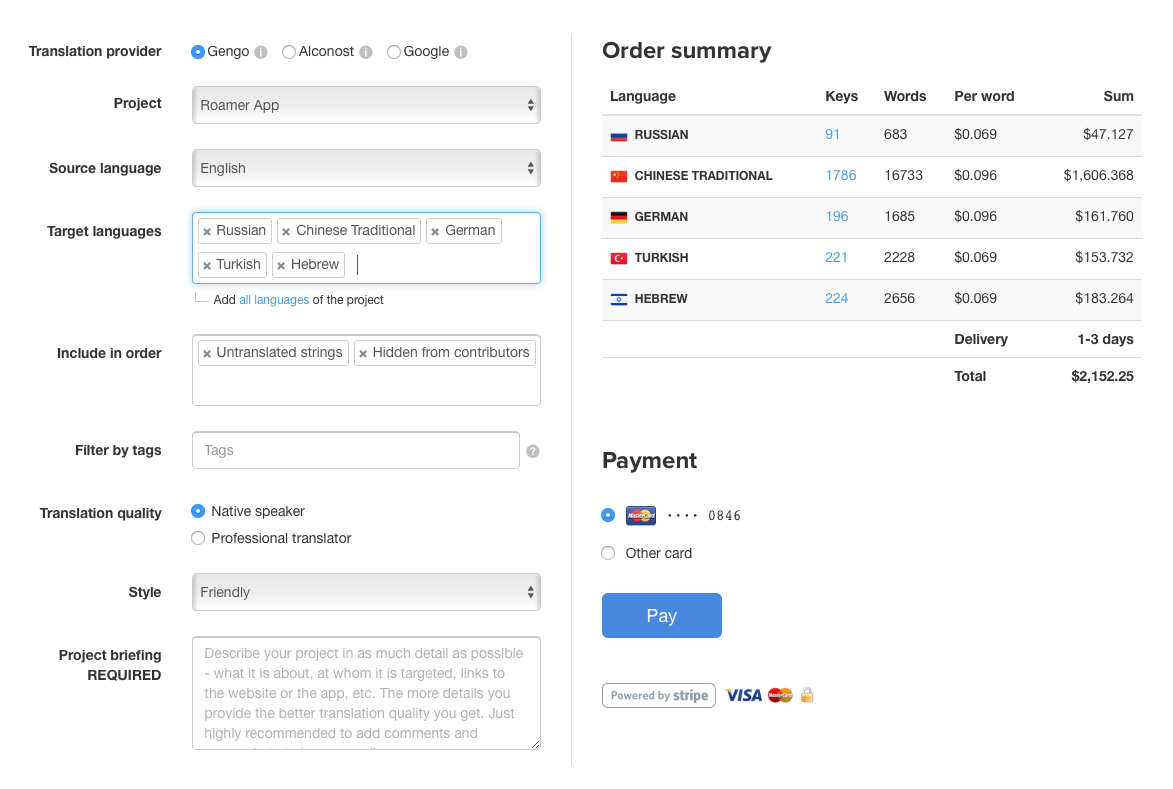

Ответ на второй вопрос не так прост: в 2014 году ещё bitnovosti проводили исследование данного рынка. И вот какая картинка нарисовалась:

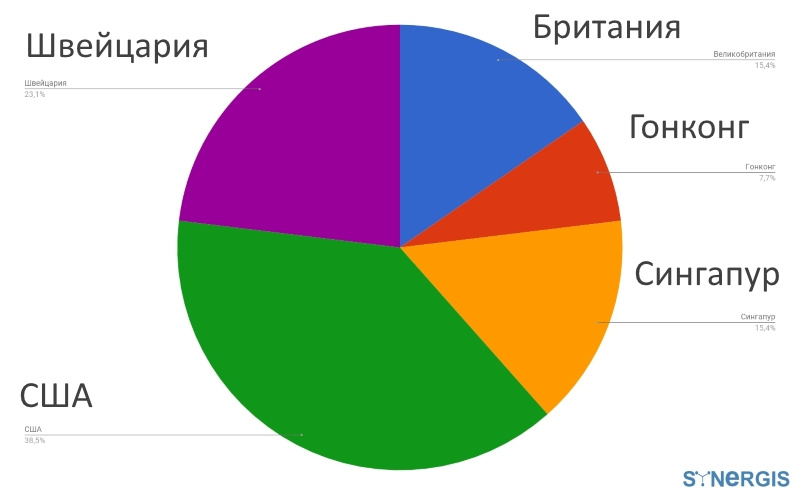

Чтобы исследование было совсем «чистым», отмечу, что речь в материале всё же шла в первую очередь о bitcoin-стартапах. А вот как выглядит ситуация на сегодня (за основу взял собственные наработки, статистику можно также собирать из источников, указанных ниже) в ТОП-30:

Добавлю, что для рассмотрения я взял только те проекты, у которых:

- Было именно ICO (например, его не было у Bitcoin'а и Ripple — хоть и по разным причинам, но не было);

- Данные о компаниях не закрыты: есть в Белой книги и/или на сайте: и в этот раз я нарочно не копал глубоко, чтобы встать на место рядового пользователя и увидеть данные фирмы, если для этого не нужно делать каких-то жутких запросов в формате СПАРК;

- Капитализация позволяет делать обобщающие выводы.

- По списку coinmarketcap я дошёл до 41 места, но не включал: btc, ltc (хотя у этой монеты есть и Litecoin Association из США, и Litecoin Foundation из Сингапура), monero; EOS, т.к. компания уже была организована ранее, как, скажем и Ardor (производная от NXT); Byteball — потому что платформа не предполагает ICO в принципе;

- Кроме того, китайские проекты я тоже не трогал, так как нужно быть очень… неожиданным инвестором, чтобы создавать компанию под ICO в Поднебесной.

Конечно, совсем немного порывшись в Сети можно найти данные и других проектов: Waves, Golem (Golem Factory GmbH is a Swiss LLC established in 2017.) и так далее.

Вопрос в том, что немногие это до сих пор делают.

Поэтому, до того, как внести средства на счёт очередного ICO-проекта, рекомендую изучить следующий материал:

- Как вообще крипто-активы понимают в разных странах мира

- Общее описание в оценке ICO

- ICO с точки зрения юриста

Регистрация в Сингапуре (по ней, кстати, пошёл и ещё один недавний проект — SONM) объяснима: за 6000-10 000 долларов вы получаете компанию в технологически развитой стране, где Правительство дружелюбно (подробней читайте здесь) в целом настроено к блокчейн-стартапам. К тому же — вывод в фиат, полученных на ICO средств здесь не сравним, скажем, с Россией (если с этой юрисдикцией вообще что-то уместно в этом аспекте сравнивать). В этом плане Гонконг — вполне логичная альтернатива Сингапуру: подробней почитать об отношении к «крипте» можно в книге, скажу лишь, что в обеих странах оно нейтрально-позитивное.