Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Что делает язык программирования «модным»? |

Сейчас много языков программирования, соперничающих за ваше внимание, особенно «горячие» (или «модные!») новые языки, такие как Ceylon, Crystal, Dart, Elixir, Elm, Go, Haxe, Julia, Kotlin, Rust, Swift, TypeScript. И новые, кажется, появляются каждый месяц!

Даже некоторые из не совсем новых языков привлекают внимание, такие языки, как Clojure, Erlang, F#, Haskell, Lua, OCaml, Scala. Некоторым из них исполнилось несколько десятилетий!

Поэтому мне стало интересно: что делает язык программирования, независимо от возраста, модным и захватывающим? Почему 27-летний Haskell все еще вызывает разговоры? Как может 31-летний Erlang вызывать эмоции после стольких лет? Какова любовь к 24-летнему Lua? Об F# до сих пор говорят очень нежно, хотя за ним стоит 12-летняя история.

Конечно, одной из главных причин является растущий в последние годы интерес к функциональному программированию. Люди изучают все их функциональные возможности, в том числе языки, предшествующие Java (порой несправедливо называемые древними и устаревшими).

Erlang примечателен OTP (Open Telecom Platform) и его системой времени исполнения (BEAM), что делает Erlang замечательным для написания распределённых отказоустойчивых приложений.

Clojure использует силу и элегантность Lisp. Lua популярен в игровой индустрии как встраиваемый язык. Kotlin и Scala пытаются улучшить Java, самый популярный язык программирования на планете.

Dart и Elm предлагают альтернативы широко презираемому JavaScript. Rust обещает безопасность памяти. Julia – технологический tour de force.

Таким образом, казалось бы, эти языки популярны по разным причинам. За исключением функционального программирования, действительно нет общих признаков. Даже 7-летний Go поднялся на вершину языковых чартов благодаря простоте и минималистичности, без каких-либо инноваций в дизайне языка!

Тогда как мы объясним тот факт, что языку Smalltalk сегодня так мало уделяют внимания? У него есть все нужное…

- Smalltalk – один из самых маленьких, простых и элегантных языков программирования, когда-либо созданных. Весь его синтаксис может поместиться на обратной стороне открытки! Это делает Smalltalk очень, очень лёгким в изучении. У Smalltalk крайне низкое, если не несущественное когнитивное трение при кодировании. Вам не нужно задумываться над языком, вы просто решаете вашу проблему.

- Smalltalk имеет великолепные «живое кодирование и отладку» в IDE, которые делают программирование чрезвычайно быстрым и продуктивным. Вы можете внести изменения в текущую программу и сразу увидеть результаты. Это почти полностью исключает цикл edit-compile-test-debug, который затрудняет работу почти со всеми иными языками программирования. И это удивительно просто в использовании. В современном мире программирования нет ничего подобного.

- Smalltalk – один из самых продуктивных языков программирования. Более чем в два раза производительнее, чем Python и Ruby. Более чем в 3 раза эффективнее JavaScript!

- Несмотря на свою относительную безвестность, Smalltalk – очень практичный промышленный язык! Он коммерчески использовался более трёх десятилетий. Его известные пользователи включают JPMorgan, Desjardins, UBS, Florida Power & Light, Texas Instruments, Telecom Argentina, Orient Overseas Container Lines, Siemens AG и прочие. Проверьте ALLSTOCKER и банкоматы на улицах Москвы.

- Smalltalk прекрасно масштабируем. В начале 2000-х годов объединённые военные силы США использовали Smalltalk для написания программы в миллион строк по моделированию боевых действий под названием JWARS. Фактически он превзошел аналогичное моделирование под названием STORM, написанное на C++ в ВВС США.

- Smalltalk имеет богатое наследие. Это был первый язык программирования для популяризации ООП, и он остается прекрасным примером языка ООП (именно поэтому он породил целое поколение языков ООП, таких как Java, Python, PHP, Ruby, Perl, Objective-C, CLOS, Dart, Scala, Groovy и прочие). Smalltalk – это правильное ООП

- Smalltalk продолжает активно развиваться, особенно в рамках проекта Pharo и Inria. И Amber для сети, и Redline для JVM. Smalltalk был модернизирован для двадцать первого века.

- Кстати, у Smalltalk также есть функции первого класса и замыкания, поэтому он хорош и для функционального программирования!

Smalltalk чрезвычайно универсален (является языком программирования общего назначения):

- Smalltalk хорош для науки о данных и численных вычислений, благодаря PolyMath и Roassal (также см. Численные методы с Pharo)

- Smalltalk хорош для Интернета Вещей и робототехники (например, Pharo Pi и ESUG on robotics)

- Smalltalk хорош для ERP (планирование ресурсов предприятия)

- Smalltalk хорош для машинного обучения и нейронных сетей

- Smalltalk хорош для обработки естественного языка

- Smalltalk хорош для виртуальной реальности (например, 3D Immersive Collaboration)

- Smalltalk можно даже использовать для программирования игрового движка Unreal

- Smalltalk используется для борьбы с Эболой!

- Smalltalk используется в широкомасштабной визуализации данных для лекарств в 16 странах

- Smalltalk можно использовать для написания кросс-платформенных мобильных приложений (2% в JS, 98% в Smalltalk!)

- Smalltalk хорош для серверной веб-разработки, благодаря веб-инфраструктуре Seaside

И я лишь начал!

Smalltalk заслуживает место среди «горячих» (или «модных!») новых языков, таких как Elixir, Elm, Go, Julia, Kotlin, Rust. В конце концов, Pharo всего 9 лет.

Об авторе

Ричард Энг – отставной разработчик программного обеспечения из Канады с более чем 30-летним опытом работы в ИТ-индустрии. Он работал в сфере видео графики, баз данных и финансов, программного обеспечения реального времени, мобильных приложений для iOS и Android, а также в веб-разработке. Он писал в основном на C, но также использовал FORTRAN, Tandem TAL, C++, C#, Objective-C, Java, Smalltalk, Python и Go. Сейчас он возглавляет кампанию Smalltalk Renaissance. Большую часть времени Ричард проводит за написанием статей и эссе.

|

Метки: author arielf программирование ооп smalltalk pharo squeak |

Тандем офисной и мобильной телефонии. Как мы разрабатывали FMC |

Использование в компании FMC приводит к упрощению бизнес-процессов организаций вкупе с возможностью оптимизации затрат. По предварительным подсчетам экономия на одной SIM-карте составит до 30% за счет сокращения времени дозвона и низких тарифов IP-телефонии.

Из дополнительных возможностей для организаций стоит отметить возможность задавать различные правила обработки вызовов внутри рабочего места и записывать входящие и исходящие звонки с мобильных и городских телефонов. Тем самым снимаются все проблемы, которые возникают у организации при использовании корпоративных тарифов на мобильную связь и офисной АТС.

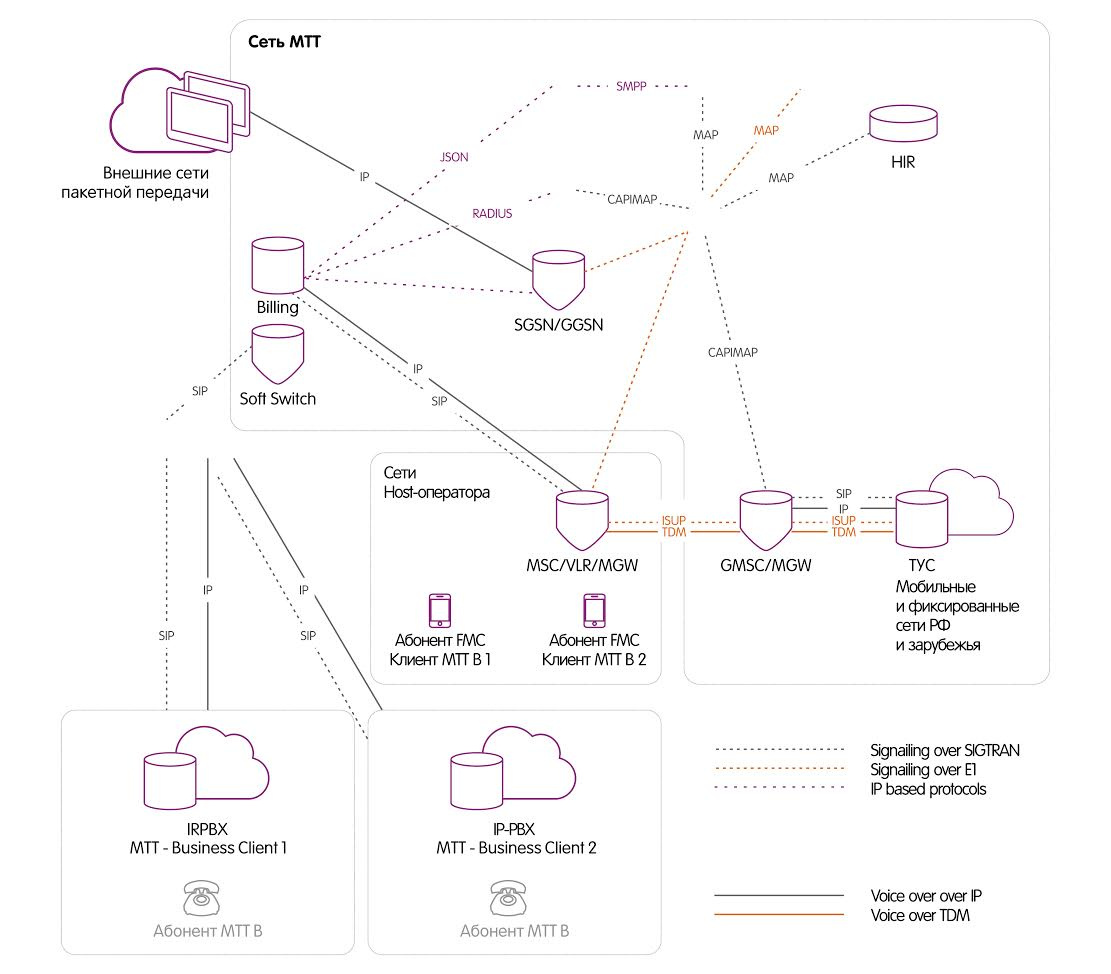

FMC в МТТ Бизнес

Проект FMC является дополнительным способом приема и инициации голосовых вызовов Виртуальной АТС. Это происходит без использования сети Интернет, только через радиоканалы GSM. При этом FMC является составной частью услуги Виртуальная АТС и не подключается вне ее. Также FMC предоставляется только с использованием SIM МТТ, ассоциированных с Виртуальной АТС.

FMC включает в себя все функции виртуальной АТС для городских и мобильных телефонов компании, не требуя при этом подключения к интернету. Для клиента, подключение услуги FMC означает получение доступа к возможности завести новое рабочее место типа ВАТС — SIM FMC. В личном кабинете администратора становится возможным указать SIM FMC в качестве одного из вариантов дозвона до абонента.

Мобильный интернет доступен абоненту уже сразу после регистрации в сети оператора сотовой связи и активации в Виртуальной АТС, при этом на ограниченный список сайтов, таких как mtt.ru, business.mtt.ru и т.п. без тарификации. Мобильный интернет без ограничения по скорости возможно подключать исключительно пакетами.

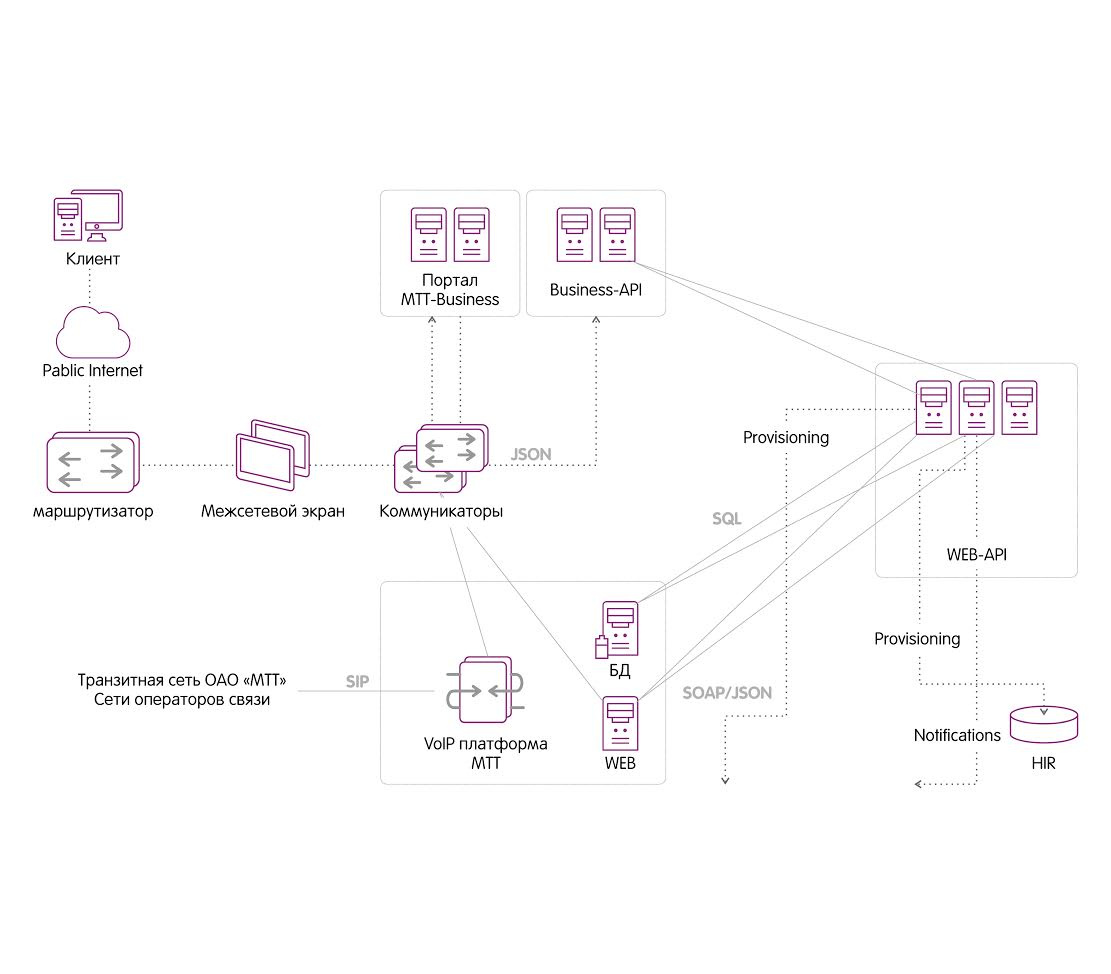

Business-API

В реализации «SIM-карта (FMC)» участвовали следующие инфраструктурные элементы компании МТТ:

- Billing платформа — для тарификации вызовов.

- WebAPI — для реализации функций по подключению номера и провиженинга на мобильной составляющей сети.

- BusinessAPI — в часть реализации бизнес-логики подключения/управления услугами.

- Инфраструктурные элементы мобильной сети (SRF, STP и т.п.).

Схема реализации услуги на уровне Business-API

Для FMC было необходимо доработать Business-API. В частности были добавлены в API следующие функции:

- получения цены за услугу FMC;

- получения списка тарифов для номеров FMC (для выбора);

- получения цены по тарифу;

- добавления/удаления услуги FMC;

- добавления/удаления/изменения номера FMC клиенту ВАТС;

- получения списка номеров FMC (со статусом активации).

Также были преобразованы Workplace в совокупность сущностей – WPsi (sip_id), WPsf (softphone), WPsim (FMC). В дальнейшем будут добавляться другие типы рабочих мест, что обеспечит гибкость в настройке переадресаций и добавлении новых типов. Для разделения сущностей рабочего места в структуру добавляется параметр type, который может принимать значения – sip, softphone, sim (в дальнейшем другие типы).

Для возможности объединения сущностей в группы для параллельного и смешанного типов переадресации был введен тип wp_group, который представляет собой структуру группировки в рамках рабочего места.

Для подключения номеров DEF используются уже существующие функции подключения номеров и установка определяемого номера. При внедрении номеров DEF в MTT-Business в рамках проекта FMC они не прописываются непосредственно на SIM-карты, а просто выполняют роль идентификатора при исходящих вызовах и через них будет также осуществляться переадресация входящих звонков на соответствующих сотрудников или группы.

В Business-API добавляется функция генерации проверочного кода и его закрепление за конкретным ЛС. Генерация и проверка кода осуществляется через личный кабинет клиента, а также посредством SMS сообщений.

Схема реализации услуги на уровне мобильной составляющей

Для того, чтобы в личном кабинете администратора можно было указать SIM FMC в качестве одного из вариантов дозвона до абонента, были сделаны доработки на стороне Business-API, WebAPI, портала MTT-Business и настроено оборудование на стороне мобильной сети.

Доработки провиженинга в HLR

Процедуры замены номера, блокировки, а также для организации входящей связи клиентов потребовали доработки следующих функций провиженинга:

- в части передачи параметров безусловной переадресации по связи мобильного номера и номера Виртуальной АТС;

- в части удаления информации из HLR о связке.

В дальнейшем предполагается использовать HLR-API для управления всеми процедурами провиженинга информации в HLR.

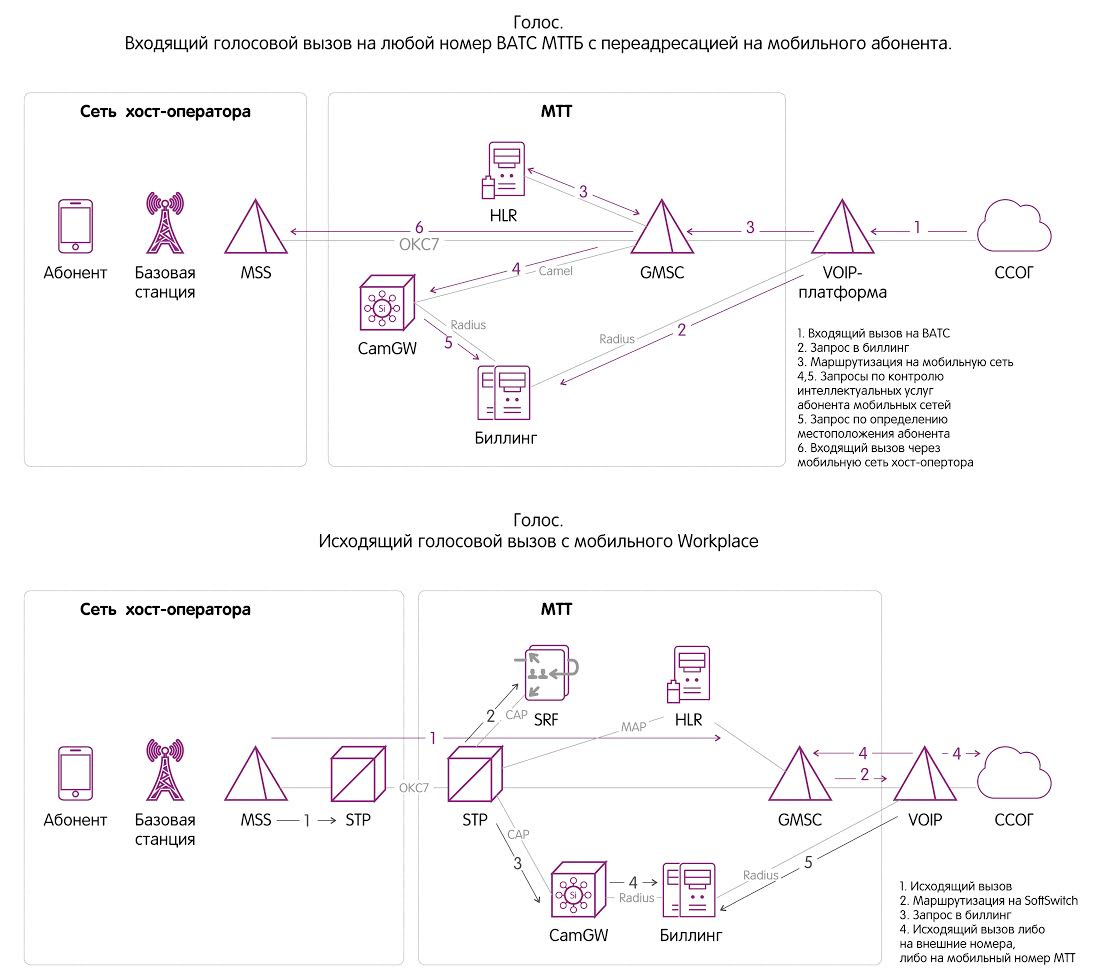

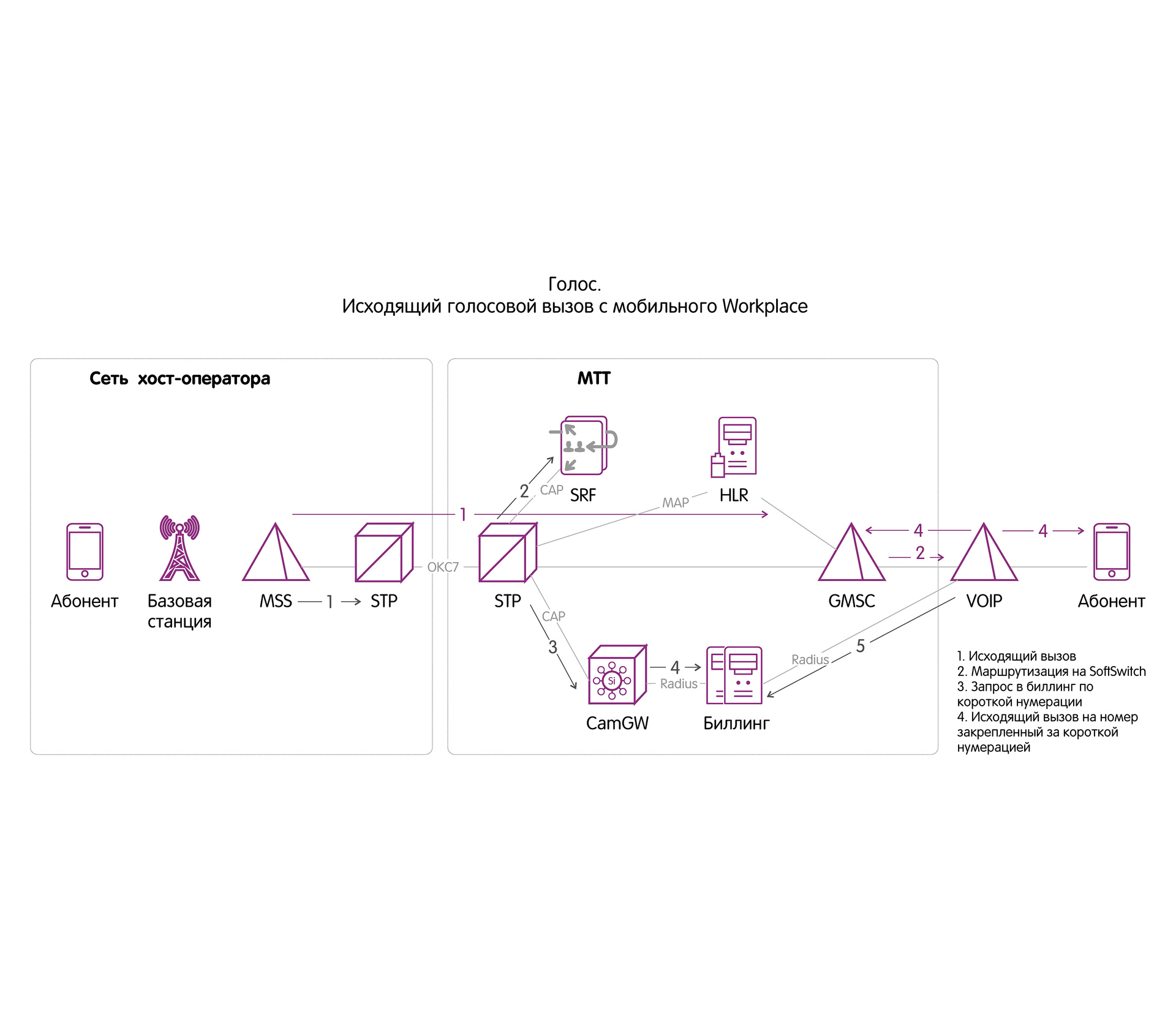

Сценарии прохождения голосовых вызовов

Сценарии прохождения вызовов представлены на схемах:

Конкурентные преимущества FMC «МТТ Бизнес»?

Базовый пакет FMC от «МТТ Бизнес» включает ряд бесплатных услуг:

- бесплатная доставка необходимого вам количества SIM-карт в офис или на указанный адрес;

- отсутствие абонентской платы как за услугу FMC в целом, так и за использование каждой SIM-карты;

- 1Гб мобильного интернета в подарок и бесплатный мобильный интернет в роуминге;

- бесплатная связь между сотрудниками внутри корпоративной Виртуальной АТС;

- бесплатные входящие звонки в домашней зоне услуги FMC.

В данный момент единая домашняя безроуминговая зона FMC «МТТ Бизнес» включает Москву, Санкт-Петербург и области столиц. Однако уже до конца 2017 года в географию присутствия FMC «МТТ Бизнес» войдут следующие города и области:

- Екатеринбург и область;

- Новосибирск и область;

- Ростов-на-Дону и область;

- Краснодар и область;

- Нижний Новгород и область.

Со временем мы планируем развернуть единую домашнюю зону FMC «МТТ Бизнес» на всей территории России.

|

Метки: author MTTBusiness разработка систем связи программирование анализ и проектирование систем блог компании мтт fmc sim- карта sim телефония связь голосовая связь мтт |

Security Week 27: ExPetr = BlackEnergy, более 90% сайтов небезопасны, в Linux закрыли RCE-уязвимость |

Зловещий ExPetr, поставивший на колени несколько весьма солидных учреждений, продолжает преподносить сюрпризы. Наши аналитики из команды GReAT обнаружили его родство со стирателем, атаковавшим пару лет назад украинские электростанции в рамках кампании BlackEnergy.

Зловещий ExPetr, поставивший на колени несколько весьма солидных учреждений, продолжает преподносить сюрпризы. Наши аналитики из команды GReAT обнаружили его родство со стирателем, атаковавшим пару лет назад украинские электростанции в рамках кампании BlackEnergy.Конечно, откровенного использования кусков кода в ExPetr не наблюдается, авторы постарались не спалиться. Но программистский почерк так просто не замаскируешь.

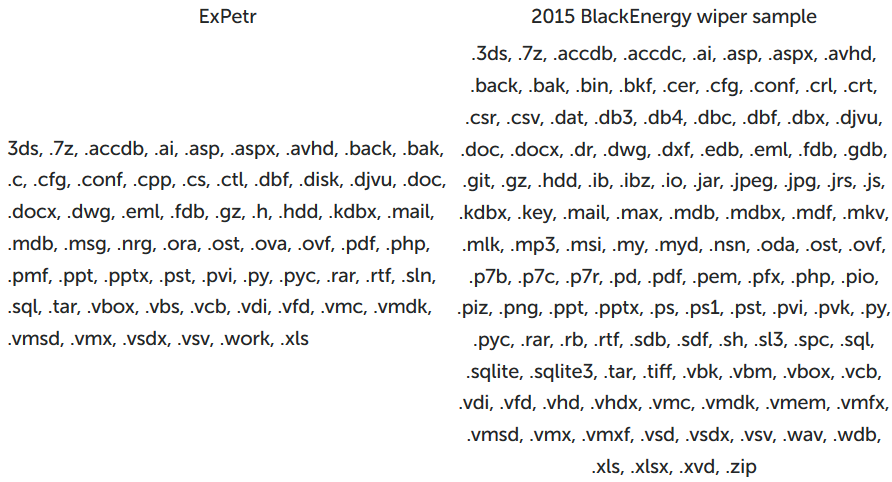

Сначала аналитики сравнили списки расширений шифруемых файлов. На первый взгляд не очень похоже – BlackEnergy работал со значительно большим разнообразием файлов, – но если приглядеться, сходство все-таки есть. Типов расширений существует множество, и из них можно собрать бесконечное число разных списков, а тут налицо явные пересечения по составу и форматированию.

Второй характерный признак – формат хранения списка расширений. И там и там расширения разделяются точкой. Само по себе это ничего не доказывает, но дало повод копать глубже.

Еще несколько схожих участков кода нашлось с помощью автоматического сравнения. Так, в коде поиска файлов с расширениями из списка в обоих семплах обнаружилось использование функции сравнения строк wcscmp для проверки, не равно ли имя файла символу текущей директории ‘.’. Снова ничего из ряда вон выходящего, но и это пошло в копилку признаков.

Исследователи нашли еще несколько строк, присутствующих и в ExPetr и в семпле из BlackEnergy:

— exe /r /f

— ComSpec

— InitiateSystemShutdown.

Вообще ничего необычного, скажете вы. Верно, но из этих ничего не доказывающих совпадений GReAT составили правило для YARA, и вот что выяснилось после его применения к нашей огромной коллекции вредоносных семплов. Каждое отдельное условие из этого правила срабатывает на очень многих файлах, но правило целиком отлавливает лишь два из них – ExPetr и BlackEnergy. Не доказательство, но очень убедительный аргумент в пользу наличия родственных связей этих семплов.

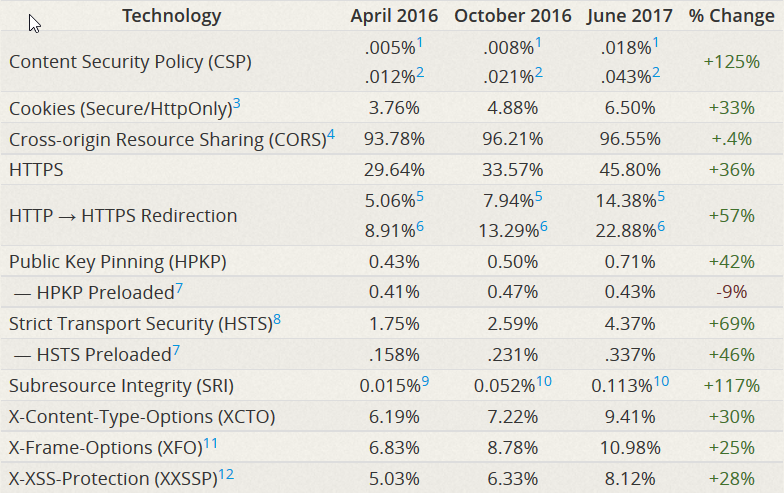

Большинство сайтов в Интернете не поддерживают технологии безопасности

Новость. Исследование. Вендоры браузеров регулярно докладывают о внедрении новых технологий, каждая из которых должна по идее перекрывать кислород подлым хакерам и защищать простых пользователей. А воз и ныне там: атаки через веб-сайты, фишинг, кража кукисов по-прежнему процветают, как будто ничего не происходит. И всё им как, с гуся вода.

А причина, между тем, очевидна – многие модные технологии, появляющиеся в браузерах чуть ли не ежемесячно, требуют поддержки на стороне сайтов. И с этим традиционно все плохо – админ не проснется, пока его площадку не взломают и не рассадят тысячам ее посетителей троянца-банкера или чего похуже. Судя по результатам исследования Mozilla Foundation, таких несознательных админов аж 93.45%.

Эту цифру они получили следующим образом: взяли верхний миллион сайтов из рейтинга Alexa, и проверили поддержку ИБ-технологий, вроде CSP, CORS и HPKP. Результаты, мягко говоря, не обрадовали – 9 из 10 сайтов получили низшую оценку (F), то есть безопасность пользователей администрацию популярных сайтов по большому счету не интересует.

Однако есть и едва заметный положительный тренд: по сравнению с прошлогодним исследованием, F-сайтов стало на 2,8% меньше. То есть еще каких-нибудь 34 года (при сохранении той же динамики), и веб станет безопасным!

В Linux закрыли RCE-баг

Новость. Из Canonical сообщают, что запатчили в Ubuntu уязвимость, позволявшую обрушить систему или заставить ее выполнить код посредством сконструированного DNS-ответа. Проблема крылась в systemd-resolved, системном DNS-резолвере в Убунте и еще нескольких дистрибутивах.

Хорошо уже хотя бы то, что DNS-записью эту дыру не поэксплуатировать, нужно прислать резолверу хитрый TCP-пакет, при обработке которого демон сплющит буфер до настолько малого размера, что данные из DNS-ответа попадут за его границы.

Хотя Canonical присвоила багу высокую степень угрозы, ситуация выглядит не очень страшно. Для эксплуатации этой уязвимости требуется заставить систему обратиться к вредоносному DNS-серверу, что уже само по себе успех. Зато она присутствует в Ubuntu с июня 2015 года (в systemd, начиная с версий 223). И в силу того, что systemd идет еще и с дистрибутивами Debian, Fedora и openSUSE, баг стоит поискать и там. Впрочем, Федора уже запатчилась.

Древности

Семейство «Ieronim»

Резидентные неопасные вирусы, записываются в .COM-файлы (кроме COMMAND.COM) при их загрузке в память. В зависимости от своей версии вирусы внедряются либо в конец, либо в начало файла Примерно раз в час выводят текст типа «Mulier pulchra est janua diaboli, via iniquitatis,scorpionis percussio. St. Ieronim». Помимо этой, содержат строку «comcommand». Перехватывают int 8, 21h.

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 32.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

|

Расширение, изменение и создание элементов управления на платформе UWP. Часть 2 |

|

Метки: author MobileDimension разработка под windows разработка мобильных приложений .net блог компании mobile dimension uwp элементы управления |

Simple Field Validation |

Ради этого подтягивать внешние зависимости представляется избыточным. Например, тот же Hibernate Validator добавляет порядка 8000 методов и 1 мб к весу финальной apk, что выглядит… избыточным )

Поиск какого-то удачного решения в интернетах не увенчался успехом, поэтому было принято решение напилить свое. Посовещавшись с коллегой (с iOS направления) пришли к идее лаконичного решения, которая была впоследствии реализована на каждой из платформ.

Реализацией этой идеи под Android и хочу поделиться. Но предупрежу сразу, что в угоду простоте восприятия идеи примеры использования будут приводится в крайне простом варианте, возможно даже наивном. Плюс, в текущей реализации идеи не используется Rx.

Итак. Начинается все с очень простого интерфейса:

public interface Validator {

boolean isValid(T value);

String getDescription();

} Собственно, это все )

Дальше нам понадобится его реализация для компоновки однотипных атомарных валидаторов воедино:

public class ValidatorsComposer implements Validator {

private final List> validators;

private String description;

public ValidatorsComposer(Validator... validators) {

this.validators = Arrays.asList(validators);

}

@Override

public boolean isValid(T value) {

for (Validator validator : validators) {

if (!validator.isValid(value)) {

description = validator.getDescription();

return false;

}

}

return true;

}

@Override

public String getDescription() {

return description;

}

} В качестве примера можно привести валидацию email поля. Для этого создадим два атомарных валидатора:

public class EmptyValidator implements Validator {

@Override

public boolean isValid(String value) {

return !TextUtils.isEmpty(value);

}

@Override

public String getDescription() {

return "Field must not be empty";

}

} public class EmailValidator implements Validator {

@Override

public boolean isValid(String value) {

return Patterns.EMAIL_ADDRESS.matcher(value).matches();

}

@Override

public String getDescription() {

return "Email should be in 'a@a.com' format";

}

} И, собственно, вариант использования:

final ValidatorsComposer emailValidatorsComposer =

new ValidatorsComposer<>(new EmptyValidator(), new EmailValidator());

button.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (emailValidatorsComposer.isValid(emailEditText.getText().toString())) {

errorTextView.setText(null);

} else {

errorTextView.setText(emailValidatorsComposer.getDescription());

}

}

}); Также эта идея подходит и для валидации DataObject’ов с последующим выводом ошибки на экран. Например, создадим валидатор для DataObject’а User:

public class User {

public final String name;

public final Integer age;

public final Gender gender;

public enum Gender {MALE, FEMALE}

public User(String name, Integer age, Gender gender) {

this.name = name;

this.age = age;

this.gender = gender;

}

}public class UserValidator implements Validator {

private String description;

@Override

public boolean isValid(User value) {

if (value == null) {

description = "User must not be null";

return false;

}

final String name = value.name;

if (TextUtils.isEmpty(name)) {

description = "User name must not be blank";

return false;

}

final Integer age = value.age;

if (age == null) {

description = "User age must not be blank";

return false;

} else if (age < 0) {

description = "User age must be above zero";

return false;

} else if (age > 100) {

description = "User age is to much";

return false;

}

final User.Gender gender = value.gender;

if (gender == null) {

description = "User gender must not be blank";

return false;

}

return true;

}

@Override

public String getDescription() {

return description;

}

} И вариант использования:

final Validator userValidator = new UserValidator();

button.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

User user = new User(null, 12, User.Gender.MALE);

if (userValidator.isValid(user)) {

errorTextView.setText(null);

} else {

errorTextView.setText(userValidator.getDescription());

}

}

}); Варианты валидации могут быть самыми различными: от валидации по ивенту (по нажатию кнопки, например, как это показано в примерах выше), до динамической валидации (в момент ввода текста):

emailEditText.addTextChangedListener(new SimpleTextWatcher() {

@Override

public void afterTextChanged(Editable s) {

if (!emailValidatorsComposer.isValid(s.toString())) {

errorTextView.setText(emailValidatorsComposer.getDescription());

}

}

});Равно как и стратегия показа ошибок тоже может совершенно различной: от фокуса на поле ошибки с показом текста ошибки и показом клавиатуры (предпочтительный на мой взгляд), до показа всех ошибок на экране разом (довольно часто встречается в андроид приложениях именно такой вариант). Рекомендации Google по показу ошибок можно посмотреть по ссылке.

По итогу получаем крайне простую и вместе с тем гибкую идею валидации полей и объектов данных, которая по-сути ни капли не утяжеляет проект и реализуется по щелчку пальцев. Как бэ профит )

|

Метки: author ZemtsovVU разработка под android android android development form validation валидация форм |

Вещи, которые мне надо было знать прежде, чем создавать систему с очередью |

В проекте, над которым я сейчас работаю, применяется распределённая система обработки данных: сначала несколько десятков машин одновременно производят некоторые сообщения, затем эти сообщения отправляются в очередь, из очереди три потока извлекают сообщения и после финальной обработки выкладывают данные в базу Redis. При этом имеется требование: от «зарождения» события в машине, производящей сообщение, до выкладывания обработанных данных в базу должно проходить не более четырёх секунд в 90% случаев.

В какой-то момент стало очевидно, что мы это требование не выполняем, несмотря на затрачиваемые усилия. Несколько произведённых измерений и маленький экскурс в теорию очередей привели меня к выводам, которые я бы хотел донести до себя самого несколько месяцев назад, когда проект только начинался. Отправить письмо в прошлое я не могу, но могу написать заметку, которая, возможно, избавит от неприятностей тех, кто только задумывается над тем, чтобы применять очереди в собственной системе.

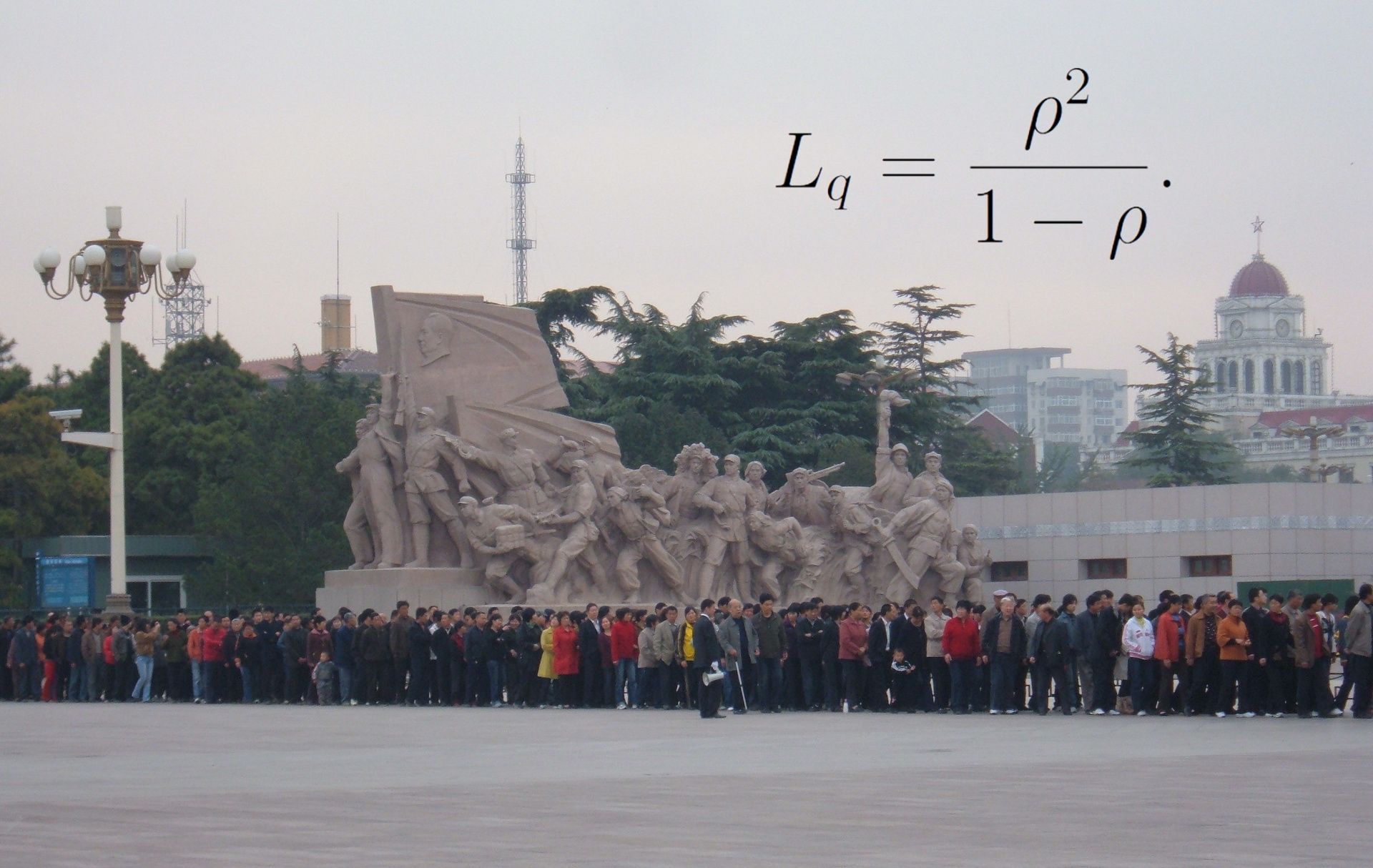

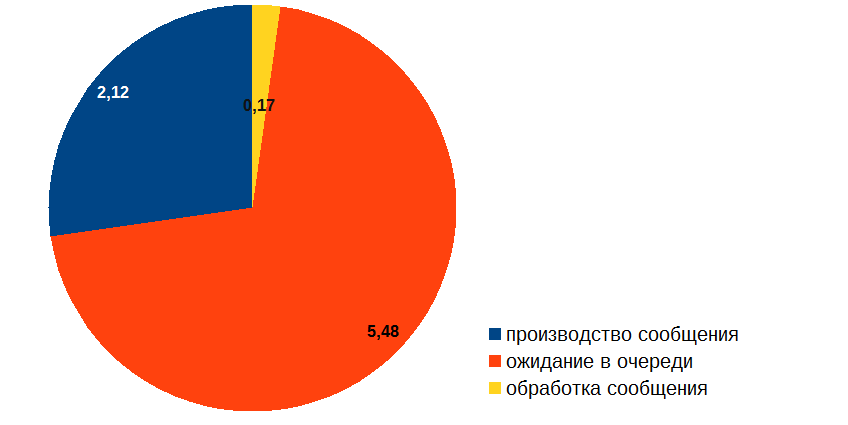

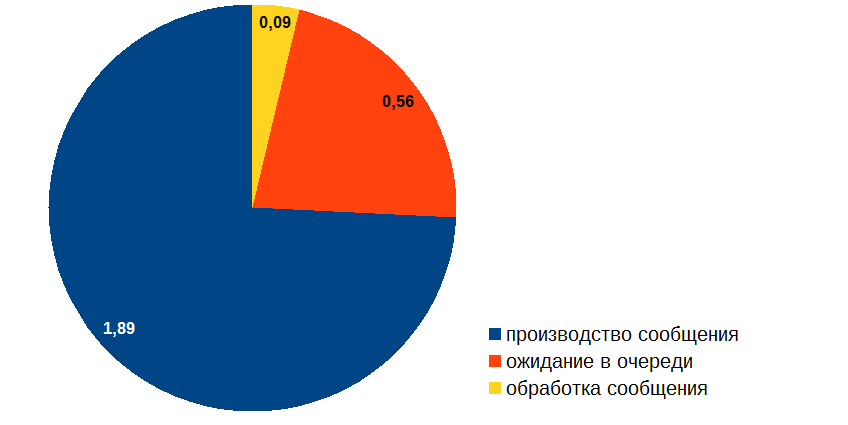

Я начал с того, что измерил время, которое сообщение проводит на разных стадиях обработки, и получил примерно такой результат (в секундах):

Таким образом, невзирая на то, что обработка сообщения занимает довольно мало времени, больше всего сообщение простаивает в очереди. Как такое может быть? И главное: как с этим бороться? Ведь если бы картинка выше была результатом профайлинга обычного кода, то всё было бы очевидно: надо оптимизировать «красную» процедуру. Но вся беда в том, что в нашем случае в «красной» зоне ничего не происходит, сообщение просто ждёт в очереди! Ясно, что оптимизировать надо обработку сообщения («жёлтую» часть диаграммы), но возникают вопросы: каким образом эта оптимизация может повлиять на длину очереди и где гарантии, что мы вообще сможем добиться желаемого результата?

Я помнил, что вероятностными оценками времени ожидания в очереди занимается теория очередей (подраздел исследования операций). В своё время в университете, впрочем, мы это не проходили, поэтому на некоторое время мне предстояло погрузиться в Википедию, PlanetMath и онлайн-лекции, откуда на меня как из рога изобилия посыпались сведения о нотации Кендалла, законе Литтла, формулах Эрланга, и т. д., и т. п.

Аналитические результаты теории очередей изобилуют довольно серьёзной математикой, основная часть этих результатов была получена в XX веке. Изучать всё это — занятие хотя и увлекательное, но довольно долгое и кропотливое. Не могу сказать, что я смог хоть сколько-нибудь глубоко туда погрузиться.

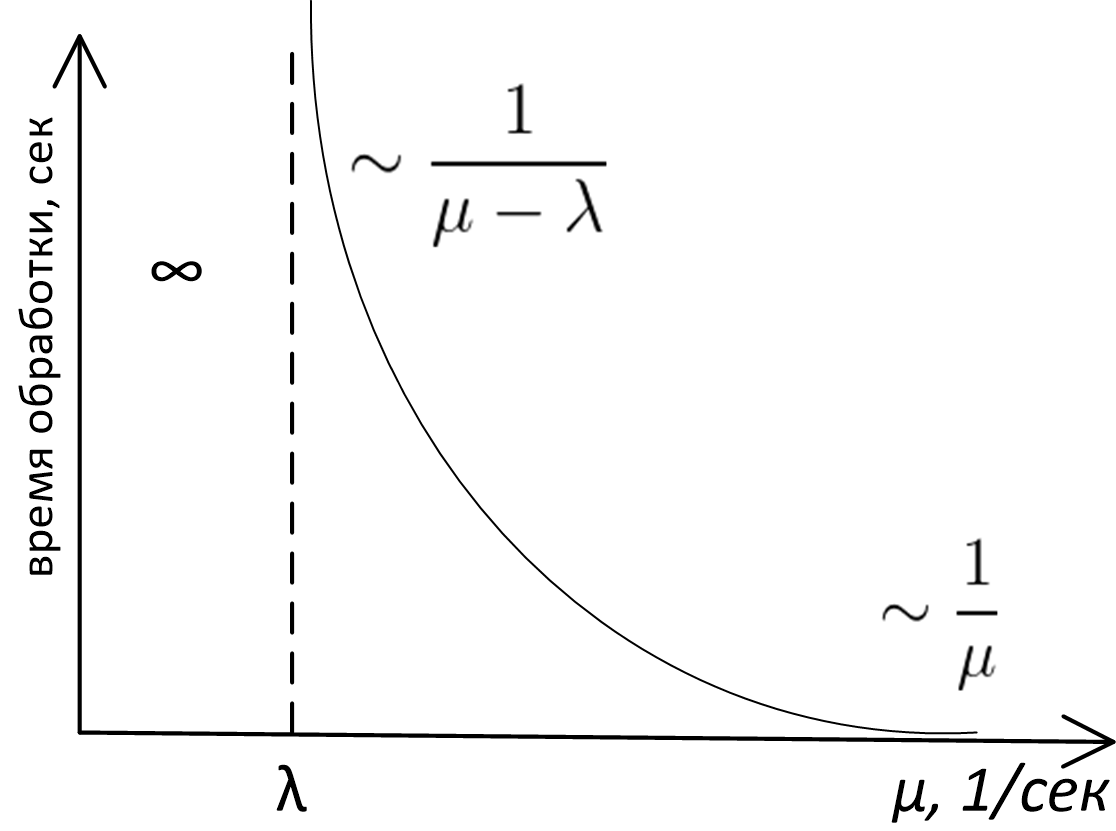

И тем не менее, пробежавшись всего лишь «по верхам» теории очередей, я обнаружил, что основные выводы, которые можно применить на практике в нашем случае, лежат на поверхности, требуют для своего обоснования только лишь здравый смысл и могут быть изображены на графике зависимости времени обработки в системе с очередью от пропускной способности сервера, вот он:

Здесь

- — пропускная способность сервера (в сообщениях за секунду)

- — средняя частота поступления запросов (в сообщениях за секунду)

- По оси ординат отложено среднее время обработки сообщения.

Точный аналитический вид этого графика является предметом изучения теории очередей, и для очередей M/M/1, M/D/1, M/D/c и т. д. (если не знаете, что это такое — см. нотация Кендалла) эта кривая описывается совершенно различными формулами. Тем не менее, какой бы моделью ни описывалась очередь, внешний вид и асимптотическое поведение этой функции будет одинаковым. Доказать это можно простыми рассуждениями, что мы и проделаем.

Во-первых, посмотрим на левую часть графика. Совершенно очевидно, что система не будет стабильной, если (пропускная способность) меньше (частоты поступления): сообщения на обработку приходят с большей частотой, чем мы их можем обработать, очередь неограниченно растёт, а у нас возникают серьёзные неприятности. В общем, случай — аварийный всегда.

Тот факт, что в правой части график асимптотически стремится к , тоже довольно прост и для своего доказательства глубокого анализа не требует. Если сервер работает очень быстро, то мы практически не ждём в очереди, и общее время, которое мы проводим в системе, равно времени, которое сервер затрачивает на обработку сообщения, а это как раз .

Не сразу очевидным может показаться лишь тот факт, что при приближении к с правой стороны время ожидания в очереди растёт до бесконечности. В самом деле: если , то это значит, что средняя скорость обработки сообщений равна средней скорости поступления сообщений, и интуитивно кажется, что при таком раскладе система должна справляться. Почему же график зависимости времени от производительности сервера в точке вылетает в бесконечность, а не ведёт себя как-нибудь так:

Но и этот факт можно установить, не прибегая к серьёзному математическому анализу! Для этого достаточно понять, что сервер, обрабатывая сообщения, может находиться в двух состояниях: 1) он занят работой 2) он простаивает, потому что обработал все задачи, а новые в очередь ещё не поступили.

Задания в очередь приходят неравномерно, где «погуще, где пореже»: количество событий в единицу времени является случайной величиной, описываемой так называемым распределением Пуассона. Если задания в какой-то интервал времени шли редко и сервер простаивал, то время, в течение которого он простаивал, он не может «сберечь» для того, чтобы использовать его для обработки будущих сообщений.

Поэтому за счёт периодов простоя сервера средняя скорость выхода событий из системы будет всегда меньше пиковой пропускной способности сервера.

В свою очередь, если средняя скорость выхода меньше средней скорости входа, то это и приводит к бесконечному удлинению среднего времени ожидания в очереди. Для очередей с пуассоновским распределением событий на входе и постоянным либо экспоненциальным временем обработки величина ожидания около точки насыщения пропорциональна

Выводы

Итак, разглядывая наш график, мы приходим к следующим выводам.

- Время обработки сообщения в системе с очередью есть функция пропускной способности сервера и средней частоты поступления сообщений , и даже проще: это функция отношения этих величин .

- Проектируя систему с очередью, нужно оценить среднюю частоту прибытия сообщений и заложить пропускную способность сервера .

- Всякая система с очередью в зависимости от соотношения и может находиться в одном из трёх режимов:

- Аварийный режим — . Очередь и время обработки в системе неограниченно растут.

- Режим, близкий к насыщению: , но ненамного. В этой ситуации небольшие изменения пропускной способности сервера очень сильно влияют на параметры производительности системы, как в ту, так и в другую сторону. Нужно оптимизировать сервер! При этом даже небольшая оптимизация может оказаться очень благотворной для всей системы. Оценки скоростей поступления сообщений и пропускной способности нашего сервиса показали, что наша система работала как раз около «точки насыщения».

- Режим «почти без ожидания в очереди»: . Общее время нахождения в системе примерно равно времени, которое сервер тратит на обработку. Необходимость оптимизации сервера определяется уже внешними факторами, такими как вклад подсистемы с очередью в общее время обработки.

Разобравшись с этими вопросами, я приступил к оптимизации обработчика событий. Вот какой расклад получился в итоге:

ОК, вот теперь можно и время производства сообщения подоптимизировать!

Также рекомендую прочесть: Принципы и приёмы обработки очередей.

|

Метки: author IvanPonomarev анализ и проектирование систем производительность очереди message queue |

[Из песочницы] Как generic-и нас спасают от упаковки |

При заходе в метод мы часто выполняемым проверку на null. Кто-то выносит проверку в отдельный метод, что бы код выглядел чище, и получается что то-такое:

public void ThrowIfNull(object obj)

{

if(obj == null)

{

throw new ArgumentNullException();

}

}И что интересно при такой проверке, я массово вижу использование именно object атрибута, можно ведь воспользоватся generic-ом. Давайте попробуем заменить наш метод на generic и сравнить производительность.

Перед тестированием нужно учесть ещё один недостаток object аргумента. Значимые типы(value types) никогда не могут быть равны null(Nullable тип не в счёт). Вызов метода, вроде ThrowIfNull(5), бессмыслен, однако, поскольку тип аргумента у нас object, компилятор позволит вызвать метод. Как по мне, это снижает качество кода, что в некоторых ситуациях гораздо важнее производительности. Для того что бы избавится от такого поведения, и улучшить сигнатуру метода, generic метод придётся разделить на два, с указанием ограничений(constraints). Беда в том что нельзя указать Nullable ограничение, однако, можно указать nullable аргумент, с ограничением struct.

Приступаем к тестированию производительности, и воспользуемся библиотекой BenchmarkDotNet. Навешиваем атрибуты, запускаем, и смотрим на результаты.

public class ObjectArgVsGenericArg

{

public string str = "some string";

public Nullable num = 5;

[MethodImpl(MethodImplOptions.NoInlining)]

public void ThrowIfNullGenericArg(T arg)

where T : class

{

if (arg == null)

{

throw new ArgumentNullException();

}

}

[MethodImpl(MethodImplOptions.NoInlining)]

public void ThrowIfNullGenericArg(Nullable arg)

where T : struct

{

if(arg == null)

{

throw new ArgumentNullException();

}

}

[MethodImpl(MethodImplOptions.NoInlining)]

public void ThrowIfNullObjectArg(object arg)

{

if(arg == null)

{

throw new ArgumentNullException();

}

}

[Benchmark]

public void CallMethodWithObjArgString()

{

ThrowIfNullObjectArg(str);

}

[Benchmark]

public void CallMethodWithObjArgNullableInt()

{

ThrowIfNullObjectArg(num);

}

[Benchmark]

public void CallMethodWithGenericArgString()

{

ThrowIfNullGenericArg(str);

}

[Benchmark]

public void CallMethodWithGenericArgNullableInt()

{

ThrowIfNullGenericArg(num);

}

}

class Program

{

static void Main(string[] args)

{

var summary = BenchmarkRunner.Run();

}

} | Method | Mean | Error | StdDev |

|---|---|---|---|

| CallMethodWithObjArgString | 1.784 ns | 0.0166 ns | 0.0138 ns |

| CallMethodWithObjArgNullableInt | 124.335 ns | 0.2480 ns | 0.2320 ns |

| CallMethodWithGenericArgString | 1.746 ns | 0.0290 ns | 0.0271 ns |

| CallMethodWithGenericArgNullableInt | 2.158 ns | 0.0089 ns | 0.0083 ns |

Наш generic на nullable типе отработал в 2000 раз быстрее! А всё из-за пресловутой упаковки(boxing). Когда мы вызываем CallMethodWithObjArgNullableInt, то наш nullable-int "упаковывается" и размещается в куче. Упаковка очень дорогая операция, от того метод и проседает по производительности. Таким образом использую generic мы можем избежать упаковки.

Итак, generic аргумент лучше object потому что:

- Спасает от упаковки

- Позволяет улучшить сигнатуру метода, при использовании ограничений

Upd. Спасибо хабраюзеру zelyony за замечание. Методы инлайнились, для более точных замеров добавил атрибут MethodImpl(MethodImplOptions.NoInlining).

|

Метки: author unsafePtr c# generics boxing |

RAML-роутинг в Play Framework |

Play framework — очень гибкий инструмент, но информации о том, как изменить формат route-файла, на просторах интернета мало. Я расскажу о том, как можно заменить стандартный язык описания маршрутов на основе route-файла на описание в формате RAML. А для этого нам придется создать свой SBT-плагин.

В двух словах о RAML (RESTful API Modeling Language). Как совершенно справедливо сказано на главной странице проекта, этот язык существенно упрощает работу с API приложения на протяжении всего его жизненного цикла. Он лаконичен, легко переиспользуется, и что самое ценное— в равной степени легко читается машиной и человеком. То есть можно воплотить подход documentation as a code, когда один артефакт (RAML-скрипт) становится точкой входа для всех участников процесса разработки — аналитиков, тестировщиков и программистов.

Постановка задачи

Наша команда работает над большой и сложной системой онлайн-банкинга. Особое внимание уделяется документированию интерфейсов и тестам. Однажды я задался вопросом, можно ли объединить тесты, документацию и кодогенерацию. Оказалось, что до определенной степени это возможно. Но для начала пара слов о том, зачем нам это понадобилось.

В большом проекте особое значение имеет документирование интерфейсов. Аналитики, разработчики сервисов и клиентских приложений должны иметь описание API системы, над которой они работают. Аналитикам важна документация в удобном для чтения виде, программисты в конечном счете описывают интерфейс в коде, причем разные команды пишут код на разных языках. Информация многократно дублируется, что затрудняет её синхронизацию. Когда команд много, почти невозможно вручную гарантировать соответствие друг другу различных форматов API. Поэтому к решению этой проблемы мы подошли основательно.

Для начала мы выбрали единый для всех команд формат описания API. Им стал RAML. Далее нам нужно было бы гарантировать (насколько это возможно), что наши сервисы соответствуют описанию, а клиентские приложения работают с описанными сервисами. Для этого мы используем инструменты тестирования, о которых я расскажу в другой статье. И последним шагом стало внедрение кодогенерации, которая создает за нас код на основе данных из RAML. Сегодня речь пойдет об инструментах кодогенерации, используемых в проекте сервера.

Обычно в документации содержится информация о конечных точках REST, описание параметров и тела запроса, HTTP-коды и описание ответов. При этом для всех вышеперечисленных элементов часто указываются примеры. Этой информации вполне достаточно для тестирования работоспособности конечной точки — просто нужно взять пример запроса для неё и отослать на сервер. Если у конечной чтоки есть параметры, то их значения нужно также взять из примеров. Пришедший ответ сравнить с примером ответа или провалидировать его JSON-схему на основании документации. Чтобы примеры ответов соответствовали ответам сервера, тот должен работать с правильными данными в БД. Таким образом, при наличии БД с тестовыми данными и документации API сервиса с описанием ответов и примерами запросов, мы можем обеспечить простое тестирование работоспособности нашего сервиса. О нашей документации, системе тестирования и БД сейчас я упомянул для полноты картины, и мы о них обязательно поговорим в другой раз. Здесь же я расскажу о том, как на основании такой документации генерировать как можно больше полезного серверного кода.

Наш сервер написан на Play 2.5 и предоставляет REST API своим клиентам. Формат обмена данными — JSON. Стандартное описание API в Play framework находится в файле conf/route. Синтаксис этого описания прост и ограничивается описанием имен конечных точек и их параметров, а также привязкой конечных точек к методам контроллера в файле routes. Нашей целью будет замена стандартного синтаксиса на описание в формате RAML. Для этого нам нужно:

- Разобраться, как в Play устроена маршрутизация и как обрабатываются route-файлы.

- Заменить стандартный механизм маршрутизации на наш механизм, использующий RAML.

- Посмотреть на результат и сделать выводы :)

Итак, давайте по порядку.

Роутинг в Play framework

Play framework рассчитан на использование с двумя языками — Scala и Java. Поэтому для описания маршрутов авторы фреймворка не стали использовать DSL на базе какого-то конкретного языка, а написали свой язык и компилятор к нему. Далее я буду говорить про Scala, но всё сказанное справедливо и для Java. Play-приложение собирается с помощью SBT. Во время сборки проекта route-файлы компилируются в файлы на Scala или Java, и далее результат компиляции используется при сборке. За обработку route-файла отвечает SBT-плагин com.typesafe.play.sbt-plugin. Давайте посмотрим, как он работает. Но для начала пару слов об SBT.

Основным понятием SBT является ключ. Ключи бывают двух типов: TaskKey и SettingsKey. Первый тип используется для хранения функций. Каждое обращение к этому ключу приводит к вызову этой функции. Второй тип ключа хранит константу и вычисляется один раз. Compile — это TaskKey, в процессе выполнения он вызывает другой TaskKey, sourceGenerators, для кодогенерации и создания исходных файлов. Собственно SBT-plugin добавляет функцию обработки route-файла к sourceGenerators.

Обычно на основе route создается два основных артефакта — файл target/scala-2.11/routes/main/router/Routes.scala и target/scala-2.11/routes/main/controllers/ReverseRoutes.scala. Класс Routes используется для маршрутизации входящих запросов. ReverseRoutes используется для вызова конечных точек из кода контроллеров и view по имени конечной точки. Давайте проиллюстрируем вышесказанное примером.

conf/routes

Тут мы объявляем параметризованную конечную точку и мапим её на метод HomeController.index. В результате компиляции этого файла получается следующий код на Scala:

target/scala-2.11/routes/main/router/Routes.scala

Этот класс занимается маршрутизацией входящих запросов. В качестве аргументов ему передаются ссылка на контроллер (точнее, инжектор, но это не существенно) и префикс URL пути, который настраивается в конфигурационном файле. Далее в классе объявлена «маска» маршрутизации controllers_HomeController_index0_route. Маска состоит из HTTP-глагола и паттерна маршрута. Последний состоит из частей, каждая соответствует элементу URL пути. StaticPart определяет маску для неизменной части пути, DynamicPart задает шаблон для URL параметра. Каждый входящий запрос попадает в функцию routes, где сопоставляется с доступными масками (в нашем случае она одна). Если совпадений не найдено — клиент получит 404 ошибку, в противном случае будет вызван соответствующий обработчик. В нашем примере обработчик один — это controllers_HomeController_index0_invoker. В обязанности обработчика входит вызов метода контроллера с нужным набором параметров и трансформация результатов этого вызова.

target/scala-2.11/routes/main/controllers/ReverseRoutes.scala

Этот код позволяет нам обращаться к конечной точке через соответствующую функцию, например, во view.

Итак, чтобы сменить формат описания маршрутов нам достаточно написать свой генератор файла Routes. ReverseRoutes нам не нужен, так как наш сервис отдает JSON и view у него нет. Чтобы наш генератор сработал, нужно включить его. Можно копировать исходники генератора в каждый проект, где он нужен, а далее подключать его в build.sbt. Но правильнее будет оформить генератор в виде плагина к SBT.

Плагин SBT

О плагинах SBT исчерпывающе написано в документации. Тут я упомяну об основных, на мой взгляд, моментах. Плагин — это набор дополнительной функциональности. Обычно плагины добавляют в проект новые ключи и расширяют существующие. Нам, например, нужно будет расширить ключ sourceGenerators. Одни плагины могут зависеть от других, например, мы могли бы использовать в качестве основы плагин com.typesafe.play.sbt-plugin и изменить в нем только то, что нам нужно. Другими словами наш плагин зависит от com.typesafe.play.sbt-plugin. Чтобы SBT автоматически подключал все зависимости для нашего плагина, тот должен быть AutoPlugin'ом. Ну и последнее: из-за вопросов совместимости плагины пишутся на Scala 2.10.

Итак, нам нужно генерировать Routes.scala на основе файла RAML. Пусть этот файл называется conf/api.raml. Чтобы документацию в RAML-формате можно было использовать для маршрутизации, необходимо каким-то способом указать в нем для каждой конечной точки метод контроллера, который необходимо вызвать при получении запроса. RAML 0.8, который мы будем использовать, не имеет средств для указания такой информации, поэтому придется делать грязный хак (RAML 1.0 решает эту проблему с помощью аннотаций, но на момент написания статьи эта версия стандарта еще сыра). Добавим информацию о вызываемом методе контроллера в первую строку description для каждой конечной точки. Наш пример в RAML-формате из предыдущей главы будет выглядеть так:

На деталях парсинга RAML останавливаться не буду, скажу лишь, что можно использовать парсер от raml.org. В результате парсинга мы получаем список правил — по одному на каждую конечную точку. Правило задается следующим классом:

Названия и типы полей говорят сами за себя. Теперь для каждого правила мы можем в файле Routes.scala создать свою маску, обработчик и элемент case в функции route. Для решения этой задачи можно вручную генерировать строку с кодом Routes.scala на основе списка правил, или применить макросы. Но лучше выбрать промежуточный вариант, который предпочли и разработчики Play — использовать шаблонизатор. PВ Play применяется шаблонизатор twirl, и мы тоже его используем. Вот шаблон из нашего плагина, генерирующий функцию route:

Выглядит несколько запутанно, но если присмотреться, то всё становится ясно. Выражения, начинающиеся с @ — это директивы и переменные шаблонизатора. Переменные @ob и @cb будут раскрыты в { и } соответственно. А, например, @(routeIdentifier(route, index)) развернется по следующему правилу:

Теперь ясно, как написать код, создающий Routes.scala на основе RAML, и понятно, как подключить его к сборке. Исходники готового плагина лежат на Github.

Планы на будущее

Плагин позволил нам использовать документацию в качестве исходного кода для сервера. Но кодогенерация не использует всей доступной информации из RAML-файла. А именно, мы никак не используем информацию о типе запроса и ответа. В Play парсинг запроса и генерация ответа происходит в методах контроллера, но мы хотим генерировать этот код автоматически. Кроме того, у нас в планах использовать версию RAML 1.0.

На сегодня всё, спасибо за внимание!

|

Метки: author Raiffeisenbank scala java блог компании райффайзенбанк play framework github raml raml 1.0 |

Rewarded Video: лучшие сценарии показа или как сделать так, чтобы вашу рекламу посмотрели |

Формат Rewarded Video (RV) стремительно растет: пользователей такая реклама практически не раздражает, так как выбор — смотреть или не смотреть — остается за ними. Однако, видео за вознаграждение работает все по тому же по закону Парето: нужно потратить время на разработку стратегии размещения RV, чтобы выжать из этого типа рекламы максимум.

По идее, реклама в приложении должна инициализироваться как можно раньше, чтобы правильно отобразить максимальное количество видео из загруженных. Казалось бы, в таком случае проще показать Rewarded Video cразу после входа в приложение — но этого как раз делать не рекомендуется. Такое решение ударит по метрикам удержания (Retention Rate) и репутации. Пользователь вряд ли захочет вернуться в приложение, где ему навязывают видеорекламу сразу после экрана загрузки.

Кроме того, Rewarded Video не стоит пускать в начало приложения и с коммерческой точки зрения: для поиска более дорогой рекламы, с более высоким eCPM, нужно время.

Еще одна особенность — креатив (само видео) в формате Rewarded Video весит больше, чем остальные виды рекламы, соответственно, и загружается дольше. “Водопад” из рекламных сетей (см. cхему) опрашивается 15-20 секунд, а на загрузку креатива нужно около 30 секунд.

Магазин приложения

Как правило, магазин приложения призывает купить внутриигровую валюту, а Rewarded Video присутствует в нем в качестве опции. Видео в этом случае инициализируется на входе в приложение и сохраняется в кэше — до момента, когда пользователь его обнаружит. Проблема в том, что пользователь, как правило, заходит в магазин приложения редко и не знает о Rewarded video.

Какие варианты? Выход из ситуации — загружать видео, когда мы понимаем, что пользователь вот-вот зайдет в магазин, потому что у него заканчивается валюта. Кроме того, попробуйте отправлять игроку уведомления о том, что у него заканчиваются деньги (“Эй, хочешь монетку бесплатно?”). Напоминать об возможности посмотреть видео и пополнить запас монеток между уровнями — тоже вполне логично.

Сanyon Crash — Fall Down

Кстати, хороший способ подгрузить и даже показать видео на старте — формат ежедневных наград. Например, сразу после загрузки пользователь видит звенящий сундучок (на его месте может быть что угодно), который призывает посмотреть видео и получить ежедневную награду.

Family Guy — The Quest For Stuff

Такая акция может проходить раз в день или раз в неделю-две, на ваше усмотрение. Примерно такой же формат прокачки хорош для игр-тапперов, где Rewarded video можно показывать много раз в обмен на постройку здания, обновление персонажей, и так далее.

PixelMon Hunter

В процессе игры

Первая возможность показать видео игроку — ситуация, когда уровень еще не пройден до конца, но ходы заканчиваются. Пользователь оказывается между двух огней: либо начать уровень заново, либо получить несколько ходов за просмотр рекламы. Display Rate (соотношение показанной рекламы к загруженной) при таком раскладе остается довольно высоким, так как реклама инициализируется заранее, в момент, когда осталось мало ходов и игрока оповестили о вознаграждении.

Blusty Bubs — Brick Breaker

Еще один хороший вариант — показать видеорекламу в обмен на подсказки в игре. К примеру, пользователь долго мучается с одним и тем же уровнем или не может разгадать паззл — тогда после нескольких неудачных попыток можно предложить ему видеорекламу в обмен на ключ к разгадке. Так сделали разработчики из студии Rusty Lake, которые создают мистический паззл, вдохновленный Твин Пиксом. В какой-то момент они поняли, что загадки в игре слишком сложны, и добавили видеорекламу для получения подсказок. Этот шаг поднял и лояльность игроков, и выручку.

Кроме подсказок есть много способов мотивировать пользователя посмотреть Rewarded video — например, предложите ему суперсилу, удваивание наград или другую фишку, облегчающую игру.

Hidden Worlds Adventure

Очевидно, что для игр можно придумать множество сценариев, однако Rewarded video отлично работают и в приложениях-утилитах. За просмотр видео можно награждать любым закрытым контентом, в том числе кастомизацией приложения. Например, этот формат прекрасно работает для приложений для знакомств, где у пользователя есть рейтинг и возможность продвинуть свой профайл выше в рейтинге.

Важно: какой бы вариант интеграции видео вы не выбрали, вознаграждение за его просмотр должно быть максимально очевидно и важно для пользователя. Есть много примеров, в которых Display Rate остается низким, несмотря на грамотное расположение рекламы — это говорит о том, что награда не очевидна для игрока.

Сanyon Crash — Fall Down

Помните и о балансе внутриигровой экономики. Те, кто не хочет расставаться с внутриигровыми покупками, могут чередовать видео с вознаграждением: скажем, игрок может посмотреть Rewarded video и получить награду только раз в 2-4 часа, а может не ждать и купить ее за реальные деньги. Для примера, вот несколько подключенных к Appodeal приложений с удачным использованием Rewarded video: Color Six, Lolo App, Block Strike, Hidden Worlds Adventure.

Источник заглавного изображения

|

|

5 приемов в помощь разработке на vue.js + vuex |

В этой статье приведу ряд приемов, которые, на мой взгляд, помогут в разработке любого крупного проекта. Этот материал для вас, если вы уже написали свой todo лист на vue.js+vuex, но еще не зарылись в крупное велосипедостроение.

1. Централизованная шина событий (Event Bus)

Любой проект на vue.js состоит из вложенных компонентов. Основной принцип — props down, events up. Подкомпонент получает от родителя данные, которые он не может менять, и список событий родителя, которые он может запустить.

Принцип годный, но создает сильную связность. Если целевой компонент глубоко вложен, приходится протаскивать данные и события через все обертки.

Разберемся с событиями. Зачастую полезно иметь глобальный event emitter, с которым может общаться любой компонент независимо от иерархии. Его очень легко сделать, дополнительные библиотеки не нужны:

Object.defineProperty(Vue.prototype,"$bus",{

get: function() {

return this.$root.bus;

}

});

new Vue({

el: '#app',

data: {

bus: new Vue({}) // Here we bind our event bus to our $root Vue model.

}

});

После этого в любом компоненте появляется доступ к this.$bus, можно подписываться на события через this.$bus.$on() и вызывать их через this.$bus.$emit(). Вот пример.

Очень важно понимать, что this.$bus — глобальный объект на все приложение. Если забывать отписываться, компоненты остаются в памяти этого объекта. Поэтому на каждый this.$bus.$on в mounted должен быть соответствующий this.$bus.$off в beforeDestroy. Например, так:

mounted: function() {

this._someEvent = (..) => {

..

}

this._otherEvent = (..) => {

..

}

this.$bus.$on("someEvent",this._someEvent);

this.$bus.$on("otherEvent",this._otherEvent);

},

beforeDestroy: function() {

this._someEvent && this.$bus.$off("someEvent",this._someEvent);

this._otherEvent && this.$bus.$off("otherEvent",this._otherEvent);

}

2. Централизованная шина промисов (Promises Bus)

Иногда в компоненте нужно инициализировать некую асинхронную штуку (например, инстанц google maps), к которой хочется обращаться из других компонентов. Для этого можно организовать объект, который будет хранить промисы. Например, такой. Как и в случае в event bus, не забываем удаляться при деинициализации компонента. И вообще, указанным выше способом к vue можно прицепить любой внешний объект с любой логикой.

3. Плоские структуры (flatten store)

В сложном проекте данные зачастую сильно вложены. Работать с такими данными неудобно как в vuex, так и в redux. Рекомендуется уменьшать вложенность, например, воспользовавшись утилитой normalizr. Утилита — это хорошо, но еще лучше понимать, что она делает. Я не сразу пришел к пониманию плоской структуры, для таких же типа себя рассмотрю подробный пример.

Имеем проекты, в каждом — массив слоев, в каждом слое — массив страниц: projects > layers > pages. Как организовать хранилище?

Первое, что приходит в голову — обычная вложенная структура:

projects: [{

id: 1,

layers: [{

id: 1,

pages: [{

id: 1,

name: "page1"

},{

id: 2,

name: "page2"

}]

}]

}];

Такую структуру легко читать, легко бегать циклом foreach по проектам, рендерить подкомпоненты со списками слоев и так далее. Но предположим, что нужно поменять название страницы с id:1. Внутри некоторого маленького компонента, который отрисовывает страницу, вызывается $store.dispatch(«changePageName»,{id:1,name:«new name»}). Как найти место, где в этой глубоко вложенной структуре лежит нужный page с id:1? Пробегать по всему хранилищу? Не лучшее решение.

Можно указывать полный путь, типа

$store.dispatch("changePageName",{projectId:1,layerId:1,id:1,name:"new name"})Но это значит, что в каждый маленький компонент рендеринга страницы нужно протаскивать всю иерархию, и projectId, и layerId. Неудобно.

Вторая попытка, из sql:

projects: [{id:1}],

layers: [{id:1,projectId:1}],

pages: [{

id: 1,

name: "page1",

layerId: 1,

projectId: 1

},{

id: 2,

name: "page2",

layerId: 1,

projectId: 1

}]

Теперь данные легко менять. Но тяжело бегать. Чтобы вывести все страницы в одном слое, нужно пробежать по вообще всем страницам. Это может быть спрятано в getter-е, или в рендеринге шаблона, но пробежка все равно будет.

Третья попытка, подход normalizr:

projects: [{

id: 1,

layersIds: [1]

}],

layers: {

1: {

pagesIds: [1,2]

}

},

pages: {

1: {name:"page1"},

2: {name:"page2"}

}

Теперь все страницы слоя могут быть получены через тривиальный геттер

layerPages: (state,getters) => (layerId) => {

const layer = state.layers[layerId];

if (!layer || !layer.pagesIds || layer.pagesIds.length==0) return [];

return layer.pagesIds.map(pageId => state.pages[pageId]);

}

Заметим, что геттер не бегает по списку всех страниц. Данные легко менять. Порядок страниц в слое задан в объекте layer, и это тоже правильно, поскольку процедура пересортировки как правило находится в компоненте, который выводит список объектов, в нашем случае это компонент, который рендерит layer.

4. Мутации не нужны

Согласно правилам vuex, изменения данных хранилища должны происходить только в функциях-мутациях, мутации должны быть синхронными. В vuex находится основная логика приложения. Поэтому блок валидации данных тоже будет логичным включить в хранилище.

Но валидация далеко не всегда синхронна. Следовательно, по крайней мере часть валидационной логики будет находится не в мутациях, а в действиях (actions).

Предлагаю не разбивать логику, и хранить в actions вообще всю валидацию. Мутации становятся примитивными, состоят из элементарных присваиваний. Но тогда к ним нельзя обращаться напрямую из приложения. Т.е. мутации — некая утилитарная штука внутри хранилища, которая полезна разве что для vuex-дебаггера. Общение приложения с хранилищем происходит через исключительно действия. В моем приложении любое действие, даже синхронное, всегда возвращает промис. Мне кажется, что заведомо считать все действия асинхронными (и работать с ними как с промисами) проще, чем помнить что есть что.

5. Ограничение реактивности

Иногда бывает, что данные в хранилище не меняются. Например, это могут быть результаты поиска объектов на карте, запрошенные из внешнего api. Каждый результат — это сложный объект с множеством полей и методов. Нужно выводить список результатов. Нужна реактивность списка. Но данные внутри самих объектов постоянны, и незачем отслеживать изменение каждого свойства. Чтобы ограничить реактивность, можно использовать Object.freeze.

Но я предпочитаю более тупой метод: пусть state хранит только список id-шников, а сами результаты лежат рядом в массиве. Типа:

const results = {};

const state = {resultIds:[]};

const getters = {

results: function(state) {

return _.map(state.resultsIds,id => results[id]);

}

}

const mutations = {

updateResults: function(state,data) {

const new = {};

const newIds = [];

data.forEach(r => {

new[r.id] = r;

newIds.push(r.id);

});

results = new;

state.resultsIds = newIds;

}

}

Вопросы

Кое-что у меня получилось не настолько красиво, как хотелось. Вот мои вопросы к сообществу:

— Как победить css анимации сложнее изменения opacity? Часто хочется анимировать появление какого-то блока неизвестных размеров, т.е. изменить его высоту с height: 0 до height: auto.

Это легко решается с javascript — просто оборачиваем в контейнер с overflow: hidden, смотрим высоту обернутого элемента и анимируем высоту контейнера. Это можно решить через css?

— Ищу нормальный способ работы с иконками в webpack, пока безуспешно (поэтому продолжаю пользоваться fontello). Нравятся иконки whhg. Вытащил svg, разбил на файлы. Хочу выбрать несколько файлов и автоматически собирать в inline шрифт + классы на основе названий файлов. Чем это можно делать?

|

Метки: author Kasheftin разработка веб-сайтов javascript vue.js vuex normalizr |

Обработка многократно возникающих SIGSEGV-подобных ошибок |

Тема изъезжена и уже не мало копий было сломано из-за неё. Так или иначе люди продолжают задаваться вопросом о том может ли приложение написанное на C/C++ не упасть после разыменования нулевого указателя, например. Краткий ответ — да, даже на Хабре есть статьи на сей счёт.

Одним из наиболее частых ответов на данный вопрос является фраза "А зачем? Такого просто не должно случаться!". Истинные причины того почему люди продолжают интересоваться данной тематикой могут быть разные, одной из них может быть лень. В случая когда лениво или дорого проверять всё и вся, а исключительные ситуации случаются крайне редко можно, не усложняя кода, завернуть потенциально падающие фрагменты кода в некий try/catch который позволит красиво свернуть приложение или даже восстановится и продолжить работу как ни в чём не бывало. Наиболее ненормальным как раз таки может показаться желание снова и снова ловить ошибки, обычно приводящие к падению приложения, обрабатывать их и продолжать работу.

Итак попробуем создать нечто позволяющее решать проблему обработки SIGSEGV-подобных ошибок. Решение должно быть по максимуму кроссплатформенным, работать на всех наиболее распространённых десктопных и мобильных платформах в однопоточных и многопоточных окружениях. Так же сделаем возможным существование вложенных try/catch секций. Обрабатывать будем следующие виды исключительных ситуаций: доступ к памяти по неправильным адресам, выполнение невалидных инструкций и деление на ноль. Апофеозом будет то, что произошедшие аппаратные исключения будут превращаться в обычные C++ исключения.

Наиболее часто для решения аналогичным поставленной задачам рекомендуется использовать POSIX сигналы на не Windows системах, а на Windows Structured Exception Handling (SEH). Поступим примерно следующим образом, но вместо SEH будем использовать Vectored Exception Handling (VEH), которые очень часто обделены вниманием. Вообще, со слов Microsoft, VEH является расширением SEH, т.е. чем-то более функциональным и современным. VEH чем-то схож c POSIX сигналами, для того чтобы начать ловить какие либо события обработчик надо зарегистрировать. Однако в отличии от сигналов для VEH можно регистрировать несколько обработчиков, которые будут вызываться по очереди до тех пор пока один из них не обработает возникшее событие.

В довесок к обработчикам сигналов возьмём на вооружение пару setjmp/longjmp, которые позволят нам возвращаться туда куда нам хочется после возникновения аварийной ситуации и каким-либо способом обрабатывать эту самую исключительную ситуацию. Так же, чтобы наша поделка работала в многопоточных средах нам понадобится старый добрый thread local storage (TLS), который также доступен во всех интересующих нас средах.

Самое простое, что необходимо сделать чтобы просто не упасть в случае аварийной ситуации — это написать свой обработчик и зарегистрировать его. В большинстве случаев людям достаточно просто собрать необходимое количество информации и красиво свернуть приложение. Так или иначе обработчик сигналов регистрируется всем известным способом. Для POSIX-совместимых систем это выглядит следующим образом:

stack_t ss;

ss.ss_sp = exception_handler_stack;

ss.ss_flags = 0;

ss.ss_size = SIGSTKSZ;

sigaltstack(&ss, 0);

struct sigaction sa;

sigemptyset(&sa.sa_mask);

sa.sa_flags = SA_ONSTACK;

sa.sa_handler = signalHandler;

for (int signum : handled_signals)

sigaction(signum, &sa, &prev_handlers[signum - MIN_SIGNUM]);Выше приведённый фрагмент кода регистрирует обработчик для следующий сигналов: SIGBUS, SIGFPE, SIGILL, SIGSEGV. Помимо этого с помощью вызова sigaltstack указываться, что обработчик сигнала должен запускаться на альтернативном, своём собственном, стеке. Это позволяет выживать приложению даже в условиях stack overflow, который легко может возникнуть в случае бесконечно рекурсии. Если не задать альтернативный стек, то подобного рода ошибки не возможно будет обработать, приложение будет просто падать, т.к. для вызова и выполнения обработчика просто не будет стека и с этим ничего нельзя будет сделать. Так же сохраняются указатели на ранее зарегистрированные обработчики, что позволит их вызывать, если наш обработчик поймёт, что делать ему нечего.

Для Windows код намного короче:

exception_handler_handle = AddVectoredExceptionHandler(1, vectoredExceptionHandler);Обработчик один, он ловит сразу все события (не только аппаратные исключения надо сказать) и нет никакой возможности что-либо сделать со стеком как в Linux, например. Единица, подаваемая первым аргументом в функцию AddVectoredExceptionHandler, говорит о том, что наш обработчик должен вызываться первым, перед любыми другими уже имеющимися. Это даёт нам шанс быть первыми и предпринять необходимые нам действия.

Сам обработчик для POSIX систем выглядит следующим образом:

static void signalHandler(int signum)

{

if (execution_context) {

sigset_t signals;

sigemptyset(&signals);

sigaddset(&signals, signum);

sigprocmask(SIG_UNBLOCK, &signals, NULL);

reinterpret_cast(static_cast(execution_context))->exception_type = signum;

longjmp(execution_context->environment, 0);

}

else if (prev_handlers[signum - MIN_SIGNUM].sa_handler) {

prev_handlers[signum - MIN_SIGNUM].sa_handler(signum);

}

else {

signal(signum, SIG_DFL);

raise(signum);

}

} Надо сказать, что для того чтобы наш обработчик сигналов стал многоразовым, т.е. мог вызываться снова и снова в случае возникновения новых ошибок, мы должны при каждом заходе разблокировать сработавший сигал. Это необходимо в тех случаях, когда обработчик знает, что исключительная ситуация возникла в участке кода, который завёрнут в некие try/catch о которых речь пойдёт позже. Если же аварийная ситуация сложилась там где мы её совсем не ожидали, дела будут переданы ранее зарегистрированному обработчику сигналов, если такового нет, то вызывается обработчик по умолчанию, который завершит терпящее аварию приложение.

Обработчик для Windows выглядит следующим образом:

static LONG WINAPI vectoredExceptionHandler(struct _EXCEPTION_POINTERS *_exception_info)

{

if (!execution_context ||

_exception_info->ExceptionRecord->ExceptionCode == DBG_PRINTEXCEPTION_C ||

_exception_info->ExceptionRecord->ExceptionCode == 0xE06D7363L /* C++ exception */

)

return EXCEPTION_CONTINUE_SEARCH;

reinterpret_cast(static_cast(execution_context))->dirty = true;

reinterpret_cast(static_cast(execution_context))->exception_type = _exception_info->ExceptionRecord->ExceptionCode;

longjmp(execution_context->environment, 0);

} Как уже упоминалось выше VEH обработчик на Windows ловит много чего ещё помимо аппаратных исключений. Например при вызове OutputDebugString возникает исключение с кодом DBG_PRINTEXCEPTION_C. Подобные события мы обрабатывать не будем и просто вернём EXCEPTION_CONTINUE_SEARCH, что приведёт к тому что ОС пойдёт искать следующий обработчик, который обработает данное событие. Также мы не хотим обрабатывать C++ исключения, которым соответствует магический код 0xE06D7363L не имеющий нормального имени.

Как на POSIX-совместимых системах так и на Windows в конце обработчика вызывается longjmp, который позволяет нам вернуться вверх по стеку, до самого начала секции try и обойти её попав в ветку catch, в которой можно будет сделать все необходимые для восстановления работы действия и продолжить работу так как будто ничего страшного не произошло.

Для того, чтобы обычный C++ try начал ловить не свойственные ему исключительные ситуации необходимо в самое начало поместить небольшой макрос HW_TO_SW_CONVERTER:

#define HW_TO_SW_CONVERTER_UNIQUE_NAME(NAME, LINE) NAME ## LINE

#define HW_TO_SW_CONVERTER_INTERNAL(NAME, LINE) ExecutionContext HW_TO_SW_CONVERTER_UNIQUE_NAME(NAME, LINE); if (setjmp(HW_TO_SW_CONVERTER_UNIQUE_NAME(NAME, LINE).environment)) throw HwException(HW_TO_SW_CONVERTER_UNIQUE_NAME(NAME, LINE))

#define HW_TO_SW_CONVERTER() HW_TO_SW_CONVERTER_INTERNAL(execution_context, __LINE__)Выглядит довольно кудряво, но по факту здесь делается очень простая вещь:

- Вызывается

setjmp, который позволяет нам запомнить место где мы начали и куда нам надо вернуться в случае аварии. - Если по пути выполнения случилось аппаратное исключение, то

setjmpвернёт не нулевое значение, после того как где-то по пути был вызванlongjmp. Это приведёт к тому, что будет брошено C++ исключение типа HwException, которое будет содержать информацию о том какого вида ошибка случилась. Брошенное исключение без проблем ловится стандартнымcatch.

Упрощённо приведённый выше макрос разворачивается в следующий псевдокод:

if (setjmp(environment))

throw HwException();У подхода setjmp/longjmp есть один существенный недостаток. В случае обычных C++ исключений, происходит размотка стека при которой вызываются деструкторы всех созданных по пути объектов. В случае же с longjmp мы сразу прыгаем в исходную позицию, никакой размотки стека не происходит. Это накладывает соответствующие ограничения на код, который находится внутри таких секций try, там нельзя выделять какие-либо ресурсы ибо есть риск их навсегда потерять, что приведёт к утечкам.

Ещё одним ограничением является то, что setjmp нельзя использовать в функциях/методах объявленных как inline. Это ограничение самого setjmp. В лучшем случае компилятор просто откажется собирать подобный код, в худшем он его соберёт, но полученный бинарный файл будет просто аварийно завершать свою работу.

Самым ненормальным действием, которое приходится принимать после обработки аппаратного исключения на Windows является необходимость вызова RemoveVectoredExceptionHandler. Если этого не сделать, то после каждого входа в наш обработчик VEH и выполнения longjmp там будет складываться ситуация как-будто наш обработчик был зарегистрирован ещё один раз. Это приводит к тому, что при каждой последующей аварийной ситуации обработчик будет вызываться всё больше и больше раз подряд, что будет приводить к плачевным последствиям. Данное решение было найдено исключительно путём многочисленных магических экспериментов и нигде никак не документировано.

Для того, чтобы решение работало в многопоточных окружениях необходимо чтобы каждый поток имел собственное место где можно сохранять контекст исполнения с помощью setjmp. Для этих целей и используется TLS, в использовании которого нет ничего хитрого.

Сам контекст исполнения оформлен в виде простого класса имеющего следующие конструктор и деструктор:

ExecutionContext::ExecutionContext() : prev_context(execution_context)

{

#if defined(PLATFORM_OS_WINDOWS)

dirty = false;

#endif

execution_context = this;

}

ExecutionContext::~ExecutionContext()

{

#if defined(PLATFORM_OS_WINDOWS)

if (execution_context->dirty)

RemoveVectoredExceptionHandler(exception_handler_handle);

#endif

execution_context = execution_context->prev_context;

}Данный класс имеет поле prev_context, которое даёт нам возможность создавать цепочки из вложенных секций try/catch.

Полный листинг описанного выше изделия доступен в GitHub'е:

https://github.com/kutelev/hwtrycatch

В доказательство того, что всё работает как описано имеется автоматическая сборка и тесты под платформы Windows, Linux, Mac OS X и Android:

https://ci.appveyor.com/project/kutelev/hwtrycatch

https://travis-ci.org/kutelev/hwtrycatch

Под iOS это тоже работает, но за неимением устройства для тестирования нет и автоматических тестов.

В заключение скажем, что подобный подход можно использовать и в обычном C. Надо лишь написать несколько макросов, которые будут имитировать работу try/catch из C++.

Так же стоит сказать, что использование описанных методов в большинстве случаев является очень плохой идеей, особенно, если учесть, что на уровне сигналов нельзя выяснить, что же привело к возникновению SIGSEGV или SIGBUS. Это равновероятно может быть как и чтение по неправильным адресам так и запись. Если же чтение по произвольным адресам является операцией не деструктивной, то запись может приводить к плачевным результатам таким как разрушением стека, кучи или даже самого кода.

|

Метки: author kutelev ненормальное программирование c++ sigsegv segmentation fault access violation signal seh veh setjmp longjmp |

Выбор алгоритма вычисления квантилей для распределённой системы |

Всем привет!

Меня зовут Александр, я руковожу отделом Data Team в Badoo. Сегодня я расскажу вам о том, как мы выбирали оптимальный алгоритм для вычисления квантилей в нашей распределённой системе обработки событий.

Ранее мы рассказывали о том, как устроена наша система обработки событий UDS (Unified Data Stream). Вкратце – у нас есть поток гетерогенных событий, на котором нужно в скользящем окне проводить агрегацию данных в различных разрезах. Каждый тип события характеризуется своим набором агрегатных функций и измерений.

В ходе развития системы нам потребовалось внедрить поддержку агрегатной функции для квантилей. Более подробно о том, что такое перцентили и почему они лучше представляют поведение метрики, чем min/avg/max, вы можете узнать из нашего поста про использование Pinba в Badoo. Вероятно, мы могли бы взять ту же имплементацию, что используется в Pinba, но стоит принять во внимание следующие особенности UDS:

- Вычисления «размазаны» по Hadoop-кластеру.

- Дизайн системы подразумевает группировку по произвольному набору атрибутов. Это означает, что количество метрик вида «перцентиль» исчисляется миллионами.

- Поскольку вычисления производятся с использованием Map/Reduce, то все промежуточные вычисления агрегатных функций должны обладать свойством аддитивности (мы должны иметь возможность «сливать» их с разных нод, производящих вычисления независимо).

- Pinba и UDS имеют различные языки имплементации – C и Java соответственно.

Критерии оценки

Исходя из этих архитектурных особенностей, мы выдвинули ряд параметров, по которым будем оценивать алгоритмы расчёта квантилей:

Точность вычисления

Мы решили, что нас устроит точность вычислений вплоть до 1,5%.

Время выполнения

Нам важно минимизировать период времени от возникновения события до визуализации его квантилей на графиках. Этот фактор складывается из трёх других:

- время «математики» (стадия Map) – накладные расходы на инициализацию структур данных и добавление данных в них;

- время сериализации – для того чтобы произвести слияние двух структур данных, они должны быть сериализованы и переданы по сети.

- время слияния (стадия Reduce) – накладные расходы на слияние двух структур данных, вычисленных независимо.

Объём памяти

В нашей системе обрабатываются миллионы метрик, и нам важно следить за разумным использованием вычислительных ресурсов. Под памятью мы подразумеваем следующее:

- RAM – объём, занимаемый структурами данных для квантилей.

- Shuffle – так как расчёт производится с использованием Map/Reduce, то неизбежен обмен промежуточными результатами между нодами. Для того, чтобы это было возможно, структура данных должна быть сериализована и записана на диск/в сеть.

Также мы выдвигаем следующие условия:

Типы данных

Алгоритм должен поддерживать вычисления для неотрицательных величин, представленных типом double.

Язык программирования

Должна присутствовать имплементация на Java без использования JNI.

Участники исследования

Naive

Чтобы иметь некий референс для сравнения, мы написали реализацию «в лоб», которая хранит все входящие значения в double[]. При необходимости вычисления квантиля массив сортируется, вычисляется ячейка, соответствующая квантилю, и берётся её значение. Слияние двух промежуточных результатов происходит путём конкатенации двух массивов.

Twitter Algebird

Это решение было найдено нами в ходе рассмотрения алгоритмов, заточенных под Spark (используется в основе UDS). Библиотека Twitter Algebird предназначена для расширения алгебраических операций, доступных в языке Scala. Она содержит ряд широко используемых функций ApproximateDistinct, CountMinSketch и, помимо всего прочего, реализацию перцентилей на основании алгоритма Q-Digest. Математическое обоснование алгоритма вы можете найти здесь. Вкратце структура представляет собой бинарное дерево, в котором каждый узел хранит некоторые дополнительные атрибуты.

Ted Dunning T-Digest

Библиотека представляет собой улучшение вышеупомянутого алгоритма Q-Digest с заявленным меньшим потреблением памяти, улучшенной производительностью и более высокой точностью.

Airlift Quantile Digest

На этот продукт мы наткнулись при реверс-инжиниринге распределённого SQL-движка Facebook Presto. Было несколько удивительно увидеть реализацию квантилей в REST-фреймворке, но высокая скорость работы и архитектура Presto (схожая с Map/Reduce) подтолкнули нас к тому, чтобы протестировать это решение. В качестве математического аппарата используется опять же Q-Digest.

High Dynamic Range (HDR) Histogram

Это решение являлось идейным вдохновителем реализации перцентилей в Pinba. Его отличительной особенностью является то, что при инициализации структуры необходимо знать верхний диапазон данных. Весь диапазон значений разбивается на N-ное количество ячеек, и при добавлении мы инкрементируем значение в какой-то из них.

Методика проведения теста

Качественная оценка

Каждое из рассматриваемых программных решений было обёрнуто некоторой прослойкой (моделью) (чтобы адаптировать его под фреймворк для тестирования). Перед проведением performance-тестов для каждой модели были написаны unit-тесты для проверки её достоверности. Эти тесты проверяют, что модель (её нижележащее программное решение) может выдавать квантили с заданной точностью (проверялись точности 1% и 0,5%).

Performance-тесты

Для каждой из моделей были написаны тесты с использованием JMH. Они были разделены на категории, про каждую из которых я расскажу подробно. Не буду «засорять» пост сырыми выводом от JMH – лучше сразу буду визуализировать в виде графиков.

Raw-тест

В этом тесте мы измеряем производительность структур данных на вставку, то есть производятся замеры времени, требуемого на инициализацию структуры и на заполнение её данными. Также мы рассмотрим, как изменяется это время в зависимости от точности и количества элементов. Измерения производились для последовательностей монотонно возрастающих чисел в диапазонах 10, 100, 1000, 10000, 100000, 1000000 при погрешности вычисления 0,5% и 1%. Вставка производилась пачкой (если структура поддерживает) или поэлементно.

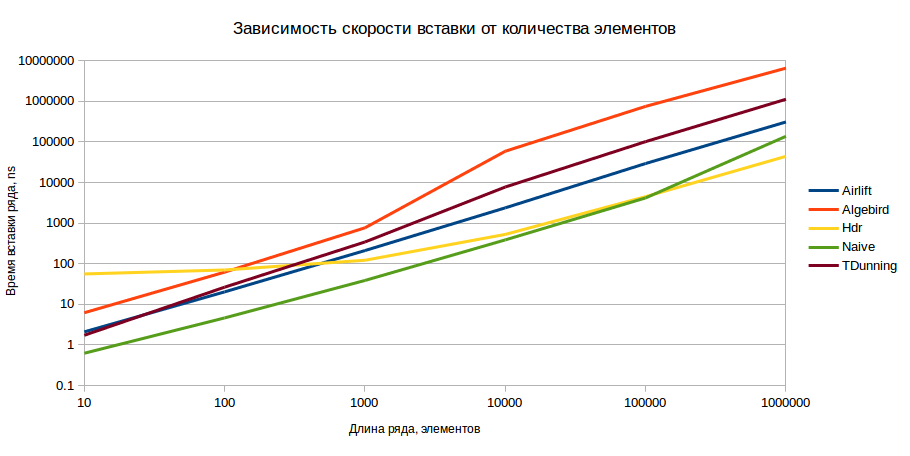

В результате мы получили следующую картину (шкала ординат логарифмическая, меньшие значения – лучше):

Результаты приведены для точности 1%, но для точности 0,5% картина принципиально не меняется. Невооружённым глазом видно, что с точки зрения вставки HDR является оптимальным вариантом при условии наличия более чем 1000 элементов в модели.

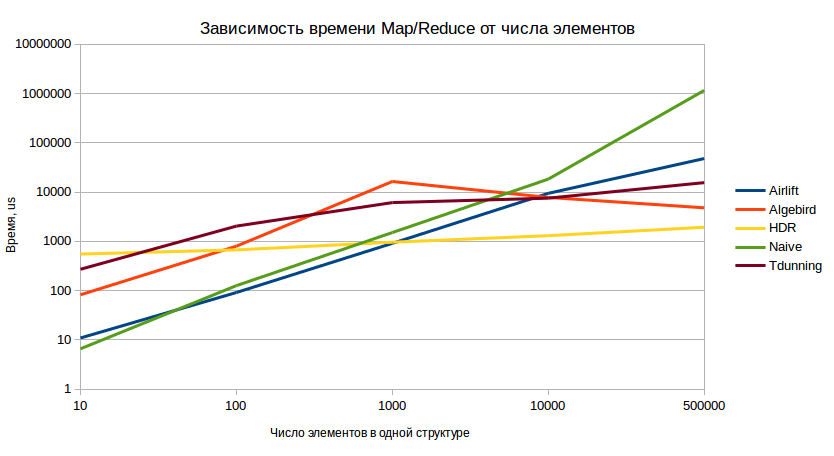

Volume test