Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

В сеть утекли исходные коды операционной системы Windows 10 [маленькая часть] |

По информации портала theregister.co.uk недавно произошла массивная утечка приватных билдов ОС Windows 10 и фрагментов ее исходных кодов.

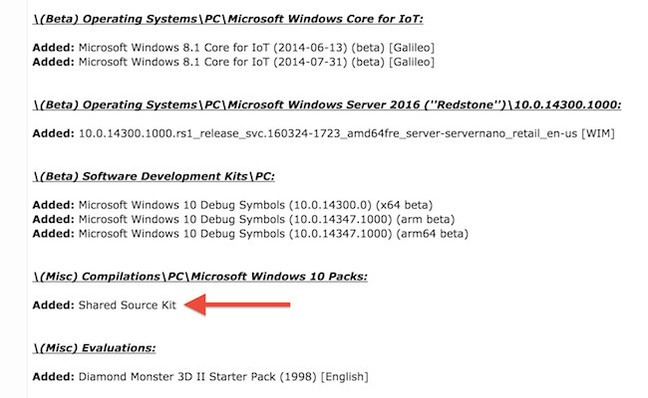

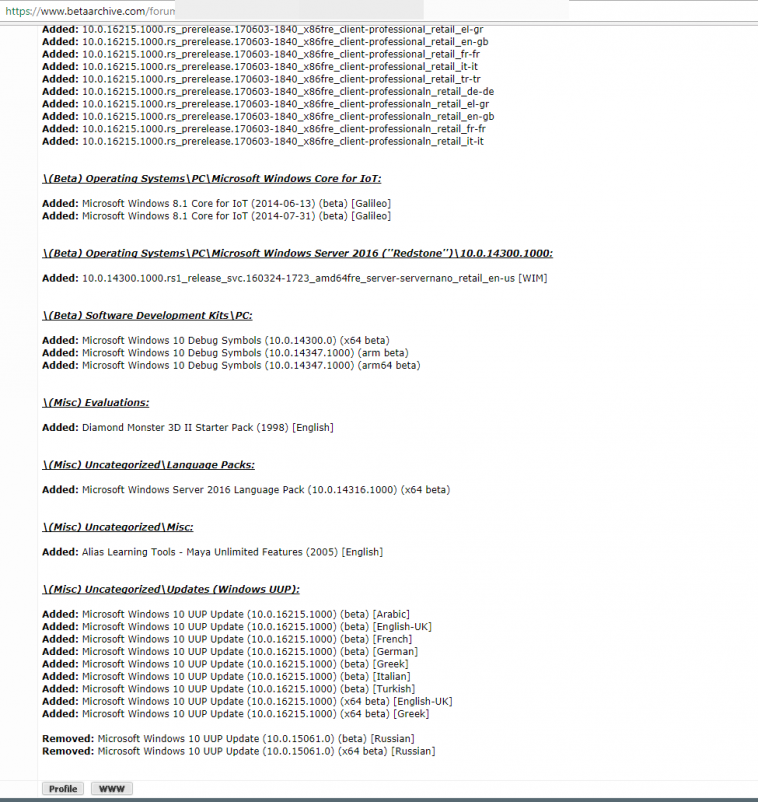

Массив из 32 терабайтов данных (в архивированном виде — 8 терабайт), состоящий из официальных и приватных образов, закрытой технической документации и исходных текстов, оказался загруженным на ресурс betaarchive.com

Предполагается, что конфиденциальные данные в этом дампе были нелегально скопированы из внутреннего хранилища Microsoft приблизительно в марте 2017 года.

По сообщениям людей, успевших ознакомиться с материалами внушительного архива, утекшие исходные коды в нем относятся к Microsoft's Shared Source Kit. Этот набор включает в себя исходники базовых драйверов Windows 10, стеков Wi-Fi,USB и PnP, драйверов систем хранения и ARM-версии ядра OneCore.

На данный момент имеются все предпосылки того, что инцидент окажется не менее значительным, чем в свое время утечка исходных кодов Windows 2000.

В довершение этого «праздника», в утекшем массиве среди вполне официальных билдов Windows 10 и Windows Server 2016 были обнаружены и секретные экземпляры, которые никогда не предназначались для публичного доступа, а использовались инженерами компании для поиска багов и экспериментального тестирования.

По мнению Криса Уильямса, редактора theregister, Internet ждет новая волна эксплоитов и вирусов, использующих ранее неизвестные уязвимости в коде новейших версий Windows.

Источник утечки и обстоятельства произошедшего пока не ясны. Представители компании Microsoft на момент публикации никак не про комментировали ситуацию.

|

Метки: author Jeditobe информационная безопасность windows 10 утечка информации |

Грех администратора или восстановление данных из стучащего HDD Western Digital WD5000AAKX |

рис. 1

Осознав, к чему привела халатность в повседневной работе, администратор попытался признать свою вину лишь в нерегулярности копирования за пределы сервера и скрыть недосмотр за массивами, сославшись на одновременный отказ двух накопителей.

Учитывая сложившиеся обстоятельства, один из руководителей компании весьма нелестно высказался о работе системного администратора и поручил последнему восстановить данные в кратчайшие сроки в весьма эмоциональной форме.

С этого момента началась цепочка событий, которая не лучшим образом отразилась на целостности пользовательских данных.

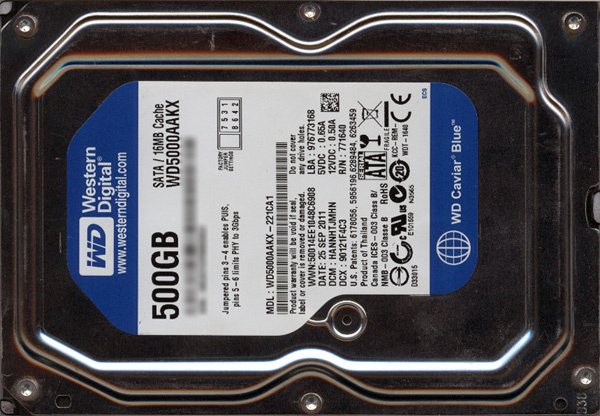

12 июня утром, сразу же после открытия, на пороге офиса нашей компании появляется человек, который сообщает, что ему срочно необходимо получить услугу бесплатной диагностики накопителя WD5000AAKX-221CA1, который подвешивает систему и не позволяет скопировать файлы. Накопитель без следов вскрытия.

Проводим стандартные диагностические мероприятия: визуальный осмотр, проверка цепей питания на печатной плате, сопротивления обмоток двигателя. Не обнаружив ничего крамольного, подключаем к порту PC3000 и подаем питание. Слышен нормальный звук раскрутки вала, прохождения калибровочного теста. По регистрам накопитель демонстрирует готовность к обмену данными. На запрос паспорта получаем от жесткого диска корректный ответ со всеми данными. Проверяем читабельность модулей микропрограммы и оцениваем их контрольные суммы. При анализе relo-list обнаруживаем, что он не пустой, что свидетельствует о том, что микропрограмма накопителя обнаружила некоторые проблемы на поверхности. Просматривая атрибуты SMART, замечаем, что 197 атрибут (текущее количество нестабильных секторов) весьма далек от нулевого значения, что подтверждает наличие проблем. Модифицируем в ОЗУ накопителя настройки: отключаем процедуры переназначения и добавления дефектов в relo-list, очищаем сам relo-list, запрещаем обновление журналов SMART. После такой модификации накопитель не будет выполнять процедуры оффлайн сканирования и обновлять журналы SMART. На этом этапе производим оценку качества чтения каждой из головок в зонах разной плотности записи. Тест подтверждает пригодность оригинального БМГ для вычитывания данных. Читаем 0 сектор.

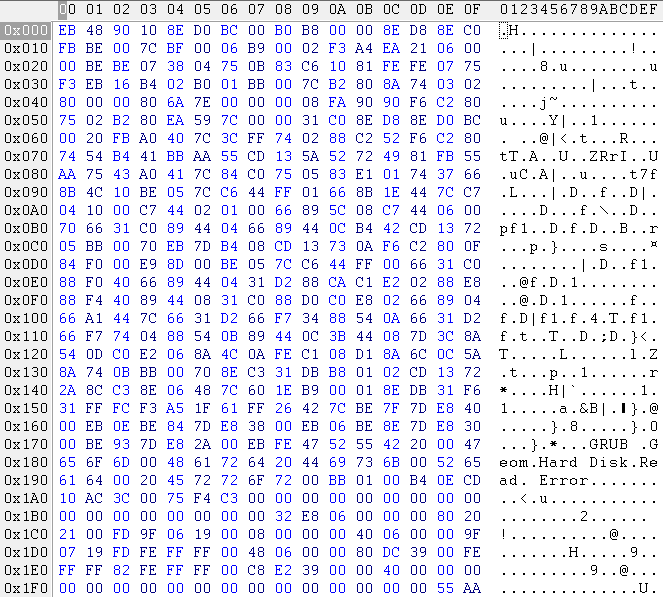

рис. 2

Обнаруживаем, что в нем содержатся записи для трех разделов.

По смещению 0x00000800 (2048) секторов располагается первый раздел Linux RAID (0xFD), размер раздела 0x00064000 (409 600) секторов.

По смещению 0x00064800 (411 648) секторов располагается второй раздел Linux RAID (0xFD), размер раздела 0x39DC8000 (970 752 000) секторов.

По смещению 0x39E2C800 (971 163 648) секторов располагается третий раздел linux swap (0x82), размер раздела 0x00400000 (4 194 304) секторов.

Анализ содержимого суперблоков первых двух разделов показывает, что они состояли в массивах RAID 1 и в каждом массиве содержит по одному разделу c Ext4. Выполнив попытку чтения метаданных файловой системы на большом разделе, обнаруживаем, что имеются затруднения в чтении.

На этом первичные диагностические мероприятия завершены, и их результат сообщается клиенту, также сообщается ценовая ниша услуги от 250 до 350 белорусских рублей и срок выполнения около 2-3 рабочих дней (исключительно в дневное время, так как накопитель требует постоянного наблюдения). Если необходимо выполнять работы во внеурочное время для сокращения сроков, то это возможно, но это прямо отразится на стоимости. План работ: модификация микрокода накопителя, локализация дефектных зон, чтение стабильных зон, анализ метаданных файловых систем на копии, вычитывание недостающих метаданных из проблемных зон, повторный анализ и построение цепочек нужных файлов для вычитывания из проблемных зон, при необходимости мероприятия по анализу регулярных выражений в областях, не занятых файлами, и возможные реконструкции поврежденной файловой системы.

Потенциальный клиент выразил свое неудовольствие по поводу ожидаемой стоимости услуг и сроков выполнения работ, а также слишком быстрой диагностики, аргументируя, что за менее, чем 15 минут невозможно сделать подобные выводы. Кроме этого, отметил, что данные принадлежат компании, а работы по восстановлению за его счет, поэтому он пока попробует сам. С этими словами клиент покинул офис.

14 июня в начале рабочего дня, данный клиент вновь пришел к нам и сообщил о том, что пытался многократно скопировать образ из накопителя используя dd. Поначалу винчестер периодически зависал, но после выключения и повторного включения снова виделся в системе и позволял продолжать копирование, но теперь накопитель пропал из системы, и выключение-включение более не помогает, а потом при очередной попытке включения из гермоблока стало доноситься какое-то жужжание.

Были проведены повторные стандартные диагностические мероприятия. На этапе пробного включения мы не услышали звука раскрутки вала, но услышали цикличные жужжащие звуки, которые данные накопители издают при безуспешных попытках старта двигателя. Учитывая, что заклинивание вала у данных накопителей случается весьма редко и как правило случается из-за серьезных деформаций корпуса, которых нет на этом накопителе, было выдвинуто предположение о залипании головок вне парковочной рампы.

Клиенту был озвучен дополнительный комплекс мероприятий, необходимый для восстановления данных, и то, что теперь сроки выполнения и стоимость возрастают из-за усугубления ситуации, на что он парировал, что залипание головок – это не великая проблема и что на youtube видел множество роликов, в которых показано, как поступать в подобных ситуациях, и это дело нескольких минут. Выслушать информацию, чем опасны подобные «методы», клиент отказался и покинул офис.

15 июня в середине рабочего дня снова появляется данный клиент (он же системный администратор), но уже не один, а в сопровождении своего прямого руководителя. Сходу была озвучена претензия, что после наших диагностик накопителю стало намного хуже, что он теперь стучит и не определяется в BIOS. На этом моменте останавливаем монолог системного администратора и говорим, что мы готовы принять письменную претензию и дать на нее ответ в установленный законом срок, но прежде, чем переходить к ведению диалога в подобном русле, давайте проведем визуальный осмотр накопителя при Вас и также сравним отличается ли его внешний вид от того, что был, а также при необходимости просмотрим видеозапись вчерашнего дня и установим было ли что-либо в наших действиях, что могло серьезным образом усугубить ситуацию. Системный администратор хотел было начать перечить, но в диалог вмешался его руководитель, который велел системному администратору выложить жесткий диск на стойку.

Сразу же обнаруживаем, что этикетка с крышки накопителя частично отклеивалась, также показываем, что момент затяжки винтов крышки разный, что явно показывает, что с накопителя снимали крышку. И предоставляем видеозапись вчерашнего дня, где на стойке видно, что наклейка на крышке накопителя не повреждена в тот момент, когда его забирал системный администратор, и отчетливо слышны его рассуждения про ролики на youtube.

Под напором фактов системный администратор перестал обвинять нас и признался в том, что разобрал накопитель и попытался вывести головки, но накопитель не заработал, а застучал. В попытке снять с себя груз ответственности сообщил руководству, что вскрытие производила наша компания, и что именно после этого накопитель стал стучать. После этого системный администратор и его руководитель вышли из офиса для беседы.

В офис вернулся уже лишь один руководитель, который попросил третий раз провести диагностические мероприятия с учетом вскрывшихся дополнительных осложнений, а также произвести диагностику второго диска из массива.

По результатам анализа второго накопителя установлено, что имеют место небольшие дефектообразования (именно из-за них накопитель был исключен из массива), и согласно метаданным файловой системы пользовательских данных после августа 2015 года нет. Таким образом вскрылся факт, что отказ дисков не был одновременным.

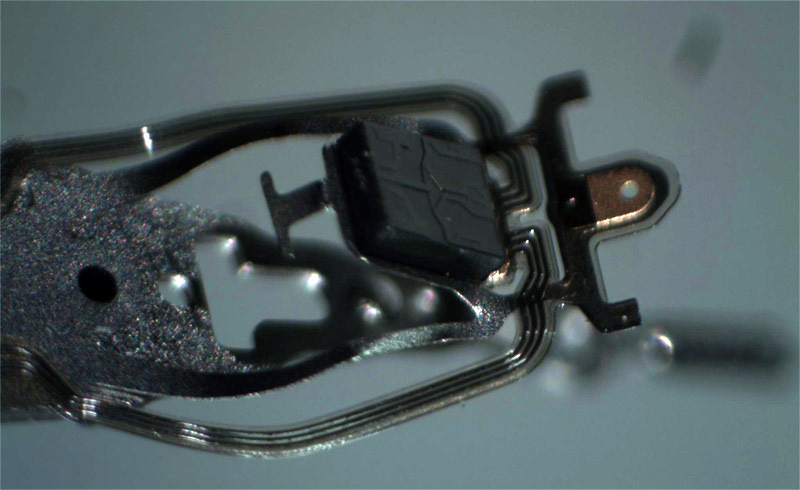

В условиях ламинарного бокса было произведено вскрытие накопителя. Повреждения БМГ были заметны визуально и даже не требовали снятия для осмотра под микроскопом. Но фотофиксация была сделана.

рис. 3

В данном БМГ обе подвески были деформированы подобным образом. Такие деформации обычно являются следствием неумелого вывода головок с поверхности на парковочную рампу. Попытки старта этого накопителя приводили к появлению дополнительных царапин на поверхности пластин. К счастью, попыток старта было немного, и окончательного убийства данных не состоялось, но характер царапин таков, что возможно перерождение в запилы.

Таким образом, вместо заурядной задачи с вычитыванием накопителя с дефектами, из-за особого усердия системного администратора имеем задачу, где необходимо выполнить пересадку БМГ и перспективы весьма туманны, так как имеются радиальные царапины в начале диска. Служебная зона данного накопителя находится в самом начале пластины т.е. в зоне с царапинами.

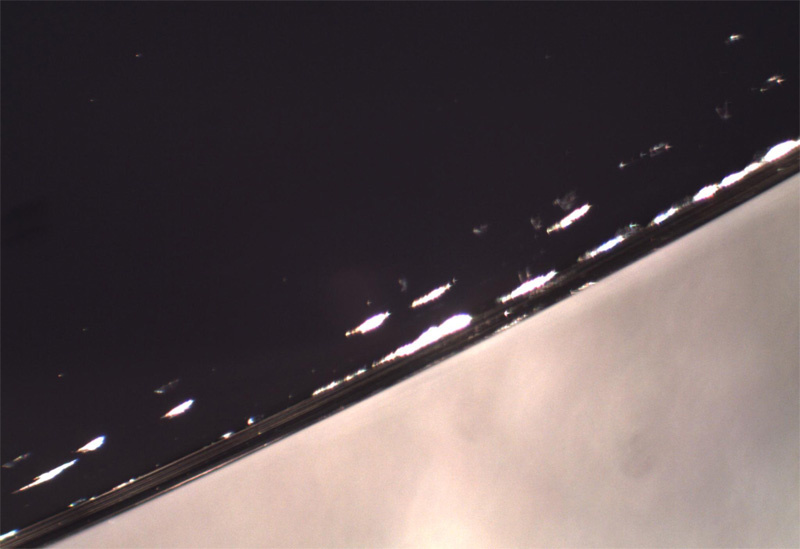

рис. 4

Обратим внимание, как изувечен край пластины оборванными слайдерами (зона повреждений примерно 0,1-0,3мм, из-за увеличения кусок окружности вырождается почти в прямую). Благо, что в этом месте при сходе с рампы у исправного БМГ слайдеры находятся еще достаточно высоко, поэтому эти самые сильные повреждения пластины угрозы не представляют.

Данная информация доводится до Заказчика, также информируем о том, что стоимость существенно выросла по причине возникновения необходимости пересадки БМГ от аналогичного донора (Tahoe LT), дополнительных работ по пересадке, а также велика вероятность, что вряд ли хватит одного донора при вычитывании проблемных зон, так как деградационные процессы будут прогрессировать. Заказчик без колебаний соглашается.

Приступая к работе, производим подбор нескольких комплектов БМГ от накопителей-доноров с учетом близости адаптивных параметров, чтобы получить максимально устойчивое чтение. Обеспыливаем гермоблок пациента и производим процедуры перестановки БМГ от накопителя донора с помощью специализированного инструмента.

рис. 5

Собрав накопитель, выполняем пробный старт. Слышен звук раскрутки вала, прохождение калибровочного теста. Какие-либо подозрительные звуки отсутствуют, по этой причине не прерываем процедуру инициализации и ожидаем порядка 40 секунд до появления готовности к обмену данными.

рис. 6

Запрашиваем паспорт накопителя и получаем пустышку, что свидетельствует о том, что накопитель не смог загрузить из служебной зоны все модули, которые необходимы для старта. Анализируем версию кода в ПЗУ накопителя и подбираем подходящий оверлей из нашей базы данных микропрограмм скопированных из накопителей. После загрузки его в память накопителя получили возможность полноценно читать и анализировать содержимое служебной зоны. По результатам проверки целостности служебной зоны нечитабельными оказались 0x11 (основной оверлей), 0x31 – транслятор, 0x32 – relo-list, 0x33 – P-list, 0x34 – G-list, 0x43 – адаптивные параметры, а также модули, ответственные за работу SMART.

Производим посекторную вычитку наиболее критичных модулей. P-list прочитался с небольшим количеством дефектов, расположение которых достаточно далеко от начала модуля. Аналогичная картина с модулем адаптивных параметров. Модули транслятора, G-list, relo-list оказались нечитабельными на 100%. Подобные повреждения модулей случаются при работе накопителя с не совсем исправными головками при попытке переписать модуль микропрограммой накопителя.

Для восстановления модуля транслятора записываем все необходимое, полученное из служебной зоны пациента, в накопитель-донор, в том числе и реконструированные 0x33 и 0x43. Выполнив пересчет транслятора с учетом P-list получим оригинальный 0x31 модуль за счет работы самой микропрограммы накопителя. Информация о скрытых дефектах в модуле 0x34 безвозвратно потеряна, поэтому создадим модуль пустышку без записей. Аналогичное действие выполним и с модулем 0x32.

Проверим возможность записи на пациенте, для этого пропишем неиспользуемые треки и попытаемся их считать. Тест записи прошел успешно, поэтому на пациент записываем восстановленные модули по 0 копии, а также корректируем информацию о регионах, чтобы активной была только копия по нулевой головке. Также вносим изменения в модуль настроек, чтобы при успешном старте не запускались процедуры оффлайн-сканирования и не работали процедуры SMART.

Производим рестарт накопителя, и в течение 10 секунд получаем информацию о готовности к обмену данных. По запросу паспорта получаем корректный ответ. Попытка чтения в пользовательской зоне выдает нам уже знакомую на первой диагностике таблицу разделов, что свидетельствует о том, что накопитель смог самостоятельно все загрузить с поверхности и инициализировать систему трансляции.

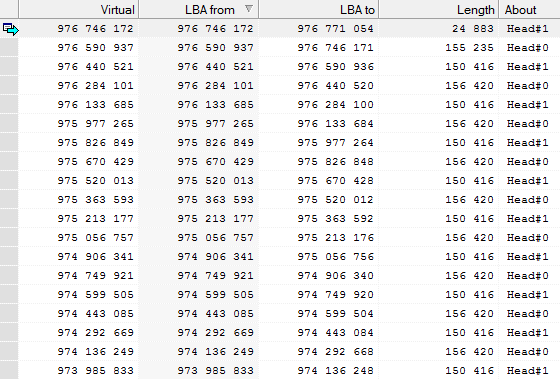

Создаем задачу посекторной копии на другой накопитель в Data Extractor и выполняем процедуру построения карты мини зон. Учитываем, что при обследовании обнаруживались царапины в начале пластины, основное чтение в UDMA режиме начнем с конечных зон.

рис. 7

Есть проблемы с чтением в границах swap раздела, но их мы игнорируем, так как раздел представляет весьма малую ценность. В границах основного второго радела чтение идет без нареканий до 57 89х ххх сектора, затем начинают появляться первые нестабильности.

Изменим чтение с UDMA режима на PIO для лучшего контроля процесса чтения и провизведем вычитку метаданных файловой системы (Ext4) второго раздела. Завершив этут операцию на 99,99% перейдем к чтению мини зон с коротким таймаутом и прыжком 10 000 секторов в случае нестабильности. Данная мера позволила нам дочитать более 85% от непрочитанного объема.

Далее переходим к анализу расположения файлов на втором разделе и строим очередь из цепочек, согласно приоритету данных в техническом задании Заказчика. Учитывая, что в исцарапанной части пластины присутствуют некоторые важные для Заказчика файлы, приступаем к многопроходному чтению в области основных дефектных зон.

При вычитке дефектных зон происходят деградации как слайдеров, так и поверхностей пластин поэтому важно исключить из чтения самые опасные участки, чтобы успеть прочитать максимум пользовательских данных с минимумом комплектов донорских головок.

В процессе проведения работ Заказчику пересылались отчеты о поврежденных файлах после каждой деградации донорского БМГ и согласовывалось использование каждого дополнительного донора. При использовании третьего динамика чтения была малозаметной, по этой причине было принято решение о прекращении дальнейших попыток получить оставшиеся данные из дефектных зон. Удалось получить более 95% всех файлов (и более 99,5% согласно основному техническому заданию). Данный результат удовлетворил Заказчика.

В заключение подведем итоги. Налицо халатное отношение системного администратора к своим обязанностям. Также бросается в глаза неуместная эмоциональность руководства, которая вредит рабочему процессу. Ведь именно из-за прессинга со стороны руководства системный администратор пытался минимизировать свои расходы и совершил множество необдуманных поступков, усугубивших состояние накопителя, чем поставил под угрозу окончательного уничтожения пользовательские данные, которые для компании представляли ценность во много раз больше, чем стоимость услуги восстановления данных. Хочется обратить внимание руководящего состава, что в подобных ситуациях срываться на эмоции – непозволительная роскошь. Куда более разумным решением будет анализ проблемы и оценка собственных возможностей для ее устранения и, если необходимо, поиска исполнителей. И лишь после решения основной проблемы разбираться в степени вины системного администратора и говорить о каких-либо взысканиях за нанесенный своим бездействием ущерб. Также руководству стоит разделить бремя вины со своим подчиненным, так как именно недоработка должностных инструкций или полное их отсутствие создало условия для развития подобной ситуации.

Предыдущая публикация: Неглубокое погружение или восстановление данных с жесткого диска после затопления офиса

|

|

Security Week 25: В *NIX реанимировали древнюю уязвимость, WannaCry оказался не доделан, ЦРУ прослушивает наши роутеры |

Земля, 2005 год. По всей планете происходят загадочные события: Nokia выводит на рынок планшет на Linux, в глубокой тайне идет разработка игры с участниками группы Metallica в главных ролях, Джобс объявил о переходе Маков на платформу Intel.

Земля, 2005 год. По всей планете происходят загадочные события: Nokia выводит на рынок планшет на Linux, в глубокой тайне идет разработка игры с участниками группы Metallica в главных ролях, Джобс объявил о переходе Маков на платформу Intel. Тем временем на конференции CancSecWest Гаэль Делалло из Beijaflore представил фундаментальный доклад об уязвимостях системы управления памятью в разнообразных NIX-ах, и проиллюстрировал свои находки эксплойтами для Apache. Все запатчились. Прошло несколько лет.

2010 год. Рафаль Войтчук продемонстрировал эксплуатацию уязвимости того же класса в сервере Xorg. В том же году Йон Оберайде опубликовал пару забавных сообщений о своих невинных играх с никсовым стеком ядра. Все снова запатчились.

2016 год. Гуглевский Project Zero разродился исследованием эксплуатации уязвимостей стека ядра под Ubuntu. Оберайде передает в комментах привет. Убунта запатчилась.

2017 год. Никогда такого не было, и вот опять. Qualys научилась мухлевать со стеком юзермода в любых никсах, согласно идеям Делалло.

Эксплойты стека юзермода основаны на простом вопросе – если динамическая область (heap) и стек будут расти навстречу друг другу, то что будет, когда они встретятся? Однако не надо думать, что ядра никсов разрабатывают дураки! Они, конечно же, подумали о таком развитии событий (ну, к нашему времени точно уже додумались). И во всех современных юниксоподобных операционках стек юзермода огорожен специальной страницей памяти, попытка доступа к которой вызывает исключение или завершение процесса.

Но вот что странно. Внезапно оказалось, что эту сторожевую страницу можно успешно обойти, для чего есть много способов. И об этом рассказывал еще Делалло в 2005 году. Все опять патчатся, весело и с песней.

Принцип эксплуатации этого бородатого бага основан на увеличении объема стека без записи в него. Это делается по-разному в разных ОС, например, с помощью рекурсивного вызова процедуры, или многомегабайтными аргументами командной строки. Указатель стека перемещается на его начало (нижний адрес), стек резко наращивается, и – хоп, – указатель стека оказывается уже за сторожевой страницей. Доступа к самой сторожевой странице не происходит, ошибки нет. Получается, что область стека перекрывается с динамической областью.

Это позволяет подменить в стеке адрес возврата из функции и таким образом запустить произвольный код с повышенными правами.

Qualys испытали эту методику лишь локально, но теоретически подобный трюк можно провернуть удаленно, ну или, как минимум, это будет полезно троянцам для повышения собственных привилегий. Исследователи видят два пути исправления этой уязвимости: фантастический и реалистический. Фантастический заключается в раздувании сторожевой страницы как минимум до 1 Мб, а лучше больше. А реалистический – это всего-то перекомпилировать весь код пространства пользователя с опцией -fsatack-check в GCC, после чего указатель стека уже не сможет перепрыгивать сторожевую страницу без записи в нее. А в FreeBSD еще стоит хотя бы включить эту самую сторожевую страницу – по умолчанию она там не задействуется.

Исследователь предположил преждевременные роды WannaCry

Роковой для многих троянец WannaCry то ли сделан кривыми руками, то ли вырвался на волю до того, как его доделали. Такую любопытную теорию высказал Джейк Вильямс из Rendition InfoSec, после глубокого анализа

Для начала, очень странным выглядит хардкодинг биткойн-адреса для выплаты выкупа. Мало того, что это позволило кому-то предприимчивому урвать себе малую толику, перебив в хекс-редакторе адрес, так еще и контролировать выплату становится невозможно – как справедливо подметил Вильямс, попробуй разберись, кому именно из жертв принадлежат падающие в кошелек транзакции. И еще, проследить дальнейшую судьбу денег с одного адреса не так уж сложно (миксеры не всегда спасают), то есть проблемы с выводом суммы обеспечены.

Гораздо практичнее генерить собственный адрес для каждого заражения, или хотя бы для нескольких заражений, это сразу сняло бы большинство проблем. Собственно, опытные рансомварщики так и делают. Но не авторы WannaCry. Всего в пойманных семплах насчитывается три варианта адреса, и вполне вероятно, что изначальным злоумышленникам принадлежит лишь один из них.

Туда же, в копилку ляпов – знаменитый «рубильник» WannaCry, домен, при обнаружении которого в Сети троянец прекращает работу. Само по себе это вполне общепринятая практика, но, помилуйте, что мешало сделать чуть более сложную проверку, чем код состояния 200? В случае многих других ботов обмен с сервером управления шифруется и троянец выключается только по команде.

С гипотезой, что вонакрай – детище криворуких «скрипт-киддис», не вяжется ряд признаков, указывающих на северокорейское происхождение этой эпидемии. Группа Lazarus, которую подозревают в связи с WannaCry, не давала повода обвинить ее в непрофессионализме. Поэтому Вильямс предложил другое объяснение. По его мнению, недоделанный WannaCry попросту случайно вырвался из тестовой среды и дальше пошел распространяться неконтролируемо.

Это чертовски похоже на правду, хотя не очень понятно, что помешало создателям вовремя дернуть за рубильник, зарегав стоп-домен, пока распространение троянца не успело принять характер эпидемии. И еще – забавно будет, если окажется, что захардкоденный биткойн-адрес представляет собой лишь плейсхолдер, и не соответствует никакому реальному кошельку. По крайней мере, списаний с известных кошельков WannaCry пока не было.

Это чертовски похоже на правду, хотя не очень понятно, что помешало создателям вовремя дернуть за рубильник, зарегав стоп-домен, пока распространение троянца не успело принять характер эпидемии. И еще – забавно будет, если окажется, что захардкоденный биткойн-адрес представляет собой лишь плейсхолдер, и не соответствует никакому реальному кошельку. По крайней мере, списаний с известных кошельков WannaCry пока не было.ЦРУ годами следит за нашими роутерами

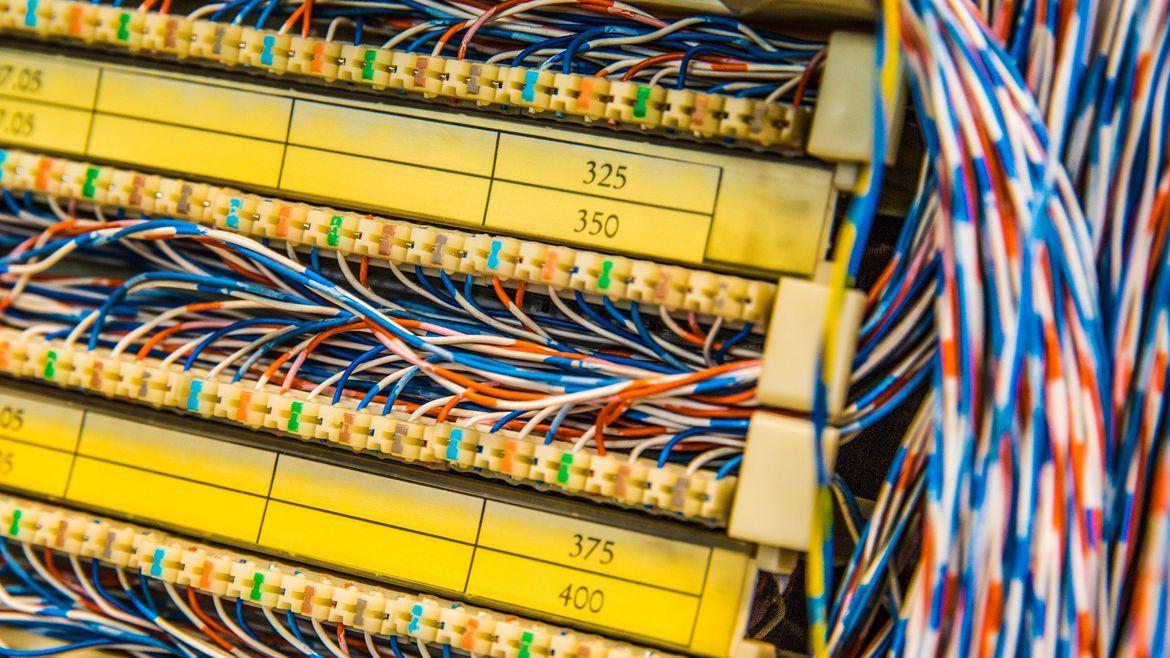

На Wikileaks опубликованы подробности программы ЦРУ по мониторингу трафика, проходящего через роутеры D-Link, Linksys, 3Com и Panet Tec. Поэтично названная Cherry Blossom, программа включает в себя создание особых прошивок, которые прошиваются на роутеры удаленно. Прошивка выглядит как настоящая, но только выдирает из трафика и передает на свой сервер имейл-адреса, имена, встречающиеся в чатах, MAC-адреса, номера VoIP. А в случае необходимости может даже перенаправлять трафик «куда надо».

Единственным более-менее сложным этапом операции выглядит внедрение прошивки на ничего не подозревающий роутер. Однако, что получается у Mirai, точно по плечу детищу ЦРУ – для роутеров агентство разработало эксплойты Tomato и Surfside. Работают они не везде, и для прочих случаев в документации рекомендовано внедрять прошивку оперативным путем. То есть внедриться в компанию-поставщика и втихаря прошить все роутеры на складе. Романтика шпионской работы, как она есть. Все-таки жив в ЦРУ дух старой школы!

Древности

«Justice»

Очень опасен, поражает COM-файлы при обращении к ним функциями DOS 43h, 4Bh, 3Dh, 56h. Записывается в конец файлов и изменяет 5 байт их начала (NOP; NOP; JMP Loc_Virus). COMMAND.COM заражается по алгоритму вируса «Lehigh». Периодически направляет записываемую на диск информацию в сектор с другим номером. Содержит текст «AND JUSTICE FOR ALL». Перехватывает int 13h и int 21h.

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 72.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw linux freebsd wannacry cherry blossom |

Результаты внедрения Zextras для SaaS провайдера |

Zimbra Open Source Edition — надежный почтовый сервер с высокопроизводительными функциями PIM/collaboration.

Zextras Suite — модульные расширения с помощью которых можно осуществлять резервное копирование в реальном времени, управлять томами, настроить мобильную синхронизацию, мгновенный обмен сообщениями и административное делегирование.

Внедрение Zimbra и Zextras проходило в несколько этапов:

- формирование плана модернизации (резервная копия данных, новая конфигурация хранения);

- установка программного обеспечения;

- создание backup storage, new life storage configuration.

Мы хотим показать, что в итоге у нас получилось после реализации всех этапов внедрения.

Дизайн Инфраструктуры: Платформа

Для улучшения производительности партнер установил мультисервер Zimbra Collaboration из 15 серверов. Все они размещены в Amazon's EC2:

Mailbox

- 1 Mailboxd + Master LDAP

- 4 Mailboxd

Proxy

- 2 Proxy + LDAP Replica + MTA (специализированный)

MTA

- 3 Inbound MTA + AS/AV

- 4 Outbound MTA

- 1 Outbound MTA (“на домене” для пакетной отправки)

Использование Storage

Благодаря сжатию и дедупликации Zextras Backup и Zextras Powerstore, возможна экстремальная оптимизация томов. Общая «пользовательская» квота maiboxes составляла 15.5TB, в то время как фактический общий размер основных объемов составляет 1.8 TB, а фактический общий размер вторичных составляет 9 TB. Это означает сохранение 30% дискового пространства. Вторичные объемы содержат электронные письма, которые хранятся более 90 дней, и сохранены как данные по блокам Amazon S3 с огромной экономией затрат на хранение. Backup занимает в общей сложности 9TB, с сохранением 32 дня после удаления (сохранение нелинейного роста – так в этом конкретном случае его можно было увеличить до 90 дней, даже не удваивая резервный размер).

Дизайн инфраструктуры: Storage

Данные хранятся на дисках Amazon EBS. Amazon EBS позволяет создавать тома хранилища и подключать их к инстансам Amazon EC2. После подключения томов на них можно создавать файловую систему, запускать базы данных или использовать любым другим образом. Тома Amazon EBS расположены в конкретных зонах доступности, внутри которых они автоматически реплицируются, чтобы защитить информацию от сбоя отдельных элементов оборудования. Все типы томов EBS обладают одинаково надежными возможностями создания снимков состояния и обеспечивают доступность на уровне 99,999 %.

Управляется storage через Zimbra Store и Zextras Powerstore, которые обеспечивают и разделение на уровни хранения, и совместимость EC2 блоков Amazon EC2. Модуль Zextras Powerstore позволяет управлять несколькими томами и HSM-политиками через Zimlet управления Zextras, полностью интегрированный в Панель управления Zimbra, что дает эффективное управление хранением.

- Первичный объем на локальных драйверах (GP2 General Purpouse SSD — Amazon EBS)

- Вторичный объем на блоках Amazon S3

- Backup на локальных драйверах (GP2 General Purpouse SSD – Amazon EBS)

- Компрессия: Первичная: НЕТ| Вторичная: Auto | Backup: Да

- Дедупликация: Первичная: Периодическая| Вторичная: Auto | Backup: Да

Детальная информация по использованию Storage:

Mailbox 1

Итоговая квота: 4.3 TB

Первичный объем: 367 GB

Backup: 2.7TB (~38% compression)

Mailbox 2

- Итоговая квота: 4.1 TB

- Первичный объем: 371 GB

- Backup: 2.5TB (~40% компрессии)

Mailbox 3

- Итоговая квота: 4.4TB

- Первичный объем: 268GB

- Backup: 2.4TB (~46% компрессия)

Mailbox 4

- Итоговая квота: 1.9 TB

- Первичный объем: 349 GB

- Backup: 1.1TB (~43% компрессии)

Mailbox5

- Итоговая квота: 775 GB

- Первичный объем: 419 GB

- Backup: 379GB (~52% компрессии)

Итоговая квота: 15.5 TB

Итоговый первичный объем: 1.8 TB

Итоговый размер S3 блок: 9 TB

Итоговый размер backup volumes: 9 TB

Клиенты SaaS провайдера также часто требуют, чтобы их IT-специалисты имели права для настройки их домена. Это было реализовано при помощи административного делегирования зимлета Zextras Admin. Этот же модуль позволяет определять пределы для домена на основании контракта с партнером и легко просматривать действия делегированных администраторов в рамках европейского законодательства.

Итого

Затраты SaaS провайдера уменьшились на порядок. Zimbra Open Source Edition + Zextras Suite уменьшили занимаемое место на серверах компании. У пользователей появилась возможность использовать мультиаренду программного обеспечения.

|

Метки: author KaterinaZextras хранение данных резервное копирование it- инфраструктура блог компании zimbra zimbra zextras open-source saas |

Как держать 20 тысяч VPN клиентов на серверах за $5 |

|

Метки: author zhovner сетевые технологии ipv6 openvpn блокировки сайтов украина vpn bgp dns |

CocoaHeads Russia. Прямая трансляция |

Привет, хабраюзеры!

Сегодня (23 июня 2017) в офисе Туту.ру пройдет очередной митап iOS разработчиков. Мы организуем прямую трансляцию митапа. Если вы не смогли к нам попасть, то у вас есть шанс увидеть все online.

Программа

- 19:10 Открытие

- 19:15 Анимация как средство самовыражения.

Александр Зимин - 20:00 Перерыв

- 20:25 Team Lead. Структурирование мыслей.

Николай Ашанин - 21:00 Перерыв

- 21:15 Викторина

- 21:35 Реактивный VIPER.

Дмитрий Котенко - 22:00 Автепати (трансляция в личные соцсеточки)

Ссылка на трансляцию

Будет доступна за 5 минут до открытия

|

Метки: author 0xy разработка под ios objective c cocoa блог компании туту.ру митап ios tuturu tutu туту тутуру |

Борьба со спамом на хостинге. Настройка EFA Project Free Spam/antivirus filter |

В этой статье, как и обещали, хотим поделиться нашим опытом борьбы со спамом. Известно, что у любой причины есть следствие. Эта фраза выражает одну из философских форм связи явлений.

Нашей причиной стали многократные жалобы на спам, исходящий от наших клиентов хостинга и VPS. Не всегда можно с уверенностью сказать, были ли это умышленные действия клиентов или они сами не подозревали, что стали жертвой спам-ботов. Что бы там ни было, проблему пришлось решать.

Спам не любят. Спам оставляет «чёрное пятно» на лице провайдера, когда его IP адреса вносят в блеклисты, от чего страдают все клиенты. Удалить IP из блеклистов — особый разговор. Но это одна сторона медали. Если вернуть репутацию IP адресу можно, то вернуть репутацию компании и доверие — намного сложнее.

Мы решили найти решение и внедрить в структуру Unihost комплекс по защите и предотвращению нежелательных рассылок. После мозговых штурмов и обсуждений, начали проверять и сравнивать, что может предложить сообщество SPAM/AV.

Вариантов на рынке много. Однако, большинство качественных решений платные с тарификацией 1 лицензия на 1 сервер или даже на количество исходящих/входящих писем, что привело бы к удорожанию тарифов. Поэтому выбирали только среди opensource.

Популярные opensource-решения против спама

Rspamd

Он подходит для систем различного масштаба. Умеет интегрироваться в различные MTA (в документации описаны Exim, Postfix, Sendmail и Haraka) или работать в режиме SMTP-прокси.

Система оценки сообщений такая же, как в SpamAssassin, в частности на основании разных факторов: регулярных выражений, блок-листов DNS, белых, серых, черных списков, SPF, DKIM, статистики, хешей (fuzzy hashes) и прочего — только в работе используются другие алгоритмы.

В Rspamd поддерживается расширение при помощи плагинов.

Apache SpamAssassin

Известность SA получил благодаря использованию технологии байесовской фильтрации. Каждое сообщение при прохождении тестов получает определенный балл и при достижении порога помещается в спам.

Легко интегрируется практически с любым почтовым сервисом. В SA доступны популярные технологии, которые подключаются как плагины: DNSBL, SPF, DKIM, URIBL, SURBL, PSBL, Razor, RelayCountry, автоматическое ведение белого списка (AWL) и другие.

Установка в общем не сложна. После установки SpamAssassin требует тонкой настройки параметров и обучения на спам-письмах.

ASSP

Платформно-зависимый SMTP-прокси-сервер, принимающий сообщения до MTA и анализирующий его на спам.

Поддерживаются все популярные технологии: белые и серые списки, байесовский фильтр, DNSBL, DNSWL, URIBL, SPF, DKIM, SRS, проверка на вирусы (с ClamAV), блокировка или замена вложений и многое другое. Обнаруживается кодированный MIME-спам и картинки (при помощи Tesseract). Возможности расширяются при помощи модулей.

Документация проекта не всегда внятная, а инструкции нередко уже устаревшие, но при наличии некоторого опыта разобраться можно.

MailScanner

MailScanner представляет собой решение «все включено» для борьбы с фишинговыми письмами и проверки почты на наличие вирусов и спама. Он анализирует содержание письма, блокируя атаки, направленные на email-клиентов и HTML-теги, проверяет вложения (запрещенные расширения, двойные расширения, зашифрованные архивы и прочее), контролирует подмену адреса в письме и многое другое.

MailScanner легко интегрируется с любым МТА, в поставке есть готовые конфигурационные файлы. Помимо собственных наработок, он может использовать сторонние решения. Для проверки на спам может использоваться SpamAssassin.

EFA-project

Есть еще один Open Source проект — «eFa-project» — Email Filter Appliance. EFA изначально разработан как виртуальное устройство для работы на Vmware или HyperV. Программа использует готовые пакеты MailScanner, Postfix, SpamAssasin (весь список ниже) для остановки спама и вирусов и они уже установлены и настроены для правильной работы в vm. Это значит, что костыли не нужны — все работает «из коробки».

В EFA входят такие компоненты:

В качестве MTA (mail transfer agent) выступает Postfix — надежный, быстрый, проверенный годами;

Ядро спам фильтра — MailScanner — плечом к плечу с антивирусом принимают на себя весь удар;

Спам фильтр — SpamAssassin — определяет письма-спам. В основу включено множество оценочных систем, MTA и наборы регулярных выражений;

ClamAV — антивирус, который работает с MailScanner;

MailWatch — удобный веб-интерфейс для работы с MailScanner и другими приложениями;

Фильтр контента — DCC — определяет массовую рассылку через отправку хеш-сумм тела писем на специальный сервер, который в свою очередь предоставляет ответ в виде числа полученных хешей. Если число превышает порог score=6, письмо считается спамом;

Pyzor и Razor — помогают SpamAssassin точнее распознавать спам, используя сети по обнаружению спама;

Для grey-листинга используется SQLgrey — служба политики postfix, позволяющая снизить количество спама, которое может быть принято получателями;

Для распознавания изображений используется модуль ImageCeberus — определяет порно изображения и т.д.

Мы выбрали EFA, поскольку проект включает в себя все лучшие характеристики вышеперечисленных. К тому же наши администраторы уже имели некоторый опыт работы с ним, поэтому выбор остановили именно на EFA. Приступим к описанию установки.

Установка и последующая настройка EFA

Устанавливать решили на VPS с чистой CentOS 6.8 x64, который выступает в качестве relay-сервера. Первым делом, необходимо обновить все системные утилиты и компоненты до последних версий, которые доступны в репозиториях. Для этого используем команду:

yum -y updateЗатем устанавливаем утилиты wget и screen, если они не были установлены:

yum -y install wget screenПосле чего, скачаем скрипт, который выполнит установку EFA:

wget https://raw.githubusercontent.com/E-F-A/v3/master/build/prepare-build-without-ks.bashДаем скрипту права на исполнение:

chmod +x ./prepare-build-without-ks.bashЗапускаем screen:

screenИ запускаем скрипт:

./prepare-build-without-ks.bashТеперь можно свернуть наш скрин используя комбинацию Ctrl + A + D.

После установки нужно заново войти на сервер через ssh, используя данные для первого входа. Это нужно для запуска скрипта инициализации и первичной настройки EFA.

После входа, система предлагает ответить на несколько вопросов, чтобы настроить EFA.

Список вопросов выглядит следующим образом:

| Функция | Свойство |

|---|---|

| Hostname | Указывается хостнейм машины |

| Domainname | Домен, к которому относится машина. В сумме с хостнеймом, получится полный FQDN сервера |

| Adminemail | Ящик администратора, который будет получать письма от самой системы (доступные обновления, различные отчеты и т.д.) |

| Postmasteremail | Ящик человека, который будет получать письма, которые имеют отношение к MTA |

| IP address | IP адрес машины |

| Netmask | Маска |

| Default Gateway | Шлюз |

| Primary DNS | Первичный DNS сервер |

| Secondary DNS | Вторичный DNS сервер |

| Local User | Логин локального администратора. Используется для входа в систему и в веб-интерфейс MailWatch |

| Local User Password | Пароль |

| Root Password | Пароль для пользователя root |

| VMware tools | Будет отображаться только, если установка происходит на виртуальную машину под управлением VMware. Она необходима для установки инструментов по работе с VMware |

| UTC Time | Если Ваша машина находится в часовом поясе UTC, необходимо выбрать Yes |

| Timezone | Тут можно выбрать другой часовой пояс, отличный от UTC |

| Keyboard Layout | Раскладка клавиатуры, которая будет использоваться в системе |

| IANA Code | Тут указывается код страны, в которой находится машина. Это необходимо для того, чтобы определить, с каких зеркал в будущем будут скачиваться обновления |

| Your mailserver | Индивидуальный параметр. Используется в случае если EFA работает и на приём писем |

| Your organization name | Название организации. Используется для заголовков в письмах |

| Auto Updates | Задается политика автообновлений. По умолчанию установлено disabled. В этом случае, автообновлений не будет, но на емейл админа будут приходить уведомления о доступных обновлениях |

После такой анкеты, отображается весь список ответов. Если что-то нужно изменить, набираем номер вопроса и вводим новые данные. Когда готовы двигаться дальше, набираем ОК и жмем Enter. Система начнет процесс автонастройки.

По завершению конфигурирования, система перезагрузится и будет в полной боевой готовности.

В следующий раз, авторизуясь по ssh, сразу отобразится конфигурационное меню EFA. В этом меню доступно множество полезных действий:

- Перезагрузка / выключение системы;

- Изменение сетевых параметров;

- Настройка MailScanner;

- Включение / выключение grey-листинг;

- Включение / отключение автообновления;

- Настройка системы как исходящего relay-сервера;

- Изменение ящика Adminemail;

- Добавление / удаление почтовых доменов;

- Изменение настроек фильтров спама;

- Восстановление mysql базу, в случае повреждения из-за аварийного завершения работы.

Это список основных опций EFA, которые недоступны для редактирования через веб-интерфейс MailWatch. Поэтому, хорошо знать, где их найти.

Ручная настройка EFA

Мы же пошли сложным путем, но более гибким. Настройку EFA под себя делали не через интерактивное меню, а правили конфигурационные файлы. Мы хотели не просто всё настроить, а еще и разобраться во всех компонентах и понять, что и как работает.

Первым делом в файле main.cf настроек postfix добавили mynetworks, с которых принимались соединения по SMTP. Затем прописали ограничения по helo запросам, отправителям, получателям, и указали пути к картам с политиками ACCEPT или REJECT при соблюдении определенных условий. Также, inet_protocols был изменен на ipv4, чтобы исключить соединения по ipv6.

Затем изменили политику Spam Actions на Store в конфигурационном файле /etc/MailScanner/MailScanner.conf. Это значит, что если письмо будет определено как спам, оно уйдет в карантин. Это помогает дополнительно обучать SpamAssassin.

После таких настроек мы столкнулись с первой проблемой. На нас обрушились тысячи писем от адресатов you@example.com, fail2ban@example.com, root@localhost.localdomain и т.д. Получатели были схожие. Также получили письма, отправленные MAILER-DAEMON, то есть фактически без отправителя.

В итоге получили забитую очередь без возможности найти среди «красного полотна» нормальные, письма не-спам. Решили делать REJECT подобных писем, используя стандартный функционал Postfix карт: helo_access, recipient_access, sender_access. Теперь вредные адресаты и подобные стали успешно REJECT’иться. А те письма, которые отправлялись MAILER-DAEMON отфильтровываются по helo запросам.

Когда очередь вычистили, а наши нервы успокоились, начали настраивать SpamAssassin.

Обучение SpamAssassin

Обучение SpamAssassin делается на письмах, которые уже попали в спам. Делать это можно двумя способами.

Через веб-интерфейс

Первый способ — через веб-интерфейс MailWatch. В каждом письме можно увидеть заголовки, тело, а также оценку по алгоритму Байеса и других показателях. Выглядит это так:

| Score | Matching Rule | Description |

|---|---|---|

| -0.02 | AWL | Adjusted score from AWL reputation of From: address |

| 0.80 | BAYES_50 | Bayes spam probability is 40 to 60% |

| 0.90 | DKIM_ADSP_NXDOMAIN | No valid author signature and domain not in DNS |

| 0.00 | HTML_MESSAGE | HTML included in message |

| 1.00 | KAM_LAZY_DOMAIN_SECURITY | Sending domain does not have any anti-forgery methods |

| 0.00 | NO_DNS_FOR_FROM | Envelope sender has no MX or A DNS records |

| 0.79 | RDNS_NONE | Delivered to internal network by a host with no rDNS |

| 2.00 | TO_NO_BRKTS_HTML_IMG | To: lacks brackets and HTML and one image |

| 0.00 | WEIRD_PORT | Uses non-standard port number for HTTP |

Открыв письмо, можно поставить галку в чекбоксе «SA Learn» и выбрать одно из нескольких действий:

- As Ham — пометить письмо как чистое (тренировка алгоритма Байеса);

- As Spam — пометить письмо как спам (тренировка алгоритма Байеса);

- Forget — пропустить письмо;

- As Spam+Report — пометить письмо как спам и отправить информацию о нём в сети по обнаружению спама (razor + pyzor);

- As Ham+Revoke — пометить письмо как чистое и отправить информацию о нём в сети по обнаружению спама (razor + pyzor).

Через консоль

Делается это просто. Команда выглядит следующим образом:

sa-learn --ham /20170224/spam/0DC5B48D4.A739DВ этой команде письмо с ID: 0DC5B48D4.A739D, которое находится в архиве спам писем за определенную дату /20170224/spam/, помечается как чистое (не спам) bash--ham.

Бытует мнение, что достаточно обучать SpamAssassin только для эффективной фильтрации почты. Мы решили тренировать SpamAssassin, скармливая ему абсолютно все письма, как чистые, так и спам. В дополнение, мы нашли базу спам-писем и отдали SA на растерзание.

Такая тренировка помогла более точно откалибровать Байесовский алгоритм. В результате фильтрация происходит гораздо эффективнее. Такие тренировки мы проводим тогда, когда почтовый трафик не очень высок, чтобы успеть проанализировать и захватить максимальное количество писем.

Для того, чтобы SpamAssassin начал работать на полную мощность, на старте ему необходимо скормить около 1000 различных писем. Поэтому наберитесь терпения и приступайте к тренировке.

Пока еще рано говорить о полной победе над спамом. Однако, сейчас количество жалоб на спам с наших серверов равно нулю. Более детально рассказывать о самом процессе обучения сейчас не будем— не хочется раскрывать все фишки. Хотя, если поковыряться в настройках, разобраться не сложно.

P.S.: Эта статья не является панацеей. Мы просто решили поделиться с вами одним из наших методов борьбы со спамом.

Всем добра и may the ham be with you! :)

|

Метки: author Ukr2net хостинг спам и антиспам системное администрирование серверное администрирование настройка linux администирование спам efa |

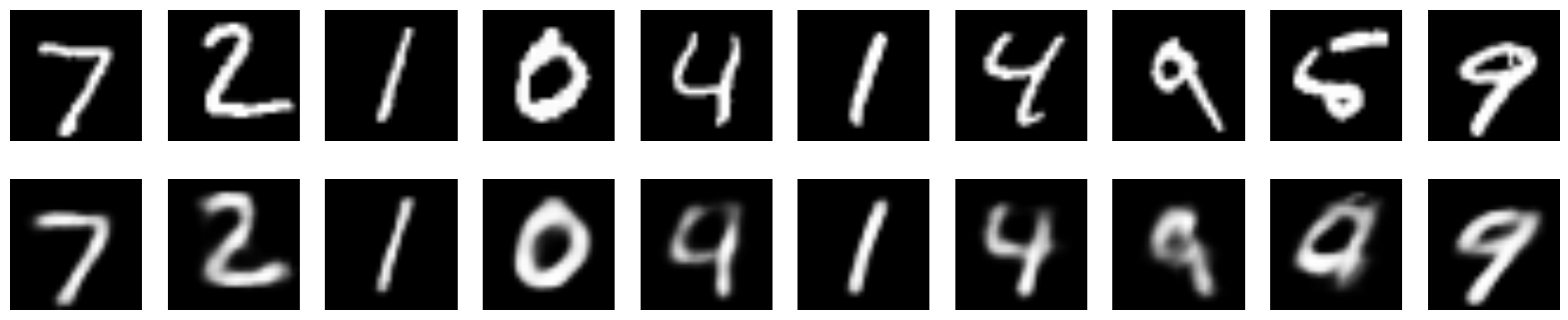

Как нам помогают нейронные сети в технической поддержке |

- Железо стало гораздо быстрее и можно легко обсчитывать модели на GPU

- Появилась куча неплохих бесплатных фреймворков для нейросетей

- Одурманенные предыдущим хайпом, компании стали собирать бигдату — теперь есть на чем тренироваться!

- Нейронки в некоторых областях приблизились к человеку, а в некоторых — уже превзошли в решении ряда задач (где тут лопаты продают, надо срочно бункер рыть)

Но управлять этим, по прежнему, сложно: много математики, высшей и беспощадной. И либо ты из физмата, либо сиди и решай 2-3 тысячи задачек в течении двух-трех лет, чтобы понимать, о чем идет речь. Разобраться по дороге на собеседование в электричке, полистав книжку «Программирование на PHP/JavaScript за 3 дня» — не получится, ну никак, и списать никто не даст (даже за ящик водки).

Вам не дадут «списать» модель нейросети даже за ящик водки. Часто именно на Ваших данных публично доступная модель работает внезапно плохо и придется разбираться в тервере и матане

Но зато, ууУУ, овладев основами, можно строить разные предсказательные модели, реализующие интересные и мощные алгоритмы. И вот тут язык начинает заворачиваться и выпадать изо рта, цепляя левый глаз…

Красота теории и практика

Даже в такой, казалось бы, интуитивно понятной и прикладной до уровня «АК-47» области, как обработка реляционных данных, крупная и очень известная компания IBM в свое время замучилась и, по сути, «выдавила» старика Кодда, знаменитого создателя «языка для базок», для прогулок на все четыре стороны. Что же произошло? Кодд утверждал, что SQL, распространяемый IBM — это зло, он не строг и не полон и не соответствует строгой и красивой теории :-) Тем не менее, мы же все пользуемся SQL до сих пор и… ничего, живые.

Примерно то же происходит сейчас и с машинным обучением. С одной стороны еженедельно или, даже, чаще, выходят окрыляющие научные публикации на тему внезапной победы ГироДраконов (имеющих в физиологических шариках — гироскопы) над ГиперКашалотами в Тьюринг-пространствах в созвездии Маленького Принца, массово появляются бесплатные прототипы на github и в дистрибутивах нейронных фреймворков, которые понимают смысл вопроса на 5% лучше предыдущих прототипов — но, по сути, продолжая ни черта не понимать суть. Одновременно с этим, путем сильнейшего группового насилия над нейросетью и самой идеей обучения с подкреплением в пространствах огромной размерности — она вдруг начинает обыигрывать Atari в двумерные игры и про победу нейросетей над чемпионами в Go, наверно, все давно знают уже. А с другой, бизнес начинает осознавать, что область еще очень сырая, находится в фазе бурного роста и прикладных, эффективно решающих задачи людей кейсов еще очень мало — хотя они, безусловно, есть и просто поражают. К сожалению, гораздо больше академических игрушек: нейронки старят лица, генерят порно (не гуглите, потеряете потенцию на сутки) и создают глючную верстку по дизайну веб-страниц.

А может взять и пригласить эту созданную нейронной сетью девушку на свидание? Потрясающий опыт, запомнится на всю жизнь.

А реальный, потрясающий успех в некоторых сферах, таких как, например, распознавание образов, достигнут ценой обучения огромных сверточных сетей из сотен слоев — что могут себе позволить, пожалуй, только гиганты индустрии: Google, Microsoft… Аналогично дело обстоит и с машинным переводом: вам нужны большие, очень большие, объемы данных и большие вычислительные мощности.

Похожая ситуация и с рекуррентными нейронными сетями. Несмотря на их «невиданную мощь» и способность предсказывать цепочки событий, генерить похожие на бред писателя под действием тяжелых наркотиков тексты и прочие фокусы — они обучаются очень и очень медленно и вам снова требуются несоразмерные вычислительные ресурсы.

Языковые нейронные модели сейчас, как никогда, очень интересны, но многие требуют значительных корпусов текстов и, опять таки, вычислительных ресурсов, что особенно пока затруднительно для русского язык. И хотя дело сдвинулось с мертвой точки и уже можно найти эмбеддинги и не только для русского, эффективно их использовать в составе сложных языковых моделей в production, не тащя 1000 килограмм питонячих потрохов и стадо хрюкающих слонов — неясно как.

Вы думаете, что развернуть Hadoop без помощи понимающих системных администраторов — просто? Пойдите лучше и похрюкайте вместе с этим стадом :)

Большую, действительно большую, надежду подают появившиеся пару лет назад генеративные состязательные сети (GAN). Несмотря на их потрясающие возможности: восстановление утраченной части изображения, повышение разрешения, изменение возраста лица, создание интерьера, применение в биоинформатике и вообще, проникновение в суть данных и генерация их по определенному условию (например: хочу увидеть много молодых девушек с красивыми попами): это, скорее, пока удел серьезных ученых-исследователей.

Поэтому рассчитывать на то, что вы займетесь deeplearning «на коленке» и что-то из этого полезного получится и быстро — не стоит (ударение на букву «о»). Нужно и знать немало и работать в «поте лица своего».

Бизнес-кейсы алгоритмов ML — в сухом остатке

Откинув громоздкую теорию и хорошенько протрезвев, можно увидеть, что остается небольшая пригоршня теоретически полезных в электронной коммерции и CRM алгоритмов, с которыми можно и нужно начинать работать и решать текущие бизнес-задачи:

- Классификация чего угодно на несколько классов (спам/не спам, купит/не купит, уволится/не уволится)

- Персонализация: какой товар/услугу человек купит, уже купив другие?

- Регрессия чего угодно в циферку: определяем цену квартиры по ее параметрам, цену автомобиля, потенциальный доход клиента по его характеристикам

- Кластеризация чего угодно в несколько групп

- Обогащение бизнесовых датасетов или предобучение с помощью GAN

- Перевод одной последовательности в другую: Next Best Offer, циклы лояльности клиента и др.

Говорят, что в голове «блондинки» (это собирательный образ, девушкам не обижаться, бывают мужчины как «блондинки») мозга нет, а два уха напрямую соединяются тонкой ниточкой. Если ниточку перерезать — уши отвалятся и упадут на пол

Бизнес-менеджерам, тем временем, ничего не остается делать, как с утра до вечера кидать в разработчиков учебниками математики со словами: «ну найдите же прикладное применение этим алгоритмам, for-fan — не предлагать!» и нанимать экспертов, понимающих научные публикации и способные, хотя бы на python, писать адекватный код.

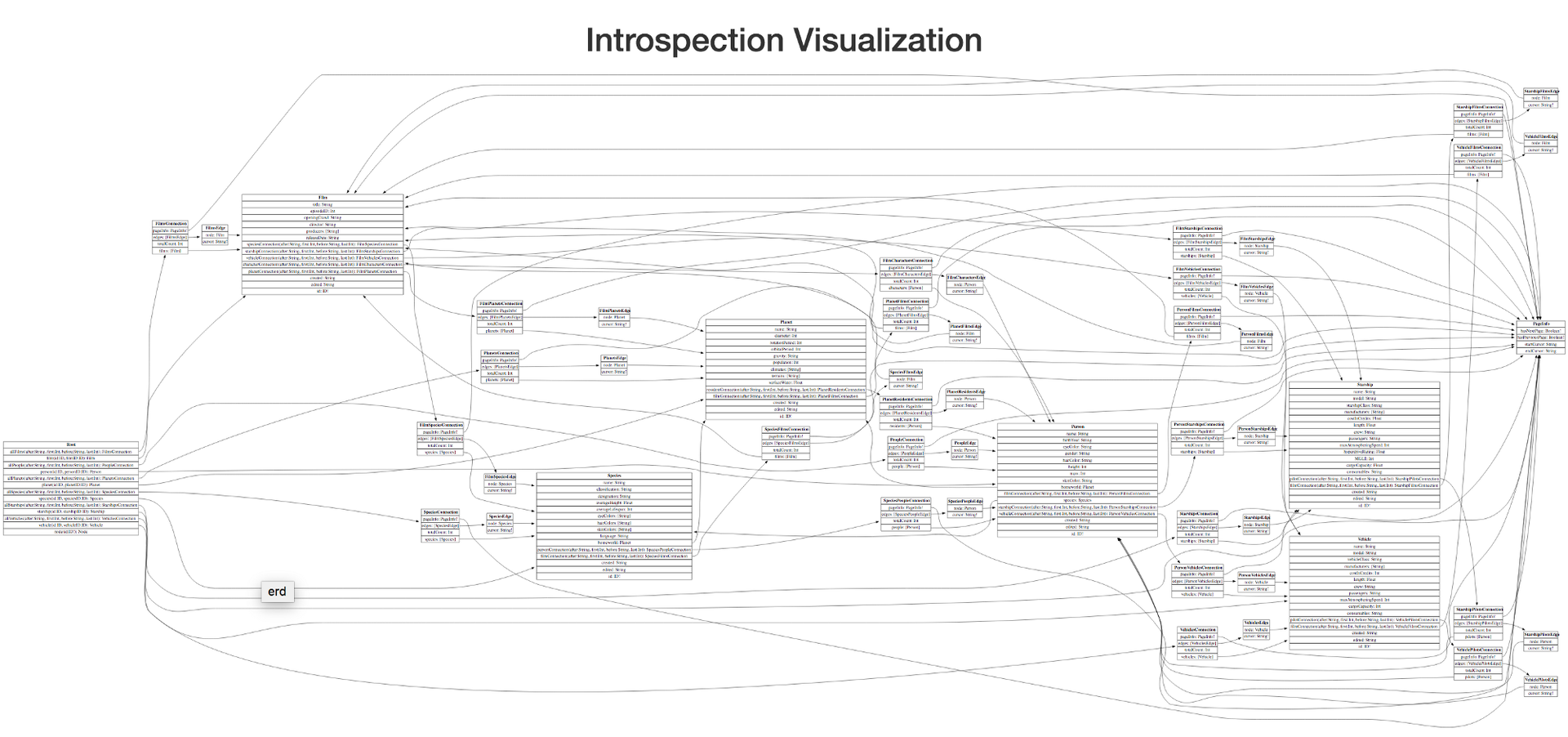

Как мы используем нейросети в техподдержке и почему?

Мы отталкивались от того, что с одной стороны у нас уже есть собранная «бигдата», достаточная для обучения нейросети (десятки тысяч примеров), а с другой — есть бизнес-задача постоянно и ежедневно классифицировать поток входящих обращений клиентов с вопросами и предложениями на заранее определенный список тем (десятки) для последующей маршрутизации на ответственных сотрудников.

Выбор алгоритма, почему нейронки

Мы рассматривали классические и хорошо известные алгоритмы для, простите за тавтологию, классификации текстов: байесовский классификатор, логистическая регрессия, машина опорных векторов, но выбрали нейросети и вот почему:

- За счет факторизации слоев и нелинейности, они способны аппроксимировать гораздо более сложные паттерны меньшим числом слоев, чем плоско-широкие модели

- Нейросети, при достаточном числе обучающих примеров, лучше работают с новыми данными «by design» (генерализация лучше)

- Нейросети могут работать лучше классических моделей и даже лучше моделей, которые предварительно парсят тексты и вычленяют из них смысловые отношения между словами и предложениями.

- Если использовать регуляризацию, похожую на действие алкоголя в мозге человека (dropout), то нейросети адекватно сходятся и не сильно страдают от переобучения

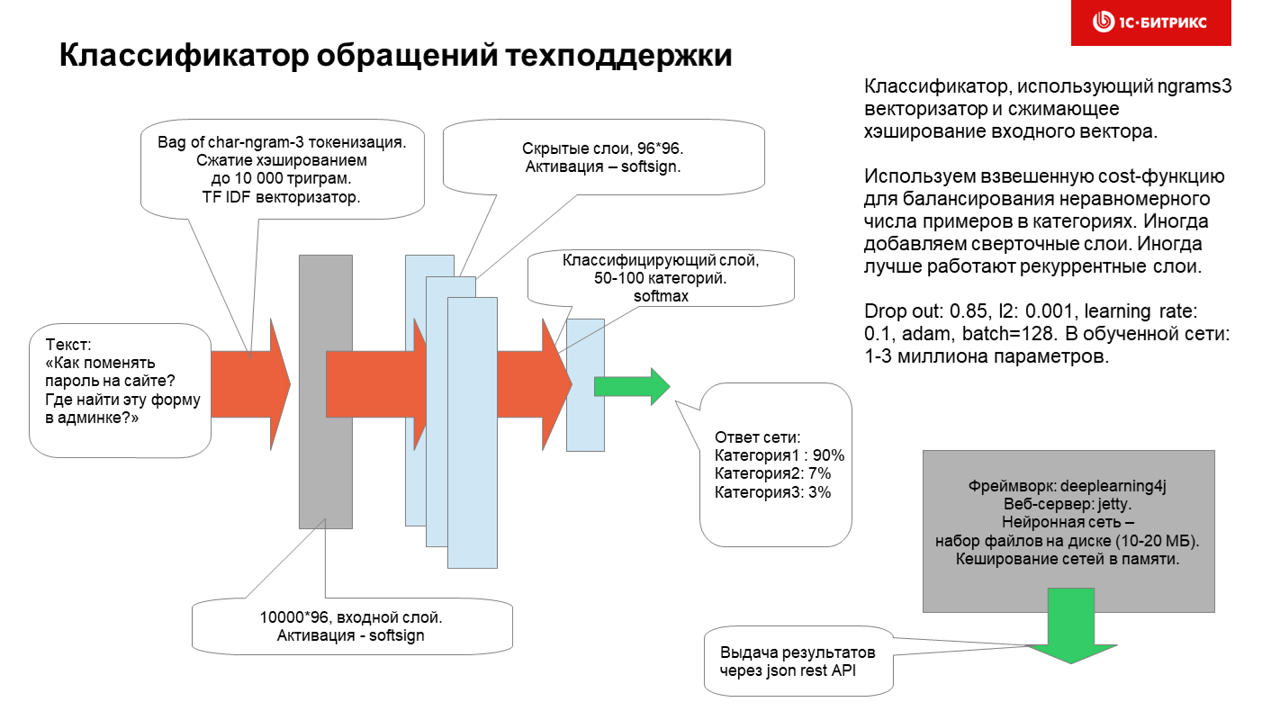

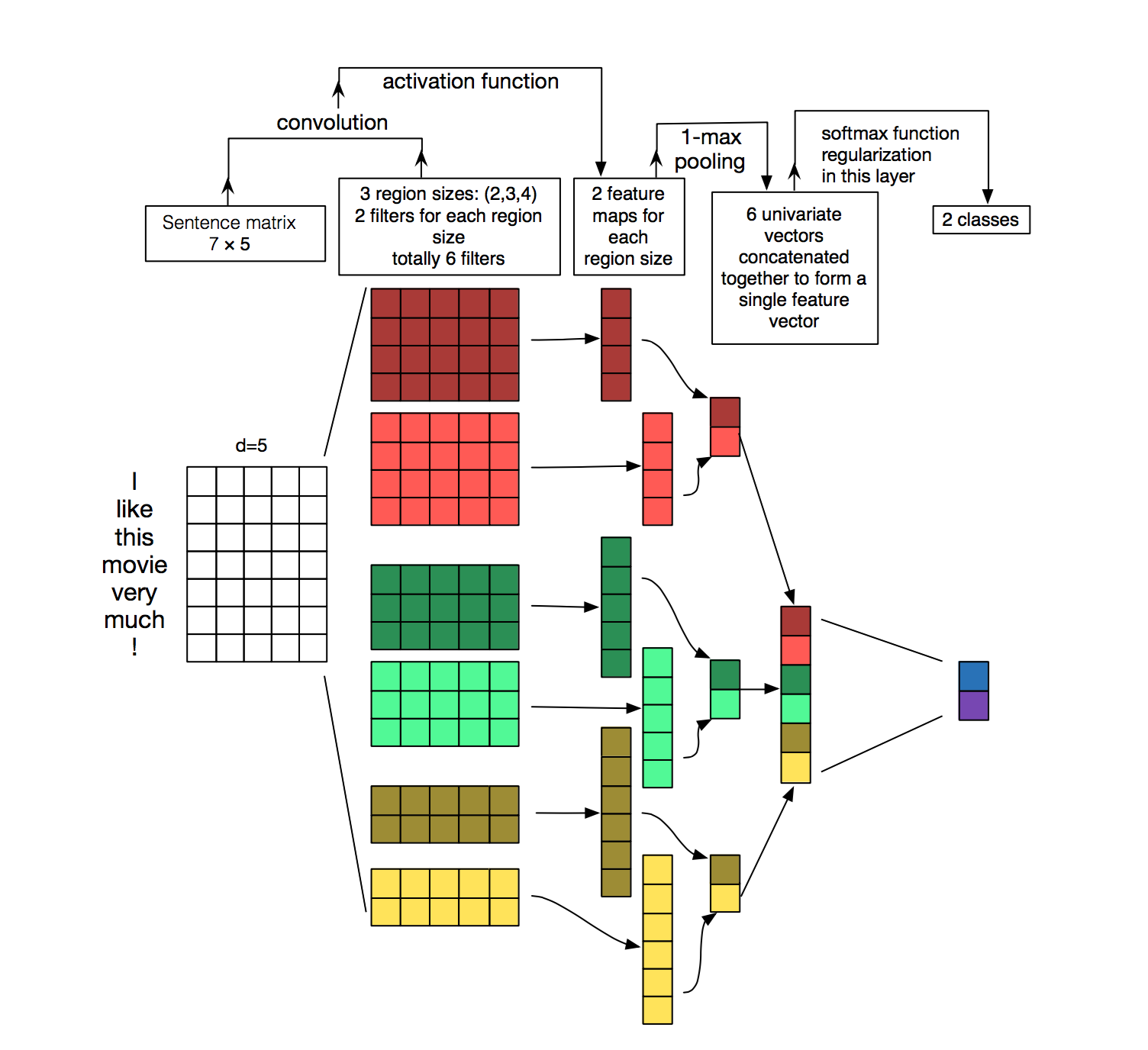

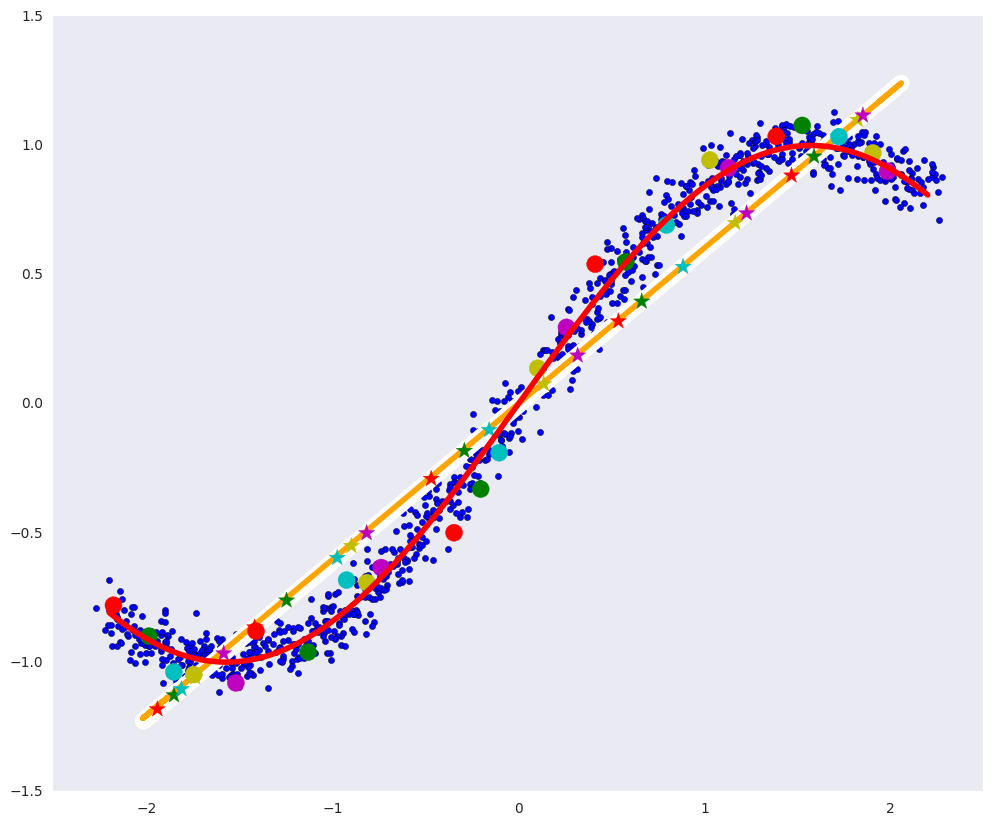

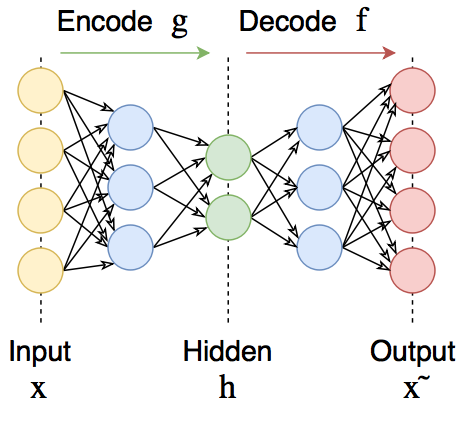

В результате мы пришли к такой, довольно простой, но, как оказалось, очень эффективной на практике архитектуре:

Обучается нейросеть часа полтора (без GPU, а на нем гораздо быстрее) и использует для обучения датасет ~ 100к привязок вопросов к категориям.

Категории распределены очень неравномерно, но эксперименты с назначением весов обучающим примерам с плохо представленными категориями (десятки-сотни примеров для рубрики) — особо не улучшили работу нейросети.

Напомню, что на вход сети подаются обращения граждан на куче языков, которые могут содержать:

- код на PHP

- верстку

- мат-перемат-сленг

- описание проблемы, задачи, идеи

- ссылки на файлы внутри продукта

Оказалось, что нейросеть работает лучше, если данные предварительно не обрабатывать и делать из них char3 ngrams как есть. В этом случае и устойчивость к опечаткам прекрасно работает, и можно ввести небольшой кусок пути к файлу или фрагмент кода или одно-два слова текста на любом языке и рубрика определиться весьма адекватно.

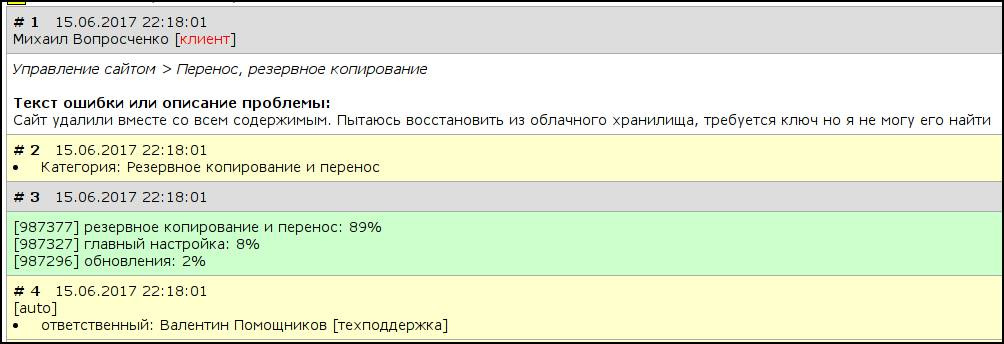

Вот как это работает изнутри:

Если при классификации нейросеть не уверена или ошибается — ее страхует человек и обращение переназначается вручную. Точность классификации пока 85% и ее, конечно можно и нужно увеличивать — но, даже текущее решение сократило немало человеко-часов, помогает увеличить качество обслуживания клиентов и является примером, что нейросети это никакие не игрушки по генерации порно — а способны работать рядом с людьми и быть очень полезными.

В голове у этого астродроида не очень мощная нейросеть — но он, тем не менее, иногда ошибаясь, приносит много пользы на протяжении 6 частей (или уже 7) киносаги

Планы на будущее

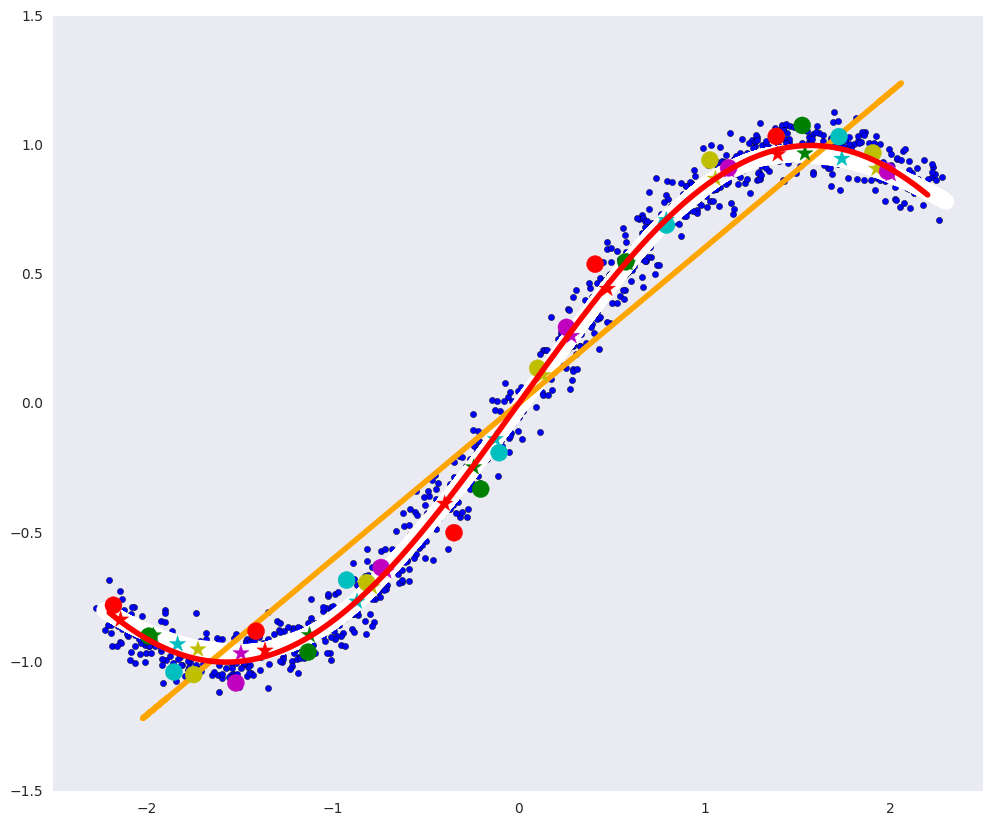

Сейчас мы экспериментируем на Keras с другими архитектурами текстовых классификаторов:

— на базе рекуррентной сети

— на базе сверточной сети

— на базе bag-of-words

Лучше всего работает многослойный классификатор, на вход которого подаются one-hot вектора символов (из небольшого словаря символов корпуса), затем проходит несколько слоев 1D-свертки c global-max/average pooling и на выходе стоит обычная feed-forward слой с softmax. Подобный классификатор обучить сквозным способом так и не получилось, и даже batch normalization не помог (надо было меньше на девушек заглядываться и слушать преподавателя) — но удалось таки хорошенько ее обучить путем последовательного обучения слоя за слоем. Видимо, когда мы придумаем, как вместо тензоров на java эффективно использовать тензоры на Keras/python/Tensorflow на production — мы обязательно выкатим эту архитектуру на бой и еще больше обрадуем наших менеджеров и клиентов.

Так работает не всем понятная 1D-свертка. Можно сказать, что создаются kernels (сверточные ядра), определяющие 1-2-3-n цепочки символов, «аля» мульти-nrgams модель. В нашем случае лучше всего работает 1D-свертка с окном 9.

В завершении поста, дорогие друзья, желаю вам не тушевать перед ML и нейронками, смело брать их и использовать, строить и обучать модели и уверен, вы сами увидите, как AI эффективно работает, как помогает снять с людей рутину и увеличить качество ваших сервисов. Всем удачи и хорошего и, главное, быстрого схождения нейросетей! Целую нежно.

|

Метки: author AlexSerbul машинное обучение блог компании 1с-битрикс нейронные сети классификатор текстов с-битрикс техническая поддержка |

[Из песочницы] Symfony 4: структура приложения |

В свое время в Symfony 3 появились каталоги bin/, src/, var/, что по-моему мнению очень удобно и понятно. Мы все привыкли работать с такими каталогами. В свою очередь, Symfony 4 движется в этом же направлении и предлагает обновленную структуру каталогов приложения.

tests/ для тестов

Все тесты теперь будут располагаться непосредственно в каталоге tests/. Ранее в каталоге tests/ всегда присутствовали каталоги с именами бандлов вашего приложения в которых находились тесты. В Symfony 4, приложения не будут (или не обязательно должны) реализовывать код в каком либо бандле. Это позволит определить собственное пространство имен тестов для автозагрузки:

{

"autoload": {

"psr-4": {

"App\\": "src/"

}

},

"autoload-dev": {

"psr-4": {

"App\\Tests\\": "tests/"

}

}

}

templates/ для шаблонов

При установке шаблонизатора Twig, теперь будет создаваться каталог templates/ в корне приложения, где и будут размещаться все шаблоны. Мне очень нравится эта идея, потому что каталог Resources, который содержал в себе до этого и публичные файлы (css, js и т.п.) и шаблоны, вносил некоторый дискомфорт. Возможно, что каталог будет называться tpl/, это еще пока окончательно не известно. В целом, перемещение шаблонов из каталога src/ делает приложение более структурированным. Теперь в src/ лежит только код. Класс Kernel, который ранее располагался в папке app/, так же перемещен в src/ где ему и место.

etc/ для конфигураций

Каталог etc/ заменит существовавший ранее app/config. Параметры окружения, которые ранее определялись в файле parameters.yml, теперь конфигурируются с помощью переменных окружения операционной системы. По умолчанию в каталоге etc/ вы обнаружите пустой файл container.yaml (yaml — это не опечатка, в Symfony 4 конфигурационные файлы в формате YAML, теперь имеют расширение yaml, вместо yml)в котором как и прежде можете определять конфигурацию контейнера. Так же там будет файл routing.yaml. В данных файлах вы будете определять только собственные настройки. Компоненты, установленные с помощью Composer, будут хранить свои настройки в отдельных файлах для каждого окружения.

Конфигурацию как и прежде можно будет задавать в трех форматах: YAML, XML, PHP. Помимо конфигурационных файлов, в каталоге etc/ появится bundles.php, который будет представлен массивом бандлов, активных в вашей системе.

//bundles.php

|

Метки: author shude symfony php symfony 4 |

[Перевод] Как мы собрали 1500 звезд на Гитхабе, соединив проверенную временем технологию и новый интерфейс |

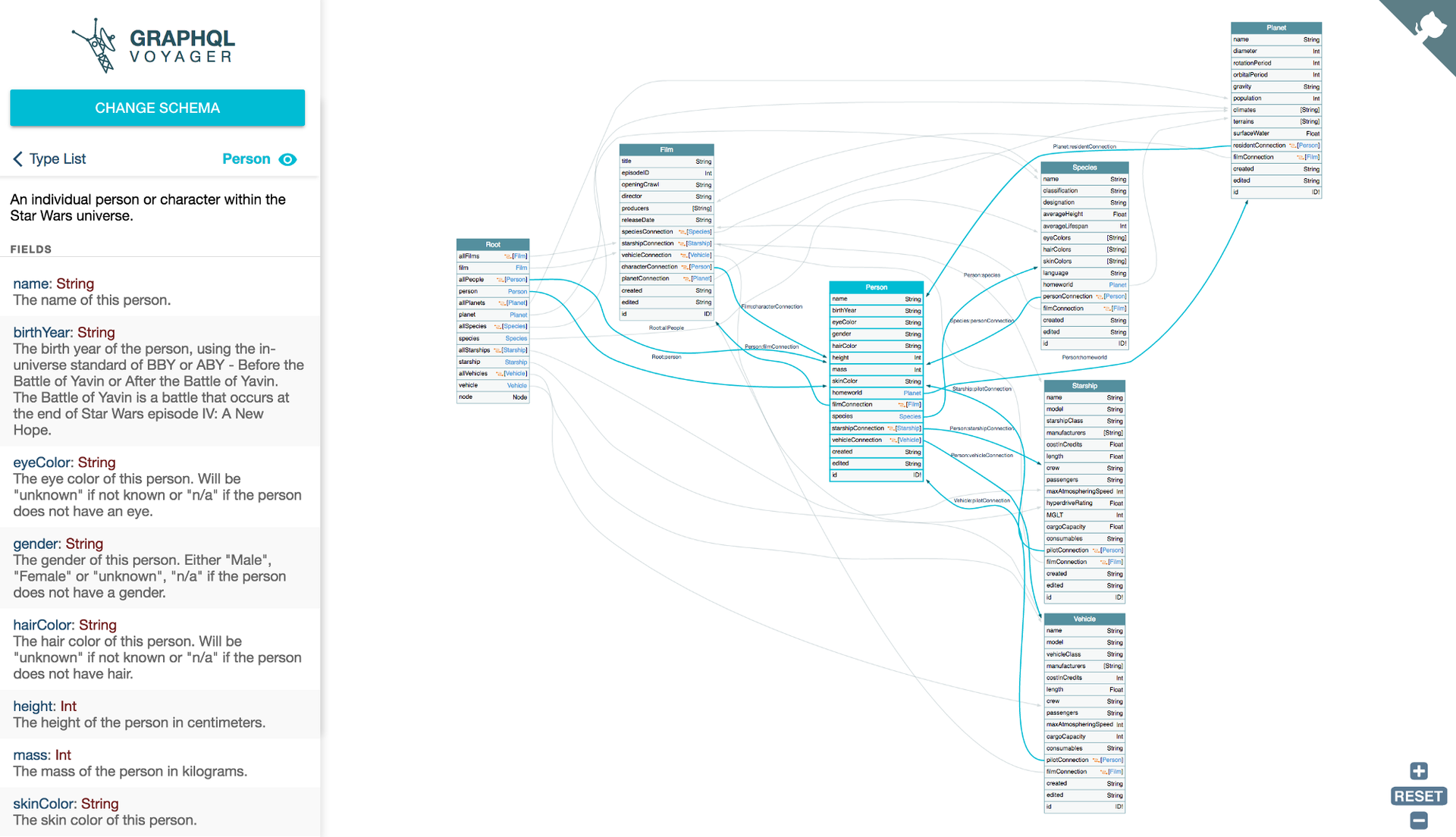

Недавно мы выпустили инструмент с открытым исходным кодом GraphQL Voyager. Удивительно, но он попал на первую страницу новостей Hacker News и GitHub, и в первые несколько дней получил 1000+ звезд. Сейчас у него уже более 1600 звезд.*

Людям понравился гладкий интерфейс, интерактивные функции и анимация. Мы использовали TypeScript, React, Redux, webpack и даже PostCSS, но это НЕ еще одна статья об этом. Давайте заглянем под капот...

Наша предыстория

Все началось несколько месяцев назад. Мой друг и я (мы называем себя APIs.guru) искали идею для проекта вокруг GraphQL (язык запросов для API, разработанных Facebook). После некоторых исследований нам попался на глаза один интересный инструмент — GraphQL Visualizer.

Вот что мы получили на выходе из GraphQL Visualizer:

Нам захотелось в него добавить:

- Цвета (черно-белое выглядело слишком скучно)

- Возможность масштабирования

- Интерактивные функции, такие как выбор вершин и ребер

Но, посмотрев исходный код, мы обнаружили фатальный недостаток этой штуки: там использовался Graphviz — инструмент, разработанный десятки лет назад, написанный на обычном C и скомпилированный в нечитабельный JavaScript с использованием Emscripten.

Выглядит даже хуже, чем то, что вылазит обычно из Uglify.js:

Как мы можем использовать что-то из 2000-го года? Мы же хипстеры, в конце концов! ReactJS, D3, webpack, TypeScript, PostCSS — вот с чем мы работаем! Не с инструментами, написанными на старомодном C ![]() .

.

Немного покопав, мы нашли самую лучшую библиотеку для решения этой задачи — Cytoscape.js. Она написана на прекрасном JavaScript и даже позволяет применять CSS-подобные селекторы прямо к самому графу. Отличный результат!

Но после недели напряженного программирования он показался нам не таким уж хорошим.

Посудите сами, вот как выглядит визуализация графа с использованием Cytoscape.js:

И это мы даже не отобразили на этом графике все детали! Что за мешанина!

Хотя код был гораздо чище, конечный результат оказался намного хуже по сравнению с оригинальным инструментом. Совершенно неюзабельно.

Оказалось, что в cytoscape.js нельзя сделать так, чтобы ребра не пересекались с вершинами графа. Мы перепробовали все варианты. Мы гуглили. Мы задавали вопросы на StackOverflow. Мы даже побеспокоили нескольких знакомых гуру SVG. Безуспешно :(

От безысходности я даже попытался хакнуть cytoscape.js, чтобы добиться читабельного результата. Ещё немного изучив этот вопрос, я вынужден был сдаться: видимо, визуализация графов — это и в самом деле rocket science (даже для магистра по прикладной математике).

Мы были побеждены...

И тогда нас осенило. А что, если мы возьмём результат работы Graphviz (это ведь просто SVG) и причешем его при помощи CSS и JS?

И это сработало ![]()

Намного лучше! И код написан меньше, чем за день ![]() .

.

Добавляем немного цвета, логотип, загружаем анимацию, еще несколько полезных функций, и вот конечный результат, то, что нам нужно:

Да, мы написали несколько сотен строк уродливых манипуляций с DOM. Да, мы упаковали весь этот бардак НЕ в виде чистого ![]() компонента React / Redux. И да, код Graphviz настолько большой, что мы выделили его в отдельный файл размером 2 МБ. Но это работает, и всем пофигу. Что подтверждается 1600 звездами на GitHub.

компонента React / Redux. И да, код Graphviz настолько большой, что мы выделили его в отдельный файл размером 2 МБ. Но это работает, и всем пофигу. Что подтверждается 1600 звездами на GitHub.

Апдейт: с момента представления статьи времени нашу разработку взяли на вооружение компании в этой области (например, Graphcool, Neo4j), и её показали на GraphQL Europe, так что уже не только 1600 звезд подтверждают это :)

Уроки выучены

«Если я видел дальше других, то потому, что стоял на плечах гигантов». — Исаак Ньютон

Не судите код по его возрасту. Особенно, если он был написан такими технологическими гигантами, как AT&T Labs (где родилась ОС Unix и языки C и C++).

К сожалению, мы оказались жертвами когнитивного искажения: старый код — это плохой код. Но истина может быть противоположной. Старый код проверен в бою тысячами пользователей в сотнях различных проектов. Большинство критических ошибок были исправлены, документация завершена, есть много вопросов и ответов на StackOverflow и Quora.

Мы живем в 2017 году, и пользовательский интерфейс из 2000-х определенно не приемлем. Но графики и математика, которые стоят за ними, не сильно меняются.

Эта идея применима во многих других областях. Так что мы должны дать шанс старому коду, особенно потому, что его всегда можно обернуть в современный интерфейс.

Вот почему мы видим огромный потенциал в Web Assembly. Этот формат позволяет соединить проверенные временем алгоритмы с современными пользовательскими интерфейсами. Мы очень хотим увидеть потрясающие вещи, которые люди будут на нем делать.

«Эмм… ты обещал мне рассказать, как получить много звезд»

Упс… Ладно. И правда. Я хотел сделать заголовок достаточно запоминающимся.

Ниже приведен список самых важных советов и трюков, которые мы используем для нашего проекта с открытым исходным кодом:

- Попытайтесь использовать название своей технологии в имени проекта (например, graphql-что-то, react-что-то и т.д.). Тогда ваш проект будет иметь более высокий ранг в результатах поиска GitHub для этих технологий.

- Ваш README-файл должен привлекать внимание. Мы положили гифку в шапке нашего README, чтобы люди могли сразу понять, о чем идет речь в нашем проекте. Если это консольное приложение — добавьте гифку с консолью (вот замечательный пример).

- Больше свистелок и перделок: добавьте значки, добавьте красивый логотип, добавьте эмодзи

- Соберите демо-версию, если это возможно, и добавьте её в ссылку в строке с описанием репозитория:

- Повторяю, сделайте демку! И не забудьте добавить ссылку с неё обратно на GitHub (мы используем GitHub Corners).

- Прежде чем постить свой проект в HackerNews / Reddit / и т.д., получите начальное число звезд (5-10), разместив его на менее популярных ресурсах или поделившись им со своими друзьями. Люди с меньшей вероятностью нажимают «звезду» на проектах с нулевым числом звезд.

- Попытайтесь получить 30-40 звезд в первый день. Тогда, вас, скорее всего, зафичерят в GitHub trending для вашего языка программирования, а это еще один источник трафика.

- Сделайте что-нибудь полезное.

Есть еще несколько статей о том, как продвигать проекты с открытым исходным кодом: здесь, здесь и здесь.

На этом все, ребятки. Если вы когда-либо завернули старый код в новый блестящий интерфейс, расскажите свою историю в комментариях ниже.

* Примечание переводчика: спустя неделю после оригинальной публикации у проекта уже 2000+ звезд.

** Заглавная картинка, как и в исходном посте, взята с сайта www.k3projektwheels.com.

|

Метки: author mngr визуализация данных open source github css graphql graphviz визуализация графов документация api |

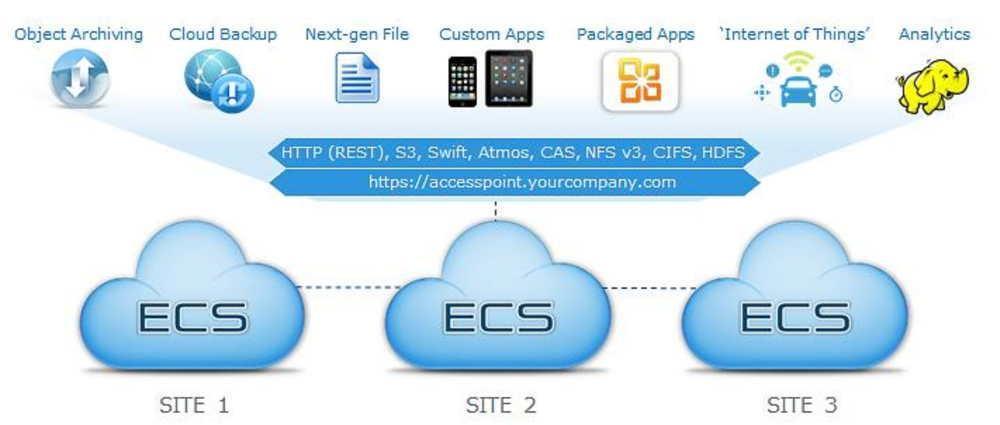

ECS (Elastic Cloud Storage) - облачная платформа хранения Dell EMC |

Однако эти проблемы - далеко не единственные. Бюджеты ИТ остаются на том же уровне или незначительно увеличиваются (примерно на 5% в год), а капитальные расходы большинства организаций каждый год вырастают почти вдвое. К тому же компаниям необходимо сохранять и улучшать уровень обслуживания, затрачивая на это все меньше ресурсов.

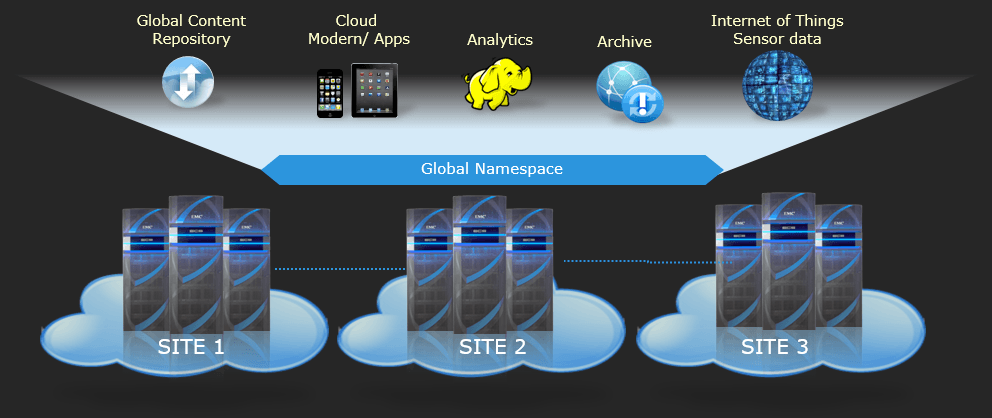

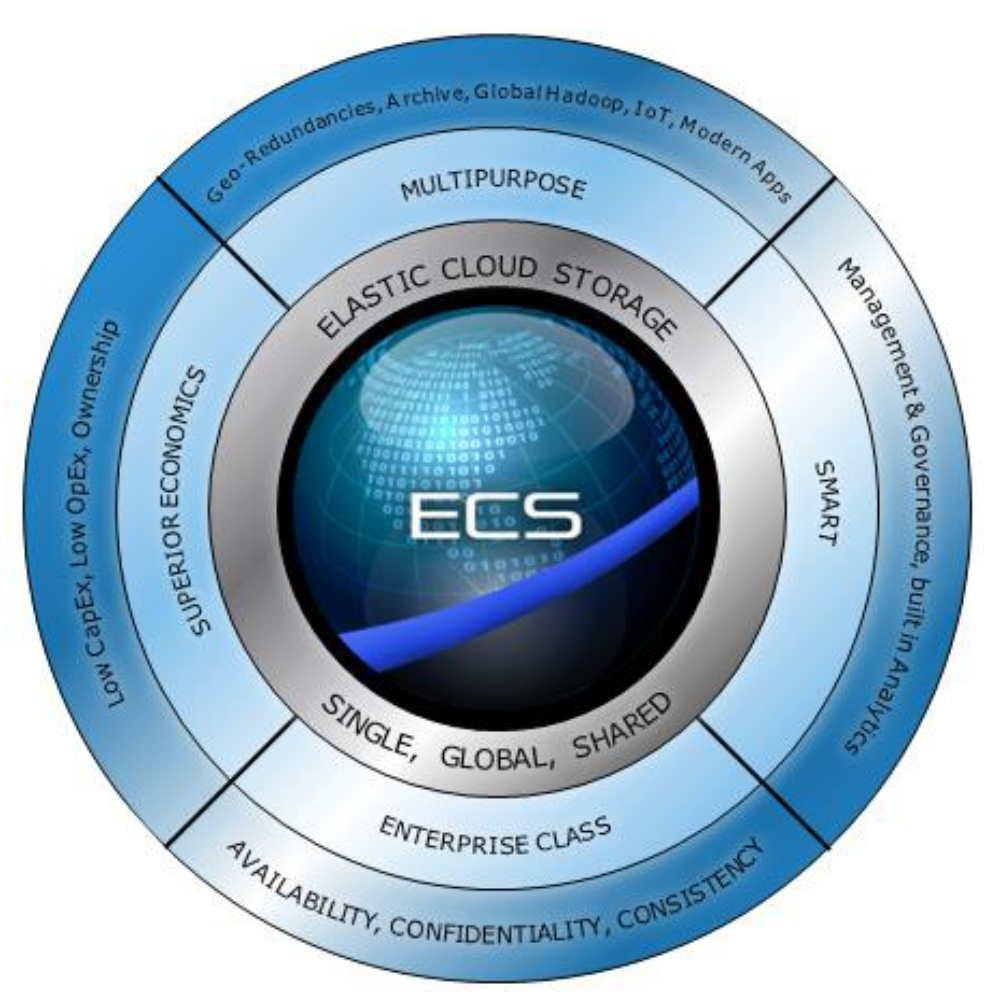

Рост объемов данных (и, соответственно, требований к инфраструктуре хранения) - тенденция отнюдь не временная, и если компании не трансформируют вовремя свой бизнес, они столкнутся с очень серьезными проблемами. Но развитие технологий позволяет найти нужные решения. Так, компания Dell EMC — крупнейший в мире поставщик систем хранения данных - создала экономически эффективную облачную платформу ECS.

Что такое ECS?

Сперва нужно отметить, что ECS - не публичный Cloud Storage, когда пользователь не знает, где хранятся его данные. Напротив, Dell EMC (Elastic Cloud Storage) — физический массив хранения (хотя есть и версия в виде ПО), и клиент сам выбирает, где его разместить. А облачным хранилищем ECS называется, поскольку систему можно использовать именно с такой целью.

Программное обеспечение ECS позволяет хранить, администрировать и анализировать неструктурированные данные в масштабной инфраструктуре из типовых компонентов. Это комплексная многопользовательская облачная платформа хранения, которая позволяет учитывать потребление ресурсов и самостоятельно их выделять.

Заказчики могут приобрести ECS как готовую программно-аппаратную систему (решение Dell EMC ECS Appliance) или в виде программного продукта (ПО ECS): он устанавливается на серверы заказчика и типовые диски, сертифицированные Dell EMC. В состав ECS входит модуль хранения неструктурированных данных, который поддерживает сервисы управления объектами и HDFS, а также поддержка файловых сервисов.

Технически эта система представляет собой:

- сервер Intel x86 с подключенными к нему полками JBOD (до 60 дисков на сервер),

- сетевые адаптеры 10GbE для подключения узлов.

Конфигурация системы включает 4/8 узлов. Емкость решения достигает 3840 Tбайт на стойку.

ECS - объектная система хранения данных третьего поколения. Она позволяет:

- консолидировать ресурсы основного хранилища и повысить окупаемость инвестиций;

- модернизировать традиционные и унаследованные приложения для более эффективного использования хранилища;

- ускоренно внедрять облачные приложения с новыми функциями для бизнеса.

Преимущества объектного хранилища:

- Доступ к объектам предоставляется по специализированным протоколам. В отличие от блочных или файловых, они работают поверх HTTP и основаны на REST: S3, Swift, Atmos.

- Ориентированность на хранение неструктурированной информации (любые файлы, которые являются статическим или динамическим контентом на стороне клиента).

- Каждый объект обладает уникальным адресом.

- Глобальное пространство имен объектов: любой объект доступен в любой момент из любого сегмента инфраструктуры.

Чем удобна ECS?

- Экономичность. ECS - многофункциональная платформа, которая предполагает множество сценариев использования и защищает инвестиции в инфраструктуру хранения Dell EMC. Она упрощает управление, повышает гибкость, а главное — снижает затраты. С точки зрения масштабирования, ECS - одно из самых экономически эффективных решений на рынке. Согласно исследованию Enterprise Strategy Group (ESG), хранить файлы в ECS минимум на 60% выгоднее по сравнению с другими облачными сервисами.

- Интеграция с существующей средой хранения. ECS «расширяет» облако до основного хранилища и позволяет освободить инфраструктуру хранения при помощи решений Dell EMC для облачных вычислений (CloudPools, CloudBoost, CloudArray и т. д.). Заказчики могут выводить неактивные данные из первичного хранилища (Isilon, VMAX Series, VPLEX, VNX Series, Vx Series, Data Domain, Data Protection Suite и т. д.) в облако, перемещая их на ECS. Такая консолидация ресурсов позволяет не покупать дополнительные и более дорогие платформы и заметно повышает эффективность имеющейся среды хранения.

- Оперативный и повсеместный доступ к данным. Объектная платформа ECS способна радикально улучшить время отклика и повысить скорость доступа к данным по сравнению с традиционной NAS. Данные защищаются при помощи кодирования и распределяются по всем узлам системы, обеспечивая мгновенный доступ для чтения/записи из любого места. При этом доступна самая последняя копия данных, что упрощает разработку приложений. Поддержка геокэширования также делает доступ более оперативным благодаря интеллектуальному системному распознаванию шаблонов операций: оно минимизирует трафик глобальной сети и улучшает латентность.

- Простота разработки приложений. Единое глобальное пространство имен не требует от разработчиков обращаться к сложным файловым системам NFS. Они могут сосредоточиться на создании приложений, а не деталях операций. Модернизируя традиционные приложения в хранилище объектов, пользователи получают дополнительные ресурсы, доступ к контенту через интернет и глобальную доступность через единое пространство имен. Кроме того, они смогут оптимально использовать ресурсы хранения в центре обработки данных. Нативные облачные приложения в полной мере используют инфраструктуру облачной среды.

- Пользователю доступны все плюсы программно-определяемой СХД. Платформа ECS полностью использует программно-определяемую архитектуру, что позволяет независимо масштабировать вычислительные ресурсы и ресурсы хранения. Все данные в ECS контейнеризированы; нет аппаратной зависимости, необходимости перекодировать или перенастраивать приложения, поскольку ECS обеспечивает поддержку нескольких протоколов. Это позволяет разработчикам гораздо быстрее внедрять инновации и выводить свои приложения на рынок.

Цифровая трансформация — это просто

Предприятия и поставщики облачных сервисов могут использовать ECS как основу для «цифровой трансформации». Традиционные бизнес-приложения сейчас сменяются облачными — а ECS устраняет разрыв между приложениями «второй» и «третьей» платформы, позволяя им использовать единую систему хранения. ECS не только справляется с огромным объемом неструктурированных данных - как многоцелевая платформа она принимает на себя самые разные нагрузки и способна подготовить компанию к любым вызовам.

ECS совместима с HDFS, OpenStack Swift и Amazon S3, а также с API Centera и Atmos. По выбору заказчика ее можно развертывать как полностью интегрированное решение, которое масштабируется до 3,8 Пбайт на стойку, или как программное решение для хранения данных на сертифицированном оборудовании. Кроме того, ECS доступна по подписке с платой за использование. Благодаря этому система завоевывает популярность у корпоративных клиентов и поставщиков услуг.

Производитель позиционирует ECS для случаев, когда требуется:

- распределенная архитектура,

- глобальное пространство имен (все центры данных с узлами active/active, геозащитой, многопротокольным доступом и поиском по метаданным).

Сценарии использования ECS

Платформа ECS применяется как:

- Глобальный репозиторий контента. Это сравнительно простое в реализации решение обеспечивает глобальный доступ к файлам и защиту данных корпоративного уровня.

- Масштабная реализация аналитики больших данных. Система обеспечивает глобальную аналитику данных из географически распределенных архивов. Это экономичное высокоплотное решение хранения для Hadoop.

- Современная платформа для приложений. ECS поддерживает множество API и протоколов, а ее архитектура active/active оптимизирована для хранения данных и доступа к ним.

- Система холодного архивирования неактивных данных. Позволяет создавать архивы, готовые к поддержке будущих приложений, а также оптимизирует существующие среды хранения.

- Развертывание платформы управления для Интернета вещей (IoT). Архитектура IoT эффективна для работы с большим объемом неструктурированных данных. А на недавнем форуме Dell EMC World 2017 было объявлено, что теперь в ECS возможна потоковая передача данных IoT.

Вот несколько вариантов использования ECS вместе с другими системами хранения Dell EMC:

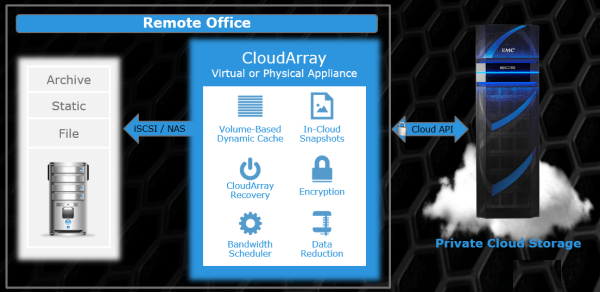

Пример 1. Комбинация ECS с Dell EMC Cloud Array. Файловые службы и хранилища для удаленных офисов без развертывания массива хранения на удаленной площадке.

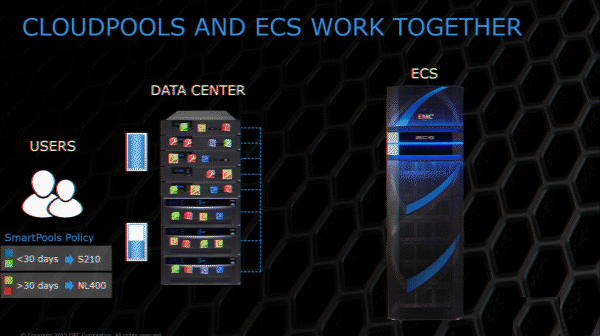

Пример 2. Комбинация ECS с Isilon (облачные пулы). Isilon (горизонтально-масштабируемая NAS) с автоматическим перемещением файлов на недорогое хранилище по заданным правилам.

Пример 3. Классическое архивирование. ECS используется в качестве архива.

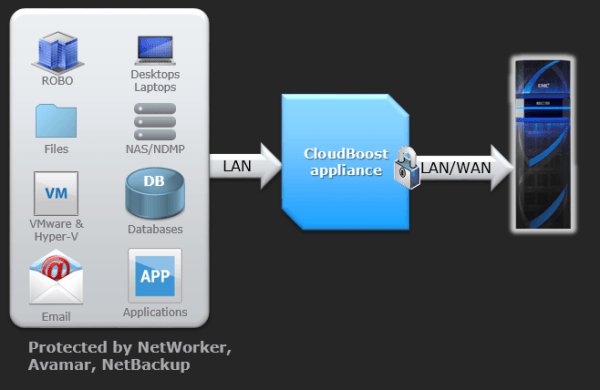

Пример 4. Комбинация с Dell EMC Cloud Boost. Долгосрочное хранение данных.

Пример 5. Разработка с использованием объектного хранилища. Мобильные приложения стали настолько развитыми, что их сложно связать с известными протоколами хранения данных (FC, NAS) без «шлюза» - например, веб-сервера. Благодаря ECS мобильные приложения получают прямой доступ к хранилищу при помощи HTTP/HTTPS и могут получать или сохранять нужные объекты.

Платформа ECS была выпущена в июне 2015 года. Сейчас ею пользуются более 250 клиентов, и у многих из них емкости инсталляций превышают петабайт. ECS поддерживает объекты, NFS и распределенную файловую систему Hadoop (HDFS), что позволяет ей хранить миллиарды файлов для облачных приложений.

|

Метки: author DellEMCTeam хранилища данных хранение данных it- инфраструктура блог компании dell emc dell emc ecs elastic cloud storage |

13 вопросов, чтобы узнать, готовы ли вы нанимать команду мобильной разработки |

Вопросы:

- Вы хотите приложение на одной платформе или на двух/трех сразу? (IOS/Android/Windows). Нужно иметь ввиду, что разработка на Android, как правило, займет больше времени и больше ресурсов (приблизительно на 20%), так как на Android больше различных расширений экрана и различных версий ОС, использующихся на текущий момент. Если бюджет ограничен, то что бы вы хотели выпустить в первую очередь?

- Вы планируете, что ваше приложение будут запускать на iPad или планшетах или часах? Если да, то это также увеличит время на разработку и тестирование.

- Как вы думаете, какое количество пользователей будет у приложения в ближайший год/три/5 лет?

- Что вы планируете делать для того, чтобы количество пользователей росло? Какие маркетинговые стратегии/шаги? Возможно видео ролик, промосайт, страницы в социальных сетях? Кто будет обрабатывать данные потоки информации от этих сервисов? (Примечание. Для публикации в Appstore обаятелен либо промо сайт приложения, либо страница в социальной сети, например, FB)

- Ваше приложение должно работать без интернета?

- Планируете ли вы монетизировать ваше приложение? Делать его платным, зарабатывать на рекламе внутри, делать платную и бесплатную версию, продавать внутри приложения что-либо?

- Планируете ли вы заниматься заполнением контента (текст, картинки, звуки…) самостоятельно или доверите этот вопрос профессионалам?

- Планируете ли вы включить в команду разработки также специалиста по тестированию, который сможет полноценно проверить работу продукта? (полное тестирование, стрессовое тестирование, нагрузочное тестирование…)?

- Планируете ли вы проверить, насколько сработает идея и улучшить свой продукт с помощью фокус-группы из вашей целевой аудитории?